La carrera hacia la supremacía cuántica

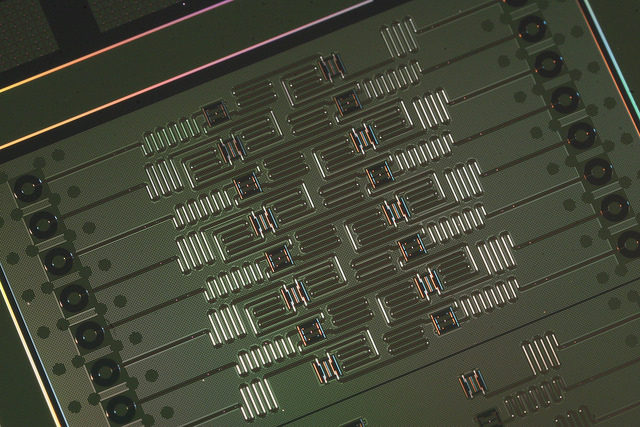

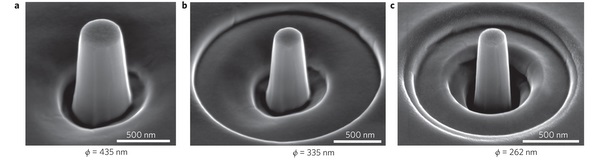

Ordenador IBM Q de 17 cúbits superconductores. Fuente: IBM.

Dos grandes empresas, IBM y Google, compiten entre sí por alcanzar la supremacía cuántica: fabricar un ordenador cuántico capaz de resolver un problema que ningún ordenador clásico del mundo haya sido capaz de resolver hasta ese día. Parece difícil, ya que los superordenadores más poderosos del mundo, que lideran el TOP500, son muy poderosos. Sin embargo, se estima que un ordenador cuántico de propósito general totalmente funcional sería capaz de tal hazaña con tan solo 50 cúbits. Como puedes imaginar, lograr la supremacía cuántica será el final de una carrera y el inicio de otra, la carrera hacia los ordenadores cuánticos comerciales. Permíteme glosar la situación actual de esta carrera entre gigantes.

El término «supremacía cuántica» fue acuñado por el físico John Preskill, que ocupa la cátedra Richard P. Feynman de Física Teórica en el Instituto Técnico de California (Caltech). Lo acuñó en octubre del año 2011 para su charla en la 25º Conferencia Solvay de Física [1]. Un término muy popular hoy en día, aunque resulta políticamente incorrecto para cierta gente [2]. El problema lingüístico es sencillo, en inglés recuerda demasiado al término «supremacía blanca», que se usó durante el apartheid de Sudáfrica entre 1948 y 1991. Para un hispanoparlante, quizás, la asociación con la segregación racial no sea tan obvia. Aun así, el propio Preskill tuvo sus propias dudas al respecto como nos contó en su blog Quantum Frontiers [3]; allí retó a sus lectores a proponer una alternativa; nadie propuso ninguna mejor.

Llamamos «cúbit» (qubit en inglés) a un «dígito binario cuántico» (quantum binary digit), o sea, a un «bit cuántico» (quantum bit). Este término matemático fue acuñado en el año 1993 por el físico Ben Schumacher, del Kenyon College, Ohio (EE.UU.), tras una conversación con uno de los padres de la teoría cuántica de la información, el físico teórico Bill K. Wootters, del Williams College, Massachusetts (EE.UU.) [4]. El concepto matemático de cúbit se puede implementar físicamente mediante cualquier sistema cuántico que presente dos niveles, o estados energéticos, que puedan estar en superposición cuántica. A veces conviene diferenciar entre «cúbit matemático» y «cúbit físico», pero en la práctica el contexto suele aclarar en qué sentido se está usando.

El primer artículo en el que se escribió el término «cúbit» se envió en 1993 a una revista de física, Physical Review A, aunque apareció en abril de 1995 [4]. Un segundo artículo del propio Schumacher, junto al matemático Richard Jozsa, de la Universidad de Cambridge (Reino Unido), que fue enviado más tarde en 1993 a una revista de óptica, acabó apareciendo publicado un poco antes, en 1994 [6]. En poco tiempo el término se hizo muy popular.

Los ordenadores cuánticos se caracterizan por su número total de cúbits, lo que en un ordenador clásico sería equivalente, más o menos, al número total de transistores de su microprocesador. En los ordenadores clásicos el número de bits se usar para otra cosa, el tamaño del bus de datos, es decir, el número de bits que puede recibir o enviar de forma simultánea desde la placa base al microprocesador. Hoy en día lo habitual es que un ordenador use un microprocesador de Intel de 64-bits (un Core i3, Core i5, o Core i7), que tiene unos cientos de millones de transistores. Sin embargo, el primer microprocesador de Intel era de 4-bits, el famoso Intel 4004, que tenía 2300 transistores; luego aparecieron los procesadores de 8-bits, como el 8080, con 4500 transistores; más tarde los de 16-bits, como el famoso 8086, con 29000 transistores; y así sucesivamente.

Un ordenador cuántico con 50 cúbits sería algo así como un ordenador clásico con una memoria capaz de almacenar 50 bits (el equivalente a siete letras de texto en formato ASCII); parece un número ridículamente pequeño, sobre todo hoy en día que los ordenadores tienen gigabytes de memoria; pero la magia cuántica oculta un as bajo la manga, el paralelismo cuántico. En cada paso de la ejecución de cierto algoritmo, el ordenador clásico aplica una operación matemática al contenido almacenado en su memoria clásica de 50 bits, llamada registro, es decir, a un valor numérico concreto de entre 250 posibles valores (uno entre unos mil billones).

Sin embargo, en el ordenador cuántico la información se almacena en un registro cuántico, que para 50 cúbits almacena un estado en superposición cuántica de todos los 250 posibles valores, cada uno con su correspondiente amplitud de probabilidad; gracias a ello, en cada paso de la ejecución del algoritmo cuántico se aplica una operación matemática que cambia de forma simultánea las 250 amplitudes de probabilidad correspondientes a cada uno de los 250 valores en superposición cuántica. Si este proceso se realiza de forma adecuada, el ordenador cuántico puede ser mucho más eficiente que un ordenador clásico; más aún, la simulación en un ordenador clásico del funcionamiento de un ordenador cuántico requerirá usar 250 registros clásicos, o aplicar 250 operaciones sobre un único registro clásico. Aunque estoy obviamente muchas sutilezas técnicas, salta a la vista que un ordenador cuántico con decenas de cúbits puede lograr la supremacía cuántica.

El gran problema de la fabricación de un ordenador cuántico es que no basta tener unos cuantos cúbits físicos para tener un registro cuántico en el que adquieran un estado de superposición cuántica coherente. Además, hay que garantizar que la coherencia cuántica no se pierda durante la aplicación de todas y cada una de las operaciones cuánticas aplicadas a los cúbits del registro cuántico. Cualquier interacción de alguno de los cúbits con su entorno (el sitio donde se encuentre cada cúbit físico) puede resultar en una medida no intencionada de su estado cuántico; la medida destruye (al menos parcialmente) el estado cuántico en superposición y entra en acción la decoherencia cuántica, con lo que el sistema de cúbits pasa a comportarse como un ordenador clásico (probabilístico). Con la tecnología actual aislar 50 cúbits del resto del universo y al mismo tiempo poder operar de forma arbitraria con cualquiera de ellos raya lo imposible. Por eso la carrera hacia la supremacía cuántica está repleta de obstáculos, incluso para gigantes como IBM y Google.

El concepto de supremacía cuántica es relevante en computación cuántica porque, en la práctica, es el único método para asegurarnos de que un supuesto ordenador cuántico con muchos cúbits es realmente un ordenador cuántico. Parece un juego de palabras, pero la diferencia entre un ordenador cuántico y un ordenador clásico probabilístico que usa cúbits como fuente de aleatoriedad es sutil; la eficiencia cuántica requiere que el ordenador sea cuántico de verdad. Con pocos cúbits se puede realizar un estudio experimental sistemático para verificar que el ordenador cuántico se comporta como tal. Pero con decenas de cúbits dicho estudio experimental es inviable.

Por todo ello, la mejor manera de confirmar que un supuesto ordenador cuántico con 50 cúbits es realmente un ordenador cuántico consiste en ejecutar en él un algoritmo que resuelva un problema cuya solución es imposible de lograr con el más potente de los superordenadores clásicos actuales; lo ideal sería que, por supuesto, el problema sea tal que sea fácil comprobar que la solución ofrecida es correcta. Hay muchos problemas así, pero es muy costoso poner a un equipo de investigadores a desarrollar programas y más programas para ejecutar en dicho ordenador esperando, no sin cierta fe, a que alguno demuestre la supremacía cuántica. Aquí es donde entra con pie firme la iniciativa de IBM llamada Quantum Experience [7].

El gigante azul ofreció en el verano de 2016 el acceso gratuito y automático a un ordenador cuántico de 5 cúbits mediante un servicio en la nube (cloud). La iniciativa ha sido todo un éxito y se estima que unos 40000 usuarios de más de 100 países han desarrollado más de 275000 algoritmos cuánticos para dicho ordenador en solo un año; la corrección de los programas se verifica en un simulador clásico, para luego ser ejecutados en la máquina física IBM Q [8]. Gracias a esta ingente cantidad de experimentos se puede validar estadísticamente que este ordenador IBM Q de 5 cúbits se comporta como debe hacerlo un ordenador cuántico de propósito general.

Validar de forma experimental que un ordenador cuántico de 16 cúbits es realmente cuántico, si bien no es imposible, requiere un coste muy elevado en tiempo y recursos. Por ello, desde marzo de 2017, la IBM Q Experience ofrece el acceso gratuito a un supuesto ordenador cuántico de 16 cúbits que usa la misma tecnología que el ordenador anterior de 5 cúbits [7]. Para este nuevo ordenador no existe un simulador clásico eficiente, aunque existe un verificador de la sintaxis del código. Un usuario solo sabrá si su algoritmo funciona correctamente tras ejecutarlo físicamente en la máquina IBM Q. Se espera que gran parte de los usuarios que ya han disfrutado de la experiencia con 5 cúbits se atrevan con la nueva máquina de 16 cúbits. Si toda va bien, dentro de un año habrá un número suficiente de experimentos como para que se pueda verificar de forma estadística que la máquina de 16 cúbits se comporta como debe hacerlo un ordenador cuántico.

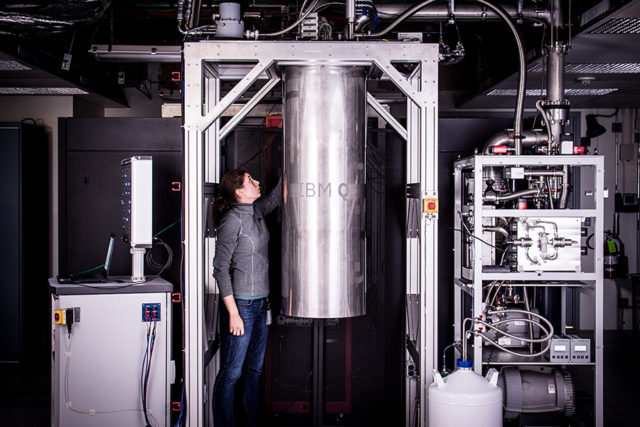

Dra. Katie Pooley junto al cilindro del contiene el sistema criogénico que contiene en su interior el ordenador IBM Q de 17 cúbits en el Centro de Investigación Thomas J. Watson de IBM. Fuente: Carl de Torres para IBM.

Permíteme enfatizar la idea del gigante azul: decenas de miles de usuarios trabajarán gratis para IBM demostrando que su máquina funciona. ¡Qué más se puede pedir! Por supuesto, mantener una máquina cuántica de 16 cúbits en funcionamiento continuo en un laboratorio tiene un coste. Por ello, las grandes mentes pensantes de IBM Q han tenido otra idea feliz, que anunciaron el pasado 17 de mayo de 2017 [7]. Su máquina de 16 cúbits tiene 17 cúbits. ¡¿Cómo?! La experiencia IBM Q ofrece acceso gratuito a 16 cúbits, ni uno más; quien quiera usar los 17 cúbits tendrá que pagar por ello. Todas las empresas, industrias, institutos de investigación y demás entes interesados en usar la máquina de 17 cúbits podrán aprender a usarla de forma gratuita, con 16 cúbits, pero para usar la máquina fetén tendrán que abonar por ello. Sin lugar a dudas el gigante azul es gigante por algo.

Seguro que te preguntas, si nadie sabe con seguridad si el ordenador IBM Q de 17 cúbits es realmente cuántico, ¿quién va a pagar por usarlo? Yo no tengo la respuesta. Lo cierto es que lo único importante para IBM Q es que la máquina de 16 cúbits sea tan usada, o más, de lo que ha sido usada la máquina de 5 cúbits en el último año. Así podrá verificar que su tecnología funciona.

El objetivo de IBM Q es fabricar un ordenador cuántico de 50 cúbits antes de 2022 capaz de lograr la supremacía cuántica. Para este proyecto lo ideal es disponer de cientos de miles de algoritmos cuánticos ya implementados y de decenas de miles de programadores cuánticos experimentados en su tecnología. Quizás alguno de esos algoritmos, implementado en 50 cúbits, sea el que logre la supremacía cuántica para IBM. Quizás en los próximos años IBM abra una competición entre sus usuarios con un buen premio en metálico para el primero que logre demostrar la supremacía. Quizás el gigante azul venza en la carrera de la supremacía cuántica contra Google gracias a esos miles de programadores que están trabajando gratis por el mero placer de usar un ordenador cuántico.

Por cierto, Google afirma tener un ordenador cuántico de 8 cúbits, pero no ha demostrado aún que sea cuántico. Ha anunciado que pretende fabricar uno de 50 cúbits antes que IBM [8]. ¿Pero quién programará dicha máquina? ¿Quién trabajará gratis para Google?

Este post ha sido realizado por Francis Villatoro (@Emulenews) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias

[1] John Preskill, “Quantum computing and the entanglement frontier,” 25th Solvay Conference on Physics (“The Theory of the Quantum World”), 19-22 Oct 2011, arXiv:1203.5813 [quant-ph].

[2] Karoline Wiesner, “The careless use of language in quantum information,” arXiv:1705.06768 [physics.soc-ph].

[3] John Preskill, “Supremacy Now?” Quantum Frontiers, 22 Jul 2012. https://goo.gl/KdnD3j

[4] John Preskill, “Who named the qubit?” Quantum Frontiers, 09 Jun 2015. https://goo.gl/EwFDyR

[5] Benjamin Schumacher, “Quantum coding,” Physical Review A 51: 2738 (1995), doi: 10.1103/PhysRevA.51.2738.

[6] Richard Jozsa, Benjamin Schumacher, “A New Proof of the Quantum Noiseless Coding Theorem,” Journal of Modern Optics 41: 2343-2349 (1994), doi: 10.1080/09500349414552191.

[7] IBM Q Experience: https://www.research.ibm.com/ibm-q/

[8] Davide Castelvecchi, “IBM’s quantum cloud computer goes commercial,” Nature 543: 159 (09 Mar 2017), doi: 10.1038/nature.2017.21585.

El artículo La carrera hacia la supremacía cuántica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una puerta cuántica robusta y ultrarrápida

- Cuántica y relatividad por todas partes

- Digitalización universal de la computación cuántica analógica en un chip superconductor

Olaia Martinez: “Elikagaien segurtasun alerten %40a etxeko praktika desegokiak dira” #Zientzialari (74)

Aurreko mendearen azken hamarkadetan izandako behi eroen gaitzaren edota koltza olioaren krisien ondorioz, kontsumorako elikagaien segurtasuna bermatzeko kontrolak areagotu egin dira azken urteetan. Hala ere, gaur egun oraindik badira esparru honetan aurre egin beharreko mehatxuak, denon ahotan dabilen palma olioaren auzia esate baterako. Baina badakigu zehatz mehatz arriskuak zeintzuk diren? Zein kontrol egiten zaizkie gure etxeetara iristen diren elikagaiei? Nola areagotu genezake jaten ditugun produktuen segurtasuna?

Galdera hauei erantzuteko Olaia Martinez, UPV/EHUko Elikagaien segurtasun eta kalitateko irakaslearekin izan gara. Bere esanetan, kontsumitzaileak berak ere erantzukizun handia dauka, izan ere, urtero gertatzen diren alerta kasuen %40a etxeko praktika desegokien ondorioz izaten da.

‘Zientzialari‘ izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Olaia Martinez: “Elikagaien segurtasun alerten %40a etxeko praktika desegokiak dira” #Zientzialari (74) appeared first on Zientzia Kaiera.

La evaluación mejora el aprendizaje

Marta Ferrero

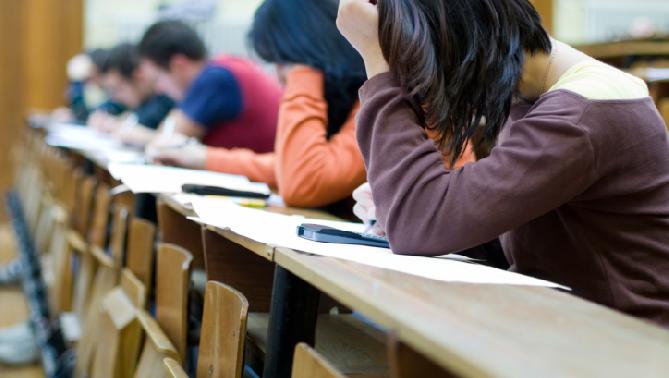

En el ámbito escolar la evaluación se suele asociar con el proceso de examinar y poner nota a los conocimientos de los estudiantes. Quizá por eso despierta tanto recelo entre muchos alumnos, familias e incluso docentes, hasta el punto de que no son pocas las voces que abogan por desterrarla definitivamente de los centros escolares. Lo que muchos desconocen es que, además de ser un medio para comprobar lo aprendido, la evaluación es un potente medio para aprender.

A mediados de la década de los 70, una revisión de la literatura puso de relieve que el acto de recuperar la información almacenada en la memoria favorece su aprendizaje (Bjork, 1975). Desde entonces, el efecto de la evaluación (o “testing effect” en inglés) ha sido objeto de estudio en innumerables ocasiones y la evidencia recogida hasta el momento apunta de forma consistente en la misma dirección: evaluar a los alumnos propicia un mejor aprendizaje y recuerdo posterior de lo aprendido que otras técnicas de estudio más populares (Adesope y cols., 2017; Bangert y cols., 1991; Phelps, 2012; Roediger y cols, 2006; Rohrer y cols., 2010). De hecho, en contra de lo que la intuición nos pueda dictar, el hecho de enfrentarse a una evaluación tiene más beneficios en el aprendizaje que leer la materia una y otra vez. Y más importante aún, como veremos a continuación, este resultado es robusto bajo una amplia variedad de circunstancias.

En el año 2006, Roediger y colaboradores realizaron una revisión cualitativa sobre el efecto de la evaluación en el aprendizaje. Los resultados mostraron que los beneficios de ésta son constantes independientemente del tipo de tarea que se emplee para ello (por ejemplo, tareas de laboratorio como la asociación de parejas de estímulos o tareas reales como la redacción de un ensayo o responder a preguntas de selección múltiple), del tipo de material objeto de estudio (por ejemplo, listas de palabras o textos) o del contenido y su complejidad. Además, encontraron que estas ganancias se mantienen constantes tanto en los laboratorios como en las aulas. Un meta-análisis de estudios realizados exclusivamente en colegios había alcanzado esta misma conclusión años atrás (Bangert y cols., 1991). En el año 2012, Phelps realizó una nueva síntesis sobre el efecto de la evaluación en el rendimiento académico de los alumnos. En esta ocasión, se incluyeron trabajos cuantitativos y cualitativos realizados entre 1910 y 2010. Una vez más, los resultados mostraron que evaluar mejora el aprendizaje.

Recientemente, Adesope y colaboradores (2017) han realizado un meta-análisis sobre el efecto de la evaluación. Su trabajo de revisión incorpora una serie de mejoras en relación a los anteriores como, por ejemplo, la inclusión de los estudios más recientes o el uso de técnicas de análisis más sofisticadas que permiten una interpretación de los datos más completa y rigurosa. Por todo ello, las conclusiones a las que llega son especialmente relevantes. En primer lugar, los resultados confirman que realizar evaluaciones favorece el aprendizaje. Este efecto es moderado si se compara con otras estrategias de estudio, como la relectura, y es mucho mayor cuando se compara con no hacer nada. En relación al formato de las tareas de evaluación empleadas, se observa que el recuerdo libre, el recuerdo con pistas, las preguntas de selección múltiple y las preguntas de respuestas cortas son las estrategias que conducen a beneficios mayores. Por ello, lo más adecuado es que el docente decida en cada caso qué formato usar en función del tipo de aprendizaje (por ejemplo, preguntas de selección múltiple para retener hechos y preguntas de respuesta corta para contenidos más abstractos y conceptuales). Además, los beneficios de aprendizaje son mayores si el formato de las pruebas finales coincide con el de las pruebas de repaso y también si se combinan diferentes tipos de tarea durante ambos tipos de prueba. Este último resultado justifica una vez más el empleo de diferentes tipos de tarea en función de la materia objeto de aprendizaje. En relación al feedback, los autores concluyen que los beneficios de la evaluación son prácticamente iguales tanto si los alumnos reciben retroalimentación sobre su rendimiento durante las pruebas de repaso como si no. Y, por tanto, recomiendan la evaluación incluso cuando no existe la opción de dar feedback. La evaluación es también eficaz independientemente del intervalo de tiempo que transcurra entre las pruebas de repaso y las finales, aunque las mejoras son mayores si este lapso de tiempo es de 1 a 6 días que si es inferior a 1 día. Y también lo es al margen del nivel académico en el que se encuentren los alumnos. Curiosamente, es preferible que los estudiantes realicen una única prueba de repaso a que realicen varias. Luego, en principio, una pequeña inversión de tiempo es suficiente para obtener mejoras. Por último, al igual que en revisiones previas, este meta-análisis muestra que los efectos de la evaluación se producen tanto en contextos artificiales como en aulas reales.

¿Por qué la evaluación está tan infravalorada en relación a otras estrategias de aprendizaje como la relectura, tan valorada por muchos estudiantes? La relectura de un texto puede propiciar un sentido de familiaridad con el mismo que nos conduce a la falsa sensación de estar aprendiendo (Bjork y cols., 2011). Sin embargo, este aprendizaje es superficial y se traduce en un rendimiento pobre a largo plazo (Roediger et al., 2006). Por el contrario, la evaluación posibilita unas condiciones de aprendizaje que, aunque aparentemente crean cierta dificultad, permiten un aprendizaje más flexible y duradero. Estas dificultades deseables, como las ha denominado Bjork (1994), impulsan los procesos de codificación y recuperación que favorecen el aprendizaje, la comprensión y el recuerdo. Junto con la dificultad que supone ser evaluado, hay otras razones que pueden explicar la mala fama de la evaluación. Por un lado, hay voces que apuntan al estrés que puede causar en los estudiantes una exposición frecuente a evaluaciones (véase, por ejemplo, Acaso, 2014). Sin entrar en más debate, es importante recalcar aquí que evaluación no es necesariamente sinónimo ni de calificación ni de prueba oficial para acceder a estudios superiores. Por otro lado, algunos críticos también apuntan a que la evaluación puede quitar tiempo para hacer otras actividades o para usar el material didáctico de una forma más creativa. Sin embargo, como apuntan Roediger y colaboradores (2006), si los alumnos no han alcanzado un dominio básico de la materia, difícilmente van a poder pensar de forma crítica y creativa sobre la misma. Además, como explican estos autores, hay muchas formas de integrar la práctica de la evaluación en el aula sin interrumpir la rutina de trabajo habitual.

En síntesis, la evidencia demuestra de forma robusta que la evaluación es una herramienta muy valiosa para favorecer el aprendizaje a largo plazo. Los numerosos estudios que se han hecho muestran además que los beneficios de la evaluación se mantienen con independencia de la edad y nivel educativo de los aprendices así como del tipo y complejidad de la materia. A la luz de estos resultados, y a pesar del creciente número de voces críticas, no hay razón para que los centros escolares no mantengan o incorporen la evaluación en sus aulas como práctica habitual.

Referencias:

Acaso, M. (2014). Dopamina, empoderamiento y responsabilidad: sin cambiar la evaluación no cambiaremos la educación.

Adesope, O. O., Trevisan, D. A., & Sundararajan, N. (2017). Rethinking the Use of Tests: A Meta-Analysis of Practice Testing. Review of Educational Research, 87, 1-43.

Bangert-Drowns, R.L., Kulik, J.A., & Kulik, C.L.C. (1991). Effects of frequent classroom testing. Journal of Educational Research, 85, 89-99.

Bjork, R. A. (1975). Retrieval as a memory modifier. In R. Solso (Ed.), Information processing and cognition: The Loyola Symposium (pp. 123-144). Hillsdale, NJ: Erlbaum.

Bjork, R.A. (1994). Memory and metamemory considerations in the training of human beings. In J. Metcalfe & A. Shimamura (Eds.), Metacognition: Knowing about knowing (pp. 185-205). Cambridge, MA: MIT Press.

Bjork, E. J., & Bjork, R. (2011). Making things hard on yourself, but in a good way: Creating desirable difficulties to enhance learning. In M. A. Gernsbacher, R. W. Pew, L. M. Hough, & J. R. Pomerantz (Eds.), Psychology and the real world: Essays illustrating fundamental contributions to society (pp. 56-64). Washington, DC: FABBS Foundation.

Phelps, R. P. (2012). The effect of testing on student achievement, 1910–2010. International Journal of Testing, 12, 21–43.

Roediger, H.L., & Karpicke, J.D. (2006). The Power of Testing Memory: Basic Research and Implications for Educational Practice. Perspectives on Psychological Science, 1, 181-210.

Rohrer D., & Pashler, H. (2010). Recent research in human learning challenges conventional instructional strategies. Educational Research, 39, 406-412.

Sobre la autora: Marta Ferrero es psicopedagoga y doctora en psicología. Actualmente es investigadora posdoctoral en el Deusto Learning Lab de la Universidad de Deusto. Es autora del blog Si tú supieras…

El artículo La evaluación mejora el aprendizaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El aprendizaje del inglés es mejor si se usa para aprender otra cosa

- Dejad de propagar el mito de los estilos de aprendizaje

- A favor de la evaluación escolar objetiva

Landareentzat ez ezik animalientzat ere: argia

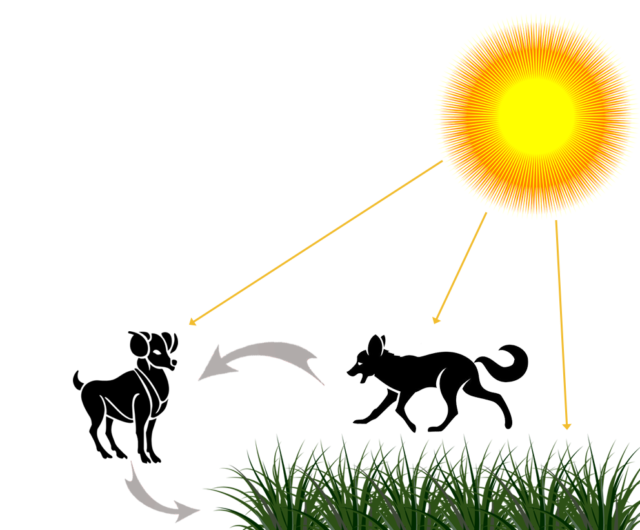

Zalantzarik gabe, bai. Alor bat baino gehiagotan du garrantzia argiak animalientzat. Batetik, ezinbestekoa da animaliak elika daitezen. Izan ere, elikadura mota edozein dela (belarjale, haragijale, orojale) oinarrian argia dago.

Landareek nahitaezkoa dute argia hazteko eta, beraz, hedaduraz, animalia belarjaleek ere argia behar dute euren elikadura bermatzeko. Era berean, haragijaleentzat ere beharrezkoa da jaten dituzten belarjaleak haz daitezen eta horretarako landareak behar dituzte. Kate trofiko guztian du eragina argiak, beraz.

1. irudia: Argiak eragina du kate trofiko guztian zehar. (Ziortza Guezuragaren irudia.)

Argia beharrezkoa da animalientzat, hortaz. Eta ez bakarrik elikadurarako, bestelako aspektuetan ere eragina du argiak, animalien jokaeran, adibidez:

- Ugalketa sasoia muga dezake argi ordu kopuruak eta baita ugalketa-sasoiaren hasiera edo amaiera markatu.

- Lozorroan sartzen diren animaliei noiz sartu seinalatzen die argiak, tenperaturarekin batera.

- Animalia migratzaileek, beste faktoreren artean, argi ordu kopuruari esker dakite noiz hasi migrazioa.

Ikusmenaren alorrean du, hala ere, argiak inpaktu gehien. Argia hautemateko mekanismoa da ikusmena, azken batean. Animalien %95ak ditu irudiak sortzen dituzten begiak eta %96ak argia hautemateko moduren bat. Begi guztiak ez dira berdin, hala ere. Ez dituzte argia eta irudiak modu berean prozesatzen eta zenbait begik ez dute irudirik sortzen.

“Begi”rik sinpleenek argia antzemateko gaitasuna baino ez dute, irudirik ez dute sortzen. Euglena protozooa da argia hauteman baina irudirik sortzen ez duen animaliaren adibidea. Ez da ikusmena zentzu hertsian, baina fotorrezepzioa (fotoien energiaren xurgapena) gertatzen da. Begi mekanismo sinpleena litzateke Euglenarena, baina animalien artean oso begi konplexuak aurki daitezke.

Argia antzeman baino ezin duten begi sinpleenetatik hasi eta irudi konplexuak garbitasunez sortzeko gai diren begietaraino eboluzio prozesua jasan dute ikusmen organoek. Lehen “begia” zelula fotorrezeptoreen xafla izan zen eta hortik hasita kamera konplexudun begira eboluzionatu dira. Hona eboluzio hipotetikoa:

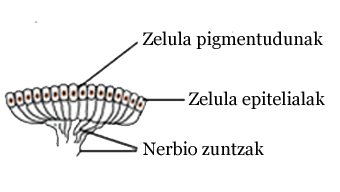

- Zelula pigmentudun xafla. Hasiera batean argia sumatzeko gai ziren zelula multzoa baino ez ziren begiak, argia detektatzeko gai. Lehen aipaturiko Euglenaren eta lapen kasua litzateke hau.

2. irudia: Zelula fotohartzaile multzoaz osaturiko xafla (Ziortza Guezuragak moldatutako irudia).

- Begi kopak. Zelula xaflak kopa itxura hartzean argia antzemateaz gain, norabidea ere nabaritu dezakete. Planariek dute mota honetako begiak.

3. irudia: Kopa itxurako begia (Ziortza Guezuragak moldatutako irudia).

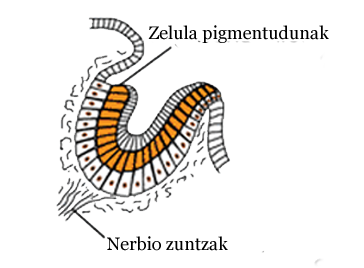

- Kamera iluna. Pinhole begia izenarekin ere ezaguna. Irudiak sortzeko gai da, fokatzeko. Irudiak nahiko ilunak dira, baina. Izan ere, oso argi gutxi sar daiteke begian. Nautilus moluskuetan aurkitu daitezke mota honetako begiak.

4. irudia: Kamera iluna motak begia (Ziortza Guezuragak moldatutako irudia).

- Lente primitibodun begia. Lenteen agerpenak argia kontzentratzeko gaitasuna ekarri zuen, ikusmena hobetzea eta argitzea ekarri zuena. Murex barraskiloek gartu dute honako mekanismoa.

5. irudia: Lente primitibodun begia (Ziortza Guezuragak moldatutako irudia).

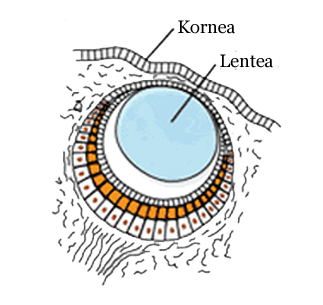

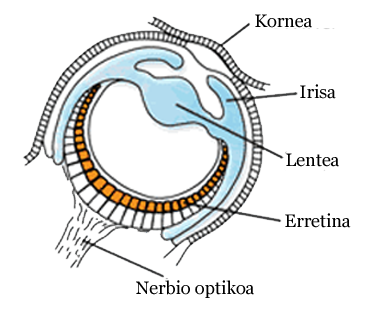

- Kamera konplexudun begia. Lente sistema konplexua da, kornea eta bestelakoei esker garbitasunez ikustea ahalbidetzen dute. Egungo ornodun gehienen begiak lirateke mota honetakoak.

6. irudia: Kamera konplexudun begia (Ziortza Guezuragak moldatutako irudia).

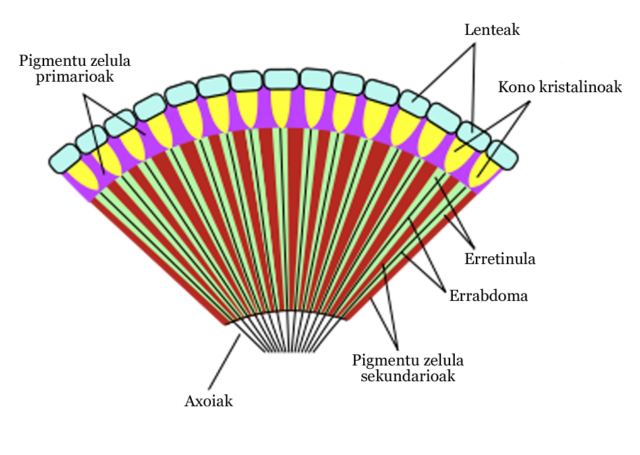

Eboluzio hipotetikoa izanik ere, ezaugarri komuna dute begi guztiek: zelula fotorrezeptoreak dituzte guztiek. Bestelako begi motak ere garatu izan dira, intsektuetan aurki daitezkeen begi konposatuak, esaterako. Kasu honetan, omatidio izeneko hainbat egiturez osaturiko begiak dira. Omatidioak begi osoak dira, bakoitzak kornea, kristalinoa eta fotorrezeptoreak du eta mosaiko itxurako irudia sortzen dute.

7. irudia: Begi konposatua (Ziortza Guezuragak moldatutako irudia De Bugboyren irudian oinarrituta).

''Argiak animalietan izan ditzakeen eraginak''Aurreko artikuluak:

Argi uhina ala argi partikula?

———————————————————————–

Egileaz: Ziortza Guezuraga kazetaria eta UPV/EHUko Kultura Zientifikoko Katedraren kolaboratzailea da.

——————————————————————

The post Landareentzat ez ezik animalientzat ere: argia appeared first on Zientzia Kaiera.

Ciencia: es complicado

Explicaciones hay, y las ha habido siempre; para cada problema humano hay siempre una solución bien conocida, elegante, plausible y equivocada. H. L. Mencken

La mente humana es una máquina maravillosa que está poseída por un insaciable deseo de conocer, de satisfacer su curiosidad, pero como todos los sistemas biológicos tiene sus defectos. Y uno de ellos es particularmente perverso: la vagancia. La mente humana quiere saber, pero el cerebro tiene un infinito anhelo de trabajar lo menos posible. Por eso siempre prefiere una explicación sencilla a una compleja; un razonamiento simple a uno más alambicado, una historia directa y sin demasiados condicionales que otra repleta de apartes, casos particulares y rincones que necesitan explicaciones complementarias. No hablamos aquí de la llamada Navaja de Ockham, un principio metodológico razonable, sino del simple problema de la pereza que hace que los seres vivos prefieran el camino con menos cuestas. Y eso, para la ciencia, es un problema, porque resulta que nuestro Universo es complejo, sutil, a veces contradictorio y siempre anti-intuitivo. Comprender el cosmos es siempre cuesta arriba.

Por eso la respuesta a casi cualquier pregunta realmente interesante se puede resumir igual que esas tortuosas relaciones personales se etiquetan en Facebook: Es Complicado.

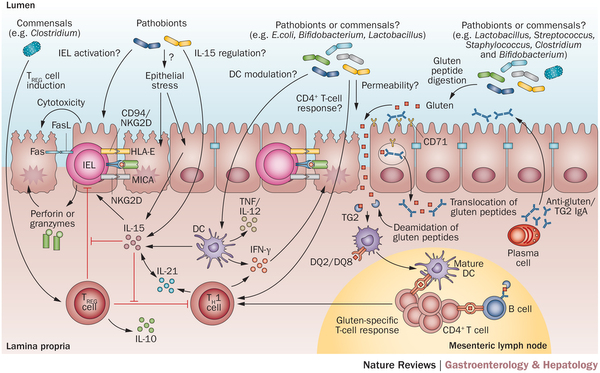

Imagen resumen en la que solo se indica la posible influencia de las bacterias intestinales en la enfermedad celíaca. Nótese la cantidad de interrogantes.

Pongamos un ejemplo relacionado con la actualidad. El pasado domingo 4 de junio de 2017 la periodista Rosa Montero publicó en la revista El País Semanal un artículo sobre intolerancias alimenticias, transgénicos, el poder de la industria farmacéutica y la demonización de la homeopatía. No se trata de desmontar sus numerosos, variados y profundos errores; otros ya lo han hecho, con brillantez. Lo que se pretende aquí es subrayar hasta qué punto este tipo de argumentos revelan el daño que hace el afán de simplicidad enfrentado a la complejidad del conocimiento científico. Porque puramente por casualidad y coincidiendo con el artículo citado la revista The Scientist publicó un amplio repaso de lo que la ciencia conoce ahora mismo sobre la celiaquía, las intolerancias alimentarias no celiacas, su prevalencia, causas y posibles orígenes, además de potenciales avenidas de tratamiento. A diferencia de la elegante, plausible y equivocada explicación defendida por Rosa Montero lo que conocemos es mucho más complejo.

La prevalencia de estas enfermedades está aumentando, es cierto, y no sabemos por qué; pero no se debe a transgénicos (que no están en nuestros campos de cultivo) y mucho menos a que la labor del gran Norman Borlaug y la Revolución Verde crearan nuevos tipos de trigo con un gluten distinto, cosa que no hizo. Sabemos que la verdadera intolerancia celiaca se comporta como una enfermedad autoinmune, creando respuesta de nuestras defensas no sólo contra algunas de las proteínas del gluten, sino sobre células propias del cuerpo. Hay un componente genético, pero resulta que casi el 40% de la población lleva variantes génicas relacionadas con la enfermedad y sólo entre el 1 y el 3% del total la desarrollan, y aún no conocemos el agente detonante que podría ser cualquier cosa en nuestro medio ambiente, tal vez la más insospechada. Existen, además, intolerancias a los cereales que no están relacionadas con el gluten, pero que pueden interactuar modificando el curso de la enfermedad.

Los síntomas abdominales son los más típicos y pueden dañar el intestino, pero ahora están apareciendo otros de síntomas en adultos (osteoporosis, anemia) cuya conexión no conocemos. Sabemos que la composición del microbioma intestinal es diferente en los celiacos, pero no sabemos de qué manera afecta a la enfermedad; aunque resulta que al menos parte del aumento del número de casos podría deberse a nuestra exitosa lucha contra las úlceras de estómago, porque la presencia de Helicobacter pylori (la bacteria que causa muchas de ellas) coincide con menos celiaquía. Y sabemos que en algunas circunstancias la infección deliberada con parásitos, como lombrices intestinales, alivia a algunos enfermos, pero no sabemos cómo ni por qué. Hay pocas certezas y muchos factores en juego. En otras palabras: es complicado.

Sería mucho más sencillo, comprensible y satisfactorio tener un único enemigo contra el que poder luchar. Sería mucho más heroico que ese enemigo tuviese defensores poderosos para así luchar hasta derrotarlos en defensa de la verdad. Sería mucho más elegante y plausible que las cosas tuviesen una explicación sencilla. Pero la realidad no es así. En ciencia muchos fenómenos surgen de la interacción de múltiples factores, lo que complica entenderlos. Por eso uno de los principios metodológicos básicos es el reduccionismo: controlar los factores que participan en un sistema complejo y modificarlos de uno en uno, de modo controlado y sistemático, para detectar cuáles influyen y de qué manera afecta cada uno. Cuando se trata de objetos o seres vivos es fácil realizar este tipo de investigación en un laboratorio. Pero cuando se trata de seres humanos no se pueden hacer experimentos, así que hay que usar los grandes números, las estadísticas y la historia para intentar conseguir los datos. Esto obliga a tratar con múltiples factores y a usar sofisticados métodos de análisis para separar sus efectos. El proceso no es simple y puede conducir a errores que luego hay que corregir, pero es el único disponible.

Esto exige años de estudio, décadas de dedicación, grandes presupuestos, captación de datos a gran escala, y también personas que dedican su carrera y deben vivir con la posibilidad, siempre presente, de que el trabajo de su vida resulte ser uno de esos errores que se descartan en los pies de página de los libros de ciencia. Exige mucho trabajo mental sin ninguna garantía de que el resultado final sea positivo y con la certeza de que, aun siéndolo, la explicación nunca será elegante y sencilla sino retorcida, compleja, llena de excepciones y sutilezas difíciles de entender. La práctica de la ciencia a veces genera la sensación de estar golpeándote la cabeza contra la pared, de estar desperdiciando tu vida dedicándote a pensar con feroz intensidad en resolver un problema que no se puede resolver. Y hacerlo antes de que los chinos, o los estadounidenses, lo consigan antes que tú.

Cuánto más fácil es buscar un culpable, un enemigo malvado, plausible y que explique todo y enfocar en la ira sobre esa imagen, sobre todo cuando lo que se quiere es la explicación de un sufrimiento humano real; cuánto más satisfactorio sentirse seguro y lleno de justicia con una explicación simple y un enemigo claro en lugar de frustrado, inseguro e incluso ignorante. La ciencia no ofrece respuestas sencillas, ni morales, ni justas: busca respuestas reales. El cerebro a veces prefiere ahorrarse el trabajo y las dudas, y es comprensible: siempre es más fácil remar a favor que en contra de la corriente. Pero aunque cueste más trabajo hay que ir donde está la verdad; por eso merece la pena. Aunque sea complicado.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Ciencia: es complicado se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De los héroes de la ciencia y sus frágiles teorías

- La ciencia y la duda

- Buscar vida extraterrestre va a ser un poquito más complicado

Nektarra jateak dakarren korapiloa

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria ———————————————————————————————————–

Kolibriak hegazti txikienak dira eta nektarra da haien janari nagusia. Nektarra diluzio bat da, intsektuak eta hegazti polinizatzaileak erakartzeko zenbait landareren loreek sortzen duten ur-diluzioa. Hori dela eta, kolibriek 12 ordutan zurrupatu behar duten ur kantitatea haien masaren halako 5 baino gehiago da, eta hori, bistan da, ur asko da, gehiegi beharbada.Ur gehiegi edaten duten animalietan hiperhidratazioa gerta daiteke, hots, urez pozoitzea. Gezurra badirudi eta arraro samarra bada ere, noiz edo noiz hori gertatzen zaie gizabanakoei, gaixotasun batzuen ondorioz batik bat. Paradoxikoa izanik ere, gastroenteritisak, esaterako, hiperhidratazioa ekar dezake. Izan ere, barne-medioaren gatz-kontzentrazioa gehiegi behera daiteke ur gehiegi edaten denean, eta barne-likidoen bolumen handia galdu ondoren gerta daiteke hori. Hori dela eta, zenbait kirolari hil ere egin dira lehiatzen ari ziren bitartean, urez pozoituta. Hiperhidratazioaren zantzuak aurkitu zituzten Andy Warhol artista ezagunaren gorpuan ebakuntza baten osteko bihotz-arritmia baten ondorioz hil zenean. Garunaren funtzioan eragiten ditu kalterik larrienak hiperhidratazioak, zeren barne-medioa gehiegi diluitzen denean neuronen zitoplasmaren eta barne-medioaren arteko elektrolitoen balantzea desorekatu egiten baita. Ezaguna denez, elektrolitoen oreka ezinbestez gorde behar da nerbio-bulkada behar bezala sortu ahal izateko.

Irudia: Odol beroko animaliarik txikiena Kuban bizi da, eta ez da satitsu etruskoa: erle-kolibria da. Mellisuga helenae du zientzia-izena eta “pájaro mosca” edo “zunzuncito” esaten diote gaztelaniaz.

Naturan animalia gutxi egon daitezke hiperhidratazioa pairatzeko arriskuan. Anfibioak egon litezke egoera horretan, larruazal iragazkorra dutelako, baina gernu-bolumen handiak ekoitziz konpontzen dute arazoa; anfibioen gernua, bestalde, oso diluitua da, kasik ez du gatzik, haien giltzurruna oso eraginkorra baita gernutik gatzak berreskuratzen. Ur gezetako arrain teleosteoak ere, urez pozoitu litezke uraren sarrera saihesteko modurik izango ez balute, baina “Ura, bizitzarako ezinbestekoa” atalean ikusi dugun bezala, oso eraginkorrak dira diluzioaren aurka dituzten hiru hesiak [1].

Uretako animalia horiek, beraz, badituzte gehiegizko uraren arazoa saihesteko modu egokiak, bestela ezingo lirateke ur gezetan bizi. Kolibriek ere, lehenago emandako arrazoi bitxiagatik, antzeko arazoei aurre egin behar diete. Kolibriek urarekin duten arazoa ez da arazo makala. Izan ere, uretan bizi diren anfibioek baino ur-sarrera handiagoak pairatzen dituzte.

Kolibrien hesteak nektarraren ur osoaren zati txiki bat bakarrik xurgatzen duela pentsatzen zen hasieran, baina gero frogatu da ezetz, gehiena xurgatzen duela. Ez zen ideia txarra, hala ere, horixe baita Nectariniidae familiako eguzki-txoriek [2] egiten dutena.

Zurrupaturiko uraren % 80 xurgatzen dute kolibriek eta, beraz, giltzurrunak kanporatu behar du ur gehiena. Hortaz, oso eraginkorra da haien giltzurruna, eta oso malgua gainera; azken batean, egunez lan handia egin behar badu ere, gauez ez du ia lanik egiten, kolibriak lozorroan sartzen baitira, eta giltzurrunak ez baitu ia gernurik sortzen.

Hala eta guztiz ere, urarena ez da arazo makala, giltzurrunak mugak dituelako, oso eraginkorra eta ahaltsua bada ere. Izan ere, litekeena da kolibriak toki beroetan bizitzera behartuta egotea. Toki hotzetan animalia homeotermoek bero gehiago galtzen dute eta, ondorioz, toki hotzetan beroetan baino gehiago jan behar dute. Baina kolibriek nekez jan lezakete jaten dutena baino gehiago, giltzurrunak askoz ere ur gehiago prozesatu beharko bailuke orduan. Hortaz, ingurune hotzetan jarritako kolibriek pisua galtzen dute, gehiegizko ur-arazoa dela medio beharko luketen nektar guztia jan ezin dezaketelako.

Lehen esan bezala, bestelakoa da eguzki-txorien jokabide fisiologikoa. Eguzki-txoriek ez dute zurrupatu duten ur guztia xurgatzen, % 60 baztertu baitezakete. Ez dakigu zein den hori egiteko erabiltzen duten mekanismoa, baina badakigu txori horientzat behar-beharrezkoa dela horrela jokatzea, bizi diren tokietan askotan hotza egiten duelako.

Horrelakoxe korapiloak ditu bizitzak: tamaina, tenperatura, giltzurrun-funtzioa eta elikatze-modua, lau faktore horiek batera eragiten diote kolibrien banaketa geografikoari. Bai korapilo ederra!

Oharrak:

[1] Larruazal iragazkaitza da lehen hesia; gernu-bolumen handia ekoizteak eta gernuko gatz-kontzentrazioa oso apala izateak osatzen dute bigarren hesia; eta gatzen barneratze aktiboa dugu hirugarrena. Azken hau da, izan ere, urez pozoitzea eragozten duena, barne-medioaren diluzioaren aurkako berezko mekanismoa baita.

[2] Familiaren izen zientifikoak dioen bezala, txori horiek ere nektar-jaleak dira.

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso dugu.

The post Nektarra jateak dakarren korapiloa appeared first on Zientzia Kaiera.

Cómo el Ártico se volvió salado

El Océano Ártico fue una vez un gigantesco lago de agua dulce. Sólo después de que el puente terrestre entre Groenlandia y Escocia se hubiese sumergido lo suficiente, grandes cantidades de agua salada llegaron desde el Atlántico. Con la ayuda de un modelo climático, investigadores del Instituto Alfred Wegener (Alemania) han demostrado cómo tuvo lugar este proceso, permitiéndonos por primera vez comprender con mayor precisión cómo se desarrolló la circulación atlántica que conocemos hoy.

Cada año, aproximadamente 3.300 kilómetros cúbicos de agua dulce fluyen hacia el océano Ártico. Esto equivale al diez por ciento del volumen total de agua que todos los ríos del mundo transportan a los océanos al año. En el clima cálido y húmedo del Eoceno (hace entre 56 a 34 millones de años), la afluencia de agua dulce probablemente fue aún mayor. Sin embargo, a diferencia de hoy, durante ese período geológico no hubo intercambio de agua con otros océanos. La afluencia de aguas salinas del Atlántico y del Pacífico, que hoy encuentra su camino al Océano Ártico desde el Pacífico a través del estrecho de Bering y desde el Atlántico Norte a través de la cresta Groenlandia-Escocia, no era posible. La región que hoy está sumergida estaba por encima del nivel del mar en ese periodo.

Sólo una vez que desapareció el puente terrestre entre Groenlandia y Escocia, surgieron los primeros pasos oceánicos, conectando el Ártico con el Atlántico Norte y haciendo posible el intercambio de agua. Utilizando un modelo climático, los investigadores han simulado con éxito el efecto de esta transformación geológica en el clima. En sus simulaciones, sumergieron gradualmente el puente terrestre a una profundidad de 200 metros, un proceso tectónico de inmersión que en la realidad duró varios millones de años. Curiosamente, los mayores cambios en los patrones de circulación y las características del Océano Ártico sólo se produjeron cuando el puente de tierra había alcanzado una profundidad de más de 50 metros por debajo de la superficie del océano.

Esta profundidad umbral corresponde a la profundidad de la capa superficial de mezcla, esto es, la capa que determina dónde termina el agua superficial relativamente ligera del Ártico y comienza la capa subyacente de agua densa que entra del Atlántico Norte. Sólo cuando la cresta oceánica se encuentra por debajo de la capa de mezcla superficial puede el agua salina más pesada del Atlántico Norte fluir hacia el Ártico con relativamente poco obstáculo. Por tanto, solo una vez que el puente entre Groenlandia y Escocia había alcanzado esta profundidad crítica, se creó el Océano Ártico salino como lo conocemos hoy. La formación de los pasos oceánicos desempeña un papel vital en la historia del clima global, ya que conlleva cambios en el transporte de energía térmica en el océano entre las latitudes media y polar.

La teoría de que la Cuenca Ártica estuvo una vez aislada se apoya en el descubrimiento de fósiles de algas de agua dulce en los sedimentos de aguas profundas del Eoceno que se obtuvieron durante una campaña de perforación internacional cerca del Polo Norte en 2004. Lo que una vez fue un puente terrestre ahora se encuentra alrededor de 500 metros bajo el océano y está formado casi enteramente de basalto volcánico. Islandia es la única sección que queda por encima de la superficie.

Referencia:

Michael Stärz, Wilfried Jokat, Gregor Knorr, Gerrit Lohmann (2017) Threshold in North Atlantic-Arctic Ocean circulation controlled by the subsidence of the Greenland-Scotland Ridge. Nature Communications. DOI: 10.1038/NCOMMS15681

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Cómo el Ártico se volvió salado se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El óxido de grafeno que se mueve como una oruga y coge cosas como una mano

- Y el Sol se volvió azul

- Cómo usar a las ballenas como detectores de radiación

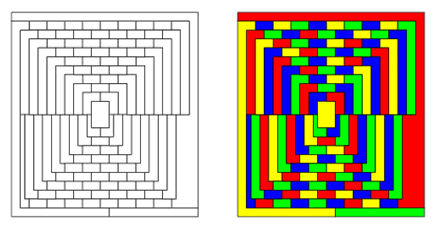

El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura?

En 1975, el divulgador científico Martín Gardner (1914-2010) publicaba un artículo (ver [1]) en el que afirmaba que el denominado mapa de Mc.Gregor –de 110 regiones– precisaba necesariamente de cinco colores para pintarse, sin que dos regiones adyacentes compartieran color. Es decir, proponía un contraejemplo al teorema de los cuatro colores. ¿Por qué continuaron entonces Appel y Haken intentando demostrar el resultado planteado por Guthrie en 1852?

El artículo de Gardner se publicó el 1 de abril de 1975, el Día de los inocentes en los países anglosajones. Muchos lectores, contrariados, enviaron a Gardner propuestas de coloreado del mapa de Mc.Gregor, para mostrarle que su afirmación era errónea.

El mapa de Mc.Gregor y la propuesta de 4-coloreado de Stan Wagon (1951).

Lo raro es que esos lectores no fueran conscientes de que se trataba de una simple broma; en ese artículo Gardner hablaba de Seis descubrimientos sensacionales que de alguna manera han escapado a la atención pública. En efecto, el divulgador:

-

‘mostraba’ una refutación de la teoría de la relatividad de Einstein, a través de un experimento del físico británico Humbert Pringl;

-

‘anunciaba’ el descubrimiento –en el Codex Madrid I y por parte de Augusto Macaroni de la Universidad Católica de Milán– de que Leonardo de Vinci había inventado el retrete auto-limpiable con el agua de su cisterna;

-

‘comentaba’ la demostración de Richard Pinkleaf –con ayuda del ordenador MacHic– de que en ajedrez, el movimiento de apertura de peón a cuatro torre de rey gana siempre la partida;

-

‘notificaba’ el sorprendente resultado –obtenido por John Brillo de la Universidad de Arizona– de que la base de los logaritmos naturales, el número e,elevado a π(163)½ es el número entero 262.537.412.640.768.744;

-

‘anunciaba’ la construcción –debida al parapsicólogo Robert Ripoff– de un motor funcionando con energía mental; y

-

‘notificaba’ el descubrimiento –por parte del especialista en teoría de grafos William McGregor– del famoso mapa del que hemos hablado antes.

Así que es lógico que, tras el 1 de abril de 1975, se continuara con la búsqueda de una demostración del teorema de los cuatro colores… Durante el largo proceso hasta llegar a su prueba, se desarrollaron teorías matemáticas como la teoría de grafos y de redes. Es decir, ni los errores ni los aciertos intentando demostrar este teorema fueron nimios; todos ellos ayudaron a la puesta a punto de este primer gran teorema demostrado –¿verificado?– usando un ordenador.

Pero, ¿es realmente una demostración? ¿Se puede garantizar la corrección de la compilación realizada por un ordenador? ¿Las computadoras son infalibles? Tras la demostración del teorema de los cuatro colores con ayuda de ordenadores, otras pruebas se apoyaron en este método, como la clasificación de los grupos simples finitos (2004) –que depende de cálculos imposibles de ejecutar con detalle a mano– o la solución de Thomas Hales (1998) del problema de Kepler sobre el empaquetamiento óptimo de esferas. Pero, ¿se puede aceptar como válida una afirmación que sólo una máquina, y no una mente humana, puede comprobar?

¿Qué es una demostración? El filósofo de la ciencia Imre Lakatos (1922-1974) la define (ver [3]) como: “Una sucesión finita de fórmulas de algún sistema dado, donde cada uno de los pasos de la sucesión es o bien un axioma del sistema, una fórmula derivada por una regla del sistema a partir de una fórmula precedente”.

Por su parte, el filósofo Thomas Tymoczko (1943-1996) califica una demostración como algo (ver [6]): convincente –debería persuadir incluso a los escépticos que dudan de la veracidad del resultado–, formalizable –la conclusión debería alcanzarse partiendo de sistemas axiomáticos–, y comprobable.

Este último es el aspecto más controvertido en el caso del teorema de los cuatro colores. ¿Puede estar un teorema probado si no se puede leer (comprobar) su demostración?

Existen dos corrientes principales que intentan responder a este dilema:

Los escépticos opinan que el aspecto de la comprobabilidad es el que pone en duda la credibilidad de la prueba. Si las pruebas deben ser verificadas, parece que entonces una persona –lo opuesto a una máquina– debe completar esta tarea: esto no puede hacerse con la prueba del teorema de los cuatro colores.

El matemático Paul Halmos (1916-2006) opinaba que la demostración realizada con un ordenador tiene la misma credibilidad que si está hecha por un adivino…Y afirmaba: “No puedo aprender nada de la demostración. La prueba no indica la razón por la que sólo se necesitan 4 colores ¿por qué no 13? ¿Qué tiene de especial el número 4?”.

El matemático Pierre Deligne (1954) comentaba: “No creo en una prueba hecha con ordenador. En primer lugar, soy demasiado egocéntrico. Creo en una demostración si la entiendo, si está clara. Un ordenador puede también cometer errores, pero es mucho más difícil encontrarlos”.

Tymockzo afirma que usar un ordenador para establecer una verdad matemática es transformar pruebas en experimentos. Afirma que el teorema de los cuatro colores ha sido confirmado a través de un experimento de física teórica, pero no probado de una manera formal. Aunque se tiene una pequeña idea de lo que el ordenador está testando, no se tiene la seguridad de lo que se está haciendo.

Los no escépticos, por su parte, argumentan del siguiente modo:

-

aunque las equivocaciones cometidas por los ordenadores son más difíciles localizar, los seres humanos fallan con más frecuencia; los ordenadores siguen un programa rígido predeterminado, y no tienen tropiezos motivados por los cambios de humor, el estrés u otros factores externos;

-

la longitud de algunas demostraciones sobrepasa la capacidad de computación humana, pero es perfectamente aceptable por los estándares de las máquinas;

-

la idea de que no pueden usarse ordenadores va a ser cada vez más insólita para las generaciones futuras: los ordenadores serán –¿son?– herramientas como el lápiz y el papel…

-

la prueba de Appel y Haken es, en esencia, tradicional, ya que consiste en una serie de pasos lógicos, que conducen a la conclusión de que la conjetura puede reducirse a una predicción sobre el comportamiento de unos2.000 mapas.

¿Quiénes tienen razón?

Para añadir un poco más de incertidumbre al tema, el filósofo Hud Hudson afirmaba dar en [2] un contraejemplo al teorema de los cuatro colores: presentaba el mapa de Zenopia, una isla formada por seis provincias que necesita seis tonos para colorearse… Entonces, ¿es falso el teorema de los cuatro colores? No, no hay que preocuparse: Zenopia es un mapa con fronteras extrañas, cuya especial geografía queda excluda del enunciado original del teorema…

Bibliografía

[1] Martin Gardner, Mathematical Games: Six Sensational Discoveries that Somehow or Another have Escaped Public Attention, Scientific American 232, 127-131, 1975

[2] Hud Hudson, No basta con cuatro colores, Gaceta de la RSME 8(2), 361-368, 2005.

[3] Imre Lakatos, What does a mathematical proof prove?, Cambridge Univers¡ity Press, 540-551, 1979.

[4] Marta Macho Stadler, Mapas, colores y números, Descubrir las matemáticas hoy: Sociedad, Ciencia, Tecnología y Matemáticas 2006 (2008) 41-68

[5] E.R. Swart, The philosophical implications of the four-colour theorem, American Mathematical Montlhy 87, 697-707, 1980

[6] Thomas Tymoczko, The four-color problem and its philosophical significance, Journal of Philosophy 76, 57-70, 1979

[7]Robin .J. Wilson, Four colors suffice: how the map problem was solved, Princeton University Press, 2002

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

- El teorema de los cuatro colores (3): Tras más de un siglo de aventura… ¿un ordenador resuelve el problema?

- El teorema de los cuatro colores (1): una historia que comienza en 1852

Lursaguek dute maitasunaren gakoa

Abiapuntua bazuten zientzialariok. Izan ere, aurrez beste lan batzuek iradoki izan dutenez, oxitozina eta dopamina bezalako gai kimikoek garuneko bi erregiotan esku hartzen dute, lursaguen arteko bikote loturak sustatze aldera: kortex prefrontal mediala (erabakiak hartzearekin zerikusia duen atala) eta accumbens nukleoa (sari sistema, plazera…) dira bi erregioak. Horiek sakon aztertuta, bikote loturak bideratzen dituen jarduera neural zehatza aurkitzea zen lan honen gakoa.

1. irudia: Microtus ochrogaster lursaguek bikotekide bakarrarekin partekatzen dute bizitza osoa. (Argazkia: Emory Unibertsitatea)

Zunda elektrikoak baliatuta, lursagu emeen garuneko bi erregio horien arteko komunikazio neurala grabatu eta entzun zuten ikertzaileek, arrekin hartu-emanetan zeuden bitartean. Hau da, bikotekide potentzial bat aurkitu, lehenbizikoz harekin ernalketa izan eta, ondotik, biziarteko lotura osatu dutela erakusten duten adierazleak (ez dira gizakiengandik hain desberdinak zentzu horretan, elkarri lapa-lapa eginda ibiltzen baitira) agertzen diren arteko prozesu guztia jarraitu zuten, emearen burmuinari begira.

Ondorioztatu dutenez, erabakiak hartzen dituen kortex prefrontalak lagundu egiten dio sari sistemaren erdigunea den accumbens nukleoari, bertan dauden neuronen oszilazio erritmikoak kontrolatuta. Bi alorren arteko konexio funtzionala iradokitzen du horrek. Gainera, ikertzaileok ikusi dutenez, konexio funtzional horren indarra desberdina da kasu bakoitzean, eta konektibitate sendoena erakusten duten emeak dira balizko bikotearenganako lotura azkarren erakusten dutenak.

Are gehiago, lehen ernalketak bizkortu egin ohi du lursagu bikotearen arteko harremana, eta garuneko konexio funtzionala ere sendotzen duela egiaztatu dute. Konexio horrek zer indar duen eta animaliok bikote lotura zer azkar (edo motel) egiten duten, korrelazioa dago bi aldagai horien artean. Era berean, emeak ar zehatz batekin bikotea osatzeko duen probabilitatea aurresan daiteke, garuneko bi erregioen arteko komunikazio mailari erreparatuta.

2. irudia: Gerora, autismoa bezalako gaitzei aurre egiten ere lagun dezake ikerketa ildo honek.

(Argazkia: Darryl Leja, National Human Genome Research Institute / CC BY 2.0 lizentziapean)

Horiek guztiak ikusita, jarraian, ikertzaileek artifizialki aktibatu zuten garuneko bi erregioen arteko zirkuitu neurala, optogenetikaren bitartez. Hala, lursagu emeen kortex prefrontalaren eta accumbens nukleoaren arteko komunikazioa indartu zuten teknika horrekin. Optogenetika bidezko estimulazioa baliatzen zuten bitarte horretan, emea ar baten ondoan jarri zuten, baina ez zegoen ez ernalketarik, ez eta kontaktu fisiko txikienik ere haien artean, arra kopa garden baten azpian baitzegoen. Harreman hori ahulegia da, berez, lursaguen arteko bikote lotura osatzeko, baina estimulazio artifizialaren ondorioz, ar horrekin bizi arteko harreman sendoa izango balu bezala hasi zen jokatzen emea.

Epe luzera begira, ikerketa ildo honetatik, erronka are zailago bati heldu nahi diote Emory Unibertsitateko kideek, Robert Liu arduradunak azaldu duenez: “Oro har komunikazio neural hobea sustatzea da gure helburua, adibidez autismoaren moduko gaitzen kasuan, kognizio sozialari bultzada emateko”.

Erreferentzia bibliografikoa:

Elizabeth Amadei et al. Dynamic corticostriatal activity biases social bonding in monogamous female prairie voles. Nature (2017). Published online 31 May 2017. DOI: 10.1038/nature22381

———————————————————————————-

Egileaz: Amaia Portugal (@amaiaportugal) zientzia kazetaria da.

———————————————————————————

The post Lursaguek dute maitasunaren gakoa appeared first on Zientzia Kaiera.

Evolución de los sistemas nerviosos: moluscos

El rasgo más característico del sistema nervioso de los moluscos es la gran importancia relativa que tiene su sistema periférico. En todos los grupos de moluscos se da alguna forma de coalescencia de neuronas que dan lugar a ganglios o encéfalos. Cefalópodos y gasterópodos presentan encéfalos bien definidos, aunque de diferente grado de complejidad y desarrollo. Los bivalvos disponen de ganglios, encefálicos y viscerales, que cumplen funciones análogas a las de los encéfalos de los anteriores. Pero además, todos ellos disponen de un extenso sistema periférico que comprende plexos nerviosos subepidérmicos y pequeños ganglios periféricos. Los ganglios periféricos son responsables del control reflejo y del procesamiento sensorial primario de órganos especiales, tales como branquias o palpos de bivalvos, y en numerosas ocasiones ambos sistemas intervienen de forma coordinada en el desarrollo de algunos comportamientos.

La importancia tan grande del sistema periférico parece deberse a la condición de animales de cuerpo blando y al hecho de tener un esqueleto hidrostático. Al disponer de una compleja y bien organizada musculatura en la superficie corporal, un control preciso a cargo del sistema central requeriría de un muy elevado número de neuronas centrales, por lo que resulta mucho más económico, desde el punto de vista de la organización nerviosa disponer de una extensa organización periférica responsable del control local. La ausencia de articulaciones impide disponer de sentidos de posición; sin la información que proporcionan los receptores de estiramiento de uniones articuladas, los cefalópodos desconocen la posición de sus brazos; tampoco puede estimar el peso de un objeto, sólo conocer su textura y tamaño. La gran importancia funcional del sistema periférico es lo que, sin embargo, les permite alcanzar los grandes tamaños propios de algunas especies.

El sistema nervioso central de los gasterópodos está formado por pares de ganglios conectados por células nerviosas; hay ganglios encefálicos, pedales, osfradiales, pleurales y viscerales, y en algunos casos, bucales también. En este grupo han surgido dos líneas principales, la de los opistobranquios, por un lado, y la de los prosobranquios y caracoles pulmonados, por el otro. La primera corresponde a animales que han abandonado las actividades de excavación de sus antecesores y que ramonean y pastan libremente, por lo que cuentan con elaborados sistemas de defensa química. Viven en ambientes simples y su sistema nervioso es simple, por lo que el comportamiento de estos animales se caracteriza por un repertorio limitado de subrutinas.

Los prosobranquios y pulmonados, sin embargo, ocupan nichos más complejos y presentan ganglios encefálicos más desarrollados, a la vez que sistemas sensoriales de alta resolución. Son capaces de desarrollar comportamientos de orden superior, muy elaborados. Un ilustrativo ejemplo de comportamiento elaborado es el del depredador Fusitriton oregonensis, que adhiere su puesta a la roca y patrulla la zona para rechazar a posibles depredadores; los detecta gracias a ojos muy desarrollados y los ataca propinándoles golpes con sus conchas.

Dada la condición sedentaria de la mayoría de los bivalvos, su sistema nervioso es bastante más simple que el del resto de moluscos. Carecen de un encéfalo, y el sistema consiste en una red nerviosa y una serie de pares de ganglios. En la mayoría de bivalvos hay dos ganglios cerebro-pleurales, a cada lado del esófago, los cerebrales controlan los órganos sensoriales y los pleurales la cavidad del manto. Los ganglios pedales controlan el pie, y los viscerales, que se encuentran tras el músculo aductor posterior, pueden llegar a tener gran tamaño en los bivalvos que nadan; los que tienen largos sifones también cuentan con un par de ganglios que los controlan.

Los cefalópodos, por su parte, tienen modos de vida muy activos, viven en un medio tridimensional y son depredadores. Disponen de desarrollados receptores de equilibrio, receptores de posición corporal análogos a la línea lateral de los peces pelágicos, y habilidades fotorreceptoras muy notables; también pueden identificar texturas.

Tienen encéfalos muy desarrollados, con un elevado número de neuronas, y sus comportamientos pueden ser muy elaborados, con alta capacidad de aprendizaje. El sistema periférico también está muy desarrollado. Cada ventosa de un pulpo tiene su propio ganglio periférico, aunque también está comunicado con el sistema nervioso central. Los ganglios realizan integración quimio y mecanorreceptora y son responsables del control motor de la ventosa.

El sistema central y el periférico actúan en serie y en paralelo. Los comportamientos complejos suelen generarse en el central, aunque el periférico puede participar en la recepción del estímulo y en el control motor final. En los moluscos se producen tanto comportamientos fijados como no fijados. Ejemplos relativamente bien conocidos de modelos de acción fijos son la natación de huida del opistobranquio Tritonia, que está basado en un grupo de cuatro neuronas del sistema nervioso central, y el comportamiento ventilatorio de la branquia de Aplysia. Sin embargo, el comportamiento alimenticio –en el que intervienen el encéfalo y los ganglios bucales-, o el de rechazo de alimento de gasterópodos –en el que interviene el ganglio abdominal- son buenos ejemplos de comportamientos no fijados.

Por último, hay plasticidad en el comportamiento y la actividad neural de moluscos debido a fenómenos de plasticidad de los reflejos simples (habituación, sensitización, aprendizaje asociativo) y a la capacidad para modificar taxias y desarrollar comportamientos complejos gracias al aprendizaje asociativo.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: moluscos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: cnidarios y gusanos no segmentados

- Moluscos en el Arte

- Evolución del tamaño animal

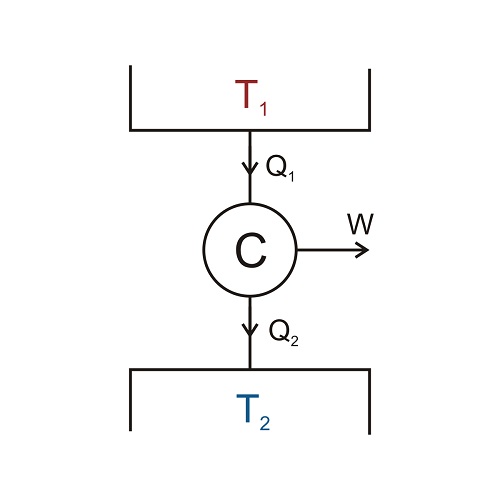

Carnot y los comienzos de la termodinámica (1)

Carnot fue uno de de los ingenieros franceses que se propusieron estudiar los principios científicos subyacentes al funcionamiento de la máquina de vapor con el objetivo de lograr la máxima potencia de salida con la máxima eficiencia. Como resultado de sus estudios, Carnot y otros ayudaron a establecer la física del calor, lo que se conoce como termodinámica.

Nicolas Léonard Sadi Carnot (1796-1832), en este imagen vistiendo el uniforme de estudiante de L’École polytechnique, fue hijo de Lazare Carnot, uno de los generales de confianza de Napoléon. Murió a los 36 años como conseuencia de la epidemia de cólera que se extendió por Europa en la época.

Carnot comenzó con la observación experimental de que el calor no fluye por sí solo de un cuerpo frío a uno caliente. Se deduce entonces que si, en una situación dada, se hace fluir calor de lo frío a lo caliente, debe tener lugar algún otro cambio en otra parte. Es decir, debe realizarse algún trabajo. Por ejemplo, un refrigerador o un acondicionador de aire son también “máquinas térmicas”, pero su ciclo funciona de manera inversa a una máquina de vapor o un motor de automóvil. Hace falta trabajo (en forma de energía eléctrica o mecánica) para bombear el calor de un cuerpo frío (desde el interior del compartimento o la habitación fríos) a uno más caliente (la habitación donde está el refrigerador o el aire exterior). Utilizando una argumentación muy elegante1 Carnot demostró que ninguna máquina puede ser más eficiente que una máquina ideal y reversible, y que todas las máquinas de este tipo tienen la misma eficiencia.

¿Y que es una máquina ideal y reversible? De entrada algo que no existe en el mundo real (por eso se llama ideal), pero que es extremadamente útil para entender los límites de las máquinas reales. Íntimamente ligado a la idealidad está el concepto de reversibilidad. Una máquina reversible es aquella en la que el ciclo desde la energía de entrada al trabajo de salida más la energía residual, y vuelta a la energía de entrada, se puede ejecutar en sentido inverso sin ninguna pérdida o ganancia adicional de calor u otras formas de energía.

Como todas las máquinas reversibles tienen la misma eficiencia, sólo se tiene que elegir una versión simple de una máquina reversible y calcular su eficiencia para un ciclo para encontrar un límite superior a la eficiencia de cualquier máquina. Esta máquina simple se representa esquemáticamente en el siguiente diagrama. Durante un ciclo de funcionamiento, la máquina, representada por la C de Carnot, absorbe la energía térmica Q1 del cuerpo caliente a temperatura T1, produce un trabajo útil W, y descarga una cierta cantidad de energía térmica Q2 al cuerpo frío a temperatura T2. El ciclo puede repetirse muchas veces.

Observando el diagrama y empleando la ley de conservación de la energía vemos que se tiene que cumplir que Q2 = Q1 – W; o, dicho en términos coloquiales, el calor que sale es la diferencia entre el que entra menos el trabajo que realiza la máquina. Pero, como la eficiencia vimos que era la proporción entre la energía de salida (ahora añadimos “útil”, esto es, el trabajo) y la energía de entrada, tenemos que ef = W/Q1.

Carnot calculó la eficiencia de este ciclo esquemático y encontró que las proporciones de calor y trabajo en una máquina reversible dependen solamente de la temperatura2 de la sustancia caliente desde la cual la máquina obtiene el calor y la temperatura2 de la sustancia fría que extrae el calor residual de la máquina.

La expresión que encontró Carnot para la eficiencia de las máquinas reversibles es, escrita con nomenclatura actual, ef = W/Q1 = 1 – T2/T1

Démonos cuenta de que la única forma de obtener una eficiencia del 100%, es decir ef = 1, es si hacemos que T2, la temperatura de la sustancia que recibe el calor residual, sea el cero absoluto, algo físicamente imposible, como veremos. Esto significa, de nuevo en términos coloquiales, que toda máquina debe liberar algo de calor residual al exterior antes de volver a tomar más energía del cuerpo caliente. Y esto, tan simple, es de una importancia enorme.

Notas:

1 Una argumentación a la que, por su simplicidad, importancia y valor formativo, dedicaremos una anotación específica.

2 Las temperaturas usadas en este caso se llaman temperaturas absolutas (T), o Kelvin, (por el señor Kelvin que fue el primero en introducir esta escala). En la escala absoluta, las mediciones de temperatura son iguales a las temperaturas (t) en la escala Celsius (°C) más 273. No se usa signo de grado, °, para grados Kelvin, el símbolo utilizado es K. Por tanto, el agua se congela a T = 273 K y cuando T = 0 K hablamos de cero absoluto. Ya explicaremos el origen de esta escala más adelante en la serie.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Carnot y los comienzos de la termodinámica (1) se ha escrito en Cuaderno de Cultura Científica.

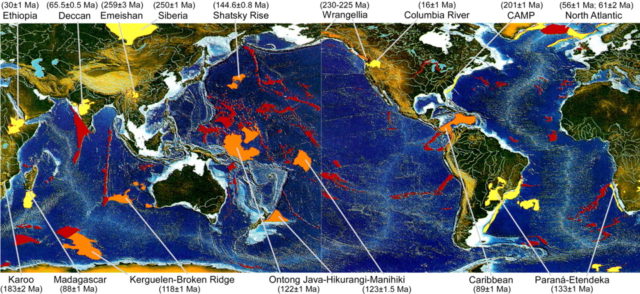

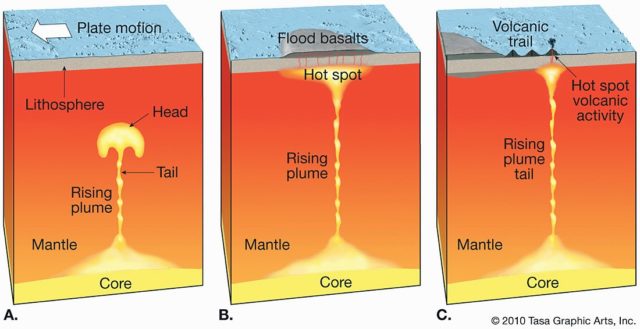

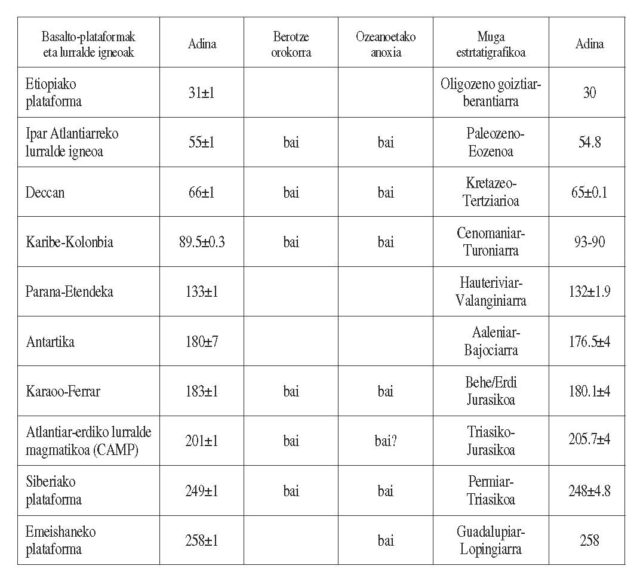

Entradas relacionadas:Lurralde igneo erraldoiak: Lurraren indar-erakustaldia

“Bolkanismo anomalotzat” jotzen da plaken arteko mugetatik urrun gertatzen dena. Ondorioz, onartzen da plaka-tektonikak ezin duela bolkanismo mota hori azaldu. LIPetan pilatutako basalto-bolumenak izugarriak dira; sarritan 1.000-2.000 km-ko diametroko lurraldeak estaltzen dituzte, lodiera kilometrikoa dutelarik (1-5 km); beraz, milioi bat km3 baino basalto gehiago pila daiteke (Elosegi eta Apraiz, 2004). Pilaketa prozesua metro gutxiko laba-kolada bakunen gainezartzaren ondorioa da.

LIPek ezaugarri modura dute, era berean, Geologian laburtzat hartzen den epean azaltzea, eta onartu ohi da 1 ma baino arinago garatzen direla.

Horren epe laburrean horrenbeste arroka igneo azaleratzen delarik, atmosferara gas kantitate izugarriak igortzen dira. Ondorioz, eragina dute bai Lurreko batezbesteko tenperaturan, bai klimatologian, bai eta ozeanoetako baldintzetan, eta zenbait suntsipen biologiko orokor sustatu dituzte.

1. irudia: Fanerozoikoko lurralde igneo erraldoien kokapena (Mahoney eta Coffin, 1997). Kontinente-lurrazalean garatutako basalto-plataformak (flood-basalt) kolore horiarekin daude adierazita, ozeano-lurrazalean kokatutako ozeano-plataformak (oceanic plateau) laranja kolorez. Gorriz, bolkanismo anomaloa adieraten dituzten beste eremuak.

Lurralde igneo erraldoiek daukaten bolumen handia eta isurtze-denbora laburra uztartuz, erraz uler dezakegu produkzio magmatikoa ikaragarrizkoa behar duela, urtero kilometro kubikoa baino handiagoa.

Halako emaria lortzeko mantuak ohiko tenperaturak baino beroagoak behar ditu izan eta magmaren igoera azkarra izan behar da.

Aurrez aipatutako zehaztapenak kontutan hartuz, mendearen hasieran eztabaida sutsua izan zen LIPen jatorria azaltzeko muturreko bi hipotesien artean. Batak mantuko luma gorakorren jarduera (lumen eredua) erabiltzen du eragile gisa, eta besteak, kontinenteko litosferaren lodiera-ezberdintasunetan sortutako, tokian tokiko, konbekzio-korronteak eta mantuaren hetereogeneotasuna (plaken eredua).

Egun, eztabaida baretu da, egindako azken ikerketek zeharo indartu dutelako luma gorakorraren eredua.

Aipagarria da, adibidez, LIP gazte gehienek, sortu zitueneko luma gorakorrekin duten lotura zuzena, bien artean 200-300 km zabal den bolkan-katea edo gandor aseismikoa agertzen baita (2. irudia).

Jakinik LIPen erupzio-proportzioa, lotuta duten bolkan-kateena baino 2-3 magnitude-orden handiagoa dela, luma gorakorren bilakaera logikoa ondorengoa litzateke: luma gorakorren buruek anomalia termiko handia eragiten dute listoferaren azpian, eta horren eraginez, LIPak garatzen dira. Lumaren burua lausotu eta indarra galtzen duenean, lumaren zutabea edo isatsa baizik ez da geldituko, eta zutabe horrek Hawaii-Emperor antzeko bolkan-katea edo gandor aseismikoa baino ez du sortuko, anomalia termiko murritzagoa eragiten duena (2. irudia).

Isatsaren bizia luzea da eta puntu bero bat mantenduko du lurrazalean. Puntu bero horrek, bolkanketa prozesu geologikoki jarraituak izango ditu.

2. irudia: Luma gorakorraren buruak litosferaren oinera iritsita, lurralde igneo erraldoia sortuko du (kasu honetan basalto-plataforma bat). Buruak indarra galtzen duenean aldiz, bolkan-katea edo gandor aseismikoa sortzen da zutabe edo isatsaren eraginez.

Basalto-plataformek eta, ondorioz, luma gorakorrek lotura zuzena dute superkontinenteen edo kontinenteen apurketa prozesuekin. Luma gorakorrek bultzada eragiten dute litosferaren azpian, eta horren eraginez, domo egiturak sortzen dira 1000m-ko altueraraino. Domoek estentsioaren eragipean jartzen dute kontinente-litosfera eta estentsio-indarrek LIPen sorrera erraztu eta ozeano baten garapenarekin buka dezakeen rifting prozesua abiarazten dute.

Rifting prozesua eraginkorra izanik, ozeano berria sortzen denean, normala baino lodiagoa izango da luma gorakorraren eraginpean garatutako ozeano-lurrazala. Aldiz, lodiera normala izan ohi du luma-gorakorren eraginetik urrun sortzen den ozeano-lurrazal berriak. Adibidez, ozeano-lurrazalerako normala dena baino lodiera handiagoa erakusten dute Hego Ameriketako eta Afrikako ertzak Paranáko luma gorakorraren inguruan, Indiako ertzak Deccan luma gorakorraren inguruan edo Groenlandia eta Europako ertzak Islandiako luma gorakorraren inguruan.

LIPen eta kontinenteen apurketaren arteko adin-harremana aspalditik ezaguna da geologoontzat. Azken 300 ma-tan eskala handiko hamar LIP garatu dira. Etiopiakoa da gazteena eta ez dago zalantzetan Itsas Gorriko, Adeneko golkoko eta Eki-Afrikako riftaren sorrerarekin duen harreman estua. Era berean, antzeko harremanak aurkitu dira 55 ma-ko Groenlandiako LIParen eta Ipar Atlantikoaren zabalkuntzaren artean, 66 ma-ko Deccaneko LIParen (3. irudia) eta iparmendebaldeko ozeano Indikoaren irekitzearen artean, 133 ma-ko Paranáko LIParen eta Hego Atlantikoaren irekitzearen artean, 183 ma-ko Karooko LIP-aren eta hegomendebaldeko ozeano Indikoaren zabalkuntzaren artean edo 201 ma-ko Atlantikoaren erdialdeko LIP-aren eta ozeano Atlantikoaren Ekuatore aldeko irekitzearen artean. Hala ere, zalantzak sortzen dituzten salbuespenak ere badaude. Ezagutzen den LIP handienak, Siberiakoak, ez du lotura zuzenik ozeano baten sorrerarekin, nahiz eta bere inguruan estentsioaren aztarnak ugari izan eta arro sedimentario sakonak aurkitu. Baliteke, hasierako estentsio-egoera orokorra kontinenteen apurketa gertatu aurretik aldatu izana eta, ondorioz, arro ozeanikoaren garapena ekiditzea.

3. irudia: Deccaneko LIParen ikuspegi zoragarria. Kilometro bat baino lodiagoa den sekzio honetan oso ondo bereizten dira kolada basaltikoak. Mahabaleshwar, Ghats mendebaldean, India. Hetu Sheth-en argazkia, abenduak, 2005.

Izugarria da Lurralde igneo erraldoiek Lur osoko ingurumenean izan dezaketen eragina. Erupzio basaltikoek sulfuro dioxidoaren, karbono dioxidoaren, kloroaren eta fluorraren kopuru izugarriak igortzen dituzte atmosferara. Bolkanismo-prozesuetan sortzen diren 3-13 km bitarteko erupzio-zutabeen bidez gasak troposferaren goiko aldean eta estratosferaren beheko aldean pila daitezke. Baldintza horietan, berotegi-efektua sortzen duen gasa izanik, Lurreko berotzea eragin dezake karbono dioxidoak. Aldiz, sulfuro dioxidoak aurkako eragina du, eta sasoi hotzak eragin ditzake epe laburrera.

Hain epe laburrean hainbeste arroka bolkaniko azaleratzen delarik, klima-aldaketa azkarrak eragin ditzake atmosferara igortzen den gasak eta, ondorioz, gerta daiteke hainbat organismok baldinza berrietara egokitzeko denborarik ez izatea.

Adibide bat ematearren, Pinatubo bolkanak 20 milioi tona sulfuro dioxido igorri zituen atmosferara 1991. urtean. LIP batean astero Pinatubo antzeko bolkan bat aktibatuko litzateke milaka eta milaka urtean zehar, eta horrela sortuko ziren atmosferan, kliman zein ozeanoen konposizioan aldaketa iraunkorrak. Horrela, klima zein ozeanoetako uren konposizioa suntsipen biologikoak eragiteraino alda daiteke. Frogatu da lotura zuzena dagoela historia geologikoan gertatutako suntsipen biologiko garrantzitsuenen eta LIPen artean (4. irudia) (Courtillot, 1999). Kretazeo-Paleogeno mugan (K/Pg) gertatutako suntsipenak dinosauroen desagerpena, beste hainbat espezieren artean, ekarri zuenak Deccaneko LIPrekin lotzen da. Gaur egun, askok pentsatzen dute K/Pg mugaren aurretik organismo bizidun asko estresatuta zeudela Deccaneko LIPak sortutako klima-aldaketengantik eta Yucatango penintsulan eroritako meteoritoak suntsipena areagotu eta bapatekotu egin zuela. Baina historia geologikoan K/Pg suntsipen orokorraren antzeko eta are suntsipen bortitzagoak gertatu dira (Permiar-Triasiko muga), eta horietarako ez da meteoritoen aztarnarik aurkitu. Zer dugu beraz?

4. irudia: LIP nagusiek Lurreko berotze orokorreko garaiekin, ozeanoetako anoxia garaiekin eta suntsipen biologiko orokorreko garaiekin dituzten adin harremanak.

Erreferentzia bibliografikoak:

- Courtillot, V. (1999): Evolutionary catastrophes: the science of mass extinction. Cambridge Univ. Press, Cambridge.

- Elosegi, M. eta Apraiz, A. (2004): Basalto-plataformak: ezaugarriak, jatorria eta kontinenteen apurketa, eta suntsipen biologiko orokorrekin izan ditzaketen loturak. Ekaia, 18: 31-48.

- Mahoney, J.J. eta Coffin, M.F. (Edk.) (1997). Large Igneous Provinces: Continental, Oceanic, and Planetary Flood Volcanism. Geophys. Monogr., 100.

———————————————————————————-

Egileaz: Arturo Apraiz UPV/EHUko Geodinamika saileko irakaslea eta ikertzailea da.

———————————————————————————-

The post Lurralde igneo erraldoiak: Lurraren indar-erakustaldia appeared first on Zientzia Kaiera.

Historias de la malaria: Charles Louis Alphonse Laveran y el protozoo

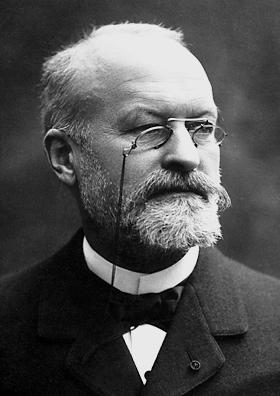

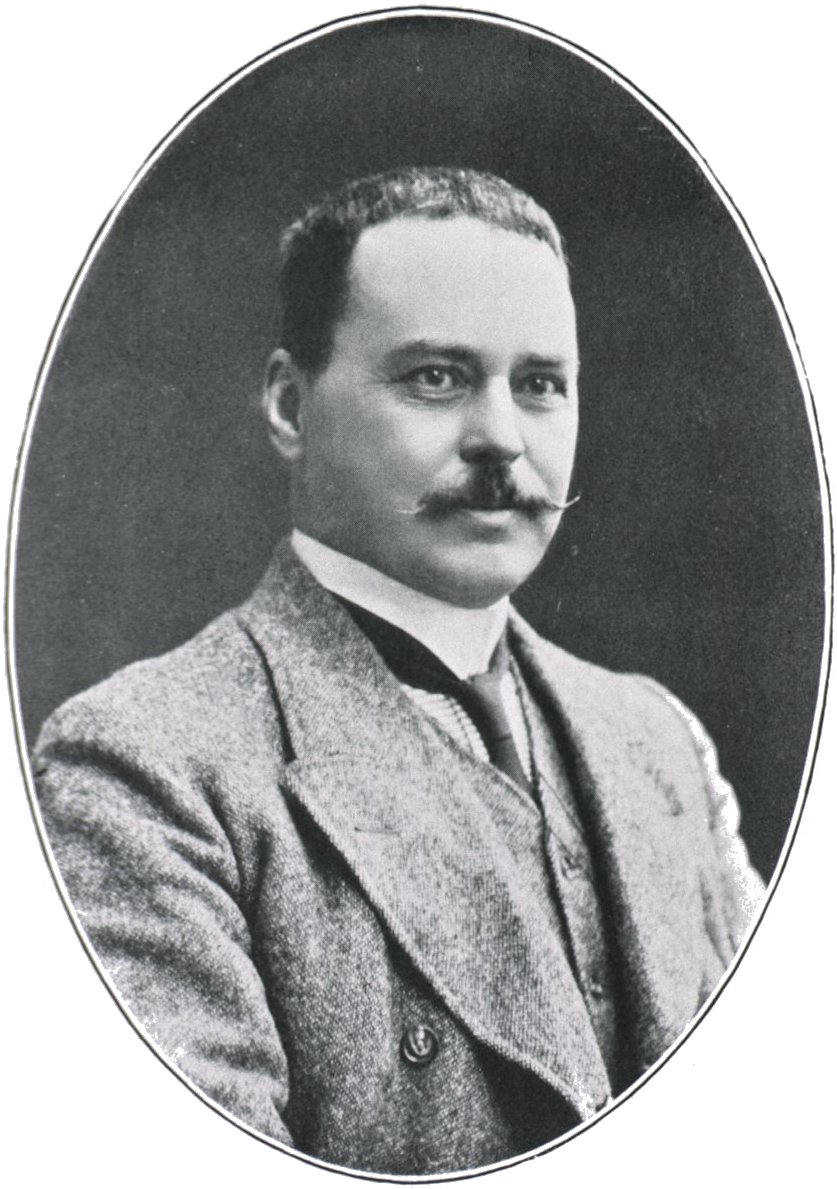

Charles Louis Alphonse Laveran

Fue Alphonse Laveran quien en 1880 identificó correctamente que era un protozoo, al que llamó Oscillaria, el agente causante de la malaria. Nació en 1845 y se licenció en Medicina en 1867. Sirvió como médico militar en la guerra con Prusia en 1870 y en 1874 fue nombrado Director de Enfermedades y Epidemiología en la Escuela de Val de Grâce. En 1878 fue destinado a Argelia donde inició sus estudios sobre la malaria, una de las enfermedades más incapacitantes y extendidas entre los soldados franceses que servían en aquella colonia.

No se conocía su causa y, para aliviar los síntomas, sobre todo los accesos de fiebre, solo era eficaz la quinina. En Bona, Laveran practicó la autopsia a soldados fallecidos por las fiebres, y encontró que padecían anemia y que su sangre tenía un color marrón oscuro por la presencia de un pigmento negro. Todo ello le llevó a estudiar al microscopio muestras de sangre de soldados enfermos, sin preparar la muestra para facilitar el examen como era habitual entonces, algo que no habían probado otros investigadores antes que él.

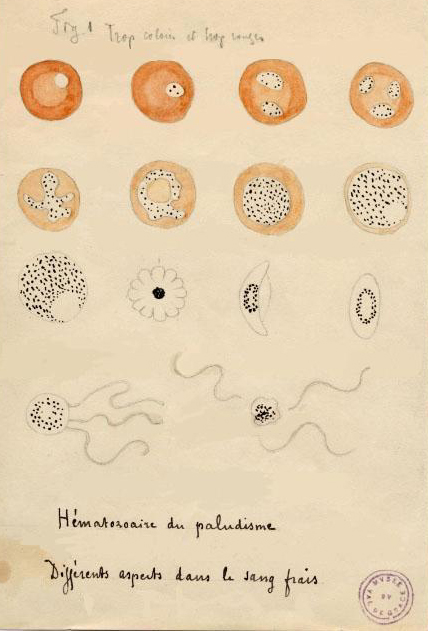

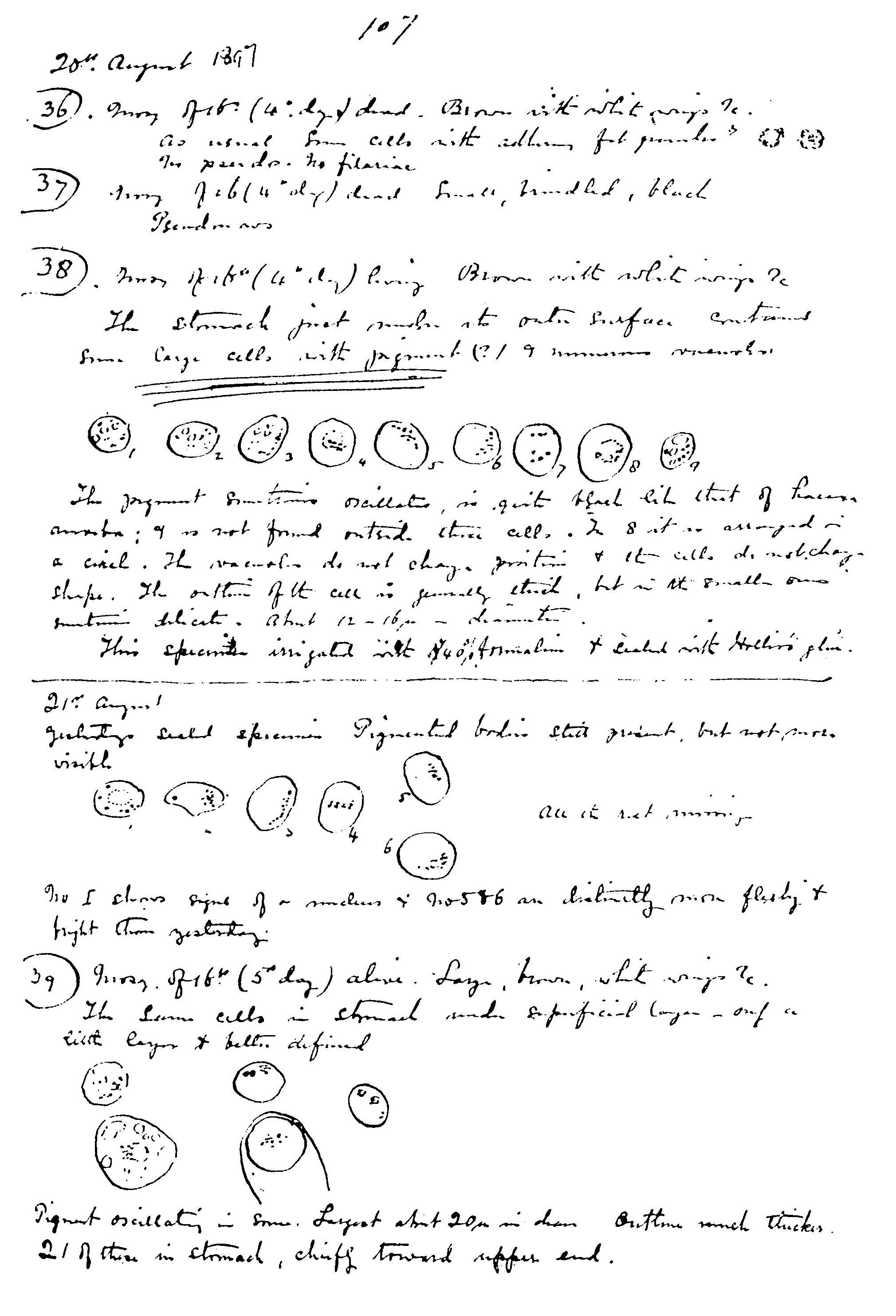

Ilustración de Laveran de 1880 con sus observaciones del parásito de la malaria en sangre fresca.