Orgullo en ciencia: Aporta o aparta: el papel de la comunicación científica en el debate trans

Imagen: itakdalee / freepick

Imagen: itakdalee / freepickLa ciencia es algo más que un sofisticado producto cultural. De hecho, se trata de una herramienta al servicio del bienestar de las personas y debe contribuir a la mejora de la sociedad en su conjunto.

Como ocurre a menudo en tantos ámbitos, también en el científico, quienes forman parte de alguno de los colectivos a los que, de forma genérica, denominamos LGBTIQ, sufren con frecuencia situaciones injustas en su día a día. Muchas de esas personas son objeto de exclusión y acoso en sus centros en mayor medida que las demás. Y se atribuye a motivos similares el que las y los estudiantes de carreras científicas pertenecientes a las minorías citadas abandonen sus estudios en una mayor proporción que el resto. Estas situaciones no son solo injustas per se, sino que, además, comprometen el carácter universal de la ciencia, puesto que no todas las personas gozan de las mismas oportunidades y condiciones para practicarla.

Por otro lado, la ciencia y su comunicación social tienen mucho que aportar a la hora de resolver problemas específicos de estos colectivos, como, por ejemplo, aquellos relacionados con la salud. Esto exige partir del reconocimiento real de la diversidad y la diferencia, y rechazar preconcepciones ancladas en un binarismo poco respetuoso con la diversidad de sexo, género y opción sexual.

Por estas razones, la asociación LGBT Ortzadar, la Cátedra de Cultura Científica y la Dirección de Igualdad de la UPV/EHU sumaron fuerzas para organizar el evento “Orgullo en ciencia”, una jornada sobre diversidad sexual y de género en el ámbito científico. La jornada, enmarcada dentro del programa Bilbao Bizkaia HARRO, tuvo lugar en Bizkaia Aretoa– UPV/EHU (Bilbao) el paso 29 de junio de 20210.

Oihan Iturbide aborda en “Aporta o aparta: el papel de la comunicación científica en el debate trans” las limitaciones de analizar y observar la diversidad de género o conceptos tan complejos como la identidad o la autopercepción individual con las herramientas propias del método científico, y explora qué papel puede jugar la comunicación científica a este respecto.

Oihan Iturbide Aranzadi es biólogo clínico y máster en Comunicación Científica, Médica y Ambiental. Es el fundador de la editorial Next Door Publishers, especializada en divulgación científica.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Orgullo en ciencia: Aporta o aparta: el papel de la comunicación científica en el debate trans se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Orgullo en ciencia: Un PRISMA para hacer la ciencia más diversa

- Orgullo en ciencia: Pío del Río Hortega, un científico en el armario. ¿A quién le importa?

- Nuevos modelos de comunicación científica

Ezjakintasunaren kartografia #361

Burutik atera ezinik izaten ditugun melodia horiek asko esaten dute garunaren funtzionamenduaz. JR Alonsok hitz egin zigun honen inguruan eta, orain, melodia horiek alde batera uzteko teknikak dakartza. Horietako bat txiklea murtxikatzea da: Earworms revisited

Modan daude kriptomonetak, inbertsio munduan arriskutsua izaten dena. Ezagunena Bitcoin da, Elon Musken txioen arabera igo eta jaitsi egiten dena eta inbertsio andana lortzen duena. Haren aurka, Bitcoinen meatzaritzak duen ingurugiro inpaktua dago. Bestelako moneta batzuk martxan jarri dira hau baliatuta Bitcoin garaitzeko. Altcoins could provide a green solution to energy-guzzling cryptocurrencies, Sankar Sivarajah eta Kamran Mahroof .

Ezagutza osoa atzitzeko gai den gizakirik ez da gaur egun. Metatutako ezagutzaren aurrean, errenazimendua beluritu egiten da. Disziplina arteko harremanak galtzen dira ondorioz, DIPCk esku hartu arte. Mining Wikipedia to unveil emergent interdisciplinary knowledge

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #361 appeared first on Zientzia Kaiera.

Divulgación científica e ingenieros en la España del Regeneracionismo (I): Ibérica y Madrid Científico

Jaume Navarro y Javier Sierra de la Torre

Siguen existiendo los quioscos: lugares habilitados en medio de plazas, de explanadas y de parques en los que se celebran conciertos populares durante las fiestas del pueblo o del barrio. Existen también (todavía internet no ha acabado con ellos) quioscos en los que comprar chicles, periódicos, y revistas. Revistas de temáticas especializadas en la vida de aristócratas, toreros, futbolistas o “famosos” en general, especializadas en cocina, en fotografía, en automovilismo y en decoración. Revistas satíricas, revistas críticas, revistas y más revistas. Con total seguridad habrá en tu quiosco más cercano revistas de todo tipo, y probablemente habrá revistas de divulgación científica.

¿Cómo hemos llegado a esta situación? Quiero decir, ¿qué pintan unas cuartillas encuadernadas sobre la última expedición a Marte expuestas entre otras que nos explican cómo decorar nuestro salón en primavera y diez recetas fáciles, rápidas y sanas para cocinar espárragos? Esta es una pregunta compleja, y no es posible contestarla satisfactoriamente en una pincelada, pero sí se puede asegurar que lo de comunicar los conocimientos científicos de manera sencilla, resumida y digerible (como los espárragos) tiene su historia. En 1996 se publicó en España un catálogo que recogía las revistas publicadas en el siglo XIX que incorporaban cuestiones científicas y técnicas. La enorme cantidad de títulos catalogados resulta tan sorprendente como la variedad de contenidos que alcanzaron a divulgar –o “vulgarizar”, como llamaban a esta actividad sin ningún sentido despectivo– en sus periódicas cuartillas. Sin embargo, casi todas eran revistas generalistas referidas a “ciencias, artes y cultura”, o cosas parecidas.

Algunos historiadores de la ciencia han designado al periodo comprendido entre 1874 y 1936 como la Edad de Plata de la ciencia española. Durante estos años algunos científicos e ingenieros civiles españoles de toda la península trabajaron para impulsar la educación científica general y construir espacios de enseñanza y debate sobre los progresos de las ciencias. Estos espacios incluyeron revistas especializadas en información científica, pero la mayoría de estas revistas no lograban mantenerse financieramente y desaparecían a los pocos años. El mundo naval ilustrado, por ejemplo,consiguió vivir cuatro años (1897-1901) hasta desaparecer, El museo popular: semanario ilustrado de literatura, ciencias y artes no vivió más de un año, y La España Agrícola no aguantó más de dos. La pluralidad de temas que tocaban las revistas de vulgarización nos enseña que existía una amplia y epistémicamente variada red de científicos e ingenieros profesionales en la España de finales del siglo XIX y principios del siglo XX dedicada a esta tarea. Pero su idea de “ciencia” estaba todavía en fase de definición y ciertamente no coincide necesariamente con lo que se pueda entender como tal en la actualidad.

Sin embargo, desaparecer no fue el destino de todas las publicaciones que vulgarizaban la “ciencia” durante esta época. Las publicaciones oficiales (las que dependían de un cuerpo profesional de la administración o que en general tenían apoyo de alguna institución) vivían más tiempo. Por ejemplo, el Observatorio del Ebro, fundado por miembros de la Compañía de Jesús en 1904, publicó a partir de 1914 Ibérica: el progreso de las ciencias y de sus aplicaciones, que se convirtió en la más longeva de las revistas de información científica en España, pues se publicó hasta el año 2005. Los temas que trataba eran de lo más diverso, con un cierto protagonismo de la observación del universo, del sol (en la que eran verdaderos especialistas) y de los fenómenos atmosféricos.

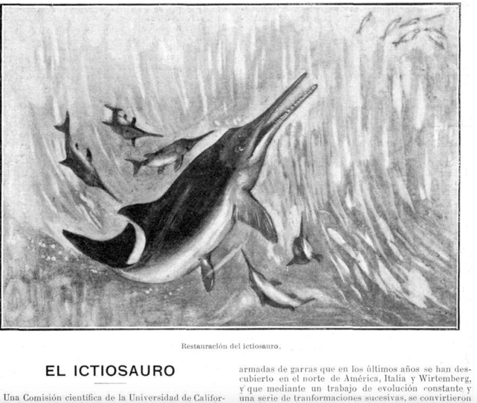

El Observatorio era (y es) una estación sismológica. En su revista mostraron varias tablas de registros sísmicos de Cataluña y del mundo, y explicaron los pormenores de los temblores de la corteza terrestre, de la vulcanología y de las herramientas que usaban para medir. Al margen de estos dos temas, los eventos científicos nacionales y extranjeros se publicitaban y eran celebrados en sus páginas. Por ejemplo, los congresos anuales de la Asociación Española para el Progreso de las Ciencias (fundada en 1907) recibían toda su atención, e igual visibilidad daban a las reuniones de otras asociaciones científicas y sus diferentes viajes, excursiones y expediciones por la península y por el mundo. Además, la historia natural (botánica, entomología, ictiología, etc.) tenía también una fuerte presencia entre sus páginas.

Varias de las noticias que publicaron no eran producciones propias: en múltiples ocasiones los vulgarizadores se hacían eco de los progresos científicos extranjeros. La pluralidad de los temas que los autores querían mostrar a su público era absoluta. En la portada que mostramos más abajo, por ejemplo, se plasma una imagen de una réplica del fondo marino hecha en Nueva York. Si se pasan las páginas, entonces nos encontramos con varias secciones dedicadas a explicaciones sobre otros temas (economía, el magnetismo en la atmósfera, el Sáhara, etc.), muchos de las cuales se extractan y traducen de revistas en otros idiomas. En la imagen de arriba también se puede ver una publicación característica: una noticia de una erupción procedente de un boletín estadounidense.

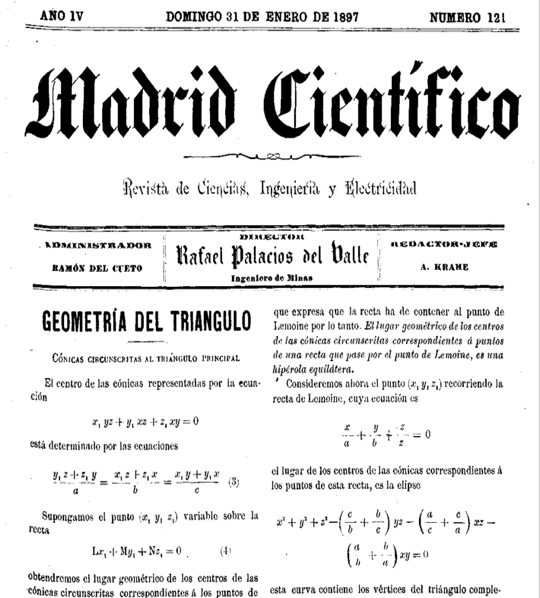

Ibérica no es la única revista de estas características (de contenido plural, al tanto de la actualidad científica global, muy enfocada hacia lo útil y esforzada a la hora de visibilizar la ciencia nacional), ni tampoco la primera, como tantas veces se repite. En 1894 (y hasta 1936) un grupo de estudiantes de la Escuela Especial de Ingenieros de Caminos, Canales y Puertos comenzó a publicar Madrid Científico, una revista editada por ingenieros para ingenieros que abordó prácticamente toda la actualidad científica de su época, y vulgarizaba la ciencia para un público que se esperaba que tuviera un mínimo de formación científica (por así decirlo, era una vulgarización de más alto nivel). Además, no contaban con apoyo institucional como Ibérica, lo cual convierte su supervivencia en algo verdaderamente destacable.

Los autores vulgarizaban todo lo que encontraban interesante sobre el estudio científico de la naturaleza y de la sociedad. La noticia sobre el descubrimiento de nuevos fósiles de ictiosauro, hallazgo que permitía explicar sus mecanismos adaptativos, se colocaba en la misma entrega en la que se hablaba de las novedades eléctricas, de la última expedición al Polo Sur, de los seguros de vida y de una detallada descripción geográfica de Nueva Zelanda. Es difícil encontrar en ambas revistas un campo de conocimiento que no fuera tocado por sus autores. Igual que en Ibérica, la historia natural tenía un papel destacado entre sus páginas: en especial, la botánica relacionada con la agronomía, pero también la zoología en general. Entre sus páginas se pueden encontrar varios estudios sobre hormigas, sobre parásitos, sobre múltiples plantas y sus tiempos de germinación y floración, sobre aves, sus nidos, sus huevos, sus crías y sus rituales, etc. Lo más sorprendente de esta revista es que era una revista de ingenieros. Los ingenieros recibían (y reciben) una rica formación científica; o, lo que es lo mismo, la ciencia formaba (y forma) parte de su núcleo de intereses. En Madrid Científico se percibe muy bien cómo la distinción entre ciencia e ingeniería no estaba bien delimitada. El ingeniero muchas veces hacía de historiador natural, de geógrafo, de geólogo, de matemático, de químico y de empresario. Su profesión era, en algún sentido, un paraguas bajo el cual todo conocimiento científico tenía cabida y utilidad. Sobre todo, tenía una concepción específica de lo que era el conocimiento moderno; concepción que quedó plasmada en sus escritos.

La vulgarización de las matemáticas también tenía su lugar en esta revista, donde Fausto Babel, que era el pseudónimo de Francisco Granadino (1865-1932), fundador de la revista e ingeniero de caminos, dedicó varias secciones a explicar la probabilidad a través de juegos de azar, y además ofrecía a los lectores pasatiempos matemáticos. La observación del cosmos y la nueva física tampoco les eran desconocidas.

Al igual que en Ibérica, los ingenieros de Madrid Científico se ocuparon de mostrar, además, qué instituciones nacionales y extranjeras se dedicaban a la práctica científica y compartieron artículos de otras revistas, a veces traducidos, otras en su lenguaje original. Los laboratorios, museos, observatorios y escuelas fueron descritos en Madrid Científico como eventos a celebrar y ejemplos a seguir. Las noticias que llegaban de la Academia de Ciencias de París, las donaciones a los museos y la inversión de diversas fundaciones se publicitaban doquiera que sucedieran. Además, los esfuerzos por vulgarizar la ciencia tenían un trasfondo muy importante: el llamado “desastre” del año 1898 precipitó un clima de crítica interna y de búsqueda de ejemplos exitosos de modernización a seguir en el exterior.

Ibérica y Madrid Científico se parecen mucho en las características que hemos dicho, y esto nos ayuda a los historiadores de la ciencia a entender cómo era la vulgarización científica en esa época (muy diferente de lo que llamamos hoy divulgación). Pero por encima de esta especificidad, ambas coinciden en un aspecto muy importante, ya mencionado más arriba: los ingenieros estaban actuando como comunicadores de lo que hoy entendemos como conocimiento científico y técnico, y en el mismo espacio mostraban cuál era su ambición modernizadora concreta. La vastedad de estas publicaciones sobre biología, geología, geografía, matemáticas, física, etc. fueron compartidas junto con noticias sobre ferrocarriles, buques construidos en acero, nuevos globos, aviones e hidroaviones, centrales hidráulicas, ganadería y agricultura científicas y modernas. ¿Cuál era la imagen, entonces, que los ingenieros tenían del conocimiento y de la modernidad? ¿Era meramente experimentación y clasificación de lo natural? Algunos historiadores de la ciencia, al hablar de Edad de Plata, se refieren especialmente a las ciencias experimentales y puras, y también a algunas aplicadas como la química o la medicina. Pero la ciencia del ingeniero y su proyecto de modernidad suelen, injustamente, dejarse al margen en estos estudios. Madrid Científico e Ibérica nos muestran, pues, cómo la vulgarización de los conocimientos científicos estaba intrínsecamente unida a la de sus aplicaciones y a los intereses de los ingenieros.

Sobre los autores: Jaume Navarro es Ikerbasque Research Professor en el grupo Praxis de la Facultad de Filosofía de la UPV/EHU y dirige el doctorado que Javier Sierra de la Torre está realizando sobre la divulgación científica en España a finales del XIX y principios del XX.

El artículo Divulgación científica e ingenieros en la España del Regeneracionismo (I): Ibérica y Madrid Científico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia y democracia: dilemas de la divulgación científica

- Sin divulgación científica no hay democracia. Sin arte tampoco

- Divulgación científica: en las mejores librerías

Edorta Santos: “Terapia zelularrak estrategia terapeutiko berriak garatzeko aukera ematen du” #Zientzialari 158

Terapia zelularrean zelulak erabiltzen dira osagai aktibo gisa eta medikamentu arruntek dituzten mugetatik haratago joatea ahalbidetzen du estrategia terapeutiko berriak garatuz. Medikuntzaren arloan aplikagarritasuna izan dezake gaixotasun kroniko, neurodegeneratibo zein inmunogenikoetan.

Honen harira, zelula amek zeresan handia dute terapia zelularrean, ez bakarrik eraldatzeko duten gaitasunagatik, baizik eta, gorputzean dauden beste zelulen jokaera aldatzeko duten gaitasunagatik. Esaterako, hanturazko osagai bat duten patologietan, gaixotasuna behin desagertuta, beste zelulei kaltetutako ehun edo organoak berreraikitzeko momentua dela ulerrarazten diote sistema immuneari.

Terapia zelularren nondik-norakoez, ikertzen dabilen zelula ametan oinarritutako hesteetako hanturazko gaixotasunaren tratamendurako sistema terapeutiko berrien garapenaz eta alor honetan etorkizun hurbileko erronkez jakiteko, Edorta Santos UPV/EHUko Farmazia Fakultateko ikertzailearekin bildu gara.

“Zientzialari” izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Edorta Santos: “Terapia zelularrak estrategia terapeutiko berriak garatzeko aukera ematen du” #Zientzialari 158 appeared first on Zientzia Kaiera.

Ríos rojos: el problema ambiental de las aguas ácidas de mina

Manuel Olías y José Miguel Nieto

Durante las avenidas, la fuerza de la corriente arrastra a algunos peces de arroyos de buena calidad hacia el río Tinto, donde no pueden soportar los altos niveles de contaminación y mueren. Fotografía de los autores.

Durante las avenidas, la fuerza de la corriente arrastra a algunos peces de arroyos de buena calidad hacia el río Tinto, donde no pueden soportar los altos niveles de contaminación y mueren. Fotografía de los autores.El río Tinto (provincia de Huelva, España) tiene un intenso color rojo como indica su nombre. Es un caso único a nivel mundial, pero su particularidad no viene dada por su color (existen muchos otros ríos rojos en el mundo) sino por su extensión. El Tinto mantiene estas condiciones durante casi 100 km, desde la cabecera en la sierra hasta su desembocadura en la ría de Huelva.

Además de las elevadas concentraciones de hierro que le dan su tonalidad, el agua del Tinto tiene un pH muy ácido y muchos otros elementos tóxicos como arsénico, cadmio y plomo. En este tipo de río no viven peces, ni moluscos, ni plantas superiores, ni casi nada. Solo se desarrollan microorganismos extremófilos, para los que esas condiciones ácidas son ideales.

Todo esto se debe a un proceso conocido como drenaje ácido de minas, una de las principales causas de la degradación de los recursos hídricos a nivel mundial. Otro ejemplo cercano es el río Odiel, vecino del Tinto, que no es tan famoso, pero transporta una cantidad de contaminantes hasta la ría de Huelva mucho mayor.

Primer vertido de aguas ácidas que se une al río Odiel; se observa el cambio de color y la desaparición de toda la vegetación (el río discurre desde la parte superior derecha a la inferior izquierda). Fotografía de los autores.

Primer vertido de aguas ácidas que se une al río Odiel; se observa el cambio de color y la desaparición de toda la vegetación (el río discurre desde la parte superior derecha a la inferior izquierda). Fotografía de los autores.Aguas ácidas en las minas

Las aguas ácidas de mina se asocian a los depósitos de sulfuros polimetálicos. En menor medida también se producen en las minas de carbón, que contiene pequeñas concentraciones de sulfuros. Los sulfuros son estables en el subsuelo, donde no hay oxígeno. Mientras se mantengan esas condiciones no causan ningún problema. Sin embargo, si estos minerales se exponen al oxígeno y agua, se disuelven generando acidez y liberando el hierro y muchos otros elementos que contienen.

Esas reacciones están catalizadas por bacterias acidófilas, de forma que si se alcanzan bajos valores de pH se multiplican las poblaciones de estas bacterias, lo que genera más oxidación de sulfuros y más acidez. Es decir, es un proceso que se retroalimenta y, una vez iniciado, perdurará durante cientos o miles de años. Si estos lixiviados llegan hasta las aguas superficiales pueden provocar la degradación total de los ecosistemas acuáticos asociados.

Este proceso se da de forma natural en las zonas donde los sulfuros afloran en la superficie. Sin embargo, la minería multiplica por varios órdenes de magnitud la oxidación natural de estos minerales al extraer grandes cantidades de sulfuros y ponerlos en contacto con la atmósfera, perforar kilómetros de túneles y galerías en el subsuelo por donde penetra el oxígeno, producir enormes escombreras y otros residuos ricos en sulfuros, etc.

Río Odiel en diferentes periodos del año. Los colores reflejan distintos niveles de contaminación, los valores más extremos (fotografía derecha) corresponde al verano cuando el caudal del río es menor. Fotografía de los autores.

Río Odiel en diferentes periodos del año. Los colores reflejan distintos niveles de contaminación, los valores más extremos (fotografía derecha) corresponde al verano cuando el caudal del río es menor. Fotografía de los autores.Contaminación en la Faja Pirítica Ibérica

La Faja Pirítica Ibérica se extiende desde la parte occidental de la provincia de Sevilla hasta la costa atlántica portuguesa, alcanzando su mayor desarrollo en la provincia de Huelva. Es una de las zonas con mayor concentración de yacimientos de sulfuros del mundo, entre ellos varios denominados supergigantes (con más de 100 millones de toneladas).

La acidez producida por la oxidación de sulfuros puede ser neutralizada si existen materiales carbonatados en las rocas encajantes de los depósitos, como ocurre por ejemplo en el distrito minero de Linares-La Carolina (Jaén). Desafortunadamente, en la Faja Pirítica prácticamente no existen rocas carbonatadas, lo que junto a la gran cantidad de sulfuros y la intensa actividad minera genera las condiciones idóneas para la formación de aguas ácidas con elevadísimas concentraciones de elementos tóxicos.

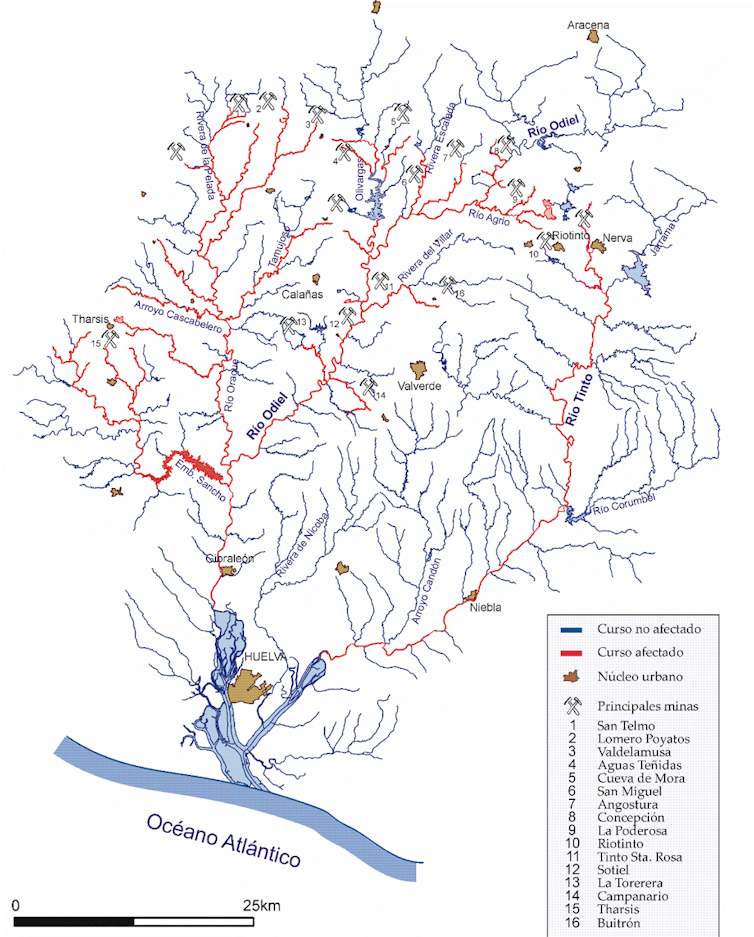

Las numerosas minas abandonas repartidas por toda la Faja Pirítica Ibérica hacen que la red fluvial de la zona esté profundamente afectada por las aguas ácidas. Cuando los ríos Tinto y Odiel desembocan en la ría de Huelva, las aguas ácidas fluviales se mezclan con el agua marina y la mayoría de los metales de origen minero precipita, acumulándose en los sedimentos del fondo.

Los organismos que habitan en estos sedimentos asimilan algunos elementos tóxicos que entran en la cadena trófica, haciendo que los niveles de contaminación de los peces y moluscos de la ría de Huelva sean muy elevados. Además, algunos elementos más móviles en condiciones de pH neutro como el arsénico y el cadmio pueden permanecer disueltos en el agua e incluso alcanzar las aguas costeras.

Mapa de las redes fluviales de los ríos Tinto y Odiel indicando las principales minas y los tramos afectados por aguas ácidas de mina.

Mapa de las redes fluviales de los ríos Tinto y Odiel indicando las principales minas y los tramos afectados por aguas ácidas de mina.Un problema antiguo…

En los pueblos de la cuenca minera onubense mucha gente piensa que los ríos Tinto y Odiel siempre han estado así, y que sus condiciones ácidas son de origen natural. Sin embargo, existen multitud de evidencias geológicas e históricas que indican que su degradación se ha producido desde el inicio de la explotación minera a gran escala a mediados del siglo XIX. Así, Juan Ramón Jiménez, vecino ilustre del pueblo de Moguer situado junto a la ría del Tinto, escribe en su libro Platero y yo:

Mira, Platero, cómo han puesto el río entre las minas, el mal corazón y el padrastreo.

Apenas si su agua roja recoge aquí y allá, esta tarde, entre el fango violeta y amarillo,

el sol poniente; y por su cauce casi solo pueden ir barcas de juguete.

¡Qué pobreza!

…Antes los pescadores subían al pueblo sardinas, ostiones, anguilas, lenguados, cangrejos…

El cobre de Riotinto lo ha envenenado todo…

…con consecuencias actuales

La minería actual tiene que cumplir con requerimientos ambientales estrictos y cuenta con tecnologías para reducir la generación de lixiviados ácidos y tratar los que se producen. El problema en la Faja Pirítica es la enorme cantidad de residuos ricos en sulfuros existentes generados por la minería antigua de los siglos XIX y XX, donde se siguen produciendo lixiviados ácidos.

Río Tintillo. Fotografía de los autores.

Río Tintillo. Fotografía de los autores.Existen grandes embalses como el del Sancho, de 58 hm³ de capacidad, que almacenan aguas ácidas y no pueden ser utilizadas para ningún fin sin un tratamiento complejo. Esta contaminación histórica también compromete la calidad del agua del futuro embalse de Alcolea (de 246 hm³ de capacidad) que se está construyendo en la cuenca del río Odiel. Aunque en la actualidad las obras están paralizadas, existe una fuerte presión de los regantes para que se retomen. Además de estas razones utilitarias, debemos mejorar las condiciones ambientales para tener unos ríos vivos y saludables, a lo que por otra parte estamos obligados por la Directiva Marco del Agua de la Unión Europea.

La producción de lixiviados ácidos de las minas de sulfuros abandonadas puede perdurar miles de años. Desde la Universidad de Huelva hemos desarrollado un sistema de tratamiento pasivo denominado Sustrato Alcalino Disperso (DAS por sus iniciales en inglés), que no necesita energía eléctrica y puede funcionar sin apenas mantenimiento durante varios años. Ya se ha construido una planta a escala real en Mina Concepción gracias al proyecto LIFE_ETAD, lo que ha supuesto un importante primer paso para la recuperación de la zona.![]()

Sobre los autores: Manuel Olías es catedrático de Hidrología Superficial e Hidrogeología y José Miguel Nieto de Cristalografía y Mineralogía en la Universidad de Huelva

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Ríos rojos: el problema ambiental de las aguas ácidas de mina se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ríos atmosféricos, las autopistas aéreas que regulan el clima

- Todos los rojos son chillones

- La contribución global de los ríos intermitentes al ciclo del carbono

Simetriaz eta bere hausturaz (eta III)

Irudia: Zientzia modernoan, simetriaren haustura simetria bera bezain garrantzitsua izatera iritsi da. (Argazkia: cocoparisienne – Pixabay lizentziapean. Iturria: pixabay.com)

Irudia: Zientzia modernoan, simetriaren haustura simetria bera bezain garrantzitsua izatera iritsi da. (Argazkia: cocoparisienne – Pixabay lizentziapean. Iturria: pixabay.com)Egungo simetria kontzeptua objektuen simetria geometrikoa deskribatzearekin batera hasi zen zedarritzen, matematika zein fisika arloetan. Hartu elur-maluta perfektu bat, bere erdigunea ardatz harturik eta horri finko eutsita 60º biratu, eta ez da hasierako elur-malutatik bereizterik izango. Aitzitik, 90º biratuz gero, errotazioaren eragina sumatu ahalko dugu. Biraketaz jabetzeko, baina, erreferentzia bat beharko dugu, edo beste era batera esanda, biraketak elur-maluta transformatuko du, baina betiere kanpo-erreferentzia batekin alderatuta.

Hala, bada, objektu baten simetriari dagozkion transformazioek (errotazioak orokortzea) bereizezin bihurtzen dituzte hasierako eta bukaerako egoerak, garrantzizkotzat ditugun propietateei erreparatuta behintzat. Simetria ulertzeko modu hori (transformaziorik egon den ala ez bereizi ezin izatea) oso emankorra izan da azken 400 urteetako zientzia-ikerketan. Hiru dira garapen aipagarrienak: (I) kontzeptua simetria fisikoetara zabaltzea, (II) talde-teoriaren garapena eta haren aplikazio zientifikoak, (eta III) «simetria-haustura» kontzeptuaren garrantzi gero eta handiagoa.

Simetriaren hausturaZientzia modernoan, simetriaren haustura simetria bera bezain garrantzitsua izatera iritsi da. Hainbesteraino, non haustura hitzaren bidez adierazten dugun, erabat hautemangarri eta materiala den zerbait puskatuko balitz bezala. Izan ere, praktikan hala ulertzen da kontzeptua.

1894an, Pierre Curie frantziarrak simetriaren garrantzia nabarmendu zuen simetriaren printzipioaren —edo, bere omenez, Curie printzipioa ere deritzonaren– bidez. Haren arabera, efektu batek ezin du bere kausak baino simetria gutxiagorik izan; alegia, efektu batek beti gordeko du bere kausak zeukan simetria edo simetria falta.

Curieren printzipioa fin-fin bete zen berrogeita hamar urte baino luzaroagoan zientziaren alor guztietan, baina arazo ugariri egin behar izan zion aurre 50eko hamarkadan, funtsezko zenbait aurkikuntza egin zenean. Printzipioak zutik iraun zuen erronka horien ostean ere, baina ia ezagutezin bihurtu arte aldatuta.

Curieren printzipioak aurre egin behar izan zion lehen erronka supereroankortasunaren testuinguruan agerturiko berezko simetria-hauste fenomenoa izan zen (eremuen teoria kuantikoan ere azalduko zen berriro geroago). Emaitzen egonkortasunari zegokion. Izan ere, problema simetriko baten emaitza simetrikoa ezegonkorra izan zitekeen; emaitza egonkorra, berriz, ez zen bere kausa bezain simetrikoa. Beraz, bazirudien Curieren printzipioa urratzen zela. Efektu kontzeptuaren esanahia zabalduta konpondu zen arazoa: teorikoki, kausa batek efektu multzo bat eragiten du (emaitza multzo bat, beraz), denak maila berean probableak, nahiz eta aldi bakoitzean bat baino ez ikusi; ondorioz, multzo osoa da kausaren simetria daukana, eta ez ikusitako efektua soilik. Arrazoibide bihurritu samarra da, baina balio izan zuen printzipioa baztertu behar ez izateko.

Bigarren erronka paritatearen urraketak ekarri zuen. Bertan, esperimentu baten emaitza posibleak bere ispilu-irudia menderatzen du. Urraketa hau Tsung Dao Lee eta Chen Ning Yang fisikariek aurreikusi zuten 1956an, eta Chien Shiung Wu fisikariak eta haren laguntzaileek detektatu zuten esperimentalki 1957an. Kasu honetan, kausa kontzeptua aldatuta da posible printzipioak irautea. Interakzio nuklear ahula gobernatzen duen legeak simetria hausten du, eta, Curieren printzipioa mantentzeko, legea kausaren barruan dagoela ulertu behar da.

Laburbilduz, Curieren simetria-printzipioak iraun du, baina zabaldu eta aldatu egin behar izan dira kausak eta efektuak ulertzeko moduak.

XX. mendearen bigarren erdian berezko simetria-hausteak biologian ere hartu zuen garrantzi handia. Fisikan ikusi dugun arrazoibidearen antzeko ibilbideari jarraitu zitzaion. Organismo oro (birusak kanpo) simetria handiko izaki gisa hasten da; sinplifikatuta, zelula isolatu eta esferiko gisa. Organismoa garatu eta hazi ahala, egoera simetrikoa gero eta ezegonkorragoa bihurtzen da, izan barneko indar eta tentsioengatik edo ingurumenekoengatik. Ezegonkortasun horrek simetria haustea eragiten du: organismoak aukeran dituen taxutze guztien artean, egonkorrena hautatuko du, nahiz eta hain simetrikoa ez izan. Hala, egonkortasunaren eta simetria-haustearen arteko dinamikak mugatu egiten ditu organismo batek hazkuntzan har ditzakeen forma posibleak. Organismoak une bakoitzean aukeran dituen egoera posibleetako zein aukeratuko duen bere barneak kontrolatuta egon daiteke (adibidez, DNAren barruko jarraibideen bidez), edo ingurumenak kontrolatuta (esaterako, tenperaturak edota konposatu jakinen presentziak).

Hortik ondorioztatu daiteke berezko simetria-hausteak errotik aldatu duela eboluzioaren teoria ulertzeko modua.

Darwinen ikuspuntutik, eboluzioak hamaika aukeraren artean esploratzeko askatasuna du, eta hura modu oso orokorrean soilik mugatzen dute lege fisiko eta kimikoek. Ustezko askatasun horrek, ordea, gertaera paradoxiko, edo, behintzat, arras deigarriak ekarri ohi dizkigu. Adibidez, espezieen leinu ezberdinetan oso itxura antzekoak garatzea, edo, teorian aukera ia infinituak egonda, errealitatean aukeren azpi-multzo nahiko mugatua baino ez gauzatzea.

Gertaera deigarri horientzako azalpen posible bat da dinamikoki egonkorra denak asko baldintzatzen duela biologikoki posiblea dena. Ikusi dugun bezala, hori ulertzeko giltzarri da simetria-haustearen kontzeptua.

Egileaz:

Cesár Tomé López (@EDocet) zientzia dibulgatzailea da eta Mapping Ignorance eta Cuaderno de Cultura Cientifica blogen editorea.

Itzulpena:Lamia Filali-Mouncef Lazkano

Hizkuntza-begiralea:Xabier Bilbao

Simetriari buruz idatzitako artikulu-sorta:- Simetriaz eta bere hausturaz (I)

- Simetriaz eta bere hausturaz (II)

- Simetriaz eta bere hausturaz (eta III)

The post Simetriaz eta bere hausturaz (eta III) appeared first on Zientzia Kaiera.

A la caza de la chocolatina

Foto: Hans Braxmeier / Pixabay

Foto: Hans Braxmeier / Pixabay

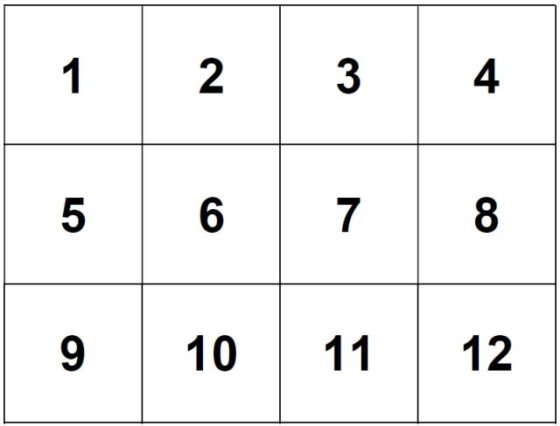

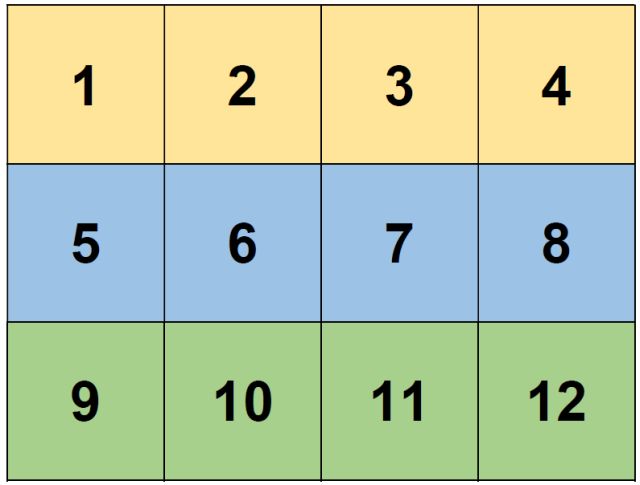

Alicia propone un juego a su amigo Benito y a su amiga Carmen. Elige una docena de cajas de cartón, las numera y las coloca en forma de cuadrícula 3×4, como muestra la imagen:

Alicia elige al azar dos de las cajas y esconde en cada una de ellas una chocolatina (son iguales), dejando el resto de las diez cajas vacías.

El juego consiste en lo siguiente:

-

Alicia muestra las cajas a Benito, quien debe ir abriéndolas por filas (es decir, en el orden 1-2-3-4-5-6-7-8-9-10-11-12) hasta que encuentre una de las chocolatinas. En ese momento se detiene. El número de cajas abiertas por Benito es su puntuación final.

-

Alicia vuelve a cerrar las cajas (dejando sus contenidos intactos) y se las ofrece a su amiga Carmen, quien las abrirá por columnas (es decir, en el orden 1-5-9-2-6-10-3-7-11-4-8-12), dejando de abrir cajas el momento de encontrar una chocolatina. Y, como en el caso de su amigo, anota el número de cajas que ha destapado hasta encontrar su primera chocolatina.

Gana este juego (y se come las dos chocolatinas) quien obtenga la puntuación más baja (quien haya encontrado antes el dulce). Y si empatan, Benito y Carmen se reparten el “botín”.

Por ejemplo, si Alicia esconde las chocolatinas en las cajas 8 y 11, Benito tendrá una puntuación de 8 (abre las cajas 1-2-3-4-5-6-7-8), mientras que Carmen obtendrá un puntaje de 9 (ya que destapará las cajas 1-5-9-2-6-10-3-7-11 hasta encontrar su primera chocolatina). Es decir, ganaría Benito.

La pregunta que se plantea es la siguiente: ¿Quién tiene más probabilidades de ganar el juego, Benito o Carmen? ¿O ninguno de los dos?

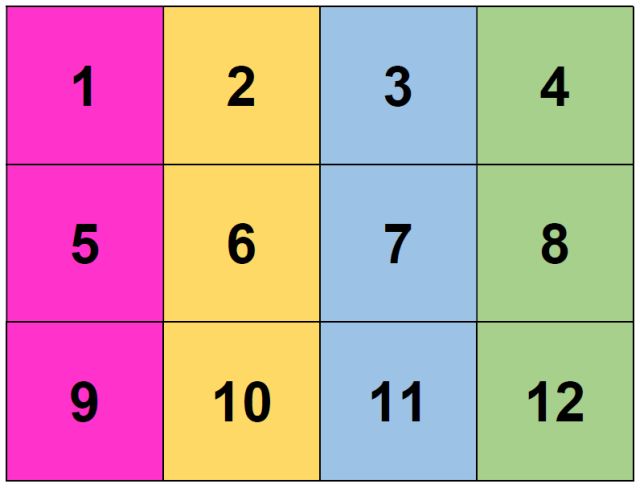

En primer lugar, recordemos que hay 66 maneras de repartir las dos chocolatinas introduciendo una en dos de las doce cajas (son las combinaciones sin repetición de 2 elementos elegidos entre 12).

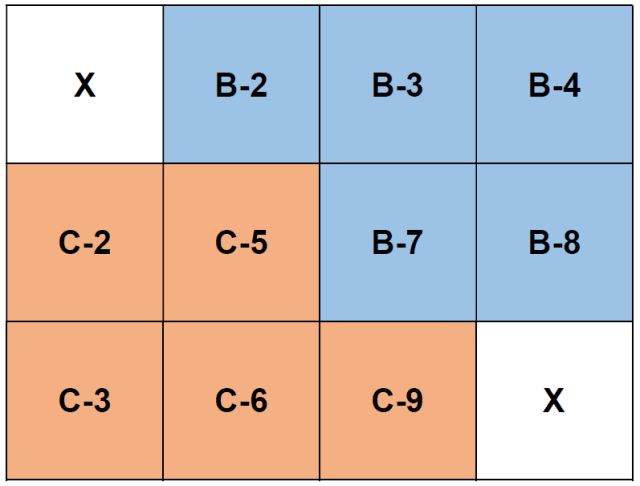

Para estudiar el problema planteado, etiquetamos una caja con B o C dependiendo de quien de los dos (B-Benito y C-Carmen) llegue antes a esa caja, y escribiremos a su lado la puntuación obtenida (si allí hubiera chocolatina) por esa persona en cada caso. Además, la caja se marcará con X si, siguiendo cada uno su trayectoria, ambos llegan a esa posición en el mismo momento. Claramente, obtenemos el siguiente resultado:

Observar que, si una chocolatina está en primera caja, Benito y Carmen empatan (hay 11 posibles posiciones para la segunda chocolatina), ya que ambos obtienen una puntuación de 1.

Si una chocolatina está en la última caja y la otra en una etiquetada con B o C, Benito gana en cinco ocasiones y Carmen en otras cinco.

Si las chocolatinas están escondidas en dos cajas etiquetadas con B, Benito gana (hay 10 reparticiones posibles). Del mismo modo, si las cajas con premio están ambas etiquetadas con C, es claro que gana Carmen (hay otras 10 distribuciones posibles).

El resto de los posibles repartos de las chocolatinas consiste en que una esté en una casilla etiquetada con B y la otra con C. Hay 25 maneras de que esto suceda. ¿Cuándo gana Benito? ¿Cuándo lo hace Carmen? ¿Cuándo empatan?

Benito gana (es decir, encuentra la primera chocolatina abriendo menos cajas que Carmen) si las chocolatinas están en:

-

B-2 y (C-3 o C-5 o C-6 o C-9),

-

B-3 y (C-5 o C-6 o C-9),

-

B-4 y (C-5 o C-6 o C-9),

-

B-7 y C-9,

-

B-8 y C-9.

Es decir, gana en 12 de las posibles posiciones de las chocolatinas en las cajas.

Y Carmen gana el juego (es decir, encuentra la primera chocolatina destapando menos cajas que Benito) si las chocolatinas están en:

-

C-2 y (B-3 o B-4 o B-7 o B-8),

-

C-3 y (B-4 o B-7 o B-8),

-

C-5 y (B-7 o B-8),

-

C-6 y (B-7 o B-8).

Es decir, gana en 11 de las 25 posibles posiciones de las chocolatinas en las cajas.

Benito y Carmen empatan si las chocolatinas están en alguna de estas 2 posiciones:

-

B-2 y C-2, o

-

B-3 y C-3.

Es decir, ¡Benito tiene más probabilidades de ganar que Carmen! ¿Por qué? Porque según el anterior análisis, Benito ganaría en 27 de los 66 casos posibles, Carmen lo haría en 26, y empatarían en 13… Aunque, recordemos, que eso no significa que no vaya a ganar Carmen.

Referencia

Egg Hunt, Futility Closet, 16 abril 2021

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo A la caza de la chocolatina se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una contribución a la teoría matemática de la caza mayor

- Un juego con un premio colosal

- ¿Quién se queda sin merendar?

Ingurune azidoetara moldatutako arrainak

Klima-larrialdiak eta bere ondorioek hamaika ertz dituzte. Aurreko batean hona ekarri genuen basoen gene-dibertsitateak klima-aldaketari nola egiten dion aurre. Gaurkoan beste ingurune batera begira jarriko gara klima-aldaketa eta gene-informazioa gurutzatzen diren lekua ezagutzeko. Orain hondartza-sasoian bete-betean gaudela, itsasora bidaia bat egingo dugu.

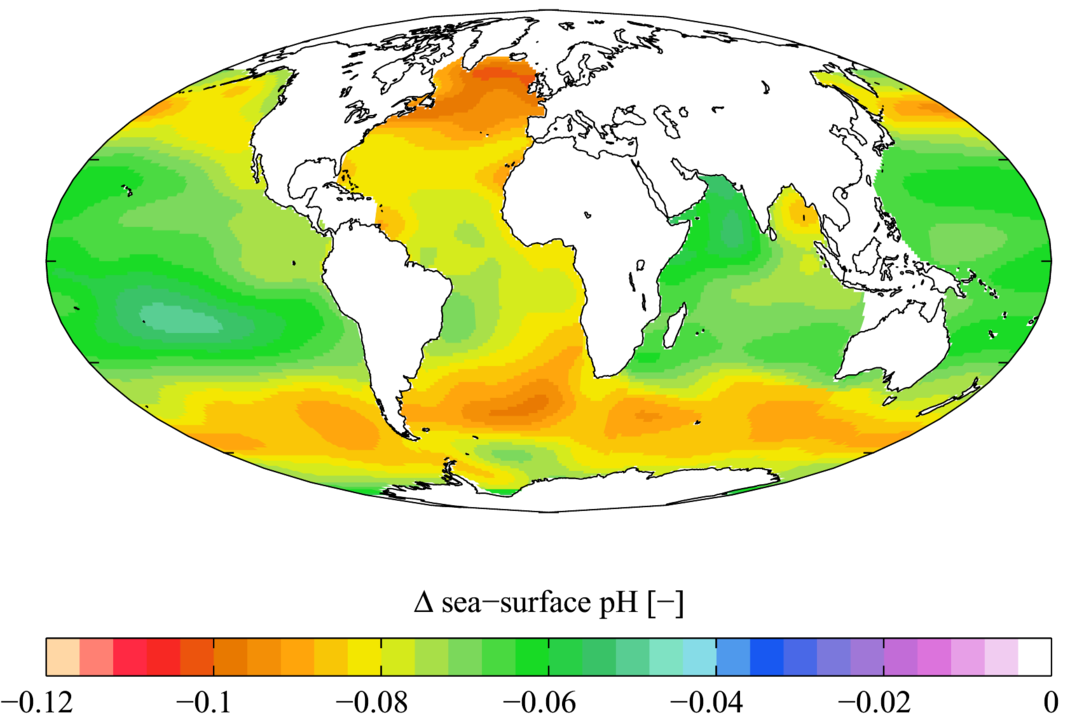

Klima-aldaketak itsaso eta ozeanoetan hainbat ondorio eragingo ditu, hala nola, hipoxia –hau da, oxigeno gutxiago egotea eskuragarri–, tenperaturen igotzea eta azidotzea. Azken honi erreparatuta, atmosferako karbono dioxidoaren kontzentrazioa handitzen den heinean, ozeanoek gas hori xurgatzen dute eta, ondorioz, azidoagoak bilakatzen dira. Horrek ozeanoetako pH jaistea eragiten du. Ozeanoak azidoagoak izateak bertan bizi diren bizidun guztiei eragiten die eta, hortaz, ondorioak itsas ekosistementzat. Ingurune azidoetan bizirik irauteko, hau da, pH-aren aldaketari aurre egiteko, itsas organismoek beren fisiologia moldatu behar dute, eta hori erdiesteko mekanismo bat da geneen funtzionamendua doitzea.

1. irudia: Forsterygion lapillum arraina ingurune azidoetara moldatu da. (Argazkia: Ian Skipworth – Domeinu publikoan. Iturria: Wikimedia)

1. irudia: Forsterygion lapillum arraina ingurune azidoetara moldatu da. (Argazkia: Ian Skipworth – Domeinu publikoan. Iturria: Wikimedia)Ingurune azidoetan geneen funtzionamendua nola aldatzen den aztertzeko, aproposak dira sumendien aktibitatea duten itsas hondoak. Bereziki aproposak dira karbono dioxidoa itsas hondotik borborka ateratzen den lekuak, ozeanoen azidotzearen antzeko baldintzak sortzen baitira. Nolabait, gerta daitekeenaren laborategi naturalak dira ingurune horiek. Halako leku gutxi badaude ere, Zeelanda Berriko White Island deitutako irla bolkanikora jo du ikertzaile-talde batek, bertan aipatutako baldintzak baitaude. Irla horretako itsas hondoan Forsterygion lapillum arrainaren laginak jaso zituzten eta erkatu zituzten baldintza ez horren azidoetan bizi diren espezie bereko arrainekin.

Baldintza normaletan eta baldintza azidoetan bizi ziren arrain horien geneen funtzionamendua aztertzeko gonadak erabili zituzten, hau da, sexu-organoak. Ikertzaileek erkatu zuten organo horietan geneek duten aktibitatea eta ondorioztatu zuten ehun bat generen funtzioa aldatuta zegoela. Horietatik ia 70 genek zuten bere funtzioa areagotua, ingurune azidoetara moldatzearen ondorioa izan daitekeena. Gene horien funtzioen artean egon ziren zelularen homeostasia mantentzea, energiaren produkzioa eta proteinen jarduerarekin lotura zuten funtzioak. Funtzio horiek areagotuta egoteak isla dezake ingurune azidoetan zeluletan pH mantentzeak sortzen duen lana, bai energiaren kontsumoari dagokiola, bai parte-hartu behar duten zelulako osagaiei dagokiola. Gainera, arrek izan zituzten aldaketa gehien geneen funtzioan eta lanaren egileek iradokitzen dute hori lotua egon daitekeela espezie horretan arrek habia zaintzeko duten zereginarekin. Nolabait, arren erantzukizuna denez ondorengoak zaintzea, arrak ingurune azidoetara hobeto moldatzea bultzatu du eboluzioak.

2. irudia: Itsaspeko sumendiak laborategi naturalak dira azidotzea aztertzeko. (Argazkia: NOAA – Domeinu publikoan. Iturria: Wikimedia)

2. irudia: Itsaspeko sumendiak laborategi naturalak dira azidotzea aztertzeko. (Argazkia: NOAA – Domeinu publikoan. Iturria: Wikimedia)Aipatutako geneen funtzionamendua doitu egin da hainbat gene-aldaeraren bitartez. Bada, lanaren egileek ondorioztatu zuten gene-aldaera horiek epe luzeko hautespen naturala jaso dutela, hau da, espezie horren gene-ondarean aspalditik dauden aldaerak direla. Gainera, ondorioztatu zuten gene-aldaera horiek ingurune ez-azidotuetan ez zutela eraginik arrainen ugaltzeko gaitasunean eta, hortaz, arrain horren populazioan arazo handirik gabe heda daitezkeela, ez baitute inolako desabantailarik sortzen egoera normaletan. Baina ingurune azidoetara moldatzeko gaitasuna emendatzen dutenez, helduleku bat izan daitezke ozeanoen balizko azidotzeari aurre egiteko.

Lan honen egileek gaineratu dute ingurune azidoetara moldatzen laguntzen duten gene-aldaera horiek arrain horren populazioan barreiatuta mantentzen direla. Arrain espezie askok ohitura dute pH ezberdinak dituzten inguruneetan ibiltzeko eta, ondorioz, azidotasun-maila ezberdinetara moldatzeko malgutasun hori populazioan mantentzea abantaila izango litzateke eboluzioaren ikuspuntutik. Izan ere, arrain batzuetan larbek dispertsio handia dute eta, modu horretara, ahalbidetu egiten da espezie bereko populazio ezberdinen arteko gene-informazioaren trukaketa. Horrek posible egingo luke azidotzeari aurre egiteko gene-aldaeren fluxua eta, ondorioz, gene-oinarri sendo bat izatea ingurunearen aldaketei aurre egiteko.

3. irudia: Ozeanoen pH-aren aldaketa 1700 eta 1990 urteen artean. (Irudia: Plumbago – CC-BY-SA 3.0 lizentziapean. Iturria: Wikimedia)

3. irudia: Ozeanoen pH-aren aldaketa 1700 eta 1990 urteen artean. (Irudia: Plumbago – CC-BY-SA 3.0 lizentziapean. Iturria: Wikimedia)Ez da gene-mekanismo bat proposatzen den lehenengo aldia itsas bizidunak ingurune azidoetara moldatzeko. Adibidez, itsas triku morean (Strongylocentrotus purpuratus) edo Mediterraneoko muskuiluan (Mytilus galloprovincialis) detektatu zen azidotzeari aurre egiteko gene-aldaerek eragin kaltegarria zutela larben biziraupenean. Hala, ingurune azidoetara moldatzea arina bazen ere, helduen populazioaren tamaina txikiagoa zen, eta horrek mugatu egingo luke aldaketa berriei aurre egiteko gaitasuna. Forsterygion lapillum arrainean, aldiz, ez dago helduen populazioaren tamainan galerarik. Hori dela eta, lanaren egileek ondorioztatzen dute arrain horretan ingurune azidoetara moldatzea errazten duten gene-aldaerek ez dutela inolako ondoriorik larben biziraupenean. Ondorioz, proposatzen duten ideia da itsas espezie bakoitzak gene-mekanismo ezberdinak erabili dituela ingurune azidoei aurre egiteko gaitasuna eskuratzeko: itsas triku morean moldapena gene-aldaera gutxi batzuek eragiten duten bitartean, Forsterygion lapillum arrainean gene-aldaera askok hartzen dute parte, bakoitzak abantaila txiki bat ematen duelarik.

Laburbilduz, Forsterygion lapillum arrainaren populazioan hedatuta daude gene-lanabesak ozeanoaren azidotzeari aurre egiteko. Hala, itxarotekoa da espezie honek moldatzeko gaitasuna izatea klima-aldaketak sortuko dituen baldintza berrietara. Jakiteko dago gauza bera gertatuko ote den beste espezie batzuetan, gurea barne.

Erreferentzia bibliografikoak:The University of Hong Kong. (2021eko maiatzaren 27a). Fish adapt to ocean acidification by modifying gene expression. ScienceDaily.

Petit-Marty, N., Nagelkerken, I., Connell, S.D., Schunter, C. (2021). Natural CO2 seeps reveal adaptive potential to ocean acidification in fish. Evolutionary Applications. 00, 1– 13. DOI: 10.1111/eva.13239 Egileaz:Koldo Garcia (@koldotxu) Biodonostia OIIko ikertzailea da. Biologian lizentziatua eta genetikan doktorea da eta Edonola gunean genetika eta genomika jorratzen ditu.

The post Ingurune azidoetara moldatutako arrainak appeared first on Zientzia Kaiera.

Mesopotamia (2): Adivinos y científicos

La Epopeya de Gilgamesh también ponía de manifiesto la creencia en que un destino anónimo, impersonal y misterioso, abarcaba todos los ámbitos de la vida. Cada persona tenía un destino, pero su conocimiento estaba limitado por el hecho de que todo lo que se podía entender de la vida y la naturaleza provenía bien de vagas y esporádicas insinuaciones proporcionadas por los dioses, o era inherente al propio orden de las cosas. El destino ataba a los mismos dioses, que tenían más conocimiento que los humanos sobre el curso predestinado de la existencia, pero tenían tan poco poder para alterarlo como la propia humanidad. Los humanos podían persuadir a los dioses para que actuasen a su favor en diversos asuntos; pero si un suceso estaba predestinado a ocurrir, nada, ni los mismos dioses, podía cambiarlo.

Estatuilla sumeria de una mujer en actitud de adoración. Fechada en el el 2800 y el 2300 a.e.c.. Fuente: Wikimedia Commons

Estatuilla sumeria de una mujer en actitud de adoración. Fechada en el el 2800 y el 2300 a.e.c.. Fuente: Wikimedia CommonsNo es de extrañar, pues, que los mesopotámicos y otros pueblos del antiguo Oriente Próximo miraran a lo divino y al universo con una mezcla de asombro y temor. La piedad religiosa fue una consecuencia, otro fue la curiosidad y la búsqueda del conocimiento. Los sumerios más curiosos encontraron pistas en el funcionamiento regular de los fenómenos naturales.

Pero el destino tenía sus propias leyes internas inherentes que cautivaban y desconcertaban a la vez. Y todos sabemos que no hay nada que le guste más a un científico que un rompecabezas. El destino parecía menos desconcertante una vez que los sumerios se dieron cuenta de que la naturaleza daba indicios de eventos futuros. Los dioses, como los humanos, también conocían el futuro aunque no pudieran cambiarlo. Con objeto de obtener una mejor visión del futuro era necesario combinar ambas fuentes de conocimiento: un objetivo de los ritos religiosos era apelar a los dioses para que les guiaran en cuanto al curso de los acontecimientos futuros.

Los primeros científicos, adivinos, augures, astrólogos, pronosticadores o, en general como Homero se refirió a ellos repetidamente en la Iliada, los «versados en el vuelo de los pájaros», examinaron los fenómenos naturales en busca de pistas sobre la manera en que sucedían las cosas. La tarea de los astrólogos sumerios y babilónicos era estudiar sistemáticamente el cielo, registrando meticulosamente por la noche los ciclos de la luna y los movimientos de los planetas y durante el día la posición en cambio permanente del sol, buscando presagios que indicasen el futuro de la naturaleza y de los humanos. Las tormentas eléctricas, los terremotos, las inundaciones, las sequías, las epidemias, las guerras, las muertes súbitas, las cosas extrañas que ocurrían por azar e incluso un error al hablar, un lapsus linguae, tenían un significado oculto para los profetas y videntes.

La cosmovisión del astrólogo y el adivino, esto es, que se puede anticipar y tomar medidas para afrontar lo que está por venir, no es muy diferente de la cosmovisión de una persona de ciencia, que al observar la naturaleza puede comprender los fenómenos naturales, lo que permite estar mejor preparado para lo que vendrá. Los antiguos sumerios de los valles de los ríos Tigris y Éufrates fueron los primeros científicos en la historia mundial porque fueron los primeros en dar este salto intelectual de la cosmovisión puramente supersticiosa a una con un importante componente científico.

Los primeros relatos científicos estaban necesariamente vinculados a historias míticas. Así, una historia identifica a un hortelano llamado Shukallituda cuyas cosechas eran destruidas repetidamente por el calor y el viento. Oró al cielo pidiendo ayuda y la recibió en forma de una nueva idea, decidió plantar su huerto a la sombra de árboles frondosos a ver qué pasaba. La idea funcionó: la sombra ayudó a las verduras a sobrevivir en el clima cálido. Shukallituda identificó un problema, concibió una solución hipotética, la probó y logró un resultado deseable que podría repetirse en otros lugares.

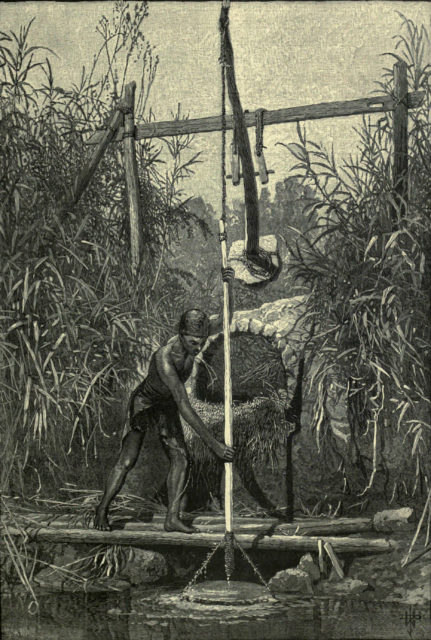

Shaduf. El esfuerzo hay que hacerlo para bajar el recipiente vacío al río, para subirlo lleno el contrapeso y la ley de la palanca hacen la mayor parte del trabajo. Fuente: Wikimedia Commons

Shaduf. El esfuerzo hay que hacerlo para bajar el recipiente vacío al río, para subirlo lleno el contrapeso y la ley de la palanca hacen la mayor parte del trabajo. Fuente: Wikimedia CommonsOtras tablillas de arcilla con escritura cuneiforme que sobreviven en Irak indican que, hace cuatro mil años, los agricultores sumerios tenían un enfoque empírico de la agricultura y usaban almanaques para registrar datos y dar consejos. El babilónico Código de Hammurabi ya incluye el uso en Mesopotamia del shaduf o, más castellano, cigoñal (un ingenioso uso de la ley de la palanca) para el riego, que luego se extendería por todo el Mediterráneo, especialmente Egipto.

Los sumerios del tercer milenio a.e.c. también recolectaron hierbas y sustancias que creían que ayudan en la curación del cuerpo, y en un momento alguien registró estos datos en una tablilla de arcilla, en la que describe qué medicamento tomar para qué enfermedad. No registra los resultados, y es más un manual que un texto de observaciones clínicas. Estas personas dedicadas a la sanación usaban sal y nitrato de sodio, aceites de plantas e infusiones hechas a partir de mirto o tomillo. Algunos medicamentos eran ungüentos que se usaban externamente. Otros era necesario ingeriros, habitualmente ayudándose con cerveza que, por su contenido alcohólico era mucho más higiénica que el agua disponible en muchos casos. Esta logro de preparar una materia médica fue notable porque en la tablilla no aparece ningún hechizo mágico o encantamiento para reforzar los efectos de la medicina. El enfoque científico de la persona que la elaboró se muestra en el uso físico de varios productos para lograr un resultado puramente físico, la curación del cuerpo humano.

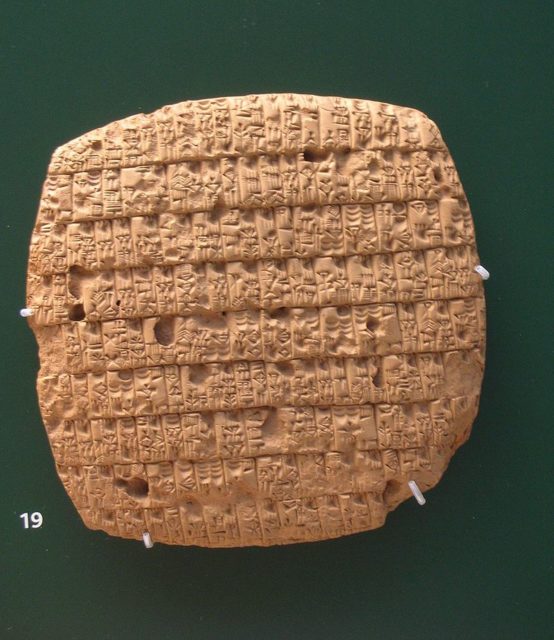

Tablilla de arcilla con escritura cuneiforme en la que se recogen las raciones de cebada que deben recibir mensualmente adultos y niños. Alrededor del 2350 a.e.c. British Museum. Fuente: Wikimedia Commons

Tablilla de arcilla con escritura cuneiforme en la que se recogen las raciones de cebada que deben recibir mensualmente adultos y niños. Alrededor del 2350 a.e.c. British Museum. Fuente: Wikimedia CommonsLos mesopotámicos hicieron también algunos descubrimientos notables ciencias físicas y matemáticas. Los químicos sumerios descubrieron una técnica para fundir cobre y estaño para producir bronce, que revolucionó el uso de herramientas en la paz y en la guerra. La gente de Sumeria también desarrolló un sistema aritmético sexagesimal que se convirtió en la base del modo más antiguo de marcar el paso del tiempo diario: sesenta segundos es un minuto, sesenta minutos es una hora. El interés inicial en la astrología se convirtió en un interés más práctico en la astronomía: los mesopotámicos se volvieron expertos en seguir el movimiento de los planetas, identificar las constelaciones del cielo nocturno y predecir las fases de la luna. Las observaciones astronómicas permitieron a los babilonios construir calendarios lunares increíblemente precisos.

Los antiguos mesopotámicos desarrollaron las primeras explicaciones de los orígenes y la composición de la tierra, los dioses y la humanidad. No las expresaron en lo que hoy llamaríamos un lenguaje descriptivo, científico, sino como mitos. Los sumerios fueron los primeros en construir embarcaciones capaces de navegar por los mares, y sus ideas se extendieron a Egipto, India, al Mediterráneo en su conjunto y al Egeo en particular.

La ciencia mesopotámica tuvo un claro impacto en el desarrollo de la ciencia griega durante el primer milenio antes de nuestra era. Los mesopotámicos anticiparon los teoremas matemáticos de Pitágoras y Euclides. La astronomía y las matemáticas babilónicas influyeron en Tales, el primer científico griego notable. Su idea de que el elemento primordial es el agua se deriva de los sumerios del milenio anterior. Las culturas antiguas adoptaron el sistema mesopotámico de medir el tiempo y calcular del calendario anual. La astronomía y la astrología mesopotámicas llegaron a ser representadas por los caldeos y los magos del antiguo Oriente Próximo.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Mesopotamia (2): Adivinos y científicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Tokian tokiko jarduera: bakteriofagoak bakterio erresistentziaren aurka

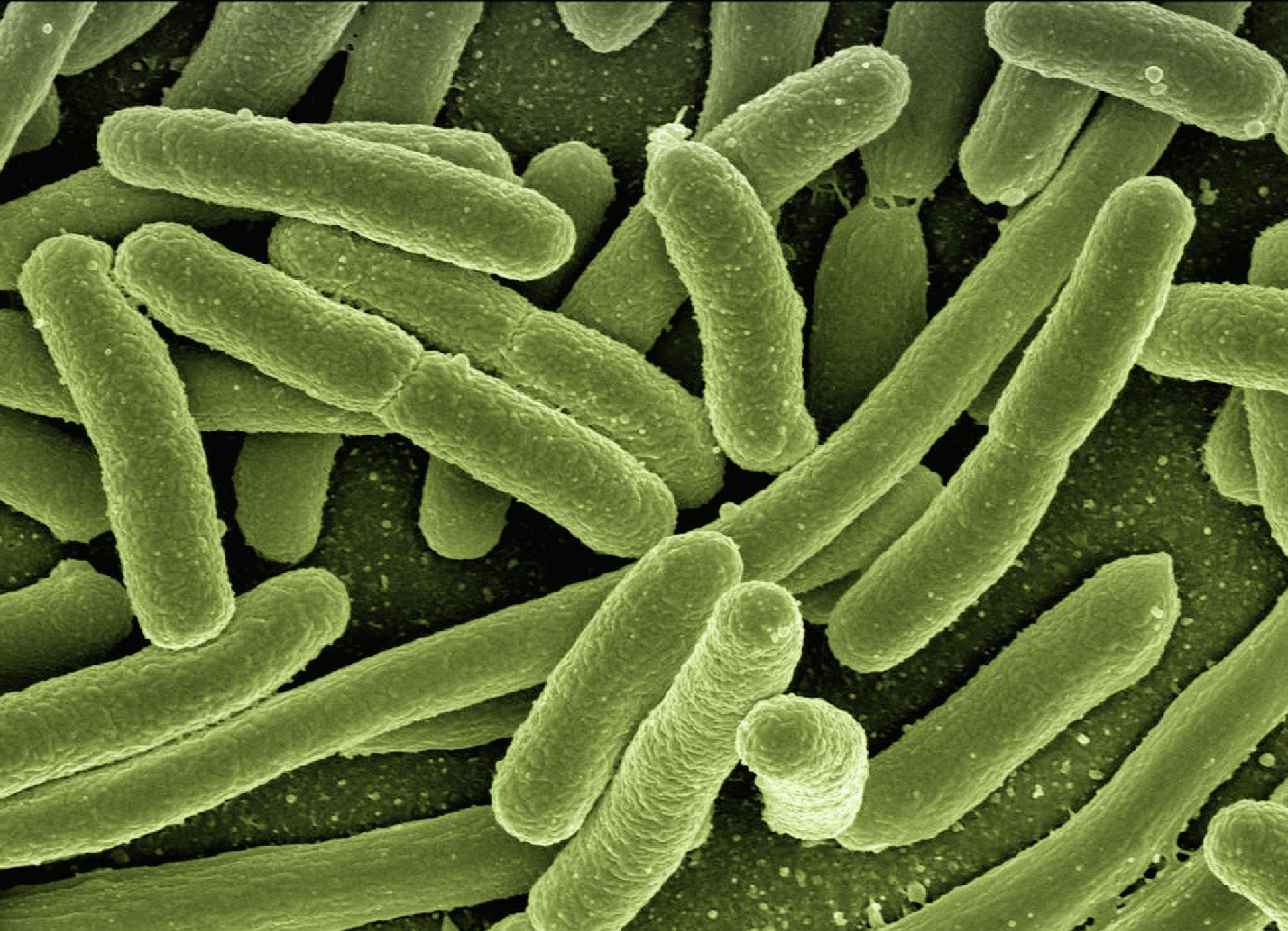

2020ko uztailaren 31n eguneratutako deskripzio oharrean, Osasunaren Mundu Erakundeak dio antibiotikoekiko erresistentzia dela gaur egun munduko osasunaren, elikadura segurtasunaren eta garapenaren arrisku larrienetako bat. Gero eta infekzio gehiago daude gero eta tratamendu zailagoa dutenak –esate baterako, pneumonia, tuberkulosia, gonorrea eta salmonellosia–, antibiotikoak eraginkortasuna galtzen ari baitira.

Bakterio infekzioen prebentzio eta tratamendurako erabiltzen diren medikamentuak dira antibiotikoak. Antibiotikoekiko erresistentzia gertatzen da bakterioak mutatu egiten direnean farmako horien erabilpenari erantzuteko. Bakterioak dira, beraz, eta ez gizakiak ez animaliak, antibiotikoekiko erresistentzia lortzen dutenak. Bakterio farmakorresistente horiek infekzioak sorraraz ditzakete gizaki eta animalietan; eta infekzio horien tratamendua zailagoa da erresistentziarik gabekoena baino.

Antibiotikoekiko erresistentziak kostu medikoak handitzea, ospitaleko egonaldiak luzatzea eta hilkortasuna gehitzea dakar.

Irudia: Antibiotikoekiko erresistentziak kostu medikoak handitzea, ospitaleko egonaldiak luzatzea eta hilkortasuna gehitzea dakar. (Argazkia: geralt – Pixabay lizentziapean. Iturria: pixabay.com)

Irudia: Antibiotikoekiko erresistentziak kostu medikoak handitzea, ospitaleko egonaldiak luzatzea eta hilkortasuna gehitzea dakar. (Argazkia: geralt – Pixabay lizentziapean. Iturria: pixabay.com)Behar-beharrezkoa da lehenbailehen aldatzea antibiotikoak preskribatu eta erabiltzeko era. Medikamentu berriak garatzen badira ere, gaur egungo portaerak aldatzen ez badira, aurrerantzean ere mehatxu larria izango da antibiotikoekiko erresistentzia. Portaera aldaketen artean egon behar dute infekzioen hedapena gutxitzeko neurriak ere, hala nola txertaketa, eskuak garbitzea, sexu harremanetako segurtasuna eta elikadura higiene txukuna.

Antibiotikoekiko erresistentzia handitzen ari da mundu osoan, oso modu arriskutsuan. Egunetik egunera ari dira agertzen eta barreiatzen planeta osoan erresistentzia mekanismo berriak, gaixotasun infekzioso ohikoenak tratatzeko dugun gaitasuna arriskuan ipintzen dutenak. Antibiotikoek eraginkortasun galdu ahala, gero eta gehiago dira tratatzen gero eta zailagoak –eta batzuetan, ezinezkoak– diren infekzioak, hala nola pneumonia, tuberkulosia, septizemia, gonorrea edo elikagaien bidez transmititzen diren gaixotasunak.

Antibiotikoak errezetarik gabe gizakiekin edo abereekin erabiltzeko eros litezkeen lekuetan okertzen ari da farmakorresistentziaren agerpena eta zabalkundea. Zuzentarau terapeutiko normalizaturik ez duten herrialdeetan, osasuneko eta albaitaritzako langileek gehiegitan preskribatzeko joera izaten dute –eta herritarrek, oro har, haiek hartzekoa–.

Neurriak lehenbailehen hartzen ez badira, munduak aurre egin beharko dio antibiotikoen ondorengo aro bati, non infekzio arruntak eta lesio txikiak hilgarriak izan ahalko baitira berriro ere. Ikus dezagun arazoaren adibide zehatz bat, eta har litezkeen neurriak.

Kanpilobakteriosia, gehienetan, Campylobacter bakterioarekin kutsatutako oilasko okela kontsumitzeagatik gertatzen da; Europako elikadura intoxikazio ohikoena da, 2019an 220.682 kasu erregistratu ziren, eta 2.400 milioi euroko kostua du urtean.

Gaur egungo kontrol neurriak antibiotikoen erabilpenean oinarritzen dira nagusiki; eta horrek Campylobacter anduiak barreiatzea dakar. Antibiotikoekin ez bada, ba ote dago bakterio horri aurre egiteko beste modurik?

Merkatuan badaude jada hainbat produktu fagoak oinarritzat dituztenak; izaki horiek bakterio itu jakin batzuk infektatu eta suntsitu egiten dituzte; esate baterako, Listeria monocytogenes, Escherichia coli eta Salmonella elikagai-patogenoak. Hala ere, oraindik ez dago produktu espezifikorik Campylobacter-ari aurre egiteko.

C-SNIPER (frankotiratzaile da ingelesez sniper) proiektuaren buruan ari da AZTI, eta hutsune hori beteko duen produktu bat lantzen ari dira. Fagoez baliatzen den arintze estrategia baten bitartez, ekimen horrek Campylobacteraren presentzia gutxitu egingo luke etxeko hegaztien haztegietan, hiltegietan eta prozesamendu instalazioetan. Gainera, Campylobacteraren aurkako tresna hori aise txertatu ahalko litzateke ekoizpenerako eta prozesaketarako jada ezarrita dauden higiene protokoloetan.

Antibiotikoentzako alternatiba bat da, eta guztiz espezifikoa denez bakterio genero bakar baten (Campylobactera) aurka, kaltegabea da landareentzat eta animalientzat, gizakiak barne, bai eta inguruko mikrobiota natural guztiarentzat. Gainera, konponbide horri esker errazagoa litzateke patogeno horren zabalkundea kontrolatzea azken produktuaren itxuran eta kalitatean kalterik egin gabe.

Fagoen espezifikotasuna gorabehera, C-SNIPER proiektuak beren-beregi eta esperimentalki aztertzen du konponbide horrek animaliaren hazkundean, osasunean eta ongizatean duen eragin orokorra. Horretarako, azterlanak egiten ari dira desorekak bazterresteko hegaztien hesteetako floran, eta tratamenduaren ondorengo bakteriofagoekiko erresistentziak. Hala, ebidentzia zientifiko berriak gehituta, proiektua lagungarria izango da bakteriofagoen erabilpenari buruzko erregulazioa finkatzeko; izan ere, AEBek, Kanadak eta Suitzak, adibidez, bakteriofagoak elikagaietan erabiltzea onetsi badute ere, Europar Batasunean oraingoz ez dago berariazko erregulaziorik horretaz.

(AZTI teknologia-zentroaren bideoa ingelesez, azpitituluak gaztelaniaz)

Egileaz:Cesár Tomé López (@EDocet) zientzia dibulgatzailea da eta Mapping Ignorance eta Cuaderno de Cultura Cientifica blogen editorea.

Itzulpena: UPV/EHUko Euskara Zerbitzua.

The post Tokian tokiko jarduera: bakteriofagoak bakterio erresistentziaren aurka appeared first on Zientzia Kaiera.

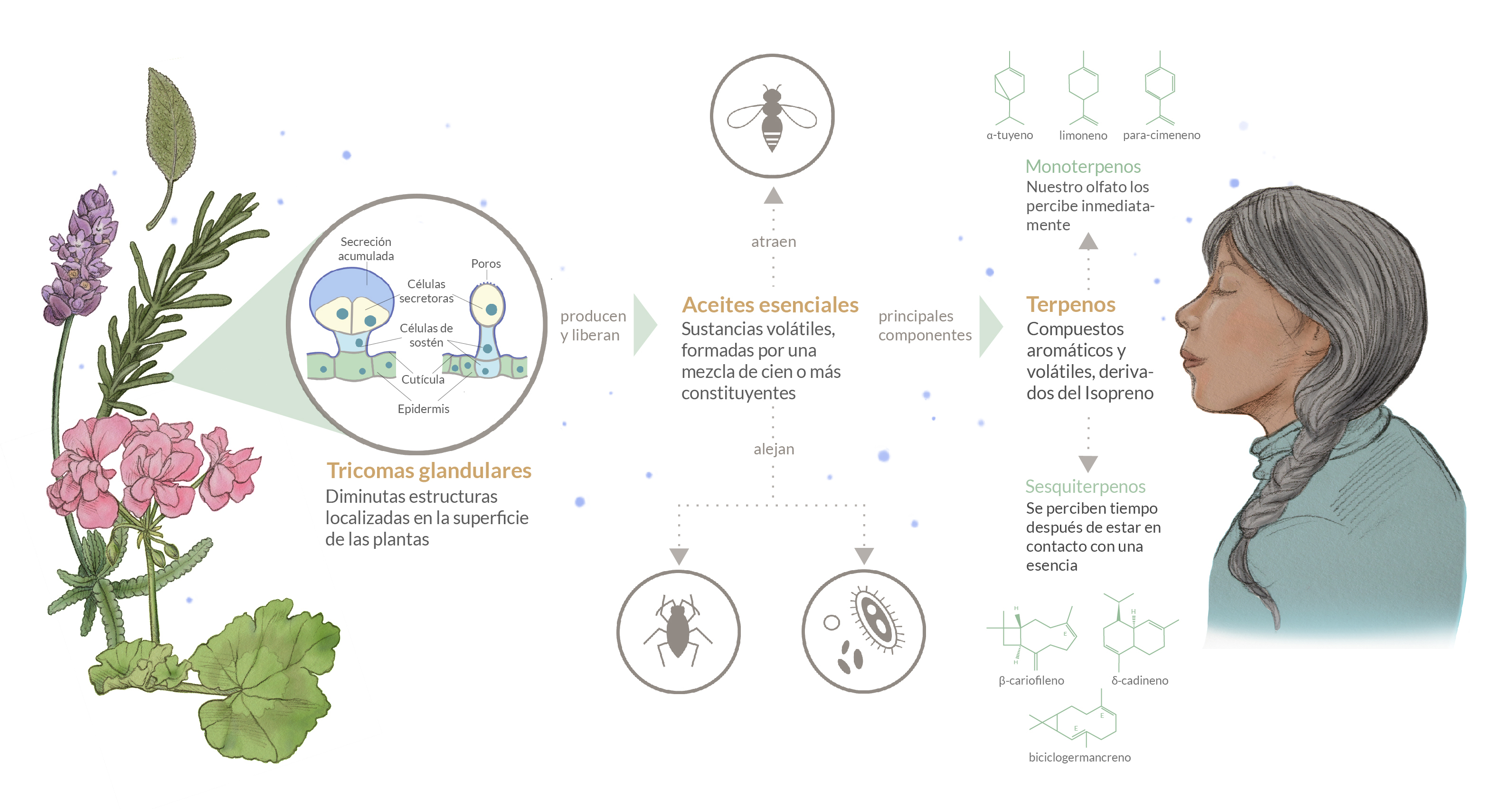

Aceites esenciales en las plantas: función y composición

Los aceites esenciales producidos por las plantas desempeñan un papel importante para su

supervivencia y desarrollo. Estas esencias funcionan principalmente como protección, y

están formadas por una mezcla de compuestos que se acumulan en estructuras especiales.

¿Quién no ha sido cautivado por el aroma del jazmín, la lavanda o el romero? Las plantas

producen y liberan sustancias volátiles (que se evaporan fácilmente), llamadas aceites

esenciales. Las podemos encontrar en las flores, hojas, yemas, tallos, semillas, raíces y

corteza de los vegetales. Algunos científicos consideran que estas sustancias forman parte

del sistema inmunológico de la plantas, ya que envían mensajes químicos que contribuyen a

protegerlas. Esto lo consiguen al repeler y envenenar depredadores y plagas, tales como

virus, bacterias, microbios e insectos; aunque en otros casos pueden servir para atraer

animales beneficiosos, como los polinizadores.

Imagen: Las esencias de las plantas. Representación de tricomas glandulares de las plantas liberando aceites esenciales, su función y composición. (Ilustración: Susana García Espinosa)

Imagen: Las esencias de las plantas. Representación de tricomas glandulares de las plantas liberando aceites esenciales, su función y composición. (Ilustración: Susana García Espinosa)Muchos de los aceites esenciales de las plantas se producen y almacenan en diminutas

estructuras llamadas tricomas glandulares. Estas se localizan en la superficie de la planta y

usualmente al romperse, como cuando rozamos las hojas de una planta de lavanda, o debido

a que poseen una cutícula (capa protectora más externa de las plantas) porosa, es cuando se

liberan las esencias al medio.

Su composición química es bastante compleja. Los aceites esenciales pueden contener una

mezcla de cien o más constituyentes, principalmente hidrocarburos terpénicos (compuestos

orgánicos volátiles y aromáticos, derivados de un hidrocarburo llamado Isopreno), como

los monoterpenos y los sesquiterpenos.

Los monoterpenos son las moléculas más abundantes en estos aceites, y son las de mayor

volatilidad. Al oler una esencia, estas serían los primeros que percibiríamos. En el mundo de

la perfumería se las conoce como notas de entrada de un perfume. Por otra parte, los

sesquiterpernos son de mayor peso molecular y por tanto, menos volátiles. Son los aromas

que se perciben tiempo después de estar en contacto con una esencia, en perfumería son las

llamadas notas de salida o fondo.

Gracias a la composición de los aceites esenciales muchas plantas pueden protegerse de

diversos factores dañinos. Afortunadamente para nuestros sentidos, esto no es más que una

placentera experiencia.

Referencias consultadas:

Butnariu, M., Sarac, I. (2018). Essential Oils from Plants. Journal of Biotechnology and Biomedical Science, 1(4), 35-43. DOI: 10.14302/issn.2576-6694.jbbs-18-2489

Amrani Joutei Khalid, Hazzoumi Zakaria, Moustakime Youssef, (2018). Essential Oil and Glandular Hairs: Diversity and Roles. IntechOpen. DOI: 10.5772/intechopen.86571

Autora: Susana García Espinosa (IG @g.espinosa.art), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2019/20

Artículo original: El alma de las plantas, las esencias de las aromáticas. Emilio Lizarraga, Cuaderno de Cultura Científica, 10 de febrero de 2019.

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo Aceites esenciales en las plantas: función y composición se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Kakalardo nekazarien lan isilak milioika urte ditu

Elikatzeko onddoak lantzen dituzten kakalardoak badira. Anbarean harrapatutako fosilak aztertu ondoren, ikertzaile talde batek ondorioztatuta du harreman hori uste baino zaharragoa izan daitekeela, eta duela 100 milioi urte hasi zela.

Gutxitan erreparatzen diegu kakalardoei, baina zenbait espeziek portaera guztiz bitxiak dituzte, batez ere haien ondorengoak babestu behar dituztenean. Portaeren artean, agian ezagunena kakalardo pilotagileena da. Intsektu horiek gorotzak bilatzen dituzte, eta, horiekin pilotak sortzen dituzte, bertan arrautzak jarri eta, larbak jaiotzean, jatekorik izan dezaten. Antzeko zerbait egiten dute kakalardo sarraskijaleek. Kasu honetan, gorotza beharrean, hilik aurkitutako animalien gorpuak baliatzen dituzte, horiek lurperatuz, haien larbek bazka egokia izan dezaten. Animalien hondarrak handiegiak direnean, lurperatu beharrean, zerraldoetan edo inguruetan arrautzak jartzen dituzte. Entomologo forentseek ederki dakiten moduan, gainera, kakalardoak ez dira horrelako gauzak egiten dituzten intsektu bakarrak.

1. irudia: Scolytinae azpifamiliako kakalardoak enborretan bizi dira, eta espezie batzuk onddoak lantzen dituzte. Irudian Dendroctonus micans kakalardoa. (Argazkia: Gilles San Martin CC-BY-SA-3.0)

1. irudia: Scolytinae azpifamiliako kakalardoak enborretan bizi dira, eta espezie batzuk onddoak lantzen dituzte. Irudian Dendroctonus micans kakalardoa. (Argazkia: Gilles San Martin CC-BY-SA-3.0)Portaera bitxien katalogoan, baina, bada oinarrizko planteamenduan bederen gugandik askoz gertuago egon daitekeen beste bat: kakalardo espezie batzuk onddoak lantzen dituzte; hortaz, zentzu batean, esan liteke beraiek ere, gizakiok bezala, nekazariak direla. Anbrosia izeneko onddoak (Fusarium generoa) lantzen dituztenez, kakalardo hauek anbrosia kakalardo gisa ezagunak dira (teknikoki, Scolytinae eta Platypodinae azpifamilietan biltzen dira intsektu hauek).

Elkarlanaren abiapuntua sinplea da: kakalardoek zuhaitzetako enborrak zulatzen dituzte, bertan arrautzak jarri eta babestutako ingurune egokia izateko. Hobia zulatzean, anbrosia onddoaren esporak zabaltzen dituzte. Onddo horiek izango dira helduen zein kakalardo larben bazka. Hori ez ezik, behin nagusitzen direla eta etxetik alde egiteko unea iristen zaienean, heldu berriek beraiekin eramango dituzte onddoen esporak, haien enbor berriaren barruan ereiteko. Kakalardoak ez dira ogibide honetan trebatuta dauden intsektu bakarrak: termita, labezomorro eta inurri espezie batzuk ere onddoak lantzen dituzte.

Prozesua ezagutzen bada, oraindik badira hutsune asko intsektu hauen ezagutzan. Haien jardun gehiena zuhaitzen barruan egiten dutenez, ez da erraza haien portaera aztertzea. Haien zuhaitz barruko bizipenez lortu diren datu apurrek, halere, erakusten dute hein batean portaera soziala ere badutela.

Bada, kakalardoen kasuan, harreman sinbiotiko hau uste baino zaharragoa izan daitekeela proposatu dute Bartzelonako eta Bergengo (Norvegia) Unibertsitateetako ikertzaileek Biological Reviews aldizkarian.

Orain arte, zientzialariek kalkulatu dute kakalardoen eta onddoen arteko harremana duela 50 milioi urte hasi zela. Horretarako, baina, ikerketa filogenetikoetan oinarritu dira. Hau da, biziaren zuhaitzean atzera jo dute, espezie batetik bestera zer puntutan desberdintzen diren kalkulatuz, eta, horren arabera, denbora estimazioak egin dituzte. Beste zenbait ikerketek are atzerago jo dute, harreman sinbiotiko hori duela 86 milioi urte hasi zela proposatuz.

2. irudia: Erregistro fosilera jo dute harremana noiz hasi zen argitzeko. Argazkian, egurra zulatzen zuen intsektu baten fosila, Myanmarren aurkitutako anbar batean kontserbatuta. (Argazkia: Peris et al.)

2. irudia: Erregistro fosilera jo dute harremana noiz hasi zen argitzeko. Argazkian, egurra zulatzen zuen intsektu baten fosila, Myanmarren aurkitutako anbar batean kontserbatuta. (Argazkia: Peris et al.)Orain, ikertzaile hauek proposatu dute harremana duela 100 milioi urte hasi zela. Argudiatu dutenez, Kretazeoan bazen harreman mota hori onddoen eta intsektu batzuen artean, baina, orain arte, lotura hori igarri ez dela argudiatu dute.

Ondorio horretara iristeko, erregistro paleontologikora jo dute. Kretazeoan datatutako anbaretan harrapatuta geratu diren fosilak aztertu dituzte, eta konturatu dira anbrosia onddoak gaur egun nekazaritza jardun horretan aritzen diren kakalardo motak baino zaharragoak direla. Horregatik, sinetsita daude garai horietan bestelako intsektu batzuk izango zirela onddo horiek zabaltzea ahalbidetzen zutenak.

Aurreko beste hainbat ikerketatan ikusi izan dute badirela anbrosiaren kakalardoaren antzeko portaerak dituzten beste koleopteroak (batez ere, Lymexylidae familiakoak). Horiek zaharragoak dira erregistro fosilean. Egileen irudikoz, horiek izan daitezke iragan urrun horretan onddoak landu zituztenak.

Ikertzaileek egin duten azalpenaren arabera, Kretazeoan onddo zein egurraz elikatzen ziren kakalardo ugari bizi ziren, eta horrek ahalbidetu zuen intsektuek esporak enbor batetik bestera garraiatu izana. Denborarekin, “bientzako onuragarri zen harreman hori eboluzionatu zen, intimoagoa zen sinbiosi mota batera”, azaldu dute egileek prentsa ohar batean. Horrela, eta beti ere eboluzioari lotutako hizkera erabilita, kakalardoek onddo horiek etxekotu zituzten.

Ikerketa honen interesa ez da zientziaren alorreko jakin-mina asetzera mugatzen. Izan ere, kakalardo hauek baso eta zuhaitz sail ugaritan izurriteak sortzen dituzte, eta, horregatik, premiazkoa da bizidun hauen portaera ondo ulertzea, ekosistemetan eta jardun ekonomikoetan sortzen diren galerak gutxitu aldera. Baina, horretaz gain, enbor baten barruan garatzen den jardun ikusezin hori azaleraztea ere soberako arrazoia da gehiago ikasteko.

Erreferentzia bibliografikoa:Peris, D., Delclos, X. and Jordal, B. (2021). Origin and evolution of fungus farming in wood-boring Coleoptera – a palaeontological perspective. Biological Reviews. DOI: https://doi.org/10.1111/brv.12763

Egileaz:Juanma Gallego (@juanmagallego) zientzia kazetaria da.

The post Kakalardo nekazarien lan isilak milioika urte ditu appeared first on Zientzia Kaiera.

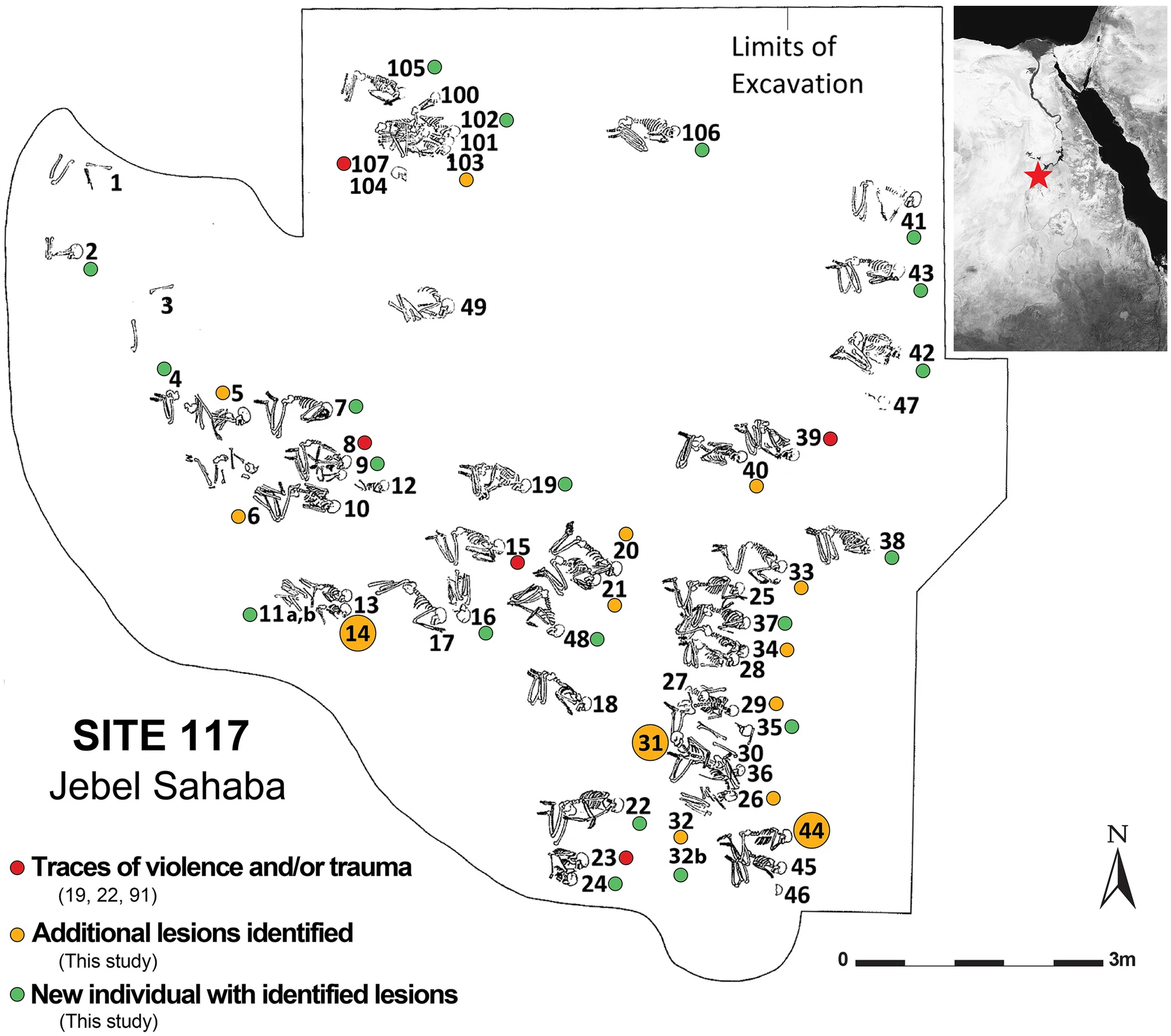

Escaramuzas, emboscadas, razias escritas en huesos

El complejo funerario más antiguo del Valle del Nilo es el cementerio de Jebel Sahaba, de hace entre 13400 y 18600 años. Los primeros análisis de los esqueletos, de hace seis décadas, mostraban rastros de violencia en los huesos de, al menos, la mitad de los individuos enterrados allí. En las tumbas había también artefactos de piedra característicos de la cultura Qadan; estaban en el espacio que en los cuerpos habían ocupado los tejidos blandos y, en ocasiones, incrustados en los mismos huesos. Por su posición no eran objetos funerarios; además, los individuos enterrados no pertenecían a la cultura Qadan, sino a otra.

El cementerio de Jebel Sahaba se excavó por primera vez en los años sesenta del siglo pasado y ha sido considerado un testimonio de violencia y guerra organizada. Han vuelto a examinar los restos del enterramiento de forma reciente, y de ese nuevo análisis han extraído consecuencias interesantes.

Han confirmado que las lesiones identificadas tuvieron su origen en episodios de violencia interpersonal y que la mayor parte fueron producidas por proyectiles. Aproximadamente, una cuarta parte de los individuos presentaban signos de traumas sufridos poco antes de morir, y casi dos terceras partes los mostraban de traumas anteriores, curados o sin curar, con independencia del sexo o de la edad que tenían en el momento de fallecer, incluidos niños de edades tan tempranas como cuatro años. Por otro lado, los objetos de piedra asociados a cada fosa habían formado parte de algún proyectil (flechas o lanzas). Esas observaciones sugieren que las agresiones no se habían producido entre miembros del grupo o dentro de las familias, sino que fueron ocasionadas por ataques producidos por otros grupos humanos.

Aunque algunas de las fosas eran dobles o múltiples y, por tanto, los sujetos enterrados en ellas habían muerto probablemente a la vez, los datos demográficos y la alteración causada posteriormente por nuevos enterramientos sugieren que el cementerio no contiene los restos humanos de un único episodio bélico. No cabe excluir la posibilidad de que Jebel Sahaba fuese un lugar de enterramiento de víctimas de violencia, pero la abundancia de heridas curadas indica que los individuos enterrados sufrieron agresiones de forma repetida; y la reutilización del espacio funerario apoya la idea de que hubo episodios repetidos de violencia interpersonal esporádica. Además, las heridas se habían producido tanto en la parte anterior como en la posterior del cuerpo, por lo que no parece probable que tuvieran su origen en enfrentamientos cara a cara entre dos grupos. Por todo ello, lo más probable es que la mayor parte fuesen consecuencia de escaramuzas, razias o emboscadas.

Los objetos hallados en el Valle del Nilo en el periodo del final del Pleistoceno y comienzo del Holoceno dan cuenta de la coexistencia en la zona de diferentes tradiciones culturales, lo que sugiere que se había producido una cierta fragmentación y aislamiento de los grupos humanos. Además, la existencia de grandes enterramientos indica que se había desarrollado un cierto grado de sedentarismo y es muy probable que hubiese una fuerte competencia entre grupos que vivían de la caza, la pesca y la recolección, cuando tuvieron que hacer frente a los cambios ambientales que se produjeron al final del Último Máximo Glacial (hace unos 20000 años) y el comienzo del Periodo Húmedo Africano (hace entre 16000 y 6000 años).

Los episodios repetidos de violencia entre grupos culturalmente diferenciados habrían sido consecuencia directa de esa fuerte competencia motivada por los cambios ambientales habidos durante ese periodo. Ocurrieron hace unos 15000 años, pero, bajo diferentes formas y a diferente escala, no han dejado de ocurrir.

Fuente: Crevecoeur, I., Dias-Meirinho, MH., Zazzo, A. et al. New insights on interpersonal violence in the Late Pleistocene based on the Nile valley cemetery of Jebel Sahaba. Sci Rep 11, 9991 (2021).

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Escaramuzas, emboscadas, razias escritas en huesos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La Sima de los Huesos sería el primer acto funerario conocido de la historia de la Humanidad

- Exposición en Bilbao: Hezurretan idatzia / Escrito en los huesos

- ¿De qué se muere la gente en el mundo?

Orgullo en ciencia: Un PRISMA para hacer la ciencia más diversa

La ciencia es algo más que un sofisticado producto cultural. De hecho, se trata de una herramienta al servicio del bienestar de las personas y debe contribuir a la mejora de la sociedad en su conjunto.

Como ocurre a menudo en tantos ámbitos, también en el científico, quienes forman parte de alguno de los colectivos a los que, de forma genérica, denominamos LGBTIQ, sufren con frecuencia situaciones injustas en su día a día. Muchas de esas personas son objeto de exclusión y acoso en sus centros en mayor medida que las demás. Y se atribuye a motivos similares el que las y los estudiantes de carreras científicas pertenecientes a las minorías citadas abandonen sus estudios en una mayor proporción que el resto. Estas situaciones no son solo injustas per se, sino que, además, comprometen el carácter universal de la ciencia, puesto que no todas las personas gozan de las mismas oportunidades y condiciones para practicarla.

Por otro lado, la ciencia y su comunicación social tienen mucho que aportar a la hora de resolver problemas específicos de estos colectivos, como, por ejemplo, aquellos relacionados con la salud. Esto exige partir del reconocimiento real de la diversidad y la diferencia, y rechazar preconcepciones ancladas en un binarismo poco respetuoso con la diversidad de sexo, género y opción sexual.

Por estas razones, la asociación LGBT Ortzadar, la Cátedra de Cultura Científica y la Dirección de Igualdad de la UPV/EHU sumaron fuerzas para organizar el evento “Orgullo en ciencia”, una jornada sobre diversidad sexual y de género en el ámbito científico. La jornada, enmarcada dentro del programa Bilbao Bizkaia HARRO, tuvo lugar en Bizkaia Aretoa– UPV/EHU (Bilbao) el paso 29 de junio de 20210.

En “Un PRISMA para hacer la ciencia más diversa” Javier Armentia expone la labor que se realiza en investigación sobre distintas realidades afectivo-sexuales en el ámbito de las ciencias, las tecnologías y las matemática sdesde la asociación PRISMA.

Javier Armentia es astrofísico, director del Planetario de Pamplona (Pamplonetario) y miembro fundador de PRISMA.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Orgullo en ciencia: Un PRISMA para hacer la ciencia más diversa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Orgullo en ciencia: Pío del Río Hortega, un científico en el armario. ¿A quién le importa?

- Lo verdaderamente divertido es hacer Ciencia

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

Ezjakintasunaren kartografia #360

Animalia sozialentzat gosearen antza du bakardadeak. Hungry lonely brains Rosa García-Verdugorena.

Aurreikusi daitekeen etorkizuneko gutxienez bi arazoren (klima-aldaketa eta ur edangarria), irtenbide osagai komuna dute: basoak Reforesting Europe would increase rainfall Elizabeth Lewis, Edouard Davin eta Ronny Meier.

Konposatu organikoetan oinarritutako etorkizuneko elektronikaren bidean, konposatuak bezain garrantzitsuak dira egingarriak diren sintesi prozesuak. DIPC-k: On-surface synthesis of triply linked porphyrin nanotapes

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #360 appeared first on Zientzia Kaiera.

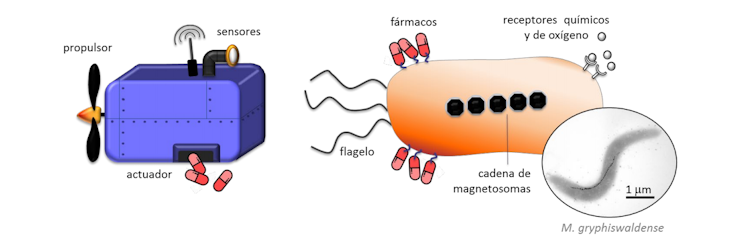

Bacterias magnetotácticas: nanorrobots de origen biológico en la lucha contra el cáncer

Lucía Gandarias y Lourdes Marcano

Imagen de microscopía electrónica de transmisión de la especie M. gryphiswaldense.

Imagen de microscopía electrónica de transmisión de la especie M. gryphiswaldense.Wikimedia Commons / Caulobacter subvibrioides, CC BY-SA

De acuerdo con los datos de la Organización Mundial de la Salud, el cáncer es la segunda causa de muerte más común en el mundo, con una tasa de mortalidad superior al 50 %. Su magnitud es tal que, de no considerarse estrategias alternativas, se prevé que el diagnóstico de nuevos casos anuales en Europa pase de los 3,5 millones actuales a más 4,3 millones en 2035.

Los tratamientos habituales para combatir esta enfermedad se basan en la combinación de cirugía, con la que se consigue eliminar el grueso del tumor, y radio y quimioterapia, utilizadas para atacar a las células cancerosas que persisten en el tejido tumoral. Estas terapias conllevan efectos colaterales que en muchas ocasiones perjudican la vida de los pacientes. Existe así la necesidad de explorar nuevas rutas para la lucha contra el cáncer, las cuales implican en la mayoría de los casos el uso de nanotecnología.

Es aquí donde se abre la puerta a la imaginación.

Los argumentos más extravagantes de películas de ciencia ficción pueden servir como inspiración para el desarrollo de nuevas estrategias de diagnóstico y tratamiento de enfermedades. Ya en los años 60 la película Viaje alucinante narraba la historia de una tripulación multidisciplinar que se embarca a bordo de un submarino micrométrico para salvar al protagonista del hematoma cerebral que le mantiene en coma. Pero, ¿es esto solo ciencia ficción?

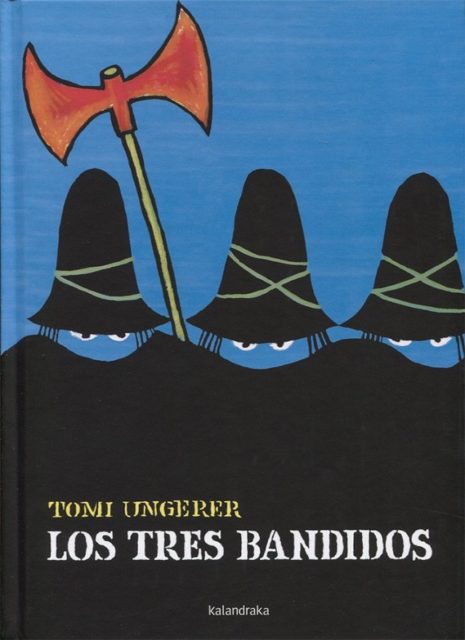

Cartel de la película Viaje alucinante (Richard Fleischer, 1966), inspirada en la novela del mismo título de Isaac Asimov.