Magnetosomas para el tratamiento del cáncer

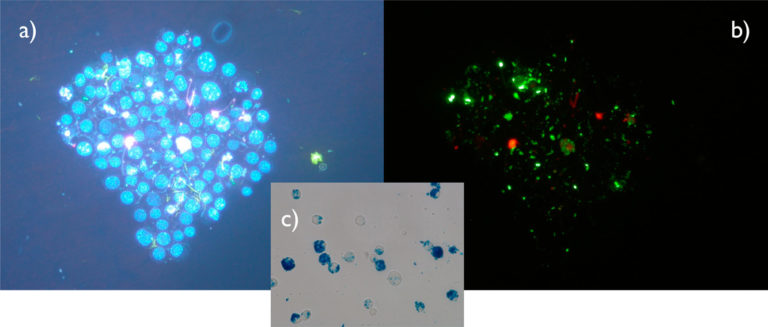

Magnetosomas internalizados por macrófagos, bajo diferentes filtros. Fuente: A. Muela et al (2016)

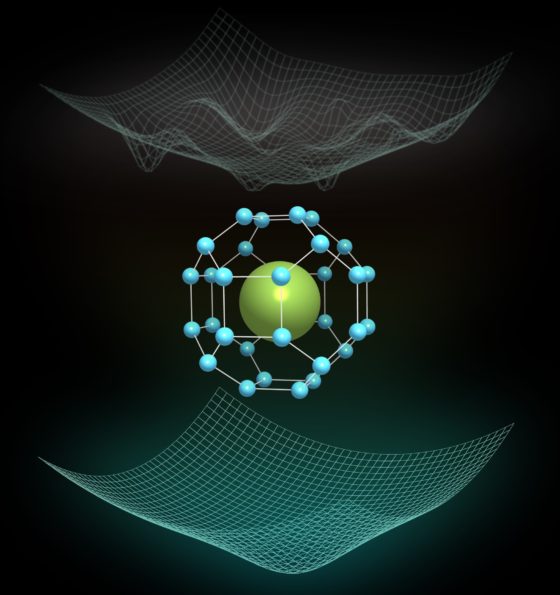

Magnetosomas internalizados por macrófagos, bajo diferentes filtros. Fuente: A. Muela et al (2016)Las nanopartículas magnéticas han permitido en los últimos años explorar modos de actuación alternativos a las terapias actualmente en uso en la lucha contra el cáncer. Una ventaja notable de las nanopartículas magnéticas es que pueden emplearse como agentes teranósticos (elementos que participan tanto en la terapia como en el diagnóstico) y entre los diferentes tipos destacan los magnetosomas, nanopartículas magnéticas sintetizadas por un tipo concreto de bacterias denominadas bacterias magnetotácticas.

Estos nanosistemas no solo se pueden usar en el transporte de fármacos sino que también presentan notables propiedades físicas y magnéticas para poder emplearlos en hipertermia —aumento de la temperatura corporal—, así como en el transporte guiado de fármacos. “El presente trabajo se centra en el estudio del potencial terapéutico de los magnetosomas en tratamientos de hipertermia magnética, una técnica que aprovecha la energía térmica producida por nanopartículas magnéticas bajo la acción de un campo magnético alterno para eliminar las células cancerígenas”, señala David Muñoz Rodríguez, investigador del Departamento de Inmunología, Microbiología y Parasitología de la UPV/EHU.

“Los magnetosomas, al contrario que las nanopartículas magnéticas de síntesis química, poseen de manera natural una membrana lipoproteica que los protege, evitando a la vez su aglomeración. Además, pueden funcionalizarse, es decir, ciertos fármacos o agentes antitumorales pueden adherirse a la membrana para poder guiarlos de forma eficiente hasta la masa tumoral. Las nanopartículas magnéticas emiten en forma de calor la energía que absorben del campo magnético alterno que se les aplica desde el exterior, provocando así un aumento de temperatura en los tumores y combatiéndolos”, indica Muñoz.

“Los magnetosomas presentan gran capacidad de producir calor (mayor que las nanopartículas magnéticas de síntesis química) y su eficiencia en la hipertermia queda demostrada al ver que el 80 % de las células morían en los experimentos realizados”, comenta David Muñoz. Además, “la hipertermia magnética tiene la ventaja de ser una terapia local, sin provocar efectos secundarios severos en el organismo. El campo magnético no debe aplicarse en cualquier zona del cuerpo, ni de cualquier manera: hay que aplicarlo solo a la zona afectada por el tumor, alcanzando una temperatura que oscile entre los 43 y 46 ºC ,ya que en este intervalo de temperatura las células entran en lo que se llama apoptosis —muerte celular programada—. Hemos demostrado que la hipertermia magnética usando magnetosomas proporciona un aumento de temperatura suficiente para reducir la viabilidad celular de forma estadísticamente significativa, induciendo a las células a que entren en apoptosis y mueran”, subraya el autor del trabajo.

El investigador ha destacado que «el uso de magnetosomas en este tipo de terapias podría tener un futuro prometedor y ser una alternativa válida a los tratamientos antitumorales convencionales”. Sin embargo, Muñoz afirma que “sería fundamental conocer la distribución de dichas partículas magnéticas en el organismo. Es decir, una vez han actuado, ¿dónde van a parar? Algunos estudios señalan que el propio organismo podría metabolizar los magnetosomas; otros dicen que suelen acumularse en órganos como el hígado, riñón, el bazo… Ahí está el hándicap”.

Referencias:

Muela, A.; Muñoz, D.; Martín-Rodríguez, R.; Orue, I.; Garaio, E.; Abad Díaz de Cerio, A.; Alonso, J.; García, J. Á.; Fdez-Gubieda, M. L. Optimal Parameters for Hyperthermia Treatment Using Biomineralized Magnetite Nanoparticles: Theoretical and Experimental Approach. (2016) J. Phys. Chem. C, 120, 24437– 24448, doi: 10.1021/acs.jpcc.6b07321

Huizar-Felix, A. M.; Munoz, D.; Orue, I.; Magen, C.; Ibarra, A.; Barandiaran, J. M.; Muela, A.; Fdez-Gubieda, M. L. Assemblies of magnetite nanoparticles extracted from magnetotactic bacteria: A magnetic study. (2016) Appl. Phys. Lett. , 108, 063109, doi: 10.1063/1.4941835

Lourdes Marcano, David Muñoz, Rosa Martín-Rodríguez, Iñaki Orue, Javier Alonso, Ana García-Prieto, Aida Serrano, Sergio Valencia, Radu Abrudan, Luis Fernández Barquín, Alfredo García-Arribas, Alicia Muela, and M. Luisa Fdez-Gubieda (2018) Magnetic Study of Co-Doped Magnetosome Chains The Journal of Physical Chemistry C 122 (13), 7541-7550 doi: 10.1021/acs.jpcc.8b01187

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Magnetosomas para el tratamiento del cáncer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lo mejor de dos mundos para avanzar en el tratamiento del cáncer

- Implante de factores de crecimiento en nanoesferas para el tratamiento de alzhéimer y párkinson

- Nanopartículas para reducir la metástasis hepática del cáncer de colon

El genio cegado por su propia teoría

Nos situamos en 1873. James Clerk Maxwell era uno de los miembros más distinguidos de la Royal Society de Londres, ya que, unos años antes había demostrado que electricidad y magnetismo son dos caras del mismo fenómeno, y que viajan de la mano en forma de onda a la velocidad de la luz. Ese mismo año publicó su magnum opus: el Tratado de Electricidad y Magnetismo, un compendio de todo su trabajo que predecía que la luz es, de hecho, una onda electromagnética.

Pero aquel tratado predecía otro fenómeno quizás más sorprendente: al igual que una masa empuja a otra masa al chocar con ella, las ondas electromagnéticas, por el mero hecho de ser ondas que transportan energía, serían capaces de transmitir movimiento al incidir en un objeto, de empujarlo. No en vano, hoy en día sabemos que este es el principio por el que funcionan las velas solares.

Por aquel entonces, William Crookes, que era químico y un gran experimentador, tenía fama por su gran habilidad creando tubos de vacío: tubos de vidrio de los que se extraía casi todo el aire con diferentes propósitos. De hecho, ha pasado a la historia por ser el creador del tubo de rayos catódicos: un tubo de vacío con dos electrodos que, años más tarde, se utilizó para descubrir los electrones y los rayos-X, e incluso sirvió para inventar el televisor.

Pero a pesar de su habilidad técnica, también tenía fama de no ser muy buen científico. O, al menos, en la Royal Society no estaba muy bien considerado, puesto que, como buen caballero victoriano, era espiritista. De hecho, durante aquel año, el buen hombre se hallaba buscando “fuerzas psíquicas”… Para ello, estaba realizando unas medidas de masa muy delicadas con talio dentro de uno de sus tubos de vacío cuando se dio cuenta de que, cuando el sol incidía en el dispositivo, las medidas salían distintas.

¿Cómo podía ser posible? Crookes lo vio claro: estaba ante una prueba empírica de la teoría de Maxwell. Esto le llevó a concebir el artilugio que conocemos como “molinillo de luz” o “radiómetro de Crookes”. Consta, cómo no, de un tubo de vacío, normalmente en forma de bombilla. En su interior hay unas aspas, con una cara negra y otra reflectante, unidas a un capuchón de vidrio que pende sobre una aguja, para evitar al máximo el rozamiento. Según Crookes, la teoría de Maxwell establece que la luz interactúa de forma diferente con la parte negra y la reflectante, lo que resulta en una fuerza neta que impulsa las aspas. Y lo cierto es que, cuando pones el molinillo a la luz… ¡las aspas giran!

Fuente: Wikimedia Commons

Fuente: Wikimedia Commons

Maxwell recibió el artículo de Crookes que describía el experimento y se quedó maravillado con la elegancia de la prueba de su propia teoría. Alabó su trabajo, perdonando su pasado espiritista, y recomendó su inmediata publicación. Se realizó una presentación del artilugio en la Royal Society por todo lo alto, y las crónicas contaron que “la ciencia había hecho un agujero en el infinito”.

Pero finalmente resultó que uno de los mayores genios científicos de la historia, cegado por su propia teoría, seducido por la supuesta elegancia de la demostración, cayó presa de su propio sesgo. Y es que la teoría electromagnética, efectivamente, establece que la luz interacciona de forma distinta con las caras de las aspas, pero más concretamente dice que la parte reflectante recibe el doble de presión que la parte negra. Y, por tanto, ¡gira al revés!, ¡debería girar para el otro lado!

Ni que decir tiene que, a partir de ese momento, empezó una carrera para investigar el verdadero funcionamiento del molinillo. Entre otras cosas, se vio que, cuando había mucho aire dentro, no giraba; cuando había demasiado poco, tampoco; cuando se enfriaba, giraba en el otro sentido… todo parecía indicar que algo tenía que ver el poco aire que quedaba dentro del tubo de vacío.

Se especuló mucho hasta que Osborne Reynolds, en 1879, dio finalmente con la solución: se trata de un fenómeno denominado transpiración térmica. Resulta que, en las condiciones del tubo de vacío, las poquitas moléculas de aire que quedan en su interior ya no interaccionan entre ellas, lo que se denomina gas enrarecido. La cara negra de las aspas se calienta más que la cara reflectante, porque absorbe la radiación, y así se calienta el aire circundante. Lo que sucede entonces es que el aire frío tiende a trepar por el borde del aspa y pasa al lado caliente, y así se produce un empuje neto hacia el otro lado.

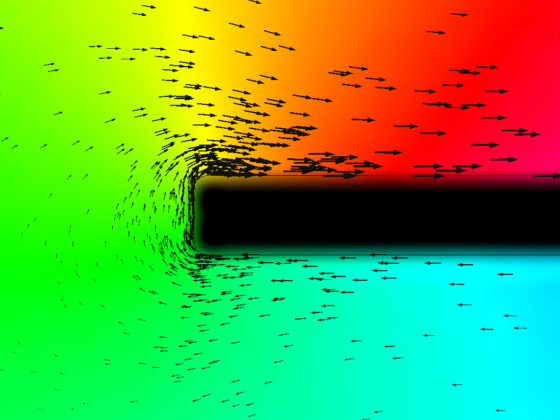

Simulación de la transpiración térmica en un molinillo de luz, por Moritz Nadler

Simulación de la transpiración térmica en un molinillo de luz, por Moritz NadlerComo epílogo, Reynolds escribió un artículo con esta explicación que revisó… Maxwell de nuevo. Pero Maxwell, quizás herido en su orgullo, decidió paralizar la publicación y escribir su propio artículo para criticar a Reynolds. Entonces Reynolds quiso publicar una crítica de la crítica de Maxwell al primer artículo suyo rechazado. Pero, entretanto, lamentablemente Maxwell murió, y de nuevo Reynolds se quedó sin publicación, esta vez por respeto al recién fallecido. Hoy en día, el molinillo es una baratija que se suele vender en tiendas de museos científicos como curiosidad.

Sobre el autor: Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute.

El artículo El genio cegado por su propia teoría se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría de la invariancia

- ¿La teoría de la invariancia es física o metafísica?

- La teoría cinética y la segunda ley de la termodinámica

La ecuación de las ciudades oscuras

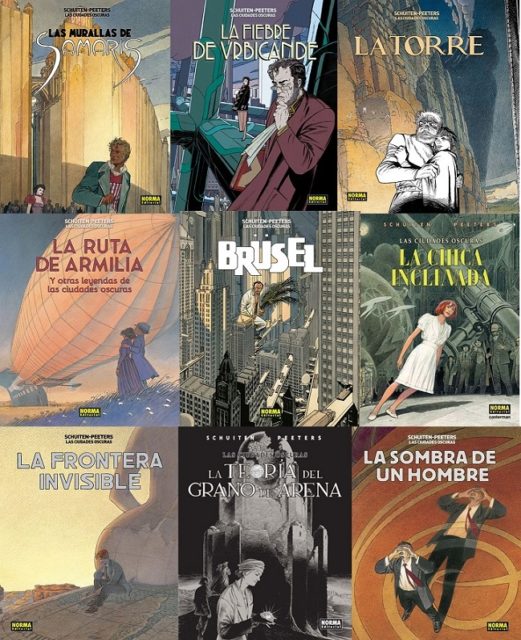

Las ciudades oscuras es una serie de novelas gráficas, publicadas originalmente en francés, del dibujante belga François Schuiten y el guionista francés Benoît Peeters, cuyo primer álbum Las murallas de Samaris fue publicado en 1983 y que sigue publicándose en la actualidad. En el momento en el que escribo estas líneas cuenta con doce álbumes: Las murallas de Samaris, La fiebre de Urbicande, La Torre, La ruta de Armilia, Brüsel, La chica inclinada, La sombra de un hombre, La Frontera Invisible (doble), La teoría del grano de arena (doble), Recuerdos del eterno presente.

En la colección de novelas gráficas Las ciudades oscuras nos encontramos ante una serie de historias entre fantásticas y surrealistas que transcurren en diferentes ciudades de un continente imaginario que se encuentra situado en el planeta Antichton, o Anti-Tierra. Este hipotético planeta fue inventado por el filósofo y matemático pitagórico Filolao (aprox. 470 – 380 a.n.e.) cuando describió un sistema cosmológico, no geocéntrico, en el que había un fuego central distinto del Sol y un planeta situado en la posición diametralmente opuesta a la Tierra, respecto a dicho fuego central, la anti-Tierra.

La arquitectura y el diseño urbanístico de las ciudades oscuras son protagonistas principales de esta serie de novelas gráficas, pero también la política, la sociedad, la ciencia, las creencias o las relaciones humanas., entre muchos otros

Nueve portadas de la serie de novelas gráficas Las ciudades oscuras de François Schuiten (dibujo) y (Benoît Peters), publicadas por Norma Editorial. Imágenes de la página web de Norma Editorial

Nueve portadas de la serie de novelas gráficas Las ciudades oscuras de François Schuiten (dibujo) y (Benoît Peters), publicadas por Norma Editorial. Imágenes de la página web de Norma EditorialEn esta entrada del Cuaderno de Cultura Científica vamos a centrarnos en uno de los álbumes de la serie titulado La fiebre de Urbicande (1985). El protagonista de esta historia es Eugen Robick, el “urbatecto” (unión de urbanista y arquitecto) oficial de la ciudad de Urbicande, que está preocupado por el diseño urbanístico de la ciudad y su falta de simetría. La ciudad de Urbicande está dividida por su río en dos zonas. La zona sur, en la que vive la alta sociedad, sería una ciudad geométrica, con avenidas rectas, que se intersecan perpendicularmente, sobre la que se han diseñado, de forma racional, edificios rectos y simétricos, mientras que la zona norte, en la que vive la parte de la sociedad que la clase alta quiere mantener alejada, posee un desarrollo urbanístico irregular.

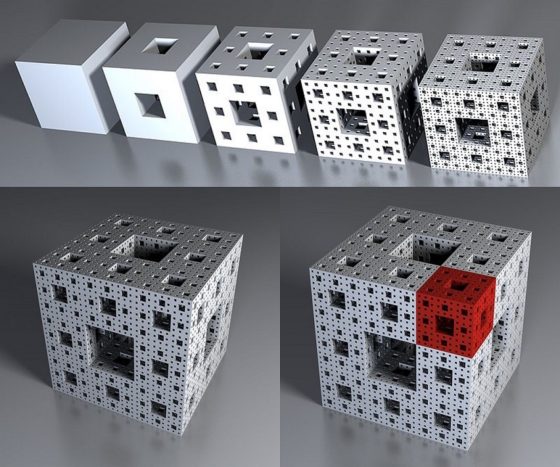

Sin embargo, un inesperado acontecimiento cambiará las preocupaciones de Eugen Robick y de los habitantes de la ciudad de Urbicande, la aparición de un misterioso cubo encontrado en unas obras y que se convertirá en el desencadenante de los acontecimientos futuros de la ciudad.

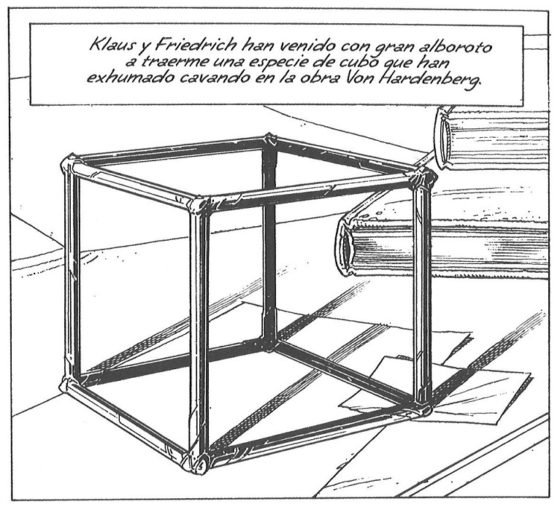

Viñeta de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en el cual vemos el cubo que se convertirá en protagonista de esta historia

Viñeta de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en el cual vemos el cubo que se convertirá en protagonista de esta historia

Aparentemente el cubo no posee un gran interés, salvo que está construido con un material extremadamente duro. El urbatecto Eugen Robick lo describe así en las primeras páginas.

“Klaus y Friedrich han venido con gran alboroto a traerme una especie de cubo que han exhumado cavando en la obra Von Hardenberg.

El objeto habría quebrado la pala de una grúa, debido a su gran solidez.

Al observarla fríamente, no tiene sin embargo nada de demasiado extraño. Es una simple estructura cúbica totalmente vacía cuyas aristas no deben de superar los quince centímetros.”

Lo curioso es que, poco tiempo después, del cubo han surgido unas prolongaciones que extendían los lados del mismo, con un crecimiento constante, hasta generar un nuevo cubo en cada una de las caras del hexaedro regular original. De forma que en esta primera etapa se ha creado una pequeña red con 7 cubos. Además, al tiempo que iba ocurriendo esto, el tamaño del cubo original ha ido creciendo también, así en un día el tamaño de las aristas del cubo, de los cubos, ha pasado de 15 a 20 centímetros. El grosor de las aristas también ha ido creciendo paulatinamente.

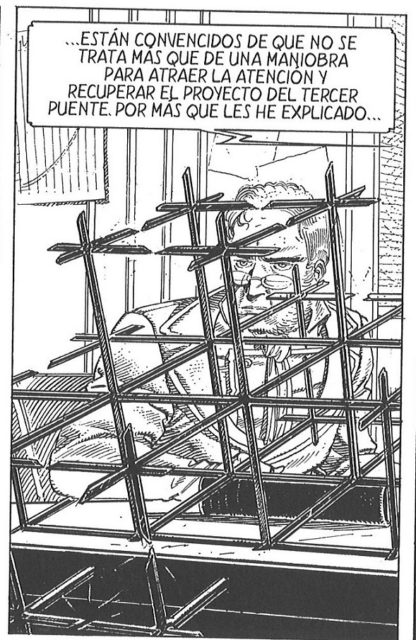

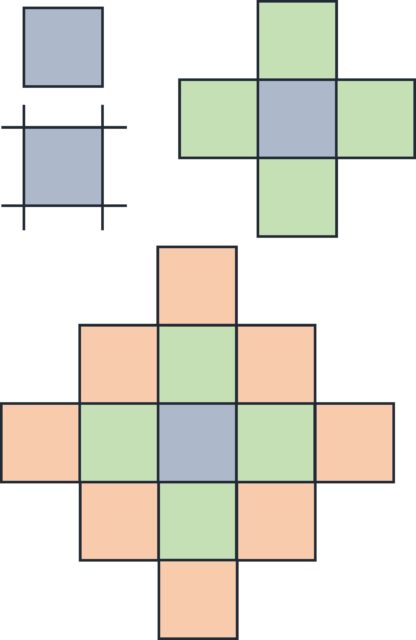

Viñeta de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en el cual vemos el momento en que se está terminando la primera etapa de desarrollo del cubo original, convirtiéndose en una pequeña red de 7 cubos, el central y uno en cada cara del mismo

Viñeta de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en el cual vemos el momento en que se está terminando la primera etapa de desarrollo del cubo original, convirtiéndose en una pequeña red de 7 cubos, el central y uno en cada cara del mismo

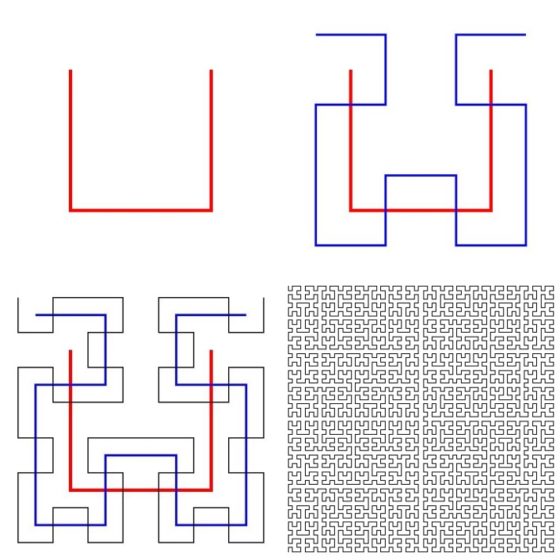

Como el proceso no para, la red de cubos va creciendo poco a poco, en tamaño y en número de ortoedros que lo conforman. En la siguiente etapa de crecimiento, en cada cara de los cubos que forman la red surgen nuevos cubos, luego de 7 cubos pasa a 25. Y en la siguiente etapa, la red de cubos, que tendrá la forma de un octaedro (es decir, una doble pirámide, hacia arriba y hacia abajo), estará formada por 63 cubos. Después, 129, 231, etcétera.

Viñetas de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en las cuales vemos al urbatecto Robick estudiar la estructura y calcular el número de cubos que tendrá en cada etapa de crecimiento

Viñetas de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en las cuales vemos al urbatecto Robick estudiar la estructura y calcular el número de cubos que tendrá en cada etapa de crecimiento

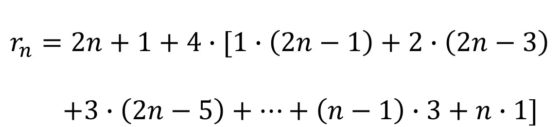

Eugen Robick, que era matemático de formación según se comenta en la parte de La leyenda de la red, empieza a estudiar la estructura reticular que se genera. En particular, obtiene una fórmula, que veremos más adelante, que le da el número de cubos que tendrá la estructura en cada paso. Pero estudiemos nosotros esa sucesión de números que nos da la cantidad de cubos que posee la red octaédrica que aparece en la novela gráfica.

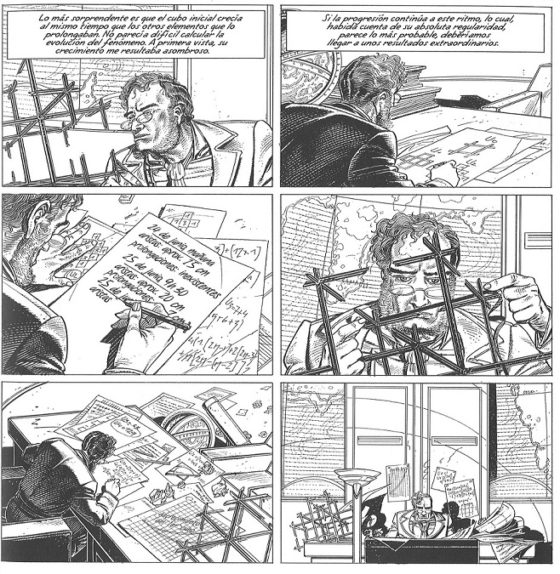

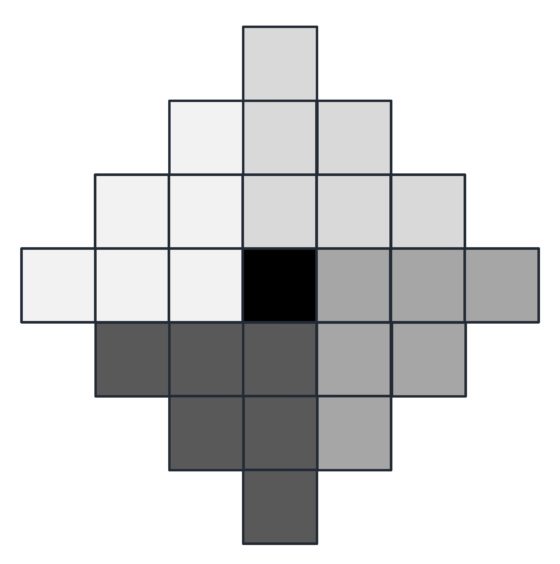

Empecemos pensando el problema en dimensión 2. Supongamos que nuestra estructura original es un cuadrado, que va creciendo y formando una red de cuadrados de forma similar a como la red de cubos de Urbicande (véase la siguiente imagen). En cada lado del cuadrado original se forma un nuevo cuadrado y sobre los lados de los nuevos cuadrados irán creciendo nuevos cuadrados.

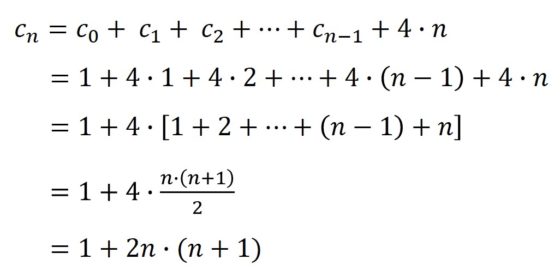

Primero, en el momento cero tenemos 1 cuadrado (c0), del que surgen 4 más, luego 5 (c1) en total. En la segunda etapa se incorporan 8, luego 13 (c2) en total… y así continúa. Pero, veamos cuantos cuadrados se incorporan en cada momento. Si nos fijamos en la anterior imagen, en la segunda etapa (c2), los cuadrados que se incorporan forman un cuadrado grande (rojo) con 3 cuadrados en cada lado, luego tiene (4 x 3 – 4 = 4 x (3 – 1) = 4 x 2 = 8 cuadrados, es decir, cuatro veces los cuadrados que hay en cada lado menos 4, de los vértices, que contábamos dos veces). En general, en el paso n-ésimo se incorporarán, a los anteriores cubos, 4 x n cubos más. Por lo tanto, se obtiene la siguiente fórmula:

Donde hemos utilizado, en el ante-último paso, la fórmula de la suma de los n primeros números (véase la entrada Matemáticas para ver y tocar ).

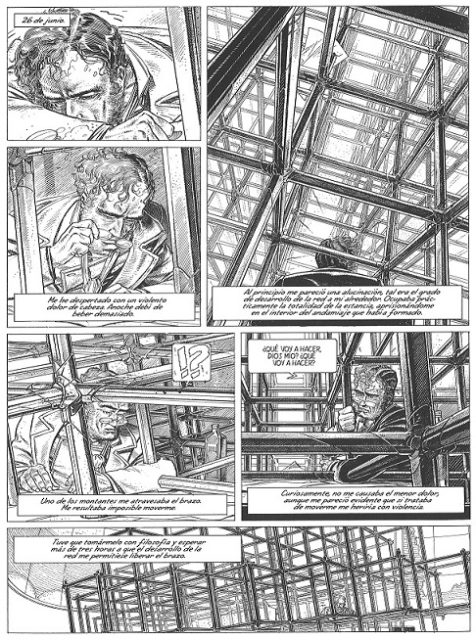

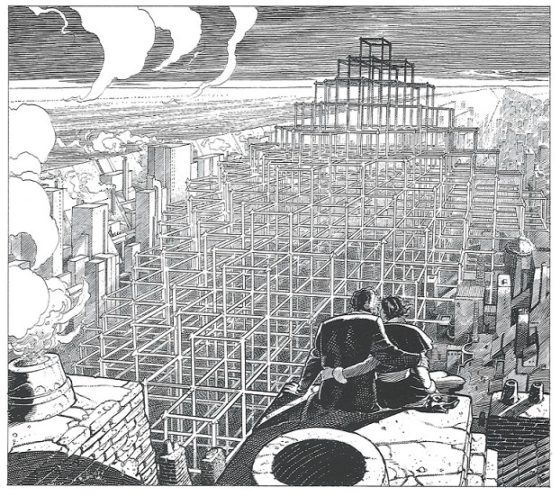

Página de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en la cual vemos al urbatecto Robick dentro de la estructura reticular que cada vez va creciendo más

Página de la novela gráfica La fiebre de Urbicande, de Scuiten-Peeters, en la cual vemos al urbatecto Robick dentro de la estructura reticular que cada vez va creciendo más

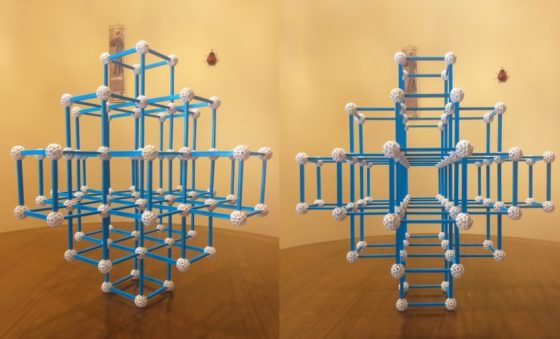

Estructura reticular con cubos, que adopta la forma de un octoedro, después de tres etapas, luego con 25 cubos, que he realizado con el material de construcción Zometool

Estructura reticular con cubos, que adopta la forma de un octoedro, después de tres etapas, luego con 25 cubos, que he realizado con el material de construcción Zometool

El razonamiento que hemos desarrollado en el plano, para cuadrados, no solo nos ayuda a entender el problema en dimensión tres, para cubos, sino que nos permite obtener fácilmente una fórmula para la cantidad de cubos de cada etapa de la red. Esto se debe a que en la etapa n-ésima la cantidad de cubos de la zona/capa central de la red octaédrica es igual a la cantidad de cuadrados de la etapa n-ésima de los cuadrados planos (cn), ya que solo nos fijamos en los cubos que están a la misma altura, en la misma capa horizontal. En la capa de arriba de la central, y también en la de abajo, hay tantos cubos como cuadrados había en la etapa anterior, luego (n – 1)-ésima de los cuadrados planos (c(n – 1)), y así con el resto. Veamos los primeros pasos. En la primera etapa hay 5 cubos en la zona central y 1 arriba y otro abajo, en total, 7 cubos. En la segunda etapa hay 13 cubos en la zona central, 5 en la zona que está justo encima y 5 en la que está justo debajo, y 1 cubo arriba del todo y 1 abajo del todo, en total 13 + 2 x 5 + 2 x 1 = 25 cubos.

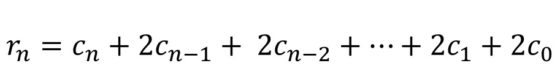

Es decir, tenemos la fórmula general para la cantidad de cubos de la red de Urbicande dada en función de los anteriores números:

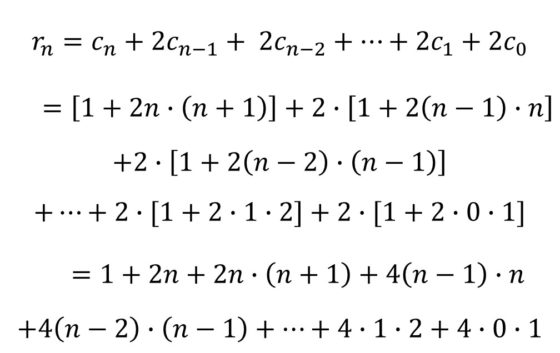

Pero sustituyendo el valor de los números de cuadrados (cn) calculados anteriormente, se obtiene:

Observemos que en la segunda igualdad hemos sumado primero los 1s de los corchetes, obteniendo el número 1 + 2n del inicio.

Hemos obtenido así una primera fórmula para el cálculo del número de cubos de la red. Si vais dando valores a n = 0, 1, 2, 3, 4, 5, … obtendréis la cantidad de hexaedros regulares de cada etapa 1, 7, 25, 63, 129, 231, …

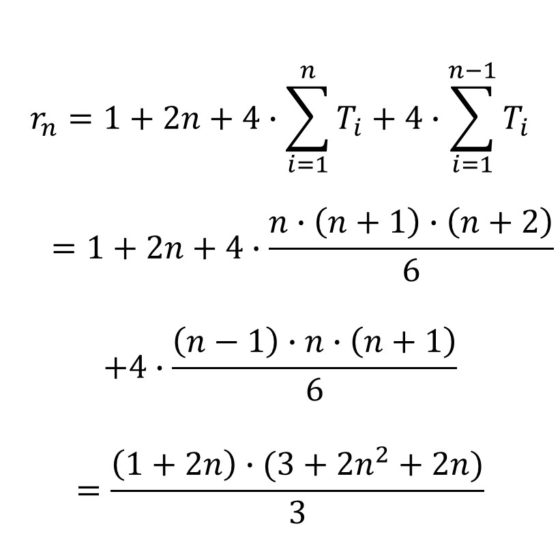

Vamos a intentar obtener una fórmula más sencilla de manejar. Si denotamos como Tn a los números triangulares, es decir, la suma de los n primeros números, Tn = 1 + 2 + … + n, que sabemos que es igual a n (n + 1) / 2, podemos demostrar que la anterior fórmula es igual a:

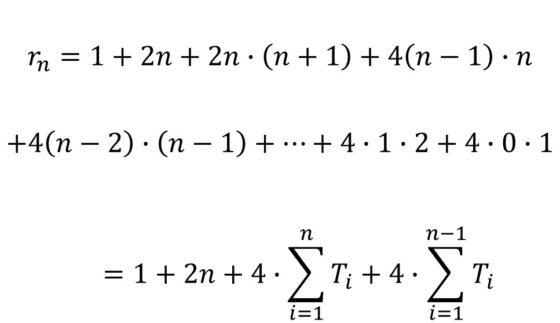

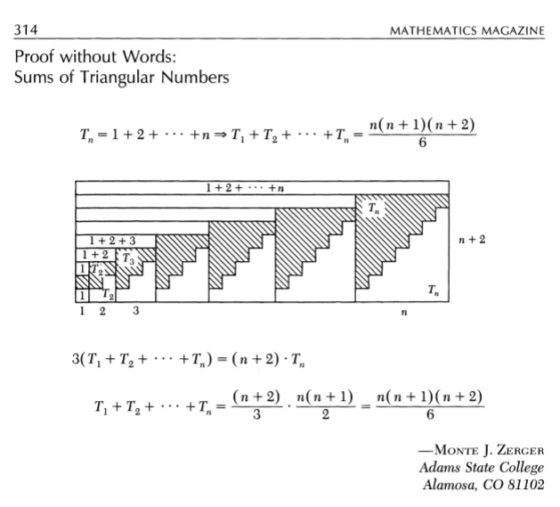

Para seguir avanzando necesitamos la fórmula de la suma de los números triangulares. En la siguiente imagen podéis ver dicha fórmula, con la demostración sin palabras que publicó Monte J. Zerger en Mathematics Magazine (diciembre, 1990) y que aparece también en el libro Demostraciones sin Palabras, de Roger B. Nelsen.

Demostración sin palabras que publicó Monte J. Zerger en Mathematics Magazine (diciembre, 1990) de la suma de los números triangulares

Demostración sin palabras que publicó Monte J. Zerger en Mathematics Magazine (diciembre, 1990) de la suma de los números triangulares

Ahora, haciendo uso de la anterior fórmula se obtiene la siguiente fórmula para la sucesión de cubos que conforman la red octaédrica de La fiebre de Urbicande:

Robick y Sofía, una mujer a la que conoce nuestro protagonista y de la que se enamora, disfrutando del paisaje de la estructura reticular, de la que se ve la pirámide superior, mientras que la inferior está ya bajo tierra

Robick y Sofía, una mujer a la que conoce nuestro protagonista y de la que se enamora, disfrutando del paisaje de la estructura reticular, de la que se ve la pirámide superior, mientras que la inferior está ya bajo tierra

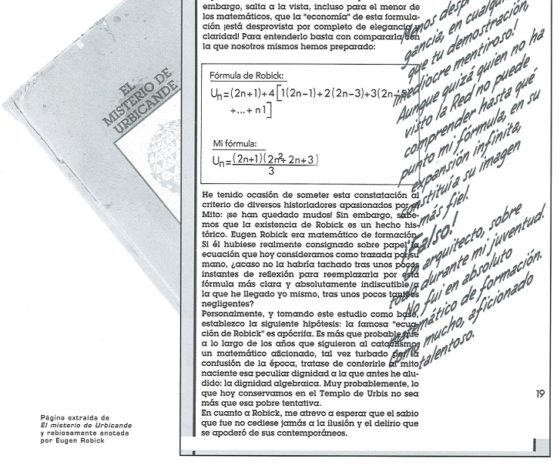

Si volvemos a la novela gráfica de Schuiten-Peeters, podemos observar que la fórmula que he obtenido coincide con una de las dos que aparecen en la misma. Una de ellas es la fórmula de Robick y la otra la que aparece en el opúsculo El misterio de Urbicande “de un tal R. de Brok”, dentro de la parte denominada La leyenda de la red, que es un documento perteneciente a los Archivos de “las ciudades oscuras”.

Página extraída del opúsculo El misterio de Urbicande, anotada por Eugen Robick, en la que podemos ver las dos fórmulas matemáticas para el número de cubos de la estructura reticular, la fórmula de Robick y la fórmula de R. de Brok (que aparece descrita como “Mi fórmula”)

Página extraída del opúsculo El misterio de Urbicande, anotada por Eugen Robick, en la que podemos ver las dos fórmulas matemáticas para el número de cubos de la estructura reticular, la fórmula de Robick y la fórmula de R. de Brok (que aparece descrita como “Mi fórmula”)

El razonamiento que utiliza Eugen Robick es diferente al mío y por eso la fórmula que obtiene es diferente. Podemos decir que yo cuento los cubos de cada capa horizontal de la estructura reticular, mientras que Robick cuenta los cubos en columnas verticales.

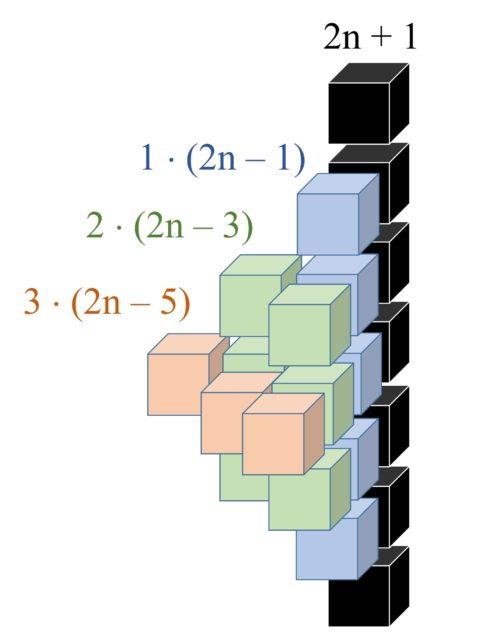

Expliquemos brevemente la idea de Robick. En la etapa n-ésima del desarrollo de la red la “columna central” de la estructura con forma de octaedro (pirámide doble) tiene 2n + 1 cubos, que es el número que aparece en primer lugar en su fórmula. Después divide la pirámide doble, menos la columna central, en cuatro partes iguales (en la siguiente imagen observamos la partición en lo que sería la vista desde arriba de la red) y calcula la cantidad de cada parte, que es la expresión que aparece multiplicando al 4.

Vista desde arriba de la estructura reticular, con la columna central que se corresponde con el cuadrado negro y las cuatro zonas de la retícula octaédrica en las que Robick divide la estructura

Vista desde arriba de la estructura reticular, con la columna central que se corresponde con el cuadrado negro y las cuatro zonas de la retícula octaédrica en las que Robick divide la estructura

Ahora razonemos visualmente (en la siguiente imagen) cómo obtiene Robick la fórmula del cálculo de los cubos de cada una de esas cuatro partes.

Ilustración, para la etapa n = 3 del crecimiento de la red, de la columna central de cubos, en la que hay 2n +1 elementos, más una de las cuatro partes en las que Robick divide la retícula. Se indican con diferentes colores los cubos que cuenta juntos, que van por alturas

Ilustración, para la etapa n = 3 del crecimiento de la red, de la columna central de cubos, en la que hay 2n +1 elementos, más una de las cuatro partes en las que Robick divide la retícula. Se indican con diferentes colores los cubos que cuenta juntos, que van por alturas

Juntando todo lo anterior se obtiene la fórmula de Robick:

No hemos entrado en el trasfondo social y político de la historia que se cuenta en La fiebre de Urbicande, pero eso dejo que lo descubráis en vuestra propia lectura de la novela gráfica.

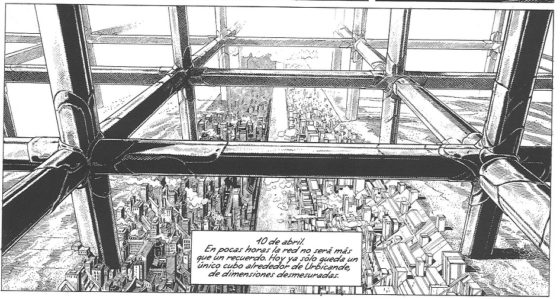

Viñeta de La fiebre de Urbicande, de Schuiten-Peeters, en la que vemos el momento en el que la red ya solo tiene un cubo alrededor de la ciudad, por lo que ya no interfiere en la vida de la misma. La red de hexaedros regulares seguirá creciendo, primero superando la ciudad, luego el continente, después el planeta y seguirá creciendo en la galaxia

Viñeta de La fiebre de Urbicande, de Schuiten-Peeters, en la que vemos el momento en el que la red ya solo tiene un cubo alrededor de la ciudad, por lo que ya no interfiere en la vida de la misma. La red de hexaedros regulares seguirá creciendo, primero superando la ciudad, luego el continente, después el planeta y seguirá creciendo en la galaxia

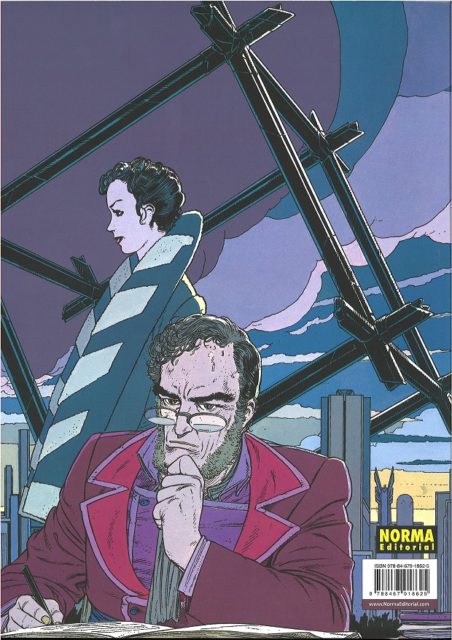

Finalizamos la entrada animando a la lectura de la serie de novelas gráficas de François Schuiten y Benoît Peeters, Las ciudades oscuras, y con la imagen de la contraportada de La fiebre de Urbicande de la edición en castellano de Norma editorial en 2015, con tres de los protagonistas de la historia, Eugen, Sofía y el misterioso cubo.

Contraportada de La fiebre de Urbicande, Schuiten-Peeters, Norma editorial, 2015

Contraportada de La fiebre de Urbicande, Schuiten-Peeters, Norma editorial, 2015

Bibliografía

1.- Francois Schiten, Benoit Peeters, La fiebre de Urbicande (Las ciudades oscuras), Norma Editorial, 2015.

2.- Roger B. Nelsen, Demostraciones sin palabras (ejercicios de pensamiento visual), Proyecto Sur, 2001.

3.- Jean-Paul Van Bendegem, A short explanation of «Le Mystère d’Urbicande», Alta plana, the impossible & infinite encyclopedia of the world created by Schuiten & Peeters

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La ecuación de las ciudades oscuras se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Triangulando: Pascal versus Sierpinski

- Buscando las soluciones del cubo de Anda

- Locura instantánea, un rompecabezas con cubos de colores

La interpretación de Copenhague de la mecánica cuántica

Sede del Instituto de Física Teórica de la Universidad de Copenhague construida y constituido, respectivamente, en 1921 con Niels Bohr como director. Popularmente conocido como Instituto Bohr, adoptó oficialmente ese nombre en 1965. Fuente: Niels Bohr Institutet

Sede del Instituto de Física Teórica de la Universidad de Copenhague construida y constituido, respectivamente, en 1921 con Niels Bohr como director. Popularmente conocido como Instituto Bohr, adoptó oficialmente ese nombre en 1965. Fuente: Niels Bohr InstitutetEl principio de complementariedad de Bohr es una afirmación de una enorme importancia, porque significaba que lo que observamos en nuestros experimentos no es lo que la naturaleza realmente es cuando no la estamos observando. Pero ahondemos sobre esto, porque la afirmación choca con el sentido común [1], lo que puede hacer más difícil asimilar lo que aquí se está diciendo [2].

De hecho, la naturaleza no favorece ningún modelo específico cuando no estamos observando; si algo podemos afirmar es que la naturaleza es una mezcla de las muchas posibilidades que podría ser hasta que observamos [3]. Al establecer un experimento, seleccionamos el modelo que exhibirá la naturaleza y decidimos si los fotones, electrones, protones e incluso las pelotas de tenis (si se mueven lo suficientemente rápido) se comportarán como corpúsculos o como ondas.

En otras palabras, según Bohr, ¡el experimentador se convierte en parte del experimento! Al hacerlo, el experimentador interactúa con la naturaleza, de tal modo que nunca podemos observar todos los aspectos de la naturaleza como realmente es “en sí” [4]. De hecho, esta expresión, si bien es atractiva, no tiene un significado operativo. En cambio, deberíamos decir que solo podemos conocer la parte de la naturaleza que nuestros experimentos ponen de manifiesto. [5] La consecuencia de este hecho, a nivel cuántico, decía Bohr, es el principio de incertidumbre, que coloca una limitación cuantitativa sobre lo que podemos aprender sobre la naturaleza en cualquier interacción dada; y la consecuencia de esta limitación es que debemos aceptar la interpretación de probabilidad de los procesos cuánticos individuales. De aquí que al principio de incertidumbre a menudo también se le llame principio de indeterminación.

No hay forma de evitar estas limitaciones, según Bohr, mientras la mecánica cuántica siga siendo una teoría válida. Estas ideas, por supuesto, están totalmente en desacuerdo con el sentido común, como apuntábamos antes. Asumimos que la naturaleza existe de manera completamente independiente de nosotros y que posee una realidad y un comportamiento definidos, incluso cuando no la estamos observando. Así, supones que el mundo fuera del lugar donde estás todavía existe más o menos como fue la última vez que lo observaste. No cabe duda de que la naturaleza se comporta así en nuestra experiencia cotidiana, y esta visión es una suposición fundamental de la física clásica. Incluso tiene un nombre filosófico; se llama «realismo», y para los fenómenos y objetos en el rango de la experiencia ordinaria es perfectamente apropiado. Pero, como Bohr a menudo enfatizó, tenemos que estar preparados para esperar que el mundo cuántico no sea como el mundo cotidiano en el que vivimos.

Parte de la dificultad viene del lenguaje que empleamos. Nuestra lengua común no puede expresar adecuadamente lo que las matemáticas consiguen hacer de manera muy eficiente. Max Born, uno de los fundadores de la mecánica cuántica, lo expresó así (nuestro énfasis):

El origen último de la dificultad radica en el hecho (o principio filosófico) de que estamos obligados a usar las palabras del lenguaje común cuando deseamos describir un fenómeno, no mediante un análisis lógico o matemático, sino mediante una imagen atractiva para la imaginación. El lenguaje común ha crecido con la experiencia cotidiana y nunca puede superar estos límites. La física clásica se ha limitado al uso de conceptos de este tipo; al analizar los movimientos visibles, ha desarrollado dos formas de representarlos mediante procesos elementales: partículas en movimiento y ondas. No hay otra forma de dar una descripción pictórica de los movimientos: tenemos que aplicarlo incluso en la región de los procesos atómicos, donde la física clásica se descompone. [6]

Juntos, el principio de complementariedad de Bohr, el principio de incertidumbre de Heisenberg y la interpretación de probabilidad de Born forman una interpretación lógicamente coherente del significado de la mecánica cuántica. Dado que esta interpretación se desarrolló en gran medida en el instituto de Bohr en la Universidad de Copenhague, se la conoce como la Interpretación de Copenhague de la mecánica cuántica. Los resultados de esta interpretación tienen profundas consecuencias científicas y filosóficas que se siguen estudiando y debatiendo. [7]

Notas:

[1] La ciencia se empeña en demostrar que el sentido común no deja de ser una colección de sesgos antropocéntricos y, por lo tanto, si bien útiles para el día a día en muchos casos, no necesariamente ciertos.

[2] Por eso es interesante fijarse en las palabras en cursiva, que están cuidadosamente seleccionadas.

[3] Este es el principio de superposición cuántico, sobre el que reflexionamos en La teoría superpositiva.

[4] Esto del “en sí” está entrecomillado porque es más un concepto filosófico que físico. Está relacionado con la caracterización de la sustancia de la época racionalista de la filosofía. Recordemos, por ejemplo, que Spinoza en la definición tercera del libro primero de la Ética decía “Por substancia entiendo aquello que es en sí y se concibe por sí, esto es, aquello cuyo concepto, para formarse, no precisa del concepto de otra cosa.”

[5] Y aquí hay que reflexionar mínimamente. Esto no es una invitación al misticismo, como algunos se apresuran a adoptar. Fijémonos en que, al fin y al cabo, conocemos incluso a nuestro mejor amigo solo a través de un mosaico de encuentros, conversaciones y actividades repetidas, en muchas circunstancias diferentes.

[6] A este respecto puede resultar interesante nuestro La verdadera composición última del universo (y IV): Platónicos, digitales y pansiquistas

[7] Una introducción a los elementos del debate puede encontrarse en nuestra serie Incompletitud y medida en mecánica cuántica

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La interpretación de Copenhague de la mecánica cuántica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Construyendo la mecánica cuántica

- La probabilidad en mecánica cuántica

- El principio de complementariedad

La crisis de reproducibilidad en ciencia

Fuente: Science

Fuente: ScienceUno de los elementos más valiosos con que debiera contar la comunidad científica es con la replicación sistemática de los estudios o, al menos, con aquellos que introducen alguna novedad significativa. Sin embargo, la mayoría de los científicos se muestran poco inclinados a tratar de replicar los experimentos o análisis realizados por otros investigadores. Al fin y al cabo, resulta mucho más gratificante hacer nuevos estudios que puedan aportar novedades de interés en un campo que limitarse a comprobar si se obtienen los mismos resultados que obtuvieron antes otros. Además, las revistas científicas no están interesadas en publicar repeticiones, máxime si las conclusiones no refutan las del primer trabajo; en ese caso no hay novedades que contar.

En varios estudios se ha llegado a la conclusión de que muchos resultados publicados no son reproducibles o solo lo son parcialmente. Aunque lleva años generando preocupación, este problema se manifestó con toda su crudeza a raíz de la publicación en 2015 de un estudio en la revista Science, según el cual tan solo para una treintena de 100 experimentos de psicología publicados en las mejores revistas científicas del campo se habían podido reproducir sus resultados. Pero el problema no se limita a la psicología, sino que afecta a un buen número de disciplinas.

De acuerdo con una encuesta realizada en 2016 por la revista Nature a 1500 investigadores de diferentes campos, el 70% habían sido incapaces de reproducir los resultados de otros colegas y el 50% no lo habían sido de reproducir sus propios resultados. Por disciplinas, estos fueron los datos de la encuesta: en química el 90% y el 60% (ajenos y propios, respectivamente), en biología el 80% y el 60%, en medicina el 70% y el 60%, en física e ingeniería el 70% y el 50%,en medicina, y en ciencias de la Tierra y el ambiente el 60% y el 40% (Baker, 2016).

Parece evidente que la imposibilidad o dificultad para reproducir resultados constituye una severa limitación al ejercicio del escepticismo, sin el cual no es posible someter a contraste los resultados y conclusiones publicadas.

Aunque a veces la imposibilidad de reproducir los resultados se refiere a casos de fraude, lo normal es que no haya trampa ni malas prácticas realizadas de forma voluntaria. Las razones por las que los resultados experimentales no se reproducen al repetirse los experimentos son diversas. Muchas veces no se especifican de forma correcta las condiciones experimentales. En otras los investigadores se ven afectados por sesgos como los expuestos en una anotación anterior y que tienen que ver con el grado de aproximación de los resultados obtenidos a las expectativas iniciales. Cuando en un conjunto de datos alguno destaca como “anómalo” es relativamente común descartarlo basándose en el supuesto de que la anomalía bien puede deberse a un error experimental sin trascendencia. En todo esto influyen de forma decisiva dos factores. Uno es que el personal de universidades y centros de investigación, como ya hemos visto, está sometido a una fuerte presión por publicar. Y el otro es que las revistas científicas rara vez aceptan publicar resultados negativos. Por esa razón, no es de extrañar que funcionen sesgos que, inconscientemente, facilitan la obtención de resultados positivos y, por lo tanto, publicables.

El tratamiento estadístico es también una fuente de resultados de difícil reproducción. Es relativamente común la práctica de ensayar diferentes procedimientos y seleccionar, entre un catálogo más o menos amplio de posibilidades, aquél cuyos resultados mejor se acomodan a las expectativas. Este es un problema serio en los campos en que se realizan ensayos que han de conducir al desarrollo posterior de tratamientos médicos. Pero, el daño que causa es general, ya que esa forma de proceder tiende a neutralizar la emergencia de nuevas ideas que debería caracterizar, de forma intrínseca, a la práctica científica. Si se opta por mostrar los resultados que mejor se acomodan a las expectativas, se deja de lado el examen crítico de posibilidades que podrían haber conducido a nuevas ideas.

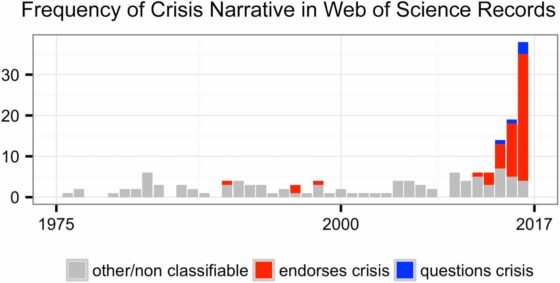

La figura muestra la frecuencia de aparición de expresiones relativas a, reales o supuestas, crisis científicas. Fuente: D Fanelli (2018) PNAS 115 (11): 2628-2631

La figura muestra la frecuencia de aparición de expresiones relativas a, reales o supuestas, crisis científicas. Fuente: D Fanelli (2018) PNAS 115 (11): 2628-2631La revista Proceedings of the National Academy of Sciences, más conocida por sus siglas PNAS y una de las más prestigiosas del mundo, publicó una serie de artículos analizando la llamada “crisis de reproducibilidad” y, en general, la validez de un discurso muy en boga mediante el que se difunde la idea de que la ciencia se encuentra hoy en crisis. De ese conjunto de estudios parece concluirse que esa idea no tiene suficiente base y que se trata, más bien, de una leyenda urbana. Sin embargo, en nuestra opinión, lo que esos estudios documentan es que el fraude no ha crecido durante las últimas décadas, de la misma forma que no ha crecido el número de artículos retractados (retirados de la publicación por los editores) en términos relativos. Pero no es tan clara la conclusión de que no hay problemas de reproducibilidad, porque el procedimiento seguido para llegar a esa conclusión es demasiado indirecto, mientras que los estudios que documentan las dificultades para reproducir resultados anteriores son bastante más directos.

En nuestra opinión, la falta de reproducibilidad procede de una progresiva relajación de los estándares que se consideran aceptables en cuanto calidad de la evidencia científica; nos referimos a asuntos tales como tamaños de muestra, claridad de la significación estadística más allá del valor de p, calidad de los blancos, etc. Los científicos como colectivo somos a la vez autores de los experimentos, autores de los artículos y revisores de estos. Que poco a poco se vayan aceptando niveles cada vez más bajos nos conviene si nuestro objetivo es el de publicar más rápidamente y engrosar un currículo investigador en un tiempo breve. Pero eso conduce, lógicamente, a un declive del rigor y exigencia generales. Ahora bien, al tratarse de un declive gradual, no se aprecia con nitidez la pérdida de calidad. Sin embargo, cuando el deterioro se acentúa se acaban dando por buenos (publicándolos) resultados que realmente no responden a hechos reales y por tanto no se pueden reproducir.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo La crisis de reproducibilidad en ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El legado de Fisher y la crisis de la ciencia

- Ciencia Patológica

- Sesgos cognitivos que aquejan a la ciencia

Roberto Frucht, matemático en tránsito

Alberto Mercado Saucedo

Fueron varias las fronteras que cruzó Roberto Frucht tanto en las matemáticas como en su trayectoria personal. Obtuvo resultados de gran importancia y profunda belleza en teoría de grafos, cuando esta área recién comenzaba a definirse como tal en el medio académico internacional, y fue autor de algunos de los primeros artículos de investigación matemática realizada en Chile, publicados en revistas internacionales en los años cuarenta del siglo veinte. Además, dejó cantidad de gratos recuerdos entre colegas y estudiantes de la Universidad Técnica Federico Santa María –UTFSM- en Valparaíso, donde fue profesor durante más de medio siglo.

Hace un tiempo tuve la oportunidad de presenciar un bello e inesperado testimonio del poeta Raúl Zurita, que estudió ingeniería a fines de los años sesenta y tuvo a Frucht como profesor. El 2015 Zurita recibió el doctorado honoris causa de la universidad, y en su discurso de aceptación dedicó varios minutos a recordar una clase dictada por un “profesor ya mayor, de baja estatura” en la que el entonces futuro poeta se encontró con la “elegancia, simpleza y belleza” de cierta fórmula matemática. Como si la clase ocurriera en esos momentos, la voz del poeta recordó el áspero andar de la tiza en el pizarrón de cuarenta años atrás: el profesor Roberto Frucht explicando a sus estudiantes la fórmula de Euler, quizá una de las expresiones más hermosas de la matemática, como bien lo percibió Zurita.

¿Dónde reside la belleza de esta fórmula? Quizá simplemente en que aparecen distintos números bien conocidos: los irracionales e, junto con el imaginario i, la raíz cuadrada de -1, relacionados por operaciones matemáticas. Pero también podemos pensar que la fórmula relaciona los mundos del álgebra y la geometría: expresa que el número -1 hace ángulo con el eje x en el plano complejo; lo mismo ocurre con el valor de para cualquier ángulo Quizá fueron estos cruces lo que impactó a Zurita y provocó tan duradero recuerdo.

De hecho, la obra literaria de Zurita hace recurrentes alusiones al mundo de las matemáticas, tema del que no hablaremos ahora pero que podemos conjeturar se originó en momentos iluminadores como el anterior, que en el discurso del poeta tuvo un trágico contrapunto en la alusión al golpe de estado y el inicio de la dictadura, lo cual afectó directamente a Zurita y dejó al pueblo chileno un triste legado, aún vigente en nuestros días. Precisamente, el profesor Frucht había llegado a Sudamérica treinta años antes huyendo de horrores similares.

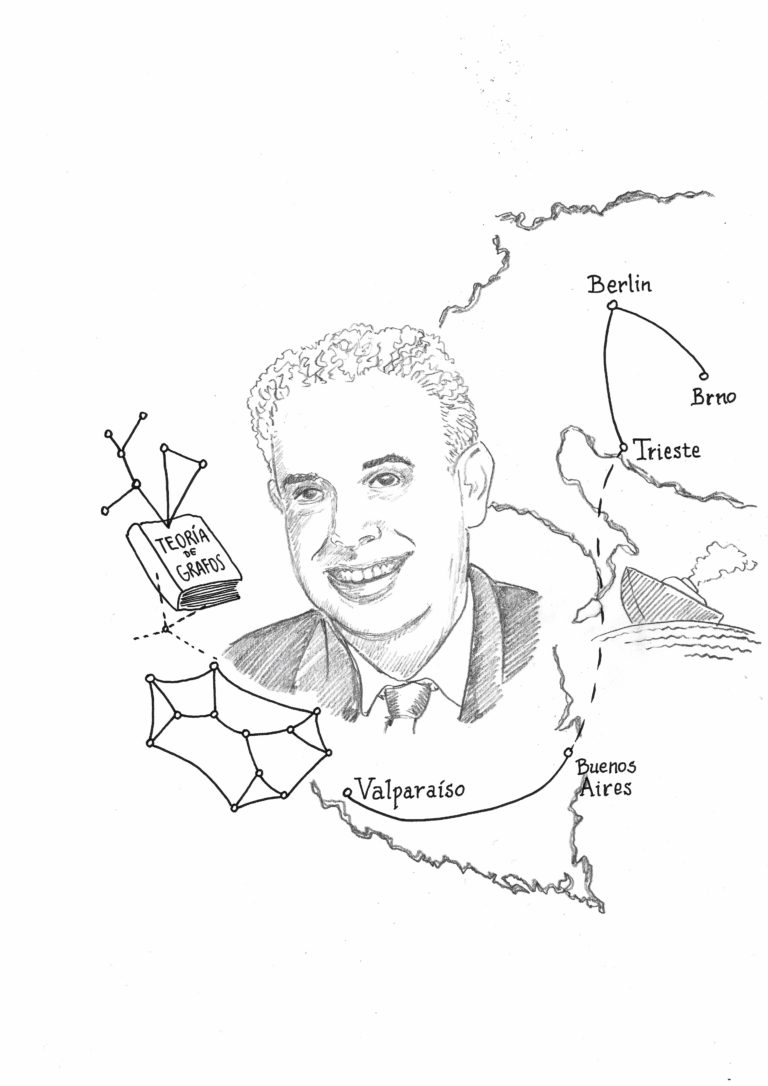

Ilustración de Constanza Rojas-Molina. Todos los derechos reservados; cesión en exclusiva para su publicación en el Cuaderno de Cultura Científica.

Ilustración de Constanza Rojas-Molina. Todos los derechos reservados; cesión en exclusiva para su publicación en el Cuaderno de Cultura Científica.Roberto Frucht nació el 9 de agosto de 1906 en Brno, ciudad que hoy pertenece a la República Checa, y luego vivió en Berlin desde los dos años de edad, cuando su familia se instaló en la ciudad alemana. Allí finalizó estudios universitarios y decidió continuar especializándose en matemáticas, para lo que obtuvo su doctorado en 1930 en teoría de grupos, área del álgebra abstracta. Obtener una de las escasas plazas en la universidad era sumamente difícil, e impartir clase en un Gimnasium (colegio) estaba reservado para los alemanes, nacionalidad que no poseía Frucht. Estas circunstancias, por no hablar del contexto internacional, de lo más complicado para un descendiente de familia judía, hicieron que en 1930 se trasladara a Trieste, Italia, donde trabajaría en una compañía de seguros por casi ocho años. Allí, inició una relación con María Mercedes Bertogna, compañera de trabajo de origen argentino, con quien se casó en 1932.

Podemos imaginar que durante esos años en Trieste el trabajo de Roberto era rutinario, pero se las ingenió para publicar artículos -escritos en alemán- sobre la investigación realizada en su doctorado, además de otros trabajos de contabilidad escritos en italiano. Pero lo mejor estaba por venir, pues un día cualquiera de 1936 un hecho fortuito determinó la trayectoria de Roberto Frucht: recibió en su oficina de seguros un catálogo con información de un libro del matemático húngaro Dénes Kőnig sobre teoría de grafos, prácticamente el primero sobre la materia, y se interesó por el título de un capítulo que era algo así como “aplicaciones de la teoría de grupos a los grafos”. Ordenó el libro y desde que lo recibió se convirtió, según sus propias palabras, en un entusiasta de la teoría de grafos. Tan fue así, que se dedicó a estudiar el tema en detalle y en especial a trabajar en los problemas abiertos planteados en el libro.

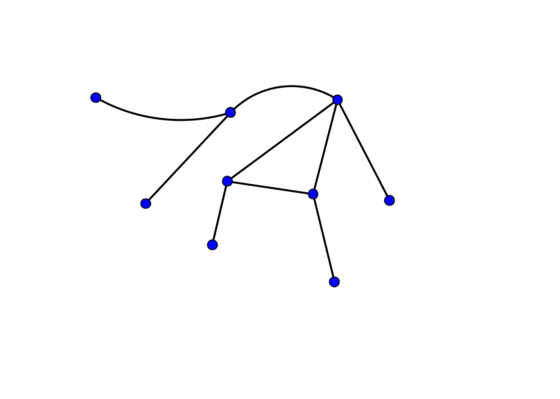

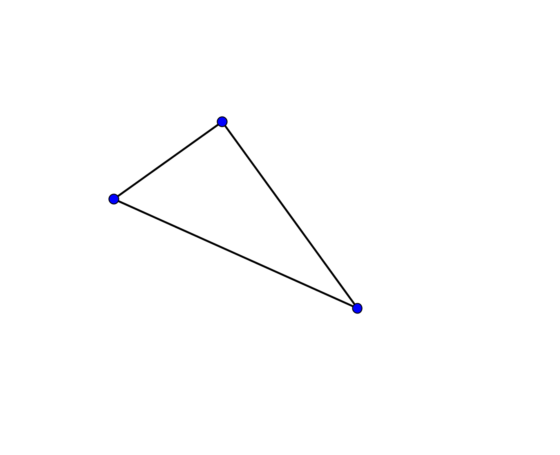

Para comprender la idea de esta área de las matemáticas, pensemos que un grafo es una colección de vértices junto con segmentos que los unen en una combinación dada, y es esta combinación lo que determina el grafo en particular. Por ejemplo un polígono: los triángulos, cuadrados y demás son grafos.

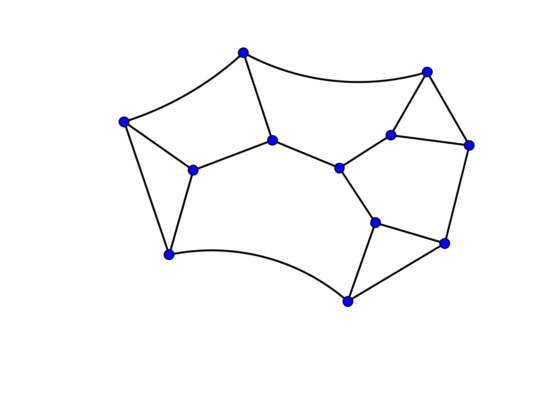

Ejemplo de grafo.

Ejemplo de grafo.

También es un grafo el diagrama del mapa del metro en una ciudad, si pensamos que cada estación es un vértice, que está unido con otro si es que hay una línea de metro entre las estaciones. Lo importante en un grafo es su estructura: el cómo se dan las conexiones, la combinación precisa, y no importan la longitud o la forma con que dibujemos sus segmentos. Es lo mismo que para el usuario del metro cuando lee el mapa, pues lo que le importa es saber si un par de vértices/estaciones dados están o no conectados.

Mapa del metro de Ciudad de México, México D.F.

Mapa del metro de Ciudad de México, México D.F.

En teoría de grafos se estudian problemas planteados sobre estas estructuras, problemas que pueden ser geométricos, combinatorios, algebraicos o de otra índole. El tema en el que se interesó Frucht está relacionado con determinar el conjunto de automorfismos de un grafo, que son permutaciones entre los vértices que no cambian su estructura. Los automorfismos son una especie de simetrías del grafo respecto a sus conexiones, y son transformaciones que forman un grupo, pues se puede definir una operación entre dos de ellas: la composición, que consiste en aplicar una transformación y luego la otra. En el caso de un triángulo, es fácil ver que todas sus permutaciones son simetrías: ya sea realizar una especie de rotación entre los tres vértices o bien intercambiar dos de ellos como en una reflexión especular (el lector podrá determinar cuántos automorfismos hay).

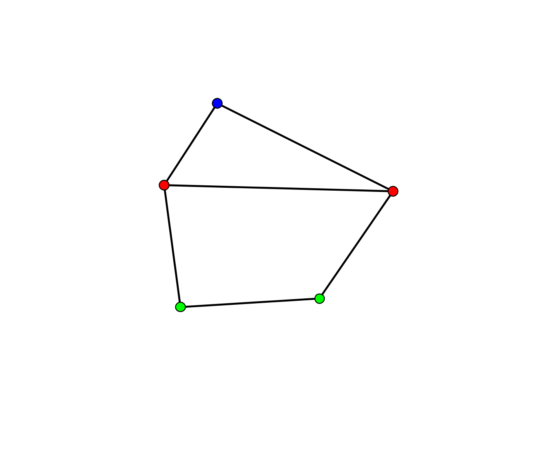

Hacemos hincapié en que no es importante el largo o forma de los segmentos. Por ejemplo, el grafo con forma de pentágono mostrado abajo posee un solo automorfismo (además de la identidad), que consiste en intercambiar los vértices verdes uno con el otro, lo mismo que los vértices rojos también entre sí, dejando fijo el vértice de color azul.

Tras estudiar el libro de teoría de grafos, uno de los primeros resultados de Roberto fue determinar el grupo de automorfismos de algunos sólidos platónicos (equivalente tridimensional de los polígonos regulares). Un año más tarde, resolvió un problema mucho más importante: König había planteado en su libro la pregunta abierta si dado un grupo finito cualquiera, éste corresponderá necesariamente a los automorfismos de un grafo, el que habría que determinar. Esto significa pasar del álgebra a la geometría, algo así como dibujar el grupo dado por medio de su grafo. Frucht respondió afirmativamente a esta pregunta, y definió un procedimiento constructivo para determinar el grafo a partir del grupo dado, lo que se conoce como Teorema de Frucht. Además, encontró un grafo especial: uno que no posee ninguna simetría más que la identidad. A este grafo se le conoce como Grafo de Frucht y se ha convertido en un ejemplo clásico en el área. Es mostrado en la siguiente figura, donde se puede notar que cada vértice posee exactamente tres conexiones; de hecho este es el grafo más pequeño con tal estructura y que no tiene automorfismos.

Grafo de Frucht

Grafo de Frucht

Frucht realizó estos trabajos entre 1936 y 1938, tristes años en Europa, en pleno auge del nazismo alemán y del fascismo italiano. Por esos años se aprobaron en Italia discriminadoras leyes raciales que complicaron la continuidad laboral de Roberto en Trieste. La familia, que ya incluía a su hija Érica, nacida en Trieste poco antes, decide mudarse a Argentina, donde vivían parientes de Mercedes. A principios de 1939 viajaron en el buque de vapor Augustus hasta el puerto de Buenos Aires, donde Frucht trabajó de nuevo en una compañía de seguros, pero también encontró la forma de seguir pensando en matemáticas, pues publicó varias notas sobre geometría diferencial en la revista de la Unión Matemática Argentina UMA, en ediciones bilingües en alemán y español.

De manera un tanto azarosa, la estadía en Buenos Aires llegó pronto a su fin, pues Roberto se encontró con la oportunidad de optar por una plaza como profesor en la UTFSM, institución que había sido recientemente creada y se abocaba a contratar un número de profesores extranjeros, sobre todo alemanes, para poder lograr rápidamente una masa crítica de académicos. Del Atlántico al Pacífico, seguramente la vida en el puerto de Valparaíso era más tranquila que en Trieste o Buenos Aires; en todo caso la familia se acostumbró sin dificultad a Valparaíso, excepto por los no poco frecuentes temblores, según Roberto contaba, un poco en tono de broma, a sus cercanos.

Roberto continuó publicando algunas notas sobre geometría diferencial y álgebra en revistas de la UMA, escritas en español y ahora con afiliación UTFSM. Retomó su trabajo en teoría de grafos gracias a una invitación del matemático Harold S.M. Coxeter para contribuir al recién creado Canadian Journal of Mathematics, para lo que se dispuso a trabajar contra el tiempo, y logró obtener interesantes refinamientos de sus resultados anteriores y publicar un artículo en 1949.

Durante las décadas que siguieron, Roberto Frucht continuó con su investigación en teoría de grafos y se convirtió en uno de los pioneros de la matemática en Chile. Fue decano de la Facultad de Ciencias de la universidad entre 1948 y 1968, director y miembro fundador de la Sociedad de Matemáticas de Chile SOMACHI, colaborador frecuente de la revista local Scientia, entre otras labores académicas, y en 1970 fue nombrado profesor emérito. Desde entonces y hasta poco antes de su fallecimiento en 1997 continuó impartiendo clases en la universidad, como aquella donde enseñó la formula de Euler y transmitió a sus alumnos, en las palabras del poeta que entonces ocupaba un pupitre de estudiante anónimo, la irremediable melancolía de lo que nos parece extremadamente bello.

Referencias:

Gary Chartrand, Ping Zhang. A First Course in Graph Theory. Dover Publications 2012.

R. Frucht. Herstellung von Graphen mit vorgegebener abstrakter Gruppe

Compositio Mathematica, tome 6 (1939), p. 239-250.

Robert Frucht. Graphs of degree three with a given abstract group. Canad. J. Math. 1 (1949), 365–378.

Roberto W. Frucht. (1982). How I became interested in graphs and groups. Journal of Graph Theory. 6(2), 101-104 https://doi.org/10.1002/jgt.3190060203

Harary, F. (1982). Homage to roberto frucht. Journal of Graph Theory, 6(2), 97–99. https://doi:10.1002/jgt.3190060202

Héctor Hevia. Grafos con grupo dado de automorfismos. Proyecciones Vol 14 No 2 (1995).

Iván Szántó, Betsabe González. Breve reseña histórica de la Revista Scientia y las publicaciones de Matemática en Chile. Boletín de la Asociación Matemática Venezolana, Vol. XXI, No. 1 (2014).

Reinhard Siegmund-Schultze. Mathematicians Fleeing from Nazi Germany Individual Fates and Global Impact. Princeton university press. 2009.

Raúl Zurita Canessa. No nos hemos perdido (Discurso). Cuadernos de Educación. Publicación Trimestral Gratuita – ISSN 0719-0271. N 35, 2016.

Sobre el autor: Alberto Mercado Saucedo es profesor de matemáticas en la Universidad Técnica Federico Santa María (Valparaíso, Chile)

Sobre la ilustradora: Constanza Rojas Molina es profesora del departamento de matemáticas de la CY Cergy Paris Université (Cergy-Pontoise, Francia)

El artículo Roberto Frucht, matemático en tránsito se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ilustraciones artísticas de un matemático

- Pierre Fatou, un matemático poco (re)conocido

- Solomon Lefschetz, matemático ‘por accidente’

Los ecos del fondo submarino: imágenes de las estructuras geológicas.

Los fósiles, los minerales o las rocas son, entre otras cosas, en lo primero que pensamos al hablar de geología, pero lo cierto es que la física es un ámbito científico que difícilmente se puede desvincular de la geología. Y es que el fundamento físico resulta clave a la hora de explicar algunos procesos geológicos que suceden tanto en el océano como en la superficie terrestre.

Con el fin de poner sobre la mesa la estrecha relación entre la geología y la física, los días 27 y 28 de noviembre de 2019 se celebró la jornada divulgativa “Geología para poetas, miopes y despistados: La Geología también tiene su Física”. El evento tuvo lugar en la Sala Baroja del Bizkaia Aretoa de la UPV/EHU en Bilbao.

La segunda edición de esta iniciativa estuvo organizada por miembros del grupo de investigación de Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Geoparque de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

Gemma Ercilla, investigadora del CSIC en el Instituto de Ciencias del Mar (Barcelona), nos explica cómo estudiar el fondo marino usando el sonido y que podemos aprender de este estudio.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Los ecos del fondo submarino: imágenes de las estructuras geológicas. se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Otra mirada al planeta: arte y geología

- Geología: la clave para saber de dónde venimos y hacia dónde vamos

- Geología, ver más allá de lo que pisamos

La topología frágil es una extraño monstruo

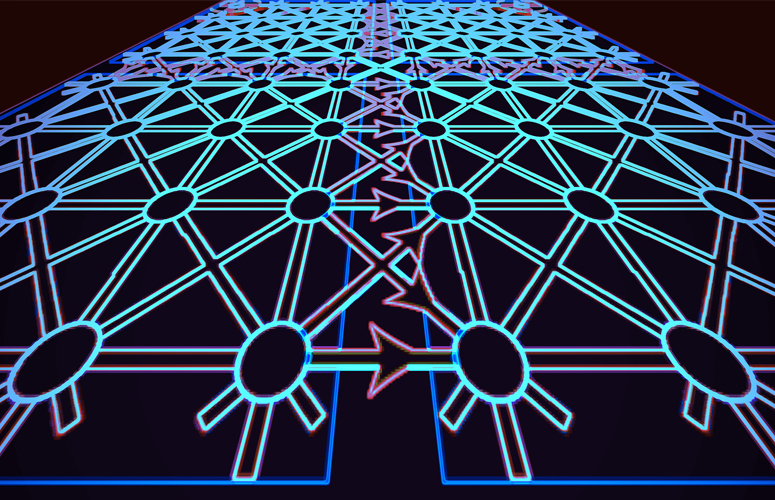

Los electrones circulan sobre la superficie de ciertos materiales cristalinos inusuales, los aislantes topológicos, excepto las veces que no lo hacen. Dos nuevos estudios publicados en la revista Science explican la fuente de ese insólito comportamiento y describen un mecanismo para restaurar la conductividad en estos cristales, apreciados por su potencial uso en futuras tecnologías, incluyendo los ordenadores cuánticos.

Los aislantes topológicos tienen un lado frágil. Imagen cortesía de Zhi-Da Song, Universidad de Princeton.

Los aislantes topológicos tienen un lado frágil. Imagen cortesía de Zhi-Da Song, Universidad de Princeton.Durante los últimos 15 años, una clase de materiales conocidos como aislantes topológicos ha dominado la búsqueda de los materiales del futuro. Estos cristales tienen una propiedad poco común: su interior es aislante —los electrones no pueden fluir—, pero sus superficies son conductoras perfectas, donde los electrones fluyen sin resistencia.

Esa era la realidad hasta que hace dos años se descubrió que algunos materiales topológicos son incapaces de conducir la corriente en su superficie, un fenómeno que se acuñó con el nombre de «topología frágil».

«La topología frágil es una extraño monstruo: ahora se predice su existencia en cientos de materiales», comenta B. Andrei Bernevig, profesor de física en Princeton y coautor de ambos trabajos. «Es como si el principio habitual en el que nos hemos basado para determinar experimentalmente un estado topológico se desmoronara”.

Para conocer cómo se forman los estados frágiles, los investigadores recurrieron a dos recursos: las ecuaciones matemáticas y la impresión 3D. Con la colaboración de Luis Elcoro, profesor del Departamento de Física de la Materia Condensada de la Facultad de Ciencia y Tecnología de la UPV/EHU, Bernevig y el investigador postdoctoral de Princeton Zhi-Da Song, construyeron una teoría matemática para explicar lo que ocurre en el interior de los materiales. A continuación, Sebastian Huber y su equipo en el ETH Zurich, en colaboración con investigadores de Princeton, el Instituto Científico Weizmann en Israel, la Universidad Tecnológica del Sur de China y la Universidad de Wuhan, probaron esa teoría construyendo un material topológico de tamaño real con piezas de plástico impresas en 3D.

Los materiales topológicos toman su nombre del campo de las matemáticas que explica cómo objetos diferentes, por ejemplo las rosquillas o las tazas de café, están relacionadas (ambas tienen un agujero). Esos mismos principios pueden explicar cómo saltan los electrones de un átomo a otro en la superficie de los aproximadamente 20.000 materiales topológicos identificados hasta la fecha. Los fundamentos teóricos de los materiales topológicos les valieron el Premio Nobel de Física de 2016 a F. Duncan Haldane, David J. Thouless y Michael Kosterlitz.

Lo que hace que estos cristales sean tan interesantes para la comunidad científica son sus paradójicas propiedades electrónicas. El interior del cristal no tiene la capacidad de conducir la corriente, es un aislante. Pero si se corta el cristal por la mitad, los electrones se deslizarán sin ninguna resistencia por las superficies que acaban de surgir, protegidos por su naturaleza topológica.

La explicación radica en la conexión entre los electrones de la superficie y los del interior. Los electrones pueden ser considerados no como partículas individuales, sino como ondas que se extienden como las ondas de agua que se generan al arrojar un guijarro a un estanque. En esta visión de la mecánica cuántica, la ubicación de cada electrón se describe por una onda que se extiende y que se denomina función de onda cuántica. En un material topológico, la función de onda cuántica de un electrón del interior se extiende hasta el borde del cristal, o límite de la superficie. Esta conexión entre el interior y el borde da lugar a un estado en la superficie perfectamente conductor.

Esta “correspondencia de interior-borde (bulk-boundary correspondence en inglés)” fue ampliamente aceptada para explicar la conducción topológica de la superficie hasta hace dos años, cuando varios trabajos científicos revelaron la existencia de la topología frágil. A diferencia de los estados topológicos habituales, los estados topológicos frágiles no contienen estados de conducción en la superficie. «El habitual principio de interior-borde se desmoronó», explica Bernevig. Pero no se pudo esclarecer cómo sucede exactamente.

En el primero de los dos trabajos publicados en Science, Bernevig, Song y Elcoro proporcionan una explicación teórica para una nueva correspondencia interior-borde que explica la topología frágil. Los autores muestran que la función de onda de los electrones en topología frágil solo se extiende hasta la superficie en condiciones específicas, que los investigadores han acuñado como correspondencia interior-borde retorcida.

El equipo descubrió, además, que se puede ajustar esa correspondencia interior-borde retorcida, y así hacer reaparecer los estados conductores de la superficie. «Basándonos en las formas de la función de onda, diseñamos un conjunto de mecanismos para introducir interferencias en el borde de tal manera que el estado del borde se convierta inevitablemente en conductor perfecto», comenta Luis Elcoro, profesor de la UPV/EHU.

Encontrar nuevos principios generales es algo que siempre fascina a los físicos, pero este nuevo tipo de correspondencia interior-borde podría además tener un valor práctico, según los investigadores. «La correspondencia interior-borde retorcida de la topología frágil proporciona un procedimiento potencial para controlar el estado de la superficie, que podría ser útil en aplicaciones de mecánica, electrónica y óptica», declara Song.

Pero probar que la teoría funciona era prácticamente imposible, dado que se tendría que interferir en los bordes a escalas atómicas infinitesimalmente pequeñas. Así que el equipo recurrió a otros colaboradores para construir un modelo de tamaño real con el que poner a prueba sus ideas.

En el segundo artículo de Science, Sebastian Huber y su equipo en el ETH Zurich construyeron la imitación en plástico de un cristal topológico a gran escala imprimiendo sus partes en impresoras 3D. Utilizaron ondas de sonido para representar las funciones de onda de los electrones. Insertaron barreras para bloquear el tránsito de las ondas sonoras, lo que es análogo a cortar el cristal para dejar al descubierto las superficies conductoras. De esta manera, los investigadores imitaron la condición de borde retorcido, y luego mostraron que manipulándolo, podían demostrar que una onda sonora que circula libremente se propaga a través de la superficie.

«Esta fue una idea y una ejecución muy de vanguardia», añade Huber. «Ahora podemos mostrar que prácticamente todos los estados topológicos que se han materializado en nuestros sistemas artificiales son frágiles, y no estables como se pensaba en el pasado. Este trabajo proporciona esa confirmación, pero aún más, introduce un nuevo principio general».

Referencias:

Valerio Peri, Zhi-Da Song, Marc Serra-Garcia, Pascal Engeler, Raquel Queiroz, Xueqin Huang, Weiyin Deng, Zhengyou Liu, B. Andrei Bernevig, and Sebastian D. Huber (2020) Experimental characterization of fragile topology in an acoustic metamaterial Science doi: 10.1126/science.aaz7654

Zhi-Da Song, Luis Elcoro, B. Andrei Bernevig (2020) Twisted Bulk-Boundary Correspondence of Fragile Topology Science doi: 10.1126/science.aaz7650

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La topología frágil es una extraño monstruo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Aislantes topológicos en sólidos amorfos

- La teoría de bandas de los sólidos se hace topológica

- Un aislante topológico intrínsecamente magnético

Así funcionan las baterías de litio

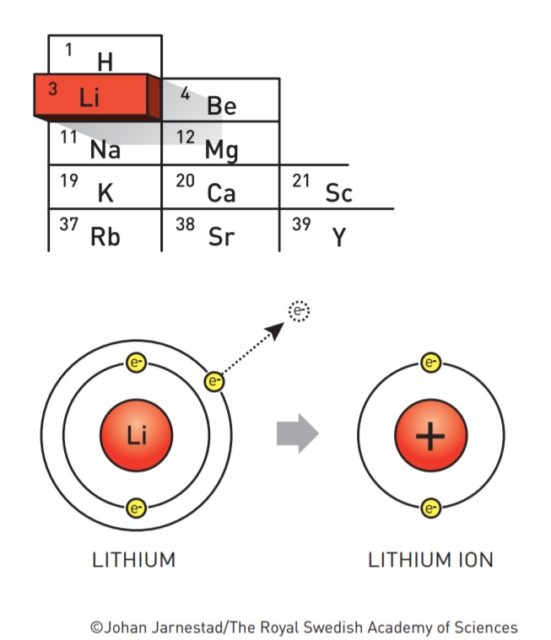

Antes de que se empezasen a fabricar baterías de litio ya se fantaseaba con la idea de poder hacer baterías de litio. La razón es que el litio es un metal que tiene tendencia a desprenderse de su electrón más externo. Al fin y al cabo, la electricidad es el tránsito de electrones, así que para producir electricidad necesitamos sustancias que tiendan a desprenderse de ellos.

Fuente: nobelprize.org

Fuente: nobelprize.org

El litio es el metal con el menor potencial de reducción (-3,05V). Esto significa que es el elemento químico que más tendencia tiene a regalar electrones. Cuando regala su electrón más externo, el litio se queda cargado positivamente. Lo representamos como Li+ y lo llamamos ion litio. De ahí que las baterías de litio también se llamen baterías de ion-litio.

Que el litio ceda electrones con tanta alegría obviamente es una ventaja, pero al mismo tiempo es una maldición. Cede electrones a cualquiera. Al aire, al agua, a todo. Esto significa que es un metal muy inestable, que se oxida rápidamente en contacto con el aire, y que en contacto con el agua reacciona de forma violenta. Esa es la razón por la que la historia de las baterías de litio no ha sido un camino de rosas.

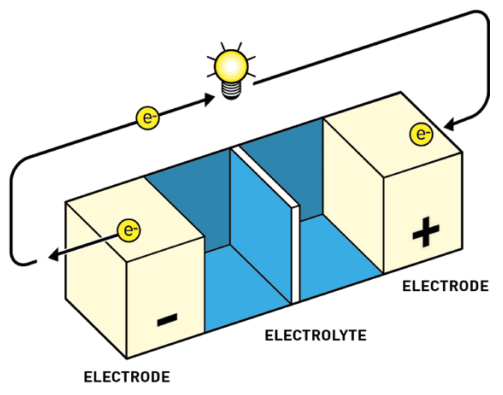

Las baterías tienen todas un mismo esquema fundamental:

-

Ánodo o electrodo negativo. Aquí es donde alguna sustancia se desprende de electrones. A estas reacciones de pérdida de electrones las denominamos reacciones de oxidación. Por convenio, al representar baterías o pilas el ánodo se dibuja a la izquierda.

-

Cátodo o electrodo positivo. Aquí es donde alguna sustancia acepta los electrones. A estas reacciones de captura de electrones las denominamos reacciones de reducción. Es la reacción inversa a la oxidación. Por convenio, al representar baterías o pilas el cátodo se dibuja a la derecha.

-

Electrolito. El electrolito actúa como separador entre el cátodo y el ánodo. Sirve para mantener el equilibrio entre las cargas del ánodo y el cátodo, ya que, si los electrones fluyen de ánodo a cátodo, se produce una diferencia de potencial, algo así como una descompensación de cargas, que frena el flujo de más electrones. El electrolito permite el flujo de iones (no de electrones) que reequilibran la carga entre ambos lados.

El ánodo y el cátodo están unidos en la batería por medio del electrolito. También se unen por fuera por medio de un conductor externo a través del cual solo circulan electrones. El conductor tiene dos extremos, polo positivo y polo negativo, como cualquier pila. Así que por el electrolito fluyen los iones de litio de un extremo a otro, y por el conductor externo fluyen los electrones.

En las baterías recargables las reacciones de oxidación (ceder electrones) y reducción (captar electrones) son reversibles, pueden fluir en ambas direcciones.

Batería Yoshino. Fuente: nobelprize.org

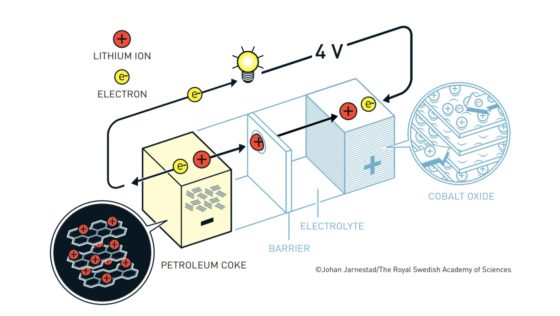

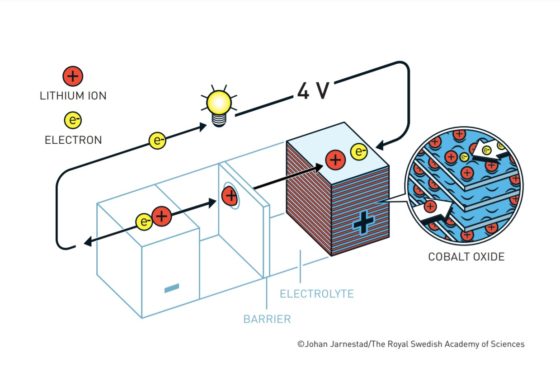

Batería Yoshino. Fuente: nobelprize.orgLas baterías de ion litio actuales más habituales tienen un cátodo de óxido de cobalto y un ánodo de un material similar al grafito denominado coque. Tanto el cátodo como en el ánodo tienen una disposición laminar en la que pueden albergar al litio. El litio viajará de cátodo a ánodo o de ánodo a cátodo a través del electrolito según el ciclo de carga o descarga. Los electrones, en cambio, circularán a través de un circuito externo.

-

Esto es lo que ocurre cuando se usa la batería

Cuando la batería está cargada, todo el litio está en el ánodo de coque. Durante la descarga los iones fluyen a través del electrolito desde el ánodo de coque hacia al cátodo de óxido de cobalto-litio. Los electrones también fluyen desde el ánodo al cátodo, pero lo hacen a través del circuito exterior, alimentando el móvil, el ordenador o el coche.

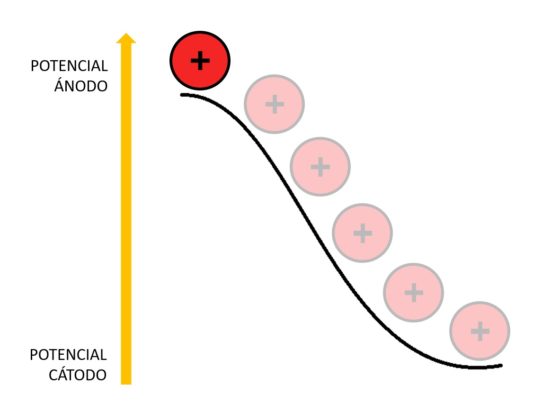

Como los iones de litio en el coque están a un potencial electroquímico más alto que en el óxido de cobalto-litio, caen desde el potencial del ánodo al potencial del cátodo. Esa es la razón por la que la batería aporta energía al aparato al que esté conectada.

Imagen: Deborah García Bello

Imagen: Deborah García Bello

El voltaje ofrecido por la batería depende de la diferencia de potencial entre el cátodo y el ánodo. Cuanto mayor sea esta diferencia, mayor voltaje obtendremos.

Cuando todos los iones de litio llegan al cátodo, la batería estará completamente descargada.

-

Esto es lo que ocurre cuando cargamos la batería

La carga de la batería se realiza conectando la batería a una fuente de energía externa como la red eléctrica. Los electrones de la red eléctrica entran en el ánodo a través del circuito externo. Esto provoca que los iones de litio abandonen el cátodo y regresen al ánodo a través del electrolito. Tanto los electrones como los iones litio se quedan acomodados en el ánodo entre las diferentes capas de coque. Cuando no fluyen más indica que la batería está completamente cargada.

La batería almacena energía en este proceso porque el potencial electroquímico del coque es más elevado que el del óxido de cobalto-litio. Esto quiere decir que los iones de litio han tenido que subir desde el potencial del cátodo hasta el potencial del ánodo.

-

Las evolución de las baterías de litio

A lo largo de la historia se han creado diferentes baterías. La de Volta, de 1800, usaba como electrodos zinc y cadmio, llegando a obtener hasta 1,1 V. Las baterías de plomo-ácido que hoy en día se utilizan en muchos coches producen 2 V cada una. Se suelen colocar 6 para producir los habituales 12V. También hay baterías de níquel-hierro (NiFe), de niquel-cadmio (NiCd), de níquel-hidruro metálico (NiMH)…

El problema que presentan estas baterías es que contienen metales tóxicos como el plomo o el cadmio. Además, ofrecen densidades energéticas relativamente bajas. Cuanto mayor sea la densidad de energía, más energía habrá disponible para acumular o transportar (por volumen o por masa). Así, las baterías de plomo-ácido ofrecen 30 Wh/kg de densidad energética, las de NiFe 40 Wh/kg, las de NiCd 50 Wh/kg y las de NiMH 80 Wh/kg. En cambio, las de ion litio ofrecen al menos 120 Wh/kg y un voltaje mayor, de 4,2 V. Hay que tener en cuenta que las pilas alcalinas clásicas, las AA, solo ofrecen 1,5 V. Por eso las baterías de litio son tan compactas y los teléfonos móviles se han aligerado tanto.

El boom en la carrera investigadora de las baterías de litio se desató en los 70 a causa de la crisis del petróleo. Estaba claro que el ánodo perfecto tendría que ser de litio. Ahora faltaba descubrir el cátodo perfecto.

La primera batería de ion litio tenía un cátodo de sulfuro de litio y titanio (LixTiS2) que era capaz de acomodar en su interior los iones de litio que llegaban desde el ánodo. El ánodo era de litio metálico, y el electrolito era de LiPF6 disuelto en carbonato de propileno. En este electrolito el litio estaba protegido tanto del agua como del aire, ganando estabilidad. Así se lograban 2,5 V. La primera batería de litio comercial fue una evolución de esta, desarrollada por la empresa Exxon. En ella se usaba litio como ánodo, TiS2 como cátodo y perclorato de litio (LiClO4) disuelto en dioxolano como electrolito.

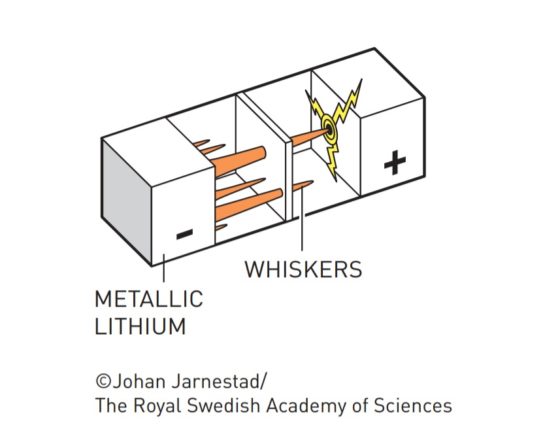

Dendritas («whiskers»). Fuente: nobelprize.org

Dendritas («whiskers»). Fuente: nobelprize.org

Pero se encontraron con un problema: cuando estas baterías se sobrecalentaban, llegaban a explotar. Descubrieron que lo que ocurría es que tras cada ciclo de carga y descarga se iban formando dendritas de litio que traspasaban la barrera de electrolito hasta llegar al cátodo, produciendo así un cortocircuito.

El problema parecía resolverse usando un ánodo diferente. En lugar de un sulfuro metálico, se probó con un óxido metálico, en concreto el dióxido de cobalto (CoO2) que, combinado con el litio se denomina óxido de cobalto-litio (LiCoO2). El LiCoO2 tiene un potencial de reducción tan alto, que ni siquiera hacía indispensable el uso de litio metálico puro como ánodo, sino que podría usarse otra sustancia que acomodase al litio de forma más estable y segura.

Batería Goodenough. Fuente: nobelprize.org

Batería Goodenough. Fuente: nobelprize.org

La respuesta llegaría en 1985 de la mano de la corporación japonesa Asahi Kasei. Descubrieron que el coque de petróleo —un sólido carbonoso derivado del refinado del petróleo— era capaz de acomodar al litio de forma muy eficiente. En muchos textos se le llama grafito. Es cierto que se le parece, pero no es exactamente grafito, sino un material de carbono que presenta dominios cristalinos grafíticos —en capas— y dominios no cristalinos. Entre unos y otros se acomodan los iones de litio.

Imagen: Litio en coque de petróleo. Fuente: nobelprize.org

Imagen: Litio en coque de petróleo. Fuente: nobelprize.org

En 1991, la empresa Sony, en colaboración con Asahi Kasei, sacaron a la venta la primera batería ion litio comercial con ánodo de óxido de cobalto-litio y cátodo de coque. El hecho de que los iones de litio entren y salgan ordenadamente en el ánodo y en el cátodo, forzados por las estructuras bidimensionales del coque y del óxido del cobalto, garantiza que las baterías apenas tengan efecto memoria. Es decir, las podemos cargar sin esperar a que se hayan descargado completamente sin miedo a que la batería se vicie.

En la actualidad se producen baterías de litio con cátodos todavía más eficientes. Como el cobalto es un elemento químico caro y relativamente escaso, el óxido de cobalto-litio se ha sustituido por el de fosfato de hierro-litio (LiFePO4) haciéndolas más baratas de producir. Se conocen como LFP, y adoptan estructuras cristalográficas diferentes. La de LFP con estructura tipo olivino es la que en la actualidad comercializa Sony. Puede durar 10 años si se carga a diario, cuando normalmente no sobrepasaban los 3-4 años. También tienen carga rápida, ya que en 2 h cargan el 95% de su capacidad.

En 2019 el desarrollo de las baterías de ion litio logró el Premio Nobel de Química repartido a partes iguales entre el alemán John B. Goodenough, el británico M. Stanley Whittingham, y el japonés Akira Yoshino. Whittingham fue quien lideró la investigación en la electrointercalación de iones de litio en disulfuros metálicos en los años 70. John Goodenough, que trabajó para Exxon, en los años 80 fue quien propuso la solución a que las baterías explotasen cuando se calentaban. Lo resolvió con el cátodo de óxido de cobalto-litio. Akira Yoshino, que trabajaba para la Corporación Asahi Kasei, en 1985 propuso el ánodo de coque.

La investigación actual en baterías de ion-litio se fundamenta en mejorar su eficiencia y el número ce ciclos de carga y descarga que pueden soportar. Se está experimentando con baterías de dióxido de carbono y litio, aunque hay expertos que aseguran que el futuro estará en el litio-grafeno.

Referencias:

They developed the world’s most powerful battery. Nobelprice.org.

Scientific Background on the Nobel Prize in Chemistry 2019 LITHIUM-ION BATTERIES. Nobelprize.org.

Baterías de iones litio, ¿cómo son?. Por Ignacio Mártil en CdeComunicación

Premio Nobel de Química 2019: Goodenough, Whittingham y Yoshino por las baterías de ión-litio. Por Francis Villatoro en La ciencia de la mula Francis.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Así funcionan las baterías de litio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Baterías de litio y oxígeno sólido

- Las baterías ion sodio, la alternativa estacionaria

- ADN para la nueva generación de baterías

Teselando el plano con pentágonos

Imagen: Osckar Espinosa / Pixabay

Imagen: Osckar Espinosa / Pixabay

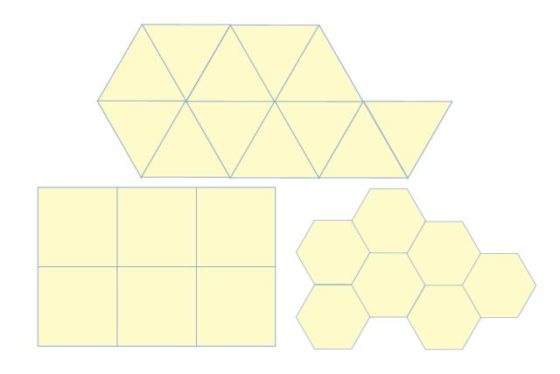

Una teselación o mosaico del plano consiste en una serie de polígonos –las teselas o losetas– que lo cubren sin dejar zonas vacías, de manera que si dos teselas se tocan, lo hacen necesariamente lado con lado o vértice con vértice.

En su obra Harmonice mundi el astrónomo Johannes Kepler estudió qué polígonos regulares podían cubrir el plano. Es decir, se preguntaba si existen mosaicos que utilicen un polígono regular como única tesela base. La respuesta es sencilla: los únicos que existen son los mosaicos por triángulos, cuadrados y hexágonos regulares.

Teselando el plano con triángulos, cuadrados y hexágonos regulares. Imagen: Wikimedia Commons.

Teselando el plano con triángulos, cuadrados y hexágonos regulares. Imagen: Wikimedia Commons.

¿Por qué no hay más? Por ejemplo, en el caso del pentágono regular, su ángulo interno es de 108 grados. Si deseáramos teselar el plano con pentágonos regulares, los vértices de dos losetas colindantes deberían tocarse sin dejar ningún hueco. Pero esto imposible, ya que 360 no es divisible por 108. De otra manera, si colocamos pentágonos regulares alrededor de un vértice, se observa en seguida que solo pueden colocarse tres, pero queda un espacio que no puede cubrirse con pentágonos.

Recordemos que un polígono regular de n lados posee ángulos internos de 180(n-2)/n grados. Así, para polígonos con siete o más lados, el ángulo interior es mayor que 120 grados pero menor que 180, con lo que llegamos a la misma conclusión que con el pentágono. Es decir, el triángulo, el cuadrado y el hexágono (regulares) son los únicos polígonos regulares cuyos ángulos internos (60 grados, 90 grados y 120 grados, respectivamente) son divisores de 360 grados.

En el estudio de mosaicos podríamos proseguir preguntarnos qué sucede al mezclar varios polígonos regulares para cubrir el plano –teselaciones semirregulares, de estos solo hay ocho–, o al usar una única pieza no regular, o al utilizar varias no regulares. Estos problemas no son sencillos de resolver. Cuando su estudio comenzó a sistematizarse llevó al desarrollo de técnicas matemáticas complejas aplicadas al estudio de teselaciones del plano (y del espacio) que después han encontrado utilidad en otros campos.

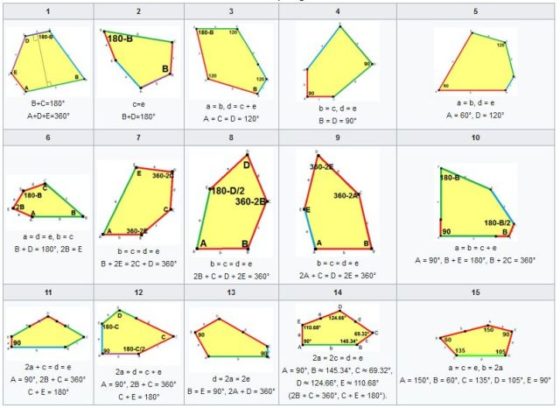

Vamos a elegir uno de estos problemas tomando el pentágono como pieza clave. La pregunta que nos planteamos es: ¿se puede teselar el plano con un único pentágono (convexo) no regular? La respuesta es que se puede, y además existen solo quince maneras de hacerlo –parece casi seguro que esta es la cantidad, aunque está en fase de revisión–.

Los quince tipos de pentágonos convexos que teselan el plano. Se denotan con letras minúsculas los lados de cada pentágono a, b, c, d, e y con letras mayúsculas los ángulos internos. Imagen: Wikimedia Commons.

Los quince tipos de pentágonos convexos que teselan el plano. Se denotan con letras minúsculas los lados de cada pentágono a, b, c, d, e y con letras mayúsculas los ángulos internos. Imagen: Wikimedia Commons.

Citamos a continuación a las personas que han descubierto estas quince clases de pentágonos: Karl Reinhardt(1895-1941)encontró cinco en 1918 (ver [1]);Richard B. Kershner (1913-1982) halló tres más en 1968 (ver [2]); Richard James descubrió el noveno tipo en 1975 tras leer un artículo de Martin Gardner sobre teselaciones pentagonales en la revista Scientific American; ese artículo también inspiró a Marjorie Rice (1923-2017) quien halló otros cuatro tipos en 1976 y 1977 (ver [3] y [4]); Rolf Stein (ver [5]) encontró el decimocuarto tipo de pentágono en 1985; y en 2015 Casey Mann, Jennifer McLoud y David Von Derau descubrieron una nueva clase (ver [6]) con ayuda de un programa informático.

El 1 de mayo de 2017 Michaël Rao anunció (ver [7]) que había realizado una prueba asistida por ordenador en la que demostraba que estos quince pentágonos convexos eran los únicos que teselaban el plano con un único tipo de loseta. La parte computacional de su demostración ha sido revisada y no contiene errores, aunque aún no se ha publicado la prueba definitiva revisada por pares.