Una nueva especie de ameba bate el récord de resistencia al calor

En plena ola de frío puede resultar reconfortante tratar sobre la increíble resistencia al calor de algunos seres vivos. Determinadas arqueobacterias proliferan a altas temperaturas en surgencias geotérmicas y en los respiraderos hidrotermales del fondo marino, donde la presión hidrostática permite que el agua alcance temperaturas muy por encima de los 100 ºC. El récord lo ostentaba la cepa 121 de Geogemma barossii, así llamada porque fue capaz de duplicar su población mientras permanecía durante 24 h en un autoclave a 121°C. Más recientemente, se descubrió en chimeneas hidrotermales del golfo de California otra arqueobacteria, Methanopyrus kandleri, capaz de reproducirse a 122°C.

Es impensable para los eucariotas[1] sobrevivir en estas condiciones. La temperatura regula el metabolismo, influye en el pH, la actividad enzimática y las propiedades de las membranas. A partir de un cierto punto, las proteínas se desnaturalizan y pierden su estructura tridimensional. Por esto, los eucariotas, y particularmente los animales, tienen límites mucho más bajos de resistencia al calor.

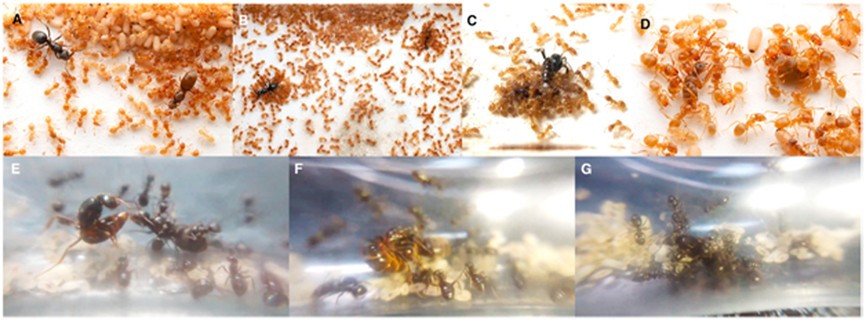

Figura 1. A la izquierda el poliqueto Alvinella pompejana, habitante de los respiraderos hidrotermales oceánicos. Probablemente es el único animal que soporta de forma constante temperaturas superiores a 60°C en una parte de su cuerpo. A la derecha la hormiga plateada del Sahara (Cataglyphis bombycina, arriba) y la hormiga roja del desierto de Australia (Melophorus bagoti, abajo, obreras y un reproductor). Son los animales terrestres con mayor resistencia al calor, manteniéndose activas por encima de los 50°C. Imágenes: Chen et al. (2024) Marine Biodiversity doi: 10.1007/s12526-024-01408-w, CC BY 4.0; Bjørn Christian Tørrissen, CC BY-SA 3.0; y Heterick et al. (2017) ZooKeys doi: 10.3897/zookeys.700.11784, CC BY 4.0.

Figura 1. A la izquierda el poliqueto Alvinella pompejana, habitante de los respiraderos hidrotermales oceánicos. Probablemente es el único animal que soporta de forma constante temperaturas superiores a 60°C en una parte de su cuerpo. A la derecha la hormiga plateada del Sahara (Cataglyphis bombycina, arriba) y la hormiga roja del desierto de Australia (Melophorus bagoti, abajo, obreras y un reproductor). Son los animales terrestres con mayor resistencia al calor, manteniéndose activas por encima de los 50°C. Imágenes: Chen et al. (2024) Marine Biodiversity doi: 10.1007/s12526-024-01408-w, CC BY 4.0; Bjørn Christian Tørrissen, CC BY-SA 3.0; y Heterick et al. (2017) ZooKeys doi: 10.3897/zookeys.700.11784, CC BY 4.0.Es cierto que los tardígrados, cuando entran en criptobiosis, sobreviven a temperaturas de 150°C, pero se trata de estados de resistencia que implican una casi completa deshidratación (solo mantienen el 3% del agua corporal). En condiciones normales no se diferencian demasiado de otros animales frente al calor. Para encontrar a los campeones en este terreno volveremos a los respiraderos hidrotermales y a los desiertos. El anélido poliqueto Alvinella pompejana, descubierto en 1980 cerca de las islas Galápagos (Figura 1), vive en tubos adheridos a las paredes de las chimeneas hidrotermales. Su cuerpo está recubierto por una gruesa capa de mucus que funciona como aislante térmico y proporciona alojamiento a bacterias simbióticas que constituyen su alimento. Alvinella genera dentro del tubo una corriente de agua que incorpora fluido caliente del manantial, rico en sulfuro, y se mezcla con agua fría y oxigenada, nutriendo así a sus bacterias. Se ha descrito que el gusano soporta en su base temperaturas de 60°C, que podrían llegar a los 80°C según otras estimaciones. En el resto del cuerpo la temperatura es menor (40-50°C), pero Alvinella es, de momento, el animal que soporta mayores temperaturas de forma sostenida.

En el medio terrestre existe una cierta competencia entre dos especies de hormigas por ostentar el título de campeona de la termorresistencia. Se trata de la hormiga plateada del Sahara (Cataglyphis bombycina) y la hormiga roja del desierto de Australia (Melophorus bagoti) (Figura 1). Esta última probablemente supera a su congénere africana, y su afición al calor es especialmente llamativa. Las hormigas rojas salen a buscar alimento cuando la temperatura del suelo llega a los 56°C y la del aire alcanza los 43.9°C. Sin embargo, las hormigas cesan completamente su actividad recolectora durante el invierno austral y parte de la primavera. Se ha descrito que continúan buscando alimento cuando el suelo alcanza los 70°C y el aire, a la altura de la hormiga, supera los 50°C. Estas hormigas solo alcanzan el pico de actividad cuando su temperatura corporal es de 46°C. Se ha comprobado en laboratorio que sobreviven tras pasar una hora a 54°C y que la máxima temperatura corporal que soportan es de 56,7°C.

Como hemos dicho, las proteínas son muy sensibles al calor y suelen perder funcionalidad a partir de los 45°C, temperaturas que no soportan la mayoría de los insectos. ¿Cómo se adaptan estas hormigas? Las proteínas de choque térmico (HSP por heat shock proteins) se encuentran en todos los seres vivos y se sintetizan en respuesta al estrés celular, sea térmico o de otros tipos. Su función es la protección y reparación de proteínas, evitando su desnaturalización. A diferencia de otros organismos, en las hormigas del desierto las HSP se producen de forma permanente, y no como consecuencia del estrés térmico. Otras adaptaciones son unas patas largas que alejan el cuerpo de la superficie del suelo, hidrocarburos muy resistentes al calor sobre la cutícula y un desplazamiento muy rápido (hasta 1 m/s en Cataglyphis), generando un flujo de aire sobre el cuerpo que ayuda a disipar el calor.

El motivo de tratar aquí estos temas es que se acaba de descubrir un nuevo récord en la resistencia de los eucariotas al calor. Un equipo liderado por Ángela Oliverio, experta en organismos extremófilos de la Universidad de Syracuse (Nueva York), describe en BioRxiv las extraordinarias propiedades de una nueva especie de ameba (Incendiamoeba cascadensis) aislada en manantiales geotérmicos del Lassen Volcanic National Park de California. En estos manantiales, con temperaturas de 49-65°C, proliferan bacterias que son fagocitadas por una comunidad de amebas.

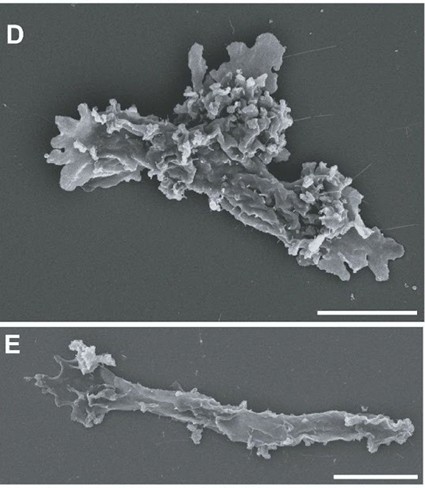

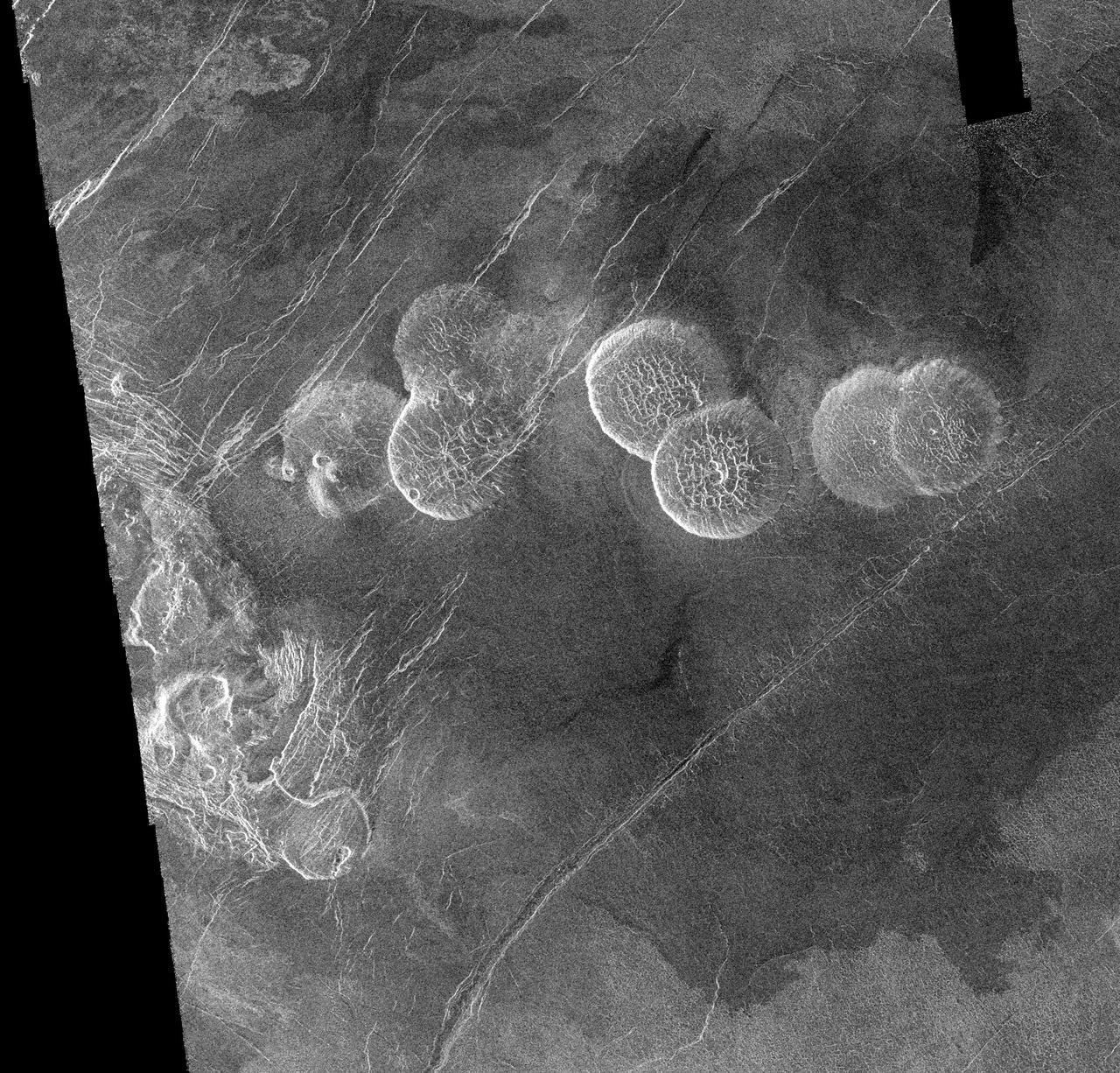

Figura 2. Incendiamoeba cascadensis, la nueva especie de ameba aislada en manantiales geotérmicos de California, observada con microscopía electrónica de barrido. Se muestran dos morfologías, amebiforme y vermiforme. Es el eucariota que soporta las mayores temperaturas, manteniendo su actividad hasta los 64°C y sobreviviendo, en forma de quiste, a 70°C. Escala: 5 μm. De Beryl Rappaport et al. (2025 BioArxiv doi: 10.1101/2025.11.24.690213v1. CC BY-NC-ND 4.0.

Figura 2. Incendiamoeba cascadensis, la nueva especie de ameba aislada en manantiales geotérmicos de California, observada con microscopía electrónica de barrido. Se muestran dos morfologías, amebiforme y vermiforme. Es el eucariota que soporta las mayores temperaturas, manteniendo su actividad hasta los 64°C y sobreviviendo, en forma de quiste, a 70°C. Escala: 5 μm. De Beryl Rappaport et al. (2025 BioArxiv doi: 10.1101/2025.11.24.690213v1. CC BY-NC-ND 4.0.En cultivos de laboratorio se observó que Incendiamoeba se multiplicaba a 63°C, permanecía activa a 64°C, y solo empezaba a formar quistes por encima de los 66°C. Aunque estos quistes se expusieran a 70°C, las amebas volvían a su actividad al bajar la temperatura, pero no se recuperaban a temperaturas superiores. Otros experimentos mostraron que las amebas eran termófilas obligadas. A 40°C no eran capaces de reproducirse, y su temperatura óptima estaba entre los 55-57°C.

La comparación del genoma de Incendiamoeba con el de otras amebas no termófilas mostró, como era de esperar, un gran número de proteínas de choque térmico y otras encargadas de la reparación del ADN. En general, la resistencia de las proteínas de esta especie al calor se reveló muy superior a la de otras amebas.

Hasta ahora solo algunos hongos y algas rojas soportaban temperaturas cercanas a los 60°C, por lo que Incendiamoeba cascadensis ha extendido los límites de resistencia al calor de la vida eucariota hasta límites insospechados.

Referencias

Beryl Rappaport, H., Petek-Seoane, N.A., Tyml, T. et al. (2025). A geothermal amoeba sets a new upper temperature limit for eukaryotes. BioRxiv [preprint]. https://www.biorxiv.org/content/10.1101/2025.11.24.690213v1.

Nota:

[1] Los organismos con núcleo celular y orgánulos especializados, es decir, todos los seres vivos menos bacterias y arqueas.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga.

El artículo Una nueva especie de ameba bate el récord de resistencia al calor se ha escrito en Cuaderno de Cultura Científica.

Nanopartículas reparadoras, una estrategia para hacer frente al alzhéimer

Cada año se detectan más de 10 millones de nuevos casos de alzhéimer y hoy en día no existe ningún tratamiento efectivo contra dicha enfermedad. En octubre de este año, se ha presentado un tratamiento experimental contra el alzhéimer en un artículo publicado en la famosa revista Signal Transduction and Targeted Therapy. Dicha terapia está basada en las nanopartículas A40-POs, y supone un cambio de paradigma.

La enfermedad de Alzheimer es el tipo de demencia más común, y, desde el punto de vista molecular, se observa una acumulación excesiva de la proteína β-amiloide. La proteína amiloide hereditaria (PAA) está presente en la membrana de las neuronas, y ciertas enzimas presentes en dicho entorno (la β-secretasa en primer lugar, y la γ-secretasa en segundo) procesan la proteína, creando un fragmento de proteína o péptido denominado β-amiloide, conformado por 40 o 42 aminoácidos. La β-amiloide no es muy soluble, y se acumula en el espacio extracelular formando estructuras similares a placas fibrilares. Cuando dichas fibras se unen a las neuronas, provocan muerte celular, y así es como la enfermedad desgasta el cerebro.

Se han realizado diversos ensayos para evitar el mencionado proceso bioquímico, sea a partir de la recuperación de las células de la glía encargadas de lavar el entorno extracelular o sea buscando la inhibición de las enzimas que producen β-amiloide. En este caso, sin embargo, el equipo investigador del Instituto de Bioingeniería de Cataluña (IBEC) y del Hospital West China de la Universidad de Sichuan (WCHSU) ha tratado de reenfocar la forma de procesar la proteína β-amiloide.

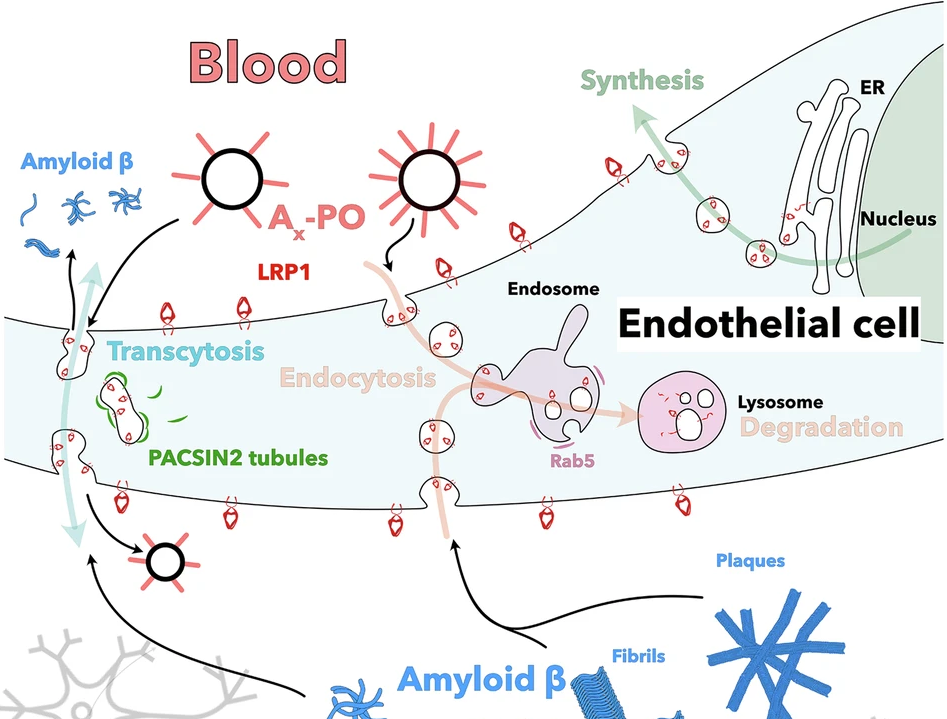

Esquema de transporte de β-amiloide del encéfalo a la sangre mediante LRP1 (low-density lipoprotein receptor-related protein 1) a través de las células endoteliales de los vasos sanguíneos. Fuente: Chen J. et al (2025) Signal Transduct Target Ther. doi: 10.1038/s41392-025-02426-1

Esquema de transporte de β-amiloide del encéfalo a la sangre mediante LRP1 (low-density lipoprotein receptor-related protein 1) a través de las células endoteliales de los vasos sanguíneos. Fuente: Chen J. et al (2025) Signal Transduct Target Ther. doi: 10.1038/s41392-025-02426-1El cerebro es un órgano muy sensible, y está protegido por la barrera hematoencefálica, que es la encargada de regular la interfaz entre la sangre y el cerebro. Se encuentra formada por las células endoteliales que conforman los vasos sanguíneos, así como por los astrocitos que se encuentran situados sobre ellos. Las células endoteliales de los vasos sanguíneos del cerebro se encuentran firmemente sujetas las unas con las otras, y, encima de ellas, se encuentras los astrocitos, cerrando todavía de manera más firme dichos enlaces. Es por ello por lo que solo unas pocas moléculas que transitan por la sangre llegan a las células del cerebro. Dicho traslado selectivo no discurre solamente de la sangre al espacio celular, ya que también ocurre del espacio celular del cerebro a la sangre, de manera que los desechos que se crean en el espacio extracelular en el cerebro se expulsan a la sangre a través de unos receptores que se encuentran en las células endoteliales. Por lo tanto, la célula endotelial es la encargada de regular la interfaz entre la sangre y el cerebro.

En el caso de la enfermedad de Alzheimer, se ha observado que dicha barrera se encuentra dañada y las células endoteliales no son capaces de trasladar las placas fibrilares de β-amiloide del cerebro a la sangre, para después poder expulsarlas. Las células endoteliales sanas cuentan con un receptor llamado LRP1 en su membrana exterior, que recoge las fibras de β-amiloide y las transporta a la sangre. En el caso de esta enfermedad, las células endoteliales de la barrera hematoencefálica están dañadas, y no cuentan con receptores LPR1. Los mencionados equipos de investigación chinos y catalanes han desarrollado una nanopartícula llamada A40-POs. Dicha nanopartícula llega hasta las células endoteliales de la barrera hematoencefálica, y renueva la expresión del receptor LRP1, por lo que las células endoteliales son capaces a través de los nuevos receptores LRP1 de captar las fibras de β-amiloide del cerebro y transportarlas a la sangre, para que luego puedan ser expulsadas del cuerpo. Los ensayos se han realizado en ratones que han desarrollado la enfermedad de Alzheimer, y una hora después de inyectar las nanopartículas en el cerebro, se ha conseguido eliminar el 60% de β-amiloide acumulado. Asimismo, en algunos casos, se ha conseguido eliminar la totalidad de las placas fibrilares tras un tratamiento de 6 meses de duración.

A pesar de que puede parecer una estrategia interesante y esperanzadora, deberemos analizar detalladamente si esta nueva terapia funciona de la misma manera en otras especies animales y en humanos.

Referencias:

Chen J, Xiang P, Duro-Castano A, Cai H, Guo B, Liu X, Yu Y, Lui S, Luo K, Ke B, Ruiz-Pérez L, Gong Q, Tian X, Battaglia G. (2025) Rapid amyloid-β clearance and cognitive recovery through multivalent modulation of blood-brain barrier transport Signal Transduct Target Ther. doi: 10.1038/s41392-025-02426-1

Guo X, Yue R, Cui Z, Wang S, Jia T, Li W, Zhang W, Shan L, Li C. (2025) Advances of therapeutic strategies for Alzheimer’s disease J Neurol. doi: 10.1007/s00415-025-13456-8.

Sobre el autor: Iker Badiola Etxaburu es doctor en biología, Profesor Pleno en la Facultad de Medicina y Enfermería de la EHU, y director de la Cátedra de Cultura Científica de la EHU

El artículo Nanopartículas reparadoras, una estrategia para hacer frente al alzhéimer se ha escrito en Cuaderno de Cultura Científica.

Grafeno

El grafeno, un material tan ligero como resistente y con propiedades extraordinarias, promete revolucionar la tecnología del futuro.

Los vídeos “Hitos científicos del siglo XXI” muestran los mayores descubrimientos y avances científicos de las últimas décadas en su sección del programa de divulgación científica Órbita Laika, en colaboración con la Cátedra de Cultura Científica de la Universidad del País Vasco.

Ficha técnica:

Producción ejecutiva: Blanca Baena

Guion: José Antonio Pérez Ledo

Dirección: Aitor Gutierrez

Grafismo: Cristina Serrano

Música: Israel Santamaría

Producción: Olatz Vitorica

Doblaje: K 2000

Locución: José Antonio Pérez Ledo

El artículo Grafeno se ha escrito en Cuaderno de Cultura Científica.

Computadores analógicos, digitales, clásicos y cuánticos

La digitalización masiva es un error irreflexivo y anticientífico, que nos puede arrastrar a la virtualidad, no a la realidad. En ciencia observamos la naturaleza real, realizamos experimentos reales, establecemos teorías que explican dichas observaciones y que prevén otros resultados no observados, los cuales podremos verificar (o no) con otros experimentos reales. Además, cuando desconocemos los fundamentos científicos profundos de sistemas complejos nos servimos de útiles métodos computacionales para tratar de simular la realidad de la mejor manera posible.

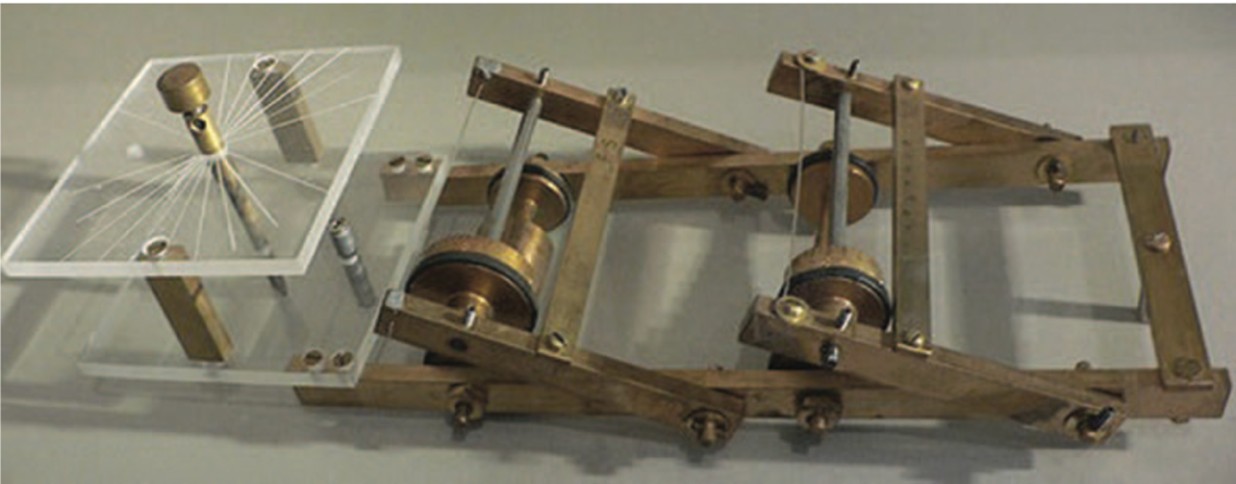

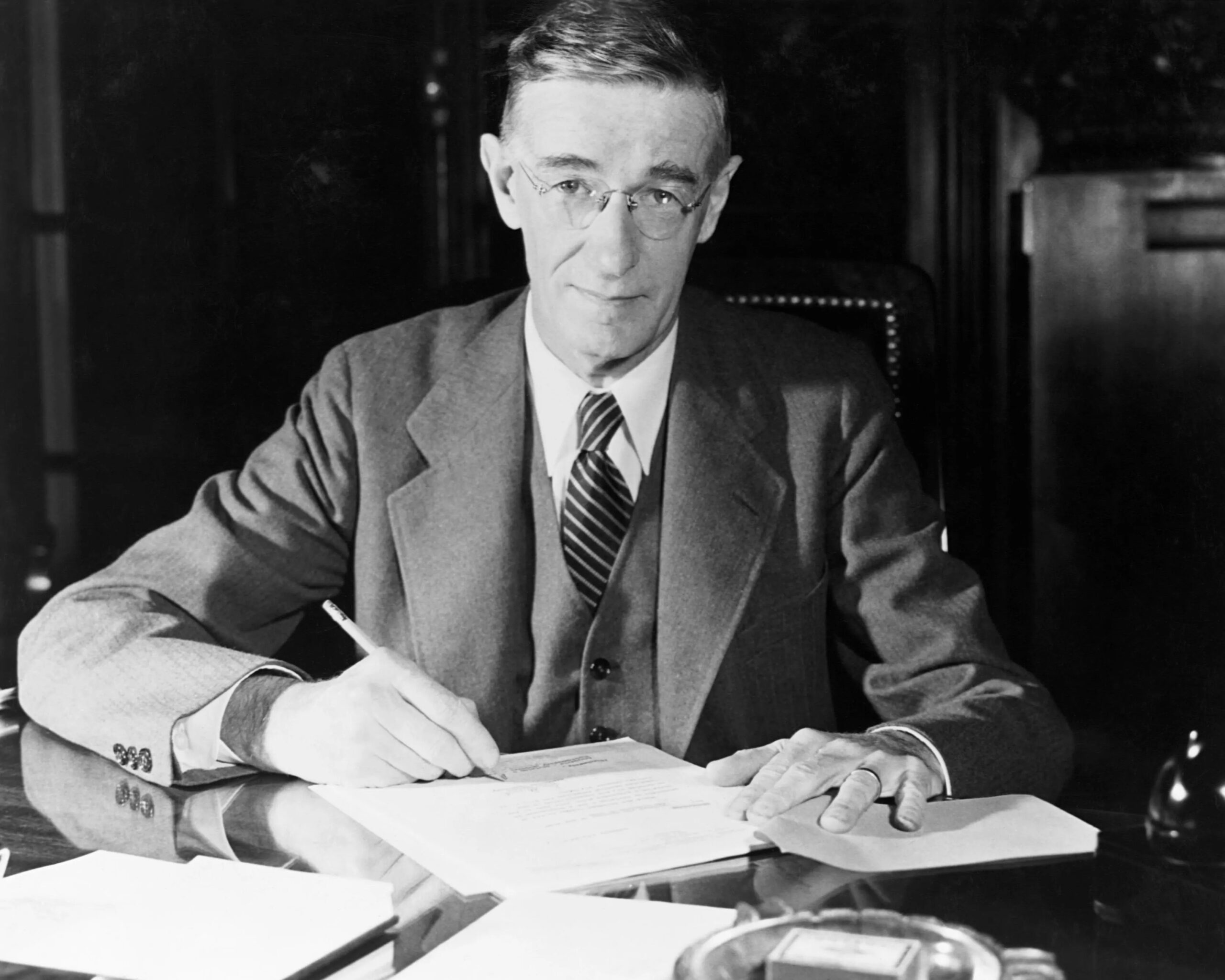

Desde la antigüedad se han construido dispositivos que usan fenómenos mecánicos, eléctricos o hidráulicos para simular análogamente la realidad. Estos son los computadores analógicos, como por ejemplo el antiguo mecanismo de Anticitera, el Analizador Diferencial, o el FERMIAC [1].

El FERMIAC inventado por Enrico Fermi en 1947 en el Laboratorio Nacional de Los Alamos. Usaba el conocido algoritmo estadístico de Monte Carlo para calcular transporte de neutrones. Fuente: Wikimedia Commons

El FERMIAC inventado por Enrico Fermi en 1947 en el Laboratorio Nacional de Los Alamos. Usaba el conocido algoritmo estadístico de Monte Carlo para calcular transporte de neutrones. Fuente: Wikimedia CommonsElectrónica analógica y digital

Aunque los computadores analógicos tienen milenios de antigüedad, éstos experimentaron un avance generalizado en el siglo XX, primero con el descubrimiento del electrón, que condujo a la construcción de diodos y triodos mediante tubos de vacío, y después con la aparición de la electrónica de estado sólido, que permitió construir diodos, transistores y amplificadores operacionales capaces de procesar información analógica en paralelo.

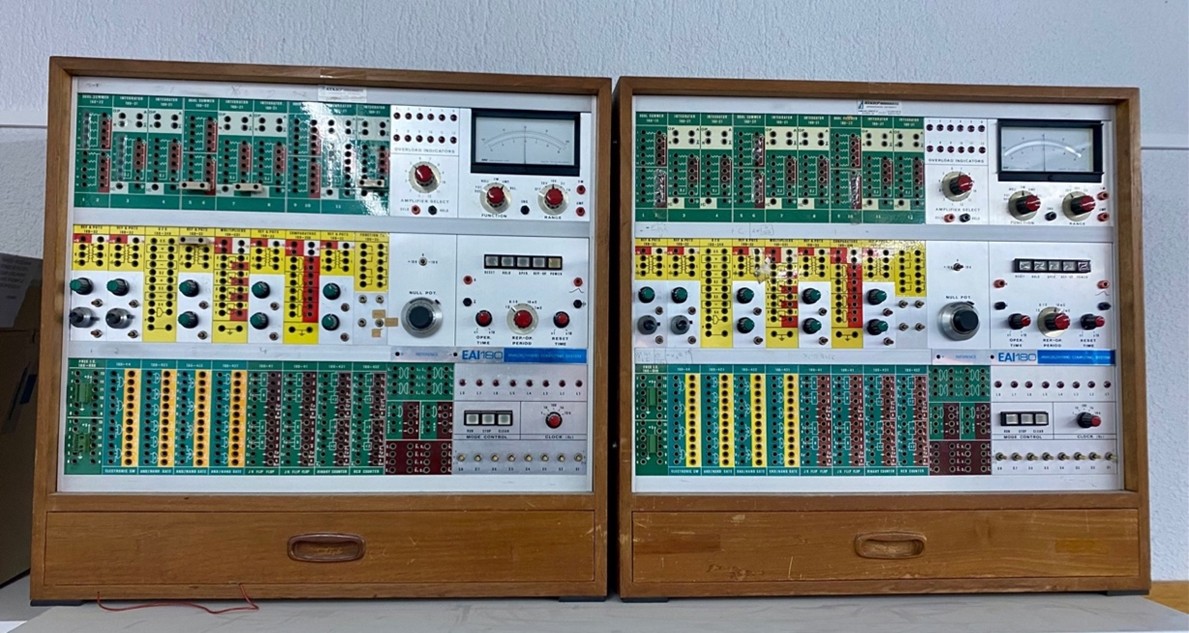

Respecto a los computadores digitales, hacia el final de la década de 1960 éstos solo eran accesibles para grandes compañías o gobiernos. Sin embargo, pequeños laboratorios de humildes universidades como la Universidad de Bilbao fundada en 1968, podían disponer de computadores analógicos, capaces de realizar complejos cálculos y simulaciones de propósito general, de enorme utilidad para cualquier rama de la ciencia.

Computadores analógicos EAI180 de Electronic Associates, Inc., en el Depto. de Electricidad y Electrónica de la Facultad de Ciencia y Tecnología de la EHU (entonces Universidad de Bilbao). Foto: Victor Etxebarria Ecenarro.

Computadores analógicos EAI180 de Electronic Associates, Inc., en el Depto. de Electricidad y Electrónica de la Facultad de Ciencia y Tecnología de la EHU (entonces Universidad de Bilbao). Foto: Victor Etxebarria Ecenarro.Los computadores analógicos pueden procesar información continua mediante lógica no determinista y en tiempo real. Por ello, realizar funciones complejas, no lineales, continuas y en paralelo con sistemas analógicos es mucho más fácil que con sistemas digitales. Sin embargo, al no trabajar con valores binarios 1 y 0, también pueden producir ruido más fácilmente que los computadores digitales. Este hecho, junto con el abaratamiento de los chips microprocesadores digitales parecieron hacer desaparecer la utilidad de la computación analógica.

Precisión, velocidad y tolerancia a errores

La distinción entre computadores analógicos y digitales no radica exclusivamente en sus mecanismos de procesamiento de información, sino también en la eficiencia, precisión y tolerancia a errores que podemos esperar en distintos tipos de cálculo y aplicaciones.

Los computadores digitales dan alta precisión en sus cálculos numéricos, ya que los datos binarios evitan inexactitudes. Esto supera en principio a cualquier computador analógico, ya que las señales analógicas que procesan pueden estar sometidas de inicio a imprecisiones.

Sin embargo, un computador analógico, al estar alimentado por flujo de señal continua, puede funcionar en tiempo real, de manera diferente a un computador digital, que procesa datos numéricos de forma secuencial. Además, un computador analógico es mucho más tolerante a errores: pequeñas variaciones en el flujo de datos de entrada no afectan drásticamente al resultado de la computación. Sin embargo, en un computador digital hay que detectar los datos binarios erróneos y corregirlos: si no, el resultado es inservible.

Computación clásica analógica o digital

Aunque la computación digital es claramente dominante, su empleo para procesar cada vez más cantidad de datos a mayor velocidad da lugar a excesos de gastos de energía y memoria, especialmente en las conocidas aplicaciones IA basadas en reconocimiento de patrones y en la generación estadística partiendo de enormes bases de datos.

Pero procesar gran cantidad de información para el reconocimiento de audio o imágenes es más fácil para los computadores analógicos: se trata de procesar directamente las propiedades físicas de las señales de audio o video. Así, un computador analógico puede realizar estas operaciones de forma más rápida y eficiente que los sistemas digitales, ya que no requiere la conversión de las señales analógicas a datos digitales. Esto hace que los computadores analógicos sean especialmente adecuados para tareas en las que la velocidad y la capacidad de manejar grandes conjuntos de datos en tiempo real sean fundamentales, aunque a costa de la alta precisión y versatilidad que ofrecen los sistemas digitales.

Además, si queremos modelar redes neuronales más realistas que las que hoy se usan en IA, no sólo existen neuronas que funcionan digitalmente, sino que de hecho la neurociencia nos explica que existen muchos más tipos de redes naturales -más bien analógicas- que pueden modelarse mejor con un computador analógico.

El principio de funcionamiento de la mente humana es más analógico que digital. El cerebro toma datos de otros sensores y redes analógicas y los utiliza para realizar sus cálculos, en lugar de acceder a ellos desde una memoria digital. Además, en lugar de un procesador digital de 256 bits, los sistemas analógicos utilizan procesadores analógicos de medida directa para realizar la misma operación. Este sistema analógico es más eficiente y disipa mucha menos energía.

Computación cuántica analógica o digital

Richard P. Feynman cuando estudiaba computación [2] decía que, si la naturaleza no es clásica sino cuántica, para simularla de forma realista, es mejor hacerlo con un computador cuántico.

La cuantización de magnitudes medibles parece sugerir que la realidad es digital, pero esto no lo sabemos. La constante de Planck y todas las asociadas son un sistema de unidades basado en las cantidades fundamentales determinadas por las leyes físicas, pero no hay nada en esto que implique una discretización del universo.

La pregunta más profunda asociada es si la realidad es entonces digital o analógica. La teoría completa de gravitación cuántica sigue siendo un problema no solucionado [3], y hay experimentos propuestos para detectar si el tiempo-espacio es discreto o continuo, digital o analógico [4].

Entre tanto, los computadores cuánticos digitales experimentan serios problemas no solo con la cantidad de qubits que pueden construirse, sino con el mantenimiento de su coherencia cuántica. Estos errores digitales deben detectarse y eliminarse. Perfeccionar los computadores cuánticos digitales requiere mantener la coherencia de los qubits, gestionar las tasas de error y abordar la complejidad del hardware, incluyendo puertas digitales. Por esta razón muchos grupos investigadores explotan las ventajas de la versión analógica de computadores cuánticos, para poder simular de forma realista la naturaleza [5]. Los computadores analógicos no están obsoletos, y dejemos claro que la virtualidad no es la realidad.

Referencias

[1] Fabrizio Coccetti (2016) The Fermiac or Fermi’s Trolley. Il Nuovo Cimento 39 C, 296. doi: 10.1393/ncc/i2016-16296-7

[2] Richard P. Feynman (1982) Simulating physics with computers. Int J Theor Phys 21, 467–488. doi: 10.1007/BF02650179

[3] Jarmo Mäkelä (2011) Is Reality Digital or Analog? arXiv:1106.2541 [physics.pop-ph] https://doi.org/10.48550/arXiv.1106.2541

[4] Todd A. Brun and Leonard Mlodinow (2019) Detecting discrete spacetime via matter interferometry. Phys. Rev. D 99, 015012. doi: 10.1103/PhysRevD.99.015012

[5] Daniel González-Cuadra, Majd Hamdan, Torsten V. Zache et al. (2025) Observation of string breaking on a (2+1)D Rydberg quantum simulator. Nature 642, 321–326. doi: 10.1038/s41586-025-09051-6

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (EHU)

El artículo Computadores analógicos, digitales, clásicos y cuánticos se ha escrito en Cuaderno de Cultura Científica.

Los viajes interplanetarios de Emilio Herrera Linares

Si a muchos les suena a día de hoy el nombre de Emilio Herrera Linares, es porque, en los últimos tiempos, se ha recuperado su figura como inventor de la «escafandra estratonáutica» o, en otras palabras, del traje de astronauta. Pero, por si eso no fuera suficiente, hay más, mucho más. Emilio Herrera, además de un pionero de la aviación y de la ingeniería aeroespacial —amén de muchas otras cosas— fue uno de nuestros mayores visionarios.

Nació en 1879 en Granada, y se formó como ingeniero militar en un momento en que la aviación formaba más parte del mundo de los sueños que del mundo real. Eso no le impidió convertirse en uno de los primeros pilotos de avión en España —también pilotaba globos y dirigibles— ni, lo que es más importante, aspirar a volar, algún día, todavía más alto, más lejos. Tal vez a la Luna… o a Marte. Para Emilio Herrera, el viaje interplanetario no era una cuestión de posibilidad, sino de tiempo. Y en eso no se equivocó. No vivió lo suficiente como para ver llegar al Apollo 11 a la Luna —falleció en 1967—, pero sí para ver es pistoletazo de salida de la carrera espacial y cómo Yuri Gagarin se convertía en la primera persona en orbitar nuestro planeta desde el espacio. Esto es: cuando Emilio Herrera nació, ni siquiera existían los aviones, cuando murió, ya había naves espaciales.

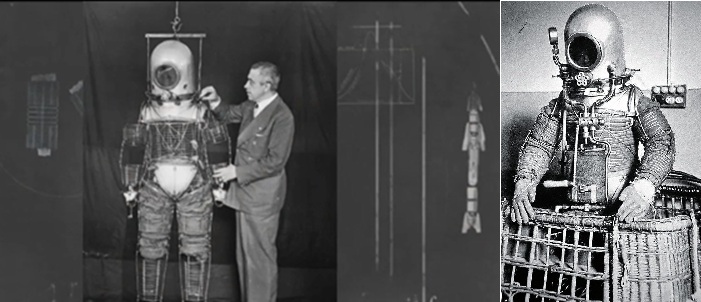

Emilio Herrera junto a su escafandra estratonáutica y la escafandra completa. Estaba pensaba para vuelos en globo a gran altitud, pero la NASA, con el inicio del programa espacial, llegaría a interesarse por ella. Fuente: Dominio público.

Emilio Herrera junto a su escafandra estratonáutica y la escafandra completa. Estaba pensaba para vuelos en globo a gran altitud, pero la NASA, con el inicio del programa espacial, llegaría a interesarse por ella. Fuente: Dominio público.Con el título de «Cómo se realizarán, antes de cincuenta años, los viajes a la Luna», el 23 de abril de 1932 la revista Estampa publicó una entrevista a Emilio Herrera en la que este imaginaba, con todo lujo de detalles y de forma lo más realista posible respecto a la tecnología del momento, cómo podrían ser esos viajes interplanetarios del futuro. Y no se limitaba a descripciones vagas —de hecho, llegó a dar conferencias sobre este asunto—: habla de masas, combustibles, velocidades, trayectorias, tiempo… describía la fase de reentrada en nuestro planeta y daba detalles como que el primer paso no debería ser intentar llegar a la Luna directamente, sino enviar una misión tripulada que simplemente la rodeada, lo que, de hecho, sucedió décadas después.

Sin duda parece que se trata de una cosa irrealizable, pero yo soy optimista. Cuando era joven fui de los primeros que pilotaron aviones en España. Entonces, hablar de aviación era tanto como hacerse acreedor del calificativo de loco […]. Quienes hemos visto esta evolución fantástica de la aviación, podemos creer que estamos más cerca de los viajes interplanetarios que hace cincuenta años lo estábamos de la aviación.

¿Y acaso se equivocó? Bueno… en cierto modo sí, porque el viaje a la Luna, al menos, fue posible mucho antes de lo que él imaginó.

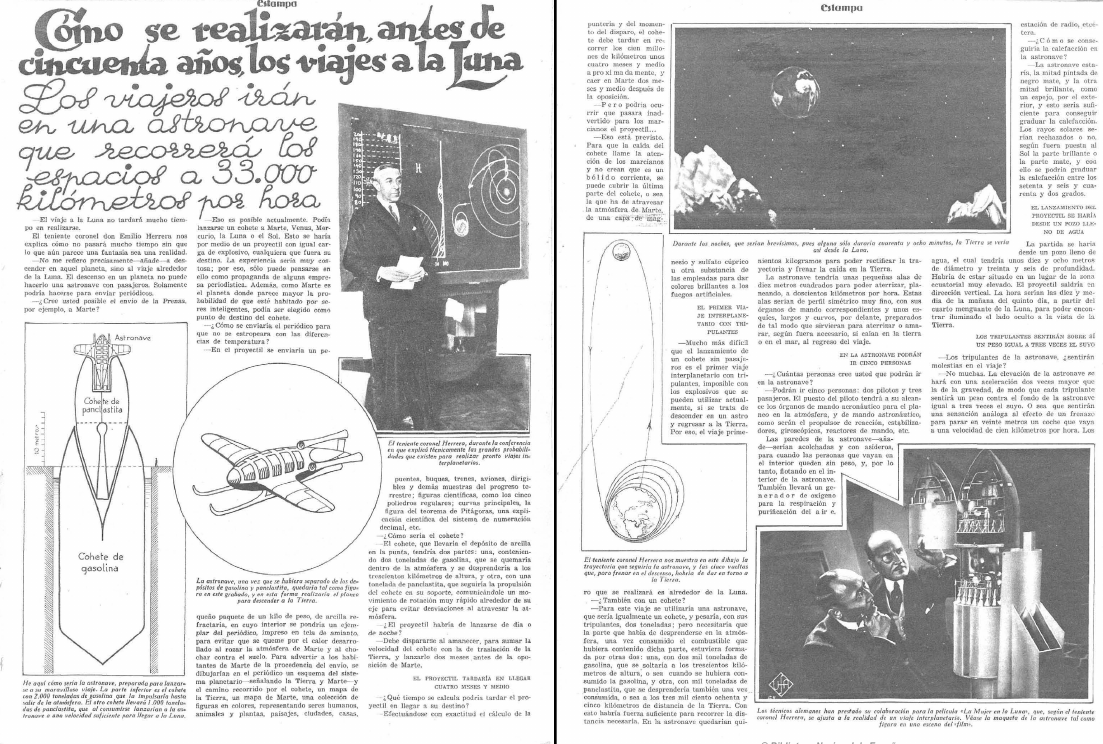

Entrevista a Emilio Herrera Linares en la revista Estampa. Se puede consultar completa en la hemeroteca digital de la Biblioteca Nacional de España.

Entrevista a Emilio Herrera Linares en la revista Estampa. Se puede consultar completa en la hemeroteca digital de la Biblioteca Nacional de España.Fuente: Dominio público.

En la entrevista describe cada fase del viaje: la aceleración inicial, la separación de la primera etapa de los cohetes, la ingravidez que sentirían los tripulantes… e incluso se permite imaginar cómo se vería la Tierra desde el espacio, a miles de kilómetros de distancia de su superficie. Lamentablemente, y aunque seguramente llegó a ver algunas de las instantáneas realizadas desde la órbita por los primeros satélites, la primera imagen en color del planeta completo, tomada por el satélite ATS-3, no se publicó hasta dos meses después de su muerte; la icónica Earthrise, un año después.

No fue la primera foto de la Tierra desde el espacio, pero sí una de las más icónicas. Earthrise, se tomó durante la misión Apollo 8 el 24 de diciembre de 1968. Emilio Herrera Linares había fallecido hacía poco más de un año: el 13 de septiembre de 1967, a los 88 años. Fuente: NASA

No fue la primera foto de la Tierra desde el espacio, pero sí una de las más icónicas. Earthrise, se tomó durante la misión Apollo 8 el 24 de diciembre de 1968. Emilio Herrera Linares había fallecido hacía poco más de un año: el 13 de septiembre de 1967, a los 88 años. Fuente: NASAY, además, encontramos otros detalles que, al leerlos desde el futuro, pueden llegar a provocarnos una sonrisa, como cuando habla de la posibilidad de enviar un periódico a Marte —recordemos que estamos en 1932— y comenta:

Para advertir a los habitantes de Marte de la procedencia del envío, se dibujarían en el periódico un esquema del sistema planetario —señalando la Tierra y Marte—, y el camino recorrido por el cohete, un mapa de la Tierra, un mapa de Marte, una colección de figuras en colores, representando seres humanos, animales y plantas, paisajes, ciudades, casas, puentes, buques, trenes, aviones, dirigibles y demás muestras del progreso terrestre; figuras científicas como los cinco poliedros regulares; curvas principales, la figura del teorema de Pitágoras, una explicación científica del sistema de numeración decimal, etc.

¿Alguien más ha pensado en el disco dorado de las Voyager?

Leer esta entrevista a Emilio Herrera —dejando a un lado detalles como que el periódico al que me acabo de referir estaría impreso en tela de amianto para evitar su combustión durante el descenso a la superficie de Marte (algo que, en realidad, tendría mucho sentido)— es volver a una época donde los ingenieros españoles no solo inventaban, y lo hacían muy bien, sino que se permitían soñar. Sueños que, en muchos casos, se vieron truncados por la guerra.

Tal vez haya llegado el momento de recuperarlos, de recordarlos y, parafraseando el epitafio de la tumba del general Herrera, no llorarlos, sino imitarlos.

Bibliografía

Díaz Roncero, F. (23 de abril de 1932). Cómo se realizarán antes de cincuenta años los viajes a la Luna. Estampa, 224.

Martínez Ron, A. (16 de nayo de 2024). La capa ‘perdida’ de Emilio Herrera: “Esto es lo único que nos queda del primer traje espacial de la historia”. El Diario.

Polanco Masa, A. (5 de julio de 2007). La escafandra estratonáutica. Tecnología obsoleta.

Polanco Masa, A. (2025). El legado del ingenio: 365 grandes inventos españoles. Serendipia.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Los viajes interplanetarios de Emilio Herrera Linares se ha escrito en Cuaderno de Cultura Científica.

El Pilish, poesía irracional con reglas extra

En la anterior entrada del Cuaderno de Cultura Científica titulada Poesía irracional, habíamos comentado que un poema, o un microrrelato, es irracional si la cantidad de letras de cada palabra se corresponde con el valor de cada dígito, en orden y hasta una cierta cantidad finita, de un número irracional, como π (la razón entre la longitud de una circunferencia y su diámetro), e (el número de Euler), ϕ (el número áureo) o la raíz de dos, √2, entre otros, o también, poemas en los que cada verso tiene tantas palabras como el valor de los dígitos del número irracional (aunque a esta cuestión ya le dedicaremos una entrada en el futuro).

Grafitti ficticio, creado con IA, de la fórmula más hermosa de las matemáticas, la fórmula de Euler, en la que aparecen los números irracionales π y e, además de 0, 1, la constante imaginaria i, así como los signos de la suma + y la igualdad =

Grafitti ficticio, creado con IA, de la fórmula más hermosa de las matemáticas, la fórmula de Euler, en la que aparecen los números irracionales π y e, además de 0, 1, la constante imaginaria i, así como los signos de la suma + y la igualdad =

El ejemplo más conocido y bonito en lengua española de poesía irracional asociada al número π (lo que algunos autores llaman pi-ema) es el poema del escritor y poeta colombiano Rafael Nieto París (1839-1899), publicado en el artículo titulado La cuadratura del círculo (Anales de Ingeniería, 2, 112-121, 1888), que ya se incluyó en la anterior entrada, pero que no me resisto a volver a incluirlo aquí.

Soy π, lema y razón ingeniosa [314159]

de hombre sabio, que serie preciosa [265358]

valorando enunció magistral. [979]

Con mi ley singular bien medido [323846]

el Grande Orbe, por fin, reducido [264338]

fue al sistema ordinario usual. [32795]

Arquímedes, en ciencias preciado [0288]

crea π, monumento afamado, [4197]

y aunque intérmina dio valuación, [16939]

periferia del círculo supo, [9 3 7 5]

duplicando geométrico grupo, [105]

resolver y apreciarle extensión. [8209]

Teorema legó, memorable [749]

como raro favor admirable [4459]

de la espléndida ciencia inmortal; [23078]

y amplia ley, filosófica fuente [16406]

de profunda verdad y ascendente [28620]

magnitud, descubrió universal. [899]

El objetivo de esta entrada es realizar una breve introducción al Pilish, es decir, a la poesía irracional realizada en base a la constante matemática π, con una serie de reglas extra introducidas por el matemático, ingeniero de software y conocido escritor de creación literaria con constricciones Michael Keith (1955), principalmente en lengua inglesa.

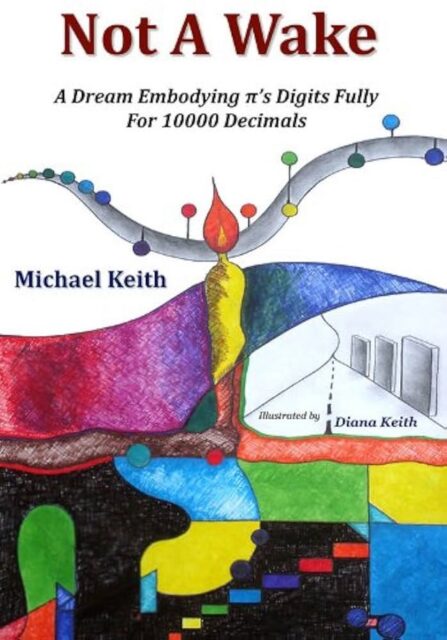

Portada del libro Not A Wake: A Dream Embodying π’s Digits Fully for 10000 Decimals / No es un despertar: un sueño que encarna los dígitos de π por completo para 10.000 decimales, de Michael Keith, primer libro escrito por completo en Pilish

Portada del libro Not A Wake: A Dream Embodying π’s Digits Fully for 10000 Decimals / No es un despertar: un sueño que encarna los dígitos de π por completo para 10.000 decimales, de Michael Keith, primer libro escrito por completo en PilishLos antecedentes del Pilish

Según Michael Keith (1955), en su página web CADAEIC.NET, uno de los primeros poemas irracionales con el número π escritos en inglés, a principios del siglo XX, es

How I need a drink, alcoholic in nature, after the heavy lectures involving quantum mechanics!

[Traducción: ¡Cómo necesito una copa, de naturaleza alcohólica, después de las pesadas clases sobre mecánica cuántica!]

Esta creación, que se apoya en los 15 primeros dígitos de la constante matemática [3,14159265358979], se debe al físico, matemático y astrónomo británico James Jeans (1877-1946).

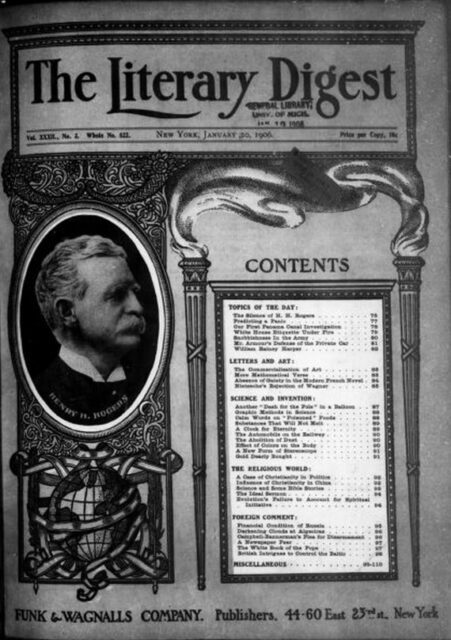

Portada del número 3, del volumen 32, de la revista Literary Digest publicado, en 1906, en Nueva York

Portada del número 3, del volumen 32, de la revista Literary Digest publicado, en 1906, en Nueva York

Aunque a principios del siglo XX ya aparecieron otros ejemplos en inglés de pi-emas. En el número 3, del volumen 32 (1906), de la revista estadounidense Literary Digest se recoge el siguiente pi-ema (con 31 dígitos de π) enviado por “Adam C. Orr, de Chicago”:

Now I, even I, would celebrate

In rhymes unapt, the great

Immortal Syracusan, rivaled nevermore,

Who in his wondrous lore

Passed on before

Left men his guidance how to circles mensurate.

[Traducción: Ahora yo, incluso yo, celebraría / con rimas inapropiadas, al gran / siracusano inmortal, sin rivales jamás, / quien en su maravillosa ciencia / transmitió ante / los hombres su guía sobre cómo medir círculos]

Los treinta y un dígitos utilizados son 3,141592653589793238462643383279. Como se puede observar aún no aparece ningún 0 en la expresión, ya que eso ocurre en el dígito que está en la posición treinta y tres. Y es precisamente la cifra 0 la que causa ciertos problemas a la hora de crear un poema irracional, como se comentará más adelante.

Estos mismos dígitos son los utilizados en otra creación que también aparece junto a esta en el artículo del Literary Digest. Estos poemas no solo son pi-emas, sino que están dedicados a uno de los sabios más importantes de la Antigua Grecia, el matemático Arquímedes de Siracusa (aprox. 287 – 212 a.n.e.), que realizó un gran avance en la aproximación al número π (véase la entrada ¿Es normal el número pi?).

Además, estos dos poemas eran una respuesta a otros dos poemas que se mencionaban en el número 20, del volumen 31 (1905), de esa misma revista, Literary Digest, uno en francés, el poema “Que j’aime à faire apprendre un nombre utile aux sages!” en su versión corta (que puede leerse en la entrada Poesía irracional, y que se remonta, como mínimo, a 1846), y el otro en alemán, que es el que se incluye a continuación.

Dir, O Held, O alter Philosoph, du Reisengenie!

Wie viele Tausende bewundern Geister

Himmlisch wie Du und göttlich!

Noch reiner in Aeonen

Wird das und strahlen

Wie im lichten Morgenrot!

[Traducción: ¡A ti, héroe, filósofo antiguo, genio viajero! / ¡Cuántos miles admiran espíritus / celestiales y divinos como tú! / Aún más puros en eones / se volverán y brillarán / como en el brillante amanecer.]

Este poema fue publicado, quizás originalmente, en el periódico alemán Frankfurter Zeitung en julio de 1905, por un “poeta y matemático alemán”, eso es todo lo que se conoce sobre el autor, y se publica ese mismo año en la revista Nature.

Siguiendo con los pi-emas en inglés, el siguiente fue publicado en 1914 en la revista Scientific American y utiliza 13 dígitos de la constante matemática.

See, I have a rhyme assisting

My feeble brain, its tasks ofttimes resisting

[Traducción: Mira, tengo una rima que ayuda a mi débil cerebro, cuyas tareas a menudo se resisten]

En muchos libros y artículos de divulgación matemática aparece la siguiente regla mnemotécnica para acordarse de los primeros decimales del número π “May I have a large container of coffee?” (¿Me podrías dar un recipiente grande de café?), pero no conozco ni el origen, ni el autor de la misma.

Página de la columna Computer Recreations de octubre de 1985 de la revista Scientific American, escrita por el matemático canadiense Alexander K. Dewdney, en la que aparecen algunos pi-emas

Página de la columna Computer Recreations de octubre de 1985 de la revista Scientific American, escrita por el matemático canadiense Alexander K. Dewdney, en la que aparecen algunos pi-emas

En la columna Computer Recreations (Recreaciones con ordenador) de octubre de 1985 de la revista Scientific American, escrita por el matemático canadiense Alexander K. Dewdney, se menciona una importante cantidad de creaciones irracionales con los primeros decimales del número π, entre las que está el siguiente ejemplo.

How I wish I could recollect pi.

Eureka! cried the great inventor.

Christmas pudding, Christmas pie

Is the problem’s very center.

[Traducción: Cómo quisiera poder recordar Pi. / ¡Eureka!, exclamó el gran inventor. / Pudín de Navidad, pastel de Navidad / Es el núcleo mismo del problema.]

El problema del cero

La mayoría de los pi-emas, sobre todo los más antiguos, no llegan hasta el dígito 33 del número π, puesto que en ese lugar se encuentra el primer cero de la expresión decimal de esta constante.

π = 3,1415926535897932384626433832795028841971693993751058209749445923078164062862089 …

El problema trivial que aparece con el cero es que escribir una palabra con 0 letras significaría no escribir ninguna palabra, por lo que los ceros pasarían desapercibidos en la creación literaria, como si no formasen parte de los dígitos de la constante matemática. Este problema ha sido resuelto de diferentes maneras por las personas que se han enfrentado a la creación literaria basada en el número π, la más sencilla, además de no incluir ninguna palabra, es construir pi-emas con menos de treinta y tres palabras, como los ejemplos mostrados aquí o en la anterior entrada.

En la página web Pi Philologi, de Antreas P. Hatzipolakis, se muestra una versión del poema “How I want a drink, alcoholic of course, after the heavy lectures involving quantum mechanics”, creada por “Alexander Volokh, David Tazartes, Steve LaCombe” en la cual el cero marca el final de cada verso, es decir, al terminar un verso siempre hay que añadir un “cero” en la expresión decimal.

El poema es el siguiente:

How I need a drink, alcoholic of course, after the tough

lectures involving quantum mechanics, but we did estimate

some digits by making very bad, not accurate, but so greatly

efficient tools!

By dropping valuable wood, a dedicated student — I, Volokh,

Alexander, can determine beautiful and curious stuff, O!

Smart, gorgeous me!

Descartes himself knew wonderful ways that could ascertain it too!

Revered, glorious — a wicked dude!

Behold an unending number — pi!

Thinkers’ ceaseless agonizing produces little, if anything.

For this constant, it stops not — just as e, I suppose.

Vainly ancient geometers computed it — a task undoable.

Legendre, Adrien Marie: «I say pi rational is not!»

Adrien proved this theorem.

Therefore, the doubters have made errors.

(Everybody that’s Greek.)

Today, counting is as bad a problem as years ago, maybe centuries even.

Moreover, I do consider that variable x, y, z, wouldn’t much avail.

Pi, imaginary, like i?

No, buffoon!

[Traducción: ¡Cómo necesito un trago, alcohólico, por supuesto, después de las duras / clases sobre mecánica cuántica! Pero sí que estimamos / algunos dígitos fabricando muy malas, imprecisas, pero enormemente / eficientes herramientas. / Dejando caer madera valiosa, un estudiante dedicado —yo, Volokh, / Alexander— puedo determinar cosas hermosas y curiosas, ¡oh! / ¡Qué inteligente y hermoso yo! / ¡El propio Descartes también conocía métodos maravillosos para determinarlo! / ¡Reverenciado, glorioso, un tipo malvado! / ¡Contemplen un número infinito: pi! / La incesante agonía de los pensadores produce poco, si acaso algo. / Para esta constante, no se detiene, igual que e, supongo. / En vano, los geómetras antiguos la calcularon, una tarea imposible. / Legendre, Adrien Marie: «¡Digo que pi racional no es!» / Adrien demostró este teorema. / Por lo tanto, los escépticos han cometido errores. / (Todos los que son griegos). / Hoy, contar es un problema tan grave como hace años, tal vez incluso siglos. / Además, considero que las variables x, y, z no servirían de mucho. / ¿Pi, imaginario, como i? / ¡No, bufón!]

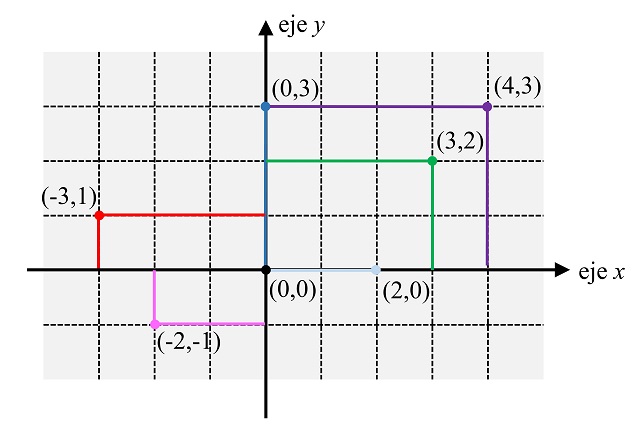

La cantidad de letras de cada palabra en cada verso, junto con el cero final, que se corresponden con los dígitos de la constante geométrica, se muestran en la siguiente imagen.

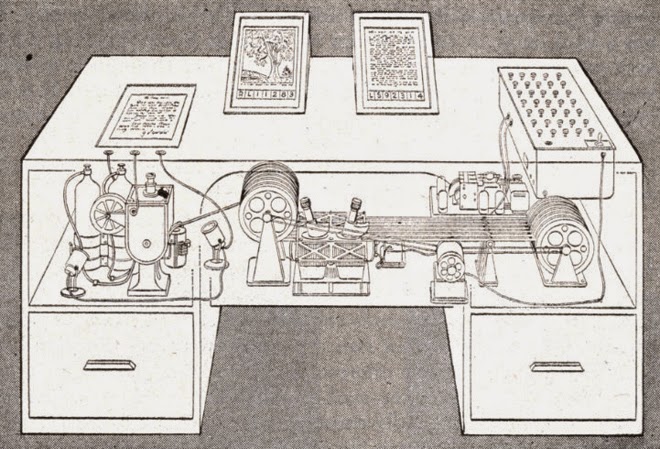

En algunos casos se incluye una palabra que “recuerda” al cero. Así, en la versión de 1846 del poema francés “Que j’aime à faire apprendre un nombre utile aux sages!”, que incluye cinco versos (véase la entrada Poesía irracional [https://culturacientifica.com/2025/12/24/poesia-irracional/]), ese quinto verso se corresponde con los dígitos 50288 y dice así “Tirez circonférence au diamètre etcetera”, es decir, la palabra circunferencia se interpreta como cero. O, en el poema que David Soul incluye en su libro Somewhen (2011), es la palabra “nothing” (nada) la que simboliza el cero.

It’s a fact

A ratio immutable

Of circle round and width

Produces geometry’s deepest conundrum

For as the numerals stay random

No repeat lets out its presence

Yet it forever stretches forth

Nothing to eternity.

[Traducción: Es un hecho. / Una proporción inmutable. / Del círculo redondo y el ancho. / Produce el enigma más profundo de la geometría. / Pues, como los números siguen siendo aleatorios. / Ninguna repetición revela su presencia. / Sin embargo, se extiende para siempre. / Nada hacia la eternidad.]

Algunos autores se decantan por que sean signos de puntuación los que representen el cero. En el siguiente poema (basado en los primeros 402 dígitos de π), cualquier signo de puntuación, que no sea un punto, representa la cifra 0. Además, hay otra regla que se compartirá con el Pilish, que las palabras de más de nueve letras representan dos dígitos adyacentes (por ejemplo, la palabra de doce letras representa los dígitos 1 y 2 en la expresión decimal del número irracional). Este poema, con el título Circle Digits A Self-Referential Story (Los dígitos circulares, una historia auto-referencial), lo he visto en el libro Pi, A Source Book (Springer, 3e, 2004), de Lennart Berggren, Jonathan Borwein y Peter Borwein, atribuido a Michael Keith que lo habría publicado en la revista The Mathematical Intelligencer, en 1986. En la siguiente imagen podéis leerlo, tal cual aparece en el libro, es decir, con forma circular.

[Traducción: Durante un rato me quedé reflexionando sobre el tamaño de los círculos. La gran computadora central procesaba silenciosamente todo su código ensamblador. En mi interior, toda mi esperanza residía en descubrir una expansión difícil de alcanzar. Valor: pi. Se esperaban decimales pronto. Introduje nerviosamente un formato de procedimientos. La computadora central procesó la solicitud. Error. Lo volví a introducir y lo volví a escribir con cuidado. Esta iteración dio cero errores en las impresiones: éxito. Esperé atentamente. Pronto, impulsado por mis pensamientos, aparecieron mnemotécnicas narrativas que relacionaban los dígitos con el verbo. La idea parecía existir, pero solo de forma abreviada, típicamente en frases cortas. Insistí y decidí firmemente usar una suma de decimales, probablemente alrededor de cuatrocientos, ¡suponiendo que el código informático se detuviera pronto! Reflexionando sobre estas ideas, las palabras me atrajeron. Pero existía un problema con los ceros. Reflexionando más, apareció la solución. El cero sugiere un elemento de puntuación. ¡Muy novedoso! Mis pensamientos culminaron. Sin puntos, concluí. Todos los signos de puntuación restantes eran ceros. La primera respuesta de expansión de dígitos se presentó ante mí. Al examinar, algunos problemas surgieron desafortunadamente ¡Ese error estúpido! La impresión que tenía mostraba cuatro nueves como decimales principales. Evidentemente preocupante. Todos los números parecían incorrectos. Reparar el error requirió mucho esfuerzo. Un mnemotécnico pi con letras parecía realmente bueno. Contar todas las letras probablemente debería ser suficiente. Buscar un registro sería útil. En consecuencia, continué, esperando una buena respuesta final de la computadora. El primer número se mostró lentamente en la pantalla plana: 3. Bien. Los dígitos finales aparentemente también eran correctos. Ahora mi esquema de memoria probablemente sería implementable. La técnica fue elegida, elegante en su esquema: por autoreferencia, se aseguró una historia mnemotécnicamente útil. De repente apareció un título adecuado: «Dígitos del Círculo». Empecé tomando un bolígrafo. Las palabras emanaban con inquietud. Deseaba más sinónimos. Rápidamente encontré mi diccionario de sinónimos (junto a mí). Rogets es probablemente esencial para esto, decidí al instante. Escribí y borré más. El Rogets me ayudó muchísimo. Mi historia prosiguió (¡qué bonito!) impecablemente. El final, sobre todo, pronto llegaría con alegría. Así que esta historia que me ayuda a recordar está indiscutiblemente completa. Pronto encontraré un editor. Allí, confío en que la narración aparecerá inmediatamente, produciendo fama. FIN.]

Las reglas del Pilish

Pero la solución más frecuente con el problema del cero ha sido utilizar palabras con diez letras, o incluso más, añadiendo reglas extra en algunos casos, como el anterior poema o el de Rafael Nieto. De hecho, el matemático y escritor Michael Keith definió el Pilish básico con esa sencilla regla, los dígitos de la constante matemática que tomen valores no nulos, es decir, del 1 al 9, dan lugar a palabras con esa cantidad de letras, mientras que para el 0 se utilizan palabras con diez (10) letras.

La siguiente composición irracional, atribuida al ingeniero de caminos, economista y escritor Josep María Albaigés Olivart (1940-2014) en la página web Pi Philologi, de Antreas P. Hatzipolakis, sería un ejemplo de Pilish básico.

¿Qué? ¿Y cómo π posee infinidad de cifras? ¡Tiene que

haber periodos repetidos! Tampoco comprendo que, de una

cantidad poco sabida, se afirme cosa así tan atrevida.

Con mi tozudez descarada, asumo audazmente el abstruso problema.

¡Vaya! Y determino pulirlo y afinar,

mejorando los complejos versillos con ingenio feraz.

En su artículo Writing in Pilish, Keith plantea definir el Pilish estándar, como extensión del Pilish básico, debido a cadenas de dígitos como 1121 o 1111211, que dificultan la creación de poemas en Pilish básico. Por lo tanto, una composición de Pilish estándar cumple que cada palabra de N letras representa: el dígito N si N es menor que 10, es decir, la palabra tiene menos de diez letras; el dígito 0 si N es igual a 10; dos dígitos consecutivos si la palabra tiene más de diez letras, por ejemplo, una palabra con 12 letras representa dos dígitos, en concreto, 12.

Keith hace además un par de aclaraciones. El apóstrofe no se cuenta, así “couldn’t” es una palabra de 7 letras, mientras que cualquier signo de puntuación, que no sea un apóstrofe, por ejemplo, un guion, se cuenta como un espacio en blanco, así “fun-filled” son dos palabras, ya que el guion – es un espacio en blanco, luego se corresponde con los dos dígitos 36.

Ilustración del poema El cuervo, de Edgar Allan Poe, realizada por el dibujante británico John Tenniel (1820-1914)

Ilustración del poema El cuervo, de Edgar Allan Poe, realizada por el dibujante británico John Tenniel (1820-1914)

En 1995, Michael Keith compuso un poema en Pilish estándar que era una versión del poema “El cuervo” del escritor estadounidense Edgar Allan Poe (1809-1849) y utilizaba 740 dígitos del número π. Como es un poema muy largo solo incluyo aquí la primera parte.

Poe, E. [31]

Near a Raven [415]

Midnights so dreary, tired and weary. [926535]

Silently pondering volumes extolling all by-now obsolete lore. [897932384]

During my rather long nap – the weirdest tap! [62643383]

An ominous vibrating sound disturbing my chamber’s antedoor. [27950288]

“This”, I whispered quietly, “I ignore”. [419716]

Perfectly, the intellect remembers: the ghostly fires, a glittering ember. [9399375105]

Inflamed by lightning’s outbursts, windows cast penumbras upon this floor. [8209749445]

Sorrowful, as one mistreated, unhappy thoughts I heeded: [92307816]

That inimitable lesson in elegance – Lenore – [406286]

Is delighting, exciting…nevermore. [2089]

Ominously, curtains parted (my serenity outsmarted), [986280]

And fear overcame my being – the fear of “forevermore”. [3482534211]

Fearful foreboding abided, selfish sentiment confided, [706798]

As I said, “Methinks mysterious traveler knocks afore. [21480865]

A man is visiting, of age threescore.” [1328230]

[…]

[Traducción: Poe, E. / Cerca de un cuervo / Medianoches tan lúgubres, cansadas y agotadoras. / Reflexionando en silencio sobre volúmenes que ensalzan toda la sabiduría ya obsoleta. / Durante mi larguísima siesta, ¡un golpe extraño! / Un ominoso sonido vibrante perturbó la antesala de mi habitación. / «Esto», susurré en voz baja, «lo ignoro». / Perfectamente, el intelecto recuerda: los fuegos fantasmales, una brasa brillante. / Inflamadas por los relámpagos, las ventanas proyectaban penumbras sobre este suelo. / Triste, como alguien maltratado, atendí a pensamientos infelices: / Esa inimitable lección de elegancia -Lenore- / Es encantadora, emocionante… nunca más. / Ominosamente, las cortinas se abrieron (mi serenidad superó), / Y el miedo se apoderó de mi ser: el miedo al «para siempre». Un presentimiento temeroso persistía, un sentimiento egoísta se confiaba, / Como dije, «Me parece que un viajero misterioso llama a la puerta. / Un hombre de sesenta años está de visita.»]

Por último, comentar que el libro Not A Wake: A Dream Embodying π’s Digits Fully for 10000 Decimals / No es un despertar: un sueño que encarna los dígitos de π por completo para 10.000 decimales, de Michael Keith, es el primer libro escrito por completo en Pilish, basado en los primeros 10.000 decimales de la constante matemática.

El artículo El Pilish, poesía irracional con reglas extra se ha escrito en Cuaderno de Cultura Científica.

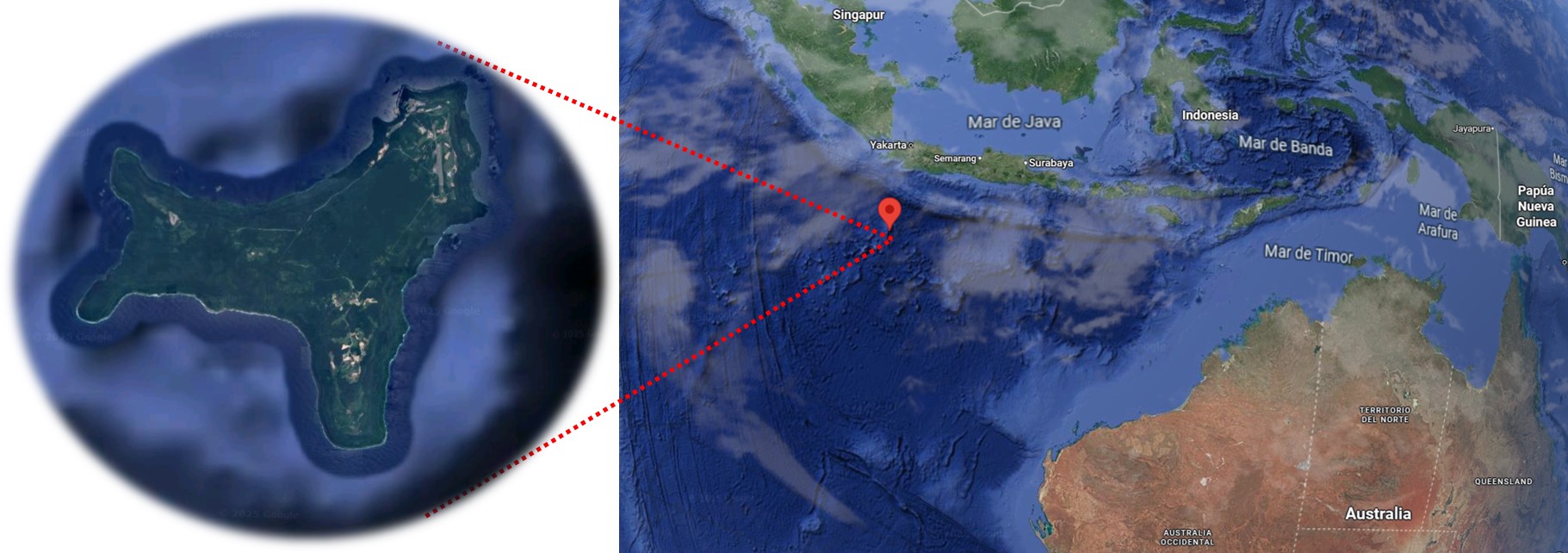

Una isla muy navideña

El día de Navidad de 1643 el capitán británico William Mynors, de la Compañía de las Indias Orientales, navegó cerca de una pequeña isla con forma de Y situada en el Océano Índico, al sur de Java y Sumatra, a la que llamó, sorpresivamente, Christmas Island.

Localización de la Christmas Island (Isla de Navidad) en el Océano Índico. Imagen tomada de Google Maps.

Localización de la Christmas Island (Isla de Navidad) en el Océano Índico. Imagen tomada de Google Maps.Aparte del nombre tan sugerente, esta pequeña isla, que actualmente pertenece a Australia, tiene otra particularidad que la hace muy especial: su historia geológica. Que, en el fondo, es la culpable de haber creado un minúsculo paraíso natural que ha provocado que dos terceras partes de la isla hayan sido declaradas Parque Nacional.

Esta historia comenzó hace unos 80 millones de años, cuando se puso en marcha un importante vulcanismo submarino en esta zona del Océano Índico. El magma ascendió hacia la superficie rompiendo la corteza hasta que la lava fue capaz de salir al exterior, pero en el fondo del mar. Ese contraste de temperaturas entre un fundido ardiente y un agua fría, provocó un enfriamiento rápido de la lava, generando rocas volcánicas. Al producirse erupciones continuas en el mismo sitio, las rocas se fueron acumulando unas encima de las otras, llegando a formar una estructura elevada conocida como monte submarino.

Tras 20 millones de años de actividad ígnea, se formó una acumulación vertical de más de 4500m de rocas volcánicas que llegó a superar la columna de agua, saliendo a superficie y dando origen a una nueva isla. En esta fase, los corales empezaron su labor, construyendo un importante atolón arrecifal que cubrió ese islote volcánico. Estas acumulaciones de coral han quedado preservadas como rocas sedimentarias carbonatadas, llamadas calizas, que sellan parcialmente las rocas volcánicas más antiguas.

El crecimiento coralino quedó temporalmente detenido hace entre 40 y 35 millones de años por un nuevo periodo de vulcanismo activo, que provocó que esas rocas volcánicas de nueva formación se entremezclasen con las calizas previamente depositadas. Pero pronto la calma precedió a la tormenta, el vulcanismo cesó y volvieron a crecer nuevos arrecifes de coral que fueron aumentando el tamaño de la isla, tanto en la vertical como en su extensión lateral.

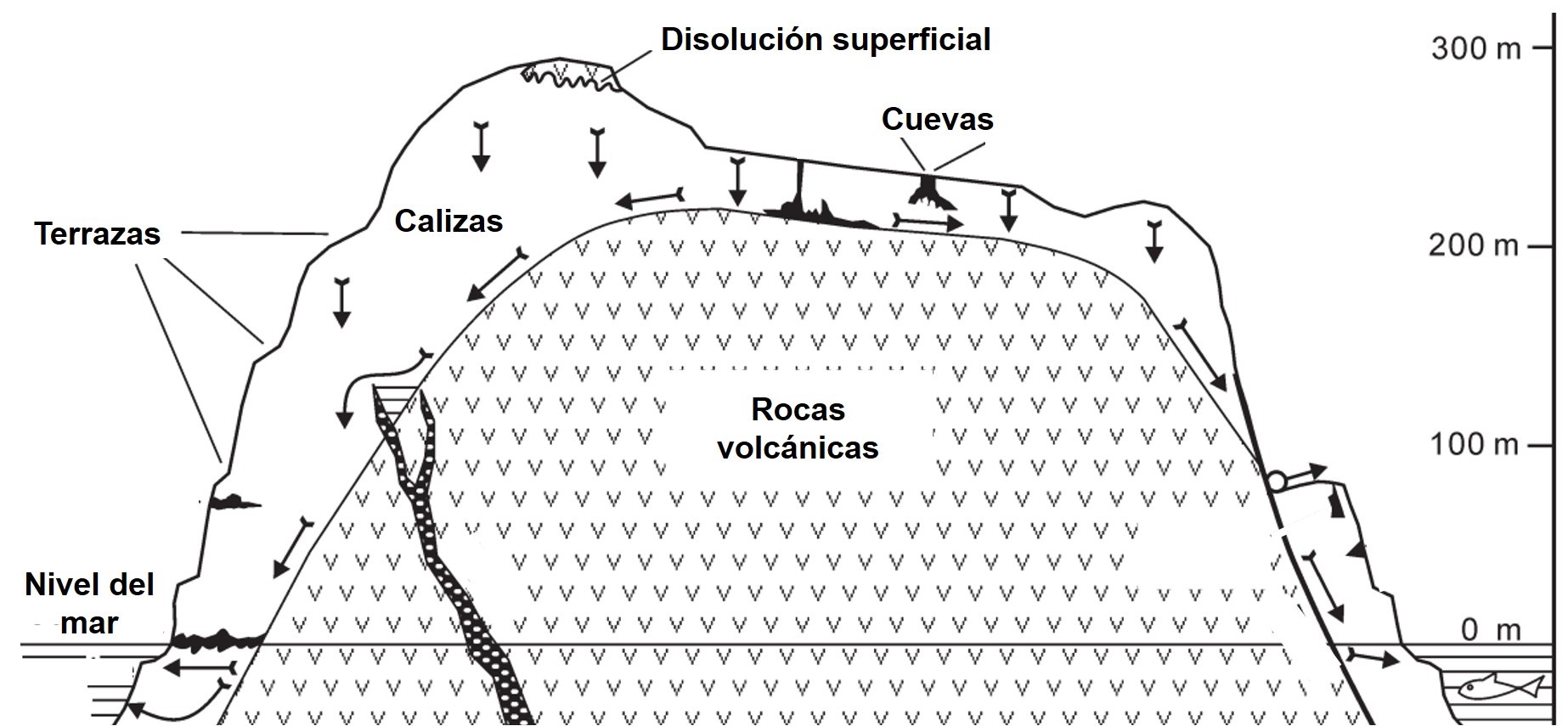

Esquema de la sección vertical de la Christmas Island, con las rocas volcánicas en el centro de la isla, las calizas cubriéndolas y las cuevas atravesando las calizas. Las fechas negras indican el flujo del agua dulce en profundidad. La escala vertical está exagerada diez veces. Imagen modificada de Grimes, K.G. (2001). Karst Features of Christmas Island (Indian Ocean). Helictite 37, 41-58.

Esquema de la sección vertical de la Christmas Island, con las rocas volcánicas en el centro de la isla, las calizas cubriéndolas y las cuevas atravesando las calizas. Las fechas negras indican el flujo del agua dulce en profundidad. La escala vertical está exagerada diez veces. Imagen modificada de Grimes, K.G. (2001). Karst Features of Christmas Island (Indian Ocean). Helictite 37, 41-58.Pero este crecimiento coralino no actuó de manera continua. Durante esta época geológica, en esta zona se produjeron numerosos ascensos y descensos del nivel marino que afectaron al desarrollo de los atolones. Por ejemplo, destaca un importe aumento del nivel del mar que sucedió hace unos 20 millones de años y que se vio reflejado en un hundimiento relativo de la isla. Estos cambios del nivel marino provocaron que la formación de arrecifes ocurriese como “a pulsos”, es decir, en varias fases temporales superpuestas, dando lugar a una morfología de las rocas calizas en terrazas, como si fuesen los peldaños de una escalera. Vamos, que los corales crecen, se mueren, vuelven a crecer, se vuelven a morir y así continuamente de acuerdo a la subida y la bajada del nivel del mar, generando parches de rocas carbonatadas dispuestos en bloques uno sobre el otro.

Hace unos 10 millones de años, cambió esta dinámica. Un descenso relativo del nivel del mar provocó que la isla quedase expuesta, deteniendo la nueva formación de arrecifes y dejando a la intemperie a las calizas que la cubrían. Y estas rocas tienen una particularidad: el carbonato cálcico del que están formadas reacciona con el agua de lluvia, que lleva dióxido de carbono disuelto, disolviéndose, valga la redundancia, tanto en superficie como en profundidad. Así, a lo largo de la superficie de la isla se ha ido formando un importante complejo de cuevas durante los últimos millones de años, en las que circula el agua dulce procedente de la lluvia que se infiltra en el subsuelo, llegando a salir al exterior en numerosas surgencias o manantiales. Incluso, en zonas bajas de la isla, el agua marina acaba entrando en algunas de estas cavidades, provocando una mezcla con esa agua dulce.

Imagen de una de las cuevas (The Grotto) formadas en las calizas de Christmas Island que actúa como depósito del agua dulce procedente de la lluvia. Foto: Wondrous World Images / Christmas Island National Park

Imagen de una de las cuevas (The Grotto) formadas en las calizas de Christmas Island que actúa como depósito del agua dulce procedente de la lluvia. Foto: Wondrous World Images / Christmas Island National ParkEn momentos más recientes también se ha formado una nueva particularidad geológica en esta isla, aunque las culpables son las aves marinas. Estos animalitos defecan, por ser fina, sobre la superficie de las rocas expuestas, generando unas acumulaciones de heces muy ricas en fósforo que se llaman guano. Que acaba disolviéndose con el agua de lluvia y del mar, mezclándose con el carbonato de las calizas para producir depósitos de fosfatos (P2O5) endurecidos que recubren las rocas. Y que han sido uno de los principales intereses económicos de la isla desde finales del siglo XIX.

Aquí acaba mi relato, pero no la historia geológica de la Christmas Island, que aún continúa escribiéndose. Los arrecifes de coral crecen en los márgenes submarinos de la isla, las aves continúan acumulando excrementos en la superficie y el agua de lluvia no cesa de disolver las rocas en profundidad. Incluso, no se puede descartar que algunas intrusiones volcánicas intenten volver a salir a superficie para sumarse a la aventura. Lo que sí es seguro es que, este, es el mejor cuento de Navidad que podía traeros en estas fechas.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la EHU

El artículo Una isla muy navideña se ha escrito en Cuaderno de Cultura Científica.

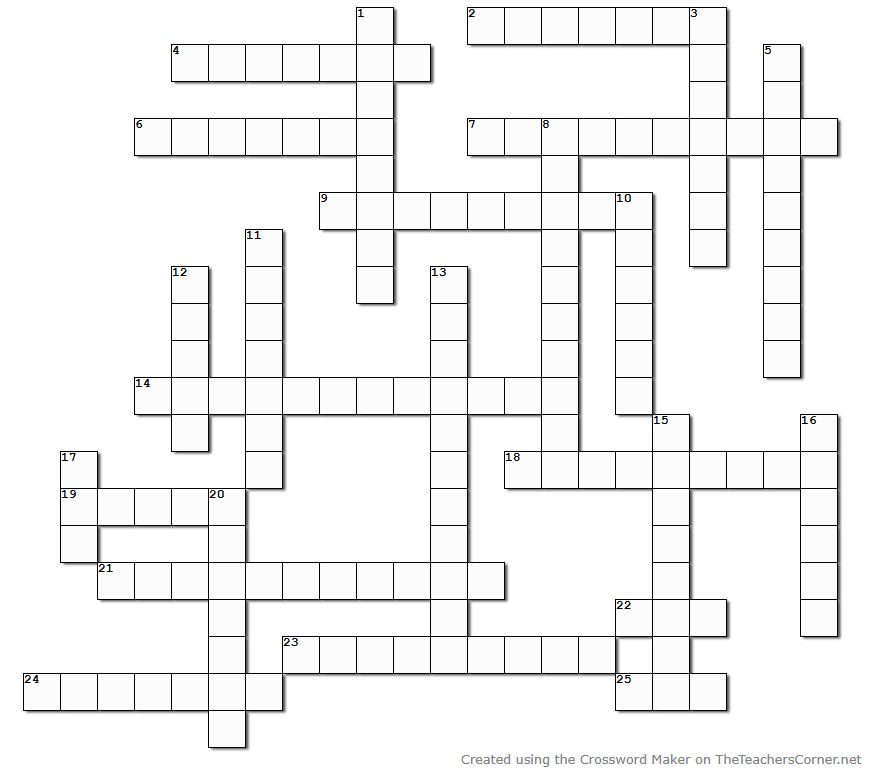

De la A a la Z: un crucigrama con grandes protagonistas de las matemáticas

Hoy proponemos un crucigrama con los apellidos de veinticinco protagonistas de las matemáticas; son trece mujeres y doce hombres cuyos apellidos van de la A a la Z. Debajo aparecen las pistas ordenadas por orden alfabético de apellidos.

Crucigrama generado en The Teacher’s Corner

Crucigrama generado en The Teacher’s Corner

A (19 horizontal)

Especialista en geometría simpléctica, fue cooptada por el grupo Oulipo en 2009. Interesada por la historia de las matemáticas, publicó, entre otros, la correspondencia entre Henri Cartan y André Weil, y un libro dedicado a la matemática rusa Sofia Kovalevskaya.

B (15 vertical)

Es el nombre colectivo de un grupo de matemáticos franceses fundado a finales de 1934. Decidieron escribir una enciclopedia bajo el título de “Éléments de Mathématique” que buscaba presentar el conjunto de las matemáticas de manera sistemática. Aunque quedó incompleta, ha tenido una gran influencia en las matemáticas del siglo XX.

C (16 vertical)

Jugó un papel fundamental en la creación de la teoría de conjuntos. Desarrolló una teoría y una aritmética completas de conjuntos infinitos, llamados cardinales y ordinales, que ampliaron la aritmética de los números naturales. Propuso la llamada “hipótesis del continuo” en 1878.

D (13 vertical)

Esta matemática argentina es conocida fundamentalmente por su trabajo en geometría algebraica. En los últimos años ha centrado su trabajo en las aplicaciones de la geometría algebraica en el ámbito de la biología molecular.

E (12 vertical)

Creía que las matemáticas eran una actividad social, y llevaba una vida itinerante con el único propósito de escribir artículos matemáticos con otros matemáticos. Este matemático húngaro intentó resolver y propuso problemas en matemáticas discretas, teoría de grafos, teoría de números, análisis matemático, teoría de aproximación, teoría de conjuntos y teoría de probabilidad.

F (10 vertical)

Esta matemática gallega investigó sobre ocultaciones estelares por la Luna, medidas de estrellas dobles, medidas astrométricas y la determinación de pasos por dos verticales. Antes de la de Matemáticas, obtuvo las licenciaturas de Química y de Farmacia y consiguió el título de Maestra Nacional.

G (6 horizontal)

Realizó importantes contribuciones a la teoría de números y la teoría de la elasticidad. Aunque tenía un gran talento como matemática, su educación autodidacta no le permitió tener la base científica sólida que hubiera necesitado para sobresalir por sus aportaciones.

H (9 horizontal)

Considerado como uno de los fundadores de la topología moderna, contribuyó significativamente a la teoría de conjuntos, la teoría descriptiva de conjuntos, la teoría de la medida y el análisis funcional.

I (11 vertical)

Este matemático japonés es conocido por su influencia en la teoría de números algebraicos.

J (4 horizontal)

Sus cálculos de mecánica orbital como empleada de la NASA fueron cruciales para el éxito del primer vuelo espacial tripulado estadounidense y de los posteriores. Su trabajo incluyó el cálculo de trayectorias, ventanas de lanzamiento y rutas de retorno de emergencia para los vuelos espaciales del Proyecto Mercury.

K (14 horizontal)

De origen ruso, realizó contribuciones notables al análisis, las ecuaciones diferenciales parciales y la mecánica. En 1874, presentó tres trabajos (sobre ecuaciones en derivadas parciales, sobre la dinámica de los anillos de Saturno y sobre integrales elípticas) en la Universidad de Gotinga como tesis doctoral.

L (25 horizontal)

Este matemático noruego desarrolló en gran medida la teoría de la simetría continua y la aplicó al estudio de la geometría y las ecuaciones diferenciales. También realizó contribuciones sustanciales en álgebra.

m (8 vertical)

Sus temas de investigación incluyeron la teoría de Teichmüller, la geometría hiperbólica, la teoría ergódica y la geometría simpléctica. En 2014 recibió la Medalla Fields, convirtiéndose en la primera mujer en ganar el premio, así como la primera iraní.

N (20 vertical)

Esta matemática alemana realizó importantes contribuciones al álgebra abstracta. El teorema que lleva su nombre explica la conexión fundamental entre la simetría en física y las leyes de conservación.

O (3 vertical)

Fue una matemática soviética que realizó trabajos pioneros sobre la teoría de ecuaciones diferenciales parciales, la teoría de medios elásticos fuertemente no homogéneos y la teoría matemática de capas límite.

P (1 vertical)

Se le considera el creador del campo de la topología algebraica. Realizó también importantes contribuciones a la geometría algebraica, la teoría de números o el análisis complejo, entre otros. A principios del siglo XX formuló la conjetura que lleva su nombre y fue resuelta por Grigori Perelman en 2003.

Q (24 horizontal)

Se le conoce como el «primer arquitecto» de la K-teoría algebraica. Recibió la Medalla Fields en 1978.

R (23 horizontal)

A pesar de carecer prácticamente de formación académica en matemáticas puras, realizó importantes contribuciones al análisis matemático, la teoría de números, las series infinitas y las fracciones continuas, incluyendo soluciones a problemas matemáticos que en su época se consideraban irresolubles.

S (7 horizontal)

Fue una de las personas que debatieron sobre un hipotético planeta que perturbaba a Urano. Sus predicciones se cumplieron en 1846 con el descubrimiento de Neptuno. Tutora de Ada Byron, tradujo la “Mécanique Céleste” de Pierre-Simon Laplace al inglés, añadiendo además una completa explicación de las bases matemáticas contenidas en el texto.

T (17 vertical)

Su investigación abarca temas de análisis armónico, ecuaciones diferenciales parciales, combinatoria algebraica, combinatoria aritmética, combinatoria geométrica, teoría de la probabilidad, detección comprimida, teoría analítica de números y las aplicaciones de la inteligencia artificial en matemáticas. Obtuvo la Medalla Fields en 2006.

u (5 vertical)

Su investigación abarca, entre otras, la teoría geométrica de ecuaciones en derivadas parciales, el cálculo en variaciones, la teoría gauge, los sistemas integrables o las ecuaciones de Schrödinger no lineales. En 2019 consiguió el Premio Abel, siendo la primera mujer (y, de momento, la única) en recibir este galardón.

V (18 horizontal)

Fue galardonada con la Medalla Fields en julio de 2022. Esta matemática ucraniana es la segunda mujer en obtener este galardón que premiaba su trabajo sobre el empaquetamiento de esferas: resolvió en 2016 el problema del empaquetamiento en dimensión 8 y, en colaboración con otros investigadores, en dimensión 24.

W (21 horizontal)

Recibió en 1953 una de las primeras Becas Fulbright, con la que pudo estudiar en la Universidad de Yale (EE. UU.). Su investigación se centró principalmente en la teoría de grupos y en la teoría de álgebras de Lie. Desde 1983 permaneció apartada del mundo académico, al tener que regresar a su Galicia natal para atender a su madre enferma.

Y (22 horizontal)

Nacido en China, este matemático ha realizado importantes contribuciones a la geometría diferencial. En 1982 recibió una Medalla Fields por “sus contribuciones a las ecuaciones diferenciales, a la conjetura de Calabi en geometría algebraica, a la conjetura de masa positiva de la teoría de la relatividad general y a las ecuaciones reales y complejas de Monge-Ampère”.

Z (2 horizontal)

Fue un lógico y matemático alemán, cuyo trabajo tiene importantes implicaciones en los fundamentos de las matemáticas. En 1904 demostró el denominado teorema de buen orden.

Nota

Si quieres comprobar si has acertado los apellidos de estos veinticinco protagonistas de las matemáticas, puedes consultar el crucigrama resuelto en este enlace. Si te has quedado con ganas de más, prueba este.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

El artículo De la A a la Z: un crucigrama con grandes protagonistas de las matemáticas se ha escrito en Cuaderno de Cultura Científica.

Las “matemáticas inversas” arrojan luz sobre por qué los problemas difíciles son difíciles

El uso de técnicas metamatemáticas ha permitido demostrar que ciertos teoremas que parecen distintos son, en realidad, lógicamente equivalentes.

Un artículo de Ben Brubaker. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

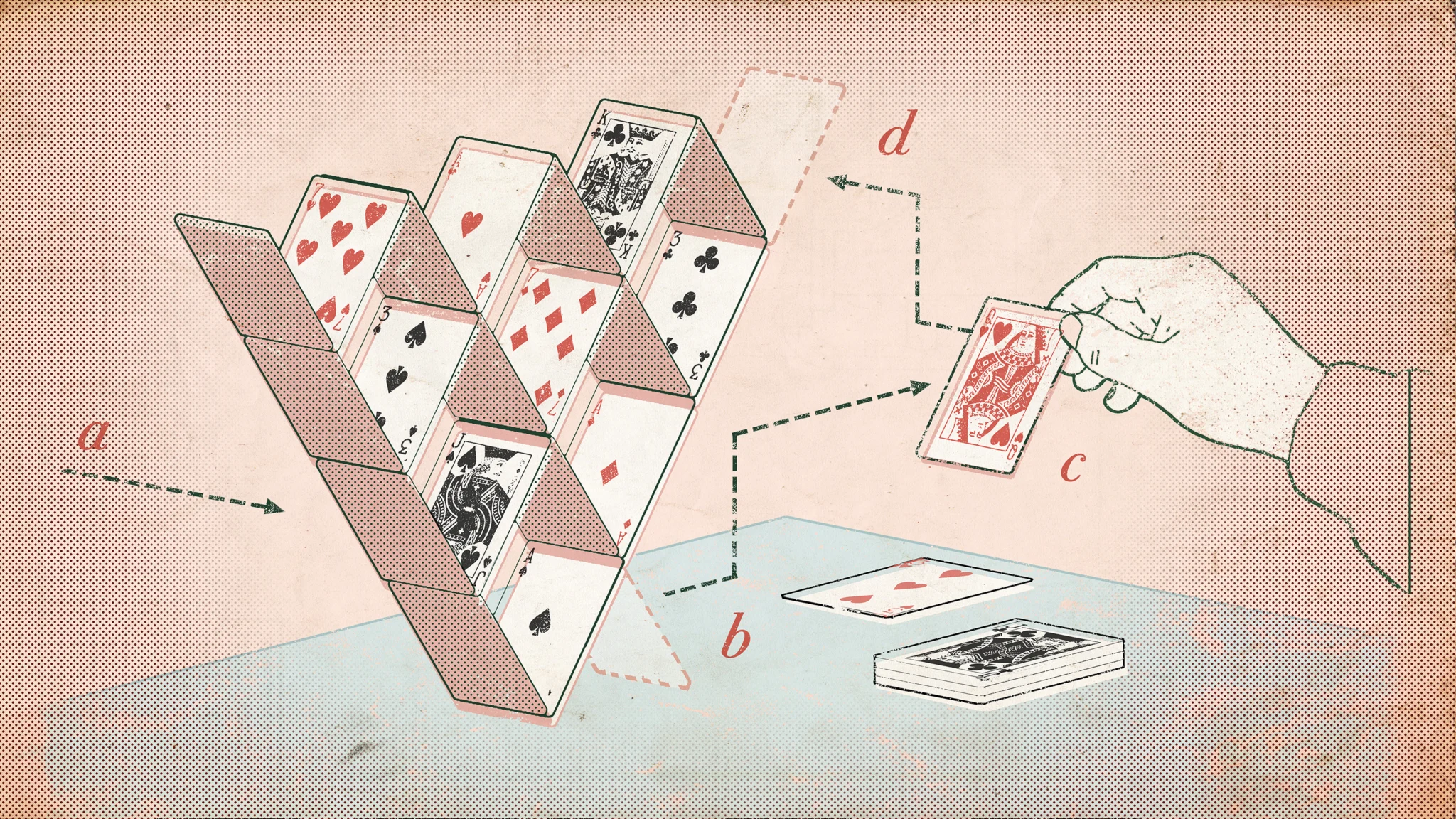

En las matemáticas inversas, los investigadores sustituyen los axiomas, los fundamentos de los sistemas matemáticos, por los teoremas que quieren demostrar. Ilustración Son of Alan / Quanta Magazine

En las matemáticas inversas, los investigadores sustituyen los axiomas, los fundamentos de los sistemas matemáticos, por los teoremas que quieren demostrar. Ilustración Son of Alan / Quanta MagazineEn lo que respecta a los problemas difíciles, los científicos de la computación parecen estar atascados. Consideremos, por ejemplo, el famoso problema de encontrar la ruta circular más corta que pase exactamente una vez por cada ciudad de un mapa. Todos los métodos conocidos para resolver este «problema del viajante de comercio» son desesperadamente lentos cuando el mapa contiene muchas ciudades, y los investigadores sospechan que no existe una forma de hacerlo mejor. Sin embargo, nadie sabe cómo demostrarlo.

Desde hace más de 50 años, los investigadores en teoría de la complejidad computacional han intentado convertir afirmaciones intuitivas como «el problema del viajante de comercio es difícil» en teoremas matemáticos irrefutables, con escaso éxito. Cada vez más, también buscan respuestas rigurosas a una pregunta relacionada y más difusa: ¿por qué no han tenido éxito sus demostraciones?

Este trabajo, que trata el propio proceso de demostración matemática como un objeto de análisis matemático, forma parte de un campo conocido por su dificultad: la metamatemática. Los metamatemáticos suelen examinar los supuestos básicos, o axiomas, que sirven como punto de partida de todas las demostraciones. Modifican estos axiomas iniciales y estudian cómo los cambios afectan a los teoremas que pueden demostrarse. Cuando se aplica la metamatemática al estudio de la teoría de la complejidad, el objetivo es determinar qué pueden y qué no pueden demostrar distintos conjuntos de axiomas sobre la dificultad computacional. De este modo, los investigadores esperan comprender por qué sus intentos de demostrar que ciertos problemas son difíciles no han prosperado.

En un artículo publicado el año pasado, tres investigadores adoptaron un enfoque distinto. Invirtieron el método que los matemáticos han utilizado durante milenios: en lugar de partir de un conjunto estándar de axiomas para demostrar un teorema, sustituyeron uno de los axiomas por un teorema y demostraron ese axioma. Mediante este enfoque, conocido como matemática inversa, demostraron que muchos teoremas distintos de la teoría de la complejidad son, en realidad, equivalentes.

«Me sorprendió que consiguieran avanzar tanto», afirma Marco Carmosino, teórico de la complejidad en IBM. «La gente va a mirar esto y va a decir: “Esto es lo que me hizo entrar en la metamatemática”».

Demostraciones con palomas

La historia del artículo sobre matemática inversa comenzó en el verano de 2022, cuando Lijie Chen, teórico de la complejidad y actualmente profesor en la Universidad de California en Berkeley, estaba terminando su doctorado. Con más tiempo libre del habitual, decidió dedicar unos meses a estudiar metamatemática.

Lijie Chen ideó una manera de invertir la relación entre dos teoremas matemáticos. Foto: Hongxun Wu

Lijie Chen ideó una manera de invertir la relación entre dos teoremas matemáticos. Foto: Hongxun Wu«Como me estaba graduando, no tenía mucho trabajo de investigación que hacer», explica Chen. «Pensé que debía aprender algo nuevo».

Durante sus lecturas, Chen empezó a reflexionar sobre una rama de la teoría de la complejidad llamada complejidad de la comunicación, que estudia cuánta información deben intercambiar dos o más personas para realizar determinadas tareas. Uno de los problemas más sencillos de este campo, conocido como el «problema de la igualdad», se asemeja a un juego colaborativo. Dos jugadores comienzan con cadenas independientes de ceros y unos, es decir, de bits. Su objetivo es utilizar la menor cantidad posible de comunicación para determinar si ambas cadenas son idénticas. La estrategia más simple consiste en que uno de los jugadores envíe la cadena completa para que el otro la compruebe. La pregunta es si existe alguna forma más eficiente de proceder.

Los teóricos de la complejidad demostraron hace décadas que la respuesta es negativa. Para resolver el problema de la igualdad, los jugadores deben enviar, como mínimo, un número de bits igual a la longitud de la cadena completa. Esta longitud constituye una cota inferior de la cantidad de comunicación necesaria.

Chen no se centraba tanto en la cota inferior del problema en sí como en la forma en que se había demostrado. Todas las demostraciones conocidas dependen de un teorema sencillo llamado principio del palomar, que establece que si se colocan más palomas que palomares, al menos un palomar contendrá más de una paloma. Aunque pueda parecer evidente, este principio es una herramienta muy poderosa en la teoría de la complejidad y en otros ámbitos de las matemáticas.

Chen encontró una pista sugerente: la relación entre el problema de la igualdad y el principio del palomar podría funcionar también en sentido inverso. Es sencillo utilizar el principio del palomar para demostrar la cota inferior del problema de la igualdad. La cuestión era si esa cota inferior podría utilizarse, a su vez, para demostrar el principio del palomar.

Una igualdad inquietante

Chen comentó su idea con Jiatu Li, que en aquel momento era estudiante de grado en la Universidad de Tsinghua y con quien había colaborado recientemente en otro artículo. Para formalizar la conexión, necesitaban elegir un conjunto de axiomas con el que trabajar. En metamatemática es habitual utilizar axiomas más restrictivos que los convencionales, ya que estos sistemas más débiles permiten identificar con mayor precisión las relaciones entre distintos teoremas. Chen y Li optaron por un conjunto de axiomas muy utilizado llamado PV1. PV1 es lo suficientemente potente como para demostrar por sí solo algunos teoremas importantes de la teoría de la complejidad computacional. Si se añade una versión concreta del principio del palomar como axioma adicional, también permite demostrar la cota inferior del problema de la igualdad. En diciembre de 2022, Li y Chen demostraron formalmente que, como Chen había sospechado, la demostración también funciona intercambiando el papel de ambos teoremas.

Igor Oliveira contribuyó a demostrar que muchos teoremas diferentes son equivalentes. Foto: Richard Cunningham

Igor Oliveira contribuyó a demostrar que muchos teoremas diferentes son equivalentes. Foto: Richard CunninghamQue la cota inferior del problema de la igualdad pueda demostrarse a partir del principio del palomar, y viceversa, implica que, dentro del marco lógico de PV1, ambos teoremas son equivalentes. Cuando Li y Chen comentaron el resultado con Igor Oliveira, teórico de la complejidad en la Universidad de Warwick, los tres se dieron cuenta de que este enfoque de matemática inversa podría aplicarse también a teoremas de otras áreas de la teoría de la complejidad. En los meses siguientes, demostraron de forma sistemática equivalencias entre muchos otros resultados.

«Al principio solo teníamos dos resultados equivalentes», explica Chen. «Ahora tenemos toda una red de ellos».

La conexión más llamativa relaciona la misma versión del principio del palomar con uno de los primeros teoremas que suelen estudiarse en los cursos introductorios de teoría de la complejidad. Este «clásico imprescindible», en palabras de Carmosino, establece una cota inferior sobre el tiempo necesario para que un tipo de ordenador teórico —una máquina de Turing de una sola cinta— determine si una cadena de ceros y unos es un palíndromo, es decir, si se lee igual de izquierda a derecha que de derecha a izquierda. Mediante la matemática inversa, Li, Chen y Oliveira demostraron que, dentro de PV1, este teorema es equivalente al principio del palomar.

«Si alguien me lo hubiera dicho, no lo habría creído», reconoció Chen. «Suena completamente absurdo».

Esta equivalencia resulta sorprendente porque ambos teoremas parecen, a primera vista, muy distintos. El principio del palomar no está vinculado de forma intrínseca al cálculo: es una afirmación elemental sobre conteo. La cota inferior para palíndromos, en cambio, se refiere a un modelo concreto de computación. El nuevo resultado sugiere que teoremas aparentemente específicos tienen un alcance mucho más general de lo que cabría esperar.

«Indica que estas cotas inferiores de complejidad que queremos comprender son mucho más fundamentales», señaló Oliveira.

Territorio inexplorado

Esta red de equivalencias también ha permitido clarificar los límites de PV1. Los investigadores ya tenían motivos para pensar que el principio del palomar no puede demostrarse a partir de los axiomas de PV1 por sí solos, por lo que los resultados de Li, Chen y Oliveira implican que los demás teoremas equivalentes probablemente tampoco sean demostrables en ese sistema.

«Me parece precioso», afirma Ján Pich, teórico de la complejidad en la Universidad de Oxford, que en 2014 obtuvo un resultado importante sobre la potencia de PV1. No obstante, advirtió que el enfoque de la matemática inversa puede resultar especialmente útil para revelar nuevas conexiones entre teoremas ya conocidos. «No nos dice gran cosa, hasta donde podemos afirmar, sobre la complejidad de enunciados que aún no sabemos cómo demostrar».

Comprender ese territorio inexplorado sigue siendo un objetivo lejano para los investigadores en metamatemática. Sin embargo, esto no ha reducido el entusiasmo de Li por el campo. Inició sus estudios de posgrado en el Instituto Tecnológico de Massachusetts en 2023 y recientemente escribió una guía de 140 páginas sobre metamatemática dirigida a teóricos de la complejidad. Es un ejemplo de una tendencia más amplia: tras décadas de relativa marginalidad, la metamatemática está atrayendo cada vez más atención por parte de una comunidad más amplia de investigadores, que aportan nuevas perspectivas al área.

«La gente está cansada de estar bloqueada», concluye Carmosino. «Es el momento de dar un paso atrás y trabajar en los fundamentos».

El artículo original, ‘Reverse Mathematics’ Illuminates Why Hard Problems Are Hard, se publicó el 1 de diciembre de 2025 en Quanta Magazine.

Traducido por César Tomé López

El artículo Las “matemáticas inversas” arrojan luz sobre por qué los problemas difíciles son difíciles se ha escrito en Cuaderno de Cultura Científica.

El lado oscuro de las hormigas: esclavistas, okupas e inductoras al matricidio

Polyergus lucidus. Foto: Gary D. Alpert, Harvard University – © Museum of Comparative Zoology, The President and Fellows of Harvard College / AntWiki