Gure baleak ziren

Garai hartan, baleen arrantzarako akordio bat zuten euskaldunek eta islandiarrek. Euskaldunek bale-arrantzarako gune bat eraiki zuten Mendebaldeko Fiordoetan. Arrantza garaia bukatuta, etxerako bidea hartu zuten euskaldunek, baina ekaitz batek eta izotz-mendiek eraginda, haien hiru itsasontzik lehorrera egin zuten eta kostaldeko arroketan gelditu ziren mugitu ezinik. Euskaldun gehienak onik atera ziren eta etxera itzuli ziren, baina batzuk, bertan gelditu ziren. Hurrengo hilabetean, hor geratu zirenak erail egin zituzten, euskaldunak hiltzea baimentzen zuten legeari jarraiki. Bertako agintariek egin berria zuten lege hori. Euskaldun batek baizik ez zuen biziraun.

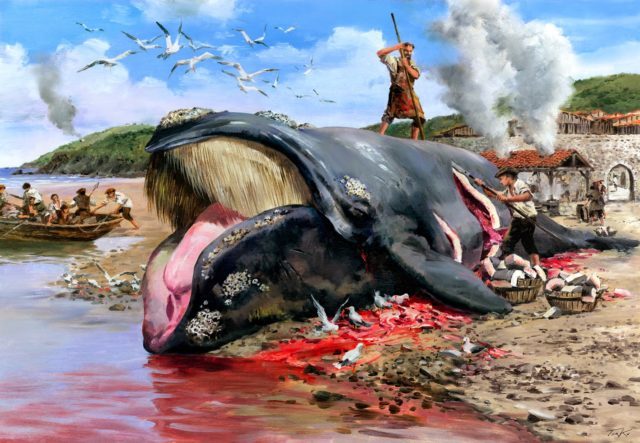

1. irudia: XVII. mendeko baleontzi euskalduna.

Islandian, XVII.mendearen hasieran egin ziren balea-arrantzaleen lehenengo aipuak. 1610.ean egin ziren, Mendebaldeko Fiordoen zonaldean, uhartearen ipar mendebaldean. Hala ere, Alex Agular Bartzelonako Unibertsitatekoak eta beste batzuek esan izan dute 1412.eko dokumentuetan aurkitu dutela aipua. Era berean, esaten da 1608.ean hiru balea-arrantzale euskaldun zeudela Strandiren, eta beste bat 1613.ean toki berean. Azken honek lehorrera egin zuen baleen gantza atera ahal izateko. Horixe zen beren merkatu-produktu preziatuena eta “sain” deitzen zioten euskaldunek. 1614.ean, lau itsasontzi iritsi ziren, eta 1615.ean 16 itsasontzi. Azken hauen artean daude hondoratu egin ziren horiek, lehen aipatu ditugunak. Islandiar kronikek diote itsasontzi horietan Martinus de Billa de Franca, Pedro de Aguirre eta Stephan de Telleria ziren kapitain. Lehorrera iritsi ziren 82 marineletatik, 13 erail zituzten gaua igarotzen ari zirela. Beste 18 hil ziren tokiko biztanleek beraien aurka egin zuten kanpainan, beti ere Ari Magnusson bertako gobernadoreak eraginda.

Hurrengo hamar urteetan, ez zen bale-arrantzale atzerritarren aipurik egin. Geroago, badaude noizean behinkako aipuak XVIII. mendea hasi arte. 1712.ean idatzizko aipuak egin ziren azkeneko aldiz, eta geroago, Islandiako agintariek debekatu egin zuten aipuak egitea. Hala ere, urte horietan oso estua izan zen islandiarren eta euskaldunen arteko harremana, zeren eta hiru euskara/islandiera glosario egin baitziren XVII-XVIII mendeetan. Hainbat adituk aztertu dituzte glosarioak eta haien artean badago Viola Giulia Miglio, Californiako (Santa Barbara) Unibertsitatekoa bera. Glosarioak Reykjaviken daude zenbait fitxategitan.

Baleek eta gizakiek aspalditik izan dituzten harremanak. Izan ere, duela 6.000-8.000 urteko arroketan aurkitu dira horren inguruko irudiak Alaskan, eta 9.000-10.000 urteko arroketan Norvegian. Euskal Herrian duela 13.000 urteko balea-arpoi aurkitu dira Lekeitioko Lumentxa kobazuloan.

Marc Pétillonek (Tolosako Unibertsitatea) dio Pirinioetako ipar isurialdean bazeudela orain 13.000-15.000 urte balea-hezurren industria bat, armak eta tresnak ekoizten zituena. Batez ere tamaina handiko lantzen puntak egiten zituzten. Isturitzen (Iparralde) aurkitutako gauzen irudiak plazaratu zituen, industria-arrastoen proba gisa. Proba zaharrena izango litzateke hura. Tresna gehiago aurkitu zituen Pirinioetako ipar aldean, ekialdetik mendebaldera. Atlantikoko jatorria zuten hezur horiek beti ere.

2. irudia: Balea-hezurrez egindako gauzak, Pétillonek deskribatuak.

Tresna horietako batzuk, gutxienez 350 km mugitu zituzten beren egileek, aurkitu diren tokiraino. Haietako batzuek 17.000 bat urte izango dituzte. Ez dira ordea aurkitu tresna horiek egin zituzten tokiak, eta ez dakigu era berean, balea arrantzatuak ala berez lehorreratuak izan ote zituzten. Edonola, tresna kopuruak eta distantziak kontuan hartuta, ez dirudi baleak noizean behinka edo ustekabean lortzen zituztenik. Pétillonek dio ehiza bide sistematiko bat izan beharko zutela.

Balea-aztarna berriagoak aurkitu dira Gijónetik gertu, Campa de Torres izeneko toki batean. 2.300-2.400 urte dituzte, beti ere balea arrantzatuak ala lehorreratuak izan ote ziren ez dakigularik.

Euskaldunek harrapatzen zuten baleari, behar bezala, euskaldunen balea esaten zioten. Ingelesez right wale eta bestela balea frantsesa: Eubalaena glacialis. 60 tonako pisua zuten, beti ere 36-72 tartean. 15-17 metrokoa zen eta 270 balea-bizar zituzten.

Udan, iparrera egiten zuten euskaldunen baleek, Savalrd, Norvegia eta Islandiara. Neguan aldiz, hegoaldera joaten ziren Madeira, Azoreetara eta Afrikako ipar mendebaldera. Zer esanik ez Bizkaiko Golkora ere etortzen ziren. Erditzeko garaia zen, eta epe jakin batean, ama eta kumea elkarrekin ibiltzen ziren. Horretatik at, garai horretan sinatzen zituzten kontratuak balea-arrantzaleek eta armadoreek eta finantzatzaileek. Talaiako gizonak ere kontratua sinatzen zuen, eta berak esaten zuen balea bat kostaldera hurbiltzen zetorrela. Talaia asko galdu dira baina badaude oraindik batzuk, hala nola Donostiakoa Ulia mendian.

“Txalupa” izen ezaguna erabiltzen zuten beren itsasontzia izendatzeko eta beste zenbait izen ere erabiltzen zituzten horretarako. Itsasontziak gutxi gorabehera 10 metroko eslora zuen eta 2-2.5 metroko zabalera. 12 bat marinela zihoazen, eta 10 arraunlari, lemazaina popan eta arpoilaria brankan. Bazeramatzaten gazta, ardoa, mantak eta hotzerako jantziak. Orion adibidez, bazeramatzaten 150 metro soka, bi arpoi, bi xabalina handi eta xabalina txiki bat.

3. irudia: Eubalaena glacialis, norvegiar fiordo batean.

Gantza zen baleek ematen zieten produktu garrantzitsuena, “sain” izenekoa. Eraikinak argiztatzeko eta berotzeko erabili zen Europa osoan zehar. Balea-bizarrak malguak ziren, baina urriak, eta oso erabiliak. Bizar horietako hezurrak tresnen euskarriak egiteko erabiltzen ziren, batez ere aiztoenak egiteko. Balearen okela fresko jaten zen, baina era berean, lehortu eta gazitu egiten zen, gero Europa osoan saltzeko.

1059.ekoak dira euskal balea-arrantzaleei buruzko lehen idatziak, Baionan eginak, eta zetazeo honen okelaren salmentari buruzkoak. Salmenta horren arauei buruzkoa eta zergei buruzkoa da ordea Donostian 1181ean plazaratutakoa. Santoñako idatziak ere badaude (1190.ekoak) eta Mutrikukoak (1200.ekoak). Asturiasen, 1232.ekoa da lehenengo idatzia eta Galizian 1371koa. Kantauri aldean, balea-arrantzarako 47 gune egon ziren, eta haietatik 14k balea bat daukate bere armarrian.

Azpiegitura, ohiturak, praktikak eta teknologia eta arautegi jakin bat behar ziren jarduera hau aurrera eraman ahal izateko. Toki askotara joaten ziren euskaldunak: Islandia, Ternua, Spitzberg uharteak eta Groenlandia. Bidaia horietan baleak ehizatzeko, aurretik ikasi behar zuten etxean nola egin itsasontziak, dirua lortu behar zuten, eta bukatzeko, elikagaiak eta bestelako baliabideak ere. Itzulitakoan gainera, jakin egin behar zuten non saldu lortutakoa, eta batez ere okela eta gantza.

Egileek iritzi desberdinak dituzte. Batzuek pentsatzen dute XII-XIII mendeetan gertatu zela jarduera honen gailurra, eta beste batzuek aldiz XIV-XV mendeetan kokatzen dute une hori. XVI.ean, nabarmen behera egin zuten ikusitako baleek, eta XVII.erako, ia desagertuak zeuden. Agian horregatik jo zuten euskaldunek iparrera eta mendebaldera. Izan ere arrantzale hauek bazuten baleen ipar/hego joan-etorrien berri eta besterik gabe, beraien atzetik joan ziren. Idazle batzuek baieztatu dute XVI. mendean 100 ale lortu zirela. Kasu askotan, balea eta bere balekumea elkarrekin zeuden. Izan ere, ezaguna zuten kumea errazagoa zela harrapatzen, eta eta harrapatuz gero, amak ez zuela beregandik urrunera egingo.

Era berean, esan beharrekoa da euskaldunek Ternuan bakailao eta baleak harrapatzen zituztela XVI. mendetik aurrera baina agian lehenagotik ere. Agian garai hartan bertan ezagunak ziren Europako Ipar Atlantikoan, eta zehazki Islandian.

4. irudia: Balea bat zatitzen Deban (Gipuzkoa). Herrirako sarreretako baten ondoan, saina egiten zen labeak ikus daitezke. Hurbilago, balea-txalupa bat urruntzen, eta talaiako ke-seinalea. (Ilustrazioa: Jose Ignacio Trekuren irudia/Deba kalez kale)

Horko aldeko herrialdeek berehala ikasi zuten zeinen onuragarria zen baleak harrapatzea. Badirudi euskaldunengandik ikasi zutela hori, zeren eta oso ohikoa baitzen euskaldun arpoilariak kontratatzea Holandan edo Ingalaterran. Jaconbo II Ingalaterrako erregeak legeztatu zuen hori 1612.ean.

Ez da erraza zenbat balea harrapatzen ziren jakitea. Lagungarria izan daiteke mandatari batzuei edo Elizari ordaintzen zitzaizkien zergak kontuan izatea. Oso gutxi gorabehera bada ere, diru-kopuru horietatik ondoriozta liteke zenbat balea zeuden garai hartan. Zarautz, Getaria eta Lekeitioko datuak bildu dituzte Alfredo Salvadorrek eta Carlos Noresek. Lehenengoa Madrilgo Natur Zientzien Museokoa da, eta bigarrena Oviedo Unibertsitatekoa. Beraiek uste dute 35 balea harrapatu zirela XVI. mendearen hasieran, eta XVIII. mendean ordea 5 baizik ez zirela izan. Batzuek esaten dute 1766.ean bukatu zela betiko arrantza hau Kantauri itsasoan. XVIII eta XIX mendeetan balearen bat harrapatu zen noizean behin, baina tresnak, ohiturak eta hurbiltzeko eta harrapatzeko teknikak ere galdu egin ziren.

Azkeneko balea Orion harrapatu zen 1901eko maiatzaren 14.ean. Dinamita erabilita hil zuten, teknika zaharrak ahaztuta zeudelako.

Islandiara ez ezik, Ternuara ere joan ziren euskaldunak. Bertan bakailaoetan aberatsak ziren itsasoak zeuden. Izan ere, batzuek iradoki dute agian bakailaoa arrantzeko joango zirela hasiera batean, eta geroago erreparatuko zietela baleen joan-etorriei.

Ternuan, XVI. mendeko bigarren laurdenean plazaratu ziren euskaldunen lehenengo aipuak. Selma Huxley dio 1531koak direla idatzi horiek. Ikertzaile hau Ternuako St.John’s Unibertsitatean ari da lanean. Horrela ba, Euskal Herrira ekartzen zituzten bakailaoa, balea-okela gatzunetan eta satina eta balea-hezurrak. Garai hartan, oso garapen handiko ontziolak zeuden Euskal Herrian, eta material hauek iritsi zirelarik, ekonomia-jarduerak burdinan, tresnetan eta armetan oinarritu ziren nagusiki. Jakina, baleetan eta bakailaoetan ere bai. Euskal marinelak izan ziren baleak harrapatzeko gizarte-antolakuntza bat lortu zuten lehenengoak, beti ere ekonomia-helburuei begira. Era berean, onartu ohi da euskaldunenak zirela itsasontzirik onenak XVI. mendearen lehenengo zatian. Horrela ba, euskal marinelak ziren nagusi Ternuan mende horretan.

5. irudia: Bizkaiko Golkoan harrapatu zen 1901. urteko maiatzaren 14an azken sardako balea, eta Orioko arrantzaleek arpoia erabili beharrean dinamita erabili zuten animalia hiltzeko.

XVI. mende osoan zehar, 15-20 itsasontzi iristen ziren udan Ternuara, eta Euskal Herrira itzultzean, 9.000 barril ekartzen zituzten. Mendearen bukaeran, behera egiten du jarduera honek, eta itsasontzi gutxi gerturatzen ziren Ternuara. Gehienak Felipe II erregeak behartuta zihoazen Itsas Armada Garaiezinean, Ingalaterraren aurka. Armada horrek pairatu zuen hondamendiak kalte egin zion euskal armadari, itsasontziak zein eskarmentu handiko marinelak galdu zirelako. Utrechteko itunak bukaera eman zion balea-arrantzaleen joan-etorriei, lur haiek frantsesen eta ingelesen artean bananduz.

Islandian bezala, Ternuan ere harreman estuak gauzatu zituzten euskaldunek bertan indiarrekin, eta batez ere mik’mac indiarrekin. Oraindik ere, badiraute euskarazko hitz batzuek hango hizkuntzan, eta Kanadako frantsesean.

William Fitzhugh (Smithsonianekoak) Hare Harboureko aztarnategian ari zela, aurkikuntza batzuk egin zituen Petit Mécatina uhartean, San Lorenzoko Golkoan. Bertan Groenlandiako baleen aztarnak daude, ez euskaldunen baleen aztarnak. Bakailao-aztarnak ere aurkitu dituzte. Bere dietan, bestelako batzuk ere suma daitezke. Batetik, baitzuten hegaztiak, hala nola alkalak, lanperna-musuak, kaiak, antzarak, ahateak, zisneak, eperrak eta beleak; bestetik bazituzten ugaztunak, adibidez fokak, etxeko txerria, basurdea, karibua, behia eta azeria; bukatzeko frutak jaten zituzten: hurrak, intxaurrak, mertxikak eta okaranak.

Egun, euskaldunen balea nekez aurkitzen da Ipar Mendebaldeko Atlantikoan, eta Ipar Amerikan, eta are urriagoa da Ipar Ekialdeko Atlantikoan, hots, Europan. Zaila da zenbat gelditzen diren jakitea. XX.mendearen hasieran, suntsitzetik gertu zeuden, 60 ale zeudela uste baitzen. Hala ere hori badaezpadako kalkulu baten ondorioa zen. Gero, gora egin zuen berriz pixkanaka kopuruak, baina 90.eko hamarkadan behera egin zuen berriro.

1980-2000 tartean Ingalaterra Berriko Akuarioak 10.000 zetazeo-behaketa fotografiatu zituen, eta Masami Fujiwara eta Hal Caswellek (Woods Holeko Institutu Ozeanografikoa), euskaldunen baleen 300 ale identifikatu zituen, hau da, Eubalaena glacialis espeziearen 300 ale antzeman zituen mende honen hasieran. Badirudi ugalkor ziren emeak hiltzen ari zirela. Egileek esan izan dute agian populazioa egonkortu egingo litzatekeela urtero bi eme ugalkor zainduko balira. Nazioarteko legeak aditzera eman du espezie hau dela tamaina handiko espezieen artean desagertzeko arriskurik bizienean dagoena.

Maiz, esan izan da euskaldunek eragin zutela XVI. mendean egoera hau Ipar Amerikan behintzat. Horri, Estatu Batuek hurrengo bi mende eta erdian egindako jarduerak gehitu beharko litzaizkioke (gogoan izan Moby Dick). Esan beharrekoa da ordea Brenna McLeod eta Trent Unibertsitateko bere taldeak (Kanada), euskaldunen balearen hezur bakar bat aurkitu zutela, Red Baylp (Labrador) balea-arrantzarako euskal guneko 218 balea-hezurren ADNa aztertu zutenean. Gehienak Balaena mysticetus espeziekoak ziren. Horri Groenlandiako Balea edo Balea Boreala esaten zaio. Euskaldunak Groenlandiara iritsi orduko, uste baino askoz ere txikiagoa zen Eusbalaena glacialis espeziearen populazioa. Ez da ahaztu behar euskaldunena izan dela historian zehar gehien harrapatu den balea.

Erreferentzia bibliografikoak:

- Aguilar, A. 1996. A review of old Basque whaling and its effect on the Right Whales (Eubalaena glacialis) of the North Atlantic. Reports of the International Whaling Comission Special Issue, 10: 191-199.

- Arrinda, A. 1977. La pesca en Euskalerria. Caja de Ahorros Municipal. San Sebastián. 261 pp.

- Azkarate, A. et al. 1992. Balleneros vascos del siglo XVI (Chateau Bay, Labrador, Canadá). Estudio arqueológico y contexto histórico. Servicio Central de Publicaciones del Gobierno Vasco. Vitoria-Gasteiz. 261 pp.

- Azpiazu, J.A. 2000. Balleneros vascos en el Cantábrico. Ttarttalo. Donostia. 172 pp.

- Bakker, P. 1991. “La lengua de las tribus costeras es medio vasca”. Un pidgin vasco y amerindio utilizado por europeos y nativos americanos de Norteamérica, h. 1540-h. 1640. Anuario del Seminario de Filología Vasca “Julio de Urquijo” 25: 439-467.

- Barthelmess, K. 2009. Basque whaling in pictures, 16th-18th century. Itsas Memoria. Revista de Estudios Marítimos del País Vasco 6: 643-667.

- Campos Santacana, M.K. & M. Peñalba Otaduy. 1997. La caza de la ballena. Su influencia en los usos y costumbres desde la Edad Media. Zainak, Cuaderno de Antropología y Etnografía, 15: 251-262.

- Ciriquiain Gaiztarro, M. 2010 (1961). Los vascos en la pesca de la ballena. Biblioteca Vascongada de los Amigos del País. San Sebastián. 270 pp.

- Edvardsson, R. & M. Rafnsson. 2006. Basque whaling around Iceland. Archeological investigation in Strakatangi, Steingrimsfjordur. The Natural History Institute of Vestfirdir. Bolungarvik, Iceland. 25 pp.

- Escribano-Ruiz, S. & A. Azkarate. 2015. Basque fisheries in Eastern Canada, a special case of cultural encounter in the colonizing of North America. En “Archaeology of culture contact and colonization in Spanish and Portuguese America”, p. 239-256. Ed. por P.P.A. Funari & M.X. Senatore. Springer Int. Publ. Switzerland.

- Estes, J.A. et al (Eds.). 2006. Whales, whaling, and ocean ecosystems. University of California Press. Berkeley.

- Fujiwara, M. & H. Caswell. 2001. Demography of the endangered North Atlantic right whale. Nature 414: 537-541.

- Graells, M.P: 1889. Las ballenas en las costas oceánicas de España. Memorias de la Real Academia de Ciencias Exactas, Físicas y Naturales de Madrid XIII: 1-115.

- Huxley Barkham, S. 1984. The Basque whaling establishments in Labrador 1536-1632 – A summary. Arctuc 37: 515-519.

- Jenkins, J.T. 1921. A history of whale fisheries, from the Basque fisheries of the tenth century to the hunting of the finner whale at the present date. H.F & G. Witherby. London. 336 pp.

- Kurlansky, M. 2000. La historia vasca del mundo. Ed. El Gallo de Oro. Bilbao.

- McLeod, B.A. et al. 2010. DNA profile of a sixteenth century western North Atlantic right whale (Eubalaena glacialis). Conservation Genetics 11: 339-345.

- Michelet, J. 1999 (1861). El mar. www.elaleph.com

- Miglio, V.G. 2008. “Go shag a horse!”: The 17th-18th century Basque-Icelandic glossaries revisited. Journal of the North Atlantic. 1: 1-12.

- Orue-Etxebarria, X. 2012. Hierro, ballenas y barcos: factores del poder económico de Bizkaia durante la Edad Media (I/II). Euskonews 623-624. 4 y 11 mayo.

- Otero, X. 2017. William W. Fitzhugh. Zazpika 21 mayo: 23-31.

- Pétillon, J.-M. 2008. First evidence of a whale bone industry in the western European Upper Paleolithic: Magdalenian artifacts from Isturitz (Pyrénées-Atlantiques, France). Journal of Human Evolution 54: 720-726.

- Pétillon, J.-M. 2013. Circulation of whale-bone artifacts in the northern Pyrenees during the late Upper Paleolithic. Journal of Human Evolution 65: 525-543.

- Salvador, A. & C. Nores. 2011. Ballena de los vascos – Eubalaena glacialis (Müller, 1776). En “Enciclopedia Virtual de los Vertebrados Españoles”. Ed. por A. Salvador & J. Cassinello. Museo Nacional de Ciencias Naturales. Madrid.

- Unsain, J.M. 2012. Balleneros vascos. Imágenes y vestiugios de una historia singular. Untzi Museoa – Museo Naval. Donostia-San Sebastián. 175 pp.

- Wikipedia. 2017. History of Basque whaling. 4 March.

- Zulueta, J. de. 2000. The Basque whalers: The source of their success. Mariner’s Mirror. International Quarterly Journal of the Society for Nautical Research 86: 261-271.

—————————————————–

Egileaz: Eduardo Angulo Biologian doktorea da, UPV/EHUko zelula-biologiaren irakasle izan da erretiratu arte. Zientzia-dibulgazioan ere aritu da. Hainbat liburu argitaratu ditu eta La biologia estupenda liburuaren egilea da.

—————————————————–

Hizkuntza-begiralea: Juan Carlos Odriozola

——————————————–

The post Gure baleak ziren appeared first on Zientzia Kaiera.

Juguetes y hormonas sexuales

A lo largo de la vida hay distintos momentos en los que se elevan los niveles de hormonas sexuales en la sangre. Uno de esos momentos es el periodo perinatal. Poco antes del nacimiento y durante unos pocos meses posteriores al mismo se produce una elevación transitoria de los niveles de testosterona en los niños y de los de estrógenos en las niñas. La siguiente subida tiene lugar en la pubertad y esa ya no es transitoria, puesto que a partir de ese momento y hasta su muy posterior declive, bien avanzada la madurez, esos niveles se mantienen altos.

La elevación puberal de los niveles de hormonas sexuales induce y acompaña la maduración sexual, así como la aparición de los caracteres sexuales secundarios. Pero si bien sabemos cuál es la función de esa elevación, no tenemos el mismo conocimiento acerca de la subida transitoria perinatal. Dado que esa elevación no antecede ni va acompañada de ningún cambio anatómico o fisiológico -al menos evidente-, se ha postulado que en ese momento el tejido diana de esas hormonas es el cerebral y que podrían ser responsable de la configuración de algunas de las diferencias existentes en el comportamiento de niños y niñas.

En un trabajo publicado hace unos años, un equipo de psicólogas de Texas A & M University dieron cuenta de los resultados obtenidos en una investigación acerca de los condicionantes del comportamiento de niños y niñas y, más en concreto, del modo en que se ve afectado por estereotipos de sexo presentes en la sociedad o por factores de naturaleza biológica.

A la edad de tres años chicos y chicas muestran diferencias en sus preferencias de juego. Los chicos tienden a jugar más que las chicas con pelotas, vehículos y juguetes de construcción, y prefieren jugar con grupos más numerosos que las chicas. En qué medida estas diferencias son debidas a una suerte de programación biológica o son el resultado de la presión social es materia de intenso debate. Aunque parece ser que la exposición uterina a distintos niveles hormonales podría inducir la preferencia por unos u otros tipos de juguetes, no se ha investigado aún cuáles pueden ser el efecto de la elevación perinatal de los niveles de hormonas sexuales en el comportamiento infantil.

Las psicólogas de la universidad tejana trabajaron con bebés de 3 y 4 meses y encontraron que, si bien el comportamiento de las niñas no parecía verse afectado por la exposición pre o postnatal a distintos niveles hormonales, en los niños sí se observó una relación. Los niños con niveles más altos de testosterona mostraban una mayor preferencia por grupos de figuras que por figuras individuales. Y la mayor preferencia por animaciones con una pelota que por animaciones con un muñeco se relacionaba con la exposición prenatal a la testosterona.

No cabe extrapolar conclusiones definitivas de estos resultados al comportamiento en edades posteriores, cuando ya se manifiestan con claridad las diferencias por unos u otros juguetes. Pero si los factores hormonales condicionan algunos aspectos del comportamiento infantil temprano, bien cabe suponer que tal condicionamiento se extienda hacia edades mayores, con todo lo que ello comporta.

Fuente:

Gerianne Alexander, Teresa Wilcox y Mary Elizabeth Farmer (2009): “Hormone–behavior associations in early infancy” Hormones and Behavior 56: 498-502; DOI: 101016/j.yhbeh.2009.08.003

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Juguetes y hormonas sexuales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Gradualismo o saltacionismo… en evolución lingüística

- Ciencia express: Qué son las hormonas

- ¿Nacidos para creer?

Ponpeiako freskoak kontserbatzeko biozida

Irudia: Ponpeiako muralak babesteko biozida gartu du UPV/EHUko ikerketa talde batek.

Ponpeiako aztarnategiko muralak hondatzen dituzten mikroorganismoen agerpena eragozten duen biozida naturala garatu eta patentatzeaz gain, degradazio biologikoarekiko erresistentea den berriztapen morteroa ere garatzen dabiltza. Horretaz gain, Ponpeiako etxeetan erabilitako materialak eta muraletan erabili ziren pigmentuak analizatu dituzte ikerketan. Lanaren emaitza praktikoak izan dira biozida eta berriztapen morteroa.

Bi dira IBeA ikerketa taldeak Ponpeiako aztarnategian dituen ikerketa lerro nagusiak:

- Aztarnategiaren hondamenerako konponbideak proposatzea.

- Freskoen pigmentuak analizatzea, haien jatorrizko itxura argitara ateratzeko.

X izpien fluoreszentzian oinarritutako espektrometro eramangarria erabili dute, jatorrian okre gorriz (hematitaz) margotutako Ponpeiar muralak identifikatzeko, gaur egun gorri ikusten diren baina horiz margotuak izan ziren muralen aldean. Izan ere, Ponpeia suntsitu zuen erupziotik etorritako material bolkaniko izugarri beroak sortutako inpaktuaren ondorioz pigmentu horiek gorrira jo zuten. Antzeko lana ari dira egiten arrosa eta purpura koloreak bereizteko, (SERS) azalera anplifikatuko Raman espektroskopia bitartez.

Ponpeiako etxeetako pareten mortero erromatarren narriadura azaltzeko hainbat kausa zehaztu ostean, konponbideak proposatzea izango da hurrengo urteetako lana. Aztarnategian bertan dauden landare esentzialen olioekin sortutako biozida probatuko dute. Espero bezala funtzionatuko balu, nabarmenki hobetu eta merkatuko litzateke konplexuaren kontserbazio lana, landare eta mikroorganismoek hormak kolonizatzea eragotziko bailuke.

Kontserbazioaren alorrean badute beste helburu bat ere: jatorrizko erromatar formulazioan oinarritutako berriztapen mortero bat garatzea, jatorrizkoarekin bateragarria izan beharko dena. Egiaztatu egin behar da mortero berriak ez duela izango narriadura fabora lezakeen iturburu agenterik.

Iturria: UPV/EHU prentsa bulegoa: Euskadiko berrikuntza, Ponpeiako freskoak kontserbatzeko

The post Ponpeiako freskoak kontserbatzeko biozida appeared first on Zientzia Kaiera.

Amor romántico

“Sin el animal que habita dentro de nosotros somos ángeles castrados.”

Hermann Hesse.

“Amor: un juego en el cual hay dos que pierden, el hombre y la mujer, y uno sólo que gana: la especie.”

Abate Prévost.

“El enamoramiento es un estado de miseria mental en que la vida de nuestra conciencia se estrecha, empobrece y paraliza.”

José Ortega y Gasset.

El amor romántico no es fácil de definir. Nada menos que catorce acepciones aparecen en el Diccionario de la Lengua (por cierto, la última afirma que así se conoce el cadillo, una planta que se considera mala hierba). Quizá nos ayude la definición que ha publicado Tiffany Field, de la Universidad de Miami:

“Amor es un sentimiento profundo de afecto y cuidado que implica intimidad, compromiso y pasión, que nutre como el aire, el agua, las palabras y el tacto, y que tiene características típicas en la conducta, la fisiología y la bioquímica de las personas.”

El amor integra, por tanto, conductas, pensamientos, emociones y moléculas asociadas con el deseo de iniciar y mantener una relación con otra persona.

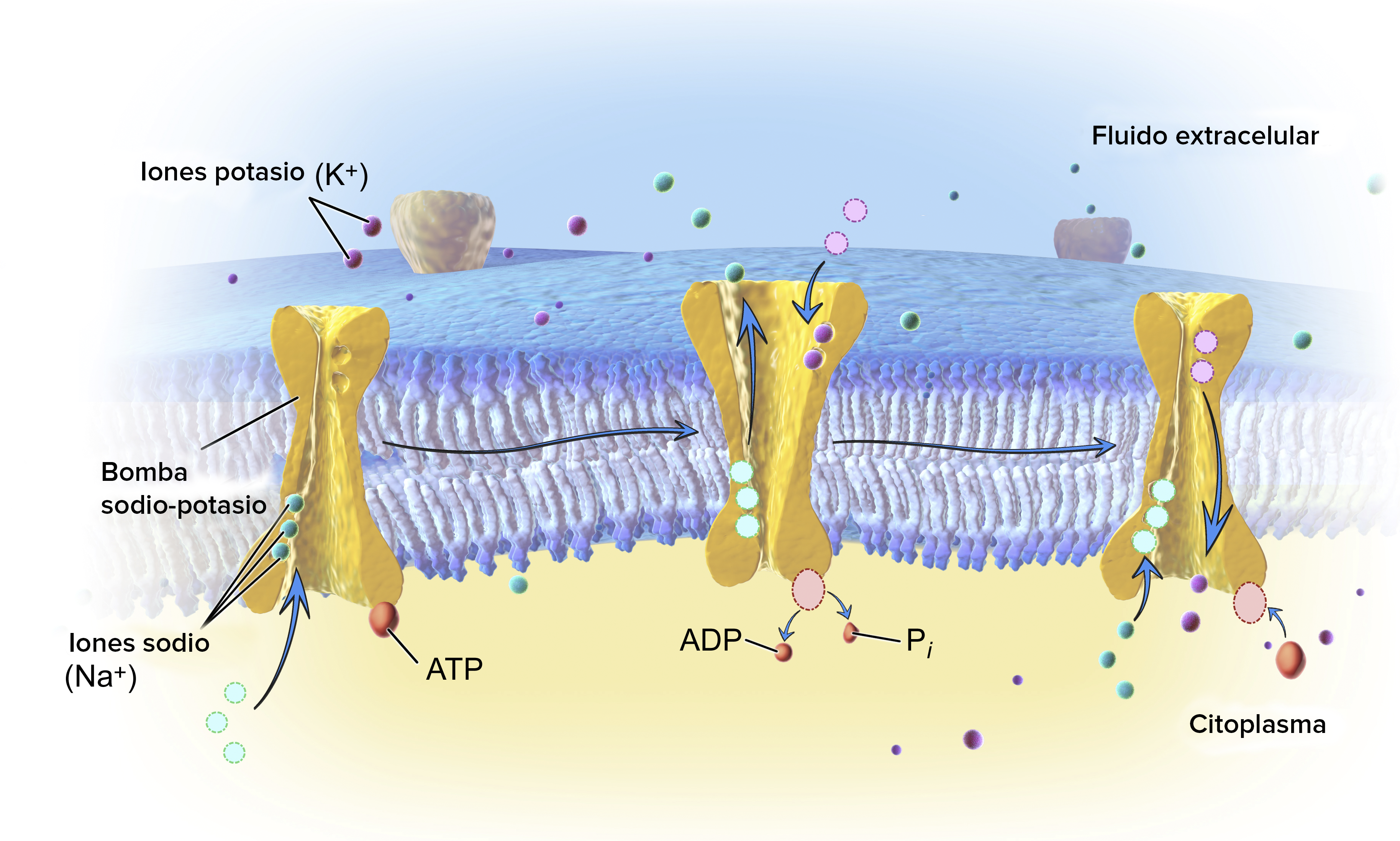

Parece que el amor incluye tres componentes: sexo, unión emocional e intimidad, y compromiso en el cuidado mutuo y de los hijos. Podemos resumir y concretar que el amor romántico es un compromiso para formar pareja con pasión, intimidad y cuidados. Es universal y aparece en todas las culturas. De manera inmediata suspende, en los que forman la pareja, la búsqueda de otras parejas. Tiene características propias en las emociones, en las conductas, en hormonas como la oxitocina o la testosterona, y en las respuestas neuropsicológicas de las zonas del cerebro relacionadas, ante todo, con los circuitos cerebrales de recompensa.

El amor tiene efectos beneficiosos para los individuos, con emociones positivas, felicidad y satisfacción vital, aunque también supone estrés, celos, a veces ruptura con tristeza y sensación de vergüenza, incluso depresión. Golpea a todos por lo menos una vez en la vida. En encuestas publicadas en Estados Unidos, Sandra Langeslag y Jan van Strien, de las universidades de Missouri y de Maryland, afirman que el porcentaje de individuos que padecen, o gozan, del amor romántico casi llega al 100%.

Hay varias hipótesis sobre el amor romántico. Garth Fletcher y sus colegas, de la Universidad Victoria de Wellington, en Nueva Zelanda, plantean tres propuestas conectadas entre sí. En primer lugar, el amor romántico es una conducta de compromiso para motivar la formación de la pareja en nuestra especie. En segundo lugar, la formación de la pareja facilita el peculiar ciclo vital de homínidos que implica dedicar una enorme y duradera inversión en tiempo y recursos para criar los hijos nacidos con un desarrollo muy temprano. Y, finalmente, el amor romántico ayuda a gestionar la pareja a largo plazo, incluyendo las relaciones familiares, y facilita la evolución de la inteligencia social y de las herramientas de cooperación dentro del grupo, clan o familia tan típicos en nuestra especie.

Según la revisión que hacen Fletcher y su grupo, los datos que se conocen son coherentes con la propuesta de que el amor romántico es una conducta de compromiso para formar la pareja. Hay referencias específicas de este objetivo en la conducta de ambos sexos, en la presencia de hormonas y en la aparición de mecanismos psicológicos peculiares del amor. Además, el amor romántico supone una ventaja pues da mejor salud y mayor supervivencia en los adultos y en las crías, o sea, en los niños.

Sin embargo, también hay conductas contrarias para el mantenimiento de la pareja y el cuidado de los hijos. Son, por ejemplo, los matrimonios arreglados y obligatorios, la poligamia, la separación, el divorcio y, en general, la infidelidad. Por el contrario, también hay mecanismos que regulan y controlan la relación y, sobre todo, la fidelidad por lo que implica de evitar la crianza de los genes de otro. Algunos autores sugieren que cada vez hay más evidencias de que, cuando nuestra especie surgió hace unos 150000 años, la conducta habitual en la reproducción era la monogamia. Cuando aparecieron los cazadores recolectores, la relación se complicó con la formación de clanes familiares, aunque siempre a partir de parejas.

En las primeras fases del amor romántico aparecen los síntomas típicos de las adicciones, sean a sustancias o a conductas. Hay euforia, deseo, tolerancia, dependencia física y emocional, abandonos, desintoxicaciones y recaídas. Helen Fisher y su grupo, de la Universidad de Indiana en Bloomington, proponen que el amor romántico es una adicción natural, y resultado de la selección natural pues es, casi siempre, positiva para la reproducción. Fisher afirma que ha evolucionado desde hace miles de años como mecanismo de supervivencia para buscar pareja y para el éxito reproductor.

El escaneo del cerebro de las personas enamoradas revela que se activan las zonas relacionadas con la recompensa y, en concreto, lugares con dopamina, el neurotransmisor conocido como recompensa química cerebral. Son las mismas zonas que funcionan con varias adiciones hacia sustancias o conductas como, por ejemplo, las armas de fuego en Estados Unidos, las autocaravanas en sus dueños, los pastelitos, la cocaína, las anfetaminas o el fútbol en los hinchas. O, en este último caso, es así para los seguidores del Oporto o del Coimbra, de la Primera División de Portugal, como declaran los 56 voluntarios del estudio de Isabel Duarte y su grupo, de la Universidad de Coimbra. Como definen los autores, este apego a un equipo de fútbol es un amor no romántico, pero con una atracción específica a su equipo y una motivación para seguirlo que se sienten premiadas por los circuitos cerebrales de recompensa. En concreto, los autores lo llaman amor tribal. O sea, al grupo, al clan, a la familia.

También el grupo de Zhiling Zou, de la Universidad del Sudoeste en Chongqing, en China, estudia el amor romántico como adicción en su primera fase y relatan que, cuando la relación amorosa progresa, los síntomas de adicción se atenúan y, poco a poco, desaparecen. Se pasa de una conducta de adicción a una conducta prosocial no adictiva.

De nuevo, como en el estudio de Helen Fisher (y en la afición al fútbol), el escaneo del cerebro revela la activación del área de recompensa y, además, de la red de emociones entre personas y con el entorno social. De nuevo, están la oxitocina y la dopamina.

Esta profunda implicación de hormonas, determinadas áreas del cerebro y neurotransmisores en el amor ha llevado a proponer que no es una emoción sino una necesidad fisiológica como el hambre, la sed, el sueño o el sexo. Así lo escribe Enrique Burunat, de la Universidad de La Laguna, cuando afirma que el amor es una conducta resultado de la selección natural para conseguir un mayor éxito en la reproducción. Los que desarrollan amor y, por tanto, compromiso para la cría de los hijos, tienen más descendencia y transmiten los genes de esa conducta a las siguientes generaciones. Los que no tienen amor, tienen menos descendencia y van desapareciendo. Así, después de miles de años, sea seleccionado la mejor conducta para el éxito en la reproducción. Y es una necesidad fisiológica y conductual inevitable. Por ello, el 100% de los humanos sienten o han sentido el amor en algún momento de su vida.

Por cierto, esta adicción al amor romántico es un poco especial. Los estudios del grupo de Jordane Boudesseul, de la Universidad de Grenoble, en Francia, demuestran que quien está enamorado cree más en el amor romántico, lo que se antoja coherente, pero, además, quien está enamorado cree en el libre albedrío aunque, también, acepta que la vida, quizá su enamoramiento en concreto, tiene un fuerte sentido determinista. Está, a la vez y sin ser consciente de ello, convencido de que se enamora obligatoriamente de quien quiere.

Para terminar, el amor romántico también tiene, a veces, un final, una ruptura que, como se dice, rompe el corazón. Nos cuenta Tiffany Field, aquella que nos definió el amor, que existe un síndrome del corazón roto. Una ruptura sentimental reproduce algo parecido a un ataque al corazón, aunque sin arterias ocluidas ni daños permanentes. Estas rupturas provocan hasta el mal funcionamiento del sistema inmune, con aumento general de la inflamación, lo que también influye en el corazón, y disminución de las defensas.

Referencias:

Boudesseul, J. et al. 2016. Free love? On the relation between belief in free will, determinism, and passionate love. Conciousness and Cognition 46: 47-59.

Burunat, E. 2016. Love is not an emotion. Psychology 7: 1883-1910.

Buss, D.M. 1996. La evolución del deseo. Alianza Ed. Madrid. 417 pp.

Duarte, I.C. et al. 2017. Tribal love: the neural correlates of passionate engagement in football fans. Social Cognitive and Affective Neuroscience doi: 10.1093/scan/nsx003

Field, T. 2016. Romantic love. International Journal of Behavioral Research & Psychology 4: 185-190.

*Fisher, H. 2004. Por qué amamos. Naturaleza y química del amor romántico. Santillana Ed. Madrid. 348 pp.

Fisher, H.E. et al. 2016. Intense, passionate, romantic love: A natural addiction? How the fields that investigate romance and substance abuse can inform each other. Frontiers in Psychology doi: 10.3389/fpsyg.2016.00687

Fletcher, G.J.O. et al. 2015. Pair-bonding, romantic love, and evolution: The curious case of Homo sapiens. Perspectives in Psychological Science 10: 20-36.

Langeslag, S.J.E. & J.W. van Strien. 2016. Regulations of romantic love feelings: preconceptions, strategies, and feasibility. PLOS ONE 11: e01611087

Song, S. et al. 2016. Romantic love is associated with enhanced inhibitory control in an emotional stop-signal task. Frontiers in Psychology doi: 10.3389/fpsyg.2016.01574

Zou, Z. et al. 2016. Romantic love vs. drug addiction may inspire a new treatment for addiction. Frontiers in Psychology doi: 10.3389/fpsyg.2016.01436

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Amor romántico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Asteon zientzia begi-bistan #196

Itsaspeko eremu berri bat aurkitu dute: arrarofotikoa eta bertan arrain asko daudela ohartu dira ikertzaileak. Murgilaldiak Curaçao uhartearen hegoaldean dagoen uharri eremu batean egin dituzte, Venezuelako ipar-mendebaldean. 80 murgilaldi inguru izan dira. Ontzi horrekin 309 metroko sakonera heltzeko aukera izan dute. Horiei esker, itsas eremu berria aurkitu dute: arrarofotikoa, 130 eta 300 metro arteko sakoneran kokatu dutena. Aztertutako 71 espezietatik, 31 bertan bizi dira batez ere.Ikertzaileek uste dute uharrietako eremurik sakonenek babesleku gisa funtzionatzen dutela.

Malgutasun izugarria du narra-txakurren bihotzak. Artikuluak ematen dizkigun datuen arabera, lo daudenean txakurren bihotz-taupadaren maiztasuna 40-60 min-1-koa da, 80-100 min-1-ko baliora igotzen da ibilian doazen txakurretan. Lasterketa aurreko urduritasunagatik 100-150 min-1-ra igotzen da eta 300 min-1-raino lasterka egiten dutenean. Narra-txakurrek ahalmen metaboliko ikaragarria dute. Lasterka ari diren artean indar handia garatzen dute eta, hala ere, urrun daude garatu dezaketen indar handienetik.

Beatriz Fernandez (Bilbo, 1984) Antartikatik itzuli da. Bertan, EHUko ikertzaile talde batek hilabetez ikertu du nola irauten duten bizirik likenek eta goroldioek euren ehunetan urik gabe. Topstep proiektuaren baitan, helburua ekoizpen masiboaren eta landareek sufritzen duten estresaren arteko erlazioa topatzea da, Fernandezek dioenez. “Antartikan, zera jakin nahi genuen: nola eusten dieten landareek tenperatura hotzei eta ur likidorik gabeko garai luzeei”, gehitzen du ikertzaileak. Antartikan topatutako landareei dagokienez, bi hodidun landare espezie besterik ez daude eta horietako bat ere ikertu dute. Biomasari dagokionez, ikertzaileak dio Antartikako kosta eremua aberatsa dela: “Esaterako, 400 liken espezie baino gehiago topa ditzakegu bertan”.

NeurozientziakUgaztunen helduaroan zehar, neuronak sortzen dira garunaren hipokanpoan memoriarekin lotutako funtzioentzat lagungarri delarik. Gizakietan ere hori gertatzen zela uste zen, baina orain argitaratu den ikerketa batek zalantzan jarri du hori. Asiako, Europako eta AEBko hainbat unibertsitatetako zientzialariek elkarlanean egindako ikerketa zabal baten arabera, hipokanpoan gertatzen den neuronen sorkuntza gelditu egiten da heldu egiten garenean. Hipokanpoko neurona berrien kopurua murrizten da jaio ostean eta helduaroan ez dago sorkuntzarik.

Ingeniaritza eta teknologia2018. urtea mugarritzat edukiko duten hamar teknologien zerrenda argitaratu du Massachusetts Institute of Technologyk eta Berriak jaso ditu artikulu interesgarri honetan. Adibidez, hiru dimentsioko inpresioak ez du ekarri benetako iraultza oraindik plastikoarekin egin delako. MITen arabera, metalezko piezak merke eta azkar inprimatu ahal izateak aldatuko du hori. Horren harira, azpimarratu dute 90.000 euro baino merkeagoa den lehen Metal 3D inprimagailua merkaturatu dutela azken hilabeteotan. Halaber, ugaztunak artifizialki ugaltzeko bidea zabalik dagoela ohartarazi dute. AEBko Michigango Unibertsitatean eta Rockefeller Unibertsitatean dagoeneko ari dira giza enbrioi artifizialak sortzen zelula amekin. Argitaratutako zerrenda horretan bada lekua aurikular itzultzaileentzat. Hizkuntza batetik bestera hitz egin ahala itzultzen duten gailuen urtea izango da aurten, MITen arabera. Badaude beste teknologia adibide batzuk artikuluan. Ez galdu!

5G sistemen ezaugarri berritzaile bat, aurreko arkitekturekin konparatuta, datu eta kontrol mailen bereizketa da. Lan honek ziklo kognitibo zentralizatu eta banatuen erabilera konbinatua aztertzen du 5G sareen maila ezberdinetan parte hartuz. Bereziki, cloudean oinarritutako maila anitzeko ziklo kognitiboa aurkezten du, 5G arkitekturaren kontrol- eta kudeaketa-atazak bermatzeko. Ondorioz, maila baxuko ziklo kognitibo banatuak erabaki logika erabiltzailearen aldirian mantentzen du. Baina, era berean, operazio informazio baliagarria cloud zerbitzarietara igotzen da.

Leeuwenhoeken mikroskopio iraultzaileen sekretua argitu dute. XVII. mendean, Anton van Leeuwenhoek, berak egindako mikroskopioei esker, inork ikusten ez zituen gauzak ikusten hasi zen. Lenteetan zegoen gakoa. Guztira, bostehun bat mikroskopio egin zituen. Orain, Delfteko ikertzaileek aztertu dute hark erabilitako bat eta ikusi dute haren lentea nola egina dagoen. Orain jakin nahi dute beira-mota bereziren bat erabiltzen ote zuen.

PaleontologiaDuela 90.000 urte neandertalek landutako zurezko tresnak aurkitu dituzte Aranbaltzan. 2013an hasi ziren aztertzen Barrikan dagoen aztarnategia. Orain arteko informazioari esker, jakin badakigu neandertal-taldeen bizileku izan zela duela 100.000 eta 44.000 urteen artean eta orain jakin da duela 90.000 urte landutako zurezko tresnak zuedela. Joseba Rios Garaizarrek (CENIEH) zuzendu du ikerketa eta harentzat “izugarrizko aurkikuntza da”. Tresnen artean, 15 cm-ko objektu zorrotz bat nabarmentzen da. Analisiak egin ondoren, zehaztu dute haginezko adar bat landuta eta sutan gogortuta egin zutela, eta lurrean zuloak egiteko erabili zutela.

Emakumeak zientzianAda Yonathek Kimikako Nobel Saria jaso zuen 2009.urtean. Haren aurkikuntza ezagutu nahi duzu? Bada, 80ko hamarkadan, israeldarrak argitu zituen erribosomaren egitura eta bere izaeran parte hartzen duten mekanismoak; hala nola, proteinen biosintesia. Ildo horri jarraiki, antibiotikoak aukeratzeko oinarri estrukturala argitu zuen. Horrela, bide berri bat ireki zuen antibiotikoak patogenoen erribosomari zuzenean eragiteko, antibiotikoen erresistentziari kontra eginez. Halaber, egitura biologikoetan kristalografia aztertzeko teknika berri bat sortu zuen: krio bio-kristalografia. Horrekin erribosoma bat nolakoa zen ezagutu zuen, hiru dimentsiotan irudikatu baitzuen.

Gailu informatikoen barruan gertatzen dena azaltzen digu Code.org-k. Horretarako bideo sorta bat aurkeztu digute. “Howcomputerswork” deitu diote bideo serie horri. Bertan, teknologia digitalaren munduan dabiltzan emakume batzuk aurkezten dizkigute.

MedikuntzaKimika, fisika, biologia, ingeniaritza eta medikuntzaren alorrean aritzen diren zientzialariak bildu dira Donostian, ESMI Europako Irudi Molekularreko Elkarteak antolatutako kongresuan aste honetan. Irudi molekularreko teknikak izan dira mintzagai eta hauek nola erabilgarriak diren gaixotasunak garapenaren lehen faseetatik antzemateko eta tratamenduen aurrean organismoak ematen duen erantzuna ebaluatzeko.“Tresna horiei esker, aukera dugu bizidunetan gertatzen diren prozesu biologikoak aztertzeko, betiere modu ez-inbaditzaile batean, hau da, kalterik sortu gabe”, azaldu du CIC Biomaguneko ikertzaile Jordi Llop-ek.

Gizonentzako pilula antisorgailu bat segurua dela frogatu dute. Albo-ondorio nagusienak hauexek ziren: aknea, aldarte-aldaketak, depresioa eta gizentzea. Orain, ondorio txarri ez duen pilula bat aurkeztu du Washingtongo Unibertsitateak. Halere, hau saio klinikoen hasiera besterik ez da izan. Oraindik eraginkorra dela frogatu behar dute eta ondoren, dosiak zeintzuk izango diren zehazteko probak egin.

Osteoporosia gaztarotik prebeni daiteke, jarduera fisiko moderatu-biziarekin eta bai kaltzioan bai D bitaminan aberatsa den dietarekin, UPV/EHUko ikerketa baten arabera. Egoera fisikoarekin eta dietarekin lotu da gaixotasuna; hau da, jarduera moderatu-bizia eta inpaktuzko kirolak gomendagarriak dira, dieta egokiarekin lagunduta, betiere gehiegikerietan erortzen ez bagara.

GenetikaGenerik ikertuen artean, beste adibide bat aurkeztu digute: APOE. Gene hau kolesterola eta antzeko molekulen prozesamendurako oso garrantzitsua da. Bereziki gibelean eta giltzurrunetan aktiboa da. Beste prozesu batzuekin ere lotura dauka: Alzheimer gaixotasunean, sistema immunologikoan eta kognizioan.

———————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

Egileaz: Uxue Razkin Deiako kazetaria da.

———————————————————————–

The post Asteon zientzia begi-bistan #196 appeared first on Zientzia Kaiera.

Naukas Bilbao 2017 – Carolina Jiménez: Ciencia y cine, avanzando de la mano

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

El cine no es más que la combinación del arte de la narrativa y el avance tecnológico. Lo sabe y lo explica como nadie Carolina Jiménez, artista de efectos especiales digitales para el cine que ha participado y participa en algunas de las superproducciones más conocidas de los últimos años.

Carolina Jiménez: Ciencia y cine, avanzando de la manoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Carolina Jiménez: Ciencia y cine, avanzando de la mano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

- Naukas Bilbao 2017 – Teresa Valdés-Solís: Limpia, fija y da esplendor

- Naukas Bilbao 2017 – Ignacio López-Goñi: Las bacterias también se vacunan

Ezjakintasunaren kartografia #209

Zenbait bakteriok ezin diote fagozitosiari aurre egin eta makrofagoak, sistema inmunearen zelulak, Troya zaldi gisa erabiltzen dituzte. NuRCaMein-ek azaltzen digu A new pathway to avoid macrophage pathogenic infections

Bestelako primateek baino gutxiago lo egiteaz gain, beharko luketen baino gutxiago egiten dute lo gizakiek, bizi estiloari dagozkion hainbat faktore kontuan izanik. Zergatik? Rosa García-Verdugok Humans, the non-sleeping primates

Atomo bat imajinatzeko eskatuk banizu, zientzia fisikoetako egungo ereduekin zerikusirik ez duen zerbait imajinatuko duzu, ziur aski. DIPC-ko jendea Our current image of atoms

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #209 appeared first on Zientzia Kaiera.

Una fibra óptica de plástico actúa como concentrador solar luminiscence

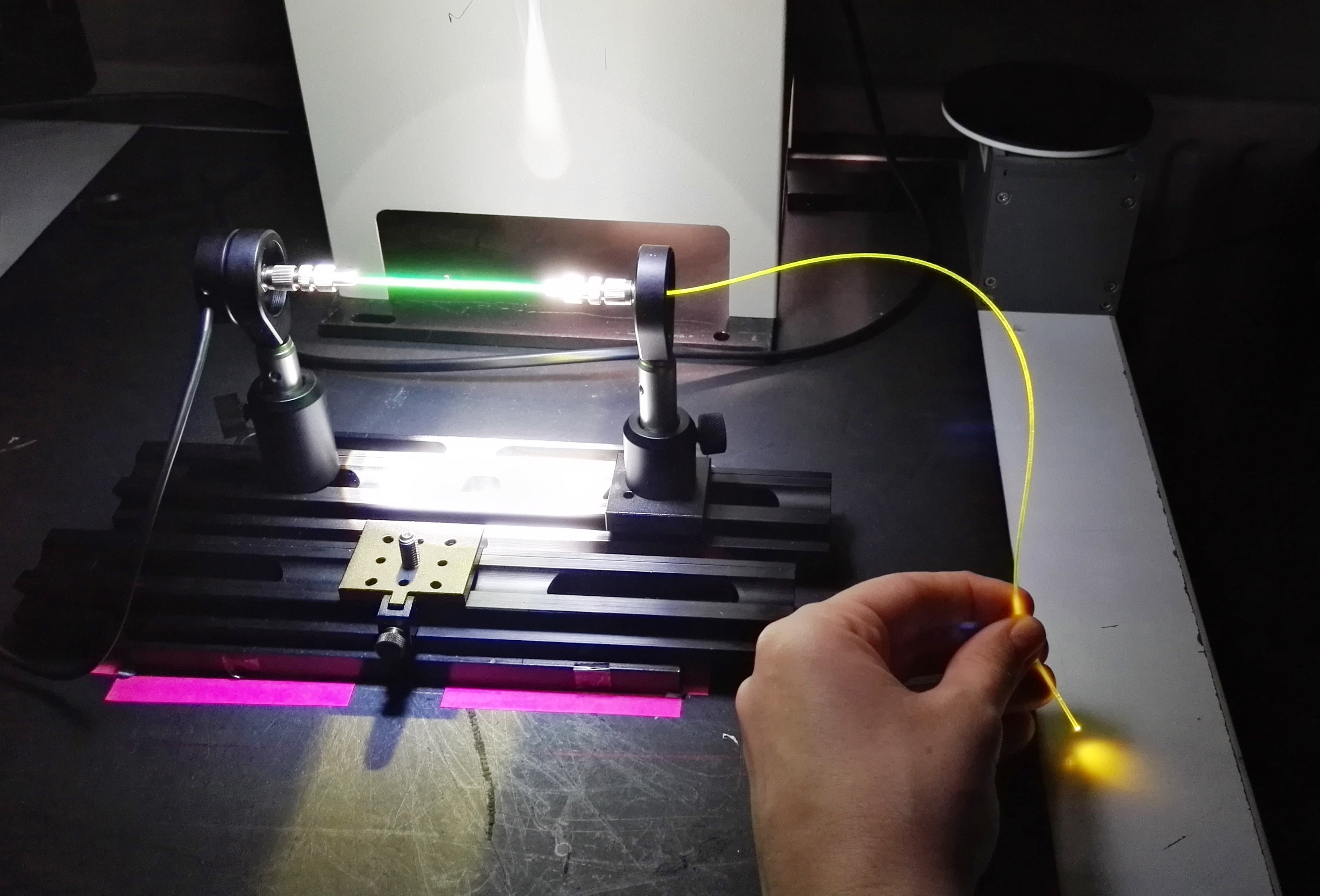

Un equipo de investigación de la UPV/EHU ha desarrollado un fibra óptica con dopantes híbridos que concentra la luz solar con un rendimiento alto y un coste bajo. Hasta ahora nunca se había utilizado como concentrador solar una fibra óptica de plástico que combina componentes orgánicos e inorgánicos.

Imagen: Itxaso Parola / UPV/EHU

Los resultados muestran que el rendimiento de la fibra al concentrar y transportar luz solar es alto, y que, conectado a células fotovoltaicas, resulta ser un sistema muy apropiado para suministrar electricidad a pequeños dispositivos.

Tan solo un 3 % de la energía consumida en 2017 proviene de sistemas eólicos, solares y de biomasa; los expertos, sin embargo, creen que actualmente la obtención de energía solar tiene las mayores perspectivas de crecimiento. No cabe duda de que siempre dispondremos de energía solar, y además de aprovecharla utilizando huertos solares, también se pueden utilizar sistemas más pequeños integrados en diversos espacios (en casas, tejados, etc.).

A nivel mundial se están llevando a cabo muchos estudios de mejora de células solares fotovoltaicas. Las células fotovoltaicas más avanzadas hasta el momento son las de silicio, pero son muchos los aspectos que necesitan ser mejorados: las fuentes de silicio son limitadas; las instalaciones requieren de grandes superficies; son necesarios sistemas de seguimiento solar, así como luz solar directa; su rendimiento disminuye mucho en días nublados o con luz difusa, etc. En definitiva, todavía resulta caro disponer de la energía solar.

Precisamente, en una investigación llevada a cabo por los departamentos de Física Aplicada I e Ingeniería de Comunicaciones de la UPV/EHU, en colaboración con el grupo Applied Organic Materials de la Universidad Técnica de Brunswick, han conseguido una fibra óptica de plástico con dopante híbrido que servirá para producir energía a pequeña escala. Para mejorar las características de la fibra óptica han añadido al polímero un dopante compuesto por substancias tanto orgánicas como inorgánicas. “Podrá utilizarse con células fotovoltaicas que alimenten pequeños dispositivos o sensores, y podría tener una gran potencialidad en el mercado de la fotovoltaica integrada en edificios o edificación verde —explica Itxaso Parola, autora de la investigación—. Además, conectada a fibras pasivas, se puede transportar la luz desde un extremo al otro de la fibra, y así, servir para alimentar dispositivos alejados de la fuente de energía”.

“La fibra óptica de plástico con dopante híbrido funciona como un concentrador solar luminiscente: absorbe la luz solar y la emite a una mayor longitud de onda; transporta la luz al extremo de la fibra, por reflexión interna total, y en el extremo de la fibra se coloca la célula fotovoltaica —explica Parola—. Es la primera vez que se utilizan para ese fin fibras ópticas de plástico que combinan componentes orgánicos e inorgánicos”. Asimismo, la investigadora de la UPV/EHU ha destacado que, como otros concentradores luminiscentes, este también resulta muy apropiado para obtener energía solar en espacios situados en sombra y en días nublados.

Según los resultados de las medidas llevadas a cabo, una fibra de 6 cm de longitud puede llegar a concentrar un tercio de la luz que emite el sol un día soleado de verano, y en opinión de la investigadora “ese resultado es muy bueno”. Han medido el rendimiento de la fibra en diversas condiciones ambientales y de iluminación, y “hemos observado que tiene un buen rendimiento en todos los casos, aunque el rendimiento es incluso algo mayor cuando la luz no incide directamente en la fibra. Esa característica es muy positiva teniendo en cuenta que el rendimiento de las células de silicio es muy pequeño en días nublados o de luz difusa”, comenta. Aunque la investigadora ha reconocido que cuando la fibra es muy larga la luz que se transporta por el interior se debilita, “con una sola fibra de 6 m de longitud hemos conseguido concentrar una intensidad de luz 1,3 veces mayor que la luz directa del sol”, detalla.

Tal como afirma la investigadora, es mucho más barato preparar sistemas como este que utilizar mayores superficies de células de silicio. De todas formas, Parola reconoce que es necesario investigar más en este campo para arrojar luz sobre varios aspectos: “Nosotros hemos realizado experimentos utilizando una única fibra, pero se necesitarían haces de fibras para poder cubrir el área activa de una célula fotovoltaica. Por otra parte, la superficie de las células fotovoltaicas es cuadrada, y al cubrir esa superficie con fibras cilíndricas siempre quedarán pequeñas zonas que no obtendrán luz. Ahora, estamos probando con diferentes diámetros de fibra; cuando la fibra es más gruesa pierde flexibilidad, pero, al mismo tiempo, absorbe más luz. Todavía tenemos mucho que investigar, pero los resultados son muy prometedores”.

Referencia:

I. Parola, D. Zaremba, R. Evert, J. Kielhorn, F. Jakobs, M. A. Illarramendi, J. Zubia, W. Kowalsky, Hans-Hermann Johannes (2018) “High performance fluorescent fiber solar concentrators employing double‐doped polymer optical fibers” Solar Energy Materials and Solar Cells. DOI: 10.1016/j.solmat.2018.01.013

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Una fibra óptica de plástico actúa como concentrador solar luminiscence se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Hidrógeno a partir de composites de fibra de carbono

- Cómo incorporar nanotubos de carbono a un plástico de aviación

- La óptica se hace atómica: la lente más pequeña del mundo

La Criatura de “La forma del agua”

Usar el cine para hablar de ciencia es algo que suelo hacer habitualmente, y muchas películas se prestan a ser analizadas desde un punto de vista biológico, y eso es lo que vamos a hacer hoy con La forma del agua. Lo primero que me gustaría comentar sobre ella es que he quedado maravillado con esta nueva película del director mexicano Guillermo del Toro, y me ha recordado a lo mucho que disfruté con su obra El laberinto del fauno. Y es que como se oye mucho por ahí, los monstruos de este cineasta son maravillosos. Si encima me dan la excusa para poder hablar de biología, pues ya tenemos la película perfecta. Pocos Premios de la Academia para mi gusto ha ganado. Cabe recordar que La forma del agua se ha llevado el Oscar a la mejor película, al mejor director, a la mejor banda sonora y al mejor diseño de dirección; un total de cuatro estatuillas de las trece nominaciones que tenía.

Cartel de la forma del agua

Pero empecemos por el principio. ¿De qué trata está película? Si hay que hacer un resumen, tenemos que decir que va sobre el amor, el amor en sus múltiples facetas. Es una oda al amor, claramente. Un precioso cuento de amor en el que uno queda atrapado desde que empiezan las primeras palabras a narrar la historia, acompañadas de unas bellas imágenes cuidadas al máximo. Y es que está claro que ese es otro de los puntos fuertes de la película, la fotografía, que junto con la magnífica banda sonora, terminan de conformar esta maravillosa historia que ha cautivado a tanta gente.

El inicio de la película

Intentaremos que no haya spoilers en el post, pero está claro que tengo que contar algunos detalles, así que si alguien no quiere que le adelante algún detalle tiene que dejar de leer aquí, aunque me voy a centrar solo en la parte biológica que concierne a la criatura y no en la historia que se relata. Y es que esta criatura me ha cautivado a muchos niveles, y nos va a dar pie para que hablemos de detalles biológicos interesantes, que podemos conocer a lo largo del metraje de la película.

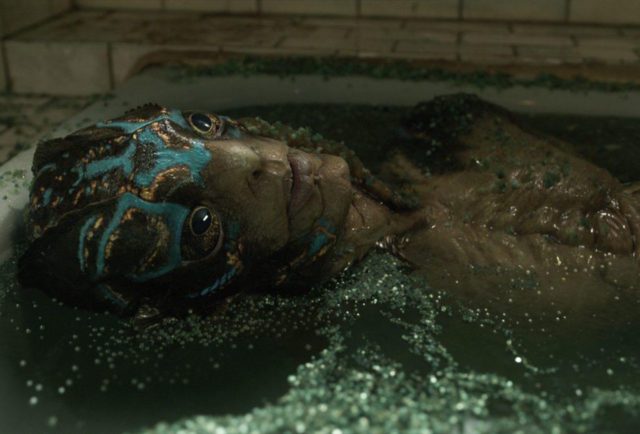

La criatura de La forma del agua

Muchos, al verla la primera vez, no hemos podido evitar acordarnos de otro de los monstruos clásicos del cine, La criatura de la Laguna Negra, de la película homónima de 1954 (Creature from the Black Lagoon), que fue titulada en español La mujer y el monstruo. Y es que el propio director, Guillermo del Toro, ha reconocido que esta película marcó su vida cuando la vio de pequeño.

“Tenía seis años cuando vi El Monstruo de la Laguna Negra en la televisión y hubo tres cosas que despertó en mí, la primera que no revelaré; la segunda fue la imagen más hermosa que había visto, me sentí abrumado por la belleza; y la tercera cosa fue que en realidad esperaba que terminaran juntos y no lo hicieron…”

La Criatura de la Laguna Negra

Tengo que reconocer que la primera frase que se nos puede pasar a la mayoría por la cabeza cuando vemos a la criatura es: – Vaya bicho más feo -, pero yo tuve la sensación contraria, me parecía una criatura de gran belleza, magnífica, digna de admiración, por lo que ahí coincido con las palabras de Del Toro, que no había leído hasta que me he puesto a buscar información para escribir esta reseña. Y es que el monstruo está perfectamente diseñado, con un cuidado extremo de todos los detalles, para que nos guste; lo que contrasta muchísimo con el disfraz, mas bien cutre, de la película de 1954, cosa que por otro lado es normal. Los monstruos de las películas antiguas nos suelen parecer mas feos casi siempre.

Comparativa

Según se narra al inicio de la película, cuando traen al monstruo a un laboratorio secreto del Gobierno, se habla de que lo encontraron en Sudamérica, del mismo modo que la Criatura de la Laguna Negra fue encontrado por un paleontólogo en el Amazonas, por lo que ambas tienen el mismo origen. El ser tiene aspecto de anfibio, y desde el primer momento se deja ver su piel húmeda y suave, aunque en algunas partes de la película se pueden intuir algo parecido a escamas, más o menos de gran tamaño que me hicieron dudar de la naturaleza de dicha criatura. Es más, atendiendo a ciertas características, podemos dudar de si estamos ante un anfibio estricto o si es un paso intermedio en la escala evolutiva entre este grupo y el de los reptiles. O incluso un espécimen intermedio entre anfibios y peces, todo ello complicado por la forma claramente antropomórfica del ser.

¿Pez, anfibio o reptil?

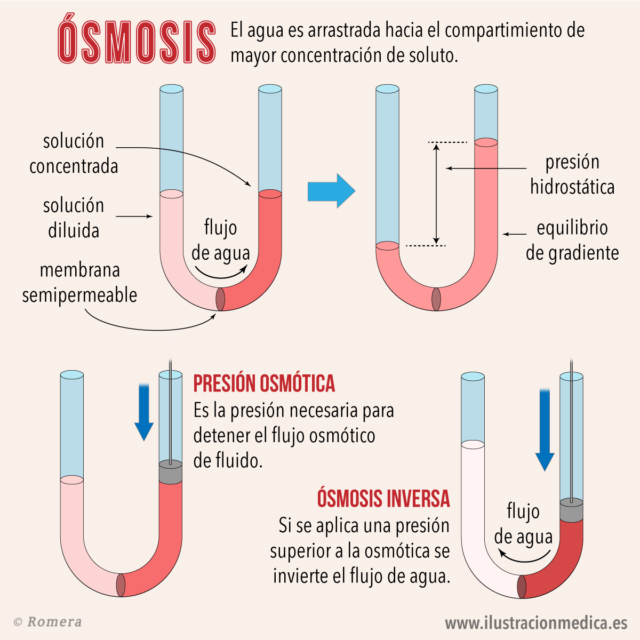

Desde el principio de la película nos dejan muy claro que la criatura necesita agua salada, por lo que tenemos que empezar hablando de ósmosis, que es un fenómeno físico que ocurre cuando tenemos dos disoluciones separadas por una membrana semipermeable, es decir una superficie que permite el paso de ciertas sustancias de forma selectiva. En el caso que nos interesa vamos a considerar que la membrana semipermeable permite el paso del agua, pero no de las sustancias que lleve disuelta, esto es, permite el paso del disolvente, pero no de los solutos. La ósmosis, se produce cuando dos disoluciones de diferentes concentraciones se encuentran separadas por una membrana de este tipo.

En este caso, el agua atravesará la membrana desde donde hay menor concentración de solutos hasta donde hay mayor concentración. La lógica y la experiencia nos dice que esto ocurre hasta que las dos disoluciones se igualan, y ambas presenten la misma concentración. A la disolución que tiene mayor concentración de solutos se le llama hipertónica, mientras que a la que tiene menos se le llama hipotónica. Cuando las dos se igualan, tras pasar el líquido desde el medio hipotónico al hipertónico, los dos medios pasan a convertirse en isotónicos, es decir, tienen la misma concentración. A partir de esto se define por ejemplo, la presión osmótica, pero no vamos a entrar en más conceptos físicos, sino que nos vamos a quedar en la aplicación biológica de este proceso. Sobre ósmosis y criaturas de este tipo nos habló magistralmente mi admirado Sergio Palacios en este post.

Ósmosis

Al igual que los peces, nuestra criatura cuenta con adaptaciones que le permiten sobrevivir a determinada concentración de sales en el agua, y debido a ello pueden vivir en el océano. Pero aquí nos encontramos el primer problema, que ahora comentaremos mientras repasamos algunas escenas de diálogo de la película, en las que se habla del origen de la criatura en los siguientes términos:

“… Sí, y lo sé bien. Yo saqué a esa bestia inmunda del fango de un río en Sudamérica y la arrastré hasta aquí. Y por el camino no congeniamos mucho.

Bien, esa criatura puede parecerles humana, porque se yergue sobre dos piernas, pero Dios nos creó a su imagen y semejanza. No creerán que Dios se parece a eso, ¿no?”

(Lo dice el Coronel Strickland hablando con las limpiadoras del laboratorio).

El actor Michael Shannon interpretando magistralmente a Strickland

Vale, tenemos una criatura marina, que dice que fue sacada del fango de un río sudamericano… No cuadra mucho, pero sigamos buscando pistas, a ver si podemos averiguar qué río era. El mismo Strickland, suelta más adelante la siguiente frase:

“Los indígenas del Amazonas lo veneraban como un Dios.”

Se trata del río Amazonas, que por cierto es el mismo río donde se hallaba la criatura de la película de 1954. Pero, ¿es el Amazonas un río de agua salada? Nada más lejos de la realidad. La consideración de agua dulce, que es como se entiende que es la de los ríos, se hace teniendo en cuenta que la salinidad esté entre un 0 y un 0,05 %, por lo que no parece muy lógico que esta criatura pueda vivir en el río Amazonas, excepto que lo haga en su desembocadura. En esa zona se mezclan los dos tipos de agua, dulce y salada, por lo que no sería extraño que los encuentros entre la criatura y los indígenas, y el lugar donde atraparon a este ser fuera la desembocadura del río Amazonas.

Delta del Amazonas

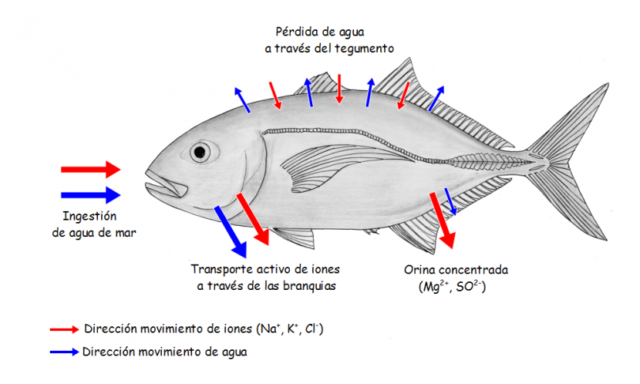

La concentración salina en los mares es de entre 33 y 35 g/l, es decir, de aproximadamente un 3,5 %, a causa de la sal común, el cloruro sódico, que hay disuelta en este medio. Sin embargo, la concentración de los fluidos corporales de los peces teleósteos, que son la mayoría de los peces que viven en medios marinos, es mucho menor, por lo que estos animales nadan en un medio hipertónico o hiperosmótico. Debido a esto, el agua tenderá a salir desde el interior de las células hacia dicho medio, por lo que corren el riesgo de morir, literalmente, deshidratados a pesar de vivir rodeados del líquido elemento. Para compensarlo no tienen mas remedio que beber.

Cabe suponer que nuestra criatura tenga las adaptaciones que los peces marinos: Al beber agua salada, está introduciendo en sus cuerpos una gran cantidad de sales que van disueltas en el agua, por lo que necesita algún mecanismo para expulsar este exceso salino. Y este mecanismo consiste en eliminar las sales mediante unas células especializadas de las branquias, y mediante una orina escasa, pero muy concentrada.

Osmorregulación en peces de agua salada

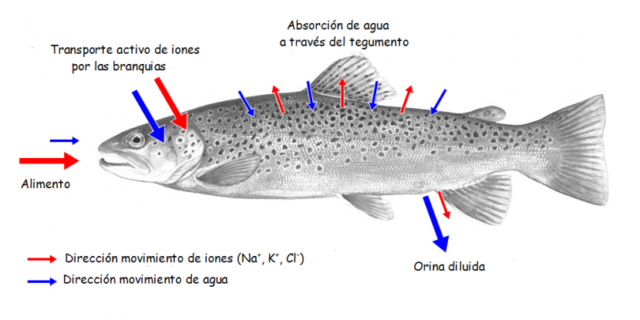

Existen peces que pueden vivir en los dos medios, es decir, los llamados peces diádromos, que viajan entre los ríos y los mares o viceversa. Hay peces que se aparean y nacen en los ríos, pero que pasan la mayor parte de su vida adulta en el mar, son los llamados peces anádromos, cuyo ejemplo más conocido quizás sean los salmones, entre los que destaca la especie Salmo salar, el salmón común o salmón del Atlántico. Entre los peces catádromos, también uno de los ejemplos más conocidos es el de las anguilas, Anguilla anguilla. Estos curiosos peces con forma alargada, nacen en el Océano Atlántico, en el conocido mar de los Sargazos, donde pasaran unos meses en forma de larva, llamadas larvas leptocéfalas, que arrastradas por las corrientes llegan hasta las costas de Europa, donde remontan los ríos para crecer y vivir en ellos durante muchos años. De adultos viajan río abajo para volver al mar de los Sargazos, donde nacieron, y reproducirse, llevando a cabo la puesta en dicho lugar.

En ambos casos, el problema está en que la osmorregulación debe adaptarse al medio en el que se encuentran en cada momento y para ello las estructuras celulares de las branquias deben cambiar acomodándose a la salinidad del medio. Cuando están en agua dulce, medio hipotónico, el epitelio branquial es capaz de absorber sales, mientras que en agua salada, medio hipertónico, las células de las branquias expulsan sal activamente. El control de la diferenciación y de la actividad de estas células se realiza mediante hormonas, así por ejemplo, el cortisol y la hormona del crecimiento activan este epitelio en la transición de los ríos al mar, mientras que la prolactina lo hace cuando ocurre el paso contrario.

Osmorregulación en peces de agua dulce

Y para complicar aún más el asunto existen algunas especies de peces llamados anfídromos, que se mueven entre el mar y el agua dulce, o entre los ríos y el agua salada, aunque no lo hacen por causas reproductivas, como los anteriores, sino para alimentarse o a causa de cambios estacionales. Un ejemplo de ellos son las lisas, Mugil cephalus, un pez carroñero muy habitual en las desembocaduras de los ríos, ya que es muy adaptable a distintas condiciones de salinidad e incluso a la contaminación. Creo que en un caso parecido a éste nos encontraríamos a nuestra criatura, que vive en el océano y que sube a la desembocadura de los ríos en busca de alimentos, más aún cuando en la película se cita que los indígenas le lanzaban flores, frutas y otros presentes. En varias escenas vemos como le encanta comer huevos cocidos, una fuente de proteína, ofrecidos por personajes humanos.

Los huevos, fuente de proteínas…

De nuevo nos encontramos otro problema de coherencia en los diálogos de la película que llegué a pensar que era un error cuando lo escuché la primera vez, y que me ha hecho buscar la versión original para ver si era un fallo de traducción. Se trata de lo que el Dr. Robert Hoffstetler le dice a Elisa, una de las limpiadoras, durante uno de los momentos más importantes del metraje:

“El agua debe tener entre un 5 y un 8 % de salinidad. Vale con sal común.”

El actor Michael Stuhlbarg con el doctor Robert Hoffstetler

¿Cómo? una salinidad mucho mayor que la media del agua del mar… ¿pero no habíamos quedado en que era una criatura marina que podía moverse a la desembocadura del río Amazonas? En un principio pensé que ahí se habían pasado con el porcentaje, quizás para enfatizar el problema de sacar a la criatura del laboratorio y hacer ver una necesidad o dependencia mayor del agua salada. Uno de los sitios más salados de nuestro planeta es el mar Muerto, cuya salinidad es variable, pero puede rondar entre un 22 y un 28 % de salinidad. El Gran Lago Salado norteamericano tiene una salinidad entre un 5 y un 22 % y muchos lagos salados sudamericanos tienen una salinidad variable entre el 3 y el 25 %. Pero nuestra criatura no vive en un lago, ni en el Mar Muerto.

Podemos aceptar que la criatura puede adaptarse a rangos variables de salinidad, lo que sumado a que también vemos que el agua del tanque del laboratorio y la bañera tienen que tener un producto (que no se menciona qué es), que le da un aspecto verdoso, y que me recordaba en todo momento a las aguas eutrofizadas. Todo ello nos da las pistas necesarias para que podamos concluir que su hábitat es una zona en la desembocadura de un río que está sufriendo este proceso de eutrofización. Esto consiste en que en un cuerpo de agua cerrado o casi cerrado, con poca corriente, los nutrientes que ingresan masivamente al sistema generan una gran biomasa de organismos de vida efímera. Al morir, toda esta masa biológica se acumula sobre el fondo al no ser totalmente consumidos por organismos descomponedores, sobre todo bacterias. Estos procesos naturales de eutrofización se pueden observar en las lagunas formadas por los cauces antiguos de ríos que se transforman en pantanos y posteriormente se cubren de vegetación. En el Amazonas, por supuesto, también ocurre esto. Por fin dimos con la clave del posible sitio de origen de nuestra misteriosa criatura.

Tanque de agua de la criatura

Cuando la criatura sale del laboratorio y tiene que pasar un tiempo en una bañera, además de lo que supone un espacio tan pequeño para un ser más alto que un humano medio, lo pasa muy mal suponemos que por no haber controlado exactamente la concentración salina del agua de la bañera, que seguramente se haya quedado corta. Gran parte de los problemas que tiene en esos momentos se deben a la necesidad de un hábitat natural amplio y acondicionado para que sobreviva, con una concentración salina adecuada.

La criatura en una bañera “eutrofizada” artificialmente

Hasta ahora, en todo momento hemos hablado de peces, pero dijimos al principio que nuestra criatura protagonista posiblemente se tratara de un anfibio, por lo que pasemos ahora a hablar de por qué pensamos esto, teniendo en cuenta las adaptaciones a la vida acuática y terrestre que vemos en la criatura, que son las típicas de este tipo de seres en la ficción.

En primer lugar atendamos a su aspecto general, con un color verdoso muy habitual en muchos grupos de anfibios, como ranas, sapos y tritones. El patrón de colores ondulado es muy característico y llamativo visto así, pero en el medio acuático eutrofizado que comentábamos antes debe significar un buen camuflaje para la criatura. La piel del tritón jaspeado, Triturus marmoratus, o las escamas del pez león, Pterois antennata, presenta patrones parecidos.

Tritón jaspeado y pez león

Es cierto que en el nuevo monstruo de Del Toro nos encontramos con la producción de luz en algunas células de la piel, lo que es una novedad frente a monstruos más clásicos. La bioluminiscencia es la producción de luz por parte de organismos vivos. Bioquímicamente hablando, se trata de una reacción en la que interviene una enzima llamada luciferasa, que hace que el oxígeno oxide a la proteína llamada luciferina, que da lugar a la oxiluciferina, produciéndose también agua y luz. Se trata de una transformación directa de energía química en energía lumínica. En la vida real las funciones de esta bioluminiscencia pueden ser múltiples, desde atraer a posibles presas, servir para comunicación entre individuos, camuflaje o distracción o como señal de advertencia. Para nuestra criatura no sabemos cual es la función en libertad, pero en la película vemos que está asociada con la regeneración de tejidos.

Bioluminiscencia

No hay anfibios bioluminiscentes que conozcamos, aunque recientemente se encontró una rana que brilla en la oscuridad, pero lo hace por fluorescencia que es diferente a la bioluminiscencia. Se trata de una rana sudamericana, la rana puntuada, o Hypsiboas punctatus, una especie que vive en montañas, pantanos, marismas y bosques tropicales y subtropicales, de varios países de Sudamérica, como Argentina, Bolivia, Brasil o Colombia, y que es capaz de brillar en la oscuridad. Lo que si tienen los anfibios es una capacidad increíble para regenerar los tejidos, así que la capacidad del monstruo para hacerlo también tiene su punto de justificación científica.

Hypsiboas punctatus

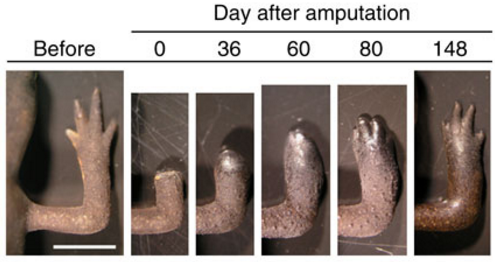

El ajolote mexicano y otras especies de salamandras y tritones presentan la capacidad de regenerar sus tejidos. Si se lesionan una extremidad o la cola son capaces de regenerarla, pero lo más asombroso es que también pueden hacerlo con partes de sus órganos vitales, como el corazón o el cerebro. Básicamente, lo que hacen estos animales es revertir sus células hasta el estado de células madre, para poder reparar los tejidos renovando todas las células que hagan falta. Al igual que nuestra bestia protagonista tiene esta capacidad para curar, estos anfibios están siendo usados para investigar posibles tratamientos de regeneración en pacientes amputados y curación de algunas enfermedades.

Regeneración en anfibios

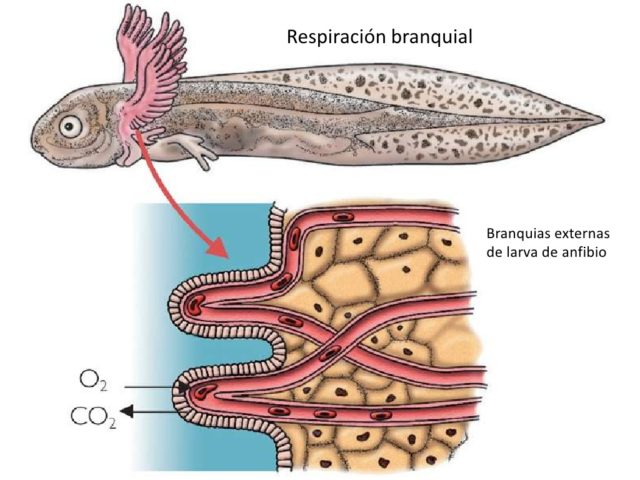

Otra característica evidente en la criatura es su modo de respiración. Desde el principio se ven unas agallas grandes en el cuello entre las que suponemos entrever varias hendiduras branquiales, que dan acceso a las branquias que usa para respirar dentro del agua. Así mismo parece claro que cuenta con pulmones, que le permiten respirar en tierra. Hay varias referencias a ello en la película:

“Absorción de oxígeno e intercambio de dióxido de carbono. ¿Qué demonios es esto hijo?”

(Lo dice el general Hoyt hablando con el coronel Strickland)

“Esta criatura puede alternar entre dos mecanismos de respiración totalmente diferentes.”

(La intervención del Dr. Robert Hoffstetler matiza datos sobre la respiración de la criatura)

Detalle de diseño de la criatura. Se ven los repliegues branquiales en la cara y el cuello

Detalle del tórax de la criatura durante una sesión de maquillaje

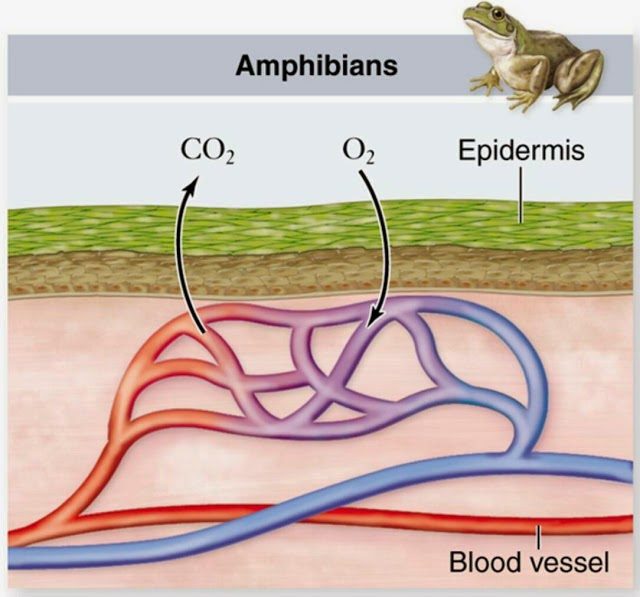

Strickland apostilla a la intervención anterior con una frase que dice: – “El pez del fango también.”-, en referencia a los peces del género Periophthalmus, también llamados saltarines del fango. Estos fascinantes seres viven en manglares tropicales y tienen la capacidad de respirar aire en un modo de vida anfibio. Tienen capacidad para respirar a través de la piel, su mucosa bucal y faringe. Esto solo es posible en condiciones de mucha humedad, limitándolos a permanecer en el área fangosa. Éste tipo de respiración cutánea es muy similar al de los anfibios, por lo que el comentario de Strickland no está tan fuera de lugar.

Otra importante adaptación para ayudar a respirar aire es la existencia de grandes cámaras branquiales que actúan como un depósito de oxígeno, lo cual les sirve mientras están en tierra. La habilidad de enterrarse en profundos hoyos de sedimentos fangosos, les ayuda en su termorregulación, y también a evitar depredadores. Además, pueden utilizar esta capacidad para desovar en estos agujeros en el fango. Gracias a la cámara branquial pueden respirar cuando están enterrados y el agua tiene poca concentración de oxígeno.

Periophthalmus barbarus

Volviendo a la película, el propio Strickland vuelve a hacer otro comentario en referencia a los pulmones de la criatura:

“¿Ve eso que tiene a lo largo del pecho? Esta criatura tiene un cartílago articulado que separa los pulmones primarios de los secundarios. (…)”

En nuestro mundo real, los anfibios usan varios sistemas de respiración, como son la cutánea, la branquial, la pulmonar y la respiración a través de la cavidad oral. La respiración cutánea la utilizan cuando están sumergidos, por ejemplo para reproducirse, y de esta manera pueden respirar también a través de la piel mientras ésta se mantenga húmeda en el exterior. Tengamos en cuenta que los anfibios fueron los primeros vertebrados que salieron del agua para llevar a cabo gran parte de su vida fuera del agua, aunque no se independizaron totalmente de ella. Su reproducción los ata al agua, ya que sus huevos, sin cáscara, necesitan ser depositado en lugares muy húmedos o masas de agua para que no se desequen.

Respiración branquial en renacuajos

Respiración cutánea en anfibios adultos

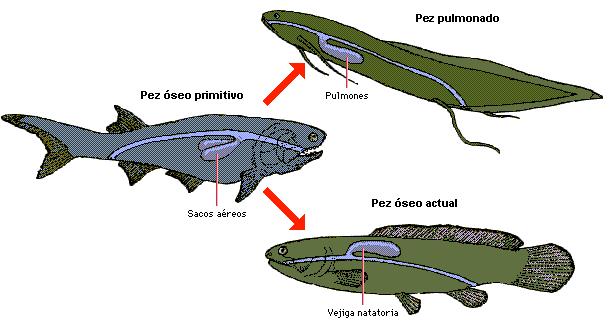

Los primeros peces que desarrollaron la capacidad de salir del agua para sobrevivir cierto tiempo en tierra, la adquirieron gracias al desarrollo de pulmones, aunque estos fueran rudimentarios y menos efectivos que los de reptiles, aves y mamíferos. Los pulmones de las salamandras y tritones son unos simples sacos de paredes lisas bien vascularizadas, mientras que los de ranas y sapos son un poco más complejos con pliegues y cámaras, lo que aumenta la capacidad respiratoria. Estos primeros pulmones que tuvieron los anfibios derivan de la vejiga natatoria de los peces.

Vejiga natatoria

En cuanto a la respiración branquial, en los renacuajos y larvas de los anfibios es la forma más usual de respirar, y, normalmente, tras la metamorfosis, al llegar a adultos, sustituyen estas estructuras por los pulmones y pasan de tener respiración branquial a tener respiración pulmonar. De todas maneras, el tipo de respiración depende de la especie. Por ejemplo los ajolotes adultos pueden conservar la respiración branquial, mientras algunos tipos de salamandras, como las del género Bolitoglossa, carecen de respiración pulmonar y lo hacen exclusivamente por respiración cutánea.

Bolitoglossa mexicana

Nuestra criatura, es un ser alto y galante, para este papel, Guillermo del Toro ha utilizado al actor Doug Jones, que también hizo del Fauno en su famosa película. Este actor no es la primera vez que se mente en la piel de un hombre-anfibio, bastante parecido a éste, puesto que ya lo hizo en otra de las películas del cineasta mexicano. En Hellboy hacía el papel Abe Sapien, aunque este personaje es descrito más como un hombre-pez. En cualquier caso el parecido de ambas criaturas es más que razonable.

Abe Sapien

El propio Guillermo Del Toro dice que para los movimientos del monstruo quería la fluidez del Silver Surfer de los 4 Fantásticos, al que por cierto también interpretó Jones en su versión cinematográfica. Para que el diseño de la criatura fuera atractivo, el director se llevaba frecuentemente el traje a su casa para pedir opinión femenina en cuestiones como el abdomen más o menos marcado, el trasero o la anchura del pecho y los hombros. Doug Jones necesitaba cuatro horas de preparación y maquillaje para terminar teniendo el aspecto de la criatura. El resultado era una piel con todas las imperfecciones y detalles que un híbrido entre humano y anfibio debería tener: en el cuello y repliegues de la piel hay imperfecciones, hoyuelos, líneas, arrugas, cicatrices, vasos sanguíneos y pliegues. En cuanto a los colores también se ven diferentes tonos y variaciones según el ángulo de observación, la sombra, el medio en el que esté y la iluminación.

Doug Jones durante una sesión de preparación del traje y el maquillaje

Se pueden ver en las extremidades de la criatura estructuras a modo de aletas, aunque no demasiado grande para primar el aspecto antropomórfico sobre el anfibio. Llama poderosamente la atención la creta dorsal que presenta a lo largo de su espalda, siguiendo la línea de la columna vertebral, que puede ser una referencia a su condición de macho. Los machos de los tritones desarrollan este tipo de crestas dorsales en su espalda y en su cola como un signo de dimorfismo sexual que se usa para hacerlos más llamativos en el cortejo.

La cresta en la espalda de la criatura

La condición de macho de nuestro espécimen queda clara desde el principio, pero se hace referencia varias veces a su entrepierna, que se observa bastante plana, sin señal de la presencia de ningún pene u órgano copulador. Es la protagonista de la película, Elisa, la que en un momento dado explica a su amiga si la criatura tiene pene o no, y es aquí donde, debido a su condición de muda, lo hace mediante gestos. Atendiendo a como lo explica, la imagen que me hice de como era la estructura del pene de la criatura me recordó a la de un animal acuático, pero que precisamente no es un anfibio, ya que la mayoría de ellos carecen de pene, sino a la de los cocodrilos, que son reptiles.

Detalle del cuerpo completo de la criatura

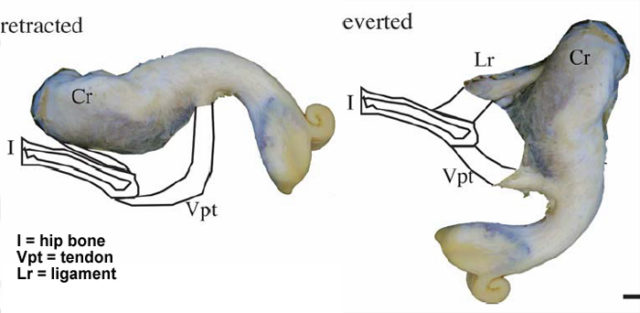

Un juguete sexual inspirado en el supuesto órgano copulador de la criatura

El aligátor americano, también conocido como caimán americano, Alligator mississipiensis, es un tipo de cocodrilo que habita en Estados Unidos. Estos animales tienen un extraño pene blancuzco y con aspecto blando, que está continuamente en erección pero retraído en el interior de la cloaca, y que solo es impulsado al exterior por un reflejo muscular, al estimularse los nervios adecuados. En nuestra criatura el pene también se mantiene en el interior del cuerpo de ésta, hasta que no es necesaria su presencia, lo que coincide un poco con la explicación de Elisa y con la entrepierna plana que vemos en pantalla. Al no depender de sangre ni de ningún tipo de mecanismo hidráulico para su funcionamiento son los músculos los que se encargan de producir su salida, y la estructura elástica de un tendón es la que hace que se retraiga de nuevo, como si de una goma elástica se tratara.

En cuanto la musculatura de la cloaca se relaja y se abre, éste se libera. Los propios científicos encargados de su estudio comparan la eyección del pene del aligátor con la salida del contenido de un tubo de pasta de dientes, para que nos hagamos una idea. Si esto es así con la criatura de La forma del agua no lo sabemos, pero a mí es lo que se me vino a la mente. De esta característica reptiliana hablaba al principio del post, cuando dudábamos de su naturaleza.

El pene siempre erecto de un aligátor

Otro de los aspectos importantes es el rostro, pues Doug Jones se tiene que expresar, y una máscara habría sido un estorbo para ello. El rostro de la criatura está conseguido con prótesis para las agallas y repliegues, que se manipulaban externamente y se movían por control remoto. Se esforzaron por crear un rostro no demasiado extraño y una boca que fuera besable, por lo que los labios son bastante humanos. Su nariz es casi inexistente, reduciéndose a dos pequeñas fosas nasales y son sus grandes ojos lo que más destaca en su rostro. Estos parpadean de una curiosa forma, en horizontal en vez de en vertical, y es debido a que posee una membrana nictitante o tercer párpado, que es transparente y sirve para protegerlo del agua cuando se sumerge. De hecho vemos como estos párpados se le cierran en algunas escenas justo cuando se está hundiendo en el agua.

Los ojos de la criatura

Son muchos los detalles que hemos analizado de esta criatura, y aún así estoy seguro de que podríamos profundizar mucho más en cada uno de ellos o en otros que se nos hayan pasado, como por ejemplo la forma de alimentación, pero queda claro que disfrutar del cine añadiendo un punto de vista científico hace que una película, ya de por sí magnífica, mejore aún más.

Este post ha sido realizado por Carlos Lobato (@BiogeoCarlos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias científicas y más información: