El principio de complementareidad

Foto: Leonardo Yip / Unsplash

Foto: Leonardo Yip / UnsplashLa mecánica cuántica se fundó sobre la existencia de la dualidad onda-corpúsculo de la luz y la materia, y el enorme éxito de la mecánica cuántica, incluida la interpretación de probabilidad, parece reforzar la importancia de esta dualidad. Pero, ¿cómo puede considerarse un corpúsculo como que «realmente» tenga propiedades de onda? ¿Y cómo puede pensarse que una onda tenga «realmente» propiedades de corpúsculo?

Se podría construir una mecánica cuántica consistente sobre la idea de que un haz de luz o un electrón pueden describirse simultáneamente por los conceptos incompatibles de onda y corpúsculo. En 1927, sin mebargo, Niels Bohr se percató de que precisamente la palabra «simultáneamente» era la clave para mantener la coherencia. Se dio cuenta de que nuestros modelos, o imágenes, de la materia y la luz se basan en su comportamiento en distintos experimentos en nuestros laboratorios. En algunos experimentos, como el efecto fotoeléctrico o el efecto Compton, la luz se comporta como si constara de partículas; en otros experimentos, como el experimento de doble rendija, la luz se comporta como si estuviera formada por ondas. Del mismo modo, en experimentos como el de J.J. Thomson con los rayos catódicos, los electrones se comportan como si fueran partículas; en otros experimentos, como los estudios de difracción de su hijo G.P. Thomson, los electrones se comportan como si fueran ondas. Pero la luz y los electrones nunca se comportan simultáneamente como si estuviesen constituidos por partículas y ondas. En cada experimento específico se comportan como corpúsculos o como ondas, pero nunca como ambos.

Esto le sugirió a Bohr que las descripciones corpusculares y ondulatorias de la luz y de la materia son ambas necesarias aunque sean lógicamente incompatibles entre sí. Deben considerarse como «complementarias» entre sí, es decir, como dos caras diferentes de la misma moneda. Esto llevó a Bohr a formular lo que se llama el principio de complementariedad:

Los dos modelos, corpuscular y ondulatorio, son necesarios para una descripción completa de la materia y de la radiación electromagnética. Dado que estos dos modelos son mutuamente excluyentes, no se pueden usar simultáneamente. Cada experimento, o el experimentador que diseña el experimento, selecciona una u otra descripción como la descripción adecuada para ese experimento.

Bohr demostró que este principio es una consecuencia fundamental de la mecánica cuántica. Afrontó la cuestión de la dualidad onda-corpúsculo, no resolviéndola a favor de ondas o partículas, sino incorporándola en los cimientos mismos de la física cuántica. Al igual que hizo con su modelo de átomo, Bohr transformó una dificultad en la base del sistema, a pesar de que esto supusiese contradecir la física clásica.

Es importante comprender qué significa realmente el principio de complementariedad. Al aceptar la dualidad onda-corpúsculo como un hecho de la naturaleza, Bohr lo que afirmaba es que la luz y los electrones (u otros objetos) tienen potencialmente las propiedades de las partículas y las ondas, hasta que se observan, momento en el que se comportan como si fueran una cosa u otra, dependiendo del experimento y la elección del experimentador. Esta era una afirmación de una enorme importancia, porque significaba que lo que observamos en nuestros experimentos no es lo que la naturaleza realmente es cuando no la estamos observando.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El principio de complementareidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de incertidumbre, cualitativamente

- El comportamiento corpuscular de la luz: el efecto Compton

- El principio de incertidumbre, cuantitativamente

Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean

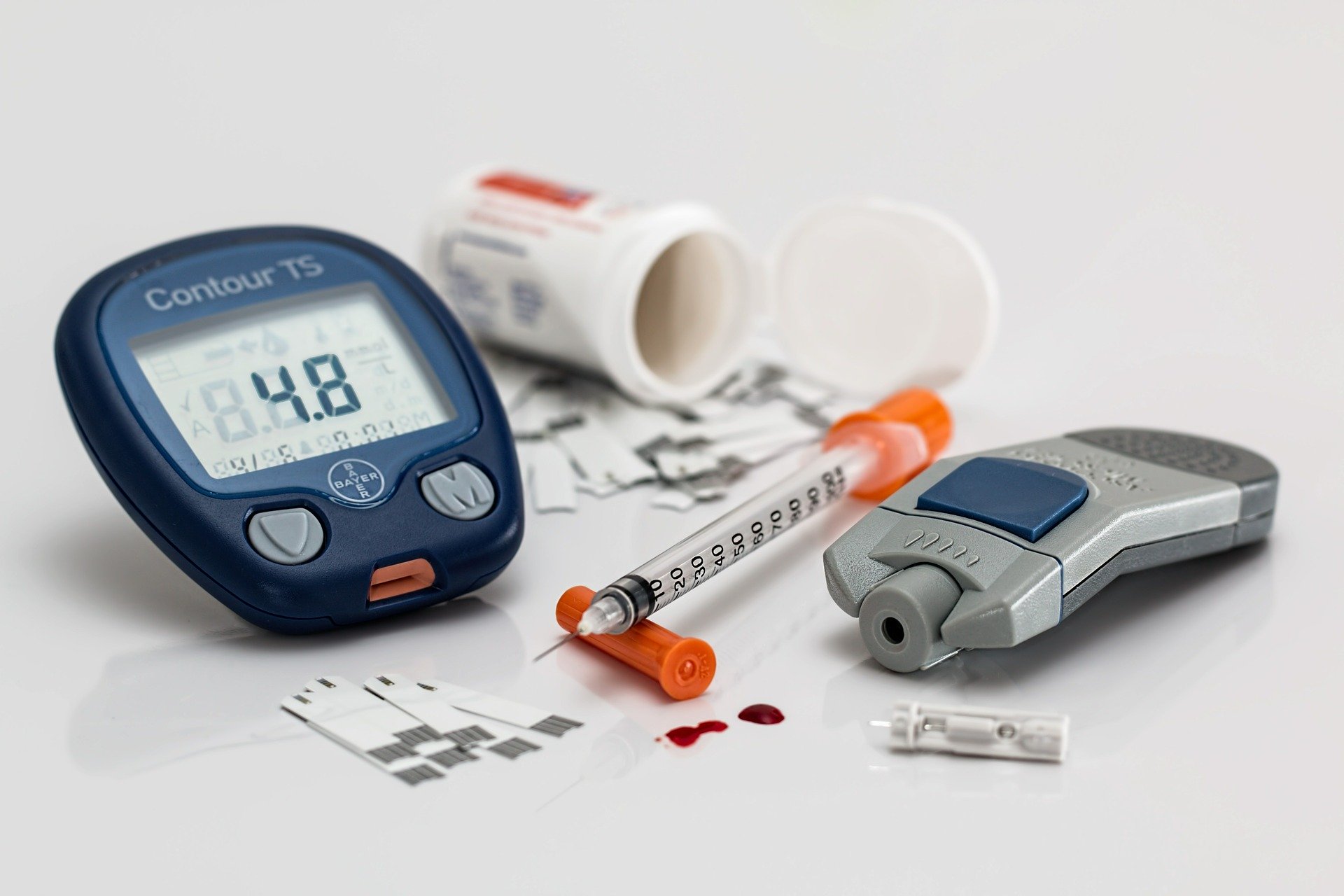

Irudia: Diabetesa duten gaixoentzat beharrezkoa da odoleko glukosaren kontzentrazioa kontrolatzea eta beharrezkoa denean intsulina injektatzea. (Argazkia: Steve Buissinne – domeinu publikoko irudia. Iturria: pixabay.com)

Diabetesa aspalditik ezagutzen den gaixotasuna da. Ideia bat emate aldera, kontuan izan behar dugu diabetesaren lehen deskribapena Ebers papiroan dagoela, k.a. 1.500. urtean. Erromatarrek eta greziarrek diabetesa ezagutzen zuten. Garai hartan, norbaitek diabetesa zuen edo ez jakiteko haren gernua dastatu behar zen. Horrela, greziarrak konturatu ziren zenbait lagunen gernua mellitus zela, alegia, gozoa zela -eztia, mellita hitzetik dator-. Orain badakigu zapore hori gehiegizko glukosa kontzentrazioaren kausa dela. Modu horretan, greziarrek bazekiten gaixotasun hori zutenek edari gozoak edan bezala kanporatzen zituztela gernuaren bidez -alegia, gernua ere gozoa zela- sifoi bat balitz bezala. Sifoi hitzaren baliokide greziarra diabetes da eta hortik, hain zuzen ere, diabetes mellitus.

Diabetesa duten gaixoek egarri handia izan ohi dute eta baita pixa egiteko gogo handia ere. Sintoma horietan oinarrituta, historian zehar hainbat aurkikuntza egin dira diabetesari buruz. 1679an, Thomas Willis mediku ingelesak sintoma horiek zituzten gaixoen gernuaren hondakinak dastatu zituen eta bi diabetes mota berezitu zituen: diabetes gozoa eta zaporerik gabeko diabetesa -esan beharrik ez dago nola iritsi zen ondorio horretara-. Gaur egun dakigunez, diabetes mellitusa diabetes gozoa da eta odoleko glukosa maila handiegiarekin lotzen da. Zaporerik gabeko diabetesa, aldiz, guztiz desberdina den gaixotasuna da eta hormona antidiuretikoaren gabeziarekin lotzen da. Hala ere, antzeko sintomak ematen dituenez, izen bera dute biek. Hortaz, garrantzitsua da jakitea diabetes mellitus eta diabetes zaporegabea fisiologikoki gaixotasun desberdinak direla. Oro har, diabetesa aipatzen denean lehenengoaz ari gara.

Diabetesa, beraz, pertsona baten odoleko glukosa maila behar baino gorago dagoenean izaten da. Oro har, odoleko azukre maila normaltzat jotzen da 65-100 mg/dl artean badago -baraurik- eta 140 mg/dl azpitik otordutik ordu bat edo bi igaro denean. Maila hori gaindituz gero, litekeena da pertsona horrek diabetesa izatea. Azukre kantitate handiegi horrek hainbat kalte ekar ditzake begietan, giltzurrunen funtzionamenduan, nerbio sisteman, eta abar. Oro har, epe luzera agertzen diren arazoak izan ohi dira. Diabetesa mota desberdinetakoa izan daiteke, baina, motarik arruntenak 1 mota eta 2 mota deiturikoak dira. Horien arteko desberdintasuna ulertzeko, lehenik eta behin beharrezkoa da glukosaren metabolismoaren erregulazioan gehiago sakontzea.

Glukosaren metabolismoa intsulinak erregulatzen du. Bere funtzio garrantzitsuena glukosa odoletik zeluletara igarotzen laguntzea da, modu horretan odoleko glukosa kontzentrazioa murriztuz. Era berean, intsulinak gibeleko glukogeno sintesia aktibatzen du eta prozesu horrek ere glukosa kontzentrazioa murrizten du. Alabaina, pankreak intsulinarik jariatzen ez badu, zeluletako paretetan dauden glukosa garraiatzaileak ez dira behar bezala aktibatzen eta glukosa ez da modu eraginkorrean sartzen zeluletara. Egoera honi 1 motako diabetesa deritzo, alegia, intsulina gabeziaren ondorioz odoleko glukosa kontzentrazioa murrizten ez denean.

Halere, bada beste akats mota bat glukosaren metabolismoaren erregulazioan. Zenbait kasutan, intsulina egon daiteke, bai, baina zeluletako intsulina hartzaileetan egotea akatsa -alegia, intsulinarekin lotu behar diren zelulako paretaren atalak-. Lotura hori ez bada modu egokian gertatzen, glukosa garraiatzaileak ez dira behar bezala aktibatzen eta glukosa ez da zeluletara sartzen. Bigarren arazo hori duten gaixoek 2 motako diabetesa dute, hots, pankreak intsulina jariatzen du, baina, intsulina ez da modu egokian lotzen hartzailearekin.

1 motako diabetesa haurtzaro edo nerabezaroan agertu ohi da, nahiz eta beranduago ere ager daitekeen. Oro har, mota honetako diabetesa bat-batean agertzen da eta intsulina hartuz kontrola daiteke. 2 motako diabetesa helduaroan agertzen da normalean eta horrek ez du zertan betirako izan behar; tratatzen bada, adibidez gizentasunaren aurka egiten bada, desagertu egin daiteke. 1 motako diabetesa baino askoz ere ohikoagoa da biztanlerian -%90-95- eta, orokorrean, sintomak ez dira hain agerikoak. Askotan ez du inongo minik sortzen eta denbora luzean oharkabean pasa daiteke -horrexegatik daude diagnostikatu gabeko kasu asko-. Oro har, 2 motako diabetesa elikadura desegokiaren eta kirol gabeziaren ondorioa izaten da. 1 motakoa, aldiz, ezin da era eraginkorrean saihestu. 1 motako diabetesa norberaren immunitate-sistemak pankrean dauden beta zelulak erasotzen dituenean gertatzen da eta horren arrazoiak genetikoak edo ingurunearenak izan daitezke -esaterako, gaixotasun birikoak jasan ondoren-.

Diabetes mellitusaren tratamenduari dagokionez, historian zehar hainbat modutara egin da, aurkikuntza berriek tratamendu eraginkorragoak ekartzen zituzten neurrian, baina, hori guztia hurrengorako utziko dugu.

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

Diabetesari buruzko artikulu-sorta:

- Diabetesa ulertzeko bidean (I): glukosaren metabolismoa

- Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean

The post Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean appeared first on Zientzia Kaiera.

Sesgos ideológicos que aquejan a la ciencia

Mapa de la previsión de la trayectoria del huracán Dorian alterado para que se ajustase a las declaraciones de Donald Trump en el sentido de que podía afectar a Alabama.

Mapa de la previsión de la trayectoria del huracán Dorian alterado para que se ajustase a las declaraciones de Donald Trump en el sentido de que podía afectar a Alabama.Los cognitivos no son los únicos sesgos que afectan al desarrollo de la ciencia. También hay sesgos ideológicos. Quienes se dedican a la investigación científica no son ajenos a la influencia de la cosmovisión, la ideología, las creencias, etc., y esos factores inciden en el desarrollo de la ciencia o en aspectos colaterales a la misma aunque de importantes repercusiones sociales. Los científicos llevados por sus creencias se ven afectados por sesgos (inconscientes, no serían casos de mala ciencia voluntaria) que les llevan realizar una actividad científica poco rigurosa (eligiendo datos -cherry picking- , interpretándolos, etc.) en la dirección de sostener con sus conclusiones científicas lo que ya creían antes de comenzar. El “razonamiento motivado” a que se ha hecho mención en la anotación anterior estaría en la base cognitiva de este comportamiento y la motivación sería un fuerte convencimiento ideológico.

En lo que a este aspecto se refiere y antes de poner algunos ejemplos ilustrativos, conviene advertir de que la incidencia de los sesgos es mayor cuanto más complejos son los sistemas que se estudian, más son las variables en juego y más difícil resulta aislar los efectos de los factores cuyo efecto se desea establecer empíricamente. La ciencia funciona a partir de la identificación de regularidades en los sistemas que estudia, pero esa identificación arroja mayores garantías cuando el sistema permite fijar o excluir factores que pueden incidir en ellas de forma incontrolada y limitar el análisis al efecto de aquellos que pueden ser modificados a voluntad o, al menos, medidos con precisión. La física es, en ese sentido, la disciplina cuyas observaciones ofrecen mayores garantías pues los sistemas que estudia son fácilmente acotables. Y a las ciencias sociales les ocurre lo contrario: es muy difícil eliminar factores de confusión y fijar con garantías los factores que se desea analizar. Y cuando es especialmente difícil descartar factores de confusión y fijar o controlar efectos de unas pocas variables, queda un amplio margen para la influencia de las motivaciones de carácter ideológico, tanto en el diseño de las investigaciones como en el posterior análisis de los resultados.

Quizás los antecedentes más antiguos del efecto de los sesgos ideológicos se remontan a los mismos orígenes de la ciencia moderna. En la controversia acerca del heliocentrismo o la naturaleza geométrica de las órbitas de los planetas (del movimiento de los cuerpos celestes, al fin y al cabo) ejercieron un efecto claro las creencias de sus protagonistas.

Algunos de los sesgos tuvieron carácter general en ciertas épocas. Las ideas de superioridad de la (supuesta) “raza blanca” o de las personas de origen caucásico con respecto a otras (supuestas) “razas” o procedencias condicionaron la investigación que se hizo en las épocas en que eran predominantes. Los prejuicios en relación con la capacidad de las mujeres para desempeñar roles considerados masculinos han ejercido una influencia muy fuerte en fechas relativamente recientes e, incluso, hoy lo siguen ejerciendo. Marlenne Zuk (2013) ha revisado críticamente algunas ideas muy extendidas acerca del (supuesto) “origen evolutivo” de las diferencias entre hombres y mujeres y ha refutado las bases de algunas de ellas.

Las creencias religiosas han alimentado actitudes claramente anticientíficas. En la actualidad el ejemplo más claro, quizás, de esta actitud es el del bioquímico Michael J. Behe, profesor de la Universidad de Lehigh, en Pensilvania (EEUU). Behe se opone a la teoría de la evolución por selección natural y defiende el llamado “diseño inteligente” que es, en realidad, una forma sofisticada de creacionismo. Según Behe, ciertas estructuras bioquímicas son demasiado complejas como para poder ser explicadas en virtud de los mecanismos de la evolución. Desarrolló el concepto de “complejidad irreducible” como un “sistema individual compuesto de varias partes bien coordinadas que interaccionan para desempeñar la función básica de este, de modo que si se eliminara cualquiera de esas partes dejaría de funcionar por completo”.

La ideología política puede tener también una influencia notable. No solo entre el púbico general, también en la comunidad científica la negación del cambio climático, en sus diferentes modalidades, está vinculada al campo conservador. La base ideológica está aquí relacionada con lo que podría considerarse una visión “optimista” del mundo, según la cual la naturaleza no tiene límites, ni desde el punto de vista de la disponibilidad o existencia de los recursos naturales, ni de la capacidad para asimilar la influencia de las actividades humanas. Esa visión optimista, junto con el hecho de que los efectos que se le atribuyen al cambio climático nos remiten a un futuro que se percibe como indefinido, neutraliza el peso de los argumentos y datos en que se basa el consenso científico al respecto.

Las actitudes anticientíficas más características de la izquierda suelen estar relacionadas con cuestiones de carácter ambiental y de salud. Sostienen que ciertas tecnologías ejercen efectos negativos sobre la salud de las personas y del medio ambiente. Se incluye en esa categoría, por ejemplo, la oposición a los organismos modificados genéticamente. Quienes defienden esas posturas suelen invocar el hecho de que son fuente de enriquecimiento para las empresas que las fabrican y comercializan, y que sus intereses se anteponen a otras consideraciones, incluidas las relativas a la salud de las personas o del medio ambiente.

Es probablemente una motivación de esa naturaleza la que anima a investigadores como Gilles-Eric Seralini. Seralini es conocido por sus opiniones contrarias a los transgénicos. En 2012 publicó un artículo en Food and Chemical Toxicology cuya conclusión era que el consumo de maíz transgénico provocaba el crecimiento de tumores en ratas de laboratorio que acababa provocándoles la muerte. El artículo, tras ser duramente criticado por numerosos científicos, fue finalmente retractado al año siguiente al entender el editor que no cumplía los estándares propios de una publicación científica debido a sus graves deficiencias metodológicas. La impresión que causa un caso como ese es que el investigador ha sacrificado el rigor exigible a un trabajo científico al objeto de obtener los resultados que mejor se acomodan a sus expectativas. J M Mulet (2013) ha expuesto aquí con claridad los pormenores de este caso.

Fuente:

Zuk, M (2013): Paleofantasy: What Evolution Really Tells Us about Sex, Diet, and How We Live. Norton & Co, New York.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo Sesgos ideológicos que aquejan a la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sesgos cognitivos que aquejan a la ciencia

- Ciencia Patológica

- #Naukas14 Algunos trucos para reducir sesgos

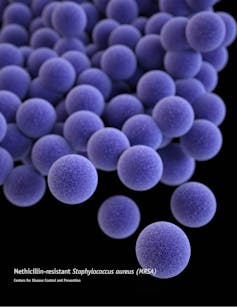

Mikrobio materia iluna

Izaki bizidunak topatu diren lekurik ustekabekoenak, agian, sakonera handian dauden harkaitzen barnealdeak dira. Mikrobio formak bizi dira lurrazaletik eta itsas hondotik metro gutxi batzuetara, baita sakonera handiagoetan ere. Bakterioak eta arkeoak topatu dituzte lurrazaletik 5 kilometrora, lur azpian Txinan. Halaber, mikrobioak topatu dituzte itsas hondoa baino 2,5 kilometro beherago.

Irudia: Laborategietan kultibatu gabeko mikrobioen populazioari mikrobio materia iluna esaten zaio. Tennesseeko Unibertsitateko Karen Lloyd irakaslearen taldea lehena izan da mikrobio horien populazioa kalkulatzen. (Argazkia: Erabilera publikoko irudia. Iturria: Pixabay.com)

Arroken barruan, arrakalen eta poroen barnean, biosfera oso bat dago. Kalkulatu da organismo horiek guztiak 2 mila milioi km³-ko arroka bolumenean banatuta daudela (Lurreko ozeano guztiek okupatzen duten bolumenaren bikoitza), eta 1030 zelula izango lituzketela, hau da, Lurreko mikrobio-bizitzaren %70. Izan ere, zatirik handiena lurpeko biosferan dago, bakterioek eta arkeoak dira gehien bat, nahiz eta alga zelulabakarrak eta onddoak ere badauden.

Mikroorganismo horietatik gutxi batzuk heterotrofoak dira, hots, materia organikoz elikatzen dira; eta oso oxigeno gutxi edo batere ez dagoen inguruneetan bizi direnez, normalean, anaerobioak dira asko eta asko. Nolanahi ere, gehienak kimiolitotrofoak dira: gai inorganikoak dira euren energia iturri. Mikroorganismo horiek hondakinak sortzen dituzte, eta beste izaki bizidun batzuk elikatzen diren kate trofikoaren oinarria dira hondakinok. Gutxienez kasu batean, sare trofiko horretan superharrapakari bat dago, Halicephalobus mephisto har nematodoa, milimetro erdiko luzerakoa. 2011n topatu zuten urre meatze batean, 1.300 metroko sakoneran.

Bizitza forma anitz dago inguru batzuetan, eta oso gutxi beste batzuetan, edo espezie bakar bat. Hegoafrikako Mponeng urre meatzean, 2,8 km-ko sakoneran, ezagutzen den ekosistema bereziena topatu da: organismoen % 99,9 baino gehiago espezie bakar batekoak dira; Desulforudis audaxviator bakteriokoak.

Eta oraindik ere izaki bizidun asko eta asko dago lurpean nork aurkituko, ezagutzen dugun biologiaz oso bestelako organismoak, baiki. Seguru asko, bide metaboliko ezezagunak dituzte, eta litekeena da metabolismo oso geldokoak izatea. 2010ean, Pazifiko Hegoaldeko Ozeano Bareko sedimentuetan lurperatutako mikrobioak topatu zituzten, eta bertan 100 milioi urte zeramatzatela kalkulatu da. Bizirik zeuden, baina oso jarduera metaboliko txikia zuten.

Mikroorganismoen metabolismoa bizi diren arroken konposizio kimikoaren araberakoa da. Hau da, arroka granitoa, basaltoa, hareharria edo buztina den. Heterogenotasun metaboliko horri esker, mikrobio komunitateak asko aldatzen dira leku batetik bestera, arrokak ez direlako berdinak leku guztietan.

Lurpeko biosfera horri mikrobio materia iluna deitzen zaio, unibertsoko materia ilunaren analogiaz. Hori bai, materia mikrobianoa ezagutzen hasiak gara. Eta ez genuke baztertu behar halakorik gure planetan soilik topatzea: Marteko lur azpiak biosfera propioa izan lezake.

Iturria:

Lawton, Graham, (2019): Earth’s deep, dark secret. New Scientist, 242 (3229), 42-45. DOI: https://doi.org/10.1016/S0262-4079(19)30841-3.

———————————————————————————-

Egileaz: Juan Ignacio Pérez Iglesias (@Uhandrea) UPV/EHUko Fisiologiako katedraduna da eta Kultura Zientifikoko Katedraren arduraduna.

———————————————————————————

The post Mikrobio materia iluna appeared first on Zientzia Kaiera.

Los números del sistema circulatorio humano

Imagen: PIXOLOGICSTUDIO/Science Photo Library

Imagen: PIXOLOGICSTUDIO/Science Photo LibraryEl corazón es el único músculo humano que se contrae una y otra vez desde que se forma hasta que se detiene, tras lo cual y si no media intervención, sobreviene la muerte.

Dieciocho días después de la fecundación se empieza a desarrollar en el embrión, un proceso que concluye prácticamente en la octava semana. Es el primer órgano que empieza a funcionar; lo hace con tres semanas, cuando aún es un tubo cardiaco primitivo. En la quinta, configurado ya como un corazón, late a 80 pulsaciones por minuto (bpm en adelante). El ritmo se eleva hasta alcanzar en la novena -cuando ya se han formado los tabiques, las válvulas y las cuatro cámaras- valores máximos, que varían entre 155 y 195 bpm. El ritmo desciende a partir de ese momento hasta los 120-160 bpm.

El corazón adulto late a una frecuencia algo superior a un latido por segundo, aunque varía entre unos individuos y otros, dependiendo del peso, la edad, la condición física y el sexo. En promedio, late cien mil veces cada día, alrededor de treinta millones al cabo de una vida.

Su trabajo consiste en bombear sangre a través de dos sistemas de vasos. El de menores dimensiones la conduce a los pulmones -donde capta O2 y se desprende de CO2– y la trae de vuelta al corazón. El mayor la impulsa para limpiarla en los filtros renales, suministrar O2 a las células, recoger el CO2 que producen, llevar las moléculas de alimento del sistema digestivo a los tejidos, transportar hormonas y otras sustancias, conducir las plaquetas a donde sean necesarias, trasladar las células del sistema inmunitario para combatir el ataque de patógenos, distribuir calor por el organismo y desempeñar otras funciones de comunicación y transporte de sustancias entre órganos.

En reposo, un corazón de adulto bombea a los tejidos alrededor de cinco litros de sangre por minuto, lo que supone unos siete mil doscientos litros diarios. En otras palabras, bombea toda la sangre del cuerpo en un minuto, aunque en condiciones de actividad intensa, ese tiempo se reduce a quince segundos. Los tres órganos que más sangre reciben son el sistema digestivo (27%), los riñones (20%) y el encéfalo (un 15%). Ahora bien, la musculatura puede llegar a recibir dos terceras partes del flujo sanguíneo total cuando el organismo hace un ejercicio intenso.

Los vasos sanguíneos del cuerpo humano recorrerían, dispuestos uno detrás del otro, del orden de cuarenta mil kilómetros, aunque esa distancia resulta de sumar la correspondiente a miles de vasos que circulan en paralelo, puesto que el sistema circulatorio se ramifica en arterias, arteriolas y capilares para alcanzar así hasta el último rincón de nuestro cuerpo, y luego reagruparse en vénulas y venas antes de retornar al corazón. Por esa razón, cada gota de sangre, célula sanguínea o partícula en suspensión no recorre esa distancia cada vez que completa una vuelta al sistema. Dado que una célula sanguínea, por ejemplo, tarda en promedio un minuto en completar el circuito, viaja a una velocidad aproximada de dos kilómetros por hora y recorre unos treinta y tres metros.

Un 45% del volumen sanguíneo está ocupado por glóbulos rojos (también llamados eritrocitos), células carentes de núcleo encargadas de transportar O2 y CO2 y cuya vida se limita a unos cuatro meses. Cada día se renuevan del orden de cien mil millones de estas células. A lo largo de su breve vida, un eritrocito pasa por el corazón unas ciento cincuenta mil veces y recorre del orden de ciento sesenta mil kilómetros.

Y todo esto sin que, prácticamente, nos demos cuenta.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Los números del sistema circulatorio humano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un viaje a través del sistema circulatorio humano

- La emergencia de un doble sistema circulatorio

- ¿Cuántas células hay en el cuerpo humano?

Asteon zientzia begi-bistan #290

Azken urteetan, modan jarri da proteina asko dituzten dietak. Horren harira, publikatu den ikerketa batean ikusi dute dieta horiek arterietan plaken pilatzea eragiten dutela. Testuan azaltzen digutenez, proteina maila altu hauek odolean zenbait aminoazidoren kopuruak handitzen dituzte, eta horrek sistema immuneko zelula makrofagoak akabatzen dituzte. Horren ondorioz, arteriak estutzen dira eta kasurik larrienetan, guztiz buxatzeko aukera dago.

Testosterona hormonaren mailaren eta zenbait gaixotasunen arteko lotura aztertzen duen ikerketarik handiena publikatu dute. Datuen arabera, testosterona-maila altua izateak bularreko eta endometrioko minbizia izateko arriskua handitzen du emakumezkoetan, eta prostatako minbiziarena gizonezkoetan. Elhuyar aldizkarian aurkituko dituzue xehetasunak.

Epilepsiaren Nazioarteko Egunaren harira, Berriako artikulu honetan gaixotasun kroniko honi buruz mintzatu dira. Kristinak eta Mikelek euren esperientziak azaldu dizkigute, gaitz hori hobeto ulertze aldera.

GenetikaGenetikan doktorea den Koldo Garcia elkarrizketatu dute Geuria.eus-en. Egun, ikertzaile lanetan ari da Biodonostia Osasun Ikerketako Institutuan, gaixotasun gastrointestinalen sailean. Bertan, genetika erabilita, gaixotasun horiek hobeto ezagutzen eta tratamendu hobeagoak egin daitezkeen ikertzen dute. Taldearen helburu nagusia da gaixotasun gastrointestinala (GI) sortzen duten mekanismo genetikoak azaltzea. Halaber, Garciak azaltzen digu zein den ikerkuntzaren egungo egoera eta zientziaren dibulgazio-lanaren garrantzia. Ez galdu!

EboluzioaRichard Wrangham primatologoaren Cathing Fire: How Cooking Made Us Human liburua aipatzen da testu honetan. Izan ere, eta autorearen hipotesiaren arabera, Homo erectus espezieak lortu zuen sua kontrolatzea eta elikagaiak kozinatzea, eta hori funtsezkoa izan zen garunaren eta adimenaren garapenerako. Elikagaiak kozinatuz handitu egin zen hauek digeritzeko eta xurgatzeko eraginkortasuna, eta horrek ondorio ebolutibo sakonak izan zituen.

AstrofisikaBerriki jakin dugu Arrakoth, iazko azarora arte Ultima Thule bezala ezagutu genuen Neptunoz haraindiko objektua, bi planetesimalen arteko batuketatik sortu zela. Hala berretsi du nazoarteko ikertzaile talde batek. Izan ere, objektuaren eraketa ez zen talka batengatik izan, “leunkiro” egindako grabitazio-hurbilpen baten emaitza baizik. Honi buruzko informazio gehiago Elhuyar aldizkarian topatuko duzue.

MaterialakNanoteknologiak ikerkuntza arlo askotan garrantzi handia du, elikagaigintzan, esaterako. Lan honetan, nanoteknologia elikadura sektorean ezartzeak eragindako aurrerapen nagusiak aurkezten dira eta zehazki, hiru arlo hauetan: nano-aberastutako elikagaiak, elikagai biltegiratzeko diseinu berriak eta nanosentsoreak. Horretaz gain, nanoteknologiaren erabilpenak eragindako eztabaida aztertzen da testuan.

FisikaAurreko astean eman genuen honen berri: Ion Errea ikertzailearen taldeak frogatu zuen tenperatura oso handiko supereroaleak lor daitezkeela askoz ere presio txikiagoetan. Honek iraultza ekar dezake, izan ere, etorkizunean presio baxuagoko material supereroaleak identifikatzeko oinarriak ezarri dituzte. Informazio gehiago Elhuyar aldizkariko artikulu honetan aurki dezakezue.

KlimatologiaHimalaiako glaziarretan industria-iraultzaren hastapenetatik poluitzaileak metatu zirela frogatu dute. Elhuyar aldizkariak azaldu digunez, ikerketak agerian utzi du Britainia Handian sortu zen industria-iraultzak eragin nabarmena izan zuela airean, izotz-zutabean ordura arte baino metal toxiko gehiago aurkitu baitute 1780tik aurrera. Baina ez zen bakarrik industria-iraultza izan horren eragile, nekazaritzak ere eragina izan zuen izan ere, nekazaritzarako lurrak lortzeko basoei su emateak zinka askatzen baitu atmosferara.

AstronomiaAurten, AEBk, Europako Batasunak eta Errusiak, Txinak eta Arabiar Emirerri Batuek misioak bidaliko dituzte Martera, bizitza arrastoak aurkitzera. Antolatuta dituzten misioen artean, ikertu nahi dute ea Marte bizia edukitzeko moduko planeta bat izan zen eta mikrobioak bizi izan ziren. Noizbait pertsonak bidali ahal izateko esperimentuak ere egingo dituzte. Marte hobeto ezagutzeko misioez gain, 2020an ilargia eta eguzkia izango dute helburu aipaturiko herrialdeek. Berriako artikuluan informazio guztia.

–——————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————————-

Egileaz: Uxue Razkin (@UxueRazkin) kazetaria da.

———————————————————————————-

The post Asteon zientzia begi-bistan #290 appeared first on Zientzia Kaiera.

Día de Darwin 2020: Evolución del Sistema Solar + Teoría evolutiva y medicina

El Día de Darwin se celebra en la capital vizcaína desde el año 2007, formando parte actualmente del calendario de citas ineludibles para los amantes de la ciencia. La Cátedra de Cultura Científica y el Círculo Escéptico este año han vuelto a conmemorar el 12 de febrero el aniversario del nacimiento del científico Charles Darwin, autor de la teoría de la evolución por selección natural. Hace ya 211 años que nació el reconocido científico y, en esta decimocuarta edición del Día de Darwin, las ponencias se centraron en la evolución del Sistema Solar y la relación entre la teoría evolutiva y la medicina.

La ponencia titulada “Pasado, presente y futuro del Sistema Solar” corre a cargo de Itziar Garate Lopez. La charla describe el Sistema Solar, una complicada familia de astros que cuenta con distintos tipos de planetas, lunas, asteroides y cometas orbitando una estrella nada extraordinaria, además de cómo pudo formarse en nuestra vecindad estelar, cómo ha cambiado desde entonces y cual es el futuro que le espera.

Itziar Garate Lopez es licenciada en Física por la Universidad de La Laguna y doctora en Ciencia, Tecnología y Observación Espacial por la UPV/EHU. Actualmente es profesora en el Departamento de Física Aplicada I de la Escuela de Ingeniería de Bilbao (UPV/EHU) e investigadora del Grupo de Ciencias Planetarias de la misma universidad. Anteriormente fue investigadora postoctoral del Centre National d’Études Spatiales en la Sorbonne Université. Su línea de investigación se centra en el estudio de la dinámica atmosférica de los planetas terrestres Venus y Marte y, más en concreto, en la formación y evolución de los vórtices polares venusianos.

En la segunda ponencia, “Teoría evolutiva y medicina: caminos convergentes”, Luis Carlos Álvaro González aborda la medicina desde una perspectiva diferente. La medicina ha vivido de espaldas a la teoría evolutiva por razones históricas y las propuestas de convergencia han ido surgiendo en los últimos años. Estas propuestas permiten un acercamiento, fundamentado en mecanismos operativos simples, que explican trastornos degenerativos, el envejecimiento con múltiples patologías asociadas, las enfermedades vasculares, los trastornos autoinmunes, diversas infecciones o las migrañas.

Luis Carlos Álvaro González es médico neurólogo del Hospital de Basurto de Bilbao y profesor del Departamento de Neurociencias de la UPV/EHU. Es autor de más de 100 publicaciones en su ámbito clínico, además de revisor de revistas especializadas nacionales e internacionales y miembro de comités editoriales. Ha sido premiado por su labor y dedicación en el área de la neurología. Autor de varios libros de divulgación de su especialidad, participa activamente en la investigación y difusión de la teoría evolutiva en el escenario clínico y para el público no experto.

La sesión está enmarcada en el ciclo Bidebarrieta Científica, una iniciativa que organiza todos los meses la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta para divulgar asuntos científicos de actualidad.

Edición realizada por César Tomé López

El artículo Día de Darwin 2020: Evolución del Sistema Solar + Teoría evolutiva y medicina se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los primeros pasos de la evolución darwiniana y sesgos cognitivos y evolución (Día de Darwin 2018)

- Una simulación más eficiente de la evolución del Sistema Solar

- Planeta X, en busca del inquilino invisible del sistema solar

Ezjakintasunaren kartografia #295

Zientzia merkatu bihurtu eta aura erromantikoa galdu duen beldur direnentzat, onbidezko irakurketa izan daiteke Jesús Zamoraren artikulua. Aurreiritziak tartean sartu ezean, noski. The marketization of science and the ‘marketization’ of science studies (& 2)

Alzheimerra goiz detektatzeko moduen bilaketan kandidatu berria: T zelulak. Rosa García-Verdugoren T cells could be key for early Alzheimer’s detection

Erreakzio biokimikoak katalizatzeko gai diren proteinak dira entzimak. Zikloadizio erreakzio bat katalizatzeko gai den proteina topatu dute DIPCn, organismo bizietan halakorik ez da aurkitu. Izena ere asmatu behar izan dute. Huisgenases, new protein catalysts which are not enzymes

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #295 appeared first on Zientzia Kaiera.

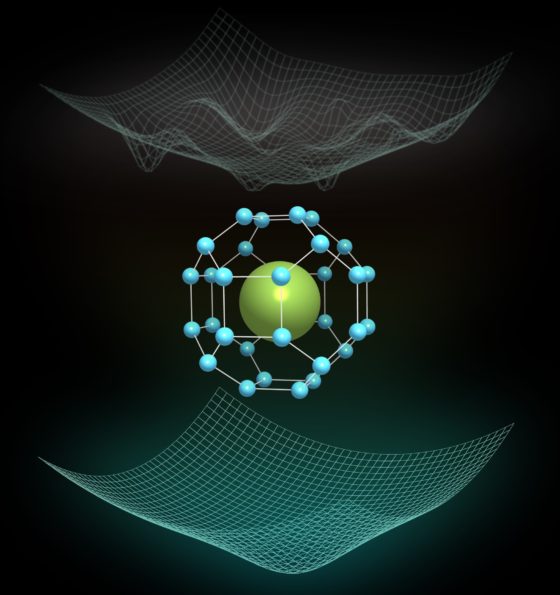

La superconductividad a 250 K se estabiliza mediante fluctuaciones cuánticas

Estructura cristalina de la fase Fm-3m de LaH10, donde una jaula de hidrógeno altamente simétrica encierra los átomos de lantano. En la parte superior se muestra un bosquejo del complejo paisaje energético clásico, donde están presentes muchos mínimos. Por otro lado, en la parte inferior vemos un bosquejo del paisaje de energía cuántica completamente reformado y mucho más simple, donde sólo sobrevive un mínimo.

Estructura cristalina de la fase Fm-3m de LaH10, donde una jaula de hidrógeno altamente simétrica encierra los átomos de lantano. En la parte superior se muestra un bosquejo del complejo paisaje energético clásico, donde están presentes muchos mínimos. Por otro lado, en la parte inferior vemos un bosquejo del paisaje de energía cuántica completamente reformado y mucho más simple, donde sólo sobrevive un mínimo.Cálculos recientes han demostrado que el material con el récord de superconductividad se estabiliza mediante fluctuaciones cuánticas. El trabajo, publicado en Nature, ha sido dirigido por Ion Errea, profesor de la Escuela de Ingeniería de Gipuzkoa de la Universidad del País Vasco (UPV/EHU) e investigador del Centro de Física de Materiales (CFM) de Donostia / San Sebastián y del Donostia International Physics Center (DIPC), junto con José A. Flores-Livas de la Universidad de Roma La Sapienza (Italia). El trabajo es fruto de una amplia colaboración internacional de investigadores de España, Italia, Alemania, Francia y Japón. Este nuevo resultado sugiere que compuestos ricos en hidrógeno pueden ser superconductores a prácticamente temperatura ambiente a presiones mucho más bajas que las predichas anteriormente, acercando la posibilidad de obtener materiales superconductores en condiciones normales.

Llegar a conseguir superconductividad a temperatura ambiente es uno de los mayores sueños de la física. Este descubrimiento podría dar lugar a una revolución tecnológica al proporcionar transporte eléctrico sin pérdidas de energía, motores o generadores eléctricos ultraeficientes, así como la posibilidad de crear enormes campos magnéticos sin necesidad de enfriamiento. Los recientes descubrimientos de superconductividad, primero, a –73ºC en sulfuro de hidrógeno y, después, a -23ºC en LaH10 han demostrado que los compuestos de hidrógeno pueden ser superconductores de alta temperatura. El problema es que ambos descubrimientos han sido realizados a altas presiones: la superconductividad solo se ha conseguido por encima de los 100 gigapascales, un millón de veces la presión atmosférica.

La temperatura de–23 °C obtenida en el LaH10 —la temperatura habitual a la que trabajan los congeladores domésticos—, es la temperatura más alta en la cual se ha observado la superconductividad. La posibilidad de observar la superconductividad de alta temperatura enLaH10, un superhidruro formado por lantano e hidrógeno, fue predicha teóricamente en 2017. Estos cálculos sugirieron que por encima de 230 gigapascales podría formarse un compuesto LaH10 altamente simétrico (grupo espacial Fm-3m), en el que una jaula de hidrógeno envuelve los átomos de lantano. Se calculó que esta estructura podría distorsionarse a presiones más bajas, y romper la estructura altamente simétrica. Sin embargo, en experimentos llevados a cabo en 2019, se pudo sintetizar el compuesto altamente simétrico a presiones mucho menores, entre 130 y 220 gigapascales, y se pudo medir la superconductividad en torno a -23ºC en todo este rango de presión. Dada la contradicción entre las presiones predichas teóricamente y los resultados experimentales, la estructura cristalina del superconductor récord y, por consiguiente, su superconductividad estaban sin esclarecer.

Ahora, gracias a los resultados de este trabajo, sabemos que las fluctuaciones cuánticas atómicas “pegan” la estructura simétrica de LaH10 en todo el rango de presión en el que se ha observado la superconductividad. En mayor detalle, los cálculos efectuados muestran que si los átomos son tratados como partículas clásicas, es decir, como simples puntos en el espacio, muchas distorsiones de la estructura tienden a bajar la energía del sistema. Esto significa que el paisaje de energía clásico es muy complejo, con muchos mínimos (ver figura), similar a un colchón muy deformado debido a la cantidad de gente que soporta. Sin embargo, cuando los átomos son tratados como objetos cuánticos, que se describen con una función de onda deslocalizada, el paisaje de energía se remodela completamente: resulta evidente un único mínimo, que corresponde a la estructura altamente simétrica Fm-3m. De alguna manera, los efectos cuánticos eliminan a toda la gente del colchón excepto a una persona, que lo deforma en un único punto.

Además, las estimaciones de la temperatura crítica utilizando el paisaje de energía cuántica concuerdan satisfactoriamente con la evidencia experimental. Esto apoya aún más la estructura de alta simetría Fm-3m como responsable de la superconductividad récord.

Referencia:

Ion Errea, Francesco Belli, Lorenzo Monacelli, Antonio Sanna, Takashi Koretsune, Terumasa Tadano, Raffaello Bianco, Matteo Calandra, Ryotaro Arita, Francesco Mauri & José A. Flores-Livas (2020) Quantum crystal structure in the 250-kelvin superconducting lanthanum hydride Nature doi: 10.1038/s41586-020-1955-z

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La superconductividad a 250 K se estabiliza mediante fluctuaciones cuánticas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El origen de la superconductividad récord

- La cuántica del protón y la superconductividad apestosa

- Fluctuaciones cuánticas y aspirinas

Aitana Lertxundi: “Gure hipotesia da ingurumenak fetuan eragina izan dezakeela” #Zientzialari (131)

Gaur egun badakigu ingurumenak gure osasunean eragiten duela, baina ingurumenak fetuan eragina izan dezakeen ala ez jakin nahi du zientziaren munduak.

Aire kutsadurak, esaterako, haurdunaldian fetuari eragiten diola badakigu, eta ez bakarrik jaiotze-faktoreetan (pisuan, adibidez), baita lau eta bost urteko haurren hazkunde-faktoreetan ere; hala nola, garapen neuropsikologikoan.

Ingurumenak umearen hazkuntzan duen eragina ikertzen du INMA proiektuan (Haurtzaroa eta Ingurumena-Infancia y Medio Ambiente) eta ekimen horretan dabil lanean Aitana Lertxundi, UPV/EHUko Medikuntza Prebentiboa eta Osasun Publikoa saileko ikertzailea. Berarekin elkartu gara gaiaren inguruan sakontzeko.

“Zientzialari” izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Aitana Lertxundi: “Gure hipotesia da ingurumenak fetuan eragina izan dezakeela” #Zientzialari (131) appeared first on Zientzia Kaiera.

Receta de un Adagio 2

Hay muchas formas de componer la tristeza. No existe una única pieza clave, una nota dolorosa, ni una fórmula mágica que haga brotar las lágrimas. Pero como el vinagre y el aceite, existen ingredientes que se repiten en casi todas las ensaladas (tristes ensaladas). Para componer la tristeza no se usan aliños sino sonidos que se parecen a los que emite un humano triste y sonidos que se parecen a los de un humano que gotea.

Puedes leer la primera parte de esta receta aquí.

Foto: seoungsuk ham / Pixabay

Foto: seoungsuk ham / Pixabay

Dice una (alegre) canción que “no se puede tocar música triste con un banjo”. En cambio, otros instrumentos como el violín o la viola da gamba, parecen siempre afinados para la depresión.

El timbre de los instrumentos parece ser un ingrediente importante a la hora de caracterizar emocionalmente una pieza musical 12. A menudo hablamos de timbres oscuros o rugosos, o timbres dulces o brillantes, sin que ningún elemento de nuestra vista, nuestro gusto o nuestro tacto pueda darnos tal información. No obstante, el timbre parece evocar sensaciones y emociones que no siempre resultan fáciles de explicar.

Existen, por supuesto, asociaciones culturalmente bien establecidas: en parte, el banjo suena alegre porque —se diría— en su eco está escrita toda la alegre música para banjo que hemos oído anteriormente. Pero no se trata solo de eso: cuando uno escarba más allá de las convenciones culturales, encuentra propiedades sonoras, tímbricas, que sistemáticamente se asocian a la alegría, a la tristeza o a la ira3.

La idea clave, vuelve a ser la misma: para componer la tristeza, debemos usar sonidos que se parecen a los que emite un humano triste. Para elegir una instrumentación, debemos buscar timbres que recuerden a los de una voz.

Los instrumentos de cuerda frotada resultan muy apropiados en este sentido: violines, violas, cellos etc. pueden alargar y vibrar cada nota de la melodía. Pueden jugar con la dinámica sin cambiar de sonido (es decir: pueden subir y bajar de volumen sobre una misma nota). Pueden variar ligeramente la afinación o incluso hacer glissandos (una rampa de frecuencias continua entre dos notas) que recuerdan a los de la prosodia humana: una de las diferencias entre el habla y la música es que el habla se mueve entre frecuencias de manera continua, mientras que la música va saltando entre notas discretas. La ausencia de trastes en la familia del violín, permite diluir las fronteras entre las notas, como habitualmente hacemos con la voz.

Todos estos recursos resultan fundamentales en el Adagion de Barber. El sonido de las cuerdas da sentido y expresividad a las notas tenidas, los retardos, las apoyaturas. La dinámica fluctúa sobre cada sonido y forma una línea continua. Basta con escuchar una versión para piano de la misma obra para comprobar cuándo se pierde al cambiar de instrumentación. O, todo lo contrario, oír cuánto se parece una versión para voz.

La lentitud del Adagio se vuelve todavía más complicada porque Barber indica que casi toda la obra debe ser tocada piano o pianissimo.La obra está escrita en si bemol menor: en esta tonalidad, apenas hay notas que se toquen con las cuerdas al aire (sin que el dedo las atrape sobre el mástil), así se evitan sonidos demasiado brillantes.

Los humanos tristes, de hecho, suelen hablar en voz baja porque no les da la energía para mucho más. Emiten sonidos opacos y comparativamente graves: este es el motivo por el que en occidente asociamos a la tristeza el modo menor (pero eso merece su propia anotación).

Esta quietud se vuelve complicada cuando se lleva al mundo de la interpretación musical: los sonidos leves hacen más evidentes los fallos. Cualquier ruido, cualquier desequilibrio llega hasta los oídos del público, que ahora tiene toda su atención enfocada para oír la música mejor.

Esta la paradoja que acompaña a cualquier virtuoso: el público aplaude y se maravilla ante los pasajes fuertes, rápidos, brillantes, aparatosos. Pero la mayor dificultad de la partitura a menudo se esconde en las notas más tímidas.

En el Adagio de Barber, sin embargo, no todo es quietud. Las primeras repeticiones del tema ascienden tímidamente y vuelven a hundirse. Pero en la tercera repetición, la música aumenta de intensidad durante minuto y medio y culmina poco antes del final. Durante el ascenso, encontramos sonidos que ya no tienen nada que ver con un humano triste: sonidos agudos, estridentes, tensos, ruidosos. Los sonidos de un humano que llora.

Existen piezas donde esta especie de transición de la tristeza al llanto se da, incluso, sobre un mismo tema, las mismas notas, la misma armonía. El nocturno en do menor (Op.48, No.1) de Chopin comienza con una sección lenta, fúnebre, callada. Se ilumina hacia la mitad (2’05’’), crece en intensidad y vuelve al tema inicial. Pero cuando lo retoma (4’10’’), el tema ha cambiado: ahora suena al doble de velocidad, su textura es mucho más densa, ruidosa, hay acordes que agitan la melodía en ambas manos. El nocturno ya no es triste, ahora suena… desesperado. Y el efecto es aún mayor porque el cambio de carácter se da sobre un mismo argumento: la misma melodía, antes abatida, ahora reclama ayuda casi a gritos. Si hubiese gritado desde el principio, quizás no la hubiésemos ni escuchado.

Referencias:

1David Huron, Neesha Anderson, Daniel Shanahan. «You Can’t Play a Sad Song on the Banjo: Acoustic Factors in the Judgment of Instrument Capacity to Convey Sadness”. Empirical Musicology Review, 2014.

2Michael Schutz, David Huron, Kristopher Keeton, Gred Loewer. “The Happy Xylophone: Acoustics Affordances Restrict An Emotional Palate”. Empirical Musicology Review, 2008.

3Xiaoluan Liu, Yi Xu, Kai Alter and Jyrki Tuomainen. “Emotional Connotations of Musical Instrument Timbre in Comparison With Emotional Speech Prosody: Evidence From Acoustics and Event-Related Potentials”. Frontiers in Psychology, 2018.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Receta de un Adagio 2 se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Nanoelikagaiak: tamainak axola duenean

Irudia: Nanoteknologia baliatuta superelikagai, megaestalki eta ultrasentsore mundu berri bati atea irekitzen dio.

Elikagaigintza industriak iraultza nanoteknologiko honekin batera aurrera egin du. Izatez, elikagaiak molekula nanometrikoez (behintzat, dituzten dimentsioetariko bat 100 nm baino txikiagoa denean) osatuta daude. Hori dela eta, ez da harritzekoa elikagaigintzan molekula txiki hauen inplementazioan aurrerapenak burutu izana. Elikagai berriekin amets egin dezagun! Goxoak eta aberastuak baina betiko itxura mantentzen dutenak.

Ziurrenik Edurnezuriren sagar gorri perfektua urdina izango balitz ipuinak beste amaiera bat izango zuen… Baina, zer-nolako elikagai motak nahi ditugu? Bakoitzak bere errezeta perfektua bilatuko luke: batzuek elikagai osasuntsuagoak eskatuko lituzkete; beste batzuek zapore originala mantenduko luketen gatz, azukre edo koloratzaile gutxiko elikagaiak nahiko lituzkete. Gainera, diabetesa edo gizentasun arazoak tratatzen lagunduko luketen elikagaiak sortzea posible izango litzateke. Eta murtxikatzeko arazoak dituzten adinduek? Zapore eta testura hobeagoko pureak hartzeko aukerak izango lituzkete. Hau guztia nanoteknologiari esker posiblea izango da.

Elikagaiei begi-bistan ikusezinak diren nanogehigarriak botaz elikagaigintza arloaren iraultza sortuko da. Dagoeneko nanoemultsioen egonkortzeari esker zaporea, dastamena edo testura desberdinak indartzeaz gain, elikagaietan farmako espezifiko bat sartzea eta digestio-aparatuan zehar duen askapena kontrolatzea posiblea da.

Baina nanoteknologiak superelikagaien sorreratik harago doa, izan ere, elikagaien paketatze perfektuak ere egin daitezke. Dudarik gabe, gaur egungo gizarteak plastikoarekiko menpekotasun handia du. Horretaz konturatzeko, etxean plastikoak eta ontziak birziklatzeko dugun poltsa begiratzearekin nahikoa da, non plastiko gehienak elikagaien estalkiak diren. Plastiko kontsumo etengabe honek ingurumen arazo larriak sortzen ari ditu. Erabiltzen diren plastiko gehienak ez dira biodegradagarriak.

Ingurumenarekiko kalte txikiagoa aurkezten dituzten plastikoek ez dituzte elikagaiak paketatzeko propietate egokiak azaltzen, adibidez: gasekiko hesi-propietate txarrak aurkezten dituzte. Mota honetako plastikoetan buztina bezalako nanopartikulak gehituz material hauen propietateak hobetuko lirateke, hauen erabilera eremuak zabalduz. Horren haritik, tupper zein elikagaiak gordetzeko erabiltzen diren ontzietan elikagaien kontserbazioa hobetzeko ere bakteriak “hiltzeko” gaitasuna duten nanopartikulak jarri daitezke.

Azkenik, nanoteknologiak elikagaigintzan izango duen beste arrakasta bat elikagaien egoera ezagutzeko nanosentsoreetan oinarritzen da. Gaur egun, iraungitze-data da elikagaiaren egoeraren berri ematen duena, baina nolakoa izan da elikagaiaren paketatze eta garraioa? Prozesu hauetan elikagaiaren egoera aldatu da? Nanosentsoreak erabiliz prozesu hauetan zehar elikagaiaren kalitatea eraldatua izan den jakitea posiblea izango litzateke estalkiaren gainazalean kolorez aldatzen duen pegatina bat jarriz.

Nanoteknologiak superelikagai, megaestalki eta ultrasentsore mundu berri batekin amets egitea ahalbidetzen du. Baina, amets hauek egia bihurtzeko azkeneko oztopo bat gainditu behar dute: herri-pertzepzioa. Biziraupen gisa, berria eta ezezaguna den guztia alde batera uzten dugu. Dena den, toxikotasun ikerketa sakonen bermearekin gure eskuetan dago etorkizuneko nanoelikagaietara eramango gaituen aurrerapausoa ematea, non tamainak axola duen.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 35

- Artikuluaren izena: Nanoelikagaiak: tamainak axola duenean.

- Laburpena: Nanoteknologiaren erabilpena funtsezko erreminta bilakatu da aplikazio askoren garapenean, eta elikagaien sektorea ez da alde batera geratu. Modu horretan, nanoelikagaien garapenak osasuntsuagoak, erresistenteagoak eta iraupen luzeagoa duten elikagaiz gozatzea ahalbidetuko duela uste da. Lan honetan, nanoteknologia elikadura sektorean ezartzeak eragindako aurrerapen nagusiak aurkezten dira eta, bereziki, honako hiru arlo hauetan jarri da arreta: nano-aberastutako elikagaiak, elikagai biltegiratzeko diseinu berriak eta nanosentsoreak. Amaitzeko, elikadura industrian nanoteknologiaren erabilpenak eragindako eztabaida aztertuko da; abantaila asko ekar ditzakeen arren, egun gizartearengan beldurra eta kezkak eragiten baititu.

- Egileak: Iñigo Lozano, Itziar Galarreta, Sonia Pérez-Yáñez, Idoia Ruiz de Larramendi.

- Argitaletxea: UPV/EHUko argitalpen zerbitzua.

- ISSN: 0214-9001

- Orrialdeak: 143-164

- DOI: 10.1387/ekaia.19684

————————————————–

Egileez:

Iñigo Lozano, Itziar Galarreta, Sonia Pérez-Yáñez, Idoia Ruiz de Larramendi UPV/EHUko Zientzia eta Teknologia Fakultateko Kimika Ez-organikoa Sailekoak dira.

———————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Nanoelikagaiak: tamainak axola duenean appeared first on Zientzia Kaiera.

Fractus, arte y matemáticas

Como viene siendo habitual en los últimos años, alrededor del 14 de marzo, día conocido internacionalmente como Día de Pi (la fecha del 14 de marzo se escribe, tanto en el sistema anglosajón, como en euskera, 03/14, que nos remite a la aproximación de pi: 3,14), desde la Cátedra de Cultura Científica, junto con BCAM y NAUKAS, celebramos la Jornada BCAM-NAUKAS en el día de Pi. Esta consiste en una serie de talleres para escolares, por la mañana, y monólogos científicos para todos los públicos, por la tarde. El programa de este año, que tendrá lugar el 13 de marzo, viernes, en el Bizkaia Aretoa (Bilbao), lo podéis consultar en el Cuaderno de Cultura Científica.

Sin embargo, el Día de Pi ha adquirido una importancia mucho mayor, después de que la UNESCO –a propuesta de la Unión Matemática Internacional– lo declarara el Día Internacional de las Matemáticas. Además, el lema de este año es Mathematics everywhere (Las matemáticas están en todas partes). Por este motivo, la Cátedra de Cultura Científica de la UPV/EHU ha decidido organizar este año una doble exposición, también en el Bizkaia Aretoa (Bilbao), sobre matemáticas y arte, entre los días 12 y 25 de marzo (de 2020). Las exposiciones son Fractus, de la artista murciana Verónica Navarro, de la que vamos a hablar en esta entrada del Cuaderno de Cultura Científica, y Azares, del artista mexicano, afincado en Bilbao, Esaú de León, a la que dedicaremos una entrada en el futuro.

Logo del Día Internacional de las Matemáticas. Toda la información sobre el mismo se recoge en idm314

Logo del Día Internacional de las Matemáticas. Toda la información sobre el mismo se recoge en idm314

Antes de hablar de la exposición Fractus, presentemos a su autora, la artista Verónica Navarro (Puerto Lumbreras, Murcia, 1983). Es licenciada en Bellas Artes y doctora por la investigación El laboratorio artístico-literario. Una investigación de interacción hipertextual en segundo y tercer ciclo de Educación Primaria, en la Facultad de Educación de la Universidad de Murcia.

Ha realizado diferentes instalaciones y exposiciones individuales y colectivas. Entre las exposiciones individuales, podemos mencionar la exposición Horma/forma/norma, en el Palacio Guevara de Lorca (2008), el Museo del Calzado de Elda (2009) y Sala Caja Murcia de Jumilla (2010), la instalación Menudo Punto, en el Centro Párraga de Murcia (2013) o la exposición Fractus en Águilas, Murcia (2019).Y entre las exposiciones colectivas, Sentido sin sentido, en la Galería Fernando Guerao, Murcia (2006), La periferia como nudo, estructuras de red en la creación contemporánea, en el Parlamento Europeo (Bruselas, Bélgica), en la Sede del Comité de las Regiones (2010), La imagen como enigma, que ha recorrido diferentes salas de Madrid, Murcia y Salamanca (2010), Historias mínimas, junto al artista Francisco Cuellar, en el Palacio Guevara, Lorca (2010) y en Espacio para la Creación Joven de Zafra y Llerena, Badajoz (2011), Las formas toman forma, en la Fundación Caja Murcia de Lorca (2012) y la Biblioteca Regional de Murcia (2013) o Infinitas, junto a la artista Teresa Navarro, en el Centro Párraga de Murcia (2019).

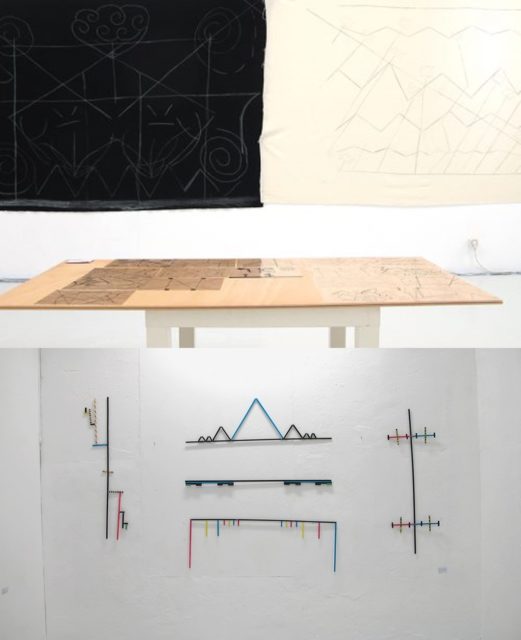

Dos imágenes de la exposición Menudo Punto, de la artista Verónica Navarro, en la cual se juntaban literatura (álbum ilustrado) y el arte (laboratorio/instalación). Fotografías de Francisco Cuellar, de la web de la editorial y laboratorio puntodepapel

Dos imágenes de la exposición Menudo Punto, de la artista Verónica Navarro, en la cual se juntaban literatura (álbum ilustrado) y el arte (laboratorio/instalación). Fotografías de Francisco Cuellar, de la web de la editorial y laboratorio puntodepapel

También ha realizado varios libros de artista, que pueden verse en su página web, entre los que podemos mencionar Punto/Línea/Fractal, Fina e infinita, Fractales, Postalnova o Granada de papel.

Fotografías de los libros de artista Granada de papel (arriba) y Postalnova (abajo), de la artista Verónica Navarro. Imágenes de la página web de la artista

Fotografías de los libros de artista Granada de papel (arriba) y Postalnova (abajo), de la artista Verónica Navarro. Imágenes de la página web de la artista

Como autora ha publicado varios libros: Libro de bolsillo, El muy punto (2014), XYZ (2012) y Menudo punto (2012). Pero, además, es directora ejecutiva y coordinadora de la editorial y laboratorio puntodepapel.

Verónica Navarro compagina su labor plástica con la educación, aunando arte, literatura y matemáticas, creando sorprendentes e interesantes talleres didácticos, creativos y para altas capacidades, así como materiales adecuados para los mismos, tanto marionetas, como álbumes ilustrados o maletas de juegos educativos.

Imagen de la exposición Fractalmente emocionados, celebrada en el Centro Párraga, Murcia, en 2017, recogiendo los trabajos desarrollados durante las seis sesiones del taller “Fractalmente emocionados” por alumnado de altas capacidades de Educación Primaria en Murcia. Imagen de la editorial y laboratorio puntodepapel

Imagen de la exposición Fractalmente emocionados, celebrada en el Centro Párraga, Murcia, en 2017, recogiendo los trabajos desarrollados durante las seis sesiones del taller “Fractalmente emocionados” por alumnado de altas capacidades de Educación Primaria en Murcia. Imagen de la editorial y laboratorio puntodepapel

Con la exposición Fractus, de Verónica Navarro, nos encontramos ante una exposición en la que se aúnan arte y matemáticas. Con el objetivo de crear la serie de obras de arte que conforman Fractus, esta artista ha utilizado las matemáticas tanto como fuente de inspiración, como herramienta de creación artística. Los fractales y, en particular, la conocida curva de Koch (que explicaremos más adelante), son elementos fundamentales para la creación de estas obras. En esta serie de obras se confronta además la geometría fractal, a través de la curva fractal de Koch, con la geometría euclídea, mediante objetos geométricos clásicos como el triángulo, el cuadrado o la circunferencia.

Como nos dice la propia artista:

Fractus es una exposición que parte de la literatura, del libro Menudo punto (Verónica Navarro, puntodepapel, 2012), para acercarnos a la geometría fractal y en concreto a la Curva de Koch, a través de obras artísticas de pequeño y mediano formato trabajadas en papel a modo de escenografías. Obras que invitan al espectador a investigar el aparente caos descrito en ellas e imaginar mundos inexplorados y mágicos.

Este libro, en el que se “reflexiona sobre los cambios que se producen en la vida y su relación con las emociones”, tiene como protagonista a un pequeño punto, que va transformando en una línea de puntos, una línea continua, que se enreda, zigzaguea, sonríe o se quiebra, hasta convertirse en el conjunto de Cantor, un fractal.

Dos imágenes del libro Menudo punto (puntodepapel, 2012), de Verónica Navarro. En la segunda imagen podemos ver el fractal conocido como conjunto de Cantor. Imágenes de la página web de la artista

Dos imágenes del libro Menudo punto (puntodepapel, 2012), de Verónica Navarro. En la segunda imagen podemos ver el fractal conocido como conjunto de Cantor. Imágenes de la página web de la artista

Puesto que estos objetos matemáticos, los fractales, son muy importantes para el trabajo de la artista Verónica Navarro y, en particular, para su exposición Fractus, es necesario que no detengamos un momento para explicar qué son los fractales y cuál es su importancia.

Para empezar, ¿qué son los fractales? Estos son objetos matemáticos de una gran complejidad, pero no es sencillo dar una definición de los mismos, ya que todas las definiciones propuestas dejan algunos de los fractales fuera. Por este motivo vamos a intentar acercarnos al concepto de objeto fractal mediante algunas de sus propiedades más características:

Autosemejanza. Su estructura se repite a diferentes escalas. Si nos fijamos en una parte cualquiera de un objeto fractal y la ampliamos convenientemente (pensemos en la lupa de un ordenador o un microscopio) obtendremos una réplica del objeto fractal inicial. También podemos pensar en algunos objetos fractales como formados por copias de sí mismos a escalas más pequeñas.

Ejemplos de la naturaleza de formas en cierto modo autosemejantes son el romanescu y el brócoli, los helechos, los árboles, las montañas, etc…

El romanescu es uno de los ejemplos más bonitos de forma de tipo fractal, en el sentido de ser autosemejante, de la naturaleza. Aquí podemos ver varias imágenes del cocinero y escritor Xabier Gutierrez de la preparación de su plato Romanescu (o como zamparse un fractal) y antxoas

El romanescu es uno de los ejemplos más bonitos de forma de tipo fractal, en el sentido de ser autosemejante, de la naturaleza. Aquí podemos ver varias imágenes del cocinero y escritor Xabier Gutierrez de la preparación de su plato Romanescu (o como zamparse un fractal) y antxoas

La autosemejanza la podemos observar claramente en objetos fractales como el conjunto de Cantor, la curva de Koch, la esponja de Menger, que aparecen ex`plicados más adelante, o el conjunto de Mandelbrot, como ya mostramos en la entrada Guía matemática para el cómic ‘Promethea’.

Rugosidad. Los fractales son objetos geométricos de una gran rugosidad, de una gran irregularidad, y la medida matemática de esa rugosidad es la “dimensión fractal” (la dimensión de Hausdorff-Besicovich), que no explicaremos aquí por su complejidad. Los objetos de la geometría clásica (recta, circunferencia, esfera,…) son objetos lisos, sin rugosidad, y por lo tanto su dimensión es un número natural (la recta y las curvas tienen dimensión 1, las superficies 2,…), mientras que los fractales son objetos geométricos rugosos y su dimensión puede ser un número real no natural (las curvas fractales tienen dimensión entre 1 y 2, las superficies fractales entre 2 y 3,…).

Mandelbulb, fractal tridimensional, construido por Daniel White and Paul Nylander en 2009. Imagen de Ondřej Karlík a través de Wikimedia Commons

Mandelbulb, fractal tridimensional, construido por Daniel White and Paul Nylander en 2009. Imagen de Ondřej Karlík a través de Wikimedia Commons

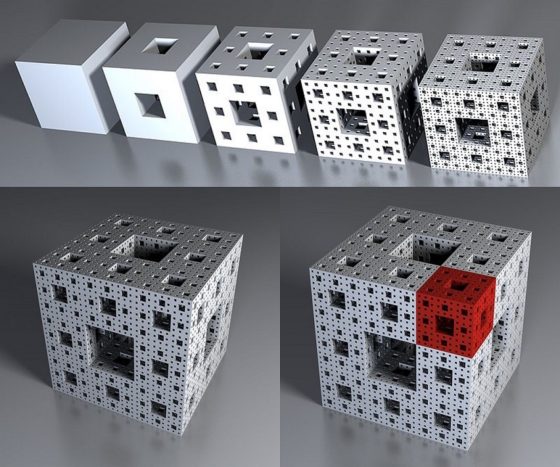

De hecho, el conjunto de Cantor tiene dimensión fractal 0,6309…, la curva de Koch 1,2618…, el conjunto de Mandelbrot tiene dimensión fractal igual a 2 (este importante fractal no entraría dentro de la familia de fractales si la definición fuese que su dimensión es un número real no natural), la esponja de Menger 2,7268…, por citar algunos.

En la parte superior, cuatro iteraciones de la definición de la esponja de Menger, mientras que en la parte inferior vemos la esponja de Menger –sugerida tras cuatro iteraciones- y como una parte, que es uno de los 27 cuadrados que conforman el cuadrado inicial, pintado de rojo, es de nuevo la esponja de Menger –aunque sugerida en tres iteraciones-. Imagen de Niabot a través de Wikimedia Commons

En la parte superior, cuatro iteraciones de la definición de la esponja de Menger, mientras que en la parte inferior vemos la esponja de Menger –sugerida tras cuatro iteraciones- y como una parte, que es uno de los 27 cuadrados que conforman el cuadrado inicial, pintado de rojo, es de nuevo la esponja de Menger –aunque sugerida en tres iteraciones-. Imagen de Niabot a través de Wikimedia Commons

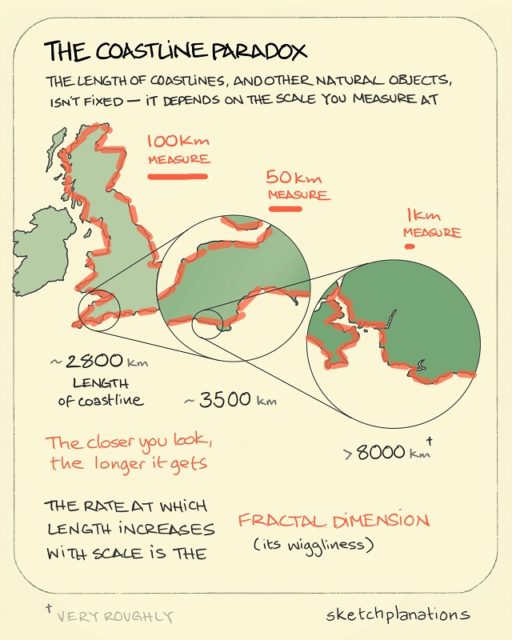

Esta propiedad está asociada a la paradoja de la costa, que planteó Mandelbrot en su artículo ¿Qué longitud tiene la costa de Gran Bretaña? (Revista Science, 1967). Supongamos que nos preguntamos cuanto mide la costa de Gran Bretaña… si medimos la imagen de una fotografía aérea tendremos una longitud, si medimos la costa con “nuestros pasos”, la escala humana, nos dará una longitud mayor, si la medimos con “pasos de gato” la longitud será mayor aún, y mucho mayor con “pasos de hormiga”… tendiendo esa longitud al infinito.

Dibujo explicativo de la paradoja de la costa, en el que se puede observar que midiendo con diferentes escalas –rectas de 100, 50 y 1 kilómetros de longitud-, se obtienen aproximaciones cada vez mayores de la longitud de la costa de Gran Bretaña –de unos 2.800, 3.500 y más de 8.000 kilómetros. Imagen de la web Sketchplanations

Dibujo explicativo de la paradoja de la costa, en el que se puede observar que midiendo con diferentes escalas –rectas de 100, 50 y 1 kilómetros de longitud-, se obtienen aproximaciones cada vez mayores de la longitud de la costa de Gran Bretaña –de unos 2.800, 3.500 y más de 8.000 kilómetros. Imagen de la web Sketchplanations

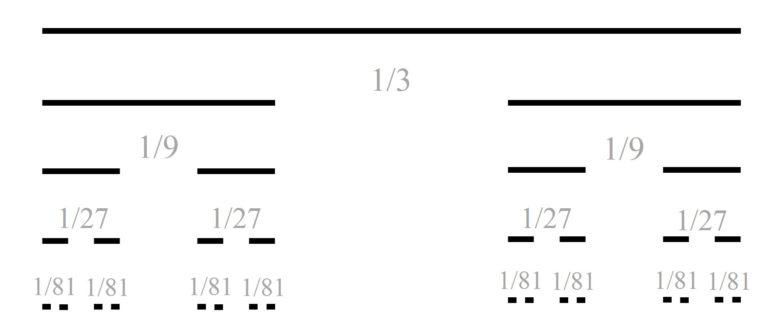

Procesos iterativos infinitos. Muchos de los objetos fractales son descritos mediante procesos iterativos, tanto geométricos, como analíticos, infinitos. Pongamos un ejemplo para ilustrarlo, el mencionado conjunto de Cantor. Este fue definido y estudiado, en 1883, por el matemático alemán, nacido en Rusia, Georg Cantor (1845-1918), de quien deriva su nombre (aunque los historiadores de las matemáticas han descubierto que realmente aparece en un artículo de 1875 del matemático británico Henry John Stephen Smith).

Para definir el conjunto de Cantor, empezamos con el intervalo [0,1] de longitud 1, sobre el que se realiza el siguiente proceso iterativo (los primeros pasos del proceso se ilustran en la imagen siguiente). Se parte el intervalo en tres partes –luego de longitud 1/3– y se quita el intervalo central, quedando los dos intervalos laterales –de longitud 1/3–. En el siguiente paso se considera cada uno de los dos intervalos y se dividen, de nuevo, en tres partes –cada una de longitud 1/9– y se eliminan los dos intervalos centrales, quedando los cuatro intervalos laterales –de longitud 1/9–. En el siguiente paso se realiza el mismo proceso para los cuatro intervalos, y así hasta el infinito.

Primeros pasos del proceso iterativo que define el fractal llamado conjunto de Cantor

Primeros pasos del proceso iterativo que define el fractal llamado conjunto de Cantor

Después de este proceso iterativo infinito queda un conjunto de puntos del segmento [0,1] inicial, que es el llamado conjunto de Cantor. Este es un conjunto muy extraño. Si se suman las longitudes de los intervalos que se han ido eliminando, la suma es 1, que es la longitud del intervalo original [0,1], por lo tanto, ese conjunto de puntos, el fractal de Cantor, “no mide nada” o “tiene medida de longitud 0”. Aunque se puede demostrar que, en el conjunto de Cantor, hay tantos puntos como en todo el intervalo [0,1].

Fotografía de Benoit Mandelbrot, su mujer Aliette Kagan, Raúl Ibáñez y Antonio Pérez, durante la celebración del International Congress of Mathematicians 2006, en Madrid

Fotografía de Benoit Mandelbrot, su mujer Aliette Kagan, Raúl Ibáñez y Antonio Pérez, durante la celebración del International Congress of Mathematicians 2006, en Madrid

El matemático polaco, nacionalizado francés y estadounidense, Benoît Mandelbrot (1924-2010) es considerado el padre, o creador, de la geometría fractal –de hecho, él bautizó a estos objetos con el nombre de “fractal”, que viene del latín “fractus”, roto, quebrado–. Además de investigar estos extraños objetos, generar la primera imagen con ordenador del que después se bautizará como conjunto de Mandelbrot y observar la gran cantidad de aplicaciones que existen de los mismos, realizó una exitosa divulgación de la geometría fractal, por ejemplo, publicando los libros Los objetos fractales: forma, azar y dimensión (1975) o La geometría fractal de la naturaleza (1982), entre muchos otros.

La geometría fractal significó un cambio de paradigma dentro de las matemáticas, que podemos ilustrar con las dos siguientes citas. La primera pertenece al libro Il Saggiatore/El ensayador (1623), del matemático italiano Galileo Galilei (1564-1642), y nos dice que la geometría euclídea y sus formas –rectas, círculos, polígonos, esferas, cubos, poliedros, etcétera– son las herramientas que deben utilizarse para modelizar la naturaleza.

“La filosofía está escrita en ese grandísimo libro que tenemos abierto ante los ojos, quiero decir, el universo, pero no se puede entender si antes no se aprende a entender la lengua, a conocer los caracteres en los que está escrito. Está escrito en lengua matemática y sus caracteres son triángulos, círculos y otras figuras geométricas, sin las cuales es imposible entender ni una palabra; sin ellos es como girar vanamente en un oscuro laberinto.”

Mientras que la segunda cita pertenece al libro La geometría fractal de la naturaleza (1982), del propio Benoît Mandelbrot, anunciando el cambio de paradigma, que la geometría euclídea no era una herramienta suficiente para modelizar la naturaleza.

“…las nubes no son esferas, las montañas no son conos, las costas no son circulares y la corteza de los árboles no son lisas, ni tampoco el rayo viaja en línea recta.”

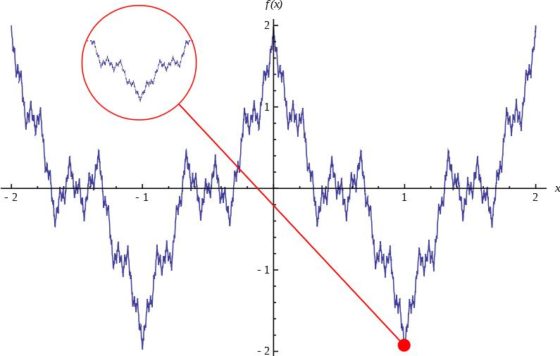

Función de Weierstrass, que es continua en todo punto y no derivable en ninguno punto. Imagen de Wikimedia Commons

Función de Weierstrass, que es continua en todo punto y no derivable en ninguno punto. Imagen de Wikimedia Commons

Sin embargo, el origen de los objetos fractales se remonta a finales del siglo XIX y principios del XX. Fue entonces cuando grandes matemáticos como Riemann, Cantor, Peano, Hilbert, Sierpinski o Hausdorff, entre otros, introdujeron algunas construcciones matemáticas “patológicas”, los primeros objetos fractales, con propiedades geométricas o analíticas contrarias a la intuición matemática. Es decir, ponían de manifiesto la existencia de lagunas en el conocimiento matemático dentro de la geometría clásica (euclídea) y el análisis. La matemática de ese tiempo los consideró “monstruos” y no hizo caso a su existencia.

El primer objeto patológico que se introdujo fue el conjunto de Cantor (1875-1883), que hemos definido más arriba, un conjunto con una infinidad no numerable de puntos, pero que no tiene longitud.

Entre esos primeros monstruos matemáticos también se encontraban curvas continuas que no tienen tangente en ningún punto (es decir, completamente irregulares, son todo picos), como es el caso de las funciones de Weierstrass (véase la anterior imagen) o Riemann, la curva de Takagi, la curva de Koch o el copo de nieve de Koch (que serán introducidas más adelante). Estas curvas también cumplían la paradoja de la costa, es decir, tienen longitud infinita. Más aún, el copo de nieve de Koch es una curva de longitud infinita pero que encierra un área finita.

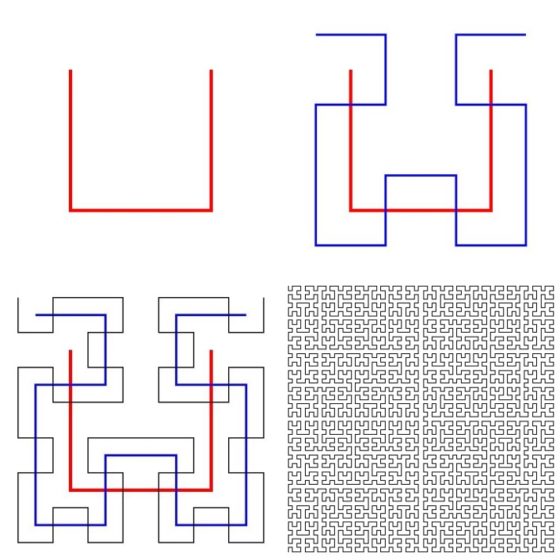

Otros objetos patológicos de esos inicios de los fractales a finales del siglo XIX y principios del siglo XX fueron ejemplos anómalos de curvas que llenan todo un cuadrado. Esta cualidad ponía en duda el concepto de dimensión, que se manejaba hasta el momento en las matemáticas. No era claro cual era la dimensión de estas “curvas”. Si era una curva la dimensión debía de ser 1, pero como llenaba todo el espacio plano (cuadrado), quizás podría ser 2. Entre otras estaban la curva de Hilbert y la curva de Peano.

El matemático alemán David Hilbert (1862-1943) introdujo, en el año 1891, la siguiente curva, definida de forma iterativa, que llena el espacio. Como podemos ver en la siguiente imagen se empieza con tres segmentos (rojos en la imagen) formando un cuadrado sin uno de sus lados (el superior en la imagen). En la primera iteración se reduce el 50% esta figura y se hacen cuatro copias, que se colocan de forma que los centros de las figuras “cuadradas” estén en los extremos de los segmentos de la figura original, de forma que los dos de arriba están en horizontal, con sentidos opuestos, y los dos de abajo en vertical, hacia abajo. Para que la figura construida (de azul en la imagen) sea continua se le añaden tres segmentos para conectar las cuatro figuras “cuadradas”. Para la siguiente iteración se realiza el mismo proceso anterior, pero para cada una de las cuatro figuras “cuadradas”, generando así la figura negra (el tercer diagrama de la siguiente imagen). Y así se continúa en un proceso iterativo infinito. En el límite infinito se obtiene una curva que llena todo el cuadrado.

Imágenes de los tres primeros pasos de proceso iterativo para generar la curva de Hilbert e imagen de la curva tras la séptima iteración. Imágenes de Geoff Richards y Alfred Nussbaumer a través de Wikimedia Commons

Imágenes de los tres primeros pasos de proceso iterativo para generar la curva de Hilbert e imagen de la curva tras la séptima iteración. Imágenes de Geoff Richards y Alfred Nussbaumer a través de Wikimedia Commons

Los fractales significaron por tanto un cambio de paradigma dentro de las matemáticas, pero además, como ya puso de manifiesto Benoit Mandelbrot, poseían una enorme cantidad de aplicaciones. Citemos algunas de ellas:

Los fractales aparecieron dentro de la matemática pura, formando parte de los estudios teóricos de los propios matemáticos. Fueron muy importantes, puesto que significaron por tanto un cambio de paradigma dentro de las matemáticas, como puso de manifiesto Benoit Mandelbrot. Pero, sus orígenes están dentro de lo que la gente de la calle llama “locuras de los matemáticos que no sirven para nada”. Sin embargo, confirmando una vez más “la irrazonable eficacia de las matemáticas (puras)”, sus aplicaciones se han ido extendiendo a casi todos los aspectos de nuestra vida cotidiana. Hay aplicaciones en multitud de áreas. Algunas de ellas:

– Computación: compresión de imágenes digitales, …

– Infografía: utilización en la industria cinematográfica (Star Trek, Star Wars, La Tormenta Perfecta, Apolo 13, Titanic, Doctor extraño, Escuadrón suicida o Guardianes de la Galaxia) o en publicidad, para diseñar paisajes, objetos, texturas, …

La primera imagen pertenece a la película Star Trek 2: La ira de Khan (Nicholas Meyer, 1982), que fue la primera película en la que se utilizaron los fractales para construir un paisaje realista, mientras que las otras dos imagenes pertenecen a la película Los guardianes de la galaxia, vol. 2 (James Gunn, 2017), en la que se utilizan los fractales para crear el planeta de Ego

La primera imagen pertenece a la película Star Trek 2: La ira de Khan (Nicholas Meyer, 1982), que fue la primera película en la que se utilizaron los fractales para construir un paisaje realista, mientras que las otras dos imagenes pertenecen a la película Los guardianes de la galaxia, vol. 2 (James Gunn, 2017), en la que se utilizan los fractales para crear el planeta de Ego

– Medicina: la osteoporosis, las arterias y venas, los pulmones o el cerebro tienen estructura fractal, así como los tumores sólidos, lo cual es utilizado para la detección temprana de algunas enfermedades, su estudio, …

– Biología: Crecimiento tejidos, organización celular, evolución de poblaciones depredador-presa, …

– Geología: análisis de patrones sísmicos, fenómenos de erosión, modelos de formaciones geológicas, …

– Economía: análisis bursátil y de mercado, …

– Telecomunicaciones: Antenas fractales, fibra óptica, estructura de la red de Internet, …

– Meteorología, Ingeniería, Acústica, nuevos materiales, Ciencias Sociales,…

y un largo etcétera.

Una de las obras de la serie Fractus (2018) de la artista Verónica Navarro. Imagen de la página web de la artista

Una de las obras de la serie Fractus (2018) de la artista Verónica Navarro. Imagen de la página web de la artistaPero volvamos a la exposición Fractus, de Verónica Navarro. La curva de Koch, como la propia artista afirmaba en el párrafo que hemos incluido al principio de la entrada, es uno de los elementos principales en la creación de las obras de la serie Fractus.

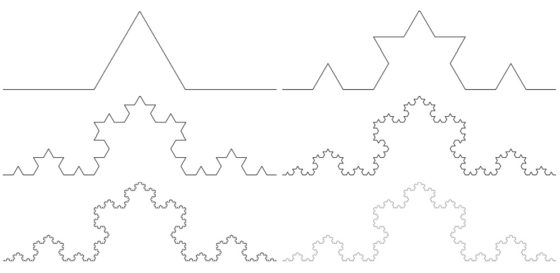

La curva de Koch fue introducida en 1904 por el matemático sueco Helge von Koch (1870-1924) como ejemplo de una curva continua que no tiene recta tangente en ningún punto. Para construir la curva de Koch, se empieza con un intervalo, por ejemplo, de longitud 1. En la primera iteración se divide el intervalo en tres partes, de longitud 1/3, y se reemplaza el intervalo central por dos segmentos de la misma longitud formando un ángulo de 60 grados entre ellos (como se ve en la imagen). La longitud total de la construcción en este primer paso es 4/3.

En la segunda iteración se realiza la misma operación en cada uno de los cuatro intervalos que se han formado en la primera. Obteniendo así una figura curva formada por 16 pequeños intervalos de longitud 1/9, luego la longitud total es 16/9 (4/3 al cuadrado). Y así se continúa en cada iteración. En el límite de este proceso infinito se obtiene la curva de Koch.

Las seis primeras iteraciones en la construcción de la curva de Koch. Imagen de Christophe Dang Ngoc Chan, a través de Wikimedia Commons

Las seis primeras iteraciones en la construcción de la curva de Koch. Imagen de Christophe Dang Ngoc Chan, a través de Wikimedia Commons

Como la longitud de la iteración n-ésima de la curva de Koch es 4/3 elevado a la potencia n, entonces, la longitud de la curva de Koch, que es el límite cuando n tiende a infinito de esa longitud es infinito. Es decir, la curva de Koch tiene longitud infinita. Claramente, la curva de Koch es autosemejante y está creada por un proceso iterativo infinito. Además, la dimensión fractal (que no hemos explicado realmente) es Ln 4/Ln 3 = 1,26186…

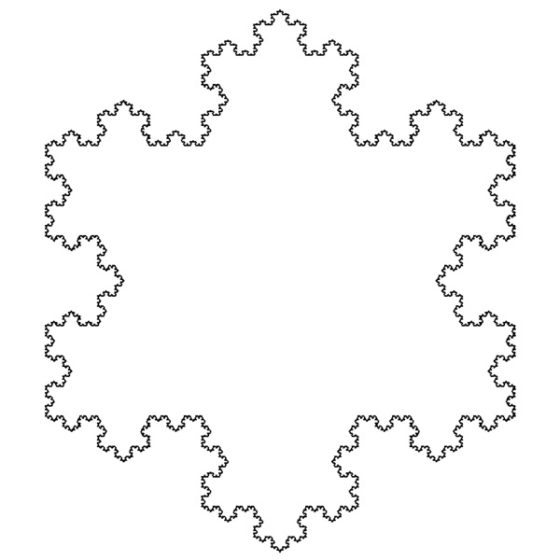

La construcción del copo de nieve de Koch es la misma que la que acabamos de ver para la curva de Koch, pero tomando como punto inicial un triángulo equilátero y realizando el proceso iterativo sobre cada uno de los lados.

Imagen de la sexta iteración del copo de nieve de Koch. Imagen de Mcgill a través de Wikimedia Commons

Imagen de la sexta iteración del copo de nieve de Koch. Imagen de Mcgill a través de Wikimedia Commons

Las delicadas obras de la serie Fractus, de Verónica Navarro, tienen unas dimensiones de 40 x 40 centímetros, el material utilizado es papel 100% algodón y están realizadas mediante la técnica del papel troquelado a mano. Si se tiene en cuenta que las formas que aparecen, además de las formas geométricas clásicas triángulo, cuadrado y circunferencia, son partes de la curva y del copo de nueve de Koch, la realización de las piezas es de una enorme dificultad y fragilidad.

En las obras aparecen diferentes capas de papel, lo que produce un contraste importante entre las formas creadas en cada capa y aparecen sombras que acentúan las formas y los contrastes. En palabras de la autora de esta serie: