Grabazio magnetikorako materialen bila

1. irudia: Grabazio magnetikoa baliatzen duen diska gogorra.

Ordenagailuetako grabazio magnetikoko memoria sistemak (diska gogorrak, USBak) hobetzeko material berriak bilatzea, baita material horien propietate magnetiko, fisiko, elektriko eta elastikoak ikertzea izan da ikerketaren helburua.

Tamaina txikiko gailuen eskari gero eta handiagoaren ondorioz, oso garrantzitsua bihurtu da eskala nanometrikoko material berriak ikertu eta garatzea. Materialak eskala nanometrikora murrizten direnean, fenomeno edo propietate fisiko berriak azaltzen dira, eragin handikoak bai zientzian bai industrian. Materialaren kristal egitura aldatuz, adibidez, propietate magnetikoak alda daitezke eta lortu nahi diren teknologikoetarako doitu.

Eskala nanometrikoko lodiera (1-2 nm eta 100 nm bitartekoak) eta kristal egitura perfektua duten materialak erabili ditu Lorenzo Fallarinok. Kromozko, ruteniozko eta platinozko kobalto aleazioak eta kromo oxidozko aleazioak silizio olata fin-finen gainean ezarri eta propietate magnetikoak ikertu ditu. Diseinua aldatuz joan da materialak etorkizun handiko grabazio magnetikoko tekniketan erabiltzeko modukoak izan arte.

Curieren tenperatura manipulatzeko aukera ematen duten aleazioak fabrikatzea lortu du ikertzaileak. Material ferromagnetikoak ferromagnetiko izateari uzten dion tenperaturari esaten zaio Curieren tenperatura, iman gisa jokatzen duten materialak iman izateari uzten dioten tenperatura, alegia.

Magnetismoa ikertzeko eta etorkizuneko aplikazio teknologikoetarako aukera handiak zabaltzen dituzten aleazio magnetikozko film finak eta geruza anitzeko filmak diseinatu, ekoitzi eta karakterizatu ditu ikertzaileak; laser bidezko tokiko berokuntzan oinarritutako grabazio magnetikoko teknika berrietan erabiltzeko material berriak.

Transferentzia teknologikoaLorenzo Fallarinok adierazi duenez, “Oso zaila da ikerketa honen emaitzak epe laburrean ikustea memoria magnetikoetan aplikatuta, baina material berri hauek aukera handiak zabaltzen dituzte laser bidezko tokiko berokuntza erabiltzen duten grabazio magnetikoko teknika berriak garatzeko”. Horretaz gain, magnetismoaren oinarrizko fisika ikertzeko oso aproposak dira material hauek.

Transferentzia teknologikoak garrantzi handia du. Ezaugarri berritzaileak dituzten material berriak bilatzea da zientziaren oinarri nagusietako bat. Berehalako helburu praktikorik gabe gauzatzen da oinarrizko ikerketa, naturak berak edo errealitateak berez dituzten oinarrizko printzipioen inguruko jakintza areagotzeko xedeari jarraituz.

Erreferentzia bibliografikoa:

L. Fallarino, B. J. Kirby, M. Pancaldi, P. Riego, A. L. Balk, C. W. Miller, P. Vavassori, A. Berger. Magnetic properties of epitaxial CoCr films with depth-dependent exchange-coupling profiles Physical Review B (Vol.95, No.13). April 2017.. DOI: DOI: 10.1103/PhysRevB.95.134445.

Iturria:

UPV/EHUko komunikazio bulegoa: Grabazio magnetikoko teknika berriak

The post Grabazio magnetikorako materialen bila appeared first on Zientzia Kaiera.

Hesiré o las proporciones en el arte antes del número áureo

Número áureo, divina proporción, razón dorada… son términos inevitablemente vinculados a las proporciones en el mundo artístico. Todos ellos (representados por la letra φ (phi)) se asocian al número irracional (un número de infinitos decimales) que se expresa mediante la siguiente ecuación:

Pero tampoco es que este número nos diga mucho, así que vayamos con la interpretación geométrica, que resulta mucho más visual:

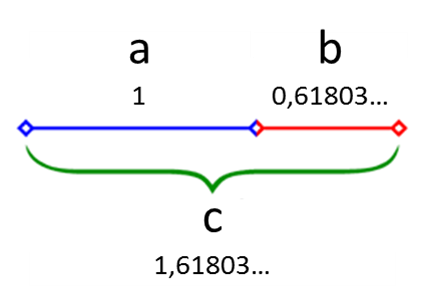

Imagen 1. Un segmento cuya división guarda las proporciones áureas Fuente: Modificación del autor sobre contenido Wikimedia commons.

Se cumple la divina proporción cuando, al dividir un segmento (c) en dos partes (a y b), la relación entre el segmento original (c) y la parte más larga (a) es la misma que entre la parte más larga (a) y la más corta (b). Dicho de otro modo, cuando:

A estas proporciones se les atribuye un valor estético por lo que han sido aplicadas en obras artísticas de todo tipo: desde cuadros renacentistas hasta el diseño de logotipos* (Imagen 2).

Imagen 2. Logotipo de Toyota diseñado a partir del número áureo. Fuente: Modificación del autor sobre contenido Wikimedia Commons.

Así que a nadie le sorprenderá que haya un software para trabajar con estas dimensiones o una página web exclusivamente dedicada al número áureo. Pero qué queréis que os diga, la cosa se nos ha ido un poco de las manos. Parece que ahora toda composición artística que se precie se adapta a la divina proporción o a la espiral áurea (la que se consigue mediante la combinación de rectángulos áureos). Hay una anécdota que refleja ese hecho a las mil maravillas. Nada más empezar 2016 un periodista comentó en twitter una peculiar fotografía que había dejado la celebración de la entrada en el nuevo año: “Suceden tantas cosas en esa imagen. Como en una hermosa pintura”. Enseguida el mensaje se hizo viral y comenzaron las parodias sobre la fotografía en cuestión. Entre ellas no podía faltar una referente a la espiral áurea.

Imagen 3. La espiral áurea dentro de la fotografía de Joel Goodman. Fuente: tweet de @GroenMNG

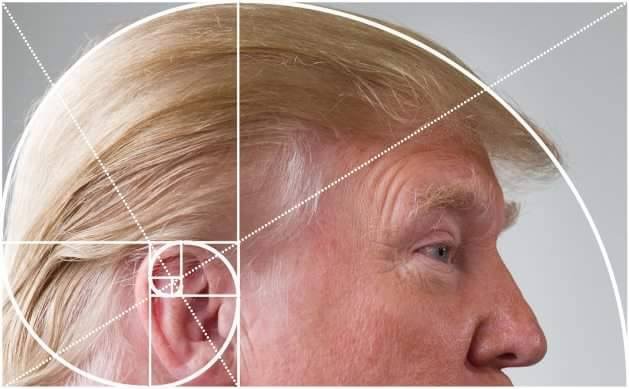

Aunque, hablando de parodias sobre el número de oro, la que más me ha llamado la atención por lo bien que se adapta a la espiral áurea es la realizada sobre la cabeza del todopoderoso presidente de los Estados Unidos. Dejo en vuestras manos decidir si en este caso la composición es artísticamente deseable.

Imagen 4. Espiral áurea sobre la cabeza de Donald Trump. Fuente: Know Your Meme

Pero este artículo no trata sobre el número áureo, del que ya se ha hablado mucho (aquí o aquí) desde que Euclides lo mencionase por primera vez en el s. III a.e.c. Aunque se supone que ya se empleó con anterioridad en la composición del Partenón (s. V a.e.c.) o, incluso, en las pirámides de Guiza (s. XXVI a.e.c.). Y precisamente hoy vamos a viajar a la tierra de las pirámides para conocer un sistema de proporciones más antiguo y mucho más “racional”. Lo haremos de la mano de un personaje que, pese a no haber trascendido al gran público, ocupa un puesto de honor en la historia del arte egipcio: el escriba real Hesiré.

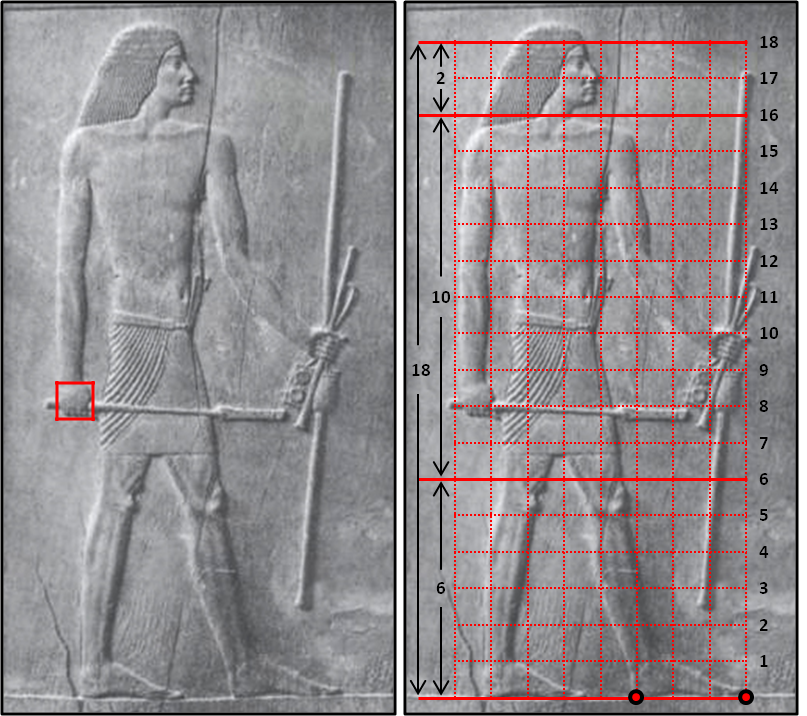

Nos remontamos a la III dinastía del Egipto faraónico, allá por el 2650 a.e.c. cuando las famosas pirámides que acabamos de mencionar ni siquiera se habían empezado a construir. Muy cerca de donde unos años después se erigirían, en la necrópolis real de Saqqara, ya había sucedido un hito: se había establecido el canon egipcio. En mayor o menor medida todos estamos familiarizados con dicho canon. ¿Quién no ha visto alguna vez una imagen del estilo de la que os muestro a continuación?

Imagen 5. Decoración hallada en el templo funerario de Hatshepsut (XVIII dinastía, 1507-1458 a.e.c). Fuente: Wikimedia Commons.

La gran mayoría de las imágenes del Antiguo Egipto siguen unos principios compositivos idénticos. Por una parte, obedecen a lo que se conoce como principio de frontalidad: la cabeza y las extremidades se representan de perfil mientras que el torso aparece de frente. Si los pensáis, dicha posición es anatómicamente imposible a menos que fuesen expertos contorsionistas. Pero eso no era mayor problema, ya que se trata de una representación simbólica, muy alejada, por ejemplo, de las esculturas griegas que intentan reflejar la anatomía humana. Por otra parte, y la que más nos interesa en este artículo, todas estas figuras siguen un canon de proporciones basado en la aplicación matemática.

Estos principios compositivos perdurarían durante dos milenios en el arte egipcio sin apenas alteraciones. Casi nada. Pero, ¿cómo fue eso posible? Para entenderlo debemos abstraernos de nuestro concepto de arte. El arte egipcio estaba completamente supeditado a la experiencia religiosa y su misión era reflejar la inalterabilidad del orden divino. De hecho, ni siquiera existía el concepto de artista. Se trataba de un arte colectivo en el que cada artesano tenía una función (esculpir o pintar, por ejemplo). Tampoco existía el concepto de belleza que podemos tener hoy en día; ésta estaba asociada a la pericia en ejecutar las normas establecidas. De ahí que el canon se perpetuase de generación en generación con algunas excepciones como los convulsos periodos intermedios o el periodo Amarnense (durante el cual el faraón Akhenatón quiso establecer un sistema monoteísta; así que ya vemos que el arte seguía relacionado con el ámbito religioso). La creación del canon egipcio fue posiblemente un proceso paulatino que se asentó, como decíamos antes, en la III dinastía. Y ahí es donde entra en escena Hesiré o, mejor dicho, Hesiré y sus puños.

Allá por 1861 el arqueólogo Auguste Mariette estaba explorando la mastaba (tipo de enterramiento precursor de las pirámides) de dicho alto cargo del faraón en la necrópolis de Saqqara. Ante sus ojos apareció una fabulosa galería llena de pinturas y unos relieves que pasarían a la historia. Trabajados en madera de cedro de color rojizo, seis de ellos han sobrevivido hasta nuestros días en buenas condiciones pese a tratarse de un material perecedero. Alguna ventaja tenía que tener permanecer enterrado en el desierto.

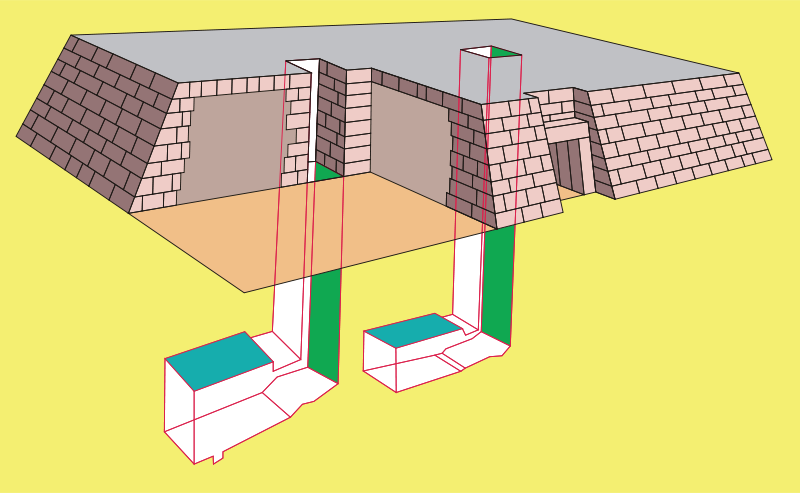

Imagen 6. Dibujo de una mastaba. Fuente: Wikimedia Commons

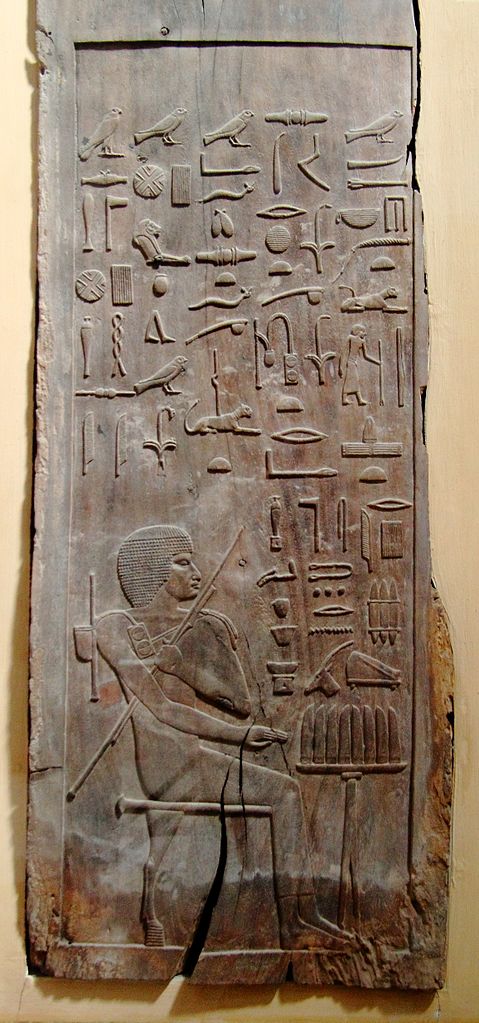

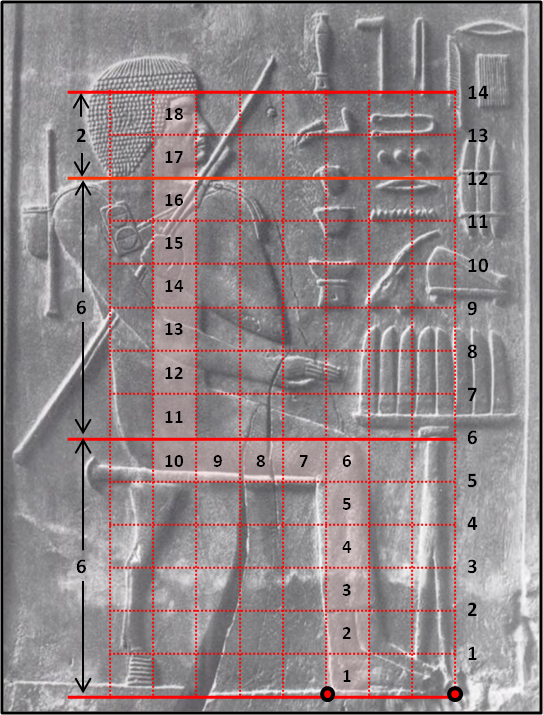

Los relieves muestran al escriba real (uno de los tantos cargos que ostentaba) en diferentes etapas de su vida. En el que os muestro en la Imagen 7 aparece con una peluca corta antes una mesa de ofrendas mientras sujeta con la mano izquierda un bastón y sus útiles de escriba. En otros casos porta el Kherep (Imagen 8), un distintivo de poder que vuelve a resaltar la importancia del simbolismo en el arte egipcio. Pues bien, serán estos bajorrelieves los que nos ayuden a comprender el sistema de proporciones del arte egipcio.

Imagen 7. Uno de los relieves de Hesiré, actualmente en el Museo egipcio de El Cairo. Fuente: Wikimedia commons

Los egipcios usaban un sistema de cuadriculas en el que cada parte del cuerpo ocupaba un número diferente de cuadrados. Antes os decía que los puños tendrían una gran importancia en esta historia y es que cada cuadrado era del tamaño de un puño*. Partiendo de esa base, cada figura de pie tendría una altura de 18 cuadrados desde los pies hasta el nacimiento del pelo. Alguien podría pensar que lo lógico hubiese sido cubrir toda la altura de la figura, pero en el caso de que portase algún objeto en la cabeza las medidas resultarían más complicadas (¡lo tenían todo pensado estos egipcios!). Siguiendo con la misma referencia, las rodillas acabarían con el sexto cuadrado y el resto del cuerpo ocuparía 10 unidades, dejando las últimas dos para cubrir el cuello y la cabeza. En la Imagen 8 podéis ver cómo se cumplen esas propiedades en uno de los relieves. Si os fijáis, la cuadricula sirve para localizar y dar tamaño a diferentes partes del cuerpo: el ombligo está a la altura del undécimo cuadrado, los pies de Hesiré ocupan tres espacios, etc. Pues bien, este sistema permitía a los egipcios mantener un sistema de proporciones constantes en una composición por muchos personajes que apareciesen (a no ser que el simbolismo exigiese un cambio, como cuando el faraón se representaba de mayor tamaño para dejar constancia de su poder).

Imagen 8. Relieve de Hesiré. A la izquierda se muestra el tamaño de la unidad de la cuadrícula que coincide con el tamaño aproximado de un puño. A la derecha la cuadricula con ciertas referencias de interés. Fuente: Modificación del autor sobre contenido Wikimedia Commons.

Tras ver la imagen anterior podemos comprender por qué las composiciones egipcias resultan tan “cuadriculadas”. Pero, ¿qué sucede cuando el personaje no está de pie? La verdad es que el sistema se aplica de una manera muy similar en las figuras sedantes, sólo que, obviamente, la altura es menor: 14 cuadrados. En todo caso, el único módulo que sufre cambios es el que va desde los hombros a las rodillas, que pasa a estar compuesto por seis cuadrados. Esto resulta lógico si tenemos en cuenta que es la parte del cuerpo que se dobla con el cambio de posición. Así, en la Imagen 9 podéis observar como el Hesiré que os mostraba ante la mesa de ofrendas cumple rigurosamente esta norma. Esto no supone ningún cambio en el resto de proporciones anatómicas, ya que el tamaño absoluto de la figura no varía, simplemente hay cuatro cuadrados que ocupan un espacio horizontal en lugar de vertical.

Imagen 9. Relieve de Hesiré en posición sedante con la cuadricula que muestra el sistema de proporciones. Fuente: Modificaciones del autor sobre contenido Wikimedia Commons.

En este sistema, sencillo a la par que elegante, los egipcios encontraron el modo para perpetuar su canon artístico durante siglos, en un periodo que se prolongó entre las dinastías III (s. XXVII a.e.c) y la dinastía XXVI (s. VII a.e.c) donde las figuras se estilizaron y su altura superó los veinte cuadrados. Así, aunque Hesiré no haya logrado la fama de sus paisanos Nefertiti o Tutankamón, su nombre ocupa un puesto de honor en la historia del arte egipcio.

Notas:

(1): Como pudimos ver hace unos días en el curso M de Matemáticas que organizan cada verano Marta Macho y Raúl Ibáñez (fieles colaboradores del Cuaderno en la sección Matemoción), y a los que pido disculpas por el intrusismo de esta entrada.

(2): El sistema de puños propuesto por el egiptólogo Erik Iversen fue replanteado por Gay Robins y más recientemente por John Legon. Según este último autor la cuadricula en la que se basa el canon de proporciones surgiría de dividir el cuerpo en tres partes iguales (6 cuadrados) de las que luego se realizarían otras subdivisiones. En cualquier caso, dado que el objetivo de este artículo es dar a conocer que el arte egipcio empleaba un sistema de proporciones basado en una cuadricula, se ha decidido mantener el concepto de puño.

Para saber más:

Gay Robins “Proportion and Style in Ancient Egyptian Art” University of Texas Press (1993).

Joan Kee “To Scale” Wiley-Blackwell (2016).

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

El artículo Hesiré o las proporciones en el arte antes del número áureo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Asteon zientzia begi-bistan #165

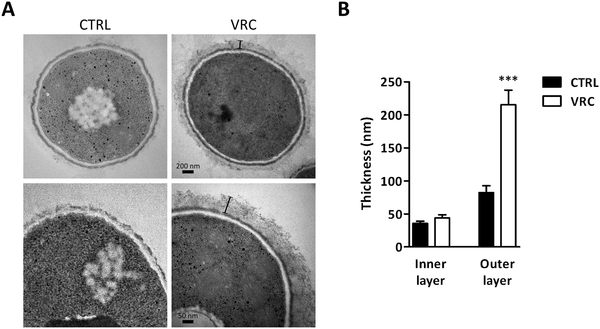

Lomentospora prolificans (L. prolificans) onddoak orain arte ezagutzen ez zen erresistentzia mekanismo bat daukala frogatu du UPV/EHUko Fungal and Bacterial Biomics ikerketa-taldeak. Onddo mota hau mikroorganismo multierresistentea da eta egun erabiltzen diren onddoen aurkako antibiotikoei erresistentea. Oso infekzio larriak sor ditzake baina immunitate sistema ahula duten pazienteengan. Onddoa voriconazolarekin tratatzean zelula horman gertatzen diren aldaketak behatuta, orain arte ezezaguna zen erresistentzia mekanismoa aurkitu du ikerketak, praktikan onddoari aurre egiteko botika eraginkorrak diseinatzea ahalbidetu dezakeena.

BiologiaEuropako zenbait zootan Triatoma generoko intsektuak erabiltzen ari dira animaliei odol-laginak hartzeko. Horiek ugaztunen odola xurgatuz elikatzen dira. Ezpainen alboetatik edo betazaletatik xurgatzen du gizakien odola lotan daudenean. Horretarako, hozkaren mina gutxitzeko entzima bat erabiltzen du, eta horixe da animalien odola erauzterakoan estresik sortzen ez duen metodo hau erabiltzeko arrazoia.

Txakurrak hain adiskidetsuak izatearen oinarria genetikan datza. Zehazki, GTF2I eta GTF2IRD1 geneak omen dira portaera hori arautzen dutenak. Juanma Gallegok azaltzen du ikerketak jarraitu dituen bideak. Batetik, portaeraren inguruko esperimentuak egin dituzte. Bestetik, analisi genetikoak egin dituzte. Halaber, ikerketa honetan, txakurren eta otsoen arteko desberdintasun genetikoetan sakondu dute.

EkologiaIbaien osasuna neurtzeko markoa berritzeko proposatu du UPV/EHUko ikerketa talde batek. Bertako kidea da Daniel Von Schiller, Biologian doktorea. Hark azaldu duenez, ibaiaren osasuna ezagutzeko egiturari dagozkion alorrak aztertu ohi dira: ibaian bizi diren espezieak, nitratoak uretan duen kontzentrazioa… ez ordea ibaien funtzionamendua. Hortaz, ibaian dauden prozesuak ikertzeko moduetan arreta jarri du. Hau da, eta ikerlariak azaltzen duen moduan, “materia organikoak deskonposatzeko behar duen denbora; ibaiaren metabolismoa, urak duen oxigenoa; hau da, ibaiak nola arnasten duen”.

ArkeologiaRapanuien gizartea loratu zen, baina gero gauzak okertu ziren Pazko uhartean. Adituek ez dute argi hondamendi horren jatorria zein izan zen. Lehen planteamendua ekozidioaren hipotesia da. Jared Diamond geografo eta antropologoak ideia horren alde agertu zen: Pazko uharteko biztanleek gaizki erabili zituzten eskura zituzten baliabide naturalak, eta horrek gosea eta bertakoen amaiera ekarri zituen. Ahalik eta eskulturarik handienak —moai delakoak— sortzeko lehia izan zen adituen arabera hondamendia eragin zuen beste elementu bat. Hilabete honetan argitaratu dute bigarren ideia bat. Anakena eta Ahu Tepeu aztarnategietan aurkitutako arrastoak aztertu dituzte eta hauxe adierazi dute ikertzaileek: “Gure ikerketak frogatu du bertako populazioa modu iraunkorrean bizi zela, eta tokiko ingurumenera ondo egokituta zegoela”.

Emakumeak zientzianBadakizu zein izan zen X izpien difrakzio bidez DNAren lehen irudia lortu zuena? Rosalind Franklin (1920-1958) kristalografoa. Haren DNAren helize bikoitzeko ereduak biologia molekularra eta funtzio genetikoak ulertzeko bidea ireki zuen “51 argazkia”ri esker.

AstronautikaNASAk 500 bideo historiko argitaratuko ditu Youtuben. Batzuk bideo oso teknikoak dira; beste asko, berriz, herritar arruntentzat interesgarriagoak izan daitezke. Kasu guztietan, hala ere, astronautikaren historia bertatik bertara jarraitzeko aukera izango du jendeak.

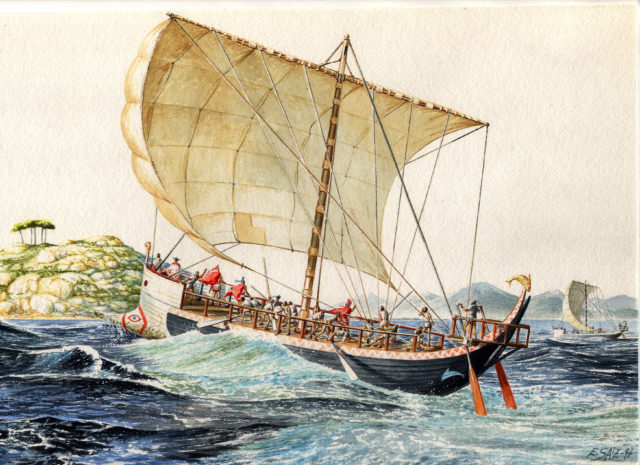

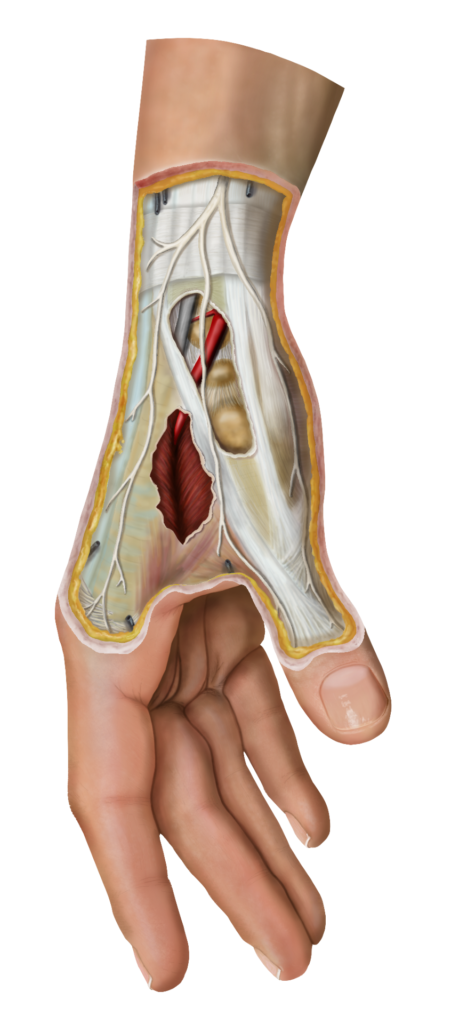

Zientzia eta arteaZientziak eta arteak bat egiten dute ilustrazio zientifikoaren lanbidea sortzeko. Espainian ez dago formakuntza arauturik diziplina honetan, normalean profesional autodidaktak dira arlo honetan murgiltzen direnak. Graduondokoa eskaini zuen lehen unibertsitatea Estatu Batuetako Johns Hopkins unibertsitatea da, eta 100 urte baino gehiagoko historiarekin, munduko unibertsitate prestigiotsuenen artean dago. Euskal Herriko Unibertsitateko Zientzia eta Teknologia Fakultateak (ZTF-FCT), beste fakultate eta erakunde batzuen laguntzarekin, lehen aldiz eskainiko du Unibertsitateko Espezialista Ilustrazio Zientifikoan berezko titulazioa.

———————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

Egileaz: Uxue Razkin Deiako kazetaria da.

———————————————————————–

The post Asteon zientzia begi-bistan #165 appeared first on Zientzia Kaiera.

Arte & Ciencia: Los objetos también tienen biografía

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Jornada 4. 1ª Conferencia

Jacobo Castellano es artista plástico: Los objetos también tienen biografía

El conocimiento científico es una herramienta esencial para averiguar el origen de las obras de arte y entender los motivos que provocaron el trabajo de un artista. El análisis de los materiales empleados para realizar una escultura o de la composición de las pinturas presentes en un cuadro nos permiten ahondar en las propias obras, encontrar su sentido y delimitar el ideario del artista. Por otro lado, el arte también ha jugado un papel fundamental como impulsor de progreso en las cuestiones comúnmente atribuidas a las ciencias, como son las medioambientales o las sociales.

''Los objetos también tienen biografía''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: Los objetos también tienen biografía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: Analogías entre el arte y la ciencia como formas de conocimiento

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

Lehen graduondokoa Ilustrazio Zientifikoaren lanbide ezezagunean

1. irudia: Angel Dominguezen ilustrazioa.

Profesional horiek formakuntza zientifikoa izaten dute gehienetan, eta geroago ilustraziora jo dute, edo bestela zientzietan espezializatutako arte ederretako profesionalak dira. Zientziak eta arteak bat egiten dute ilustrazio zientifikoaren lanbidea sortzeko, eta zientzia modu bisualean bere horretan komunikatzea edo idatzizko nahiz ahozko hitzak laguntzea helburu duen komunikazioaren adarra da.

Normalean profesional autodidaktak dira, izan ere, Espainian ez dago formakuntza arauturik diziplina honetan. Beharbada horixe izango da ilustrazio zientifikoa lanbide ezezagun bihurtzen duten faktore nagusietako bat. Noizean behin museo eta udaletxeek antolatzen dituzten tailer edo ikastaro txikiak aurki daitezke, gehien bat naturarekin erlazionatutakoak, baina horrekin ez da nahikoa diziplina honen osotasun eta konplexutasuna barne hartzeko.

2. irudia: Eduardo Sainzen ilustrazioa.

Europan formazio arautuko oso zentro gutxi daude, baina unibertsitate horietan graduondoko mota hau hainbat urtetatik hona eskaintzen da, eta sail ezberdinek sustatzen dute: arte ederrak edo diseinuak, zientziak eta medikuntzak. Graduondokoa eskaini zuen lehen unibertsitatea Estatu Batuetako Johns Hopkins unibertsitatea da, eta 100 urte baino gehiagoko historiarekin, munduko unibertsitate prestigiotsuenen artean dago.

Jakinda komunikazio zientifikoa ezinbestekoa dela zientziak aurrera egin dezan, Euskal Herriko Unibertsitateko Zientzia eta Teknologia Fakultateak (ZTF-FCT), beste fakultate eta erakunde batzuen laguntzarekin, lehen aldiz eskainiko du Unibertsitateko Espezialista Ilustrazio Zientifikoan berezko titulazioa. Graduondokoari buruzko informazio guztia hemen aurki daiteke: Ilustrazio Zientifikoko graduondoa. Unibertsitateko espezialista.

Irakasleek zientzialari, artista, jurista eta komunikatzaile talde anitz eta orekatua osatzen dute, eta nazioartean aintzatetsiak eta sarituak izan dira. Irakasle horiek guztiak oso motibaturik daude graduondoko berri honetan beren onena emateko.

3. irudia: Vega Asensioren ilustrazioa.

Graduondokoak honako hauen laguntza ekonomikoa du: Bergarako Laboratorium museoa, itsas eta elikadura-berrikuntzan aditu den AZTI-Tecnalia zentroa eta arte ederretako materiala ekoizten duen Colart etxea. Edonola ere, proiektuan parte hartu nahi duten babesle gehiagori irekita dago.

Graduondokoa 2017-18 ikasturtean eskainiko da. Momentu honetan aurre-matrikula garaian dago, eta horrela jarraituko du irailera arte, urrian hasiko baitira klaseak. Graduondokoan izena emateko baldintzak graduatua edo lizentziatua izatea eta marrazketako oinarrizko ezagutzak izatea da. Ikasleen formakuntzaren kalitatea bermatzeko xedeaz, 15 ikasle baino ez dira onartuko ikasturte akademiko bakoitzeko, horrela, irakasleek ikasle bakoitzari jarraipen pertsonalizatua egin ahal izango baitiote.

4. irudia: Carles Pucheten ilustrazioa.

Graduondokoak 40 kreditu ditu, aurrez aurreko klaseak (34,5 ECTS) eta bukaerako proiektua (4,5 ECTS) barne hartuta. Azken hori erakunde laguntzaileetan egin ahal izango da, besteak beste, museoetan, unibertsitateko sailetan edo zentro teknologikoetan. Bide batez, kolaboratzaile gehiagori parte hartzeko gonbita egiteko aprobetxatu nahi dugu. Proiektu horiek guztiak denontzako probetxugarriak izango dira, bai ikasleentzako, praktika errealak egingo baitituzte, bai erakundeentzako, profesionalak eta lanbidea bera ezagutu eta gozatuko baitituzte.

Graduondoko honetatik aterako da Ilustrazio Zientifikoan titulatutako lehen belaunaldia Espainian. Dena den, harago joateko asmoa du eta beste hauek ere lortu nahi ditu: zientzia bisualaren eremuan erreferente bihurtzea, ilustratzaile zientifikoen arteko lotura bihurtzea eta zientziaren, teknologiaren eta gizartearen zerbitzura dagoen lanbide hori ezagutzera eman eta sustatzea.

Informazio gehiago:

- Ilustrazio Zientifikoko graduondoa. Unibertsitateko espezialista

- Universidad de Aveiro

- Maastricht Academy of Fine Arts and Design

- Liverpool John Moores University

- University of Dundee

- École Supérieure Estienne des Arts Graphiques

- Zurich University of the ArtsScientific Visualization

- Hochschule Luzern Design & Kunst

- Medical Artists’ Education trust

———————————————————————–

Egileaz: Vega Asensio Biologian doktorea da, ilustratzailea eta Ilustrazio Zientifikoko graduondokoaren koordinatzailea.

———————————————————————–

The post Lehen graduondokoa Ilustrazio Zientifikoaren lanbide ezezagunean appeared first on Zientzia Kaiera.

Lo que Yellow Mellow oculta sobre los chemtrails

Uno de los últimos vídeos de Yellow Mellow trata de las cinco teorías conspirativas que DAN MÁS MIEDO. De los chemtrails a los illuminati, da un repaso muy divertido y loco a unas cuantas historias alternativas a los hechos. En un minuto, Yellow Mellow nos cuenta lo esencial sobre chemtrails: la explicación racional, la explicación alternativa y qué sentido tendría la conspiración chemtrailiana. Podéis ver el vídeo en este enlace y pasar un buen rato con esta maravillosa chica.

Desde el principio nos hace esta advertencia que transcribo: «Los hechos que os voy a contar son teorías conspirativas, ¡teorías! No estoy diciendo, en ningún momento, que yo me las crea. Y tampoco estoy diciendo, en ningún momento, que estos sean hechos reales».

Nos lo cuenta de la siguiente manera:

«Los chemtrails son esos rastros que dejan los aviones por el cielo. A veces no hay ni uno. A veces dos o tres. A veces hay como quince en muy poco espacio. La explicación oficial que se da a esto es que simplemente son rastros de los aviones comerciales que pasan por el cielo a diario. Hay rutas en las que pasan más aviones que en otras. Así que esa es la explicación. No hay nada raro. No pasa nada.

Pero el dato alternativo es que esos rastros que dejan los aviones son gases químicos que dejan ir algunos aviones que no son comerciales para que vayan cayendo lentamente sobre la población y que provocan enfermedades. Básicamente la teoría dice que nos están gaseando. Estos gases pueden provocar desde ligeros dolores de cabeza, refriados comunes, hasta cáncer —frunce el ceño—.

¿Por qué se dice esto? ¿Cuál es la razón? Pues, ¿tú qué haces cuando estás enfermo? Vas al médico, el médico te receta medicina, vas a la farmacia a comprar esa medicina. Si no estuvieses enfermo, ese proceso no lo harías y, por tanto, no irías a la farmacia a gastarte el dinero.

Pues bien. Se dice que estos gaseamientos por parte de organizaciones potentes, gobiernos, sociedades de las que hablaremos más adelante —se refiere a los illuminati—, ¿por qué están haciendo esto? Pues para beneficiar a la industria farmacéutica. Nos están enfermando para enriquecer a la industria farmacéutica. Esto es lo que cuenta la teoría».

Este vídeo me hizo recordar el artículo de John Cook, «La teoría de la inoculación: usar la desinformación para combatir la desinformación» que fue publicado en este medio. Una de las cosas que está haciendo Yellow Mellow —imagino que intuitivamente, aunque no lo sé— es seguir la estrategia de John Cook para vacunarnos contra la desinformación.

John Cook dice en su trabajo que, cuando nos exponemos a una forma débil de un virus, creamos inmunidad al virus real, y esto lo aplica al conocimiento. Cuando estamos expuestos a una “forma débil de desinformación”, esto nos ayuda a crear resistencia para que no seamos influenciados por la desinformación real. Para ello son necesarios dos elementos, precisamente los mismos que Yellow Mellow nos ofrece en este vídeo: Primero, incluye una advertencia explícita sobre el peligro de ser engañado por la desinformación. En segundo lugar, proporciona contraargumentos que explican los fallos en esa desinformación.

De esta manera, los hechos alternativos que Yellow Mellow nos cuenta a continuación, pasan a resultarnos más rocambolescos, incluso risibles. También ayuda que utilice otra poderosa herramienta que domina a la perfección: el humor.

Los aviones obtienen la energía para desplazarse de la quema de combustibles fósiles. Cuando se produce la combustión, expulsan un gas que está muy caliente que contiene vapor de agua y que se condensa rápidamente cuando entra en contacto con el aire frío que hay a esas alturas. Por eso dejan tras de sí esas estelas llamadas contrails —no chemtrails—. Estas estelas no siempre se pueden observar, ya que este fenómeno de condensación depende de las condiciones atmosféricas: presión, temperatura y humedad. De hecho, que persistan esas estelas significa que en las capas altas de la atmósfera está entrando humedad y, previsiblemente, eso implica que esa humedad viene de alguna borrasca. Si estamos en otoño o invierno, son indicativo de que al día siguiente es probable que llueva.

Yellow Mellow nos explica la justificación más inverosímil de todas las posibles: envenenarnos para enriquecer a la industria farmacéutica. Pero existen otras muchas razones, igual de inverosímiles, con cierto grado de relación con la realidad. Una de ellas nos dice que los chemtrails se utilizan para manipular el clima. Es decir, que en lugar de pensar que la persistencia de las estelas es consecuencia de la humedad atmosférica o de la entrada de una borrasca inminente, se piensa lo contrario, que las estelas son las que provocan las lluvias, no la consecuencia de estas.

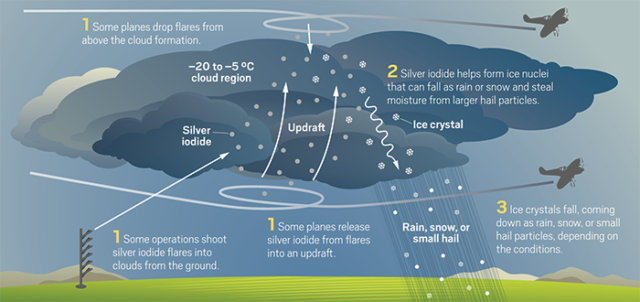

En la naturaleza, las nubes se forman cuando el vapor de agua superenfriado se condensa y luego se congela en partículas, llamadas núcleos de hielo, hechas de polvo e incluso de bacterias. Las gotitas de agua pura no pueden formar un núcleo de cristal de hielo hasta que la temperatura descienda a -40 ° C. Sin embargo, si las nubes contienen partículas de aerosol, las moléculas de agua pueden utilizar las superficies sólidas de estas semillas para organizarse en una forma cristalina a temperaturas mucho más cálidas, de -20 a -5 ° C.

En 1971, el científico atmosférico Bernard Vonnegut, publicó un artículo en la prestigiosa revista Nature sobre cómo sembrar nubes empleando diferentes sales de plata, como bromuro y yoduro de plata. El yoduro de plata es un buen agente de nucleación debido a que su red cristalina hexagonal es casi idéntica a la red que las moléculas de agua forman en el hielo y los copos de nieve. Las moléculas de agua adyacentes a la sal de plata tienden a pegarse (nucleación), cristalizando a su alrededor dando lugar a la formación de partículas de hielo. Si hay crecimiento suficiente, las partículas se vuelven lo suficientemente pesadas como para caer en forma de nieve (o, si se fusionan, en forma de lluvia). De otro modo no producen precipitación.

How cloud seeding is supposed to work. Yang H. Ku/C&EN/Shutterstock

Teóricamente esto tiene sentido, pero todavía no sabemos lo suficiente sobre las estructuras del agua cuando se va produciendo su cristalización como hielo, particularmente cuando este proceso ocurre en las superficies de otros materiales como el yoduro de plata. La nucleación de hielo es difícil de probar experimentalmente porque los actuales instrumentos no producen imágenes claras de moléculas individuales a medida que se congelan. No se conocen los procesos y es muy complicado estimar qué parte de las precipitaciones son provocadas artificialmente y qué parte se producirían de forma natural. Las estimaciones actuales más optimistas hablan del aumento de un 10% en las precipitaciones de cada nube sembrada artificialmente.

La realidad es que hacer que llueva es, de momento, más magia que ciencia. Es necesario seguir investigando para entender si la práctica funciona, cómo optimizarla y cuáles serían sus impactos ambientales, sociales y políticos.

Quizá los chemtrails que los illuminati tratan de ocultarnos, y con los que de paso nos enferman, sean los verdaderos responsables del cambio climático. Yo no lo creo. Yellow Mellow me ha vacunado contra la desinformación.

Este post ha sido realizado por Deborah García Bello (@Deborahciencia) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Lo que Yellow Mellow oculta sobre los chemtrails se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Informando sobre la información

- Un recuerdo sobre Fidel Pagés, descubridor de la anestesia epidural

- Ensayo sobre el azul

Jone Uria: “Matematika teorikoaren eta aplikatuaren arteko bidea norabide bikoa da” #Zientzialari (77)

Kontzeptua abstraktuak neurtzen dituen zientzia zehatza da matematika. Horretarako, ezarritako arau logiko batzuetatik abiatu, teoriak osatu eta berauekin zer demostratu daitekeen eta zer ez frogatzen saiatzen dira alderdi teorikoan lan egiten duten matematikariak. Baina zer dira zehazki definizio, teorema eta frogapen matematikoak? Zein da esparru teorikotik aplikaturako bidea?

Matematika teorikoaren inguruan gehiago jakiteko, UPV/EHUko matematikaria den Jone Uriarekin izan gara. Bere esanetan, matematika teorikoaren eta praktikoaren arteko lotura norabide bietan ematen da, hau da, badago teorematik abiatu eta horri aplikazioak bilatzen dizkionik, baina baita erabilera bat azaltzeko teoria garatu behar izan duenik ere.

‘Zientzialari’ izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Jone Uria: “Matematika teorikoaren eta aplikatuaren arteko bidea norabide bikoa da” #Zientzialari (77) appeared first on Zientzia Kaiera.

Con los edulcorantes artificiales (casi) todo son ventajas

Conocemos los efectos sobre la salud del consumo excesivo de azúcar. Aun así, nos resulta difícil desterrar el sabor dulce de la dieta una vez nos hemos acostumbrado a él. En artículos anteriores hemos analizado algunos posibles sustitutos, como el azúcar moreno, la miel y los siropes. Ninguno de ellos resultó ser mejor que el azúcar común.

Otra posibilidad que nos planteamos es sustituir el azúcar por edulcorantes acalóricos. Ya hemos hablado de la estevia comercial y los polialcoholes. Ahora toca informarse sobre los principales edulcorantes artificiales.

Todos los edulcorantes artificiales que encontramos en el mercado están catalogados como aditivos alimentarios. Esto implica que además del su nombre común (como sacarina o aspartamo) tienen su propia denominación como aditivos, con su correspondiente número E. Esto es importante porque significa que cada una de esas sustancias ha sido debidamente analizada antes de comercializarse y ‘ganarse’ su número E.

Hay intereses de diferente naturaleza que han llevado a publicar informaciones alarmantes sobre estas sustancias, incluso llegando a relacionarlas con el cáncer, y que, desgraciadamente siguen circulando y avivando las dudas de los consumidores. No hay nada que temer, salvo la desinformación deliberada.

Se han revisado cientos de estudios de seguridad llevados a cabo sobre cada edulcorante, incluidos estudios para evaluar el riesgo de cáncer. Los resultados de estos estudios no mostraron evidencias científicas de que estos edulcorantes causen cáncer o de que presenten cualquier otra amenaza para la salud humana. Cualquier información que contradiga esta afirmación es falsa.

Veamos algunos datos importantes sobre los principales edulcorantes artificiales:

-

Sacarina

La sacarina se sintetizó por primera vez en 1879 y comenzó a popularizarse durante la I Guerra Mundial, a causa de la escasez de azúcar. Es el aditivo E 954. Es entre 300 y 500 veces más dulce que el azúcar y no se metaboliza, se absorbe tal cual y es eliminado rápidamente a través de la orina. No aporta ninguna caloría.

-

Ciclamato

El ciclamato sódico se descubrió en 1937 y tiene un poder edulcorante entre 50 y 100 veces superior al azúcar. Es el aditivo E 952. No suele comercializarse solo, sino como edulcorante presente en bebidas y alimentos. Su absorción es mínima y se elimina por la orina.

-

Acesulfamo K

Se sintetizó por primera vez en 1967 y es unas 200 veces más dulce que el azúcar. Es el aditivo E 950. El principal inconveniente es organoléptico, ya que deja un regusto metálico en la boca si no se combina con otros edulcorantes como el aspartamo y la sucralosa. La principal ventaja es que es estable al calor, por eso se utiliza en productos horneados. Tampoco se metaboliza, con lo que se elimina íntegramente a través de la orina.

-

Sucralosa

Se descubrió en 1976. Es el aditivo E 955 y tiene un poder edulcorante 600 veces mayor que el azúcar. La principal ventaja es que resiste altas temperaturas, como el acesulfamo, y juntos generan un efecto sinérgico que aumenta el dulzor.

-

Aspartamo

Fue descubierto casualmente en 1965. Es el aditivo E 951, con un poder edulcorante 200 veces mayor que el azúcar. El aspartamo es el edulcorante que peor prensa ha tenido (y sigue teniendo). Sobre él se han publicado estudios fraudulentos que, a pesar de haber sido retractados, permanecen en nuestra memoria y hacen dudar al consumidor. Tanto es así, que algunas empresas han decidido dejar de utilizar este edulcorante por culpa de la presión mediática.

La compañía PepsiCo sufrió una caída del 5% de sus ventas en uno de sus buques insignia, la Pepsi Light. La razón fue que su contenido en aspartamo era percibido por parte de los consumidores como un riesgo para la salud.

El aspartamo está formado por la unión de dos aminoácidos naturales y habitualmente presentes en muchísimos alimentos, la fenilalanina y el ácido aspártico. En su degradación metabólica se obtienen ambos aminoácidos por separado. Ninguna de estas sustancias, juntas o separadas, son perjudiciales para la salud en un consumo normal. Pero sí puede afectar a personas con una enfermedad metabólica llamada fenilcetonuria. Por este motivo los alimentos con aspartamo incluyen en su etiqueta la siguiente advertencia: «fuente de fenilalanina». Para los que no padecemos esta enfermedad, el aspartamo no supone ningún riesgo.

-

¿Todo son ventajas?

La principal ventaja es que todos los edulcorantes artificiales son seguros. A diferencia de los polialcoholes, no se ha demostrado que afecten a la microflora intestinal ni tienen efectos laxantes, como sí ocurre con los productos comerciales actuales de estevia, hechos a base de eritritol.

Además, el sabor y el dulzor de unos y otros es diferente, lo que permite que cada cual escoja el que más le guste, y que los fabricantes utilicen uno o varios hasta llegar a un sabor que, en muchos casos, resulta difícilmente distinguible del azúcar.

Tienen un índice glucémico nulo, con lo que no afectan a los niveles de glucosa en sangre, pudiendo ser consumidos por personas con diabetes.

A estas ventajas hay que sumar la que suele resultarnos más interesante: ninguno de estos edulcorantes artificiales aporta calorías.

-

Casi todo son ventajas

Si no engordan ni son perjudiciales para la salud, evidentemente son la mejor opción de todas para sustituir el azúcar. En cambio, todo lo referente a la alimentación no puede analizarse sin tener en cuenta las conductas de consumo.

Algunas líneas de investigación actuales se centran en el estudio del consumo de alimentos con edulcorantes artificiales y su relación con la obesidad. Puede parecer contradictorio, pero la realidad es que sí existe relación, aunque no exista un consenso sobre cómo sucede. Hay varios factores que afectan, como que el consumo de edulcorantes está relacionado con malos hábitos alimenticios, con una peor gestión del apetito y con la falsa percepción de un menor consumo calórico global.

-

Conclusiones

Los edulcorantes artificiales son los mejores sustitutos del azúcar. Son los mejores si, y sólo si, se usan dentro de una dieta saludable. Esta matización es importante porque, que un alimento contenga edulcorantes artificiales en lugar de azúcar, no lo convierte en un alimento saludable. Un alimento ultraprocesado, como galletas, bollería industrial, panes industriales, zumos industriales, etc. generalmente son alimentos de baja calidad nutricional, contengan azúcar o edulcorantes. La calidad de un alimento estriba en el alimento completo, no en sus ingredientes individuales. Por ejemplo, una galleta sin azúcar seguirá siendo un alimento poco recomendable si contiene harinas refinadas o grasas de baja calidad.

Si seguimos una dieta saludable, rica en materias primas de calidad y productos frescos, y nos gusta endulzar el café, el yogur, o tomar un refresco de vez en cuando, los edulcorantes artificiales son una buena opción.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Con los edulcorantes artificiales (casi) todo son ventajas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Zimitzaren musua

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria ———————————————————————————————————–

Europako zenbait zootan Triatoma generoko intsektuak erabiltzen ari dira animaliei odol-laginak hartzeko.

1. irudia: Triatoma espezieko intsektua. (Bernard Duponten argazkia).

Dirudienez, ez da erraza zooetako zenbait animaliari odola erauztea, osasun-azterketak egiteko hartu behar diren odol-laginak txikiak badira ere. Anestesiatu egin behar dira animaliak. Baina zenbait espezietan ―jirafetan, esaterako― oso arriskutsua da anestesia, eta, beraz, odola maiz erauzi behar bazaie, jirafa hiltzeko arriskua handiegia izaten da.

Triatoma generoko intsektuak ugaztunen odola xurgatuz elikatzen dira. Espezie asko dira genero horretakoak eta batzuk oso ugariak Ameriketan. Hego Amerikan chinche besucona, vinchuca, chipo edo barbeiro izenez deitzen dituzte, eta kissing bug izenaz ingelesez. Horregatik, euskaraz, “zimitz musukatzailea” izena eman diogu guk.

Odola erauzteko metodo hori arrakastatsua izan da hipopotamo, gepardo, jirafa, elefante eta errinozero zurietan. Zimitz musukatzaile izena intsektuaren elikatze-portaerari dagokio. Izan ere, ezpainen alboetatik edo betazaletatik xurgatzen du gizakien odola lotan daudenean. Horretarako, hozkaren mina gutxitzeko entzima bat erabiltzen du, eta horixe da animalien odola erauzterakoan estresik sortzen ez duen metodo hau erabiltzeko arrazoia.

Prozedura bitxi hau garatu dutenen arabera, erabilitako zimitz musukatzaileak gizatasunez hiltzen dituzte, baina, egia esan, ez dute azaldu xurgaturiko odola eskuratzeko zer egiten duten.

Kontu bitxia da hau, zeren zooetako animalien osasuna zaintzeko erabiltzen den Triatomak osasun-arazo larriak sorraraz baititzake Erdialdeko Amerikan eta Hego Amerikako zenbait herritan. Izan ere, Trypanosoma cruzi protozooak eragiten duen Chagas gaitza kutsa dezake, eta, gainera, bere listu-proteinek alergia-erreakzio gogorrak eragiten dituzte. Zimitzaren musuaren paradoxak!

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso du

The post Zimitzaren musua appeared first on Zientzia Kaiera.

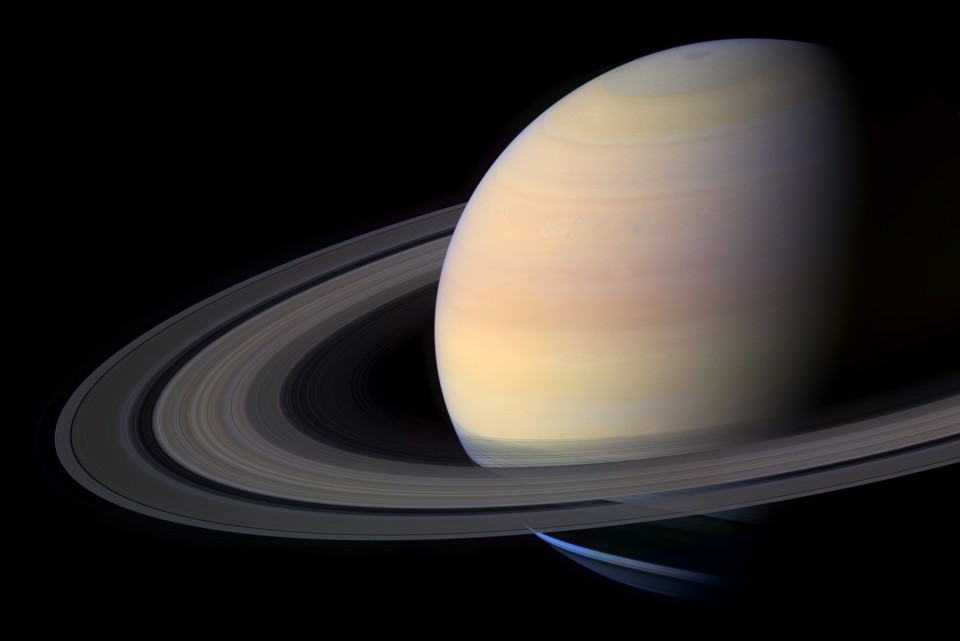

Saturno en un vaso de aceite

El planeta Saturno

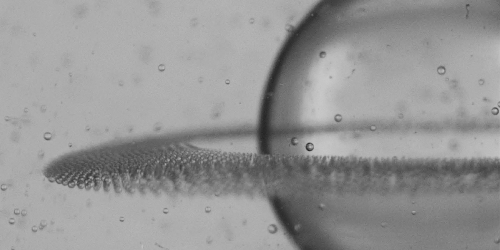

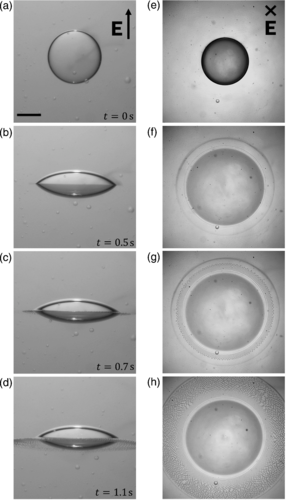

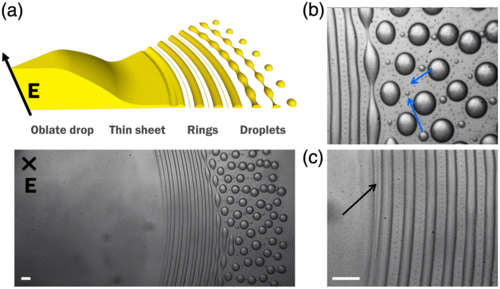

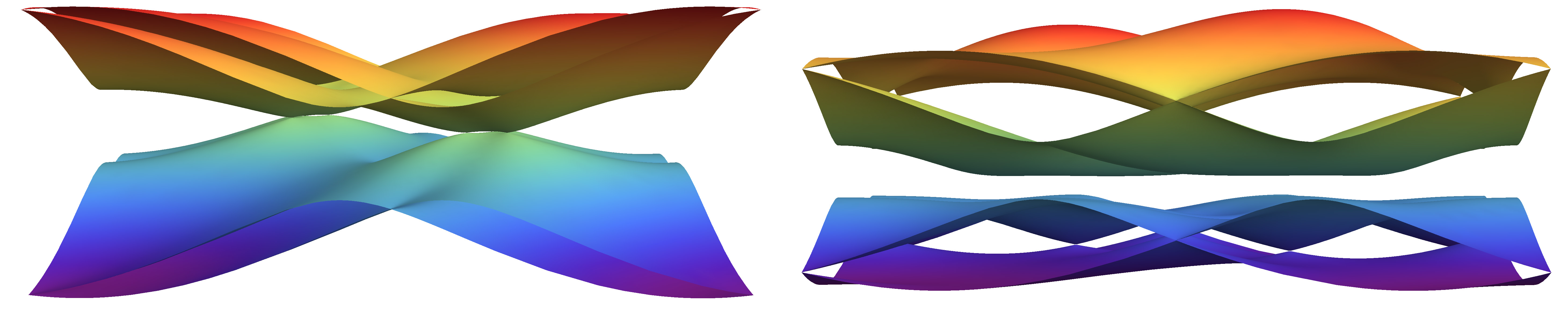

Si colocamos una gota de líquido en un campo eléctrico y se extiende a lo largo de la dirección del campo, formando chorros que rocían pequeñas gotas líquidas en cada extremo. Ahora Quentin Brosseau y Petia Vlahovska trabajando en la Universidad de Brown (EE.UU), han descubierto un nuevo comportamiento donde, en lugar de chorros, la gota produce anillos de líquido en su ecuador, tomando una forma parecida al planeta Saturno.

El efecto Brosseau-Vlahovska

Aparte de la curiosidad, ¿esto sirve para algo? Probablemente sí, pero esto acaba de descubrirse con lo que necesitaremos algún tiempo. Pero vayamos por partes.

La pulverización en chorros se produce cuando la gota se llena con un líquido que es más conductor que el fluido en el que está suspendido. Cuando se aplica un campo eléctrico el líquido en la superficie de la gota fluye desde el ecuador hasta los polos. Como resultado la gota se extiende a lo largo del eje polar, de modo que se asemeja a un balón de fútbol americano con dos conos puntiagudos en cada extremo. Las interfaces puntiagudas son inestables y hay pequeñas gotas de líquido que escapan continuamente. Este comportamiento es muy importante en algunas aplicaciones con las que estamos muy familiarizados: se produce en las nubes de tormenta y en las impresoras de chorro de tinta. En estos casos las gotas de líquido son más conductoras que el aire en el que están suspendidas.

En sus experimentos, Brosseau y Vlahovska invirtieron los términos usando una gota de aceite de silicio que era menos conductora que el fluido circundante de aceite de ricino. Esta vez, el líquido en la superficie fluyó al ecuador de la gota en lugar de a sus polos, haciendo que la gota de tamaño milimétrico se aplanara hasta adoptar la forma de una lente.

Al igual que en el caso anterior más la interfaz de la gota era inestable, arrojando finos anillos de líquido que posteriormente se rompían en microgotas de unos 10 micrómetros de tamaño. Este desprendimiento continuó durante unas pocas decenas de segundos hasta que la gota original se transformó en miles de microgotas de tamaño uniforme.

Este fenómeno aún no se entiende completamente desde el punto de vista teórico. Pero los científicos pueden especular con lo que han visto de momento. El proceso podría utilizarse para dosificar con precisión fármacos en partículas líquidas diminutas o para crear miles de microrreactores para experimentos de química de alto rendimiento. ¿Quién sabe? Lo mismo dentro de 10 años usamos un dispositivo de forma rutinaria que se base en este fenómeno y ni lo sepamos, como pasa hoy día con las impresoras.

Referencia:

Quentin Brosseau and Petia M. Vlahovska (2017) Streaming from the Equator of a Drop in an External Electric Field Phys Rev. Let. doi: 10.1103/PhysRevLett.119.034501

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Saturno en un vaso de aceite se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- Blandito no salpica

- Aislantes topológicos en sólidos amorfos

El diablo y Simon Flagg, una lectura ligera para el verano

Esta entrada del Cuaderno de Cultura Científica aparece justo en el ecuador del verano, a punto de terminar el mes de julio y de empezar el mes de agosto. Por este motivo, me ha parecido interesante traer a este espacio la recomendación de una lectura ligera, un cuento de apenas dos páginas, cuyo título es El diablo y Simon Flagg (1954), del escritor de ciencia ficción y matemático Arthur Porges (1915-2006).

En agosto de 2015, en la entrada titulada La chica que soñaba con una cerilla y un bidón de gasolina mostrabamos un ejemplo de una novela, y no una novela cualquiera, sino todo un bestseller, La chica que soñaba con una cerilla y un bidón de gasolina, del escritor sueco Stieg Larsson, en la cual aparecían algunas referencias a un resultado de la matemática teórica, exactamente de la teoría de números, el conocido como el último teorema de Fermat. De hecho, su protagonista Lisbeth Salander se pasaba toda la novela intentando probar dicho teorema, consiguiéndolo justo en las últimas páginas del libro.

Portada de la novela “La chica que soñaba con una cerilla y un bidón de gasolina” (Destino, 2008), de Sieg Larsson

En ese tiempo, estaba yo preparando mi artículo Avatares literarios del último teorema de Fermat, en el cual se realiza un recorrido por este resultado matemático, su historia y las diferentes reflexiones que el mismo ha motivado en la cultura y la sociedad, a través de más de cuarenta relatos y novelas que lo han incorporado a sus páginas, ya sea a través de sencillas referencias o como una parte fundamental de su argumento.

Pero expliquemos brevemente en qué consiste este resultado de la teoría de números, como ya se hacía en la entrada del Cuaderno de Cultura Científica que acabo de mencionar.

Leyendo el libro Arithmetica de Diofanto, el matemático francés Pierre de Fermat se planteó si, al igual que la ecuación del teorema de Pitágoras, , se cumplía para ternas de números enteros positivos, como (3, 4, 5), (5, 12, 13) o (8, 15, 17), las conocidas como ternas pitagóricas, también sería posible encontrar ternas de números enteros positivos que cumplieran la ecuación de Pitágoras, pero con potencias cúbicas,

, e incluso para potencias mayores que tres,

, con

. Fermat había escrito en uno de los márgenes del libro de Diofanto la siguiente frase (aunque en latín) “Tengo una prueba verdaderamente maravillosa para esta afirmación, pero el margen es demasiado estrecho para contenerla”. Sin embargo, no dejó escrita en ningún lugar, o no se encontró nunca, esa demostración.

A pesar de la afirmación de Fermat, y de que infinidad de matemáticos y matemáticas de todo el mundo intentaron desde entonces demostrar que no existían soluciones, con números enteros positivos, de la ecuación , para

, no fue posible demostrar completamente el conocido como “último teorema de Fermat” hasta que Andrew Wiles mostró su demostración al mundo en 1995, eso sí, con unas técnicas muy sofisticadas que no existían en la época de Fermat, 350 años antes.

Pero lo curioso del último teorema de Fermat, es que siendo un resultado de la matemática teórica, de esos que parecen un juego matemático sin ningún tipo de interés para la sociedad, ni aplicación a la vida real, terminó fascinando a la sociedad y calando en el arte y la cultura, principalmente tras la demostración de la conjetura en 1995.

Detrás del teorema matemático, y su demostración, se encontraba una historia fascinante, romántica y cautivadora, con los ingredientes necesarios para ser una buena historia: el resultado está escrito en el margen de un libro, su autor no es matemático de profesión sino jurista, la prueba mencionada en el margen no aparece, los grandes matemáticos fracasan uno tras otro en su intento de demostrarlo, un suicidio frustrado por la pasión puesta en el reto matemático, el teorema de indecibilidad de Gödel planea dudas sobre la existencia de una demostración, miles de aficionados tratan a su vez de resolver lo que los profesionales no han logrado, y cuando al fin surge un matemático prodigioso que anuncia la resolución, el propio Wiles, aparece un error en la prueba que tardará un año en ser corregido. Todos estos elementos, y algunos más, han conseguido fascinar a muchas personas. Esta era una historia con una gran fuerza narrativa y la literatura lo vio claro, incorporándola a sus páginas.

Como se decía en la novela en Londres después de la medianoche (Seix Barral, 2014), del escritor mexicano Augusto Cruz, “imposible no sentirse fascinado por la historia del último teorema de Fermat”.

Portada de la novela en “Londres después de la medianoche” (Seix Barral, 2014), de Augusto Cruz

Antes de la llegada de la demostración de Andrew Wiles, mientras que la comunidad matemática trabajaba sin descanso para demostrar la conjetura de Fermat que había sido formulada hacía trescientos años, la sociedad se quedó con la idea de que era un resultado extremadamente difícil de resolver, o incluso, imposible. Esta idea caló profundamente en la literatura. De hecho, en esta pequeña recomendación veraniega que traemos hoy aquí, se jugaba, en clave de humor, con la idea de que era un resultado matemático que no tenía solución.

En el relato de Arthur Porges, El diablo y Simon Flagg (1954), el matemático Simon Flagg reta al diablo a que le conteste a una pregunta difícil en menos de 24 horas, si lo hace se puede quedar con su alma, si no le dará 100 mil dólares al matemático. Y la pregunta no es otra que “¿Es cierto el último teorema de Fermat?”.

Pasado el tiempo, el diablo le contesta a Simon, “Tú ganas, Simón —dijo casi en un susurro, mirándolo con un respeto absoluto—. Ni siquiera yo puedo aprender en tan poco tiempo las matemáticas requeridas para un problema tan difícil. Cuanto más indago sobre él, más difícil se torna”. Y para enfatizar dicha dificultad añade “¿Sabes —confió el diablo— que ni siquiera los mejores matemáticos de otros planetas, todos mucho más avanzados que el tuyo, lo han resuelto? Vamos, hay un tipo en Saturno semejante a una seta con zancos que resuelve mentalmente ecuaciones diferenciales en derivadas parciales; y hasta él ha desistido”. A pesar de haber perdido la apuesta, el diablo finalmente se queda enganchado con este problema matemático y continúa intentando resolverlo.

Imagen de la publicación en castellano del relato “El diablo y Simon Flagg”, que apareció en la Revista Extensión (México), en 1981

Preparando mi artículo Avatares literarios del último teorema de Fermat, en el que podéis leer sobre la presencia del teorema de Fermat en la narrativa, descubrí una traducción al castellano, que está accesible en versión digital, del relato de Arthur Porges, originalmente escrito en inglés, que os traigo aquí como recomendación literaria para una tarde de verano. Este relato fue traducido y publicado en la Revista Extensión (México), en 1981, y digitalizado por la Universidad Veracruzana.

Esta es, por lo tanto, mi recomendación para una tarde de verano…

El diablo y Simon Flagg [PDF]

Bibliografía

1.- Raúl Ibáñez, Avatares literarios del último teorema de Fermat, Revista Epistémocritique (enviado para su publicación), 2017.

2.- Stieg Larsson, La chica que soñaba con una cerilla y un bidón de gasolina (serie Millenium, 2), Destino, 2008.

3.- Augusto Cruz, Londres después de la medianoche, Seix Barral, 2014.

4.- Arthur Porges, El diablo y Simon Flagg, Revista Extensión (México), n. 15, p. 22-23, 1981 (versión en castellano, el original es de 1954). Versión digital aquí.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El diablo y Simon Flagg, una lectura ligera para el verano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una paradoja del infinito: la oferta del diablo

- Técnicas de demostración para casos ‘desesperados’

- Más matemáticas para ver y tocar

Adiskiderik hoberenak, erraietatik

Datorren urtean estreinatuko den Alpha izeneko filmean istorio polita kontatzen da. Historiaurreko gizaki baten eta otso baten arteko harremanak gidatzen du kontakizuna. Dena horrela hasi omen zen, aurrerakinaren arabera. Ez zen horrela izan noski, baina berdin dio. Puristek esango dute, seguruenera, filmak historia desitxuratzen duela. Eta egia da, baina fikzioa fikzioa da, eta entretenitzeko zein jakin-mina pizteko balioa aitortu behar zaio.

Oso bestelakoa izan zen txakurren etxekotzea, zantzu guztien arabera. Gizakiak belaunaldiz belaunaldi egindako hautespenari esker, gaur egun mota guztietako txakurrak daude. Txakur horien eta otsoen portaera alderatuta, ondorio argia atera dute zientzialariek: antzeko baldintzetan hezita ere, txakurrak otsoak baino lagunkoiagoak dira. Gizakiei kasu gehiago egiten diete, eta emandako aginduak hobeto jarraitzen dituzte. Halako ondoriora iristeko, ordea, ez da ikerketa sakonik behar. Halere, zientzialariek desberdintasun horren arrazoi genetikoak bilatu dituzte. Eta, diotenez, aurkitu dituzte.

Science Advances aldizkarian argitaratu dituzte emaitzak. Txakurrak hain adiskidetsuak izatearen oinarria genetikan datza. Zehazki, GTF2I eta GTF2IRD1 geneak omen dira portaera hori arautzen dutenak, zientzialariek proposatutakoaren arabera.

1. irudia: Ikerketa egiteko txakurrak eta gatibutzan hezitako otsoak erabili dituzte. Irudian, otso horietako bat, ikertzaile baten alboan. (Argazkia: Monty Sloan/Science Advances)

Gizakiengan, gene horiek Williams-Beurenen sindromeari lotuta daude. Jaiotzatiko sindrome honek kognizioan eragina du, baina gaixotasunaren beste ezaugarri bat da hipersozializazioa eragiten duela. Sindromea dutenek pertsona ezezagunak berehala adiskidetzat jotzen dituzte. Eta hor da, hain zuzen, gizakien aurrean txakur gehienek erakutsi ohi duten jarrera.

Ikerketak bi bide jarraitu ditu. Batetik, portaeraren inguruko esperimentuak egin dituzte. Bestetik, analisi genetikoak egin dituzte. Bietatik atera dituzte ondorio interesgarriak.

Portaera ikertzeko, ariketa bat egin dute kanidoekin: arraza desberdinetako 18 txakur eta gatibutzan hezitako 10 otso erabili dituzte horretarako. Saltxitxa zati bat duen kutxa bat irekitzen irakatsi diete guztiei, baina ariketa hori egoera desberdinetan proposatu diete. Alboan gizakirik izan gabe, gizaki ezezagun bat alboan izanda, eta, azkenik, kanidoek aurretik ezagutzen zuten gizaki batez lagunduta.

Oro har, gizakiaren presentzia soila nahikoa izan da txakurren artean atazarekiko kontzentrazio maila jaisteko, gizakiari hurbiltzeko joera handiagoa izan delako. Hiru egoeratan, otsoek hobeto bete dute kutxa irekitzeko ariketa. Ikertzaileek adierazi dutenez, kontua ez da izan txakurrek gaitasun gutxiago izan dutela ariketa egiteko, baizik eta arreta gizakiengan jarri dutela, kutxan jarri beharrean.

Bigarren fase batean, gizaki batek animaliei hurbiltzeko dei egin die. Txakurrak zein otsoak, biak ala biak hurbildu dira gizakiarengana, baina otsoek denbora gutxiago eman dute pertsonaren alboan, eta lehenago bueltatu dira saltxitxa zati goxo hori eskuratzeko zereginetara.

Analisi genetikoari dagokionez, txakurren eta otsoen arteko desberdintasun genetikoetan sakondu dute. Izan ere, ikerketa honetan parte hartu duten hainbat zientzialarik aurretik ere identifikatua zuten desberdintasun horretan gako den gene bat: WBSCR17 izenekoa, hain zuzen. Emaitzak 2010ean argitaratu zituzten Nature aldizkarian.

Oraingoan, ordea, gizakiei eragiten dien sindrome bat izan dute abiapuntu. Princentongo Unibertsitateak zabaldutako ohar batean, ikerketaren egile nagusietako bat den Bridgett von Holdt biologoak azaldu du abiapuntu hau. “Williams-Beurenen sindromea dutenek zein txakurrek komunean duten antzeko portaera hau izan zen pentsarazi ziguna agian bi fenotipoen arkitektura genetikoan antzekotasunak egon zitezkeela”.

2. irudia: Txakurren jatorria argitzeak gizakiaren historia argitzen lagun dezake, azken 40.000 urteetan gizakiak txakurrak bidelagun izan dituelako. (Argazkia: Tim Mossholder/Unsplash).

Etxekotzearen oinarriakGizakien kanpalekuetara hurbiltzen ziren otsoak izan ziren lehen txakurren arbasoak. Orain arte, adituen artean gehien zabaldutako hipotesia izan da hasierako animalia horiek gaitasun kognitiboen arabera hautatuak izan zirela: gizakiek, batez ere, haien imintzioak eta ahotsa hoberen antzemateko gai ziren animaliak hautatzen zituzten etxekotzeko. Ikerketa honen egileek, ostera, bestelako proposamena egiten dute: gizakiengana hurbiltzeko joera handiagoa zuten animaliak izan ziren hautatuak.

Von Holdtek laburbildu duenez, “Gizaki primitiboek beraiekin egoteko nortasuna zuen otso batekin kontaktua egin bazuten, eta soilik mota honetako txakur primitiboak hezi bazituzten, orduan portaera soziala izateko ezaugarria handitu zuten txakurrengan”.

Azken urteetan, genetika ezinbesteko tresna bihurtu da gizakiaren adiskiderik hoberenak ulertzeko. Bereziki paleogenomika izan da baliagarria horretarako. Gainera, gizateriaren iragana ulertzeko tresna aproposa da txakurren eboluzioa aztertzea. Izan ere, etxekotu zenetik, txakurra gizakiaren ondoan egon da, eta txakurren bidea jarraitzeak gizakien migrazioa eta bizimodua hobeto ulertzea dakar ezinbestean. Harreman pribilegiatu honi esker, txakurrek arrakasta ebolutibo itzela izan dute, gizakiarekin batera, munduan zehar barreiatu baitira.

Halere, eta giza eboluzioan gertatu ohi den moduan, txakurren iragana zehazterakoan, oraindik orain datu kontrajarriak daude. Iaz Science aldizkarian plazaratutako ikerketa baten arabera, txakurrak bi leku eta garai desberdinetan etxekotuak izan ziren, Eurasiako bi muturretan: Europan eta Txinan. Hilabete honetan bertan Nature Communications aldizkarian argitaratutako beste ikerketa batek dio, aldiz, etxekotzea behin baino ez zela gertatu, duela 40.000 eta 20.000 urte bitartean. Etxekotzea behin ala bitan izan ala ez, aditu guztiak ados daude ideia berean: gaur egungo txakurrak, noizbait, bi taldetan banandu zirela. Ekialdeko Asiako arrazak, batetik, eta gainerako Eurasiako eta Afrikako arrazak, bestetik.

Erreferentzia bibliografikoa:

Bridgett M. von Holdt et al. Structural variants in genes associated with human Williams-Beuren syndrome underlie stereotypical hypersociability in domestic dogs – Science Advances 19 Jul 2017: Vol. 3, no. 7, e1700398 DOI: 10.1126/sciadv.1700398

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Adiskiderik hoberenak, erraietatik appeared first on Zientzia Kaiera.

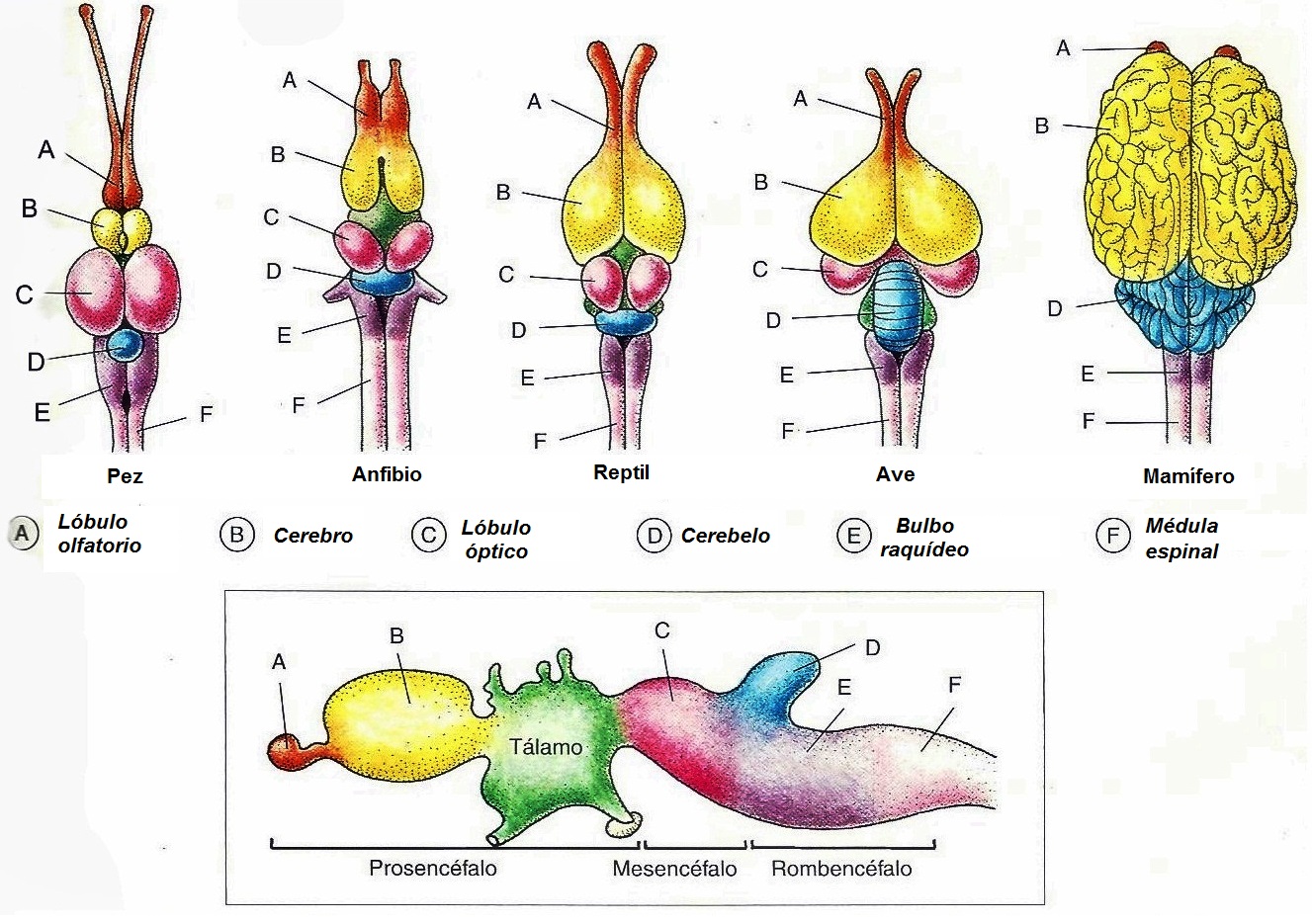

Evolución de los sistemas nerviosos: el tronco encefálico y el cerebelo

Panorama general del encéfalo de vertebrados

Como vimos en una anotación anterior, en el encéfalo de vertebrados puede diferenciarse un conjunto de estructuras en función de su origen embriológico. No obstante, siguiendo un criterio funcional, en el encéfalo adulto se consideran tres grandes áreas que no se corresponden exactamente con las anteriores. Son:

(1) el tronco encefálico, en el que se encuentran (1.1) la medulla oblongata o médula (correspondiente al diencéfalo embrionario), (1.2) el puente (procedente del metencéfalo embrionario) y (1.3) el mesencéfalo (que se corresponde al área embrionaria del mismo nombre) y que está integrado por el tectum y el tegmentum;

(2) el cerebelo que, junto con el puente, procede del metencéfalo; y

(3) el encéfalo anterior o prosencéfalo. Este último está, a su vez, integrado por: (3.1) el diencéfalo, que incluye (3.1.1) el tálamo y (3.1.2) el hipotálamo; y (3.2) el cerebro, que está formado por (3.2.1) los núcleos basales y (3.2.2) la corteza cerebral.

La lista anterior sigue una secuencia de abajo arriba, empezando por lo que se encuentra en la zona inferior del encéfalo y acabando con lo que se encuentra en la superior. Si se tratase de animales con una disposición corporal horizontal, habría que sustituir superior por anterior, e inferior por posterior. La lista refleja, además, una secuencia evolutiva: empieza por lo más antiguo y termina por lo que se ha desarrollado más recientemente. Con la excepción de los agnatos (sin mandíbula), todos los vertebrados comparten esa configuración, si bien el grado de desarrollo varía entre ellos.

Dedicaremos esta entrada a repasar el tronco encefálico y el cerebelo; y dejaremos las regiones del encéfalo anterior para más adelante.

El tronco encefálico

Es la estructura más simple del encéfalo y tiene una antigüedad de cerca de 500 millones de años. Establece la conexión entre el resto del encéfalo y la médula espinal. Aunque hay fibras que simplemente pasan a través del tronco, la mayor parte de ellas establecen conexiones sinápticas en su interior, por lo que interviene en importantes procesos, como son:

1. Procesos sensoriales y respuestas motoras en los que intervienen los llamados nervios craneales, con la excepción de los nervios olfatorio y óptico, que siguen trayectorias independientes. Por lo tanto, participa en el procesamiento de información sensorial procedente de la cabeza y en las respuestas dirigidas a sus órganos efectores.

2. Control reflejo del corazón, vasos sanguíneos, respiración y digestión. Este conjunto de funciones son las que participan en el mantenimiento de la constancia de las características del medio interno (homeostasia).

3. Modulación de las sensaciones de dolor.

4. Regulación de los reflejos musculares implicados en el equilibrio y el mantenimiento de la postura corporal.

5. Modulación de la actividad general del encéfalo a través de la formación reticular, red difusa de neuronas que forma parte del tronco encefálico. La formación reticular recibe múltiples inputs sinápticos y envía señales a la corteza cerebral para activarla o generar un estado de atención. El conjunto de vías ascendentes por las que se envían esas señales se denomina sistema de activación reticular.

6. Aunque tradicionalmente se había pensado que los centros responsables del sueño se encontraban en el tronco encefálico, la evidencia más reciente sugiere que tales centros se localizan en el hipotálamo.

El cerebelo

En todos los vertebrados que tienen cerebelo, éste tiene un conjunto similar de circuitos. En mamíferos y aves consiste de tres partes funcionalmente diferentes, que probablemente han experimentado una aparición secuencial a lo largo de la evolución de estos grupos. Cada una de ellas cumple ciertas funciones, pero en conjunto, su tarea consiste en el control inconsciente de la actividad motora.

El vestibulocerebelo se ocupa del mantenimiento del equilibrio y controla el movimiento de los ojos.

El espinocerebelo mejora el tono muscular y coordina los movimientos voluntarios para los que se requiere destreza. Esta región es especialmente importante para asegurar una adecuada ejecución temporal de las contracciones musculares en las que intervienen varias articulaciones. Recibe inputs de receptores periféricos que dan cuenta de los movimientos corporales y de las posiciones de cada momento. Actúa comparando las “órdenes” de los centros motores de la corteza con la ejecución real a cargo de los músculos, y corrigiendo las desviaciones o errores que se producen. Es incluso capaz de predecir la posición que tendrá una parte del cuerpo en el instante próximo y realizar los correspondientes ajustes.

El cerebrocerebelo interviene en la planificación y comienzo de los movimientos voluntarios, enviando señales a las correspondientes áreas corticales. También está implicado en las memorias de procedimiento, que son las que contienen la información relativa a movimientos aprendidos a base de entrenamiento repetitivo.

Fuente: Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: el tronco encefálico y el cerebelo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: el tamaño encefálico

- Evolución de los sistemas nerviosos: el tamaño de las regiones encefálicas

- Evolución de los sistemas nerviosos: el sistema central de vertebrados

La fe en las leyes de conservación

La energía “liberada” en una explosión nuclear es idéntica a la que tenía la bomba antes de explosionar.

La ley de conservación de la energía ha tenido un éxito enorme. Se cree tan firmemente que parece casi imposible que cualquier nuevo descubrimiento pueda refutarla. Sin embargo, en algunos experimentos, la energía parece aparecer o desaparecer en un sistema, sin que pueda ser explicado el fenómeno por cambios en formas conocidas de energía macroscópica. Por ejemplo, a medida que se añade calor a un cubo de hielo que está fundiéndose la temperatura del cubito de hielo no aumenta. En casos como este, históricamente los científicos han preferido asumir que el calor añadido toma la forma de una especie de energía aún no investigada, en lugar de considerar seriamente la posibilidad de que la energía no se conserva [1].

Así, el filósofo alemán Leibniz propuso en su momento que la energía podría ser disipada entre “las pequeñas partes” de los cuerpos. Avanzó esta idea específicamente para mantener el principio de conservación de energía en colisiones inelásticas y en procesos donde hay fricción. La fe de Leibniz en la conservación de la energía estaba justificada. Posteriormente se demostró que la “energía interna”, almacenada como movimiento de las partículas submicroscópicas en el material con el que se experimenta, cambió la cantidad exacta para explicar los cambios observados en la energía externa, como es el caso de un cubo de hielo que se funde.

Otro ejemplo similar es la “invención” del neutrino por Wolfgang Pauli en 1930. Los experimentos habían sugerido que la energía desaparecía en ciertas reacciones nucleares. Pauli propuso que en estas reacciones se producía una partícula subatómica desconocida e indetectable (con la tecnología disponible en aquel momento), que Enrico Fermi llamó el “neutrino”. Pauli propuso que el neutrino portaba parte de la energía. Los físicos aceptaron la teoría de los neutrinos durante más de 20 años, sin que se demostrase su existencia experimentalmente. Finalmente, en 1956, los neutrinos fueron detectados en experimentos con la radiación de un reactor nuclear. De nuevo, la fe en la ley de conservación de la energía resultó estar justificada.

La idea de “conservación” es tan poderosa en ciencia que los científicos creen que siempre estará justificada. Cualquier aparente excepción a la ley se entenderá tarde o temprano de una manera tal que no nos obligue a renunciar a la ley. A lo sumo, estas excepciones podrán conducirnos a descubrir nuevas formas de materia o energía, haciendo que la ley sea aún más general y poderosa [2].

El matemático y filósofo francés Henri Poincaré expresó esta idea en 1903 en su libro La Science et l’Hypothèse:

. . . el principio de conservación de la energía significa simplemente que hay algo que permanece constante. De hecho, sin importar las nuevas nociones que las experiencias futuras nos den del mundo, estamos seguros de antemano que habrá algo que permanecerá constante, y a lo que podremos llamar energía.

El descubrimiento de qué se conserva en la naturaleza constituye la colección [3] de logros más importante de las ciencias físicas. De hecho, estas leyes de conservación constituyen poderosísimas herramientas de análisis y todas afirman que, pase lo que pase en un sistema de cuerpos en interacción, ciertas propiedades medibles permanecerán constantes mientras el sistema permanezca aislado

Notas:

[1] A este respecto pude ser interesante leer El tribunal de la experiencia sobre el concepto de hipótesis auxiliar.

[2] La teoría de la relatividad y los estudios de las reacciones nucleares, como en el caso del neutrino, permitió generalizar la ley de conservación de la energía a la ley de conservación de la masa-energía, siendo masa y energía dos formas equivalentes según E = mc2, donde c es la velocidad de la luz en el vacío. Esto no es más que una generalización de la primera ley de la termodinámica.

[3] La colección se ha ampliado en las últimas décadas gracias a los avances en física de partículas. Esta es una lista parcial de las leyes de conservación conocidas. Hay otras candidatas pendientes de más datos.

Masa-Energía.

Momento lineal.

Momento angular.

Carga eléctrica.

Carga de color.

Isoespín débil.

Probabilidad.

Simetría CPT.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La fe en las leyes de conservación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Se intuye la conservación de la energía (1)

- De las leyes de conservación (I)

- De las leyes de conservación (y III)

Eguneroko zientzia

Rosalind Franklin: “Zientzia eta eguneroko bizitza ezin dira bereizi eta ez dute bereizita egon behar”.

—————————————————–

Egileez: Eduardo Herrera Fernandez, Leire Fernandez Inurritegi eta Maria Perez Mena UPV/EHUko Letraz – Diseinu Grafikoko eta Tipografiako Ikerketa Taldeko ikertzaileak dira.

—————————————————–

Aipua eta irudia UPV/EHUko Zientzia Astea: Alfabetatze zientifikoa Alfabetización científica liburutik jaso dugu. Eskerrak eman nahi dizkiegu egileei eta UPV/EHUko Zientzia Astearen arduradunei, edukia blogean argitaratzeko baimena emateagatik.

The post Eguneroko zientzia appeared first on Zientzia Kaiera.

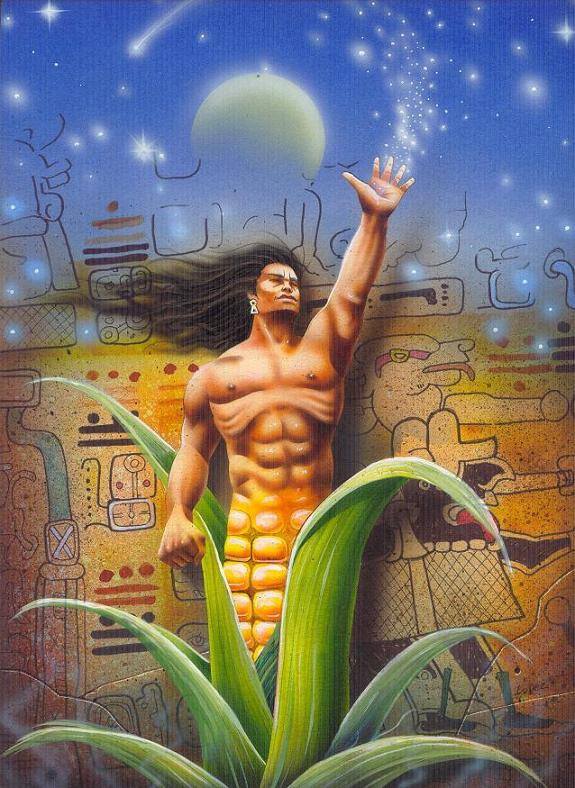

Ingredientes para la receta: El maíz

“Únicamente masa de maíz entró en la carne de nuestros padres, los cuatro hombres que fueron creados.”

Popol Vuh, Libro Sagrado de los Mayas.

El maíz, de nombre científico Zea mays, pertenece a la familia Graminiae, y es, por tanto, una gramínea como el arroz, el trigo, el centeno o la avena. Es el cereal más importante de la dieta en Latinoamérica y en África, y el segundo cereal más cultivado en el planeta. Proviene de América, donde mantiene una gran diversidad de tipos y es su centro Vavilov. Llegó a la templada Europa y a Asia y África en los siglos XVI y XVII. Era un alimento seguro y barato y lo fue durante siglos, sobre todo en Europa central. También alimentaba a los esclavos en el tráfico de África hacia América.

En el siglo XX, la producción de maíz aumentó con la mejora en las semillas, los regadíos, los nuevos abonos, los pesticidas y los nuevos usos del cereal en la industria y en la dieta. En Europa y Norteamérica, las cosechas se doblaron y, después, se triplicaron. Es una planta con facilidad para adaptarse a diferentes entornos, gran poder energético y fácil cosecha. En muchos países en desarrollo está desplazando a cultivos tradicionales más problemáticos.

Es, también, uno de los principales cultivos para alimentar al ganado. Es más, en la actualidad se siembra sobre todo para su uso como pienso. Ellen Messer afirma que solo un quinto del maíz sembrado va a la dieta humana, dos tercios son para el ganado y un décimo para alimentos procesados e, incluso, para productos que no se usan en alimentación.

El maíz crece entre los 50º de latitud norte, en Rusia y Canadá, hasta casi los 50º de latitud sur, en Sudamérica. Lo hace a altitudes bajo el nivel del mar, en las llanuras del mar Caspio, hasta los 3600 metros de altura, en los Andes del Perú, y con precipitaciones desde 250 mililitros, en Rusia, hasta más de 10000 mililitros, en la costa de Colombia hacia el Pacífico, y con tiempos de crecimiento que van de los 3 a los 13 meses.

Las variedades del maíz tienen características a veces muy diferentes. Las plantas tienen de 70 centímetros a 6 metros de altura, de 8 a 48 hojas por planta, de 1 a 15 troncos por semilla sembrada, con mazorcas de 7 a 70 centímetros de longitud. Además, tienen diferentes distribuciones geográfica, climática y de resistencia a las plagas. Como dijo algún experto hace décadas, los primeros que cultivaron el maíz crearon “una de las plantas cultivadas más heterogéneas que existen.”

El rendimiento es de 2.5 toneladas por hectárea de media en los países en desarrollo hasta las 6.2 toneladas por hectárea en los países industrializados. Es en el Medio Oeste de Estados Unidos donde, desde el final de la Segunda Guerra Mundial, se cosecha más de la mitad de la cosecha mundial de maíz. En el año 2008 fueron algo más de 300 millones de toneladas. El segundo productor mundial es China, y el tercero Brasil. Entre Estados Unidos, China, Francia, Argentina, Hungría y Thailandia controlan el 95% del comercio mundial de maíz que varía entre 60 y 70 millones de toneladas, la mayoría para alimentación animal. España, en 2008, produjo algo más de 3.5 millones de toneladas.

El maíz sigue siendo un componente importante en la dieta en las regiones en que se domesticó: México, América Central, el Caribe y en los Andes en Sudamérica. Y se ha convertido en un componente esencial de la dieta en África Oriental, en parte de Indochina y en algunas regiones de China. El consumo más alto por persona es de casi 100 kilogramos al año en México, Guatemala y Honduras, donde se prepara como tortillas. En estas regiones, más África y Rumania, supone el 70% de las calorías de la dieta. En África Oriental se come como gachas.

Sin embargo, como ya he escrito más arriba, el uso más significativo del maíz es como alimento del ganado y, en último término, como carne, leche y otros productos en la dieta humana. En Estados Unidos, más de la mitad del maíz cosechado es para el ganado y en Alemania llega a las tres cuartas partes. En países como Pakistán, India o Egipto, el maíz como pienso para el ganado es más caro que el maíz como alimento humano.

Hay más de 300 variedades de maíz, muchas de ellas con decenas de linajes. Pero su ancestro salvaje sigue siendo un misterio, cada vez más claro por las investigaciones como veremos ahora, pero todavía objeto de debate tanto sobre la especie originaria como sobre la región geográfica donde ocurrió la domesticación.

Dos matas de teosinte

El origen parece estar en el teosinte, que pueden ser varias subespecies de la especie Zea mays, la misma que el maíz cultivado. Es una hierba de gran porte que crece en México y Guatemala. Ya Vavilov, en 1931, propuso al teosinte como antepasado del maíz. Entre las hierbas conocidas como teosinte hay cuatro con el mismo número de cromosomas que el maíz y que pueden hibridar con él y entre sí.