Asteon zientzia begi-bistan #517

Asteon zientzia begi-bistan igandeetako gehigarria da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna jaso eta laburbiltzea da gure helburua.

Karbono dioxidoak (CO₂) beroari eusteko duen eraginkortasuna bere egitura kuantikoari esker da. Harvardeko ikertzaileek aurkitu dute CO₂ molekulen bi mugimendu (hula-hoop eta luzatze-malguki modukoak) elkarrekin nahasten direla Fermiren erresonantzia deritzon fenomenoaren bidez. Horri esker, CO₂-ak argi infragorria modu bereziki eraginkorrean xurgatzen du, berotegi-efektua areagotuz. Aurkikuntza honek CO₂-ren eskala logaritmikoaren oinarriak argitzen ditu eta klima-aldaketa mekanika kuantikoko oinarriekin azaltzeko aukera ematen du. Azalpen guztiak Zientzia Kaieran.

Edward Page Mitchellen Takiponpoa kontakizunean, oztopo bat gainditzeko asmoz, maitemindutako bikote batek garraiobide iraultzaile bat erabiltzen du. Takiponpoa antipoden arteko zulo bat da, Lurraren erditik igarotzen den tunel ideala. Zientzia Kaieran Víctor Etxebarria Sistemen Ingeniaritzako eta Automatikako katedradunak tramankulu horren ebazpen matematiko eta fisikoetako batzuk azaltzen ditu. Hala nola, grabitatearen legeak aplikatuta, objektuak linealki beheranzko azelerazioarekin erortzen dira, Lurraren erdigunean abiadura maximoa lortuz. Beraz takiponpoan pakete batek 42 minutu besterik ez ditu behar beste puntara iristeko, energiarik gastatu gabe.

GenetikaDepresioaren genetika aztertzeko inoizko metaanalisi handienean, 700 aldaera genetiko eta 300 gene inguru identifikatu dira, neurona eta emozio-kontrolaren eremuetakoekin lotuta. Aurretik gehienbat jatorri europarreko populazioetan egin dira ikerketak, diskriminazio genetiko eta terapeutikorako arriskua sortuz. Egindako aurkikuntzek tratamendu berrien garapena ahalbidetu dezakete, hala nola, pregabalina eta modafinila depresioaren aurka bideratzea. Ikertzaileek azpimarratu dute ikerketak beste populazioetan zabaltzearen garrantzia, ikuspegi inklusiboago bat lortzeko. Emaitzak Cell aldizkarian argitaratu dituzte. Informazioa Elhuyar aldizkarian.

MatematikaJosu Doncel Matematikan doktoreak Hanoiko dorrea jokoa azaltzen du Zientzia Kaierako artikuluan. Indiako kondaira batean oinarritutako jokoa da, non 64 disko hiru zutoinen artean ordenan mantenduz mugitu behar diren. Kondairak dio, monjeek azken diskoa lekuz aldatzean, mundua amaituko dela. Matematiken bidez kalkulatuta, disko guztien mugimenduak 264−12^{64} – 1264−1 segundu behar ditu, hau da, 500.000 milioi urte baino gehiago. Metodo errekurtsiboa erabiliz, diskoen mugimenduak planifikatu daitezke, baina emaitzek erakusten dute ez garela munduaren amaieratik gertu, kondaira egiazkoa balitz ere.

BiologiaOlga Ibañez Solék, Biologia eta Bioinformatikan aditua, zahartzeak DNAri eta geneen erabilerari eragiten dizkion kalteak ikertzen ditu. Bere doktoretzan, genoma ez dela uniformeki kaltetzen ondorioztatu zuen; gene luzeek, bereziki sinapsi neuronalekin lotutakoek, kalte handiagoak jasaten dituzte, eta horrek neurodegenerazioan izan dezake eragina. Ikerketa hau alzheimerraren eta beste gaixotasun neurodegeneratiboen ulermenean lagungarria izan daiteke. Gaur egun, Alemanian, haur goiztiarren biriken zahartze goiztiarra ikertzen ari da. Zientzialari honen inguruko informazio gehiago UEU webgunean.

Adimen artifizialaAdimen artifizial sortzailearen inpaktu sozial eta ingurumenekoak aztertu dituzte eta Environmental Science and Ecotechnology aldizkarian argitaratu dute ikerketa. Ondorioek hardwarearen hondakinak, karbono-aztarna, energia-kontsumoa eta gizartean eragindako arrakala digitala eta diskriminazioa nabarmentzen dituzte. Proposamenen artean, komunitateekin lankidetza, lan-baldintzen hobekuntza, eta gobernantza etikoa azpimarratzen dira. Etorkizunerako, inpaktuak ebaluatzeko eredu integralak eta gardentasun handiagoa eskatzen dituzte, garapen jasangarria eta etikoa lortzeko helburuarekin. Datuak Elhuyar aldizkarian.

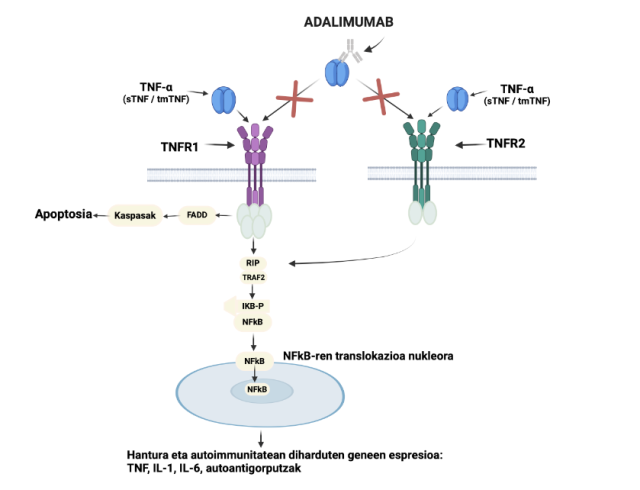

FarmakologiaArtritis erreumatoidea gaixotasun kroniko eta autoimmunea da, zeinean immunitate sistemaren gehiegizko aktibazioak artikulazioen suntsipena eragiten duen. Horrek hantura, mina eta ezgaitasuna dakar, gaixoaren bizi kalitatea nabarmen murriztuz. Tratamenduen helburua sintomak arintzea eta gaixotasunaren garapena moteltzea da. Adalimumab, antigorputz monoklonala, immunitate sistema modulatzeko gaitasuna du eta 2002tik oinarrizko tratamendu bihurtu da. Larruazalpeko injekzio bidez administratzen da, eta eraginkortasuna eta segurtasuna erakutsi du epe luzeko entseguetan. Etorkizuneko ikerketek terapia berriak garatzea bilatzen dute, baina gaur egun, adalimumabak funtsezko rola betetzen du. Azalpenak Zientzia Kaieran.

Itsas biologiaIdelisa Bonnelly Dominikar Errepublikako itsas zientzien aitzindaria izan zen, Karibeko itsas kontserbazioaren ama gisa ezaguna. Columbian itsas biologia ikasi ondoren, bere herrialdera itzuli zen eta 1966an Itsas Biologiako Institutua (CIBIMA) sortu zuen, itsas ikerketa eta prestakuntza sustatzeko. Banco de la Plata xibartentzako santutegi bihurtzea lortu zuen, Atlantikoan babestutako lehen eremua. Bere lanak nazioarteko ospea ekarri zion, hainbat sari eta aintzatespen lortuz. Fundemar erakundea sortu zuen kostaldeko baliabideen erabilera jasangarria bultzatzeko. Zientzialari honen inguruko informazio gehiago Zientzia Kaieran.

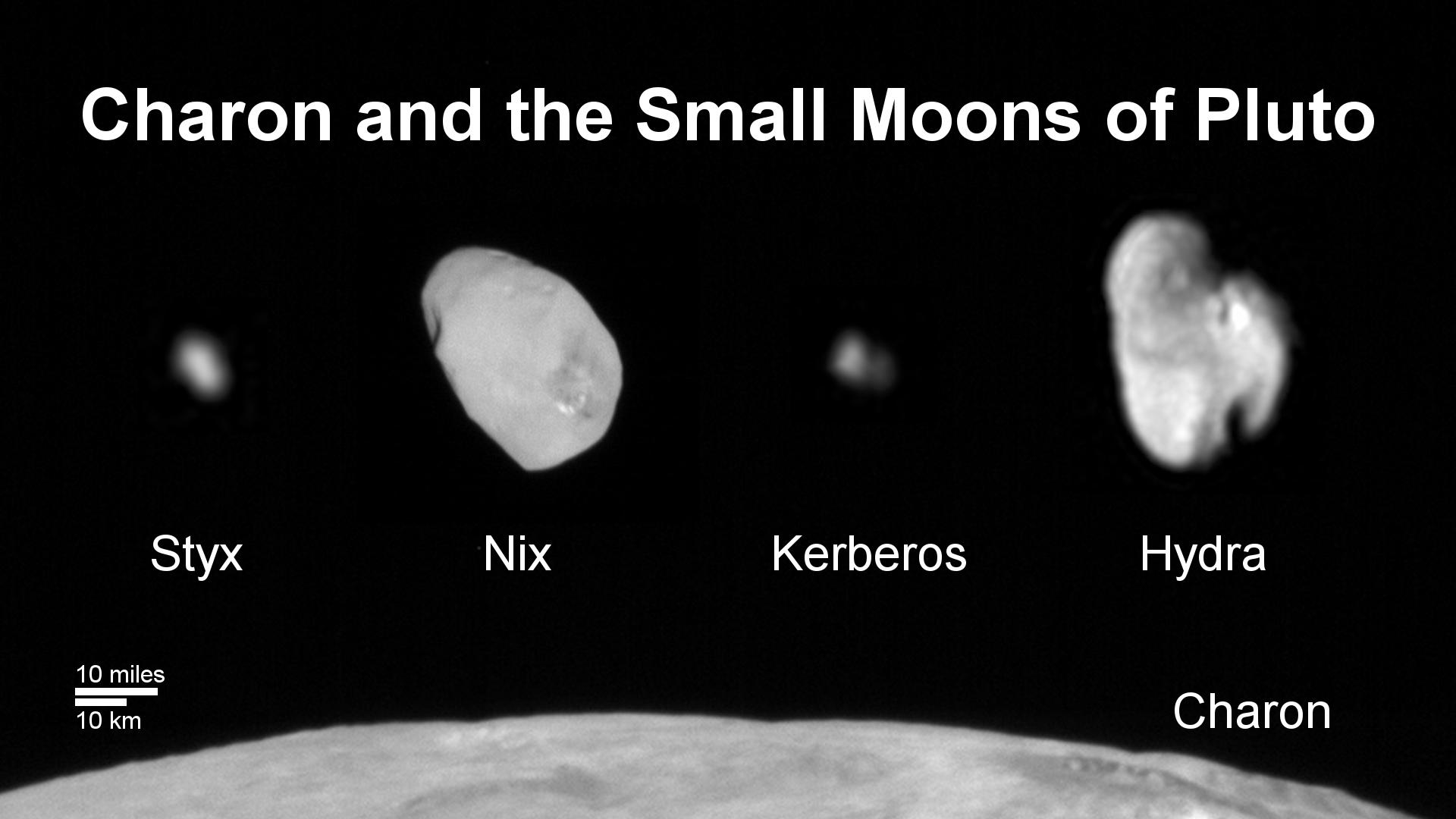

AstrofisikaDIPCko eta Singapurko ikertzaileek material berri bat sortu dute, axioien portaera (materia ilunaren osagai hipotetikoa) imitatzeko gai dena. Material topologiko eta fotonikoak uztartuz, argia norabide bakarrean gidatzen duen kristal egitura diseinatu dute, axioien ezaugarriak errepikatuz. Horrek materia iluna detektatzeko bide berriak ireki ditzake. Materia iluna ulertzeko gakoa izan daitezkeen axioiak detektatzea zaila denez, tresna honek zientzialariei hipotesiak egiaztatzeko aukera ematen die, unibertsoaren ezezaguna argitzeko bidean aurrerapauso esanguratsua izanik. Informazioa Berrian.

Egileaz:Enara Calvo Gil kazetaria da eta UPV/EHUko Kultura Zientifikoko Katedraren komunikazio digitaleko teknikaria.

The post Asteon zientzia begi-bistan #517 appeared first on Zientzia Kaiera.

Naukas Bilbao 2024: El sexo obliga a cocinar

La decimocuarta edición del mayor evento de divulgación científica volvió al Palacio Euskalduna de Bilbao durante los días 19, 20, 21 y 22 de septiembre de 2024.

Esa fuerza de la naturaleza que es Juan Antonio Cuesta, Catedrático de estadística (jubilado «desde el 7 de octubre de 2024 por la mañana») de la Universidad de Cantabria, explica por qué el que las personas mientan a la hora de responder encuestas implica que es necesario «cocinarlas».

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2024: El sexo obliga a cocinar se ha escrito en Cuaderno de Cultura Científica.

Ezjakintasunaren kartografia #524

Ezjakintasunaren kartografian astean zehar Mapping Ignorance blogean ingelesez argitaratutako artikuluen mamia euskaraz biltzen duen gehigarria da.

Errealismo zientifikoa egiarekiko hurbilketa bat bezalakoa bada, ez da harritzekoa zientzia-filosofo askok egiantzekotasunaren kontzeptuaren definizio on bat lortzeko ahalegina egin izana. Jesús Zamoraren Closer to the truth (2): The ugly duckling problem.

Medikuntza izeneko zientzia aplikatu bat existitzeko bezain antzekoak gara pertsonak gure artean, baina aldeak nahiko esanguratsuak dira medikuntza artisau lantzat hartzeko, artisau hobeekin edo okerragoekin. Hau ere entzefaloari eta bere adierazpenei aplikatzen zaie: Person-to-person variation in brain dynamics

Mutazioek berez ez dakarte leuzemia bezalako minbizia garatzea. Beste faktore batzuek ere eragiten dute haien agerpena. TRAF6 functions as a tumor suppressor in myeloid malignancies por Marta Irigoyen.

Material sinple eta egituratu gabeko plataforma batean polaritoiak kanalizatzeko gaitasunak aukera interesgarriak ematen dizkio nanofotonikari. DIPC jendeak Polariton loss-induced canalization in thin slabs

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #524 appeared first on Zientzia Kaiera.

Identificadas estrellas individuales en el universo distante

Un equipo internacional de astrónomos/as entre los que se encuentra el investigador Ikerbasque Tom Broadhurst, que desarrolla su trabajo en la Universidadd el País Vasco (UPV/EHU) y DIPC- Donostia International Physics Center- fotografió más de 40 estrellas individuales en una galaxia tan lejana que su luz ha tardado la mitad de la edad del universo en llegar hasta nosotros.

Arco del Dragón en Abell 370. Fuente: Hubble / NASA

Arco del Dragón en Abell 370. Fuente: Hubble / NASAUtilizando el Telescopio Espacial James Webb (JWST) de la NASA, observaron una galaxia a casi 6.500 millones de años luz de la Tierra, momento en que el universo tenía la mitad de su edad actual. En esta galaxia distante, el equipo identificó 44 estrellas individuales, visibles gracias al uso de lentes gravitacionales y a la alta sensibilidad del JWST. Este descubrimiento marca un logro sin precedentes: el mayor número de estrellas individuales detectadas en el universo distante. Además, abre una vía para investigar uno de los mayores misterios del universo: la materia oscura.

El equipo de astrofísicos localizó estas estrellas mientras inspeccionaban imágenes del JWST de una galaxia conocida como el Arco del Dragón, ubicada en la línea de visión desde la Tierra detrás de un cúmulo masivo de galaxias llamado Abell 370. Debido a la gravitación (por la inmensa masa de este cúmulo) se produce el llamado efecto de lente gravitacional, deformando la luz que nos llega de lo que esté detrás (el arco de dragón) y haciéndonos ver ese pasillo de proporciones cósmicas en lugar de la característica espiral. Que es lo que se vería sin ese efecto.

El equipo analizó los colores de cada una de las estrellas dentro del Arco del Dragón y descubrió que muchas son supergigantes rojas, similares a Betelgeuse en la constelación de Orión, que se encuentra en las etapas finales de su vida. Esto contrasta con descubrimientos anteriores, que identificaron predominantemente supergigantes azules, como Rigel y Deneb, que se encuentran entre las estrellas más brillantes del cielo nocturno. Según los investigadores, esta diferencia en los tipos estelares también destaca el poder único de las observaciones del JWST en longitudes de onda infrarrojas.

La mayoría de las galaxias, incluida la Vía Láctea, contienen decenas de miles de millones de estrellas. En galaxias cercanas como Andrómeda, las científicas y científicos pueden observar las estrellas una por una. Sin embargo, en galaxias a miles de millones de años luz, las strellas aparecen combinadas, ya que su luz debe viajar miles de millones de años antes de llegar a nosotros, lo que representa un desafío constante para los y las científicas que estudian cómo se forman y evolucionan las galaxias. Las galaxias que están muy lejos suelen parecer una mancha difusa y borrosa, y aunque estuvieran formadas por muchísimas estrellas individuales, hasta la fecha no había sido posible identificarlas una a una por las limitaciones de los telescopios.

Se espera que futuras observaciones con el JWST capturen más estrellas magnificadas en la galaxia del Arco del Dragón. Estos esfuerzos podrían conducir a estudios detallados de cientos de estrellas en galaxias distantes. Además, estas observaciones de estrellas individuales podrían proporcionar información sobre la estructura de las lentes gravitacionales e incluso arrojar luz sobre la esquiva naturaleza de la materia oscura, ya que como concluyen en un reciente artículo el equipo de la UPV/EHU-DIPC, formado por el propio investigador Ikerbasque Tom Broadhurst, junto a George Smoot, galardonado con el Premio Nobel de Física y la estudiante de doctorado Paloma Morillo, las posiciones de las estrellas en el arco del dragón implican que la materia oscura es similar a ondas en lugar de partículas pesadas.

Referencia:

Fudamoto, Y., Sun, F., Diego, J.M. et al. (2025) Identification of more than 40 gravitationally magnified stars in a galaxy at redshift 0.725. Nat Astron doi: 10.1038/s41550-024-02432-3

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Identificadas estrellas individuales en el universo distante se ha escrito en Cuaderno de Cultura Científica.

Idelisa Bonnelly, Karibeko itsas kontserbazioaren ama

Idelisa Bonnelly zientzialaria (1931-2022) Latinoamerikako ikertzaile eta irakasle oparoa izan zen. Bere herrialdean, Dominikar Errepublikan, itsas zientzien garapenaren aitzindari izan zen, 1960ko hamarkadatik aurrera. Ikertu zituen arlo nagusiak itsas biologia eta kostaldeko eta itsasoko baliabideen kudeaketa izan ziren.

Idelisa Bonnelly 1931ko irailaren 10ean jaio zen Dominikar Errepublikaren erdiguneko Santiago de los Caballeros hirian, haran eta mendi artean. Oraindik umea zela, familia Santo Domingora, hiriburura, joan zen bizitzera. Bertan, Idelisa kostaldeko itsaslabarretatik oso gertu hazi zen. Arroken artean sortzen ziren putzu txikietan ezkutatuta zeuden karramarroak, barraskiloak eta txirlak bilduz entretenitzen zen, eta arraina jaten zuenean, galdera asko etortzen zitzaizkion burura: nondik zetozen arrainak, nola bizi ziren, nola egiten zuten arnas, nola elikatzen ziren, nola ugaltzen ziren, eta abar. Eta jakingura horrek bultzatu zuen ikastera, bere zalantzen erantzunak aurkitzen saiatzeko.

1. irudia: Idelisa Bonnelly, Latinoamerikako ikertzaile eta irakaslea, Dominikar Errepublikan itsas zientzien garapenaren aitzindari izan zen. Iturria: Mujeres con Ciencia)

1. irudia: Idelisa Bonnelly, Latinoamerikako ikertzaile eta irakaslea, Dominikar Errepublikan itsas zientzien garapenaren aitzindari izan zen. Iturria: Mujeres con Ciencia)Garai hartan, unibertsitate bat besterik ez zegoen herrialdean: Santo Domingoko Unibertsitate Autonomoa. Baina bertan ez zegoen zientzia fakultaterik, eta ez zen biologiarik ematen. Hala ere, landareak eta animalia lehortarrak aztertzen zituzten naturalista dedikatu batzuk bazeuden han. Bigarren Hezkuntza amaitzean, beste orientaziorik gabe, Idelisak New Yorkera joatea erabaki zuen, han ikasten jarraitzeko. Westchester Community Collegen graduatu zen teknologo mediko gisa. Ikastegiko ikasle latino bakarra izan zen, baita bere klaseko nota onenak lortu zituena ere. Irakasleek, Idelisaren gaitasun eta interesen jakitun, unibertsitatean sartu eta biologia ikastea gomendatu zioten, ondoren itsas zientzietan espezializatu ahal izateko.

Eta horixe egin zuen. Columbia Unibertsitatean eman zuen izena gradua egiteko, eta itsas biologiako lizentzia eskuratu zuen 1956an. Ondoren, bost urte geroago, graduondoko maisutza lortu zuen New Yorkeko Unibertsitatean. Bonnellyk New Yorkeko Zoologikoan eginiko aldi baterako lanen bidez finantzatu zuen bere prestakuntza. Ikasketak amaitu ondoren, New Yorkeko akuarioan hasi zen lanean, Ross F. Nigrelli eta Sophie Jakowskaren ikerketa laguntzaile gisa. Bi horiek itsas zientzialari ospetsuak ziren eta ikerketa laborategia zuzentzen zuten. Idelisa akuarioko espezimenen osasuna mantentzeko arduraduna zen. Aldi hori erabakigarria izan zen Idelisaren ikertzaile prestakuntzan, eta “entrenamendurik onena eta anitzena” izan zela esango zuen aurrerago.

Dominikar Errepublikarako itzuleraBere karrera zientifikoa AEBn eraikitzen jarraitu ordez, Bonnellyk erabaki zuen bere herrialdera itzultzea, eta itsas zientziak berarekin eramatea. Rafael Leónidas Trujilloren (1930-1961) diktadura amaitu berri zen; zalantzarik gabe, Latinoamerikako tirania odoltsuenetako bat. Etxera itzultzean, zientzialariak huts handia sentitu zuen irakaskuntza eta ikerketa zientifikoaren esparruan, baina baita aldaketarako borondate handia ere, askatasunean, demokrazian, ekitatean eta espiritu kritikoan oinarritutako gizarte berri bat eraikitzeko.

Santo Domingoko Unibertsitate Autonomoan sartu zen. Bere helburua zen itsas ingurugiroaren zientziak sustatzea 1966an ezarritako Itsas Biologiako Institutuaren bidez. Izan ere, erakunde hori lehena izan zen herrialdean biologiaren arloko ikerketa gauzatzen. Gerora, Itsas Biologiako Ikergune bihurtu zen (CIBIMA).

2. irudia: Beste irakasle eta aholkulari batzuekin batera, Idelisa Bonnellyk herrialdeko lehen Biologia Eskolaren sorrera sustatu zuen. (Iturria: Mujeres con Ciencia)

2. irudia: Beste irakasle eta aholkulari batzuekin batera, Idelisa Bonnellyk herrialdeko lehen Biologia Eskolaren sorrera sustatu zuen. (Iturria: Mujeres con Ciencia)Hasierako uneak zailak izan ziren, giza baliabide eta baliabide materialen faltagatik —ekipo zaharrak lagatzeko eskatu eta konpondu egin behar izan zituzten, eta/edo beste laborategi batzuk erabili CIBIMA finkatzen zen bitartean—. Besteak beste, biokimika, histokimika eta parasitologiako bere ezagutzak baliatuta, Bonnellyk oso motibatuta zeuden irakasleen eta ikertzaileen talde txiki bat prestatu zuen; eta, handik gutxira, beren ikerketen emaitzak hasi ziren argitaratzen nazioarteko aldizkari zientifikoetan.

Beste irakasle eta aholkulari batzuekin batera, Idelisa Bonnellyk herrialdeko lehen Biologia Eskolaren sorrera sustatu zuen, zeinaren helburu nagusia baitzen zientzialari eta ikertzaile kualifikatuak prestatzea Dominikar Errepublikan zientzia biologikoen garapenerako ateak irekitzeko,eta, horren bidez, lurreko zein itsasoko natura mehatxatzen zuten ingurugiroko arazoei erantzuna emateko.

Kontserbaziora bideratutako karreraBere ibilbidearen hasieran, itsasoari eta haren baliabideei buruz zeuden ezagutzak urriak ziren, baina agerikoa zen jada kostaldeko inguruak degradatzen ari zirela eta espezie asko murrizten ari zirela, bereziki arrantzakoak. Berariazko erregulazioak oso mugatuta zeuden. Hori dela eta, CIBIMAk herrialdeko kostaldeko espezieen lehen azterketa taxonomikoak abiarazi zituen, zenbait espezieren (otarraina, karramarroa, izkira, etab.) debekualdiak ezartzeko. Horrez gain, ikerketa biokimikoak ere abiarazi zituzten, itsas elikagaien kalitatea kontrolatzeko. Bonnelly ekimen gehienetan egon zen inplikatuta.

Zientzialariak etengabe borrokatu zuen bere bizitzan eta ibilbide profesionalean ozeanoetako biodibertsitatea babesteko. Gauza asko lortu zituen, baina bereziki nabarmentzekoa da 1986an Ipar Atlantikoko xibartentzako lehendabiziko eremu babestua sortu zuela. Garai hartan, Banco de la Plata arrantzarako gunea besterik ez zen. Bonnellyren lana erabakigarria izan zen ulertzeko gune hori baleen ugalketarako lekurik garrantzitsuena zela, eta baleak desagertzeko arriskuan zeudela. Egun Bancos de la Plata y la Navidad Santutegi gisa ezaguna den eremu hori Ozeano Atlantikoan eremu babestu izendatutako lehena izan zen, baita munduan lehenetarikoa ere. Ekarpen horrengatik, Idelisa Bonnellyk hainbat aintzatespen jaso zituen: Zientziako Emakume Dominikarrarentzako Merezimendu Domina, Dominikar Errepublikako Gobernuaren eskutik (1986); Zientzietako Sari Nazionala, Dominikar Errepublikako Zientzien Akademiaren eskutik (1987); eta Nazio Batuen Ingurumen Programak (NBIP) Global 500 Ohorezko Koadroan sartu zuen (1987).

3. irudia: Xibarta Bancos de la Plata y la Navidad Santutegian. (Iturria: Mujeres con Ciencia)

3. irudia: Xibarta Bancos de la Plata y la Navidad Santutegian. (Iturria: Mujeres con Ciencia)Bonnellyren ekoizpen zientifiko zabala nazioartean erabili izan da itsas eta kostaldeko Ingurumen Zuzenbidean eragiteko, eta zientzialariak askotariko aintzatespenak jaso zituen bere lan bikainagatik. Zientzien Akademiako akademiko izendatu zuten 2007an, Corripio Fundazioak Ekologiako Sari Nazionala eman zion 2008an, eta UNESCOren Marie Curie domina jaso zuen 2009an. 2010ean, Victoriako Biologiaren Kontserbaziorako Sozietateak (Columbia Britainiarra, Kanada) Biologiako Zerbitzu Nabarmenaren saria eman zion; eta, 2011n, Orden al Mérito de Duarte, Sánchez y Mella izeneko saria eman zioten, herrialdeko gobernuak ematen duen garrantzitsuena. 2013an, BBCk Latinoamerikako hamar emakumezko zientzialari garrantzitsuenen artean sailkatu zuen.

Unibertsitatetik erretiratu ondoren, Bonnellyk Itsas Ikasketen Fundazio Dominikarra sortu zuen, Fundemar. Erakundearen helburua zen ekosistemen eta baliabideen erabilera jasangarria sustatzea, ikerketaren, hezkuntzaren eta kontserbazio proiektuen garapena babestearen bidez. Proiektu hori lanerako plataforma berri bat izan zen harentzat, Dominikar Errepublikako kostaldeko baliabideen eta itsas ugaztunen aldeko lanari jarraipena ematekoa.

Idelisa Bonnelly, Karibeko itsas kontserbazioaren ama, 2022ko uztailaren 3an zendu zen, 90 urte zituela.

Informazio zientifikoa eta aukerak eskura dauzkagu, bai gizonezkoentzat bai emakumezkoentzat; bereziki emakumezkoentzat. Zientzia datuak dira, pertseberantzia, diziplina; eta, askotan, baita maitasuna ere. Eta emakumeek asko dakite horri guztiari buruz.

– Idelisa Bonnelly

Iturriak:- Idelisa Bonnelly: madre de la conservación marina en el Caribe, Oceánicas

- Odalis Mejía Perdomo, Idelisa Bonnelly: «… la ciencia se trata de datos, de perseverancia, de disciplina y, muchas veces, de amor, y las mujeres saben mucho de todo ello», Mujeres Científicas en las Américas: sus Historias Inspiradoras, 2013, 147-156

- Idelisa Bonnelly: Por un mundo más habitable, ONU Mujeres, 2015ko maiatzaren 14a

- Idelisa Bonnelly, Wikipedia

Edurne Gaston Estanga elikagaien zientzia eta teknologiako doktorea da. Gaur egun, zientzia eta teknologiaren ezagutza zabaltzea sustatzen duten erakundeen proiektuak kudeatzen ditu.

Jatorrizko artikulua Mujeres con Ciencia blogean argitaratu zen 2024kourriaren 17an: Idelisa Bonnelly, la madre de la conservación marina en el Caribe.

Itzulpena: UPV/EHUko Euskara Zerbitzua.

The post Idelisa Bonnelly, Karibeko itsas kontserbazioaren ama appeared first on Zientzia Kaiera.

¡Ni se te ocurra teletransportarme, Scotty!

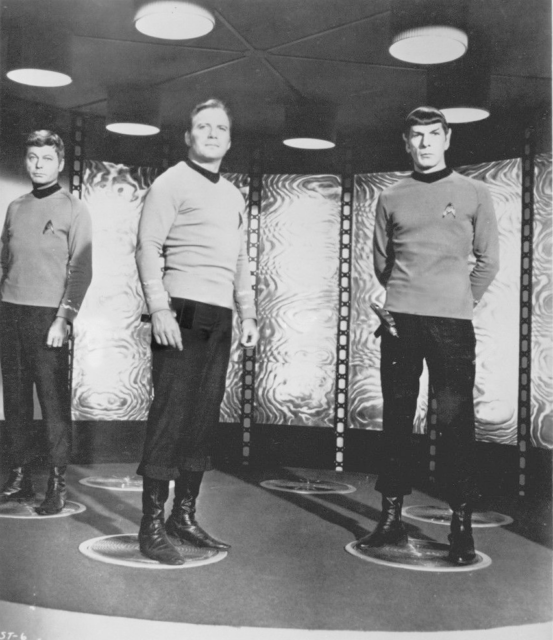

Es posible que solo exista una persona en el mundo que no haya soñado alguna vez con teletransportarse a… bueno, a cualquier sitio: Leonard McCoy —Bones, para los amigos—, director médico de la nave USS Enterprise. Y, si nos atenemos a las leyes de la física, puede que en ese sentido fuera el más cuerdo de toda la tripulación, porque, aunque es posible que el sistema de teletransporte de Star Trek sea el más coherente que podemos encontrar en la ciencia ficción desde el punto de vista científico —y tampoco es que lo sea mucho—, pasa por alto detalles que podrían hacer que el viaje no fuera tan placentero y seguro como parece.

El actor DeForest Kelly, como el doctor Leonard McCoy; William Shatner, como el capitán Kirk, y Leonard Nimoy, como Spock en la sala del transportador de la USS Enterprise (Star Trek, TOS, 1968). Fuente: NBC Television

El actor DeForest Kelly, como el doctor Leonard McCoy; William Shatner, como el capitán Kirk, y Leonard Nimoy, como Spock en la sala del transportador de la USS Enterprise (Star Trek, TOS, 1968). Fuente: NBC Television

Existen innumerables manuales técnicos —ficticios, claro— en los que podemos encontrar información sobre cómo funcionan todos los sistemas de la nave Enterprise. En el escrito en 1991 por Rick Sternbach y Michael Okuda —el que tengo más a mano, aunque es el manual de la Enterprise de Picard—, se describe el funcionamiento de los teletransportadores en cuatro etapas:

-

Programación de las coordenadas de destino y análisis del entorno. Algo bastante conveniente para que nadie acabe materializándose dentro de una roca o en un ecosistema mortal.

-

Escáner de los átomos, a nivel individual, del sujeto al que se va a teletransportar.

-

Almacenamiento en memoria y compensación del desplazamiento Doppler del haz de teletransporte debido al movimiento entre la nave y el lugar de destino.

-

Envío del haz.

Suena bastante sensato, ¿no? Y lo es en bastantes sentidos, sobre todo en algunos detalles. No solo tienen en cuenta el efecto Doppler, sino la distorsión del espacio-tiempo en condiciones de curvatura, lo que haría imposible el teletransporte; el peligro de chocar contra el escudo deflector de otra nave si los tiene activados, o mi favorita: la imposibilidad de, a diferencia del replicador de alimentos que funciona a nivel molecular, utilizar el teletransportador para clonar personas, algo que, efectivamente, prohíbe la mecánica cuántica.

Pero vayamos poco a poco y veamos a qué nos referimos cuando hablamos de teletransporte en el mundo real —o en el mundo cuántico, para ser más precisos— y cómo funciona.

Cada cierto tiempo, de forma recurrente, aparece en los medios alguna noticia relacionada con este tema. Suelen ser ciertas: hemos logrado el teletransporte cuántico de partículas muchísimas veces. Ahora bien, de ahí a que podamos empezar a pensar en irnos de vacaciones al otro extremo del mundo utilizando este sistema hay un trecho.

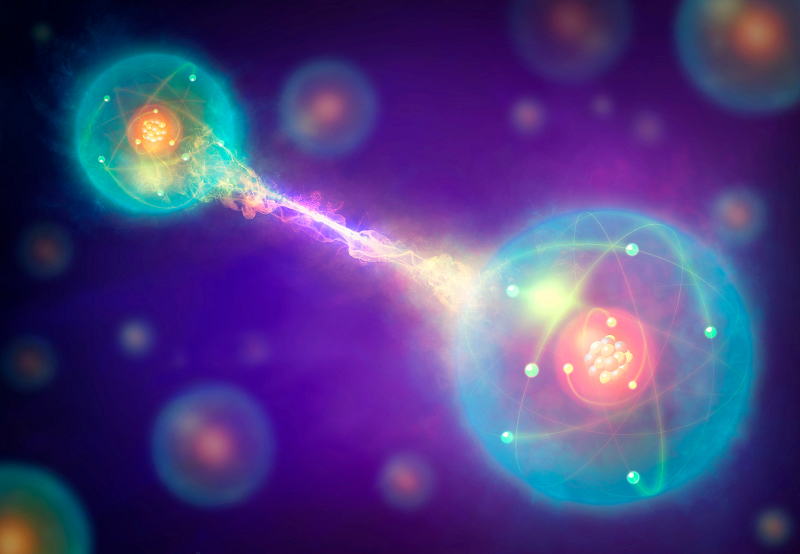

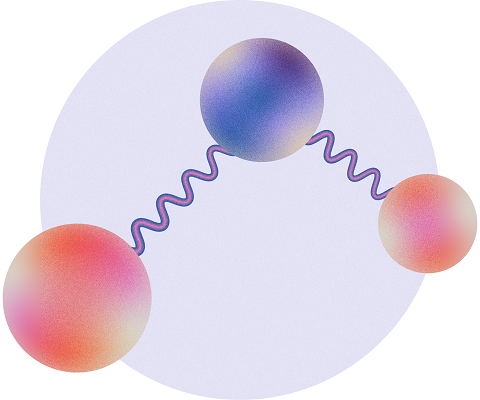

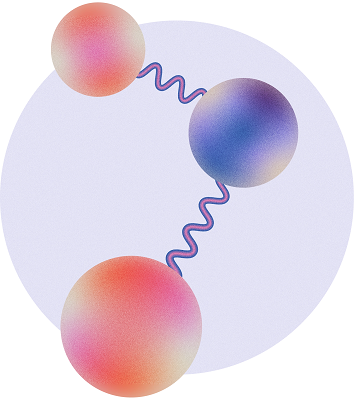

En física cuántica, eso a lo que llamamos teletransporte es posible gracias a una de las propiedades más espeluznantes —según diría Albert Einstein— de las partículas: el entrelazamiento. Que dos partículas se encuentren entrelazadas solo significa que comparten la misma función de onda, por lo que, si actuamos sobre una, estamos actuado irremediablemente sobre la otra. Desarrollemos un poco esto: podríamos tener dos partículas diferentes, cada una con su propia función de onda, y sumarlas sin mayor problema; en ese caso, podríamos volver a separar cada componente si quisiéramos. En cambio, en el entrelazamiento no hay dos funciones de onda individuales, sino que el sistema de dos, tres, cuatro… o las partículas que sean está descrito por la misma ecuación, y es imposible hacer nada sobre ninguna de ellas sin que afecte al resto. Lo espeluznante, en realidad,no es que se puedan relacionar partículas de esta manera, sino que cualquier acción que se ejerza sobre una parte del sistema, se va a reflejar en el resto de componentes de manera inmediata, con independencia de si están en la misma habitación, en la Luna o en la galaxia de Andrómeda, algo que parece que desafía el límite de la velocidad de la luz. En realidad no es así, como veremos más adelante, ya que lo que podemos o no hacer con el entrelazamiento tiene sus limitaciones y enviar información es una de ellas.

Dos partículas entrelazadas comparten la misma función de onda. Esto quiere decir que cualquier operación que efectuemos sobre uno de ellos, le afectará al otro. Fuente: Mark Garlick / Science Photo Library

Dos partículas entrelazadas comparten la misma función de onda. Esto quiere decir que cualquier operación que efectuemos sobre uno de ellos, le afectará al otro. Fuente: Mark Garlick / Science Photo Library

Perfecto, pero ¿cómo podemos usar esta propiedad para teletransportar cosas? Lo cierto es que hay que hacer algunos trucos. Tengamos en cuenta que, cuando hablamos de teletransporte cuántico lo que enviamos no son partículas materiales, sino estados, esto es, la información que describe la partícula y gracias a la cual podemos replicarla al otro lado.

Dejemos que Scotty y, por ejemplo, Spock, le amarguen un poquito la existencia a McCoy y hagan un pequeño experimento con él. Van a intentar teletransportarlo a la superficie del planeta al que acaban de llegar, pero utilizando las propiedades de la física cuántica en lugar del sistema habitual. Para ello, antes de nada, habrá que hacer algunos preparativos.

En primer lugar, haría falta un sistema auxiliar que ayudara con todo el proceso, así que Spock construye un par de tricorders que van a estar entrelazados. Se encontrarán metidos cada uno en una caja, en estado de superposición encendido/apagado, de tal manera que, si en un momento dado alguien abre una de las cajas, observa uno de ellos y ve que está encendido, sabrá que el de la otra caja está apagado. Spock le da un de los tricorders a McCoy y el otro se lo lleva él en una lanzadera a la superficie del planeta.

Centrémonos ahora en McCoy y su tricorder, y vamos a entrelazarlos entre sí también. Para que los estados no colapsen, Scotty encerrará a Bones con su dispositivo en la sala del teletransportador, cerrará la puerta y lo dejará ahí aislado, de tal manera que tendremos un estado de superposición conjunto: McCoy, desde ese momento, podría estar vivo o muerto —independientemente de que también esté muy enfadado— y su tricorder podría estar encendido o apagado. Así que habría cuatro estados posibles: McCoy vivo-tricorder encendido, McCoy muerto-tricorder apagado, McCoy vivo-tricorder apagado, McCoy muerto-tricorder encendido, que se denominan estados de Bell.

Ahora bien, como hemos dicho que el tricorder de McCoy está entrelazado, a su vez, con el que se llevó Spock a la superficie del planeta, sabemos que cualquier cosa que le pase a McCoy en la Enterprise influirá en el estado del tricorder de Spock.

Scotty empieza con el proceso de teletransporte, así que, a partir de este momento, debe tener mucho cuidado si no quiere cargarse a McCoy. Necesita enviarle a Spock información sobre lo que está pasando dentro de la sala del teletransportador, pero sin abrir la puerta ni obtener información directa de McCoy o su tricorder, porque, al ser un sistema cuántico, podría hacer que colapsara en un estado no deseado. Una estrategia que podría seguir sería hacer mediciones indirectas, utilizando los sensores de la Enterprise para averiguar si, en determinado momento, los dos se encuentran en estados similares como vivo/encendido o muerto/apagado, o si uno está «funcionando» y el otro no, sin especificar cuál es cuál… Este proceso se llama medida de Bell, y es una forma de obtener información de un sistema de dos partículas entrelazadas. En la práctica, los estados que le interesan a Scotty son aquellos en los que McCoy está vivo, y que, recordemos, debido al entrelazamiento guardarán relación también con el estado del tricorder de Spock. Solo hay un pequeño problema… aunque Scotty consiga acceder a uno de los estados en los que Bones está bien, cuando haga la medida de Bell, se lo tendrá que cargar igualmente.

Pero mantengamos la calma. Aunque McCoy desaparezca, para entonces su información habrá quedado codificada en los tricorders entrelazados, y Spock, con las instrucciones necesarias, que Scotty tendrá que enviarle por canales convencionales, podrá recuperarla y recrear a su compañero sano y salvo sobre la superficie del planeta en el que está.

Aquí la cosa se pone demasiado bizarra, porque, en esta analogía, lo que sucedería es que, cuando Spock abriera su caja para ver el estado de su tricorder, se encontraría a McCoy dentro, lo que es bastante antiintuitivo. Así que, llegados a este punto… llamemos a McCoy fotón C, al tricorder que se queda con él, fotón A, y al tricorder que tiene Spock, fotón B. Ahora el proceso de teletransporte en este universo paralelo de Star Trek quedaría así:

-

Spock entrelaza los fotones A y B.

-

Se lleva el fotón B consigo al planeta.

-

Scotty quiere enviarle a Spock un fotón C que tiene en la Enterprise, así que lo entrelaza con el A, que se ha quedado él.

-

Scotty hace una medida de Bell sobre el sistema C + A, destruyendo C en el proceso, pero haciendo que la información quede codificada en el sistema A + B.

-

Le envía la información de su medida a Spock por medios convencionales.

-

Spock recrea en su fotón B el estado de C.

Ahora todo parece algo más complicado que lo que vemos en televisión, ¿no? Por no mencionar que no podemos teletransportar nada a ningún lugar en el que no hayamos estado antes o, en su defecto, hayamos enviado una parte de nuestro sistema auxiliar entrelazado, que podría ser tremendamente complejo si estamos hablando de teletransportar a un ser vivo. Este tipo de teletransporte tampoco nos sirve para comunicarnos —de ahí que el límite de la velocidad de la luz no suponga un problema—, porque sin la información que Scotty le envía a Spock por canales sublumínicos, este no sabría qué tendría que hacer para recrear el estado del fotón que le quieren enviar.

Cuestión aparte es el destino que le esperaría al pobre McCoy o a cualquiera que se prestara como tribble de experimentos para probar este tipo de teletransporte: ¿seguro que el original que destruiríamos y la copia que recrearíamos serían la misma persona? Y sí, destruir el original es completamente necesario, porque, como comentamos más arriba, la física cuántica no permite hacer copias perfectas, solo puede existir una a la vez.

Aunque no soy tan tecnofóba como Bones, creo que, en este asunto, me voy a poner de su lado. En estos términos… ¡ni se te ocurra teletransportarme, Scotty! Dicho lo cual… larga vida y prosperidad a todos.

NBC Television

NBC Television

Bibliografía

Bennett, C. H., Brassard, G., Crépeau, C., Jozsa, R., Peres, A. y Wootters, W. K. (1993) Teleporting an unknown quantum state via dual classical and Einstein–Podolsky–Rosen channels Physical Review Letters doi: 10.1103/PhysRevLett.70.1895

Sternbach, R., Okuda, M. y Roddenberry, G. (1991). Star Trek. TNG. Technical manual. Pocket Books.

.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo ¡Ni se te ocurra teletransportarme, Scotty! se ha escrito en Cuaderno de Cultura Científica.

Adalimumab artritis erreumatoidearen tratamendurako: azken urteetako ikasketak

Gaur egun, kasuen gorakada dela eta, geroz eta ezagunagoa egiten ari den gaixotasuna da artritis erreumatoidea. Espainia mailan 200.000 kasu baino gehiago daude eta ohikoa bihurtzen ari da gaixotasun hau pairatzen duen norbaitekin elkarbizitzea; baina, zer dakigu artritis erreumatoidea eta bere tratamenduez?

Artritis erreumatoidea, zenbaitek artrosiarekin nahastu izan ohi duena, gaixotasun kroniko eta autoimmunea da, zeinean immunitate sistemaren gehiegizko aktibazioak, norbanakoaren ehunak erasotuko dituen, artikulazioak, batez ere. Gaixotasun honetan kartilagoaren zein hezurraren suntsipena ikusi daiteke; zurruntasuna, hantura edo artikulazioen funtzioaren galera suposatuz. Min kronikoak eta gaixotasunaren garapenaren ondorioz agerturiko ezgaitasunak gaixoaren bizi kalitatearen murrizpena dakar. Komorbilitate eta arazo psikosozial ezberdinekin erlazionatua dago, eta ohikoak izaten dira eguneroko ekintzak burutzeko ezintasun fisikoa edota arazo mentalak, inguru familiarrean, sozialean edo laboralean islatzen direlarik. Esan daiteke beraz, inpaktu soziosanitario handia duen gaixotasuna dela.

Urteetan zehar artritis erreumatoidearen tratamenduaren inguruko ikerketa ugari egin dira eta gaixoarengan zein gizartean duen eragina ikusita, gaixotasunaren bilakaera kontrolpean izatea garrantzitsua dela argi dago. Egun, antiinflamatorio ez esteroideekin sintomak arintzeaz gain, gaixotasunaren bilakaera moteltzea ere lortu da gaixotasun erreumatikoaren garapena modulatzen duten farmakoak bezalako medikamentuei esker. Ildo horretan, tratamendu biologikoa da adalimumab, immunitate sistema modulatzeko gaitasuna duen antigorputz monoklonala. Tratamendu honen aurkikuntzak emaitza esperantzagarriak aurkeztu zituen gaixotasun honen garapenaren nolabaiteko kontrolean. Arrakasta horren zergatia ulertzeko asmoz, artritis erreumatoidearen ezaugarriak eta adalimumaben indikazioa, ekintza mekanismoa eta bere parametro biofarmazeutikoen inguruko datuak azpimarratu dira lan honetan.

Irudia: Adalimumaben ekintza-mekanismoa. (Irudia: Larreta, Enara et. al. (2024). Iturria: Ekaia aldizkaria)

Irudia: Adalimumaben ekintza-mekanismoa. (Irudia: Larreta, Enara et. al. (2024). Iturria: Ekaia aldizkaria)Adalimumab larruazalpetik administratzen den disoluzio injektagarria da eta aurrez kargatutako pluma edo xiringa moduan formulatuta aurkitu genezake ospitaleetako farmazia zerbitzuetan. Aipatu bezala, immunitate sistema neurri batean modulatzeko gaitasuna dauka eta 2002an merkaturatu zenetik artritis erreumatoidearen tratamenduaren oinarri garrantzitsuenetako bat izatera heldu da, bere erabilera azkarra gaixotasunaren eboluzio hobeago batekin erlazionatu baita. Hala ere, 20 urte igaro dira adalimumabaren merkaturatzetik eta beraz, datu eguneratuen bilketa egitea garrantzitsua da epe luzera erakutsi duen eraginkortasuna eta segurtasuna ebaluatzeko. Horretarako, azken urteotako entsegu eta ikerketa ezberdinak bildu dira eta adalimumaben helmena benetan nolakoa den aztertu da.

Amaitzeko esan, ikerketa prozesu luze bat geratzen dela artritis erreumatoidea erabat sendatzea lortuko duen tratamendua eskuratzeko, izan ere, etiologia ezezaguna izateak eta gaixotasunean zeharreko mekanismo anitzen aktibazioak tratamenduen aurkikuntzan zailtasunak ipintzen ditu. Terapia biologiko berriak lortzeko ikerketak aurrera doaz, eta ama zelula mesenkimalak ere ikertuak izaten ari dira duten ahalmen birsortzailea dela eta. Bitarte horretan, adalimumabak eraginkortasun eta segurtasun ona duela erakutsi du entseguetan eta baita gaixoen bizi kalitatea hobetzen duela ere. Esan daiteke beraz, artritis erreumatoidean funtsezkoa izaten jarraituko duen tratamendua dela.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: 46

- Artikuluaren izena: Adalimumab artritis erreumatoidearen tratamendurako: Azken urteetako ikasketak

- Laburpena: Artritis erreumatoidea (rheumatoid arthritis, RA) mintz sinobialaren hantura kronikoa eragiten duen gaixotasun autoimmunea da. Kartilagoaren zein hezurraren suntsipena eragiten du; ondorioz, zurruntasuna, hantura edo artikulazioen funtzioaren galera gertatzen dira, eta horrek gaixoaren bizi-kalitatea murriztea dakar, ezgaitasuna eraginez. Urteetan zehar RAren tratamenduaren inguruko ikerketa ugari egin dira, eta egun, sintomak arintzeaz gain, gaixotasunaren bilakaera moteltzea ere lortu da gaixotasun erreumatikoaren garapena modulatzen duten farmakoei (disease modifying anti-rheumatic drugs, DMARD) esker. Ildo horretan, adalimumab DMARD biologikoa da, gaitasun immunomodulatzailea duen α tumorearen nekrosi-faktorearen (tumor necrosis factor a, TNFα) aurkako antigorputz monoklonala. Adalimumabekin emaitza itxaropentsuak lortu dira gaixotasun horren garapenaren kontrolean. Arrakasta horren zergatia ulertzeko asmoz, RAren ezaugarriak eta adalimumaben indikazioa, ekintza-mekanismoa eta bere parametro biofarmazeutikoen inguruko datuak aurkeztu dira. Hala ere, 20 urte igaro dira adalimumab merkaturatu zenetik, eta, beraz, datu eguneratuen bilketa egitea garrantzitsua da epe luzera erakutsi duen eraginkortasuna eta segurtasuna ebaluatzeko. Horretarako, azken urteotako saiakuntza eta ikerketa ezberdinak bildu dira, eta adalimumaben helmena benetan nolakoa den aztertu da. Amaitzeko, esan ikerketa-prozesu luzea geratzen dela RA sendatzea lortuko duen tratamendua eskuratzeko. Bitarte horretan, adalimumabek gaixotasuna nolabait kontrolpean izatea lortu du, eta gaixoen bizi-kalitatea hobetzen jarraituko du.

- Egileak: Enara Larreta, Manoli Igartua, Rosa María Hernández eta Edorta Santos-Vizcaíno

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- eISSN: 2444-3255

- Orrialdeak: 205-225

- DOI: 10.1387/ekaia.24989

Enara Larreta, Manoli Igartua, Rosa María Hernández eta Edorta Santos-Vizcaíno UPV/EHUko Farmazia fakultateko Farmazia eta Elikagaien Zientziak Saileko ikertzaileak dira.

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Adalimumab artritis erreumatoidearen tratamendurako: azken urteetako ikasketak appeared first on Zientzia Kaiera.

Los humanos, un Macguffin matemático

Siempre que escucho la palabra “Macguffin” mi mente se va hacia el gran cineasta británico Alfred Hitchcock (1899-1980), autor de grandes películas como La ventana indiscreta (1954), Vértigo (1958), Con la muerte en los talones (1959), Psicosis (1960) o Los pájaros (1963). Y más concretamente me remite al libro El cine según Hitchcock, que recoge la entrevista que le hizo el cineasta francés Francois Truffaut (1932-1984), un libro de cuya lectura he disfrutado en varias ocasiones.

Fotografía de la entrevista que hizo el cineasta francés Francois Truffaut al cineasta británico Alfred Hitchcock en 1962

Fotografía de la entrevista que hizo el cineasta francés Francois Truffaut al cineasta británico Alfred Hitchcock en 1962¿Qué es el Macguffin?

El Macguffin, término acuñado por el maestro del suspense Alfred Hitchcock, es un objeto, persona, situación o suceso necesario para impulsar la trama y la motivación de los personajes, pero insignificante, sin importancia o irrelevante en sí mismo. Como diría Truffaut “es el pretexto”.

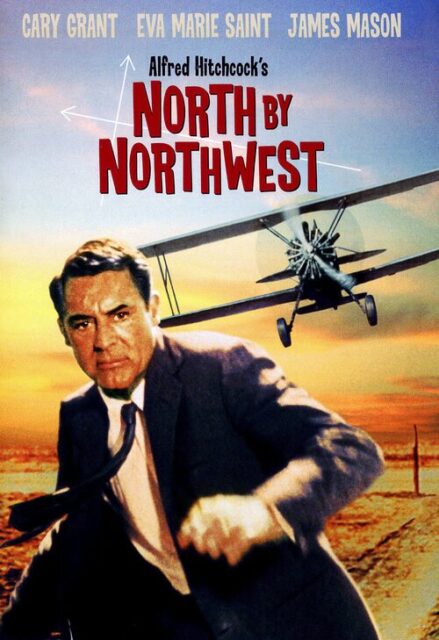

Por ejemplo, en las películas de espías suele ser un secreto o unos documentos, que hacen que la trama se desarrolle, pero que realmente da igual cuál sea el secreto o el contenido de los documentos. Como afirmó el propio Hitchcock, “el Macguffin es lo que persiguen los espías, pero al público le da igual”. En la película Con la muerte en los talones, el protagonista, encarnado por el actor estadounidense Cary Grant (1904-1986), es un agente publicitario que es confundido con un agente del gobierno por unos espías e intentan asesinarlo, motivando la huida del publicista para salvar su vida. Mientras que en la película Psicosis el Macguffin es el robo de un dinero y la posterior huida de su protagonista femenina, interpretada por la actriz estadounidense Vera Miles (1929), que provoca que se esconda en un pequeño hotel regentado por el tímido Norman Bates, que interpretaba el actor estadounidense Anthony Perkins (1932-1992), y que era realmente la parte central de la película. Otro ejemplo interesante es la estatuilla de la película El halcón maltés (1941), interpretada por Humphrey Bogart, Mary Astor y Peter Lorre, y basada en la novela negra homónima del escritor estadounidense Dashiell Hammett (1894-1961), que es el objeto de deseo de una serie de personajes de dudosa moral.

Cartel de la película Con la muerte en los talones (1959), dirigida por Alfred Hitchcock e interpretada por Cary Grant, Eva Marie Saint, James Mason y Martin Landau

Cartel de la película Con la muerte en los talones (1959), dirigida por Alfred Hitchcock e interpretada por Cary Grant, Eva Marie Saint, James Mason y Martin LandauPara finalizar con los ejemplos, un Macguffin esclarecedor, más moderno y en otro tipo de película, como es The Blues Brothers (1980), donde los personajes encarnados por los actores estadounidenses John Belushi (1949-1982) y Dan Aykroyd (1952), intentan conseguir el dinero necesario para salvar el orfanato en el cual se criaron, lo cual no es más que la excusa para realizar un viaje con el objetivo de reunir a los miembros de un grupo musical y llenar ese viaje de humor y música, buena música de blues y soul.

En el libro El cine según Hitchcock, el maestro del suspense explicaba el origen del término de la siguiente forma.

Y ahora, conviene preguntarse de dónde viene el “MacGuffin”. Evoca un nombre escocés y es posible imaginarse una conversación entre dos hombres que viajan en un tren. Uno le dice al otro: “¿Qué es ese paquete que ha colocado en la red?” Y el otro contesta: “Oh, es un Mac Guffin”. Entonces el primero vuelve a preguntar: “¿Qué es un Mac Guffin?” Y el otro: “Pues un aparato para atrapar a los leones en las montañas Adirondaks”. El primero exclama entonces: “¡Pero si no hay leones en las Adirondaks!” A lo que contesta el segundo: “En ese caso no es un Mac Guffin”.

Esta anécdota demuestra el vacío del Mac Guffin … la nada del Mac Guffin.

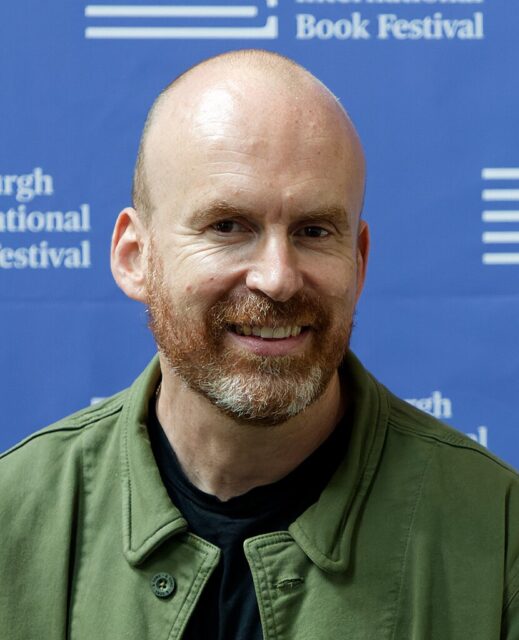

Los humanos, de Matt HaigLa novela a la que vamos a dedicar esta entrada del Cuaderno de Cultura Científica, Los humanos (2013), del escritor británico Matt Haig (1975), contiene un Macguffin matemático. Pero vayamos por partes. Primero presentemos brevemente a su autor.

Matt Haig es un periodista y escritor inglés, que escribe tanto para adultos, como para jóvenes. Estudió Inglés e Historia en la Universidad de Hull. Entre sus libros nos encontramos novelas como Los humanos (2013), Cómo detener el tiempo (2017), La biblioteca de la medianoche (2020) o La vida imposible (2024), cuya protagonista es matemática; libros para jóvenes como Shadow Forest: el bosque de las sombras (2007), El chico que salvó la navidad (2015), La duendecilla sincera (2018) o Evie, la amiga de los animales (2019), y libros de no ficción como Razones para seguir viviendo (2015), Apuntes sobre un planeta estresado (2018) o El libro de la esperanza (2021).

Fotografía de Matt Haig en el Edinburgh International Book Festival de 2024

Fotografía de Matt Haig en el Edinburgh International Book Festival de 2024

Respecto a la novela Los humanos, lo primero es recomendar a las personas que estáis leyendo esta entrada que la leáis, no porque sea una novela relacionada con las matemáticas, sino porque es una novela interesante y muy divertida.

Pero para hablar de esta novela podemos empezar por la sinopsis escrita por la editorial:

El profesor Andrew Martin de la Universidad de Cambridge acaba de descubrir el secreto de los números primos, encontrando al mismo tiempo la clave que garantizará el fin de la enfermedad y la muerte. Convencidos de que los secretos de los números primos no pueden dejarse en manos de una especie tan primitiva como los humanos, los vonadorianos, una civilización extraterrestre mucho más evolucionada, envían a un emisario para hacer desaparecer a Martin y a su descubrimiento. Y así es como un vonadoriano con el aspecto externo de Martin aparece con la misión de matar a la esposa, al hijo y al mejor amigo del profesor, pero no puede dejar de sentirse fascinado por esa fea especie y sus costumbres incomprensibles.

Portada de la novela Los humanos, de Matt Haig (Roca Editorial, 2014)

Portada de la novela Los humanos, de Matt Haig (Roca Editorial, 2014)El punto de partida de la novela es que el matemático y profesor de la Universidad de Cambridge (Gran Bretaña) Andrew Martin ha demostrado la llamada hipótesis de Riemann, uno de los problemas matemáticos abiertos, es decir, que está aún por resolverse, más importantes. De hecho, la hipótesis de Riemann es uno de los siete “problemas del milenio” que anunció el Instituto Clay de Matemáticas en el año 2000, con una recompensa de un millón de dólares para quien lo resolviese. Más aún, este problema ya estaba en la lista de los 23 problemas que recogió el matemático alemán David Hilbert (1862-1943) en el Congreso Internacional de Matemáticos de 1900, como problemas más importantes para el nuevo siglo xx.

Sin embargo, para una civilización extraterrestre, los vonadorianos, este es un conocimiento demasiado poderoso, que en manos de los humanos podría poner en peligro el equilibrio del universo y provocar su destrucción. Por este motivo, deciden reemplazar a Martin por un clon alienígena, que es realmente el protagonista de esta historia narrada por él mismo, y borrar toda evidencia de su descubrimiento, destruyendo los documentos relacionados con la demostración, los rastros digitales de la misma o las personas que hayan podido tener algún conocimiento de esta prueba, como la familia del matemático, su mujer y su hijo, y alguno de sus colegas.

Resulté ser un hombre casado de 43 años, la mitad exacta de una vida humana. Tenía un hijo. Era el profesor que acababa de resolver el enigma matemático más importante al que se habían enfrentado los humanos. Apenas tres horas antes había hecho progresar la especie humana más allá de lo que cualquiera habría podido imaginar.

La hipótesis de Riemann no es más que un pretexto, es decir, el Macguffin de esta historia, para contarnos de forma divertida cómo nos vería un extraterrestre a los terrícolas y hablar de lo que significa ser humano, del amor, la amistad, la familia, las relaciones humanas, los conflictos, la vida o la muerte.

Portada de la versión británica de la novela Los humanos / The humans (2013), de Matt HaigLas matemáticas de los vonadorianos

Portada de la versión británica de la novela Los humanos / The humans (2013), de Matt HaigLas matemáticas de los vonadorianos

Antes de entrar en materia, un pequeño comentario sobre el hecho de que los vonadorianos son una civilización extraterrestre para la cual las matemáticas son extremadamente importantes y un conocimiento esencial para ellos. Para que nos hagamos una idea de esto, incluyo algunas sencillas citas de la novela, que son pensamientos del vonadoriano protagonista.

La primera:

Yo nunca quise que me mandasen aquí. Se trataba de una tarea que, tarde o temprano, alguien tenía que asumir y, después de la charla que di en el Museo de las Ecuaciones Cuadráticas –que muchos tacharon de blasfemia, de supuesto crimen contra la pureza matemática–, a los anfitriones [los dirigentes de los vonadorianos] les pareció el castigo perfecto.

La segunda:

Por supuesto, en teoría aquella era mi ciudad […]. La falta de imaginación geométrica me tenía fascinado: no había ni tan siquiera un decágono a la vista. […] Pronto aprendería que en las ciudades todo es una tienda. Son a los moradores de la Tierra lo que las cabinas de ecuaciones son a los vonadorianos.

La tercera:

Allá de donde venimos la tecnología que hemos creado sobre las bases de nuestro entendimiento supremo y exhaustivo de las matemáticas nos ha supuesto no solo la posibilidad de atravesar grandes distancias, sino también de reajustar nuestros propios componentes biológicos, renovarlos y reponerlos. Estamos equipados psicológicamente para tales progresos. Nunca hemos vivido una guerra civil. Nunca anteponemos los deseos individuales a las necesidades del colectivo.

En general, las citas matemáticas de la novela tienen un objetivo literario y no rigurosidad matemática. Por ejemplo, en cierto momento el vonadoriano clon de Andrew Martin se queja de que el orden de prioridad de las noticias en televisión es incomprensible para él y se sorprende de que no hable de “nuevas observaciones matemáticas” (lo cual es un comentario bastante indefinido y confuso) o de “polígonos todavía por descubrir” (también bastante impreciso e incluso que puede considerarse equívoco).

La hipótesis de RiemannA pesar de que la hipótesis de Riemann es solamente una excusa para hablar de los humanos, de la humanidad, Matt Haig sí intenta explicar en la novela, de forma muy sencilla y bastante literaria, en qué consiste la misma o, al menos, algunas ideas relacionadas con ella.

Así, cuando el vonadoriano con aspecto de Andrew Martin descubre en el ordenador del matemático de la Universidad de Cambridge el documento que contiene la demostración de la hipótesis de Riemann, hay un pequeño capítulo de la novela dedicado a los números primos y su distribución dentro de los números naturales (por cierto que una introducción a estos temas puede leerse en las entradas del Cuaderno de Cultura Científica Buscando lagunas de números no primos y El poema de los números primos, así como en el libro La gran familia de los números, que se menciona en la bibliografía), que comentaremos a continuación, aprovechando el texto de la novela.

Pero antes, así es como describe Matt Haig al autor de la hipótesis, el matemático alemán Bernhard Riemann (1826-1866).

Aprendí algo más sobre Bernhard Riemann, un niño prodigio alemán horrorosamente tímido que vivió en el siglo xix y que, ya desde una edad temprana, demostró su habilidad excepcional con los números, antes de sucumbir a su carrera de matemático y a la serie de crisis nerviosas que minaron su adultez. Más tarde descubriría que ese era uno de los problemas fundamentales que tienen los humanos con la comprensión numérica: simple y llanamente, su sistema nervioso no está capacitado.

La verdad es que no dice gran cosa, salvo que era un niño prodigio y que “sufría crisis nerviosas”, sobre una de las grandes mentes matemáticas de la historia, que realizó avances revolucionarios en todas las áreas de las matemáticas en las que trabajó, en particular, el análisis matemático, la geometría diferencial y la teoría de números. Muchos son los conceptos y resultados matemáticos asociados a su nombre, como la integral de Riemann, las ecuaciones de Cauchy-Riemann, las superficies de Riemann, la geometría riemanniana, el tensor de curvatura de Riemann, la función zeta de Riemann o la hipótesis de Riemann, entre otras.

Caricatura de Bernhard Riemann, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los números primos

Caricatura de Bernhard Riemann, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los números primos

Pero vayamos con los números primos. El primer párrafo sobre los mismos, que nos narra el vonadoriano, es el siguiente.

Los números primos vuelven a la gente loca, pero literalmente, sobre todo por la cantidad de enigmas que quedan sin resolver. Lo único que parecían saber es que un primo es un número entero que solo puede dividirse por 1 y por sí mismo, pero, más allá de eso, se dan de bruces con un problema tras otro.

La verdad es que es un comentario bastante simplista, puesto que viene a decir que el único conocimiento que se tiene sobre los números primos es su definición, es decir, que son aquellos números naturales que solamente se pueden dividir por 1 y por ellos mismos. Por ejemplo, el número 25 no es primo ya que se puede dividir por 5, mientras que el número 19 sí es primo, ya que solamente es divisible por el 1 y él mismo, al igual que lo son los números 2, 3, 5, 7, 11 y 13, entre otros. Sin embargo, los humanos llevamos más de dos milenios investigando sobre los números primos y obteniendo muchos e importantes resultados, como que existen infinitos números primos, como ya demostraron los antiguos griegos, que todo número natural se puede expresar de forma única como producto de números primos (el teorema fundamental de la aritmética), que la función contador de números primos, es decir, para cada número x, la cantidad de números primos menores o iguales que x se aproxima por la función x/Ln x (el teorema de los números primos), y así existen miles y miles de resultados más que podríamos añadir. Cabe mencionar que existen muchos libros dedicados solo a los resultados sobre los números primos, de los que mencionaremos aquí cuatro en clave más divulgativa, por si hay alguien interesado: 1) Prime Numbers, The Most Mysterious Figures in Math (David Wells, John Wiley & Sons, 2005); 2) The Little Book of Bigger Primes (Paulo Ribenboim, Springer Verlag, 2004); 3) La música de los números primos (Marcus du Sautoy, Acantilado, 2007); 4) Los números primos, un largo camino al infinito (Enrique Gracián, RBA, 2010).

Aunque después del párrafo anterior, sí menciona alguno de los conocimientos que la humanidad ha alcanzado sobre los números primos, casi siempre expresado de una forma más literaria, o incluso poética, que matemática. Por ejemplo, afirma que se conoce que hay infinitos números primos (la sencilla y hermosa demostración de los griegos podéis leerla en la entrada Buscando lagunas de números no primos), pero además menciona que son numerables, es decir, que se pueden contar (sobre los conjuntos infinitos podéis leer la serie de entradas titulada El infinito en un segmento: uno, dos y tres), de la siguiente forma.

Saben que el total de todos los números primos es igual al total de todos los números, pues ambos sumarían infinitos. Para el humano medio, esto constituye un hecho bastante desconcertante, pues ciertamente tienen que existir más números aparte de los primos. Tan imposible les resulta asimilar que, al enfrentarse al tema, más de uno se ha metido un revólver en la boca, ha apretado el gatillo y se ha volado los sexos.

Aquí realmente está mezclando dos temas apasionantes e importantes, primero que hay infinitos números primos, que puede entenderse bien por sí solo, pero a la vez nos habla de que hay tantos como números naturales, hecho que está relacionado con la dificultad de entender el infinito y sus paradojas, como lo mencionado, que una parte del conjunto (los números primos) tenga tantos elementos como todo el conjunto (los números naturales). Aunque este segundo tema es un poco complejo para las personas que lean la novela, es muy exagerado decir que “tan imposible les resulta asimilar que, al enfrentarse al tema, más de uno se ha metido un revólver en la boca, ha apretado el gatillo y se ha volado los sexos”, aunque tenemos que entender que esto es literatura y no divulgación de las matemáticas.

El siguiente párrafo dice lo siguiente:

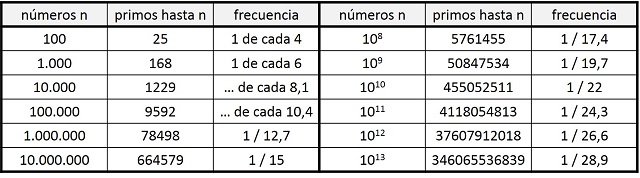

Los humanos también han llegado a entender que los números primos se parecen mucho al aire terráqueo. Cuánto más arriba subes, menos hay. Por ejemplo, hay 25 números primos menores que 100, pero solo 21 entre 100 y el 200 y solo 16 entre 1.000 y 1.100. Sin embargo, a diferencia de aire en la Tierra, no importa lo mucho que subas en la escala de los números, siempre habrá algún número primo. Por ejemplo, 2.097.593 es primo y hay millones más entre ese y, pongamos, 4314398832739895727932419750374600193. En consecuencia, podemos decir que la atmósfera de los números primos recubre todo el universo.

La primera parte ofrece el primer comentario sobre la distribución de los números primos dentro de los naturales, que es el tema central sobre el que versa la hipótesis de Riemann. Y efectivamente es así. Como se comentaba en la entrada Buscando lagunas de números no primos, entre los 100 primeros números hay 25 primos, es decir, 1 de cada 4 números es primo. Sin embargo, si miramos entre los 1.000 primeros números, resulta que hay 168 que son primos, 1 de cada 6 números. Un porcentaje menor. Y así, como podemos ver en la siguiente tabla, según vamos ampliando la cantidad de números considerados, existe un menor porcentaje de números primos. Luego según vamos avanzando en la recta de números naturales, los números primos van siendo cada vez más infrecuentes, y los números compuestos van ocupando más el espacio dentro de los números naturales.

Tabla con la cantidad de números primos y frecuencia de los mismos para cantidades de números que son potencias de 10

Tabla con la cantidad de números primos y frecuencia de los mismos para cantidades de números que son potencias de 10

Sin embargo, el segundo comentario solo es una forma diferente y poética de volver a afirmar que existen infinitos números primos.

La distribución de los números primosEl texto del capítulo “Números primos” sigue asi:

En 1859, no obstante, en la Academia de Berlín, un Bernhard Riemann cada vez más enfermo enunció la que sería la hipótesis más estudiada y celebrada de todas las matemáticas. Afirmaba que había un patrón, o al menos lo había para los primeros mil números primos. Y era bello, cristalino e involucraba algo llamado “función zeta”, una especie de máquina mental, una curva de aspecto complejo que servía para investigar las propiedades de los primos. Si los colocabas en ella, formaban un orden en el que nadie se había fijado con anterioridad: ¡un patrón! ¡La distribución de los números primos no era arbitraria!

Una vez más mencionemos que esto no es un texto de divulgación de las matemáticas, sino literatura, ya que lo afirmado en el anterior párrafo hay que cogerlo con pinzas, pero como lector tengo que entender la intención narrativa del autor de la novela.

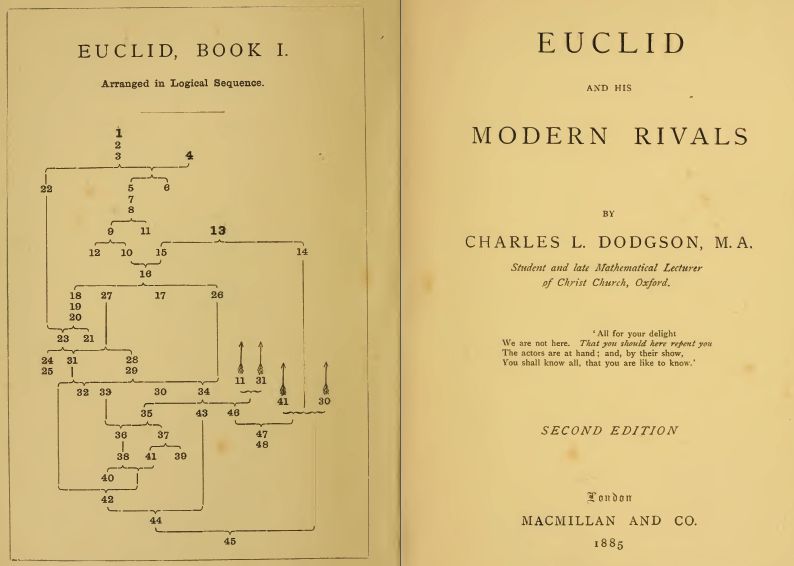

Para empezar, podemos considerar que la hipótesis de Riemann es una de las conjeturas más importantes y estudiadas, no en vano estaba entre los 23 problemas de Hilbert (en 1900) y entre los siete problemas del milenio (en 2000), pero hay otros problemas matemáticos también importantes y muy estudiados, como el último teorema de Fermat, conjeturado por el matemático francés Pierre de Fermat (1601-1665) hacia 1637 y demostrado por el matemático británico Andrew Wiles en 1995 (puede leerse sobre esta cuestión en la entrada Euler y el último teorema de Fermat); la conjetura de Poicaré, formulada por el matemático francés Henri Poincaré (1854-1912) en 1904 y demostrada por el matemático ruso Gregori Perelman en 2006 (véase la entrada La conjetura de Poincaré-Perelman-Miander); o el problema del quinto postulado de Euclides y la existencia de las geometrías no euclídeas, un problema que tardó más de dos milenios en resolverse, por matemáticos como Nikolai Lobachevski (1752-1856) y János Bolyai (1802-1860); o incluso problemas matemáticos que permanecen abiertos, como la conjetura de Goldbach, formulada por el matemático prusiano Christian Goldbach (1690-1764) en 1742 (véase la entrada La conjetura de Goldbach); o cualquiera de los problemas del milenio, que son la conjetura de Birch y Swinnerton-Dyer, en teoría de números algebraica; la conjetura de Hodge, en geometría algebraica; la solución de las ecuaciones de Navier-Stokes de la mecánica de fluidos; el problema P = NP, en ciencias de la computación; la conjetura de Poncaré, en topología (ya resuelta en 2006); el problema de la masa en la teoría de Yang-Mills, en la teoría cuántica de campos; y la mencionada hipótesis de Riemann, en análisis complejo y teoría de números primos, que es una de las más importantes y conocida.

Caricatura de David Hilbert, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de David Hilbert, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Lo siguiente que vamos a comentar es la frase “afirmaba que había un patrón, o al menos lo había para los primeros mil números primos”, a la que podemos ponerle algunos peros matemáticamente hablando. Decir que había un patrón es ambiguo y simplista, aunque a Matt Haig le pueda valer para la novela.

Desde la matemática griega se ha intentado descubrir, sin éxito, la existencia de algún patrón en la distribución de los números primos dentro de los naturales, pero, como decía el matemático suizo Leonhard Euler (1707-1783), este será uno de esos misterios que la humanidad nunca será capaz de desvelar.

No existe ninguna fórmula que nos permita determinar cuál es el número primo n-ésimo, para cualquiera que sea la posición n, ni una expresión matemática que posibilite, conocidos todos los primos hasta uno dado, obtener el siguiente.

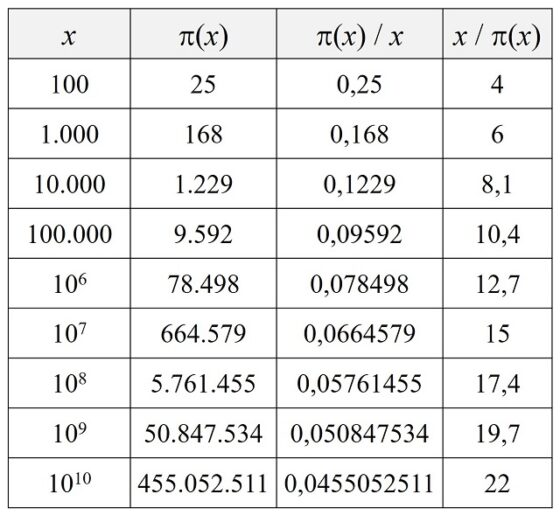

Aunque, una aproximación a la distribución de los números primos es el estudio de la función contador de números primos. Dado un número x se define pi(x) como la cantidad de primos menores, o iguales, que x. Si se observan los números primos hasta 100 se puede comprobar que pi(20) = 8 (que son 2, 3, 5, 7, 11, 13, 17 y 19) o pi(100) = 25 (que son, además de los anteriores, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73 79, 83 89 y 97). En la siguiente tabla se muestra el valor de la función contador de números primos (x) para las primeras potencias de 10, junto con la densidad (x) / x –la proporción de números primos respeto a los naturales, hasta x– y la frecuencia, x / (x) –cuántos números naturales hay por cada primo, hasta x–, que nos incide en la idea anterior de que cada vez hay menos números primos.

La primera aproximación a la distribución de los números primos vino de la mano del matemático alemán Carl F. Gauss (1777-1855), que, a la edad de 15 años, conjeturó que, aunque no se podía conocer con precisión el valor de la función contador de números primos (x), se podía aproximar con la ayuda de la función logaritmo neperiano. Este resultado, conocido como teorema de los números primos, establece que la función (x) se aproxima a la función x / Ln(x), cuando x tiende a infinito. Este teorema fue demostrado en 1896, de forma independiente, por el matemático francés Jacques Hadamard (1865-1963) y el belga Charles-Jean de la Vallé Poussin (1866-1962). Por ejemplo, si se considera x = 106, como Ln(106) es 6 multiplicado por Ln(10) = 2.30258509…, entonces x / Ln(x) es aproximadamente 72.382, siendo la cantidad de primos 78.498.

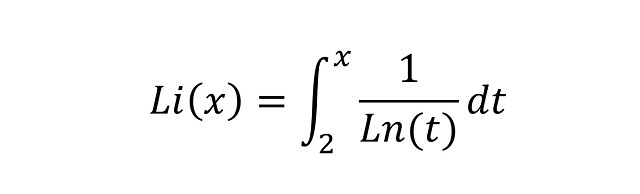

El propio Gauss dio una mejor aproximación a la función contador de números primos mediante la función logaritmo integral

Volviendo al caso de x = 106, mientras que la diferencia de x / Ln(x) con (x) es de 6.116 números, la variación del logaritmo integral Li(x), no os preocupéis ahora de su significado, es sólo de 130.

Pues resulta, que la hipótesis de Riemann, cuya formulación es bastante compleja y está relacionada con los ceros de la conocida función zeta de Riemann que se define sobre los números complejos (ya volveremos sobre ella en alguna futura entrada de Cuaderno de Cultura Científica), es equivalente al hecho de que el logaritmo integral es una “buena” aproximación.

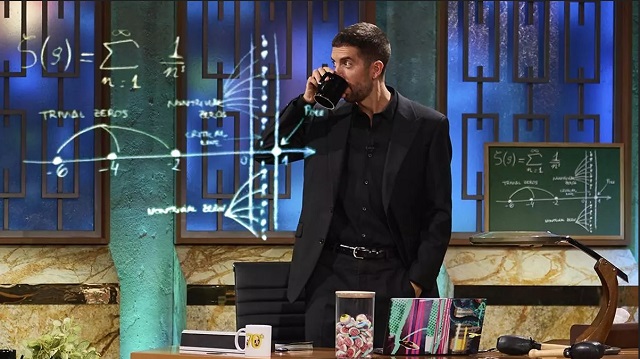

La pizarra del programa La Revuelta, de David Broncano, en TVE, está relacionada con la hipótesis de Riemann, puesto que representa la función zeta de Riemann y la recta donde estarían, según la hipótesis, los ceros no triviales de dicha función. Sobre la pizarra podéis leer el artículo del diario.es titulado El misterio de la pizarra de Broncano: ¿qué pinta esta maravilla de las matemáticas en La Revuelta?Para terminar

La pizarra del programa La Revuelta, de David Broncano, en TVE, está relacionada con la hipótesis de Riemann, puesto que representa la función zeta de Riemann y la recta donde estarían, según la hipótesis, los ceros no triviales de dicha función. Sobre la pizarra podéis leer el artículo del diario.es titulado El misterio de la pizarra de Broncano: ¿qué pinta esta maravilla de las matemáticas en La Revuelta?Para terminar

Para cerrar esta entrada del Cuaderno de Cultura Científica, me gustaría incluir los puntos relacionados con las matemáticas del listado de los 97 “consejos para un humano” que escribe el vonadoriano con aspecto de Andrew Martin al final de la historia, que están escritos para “su hijo” (el de Andrew Martin).

Consejo 12: Los telediarios deberían abrir con noticias de matemáticas y seguir con poesía, y a partir de ahí, que hagan lo que quieran.

Consejo 59: Los números son bonitos. Los primos son bonitos. Ya lo entenderás.

Bibliografía

1.- Francois Truffaut, El cine según Hitchcock, Alianza editorial, 1974.

2.- Matt Haig, Los humanos, Roca Editorial, 2014.

3.- R. Ibáñez, La gran familia de los números, Libros de la Catarata, 2021.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Los humanos, un Macguffin matemático se ha escrito en Cuaderno de Cultura Científica.

Lurreko malgukia

Edward Page Mitchell (1852-1927) kazetari estatubatuar bat izan zen. Aintzatespen berezia jaso zuen New Yorkeko The Sun egunkarian argitaratu zituen zientzia-fikziozko kontakizunengatik. Hain zuzen, egunkari horretako editore burua ere izan zen, 1926an erretiroa hartu zuen arte. 1973an haren lehenengo 30 narrazioen antologia bat argitaratu zen (1874-1886), The crystal man izenburupean. Izenburu hori bat zetorren bere kontakizun iradokitzaileenetako batekin, ikusezintasunari buruzkoa, zeina 1881ean argitaratu baitzen, H.G. Wellsen eleberri ospetsua argitaratu baino 16 urte lehenago.

Mitchellen istorioetako hamar gaztelaniara itzulita argitaratu ziren. Istorio horietan, gizaki ikusezinaz gain, beste gai batzuk ere lantzen dira, hala nola denboran zeharreko bidaiak, garun artifiziala (Babbageren makina analitikoa baino hobea) eta teleportazioa. Zientzia-fikziozko hamar kontakizun bikain horietatik nire gustukoenak ez dauka zerikusirik gaur egun oker aipatu ohi diren balizko teknologia kuantikoekin edo AA penagarriarekin. Takiponpoa da.

Takiponpoa (El Taquipompo)Maitemindutako bikote batek ezkontzeko baimena eskatzen du, baina oztopo handi bat dago: emaztegaiaren familia matematikari familia entzutetsua izanik, senargaiak bertan sartzea merezi duela erakutsi behar du. Kontakizunaren xehetasun gehiago hemen aipatu gabe –izugarri gomendatzen dut kontakizun osoa irakurtzea–, jarraian tramankulu protagonistaren ebazpen matematiko eta fisikoetako batzuk azalduko ditugu.

Objektuak azkar garraiatzeko lurra, itsasoa edo airea erabili behar ditugu, eta energia asko gastatu. Askoz ere eraginkorragoa eta azkarragoa da takiponpoa, eta ez du energiarik gastatzen. Nola funtzionatzen du takiponpoak Lurrean?

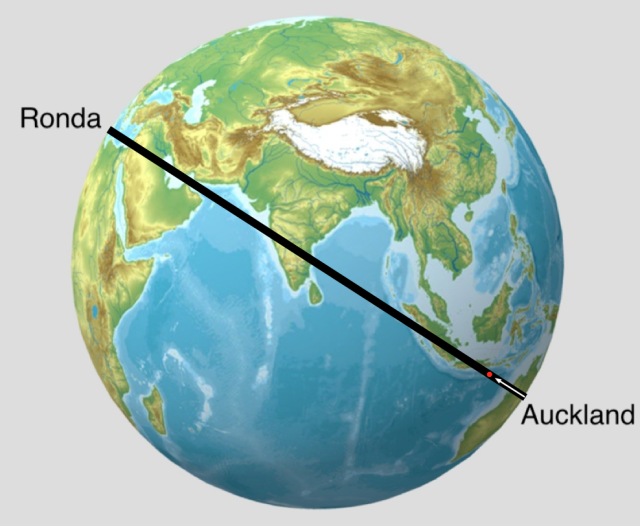

Kalkuluak egiteko, fisikarioi hipotesi sinplifikatzaileak ezartzea gustatzen zaigu, hutseko behi esferikoa kasu. Oraingoan imajinatuko dugu zulo bat egin dezakegula Aucklandetik (Zeelanda Berria) Rondara (Espainia). Hiri horiek elkarren antipodak direnez, eta ustez behintzat gure planeta esfera bat denez, tunela Lurraren erditik igarotzen da. Suposatuko dugu, halaber, Lurraren dentsitatea konstantea dela eta zuloari aire guztia kentzen diogula. Horixe da takiponpoa, 1. irudian ikus daitekeen moduan.

1. irudia: antipoden arteko salgaien garraio azkarra. (Argazkia: felipezaratemontero, aldatuta – CC BY 4.0 lizentziapean. Iturria: Sketchfab)Nola funtzionatzen du?

1. irudia: antipoden arteko salgaien garraio azkarra. (Argazkia: felipezaratemontero, aldatuta – CC BY 4.0 lizentziapean. Iturria: Sketchfab)Nola funtzionatzen du?

Aucklandetik Rondara premiazko bidalketa bat egin behar badugu, paketea zuzenean zulotik bota dezakegu. Grabitazio unibertsalaren legearen arabera, planetatik kanpoalderantz grabitate indarra alderantziz proportzionala da distantziaren karratuarekiko, baina zer gertatzen da tunelaren barruan bidali dugun pieza erortzen den bitartean? Kalkuluak ez dira zailak, baina ezta azalekoak ere; izan ere, azelerazioa ez da konstantea, objektutik Lurraren erdigunera dagoen distantziaren araberakoa baizik.

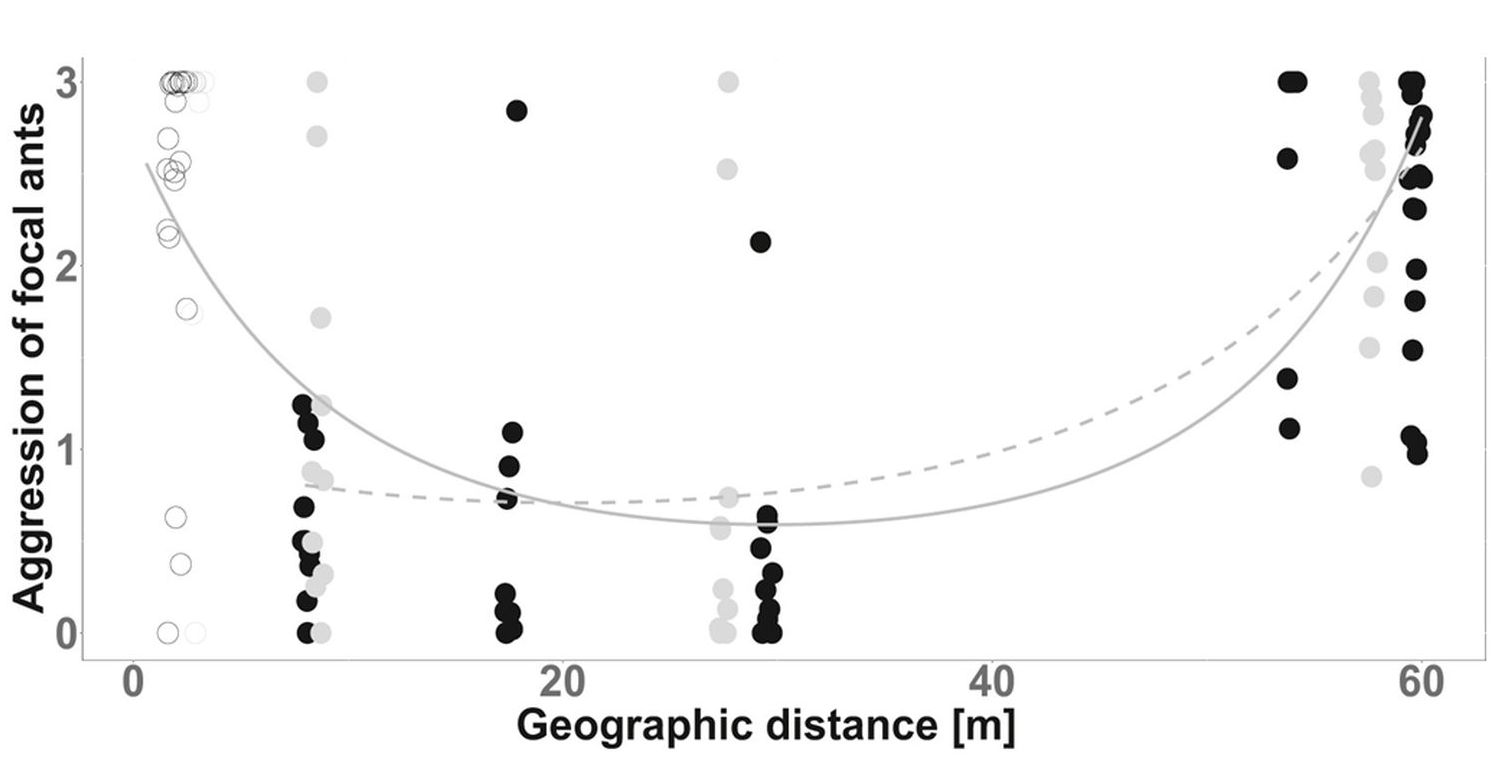

Gaussen legea grabitate eremuari aplikatzen badiogu eta objektutik Lurraren erdigunerako distantziaren baliokide den erradioa duen esferaren bolumena kalkulatzen badugu, frogatu dezakegu azelerazioa (eta objektu horren gaineko indarra) jaitsi egiten dela Lurraren erdigunerako distantzia jaisten den heinean, modu linealean. Hori horrela, oso erraza da takiponpoaren bidez bidali dugun gorputzaren gaineko indarraren proportzionaltasun konstantea kalkulatzea, zeina planetaren dentsitatearen eta grabitazio unibertsalaren konstantearen araberakoa baita.

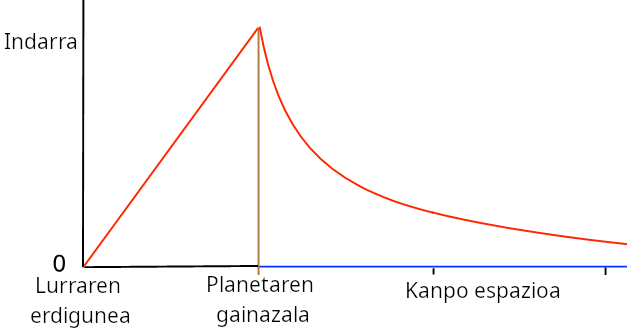

2. irudian Lurrak objektuaren gainean eragiten duen grabitazio indarra irudikatu dugu, izan tunelaren barruan zein kanpo espazioan. Benetako aldaketa planetaren gainazalean gertatzen da. Takiponpoaren barruan distantziarekiko proportzionala den indar hori Hookeren legearen arabera malgukiek jasaten dutenaren berdina da, eta horrek adierazten digu Lurrak malguki batek bezalaxe erantzuten duela.

2. irudia. Lurrak objektuari egiten dion erakarpen indarra, planetaren erdigunearekiko kokatuta dagoen lekuaren arabera.

2. irudia. Lurrak objektuari egiten dion erakarpen indarra, planetaren erdigunearekiko kokatuta dagoen lekuaren arabera.Fisikarioi asko gustatzen zaizkigu malgukien balantzetan, musika tresnetan eta askotariko uhinetan agertzen diren osziladore harmonikoak, eta unibertso osoa horien bidez azaldu nahi izaten dugu. Hori takiponpoaren kasu xumeari aplikatuta, adieraz dezakegu Aucklandetik Rondara bidalitako premiazko paketea linealki beheranzkoa den azelerazioarekin eroriko dela Lurraren erdigunera, erdiko puntua goreneko abiaduran igaroko duela eta modu simetrikoan iritsiko dela Rondara. Rondan paketea jasotzen ez badugu, berriz ere eroriko da eta Aucklandera iritsiko da, eta ez du batere energiarik behar izango joan-etorri osoan.

Takiponpoaren zifrak LurreanZenbat denbora behar da paketea herri batetik bestera iristeko? Kalkulu integral erraz bat eginda –grabitazio unibertsalaren konstantea G (6,67 10-11 N m2/kg2) eta Lurraren dentsitatea (5520 kg/m3) erabiliz–, ondoriozta dezakegu takiponpoak 2530 segundo besterik ez dituela behar paketea helmugara eramateko, hau da, 42 minutu pasatxo; eta berdin dio paketea arina edo astuna izan.

Mugimendu harmoniko sinpleari aplikatuta, denbora hori oszilazio aldiaren erdia da; horrenbestez, mugimendu harmoniko horren periodoa T=5060 segundo da (joan-etorria). Oszilazio horren maiztasuna, Hertzetan (HZ), periodoaren alderantzizkoa da.

Takiponpoa gaur egungo garraiobideetako edozein baino askoz ere azkarragoa da. Tramankuluak Lurraren erdigunean hartzen duen abiadura gorena kalkulatuta, ondoriozta dezakegu 7910 m/s-koa dela edozein pakete bidalita ere, eta ez du ez erregairik ez elektrizitaterik behar. Espero dugu aurkikuntza hori nahikoa izana Edward P. Mitchellen kontakizuneko bikote zoriontsuak ezkontzea merezi duela erakusteko.

Erreferentzia bibliografikoa:- Sam Moskowitz (Ed.) (1973). The Crystal Man: Stories by Edward Page Mitchell. Doubleday Science Fiction ISBN: 978-0385031394

- Edward Page Mitchell (2015). El espectroscopio del alma. Orciny Press ISBN: 978-8494318115

Víctor Etxebarria Ecenarro Bilboko Juan Crisóstomo Arriaga Kontserbatorioan diplomatutako luthierra da, eta Sistemen Ingeniaritzako eta Automatikako katedraduna da Euskal Herriko Unibertsitatean (UPV/EHU).

Jatorrizko artikulua Cuaderno de Cultura Científica blogean argitaratu zen 2024ko urriaren 27an: El muelle de la Tierra.

Itzulpena: UPV/EHUko Euskara Zerbitzua.

The post Lurreko malgukia appeared first on Zientzia Kaiera.

Primer plasma en el tokamak SMART de la Universidad de Sevilla

En el marco de un proyecto pionero en el camino hacia el desarrollo de la energía de fusión, el tokamak SMART ha generado con éxito su primer plasma. Este paso acerca a la comunidad internacional a la energía de fusión; una fuente de energía sostenible, limpia y prácticamente ilimitada.

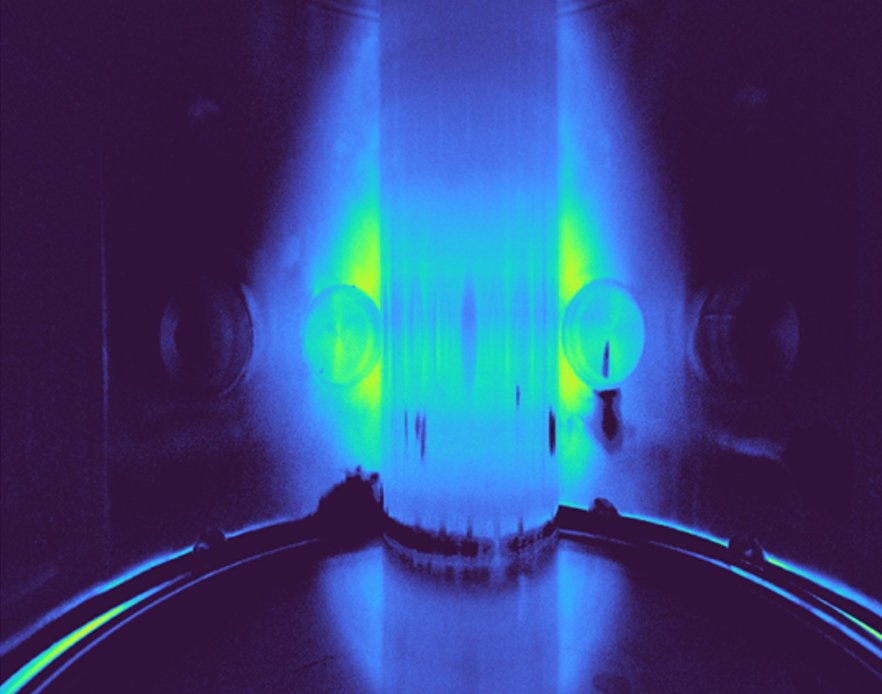

Primer plasma en el SMall Aspect Ratio Tokamak – SMART – grabado con una cámara superrápida en el espectro visible. Fuente: Universidad de Sevilla

Primer plasma en el SMall Aspect Ratio Tokamak – SMART – grabado con una cámara superrápida en el espectro visible. Fuente: Universidad de SevillaEl tokamak SMART (SMall Aspect Ratio Tokamak) es un dispositivo de fusión experimental de última generación diseñado, construido y operado por el Laboratorio de Ciencia del Plasma y Tecnología de Fusión (PSFT) de la Universidad de Sevilla. Se trata de un tokamak esférico único en el mundo debido a su flexibilidad para generar plasmas con distintas formas. SMART ha sido diseñado para demostrar las propiedades físicas e ingenieriles únicas que los plasmas con forma de triangularidad negativa tienen en el camino hacia el desarrollo de plantas de energía de fusión compactas basadas en Tokamaks Esféricos.

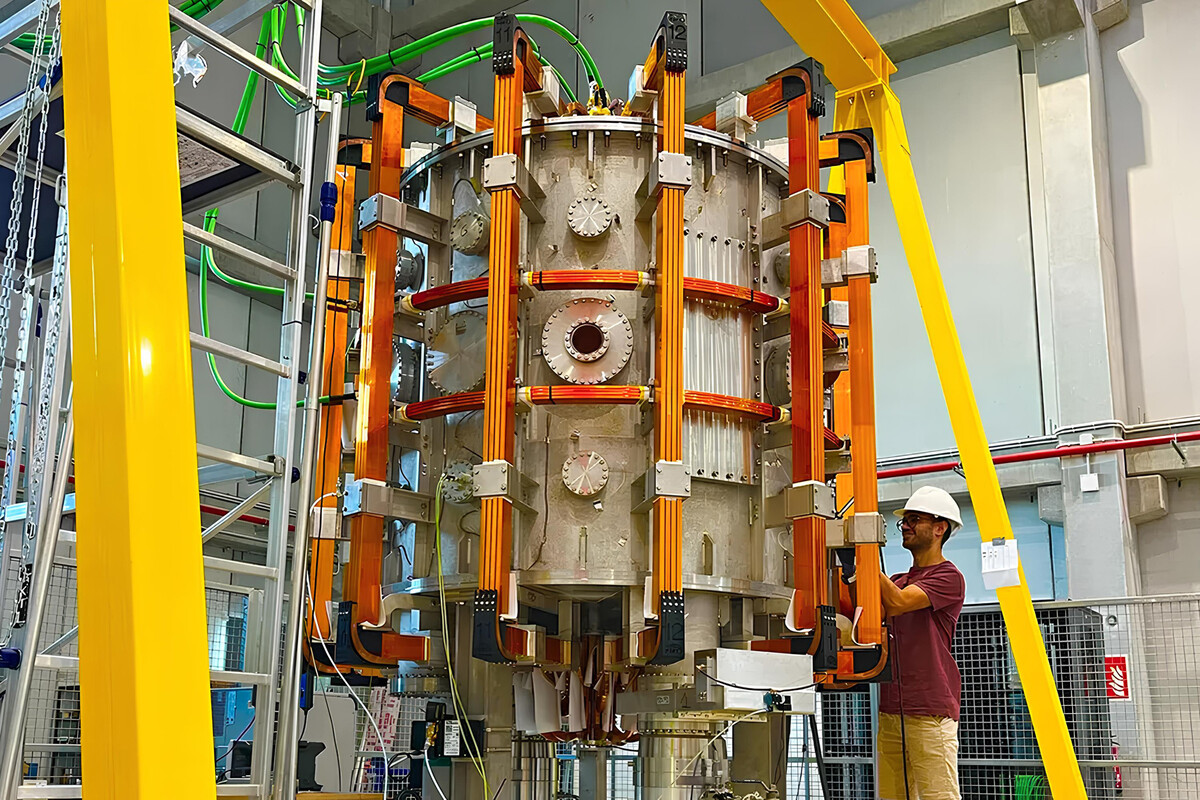

SMART explora un camino potencialmente revolucionario al combinar plasmas de fusión de alto rendimiento con atractivas soluciones para su implementación en reactores de fusión super compactos. Fuente: Universidad de SevillaUna cuestión de triangularidad

SMART explora un camino potencialmente revolucionario al combinar plasmas de fusión de alto rendimiento con atractivas soluciones para su implementación en reactores de fusión super compactos. Fuente: Universidad de SevillaUna cuestión de triangularidad

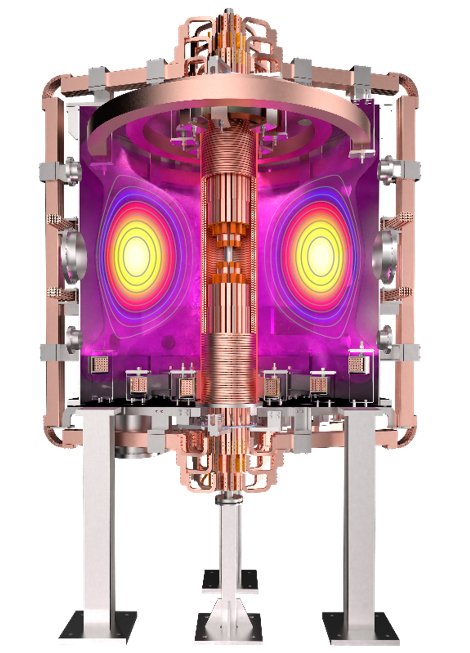

La triangularidad describe la forma del plasma. La mayoría de los tokamaks funcionan con triangularidad positiva, lo que significa que la forma de la sección del plasma parece una D. Si la forma del plasma se asimila a una D invertida (como se aprecia en la imagen de abajo), tiene triangularidad negativa.

Render del Tokamak SMART con un plasma de triangulación negativa en el interior. Fuente: Universidad de Sevilla

Render del Tokamak SMART con un plasma de triangulación negativa en el interior. Fuente: Universidad de SevillaLos plasmas con de triangularidad negativa presentan un rendimiento mejorado ya que suprimen las inestabilidades que degradan el confinamiento del reactor, evitando daños graves a la pared del tokamak. Además de ofrecer un alto rendimiento de fusión, la triangularidad negativa también presenta soluciones atractivas para el control de la potencia generada en las reacciones de fusión, dado que el calor que escapa se distribuye en un área mayor. Esto también facilita el diseño para futuras centrales eléctricas de fusión más compactas y eficientes.

Fusión compactaSMART es el primer paso en la estrategia Fusion2Grid, liderada por el equipo PSFT y en colaboración con la comunidad internacional de fusión, que tiene como objetivo el diseño de una planta de potencia basada en fusión por confinamiento magnético más compacta y eficiente usando tokamaks esféricos con forma de triangularidad negativa. SMART será el primero de este tipo que funcionará a temperaturas de fusión.

El objetivo del tokamak SMART es proporcionar las bases científicas y tecnológicas para el diseño del reactor de fusión más compacto posible. Este primer plasma representa un logro importante para el proyecto, así como para el avance hacia este objetivo.

Referencia:

Dominguez-Palacios, J., Futatani, S., García-Muñoz, M. et al. (2025) Effect of energetic ions on edge-localized modes in tokamak plasmas. Nat. Phys. doi: 10.1038/s41567-024-02715-6

Edición realizada por César Tomé López a partir de materiales suministrados por la Universidad de Sevilla.

El artículo Primer plasma en el tokamak SMART de la Universidad de Sevilla se ha escrito en Cuaderno de Cultura Científica.

Hanoiko dorrearen analisi matematikoa

Kondairak dioenaren arabera, Indiako tenplu batean hiru zutoin luze zeuden eta zutoinetako batean 64 disko zeuden ordenatuta, handiena behean eta txikiena goian zeudelarik (hau da, ezin zen egon disko txikiago bat handiago baten gainean). Bertako monjeak diskoak beste zutoin batera mugitzen hasi ziren; izan ere, haien ustez, disko guztiak beste zutoin batean jartzean (jatorriko zutoinaren ordena mantenduz) bukatu egingo da mundua. Diskoak mugitzeko, monje bakoitzak disko bat baino ezin zuen hartu segundu oro eta, gainera, diskoen tamainen ordena mantendu behar zen zutoin guztietan. Munduaren bukaeratik gertu gauden edo ez matematikak erabiliz aztertuko dugu.

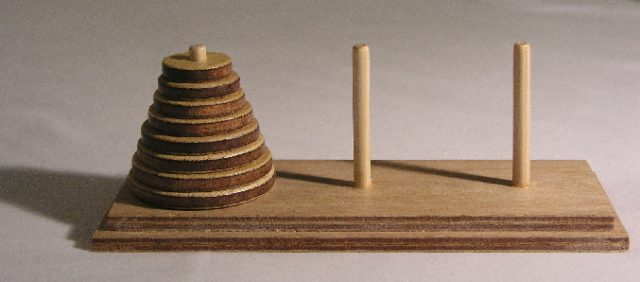

Irudia: Hanoiko dorrea (Argazkia: egile ezezaguna – CC BY-SA 3.0 lizentziapean. Iturria: Wikimedia Commons)

Irudia: Hanoiko dorrea (Argazkia: egile ezezaguna – CC BY-SA 3.0 lizentziapean. Iturria: Wikimedia Commons)Hanoiko dorrea goiko kondairan oinarritutako jolasa da, Eduard Lucas matematikariak asmatua asmatua 1883. urtean. Ordutik, hainbat eta hainbat umek jolastu dute Hanoiko dorrera.

Pentsa dezagun hiru diskoz osaturiko Hanoiko dorrea dugula. Diskoei 1, 2 eta 3 deituko diegu (1 txikiena, 2 ertaina eta 3 handiena izanik) eta zutoinei A, B eta C. Horrela, A zutoinetik C zutoinera pasatuko ditugu diskoak. Eragiketa honi H3AC deituko diogu (H hanoi, 3 disko daudelako eta AC A zutoinetik C zutoinera pasatzen ditugulako). Beraz, H3AC ebazteko, honako urratsak jarraituko ditugu: