Poniéndole cara a una muestra de ADN

Un estudio de la Universidad del País Vasco / Euskal Herriko Unibertsitatea (EHU) ha descubierto una fuerte relación entre diez marcadores genéticos con la morfología de la cara de personas españolas. La investigadora Belén Navarro, autora del trabajo, destaca la importancia de realizar investigaciones en poblaciones específicas, para conseguir modelos de predicción con los que poder reconstruir el rostro de una persona a partir de muestras de ADN.

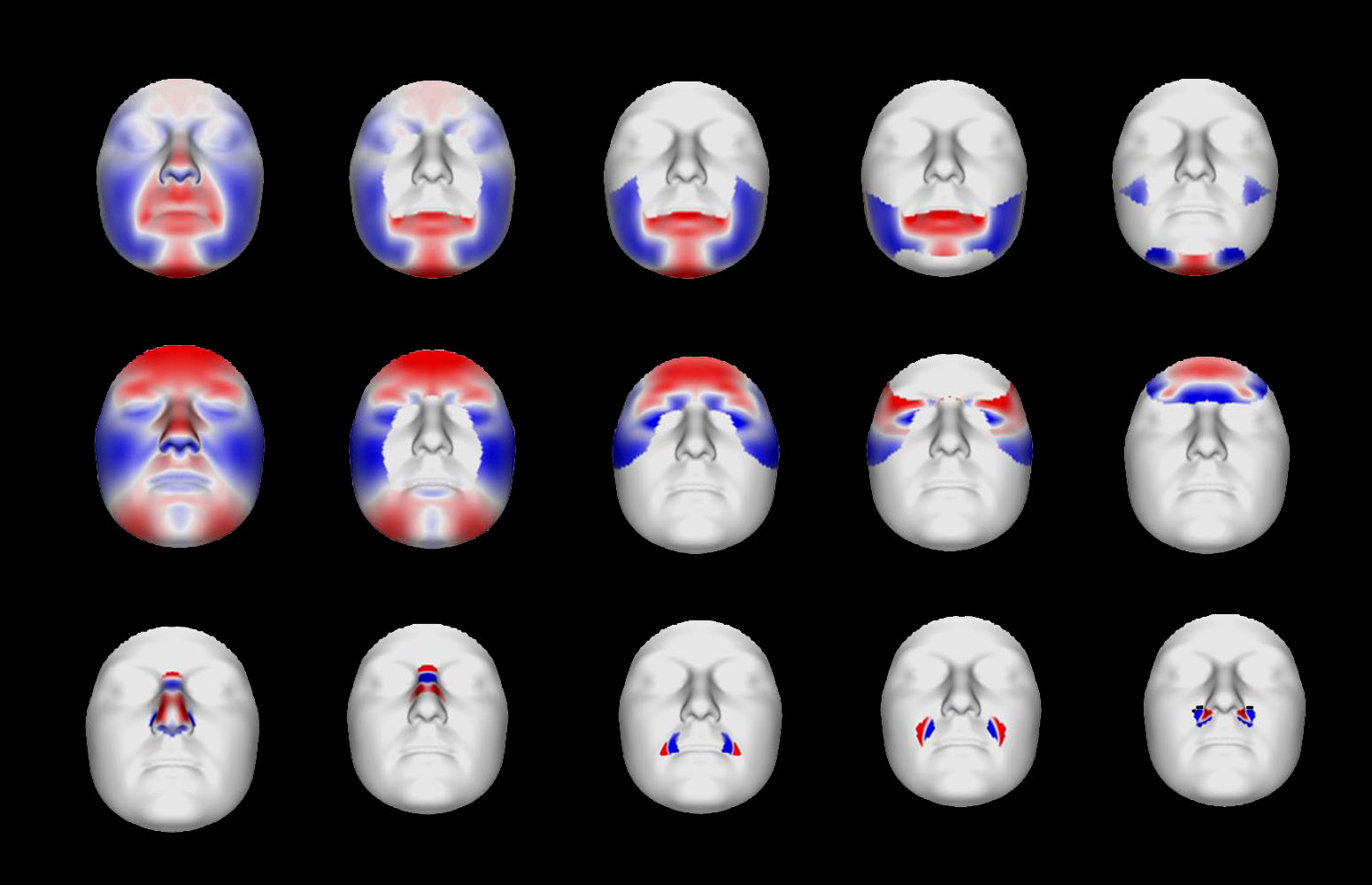

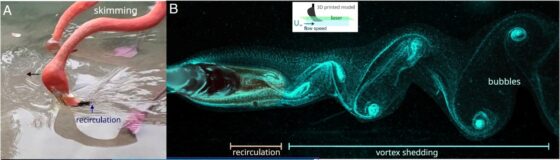

Las zonas marcadas en color señalan aquellas específicas donde se ha encontrado que algún marcador genético tiene asociación. El color muestra el desplazamiento del tejido blando del rostro en función del genotipo. Para un genotipo específico, el azul indica movimiento hacia el interior y el rojo hacia el exterior. Por ejemplo, en las figuras de la nariz, el color rojo señala una nariz que sobresale más hacia fuera, pero con las fosas nasales más recogidas hacia dentro; por tanto, sería una nariz más proyectada hacia fuera y estrecha. Fuente: Belén Navarro / EHU

Las zonas marcadas en color señalan aquellas específicas donde se ha encontrado que algún marcador genético tiene asociación. El color muestra el desplazamiento del tejido blando del rostro en función del genotipo. Para un genotipo específico, el azul indica movimiento hacia el interior y el rojo hacia el exterior. Por ejemplo, en las figuras de la nariz, el color rojo señala una nariz que sobresale más hacia fuera, pero con las fosas nasales más recogidas hacia dentro; por tanto, sería una nariz más proyectada hacia fuera y estrecha. Fuente: Belén Navarro / EHULa obtención de datos de la apariencia física puede ayudar a guiar la búsqueda de sospechosos en casos penales o a la identificación de personas desaparecidas, por lo que es muy interesante poder llegar a predecir las características externas humanas y en particular la forma de la cara mediante análisis de una muestra de ADN.

El análisis de ADN es una herramienta esencial en biología forense, ya que permite la identificación individual mediante la comparación de perfiles genéticos de los vestigios con muestras de referencia. Los últimos avances en el campo de la genética forense buscan determinar las características externamente visibles a partir del ADN que puedan facilitar la identificación. Sin embargo, la morfología de la cara es un rasgo muy complejo.

Ponerle cara al ADNLa investigadora Belén Navarro, del grupo BIOMICs de la EHU, explica que la finalidad “es utilizar ciertos marcadores concretos para poder predecir la forma de la cara de una persona en una escena del crimen o cuando se quiere identificar a alguien y se encuentran solo restos óseos. En las muestras forenses el ADN es muy limitante. No se pueden analizar todos los marcadores que se quieran”. Por ello, es importante “intentar reducir al máximo y quedarse con aquellos marcadores que son más significativos o que tienen más peso”, añade.

Recientes estudios de asociación de todo el genoma han arrojado luz sobre posibles marcadores asociados con los rasgos de la cara. En un trabajo llevado a cabo por el grupo de investigación BIOMICs de la Universidad del País Vasco, que se dedica entre otros ámbitos a la genética forense, han seleccionado un conjunto de 116 posibles marcadores del ADN y han estudiado cómo se asocian con los rasgos faciales en unas 500 personas de diferentes lugares de la península ibérica. “Hemos seleccionado genes y marcadores genéticos que ya se habían asociado con la morfología facial en otras poblaciones a nivel europeo, y lo hemos probado aquí, para ver si había diferencias —explica la investigadora de BIOMICs—. Hemos querido analizar todos y filtrar cuáles de ellos serían los más informativos en nuestra población, para, en caso de tener que utilizar este sistema, centrarnos solamente en ciertos marcadores. Eso es muy útil cuando no se tiene tanto ADN como para poder mirar todos”.

El equipo de investigación de la EHU escaneó el rostro de las personas voluntarias, y así “tomamos una serie de puntos de referencia cefalométricos y estudiamos cómo varían los rasgos del rostro (los ojos, la nariz, caras más anchas, más estrechas, la frente, la barbilla…), llegando a analizar regiones muy concretas de la cara”. A partir de las muestras de saliva estudiaron los citados marcadores genéticos y “luego analizamos si había asociación entre esa variación facial con los marcadores que teníamos”, añade Navarro. El equipo de investigación ha conseguido ver de esta manera, “por ejemplo, que hay una zona de la frente que está un poco más hundida cuanto se tiene un determinado genotipo (o conjunto de genes) para un marcador, o que cuando se tiene otro la frente es más sobresaliente, etc.”, relata la investigadora.

Los resultados han revelado asociaciones significativas dentro de diferentes segmentos faciales: “En particular, diez de los marcadores han presentado una fuerte asociación dentro de esta población local, y algunos de estos han revelado correlaciones con regiones faciales que no habían sido detectadas en investigaciones anteriores”, afirma Navarro.

La importancia de los estudios en poblaciones de referencia pequeñas

Estos hallazgos resaltan “la importancia de analizar marcadores candidatos en diversas poblaciones de referencia para identificar marcadores robustos que a la vez proporcionen información precisa”, dice la investigadora. Si bien gran parte de la investigación realizada hasta ahora se ha centrado en las poblaciones europeas como un grupo homogéneo, “nuestro trabajo muestra que la población que hemos estudiado puede presentar diferencias. Estos resultados sugieren que podría ser valioso no solo realizar estudios europeos a gran escala, sino también considerar estudios específicos de subpoblaciones más pequeñas”, añade. Este enfoque podría ayudar en la consecución de futuros modelos predictivos.

En este camino es fundamental hilar fino: “Ahora habría que validar nuestros resultados con más personas. Habría que probar en otras poblaciones para ver si, por ejemplo, estos resultados se enmarcan a todo el sur europeo o solo a nuestro entorno”. Actualmente el grupo sigue adelante con esta investigación utilizando otros métodos de medida de las características faciales: “Ahora estamos utilizando distintas medidas que están definidas antropológicamente: distancia entre los ojos, entre la nariz y la boca, entre las dos comisuras, etc.”, añade la investigadora. Un siguiente paso sería “intentar conseguir modelos de predicción, que revelen por ejemplo una determinada distancia en el rostro de una persona cuando se detecte ciertos genotipos”. Así sí que se podría “reconstruir más o menos el rostro de una persona. Pero para conseguirlo es necesario seguir validando estos avances en una población mucho más amplia”, concluye Navarro.

Referencia:

Belén Navarro-López, Franziska Wilke, Victoria Suárez-Ulloa, Miriam Baeta, Rubén Martos-Fernández, Olatz Moreno-López, Iñigo Olalde, Begoña Martínez-Jarreta, Susana Jiménez, Susan Walsh, Marian M. de Pancorbo (2025) Exploring the association between SNPs and facial morphology in a Spanish population. Sci Rep doi: 10.1038/s41598-025-98748-9

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Poniéndole cara a una muestra de ADN se ha escrito en Cuaderno de Cultura Científica.

La kriptonita ¡existe!

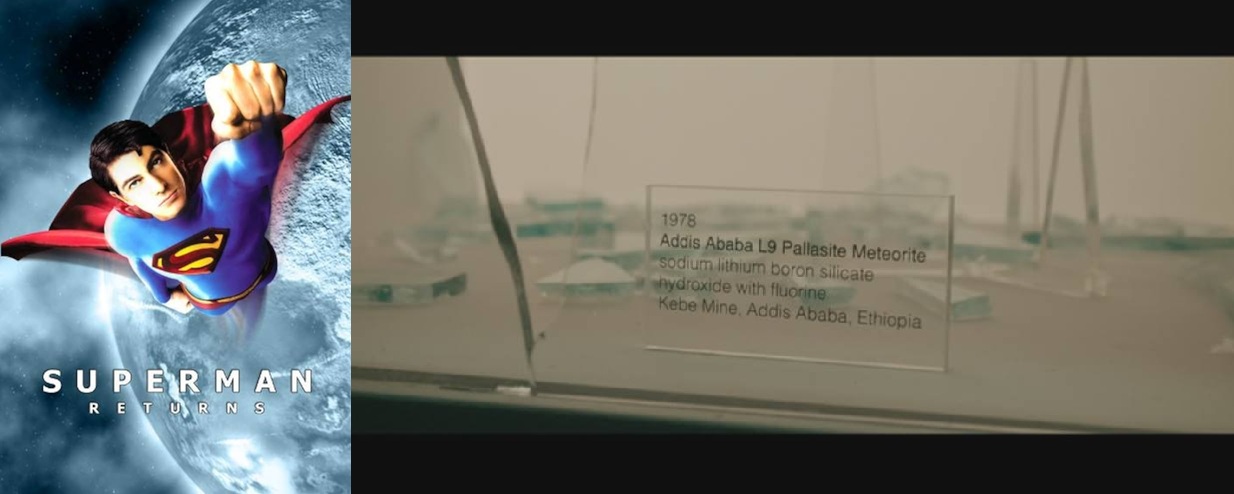

Vale… tal vez el título de este artículo sea un poco sensacionalista, pero kriptonita es lo que le apareció en 2007 en los resultados de búsqueda a Chris Stanley, mineralogista y geólogo del Museo de Historia Natural de Londres, cuando introdujo la composición de un mineral recientemente descubierto en una mina de Jadar (Serbia). Se trataba de un hidróxido de silicato de boro, litio y sodio —LiNaSiB₃O₇(OH)—, muy similar a un exótico material que aparecía expuesto en el Museo de Historia Natural de Metrópolis en la película Superman Returns, estrenada el año anterior.

La composición de la kriptonita en Superman Returns es muy similar a la del mineral que Chris Stanley estaba analizando en 2007, salvo porque aquella también contenía flúor. Fuente: Warner Brothers / fair use

La composición de la kriptonita en Superman Returns es muy similar a la del mineral que Chris Stanley estaba analizando en 2007, salvo porque aquella también contenía flúor. Fuente: Warner Brothers / fair use

Los orígenes de la kriptonita se remontan al propio creador de Superman, Jerry Siegel, quien parece ser que ya mencionó algo así en una historia inédita de 1940 titulada «El K-Metal de Kripton», que nunca se llegó a publicar. La primera aparición oficial se produjo algo después: bien en 1943, o bien en 1945 —existen dos capítulos candidatos— en el serial radiofónico Las aventuras de Superman. No fue, sin embargo, hasta 1949 cuando hizo su aparición en el universo de los cómics del superhéroe.

Desde entonces, la kriptonita, el único talón de Aquiles de Superman, ha tomado diversas formas y colores, y ha mostrado diferentes propiedades. Empezó siendo roja, pero también la ha habido azul, negra, rosa, carmesí, dorada, plateada, blanca… y, por supuesto, verde, que es la que primero se nos viene a la cabeza a la mayoría. Sobre su composición nunca se habían dado demasiados detalles, aunque hay quien llegó a especular con que el gas noble kriptón podría estar involucrado en su fórmula…. hasta 2006, cuando apareció descrita en Superman Returns como «hidróxido de silicato de boro y litio y sodio con flúor».

La kriptonita verde es la variante más popular. Fuente: Canva/whitehoune

La kriptonita verde es la variante más popular. Fuente: Canva/whitehoune

Seguramente, la coincidencia debió de ser una sorpresa para Chris Stanley, pero, lejos de aprovechar la conyuntura para bautizar el nuevo mineral que tenía entre manos como kriptonita —en realidad, hubiera sido confuso, ya que el mineral que tenía entre manos no contenía kriptón— se quedó con el nombre de jadarita, dado su lugar de procedencia.

Hubiera sido fantástico que la jadarita presentara un aspecto similar al de la kriptonita, pero lo cierto es que las similitudes entre ambas acaban en la fórmula. A la jadarita le falta el flúor en su composición —¡a ver si va a ser ese el ingrediente secreto!— y, aunque también tiene estructura cristalina, el tamaño de sus cristales es del orden de micras, por lo que su textura es más bien terrosa. Por otro lado, es blanca mate, en lugar de verde brillante — salvo si la irradiamos con luz ultravioleta, en cuyo caso muestra un suave brillo rosa anaranjado—, y no emite ningún tipo de radiactividad, así que parece que Superman, por el momento, no tendría de qué preocuparse.

Muestra de jadarita. La jadarita y la kriptonita, a la hora de la verdad, no se parecen demasiado. Foto: Dungodung – Own work, CC BY-SA 4.0 / Wikimedia Commons

Muestra de jadarita. La jadarita y la kriptonita, a la hora de la verdad, no se parecen demasiado. Foto: Dungodung – Own work, CC BY-SA 4.0 / Wikimedia Commons

Sin embargo, y lejos de limitarse a una mera curiosidad geológica, la jadarita, como la kriptonita, tiene un potencial oculto: es muy rica en litio y en boro, dos elementos fundamentales en la transición energética y el desarrollo tecnológico e industrial. La mina de Jadar, donde se encuentra, es uno de los mayores depósitos de litio —y boro— del mundo, lo que la convierte en un posible recurso estratégico sin precedentes para Europa… pero cuya explotación podría conllevar daños medioambientales sin precedentes también. Un conflicto de intereses bastante propio de una película de Superman, por cierto.

El hallazgo de la jadarita, en cualquier caso, fue toda una sorpresa, y apareció en la revista Time como uno de los diez mejores descubrimientos científicos de 2007; la BBC, por su parte, lo reconoció como una de las historias más populares del año. Y nosotros… bueno, es que si hay una historia fantástica —en varias de las acepciones de la palabra— de por medio es imposible resistirse a escribir sobre ella.

Bibliografía

Stanley, Christopher J., Jones, Gary C., Rumsey, Michael S., Blake, Christopher, Roberts, Andrew C., Stirling, John A.R., Carpenter, Graham J.C., Whitfield, Pamela S., Grice, Joel D., Lepage, Yvon (2007) Jadarite, LiNaSiB3O7(OH), a new mineral species from the Jadar Basin, Serbia. European Journal of Mineralogy, 19 (4) 575-580 doi:10.1127/0935-1221/2007/0019-1741

BBC News (24 de abril de 2007). ‘Kryptonite’ discovered in mine. BBC News.

Stanley, C. (s. f.). Dr Chris Stanley. Natural History Museum

Reuters (25 de abril de 2007). Scientists unearth Superman’s “kryptonite”. Reuters.

Paul, A. (14 de julio de 2025). Yes, Superman’s kryptonite is (sort of) real. Popular Science.

Ríos, O. (17 de marzo de 2022). Superman y los diferentes tipos de kriptonita. Comicverso.

Singer, B. (Director). (2006). Superman Returns [Película]. Warner Bros. Pictures.

Stiefel, K. E. (15 de marzo de 2018). Kryptonite in Superman. Science On.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo La kriptonita ¡existe! se ha escrito en Cuaderno de Cultura Científica.

Tiras cómicas de Moebius (I)

En la sección Matemoción del Cuaderno de Cultura Científica somos unos apasionados de la banda de Moebius y de los cómics. Por este motivo, no puede extrañar a ninguna de las personas que habitualmente leéis las entradas de esta sección que nos interesemos por el uso de la banda de Moebius en los cómics.

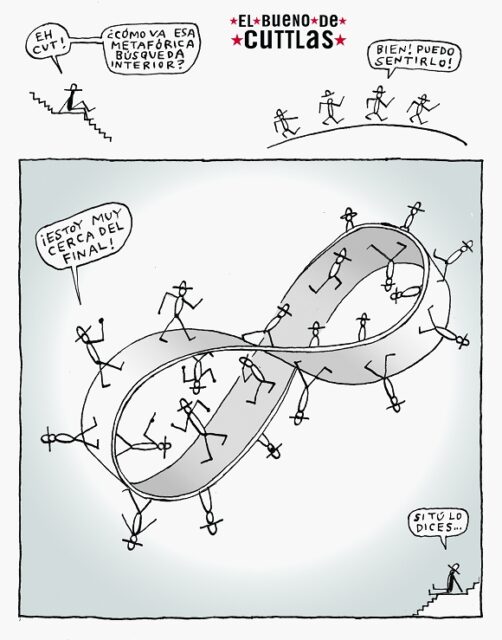

En la entrada Matemática punk, un homenaje a Calpurnio se mostraba un ejemplo de como la banda de Moebius puede aparecer en el humor gráfico, a través de una de las viñetas de El bueno de Cuttlas titulada La banda de Moebius, del ilustrador, historietista, guionista, animador y videojockey aragonés Calpurnio, seudónimo de Eduardo Pelegrín Martínez de Pisón (1959-2022), publicado en 20 Minutos.

El bueno de Cuttlas (La banda de Moebius), de Calpurnio, publicado en 20 Minutos

El bueno de Cuttlas (La banda de Moebius), de Calpurnio, publicado en 20 Minutos

Una novela gráfica en la que se utiliza la banda de Moebius de una forma metafórica, como símbolo del cambio de fortuna en la vida de su protagonista, de la buena a la mala fortuna, es el cómic El número 73304-23-4153-6-96-8 (La cúpula, 2008), del historietista suizo Thomas Ott, sobre la que podéis leer en la entrada De menú para hoy, dos novelas gráficas negras con salsa matemática.

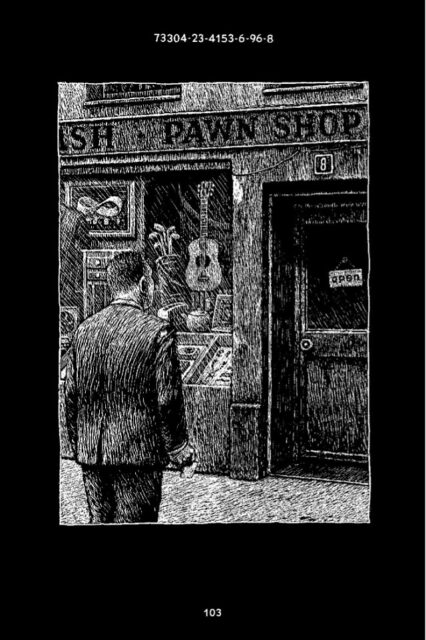

Página de la obra El número 73304-23-4153-6-96-8, de Thomas Ott, en la que su protagonista se dirige a una tienda de empeños, pawn shop, en cuyo escaparate, arriba a la izquierda, podemos observar la imagen de la banda de Moebius

Página de la obra El número 73304-23-4153-6-96-8, de Thomas Ott, en la que su protagonista se dirige a una tienda de empeños, pawn shop, en cuyo escaparate, arriba a la izquierda, podemos observar la imagen de la banda de Moebius

Por otra parte, un ejemplo muy bonito de la presencia de la banda de Moebius en un cómic es Promethea (1999-2005), del mítico guionista Alan Moore y el dibujante James H. Williams III, donde la banda de Moebius es un camino infinito de piedra por el que pasean dos de las encarnaciones de Promethea, Sophie y Barbara. Sobre las muchas matemáticas que hay en este cómic podéis leer la entrada Guía matemática para el cómic Promethea.

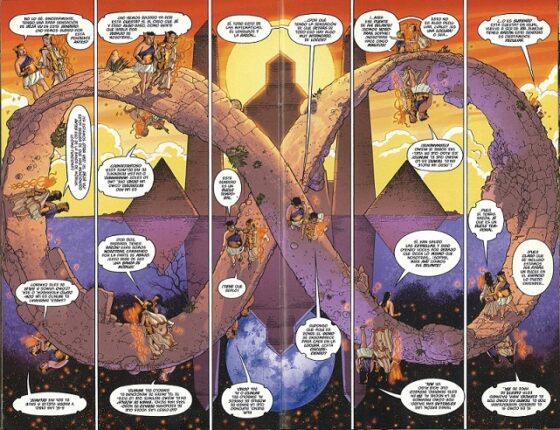

Ilustración de doble página que muestra a las dos Prometheas, encarnadas por Sophie y Margaret, paseando por un camino, sin fin, con forma de banda de Moebius

Ilustración de doble página que muestra a las dos Prometheas, encarnadas por Sophie y Margaret, paseando por un camino, sin fin, con forma de banda de Moebius

En esta entrada del Cuaderno de Cultura Científica vamos a hablar de un tipo de uso diferente de la banda de Moebius en el cómic, cuando la estructura del mismo está dada por la propia superficie de Moebius, generando lo que podemos llamar una tira cómica de Moebius.

Tira cómica de Moebius

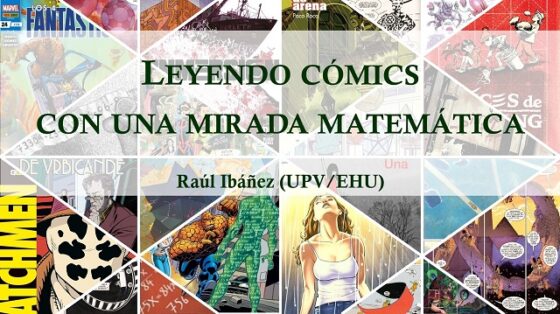

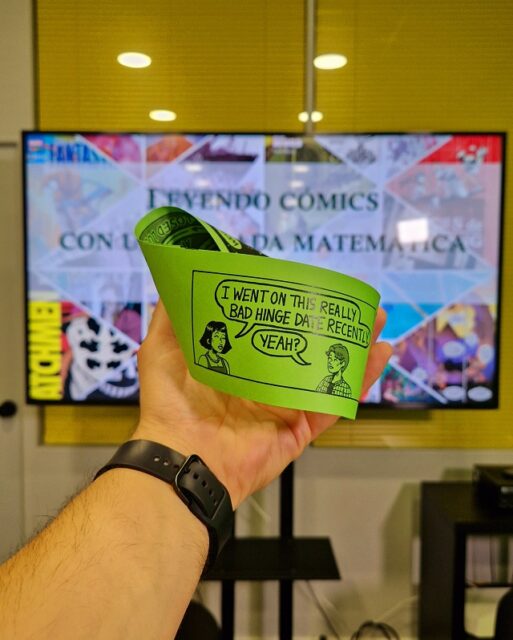

Preparando mi charla Leyendo cómics con una mirada matemática, que impartí a finales de mayo en la librería Joker de Bilbao, librería especializada en cómic que recibió el Premio Librería Cultural 2023, compartí con el público una interesante tira cómica de Moebius de la artista estadounidense Katherine Myers (@katemyyers.art en instagram).

Portada de la presentación de la conferencia Leyendo cómics con una mirada matemática (Librería Joker, Bilbao)

Portada de la presentación de la conferencia Leyendo cómics con una mirada matemática (Librería Joker, Bilbao)

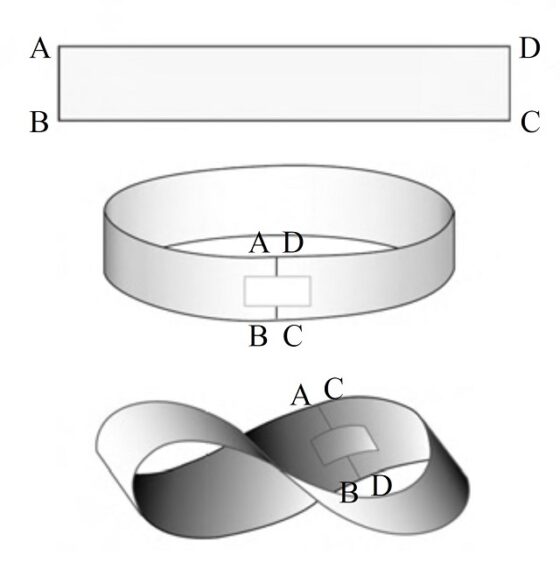

Pero antes de la tira cómica, vayamos con lo elemental, qué es una banda de Moebius (aunque muchas de las personas que estáis leyendo esta entrada quizás ya lo conocéis, nunca está de más recordar los conceptos básicos). Una banda de Moebius es una banda retorcida que podemos construir de forma sencilla de la siguiente forma. Si tomamos una tira de papel y pegamos los extremos se obtiene una banda normal, que es una superficie con dos caras (el interior y el exterior) y dos bordes (el de arriba y el de abajo), pero si primero giramos uno de los extremos del papel media vuelta y después juntamos los extremos se obtiene la banda de Moebius, una superficie que solo tiene una cara y un solo borde (como se observa en la siguiente imagen), y propiedades muy curiosas (véase el libro Las matemáticas como herramienta de creación artística (Catarata, 2023) o las entradas Arte Moebius (I) o Arte Moebius (II)).

Una de las técnicas habituales para comprobar que la banda de Moebius solo tiene una cara es empezar a pintar la tira de papel longitudinalmente, de manera que cuando lleguemos al punto de partida habremos pintado toda la superficie retorcida, es decir, la única cara de esta superficie. De hecho, si se realiza esta misma operación sobre la banda normal, sin retorcer antes de pegar los extremos, solamente pintaremos una de las caras, la exterior o la interior.

Por otra parte, una tira cómica es una historieta corta, de unas pocas viñetas, e incluso una única viñeta, cuyo formato suele ser rectangular alargado (apaisado), aunque la estructura y longitud es variable, y que se suelen publicar en periódicos y revistas. Algunos conocidos ejemplos de tiras cómicas son Mafalda (del historietista argentino Quino, Joaquín Salvador Lavado Tejón (1932-2020)), como la de la siguiente imagen, Garfield (del autor de cómics estadounidense Jim Davis), Snoopy (del historietista estadounidense Charles Schulz (1922-2000)), las tiras cómicas de Forges (el humorista gráfico madrileño Antonio Fraguas de Pablo (1942-2018)), las distintas tiras cómicas de Max (el artista catalán Francesc Capdevila), como Bardín, el superrealista, El bueno de Cuttlas de Calpurnio o las tiras cómicas, publicadas en diferentes periódicos, de El Perich (el humorista gráfico catalán Jaume Perich Escala (1941-1995)), entre muchos otros.

Ejemplo de tira cómica de Mafalda, del historietista argentino Quino, Joaquín Salvador Lavado Tejón (1932-2020)

Ejemplo de tira cómica de Mafalda, del historietista argentino Quino, Joaquín Salvador Lavado Tejón (1932-2020)

La tira cómica de Moebius es también una historieta corta, de unas pocas viñetas, pero con algunas diferencias significativas, que funciona de la siguiente manera.

1.- Para empezar, la tira cómica de Moebius se imprime, por las dos caras, en una tira de papel apaisada, pero en la segunda cara la orientación de impresión es la contraria a la de la primera cara, es decir, girada 180 grados.

2.-Cuando se toma la tira de papel apaisada y se juntan los extremos, pero dando primero media vuelta a uno de ellos, entonces la tira de papel sobre la que está impresa la tira cómica se convierte en una banda de Moebius, de manera que solo tiene una cara.

3.-La historieta se ha impreso en las dos caras de la tira de papel apaisada, como hemos dicho, cambiando la orientación de la cara de atrás, de manera que cuando se juntan los extremos formando la banda de Moebius, la historieta que se iniciaba en la primera “cara” se continúa en la segunda “cara” sin necesidad de dar la vuelta a la “tira”.

4.-Por lo tanto, disponemos de una historieta continua que tiene el doble de longitud, pero al llegar a la parte final, como se regresa al inicio de nuevo (no olvidemos que es una superficie de Moebius, de una única cara) se puede continuar leyendo el cómic otra vez, sin interrupción, de manera que si se construye una historia circular (como veremos en la tira cómica de Moebius de la artista estadounidense Katherine Myers) tendremos una historieta infinita.

5.-Por último, mencionar que la tira cómica de Moebius, a diferencia de la tira cómica clásica, tiene una existencia independiente del periódico o revista en la que se pudiera publicar, ya que para poderla leer bien habría que cortarla del periódico y pegar sus extremos formando la tira cómica de Moebius (en la siguiente imagen se muestra la creación de Myers).

Fotografía de la tira cómica de Moebius, creada por la artista estadounidense Katherine Myers en 2024

Fotografía de la tira cómica de Moebius, creada por la artista estadounidense Katherine Myers en 2024Una tira cómica de Moebius, por Katherine Myers

Aunque lo mejor para entender qué es una tira cómica de Moebius es ver un ejemplo concreto.

Pero antes de mostrar esta historieta infinita creada sobre una estructura tan particular, la superficie de Moebius, presentemos brevemente a la artista que la creó, Katherine Myers. Como ella misma se describe en su página web (Kate Myers), ha estudiado el grado de Animación y Efectos Especiales en la Escuela de Arte de la Universidad Carnegie Mellon (Pittsburgh, Pensilvania, EE.UU.). En su trabajo, se centra en contar historias, utilizando las convenciones de género que se encuentran a menudo en el terror y la ciencia ficción para expresarse de una manera atractiva y visceral. Le fascina la fisicalidad del cuerpo humano y emplea estrategias como los medios basados en el tiempo, el arte secuencial y los efectos prácticos para recrear texturas y formas corporales en contextos anormales e investigar temas como la mortalidad y el yo. Le encanta la accesibilidad que ofrecen tanto el cine como los medios impresos: quiere que su trabajo sea lo más accesible posible. Dirige Full Tilt Comics con su socia Maddie Smoyer y también crea efectos prácticos y de maquillaje para Just a Head Productions.

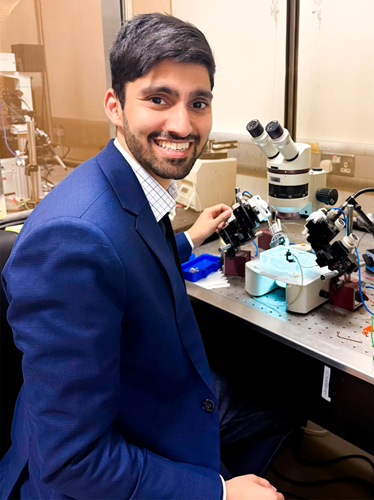

Fotografía de Kate Myers en el PIE 2025 – Pittsburgh Indie Expo, del año 2025, en el stand de Full Tilt Comics, donde se observan algunas de sus tiras cómicas de Moebius

Fotografía de Kate Myers en el PIE 2025 – Pittsburgh Indie Expo, del año 2025, en el stand de Full Tilt Comics, donde se observan algunas de sus tiras cómicas de Moebius

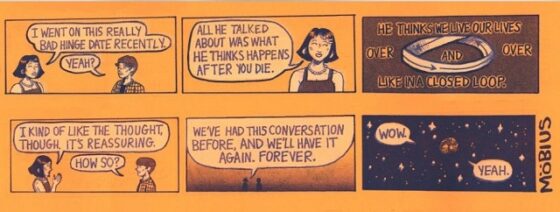

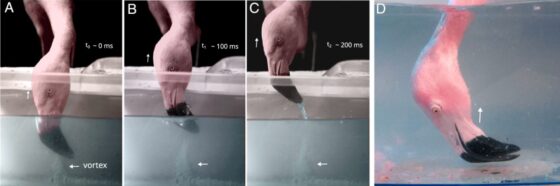

Presentemos finalmente la tira cómica de Moebius de la artista Kate Myers. Está formada por seis viñetas, tres que irán impresas en la primera cara (la fila de viñetas de arriba en la siguiente imagen) y las otras tres, pero giradas 180 grados, en la segunda cara (la fila de abajo de la siguiente imagen) de la tira de papel. En la historieta aparecen dos personajes, uno de ellos es una joven que le cuenta a su interlocutora cómo le ha ido en su última cita. Veamos las seis viñetas.

Las viñetas que van impresas en la “cara” superior y en la “cara” inferior de la tira de papel con la que se forma la tira cómica de Moebius de la artista Kate Myers

Las viñetas que van impresas en la “cara” superior y en la “cara” inferior de la tira de papel con la que se forma la tira cómica de Moebius de la artista Kate Myers

Por lo tanto, cuando la tira cómica de Moebius ya está montada, la lectura de las viñetas es la evidente y que explicamos a continuación. Primero se leen las tres viñetas de la parte de arriba de la anterior imagen. Pero después de la tercera viñeta, en la tira de Moebius, la siguiente es la primera viñeta de la parte de abajo (por el medio giro de la tira antes de pegar los extremos). Por lo tanto, se continúa la lectura con las tres viñetas de abajo. Aunque al llegar a la tercera viñeta de abajo, la siguiente en la tira de Moebius es, de nuevo, la primera viñeta de arriba, por lo que se puede continuar leyendo la historieta de una forma circular e infinita.

A continuación, incluyo una traducción del texto de la tira cómica de Moebius de Kate Myers.

Primera viñeta:

– Recientemente tuve una primera cita muy mala.

– ¿Sí?

Segunda viñeta:

– De lo único que habló fue sobre lo que cree que sucede después de morir.

Tercera viñeta:

– Él piensa que vivimos nuestras vidas una y otra vez como en un circuito cerrado.

Cuarta viñeta:

– Aunque me gusta la idea. Es reconfortante.

– ¿En qué sentido?

Quinta viñeta:

– Ya hemos tenido esta conversación antes, y la volveremos a tener de nuevo. Para siempre.

Sexta viñeta:

– ¡Guau!

– ¡Sí!

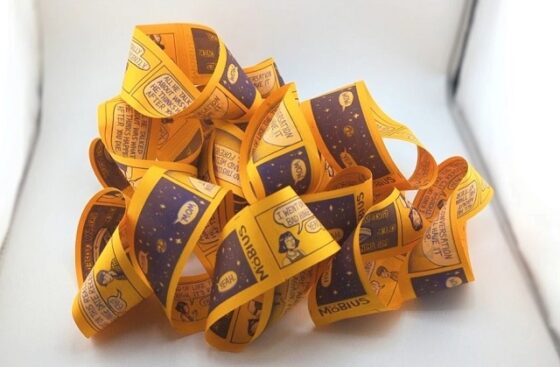

Un montón de tiras cómicas de Moebius de la artista estadounidense Kate Myers

Un montón de tiras cómicas de Moebius de la artista estadounidense Kate MyersSobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Tiras cómicas de Moebius (I) se ha escrito en Cuaderno de Cultura Científica.

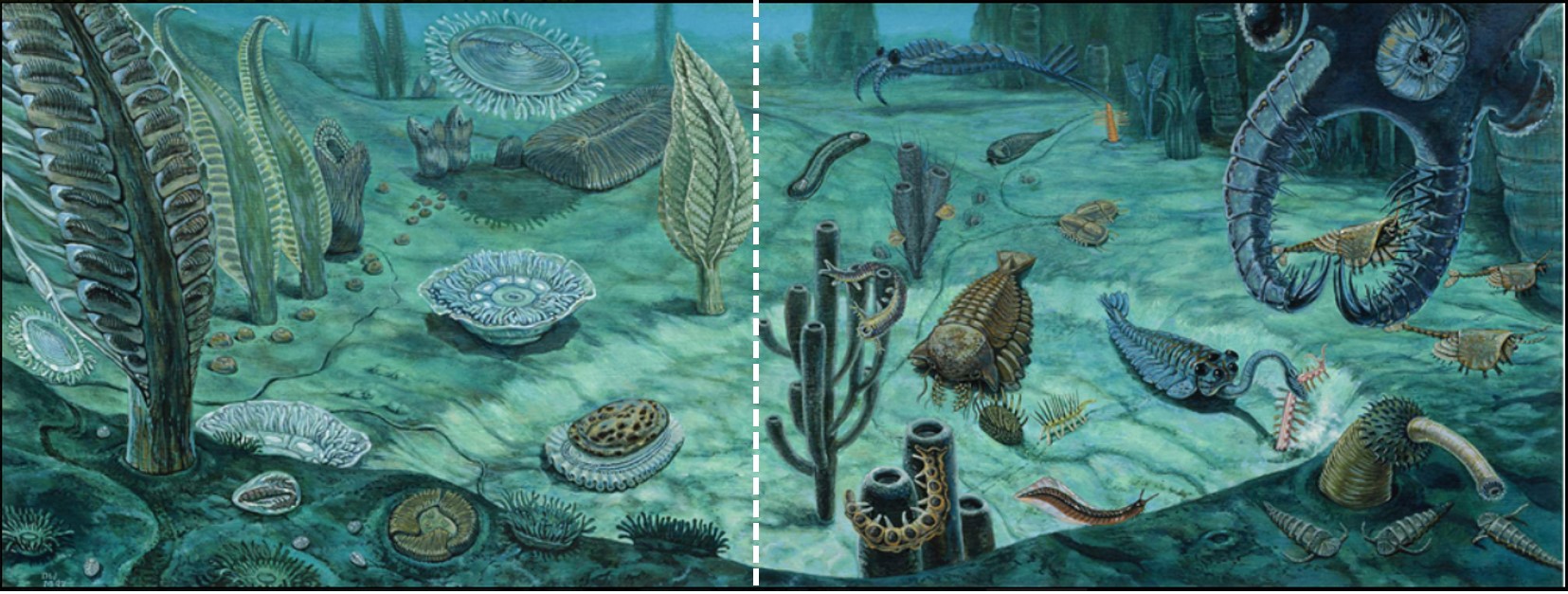

Uno de los sólidos más comunes en el universo, el LDA, no es del todo amorfo como se creía

El agua en estado sólido se supone que puede formar un vidrio, lo que se conoce como hielo amorfo de baja densidad (LDA, por sus siglas en inglés). Durante décadas el LDA ha sido considerado un sólido desordenado, casi una “instantánea congelada” del agua líquida. Sin embargo, un nuevo estudio demuestra algo notable: este tipo de hielo no sería completamente amorfo, sino que contendría cristales diminutos en su seno. Las implicaciones de algo aparentemente tan trivial son enormes.

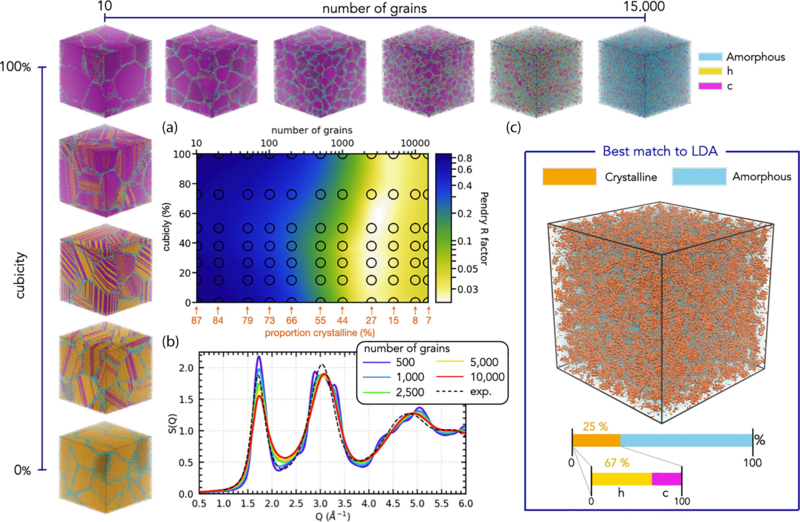

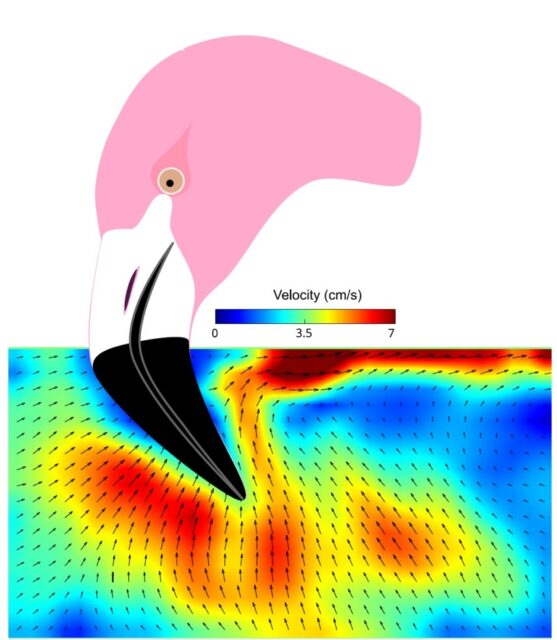

Dos modelos y un experimento muy ingeniosoEl equipo de investigación recurrió a dos modelos computacionales muy utilizados en las simulaciones de las masas de agua para recrear el LDA. Ambos modelos —uno que simula el enfriamiento desde agua líquida y otro que reproduce el proceso de vitrificación desde un estado cristalino— no lograron generar un sólido totalmente caótico, amorfo. En cambio, en los dos casos surgieron nanocristales dispersos en la estructura amorfa.

Fuente: M.B. Davies et al (2025) Physical Review B doi: 10.1103/PhysRevB.112.024203

Fuente: M.B. Davies et al (2025) Physical Review B doi: 10.1103/PhysRevB.112.024203Para validar estos resultados, los científicos complementaron las simulaciones con experimentos en el laboratorio muy ingeniosos. Produjeron hielo LDA a partir de dos rutas distintas: como deposición de vapor a muy baja temperatura y como calentamiento de hielo amorfo de alta densidad. Si el LDA fuese verdaderamente amorfo ambas rutas deberían obtener el mismo resultado. Sin embargo, comprobaron que, tras recristalizar, cada muestra mostraba diferencias en la proporción de estructuras cristalinas hexagonales. Esta “memoria” de la ruta de formación solo es posible si existen cristales microscópicos en el material

Este enfoque combinado, datos experimentales y modelado computacional, apunta a que el LDA no es un vidrio puro sino una forma parcialmente cristalina de hielo. Según los autores, la proporción estimada de cristales puede alcanzar hasta un 20 % del volumen total del material.

El LDA es uno de los sólidos más comunes del universo¿Por qué importa este hallazgo? En primer lugar, porque revela la verdadera naturaleza de uno de los sólidos más comunes en el universo. El LDA se encuentra en cometas, nubes moleculares del espacio profundo e incluso en las capas superiores de las atmósferas planetarias. Si su estructura es parcialmente cristalina, esto puede alterar cómo interactúa con la luz, cómo se funde y cómo influye en la química del entorno.

LDA y las anomalías del aguaEn segundo lugar, esta conclusión tiene implicaciones para entender las famosas “anomalías” del agua — fenómenos como su máxima densidad a 4 °C o la existencia de dos posibles estados líquidos en condiciones extremas. El hecho de que el LDA carezca de un equivalente líquido perfectamente correspondiente desafía ciertas teorías sobre el comportamiento del agua superenfriada En otras palabras, la existencia de estos nanocristales pone en entredicho el papel del LDA como referencia estructural para estudiar el agua en condiciones extremas.

Este hallazgo no solo refina nuestra comprensión del agua en condiciones extremas, sino que también invita a reevaluar qué entendemos por estructuras amorfas. Incluso en los sistemas aparentemente más desordenados, la naturaleza parece esconder un grado inesperado de organización.

Referencias:

M.B. Davies et al (2025) Low-density amorphous ice contains crystalline ice grains Physical Review B doi: 10.1103/PhysRevB.112.024203

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Uno de los sólidos más comunes en el universo, el LDA, no es del todo amorfo como se creía se ha escrito en Cuaderno de Cultura Científica.

Las anaranjadas perlas de la Luna

A nuestra escala -la de la humanidad- la Luna ha permanecido en el cielo como un cuerpo gris e inmutable. Su rostro, completamente cubierto de cráteres, nos hace pensar en un mundo geológicamente muerto, casi fósil. Pero no siempre fue así. Nuestra Luna, al igual que la Tierra, también tuvo una juventud fiera y volátil.

Hace unos 3500 millones de años, ocurrieron sobre la superficie lunar fenómenos volcánicos como las fuentes de lava, impulsadas por la expansión de burbujas de gas que procedían del interior del manto lunar. Estas erupciones -que estaban ocurriendo en el casi vacío del espacio- eran muy diferentes a las que ocurren en la Tierra. Gracias a los minúsculos restos de vidrio formados durante estos eventos, los científicos están comenzando a descifrar algunos secretos lunares que hasta ahora habían pasado desapercibidos.

Un nuevo estudio publicado en Icarus por Williams et al. (2025) ofrece una nueva perspectiva sobre este tipo de erupciones gracias al estudio a escala microscópica de unas pequeñas “perlas” de vidrio volcánico que trajeron a nuestro planeta los astronautas de la misión Apolo 17 y que ha permitido reconstruir la presión, la temperatura y la composición de la nube de gases volcánicos fruto de una erupción, abriéndonos la puerta a comprender mejor los mecanismos eruptivos en la Luna.

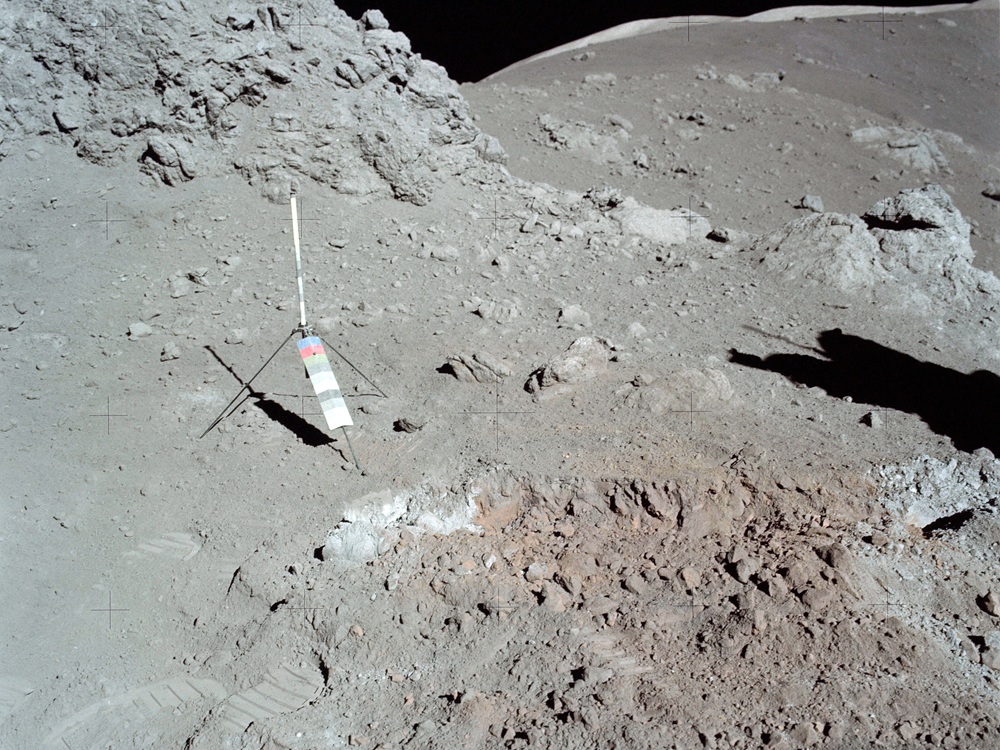

Imagen de una de las “trincheras” excavadas para que aflorasen mejor las perlas de color anaranjado. Destaca mucho la diferencia de color entre el regolito de color gris y el anaranjado que hay por debajo de la capa superficial. Imagen cortesía de la NASA.

Imagen de una de las “trincheras” excavadas para que aflorasen mejor las perlas de color anaranjado. Destaca mucho la diferencia de color entre el regolito de color gris y el anaranjado que hay por debajo de la capa superficial. Imagen cortesía de la NASA.La historia del estudio de vidrios lunares comienza en 1972, en el valle de Taurus-Littrow. Los astronautas de la misión Apolo 17 Eugene Cernan y Harrison Schmitt hicieron un descubrimiento asombroso e inesperado en el llamado cráter Shorty: una pequeña zona anaranjada como un oasis entre el infinito gris del regolito lunar.

Schmitt: ¡Oh, hey! ¡Espera un momento!

Cernan: ¿Qué?

Schmitt: ¿… dónde están esos reflejos? Ya me han engañado en otras ocasiones. ¡Hay tierra de color naranja!

Cernan: ¡Bien, no te muevas hasta que no lo vea!

Schmitt: ¡Está por todas partes! ¡Naranja!

Cernan: No te muevas hasta que lo vea.

Schmitt: Lo he removido con mis pies.

Cernan: ¡Hey, aquí está! ¡Puedo verlo desde aquí!

Schmitt: ¡Es naranja!

Cernan: Espera un momento, que subo la visera. ¡Sigue siendo naranja!

Schmitt: ¡Claro que lo es! ¡Que locura! ¡Naranja! Tengo que excavar una trinchera, Houston.

Este suelo naranja al que se refieren en la transcripción de la conversación, junto con el suelo más oscuro de alrededor, estaba formado por incontables pequeñas “perlas” de vidrio anaranjado, restos de un magma enfriado rápidamente y arrojados al cielo durante la erupción mediante fuentes de lava. Los astronautas recogieron estas muestras en tubos de muestras, los sellaron y protegieron de la contaminación de la atmósfera terrestre para su posterior estudio.

Durante décadas, los científicos habían pensado que estas perlas tenían algo de especial. Mientras las gotas de roca fundida viajaban a través del gas expulsado por la erupción, funcionaban como una especie de esponja en miniatura. Conforme estas gotas se alejaban de la parte central de la pluma de gases emitidos por la erupción, mucho más densa y caliente, algunos elementos se condensaron directamente sobre la superficie de estas perlas, recubriéndolas.

Estas coberturas, conocidas como sublimados, son como una especie de “fantasma” de la pluma de gases volcánica, aportándonos un registro directo de su química. Pero hasta ahora, el problema era leer su mensaje, ya que, con menos de 100 nanómetros de espesor, estas capas de minerales son muy frágiles, reactivas con la atmósfera terrestre y, por lo tanto, muy difíciles de analizar.

El astronauta y geólogo norteamericano Harrison Schmitt es uno de los protagonistas de esta historia. Aquí lo podemos ver con un gigantesco bloque de roca fragmentado que probablemente provenga de la formación de un cráter de impacto. Imagen cortesía de NASA.

El astronauta y geólogo norteamericano Harrison Schmitt es uno de los protagonistas de esta historia. Aquí lo podemos ver con un gigantesco bloque de roca fragmentado que probablemente provenga de la formación de un cráter de impacto. Imagen cortesía de NASA.Es en esta dificultad del estudio de estas muestras donde destaca este nuevo estudio. Los autores han podido trabajar con las muestras de unas perlas de vidrio oscuro que nunca han sido expuestas al aire de la atmósfera terrestre y que aparecen también junto a las anaranjadas.

Mediante unas técnicas de estudio microscópico han podido hacer observaciones tanto a nivel morfológico como químico. No ha sido una tarea fácil, ya que, desde la apertura del tubo donde estaba esta muestra hasta el moverlas entre los distintos instrumentos, se ha tenido que hacer en una atmósfera de nitrógeno puro o en vacío. Algo que no es precisamente pan comido, pero necesario para poder realizar el estudio con las garantías de que al menos no habría alteraciones químicas en la superficie de las perlas.

Este meticuloso análisis ha conseguido descifrar una historia escrita en las distintas capas de las perlas. Una de las cosas que más han llamado la atención de los científicos es la aparición de unos “montículos” microscópicos y con forma semiesférica. Estos están formados por la esfalerita policristalina, un sulfuro de cinc.

Para que se forme la esfalerita, la nube de gas volcánico tiene que contener -obviamente- azufre y cinc. Pero más importante es este otro detalle: su formación apunta directamente a otro elemento, el hidrógeno. Los modelos termodinámicos nos cuentan que en una nube de gas pobre en hidrógeno, el cinc prefiere enlazarse con el cloro para formar cloruro de cinc. La prevalencia del sulfuro de cinc en estas perlas es una fuerte evidencia de que el gas volcánico era rico en hidrógeno en comparación con los elementos halógenos (flúor, cloro, bromo, yodo y astato). Esta prueba sirve como apoyo a la teoría de que el manto lunar no está totalmente seco, sino que contiene grandes cantidades de elementos volátiles que eran capaces de impulsar estas erupciones.

Pero cuando los investigadores pudieron observar más de cerca estos montículos de esfalerita, descubrieron también un gradiente químico muy sutil, pero consistente entre los montículos: en la base, donde se unen a la perla de vidrio, estaban especialmente enriquecidos en hierro con respecto a la cima del montículo. Esta distribución, según interpretan los autores, nos cuenta la historia del viaje de la perla por la nube de gas.

Los modelos muestran que el sulfuro de hierro se condensa a temperaturas más altas y menores presiones que el sulfuro de cinc. Esto significa que conforme la perla sale disparada de la fisura volcánica, pasa primero por una región más densa y caliente donde se enriquecería en el hierro.

Conforme viajara hacia afuera de la nube de gas, hacia las zonas más frías y con menor presión, este cambio en las condiciones favorecería el depósito de las capas ricas en cinc sobre las anteriores. Esto sirve como una especie de registro de las condiciones de presión y temperatura dentro de la misma nube de gas, y del rápido viaje de la perla a través de esta.

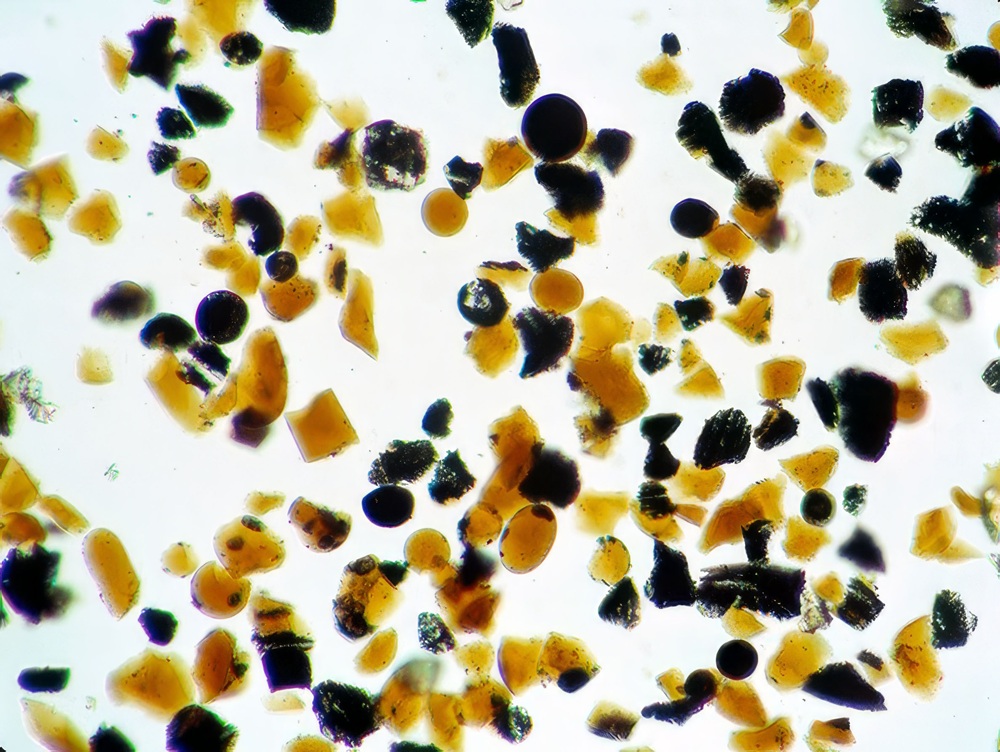

Imagen de las “perlas” de color anaranjado vistas al microscopio. Las más grandes de la imagen están en torno a las 40 micras. Cortesía de NASA/JSC.

Imagen de las “perlas” de color anaranjado vistas al microscopio. Las más grandes de la imagen están en torno a las 40 micras. Cortesía de NASA/JSC.Los investigadores han encontrado otras morfologías sobre la superficie que se habrían superpuesto sobre los montículos, lo que también sugiere que hay un orden en el depósito de otros minerales sobre las perlas. Y este detalle implicaría lo siguiente: No todas las perlas siguieron la misma trayectoria, sino que unas pudieron seguir una más corta antes de caer sobre la superficie y en la que solo dio tiempo a formar los montículos y otras que salieron disparadas mucho más altas y que por lo tanto tuvieron tiempo de quedar recubiertas de una manera más compleja al pasar más tiempo por la pluma de gases de la erupción.

Y, por último, nos falta la interpretación de la propia erupción a partir de estos datos. Los científicos han comparado las perlas de color oscuro con las famosas perlas naranjas. Mientras que las oscuras están recogidas de aproximadamente medio metro de profundidad, las naranjas estaban a muy pocos centímetros de la superficie. Los investigadores piensan que el depósito de estos materiales volcánicos ocurrió en una sola erupción, y por lo tanto su posición estratigráfica es importante: las perlas oscuras se depositaron antes que las naranjas.

Los análisis que se habían realizado anteriormente de las perlas naranjas habían mostrado que los sublimados no estaban compuestos principalmente por sulfuro de cinc, sino por cinc metálico que posteriormente había reaccionado para dar lugar a otros minerales. Los modelos termodinámicos muestran que para que se precipite el cinc nativo en vez de la esfalerita, la presión del gas en la nube tuvo que ser extremadamente baja, órdenes de magnitud por debajo a la presión a la que se forma el sulfuro de cinc.

Esto nos da una pista fundamental sobre la erupción: es posible que comenzase con una presión muy alta, creando una densa nube de gas que provocó el depósito rico en sulfuro de hierro y cinc sobre las primeras perlas de vidrio negro. Con el tiempo, la fuerza de la erupción fue disminuyendo -como ocurre en las erupciones terrestres-, la nube de gas comenzó a ser menos densa y las perlas naranjas se fueron recubriendo del cinc en estado nativo.

Los diferentes recubrimientos de las perlas, separadas por apenas unas decenas de centímetros en el regolito lunar, sirven como un testimonio de la variación en la intensidad de la erupción a lo largo del tiempo, como si pudiésemos ver una película que ha quedado registrada en minúsculos detalles de la geología lunar.

Este trabajo nos abre una ventana para refinar los modelos de funcionamiento del vulcanismo lunar y de la composición de su interior, pero también demuestra que la Luna era un mundo con sistemas volcánicos que evolucionaban y eran químicamente diversos. Y nos debe recordar que, aunque no hayamos vuelto a la Luna -el ser humano, me refiero-, las muestras que se tomaron durante las misiones Apolo todavía tienen mucho que contarnos… ¿Qué secretos aguardarán a ser descubiertos?

Referencias:

Williams, T. A., Parman, S. W., Saal, A. E., Akey, A. J., Gardener, J. A., & Ogliore, R. C. (2025). Lunar volcanic gas cloud chemistry: Constraints from glass bead surface sublimates Icarus, 438, 116607. doi: 10.1016/j.icarus.2025.116607

Fuente de la conversación: N.G. Bai ley and G.E. Ulrich (1975) APOLLO 17 VOICE TRANSCRIPT Pertaining to the geology of the landing site U.S. Geological Survey – Branch of Astrogeology

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Las anaranjadas perlas de la Luna se ha escrito en Cuaderno de Cultura Científica.

Confirmado: El «hombre dragón» es denisovano

Reconstrucción artística de la apariencia que tendría un denisovano. Ilustración: Chuang Zhao

Reconstrucción artística de la apariencia que tendría un denisovano. Ilustración: Chuang Zhao

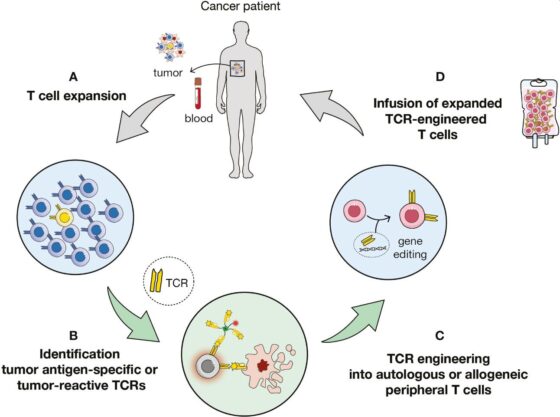

Hay quien suele imaginar el camino evolutivo del ser humano como una línea recta que se mueve directa desde nuestros orígenes en África hasta la actualidad, en nuestras ciudades, con ordenadores, coches y teléfonos. Es bastante conocida la viñeta que muestra una ordenada sucesión de figuras, desde el primate encorvado hasta el señor erguido vistiendo orgulloso un traje. A veces se representa la evolución como un árbol, con un tronco común del que nacen diferentes ramas que se extiende de manera independiente creciendo o cortándose abruptamente. La realidad es mucho más compleja y difícil de visualizar, una especie de embrollada madeja con docenas de hilos que no solo se enredan, se anudan o se cruzan, sino que pueden mezclarse dando lugar a nuevos hilos. Homo sapiens, Homo habilis, Homo rudolfensis, Homo heidelbergensis, Homo neanderthalensis, Homo floresiensis, Homo naledi, Homo denisovensis… las hebras son tan variadas y traviesas que se enmarañan con el tiempo y representan un quebradero de cabeza para los científicos que, además, a menudo se ven obligados a trabajar con solo un trocito de ellas.

Uno de los cabos sueltos en ese confuso ovillo de especies del género Homo apareció no hace mucho. En 2008, un equipo de investigadores del Max Planck encabezados por Svante Pääbo, que diez años más tarde ganaría el Premio Nobel de Medicina, analizó un pequeño fragmento de hueso del dedo meñique de una niña, encontrado en las cuevas de Denísova, en los montes Altái de Siberia. Los resultados genéticos fueron sorprendentes. El ADN mitocondrial de aquella niña ofrecía pistas de linajes bien conocidos pero no se podía clasificar claramente como sapiens o como neandertal. La madeja se enredaba aún más. Más adelante, cuando se logró secuenciar su genoma nuclear completo, la conclusión apuntaba a que esa niña estaba más emparentada con los neandertales, con quienes compartió un antecesor común, antes de divergir hace aproximadamente unos 400.000 años. La cueva se convirtió en un buen filón de pistas y, desde entonces, se han encontrado diferentes artefactos y herramientas, así como otros restos humanos. Un molar (bastante grande), varios dientes más, y un puñado de pequeños fragmentos óseos pertenecientes a diferentes estratos y, por tanto a diferentes épocas. Posteriores estudios ayudaron a concluir que nos encontrábamos ante un linaje de humanos diferente al que, en honor a la cueva donde se descubrieron, se bautizó como los denisovanos. La escasez de restos fósiles obligó a aguzar el ingenio de los investigadores y el Homo denisovanis se convirtió en la primera especie humana que se catalogó utilizando ADN y descubriendo que los denisovanos no solo convivieron con sapiens y neandertales, sino llegaron a tener descendencia con ambos.

Lo que no podían sospechar todos los científicos que luchaban por trabajar con esos limitados y escasos restos es que existía un gran cráneo denisovano, oculto desde hace décadas, sin que nadie lo supiera. En 1933, setenta y cinco años antes del primer descubrimiento denisovano, un hombre participaba en la construcción de un puente cerca de la ciudad de Harbin, en China. Por aquel entonces el ejército japonés ocupaba el norte de China y obligaba a un grupo de soldados chinos capturados a trabajar en aquella infraestructura. De entre los escombros, surgió una calavera, incompleta, extraña y diferente. Uno de los soldados chinos la cogió y la escondió de sus enemigos, pensando que tenía en su poder algo valioso. Durante décadas no compartió su hallazgo con nadie, incluso llegó a ocultarla en un pozo cerca de su casa para que no se la quitaran y así pasaron los años. Poco antes de su muerte, aquel hombre reunió a su familia y les habló del pozo y del «precioso tesoro» que guardaba, seguía creyendo que ese insólito cráneo tenía un gran valor. En 2018, sus nietos herederos lo encontraron, lo sacaron del pozo y, lejos de hacerse ricos con él, lo donaron a la Universidad GEO de Hebei.

El soldado había fallecido sin aclarar el lugar exacto donde había encontrado el cráneo y el equipo de paleoantropólogos de Hebei, liderados por Quian Ji, junto a otros expertos en datación y geocronología de la Universidad Griffith, en Australia, tuvieron que esforzarse para confirmar su procedencia. Analizaron isótopos de estroncio incrustados en las fosas nasales del cráneo con una capa específica de sedimentos alrededor del puente y pudieron llegar a una primera aproximación de su edad, entre 138.000 y 309.000 años. Más tarde llegarían estudios de datación por uranio que lo situaban, como mínimo, en 146.000 años.

Realmente era un cráneo extraño, visiblemente más grande que cualquiera que se hubiera encontrado jamás. Realizaron una reconstrucción del cráneo encontrado en Harbin y llegaron a la conclusión de que «pertenecía a un varón de mejillas planas, boca ancha y carente de barbilla. Una imponente frente colgaba sobre sus ojos hundidos y su nariz bulbosa. Y dentro de su enorme cráneo había un cerebro descomunal, que medía un 7 % más que el cerebro medio de un ser humano actual».

El cráneo encontrado en el puente cerca de Harbin, China en 1933 | Qiang Ji, Wensheng Wu et al. (2021) Cell doi: 10.1016/j.xinn.2021.100132 CC BY-ND 4.0

El cráneo encontrado en el puente cerca de Harbin, China en 1933 | Qiang Ji, Wensheng Wu et al. (2021) Cell doi: 10.1016/j.xinn.2021.100132 CC BY-ND 4.0

En 2021, los investigadores publicaron sus resultados en Cell, describiendo el cráneo e indicando que correspondía a «un homínido extinto masivo en tamaño con una longitud craneal máxima muy grande, tanto en longitud nasiooccipital como en anchura del toro supraorbitario; bóveda craneal larga y baja, con frontal retraído, contorno parietal uniformemente curvado y contorno occipital redondeado; sin quilla sagital; cara superior extremadamente ancha, con órbitas grandes y casi cuadradas; altura facial baja en relación con la anchura facial superior; toro supraorbitario ancho, masivamente desarrollado y suavemente curvado». Estaban entusiasmados y concluyeron que ese cráneo, con todos esos rasgos diferenciados, debía pertenecer a una especie propia. La llamaron Homo longi, en honor a Longjian, la región donde se encontró el cráneo. Longjian significa gran dragón y, consecuentemente, al gran cráneo datado en el Pleistoceno medio tardío se le terminó conociendo como «el hombre dragón», un suculento nombre que abrió muchas portadas por aquellos años.

Reconstrucción virtual en 3D del cráneo del «hombre dragón» encontrado en el puente de Harbin, China. Fuente: Xijun Ni et al (2021) The Innovation doi: 10.1016/j.xinn.2021.100130 CC BY-ND 4.0

Reconstrucción virtual en 3D del cráneo del «hombre dragón» encontrado en el puente de Harbin, China. Fuente: Xijun Ni et al (2021) The Innovation doi: 10.1016/j.xinn.2021.100130 CC BY-ND 4.0

El sueño de cualquier paleontólogo es descubrir una nueva especie, ser recordado por encontrar y bautizar un nuevo hilo de la compleja madeja humana, sin embargo ese anhelo puede desembocar, y de hecho así ocurre frecuentemente, en prisas y confusiones. La emoción por el nuevo descubrimiento pronto fue sustituido por críticas en diversos medios especializados y muchos expertos expresaron sus dudas al artículo publicado en Cell. Entre ellos destaca la voz autorizada de María Martinón (CENIEH) que, en un artículo publicado en Science en 2021, afirmaba que «es prematuro nombrar una nueva especie, especialmente un fósil sin contexto y con contradicciones en el conjunto de datos». Cuanto más se analizaba más fuerza tomaba la idea de que el «hombre dragon» podría representar no una nueva especie humana, sino el primer cráneo de un denisovano.

Por supuesto, cada vez que surge una hipótesis en ciencia también aparecen científicos dispuestos a corroborarla o echarla por tierra. La primera en saltar al escenario fue Qiaomei Fu, una genetista china del Instituto de Paleoantropología de Pekin que trabajaba en el primer ADN denisovano procedente del pequeño hueso de Siberia. Comparar ese ADN denisovano de la niña de la cueva de Denísova con el ADN del cráneo del «hombre dragón» despejaría todo el misterio. Intentaron extraer material genético de una parte del cráneo llamada hueso petroso (que suele ser una buena fuente) y también de un diente adherido a la mandíbula superior (la inferior no se ha conservado). No lo consiguieron, pero sí lograron secuenciar fragmentos de 95 proteínas antiguas que compararon con secuencias de humanos modernos, neandertales y, cómo no, sus muestras del hueso denisovano. No encontraron correlación con los dos primeros pero sí descubrieron una secuencia proteica idéntica, tanto en la niña de Denísova como en el cráneo de Harbin… Esto sugería que el «hombre dragón» sí que podría ser denisovano… pero sin ADN que lo confirmase, no era suficiente.

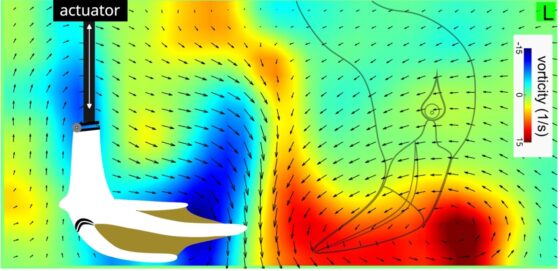

En rojo la localización de los 0,3 mg de cálculo dental extraídos del cráneo de Harbin, donde se capturó y secuenció el ADNmt. Fuente: Qiaomei Fu, Peng Cao, et al. (2025) Cell doi:10.1016/j.cell.2025.05.040 CC BY-ND 4.0

En rojo la localización de los 0,3 mg de cálculo dental extraídos del cráneo de Harbin, donde se capturó y secuenció el ADNmt. Fuente: Qiaomei Fu, Peng Cao, et al. (2025) Cell doi:10.1016/j.cell.2025.05.040 CC BY-ND 4.0

Qiaomei Fu no se dio por vencida y, unos años más tarde, lo ha conseguido. «En lugar de buscar material genético en el propio cráneo, ella y su equipo rasparon un pequeño fragmento de placa dental fosilizada, o cálculo dental, de la raíz ennegrecida del único molar restante del cráneo». Aunque el cálculo contiene menos ADN antiguo que el que se encuentra habitualmente en huesos o dientes, su estructura mineral permite preservar mejor su contenido. Fue un momento emocionante. El equipo de Fu logró raspar apenas 0,3 miligramos de cálculo de ese diente. Puede parecer muy poco, y mucho menos si tenemos en cuenta que «casi cuatro quintas partes de ese material genético extraído provenían de contaminación moderna», pero con lo que quedó pudieron conseguir el ADN que necesitaban. Sus resultados se han publicado hace unos días en la Revista Cell y confirman que coinciden con el ADN mitocondrial de genomas denisovanos previamente secuenciados, lo que confirma que «el hombre dragón» es de hecho un denisovano.

Referencias científicas y más información:

Qiaomei Fu, Peng Cao, et al. (2025) Denisovan mitochondrial DNA from dental calculus of the >146,000-year-old Harbin cranium Cell doi:10.1016/j.cell.2025.05.040

Marshall, Michael (2025) Who Were the Ancient Denisovans? Fossils Reveal Secrets about the Mysterious Humans Nature doi:10.1038/d41586-025-01549-3.

Lewis, Dyani (2025) First Ever Skull from ‘Denisovan’ Reveals What Ancient People Looked Like Nature DOI:10.1038/d41586-025-01899-y.

Sobre el autor: Javier «Irreductible» Peláez es escritor y comunicador científico multimedia. Es ganador de tres premios Bitácoras, un premio Prisma a la mejor web de divulgación científica y un Premio Ondas al mejor programa de radio digital.

El artículo Confirmado: El «hombre dragón» es denisovano se ha escrito en Cuaderno de Cultura Científica.

Sobrarbe-Pirineos: qué hacemos en un geoparque de montañas

¿Qué tienen en común un paisaje espectacular, un fósil milenario y una cantera abandonada? Todos forman parte del patrimonio geológico, un testimonio de la historia de la Tierra con un gran valor científico, educativo, cultural y estético, y base del patrimonio natural. Sin embargo, su importancia continúa siendo poco apreciada.

Para acercar las distintas aproximaciones del patrimonio geológico a la sociedad, los días 26, 27 y 28 de marzo se celebró la quinta edición de las jornadas divulgativas “Geología para poetas, miopes y despistados. Patrimonio patrimonio”. Organizadas por el grupo de investigación consolidado Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco (UPV/EHU), estas jornadas contaron con la colaboración del Vicerrectorado del Campus de Bizkaia, la Cátedra de Cultura Científica de la UPV/EHU, el Geoparque de la Costa Vasca / Geoparkea y el Ente Vasco de la Energía (EVE).

Los geoparques no son solo curiosidades científicas, también son motores de desarrollo de las áreas donde se implantan. Los geoparques de montaña son muy particulares. Ánchel Belmonte las describe en esta conferencia.

Ánchel Belmonte Ribas es doctor en Geología y Coordinador de la Comisión Científico Asesora del Geoparque Mundial UNESCO Sobrarbe-Pirineos.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Sobrarbe-Pirineos: qué hacemos en un geoparque de montañas se ha escrito en Cuaderno de Cultura Científica.

PCSK9, sospechoso habitual

La proteína PCSK9 (del inglés Proprotein Convertase Subtilisin/Kexin type 9) es miembro de una familia de proteínas llamadas proproteínas convertasas. Dentro de la familia, PCSK9 fue la última en descubrirse y difiere de las demás por su comportamiento. Aquellas personas que tienen problemas de hipercolesterolemia probablemente tengan conocimiento de su existencia puesto que las personas que no responden a tratamientos clásicos como las estatinas se medican con inhibidores de PCSK9.

¿Qué hace PCSK9?PCSK9 es una enzima que tiene la capacidad de cortar otras proteínas como si fuera una tijera, pero en la mayoría de las ocasiones no hace uso de esa cualidad más que consigo misma. Antes de que se produzca el corte, PCSK9 no es funcional; de ahí la importancia de que se corte a sí misma para que se vuelva activa. La proteína, una vez procesada, funciona principalmente como transportadora. Se une a otras proteínas para llevarlas a orgánulos determinados donde son procesadas.

PCSK9 en la hipercolesterolemia

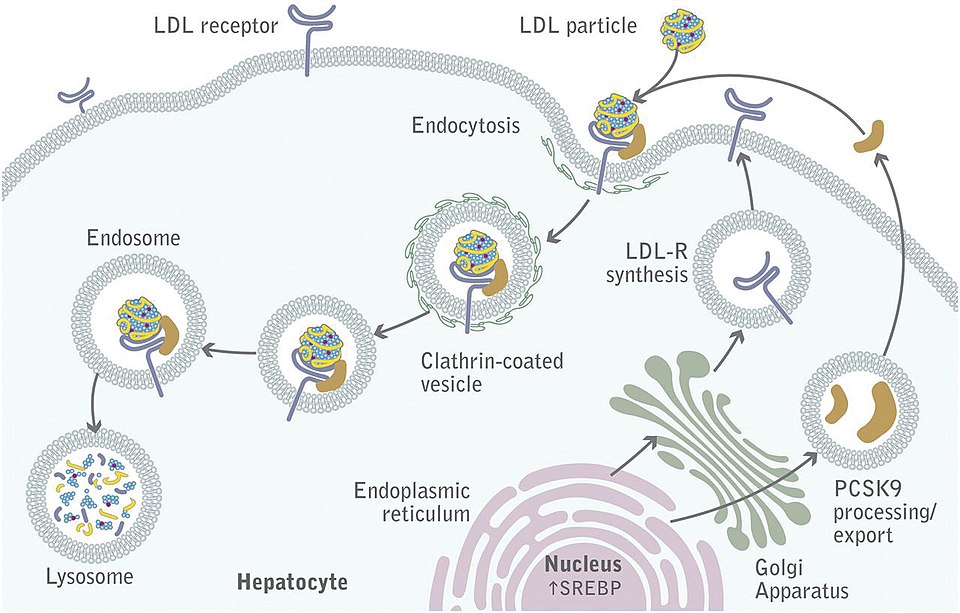

PCSK9 en los hepatocitos. Fuente: Gilles Lambert, Barbara Sjouke, Benjamin Choque, John J.P. Kastelein, G. Kees Hovingh – doi: 10.1194/jlr.R026658 CC BY 4.0 / Wikimedia Commons

PCSK9 en los hepatocitos. Fuente: Gilles Lambert, Barbara Sjouke, Benjamin Choque, John J.P. Kastelein, G. Kees Hovingh – doi: 10.1194/jlr.R026658 CC BY 4.0 / Wikimedia CommonsEn el caso de la hipercolesterolemia se ha visto que PCSK9 se une al receptor del colesterol LDL (lipoproteína de baja densidad, del inglés low density lipoprotein); también llamado coloquialmente colesterol malo por su papel en la ateroesclerosis; en los hepatocitos del hígado. El hígado es el órgano que procesa el colesterol que circula por la sangre. Para ello, los hepatocitos que son las células funcionales del hígado tienen unas proteínas que se llaman receptores, los cuales son específicos para diferentes tipos de moléculas. Uno de estos receptores es el del colesterol LDL. Este receptor capta el colesterol LDL de la sangre y se procesa dentro del hepatocito. La proteína PCSK9 tiene la capacidad de unirse al receptor del colesterol LDL que se encuentra anclado sobre la membrana del hepatocito y lo transporta al lisosoma, orgánulo donde se da la degradación del receptor. De esta manera, un alto contenido de PCSK9 celular provoca la destrucción de los receptores de colesterol LDL de los hepatocitos; el colesterol LDL no se internaliza y se acumula en la sangre.

PCSK9 y cáncer

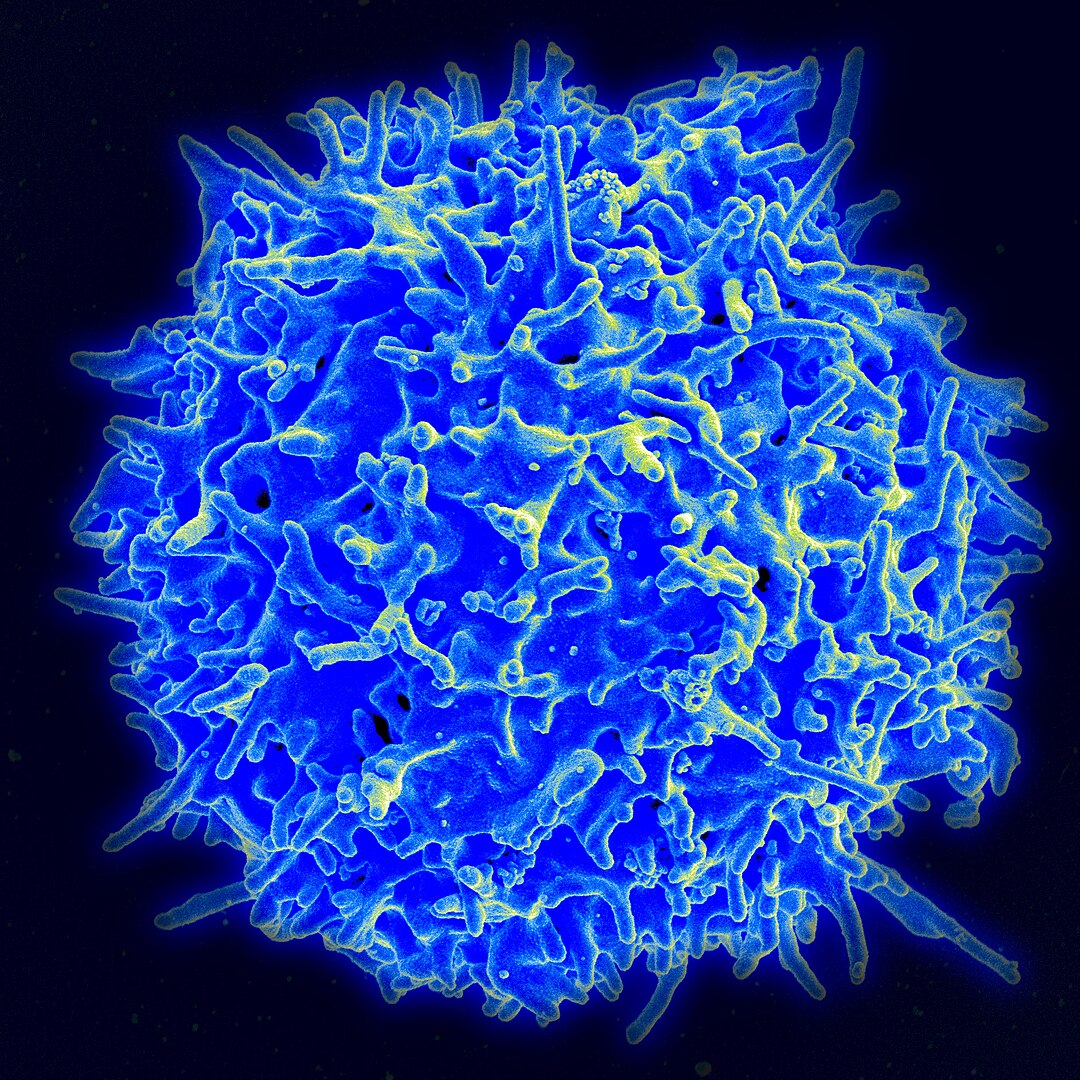

La hipercolesterolemia no es la única patología en la cual se ha identificado a PCSK9. También se ha observado que algunos tumores poseen grandes cantidades de esta proteína. En algunos tipos de tumores como es el caso del cáncer colorrectal, el cáncer de estómago o el cáncer del cuello del útero, se ha visto que PCSK9 también realiza el papel de transportador. En estos casos transporta la proteína MHC I (del inglés Major Histoconpatibiity Complex type I) o complejo mayor de histocompatibilidad clase I. Este complejo formado por proteínas aparece en todas nuestras células nucleadas y su función es presentar antígenos a las células del sistema inmune. Los antígenos son pequeños trozos de proteínas capaces de producir una reacción inmunitaria. Si nuestro cuerpo detecta un antígeno que no es propio como puede ser un fragmento de la proteína de un virus, las células del sistema inmune lo reconocerán y comenzará la respuesta inmunitaria. De esta manera cuando un tumor se va desarrollando, las células aberrantes expresan antígenos modificados también llamados neoantígenos que son presentados a través del MHC I y las células del sistema inmune los reconocen como extraños y atacan a las células tumorales. Tal y como ocurre con el receptor del colesterol LDL, PCSK9 transporta el complejo MHC I a los lisosomas donde se degrada y las células tumorales no visibilizan sus neoantígenos, de esa manera los tumores se vuelven invisibles para las células del sistema inmune y de ahí su agresividad.

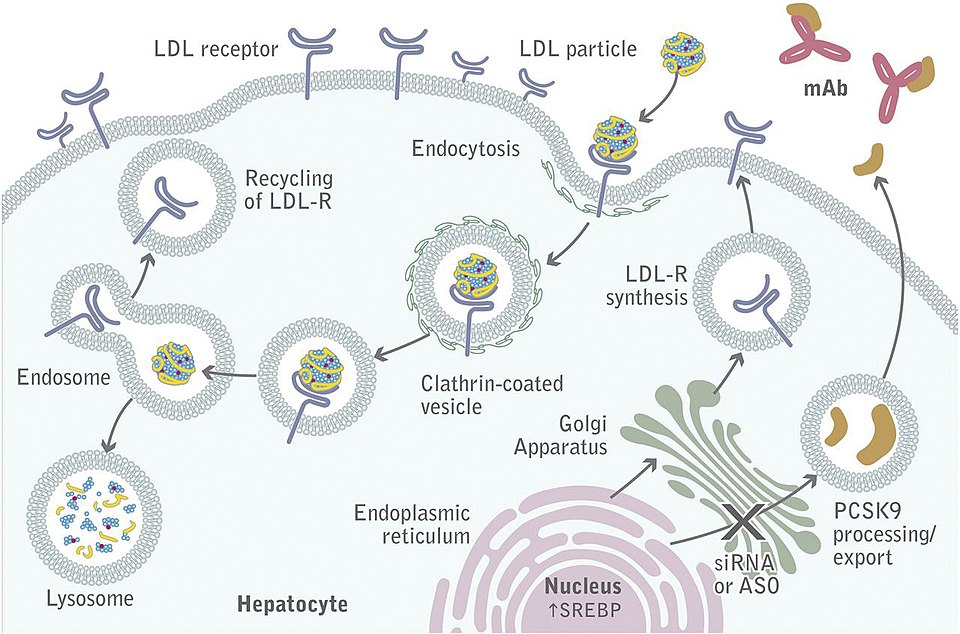

Tratamientos contra PCSK9 Los anticuerpos monoclonales (mAb) bloquean la acción de PCSK9 permitiendo el reciclado del receptor de LDL. Fuente: Gilles Lambert, Barbara Sjouke, Benjamin Choque, John J.P. Kastelein, G. Kees Hovingh – doi: 10.1194/jlr.R026658 CC BY 4.0 / Wikimedia Commons

Los anticuerpos monoclonales (mAb) bloquean la acción de PCSK9 permitiendo el reciclado del receptor de LDL. Fuente: Gilles Lambert, Barbara Sjouke, Benjamin Choque, John J.P. Kastelein, G. Kees Hovingh – doi: 10.1194/jlr.R026658 CC BY 4.0 / Wikimedia CommonsLos primeros tratamientos que se desarrollaron contra PCSK9 se diseñaron para atajar los problemas de hipercolesterolemia. Se desarrollaron anticuerpos que bloqueaban la acción de PCSK9 impidiendo su unión a los receptores de colesterol LDL o más recientemente se ha usado la tecnología del pequeño ARN interferente, que permite el silenciamiento a nivel de ARN. Es evidente que, visto el papel de PCSK9 en el cáncer, nos puede surgir la pregunta de si estos medicamentos pueden ser también útiles contra esta enfermedad. Por ello, la investigación actual parece ir en la línea de describir nuevas aplicaciones para estos inhibidores de PCSK9 dado que, al haber superado ya todas las medidas de seguridad requeridas por las agencias que regulan la comercialización de los medicamentos, su utilización como terapia antitumoral podría aplicarse de forma segura en mucho menos tiempo que los nuevos medicamentos.

Bibliografía

Xinjian Liu, Xuhui Bao, Mengjie Hu, Hanman Chang, Meng Jiao, Jin Cheng, Liyi Xie, Qian Huang, Fang Li, Chuan-Yuan Li (2020) Inhibition of PCSK9 potentiates immune checkpoint therapy for cancer Nature doi: 10.1038/s41586-020-2911-7

Roth EM, Davidson MH (2018) PCSK9 Inhibitors: Mechanism of Action, Efficacy, and Safety Rev Cardiovasc Med doi: 10.3909/ricm19S1S0002

Melendez QM, Krishnaji ST, Wooten CJ, Lopez D. (2017) Hypercholesterolemia: The role of PCSK9 Arch Biochem Biophys. doi: 10.1016/j.abb.2017.06.001

Sobre los autores: Ander Martín es doctor en biotecnología e investigador en la Facultad de Medicina y Enfermería de la UPV/EHU, e Iker Badiola Etxaburu es doctor en biología, Profesor Pleno en la Facultad de Medicina y Enfermería de la UPV/EHU, y director de la Cátedra de Cultura Científica de la UPV/EHU

El artículo PCSK9, sospechoso habitual se ha escrito en Cuaderno de Cultura Científica.

Un volcán escondido… a la vista de todos

En los últimos cuatro años, el rover Perseverance ha estado investigando la inmensa cuenca formada por el cráter Jezero buscando signos de la existencia de vida en el pasado remoto del planeta Marte, cuando este lugar era muy diferente y albergaba un profundo lago al que llegaban las aguas desde distintos ríos y en el que incluso existía un delta cuya forma todavía se intuye desde el espacio. Pero al comenzar su andadura, el rover descubrió que todas las rocas del fondo no eran sedimentarias -como uno podría esperar del fondo de un lago- sino que también había rocas ígneas, formadas a partir de un magma que se enfría.

Esta primera sorpresa ayudó a los científicos a confirmar la hipótesis de que el cráter Jezero no solo había sido transformado por la actividad del agua, sino que también existían otros procesos activos. Y es que, si el fondo del cráter estaba cubierto por materiales volcánicos, ¿de dónde procedían? Porque tampoco es que hubiese ningún volcán cercano… al menos en apariencia.

Pero en un nuevo estudio publicado por Cuevas-Quiñones et al. (2025) en Communications Earth & Enviroment parece haber encontrado un volcán que habría permanecido escondido a la vista de todos, aunque suene contradictorio. Este, en realidad, estaría en una montaña que aparece en el borde sureste del cráter Jezero y que oficialmente se denomina Jezero Mons.

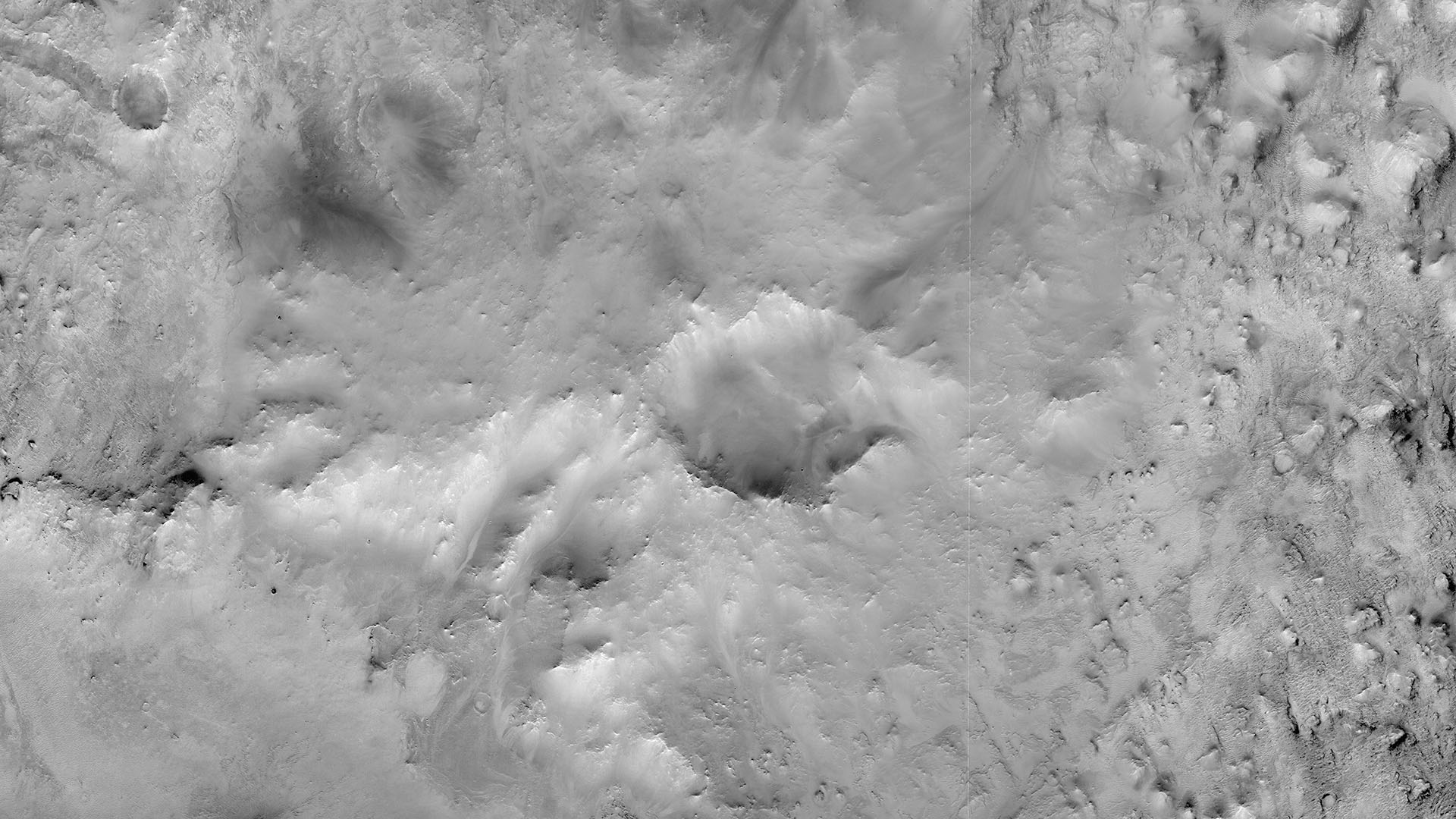

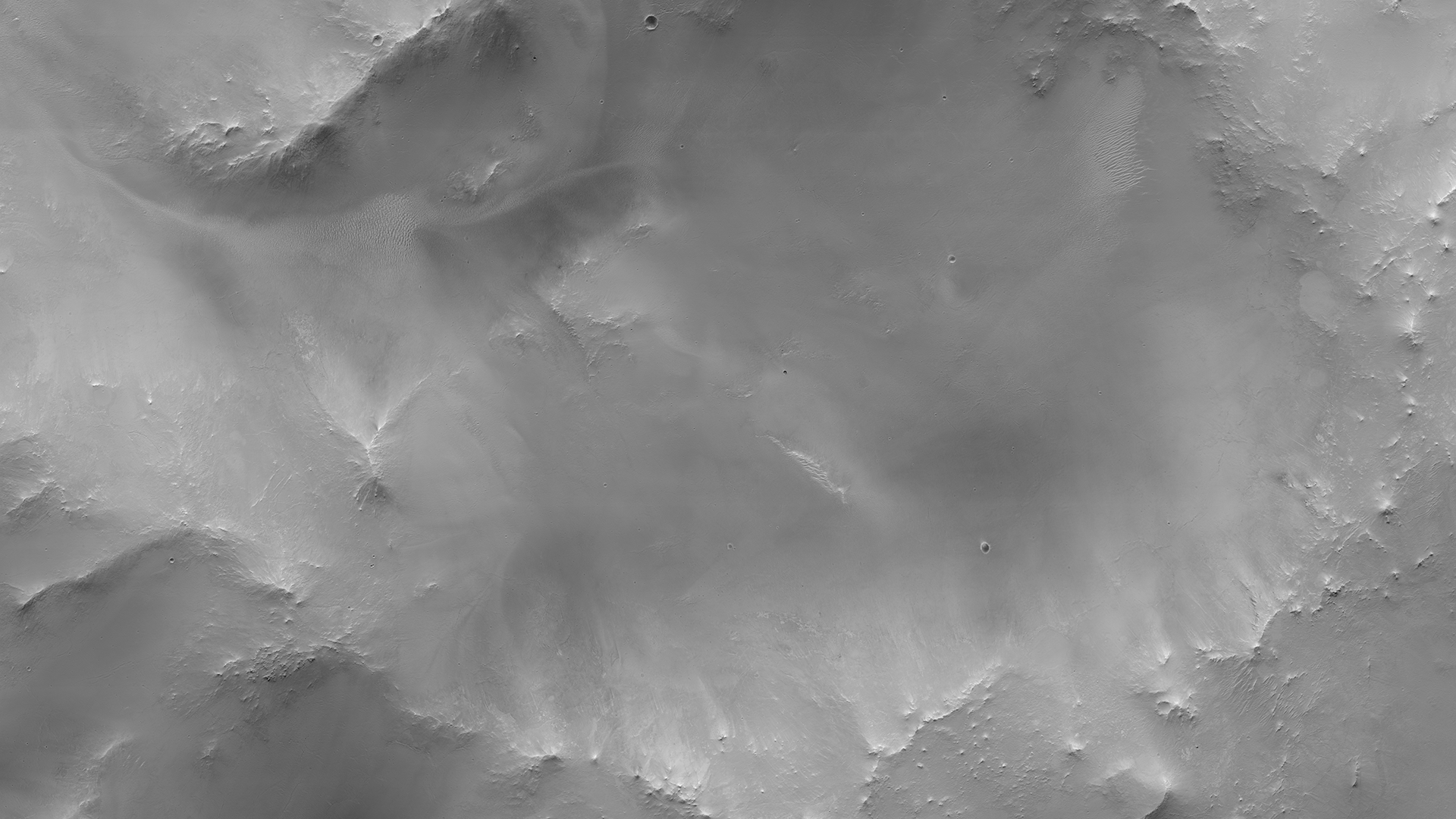

En el centro de la imagen podemos ver el cráter que se encuentra sobre la cima de Jezero Mons, con una forma ovalada y una abertura. En la esquina inferior izquierda podemos observar también una parte del perfil del cráter Jezero, notable especialmente por su superficie más llana y suave que el terreno que le rodea. Imagen cortesía de NASA/JPL/ASU.

En el centro de la imagen podemos ver el cráter que se encuentra sobre la cima de Jezero Mons, con una forma ovalada y una abertura. En la esquina inferior izquierda podemos observar también una parte del perfil del cráter Jezero, notable especialmente por su superficie más llana y suave que el terreno que le rodea. Imagen cortesía de NASA/JPL/ASU.Desde el sitio de aterrizaje del Perseverance, Jezero Mons domina una buena parte del horizonte sureste gracias a sus dos kilómetros de altura. Durante años, los mapas creados a partir de los datos orbitales tomados por las distintas sondas clasificaban esta inmensa mole como parte de lo que llamamos basamento, la corteza antigua y completamente cubierta de cráteres que forma el borde del cráter y sobre el que este fue excavado.

Pero la forma y el tamaño de este “monte” ya había levantado anteriormente la suspicacia de algunos científicos, pero se necesitaban más datos para confirmar que podríamos estar ante algo más que un simple relieve. Para ello, en esta investigación se han ayudado de los datos tomados por misiones anteriores para poder comprender mejor a este sospechoso. Pero, ¿qué pistas han encontrado en estos datos? Os las desgrano una a una.

El primer aspecto en el que se fijaron es la morfometría -término bajo el que se esconde el estudio de la forma de la montaña. Jezero Mons es una estructura prácticamente cónica con unos 21 kilómetros de diámetro y con un cráter desfigurado -poco circular en este caso, y con una abertura- en su cima. No solo se quedaron aquí, sino que aprovecharon para medir las pendientes de las laderas, la proporción entre su anchura y la altura y el tamaño del cráter de su cima con relación a la base para poder comparar edificios volcánicos en la Tierra y en Marte.

Los resultados fueron apabullantes. Jezero Mons se ajustaba a la perfección al perfil de otros volcanes compuestos -o estratovolcanes- marcianos como Zephyria Tholus y Apollinarus Tholus y también es muy parecido al del monte Sidley, un gran pico volcánico -bueno, de hecho el volcán más alto- de nuestra Antártida terrestre.

Pero en lo que desde luego no se parece en nada es a los volcanes en escudo, con sus bases muy anchas y sus suaves laderas -como Mauna Loa, en Hawái- y que dominan el espectro volcánico de Marte, ni tampoco se parece a un cráter en pedestal -esos cráteres “formados” sobre una meseta elevada-. Así que parece que su forma dice a gritos la palabra estratovolcán, esos que en nuestro planeta pueden dar lugar a violentas erupciones volcánicas.

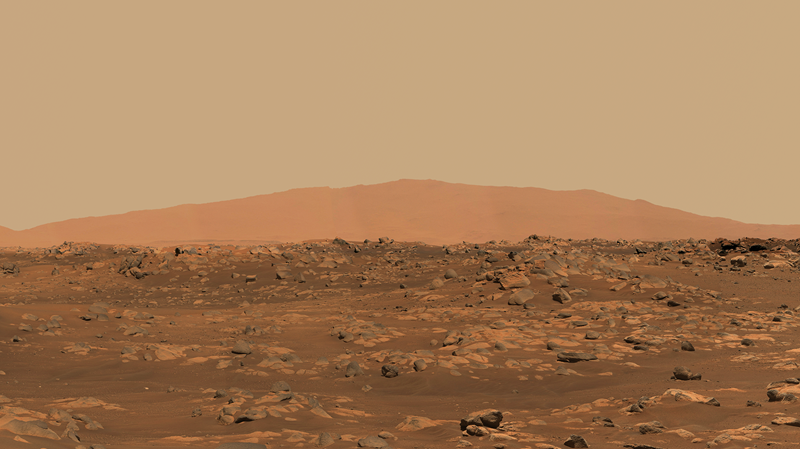

En esta imagen podemos ver perfectamente el perfil de Jezero Mons visto desde la posición del Perseverance en los primeros 100 días de su misión. Es llamativo como ocupa la mayor parte del horizonte, ya que no solo es una forma prominente, sino que se encuentra elevado por estar situado sobre las tierras altas de Marte, mientras que el Perseverance está en el interior de un cráter excavado sobre estas. Imagen cortesía de NASA/JPL/NASA/ASU/MSSS.

En esta imagen podemos ver perfectamente el perfil de Jezero Mons visto desde la posición del Perseverance en los primeros 100 días de su misión. Es llamativo como ocupa la mayor parte del horizonte, ya que no solo es una forma prominente, sino que se encuentra elevado por estar situado sobre las tierras altas de Marte, mientras que el Perseverance está en el interior de un cráter excavado sobre estas. Imagen cortesía de NASA/JPL/NASA/ASU/MSSS.La segunda pista en la que se han fijado los científicos es en sus propiedades “térmicas”. Y me explico: Usando los datos del instrumento THEMIS de la sonda Mars Odyssey han medido lo que conocemos como inercia térmica, la capacidad de los materiales para retener el calor. El basamento rocoso de Marte, sólido y denso, se calienta de día y sigue caliente durante la noche marciana, dando valores de inercia térmica altos. En contraste, los materiales sueltos y de grano fino como pueden ser la arena o la ceniza volcánica no son buenos conductores, de tal forma que se calientan y enfrían muy rápidamente, lo que da como resultado valores bajos de inercia térmica.

La superficie de Jezero Mons tiene una inercia térmica baja muy característica. Esto sugiere que no está formada por coladas de lava sólidas y endurecidas, sino que está cubierta por una potente capa de materiales finos y poco consolidados, un detalle que es una señal perfecta de depósitos de ceniza formados a partir de erupciones explosivas.

La tercera y última pista sobre la que se apoya este descubrimiento es la mineralogía. Gracias al instrumento CRISM de la Mars Reconaissance Orbiter, se pueden distinguir minerales por como reflejan la luz -al fin y al cabo es un espectrómetro- permitiendo a los científicos crear un mapa de la composición química de la montaña. Y han descubierto que sus laderas son ricas en piroxenos, un mineral que es uno de los más habituales en las rocas volcánicas de tonos oscuros que cubren la superficie de Marte.

Y, además, se han encontrado también minerales de alteración alrededor del cráter de la cima. Los investigadores han hallado arcillas e incluso un área con sílice opalino (sílice hidratada). Estos minerales no serían productos volcánicos primarios, sino que se forman cuando los gases volcánicos, el agua y la roca caliente interactúan entre sí.

De hecho, su presencia sugiere la existencia en el pasado de actividad hidrotermal, con quizás aguas termales y fumarolas sobre la cima. Estos ambientes están considerados hoy día como objetivos primordiales en la búsqueda de vida, ya que nos aportan unos ingredientes importantes para el desarrollo de esta: agua, energía, y nutrientes.

Si ya de por sí estas tres pistas parecen apuntar claramente al origen volcánico de Jezero Mons, todavía queda quizás una de las evidencias más fuertes: una relación física entre el fondo del cráter y el volcán. Las imágenes de alta resolución muestran varios depósitos amplios con formas lobuladas que parecen fluir desde el flanco noroeste de la montaña y desparramarse sobre la llanura que forma el fondo del cráter.

Detalle del cráter de la cima de Jezero Mons. Si nos fijamos, el número de cráteres de impacto que hay sobre este es excepcionalmente bajo si lo comparamos con los terrenos circundantes, lo que quiere decir que probablemente su formación es más reciente o que al menos su superficie ha sido renovada por otros procesos… como puede ser el vulcanismo. Imagen cortesía de NASA/JPL/Universidad de Arizona.

Detalle del cráter de la cima de Jezero Mons. Si nos fijamos, el número de cráteres de impacto que hay sobre este es excepcionalmente bajo si lo comparamos con los terrenos circundantes, lo que quiere decir que probablemente su formación es más reciente o que al menos su superficie ha sido renovada por otros procesos… como puede ser el vulcanismo. Imagen cortesía de NASA/JPL/Universidad de Arizona.Estos depósitos se superponen sobre el terreno fracturado y antiguo del fondo del cráter y tienen un aspecto de debris flows, o flujos de derrubios en castellano. Bajo este nombre se esconden procesos en los que masas de tierra empapadas en agua y fragmentos de roca fluyen ladera abajo, pero también podrían ser la señal de flujos piroclásticos -corrientes de gas y materiales volcánicos a altas temperaturas- que descienden por las laderas de los volcanes durante una erupción explosiva.

Esta conexión física da un sentido a cómo podrían haber llegado los materiales volcánicos al centro del cráter Jezero. Y es que este volcán no sería simplemente una montaña lejana, sino que era un proceso activo capaz de depositar grandes cantidades de ceniza y otros materiales a la cuenca del lago que albergó antaño el cráter.

Identificar Jezero Mons como un volcán no solo nos ayuda a resolver un enigma geológico, sino que aporta una visión totalmente diferente a como era el ambiente en este lugar. No era solo un lago tranquilo, era un paisaje cambiante en el que la actividad volcánica podría enriquecer el agua con minerales y calor, haciéndolo más adecuado para el desarrollo de la vida.

Pero hay todavía una ramificación más para este estudio y que entronca con la misión del Perseverance: El rover está recogiendo muestras que en algún momento vendrán a nuestro planeta -aún no sabemos cuándo-, pero si algunas de estas están directamente relacionadas con Jezero Mons, su valor científico se dispara: Son muestras de un volcán marciano concreto.

Y es que ese detalle nos permitiría datar con precisión cuál es su edad gracias a las técnicas de datación radiométrica, pero, además, también contemporizar mejor los materiales que vemos en el fondo del cráter Jezero y a calibrar nuestras escalas de edad de la superficie de Marte que actualmente dependen de contar cráteres, ya que no hemos podido traer muestras todavía a la Tierra.

¿Qué más sorpresas nos deparará la misión del Perseverance? La verdad es que no lo sabemos, pero, por si acaso, mantengamos los ojos bien abiertos… Marte siempre está dispuesto a sorprendernos incluso a plena luz del día.

Bibliografía:

Cuevas-Quiñones, S. C., Wray, J. J., Rivera-Hernández, F., & Adler, J. B. (2025). Evidence for a composite volcano on the rim of Jezero crater on Mars. Communications Earth & Environment, 6(1), 340. doi: 10.1038/s43247-025-02329-7

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Un volcán escondido… a la vista de todos se ha escrito en Cuaderno de Cultura Científica.

Los árboles pueden ayudarnos a predecir erupciones volcánicas

Los satélites de NASA podrían detectar cambios en la vegetación desde el espacio antes de la erupción de un volcán. Imagen: Jeff Schmaltz / MODIS / NASA

Los satélites de NASA podrían detectar cambios en la vegetación desde el espacio antes de la erupción de un volcán. Imagen: Jeff Schmaltz / MODIS / NASA

El diez por ciento de la población mundial vive en zonas susceptibles a peligros volcánicos. Sin ir más lejos, yo mismo escribo estas letras a la sombra del gran pico Teide, desde una isla que alberga más de un centenar de conos volcánicos. Aquellos que viven bajo sus laderas se enfrentan a rocas expulsadas, toneladas de polvo y material magmático, gases tóxicos e inflamables, nubes de ceniza, terremotos, deslizamientos de tierra e incluso tsunamis provocados por esa actividad. Afortunadamente, la ciencia ha avanzado de manera notable en las últimas décadas desarrollando conocimiento y tecnologías que hacen posible la detección e interpretación de las señales precursoras que anticipan una erupción. Un buen ejemplo de esta ciencia predictiva lo encontramos en la erupción de la isla de la Palma en 2021 que permitió minimizar el número de víctimas gracias a la alerta temprana de los vulcanólogos. Sin embargo, debemos reconocerlo, es un campo científico que está dando sus primeros pasos, aún estamos en pañales y cualquier ayuda que obtengamos será bienvenida.

Los fenómenos naturales no surgen de la nada, siempre existe un proceso de efectos y consecuencias que desencadenan una reacción. En la mayoría de los volcanes la erupción se produce «cuando el depósito en el que se almacena el magma alcanza una presión determinada y rompe, produciendo cambios de forma y/o terremotos, por lo que su vigilancia, permite en ocasiones, realizar pronósticos a corto plazo sobre una posible erupción». En los centros de investigación y seguimiento los vulcanólogos trabajan atentos a cualquier cambio que apunte al inicio de la actividad y a una posible erupción a corto o medio plazo. Esos indicadores incluyen «actividad sísmica, cambios en la altura del terreno y, especialmente, emisiones de gases como el dióxido de azufre o el dióxido de carbono».

Los compuestos de azufre son algo más fáciles de detectar desde el espacio, utilizando satélites en órbita, mientras que las emisiones de dióxido de carbono son mucho más difíciles de registrar y, a menudo, es necesario desplazarse en persona hasta el volcán con equipos de detección, con el riesgo que esto implica. Poder detectar con precisión emisiones de CO2 sería un paso en la dirección adecuada ya que el dióxido de carbono precede a la emisión de su homólogo sulfúrico y constituye uno de los primeros indicios de que el volcán está activo.

«Los volcanes emiten mucho dióxido de carbono», explica el vulcanólogo Robert Bogue en la web de NASA, «pero la cantidad de dióxido de carbono que ya hay presente en la atmósfera suele ser tan alta que a menudo resulta difícil medir específicamente el dióxido de carbono volcánico. Las grandes erupciones pueden expulsar suficiente dióxido de carbono como para registrarlas desde el espacio, con sensores como el Observatorio Orbital de Carbono 2 de la NASA, pero la detección de estas señales de alerta mucho más tenues resulta muy complicada. Un volcán que emita una modesta cantidad de dióxido de carbono que podrían presagiar una erupción no aparecerá en las imágenes satelitales».

El magma ascendente calienta una poza de agua en Costa Rica, cerca del volcán rincón de la Vieja y libera dióxido de carbono indicando un aumento de su actividad. Foto: Alessandra Baltodano / Universidad Chapman / NASA

El magma ascendente calienta una poza de agua en Costa Rica, cerca del volcán rincón de la Vieja y libera dióxido de carbono indicando un aumento de su actividad. Foto: Alessandra Baltodano / Universidad Chapman / NASA

Sin embargo, hace solo unos días la agencia espacial NASA ha publicado un artículo en su web oficial en el que descubrimos una ayuda inesperada para registrar esas emisiones de CO2: los árboles se vuelven más verdes, y eso sí que se puede detectar desde el espacio.

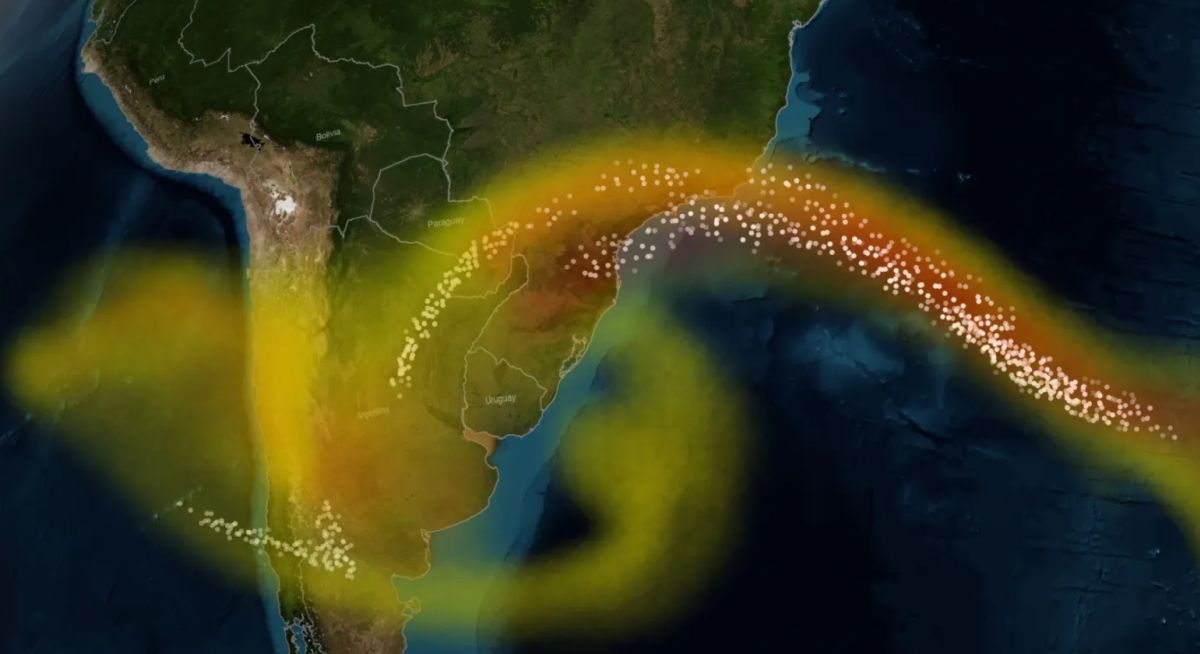

Conforme el magma volcánico asciende, liberando dióxido de carbono hacia la superficie, los árboles que absorben ese CO2 adquieren un color verde más intenso. Estos cambios en la tonalidad son visibles en imágenes de satélites, instrumentos meteorológicos y vehículos aerotransportados. «La detección remota del enverdecimiento de la vegetación por dióxido de carbono proporciona a los científicos otra herramienta que, sumada a las ondas sísmicas y los cambios en la altura del suelo, nos ofrecen una idea más clara de lo que está ocurriendo bajo el volcán».

En la actualidad contamos con numerosos satélites que podrían servir para realizar este tipo de análisis, el Landsat 8,el satélite Terra, el Sentinel-2 y otras sondas de observación terrestre y meteorológica a las que se pueden sumar proyectos aerotransportados como el Experimento Unificado de Validación Aérea: Tierra-Océano.

Los proyectos que ya se están llevando a cabo en este sentido cuentan con un añadido extra y sirven como experimentos multidisciplinares en los que, además de en la vulcanología podrían ser de utilidad en ecología y estudio de las consecuencias del calentamiento global. «Será muy interesante estudiar no solo la respuesta de los árboles al dióxido de carbono volcánico como alerta temprana de una erupción, sino también su capacidad de absorción, como una ventana al futuro de la Tierra cuando todos los árboles del planeta estén expuestos a altos niveles de dióxido de carbono».

Por supuesto esta señal natural en el color de los árboles tiene sus limitaciones, por ejemplo en volcanes donde la vegetación a su alrededor es escasa o inexistente. «Ninguna de las señales que utilizamos actualmente es la gran solución y monitorear los efectos del dióxido de carbono volcánico en los árboles tampoco será la panacea. Pero sí podría ser un punto de inflexión».

Referencias científicas y más información:

James Riordon «NASA Satellite Images Could Provide Early Volcano Warnings» NASA’s Earth Science News Team (2025)

Sascha Pare «The closer a volcano is to erupting, the greener the trees around it look from space» Live Science (2025)

Sobre el autor: Javier «Irreductible» Peláez es escritor y comunicador científico multimedia. Es ganador de tres premios Bitácoras, un premio Prisma a la mejor web de divulgación científica y un Premio Ondas al mejor programa de radio digital.

El artículo Los árboles pueden ayudarnos a predecir erupciones volcánicas se ha escrito en Cuaderno de Cultura Científica.

Valle Salado: ¿de dónde viene la sal? ¿De dónde viene el agua?

¿Qué tienen en común un paisaje espectacular, un fósil milenario y una cantera abandonada? Todos forman parte del patrimonio geológico, un testimonio de la historia de la Tierra con un gran valor científico, educativo, cultural y estético, y base del patrimonio natural. Sin embargo, su importancia continúa siendo poco apreciada.

Para acercar las distintas aproximaciones del patrimonio geológico a la sociedad, los días 26, 27 y 28 de marzo se celebró la quinta edición de las jornadas divulgativas “Geología para poetas, miopes y despistados. Patrimonio patrimonio”. Organizadas por el grupo de investigación consolidado Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco (UPV/EHU), estas jornadas contaron con la colaboración del Vicerrectorado del Campus de Bizkaia, la Cátedra de Cultura Científica de la UPV/EHU, el Geoparque de la Costa Vasca / Geoparkea y el Ente Vasco de la Energía (EVE).