Los números primos de las ciudades oscuras

En esta nueva entrada del Cuaderno de Cultura Científica regresamos a una maravillosa serie de novelas gráficas, Las ciudades oscuras, publicadas originalmente en francés, del dibujante belga François Schuiten (1956) y el guionista francés Benoît Peeters (1956), cuyo primer álbum Las murallas de Samaris fue publicado en 1983. A día de hoy se han publicado los siguientes álbumes: Las murallas de Samaris, La fiebre de Urbicande, La Torre, El Archivista (extra), La ruta de Armilia, Brüsel, La chica inclinada, La sombra de un hombre, La Frontera Invisible (doble), La teoría del grano de arena (doble), Recuerdos del eterno presente, El eco de las ciudades (extra) y El regreso del Capitán Nemo.

En la entrada titulada La ecuación de las ciudades oscuras centramos nuestra atención en el álbum La fiebre de Urbicande (1985), en la red de cubos con forma de un octaedro (es decir, una doble pirámide, hacia arriba y hacia abajo), que protagoniza esta novela gráfica, y las fórmulas matemáticas que aparecen en el cómic y que describen la cantidad de cubos de la red. Mientras que en esta entrada vamos mirar ál álbum La teoría del grano de arena (2007/08).

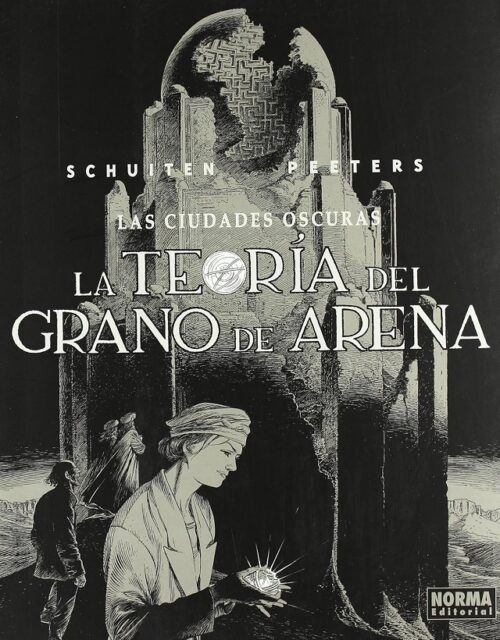

Portada de la edición en español, de Norma Editorial, del cómic La teoría del grano de arena (2010), de Francois Schuiten (dibujante) y Benoit Peeters (guionista), perteneciente a su serie Las ciudades oscuras

Portada de la edición en español, de Norma Editorial, del cómic La teoría del grano de arena (2010), de Francois Schuiten (dibujante) y Benoit Peeters (guionista), perteneciente a su serie Las ciudades oscuras

Como comentábamos en la anterior entrada, en Las ciudades oscuras nos encontramos ante una serie de historias entre fantásticas y surrealistas que transcurren en diferentes ciudades de un continente imaginario que se encuentra situado en el planeta Antichton, o Anti-Tierra. Este hipotético planeta fue inventado por el filósofo y matemático pitagórico Filolao (aprox. 470 – 380 a.n.e.) cuando describió un sistema cosmológico, no geocéntrico, en el que había un fuego central distinto del Sol y un planeta situado en la posición diametralmente opuesta a la Tierra, respecto a dicho fuego central, la anti-Tierra.

La teoría del grano de arena

La historia de La teoría del grano de arena transcurre en la ciudad de Brüsel (en el año 784, de Antichton), ciudad que ya aparecía en el álbum homónimo de la serie.

Con la llegada a Brüsel de un misterioso y extraño sujeto, Gholam Mortiza Khan, jefe de la tribu de los Bugtis que viven en la desértica y alejada zona de Boulachistan, con la intención de vender algunas joyas de su tribu para comprar armas, empiezan a ocurrir extraños sucesos, como la aparición de forma misteriosa y continua de una gran cantidad de arena en un piso en el que vive una madre con sus dos hijos, la materialización de misteriosas piedras, de diferentes formas, pero tamaños similares, en el piso del florista Constant Abeels, protagonista del álbum Brüsel, la pérdida de peso, pero sin adelgazar, del propietario y chef de la famosa brasserie Maurice, o los extraños ruidos de la casa en la que vive Elsa Autrique, la experta en arte tribal a la que acude el guerrero Bugti.

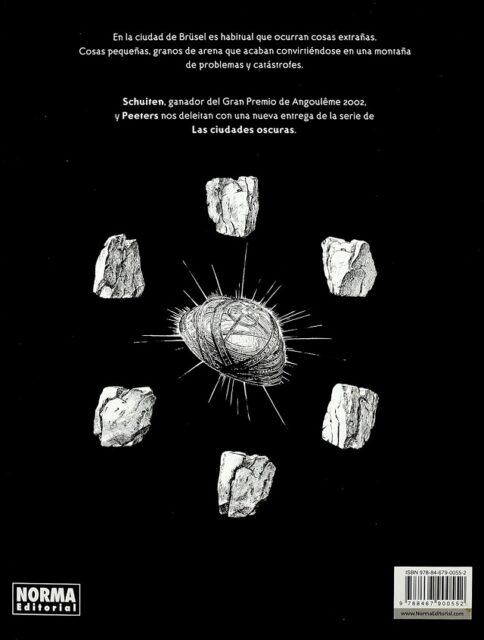

Contraportada de la edición en español, de Norma Editorial, del cómic La teoría del grano de arena (2010), de Francois Schuiten (dibujante) y Benoit Peeters (guionista), perteneciente a su serie Las ciudades oscuras

Contraportada de la edición en español, de Norma Editorial, del cómic La teoría del grano de arena (2010), de Francois Schuiten (dibujante) y Benoit Peeters (guionista), perteneciente a su serie Las ciudades oscuras

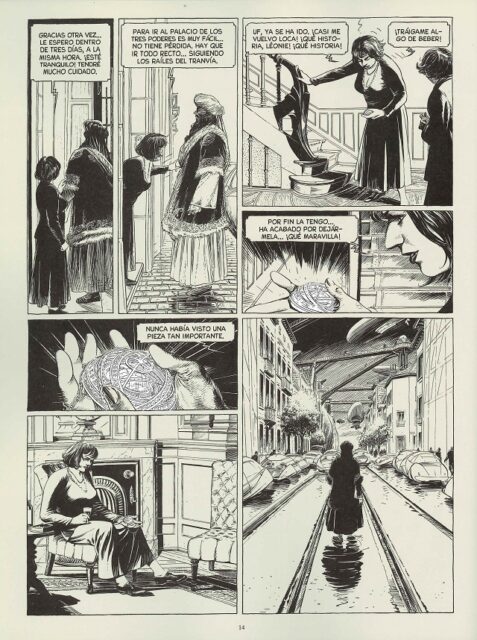

Con el paso de los días los sucesos son cada vez más graves y preocupantes, por lo que se contrata a una mujer “coleccionista de fenómenos sin explicación” para que investigue el origen de los extraños fenómenos que están ocurriendo en la ciudad. Se trata de Mary Von Rathen, protagonista del álbum La chica inclinada. La investigación de los extraños sucesos le llevan a deducir que todos están relacionados con una persona, el jefe de los Bugtis, Gholam Mortiza Khan. Pero como el guerrero Bugti falleció poco después de su llegada a la ciudad, atropellado por un tranvía, resulta complicado averiguar el origen de los desastres. Aunque el lector sabe que está relacionado con una joya muy especial que llevaba el jefe Bugti, el Nawaby (que aparece en la imagen anterior, en el centro, así como en la imagen siguiente, la página de la novela gráfica en la que el guerrero Bugti le deja la joya a Elsa Autrique), que fue un botín de guerra que le quitó al jefe de los Moktars, con los que están en perpetuo conflicto.

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a la experta en arte tribal Elsa Autrique admirando el Nawaby, una joya muy especial, que le ha dejado el jefe de los Bugtis

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a la experta en arte tribal Elsa Autrique admirando el Nawaby, una joya muy especial, que le ha dejado el jefe de los Bugtis

Cuando los dos hijos del jefe Bugti, Gholam Mortiza Khan, viajan a Brüsel en busca de su padre, se descubre que el motivo de los extraños fenómenos que están ocurriendo es la joya Nawaby, que deberá ser devuelta a su lugar de origen para restablecer el orden que había sido roto por el robo del objeto más sagrado de los Moktars, el Nawaby. Entonces, la investigadora Mary Von Rathen, el florista Constant Abeels y los hijos de Gholam Mortiza Khan realizarán un viaje a Boulachistan a devolver el Nawaby a los Moktars.

Los números primos oscuros

En esta historia de las ciudades oscuras nos encontramos con una sencilla mención a los números primos, que explicaremos a continuación.

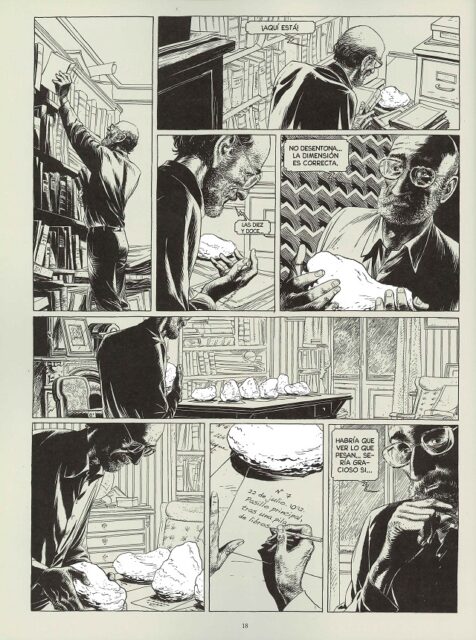

Como hemos comentado más arriba, en el apartamento del florista Constant Abeels empiezan a aparecer piedras, una a una, que el protagonista de Brüsel empieza a catalogarlas (número en la serie de apariciones, fecha, hora y lugar de la aparición) y medirlas. Entonces descubre que todas las piedras, que tienen formas distintas y dimensiones parecidas, pesan exactamentre lo mismo, 6.793 gramos. Entonces, Constant le menciona a Maurice, que es quien le ha dejado la báscula, que “6.793 … es un número primo”, a lo que el chef le contesta “un número primo … ¡lo que faltaba!”.

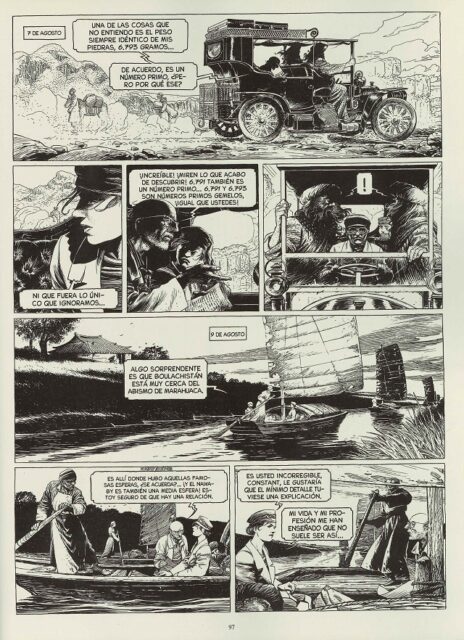

Página de la novela gráfica La teoría del grano de arena, en la que se muestra al florista Constant Abeels catalogando las primeras piedras que aparecen en su apartamento

Página de la novela gráfica La teoría del grano de arena, en la que se muestra al florista Constant Abeels catalogando las primeras piedras que aparecen en su apartamento

Aunque los números primos son muy conocidos, recordemos que son aquellos números naturales que solamente se pueden dividir por 1 y por ellos mismos. Así, por ejemplo, el número 25 no es primo ya que se puede dividir por 5 (además de por 1 y 25), o tampoco el 27 (divisible por 3 y 9), mientras que el número 19 sí es primo, ya que solamente es divisible por el 1 y él mismo, al igual que lo son los números 2, 3, 5, 7, 11 y 13, entre otros. Para quien quiera profundizar más en el significado de los números primos puede leer la entrada Buscando lagunas de números no primos, o algunas de las otras entradas que hemos escrito en el Cuaderno de Cultura Científica sobre esta importante familia de números.

La mención a que el número 6.793 es un número primo podría haberse limitado al anterior pasaje y ser algo puramente anecdótico, pero los números primos volverán a mencionarse más adelante en la historia.

Cuando Maurice está ayudando a Constant a sacar las piedras de su piso, ya que existe el peligro de que el suelo acabe rompiéndose por el peso de las piedras, el chef, que recordemos que está perdiendo peso pero sin adelgazar, le dice al florista “me estoy enamorando de tus números primos”. Es una metáfora para referirse a las piedras, por lo que sigue siendo anecdótico, pero mantiene viva la referencia a los números primos.

Pero es cuando la investigadora Mary Von Rathen, el florista Constant Abeels y los hijos de Gholam Mortiza Khan van de viaje hacia Boulachistan cuando volverán a aparecer con un poco más de protagonismo. Los cuatro van en un coche cuando se podruce el siguiente diálogo:

– [Constant]: Una de las cosas que no entiendo es el peso siempre idéntico de mis piedras, 6.793 gramos… De cuerdo, es un número primo, ¿pero por qué ese?

– [Mary]: Ni que fuera lo único que ignoramos…

– [Constant]: ¡Increíble! ¡Miren lo que acabo de descubrir! 6.971 también es un número primo … 6.971 y 6.973 son números primos gemelos, ¡igual que ustedes!

[Se refiere a los hijos de Gholam Mortiza Khan que son hermanos gemelos]

Recordemos el concepto de números primos gemelos. Como todos los números pares, a excepción del 2, son números no primos, entonces lo más cerca que pueden estar dos números primos, salvo el 2 y el 3 que están pegados, es con solo un número par entre ellos. Y precisamente, a las parejas de números primos que están tan cerca, es decir, con solo un número par entre ellos, o dicho de otra forma, que la diferencia entre ellos es 2, se les llama números primos gemelos, como las parejas 11 y 13, 17 y 19, o los que aparecen en la novela gráfica, 6.971 y 6.973.

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a Mary Von Rathen, Constant Abeels y los hijos de Gholam Mortiza Khan en su viaje a Boulachistan

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a Mary Von Rathen, Constant Abeels y los hijos de Gholam Mortiza Khan en su viaje a Boulachistan

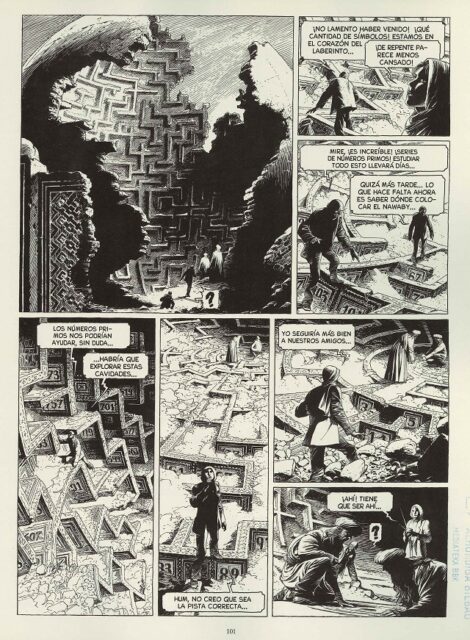

Al llegar a Boulachistan, los cuatro personajes de esta historia se dirigirán a la antigua fortaleza de los Moktars, para dejar al Nawaby en su sitio. La fortaleza tiene una gran cúpula en su parte superior, pero está medio derruida, como consecuencia del desorden causado por el robo de la joya moktar. Esa cúpula esférica posee una especie de decoración en forma de laberinto en su interior. Al entrar los viajeros en su interior se podrá observar muchos números en las paredes del laberinto. Esos números son números primos (entre los que se ven están 3, 5, 11, 83, 89, 97, 563, 599, 607, 701, 719) que están distribuidos alrededor del centro del laberinto. Al verlos dentro del laberiento, se produce el siguiente diálogo.

– [Constant]: Mire, ¡es increible! ¡Series de números primos! Estudiar todo esto llevará días…

– [Mary]: Quizás más tarde … lo que hace falta ahora es saber dónde colocar el Nawaby.

– [Constant]: Los números primos nos podrán ayudar sin duda… habría que explorar esas cavidades…

– [Mary]: Hum, no creo que sea la pista correcta… Yo seguiría más bien a nuestros amigos…

[Y mira a los hijos de Gholam Mortiza Khan que están en el centro del laberinto, donde efectivamente irá la joya, aunque ese centro donde están los hermanos gemelos está justo al lado de la primera pareja de números primos gemelos, 3 y 5]

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a Mary Von Rathen, Constant Abeels y los hijos de Gholam Mortiza Khan en la cúpula de la fortaleza de los Moktars

Página de la novela gráfica La teoría del grano de arena, en la que se muestra a Mary Von Rathen, Constant Abeels y los hijos de Gholam Mortiza Khan en la cúpula de la fortaleza de los Moktars

Y ya no sabemos más sobre el significado de los números primos que se encuentran en la cúpula laberíntica de la torre de los Moktars. Puesto que el Nawaby es muy importante para los Mokstar y se encuentra colocado en el centro de un laberinto de números primos, estos deben ser muy importantes, al menos para los Moktars, pero la historia no nos cuenta nada más. Quizás haya que buscarlos en las publicaciones extra, como en El Archivista o El eco de las ciudades.

Para concluir simplemente recomendaros esta interesante serie de novelas gráficas, Las ciudades oscuras, de uno de los grandes del cómic europeo, François Schuiten (dibujo), acompañado en esta serie por el escritor Benoit Peeters.

Portadas de las dos publicaciones extra, publicadas en español por Norma Editorial, de la serie de novelas gráficas Las ciudades oscuras

Portadas de las dos publicaciones extra, publicadas en español por Norma Editorial, de la serie de novelas gráficas Las ciudades oscurasSobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Los números primos de las ciudades oscuras se ha escrito en Cuaderno de Cultura Científica.

Aprendizaje por refuerzo basado en modelos de máxima entropía

El problema de la toma de secuencias de decisiones que sean globalmente óptimas, a menudo en relación con la disponibilidad de una capacidad de previsión, es relevante para la aplicación de técnicas y modelos de Inteligencia Artificial en ámbitos tan diversos cómo la robótica y las finanzas (Sargent and Stachurski 2024).

Aunque las tomas de decisiones se refieran típicamente al presente, la posibilidad de retrasar la toma de una decisión específica, reservándonos el derecho de tomarla (o de no hacerlo) en un momento futuro bien determinado, es en sí una posible acción, cuyo valor cabe entender y cuantificar (Roman 2004). Cabe preguntarnos: ¿En qué sentidos la opcionalidad es un elemento significativo para la toma de decisiones (o, mejor dicho, en la definición de secuencias óptimas de decisiones)? ¿Como medir la opcionalidad? ¿Cómo utilizarla?

Foto: Pietro Jeng / UnsplashAprendizaje por refuerzo

Foto: Pietro Jeng / UnsplashAprendizaje por refuerzo

En ciencias de la computación e inteligencia artificial, el aprendizaje automático por refuerzo es un conjunto de metodologías que tiene por objetivo la formulación de secuencias óptimas de decisiones (“políticas”) frente a un entorno (por ejemplo, un videojuego) cuyas reacciones a acciones definidas (cuyas probabilidades de transición) son en principio desconocidas. Usando estas técnicas, un agente automático inteligente aprende a optimizar una recompensa (Malone 1975) que recibe de un entorno simulado o real a las acciones que decide tomar según su observación (potencialmente lagunosa) del estado pasado y actual, determinista y completo o estocástico e incompleto/probabilista del entorno mismo (Sutton and Barto 2018).

La estructura recursiva permite al agente equilibrar recompensas inmediatas con recompensas futuras descontadas.

La limitación fundamental del enfoque de aprendizaje por refuerzo en aplicaciones reales, y especialmente en entornos con espacios de estados y de acciones de alta dimensionalidad y cardinalidad, y potencialmente de limitada observabilidad, se encuentra en su limitada eficiencia en muestreo: llevarlos a la práctica requiere tiempos largos de interacción entre el agente que va aprendiendo y el entorno que observa y sobre en el que acciona, y grandes cantidades de capacidad de cálculo.

Reducir esos costes es valioso, por ejemplo, para poder llevar de forma eficaz herramientas basadas en esas capacidades de gestión óptima a los complejos problemas puestos por las transiciones climático-energética, digital y demográfica.

Esa reducción de costes de entrenamiento puede apoyarse en una extensión de los procedimientos lógicos en base a los cuales se definen los procesos de aprendizaje hacia contextos de incertidumbre como esos entornos desconocidos.

Pero, ¿como juntar probabilidad e incertidumbre, por un lado, y lógica rigurosa por el otro?

La teoría de la probabilidad como lógica extendidaJaynes (1957) redefine la mecánica estadística, que describe las propiedades y la evolución de sistemas físicos conocidos de forma incompleta, a partir de la propuesta que Shannon (1948) formula para la medición del contenido de la información de un mensaje por ejemplo transmitido por una estación radio. Esa medición se basa en la entropía , un valor (esperado) de la probabilidad del propio mensaje (en bits si el logaritmo es en base 2): mensajes “inevitables”, que ya sabemos que vamos a recibir (“lluvia en Donostia”) conllevan información nula, mientras que mensajes más improbables (“has ganado la lotería”) conllevan información progresivamente más significativa.

Jaynes parece proponer sacar la información/entropía de Shannon del ámbito de la comunicación para darle el rol de una (de la) cantidad física fundamental. La cosecha de esa resemantización: es posible llegar de la entropía a cualquier elemento de la mecánica estadística en pocos elegantes pasos.

Un problema es por un lado, según las observaciones del propio Shannon (1956), la dificultad de verificar empíricamente el carácter “primario” de la entropía/información en las ciencias físicas. Un otro problema (Lairez 2024) es puesto por la necesaria extensión de la interpretación de probabilidad frecuentista clásica bien basada en axiomas (Kolmogorov 1933) en la dirección de una interpretación bayesiana: de la frecuencia de un evento en el limite de infinitas repeticiones de un experimento hacia un “grado de creencia” que es a menudo percibido como inherentemente subjetivo (por ejemplo: quien es el “creyente” respecto a quien se define la medición de probabilidad?) y por consecuencia menos científico.

Por otro lado, si un axioma es un punto de partida completamente arbitrario para un desarrollo formal, cabe observar como los “axiomas” de la teoría de la probabilidad en 1957 ya no son definibles como tales: casi una década antes de Jaynes, Cox (1946) ya se pone el problema de definir una extensión de la lógica binaria de Boole (2003 [1854]) a situaciones y enunciados “grises” con valores de verdad asociados intermedios entre el seguramente falso y el absolutamente cierto a partir de pocos requerimientos básicos (Terenin and Draper 2015).

A partir de esos requerimientos básicos, Cox (1946) consigue llegar a los “axiomas” arriba: cualquier medición consistente (cualquier álgebra) de niveles de certidumbre tiene que seguir las reglas de la teoría de la probabilidad. Los “axiomas” de la teoría de la probabilidad por consecuencia ya no son propiamente axiomas, es decir puntos de apoyo arbitrarios para un desarrollo matemático, sino consecuencias directas de unos requerimientos lógicos. Como propone posteriormente Jaynes (2003): la teoría de la probabilidad, interpretada como una extensión de la lógica, puede representar el marco general para el razonamiento y la inferencia en condiciones de incertidumbre — una base directamente relevante para la Inteligencia Artificial. En esa teoría de la probabilidad reinterpretada como una lógica formal para enunciados inciertos, un rol central es asumido por el teorema de Bayes (Bolstad and Curran 2016), que describe las reglas para actualizar, potencialmente de forma recursiva, unos grados de creencia frente a nuevas observaciones, o, para decirlo mejor, una (distribución de valores de grados de) creencia/certidumbre/credibilidad de un enunciado en base a nuevas evidencias (por ejemplo datos numéricos) .

En esa cadena de actualizaciones recursivas, un problema abierto es evidentemente como definir el punto cero, es decir el punto de partida de esa cadena de creencias progresivamente actualizadas: la distribución a priori, que describe asunciones (y potencialmente prejuicios) antes de la adquisición de cualquier dato.

Una posible superación del carácter subjetivo de la interpretación bayesiana de la teoría de la probabilidad pasa nuevamente por el mismo Jaynes (1957), y por su definición, inspirada en Jeffreys (1946), de los métodos de máxima entropía, que derivan formas funcionales y parámetros de una distribución de probabilidad a priori a través de una maximización de la entropía. La distribución a priori de máxima entropía se obtiene maximizando la expresión de la información de Shannon sujeta a condicionantes que expresan todo lo que es noto o asumido sobre . Diferentes asunciones y prejuicios pueden legítimamente corresponder a distribuciones de máxima entropía diferentes, pero convergerán rápidamente a la misma distribución a posteriori en consecuencia de la misma cadena de observaciones.

Aprendizaje por refuerzo basado en modelosEl aprendizaje por refuerzo basado en modelos intenta definir la información a priori disponible sobre un nuevo entorno a explorar/explotar, para reducir los costes del aprendizaje por refuerzo mediante procedimientos para esbozar mapas de su espacio de fases y configuraciones antes de la fase de experimentación/entrenamiento.

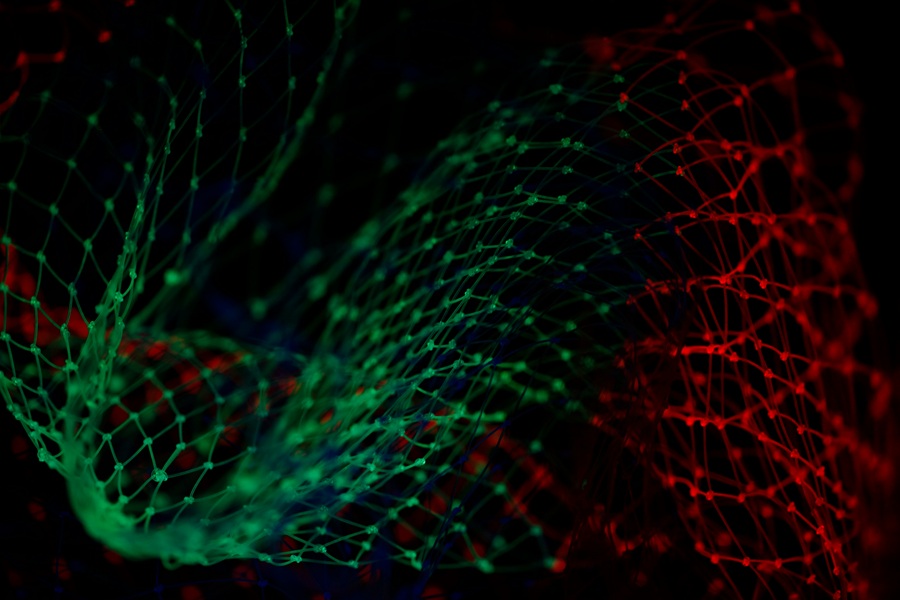

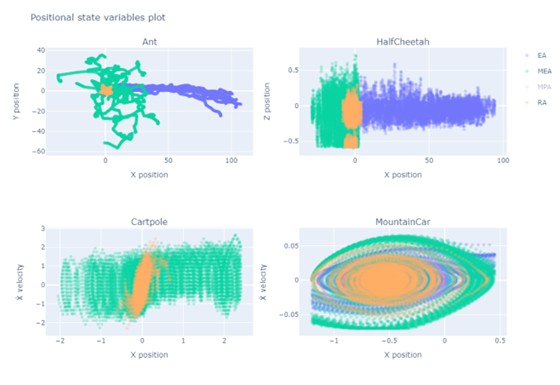

Hasta antes de empezar a interaccionar con el entorno, simplemente observándolo desde fuera, los agentes que maximicen (valores esperados, descontados) recompensas correspondientes con la información según Shannon están aprendiendo de forma implícita a aproximar la distribución que describe las transiciones del entorno. Cestero (2024), por ejemplo, muestra como recompensas basadas en la información de Shannon resultan ser ideales para las fases tempranas y de meta-aprendizaje, de forma independiente de la estructura y del sentido de las recompensas a utilizar para las fases de explotación. En este sentido, maximizar la información disponible en fases tempranas parece ser una buena estrategia de meta-aprendizaje y de observación del entorno mediante una interacción no orientada a una explotación específica. Por ejemplo: la Figura 1 describe como mejoran las capacidades de exploración de un agente que hayan sido inicializados con la experiencia de otro agente (su versión “estudiante”) cuya recompensa “abstracta” y no orientada a resultados aplicativos era una medición de la información según Shannon.

Figura 1: Las capacidades de exploración de un agente inicializado con la experiencia cobrada maximizando la información recolectada (en morado) superan significativamente las alternativas

Figura 1: Las capacidades de exploración de un agente inicializado con la experiencia cobrada maximizando la información recolectada (en morado) superan significativamente las alternativasUna manera de hacer concretas estas capacidades adquiridas mediante una interacción no orientada a resultado es, por ejemplo, el algoritmo SMILE (Mutti, Pratissoli, and Restelli 2021), que busca las configuraciones en el espacio de las fases que maximizan una medición de utilidad futura, por ejemplo, para asociarlas a nuevas acciones secundarias, o compuestas o de más alto nivel, en términos de las cuales definir las políticas óptimas a aprender. Se trata, esencialmente, del aprendizaje de un nuevo vocabulario de acciones, máximamente esparzo e informacional, en el que basar la optimización de Bellman. Para ello, son especialmente valiosos mapas del nivel de opcionalidad que conlleva cada posición en el espacio de las fases. Usando el mapa, el agente puede privilegiar esas posiciones.

Lo que resulta de la experimentación con respecto a la búsqueda de nuevas capacidades (skills), y al definir e incluir automáticamente entre las acciones disponibles nuevas secuencias de decisiones que buscan los estados “más interesantes”, es que es exactamente una medición de información de Shannon, que es capaz de identificar configuraciones en las que es difícil entrar y a partir de las cuales es fácil llegar a numerosas nuevas configuraciones (por ejemplo, una puerta difícil de encontrar que en un laberinto dé acceso a una nueva parte del mismo).

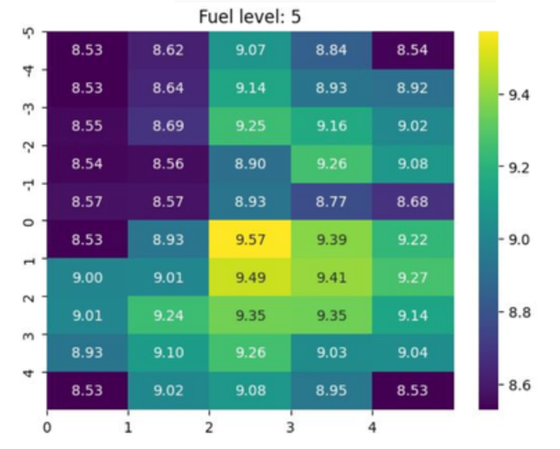

El ejemplo en la Figura 2 abajo representa un entorno de juego de agentes de aprendizaje por refuerzo de tipo taxi (Towers et al. 2024), en el que un agente toma el rol de un conductor que recibe recompensas por recoger y llevar a un pasajero a un destino concreto, extendiendo sus características con una gestión energética de una “gasolina” y teniendo en cuenta los costes de movimiento. El problema del entorno es resuelto por ejemplo mediante optimización de política proximal (Schulman et al. 2017), integrado con el aprendizaje a priori y basado en métodos SMILE de nuevas acciones que directamente llevan el taxi hacia localizaciones en el mapa especialmente valiosas en términos informacionales, entrópicos y de opcionalidad.

Figura 2: Mapa de opcionalidad en un entorno Taxi Fuel para métodos SMILE

Figura 2: Mapa de opcionalidad en un entorno Taxi Fuel para métodos SMILEA nivel de resultados, el algoritmo de búsqueda a priori de capacidades y estrategias muestra mejoras claras en la exploración y en la identificación de estados de alta opcionalidad, aunque todavía enfrenta dificultades para aprender de manera eficiente ciertas políticas complejas o altamente especializadas. El resultado de ese análisis a priori del entorno a explorar/explotar es en cualquier caso una significativa mejora en la política óptima identificada por el aprendizaje.

Opcionalidad e informaciónLos resultados de Cox indican como la entropía de Shannon representa una medición útil para la toma de decisiones del nivel de opcionalidad de un agente en fase de meta-aprendizaje, es decir, con independencia de la recompensa a definir para la fases “prácticas” sucesivas de exploración/explotación. En este sentido, para contestar a las preguntas iniciales, el valor de la opcionalidad, medida en bits, parece ser evidente sobre todo en fases (¿tempranas?) de meta-aprendizaje, en las cuales (¿todavía?) no estén bien definidos los objetivos a perseguir.

Referencias:

Bolstad, William M, and James M Curran (2016) Introduction to Bayesian Statistics. John Wiley & Sons.

Boole, G. (2003 [1854]) An Investigation of the Laws of Thought: On Which Are Founded the Mathematical Theories of Logic and Probabilities. Edited by John Walton and George Maberly. Cambridge University Press.

Cestero, J., Quartulli, M., Restelli, M. (2024) Building Surrogate Models Using Trajectories of Agents Trained by Reinforcement Learning. In: Wand, M., Malinovská, K., Schmidhuber, J., Tetko, I.V. (eds) Artificial Neural Networks and Machine Learning – ICANN 2024 Lecture Notes in Computer Science, vol 15019. Springer, Cham. doi: 10.1007/978-3-031-72341-4_23

Cox, R. T. (1946) Probability, Frequency, and Reasonable Expectation American Journal of Physics 14 (1): 1–13. doi: 10.1119/1.1990764.

Jaynes, E. T. (1957) Information Theory and Statistical Mechanics The Physical Review 106 (4): 620–30. doi: 10.1103/PhysRev.106.620

Jaynes, E. T. (2003) Probability Theory: The Logic of Science. 1st ed. Cambridge University Press. PDF

Jeffreys, H. (1946) An Invariant Form for the Prior Probability in Estimation Problems Proceedings of the Royal Society of London. Series A, Mathematical and Physical Sciences 186 (1007): 453–61 JSTOR: http://www.jstor.org/stable/97883.

Kolmogorov, A. N. (1933) Grundbegriffe Der Wahrscheinlichkeitsrechnung. Springer Nature Ergebnisse Der Mathematik 3 (2): 3–47.

Lairez, Didier (2024) Thermostatistics, Information, Subjectivity: Why Is This Association so Disturbing? Mathematics 12 (10). doi: 10.3390/math12101498.

Malone, John C. (1975) William James and BF Skinner: Behaviorism, Reinforcement, and Interest Behaviorism 3 (2): 140–51. JSTOR: https://www.jstor.org/stable/27758839

Mutti, M., L. Pratissoli, and M. Restelli (2021) Task-Agnostic Exploration via Policy Gradient of a Non-Parametric State Entropy Estimate. arXiv arXiv:2007.04640v2 [cs.LG]

Roman, Steven (2004) Introduction to the Mathematics of Finance: From Risk Management to Options Pricing. Springer Science & Business Media.

Sargent, Thomas J, and John Stachurski (2024) Dynamic Programming: Finite States arXiv arXiv:2401.10473v1 [econ.GN]

Schulman, John, Filip Wolski, Prafulla Dhariwal, Alec Radford, and Oleg Klimov (2017) Proximal Policy Optimization Algorithms arXiv arXiv:1707.06347v2 [cs.LG]

Shannon, C. E. (1948) A Mathematical Theory of Communication The Bell System Technical Journal 27: 379–423. doi: 10.1002/j.1538-7305.1948.tb01338.x

Shannon, C. E. (1956) “The Bandwagon (Editorial).” IRE Transactions on Information Theory. Collected Papers Of Claude E. Shannon PDF

Sutton, Richard S., and Andrew G. Barto (2018) Reinforcement Learning: An Introduction. Second Edition. The MIT Press.

Terenin, A., and D. Draper (2015) Cox’s Theorem and the Jaynesian Interpretation of Probability.” arXiv arXiv:1507.06597v3[math.ST]

Towers, Mark, Ariel Kwiatkowski, Jordan Terry, John U. Balis, Gianluca De Cola, Tristan Deleu, Manuel Goulão, et al. (2024) Gymnasium: A Standard Interface for Reinforcement Learning Environments arXiv arXiv:2407.17032v3 [cs.LG]

Sobre el autor: Marco Quartulli es doctor en Electrónica e Informática y responsable del área de Energía y Medio Ambiente de Vicomtech

Sobre Vicomtech: Centro tecnológico espacializado en tecnologías digitales relacionadas con Artificial Intelligence y Visual Computing & Interaction. Transfiere tecnología para que las empresas sean más competitivas y para conseguir un impacto positivo en la sociedad, en coherencia con su compromiso social.

Basque Research & Technology Alliance (BRTA) es una alianza que se anticipa a los retos socioeconómicos futuros globales y de Euskadi y que responde a los mismos mediante la investigación y el desarrollo tecnológico, proyectándose internacionalmente. Los centros de BRTA colaboran en la generación de conocimiento y su transferencia a la sociedad e industria vascas para que sean más innovadoras y competitivas. BRTA es una alianza de 17 centros tecnológicos y centros de investigación cooperativa y cuenta con el apoyo del Gobierno Vasco, SPRI y las Diputaciones Forales de Araba, Bizkaia y Gipuzkoa.

El artículo Aprendizaje por refuerzo basado en modelos de máxima entropía se ha escrito en Cuaderno de Cultura Científica.

Cómo se forman los “pancake domes” de Venus

A menudo decimos que Venus es el planeta gemelo de la Tierra, pero esta comparación solo se sostiene si nos referimos exclusivamente al tamaño y a la composición de ambos. Las distintas misiones espaciales que han viajado al planeta han demostrado que es un mundo tremendamente hostil para los seres humanos y nuestra tecnología en todos los sentidos de la palabra: temperaturas en la superficie que superan los 450ºC, una densa atmósfera compuesta principalmente por dióxido de carbono y una presión aplastante que en su superficie alcanza a ser 92 veces superior a la de la Tierra.

Y no solo hay estas diferencias. Su relieve nos recuerda muy poco al de la Tierra, quizás por la ausencia de una tectónica de placas y una hidrosfera que sean los principales protagonistas de su modelado. Lo que nos sugiere que planetas que pudieron ser muy similares en sus orígenes pueden tener una evolución totalmente diferente.

Algunos autores llegan a segerir que el funcionamiento a nivel geológico hoy podría ser similar al de la Tierra durante el eón Arcaico -entre hace 4000 y 2500 millones de años. Si esto es así podríamos estar ante un análogo perfecto para comprender como era nuestro planeta en esas primeras etapas tras su formación y poder ver que procesos dinámicos existían tanto en la superficie como en su interior.

Hoy vamos a detenernos en unas formas del relieve que aparecen en Venus y que no tienen un equivalente terrestre: Son los pancake domes o, en castellano, los domos tortita. Aunque su nombre nos recuerde más a una dulce delicia culinaria, son una expresión del intenso vulcanismo venusiano.

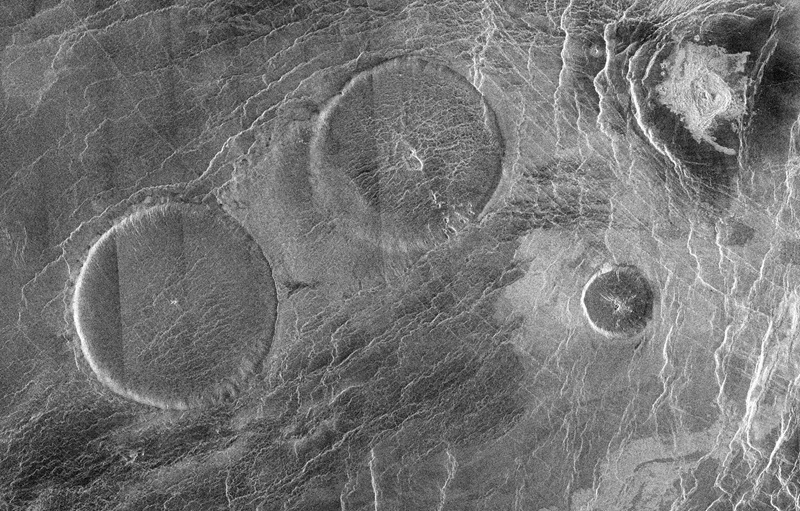

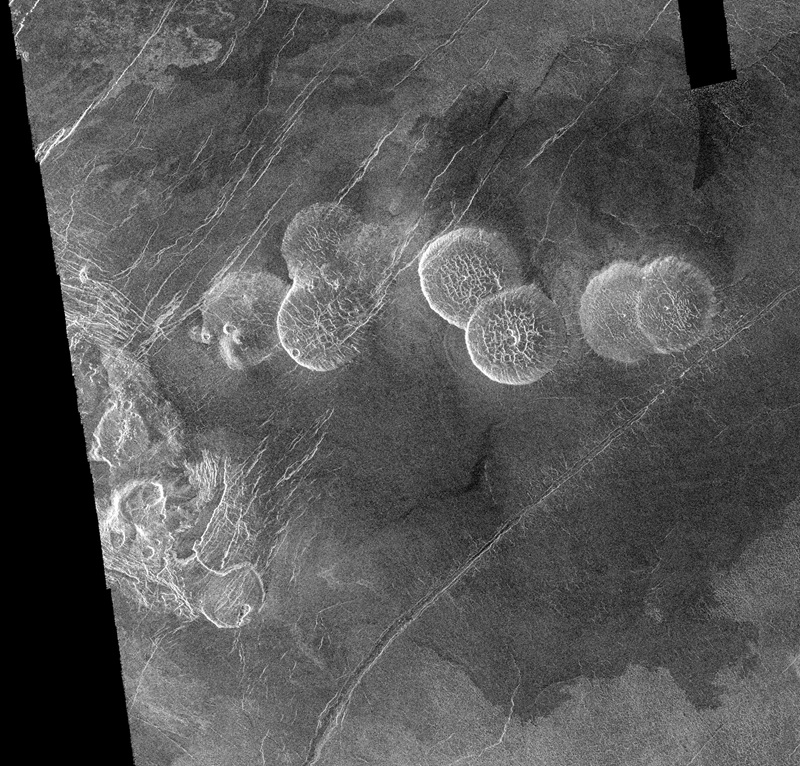

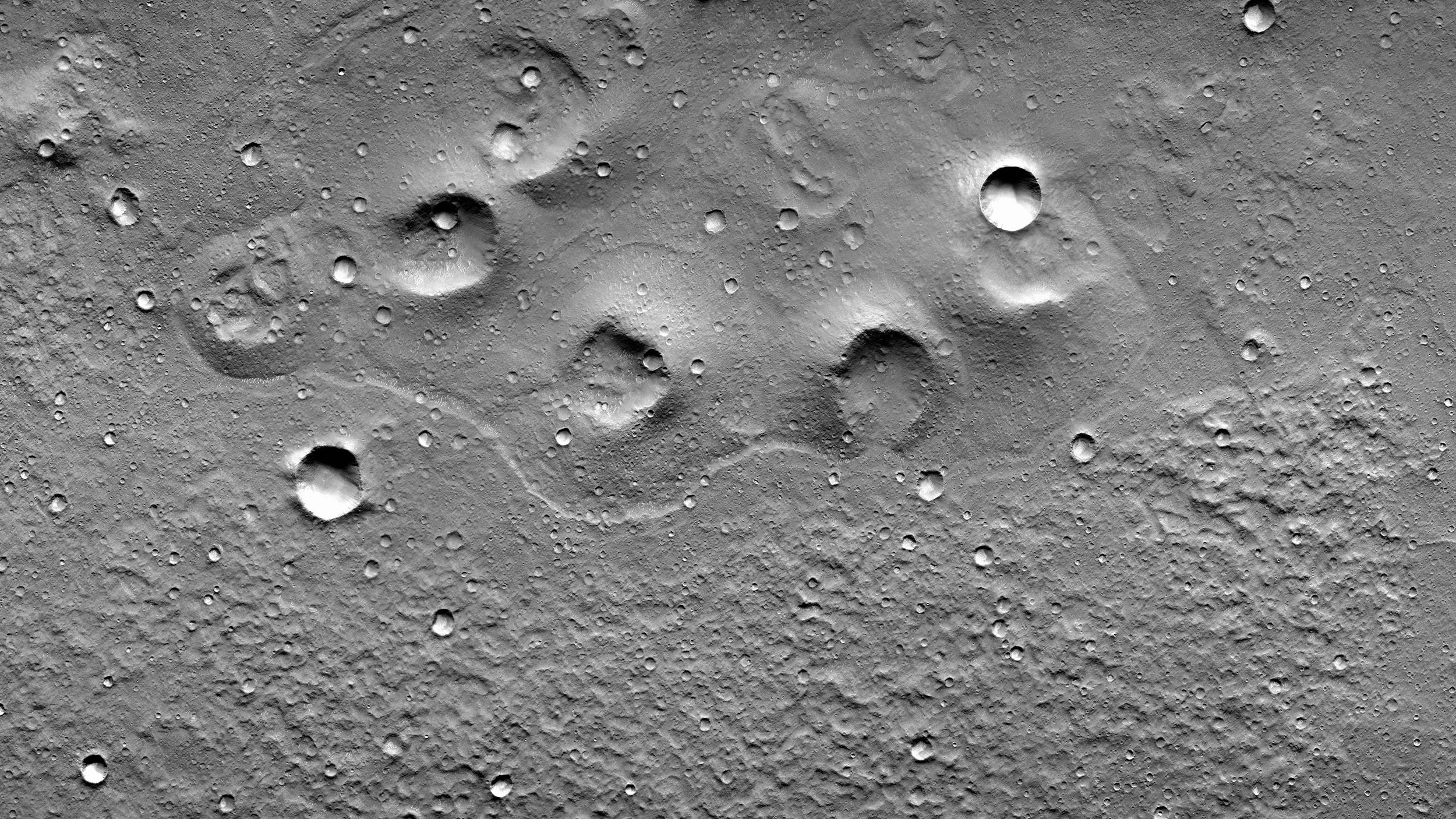

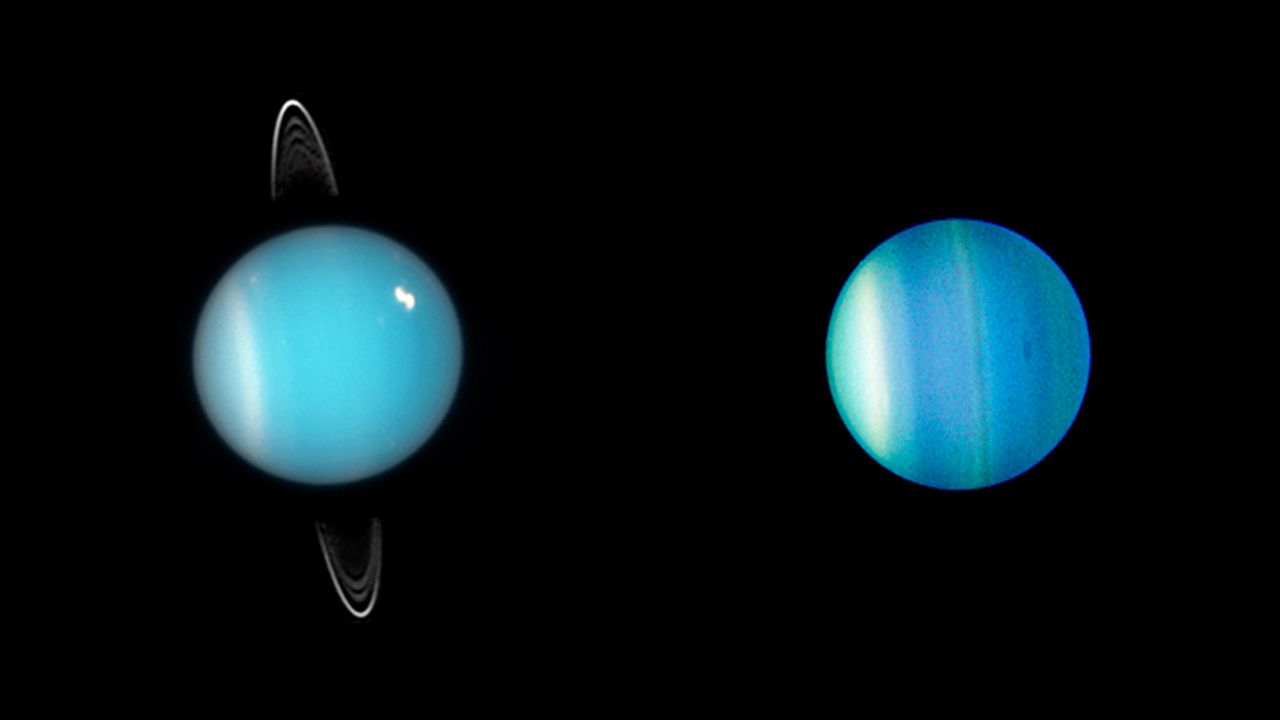

En esta imagen podemos ver al menos tres pancake domes sobre la superficie de Venus gracias al radar de la misión Magellan. Lo más destacable de estos es la forma circular casi perfecta -hasta el punto de que casi parecen cráteres de impacto, aunque al revés- y los sistemas de fracturas que se ven en su superficie, que podrían indicar procesos posteriores relacionados con el enfriamiento de la lava y subsidencia. Imagen cortesía de NASA/JPL.Los pancake domes

En esta imagen podemos ver al menos tres pancake domes sobre la superficie de Venus gracias al radar de la misión Magellan. Lo más destacable de estos es la forma circular casi perfecta -hasta el punto de que casi parecen cráteres de impacto, aunque al revés- y los sistemas de fracturas que se ven en su superficie, que podrían indicar procesos posteriores relacionados con el enfriamiento de la lava y subsidencia. Imagen cortesía de NASA/JPL.Los pancake domes

¿Cómo son estos relieves? Son una especie de mesetas prácticamente circulares cuyo diámetro puede alcanzar las varias decenas de kilómetros y medir alrededor de un kilómetro de altura. Su techo es muy plano, pero los bordes que lo delimitan son muy escarpados. Vamos, como si cogemos un vaso y lo introducimos al revés sobre la arena de la playa, dejando solo visible algo más que su “culo”.

Durante décadas, los científicos han discutido como se formaron -por desgracia nuestra ventana temporal de observación de Venus ha sido muy corta y no hemos visto formarse ninguno- pero todo apunta a que aparecen a partir de la emisión de lava por uno o más puntos de la superficie. Sobre cuál es la composición de las lavas que dan lugar a estos relieves tan característicos también hay distintas teorías que van desde que son lavas muy ricas en sílice y viscosas -similar a las riolitas terrestres- a composiciones más basálticas, en las cuales la lava es más fluida.

Precisamente, la composición de la lava no sería suficiente para explicar cómo podían adquirir estas formas tan concretas, ya que se asume que la litosfera -la capa más externa y rígida de los planetas- y sobre la que aparecían estas coladas de lava, es completamente rígida, algo que en el caso de Venus sería bastante difícil.

Pero un estudio recién publicado por Borrelli et al. (2024) muestra que la historia es, efectivamente, un poco más complicada. Han observado muestras de flexión en la litosfera -zonas donde esta se dobla o se pliega- alrededor de 14 domos de 75 estudiados, demostrando que esta no es completamente rígida. Así, la gran carga de materiales volcánicos que se sitúa sobre la litosfera sería capaz de provocar un hundimiento de esta y generar una depresión que, en ocasiones, vendría acompañada de un pequeño pliegue -como una especie de chichón que se formaría en las proximidades del domo. Algo que no se había tenido en cuenta en los modelos anteriores donde la corteza se comportaba de manera excesivamente rígida.

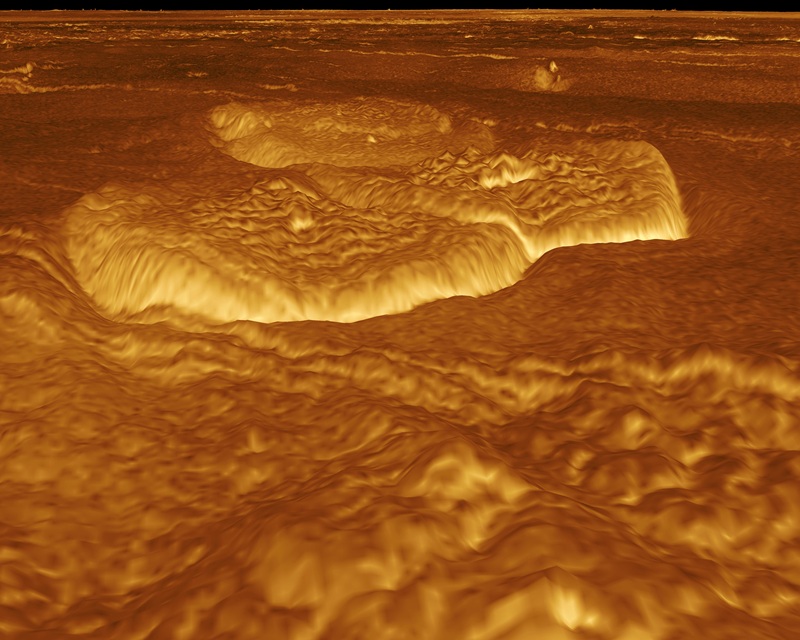

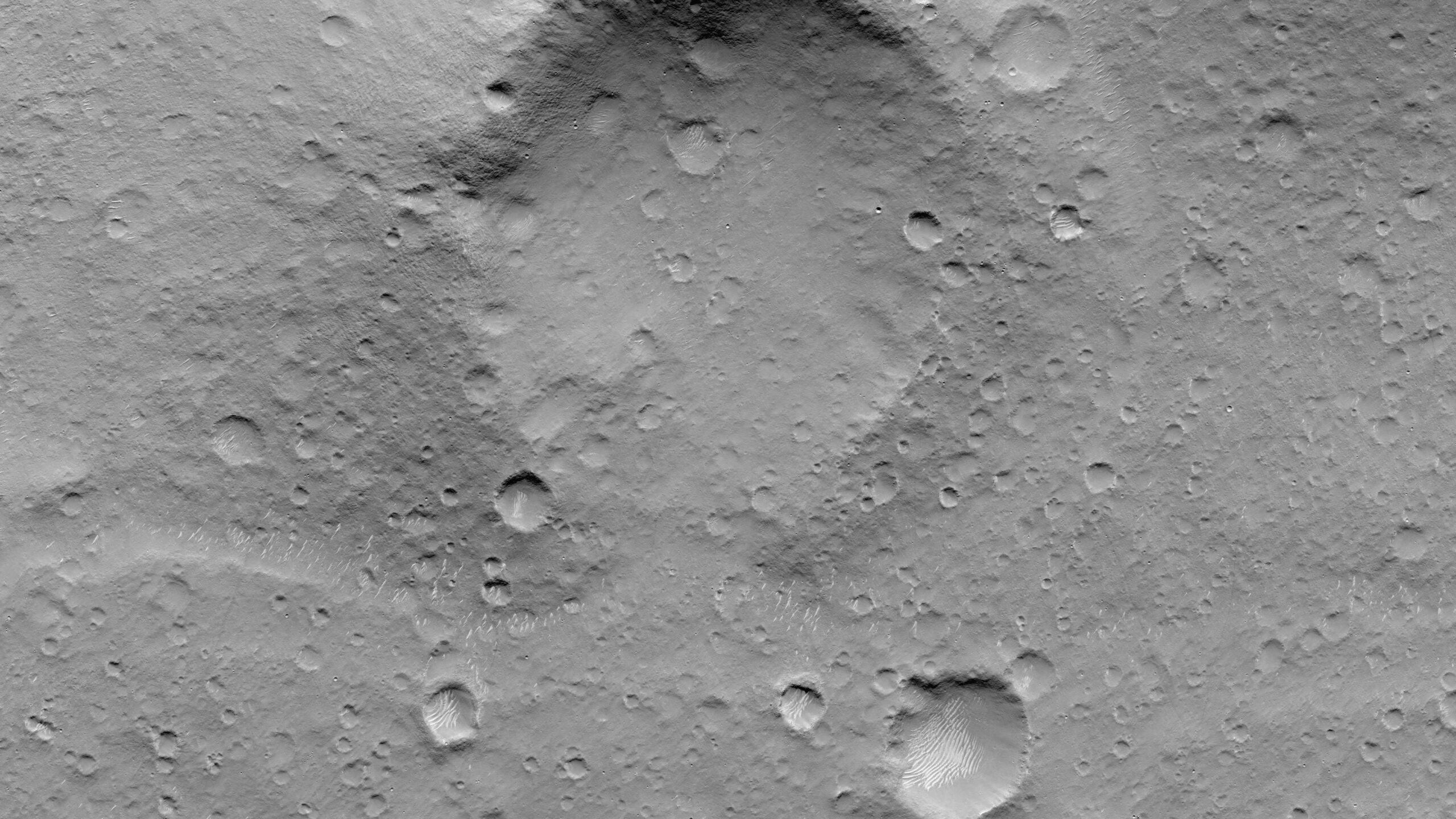

La corteza de Venus es flexible Reconstrucción tridimensional de unos pancake domes a partir de datos de la Magellan. Una cosa muy característica de estos son sus escarpadas laderas sobre la llanura circundante. Imagen cortesía de NASA/JPL.

Reconstrucción tridimensional de unos pancake domes a partir de datos de la Magellan. Una cosa muy característica de estos son sus escarpadas laderas sobre la llanura circundante. Imagen cortesía de NASA/JPL.En este estudio, los científicos han modelado la formación de estos domos como una colada de lava que se desparrama sobre una litosfera elástica capaz de deformarse por el peso de la propia lava, como si apretásemos un bote de miel y la dejásemos caer sobre un folio que tenemos cogido con ambas manos.

Este pequeño cambio tiene grandes consecuencias. En primer lugar, el suelo que hay debajo de la lava comienza a hundirse como respuesta al peso y, por lo tanto, al tiempo que va haciéndose más profundo necesita un mayor volumen de lava para formar los domos.

En segundo lugar, la forma de esta depresión flexural y del “chichón” que antecede a los domos -y que no aparece en todos los casos- está relacionada con el contraste de densidades entre la lava que forma el domo y el manto que hay por debajo, así como por la propia elasticidad de la litosfera. Esto puede parecer una obviedad, pero es importantísimo, ya que de algún modo un mejor estudio de los domos y otras formas del relieve pueden darnos pistas sobre el estado de la litosfera y el mismo manto simplemente estudiando su respuesta a la deformación y al peso.

Uno de los resultados más importantes de este estudio es que la flexión de la litosfera tiene una influencia clave sobre la morfología del domo. Y es que la aparición de la flexura tiende a hacer la superficie de los domos más planas y sus bordes más escarpados, un aspecto que encaja perfectamente con las observaciones de los domos de Venus. Esto sirve como apoyo para la idea de que la flexura en sí misma no es solo una consecuencia pasiva del proceso eruptivo que emplaza las lavas en la superficie, sino que de manera activa da forma y moldea a estos domos.

Pero hay más. Han estudiado un domo del que hay datos de muy buena calidad tomados por las misiones espaciales, Narina Tholus. De este se ha podido obtener un buen modelo topográfico donde se aprecian señales de la flexura. Sobre este domo han podido comparar la salida de los distintos modelos numéricos -en los que han ido variando los distintos parámetros- y la topografía real, obteniendo unos detalles sobre los posibles procesos de formación muy interesantes.

Distintos pancake domes situados en Alpha Regio, en Venus. De media, los que vemos en la imagen tienen unos 25 kilómetros de diámetro y unos 750 metros de altura. Es llamativo que en el centro de algunos de estos aparece una depresión similar a un cráter, probablemente también fruto de la subsidencia del propio domo tras cesar la inyección de la lava. Imagen cortesía de NASA/JPL.

Distintos pancake domes situados en Alpha Regio, en Venus. De media, los que vemos en la imagen tienen unos 25 kilómetros de diámetro y unos 750 metros de altura. Es llamativo que en el centro de algunos de estos aparece una depresión similar a un cráter, probablemente también fruto de la subsidencia del propio domo tras cesar la inyección de la lava. Imagen cortesía de NASA/JPL.Uno de los resultados más destacables es que la lava de los domos podría estar extendiéndose por la superficie durante mucho tiempo tras el final de la erupción. De hecho, en este caso, las simulaciones muestran que este proceso pudo durar entre 30.000 y 300.000 años, mucho más de los que suelen durar las erupciones más convencionales.

Esto implicaría que una gran parte de la forma de estos domos se consigue a través de procesos de relajación viscosa tiempo después del final de la actividad volcánica. Este mecanismo que estaría facilitado por las altas temperaturas de la superficie de Venus, que mantendría la lava caliente durante mucho más tiempo, facilitando su movimiento.

La cuestión de la densidad de la lavaPero, además, han podido estimar la densidad de la lava que formó Narina Tholus y la horquilla de sus cálculos se encuentra en el orden de los 2.400 a los 2.700 kg/m3, un dato que es algo problemático. Es más alto que lo que esperarían para una lava con alto contenido en sílice y altamente vesicular (con “burbujas” formadas por los gases que escapan de la lava), como pueden ser las riolitas, por ejemplo.

Y, de hecho, lavas con densidades aún más bajas, pero que autores anteriores postulaban que podrían formar estos domos (hablamos de densidades alrededor de 1.500 kg/m3) no son capaces de producir la suficiente flexura para ajustarse a la forma del domo, ya que no tendrían una densidad suficiente para forzar una curvatura tan importante de la litosfera.

Esto a su vez implica que la lava que ha formado este domo no tendría una gran cantidad de volátiles. En cambio, la densidad calculada es consistente con otras posibilidades adicionales. Podría ser una lava silícea más densa como la andesita, pero más pobre en gas o, incluso, una lava basáltica algo vesicular.

Como podéis ver, estas posibilidades nos pueden parecer algo dispares, pero en realidad acotan bastante el rango de la composición química de la lava y descartan en cualquier caso una alta vesicularidad de la lava y por lo tanto, las posibilidades con menor densidad.

Mientras llegan las próximas misiones a Venus, en especial la EnVision de la ESA y la VERITAS de la NASA, estos nuevos modelos sobre los procesos que ocurren en Venus pueden servirnos como un punto de partida para interpretar mejor una superficie que todavía sigue llena de preguntas por resolver y, quien sabe, si quizás tendremos la oportunidad de ver crecer alguno de estos domos.

Referencias

Borrelli, M. E., Michaut, C., & O’Rourke, J. G. (2024). Formation of Pancake Domes on Venus as Viscous Flows Over an Elastic Lithosphere. Preprints. doi: 10.22541/essoar.172108546.66381561/v1

Borrelli, M. E., O’Rourke, J. G., Smrekar, S. E., & Ostberg, C. M. (2021). A Global Survey of Lithospheric Flexure at Steep‐Sided Domical Volcanoes on Venus Reveals Intermediate Elastic Thicknesses. Journal of Geophysical Research: Planets, 126(7), e2020JE006756. doi: 10.1029/2020JE006756

Ghail, R. C., Smrekar, S. E., Widemann, T., Byrne, P. K., Gülcher, A. J. P., O’Rourke, J. G., Borrelli, M. E., Gilmore, M. S., Herrick, R. R., Ivanov, M. A., Plesa, A.-C., Rolf, T., Sabbeth, L., Schools, J. W., & Gregory Shellnutt, J. (2024). Volcanic and Tectonic Constraints on the Evolution of Venus. Space Science Reviews, 220(4), 36. doi: 10.1007/s11214-024-01065-2

Quick, L. C., Glaze, L. S., Baloga, S. M., & Stofan, E. R. (2016). New approaches to inferences for steep-sided domes on Venus. Journal of Volcanology and Geothermal Research, 319, 93-105. doi: 10.1016/j.jvolgeores.2016.02.028

Sakimoto, S. E. H., & Zuber, M. T. (1995). The spreading of variable-viscosity axisymmetric radial gravity currents: Applications to the emplacement of Venusian ‘pancake’ domes. Journal of Fluid Mechanics, 301, 65-77. doi: 10.1017/S0022112095003806

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Cómo se forman los “pancake domes” de Venus se ha escrito en Cuaderno de Cultura Científica.

Resistencia y anticorrosión en elementos de fijación bimetálicos estampados en caliente

En múltiples sectores industriales existe una gran demanda de componentes con geometrías específicas que combinen eficazmente buenas propiedades mecánicas con alta resistencia a la corrosión en entornos agresivos. Por ejemplo, elementos de sujeción expuestos a entorno marino, componentes de suspensión en automoción o herramientas de mano son algunos de estos componentes. Gracias a las nuevas tecnologías de fabricación aditiva, es posible la producción de piezas bimetálicas, es decir, piezas compuestas por un material en su cuerpo principal, pero con recubrimiento de otro metal, que cumplen con estos requisitos.

Foto: Shaun Dakin / Unsplash

Foto: Shaun Dakin / UnsplashEn esta línea, en el proyecto ReIMAGIN, financiado por el programa ELKARTEK del Gobierno Vasco, se ha desarrollado un estudio sobre la fabricación de cilindros híbridos mediante recargue por láser (DED-LB), aplicando una capa de acero inoxidable AISI 316 sobre un substrato de acero estructural con buenas propiedades mecánicas, concretamente 42CrMo4. Esta combinación busca aprovechar la resistencia mecánica del acero base y la protección frente a la corrosión del recubrimiento, proponiendo una solución eficaz para componentes de altas prestaciones. Entre las aplicaciones potenciales se encuentran elementos de sujeción en entornos offshore, herramientas de mano, sistemas de suspensión y, en general, piezas sometidas tanto a cargas mecánicas elevadas como a medios agresivos. Dentro de la fabricación de este tipo de piezas, uno de los procesos de conformado más empleados es la forja o estampación en caliente. Este proceso puede tener influencia tanto en la unión bimetálica formada mediante el proceso DED-LB como en las propiedades anticorrosivas del material de recubrimiento. Por ello, se decidió investigar cuál sería el efecto de esta deformación en caliente sobre cilindros recargados con inoxidable.

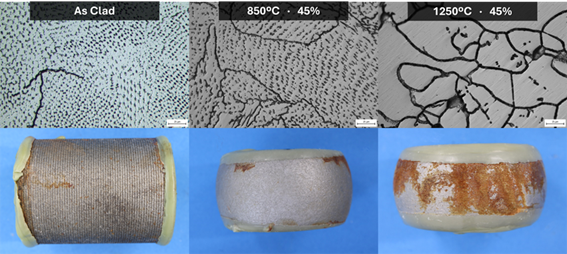

El recubrimiento inicial se realizó mediante la técnica DED-LB, empleando como substrato cilindros de 42CrMo4 de 50 mm de diámetro por 70 mm de longitud. Sobre este substrato se depositó una capa de 1 mm del acero inoxidable 316. Tras esta fabricación inicial, se realizaron procesos de forja en caliente a 850 ºC y a 1250 ºC con distintos grados de deformación, simulando condiciones industriales de alta exigencia.

Cilindros recargados a los que se han aplicado distintos grados de deformación mediante estampado en caliente, siendo 60% la deformación máxima. Fuente: Centro de Investigación Metalúrgica AZTERLAN (Todos los derechos reservados; cesión en exclusiva para el Cuaderno de Cultura Científica).

Cilindros recargados a los que se han aplicado distintos grados de deformación mediante estampado en caliente, siendo 60% la deformación máxima. Fuente: Centro de Investigación Metalúrgica AZTERLAN (Todos los derechos reservados; cesión en exclusiva para el Cuaderno de Cultura Científica).Posteriormente, se aplicaron diferentes tratamientos térmicos para analizar el efecto combinado de la temperatura y la deformación sobre la microestructura y el comportamiento frente a la corrosión del recargue de inoxidable 316. Antes de nada, se identificó mediante líquidos penetrantes el umbral de deformación a partir del cual comienzan a aparecer defectos superficiales. A 850 ºC no se detectan grietas relevantes hasta deformaciones del 30 %, mientras que a 1250 °C los recubrimientos se mantienen aparentemente íntegros hasta deformaciones del 45 %.

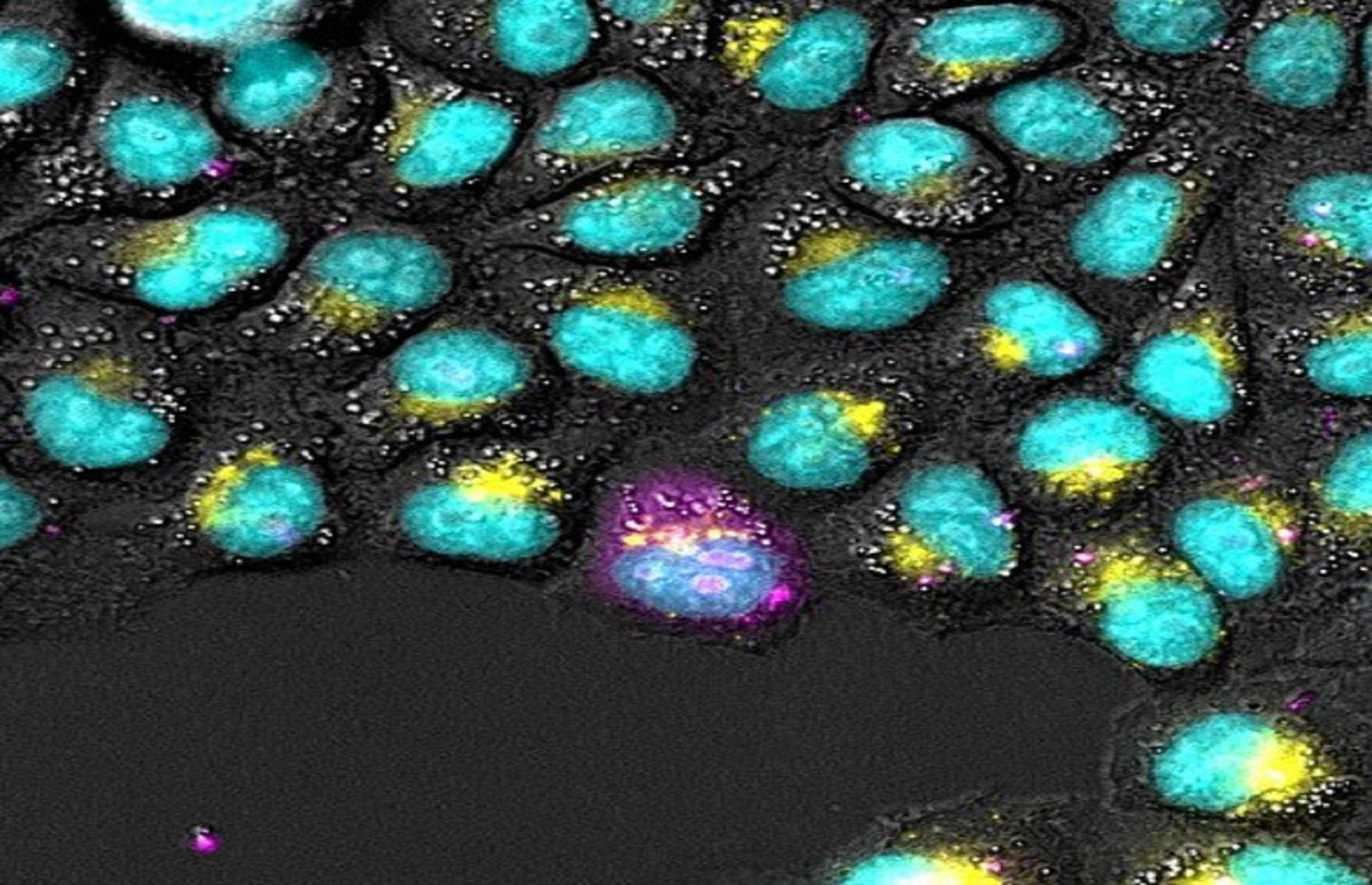

El análisis microestructural de los recargues de inoxidable AISI 316 se ha realizado mediante microscopía óptica y electrónica. En el estado inicial (as clad, previo a la forja), el recubrimiento muestra una microestructura típicamente dendrítica, con carburos de cromo dispersos y sin indicios de sensibilización (acumulación de carburos de cromo en los bordes de grano). Sin embargo, las microestructuras de las piezas estampadas en caliente muestran una evolución clara hacia la sensibilización, especialmente a temperaturas elevadas; a 850 °C, se observan bordes de grano marcados, aunque se mantienen también los carburos de cromo dispersos por la matriz. A 1250 °C, no obstante, la sensibilización es completa en todas las muestras, incluso en aquellas con baja deformación, indicando que la temperatura, más que la deformación, es el factor determinante en este fenómeno.

Finalmente, los ensayos de corrosión acelerada en niebla salina confirmaron estos resultados microestructurales. Las muestras as clad y las estampadas a 850 °C resistieron la exposición durante 96 horas sin oxidación, salvo en aquellas zonas concretas que presentaban grietas ya detectadas por líquidos penetrantes. Al contrario, las muestras estampadas a 1250 °C mostraron una oxidación total del recubrimiento después de tan solo 24 horas, indicando una pérdida completa de su funcionalidad anticorrosiva.

Microestructuras e imágenes de piezas sometidas a ensayo de niebla salina: as clad (izquierda), estampada a 850ºC con 45% de deformación (centro) y estampada a 1250ºC con 45% de deformación (derecha). Fuente: Centro de Investigación Metalúrgica AZTERLAN (Todos los derechos reservados; cesión en exclusiva para el Cuaderno de Cultura Científica).

Microestructuras e imágenes de piezas sometidas a ensayo de niebla salina: as clad (izquierda), estampada a 850ºC con 45% de deformación (centro) y estampada a 1250ºC con 45% de deformación (derecha). Fuente: Centro de Investigación Metalúrgica AZTERLAN (Todos los derechos reservados; cesión en exclusiva para el Cuaderno de Cultura Científica).

En conclusión, los resultados de este estudio demuestran que la estrategia de fabricar componentes bimetálicos mediante recargue láser DED-LB es viable, siempre que se controlen cuidadosamente las condiciones térmicas a las que se someten las piezas durante los procesos posteriores. El acero inoxidable 316 puede mantener sus propiedades anticorrosivas incluso tras deformaciones intensas, siempre que no se supere el umbral crítico de temperatura (entre 850 ºC y 1250 ºC) que activa la sensibilización. Con vistas a aplicaciones industriales, esto abre la puerta al diseño de componentes híbridos que ofrezcan un buen equilibrio entre resistencia mecánica y durabilidad frente a la corrosión.

Sobre el autor: Xabier Lasheras. AZTERLAN Metallurgy Research Centre

Sobre AZTERLAN: Con el firme compromiso de impulsar el desarrollo tecnológico y la competitividad de las empresas, AZTERLAN cuenta con más de 45 años de experiencia ofreciendo soporte tecnológico, conocimiento metalúrgico experto y soluciones avanzadas a la industria de transformación metal-mecánica y a sus sectores cliente.

Basque Research & Technology Alliance (BRTA) es una alianza que se anticipa a los retos socioeconómicos futuros globales y de Euskadi y que responde a los mismos mediante la investigación y el desarrollo tecnológico, proyectándose internacionalmente. Los centros de BRTA colaboran en la generación de conocimiento y su transferencia a la sociedad e industria vascas para que sean más innovadoras y competitivas. BRTA es una alianza de 17 centros tecnológicos y centros de investigación cooperativa y cuenta con el apoyo del Gobierno Vasco, SPRI y las Diputaciones Forales de Araba, Bizkaia y Gipuzkoa.

El artículo Resistencia y anticorrosión en elementos de fijación bimetálicos estampados en caliente se ha escrito en Cuaderno de Cultura Científica.

La memoria de la Tierra. El reconocimiento internacional del patrimonio geológico

¿Qué tienen en común un paisaje espectacular, un fósil milenario y una cantera abandonada? Todos forman parte del patrimonio geológico, un testimonio de la historia de la Tierra con un gran valor científico, educativo, cultural y estético. Sin embargo, su importancia continúa siendo poco apreciada.

Para acercar las distintas aproximaciones del patrimonio geológico a la sociedad, los días 26, 27 y 28 de marzo se celebró la quinta edición de las jornadas divulgativas “Geología para poetas, miopes y despistados. Patrimonio patrimonio”. Organizadas por el grupo de investigación consolidado Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco (UPV/EHU), estas jornadas contaron con la colaboración del Vicerrectorado del Campus de Bizkaia, la Cátedra de Cultura Científica de la UPV/EHU, el Geoparque de la Costa Vasca / Geoparkea y el Ente Vasco de la Energía (EVE).

En esta charla Asier Hilario, presidente de la Comisión Internacional sobre Geopatrimonio de la International Union of Geological Sciences (IUGS), nos explica el concepto de patrimonio geológico y como ha ido evolucionando con el tiempo.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo La memoria de la Tierra. El reconocimiento internacional del patrimonio geológico se ha escrito en Cuaderno de Cultura Científica.

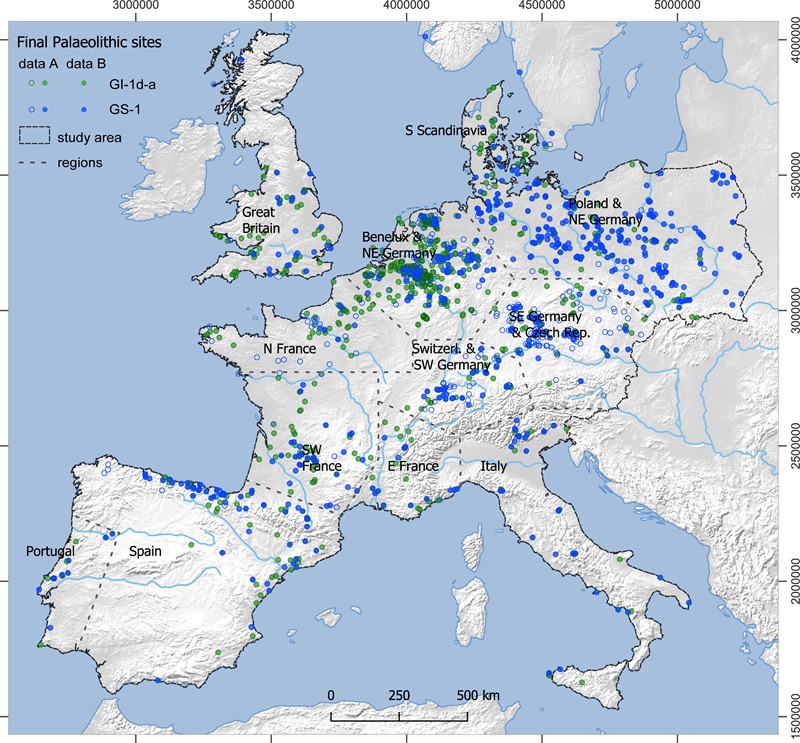

Las respuestas demográficas al cambio climático al final del Paleolítico

Un nuevo estudio liderado por la Universidad de Colonia y con la participación de 25 investigadores de toda Europa ha descubierto cómo afectó el cambio climático hace más de 12.000 años a las poblaciones humanas prehistóricas. La investigación ha descubierto cambios significativos en el tamaño y la densidad de la población durante periodos clave al final de la última Edad de Hielo, concretamente durante el Paleolítico final, hace entre 14.000 y 11.600 años. Los datos para la península ibérica han sido sintetizados por nvestigadores de la Universidad del Algarve (Portugal) y de la Universidad del País Vasco / Euskal Herriko Unibertsitatea. Concretamente, Alvaro Arrizabalaga, del Grupo Consolidado de Investigación en Prehistoria GIZAPRE (EHU), es coautor de este estudio.

La investigación se centra en dos periodos clave: la mejoría climática que se produjo en el Paleolítico final, entre los años 14.000 y 12.500, (el llamado GI-1d-a) y el enfriamiento climático breve que se desarrolla entre hace unos 12.500 y 11.600 años, al final de la última glaciación . Este último periodo, llamado Dryas Reciente ( GS-1), representa el último coletazo frío del Pleistoceno y da paso al ciclo climático Holoceno, en el que nos encontramos todavía en la actualidad.

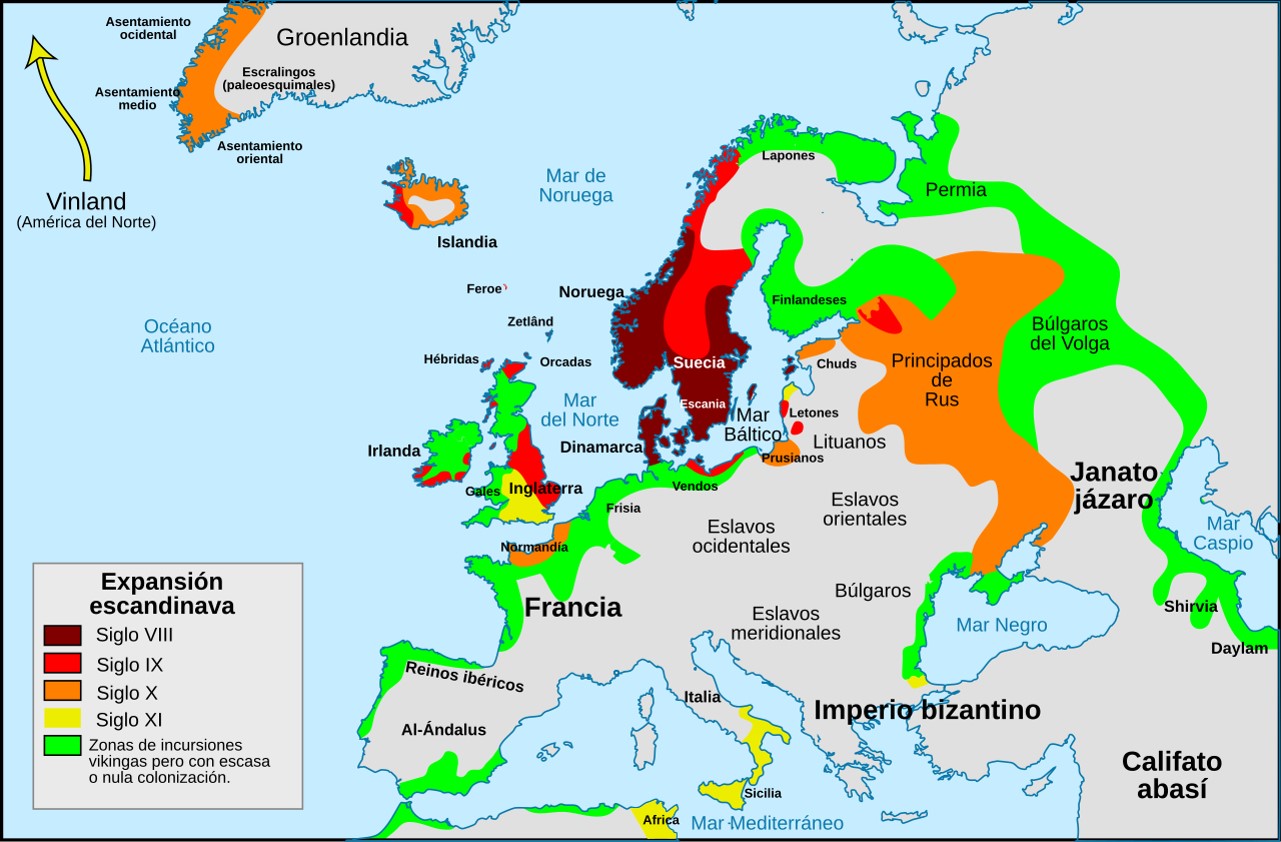

Localizaciones de los yacimientos objeto del estudio. Fuente: Schmidt et al (2025) PLoS ONE doi: 10.1371/journal.pone.0310942 CC BY 4.0

Localizaciones de los yacimientos objeto del estudio. Fuente: Schmidt et al (2025) PLoS ONE doi: 10.1371/journal.pone.0310942 CC BY 4.0El Protocolo de Colonia

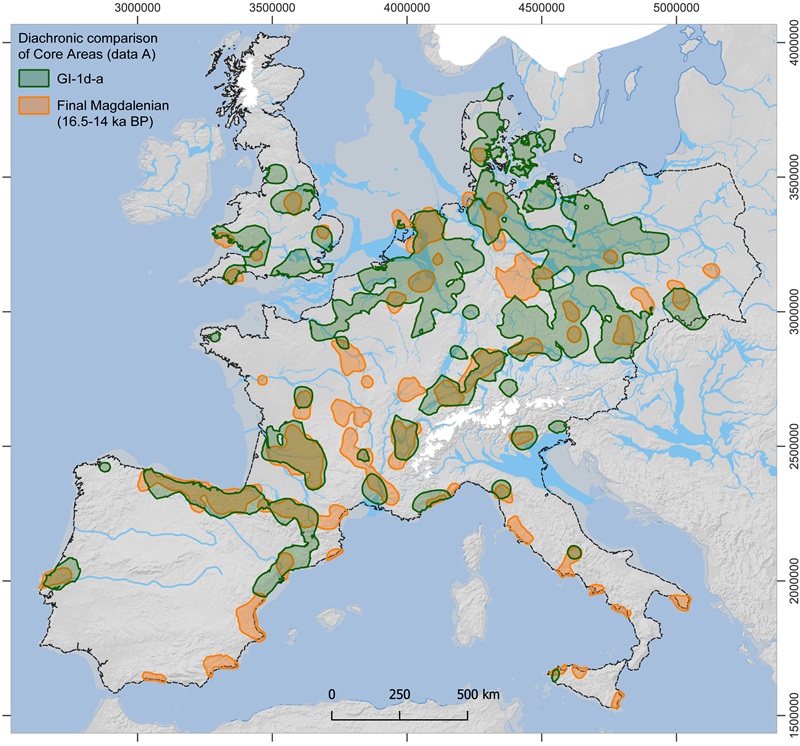

Utilizando una innovadora metodología geoestadística, llamada Protocolo de Colonia, y una amplia base de datos arqueológicos, los investigadores estimaron los cambios en tamaño y densidad poblacional sobre diferentes marcos regionales en Europa entre hace 14.000 y 11.600 años.

Comparación diacrónica de los principales núcleos poblacionales en dos periodos. Fuente: Schmidt et al (2025) PLoS ONE doi: 10.1371/journal.pone.0310942 CC BY 4.0

Comparación diacrónica de los principales núcleos poblacionales en dos periodos. Fuente: Schmidt et al (2025) PLoS ONE doi: 10.1371/journal.pone.0310942 CC BY 4.0Durante el primer período de mejoría climática (GI-1d-a), los humanos continuaron repoblando y expandiéndose hacia el norte y noreste de Europa central, convirtiendo esta región en el centro de la dinámica demográfica en Europa por primera vez en toda la Prehistoria. Las poblaciones del suroeste de Europa, sobre todo en la Península ibérica y Francia, empezaron a disminuir en comparación con los datos demográficos de los periodos precedentes.

Como consecuencia del repentino enfriamiento, a lo largo del Dryas Reciente, los datos muestran que la población europea se pudo reducir hasta la mitad. Sin embargo, en algunas zonas del centro y este europeo como el norte de Italia, Polonia y el noreste de Alemania, la densidad poblacional incluso aumentó.

Reacción demográfica

Para los investigadores, este fenómeno es una muestra de lo rápido que los humanos prehistóricos reaccionaron frente al cambio climático. «Nuestros datos sugieren que muchas comunidades humanas emigraron hacia el este para adaptarse al nuevo clima, en lugar de desaparecer», explica Isabell Schmidt, del Departamento de Arqueología Prehistórica de la Universidad de Colonia, que lidera la publicación. El estudio pone de relieve que, a diferencia del anterior periodo de colapso poblacional (durante el Gravetiense, hace unos 25.000 años), los humanos del Paleolítico final respondieron emigrando a zonas aparentemente más favorables.

Referencia:

Schmidt I, Gehlen B, Winkler K, Arrizabalaga A, Arts N, Bicho N, et al (2025) Large scale and regional demographic responses to climatic changes in Europe during the Final Palaeolithic PLoS ONE doi: 10.1371/journal.pone.0310942

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Las respuestas demográficas al cambio climático al final del Paleolítico se ha escrito en Cuaderno de Cultura Científica.

Fumatas geológicas en los fondos marinos

Hace unas semanas, medio mundo estuvo pendiente del color del humo que salía de una estrecha chimenea situada en el tejado de un edificio de una minúscula ciudad estado situada en la capital italiana. Pues, aunque no os lo creáis, esta situación es muy habitual entre las geólogas y los geólogos, aunque, en nuestro caso, no levantamos la vista al cielo para observar esas fumatas. En realidad, debemos sumergirnos en el fondo oceánico para vigilar nuestras propias chimeneas. Me estoy refiriendo a las fumarolas o venas hidrotermales submarinas.

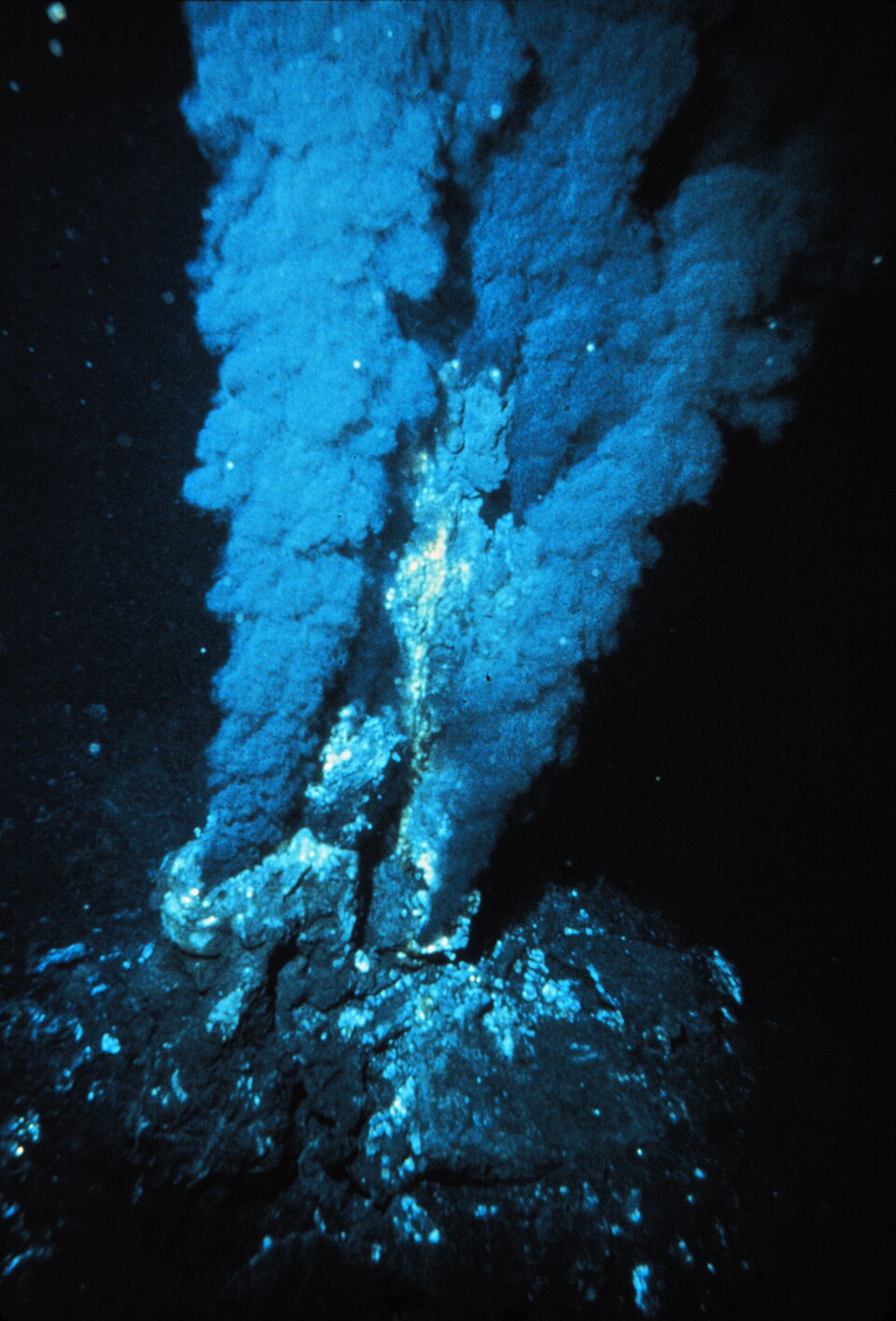

Fumarola negra en la vena hidrotermal de la dorsal centro-Atlántica. Fuente: P. Rona / OAR/National Undersea Research Program (NURP); NOAA – NOAA Photo Library, Dominio público, Wikimedia Commons

Fumarola negra en la vena hidrotermal de la dorsal centro-Atlántica. Fuente: P. Rona / OAR/National Undersea Research Program (NURP); NOAA – NOAA Photo Library, Dominio público, Wikimedia CommonsLas fumarolas son unas estructuras geológicas que se forman en los fondos oceánicos debido a un ciclo del agua muy particular. Este viaje comienza cuando el agua marina se infiltra en la corteza terrestre a través de fracturas del terreno y empieza a circular por el interior del subsuelo donde se calienta, muchas veces debido a que pasa cerca de depósitos magmáticos, pudiendo alcanzar temperaturas superiores a los 300ºC. Con estas temperaturas, el agua es capaz de captar los elementos químicos que componen las rocas que atraviesa en su viaje subterráneo, llevándolos disueltos con ella. Cuando se topa con nuevas fracturas, el agua asciende y vuelve a salir al fondo marino, liberando entonces los gases y minerales que arrastraba, los cuales, tras sufrir un enfriamiento muy brusco al contactar con el agua oceánica, precipitan formando unas estructuras tubulares que pueden alcanzar varios metros de altura.

Imaginaos la escena. Os encontráis con unas enormes estructuras tubulares de las que salen gases a gran temperatura desde su parte superior, pero que se encuentran en los fondos marinos, a varios miles de metros de profundidad. De ahí que, de manera informal, también se las conozca como chimeneas submarinas.

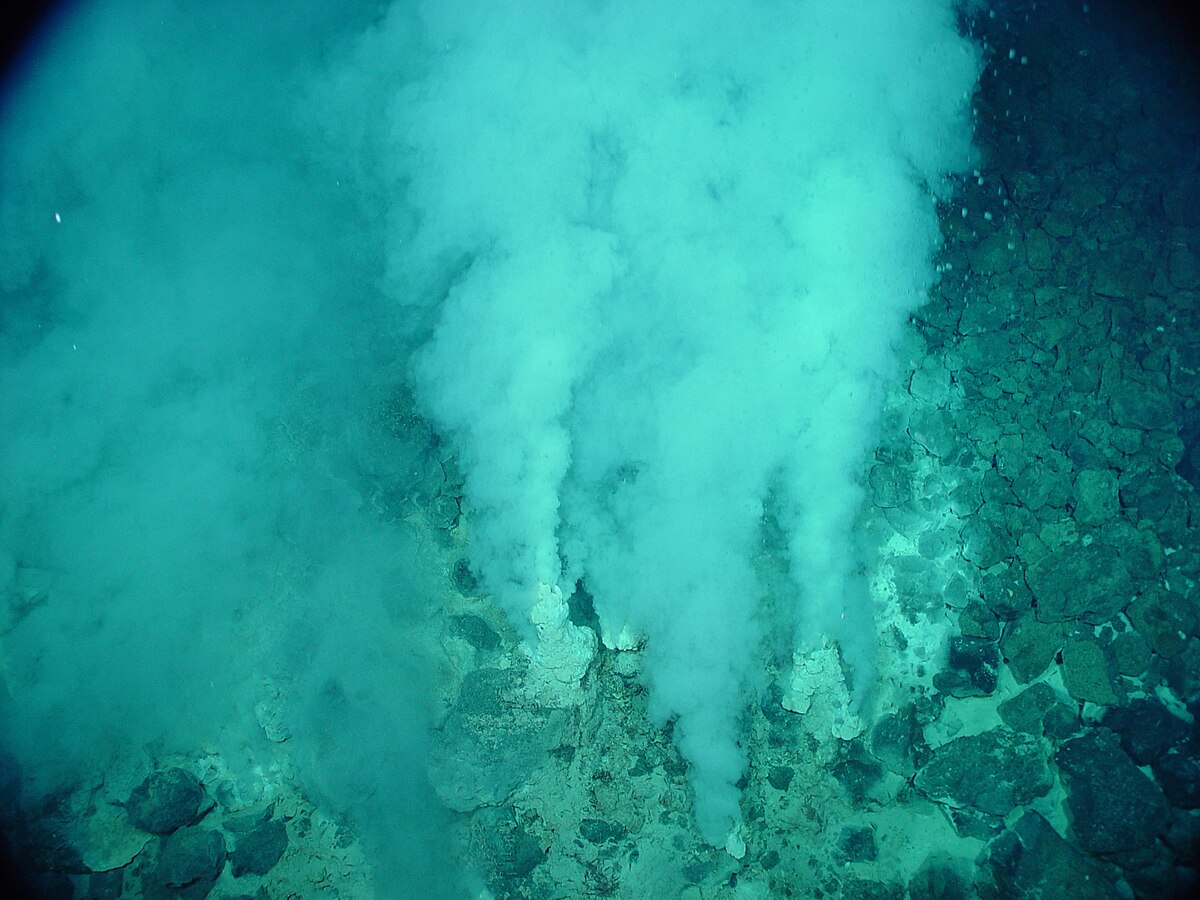

Fumarola blanca en la vena hidrotermal Champagne, asociada a los volcanes submarinos Eifuku del Océano Pacífico (cerca de Japón). Fuente: NOAA – Dominio público, Wikimedia Commons

Fumarola blanca en la vena hidrotermal Champagne, asociada a los volcanes submarinos Eifuku del Océano Pacífico (cerca de Japón). Fuente: NOAA – Dominio público, Wikimedia CommonsVolviendo al símil del principio, aquí también podemos encontrarnos con fumarolas negras. En este caso, el color de los minerales y los gases que expulsan estas venas hidrotermales se debe a que, en su composición, dominan los sulfuros de hierro, de cobre, de cinc y de otros metales que tienen una coloración en tonos oscuros y negros. Y también tenemos fumarolas blancas, formadas por fluidos hidrotermales no tan calientes como los de las fumarolas negras (250-300ºC) y que precipitan silicatos de calcio, bario y otros minerales alcalinos de colores claros y blanquecinos.

Pero las fumarolas submarinas no son solo una curiosidad geológica presente en una parte aún poco conocida de nuestro planeta, los fondos oceánicos. Sino que también son clave en el estudio de la dinámica interna de la Tierra. Como os comentaba anteriormente, este proceso se asocia a depósitos magmáticos submarinos, principalmente a los procesos volcánicos de las dorsales oceánicas, que son zonas donde se está formando nueva corteza terrestre, haciendo que se separen entre sí dos placas tectónicas. De hecho, las fumarolas negras suelen aparecer en zonas cercanas a las dorsales, mientras que las fumarolas blancas se generan en áreas más alejadas de las mismas. Vamos, que estudiar el comportamiento y formación de estas chimeneas submarinas nos da pistas para comprender lo que está sucediendo bajo tierra mientras se forma nueva corteza en las dorsales oceánicas.

Aunque su interés no termina aquí. Las fumarolas se pueden considerar como grandes acumulaciones o depósitos de minerales formados por metales y otros elementos químicos con un gran interés económico y comercial. Su estudio, por tanto, nos aporta una valiosa información científica sobre los procesos geológicos que contribuyen a la formación de estos recursos minerales, lo que nos permite buscar yacimientos minerales en superficie que tuviesen un origen similar hace millones de años.

También nos informan sobre uno de los recursos geológicos más en boga actualmente, la energía geotérmica. Como su propio nombre indica, esta nueva fuente de energía, totalmente renovable e inagotable, se basa en utilizar el calor del interior de la Tierra. Y, en las fumarolas, este calor subterráneo está disponible en forma de gases o vapor que sale al exterior en los fondos submarinos, cuya energía calorífica podría ser transformada en energía eléctrica.

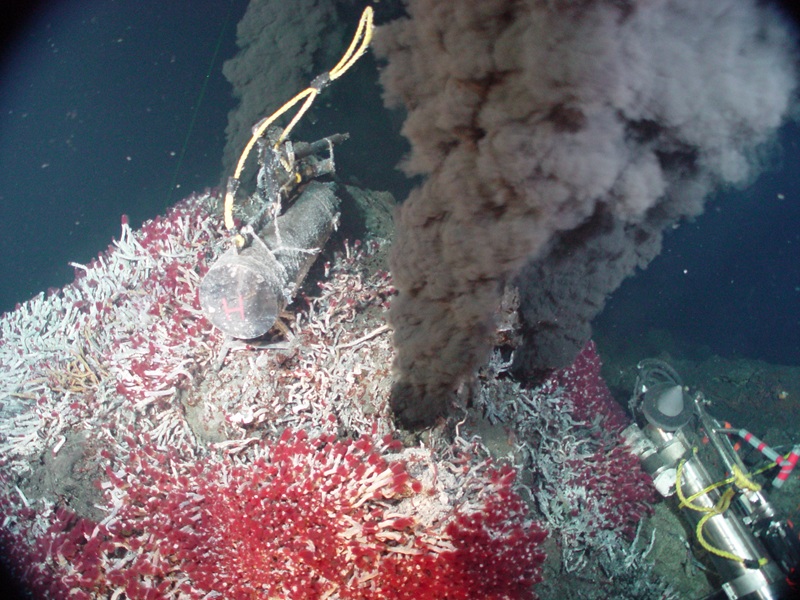

Grandes colonias de gusanos tubícolas asociados a una fumarola negra en la vena hidrotermal Sully, presente en el gran campo de venas hidrotermales Endeavour del Océano Pacífico noroccidental. Fuente: NOAA – Dominio Público. Wikimedia Commons

Grandes colonias de gusanos tubícolas asociados a una fumarola negra en la vena hidrotermal Sully, presente en el gran campo de venas hidrotermales Endeavour del Océano Pacífico noroccidental. Fuente: NOAA – Dominio Público. Wikimedia Commons Pero he dejado para el final la mayor curiosidad geológica de estas estructuras. Cuando vemos una grabación de las fumarolas en plena acción, nos vienen a la mente representaciones medievales del mismísimo Infierno. Nos encontramos en medios ambientes con valores extremos de pH, tanto muy ácidos como muy alcalinos, con agua y gases a temperaturas muy altas, totalmente rodeadas de metales y elementos químicos tóxicos como el metano o el dióxido de carbono. Pues, en realidad, son auténticos vergeles de vida. Aquí se desarrollan ecosistemas únicos donde proliferan organismos que se han adaptado y han evolucionado para prosperar en entornos muy hostiles, encontrándonos con enormes gusanos tubícolas, bivalvos gigantescos, crustáceos de conchas transparentes y otros seres que parecen salidos de los peores sueños de H. P. Lovecraft. Aunque si hay alguna forma de vida que destaca sobre las demás, esas son las bacterias extremófilas. Pequeños seres que se alimentan de sulfuro, nitrógeno o metano, acostumbrados a vivir en medios con temperaturas elevadísimas, y que fueron las primeras formas de vida de nuestro planeta. Por lo que estudiar las comunidades de bacterias y arqueas que proliferan en las fumarolas submarinas nos permitirá comprender, al menos, cómo evolucionó la vida primigenia en la Tierra.

Creo que ahora ya comprendéis por qué las geólogas y los geólogos miramos con tanta atención estas chimeneas, fijándonos también en color de la fumata que sale de su parte superior. Estas curiosas estructuras submarinas nos permiten conocer mejor la dinámica interna de nuestro planeta, los ciclos geoquímicos de la Tierra y el origen y evolución de la vida en entornos extremos. Y, posiblemente, eso sea lo que las ha salvado, al menos de momento, porque tener una fuente casi inagotable de recursos minerales de interés económico a nuestra disposición, es una gran tentación. Espero que el interés científico siga primando por mucho tiempo.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Fumatas geológicas en los fondos marinos se ha escrito en Cuaderno de Cultura Científica.

Inmersión, un cómic empapado de matemáticas (I)

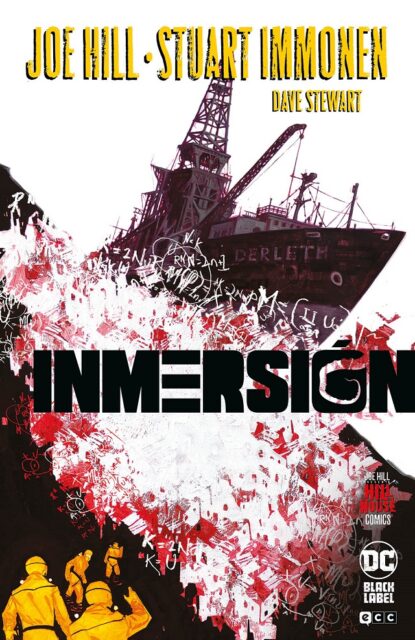

Acabo de terminar de leer el cómic Inmersión (Hill House Comics – DC Black Label; ECC Ediciones, 2021), de Joe Hill (guion), Stuart Immonen (dibujo) y Dave Stewart (color), que tiene muchas referencias matemáticas, de las cuales vamos a hablar en esta entrada del Cuaderno de Cultura Científica.

Portada de la edición en español, publicada por ECC Ediciones en 2021, del cómic Inmersión, de Joe Hill (guion) y Stuart Immonen (dibujo), que recoge los seis números/grapas que lo conforman

Portada de la edición en español, publicada por ECC Ediciones en 2021, del cómic Inmersión, de Joe Hill (guion) y Stuart Immonen (dibujo), que recoge los seis números/grapas que lo conforman

En la propia portada del recopilatorio de los seis números que componen el cómic Inmersión, que es del artista estadounidense Jeremy Wilson, ya vemos diferentes símbolos que, aunque quizás no reconozcamos, sí los identificamos como símbolos matemáticos.

Un cómic de Joe Hill, Stuart Immonen y Dave Stuart

Los seis números del cómic Inmersión (Plunge, en inglés), creado por el escritor estadounidense Joe Hill, responsable también de su guion, dibujado por el artista canadiense Stuart Immonen y coloreado por el artista del color estadounidense Dave Stewart, fueron publicados originalmente por Hill House Cómics, una línea editorial de cómics de terror creada y dirigida por Joe Hill, dentro del sello editorial DC Black Label de DC cómics.

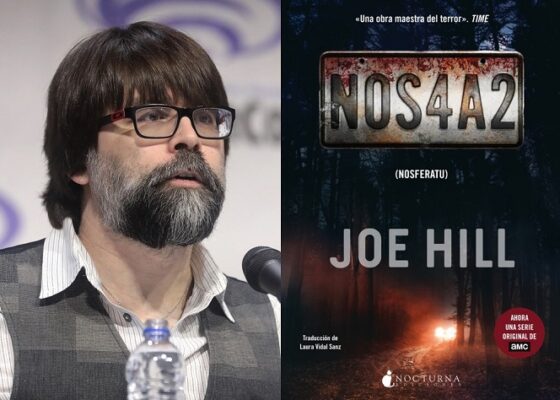

El escritor y creador de cómics estadounidense Joseph Hillstrom King (1972), cuyo nombre artístico es Joe Hill, es un autor destacado dentro de los géneros literarios de terror, fantasía oscura y ciencia ficción. Entre las novelas escritas por Joe Hill están El traje del muerto (2007) o NOS4A2 (2013), mientras que dentro de la ficción gráfica es el autor de los guiones de comics como Locke & Key (2008-13), La capa (2007-2011) o Un cesto de cabezas (2019). Como anécdota diremos que este galardonado escritor es el hijo del famoso escritor de misterio y terror Stephen King (1947).

Fotografía del escritor y creador de cómics Joe Hill y portada de su novela NOS4A2 (Nosferatu)

Fotografía del escritor y creador de cómics Joe Hill y portada de su novela NOS4A2 (Nosferatu)

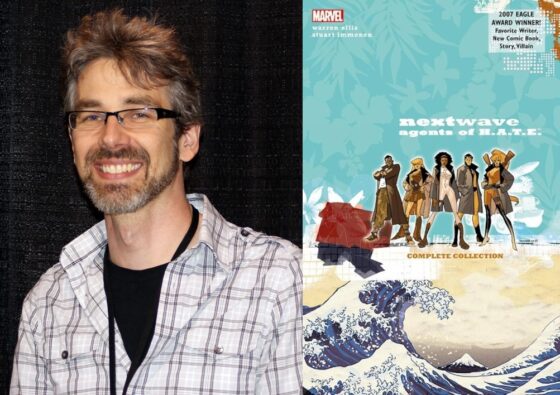

Stuart Immonen es un dibujante de cómics canadiense que ha trabajado tanto para cómics de DC cómics, como Action comics (1997-1999), Inferno (1997), Las aventuras de Superman (1995-2000), Superman: End of the Century (2000) o Superman: Identidad secreta (2004), entre otros, como para cómics de Marvel, como Los 4 fantásticos (2001-2009), Nextwave: Agentes de H.A.T.E (2006-07), Los nuevos vengadores (2009-2011), Miedo encarnado (2011), El increíble Spiderman (2017-18), entre muchos otros.

Fotografía del dibujante Stuart Immonen y portada del cómic Nextwave: Agentes de H.A.T.E, escrito por Warren Ellis y dibujado por Stuart Immonen

Fotografía del dibujante Stuart Immonen y portada del cómic Nextwave: Agentes de H.A.T.E, escrito por Warren Ellis y dibujado por Stuart Immonen

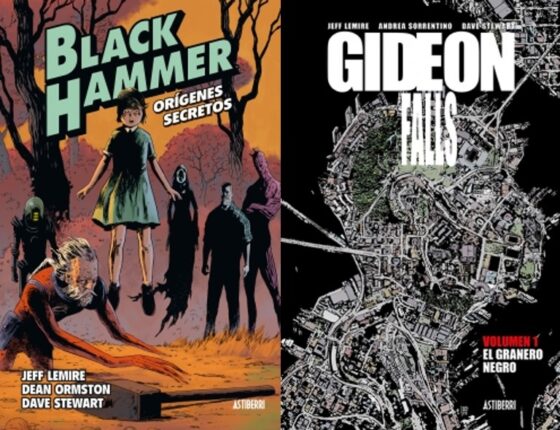

Finalmente, el color de los dibujos de Inmersión se debe al artista Dave Stewart, cuyo trabajo ha sido galardonado en diferentes ediciones de los prestigiosos Premios Eisner. Entre sus trabajos destacan AIDP (2006-2020), Baltimore (2010-2017), Fatale (2013-2015), Black Hammer (2017-2025), Sherlock Frankenstein y la legión del mal (2018), Gideon Falls (2019-2021), Hellboy (2020-2024), entre muchos otros, que incluyen las últimas portadas de The Walking Dead.

Portadas del volumen 1 de Black Hammer (2017) y Gideon Falls (2019), cuyo colorista es Dave Stewart

Portadas del volumen 1 de Black Hammer (2017) y Gideon Falls (2019), cuyo colorista es Dave StewartInmersión, de Joe Hill

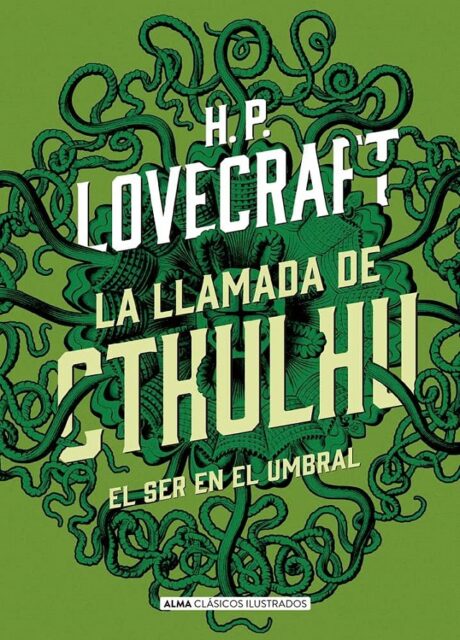

El escritor Joe Hill, el dibujante Stuart Immonen y el colorista Dave Stewart se juntaron para crear este cómic de terror, que intenta homenajear al género de terror de los años ochenta. Mientras lo leía me vinieron a la cabeza dos referencias del género de terror, por una parte, una película clásica de terror de los años ochenta, La cosa (1983), del director estadounidense John Carpenter (1948), pero también un clásico del terror como es el escritor estadounidense H. P. Lovecraft (1890-1937) y sus mitos de Cthulhu. De hecho, el propio Joe Hill menciona la ciudad submarina de R’lyeh, un lugar ficticio de los mitos de Cthulhu, que según su autor estaba situada en la latitud 47°9′ sur y la longitud 126°43′ oeste en el océano Pacífico, como un punto de partida en su relato de horror.

Un par de curiosidades relacionadas con R’lyeh. La primera es que el escritor August W. Derleth (1909-1971), del círculo de Lovecraft, también utilizó la ciudad sumergida de R’lyeh en sus escritos. Además, su nombre, como veremos más adelante, aparece mencionado en el cómic Inmersión. La segunda curiosidad es que la primera vez que aparece la ciudad submarina de R’lyeh, que es el lugar en el que habita aletargada la entidad cósmica Cthulhu, es en el relato corto de H. P. Lovecraft La llamada de Cthulhu (1926). En este relato puede leerse la siguiente descripción de la ciudad.

Sin conocer el futurismo, Johansen describe, al hablar de la ciudad, algo muy parecido a una obra futurista. En vez de referirse a una estructura definida, algún edificio, se reduce a hablar de vastos ángulos y superficies pétreas… superficies demasiado grandes para ser de este mundo, y cubiertas por jeroglíficos e imágenes horribles. Menciono estos ángulos pues me recuerdan los sueños que me relató Wilcox. El joven escultor afirmó que la geometría de la ciudad de sus sueños era anormal, no euclidiana, y que sugería esferas y dimensiones distintas de las nuestras. Ahora un marino ilustrado tenía ante la terrible realidad la misma impresión.

En la misma se hace mención a la geometría no euclideana, así como a esferas y dimensiones distintas de las nuestras. Pero dejemos a Lovecraft y volvamos a nuestro cómic lovecraftiano Inmersión.

Portada de la edición de 2017 de la editorial Alma, dentro de su colección Clásicos Ilustrados (la ilustración es del artista, escritor y diseñador inglés John Coulthart), del relato corto La llamada de Cthulhu (1926), de H. P. Lovecraft

Portada de la edición de 2017 de la editorial Alma, dentro de su colección Clásicos Ilustrados (la ilustración es del artista, escritor y diseñador inglés John Coulthart), del relato corto La llamada de Cthulhu (1926), de H. P. Lovecraft

Esta es la sinopsis escrita sobre el cómic en la página web de la editorial ECC:

En 1983, el Derleth, un buque de perforación de última generación, desaparece cerca del Círculo Polar Ártico. Décadas más tarde empieza a emitir una señal de socorro…

La compañía petrolífera Rococo sigue la señal hasta un remoto atolón del Estrecho de Bering y contrata a los hermanos Carpenter y su tripulación de rescate para investigar el barco fantasma. Junto con una bióloga marina y un ejecutivo petrolífero, los hermanos se embarcan en una siniestra misión para averiguar las causas de la desaparición del barco y recuperar los cuerpos de la tripulación… ¡pero resulta que los hombres del Derleth no están muertos! Aunque tampoco están ya del todo… vivos…

Como vemos hay dos referencias claras en la sinopsis. Por una parte, el buque de perforación que desapareció en 1983 es el Derleth, que nos remite al círculo de Lovecraft. Por otra parte, dos de los personajes de la historia son los hermanos Carpenter, que nos hace pensar que la asociación con la película La cosa (1982) no es casual, sino intencionada.

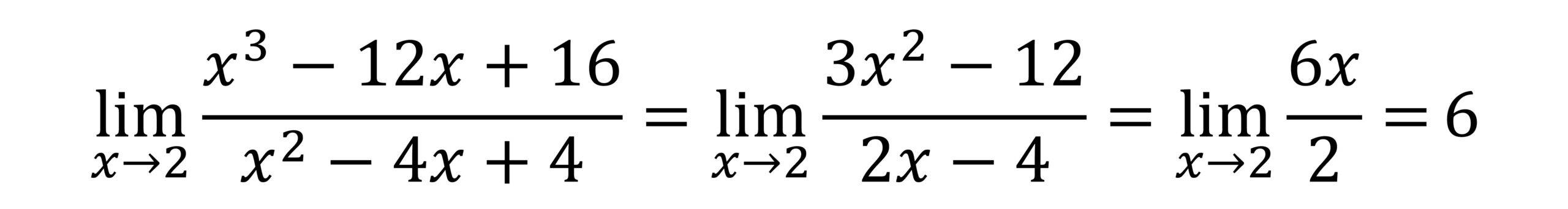

Las portadas de las grapas del cómic Inmersión

Las matemáticas están muy presentes en este cómic de terror creado por Joe Hill, tanto en la historia, como en la estética, puesto que ya desde las portadas, así como en las páginas de los créditos, de los seis números que componen este cómic, están presentes las matemáticas.

En la siguiente imagen se muestran las seis portadas de la publicación original de Inmersión (Plunge), que realizó el artista Jeremy Wilson.

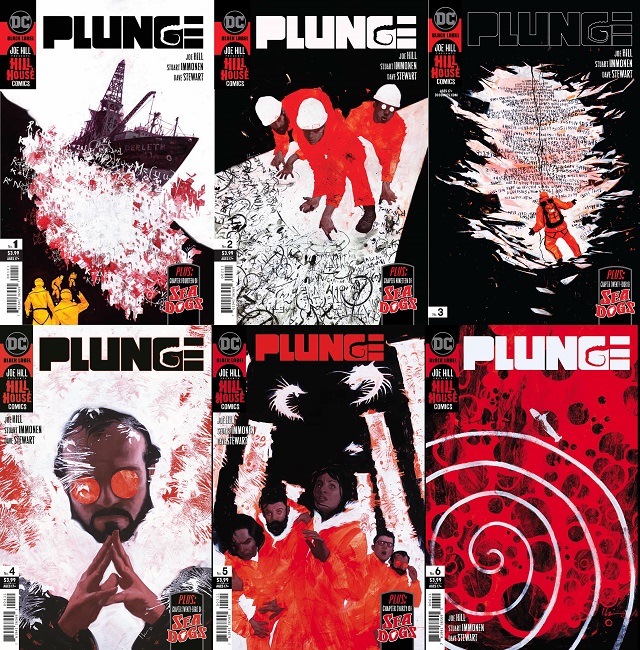

Portadas de la edición original (en inglés) de los números #1-6 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

Portadas de la edición original (en inglés) de los números #1-6 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

En las dos primeras portadas aparecen símbolos matemáticos como si hubiesen sido sacados de una pizarra, aunque muy mezclados unos con otros. En la tercera portada, que veremos con más detalle ahora, vemos a una persona ante una pared que está llena de números. En las portadas de los números cuatro y cinco no hay números, ni símbolos matemáticos. Y en la última portada nos encontramos con una espiral de Arquímedes (más o menos) en blanco.

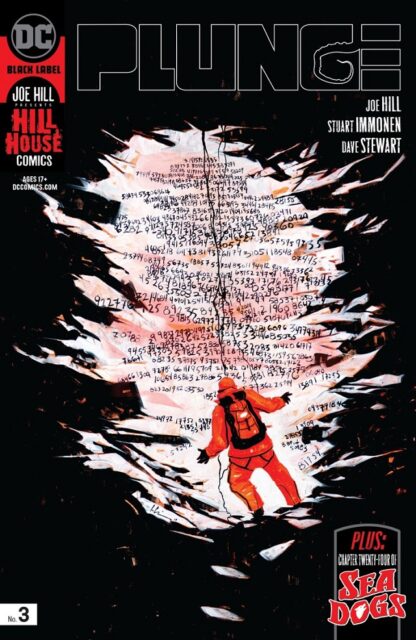

Pero volvamos a la portada del número tres. Como se puede ver en la siguiente imagen el número que aparece pintado en la pared es el número pi (para saber un poco más sobre este número véase la entrada ¿Es normal el número pi? ). En la primera línea podemos ver 3.1415926535; en la segunda línea 89793238462643383279; en la tercera línea 5028841971693993751058209; y así siguen muchas más líneas con los distintos decimales del número pi.

Portada de la edición original (en inglés) del número #3 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart, en la que aparecen los primeros decimales del número pi

Portada de la edición original (en inglés) del número #3 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart, en la que aparecen los primeros decimales del número piMatemáticas hasta en los créditos

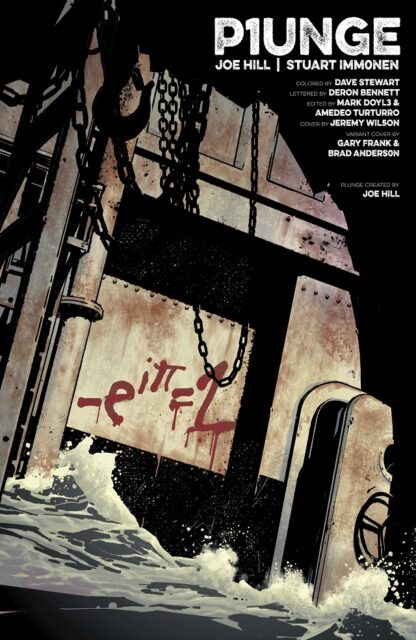

En la página de créditos, que en todos los números va en la parte del principio, salvo en el número seis, también nos encontramos matemáticas. Todas las páginas de créditos son el dibujo oscuro, con sombras, de una parte del buque Derleth medio hundido, como en la siguiente imagen.

Página de créditos de la edición original (en inglés) del número #1 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

Página de créditos de la edición original (en inglés) del número #1 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

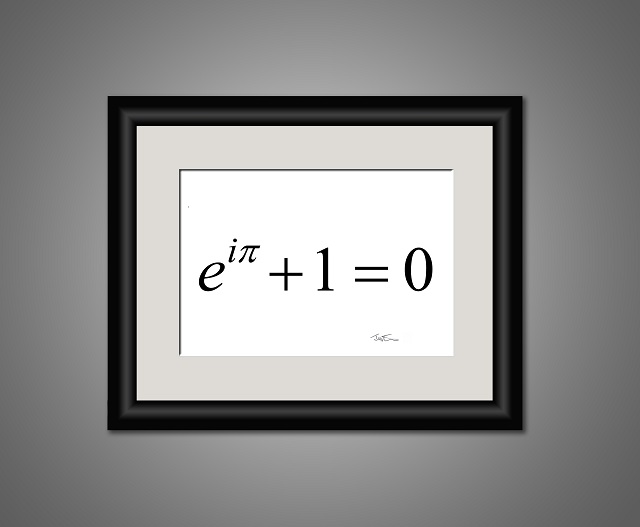

Como podemos observar en esta imagen, en una plancha de metal del barco, a la izquierda en la imagen, al lado de una puerta metálica, vemos una fórmula matemática, que parece pintada en sangre, pero escrita de tal manera que a la izquierda tenemos una expresión matemática que es igual a la parte de la derecha, que es un número que va a coincidir con el número de entrega de la serie, por lo que en este caso está pintado el número 1. La fórmula que aparece en la plancha metálica es correcta, de hecho, en este caso es la famosa fórmula de Euler, conocida como la fórmula más hermosa de las matemáticas.

Esta es una imagen con la famosa fórmula de Euler, de la exposición Mathematical Photography de Justin Mullins, que podéis ver en el portal divulgamat o en la página web de su autor, Justin Mullins

Esta es una imagen con la famosa fórmula de Euler, de la exposición Mathematical Photography de Justin Mullins, que podéis ver en el portal divulgamat o en la página web de su autor, Justin Mullins

Además, como vemos, se incluye un número, en concreto, el número 1, en el título del cómic, en inglés “P1unge” (un “1” en lugar de la letra “ele”) y en español “1nmersión” (un “1” en lugar de la “i”). Y si nos fijamos un poco más en los nombres responsables del cómic aparece un “3”, en lugar de una “e”, en el nombre de uno de los dos productores, Mark Doyl3 y Amadeo Turturro.

Esta idea de sustituir letras de los créditos por números o símbolos matemáticos va a ir aumentando en cada entrega del cómic, hasta la sexta y última grapa que vemos en la siguiente imagen, en la que además cambia un poco el formato, separando la imagen del buque, con el número de entrega (sexta), y los créditos.

Páginas de créditos de la edición original (en inglés) del número #6 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

Páginas de créditos de la edición original (en inglés) del número #6 del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

Los nombres de los responsables del cómic (guion, dibujo, color, editores, portada, portada alternativa y creado por) ya son completamente irreconocibles por los números y símbolos matemáticos que aparecen, así como el título, Plunge (en inglés), que vemos en la anterior imagen cómo está escrito, e Inmersión (en español), que está escrito así: “1 = # 3 ? 5 1 0 =”.

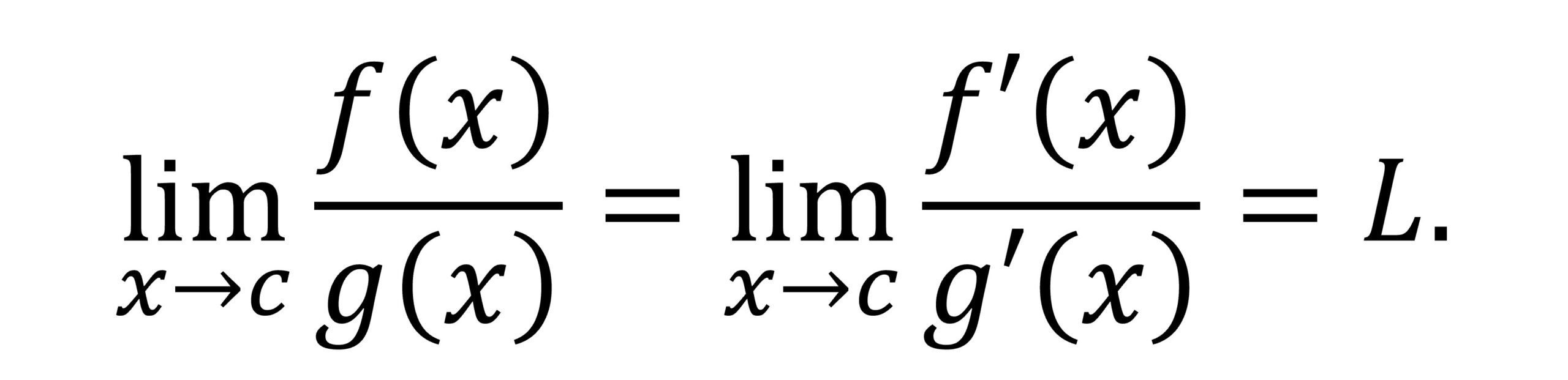

Si observamos la fórmula matemática de la plancha metálica, que nos da igual a 6, ya que estamos en el número seis de la publicación, podemos observar que también es una expresión matemática correcta (bueno, hay una pequeña errata ya que falta una x, pero la idea está bien). De hecho, es un límite del tipo 0/0 que se calcula mediante la conocida regla de L’Hopital (el nombre deriva del matemático francés Guillaume François Antoine, marqués de l’Hopital (1661-1704), aunque el resultado es realmente del matemático suizo Johann Bernoulli (1667-1748), de hecho, esa es una interesante historia que ya contaremos en otra ocasión) para el cálculo de límites de la forma 0/0 (cero / cero) o (infinito / infinito), que consiste en derivar numerador y denominador.

Incluyamos la regla de L’Hopital simplemente para entender un poco mejor la fórmula que aparece en el cómic, aunque sin darle más importancia de la necesaria.

Regla de L’Hopital: Sean f y g dos funciones continuas definidas en un intervalo [a, b], derivables en el intervalo abierto (a, b) y sea c perteneciente a dicho intervalo (a, b) tal que f(c) = g(c) = 0 y g‘(x) distinto de 0, si x = c.

Si existe el límite L de f ‘ / g‘ (las derivadas) en c, entonces existe el límite de f / g (en c) y es igual a L. Por lo tanto,

La imagen que aparece en el cómic, corregida, sería la siguiente.

Expresión del cálculo de un límite del tipo 0/0 utilizando la regla de L’Hopital, que aparece en el número seis del cómic Inmersión

Expresión del cálculo de un límite del tipo 0/0 utilizando la regla de L’Hopital, que aparece en el número seis del cómic Inmersión

En las páginas de créditos de los números #2, #3, #4 y #5 también aparecen fórmulas matemáticas, pintadas como si fuera sangre, integrales, derivadas y límites.

Páginas de créditos de los números #2, #3, #4 y #5 de la edición original (en inglés) del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave Stewart

Páginas de créditos de los números #2, #3, #4 y #5 de la edición original (en inglés) del cómic Plunge / Inmersión, de Joe Hill, Stuart Immonen y Dave StewartLas matemáticas contribuyen a crear el ambiente de terror del cómic. Diagramas y símbolos matemáticos, listas de números (los decimales del número pi), así como fórmulas matemáticas pintadas de rojo, como si fuera sangre que está goteando, fórmulas extrañas, raras, frías, sin ningún significado para la persona que lee el cómic.

En la siguiente entrada del Cuaderno de Cultura Científica abordaremos las matemáticas que aparecen en la propia historia del cómic.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Inmersión, un cómic empapado de matemáticas (I) se ha escrito en Cuaderno de Cultura Científica.

Un aumento en el límite sin repetidores nos acerca a la criptografía cuántica comercial

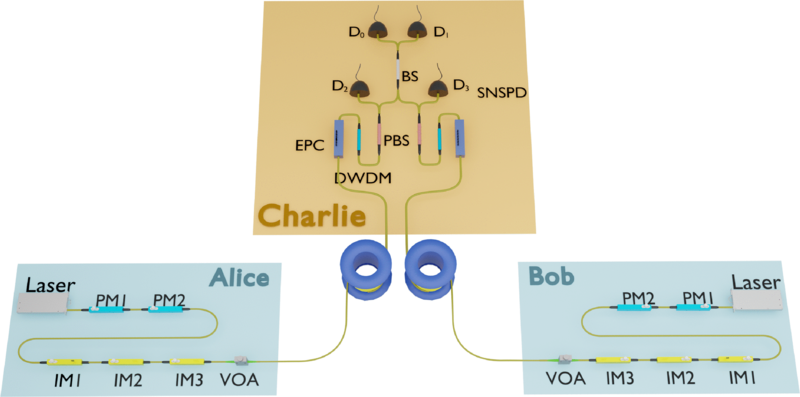

La criptografía cuántica promete comunicaciones seguras basadas en las leyes fundamentales de la física. Sin embargo, llevar esta tecnología del laboratorio al mundo real es todo un reto, especialmente debido a las pérdidas de señal en largas distancias. Un reciente presenta un avance significativo en este aspecto: un sistema de distribución de claves cuánticas (QKD, por sus siglas en inglés) que supera el llamado «límite sin repetidores» utilizando tecnologías ya disponibles comercialmente.

Source: Likang Zhang et al (2025) Phys. Rev. X doi: 10.1103/PhysRevX.15.021037 CC BY 4.0¿Qué es el «límite sin repetidores»?

Source: Likang Zhang et al (2025) Phys. Rev. X doi: 10.1103/PhysRevX.15.021037 CC BY 4.0¿Qué es el «límite sin repetidores»?