Germenez

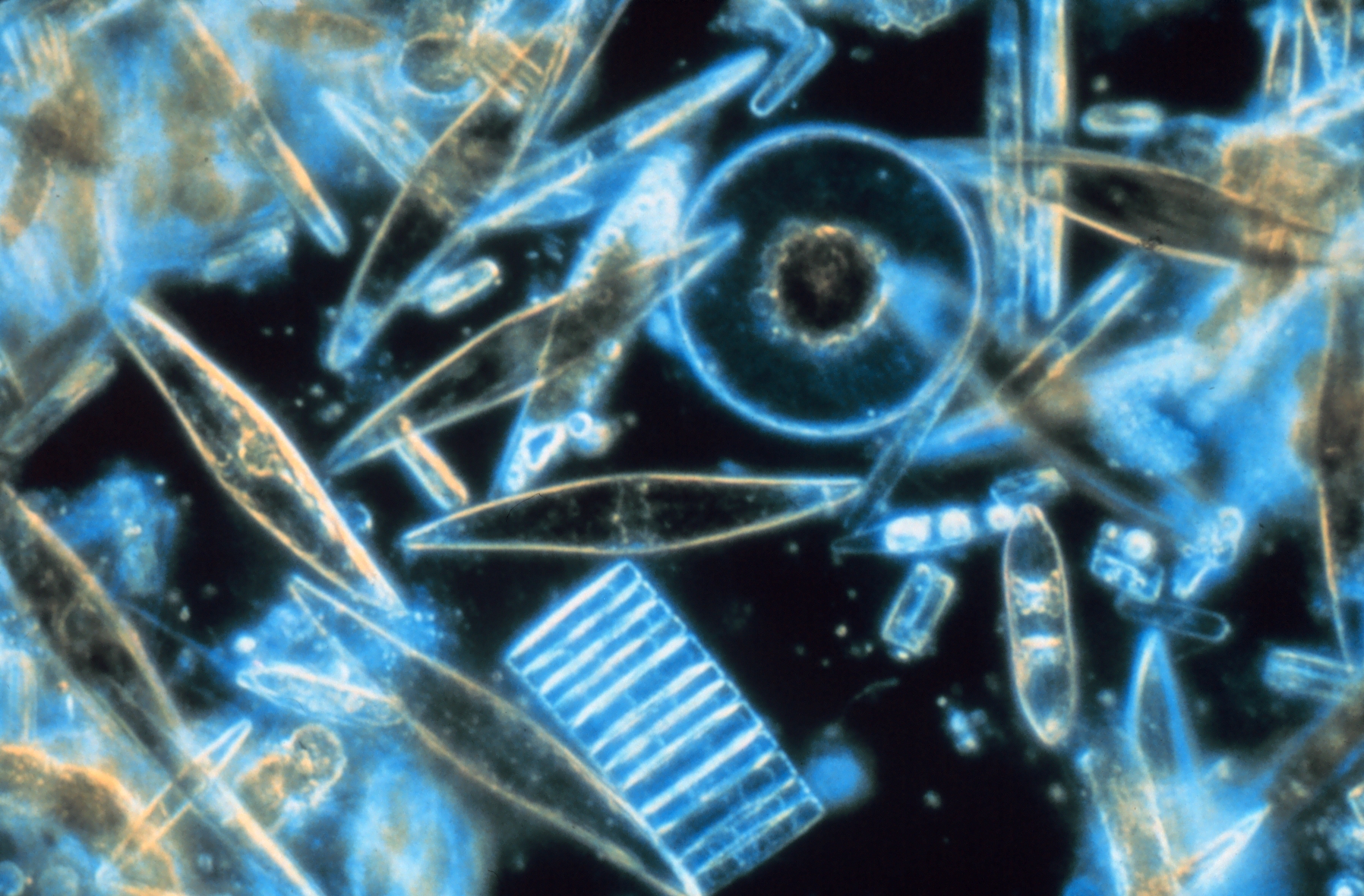

1. irudia: Mikroskopioaren garapenari esker, ordura arte ezezagunak ziren izakiak aurkitu ziren.

Mikroskopiaren garapenak, XVII. mendearen hasieran, ahalbidetu zuen ordura arte ezezagunak ziren izaki bizidunak aurkitzea. Antoni van Leeuwenhoek-ek mendearen azken laurdenean egindako behaketa aitzindariek agerian jarri zuten “animaliakulu”-en existentzia ur ezberdinetan, hortzetan edo giza esperman. Eskuragai zeuden tresna optiko gehienen akatsek eragotzi zuten behaketa zinez esanguratsuak egitea XIX. mendeko 30eko urteak arte.

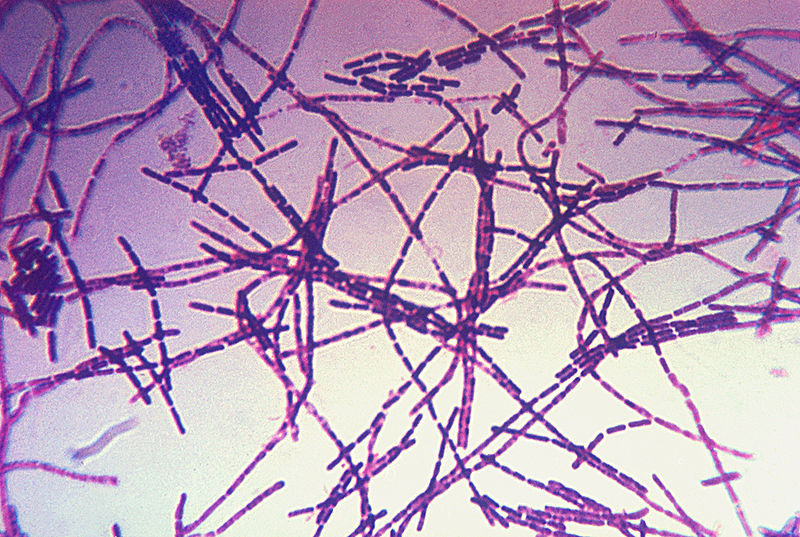

1835ean Agostino Maria Bassi-k frogatu zuen onddo ñimiño batek muskardina eragiten zuela zeta-harretan. Laster lotuko ziren mikrobioak beste gaixotasun batzuekin: aipagarria da Casimir Joseph Davaine, behin eta berriz behatu zituena barra-itxurako egiturak –berak “bakteridia” deitutakoak – karbunkoz (antrax) hiltzen ziren animalien odolean. Egitura horien eta gaixotasunaren arteko lotura, alegia kausa ala ondorio ote ziren, eztabaida irekia zen.

2. irudia: Karbunkoz (antrax) hiltzen ziren animalien odolean topatutako egiturak ‘Bacillus anthracis’ bakteria zen.

Garai horretatik aurrera, hartzidura- eta usteltze-prozesuetan interesatutako zientzialari europarrak pixkanaka hasi ziren gaixotasunaren teoria germinal bat garatzeko bidean. 1840an Jacob Henle-k horrelako teoria baterako marko teoriko orokorra finkatu zuen; aldi berean, Theodor Schwann-ek frogatu zuen airean zegoen zerbait –eta ez airea bera– zela izaki bizidunen gorputzetan usteltzea hasten zuena. 1864an Louis Pasteur-ek zientzialarien eta herritarren arreta erakarri zuen teoria germinalaren kausalitatearen bere azalpenarekin. Horrek eztabaida handia sortu zuen hurrengo hamarkadan, harik eta Robert Koch-ek lehenbizi karbunkoaren azken eragilea identifikatu zuen arte (1876) eta geroago tuberkulosia eta kolerarena. Dena den, gaixotasunaren hainbat teoria germinalek hedatzen jarraitzen zuten XIX. mendeko azken hamarkadetan; XX. mendeko hasiera arte ez zen adostasunik lortuko.

Koch-ek eta bere kolaboratzaileek teoria germinalari egindako ekarpena mikroorganismoen identifikaziotik haratago zabaldu zen. Kochek programa bat idatzi zuen, informalki “Kochen postulatuak” izenaz ezagutzen zena. Programa horrek indarrean jarraitzen du hainbat berrikuspenen ondoren, oinarrizko tresna gisa baita mikrobio jakinen eta gaixotasunen arteko lotura kausala berresteko. Kochek eta bere kideek ekarpen garrantzitsuak egin zizkioten bakterioen identifikazioari, tindaketa-teknikak garatuz garaiko koloratzaile industrialetan oinarrituta; horrela, 1900erako finkatuta zeuden dozenaka gaixotasunen kausa bakterianoak. Horrek bi ondorio nagusi izan zituen: lehenik, mediku asko konbentzitu ziren gaixotasun bakoitzaren kausa bakterio bat izan behar zela, eta bigarrenik, gaixotasunak soilik sintomen bidez ezagutzeari utzi zitzaion, eta beren kausengatik ere hasi ziren ezagutzen, laborategian.

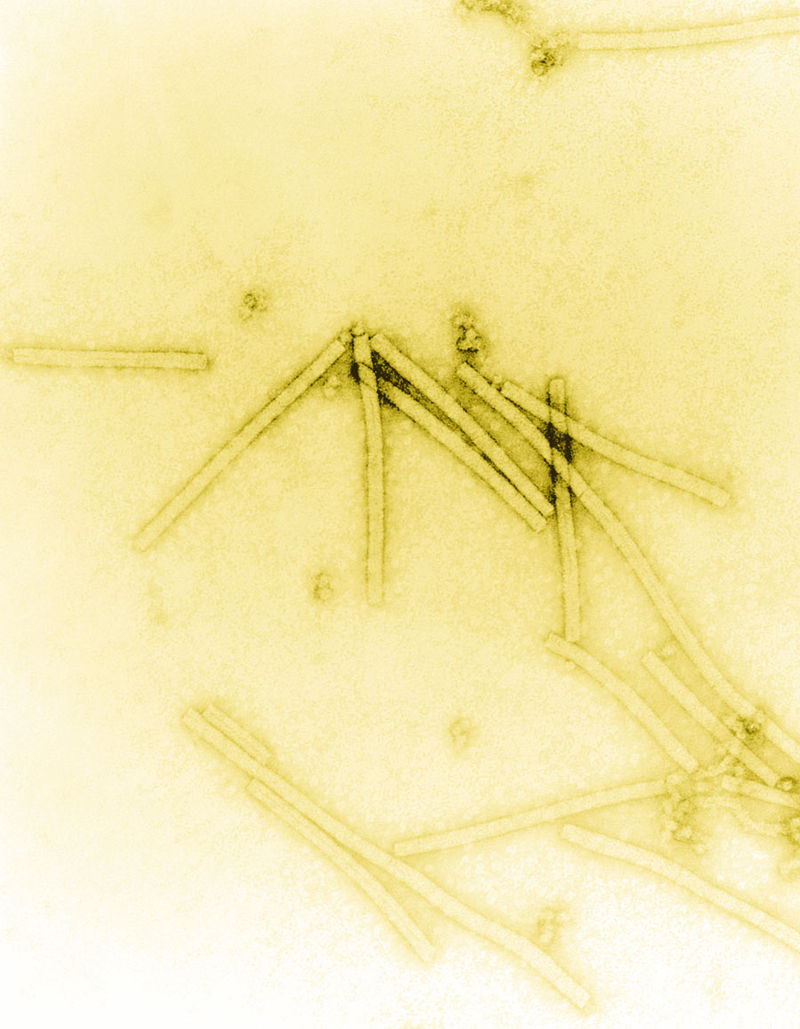

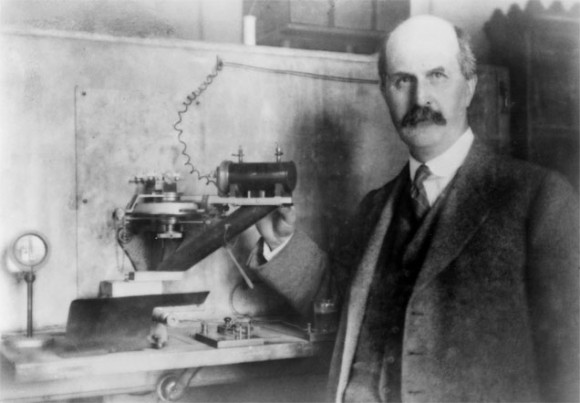

Bakterio-iragazpen prozesuen hobekuntzek, 1880. urtetik aurrera, ikusarazi zien ikertzaile askori existitu behar zirela gaixotasunak eragiten zituzten agenteak, bakterio ezagunak baino txikiagoak zirenak. Horrela, 1896an Martinus Willen Beijernick-ek birus iragazlearen ideia proposatu zuen, oso eztabaidagarria baina balioduna: ustez uretan disolbagarria den mikrobio bat, aski txikia iragazkietatik pasatzeko, eta ikusezina garaiko mikroskopioetan. Identifikatutako mota horretako lehen eragileak tabakoaren mosaikoarena, ahoeriarena (abereen sukar aftosoa) eta sukar horiarena izan ziren. Birologia azkar asko garatu zen zientzia gisa XX. mendearen hasieran. Fagoen fenomenoa ―bakterioak bakarrik kutsatzen dituzten birusak― Frederick William Twort eta Félix d’Hérélle-k identifikatu zuten, nork bere aldetik, Lehen Mundu Gerran. Mikroskopio elektronikoaren garapenak, 30eko urteetan, birusak ikustea ahalbidetu zuen.

3. irudia: Tabakoaren mosaikoaren birusa da identifikatu zen lehen birusa.

XX. mendean zehar germenen ideia herritarren kontzientzian errotu zen, neurri handi batean erakundeen publizitate-kanpainei esker eta, neurri handiagoan, norberaren eta etxearen garbiketarako produktuei esker.

Germenak, oraindik ere, etengabeko mehatxu dira giza osasunerako, mundu-mailako garraioaren unibertsaltasun eta bizkortasunak, eta industria-mailan prozesatutako elikagaien erabilerak larriagotua.

Birusen egituraren argitzeak eta, XX. mendeko azken hamarkadetan, prioien (proteina infekziosoak) aurkikuntzak ezinbesteko egin dute teoria germinal klasikoa berrikustea, organismo patogeno bizien ideian oinarritzen dena.

——————————————–

Egileaz: Cesár Tomé López (@EDocet) zientzia dibulgatzailea da eta Mapping Ignorance eta Cuaderno de Cultura Cientifica blogen editorea.

Itzulpena: Leire Martinez de Marigorta

Hizkuntza-begiralea: Gidor Bilbao

——————————————–

The post Germenez appeared first on Zientzia Kaiera.

El tamaño sí importa, que se lo pregunten a Colón (o de la geometría griega para medir el diámetro de la Tierra)

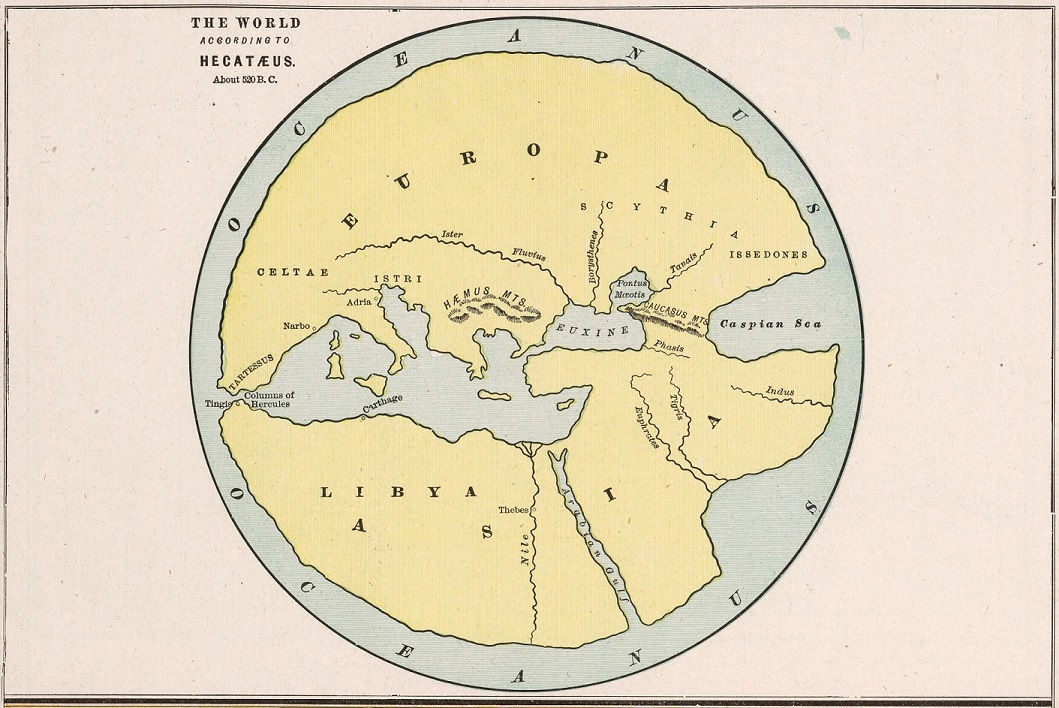

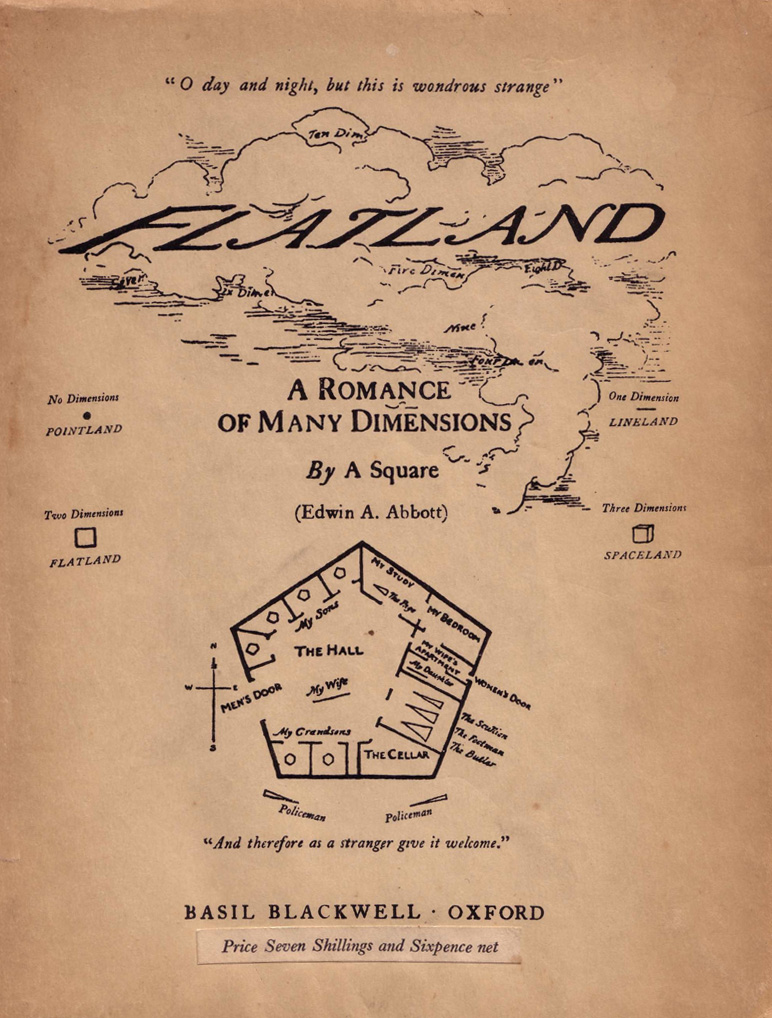

Si miramos a nuestro alrededor, puede dar la impresión de que vivimos en un planeta plano, como así lo creyeron muchos pueblos en la antigüedad. Babilonios, egipcios, chinos, incas, nativos americanos, o incluso los primeros griegos, pensaron que la Tierra era plana. Según el filósofo y matemático griego Tales de Mileto (aprox. 624-547 a.n.e.), la Tierra es un disco flotando en un mar de agua, mientras que, para su discípulo Anaximandro (aprox. 610-545 a.n.e.), es un cilindro, con la ecúmene (el mundo habitado) en una de sus tapas planas. Precisamente, el mapa de la ecúmene de Anaximandro está considerado uno de los primeros mapas geográficos del mundo.

Reconstrucción del mapa de Hecateo, basado en el mapa de Anaximandro, perteneciente al “Cram’s atlas of the world, ancient and modern” (1901), de G. F. Cram. Imagen de la David Rumsey Map Collection [2] Sin embargo, también fueron los antiguos griegos quienes pronto descubrirían que la Tierra tiene forma esférica, como aparece recogido en el diálogo del filósofo griego Platón (aprox. 427-347 a.n.e.) Fedón o la inmortalidad del alma o en el Tratado del Cielo de su discípulo Aristóteles (384-322 a.n.e.), este último con argumentos físicos y lógicos que lo demostraban.

Reconstrucción del mapa de Hecateo, basado en el mapa de Anaximandro, perteneciente al “Cram’s atlas of the world, ancient and modern” (1901), de G. F. Cram. Imagen de la David Rumsey Map Collection [2] Sin embargo, también fueron los antiguos griegos quienes pronto descubrirían que la Tierra tiene forma esférica, como aparece recogido en el diálogo del filósofo griego Platón (aprox. 427-347 a.n.e.) Fedón o la inmortalidad del alma o en el Tratado del Cielo de su discípulo Aristóteles (384-322 a.n.e.), este último con argumentos físicos y lógicos que lo demostraban.

El siguiente pasaje es del diálogo Fedón o la inmortalidad del alma (Platón, Diálogos, Espasa-Calpe, 1984):

Primeramente, repuso Sócrates, estoy convencido de que, si la Tierra está en medio del cielo, y es de forma esférica, no tiene necesidad ni del aire ni de ningún otro apoyo que la impida caer…

Además, estoy convencido de que la Tierra es muy grande y que no habitamos en ella más que esta parte que se extiende desde Fasis hasta las columnas de Hércules, repartidos alrededor del mar como las hormigas y las ranas alrededor de un pantano…

Se dice, mi querido Simmias, que si se mira esta Tierra desde un punto elevado, se parece a uno de esos balones de cuero…

Por otra parte, los argumentos de la esfericidad terrestre que aparecen en la obra de Aristóteles son sencillos y contundentes, como puede leerse en el libro El sueño del mapa perfecto (RBA, 2010), la posición de las estrellas en el firmamento, la existencia de usos horarios o la existencia y forma del horizonte.

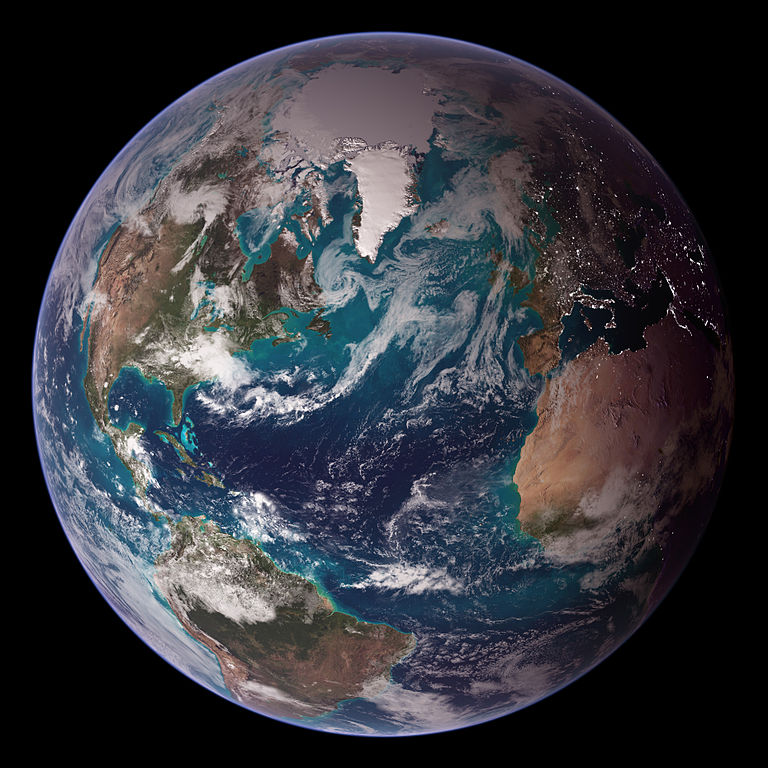

Representación de la Tierra vista desde el espacio utilizando datos obtenidos por la NASA y NOAA. Imagen de la NASA realizada por Reto Stöckli

Representación de la Tierra vista desde el espacio utilizando datos obtenidos por la NASA y NOAA. Imagen de la NASA realizada por Reto StöckliUna vez conocida la forma del planeta en el que vivimos, surge la cuestión de conocer cuál es su tamaño. De nuevo, fue la ciencia griega la que se puso manos a la obra, y realizó algunas estimaciones, utilizando la geometría, del perímetro terrestre.

Ya Aristóteles, en el mencionado Tratado del cielo, escribía que los “matemáticos” habían calculado la longitud de la circunferencia del globo terráqueo, estableciéndola en 400.000 estadios (más adelante, discutiremos el valor de esta unidad de longitud). Según parece la estimación citada por Aristóteles se debía al matemático y astrónomo griego Eudoxo de Cnido (aprox. 400-347 a.n.e.), considerado el fundador de la astronomía matemática.

La siguiente estimación del tamaño de la Tierra aparece en la obra El Arenario de uno de los más grandes científicos griegos, Arquímedes de Siracusa (aprox. 287-212 a.n.e.), quien en el transcurso de la discusión sobre la cantidad de granos de arena que se necesitarían para llenar todo el universo, y, por tanto, sobre el tamaño del universo, afirma que “el perímetro de la Tierra es de 3.000.000 de estadios y no más”, aunque también reconoce que hay quienes afirman que es de 300.000 estadios, que a él le parece demasiado pequeña.

“Muerte de Arquímedes”, del pintor francés Edouard Vimont (1846-1930)

“Muerte de Arquímedes”, del pintor francés Edouard Vimont (1846-1930)La medición griega más famosa, y certera, del perímetro de la Tierra se debe al sabio polifacético griego Eratóstenes de Cirene (276-194 a.n.e.). Eratóstenes trabajó en geografía, matemáticas, astronomía, filosofía, cronología, gramática, crítica literaria e incluso escribió poesía, lo que motivó que sus compañeros le pusieran el mote “pentathlos”, en referencia a la prueba atlética “penthlaton” que integraba cinco disciplinas. Pero el hecho de que trabajara en tantos campos también fue la razón por la cual le pusieran también otro apodo, “beta”, es decir el segundo, que puede interpretarse como una persona que ocupa el tiempo en muchas cosas no puede ser excelente en cada una de ellas. A pesar de este apodo, Eratóstenes fue uno de los grandes sabios de la antigüedad. Con 30 años fue nombrado director de la Biblioteca de Alejandría, puesto en el que permaneció hasta su muerte, 45 años después.

Antes de continuar nuestro viaje, una breve parada para hablar de la Biblioteca y el Museo de Alejandría.

Tras anexionar Egipto a su imperio, Alejandro Magno (356-323 a.n.e.), rey de Macedonia, fundaría la ciudad de Alejandría en el año 331 a.n.e., la cual se convertiría en la ciudad más importante e influyente durante siglos, sustituyendo a Atenas en hegemonía cuando esta perdió su esplendor. A la muerte de Alejandro, cuando este contaba con 33 años, se desmanteló su imperio y en el trono de Egipto se instaló el rey Ptolomeo I, fundando la dinastía de los Lángidas. Este decide poner en práctica el proyecto aristotélico de un saber universal, motivo por lo que construye la Biblioteca y el Museo, y hace el siguiente llamamiento: “Pido a todos los soberanos y gobernantes de la Tierra que envíen a nuestra ciudad de Alejandría las obras de poetas y prosistas, retóricos y sofistas, médicos y adivinos, historiadores, filósofos y …”.

La Biblioteca llegaría a tener 700.000 rollos. Hay que tener en cuenta que las obras se escribían en papiros (el nombre griego para papiro es Biblos, de donde surge la palabra Biblioteca), los cuales no se plegaban, sino que se enrollaban alrededor de un bastón. Cada obra podía estar formada por varios rollos (volumen en latín), es decir, varios volúmenes.

Imagen de la película “Ágora” (2009), dirigida por Alejandro Amenábar, en la que vemos a Hipatia, interpretada por la actriz Rachel Weisz, en la Biblioteca de Alejandría, aunque en esa época ya no era la Gran Biblioteca, sino la Biblioteca hija, mucho más humilde, intentando salvar algunos rollos de dicha biblioteca, durante su destrucción por orden del emperador Teodosio el Grande

Imagen de la película “Ágora” (2009), dirigida por Alejandro Amenábar, en la que vemos a Hipatia, interpretada por la actriz Rachel Weisz, en la Biblioteca de Alejandría, aunque en esa época ya no era la Gran Biblioteca, sino la Biblioteca hija, mucho más humilde, intentando salvar algunos rollos de dicha biblioteca, durante su destrucción por orden del emperador Teodosio el Grande“Buscadores de libros” se pusieron a rastrear en los principales mercados del mundo mediterráneo, comprando, a precio de oro, todos los manuscritos que encontraban, y si no podían comprarlos, los conseguían por otros medios (robo, soborno o extorsión). Además, cuando un navío entraba en el puerto de Alejandría los soldados entraban en el barco en busca de todos los manuscritos que se encontraban en el navío para llevarlos a los talleres de la Biblioteca, donde eran cuidadosamente estudiados y copiados por escribas. Si se trataba de un ejemplar raro, se le devolvía al dueño la copia. A esta colección de la Biblioteca se la llamó “los fondos de los barcos”.

El Museo era una especie de centro de investigación financiado por el estado, dedicado a todas las Musas, de ahí su nombre, es decir, a todo tipo de conocimiento. Por él pasaron grandes sabios como Euclides, Apolonio, Eratóstenes, Hiparco, Aristarco, Herón o Ptolomeo.

Con el paso de los siglos el sueño de toda la sabiduría del mundo reunida en la Biblioteca de Alejandría se desvanecería. Diferentes desastres asolaron Alejandría, miles de libros se quemaron y la Biblioteca acabó totalmente destruida. Lo cierto es que la destrucción de las obras de la Biblioteca de Alejandría es sin duda una de las mayores tragedias de la historia de la humanidad, en la que se han perdido para siempre parte de la cultura y ciencia humanas.

Pero volvamos a la estimación del diámetro de la Tierra realizada por Eratóstenes, quien estableció en 252.000 estadios la longitud del meridiano terrestre que pasa por Alejandría. Conocemos el método utilizado por Eratóstenes gracias al astrónomo griego Cleomedes (aprox. 10-70) y a algunos autores clásicos como Herón, Estrabón, Plinio o Vitrubio, entre otros.

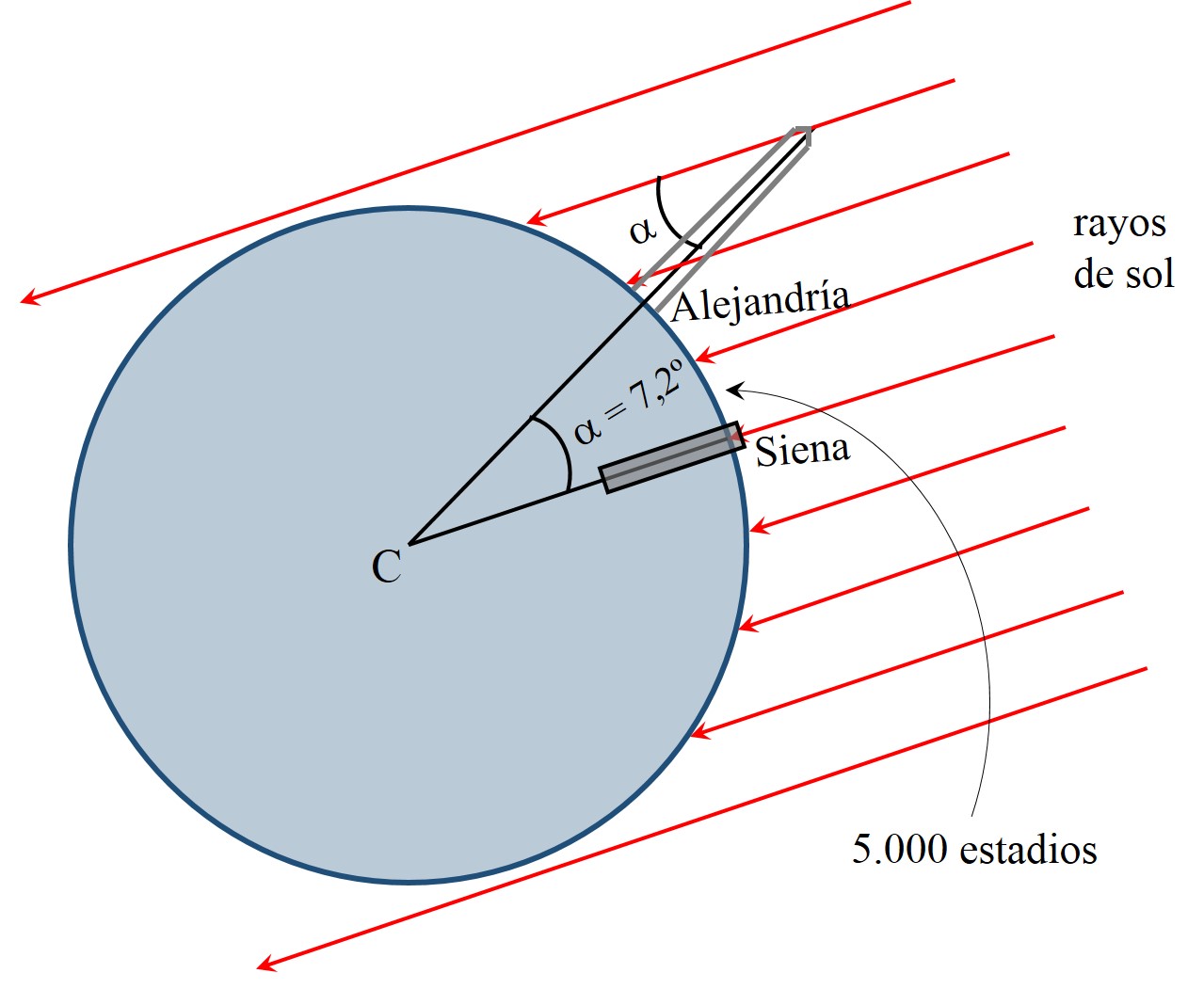

La medición de la circunferencia terrestre realizada por Eratóstenes tenía en cuenta que la Tierra es esférica, que podemos considerar que los rayos del Sol llegan paralelos al encontrarse con la superficie terrestre, debido a la distancia a la que se encuentra el astro, así como que las ciudades consideradas, Alejandría y Siena (en la actualidad, Asuán), estaban situadas en el mismo meridiano.

La primera estimación necesaria para el cálculo fue la de la distancia entre Alejandría y Siena, que el director de la Biblioteca consideró de 5.000 estadios. Según cuenta la leyenda, Eratóstenes preguntó a los caravaneros que comerciaban entre ambas ciudades, quienes le contestaron que un camello, que recorría una distancia aproximada de 100 estadios al día, tardaba 50 días en ir de una ciudad a otra. Aunque es muy probable que el sabio griego consultase ese dato en los libros de la biblioteca, contrastando las informaciones que caravaneros o saldados pudieran proporcionarle.

Por otra parte, la ciudad de Siena se encontraba en el trópico de Cáncer, es decir, que al mediodía del solsticio de verano (hacia el 21 de junio) los rayos solares caían perpendicularmente sobre la ciudad, lo cual podía ser comprobado observando que la luz se reflejaba en el fondo de un pozo profundo.

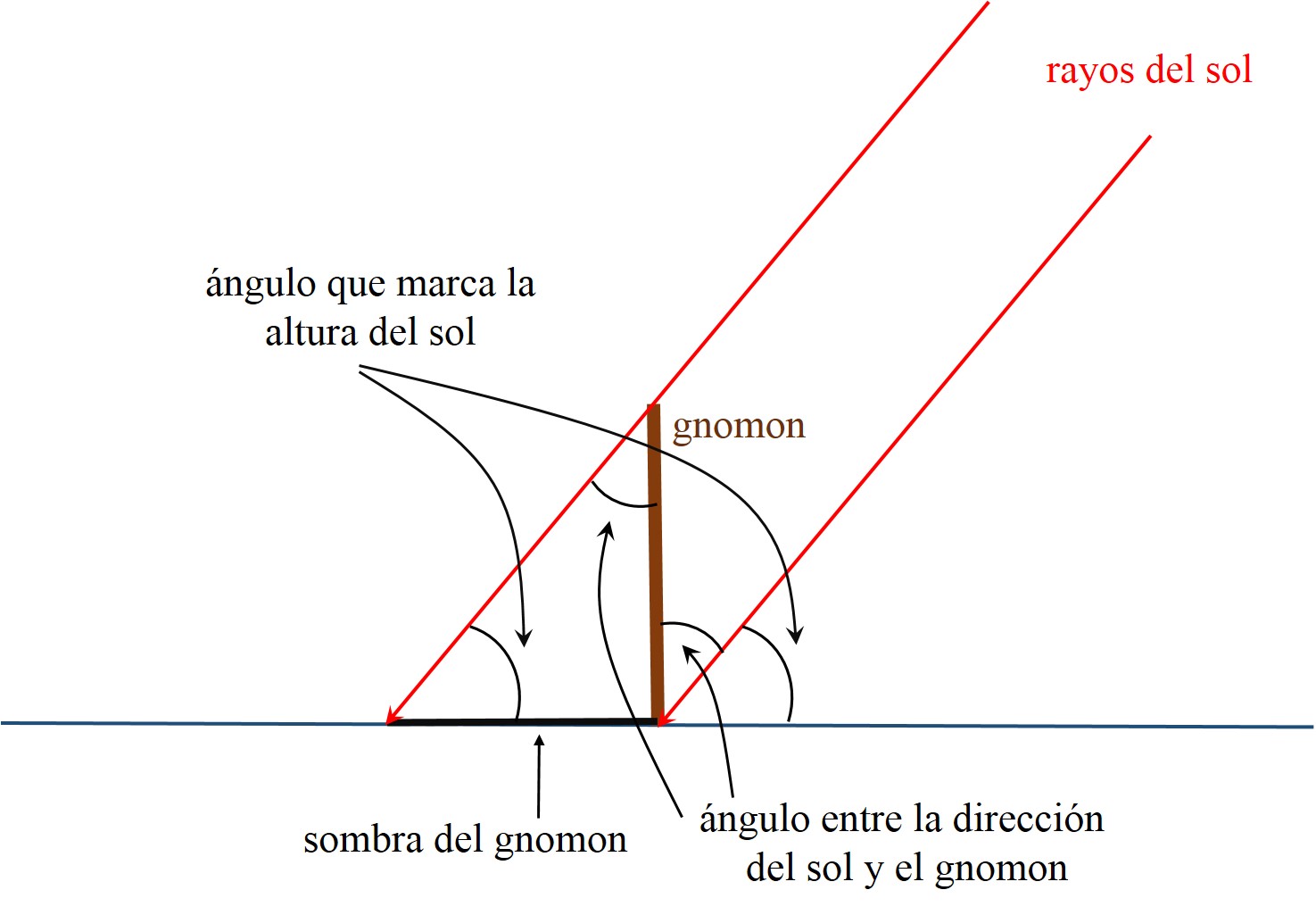

Además, Eratóstenes necesitaba medir el ángulo de inclinación del sol en Alejandría con respecto a la vertical (el ángulo α en la imagen con el esquema de la medición), lo cual se podía calcular con un sencillo gnomon (es decir, una estaca vertical colocada sobre una base horizontal), como se muestra en el esquema, aunque parece ser que Eratóstenes utilizó un gran obelisco.

Haciendo uso del gnomon y su sombra mediante los rayos solares se calcula la altura angular del Sol

Haciendo uso del gnomon y su sombra mediante los rayos solares se calcula la altura angular del SolHaciendo uso de un particular gnomon, el obelisco en la ciudad de Alejandría, Eratóstenes midió el ángulo de la inclinación del Sol respecto a la vertical (el ángulo α) en el mediodía del solsticio de verano, que, según sus cálculos, era 1/50 de una circunferencia, es decir, 360º / 50 = 7,2º. Como ya hemos dicho, el sol cae verticalmente en ese momento sobre la ciudad de Siena, luego el arco del ángulo del meridiano entre Alejandría y Siena es también 7,2º.

Al mediodía del solsticio de verano, los rayos solares caían verticalmente sobre la ciudad egipcia de Siena, por lo que se reflejaba en el fondo de cualquier pozo, mientras que sobre Alejandría caían formando un ángulo de 7,2º con la vertical, por ejemplo, un obelisco

Al mediodía del solsticio de verano, los rayos solares caían verticalmente sobre la ciudad egipcia de Siena, por lo que se reflejaba en el fondo de cualquier pozo, mientras que sobre Alejandría caían formando un ángulo de 7,2º con la vertical, por ejemplo, un obeliscoYa solo queda un pequeño cálculo. Si la longitud de un arco de meridiano de 7,2º, entre Alejandría y Siena, es de 5.000 estadios, entonces la circunferencia completa, correspondiente a los 360º, será de (360º / 7,2º) x 5.000 = 50 x 5.000 = 250.000 estadios.

Aunque según algunos autores, Eratóstenes llevó a cabo diferentes mediciones hasta considerar la estimación final de 252.000 estadios.

Uno de los problemas actuales para poder valorar las estimaciones antiguas del perímetro terrestre es el valor de la medida de longitud utilizada, en este caso, el estadio. En aquellos tiempos no existían medidas unificadas y el valor de los estadios variaba de unos lugares a otros, por lo que existen diferentes posibilidades a la hora de convertir los estadios en metros. Si consideramos el estadio egipcio, cuyo valor era de 157,5 metros, la estimación de Eratóstenes del perímetro terrestre era de 39.690 kilómetros. Si tenemos en cuenta que la longitud de uno de los meridianos terrestres es aproximadamente de 39.940 kilómetros (mientras que el ecuador mide 40.075 kilómetros), podemos decir que la de Eratóstenes no era una mala estimación.

Curiosamente, todas las estimaciones que realizó el director de la Biblioteca de Alejandría fueron ligeramente incorrectas, pero los errores se compensaron para dar una estimación que se aproxima bastante a la realidad. Las ciudades de Alejandría y Siena no se encontraban exactamente en el mismo meridiano, la longitud entre ambas ciudades era imposible de calcular en aquella época con cierta exactitud y con el método del gnomon el cálculo del ángulo de los rayos solares era más bien aproximado.

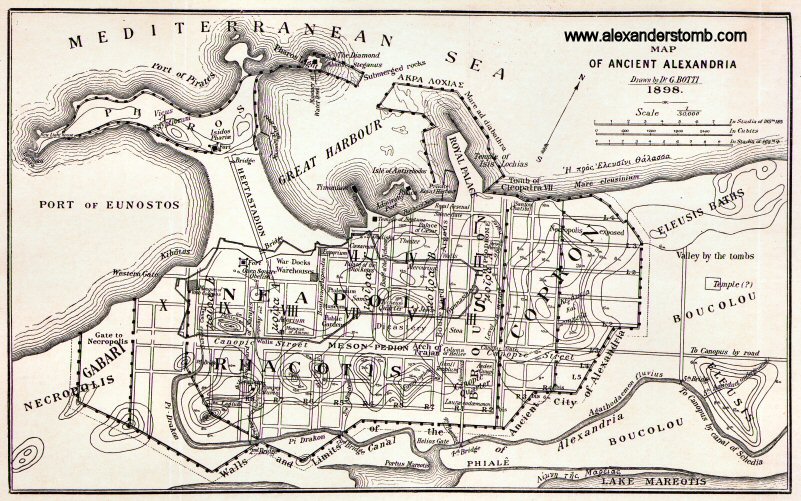

Reconstrucción del plano de la antigua Alejandría, realizado en 1898 por G. Botti, director del Museo Greco-Romano. Imagen de la página web Alexanders Tomb

Reconstrucción del plano de la antigua Alejandría, realizado en 1898 por G. Botti, director del Museo Greco-Romano. Imagen de la página web Alexanders TombOtra estimación importante del tamaño de la Tierra fue realizada por el político, astrónomo y filósofo estoico griego Posidonio (aprox. 130-50 a.n.e.), quien fuera uno de los grandes geógrafos de su tiempo. Al igual que en el anterior caso, su medición también nos ha llegado a través de diferentes autores clásicos.

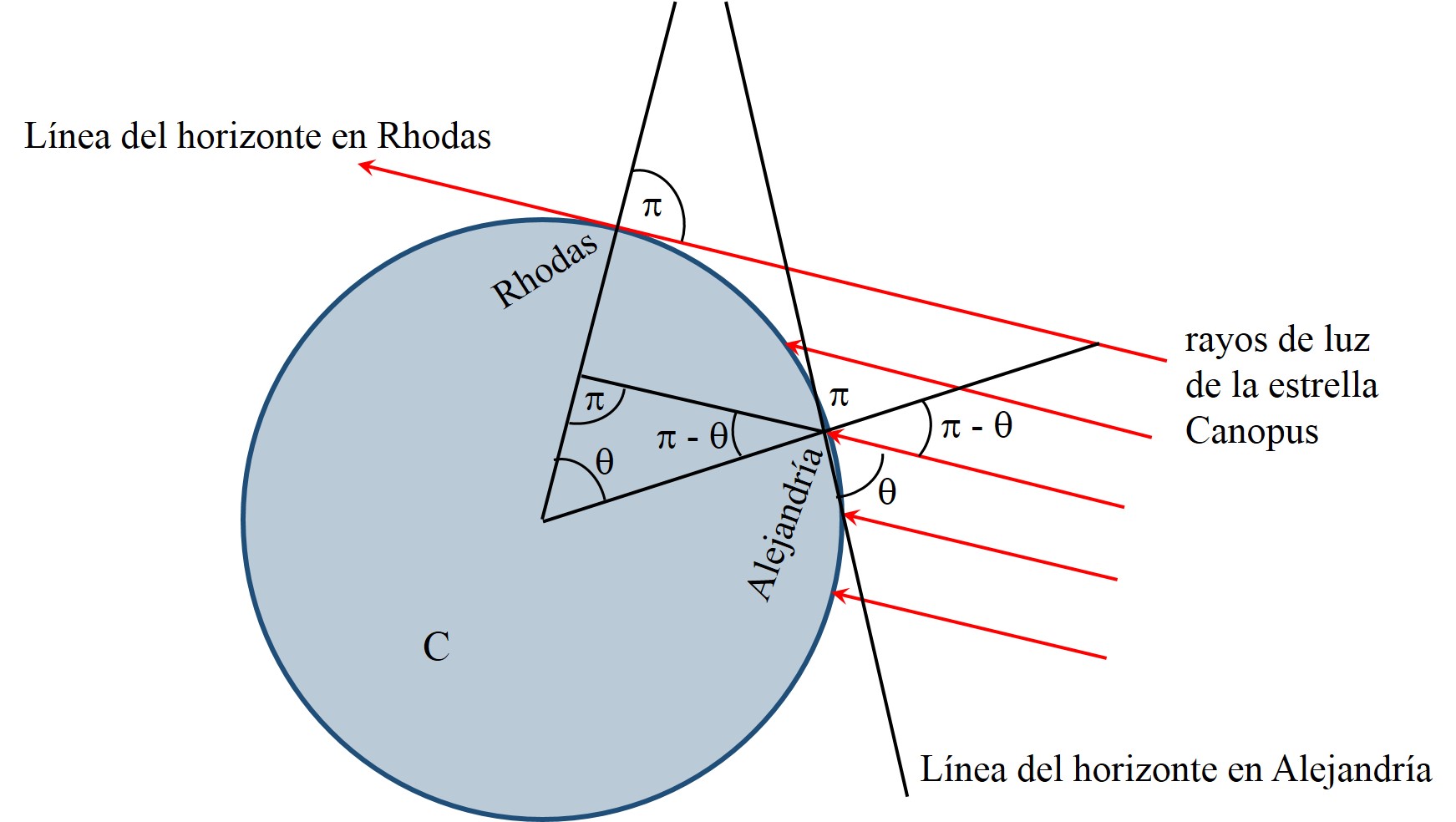

De nuevo, la idea fue medir un arco de meridiano, en concreto, entre las ciudades de Rodas y Alejandría (aunque, como en el caso anterior, no están exactamente sobre el mismo meridiano). Desde su observatorio en Rodas, Posidonio observó que la estrella Canopus, la segunda más brillante del cielo, se encontraba sobre el horizonte, mientras que esa misma estrella se veía elevada en el cielo un ángulo de 1/48 de circunferencia completa, es decir, 7,5º (el ángulo θ en la siguiente imagen). Por lo tanto, el ángulo del arco de meridiano entre Rodas y Alejandría era también 7,5º. Según Cleomedes, Posidonio consideró que la distancia entre Rodas y Alejandría era de 5.000 estadios, lo que hacía que la estimación de la Tierra fuera de 48 x 5.000 = 240.000 estadios. Sin embargo, el geógrafo e historiador griego Estrabón (aprox. 63 a.n.e.-24 n.e.), en su Geografía, recoge la posterior estimación de Posidonio de 180.000 estadios, obtenida al realizar un cálculo más acertado de la distancia entre ambas ciudades de 3.750 estadios.

Esquema de la medición del meridiano terrestre que pasa por Alejandría y Rodas. Cuando la estrella Canopus se ve en el horizonte desde Rodas, en Alejandría se ve con un ángulo θ, igual al ángulo del arco de meridiano terrestre entre Rodas y Alejandría

Esquema de la medición del meridiano terrestre que pasa por Alejandría y Rodas. Cuando la estrella Canopus se ve en el horizonte desde Rodas, en Alejandría se ve con un ángulo θ, igual al ángulo del arco de meridiano terrestre entre Rodas y AlejandríaSi consideramos los estadios egipcios la estimación de Posidonio, de 180.000 estadios, equivalía a 28.350 kilómetros, quedando así reducidas las dimensiones reales de la Tierra.

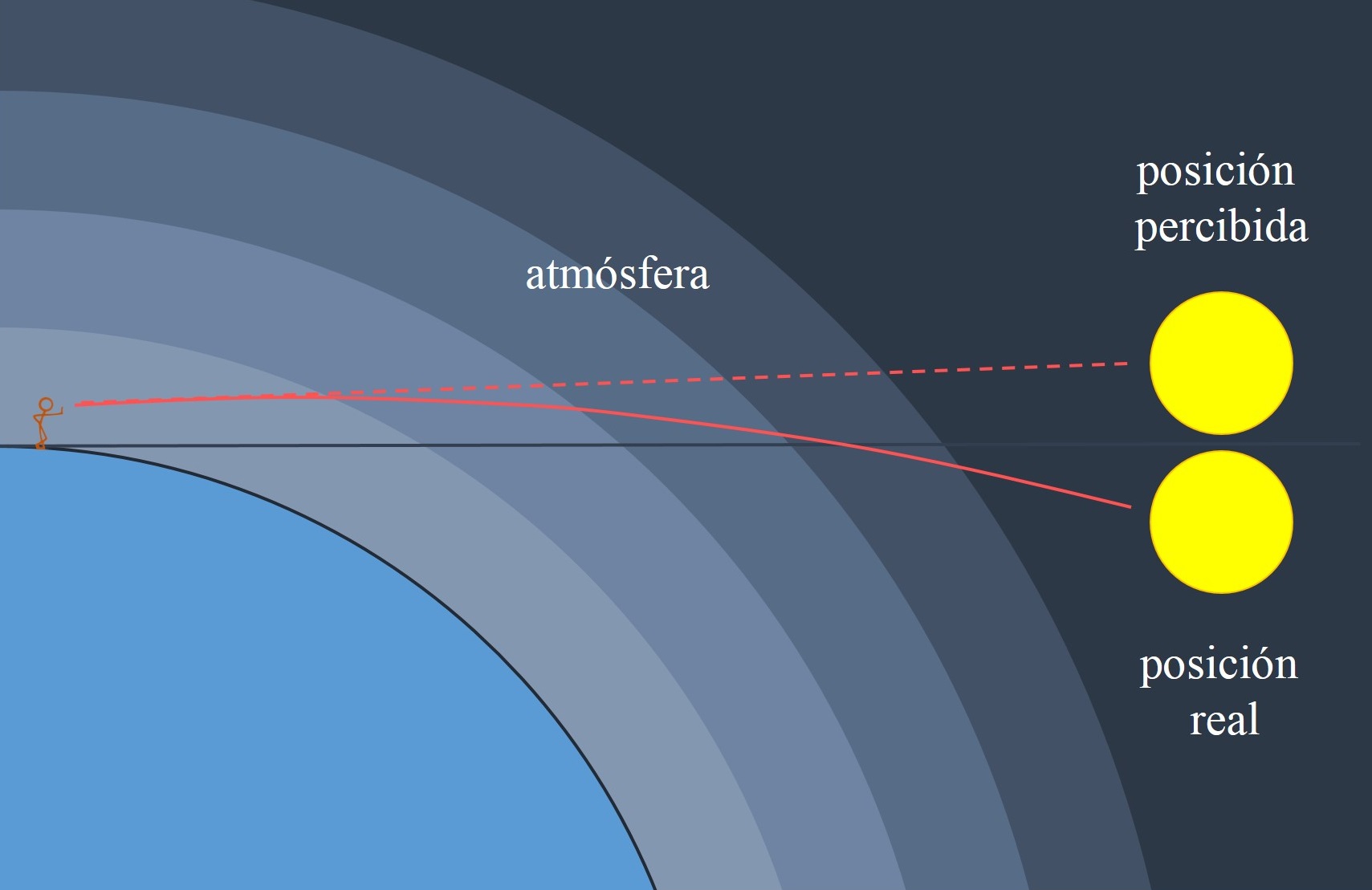

El método de Posidonio es, como el de Eratóstenes, sencillo, ingenioso y geométricamente impecable, aunque comete un error desde el punto de vista de la física. El filósofo estoico no tuvo en cuenta la refracción atmosférica terrestre, que provoca que cuando observamos objetos celestes cerca del horizonte su posición esté más baja de lo que nosotros creemos. Lo cual provoca que veamos el Sol, o las estrellas, por encima de su posición real. Si los rayos de luz no sufrieran este efecto, Posidonio no habría visto Canopus cuando lo vio, sino más tarde, y, en consecuencia, el ángulo que habría obtenido habría sido menor.

Esquema de la refracción atmosférica terrestre

Esquema de la refracción atmosférica terrestreEl astrónomo, matemático y geógrafo greco-romano Claudio Ptolomeo (aprox. 90-170), dio por buena la estimación de Posidonio de 180.000 estadios (unos 28.350 kilómetros), y es la que recogió en su obra Geografía cuando en la misma aborda la cuestión del tamaño de la Tierra.

La Geografía de Ptolomeo, que estaba formada por 8 libros, era una recopilación de todo el saber geográfico del mundo en su tiempo. El libro I era un tratado de cartografía, de los libros II al principio del VII se daban las coordenadas geográficas, longitud y latitud, de gran cantidad de lugares de la ecúmene, 8.000 ubicaciones diferentes, en el final del libro VII se describían tres proyecciones cartográficas para crear mapas del mundo (aunque los mapas de Ptolomeo que conocemos hoy en día se deben a las primeras ediciones impresas del siglo XV) y el libro VIII era un atlas de mapas regionales, que contenía cuatro mapas de África, doce de Asia y diez de Europa.

Mapa del mundo con la primera proyección de Ptolomeo, que aparece en el Codex Vaticanus Urbinas Graecus 82 (Constantinopla, aprox. 1300), copia manuscrita bizantina de la “Geografía” de Ptolomeo. Imagen: Wikimedia Commons

Mapa del mundo con la primera proyección de Ptolomeo, que aparece en el Codex Vaticanus Urbinas Graecus 82 (Constantinopla, aprox. 1300), copia manuscrita bizantina de la “Geografía” de Ptolomeo. Imagen: Wikimedia Commons Los diferentes manuscritos de la Geografía de la época de Ptolomeo se perdieron y la obra estuvo “perdida” hasta el siglo XIII que apareció una copia bizantina. La primera edición manuscrita en latín fue de 1406, y le seguirían muchísimas más (de hecho, se han conservado 38 códices o libros manuscritos). Pero fundamentalmente, a partir del momento en el que se empiezan a realizar ediciones impresas de las obras, junto con los dos conocidos mapas del mundo y los demás mapas regionales (en especial la hermosa edición impresa en Ulm, de 1482, con los conocidos grabados de mares azules y bordes amarillos, uno de cuyos mapas puede verse en la entrada Imago mundi, 7 retratos del mundo), la obra se convierte en una referencia fundamental en geografía y cartografía, y un auténtico “best-seller” durante varios siglos.

Terminaremos esta entrada del Cuaderno de Cultura Científica con un par de comentarios sobre el navegante y explorador italiano (aunque hay expertos que opinan que pudo ser catalán, gallego, portugués, andaluz, e incluso vasco) Cristóbal Colón (1451-1506) y el “descubrimiento” de América.

“Colón en Salamanca” (1887), de Joan Brull i Vinyoles (1863-1912). Imagen de Catàleg d’obres de Joan Brull i Vinyoles

“Colón en Salamanca” (1887), de Joan Brull i Vinyoles (1863-1912). Imagen de Catàleg d’obres de Joan Brull i Vinyoles El primer comentario está relacionado con la forma de la Tierra. Una de las creencias asociadas al descubrimiento de América, que nos enseñaron en nuestra etapa escolar, es que en aquél tiempo todo el mundo creía que la Tierra era plana, y que Colón tuvo que enfrentarse a esa creencia para encontrar quien apoyara su búsqueda de las Indias por el Océano Atlántico.

Es cierto, que una interpretación literal de la Biblia en la Edad Media llevó a la concepción de una Tierra plana. Esta idea fue popularizada por la famosa Topographica Christiana del monje griego Cosmas Indicopleustes (siglo VI). La forma plana del Orbis Terrarum se convirtió en una verdad oficial defendida por muchos teólogos cristianos y personas afines al poder, y fue la creencia que mucha gente humilde a la que no llegó otro conocimiento más que el que recibían de la Iglesia.

Mapa del mundo de Cosmas Indicopleustes. Orientado con el norte hacia arriba, el mapa muestra la Tierra rectangular, colocada en el centro y rodeada por el Océano. A la izquierda se observa el mar Mediterráneo, en el que desemboca el río Nilo, mientras que a la derecha están representados, arriba, el mar Caspio y, abajo, los golfos Árabe (Mar Rojo) y Pérsico, en este último desembocan los ríos Tigris y Eufrates. Imagen: Wikimedia Commons.

Mapa del mundo de Cosmas Indicopleustes. Orientado con el norte hacia arriba, el mapa muestra la Tierra rectangular, colocada en el centro y rodeada por el Océano. A la izquierda se observa el mar Mediterráneo, en el que desemboca el río Nilo, mientras que a la derecha están representados, arriba, el mar Caspio y, abajo, los golfos Árabe (Mar Rojo) y Pérsico, en este último desembocan los ríos Tigris y Eufrates. Imagen: Wikimedia Commons. Sin embargo, como hemos comentado, muchos siglos antes los griegos ya habían descubierto que la Tierra tenía forma esférica, y esta idea no fue abandonada por los sabios, ni las personas cultas, durante la Edad Media. Por este motivo, en los tiempos de Cristóbal Colón no había ninguna duda sobre la forma del planeta. Este mito erróneo tiene su origen en la biografía romántica que escribió el escritor estadounidense Washington Irving (1783-1859), Vida y viajes de Cristóbal Colón (1828).

El segundo comentario está relacionado con el tamaño de la Tierra. Entre los libros que se conoce que leyó, y anotó, Cristóbal Colón están Historia rerum ubique gestarum (1477) del Papa Pío II (Aeneas Sylvius Piccolomini, 1405-1464), que contiene la estimación de Eratóstenes del tamaño de la Tierra, la versión impresa (1480) del Imago Mundi de Pierre d’Ailly (1350-1420), la primera versión en latín (1478) de la Geografía de Ptolomeo, con la estimación de Posidonio y sus mapas cónicos del mundo, así como la primera edición en latín (1485) del libro de Marco Polo (1254-1324), narrando sus viajes a Catay (China) y Cipangu (Japón), De consuetudinibus et condicionibus orientalium regionum (1300).

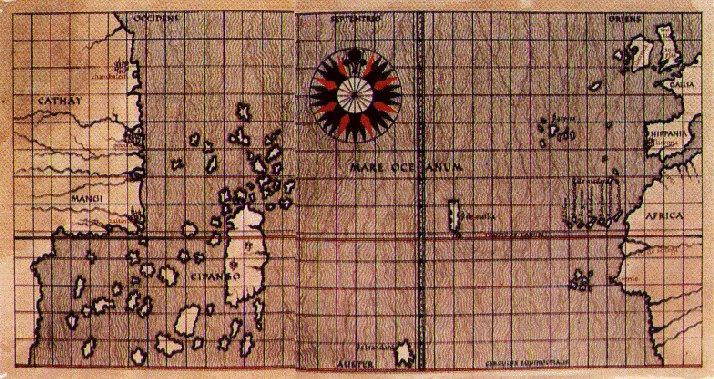

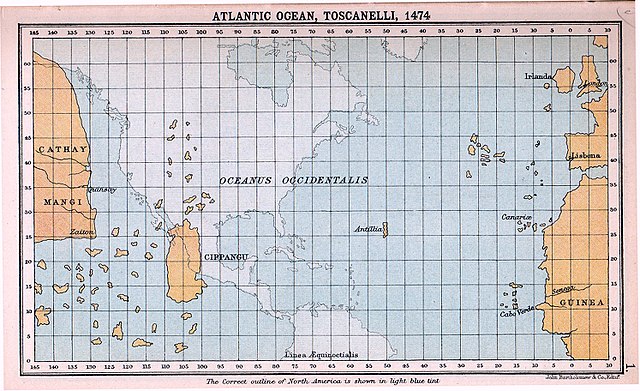

Una de las personas que creyó en el relato que Marco Polo hizo de su viaje fue el matemático y astrónomo italiano Paolo Toscanelli (1397-1482). Toscanelli, después de hablar con algunos navegantes e influenciado el tamaño de la Tierra recogido en las Geografías de Estrabo y Ptolomeo, propuso alcanzar Asia viajando por el oeste y diseñó un mapa del Atlántico que mostraba la cercanía, por otra parte errónea, de Catay y Cipangu, con Europa, sin América, que no se sabía que existía, de por medio.

Mapa del océano Atlántico (1468) de Paolo Toscanelli

Mapa del océano Atlántico (1468) de Paolo Toscanelli  Reconstrucción moderna, con la silueta del continente americano dibujada en su posición más o menos real, de un mapa del océano Atlántico (1474) de Paolo Toscanelli, enviado al obispo de Lisboa, y posteriormente, a Cristóbal Colón

Reconstrucción moderna, con la silueta del continente americano dibujada en su posición más o menos real, de un mapa del océano Atlántico (1474) de Paolo Toscanelli, enviado al obispo de Lisboa, y posteriormente, a Cristóbal Colón El navegante Cristóbal Colón tuvo conocimiento de las ideas y el mapa de Toscanelli, además de leer la Geografía de Ptolomeo, con la medida del perímetro terrestre de Posidonio, lo que le animaría a aventurarse en un viaje hacia las Indias a través del océano Atlántico. En el camino “descubriría” un “nuevo mundo”, que en un principio llamarían las “Indias Occidentales”, en contraposición a las “Indias Orientales”, a las que nunca llegó.

“Por el Oro, Dios y la Gloria” (2016), de Igor Babailov. Imagen de [7]

“Por el Oro, Dios y la Gloria” (2016), de Igor Babailov. Imagen de [7]

Biblioteca

1.- Raúl Ibáñez, El sueño del mapa perfecto; cartografía y matemáticas, RBA, 2010.

2.- David Rumsey Map Collection.

3.- Aubrey Diller, The Ancient Measurements of the Earth, Isis, vol. 40, n. 1, p. 6-9, 1949.

4.- I. E. Drabkin, Posidonius and the Circumference of the Earth, Isis, vol. 34, n. 6, p. 509-512, 1943.

5.- V. Frederick Rickey, How Columbus Encountered America, Mathematics Magazine, vol. 65, n. 4, p. 219-225, 1992.

6.- Denis Guedj, El Teorema del Loro, Anagrama, 2000

7.- Catàleg d’obres de Joan Brull i Vinyoles

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El tamaño sí importa, que se lo pregunten a Colón (o de la geometría griega para medir el diámetro de la Tierra) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Salaketa faltsuak atzemateko gai den softwarea garatu du Poliziak

XIX. mendean Eugene Vidocq detektibeak kriminalistikaren oinarriak jarri zituenetik denbora dezente igaro da, eta askotarikoak dira delituak argitu aldera komisaldegietan erabiltzen diren teknikak. Horietako batzuk oso ezagunak dira, bai telebistan edota auzi ospetsuenetan agertu direlako: DNA bidezko identifikazioak, erretratu robotak edota hatz-aztarnak dira horren adibide.

1. irudia: Kriminalistikaren alorrean delituak atzemateko teknika ugari garatzen ari dira, besteak beste, delitua noiz eta non izango den aurreratu nahian. (Argazkia: Juanma Gallego)

Baina badira beste zenbait teknika hain ezagunak ez direnak, batez ere garapen bidean daudelako, eta segurtasunari eta norbanakoen askatasunei eragiten dieten faktore guztietan bezala, halabeharrez tentu handiz garatu behar direlako.

Adibidez, datu espazialak, denborazkoak eta jarduera kriminalari lotutako estatistikak batuz, geodelituaren arloa garatzen ari da, eta AEBtako hainbat estatutan app gisa erabiltzen hasiak dira, patruilariek erronda egin baino lehenago eremurik “beroenak” zeintzuk izan litezkeen jakin dezaten. Gugandik gertu, duela hainbat urte Gasteizko Delituen Atlasa osatu zuen Eileen Matz ikasleak, Udaltzaingoarentzat erabilgarria izango zelakoan, baina Udalak ez du zabaldu izan nahi horren erabileraren inguruko informaziorik.

Datuen bidezidor beretik, bestelako aplikazioak zabaldu dira. Adibidez, Journal of Drug Issues aldizkarian argitaratutako ikerketa batean AEBtako zenbait hiritan kokainak zuen prezioari buruzko datuak erabili zituzten trafikatzaileek erabiltzen hasiak zituzten ibilbide berriak azalarazteko.

Are gehiago, neurozientziaren alorrean ere hasierako probak egin dira azken urteotan, pertsona batek esandakoa egia ote den igartzen saiatzeko, poligrafoaren famatuaren bertsio berritu bat balitz bezala. Neurozuzenbidea deitu izan zaio diziplinari. Jose Ramon Valdizan neurofisiologo espainiarra da mundu mailan teknika horietako bultzatzaile handienetako bat, eta bereziki P300 garuneko uhinaren analisia baliatu du ospa handiko hainbat kasu ikertzeko. Kazetari honi Valdizanek aitortu dio teknikak duen trabarik handiena: Espainiako legeak ez du teknika hori aintzat hartzen, eta defentsako abokatuek hori baliatzen omen dute sumario osoa bertan behera uzten saiatzeko.

Duela gutxi teknika honen aldaera berri bat aurkeztu dute. Kasu honetan, auzipetuen testigantzak ez, baizik eta lapurreta txikien haritik idatziz jasotako salaketak ikertzen duen softwarea asmatu dute. Hala izanik, ez dirudi traba legal gehiegirik izango duenik.

VeriPol izena eman diote, eta funtsean salaketen testua aztertzen duen programa bat da. Knowledge-Based Systems aldizkarian argitaratutako ikerketa artikuluan zehaztu dutenez (Researchgaten ere eskuragarri), sistema eraikitzeko hiru metodologia erabili dituzte: Hizkuntzaren Prozesamenduko algoritmoak, aldagaien aukeraketa, eta ikasketa automatikoko algoritmoak. “Honek aukera ematen digu ulertzeko jendeak nola gezurra esaten dion poliziari, eta baita benetako salaketa batek zer nolako itxura duen jakiteko”, zehaztu dute artikuluan.

Bertan azaldu dutenaren arabera, lapurretei buruz egiten diren salaketa faltsuak zehaztea zaila da, baina egileek kalkulatu dute halako salaketen %57 ez direla egiazkoak.

2. irudia: Batez ere telefono mugikorren ustezko lapurretak atzeman dituzte VeriPol ereduari esker; asko asmatzen omen dira asegurua kobratzeko. (Argazkia: Josh Felise / Unsplash)

Egoera horri aurre egin nahi izan zion Miguel Camacho Espainiako Polizia Nazionaleko inspektoreak. Polizia izateaz gain, matematikaria eta estatistikaria da Camacho, eta polizia prediktiboan doktoretza egin du Los Angeleseko UCLA Unibertsitatean. Bertatik Espainiara itzultzean bururatu zitzaion software hori garatzea, El País egunkariak argitaratutako artikulu baten arabera.

Hainbat kolaboratzailerekin batera VeriPol izeneko eredua garatu du, eta Espainiako Polizia Nazionalak salaketak biltzeko erabiltzen duen SIDENPOL izeneko fitxategian txertatu ahal izateko prestatu zuten. Modu horretan, poliziak jasotako salaketa errealekin probatu ahal izan dute tresna. Ikerketa artikuluan bertan zehazten dutenez, zientzia literaturan ikerketa helburuetarako erabili diren beste ereduak ez bezala, benetako testuekin frogatu eta balioztatu den lehen eredua da VeriPol.

Artikuluan aitortu dute oso arlo berria dela honakoa, eta, horregatik, zaila egin zaie orain arte proposatu diren beste hainbat eredurekin alderatzea. Gainera, testu faltsuak atzemateko ereduek posta elektronikoan izaten den spam-a edo internet bitartez egindako produktuen kritika faltsuak izan dituzte ohiko jomuga.

Poliziari gezurra esaten zaionean maizen erabiltzen diren hitz multzoak atzematen ditu VeriPolek. Sistema “entrenatzeko” 2015ean jasotako 1.122 salaketa izan dituzte oinarri. Horietatik 534 benetakoak ziren, eta 588, faltsuak. Salaketa horietan guztietan argi zegoen benetakoak ala faltsuak ote ziren, itxitako auziak zirelako. Gehienetan, lapurreta txikiak azaltzen zituzten salaketak ziren, hala nola mugikorren edo diru-zorroen ebasteak. Antza, salaketa gehienak sakelako telefonoarekin lapurretari lotuta daude, eta arlo honetan salaketa faltsu asko omen daude aseguruak kobratzeko. Baina erraza omen da iruzur horiek atzematea: egileen arabera, VeriPolek %91 asmatzen du. Horretan trebatuta dagoen polizia baten kasuan, asmatze tasa %75 dela kalkulatu dute.

Artikuluaren egileen esanetan, benetako salaketek zehaztasun gehiago eskaini ohi dituzte, baina salaketa faltsuetan zehaztasun horiek alboratzen dira. Era berean, benetako salaketek gertatutakoa eta lapurra bera sakontasun handiagorekin deskribatzen dituzte. Diskurtso faltsuan, berriz, ustez lapurtutako objektuan jartzen dute arreta, teorian izan den gertakarian arreta jarri beharrean. Hortaz, “asegurua”, “kontratua”, edota “iPhone” bezalako hitzak maiz agertzen dira.

Ba dira bereziki esanguratsuak diren bestelako terminoak. “Eguna” da horietako bat (“duela hiru egun lapurtu zidaten”, “ostegunean lapurtu zidaten” esan beharrean). “Motxila”, “kaskoduna” edo “beltzez jantzita” dira salaketa faltsuetan sarri errepikatzen diren terminoak.

Sinesgarritasunaren adierazle diren terminoak ere badira, hala nola “autobusa”, “tiratu” edo “hil”. Norabide berdinean, “ataria” edo “eskailburua” bezalako terminoek ere fidagarritasuna daukate, etxetik gertu izandako gertaeraren adierazle direlako; aldiz, gezurra diotenek ustezko gertakaria etxetik “urrun” kokatu nahi dute. Ezezko esaldi asko egoteak zalantzagarritasun adierazletzat hartzen da, eta baita “apenas” bezalako hitzak.

Proba pilotua izan da honakoa, baina egileek espero dute sistema polizialean txertatu ahal izatea. Iazko abenduak sistema honek Espainiako Polizia Fundazioaren Ikerketa saria eskuratu zuen, sustantzia arriskutsuak atzematea errazten duen “sudur elektroniko” batekin batera.

Erreferentzia bibliografikoa:

Quijano-Sánchez, Lara, et al., (2018). Applying automatic text-based detection of deceptive language to police reports: Extracting behavioral patterns from a multi-step classification model to understand how we lie to the police. Knowledge-Based Systems 149, 155-168. DOI: https://doi.org/10.1016/j.knosys.2018.03.010

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Salaketa faltsuak atzemateko gai den softwarea garatu du Poliziak appeared first on Zientzia Kaiera.

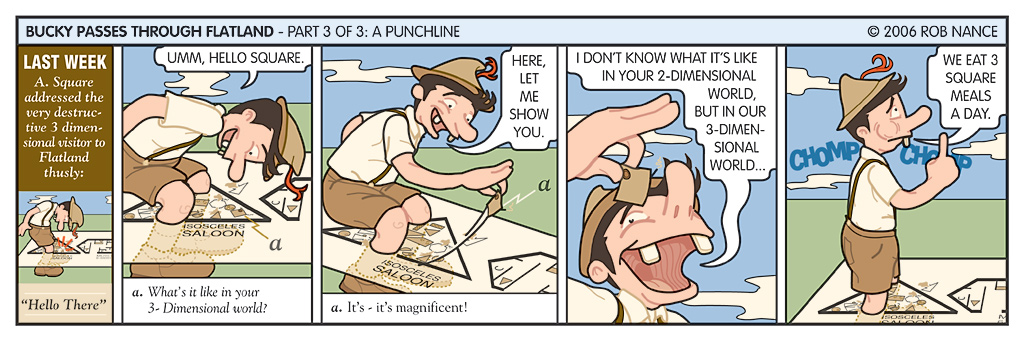

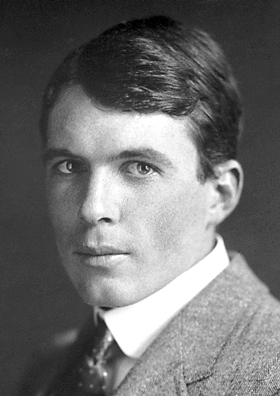

Cristalografía (y 15): El siglo de Bragg

En la conferencia que impartió Thomson ante la Sociedad Filosófica de Cambridge el 11 de noviembre de 1912, en la que presentaba las propuestas de W Lawrence Bragg, estuvo presente el físico Charles TR Wilson (que se haría famoso por sus cámaras de niebla para localizar rayos cósmicos y otras partículas y que le valdrían el premio Nobel en 1927). En el turno de preguntas Wilson sugirió que los rayos X también deberían reflejarse en las caras externas de los cristales, siempre y cuando las caras fuesen suficientemente lisas.

La idea tenía sentido, por lo que Lawrence realizó inmediatamente una serie de experimentos en las caras de exfoliación de la mica, ya que se suponía que debía de ser muy plana incluso a escala atómica. Lawrence pudo fotografiar esta reflexión y en diciembre, esto es, poco más de un mes después de la sugerencia de Wilson, aparecía en Nature su The Specular Reflexion of X-rays.

Por su parte William H Bragg demostró poco después que el espectrómetro de rayos X que había construido podía detectar los rayos X monocromáticos difractados, pero no con una placa fotográfica sino con un detector de ionización de gas.

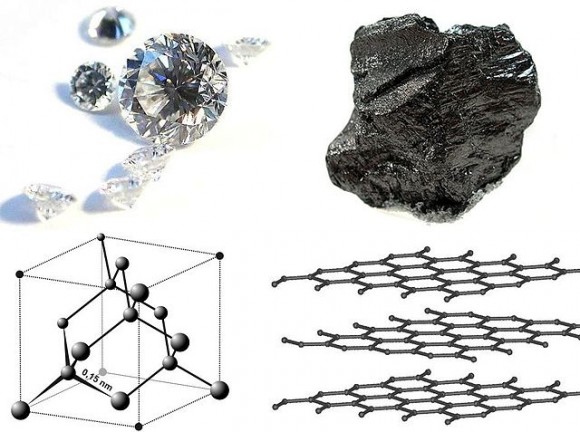

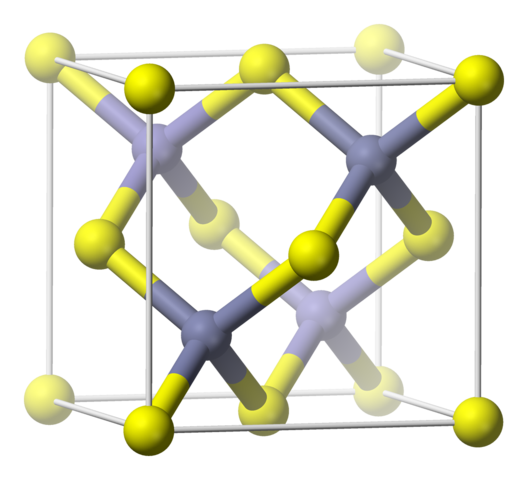

La importancia de la ley de Bragg, así como la capacidad del espectrómetro para registrar las intensidades de los rayos X de una longitud de onda determinada, quedó demostrada de forma espectacular en dos artículos aparecidos en los Proceedings of the Royal Society en 1913. En uno de ellos, firmado sólo por Lawrence, se analizaban las estructuras de los cristales de los cloruros de sodio y potasio, y del bromuro e ioduro de potasio; en el otro, de Lawrence con William, se estudiaba la estructura del diamante.

La metodología desarrollada por los Bragg constituía una forma fiable de determinar la estructura interna de todos los sólidos cristalinos y, por tanto, de explicar sus propiedades. Una vez que se descubrió la estructura del diamante, con átomos de carbono enlazados firmemente en tres dimensiones, era fácil entender que fuese tan duro. Cuando en los años treinta se determinó la estructura del grafito, de idéntica composición química que el diamante, se entendió que, a pesar de ello, fuese tan blando, que reaccionase químicamente de forma tan diferente y que tuviese comportamiento electrónico tan distinto.

Durante las décadas siguientes la ecuación de Bragg y el espectrómetro se convirtieron en los ejes de la investigación difracción de rayos X, desplazando el método policromático de Laue. Con todo, algunos investigadores usaban ambos procedimientos, el más famoso Linus Pauling en la determinación de las estructuras de la hematita y el corindón en 1925.

En 1919 Lawrence sucedió a Ernest Rutherford en la cátedra de física de la Universidad de Manchester. Allí se dedicó al estudio de las propiedades químicas y físicas de los silicatos, los minerales más abundantes en la corteza terrestre y que, sin embargo, las aproximaciones químicas tradicionales no habían terminado de explicar satisfactoriamente a nivel atómico. Por ejemplo, hoy sabemos por qué la mica y el talco son blandos o el berilo duro gracias al trabajo de Lawrence en esta época.

Lawrence demostró que muchos minerales, especialmente los silicatos, están dominados por el oxígeno cargado negativamente que ocupa buena parte del espacio mientras que los cationes metálicos ocupan los intersticios que dejan. En el caso de los silicatos descubrió una coordinación tetraédrica de cuatro átomos de oxígeno independiente del ratio silicio: oxígeno.

También durante la época de Manchester, Lawrence resolvió las estructuras del latón-gamma y de varias aleaciones magnéticas, fundamentales para el desarrollo de la teoría moderna de los metales.

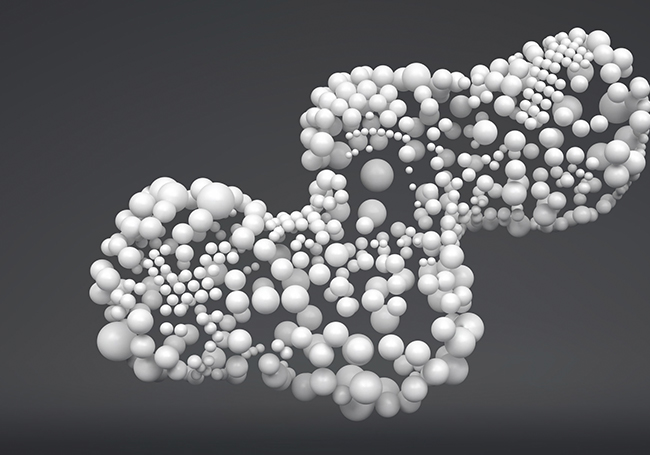

En 1938, Lawrence volvía a suceder a Rutherford, esta vez al frente del laboratorio Cavendish de Cambridge, al que revolucionaría, sobre todo tras el esfuerzo bélico de la Segunda Guerra Mundial, orientándolo hacia la cristalografía de interés biológico, donde él veía el futuro. Aquí, basándose en el trabajo de 1934 de JD Bernal y Dorothy Crowfoot (después Hodgkin) que demostraba que las proteínas cristalizadas difractaban los rayos X en patrones complejos, alentaría a Max Perutz y John Kendrew (ambos Nobel de química 1962), en la determinación cristalográfica por rayos X de la estructura, endiabladamente compleja, de las proteínas hemoglobina y mioglobina. Más tarde daría rienda suelta a las investigaciones de Francis Crick y James Watson sobre el ADN (ambos Nobel de medicina o fisiología 1962).

En 1953, Lawrence se convirtió en director de la Royal Institution. De nuevo su impulso revolucionaba una institución: la nueva línea de la cristalografía de estructuras biológicas se veía potenciada con la construcción de un difractómetro lineal de rayos X automatizado, primero en su género. Fue este aparato el que permitió a Kendrew, al que Bragg había incorporado como investigador “honorario”, junto a David Phillips determinar los últimos detalles de la primera proteína caracterizada, la mioglobina. También ayudaría a Phillips y a Louise Johnson con la determinación y modo de actuación de la estructura de la primera enzima, la lisozima.

Desde su descubrimiento en 1912 el método de los Bragg permitió el establecimiento de múltiples grupos de investigadores en todo el mundo trabajando en la determinación de todo tipo de estructuras moleculares. No menos de 24 premios Nobel se han concedido relacionados con la difracción de rayos X. Hoy día sigue estando en el corazón de la cristalografía y, con esta, en todas las ramas de la ciencia.

Referencias generales sobre historia de la cristalografía:

[1] Wikipedia (enlazada en el texto)

[3] Molčanov K. & Stilinović V. (2013). Chemical Crystallography before X-ray Diffraction., Angewandte Chemie (International ed. in English), PMID: 24065378

[4] Lalena J.N. (2006). From quartz to quasicrystals: probing nature’s geometric patterns in crystalline substances, Crystallography Reviews, 12 (2) 125-180. DOI:10.1080/08893110600838528

[5] Kubbinga H. (2012). Crystallography from Haüy to Laue: controversies on the molecular and atomistic nature of solids, Zeitschrift für Kristallographie, 227 (1) 1-26. DOI: 10.1524/zkri.2012.1459

[6] Schwarzenbach D. (2012). The success story of crystallography, Zeitschrift für Kristallographie, 227 (1) 52-62. DOI: 10.1524/zkri.2012.1453

Este texto es una revisión del publicado en Experientia docet el 20 de febrero de 2014

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Cristalografía (y 15): El siglo de Bragg se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Zientzia, noren izenean?

1. irudia: Ikerketa-artikuluak sinatzea ezinbestekoa da ibilbide akademikoan aurrera jarraitzeko. (Argazkia: Free-Photos – domeinu publikoko irudia. Iturria: pixabay.com)

Zientzialari baten curriculumak ezer gutxi balio du ikerketa-artikuluak -zientziaren munduan paper deitzen direnak- sinatzen ez baditu. Are gehiago, zenbat eta paper gehiago sinatu, haren curriculuma beteagoa egongo da. Egia da beste hainbat ezaugarri ere kontuan hartzen direla, baina, pisu gehiena argitalpen zientifikoek daramate. Horren harira, duela gutxi J. Ioannidis, R. Klavans eta K. Boyack ikertzaileek zientzia-artikuluen egile hiperoparoak identifikatu dituzte Nature aldizkariarentzat. Izen hori jarri diete urte batean 72 artikulu baino gehiago argitaratzen dituzten egileei -bost egunez behin argitalpen bat litzateke hori-. Horietako egileak ez dira gutxi: 9.000 baino gehiago daude munduan.

Zientzia-artikuluen garrantziaZientzia-argitalpenen mundua oso arrotza izan daiteke gertutik ezagutzen ez dutenentzat. Argitalpenen garrantzia honetan datza: zientzialari batek ikerketa egin ostean, zientzia-komunitateari bere ikerketen emaitzak jakinarazi behar dizkio; izan ere, komunikatzen ez den zientzia egiten ez denaren parekoa da. Horretaraino guztizko adostasuna dago. Alabaina, egun, kalitate altuko aldizkarietan argitaratutako artikuluek garrantzi handia dute eta, hortaz, lehia sortzen da aldizkari horietan argitaratzeagatik. Aldizkari horietan argitaratzen ez denak pisu txikia du ikertzailearen curriculumean eta, hortaz, ibilbide akademikoan jarraitzeko aukerak murrizten zaizkio etengabe argitaratzen ez badu. Era berean, diru-laguntzak jasotzeko edota akreditazioak lortzeko ikertzaileak argitaratu dituen artikuluak zenbatu ohi dira: artikulu kopurua eta artikuluak argitaratu direneko aldizkarien kalitatea hartu ohi dira kontuan, nagusiki.

2. irudia: Egunotan ohikoa da ikerketa-talde handiek elkarlanean lan egitea eta, hortaz, sinatzaile asko izan ditzakete ikerketa-artikuluek. (Argazkia: rawpixel – domeinu publikoko irudia. Iturria: pixabay.com)

Esandakoaren ondorioz, ahalik eta artikulu gehien argitaratzea da ikertzaile askoren nahia -eta beharra, kasu askotan-. Ildo horretatik, Nature aldizkarian argitaratu berri den gutunean egile hiperoparoak aztertu dituzte, hots, 5 egunean behin ikerketa-artikulu bat argitaratzen dutenak. Horrek, jakina, ez du esan nahi praktika okerrak egiten ari direnik -egiten ari ez direnik ere ez-. Egile oparo horiek identifikatzeko datu-baseetan ikertzaileak bilatu dituzte, eta baita aurkitu ere. Azalpena sinplea da: ikertzaile garrantzitsuek talde handiak gidatzen dituzte, edota hainbat talde, eta talde horiek argitaratzen dituzten ekarpen guztiak sinatzen dituzte. Esaterako, fisikaren alorreko punta-puntako ikerketetan ez da arraroa artikulu batek bostehun edo mila egiletik gora izatea.

Ioannidis eta bere lankideek identifikatu dituzten 9.000 egile hiperoparoen %86 fisikaren esparrukoak dira. Beste 1.000 inguru txinatarrak edo korearrak dira eta egileek zalantzan jarri dituzte autoretza horiek -diru truke argitaratutakoak izan ote litezke, edo ustelkeria kasuekin lotuta egon litezke-. Bi talde horiek alde batera utzita, 265 egile identifikatu dituzte. Kopuru hori handia edo txikia den testuinguruan jartzeko, esan behar da ikertzaile hiperoparoen kopurua 20 aldiz handitu dela 2001etik 2014ra -egile arrunten kopurua, berriz, 2,5 aldiz handitu da-. Berriro ere azpimarratu behar da horrek ez duela esan nahi, inondik inora ere, egileok praktika okerrak egiten ari direnik. Alabaina, Nature-ko gutuna sinatu dutenek zientzia-argitalpenen autoretzaren gaiak ekar ditzakeen arazoak plazaratu nahi izan dituzte.

Autoretza zer denGuzti honek zientzia-ekarpen baten autoretza norena den erabakitzeko irizpideak berraztertzea eska dezake. Ikerketa-artikulua sinatu behar al du lanaren berrikuspena bakarrik egin duen zientzialariak? Sinatu behar al du diru-laguntza lortu duen ikertzaileak? Sinatu behar al du lan automatizatu hutsak egin dituen ikertzaileak? Zentzu horretan, lan baten egile izatea zer den erabakitzeko Vancouver irizpideak dira onartuenak. Irizpide horien arabera, argitalpen baten egile izango da ekarpen adierazgarriak egin dituen ikertzailea -datuak lortzen, analizatzen edo interpretatzen-, lana idazten edo berrikusten parte hartu duena, azken emaitza onetsi duena eta ikerketa-lanaren atal guztien erantzule dena. Era berean, irizpide horien arabera artikulu baten edozein sinatzailek gai izan behar du beste egile guztiek zein lan zehatz egin duten jakiteko eta, gainera, beste egileen lanean konfiantza osoa izan behar dute. Azaldutako irizpide horiek guztiak betetzen ez dituztenen izenak “esker onak” atalean izendatu beharko dira, baina, ez dira argitalpenaren egileak izango -ez lukete izan beharko behintzat Vancouver irizpideen arabera-.

Vancouver irizpideak betetzea zaila da eta, ziur asko, sarri askotan ez dira betetzen. Esaterako, diru-laguntzen lorpen hutsak edota talde baten zuzendaritzak soilik ez du bidezko egiten ikerketa-artikulua sinatzea. Zientziaren izen ona mantendu nahi bada, zientzialariok paper baten autoretza modu egokian sinatzea ezinbestekoa da, baina, baita diru-laguntzak eta curriculum akreditazioak ematen dituzten erakundeen aldetik curriculum ekarpenak modu egokian egitea. Zientziaren izenean.

Erreferentzia bibliografikoa:

Ioannidis, John P.A., Klavans, Richard & Boyack Kevin W., (2018). Thousands of scientists publish a paper every five days. Nature 561, 167-169. DOI: https://doi.org/10.1038/d41586-018-06185-8

Informazio osagarria:

- Who gets credit? Survey digs into the thorny question of authorship, Giorgia Guglielmi, nature.com, 2018.

- Defining the role of authors and contributors, International Committee of Medical Journal Editors, icmje.org.

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Zientzia, noren izenean? appeared first on Zientzia Kaiera.

Una fórmula para dominarlos a todos: El trabajo

A los científicos nos encanta ir reduciendo la multiplicidad del mundo observable a combinaciones de objetos más simples o a leyes más generales.

Con esta actitud hemos desarrollado explicaciones relativamente sencillas que dan cuenta de multitud de fenómenos de mucha mayor complejidad. Podríamos citar como ejemplos la tabla periódica o las ecuaciones de Maxwell.

Es preciso recordar que la naturaleza no tiene por qué ser simple ni elegante y que hay cierta complejidad con la que tenemos que lidiar, bastante agradecidos deberíamos estar de que se “deje” describir con las matemáticas.

Entre todos los científicos quizá los físicos seamos de los más recalcitrantes en esta actitud. Desearíamos que cualquier factor de una fórmula fuera una combinación de las constantes universales: c, ℏ, e… mientras que un ingeniero, que tiene que vérselas con el intransigente MundoRealTM, no tendrá mayores reparos en ir haciendo pruebas y ajustar su valor “a mano”, perdón, heurísticamente.

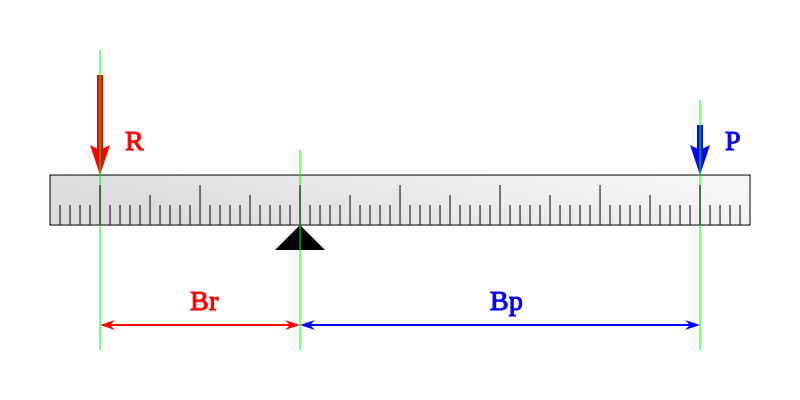

Con las fórmulas nos pasa algo parecido. Por ejemplo, la ley de la palanca, todo el mundo la conoce, todo el mundo la aplica (imagen de abajo). Muy bien, pero, ¿por qué? ¿De dónde sale eso? Cuando juntemos las fórmulas claves de la ciencia: las leyes de la termodinámica, las leyes de Newton… ¿habrá que hacerle un hueco a esta “ley de la palanca” que nadie sabe de dónde salió ni a quién debe pleitesía?

P · Bp = R · Br. La fuerza que se hace por un lado multiplicada por la distancia al punto de giro será igual a la fuerza que se resiste por el otro lado multiplicada por la distancia al punto de giro. Fuente: Dnu72 / Wikimedia Commons

P · Bp = R · Br. La fuerza que se hace por un lado multiplicada por la distancia al punto de giro será igual a la fuerza que se resiste por el otro lado multiplicada por la distancia al punto de giro. Fuente: Dnu72 / Wikimedia CommonsPues no. Esta fórmula es fácilmente derivable de nuestra vieja amiga, la conservación de la energía que, como ya os contamos aquí, es de los asuntos que más claro vemos (aunque haya quien siga buscando un móvil perpetuo de primera especie y que Lisa Simpson lo tire por tierra con un proyecto escolar).

Nuestro objetivo en esta serie será derivar las fórmulas de los distintos mecanismos a partir de la conservación de la energía.

Como vamos a hablar de energía y trabajo quizá lo primero sería explicar cómo definimos el trabajo en física.

Para ser más precisos diremos “el trabajo que hace una fuerza”. Y dicho en palabras más sencillas sería: ¿Qué efecto ha producido esa fuerza en el sistema?

A ver qué os parece esta metáfora:

Tenéis una mina y un grupo de trabajadores que están con el mineral y las vagonetas. Miremos por la ventana.

Trabajador1: Está sentado tan tranquilo.

Trabajador2: Está empujando una vagoneta y esta se mueve en el sentido que está siendo empujada.

Trabajador3: Está empujando una vagoneta que se mueve por unos raíles, pero el tipo la empuja perpendicularmente al movimiento.

Trabajador4: Mientras dos trabajadores empujan una vagoneta en un sentido, nuestro amigo empuja en sentido contrario.

Volvamos a nuestra oficina y vayamos pensando en las nóminas de este mes.

El trabajador número uno, cuya fuerza es cero, supongo que no esperará ningún pago. Podríamos decir en lenguaje común que el trabajo ha sido cero.

El trabajador número dos sí que parece que nos esté aportando algún efecto, algún trabajo. La vagoneta se mueve y tiene que ver con la fuerza que está recibiendo. Muy bien. De hecho, si empujase con más fuerza o la vagoneta se moviese más distancia, me plantearía pagarle más.

El trabajador número 3 suda como un pollo, el pobre, pero no me aporta nada, la fuerza que él hace no tiene un efecto sobre el resultado que vemos. Lo siento, pero no cobrará, trabajo = cero.

El trabajador número cuatro me va a oír cuando acabe el día. No sólo no está aportando, sino que está dificultando, no diré que no tiene un efecto sobre el sistema, sí que lo tiene: negativo. Así que, bien podría pedirle yo dinero, en lugar de dárselo.

Escribamos esto como una ecuación:

El trabajo (el efecto) es directamente proporcional a la fuerza que se hace, a la distancia que se recorre… pero resulta importante el ángulo con el que se hace. Siendo lo más favorable estar alineado y apuntar en el mismo sentido, de influencia cero si se está perpendicular y negativo si se aplica la fuerza en sentido contrario al movimiento. Esto matemáticamente queda bien definido de la siguiente manera:

W = F · d · cos ɸ

W: Trabajo

F: Fuerza

d: distancia

ɸ: ángulo entre la fuerza y el desplazamiento.

La función coseno nos selecciona esa “parte” de la fuerza que está alineada con el desplazamiento y nos dará el valor negativo si va en sentido contrario.

Por lo tanto, si fuerza y desplazamientos están alineados y van en el mismo sentido, tendremos:

W = F · d

En la próxima entrega hablaremos de conservación de la energía y cómo aplicar estos argumentos a la obtención de la ley de la palanca.

Sobre el autor: Javier Fernández Panadero es físico y profesor de secundaria además de escritor de libros de divulgación.

El artículo Una fórmula para dominarlos a todos: El trabajo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Materialak bioelektronikarako

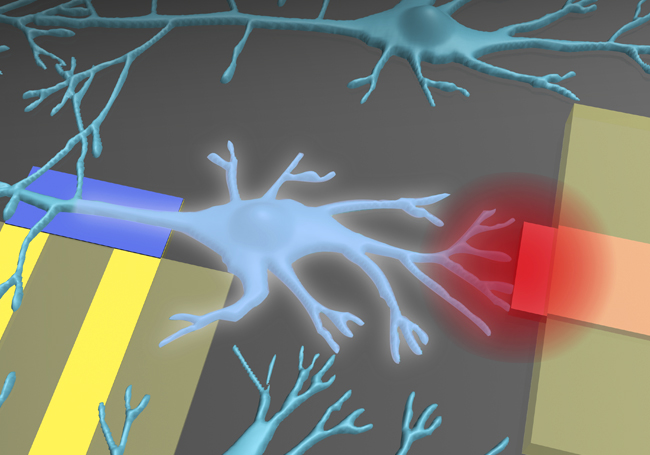

Eroankortasun ioniko eta elektronikoko material polimeriko berriak sintetizatu dira ikerketan bioelektronikan erabiltzeko eta etorkizun oparoko emaitzak lortu dituzte ehun-ingeniaritzaren eremuan.

Propietate mekaniko bigunak eta eroankortasun ioniko eta elektronikoa dituzten eta ehun biologikoekiko bateragarriak diren materialen belaunaldi berria lortzeko behar handia dago bioelektronikaren arloan. Gaur egungo aplikazio bioelektronikoetan gehien erabiltzen den polimero eroalea PEDOTa da (poli 3,4-etilendioxitiofenoa) eta PSSarekin (poli(3,4-etilendioxitiofeno)-poli(estireno sulfonato)arekin) dopatu ohi da, eroankortasun elektroniko eta ioniko, biobateragarritasun eta egonkortasun handiak baititu.

PEDOTa PSSarekin dopatuta merkaturatzen da egun, baina eragozpen bat du: ez da biofuntzionala. Haren biobateragarritasuna hobetzeko, PEDOT-material berriak ekoiztea izan du ardatz ikerketak; PSSa erabili beharrean, hainbat polisakaridorekin egonkortu dute PEDOTa, hala nola xantana gomarekin eta guar gomarekin, materiala hobeto txerta dadin giza ehunetan.

Biobateragarritasuna hobetzea

Ikerlan honetan egin diren PEDOT-polisakarido konbinazioetatik abiatuz, bi material berri sortu dira:

1. Gel ionikoak. PEDOTa duten lehen gel ionikoak dira. Propietate paregabeak ditu, osatzen duten materialen konbinazioaren ondorioz: eroankortasun elektronikoa PEDOTaren eraginez, eroankortasun ionikoa likido ionikoagatik eta elastikotasuna guar goma polisakaridoari esker. Material honek gainditu egiten ditu dagoeneko existitzen diren PEDOT-hidrogelak, ez baita lehortzen, egonkorragoa da eta ez ditu galtzen ez propietate mekanikoak ez eroankortasuna. Propietateak eta bioelektronikan dituzten aplikazioak ikertzen ari dira, besteak beste, elektrofisiologiarako larruazaleko elektrodo gisa duten erabilera. Larruazalaren gainean jarrita, gorputzeko jarduera elektrikoa transmititzen dute elektrodoetara, erregistratzeko.

2. Scaffold hiru dimentsioko egitura porotsuak. Zelulak hiru dimentsiotan hazteko eta ehunak sortzeko euskarriak dira. Polisakarido edukiari eta elkarrekin konektatuta dauden poroei esker, zelulek afinitate handia dute aldamioekiko. Frogatu dute material horien porositatea eta propietate mekanikoak oso erraz eralda daitezkeela, eman nahi zaien erabileraren arabera. PEDOTaren eta polisakaridoaren edukia aldatuz, poroek diametro handiagoa edo txikiagoa izan dezakete eta aldamioa, oro har, bigunagoa edo gogorragoa izan.

Emaitzen arabera material polimeriko hauen propietate paregabeei esker, aplikazio berriak zabaldu daitezke bioelektronikaren arloan: gailu elektronikoak gure gorputzarekin txertatzea lortzen dute, baita egungo aplikazioak hobetu.

Iturria: UPV/EHUko prentsa bulegoa. Etorkizun oparoko materialak bioelektronikarako

The post Materialak bioelektronikarako appeared first on Zientzia Kaiera.

La cultura del fútbol

“En un partido que acabó siendo legendario se llegó, incluso, a invocar la mano de Dios.”

Juan Ignacio Pérez.

“En el fútbol hay que intentar engañar al contrario, ¿sí o no?”

Mauricio Pochettino, entrenador.

Todo el estudio de los políticos se emplea en cubrirle el rostro a la mentira para que parezca verdad, disimulando el engaño y disfrazando los designios.”

Diego de Saavedra Fajardo (1584-1648).

“El lenguaje político está diseñado para que las mentiras parezcan verdades.”

George Orwell.

“Hay tres cosas que la mayoría de los estadounidenses toman como un artículo de fe: el cielo es azul, el Papa es católico, y los políticos son mentirosos.”

Brian Montopoli, periodista CBS, 2012.

“Todo cuanto sé con mayor certeza sobre la moral y las obligaciones de los hombres, se lo debo al fútbol.”

Albert Camus.

En julio de este año los medios comentaron un informe, publicado por el Washington Post, sobre las mentiras que Donald Trump ha dicho desde que tomó posesión de la presidencia en enero de 2017. Solo en los dos últimos meses antes de la publicación del informe había mentido unas 1000 veces con mentiras totales, afirmaciones falsas o medias verdades. Algo así, como media, unas 16 mentiras al día. A esta conducta, los psiquiatras la diagnostican como mitomanía, mentira patológica o pseudología fantástica. Trump y sus colegas lo llaman hechos alternativos o postverdades.

No hay muchas estadísticas pero se ha propuesto que uno de cada diez adultos es mitómano, sin diferencias entre géneros. Las estadísticas de Trump, según el Washington Post, indican que va a peor pues miente cuatro veces más que cuando llegó a presidente: entonces el promedio era de 4.6 mentiras al día y, ahora, hemos visto que llega a las 16 al día.

Y, también en el mes de julio, la prensa publicó un estudio de la cadena suiza de televisión RTS sobre el tiempo que pasó en el suelo el jugador brasileño Neymar durante los cuatro primeros partidos que jugó en el Campeonato Mundial de Fútbol de Rusia. En total fueron 14 minutos, en el suelo, derribado y con muchos dolores y aspavientos. Después de la publicación del informe de la RTS, en el siguiente partido, el quinto que jugó Neymar, casi no cayó al suelo. Brasil perdió y fue eliminada.

Es una conducta habitual en el fútbol. Como decía Pochettino en la cita que abre este texto, si hay que engañar, se engaña y ya está. Sobre la conducta de Neymar, el exjugador internacional brasileño Rivaldo escribió en las redes sociales que

“Neymar, juega como siempre lo hiciste y no te preocupes con los comentarios de los otros países, porque muchos ya regresaron a casa. Si tienes que eludir, elude. Si tienes que hacer un filigrana, hazla. Si tienes que hacer un gol, anótalo. Si tienes que caer por una falta, cae. Y si tienes que ganar tiempo quedándote en el piso, gánalo. Porque todos hacen los mismo.”

Es la cultura del fútbol, hay que ganar como sea. Como dice Rivaldo, los que pierden ya están en casa. En el estudio de Paul Morris y David Lewis, de la Universidad de Portsmouth, en Inglaterra, sobre imágenes de la Premier inglesa y con el diagnóstico de 30 observadores cualificados, se detecta cuándo y cómo se simula una falta. Hay cuatro conductas que indican que el jugador está simulando una falta:

- se agarra partes del cuerpo que no han sido tocadas por el contario.

- exageran de más al tocar el suelo (grita, se retuerce, rueda sobre sí mismo.,…).

- después del contacto, da unos pasos y cae al suelo.

- al sentir la proximidad del contrario levanta ambos brazos con las manos abiertas, echa el tórax y dobla las piernas hacia atrás, queda arqueado en el aire y, después, cae al suelo. Los autores denominan, con ironía, esta gesticulación como el “arco del arquero”.

Simular un derribo es una estrategia muy utilizada por los futbolistas para conseguir que el árbitro pite una falta o un penalti. Después de todo, en el fútbol el reglamento se aplica a criterio de los árbitros. Pero, la simulación es, a su vez, una jugada ilegal según el ¡reglamento. Para detectar faltas simuladas, Peter Renden y su grupo, de la Universidad Libre de Amsterdam, están desarrollando, con las propuestas de lenguaje corporal de Morris y Lewis, un protocolo para descubrir las simulaciones. Solo necesitan revisar los movimientos del jugador y el diagnóstico de observadores expertos como árbitros y jugadores.

En la práctica del juego, tirarse en el área para simular un penalti lo estudiaron Eran Sabag y su colegas, del Instituto Wingate de Netanya, en Israel, con 160 grabaciones de 339 jugadas de la Primera División israelí analizadas por 16 árbitros experimentados.

En el 34.5% de las jugadas analizadas el delantero se tira cuando siente al defensa y simula la falta. Y en el 14% de las jugadas simuladas, el delantero ve la tarjeta amarilla por simular la falta pero, también, en el 8.5% de las simulaciones el árbitro pita penalty. Según los evaluadores, el porcentaje de simulaciones es el doble, con el 17.7%, que las jugadas en que el defensa derriba realmente al delantero.

Pero también hay simulaciones en el resto del campo y no solo en el área de penalti. Según la revisión de Daryl Rosenbaum y sus colegas, de la Universidad Wake Forest de Winstom-Salem, en Estados Unidos, del repaso de grabaciones de 89 partidos en cuatro torneos internacionales, en cada equipo y por partido hay una media de 5.27 lesiones atendidas por los servicios médicos de cada club y que permiten seguir jugando al futbolista atendido. Pero también hay una media de 0.41 lesiones que obligan al jugador a retirarse. Y las lesiones que permiten seguir jugando abundan más en el último tercio del segundo tiempo y en jugadores del equipo que va ganando.

En el fútbol femenino y según un estudio del mismo grupo, el número de lesiones atendidas es parecido, 5.74 de media para las que permiten seguir jugando y 0.78 de las que obligan a cambiar a la jugadora.

Es evidente para cualquier practicante de este deporte que el engaño es esencial en su juego. El grupo de Iris Guldenpenning, de la Universidad de Paderborn, en Alemania, ha estudiado como una de las más espectaculares jugadas de fútbol, el dribling a un contrario, se basa en engañarle y provocar su movimiento para esquivarle y seguir la jugada. Ahí intervienen las neuronas espejo cerebrales que más adelante mencionaré.

Tan evidente y, a veces, tan escandalosa, es la utilización del engaño en el fútbol que el grupo de Francisco Javier Ponseti, de la Universidad de las Islas Baleares, ha preparado un cuestionario para cuantificar la disposición al engaño en los deportistas jóvenes. Lo prueban con 110 adolescentes, con 41 chicas, de 10 a 19 años y una edad media de 14.6 años. Entre ellos, hay 42 practicantes de fútbol y, para ellos, hay una propensión al engaño superior a la media. En esta investigación falta una encuesta a entrenadores y responsables de las canteras de los clubs sobre que jugadores elegirían para sus equipos, los que están por debajo o por encima de la media de simulaciones.

Volvamos a Donald Trump, a su extraordinario récord de mentiras y a la abundante presencia del engaño en la práctica política. Mentira y política van unidas desde hace siglos, desde siempre. Jonathan Swift ya lo comentaba con su típica ironía en su breve tratado titulado “El arte de la mentira política”, publicado en 1733. Allí dice que desconoce, a pesar de sus prolongadas investigaciones, quien convirtió la mentira en un arte y la adaptó a la política. Quizá, si leemos lo que escribió Swift, nos convenzamos de que, proféticamente, describía a Trump, o quizá los políticos de su tiempo eran ya muy parecidos a los actuales.

“La superioridad de su genio no consiste en otra cosa que en un fondo inagotable de mentiras políticas, que distribuye con largueza cada minuto que habla y que, por una generosidad sin paralelo, olvida, y consecuentemente contradice la siguiente media hora. Hasta ahora no se ha detenido a considerar si una proposición es verdadera o falsa, sino si es conveniente en tal momento y para tal compañía.”

Y, como seguidor de la teorías de Swift, seguro que Trump apoya la definición de mentira política que ofrece:

“el arte de hacer creer al pueblo falsedades saludables con vistas a un buen fin.”

Swift concluye que “todo el mundo miente”, tanto en política como, aunque en aquellos años lo ignoraba, en el fútbol.

Para confirmar, quizá, lo que proponía Swift, nos servirá el estudio, publicado en 2013, por Alessandro Bucciol y Luca Zarri, de la Universidad de Verona, en el que revisaban 2459 declaraciones, de 2007 a 2012, de 444 líderes políticos de Estados Unidos, tomadas de la base de datos PolitiFact que estudia la veracidad de las declaraciones de los políticos de aquel país.

El 64% de las declaraciones son, más o menos, mentiras y, en concreto, el 27.5% son mentiras totales. Como media, mienten más a los 56 años, y lo hacen, sobre todo, cuando tratan de finanzas públicas, de política en general y de economía. Mienten más los republicanos que los demócratas. Por ejemplo, en las elecciones en que salió elegido Obama fue el candidato que menos mentía. Lo cual no quiere decir que no mentía, solo que lo hacía con menos intensidad. Ya lo afirmó Otto von Bismarck en el siglo XIX: “Nunca se miente más que después de una cacería, durante una guerra y antes de las elecciones.”

Los últimos datos, del 15 de agosto, sobre Donald Trump en la PolitiFact dicen que miente, más o menos, el 69% de sus declaraciones, y el 47% de ellas son absolutamente falsas.

Por supuesto, no debemos creer que solo Neymar y Trump o, si se quiere, futbolistas y políticos, son los únicos que mienten. Un equipo formado por decenas de expertos llamado Grupo de Investigación Global sobre el Engaño, entre los que está Jaume Masip, de la Universidad de Salamanca, ha investigado la mentira y el engaño con voluntarios de 75 países con 43 idiomas diferentes. La conclusión es que todas las culturas conocen al estereotipo del mentiroso. Y su conducta más reconocible es que no miran a los ojos de su interlocutor, están nerviosos y su conversación puede ser incoherente. Pero, sobre todo, su conclusión es que en todas partes hay mentirosos. Un mundo de mentiras se titula la publicación de este grupo.

Cuando alguna conducta de la especie humana está extendida en muchos, casi todos por no exagerar, los individuos, podemos plantear la hipótesis de que ha sido seleccionada por el proceso de la evolución. De alguna manera ayuda a la supervivencia y la reproducción y es seleccionada para la mejor adaptación de la especie. Así, el engaño y la mentira son conductas beneficiosas para la especie humana.

Esta propuesta la han revisado Charles Bond y Michael Robinson, de la Universidad Cristiana de Texas en Fort Worth. En primer lugar, concluyen que la mentira y el engaño no son conductas exclusivas de nuestra especie sino que abundan en plantas, insectos, moluscos como, por ejemplo, los pulpos, camaleones, chimpancés, Homo sapiens y muchos otros.

Definen la mentira y el engaño como “una comunicación falsa que busca el beneficio del comunicador”. La búsqueda del beneficio puede ser consciente o no como ocurre en el caso de mimetismos y camuflajes permanentes. La conclusión de los autores es que la propensión a la mentira y el engaño es, en parte y según la especie, genética, y en parte puede basarse en el entorno social, en la cultura y en el aprendizaje. En nuestra especie, la genética de la mentira se basa en estudios con gemelos, en familias y en grandes grupos de voluntarios. De algún modo todavía no muy conocido, mentir es una ventaja evolutiva en Homo sapiens. Como especie, no solo como futbolista o político.

Detrás de la selección evolutiva de esta conducta, empezamos a conocer el funcionamiento del cerebro cuando se miente o engaña. Sería la base funcional de la adaptación que se ha seleccionado. Se ha sugerido la participación de las neuronas espejo. Estas neuronas cerebrales se activan cuando se observa una acción en otro individuo. Por tanto, reflejan el comportamiento del otro y participan en conductas como la imitación o la empatía. Así, se pueden adivinar en el otro sentimientos y sensaciones que, es obvio, es importante conocer para engañar o mentir.

En la actualidad, se investiga la intervención de las neuronas espejo tanto en el fútbol como en la política. Quizá, en algún momento, se encuentren evidencias de que las neuronas espejo de Donald Trump y de Neymar se parecen o, por lo menos, que funcionen parecido y provoquen conductas similares. Es la cultura del fútbol en la política, o viceversa, o, en todo caso, la mentira y el engaño y sus beneficios en nuestra especie. Es la cultura del engaño en que las reglas para su control se aplican a criterio del árbitro o del juez. Ante los mismos hechos, la aplicación puede no ser la misma.

Referencias:

Bond, Jr., C.F. & M. Robinson. 1988. The evolution of deception. Journal of Nonverbal Behavior 12: 295.307.

Bucciol, A. 2018. False claims in politics: Evidence from the US. Research in Economics 72: 196-210.

Bucciol, A. & L. Zarri. 2013. Lying in politics: Evidence from the US. Working Paper University of Verona Series 22: 43 pp.

Camus, A. 1957. Lo que debo al fútbol. France Football. Octubre.

Courtine, J.-L. 2006. Introducción. En “El arte de la mentira política”, p. 7-21. Sequitur. Madrid. 96 pp.

Morris, P.H. & D. Lewis. 2009. Tackling diving: The perception of deceptive intentions in association football (soccer). Journal of Nonverbal Behavior 34: 1-13.

Guldenpenning, I. et al. 2017. How to trick your oponent: A review article on deceptive actions in interactive sports. Frontiers in Psychology 8: 917.

Pennisi. E. 2011. Soccer and the art of deception. Science 331: 280.

Pérez, J.I. 2018. Fútbol es fútbol. Deia. 1 julio.

Ponseti, F.J. et al. 2012. El Cuestionario de Disposición al Engaño en el Deporte (CDED): su aplicación a jóvenes deportistas. Revista de Psicología del Deporte 21: 75-80.

Renden, P.G. et al. 2014. Foul or dive? Motor contributions to judging ambiguous foul situations in football. European Journal of Sport Science 14: S221-S227.

Rosenbaum, D.A. et al. 2010. Estimation of injury simulation in international men´s soccer. International Journal of Sport Science 31: 747-750.

Rosenbaum, D.A. et al. 2011. Estimation of injury simulation in international women´s football. Research in Sports Science 19: 162-169.

Sabag, E. et al. 2018. To dive or not dive in the penalti área? The questionable art of deception in soccer. International Journal of Sport and Exercise Psychology doi: 10.1080/1612197X.2018.1462100.

The Global Deception Research Team. 2006. A world of lies. Journal of Cross Culture Psychology 37: 60-74.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo La cultura del fútbol se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Asteon zientzia begi-bistan #222

Asteroide batean bi ibilgailu jarri ditu Japoniako espazio-agentziak. Hori egiten den lehen aldia da. JAXAtik jakinarazi dutenez, bi ibilgailuak egoera onean daude, irudiak eta datuak bidaltzen ari dira. Asteroidearen irudiak lortzeaz gain, gainazaleko tenperatura neurtzen dute ibilgailuek. Baina misioa ez da hemen amaituko. Hayabusa2 espazio-ontziak beste bi zunda askatu eta asteroidean jartzea dute aurreikusita.

Sustatuk ere eman du albiste honen berri eta asteroidetik egindako argazkia ere ikus daiteke artikuluan. Testuan zehar Ryugu asteroidearen ezaugarriak ezagutu ditzakegu: kilometro bat inguruko diametroa du, eta ondorioz, oso grabitate baxua du. Hayabusa2 asko gerturatu behar izan zaio roverrak bere gainera askatzeko, 55 metroraino.

KimikaNoizbait saiatu zara espagetiak bi zatitan banatzen? Lehendabiziko ikerketek azaldu zuten espagetia apurtzean alderantzizko indarrak eta bibrazioak sortzen direla eta horiek dira, hain zuzen, espagetia zati gehiagotan apurtzea eragiten dutenak. Josu Lopez-Gazpiok gogoratzen digu gainera, espagetien inguruko ikerketari esker bi fisikari frantziarrek lortu zuteko 2006ko Ig Nobel Saria. Orain, MITeko bi matematikarik espagetiak zatitzearen fenomeno hori azaltzea lortu dute eta, gainera, irtenbidea eman diote. Jo ezazu artikulura!

Medikuntza2004an diagnostikatu zioten aplasia medularra eta 2006an hezur muineko transplante batek sendatu ondoren, mediku ikasketak hasi zituen Blai Signesek. Egun, mediku egoiliarra da Nafarroako Ospitale Gunean. Hezur muineko transplanteaz mintzatu da nagusiki: “Jendeak hezur muina ematea eta bizkarrezur muina ematea nahasten ditu, eta uste du oso mingarria dela, baina ez da horrela. Bizirik gaudela egin daiteke; hiru-lau ordutan sofa batean eserita egiten da, eta ez du minik ematen. Pertsona bati bizia salba diezaiokezu”.

EHUko irakasle batek gizakiaren eta makinaren arteko nahasketaren eta zibermedikuntzaren gaurko panorama erretratatu du nazioartean argitaraturiko txosten batean. Horretaz gain, Gorka Oribe teknologia hezurraren sorkuntzan aplikatzeko lanean ari da. Begi bionikoak, burmuinean txertaturiko elektrodoak depresioa tratatzeko, gorputzaren parametroak kontrolatzen dituzten tatuaje elektronikoak izan dira mintzagai artikulu interesgarri honetan. Ez galdu!

NeurozientziaNeurozientzialariek aurretik ezagutzen zuten irakurketarekin lotutako eremu nagusia baina orain eremu hori bi zatitan banatzen dela argitu dute. Ikerketa honen arabera, atzealdeko zatiak ikusizko informazioa jasotzen du eta aurrealdekoa informazio lexiko-semantikoaz arduratzen da.

GenetikaGenetika herri-kulturan pisu handia hartzen ari da Koldoren ustez. Albiste, adierazpen edota publizitateetan aurki ditzakegu “gure DNAn dago”, “geneen boterea zure eskura” eta halako esaldiak. Koldoren esanetan, ordea, euren produktuari sinesgarritasuna emateko erabiltzen dute baina horrek zientzia gaizki interpretatzea dakar. Horregatik, testu honen bidez bere ardura azaltzen du, “primeran” dagoelako genetika kontzeptuak hedatzea baina betiere gizartea genetikan alfabetatzea helburu izanik.

IngeniaritzaAdimen artifizialaren alorrean egiten diren aurrerapausoek miresmena eta kezka sortzen dute aldi berean. Adituek, beraz, adimen artifizialaren arriskuak ekidin eta onurak eskuratu nahi dituzte. Gaiaren alde etikoa da nagusiki nabarmentzen dutena. Arautze etikoa “konplexua” baina “beharrezkoa” dela azpimarratu dute. Orobat, partekatutako erantzukizunak ezartzen dituzten sistemen alde azaldu dira adituak.

BiologiaElefante afrikarrari eta zeroiei buruz idatzi dute Juan Ignacio Perezek eta Miren Bego Urrutiak. Ezaugarri komunak dituzte bi espezie hauek, elkarrengandik gertu ez dauden arren. Lehenengoa, lehorreko espeziea da eta bestea, itsasokoa. Bizitza luzekoak dira biak, 60 urtera hel baitaitezke, eta bizitzaren bigarren hamarkadan heltzen dira ugaltze-heldutasunera. Janari tona asko jaten dute biek ala biek eta bide luzeak egiten dituzte janariaren bila joateko. Ezaugarri gehiago dituzte komunean, irakur ezazue artikulua osorik horiei buruz gehiago jakiteko.

Zilarrezko partikulen eraginpean zebra arrainek epe luzera jasandako ondorioak aztertu ditu ikerketa batek. Zilarra uretan agertzeko duen moduak (disolbatuta edo nanopartikulatan) eragina du metalak arrainen organoetan duen banaketan ikerketaren emaitzen arabera. Gainera, jakin da zilar disolbagarriak epe laburreko alterazioak eragiten dituela eta nanopartikulek, berriz, epe luzeagora.

——————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

———————————————————————–

Egileaz: Uxue Razkin kazetaria da.

——————————————————————

The post Asteon zientzia begi-bistan #222 appeared first on Zientzia Kaiera.

Maia García Vergniory: “Materiales que nos cambiaron”