Personas famosas que estudiaron matemáticas: literatura y cine

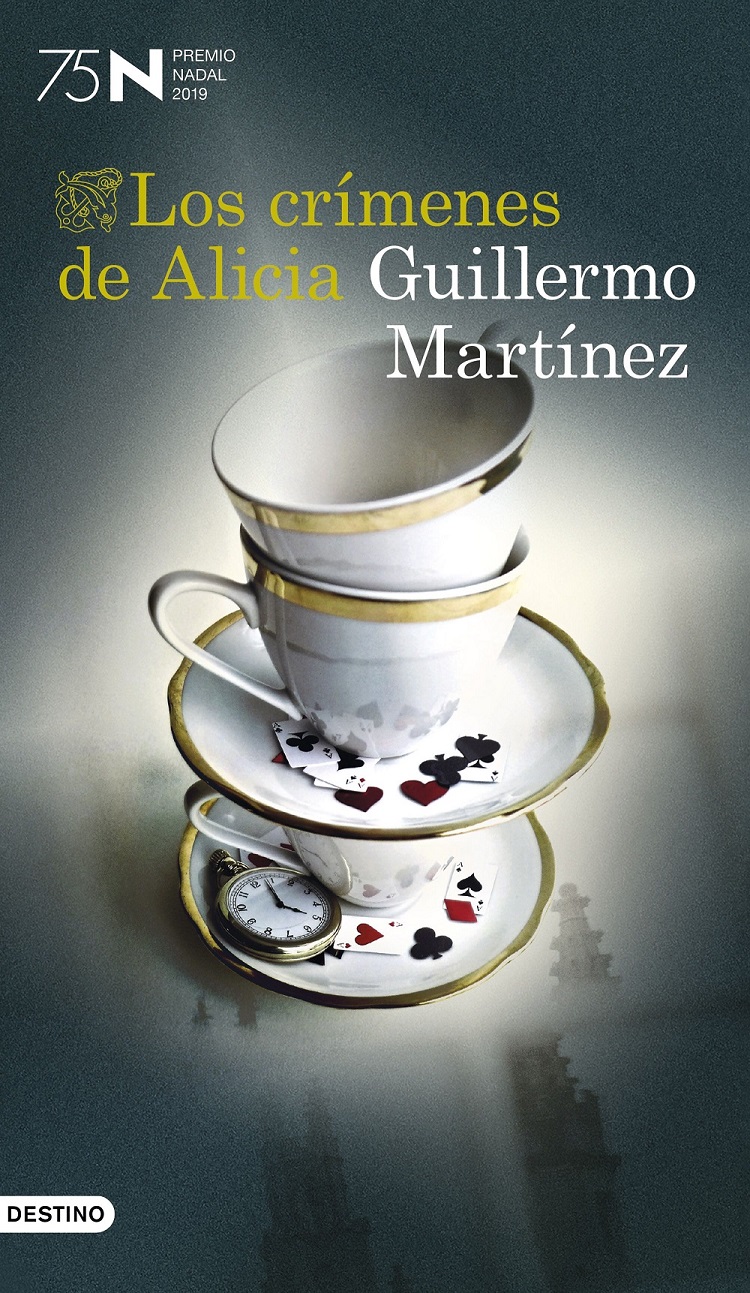

El día de Reyes de este año 2019, como todos los años, se concedía en Barcelona el Premio Nadal de novela, que la editorial Destino (ahora perteneciente al grupo Planeta) concede, desde el año 1944, a la mejor novela inédita. El ganador de esta 75ª edición era el escritor argentino Guillermo Martínez, por su novela Los crímenes de Alicia, una novela de intriga en la que dos matemáticos investigan una serie de crímenes relacionados con Lewis Carroll, el autor de Alicia en el País de las Maravillas.

Portada de la novela Los crímenes de Alicia (Destino, 2019), del escritor argentino Guillermo Martínez, ganadora del Premio Nadal 2019. Imagen de la página de Planeta de Libros

Portada de la novela Los crímenes de Alicia (Destino, 2019), del escritor argentino Guillermo Martínez, ganadora del Premio Nadal 2019. Imagen de la página de Planeta de LibrosEl escritor Guillermo Martínez (Buenos Aires, 1962), que muchas personas conocerán por su novela Los crímenes de Oxford (2003), que fue llevada al cine por el director bilbaíno Alex de la Iglesia, y que es el autor de otras novelas como Acerca de Roderer (1993), La muerte lenta de Luciana B. (2007) o Yo también tuve una novia bisexual (2011), de libros de cuentos, como Infierno Grande (1989) o Una felicidad repulsiva (2013), de libros de ensayos como La fórmula de la inmortalidad (2005) y La razón literaria (2016), muchos de ellos galardonados con diferentes premios, y que colabora con diferentes diarios argentinos, como La Nación o Clarín, es matemático.

Guillermo Martínez, se licenció en matemáticas por la Universidad Nacional del Sur, en Bahía Blanca, en 1984, se doctoró en Buenos Aires en Lógica en 1992 y posteriormente completó estudios posdoctorales en Oxford. Como podemos observar igual que el protagonista de sus dos novelas de intriga. De hecho, también tiene ensayos sobre matemáticas, como los libros Borges y la matemática (2006) o Gödel para todos (2009), este junto al matemático Gustavo Piñeiro. Ha sido profesor de Lógica Matemática y Álgebra en la Universidad de Buenos Aires, aunque ahora está de excedencia, dedicado por completo a la literatura.

Guillermo Martínez en el momento de recoger el Premio Nadal 2019 por su novela Los crímenes de Alicia. Fotografía de Planeta de Libros

Guillermo Martínez en el momento de recoger el Premio Nadal 2019 por su novela Los crímenes de Alicia. Fotografía de Planeta de LibrosAl igual que el escritor Guillermo Martínez, muchas otras personas que han sido conocidas, o famosas, en el mundo de la literatura, el arte, la música, el cine, el deporte o incluso la política, también estudiaron matemáticas, o más aún, se iniciaron en el mundo de esta ciencia, ya sea en la investigación, la empresa o la enseñanza.

En esta entrada del Cuaderno de Cultura Científica abrimos una pequeña serie dedicada a estas personas, que destacaron en otros ámbitos de la sociedad y la cultura, pero que se graduaron en matemáticas, e incluso realizaron un doctorado. Empezaremos, en la presente entrada, con la literatura y el cine.

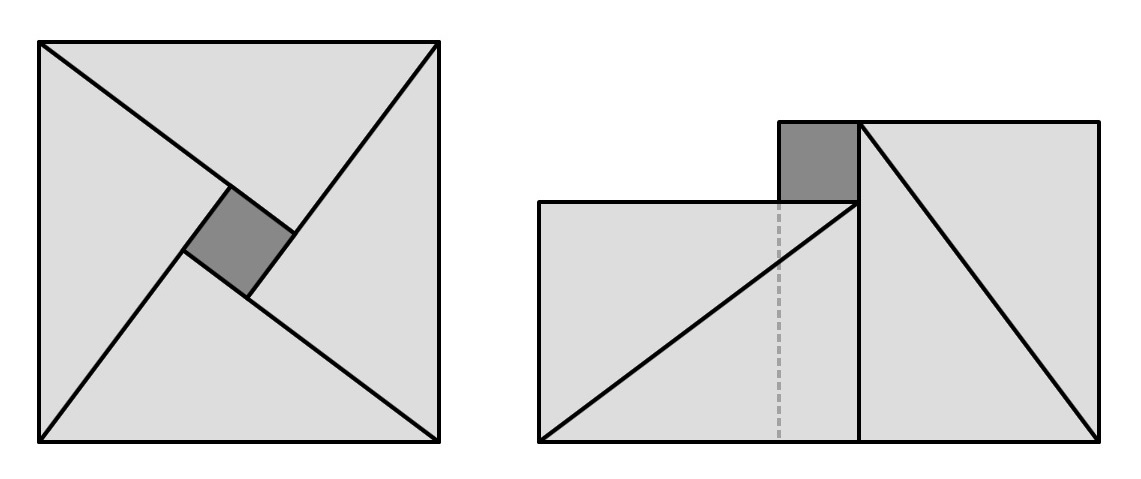

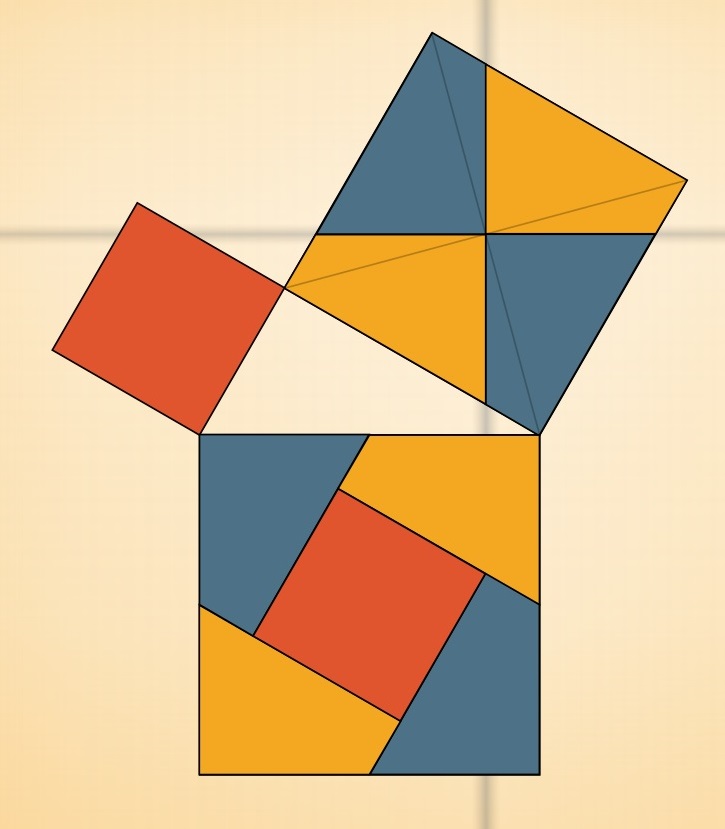

Sin ir más lejos, el mencionado escritor inglés Lewis Carroll, autor de Alicia en el país de las maravillas, Alicia a través del espejo, Bruno y Silvia o La caza del Snark, entre otras, era también matemático. Trabajó en el campo de la lógica matemática, aunque publicó en muchos tópicos distintos. De hecho, Lewis Carroll era solo su seudónimo, y se llamaba realmente Charles Lutwidge Dogson (1832-1898).

Ilustración de John Tenniel de Alicia en el País de las Maravillas (1865), de Lewis Carroll

Ilustración de John Tenniel de Alicia en el País de las Maravillas (1865), de Lewis CarrollCharles Dogson siempre estuvo ligado a la Universidad de Oxford, primero como estudiante, en el college Christ Church, donde se graduó en matemáticas con el mejor expediente de ese curso, y después como profesor, también en el college Christ Church. Fue autor de varios libros de matemáticas, aunque no muy importantes, sobre geometría, trigonometría, aritmética o algebra. El más destacado por su interés histórico fue Euclides y sus rivales modernos (1879). Sobre lógica publicó dos libros: El juego de la lógica (1887) y Lógica simbólica (1896). Además, publicó libros de problemas de ingenio, como Problemas de almohada (que la editorial Nivola publicó en español en 2005) o Un cuento enmarañado (Nivola, 2002).

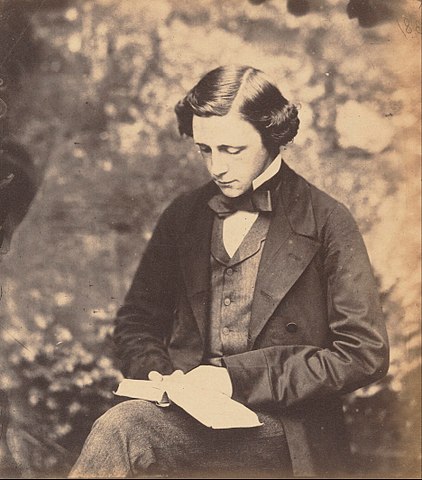

Autorretrato de Charles Dogson, conocido por el seudónimo, Lewis Carroll, de aproximadamente 1856. La fotografía era una de sus pasiones. Imagen de Wikimedia Commons

Autorretrato de Charles Dogson, conocido por el seudónimo, Lewis Carroll, de aproximadamente 1856. La fotografía era una de sus pasiones. Imagen de Wikimedia CommonsPero hay más ejemplos, algunos fueron Premio Nobel de Literatura, como el español José de Echegaray (1832-1916), conocido por su carrera literaria como dramaturgo y poeta que le valió el Premio Nobel de Literatura en 1904, convirtiéndose en el primer español en obtener un Premio Nobel, y también por su paso por la política, fue Ministro de Fomento (1869-1870 y 1872) y de Hacienda (1872-1873).

Sin embargo, el madrileño José de Echegaray era ingeniero y matemático. Realizó importantes contribuciones a las matemáticas y a la física, de hecho, según algunos autores es considerado el mejor matemático del siglo XIX. Algunas de sus obras científicas fueron: i) Cálculo de Variaciones (1858), que era un tema casi desconocido en España; ii) Problemas de Geometría plana (1865); iii) Problemas de Geometría analítica (1865), calificada de obra maestra por el matemático Zoel García de Galdeano; iv) Teorías modernas de la Física (1867); v) Introducción a la Geometría Superior (1867), exponiendo en el mismo la geometría de Chasles; vi) Memoria sobre la teoría de los Determinantes (1868) , primera obra en España sobre este tema; vii) Tratado elemental de Termodinámica (1868), breve ensayo sobre una ciencia que estaba naciendo entonces.

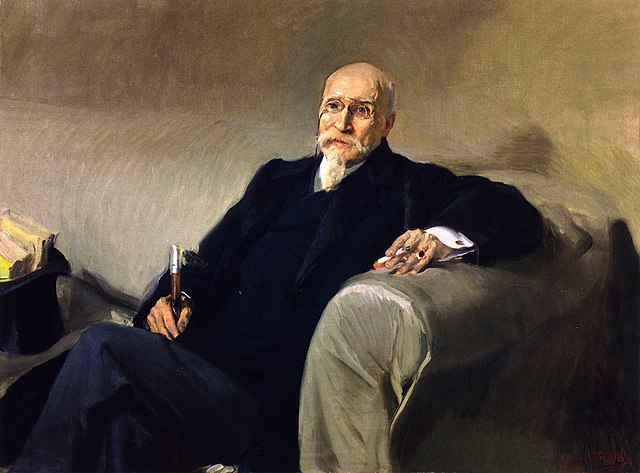

Retrato de José de Echegaray, de principios del siglo XX, realizado por el pintor valenciano Joaquín Sorolla. Imagen de Wikimedia Commons

Retrato de José de Echegaray, de principios del siglo XX, realizado por el pintor valenciano Joaquín Sorolla. Imagen de Wikimedia CommonsJosé de Echegaray fue presidente del Ateneo de Madrid (1888); director de la Real Academia Española (1896); senador vitalicio (1900) y dos veces presidente de la Real Academia de Ciencias Exactas, Físicas y Naturales (1894-1896 y 1901-1916); primer Presidente de la Sociedad Española de Física y Química, creada en 1903; catedrático de física matemática de la Universidad Central (1905); presidente de la sección de Matemáticas de la Asociación Española para el Progreso de las Ciencias (1908); y primer Presidente de la Sociedad Matemática Española (1911).

También fue premio Nobel de Literatura, en 1950, el inglés Bertrand Russell (1872-1970). Betrand Russell es conocido por ser uno de los más grandes filósofos del siglo XX, escritor, pacifista controvertido y singular que se opuso a prácticamente todas las guerras modernas, así como al uso y posesión de armas nucleares, aunque en ciertos momentos también defendió la guerra preventiva contra la URSS.

Fotografía de Bertrand Russell, de 1924, realizada por Lady Ottoline Morrell. Imagen de Wikimedia Commons

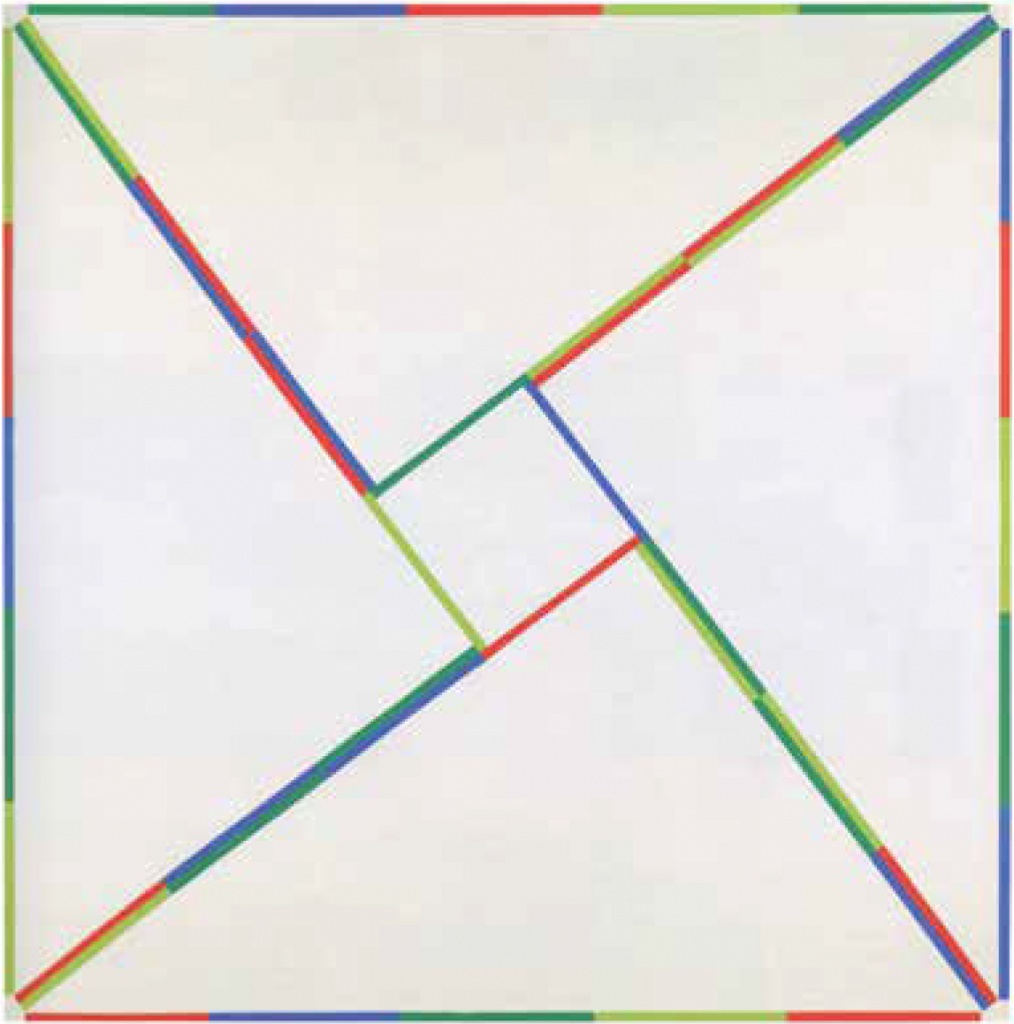

Fotografía de Bertrand Russell, de 1924, realizada por Lady Ottoline Morrell. Imagen de Wikimedia CommonsSin embargo, Bertrand Russell estudió matemáticas en el Trinity College de Cambridge y destacó por su trabajo en lógica matemática, en particular, por su estudio de los fundamentos de las matemáticas. Su gran contribución, en la ciencia de Pitágoras, fue la indudablemente importante obra Principia Mathematica (1910-1913) con su profesor de Cambridge Alfred N. Whitehead (1861-1947), libro en tres volúmenes en donde a partir de ciertas nociones básicas de la lógica y la teoría de conjuntos se pretendía deducir la totalidad de las matemáticas, mostrando así el poder de los lenguajes formales. Un libro profundamente influyente e importante que contribuyó al desarrollo de la lógica, la teoría de conjuntos, la inteligencia artificial y la computación, y que causó un impacto importante en pensadores de la talla de David Hilbert, Ludwig Wittgenstein, que fue su estudiante, Alan Turing, Willard Van Orman Quine y Kurt Gödel.

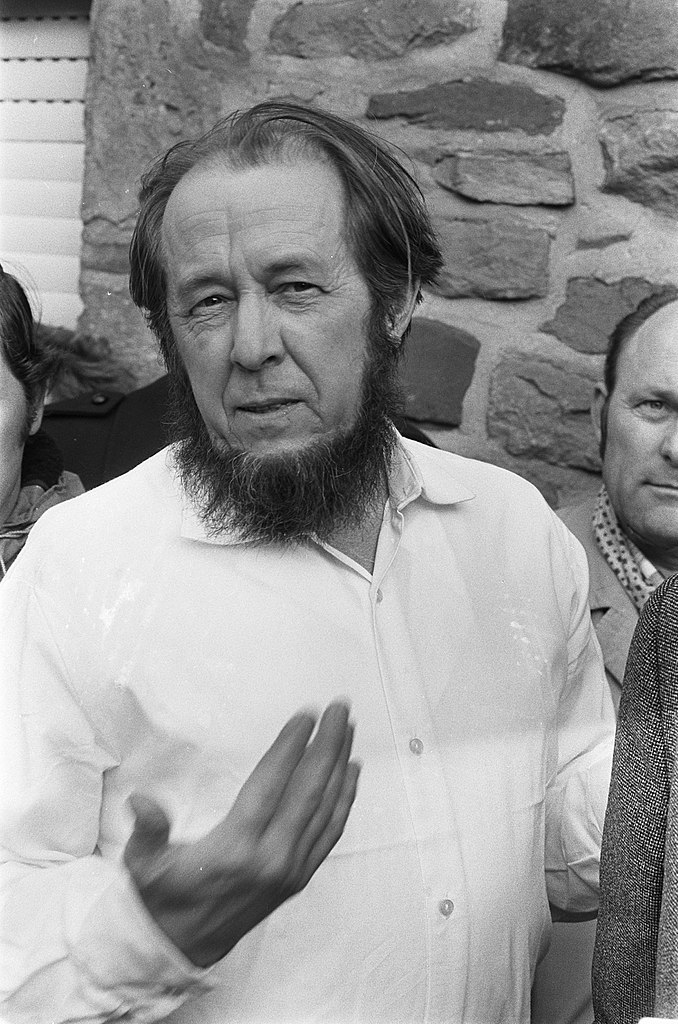

Otro ejemplo de matemático que obtuvo el Premio Nobel de literatura, en 1970, es el ruso Aleksandr Solzhenitsyn (1918-2008), cuya obra más conocida es el ensayo Archipiélago Gulag (1973), en la que denuncia la represión política de la antigua Unión Soviética. Otras de sus obras son las novelas Un día en la vida de Iván Denísovich (1962), Pabellón del cáncer (1968) o Agosto de 1914 (1971).

Fotografía del matemático y escritor Aleksandr Solzhenitsyn, de 1974, realizada por la Agencia de Fotografía ANEFO. Imagen de Wikimedia Commons

Fotografía del matemático y escritor Aleksandr Solzhenitsyn, de 1974, realizada por la Agencia de Fotografía ANEFO. Imagen de Wikimedia CommonsAleksandr Solzhenitsyn estudió matemáticas y física en la Universidad de Rostov. Se graduó en 1941. Poco antes se había casado con la matemática Natalia Dmitrievna Svetlova. Empezó a servir ese mismo año en el ejército soviético hasta 1945 en el cuerpo de transportes primero y más tarde de oficial artillero. Participó en la mayor batalla de tanques de la historia (Batalla de Kursk) y fue detenido en febrero de 1945 en el frente de Prusia Oriental, cerca de Königsberg (hoy Kaliningrado) poco antes de que empezara la ofensiva final del ejército soviético que acabaría en Berlín. Fue condenado a ocho años de trabajos forzados y a destierro perpetuo por las opiniones antiestalinistas que había escrito a un amigo. Lo encerraron en la Lubyanka y los primeros años de su cautiverio los pasó en varios campos de trabajo, gulags, hasta que gracias a sus conocimientos matemáticos fue a parar a un centro de investigación científica para presos políticos vigilado por la Seguridad del Estado; eso le inspiró su novela El primer círculo (1968).

Fue liberado en 1956 y empezó a trabajar como profesor de matemáticas, al tiempo que se dedicaba a escribir y a publicar sus novelas. Tras ser investigado y perseguido por la KGB, sería expulsado de la Unión Soviética en 1974.

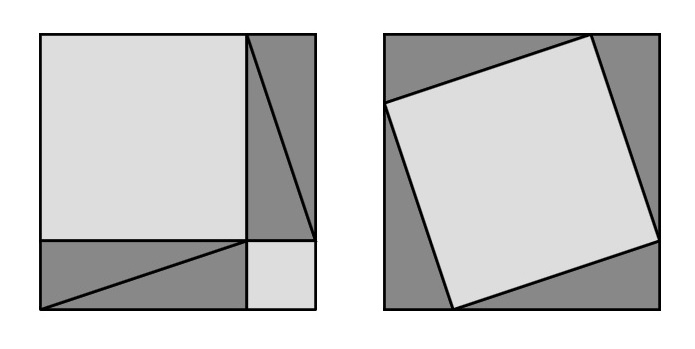

Cartel de la película Drácula, de Bram Stoker, dirigida por el cineasta Francis Ford Coppola en 1992

Cartel de la película Drácula, de Bram Stoker, dirigida por el cineasta Francis Ford Coppola en 1992Aunque no fue premio Nobel de literatura, Bram Stoker, el autor de la famosa novela Drácula (1897), también era matemático. El escritor irlandés Bram Stoker (1847-1912) se graduó en matemáticas en el Trinity College de Dublín en 1870 y, aunque parece ser que no era verdad, él empezó a decir con el tiempo que se “graduó con honores en matemáticas”. Sin embargo, cediendo a los deseos paternos, Bram Stoker siguió la carrera de funcionario público en el Castillo de Dublín, entre 1870 y 1878. Aunque conseguiría su Master of Arts (posgrado) en 1875. En 1878 empezaría a trabajar como asistente del actor Sir Henry Inving y también como gerente del Lyceum Theatre, que pertenecía al mencionado actor.

Entre sus obras nos encontramos un cuento infantil titulado Cómo se volvió loco en número 7(que publicó la editorial Nivola en 2010 y la editorial Gadir en 2013).

Portada del libro Cómo se volvió loco el número 7, de Bram Stoker, publicado por la editorial Gadir en 2013, con ilustraciones de Eugenia Ábalos

Portada del libro Cómo se volvió loco el número 7, de Bram Stoker, publicado por la editorial Gadir en 2013, con ilustraciones de Eugenia Ábalos Seguimos con más escritores famosos. El argentino Ernesto Sábato (1911-2011), autor de las célebres novelas El túnel (1948), Sobre héroes y tumbas (1961) o Abbadón el exterminador (1874), y también libros de ensayo como Uno y el Universo (1945), Hombres y engranajes (1951), o El escritor y sus fantasmas (1963), estudió físicas y matemáticas en la Universidad Nacional de La Plata, universidad en la que se doctoró en 1937 investigando en temas de física. Después obtuvo una beca para investigar sobre las radiaciones atómicas en el Laboratorio Curie, iría al MIT en 1939 y finalmente regresaría en 1940 a la Universidad Nacional de La Plata, donde trabajó como profesor. En 1943, tras una crisis existencial, abandonó definitivamente su carrera científica y se centró en la literatura y la pintura.

Fotografía de Ernesto Sábato y Jorge Luis Borges, aparecida en la revista Gente, en 1975

Fotografía de Ernesto Sábato y Jorge Luis Borges, aparecida en la revista Gente, en 1975La novelista, guionista y directora de cine francesa Marguerite Duras (1914-1996), autora entre otras de las novelas El amante (1984), El arrebato de Lol V. Stein (1964), El vicecónsul (1965) o Los ojos azules pelo negro (1986), o del guion de la película Hiroshima Mon Amour (1960), del director francés Alain Resnais, también está conectada con las matemáticas. Para empezar, Marguerite G. M. Donnadieu, que era su verdadero nombre, nació en Saigón, la Indochina francesa, su padre era profesor de matemáticas y su madre maestra. Según se cuenta en sus biografías, ella tuvo muy claro desde el principio que quería ser escritora, pero su madre quería que estudiara matemáticas como su padre (que falleció cuando Marguerite tenía cuatro años). Con diecisiete años Marguerite Donnadieu viajó a Francia, donde empezó a estudiar el grado de matemáticas, pero lo abandonó para concentrarse en Ciencias Políticas, y después Derecho. En una entrevista ella afirmaba que abandonó las matemáticas porque en ese momento tenía un novio, del que estaba muy enamorada, que quería casarse con ella y este le expresó que tenía sus dudas de que una matemática pudiese cuidar de sus hijos. Aunque ella se dio cuenta de la estupidez de su pensamiento, terminó dejando los estudios de matemáticas.

Fotografía de Marguerite Duras. Imagen de la página sobre cine IMDB

Fotografía de Marguerite Duras. Imagen de la página sobre cine IMDBEn poesía nos encontramos algunos poetas que son también matemáticos. El gran poeta chileno Nicanor Parra (1944-2018), creador de la antipoesía (en la entrada del Cuaderno de Cultura Científica Los números poéticos 2 [https://culturacientifica.com/2018/07/25/los-numeros-poeticos-2/] incluíamos algunos pequeños poemas relacionadas con las matemáticas), estudió matemáticas y ejerció de profesor de matemáticas. Aunque todos le conocemos como poeta, uno de los grandes de la poesía del siglo XX, tuvo una larga carrera científica.

En 1937 se graduó en matemáticas por la Universidad de Chile y empezó a trabajar como profesor, primero en el Liceo de Santiago, después como profesor de física y matemáticas en el Liceo de hombres de Chillán, de donde procedía él, y de nuevo en Santiago, tras el terremoto de Chillán, dando clases de física en un internado y de matemáticas en la Escuela de Artes y Oficios. Después, en 1943 consiguió una beca para hacer un posgrado en Mecánica Avanzada en la Universidad de Brown, en EEUU, y a su regreso a Chile, en 1946, se incorporó como profesor de Mecánica Racional en la Universidad de Chile. Posteriormente fue director de la Escuela de Ingeniería. En 1949 se fue a estudiar cosmología a la Universidad de Oxford (en Inglaterra).

Por supuesto que, durante todo ese tiempo, en paralelo, desarrolló una fructífera carrera literaria, que es la que lo hice conocido mundialmente. Las décadas de los años 1950 y 1960 se dedicó en cuerpo y alma a la literatura y el arte. Los primeros años de la década de 1970, fueron políticamente complicados en Chile. En 1973, tras el golpe de estado de Pinochet, entró a formar parte del Departamento de Estudios Humanísticos de la Facultad de Matemáticas de la Universidad de Chile. Y con el regreso de la democracia, abandonó completamente su carrera científica y docente.

El poema Pensamientos…

Qué es el hombre

…………………….se pregunta Pascal:

Una potencia de exponente cero.

Nada

……… si se compara con el todo

Todo

……… si se compara con la nada:

Nacimiento más muerte:

Ruido multiplicado por silencio:

Medio aritmético entre el todo y la nada.

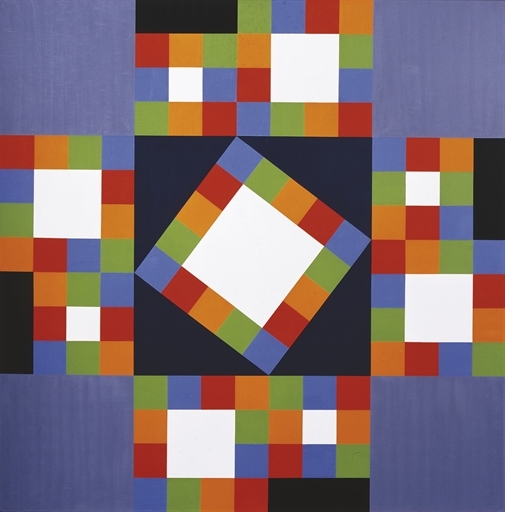

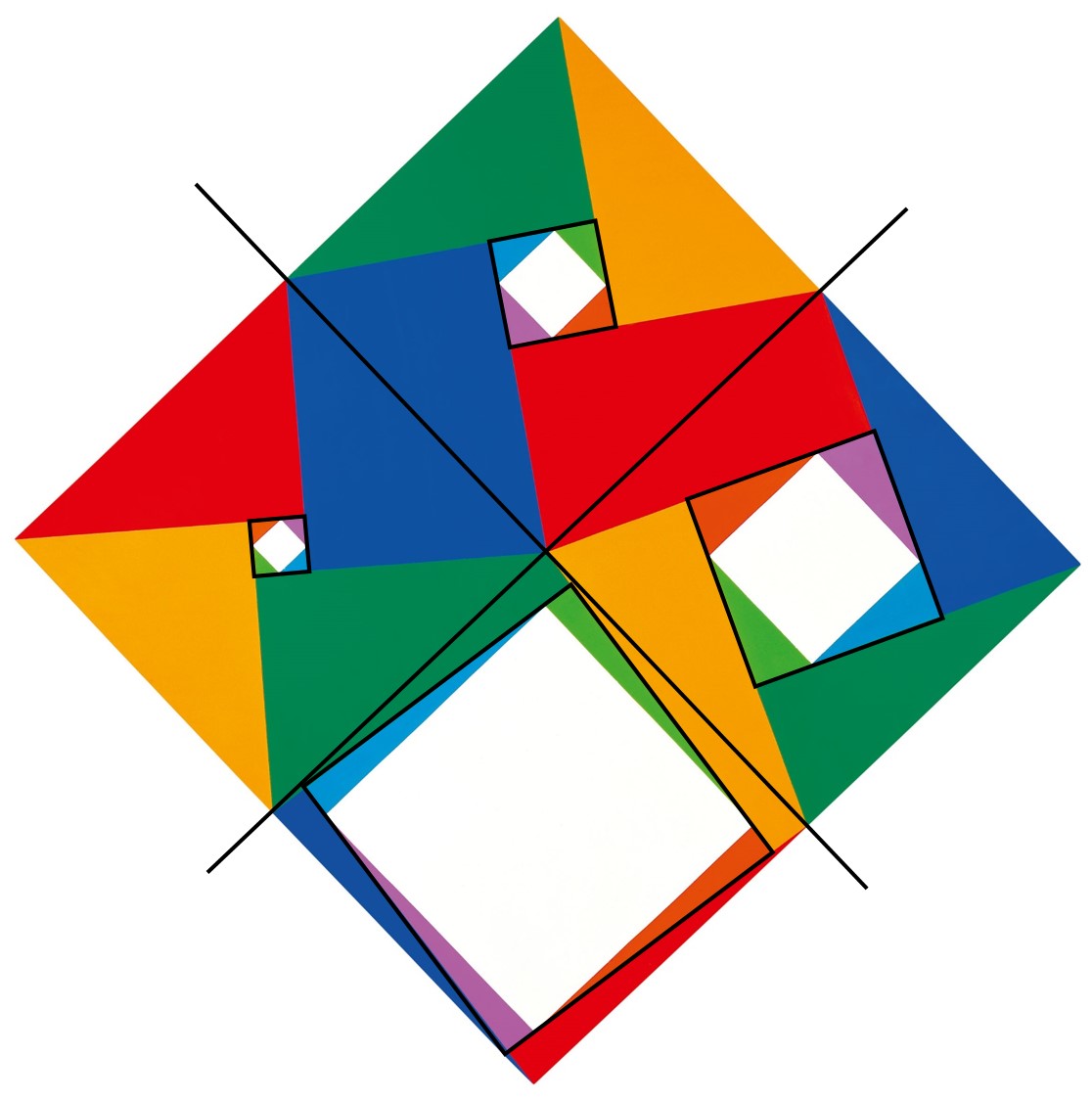

O, por ejemplo, en el mundo del teatro tenemos al dramaturgo español Juan Mayorga, autor de magníficas obras teatrales como El chico de la última fila (2006), La tortuga de Darwin (2008), El cartógrafo (2009), Reikiavik (2012), El arte de la entrevista (2014), o Intensamente azules (2018), que hemos podido disfrutar últimamente en nuestros teatros. Además, recibió el Premio Nacional de Teatro en 2007, Premio Nacional de Literatura Dramática en 2013 y en 2018 fue elegido Miembro de la Real Academia Española, letra M.

Cartel de la obra Intensamente azules (2018), del dramaturgo Juan Mayorga, interpretada por el actor César Sarachu

Cartel de la obra Intensamente azules (2018), del dramaturgo Juan Mayorga, interpretada por el actor César SarachuEste dramaturgo madrileño se licenció, en 1988, en Matemáticas en la Universidad Autónoma de Madrid y en Filosofía en la UNED. A partir de 1994 y durante cinco años fue profesor de matemáticas en diferentes institutos de Madrid y Alcalá de Henares. Desde entonces su carrera se ha centrado fundamentalmente en el teatro, como autor y como docente, pero también fundando compañías teatrales y teatros. Aunque, en 1997 se doctoró, por la UNED, en Filosofía.

A pesar de todo, como él mismo dice, las matemáticas son para él una pasión que descubrió en la adolescencia y nunca me le han abandonado, las matemáticas le han formado como hombre, pero también le forman como dramaturgo. Más aún, podemos encontrar rastros de matemáticas en algunas de sus obras, por ejemplo, en El chico de la última fila o en Intensamente azules. De esta última:

Siete pasos después me he cruzado con un hombre que llevaba puestas unas gafas de nadar intensamente amarillas. Lo he seguido con discreción hasta un bar de nombre El Número i desde cuyo exterior he observado el interior. […] “Este bar tiene forma de raíz cuadrada de menos uno”, me he dicho […]. En una pared del bar hay un retrato de Euler, inventor de los números imaginarios.

Bueno, hemos destacado algunos nombres dentro de la literatura, aunque hay más, como el novelista J. M. Coetzee, premio Nobel de Literatura en 2003, el escritor y guionista, por ejemplo, del programa de tv La bola de Cristal, Carlo Frabetti, el escritor Ricardo Gómez que escribe tanto literatura infantil y juvenil, como para adultos, el escritor de ciencia ficción Larry Niven, o la escritora Catherine Shaw (seudónimo de la matemática Leila Schneps) que ha escrito novelas de misterio relacionadas con las matemáticas como La incógnita Newton, entre otros.

Pero si pensamos en otros campos diferentes de la literatura y que podrían parecernos a priori más lejanos aún de las matemáticas, como puede ser el cine, ¿existirán también ejemplos de personas que se han hecho famosas dirigiendo o interpretando películas, pero que han estudiado matemáticas?

En esta parte, dedicada al cine, me gustaría empezar por una actriz que intervino en una maravillosa serie estadounidense de los años 1980, Aquellos maravillosos años. Entonces no me perdía un capítulo de esta serie cada semana. Los dos protagonistas principales eran un chico y una chica adolescentes. Ella estaba interpretada por la actriz Danica McKellar, que ha seguido apareciendo en diferentes series, como algunos capítulos de The Big Bang Theory, Cómo conocí a vuestra madre o Navy, Investigación criminal, en algunas películas para diferentes canales de televisión, o ha protagonizado la serie Proyecto MC2 de Netflix.

Imagen de los tres personajes adolescentes principales de la serie Aquellos maravillosos años y fotografía de 2018 de la actriz Danica McKellar. Imagen de Wikimedia commons

Imagen de los tres personajes adolescentes principales de la serie Aquellos maravillosos años y fotografía de 2018 de la actriz Danica McKellar. Imagen de Wikimedia commonsDanica McKellar se graduó, cum laude, en matemáticas por la Universidad de California, Los Ángeles (UCLA), en 1998, con 23 años (nació en 1975). Después empezó a investigar en matemáticas, llegando a publicar un artículo en el que se recoge el resultado conocido como “Teorema de Chayes-McKellar-Winn”.

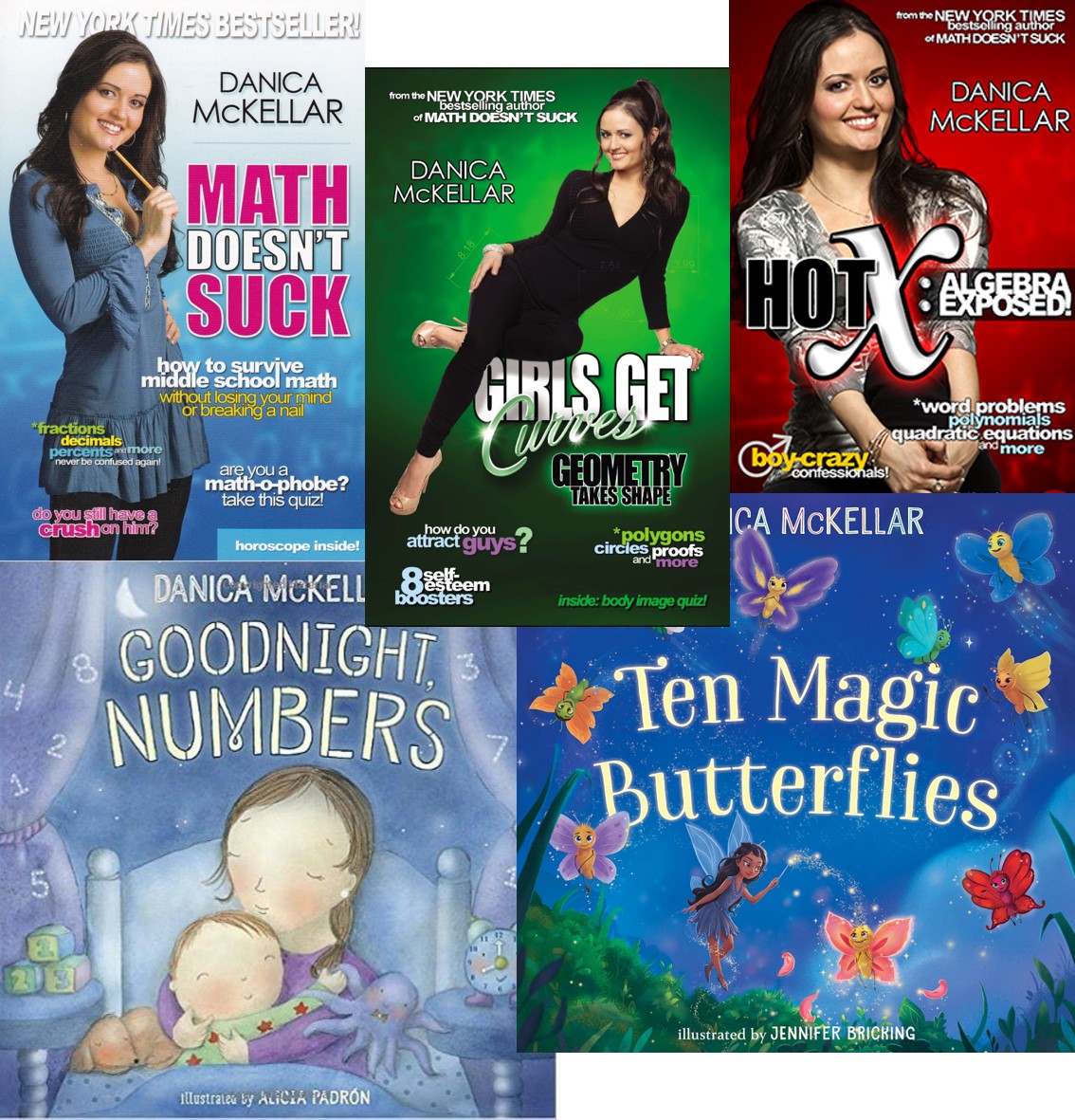

Ha escrito cuatro libros, tres de los cuales han sido grandes éxitos. El libro Las matemáticas no apestan: cómo sobrevivir a las matemáticas en la educación secundaria sin perder la cabeza o romperte una uña (2008), fue todo un bestseller. También otros libros con títulos (en inglés) cuya traducción es más o menos… Besa mis matemáticas: enseñando quien manda en pre-álgebra (2009), X caliente: el álgebra al descubierto (2010) y Las chicas tienen curvas: la geometría da la forma (2012). En estos libros, la actriz y matemática busca acercar las matemáticas a las jóvenes adolescentes.

Portadas de prensa y algunos de los libros de la actriz y matemática estadounidense Danica McKellar

Portadas de prensa y algunos de los libros de la actriz y matemática estadounidense Danica McKellarTambién ha publicado, en los últimos años, libros infantiles, como Buenas noches números (2017), Diez mariposas mágicas (2018) o Bathtime, Mathtime (Hora del baño, hora de las matemáticas, 2018) y No abras este libro de matemáticas, sumas y restas, (2018).

La actriz estadounidense Teri Hatcher (California, 1964) que muchas personas conocerán por su papel en la serie Mujeres desesperadas y que tiene una larga carrera entre el cine y la televisión, entre las que destacan, en popularidad, la serie Louis y Clark, Las nuevas aventuras de Superman, o la película El mañana nunca muere, también está conectada con las matemáticas.

Fotografía de las protagonistas de la serie Mujeres desesperadas, con la actriz Teri Hatcher en el medio de la imagen

Fotografía de las protagonistas de la serie Mujeres desesperadas, con la actriz Teri Hatcher en el medio de la imagenTeri Hatcher estudió los grados de matemáticas e ingeniería en De Danza College en Cupertino (California), al mismo tiempo que estudiaba actuación en el American Conservatory Theather.

La actriz, escritora, productora y creadora de series web estadounidense Felicia Day (Alabama, 1979), que actuó en series como Buffy cazavampiros, Eureka o Sobrenatural, entre otras, se graduó en matemáticas y música en la Universidad de Texas en Austin. En una entrevista afirmó que siempre había adorado las matemáticas, pero que no eran su carrera definitiva y, de hecho, nunca se dedicó a esta ciencia tras sus estudios.

Felicia Day interpreta a la cazadora de vampiros Vi en la serie Buffy cazavampiros

Felicia Day interpreta a la cazadora de vampiros Vi en la serie Buffy cazavampirosTambién estudió Matemáticas en la Universidad de Chicago la actriz Morgan Saylor (Chicago, 1994), de la serie Homeland, en la cual interpreta a Dana Brody. En una entrevista cuenta una anécdota compartida por todas las personas que hemos estudiado matemáticas. Explica que muchas veces al salir con amigos y amigas le piden a ella que haga la cuenta, y explica que su respuesta suele ser “he estudiado matemáticas, no aritmética”.

Escena de la serie Homeland en la que aparecen tres de sus protagonistas, Claire Danes (Carrie), Damian Lewis (Nicholas Brody) y Morgan Saylor (Dana Brody, hija de Nicholas)

Escena de la serie Homeland en la que aparecen tres de sus protagonistas, Claire Danes (Carrie), Damian Lewis (Nicholas Brody) y Morgan Saylor (Dana Brody, hija de Nicholas)La actriz estadounidense Jane Alexander (Boston, 1939), que ha actuado en películas míticas como Todos los hombres del presidente (1976), Kramer vs Kramer (1979), Brubaker (1980) o Las normas de la casa de la sidra (1999), entre muchas otras, además de muchísimas series de televisión y obras de teatro, por las que ha recibido varias nominaciones y premios Tony, se graduó en matemáticas y también en teatro en el Sarah Lawrence College de Bronxville, Nueva York.

Jane Alexander junto a Dustin Hoffman en una escena de la película Kramer vs Kramer, dirigida por Robert Benton en 1979

Jane Alexander junto a Dustin Hoffman en una escena de la película Kramer vs Kramer, dirigida por Robert Benton en 1979En España, la actriz madrileña Sofía Nieto (Alcorcón, 1984), de las series Aquí no hay quien viva y La que se avecina, estudió matemáticas en la Universidad Autónoma de Madrid, y luego se especializó en probabilidad, área a la que pertenece su tesis doctoral.

Sofía Nieto en una de las escenas de la serie Aquí no hay quien viva

Sofía Nieto en una de las escenas de la serie Aquí no hay quien vivaEl año 2011, Sofia Nieto presentó uno de los desafíos matemáticos que se publicaron en la página web del periódico El País para celebrar el centenario de la Real Sociedad Matemática Española. Aquí tenemos el desafío que presentó:

Desafío 32: Partículas en movimiento

Solución del desafío 32 (el video de la solución está en la columna de la derecha)

El director de cine Paul Verhoeven (Amsterdam, 1938), que se hizo famoso con películas como Robocop (1987), Desafío Total (1990), Instinto Básico (1992), El hombre sin sombra (2000), entre otras, se graduó por la Universidad de Leiden en Matemáticas y Física. Se unió a la armada neerlandesa y fue allí donde empezó a rodar y a hacer sus primeros documentales, luego entró en la televisión y ya no dejaría su carrera de director.

Y como es bien conocido, dentro del equipo de guionistas y productores de Los Simpson y Futurama, hay muchas personas que han estudiado matemáticas, física u otras ciencias. En particular: A) J. Stewart Burns: Licenciado en Matemáticas por la Universidad de Harvard y Máster en Matemáticas por U.C. Berkeley. Productor y Guionista de Futurama (y de Los Simpsons desde 2002); B) Al Jean: Licenciada en Matemáticas por la Universidad de Harvard. Ha estado en el equipo de Los Simpsons desde el principio, aunque en la actualidad es Productora Ejecutiva y guionista de esta serie; C) Ken Keeler: Doctor en Matemática Aplicada por la Universidad de Harvard y Máster en Ingeniería Electrónica. Productor Ejecutivo y Guionista de Futurama, aunque antes había sido guionista para Los Simpsons.

Imagen de los personajes principales de la serie de tv Los Simpson

Imagen de los personajes principales de la serie de tv Los Simpson Bibliografía

1.- Página web del escritor Guillermo Martínez [http://guillermomartinezweb.blogspot.com/]

2.- Página de Wikipedia sobre José de Echegaray [https://es.wikipedia.org/wiki/Jos%C3%A9_Echegaray]

3.- Página de Wikipedia de Bertrand Russell [https://es.wikipedia.org/wiki/Bertrand_Russell]

4.- Página de Wikipedia de Aleksandr Solzhenitsyn [https://es.wikipedia.org/wiki/Aleksandr_Solzhenitsyn]

5.- Página de Wikipedia de Ernesto Sábato [https://es.wikipedia.org/wiki/Ernesto_Sabato]

6.- Jean Vallier, C’était Marguerite Duras: Tome 1, 1914-1945, Fayard, 2006.

7.- Página de Wikipedia de Nicanor Parra [https://es.wikipedia.org/wiki/Nicanor_Parra]

8.- Página web de Juan Mayorga [https://es.wikipedia.org/wiki/Juan_Mayorga]

9.- Página de Wikipedia de Danica McKellar [https://es.wikipedia.org/wiki/Danica_McKellar]

10.- Página de Wikipedia de Teri Hatcher [https://es.wikipedia.org/wiki/Teri_Hatcher]

11.- Página de Wikipedia de Felicia Day [https://es.wikipedia.org/wiki/Felicia_Day]

12.- Página de Wikipedia de Morgan Saylor [https://es.wikipedia.org/wiki/Morgan_Saylor]

13.- Página de Wikipedia de Jane Alexander [https://es.wikipedia.org/wiki/Jane_Alexander]

14.- Página de Wikipedia de Paul Verhoeven [https://es.wikipedia.org/wiki/Paul_Verhoeven]

15.- Simon Singh, Los Simpson y las matemáticas, Ariel, 2013

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Personas famosas que estudiaron matemáticas: literatura y cine se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El rostro humano de las matemáticas

- Las dos culturas de las matemáticas: construir teorías o resolver problemas

- Un kilogramo de novelas y matemáticas

La luz como onda

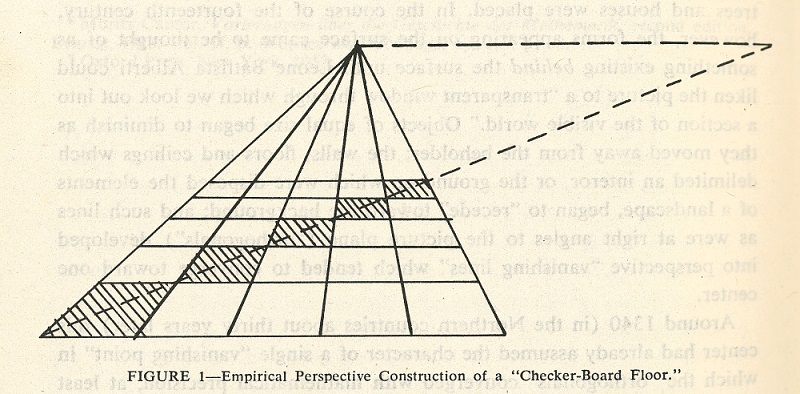

La convicción de que el mundo y todo lo que contiene es materia en movimiento llevó a los científicos anteriores al siglo veinte a buscar modelos mecánicos para la luz y el calor; es decir, intentaron imaginar cómo los efectos de la luz, el calor y otros fenómenos podrían explicarse en detalle como la acción de objetos materiales. Por ejemplo, pensemos la forma en la que la luz rebota en un espejo. Un modelo para este efecto podría representar a la luz como si consistiera en partículas de materia que se comportan de alguna manera como pequeñas bolas de ping-pong. Sin embargo, la luz exhibe interferencia y difracción, sugiriendo un modelo que involucra ondas. Estos modelos mecánicos fueron útiles durante un tiempo, pero a la larga demostraron ser demasiado limitados. Con todo, la búsqueda de estos modelos llevó a muchos nuevos descubrimientos, que a su vez provocaron cambios importantes en la ciencia, la tecnología y la sociedad.

En términos más básicos posibles, la luz es una forma de energía. El físico puede describir un haz de luz estableciendo valores para su velocidad, longitud de onda o frecuencia e intensidad. Pero para los científicos, como para todas las personas, “luz” también significa brillo y sombra, la belleza de las flores de verano y las hojas del otoño, de las puestas de sol rojas y de los lienzos pintados por los grandes maestros. Son formas diferentes de apreciar la luz. La primera se concentra en los aspectos mensurables de la luz, un enfoque enormemente fructífero en física y tecnología. La otra forma se refiere a las respuestas estéticas ante la luz en la naturaleza o el arte. Otra forma de considerar la luz es el proceso neuro-biofísico de la visión. E incluso otra más es la consideración filosófica de nuestra propia y personal interpretación de los efectos de la luz en nosotros a consecuencia de estos procesos.

Estos aspectos de la luz no se separan fácilmente. Así, en la historia temprana de la ciencia, la luz presentaba problemas más sutiles y más esquivos que la mayoría de los otros aspectos de la experiencia física. Algunos filósofos griegos creían que la luz viaja en línea recta a alta velocidad y contiene partículas que estimulan el sentido de la visión cuando entran en el ojo. Durante siglos después de la era griega, este modelo de partículas sobrevivió casi intacto. Alrededor de 1500, Leonardo da Vinci, observando una similitud entre los ecos del sonido y el reflejo de la luz, especuló que la luz podría ser una onda.

La filosofía de la naturaleza, y los filósofos, se dividió en dos bandos a cuenta de la naturaleza de la luz durante el siglo XVII. Algunos, incluido Newton, favorecieron un modelo basado en gran medida en la idea de la luz como una corriente de partículas. Otros, incluido Huygens, apoyaron un modelo de onda. A finales del siglo XIX, parecía haber pruebas incontrovertibles que apoyaban el modelo de onda. De ahí que en próximas entregas abordemos la cuestión: ¿hasta qué punto un modelo de onda explica el comportamiento observado de la luz? El modelo de onda se tomará como una hipótesis y examinaremos las pruebas que lo respaldan. Veremos que el modelo de onda funciona espléndidamente para todas las propiedades de la luz conocidas antes del siglo XX. En una próxima serie veremos que para otros fenómenos es necesario usar un modelo de partículas y que, finalmente, la física actual adopta una solución salomónica, completamente anti-intuitiva, en lo que conocemos como mecánica cuántica.

En próximas entregas de esta serie, pues, veremos los distintos aspectos de la luz. Ya hemos mencionado la antigua opinión, más tarde probada experimentalmente, de que la luz viaja en línea recta y a alta velocidad. El uso diario de los espejos muestra que la luz también puede reflejarse. La luz también puede refractarse y muestra los fenómenos de interferencia y difracción, así como otros fenómenos característicos de las ondas, como la polarización y la dispersión. Todas estas características son las que prestaron un fuerte apoyo al modelo de onda de la luz.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La luz como onda se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Por qué en Alemania los lobos se sienten más seguros en territorio militar

Lobo euroasiático en Noruega. Imagen: Wikimedia Commons

Lobo euroasiático en Noruega. Imagen: Wikimedia CommonsEs la de los lobos una historia trágica en Europa, donde fueron empujados casi a la extinción durante el siglo XX. Su convivencia con una sociedad que dependía de la ganadería para sobrevivir se convirtió en algo casi imposible y poco deseable incluso para muchos que, con la intención de defender su modo de vida, prácticamente acabaron con ellos en el continente. Su imagen pública contribuyó a que esto no le pareciese del todo mal a casi nadie. Poco importa que sean un antecesor del perro, el mejor amigo del hombre, porque también son el malo en muchos cuentos infantiles populares. “El hombre es un lobo para el hombre”, decimos cuando nos referimos a la maldad entre humanos. Qué pobre metáfora para el lobo.

Frente a esto, el lobo ha mostrado ciertas capacidades admirables, y una de ellas se su habilidad para la resistencia, la adaptabilidad y la reconquista de sus territorios perdidos. Tras prácticamente desaparecer de Europa, en las últimas décadas el lobo está volviendo y ya cuenta con poblaciones silvestres que suman unos cuantos miles de ejemplares. Cambios en la legislación y en la opinión pública hacia la conservación, también la de los grandes carnívoros, así como un abandono de los entornos rurales que está permitiendo más y mayores manadas de hervíboros, son parte de la causa.

El caso de Alemania

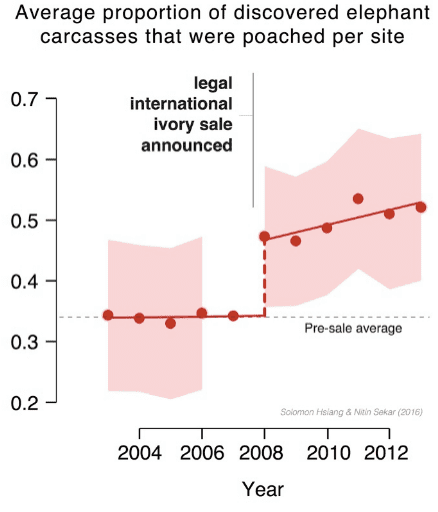

En Alemania en concreto, donde los lobos fueron erradicados durante el siglo XIX, se ha observado un incremento del 36% anual en el número de lobos entre 2000 y 2015, y un reciente estudio ha podido observar que las áreas en torno a las bases militares han jugado un papel central en su crecimiento. Esas zonas han servido como lugares para la avanzadilla de esta recolonización, mucho más que las áreas protegidas de carácter civil, según ese estudio, publicado en la revista Conservation Letters y del que se hace eco Science.

Igual que en muchas otras zonas de Europa central, Alemania instauró leyes de protección de la biodiversidad en los años 80 y 90, poniendo las bases de la recuperación del lobo y su hábitat. El abandono de los entornos rurales y de las tierras de cultivo también suponía una ventaja para estos animales: menos humanos y más caza. A finales de los 90, los lobos comenzaron a retornar al país desde los bosques de Polonia. Durante varios años solo eran detectados ya muertos a manos de un cazador o por un atropello, pero en 2001 se registró el nacimiento de la primera camada de lobos en la región de Sajonia-Brandenburgo, y desde entonces se han expandido al menos a otros seis estados alemanes.

Su éxito en la reentrada es un ejemplo de su éxito adaptándose a nuevos entornos, así como de su carácter explorador de nuevos territorios. Resulta especialmente llamativo que en esa exploración, las bases militares y sus áreas alrededor les resulten especialmente atractivas. Según los resultados de esos estudios, la primera pareja de lobos que se encuentra en un nuevo estado, lo hace siempre en territorio de entrenamiento militar, así como la segunda y normalmente también la tercera. Después de eso, las siguientes parejas se van encontrando en áreas civiles protegidas y otros hábitats.

Fue precisamente en terrenos del ejército donde nacieron los lobeznos de 2001. Los oficiales pudieron observar primero a una pareja de lobos, probablemente llegados del oeste de Polonia, y en el verano cómo estaban acompañados de cuatro cachorros. Poco después aparecieron otros dos pequeños. Eran los primeros lobos nacidos en Alemania en más de un siglo.

Por qué en zonas militares

¿Por qué ese gusto por los terrenos pertenecientes al ejército? Según los investigadores, no hay indicadores de que esos hábitats fuesen mejores que otras reservas naturales en cuanto a la densidad forestal o de carreteras, pero al comparar las tasas de mortalidad, descubrieron sorprendidos que éstas eran más altas en las zonas de protección civil que en las de entrenamiento en las bases militares.

La clave es la caza ilegal. Las áreas de entrenamiento del ejército no están valladas, lo cual quiere decir que lobos y ciervos (sus presas) pueden entrar y salir a voluntad, pero sí están señalizadas y cerradas al público. En su interior las poblaciones de ciervos y similares son controladas por agentes forestales federales y la caza privada está estrictamente regulada. Eso supone menos oportunidades para la caza ilegal de lobos.

Lobos ibéricos, subespecie endémica de la península ibérica. Imagen: Wikimedia Commons.

Lobos ibéricos, subespecie endémica de la península ibérica. Imagen: Wikimedia Commons.Sin embargo, en otros espacios las poblaciones de ciervos y su regulación están en manos privadas. Suelen ser áreas más pequeñas con mayor movimiento de cazadores, así que hay una mayor probabilidad de que alguien con inquina a los lobos (siguen teniendo mala imagen para mucha gente, y al fin y al cabo se les puede considerar competidores en la caza) se encuentre con uno y le dispare.

Mantener esas áreas de conservación

A día de hoy, explica Ilka Reinhardt, bióloga del Instituto Alemán de Monitorización e Investigación del Lobo, la caza ilegal no es una gran amenaza para las poblaciones de lobos, que son lo suficientemente numerosas en la mayoría de las regiones de Alemania donde están presentes como para soportar algunas muertes puntuales, pero sí que ha podido ser un impedimento para que las primeras parejas que llegaron se asentasen en reservas naturales civiles.

Por eso, esta investigadora y sus colegas proponen que cuando esas zonas militares sean reasignadas a otros usos, se conviertan en grandes reservas naturales que mantengan sus estrictas regulaciones cinegéticas, ya que, sin pretenderlo, han actuado como áreas de conservación de la biodiversidad de forma más eficaz que otras que sí tenían en principio ese objetivo.

Referencias:

Wolves reappear in Germany – Science

Military training areas facilitate the recolonization of wolves in Germany – Conservation Letters

Germany’s wolves are on the rise thanks to a surprising ally: the military – Science

El artículo Por qué en Alemania los lobos se sienten más seguros en territorio militar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cómo sienten y piensan los bilingües?

- El territorio económico de los cazadores-recolectores del Paleolítico Superior

- Los parabenos usados en cosmética son seguros

En busca de la identidad personal

Imagen: Pixabay

Imagen: PixabayPara los adolescentes, la aceptación por el grupo del que se consideran parte es de importancia capital. Tienen una gran preocupación por la imagen que proyectan, sobre todo hacia quienes forman su círculo social. Por esa razón se avergüenzan con facilidad, incluso, por el mero hecho de saberse observados.

Sufren más que niños y adultos al sentirse excluidos de un grupo, y ese sufrimiento tiene un correlato neurológico. Cuando un adulto se siente excluido, se activan las áreas del encéfalo implicadas en la percepción del dolor, el enfado y el disgusto, sí, pero a continuación se activa una zona de la corteza cerebral que relativiza la importancia de la exclusión. En adolescentes, sin embargo, esta última zona apenas se activa, y las anteriores lo hacen en mayor medida que en niños y adultos. Por tanto, no debe extrañar que los amigos tengan un gran ascendiente sobre ellos.

En ninguna otra etapa de la vida importan tanto las amistades como en la adolescencia, ni se otorga tanta importancia a sus opiniones como en esos años. Por eso, los adolescentes asumen más riesgos en presencia de amigos que cuando están solos. Es más, el circuito de recompensa encefálico se activa más y las regiones cerebrales implicadas en el autocontrol responden en menor medida cuando están en compañía de amigos; en los adultos no se observa eso. Y es que los adolescentes experimentan una fuerte necesidad de pertenencia al grupo, y por esa razón sus decisiones se ven muy afectadas por la presencia de sus “colegas”.

Hasta la pubertad, el comportamiento prosocial es bastante indiscriminado. Sin embargo, entre los 16 y los 18 años se va haciendo más selectivo. Los amigos pasan a ser los máximos beneficiados en confianza, reciprocidad y generosidad. En otras palabras, los adolescentes dan cada vez más importancia a la identidad de las personas con las que se relacionan, probablemente por las mismas razones por las que les valoran cada vez más su propia identidad y cómo les ven los demás conforme se van considerando miembros de un grupo.

Por otro lado, durante la adolescencia se sigue desarrollando la “teoría de la mente”, esa facultad de adoptar el punto de vista mental de otros individuos que probablemente compartimos con otras especies, como chimpancés, orangutanes y ciertos cuervos. Y de modo similar, la capacidad para la introspección y el análisis del estado mental propio no se desarrolla de forma completa hasta mediada la tercera década de vida. En parte por estas razones, durante esta etapa cambia también la forma en que los adolescentes se relacionan con los demás.

En la niñez no se diferencia con nitidez el daño accidental del intencionado, pero esa distinción se acentúa de la pubertad en adelante. Conforme pasan los años, al presenciar un daño accidental, las áreas del encéfalo que procesan el dolor se activan cada vez menos y, por comparación, al presenciar un daño causado de forma intencionada, se activan cada vez más las áreas de la corteza prefrontal que valoran y hacen juicios. La valoración de la intencionalidad dañina de una acción es el punto de partida de los juicios morales, por lo que durante la adolescencia esos juicios se hacen cada vez más sofisticados.

Como afirma la neuropsicóloga Sarah-Jay Blakemore, durante la adolescencia nos inventamos a nosotros mismos; en eso, precisamente, consiste ser adolescente. Ese largo viaje nos proporciona un sentido de la identidad personal y una comprensión de los demás que nos capacita para, al llegar a la edad adulta, ser independientes de nuestros progenitores y estar más integrados en el grupo de nuestros pares.

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo En busca de la identidad personal se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Blogueando desde la Universidad: una experiencia personal

- “La cultura científica o la misteriosa identidad del señor Gauss” por Raúl Ibáñez

- Planeta X, en busca del inquilino invisible del sistema solar

Otra mirada al planeta: arte y geología

Si cerrásemos los ojos para visualizar la imagen de un geólogo, probablemente imaginaríamos a una persona descubriendo fósiles y recopilando y coleccionando minerales. No obstante, esta disciplina académica cuenta con muchísimas más aplicaciones desconocidas para gran parte de la sociedad.

Con el objetivo de dar visibilidad a esos otros aspectos que también forman parte de este campo científico nacieron las jornadas divulgativas “Abre los ojos y mira lo que pisas: Geología para miopes, poetas y despistados”, que se celebraron los días 22 y 23 de noviembre de 2018 en el Bizkaia Aretoa de la UPV/EHU en Bilbao.

La iniciativa estuvo organizada por miembros de la Sección de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Ente Vasco de la Energía (EVE-EEE), el Departamento de Medio Ambiente, Planificación Territorial y Vivienda del Gobierno Vasco, el Geoparque mundial UNESCO de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

Los invitados, expertos en campos como la arquitectura, el turismo o el cambio climático, se encargaron de mostrar el lado más práctico y aplicado de la geología, así como de visibilizar la importancia de esta ciencia en otros ámbitos de especialización.

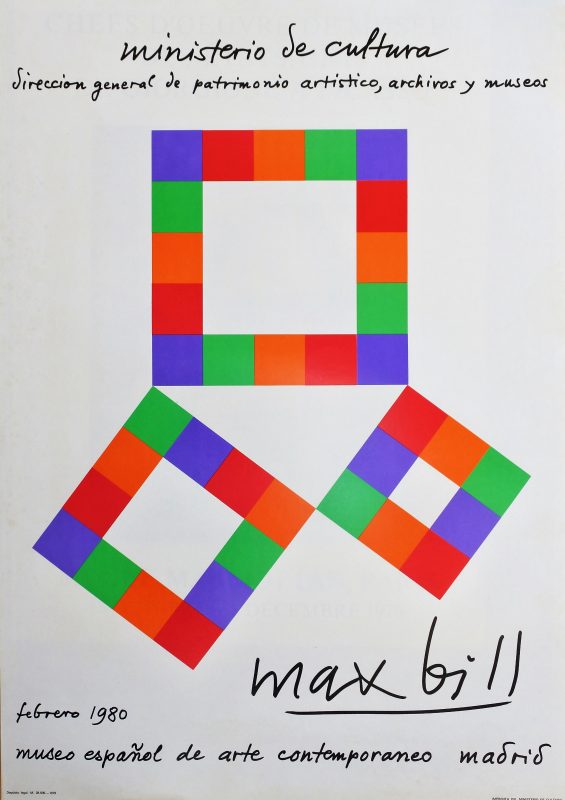

El geólogo Joaquín del Val, autor del blog “Arte y Geología”, analiza la relación existente entre arte contemporáneo y geología. A lo largo de los últimos quince años numerosos artistas han encontrado su fuente de inspiración y creatividad en las ciencias de la Tierra y, en especial, en la geología.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Otra mirada al planeta: arte y geología se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Patrimonio geológico: la otra mitad del ambiente

- Geología: la clave para saber de dónde venimos y hacia dónde vamos

- Arquitectura y geología: materialidad y emplazamiento

En busca del compuesto perdido

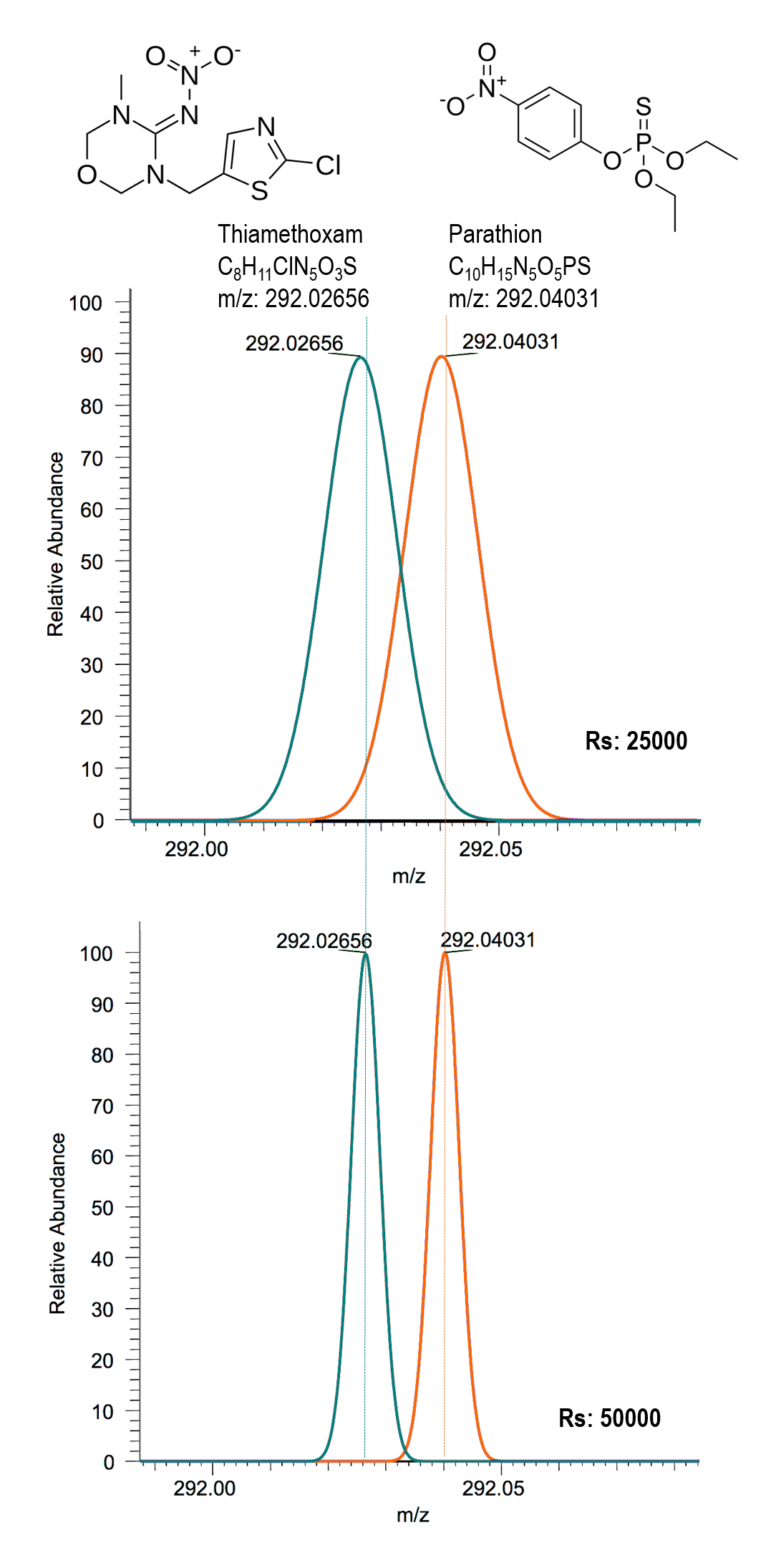

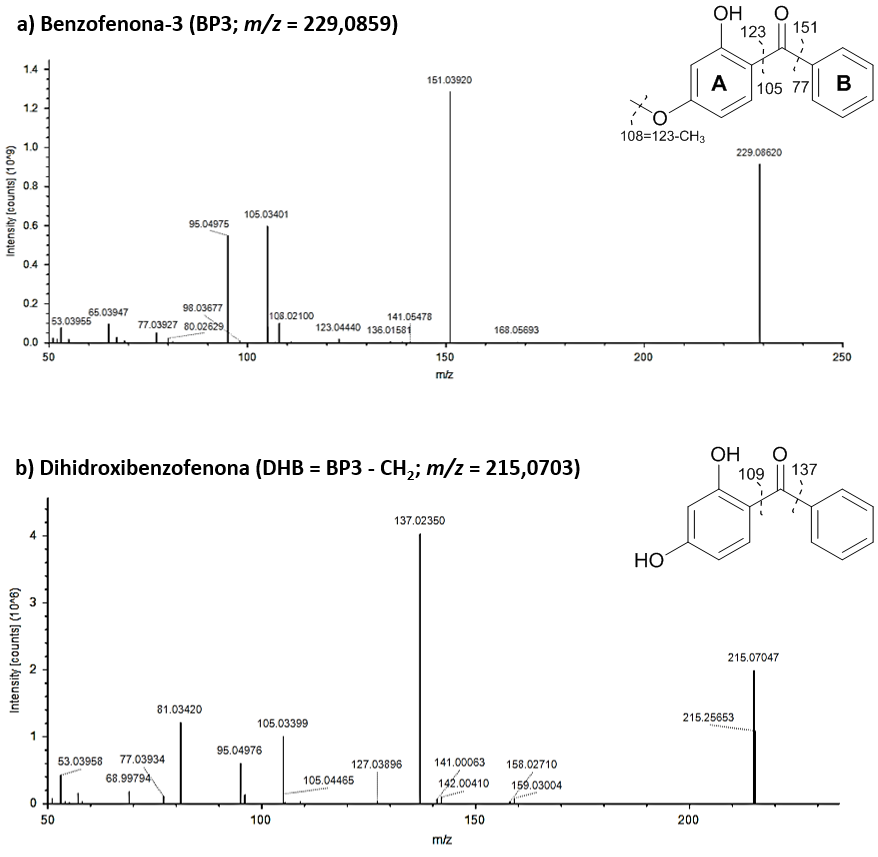

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebrará dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Durante las próximas semanas en el Cuaderno de Cultura Científica y en Zientzia Kaiera se publicarán regularmente artículos que narren algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas. Comenzamos con la serie “Espectrometría de masas”, técnica analítica que supone el ejemplo perfecto del incesante avance de la Ciencia y la Tecnología.

Las series de policías e investigadores han puesto en nuestras vidas el laboratorio científico y con él, la espectrometría de masas. La realidad es algo diferente a la ficción, pero en ambos casos es cierto que la espectrometría de masas es una técnica muy habitual cuando se trata de buscar moléculas, tanto si sabemos lo que estamos buscando como si no.

Pondré un ejemplo en el que la espectrometría de masas ha sido una técnica clave. Todos sabemos que está prohibido conducir bajo los efectos de sustancias estupefacientes. En caso de sospecha o simplemente en un control rutinario se realiza un test “in situ”. Se toma una muestra de saliva y mediante una reaccion enzimática (inmunoensayo) se obtendrá un resultado positivo o negativo. En ocasiones, moléculas similares a las buscadas pero que podrían no estar prohibidas presentan reactividades cruzadas, por lo que los resultados positivos se confirman en el laboratorio, principalmente mediante espectrometría de masas. En estos casos es importante corroborar la identidad de la molécula (lo que se conoce como análisis cualitativo). En segundo lugar, se procede al análisis cuantitativo, es decir, a calcular la concentración del compuesto en el organismo.

¿Pero qué sucede si el resultado del primer test es negativo, pero el comportamiento del individuo indica claramente el consumo de algún tipo de droga? En este caso hay que poner a trabajar la mente y la maquinaria científica.

Hace algunos años, irrumpieron en el mercado unas mezclas de plantas, declaradas como incienso, que fumadas, provocaban efectos similares a los del cannabis (Imagen 1). A pesar de que la policía había detectado el consumo de estos productos, no se encontraban en ellos ninguna de las drogas incluídas en los analísis de rutina de los laboratorios de toxicología forense. Después de que un par de adolescentes acabaran en urgencias estaba claro que teníamos que cambiar la estrategia de búsqueda.

Imagen 1. Un sobre de Spice, mezcla de plantas empleada como “incienso”. Fuente: Wikimedia Commons.

Imagen 1. Un sobre de Spice, mezcla de plantas empleada como “incienso”. Fuente: Wikimedia Commons.En la mayoría de los laboratorios de toxicología los análisis de basan en una estrategía de tipo dirigido (“target”), es decir, sólo se ve lo que se busca. Traducido al idioma de la espectrometría de masas significa que el instrumento solo registra las relaciones masa/carga (m/z) que nosotros hayamos incluído en el método de análisis. Para todo lo demás, el instrumento es ciego. Esta es la principal desventaja de esta estrategia. La principal ventaja es la sensibilidad, es decir, así alcanzamos a detectar compuestos en concentraciones más bajas y evitar falsos resultados negativos.

Punto uno: abrir horizontes

Partiendo de la base de que se nos estaba escapando algo, conseguimos concentrar una muestra del extracto de las plantas y utilizamos un modo de análisis no dirigido con el que, gracias a la espectrometría de masas, pudiésemos encontrar compuestos que el modo dirigido nos impedía ver.

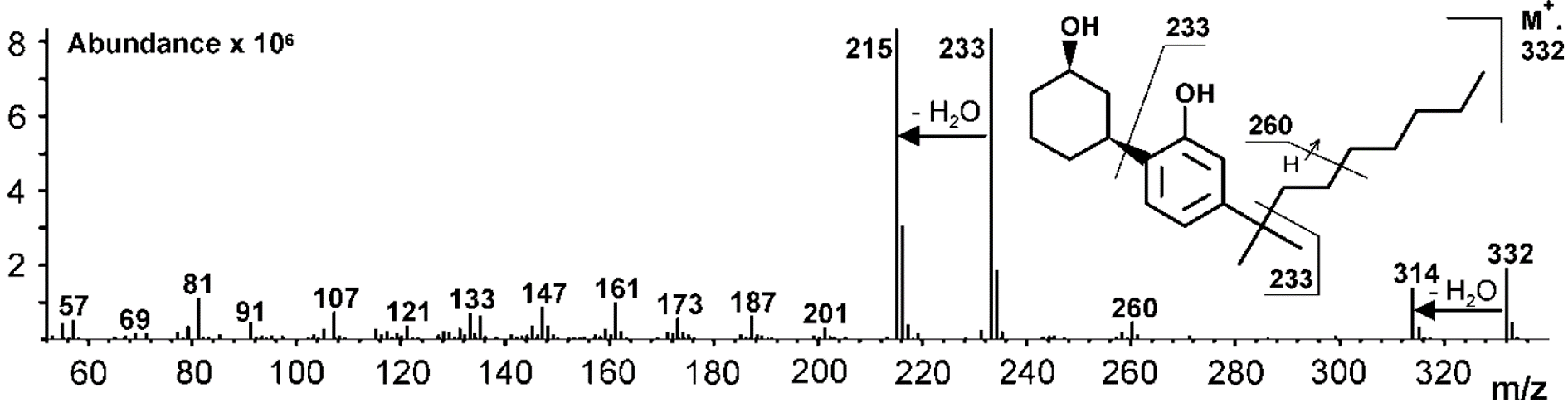

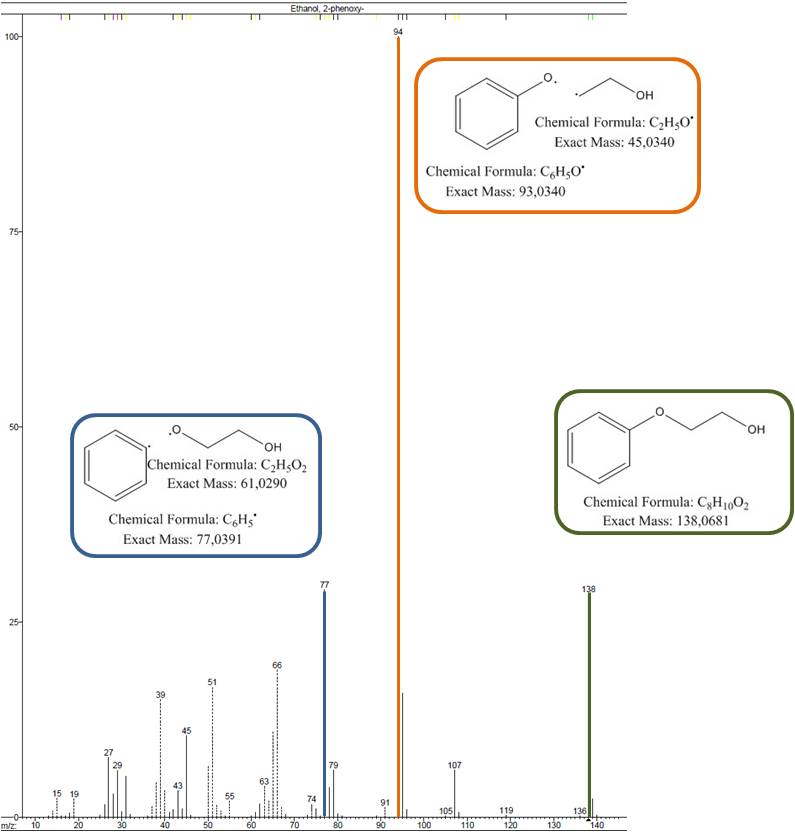

Comparando los espectros de masas, que son como la huella dactilar de una molécula (Imagen 2). pudimos identificar algunos de los compuestos mayoritarios. Para otros, en cambio, fue necesario usar información complementaria como la resonancia magnética nuclear. Gracias a estos análisis, se pudo comprobar que en esa mezcla de incienso había cannabinoides sintéticos, que en muchos casos habían sido desarrollados por la industria farmaceútica, pero no habían llegado al mercado de los medicamentos por diferentes razones. Estas sustancias producen efectos similares a los del cannabis pero no estaban incluídas en ninguna base de datos y por eso pasaban totalmente desapercibidas en los análisis rutinarios. Además, no existían datos sobre toxicidad o efectos secundarios.

Imagen 2. Espectro de masas del cannabinoide sintético CP 47,497. Fuente: Laboratorio de toxicología forense, Freiburg, Alemania.

Imagen 2. Espectro de masas del cannabinoide sintético CP 47,497. Fuente: Laboratorio de toxicología forense, Freiburg, Alemania.

Punto dos: definir nuevas metas

Una molécula interactúa con su receptor mediante una unión de tipo llave-cerradura. Esto quiere decir que, conociendo la parte estructural que interactúa con el receptor, se pueden realizar cambios en el resto de la molécula manteniendo su función. En este principio se basa el desarrollo de fármacos y la mayoría de modificaciones van destinadas a aumentar la solubilidad, la permeabilidad o mejorar la farmacocinética. Sin embargo, en el caso de los cannabinoides sintéticos usados en estos “inciensos”, esos cambios consiguen que, manteniendo el efecto sobre el sistema nervioso central, las moléculas no sean detectadas en los análisis rutinarios. El peligro de estas modificaciones radica en la posibilidad de potenciar los efectos centrales de estas sustancias y en la falta de estudios toxicocinéticos. Y aquí vuelve a entrar en juego la espectrometría de masas. Es necesario cuantificar estas sustancias y correlacionar estas concentraciones con los efectos que experimentan los consumidores.

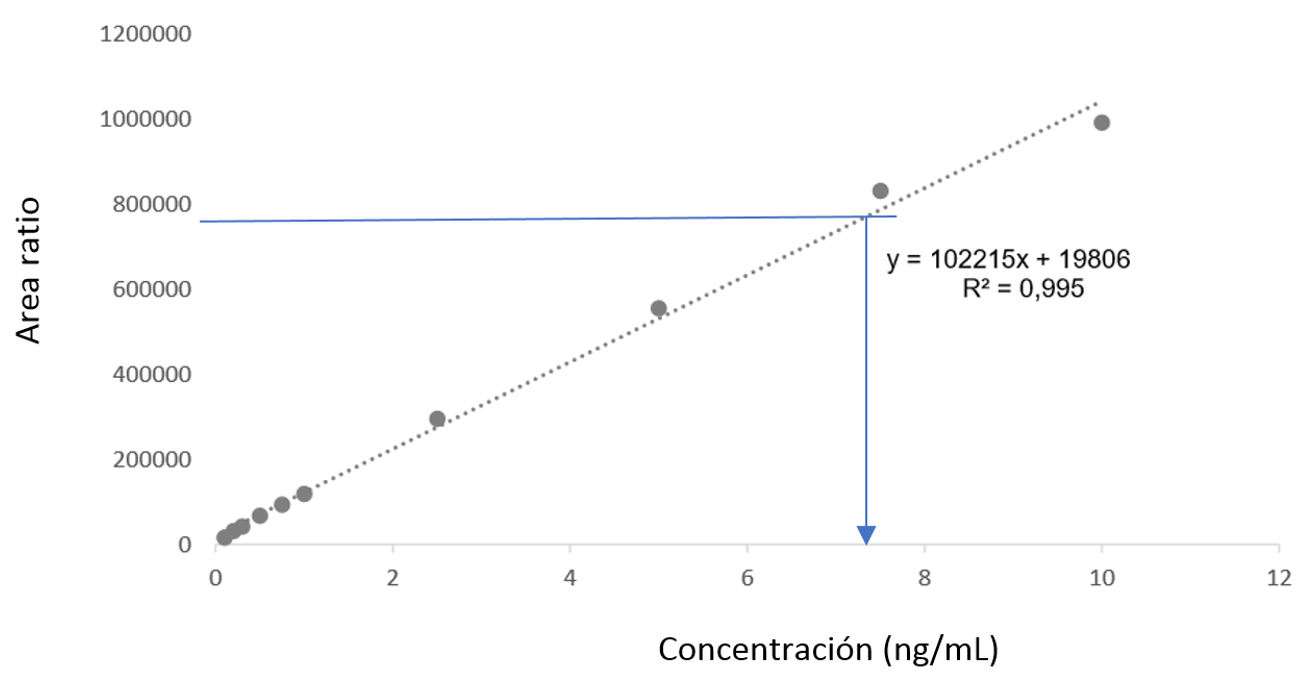

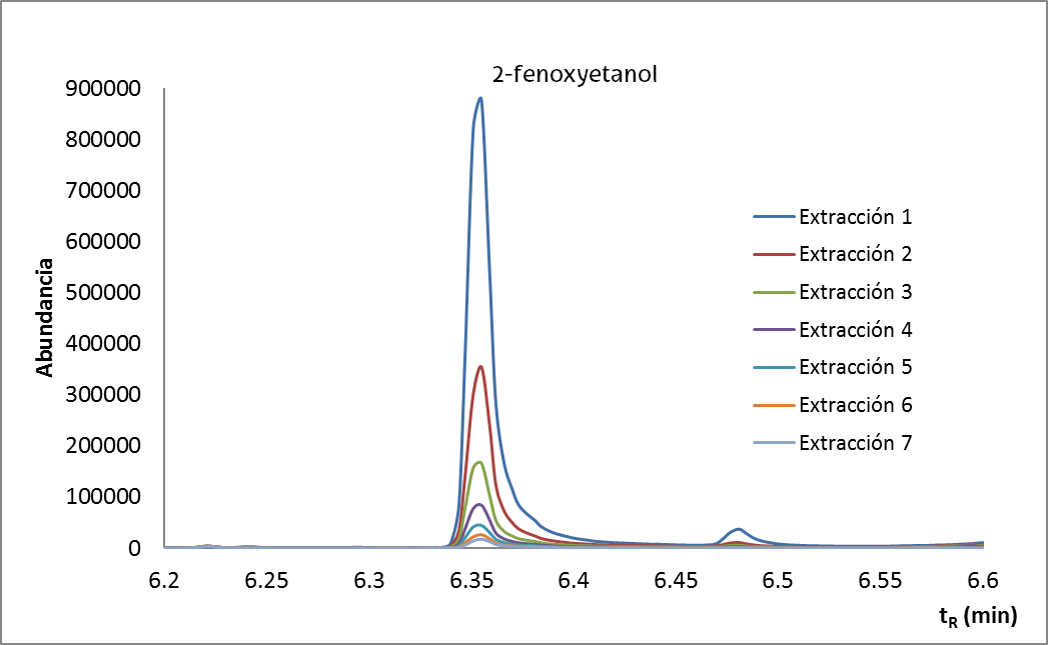

Para poder calcular la concentración de un compuesto es necesario construir una curva de calibrado. En ésta se representa gráficamente la señal obtenida para una seria de muestras en función de la concentración del compuesto en esas muestras (que nosotros hemos elegido y preparado). En espectrometría de masas la construcción de la curva de calibrado es un poco más compleja, ya que es necesaria la adición de otra sustancia (el estándar interno) para corregir efectos de la técnica. Así, conociendo la señal obtenida para una muestra de concentración desconocida se puede obtener el valor de su concentración (flecha azul). En el caso de los cannabinoides sintéticos, calcular las concentraciones es una forma de relacionar dosis y efectos de estas sustancias en el organismo y evaluar su perfil toxicocinético, es decir, a partir de qué concentraciones comienzan los efectos tóxicos y con qué velocidad el cuerpo humano es capaz de eliminarlos del organismo.

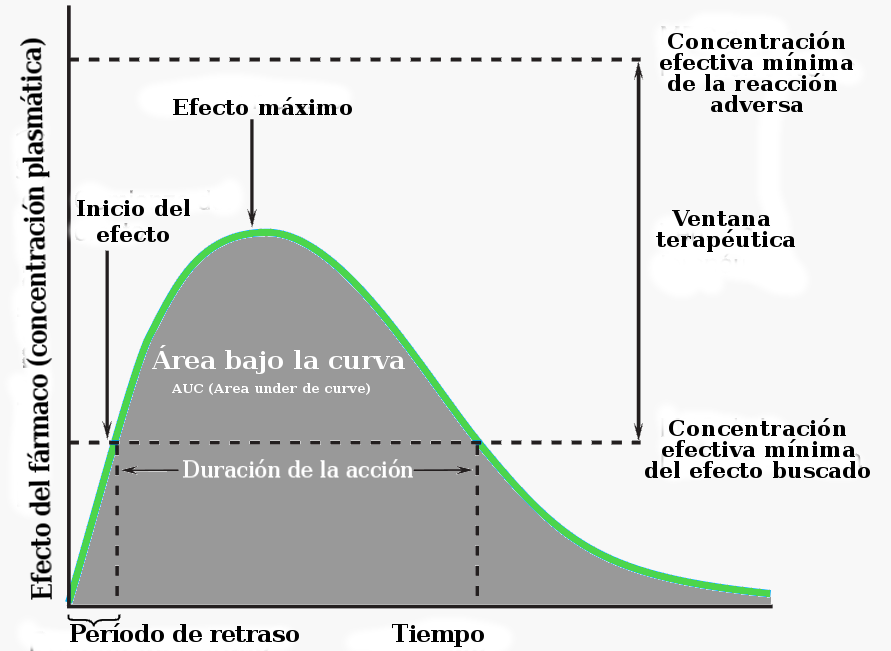

Imagen 3. Ejemplo de curva de calibrado. Fuente: Nerea Ferreirós.

Imagen 3. Ejemplo de curva de calibrado. Fuente: Nerea Ferreirós.La espectrometría de masas se emplea también en el desarrollo de medicamentos para establecer los perfiles farmacocinéticos de las sustancias objeto de estudio. O lo que es lo mismo: qué le pasa a un fármaco desde el momento en que entra en contacto con el organismo (por vía oral, parenteral…) hasta su eliminación del mismo. Hay que recordar que un fármaco es activo mientras sus concentraciones en sangre permanezcan dentro de una determinada ventana terapeutica. Concentraciones menores al límite inferior de la ventana implican inactividad y mayores, toxicidad.

De igual modo que se monitorizan las constantes vitales, se pueden monitorizar las concentraciones de los medicamentos en los pacientes. En la práctica clínica es un proceso habitual para estimar las dosis adecuadas de los medicamentos, sobre todo para compuestos con una estrecha ventana terapéutica o en casos en los que la respuesta del paciente no es la esperada. La monitorización de fármacos es un proceso indispensable en el desarrollo de medicamentos, antes de que puedan ser comercializados. También permite construir perfiles farmacocinéticos, es decir, medir las concentraciones en sangre de un determinado compuesto desde la aplicación hasta la eliminación, que permiten conocer parámetros indispensables (Imagen 4) para comprender su comportamiento. Para ello se emplea mayoritariamente la espectrometría de masas por la selectividad y sensibilidad que aporta. Además permite el desarrollo de métodos rápidos y robustos de análisis. Este conocimiento es esencial para poder utilizar los medicamentos o cualquier otro tipo de sustancias de forma segura.

Imagen 4. Curva farmacocinética. Fuente: Wikimedia Commons.

Imagen 4. Curva farmacocinética. Fuente: Wikimedia Commons.

Punto tres: buscar una aguja en un pajar

No sólo es importante saber qué buscar, sino que en muchos casos es necesario determinar mínimas cantidades de los compuestos a analizar, sobre todo en el caso de compuestos de elevada potencia. Un resultado positivo o negativo, por ejemplo en casos de consumo de drogas al volante, va a determinar el tipo y la cuantía del castigo. Lo mismo pasa en el deporte. La aparición de sustancias prohibidas es indicativo de dopaje, con sus múltiples consecuencias. Por todo ello, la cuantificación de sustancias tiene que ser lo más fiable posible y poder medir concentraciones, que en algunos casos, rondan los límites que permite la tecnología. Y la espectrometría de masas es una técnica de análisis selectiva y que permite determinar concentraciones del orden de las partes por billón, dependiendo de los compuestos a analizar y la matriz en la que se encuentran. Para que nos hagamos una idea, sería como encontrar un determinado grano en un metro cúbico de arena.

En definitiva, se puede afirmar que los espectrómetros de masas son los ojos del investigador para poder ver todos esos compuestos perdidos, los que aún no conocemos y los que sí, para obtener información que nos ayude a entender mejor diferentes procesos y a dar respuesta a múltiples preguntas, permitiendo el avance del conocimiento científico.

Sobre la autora: Nerea Ferreirós Bouzas se doctoró en la Facultad de Ciencia y Tecnología de la UPV/EHU y es investigadora en el Instituto de Farmacología Clínica de la Goethe-Universität de Fráncfort del Meno, Alemania.

El artículo En busca del compuesto perdido se ha escrito en Cuaderno de Cultura Científica.

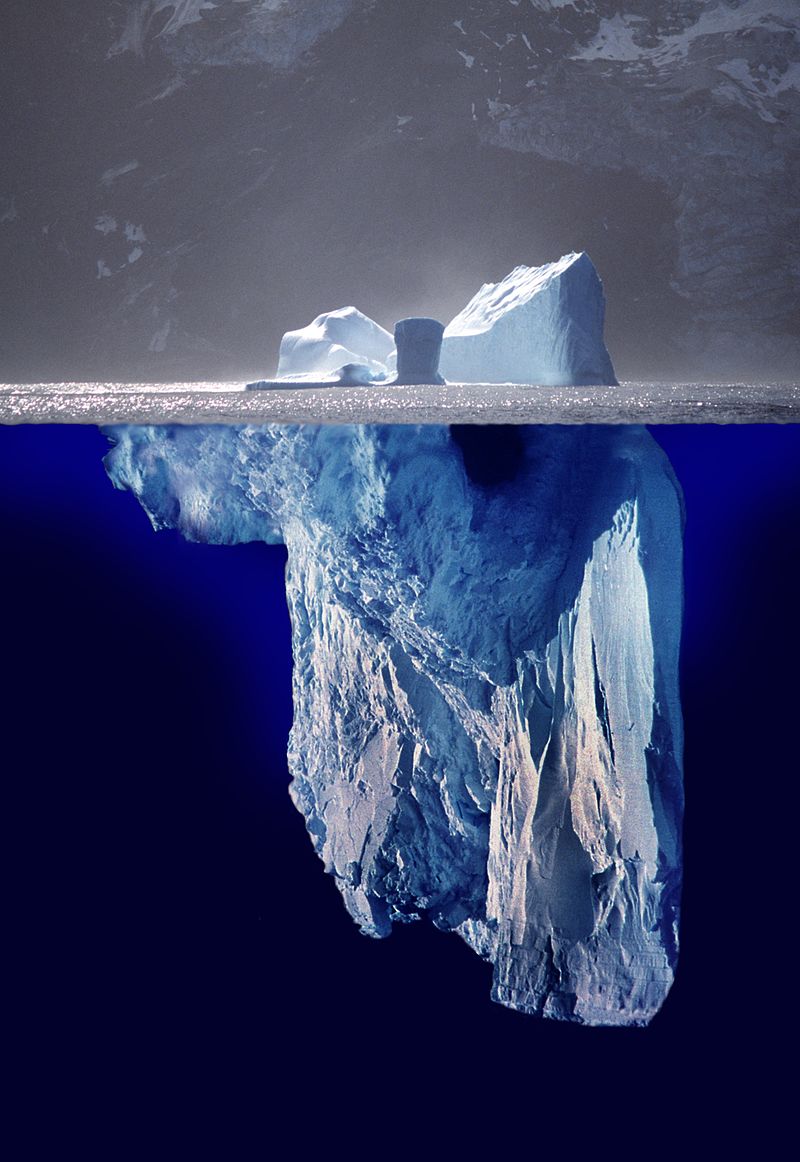

Entradas relacionadas:- ¿Quién se encuentra en el lado oculto del iceberg?

- Espectrometría de masas: de un isótopo de neón a elefantes que vuelan

- A new hero is born: La espectrometría de masas al servicio de la justicia

Experimentación y evidencia: dos visiones opuestas

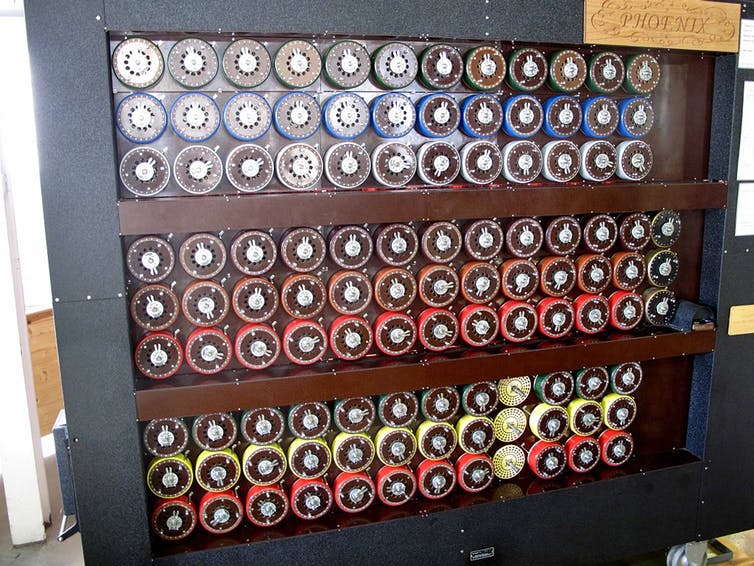

La aproximación que tuvo éxito a la hora de descifrar las comunicaciones alemanas durante la Segunda Guerra Mundial se basaba en el teorema de Bayes no en la frecuencia pura de las señales. En la imagen, reproducción de “la bomba”, la máquina que permitía descifrar los mensajes de Enigma, el sistema de codificación alemán. Fuente: Ted Coles/Wikimedia

La aproximación que tuvo éxito a la hora de descifrar las comunicaciones alemanas durante la Segunda Guerra Mundial se basaba en el teorema de Bayes no en la frecuencia pura de las señales. En la imagen, reproducción de “la bomba”, la máquina que permitía descifrar los mensajes de Enigma, el sistema de codificación alemán. Fuente: Ted Coles/Wikimedia

Anteriormente, hablábamos de estándares de evidencia científica y del problema filosófico de la inferencia inductiva; de cómo Ronald Fisher, hace un siglo, promovió métodos —como los contrastes de hipótesis— que evaden el problema, y adelantábamos que dichos métodos suponen una aproximación frecuentista a la realidad. A continuación abundaremos en el problema metodológico que plantean la medida y la estimación estadística de la (in)certidumbre, y que tiene su raíz en el concepto mismo de probabilidad. Esto da lugar a dos visiones opuestas aunque, como veremos, estrechamente relacionadas, lo que en estadística se denomina frecuentismo vs. bayesianismo.

La probabilidad, en su definición más básica, es una medida de la certidumbre asociada a un suceso futuro. Aquí por suceso entendemos eventos que bien pueden ser simples, como la probabilidad de obtener “cara” al lanzar una moneda, o complejos, como la probabilidad de que un jugador de fútbol marque un penalti. Esta es la única definición operativa para la aproximación frecuentista, en la que la probabilidad de un suceso es simplemente la frecuencia relativa de dicho suceso cuando el experimento se repite infinitas veces. Es decir, si tirásemos infinitas veces una moneda ideal, obtendríamos “cara” la mitad de las veces, por lo que decimos que la probabilidad de “cara” (dada una moneda ideal) es de 0.5.

Por tanto, la aproximación frecuentista se dedica a responder a Pr(D | H), esto es, la probabilidad de ciertos datos asumiendo cierta hipótesis: ¿es normal obtener 58 caras y 42 cruces en 100 lanzamientos si la moneda no está trucada? Las limitaciones saltan a la vista: ¿qué me dice esto respecto a asumir que la moneda está trucada?, ¿cómo de trucada?, ¿cómo cambia mi conocimiento sobre esta cuestión si hago otros 100 lanzamientos y obtengo, por ejemplo, 47 caras y 53 cruces? Como vimos al hablar de p-valores, lo más a lo que podemos aspirar es a rechazar que no esté trucada, y si no lo logramos, no obtenemos ninguna información.

¿Podemos hacerlo mejor? Así lo afirma la aproximación bayesiana. Para ello, necesitamos extender la definición de probabilidad, que ahora pasa a ser la certidumbre asociada a una hipótesis dada cierta evidencia disponible: ¿qué certidumbre tengo de que la moneda (no) está trucada si obtengo 58 caras y 42 cruces en 100 lanzamientos? Dicho de otra manera, el enfoque bayesiano se ocupa de Pr(H | D), de las preguntas de la ciencia. No obstante, resulta paradójico que ambas corrientes —deductiva vs. inductiva— se encuentren irreconciliablemente unidas mediante un resultado fundamental de teoría de la probabilidad: el teorema de Bayes.

![]()

La probabilidad frecuentista se transforma en la probabilidad bayesiana, o a posteriori, simplemente multiplicando por Pr(H), que no es otra cosa que la información a priori que disponemos del problema en cuestión. La inclusión de este factor, que no está exento de sutilezas, pone muy nerviosos a los frecuentistas, ya que lo ven como una fuente de subjetividad y de sesgos que no tiene lugar en un análisis estadístico. A esto, los bayesianos replican que el frecuentismo no soluciona este problema, sino que simplemente evita la pregunta.

Así pues, el enfoque frecuentista puede verse como un caso particular del bayesiano con un conjunto de suposiciones implícitas que no son necesariamente buenas. Por el contrario, a través del teorema de Bayes se hace explícita esta elección, lo que da enormes ventajas tanto filosóficas (se responde directamente a la pregunta que nos interesa) como metodológicas (por ejemplo, es sencillo y directo actualizar mi grado certidumbre sobre la hipótesis cuando obtengo nuevos datos o nueva información), ventajas que se hacen más evidentes cuando las preguntas que nos hacemos y los modelos que planteamos son más y más complejos.

Entonces, ¿cuál es la moraleja? ¿Es el frecuentismo erróneo? No necesariamente. Pero sí es cierto que sus métodos, numerosos y diversos, se prestan con más facilidad a una elección, uso o interpretación incorrectos, incluso entre expertos, y en determinados contextos esto lleva a conclusiones erróneas. Es por ello que muchos de sus detractores lo consideran perjudicial para la ciencia y promueven el bayesianismo como solución. No obstante, hoy en día, todavía los cursos introductorios a la estadística de cualquier carrera universitaria siguen siendo superficialmente frecuentistas.

Sobre el autor: Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute

El artículo Experimentación y evidencia: dos visiones opuestas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Prohibir los herbicidas con glifosato es anteponer la ideología a la evidencia científica

- Galileo vs. Iglesia Católica redux (VI): Visiones

- Algunas visiones en filosofía de la ciencia sobre sus valores

La notación polaca, la de Jan Łukasiewicz

La notaciones de prefijo (o polaca, en homenaje a Jan Łukasiewicz), de infijo y de postfijo (o polaca inversa) son formas de escritura de expresiones algebraicas que se diferencian por la posición relativa que toman los operadores y los operandos. En la notación de prefijo, el operador se escribe delante de los operandos (+ 3 4), entre los operandos en la notación de infijo (3 + 4) y tras los operandos en la de posfijo (3 4 +).

La notación de prefijo fue propuesta en 1924 por el matemático, lógico y filósofo polaco Jan Łukasiewicz (1878-1956), de allí el nombre alternativo por la que se conoce.

Jan Łukasiewicz. Imagen: Wikimedia Commons.

Jan Łukasiewicz. Imagen: Wikimedia Commons.Al igual que la de postfijo, la notación polaca permite prescindir de los paréntesis en el caso de operadores de aridad fija conocida. Por ejemplo, la operación 5 * (12 + 4).puede escribirse en prefijo como: * 5 (+ 12 4); o sencillamente: * 5 + 12 4 (y como 5 12 4 + *en postfijo).

Łukasiewicz introdujo esta notación con la intención de simplificar la lógica proposicional. El matemático y lógico Alonzo Church la mencionaba en su libro clásico Introduction to Mathematical Logic (1956) como una notación digna de observación. Aunque dejó pronto de utilizarse en lógica, encontró su lugar en las ciencias de la computación. Por ejemplo, el lenguaje de programación LISP basa precisamente su sintaxis en la notación polaca.

Las calculadoras Hewlett-Packard usan la notación polaca inversa, económica en número de entradas, pero que requiere un esfuerzo adicional para la interpretación del resultado. Esta empresa utilizó este sistema por primera vez en 1968, en la calculadora de sobremesa HP-9100A. Y fue también ésta la notación de la primera calculadora científica de bolsillo, la HP-35, usada entre 1972 y 1975.

La HP9100A y la HP-35. Creada con imágenes de Wikimedia Commons.

La HP9100A y la HP-35. Creada con imágenes de Wikimedia Commons.En ciencias de la computación, la notación de postfijo se usa en lenguajes de programación orientados a pila y en sistemas basados en tuberías.

Pero volvamos, para finalizar, a Jan Łukasiewicz, al que rendimos hoy homenaje porque falleció un 13 de febrero, en Dublin, donde emigró tras la Segunda Guerra Mundial.

Como ya hemos comentado, trabajó fundamentalmente en lógica proposicional, sistema formal en el que pensaba realizar innovaciones. Estudió los sistemas axiomáticos de la lógica e impulsó las lógicas multivaluadas, dando una interpretación de la lógica modal.

Hoc est falsum (Esto es falso).

No, no, lo que he comentado arriba no es falso. Esta sentencia es la versión de Girolamo Savonarola de la famosa paradoja del mentiroso. Jan Łukasiewicz dio una solución de esta paradoja en los siguientes términos:

Todo principio lógico contiene variables. Estas variables, como las variables en matemáticas, pueden tener varios valores. Existe una ley lógica que dice que todos los principios lógicos se refieren solo a aquellos objetos que pueden ser valores de variables. Se puede demostrar que la frase anterior que contiene la contradicción no puede ser el valor de una variable. Por lo tanto, los principios lógicos no se aplican a esta oración. Esta construcción está fuera de la lógica.

Más información:

-

Jan Lukasiewicz et la notation polonaise inverse, Almanac mathématique

-

O’Connor, John J.; Robertson, Edmund F., Jan Łukasiewicz, MacTutor History of Mathematics archive, University of St Andrews

-

Curriculum Vitae of Jan Łukasiewicz, Metalogicon VII (2), 133-137, 1994

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La notación polaca, la de Jan Łukasiewicz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Sonido (y 2)

Un oficial y un soldado de un regimento de Feldartillerie alemán en 1917. Su equipamiento les permitía detectar la llegada de aviones por el sonido, e identificarlos visualmente gracias a los prismáticos incorporados. Fuente: Rare Historical Photos

Un oficial y un soldado de un regimento de Feldartillerie alemán en 1917. Su equipamiento les permitía detectar la llegada de aviones por el sonido, e identificarlos visualmente gracias a los prismáticos incorporados. Fuente: Rare Historical PhotosSiempre ha sido bastante obvio que el sonido emplea un tiempo para viajar desde la fuente hasta el receptor. Cronometrando los ecos en una distancia conocida, el matemático Marin Mersenne calculó por primera vez en 1640 la velocidad del sonido en el aire. Pasaron otros 70 años antes de que William Derham, comparando el flash y el ruido de los cañones a 20 km de distancia, se acercara a las mediciones modernas. El sonido en el aire al nivel del mar a 20 ° C se mueve a unos 344 m/s. Al igual que para todas las ondas, la velocidad de las ondas de sonido depende de las propiedades del medio: la temperatura, la densidad y la elasticidad. Las ondas de sonido generalmente viajan más rápido en líquidos que en gases, y más rápido todavía en sólidos. En el agua de mar su velocidad es de unos 1500 m/s; en el acero unos 5000 m/s; en el cuarzo unos 5500 m/s.

La interferencia de las ondas de sonido se puede mostrar de varias maneras. Una de las consecuencias de las características de las interferencias es que, en una sala grande con superficies duras que reflejen el sonido, habrá puntos “muertos”. En estos puntos, las ondas de sonido interfieren con las reflejadas, con lo que tienden a cancelarse entre sí. Los ingenieros acústicos deben considerar esto al diseñar la forma, la posición y los materiales de un auditorio.

Otro ejemplo interesante y bastante diferente de la interferencia de sonido es el fenómeno conocido como batimento. Cuando dos notas de frecuencia ligeramente diferente se escuchan juntas, interfieren. Esta interferencia produce batimentos, una pulsión rítmica de la intensidad del sonido (trémolos). Los afinadores de piano y los músicos de instrumentos de cuerda utilizan este hecho para afinar dos cuerdas al mismo tono. Simplemente ajustan una cuerda u otra hasta que los batimentos desaparecen.

La refracción del sonido por diferentes capas de aire explica por qué a veces no se puede escuchar el trueno después de ver un rayo. Una refracción similar del sonido ocurre en capas de agua de diferentes temperaturas. Los geólogos utilizan la refracción de las ondas de sonido para estudiar la estructura profunda de la Tierra y para localizar combustibles fósiles y minerales. Por ejemplo, se crean ondas de sonido muy intensas en el suelo (explosiones de dinamita, por ejemplo). Las ondas de sonido viajan a través de la Tierra y son recibidas por dispositivos de detección en diferentes ubicaciones. La trayectoria de las ondas, al ser refractadas por las capas del terreno, se puede calcular a partir de las intensidades de sonido relativas y los tiempos alas que son recibidas. A partir del conocimiento de las trayectorias se pueden hacer estimaciones de la composición de las capas.

Como exlicamos en su momento, la difracción es una propiedad de las ondas sonoras. Las ondas de sonido doblan las esquinas y barreras para llegar al oyente.

Las ondas sonoras se reflejan, al igual que las ondas en una cuerda o en el agua, cada vez que se encuentran con un límite entre diferentes medios. Las características arquitectónicas llamadas “galerías o gabinetes de secretos” muestran vívidamente cómo se puede enfocar el sonido mediante el reflejo en superficies curvas. Un uso inteligente de la sala de los secretos se atribuye a Juan de Herrera mientras se construía el Real Monasterio y Sitio de San Lorenzo de El Escorial, como puede leerse aquí. Pero ya eran conocidas siglos antes: la de la Alhambra, por ejemplo, data de 1358.

Todos estos efectos son de interés en el estudio de la acústica. Además, el buen diseño acústico de los edificios públicos se reconoce actualmente como una factor importante para distinguir un buen diseño arquitectónico.

Hasta ahora hemos visto los fenómenos básicos de las ondas mecánicas, que terminan con la teoría de la propagación del sonido. Las explicaciones de estos fenómenos se consideraron el triunfo final de la mecánica newtoniana aplicada a la transferencia de energía de las partículas en movimiento. La mayoría de los principios generales de la acústica se descubrieron en la década de 1870. Desde ese momento tal vez su influencia más importante en la física moderna fue su efecto en la mentalidad de las personas de ciencia. Los éxitos de la acústica las alentaron a tomarse en serio el poder del punto de vista ondulatorio, incluso en campos alejados del original: el movimiento mecánico de las partículas que se mueven adelante y atrás o arriba y abajo en un medio. Pero en nada tuvo más importancia que en el estudio de un fenómeno importantísimo: la luz.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Sonido (y 2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Mi hija quiere ser ingeniera

La UNESCO publicó en 2017 el informe Cracking the Code: Girls’ and women’s education in science, technology, engineering and mathematics (STEM), en el que se analizan los factores que dificultan o facilitan la participación, logros y progreso de las mujeres en las disciplinas científicas y tecnológicas, así como las medidas que pueden promover el interés de las chicas en los correspondientes estudios.

Según el informe, la decisión de muchas de ellas de no cursarlos es la consecuencia de un sesgo de auto-selección derivado de las circunstancias en que se han socializado. En la elección de la carrera incidirían estereotipos transmitidos a las niñas consciente o inconscientemente, principalmente en el entorno familiar pero también en contextos sociales más amplios.

Las características del ámbito escolar también parecen ser importantes pues la elección por las chicas de carreras del campo científico y tecnológico se ve favorecida por la presencia en el personal docente de profesoras en esas materias. Porque la profesoras -las buenas sobre todo- constituyen modelos de referencia que promueven la elección por las chicas de esos estudios.

Como hemos señalado en una ocasión anterior, la función de la Cátedra de Cultura Científica de la UPV/EHU no se limita a la promoción del conocimiento científico entre la ciudadanía como si esta tarea se desarrollase en el vacío y se justificase por sí misma. Desempeña esa labor al servicio de un interés superior, porque una mayor extensión de la cultura científica favorece la existencia de una ciudadanía más libre y capacitada para incidir en su propio destino y en el devenir de la sociedad a la que pertenece. En ese sentido, la promoción de la igualdad de oportunidades entre hombres y mujeres en el ámbito científico ayuda a que hombres y mujeres disfruten de los mismos ámbitos de libertad y misma capacidad de decisión.

En ese contexto ha de enmarcarse nuestro interés por remover los obstáculos que dificultan el acceso de las mujeres a entornos culturales y profesionales científico-tecnológicos. Con ese objetivo en mente publicamos Mujeres con Ciencia; lo hacemos con el propósito, entre otros, de dar a conocer el trabajo de las mujeres en los ámbitos científico y tecnológico, y poner así a disposición de las jóvenes estudiantes, de sus familias y del público en general modelos que puedan servir de referencia. En eso consiste nuestra tarea de todos los días.

Y por lo mismo, cada 11 de febrero nos sumamos a la celebración del Día Internacional de la Mujer y la Niña en la Ciencia. En 2017 lo hicimos poniendo el foco en las científicas del futuro, en 2018 recordamos a las que no han tenido el reconocimiento que merecían. Y este año nos hemos querido fijar en la gran diferencia que hay entre chicos y chicas en el acceso a carreras de ingeniería y en la incidencia de los estereotipos en esa brecha.

Los datos son contundentes: tan solo un 25% de quienes se matriculan en estudios tecnológicos en la UPV/EHU -ingenierías, principalmente- son chicas. Ese porcentaje contrasta sobremanera con el de quienes lo hacen en ciencias de la salud (75%). Y también se diferencia, aunque no en una medida similar, de quienes cursan estudios de letras y artes (60%), ciencias sociales y jurídicas (57%) y ciencias experimentales y naturales (50%). Aunque seguramente esos porcentajes son diferentes de los de otras universidades en España o en otros países occidentales, lo más probable es que en todos ellos se produzcan diferencias de ese tipo y similar magnitud. Porque el fenómeno que describe es de carácter muy general.

Como en años anteriores, celebraremos el “Día Internacional de la Mujer y la Niña en la Ciencia” con la publicación de un vídeo de corta duración: Mi hija quiere ser ingeniera. Este vídeo ha contado con la colaboración de Iberdrola y ha sido producido por K2000 y dirigido por Aitor Gutiérrez, sobre un guion de José A. Pérez Ledo.

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

El artículo Mi hija quiere ser ingeniera se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El alma de plantas, las esencias de las aromáticas

Emilio Lizarraga

Las plantas aromáticas fueron empleadas desde tiempos remotos con el fin de mejorar el sabor de los alimentos, obtener perfumes y curar enfermedades. Estos vegetales poseen estructuras especializadas que producen y vierten al exterior sustancias conocidas como esencias o aceites esenciales. En la naturaleza cumplen un rol importante en la defensa de los vegetales como constituyentes antibacterianos, antivirales, antifúngicos e insecticidas, además de jugar un rol ecológico como agentes para evitar el ataque de herbívoros y como atrayentes de insectos para favorecer la dispersión de polen.

Una trágica historia de amor…

Las esencias ó aceites esenciales, son sustancias producidas por las plantas aromáticas en determinadas estructuras celulares. Las aromáticas como se las conoce habitualmente, son plantas que estuvieron prácticamente presentes en la vida de los humanos desde la noche de los tiempos.

La mitología griega por ejemplo, relata a su modo, como surge la primera planta de menta (Mentha sp.), quien tiene de protagonista a la ninfa Menthe quien vivía un ilícito romance con Hades “el Dios del Inframundo”. Como ya es conocido, muchas de estas historias suelen tener un trágico final, y, este romance no es la excepción. Démeter (suegra de Hades) descubre este amorío y le comunicó a Perséfone (esposa de Hades) la desafortunada novedad. Y, aún hasta hoy no se tiene la certeza, si Démeter o su hija es quien golpea a Menthe hasta matarla. El cuerpo desintegrado de la ninfa fue descubierto por Hades y este haciendo uso de sus poderes, logró que a partir de los restos de su amada brotaran plantas de menta.

Es sumamente representativa esta historia y su relación con la planta de menta, ya que es sin lugar a dudas la especie aromática más conocida y ampliamente usada desde tiempos remotos.

Hojas de Menta x piperita (peperina). El género Mentha, incluye aproximadamente unas treinta especies además de contar con algunas especies híbridas.

Hojas de Menta x piperita (peperina). El género Mentha, incluye aproximadamente unas treinta especies además de contar con algunas especies híbridas. Algo huele bien

Las plantas aromáticas están definidas por sus caracteres organolépticos, es decir, impresionan los sentidos del olfato y el gusto. Esta caracterización, que se ajusta a la percepción humana tiene origen en componentes propios de las plantas: diferentes sustancias que les confieren aroma y sabor.

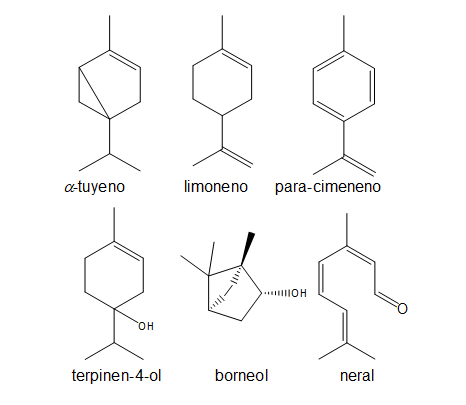

Las especies aromáticas, poseen en sus tejidos, o vierten al exterior sustancias líquidas volátiles denominadas aceites esenciales, esencias o aceites volátiles. Y, de acuerdo al uso que se les dé, se las puede agrupar en: perfumíferas, terapéuticas y condimenticias.

Se estima que el interés por los aceites esenciales tuvo su origen en Oriente, concretamente, en Egipto, Persia e India, donde se desarrolló la destilación simple como el método para su extracción del material vegetal. Mas tarde, a principios de la Edad Media, se comercializaban aceites perfumados y ungüentos naturales que no eran exactamente aceites esenciales. Estas mezclas se guardaban en recipientes traslúcidos y se sometían a la acción de luz del sol o a calentamiento, logrando finalmente la separación de los aceites esenciales y de los constituyentes sólidos de la mezcla.

Por otra parte, ciertas flores se maceraban con vino antes de adicionarle grasas, y el producto de esa extracción conocida como digestión, se filtraba y calentaba con el fin de obtener las esencias (Jirovetz y Buchbaver, 2005). También se recurrió a exprimir los órganos vegetales mediante el uso de telas o lienzos y mas tarde se perfeccionaron prensas para obtener mayor cantidad de esencia pura.

El alma de las plantas