Contenido de entrenamiento y condición física en mujeres futbolistas de élite

El fútbol es el deporte alrededor del cual orbitan, además de los miles de fieles seguidores, sectores como la hostelería, el periodismo, la publicidad o la moda. Pero, ¿hay lugar para la ciencia?

Aunque resulte difícil imaginar la relación que pueda existir entre disciplinas científicas como la física, las matemáticas o la antropología y el fútbol, cada vez son más las ocasiones en las que, sorprendentemente, la ciencia puede explicar muchos de los acontecimientos que suceden en un campo de fútbol e incidir en aspectos como la mejora del rendimiento de los jugadores y, en consecuencia, de los resultados.

La relación entre estas dos disciplinas fue el hilo conductor de un ciclo de conferencias organizado por la Cátedra de Cultura Científica con el apoyo de la Diputación Foral de Bizkaia y la colaboración de Fundación Española para la Ciencia y la Tecnología (FECYT) – Ministerio de Ciencia, Innovación y Universidades”, que tuvo lugar en el Bizkaia Aretoa de la UPV/EHU de Bilbao los meses de octubre y noviembre de 2018. Enmarcado en el ciclo de conferencias “Zientziateka”, que contó con cinco conferencias impartidas por especialistas de diversos campos en las que se ilustró la conexión que existe entre diferentes disciplinas científicas y el fútbol.

Aduna Badiola, doctora en Ciencias de la Actividad Física y Deporte y profesora del departamento de Educación Física y Deportiva de la UPV/EHU, aborda en esta charla la incidencia del programa de entrenamientos y el calendario de partidos en la composición corporal y el rendimiento físico de las jugadoras de fútbol de equipos de primera división.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Contenido de entrenamiento y condición física en mujeres futbolistas de élite se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La condición física de los árbitros de fútbol

- Fútbol, periódicos y estadísticas

- Ciencia de datos y fútbol: predicción del riesgo de lesiones en el deporte profesional

50 años modificando genes (en seres humanos)

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

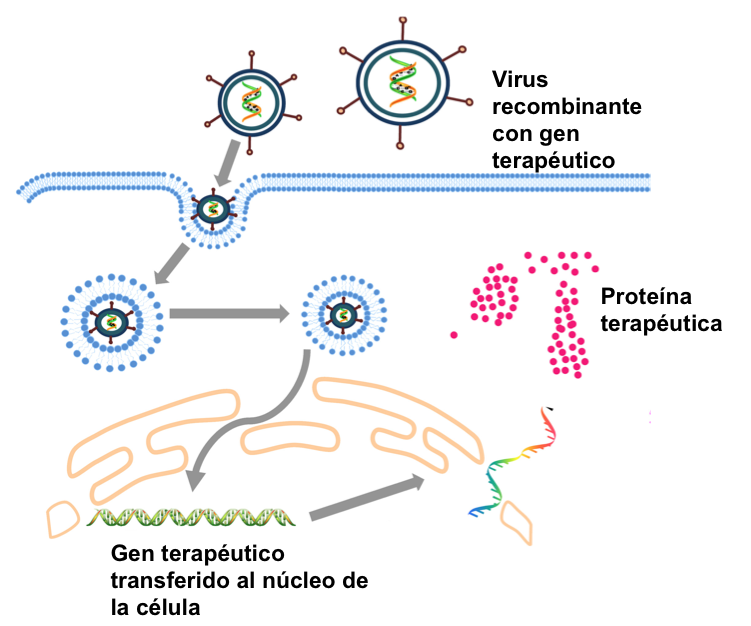

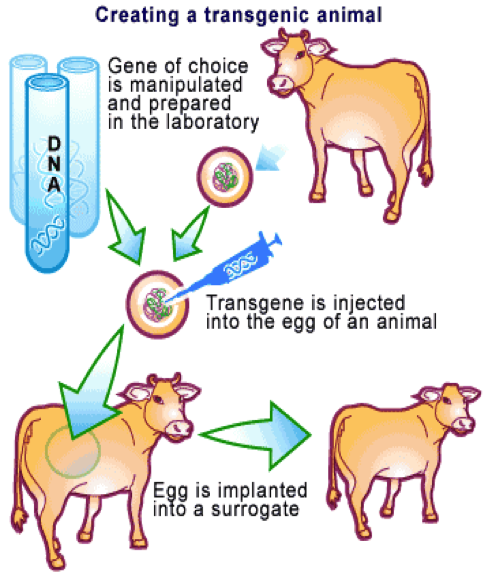

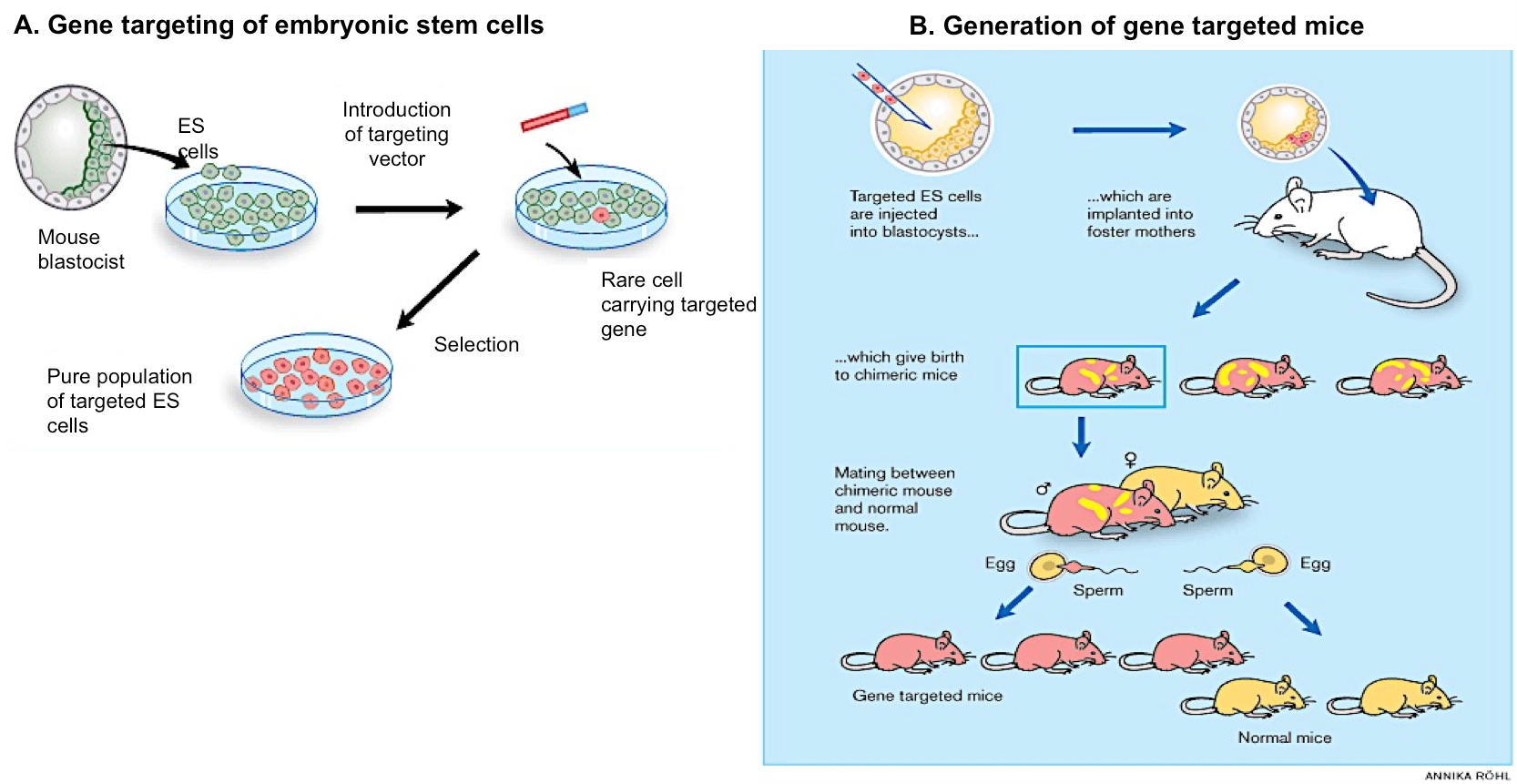

En las anteriores entradas de esta serie, hemos realizado un breve resumen de la historia y de las aplicaciones del DNA recombinante en bacterias (01) y en animales (02). Prácticamente en paralelo al trabajo para insertar genes en el genoma de animales, se planteó la posibilidad de aplicar esta tecnología también a los seres humanos, especialmente en casos en los que la alteración de un gen provoca una deficiencia en la proteína correspondiente y la aparición de alguna patología severa. Talasemia, fibrosis quística, distrofia muscular de Duchenne o hemofilia son solo algunos ejemplos de las más de 6.000 patologías, que están causadas por errores en un gen determinado. Desde los años 90 se han desarrollado metodologías basadas en el DNA recombinante para tratar algunas de estas dolencias. Este tipo de intervención, denominada terapia génica, consiste en modificar el genoma de un virus de manera que porte una versión correcta de un gen humano (gen terapéutico) y lo inyecte en las células de los pacientes que tienen una versión defectuosa de ese gen (Figura 1). Si el tratamiento es exitoso, el gen terapéutico administrado producirá una proteína funcional que mejorará, al menos en parte, los síntomas de la enfermedad.

Figura 1. Fundamento de la terapia génica. Virus no patogénos se modifican mediante ingeniería genética para que porten una versión correcta de un gen humano (en verde); los virus lo transfieren a las células del paciente y éstas expresan la proteína correcta o terapéutica (en rosa). Modificado de Lee, CS et al., Genes Dis. 2017 Jun;4(2):43-63.

Figura 1. Fundamento de la terapia génica. Virus no patogénos se modifican mediante ingeniería genética para que porten una versión correcta de un gen humano (en verde); los virus lo transfieren a las células del paciente y éstas expresan la proteína correcta o terapéutica (en rosa). Modificado de Lee, CS et al., Genes Dis. 2017 Jun;4(2):43-63.

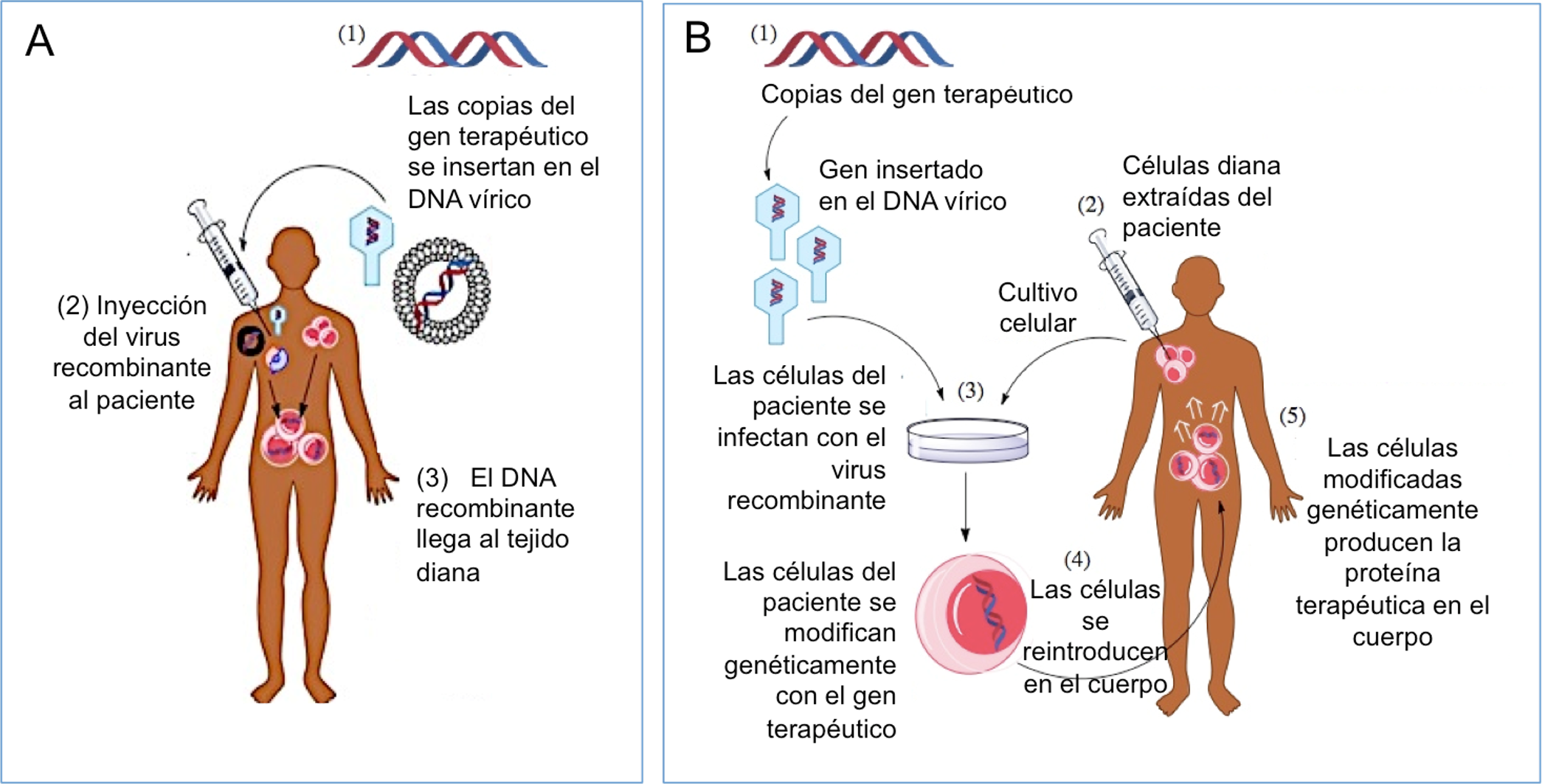

El virus recombinante que porta el gen terapéutico se puede inyectar en el paciente vía intravenosa, o en un tejido específico (terapia génica in vivo, Figura 2A). También es posible extraer células del paciente, exponerlas al virus recombinante en el laboratorio y posteriormente re-inyectar las células modificadas en el paciente (terapia génica ex vivo, Figura 2B).

Figura 2. A: Terapia génica in vivo. Los virus recombinantes portadores del gen terapéutico se inyectan directamente al paciente y el virus alcanza el órgano diana. B: Terapia génica ex vivo. Los virus recombinantes portadores del gen terapéutico infectan in vitro las células del paciente; posteriormente las células modificadas se reintroducen en el paciente. Fuente: Wikimedia Commons

Figura 2. A: Terapia génica in vivo. Los virus recombinantes portadores del gen terapéutico se inyectan directamente al paciente y el virus alcanza el órgano diana. B: Terapia génica ex vivo. Los virus recombinantes portadores del gen terapéutico infectan in vitro las células del paciente; posteriormente las células modificadas se reintroducen en el paciente. Fuente: Wikimedia Commons

A pesar de sus posibilidades, hasta hace muy poco tiempo la terapia génica ha producido más decepciones que éxitos. El primer ensayo clínico de terapia génica se realizó en 1990: una niña de cuatro años con una forma severa de inmunodeficiencia genética fue tratada en los Institutos Nacionales de la Salud de EEUU. Los investigadores extrajeron sus glóbulos blancos, insertaron en ellos copias normales del gen defectuoso y re-inyectaron las células corregidas en su cuerpo. Este ensayo se consideró exitoso porque mejoró en gran medida la salud y el bienestar de la niña tratada. Sin embargo, junto con la terapia génica, la paciente continuó recibiendo su terapia farmacológica tradicional, lo cual hizo difícil determinar la verdadera efectividad de la terapia génica por sí sola.

Esos prometedores primeros resultados se vieron truncados en 1999 por la trágica muerte de un paciente de 18 años, Jesse Gelsinger, en un ensayo clínico de terapia génica. Jesse, que presentaba una enfermedad hepática no severa, murió porque el virus utilizado para transportar el gen funcional activó su sistema inmunológico y provocó un fallo multi-orgánico. Poco después, la aplicación de un procedimiento de terapia génica volvió a generar alarma por un nuevo problema: el desarrollo de leucemia en varios niños que habían participado años antes en un ensayo de terapia génica para corregir una inmunodeficiencia genética que padecían. Se comprobó que, en estos niños, la inserción del gen terapéutico había causado la activación permanente de otro gen cercano, el cual indujo la leucemia. Este ensayo y otros que estaban en marcha en aquél momento tuvieron que interrumpirse y muchos de ellos quedaron definitivamente abandonados.

Actualmente, los procedimientos de terapia génica han superado muchos de estos problemas iniciales, gracias al desarrollo de virus más eficaces que generalmente no integran el gen terapéutico en el genoma de las células humanas, y que, además, no activan el sistema inmunológico del paciente. Tanto es así, que ahora mismo hay en marcha ensayos clínicos de terapia génica para unas 50 enfermedades diferentes, con algunos resultados muy esperanzadores.

En los últimos 30 años, en todo el mundo, se han llevado a cabo unos 3.000 ensayos clínicos de terapia génica, de los que casi 500 se han realizado entre los años 2017 y 2018. A pesar de este elevado número, solo tres tratamientos de terapia génica han sido aprobados por las agencias del medicamento estadounidenses o europeas y se pueden encontrar actualmente en el mercado: Strimbelis, para la inmunodeficiencia congénita a la que nos hemos referido anteriormente, Luxturna, para la amaurosis congénita de Leber (un tipo de distrofia genética de la retina) y, más recientemente, Zolgensma, para niños de menos de 2 años con atrofia muscular espinal

La situación actual de uno de estos tratamientos ilustra uno de los problemas adicionales de este tipo de terapia: su elevado coste económico. Cuando en 2016 las autoridades europeas aprobaron Strimbelis, el tratamiento tenía un precio de unos 600.000€ anuales y entre 2017 y 2018 solo 7 pacientes habían utilizado esta terapia en todo el mundo. El elevado coste y la escasa demanda pueden llevar, de hecho, a la inviabilidad comercial de estos tratamientos. Es el caso de Glybera, un tratamiento de terapia génica para tratar una rara deficiencia genética de lipasa que puede causar pancreatitis grave. Glybera, denominado coloquialmente «el fármaco del millón de dólares» debido a su coste, fue aprobado en 2012. En 2017 la empresa dejó de vender Glybera debido a su escasa demanda (solo 31 personas han recibido Glybera en todo el mundo).

Paralelamente al uso de la terapia génica para el tratamiento de enfermedades monogénicas, se han desarrollado aplicaciones de esta tecnología al tratamiento de algunos tipos de cáncer. Este es el caso de las denominadas terapias CAR-T, diseñadas para que sea el sistema inmune del paciente el que combata el cáncer: se trata de extraer de los pacientes un tipo de linfocitos (las células T), para modificarlos genéticamente en el laboratorio de forma que, tras re-introducirlos, detecten y destruyan las células cancerosas que hay en el paciente. Aunque este tipo de terapia produce resultados clínicos bastante variables, algunas personas con cánceres de origen sanguíneo han tenido recuperaciones llamativas y permanecen en remisión meses o años después del ensayo. Actualmente, las autoridades norteamericanas han aprobado dos tratamientos basados en esta estrategia: Yescarta (para un tipo de linfoma de las células B) y Kymriah (para la leucemia linfoblástica aguda). Se espera que en un futuro relativamente próximo esta tecnología sea también aplicable a tumores sólidos.

Sin duda, son aún numerosos los desafíos técnicos que deben abordarse para conseguir que la terapia génica sea una alternativa práctica, rutinaria, económica, segura y efectiva para tratar enfermedades. Afortunadamente, el desarrollo de las técnicas de edición genética, como CRISPR, va a permitir avanzar en todas estas cuestiones.

Tecnología CRISPR aplicada a la terapia génica

En 2012, cuando parecía que la tecnología del DNA recombinante había tocado techo, se anunció el desarrollo de una nueva metodología que permite editar genes, denominada CRISPR. Mediante esta metodología, un gen alterado puede ser eliminado o corregido de forma directa y sin necesidad de utilizar virus intermediarios. Para detalles sobre la técnica CRISPR, puede consultarse el artículo 2 de esta serie, en el que explicamos los elementos que son necesarios para su aplicación, así como sus ventajas e inconvenientes.

La tecnología CRISPR, permite realizar de una manera mucho más eficaz, rápida y económica muchas de las aplicaciones que hasta hace poco se llevaban a cabo mediante la tecnología del DNA recombinante, incluida la terapia génica. .

Actualmente se están llevando a cabo múltiples ensayos clínicos basados en CRISPR para tratar diversos tipos de cáncer. En China hay ensayos que incluyen pacientes de cáncer de esófago, pulmón, vejiga, cérvix o próstata. mientras que en EEUU y Europa se están desarrollando ensayos para tratar pacientes con melanoma, sarcoma o mieloma múltiple. También se han iniciado, o están a punto de hacerlo, ensayos clínicos basados en CRISPR para enfermedades monogénicas como beta talasemia, anemia falciforme, hemofília A, amaurosis congénita de Leber, fibrosis quística, distrofia muscular de Duchenne o Huntington.

La tecnología CRISPR está dando lugar a un sinfín de aplicaciones en el ámbito Biosanitario, no solo para el tratamiento de enfermedades, sino también para el desarrollo de estrategias indirectas de salud, como la creación de mosquitos resistentes al parásito responsable de la malaria, de moléculas que producen el “suicidio” de patógenos, de plantas resistentes a virus, hongos o insectos, o para la elaboración de alimentos menos alergénicos, entre otras.

No cabe duda que estamos asistiendo a los inicios de la aplicación de esta potente metodología, en la que hay depositadas grandes expectativas en el ámbito científico, médico e industrial, y que muy probablemente veremos crecer de manera insospechada en los próximos años.

Cuestiones éticas en terapia génica

El auge de la metodología CRISPR obliga a la sociedad a plantearse cuestiones éticas y a tomar decisiones sobre qué aplicaciones deberían ser desarrolladas y cuáles no. Algunas de estas cuestiones ya se plantearon y discutieron en relación con la tecnología del DNA recombinante. Otras, sin duda, irán apareciendo conforme la tecnología se desarrolle y la imaginación humana proponga nuevas aplicaciones.

Una de las cuestiones que más debate suscitó inicialmente en terapia génica, y que ahora vuelve a estar de actualidad con el desarrollo de la tecnología CRISPR, es la posibilidad de intervenir sobre el genoma de embriones humanos. El aspecto más controvertido de esta intervención es que las modificaciones introducidas podrían afectar a las células de la línea germinal (óvulos y células espermáticas) y, por tanto, transmitirse a generaciones futuras.

A priori, la terapia génica sobre embriones humanos podría tener un objetivo de carácter terapéutico (el tratamiento de alguna patología), o bien el de “mejora” del individuo. Aunque por razones diferentes, ambas cuestiones son controvertidas. Ciertamente, si la intervención se ha realizado porque existe un trastorno genético importante, cabría pensar que esta modificación sería también beneficiosa para los descendientes; sin embargo, podría afectar al desarrollo del feto o tener efectos secundarios a largo plazo que aún se desconocen. Además, dado que las personas que se verían afectadas por la modificación (el embrión y sus descendientes) aún no han nacido, no tendrían derecho a elegir si desean, o no, recibir el tratamiento. Todo ello ha llevado a que numerosos países hayan desarrollado directrices para evitar cambios en el genoma que puedan afectar a la descendencia y tanto EEUU como la Unión Europea han acordado no utilizar fondos públicos para estos procedimientos. Por otra parte, existe un amplio consenso internacional en considerar éticamente inadecuada la aplicación de estas metodologías para la mejora de rasgos físicos o psicológicos. Además de los motivos citados en el contexto de los tratamientos terapéuticos, existen poderosas razones que desaconsejan el uso de la terapia génica para la “mejora” de los individuos, entre otras, el hecho de que se podría producir un impacto negativo en lo que la sociedad considera «normal», lo cual podría derivar en una mayor discriminación hacia las personas con rasgos «indeseables».

A pesar de que estas cuestiones ya fueron debatidas hace años, la posibilidad técnica de editar genomas mediante CRISPR ha activado nuevamente el debate. Tanto es así, que en diciembre de 2015 se organizó una primera cumbre internacional para deliberar sobre los aspectos científicos, éticos, legales y sociales de la edición génica en humanos. En esa cumbre se pusieron de manifiesto potenciales problemas derivados de la aplicación de la tecnología CRISPR a la línea germinal. Entre ellos, el riesgo de resultados indeseados por una edición incorrecta o incompleta del genoma, la dificultad para eliminar las modificaciones una vez introducidas, así como para predecir las implicaciones futuras de tales modificaciones en sus portadores y en la población humana en general. En la cumbre de 2015 se concluyó que sería “irresponsable” proceder a cualquier uso clínico de CRISPR para la edición génica en embriones y se acordó abordar un debate internacional continuo para valorar los potenciales beneficios y riesgos de esta tecnología y realizar una supervisión continuada de su desarrollo.

A pesar de estas recomendaciones, unos días antes de iniciarse la segunda cumbre internacional sobre edición genómica en humanos a finales de 2018, el investigador chino Jiankui He dio a conocer el nacimiento de dos gemelas a partir de embriones sometidos a un proceso de edición génica para eliminar el gen CCR5. Este gen codifica una proteína que utiliza el virus VIH para introducirse en las células humanas y, debido a esta modificación, estas niñas serán posiblemente resistentes a la infección por este virus. Como no podía ser de otra manera, el procedimiento llevado a cabo por el Dr. He fue el centro de interés de la cumbre, en la que se señaló que «incluso si se verifican las modificaciones genéticas realizadas, el procedimiento fue irresponsable y no cumplió con las normas internacionales».

La actuación del Dr. He ha sido duramente criticada por la inmensa mayoría de los científicos y de los gobiernos, incluido el chino, y recientemente declarada ilegal. El rechazo generado ha inducido algunos cambios a nivel internacional. Así, el gobierno chino aplica ahora regulaciones más estrictas para experimentos que utilizan la edición de genes y cerca de 30 naciones disponen ya de medidas legislativas que prohíben la edición de la línea germinal humana. Este 2019, la UNESCO, junto con 18 científicos de primera línea procedentes de 7 países, han llamado a una moratoria global que prohíba cualquier ensayo clínico de la edición en línea germinal humana (ya sea en embriones, en óvulos o en esperma). En cualquier caso, el progreso vertiginoso de la tecnología de la edición génica en los últimos tres años y las discusiones generadas sugieren que es hora de definir un camino riguroso y responsable hacia tales ensayos.

Figura 3. Participantes de la 1ª cumbre sobre edición genética (2015). De izquierda a derecha, Jennifer Doudna, Bill Skarnes, Feng Zhang, J. Keith Joung, Jonathan Weissman, Jin-Soo Kim, Emmanuelle Charpentier, y Maria Jasin. Tomado de National Academies of Sciences, Engineering, and Medicine. 2015. International Summit on Human Gene Editing: A Global Discussion. Washington, DC: The National Academies Press. doi: 10.17226/21913

Figura 3. Participantes de la 1ª cumbre sobre edición genética (2015). De izquierda a derecha, Jennifer Doudna, Bill Skarnes, Feng Zhang, J. Keith Joung, Jonathan Weissman, Jin-Soo Kim, Emmanuelle Charpentier, y Maria Jasin. Tomado de National Academies of Sciences, Engineering, and Medicine. 2015. International Summit on Human Gene Editing: A Global Discussion. Washington, DC: The National Academies Press. doi: 10.17226/21913Sobre los autores: Ana I. Aguirre, José Antonio Rodríguez y Ana M. Zubiaga son profesores del departamento de Genética, Antropología Física y Fisiología Animal de la Facultad de Ciencia y Tecnología, e investigadores del grupo de investigación consolidado del Gobierno Vasco Biología Molecular del Cáncer.

El artículo 50 años modificando genes (en seres humanos) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 50 años modificando genes (en animales)

- 50 años modificando genes (en bacterias)

- Investigación con medicamentos en seres humanos: del laboratorio a la farmacia

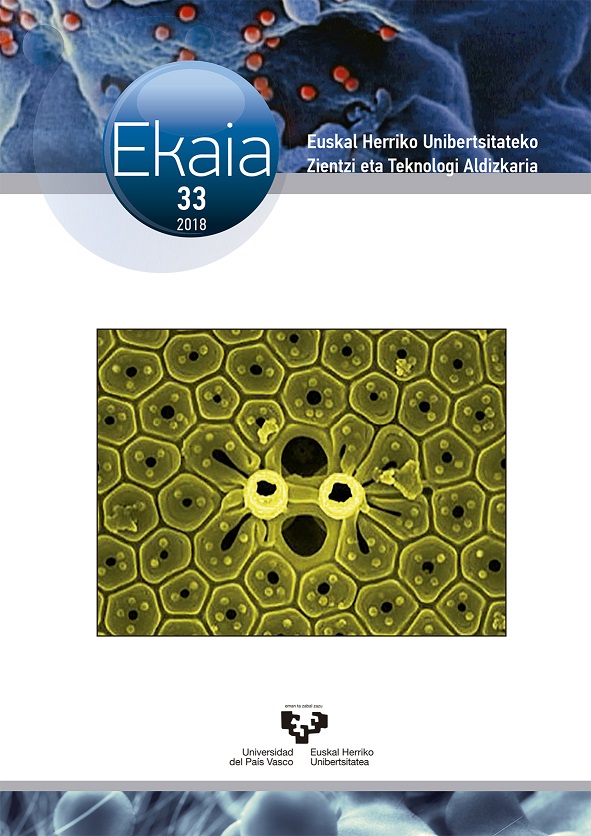

Ikusgai-eremu elektromagnetiko osoan zehar igorpen sintonizagarria duten BODIPY laser-koloratzaileak

Irudia: BODIPY (BOron DIPYrromethene) izeneko kromoforoaren ezaugarri fotofisikoak berde-hori gune espektralean azpimarratzekoak dira.

Alde batetik, gaur egun bide sintetiko ugari daude eskuragarri molekula organikoen oinarrizko egitura sakonki eta selektiboki eraldatzeko. Beraz, posible da molekula-egitura nahi den moduan diseinatzea aplikazio berezi baten eskakizunak betetzeko. Beste alde batetik, duela gutxi mikroskopia fluoreszentean zegoen detekzio muga (difrakzio muga) gainditu da eta orain bioirudiaren bidez zuntza fluoreszente molekula bakar bat detektatzea posiblea da (nanoskopia edo superbereizmen mikroskopia, Nobel Saria 2014n). Teknika hau biofotonikan gero eta arrakastatsu eta ospetsuagoa da, ahalbidetzen duelako prozesu biokimikoak jarraitzea eta biomolekulek gorputzean duten kokapena ezagutzea argiaren emisioaren bidez.

Hori dela eta, propietate fotofisiko hobeak eta iraunkorrak dituzten koloratzaile fluoreszente berrien garapena sustatu da, bioirudirako zuntza fluoreszenteak garatzeko zein laser sintonizagarrietan ingurune aktibo gisa erabiltzeko. Izan ere bi aplikazio hauetan fluoroforoek bete behar dituzten ezaugarri nagusiak berdinak dira. Hau da, argiaren absortzioa eraginkorra izatea, argiaren igorpena distiratsua izatea, eta luzaroan erradiazio ahaltsua jasatea hondatu gabe. Gaur egun, hainbat molekula organiko komertzialki eskuragarri daude ikusgai eremu osoan zehar aukeratzeko, baina askotan aurreko eskakizun guztiak ez dira betetzen.

Behar honen aurrean, gure ikerkuntza taldean (Espektroskopia Molekularreko Laborategian, UPV/EHU), eta kimika organiko taldearekin batera (Eduardo Peña Cabrera irakaslea, Guanajuato unibertsitatetik Mexikon), ikusgai-eremu osoan zehar eraginkortasun fluoreszente eta fotoegonkortasun ezin hobeak aurkezten dituzten koloratzaile berriak diseinatzea erabaki genuen.

Horretarako abiapuntu bezala BODIPY (BOron DIPYrromethene) izeneko kromoforoa hartu genuen. Koloratzaile honen ezaugarri fotofisikoak berde-hori gune espektralean azpimarratzekoak dira. Hala ere, bere abantailarik nagusiena kromoforoaren moldagarritasun sintetikoan datza. Izan ere, hainbat bide sintetikori jarraituz selektiboki posizio zehatzetan eta talde funtzional ugari erabiliz molekula-egitura erabat alda daiteke. Hala nola, bibliografian BODIPYei “El Dorado” edo “kameleoiak” esaten diete, sintetikoki duten erreaktibotasuna goraipatzeko, eta nabarmentzeko nola ordezkatzaile aproposak erantsiz kromoforoan honen ezaugarri fotofisikoak gogotik modula daitezke, hurrenez hurren.

Izaera honetaz baliatuz, gure helburua BODIPYen absortzio/igorpen banda espektralak ikusgaiko eremuaren bi ertzetara bultzatzea izan da, hots, alde gorrira edo urdinera, nukleo kromoforikoan talde funtzional aproposak erabiliz, eta ezaugarri fotofisiko optimoak mantenduz. Eremu berde-horitik (BODIPYen ohiko igorpen eremua) abiatuz lerrokatzea alde gorrira lortzeko, hain zuzen ere, talde aromatikoak txertatu dira sistema konjokatua hedatuz. Kontrako lerrokatzea lortzeko, hau da, urdinera, kromoforoan heteroatomoak zuzenean erantsi dira, sistema konjokatu berri bat sorraraziz.

Diseinu molekular honen ondorioz, BODIPYan oinarritutako koloratzaile fluoreszenteak lortu dira ikusgai-eremu osoan zehar argia absorbatu eta igortzen dutelarik. Kasu guztietan, eraginkortasun fluoreszentea ia ehuneko ehuna da, nahiz eta ingurunea aldatu, eta seinale fluoreszentea mantentzen da lagina laser ahaltsuekin luzaro bonbardatu arren. Are gehiago, guk garatutako fluoroforoen portaera fotonikoak eskuragarri dauden pareko koloratzaileenak baino hobeak dira. Beraz, BODIPY berri hauek aproposak dira bai zuntza fluoreszente bezala prozesu biokimikoak behatzeko mikroskopia fluoreszentea bitartez (bioirudia), bai ingurune aktibo moduan erabiltzeko igorpen sintonizagarria duten laserrak lortuz.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 33

- Artikuluaren izena: Ikusgai-eremu elektromagnetiko osoan zehar igorpen sintonizagarria duten BODIPY laser-koloratzaileak.

- Laburpena: Lan honetan, molekula-egiturak BODIPY deritzen koloratzaileen propietate fotofisikoetan duen eragina aztertzen da, gehienbat alde ikusgai gorritik urdinera laser sintonizagarrien ingurune aktiboa garatzeko. BODIPYaren ordezkapen-patroiaren arabera propietate espektroskopikoak modula eta optimiza daitezke. Horrela, BODIPYaren oinarrizko kromoforoa abiapuntutzat hartuta (absortzio/igorpen eremu ikusgai berde/horian) aldaketak egin dira egitura molekularrean banda espektralak lerrokatzeko, bai eremu urdinera (heteroatomoak meso posizioan sartuz), bai eremu gorrira (π sistema deslokalizatua hedatuz). Ondorioz, koloratzaile komertzialekin konparatuz gero, eremu espektral ikusgai osoa betetzen duten BODIPY koloratzaile berriak garatu dira, propietate fotofisiko eta laser hobetuekin.

- Egileak: Edurne Avellanal-Zaballa, Ixone Esnal, Jorge Bañuelos

- Argitaletxea: UPV/EHUko argitalpen zerbitzua.

- ISSN: 0214-9001

- Orrialdeak: 97-114

- DOI: DOI: 10.1387/ekaia.17771

————————————————–

Egileez:

Edurne Avellanal-Zaballa, Ixone Esnal, Jorge Bañuelos UPV/EHUko Zientzia eta Teknologia Fakultateko Kimika Fisikoa sailean dabiltza.

————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Ikusgai-eremu elektromagnetiko osoan zehar igorpen sintonizagarria duten BODIPY laser-koloratzaileak appeared first on Zientzia Kaiera.

La isla Pitcairn y el motín de la ‘Bounty’

Bounty = Generosidad

HMS Bounty II, réplica de 1960 del HMS Bounty original, en una imagen de 2010. Este barco se hundió frente a las costas de Carolina del Norte en 2012 a consecuencia del huracán Sandy.

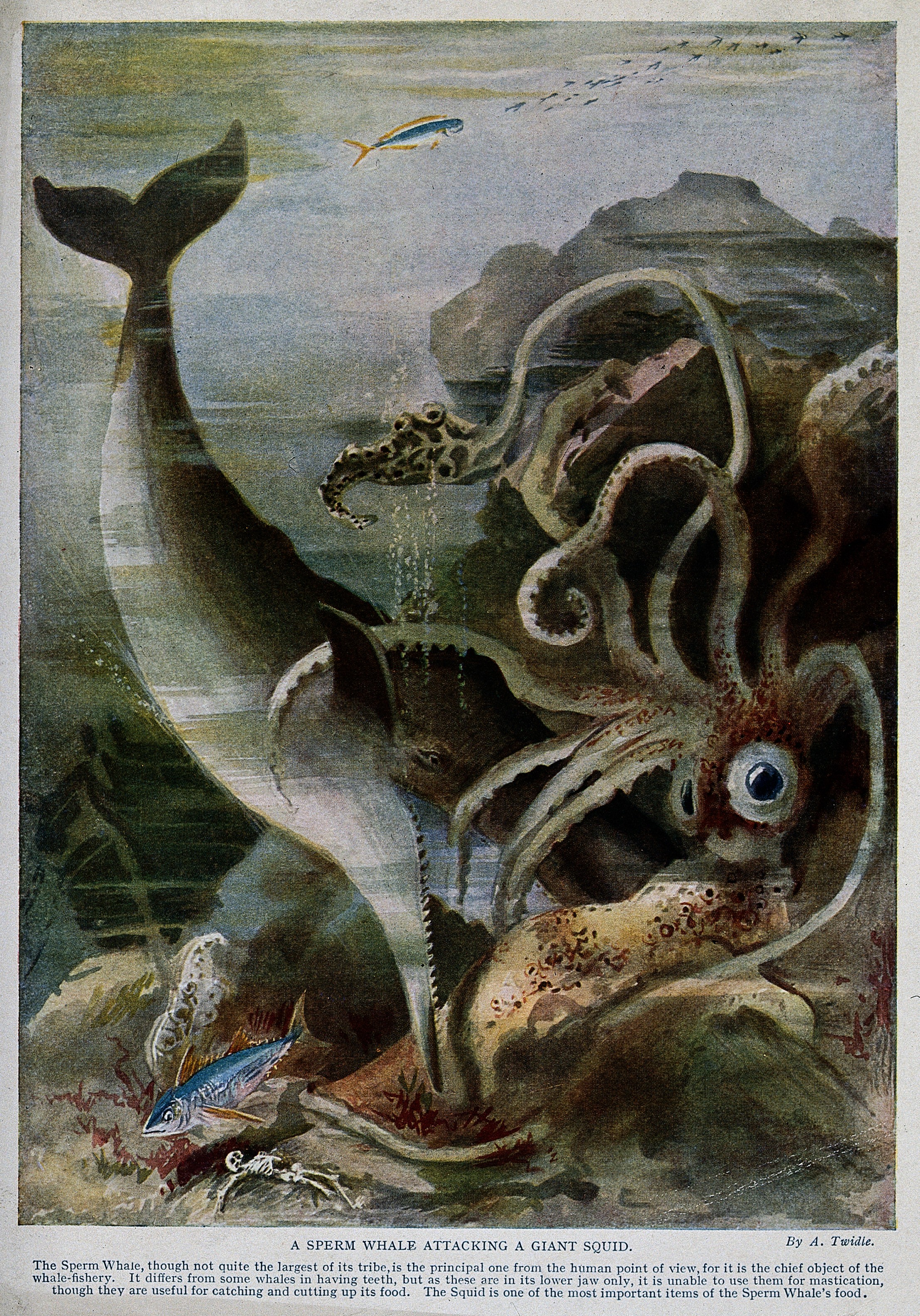

HMS Bounty II, réplica de 1960 del HMS Bounty original, en una imagen de 2010. Este barco se hundió frente a las costas de Carolina del Norte en 2012 a consecuencia del huracán Sandy.El 26 de octubre de 1788, el barco Bounty de Su Majestad llegó a Tahití. El capitán era el Teniente de la Armada Real William Bligh, experimentado y capaz de terminar con éxito las misiones que le encomendaban. Era de los mandos que había acompañado a James Cook en su tercera expedición. La Bounty había partido del puerto de Spithead, en Inglaterra, frente a Southampton, el 23 de diciembre de 1787. Tenía 215 toneladas, construido en 1784, con 28 metros de largo y 7.6 metros de ancho. La tripulación la componían 46 hombres. Era un barco de carga que compró la Armada Real para el viaje a Tahití en una expedición, promovida por la Royal Society, con el objetivo de recoger plantones del árbol del pan en Tahití y llevarlos al Caribe para replantarlos, iniciar su cultivo y cosechar un alimento barato para los miles de esclavos que se traían de África a las plantaciones de las Antillas. Contaré esta historia con la ayuda del extraordinario relato periodístico, titulado “Los amotinados de la Bounty”, que Julio Verne publicó en 1879.

El árbol del pan, de nombre científico Artocarpus altilis, procede de antepasados del mismo género de Filipinas y las islas Molucas, al sur de Filipinas y que, ahora, pertenecen a Indonesia. Su origen está en el oeste del Pacífico. Las migraciones humanas, de oeste a este, por las islas del Pacífico, llevaron el árbol del pan a Oceanía y evolucionaron, por cultivo y selección, en la especie, Artocarpus altilis, que conocemos ahora. A partir del siglo XVII, los navegantes europeos lo llevaron a todas las zonas tropicales del planeta y, especialmente, a las Antillas.

Hojas y fruto del árbol del pan. Foto: Wikimedia Commons

Hojas y fruto del árbol del pan. Foto: Wikimedia CommonsSeis meses permaneció la Bounty en la isla de Matavai, en el grupo de Tahití, mientras recolectaban los plantones del árbol del pan. Allí, la tripulación encontró amigos y parejas entre los tahitianos. Cargaron 1015 ejemplares del árbol del pan hasta llenar la bodega.

Cuando Bligh ordenó partir para llevar la carga al Caribe, la tripulación no quería hacerlo, estaban a gusto en Tahití. Pero partieron, y el 28 de abril de 1789, con la Bounty en el mar, camino al Caribe, estalló el motín a bordo. Fletcher Christian, segundo de a bordo, junto a 18 miembros de la tripulación, se amotinó contra el capitán Bligh. Abandonaron al capitán y a los que no se amotinaron en una barca y, después de 47 días de viaje y 6500 kilómetros, llegaron a Timor, fueron rescatados y regresaron a Inglaterra.

Isla Pitcairn. Foto: Wikimedia Commons

Isla Pitcairn. Foto: Wikimedia CommonsLos amotinados eran 29 que, bajo el mando de Fletcher Christian, partieron en la Bounty y regresaron a Tahiti. Pronto empezaron los problemas entre los amotinados. Unos querían quedarse en Tahití y otros huir y esconderse en alguna isla del Pacífico. Christian, con nueve amotinados, seis tahitianos y 13 tahitianas más una niña, cargaron el barco con plantas y animales necesarios para instalarse en otra isla y marcharon de noche de Tahití. Los tahitianos fueron invitados a una fiesta en el barco que zarpó durante la noche, y los amotinados los raptaron. Su intención era llegar a la isla Pitcairn y refugiarse en ella.

Al llegar a la isla, el 15 de enero de 1790, quemaron el barco para borrar su rastro y que no les encontrase la vengativa y justiciera Armada Real. Todavía se ven los restos de la Bounty en la costa de la isla y los isleños celebran cada 23 de enero el aniversario quemando una maqueta de pequeño tamaño del barco.

Bounty Bay, en la isla Pitcairn, a donde llegó la Bounty y fue quemada.

Bounty Bay, en la isla Pitcairn, a donde llegó la Bounty y fue quemada.Para 1794 quedaban cuatro de los amotinados. Habían continuado las peleas entre ellos, sobre todo por las mujeres de Tahití que les acompañaban. Incluso Christian fue acuchillado por un tahitiano en una pelea. Fueron años de alcohol, violaciones y asesinatos, y para 1800 solo quedaban dos amotinados, Young y Adams, y el primero murió de una ataque de asma. En la isla sobrevivió Adams como único hombre, con seis mujeres tahitianas y unos veinte niños que llevaban los apellidos de los amotinados. Todavía los utilizan los habitantes actuales de la Isla Pitcairn que descienden de aquellos marineros amotinados .

John Adams recuperó una Biblia de los libros que iban en la Bounty, volvió a la religión y a las buenas costumbres, llegó la paz, la isla prosperó y la población creció. Unos años más tarde, la Armada Real los encontró.

Era 1814, décadas después del motín, cuando dos barcos de guerra ingleses, el Briton y el Tagus, a las órdenes del capitán Thomas Staines, navegando por el centro del Pacífico Sur, encontraron una pequeña isla volcánica, con 9.6 kilómetros de circunferencia, unos 4 kilómetros de longitud, 4.35 kilómetros cuadrados de superficie y un cono volcánico que, en su punto más alto, alcanzaba los 300 metros. La había descrito años atrás el explorador Philip Cateret, que había descubierto la isla el 3 de julio de 1767. Fue bautizada como Pitcairn en recuerdo de uno de los marineros que primero habían desembarcado en ella. Era una isla montañosa, pequeña, volcánica y con unas costas escarpadas, casi sin playas ni puertos accesibles. Ahora es el último Territorio Británico de Ultramar en el Pacífico. Por cierto, había una copia de los diarios de viaje de Cateret en la Bounty y sirvió de guía a Fletcher Christian para encontrar la isla y refugiarse en ella.

El Briton y el Tagus fueron recibidos por una pequeña embarcación con dos hombres que se presentaron como descendientes de los amotinados de la Bounty. Para 1856 los descendientes de los amotinados eran 196 y el gobierno británico consideró que la isla no tenía suficientes recursos para mantenerlos y los trasladó a la isla Norfolk, más cercana a Nueva Zelanda y Australia y a unos 6000 kilómetros al oeste de la isla Pitcairn. Quedó deshabitada pero, un par de años más tarde, 16 de los trasladados regresaron y, en otros cinco años, lo hicieron 27 más. En la actualidad, en la isla Norfolk hay 1600 residentes permanentes y, según el censo de 2006, la mitad descienden de los amotinados que no volvieron a Pitcairn.

Los que quedaron en Norfolk, años después, en 2015, sirvieron a Miles Benton y su grupo, de la Universidad Tecnológica de Queensland, en Australia, para estudiar su ADN. Lo analizaron en las mitocondrias, heredado por vía materna, y en el cromosoma Y del núcleo, que solo se encuentra en los hombres.

Habitantes de la isla Pitcairn en 1916

Habitantes de la isla Pitcairn en 1916Los resultados confirman lo que había supuesto Miles Benton, según la historia que conocía de los habitantes de la isla Pitcairn: el ADN mitocondrial es de linaje polinésico, de las únicas mujeres que llegaron a la isla, las tahitianas que secuestraron Fletcher Christian y sus hombres; y el cromosoma Y tiene su origen en Europa ya que viene de los marineros europeos amotinados en la Bounty. Dos siglos después y once generaciones más tarde, el ADN confirma el origen genético de los descendientes de la Bounty. Más de siglo y medio después, en los primeros años del siglo XXI, en la isla Pitcairn, en 2014, quedan 56 habitantes.

El motín de la Bounty y los hechos y aventuras que le siguieron son populares y han aparecido, según Maria Amoamo, de la Universidad de Otago, en Nueva Zelanda, en unos 1200 libros, más de 3200 artículos en periódicos y revistas, en documentales e, incluso y lo que más difusión le ha dado, en tres superproducciones de Hollywood con mucho presupuesto y grande estrellas como protagonistas. Es Maria Amoamo la mayor especialista sobre la población actual de la isla Pitcairn. Vivió en la isla entre 2008 y 2013, más o menos dos años y medio, acompañando a su marido, médico de profesión y contratado por el gobierno británico para cubrir el servicio sanitario en la isla. Durante su estancia, Maria Amoamo contactó con la población, aprendió de su modo de vida y tomó numerosas notas y fotografías de las actividades cotidianas en la isla. Con ello completó su proyecto postdoctoral en la Universidad de Otago.

El futuro de la isla y de sus habitantes se basa, en la actualidad, en el turismo y en los cruceros que llegan para visitarla. Para atraer visitantes tiene su historia, tan conocida y propagada, sobre todo por Hollywood, una historia que crea morbo y lleva a los turistas a Pitcairn a conocer a sus habitantes, descendientes de los amotinados de la Bounty, y, también, tiene la naturaleza, aun poco conocida y todavía menos publicitada. Como ejemplo sirve el estudio de Alan Friedlander y su grupo, de la Sociedad Geográfica Nacional de Estados Unidos, en las cuatro islas del grupo Pitcairn: Ducie, Henderson, Oeno y Pitcairn. Han recogido animales y algas en 97 lugares de las costas de estas islas entre 5 y 30 metros de profundidad, y han explorado con cámaras de video 21 puntos entre 78 y 1585 metros.

Los resultados son espectaculares, con nuevas citas de especies conocidas de otras zonas del Pacífico y algunas especies nuevas todavía sin describir. Los autores proponen que, por su gran biodiversidad y la rareza de las especies encontradas, deben protegerse las costas de la todas las islas del grupo.

Pero ya en 1995, T.G. Benton, de la Universidad de Cambridge, comparó la basura de las playas de las islas Ducie y Oeno, del grupo Pitcairn y deshabitadas, con la basura de la playa Inch Straud, en el sudoeste de Irlanda. Y, sorprendentemente, no encontró mucha diferencia. En el Pacífico hay botellas de cristal y de plástico, y boyas de pesca, y en Irlanda abundan los envoltorios de chucherías y las bolsas de plástico. Como ejemplo, de las 130 botellas de vidrio encontradas en las playas de la isla Ducie, 41 venían de Japón, 11 de Escocia y 9 de Gran Bretaña, y la mayoría eran de whisky.

Basura en Pitcairn. Fuente: newshub.co.nz

Basura en Pitcairn. Fuente: newshub.co.nzY 20 años más tarde, como veíamos hace unas semanas, es evidente que la contaminación en nuestro planeta ya es un problema global, sin límites geográficos, y llega a lugares tan apartados como estas solitarias islas del centro del Pacífico. Fueron Jennifer Lavers y Alexander Bond, quienes visitaron la isla Henderson del grupo Pitcairn, deshabitada y conocida como un paraíso para las aves. Pero, cuantificaron los plásticos de sus playas y se encontraron que era uno de los lugares con más plásticos de todos los mares del planeta. En las playas, había de 20 a 670 fragmentos de plástico por metro cuadrado, y en los fondos frente a la costa, el número era de 53 a 4500 fragmentos por metro cuadrado.

Cada día llegan a la isla, arrastrados por las corrientes oceánicas, entre 17 y 268 nuevos fragmentos. Y, no hay que olvidar, que es una isla deshabitada, es decir, todo el plástico viene del exterior y, además, de lugares muy lejanos, algunos a miles de kilómetros. Los autores detectan que los restos de plástico relacionados con la pesca llegan desde China. Japón y Chile.

Para terminar, años más tarde del famoso motín, el entonces Vicealmirante William Bligh, al mando del Assisstance, partió de nuevo hacia el Pacífico para llevar el árbol del pan a las Antillas, y lo consiguió. En la actualidad, el árbol del pan es un alimento barato y popular en el Caribe.

Referencias:

Amoamo, M. 2016. Pitcairn Island: Heritage of Bounty descendants. Australian Folklore 31: 155-171.

Amoamo, M. 2016. Pitcairn and the Bounty story. En “Tourist Pacific Cultures”, p. 73-87. Ed. por K. Alexeyeff & J. Taylor. ANU Press. Canberra, Australia.

Amoamo, M. 2017. Re-imaging Pitcairn Island. Shima 11: 80-101.

Benton, M.C. et al. 2015. “Mutiny on the Bounty”: the genetic history of Norfolk Island reveals extreme gender biased admixture. Investigative Genetics DOI: 10.1186/s13323-015-0028-9

Benton, T.G. 1995. From castaways to throwaways: marine litter in the Pitcairn Islands. Biological Journal of the Linnean Society 56: 415-422.

Bligh, W. 2015 (1838). El motín de la Bounty (Diarios del capitán Bligh). ePub r1.3. Titivillus. 13.04.15.

Diamond, J. 2006. Colapso. Random House Mondadori. Barcelona. 457 pp.

Friedlander, A.M. et al. 2014. The real Bounty: Marine diversity in the Pitcairn Islands. PLOS ONE 9: e100142

Gibbs, M. & D. Roe. 2016. Do you bring your gods with you or Do you find them there waiting? Reconsidering the 1790 Polynesian colonization of Pitcairn Island. Australian Folklore 31: 173-191.

González, D. 2011. Pitcairn, la isla de la endogamia. Blog Fronteras. 17 octubre.

Lavers, J.L. & A.L. Bond. 2017. Exceptional and rapid accumulation of anthropogenic debris in the one of the world’s most remote and pristine islands. Proceedings of the National Academy of Sciences USA DOI: 10.1073/pnas1619818114

Verne, J. 2006 (1879). Los amotinados de la Bounty. Biblioteca Virtual Universal. Ed. del Cardo. 14 pp.

Wikipedia. 2017. Pitcairn Island. 5 December.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo La isla Pitcairn y el motín de la ‘Bounty’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Particiones: Hardy y Ramanujan

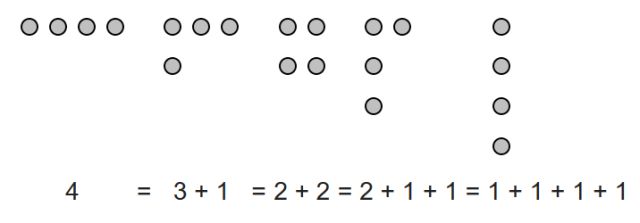

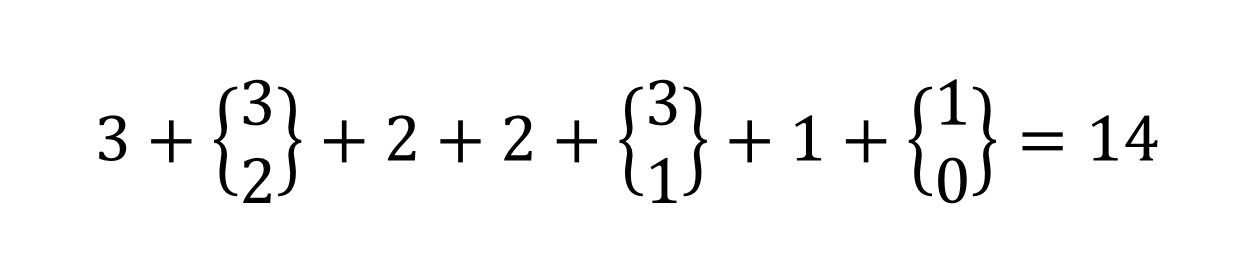

Una partición de un número entero positivo n es una forma de descomponerlo como suma de enteros positivos. El orden de los sumandos no es relevante, por lo que normalmente se escriben de mayor al menor. Por ejemplo, las particiones del número 4 son:

4 = 2+1+1 = 3+1 = 2+2 = 1+1+1+1.

Estas particiones se suelen visualizar a través de diagramas, como los diagramas de Ferrers, que deben su nombre al matemático Norman Macleod Ferrers.

Diagrama de Ferrers del número 4. Imagen: Wikimedia Commons.

Diagrama de Ferrers del número 4. Imagen: Wikimedia Commons.

La teoría de particiones de números se utiliza en el estudio de polinomios simétricos, del grupo simétrico y en teoría de representación de grupos, entre otros.

La función de partición >p>(n) indica el número de posibles particiones del entero n; por ejemplo, p(4)=5. El valor de p(n) crece muy rápidamente al aumentar n. Por ejemplo, p(100)=190.569.292 y p(1000)=24.061.467.864.032.622.473.692.149.727.991.

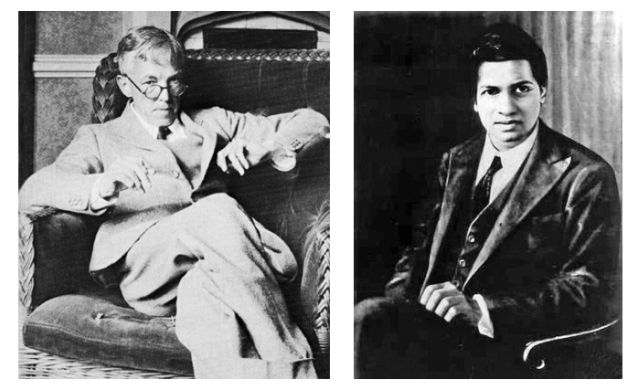

Godfrey Harold Hardy y Srinivasa Ramanujan. Imágenes: Wikimedia Commons.

Godfrey Harold Hardy y Srinivasa Ramanujan. Imágenes: Wikimedia Commons.

Matemáticos de la talla de Godfrey Harold Hardy (1877-1947) y Srinivasa Ramanujan (1887-1920) trabajaron en el tema de las particiones de números, obteniendo algunas expresiones asintóticas para la función partición. Y Partition es precisamente el título de una obra de teatro del dramaturgo Ira Hauptman con los dos geniales matemáticos antes citados como protagonistas.

El título Partition se refiere tanto a la teoría matemática de las particiones de números como a las particiones –en el sentido de antagonismo– de temperamento, de cultura y de método matemático que distanciaron a los dos personajes.

La obra comienza en 1918, con una escena en Scotland Yard, donde un oficial de policía interroga a Ramanujan. El joven matemático ha intentado suicidarse tirándose a las vías del tren; ha bebido sin darse cuenta Ovaltine que contiene rastros de productos animales y, por lo tanto, piensa que ‘está contaminado’. Hardy consigue que no le encarcelen declarando ante la policía que Ramanujan es miembro de la Royal Society.

La siguiente escena tiene lugar cinco años antes. Hardy y Alfred Billington –un colega ¿ficticio? de Hardy de la Universidad de Cambridge– discuten sobre una carta que el matemático británico acaba de recibir. Es de Ramanujan, un joven autodidacta indio que, junto a la misiva, le ha enviado algunos cuadernos que contienen extraordinarias fórmulas matemáticas. Intrigado por los brillantes resultados de Ramanujan, Hardy decide invitarle a Cambridge para conocer los detalles de su método de trabajo.

Ramanujan, un simple empleado de correos perteneciente a una de las castas más bajas de la India y sin formación universitaria, acepta la invitación y viaja a Inglaterra desde Madrás.

Cartel de una de las representaciones de Partition. Imagen: University of California, Berkeley.

Cartel de una de las representaciones de Partition. Imagen: University of California, Berkeley.

Nada más conocerse, Hardy y Ramanujan perciben el abismo que los separa. El británico es ateo, seguro de sí mismo, independiente, fiel a la lógica racional y tenaz defensor del método deductivo. Por el contrario, el joven indio es religioso, tímido, leal a su intuición y mantiene que sus resultados matemáticos le son concedidos por la diosa Namagiri durante el sueño.

Hardy intenta inculcar a Ramanujan el rigor científico basado en las demostraciones; quiere hacer del él un ‘matemático completo’. Pero el genio indio no consigue entender lo que el profesor quiere explicarle; Ramanujan sabe que sus fórmulas son ciertas porque Namagiri se las dicta en sueños. Hardy intenta convencer al joven matemático de la necesidad de demostrar sus resultados para ratificarlos. Pero Ramanujan está convencido de que las matemáticas se descubren, en contra de la opinión del profesor que asegura que se deducen.

En Partition, Hardy propone a Ramanujan abordar la solución del Último Teorema de Fermat –es pura ficción, nunca trabajaron en este tema–. El joven se obsesiona con este problema y pide ayuda a Namagiri, quien conversa con el espectro de Pierre Fermat para complacer a su protegido. Fermat confiesa a la diosa que no recuerda la demostración de su teorema; de hecho reconoce que ni siquiera es consciente de haber escrito alguna vez una prueba…

La guerra estalla en Europa. Hardy deja en un segundo plano las matemáticas para dedicarse a la política. Ramanujan, desvalido, se obsesiona con el problema de Fermat y acaba enfermando. Al poco tiempo, ya en su país, muere afectado de una tuberculosis.

La obra finaliza con un emotivo discurso de Hardy ante los miembros de la London Mathematical Society sobre la figura de su admirado, y ya desaparecido, Ramanujan.

Por cierto, casi al final de la obra, Hardy visita a Ramanujan en el hospital y se alude al famoso número de Hardy-Ramanujan: el profesor comenta al joven que ha llegado al sanatorio en el taxi número 1729; inmediatamente Ramanujan advierte que 1729 es el menor entero positivo que puede expresarse como una suma de dos cubos de dos maneras diferentes (1729=103+93=123+13).

Referencias

-

Ira Hauptman, Partition, Libreto de la obra (puede adquirirse en Playscripts Inc.)

-

Kenneth A. Ribet,Theater Review: a Play by Ira Hauptman, Notices AMS Vol 50, núm. 11, 1407-1408, diciembre 2003.

-

Marta Macho Stadler, Partición, de Ira Hauptman, DivulgaMAT, 2007

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Particiones: Hardy y Ramanujan se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema del pollo picante (o sobre particiones convexas equitativas)

- Pál Turán: teoría de grafos y fábricas de ladrillos

- Uno, dos, muchos

Polinizatzaileekin bueltaka: erleak eta gehiago

Irudia: Erleak salbatzeko kanpainak jarri izan dira abian, polinizazioan dute garrantzia dela eta. Erleak ez dira, baina polinizatzaile bakarrak, ezta nagusiak ere.

Polena garraiatzen landareen ugalketa ahalbidetzen dituzten animaliak dira polinizatzaileak. Zonalde epeletan landareen %78k eta zonalde tropikaletan landareen %94k behar dute animalien polinizazioa. Giza elikadurarako erabiltzen diren laboreen %75ean baino gehiagotan dute eragina polinizatzaileek maila batean edo bestean. Kontuan izan behar da, hala ere, bolumenari dagokionez, giza kontsumoaren gehiengoa (%60) animali polinizaziorik behar ez duten laboreak direla eta animalien polinizaioa behar dutenak %35 direla.

Polinizatzailerik ezagunena, zalantzarik gabe, erlea da. Eta erlea esatean ezti-erlea (Apis mellifera) da gogora datorrena kasu gehienetan. Honi lotuta, ikerketa honen arabera, jendearen %99ak erleak ezinbestekoak edo oso garrantzitsuak direla uste badu ere, %14ak baino ez da gai erle espezie kopurua asmatzeko (1.000 espezie gora behera). Eta zenbat erle espezie daude? 100? 2.000? Ezta hurrik eman ere. 20.000 erle espezie inguru daude munduan.

90eko hamarkadan izan ziren erleen egoeraren inguruko lehenengo alarma hotsak. Orduan argirtaratutako ikerketaren arabera, polinizazioaren inguruko kezka areagotze bidean zen erleen populazioek behera egiten zuten heinean.

1985 eta 2005 urteen artean ezti-erle kolonien %25 galdu ziren Erdialdeko Europan. Estatu Batuetan %59 1947 eta 2005 artean. Collony Collapse Disorder (CCD) izena eman zaio erle kolonien galera jarraituari. Honen atzean ez da kausa bakarra identifikatu, hainbat faktorek dute eragina: habitatetan aldaketak, fragmentazioa, patogenoak, aldaketa klimatikoa, intsektiziden erabilera, nekazaritzaren intentsifikazioa…

Ezti-erleak salbatzeko zenbait kanpaina egin dira nazioartean: TED Talkak egin dira, Greenpeacek ere mundu mailako kanpaina abiatu du eta zereal marka batek ere nazioarteko kanpaina jarri du martxan.

Polinizatzaileen aniztasunazEzagunenak badira ere, ezti-erleak ez dira polinizatzaile bakarrak. Bestelako intsektuak (tximeletak, liztorrak, inurriak, kakalardoak, euliak…) ere polinizatzaileak dira. Baita zenbait ornodun, hala nola, saguzarrak, kolibriak, zenbait karraskari eta baita sugandilak ere. Polinizazioen %14aren arduradunak baino ez dira ezti-erleak.

Portaera moldaketak eta egokitzapen morfologikoak jasan ditu ezti-erleak nektarra eta polena jaso, garraiatu eta biltzerako orduan oso eraginkor bilakatu dutenak, Juan Carlos Pérez Hierro biologoak azaltzen duenez. Horrek, baina, ez du polinizatzaile on bilakatzen, bidean galdutako polena baita polinizatzen duena eta Apis mellifera asko hartu eta gutxi galtzeko dago diseinaturik.

Ezti-erleak, beraz, ez dira polinizatzaile nagusiak. Are gehiago, ezti-erleak polinizatzaile basatien lanaren osagarri dira, ordezkatzaile baino. Megachilidae familiako erleak planetako polinizatzailerik eranginkorrenetarikoak kontsideratzen dira, Juan Carlos Pérez Hierroren esanetan.

Zer bestelako polinizatzaileak daude, baina? Ezti-erle eta gainerako erleez gain hainbat polinizatzaile mota aurki daitezke:

- Intsektuak: Liztorrak, lore-euliak, tximeletak eta baita kakalardoak ere, besteren artean.

- Hegaztiak: Kolibriak dira hauen artean ezagunenak, baina melifagoak eta eguzki txoriak ere polinizazio lanetan ibiltzen dira.

- Ugaztunak: Saguzarrak, zenbait karraskari edota lemurrak, besteak beste.

Erreferentzia bibliografikoak:

- Ollerton, J. , Winfree, R. and Tarrant, S. (2011). How many flowering plants are pollinated by animals?. Oikos, 120 (3), 321-326, DOI: 10.1111/j.1600-0706.2010.18644.x

- Klein, Alexandra-Maria, et al., (2006). Importance of pollinators in changing landscapes for world crops. Proceedings of the Royal Society B: Biological Sciences, 274 (1608), DOI: http://doi.org/10.1098/rspb.2006.3721

- Wilson, Joseph S., Forister, Matthew L., Carril, Olivia (2017). Interest exceeds understanding in public support of bee conservation. Frontiers in Ecology and the Environment, 15(8), 460–466, DOI:10.1002/fee.1531

- Michener, Charles D. The Bees of The World. The Johns Hopkins University Press. Baltimore. 2007

- Watanabe, Myrna E. (1994). Pollination Worries Rise As Honey Bees Decline. Science, 265 (5176), 1170, DOI: 10.1126/science.265.5176.1170

- Potts, Simon G., et al. (2010). Declines of managed honey bees and beekeepers in Europe. Journal of Apicultural Research, 49 (1), 15-22, DOI: 10.3896/IBRA.1.49.1.02

- Potts, Simon G., et al. (2010). Global pollinator declines: trends, impacts and drivers. Trends in Ecoloby and Evolution, 25 (6), 345-353, DOI: https://doi.org/10.1016/j.tree.2010.01.007

- Garibaldi, Lucas A., et al. (2013). Wild Pollinators Enhance Fruit Set of Crops Regardless of Honey Bee Abundance. Science, 339 (6127), 1608-1611, DOI: 10.1126/science.1230200.

- Regan, E. C. et al. (2015), Global Trends in the Status of Bird and Mammal Pollinators. Conservation letters, 8, 397-403, DOI: 10.1111/conl.12162

- IPBES. The assessment report on pollinators, pollination and food production. Secretariat of the Intergovernmental Science-Policy Platform on

Biodiversity and Ecosystem Services. Bonn. 2016. - IUCN. European Red List of Bees. Publication Office of the European Union. Luxembourg. 2014

- Aizen, Marcelo A., et al. (2008). Long-Term Global Trends in Crop Yield and Production Reveal No Current Pollination Shortage but Increasing Pollinator Dependency. Current Biology, 18 (20), 1572-1575, DOI: https://doi.org/10.1016/j.cub.2008.08.066

- Potts, Simon G., et al. (2016). Safeguarding pollinators and their values to human well-being. Nature, 540, 220–229, DOI: 10.1038/nature20588

- Winfree, Rachael. (2008). Pollinator-Dependent Crops: An Increasingly Risky Business. Current Biology, 18 (20), R968-R969, DOI: https://doi.org/10.1016/j.cub.2008.09.010

———————————————————————–

Egileaz: Ziortza Guezuraga (@zguer) kazetaria da eta Euskampus Fundazioko Kultura Zientifikoko eta Berrikuntza Unitateko zabalkunde digitaleko teknikaria.

——————————————————————

The post Polinizatzaileekin bueltaka: erleak eta gehiago appeared first on Zientzia Kaiera.

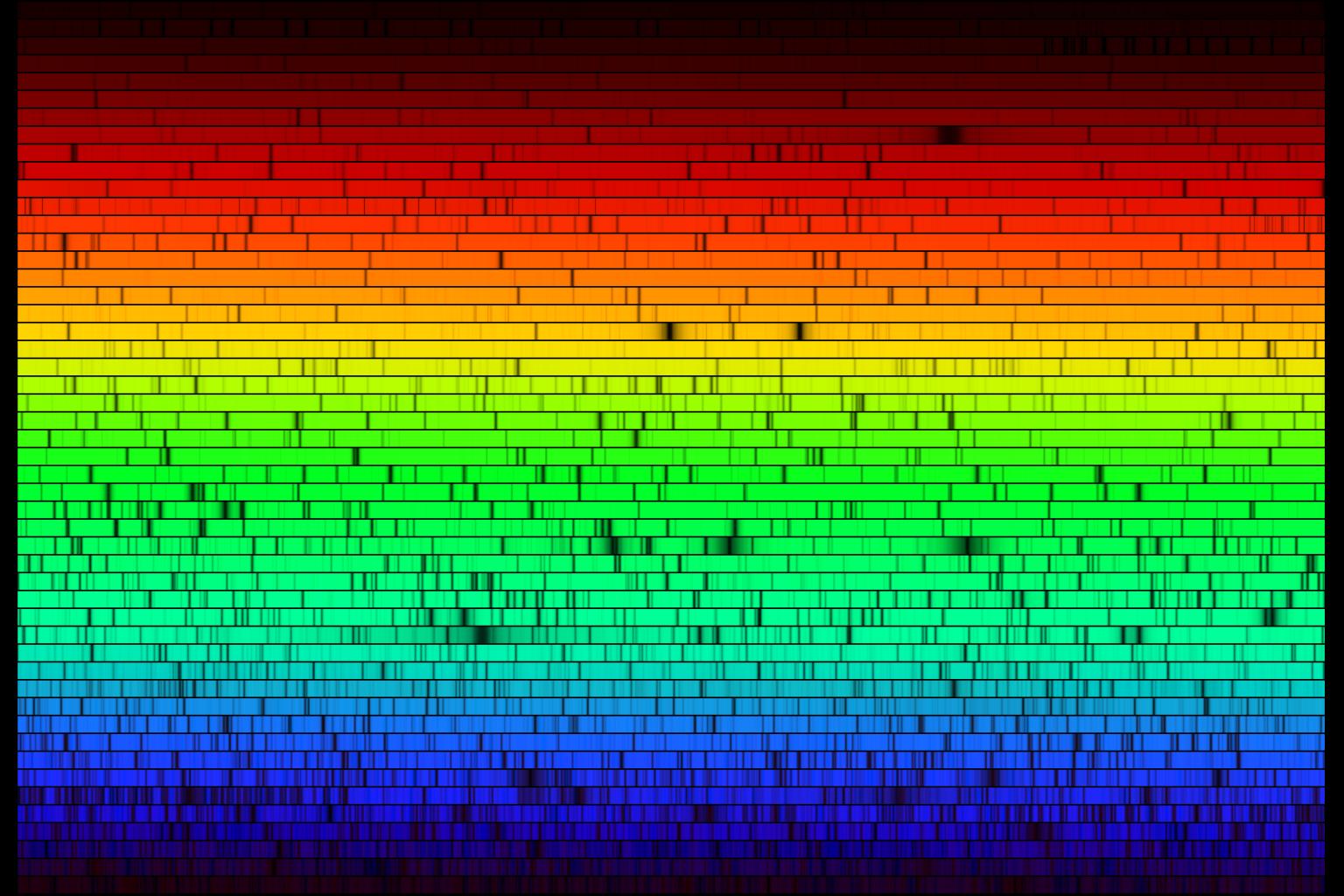

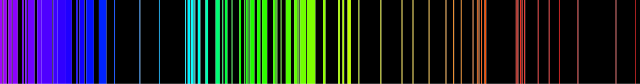

Los espectros de absorción de los gases

Los muchos cientos de líneas de absorción del espectro solar. Fuente: NOAO

Los muchos cientos de líneas de absorción del espectro solar. Fuente: NOAOEn 1802, William Wollaston vio en el espectro de la luz solar algo que antes se había pasado por alto. Wollaston notó un conjunto de siete líneas [1] oscuras, muy definidas, espaciadas irregularmente, a lo largo del espectro solar continuo. No entendía por qué estaban allí y no investigó más.

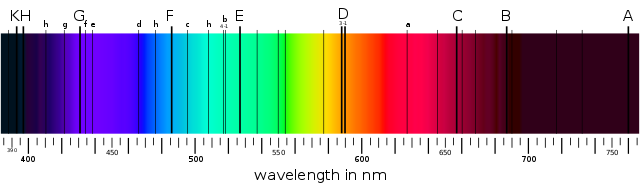

Una docena de años después, Joseph von Fraunhofer, utilizando mejores instrumentos, detectó muchos cientos de esas líneas oscuras. A las líneas oscuras más prominentes, von Fraunhofer asignó las letras A, B, C, etc. Estas líneas oscuras se pueden ver fácilmente en el espectro del Sol incluso con espectroscopios modernos bastante simples. Las letras A, B, C,. . . todavía se usan para identificarlas. En los espectros de varias estrellas brillantes von Fraunhofer también encontró líneas oscuras similares. Muchas, pero no todas, de estas líneas estaban en las mismas posiciones que las del espectro solar. Todos estos espectros se conocen como espectros de líneas oscuras o espectros de absorción. [2]

Espectro solar en el que se aprecian las líneas principales de von Fraunhofer. Fuente: Wikimedia Commons

Espectro solar en el que se aprecian las líneas principales de von Fraunhofer. Fuente: Wikimedia CommonsEn 1859, Kirchhoff hizo algunas observaciones clave que condujeron a una mejor comprensión tanto de los espectros de los gases, tanto de los de absorción como los de emisión. Ya se sabía que las dos líneas amarillas prominentes en el espectro de emisión del vapor de sodio calentado tenían las mismas longitudes de onda que dos líneas oscuras prominentes vecinas en el espectro solar [3]. También se sabía que la luz emitida por un sólido forma un espectro perfectamente continuo que no muestra líneas oscuras. Esta luz, que contiene todos los colores, es una luz blanca. Kirchhoff hizo algunos experimentos con ella. La luz blanca primero pasó a través de un vapor de sodio a temperatura baja y el resultado por un prisma. El espectro producido mostró el patrón de arco iris esperado, pero tenía dos líneas oscuras prominentes en el mismo lugar en el espectro que las líneas D del espectro del Sol. Por lo tanto, era razonable concluir que la luz del Sol también estaba pasando a través de una masa de gas de sodio. Esta fue la primera prueba de la composición química de la envoltura de gas alrededor del Sol.

El experimento de Kirchhoff se repitió con varios otros gases relativamente fríos, colocados entre un sólido brillante y el prisma. Cada gas produce su propio conjunto característico de líneas oscuras. Evidentemente, cada gas absorbe de alguna manera la luz de ciertas longitudes de onda de la luz que pasa. Además, Kirchhoff mostró que la longitud de onda de cada línea de absorción coincide con la longitud de onda de una línea brillante en el espectro de emisión del mismo gas [4]. La conclusión es que un gas puede absorber solo la luz de esas longitudes de onda que, cuando se excita, puede emitir.

Cada una de las diversas líneas de von Fraunhofer en los espectros del Sol y otras estrellas se ha identificado en el laboratorio como correspondiente a la acción de algún gas. De esta manera, se ha determinado toda la composición química de la región exterior del Sol y otras estrellas. Esto es realmente impresionante desde varios puntos de vista. Primero, es sorprendente que la comunidad científica pueda conocer la composición química de objetos a distancias inimaginables, algo que hasta ese momento, casi por definición, se creía imposible. Es aún más sorprendente que los sustancias químicas fuera de la Tierra resulten ser las mismas que las de la Tierra [5][6]. Finalmente, este resultado lleva a una conclusión sorprendente: los procesos físicos que causan la absorción de luz en el átomo deben ser los mismos en las estrellas y en la Tierra. [7]

Notas:

[1] Ya explicamos aquí (nota 3) por qué son líneas.

[2] Un momento. ¿Espectros de absorción en algo que emite luz? ¿Eso como va a ser? Ello se debe a que las estrellas tienen capas y parte de la luz emitida por las interiores es absorbida por la más externa. Brutamente, las líneas de los espectros de absorción de las estrellas nos dicen qué composición tiene esta capa externa, como explicamos a continuación.

[3] A estas líneas oscuras del espectro solar von Fraunhofer les había asignado la letra D.

[4] Ojo. La recíproca no es cierta, esto es, no todas las líneas de emisión están representadas en el espectro de absorción. Pronto veremos por qué.

[5] Newton asume que esto es así pero sin pruebas, con todo lo que ello supone.

[6] Esto es así porque el espectro más complejo de una estrella puede reproducirse empleando los elementos químicos disponibles en un laboratorio terrícola.

[7] Galileo y Newton asumieron que la física terrestre y la celeste obedecen las mismas leyes. Se había comprobado a nivel macroscópico; he aquí la prueba a nivel microscópico.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los espectros de absorción de los gases se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los espectros de emisión de los gases

- Computación cognitiva de espectros infrarrojos

- Absorción del alimento

No era tan fácil: wifi y cáncer

La radiación cancerígena no es la wifi, sino la ultravioleta del Sol. Foto: Bernard Hermant / Unsplash

La radiación cancerígena no es la wifi, sino la ultravioleta del Sol. Foto: Bernard Hermant / UnsplashNos habréis oído miles de veces decir que las radiaciones electromagnéticas de baja frecuencia, como las ondas de radio, las que se usan para telefonía o la WIFI no son cancerígenas porque no son ionizantes. Lo decimos y lo repetimos mil veces, luchando contra los que propagan el miedo (algunos interesadamente) a las antenas, los cables de alta tensión, etc. En ocasiones se nos escapa un tono áspero, impaciente, como si se tratara de un asunto evidente o sencillo de entender. Pero no lo es, ni mucho menos.

Ser una radiación ionizante quiere decir que al interaccionar con la materia será capaz de “arrancar” electrones a esos átomos, produciendo cambios. Por ejemplo, en la molécula de ADN podrían inducir mutaciones que llevasen a transformar células en cancerosas, o si se tratase de embriones podrían crear malformaciones o hacerlos inviables.

Vayamos por partes.

Los saltos electrónicos

Ya sabéis que los electrones se sitúan en los átomos en niveles de energía discretos, separados, que pueden tener sólo ciertos valores y no otros. Ejemplo inventado: en el átomo de nosécuantitos los niveles de energía serán 1, 3, 7, 12 (todos los números a partir de aquí son inventados para que se pueda seguir mejor la explicación). De esta forma un electrón que esté en el nivel de energía 3 necesita cuatro unidades de energía para pasar al nivel siguiente. Si no recibe esa energía, no podrá subir de nivel.

Los cuantos

Con la llegada de la física cuántica descubrimos que la energía se transmitía en “paquetes”, en cuantos, y que esos paquetes dependían de la frecuencia de la radiación (en la luz visible sería el color, menos frecuencia para el rojo y más para el azul, con valores intermedios en todo el arcoiris). De esta forma los paquetes de luz roja, por ejemplo, podrían tener una energía de una unidad, en cambio los de luz azul de dos unidades. La luz se compone de esos cuantos, de esos paquetitos, cuando tenemos más intensidad de luz es porque mandamos más paquetes, no que esos paquetes tengan más energía cada uno, os recuerdo que la energía de cada paquete solo depende de la frecuencia de la luz.

La luz y la materia

¿Qué pasa cuando la luz llega a la materia? Pues que los electrones pueden absorber esos cuantos de luz, esos fotones, y ascender de nivel. Si volvemos al ejemplo que pusimos, tenemos un electrón en el nivel de energía correspondiente a 3 unidades y, para saltar al nivel de 7 unidades, necesita de 4 unidades de energía. Si iluminamos con luz roja (dijimos que cada fotón tenía una unidad) no será suficiente la absorción de un fotón para saltar de nivel, así que el salto no se produce. Esa luz no se absorberá, el electrón no puede ir “guardándose” fotones). Si iluminamos con luz azul tampoco (dijimos que cada fotón azul tenía dos unidades). Así que será necesario iluminar con una luz de una frecuencia suficientemente alta para que esos fotones tengan la energía suficiente para hacer que el electrón cambie de estado. Quizá ocurra con luz ultravioleta, rayos X, etc.

Sería como si le diéramos pequeñas escaleras a alguien que tiene que escalar un muro, pero de insuficiente altura. Por más escaleras pequeñas que le demos (y que no puede empalmar) será imposible que suba el muro. De la misma manera, por más intensa que sea la luz roja con que iluminemos (por más numerosos que sean los paquetes) será imposible que el electrón cambie de nivel energético.

El efecto fotoeléctrico

Este fenómeno se observó en el llamado efecto fotoeléctrico: al iluminar una sustancia se producía una corriente eléctrica (se “arrancaban” electrones), pero si la frecuencia bajaba de cierto valor (frecuencia de corte) dejaba de producirse la corriente. Esto llamaba mucho la atención, porque se entendía que si la energía de a luz que iluminaba era suficientemente alta el efecto debía producirse. Tuvo que ser con la llegada de la teoría de los cuantos que se diera la explicación correcta al fenómeno, y tuvo que ser Einstein el que resolviera el entuerto, quien posteriormente recibiría el premio Nobel por esta contribución (y no por la Teoría de la Relatividad, como a veces se cree).

No era tan fácil

Como veis, no era tan fácil eso de que las radiaciones de baja frecuencia no son ionizantes. Hemos tenido que tirar de la teoría cuántica y del amigo Einstein para tener una explicación científicamente satisfactoria del asunto. Esto es algo que no habría que perder de vista cuando contamos con aspereza a profanos que las radiaciones de baja frecuencia no son ionizantes.

Demostraciones que quizá no demuestran lo suficiente

Un amigo me contaba un día que para ilustrar esto le gusta un experimento que es bastante curioso. Si iluminas un cartel de esos de “Extintor”, “Salida”, con una luz de baja frecuencia, por ejemplo un puntero láser rojo, no dejan casi “huella brillante”, pero si lo iluminas con luz azul, una vez que apagas la luz, queda como una “pintura de luz” por donde pasaste. Señal de que, a pesar de la intensidad total de la luz, hay paquetitos de más energía y paquetitos de menos energía. Si queréis hacerlo, probadlo primero, porque no funciona con todos los tipos de carteles.

El problema es que mi amigo decía que con la luz de baja frecuencia “casi” no quedaba rastro… y este “casi” es un problema. La frecuencia de corte es un corte abrupto, no hay efecto a partir de ahí. Si hubiera un efecto pequeño, este podría ser apreciable si aumentásemos la intensidad de la luz, si algunos paquetitos consiguen funcionar, podríamos mandar muchos y montar un buen lío… Pero se supone que lo que queríamos ilustrar es que en frecuencias bajas NO hay efecto.

Medidas epidemiológicas

Aunque no sería necesario buscar el efecto de algo que no tiene sentido con los conocimientos asentados, no cuesta mucho (más que personal, tiempo y dinero) llevarlo a cabo, y como hay gente interesada y preocupada por esto, pues se ha hecho. Las conclusiones mirando todos los estudios y teniendo en cuenta que se hayan hecho de forma adecuada (sin problemas metodológicos, p.ej.) es que no hay tal efecto de un aumento de cáncer en personas sometidas a intensidades comunes de radiaciones de baja frecuencia. Si lo hubiera, nos habría tocado buscar si era una correlación espúrea, si necesitábamos modificar nuestras fórmulas… pero no es así.

Así que ni el conocimiento sobre radiación, ni los estudios en población muestran que estar en un edificio donde hay wifi, o usar teléfonos móviles, vaya a aumentar tus probabilidades de tener cáncer.

No, no era tan fácil

¿Era evidente? ¿Era fácil? ¿Tenéis conocimientos de cierta profundidad sobre electromagnetismo y cuántica, interacción radiación-materia? Bueno, incluso si así fuera, ¿hemos de tratar con altivez a quien no los tiene? Yo diría que no.

Sigamos informando, expliquemos (aquí tenéis una manera de cómo hacerlo), luchemos contra los que se aprovechan del miedo de los poco informados… pero, repito, no es un asunto tan fácil.

Si te preocupa el cáncer…

Dejadme que aproveche para recordar que, en cambio, el consumo de alcohol y tabaco, o la excesiva exposición a la radiación UV (y otras radiaciones ionizantes, de mayor frecuencia, como los rayos X) sí son cancerígenos comprobados y bastante “eficientes”. Esto es algo que sabemos tanto por los estudios en laboratorios, como por los epidemiológicos. De manera que si queréis reducir vuestras probabilidades de tener cáncer, ya tenéis algunas cosas que podéis hacer.

Sobre el autor: Javier Fernández Panadero es físico y profesor de secundaria además de escritor de libros de divulgación.

El artículo No era tan fácil: wifi y cáncer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sin atajos frente al cáncer

- Hacia la decisión compartida en los programas de cribado de cáncer de mama

- Microbiota y cáncer

Dozena erdi ariketa 2019ko udarako (2): Zifren bila

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain, tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure bigarren ariketa: Zifen bila.

———————————————————————————-

Ariketak “Calendrier Mathématique 2019. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki daiteke.

———————————————————————————-

The post Dozena erdi ariketa 2019ko udarako (2): Zifren bila appeared first on Zientzia Kaiera.

Evolución [Para creyentes y otros escépticos]

Ignacio López-Goñi, lector

No todas las religiones, ni todos los cristianos, abominan de la evolución

Todavía hoy en día siempre que se trata el tema de la evolución, muchos creyentes muestran cierta reticencia a asumir el hecho de la evolución de la vida y del ser humano con todas sus consecuencias. Piensan que hay ciertos momentos de la historia del cosmos que la evolución supuestamente no puede explicar, y recurren a esos “huecos” para “meter” la acción de Dios en el mundo. Para algunos Dios no es más que un gran mago capaz de sacar cualquier truco de su chistera, ocupado en insuflar vida, o “almas”, en ciertos momentos de la historia natural, o en arreglar algo que se le había ido de las manos. Ese es el Dios del creacionismo o de eso que se llama diseño inteligente, un Dios que sólo puede actuar como lo haría un ingeniero: diseñando, construyendo y ensamblando piezas. Pero creación y creacionismo no son lo mismo. El creacionismo, popular e incluso beligerante en el mundo anglosajón entre los movimientos cristianos protestantes, mantiene una interpretación literal de los relatos bíblicos, que es claramente contraria con la evidencia científica. En el extremo opuesto se sitúa el pensamiento materialista, para el que la evolución del cosmos es suficiente para explicar el origen del mundo que nos rodea, sin necesidad de un Dios que le dé sentido. Pero, ¿pueden ser compatibles ambas posturas, afirmar que la vida ha surgido como consecuencia de mecanismos puramente naturales y la existencia de un Dios creador?

Evolución [Para creyentes y otros escépticos]. Javier Novo. 2019. ISBN: 978-84-321-5053-1

Evolución [Para creyentes y otros escépticos]. Javier Novo. 2019. ISBN: 978-84-321-5053-1Javier Novo, es Catedrático de Genética en la Universidad de Navarra y trabaja en la evolución de las secuencias genéticas que controlan el desarrollo del cerebro humano, y acaba de publicar un libro titulado “Evolución para creyentes y otros escépticos”. En él explica de manera muy asequible para un público general cómo funciona la evolución, y argumenta que esa cadena de casualidades que ocurren en la evolución del cosmos se puede ajustar muy bien con la idea de un Dios que da sentido a todo, y no de un Dios artesano, como tantos cristianos e incluso escépticos piensan.

La evolución no es progresar sino explorar

En los primeros capítulos, Novo explica con multitud de ejemplos sencillos y de forma muy didáctica, cómo funciona realmente la evolución, que resumo aquí esquemáticamente en ocho puntos:

1. Evolución no significa que todos los individuos de una especie deban estar constantemente transformándose para alcanzar el “siguiente” estado evolutivo, transformarse de golpe en otra especie. Es mucho mejor hablar de “poblaciones” de individuos que de especies. La evolución ocurre dentro de una gran población, cuando un pequeño número de individuos sufren algún cambio que les permite adaptarse mejor a las condiciones ambientales en las que viven. Se seleccionan las variaciones que ya estaban presentes en la población antes de que se diese ninguna necesidad de poseerlas, antes de que fuesen útiles. La selección natural no “crea” nada, simplemente escoge entre las variantes existentes.

2. La selección natural explica muy bien cambios sencillos. Pero es un error pensar que la evolución siempre funciona de manera gradual, a base de pequeñitos cambios que gradualmente van llevando una población de seres vivos hacia su óptimo, siempre adaptándose mejor y mejor; y que es precisamente la acumulación sucesiva de muchos de estos cambios infinitesimales lo que explica los grandes cambios macroevolutivos (la conversión de un ala en brazo o de un mono a un ser humano).

3. La evolución no es una línea única, no es un gran tronco lineal en el que las especies se van sucediendo una tras otra, hasta llegar a la penúltima y por fin al ser humano. En un árbol en el que las especies que existen en la actualidad son los brotes más externos, un árbol lleno de nudos y ramillas que se han quedado en el camino y nunca han llegado a formar parte de la copa.

4. La selección natural no lo es todo. No es correcto presentar la evolución como un lento e imparable proceso de optimización que siempre alcanza la solución mejor. A veces existen situaciones de aislamiento más o menos brusco que hace que las poblaciones sigan derroteros diferentes. Estos cambios bruscos son tanto más drásticos cuanto menor es el número de individuos que han quedado aislados. Este fenómeno (deriva genética) ha sido más la regla que la excepción en la historia de la Tierra. La colonización del planeta se ha hecho a base de ocupar nuevos nichos, en un proceso repleto además por varias extinciones masivas. Colonización y extinción constituyen dos poderosas fuerzas evolutivas.

5. La evolución a veces es “sucia” y un tanto chapucera. La deriva genética no solo introduce cierta impredictibilidad, sino que explica la existencia de diseños “malos”: en la naturaleza abundan las estructuras que analizadas en detalle responden a un diseño bastante deficiente. La evolución no conoce otra forma de arriesgar que generando lo inesperado; y lo inesperado a menudo es lo no perfecto. Lo verdaderamente sorprendente es que esas imperfecciones constituyan la base para lograr auténticos avances, nuevos modos de sobrevivir y prosperar en las innumerables oportunidades que ofrece nuestro planeta.

6. La evolución no es un proceso uniforme, gradual, que se produce a una velocidad constante (habitualmente lenta), siempre en la misma dirección. No, la evolución puede dar saltos. A veces, un cambio ecológico sencillo puede provocar una transición evolutiva notable. Fue lo que ocurrió en la denominada explosión del Cámbrico, un breve lapso de tiempo (cuarenta millones de años) en los que se originaron la mayor parte de los planes corporales de los animales.

7. Evolución y desarrollo embrionario tienen mucho que ver. Los genes implicados en el control del desarrollo embrionario son esencialmente los mismos en la mayoría de los seres vivos. Muchos cambios que parecen grandes saltos evolutivos pueden explicarse por un recableado o reconfiguración de determinadas redes genéticas que controlan el desarrollo embrionario, son pequeñas modificaciones en esa maraña de conexiones genéticas que pueden tener como resultado trayectorias evolutivas separadas. Se pueden modificar así estructuras biológicas enteras a partir de cambios relativamente sencillos. No hace falta una mutación para cambiar el brazo, seguida de otra para la mano, otra después para cada dedo … No, cuando cambia la red genética que controla el desarrollo del miembro superior, todo el miembro se reconfigurará; pequeños cambios en los sistemas genéticos que determinan la forma de la cabeza ayudarán a entender cómo puede crecer el cráneo y cambiar la cara a la vez. Cuando hablamos de redes complejas como éstas, cambios ligeros en el input pueden dar como resultado modificaciones relativamente drásticas y difíciles de predecir.

8. La evolución a veces retrocede. En realidad simplemente selecciona de entre lo que tiene a su disposición, que a su vez es el resultado de selecciones anteriores. Por eso, evolucionar no es progresar, sino explorar. Muchas veces genes que ya estaban en organismos más sencillos haciendo determinadas cosas, son después “reutilizados” para nuevas funciones en otros organismo más adelante. La evolución se comporta como un amante del bricolaje que toma cosas viejas, ya usadas, y las combina de modos nuevos (la idea es del Premio Nobel François Jacob). Por eso, a veces, la evolución “crea” estructuras que parecen mal diseñadas, no son las “mejores” pero son lo suficientemente buenas como para permitir que la vida siga adelante en ese nicho ecológico concreto. La evolución nunca construye un órgano partiendo de cero, no planifica el funcionamiento del sistema circulatorio como lo haría un experto en hidráulica, no conecta las neuronas como lo haría un ingeniero electrónico. Al contrario, está limitada por las imperfecciones y los fallos del pasado, y con esas herramientas tiene que salir adelante. El resultado final de esa exploración a tientas es el famoso árbol de la vida: unas ramas se habrán quedado secas a mitad de camino, de los nudos interiores han salido otras que hoy forman la copa.

El “problema” de la mente y el ser humano

Hasta aquí la lectura del libro de Novo nos habrá permitido entender un poco mejor cómo funciona la evolución, con la intención de prepararnos para la pregunta esencial: el origen del ser humano. Novo comienza a abordar este tema hablando de la evolución de la mente, ese conjunto de fenómenos cognitivos y emocionales que da lugar a una experiencia subjetiva, a ese “yo” que vive en primera persona sensaciones sublimes que resulta tan difícil explicar con palabras.

En el fondo, el tema de la evolución humana se reduce al problema de la aparición de la mente humana, esa dimensión espiritual que algunos designan con la palabra “alma”. ¿Cómo han aparecido todos esos fenómenos que describimos como mente humana? ¿Ha sido un proceso puramente natural? ¿Ha intervenido Dios de algún modo? Esta es, sin duda alguna, la principal piedra de tropiezo para el creyente que se enfrenta con el hecho evolutivo. La enseñanza católica en este punto es algo difusa, pero suele resumirse con la afirmación de que Dios ha “infundido el alma”, ha insuflado el aliento de vida mediante el cual los seres humanos adquieren esa dimensión espiritual.

Con demasiada frecuencia se ha acudido a la “solución” un tanto ingenua de decir que “la evolución crea el cuerpo y Dios crea el alma”. Pero no podemos pensar que nuestra mente, espíritu, consciencia o alma es una cosa, una especie de “nubecilla”, una sustancia separada que hizo su aparición súbitamente sobre la superficie de la tierra con la aparición de los primeros seres humanos. Hoy en día, es innegable que los sustratos neurológicos sobre los que se asienta la consciencia están presentes en el reino animal y por tanto tienen una historia muy antigua. Lo cual tiene mucho sentido si recordamos que la evolución es exploración, búsqueda incansable de nuevas soluciones. En este contexto, no tiene nada de extraño que todas las habilidades cognitivas necesarias para la vida social, la cooperación, la empatía, la equidad, la planificación, el viaje mental, la fabricación de herramientas o la comunicación simbólica hayan sido “probadas” o “intentadas” repetidas veces a lo largo de la historia evolutiva.

Determinar con certeza quienes fueron los primeros humanos quizá sea imposible. Así, explorando a tientas, el hombre llegó al mundo sin hacer ruido, silenciosamente. Teilhard de Chardin fue el primero en utilizar el término hominización para este largo proceso, y tuvo también la magnífica intuición de compararlo con la infancia. Hablamos a menudo del uso de razón que alcanzan los niños en torno a los seis o siete años. Parece que antes de esa edad aún no son totalmente racionales, y por eso no les exigimos responsabilidades; pero llega un momento en su vida en que adquieren esa racionalidad y comienzan a construir su propia historia. De modo que un niño, se hace mayor y se convierte en un ser capaz de tomar decisiones libres. Algo ha cambiado en esa mente, en los procesos cognitivos que la sustentan, pero el cambio ha ido fraguándose durante años y ha llegado silenciosamente.

De modo semejante, los últimos dos millones de años de evolución humana han sido esa infancia que preparaba el momento de nuestra irrupción final en la historia del cosmos. Es inútil buscar un instante preciso, y es muy probable que nunca lleguemos a saber los detalles exactos de lo que sucedió. La pregunta de quién fue realmente el primer humano resulta irrelevante, como irrelevante es intentar precisar el momento en el que un niño pierde la inocencia y se hace mayor; porque cuando tenemos la seguridad de que el cambio se ha producido, ya es tarde. Cuando vemos los rastros de un comportamiento adulto en nuestro deambular evolutivo, ya han transcurrido miles de años de infancia.

Dios y evolución

Notables escépticos como el premio Nobel de Física Steven Weinberg aluden al hecho de que la ciencia muestra la ausencia de propósito o sentido en las leyes que gobiernan el universo: “cuanto más estudiamos el universo, menos sentido encontramos”. En efecto, el conocimiento de los mecanismos evolutivos nunca nos dirá nada acerca del sentido o significado que tienen; se trata de una cuestión totalmente ajena a la propia metodología científica, ¿por qué debería la ciencia encontrar sentido? Sencillamente, no es el objeto de la ciencia experimental encontrar el sentido, propósito o significado que puedan tener los procesos naturales.