Évariste Galois: contra el tiempo

«Lejos de cualquier lirismo, Billette ha sabido crear un universo históricamente anclado, pero moderno por su lenguaje y su intención, por la explosión cronológica del relato, así como por el humor y un toque fantástico».

Raymond Bertin, « Combat pour un nouveau monde / Contre le temps », Cahiers de théâtre Jeu, 2012

Libreto de Contre le temps.

Libreto de Contre le temps.

Contre le temps –Contra el tiempo– (2011) es una obra de teatro de la dramaturga Geneviève Billette. Se estrenó en Montreal (Canadá) el 8 de noviembre de 2011, año en el que se conmemoraba el centenario del nacimiento de Évariste Galois. En la imagen posterior aparecen los personajes de la obra; de izquierda a derecha:

-

Stéphanie, la amada de Galois.

-

El poeta Gérard de Nerval, encarcelado en la prisión de Sainte-Pélagie en febrero de 1832 por un alboroto nocturno. Allí conoce a Galois y entablan amistad.

-

Évariste Galois, protagonista de la historia.

-

Gabriel, el padre de Galois.

-

Adélaïde, la madre de Galois que se siente culpable por haber perdido el contacto con su hijo durante su estancia en prisión.

-

Alfred, el hermano pequeño de Galois, que sólo desea pasar tiempo con Évariste.

-

Augustin, el amigo de Galois que no entiende la razón de sus matemáticas.

-

El espectro del matemático Jean-Baptiste Fourier, que anhela que Galois redacte su legado científico. Se siente culpable por haber fallecido sin terminar la evaluación de un documento de Galois. Junto a Gérard de Nerval, aporta la nota cómica a una obra de claro corte dramático.

Los personajes de la obra. Fotografía de producción.

Los personajes de la obra. Fotografía de producción.

A continuación resumimos el guion y compartimos algunas citas (traducidas por la autora de esta anotación).

Estamos en 1832, en París. Évariste Galois acaba de abandonar la prisión en la que ha permanecido encarcelado durante ocho meses por motivos políticos. Activo republicano, había sido arrestado, por segunda vez, por un acto de sedición contra el rey Luis Felipe de Orleans. Es un joven apasionado y comprometido; vive por la democracia y la investigación científica.

El matemático intenta terminar su tratado de álgebra porque sospecha que va a morir; lucha contra el tiempo. La noche anterior al duelo que le lleva a la muerte, Galois escribe en el margen de la memoria que está intentando terminar:

Hay algo a completar en esta demostración. No tengo tiempo.

Su madre –con la que ha perdido el contacto desde hace meses– corre a buscarlo para abrazarle y transmitirle su cariño. Un curioso personaje impide a Adélaïde acercarse a Galois: es el fantasma de Jean-Baptiste Fourier, que se siente culpable por haber fallecido –en mayo de 1830– unos días después de haber recibido un manuscrito de Galois para –como secretario vitalicio de la académie des Sciences– evaluar. Sin haber sido revisado, este documento se perdió. Fourier sabe que Galois va a morir y no quiere que nadie le entretenga para que finalice la redacción de su legado matemático.

Galois redacta con gran excitación. Se detiene en algunos momentos para recordar detalles de su vida. Se acuerda afligido de su padre –alcalde de Bourg-la-Reine, de ideas liberales– que se suicida en 1829 no pudiendo soportar el descrédito ante sus conciudadanos promovido por el párroco de la ciudad. Galois lamenta no haber percibido el mal momento anímico por el que pasaba Gabriel. Pero sigue escribiendo, con pasión, con un arrebato cercano a la locura. Recuerda a su amada Stéphanie, a su hermano pequeño, a su madre…

Galois encarna al genio romántico, apasionado por la vida y por intentar cambiar el orden del mundo. Sus ansias por aprender se habían visto frenadas por las autoridades académicas; fue expulsado de la École Polytechnique que apoyaba a una monarquía repudiada por Galois.

Adélaïde: La dirección de la École se declara monárquica, ¿y qué? Eso no te impedirá pensar, trabajar, ¡el álgebra no tiene banderas!

Évariste: El álgebra es también una visión del mundo.

En una conversación con su amigo Augustin, explica la razón por la que sus matemáticas son revolucionarias:

¿Por qué crees que nadie antes de mí había conseguido resolver el problema? Los otros matemáticos no carecen de inteligencia. Conozco sus trabajos de memoria, sé exactamente cómo piensan […]. Uno a uno, han fracasado con la ecuación de grado 5, porque aislaban el problema. […] La única manera de resolverlo era con otra perspectiva. Mi método de resolución general, Augustin, […] era la única solución.

Al definir la estructura de grupo, Galois establece un nuevo territorio a explorar, un territorio con inmensas posibilidades:

Augustin: Comprendo el principio, pero ¿para qué sirve?

Évariste: Para pensar de manera amplia. […] También para ir más allá. Permite anticiparse.

Augustin: ¿Pero a qué se dedica?

Évariste: No te entiendo…

Augustin: Las aplicaciones concretas.

Évariste: Ah eso… Ninguna. […]

Augustin: Vamos… Cuando vayas donde un mecenas, ¿qué le dirás? ¿A quién beneficiarán tus grupos de inmediato?

Évariste: A nadie. Por ahora, a nadie. No… no es para nosotros. Los químicos se apropiarán de ello. Los físicos también. Pero las aplicaciones concretas, como dices, creo que no serán visibles más que dentro de doscientos años. […]

Augustin: Esto es serio, Évariste. No has podido pasarte noches enteras de trabajo sin conocer la utilidad de tus investigaciones… Es imposible. ¡Imposible!

Évariste: Lo que dices es estúpido. ¿Cómo quieres inventar si sabes exactamente lo que estás buscando? Me he obsesionado con la ecuación de grado 5, esto es lo que me ha permitido progresar, noche a noche, hasta la idea de grupo. No se puede investigar, Augustin, realmente investigar, conociendo con antelación el paisaje final.

Augustin: Doscientos años… nadie se beneficiará. Me refiero a que ninguno de nosotros estará…

Évariste: Es cierto, es lo que más me fascina. Hacer posible un mundo que nunca conoceré.

Por cierto, el tiempo le ha dado la razón. Sus teorías matemáticas permiten estudiar objetos complejos en términos de simetrías y de permutaciones y, hoy en día, se aplican a áreas tan variadas como la informática, la química, la física o la criptografía.

Contre le temps finaliza con la aprobación por parte de Fourier de los trabajos de Galois. Cuando el matemático yace ya herido de muerte tras su duelo, Fourier le tranquiliza:

Está todo. (Pausa) Está todo, Galois.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Évariste Galois: contra el tiempo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Estudiar más que conocer, buscar más que encontrar la verdad

- Contra la meritocracia

- El rostro humano de las matemáticas

Antropozenoa askoz lehenago hasi zela proposatu dute

Hasiera batean geologoen artean zegoen terminoa baino ez zen, baina, pixkanaka, gero eta gehiago zabaltzen hasi da publiko zabalaren artean. Antropozoenoaz ari gara, gizaki modernoaren eraginaren ondorioz eratu den garai geologiko berriaz, hain zuzen. Momentuz modu ez ofizialean hitz egiten da gaiari buruz, baina nazioarteko taula estratigrafikoan ere garantia guztiekin sartzeko lanean ari da nazioarteko batzorde bat, tartean Alejandro Cearreta euskal geologoa horretan buru-belarri dagoelarik.

Gauzak ofizialdu bitartean, eztabaida dago Antropozenoa berez noiz hasi zen erabakitzerakoan. Bereziki garai geologiko bat definitzerakoan geologoek argi ikusi behar dutelako garai hori laburbiltzen duen ezaugarria mundu osoan zehar barreiatuta dagoela, hots, inpaktu globala duela. Horregatik, adibidez, askotan ukatu da Antropozenoaren abiapuntua iraultza industrialaren garaian dagoenik, horren eragina globala izan ez zelakoan. Bonba nuklearren garapenaren ondorioz mundu osoko laginetan egiazta daitekeen isotopo erradioaktiboen presentzia, berriz, Antropozenoaren ezaugarritzat jo izan da gehienetan.

1. irudia: Industria iraultza agertu arte gizakiak bereziki nekazaritzaren bitartez aldarazi du ingurunea, baina baita abeltzaintzaren eta artzaintzaren bidez ere. Irudian, Italiako Alpetan egiten den sasoiko artzaintza. (Argazkia: Andrea Kay)

Dena dela, eztabaida ez dago ebatzita, eta arkeologoek ere haien ekarpena egin nahi dute. Ez da hau egiten duten lehen aldia, baina bai agian horretan indar gehien erakutsi dutena, egile kopuruari eta erabilitako euskarriari erreparatzen badiegu bederen. Orotara, 255 ikertzailek parte hartu dute ikerketan, eta, horietatik, 120 egilek zientzia artikulua sinatu dute. Bakoitzak espezializazio arloa duen eremuari edo garaiari buruzko datuak eman ditu. Bestalde, ezin daiteke esan munduko aniztasuna ordezkatuta ez dagoenik: mundua 146 eremutan banandu dute, eta eremu bakoitzean izan den lurren erabileraren bilakaera aztertu dute. Datuak eta ondorioak Science aldizkarian plazaratutako ikerketa batean bildu dituzte.

Bertan azaldu nahi izan dute gizakiak azken hamar milurtekoetan egin duen lurraren erabilera nolakoa izan den, eta bereziki mapen bidez egin dute hori. Bertan jaso dute, besteak beste, nekazaritza estentsiboaren eta intentsiboaren zabalpena, eta baita artzaintzaren bilakaera ere, ehiza-bilketaren desagerpenarekin batera. Azkenik, hiri-gizarteen agerpena jaso dute ere mapa bilduma horretan.

Gogoratu dutenez, duela 10.000 urte inguru ehiza, arrantza eta bilketa ziren ohiko jarduerak, baina Kristo aurreko 1.000. urtearen bueltan planetaren erdian bai nekazaritza zein artzaintza nagusituak zeuden. Horiek izan ziren, hain zuzen, gaur egungo munduari forma eman zioten jardunak, eta ingurumenean eragin esanguratsua izan zuten lehen garai horietatik. Horrenbestez, egileek diote orain arte uste zen baino dezente lehenago gertatu zela gizakiaren inpaktua planetan. Hala izanik ere, onartu dute bereziki industria iraultzaren ondoren hasi zela artean aurrekaririk ez zuen ingurumenaren suntsiketa. Ikertzaileek argudiatu dute klima aldaketari buruzko ikerketetan, eta, bereziki, lurraren erabilerari buruzko eztabaidetan ezagutza hau kontuan hartu behar dela.

2. irudia: Landaredia nahita eta kontrolpean erretzea hainbat milurtekoz erabili izan den nekazaritza teknika da, eta hori ekosistemen kalterako izan da. Irudian, Kabwe izeneko eskualdea ageri da, Zambian. (Argazkia: Andrea Kay)

Ikerketa ArchaeoGLOBE izeneko egitasmoaren barruan garatu dute. Inkesta komunak erabiltzen dituzte ikertzaileek mundu osoko gizarteak ikertzeko antzeko irizpideen arabera. Horrela, mundu osoan lurrarekiko harremana nola aldatu den ikertu nahi izan dute. Mundu mailan ingurumen zientziak eta arkeologia lotzen ditu metodologia berritzaile honek. Funtsean, modu sintetiko batean bildu eta estandarizatu nahi izan dute gaur egun lurzoruen erabileraren inguruan arkeologoek daukaten ezagutza, modu horretan ebatzi ahal izateko zein izan den ingurumenean egon den eragina. Inpaktu hau bereziki paisaien erabilpenean abiatu da, eta bioaniztasunaren, ekosistemen eta klimen aldaketa ekarri ditu. Ehiztari-biltzaileek hasi zituzten aldaketa horiek, baina nekazaritza intentsiboaren zein hirien agerpenarekin eragin hau askoz handiagoa izan zen.

Kontu honi guztiari baikortasun puntu bat atera nahian edo, ikertzaileek babestu dute datu berriak eskutan aukera egongo dela ikasteko hasierako gizarte horiek hainbat arazori eman zizkioten irtenbideen inguruan, hala nola deforestazioari edota ur eskasiari.

“Duela 12.000 urte inguru, gizakia batez ere bilketan ari zen, eta horrek esan nahi du ez zuela ingurumenarekin elkar eragiten nekazariek egin ohi duten modu bizian”, adierazi du, prentsa ohar batean Gary Feinman ikertzaileak. “Eta orain ikusten dugu duela 3.000 urte munduko leku askotan benetan laborantza inbaditzailea egiten zuen jendea bazegoela”, laburbildu du.

Azkenik, eta metodologiari erreparatuz, adierazi dute orain aurrean duten erronka dela hain sakonki ikertu ez den hainbat eremutan sakontzea, planeta osoaren irudi ahalik eta osatuena lortu aldera.

Erreferentzia bibliografikoa:

Stephens, Lucas et al. (2019). Archaeological assessment reveals Earth’s early transformation through land use. Science. 365 (6456), 897-902. DOI: 10.1126/science.aax1192

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Antropozenoa askoz lehenago hasi zela proposatu dute appeared first on Zientzia Kaiera.

El modelo atómico de Rutherford

El oro se emplea en las naves espaciales como protector contra la radiación. Pero básicamente radiación térmica (infrarrojo), visible y, combinado con otros materiales, ultravioleta. Tras leer esta anotación sabrás que el espesor de oro necesario para proteger contra una fuente de radiación alfa a una nave espacial o a una astronauta haría las misiones espaciales prohibitivamente caras. Fuente: NASA

El oro se emplea en las naves espaciales como protector contra la radiación. Pero básicamente radiación térmica (infrarrojo), visible y, combinado con otros materiales, ultravioleta. Tras leer esta anotación sabrás que el espesor de oro necesario para proteger contra una fuente de radiación alfa a una nave espacial o a una astronauta haría las misiones espaciales prohibitivamente caras. Fuente: NASA¿Cómo llega Rutherford a la conclusión de que el átomo debía tener una concentración de masa y carga, esto es, un núcleo a partir de los primeros experimentos de Geiger y Marsden? Veámoslo con algo más de detalle partiendo de la base de que el modelo imperante en ese momento es el modelo atómico de Thomson.

Lo primero que parecía evidente es que debía existir algo (los núcleos) que tenía que ser mucho más densos que cualquier cosa en los átomos de Thomson. Simplemente, porque una partícula α que se mueve directamente hacia uno de ellos se ve detenida y devuelta. Una analogía sería que una pelota de tenis rebota si impacta con una roca, pero no si lo que se encuentra delante es una nube de partículas de polvo de la misma masa que esa misma roca.

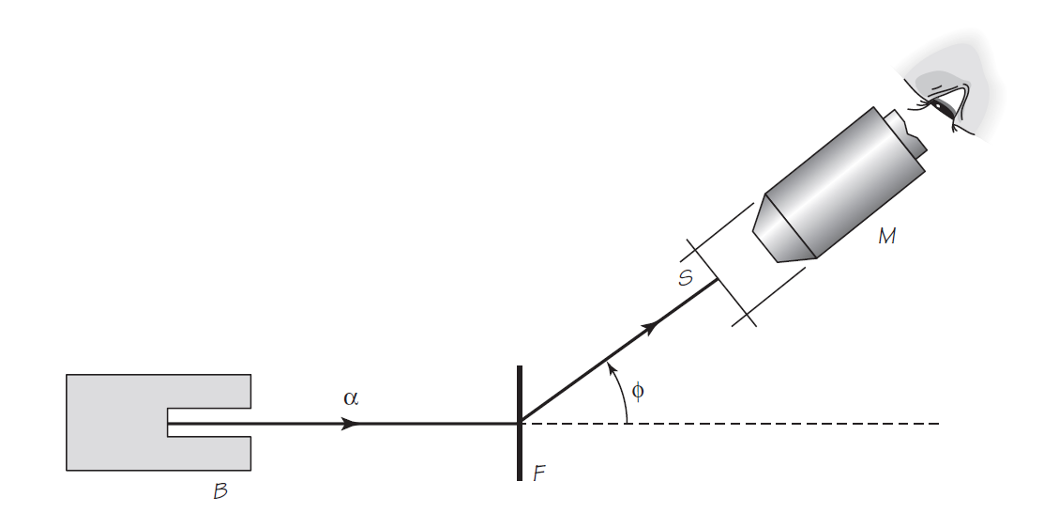

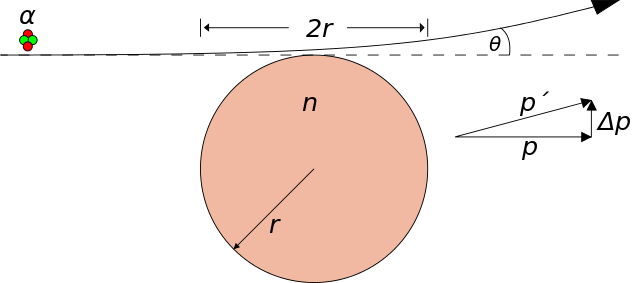

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics LibraryEl esquema de la Figura 1 se basa en uno de los diagramas de Rutherford en su artículo de 1911 [1], que sentó las bases de la teoría moderna de la estructura atómica. Muestra dos partículas α cargadas positivamente, A y A’. La partícula α A se dirige directamente hacia un núcleo masivo N. Si el núcleo tiene una carga eléctrica positiva, repelerá la partícula α, que tiene carga positiva. Debido a esta fuerza eléctrica repulsiva, A frenará hasta detenerse a cierta distancia r de N y luego cambiará el sentido de su movimiento, volverá hacia atrás. A’ es una partícula α que no se dirige directamente hacia el núcleo N. Es rechazada por N de tal forma que sigue una trayectoria que se puede demostrar matemáticamente que debe ser una hipérbola. La desviación de A’ de su trayectoria original está indicada por el ángulo ϕ.

Rutherford consideró los efectos en la trayectoria de la partícula α de las variables importantes: la velocidad de la partícula, el grosor de la lámina y la cantidad de carga Q en cada núcleo. Según el modelo de Rutherford, la mayoría de las partículas deberían dispersarse en ángulos pequeños, porque la posibilidad de acercarse a un núcleo muy pequeño directamente es muy pequeña. Pero un número significativo de partículas α debería dispersarse en ángulos grandes. Eran necesarios nuevos experimentos.

Figura 2. Fuente: Cassidy Physics Library

Figura 2. Fuente: Cassidy Physics LibraryGeiger y Marsden comprobaron [2] estas predicciones con el dispositivo esquematizado en la Figura 2. La caja de plomo B contiene una sustancia radiactiva (radón) que emite partículas α. Las partículas que emergen del pequeño orificio en la caja se desvían en diversos ángulos al pasar pasan a través de una fina capa de metal F. El número de partículas desviadas en cada ángulo ϕ se encuentra dejando que las partículas golpeen una pantalla de sulfuro de zinc S. Cada partícula que golpea la pantalla produce un centelleo (un punto de fluorescencia momentáneo). Estos centelleos se pueden observar y contar mirando a través del microscopio M. El microscopio y la pantalla se pueden mover conjuntamente a lo largo de toda la circunferencia, cubriendo de esta manera todos los ángulos ϕ.

Geiger y Marsden descubrieron que el número de partículas α contadas dependía del ángulo ϕ de dispersión, de la velocidad de las partículas y del grosor de la lámina. Estos hallazgos coincidieron con las predicciones de Rutherford y respaldaron un nuevo modelo atómico, en el cual la mayor parte de la masa y toda la carga positiva ocupan una región muy pequeña en el centro del átomo.[3][4]

Notas:

[1] E. Rutherford (1911) «The Scattering of α and β Particles by Matter and the Structure of the Atom», Philosophical Magazine. Series 6, vol. 21.

[2] H. Geiger, Hans & E. Marsden (1913). «The Laws of Deflexion of α Particles through Large Angles», Philosophical Magazine. Series 6. vol. 25

[3] Lo que implica que la mayor parte del átomo es espacio vacío.

[4] Curiosamente y desde el punto de vista electrostático el átomo de Rutherford es un caso particular del átomo de Thomson. Esto permitió que el primer modelo cuántico del átomo se desarrollase basándose en el modelo de Thomson. Lo hizo Arthur E. Hass en 1910. Esta historia, bastante desconocida, la conté en este video.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El modelo atómico de Rutherford se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Rutherford: la radiactividad y el descubrimiento del núcleo atómico, por El zombi de Schrödinger

- El modelo atómico de Thomson

- 1913-2013: del modelo atómico de Bohr al Higgs

Sukaldeko trapu zikinak

1. irudia: Sukaldeko trapuak bakterioz beteta egon ohi dira, ikerketen arabera. (Argazkia: Hans Braxmeier / Pixabay)

Hainbat ikerketek erakutsi dutenez bakterio heterotrofiko eta enteriko ugari aurki daitezke sukaldeko trapu, zapi, mostratxa eta antzekoetan. Trapu horietan dagoen ingurune umelari esker, mikroorganismoak hedatzeko leku hobeezinak dira. Hori aspalditik ezagutzen dugu: 1995ean egindako ikerketa baten arabera, hogeita hamar bakterio espezie baino gehiago maiztasun handiz aurkitu zituzten sukaldeetan. Horien artean, E. coli, K. pneumoniae, Ent. cloacae, Enterobacter spp., B. subtilis, Bacillus spp. eta Staphylococcus spp. izan ziren ugarienak eta, horietako batzuk, aztertutako sukaldeen %50 baino gehiagotan zeuden. Bakterio kopuruari dagokionez, Enriquez eta bere lankideek frogatu zuten kasu askotan milioi bat unitate kolonia-eratzaile (CFU) baino gehiago daudela sukaldeko trapuetatik erauzitako likido mililitroko. Bide batez, sukaldeko trapuen %14an Salmonella spp. aurkitu zuen Enriquezen taldeak.

Antzeko bidetik, Charles Gerbaren taldeak antzeko lana egin zuen sukaldeko trapuen kasuan eta antzeko emaitzak lortu zituzten. Garbiak diruditen sukaldeko trapuen eta toallen kopuru garrantzitsu batek, %20-40 ingurukoa, bakterioen kutsadura maila altua dute. Komuneko eta sukaldeko toallen kasuan azalpenak ematea erraza da; izan ere, hainbat faktorek laguntzen dute mikroorganismoen maila altu mantentzea. Alde batetik, eskuak ez badira ondo garbitzen, bertan dauden bakterioak toallara igaro daitezke eta bertan arazo handirik gabe hazten dira. Bestetik, aipatutako bide honetatik zein beste batetik toalletara iristen diren bakterioek hezeak dauden toallaren tolesturetan bizileku ederra dute. Hezeak, ilunak eta aireztapen eskasekoak, leku zoragarriak dira komunak bakterioentzat. Sukaldeetan aldiz, elikagaietatik bakterio ugari iristen dira gure etxeetara. Komunetan, gainera, Gerba berak aztertutako beste fenomenoa gertatzen da: geure hondakinak komun-zuloan hustu ondoren, ponpa tiratzean bakterioz betetako bioaerosola sortzen da eta komuneko leku guztietara hedatzen da –Jakinduriek mundue erreko dau saioetan sarritan azaldu izan dudan moduan-.

Charles Gerba mikrobiologoak eta bere ikerketa taldeak egindako azken lanen arabera -emaitzak oraindik ez dira argitaratu- komuneko toallen %90 bakterio koliformeekin kutsatuta dago. Bakterio koliforme horiek uraren eta elikagaien kutsadura mikrobiologikoaren adierazle dira. Hori gutxi balitz, toallen %14ak E. coli bakterioa du. Antzeko bidetik doaz sukaldeetan egindako ikerketen emaitzak -horiek bai, argitaratuta daude jada-. Ikerketa gauzatzeko 82 sukalde trapu aztertu zituzten. Toalla batzuk mila CFU besterik ez zituzten arren, beste batzuetan mila milioi CFU neurtu zituzten. Batez beste, 3,16´108 CFU zeuden aztertutako sukaldeko toalletan. Toallen %89an bakterio koliformeak zeuden eta %25,6ean E. coli identifikatu zen. Bestalde, trapuak zein maiztasunekin garbitzen diren bakterio kopuruarekin lotu ahal izan zuten, alegia, trapua zenbat eta maizago garbitu, orduan eta bakterio gutxiago daude. Hala ere, garbiketak ez ditu bakterioak guztiz kentzen eta, ondo egiten ez bada, bakterio kantitate nabarmenak egon daitezke bertan. Modu argigarrian azaltzen du Gerbak berak: bi egun baino gehiagoz esekita egon den toalla batekin aurpegia garbituta aurpegia komun-zuloan sartuta baino E. coli gehiago hartzen dira.

Ikertzaileen gomendioa toallak bi egunez behin garbitzea da eta sukaldeko trapuen kasuan ere, maiztasun handiz garbitzea aholkatzen dute. Sukaldeko trapuen kasuan, garbiketako metodorik eraginkorrena lixiba dela frogatu du Gerbaren taldeak. Oro har, trapu gehienak nahiko ondo garbitzen dira 4 g/L lixiba kontzentrazioa duen disoluzioan bi minutuz murgiltzen badira. Hala ere, ohartarazten dute, trapuaren materialaren arabera eta bakterio kopuruaren arabera, zenbaitetan oso zaila da garbiketa eraginkorra lortzea. Badaezpada ere, nik oraintxe garbituko ditut nireak…

Erreferentzia bibliografikoa:

Gerba, C. P., Tamimi, A. H., Maxwell, S., Sifuentes, L. Y., Hoffman, D. R., & Koenig, D. W. (2014). Bacterial occurrence in kitchen hand towels. Food Protection Trends, 34(5), 312-317.

Informazio osagarria:

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Sukaldeko trapu zikinak appeared first on Zientzia Kaiera.

Todos los rojos son chillones

Foto: Janke Laskowski / Unsplash

Foto: Janke Laskowski / UnsplashUn vestido rojo destaca en cualquier fiesta, terraza o sarao. La prenda roja atrae nuestra atención pero, ¿alguna vez se ha preguntado por qué?

Blanco, negro y rojo

Lingüísticamente, “rojo” es el primerizo, la primera palabra cromática, el hermano mayor de todos los demás colores.

No todas las culturas humanas desarrollan palabras para nombrar los colores, como “amarillo”, “rosa” o “marrón”. En cambio, todas distinguen entre el día y la noche. Entre lo visible y lo que no se puede ver. De alguna manera, todas las lenguas humanas son capaces de distinguir su “blanco” de su “negro”, su claro de su oscuro. Pero a partir de ahí, no todas las culturas han necesitado desplegar palabras para describir colores particulares.

La evolución lingüística, no obstante, suele conducir a un punto en el que las sociedades humanas comienzan a nombrar las cosas por su apariencia externa, los colores. Y curiosamente, casi siempre la primera palabra que emerge para cumplir esa función, después de blanco y negro, suele ser el rojo.

Henry & Co. / Unsplash

Henry & Co. / UnsplashGracias a la antropología lingüística sabemos que si una lengua humana solo cuenta con tres palabras para designar la apariencia externa de las cosas, esas tres palabras serán “claro”, “oscuro” y “rojo”. Evidentemente, eso llama la atención de cualquier psicólogo cognitivo. De todos los colores, el rojo debe ser especial porque, lingüísticamente al menos, es casi siempre el primer color. O, dicho al revés, algo tendrá, alguna vivacidad especial, para que siempre le toque ser el primerizo, el hermano mayor.

Se puso colorado

Al ser el primer color, es normal que en algunas lenguas rojo todavía signifique “todos los colores” o “cualquier color”. En lengua comanche, por ejemplo, rojo es sinónimo de color. Incluso en griego clásico, la raíz de “chroma” es “chros”, que también representa la piel humana o, en general, la presencia exterior. Además, está presente en la palabra ocre, un rojo primigenio.

Aunque tampoco hay que irse tan lejos. En español, ¿qué significa la expresión “ponerse colorado”, sino sonrojarse?

También es el color que ha tenido más margen temporal para evolucionar. Siempre se menciona que los esquimales tienen decenas de palabras para designar el blanco; pero no es tan conocido que los maoríes, por ejemplo, tienen tantas o incluso más variedad de palabras para designar el complejo universo del rojo.

Los frutos rojos, las hojas verdes

Todos los rojos son chillones pero, ¿de dónde le viene esa vivacidad especial?

“Le regaló una rosa roja y él, tímido, se puso colorado”. El pincel de la literatura romántica colorea de rojo el amor, la pasión, la atracción y el placer. Es el pigmento de las flores y de la piel. Pero, pero, pero… la naturaleza no es tan romántica. Biológicamente, el rojo no nació del amor y las flores, sino del hambre y los frutos.

Ser el primer color tiene una preciosa explicación evolutiva. En comparación con otras funciones biológicas del cuerpo humano, nuestra visión tricromática es relativamente reciente, se conformó hace unos 30 o 40 millones de años. Se conoce como ‘tricromática’ porque se configura sobre 3 ejes: el eje blanco/negro, el eje azul/amarillo y, por último, el eje el rojo/verde. Este tercer eje, el último en evolucionar, lo compartimos con otros simios tricromáticos. Los demás animales (los pájaros, los peces, los insectos…) han desarrollado otro tipo de espectros cromáticos.

¿Cuál es la razón evolutiva que llevó a ciertos simios a desarrollar ese tercer eje rojo/verde? La explicación simplificada es que éramos recolectores. Poder ver el color rojo, contrastándolo con el verde, supuso un fenomenal avance evolutivo porque nos permitió poder resaltar en un solo golpe de vista el jugoso y deseable fruto rojo frente a las desabridas hojas verdes de fondo.

Foto: Xiaokang Zhang / Unsplash

Foto: Xiaokang Zhang / UnsplashEl color rojo es el resultado evolutivo de la tecnología visual desarrollada por los monos recolectores para distinguir la fruta madura de las hojas. Por eso es el color que se distingue desde más lejos, a primera vista y sin esfuerzo.

Evolutivamente, rojo significa comida, significa jugoso, el fruto que se esconde tras las hojas de los arbustos. Significa también caza, el animal sobre la hierba. Significa, en definitiva, que ha llegado poderosa la primavera.

Siempre forma, nunca fondo

Por esa razón, el color rojo fuerza la distinción entre la forma y el fondo. El rojo es siempre forma; nunca es fondo.

En una original exposición sobre el color rojo que acogió en Mayo el Campus de Gipuzkoa (UPV/EHU), el pintor Manuel Bocanegra presentó una obra paradójica. Se trata de un marco vacío pintado de rojo.

‘Pausa’, obra de Manuel Bocanegra.

‘Pausa’, obra de Manuel Bocanegra.Ekai Txapartegi, Author provided

¿Por qué no se pintan de rojo los marcos de los cuadros? Porque un marco rojo empujaría la pintura al fondo y convertiría la pared en su propio marco. Manuel Bocanegra ha dejado vacío, intencionadamente, el espacio enmarcado porque, se ponga lo que se ponga, pasaría a ser paisaje, al igual que la pared que la sostiene.

Lo rojo viene al frente y arrastra al fondo todo lo demás. Como cuando va recogiendo grosellas una a una por los matorrales, mecánicamente, en una coordinación espontánea entre el ojo y la mano. Todo lo demás es fondo, que ni se ve. Simplemente, la mano se abalanza a por el objeto rojo que la vista trae al frente.

¡Mírame, estoy aquí!

Si quiere destacar algo, píntelo de rojo. Como las señales más importantes, de tráfico y de emergencia. El Reino Unido tuvo la mala idea de pintar de verde sus buzones de correos. En 1874 tuvo que volver a pintarlos, pero esta vez de rojo, porque la gente se chocaba contra los postes verdes. Psicológicamente, el rojo es el color más saliente. El que más llama la atención.

El rojo se impone. Para corregir textos, por ejemplo, se usa el rojo. O esa conocida lata de refresco, un verdadero imán para nuestra vista, símbolo del capitalismo más instintivo.

Si se viste de rojo, vibra, porque instantáneamente le convierte en un objeto de deseo. La naturaleza aprendió ese truco hace millones de años pintando sus frutos de rojo, así como las partes más eróticas de nuestro cuerpo: los labios, el pecho y los genitales.

En definitiva, todos los rojos son chillones porque este le grita descarado: “¡Míreme, estoy aquí! El resto no le interesa”.![]()

Sobre el autor: Ekai Txapartegi es profesor del Departamento de Lógica y Filosofía de la Ciencia en la Facultad de Educación, Filosofía y Antropología de la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Todos los rojos son chillones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una fórmula para dominar todos los mecanismos

- Una fórmula para dominarlos a todos: La conservación de la energía y la ley de la palanca

- Una fórmula para dominarlos a todos: El trabajo

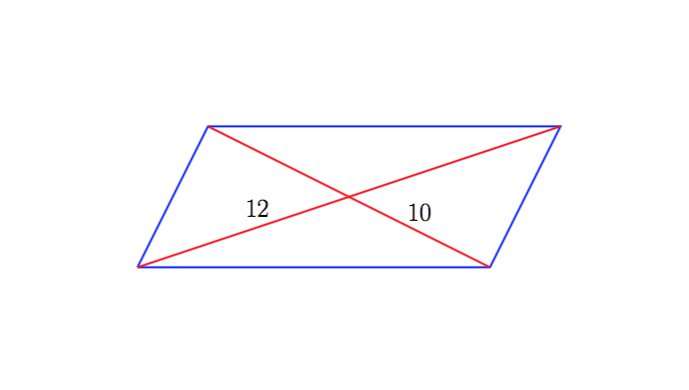

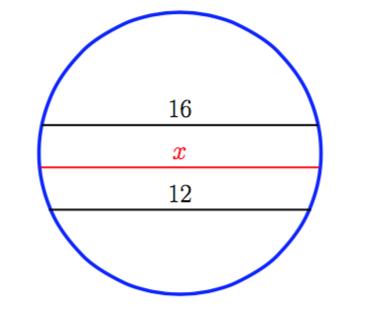

Dozena erdi ariketa 2019ko udarako (6): Luzeren bila

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain, tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure azken ariketa: Luzeren bila.

———————————————————————————-

Ariketak “Calendrier Mathématique 2019. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki daiteke.

———————————————————————————-

The post Dozena erdi ariketa 2019ko udarako (6): Luzeren bila appeared first on Zientzia Kaiera.

Historias de la malaria: La lucha contra la malaria

Combatiendo la malaria en la Ilslas Salomón. Foto: Jeremy Miller /AusAID / Wikimedia Commons

Combatiendo la malaria en la Ilslas Salomón. Foto: Jeremy Miller /AusAID / Wikimedia CommonsFue después de la Segunda Guerra Mundial cuando la Organización Mundial de la Salud (OMS), integrada en las Naciones Unidas, incluyó, entre sus objetivos prioritarios, la detección, control y erradicación de la malaria. Así se promovió la colaboración y participación de las autoridades de muchos países y, además, fondos para financiar los programas antimalaria que proponía la OMS.

La creación de la OMS se hizo oficial el 7 de abril de 1948 pero antes y después de la Segunda Guerra Mundial, hasta ese año, la malaria era de interés para muchos países y organizaciones. José Antonio Nájera lo contaba en 1989 cuando era Director, en su sede de Ginebra, del Programa de Acción contra la Malaria de la OMS. En esos años anteriores a la OMS, hubo campañas con éxito y otras que fracasaron: en los ejércitos que lucharon en la Primera Guerra Mundial; la construcción del Canal de Panamá; el control del agua en el Valle del Tennessee en Estados Unidos; las plantaciones en Malasia; la erradicación de los mosquitos en Brasil o Egipto, el desarrollo de métodos de erradicación en España y Portugal, y tantos otros. En España, el último caso se diagnosticó en 1962, y en 1964 la OMS declaró al país como libre de malaria, cuando en 1937 había unos 100000 casos al año.. Fue en 1973 cuando se declaró a Grecia país libre de malaria cuando antes de la Segunda Guerra Mundial tenía de uno a dos millones de casos anuales.

Incluso organizaciones internacionales, como la Organización para la Salud de la Liga de las Naciones, ya tenía una Comisión de la Malaria cuyo primer informe se publicó en 1924. También la Organización Panamericana de la Salud, y desde 1907, celebraba conferencias y publicó informes sobre la malaria.

Pero fue con la OMS cuando se inició la lucha sistemática contra la malaria a nivel internacional. Los primeros informes de la comisión de expertos de la OMS se publicaron en 1947, antes de que la organización empezara a funcionar de manera oficial. En esa fecha, su objetivo era utilizar el DDT para el mosquito vector, siempre con la participación financiera de los sistemas de salud de los países implicados. Además, siempre se menciona el drenaje de marismas y pozos, la importación del pez Gambusia que se alimenta de las larvas de los mosquitos, utilizar venenos como el vertido de petróleo o la utilización del Verde País (con arsénico), todo ello para evitar el desarrollo de las larvas del mosquito.

El segundo informe, de 1948, incluye la declaración de la política oficial de la OMS sobre la malaria. También se nombró una sección dedicada a la malaria en el Comité Ejecutivo de la OMS. La Asamblea oficial de la OMS, llamada Asamblea de la Salud, de 1948, pedía, además de la formación de la sección de la malaria, estudios sobre la extensión de la malaria y el tratamiento a los enfermos, la mejora de las prácticas agrícolas y en la construcción de casas, y conseguir fondos para investigación.

El siguiente informe, de 1950, revela la escasez de personal preparado para la detección y el control de la enfermedad en los trabajos en aldeas y pueblos. Hay 250 millones de enfermos y 2,5 millones de muertes. Y llegan la OMS y el DDT a los países con malaria. Además, en los informes hasta 1954 aparecen las primeras citas de cepas de mosquitos resistentes al DDT. En concreto, aparecen mosquitos resistentes en Estados Unidos, Grecia y Panamá. Se piden más estudios de campo sobre estas resistencias, con datos más precisos.

Pero las campañas tienen éxito en muchos países y, en 1957, la OMS publica un Informe Técnico para establecer los criterios que determinan que la malaria deja de ser una enfermedad endémica en un determinado entorno, así como el protocolo para la observación continua de nuevos enfermos y de criaderos de mosquitos para reaccionar con prontitud y eficacia si fuera necesario.

Hasta 1955, el objetivo de la OMS era controlar la enfermedad pero, a partir de este año, los programas intentan erradicar la malaria. Ya se había aprobado en 1954 en la Conferencia Sanitaria Panamericana, celebrada en Santiago de Chile, y en la Conferencia Asiática sobre la Malaria, en Baguío, Filipinas. Era un plan basado en el DDT y, sobre todo, en la participación directa de los organismos antimalaria de los países implicados. Era importante resaltar que los gastos para el control de la enfermedad eran mayores que los necesarios para erradicarla. Además, los programas de control, que debían durar muchos años, daban tiempo a la aparición de resistencias en los mosquitos.

Al año siguiente, en 1955, el Comité Ejecutivo de la OMS recomendó la erradicación en la Octava Asamblea Mundial sobre Salud, celebrada en México. También se aprueba que la OMS tenga un presupuesto especial y concreto dedicado a la lucha contra la malaria y comenzaron las campañas de la organización contra la malaria.

En el siguiente informe de la OMS sobre la malaria, publicado en 1957, se define la erradicación de la enfermedad como “el final de la transmisión de la malaria y la desaparición de enfermos infectados por medio de una campaña limitada en el tiempo y practicada con un grado de perfección tal que, cuando termine, no haya transmisión ni reaparición de la enfermedad”. De nuevo se destaca que los gastos de la erradicación son menores que los necesarios para el control y que, por otra parte, se acortan los tiempos y se evita que aparezcan las resistencias.

En las reuniones de la OMS y de otros organismos internacionales relacionados con la salud era evidente la sensación de urgencia creada por una insistente llamada humanitaria contra la extensión y las consecuencias de la malaria para la población de muchos países y regiones del planeta. Las últimas decisiones habían iniciado muchos programas de erradicación pero, en muchos casos, con poco éxito por la falta de datos fiables sobre la presencia y extensión de la malaria, con sistemas administrativos y sanitarios escasos o poco desarrollados, falta de personal entrenado y de coordinación en campañas con países vecinos, y, también, la escasez de fondos para investigación básica y aplicada sobre la enfermedad.

Los mayores problemas estaban en el África tropical y en el Sureste de Asia, con algunos éxitos en campañas concretas como Liberia o Camerún. Pero, a menudo, los programas no se terminaban y se interrumpían por muchas y variadas razones. Incluso en Ceilán, actual Sri Lanka, donde se suponía erradicada la malaria, tuvo posteriormente una epidemia masiva con miles de enfermos. Poco a poco se iba extendiendo la convicción de que, a medio plazo, no sería posible la erradicación. Falta la infraestructura sanitaria eficaz y preparada en la mayoría de los países con malaria endémica.

Para mediados de los sesenta, la malaria estaba erradicada en Europa, en la mayor parte del área asiática de la URSS, varios países del Cercano Oriente, Estados Unidos, casi todo el Caribe, grandes zonas del norte y el sur de Sudamérica, Australia, Japón, Singapur, Corea y Taiwan. La enfermedad había desaparecido del 80% de las áreas geográficas en que había sido endémica.

Pero en África, al sur del Sáhara, los programas antimalaria no habían funcionado. Era difícil organizarlos con eficacia. Además, empezaban a aparecer las resistencias al DDT.

En la Asamblea Mundial de la Salud de 1967, celebrada en Ginebra, se ajustan los objetivos y, aunque se mantiene la erradicación como meta final, se plantea el control de la malaria como una etapa intermedia, válida y necesaria. Para conseguirlo se analizan los programas en marcha y se decide cuales de ellas pueden erradicar la enfermedad en un plazo aceptable y se sigue adelante con ellos. Los que no cumplen este requisito, se consideran programas de control de la malaria. Y en la Asamblea de 1969, visto que, según expertos como George Davidson, el número de casos se acercaban a cifras de antes de la Segunda Guerra Mundial, se pasó definitivamente al control de la enfermedad, con la erradicación como objetivo a más largo plazo. Para finales de esta década, hay resistencias del plasmodio a los fármacos, sobre todo a la cloroquina y para el Plasmodium falciparum, el parásito más letal. La OMS vuelve a destacar los problemas de financiación y la escasez de personal técnico preparado.

En 1973, según la OMS, hay cuatro millones de casos, y en 1977, subían hasta once millones, y a principios de los ochenta, vuelven a bajar a los siete millones. Y siempre sin incluir el África tropical. Por ello, en 1974 se publican los protocolos para cambiar un programa de erradicación fallido por un programa de control. El control se basa en fármacos y vacunas contra el plasmodio, el control de los mosquitos y la protección de la población a la picadura de los insectos.

A partir del final de la década de los setenta, la OMS promueve la inclusión de los programas de control en los sistemas de salud primario de cada país. En concreto y según los acuerdos de la 31ª Asamblea Mundial de la Salud, en 1978 y en Ginebra, se busca reducir la mortalidad y los efectos negativos que provoca la malaria en lo social y en lo económico. Además hay que promover la prevención y el control de la enfermedad, y siempre con el objetivo final de la erradicación.

El número de casos que ha catalogado la OMS entre 1964 y 1985, según cuenta José Antonio Nájera, lleva a algunas conclusiones interesantes. En primer lugar, no se incluyen los datos de África porque son escasos y sin continuidad y, a menudo, poco fiables y confusos. Si se excluyen África, China y la India, en el resto del planeta y a partir de mediados de los setenta, el número de enfermos se mantiene estable. De China llegan los primeros datos en 1977 y, en años posteriores, la cifra desciende con rapidez; en la India, después de una epidemia masiva, con la reaparición de la malaria en 1975, se vuelve a controlar la enfermedad en los ochenta.

Entre los sesenta y finales de los novena, la confianza en erradicar la malaria llevó al descuido en los programas y, en consecuencia, a un gran aumento de enfermos y fallecimientos. Al comienzo del siglo XXI cambió la situación y volvió la malaria a ser objetivo prioritario en los programas de salud mundial. Aumentaron los fondos para investigación y se plantea la hipótesis de que continentes enteros se libren de la malaria y, con tiempo, hasta que se erradique de todo el planeta. Por entonces, la OMS considera que el mayor problema es la falta de financiación sólida, previsible y demostrada, lo que dificulta acuerdos políticos a medio y largo plazo y la colaboración regional. Y, desde la práctica, siguen apareciendo resistencias a los fármacos antiplasmodio y de los mosquitos ante los insecticidas. Por ejemplo, en 1985, la resistencia uno o a varios insecticidas había aparecido en 57 especies de Anopheles y afectaba a los programas de control de 62 países. Y la resistencia a los fármacos contra el parásitos se había detectado en 35 países de Asia, el norte de Sudamérica y el África tropical. Y. además, se sigue notando la falta de rigor y profesionalidad en los sistemas de salud de muchos países implicados.

En 1990-1992, según Nevill, de la Unidad de Malaria de Nairobi, en Kenia, el 40% de la población mundial vivía en zonas con malaria endémica, con 100 millones de casos y un millón de muertes cada año. La OMS lanzó un nuevo programa con los siguientes objetivos: diagnóstico y tratamiento precoz; aplicación de medidas preventivas; comprobar la presencia de malaria; y revisión frecuente de los factores económicos, sociales y ecológicos que favorecen la presencia y extensión de la enfermedad.

La iniciativa Roll Back Malaria, con más de 500 participantes públicos y privados, se inició en 1998 y consiguió una gran reducción en la trasmisión de la malaria en África entre 2000 y 2010. Pero, todavía en 2010, el 57% de la población vive en zonas donde el peligro de la trasmisión es intenso.

En una revisión publicada en 2010 por Vandana Wadhwa y sus colegas, de la universidad de Boston, y con datos de la OMS de 1999, la mortalidad provocada por la malaria durante el siglo XX va de casi 200 millones de muertes en 1900, unos 170 millones en 1930, 40 millones en 1950, menos de 10 millones en 1970 y décadas posteriores hasta 1997, todo ello sin incluir África. En cambio, en el África subsahariana se producen el 90% de las muertes con cifras que van desde los 200 millones de 1900 a unos 160 millones en 1967, y unos 100 millones en 1970. En otra revisión, publicada en 2004 por Simon Hay y sus colegas, de la Universidad de Oxford, se enumera el porcentaje de población expuesta a la malaria. En 1900 era el 77% de la población mundial; en 1946, era el 68%; en 1965, el 57%; en 1975, el 52%; en 1994, el 46%; en 2002, el 48%; y en 2010, el 50%. Parece que la situación que provoca el descenso de la población en riesgo se ha detenido. Y los enfermos en la segunda década del siglo XXI son, según la OMS, 225 millones en 2011, 217 en 2012, 210 en 2013, 210 en 2014, 211 en 2015, y 216 en 2016. Las cifras descienden pero no mucho y se mantienen en más de 200 millones de casos.

Se inicia la Estrategia para 2020 con objetivos como reducir la tasa de mortalidad en un 40% por lo menos, la incidencia de casos en un 40% por lo menos, eliminar la malaria en 10 países por lo menos, y evitar el resurgimiento de la enfermedad en los países declarados exentos. La campaña más reciente de la OMS contra la malaria es el Programa Mundial sobre Paludismo, con una última actualización el 14 de diciembre de 2017. Sus objetivos se rigen por la Estrategia Técnica Mundial contra la Malaria 2016-2030, aprobada por la 68ª Asamblea Mundial de la salud de mayo de 2015. A pesar del progreso en la lucha contra la malaria, en 2013 el 90% de los enfermos se localizaba en África y dos países, República Democrática del Congo y Nigeria, sumaban el 40%, casi la mitad de todos los enfermos del planeta. Las muertes en África han descendido desde 764000 en 2000 a 395000 en 2015.

La Estrategia Técnica fijó cuatro objetivos para 2030: reducir la incidencia de la malaria en al menos un 90%; reducir la tasa de mortalidad en al menos un 90%; eliminar la malaria en 35 países como mínimo; y prevenir la reaparición de la malaria en todos los países que estén libres de la enfermedad. La OMS plantea que uno de los objetivos básicos para conseguir lo anterior es el apoyo técnico a todos los países con malaria endémica. Además, la OMS debe formular y difundir orientaciones y políticas mundiales sobre el control y la eliminación de la malaria.

El último Informe Mundial sobre Malaria de la OMS corresponde a 2018, presentado en Maputo, Mozambique, y se publicó el 19 de noviembre. El número de enfermos de malaria censados en 2017 fue de 219 millones de personas y no hay cambios significativos en el periodo 2015-2017. La gran mayoría de los enfermos, hasta el 92%, está en África. Plasmodium falciparum es el parásito responsable del 99.7% de los casos en África. Los casos de malaria habían aumentado en 10 de los 11 países con mayor incidencia de la enfermedad y todos están en África. Estos países africanos con malaria endémica justifican el aumento de enfermos por la aparición de más resistencias del plasmodio a los fármacos y de los mosquitos a los insecticidas.

En 2017, el número de muertes por la malaria fue de 435000 en todo el mundo. Los niños menores de 5 años son el grupo más vulnerable, con el 61% de todos los fallecimientos. El 93% de estas muertes se dio en África.

En el Informe de 2017, la OMS cuantifica la entrega de 624 millones de mosquiteros tratados con insecticidas, la realización de 276 millones de pruebas de diagnóstico, y de casi 3000 millones de tratamientos continuados con la droga más utilizada por la OMS en la actualidad, la artemisina. Lo más efectivo es el diagnóstico rápido, los mosquiteros con insecticidas, los fármacos adecuados, la investigación para conseguir una vacuna, y los protocolos para la vigilancia de la enfermedad y una respuesta rápida. También se menciona que la OMS certifica a Paraguay como libre de malaria en 2018, mientras que Argelia, Argentina y Uzbekistán lo han solicitado. En 2017, China y El Salvador declaran cero casos de malaria autóctona.

En la actualidad, a fecha de enero de 2019, el Director del Programa Mundial sobre la Malaria de la OMS es el Dr. Pedro Alonso, fotografiado aquí en la sede de la OMS en Ginebra. Fuente: OMS

En la actualidad, a fecha de enero de 2019, el Director del Programa Mundial sobre la Malaria de la OMS es el Dr. Pedro Alonso, fotografiado aquí en la sede de la OMS en Ginebra. Fuente: OMS

Por otra parte, en una revisión publicada en 2012, Christopher Murray y sus colegas, del Instituto para la Evaluación y la Medición de la Salud de Seattle, encuentran que el número de fallecidos provocados por la malaria es mayor de lo calculado hasta ahora, sobre todo porque hay más muertes en enfermos de más de cinco años. Según sus cálculos, entre 1980 y 2010, son de 995000 en 2004, un pico de 1817000 en 2004, y una caída hasta 1238000 en 2010. Este descenso en 2010 se detecta tanto en África como en otros lugares.

Para terminar, Bruno Moonen, director de la lucha contra la malaria de la Fundación Bill y Melinda Gates, escribió en 2017 que la erradicación es la única solución sostenible y equitativa. La alternativa, el control como programa indefinido, no es sostenible. Mantener la financiación para un control sin fecha final para la erradicación, y especialmente cuando se ha alcanzado un nivel de la enfermedad, es muy difícil. Y cuando no se tiene un presupuesto adecuado, la malaria puede resurgir.

El programa sin fecha final de control requiere una inversión constante de fondos en investigación y desarrollo para conseguir, en una situación en la que el plasmodio y el mosquito evolucionan constantemente. Sin embargo, los países que han conseguido erradicar la malaria son capaces de mantenerse libres de la enfermedad, aunque también es cierto que en 2018 se detectaron 68 casos de reaparición de malaria en poblaciones donde se había reducido la población de mosquitos, según cuenta Dan Strickman, de la Fundación Bill y Melinda Gates.

Pero los programas de erradicación deben alcanzar su objetivo. No hacerlo es costoso y termina por necesitar muchos fondos, quizá tomados de otras prioridades del país. Por ello, la organización de un programa de erradicación debe, en primer lugar, decidir si es factible. Si no lo es, lo mejor es no iniciarlo y seguir con el control.

Y, además, queda la llamada malaria de aeropuerto, es decir, la que llega a países que han erradicado la enfermedad desde aquellos donde sigue siendo endémica. Pueden llegar viajeros enfermos pero, también, mosquitos con el plasmodio. Por ejemplo, en agosto de 1984, una paciente de 76 años ingresó en un hospital de Madrid con fiebre y síntomas respiratorios y fue tratada de neumonía. Un mes después tuvo una infección bacteriana y le recetaron antibióticos. En un análisis de sangre apareció Plasmodium falciparum y, tratada con cloroquina y quinina, murió pocos días después por complicaciones respiratorias. En su revisión publicada en 1989, Isaäcson, de la Universidad de Witwatersrand, en Sudáfrica, incluyó este caso en la malaria de aeropuerto que, como decía, se supone que se infectaron por la picadura de mosquitos que han viajado en avión desde países con malaria. En el caso de Madrid, la paciente había visitado a su hija que vivía a menos de seis kilómetros del aeropuerto. Los casos importados en Europa, y según la OMS, provocaron hasta 100 muertes entre 1969 y 1974.

Referencias:

Breman, J.G. et al. 2004. Conquering the intolerable burden of malaria: What’s new, what’s needed: A summary. American Journal of Tropical Medicine and Hygiene 71, Suppl 2: 1-15.

Bruce-Chwatt. 1984. Malaria: from eradication to control. New Scientist 102: 17-20.

Bruce-Chwatt, L.J. 1986. Malaria control at the cross-roads! Where do we go from here? Memórias do Instituto Oswaldo Cruz 81: Suppl. II: 1-4.

Davidson, G. 1982. Who doesn’t want to eradicate malaria? New Scientist 96: 731-736.

Dietz, K. et al. 1974. A malaria model tested in the African Savannah. Bulletin of the WHO 50: 347-357.

Hanson, K. 2004. Public and private roles in malaria control: the contributions of economic analysis. American Journal of Tropical Medicine and Hygiene 71, Suppl 2: 168-173.

Hay, S.I. et al. 2004. The global distribution and population at risk of malaria: past, present and future. Lancet Infections Diseases 4: 327-336.

Hemingway, J. et al. 2016. Tools and strategies for malaria control and elimination: What do we need to achieve a grand convergence in malaria? PLOS Biology 14: e1002380.

Isaäcson, M. 1989. Airport malaria: a review. Bulletin of the WHO 67: 737.743.

Konradsen, F. et al. 2004. Engineering and malaria control: learning from the past 100 years. Acta Tropica 89: 99-108.

Lomborg, B. 2017. Aprender de la malaria. El País 4 agosto.

Moonen, B. & C. Shiff. 2017. Should we commit to eradicating malaria worldwide? British Medical Journal 356: j916.

Murray, C.J.L. et al. 2012. Global malaria mortality between 1980 y 2010: a systematic analysis. Lancet 378: 413-431.

Mwenesi, H.A. 2005. Sopcial science research in malaria prevention, management and control in the last two decades: An overview. Acta Tropica 95: 292-297.

Nájera, J.A. 1989. Malaria and the work of WHO. Bulletin of the WHO 67: 229-243.

Nevill, C.G. 1990. Malaria in Sub-Saharian Africa. Social Science & Medicine 31: 667-669.

Noor, A.M. et al. 2014. The changing risk of Plasmodium falciparum malaria infections in Africa: 2000-2010: a spatial and temporal analysis of trasmission intensity. Lancet 383: 1739-1747.

OMS. 2015. Estrategia Técnica Mundial contra la Malaria 2016-2030. OMS. Ginebra. 30 pp.

OMS. 2017. Programa Mundial sobre Paludismo de la OMS. OMS. Ginebra. 8 pp.

OMS. 2018. Informe Mundial sobre el Paludismo 2018. OMS. Ginebra. 10 pp.

Shah, S. 2010. The fever. How malaria has ruled humankind for 500.000 years. Picador. New York. 309 pp.

Strickman, D. 2018. La lucha contra los mosquitos. Investigación y Ciencia septiembre: 38-43.

Wadhwa, V. et al. 2010. The history and progression of malaria: A global and regional view. En “Malaria in South Asia”, p. 1-27. Ed. por R. Akhtar et al. Springer-Science-Business Media.

Yanney, G. 2004. Roll Back Malaria: a failing global health campaign. British Medical Journal 328: 1086-1087.

Zulueta, J. de et al. 1975. Receptivity to malaria in Europe. Bulletin of the WHO 52: 109-111.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historias de la malaria: La lucha contra la malaria se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historias de la Malaria: La vacuna

- Historias de la malaria: El parásito

- Historias de la malaria: El árbol de la quina

Asteon zientzia begi-bistan #267

Klima larrialdiari aurre egiteko gizarteak zenbait neurri har ditzake, Berrian irakur daitekeenez. Hala nola, elikadura ohiturak aldatzea. Jendeak haragi gutxiago jan beharko lukeela dio IPCC Klima Aldaketari Buruzko Gobernu Arteko Taldeak ateratako azken txostenak, adibidez. Badira beste batzuk: erabilera bakarreko plastikozko poltsak gutxiago erabiltzea; etxeko energia iturri kutsagarriak aldatu eta energia berriztagarriak erabiltzea eta ingurumenari kalte egiten ez dioten materialekin egindako jantziak erostea.

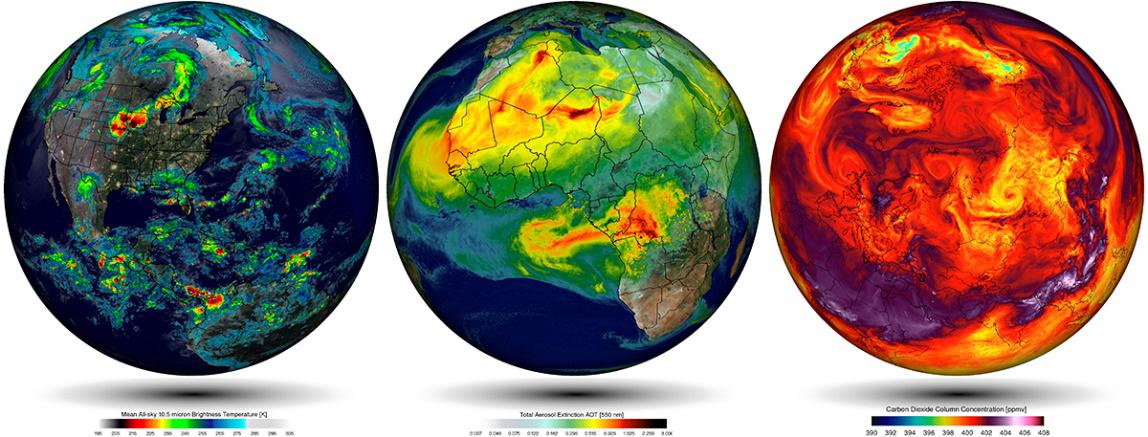

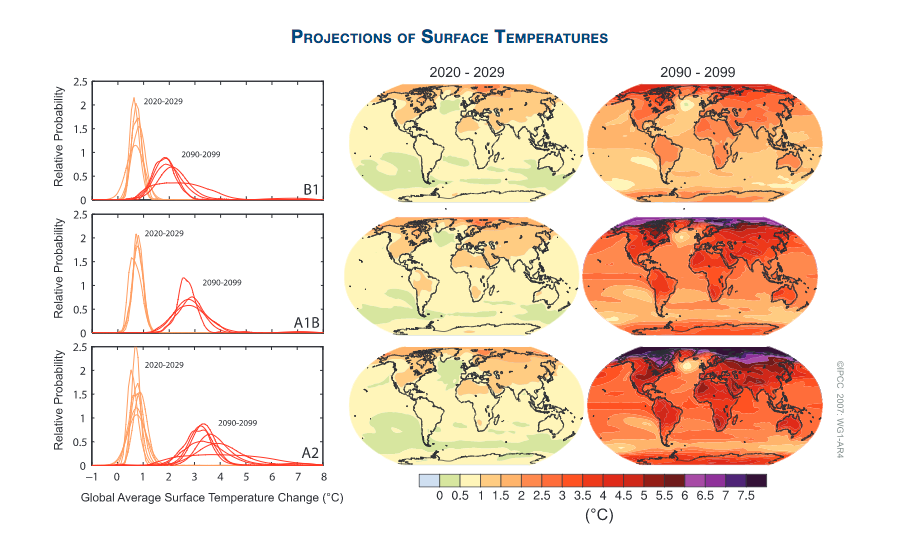

Lurraren historia modernoko laugarren urterik beroena izan zen 2018. urtea. Klima-aldaketa gertatzen ari dela argi dugu jada eta egoera hori nagusiki gizakiaren industria jardueragatik sortu dela ere bai. IPCCren “Global Warming of 1,5ºC txosten bereziak argi uzten du: jarduera horrek planetaren tenperatura gutxi gorabehera 1 ºC igo duela uste da. Gure planetak aurre egin beharko dien egoera posibleak aztertzeko, NASA, UK Met Office eta halako taldeek simulazioak erabiltzen dituzte, hau da, etorkizuneko egoera posibleak eraikitzeko erabiltzen diren tresnak.

PaleontologiaDuela 550 milioi urteko animalia mugikor eta bilateral baten fosila aurkitu dute Dengyingen, Yangtze ibaiaren arroilen inguruan (Txina). Elhuyar aldizkariak azaldu digunez, Yilingia spiciformis deitu diote, eta, guztira, 35 ale bildu dituzte. Zientzialariek ondorioztatu dute arrastoak itsas hondoan narrasean ibiltzean sortu zituztela. Horretaz gain, esan dute nerbio-sistema bat zutela.

KimikaPaketatze-industrian jatorri petrokimikoa duten polimeroak (polipropilenoa PP, polietilen tereftalatoa PET edo polietilenoa PE) ordezkatzeko, biopolimeroak gero eta gehiago erabiltzen dira. Biopolimero hauen artean, poliazido laktikoa (PLA) dago, adibidez. Bioiturrietatik eratorria eta biodegradagarria da. Aktibitate antibakterianoa erakusten duten biopolimero asko daude, baina bakterioen aurkako aktibitaterik onena erakusten duena kitosanoa da.

IngurumenaMikroplastikoz osatutako partikulak ere Artikora iritsi dira. Hala aditzera eman dute Alfred Wegener institutuko ikertzaileek. Zer aurkitu dute bertan baina? Kautxua, polietilenoa, berniza edota poliamida izan dira konposatuetako batzuk. Partikula horietatik, %80 inguruk 25 mikra edo gutxiagoko neurria zuten. Kanadan ere topatu dituzte mikroplastikoak.

Emakumeak zientzianIzaro Zubiria albaitaria eta ikertzailea elkarrizketatu du Ana Galarragak. Bertan, Zubiriak kontatzen du naturaz inguratuta bizi izan dela jaio zenetik eta beraz logikoa izan zela ikasketa horiek aukeratzea. Oso ikasketa gogorrak direla dio gizartean aitortza eskasa duelako. Elikagaien kalitatea eta segurtasun Masterra egin zuen horren ondotik eta baita tesia ere. Geroago, Gasteizko ukuilu batean aritu zen lanean, peoi gisa, azpiak ateratzen, behiak ezten… Horretaz gain, Zubiriak CAF-Elhuyar sariketan parte hartu eta NEIKER sari berezia irabazi zuen.

–——————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

Egileaz: Uxue Razkin kazetaria da.

——————————————————————

The post Asteon zientzia begi-bistan #267 appeared first on Zientzia Kaiera.

Ignacio López Goñi – Naukas Bilbao 2018: La pandemia del siglo XXI

Imagen de Ally White / Pixabay

Imagen de Ally White / PixabayIgnacio López Goñi es un divulgador de la microbiología siempre excelente pero de alguna manera proporcional: crece con el tamaño del escenario. En esta charla ante 2000 personas reunidas en el Euskalduna explica como nadie la pandemia que se nos viene encima en este siglo, la resistencia bacteriana a los antibióticos. López Goñi consigue que en la explicación intervengan todas y cada una de las personas presentes en el auditorio.

Ignacio López Goñi: ''La pandemia del siglo XXI''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Ignacio López Goñi – Naukas Bilbao 2018: La pandemia del siglo XXI se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Ignacio López-Goñi: Las bacterias también se vacunan

- Ignacio López-Goñi: «El sistema de defensa de las bacterias es el mejor editor de genomas que existe»

- Ana Aguirre – Naukas Bilbao 2018: Somos binarios…. ¿o no?

Ezjakintasunaren kartografia #274

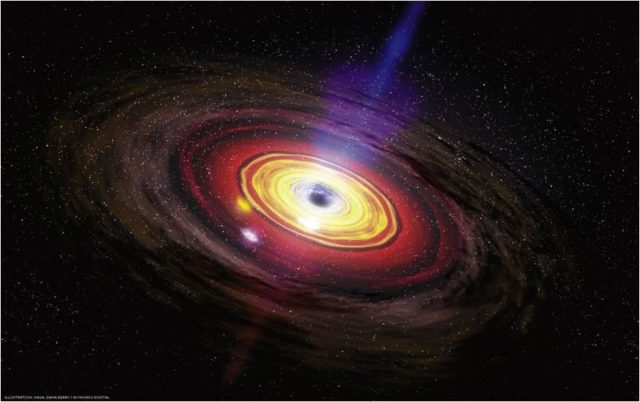

Nukleo galaktiko aktiboan zer gertatzen den analizatzeko horizonteaz haratago ikus dezakegu. Agian bai: Lurreko atmosfera detektore erraldoi gisa erabilita: The MAGIC Telescopes-eko Marina Manganarok azaltzen du: Beyond an invisible horizon

Zientzia fikzioa dirudi mikroskopio optiko normal baten datuekin adimen artifizialak lortu dezakeena. Daniel Morenok kontatzen du Computation can push optical microscopy towards unsuspected limits artikuluan.

Gehien interesatzen den tokian argiarekin elkarreragiten duten atomo gutxiko lodierako zilarrezko plasmoiak lortu daitezke. ACS Nanoko portada izan da DIPCkoen ikerketa: Sharp near-infrared plasmons in atomically thin crystalline silver

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #274 appeared first on Zientzia Kaiera.

¿Cómo llegan bacterias resistentes y residuos de antibióticos a los alimentos?

Foto: Brian Chan / Unsplash

Foto: Brian Chan / UnsplashHoy en día, prácticamente todas las personas constituimos un eslabón en la cadena de transmisión de antibióticos y de bacterias resistentes a antibióticos en el medio ambiente.

Esto es así porque prácticamente todo lo que ingerimos, empezando por el agua que bebemos y pasando por los alimentos de origen animal y vegetal, puede contener residuos de antibióticos o bacterias resistentes a antibióticos o sus genes. Los adquieren bien por contaminación, bien porque se encuentran naturalmente en los alimentos o bien porque se les ha añadido en el proceso de elaboración.

Residuos de antibióticos en alimentos

Las normativas europeas y estadounidenses definen los residuos de antibióticos como sustancias farmacológicamente activas (ya sea el principio activo, sus productos de degradación o sus metabolitos) que permanecen en el alimento obtenido a partir de animales a los que se les ha administrado el fármaco.

En principio, los productos de origen animal no deben ser consumidos hasta que el animal haya metabolizado el fármaco. Hay un tiempo establecido entre la administración y el sacrificio del animal para su consumo. Pero, aun así, es posible encontrar residuos en carnes, huevos y leche. También se han encontrado residuos de antibióticos en alimentos de origen vegetal e incluso en el agua de grifo.

Los huevos pueden contener residuos de antibióticos.

Los huevos pueden contener residuos de antibióticos.Tookapic/Visualhunt

La presencia de residuos de antibióticos utilizados en veterinaria en alimentos está limitada por normativas establecidas por las autoridades competentes en cada caso. En Europa, la EFSA (European Food Safety Authority) establece las directrices a aplicar y cada país miembro debe adecuar su normativa ajustada a esas directrices.

En general, cada vez que se aprueba un nuevo antibiótico (u otro tipo de medicamento) de uso veterinario para animales de consumo humano, debe de pasar una serie de análisis y evaluación de riesgos. Teniendo en cuenta los datos obtenidos de estos análisis, se establecen los límites aceptables de ingesta diaria (ADI). A partir de estos, se determinan los niveles máximos de residuos (LMR) permitidos en alimentos.

Es muy difícil determinar la ingesta real de residuos de antibióticos de cada individuo. Puede variar mucho dependiendo del país, de la dieta, etc. Por ello, los trabajos científicos publicados se refieren a lugares concretos y los resultados son difíciles de extrapolar.

En un estudio realizado en Hong Kong con niños, se analizaron los residuos de antibióticos en leche, agua potable y alimentos ingeridos y en orina. Se detectaron residuos de quinolinas, sulfamidas, macrólidos y penicilina. Pero tanto la ingesta estimada como los niveles detectados en orina estaban por debajo de los límites establecidos por las normativas vigentes.

Efectos para la salud

Sin embargo, aunque los niveles estén dentro de la normativa vigente y sean incluso indetectables, lo cierto es que las personas estamos continuamente expuestas a residuos de antibióticos. Esta exposición crónica a cantidades muy pequeñas de numerosos compuestos diferentes puede ser más perjudicial para la salud que las dosis terapéuticas durante periodos cortos, como cuando se trata una infección.

Los residuos de antibióticos en los alimentos pueden causar problemas graves de salud en las personas, como alergias, efectos inmunopatológicos y citotóxicos y aumentar el riesgo de desarrollar cáncer. Además, pueden alterar la composición del microbioma humano, especialmente del microbioma intestinal.

Comparada con la exposición por uso terapéutico, la exposición crónica a muchos antibióticos diferentes, aunque sea a niveles muy bajos, puede ejercer una mayor presión de selección sobre bacterias resistentes y no resistentes a antibióticos.

La exposición crónica a antibióticos es especialmente importante en niños después de la lactancia, cuando empiezan a ingerir otro tipo de productos. Los residuos de antibióticos en los alimentos pueden determinar el desarrollo de su microbioma. Estudios epidemiológicos y experimentales sugieren que tienen un efecto acumulativo, por lo que su efecto puede ir sumándose incluso de generación en generación.

Por otra parte, en 1976 se demostró por primera vez que el uso de antibióticos en veterinaria provocaba la colonización de bacterias resistentes en los pollos de una granja. También la adquisición de esa resistencia en el microbioma del tracto intestinal de los trabajadores de la granja.

En muchos estudios posteriores se ha demostrado que bacterias resistentes en animales pueden transmitir los genes de resistencia a bacterias presentes en el intestino humano. Esto ocurre, muy presumiblemente, vía alimentos.

Bacterias resistentes a antibióticos en alimentos

La presencia de bacterias en los alimentos puede ser intencionada, como, por ejemplo, en productos fermentados, como probióticos o incluso como bioconservantes. Los órganos competentes en cada caso (EFSA, en Europa) publican periódicamente listas de bacterias reconocidas como seguras para su uso en alimentación. Entre otras condiciones, estos microrganismos no deben producir antibióticos ni tener genes de resistencia.

No obstante, la presencia de bacterias resistentes puede ocurrir en alimentos preparados a partir de materia prima cruda, como, por ejemplo, alimentos fermentados tradicionales. O puede ser accidental, por contaminación de diferentes fuentes. Además, la matriz de los alimentos y las condiciones de conservación y procesado pueden favorecer la transmisión de genes de resistencia entre bacterias.

‘Staphylococcus aureus’, principal causa de mastitis en vacas.

‘Staphylococcus aureus’, principal causa de mastitis en vacas.Wikimedia Commons / Eric Erbe, Christopher Pooley

Preocupa especialmente la presencia de bacterias resistentes que provocan enfermedades transmitidas por los alimentos, como Salmonella o Campylobacter o bacterias responsables de zoonosis, como cepas resistentes de Staphylococcus aureus.

Además, bacterias comensales resistentes, no patógenas, pueden transferir los genes de resistencia a bacterias patógenas tanto en el procesado de los alimentos como tras la ingestión. Dado que algunas de las bacterias presentes en los alimentos tienen capacidad de aguantar las condiciones del tracto digestivo, colonizar el intestino y permanecer en él largos periodos de tiempo, pueden aumentar el riesgo de transmitir genes de resistencia tanto en el microbioma humano como en el medio ambiente.

Por todo ello, es importante monitorizar y reducir la presencia de todo tipo de bacterias resistentes (tanto comensales como patógenas) en los alimentos. Así mismo, es importante estudiar los elementos genéticos móviles presentes en los alimentos para entender su epidemiología e implementar métodos para reducir su presencia.

Todo ello, unido al cumplimiento de las buenas prácticas en los procesos de elaboración y buenas prácticas de higiene en todas las fases de la cadena alimentaria, “desde la granja a la mesa”.

Nota: Este artículo constituye un resumen de la charla impartida en el curso de verano de la UPV/EHU organizada por el JRL Environmental Antibiotic Resistence.![]()

Sobre la autora: Mailo Virto Lekuona es profesora titular de Biquímica y Biología Molecular en la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Cómo llegan bacterias resistentes y residuos de antibióticos a los alimentos? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El camino hacia los antibióticos inservibles

- Bacterias hospitalarias: resistentes e indetectables

- Una nueva vía para la lucha contra la resistencia a los antibióticos

Izaro Zubiria, albaitaria: “Lehen sektorean eta ikerketan emakume izateak desabantailak ditu”

Ez du damurik, baina gogoan du jaso zuen lehen kolpea: “Hirugarren mailan izan zen. Haragitarako behiak zituen lagun bat zuen aitak, eta uda hartan harekin lana egitea bururatu zitzaidan, ganadutegiko lana ikasteko. Haren baserrira joan ginenean, baina, berehala esan zidan bere albaitaria gizona zela, handia, eta ehun kilokoa; ea zer egin behar nuen nik, emakumea eta hain txikia izanik”. Nolabait, orduan egin zuen topo errealitatearekin aurrez aurre.

Irudia: Izaro Zubiria Ibarguren albaitaria eta ikertzailea. (Argazkia: Maitane Lopetegi Arozena)

Bigarren kolpea izan zen jabetzea zer aitortza eskasa duten albaitaritza-ikasketek gizartean, beste ikasketa batzuekin alderatuta: “Oso ikasketa gogorrak dira, eskakizun handikoak, eta lanean hartzen duzun ardura ere oso da handia. Jendeak, ordea, ez du hori ikusten, eta profesioa ez dago aitortuta beharko zukeen neurrian, inondik inora ere”.

Hala ere, aurrera egin zuen, eta, ipurtarin samarra denez, azken urtea egiten ari zela dagoeneko hasi zen begiratzen zer aukera egon zitezkeen. Irakasle baten bitartez NEIKERekin harremanetan jarri, eta sei hilabetez aritu zen animalien elikadurari buruzko zenbait proiektutan eta intseminazio-laborategian.

“Aldez aurretik, ez nuen pentsatuko ikerketa-mundua gustatuko zitzaidanik. Nik naturarekin harreman zuzena eta jarduera mugitu bat izan nahi nituen, eta ez nuen uste laborategi batean sartuta gustura egongo nintzenik. Baina oso lan aktiboa da, lan pila bat egitea tokatu zitzaidan, eta asko gustatu zitzaidan”, onartu du Zubiriak.

Sei hilabeteko praktikak amaitu zituenean, elikagaien kalitatearen eta segurtasunari buruzko master bat zegoela ikusi zuen, eta, ordurako bazuenez asmoa agian doktoretza-beka bat eskatzeko, aproposa izan zitekeela pentsatu zuen. “Gainera krisi-garaia zen, eta horrek ateak zabaltzen lagunduko zidala iruditu zitzaidan”, gogoratu du.

Masterra hasi eta berehala doktoretza egiteko aukera sortu zitzaion, aurkeztu, eta eman egin zioten -lehenengo lekuan geratu zen-. “Ilusio handiarekin heldu nion aukerari nahiz eta beldurra ere ematen zidan tesi batean sartzeak. Laginak hartu, irtenbideak bilatu, ideia berriak proposatu… horretarako banekien balio nuela, baina ordenagailu aurrean eserita hainbeste ordu eman beharrak beldurra ematen zidan”. Hala ere, aurrera egitea erabaki zuen.

Tesiaren zati handi bat Fraisoro nekazaritza eskolako ukuiluan gauzatu behar zen behiekin, eta bertan ere lehen aldian zalantzaz hartu zuten, ukuiluan aritzeko profila ez ote zuen pentsatuz.

Alabaina, praktiken eta tesiaren artean, Gasteizko ukuilu batean aritu zen lanean, peoi gisa, azpiak ateratzen, behiak ezten… Lan gogorra zen, eta gaizki ordaindua, baina asko ikasi zuen, eta oso baliagarria izan zitzaion entseguak diseinatzeko, ukuiluan moldatzeko, eta baserritarrekin parez pare tratatzeko: “Ikusi zutenean banekiela ukuiluko lanak egiten, jarrera aldatu zuten eta asko lagundu zidaten”. Bera ere ez zen ikerketako lanak egitera mugatu; baserrikoak ere egiten zituen. “Azkenean, peoi-lana giltzarri izan da nire bizitza profesionalean, horrek eman baitit aukera baserritarrak ulertzeko, haiekin batera aritzeko, eta lagunak egiteko”.

Ama izatea, zigor bikoitzaUkuiluko entseguak hasi bezain laster, ezusteko bat izan zuen: haurdun zegoela jakin zuen. Ilusioz, ama izango zela erabaki zuten bikotekideak eta biek. Orduan, beste kolpe handi bat jaso zuen: bekarekin zegoenez ez zegokion amatasun baimenik. Gehienez ere, soldatarik gabeko sei hilabeteko etenaldi bat har zezakeen

Bidegabekeria horren aurrean, ez zuen etsi, eta haurdunaldiaren azken egunera arte lana egin zuen. Haurra jaiotakoan, berriz, zuzendariaren, ingurukoen eta, batez ere, bikotekidearen laguntzarekin, berehala itzuli zen lanera, beka ez eteteagatik. Horrek amatasuna zapore gazi-gozo batez bizitzera eraman zuen; haur baten etorrerak dakarren aldaketa eta esfortzuari, batez ere lehen hilabeteetan, lanarena gehitzen baitzitzaion. Horrez gain, jendearen aipamenak ere entzun behar izan zituen, aitaren inplikazio totalaz eta amaren hutsuneaz jabetzean: “Momentu horretan aitak denbora gehiago ematen zuen alabarekin, kalean ere hala ikusten zuten eta hala adierazten zidaten. Gizartea ez dago irudi horretara ohituta baina ni ez nintzen ondo sentitzen hori entzutean”.

Zubiriak garbi dio: “Hori gertatzen zaio mutil bati, eta ez da ezer gertatzen. Aita izango zen, lanean jarraituko zuen aurretik ari zen moduan eta kito”.

Bigarren entseguak bukatu, eta ordenagailuaren aurrean esertzea egokitzen zitzaion orduan. Baina nekazaritza-kooperatiba batetik lana eskaini zioten, animalien elikadura-gaiak aurrera eramateko, eta lana onartu zuen. Bigarren haurra izan zuen eta I+Gko eta kooperazioko proiektu batzuk garatzea lortu zuen. Une horretan CAF-Elhuyar sariketaren berri izan zuen, eta lan bat aurkeztea erabaki zuen. Gainerako guztiarekin batera artikulua idazteak lan handia eman zion arren, merezi izan zuelakoan dago. Hain zuzen, NEIKER sari berezia irabazi zuen.

“Sekulako poza eman zidan. Sentitu nuen azkenean jaso nuela egindako lan guztiagatik merezi nuen aitortza”, adierazi du Zubiriak. Are gehiago: saria tesia berriro hartzeko akuilu ere izan da. “Hasitakoak bukatzearen aldekoa naiz, baina ez dut izan behar den adina ilusio horrelako lan bat aurrera eramateko. Orain aldiz, bai, gogotsu nago eta saiatuko naiz. Beraz, onartu behar dut niretzat sari hori irabaztea bultzada handi bat izan dela”.

Fitxa biografikoa:Izaro Zubiria Gaztelun jaio zen, 1989an. Albaitaritza ikasi zuen, eta, jarraian Elikagaien kalitatea eta segurtasun Masterra. Doktorego-tesia egiten hasi zen, eta, denboraldi batez eten badu ere, berriro itzuli da ikerketara. Tartean, beste lan eta proiektu asko ere egin ditu, gehienak ganaduarekin eta elikadurarekin lotuta.

———————————————————————————-

Egileaz: Ana Galarraga Aiestaran (@Anagalarraga1) zientzia-komunikatzailea da eta Elhuyar Zientzia eta Teknologia aldizkariko erredaktorea.

———————————————————————————-

Elhuyar Zientzia eta Teknologia aldizkariarekin lankidetzan egindako atala.

The post Izaro Zubiria, albaitaria: “Lehen sektorean eta ikerketan emakume izateak desabantailak ditu” appeared first on Zientzia Kaiera.

No todo es ciencia en ‘El club de la lucha’

Copyright © 1999 by 20th Century Fox. All Rights Reserved. Fair use.

Copyright © 1999 by 20th Century Fox. All Rights Reserved. Fair use.

«Tyler se lame los labios, húmedos y brillantes, y me besa el dorso de la mano».

La película que más veces he visto en mi vida es El club de la lucha. Dirigida por David Fincher, está basada en la novela homónima de Chuck Palahniuk, un escritor discípulo de la generación beat, héroe de muchas adolescencias rebeldes.

«Tyler inclina unos centímetros el bote que contiene el polvo de hipoclorito sobre el beso húmedo y brillante del dorso de mi mano. —Es una quemadura química—dice Tyler—y te dolerá más que cualquier otra quemadura. Peor que cien cigarrillos.

El beso brilla en el dorso de mi mano. —Te quedará una cicatriz—dice Tyler».

La primera regla del club de la lucha es no hablar del club de la lucha. Así que no voy a hablar del club de la lucha, sino de la ciencia de El club de la lucha. En esta novela hay descripciones científicas veraces mezcladas con licencias fantásticas. Desde cómo fabricar una bomba casera, cómo hacer una quemadura química con hipoclorito, a cómo fabricar jabón utilizando la grasa que se desecha tras las liposucciones.

Las descripciones son exquisitas. La ciencia se utiliza como recurso literario para tratar cuestiones de calado como el individuo, la libertad y la propiedad.

«Un explosivo interesante es el permanganato potásico mezclado con azúcar en polvo. La idea consiste en mezclar un ingrediente que se queme con rapidez con un segundo ingrediente que aporte oxígeno suficiente para la combustión. Al arder tan rápido se produce la explosión.

Peróxido de bario y polvo de zinc.

Nitrato de amoníaco y aluminio en polvo.

La nouvelle cuisine de la anarquía.

Nitrato de bario con salsa de azufre y guarnición de carbón vegetal. Ya tienes un compuesto de pólvora básica.

Bon appétit».

Copyright © 1999 by 20th Century Fox. All Rights Reserved. Fair use.

Copyright © 1999 by 20th Century Fox. All Rights Reserved. Fair use.El club de la lucha es un ejemplo de que la cultura científica puede refinar el argumento de una novela o de una película. Se puede utilizar como metáfora, igual que cualquier otro recurso. Para plumas adecuadas, las descripciones científicas pueden ser tan hermosas como las de cualquier otro paisaje. No todo van a ser profundos ojos azules.

«Con jabón suficiente —dice Tyler— podrás volar el mundo entero».

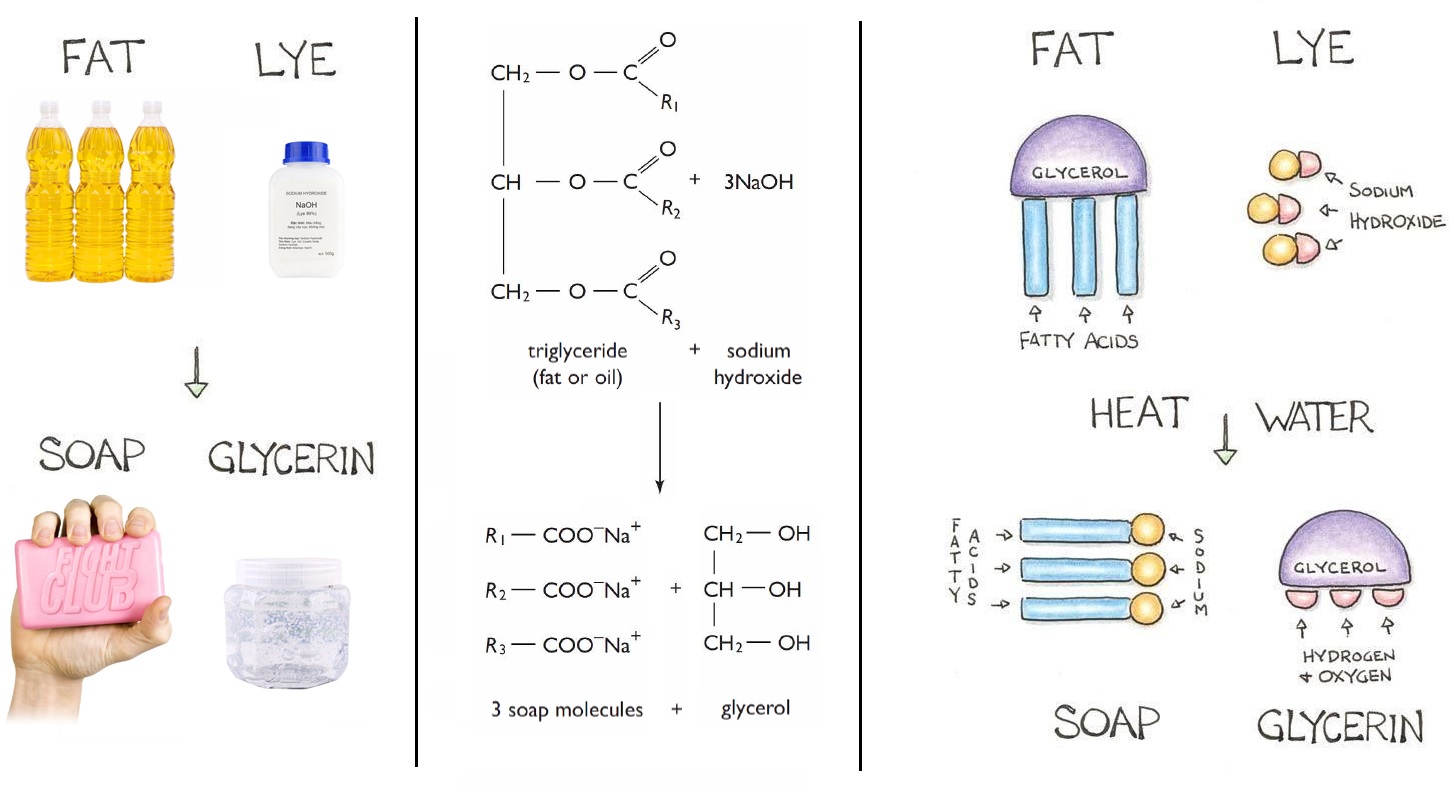

En el octavo capítulo de la novela comienzan a fabricar jabón a partir de grasa humana.

«Esta grasa —me explica Tyler— tiene mucha sal, así que, cuanta más agua, mejor».

Vierte toda la grasa en ollas con agua hirviendo. Cuando la grasa se derrite, el sebo sube a la superficie, mientras que la sal se irá disolviendo en el agua. Esto se hace porque la grasa humana contiene mucha sal y con tanta sal el jabón no solidifica. El sebo de calidad es el que se forma en superficie.

«Hierve y espuma. Hierve y espuma».

La pastilla de jabón de color rosa se convirtió en el emblema de la película.

El sebo espumado lo van colocando en briks abiertos para que enfríe. Luego los meten en la nevera para que no se enrancie.

«Una capa de algo espeso y claro comienza a cubrir la superficie del sebo del frigorífico. —El sebo —le advierto—se está separando. —No importa —dice Tyler—. La capa más clara es de glicerina. O la agregas de nuevo cuando hagas el jabón o bien la espumas y la quitas».

Las grasas son químicamente triglicéridos. Esto es glicerina unida con enlace tipo éster a ácidos grasos. Durante la reacción de saponificación en la que las grasas se transforman en jabón, estos enlaces tipo éster se rompen y dan lugar a la formación de sales, dejando libre la glicerina. Para formar sales, lo que se hace en esta reacción es mezclar la grasa con una base como el NaOH o el KOH, así se forman las sales de sodio y de potasio respectivamente. Esas sales son lo que conocemos como jabón.

«Tyler vendía el jabón en los grandes almacenes a 20 dólares la pastilla. Dios sabe a cuánto lo venderían ellos. Era maravilloso. Le revendíamos a las mujeres ricas sus propios culos celulíticos».

En El club de la lucha fabrican jabón no solo por lo lucrativo del negocio del jabón. Lo que les interesaba realmente es la glicerina. La glicerina es uno de los reactivos necesarios para fabricar explosivos como nitroglicerina, dinamita o gelignita.