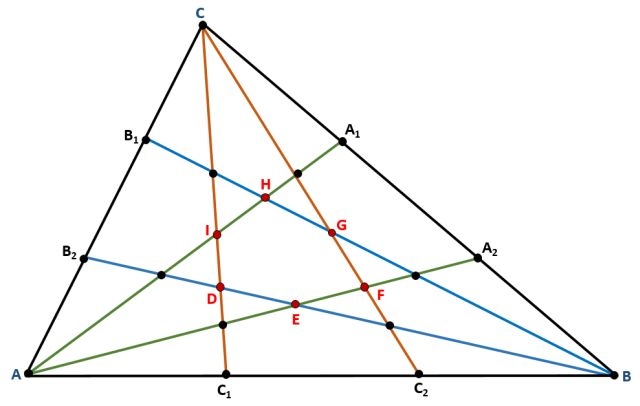

Test azterketa informatizatzen

Irudia: Aukera anitzeko testa.

Arrazoi ugari daude ordenagailua erabiltzeko, azterketa bat egitean. Zenbait ikerketen arabera, test informatikoek abantaila asko dauzkate paperean egiten direnen aldean; besteak beste, azterketa gehiago egin daitezke, toki oso ezberdinetan eta aldi berean, horrela, kopia-kasuak saihestuz. Erantzunak ere azkarrago prozesatzen dira, eta, ondorioz, ikasleek bukatu bezain laster izango dute probaren emaitza; gainera, galderak formatu egokiagotan egin daitezke, multimedia, elementu dinamikoak edota interaktiboak erabiliz. Bestalde, azterketak egiteko ordenagailua erabiltzeak ingurumenari ere laguntzen dio, papera erabiltzen ez den heinean, zuhaitz gutxiago moztu beharko dira eta.

Test informatizatu hauek bi erakoak izan daitezke: ohikoak, hau da, azterketa egingo duten pertsona guztiek azterketa bera izango dute, edo egokigarriak, hau da, azterketa egiten ari den pertsonak galderari ondo erantzuten badio, galdera zailagoa jarriko zaio; gaizki erantzuten badio, ordea, galdera errazagoa egingo zaio, duen ezagutza-maila finkatu arte. Test egokigarriak informatizatuak izaten dira eta item bakoitzak parametro batzuk eduki behar ditu, ondorioz, kalibraketa egitea ezinbestekoa da.

Kalibraketa aurrera eraman ahal izateko egin behar den lehenengo gauza item edo galdera-sorta bat sortzea da, ondoren kalibratu ahal izateko. Kalibraketa hori bi motatakoa izan daiteke: adituetan oinarritutako kalibraketa edo kalibraketa psikometrikoa.

Adituetan oinarritutako kalibraketak oinarritzat estatistika konplexua erabili beharrean adituen esperientzia erabiltzen du, eta Testaren Teoria Klasikoa hartzen du ardatz gisa. Kalibraketa-prozesu honek bi zati ditu, item-administrazioa alde batetik eta datuen analisia eta kalibraketa bestetik. Lehenengo pausoan adituengandik informazioa jasotzen da, item bakoitzeko erantzun zuzena eta zailtasun-maila, bigarren pausoan, datu horiek aztertu eta item bakoitzaren zailtasuna lortzen da.

Kalibraketa psikometrikoa Itemaren Aurreko Erantzun-Teorian oinarrituta dago, eta pertsona askok egingo dituzten azterketetarako pentsatuta dago. Kalibraketa hau aurrera eramateko 6 pauso eman behar dira: esperimentuaren diseinua, esperimentua aurrera eramatea, aurre analisiak, parametroen kalkulua, doikuntza-analisiak eta parametroak alderatzea. Baina labur adierazita, lehenbizi itemen erantzunak jaso behar dira ahalik eta pertsona gehienengandik eta ondoren datu horiek aztertu eta itemak kalibratu.

Test on bat prestatzea ez da zaila kalibratutako item-banku bat badago, baina, hain zuzen ere, prozesu hori astuna eta luzea suertatzen da, zaila ez izan arren. Pausu batzuei jarraitu ostean, ez da zaila kalibraketa hori lortzea, baina baliabide ugari behar dira horretarako, batez ere, pertsonak; adituak, lehenengo kalibraketaren kasuan, eta testa erantzungo duten pertsonak, bigarrenean.

Bi prozesu hauen konbinaketa baten ondorioz 127 item zituen banku bat kalibratu zen. Item hauek euskarazko testu baten ulertze-maila neurtzeko erabiltzen ari dira proba batean Hizeba sistema erabiliz. Azpimarratu beharra dago, egindako ahalegina handia izan arren, kalibraketak merezi izan duela.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 30

- Artikuluaren izena: Azterketa informatizatu eraginkor baten bila.

- Laburpena: Gaur egun testak ohikoak dira ezagutza ebaluatzeko garaian. Gehienetan, ebaluatzailearen esperientzian eta eskarmentuan oinarrituta hartzen dira azterketarako galdera edo itemak. Test Egokigarri Inrormatizatu (TEI) batean pertsona akoitzak item ezberdinak ditu, aurreko erantzunen arabera. Hori lortu ahal izateko, item bakoitza kalibratu egin behar da, hau da, item bakoitzari balio batzuk eman behar zaizkio, prozesu jakin, zehatz bati jarraituz. Artikulu honetan azaltzen da zer egin behar den TEI bat osateko eta itemak kalibratzeko.

- Egileak: Anaje Armendariz, Javier López-Cuadrado, Tomás Pérez, Conchi Presedo

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 145-152

- DOI: 10.1387/ekaia.16368

—————————————————–

Egileaz: Anaje Armendariz, Javier López-Cuadrado eta Conchi Presedo UPV/EHUko Bilboko Ingeniaritza Eskolakoak dira eta Tomás Pérez Hizkuntza eta Sistema Informatikoak sailekoa da.

—————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Test azterketa informatizatzen appeared first on Zientzia Kaiera.

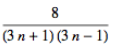

El valle de la evaporación de planetas

El telescopio espacial Kepler de la NASA ha revolucionado nuestro conocimiento de los planetas extrasolares. Este satélite ha descubierto nada más y nada menos que más de 2.300 exoplanetas alrededor de otras estrellas mediante el método del tránsito. Una de las conclusiones más importantes que podemos extraer de este cúmulo de datos es que hay dos tipos de planetas que son muy comunes en el universo y que, curiosamente, se hallan ausentes de nuestro sistema solar. Nos referimos a los minineptunos y a las supertierras. Los dos tienen tamaños comprendidos entre el de nuestro planeta y el de Neptuno —que tiene cuatro veces el diámetro de la Tierra—, pero sus propiedades no pueden ser más diferentes.

Las supertierras, como su nombre indica, son una versión en grande de la Tierra, pero lo importante es que su superficie es sólida. Los minineptunos, por contra, están rodeados de una gruesa atmósfera y contienen grandes cantidades de hielos de agua, amoniaco y metano. Es lógico pensar que cuanto más pequeños sean estos planetas serán más parecidos a la Tierra y precisamente eso es lo que observamos en los datos observacionales. ¿Pero dónde está el límite entre las supertierras y los minineptunos?

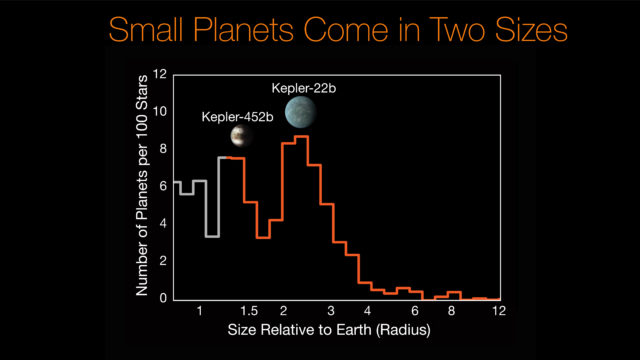

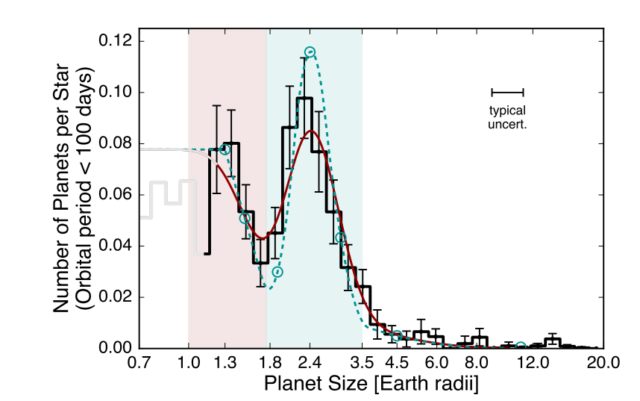

Frecuencia de planetas en función de su tamaño según los datos de Kepler.Se observa la escasez de mundos entre 1,75 y 2 radios terrestres, el ‘valle misterioso’ (NASA/Ames Research Center/CalTech/University of Hawaii/B.J. Fulton)

En los últimos años esta frontera entre los dos tipos de exoplaneta se ha situado un tanto arbitrariamente alrededor de los dos radios terrestres. Es decir, un planeta con un tamaño superior será un minineptuno, mientras que si es inferior será una supertierra. Parece lógico, ya que un planeta más grande posee una mayor gravedad y es capaz de atrapar mejor las sustancias volátiles que caracterizan a los minineptunos. Igualmente, es razonable pensar que todos los tamaños de planetas de este tipo son más o menos igual de frecuentes. Sin embargo, en el último análisis de datos de la misión Kepler saltó la sorpresa. El telescopio de la NASA pudo comprobar que, contra lo que uno podría esperar, no existe un continuo de tamaños para los exoplanetas con radios comprendidos entre el de la Tierra y Neptuno, sino que la naturaleza favorece dos grupos muy claros de tamaños.

Efectivamente, Kepler nos ha enseñado que la mayor parte de supertierras tiene un tamaño de 1,3 veces el de la Tierra, mientras que los minineptunos suelen tener 2,4 veces el tamaño de la Tierra (o sea, casi justo el doble). Los mundos con un tamaño comprendido entre ambos escasean dramáticamente. Parece que la naturaleza ha decidido ponernos las cosas fáciles y ha introducido un mecanismo para que los exoplanetas de tamaño intermedio sean o bien supertierras, o bien minineptunos. Ahora bien, ¿cómo es esto posible?

Es importante reflexionar sobre lo que nos están diciendo los datos. De algún modo el Universo solo permite planetas de un tamaño concreto, como si estuviese en marcha un misterioso mecanismo cuántico planetario (obviamente, conviene aclarar que Kepler ha detectado planetas de tamaño intermedio entre supertierras y minineptunos, pero su frecuencia es muy baja). ¿Qué mecanismo es capaz de explicar esta distribución planetaria tan extraña?

Los investigadores James Owen y Yanqin Wu ya predijeron en 2013 esta diferencia cuando introdujeron la hipótesis del ‘valle de la evaporación’. De acuerdo con esta teoría, la mayor parte de supertierras serían los núcleos desnudos de minineptunos que han perdido su densa atmósfera por estar demasiado cerca de su estrella (recordemos que la mayoría de exoplanetas descubiertos por Kepler tienen un periodo muy corto, más que nada porque es más fácil detectar los planetas que están próximos a su estrella). Muy bien, pero quizás alguno pueda pensar que esta hipótesis no aclara el misterio. ¿Por qué la mayoría de los núcleos de minineptunos tienen el mismo tamaño? Y, además, tampoco explica por qué los minineptunos más frecuentes tienen todos 2,4 radios terrestres.

¿Puede la hipótesis del valle de la evaporación explicar la diferencia entre supertierras y minineptunos? (Fulton et al.)

Veamos. La cuestión es que, antes de que se produzca la fotoevaporación total por acción de los vientos estelares y la luz de longitudes de onda más energéticas procedentes de la estrella, la atmósfera del minineptuno se expandirá aumentado su tamaño. Cuanto más pequeño sea el núcleo del minineptuno o más cerca esté de la estrella, mayor será la fotoevaporación. El resultado es que los minineptunos tienden a tener el mismo radio porque así se mantiene constante el flujo radiativo que recibe de su estrella. Sin embargo, una vez que se alcanza un umbral crítico en la pérdida de la atmósfera el proceso de evaporación es muy rápido, lo que explica que no haya planetas con un tamaño intermedio. En cuanto al tamaño de los núcleos, 1,3 radios terrestres es el tamaño mínimo para que, con una composición similar a la terrestre, un planeta tenga la suficiente gravedad como para poder rodearse de una atmósfera densa de hidrógeno y helio.

Recientemente James Owen y Yanqin Wu han afinado su modelo para ajustarlo a los últimos datos de Kepler y lo cierto es que encaja a la perfección. Es verdad que el modelo de Owen y Wu predice minineptunos cuyo tamaño más frecuente sean 2,6 radios terrestres, mientras que Kepler nos dice que el tamaño preferido es de 2,3 radios terrestres, pero es una diferencia que cae dentro del error de los datos de Kepler. Si el modelo del valle de la evaporación es correcto, y parece que lo es, podemos extraer varias conclusiones muy valiosas sobre la evolución de los planetas extrasolares. Por un lado, que la mayor parte de supertierras que son núcleos evaporados de minineptunos tienen una composición similar a la terrestre y una masa de tres veces la de la Tierra, lo que apunta a que se formaron por dentro de la línea de nieve de su sistema estelar.

Por otro lado, que la atmósfera de los minineptunos está compuesta principalmente por hidrógeno y helio y tuvo que haberse formado por acreción de material del disco protoplanetario, por lo que no se creó posteriormente como resultado de la liberación de gases del interior planetario (un fenómeno que se cree ocurrió en los planetas rocosos del sistema solar).

Resulta fascinante que un modelo tan simple pero elegante como el del valle de la evaporación nos explique la curiosa relación entre los dos tipos de mundos más comunes de la Galaxia. Y surge la duda: ¿puede haber tenido este modelo alguna influencia en nuestro sistema solar primigenio?

Este post ha sido realizado por Daniel Marín (@Eurekablog) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias:

James Owen et al., The evaporation valley in the Kepler planets, arXiv:1705.10810, mayo 2017.

El artículo El valle de la evaporación de planetas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 25 años de planetas extrasolares

- Venkatraman Ramakrishnan entrevistado por Mikel Valle

- Cartografiando el Cosmos

Ni mitos ni remedios caseros: así me libré del acné

Como la mayoría de la gente, yo también he tenido algún problema con la piel. Entre ellos el acné. Los problemas surgieron en la adolescencia y me acompañaron hasta terminar la carrera. Lo que más quebraderos me daba eran unos pequeños granitos que me salían en la frente. Fui al dermatólogo y éste me recomendó una crema con peróxido de benzoílo. Es un tratamiento habitual, pero mi piel no pudo suportarlo. Se me secó e irritó la frente. Me resultó tan desagradable que enseguida tiré la toalla. Imaginaba que acabaría curándose solo, con la edad, pero eso no es así, el acné puede acompañarnos toda la vida.

Entre mi nefasta experiencia con aquel producto y la poca fe que por aquel entonces tenía en la cosmética, estuve muchos años sin utilizar ningún producto específico. Mi problema no era grave, ni siquiera era evidente, pero a mí me traía por el camino de la amargura.

-

¿Qué es el acné?

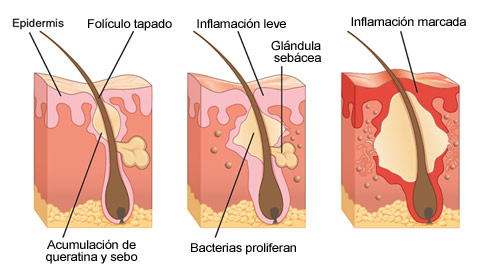

Aunque existen varios tipos, el acné es una afección de la piel que suele ser consecuencia de los cambios en nuestros niveles hormonales, por eso se da especialmente en la pubertad y durante los años de adolescencia.1

Las hormonas llamadas andrógenos se encargan de establecer la comunicación entre las glándulas sebáceas —las que generan el sebo de la piel— con los folículos —pequeñas aberturas de la piel por las que se secreta el sebo—.

En esencia, el acné es la consecuencia de una mala comunicación entre las glándulas sebáceas y los folículos. Normalmente, el sebo protege la piel con una capa resistente al agua, pero los cambios hormonales provocan que la secreción se acelere y la piel se vuelva más oleosa. Las capas externas de la piel se vuelven más gruesas y densas influidas por las mismas hormonas. El resultado es que los folículos se obstruyen con una mezcla densa de células y sebo. Se forman los puntos negros, en los que la mezcla se oscurece al entrar en contacto con el aire, o los puntos blancos, recubiertos por la superficie de la piel.

Aquí es donde se involucra una bacteria llamada P. Acnes. Ésta se multiplica en ambientes poco aireados como los poros obstruidos causando inflamación. Las consecuencias: un aumento de granitos enrojecidos, pústulas o incluso lesiones severas y profundas llamadas nódulos y quistes.

Las células encargadas de eliminar los residuos, los macrófagos, acaban con los tejidos dañados y estimulan la piel para que repare el daño. Esto lleva desde algunos días hasta semanas, según la gravedad del acné.

-

Algunos mitos sobre alimentos que causan acné

La preocupación de la influencia de la dieta en el acné surgió en los años 30, donde el chocolate, el azúcar y el yodo estaban entre los factores dietéticos implicados. En los estudios sobre el acné que se hicieron hasta los años 70, no se encontró ninguna conexión entre la dieta y el acné, así que este concepto se olvidó durante años. En cambio, hace un par de décadas estas ideas volvieron a la palestra. Se hicieron nuevos estudios2, algunos concluyentes y otros no. De ahí surgieron algunas certezas y proliferaron ciertos mitos. Veamos algunos de ellos:

-

Leche

Se han realizado varios estudios3, con diferentes rangos de edad y diferentes productos lácteos4, que han llevado a concluir que el consumo de lácteos sí puede desencadenar acné. Todavía se desconoce qué ingredientes de la leche son los responsables y, por tanto, cómo sucede esto. Existe mayor evidencia con el consumo de leche desnatada5, cosa que podría atribuirse a la alfa-lactoalbúmina. Como esto no sucede siempre, no le ocurre a todo el mundo y no prevalece con todos los lácteos, consumir menos lácteos es un consejo que no hay que tomar muy en serio.

-

Dulces, golosinas y otros alimentos de alto índice glucémico

En teoría, las dietas de elevada carga glucémica aumentarían la concentración de insulina, estimulando la producción de sebo y contribuyendo a las lesiones de acné. La realidad es que los estudios demuestran que una dieta de baja carga glucémica mejora el acné6. Por esto es recomendable dejar de consumir alimentos con azúcar añadido (dulces, bollería, golosinas, refrescos azucarados, etc.), edulcorantes como la miel o siropes, así como pan, pasta o cereales hechos con harinas blancas.

-

Chocolate

Posiblemente el chocolate sea el alimento que más relacionamos con el acné, pero sorpresa, es un mito. No existe ninguna evidencia científica que relacione el consumo de chocolate con el acné. De hecho, los antioxidantes que contiene el chocolate son beneficiosos para la piel.

Podemos pensar que la razón de este mito estriba en el tipo de chocolate que consumimos. Si el chocolate contiene azúcar, es un alimento de alto índice glucémico y, por tanto, sí podríamos relacionarlo con el acné. 7El problema del chocolate está en el azúcar, así que la mejor opción es tomar chocolate sin azúcar.

-

Alimentos grasos como la pizza o las patatas fritas

Un mito común sobre el acné es que la grasa alimentaria se traduce en más grasa en los poros, pero no hay una relación directa entre ambas.8 De todos modos, una dieta rica en grasas saturadas puede estimular las microinflamaciones en todos los órganos del cuerpo, incluida la piel.

-

Remedios contra el acné

Si buscas remedios contra el acné, huye de todo aquel que te prometa resultados en unos días, milagros o recetas caseras. Leerás por ahí burradas como emplear bicarbonato, pasta de dientes, miel, yogur o sudocrem. No utilices nada de eso.

Tanto el bicarbonato como la pasta de dientes son sustancias alcalinas y abrasivas que pueden avivar las lesiones e irritarte la piel. No emplees alimentos, como miel o yogur. Los azucares que contienen servirán como alimento a la bacteria del acné. El sudocrem es interesante si lo que tienes en un corte o arañazo, porque favorecerá la cicatrización, pero no actúa contra la causa del acné y puede obstruir aún más los poros. Tampoco utilices ninguna otra crema que no esté indicada para el acné. Una crema comedogénica podría empeorar el problema.

Otro de los falsos remedios contra el acné es el sol. Probablemente hayas escuchado que tomar el sol y broncearse reseca los granos y los cura. No es así. El bronceado puede disimular algunas marcas del acné, pero la realidad es que recientemente se ha descubierto que la radiación ultravioleta del sol empeora el acné.9 Los efectos desecantes del sol provocarán que tu piel sufra un efecto rebote y se acelere la producción de sebo. El engrosamiento de la capa externa de la piel obstruirá los poros e impedirá que el sebo se libere adecuadamente. Para evitar esto, es necesario utilizar productos de protección solar específicos para pieles con acné, fluidos sin aceites y con texturas no comedogénicas.

Para encontrar el mejor remedio contra el acné, seguro y eficaz, deberás acudir a tu médico, a tu dermatólogo y preguntarle a tu farmacéutico. Según la gravedad del acné, tu tipo de piel, tu edad y tus hábitos de vida, te recomendará seguir un tratamiento u otro. Los más comunes son:

-

Tratamientos tópicos

Son cremas que se aplican sobre la piel. Suelen contener peróxido de benzoílo y retinoides. El peróxido de benzoílo mata a la bacteria responsable del acné, reduce el enrojecimiento y exfolia las células muertas. La principal desventaja de este tipo de tratamiento es que puede dejar la piel enrojecida, irritada, con sequedad y con descamaciones superficiales visibles.

Los retinoides son un grupo de derivados de la vitamina A con resultados excepcionales contra el acné. Ayudan a exfoliar las células superficiales que obstruyen los poros. La desventaja es que fotosensibilizan la piel, por lo que sólo pueden utilizarse por la noche o deben estar formulados en productos con protección solar.

Otras sustancias comunes en este tipo de cosméticos son la niacinamida —con efecto calmante—, la piroctona olamina y el glicacil —para luchar contra la proliferación bacteriana—, el procerad —una ceramida que evita las irritaciones y las marcas del acné—, LHA, ácido linoleico y ácido salicílico —microexfoliantes y con acción queratolítica—.

-

Tratamientos orales

Los tratamientos orales habituales son los antibioticos y la isotretinoína10. Los tratamientos antibióticos sólo se prescriben en casos de acné graves y cuando los tratamientos tópicos resultan insuficientes. La doxiciclina es el más habitual.

El principal inconveniente es que estos antibióticos hacen que la piel se vuelva muy sensible a la luz solar. Por eso es imprescindible combinarlos con cosméticos con protección solar, fórmulas ligeras y no comedogénicas.

La isotretinoína es el medicamento más potente contra el acné. Seca la fuente original del acné (el sebo excesivo) y detiene indefinidamente la aparición de granitos. Esta solución es el último recurso. Los pacientes deben monitorizar su respuesta corporal al tratamiento mediante análisis de sangre realizados con regularidad. Los efectos secundarios incluyen sequedad severa en la piel y los labios o las fosas nasales, lo que podría causar descamación, tirantez e incluso sangrado en la nariz. A demás es fotosensibilizante, lo que significa que hace a la piel más vulnerable al sol.

Si estás tomando isotretinoína, tendrás que mantener la piel hidratada con cremas hidratantes de textura rica y usar un alto índice de protección solar. Utiliza algún bálsamo labial específicamente diseñado para labios muy secos.

-

Conclusiones

Al terminar la carrera de química, algunos de mis compañeros se decantaron por la cosmética. Ellos fueron mi nexo con esa ciencia y la razón por la que me atreví a volver a pedir asesoramiento. Esta es la conclusión: si tienes un problema de acné, pide asesoramiento. Consúltalo con tu médico, tu dermatólogo, tu farmacéutico.

Probé nuevos productos adaptados a mi piel y a mi estilo de vida, en mi caso sin peróxido de benzoílo, ya que resultó ser demasiado agresivo para mi piel. Esta vez sí tenía esperanzas. Me había librado de mis prejuicios gracias a entender la ciencia que hay tras el estudio del acné y de los productos cosméticos y farmacológicos que lo combaten. Tardé semanas en empezar a ver resultados, pero los resultados llegaron. Mi caso era un caso leve, que pude solucionar en poco tiempo y sólo empleando tratamientos tópicos. Jamás he vuelto a tener esos molestos granitos en mi frente, ni marcas, ni irritaciones, ni rojeces. Ojalá hubiese sabido todo esto un poco antes.

Fuentes:

[1] ¿Qué es y cuáles son las causas del acné? Artículo de La Roche-Posay.

[2]The Johnson & Johnson Skin Research Center; CPPW, a division of Johnson & Johnson Consumer Companies, Inc.; Skillman, NJ USA. The relationship of diet and acné. A review. Dermatoendocrinol. 2009 Sep-Oct; 1(5): 262–267.

[3] Adebamowo CA, Spiegelman D, Danby FW, Frazier AL, Willett WC, Holmes MD. High school dietary dairy intake and teenage acne. J Am Acad Dermatol. 2005;52(2):207–214

[4] Adebamowo CA, Spiegelman D, Berkey CS, et al. Milk consumption and acne in adolescent girls. Dermatol Online J. 2006;12(4):1

[5] Adebamowo CA, Spiegelman D, Berkey CS, et al. Milk consumption and acne in teenaged boys. J Am Acad Dermatol. 2008;58(5):787–793

[6] Smith RN, Mann NJ, Braue A, Mäkeläinen H, Varigos GA. A low-glycemic-load diet improves symptoms in acne vulgaris patients: a randomized controlled trial. Am J Clin Nutr. 2007;86(1):107–115

[7]De granos, leche y chocolate. Dermapixel, 2012.

[8] Mitos sobre los alimentos que producen acné. Artículo de La Roche-Posay.

[9] A Angel, DW Osborne, GJ Dow. Topical acne vulgairs medication with a sunscreen. Patent US7252816 B1, 2007

[10] Los efectos secundarios de los tratamientos contra el acné. Artículo de La Roche-Posay.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Ni mitos ni remedios caseros: así me libré del acné se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La sensación de ingravidez es como estar en caída libre continuamente

- Remedios que curan

- #Naukas15 Mitos y realidades de la seguridad informática

Dozena erdi ariketa 2017ko udarako (2): Fitxen balio altuena

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure bigarren ariketa: Fitxen balio altuena

2) Aurpegi bakoitzean zenbaki bat idatzita duten lau fitxa ditugu. Denetara 1etik 8rainoko zenbaki guztiak daude idatzita. Fitxak behin bota eta 6, 1, 4 eta 3 zenbakiak agertu dira; bigarrenean, 1, 3, 5 eta 7; hirugarrenean, 3, 7, 2 eta 6. Zein da jaurtialdi batean agertzen diren zenbakiak batuz lor daitekeen baliorik handiena?

———————————————————————————-

Ariketak “Calendrier Mathématique 2017. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki dezakezu.

———————————————————————————-

The post Dozena erdi ariketa 2017ko udarako (2): Fitxen balio altuena appeared first on Zientzia Kaiera.

Mosaicos hexagonales para el verano

El pasado 25 de julio, de 2017, tuve el placer de participar en la jornada RSME-ANEM que tuvo lugar en Sevilla, dentro del XVIII Encuentro Nacional de Estudiantes de Matemáticas. Aprovechando mi estancia en la capital hispalense me acerqué a CaixaForum Sevilla, donde disfruté de dos magníficas exposiciones. La primera de ellas, Sorolla, un jardín para pintar, fue una exposición muy interesante sobre la relación del pintor valenciano Joaquín Sorolla con los patios y jardines andaluces y los de su propia casa madrileña, que él mismo diseñó. La segunda fue todo un descubrimiento para mí, la magnífica exposición Anglada-Camarasa (1871-1959), del pintor modernista catalán Hermenegildo Anglada Camarasa.

“La sibila” (1913), de Hermenegildo Anglada Camarasa

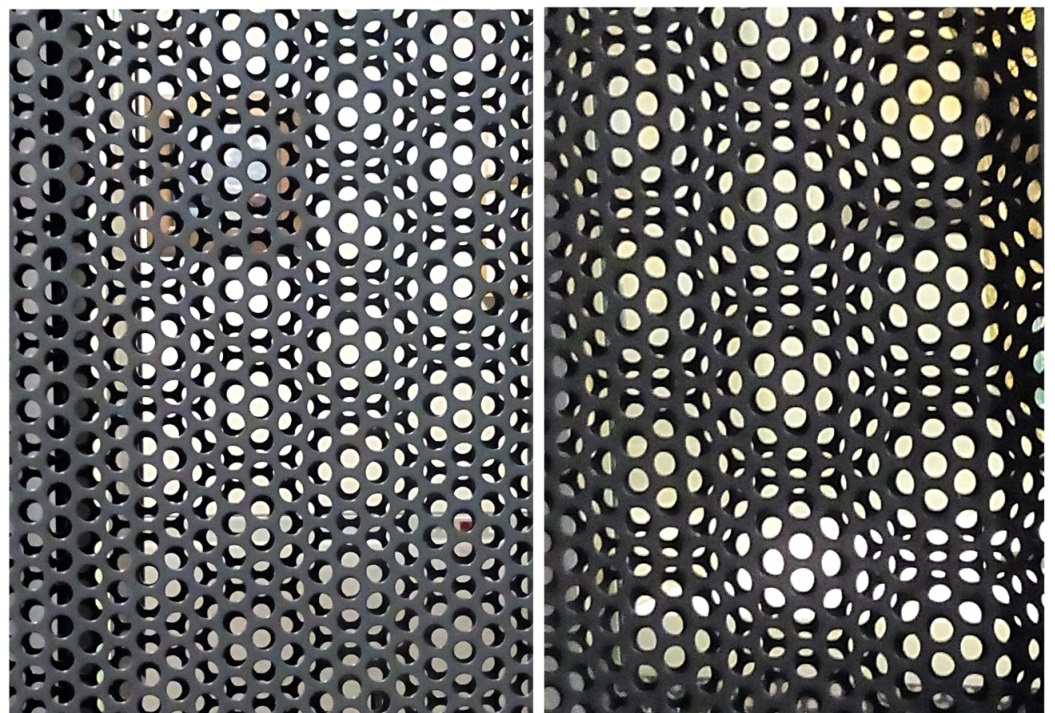

Sin embargo, en esta entrada del Cuaderno de Cultura Científica no voy a hablar de estas dos magníficas exposiciones, sino de un pequeño elemento funcional y decorativo que CaixaForum Sevilla utilizó para separar espacios en la exposición de Anglada Camarasa. Se trataba de una construcción con dos placas de metal con pequeños agujeros redondos y colocadas en paralelo, una detrás de la otra. Lo interesante de este pequeño elemento decorativo era el efecto óptico que se producía al mirarlo. Como se puede apreciar en las siguientes imágenes (que por desgracia no tienen la intensidad de lo que se realmente se veía), el efecto óptico consistía en la impresión de que se estaba mirando un mosaico de hexágonos regulares. Un bello efecto óptico, que no pude evitar fotografiar de inmediato.

Efecto óptico, de mosaico hexagonal, producido por dos placas metálicas paralelas con agujeros redondos en CaixaForum Sevilla

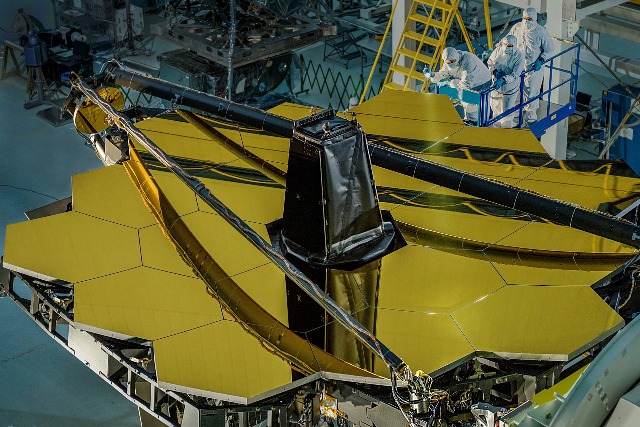

Como ya comentamos en la entrada Diseños geométricos de chocolate, solamente existen tres diseños de mosaicos regulares, es decir, realizados con polígonos regulares, aquellos que utilizan cuadrados, triángulos y hexágonos. El mosaico hexagonal, que vino a mis ojos a través del efecto óptico en CaixaForum Sevilla, está presente en muchos elementos de nuestra vida, desde sencillos elementos decorativos de nuestras casas y ciudades (de hecho, en la mencionada entrada del Cuaderno mostramos el mosaico hexagonal de baldosas que el arquitecto barcelonés Antoni Gaudí (1852-1926) creó para los suelos de la Casa Milá, La Pedrera, de Barcelona, y que ahora es todo un símbolo de la ciudad condal) a importantes aplicaciones industriales (como el Telescopio Espacial James Webb, de la NASA, la ESA y la CSA, cuyo espejo está formado por 18 segmentos hexagonales), pasando por su presencia en el arte.

Mosaico hexagonal del Paseo de Gracia, en Barcelona, con el diseño que realizó Antoni Gaudí para los suelos de la Casa Milá

Espejo, formado por un mosaico hexagonal con 18 hexágonos, del Telescopio Espacial James Webb, que será el sucesor del Telescopio Espacial Hubble y del Spiltzer, y que se lanzará al espacio en octubre de 2018

El objetivo de esta entrada es mostrar algunos ejemplos de la presencia del mosaico de hexágonos en el arte. Debido a que su uso en el arte, el diseño y la arquitectura es enorme, solo vamos a dar una pequeña muestra.

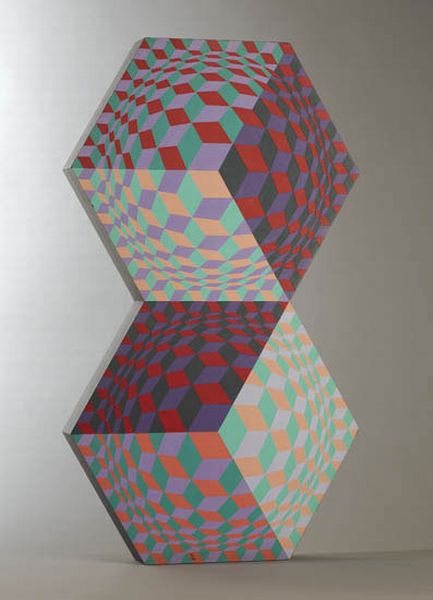

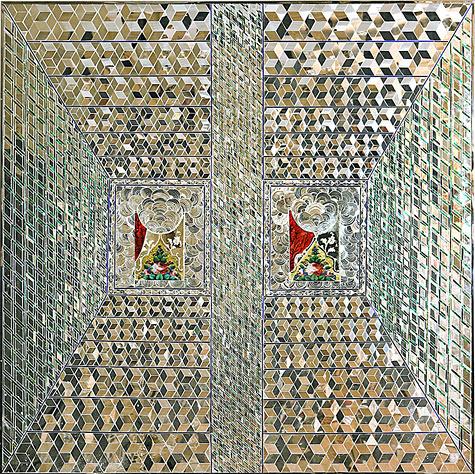

Iniciaremos este corto paseo con algunas obras del maestro del Op Art, arte óptico, el artista húngaro, que vivió la mayor parte de su vida en Francia, Víctor Vasarely (1906-1997). Entre las muchas obras de Vasarely, nos encontramos con una serie de nueve obras con el título conjunto Homenaje al hexágono (1969), que se encuentran en el MOMA (Museo de Arte Moderno) de Nueva York.

Una de las obras de la serie “Homenaje al hexágono” (1969), de Víctor Vasarely, que se encuentra en el MOMA de Nueva York

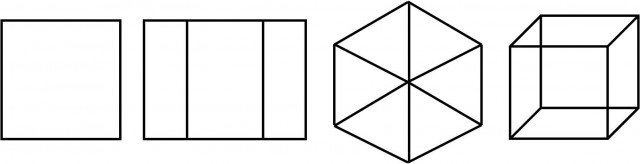

Aunque, como vemos en la imagen anterior, Vasarely no realiza un mosaico limpio de hexágonos, sino que juega con otro efecto óptico, muy habitual en su obra, lo que él llama “cubo de Kepler”. La proyección ortogonal de un cubo (desde una dirección que es paralela a una de las diagonales del cubo) es una imagen plana representada por un hexágono formado por tres rombos, que es la que se observa en cada uno de los hexágonos de la anterior obra de Vasarely. Si el cubo está vacío, es decir, solo está formado por las aristas laterales, entonces la proyección ortogonal del mismo es un hexágono formado por seis triángulos, como comentamos en la entrada Hipercubo, visualizando la cuarta dimensión.

Proyecciones ortogonales de un cubo siguiendo una dirección a) perpendicular a dos de las caras del cubo, y paralela a las otras cuatro; b) paralela solamente a dos de las caras del cubo; c) paralela a la diagonal; d) no paralela ni a las caras ni a la diagonal

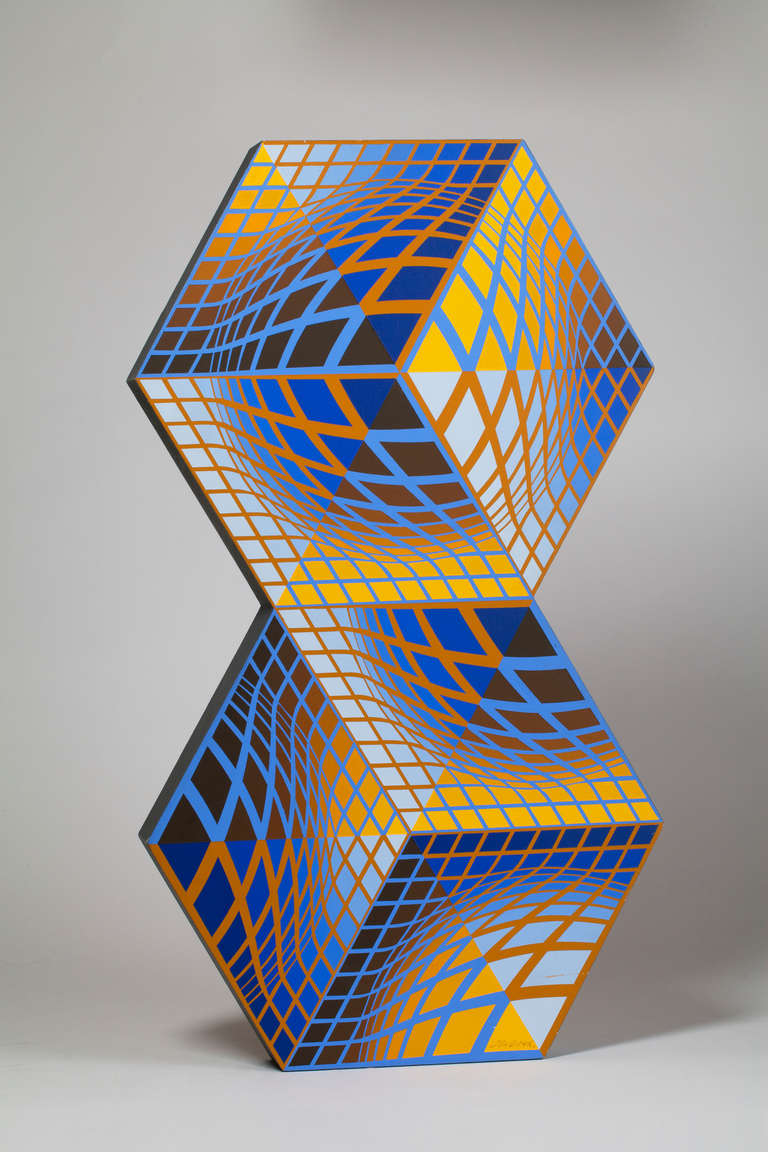

A continuación, mostramos dos esculturas de Victor Vasarely formadas ambas por dos hexágonos y en cada una de ellas se muestra la imagen hexagonal del cubo que acabamos de comentar, en la primera obra formada por rombos y en la segunda por triángulos.

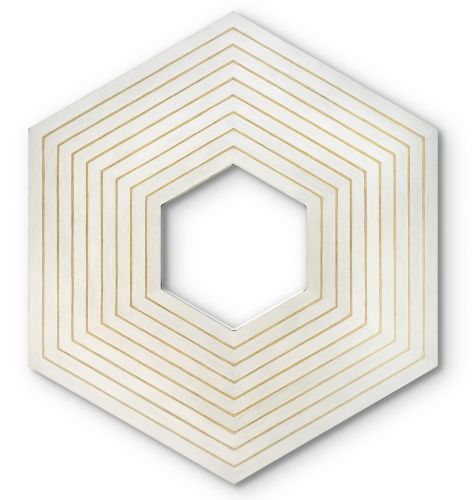

“Kettes” (que en húngaro significa “dos”), obra de Victor Vasarely, de 1984, pintada sobre madera

“Sin título” (1984), obra de Victor Vasarely, pintada sobre madera

El hexágono formado por tres rombos crea un efecto óptico muy conocido, y popular, del cubo, ya que da la impresión tanto de que es un cubo “hacia fuera”, como “hacia dentro”, a la vez. Es decir, se crea una doble impresión visual, en la que vemos tanto la imagen en la que el vértice del cubo que está en el centro de la imagen está más cerca de la persona que observa el “cubo”, como la imagen en la que está más lejos. Además, se puede jugar con los colores del cubo para marcar más una opción u otra. Obsérvense este efecto en las dos primeras obras de Vasarely.

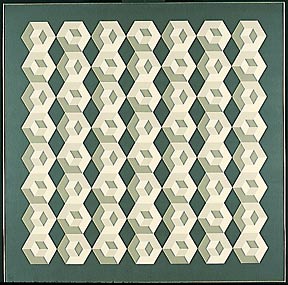

Este efecto óptico del cubo, formado por hexágonos de tres rombos, es muy habitual en la decoración de casas, comercios, bares y otros locales de nuestras ciudades.

El artista óptico Victor Vasarely juega con estos elementos, junto con otros elementos, como formas, colores y proyecciones, para sacarle el máximo rendimiento.

“Cinético” (1971), de Victor Vasarely

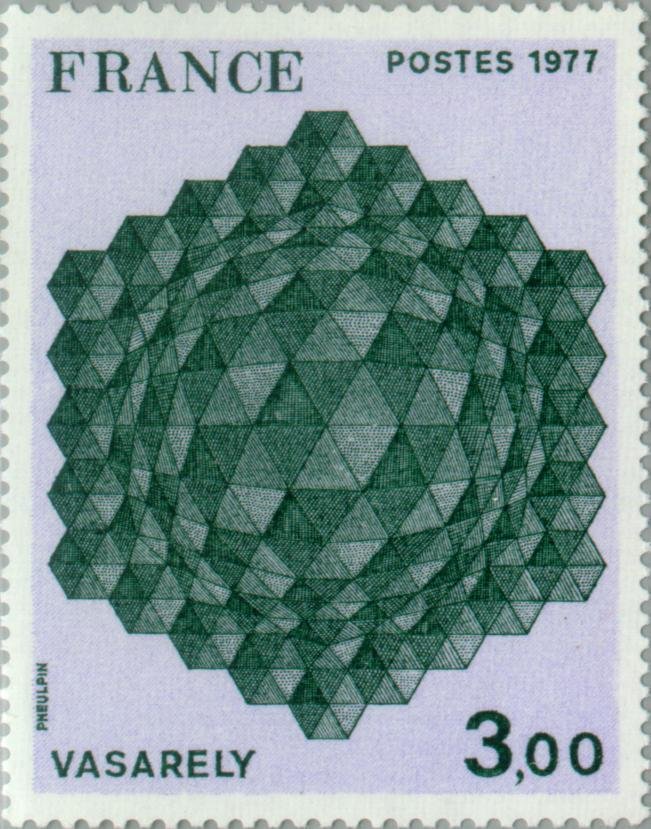

En Francia se realizó un sello en 1977 con la obra de Victor Vasarely Tributo al hexágono, que se puede ver en la siguiente imagen.

Sello de 1977, con el valor de 3,00 francos, de la obra de Victor Vasarely, “Tributo al hexágono”

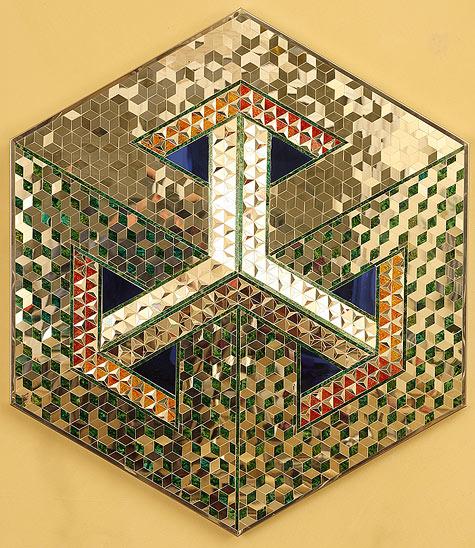

Estas son solo algunas de las muchas obras de Victor Vasarely relacionadas con el hexágono. Terminamos con otra en la que una vez más se juega con el efecto óptico del cubo, aunque con un doble efecto, como se puede apreciar.

“Bi-sanction”, de Victor Vasarely

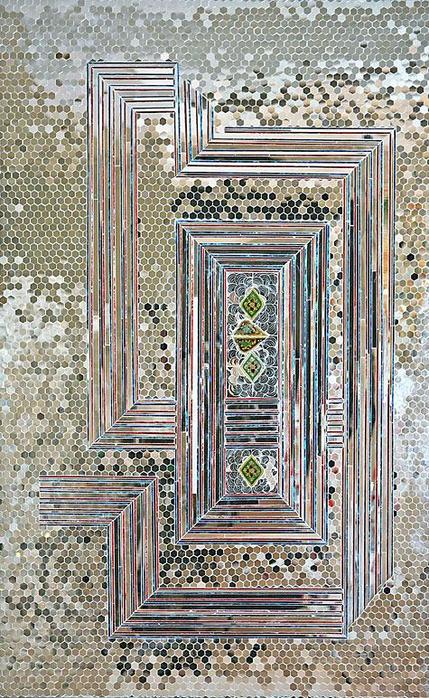

Hay una artista muy interesante, por la utilización de patrones geométricos en su trabajo, que tiene algunas obras que me recuerdan mucho a estos estudios ópticos de Victor Vasarely sobre el hexágono y el cubo, es la artista iraní Monir Shahroudy Farmanfarmaian (Qazvin, Irán, 1924).

Esta artista iraní tiene una serie de mosaicos de espejos con piezas triangulares, cuadradas y hexagonales con las que juega creando imágenes globales más potentes, en particular, en varias de sus obras utiliza piezas hexagonales, que son cubos proyectados sobre el plano. En la primera de las que traemos aquí la imagen global es de nuevo un hexágono representando una imagen plana del cubo, que a su vez realiza un juego óptico.

“Hexágono” (2004), de la artista iraní Monir Shahroudy Farmanfarmaian

En la siguiente obra de Farmanfarmaian, Recuerdo 1 (2008), que como en sus demás obras nos transmite su admiración por el arte árabe antiguo, sus mosaicos y sus estructuras geométricas, crea una obra cuadrada, de nuevo utilizando piezas espejadas con forma hexagonal, que es un cubo proyectado.

“Recuerdo 1” (2008), de Monir Shahroudy Farmanfarmaian

Con la misma idea, pero con pequeños espejos hexagonales limpios, sin la referencia al cubo, se construye su obra, Recuerdo 2 (2008).

“Recuerdo 2” (2008), de Monir Shahroudy Farmanfarmaian

El hexágono es un elemento principal en muchas de sus obras. Terminaremos este pequeño paseo por el trabajo de la artista iraní Monir Shahroudy Farmanfarmaian con dos obras más relacionadas con este poliedro regular. La primera de ellas es parte de una serie de obras, todas de similar estructura, pero cuyas piezas forman un poliedro regular con diferente número de lados en cada una de ellas, desde tres (triángulo), hasta 10 (decágono) lados.

“Primera familia, hexágono” (2010), de Monir Shahroudy Farmanfarmaian

“Los dos hexágonos” (2005), de Monir Shahroudy Farmanfarmaian

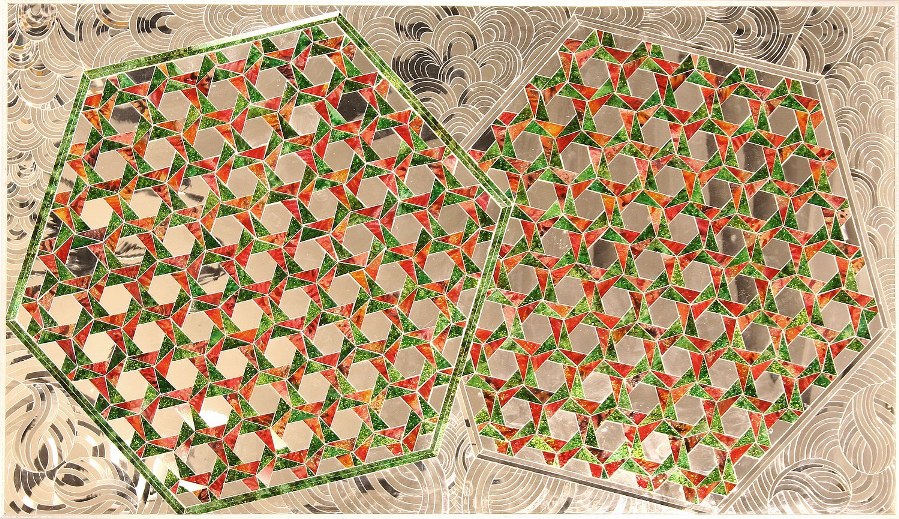

Pero volvamos a los mosaicos hexagonales y de nuevo a los movimientos artísticos del siglo XX. Si antes hablábamos del arte óptico de la mano de Victor Vasarely, ahora nos adentraremos en la abstracción geométrica. El pintor argentino Rogelio Polosello (1939-2014), que fue un pintor que trabajó dentro de la abstracción geométrica, tiene una serie de cuadros que son mosaicos de hexágonos con rombos en su interior, como el que mostramos a continuación.

“Héxagono No. 4” (1974), de Rogelio Polosello

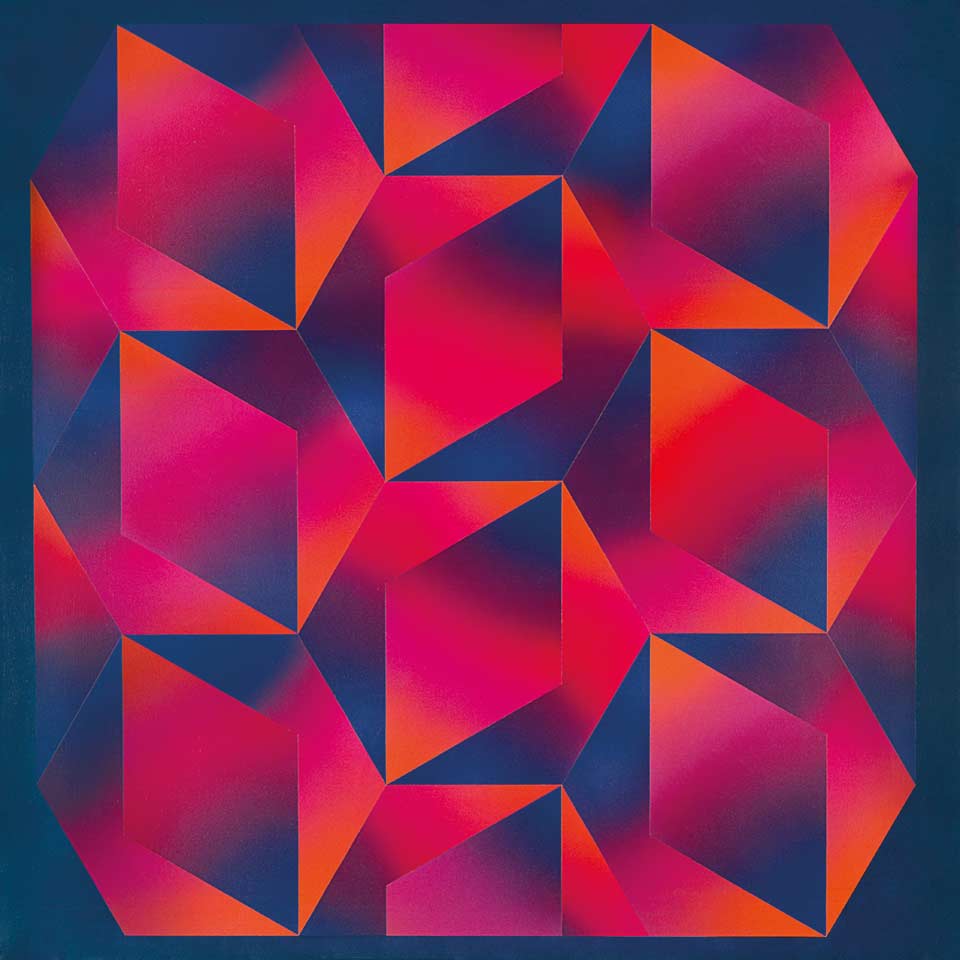

Otros artistas de la abstracción geométrica también han utilizado el hexágono, aunque no sea el mosaico hexagonal. Veamos un par de ejemplos. El primero es del pintor y grabador norteamericano Frank Stella (Massachusetts, 1936).

“Sydney Guberman” (1964), de Frank Stella

Y la segunda es de la artista estadounidense Edna Andrade (1917-2008) cuyo arte podemos enmarcar entre la abstracción geométrica y el arte óptico.

“Hot Blocks” (1966-67), de Edna Andrade

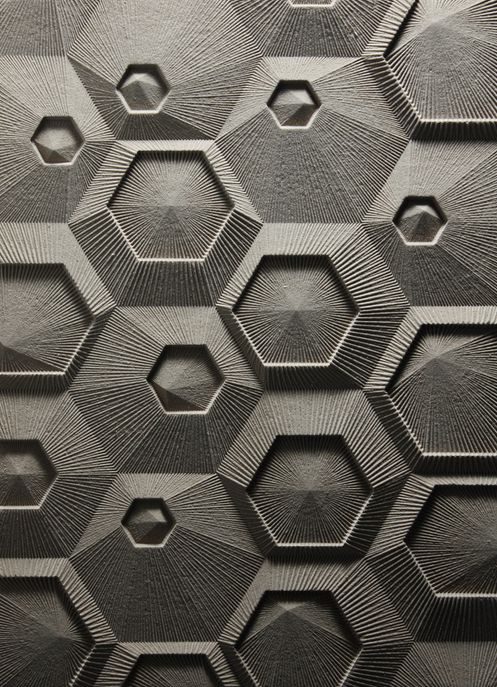

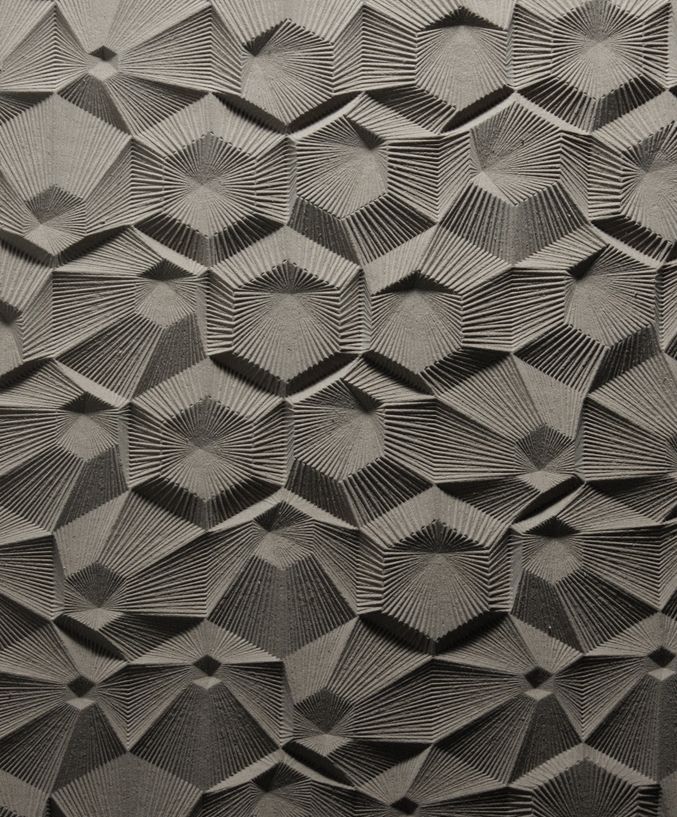

Vamos a terminar con alguien más actual que realiza obras basadas en el mosaico hexagonal, es el joven diseñador y arquitecto estadounidense Elijah Porter. Las siguientes imágenes son proyectos de superficies arquitectónicas realizadas por Porter.

Bibliografía

1.- Sorolla, un jardín para pintar, del 5 de julio al 31 de octubre de 2017, CaixaForum Sevilla

2.- Anglada-Camarasa (1871-1959), del 4 de marzo al 20 de agosto de 2017, CaixaForum Sevilla

3.- Página web de la NASA sobre el Telescopio Espacial James Webb

4.- Victor Vasarely, Hommage to the Hexagon (Hommage À La Hexagone) 1969, serie de obras perteneciente al MOMA

5.- Recollections: Monir Farmanfarmaian (2008), Nafas art magazine, Universes in univers

6.- Cosmic Geometry: The Life and Work of Monir Shahroudy Farmanfarmaian , Vogue, 2011

7.- Frank Stella – Connections – Haunch of Venison – London, Art Splash Contemporary Art

8.- Página de Elijah Porter en Flickr

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Mosaicos hexagonales para el verano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El diablo y Simon Flagg, una lectura ligera para el verano

- Cómo se formaron las columnas hexagonales de la Calzada del Gigante

- El número nueve en una noche de verano

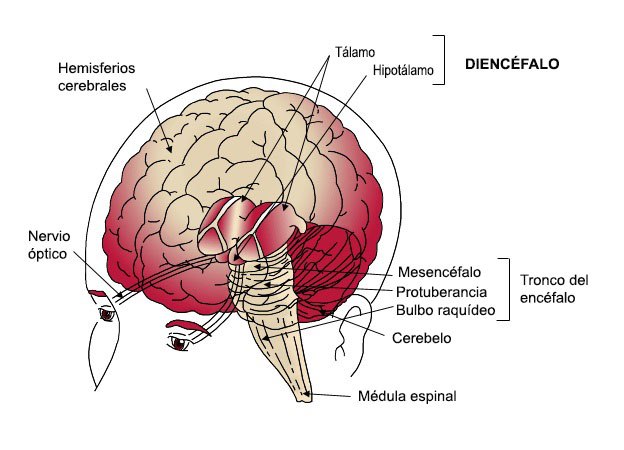

Sistemas nerviosos: el sistema límbico

Ubicación de la amígdala en humanos

El sistema límbico no constituye una región encefálica separada, con entidad propia, sino que lo integran un conjunto de estructuras ubicadas en diferentes áreas que se hallan dispuestas, principalmente, a ambos lados del tálamo, justo por debajo del cerebro, y que establecen múltiples e intrincadas conexiones neuronales entre ellas. A este sistema pertenecen ciertas porciones de áreas tales como la corteza cerebral, los núcleos basales, el tálamo y el hipotálamo, por lo que incluye estructuras con origen en diferentes vesículas embrionarias (telencéfalo, mesencéfalo y diencéfalo).

El sistema límbico está implicado en numerosas funciones, como la génesis de las emociones, la motivación, la memoria a largo plazo, la olfacción, el comportamiento sociosexual y la supervivencia.

En el pasado también ha sido denominado cerebro paleomamífero o corteza paleomamífera, un nombre que tiene que ver con una concepción de la arquitectura encefálica basada en su antigüedad evolutiva. Según esa concepción, los componentes del encéfalo serían: (1) el encéfalo primitivo (o reptiliano), al que corresponden el tallo encefálico, el puente, el cerebelo, el mesencéfalo, los ganglios basales más antiguos y los bulbos olfatorios; (2) el encéfalo intermedio (o “mamífero antiguo”), al que corresponden las estructuras del sistema límbico; y (3) el encéfalo superior o racional (o “mamífero nuevo”), integrado por los hemisferios cerebrales y algunas áreas subcorticales. Aunque esa clasificación de las estructuras y sus funciones no está desencaminada, las denominaciones no se compadecen con la historia evolutiva real de las correspondientes áreas, porque la distinción entre “reptiliano”, “mamífero antiguo” y “mamífero nuevo” carece de la debida fundamentación. Los ancestros comunes de reptiles y mamíferos ya tenían un sistema límbico bien desarrollado y configurado de forma similar al actual. Y las aves, que evolucionaron de los dinosaurios en la misma época en que aparecieron los mamíferos también tienen un sistema límbico bien desarrollado.

Uno de los componentes más importantes de este sistema es la amígdala, una estructura subcortical doble (una en cada hemisferio) que se encuentra por debajo del lóbulo temporal. Desempeña funciones importantes en el procesamiento de la memoria, la toma de decisiones y las reacciones emocionales. Es de especial importancia su rol en el procesamiento de señales que generan miedo. La amígdala activa el sistema de estrés de lucha o huida controlado por el hipotálamo y que permite preparar al organismo para que adopte uno de esos dos comportamientos. Aunque la decisión relativa a la adopción de uno de ellos es posterior y corre a cargo de la corteza, el sistema activado por la amígdala permite que, sea cual sea, la respuesta se produzca con la máxima intensidad ya que hace que el organismo disponga de abundante energía y oxígeno para ello.

El hipotálamo mantiene una intrincada red de relaciones con las áreas corticales superiores y con el resto del sistema límbico, principalmente con la amígdala. Juega, como ya vimos en una anotación anterior, un papel clave en la coordinación de diferentes respuestas a cargo del sistema nervioso autónomo y el sistema hormonal. Y es, como acabamos de ver, el centro que desencadena las acciones propias de la respuesta de lucha o huida que activa la amígdala.

La corteza superior también juega un papel importante en el desarrollo de comportamientos en los que está implicado el sistema límbico. Si bien este último desencadena acciones fisiológicas rápidas en respuesta a señales que le llegan directamente, la corteza cerebral interviene para hacer una valoración precisa de la información que ha desencadenado la primera respuesta, y también para dar lugar a la secuencia de respuestas motoras adecuadas. Las respuestas consistentes en atacar o huir de un adversario, desplegar la actividad de emparejamiento o la expresión de emociones pueden ser inducidos por el sistema límbico, pero la valoración precisa de su conveniencia e intensidad y la ejecución de las órdenes motoras que dan lugar a los movimientos que las desarrollan son tareas propias del cerebro. Un ejemplo ilustrativo del papel de la corteza en determinadas respuestas en las que participa el sistema límbico es su intervención en la génesis de la sonrisa. La secuencia estereotipada de movimientos que la producen está preprogramada en la corteza cerebral y, en determinadas circunstancias, el sistema límbico puede invocarla para dar lugar a su expresión de forma involuntaria. Pero como sabemos, también podemos ejecutar la misma secuencia de forma voluntaria como consecuencia de una decisión consciente como, por ejemplo, al posar para una fotografía.

Otra vertiente importante de la actividad del sistema límbico es su implicación en el refuerzo o supresión de comportamientos que han sido, respectivamente, placenteros o desagradables. Las regiones del sistema límbico implicadas en esas funciones se denominan centros de recompensa o de castigo, porque su estimulación provoca sensaciones placenteras o desagradables. Los centros de recompensa son especialmente abundantes en áreas que intervienen en actividades tales como la alimentación, la bebida y la actividad sexual, razón por la cual beber, comer y practicar sexo son actividades que reportan placer.

Fuentes:

Eric R. Kandel, James H. Schwartz, Thomas M. Jessell, Steven A. Siegelbaum & A. J. Hudspeth (2012): Principles of Neural Science, Mc Graw Hill, New York

Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas nerviosos: el sistema límbico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el sistema central de vertebrados

- Sistemas nerviosos: el sistema periférico de vertebrados

- Sistemas nerviosos: el tálamo y el hipotálamo

Una cuestión de movimiento

Hemos visto que durante la década de 1840 muchos científicos reconocieron que el calor no es una sustancia sino una forma de energía que puede convertirse en otras formas. James Prescott Joule y Rudolf Clausius fueron un paso más allá. El calor puede producir energía mecánica, y la energía mecánica puede producir calor; por lo tanto, razonaron, la “energía calorífica” de una sustancia es simplemente la energía cinética de sus átomos y moléculas. Esta idea, que constituye la base de la teoría cinético-molecular del calor, es mayormente correcta.

Sin embargo, y a pesar de lo que pueda parecer leyendo los libros de texto habituales, donde parece que desde que Dalton propone la hipótesis atómica en 1805, ésta es inmediatamente aceptada, la idea de átomos y moléculas tuvo tantos partidarios como detractores a lo largo en el siglo XIX e incluso en el siglo XX [1]. Las moléculas, como sabes, son las partes más pequeñas de una sustancia, y están compuestas de átomos, que son las partes más pequeñas de un elemento. Si admites su existencia ideas como la homeopatía se convierten inmediatamente en absurdos [2] y otras, como las leyes de proporción de la química, se vuelven lógicas.

Volviendo a las ideas de Joule y Clausius, si esos pedacitos de materia realmente existieran, serían demasiado pequeños como para poder observarlos incluso con los más poderosos microscopios. Como los científicos no podían observar las moléculas, no podían confirmar directamente la hipótesis de que el calor es energía cinética molecular. Por lo tanto, recurrieron a la forma indirecta de comprobar la plausibilidad de la hipótesis, que siempre es útil: derivaron de esta hipótesis las predicciones sobre el comportamiento de grandes muestras de materia mensurables, y luego comprobaron estas predicciones con experimentos [3].

Por razones que se harán evidentes según avancemos en esta serie, es más fácil comprobar las predicciones de la hipótesis atómica observando las propiedades de los gases. La consecuencia última de estos desarrollos en la segunda mitad del siglo XIX, la teoría cinética de los gases, es uno de los últimos grandes éxitos de la mecánica newtoniana.

Una de las características más fáciles de medir de un gas confinado es su presión. La experiencia que tenemos con globos y neumáticos hace que la idea de la presión del aire parezca obvia. Pero hay sutilezas importantes. Una implica la presión que ejerce el aire que nos rodea.

En su libro sobre mecánica, Discorsi e Dimostrazioni Matematiche Intorno a Due Nuove Scienze (1638), Galileo llama la atención sobre el hecho de que las bombas de pistón no pueden elevar el agua más de 10 metros. Este era un hecho muy conocido en la época, ya que se usaban este tipo de bombas volumétricas para sacar agua de pozos o para evacuar el agua de las minas. Si recordamos, esta fue la motivación primera para el desarrollo de las máquinas de vapor.

Pero, ¿por qué solo 10 metros? Para empezar, ¿por qué funcionaban siquiera las bombas?

En las próximas entregas observaremos las propiedades de un gas simple para, posteriormente, intentar explicar el origen de las propiedades de los gases además de sus consecuencias prácticas y, además, el de las leyes de la termodinámica basándonos solo en la teoría cinética. Todo ello con las matemáticas de primaria.

Notas:

[1] Incluso hubo premios Nobel de química, como Ostwald, que negaron la existencia de átomos y moléculas hasta que se conocieron los resultados de los experimentos de Perrin en 1908 que probaban que la teoría de Einstein sobre el movimiento browniano, basada precisamente en la existencia de moléculas, era correcta.

[2] Fue la indefinición del XIX sobre la cuestión atómica una de las patas que permitieron la popularización de esta, hoy ya sí con todas letras, estafa. Las otras dos patas fueron el desconocimiento de la existencia del efecto placebo y el hecho estadístico de que la mayor parte de las personas que enferman se curan por sí mismas (hay cientos de miles de resfriados cada año por cada colangiocarcinoma, por ejemplo). La homeopatía es una práctica iniciada en el desconocimiento que hoy se mantiene basada en el negocio y en la ignorancia. Si admites la existencia de átomos y moléculas, automáticamente el gasto en estudios sobre los efectos de la homeopatía es tan lógico como el gasto en enviar sondas a Saturno a buscar botijos que orbiten el planeta. En ambos casos las base teórica es igualmente absurda.

[3] Como hemos apuntado en la nota [1] hasta que no se pudieron hacer predicciones que eran ciertas si, y solo si, la hipótesis atómica era correcta, como las que se derivan de la teoría del movimiento browniano de Einstein, ningún resultado fue concluyente.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Una cuestión de movimiento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Se intuye la conservación de la energía (1)

- La fe en las leyes de conservación

- Potencia y eficiencia de una máquina

Oinarrian, zientzia

Irène Joliot-Curie: “Zientzia gizakien bizitza hobetzen eta sufrimendua arintzen duen aurrerapen ororen oinarria da”.

—————————————————–

Egileez: Eduardo Herrera Fernandez, Leire Fernandez Inurritegi eta Maria Perez Mena UPV/EHUko Letraz – Diseinu Grafikoko eta Tipografiako Ikerketa Taldeko ikertzaileak dira.

—————————————————–

Aipua eta irudia UPV/EHUko Zientzia Astea: Alfabetatze zientifikoa Alfabetización científica liburutik jaso dugu. Eskerrak eman nahi dizkiegu egileei eta UPV/EHUko Zientzia Astearen arduradunei, edukia blogean argitaratzeko baimena emateagatik.

The post Oinarrian, zientzia appeared first on Zientzia Kaiera.

Un alelo para las gafas de color de rosa

Hay una variante alélica de la región promotora del gen del transportador de serotonina (5-HTTLPR) que está asociada con una diferencia a la hora de reparar en unas imágenes u otras, dependiendo de su contenido afectivo, positivo o negativo.

Vayamos por partes. La serotonina es un neurotransmisor, o sea, una molécula mensajera que interviene en las conexiones sinápticas entre neuronas en ciertas vías nerviosas. En otras palabras, es una molécula que una neurona (presináptica) vierte al espacio existente entre ella y la neurona contigua (hendidura sináptica), y se une a unos receptores que hay en la membrana de esta segunda neurona (postsináptica); una vez unida a su receptor, da lugar a los efectos correspondientes. Lo que aquí nos interesa es que el neurotransmisor no permanece permanentemente unido al receptor, sino que se libera del mismo y vuelve a quedar en la hendidura sináptica. Por otro lado, en la neurona presináptica (la que ha vertido el neurotransmisor a la hendidura sináptica) hay unas proteínas transportadoras, que lo recuperan y lo introducen de nuevo en la neurona; de esa forma se recicla y se puede volver a utilizar.

Pues bien, la variante alélica a que hacemos referencia aquí da lugar a que unos individuos tengan transportadores de serotonina diferentes de los que tienen otros. Los individuos homocigóticos para el alelo largo (LL) tienen una tendencia a fijarse y procesar material de contenido afectivo positivo, a la vez que evitan el negativo. Podría decirse, si se permite la metáfora cursi, que tienden a ver la vida de color de rosa. Ese rasgo está ausente en quienes poseen el alelo corto (SS o LS). Al parecer, los homocigóticos para L producen una proteína transportadora más activa que los otros individuos y como consecuencia de ello, reciclan más rápidamente la serotonina y la ponen antes a disposición de las neuronas presinápticas en los circuitos neuronales en los que participan. De esa forma esas neuronas presinápticas disponen de más serotonina. Y son quienes tienden a fijarse en las cosas buenas quienes poseen el alelo largo de la región promotora en cuestión. En definitiva, el sesgo que conduce a fijarse en un tipo de contenidos u otros y procesarlos está asociado con un polimorfismo genético común. En otras palabras, una actitud que puede influir en la visión más o menos optimista que tengamos de las cosas parece que tiene sustrato genético.

Por otra parte, que quienes tienen el alelo LS o SS tiendan a fijarse más en los aspectos desfavorables de las cosas es un problema, porque sufren neurosis, desórdenes emocionales y depresiones con más facilidad que los que se fijan en los aspectos favorables. Un aspecto colateral, pero muy importante de este asunto es que las mujeres tienen en general más receptores postsinápticos de serotonina pero menos transportadores. Como consecuencia de ello, reciclan este neurotransmisor a menor velocidad, lo que hace que su disponibilidad en la neurona presináptica sea menor. Y resulta que las mujeres tienen una mayor predisposición que los hombres a sufrir depresión.

Fuente: Elaine Fox, Anna Ridgewell & Chris Ashwin (2009): Looking on the bright side: biased attention and the human serotonin transporter gene. Proceedings of the Royal Society B 276: 1747-1751

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Un alelo para las gafas de color de rosa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Nacidos para creer?

- Las recetas del franciscano y “El nombre de la rosa” (y 3)

- Una nueva diana terapéutica para el neuroblastoma

Todo lo que se puede medir en un río

El grupo de investigación Ecología de ríos/Stream ecology del Departamento de Biología Vegetal y Ecología de la UPV/EHU es un grupo especializado en el estudio del funcionamiento de los ríos, constituido por expertos en múltiples áreas. Dentro del marco del proyecto europeo Globaqua, en el que participan más de 10 instituciones europeas, han realizado un amplio trabajo de revisión que ha tenido como fruto un artículo “en el que sintetizamos y clasificamos todos los procesos que se pueden medir en los ríos; explicamos cómo se pueden realizar las mediciones (métodos que existen en la literatura), cómo responden dichos procesos a diversos estresores ambientales, etc.”, explica Daniel von Schiller, uno de los autores del artículo. Se trata de una “proposición que plantea un nuevo marco de trabajo muy apropiado tanto para investigadores como para gestores”, manifiesta.

Según constatan en el artículo, “tal y como marca la Directiva Marco del Agua, los ecosistemas de los ríos se deberían evaluar tanto desde el punto de vista de su estructura como de su funcionamiento, porque así se obtiene una mejor estimación del estado ecológico de un río”. El investigador hace una analogía con el cuerpo humano: “Si en un enfermo solo se mira si tiene corazón, pulmones y riñones, pero no se miden el pulso del corazón, cuánto volumen de aire respira o qué filtran los riñones, no se evalúa bien el estado de salud del paciente o en nuestro caso el estado ecológico del ecosistema que se está midiendo”.

Actualmente, las medidas que marcan los protocolos para saber cuál es el estado ecológico de los ríos son estructurales (relacionadas con la forma del canal, calidad del agua o composición de las comunidades biológicas): medidas de comunidades, de contaminantes, de temperatura, de concentración de nutrientes, etc. El funcionamiento de un ecosistema, sin embargo, se define como el conjunto de procesos que regulan tanto los flujos de materia como los flujos de energía dentro de un ecosistema. Los investigadores proponen, en ese sentido, toda una serie de medidas de funcionamiento complementarias, relacionadas con procesos de metabolismo, de descomposición de la materia orgánica, de ciclado de nutrientes, de dinámica de contaminantes y de dinámica de las comunidades fluviales.

En el estudio, además de recopilar métodos de medida de los diferentes procesos encontrados en la bibliografía, los han clasificado en función de variables como dificultad, complejidad, costes, escalas espaciales y temporales de medida, etc. “Por último —explica Daniel von Schiller—, hemos realizado un estudio exhaustivo en la literatura de las respuestas de los diferentes procesos a estresores ambientales de origen antropogénico (tales como contaminación, canalizaciones, acidez, etc.)”.

Como conclusión, el investigador manifiesta que “es la primera vez que se sintetiza todo lo que se puede medir en cuanto a procesos en ríos, y no solo presentamos qué se puede medir, sino también presentamos por qué, cómo y qué ventajas tiene un proceso frente a otro, y además cómo responde a estresores”. El objetivo de los investigadores ha sido crear una herramienta con la que puedan trabajar tanto personal investigador como gestor. El equipo, además, está ya en contacto con diferentes agentes y organismos relacionados con el control de aguas, entre las que se encuentra la Agencia Vasca del Agua – URA, para poner en marcha un novedoso proyecto de implementación de medidas e índices funcionales en ríos.

Referencia:

Daniel von Schiller et al. (2017).. “River ecosystem processes: A synthesis of approaches, criteria of use and sensitivity to environmental stressors”.. Science of the Total Environment. Vol. 596–597. Pages 465–480.. DOI: 10.1016/j.scitotenv.2017.04.081

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Todo lo que se puede medir en un río se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: ¡La geología por encima de todo!

- Un nuevo mecanismo de resistencia antifúngico

- El análisis del supercúmulo “El Gordo” limita qué puede ser la materia oscura

La parábola del coche eléctrico

El XX parecía destinado a ser el siglo de los vehículos eléctricos. Otras muchas facetas de la actividad industrial, urbana y doméstica se vieron afectadas por la electrificación en ese siglo. No así los automóviles. El primer vehículo eléctrico del que se tiene noticia fue obra del químico británico Robert Davidson. Lo fabricó en Aberdeen en 1837. En 1842 construyó otro con una batería de zinc, llamado Galvani, que se desplazaba a 4 millas por hora. El zinc que consumía era cuarenta veces más caro que el carbón que había que quemar en una máquina de vapor para conseguir el mismo resultado y, en todo caso, no era de ninguna utilidad. En 1884 Thomas Parker construyó en Londres el primer coche eléctrico de baterías recargables –un prototipo, en realidad- y en 1888 Andreas Flocken creó en Alemania el Flocken Elektrowagen, considerado el primer coche eléctrico verdadero de la historia. A partir de entonces se empezaron a fabricar industrialmente y llegaron a ser bastante populares por su fácil manejo y comodidad.

A finales del XIX había en Londres una amplia flota de taxis eléctricos conocidos con el nombre de “colibríes”. El Comisionado de la Policía Metropolitana aprobó su uso para hacer frente al creciente problema de tráfico, ya que ocupaban la mitad de espacio que los coches de caballos. Taxis similares circularon por París, Berlín y Nueva York. A comienzo del siglo XX había en los Estados Unidos más de treinta mil coches eléctricos registrados. Eran mucho más populares que los de gasolina, menos ruidosos y no contaminaban el aire de las ciudades. Sin embargo, en poco más de una década la fabricación de esos coches se redujo hasta cesar. Los conductores de los coches de caballos londinenses lanzaron una intensa campaña haciendo publicidad de las averías y accidentes de sus rivales eléctricos hasta conseguir sacar del mercado a la London Electric Cab Company. Los coches eléctricos tuvieron algunos problemas técnicos, es cierto, pero fueron exagerados por sus rivales, que se esforzaron por mostrar a sus nuevos competidores bajo la peor apariencia posible.

Al mismo tiempo, el descubrimiento de grandes reservas de petróleo hizo que el precio de éste se desplomase, y Henry Ford empezó a vender coches de gasolina a la mitad de precio que los eléctricos. La construcción de mejores carreteras en Norteamérica incentivó los desplazamientos de larga distancia en automóvil, algo que no estaba al alcance de los coches eléctricos por su escasa autonomía y excesivo tiempo necesario para recargar las baterías. La introducción en 1912 del motor de arranque eléctrico acabó por inclinar la balanza a favor del coche con motor de combustión interna. Así fue como este acabó siendo el que ganó el siglo que, al comienzo, iba a ser del motor eléctrico.

El prematuro fracaso de los coches eléctricos es una parábola que ilustra una de las dificultades más sorprendentes que afectan al desarrollo de ciertas novedades. Hay innovaciones supuestamente beneficiosas que no consiguen abrirse camino en el momento en que se intentan por primera vez. Para que la novedad tenga éxito deben darse, de forma simultánea, determinadas condiciones. En caso contrario, la experiencia está abocada al fracaso. En otras palabras: no basta con buenas ideas, hace falta, además, que las circunstancias acompañen. Es posible que en el pasado se quedasen en el cajón o la estantería ideas excelentes que tuvieron la mala fortuna de nacer antes de tiempo. Esa es la razón por la que se desarrollan hoy programas para recuperar buenas ideas que, cuando surgieron, no tenían el terreno abonado pero que quizás lo tengan en la actualidad.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 21 de mayo de 2017.

El artículo La parábola del coche eléctrico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Gilbert, el campo y lo eléctrico

- La diferencia de potencial eléctrico

- El misterio del pez eléctrico monofásico*

Arte & Ciencia: La ciencia como herramienta del arte

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Jornada 4. 2ª conferencia.

Déborah García Bello es investigadora de la relación entre arte y ciencia y divulgadora científica: La ciencia como herramienta del arte.

Las colaboraciones que existen entre artistas y científicosEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: La ciencia como herramienta del arte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: Analogías entre el arte y la ciencia como formas de conocimiento

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

Hondakinen bigarren bizitza

Irudia: Soja aleak.

Ikerkuntza-lan honetan polisakaridoak eta proteinak erabili dira, berriztagarriak, ugariak eta ingurunearekin errespetutsuak izateaz gain, biokonpositeak eratzeko gaitasun bikainak dituztelako. Proteinen artean, landare-proteinak azpiproduktu edo hondakin gisa daude eskuragarri barazkigintzan zein nekazaritza-industrian. Hauen artean, soja-proteina aukera interesgarria da. Soja-proteina, soja-olioa ekoizterakoan azpiproduktu gisa lortzen da eta gainera, naturako proteinarik merkeenetarikoa da. Bestalde, landareetatik eratorritako polisakaridoen artean, agarra etorkizun handiko produktua da. Itsasoko alga gorritik erdietsi daiteke eta bere berriztagarritasuna, biodegradagarritasuna eta gelifikazio gaitasun altuagatik biokonpositeak garatzeko aukera interesgarria da. Hala ere, agarraren erauzketa ez da hain merkea; horregatik, soja-proteinan oinarritutako biokonpositeak prestatzeko alga-industrian sortutako hondakin naturala betegarri gisa erabiltzea proposatzen da (guk dakigula, ez da hau inoiz era horretan erabili). Gainera, hondakin horren erabilerak honako bi abantaila hauek izan ditzake: batetik, hondakina bera, era eraginkorrago batean erabil daiteke; eta bestetik, kostu baxuagoko azpiproduktuak lor daitezke. Hain zuzen, ekonomiarako eta ingurumenerako onurak ekar ditzake konposite jasangarriago horien garapenak.

Nahiz eta soja-proteinan oinarritutako biopolimeroek polimero sintetikoak ordezkatzeko ahalmena izan, eragozpen batzuk badituzte haien egitura kimikoarengatik, izaera higroskopikoa eta hauskortasuna, hain zuzen. Horren ondorioz, aldaketa batzuk beharrezkoak dira materiala erabilgarria bilakatzeko. Testu inguru honetan, biopolimeroen prozesatzea nahiz amaierako propietateak hobetzeko plastifikatzaileak beharrezkoak dira eta horregatik glizerola plastifikatzaile gisa erabili zen.

Gehigarriez gain, biokonpositeen propietateak hobetzeko polimeroaren prozesatze metodoa kontuan izatea garrantzitsua da. Ikerkuntza-lan askotan soluzio- eta konpresio- metodoak erabili ohi dira proteinetan oinarritutako konpositeak garatzeko. Hala ere, biokonposite berrien bideragarritasun komertziala zuzenki erlazionatuta dagoenez aplikazio industrialetan plastiko konbentzionalak garatzeko erabilitako teknikekin, lan honetan estrusio eta injekzio prozesatze-metodoak erabili ziren, soja-proteinan eta alga-hondakin betegarriz oinarritutako biokonpositeen garapenerako.

Orokorrean, alga-hondakin betegarriak soja-proteinarekiko bateragarritasun ona erakutsi zuen. Soja-proteinazko pelletak estrusio metodoaren bidez eta biokonpositeak injekzio metodoaren bidez lortu ziren. Lortutako biokonpositeen propietate funtzionalei dagokienez, alga-hondakinaren gehikuntzak ez zuen proteinan oinarritutako biokonpositeen hesi-propietate bikainak aldatu eta propietate optiko egokiak mantendu ziren paketatze aplikazioetan erabiltzeko. Bestalde, alga-hondakina balioztatzean, hondakinen kantitatea eta materialen kostua murriztu zen eta balio erantsizko produktuak garatu ziren.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 30

- Artikuluaren izena: Nola erabili azpiproduktuak eta hondakinak, propietate egokiak dituzten material jasangarriak garatzeko?

- Laburpena: Ikerkuntza-lan askotan soluzio- eta konpresio- metodoak erabili ohi dira proteinetan oinarritutako konpositeak garatzeko. Hala ere, biokonposite berrien merkatu-bideragarritasuna, zuzen lotuta dago industria-aplikazio konbentzionalak garatzeko teknikekin eta, beraz, lan honetan estrusio eta injekziorako prozesatze-metodoak erabili dira, soja-proteinan oinarritutako biokonpositeak garatzeko. Bestalde, agarra erauzterakoan hondakin naturala lortzen da. Hondakin hau, biokonpositeen betegarri gisa erabili da. Betegarri honek, soja-proteinarekiko bateragarritasun ona erakutsi zuen, eta horrela biokonposite jasangarriagoak garatu dira. Biokonpositeeen hesi-propietateak eta propietate optikoak egokiak izan ziren paketatze aplikazioetarako.

- Egileak: Tania Garrido, Itsaso Leceta, Pedro Guerrero eta Koro de la Caba

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 93-104

- DOI: 10.1387/ekaia.16278

—————————————————–

Egileez: Tania Garrido, Itsaso Leceta, Pedro Guerrero eta Koro de la Caba UPV/EHUko BIOMAT ikerketa Taldearen kideak dira.

—————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Hondakinen bigarren bizitza appeared first on Zientzia Kaiera.

Por qué no nos basta con el viento

Parque eólico de Páramo de Poza II, Poza de la Sal. Foto del autor

Sobrevivir a largo plazo como especie es, como las infames resoluciones de año nuevo, uno de esos objetivos que nadie persigue pero que todos aceptamos como evidente en sí mismo. Lo cierto es que hay muchas formas de plantearlo: ¿qué consideramos «largo plazo»? ¿Tiene que importarnos, necesariamente, lo que pueda ocurrirles a unos Homo sapiens que todavía no han nacido? Y, sobre todo, ¿qué entendemos por sobrevivir? La existencia de nuestros antepasados en las sabanas africanas, en números reducidos y rodeados de miseria, privaciones y aplicados depredadores es un modo de vida sin duda natural y sostenible. Así se mantuvo década tras década, siglo tras siglo, durante muchas decenas de miles de años. ¿Es esto lo que queremos para nuestra descendencia?

No cuesta mucho dudar de semejante concepto de supervivencia. Dejemos de lado a los ecologistas radicales que, secretamente o no tanto, desearían diezmar nuestras muchedumbres hasta dejarlas en poquedumbres, arrancarnos de las manos nuestros teléfonos inteligentes y nuestros frigoríficos y arrojarnos de vuelta al paleolítico, donde podremos poner en práctica la «dieta paleo»… de algún animal con dientes afilados. Lo que de verdad entendemos por «supervivencia a largo plazo» es una existencia estable e iluminada, con tecnología —desde luego— pero en equilibrio con el resto de los seres vivos que nos rodean, a lo largo de al menos tantas decenas de miles de años como llevamos en este caballito de tiovivo esférico que llamamos Tierra.

Dejaré para mejor ocasión el frente abierto de si tal deseo puede cumplirse, pero suponiéndolo posible, tengo una noticia: no hay forma de poder realizar un objetivo así si no encontramos el modo de satisfacer nuestras necesidades energéticas de un modo completamente renovable. El segundo principio de la Termodinámica prohíbe, a la postre, la existencia de fuentes de energía sin fin: sin embargo, en tanto nuestro número no se dispare exponencialmente ni hablemos de escalas de tiempo cósmicas no deberíamos preocuparnos. Podemos representarnos a nosotros mismos «agotando» el petróleo, o —al nivel de extracción energética de los procesos de fisión nuclear industrial actuales— el uranio: es mucho más difícil pergeñar formas de acabar con el viento o la luz del sol.

La tecnología de nuestro siglo tiene, en el campo de las energías renovables, tres protagonistas fundamentales: la eólica, la solar y la hidroeléctrica. En el caso de esta última, parece evidente el motivo por el que no satisfacemos todas nuestras necesidades de energía con ella: es fuertemente dependiente de la existencia de grandes masas de agua que represar y terrenos con cuencas en los que hacerlo —recursos que no están disponibles con la frecuencia que desearíamos. Las otras dos fuentes energéticas no tienen, a primera vista, más límites para su despliegue que la disponibilidad de terrenos y la voluntad inversora de Estado y empresas; competirán entre sí y la más rentable tomará la delantera. El mercado decide: ¿qué está escogiendo?

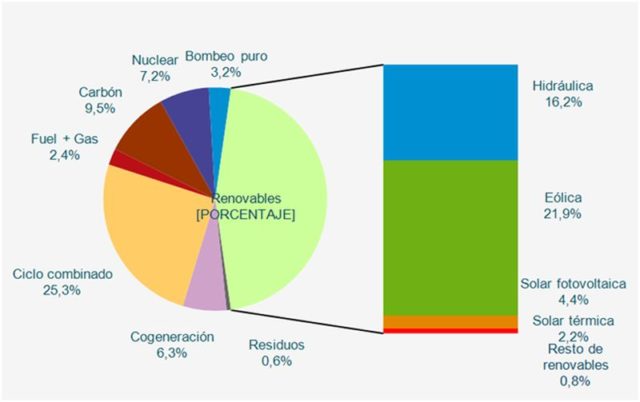

Estructura de potencia instalada a 31/12/2016. Sistema eléctrico nacional. Fuente: Red Eléctrica de España.

Observemos el gráfico de distribución de la potencia instalada en España por tipo de fuente. Si recalculamos los porcentajes de las renovables sobre su propio total obtenemos que la energía hidráulica supone un 35,6%, la eólica un 48,1% y la solar, en todos sus tipos, un magro 9,7%, quedando un testimonial 4,8% para otras fuentes de energía como la biomasa, la geotérmica o la maremotriz. La inmensa mayoría de los embalses posibles en España ya están construidos, así que no es de esperar que el porcentaje de la energía hidráulica aumente significativamente en el futuro. Está claro que el modo de generación que más rentable está resultando y sobre el que puede predecirse un mayor crecimiento en los próximos cinco años es el viento. La pregunta clave para el futuro de nuestras necesidades energéticas es: ¿por qué no alimentar todo con aerogeneradores?

Los nuevos gigantes

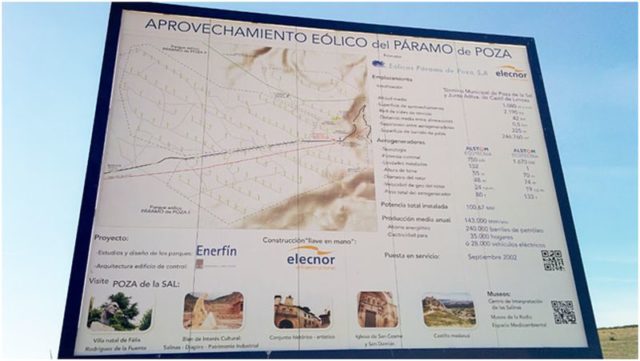

Desde finales de los años 90, los aerogeneradores han pasado de ser una visión extraña a salpicar nuestra geografía con casi mil parques contabilizados a finales de 2016, distribuidos por todas las regiones españolas con las llamativas excepciones de Extremadura y Madrid (Ceuta y Melilla tampoco tienen parques eólicos, pero su pequeño tamaño hace más difícil sorprenderse por ello). Estos nuevos molinos serían, a la vista de un aspirante a moderno Alonso Quijano, una vista mucho más espantable que los antiguos: bestias blancas dispuestas en grupos de varias decenas, de tres aspas con un diámetro de giro de más de sesenta metros, apoyadas sobre una airosa columna de otros tantos de altura —el diseño convencional, de origen danés, dicta que la longitud de la pala tenga aproximadamente la mitad de la altura de la columna para un efecto más agradable a la vista.

La rotación del aerogenerador, comprendida habitualmente entre las 8 y las 30 revoluciones por minuto para velocidades del viento entre los 5 m/s (la llamada «velocidad de conexión», por debajo de la cual el sistema no puede girar) y los 25 m/s (la «velocidad de corte», a partir de la que las aspas frenan para evitar problemas de sobrecalentamiento y cargas mecánicas excesivas), permite mover un generador que transforma el movimiento en energía eléctrica. El sistema es más complejo de lo que parece —¿qué no lo es?— pero funciona con una eficiencia de conversión máxima del 46%: de la energía total contenida en el movimiento del aire frente a las palas, hasta un 46% puede extraerse y convertirse en electricidad apta para ser vertida a las redes de distribución.

Para un sistema cuyo «combustible» es completamente gratuito, la cifra es completamente excepcional. De hecho, esta conversión máxima se encuentra tan cerca del límite teórico de extracción de energía del viento (conocido como límite de Betz, y que surge del hecho de que la velocidad del aire tras atravesar el plano de las aspas del aerogenerador no puede descender a cero) que el sistema no se optimiza para un aprovechamiento máximo, sino para un coste mínimo de fabricación y despliegue dada una conversión razonable. La energía eólica ya puede compararse en pie de igualdad con otras fuentes energéticas.

No es de extrañar, por tanto, que en los últimos tiempos un número creciente de colectivos ecologistas estén clamando por la sustitución de las centrales nucleares con energías renovables. El último ejemplo, el pasado mes de junio en Madrid, vio reunirse a varios cientos de personas en una manifestación convocada por más de 120 asociaciones (!). El lema principal de esta manifestación, «Cerrar Almaraz y todas las demás, 100% renovables», expresa la preocupación común entre los colectivos que hacen política con la ecología de que las centrales nucleares son peligrosas y deben ser sustituidas, a la mayor brevedad posible, por fuentes de energía renovable. Como hemos visto, la fuente de energía más preparada para intentar realizar esa transición en un plazo relativamente corto de tiempo es el viento. Planteémosnos la pregunta: ¿es posible sustituir una central nuclear como Almaraz con parques eólicos? Y de ser la respuesta afirmativa, ¿qué implicaría exactamente?

Efecto estela y factor de carga

Cuando se trata de adaptar una tecnología como la eólica para su uso a gran escala es necesario no perder de vista dos fenómenos fundamentales. El primero de ellos impone una consideración práctica de alcance a la hora de diseñar parques eólicos. El segundo establece una limitación más seria, dependiente de la naturaleza misma del recurso aprovechado.

Fijémonos en un molino concreto, con un determinado diámetro de rotor (utilizaremos este parámetro más adelante). El efecto estela es la alteración en el flujo de aire que lo atraviesa debido a las turbulencias inducidas por las aspas y a la propia extracción de la energía del movimiento. El viento saliente de la hélice se mueve más lentamente que el entrante —esa es exactamente la diferencia entre un aerogenerador y un ventilador— y lo hace, además, de un modo más irregular. Esto afectará a otros generadores situados a sotavento del molino en el que nos hemos fijado.

Para compensar el efecto estela, los diseñadores de parques eólicos utilizan el criterio de separar los generadores en filas perpendiculares a la dirección de los vientos dominantes en cada zona, separadas entre sí entre 5 y 9 diámetros de rotor. La separación entre molino y molino en la dirección perpendicular a la de los vientos dominantes (es decir, según las filas en las que se ubiquen) puede ser inferior, de 3 a 5 diámetros. Además, los generadores se colocan al tresbolillo, de manera que se aumente la distancia al máximo posible entre los ubicados en filas contiguas. A pesar de estas precauciones, es común encontrarse con pérdidas «de parque» del orden del 5% respecto a lo que podría generar un solo molino en las mismas condiciones de viento.

Construcción del parque eólico de Loja (Ecuador). Foto de franzpc con licencia CC BY-ND 2.0.

Diseñar un parque de aerogeneradores no es una tarea trivial. Desde el punto de vista del mantenimiento y la interconexión eléctrica, interesa colocar los molinos lo más próximos posible entre sí para reducir pérdidas eléctricas y disminuir las distancias de los viales (los caminos que permiten recorrer el parque para realizar tareas de mantenimiento y que tienen que soportar el paso de los transportes especiales y las grúas necesarios para el montaje de los aerogeneradores). Sin embargo, el efecto estela obliga a mantener unas distancias mínimas que, para diámetros de rotor de 60 metros, puede superar el medio kilómetro —será mayor para rotores más grandes. La topografía de la zona conspira en la mayor parte de las ocasiones para hacer todo más complejo aún, restringiendo las posiciones posibles para las bases de los aerogeneradores, complicando la distribución de los viales y alterando localmente el flujo del viento.

El segundo fenómeno a considerar es el llamado factor de carga. El viento, por su naturaleza, es un recurso variable en el tiempo: y varía, además, de una forma muy compleja a diferentes escalas. En nuestras latitudes el viento suele ser más fuerte en invierno que en verano: se trata de la variación estacional. Por su parte, los cambios en la temperatura del suelo y el aire a lo largo del día suelen provocar un patrón de variación diaria por el que los vientos son más rápidos en las horas cercanas al mediodía solar que por la noche. Finalmente, y a escalas temporales más pequeñas, el viento se comporta de forma aleatoria que puede modelarse matemáticamente. El factor de carga es la razón entre la energía efectivamente generada por un molino a lo largo de un periodo de tiempo determinado y la máxima que podría generar, para una velocidad óptima y constante del viento. Los factores de carga habituales en aerogeneradores suelen estar entre el 20 y el 30%.

El viento frente al uranio

Ya disponemos de las herramientas necesarias para contestar a la pregunta que nos planteamos hace unos párrafos: ¿es posible sustituir una central nuclear como la de Almaraz con parques eólicos? En caso afirmativo, ¿cómo sería un parque de aerogeneradores con la misma potencia? Observemos primero los siguientes datos reales de los últimos diez años para la generación eólica y la nuclear, obtenidos del anuario estadístico de Red Eléctrica de España.

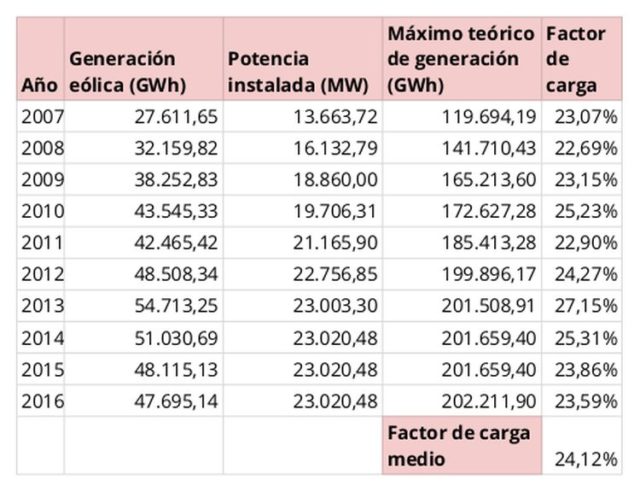

Generación eólica en España (2007-2016). Fuente: Red Eléctrica Española

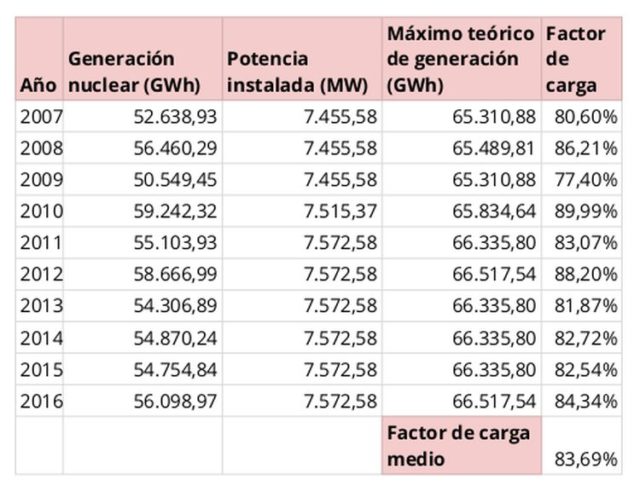

Generación nuclear en España (2007-2016). Fuente: Red Eléctrica Española

Los datos han sido tabulados de forma que la comparación sea sencilla. Para empezar, llama la atención la gran diferencia entre potencia instalada eólica y nuclear. El número de aerogeneradores ha aumentado de forma constante en nuestro país hasta el año 2012, en el que un cambio legislativo en la asignación de primas de generación renovable detuvo por completo la expansión del sector —este mismo año se han reanudado las subastas de potencia renovable con un sistema nuevo de subasta que tiende, a la vista de los resultados, a eliminar las primas: veremos cómo evoluciona el mercado a partir del año que viene.