Frank Stella, la forma del lienzo

En mi anterior entrada del Cuaderno de Cultura Científica de la Universidad del País Vasco / Euskal Herriko Unibertsitatea Mosaicos hexagonales para el verano se mostraban algunas obras de arte relacionadas con los mosaicos hexagonales, e incluso solo con el propio hexágono. En particular, se mencionaba a un artista abstracto y minimalista norteamericano, Frank Stella, y su obra Sydney Guberman (1964), cuya forma es hexagonal. Y es precisamente la forma de esta obra, no por el hecho de que sea hexagonal, sino porque no es el típico lienzo rectangular, lo que me ha hecho volver a mirar desde este espacio la obra de este artista.

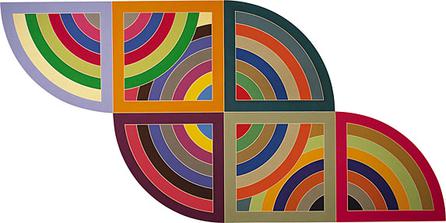

“Emperatriz de la India” (1965), de Frank Stella, de la serie V del artista

La revolución artística que se produjo con la llegada de la abstracción en el siglo XX trajo consigo también una reflexión sobre la forma de la obra de arte, y en particular, del lienzo sobre el que se pintaba. Esta reflexión está muy presente en la obra del artista de Massachusetts (EE.UU.), Frank Stella, quien juega con la forma del lienzo, no solo rompiendo con la forma rectangular usual, sino haciendo que la forma del lienzo sea parte de la propia obra.

No estamos hablando simplemente de elegir otra forma para el lienzo sobre el que se va a pintar, como por ejemplo, en el Autorretrato con Endymion Porter (1635), del pintor flamenco Anton van Dyck (1599 – 1641), que es ovalado, sino de una ruptura total con las formas clásicas de la pintura, rectangular, ovalada o circular, y la incorporación de la forma como parte de la propia obra, de la propia creación artística.

“Autorretrato con Endymion Porter” (1635), de Anton van Dyck, en el Museo del Prado de Madrid

Frank Stella no es en único artista que juega con la forma de los “lienzos”, de hecho en la década de 1960 muchos artistas abstractos decidieron incorporar la reflexión de la forma del lienzo a sus obras, aunque sí es uno de los más significativos, y es del que vamos a mostrar algunas obras en esta entrada.

El pintor y grabador norteamericano Frank Stella nació en Malden, Massachusetts, en 1936. Si leemos un poco sobre la obra de este artista descubriremos que se inició en el expresionismo abstracto, movimiento artístico al que pertenece su serie de obras Black Paintings (pinturas negras), que están formadas por bandas negras paralelas, separadas por estrechas líneas blancas que realmente son espacios no pintados entre las blandas negras paralelas. Como podemos leer en la página The Art Story, Modern Art Insight [theartstory.org] este recurso artístico plantea una reflexión al espectador sobre la naturaleza bidimensional de la pintura, realizando así un camino inverso al que se produjo con la invención de la perspectiva en el renacimiento.

Las bandas negras paralelas de cada obra seguían un patrón diferente, por ejemplo en la siguiente obra, Matrimonio entre razón y miseria II (1959), las bandas negras tenían forma de U invertida, pero en general cada obra tenía su propio patrón geométrico.

“Matrimonio entre razón y miseria II” (1959), de Frank Stella, y que se encuentra en el MoMA

Una de las frases más famosas de Frank Stella para definir su arte es

“Mi pintura se basa en el hecho de que solo lo que se puede ver allí está allí… lo que ves es lo que ves”.

Esta serie de obras tuvo una gran importancia dentro del minimalismo, movimiento artístico dentro del cual Stella fue uno de sus artistas más significativos.

A partir de 1960 Frank Stella empezaría a utilizar aluminio y cobre para sus lienzos, y también pintaría bandas paralelas de diferentes colores, no solamente negras, como en su obra Harran II (1967), que pertenece a la serie de obras Protractor (trasportador). Se producirían sus primeras obras cuyos lienzos tendrían formas particulares, no rectangulares.

“Harran II” (1967), de Frank Stella, que pertenece al Museo Guggenheim y que tiene un tamaño considerable, 3 metros de alto por 6 metros de largo

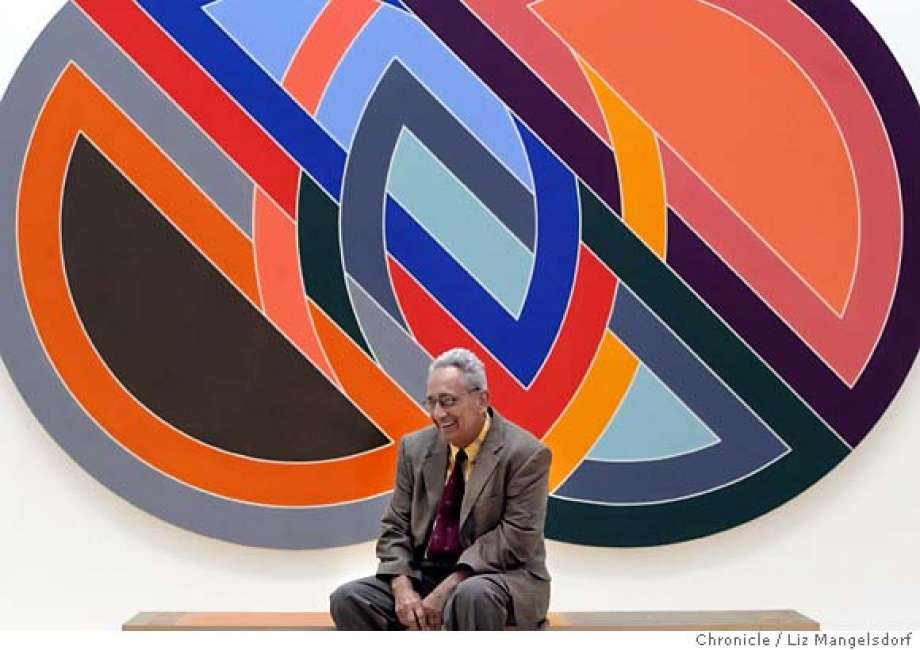

A continuación, mostramos otra obra de Frank Stella perteneciente a la serie Protractor, Firuzabad (1970), cuando se exhibió en el Museo de Arte Moderno de San Francisco. En la imagen vemos al propio artista posando para la fotografía de Liz Mangelsdorf.

El artista Frank Stella delante de su obra “Firuzabad” (1970), que es el nombre de una ciudad iraní, en el Museo de Arte Moderno de San Francisco, en 2004

Una serie de obras de Frank Stella que es en sí misma una reflexión sobre la forma de los lienzos, es su serie Irregular polygons (polígonos irregulares), de mediados de la década de 1960. En esta serie de obras, Stella fusiona formas sencillas, para crear formas irregulares más complejas. De nuevo el color es una parte esencial de las obras.

“Moultonboro III” (1966), de Frank Stella, cuyo nombre hace referencia, al parecer, a un pueblo de New Hampshire (EE.UU.)

La obra Moultonboro III (1966) está formada por un triángulo trazado por una banda ancha amarilla y de interior también amarillo, aunque diferente al anterior para diferenciarlos, colocado en la parte superior izquierda de una forma de color rojo que nos sugiere un cuadrado, ya que no está completo sino que el espectador puede formarlo o no en su mente mientras observa la obra, como si descansara debajo del triángulo. Además, separando el cuadrado rojo y el triángulo amarillo se forma una banda en forma de algo similar a una letra Z, de color azul. El contraste entre formas y colores es un elemento esencial en las obras de la serie Irregular Polygons, que además crea una ilusión de objetos planos que saltan a la tercera dimensión superponiéndose, plegándose o arrugándose.

Stella hace varias versiones de esta obra, utilizando diferentes colores, al igual que con otras obras. Por ejemplo, en Moultonboro II el triángulo es blanco, con una banda ancha verde y el cuadrado es negro.

Fotografía de la exposición “Irregular Polygons 1965-66” de Frank Stella en el Toledo Museum of Art, en 2011. Las obras que aparecen son “Ossipee II” (1966), “Chocorua IV” (1966), “Effingham IV” (1966) y “Moultonville I”I (1966)

Los nombres de la serie Irregular Polygons son nombres de pueblos, y otros lugares, de New Hampshire.

Posteriormente, en series como Polish Villages (pueblos polacos), e influenciado por el constructivismo ruso, utiliza formas geométricas no tan sencillas como en la serie Irregular Polygons, creando imágenes cada vez más complejas. Los nombres de las obras de esta serie son nombres de pueblos polacos y las obras hacen referencia a las sinagogas destruidas por los Nazis.

“Olkienniki III” (1972), de Frank Stella, perteneciente a la serie “Polish Villages”

En obras posteriores, como en la serie Indian Birds (pájaros de la India), Stella traspasa el concepto de “pintura” para realizar obras más cercanas a lo podíamos llamar “esculturas verticales para paredes”, con una complejidad enorme.

“Jungli Kowwa” (1979), de Frank Stella, perteneciente a la serie “Indian Birds”

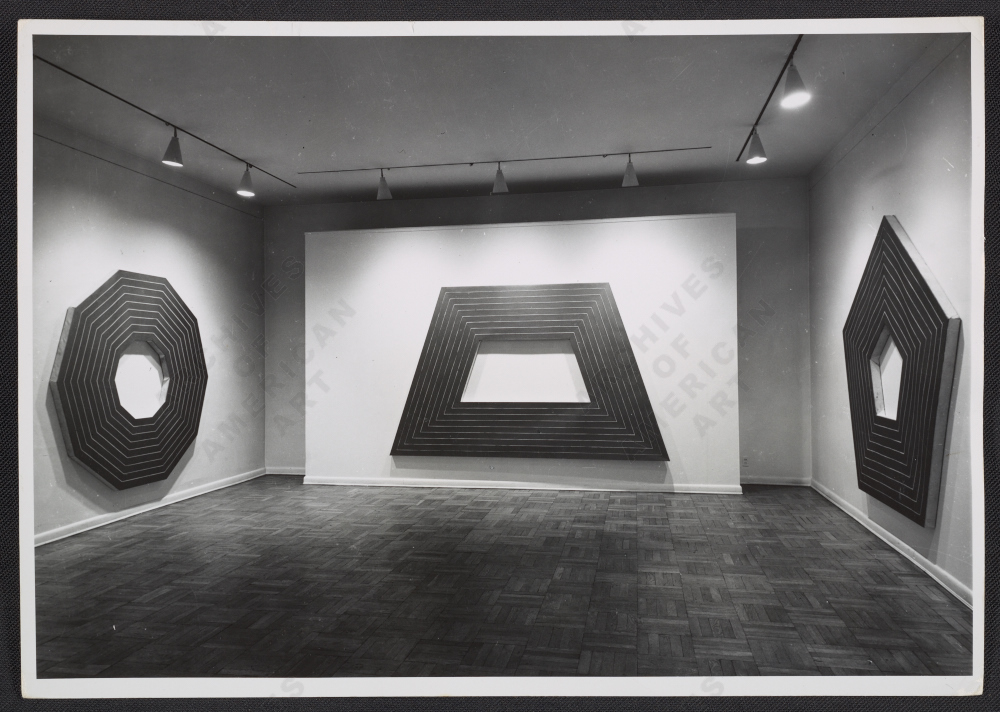

Pero volvamos a los lienzos geométricos de la década de los años 1960, donde realiza obras con formas geométricas sencillas a base de bandas anchas, como por ejemplo sencillos polígonos (triángulos, cuadrados, pentágonos, hexágonos,etc), realizados por bandas anchas, ya sean pintadas en negro o realizadas en aluminio o cobre.

Fotografía de Rudy Burckhardt de la exposición de Frank Stella en la Galería Leo Castelli en 1964

“Henry Garden” (1963), de Frank Stella, perteneciente a su serie realizada en aluminio, que consiste en una serie de octógonos concéntricos

Pero vamos a terminar esta pequeña introducción a la obra de lienzos con diferentes formas del artista norteamericano Frank Stella con algunas de sus esculturas geométricas. En la primera de estas esculturas, Estrella inflada y estrella de madera (2014), aparecen dos dodecaedros estrellados, realizados en aluminio y madera de teca.

“Estrella inflada y estrella de madera” (2014), de Frank Stella, dentro del International Sculpture Route Amsterdam – ARTZUID 2015

Y la segunda escultura Estrella negra (2014) es un icosaedro estrellado, realizado en fibra de carbono.

“Estrella negra” (2014), de Frank Stella, dentro de la exposición “Frank Stella: A Retrospective” en el Whitney Museum of American Art, fotografiada por Nic Lehoux

Bibliografía

1.- Frank Stella – Connections – Haunch of Venison – London, Art Splash Contemporary Art

2.- Liz Rideal, Cómo leer pinturas, una guía sobre sus significados y métodos, Blume, 2015.

3.- Entrada sobre Frank Stella en la página web The Art Story, Modern Art Insight

5.- Exposiciones de Frank Stella en la galería Leo Castelli

7.- International Sculpture Route Amsterdam – ARTZUID

8.- Anna Painchaud, Unbounded Doctrine, encountering the art-making career of Frank Stella, Arts Editor, 2015

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Frank Stella, la forma del lienzo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Mosaicos hexagonales para el verano

- El caso de William & Frank Buckland

- Artistas que miran a las matemáticas

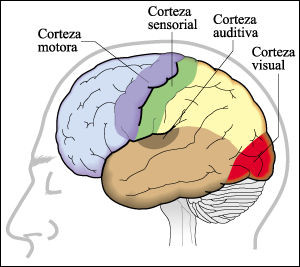

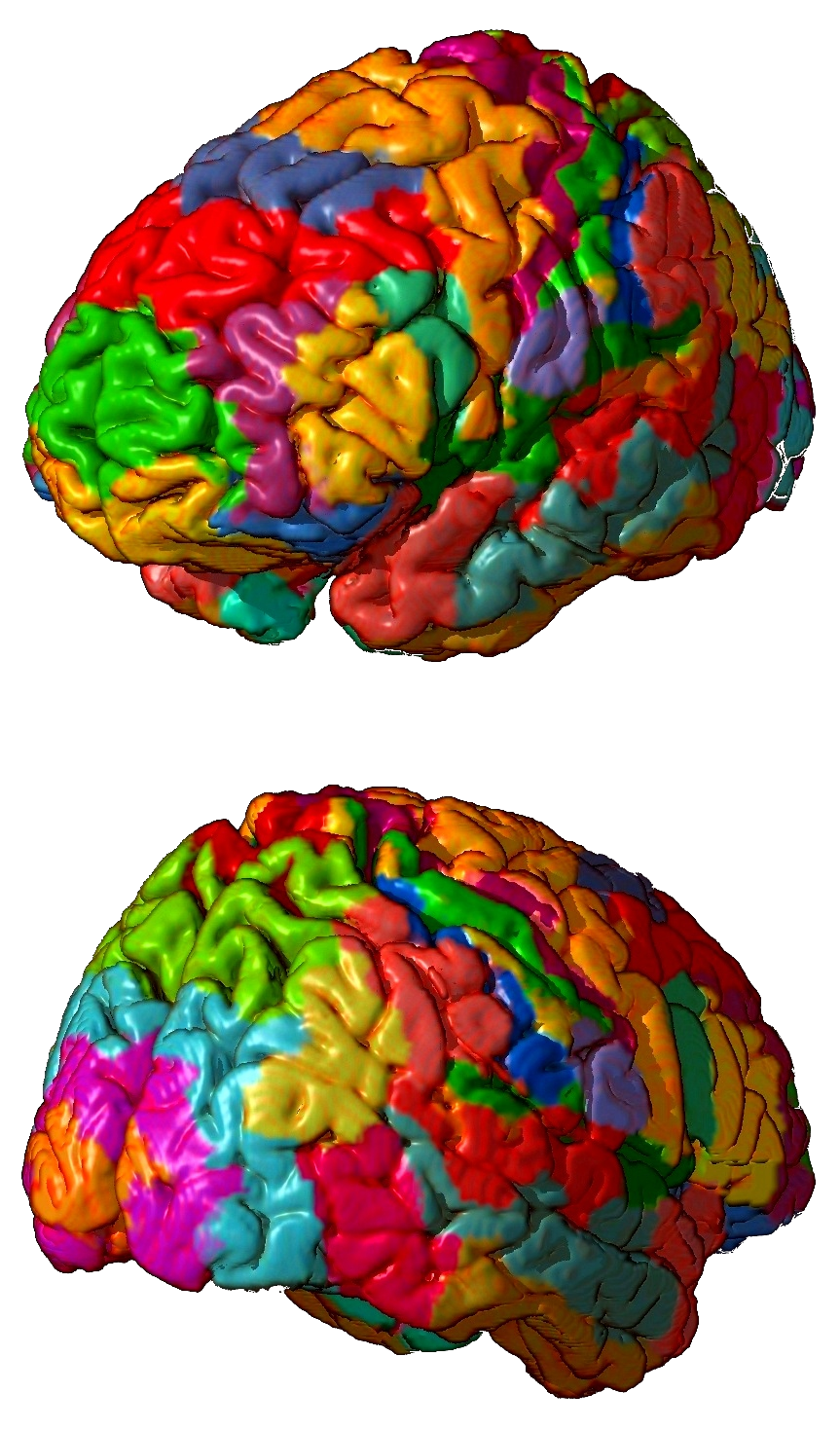

Sistemas nerviosos: las áreas sensoriales

Las áreas sensoriales son las que reciben y procesan información procedente de los receptores sensoriales, normalmente pertenecientes a los que denominamos “órganos de los sentidos”. Se denominan áreas sensoriales primarias a aquellas que reciben señales cuyo origen inmediato anterior es el tálamo. Como vimos aquí, el tálamo ejerce la función de estación de relevo de la información sensorial y de filtro -de acuerdo con su potencial relevancia- de dicha información. En general, cada hemisferio cerebral recibe información procedente del lado del cuerpo opuesto. Así, la corteza visual izquierda recibe las señales procedentes de la retina del ojo derecho.

Por otro lado, la información visual, auditiva y somatosensorial da lugar a la definición en la corteza de mapas sensoriales topográficos, de manera que la información procedente de células sensoriales adyacentes llega a neuronas corticales adyacentes también. Se pueden elaborar mapas sensoriales de todos los vertebrados y, lógicamente, a cada especie corresponde el suyo propio, que cuya configuración depende de la importancia relativa de cada modalidad sensorial para dicha especie. Los siluros, por ejemplo, tienen mapas sensoriales en el rombencéfalo con áreas muy extensas para los receptores gustativos de su superficie corporal y de boca y faringe. No obstante, la mayor parte de la información disponible se refiere a los mamíferos. A ellos, principalmente, nos referiremos a continuación.

La información visual llega de los ojos hasta la denominada “corteza visual primaria” (V1) (área de Brodmann 17) tras pasar por el núcleo geniculado lateral del tálamo. La corteza visual primaria se encuentra en el lóbulo occipital (zona posterior) y en ella se configura un mapa (retinotópico), en el que la configuración espacial de los puntos que reciben las señales reproduce la de los fotorreceptores en la retina. La información visual es posteriormente procesada de manera parcial en diferentes áreas de la corteza, pues se trata de una información con varios componentes (color, posición, trayectoria, contexto, etc.) que son procesados de manera independiente hasta que otras áreas (asociativas) de la corteza recrean la imagen.

La corteza auditiva primaria se halla en el lóbulo temporal (áreas de Brodmann 41 y 42) y es, como su nombre indica, el área cortical encargada de un primer procesamiento de la información auditiva. La información llega de los oídos tras pasar por el núcleo geniculado medial del tálamo, y también aquí se halla definido un mapa sensorial, denominado tonotópico. En este caso, las células de la corteza próximas entre sí reciben información relativa a frecuencias de sonido similares; ha de tenerse en cuenta que la recepción de sonidos en el oído se produce de tal forma que los tonos se reciben con arreglo a una disposición espacial de los receptores (células pilosas). La corteza auditiva primaria –que identifica tono y volumen del sonido- se halla rodeada por la secundaria, y esta a su vez, por la terciaria. Cada una de ellas iría procesando aspectos cada vez más complejos de la información sonora.

Con la denominación de corteza somatosensorial se hace referencia a una franja de los lóbulos parietales del cerebro de mamíferos (áreas de Brodmann 1, 2 y 3) a la que llegan las denominadas sensaciones somáticas procedentes de receptores situados en la superficie corporal y en músculos y articulaciones. Se trata de receptores de tacto, presión (barorreceptores), temperatura (termorreceptores), dolor (nociceptores), los superficiales, y de posición (propioceptores), los musculares y articulares. En vertebrados no mamíferos la propiocepción es procesada en otras áreas encefálicas; así, en peces es el cerebelo el que procesa la información procedente de piel y aletas, y en tortugas y ranas son los ganglios talámicos los que generan respuestas somatotrópicas.

Como ocurre con la información visual y auditiva, cada región de la corteza somatosensorial recibe inputs de un área específica del cuerpo; a esas regiones se las denomina “áreas de representación”. Además, cuanto mayor es la densidad de receptores en una determinada zona del cuerpo, mayor es la superficie de la corteza dedicada a procesar esa información. Esa proporcionalidad y la disposición en que se encuentran las “áreas de representación” han permitido elaborar el correspondiente mapa somatotrópico, en el que se pueden localizar las diferentes sensaciones. También han permitido elaborar una forma de representación muy ilustrativa que corresponde a un cuerpo del animal en cuestión en la que el tamaño de cada parte del cuerpo es proporcional a la superficie de su correspondiente área de representación. Cuando la imagen representa una figura humana se denomina “homúnculo sensorial”.

La información olfativa llega, en primer lugar, al bulbo olfativo, donde es procesada parcialmente. Las células mitrales del bulbo olfativo envían las señales a diferentes áreas cerebrales siguiendo dos rutas principales: (1) una subcortical, que se dirige principalmente a regiones del sistema límbico, y (2) otra talámico-cortical. La ruta subcortical implica al hipotálamo, dada la importancia de los olores en el comportamiento alimenticio y sexual. La talámico-cortical, sin embargo, es importante para la identificación precisa de olores y su percepción consciente.

Aunque la información gustativa alcanza a diferentes áreas de la corteza, se considera que la responsable de la percepción del gusto es la corteza gustativa primaria. Se subdivide en dos subestructuras, la ínsula anterior (en la ínsula) y el opérculo frontal (en el giro frontal inferior del lóbulo frontal).

Finalmente, cada región de la corteza sensorial proyecta la información recibida, a través de la materia blanca, hacia áreas de la corteza próximas, donde es sometida, junto con la de otras regiones, a elaboración, análisis e integración. En dicha integración intervienen otros elementos (memoria, emociones evocadas, etc.) y, como consecuencia de ello, pueden elaborarse las correspondientes respuestas, motoras principalmente.

Fuentes:

Eric R. Kandel, James H. Schwartz, Thomas M. Jessell, Steven A. Siegelbaum & A. J. Hudspeth (2012): Principles of Neural Science, Mc Graw Hill, New York

Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas nerviosos: las áreas sensoriales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el sistema central de vertebrados

- Sistemas nerviosos: el tálamo y el hipotálamo

- Sistemas nerviosos: el cerebro de vertebrados

La ley del gas ideal y la tercera ley de la termodinámica

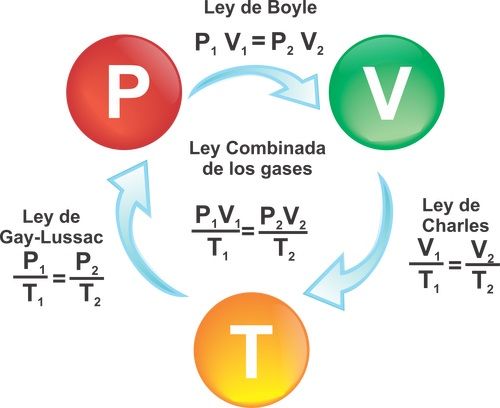

Boyle se dio cuenta de que si la temperatura de un gas cambia durante un experimento, la relación P = a/V ya no es correcta. Por ejemplo, la presión ejercida por un gas en un recipiente cerrado de tamaño fijo aumenta si el gas se calienta, aunque su volumen permanece constante. Sin embargo, si la temperatura de un gas se mantiene constante, entonces la regla de Boyle sí funciona. Así, modificamos la regla de la siguiente manera:

P = a/V, si T es constante (a)

Muchos científicos a lo largo del siglo XVIII también investigaron cómo, por ejemplo en un globo de paredes delgadas, los gases se expanden cuando se aporta calor, a pesar de que la presión sigue siendo la misma. Finalmente, se acumularon suficientes indicios como para formular una regla general sorprendentemente simple. El químico francés Joseph-Louis Gay-Lussac (1778-1850) encontró que todos los gases que estudió (aire, oxígeno, hidrógeno, dióxido de carbono, etc.) cambian su volumen de la misma manera. Si la presión se mantenía constante, entonces el cambio de volumen era proporcional al cambio de temperatura. Esto puede expresarse en símbolos:

ΔV ∝ ΔT, si P es constante (b)

Por otra parte, si el volumen se mantenía constante (usando, por ejemplo, un contenedor rígido), el cambio en la presión del gas era proporcional al cambio de la temperatura:

ΔP ∝ ΔT, si V es constante (c)

Los datos experimentales obtenidos por Boyle, Gay-Lussac y muchos otros científicos se expresan en las tres proporcionalidades, (a), (b) y (c). Éstas relacionan las tres características principales de una cantidad fija de un gas: la presión, el volumen y la temperatura, medidos cada uno desde cero, cuando una variable se mantiene constante. Introduciendo una nueva constante, k, estas tres proporcionalidades pueden unirse en una sola ecuación general conocida como ley del gas ideal.

P·V = k·T

Esta ecuación es uno de los descubrimientos más importantes sobre los gases, pero al usarla se debe tener un cuidado extremo con las unidades. La constante de proporcionalidad k depende del tipo de gas (en concreto de su masa molar); T, la temperatura del gas, tiene que ser dada en la escala absoluta, o Kelvin, donde, como ya mencionamos, T (K) = T (° C) + 273,15. La presión P es siempre la presión total (en unidades de N / m2, a la que se da el nombre de Pascal, abreviatura Pa), e incluye la denominada presión ambiente de la atmósfera. Esto es algo que se suele olvidar. Así, si inflo en neumático trasero de mi coche hasta los 2,2 ·105 Pa por encima de la presión atmosférica tal y como indica el fabricante, la presión real dentro del neumático es de 2,2 ·105 Pa + 1,0 ·105 Pa = 3,2 ·105 Pa.

La ecuación que relaciona P, V y T se denomina “ley” del gas ideal porque no es completamente exacta para gases reales a presiones muy bajas. Tampoco se aplica cuando la presión es tan alta, o la temperatura tan baja, que el gas está a punto de pasar a ser líquido. Por lo tanto, no es una ley de la física en el mismo sentido que la majestuosa ley de la conservación de la energía, que es válida en todas las circunstancias.

En realidad es simplemente es un resumen útil aproximado de resultados experimentales de las propiedades observadas de gases reales. No hay más que considerar lo que sucedería si intentamos bajar la temperatura del gas al cero absoluto; Es decir, T = 0 K (o, en Celsius, t = – 273,15 ° C). En este caso extremo, todo el término de la ecuación en el que está la temperatura sería cero. Por tanto, el término PV también debe ser cero. A presión constante, el volumen se reduciría a cero, lo que no tiene sentido si tenemos una cantidad de gas distinta de cero.

De hecho, todos los gases reales se vuelven líquidos antes de alcanzar esa temperatura. Tanto el experimento como la teoría termodinámica indican que es realmente imposible enfriar cualquier cosa -gas, líquido o sólido- exactamente a esta temperatura de T = 0 K. Este hecho se conoce como tercera ley de la termodinámica.

Sin embargo, una serie de operaciones de enfriamiento pueden producir temperaturas que se acercan mucho a este límite. En vista del significado único de la temperatura más baja para un gas que obedece a la ley del gas ideal, Lord Kelvin (William Thomson) propuso la escala de temperatura absoluta y puso su cero a – 273,15 ° C. Esta es la razón por la que la escala absoluta se denomina a veces escala de Kelvin, y por qué las temperaturas en esta escala se miden en kelvins.

La ley del gas ideal, P·V = k·T, es una ley fenomenológica, es decir, resume hechos experimentales sobre gases. La teoría cinética de los gases ofrece una explicación teórica de estos hechos. Para prepararnos para eso, necesitamos desarrollar un modelo cinético de un gas.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La ley del gas ideal y la tercera ley de la termodinámica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Carnot y los comienzos de la termodinámica (2)

- La segunda ley de la termodinámica

- Carnot y los comienzos de la termodinámica (1)

Zientziaz haratago

Pedro Miguel Etxenike: “Zientzia ez da egiazko jakintza eskuratzeko modu bakarra”.

—————————————————–

Egileez: Eduardo Herrera Fernandez, Leire Fernandez Inurritegi eta Maria Perez Mena UPV/EHUko Letraz – Diseinu Grafikoko eta Tipografiako Ikerketa Taldeko ikertzaileak dira.

—————————————————–

Aipua eta irudia UPV/EHUko Zientzia Astea: Alfabetatze zientifikoa Alfabetización científica liburutik jaso dugu. Eskerrak eman nahi dizkiegu egileei eta UPV/EHUko Zientzia Astearen arduradunei, edukia blogean argitaratzeko baimena emateagatik.

The post Zientziaz haratago appeared first on Zientzia Kaiera.

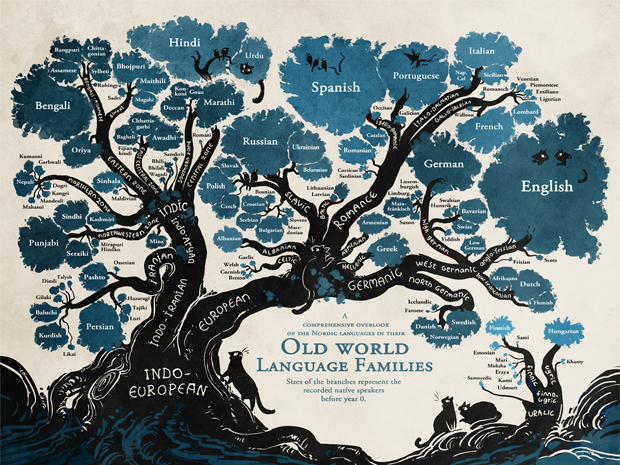

Gradualismo o saltacionismo… en evolución lingüística

El gradualismo y el saltacionismo son dos grandes corrientes de pensamiento en biología evolutiva. Los gradualistas sostienen que la evolución de las especies ocurre de forma gradual, mientras los saltacionistas defienden la idea de que los cambios son abruptos, y que antes y después de los mismos, prácticamente no se produce variación alguna durante largos periodos de tiempo; en otras palabras, que la evolución no ocurre poco a poco sino a saltos.

Se han planteado incógnitas similares en relación con la evolución de las lenguas. Hace unos años, un grupo liderado por el británico Mark Pagel analizó la evolución de diferentes grupos de lenguas: indoeuropeas (en Europa), bantúes (en África) y austronesias (en el Pacífico). Encontraron que los cambios más importantes ocurren en los periodos en que se produce la divergencia de distintas variedades dentro de una misma lengua y que acaban dando lugar a nuevas lenguas. Así, han llegado a la conclusión de que un tercio de la variación del vocabulario en las lenguas bantúes se ha producido en los periodos de diferenciación, y que esas proporciones han sido de un 20% en las lenguas indoeuropeas, y de un 10% en las austronesias.

La hipótesis que proponen para explicar ese fenómeno es que la diferenciación que da lugar a la aparición de nuevas lenguas es un proceso de evolución cultural que no ocurre, como pasa con otros, de manera pasiva. Según los autores, esa diferenciación tendría una cierta componente activa, una componente que obedecería al interés de las comunidades de hablantes por diferenciarse unas de otras. A eso se debería que en los momentos iniciales de la diferenciación los cambios se produzcan de forma especialmente rápida, haciéndose más graduales posteriormente.

Es interesante valorar las diferencias observadas entre las tres familias lingüísticas. Las distintas proporciones de diferenciación en las bifurcaciones dentro de cada familia de lenguas son coherentes con la idea de la componente activa en el proceso de generación lingüística. Allí donde la separación entre comunidades vino muy determinada por barreras físicas (todo un amplio mar separando diferentes archipiélagos), no era necesario acentuar las diferencias, pues las comunidades ya estaban separadas físicamente; y así, el proceso de diferenciación ha sido mucho más pasivo. Esto es, el mismo aislamiento de las comunidades actuaría diferenciando pasivamente a unas lenguas de otras. Muy probablemente las comunidades bantúes experimentaban, por comparación, una mayor necesidad de diferenciación cultural, por lo que la diferenciación de esas lenguas ha contado con una componente más activa que las de las otras familias.

Las lenguas, en todo el mundo, son algo más que meras herramientas de comunicación, tanto si nos gusta como si no.

Fuente:

Atkinson, Q., Meade, A., Venditti, C., Greenhill, S., Pagel, M. (2008): Language evolves in punctuational bursts. Science 319 (5863), p. 588. doi: 10.1126/science.1149683

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Gradualismo o saltacionismo… en evolución lingüística se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: evolución del tamaño de las regiones encefálicas

- Turquía prohíbe la enseñanza de la evolución – pero la ciencia no es un sistema de creencias

- Sistemas nerviosos: evolución del tamaño encefálico

Verdín, eucaliptos y cambio climático

Un estudio del Departamento de Biología Vegetal y Ecología de la UPV/EHU evidencia que los efectos del cambio climático, en este caso la escasez de agua en los sistemas acuáticos junto con la presencia de plantaciones de eucaliptos, están cambiando el metabolismo de dichos sistemas. Se trata, según Aingeru Martínez, uno de los autores del estudio, de otra evidencia de la alteración de los ciclos de nutrientes a nivel global.

El aumento de temperatura es, normalmente, el aspecto más destacado del cambio climático; sin embargo, no es el único. Las variaciones en el nivel de agua constituyen otro aspecto a tener en cuenta. Según Martínez, “se está observando que existen periodos cada vez más pronunciados y prolongados de escasez de agua en los sistemas acuáticos, lo cual es normal en regímenes áridos y mediterráneos; pero se está dando también en zonas de ambiente templado como la nuestra. Es importante saber qué impacto tiene eso sobre los ecosistemas acuáticos”.

El estudio contempla, además, el efecto que producen las plantaciones de monocultivo de Eucalyptus grandis, una de las especies de árboles más plantadas del mundo, en los ecosistemas acuáticos. Y es que las hojas de eucalipto, una vez sumergidas, transfieren al agua materia orgánica disuelta, “algo similar a lo que ocurre cuando hacemos una infusión”, aclara. Así es como se crean los lixiviados de hojarasca que, en el caso del eucalipto, “son muy recalcitrantes, ricos en compuestos secundarios complejos y aceites que son difícilmente metabolizables por las comunidades biológicas; incluso llegan a ser tóxicos”, explica Martínez. “Nos parecía importante unir estos dos aspectos: por una parte, el modo en el que puede afectar la escasez de agua, y por otra parte, el hecho de que los sistemas acuáticos estén rodeados de plantaciones de eucalipto”, añade.

La investigación se ha centrado en el análisis de los citados efectos en el biofilm, “el verdín que vemos en las piedras de ríos y embalses”, aclara Martínez. El biofilm es uno de los componentes básicos de las cadenas tróficas, y “juega un papel fundamental tanto en el ciclo biogeoquímico de la materia orgánica disuelta como en la transferencia de materia, nutrientes y energía a niveles tróficos superiores. Así, alteraciones en el metabolismo del biofilm podrían generar una reacción en cascada, y afectar al funcionamiento de los ecosistemas de agua dulce”, afirma Aingeru Martínez.

Para poder conocer los efectos de los lixiviados de hojarasca en el biofilm, han llevado a cabo un experimento en el que han sumergido sustratos artificiales colonizados por biofilm en cinco diferentes concentraciones de lixiviados de E. grandis, “a fin de simular las concentraciones que se pueden encontrar en los sistemas naturales según el grado de escasez de agua”. Han medido los efectos sobre el crecimiento, la respiración, la producción primaria, la concentración de nutrientes y la actividad exoenzimática. “Los efectos más significativos se observaron sobre la respiración y la producción primaria. Esto altera el metabolismo de la comunidad, ya que se vuelve más heterótrofa, es decir, existe un mayor consumo de oxígeno y liberación de CO2 al medio”.

Por lo tanto, debido a la importancia del biofilm sobre el funcionamiento de los sistemas de agua dulce, “se podría decir que los periodos de escasez de agua, junto con la presencia de plantaciones extensivas de eucaliptos, alteran el metabolismo y, por tanto, el funcionamiento de los sistemas de agua dulce a nivel mundial. Teniendo en cuenta la importancia de los sistemas acuáticos de agua dulce en el ciclo del carbono, a nivel global, se trataría de una evidencia más de que nuestras actividades están produciendo cambios en los ciclos de nutrientes a nivel global”.

Referencia:

Martínez A, Kominoski JS & Larrañaga A, (2017) “Leaf-litter leachate concentration promotes heterotrophy in freshwater biofilms: Understanding consequences of water scarcity”.. Science of the Total Environment. Vol. 599–600. Pages 1677–1684.. DOI: 10.1016/j.scitotenv.2017.05.043.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Verdín, eucaliptos y cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El declive de las praderas de algas por el cambio climático

- Del cambio climático

- “El cambio climático: ciencia, política y moral” por José Manuel Sánchez Ron

Retrodiagnósticos

Goya atendido por el doctor Arrieta (Francisco de Goya, 1820). La cartela de abajo reza (sic): “Goya agradecido, á su amigo Arrieta: por el acierto y esmero con qe le salvo la vida en su aguda y / peligrosa enfermedad, padecida á fines del año 1819, a los setenta y tres de su edad. Lo pintó en 1820” . Cuadro del Instituto de Arte de Mineápolis.

Acertar con los pronósticos o, lo que viene a ser lo mismo, predecir con éxito lo que ocurrirá no es fácil. Y en muchas ocasiones, tampoco lo es acertar con los diagnósticos. La dificultad aumenta cuando de lo que se trata es de indagar acerca de las enfermedades de personas desaparecidas hace tiempo. Eso es lo que intentan hacer en la Historical Clinicopathological Conference, que se celebra todos los años en la Facultad de Medicina de la Universidad de Maryland (EEUU), con personalidades de las que se sabe que sufrieron alguna enfermedad y se dispone de alguna información acerca de sus síntomas.

Cada año se escoge una figura histórica y se propone a un especialista que realice un diagnóstico a partir de la información disponible. Este año le ha tocado a Goya, y la especialista que ha tratado de diagnosticar su enfermedad ha sido Ronna Hertzano, experta en audición. Goya cayó enfermo de “cólico” en 1792 a la edad de 46 años. Un año más tarde una enfermedad misteriosa le obligó a guardar cama. Tenía dificultades de visión, pérdida de equilibrio, fuertes dolores de cabeza y pérdida de audición. Necesitó dos años para recuperarse, al cabo de los cuales quedó sordo para el resto de su vida.

La doctora Hertzano barajó la posibilidad de que se tratase de una intoxicación con plomo, pues lo utilizó con abundancia para pintar, pero en ese caso, los síntomas se hubieran prolongado en el tiempo, como le ocurrió con la sordera. Más probable que haberse intoxicado con plomo, Goya pudo haber contraído la sífilis, pero esta enfermedad muestra síntomas de deterioro neurológico progresivo a lo largo de muchos años, y no hay datos que avalen ese deterioro. Ronna Hertzano se ha inclinado finalmente por una enfermedad autoinmune, el síndrome de Susac. Se trata de una enfermedad muy rara que se caracteriza porque el paciente sufre alucinaciones, parálisis y pérdida de audición. El sistema inmune ataca pequeños vasos sanguíneos encefálicos y el daño puede extenderse a ojos y oídos. No suele durar más de tres años.

En la Historical Clinicopathological Conference se han diagnosticado otros personajes célebres. Lenin pudo haber muerto a causa de una ateroesclerosis cerebral acelerada. Darwin, quien padeció durante buena parte de su vida una molesta enfermedad gastrointestinal, pudo haber sufrido el denominado síndrome de vómitos cíclicos; se trata de una enfermedad de causa desconocida aunque con una cierta componente genética y que no tiene cura, pero cuyos síntomas pueden ser tratados en la actualidad. Poe pudo haber muerto de rabia o, quizás, de delirium tremens. Es probable que la enfermera Florence Nightingale sufriese un trastorno bipolar con rasgos psicóticos o, alternativamente, síndrome de estrés postraumático; la enfermedad se le declaró con 35 años cuando se encontraba en Turquía trabajando como enfermera del ejército británico en condiciones terribles. Mozart quizás falleció por culpa de una fiebre reumática aguda. Es muy posible que Beethoven sufriera sífilis, aunque también pudo haberse envenenado con plomo. Y Pericles pudo haber muerto de tifus. Estos son algunos de los personajes retrodiagnosticados en Maryland.

Tratar de diagnosticar una enfermedad de forma retrospectiva, como se hace en este congreso no deja de ser un divertimiento. Pero tiene su interés. Por un lado, puede arrojar luz acerca de las causas de la muerte de personajes históricos relevantes, lo que en algunos casos tiene importancia histórica. Pero tiene también interés científico, ya que se trata de un ejercicio sometido al escrutinio del resto de especialistas y, muy probablemente, sirve para mejorar las técnicas de diagnóstico que se aplican a los enfermos de hoy. Es, cuando menos, un espléndido ejercicio docente.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 4 de junio de 2017.

El artículo Retrodiagnósticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Ciencia a presión: Científicos que avalan patrañas

La expresión publish or perish (publica o perece) es de sobra conocida en el ámbito científico. Quiere expresar la importancia que tienen las publicaciones en los currículos del personal investigador. En ciencia no basta con hacer observaciones, obtener unos resultados y derivar conclusiones. Hay, además, que hacerlo público y, a poder ser, en medios de la máxima difusión internacional. La ciencia que no se da a conocer, que no se publica, no existe. El problema es que de eso, precisamente, depende el éxito profesional de los investigadores, sus posibilidades de estabilización y de promoción. De ahí la conocida expresión del principio.

El mundo de la comunicación tiene también sus normas. En comunicación se trata de que lo que se publica sea consumido. De la misma forma que la ciencia que no se publica no existe, en comunicación tampoco existen los contenidos que no se consumen: o sea, no existen los artículos que no se leen, los programas de radio que no se oyen, los de televisión que no se ven o los sitios web que no se visitan. En comunicación valdría decir “sé visto, oído o leído, o perece”.

Ambas esferas tienen ahí un interesante punto en común. Y por supuesto, en comunicación o difusión científica el ámbito de confluencia se aprecia en mayor medida aún. Confluyen aquí ambas necesidades, la de hacer públicos los resultados de investigación y, además, conseguir que lleguen a cuantas más personas mejor.

El problema es que la presión por publicar y por tener impacto comunicativo puede conducir tanto a unos como a otros profesionales, a adoptar comportamientos deshonestos, contrarios a la ética profesional e, incluso, a desvirtuar completamente el fin de la ciencia y de su traslación al conjunto del cuerpo social. Y también puede conducir, y de hecho ha conducido, a que se haya configurado un sistema de publicaciones científicas con patologías.

De todo esto se trató el pasado 31 de marzo en “Producir o perecer: ciencia a presión”, el seminario que organizarono conjuntamente la Asociación Española de Comunicación Científica y la Cátedra de Cultura Científica de la UPV/EHU.

1ª Conferencia

José Manuel López Nicolás, profesor de la Universidad de Murcia y divulgador científico: Científicos que avalan patrañas

Científicos que avalan patrañasEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Ciencia a presión: Científicos que avalan patrañas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Curso de verano “La ciencia de nuestras vidas”: Cuando la música era ciencia, por Almudena M. Castro

- Curso de verano “La ciencia de nuestras vidas”: Arte, literatura y ciencia, por Gustavo A. Schwartz

- Curso de verano “La ciencia de nuestras vidas”: La ciencia del habla, por Manuel Carreiras

CO2 bahiketa klima-aldaketa arintzeko

1. irudia: Klima-aldaketari aurre egiteko hainbat bide ikertzen eta lantzen ari dira zientzialariak.

Gizakion jarduerak Lurraren tenperatura igotzea ekarri du (berotegi-efektua). Fenomenoa ulertzeko Lurraren energia-fluxuei erreparatu behar zaie. Eguzkitik datorren erradiazioa Lurraren gainazalera iristen denean, zirkulazio atmosferiko eta ozeanikoek banatu egiten dute, eta geroago espaziora itzultzen da. Jasotako eta itzulitako erradiazioaren arteko orekak biziarentzat egokiak diren baldintzak mantentzen ditu. Berotegi-efektuko gasen kontzentrazioa igotzen bada, aldiz, Lurrak espaziora irradiatzen duen energia kantitatea murriztu egiten da, eta horrek gehiago beroarazten du atmosfera.

Badira berotegi-efektuko gas ugari; horietatik sei araututa daude klima-aldaketari buruzko nazioarteko araudian (Kyotoko protokoloa): karbono dioxidoa (CO2), oxido nitrosoa (N2O), metanoa (CH4), hidrofluorokarbonoak (HFC), perfluorokarbonoak (PFC) eta sufre hexafluoruroa (SF6). Horien artean CO2 da ugariena. Konposatu hori era naturalean sor daitekeen arren (jarduera bolkanikoan izan dezake jatorria, adibidez), karbonodun materialen erabilera antropogenikoaren ondorioz (energia-iturri fosilen errekuntzaz) bilakatu da klima-aldaketaren eragile nagusia.

Karbono dioxidoa konposatu ez-erreaktiboa da, eta ondorioz, atmosferan denbora luzez irauten du. Karbono dioxidoaren isuriak atmosferan metatzen dira, eta horregatik beharrezkoa da horiek murriztea. Helburu hori betetzeko hainbat estrategia proposatu dira. Aukera guztietan lehen pausua CO2-a bahitzea da, atmosferara isuri aurretik, eta ondoren, bi aukera daude: i) CCS, Carbon Capture and Storage; eta ii) CCU, Carbon Capture and Utilization. Teknologia bien arteko desberdintasuna bahitutako CO2-aren azken erabileran datza: i) CCS teknologiaren bidez, bahitutako CO2-a iraupen luzeko biltegiratzea bermatuko duten guneetara (akuifero gazi sakonetara, edota petrolio- edo gas-gordailuetara) bideratzen da; ii) CCU teknologiarekin, aldiz, bahitutako CO2-a produktu komertzial bihurtzen da.

2. irudia: CCS estrategiaren irudikapen eskematikoa.

Artikulu honen helburua CCS teknologiaren testuingurua aztertzea da, berrikuspen kritiko baten ikuspuntua hartuta. Nahiz eta CCU teknologiak soluzio ideala dirudien, teknologia bien artean komenigarriena zein den aukeratzeko, egoera zehatz bakoitzean teknologia biek duten kostu-errentagarritasuna eta ingurugiroarekiko eraginak era sakon batean aztertu behar dira, faktore bien arteko oreka egokia bermatzeko. Gainera, CCU teknologia ezin da CCS teknologiaren alternatiba moduan hartu, kudeatu dezakeen CO2 kantitatea desberdina baita. Adibide moduan, kalkulatzen da produktu kimiko eta erregai sintetikoak ekoizteko bideek CO2-isurketen % 10 inguru kudea dezaketela.

CCS teknologiak erregai fosilen erabilera jarraitua ahalbidetzen du, CO2-aren atmosferarako isurketak murrizten dituen bitartean. Hala ere, baditu zenbait arazo, hala nola, inbertsio ekonomiko eta energia-beharrizan handiak, epe luzerako biltegiratzea iraunkorra dela egiaztatu beharra, biztanleriaren erresistentzia, eta biltegiratzeko lekuen falta herrialde batzuetan.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 30

- Artikuluaren izena: Azterketa informatizatu eraginkor baten bila.

- Laburpena: Gero eta arreta gehiago eskaintzen ari zaio klima-aldaketari. Gizakion jardueraren eraginez Lurraren tenperatura igotzen ari da. Berotegi-efektuko gasen artean karbono dioxidoa (CO2) ugariena da, eta energia-iturri fosilen errekuntzan du jatorri antropogeniko nagusia. CO2-ak denbora luzez irauten du atmosferan eta, ondorioz, beharrezkoa da haren isurketak murriztea. Helburu hori betetzeko, karbono dioxidoaren bahiketa- eta biltegiratze-teknologia (CCS teknologia) erabil daiteke. Horretan, lehenengo pausoa, ekoitzitako CO2-a bahitzea da, atmosferara isuri aurretik. Ondoren, garraiatu eta formazio geologiekoetan (akuifero gazi sakonetan, edota petrolio- edo gas-gordailuetan) biltegiratzen da. CCS teknologiak erregai fosilen erabilera jarraitua ahalbidetzen du, CO2-aren atmosferarako isurketak murrizten dituen bitartean. Hala ere, baditu zenbait arazo, hala nola, inbertsio ekonomiko eta energia-beharrizan handiak, epe luzerako biltegiratzea iraunkorra dela egiaztatu beharra, biztanleriaren erresistentzia eta biltegiratzeko lekuen falta herrialde batzuetan.

- Egileak: Ainara Ateka, Irene Sierra eta Javier Ereña

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 81-92

- DOI: 10.1387/ekaia.16204

—————————————————–

Egileaz:

Ainara Ateka eta Javier Ereña UPV/EHUko Ingeniaritza Kimikoa Sailekoak (Zientzia eta Teknologia Fakultatea) dira eta Irene Sierra Ingeniaritza Kimikoa Sailekoa (Farmazia Fakultatea) da.

—————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post CO2 bahiketa klima-aldaketa arintzeko appeared first on Zientzia Kaiera.

Los límites del Hyperloop

Durante el pasado mes de julio hemos asistido a las primeras pruebas integradas de un sistema hyperloop en las instalaciones de Hyperloop One —la empresa más destacada de las que compiten por poner en marcha este sistema— en Las Vegas, Nevada. Pero ¿qué es un hyperloop? Es difícil no estar al menos vagamente familiarizado con la propuesta de un «quinto modo de transporte» realizada por el magnate Elon Musk, conocido por SpaceX y Tesla, en un white paper de 2013 [1] dado el tratamiento masivo que cualquier avance técnico o propuesta relacionada con el asunto tiene en todos los medios de comunicación.

En breve: un hyperloop es un sistema de cápsulas de transporte que se desplazan sin contacto a velocidades cercanas a la del sonido a través de un tubo en el que se ha evacuado el aire hasta llegar a condiciones de casi vacío, y que aceleran mediante motores de inducción lineales ubicados a intervalos regulares dentro de los tubos. Un sistema así puede sorprender por lo atrevido de la propuesta, pero una lectura rápida de las especificaciones técnicas y las estimaciones de costes avanzadas por Musk levanta, legítimamente, más de una ceja en la comunidad de expertos en transporte [2][3]. Más allá de análisis teóricos, los propios progresos de la empresa que más ha avanzado en la implementación física del concepto desvelan cuáles serán los problemas a los que tendrá que enfrentarse en un futuro inmediato y que tienen el potencial de dar al traste con todo el proyecto.

Durante la madrugada del sábado 29 de julio, Hyperloop One realizó su primera prueba de «fase 2» [4]. La cápsula de prueba denominada XP-1 recorrió un total de 437 metros en un tubo evacuado a una presión inferior a 100 Pa (la milésima parte de la presión atmosférica), alcanzando en el proceso una velocidad máxima de 310 km/h. El motor de inducción lineal utilizó para ello un estátor de 300 metros de longitud, de donde podemos deducir algún parámetro más de la prueba aplicando algo de cinemática elemental.

Suponiendo que la cápsula partió del reposo y que la aceleración impartida fue constante, resulta que debió estar sujeta a 12,36 m/s², unos 1,26 g. La frenada debió ser algo más intensa, de 2,76 g: afortunadamente, la XP-1 no es más que un chasis cubierto con una estructura hueca de fibra de vidrio [5]. Unos potenciales pasajeros habrían encontrado el viaje extremadamente poco confortable. No hay que olvidar, sin embargo, que la limitación de longitud que presenta el tramo de pruebas de Hyperloop One en Las Vegas prácticamente obliga a sostener aceleraciones y frenadas de semejante intensidad si se desea probar el sistema a cualquier velocidad significativa.

Vista frontal de la sección del tubo de pruebas de Hyperloop One. Fuente: Hyperloop One

Hyperloop One es un tanto parca ofreciendo datos técnicos relacionados con sus pruebas, aunque un poco más de estudio sobre el vídeo y los materiales de prensa publicados deberían permitir hacer alguna inferencia más allá de la cinemática del sistema. Será importante conocer con alguna precisión las dimensiones de la cápsula: en la documentación disponible se afirma que mide 8,69 metros de longitud y 2,71 metros de altura. Examinando las imágenes disponibles esta altura parece excesiva; además, el parámetro fundamental de la anchura de la cápsula, necesario para calcular su sección y sus características aerodinámicas, no aparece por ninguna parte. Un pequeño trabajo de estimación sobre el vídeo de la prueba permite conjeturar que el diámetro interior del tubo debe rondar los 4 metros, mientras que la cápsula misma debería tener una anchura de alrededor de 3 metros.

La altura del carenado parece no superar los 1,80 metros a la vista de las fotografías. Tomemos una altura de 2 metros para arrojar una sección transversal aproximada de 6 m²; el tubo mismo tendría una sección interior de 12,67 m². Estos datos son consistentes con la intención de Hyperloop One de centrarse en el segundo de los diseños propuestos por Musk: el hyperloop de mercancías —aunque Musk lo concibió como un medio mixto de viajeros y carga que podría transportar vehículos como (naturalmente) un Tesla S. El primer diseño, de menor sección y supuestamente de construcción más barata, sería prácticamente un homoducto [6] que lanzaría a un pequeño grupo de personas reclinadas en el interior de un tubo de 1,35 por 1,10 metros como si fueran fajos de billetes en un supermercado. En cualquier caso, la incertidumbre propia de las medidas nos permite estimar que la cápsula ocupa alrededor de la mitad de la superficie disponible en su desplazamiento. ¿Por qué es esto importante?

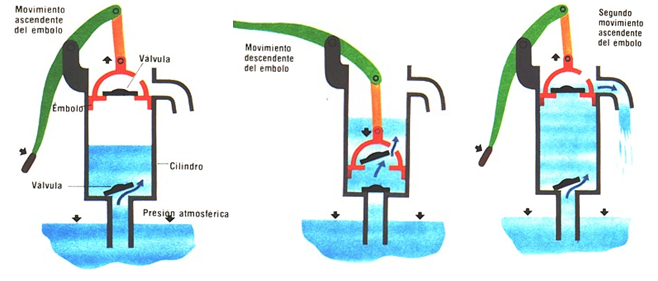

El límite de Kantrowitz

El mismo equipo de Elon Musk, en la redacción del artículo original que sirvió como pistoletazo de salida para la definición del hyperloop, resaltó un parámetro clave de dinámica de gases que resulta limitante en el diseño de un sistema de transporte que debe alcanzar velocidades transónicas —cercanas a las del sonido— en el interior de un tubo, por analogía con el flujo de aire a través de la boca de una turbina en un motor a reacción. Se trata del llamado «límite de Kantrowitz», por Arthur Kantrowitz, ingeniero estadounidense que derivó la expresión de un límite en el flujo de un gas a velocidades transónicas cuando atraviesa una zona en la que se fuerza una reducción en su sección [7]. Como el flujo del gas debe ser continuo, un estrechamiento supone un aumento correspondiente de su velocidad hasta alcanzar la velocidad local del sonido; en este momento el flujo de gas resulta obstruido.

En el hyperloop el límite de Kantrowitz puede visualizarse como un «efecto jeringa». En una jeringa, si se impide el flujo de aire a través de su boquilla, el émbolo no puede seguir avanzando si no es comprimiendo el aire que haya en su interior realizando un esfuerzo inconmensurable con el necesario para hacerlo avanzar en condiciones de flujo normal —es decir, con la boquilla sin tapar. El límite de Kantrowitz es, entonces, la velocidad a la que la sección mínima del hueco entre la cápsula y el tubo provoca un aumento súbito en la resistencia del aire, por poco que sea. De hecho, la ecuación del límite relaciona la razón entre el hueco citado y la sección interna del tubo con la velocidad, y ni siquiera tiene en cuenta la presión local del aire [8].

Las estimaciones que hemos realizado antes sobre las dimensiones de la cápsula XP-1 permiten averiguar la velocidad a la que el sistema debería encontrarse con el límite de Kantrowitz: ocurrirá alrededor de Mach 0,55, o suponiendo una temperatura interior del tubo de 20 °C, a 188 m/s², es decir, 677 kilómetros por hora. Una cifra algo decepcionante teniendo en cuenta que el relato de Hyperloop One de la prueba incluye la siguiente cita textual, un tanto fanfarronesca dadas las condiciones actuales de las instalaciones de ensayo:

With an additional 2000 meters of stator, we would have hit 1100 km per hour […]

Es decir, 2 kilómetros adicionales de aceleración habrían permitido alcanzar los 1100 km/h. Esto, simplemente, no es cierto salvo que el sistema disponga de potencia suficiente para arrastrar la cápsula más allá del pico de resistencia impuesto por la dinámica de gases, algo que sin duda dispararía el consumo energético de todo el conjunto mucho más allá de lo previsto, afectando de forma crítica a su viabilidad.

El artículo original de Musk discutió —correctamente— la pertinencia del límite de Kantrowitz en el sistema del hyperloop. Las velocidades previstas tanto por Musk como por Hyperloop One para el sistema se encuentran en el entorno de Mach 0,9 (aproximadamente 1100 km/h), lo que arroja una relación de sección libre frente a total de 0,99. Es decir, un hyperloop solo podría funcionar a la velocidad objetivo en el interior de un tubo gigantesco respecto a su propia sección transversal, eliminando así toda posible ventaja que la existencia del tubo pudiera conllevar. Pero Musk abordó el problema proponiendo una solución decididamente ingeniosa: ¿por qué no incorporar en el frontal de la cápsula un compresor axial similar al de los turborreactores? De esta forma, sería la propia cápsula la que evacuaría el aire que se fuera encontrando, aumentando así la sección libre en función de la tasa de compresión que proporcionara el sistema. Yendo un paso más allá, Musk y su equipo calcularon que el compresor debería ofrecer una relación de compresión de 20 a 1, y realizaron los cálculos necesarios para aprovechar parte del aire para los sistemas de soporte vital de la cápsula, a la vez que tenía en cuenta el resultado impuesto por la termodinámica para un gas que se comprime: un aumento de su temperatura.

Frontal de la cápsula de Hyperloop One. Obsérvese la ausencia de ningún tipo de estructura. En la fotografía, de izquierda a derecha, Josh Giegel y Shervin Pishevar, cofundadores de Hyperloop One. Fuente: Hyperloop One.

Sin embargo, una simple inspección de la cápsula XP-1 permite descartar que disponga de compresor axial alguno montado en su frontal —mostrado, por otro lado, en prácticamente todas las recreaciones artísticas de la cápsula del hyperloop como la que encabeza este artículo, realizada por Hyperloop One (aunque ya no puede encontrarse en su web). Esta falta de compresor es la que permite calcular con tanta seguridad a qué velocidad encontrará el límite de Kantrowitz; ahora bien, ¿no bastará con instalar un compresor en el frontal para solventar el problema? Después de todo, según afirmó a principios de año el Dirk Ahlborn, director de Hyperloop Transportation Technologies (y competencia de Hyperloop One en la carrera por traer a la realidad los tubos), «la tecnología [para construir un hyperloop] no es la cuestión —ya existe» [9].

Pues bien, esta afirmación es falsa. Hoy por hoy no existe un compresor axial con las características necesarias para equipar una cápsula de hyperloop como la que Hyperloop One está proponiendo, ni de hecho como ningún otro diseño. Los compresores de las turbinas utilizadas en aviación superan con frecuencia las relaciones de compresión de 20:1, pero funcionan con keroseno. Sin duda no es imposible desarrollar una turbina eléctrica que realice esa función, aunque la incógnita sobre su desarrollo obligaría a ser más prudente con los plazos y no realizar afirmaciones como las que acostumbran a hacer los participantes en la «carrera del hyperloop» —y a difundir, sin crítica ni comentario, los medios de comunicación. El consumo eléctrico de este teórico compresor eléctrico es también una incógnita, por más que simples cálculos termodinámicos permitan establecer un límite inferior.

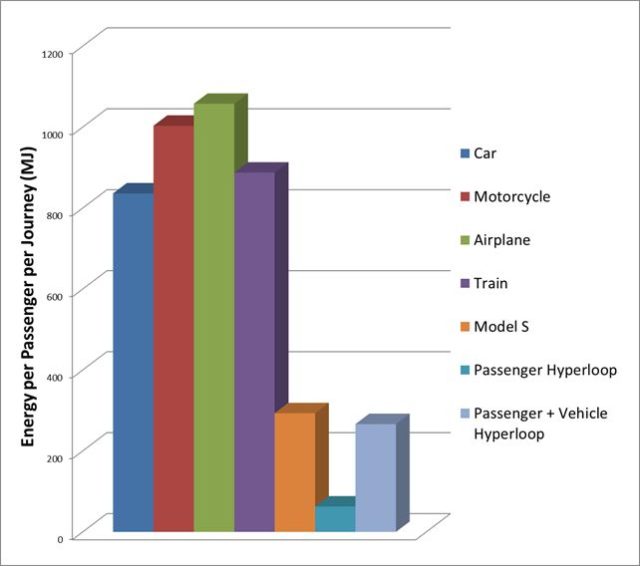

Por esto, el balance energético total del sistema citado por Musk debe ser puesto claramente en duda. Si además tenemos en cuenta que el gasto energético mostrado para los diferentes medios de transporte en la primera figura del paper es clara ¿e intencionadamente? erróneo —en lo que respecta, al menos, al ferrocarril— no es ninguna insensatez dudar, como muchos llevamos tiempo haciéndolo, de la viabilidad del sistema en su conjunto.

Gastos energéticos por trayecto citados por Musk en su paper. Los valores «por pasajero y trayecto» y no por pasajero-kilómetro hacen la gráfica ambigua, aunque suponiendo que se refiere al proyecto de alta velocidad Los Ángeles-San Francisco, un valor más razonable basado en cálculos realistas [10] es al menos cuatro veces inferior (!) al reportado por Musk

¿Tener compresor o no tener compresor?

Llegados a este punto nos encontramos con una disyuntiva: o bien se desarrolla el compresor axial eléctrico necesario para el funcionamiento del sistema tal y como fue diseñado, o no. En el primer caso podríamos, teóricamente, incrementar la velocidad punta del sistema de transporte hasta un régimen cuasi-transónico. Nos encontraríamos entonces con una limitación termodinámica por la que pasa de puntillas el diseño original: como quiera que un gas sujeto a compresión incrementará fuertemente su temperatura, es necesario hacer algo con la energía adicional si no deseamos que la cápsula se transforme en una especie de horno de aire —un horno de aire es un artefacto ideal para hacer patatas fritas con muy poca grasa, pero no muy indicado para transportar personas o mercancías. Musk concibe un sistema de refrigeración basado en agua, un par de intercambiadores térmicos (intercoolers) y varios tanques dispuestos para almacenar agua y vapor, y los dimensiona de acuerdo con sus cálculos.

Un poco más adelante, en una sola línea de la descripción del sistema compresor y como pretendiendo que pase inadvertido (apartado 4.1.3) se afirma lo siguiente:

Water and steam tanks are changed automatically at each stop.

Es decir, «los tanques de agua y vapor son intercambiados [por otros frescos] automáticamente en cada parada». Este curioso y poco reportado (¿por trivial?) paso tiene una cierta reminiscencia a los depósitos de agua de las antiguas locomotoras de vapor. Tiene también el defecto de complicar la logística de la gestión de las cápsulas, algo que para mantener el flujo previsto de pasajeros del sistema tiene que realizarse con total precisión y a gran velocidad al objeto de mantener el flujo de pasajeros previsto que da sentido al sistema en su conjunto. Es, además, una complejidad a añadir al previsto cambio de batería tras cada viaje: como quiera que la cápsula no obtiene energía de la infraestructura como lo haría un tren eléctrico, toda la operación interna del sistema (compresor, intercambiadores de calor, válvulas y sistemas de soporte vital, entre otros) tiene que sustentarse con baterías.

El mismo Musk, a través de Tesla, su empresa automovilística, lleva ya años preconizando la creación de una infraestructura de intercambio rápido de baterías para sus coches eléctricos. Esto tendría la ventaja obvia de sustituir los potenciales largos tiempos de carga de las baterías de los vehículos por un futurista y automático intercambio robotizado. Sin embargo, la creciente disponibilidad de sistemas de carga rápida (y, potencialmente, la introducción de un punto clave de fallo en una conexión eléctrica fundamental en los vehículos, con el consiguiente y previsible descenso en la fiabilidad) ha impedido que esta tecnología se desarrolle [11]. Ni siquiera hay prototipos que puedan adaptarse para su uso en las cápsulas del hyperloop: cuánto menos los habrá si se trata de intercambiar baterías junto con tanques de aire y vapor de agua a presión y sobrecalentado, que deben conectarse no ya mediante un contacto eléctrico, sino mediante válvulas robustas.

La otra opción en la disyuntiva de diseño es olvidar el compresor frontal y operar el sistema a velocidades subsónicas por debajo de Mach 0,5. Un hyperloop que opere a una velocidad punta en el entorno de los 600 km/h podría ser factible, aunque está mucho menos claro que el sistema de transporte resultante sea atractivo en costes de construcción por km, costes de mantenimiento, consumo energético y confort respecto de su competencia más obvia, el tren de alta velocidad. Décadas de desarrollo por parte de empresas y organismos públicos en los EE.UU., Alemania, Japón y China han llevado al despliegue comercial de un sistema presentado por muchos expertos como «el transporte del futuro»: el tren de levitación magnética o maglev.

Hoy hay una línea en el mundo funcionando comercialmente como un tren de levitación magnética de alta velocidad: el Transrapid de Shanghai que cubre una distancia de 30,5 kilómetros en 8 minutos a una velocidad máxima récord de 430 km/h. El resto de los trenes de levitación magnética existentes en el mundo son líneas automáticas de baja o media velocidad, concebidas según el modelo people mover propio de grandes aeropuertos. En el futuro la Chūō Shinkansen [12][13], una línea de mayor alcance y más similar al perfil de transporte al que aspira hyperloop, deberá cubrir el trayecto Tokio-Nagoya-Osaka en algo más de una hora, alcanzando una velocidad punta de 505 kilómetros por hora. Según la planificación actual esta línea —una auténtica maravilla de la ingeniería, con más del 86% del trayecto en su primer tramo ejecutado en túnel— debería poner en servicio su primer tramo (Tokio-Nagoya) en 2027 y el segundo (Nagoya-Osaka) en 2045. No puedo dejar pasar la oportunidad de que estos y no otros son plazos realistas para una infraestructura de transporte puntera; en ningún caso lo son los que se están divulgando desde el entorno de hyperloop y Elon Musk.

De todos modos, la mayoría de expertos en sistemas de transporte opinan que los grandes proyectos de trenes de levitación magnética son «elefantes blancos» [14]: obras realizadas más como forma de señalar el prestigio de un país que como forma práctica de mover grandes flujos de personas entre ubicaciones populosas. El potencial incremento en la velocidad comercial de un sistema maglev requiere de unos costes por kilómetro consecuentemente elevados, que solo se justifican con una demanda de transporte extremadamente intensa. A falta de tales condiciones y con un riesgo tecnológico inexistente, el tren de alta velocidad se erige como la alternativa al transporte privado. Fiable [15] y maduro aunque todavía con margen de mejora, permite conectar entre sí centros urbanos separados por centenares de kilómetros con mínimo impacto ambiental y costes conocidos.

El concepto del hyperloop plantea, además de las aquí reseñadas, muchas otras dudas y limitaciones técnicas no menos importantes desde puntos de vista tecnológicos, operativos y de seguridad. Es por todo esto que puede afirmarse con rotundidad que hyperloop no ocurrirá. Desde luego no en cuatro años, como afirma Hyperloop One. Tampoco en veinte años —el mínimo razonable para un proyecto con tanta tecnología en el aire. Y quizá nunca.

Este post ha sido realizado por Iván Rivera (@Brucknerite) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU

Para saber más

[1] Musk, E. R. et al. (12/08/2013). Hyperloop Alpha. Visitado el 14/08/2017 en http://www.spacex.com/sites/spacex/files/hyperloop_alpha-20130812.pdf.

[2] Bradley, R. (10/05/2016). The Unbelievable Reality of the Impossible Hyperloop, MIT Technology Review. Visitado el 14/08/2017 en https://www.technologyreview.com/s/601417/the-unbelievable-reality-of-the-impossible-hyperloop/.

[3] Konrad, A. (18/11/2016). Leaked Hyperloop One Docs Reveal The Startup Thirsty For Cash As Costs Will Stretch Into Billions, Forbes. Visitado el 14/08/2017 en https://www.forbes.com/sites/alexkonrad/2016/10/25/hyperloop-one-seeks-new-cash-amid-high-costs/#4f78547d125c.

[4] Giegel, J., Pishevar, S. (02/08/2017). Hyperloop Gets More Real Every Time We Test, Hyperloop One. Visitado el 14/08/2017 en https://hyperloop-one.com/blog/hyperloop-gets-more-real-every-time-we-test.

[5] Hyperloop One. (10/08/2017). What Testing Has Taught Us. Visitado el 14/08/2017 en https://hyperloop-one.com/blog/what-testing-has-taught-us.

[6] «Homoducto», del latín homo (ser humano) y ductus (conducto), palabra acuñada por @Mssr_Pecqueux en conversación de Twitter https://twitter.com/brucknerite/status/733684888033984512.

[7] Kantrowitz, A., Coleman, duP. (05/1945). Preliminary Investigation of Supersonic Diffusers. Advance Confidential Report L5D20, National Advisory Committee for Aeronautics. Visitado el 14/08/2017 en http://www.dtic.mil/dtic/tr/fulltext/u2/b184216.pdf.

[8] Una expresión apropiada para el límite de Kantrowitz según se aplica al Hyperloop es:![]()

Donde Abypass es la sección libre, Atube la sección interna total, γ el factor de expansión isentrópica y M el número de Mach del flujo de aire (equivalente a la velocidad de avance de la cápsula).

[9] Carlström, V. (26/01/2017). HTT’s CEO says a hyperloop line will be up and running within three years: “The technology is not the issue – it already exists”, Business Insider Nordic. Visitado el 14/08/2017 en http://nordic.businessinsider.com/htts-ceo-says-a-hyperloop-line-will-be-up-and-running-within-three-years-the-technology-is-not-the-issue–it-already-exists-2017-1/

[10] García Álvarez, A. (01/2008). Consumo de energía y emisiones del tren de alta velocidad en comparación con otros modos. Vía Libre, (515). Visitado el 14/08/2017 en https://www.vialibre-ffe.com/PDF/Comparacion_consumo_AV_otros_modos_VE_1_08.pdf

[11] Korosec, K. (10/06/2015). Tesla’s battery swap program is pretty much dead, Fortune. Visitado el 14/08/2017 en http://fortune.com/2015/06/10/teslas-battery-swap-is-dead/

[12] Chuo Shinkansen Maglev Line. Railway Technology. Visitado el 14/08/2017 en http://www.railway-technology.com/projects/chuo-shinkansen-maglev-line/.

[13] JR Central (2012). The Chuo Shinkansen using the Superconducting Maglev System. JR Central Annual Report. Visitado el 14/08/2017 en http://english.jr-central.co.jp/company/ir/annualreport/_pdf/annualreport2012-05.pdf

[14] Binning, D. (11/02/2008). Maglev – the Great Debate, Railway Technology. Visitado el 14/08/2017 en http://www.railway-technology.com/features/feature1606/

[15] European Commision. (10/02/2017). Rail accident fatalities in the EU. Visitado el 14/08/2017 en http://ec.europa.eu/eurostat/statistics-explained/index.php/Rail_accident_fatalities_in_the_EU

El artículo Los límites del Hyperloop se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En los límites del frío

- Cuántica y relatividad por todas partes

- ¿Por qué el Rover Curiosity es más lento que un caracol?

Más allá de los experimentos

Un error muy extendido, usado también como argumento a favor de algunas pseudociencias y en contra de ciertas teorías como la de la Evolución por Selección Natural, es postular que sólo puede ser conocimiento científico aquel que surge de un experimento. Según esta idea la ‘verdadera ciencia’ es la que sale de los laboratorios, de la comprobación de hipótesis en un entorno controlado con estricta determinación de variables sistemáticamente bien controladas para evitar la interacción. Todas las fuentes de error son localizadas y eliminadas, todas las fuentes de ruido minimizadas y cada variable independiente es determinada y su influencia sobre el fenómeno estudiado es medida; la ciencia es o debe ser como la física o la química, un ejercicio de extrapolación controlada a partir de casos limitados estudiados en laboratorio, porque el único conocimiento real es el que tiene base experimental.

En ocasiones se llega a discutir incluso la posibilidad de generalizar y se intenta argumentar que ninguna ley puede ser considerada verdaderamente científica a no ser que se pueda demostrar que se cumple en todos y cada uno de los casos; es el origen del ‘amimefuncionismo’ tan típico para defender pseudociencias como la homeopatía. En el fondo, y dada la imposibilidad práctica de cumplir esta condición, se trata de negar la existencia misma de la ciencia o el conocimiento: si es imposible generalizar es imposible saber, dado que cada caso concreto es independiente de todos los demás y cualquier abstracción es imposible. Si cada caso es un caso particular nunca podemos saber nada en general y el conocimiento es imposible: nihilismo epistemológico, o la ignorancia disfrazada de escepticismo extremo.

Igual ocurre con la exigencia de que todo conocimiento científico provenga de un experimento, que para empezar niega la consideración de ciencia a cualquier proceso histórico: como no podemos hacer un experimento que repita la historia de la Tierra la Evolución por Selección Natural no es una teoría científica. Como tampoco puede serlo el Big Bang, la tectónica de placas o la secuencia principal de la evolución estelar. En su interpretación más extrema hasta la historia humana sería imposible de conocer, ya que el Imperio Romano, las sociedades paleolíticas o el Siglo de Oro español son imposibles de reproducir experimentalmente. El pasado sería por tanto incognoscible.

Muchos de quienes usan este tipo de argumentos para defender las bondades de una pseudoterapia o como garrota contra Darwin no son conscientes de que en realidad están rechazando la existencia de cualquier posibilidad de conocimiento al hacerlo; tampoco es que a la mayoría de ellos les moleste demasiado. Llevado al extremo el nihilismo epistemológico haría también imposible cosas como perseguir a un criminal: en ausencia de testigos directos o grabaciones no habría ninguna forma de demostrar la comisión de un crimen, ya que ninguna pista sería suficiente prueba. No sólo el conocimiento, sino la misma sociedad dejaría de funcionar si nuestros criterios de confirmación fuesen tan estrictos. La exigencia de experimentación y de estudio caso por caso son formas de rechazo del intelecto mismo; incluso de los elementos clave de la Humanidad, una especie de auto odio en versión intelectual.

El universo que hay ahí fuera es cognoscible; las leyes existen, las generalizaciones son posibles y el experimento es una herramienta más a disposición de quien busca el conocimiento. A partir de casos concretos se pueden crear conclusiones generales que pueden ser útiles en presencia de nuevos casos. Lo ocurrido en el pasado deja pistas en el presente que pueden ser utilizadas para reconstruir lo ocurrido. Las leyes científicas existen y se pueden usar, aunque pocas sean inmutables y eternas. El cosmos es sutil, pero no malicioso, lo que nos permite usar la razón y fiarnos de las conclusiones obtenidas con ella incluso cuando se refieren a un pasado remoto. El avance de la ciencia nos demuestra que podemos conocer el universo y los intentos de rechazar esta idea para defender absurdas teorías no muestran más que la bancarrota intelectual de quienes están dispuestos a rechazar la idea misma de conocimiento sólo por no dar su brazo a torcer.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Más allá de los experimentos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Curso de verano “Las dos culturas y más allá”: El caso de la lingüística y las ciencias cognitivas

- Curso de verano “Las dos culturas y más allá”: Ciencia, Sociedad y Desarrollo

- Curso de verano “Las dos culturas y más allá”: Ciencia y Poder

Dozena erdi ariketa 2017ko udarako (3): Saskibaloi txapelduna

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure hirugarren ariketa: Saskibaloi txapelduna

———————————————————————————-

Ariketak “Calendrier Mathématique 2017. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki dezakezu.

———————————————————————————-

The post Dozena erdi ariketa 2017ko udarako (3): Saskibaloi txapelduna appeared first on Zientzia Kaiera.

Amelia quiere explorar el desierto

Sí, Amelia quiere explorar el desierto. Ha conseguido el patrocinio de una millonaria que le impone unas cuantas reglas para que agudice su ingenio. Las explicamos a continuación.

Amelia tiene a su disposición una cantidad ilimitada de gasolina almacenada en el lugar de salida, en el límite del desierto.

Para realizar su viaje, dispone de un jeep en el que puede transportar como máximo, en cada momento, una unidad de combustible. Con cada unidad de gasolina puede viajar una unidad de distancia; se supone que el consumo de combustible es constante.

En cualquier momento del viaje, Amelia puede dejar cualquier cantidad de combustible en un depósito para poder recogerlo más tarde al volver a pasar por allí. La mecenas le exige, además, que siempre que el jeep comience a salir del desierto debe regresar necesariamente al punto de partida.

Con todas estas normas impuestas, la pregunta es: ¿hasta dónde puede llegar Amelia en su paseo por el desierto?

Vamos a intentar ver que puede llegar tan lejos como quiera, solo con un poco de estrategia por su parte. Para ello, vamos a explicar lo lejos llegaría realizando tres viajes –saliendo tres veces del punto de partida– para describir después el caso general.

La estrategia de Amelia si realiza tres salidas

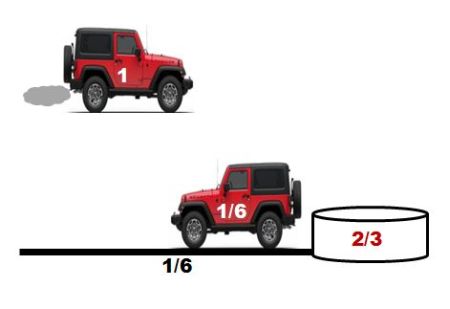

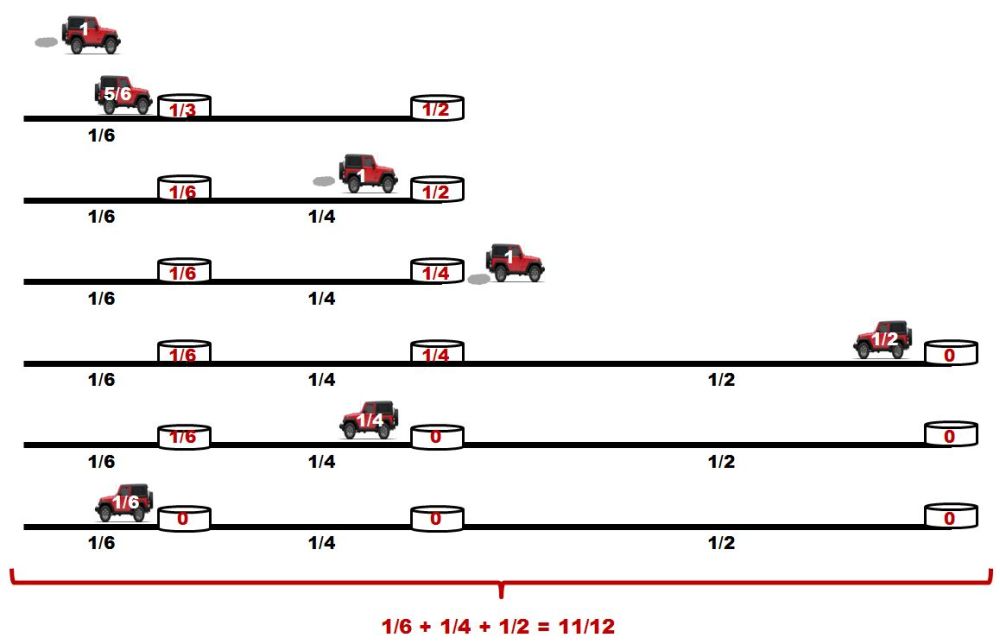

Amelia sale de la base una unidad de gasolina en el depósito del jeep y conduce 1/6 de unidades de distancia. Es decir, ha consumido la sexta parte del combustible. Deja 2/3 de unidades de combustible en un depósito, y regresa al punto de partida con el 1/6 de combustible que le queda.

Figura 1: Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

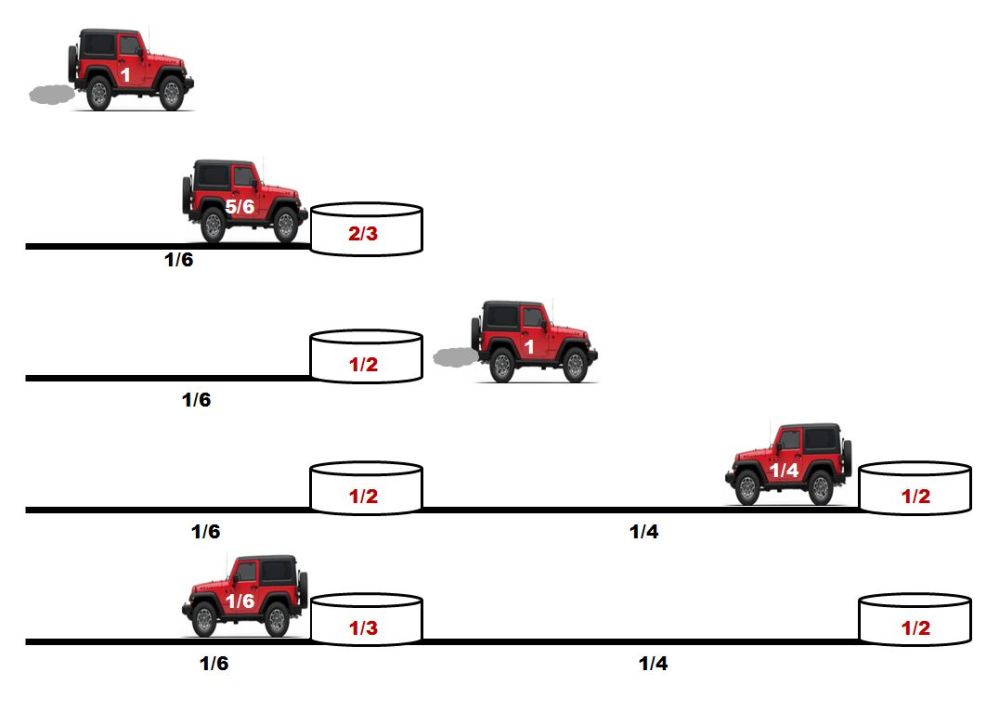

Amelia vuelve a cargar el depósito del jeep al máximo –es decir con una unidad de combustible– y conduce 1/6 de unidades de distancia. Ha gastado 1/6 de unidades de gasolina; llena el depósito del coche con 1/6 de combustible tomado del depósito, y vuelve a adentrarse en el desierto, dejando en el primer depósito 1/2 de unidades de fuel. Desde ese punto conduce 1/4 de unidades de distancia y deposita 1/2 unidad de gasolina en un segundo recipiente. Le quedan 1/4 de unidades de fuel, lo justo para llegar al primer bidón. De ese recipiente toma 1/6 de unidades de combustible –es decir, deja el primer bidón con 1/3 de unidades de fuel– y llega a la base con el depósito del coche vacío.

Figura 2 : Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

Amelia carga el coche con el máximo de gasolina, llega al primer bidón y utiliza 1/6 de combustible para volver a llenar el depósito del jeep –así, en el primer depósito, deja 1/6 de unidades de gasolina–. Llega al segundo recipiente tras recorrer 1/4 de unidades de distancia, y allí vuelve a llenar el vehículo con fuel, dejando en el segundo depósito 1/4 de unidades de combustible, y continúa su viaje hacia el interior del desierto. Tras recorrer 1/2 unidad de distancia, da la vuelta, llega al segundo recipiente gastando todo el combustible que le queda, usa el fuel del segundo recipiente para llegar al primero y de nuevo toma la gasolina del primer bidón para regresar al punto de partida.

Figura 3: Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

Así, con estas tres idas y vueltas, Amelia se ha adentrado en el desierto 11/12 de unidades de distancia.

Entendiendo el caso general

La estrategia utilizada por Amelia con tres salidas desde el límite del desierto puede generalizarse para cualquier n:

-

El jeep realiza n viajes de ida y vuelta.

-

En la primera salida, viaja 1/(2n) de unidades de distancia, deja (n − 1)/n unidades de gasolina en el primer depósito, quedándose con el combustible justo para llegar a la base.

-

En cada una de las n − 1 siguientes salidas, y en dirección hacia el interior del desierto, Amelia va tomando de cada depósito el combustible necesario para llenar al máximo el jeep y llegar al siguiente depósito. Y al regresar, va tomando solo la gasolina suficiente para llegar al depósito anterior.

-

Esta operación la puede realizar n veces, dejando en su último viaje todos los bidones vacíos, y habiendo recorrido en la dirección del desierto

1/2 + 1/4 + 1/6 + … + 1/(2n) = 1/2 (1 + 1/2 + 1/3 + … + 1/n)

de unidades de distancia.

Recordemos que 1 + 1/2 + 1/3 + … + 1/n es el n-ésimo número armónico,la suma parcial n-ésima de la serie armónica, que es una serie divergente.

¿Y que tiene esto que ver con el viaje de Amelia? Si la exploradora utiliza la estrategia anteriormente descrita, podrá adentrarse en el desierto todo lo que desee, porque para n suficientemente avanzado,

1/2 (1 + 1/2 + 1/3 + … + 1/n)

es tan grande como se desee… Como el desierto, sea cual sea el que ha elegido Amelia, tiene dimensiones finitas, la exploradora puede recorrerlo por completo. Solo necesita suficiente tiempo –que no sobrepase su tiempo de vida–: Amelia completará su aventura. Aunque es probable que arruine a su mecenas y, sobre todo, que desperdicie un combustible precioso de manera un tanto caprichosa…

Más información:

-

Jeep problem, Wikipedia

-

Jeep problem, Wolfram Math World

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Amelia quiere explorar el desierto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Mestizajes: ¿Cómo sabe una metáfora? Poética y ciencia, por Amelia Gamoneda

- ¿Quién quiere vivir para siempre?

- El diablo y Simon Flagg, una lectura ligera para el verano

Sistemas nerviosos: el cerebro de vertebrados

Áreas de Brodman en un cerebro de primate

El cerebro, que se desarrolla a partir del telencéfalo embrionario, es la estructura encefálica de vertebrados que ha alcanzado en mamíferos su máximo desarrollo. Contiene, a su vez, el bulbo olfatorio, los ganglios basales, el hipocampo y la corteza cerebral.

El prosencéfalo de todos los vertebrados posee una estructura en láminas denominada pallium. El pallium de agnatos (lampreas), peces condrictios (tiburones) y anfibios obedece a un esquema básico general, consistente en dos hemisferios unidos por una región denominada septum. Cada uno de los hemisferios asemeja un cilindro formado por tres capas, en cuyo interior quedan cavidades llenas de líquido denominadas ventrículos. La capa que da al ventrículo y la que da al exterior son de materia blanca, y la que queda entre ellas, de materia gris. En el resto de los grupos (peces teleósteos, reptiles, aves y mamíferos) se produce una fuerte modificación del esquema básico, debido al crecimiento diferencial de diferentes zonas del pallium original en cada uno de ellos. En mamíferos se diferencian cuatro zonas en el contorno de la forma cilíndrica antes mencionada, que se denominan pallium dorsal, medio, ventral y lateral, cuyo desarrollo daría lugar, respectivamente, al neocortex, el hipocampo, la amígdala y la corteza olfativa. El neocortex es la región que alcanza un mayor desarrollo de todas ellas.

El cerebro es un órgano con simetría bilateral y su desarrollo en mamíferos da forma a dos mitades o hemisferios cerebrales que, en los placentarios, se encuentran conectadas por el corpus callosum, una especie de “autopista de información” por la que se estima atraviesan unos 300 millones de axones neuronales. Cada hemisferio cerebral consiste en una fina capa de materia gris (corteza o córtex cerebral) que cubre una capa gruesa interna de materia blanca (médula cerebral). En el interior de la materia blanca se encuentra otra región de materia gris, los ganglios basales. La materia gris está formada por cuerpos neuronales empaquetados, sus dendritas y células gliales. La materia blanca está formada por ramos o fascículos de axones cubiertos de vainas de mielina. El color blanco se debe a la vaina de mielina, que está formada por lípidos.

Simplificando, se puede decir que la materia gris procesa la información, o sea, integra inputs de diferentes procedencias y elabora nuevas señales, mientras que la blanca la conduce, esto es, envía las señales a otros destinos. Las fibras de la materia blanca transmiten información de una zona a otra de la corteza o, también, a zonas que no se encuentran en ella. Es así como se produce la integración que permite el procesamiento de las señales que se reciben y la consiguiente elaboración de respuestas.