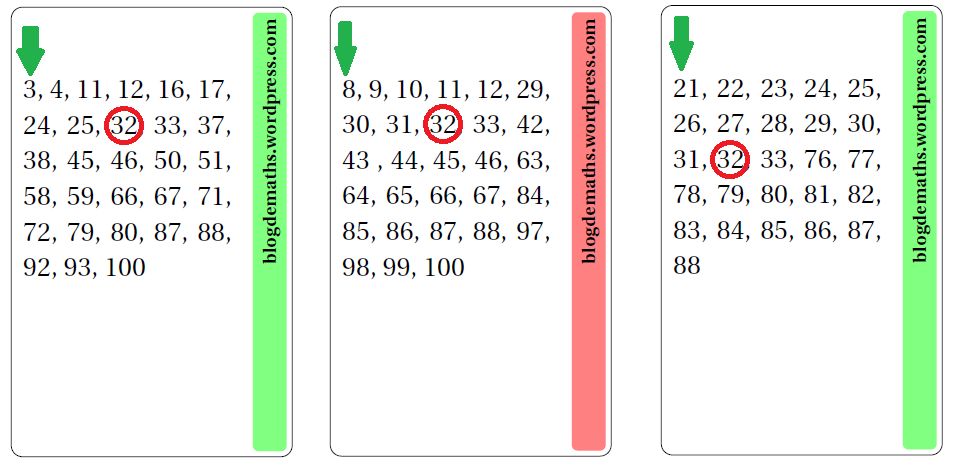

El frustrante viaje de un átomo de carbono, mención especial del jurado “On zientzia”

“El frustrante viaje de un átomo de carbono” de Julio Ruiz Monteagudo recibió la mención especial del jurado en la 7ª edición de los premios On zientzia. El ciclo del carbono puede explicarse de muchas maneras, pero pocas serán tan musicales, divertidas y didácticas como este vídeo de poco más de 4 minutos.

¿Tienes una idea genial para explicar un concepto científico en un vídeo? ¿Quieres ver tu trabajo emitido en televisión? La Fundación Elhuyar y el Donostia International Physics Center (DIPC) han organizado la octava edición de On zientzia, un concurso de divulgación científica y tecnológica enmarcado en el programa Teknopolis, de ETB. Este certamen pretende impulsar la producción de vídeos cortos y originales que ayuden a popularizar el conocimiento científico.

On zientzia tendrá tres categorías. El mejor vídeo de divulgación recibirá un premio de 3.000 euros. Para impulsar la producción de piezas en euskera, existe un premio de 2.000 euros reservado a la mejor propuesta realizada en ese idioma. Por último, con el objetivo de impulsar la participación de los estudiantes de ESO y Bachillerato, hay un premio dotado con 1.000 euros para el mejor vídeo realizado por menores de 18 años.

Los vídeos han de tener una duración inferior a los 5 minutos, se pueden realizar en euskera, castellano o inglés y el tema es libre. Deben ser contenidos originales, no comerciales, que no se hayan emitido por televisión y que no hayan resultado premiados en otros concursos. El jurado valorará la capacidad divulgativa y el interés de los vídeos más que la excelencia técnica.

Las bases las encuentras aquí. Puedes participar desde ya hasta el 25 de abril de 2018.

Edición realizada por César Tomé López

El artículo El frustrante viaje de un átomo de carbono, mención especial del jurado “On zientzia” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fallos científicos en el cine, mejor vídeo de divulgación joven “On zientzia”

- El mecanismo de la vida, mejor vídeo de divulgación joven “On zientzia”

- Soy esa bacteria que vive en tu intestino, mejor vídeo de divulgación “On zientzia”

La potencia sin control no sirve de nada

«La potencia sin control no sirve de nada». Este es el eslogan de la que, con toda probabilidad, ha sido la campaña publicitaria de neumáticos más exitosa de la historia. Fue realizada en 1995 por la agencia de publicidad Young & Rubicam para Pirelli.

Uno de los cometidos pretendidos en el diseño de automóviles es que se mantengan pegados a la carretera. Esto se logra sobre todo gracias a la aerodinámica, de manera que, al aumentar la potencia el automóvil no se separe del suelo. Podríamos decir que la aerodinámica de un automóvil sería la contraria a la de un avión.

La aerodinámica es fundamental, sobre todo en los coches deportivos y de competición, pero, no hay que olvidar la importancia de los neumáticos. Mi padre, que se dedicó durante años a la industria del neumático, siempre dice que «los neumáticos son la única parte del coche que está en contacto directo con la carretera», por eso son tan importantes. No le falta razón.

Utilizamos ruedas desde hace miles de años, pero la idea de ponerle caucho en el borde exterior es relativamente nueva. Fue a principios del siglo XIX cuando por primera vez se utilizó este polímero natural para recubrir las ruedas de madera. Antiguamente se enfundaban en cuero o metal.

El caucho se obtiene de varios tipos de plantas, pero principalmente se extrae del látex que surge de los cortes hechos del tronco de Hevea brasiliensis. En la década de 1920 los laboratorios de Bayer inventarían el caucho sintético.

El caucho natural se somete a varios procesos sucesivos como la coagulación, el lavado y el refinado. El caucho natural resulta poco elástico y se reblandece fácilmente con el calor. Se desgasta con rapidez, así que su futuro no parecía muy prometedor.

El químico Charles Goodyear dedicó varios años de su vida a investigar el caucho. En 1839 descubrió el vulcanizado, que es un procedimiento que consiste en calentar el caucho en presencia de azufre en polvo. En resultado final es que las moléculas elásticas de caucho se quedan unidas entre sí mediante puentes de azufre. De esta manera se consigue un caucho más duro y resistente sin perder elasticidad. El vulcanizado es el proceso químico que dio origen a los neumáticos que utilizamos hoy en día.

Desgraciadamente Charles Goodyear no patentó su invento. El ingeniero Thomas Hancock, habiendo llegado más tarde a la misma conclusión se hizo con la patente en 1843. Fue entonces cuando se hicieron populares las ruedas de goma maciza.

Charles Goodyear sigue estando asociado al mundo del neumático debido a que una empresa de éxito de la industria de la automoción tomó su nombre. Sin embargo, esta compañía no tiene ninguna relación con él.

Hasta entonces los neumáticos eran de color claro, por lo que se ensuciaban con facilidad y comprometían la estética. En 1885 la empresa Goodrich decidió fabricar ruedas de color negro. Al tintar el caucho se hizo un descubrimiento sorprendente, los neumáticos negros duraban más. Esto es debido a que el tinte negro absorbe los rayos ultravioletas que son, en parte, los causantes del agrietamiento del caucho.

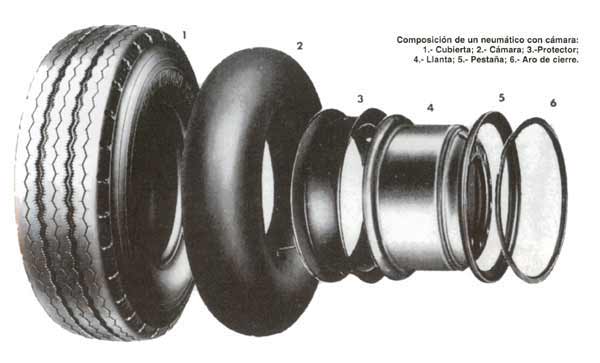

La primera rueda neumática —llena de aire— fue patentada en 1845 por el ingeniero Robert W. Thomson. Sin embargo, no fue hasta 1888 que el ingeniero John Boyd Dunlop, desarrolló el primer neumático con cámara de aire. Lo inventó para envolver las ruedas del triciclo que su hijo de nueve años usaba para ir a la escuela por las calles bacheadas de Belfast. Esas precarias cámaras de aire consistían en unos tubos de goma hinchados. Envolvió los tubos con una lona y los pegó sobre las llantas de las ruedas del triciclo. Patentó el neumático con cámara de aire en 1889. Había ganado en comodidad, aun así, al neumático le faltaban algunos obstáculos por vencer. Era muy trabajoso repararlos, ya que estaban adheridos a la llanta.

En 1891, Édouard Michelin, quien era conocido por su trabajo con el caucho vulcanizado, decidió desarrollar un neumático que pudiera separarse de la llanta y así facilitar el trabajo. Los neumáticos de Michelin resultaron tan prácticos que al año siguiente ya eran los que utilizaban la mayoría de ciclistas. Poco después también los llevarían los carruajes. En 1946, la compañía Michelin desarrolló el método de construcción de neumáticos radiales que supusieron un antes y un después en la conducción deportiva.

En los años 40 se incluyeron nuevos materiales en la composición del neumático, como el rayón, el nailon y el poliéster. Cuando terminó la segunda guerra mundial, se empezó a trabajar en la fabricación de un neumático que sellara herméticamente sobre la rueda, lo que al fin eliminó la necesidad de acompañarlos de cámara de aire. La evolución fue vertiginosa, propiciada en gran medida por la Fórmula 1. En los neumáticos modernos se utilizan más de doscientos materiales distintos, entre ellos el acero, la fibra de carbono o el kevlar. En la actualidad el caucho vulcanizado lo encontramos, sobre todo, en la superficie del neumático.

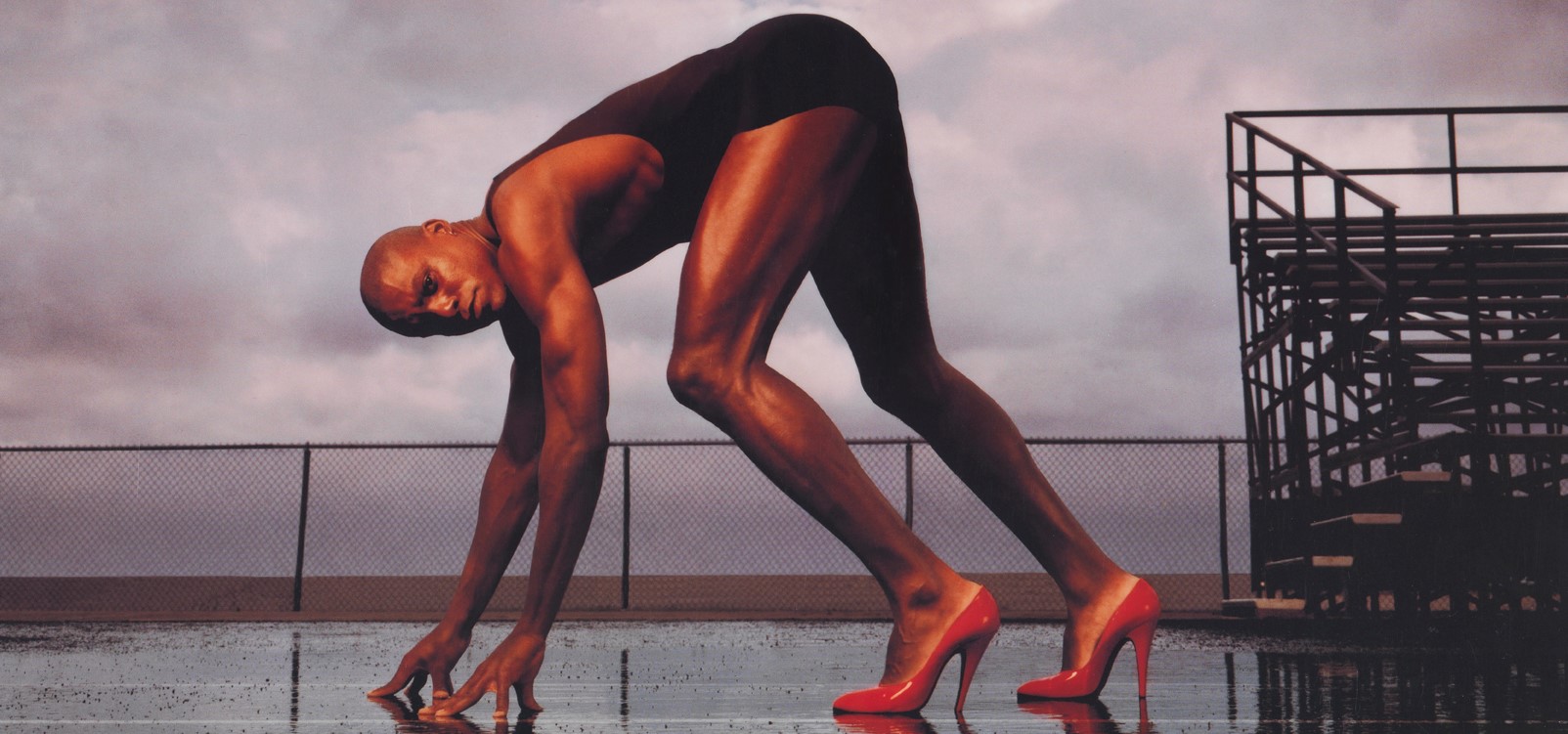

En automoción —y en otros aspectos de la vida— sigue siendo muy certero eso de que «la potencia sin control no sirve de nada». En las vallas publicitarias y en prensa, bajo este eslogan de Pirelli salía una magnífica imagen del deportista Carl Lewis con zapatos de tacón. En la versión televisiva del anuncio, la planta de sus pies estaba cubierta de caucho.

Y es que, entre otros aspectos ingenieriles, los neumáticos y en consecuencia la ciencia del caucho es fundamental para el control de la conducción. Al fin y al cabo, como dice mi padre, es la única parte del coche que está en contacto directo con el asfalto. Cuando vamos en coche los neumáticos son nuestros pies en el suelo.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo La potencia sin control no sirve de nada se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿La publicidad no sirve para nada?, ¡ja!

- Potencia y eficiencia de una máquina

- Fotovoltaicos siempre a máxima potencia

Una hiperlente que permite ver un virus en la superficie de una célula viva

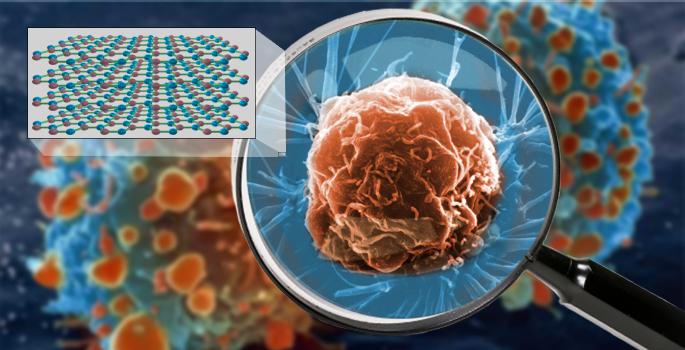

Imagina que te digo que existe una lente óptica tan potente, una hiperlente, que permite ver detalles del tamaño de un pequeño virus en la superficie de una célula viva en su entorno natural. Suena increíble, tanto más cuanto más sepas de biología o de física, pero existe realmente.

Una representación artística de una hiperlente que permite ver una célula viva con detalle. Arriba a la izquierda, la estructura cristalina del nitruro de boro hexagonal (hBN). Imagen de Keith Wood, Vanderbilt University

La ciencia y la ingeniería han desarrollado muchos instrumentos capaces de producir imágenes con resolución a nanoescala, como microscopios basados en flujos de electrones y otros llamados de fuerza atómica. Sin embargo, estos instrumentos son incompatibles con organismos vivos, ya que, o bien operan bajo un alto vacío, o exponen las muestras a niveles nocivos de radiación, o requieren técnicas letales de preparación de muestras como la liofilización o extraen las muestras de su entorno natural basado en disoluciones.

La razón principal para desarrollar las llamadas hiperlentes (lentes ópticas con una resolución mucho menor que la longitud de onda de la luz empleada) es la posibilidad de que pudiesen proporcionar imágenes detalladas de las células vivas en sus entornos naturales utilizando luz de baja energía que no las dañe. El trabajo realizado por un equipo de investigadores encabezado por Alexander Giles, del Laboratorio de Investigación Naval de los Estados Unidos, ha llevado la construcción de hiperlentes un paso más allá simplemente purificando el material a niveles que hace unas décadas eran inimaginables.

El material óptico empleado es el nitruro de boro hexagonal (hBN), un cristal natural con propiedades de hiperlente. La mejor resolución que se había conseguido previamente usando hBN fue de 36 veces más pequeña que la longitud de onda infrarroja utilizada: aproximadamente el tamaño de la bacteria más pequeña. El nuevo trabajo describe mejoras en la calidad del cristal que mejoran su capacidad en un factor de diez.

Los investigadores lograron esta mejora al fabricar cristales de hBN usando boro isotópicamente purificado. El boro natural contiene dos isótopos que difieren en peso en aproximadamente un 10 por ciento, una combinación que degrada significativamente las propiedades ópticas del cristal en el infrarrojo.

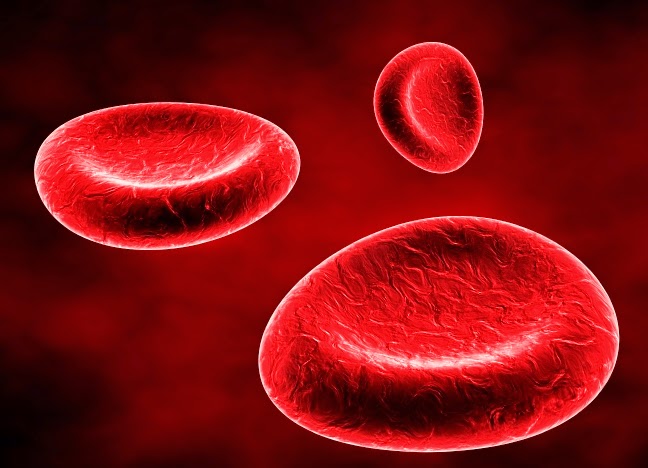

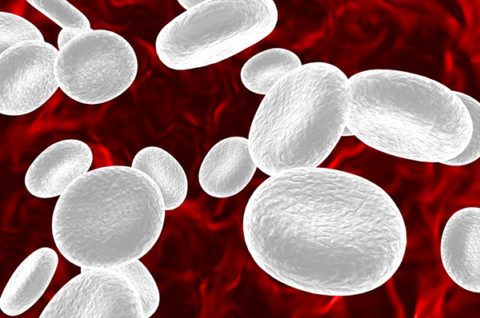

Los científicos calculan que una lente hecha de su cristal purificado puede, en principio, capturar imágenes de objetos de 30 nanómetros de tamaño. Para poner esto en perspectiva, un pelo humano tiene entre 80.000 y 100.000 nanómetros de diámetro. Un glóbulo rojo humano tiene aproximadamente 9.000 nanómetros y los virus varían de 20 a 400 nanómetros.

La física de las hiperlentes es bastante compleja. El nivel de detalle con el que los microscopios ópticos pueden generar imágenes está limitado por la longitud de onda de la luz y el índice de refracción del material de la lente. Cuando esto se combina con los factores de apertura de la lente, la distancia desde el objeto a la lente y el índice de refracción del objeto bajo observación, se traduce en un límite óptico típico de aproximadamente la mitad de la longitud de onda utilizada para la obtención de las imágenes.

En las longitudes de onda infrarrojas utilizadas en este experimento, este “límite de difracción” es de aproximadamente 3.250 nanómetros. Este límite puede superarse mediante el uso de hBN debido a su capacidad para soportar polaritones de fonones superficiales, partículas híbridas formadas por fotones de luz que se acoplan con átomos del cristal que poseen carga y vibran. Estos polaritones tienen longitudes de onda mucho más cortas que la luz incidente.

El problema con el uso de polaritones ha sido siempre la rapidez con la que se disipan. Mediante el uso de cristales de hBN hechos con un 99% de boro isotópicamente puro, los investigadores han podido comprobar que existe una reducción drástica de las pérdidas ópticas en comparación con los cristales naturales, es decir, que aumenta el tiempo de vida del polaritón, lo que les permite viajar el triple de distancia. Este mayor recorrido se traduce en una mejora significativa en la resolución de las imágenes. El análisis teórico de los investigadores sugiere que es posible incluso otro factor de mejora de diez adicional.

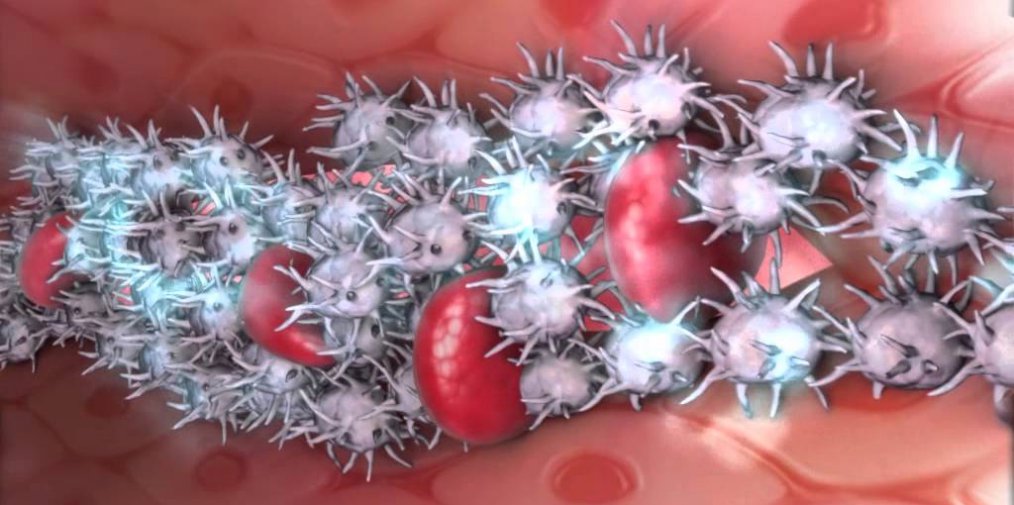

En 1654, Anton van Leeuwenhoek utilizó uno de los primeros microscopios para descubrir el mundo desconocido hasta ese momento de la vida microscópica. Este resultado en el desarrollo de hiperlentes es un paso importante para llevar el descubrimiento de van Leeuwenhoek a un nivel completamente nuevo, que permitirá a los biólogos observar directamente los procesos celulares en acción, como virus invadiendo células o células inmunes que atacan invasores extraños, abriendo innumerables posibilidades en la investigación biomédica.

Referencia:

Alexander J. Giles et al (2017) Ultralow-loss polaritons in isotopically pure boron nitride Nature Materials doi: 10.1038/nmat5047

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Una hiperlente que permite ver un virus en la superficie de una célula viva se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Otra pieza en el puzle de la fotosíntesis

- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- Estroncio en la leche

La artista Anni Albers, The Walking Dead y la teoría de nudos

Las personas que han visitado durante las últimas semanas el Museo Guggenheim de Bilbao han tenido la suerte de poder disfrutar de una exposición interesante e inspiradora, “Anni Albers, tocar la vista” (6 de octubre de 2017 – 14 de enero de 2018). Esta exposición nos acerca a la obra de la artista de origen alemán, afincada en Estados Unidos, Anni Albers (1899-1994), quien seguramente sea la artista textil más importante del siglo XX, aunque también trabajó otras técnicas como el grabado, la pintura o el diseño de joyas.

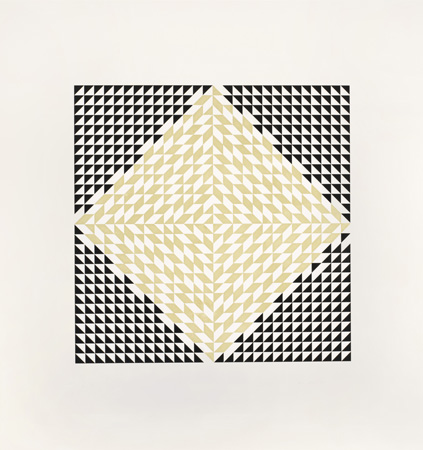

Anni Albers, “Estudio para Colgadura no realizada” (sin fecha), Gouache sobre papel, The Josef and Anni Albers Foundation

La exposición está compuesta por alfombras y colgaduras textiles, telas, diagramas geométricos, dibujos y estudios para el diseño de obras textiles, joyas, aguatintas, litografías, serigrafías e impresiones offset, acuarelas y otros tipos de pinturas, en las cuales la geometría juega un papel fundamental.

Las personas que deseen más información sobre la exposición pueden visitar la página del Museo Guggenheim-Bilbao Anni Albers, tocar la vista o ver los cuatro videos que el museo ha colgado en su canal de youtube y que están aquí.

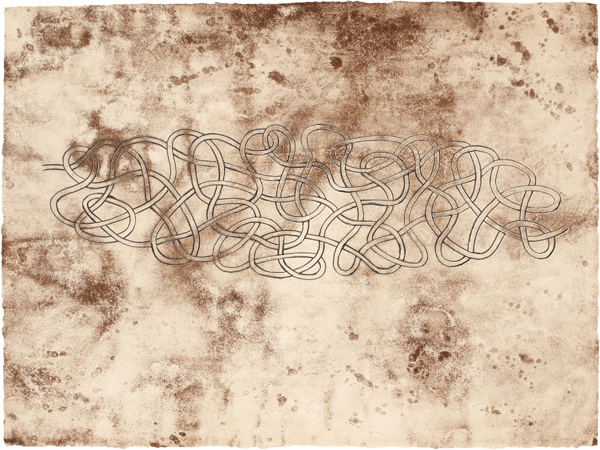

Anni Albers, “Segundo movimiento V” (1972), Aguatinta, The Josef and Anni Albers Foundation

La visita a la exposición Anni Albers, tocar la vista fue una experiencia enriquecedora. Descubrí a una artista excepcional y disfruté de unas creaciones artísticas increíbles. Tengo ganas de volver para sumergirme de nuevo en el arte de Anni Albers, y descubrir más sobre los procesos creativos, claramente conectados con las matemáticas, de esta artista. Aunque muchas de las obras de la exposición despertaron la curiosidad de mi mirada matemática, me gustaría destacar aquí la serie de obras dedicadas a los “nudos”, como su litografía Enredada (1963),

Anni Albers, “Enredada” (1963), litografía, The Josef and Anni Albers Foundation

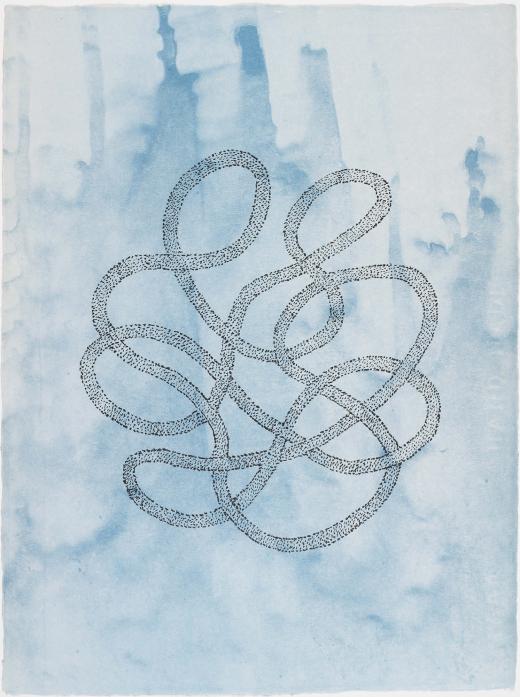

o su, también litografía, Sin título (1963),

Anni Albers, “Sin título” (1963), litografía, The Josef and Anni Albers Foundation

que rápidamente me recordaron a la teoría de nudos de las matemáticas. De hecho, esta última obra me hizo recordar la fotografía realizada por un microscopio electrónico de un fragmento anudado del ácido desoxirribonucleico, ADN, cuyo estudio es uno de los campos de aplicación de la teoría de nudos.

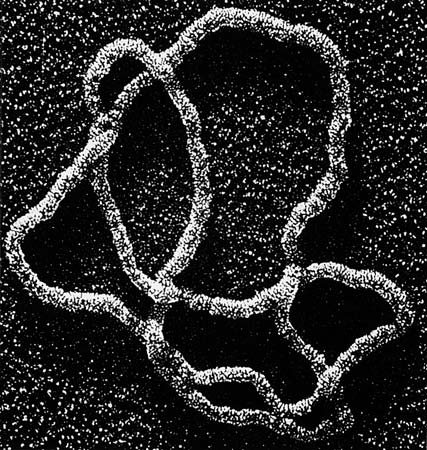

Fotografía de un fragmento de ADN anudado visto con un microscopio electrónico, realizada por Steven A. Wasserman y Nicholas R. Cozzarelli

La teoría de nudos, que ya mencionamos brevemente en la entrada del Cuaderno de Cultura Científica La topología modifica la trayectoria de los peces, es una rama de la topología que se dedica al estudio matemático de los nudos, que surgió en el siglo XX, aunque tiene sus orígenes en el siglo XIX con el trabajo de matemáticos como el alemán Carl Friedrich Gauss (1777-1855), su alumno Johann B. Listing (1808-1882) o el inglés Peter G. Tait (1831-1901). La teoría de nudos tiene numerosas e importantes aplicaciones fuera de las matemáticas, como por ejemplo en biología molecular, medicina, mecánica estadística, física de polímeros y de cristales, teoría física de cuerdas, criptografía, o ciencias de la computación.

La idea matemática de nudo es una abstracción matemática de lo que sería un nudo físico. Se coge una cuerda, se anuda de una forma más o menos enrevesada y se pegan los extremos. Desde el punto de vista matemático nos interesa la línea cerrada que describe la cuerda, sin tener en cuenta el grosor de la misma, es decir, un nudo es una línea curva anudada cerrada, que no tiene puntos de intersección, en nuestro espacio tridimensional.

Como estamos hablando de nudos en topología, esto significa que podemos deformar estirando o encogiendo la línea, es decir, la cuerda, y cambiándola de forma en el espacio, lo cual no altera el nudo, siempre que no se corte o pegue la misma. De hecho, se dice que dos nudos son equivalentes, que para nosotros es tanto como decir que “son iguales desde el punto de vista topológico”, cuando se puede deformar un nudo en el otro de forma continua, es decir, sin realizar cortes, ni pegar.

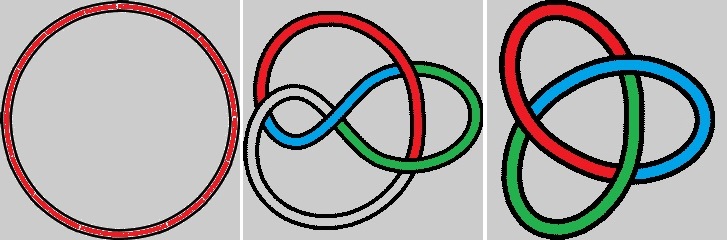

El nudo más simple es cuando cogemos la cuerda y unimos los extremos sin anudar, es decir, es la circunferencia, en la que no existe un nudo como tal, podríamos decir que es el no-nudo. Cualquier deformación espacial de la circunferencia, como en la imagen de abajo realizada con el juguete Tangle, sigue siendo el no-nudo.

Cuatro deformaciones en el espacio del nudo trivial, realizadas con el juguete Tangle, luego los cuatro nudos resultantes son equivalentes entre sí, son el mismo nudo, el no-nudo

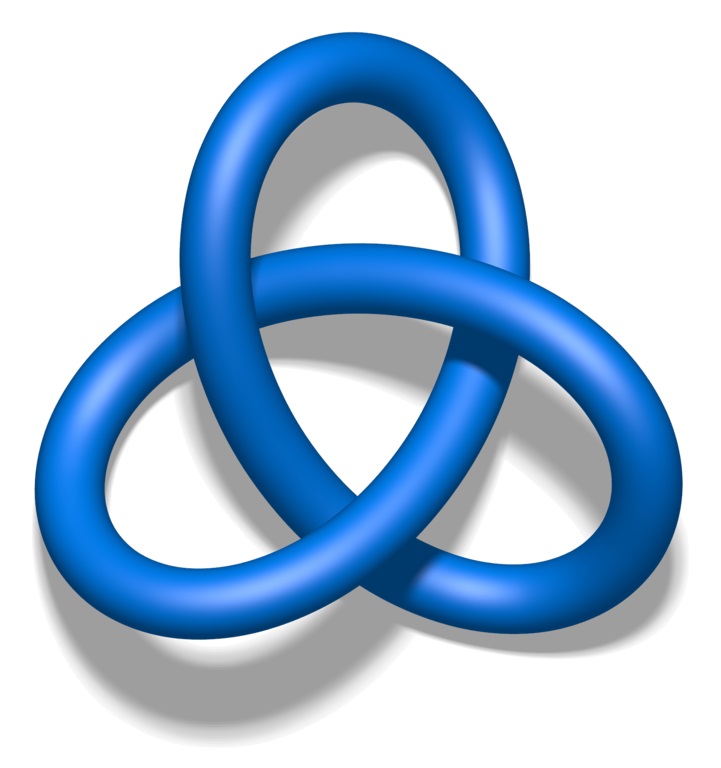

El nudo más sencillo no trivial es el nudo de trébol, que es cuando hacemos un nudo sencillo a la cuerda y después anudamos los extremos. Es imposible deformarlo al nudo trivial sin cortar la cuerda y volver a pegarla, luego topológicamente el no-nudo y el nudo de trébol no son el mismo, no son equivalentes.

Nudo de trébol en el espacio tridimensional. Jim Belk, de wikimedia

El nudo de trébol es un símbolo muy común desde la antigüedad, ya que su versión plana es la triqueta, o triquel, que fue ampliamente utilizada, por ejemplo, en el arte celta, en la religión cristina, como símbolo de la trinidad (padre, hijo y espíritu santo), en una de las versiones del Valnout alemán, que se relaciona con el dios Odín, o en el Mjolnir, martillo del dios Thor de la mitología nórdica. Y hoy en día nos la encontramos con mucha frecuencia en la cultura popular, por ejemplo, en la katana de Michonne de la serie de TV Walking Dead, así como en muchas otras series, películas o video juegos.

La katana de Michonne, de la serie The Walking Dead, tiene el símbolo de la triqueta, que es el nudo de trébol

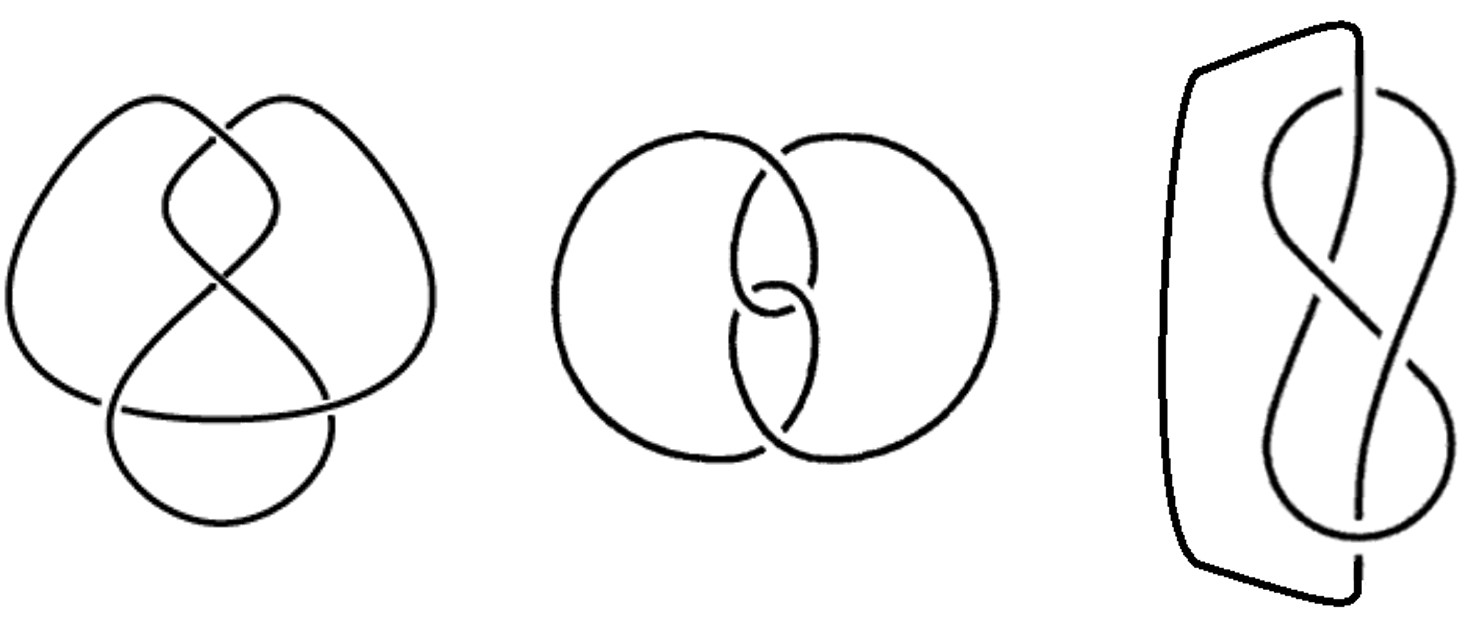

Para estudiar los nudos se utilizan representaciones gráficas planas de los mismos, que son proyecciones sobre el plano de los nudos tridimensionales, como si les hiciéramos una fotografía. Se utilizan solo las proyecciones buenas, las llamadas regulares, en las que solamente hay un número finito de puntos dobles (cruces) como puntos singulares. En las proyecciones no regulares perderíamos parte de la información del nudo. Estas representaciones se llaman diagramas del nudo. Son líneas continuas en el plano, que solo se pintan discontinuas cuando esa parte del nudo pasa por debajo de la que ya está pintada, como se muestra en los siguientes ejemplos. También podemos pensar en los diagramas de los nudos, como la representación de un nudo, como cuerda anudada, que apoyamos en una superficie plana.

Tres diagramas diferentes del nudo de Saboya, o nudo del ocho

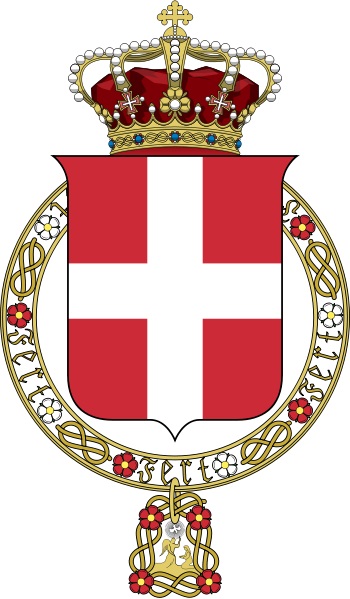

El nudo de Saboya, o nudo del ocho, que aparece en la anterior imagen, es un nudo cuyo diagrama tiene cuatro cruces, el diagrama del trébol tenía solamente tres, y se llama así porque aparece en el escudo de armas de la Casa de Saboya.

Escudo de armas de la Casa de Saboya con distintas copias del diagrama del nudo de ocho, o de Saboya

A continuación, mostramos el diagrama del nudo de la obra Sin título (1963), de Anni Albers.

La teoría de nudos estudia las propiedades topológicas de los nudos, en particular, el problema más importante es la clasificación de los diferentes nudos que existen, el cual incluye el problema de reconocimiento, es decir, determinar cuándo dos nudos son equivalentes, para lo cual se desarrollan herramientas matemáticas que nos permitan saber cuándo dos nudos son, o no, equivalentes (el mismo desde el punto de vista topológico).

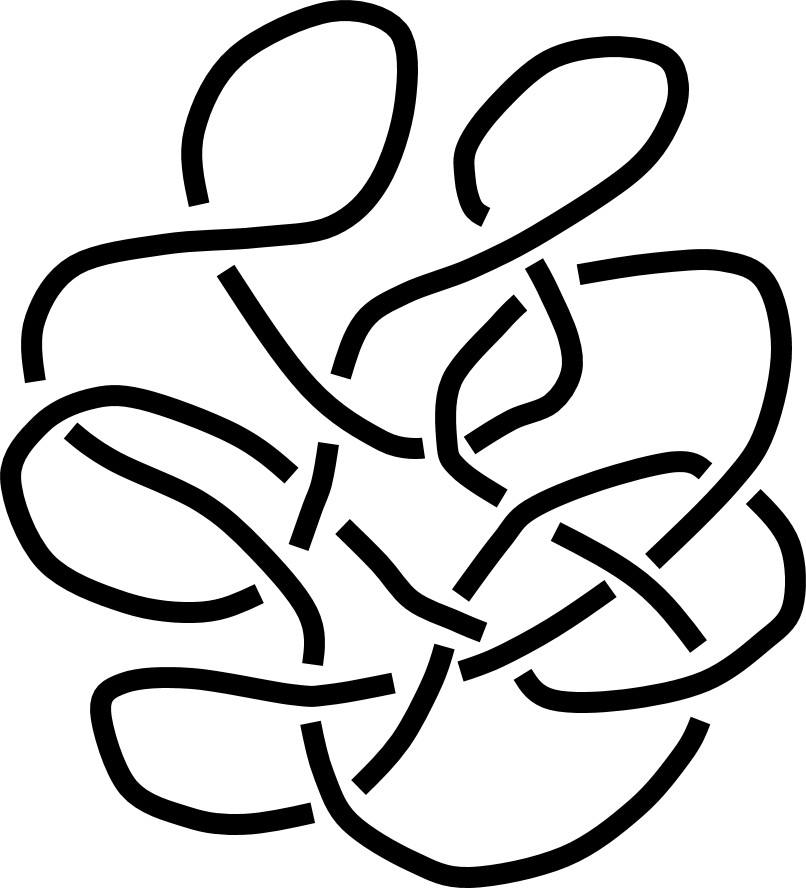

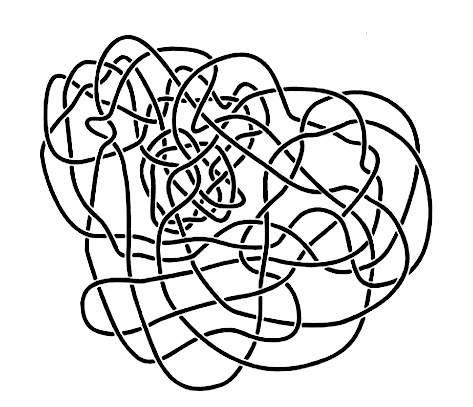

En particular, deberemos de estudiar cuando dos diagramas corresponden a nudos equivalentes. Por ejemplo, nos podemos preguntar si un diagrama complejo como el que aparece en la imagen de abajo, y que se conoce como nudo gordiano de Haken, es topológicamente equivalente al no-nudo, es decir, que no hay nudo, solamente está enmarañado. El propio matemático alemán Wolfgang Haken, conocido por demostrar junto al matemático estadounidense Kenneth Appel el teorema de los cuatro colores, demostró que efectivamente dicho nudo es equivalente al no-nudo.

Nudo gordiano de Haken

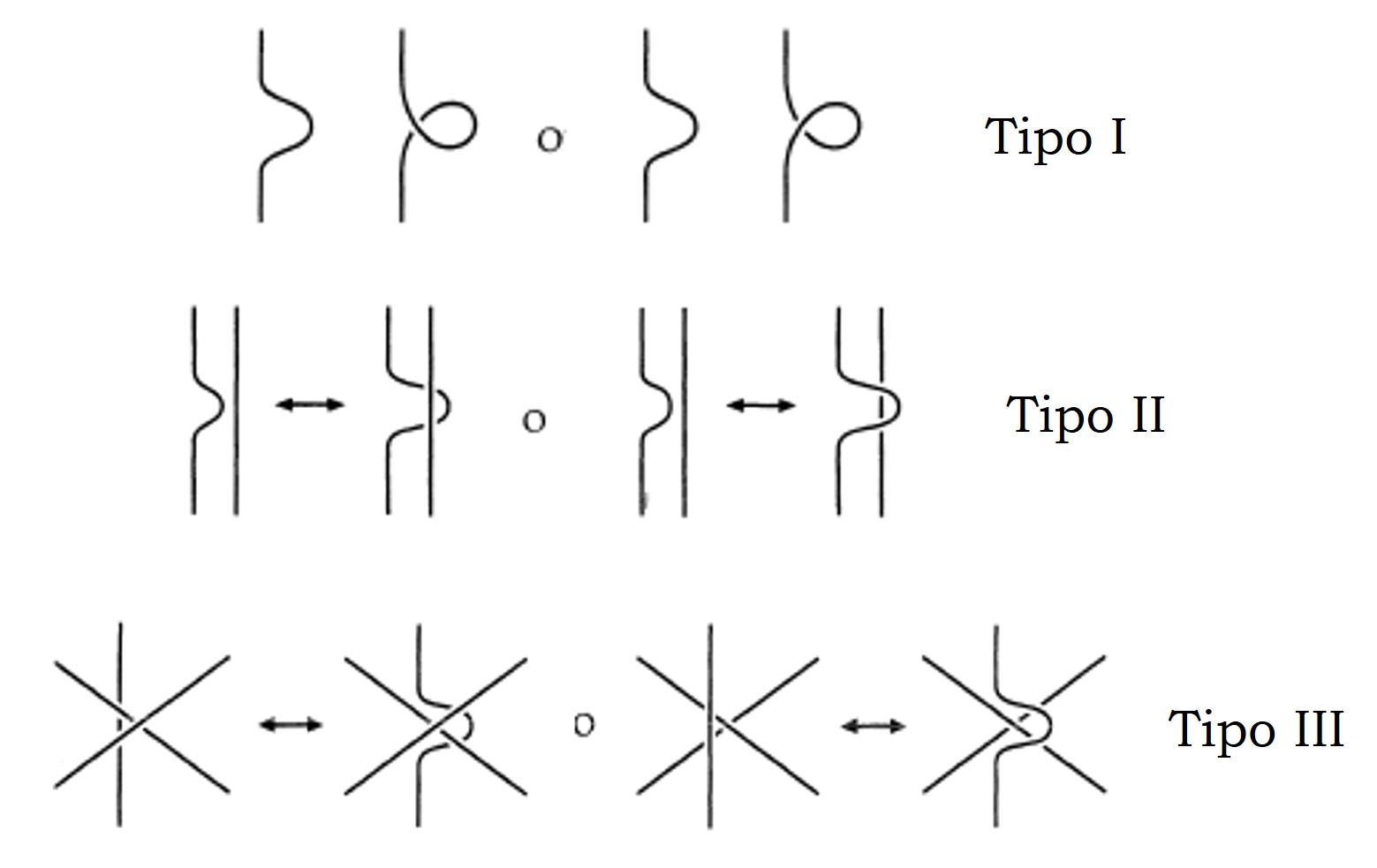

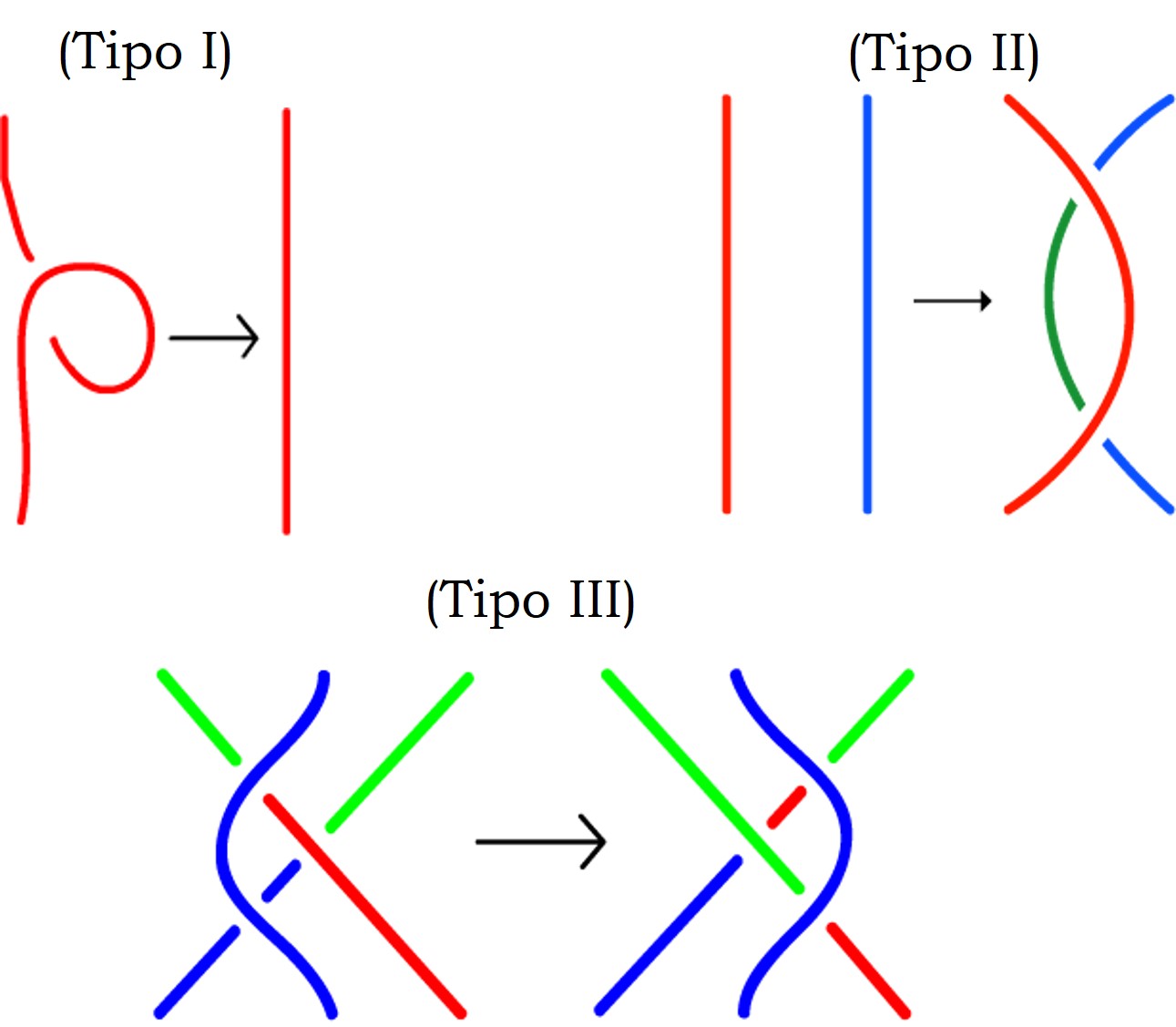

En la década de 1920, que fueron los inicios de la teoría de nudos, el matemático alemán Kurt Reidemeister (1893-1971), dio una primera herramienta para determinar cuándo dos diagramas correspondían a nudos equivalentes. Demostró que:

“Dos diagramas representan nudos equivalentes si, y sólo si, se puede pasar de uno a otro mediante un número finito de transformaciones del tipo I, II y III (que se muestran a continuación).”

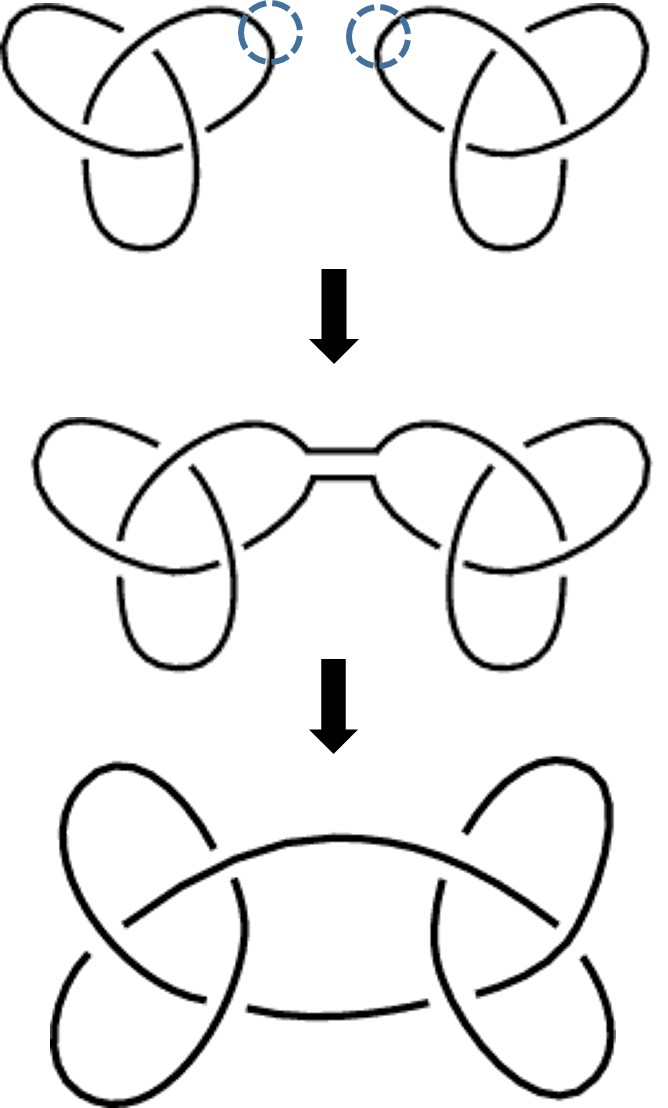

Transformaciones de Reidemeister de tipo I, II y III de los diagramas de nudos

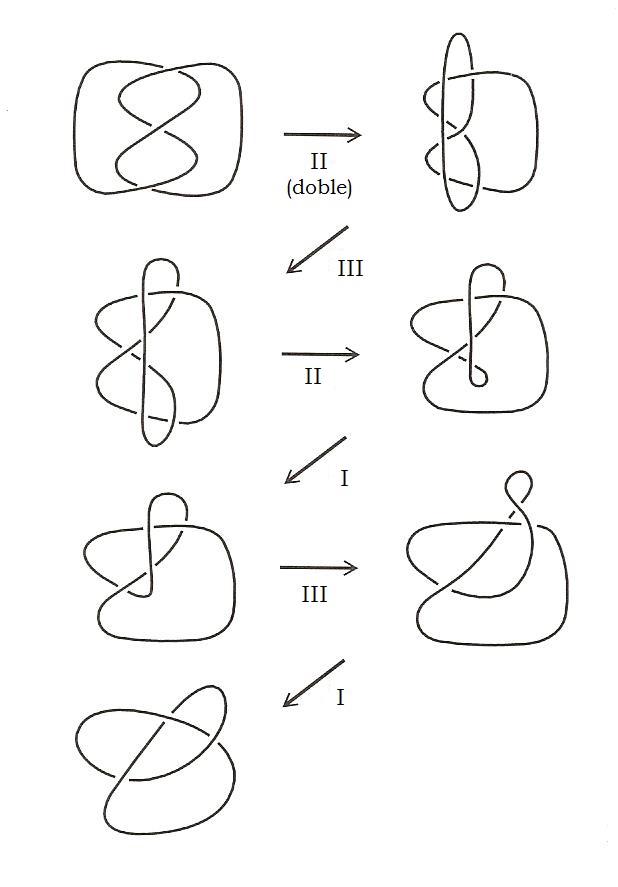

A continuación, vemos un nudo con tres cruces que es equivalente al nudo de trébol, puesto que mediante una serie de movimientos de Reidemeister puede transformarse uno en otro, como se muestra en la siguiente imagen.

Los movimientos de Reidemeister transforman el diagrama con tres cruces inicial en el diagrama del nudo de trébol, luego ambos son equivalentes, corresponden al mismo nudo topológico

Existe un tipo especial de nudos, aquellos que son equivalentes a su imagen especular. Se llaman nudos anfiquirales. La imagen especular de un nudo es aquella que se obtiene como reflejo en un espejo, es decir, es el nudo simétrico respecto a un plano del espacio. Dado el diagrama de un nudo, entonces el diagrama del nudo imagen especular del primero es igual salvo que tiene los cruces dados la vuelta, es decir, la línea continua se convierte en discontinua, y la discontinua en continua.

El nudo de Saboya es un nudo anfiquiral, como se muestra en la siguiente imagen, mientras que el nudo de trébol puede demostrarse que no es anfiquiral.

Otra división importante de los nudos de cara a su estudio y clasificación es en nudos primos y nudos compuestos. La idea es descomponer los nudos en otros más simples, los llamados nudos primos, que son los que no se pueden descomponer en otros más simples aún y a partir de los cuales se generan todos los demás, y entonces centrar el estudio general de los nudos en estos.

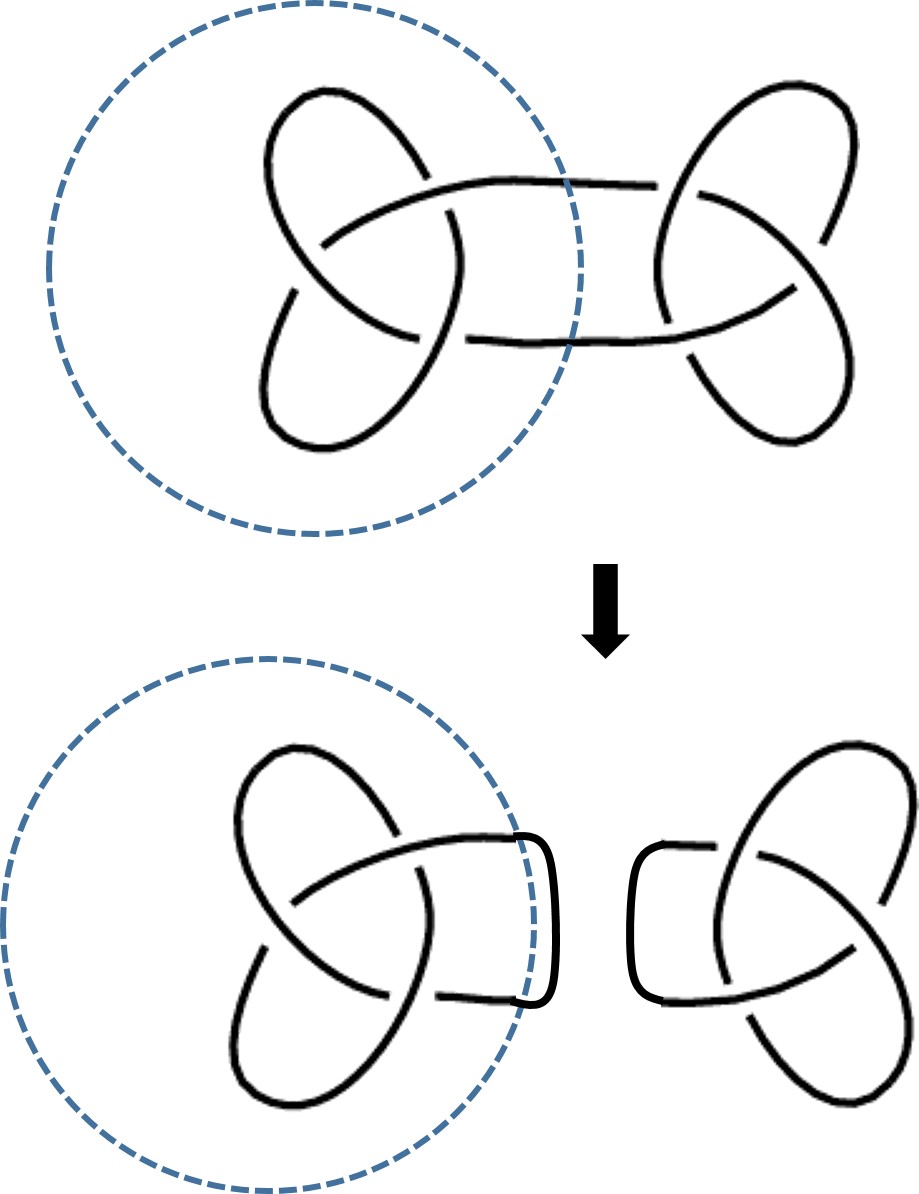

Por lo tanto, tenemos dos “operaciones” con nudos, que son una inversa de la otra, la descomposición y la suma conexa. Un nudo se descompone mediante una esfera (en el diagrama plano sería una circunferencia) que corta transversalmente al nudo en dos puntos, por los que se corta el nudo generándose dos partes disjuntas, cada una de las cuales se cierra de nuevo al pegar los dos puntos extremos mediante un segmento, generándose así dos nudos. Un nudo es primo si no se puede descomponer en dos nudos no triviales.

Descomposición del conocido como nudo de la abuela en dos copias del nudo de trébol

Cualquier nudo no primo se obtiene mediante la operación inversa a la anterior, la suma conexa, a partir de un número finito de nudos primos. En la imagen siguiente vemos la suma conexa del nudo de trébol y de su imagen especular, que es el nudo de rizo o nudo cuadrado.

Suma conexa del nudo de trébol y su imagen especular, que es el nudo de rizo, o nudo cuadrado

El nudo de la abuela, que es la suma conexa de dos copias del nudo de trébol, es un nudo no anfiquiral, mientras que el nudo de rizo, que es la suma conexa del nudo de trébol y su imagen especular, sí es anfiquiral. En consecuencia, ambos nudos no son equivalentes.

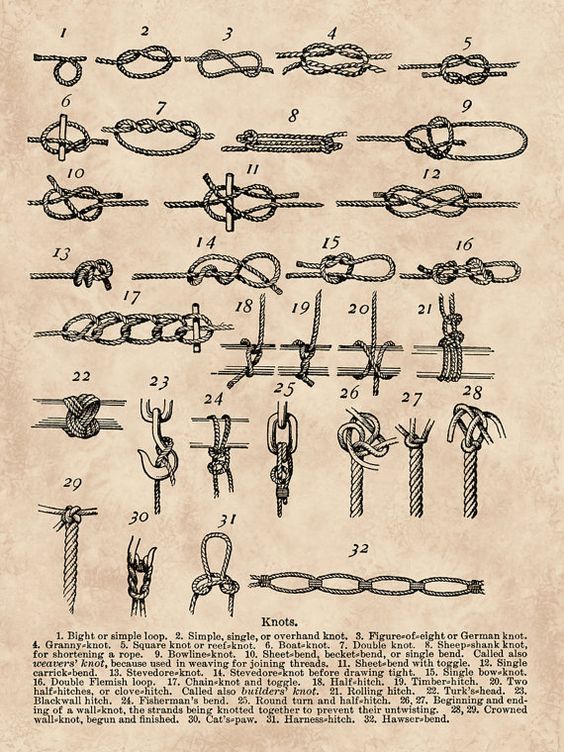

Algunos de los nombres de los nudos matemáticos, como el nudo del ocho, el nudo de la abuela, el nudo de rizo, el nudo del cirujano o el nudo del amor verdadero, entre otros, derivan de los nombres de los nudos físicos, los nudos utilizados en la navegación y en muchas otras actividades de nuestra sociedad, como la escalada, la medicina, la costura o la decoración, desde la antigüedad.

Según el diccionario de la RAE, un nudo (físico) es un “lazo que se estrecha y cierra de modo que con dificultad se pueda soltar por sí solo, y que cuanto más se tira de cualquiera de los dos cabos, más se aprieta”. En matemáticas, para estudiar cómo de anudado está un nudo se unen los dos cabos del mismo, cerrando el nudo y no dejando que se pueda deshacer.

Poster de estilo vintage con nudos marineros, entre los que están el nudo simple (2), que da lugar al nudo de trébol, el nudo de ocho (3), el nudo de la abuela (4), el nudo de rizo o cuadrado (5) o el nudo doble (7), relacionado con el nudo del cirujano

Pero continuemos con el estudio topológico de los nudos. Con el fin de resolver el problema de la clasificación de los nudos se introducen invariantes de los mismos. Los invariantes son objetos (por ejemplo, un número, un polinomio o un grupo) o propiedades (como la tricoloreabilidad) de un nudo, que tienen el mismo valor para todos los nudos equivalentes. En consecuencia, si un invariante es distinto para dos nudos, estos no pueden ser equivalentes.

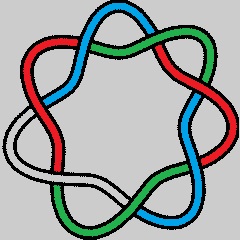

Un primer ejemplo de invariante sería el “mínimo número de cruces de un nudo”. Consideremos un nudo N, se define el mínimo número de cruces c(N) del nudo N, como el menor número de cruces que puede tener un diagrama D de N, es decir, si denotamos por c(D) el número de cruces de un diagrama D, sería el mínimo valor de c(D), para todos los diagramas D del nudo N.

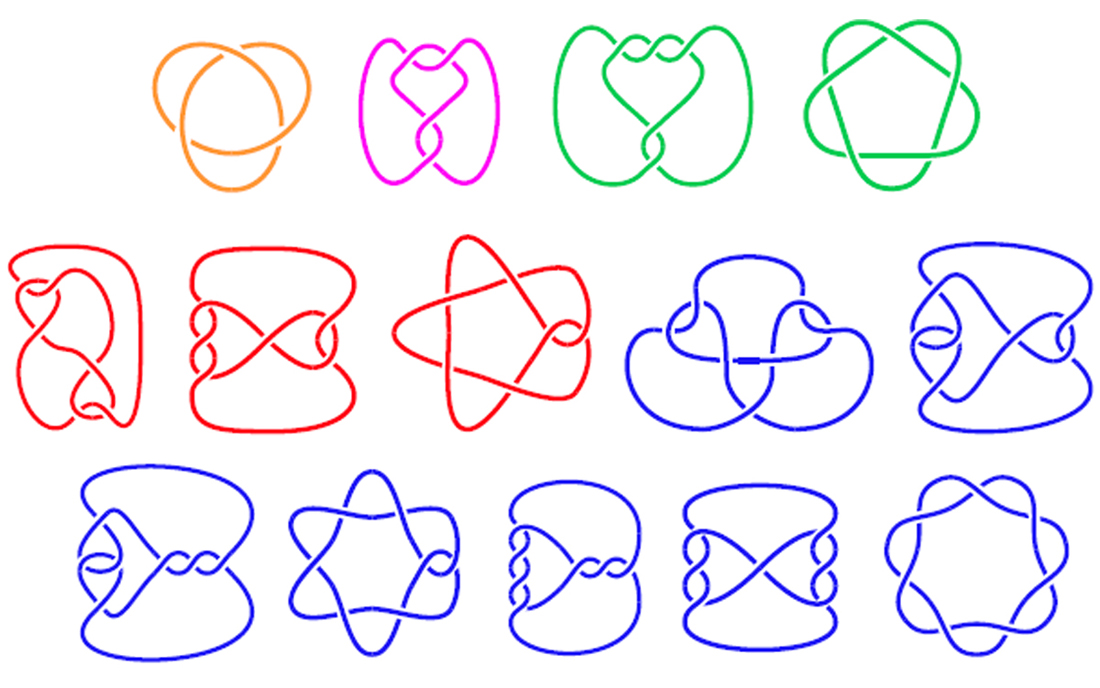

Si c(N) = 0, entonces N es el nudo trivial. No existen nudos para los cuales el mínimo número de cruces sea 1 o 2, cualquier diagrama que dibujemos con 1 o 2 cruces se puede transformar mediante movimientos de Reidemeister en el no-nudo. Los únicos nudos con c(N) = 3 son el nudo de trébol, y su imagen especular, mientras que el único con c(N) = 4 es el nudo de Saboya.

La primera clasificación de los nudos la realizó el matemático inglés Peter G. Tait en 1846, sin las herramientas aún de la topología, e incluía todos los nudos primos con mínimo número de cruces menor o igual que 7, que son el no-nudo y los 14 que aparecen en la imagen de abajo (obsérvese que en dicha clasificación no se está distinguiendo entre un nudo y su imagen especular).

Clasificación de los nudos con mínimo número de cruces menor o igual que 7. Cada color se corresponde con los nudos con el mismo número mínimo de cruces, desde 3 hasta 7

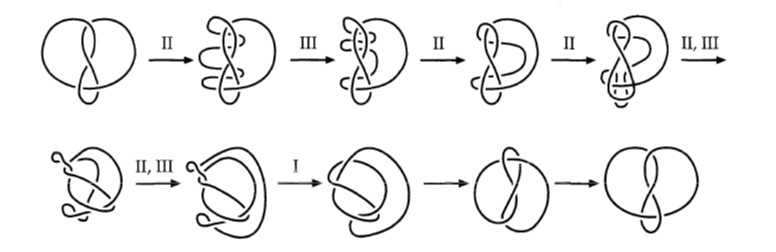

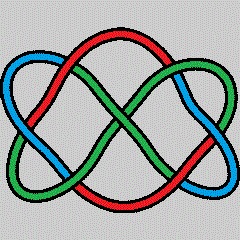

Un invariante sencillo, que nos permitirá distinguir entre algunos nudos que no son equivalentes, es la tricoloreabilidad. Un diagrama se dice que es tricoloreable si, dado un conjunto de tres colores, se puede asignar un color a cada arco del diagrama de forma que: i) se utilizan al menos dos de los tres colores; ii) si en un cruce aparecen dos de los colores, entonces también aparece el tercero.

Se puede demostrar fácilmente que la coloreabilidad no varía con los tres tipos de movimientos de Reidemeister, por lo que, si un diagrama es tricoloreable, lo es cualquier otro equivalente. Es decir, si un diagrama es tricoloreable y otro no, entonces se corresponden con nudos no equivalentes.

La tricoloreabilidad no varía con los tres movimientos de Reidemeister

El no-nudo es trivialmente no tricoloreable, ya que no se puede utilizar más de un color, el nudo de trébol sí es tricoloreable y el nudo de Saboya no.

Veamos un ejemplo de cómo distinguir nudos, con el mismo número mínimo de cruces, mediante la tricoloreabilidad. Los nudos 71 y 74, que podemos ver en la clasificación anterior (el primero y cuarto de los nudos con mínimo número de cruces 7), y que tienen mínimo número de cruces, no son equivalentes, ya que 71 no es tricoloreable, mientras que 74 sí lo es.

Claramente el nudo 71 no es tricoloreable, puesto que, si pintamos uno de los segmentos de un color, por ejemplo, rojo, solo pueden ocurrir dos cosas, o todos los demás son también rojos, con lo cual no se utilizan al menos dos colores, o los colores de los demás segmentos quedan determinados y al llegar de nuevo al segmento rojo inicial habrá tres cruces cada uno con dos colores y por cada color elegido para el segmento que falta por marcar se obtienen dos cruces con solo dos colores, como se muestra en la siguiente imagen.

El nudo 71 no es tricoloreable

Mientras que el nudo 74, que es un nudo celta y también el nudo infinito del Budismo, es tricoloreable, como se muestra en la siguiente imagen.

El nudo 74 es tricoloreable

Continuará en mi siguiente entrega de la sección Matemoción del Cuaderno de Cultura Científica…

…CONTINUARÁ…

Colgante con el nudo infinito del budismo

Bibliografía

1.- Museo Guggenheim-Bilbao, Anni Albers, tocar la vista, 6 de octubre de 2017 – 14 de enero de 2018.[]

2.- The Josef and Anni Albers Foundation

3.- Canal de youtube del Museo Guggenheim-Bilbao, Anni Albers, Tocar el viento.

4.- Raúl Ibáñez, La topología modifica la trayectoria de los peces, Cuaderno de Cultura Científica, 2016.

5.- María Teresa Lozano, La teoría de nudos en el siglo XX, Un Paseo por la Geometría 1998/99, Departamento de Matemáticas, UPV/EHU, 1999. Versión on-line en divulgamat

6.- Sergio Ardanza Trevijano, Excursiones matemáticas en biología, Un Paseo por la Geometría 2005/06, Departamento de Matemáticas, UPV/EHU, 2006. Versión on-line en divulgamat

7.- Martín Gardner, Huevos, nudos y otras mistificaciones matemáticas, Gedisa, 2002.

8.- Colin C. Adams, The Knot Book, An Elementary Introduction to the Mathematical Theory of Knots, AMS, 2001.

9.- Stephan C. Carlson, Topology of Surfaces, Knots, and Manifolds, John Wiley and Sons, 2001.

10.- The Knot Atlas

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La artista Anni Albers, The Walking Dead y la teoría de nudos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría de grafos y “Così Fan Tutte”

- Arthur Cayley, la teoría de grafos y los isómeros químicos

- El quipu: ¿algo más que un registro numérico?

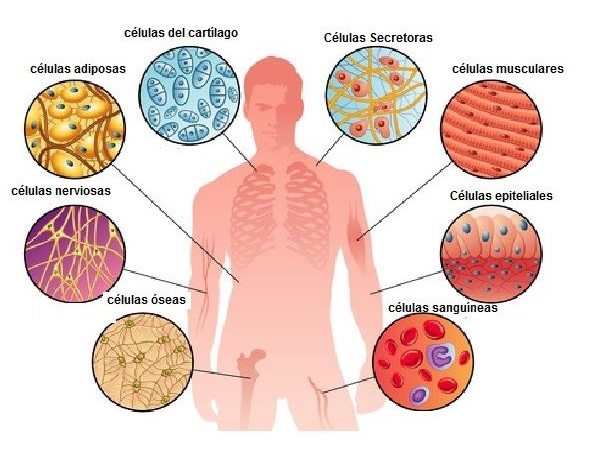

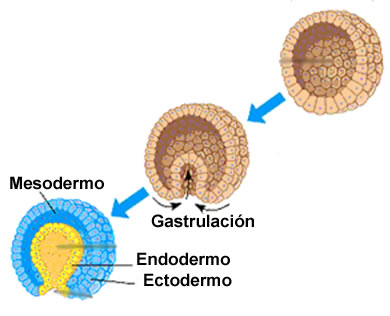

Los tipos celulares humanos y su origen embrionario

El desarrollo embrionario comienza en los animales con la división del óvulo fecundado y las sucesivas subdivisiones posteriores. En las esponjas, tras la quinta subdivisión se forma una larva ovoide de 32 células, a partir de la cual se desarrolla el individuo adulto. En el resto de animales, tras la séptima subdivisión el embrión está formado por 128 células que se disponen en una capa y adopta forma esférica. Ese estado se denomina blástula, y en su interior hay una cavidad denominada blastocele que está llena de líquido o de vitelo.

A continuación se produce la gastrulación; algunas células migran hacia el interior y se disponen en dos capas, de manera que el embrión adopta la forma de un recipiente aproximadamente esférico que delimita una cavidad llena de líquido con una apertura al exterior. Esa configuración se denomina gástrula. Su capa externa es el ectodermo y la interna el endodermo. Los animales diblásticos -cnidarios y ctenóforos- retienen ese esquema básico a partir del cual desarrollan sus estructuras. En los más simples -los cnidarios- el ectodermo da lugar a la epidermis y el endodermo a la gastrodermis, y aunque tienen diversos tipos celulares, esas capas pueden considerarse sus únicos tejidos. En rigor no se puede decir que tengan órganos. En los embriones del resto de animales se desarrolla una tercera capa a partir del endodermo que se dispone entre las otras dos: el mesodermo. Cada una de esas tres capas da lugar a un conjunto de tipos celulares. Se presenta a continuación un breve repaso de los grandes grupos de tipos celulares en la especie humana en función de su origen embrionario.

A partir del endodermo surgen las células secretoras epiteliales de las glándulas exocrinas, que son las que vierten sus productos al exterior o a algunos órganos del sistema digestivo. Son veintisiete tipos celulares. Entre ellas se encuentran las células de las glándulas salivares, glándulas lacrimales, glándulas sudoríparas, próstata, glándulas de Bartholí, y también de glándulas del estómago, como las que producen pepsinógeno o ácido clorhídrico. Origen endodérmico tienen también los treinta y seis tipos celulares que producen hormonas (endocrinas). A este grupo pertenecen, entre otras, las de la pituitaria anterior, un buen número de células propias de los tractos respiratorio e intestinal, de las glándulas tiroides, paratiroides y adrenal, o de los islotes de Langerhans del páncreas.

Del ectodermo derivan principalmente células del tegumento y del sistema nervioso. Hay quince tipos celulares del sistema tegumentario; la mayoría de ellas son células epiteliales queratinizantes. Las del sistema nervioso son mucho más numerosas. Están, por un lado, las transductoras -convierten información sensorial en potenciales eléctricos de membrana-; son dieciséis, aunque si se consideran los cuatro tipos de células fotorreceptoras, habría que contar diecinueve. Por otro lado, tenemos las células del sistema nervioso autónomo, colinérgicas, adrenérgicas y peptidérgicas, con varios tipos celulares dentro de cada categoría. Otros doce tipos corresponden a células que dan soporte a sistemas receptores o a neuronas del sistema periférico. Y por supuesto, a este gran grupo pertenecen las neuronas y células gliales del sistema nervioso central; en esta categoría hay una gran variedad de células de difícil clasificación, pero su número podría rondar los veinticinco. Y para terminar con este grupo, habría que considerar los dos tipos celulares del cristalino.

Finalmente, están las células que derivan del mesodermo. De ese origen son los tres tipos celulares que almacenan grasas (los dos adipocitos y el lipocito del hígado). También lo son los que desempeñan funciones de barrera en el riñón (siete) y en otros órganos (doce). Hay veintiún tipos cuya función es producir matrices de material extracelular. También derivan del mesodermo las células contráctiles (más de una docena) y las de la sangre y del sistema inmunitario (más de veinte). Y para terminar hay ocho tipos celulares de origen mesodérmico que son germinales o que proporcionan soporte y nutrientes a las células germinales.

A la hora de valorar esta información ha de tenerse en cuenta que no todos los especialistas dan por buenas ciertas distinciones entre unos tipos celulares y otros, y que en algunos casos, las categorías no están del todo claras o se encuentran en revisión permanente. Las células nerviosas, por ejemplo, tienen especial dificultad.

A modo de resumen, se puede decir que hay más de sesenta tipos celulares de procedencia endodérmica, más de setenta de procedencia ectodérmica y más de ochenta de procedencia mesodérmica. En conjunto, los seres humanos tenemos más de doscientos veinte tipos celulares. Es muy posible que esa cifra sea muy similar en el resto de primates y, hasta donde sabemos, ningún otro grupo animal hay tal diversidad celular. En otras palabras, en ningún otro grupo hay tal diversificación de funciones o, utilizando una expresión más propia de otras disciplinas, tanta división del trabajo. Hay autores que consideran la diversidad de tipos celulares como un buen indicador de complejidad, por lo que de acuerdo con esa idea, los seres humanos seríamos los animales más complejos. No sé si esa consideración es adecuada, pero si aceptamos que la división del trabajo proporciona una mayor eficacia, quizás si podamos decir que somos la especia con mayor eficacia biológica.

Fuente: List of distinct cell types in the adult human body

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Los tipos celulares humanos y su origen embrionario se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historia mínima de la complejidad animal

- A mayor tamaño, mayor complejidad

- Sistemas nerviosos: el sistema periférico de vertebrados

El principio de relatividad (y 4): la versión de Einstein

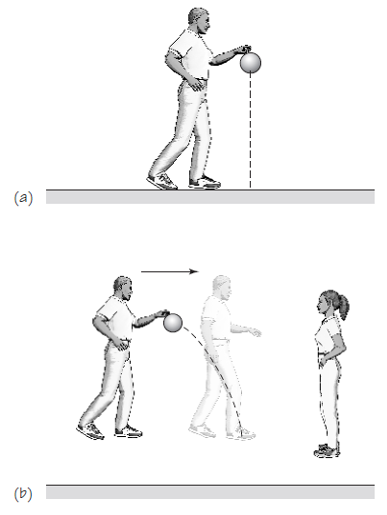

Montaje experimental para la comprobación del principio de relatividad de Einstein en un hotel.

Al formular su propia teoría de la invariancia [1], Einstein lo que va a hacer es ampliar la invariancia de Galileo afirmando que el principio de relatividad debe aplicar a todas las leyes de la física, como las leyes que rigen la luz y otros efectos del electromagnetismo, no solo a la mecánica. Einstein usó este principio como uno de los dos postulados de su teoría, de la cual luego derivó las consecuencias por deducción.

El principio de relatividad de Einstein podría expresarse de la siguiente manera:

Todas las leyes de la física son exactamente las mismas [2] para cada observador en cada marco de referencia que está en reposo o moviéndose con una velocidad relativa uniforme. Esto significa que no hay ningún experimento que se pueda realizar dentro de un marco de referencia que revele si éste está en reposo o moviéndose a una velocidad uniforme.

Como vemos esto no es más que el principio de relatividad de Galileo en el que se ha sustituido “las leyes de la mecánica” por “todas las leyes de la física”.

Como decir repetidamente “marcos de referencia que están en reposo o en velocidad uniforme en relación con otro marco de referencia” es bastante prolijo, los físicos le dan un nombre a este concepto, marcos de referencia inerciales, ya que la ley de inercia de Newton se cumple en ellos. Los marcos de referencia que se aceleran respecto a otros se denominan marcos de referencia no inerciales.

Los marcos de referencia no inerciales no están incluidos en la parte de la teoría de la invariancia que estamos tratando; debido a esta limitación a esta parte de la teoría se la conoce popularmente como teoría de la relatividad especial. Está restringida pues a marcos de referencia inerciales, aquellos que están en reposo o se mueven con una velocidad uniforme relativa entre sí.

Si nos fijamos, según el principio de relatividad en la versión de Einstein, las leyes del movimiento de Newton y todas las otras leyes de la física siguen siendo las mismas para los fenómenos que ocurren en cualquier marco de referencia inercial. Este principio no dice en absoluto que “todo es relativo”. Por el contrario, demanda que busquemos las relaciones que no cambian cuando pasamos nuestra atención de un marco de referencia en movimiento a otro. Las mediciones físicas, pero no las leyes físicas [2], dependen del marco de referencia del observador.

El principio de relatividad es, como decíamos antes, uno de los dos postulados a partir de los cuales Einstein derivó las consecuencias de la teoría de la invariancia. El otro postulado se refiere a la velocidad de la luz, y es especialmente importante cuando se comparan las observaciones entre dos marcos de referencia inerciales en movimiento relativo, ya que dependemos principalmente de la luz para hacer observaciones. Trataremos de él en nuestra próxima entrega de la serie.

Notas:

[1] Popularmente conocida como teoría de la relatividad.

[2] Por eso Einstein se refería a su teoría como teoría de la invariancia, porque las leyes no varían.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El principio de relatividad (y 4): la versión de Einstein se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de relatividad (2): la versión de Galileo

- El principio de relatividad (3): la invariancia de Galileo

- El principio de relatividad (1): movimiento relativo

La reacción de las madres al llanto de los bebés es universal

Los bebés humanos no se diferencian demasiado de los bebés de otras especie de mamíferos al señalar estados de malestar mediante vocalizaciones que expresan disgusto. Esas situaciones pueden ser la separación de la cría de la madre, el hambre o el malestar físico por algún golpe o enfermedad. Los bebés lloran, pero otras crías de corta edad emiten sonidos equivalentes. De la misma forma, las madres de las especies de mamíferos suelen responder a esos llantos o vocalizaciones recogiendo a la cría, estableciendo alguna forma de contacto físico o comunicándose con ella; a veces también defendiéndola de posibles depredadores o alimentándola. Y en ocasiones son las madres de otros bebés u otras cuidadoras las que reaccionan, mostrando incluso fuertes respuestas emocionales. Esto se ha observado, además de en humanos, en marmotas, focas, gatos, murciélagos, y otras especies.

Dada la gran dependencia de las crías humanas de la atención y cuidado de los adultos, y la larga historia de tal dependencia, no es de extrañar que algunos mecanismos de la respuesta de estos a las crías sean automáticos y se hallen, de alguna forma, impresos en sus sistemas nerviosos. Así, algunas reacciones del sistema nervioso autónomo y del sistema nervioso central de los padres a las caras de los bebés difieren de las respuestas a las caras de los adultos. Pero igualmente podría ocurrir que haya respuestas que varíen en función de factores culturales.

Una investigación reciente ha aportado elementos de interés para valorar en qué medida las respuestas de las madres humanas al llanto de sus bebés son universales o varían de unas culturas a otras. El resultado más sobresaliente de esa investigación es que las madres primíparas (primerizas) responden al llanto de sus criaturas de forma similar, con independencia de sus orígenes culturales1. Todas ellas cogen al bebé en sus brazos y le hablan, pero no tratan de distraerlo, de mostrarles cariño de forma explícita, ni les dan de mamar en esas circunstancias, como hacen las de otras especies de mamíferos. Tanto las madres primerizas al oír llorar a sus criaturas, como otras más experimentadas al oír a otros bebés, muestran patrones comunes de actividad encefálica: se activan el área motora suplementaria -área de la corteza cerebral implicada en la programación, generación y control de acciones motoras y secuencias de habla-, así como las regiones temporales superiores relacionadas con el procesamiento de estímulos sonoros. La activación de esas áreas parece producirse, además, antes de que las madres tengan plena consciencia de que van a responder al llanto, lo que constituye una indicación de la importancia de tal comportamiento en términos, lógicamente, de la supervivencia de la cría.

En mujeres que no son madres, sin embargo, no se producen esas respuestas de la actividad encefálica al llanto de los bebés. Al oírlos, las madres presentan respuestas más pronunciadas que las mujeres que no lo son en zonas encefálicas implicadas en el procesamiento de emociones, lo que, además de su significado funcional, da cuenta de una considerable plasticidad en el encéfalo materno, ya que los cambios en las respuestas pueden producirse en periodos muy breves de tiempo, de tan solo tres meses incluso.

Este estudio pone de manifiesto el carácter universal de la respuesta de las madres al llanto de sus criaturas y de otros bebés. Y sus resultados son acordes con otros trabajos en los que se ha mostrado el amplio surtido de comportamientos maternos que favorecen la supervivencia de la progenie. El llanto es una poderosa herramienta, además de señalar la condición física de los más pequeños (un llanto poderoso es señal de buena condición) es la alarma que se dispara cuando las cosas no van del todo bien. Que la madre responda a la alarma como su mensaje merece no solo favorece la supervivencia de la criatura; si además, responde de forma diferente al llanto que a otro tipo de llamadas que no indican riesgo inminente, el bebé aprende a confiar en la seguridad que le proporciona el vínculo, con lo que ello implica a los efectos de adquirir el comportamiento prosocial tan importante para el resto de su vida en el grupo.

Fuente: Marc H. Bornstein et al (2017): Neurobiology of culturally common maternal responses to infant cry. PNAS

1 Este aspecto concreto de la investigación que ha servido de referencia se estudió en madres de los siguientes países: Argentina, Bélgica, Brasil, Camerún, Francia, Kenia, Israel, Italia, Japón, Korea del Sur, y los Estados Unidos. Los trabajos de actividad encefálica (FMRi) se limitaron a madres de China, Italia y Estados Unidos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La reacción de las madres al llanto de los bebés es universal se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuando los bebés comienzan a combinar gesto y habla

- Digitalización universal de la computación cuántica analógica en un chip superconductor

- El altruismo en las mujeres se ve recompensado

El pintor que engañó a los nazis, pero no a la química.

Amsterdam tras la liberación (1945)

Amsterdam, junio de 1945

La ciudad había sido liberada y, pese a que las cicatrices que había dejado la guerra tardarían en cerrarse, se respiraba optimismo y alegría en la ciudad. Sin embargo, Han no paraba de dar vueltas en un catre mugriento. La falta de morfina le impedía dormir y la acusación que pesaba sobre su persona no ayudaba en absoluto. A duras penas se levantó y profirió un grito más frío que los barrotes que le confinaban en aquella celda:

-

¡Estúpidos! ¡Idiotas! ¡Eso no es un Vermeer! ¡Esa obra la pinté yo!

Había sido condenado por un crimen que no había cometido. Era inocente. Más o menos.

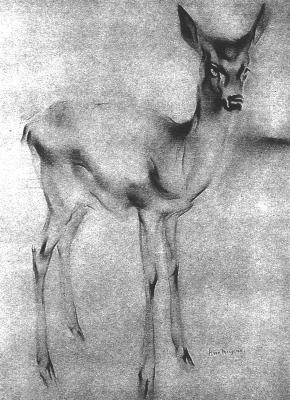

La Haya, 1928

Desde que en 1913 abandonase los estudios de arquitectura y se dedicase a la pintura, Han van Meegeren se había abierto un hueco en el panorama artístico holandés. No le faltaba talento e incluso había ganado algún que otro premio. Réplicas de su obra, El cervatillo, realizada para la princesa Juliana, colgaban de las paredes de una multitud de casas (Imagen 1). Por si fuera poco, era un reconocido retratista. Pero, tras su segunda exposición en solitario, su carrera sufriría un gran revés. Una crítica supuso su epitafio como pintor: “Posee todas las virtudes, excepto la originalidad”. El estilo de van Meegeren, heredado de los grandes maestros del XVII, no encajaba en el siglo de las nuevas vanguardias. El orgullo y el desprecio por el arte moderno no le permitieron encajar ese golpe. Si sus obras no podían ser admiradas en su época, no le quedaba otro remedio: las haría viajar en el tiempo.

Imagen 1. El cervatillo, de Han van Meegeren (1921). Fuente

Riviera francesa, 1932

La venganza es un plato que se sirve frío. Pero, además, hay que saber cocinarlo. Han había decidido esconderse en las sombras y elaborar un minucioso plan para ridiculizar al lobby de la crítica artística. Se mudó con su familia a una pequeña localidad de la Costa Azul y se dispuso a pintar una gran obra maestra al estilo de Vermeer. Y no se limitaría a realizar una burda copia, pintaría un original que pudiese haber hecho el famoso pintor. ¿Y por qué elegir a dicho artista? Por una parte, porque había dejado escasas obras para la posteridad y una nueva causaría un tremendo impacto. Por otra, y quizás la más importante, porque cuadros como La callejuela o La joven de la perla le otorgaban, según algunos, el título de mejor pintor de su siglo. Estas cosas hay que hacerlas a lo grande.

Imagen 2. Cristo en casa de Marta y María (160×142 cm), de Vermeer (1654-56). Fuente

Pero para pintar como el genio de Delft hacía falta algo más que sed de venganza y un aplastante dominio de la técnica. Había que mimar los detalles hasta el extremo. Van Meegeren hizo acopio de los pigmentos que usaba el flamenco (bermellón, blanco de plomo, lapislázuli, etc.) e incluso fabricó sus propios pinceles siguiendo la costumbre de la época. Por otra parte, recopiló auténticas obras del siglo XVII. Las obras por sí mismas no le importaban lo más mínimo, pero necesitaba lienzos que hubiesen sufrido el desgaste de 300 años. Con precisión de cirujano eliminó la pintura sobre el lino y así consiguió el soporte ideal para sus cuadros. Durante los siguientes años se dedicó a perfeccionar su técnica hasta que estuvo seguro de que nadie le descubriría. Una vez listo, sólo faltaba seleccionar el tema para su obra y qué mejor que recurrir a otro gran maestro del que Vermeer había recibido influencias: Caravaggio. La cena de Emaús sería el tema elegido.

Imagen 3. Cena de Emaús (140×197 cm) de Caravaggio (1596-1602). Fuente

Seguro que van Meegeren no podía estar más satisfecho al dar su última pincelada. Pero todavía quedaba un tremendo obstáculo. La pintura al óleo se va secando y agrietando con los años. Con aquel cuadro todavía húmedo no engañaría a ningún experto. Pero, como decíamos, todo estaba cuidado hasta el extremo. El holandés había mezclado los pigmentos con baquelita, un polímero que se endurece con el calor. Sólo quedaba meter el lienzo en el horno. Tras sacarlo, le dio una capa de barniz y lo enrolló de modo que surgiesen craqueladuras en las marcas que habían dejado las antiguas obras sobre los soportes reusados. Y como quiera que los cuadros acumulan suciedad a lo largo de los años (y no digamos de los siglos), ensució la superficie para deslucir su reciente creación. Lo había conseguido: había pintado un Vermeer.

Mónaco, Septiembre de 1937

El corazón del doctor Abraham Bredius nunca había latido tan rápido. Un tratante le había hecho llegar un cuadro para examinar (Imagen 4). No cabía duda. Era una obra maestra de Vermeer o, según sus propias palabras, era “la gran obra maestra” de Vermeer. Y él lo haría público. Una medalla más en su gloriosa carrera.

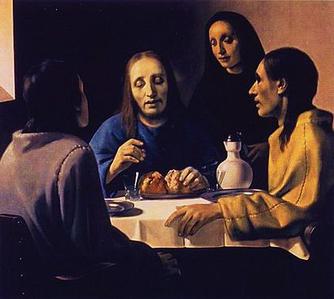

Imagen 4. La cena de Emaús (115-127 cm), de Han van Meegeren (1936-37). Fuente

A Hans van Meegeren solo le faltaba dar el último estoque. Según sus planes, había llegado el momento de humillar a la crítica y a esos supuestos expertos en arte encabezados por Bredius. Pero algo le hizo cambiar de opinión. Se sospecha que la fortuna que había logrado con la venta del cuadro tuvo algo que ver (más de cuatro millones y medio de euros al cambio actual). Con ese dinero compró una mansión en Niza y siguió trabajando con la técnica que tanto había tardado en depurar.

Berlín, agosto de 1943

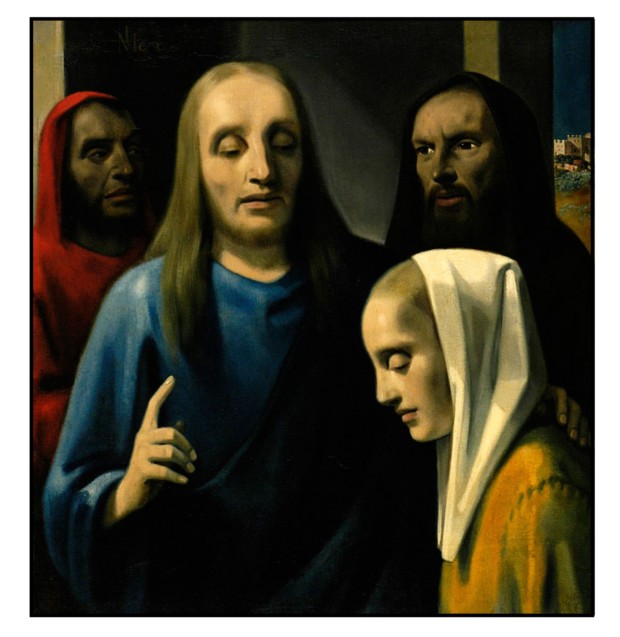

Las fuerzas del Eje han perdido el Norte de África, pronto caerá Italia. Quizás por eso Hermann Göring decide poner a salvo su incomparable colección de arte. En ella destaca una obra de Vermeer: Cristo entre los adúlteros (Imagen 5).

Imagen 5. Cristo entre los adulteros (96×88 cm), de Han van Meegeren (1943). Fuente

Mina de sal de Altausse (Austria), mayo de 1945

La Segunda Gran Guerra llega a su fin y los aliados siguen ganando terreno. Al entrar en la mina de sal de Altausse encuentran cientos de cajas almacenadas con un total de más de 6000 obras de arte (Imagen 6). El valor de aquellas piezas es incalculable. Hay una que hará especial ilusión al recién liberado pueblo holandés, una que lleva la firma insigne de Vermeer.

Imagen 6. Obras de arte encontradas en posesión de los nazis en las minas de sal de Altausse (1945). Fuente

Las investigaciones de las autoridades holandesas no se hacen esperar y el comerciante nazi que había vendido la obra a Göring pronto confiesa el origen de aquella pieza. Todos los focos apuntan hacia un pintor holandés que había desaparecido del panorama artístico: Han van Meegeren. Había expoliado patrimonio de su propio país, había negociado con los invasores. Aquello era alta traición y se pagaba con la vida.

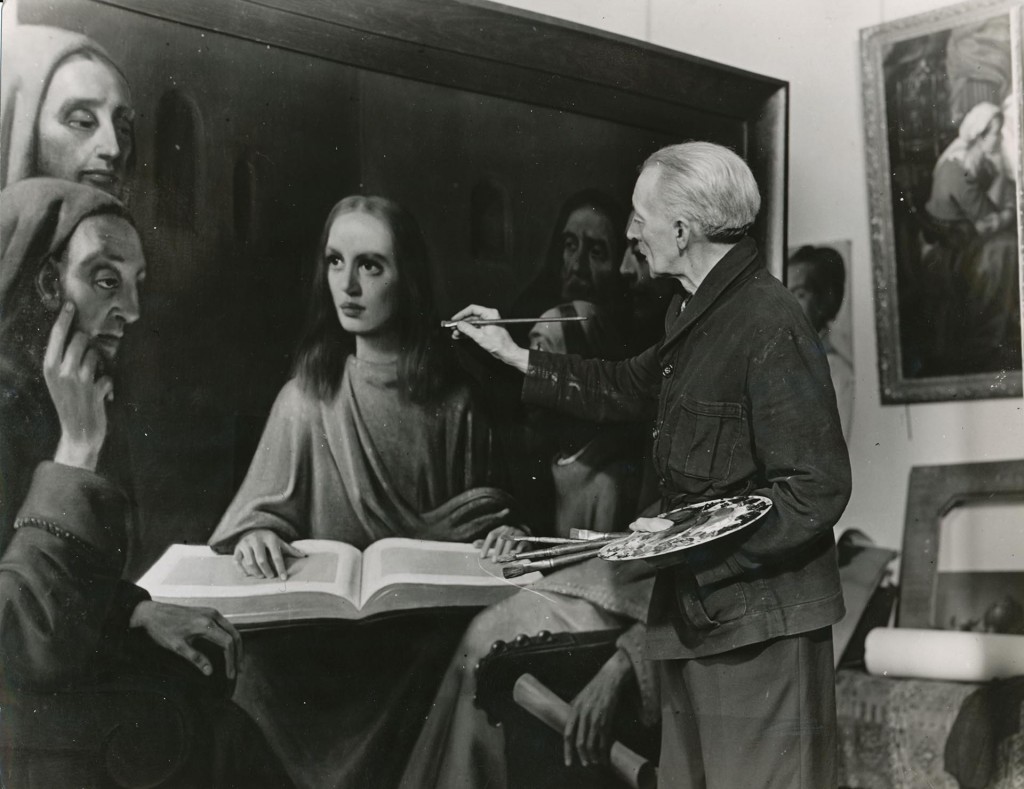

Amsterdam, finales de 1945

Han van Meegeren se jugaba la cabeza con cada pincelada. Había conseguido esquivar la condena, pero solo a cambio de demostrar que era capaz de falsificar un Vermeer. Durante seis semanas tuvo lugar uno de los juicios más peculiares de la historia. El pintor no solo exigió su material, sino también tabaco, alcohol y morfina, alegando que le eran completamente necesarias para desatar su creatividad. Volvió a elegir un cuadro en el que Cristo era el gran protagonista: Jesús entre los doctores. Pese a que su técnica había empeorado, consiguió salvar el cuello. En aquella corte se pintó el último Vermeer (Imagen 7).

Imagen 7. Han van Meegeren pintando su última obra enfrente de un panel de expertos (1945). Fuente

Amsterdam, finales de 1947

Quien es capaz de crear un Vermeer puede crear cualquier historia. Van Meegeren esgrimió que sus obras solo tenían la finalidad de engañar a los nazis para salvar el patrimonio patrio. Había pasado de traidor a héroe. Una encuesta realizada ese mismo año le situaba como la persona más popular de su país, solo tras el primer ministro y por encima del propio principie, para cuya mujer había pintado aquel cervatillo cuando todavía era un pintor honesto.

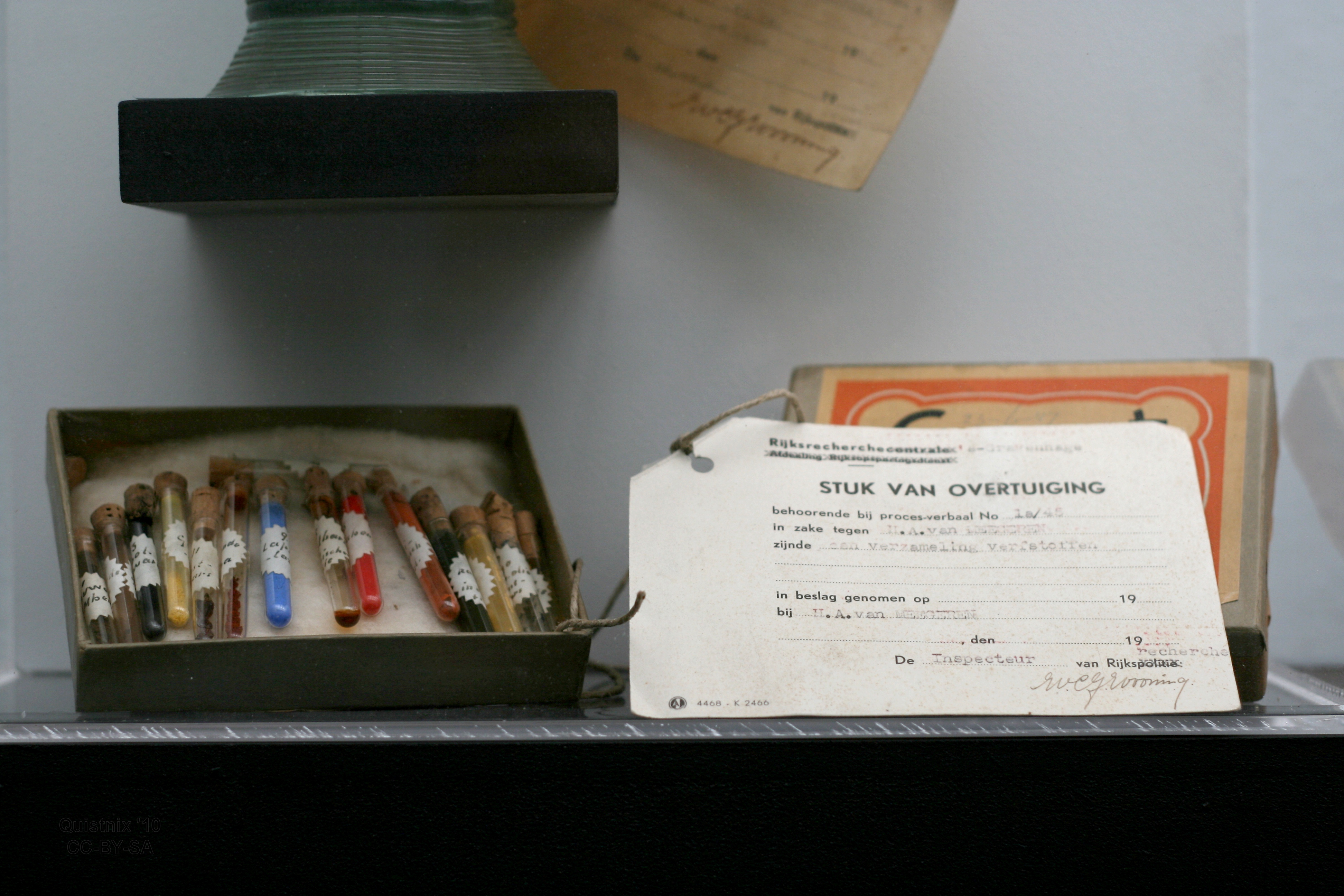

En cualquier caso, el falsificador se enfrentaba ahora a cargos de fraude. En este juicio no sería necesario que cogiese de nuevo el pincel. Su modus operandi quedaría al descubierto gracias a pruebas más fiables: entraba en acción la evidencia científica. Y lo hacía de la mano de Paul Coremans, doctor en Química Analítica y responsable científico de Museos Reales de Bellas Artes de Bélgica. Gracias a meticulosos análisis químicos se confirmó la presencia de baquelita (polímero comercializado a partir de 1910), tal y como van Meegeren había confesado. Además, se hallaron rastros de Albertol, una resina sintetizada en 1910 que habían encontrado en el taller del falsificador, y azul cobalto, pigmento descubierto en 1802 y que, obviamente, Vermeer nunca pudo usar (Imagen 8). La suciedad escondida entre las craqueladuras, que tanto habían ayudado a engañar a los expertos, resultó no ser natural, sino tinta india con la que van Meegeren había dado un toque añejo a sus pinturas.

Frente al tribunal y la multitud que seguía el juicio, Coreman fue mostrando las evidencias una a una. El propio van Meegeren quedó impresionado – Un trabajo excelente, señoría- le confesó al juez. Sin duda, aquel 29 de octubre marcó un antes y un después en cuanto a la importancia de los estudios científicos en obras artísticas.

Imagen 8. Pruebas presentadas contra van Meegeren en la acusación de fraude. Fuente

Dos semanas después Van Meegeren fue condenado a un año a prisión, aunque jamás cumpliría dicha condena. El hombre que engañó a Göring falleció el 30 de diciembre. No sin antes haber visto consumada su venganza.

Han van Meegeren fue uno de los mejores falsificadores de todos los tiempos, el mejor si hacemos caso a la opinión del propio Coreman. Posiblemente su engaño no se hubiese descubierto hasta mucho después de no haberse visto envuelto en esta rocambolesca historia. Algo que nos lleva a pensar cuántos falsificadores habrá de los que no conozcamos ni el nombre. ¿No son esos realmente los mejores? Aquellos cuyas obras descansan en las paredes de museos y colecciones privadas sin que nadie se percate, a la espera de que algún estudio científico desvele su verdadero origen. Para reflexionar sobre este hecho acabemos con una sentencia que dejó durante su juicio el protagonista de nuestro relato:

“Ayer esta pintura valía millones y expertos y amantes del arte hubiesen venido de cualquier parte del mundo para admirarla. Hoy no vale nada, y nadie cruzaría la calle ni para verla gratis. Pero la pintura no ha cambiado. ¿Qué es lo que ha cambiado?”

Epilogo

Tras la muerte de van Meegeren hubo quien se negó a creer su confesión y llegó a denunciar a Coreman por devaluar las obras de arte que seguían considerando auténticos Vermeers. En 1968, la revista Science publicaba un artículo en el que el estudio de radioisótopos de polonio y radio demostraba que obras como La cena de Emaús habían sido pintadas en el siglo XX (sirve este artículo también para hacer arqueología científica y ver que diferentes eran las publicaciones de aquella época). Desde entonces los métodos científicos han ido avanzando y se han realizado nuevos análisis (presencia de impurezas, análisis cromatográficos, etc.) que siguen descubriendo fallos en las falsificaciones de van Meegeren, dejando en evidencia que hoy sería casi imposible engañar a todo el mundo como él hizo.

Para saber más

R. C. Willams “The Forensic Historian: Using Science to Reexamine the Past” M.E. Sharpe (2013).

J. S. Held (1951) “Reviewed Works: Van Meegeren’s Faked Vermeers and de Hooghs: A Scientific Examination by P. B. Coremans, A. Hardy, C. M. Hutt; Back to the Truth: Vermeer–Van Meegeren, Two Genuine Vermeers by Jean Decoen, E. J. Labarre” College Art Journal, 10 (4) 432-436. DOI: 10.2307/772736

Essential Vermeer: Han van Meegeren’s Fake Vermeers

Essential Vermeer: Vermeer: Erroneous Attributions and Forgeries

B. Keisch (1968) “Dating Works of Art through Their Natural Radioactivity: Improvements and Applications” Science 160 (3826) 413-415 DOI: 10.1126/science.160.3826.413

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

El artículo El pintor que engañó a los nazis, pero no a la química. se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas14 La química del arte…pero bien

- Los cimientos de la química neumática al estilo van Helmont (y 3)

- Biringuccio, la química práctica y rentable del XVI

Naukas Bilbao 2017- Daniel Torregrosa: ¡Estamos rodeados!

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Daniel Torregrosa nos advierte, por si no lo supiésemos, de que estamos rodeados de químicos. Y pone algunos ejemplos. Imposible permanecer impasible ante semejantes barbaridades.

Daniel Torregrosa: ¡Estamos rodeados!Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017- Daniel Torregrosa: ¡Estamos rodeados! se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017, en directo

- Naukas Pro 2017: Amaia Zurutuza y el grafeno

- Naukas Pro 2017: Carlos Briones y el origen de la vida

La enseñanza multilingüe de las lenguas

Una investigación llevada a cabo en el Departamento de Teoría e Historia de la Educación por la profesora Elizabet Arocena, dirigida por el investigador Ikerbasque Durk Gorter y la catedrática de la UPV/EHU Jasone Cenoz, ha concluido que existen bases pedagógicas para poder implantar y extender el enfoque multilingüe en la enseñanza de las lenguas en las aulas.

Según explica la profesora e investigadora Arocena, “los hablantes multilingües no aíslan las lenguas en sus mentes. Es decir, no son una suma de hablantes monolingües. Rebasan los límites interlingüísticos, y, por ejemplo, utilizan en su lengua más débil lo aprendido en sus otras lenguas”. Actualmente, muchos investigadores internacionales ponen en tela de juicio la tendencia a enseñar idiomas por separado y defienden otro enfoque más generalizado, un enfoque multilingüe; es decir, proponen dotarlos de herramientas que les ayuden a utilizar en otras lenguas lo aprendido en una de ellas.

El objetivo de la investigación de Arocena ha sido analizar hasta qué punto está extendido el enfoque multilingüe en los centros de enseñanza vascos y si existen en ellos bases pedagógicas para poder implantarlo y extenderlo. Para ello, la investigadora ha llevado a cabo entrevistas entre el profesorado de distintas lenguas y ha observado sus clases, con el objetivo de recabar sus opiniones y analizar sus modos de impartir clase. Por otra parte, para analizar las tendencias del alumnado, ha solicitado a los y las alumnas cumplimentar una encuesta de información general (edad, lengua materna, qué uso hacen de las lenguas, cuándo…); además, la investigadora ha analizado tres redacciones de cada estudiante.

La investigadora ha recopilado diversas opiniones y creencias del profesorado. Entre otras conclusiones, el profesorado destaca que para la enseñanza de las lenguas consideran al alumnado monolingüe, y que persiguen el objetivo de conseguir el mismo nivel que las personas monolingües en ese idioma, aunque saben que es muy difícil conseguirlo en las tres lenguas por igual. Asimismo, creen que en las clases no se debe hacer referencia a otras lenguas como ayuda en la enseñanza, que no se debe dar una alternancia de código en clase. Sin embargo, Arocena ha constatado que la utilización de otras lenguas en la enseñanza lingüística es más frecuente de lo esperado, sobre todo para explicar vocabulario y conceptos difíciles.

Por otra parte, de los textos redactados por el alumnado, la investigadora ha concluido que los estudiantes rompen con las barreras inducidas por el enfoque monolingüista, ya que utilizan en una lengua recursos que han aprendido para otra. De hecho, “hemos constatado que además de transferir léxico, el alumnado es capaz de transferir recursos de puntuación, organización textual y contenidos”, añade Arocena. En opinión de la investigadora, las características de las redacciones ponen de manifiesto que “es necesario considerar al hablante como multilingüe, debido a que no escribe de diferente manera en uno u otro idioma. A menudo no tenemos en cuenta todo ello, y es muy importante contemplar las herramientas que los alumnos utilizan como multilingües que son: ¿Si saben utilizar un recurso en una lengua, por qué no les enseñamos cómo transferirlo a sus otras lenguas? ¿Por qué no utilizamos dicha transferencia en el proceso de aprendizaje de otra lengua?”.

Referencia:

E. Arocena-Egaña et al (2015) Teachers’ beliefs in multilingual education in the Basque country and in Friesland Journal of Immersion and Content-Based Language Education doi: 10.1075/jicb.3.2.01aro

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La enseñanza multilingüe de las lenguas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El oído absoluto y las lenguas tonales

- El aprendizaje del inglés es mejor si se usa para aprender otra cosa

- Los cuantificadores se aprenden en el mismo orden, sea cual sea la lengua

Relojes astronómicos

En una época en la que los dispositivos digitales nos permiten saber la hora con una precisión sin precedentes o en que las aplicaciones móviles pueden darnos datos astronómicos exactos, quizás no seamos capaces de entender en toda su amplitud el sentido de maravilla que suscitaba entre nuestros antepasados un artilugio capaz de dar esta información de antemano.

Durante muchos siglos, los relojes astronómicos fueron lo más parecido a los ordenadores actuales. No sólo permitían conocer la hora y la fecha del año, muchos de ellos daban además las horas de salida y puesta del Sol, las fases de la Luna o las posiciones de los planetas y las estrellas. Mediante engranajes cuidadosamente calculados y vinculados con los ritmos de los astros, estos mecanismos permitían reproducir ciclos astronómicos y determinar con antelación fenómenos tan complejos como los eclipses de Sol o de Luna.

Aunque hay quien considera al Mecanismo de Anticitera un precursor de estas calculadoras mecánicas, la edad dorada de los relojes astronómicos tiene lugar entre los siglos XIV y XVI. En esta época, las ciudades más prósperas comienzan a instalar estas prodigiosas maquinas. Si bien existen algunas variaciones importantes entre los distintos modelos, los relojes astronómicos se pueden clasificar en tres tipos principales.

Los primeros dos tipos se denominan “de astrolabio”, incluyen un círculo eclíptico giratorio y manecillas para indicar los movimientos del Sol y de la Luna, además de la hora. Este tipo de mecanismos permitía ofrecer todas las indicaciones propias de un astrolabio (Sol, Luna, estrellas brillantes, planetas). El primero de estos tipos engloba los relojes de astrolabio realizados en Lund, Doberan, Estrasburgo (reloj antiguo), Frankfurt y Praga, todos ellos anteriores a 1500.

Reloj astronómico de Lund (Suecia). Foto: © Paco Bellido

El segundo tipo de relojes de astrolabio engloba los realizados en Munster, Ulm, Lyon, Olomouc, Estrasburgo (reloj nuevo), posteriores al año 1500. La principal diferencia entre los dos tipos estriba en la proyección de la bóveda celeste utilizada, polo norte en el primer tipo y polo sur en el segundo.

Detalle del reloj astronómico de la Catedral de Estrasburgo. Foto: © Paco Bellido

El tercer tipo de reloj astronómico monumental tiene su origen en Italia, concretamente en el reloj construido en Padua por Jacopo Dondi. Este tipo de reloj consta de un cuadrante y varios círculos concéntricos que indican las horas, las 12 constelaciones zodiacales, la posición del Sol y de la Luna en el cielo y su fase correspondiente y, en el centro del reloj, el disco de la Tierra que porta las manecillas de las horas. En Italia se pueden ver relojes de este tipo en Venecia, Brescia y Cremona. También hay ejemplos en otros países, por ejemplo en Danzig (Polonia) y Rostock (Alemania) y en varias ciudades británicas: Hampton Court, Exeter, Ottery, Wells y Wimborne.

El reloj astronómico de Padua. Foto: © Paco Bellido

Los primeros relojes astronómicos representaban el sistema solar atendiendo al modelo geocéntrico. En el centro del dial se situaba un disco o esfera que representaba la Tierra, ubicada en el centro del Universo. El Sol, la luminaria mayor, solía aparecer representado por una esfera dorada que giraba alrededor de la Tierra. En este esquema la experiencia cotidiana iba de la mano de la visión cosmológica imperante en la Europa precopernicana.

El reloj astronómico del Torrazzo de Cremona. Foto: © Paco Bellido

Sobre la fachada sur del Ayuntamiento de la Ciudad Vieja de Praga se encuentra el más conocido de los relojes astronómicos. Está formado por tres componentes principales: un calendario perpetuo que indica el santo del día y la fecha; una esfera astronómica, que indica las posiciones del Sol y de la Luna en el cielo y, en la parte superior, el desfile de los apóstoles, una cabalgata mecánica que atrae a multitud de turistas cada hora.

La parte más antigua del reloj, el mecanismo y la esfera astronómica, datan de 1410 y son obra del relojero Mikuláš de Kadaň y del profesor Jan Šindel. Alrededor de 1490 se agregó el calendario perpetuo y se añadieron las esculturas góticas que decoran la fachada del reloj. En 1552 fue reparado por Jan Taborský y a partir de esta fecha funcionó intermitentemente.

Detalle del astrolabio del reloj astronómico de Praga. Foto: © Paco Bellido

El reloj astronómico reproduce la forma de un astrolabio mecánico. También se puede interpretar como un planetario primitivo que muestra el aspecto actual del universo.

Las catedrales y grandes templos son otro lugar habitual de estos ingeniosos mecanismos. Durante buena parte de la historia, las horas de la liturgia se determinaron mediante relojes de sol, clepsidras y relojes de arena, pero a finales del siglo XIII empiezan a aparecer relojes mecánicos en monasterios e iglesias que permiten calcular con exactitud la fecha de las fiestas religiosas móviles, en particular, la fecha de la Pascua. En ocasiones, como ocurre en Beauvais (Francia), el reloj encierra un mensaje espiritual de gran simbolismo religioso.

La ciudad alsaciana de Estrasburgo fue una de las primeras en disponer de un gran reloj monumental. La construcción del primer reloj de la catedral tuvo lugar entre 1352 y 1354. Algunas piezas del reloj original se pueden ver actualmente en un museo de la ciudad, pero la catedral cuenta con un nuevo reloj astronómico, el tercero que ha tenido. Una maravilla creada por el autodidacta Jean-Baptiste Schwilgué (1776-1856), quien dedicó su vida a la tarea de volver a poner en marcha el ingenio astronómico de la catedral.

Reloj astronómico de Estrasburgo. Foto: © Paco Bellido

Este reloj ha servido de inspiración a multitud de relojeros de todo el mundo. Por ejemplo, al danés Jens Olsen, uno de los fundadores de la Sociedad Astronómica Danesa, que en 1955 pudo cumplir su sueño de poner en marcha su reloj astronómico compuesto por 15.448 piezas individuales, aunque él no vivió para verlo. El reloj de Olsen se puede visitar en el Ayuntamiento de Copenhague y está considerado uno de los más precisos del mundo. La rueda dentada que se mueve más despacio da una vuelta cada 25.753 años.

El ingenio mecánico de Jens Olsen. Foto: © Paco Bellido

Algunos relojes astronómicos ofrecen una cantidad de información realmente asombrosa. La Torre Zimmer de Lier (Bélgica), por ejemplo, no solo indica con precisión la posición de los principales planetas, en su interior se encuentra el departamento de cálculos astronómicos donde encontramos toda una serie de diales que indican desde el período de Saros, hasta la ubicación de los cometas Encke y Halley, pasando por la posición de los radiantes de las principales lluvias de meteoros.

La Torre Zimmer de Lier (Bélgica) ideada en los años treinta del siglo pasado por Louis Zimmer. Foto: © Paco Bellido

Un buen número de estos relojes históricos están incluidos en la Lista del Patrimonio de la Humanidad de la UNESCO, no en vano son maravillas de la ingeniería mecánica y una muestra indiscutible del ingenio humano.

Este post ha sido realizado por Paco Bellido (@ElBesoenlaLuna) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Relojes astronómicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Relojes y cronómetros (I): la conexión astronómica

- Relojes y cronómetros (III): el problema de la longitud

- Relojes de ADN

El mecanismo de la vida, mejor vídeo de divulgación joven “On zientzia”

“El mecanismo de la vida” de Leonel Virosta Gutiérrez es el vídeo ganador del premio joven al mejor vídeo de divulgación de la 6ª edición de los premios On Zientzia. Leonel explica el funcionamiento de las células, como se forma un bebé, cómo infecta un virus y una cantidad increíble de cosas en tan solo 5 minutos.

¿Tienes una idea genial para explicar un concepto científico en un vídeo? ¿Quieres ver tu trabajo emitido en televisión? La Fundación Elhuyar y el Donostia International Physics Center (DIPC) han organizado la octava edición de On zientzia, un concurso de divulgación científica y tecnológica enmarcado en el programa Teknopolis, de ETB. Este certamen pretende impulsar la producción de vídeos cortos y originales que ayuden a popularizar el conocimiento científico.

On zientzia tendrá tres categorías. El mejor vídeo de divulgación recibirá un premio de 3.000 euros. Para impulsar la producción de piezas en euskera, existe un premio de 2.000 euros reservado a la mejor propuesta realizada en ese idioma. Por último, con el objetivo de impulsar la participación de los estudiantes de ESO y Bachillerato, hay un premio dotado con 1.000 euros para el mejor vídeo realizado por menores de 18 años.

Los vídeos han de tener una duración inferior a los 5 minutos, se pueden realizar en euskera, castellano o inglés y el tema es libre. Deben ser contenidos originales, no comerciales, que no se hayan emitido por televisión y que no hayan resultado premiados en otros concursos. El jurado valorará la capacidad divulgativa y el interés de los vídeos más que la excelencia técnica.

Las bases las encuentras aquí. Puedes participar desde ya hasta el 25 de abril de 2018.

Edición realizada por César Tomé López

El artículo El mecanismo de la vida, mejor vídeo de divulgación joven “On zientzia” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fallos científicos en el cine, mejor vídeo de divulgación joven “On zientzia”

- Soy esa bacteria que vive en tu intestino, mejor vídeo de divulgación “On zientzia”

- Keats vs Feynman, mejor vídeo de divulgación “On zientzia”

La tentación de la posesión

Por definición el conocimiento es compartido, ya que el saber que no se transmite es como si no existiera. Esto supone que la ciencia, como conocimiento del universo, es por necesidad de todos los humanos que quieren compartirla: no puede existir un trozo del saber que tenga dueño. Y sin embargo somos humanos y los científicos no son inmunes a la tentación de la posesión: la tendencia a apropiarse y hacer suyo un campo, un conocimiento o una técnica y a considerar un intruso o algo peor a quien pretende inmiscuirse y compartir. Con ser una querencia natural en la Humanidad cuando ocurre en ciencia trae malas consecuencias.

La cosa empieza simple, con el legítimo orgullo de haber encontrado una técnica potente, de haber realizado un importante avance en un campo muy especializado o de haber resuelto un problema especialmente enrevesado, pero pronto se convierte en una cuestión de propiedad: la técnica no puede retocarse, modificarse o aplicarse a otros problemas, el avance en la comprensión de un campo se puede extender a otros, la solución del enrevesado problema es la única solución posible de cualquier otro problema. Quien desea utilizar la técnica o la teoría es considerado un intruso, un advenedizo, alguien que en el fondo desea aprovecharse del trabajo ajeno; sólo el creador inicial se considera con derecho a explotar las consecuencias y derivaciones de sus avances. Así se crean escuelas cerradas de pensamiento compuestas por los discípulos del maestro original que funcionan como verdaderos clubes que tienen reservado el derecho de admisión.

Como consecuencia los avances se ralentizan, los conocimientos tienden a fosilizarse y las disciplinas o subdisciplinas empiezan a ser abandonadas por la gente más brillante, que no quiere quedar atrapada en un campo dominado por una única teoría o hipótesis defendida por una falange de discípulos celosos de cualquier recién llegado. El problema se complica aún más cuando el avance científico depende del acceso a piezas materiales concretas: especímenes particulares, fósiles o datos imposibles de replicar. Se conocen casos de fósiles humanos, por ejemplo, que han pasado años (o décadas) ocultos y sin que la profesión pudiese acceder a ellos porque el descubridor original estaba preparando una descripción inicial que jamás llegaba.

En según qué campos este tipo de ‘secuestro’ de evidencia física es imposible: todas las Arabidopsis thaliana o Drosophila melanogaster tienen los mismos genes, igual que todas las galaxias son analizables desde cualquier telescopio; por eso es mucho más difícil que un laboratorio, gran pope o escuela de seguidores se apropie de una ruta genética o de una teoría cosmológica, aunque tampoco se pueda considerar inimaginable. A veces una teoría, hipótesis o técnica puede ser para el científico que la crea casi como un hijo (intelectual) y generar el mismo tipo de reacciones de posesión y protección que crea un descendiente físico.

Porque no hay sensación más estimulante que comprender un pedacito del misterio que es el cosmos después de años de preguntas y un sinfín de ingeniosos y fallidos intentos de entenderlo; imagine dedicar décadas de su vida a resolver un intrincado rompecabezas sin tener la imagen de la caja y tras años de lento y doloroso avance descubrir la pieza que hace que todo tenga sentido, la clave que permite por fin contemplar el conjunto y entenderlo. Nuestro cableado interno responde ante esto con un subidón difícil de describir, tanto más intenso como que en realidad no hay ninguna garantía de que el esfuerzo y la dedicación vayan a dar resultado: cuando se compra un rompecabezas se sabe que es casi seguro que pueda resolverse, pero cuando se aborda un problema científico cabe la posibilidad de que nunca se alcance la solución. Cuando llega, si es que llega, es casi imposible transmitir la sensación a quien no se dedica a esto.

Y de ahí la tentación de la posesión, tan humana y por ello tan comprensible al mismo tiempo que tan problemática para el avance del conocimiento. Un riesgo real que sólo podría eliminarse si los científicos fuesen robots.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La tentación de la posesión se ha escrito en Cuaderno de Cultura Científica.

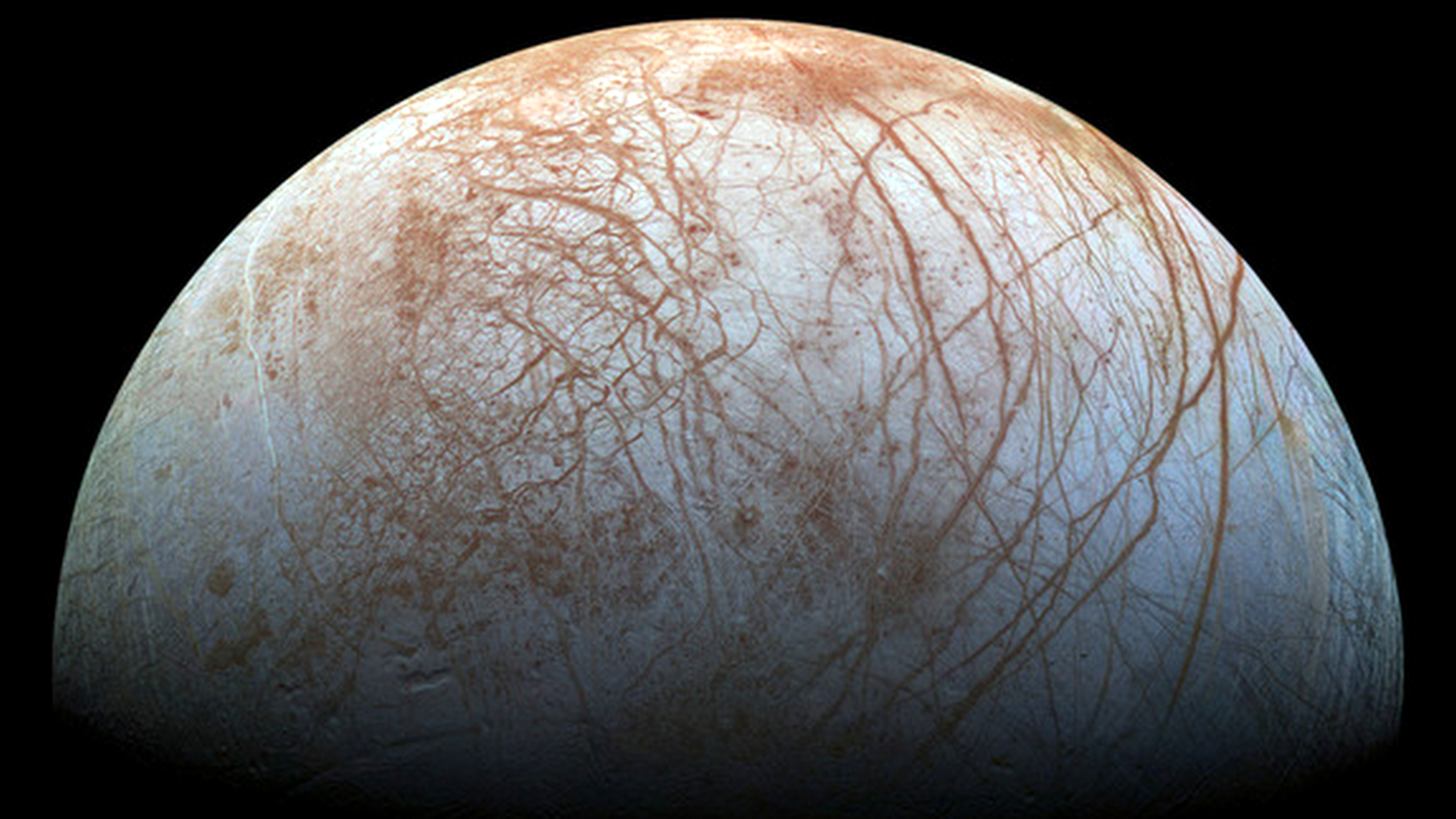

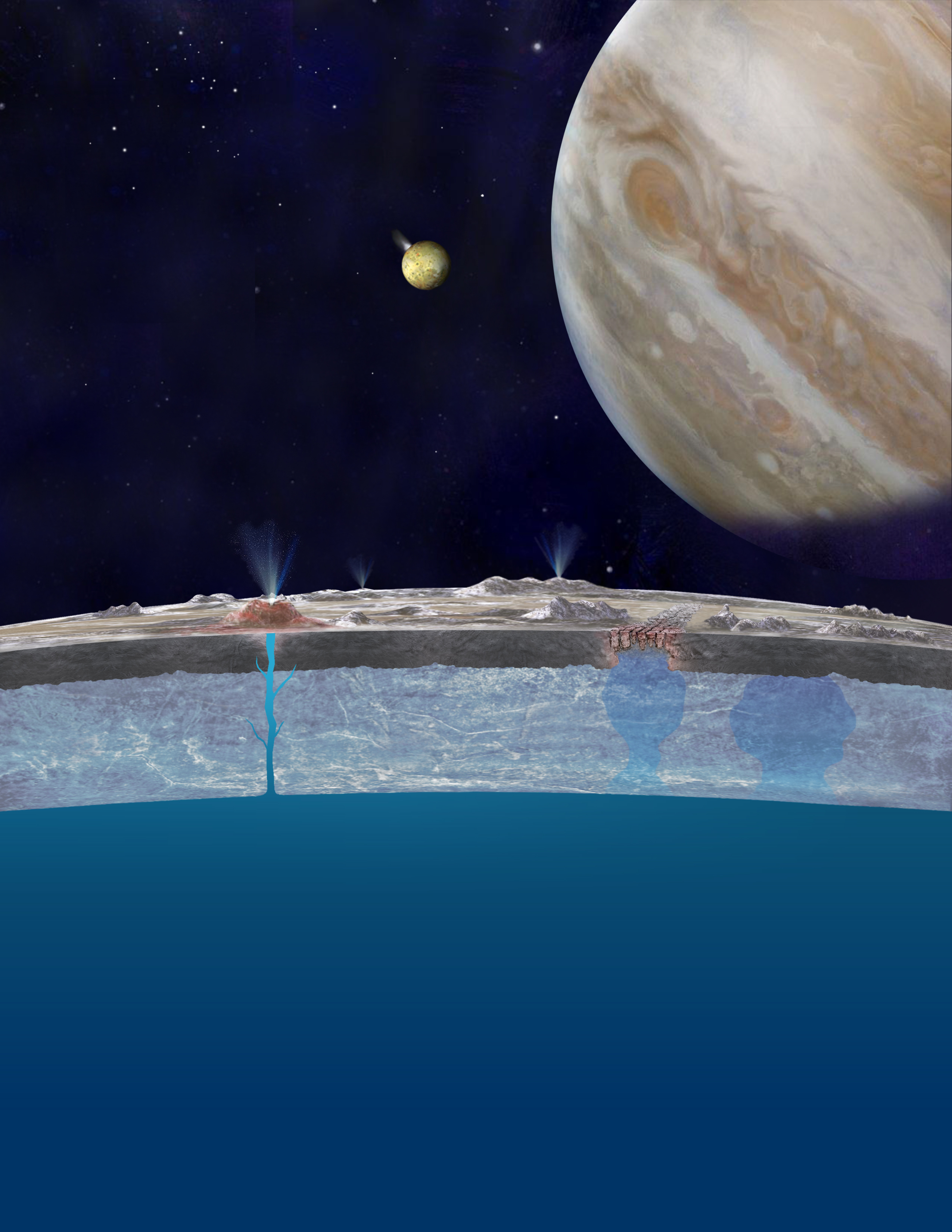

Entradas relacionadas:La presencia de sales podría hacer que exista una tectónica de placas en Europa

La capa helada de la luna de Júpiter, Europa, podría tener placas tectónicas similares a las de la Tierra. La presencia de actividad tectónica de placas podría tener implicaciones importantes para la posibilidad de que exista vida en el océano bajo la superficie de la luna.