Grissel Trujillo de Santiago: «Biofabrikazioak aukera ematen dit zientziatik lan egiteko eta benetako arazoak konpontzeko»

Grissel Trujillo de Santiago doktorea Monterreyko Teknologikoko irakasle ikertzailea da, bai eta Alvarez-Trujillo laborategiko zuzendarietako bat ere. FORMA Foods-eko Chief Scientific Officer da, hurrengo belaunaldiko haragi produktuetan ikuspuntua jarrita duen enpresa. Ikertzaileen Sistema Nazionaleko kidea da (2. mailakoa), eta Mexikoko Zientzien Akademiako kide erregularra.

Kimikari farmazeutiko biologoa da Nuevo Leóngo Unibertsitate Autonomoan, eta Zientziakomaisua eta doktorea Monterreyko Teknologikoan. Doktorego osteko bi urteko egonaldia egin zuen Harvarden eta MITen. Ikerketa egonaldi ugari egin ditu Indiako eta Italiako prestigio handiko unibertsitateetan.

3D inprimaketa eta bioinprimaketa kaotikoaren asmatzaile liderra da. Bere ikerketa ildoek bioinprimaketari eta biomaterialen ingeniaritzari buruz dihardute. Patente mexikar bat eta patente prozesuan dauden sei teknologia ditu. 80 artikulu baino gehiago argitaratu ditu nazioarteko aldizkari zientifikoetan, eta 7.500 aldiz baino gehiagotan aipatu dute.

Beste beste, Zientzien Akademia Mexikarraren (AMC) zientzialari gazteentzako 2023ko ikerketa saria (AMC) jaso zuen, Kimikaren arloko 2024ko lider emergentea da American Chemical Society-ren eskutik, L ‘Oréal-UNESCO-AMC fundazioaren “Zientziako Emakumeentzat” beka jaso zuen 2019an, SEP Reconoce-k bioinprimaketan egindako lana nabarmendu zion 2022an, ISBFk emandako “Professional Development Award” saria jaso zuen 2023an, bere jaioterriak “Herritar Nabarmena” izendatu zuen, eta Monterreyko Ingeniaritza eta Teknologia Zientzien Eskolako irakasle nabarmenen zirkuluko kide da. Mario Álvarez kidearekin batera jaso zuen CINVESTAV-ek eta Neolpharma-k emandako Bioteknologiako Berrikuntzaren saria, bai eta Rómulo Garza 2022 saria ere, “Ekintzailetzara daraman ikerketa” kategoriaren lehenengo edizioan.

Irudia: Grissel Trujillo de Santiago. (Argazkia: Mujeres con Ciencia).Zein da zure ikerketa arloa?

Irudia: Grissel Trujillo de Santiago. (Argazkia: Mujeres con Ciencia).Zein da zure ikerketa arloa?

Nire ikerketa arloa biofabrikazioa da: zientzia materialak, biologia eta ingeniaritza elkartzen dituen alorra da, egitura biziak diseinatu eta eraikitzeko. Bereziki, fluxu kaotikoetan oinarritutako 3D inprimaketako teknologiak garatzen espezializatzen naiz. Horiei esker, material bigunen barruan arkitektura konplexu eta funtzionalak sor daitezke, hala nola hidrogelak. Teknologia horiek medikuntza birsortzailean, eredu biomedikoetan, belaunaldi berriko elikagaietan eta beste muga emergente batzuetan aurrerapenak sustatzen dituzte. Barne antolaketa duten eta naturan inspiratuta dauden egiturak fabrikatzeko modu sinple baina boteretsuak aurkitzearen zale amorratua naiz.

Zergatik zabiltza arlo horretara?Izugarri hunkitzen nau naturak printzipio sinpleetatik abiatuta egitura adimendunak, eraginkorrak eta ederrak nola sortzen dituen ikusteak, hau da, konplexutasuna sinpletasunaren bidez sortzea. Zientziatik abiatuta logika natural horri heltzea eta teknologia bihurtzea da mundu osasungarriago, bidezkoago eta jasangarriago bat sortzen laguntzeko dudan modua. Gainera, biofabrikazioak aukera ematen dit zientziatik lan egiteko eta benetako arazoak ebazteko, gehien maite dudanarekin konektatzen nauen sormenezko dimentsio batekin:xede bat izanda eraikitzea.

Arlo horri esker, amets handiak izan ditzaket eta modu zehatzean jardun:mikroegituratutako konstruktu bat laborategian diseinatzetik, lan horrek osasunean duen inpaktu errealarekin, elikadurarekin edo ingurumenarekin konektatzeraino. Zientzian aritzeko eta horretaz gozatzeko modua da, baina beti bizitzak eraldatzeko xedearekin.

Izan al duzu erreferenterik zure ibilbidean?Izugarri inspiratu nauten pertsona ugari egon dira. Esparru akademikoan, Ali Khademhosseini, Mario Moisés Álvarez, Ernesto Di Maio eta Cecilia Rojas mentoreek zientziari buruz irakasteaz gain, osotasunari, ikuspegiari eta lidergoari buruz ere irakatsi zidaten. Horrez gain, Anthony Atalaren, Bob Langerren eta Jennifer Lewis eta Neri Oxman bezalako emakumeen lana eta ikuspegia ere izugarri miretsi ditut; izan ere, alorra sormenez, zorroztasunez eta ausardiaz irauli dute.

Baina, zalantza barik, nire erreferentziazko irudi nagusia nire ama izan da. Bizitzaren aurrean izan beharreko sendotasunaren, erresilientziaren, jakituria praktikoaren eta alaitasunaren eredu izan da niretzat,etengabeko iparrorratza.

Zer da zure alorrean deskubritu edo ebatzi nahi zenukeena?Nire bihotza betetzen duena horretarako beharra duten pazienteentzat organo funtzionalak inprimatzea da. Zenbait aitzindari garrantzitsurengandik, hala nola Anthony Atalarengandik, jaso nuen ametsa da eta horrekin bat egin nuen nire konpromiso eta indar osoz. Urratsez urrats, aurrerapen bakoitzarekin aurrera eginez, horra hel gaitezkeela pentsatzeak hunkitu egiten nau.

Baina bide horretan oso garrantzitsuak diren beste arazo batzuetarako konponbideak ere sor ditzakegu: gaixotasunak ikertzeko eredu berrietatik elikagai jasangarriagoak ekoizteko teknologietara. Asko axola dit egiten dugunak ingeniari eta zientzialari bikainak prestatzeko balio dezala, proiektu eraldatzaileen liderrak izan daitezen.

Eta nire ametsa da ideia horiei esker prestatzen ditugun pertsona horientzat profil altuko lanak eskainiko dituzten elkarteak sortzea; Mexikotik ezagutzan oinarritutako ekonomia eraiki ahal izatea, independenteagoa, oparoagoa eta bilakatuagoa. Zientziak eta teknologiak loratuko den gizartea erein dezatela:gizatiarra, sortzailea, independentea eta ekitatiboa. Ez gaitzatela soilik gure kultura sutsuagatik ezagutu (koloreak, musika, alaitasuna), baita sortzen ditugun ezagutzagatik eta teknologiengatik ere, eta gure asmamenagatik, problema konplexuak ebazteko dugun gaitasungatik eta gure zientzialarien bikaintasungatik.Mexikok distira egin dezala, baita inspiratu ere.

Zein aholku emango zenioke ikerketaren munduan hasi nahi duen norbaiti?Deiari entzun diezaiotela. Ez da guztientzako ibilbidea, baina sentitzen badute beren izaerarekin bat egiten duela, orduan merezi du. Ikerketa ez da lana, xededun bidea baizik, etengabeko hazkuntza eskatzen duena. Eta benetako edozein hazkuntza bezalaxe, batzuetan mingarria edo deserosoa da. Zalantza, neke, frustrazio… uneak daude, baina baita deskubrimenduko, lotura sakoneko eta benetako alaitasuneko uneak ere.

Pasioa behar da, baina baita diziplina, erresilientzia eta berriro hasteko gaitasun handia ere.Izan inguruan erronkak proposatzen dizkizuten, zaintzen zaituzten eta inspiratzen zaituzten pertsonak. Eta egin zientzia maitasunez, zorroztasunez eta xede jakin batekin. Saia zaitez arazo garrantzitsuak ebazten eta gainerakoei zerbitzatzen; izan ere, denbora eta baliabideak beti dira mugatuak. Horregatik, gure mundua eraldatzeko erabiltzea merezi du (beti onerako).

Jatorrizko elkarrizketa Mujeres con Ciencia blogean argitaratu zen 2025eko abuztuaren 2an: “Grissel Trujillo de Santiago: «La biofabricación me permite trabajar desde la ciencia para resolver problemas reales»“.

Itzulpena: EHUko Euskara Zerbitzua.

Ikertzen dut atalak emakume ikertzaileen jardunari erreparatzen die. Elkarrizketa labur baten bidez, zientzialariek azaltzen dute ikergai zehatz bat hautatzeko arrazoia zein izan den eta baita ere lanaren helburua.

The post Grissel Trujillo de Santiago: «Biofabrikazioak aukera ematen dit zientziatik lan egiteko eta benetako arazoak konpontzeko» appeared first on Zientzia Kaiera.

Atzekoz aurrera

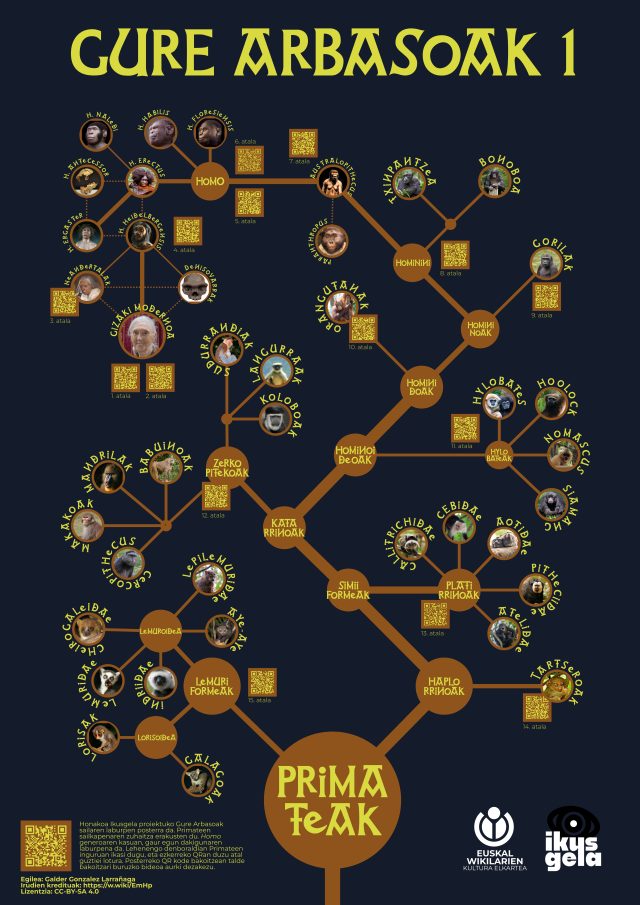

Gure arbasoak sailaren lehen denboraldian primateak aztertu genituen: lehen bereizketa sudur hezea duten Lemuriformeen eta sudur lehorra dugun haplorrinoen artekoa da, eta Madagaskarko lemurrei esker espeziazioaz hitz egin genuen, tarseroen bidez daltonismoa eta koloreen pertzepzioa azaldu genuen, eta simiiformeen artean platirrinoak eta katarrinoak bereizi genituen, plaken tektonikak tximinoak Amerikara nola iritsi ziren kontatzeko aukera emanda. Halaber, isatsa duten zerkopitekoak eta isatsik ez dugun Hominoideoak bereizi genituen, hylobateen taldeaz eta talde monofiletiko/parafiletikoez aritu ginen, eta orangutanekiko eta gorilekiko arbaso komunak nola ulertzen diren azaldu genuen.

Hominoideen barruan Hominini leinua hartu genuen aztergai, txinpantzeak eta bonoboak ditugulako lehengusurik gertukoenak, eta hortik aurrera Hominina subtribura salto egin genuen Lucy Australopithecus eta gure bi hanken gaineko ibilera azaltzeko. Paranthropus generoa bereizi ondoren Homo generora iritsi ginen, gizaki egiten gaituenaren inguruan eta zenbat giza espezie dauden azalduz, kontatzeko moduak erantzun desberdinak ematen dituela ikusita. Ondoren neandertalei buruz aritu ginen, gure espeziearekin gurutzatu eta arbaso ere izan zirelako, eta horrek lotu gintuen gizateriaren kolonizazio globalaren kontakizunera. Azkenik, Cro-Magnonez eta Europako gizaki modernoaren kategoria kulturalaz aritu ginen, eta “denok gara Eneko Aristaren ondorengo” bideoan azaldu genuen guztiok familia bera garela eta oso gertutik partekatzen ditugula arbaso komunak.

Irudia: “Gure arbasoak” sailaren lehen denboraldiaren informazioarekin posterra. (Argazkia: Theklan – CC BY-SA 4.0 lizentziapean. Iturria: Wikimedia Commons)

Irudia: “Gure arbasoak” sailaren lehen denboraldiaren informazioarekin posterra. (Argazkia: Theklan – CC BY-SA 4.0 lizentziapean. Iturria: Wikimedia Commons)“Gure arbasoak” Ikusgela hezkuntza proiektuaren bideo-sorta bat da. Euskal Wikilarien Kultur Elkartearen ikus-entzunezko egitasmoa da eta EHUko Kultura Zientifikoko Katedraren kolaborazioa izan du.

The post Atzekoz aurrera appeared first on Zientzia Kaiera.

Argazki onenaren Oscar Saria… Geologiarentzat da!

Kontu bat dute komunean El bueno, el feo y el malo spaghetti western ospetsuak (espero dut une honetan zuek ere Ennio Morriconeren soinu-banda zoragarria kanta-marmarrean aritzea), Indiana Jones y la última cruzada filmeko fantasia eta arkeologia kutsuko abenturak (ziur nago orain John Williams-en melodia gogoratu duzuela) eta Conan el Bárbaro filmeko ezpata eta sorginkeriazko historia epikoak (Basil Poledourisek sortutako perkusio indartsuaren unea da): Tabernas basamortua.

1. irudia: Tabernas basamortua. (Argazkia: Dgalan, CC BY-SA 4.0 / Wikimedia Commons)

1. irudia: Tabernas basamortua. (Argazkia: Dgalan, CC BY-SA 4.0 / Wikimedia Commons)Clint Eastwood mantso, kopeta ilun eta pontxo higatua soinean zeramala ibiltzen zen, Harrison Ford nazien aurka borrokatzen zen, zigorra airean, eta Arnold Schwarzeneggerrek gihar koipetsuak erakusten zituen bere ezpataz zirkuluak eginez, baina inguratzen zituen paisaiak erakartzen zuen gure arreta, istorioan arreta osoz murgiltzeko aukera emanez. Eta, jakina, Geologia da efektu magiko horren erruduna.

2. irudia: 1969an Tabernas basamortuan El Condor westernerako eraikitako dekoratuak, gerora beste film batzuetarako erabili zirenak, besteak beste, Conan el Bárbaro. (Argazkia: Jaime Cantero Dole – Lan propioa, CC BY-SA 4.0 / Wikimedia Commons).

2. irudia: 1969an Tabernas basamortuan El Condor westernerako eraikitako dekoratuak, gerora beste film batzuetarako erabili zirenak, besteak beste, Conan el Bárbaro. (Argazkia: Jaime Cantero Dole – Lan propioa, CC BY-SA 4.0 / Wikimedia Commons).Almeria probintzian, Tabernas, Gádor, Santa Cruz de Marchena, Alboloduy eta Gérgal udalerrien artean dago Europa osoko basamortu bakarra, hitzaren zentzu hertsian. Basamortutzat hartzen da ez tenperaturagatik, baizik eta prezipitazioengatik; izan ere, oso euri gutxi egiten du eta, egiten duenean, modu ekaiztsuan eta barra-barra izaten da. Baina, zer pentsatuko zenukete esango banizue duela milioi urte gutxi batzuk eremu hori itsas hondoa izen zela?

Orain, gure DMC DeLoreanera igo eta atzera egingo dugu duela 8 milioi urtera arte, hau da, Miozenoaren amaierara arte. Une hartan, itsasertza Tabernasen iparraldean zegoen, hain zuzen ere, gaur egun Filabres mendilerroa izenez ezagutzen dugun mendi goragunearen hegalaren oinean. Hortaz, Tabernas eremua itsas hondoa zen, eta han jalkitzen ziren menditik zetozen ibaiek herrestan eramandako materialak, zeinek erresistenteagoak ziren harkaitzak (hareharriak) sortu zituzten bigunagoak ziren beste harkaitz batzuekin (tuparriak) nahastuta.

Hementxe amaitzen da gure filmaren lehenengo ekitaldia, eta gure gidoiaren argumentuaren lehenengo biraketa agertzen da. Izan ere, duela 7 milioi urte, tektonika agertu zen, pertsonaia nagusi berri bat. Garai hartan, plaka tektoniko afrikarrak, zeina Iparralderantz mugitzen baitzen, plaka tektoniko iberiarrarekin egin zuen talka. Ahalegin handi horrek lurpean zeuden material geologiko zaharrenak azaleratzea eragin zuen, eta beste mendi goragune bat eraiki zen Tabernasen hegoaldean: Alhamilla mendilerroa. Hala, Tabernas eremua itsas adar mehe eta luzea bihurtu zen bi mendilerroren artean. Baina tektonikak, bere rolean erabat murgilduta, bere jardunean jarraitu zuen; ondorioz, duela bi milioi urte baino gehiago, itsasoak atzera egin zuen eremu horretan, eta itsasertza gaur egungotik oso hurbil geratu zen.

Hala, hirugarren ekitaldian sartuko gara bete-betean. Gure protagonistak, Tabernaseko sakonuneak, hala ere, aurre egin zion gaur egungo basamortu bihurtzeari. Milioi eta erdi urtez baino gehiagoz, eremu horretan gaur egungo sabanaren antzeko ingurunea garatu zen, klima erdi idorra zuena. Han, aintzira txikiak, zabalak, baina ia sakonerarik gabekoak, eratu ziren. Aintzira horiek errekastoek eta errekek elikatzen zituzten, mendietatik erdiguneko eremu deprimituenetara lokatza eta harkaitz zatiak eramaten zituztenek.

3. irudia: Tabernas basamortuko muino baten itxura. Ikus daiteke kareharriak (laranja kolorekoak, eta elkarren arteko geruza paraleloetan jarriak) eta tuparriak (gris kolorekoak) tartekatzen direla. (Argazkia: Rabealga, CC BY-SA 3.0 / Wikimedia Commons)

3. irudia: Tabernas basamortuko muino baten itxura. Ikus daiteke kareharriak (laranja kolorekoak, eta elkarren arteko geruza paraleloetan jarriak) eta tuparriak (gris kolorekoak) tartekatzen direla. (Argazkia: Rabealga, CC BY-SA 3.0 / Wikimedia Commons)Baina istorioaren amaierara iritsi gara, oraingoan ezinbestekoa den laugarren ekitaldira: eremuaren egungo konfigurazio geologikoa. Eta, aipatutako filmetan bezala, orain sartuko dugu akzio guztia. Azken ehunka mila urteetan, gaur egun eremu osoa mende hartzen duen klima idorra ezarri zen, eta, ondorioz, desagertu egin ziren aintzira txikiak. Eta euria gutxitan egiten hasi zen, modu ekaiztsuan eta barra-barra. Hori horrela, material geologiko bigunenak (tuparriak) higatu egin ziren eta erreken urek eraman zituzten herrestan. Material gogorrenak (kareharriak), berriz, geldirik mantendu eta gainerakoen gainetik nagusitu ziren. Erreka horiek, denborak aurrera egin ahala, lurrazala zulatzen eta beren ibilgua ahokatzen hasi ziren; hala, gero eta sakonagoak ziren karkabak eta sakanak eratu ziren, eta horien ondoan mendixkak eta muinoak goratzen hasi, beren patuaren zain.

Hala, lurzoruaren gainazalean herrestan doan ur tanta baten pazientzia berarekin, gaur egungo Tabernas basamortuaren paisaia adierazgarria sortu zen. Testu honen hasieran aipatu ditudan filmen alegia ederrak kokatzeko paisaia ezin hobea. Film horiek eta Almerian filmatu ziren beste hainbat filmen kokaleku izan zen.

Ikusten duzuenez, errealitateak beti gainditzen du fikzioa. Inguratzen gaituzten harkaitzak gai dira Hollywoodeko gidoi bakar batek ere berdinduko ez dituen istorio ederrak kontatzeko. Espero dut milioika urteko istorio horiek transmititzen jarraitzea, Conanen unibertsoko saga cimmeriarren estiloan.

Egileaz:Blanca María Martínez (@BlancaMG4) Geologian doktorea da, Aranzadi Zientzia Elkarteko ikertzailea eta EHUko Zientzia eta Teknologia Fakultateko Geologia Saileko laguntzailea.

Jatorrizko artikulua Cuaderno de Cultura Científica blogean argitaratu zen 2025eko maiatzaren 8an: El Óscar a la mejor fotografía es para… ¡La Geología!

Itzulpena: UPV/EHUko Euskara Zerbitzua.

The post Argazki onenaren Oscar Saria… Geologiarentzat da! appeared first on Zientzia Kaiera.

Suzanne Corkin, memoriaren misterioak argitu zituen neurozientzialaria

Suzanne Corkin (1937-2016) estatubatuarra batez ere ezaguna da giza memoriari buruz egin zuen lan aitzindariagatik. Alzheimerra, parkinsona eta amnesia zuten pazienteekin egindako ikerketen bidez, neurozientzialari honek ezagutza sakonak ekarri zituen gure oroitzeko (eta ahazteko) moduari buruz, eta memoriari eta asaldura kognitiboei buruz genuen ulermena goitik behera aldatu zuen. Neuropsikologiaren alorrean egin zituen ekarpenez gain, Corkin mentore inspiratzailea eta zientziaren esparruan emakumeek eta gutxiengoek parte hartzearen defendatzailea izan zen.

1. irudia: Suzanne Corkin. (Argazkia: Mujeres con Ciencia).

1. irudia: Suzanne Corkin. (Argazkia: Mujeres con Ciencia).Suzanne Hammond Corkin 1937ko maiatzaren 18an jaio zen Hartforden (Connecticut, AEB), eta Mabelle eta Lester Hammonden alaba bakarra izan zen. Psikologia ikasi zuen Massachusettseko Smith Collegen eta graduondoko prestakuntzak Montrealgo (Kanada) McGill Unibertsitatera eraman zuen eta han doktoregoa egiten hasi zen Brenda Milner neuropsikologo ospetsuaren zuzendaritzapean.

Garai horretan, 1962an, Corkinek H.M. ezagutu zuen, eta paziente haren benetako izena (Henry Molaison) sekretupean mantendu zen 2008 hil egin zen arte. Garuneko kirurgia baten ondorioz amnesia edo memoriaren galera larria zuen gizon bat zen, eta Corkinen tesiaren gaia izan zen, Somesthetic function after focal cerebral damage (Garuneko foku-kaltearen osteko funtzio somestesikoa) izenekoa. Tesi horretan pazientearen ukipen-memoria esploratu zuen. Hasierako topaketa horrek hamarkadak iraungo zituen eta giza memoriaren ulermena goitik behera aldatuko zuen ikerketa-harreman baten oinarriak ezarriko zituen.

Karrera abangoardista memoriaren neurozientzianBere doktoregoa eskuratu ondoren, Corkin Hans-Lukas Teuber neuropsikologoaren laborategian sartu zen Massachusettseko Teknologia Institutuan (MIT, ingelesezko sigletan) 1964an. Hans-Lukas Teuber 1977an hil ostean, Suzannek laborategiko zuzendaritza bere gain hartu zuen, eta 1981ean irakasle postua lortu zuen unibertsitate horretan.

MITen bost hamarkada baino gehiagoz egon zen, eta Corkinek Portaeraren Neurozientziako Laborategia zuzendu zuen. Bere lana memoria-sistema espezifikoak, haren oinarri neurologikoak eta alzheimerra eta parkinsona bezalako gaixotasunetan dauzkan alterazioak argitzea izan zen. Paziente horietan ezagutza-defizitak ebaluatzeko jokabide-zereginak garatu zituen eta mundu-mailan aitzindaria izan zen giza neuroirudi metodoak erabiltzen, besteak beste erresonantzia magnetiko funtzionalaren bidezko irudia (zeregin zehatz bat egitean garuneko eskualde aktiboak erakusten dituen teknika), gaixotasun horiek garuneko memoria-sareetan nola eragiten zuten aztertzeko.

H.M.ren legatua

Corkinen ibilbide profesionalaren funtsezko oinarria H.M.ren ikerketa izan zen, eta hil arte ikertu zuen. Pazienteari bere epilepsia larria arintzeko 1953an egin zioten garuneko kirurgia batek amnesia sakona eragin zion, eta epe luzean oroitzapenak sortzeko ezinduta geratu zen. Hala ere, bere adimena eta beste gaitasun kognitibo batzuk berdin mantendu ziren. Hala, memoriari buruz ikertzeko ohiz kanpoko kasua izan zen. Corkinek 1962tik 2008ra arte ikertu zuen, eta bere burua aurkeztu behar izan zuen topo egiten zuten bakoitzean, H.M. ez zelako Corkinez gogoratzeko gai.

Corkinek H.M.rekin egin zuen ikerketak ezeztatu egin zuen memoria burmuin osoan zehar modu uniformean banatzen zela, eta frogatu egin zuen epe luzerako oroitzapenak ezartzeko gaitasuna lobulu tenporalen eremu zehatzetan zegoela, hipokanpoa barne.

Gainera, bere lanak memoria-sistema ugari zeudela erakutsi zuen. H.M.k gertakari berriak kontzienteki gogoratu ezin zituen arren, gaitasun motorreko zereginak ikasi eta horietan hobetu ahal zuen, hala nola ispilu batean izar bat marraztea, aurretik egin izanaren kontzientzia izan gabe. Horrek ezinbesteko bereizketa ezarri zuen memoria deklaratiboaren edo esplizituaren (kontzienteki gogoratu ahal diren gertakari guztiak aipatzen dituena, hala nola gertakari espezifikoak) eta memoria ez deklaratiboaren edo inplizituaren (memoria mota horri esker, aurretiazko esperientziek zeregin bat egiten laguntzen dute, esperientzia horiek bizi izanaren hautemate kontzientea izan barik) artean, eta frogatu zuen burmuineko bi erregio desberdinen menpe zeudela.

2. irudia: Permanent present tense liburuaren azala. (Argazkia: Mujeres con Ciencia).

2. irudia: Permanent present tense liburuaren azala. (Argazkia: Mujeres con Ciencia).Corkinen lana 150 ikerketa-artikulu baino gehiagotan eta hamar liburutan agertu zen. 2013an argitaratutako liburuan, Permanent Present Tense, H.M.ren historia dator zehatz-mehatz.

Mentore inspiratzailea eta emakumeek zientzian parte hartzearen defendatzaileaSuzanne Corkin ereduzko mentorea ere izan zen, zabal aitortua esparru zientifikoan emakumeei eta gutxiengoei emandako babesagatik. Bere mentoretzarako ikuspuntua errespetuan eta lankidetzan oinarritzen zen, eta bere ikasleak pareko gisa tratatzen zituen, haien adimen-independentzia sustatzeko. Bere taldea ikerketaren esparru guztietan sartzen zuen, dirulaguntzak eskatzetik laborategia kudeatzeraino, eta haien etorkizuneko karreretarako zorrotz prestatzen zituen.

Berdintasunarekin zuen konpromisoa agerikoa zen laborategian; izan ere, emakume eta gizon askok zeuden, eta Corkinek espektatiba berdinak zituen guztientzat, bereizketarik egin gabe. Emakume akademiko gisa izandako esperientziak eta erronkak partekatzen zituen, eta beren buruak defendatzera eta generoak haien aspirazio profesionalak ez mugatzera adoretzen zituen gainerako emakumeak. Kontziliazio familiarreko (senarra, bi seme eta alaba bat izan zituen) eta laboraleko eredua izan zen bere garairako, eta horrek aukera eman zion familiako deiei lan-bileretan erantzuteko. Horrez gain, MITen emakumezko irakasleen soldata-parekotasunaren aldekoa izan zen.

Suzanne Hammond Corkin gibeleko minbizia baten ondorioz hil zen 2016ko maiatzaren 24an, Danversen (Massachusetts), 79 urte zituela. Memoria eta garuneko funtzioen beste alderdi batzuk ezagutzeko konpromisoarekiko leial mantenduz, bere burmuina ikerketa xedeetarako erabil zezatela eskatu zuen.

Iturriak- Alice Cronin-Golomb, The Elements of Style: A Tribute to Suzanne Corkin, Journal of Cognitive Neuroscience (2013) 25 (1): 143–155

- Professor Emerita Suzanne Corkin dies at 79, MIT, 2016ko ekainak 1

- The Man Who Couldn’t Remember, Nova, 2009ko ekainak 1

- Geoff Watts, Suzanne Corkin, The Lancet, vol. 388, no. 10042 (2016) 336

- Suzanne Corkin, Wikipedia

Edurne Gaston Estanga elikagaien zientzia eta teknologiako doktorea da. Gaur egun, zientzia eta teknologiaren ezagutza zabaltzea sustatzen duten erakundeen proiektuak kudeatzen ditu.

Jatorrizko artikulua Mujeres con Ciencia blogean argitaratu zen 2025eko ekainaren 152an: “Suzanne Corkin, la neurocientífica que desveló los misterios de la memoria“.

Itzulpena: UPV/EHUko Euskara Zerbitzua.

The post Suzanne Corkin, memoriaren misterioak argitu zituen neurozientzialaria appeared first on Zientzia Kaiera.

Bostak: zientzia edo musika bizimodua ateratzeko

Musikan aritzen direnek “letretakotzat” jo ohi dute beren burua. Gogoan dauzkat Bilboko “Juan Crisóstomo de Arriaga” kontserbatorioko eskolak, Jesús Alonso Moral nire irakasle maiteak hari dardaratsuak azaltzen zituenean, eta arbelean A anplitude jakin batek, omega maiztasunak eta phi faseak osatzen zuten ekuazio ezaguna idatzi behar zuenean. Ikasleek protesta egiten zioten adierazpen matematikoak ikustean:

“Faborez, letretakoak garela!”

Jesúsek izukaitz erantzun ohi zuen:

“Horregatik jartzen dizkizuet, ba, letrak: A, omega, phi, …”

eta xehetasun osoz azaltzen zuen horien esanahi musikala.

Bizimodua ateratzeaZientzia eta musika lanbide exijenteak dira, eta prestakuntza, lan, ikasketa eta ahalegin jarraitu handia eskatzen dute horien bidez bizimodua atera ahal izateko. Musikari eta zientzialari handiek, hala nola William Herschel-ek edo Max Planck-ek, zientziarekin bizimodua ateratzea erabaki zuten. Biak dira ezagunagoak zientziaren esparruan egindako ekarpenengatik: Uranoren deskubrimendua, Herschel-en eguzkiaren apexaren kalkulu garrantzitsua, edo Planck-en mekanika kuantikoaren aparteko hastapenak. Hala ere, Herschel-en sinfonia bikainak edo Planck-en pianorako obrak edo Die Liebe im Walde opereta galduak ez dira hain gogoangarriak izan.

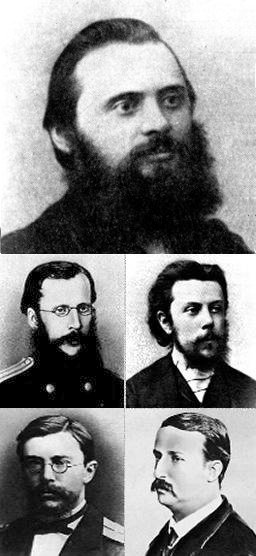

Bostak:Mili Balákirev konpositorea berezko musika errusiarra sortzeko mugimendu baten liderra izan zen San Petersburgon 1856 eta 1870 artean, eta César Cui, Modest Mússorgski, Nikolái Rimski-Kórsakov eta Alexandr Borodín biltzea lortu zuen. Bosten talde horretatik, soilik liderra zen musikari profesionala –urte batez matematikak ikasi zituen Kazango Unibertsitatean, baina ikasketak utzi zituen–.

1. irudia: bostak. Ezkerretik eskuinera eta goitik behera: Mili Balákirev, César Cui, Modest Músorgski, Nikolái Rimski-Kórsakov eta Aleksandr Borodín. (Argazkia: jabari publikoko argazkia. Iturria: Wikimedia Commons)

1. irudia: bostak. Ezkerretik eskuinera eta goitik behera: Mili Balákirev, César Cui, Modest Músorgski, Nikolái Rimski-Kórsakov eta Aleksandr Borodín. (Argazkia: jabari publikoko argazkia. Iturria: Wikimedia Commons)Egia esan, zientziak eta musikak ez dute ahalbidetzen lasaitasunez bizi ahal izatea. Cui ingeniaria zen, baina armada inperialeko jeneral izatetik bizi zen. Mússorgski-k musikari autodidakta izan nahi zuen, baina jaso ahal izan zituen ordainsari urriak funtzionario zibila izatearen ondorioz jaso zituen. Rimski-Kórsakov Errusiako armadaren nominaren menpe bizi izan zen: eskolak eman zituen San Petersburgoko kontserbatorioan uniformea jantzita, eta itsas armadako bandetako ikuskari gisa amaitu zuen. Borodín-ek medikuntza ikasi zuen, zehazki, kimikako espezializazioa, eta esparru horretan lan egin zuen bizitza osoan.

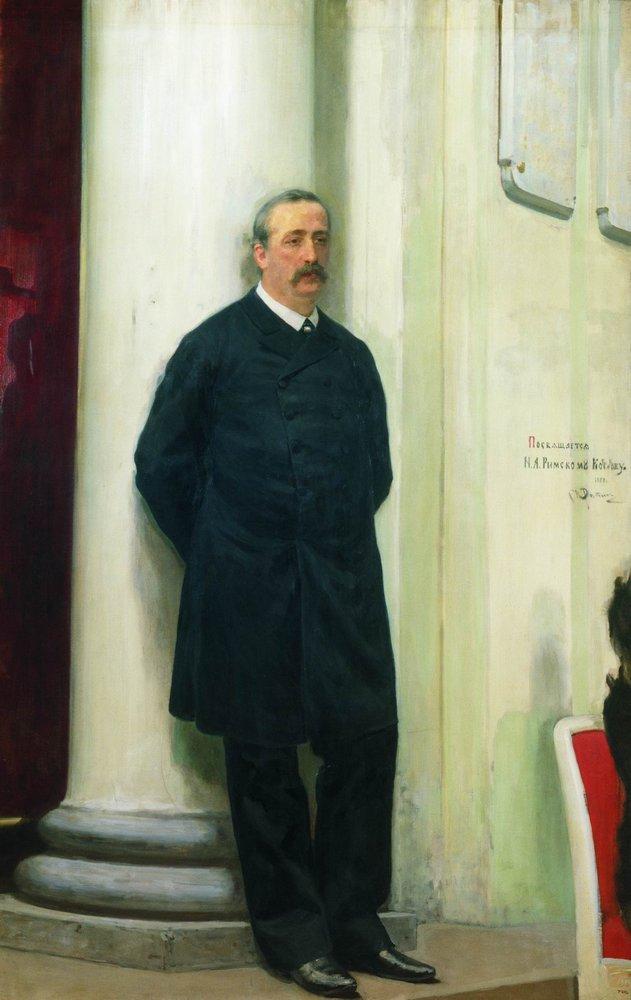

Borodín eta zientziaBosten taldeko kideak bere musikagatik gogoratzen ditugu, baina ez zuten horren bidez bizimodua ateratzea lortu. Borodín-en kasua bereziki nabarmentzekoa da, bere ekarpen zientifikoen nahiz musika obren kalitate bikainagatik. San Petersburgoko Medikuntza eta Kirurgia Akademian graduatu zen, eta 1858an doktorego tesia defendatu zuen gai honi buruz: “Azido fosforiko eta artsenikoen arteko analogia, ikuspegi kimiko eta toxikologikotik”. Aurrerago, zenbait egonaldi egin zituen atzerrian, eta doktorego ondoko kontratu bat lortu zuen Heidelbergeko Unibertsitatean, Robert Bunsen-en laborategiko Emil Erlenmeyer-en taldean.

2. irudia: «Aleksandr Porfiryevich Borodín konpositore eta kimikariaren erretratua» (1888), Iliá Repin-ek egina. (Argazkia: jabari publikoko argazkia. Iturria: Wikimedia Commons)

2. irudia: «Aleksandr Porfiryevich Borodín konpositore eta kimikariaren erretratua» (1888), Iliá Repin-ek egina. (Argazkia: jabari publikoko argazkia. Iturria: Wikimedia Commons)Borodín-ek frogatu zuen lehen aldiz ordezkapen nukleofiloa, kimika organikoan garrantzi handia duen erreakzioa. 1861ean metil bromuroa prestatu zuen zilar azetatotik abiatuta deskarboxilazio eta halogenazioko erreakzio konbinatu batean. Lan horretan oinarrituta, 1939an, Cläre eta Heinz Hunsdiecker kimikari alemaniarrek egiaztatu ahal izan zuten azido karboxilikoen zilar gatzek halogeno batekin erreakzionatzen dutenean, substratuak baino karbono atomo bat gutxiago duen alkilohaluro bat osatzen dela. Ondoren, erreakzio hori, Hunsdiecker-ek patentatutakoa, Hunsdiecker-en erreakzio edo, batzuetan, Hunsdiecker-Borodín-en erreakzio gisa egin zen ezagun.

Borodín eta hezkuntza zientifikoaXIX. mendean, Errusian ez zen inolako hezkuntza zientifikorik eskaintzen emakumeentzat. Eta horren garrantziaz jakitun, 1872an Borodín-ek beste kide batzuekin sortu zuen bere herrialdeko emakumeentzako lehendabiziko medikuntza ikastaroa. Ikasketa horiek obstetrizia ikastaro gisa hasi ziren, baina berehala bihurtu ziren emakumeentzako goi-mailako heziketa medikoko ikastaro, eta Borodín-ek dedikazio handia eskaini zien eskolaren administrazioari nahiz irakaskuntzari berari. Azkenean, Emakumeentzako Medikuntza Fakultate bihurtu zuten, eta aurrera atera ahal izan zen pertsona askoren lanari esker eta Alejandro II.a tsarraren babes finantzarioari esker. Hala ere, 1885ean, Alejandro III.aren erreinaldian, agintaritzek Fakultatea itxi zuten. Borodín-ek disgustu handia hartu zuen, eskola mantentzeko eginiko ahalegin guztiek porrot egin baitzuten.

Borodín eta musikaBorodín-ek ezin izan zion denbora handia eskaini musikari, Rimski-Kórsakov-ek adierazi zuen moduan. Borodín-en eta bere emaztearen —Ekaterina Protopópova pianista— etxe familiarrera egindako bisitetan, Rimski-k lagunari esaten zion denbora gehiago bidera zezala musikara, eta ez hainbeste kimikara. Franz Liszt boteretsuak ere babestu zituen Borodín-en obra batzuen estreinaldiak Europa osoan, eta, dirudienez, Borodín-ek Weimarrera eginiko bisitaldi batean, musikari handiari eskertu zion bere esku-hartzea, baina umilki aitortu zion “igandeko” konpositore bat besterik ez zela.

1881eko udako oporretan, Borodín-ek lortu zuen denbora laburrean bere 2. hari-kuartetoa konposatzea. Lirismo eta adierazpen handiko obra da, eta bere Katenka maiteari dedikatu zion, ezkontza urteurreneko opari gisa. Adierazi behar da bere operarik garrantzitsuena Igor printzea izan zela; horren hiru sinfoniak garrantzi handiko obrak dira eta Errusiako eskolari ospea eman zioten munduan. Hala ere, Borodín-en izaeraren alderdirik bereziena obra apalagoetan hauteman daiteke, benetan ederra den inspirazioz eginda daudenak eta zeinetan harmonia nagusi den:

Iturriak:- Borodine, A (1861). Ueber Bromvaleriansäure und Brombuttersäure. Justus Liebigs Annalen der Chemi, 119:121–123. DOI: 10.1002/jlac.18611190113

- Husdiecker, Clare; Vogt, Egon; Hunsdiecker, Heinz (1939). US patent 2176181: «Method of manufacturing organic chlorine and bromine derivatives».

- Rimski-Kórsakov, Nikolái Andreievich (1906). Mi vida musical. Madrid 1934, Maxtor Editorial 2020. ISBN 978-84-9001-671-8.

Víctor Etxebarria Ecenarro Bilboko Juan Crisóstomo Arriaga Kontserbatorioan diplomatutako luthierra da, eta Sistemen Ingeniaritzako eta Automatikako katedraduna da Euskal Herriko Unibertsitatean (EHU).

Jatorrizko artikulua Cuaderno de Cultura Científica blogean argitaratu zen 2025eko irailaren 21ean: El Grupo de los Cinco: ciencia o música para ganarse la vida

Itzulpena: EHUko Euskara Zerbitzua.

The post Bostak: zientzia edo musika bizimodua ateratzeko appeared first on Zientzia Kaiera.

Zientzia auzitegietan (eta X): zientzia krimenen aurka

2025. urtean zehar auzitegien arloan dagoen zientziari buruzko artikulu-sorta argitaratu dugu Zientzia Kaieran. Azken atal honetan aurrekoen berrikuspena egingo dugu eta punturik aipagarrienak azpimarratuko ditugu.

Urtarrilean hasitako artikulu-sorta honetan zientziak krimenaren eta gaizkileen aurka nola egiten duen azaldu dugu. Urte honetan zehar ikusi dugun bezala, estua da zientziaren eta auzitegien arteko lotura. Ikusi dugu, era berean, antzekoak direla metodo zientifikoa eta krimenen ebazpenerako metodoa. Hainbat kasu zehatz aztertu ditugu, batzuk aspaldikoak, eta beste batzuk duela gutxi ebatzi direnak. Artikuluetan zehar hainbat esparru desberdin izan ditugu aztergai: kimika, fisika, biologia, balistika, toxikologia… Historian zehar egin diren aurrerapausoak ere aztertu ditugu eta ikusi dugu nola joan diren erabiltzen analisi-metodo desberdinak krimenen ebazpenean. Lehen forentseek lehen sinetsiko ez zituzten teknikak ohikoak dira gaur egun, eta XIX. mendean aske geldituko ziren gaizkileak gaur egun berehala harrapatzen dira.

Irudia: auzitegi-zientziak aukera ematen du zientziaren hainbat arlori buruz sakontzeko (Argazkia: cottonbro studio – domeinu publikoko irudia. Iturria: pexels.com).

Irudia: auzitegi-zientziak aukera ematen du zientziaren hainbat arlori buruz sakontzeko (Argazkia: cottonbro studio – domeinu publikoko irudia. Iturria: pexels.com).(I) Hastapenak izeneko atalean auzitegi-zientzien funtsaz aritu gara eta azaldu dugu nahiko berria dela delituak metodo zientifikoaren eta ebidentzien bidez ebaztearen ideia. Hori ez da beti horrela izan eta, esan bezala, hastapenetan intuizio hutsek, testigantza subjektiboek… osatzen zuten froga-multzorik handiena. Gaur egun badakigu krimenaren agertokiak informazio asko gordetzen duela, eta hori irakurtzen jakin behar dela. Horrexetarako behar dira auzitegi-zientziak. Ildo horretatik, (II) artsenikoa eta Marsh-en proba izenburudun atalean toxikologiaren hastapenetara joan gara, artsenikoa oinarri duten pozoiak aztertzeko. Giulia Tofana pozoitzailearen historia bitxia berrikusi dugu, eta hitz egin dugu 1832an James Marshek diseinatutako artsenikoa detektatzeko probaz. Aztertu dugu nola proba horri esker John Bodle errudun izan zela nola ebatzi zuten, eta azaldu dugu Marshen probari esker hasi zela amaitzen artseniko-pozoiketen inpunitatea.

Hurrengo atalean, (III) krimenaren agertokia izenekoan, definizioetara jo dugu. Krimenaren agertokia definitu dugu, krimena gertatu den leku fisikoa dela esanez: krimenaren lekuko isila. Krimen bat gertatzen denean poliziak ematen dituen lehen urratsak azaldu ditugu, eta forentseen lanik garrantzitsuenak zeintzuk diren azpimarratu dugu. Garrantzitsuena elementu guztiak bere horretan irauten dutela bermatzea da; izan ere, ebidentzia batzuk degradatu egin daitezke denbora pasa ahala.

Berriro ere toxikologiari heldu diogu (IV) pozoiak eta toxikologia atalean: pozoiek badute misterio puntua eta, ziurrenik, interes gehien pizten duen toxikologiaren atala da. Kasu honetan, ordea, ez dugu artsenikoaz bakarrik hitz egin eta modu orokorrean mintzatu gara pozoiez. Esan dugun bezala, pozoiak dira ezagutzen diren armarik zaharrenetakoak, eta toxikologoak aspalditik ahalegindu dira substantzia hilgarriak detektatzen eta antidotoak bilatzen. Hortik tiraka, Orfila jaunaren aipamena eginez amaitu dugu atala. Orfilari eta toxikologiari buruz asko izan dugu esateko, eta hariari tiraka jarraitu dugu (V) Orfila eta Lafarge kasua atalean. Charles Lafarge-ren hilketa entzutetsua kontatu dizuet, Orfilak aditu gisa epaiketan izan zuen parte-hartzea kontatu dizuet eta kasu hura nola ebatzi zen. Orfila toxikologiaren aitzindaritzat hartzen da eta bi lan garrantzitsu argitaratu zituen: 1813an Traité des Poisons ou Toxicologie Générale eta 1817an Eléments de Chimie Médicale, toxikologiaren oinarrizko bibliografia osatu zuten lanak. Orfilaren ekarpena ezinbestekoa izan zen Charles Lafargeren emaztea, Marie-Fortunée, errudun jotzeko.

(VI) aztarnak, ebidentziak eta frogak atalean definizioetara jo dugu berriro, eta hor auzitegi-zientzien eta justiziaren arteko desberdintasun batzuk aipatu ditugu. Ebidentzia guztiak ez dira froga, eta aztarna guztiak ez dira ebidentziak. Hauxe da gakoa: aztarna bat ebidentzia bihurtzen da objektiboa denean, krimenarekin estuki lotuta dagoenean edo, nolabait, hipotesiaren egiaztapena dakarrenean. Aldiz, epaileak ebidentzia ontzat ematen badu, froga izango da eta gaizkilea kondenatzeko edo errugabea absolbitzeko baliogarria izango da.

Azaldu dizuet zientzia ez dela hutsik gabekoa, eta (VII) zientziak huts egiten duenean izeneko atalean auzitegi-zientzien historian gertatutako zenbait akats kontatu dizkizuet. Kasu adierazgarrienetako bat 1991. urtean biziarteko kartzela-zigorrera kondenatutako Patricia Stallings-en kasua da. Kasuaren ebazpena (VIII): gaixotasuna edo pozoitzea? atalean kontatu dizuet, ebazpenean auzitegi-laborategiek egindako akatsetan azpimarra jarriz. Ez dugu ahaztu behar, zientziak berak bezala, auzitegi-zientziak ere akatsak egin ditzakeela. Tentuz ibili beharreko kontua, jokoan dagoena kontuan hartzen badugu.

Artikulu-sortaren amaierara hurbilduz, (IX) hatz-marken analisiaren hastapenak atalean ezinbestez aztertu behar den beste gai bat ekarri dut: hatz-marken analisiak auzitegi-zientzietan izan duen garrantzia. Hatz-markek argi uzten dute Locard-en printzipioa, alegia, ez dela posible gaizkileak ekintza kriminala egitea, are gutxiago ekintza kriminalak eskatzen duen indarkeriarekin, inongo arrastorik utzi gabe. Arrasto horiek askotarikoak izan daitezke: hatz-markak, DNA… agian gaur egun oraindik ezagutzen ez ditugunak ere.

Artikulu-sortari amaiera ematen diot irakurtzen ari zareten honekin, baina auzitegi-zientziei buruz oraindik asko dago esateko. Auzitegietako lanari buruz ikasitakoaz aparte, zientziari berari buruz ikasteko aukera ona ematen du auzitegi-zientziak; izan ere, krimenak beti sortzen du jakin-mina, misterioa eta abar. Horixe da zientziaren dibulgazioak behar duena: zientziari buruz irakurtzeko interesa piztea.

Erreferentzia bibliografikoak:- AEBetako Justizia Departamentua (2000). Crime Scene Investigation: A guide for lae enforcement. U.S. Department of Justice, Office of Justice Programs.

- Bertomeu Sánchez, José Ramón (2006). Sentido y sensibilidad: Mateu Orfila, el ensayo de Marsh y el caso Lafarge, Cuadernos de la Fundación Antonio Esteve, 6, 73-97.

- Cornago Ramírez, Mª del Pilar (2023). Estudio forense de huellas dactilares. In Cornago Ramírez, Mª del Pilar; Esteban Santos, Soledad. Química Forense (230-263 or.). UNED

- Esteban Santos, Soledad (2023). La Química en el contexto de la ciencia forense. In Cornago Ramírez, Mª del Pilar; Esteban Santos, Soledad. Química Forense (21-47 or.). UNED

- McDermid, Val (2014). Forensics: what bugs, burns, prints, DNA, and more tell us about crime. Grove Press.

- Mulet, J.M. (2016). La ciencia en la sombra. Planeta argitaletxea.

- Olson, A., Ramsay, C. (2025) Errors in toxicology testing and the need for full discovery. Forensic Science International: Synergy, 11, 100629. DOI: 10.1016/j.fsisyn.2025.100629

- Serrula Rech, Fernando (koord) (2022). Investigación forense de la escena del crimen. Asociación Galega de Médicos Forenses.

Josu Lopez-Gazpio (@Josu_lg), Kimikan doktorea, zientzia dibulgatzailea eta GOI ikastegiko irakasle eta ikertzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

Zientzia auzitegietan buruzko artikulu-sorta:

- Zientzia auzitegietan (I): hastapenak

- Zientzia auzitegietan (II): artsenikoa eta Marsh-en proba

- Zientzia auzitegietan (III): krimenaren agertokia

- Zientzia auzitegietan (IV): pozoiak eta toxikologia

- Zientzia auzitegietan (V): Orfila eta Lafarge kasua

- Zientzia auzitegietan (VI): aztarnak, ebidentziak eta frogak

- Zientzia auzitegietan (VII): zientziak huts egiten duenean

- Zientzia auzitegietan (VIII): gaixotasuna edo pozoitzea?

- Zientzia auzitegietan (IX): hatz-marken analisiaren hastapenak

- Zientzia auzitegietan (eta X): zientzia krimenen aurka

The post Zientzia auzitegietan (eta X): zientzia krimenen aurka appeared first on Zientzia Kaiera.

Ura garbitzeko mintzak: funtzionamendua eta lortzeko era

Gaur eguneko arazoen artean gehien kezka dezakeenetarikoa edateko uraren kutsadura da. Denbora aurrera joan ahala pertsona eta izaki bizidun gehiagori eragiten dio arazo honek, herrialde txiroenek kalteen efektu handienak pairatuz.

Problematika honi aurre egiteko dagoen aukerarik onena uren tratamendua da, hau da, kutsatzaileak uretara heldu baino lehen kudeatzea edota, behin uretan barneratu direla, eliminatzea. Aipatutako azken prozedura ur araztegietan aurrera eramaten da, hiru pausu nagusitan banatzen delarik: fase primarioak solido eta olioen sedimentazioa bultzatzen du, fase sekundarioa bakterioen metabolismoaz baliatzen da materia organikoa prozesatzeko, azkenik fase tertziarioa emanez, non bestelako kutsatzaileen kudeaketa ematen den.

Hirugarren fasera heltzen diren kutsatzaileak ugariak eta natura ezberdinekoak dira. Zehaztasun altuko hainbat prozesu behar izaten dira edateko ura lortzeko, baliabide ekonomiko eta denbora kopuru handiak behar izanik. Modu honetan hobekuntza argi bat aurkezten da: prozesu baten sorrera, non hainbat kutsatzaile harrapatzeko aukera ematen den, nahiz eta beraien aktibitatea ezberdina izan, jarraian hauen kudeaketa edo berreskurapena ahalbidetzen duena eta ingurumenari ahalik eta kalte gutxien eragiten diona.

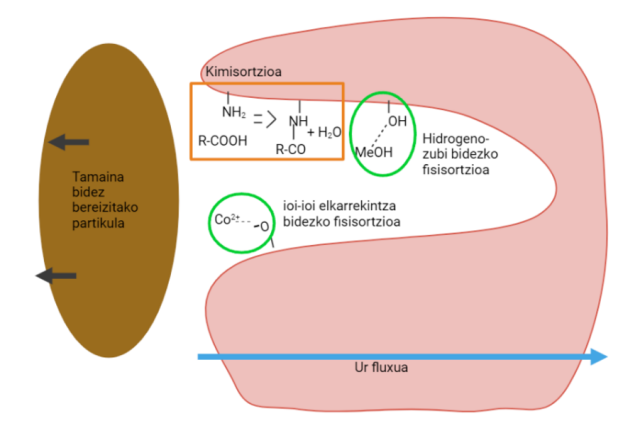

Testuinguru honetan mintzen teknologia garatu da: indar eragile ezberdinen bitartez, likido batean dauden konposatuen kontzentrazioa aldatzeko gai diren azalera porotsuak. Hauek bi mekanismo nagusiren bidez eragiten dute (irudia). Alde batetik, tamainaren bidezko bereizketaren bitartez, mintza osatzen duten poroak baino tamaina handiagoko partikulek ezin dute mintza zeharkatu, uretan gera zitezkeen partikula edo sedimentuak eliminatuz. Beste aldetik, adsortzio fenomenoa agertzen da, hau mintzaren materialaren eta kutsatzaileen arteko elkarrekintza fisiko-kimikoen bitartez lortzen du arazketa.

Irudia: mintzen poroetan eman daitezkeen prozesu ezberdinen laburpena. (Iturri: Ekaia aldizkaria)

Irudia: mintzen poroetan eman daitezkeen prozesu ezberdinen laburpena. (Iturri: Ekaia aldizkaria)Erabilitako materiala eta poroak izanik mintzen ezaugarri garrantzitsuenak, hauek sortzeko erabiltzen diren produktuak eta prozesuak kritikoak dira. Prozesuen bitartez, poroen tamaina zein distribuzioa eta mintzaren dimentsioak zehazteko gaitasuna lortzen da. Produktuaren arabera, lortutako elkarrekintzak zehazten dira, aldi berean, erabil daitezkeen prozesatzeak mugatzen dira. Ohiko produktuak polimeroak edo zeramikak dira. Lehenak, hainbat disolbatzailetan disolba daitezke eta tenperatura altuetan bigundu edo urtzeko gaitasuna dute, baina beraien propietateak aldatzeko eta beste motatako produktuak barneratzeko erraztasunak dituzte. Zeramiken kasuan, aldiz, kimikoki geldoak dira, zurruntasun altukoak eta fusio puntu oso altuekin, baina sintesi prozesu garestiak dituzte. Horrela izanik, mintz polimerikoak disoluziotik edo egoera bigundutik sortzen dira, zeramikoak hautsen tratamendutik edo sintesi zuzenaren bidez sortzen diren bitartean.

Hainbat material egonik, eta bakoitzak zenbait prozesatze izatean, mintzen propietate fisiko-kimikoen aukera zabalak aurkezten dira, munduko eta industriako ur kutsatuekiko erantzun espezifikoak lortzeko gaitasuna lortuz. Teknologia honekin agertzen den arazoa birziklapena izanik, garrantzizkoa da materialen eta hauek lortzeko prozeduren hobekuntzak garatzea, bizitza-denbora luzatzea zein berrerabilpena erraztea izango lirateke bilatzen diren ezaugarri nagusiak. Modu honetan ikerketaren bultzatzeak duen garrantzia ikusten da, mota hauetako aurrerapenak ingurumen eta industriarako onuragarriak izatean, hobekuntzak beste eremuetara luzatzeko gaitasuna lor baitaiteke, gizaki eta planetarentzako onurak dakarrena.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: 47

- Artikuluaren izena: Ura garbitzeko mintzak: funtzionamendua eta lortzeko era.

- Laburpena: Munduan zehar aurkitzen den arazo larrienetarikoa edateko uraren gabezia hedatuz doala da, hainbat kutsatzailek eraginda. Mintzen garapena premiazkoa da askotariko ur-eskuragarritasuneko egoeretan kutsatzaileen kudeaketa aurrera eramateko. Garbiketa-mekanismo bakoitzaren arabera (tamainaren araberako bereizketa edo adsortzioa) material batzuk erabiliko dira, oro har polimeroak edo zeramikak. Modu honetan, prozesatze-metodo asko garatu dira material eta baldintzen arabera. Alde batetik, zeramikak zurrunak eta kimikoki geldoak direnez gero, haien prozesatzea zein erabilera muturreko egoeretarako dira egokiak. Beste alde batetik, polimeroak disolbagarriak direnez eta tenperaturarekin biguntzeko gaitasuna dutenez, egoera leunagoetan maneiatu behar dira. Lan honetan, ura garbitzeko erabiltzen diren mintzen ezaugarri orokorrak aurkezten dira; hau da, kutsatzaileak kentzeko erabiltzen diren mekanismo fisiko edo/eta kimikoak, mintz bat eratzeko prozesatze-teknikak eta sortzeko material bakoitzaren propietateak.

- Egileak: Peio Martinez eta Antonio Veloso-Fernández

- Argitaletxea: EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- eISSN: 2444-3255

- Orrialdeak: 205-220

- DOI: 10.1387/ekaia.26141

Peio Martinez eta Antonio Veloso-Fernández EHUko Zientzia eta Teknologia Fakultateko Kimika Fisikoa Saileko ikertzaileak dira.

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Ura garbitzeko mintzak: funtzionamendua eta lortzeko era appeared first on Zientzia Kaiera.

Claudia Prieto: «Nahi nuke gure ikerketek erresonantzia magnetiko aurreraturako sarbidearen oztopoak murrizten lagun dezatela»

Claudia Prieto doktorea ingeniari zibil industriala da, aipamen elektrikoarekin (Txileko Pontificia Universidad Católica unibertsitatea, UC); masterra eta doktoregoa erakunde horretan bertan eskuratu zituen 2007an, eta doktorego ondoko egonaldi bat egin zuen Londresko King’s College-en, non irakasle titular izatera iritsi zen 2020an. Egun, irakasle titularra da UCko Ingeniaritza Elektrikoko Sailean, bai eta UCko Ingeniaritza Eskolako ikerketa eta berrikuntzako zuzendaria eta Osasunerako Ingeniaritza eta Adimen Artifizialeko Milenio Institutuko (iHEALTH) zuzendaria ere, non irudietan oinarritutako arreta medikoa hobetzeko teknologia berritzaileen garapena zuzentzen duen.

Prieto doktoreak bihotzeko miaketen denbora nabarmen murrizten duten erresonantzia magnetikoko teknologia aurreratuak garatu ditu; eta, horri esker, pazientearen erosotasuna eta diagnostikoaren efizientzia hobetzea lortu da. Doktorearen lana nazioartean aitortu dute: 2024an, “ISMRM Fellowship” sari prestigiotsua jaso zuen, International Society for Magnetic Resonance in Medicine erakundearen eskutik; 2025ean, Society for Cardiovascular Magnetic Resonance sozietatearen SCMR nazioarteko konferentziako programako buru izan zen; eta, 2025ean , “Berritzaileak Osasunean” ikerketa kategoriako saria jaso zuen Txileko Berrikuntza Farmazeutikoko eta Emakume Enpresarien Ganberaren eskutik.

Irudia: Claudia Prieto. (Argazkia: ikertzaileak emandako irudia). Zein da zure ikerketa arloa?

Irudia: Claudia Prieto. (Argazkia: ikertzaileak emandako irudia). Zein da zure ikerketa arloa?

Nire ikerketa adimen artifizialean (AA) oinarritutako soluzioen eta irudi medikoen teknika berrien garapenean zentratzen da, hauek barne hartuta: irudien fisika, irudien berreraikuntza, mugimenduaren zuzenketa (alderantzizko problemak) eta horien aplikazio klinikoa. Bereziki, erresonantzia magnetikoko (MRI, ingelesezko siglengatik) teknologia multiparametriko kuantitatiboen garapenean espezializatuta nago. Horien xedea da gaixotasun kardiobaskular eta metabolikoen diagnostiko zehatzagoak, integralagoak eta egokiagoak eskuratzea. Gure ikerketaren helburu nagusia da fisika eta AA integratzen dituzten soluzio berritzaileak sortzea, irudietan oinarritutako arreta medikoa hobetzeko, eta hori irisgarriago eta eskuragarriago bihurtzeko. Lan horri esker garatu dira bihotzeko eta abdomeneko bereizmen handiko erresonantzia magnetikorako metodoak eta askotariko kontrasteak eskuratze denbora murriztuta, eta lagundu egin du erresonantzia magnetikoko aztarna digitala (MRF) bezalako mapaketa kuantitatiboko tekniketan aurreratzen, zeinen xedea baita ehun miokardiko eta hepatikoaren karakterizazioa egitea.

Zergatik zabiltza arlo horretan?Ikerketa arlo horretan nabil gizartean inpaktu zuzena izan dezaketen arazoen soluzioak diziplinarteko lanaren bidez aurkitzeko aukera oso erakargarria delako. Arlo horrek fisika, matematika, konputazio zientziak eta medikuntza konbinatzen ditu, eta, beraz, intelektualki oso estimulagarria da. Gainera, oraindik ebatzi gabeko erronka handiak daude esparru horretan; eta, beraz, motibazio iturri etengabea da.

Izan al duzu erreferenterik zure ibilbidean?Zorte handia izan dut nire karreran zehar ikerketa arlo honekiko entusiasmo eta konpromiso irmoa transmititu didaten kideak aurkitu ditudalako. Horietako asko gako erreferenteak izan dira nire garapen profesionalaren etapa ezberdinetan.

Zer da zure alorrean deskubritu edo ebatzi nahi zenukeena?Nire ekarpena egin nahi nuke diagnostiko zehatz, irisgarri eta egokiagoak lortzea ahalbidetuko duten irudi medikoko teknologien garapenean, bereziki baliabide mugatuko testuinguruetan. Nahi nuke gure ikerketek erresonantzia magnetiko aurreraturako sarbidearen oztopoak murrizten laguntzea, bai kostuari bai konplexutasunari dagokionez, tresna horiek mundu osoko paziente gehiagori hurbildu ahal izateko.

Zein aholku emango zenioke ikerketaren munduan hasi nahi duen norbaiti?Jakingura, pertseberantzia eta taldean lan egiteko gaitasuna lantzeko gomendatuko nieke. Ikerketa etengabe ikastea eskatzen duen bidea da, aukera ematen diguna helburu komunak dituen eta arrakasta handiak lortzen dituen komunitate bateko kide izateko. Funtsezkoa da, halaber, mentore onak bilatzea, inspiratzen zaituzten pertsonez inguratzea eta benetan norberaren grina pizten duten gaiak aukeratzea.

Jatorrizko elkarrizketa Mujeres con Ciencia blogean argitaratu zen 2025eko abuztuaren 2an: “Claudia Prieto: «Aspiro a que nuestras investigaciones ayuden a reducir las barreras de acceso a la resonancia magnética avanzada»“.

Itzulpena: EHUko Euskara Zerbitzua.

Ikertzen dut atalak emakume ikertzaileen jardunari erreparatzen die. Elkarrizketa labur baten bidez, zientzialariek azaltzen dute ikergai zehatz bat hautatzeko arrazoia zein izan den eta baita ere lanaren helburua.

The post Claudia Prieto: «Nahi nuke gure ikerketek erresonantzia magnetiko aurreraturako sarbidearen oztopoak murrizten lagun dezatela» appeared first on Zientzia Kaiera.

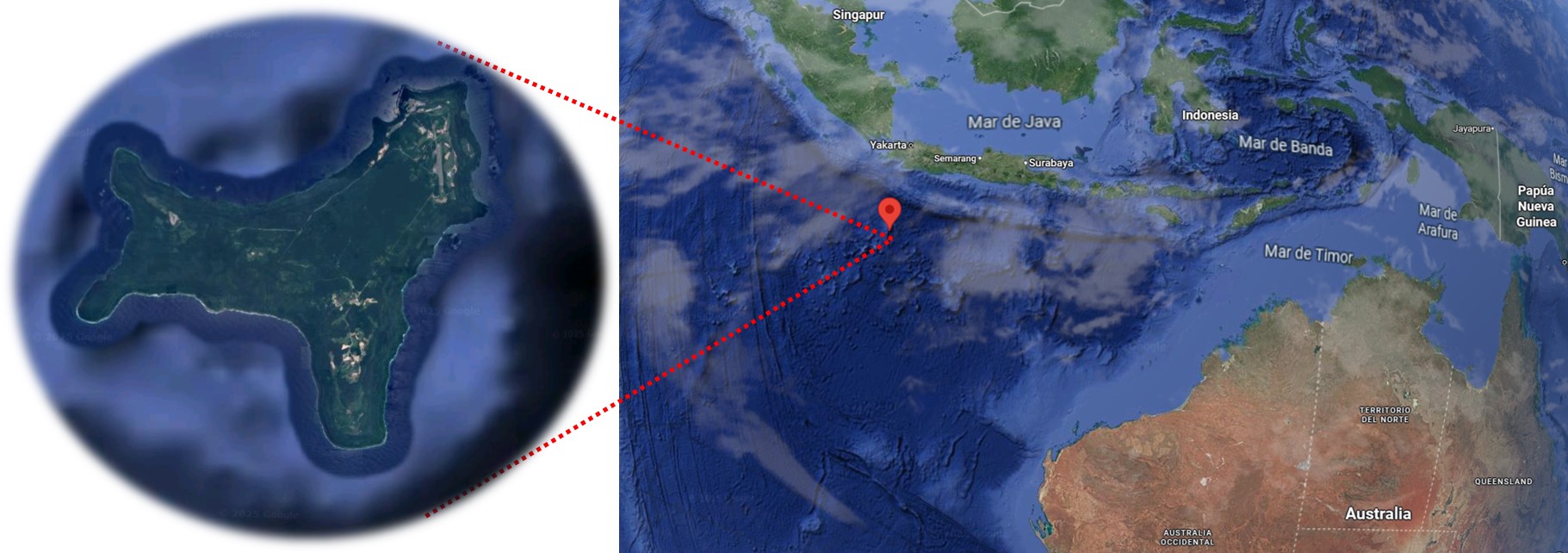

Madagaskar

Madagaskar da eboluzioak nola funtzionatzen duen ikasteko leku bikain bat, bertan dagoen fauna berezia Afrikatik isolatuta egon baita milioika urtez. Eboluzioa itsua da, eta ausazkoa; ez du helbururik: aipatu dugu nola mutazioen ondorioz gure arbasoren batek isatsa galdu zuen, nola periferian bizi zen talde txiki baten baitan beste espezie bat sor zitekeen, edo nola Mundu Berriko tximinoen arbasoek Atlantikoa zeharkatu zuten eta bertan eboluzionatu zuten. Madagaskarren gertatutakoa hirugarren modukoa da: berriro ere itsasoa zeharkatu zuen baltsa begetal bat dugu, eta gainean, lemur guztien arbasoa. Orain dela 50 milioi urte inguru iritsi ziren Madagaskar uhartera eta mundu bitxi bat aurkitu zuten, hutsik zeuden txoko ekologiko askorekin eta eboluzioak eskaintzen dituen aukera guztiekin.

Aie-aiea, izen zientifikoz Daubentonia madagascariensis, primate bitxienetako bat da eta eboluzioaren ausazkotasunaren adibide bikaina. Hatz luzeak dituen lemur gautiarra da, karraskariek bezala etengabe hazten diren ebakortzak dituena, eta hirugarren hatz oso luzea erabiltzen du zuhaitzen azalean kolpeak emateko eta intsektuen larbak aurkitzeko. Belarriak ultrasoinuak detektatzeko moldatuta ditu, eta seigarren behatz bat du, sasibehatz moduko bat. Kondairek diote bere hatz bitxiarekin zuregana zuzentzen bada heriotza etorriko dela, eta horregatik jotzen dute gaueko espiritu gaiztotzat. Baina aie-aieak ez zuen eboluzionatu “larbak aurkitzeko” edo “gizakien heriotza ekartzeko”: hori guztia ausaz gertatutakoa da; iraganean bizirautea lortu zuen bere hatz luzearekin, eta baliteke orain ez lortzea, hatz luzeak beldurra ematen digulako. Eboluzioa ez dago zuzenduta: ezin da aukeratu, soilik biziraun.

“Gure arbasoak” Ikusgela hezkuntza proiektuaren bideo-sorta bat da. Euskal Wikilarien Kultur Elkartearen ikus-entzunezko egitasmoa da eta EHUko Kultura Zientifikoko Katedraren kolaborazioa izan du.

The post Madagaskar appeared first on Zientzia Kaiera.

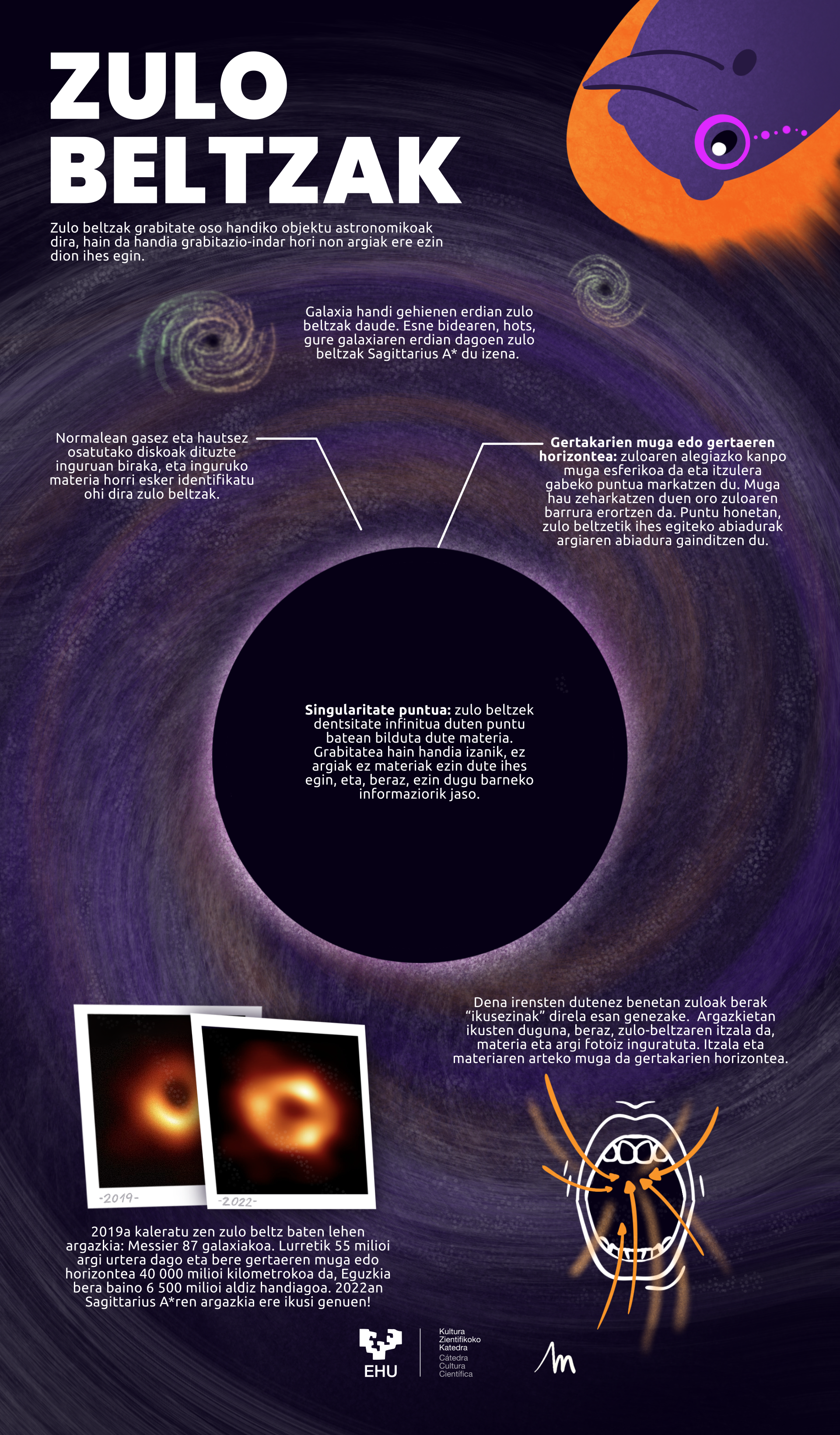

Kiñuren begirada: zulo beltzak

Unibertsora begira jarri da oraingoan gure Kiñu, zehazki, zulo beltzetara. Zelan begiratu, baina, argirik emititzen ez duen zerbait? Izan ere, definizioz, zulo beltza, beltza da, ez du argirik igortzen. Baina begiratu soilik ez, zulo beltzei egindako bi argazki dakartza Kiñuk.

Zelan egingo zaizkio argazkiak, baina? Berez, ezin zaio argazkirik atera argirik igortzen ez duen objektuari. Zorionez, galaxien zentroko zulo beltzak materiaz inguratuta daude, eta hori da, hain zuzen ere, zulo beltzen argazkiak ateratzea ahalbidetzen duena. Hau da, ez dugu zulo beltza bera ikusi, ikusten duguna bere itzala da, materiaz eta argi fotoiez inguratuta.

Itzala eta materiaren arteko mugari gertakarien horizontea deritzo. Muga esferiko bat da, itzulera gabeko puntua. Zulo beltzaren grabitatea hain handia izanik, ez argiak ez materiak ezin dute ihes egin muga horretatik kanpo, eta, beraz, ezin dugu barruko informaziorik jaso.

Hilero, azkenengo ostiralean, Kiñuk bisitatuko du Zientzia Kaiera bloga. Kiñuren begirada gure triku txikiaren tartea izango da eta haren eskutik gure egileek argitaratu duten gai zientifikoren bati buruzko daturik bitxienak ekarriko dizkigu fin.

Egileaz:Maddi Astigarraga Bergara (IG: @xomorro_) Biomedikuntzan graduatua, EHUko Ilustrazio Zientifikoko masterra egin du eta ilustratzailea da.

The post Kiñuren begirada: zulo beltzak appeared first on Zientzia Kaiera.

Elisa Bachofen, karrera teknikoetan emakumeak sartzeko bidea ireki zuen Argentinako eta Hego Amerikako lehen ingeniari zibila

Hogeita hamar urte baino gehiago eman zituen bide obrak diseinatzen, eta zubien eraikuntzaren alorrean alderdi teknikoak gainditu zituen. 27 urte zituela, Elisa Bachofen (1891-1976) Argentinako eta Hego Amerikako ingeniari zibil gisa graduatzen lehen emakumea izan zen. Horri esker, bide egin zien beste profesional batzuei, eta karrera teknikoak ikasteko bere urratsak jarraitzera bultzatu zituen. Halaber, asmatzailea eta eskubide feministen aldeko militantea izan zen, bereziki hezkuntzarako sarbideari lotuta.

1. irudia: Elisa Bachofen. (Argazkia: Mujeres con Ciencia).

1. irudia: Elisa Bachofen. (Argazkia: Mujeres con Ciencia).Elisa Buenos Airesen jaio zen 1891ko maiatzaren 2an. Bere aita ingeniari suitzarra zen, eta Londresetik Hego Amerikako hiri horretara Alpargatas ehun fabrikarako makinak eramateko kontratatu zuten.

Familiaren eraginez, eta txikitatik edozein motako makinekiko zaletasunak bultzatuta, Ingeniaritza Zibileko karreran izena eman zuen, Buenos Airesko Unibertsitateko Zientzia Zehatzen, Fisikoen eta Naturalen Fakultatean, eta bertan lortu zuen bere titulua 1918an. Bere graduko tesian kotoi-fabriketan iruteko makina bat proposatu zuen, Argentinako Chaco probintzian, zehazki.

1919an zubien proiektugile lanetan aritu zen Zubi eta Bideen Zuzendaritzan, eta hala jarraitu zuen 1932ra arte. Hurrengo urtean, Bideen Zuzendaritza Nazionala sortu ostean, arloa antolatu eta Bide Lanen Zuzendaritzako buru izan zen hogei urtez.

Heziketa teknikoa emakume ororentzatBachofenek emakumezkoen heziketa teknikoa ahalbidetzeko ekimen desberdinak sustatu zituen, etxean eskura zitezkeenak baino ezagutza zabalagoetarako sarbidea izan zezaten.

“Patria y Hogar” Argentinako Damen Elkartearen esparruan Emakumeen Kontseilu Nazionaleko Liburutegian eman zituen ikastaroen gaiak honako hauek ziren, besteak beste: etxeko esparruari aplikatutako elektrizitatearen, eta automobilentzako mekanika eta motorren oinarrizko kontzeptuak. Bere helburua emakumeen bokazio zientifiko-teknikoa piztea zen, beren ohiko zaintzaile rola alde batera utzi gabe, eta diskurtso hori iraultzailea izan zen garai hartan.

Halaber, familiaren ibilbideak Elisaren ahizpari, Estherri, bidea erraztu zion, eta, horri esker, 1922an Argentinan ingeniari titulua eskuratzen laugarren emakumea izan zen.

Argentinan emakumeen kasuan unibertsitaterako sarbidea debekatuta ez zegoen arren, “neskentzako” karrerak zeuden, eta prestakuntza teknikoak gizonezkoei mugatuta egon ohi zeuden.

Munduaren amaieraren asmatzaileaBere grina ez zen soilik ingeniaritzara, bideen obretara eta militantzia feministara mugatu; asmatzaile nabarmena ere izan zen, eta lau tresna patentatu zituen. 1924 eta 1930 bitartean patentatu zituen “kotoimetro” bat (kotoia sailkatzeko ekipoa), lurreko bideak hobetzeko metodo eta ekipo bat, eta bideetako irregulartasunak erregistratzeko gailu bat.

1943an Stella Genovese arkitektoarekin batera arrisku sismikoko tokietan eskola seguruak eraikitzeko proiektu bat egin zuen. Proposamena San Juan probintziako hogeita bost eraikinetan aplikatu zen, Argentinako mendikate aurreko arrisku telurikoa duen eremu batean.

Hala ere, beren lana Arkitekturako V. Erakustoki Nazionalean baztertu zuten, interes arkitektoniko txikia zuelakoan. 1944an lurrikara handi batek hiriko eraikinen % 80 suntsitu zuen, baina Elisa eta Stellak diseinatutako eraikinek zutik iraun zuten.

Horri esker, biek sari bat lortu zuten 1947an, Arkitekto Panamerikarren VI. Biltzarrean.

Asmatzaile gisa izandako ibilbideari esker Asmatzaileen Elkartearen Batzorde Teknikoko presidente izan zen 1938 eta 1943 bitartean. Garai hartan Asmatzailearen Gida egin zuen, beste pertsona batzuei laguntza emateko asmakizunak diseinatu eta patentatzeko orduan.

Militantzia feminista eta omenaldiak1918an Batasun Feminista Nazionaleko kide sortzaile izan zen, eta elkarte hori izan zen, hain zuzen ere, Argentinan emakumeen eskubideen alde borrokatu zen erakunde nagusietako bat politikan, hezkuntzan eta bizitza publikoan sartu ahal izateko.

2. irudia: Elisa Beatriz Bachofenen omenezko monumentua; Resistencia, Chaco, Argentina. (Argazkia: Mujeres con Ciencia)

2. irudia: Elisa Beatriz Bachofenen omenezko monumentua; Resistencia, Chaco, Argentina. (Argazkia: Mujeres con Ciencia)Estatuko erakundeetan egindako ibilbideaz gain, Liburutegi Zientifiko eta Teknikoen Argentinako Elkarteko buru zein Negozio Emakumeen eta Emakume Profesionalen Elkarteko Zuzendaritza Batzordeko kide izan zen, eta kudeaketa pribatuko enpresa ugariri aholkularitza eman zien.

Sariak, ohorezko diplomak eta zilarrezko eta urrezko dominak jaso zituen, eta hitzaldiak eman zituen Europan, Estatu Batuetan, Israelen eta Brasilen.

1955ean, kolpe militarraren ostean, Argentinatik alde egitea erabaki zuen. Estatu Batuetara joan zen, eta bertan bere proiektuak garatzen jarraitu zuen.

Aurrerago Argentinara bueltatu zen, eta zeregin nabarmena izan zuen Informazioaren Zientzien arloan, erakunde tekniko nabarmenen zuzendaritzaren ardura bere gain hartu zuen, hala nola Industria Teknologiako Institutu Nazionalaren Ikerketa Dokumentaleko Zentroan (INTI) eta Ikerketa Zientifiko eta Teknikoen Kontseilu Nazionalaren Dokumentazio Zientifikoaren Zentroko Sailkapen Hamartar Unibertsalaren Batzorde Nazionalean (CONICET).

Buenos Airesen zendu zen 1976ko azaroaren 19an.

2018an, bere graduazioaren mendemugan, Buenos Airesko Unibertsitateko Ingeniaritza Fakultateak “Elisa Bachofen” Emakume Ingeniarien Lehenengo Jardunaldia antolatu zuen, eta, geroztik, urtero egin da. Gaur egun kale jakin batzuei eta tunelak eraikitzeko makina bati bere izena jarri diote.

2021az geroztik bere omenez ÑuSat Argentinako nanosateliteetako bati bere izena jarri zioten, eta Aleph-1 merkataritza-konstelazioaren parte da.

Iturriak:- Carolina Hadad, Elisa Bachofen: puente al futuro, Científicas de acá, 2021eko maiatzaren 2a

- Elisa Beatriz Bachofen, Centro Argentino de Ingenieros

- Día de la Ingeniería: la historia de la primera especialista latinoamericana, Diario Clarín, 2020ko ekaiarena 6a

- Elisa Beatriz Bachofen (1891-1976), Mujeres en la ciencia y la tecnología, CONICET, 2021

- Silvina Boggi, ¿Por qué Elisa Beatriz Bachofen?, 2018ko uztailaren 19a, 12. orrialdea

Analía Boggia Komunikazio Sozialean lizentziaduna, kazetaria, irakaslea eta dibulgatzailea da. Egun, Ikerketa Zientifikoko Komunikazio Sozialari buruzko Master ofiziala egiten ari da Valentziako Nazioarteko Unibertsitatean.

Jatorrizko artikulua Mujeres con Ciencia blogean argitaratu zen 2025ko maiatzaren 8an: Elisa Bachofen, primera ingeniera civil argentina y sudamericana que abrió caminos para incluir mujeres en carreras técnicas

Itzulpena: EHUko Euskara Zerbitzua.

The post Elisa Bachofen, karrera teknikoetan emakumeak sartzeko bidea ireki zuen Argentinako eta Hego Amerikako lehen ingeniari zibila appeared first on Zientzia Kaiera.

Orain arte unibertsoa super-ordenagailu baten simulazioa izan zitekeen

Uste zen ezinezkoa zela zientziak argitzea garai batean soilik filosofia eta zientzia-fikzio arloetan agertzen zen hipotesia. Berriki argitaratutako ikerketa batean, matematikaren eta fisikaren arloetatik eman diote behin betiko erantzuna zientzialariek: ez, ezinezkoa da unibertsoa goi mailako konputazio kuantiko baten simulazioa izatea. Gainera, ikerketa berak osotasunaren teoremaren existentzia ukatzen du. Izan ere, errealitatearen alderdi fisiko guztien deskribapenak zerbait sakonagoa eskatzen baitu.

Unibertsoaren jatorriaren inguruko galderak gizakien existentzia bezain zaharrak dira. Lehenengo zibilizazioen galdera existentzialetatik egungo grabitazio kuantikoraino, historikoki gizakia etengabe saiatu da azaltzen unibertsoaren zergatia. Hori dela eta, mendeetan zehar milaka teoria garatu dira gai horren inguruan. Orain, garai digitalaren etorrerarekin, super-ordenagailuen inguruko teoria berri ugari agertu dira. Egora hori baliatuz, azken hamarkadetan zientzia-fikzioko pelikula askok argumentu nagusi gisa erabili dute unibertsoa super-ordenagailu baten simulazio bat izatearen ideia. Zehatzago, egungo giza zibilizazioa baino askoz garatuago dagoen beste zibilizazio bateko teknologiak sortutako simulazio bat dela esan da. Harrigarria badirudi ere, egun arte, zientziak ez zuen teoria hau matematikoki baztertu.

Irudia: Matrix filmean, konputagailuz simulatutako mundu batean, protagonistek pilula gorria edo urdina aukeratu behar dute, munduaz ezagutu nahi duten aldea zein den: ilusioa ala errealitatea. Argazkia: ANIRUDH – Unplash lizentziapean. Iturria: Unplash)

Irudia: Matrix filmean, konputagailuz simulatutako mundu batean, protagonistek pilula gorria edo urdina aukeratu behar dute, munduaz ezagutu nahi duten aldea zein den: ilusioa ala errealitatea. Argazkia: ANIRUDH – Unplash lizentziapean. Iturria: Unplash)Orain, Kanadako British Columbia Unibertsiateko ikertalde batek matematikoki frogatu du zientzia-fikzioan askotan erabiltzen den teoria hori gertatzea ez dela sinesgaitz, baizik eta zuzenean ezinezkoa. Horretarako, ikertzaileak naturaren funtsezko izaera ikertu eta hori simulatzeko aukera duen inolako konputagailurik ez dagoela frogatu dute.

Simulaziotik harago doan aurkikuntzaHala ere, ikertaldeak lortutako emaitzak, Matrix batean bizi garen ideia deuseztatu ez ezik, frogatu egiten du gure errealitateak algoritmo guztietatik ihes egiten duela. Hau da, unibertsoaren existentzia edozein algoritmoren irismenetik harago dagoen ulermen mota batean oinarritzen dela erakusten du ikerketak. Aurkikuntza hauek balio handia dute; izan ere, simulatutako unibertso batean biziko bagina simulazio berberak bizitza sortzeko aukera izango luke. Orain arte, hipotesi hauek soilik ikuspuntu filosofiko batetik jorratu zitezkeela uste zen, baina artikuluaren lehen autore den Mir Faizal-ek adierazten duen bezala, “Lehen uste zen ideia hauek ikerketa zientifikoaren irismenetik kanpo zeudela. Hala ere, berriki egin dugun ikerketak erakutsi du, berez, zientifikoki hel dakiekeela”.

Ikerketa honetan ikertzaileek ukigarri edo behagarriak diren fenomenoetatik harago joan behar izan dute. Ez Newtonen fisika klasikoak ez Einsteinen erlatibitatearen teoriak ez zien balio naturaren funtsezko izaera ikertzeko. Mekanika kuantikoak gehiago gerturatzeko bidea ireki zien, eta gaur egun abangoardiakotzat jotzen den grabitate kuantikoaren hipotesian sakon murgiltzeko aukera eman zien. Teoria honen arabera, espazioa eta denbora ez dira funtsezko elementuak; askoz harago dagoen elementu bat da gure errealitate fisikoaren atzean dagoen oinarrizko funtsa: informazio hutsa.

Fisikariek diote informazio huts hori gure unibertso fisikotik harago dagoen entitate matematiko batean dagoela. Hain zuzen ere, ‘Platonen erreinu’ izena eman diote zientzialariek izate abstraktu horri eta, zientzialarien ustez, bertatik sortuko ziren espazioa eta denbora. Hala ere, teoria hori simulatutako unibertso baten existentzia frogatzeko argumentu bezala erabiltzeko aukera ukatzen du ikerketa berri honek. Izan ere, ikertaldeak frogatu zuen oinarri den informazio huts horrek ere ezin duela errealitatea guztiz deskribatu konputazioa soilik erabiliz.

Ulermen ez-algoritmikoaOndorio horretara heltzeko, ikertzaileek goi mailako teorema matematikoak erabili zituzten. Helburua gure errealitatea bere osotasunean azaltzeko ulermen ez-algoritmikoaren beharra frogatzea zen eta, horretarako, beste hainbaten artean, Gödelen osogabetasun teorema erabili zuen ikertaldeak.

Azken finean, gure unibertsoa super-ordenagailuek garatutako simulazio bat izango balitz, nahiz eta oso konplexua izan, betiere algoritmoek deskribatutako pausoz pausoko errezeta bat jarraitu beharko luke. Eta hor dago gakoa. Gure errealitatean badira soilik ulermen ez-algoritmikoak argitu dezakeen hainbat egia absolutu. “Egia Gödeliar” hauek benetakoak dira, baina ez dute sekuentzia logikorik jarraitzen eta ezin dira frogatu konputazioa erabiliz. Beraz, ikerketak argitzen du ezinezkoa dela errealitate fisikoaren alderdi guztiak deskribatzea grabitazio kuantiko konputazionala erabiliz: “Ezin da fisikoki osoa eta guztiz sendoa den teoria bat eratorri soilik konputazioa erabiliz. Horregatik, lege konputazionalak edo espazio-denbora bera baino gehiago, funtsezkoagoak diren osagaiak eta ulermen ez-algoritmikoa behar dira”, dio Faizal-ek.

Osotasunaren teoriaren bilaUrte askotan zehar, mundu osoko fisikariak osotasunaren teoremaren bila aritu dira. Teorema horrek errealitatearen alderdi fisiko guztiak deskribatzeko gai izan beharko luke. Baina ikertaldeak adierazten duenez, “Ezinezkoa da. Izan ere, fisikaren oinarrizko legeak ezin dira espaziora eta denborara mugatu, lege horiek sortzen baitituzte espazio-denborak”. Ikerketa honetan zientzialariek osotasunaren teoriaren existentzia eza aldarrikatzen dute; izan ere, “errealitatearen deskribapen oso eta trinko batek zerbait sakonagoa eskatzen du”.

Erreferentzia bibliografikoa:Faizal, Mir; Krauss, Lawrence M.; Shabir, Arshid; Marino, Francesco (2025). Consequences of Undecidability in Physics on the Theory of Everything. Journal of Holography Applications in Physics, 5 10–21. DOI: 10.22128/JHAP.2025.1024.1118

Egileaz:Oxel Urra Elektrokimikan doktorea da, zientziaren eta artea uztartzen duten proiektuetan aditua, egun zientzia-komunikatzailea da.

The post Orain arte unibertsoa super-ordenagailu baten simulazioa izan zitekeen appeared first on Zientzia Kaiera.

Maiek eklipseak iragartzea nola lortu zuten argitu dute

Behaketan oinarrituta, maiak gai izan ziren eguzki eklipseak iragartzeko. Kodize zahar baten azterketatik, ‘egunen zaindariek’ hau nola lortu zuten ondorioztatu dute ikertzaileek.

Egunen zaindariak zeuden maien hirietan, eta, bitxia bada ere, oraindik ere Mexikoko eta Guatemalako zenbait komunitate indigenatan antzeko funtzioa betetzen duten pertsonak daude. Horien esku zegoen denbora neurtzea, bai eta horren gaineko erritualen kudeaketa ere; bada, hein handi batean, denboran zehar mantendu dira ezagutza hauek.

1. irudia: askotan maien zibilizazioa irudi mistiko bati lotuta dago, baina behaketa enpirikoa eta matematika funtsezkoa izan ziren haientzat. (Argazkia: Paweł Wielądek. Iturria: Unsplash)

1. irudia: askotan maien zibilizazioa irudi mistiko bati lotuta dago, baina behaketa enpirikoa eta matematika funtsezkoa izan ziren haientzat. (Argazkia: Paweł Wielądek. Iturria: Unsplash)Kultura gehienetan denboraren neurketaren inguruko ezagutza duten pertsona espezialistak egotea normala da, baina Erdialdeko Amerikako herrietan bereziki garrantzitsua zen horrelako adituak izatea, hainbat egutegi sistema bateratzen zituztelako. Haab izenekoa egutegi zibila zen, 365 egunekoa. Gure hamabi hilabeteak beharrean, egutegi honek hemezortzi zituen, bakoitza hogei egunekoa, eta amaiera bost egun gehitzen zizkieten. Baina, horrez gain, 260 eguneko Tzolkin egutegi erlijioso eta errituala zuten. Besteak beste, jaiotza egunaren arabera, pertsona baten patua aurreikusteko erabiltzen zuten egutegi hau, funtzio astrologikoa betez.

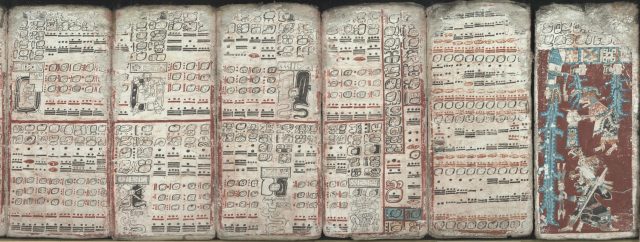

Azken honetan oinarritua dago, hain zuzen, Dresdeko kodizean agertzen den informazioa. Zuhaitz baten azalarekin egindako kodizea da, 39 orriz osatuta, eta, orotara, hiru metro eta erdiko luzera du. Gaurdaino iritsi zaigun maien eskuizkribu bakarrenetakoa da. Bertan, errito eta igartze egutegiak, meteorologia eta astronomia taulak eta jainkoen irudiak azaltzen dira maien agiri garrantzitsu honetan.

Ezaguna da maiak gai izan zirela eklipseak aurreikusteko, baina oraindik ez da oso ondo ulertzen zelan lortzen zuten hau egitea. Baina adituek jakin bazekiten Dresdeko kodizea gako izan daitekeela, duela mende bete inguru ezagutzen baita kodize hau eklipseei lotuta dagoela. Horren atzean dagoen funtzionamendu zehatza, alabaina, ez zen ondo ulertzen. Baina berriki New York Plattsburgh (AEB) Unibertsitateko John Justeson antropologoak eta Justin Lowry arkeologoak Science Advances aldizkarian argitaratutako zientzia artikulu batean argitu dunenez, agiria interpretatzeko gakoa ilargi zikloetan egon daiteke.

Egunen zaindariek urteetan zehar Ilargiaren jarraipena egin zuten, eta, denborarekin, pilatutako behaketei esker, eklipseak jaso zituzten agirian, taulan doiketak eginez. Ikertzaileak konturatu direnez, belaunaldiz belaunaldi maiek doiketa berriak sartzen zituzten taula astronomikoa hobetzeko. Modu horretan gai izan ziren eklipseak aurreikusteko. Orotara, Dresdeko kodizeak 405 ilargi hilabete jasotzen ditu, lehen eklipse batetik abiatuta eta azken eklipse bateraino.

Bertan erakutsitako ezagutza behaketan oinarrituta zegoenez, ikertzaileek proposatu dute maiek eguzki eklipse bat ikusten zutenean konturatzen zirela ilargi berria zegoela, eta, modu horretan, bi aldagaien arteko lotura ondorioztatuko zutela. Beste horrenbeste gertatuko zen ikustean ilargi eklipseak ilbetean gertatzen direneko ezagutzarekin.

Gaur egun jakin badakigu ilberri eta ilbete bakoitzean ez dagoela eklipserik, hori soilik gertatzen baita Ilargiaren nodoetan, hau da, Ilargia ekliptikarekin gurutzatzen denean. Ilargian nodoaren erdigunean dagoenean ilargi eklipse totala gertatzen da, baina erdigune horretara iristeko bi egun falta direnean —edo bi egun pasa direnean—, eklipse partziala gertatuko da. Bada, orain ondorioztatu dutenez, kontu honetan ere maiek aurreikuspen gero eta hobeagoak egin zituzten ilberria nodoarekiko hurbilago noiz egongo zen ebazteko.

2. irudia: besteak beste, errito eta igartze egutegiak, meteorologia eta astronomia taulak eta jainkoen irudiak azaltzen dira Dresdeko kodizean. (Argazkia: egile ezezaguna – jabari publikoa: Iturria: Wikimedia Commons)

2. irudia: besteak beste, errito eta igartze egutegiak, meteorologia eta astronomia taulak eta jainkoen irudiak azaltzen dira Dresdeko kodizean. (Argazkia: egile ezezaguna – jabari publikoa: Iturria: Wikimedia Commons)Artikulu hau egin duten zientzialariek argitu dute ez dutela uste maiek nodoen fenomenoa ezagutzen zutenik, “baina jakin behar zuten horren bueltan zeozer bazegoela”, Lowryren esanetan.

Kodizeari zentzu berria eman diote, ikertzaileak sinetsita daudelako hasieran eklipseen taula ilargi egutegia izan zela, baina gero egokitu zutela eguzki eklipseak iragartzeko. Arrazoinamendu horren abiapuntua honetan datza: sei ilargialdiren sei edo zazpi taldetan egituratuta dago egutegia, eta egileek uste dute horrek erakusten duela hilabeteetan oinarritutako kontabilitate batetik iragarpen eredu batera pasa zirela.

Kodizearen azken azterketa honetatik atera duten beste irakaspen bat da maiak gai zirela aurreikusteko bai beren zeru ikusgarrian agertzekoak ziren eklipseak zein beren ikusmen lerrotik kanpo gertatu behar zirenak ere. Horretaz konturatu dira alderatu dituztenean kodizea eta NASAk azken 5.000 urteetan geratu diren eklipseen datu basea

Maiek eklipseak fenomeno arriskutsutzat hartzen zituztenez, ikertzaileek interpretatu dute seguruenera maiek beren erritualen arrakastatzat hartuko zituztela aurreikusi bai baina azkenean ikusteko gai izan ez ziren eklipse hauek. Kodizean bertan ageri diren erritual horien helburu nagusia izango litzateke, hain justu, iluntasunaren etorrera saihestea.

Ikerketaren beste irakaspen bat izan da maiek doitasun handia izan zutela fenomenoak erregistratzerakoan. Diotenez, ilargi hilabetearen iraupena zehaztean batez bestean bi segundo baino gutxiagoko akatsa izan zuten gaurko baloreekiko, eta hori egin zuten, gainera, gailu optikorik gabe. Doitasun hau eklipseetan nabaritu zen ere, daten erdia baino gehiago bat datozelako Erdialdeko Amerikan XI. eta XII. mendeetan izandako eklipseen egunekin.

Egileaz ikerketaz baliatu dira nabarmentzeko maientzat behaketa enpirikoa eta matematika funtsezkoak zirela, askotan zibilizazio horren inguruan irudi mistikoa zabalduta dagoen arren.

Erreferentzia bibliografikoa:Justeson, John; Lowry, Justin (2025). The design and reconstructible history of the Mayan eclipse table of the Dresden Codex. Science Advances, 11, 43. DOI: 10.1126/sciadv.adt9039

Egileaz:Juanma Gallego (@juanmagallego) zientzia kazetaria da.

The post Maiek eklipseak iragartzea nola lortu zuten argitu dute appeared first on Zientzia Kaiera.

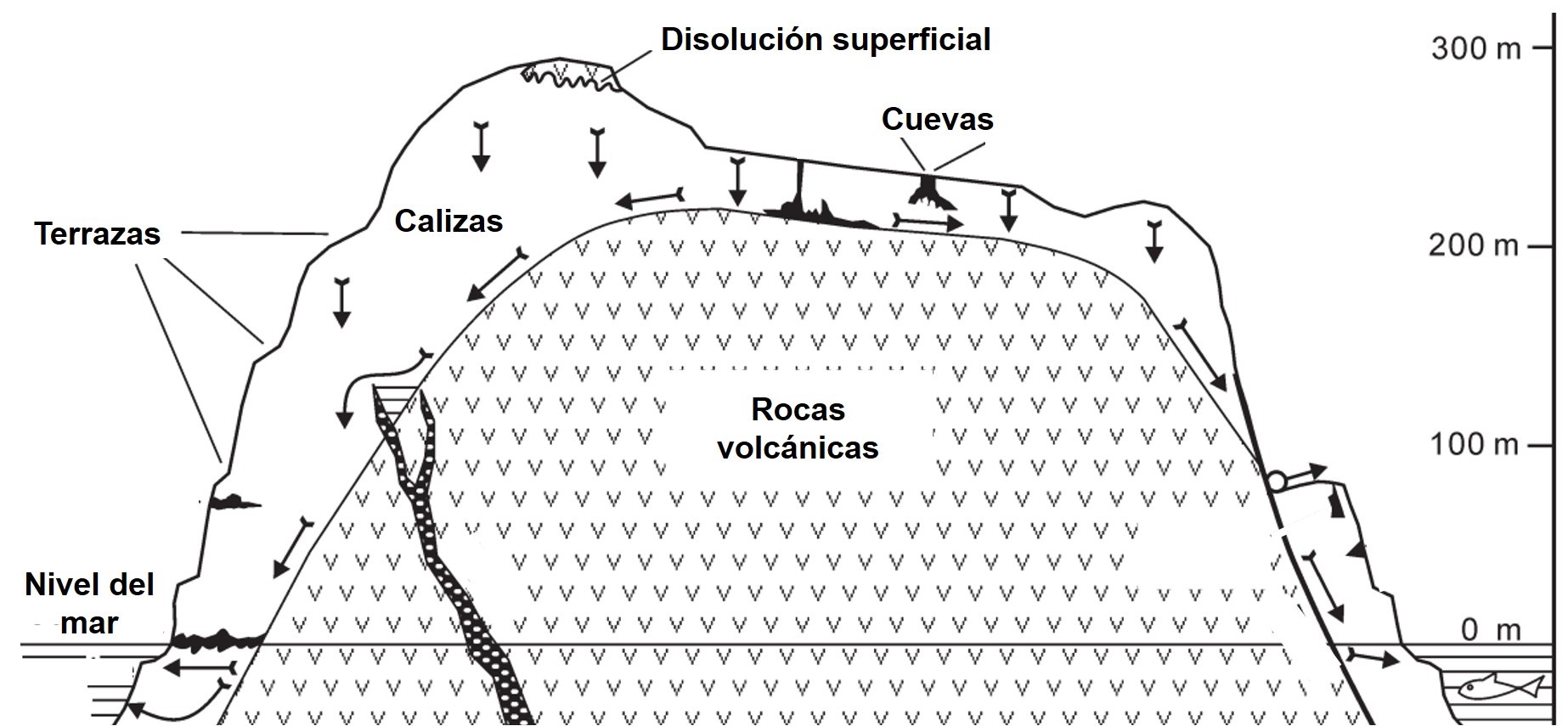

Bitrimeroak: aldi berean termoplastikoak eta termoegonkorrak diren polimeroak

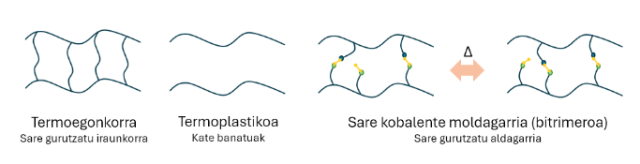

Molekula berdin edo ezberdinak (monomeroak) kopuru altuetan lotura kobalenteen bidez lotzen direnean, kateak sortuz, polimero deituriko materiala sortzen dute. Polimero hauek naturalak edo sintetikoak izan daitezke, monomeroen eratorriaren arabera, baina are garrantzitsuagoa da polimeroaren izaeraren araberako sailkapena: termoplastikoa, termoegonkorra edo elastomeroa. Izaera bakoitzak kateen arteko elkarrekintza ezberdinak aurkezten ditu, materialari ezaugarri fisiko ezberdinak emanez.

Nahiz eta polimero guztiak oso erabiliak izan, elastomero eta termoegonkorrek arazo bat aurkezten dute, beraien birziklapen prozesua oso etekin baxukoa da beraien erresistentzia kimiko eta fisikoak direla eta. Problematika honen aurrean, polimero mota berri bat aztertu da, bitrimeroak deritzonak.

Bitrimeroak osatzen duen egitura sare kobalente moldagarri (Covalent Adaptable Networks, CANs) modura ezagutzen da, kateak beraien artean lotuta daude, baina estimulu ezberdinen bitartez (beroa, argia…), loturen berrantolaketa lortzen da (irudia). Propietate honen bitartez, termoegonkorrek duten gogortasuna eta termoplastikoek duten birziklagarritasuna lortzen dira material berean, baita apurketak berez konpontzeko aukera ere.

Irudia: sare kobalente moldagarrien barne-egituraren eta polimero tradizionalen arteko konparazioa. (Iturria: Ekaia aldizkaria)

Irudia: sare kobalente moldagarrien barne-egituraren eta polimero tradizionalen arteko konparazioa. (Iturria: Ekaia aldizkaria)Propietate mekanikoekin batera, amaierako produktuaren epe luzeko zein sintesi prozesuan erabiltzen diren produktu kimikoen toxikotasuna oso ezaugarri garrantzitsuak dira. Ohiko epoxi erretxinen sintesian erabiltzen diren produktuek eragin kaltegarria dute izaki bizidunetan, horrela, bitrimeroen sintesia produktu naturalen bitartez interes altukoa da, epoxi erretxinen antzeko propietate mekanikoak, birziklagarritasun hobea eta toxikotasun baxuagoa lortzeko asmoz. Modu honetan artikulu hau garatu da, banilina, putresina eta soja-oliaren bitartez sintetizatutako bitrimero baten sorrera aztertu da, baita materialaren propietate bereizgarriak ere, hau da, bero eta presioaren bitartez loturen berrantolaketa ematea eta zatitutako materiala berez konpontzea.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: 47

- Artikuluaren izena: Bitrimeroak: aldi berean termoplastikoak eta termoegonkorrak diren polimeroak.

- Laburpena: Izaeraren arabera polimero termoegonkor, termoplastiko eta elastomeroak aurkitzen dira. Horietatik birziklatzeko arazo handienak sortzen dituztenak lehenak dira. Alde batetik, polimero termoegonkorren egitura oso gurutzatua denez, propietate fisiko eta kimiko onak aurkezten dituzte, baina ez dira tenperaturarekin biguntzen, ezta urtzen ere, degradatu baizik. Beste alde batetik, termoplastikoek bigundu eta urtzeko aukera dute, haien propietate fisiko-kimikoak termoegonkorrenak baino okerragoak izanik. Horren aurrean, termoplastikoen birziklagarritasuna eta termoegonkorren propietate mekaniko onak lortzeko, bitrimeroak garatu dira. Bitrimeroak sare kobalente moldagarri batez osatutako material polimerikoak dira. Horrela, erresistentzia mekanikoa birziklatze-zikloetan zehar mantentzeko gaitasuna lortzen da. Horretarako kateen arteko lotura kobalenteek itzulgarriak izan behar dute; adibidez, Schiff base baten imina taldeen kasua. Lan honetan, produktu naturaletik abiatuta eta biobateragarria den soja-olio epoxidatuaren bitartez termoegonkorra den bitrimero bat sintetizatu da. Horretarako, lehendabizi Schiff basea sintetizatu da bi produktu natural erabilita: 4-hidroxi-3-metoxibenzaldehidoa (banilina) eta 1,4-butanodiamina (putresina), eta ondoren, soja-olio epoxidatuarekin gurutzatu da. Konposatu horrekin hainbat karakterizazio egin ondoren (termiko eta mekanikoak), haren propietate bitrimerikoak egiaztatu dira, eta erretxina termoegonkorrak ordezkatzeko erabil daitekeela frogatu da.

- Egileak: Peio Martinez, Leyre Pérez-Álvarez eta Antonio Veloso-Fernández

- Argitaletxea: EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- eISSN: 2444-3255

- Orrialdeak: 187-203

- DOI: 10.1387/ekaia.26321

Peio Martinez eta Antonio Veloso-Fernández EHUko Zientzia eta Teknologia Fakultateko Kimika Fisikoa Saileko ikertzaileak dira.

Leyre Pérez-Álvarez EHUko Zientzia eta Teknologia Fakultateko Kimika Fisikoa Saileko eta BCMaterials ikerketa-zentroko ikertzailea da.

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Bitrimeroak: aldi berean termoplastikoak eta termoegonkorrak diren polimeroak appeared first on Zientzia Kaiera.

Iballa Burunat Pérez: «Neurozientzia musikalaren arloko ikerketak garuna hobeto ulertzen lagun diezagula nahi dut»

Iballa Burunat Pérez Kanarietako ikertzailea da, musikaren neurozientzian espezializatuta dago eta Finlandiako Centre of Excellence in Music, Mind, Body and Brain zentroan lan egiten du.