Los beneficios de las prendas de compresión para los jugadores de fútbol

A pesar de que se hayan publicado numerosos estudios científicos sobre los procesos subyacentes a la recuperación post-ejercicio, el conocimiento de los procesos de recuperación permanece en un estadio de subdesarrollo científico en comparación con el avance experimentado en el área del entrenamiento para el fútbol. Actualmente, se están estudiando los efectos de algunas estrategias de recuperación de la fatiga o del daño muscular inducido por el ejercicio en futbolistas, pero, hasta la fecha, ningún trabajo había evaluado los beneficios de llevar diferentes tipos de prendas de compresión durante partidos de futbol y el posterior periodo de recuperación. La tesis doctoral de Diego Marqués Jiménez, ‘Efectividad de las prendas de compresión como modalidad de recuperación de la fatiga muscular en jugadores de fútbol’, viene s suplir esta carencia.

La tesis hace un compendio de cuatro investigaciones, entre las que hay una revisión de los principales mecanismos de fatiga y daño muscular en fútbol, así como consideraciones a tener en cuenta para la evaluación del proceso de recuperación en fútbol, una revisión sistemática con meta-análisis sobre los efectos de la terapia compresiva en la recuperación del daño muscular por ejercicio y dos estudios experimentales que analizan la influencia de jugar partidos de fútbol llevando diferentes prendas de compresión, y la de las mismas durante los tres días posteriores al partido.

Las demandas competitivas y las elevadas y variables exigencias físicas a las que es sometido el futbolista pueden derivar en un gran nivel de fatiga y estrés en los sistemas fisiológicos, pudiendo afectar al tiempo para recuperarse por completo después de la competición y tener una incidencia en el rendimiento en los días posteriores al partido. Además, y dado que el deportista pasa más tiempo recuperando que entrenando, optimizar el periodo de recuperación mediante la aplicación de diferentes estrategias de recuperación es un procedimiento esencial en la preparación del próximo partido o entrenamiento. Así, esta tesis doctoral aporta más información sobre una estrategia que puede optimizar dichos procesos de recuperación.

Los resultados de la revisión sistemática con meta-análisis muestran que las prendas de compresión pueden favorecer la recuperación después del ejercicio, pero los resultados necesitan corroboración y son poco concluyentes, ya que la mayoría de los estudios incluidos tienen una alta heterogeneidad, de modo que deben ser interpretados con cautela. Los resultados de los estudios experimentales muestran que, a pesar de la poca significación estadística alcanzada, los diferentes tipos de prendas de compresión podrían tener un efecto positivo tanto en la atenuación de las respuestas provocadas tanto por la fatiga como por el daño muscular inducido por el ejercicio.

En respuesta a los síntomas de la fatiga, las perneras de compresión parecen ser más efectivas y, en respuesta a los síntomas del daño muscular, las perneras y musleras de compresión parecen ser las más efectivas. En cualquier caso, y como el autor señala, “la alta variabilidad en la respuesta física del futbolista a las exigencias de un partido de futbol pone de manifiesto la necesidad de nuevos estudios en situaciones reales de juego, que permitan establecer conclusiones prácticas y que sean aplicables teniendo en cuenta dicha la variabilidad”. Esto permitiría verificar la influencia de esta estrategia de recuperación en las respuestas físicas, fisiológicas y perceptivas en futbolistas.

Referencias:

Marqués-Jiménez, D., Calleja-González, J., Arratibel, I., Delextrat, A., Terrados, N. ‘Fatigue and recovery in soccer: evidence and challenges’. The Open Sports Sciences Journal, 10, (Suppl 1: M5) 52-70 (2017).

Marqués-Jiménez D, Calleja-González J, Arratibel I, Delextrat, A., Terrados, N. ‘Are compression garments effective for the recovery of exercise-induced muscle damage? A systematic review with meta-analysis’. Physiology y Behavior, 153: 133–484. (2016).

Marqués-Jiménez D, Calleja-González J, Arratibel I, Delextrat, A., Uriarte, F., Terrados, N. ‘Physiological and physical responses to wearing compression garments during soccer matches and recovery’. J Sports Med Phys Fitness (2017). Doi: 10.23736/S0022-4707.17.07831-8.

Marqués-Jiménez D, Calleja-González J, Arratibel I, Delextrat, A., Uriarte, F., Terrados, N. ‘Influence of different types of compression garments on exercise-induced muscle damage markers after a soccer match’. Research in Sports Medicine (2017) (aceptado y pendiente de publicación).

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Los beneficios de las prendas de compresión para los jugadores de fútbol se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La condición física de los árbitros de fútbol

- Fórmulas matemáticas y números: cómo ayuda la economía al fútbol

- Algoritmos de triaje para readmitidos en urgencias

12000 francos para conquistar el mundo

No hay duda de que Napoleón era un hombre con una mente brillante. Pero a conquistar medio mundo no se llega sino subiéndose a hombros de gigantes.

Napoleón conquistó tierras, derrotó ejércitos, sentía que podía con todo… menos con las bacterias y el escorbuto que sufrían sus soldados debido a una alimentación basada básicamente en carne cocida y algo de pan. Carne, además, en dudoso estado porque no conseguían que durase más de 3 o 4 días.

Como hombre listo que era, Napoleón sabía que sus soldados debían estar sanos y bien alimentados para enfrentarse a la batalla en sus mejores condiciones. Permanecían largas temporadas fuera de Francia y el abastecimiento era complicado. Necesitaba una solución.

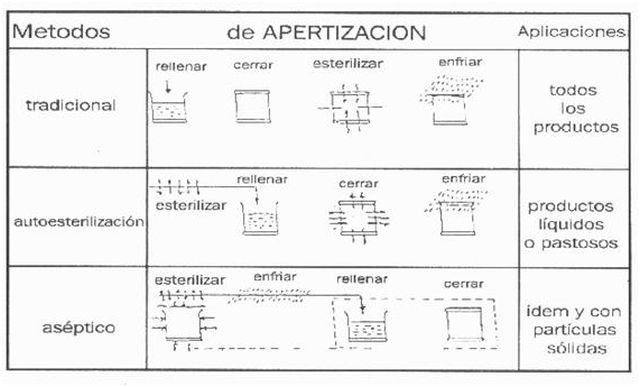

Esa solución se la dio Nicolás Appert, pastelero francés interesado en conseguir que los alimentos se conservaran durante más tiempo. Este pastelero revolucionó el mundo con un método que hoy todos utilizamos y que lleva su nombre, apertización. Puede que esta palabra no les suene, pero ¿y si les digo “conservas”? Todos tenemos alguna lata de tomate o atún en nuestra casa y se lo debemos a él.

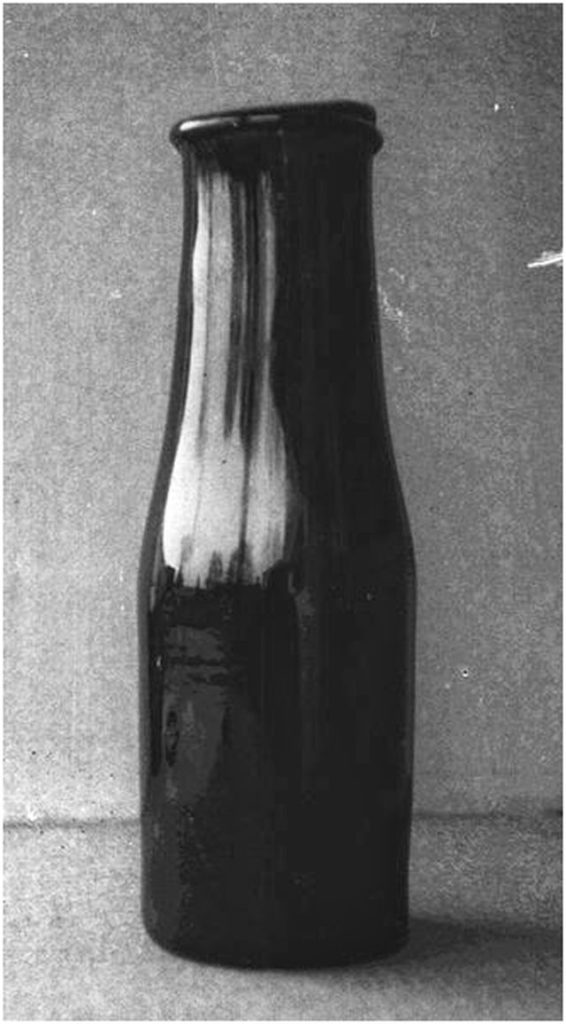

Nicolás Appert consiguió que los alimentos se mantuvieran en perfectas condiciones durante largas temporadas aunque no sabía bien por qué, ya que en aquella época no tenía medios para averiguarlo. Para ello utilizó botellas de vidrio con la boca ancha donde introducía los alimentos y que sumergía parcialmente dentro de cazuelas con agua hirviendo (al baño maría). Antes las cerraba especialmente bien con corcho y cera, sujetándolas con alambres para evitar que el aire entrara en ellas. Estudió los tiempos, cantidad y temperatura dependiendo del alimento. Se dio cuenta de la importancia de una estricta higiene a la hora de manipular los alimentos y de que un cierre hermético era clave para que su método funcionara correctamente.

Él no fue consciente en ese momento, pero acababa de descubrir la esterilización por calor. Posteriormente Louis Pasteur consiguió dar una explicación científica a los experimentos de Nicolás Appert. Al igual que Napoleón, Pasteur se subió a hombros de este gigante y le agradeció sus experimentos, ya que gracias a ellos llegó a tirar por tierra la teoría de la “generación espontánea” e inventó la hoy llamada pasteurización. Eso sí, 54 años después que Appert.

Botella de conservas de Appert

El método de Appert llamó la atención de Napoleón, como no podía ser de otra manera, y comenzó a usarlo para abastecer a la marina francesa. Otorgó a Nicolás el premio de 12.000 francos fruto de un concurso creado para aquel que encontrara una manera eficaz de conservar alimentos (dudosa manera de invertir en ciencia, no lo cuenten por ahí, no vaya a ser que les copien). Con esos 12.000 francos Appert abrió la primera fábrica de conservas que, pese a que fue quemada y destruida en la guerra franco-prusiana, estuvo en activo hasta 1933. No hizo mal negocio Napoleón: 12.000 francos por conquistar el mundo.

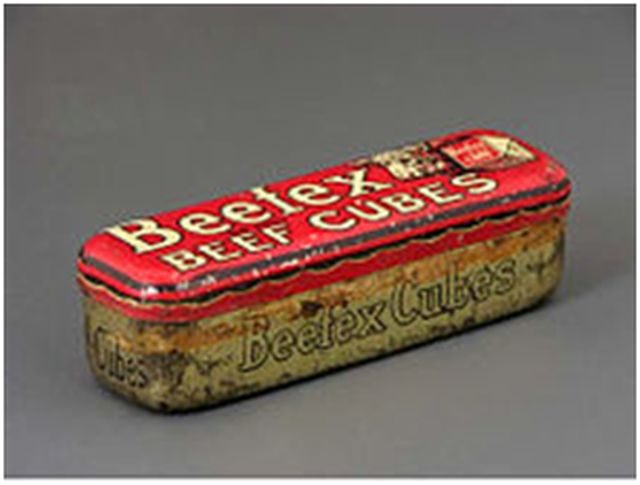

Appert era un hombre inquieto y no dejó nunca de hacer experimentos y, por supuesto, de proporcionarle soluciones a las tropas napoleónicas. Quizá por casualidad se dio cuenta de que, eliminando completamente el agua de un caldo, obtenía una pasta (él la llamaba “cubo de caldo”) a la que si se le incorporaba nuevamente agua, aunque fuera mucho tiempo después, volvía a convertirse en un caldo similar al original. Nicolás Appert inventó el caldo concentrado que tan explotado ha sido posteriormente como recurso para potenciar el sabor en los guisos o simplemente convertirlo de nuevo en caldo.

Recipiente metálico para cubo de caldo de la primera mitad del siglo XX (Museo del Objeto. Ciudad de México).

Como se podrán imaginar, esto fue otra gran revolución para facilitar la alimentación del ejército. Napoleón estaba realmente encantado con Nicolás Appert. Sus descubrimientos consiguieron unas tropas bien alimentadas, que junto a una gran estrategia le llevaron a construir un imperio de unas magnitudes asombrosas.

Basándose siempre en diferentes momentos de la desecación de productos, Appert llegó también a inventar el concentrado de leche, es decir, la leche condensada. Gran cantidad de nutrientes, altamente calórica, de fácil conservación y duradera. Un manjar para quien se encuentra en el frente.

Con alimentos en conserva, comenzando por legumbres, siguiendo por frutas y verduras, con caldo concentrado con el que podían aportar nutrientes en una sopa calentita y la leche condensada, la marina de Napoleón tenía una importante ventaja añadida sobre las tropas de otros países. No había quien pudiera con ellos. Napoleón, gracias a Nicolás Appert había vencido al gran ejército de bacterias que consumían sus alimentos y a terribles enfermedades como el escorbuto que mermaban los recursos humanos de sus contrincantes.

Esto llevó a Nicolás Appert a convertirse en héroe nacional, ganando la medalla de oro de la Société d’Encouragement pour l’Industrie Nationale por facilitar el acceso a este tipo de alimentos no sólo a la marina y ejército sino a toda la población francesa.

Pero no todo iba a ser fácil para Napoleón, es evidente que no finalizó con éxito su conquista mundial (si no, estaría leyendo esto en francés), y todo comenzó en Rusia. Allí los métodos de Nicolás Appert encontraron un fallo: las botellas en las que se conservaban los alimentos eran frágiles y se rompían, además no se podían apilar con facilidad. Cuando conseguían alcanzar su destino, muchas de ellas llegaban rotas y no se podían aprovechar los alimentos que contenían. Este declive, unido a las adversas condiciones rusas, fue el principio del fin de Napoleón.

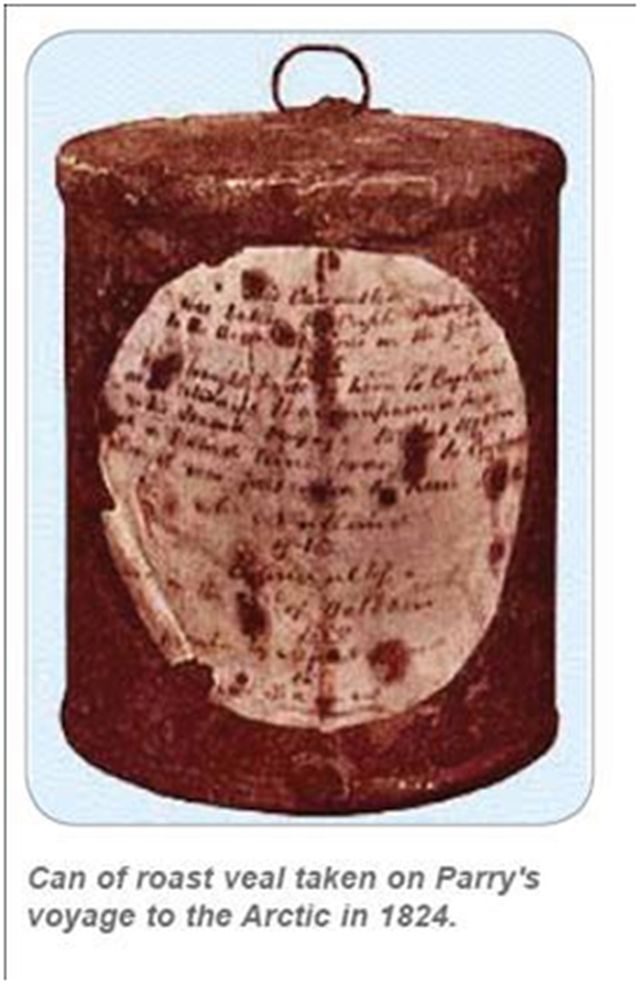

Mientras tanto, sus enemigos se habían fijado en el método de Appert, lo mejoraron y encontraron una solución para la fragilidad de los envases. El inglés Durant le pide al rey Jorge la patente del método para conservar alimentos tan sólo dos meses después de que Nicolás publicara el libro “Le livre de tous les ménages ou L’Art de conserver, pendant plusieurs années, toutes les substances animales et végétales” (El libro de todos los hogares o El arte de preservar, durante varios años, todas las sustancias animales y vegetales). Durant, que nunca llegó a fabricar ni una sola lata, vendió esta patente a Bryan Donkin y John Hall, dueños de una fundición donde comienzan a fabricar latas de hierro cubiertas de estaño. Desde luego que era un método más cómodo y práctico para el envío de alimentos a los soldados e igual de eficaz.

Appert también lo intentó, pero ya era tarde, los ingleses ya eran capaces de fabricar alimentos en conserva y con mayores ventajas. Aunque no crean que los ingleses eran tan listos. Tuvieron que pasar 45 años hasta que un americano Ezra J. Warner, inventara el abrelatas. Hasta ese momento se utilizaban navajas o bayonetas, o incluso disparos de fusil para abrir las dichosas latitas.

Nicolás Appert no patenta ninguno de sus métodos anteponiendo las necesidades de la población a sus propios intereses económicos. Lamentablemente muere solo y arruinado en 1841 a los 92 años. Su cadáver es enterrado en una fosa común. Triste final para el pastelero que ayudó a Napoleón a conquistar medio mundo.

Hoy en día nos queda su legado: el caldo concentrado, la leche condensada, la obtención de gelatina y los inicios de lo que posteriormente sería el autoclave: básico para la esterilización tanto de objetos como de las propias conservas.

Aunque no conozcamos el nombre de su método, la apertización, lo utilizamos con frecuencia en nuestros hogares cuando preparamos conservas caseras (háganlo con cuidado, si no cierran herméticamente el envase, puede contaminarse con bacterias peligrosas como el Clostridium botulinum).

Imagen: Mundolatas.com

Ahora, cada vez que añadan un poco de caldo concentrado al guiso o calienten un tarro al baño maría para hacer una conserva, acuérdense del pastelero que revolucionó la conservación de alimentos durante la Revolución francesa y ayudó a ganar a Napoleón la guerra más importante, la de la alimentación.

Este post ha sido realizado por Gemma del Caño (@FarmaGemma) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias:

Historia y Biografías. Nicolás Appert

Historia de la alimentación militar en Europa durante los siglos XIX y XX. Miguel Krebs. 2008

El gran libro de las conservas. Carol W. Costenbader

Fundación Cotec para la innovación tecnológica. DOCUMENTOS COTEC SOBRE NECESIDADES TECNOLÓGICAS. Conservas Vegetales.

Tatiana Díaz. Octubre 2014. Napoleón y las conservas de alimentos, el inicio militar de un avance científico-tecnológico.

El artículo 12000 francos para conquistar el mundo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Libros para enamorarse

- El consumo de alcohol para el corazón y las dificultades de divulgar ciencia

- #Naukas14: Experimentos para entender el mundo

Emakume jakintsu horietako bat izan nahi nuke

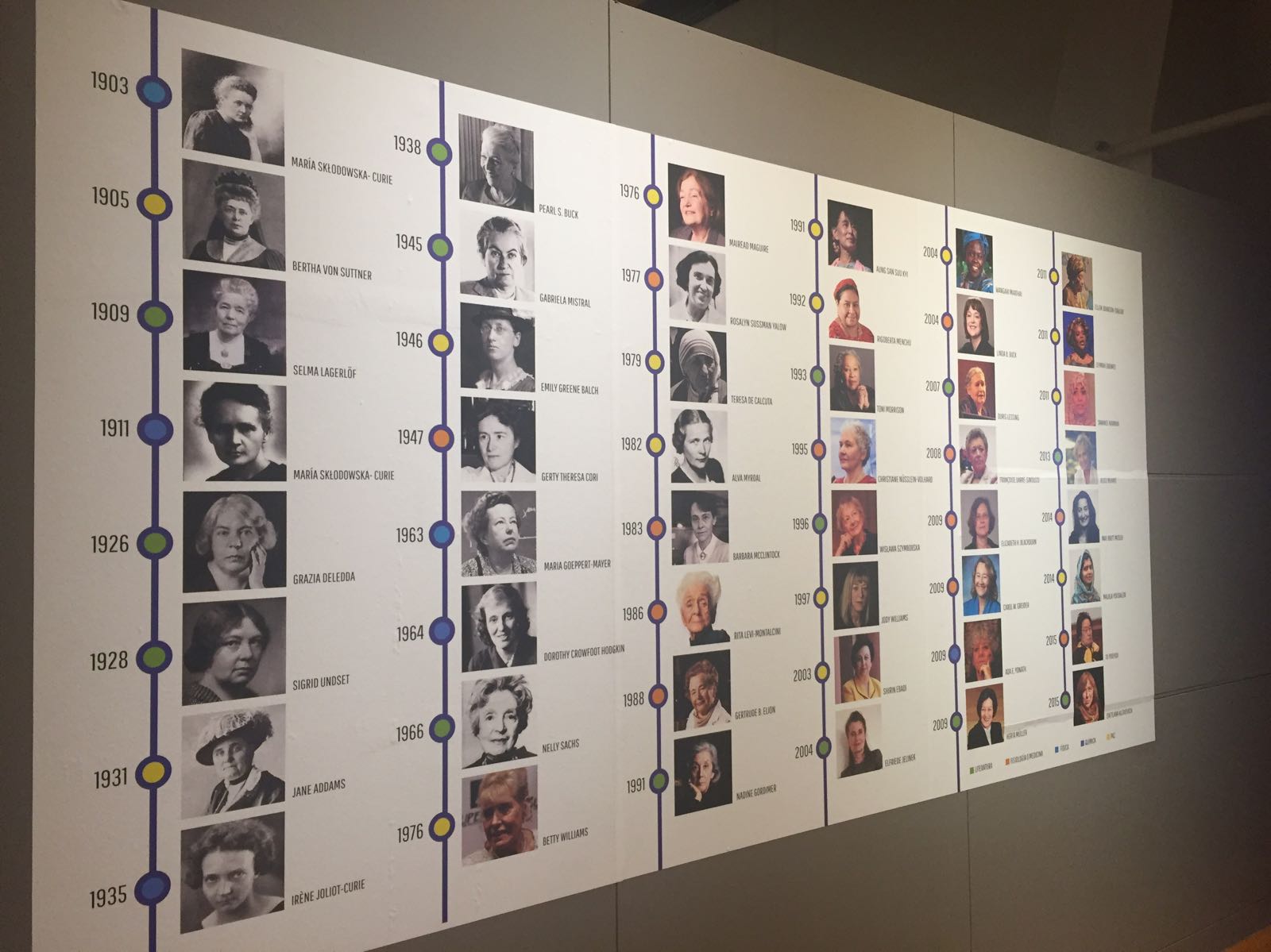

1. irudia: Nobel Saria irabazitako emakumeekin osatutako murala.

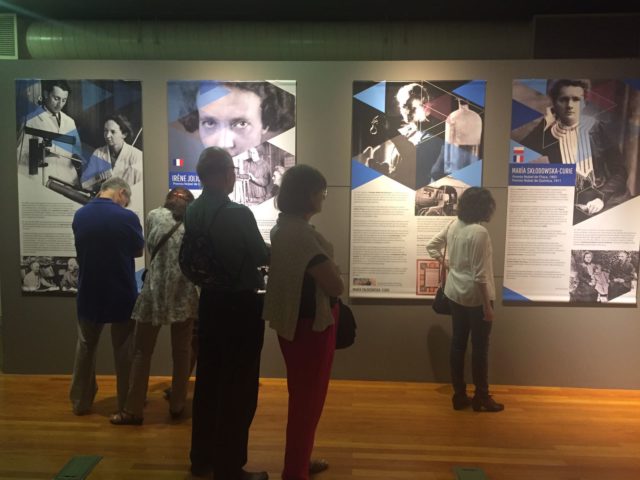

Madrilen dagoen Espainiako Natura Zientzien Museo Nazionalera bertaratu da jende andana. Igandea da. Familia ugari ilaran. Oso leku poliglota bilakatu da museoa gainera; alemanieraz, ingelesez eta euskaraz ari da jendea.

Nobel Sariak irabazi zituzten emakumeen argazkiak ageri dira hormetan; eta horien ondoan, euren ibilbide profesionala laburbiltzen dituzten testu interesgarriak. Horretaz gain, sariekin eta protagonistekin zerikusia duten objektuak bildu dituzte, hala nola eskuizkribuak, Nobel dominak, Nobel oturuntzan erabiltzen zen baxera; eskulturak… Mujeres Nobel erakusketak –martxora arte zabalik– barne hartzen ditu Fisiologia eta Medikuntza, Fisika, Kimika, Literatura eta Bakearen sariak historian zehar irabazi dituzten emakumeen lorpenak. Gainera, azken atalean Concha Espina –ez da soilik hiriko metroko geldialdi bat– idazleari buruzko informazioa aurki daiteke, Literatura Nobel saria irabazteko zorian izan baitzen behin baino gehiagotan.

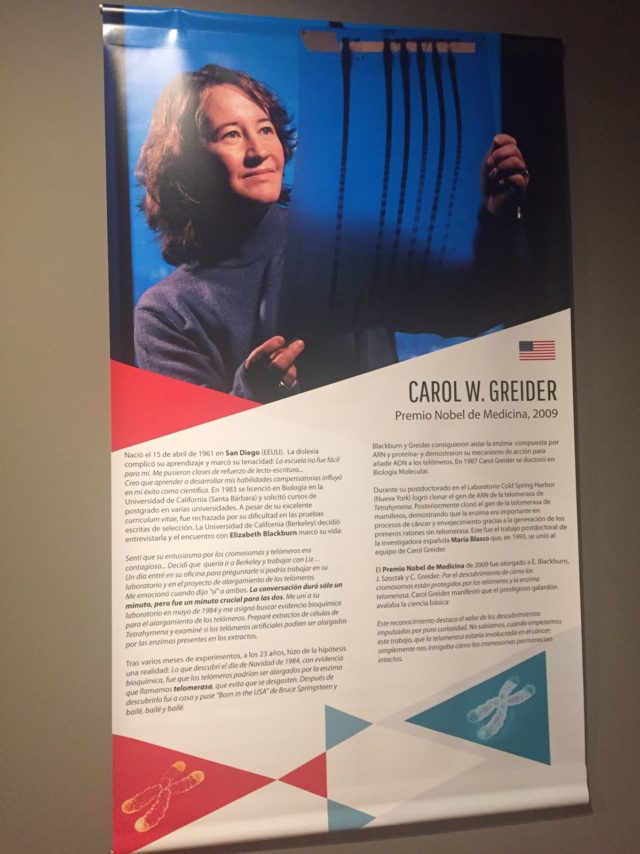

2. irudia: Carol W. Greider 2009ko Medikuntza Nobel saridunaren inguruko kartela.

Aitak ez du ahaztu semearen galdera, ia erregua izan dena. Beraz, hasi zaio azaltzen, adibidez, Maria Sklodowska-Curieren lana, aski ezaguna dena. Umeak agian ez du ulertuko, baina atentzioa eman dio. Material erradioaktiboak ikertu zituen, batez ere uranioa. Birritan irabazi zuen Nobela. Lehena, Fisikakoa 1903an jaso zuen, elementu erradioaktiboekin egindako ikerketengatik. Bigarrena, 1910ean izan zen, Kimika arloan: radioa eta polonioa aurkitzeaz gain, lehenengoa isolatzea lortu zuen.

Horretaz gain ere, kontatu dio, tartean, Ada Yonathen ibilbidea, 2009. urtean Nobela jaso zuen kristalografoarena. Erribosomaren egitura eta funtzioan egindako ikerketengatik lortu zuen saria. “Eta honek? Zer egin zuen?”, esaten dio aitari hanka kolpatuz. Carol Greider, Medikuntza Nobel saridunari begira gelditu zaio semea. Doktoretza ondoko Cold Spring Harbor laborategian telomerasaren ARN genea klonatzea lortu zuen zientzialariak. Horren ondotik, ugaztunetan egitea lortu zuen eta horri esker ikusi zuen entzima horiek pisu handia zutela minbiziaren prozesuan. Maria Blasco ikertzaile espainiarra Greiderren taldean aritu zen, esaterako.

Telomeroek eta telomerasa entzimek kromosomak babesten zituztela ikusi zuen eta aurkikuntza horregatik eman zioten saria, Helen Blackburnekin partekatu zuena; lehen aldia izan zen Nobel sari bat bi emakumek eskuratzen zutela. “Ikerketa honetan hasi ginenean, ez genekien telomerasa minbizian sartuta egongo zenik. Kromosomak bere horretan gelditzeak jakin-mina piztu zigun, besterik gabe”, esan zuten ikertzaileek. Kuriositateak daukan indarra.

3. irudia: Nobel saria irabazi duten emakumeen inguruko erakusketan emakume hauen bizitzari buruzko informazio topa daiteke.

May-Britt Moserren lana aipatzekoa da ere. Garunaren mundua ezagutzeko asmoz, psikologia ikasketak abiatu zituen. Terje Sagvoldenen laborategian hasi zen lanean bigarren seihilekoan. Une hartan, arratoietan hiperaktibitatea ikertzen ari ziren bertako ikertzaileak. Bi urtez, hiperaktibitatean eta arratoien jokabidean sakondu zuen. Bere asmoa, halere, Per Andersenen sailean lan egitea zen. Neurozientzia arloan murgildu nahi zuen baina sail horretan zeuden bakarrak medikuak ziren eta psikologoak ez zituzten aintzat hartzen. Bada, azkenean onartu zuten. Egindako lanari esker, Moserrek frogatu zuen memorian eta ikasketa espazialean eragina zuen zatia hipokanpoaren alde dortsala zela.

Irène Joliot-Curie, Rita Levi-Montalcini, Selma Lagerlöf, Bertha von Sutnner, Teresa Kalkutakoa, Wangari Maathai, Irena Sendler eta Concha Espinak osatzen dute erakusketan ageri diren emakume Nobel saridunen zerrenda. Horiek guztiek badute gauza bat komunean: ez dizkiete gauzak erraz jarri baina atera dira itzaletik. Ume hura ohartu da euren indarraz eta jakintzaz, atea zeharkatu bezain laster honakoa bota duelako ahoz goran: “Aita, nik argi dut. Handia naizenean, emakume jakintsu horietako bat izan nahi nuke”.

———————————————————————–

Egileaz: Uxue Razkin Deiako kazetaria da.

———————————————————————–

The post Emakume jakintsu horietako bat izan nahi nuke appeared first on Zientzia Kaiera.

Por qué la filosofía es tan importante para la educación científica

Subrena E. Smith

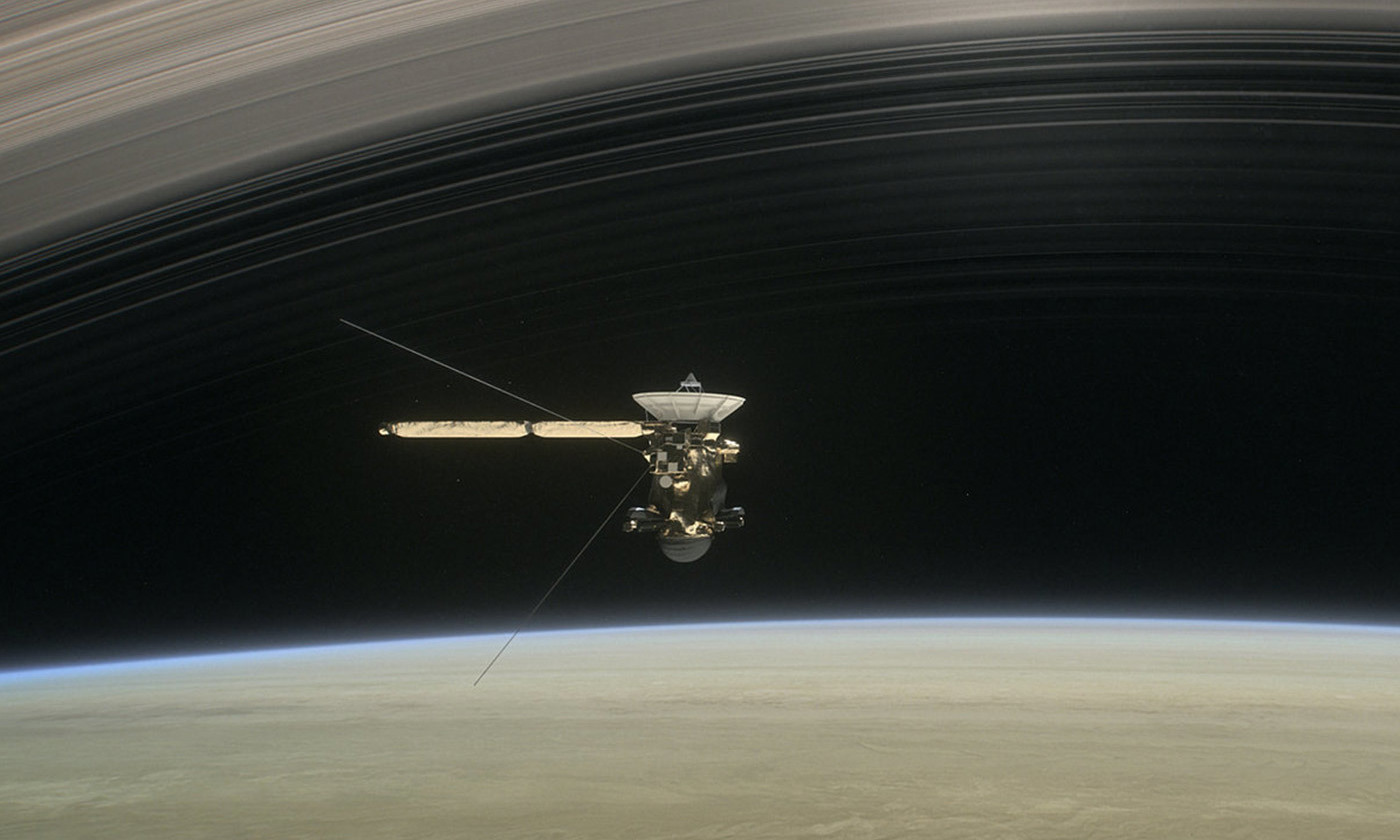

La misión Cassini fue una consecuencia directa de los experimentos mentales de Albert Einstein. Imagen: JPL/NASA

Cada semestre, enseño cursos sobre filosofía de la ciencia a estudiantes de grado en la Universidad de New Hampshire. La mayoría de los estudiantes se matriculan en mis cursos para satisfacer los requisitos de educación general, y la mayoría de ellos nunca antes han asistido una clase de filosofía.

El primer día del semestre, trato de darles una idea de lo que va la filosofía de la ciencia. Comienzo por explicarles que la filosofía aborda cuestiones que no pueden resolverse solo con los hechos, y que la filosofía de la ciencia es la aplicación de este enfoque al campo de la ciencia. Después de esto, explico algunos conceptos que serán centrales para el curso: inducción, pruebas y método en la investigación científica. Les digo que la ciencia procede por inducción, las práctica de recurrir a observaciones pasadas para hacer afirmaciones generales sobre lo que aún no se ha observado, pero que los filósofos consideran que la inducción está inadecuadamente justificada y, por lo tanto, es problemática para la ciencia. Luego me refiero a la dificultad de decidir qué prueba se ajusta a cada hipótesis de manera única, y por qué es vital para cualquier investigación científica tener esto claro. Les hago saber que “el método científico” no es singular y directo, y que existen disputas básicas sobre cómo debería ser la metodología científica. Por último, hago hincapié en que, aunque estos temas son “filosóficos”, sin embargo tienen consecuencias reales sobre cómo se hace ciencia.

En este punto, a menudo me hacen preguntas como: “¿Cuáles son sus credenciales?””¿A qué universidad asistió?” y “¿Es usted una científica?”

Tal vez hacen estas preguntas porque, como filósofa de extracción jamaicana, encarno un grupo de identidades poco común, y sienten curiosidad por mí. Estoy segura de que eso es en parte así, pero creo que hay más, porque he observado un patrón similar en un curso de filosofía de la ciencia impartido por un profesor más estereotípico. Como estudiante de posgrado en la Universidad de Cornell en Nueva York, trabajé como profesora asistente en un curso sobre la naturaleza humana y la evolución. El profesor que lo impartía daba una impresión física muy diferente a la mía. Era blanco, varón, barbudo y de unos 60 años: la imagen misma de la autoridad académica. Pero los estudiantes eran escépticos sobre sus puntos de vista sobre la ciencia, porque, como algunos decían, desaprobantes: “No es un científico”.

Creo que estas respuestas tienen que ver con dudas sobre el valor de la filosofía en comparación con el de la ciencia. No es de extrañar que algunos de mis alumnos duden de que los filósofos tengan algo útil que decir acerca de la ciencia. Son conscientes de que científicos prominentes han declarado públicamente que la filosofía es irrelevante para la ciencia, si no completamente inútil y anacrónica. Saben que la educación STEM (ciencia, tecnología, ingeniería y matemáticas, por sus siglas en inglés) tiene una importancia mucho mayor que cualquier cosa que las humanidades puedan ofrecer.

Muchos de los jóvenes que asisten a mis clases piensan que la filosofía es una disciplina confusa que solo se ocupa de cuestiones de opinión, mientras que la ciencia se dedica al descubrimiento de hechos, a proporcionar pruebas y la difusión de verdades objetivas. Además, muchos de ellos creen que los científicos pueden responder a las preguntas filosóficas, pero los filósofos no tienen nada que aportar a las científicas.

¿Por qué los estudiantes universitarios tratan tan a menudo a la filosofía como completamente distinta y subordinada a la ciencia? En mi experiencia, destacan cuatro razones.

Una tiene que ver con la falta de conciencia histórica. Los estudiantes universitarios tienden a pensar que las divisiones departamentales reflejan divisiones precisas en el mundo, por lo que no pueden darse cuenta de que la filosofía y la ciencia, así como la supuesta división entre ellas, son creaciones dinámicas humanas. Algunos de los temas que ahora se etiquetan como “ciencia” en algún momento estuvieron bajo encabezados diferentes. La física, la más segura de las ciencias, estuvo una vez el ámbito de la “filosofía natural”. Y la música correspondía naturalmente a la facultad de matemáticas. El alcance de la ciencia se ha reducido y ampliado, dependiendo de la época y el lugar y los contextos culturales donde se practicó.

Otra razón tiene que ver con los resultados concretos. La ciencia resuelve problemas del mundo real. Nos da tecnología: cosas que podemos tocar, ver y usar. Nos da vacunas, cultivos transgénicos y analgésicos. La filosofía no parece, para los estudiantes, tener elementos tangibles que mostrar. Pero, por el contrario, los tangibles filosóficos son muchos: los filosóficos experimentos mentales de Albert Einstein hicieron posible la Cassini. La lógica de Aristóteles es la base de la informática, que nos dio ordenadores portátiles y teléfonos inteligentes. Y el trabajo de los filósofos sobre el problema mente-cuerpo preparó el terreno para el surgimiento de la neuropsicología y, por lo tanto, de la tecnología de imagenes del encéfalo. La filosofía siempre ha estado trabajando silenciosamente a al sombra de la ciencia.

Una tercera razón tiene que ver con las preocupaciones sobre la verdad, la objetividad y el sesgo. La ciencia, insisten los estudiantes, es puramente objetiva, y cualquiera que desafíe esa visión debe estar equivocado. No se considera que una persona sea objetiva si aborda su investigación con un conjunto de supuestos previos. Por contra, sería “ideológica”. Pero todos somos “parciales” y nuestros prejuicios alimentan el trabajo creativo de la ciencia. Este problema puede ser difícil de abordar, ya que la concepción ingenua de la objetividad está muy arraigada en la imagen popular de lo que es la ciencia. Para abordarlo, invito a los estudiantes a mirar algo cercano sin ningún prejuicio. Luego les pido que me digan lo que ven. Se paran … y luego reconocen que no pueden interpretar sus experiencias sin recurrir a ideas anteriores. Una vez que se dan cuenta de esto, la idea de que puede ser apropiado hacer preguntas sobre la objetividad en la ciencia deja de ser tan extraña.

La cuarta fuente de incomodidad para los estudiantes proviene de lo que ellos consideran que es la educación científica. Una tiene la impresión de que piensan que la ciencia consiste principalmente en enumerar las cosas que existen -los “hechos” – y que la educación científica es enseñarles cuáles son estos hechos. Yo no respondo a estas expectativas. Pero como filósofa, me preocupa principalmente cómo se seleccionan e interpretan estos hechos, por qué algunos se consideran más importantes que otros, las formas en que los hechos están empapados de prejuicios, y así sucesivamente.

Los estudiantes a menudo responden a estas cuestiones declarando con impaciencia que los hechos son hechos. Pero decir que una cosa es idéntica a sí misma no es decir nada interesante acerca de ella. Lo que los estudiantes quieren decir con “los hechos son hechos” es que una vez que tenemos “los hechos” no hay lugar para la interpretación o el desacuerdo.

¿Por qué piensan de esta manera? No es porque esta sea la forma en que se practica la ciencia sino, más bien, porque así es como normalmente se enseña la ciencia. Hay una cantidad abrumadora de hechos y procedimientos que los estudiantes deben dominar para llegar a ser competentes científicamente, y solo tienen un tiempo limitado para aprenderlos. Los científicos deben diseñar sus cursos para mantenerse al día con un conocimiento empírico en rápida expansión, y no tienen el placer de dedicar horas de clase a preguntas que probablemente no están capacitados para abordar. La consecuencia involuntaria es que los estudiantes a menudo salen de sus clases sin darse cuenta de que las preguntas filosóficas son relevantes para la teoría y la práctica científica.

Pero las cosas no tienen por qué ser así. Si se establece la plataforma educativa adecuada, los filósofos como yo no tendrán que trabajar a contracorriente para convencer a nuestros estudiantes de que tenemos algo importante que decir acerca de la ciencia. Para esto necesitamos la ayuda de nuestros colegas científicos, a quienes los estudiantes ven como los únicos proveedores legítimos de conocimiento científico. Propongo una división explícita del trabajo. Nuestros colegas científicos deberían continuar enseñando los fundamentos de la ciencia, pero pueden ayudar dejando claro a sus alumnos que la ciencia está repleta de importantes cuestiones conceptuales, interpretativas, metodológicas y éticas que los filósofos están en una posición única para abordar, y que lejos de ser irrelevantes para la ciencia, los asuntos filosóficos se encuentran en su núcleo.

Sobre el autor: Subrena E. Smith es profesora ayudante de filosofía en la Universidad de New Hampshire (Estados Unidos).

Texto traducido y adaptado por César Tomé López a partir del original publicado por Aeon el 13 de noviembre de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0).

![]()

El artículo Por qué la filosofía es tan importante para la educación científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La importancia de la educación científica, por Juan Carlos López

- La educación no es la materia prima de la mano de obra

- Heinrich Rohrer: Priorizar la educación para garantizar la calidad, por P. M. Etxenike y J. M. Pitarke

El Rubius hace un vídeo de química y la lía parda

El último vídeo que el Rubius subió a su canal ha superado los 6 millones de reproducciones en sólo cuatro días. Se trata de la primera entrega de lo que será una serie de vídeos sobre experimentos científicos. Y para experimentos científicos chulos, están las reacciones químicas redox. Eso es lo que hace el Rubius durante todo el vídeo, diferentes versiones de la reacción redox conocida como «pasta de dientes de elefante».

Es una reacción química muy atractiva que muchos profesores de ciencias y divulgadores hemos hecho más de una vez. Es un triunfo asegurado. Existen varias versiones, pero el resultado de todas ellas es que el agua oxigenada se oxida. No es una redundancia. Cuando el agua oxigenada se oxida, libera oxígeno gaseoso.

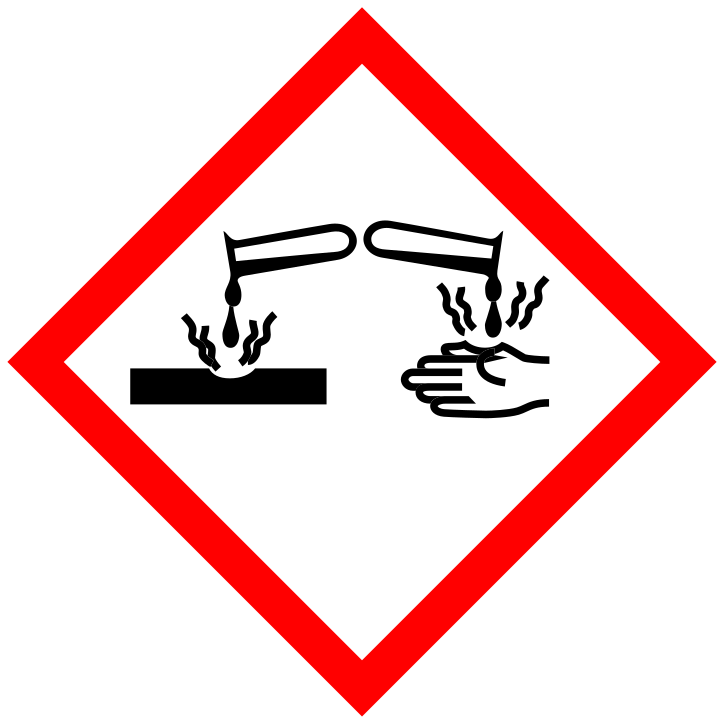

El agua oxigenada se denomina peróxido de hidrógeno o, como también la llama el Rubius, «esta vaina loca». El agua oxigenada que normalmente tenemos en casa, la de uso sanitario, suele ser peróxido de hidrógeno disuelto en agua con una concentración del 3-4%. El agua oxigenada que el Rubius utiliza para este experimento está más concentrada, es peróxido de hidrógeno al 12%. Es imprescindible que el agua oxigenada tenga una concentración superior al 9% para que el experimento sea vistoso. Por eso hay que tener especial precaución al manipularla. El Rubius se pone guantes y gafas protectoras, siguiendo las advertencias de seguridad del envase. El pictograma de peligrosidad que figura en la etiqueta es el de sustancia corrosiva. Efectivamente el peróxido de hidrógeno es capaz de producir quemaduras en la piel y en los ojos.

El agua oxigenada se descompone de forma natural en agua y oxígeno, pero esto sucede tan lentamente que no se percibe. Para favorecer esta reacción se pueden utilizar varios métodos. O bien añadir una sustancia que sirva de catalizador, es decir, una sustancia que acelera esa descomposición. O bien añadir una sustancia oxidante (con un potencial de oxidación mayor que el del agua oxigenada).

Como catalizador se suele emplear un yoduro (normalmente la sal yoduro potásico). El yoduro reacciona con el peróxido de hidrógeno liberando agua e hipoyodito, y el hipoyodito reacciona con el peróxido de hidrógeno liberando oxígeno y volviendo a su estado inicial de yoduro. Es decir, que el yoduro empieza y termina la reacción de la misma manera, mientras que el peróxido de hidrógeno se transforma en agua y oxígeno. Cuando una sustancia es capaz de provocar una reacción química sin alterarse, se denomina catalizador. Si la sustancia cambia, ya no sería un catalizador, sino un reactivo.

El Rubius no utiliza un catalizador de yoduro, sino que utiliza otra sustancia como reactivo llamada permanganato potásico. El permanganato potásico es un fuerte oxidante de un intenso color violeta. En contacto con el peróxido de hidrógeno consigue oxidarlo a agua y oxígeno. Por su parte, el permanganato potásico sufre una reducción, la reacción inversa a la oxidación. Esta reducción se aprecia en el cambio de color de violeta a marrón.

Cuando una sustancia se oxida ocurre a costa de que otra sustancia de reduzca. Por eso a este tipo de reacciones químicas las llamamos reacciones redox.

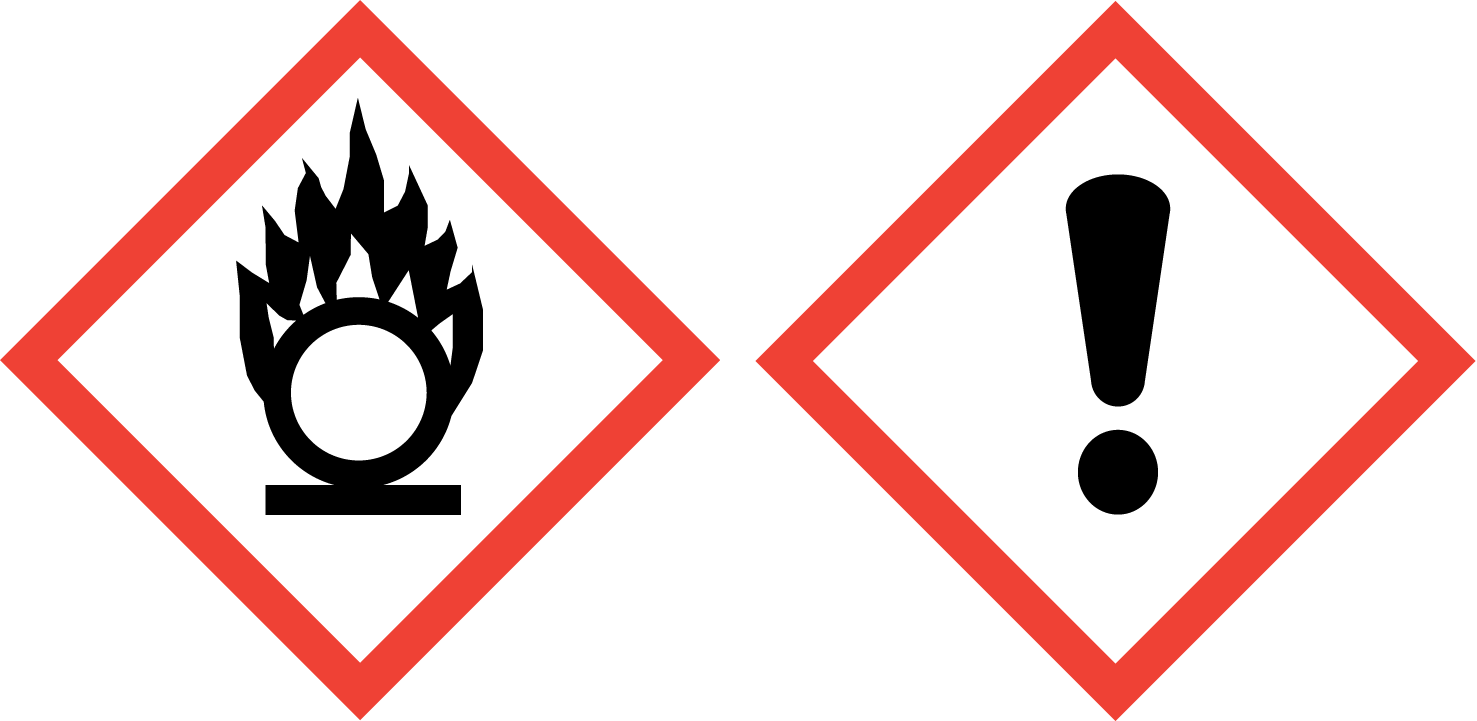

En el envase del permanganato que el Rubius muestra a cámara figuran dos pictogramas de peligro. El primero indica que se trata de una sustancia comburente, es decir, que puede provocar o agravar un incendio o explosión. El segundo pictograma, el que llama más la atención del Rubius es el que contiene un signo de exclamación. Él lo llama «hazardous, hazard», que significa peligroso, peligro. Efectivamente eso es lo que significa ese pictograma: peligroso para la salud. La etiqueta también incluye como advertencias de seguridad el uso de guantes y gafas. El permanganato puede provocar quemaduras en los ojos y en la piel.

En la primera parte del experimento, el Rubius hecha una cucharada de permanganato en una botella de vidrio a la que llama «instrumento 100tífiko». Sobre este polvo de permanganato vierte directamente un vaso de peróxido de hidrógeno. El Rubius dice «No sé si es buena idea, así que me voy a apartar un poco». Instantáneamente sale disparado un chorro de gas de la botella. Por suerte para el Rubius ese gas no es peligroso, ya que se trata de oxígeno y vapor de agua. «Esto no lo había hecho antes. No sabía que iba a reaccionar así». Aquí es cuando los técnicos en prevención y riesgos laborales se ponen nerviosos.

A continuación, hace un nuevo experimento utilizando unas sustancias más: agua, jabón y colorante azul. Primero hecha una cucharada de permanganato, añade un poco de agua y agrega un chorro de fairy. Agita la botella hasta que todo esté completamente mezclado y el permanganato disuelto. En las paredes internas del cuello de la botella hecha un poco de colorante azul. «Espero que esto funcione. No sé qué coño va a pasar. Sólo he visto tutoriales en Youtube, sinceramente».

Sobre esta mezcla añade un vaso de peróxido de hidrógeno. Inmediatamente sale disparada una columna de espuma blanca. Esta espuma va arrastrando parte del permanganato, que la tiñe de rosa y marrón, y parte del colorante, que la tiñe de azul. El Rubius exclama «¡Loco, qué bonito!».

La reacción que ha ocurrido es la misma que la anterior, una reacción redox en la que el peróxido de hidrógeno se oxida a agua y oxígeno, y el permanganato se reduce. Lo que sucede esta vez es que el gas oxígeno que se forma se queda atrapado en la disolución jabonosa, formando una gran cantidad de espuma. Cuanto más espumante contenga el jabón (ya sea fairy o cualquier otro jabón), saldrá más cantidad de espuma y de mayor densidad.

«Según Google no pasaría nada si lo toco, pero nunca os fieis de Google». Aun así, el Rubius toca la espuma. Dice que está calentita y que le recuerda al puré de patatas.

A continuación, el Rubius repite el experimento a mayor escala en la terraza de su casa. Os animo a verlo. Pero antes de terminar, como química debo hacer una advertencia de seguridad para que nadie la líe parda: por muchos tutoriales de Youtube que hayas visto, si no sabes nada de química jamás hagas un experimento con sustancias peligrosas. Porque como dice el Rubius, “no sabes qué coño va a pasar”.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo El Rubius hace un vídeo de química y la lía parda se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El microondas es seguro, lo que hace es calentar

- Los cimientos de la química neumática al estilo van Helmont (y 3)

- El lenguaje de la química

Bizi al daiteke oilasko bat bururik gabe?

Hala ere, 1945ean Coloradoko baserri batean kasu oso bitxi bat gertatu zen; izan ere, afarirako oilaskoari burua moztu ondoren bizirik jarraitu zuen, eta baita bizirik jarraitu ere, 18 hilabete geroago hil baitzen oilasko gajoa. Baina, oilasko bat bururik gabe 18 hilabetez bizi al daiteke? Edo, guztia dirua lortzeko iruzur bat izan zen?

1. irudia: Burua moztu ondoren, oilaskoek bizirik jarrai dezakete denbora tarte labur batez. Mike oilaskoa 18 hilabetez egon zen bizirik buruaren zati bat gabe. (Argazkia: Wernerdetjen / Pixabay.com)

1945eko irailaren 10ean, Fruitako (Colorado, AEB) Clara Olsen eta bere senarra, Lloyd, oilaskoa akabatzen ari ziren baserrian. Beste askotan egin legez, Clarak lumatu eta garbitu egiten zituen Lloydek akabatutako oilaskoak. Egun hartan 40-50 oilasko akabatu zituen Lloydek bere aizkorarekin. Alabaina, Lloydek aukeratutako oilaskoetako bat, 5 hilabeteko Wyandotte oilasko bat, ez zen hil burua moztu eta minutu gutxi batzuetara, beste oilaskoa guztiak bezala. Antza, kolpeak ez zuen zain jugularra kaltetu eta oilaskoak —geroago Mike izena jarriko zioten— ibiltzen jarraitzen zuen. Eta ez hori bakarrik, mokorik ez bazuen ere, mokokatzen ahalegintzen jarraitzen zuen. Jaramon gehiagorik egin gabe, Lloydek oilaskoa kaxa batean sartu zuen hurrengo egunera arte.

2. irudia: Mike Wyandotte motako oilaskoa zen. (Argazkia: Monica Mommyandlove/ Pixabay.com)

Hurrengo egunean, ordea, Mikek bizirik jarraitzen zuen. Antza, bururik gabe, baina normaltasunez mugitzen zen kaxa barruan alde batetik bestera. Olsen jaunak erabaki zuen Mike zaindu egingo zuela eta maskota moduan hartu zuen. Olsen familiak hegazti berezi hori zaindu zuen, eta esnea eta ura tantaz tantako batekin emanez elikatzen zuten, janaria zuzenean hestegorrira isuriz. Gainera, xiringa baten bidez eztarrian agertzen zitzaion mukia kentzen zioten. Handik gutxira, Mike oilaskoa ospetsua egin zen eta pixkanaka geroz eta ospe gehiago hartu zuen eta ikuskizunak ere antolatzen zituzten bururik gabeko oilaskoa ikusi ahal izateko.

Life Magazine aldizkariak Olsen familia elkarrizketatu zuen, eta Utahko Unibertsitateak ere egiaztatu zuen Mike oilaskoa bizirik zegoela. Unibertsitateko ikertzaileak saiatu ziren beste oilasko batzuekin Mikeri gertatutako errepikatzen, baina ez zuten lortu. Mikek bira artistikoa ere egin zuen, eta Kalifornian eta Arizonan ere egon zen. Mike eta Olsen familia Phoenixeko motel batean zela, konturatu ziren Mikeri mukia kentzeko xiringa eta janaria ahaztu egin zutela. Tamalez, beste aukeraren bat aurkitu baino lehen, Mike itota hil zen eta horrela bukatu zen mirarizko oilasko haren bizitza, burua aizkorarekin moztu eta 18 hilabete geroago.

Zientziaren azalpenaOro har, oilasko bati burua mozten zaionean garuna eta gorputzaren gainerako zatia bananduta geratzen dira, baina, denbora tarte labur batez bizkarrezur-muineko zirkuituek oxigeno apur bat dute. Garunarekin konexioa galtzen denean, zirkuitu horiek modu espontaneoan aktibatzen dira eta neuronak aktibatu egiten dira eta, esaterako, hankak mugitzen has daiteke oilaskoa. Hala ere, mugimendu horiek ez dute irauten 15 bat minutu pasa direnean.

Mikeren kasuan, litekeena da aizkorakadak garunaren zati handi bat moztea, baina, zerebeloa eta bizkarrezur-erraboila bere horretan geratzea. Hori horrela izanda, oilaskoaren ezinbesteko bizi-funtzioak ez ziren eten. Mikek arnasten jarraitzen zuen eta bere bihotzak odola punpatzen jarraitzen zuen. Horretaz gainera, adituek uste dutenez bigarren faktore bat ere ezinbestekoa izan zen Mike ez hiltzeko, hain zuzen ere, lepotik odol-galtzea saihesteko moduko odol koagulua agertu izana. Hortaz, baliteke Mikeren garunaren %80 kaltetu gabe geratu izana aizkorakadaren ondoren eta, hortaz, zientifikoki zehatzagoa da esatea oilasko hari garunaren zati bat eta aurpegia falta zitzaiola, eta ez burua. Izan ere, oiloen kasuan garunaren zatirik handiena buruaren atzealdean dago, eta ez aurrealdean.

Irakaspen txiki batAzalduta geratu den bezala, Mike oilaskoa ez zen bururik gabe bizi. Izatekotan, aurpegiaren zati handi bat falta zuen, baina, oilaskoak ezin dira bururik gabe bizi, minutu gutxi batzuk pasa ondoren gaitasun motorra eta beste bizi funtzioak egiten jarraitzeko gaitasuna amaitu egiten baitzaie. Egun, Mike oilaskoak webgunea ere badu, eta noizean behin Interneten ikusten dira Mikeri buruzko artikuluak, baina, kontuz eta arretaz irakurri itzazu. Mike ez zen 18 hilabetez bururik gabe bizi izan, baizik eta aurpegiaren zati handi bat galduta. Agian hori bera ere bitxia eta mirarizkoa da, bai, baina, azalpen zientifikoa du.

Informazio osagarria:

- Here’s why a chicken can live without his head, modernfarmer.com

- The chicken that lived for 18 months without a head, bbc.com

- La ciencia explica cómo un pollo puede vivir sin cabeza durante más de un año, elconfidencial.com

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Bizi al daiteke oilasko bat bururik gabe? appeared first on Zientzia Kaiera.

¿Y si la Gran Oxidación tuvo un origen geológico?

Si uno se interesa por el origen de la vida en Tierra tarde o temprano se encuentra con el fenómeno conocido como la Gran Oxidación, hace unos 2400 millones de años. La Gran Oxidación fue un cambio radical en la atmósfera de la Tierra en el que ésta empezó a contener cantidades importantes de oxígeno o, como dicen los químicos, pasó de ser reductora a oxidante. La vida, tal y como la conocemos hoy día, es consecuencia de la adaptación a esta circunstancia y habrían sido otras formas de vida, las cianobacterias, las que hace 2800 millones de años habrían provocado ese cambio atmosférico al ser las primeras criaturas fotosintéticas capaces de producir oxígeno molecular.

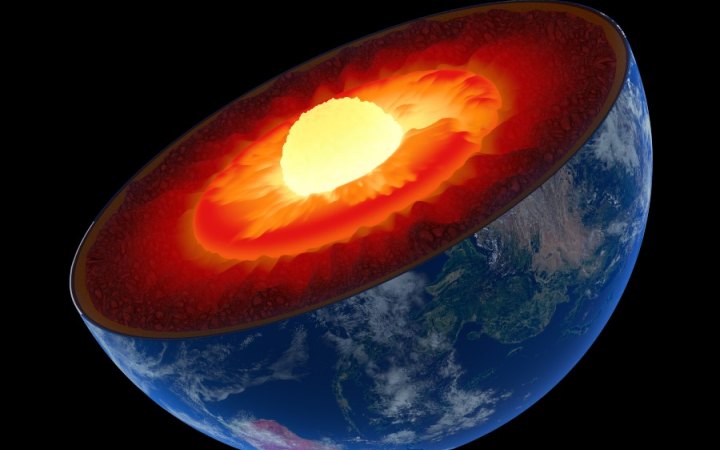

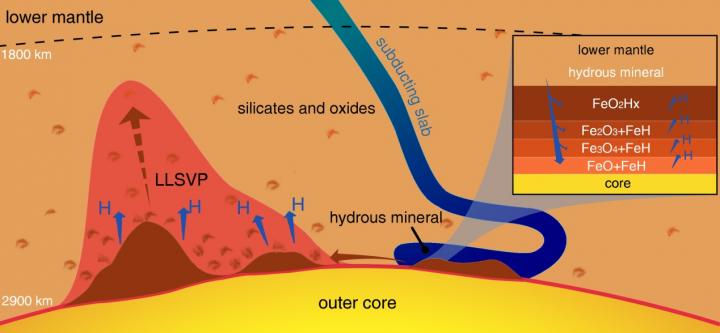

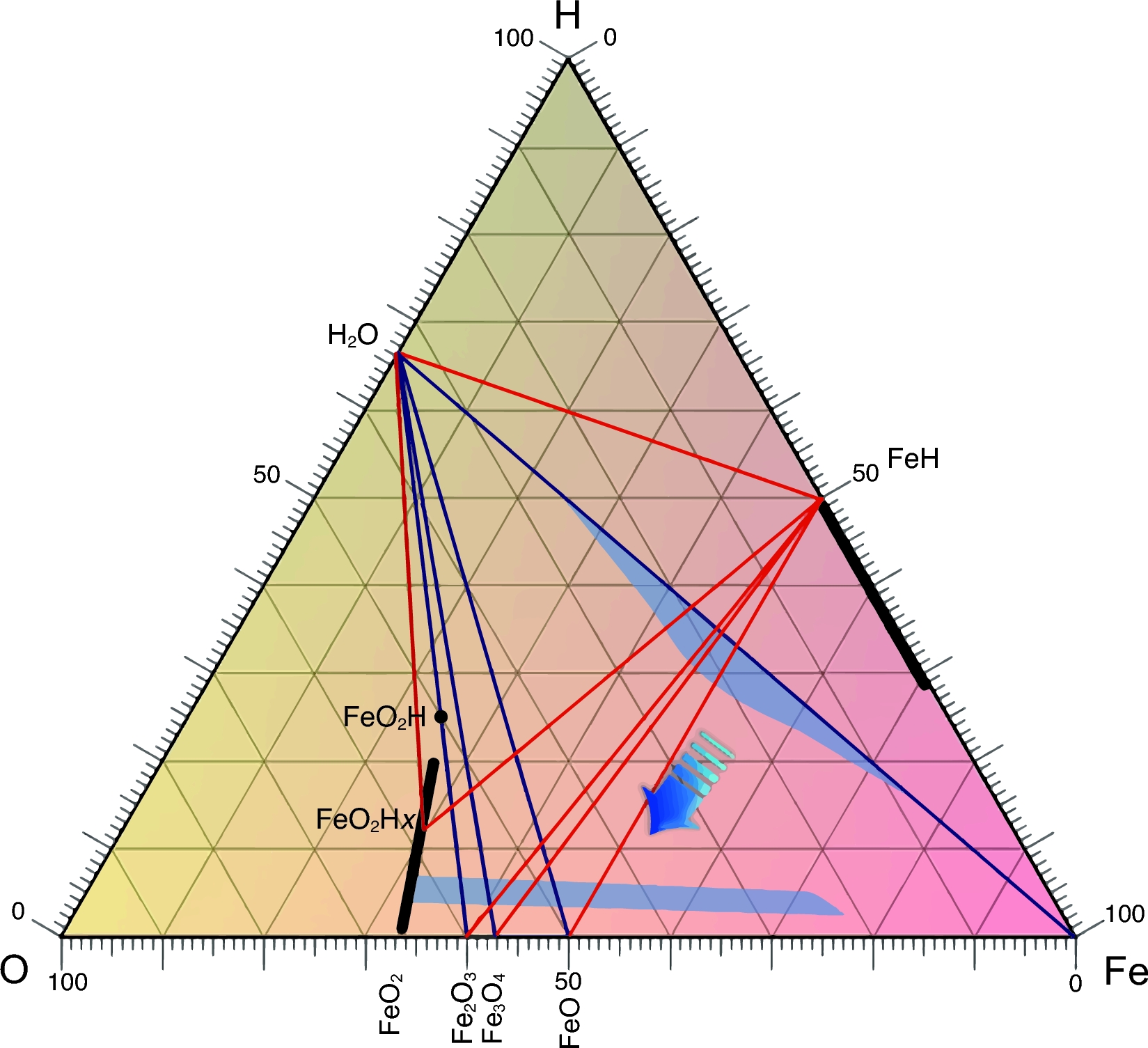

Pero, ¿y si esto, que está en cualquier libro de texto, no hubiera sido así? Un equipo internacional encabezado por Ho-kwang “Dave” Mao, de la Carnegie Institution (EE.UU.), propone otra idea basada en un fenómeno puramente geológico. En este fenómeno solo interviene el agua el hierro y las altas presiones y temperaturas del interior de la Tierra.

Cuando la acción de la tectónica de placas lleva minerales que contienen agua hacia el interior del planeta hasta encontrarse con el núcleo de hierro de la Tierra, las condiciones extremas de presión y temperatura hacen que el hierro tome átomos de oxígeno de las moléculas de agua y libere los átomos de hidrógeno. El hidrógeno escapa a la superficie, pero el oxígeno queda atrapado formando dióxido de hierro cristalino, FeO2, que solo puede existir a estas presiones y temperaturas tan intensas.

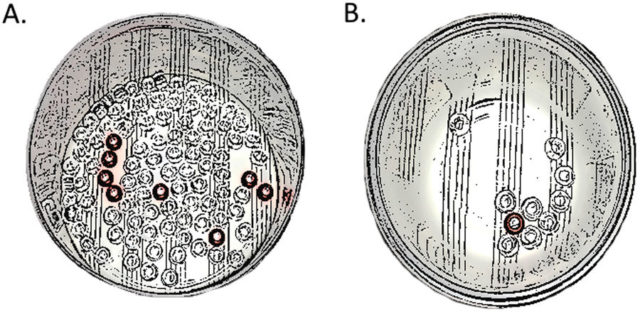

Utilizando cálculos teóricos y experimentos de laboratorio para recrear el entorno del límite núcleo-manto, el equipo determinó que el dióxido de hierro puede crearse efectivamente, utilizando para ello una celda de yunque de diamante calentada por láser para exponer los materiales a entre 950 y 1 millón de veces la presión atmosférica normal y 2000 ºC de temperatura.

Los investigadores calculan que se podrían estar transportando 300 millones de toneladas de agua hasta el hierro del núcleo y generando enormes rocas de dióxido de hierro cada año. Estas rocas extremadamente ricas en oxígeno podrían acumularse año tras año por encima del núcleo, creciendo hasta alcanzar tamaños colosales, como los de un continente. Un acontecimiento geológico que calentara estas rocas de dióxido de hierro podría causar una erupción masiva, liberando repentinamente una gran cantidad de oxígeno a la superficie.

Los autores plantean la hipótesis de que si una explosión de oxígeno de este tipo podría inyectar una gran cantidad del gas en la atmósfera de la Tierra, nada impediría que esta fuese la causa de la Gran Oxidación, impulsora de la vida dependiente del oxígeno que conocemos.

Este descubrimiento puede tener muchas más consecuencias para la geoquímica. Esta hidrólisis, el término que los químicos usamos para referirnos a la rotura de la molécula de agua, a alta presión y tempertaura afectaría a la geoquímica desde las profundidades de la Tierra hasta, como hemos visto, la atmósfera. Hay que revisar muchas teorías.

Referencia:

Ho-Kwang Mao et al (2017) When water meets iron at Earth’s core–mantle boundary National Science Review doi: 10.1093/nsr/nwx109

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo ¿Y si la Gran Oxidación tuvo un origen geológico? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Otra pieza en el puzle de la fotosíntesis

- Un origen químico de la vida elegantemente simple

- Un mecanismo que explica el origen de la homoquiralidad biológica

El disputado voto del Señor Condorcet (I)

En nuestra sociedad hay innumerables ocasiones en las que un colectivo de personas debe tomar decisiones sobre diferentes alternativas que se le plantean, como quién debe ser la persona que preside una nación, quien el candidato o candidata de un partido político, dónde se celebrarán los siguientes juegos olímpicos, cuál ha sido la mejor película, o libro, del año, qué empresa debe contratar una comunidad de vecinos para arreglar la fachada de su casa o qué política debe de seguir determinado gobierno, partido político o empresa, y muchas otras cuestiones similares.

Ante lo cual se nos plantea la cuestión trascendental de cómo elegir la propuesta que mejor represente las preferencias de los individuos del colectivo, es decir, cómo convertir las preferencias individuales en una preferencia colectiva, de la mejor forma posible.

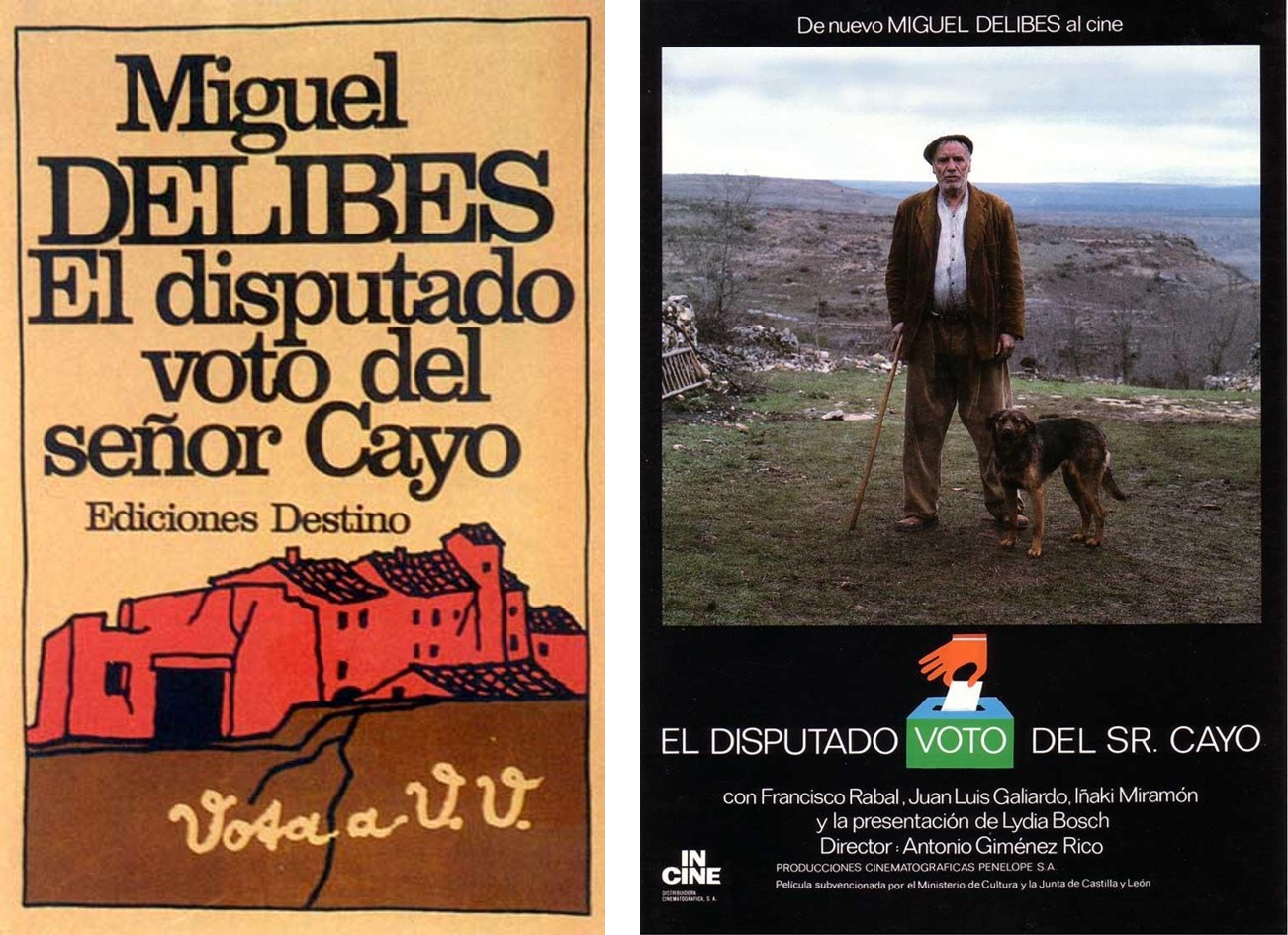

Portada del libro “El disputado voto del Señor Cayo” (Destino, 1978), del escritor Miguel Delibes, y cartel de la película homónima de 1986 del director Antonio Giménez-Rico

Aunque pueda parecer lo contrario, ya que las votaciones son algo habitual en nuestra vida cotidiana, la cuestión no es precisamente sencilla. Para ilustrar esto vamos a mostrar dos ejemplos clásicos interesantes.

El primero es la paradoja de Condorcet. Marie-Jean-Antoine

Nicolás de Caritat, Marqués de Condorcet (1743-1794) fue un filósofo, matemático y político francés, que tuvo un papel relevante durante la Revolución francesa.

Marie-Jean-Antoine Nicolás de Caritat, Marqués de Condorcet (1743-1794)

Supongamos que se está decidiendo cuál de las tres ciudades, Bilbao, Donosti y Gasteiz, va a ser la capital del País Vasco, y se designa una comisión de expertos internacional, formada por 12 personas, para tal fin.

Tras un tiempo de estudio del problema y las consiguientes deliberaciones llega la votación, obteniéndose un empate entre las tres candidaturas, con cuatro votos cada una. Ante lo cual, se pide a los expertos que indiquen su orden de preferencia entre las tres ciudades, obteniéndose las siguientes preferencias:

El alcalde de Bilbao que está en la reunión, como representante de la capital de Bizkaia, toma la palabra y dice lo siguiente:

“Si comparamos solamente las ciudades de Bilbao y Donosti observaremos que 8 de los 12 expertos prefieren Bilbao a Donosti. Por otra parte, si comparamos ahora Donosti y Gasteiz, observaremos que, de nuevo, 8 de los 12 expertos prefieren Donosti a Gasteiz. En conclusión, los expertos prefieren Bilbao a Donosti, y Donosti a Gasteiz, por lo tanto, la ciudad preferida es Bilbao, que debería ser la capital del País Vasco.”

Pero entonces, el alcalde de Vitoria-Gasteiz, que también está presente en la reunión, manifiesta lo siguiente:

“Querido alcalde de Bilbao, quizás antes de tomar ninguna decisión deberíamos tener en cuenta también la comparación entre Bilbao y Gasteiz, y veremos que la mayoría de los expertos, de nuevo 8 de 12, prefiere Gasteiz a Bilbao. En consecuencia, vuestro razonamiento queda así anulado.”

Como podemos ver en este ejemplo, se ha producido una preferencia cíclica, cuando se comparan las candidaturas dos a dos la mayoría de los expertos prefiere Bilbao a Donosti, Donosti a Gasteiz, y Gasteiz a Bilbao, por lo que no podemos determinar cuál es la ciudad preferida por los expertos, y por tanto, la capital del País Vasco. Esto es lo que se conoce con el nombre de paradoja de Condorcet.

Pero vayamos con un segundo ejemplo, más esclarecedor aún. Imaginemos que hay que elegir la sede de los siguientes Juegos Olímpicos, y que las ciudades candidatas a ser la sede de los mismos son Barcelona (BCN), Johannesburgo (JNB), Los Ángeles (LAX), Sydney (SYD) y Tokio (TYO).

El COI – Comité Olímpico Internacional, que es el “organismo encargado de promover el olimpismo en el mundo y coordinar las actividades del Movimiento Olímpico”, es también quien se encarga de la elección de las sedes de los Juegos Olímpicos.

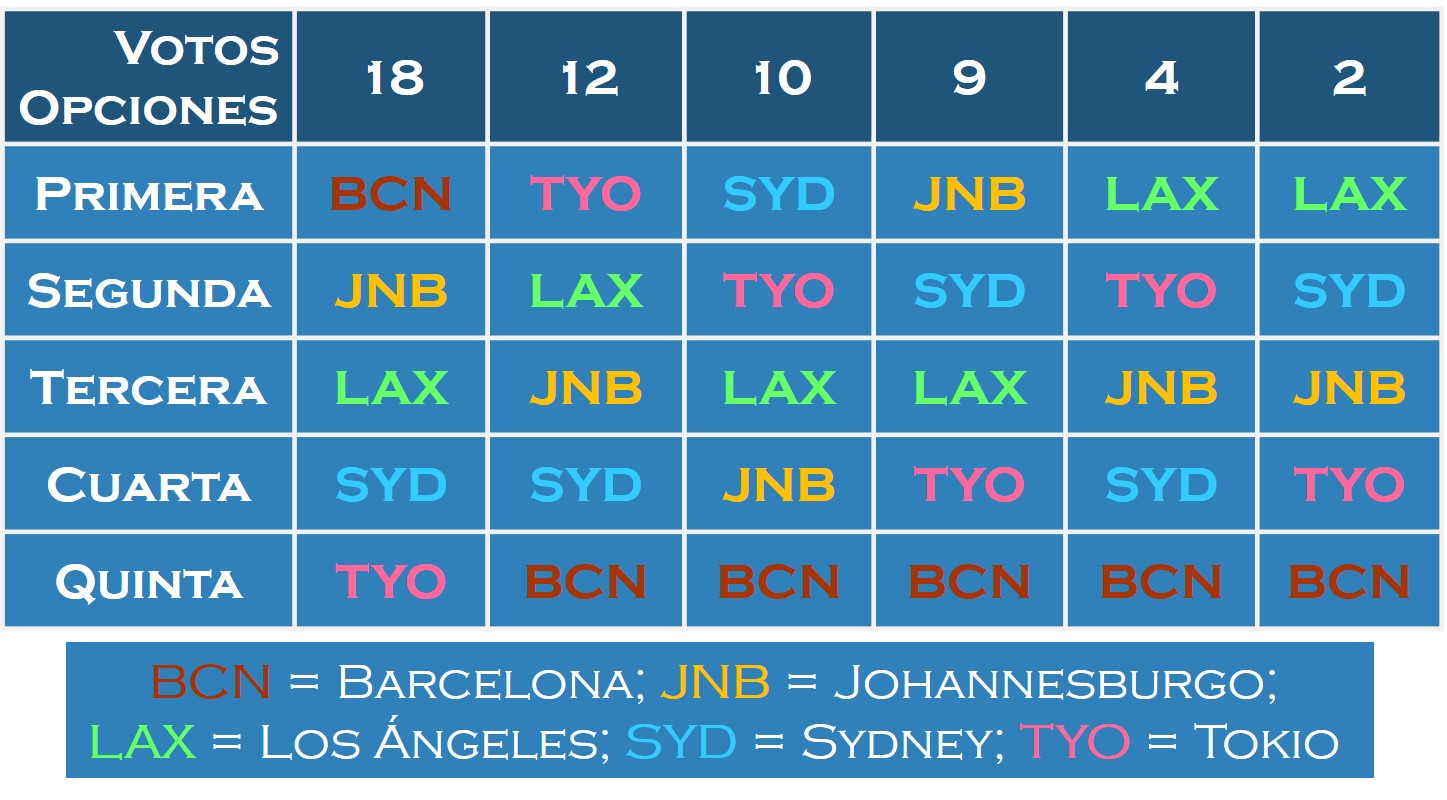

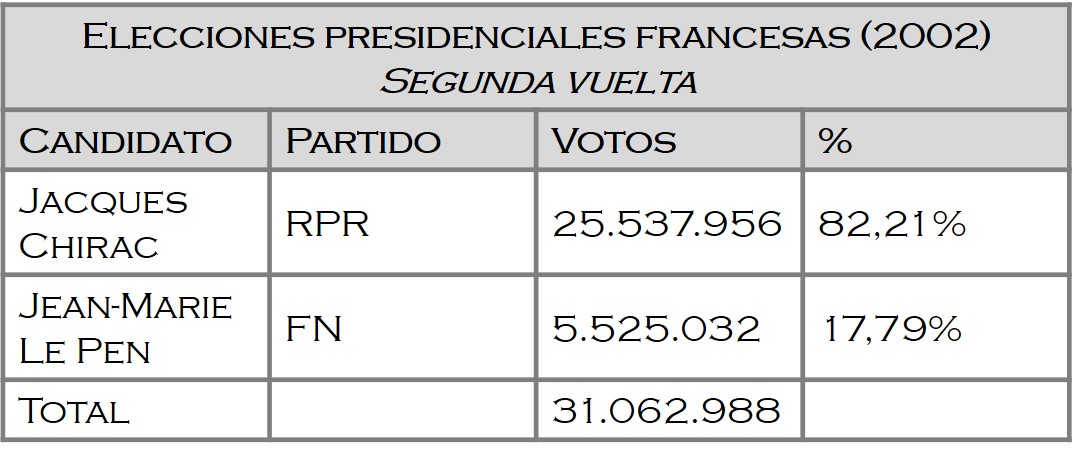

Supongamos que el número de compromisarios del COI que pueden tomar parte en la votación para la elección de la sede de las Olimpiadas es 55 (aunque en realidad son del orden de cien), y que para conocer mejor la opinión personal de cada uno de los compromisarios respecto al problema de la elección de la sede de los JJ. OO., se les pide en esta ocasión que ordenen las ciudades candidatas en función de sus preferencias, primero la ciudad que piensan que debería ser la sede, después su segunda opción, seguida de la tercera, la cuarta y finalmente, la última opción. E imaginemos que el resultado de las votaciones ha sido el siguiente:

Por ejemplo, 18 de los compromisarios han ordenado las ciudades de la siguiente forma: Barcelona es su opción preferida, su segunda opción es Johannesburgo, la tercera es Los Ángeles, seguida de Sydney y por último, Tokio. Y de forma similar, como se indica en la tabla anterior, el resto de compromisarios.

Una vez que tenemos fijadas las preferencias individuales de los miembros del Comité Olímpico Internacional, debemos de decidir cuál es la ciudad ganadora, es decir, establecer la preferencia colectiva.

A. Método de votación “mayoría simple”.

Este método, conocido también como “método de pluralidad”, es el método de votación más antiguo y sencillo que existe. Cada votante expresa su preferencia individual votando por su candidatura preferida y al final se cuentan los votos que recibe cada una de las opciones que se han presentado, y la que ha obtenido más apoyos, más votos, es la ganadora.

Este sencillo sistema es uno de los más utilizados, sobre todo en grandes votaciones. Por ejemplo, es el sistema utilizado en las elecciones presidenciales de Canadá, EE.UU., México, Venezuela, Palestina, Panamá o Ruanda, entre muchos otros países. Así mismo, también suele ser el sistema utilizado en las elecciones primarias de muchos partidos políticos.

Papeleta electoral general de las elecciones de las elecciones de 2016 a Presidente y Vice-presidente de los Estados Unidos de América

Entre los inconvenientes de este sistema de votación está el que puede ganar una candidatura para nada deseada por la mayoría de las personas del colectivo de votantes, si hay varias opciones similares que hacen que el voto se divida dentro de esas opciones parecidas. Es un sistema que permite desarrollar estrategias para manipular el resultado, por ejemplo, si hay dos opciones de voto y quien convoca las elecciones teme que pierda su opción, puede plantear dividir la opción contraria en dos opciones parecidas que se deriven de ella, para que se divida el voto. Por ejemplo, en las elecciones para la salida de Gran Bretaña de la Unión Europea, Brexit, donde había dos opciones SI (salir de la UE) y NO (permanecer), podría haber tenido tres opciones del siguiente estilo:

A. salir de la UE, manteniendo una alianza estratégica con ella;

B. salir de la UE, rompiendo toda relación;

C. permanecer en la UE.

Quizás así el voto del SI se podría haber dividido entre las opciones A y B. Es un ejemplo simple, pero nos sirve para ilustrar la idea.

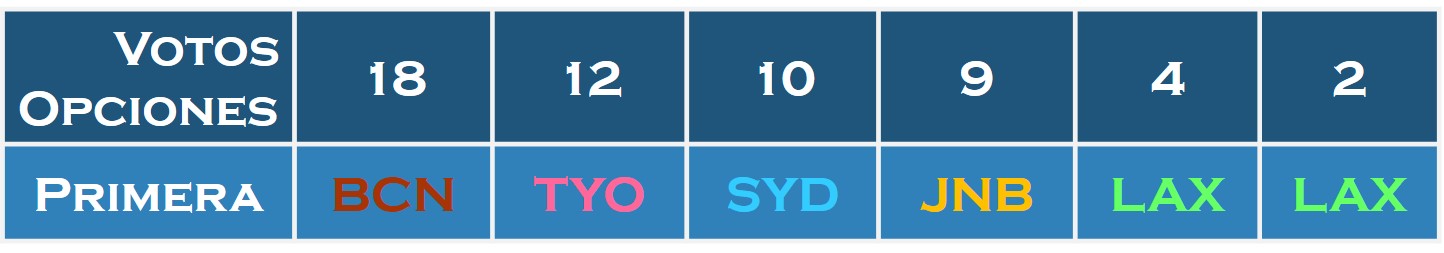

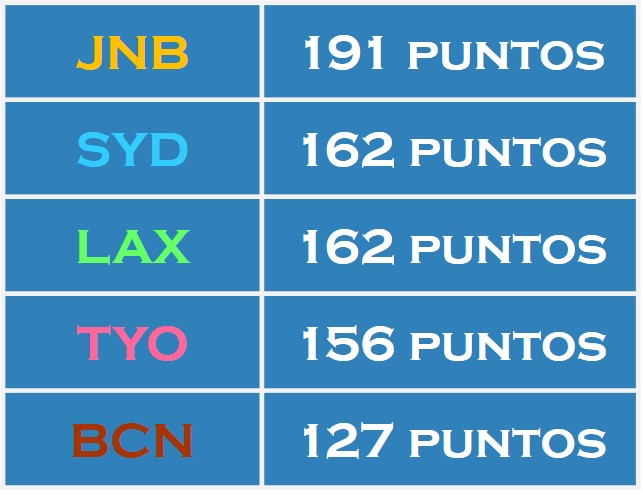

Utilizando este sistema de votación, el de la mayoría simple, los resultados para la elección de la sede de los siguientes Juegos Olímpicos habrían sido estos:

Es decir, Barcelona (BCN), 18 votos; Tokio (TYO), 12 votos; Sydney (SYD), 10 votos; Johannesburgo (JNB), 9 votos; y Los Ángeles (LAX), 6 votos. Por lo tanto, la ciudad ganadora, y en consecuencia, sede de los siguientes JJ.OO. habría sido

B. Método de votación “segunda vuelta”.

Otro de los métodos de votación utilizado en muchas elecciones presidenciales, como en Francia, Brasil, Portugal, Polonia, Rusia, Colombia, Argentina, Chile, Perú o Indonesia, es el método de segunda vuelta, también llamado “balotaje” (que viene del vocablo francés ballottage).

Este consiste en lo siguiente. Si tras la primera votación, en la que cada persona vota por su candidatura preferida como en el sistema de mayoría simple, alguna de las candidaturas ha alcanzado la mayoría absoluta, es decir, más del 50% de los votos, entonces es la ganadora. En caso contrario, las dos opciones más votadas pasan a la segunda vuelta, produciéndose entonces una votación únicamente entre estas dos opciones.

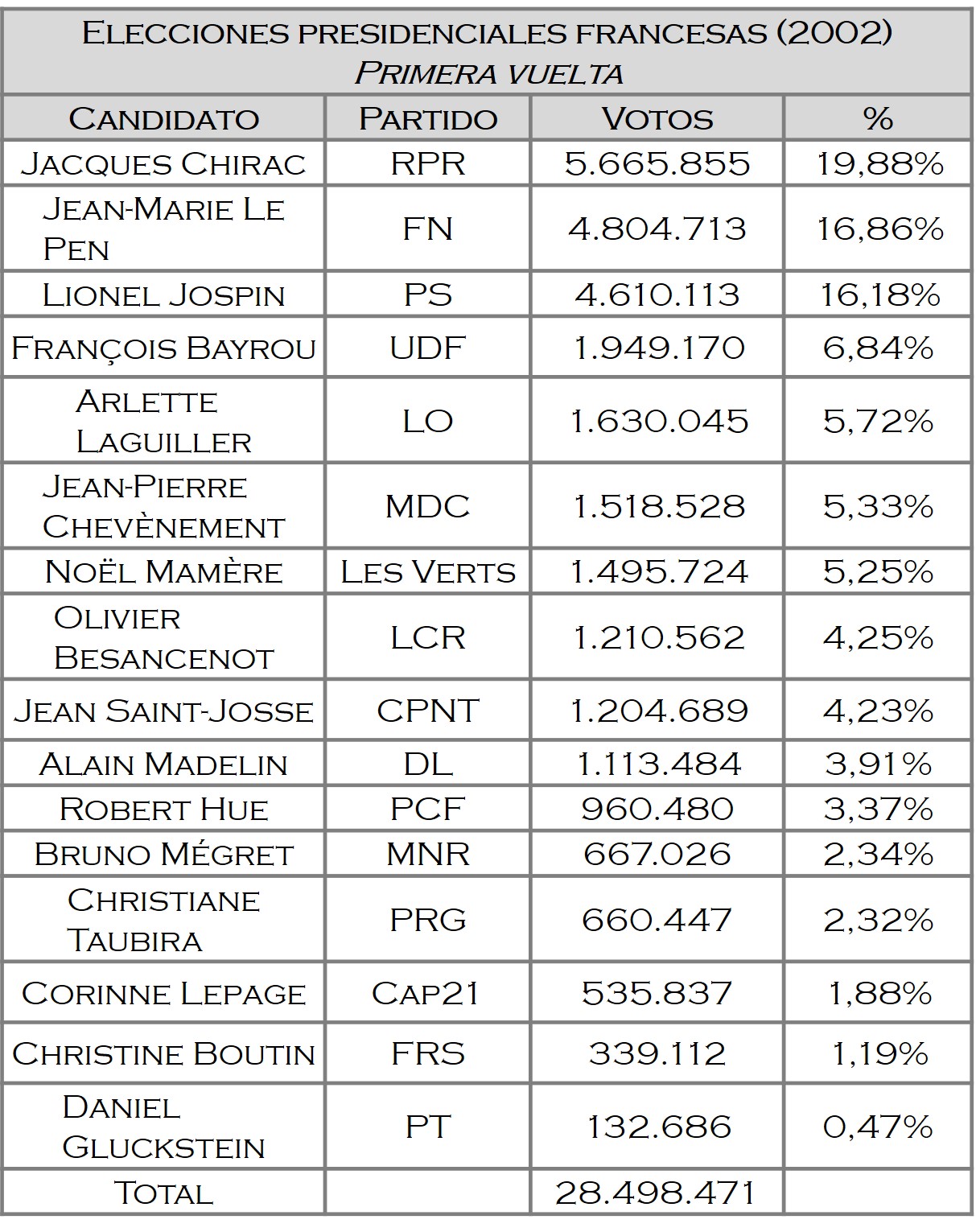

Veamos un caso real, las elecciones francesas de 2002, en las cuales había 16 candidatos a la presidencia de la República Francesa. En la primera vuelta los resultados fueron:

Los dos candidatos que pasaron a la segunda vuelta fueron Jacques Chirac (del RPR – Agrupación por la República, partido conservador francés neo-gaullista) y Jean-Marie Le Pen (del FN – Frente Nacional, partido político de extrema derecha francés). Jean-Marie Le Pen dejó fuera de la segunda vuelta, por un pequeño porcentaje, al socialista Lionel Jospin, que era a priori el candidato natural para pasar a la segunda vuelta.

En la segunda vuelta el resultado de la votación entre Jacques Chirac y Jean-Marie Le Pen fue

con un triunfo aplastante de Jacques Chirac, mientras que Jean-Marie Le Pen no obtuvo un incremento significativo en el porcentaje de votos.

Volviendo a nuestro ejemplo, si observamos los resultados de la votación por parte de los miembros del COI, las dos candidaturas más votadas han sido Barcelona, con 18 votos –que son el 32% de los votos– y Tokio, con 12 votos –que son el 21,8% de los votos–. Como ninguna de las candidaturas ha obtenido mayoría absoluta, esas dos ciudades, Barcelona y Tokio, pasan a la segunda vuelta. Y se produce por tanto una segunda votación.

En la vida real, entre la primera y la segunda votación pueden producirse cambios en la opinión de los votantes. Los motivos pueden ser muy diversos. Por ejemplo, puede que haya votantes que estén desencantados o cansados de las elecciones, o puede que las candidaturas que han pasado a la segunda vuelta no tengan el atractivo suficiente para algunos votantes, o que algunos votantes modifiquen su intención de voto en la segunda vuelta por sugerencia de quienes apoyaban la candidatura por la que habían votado en la primera.

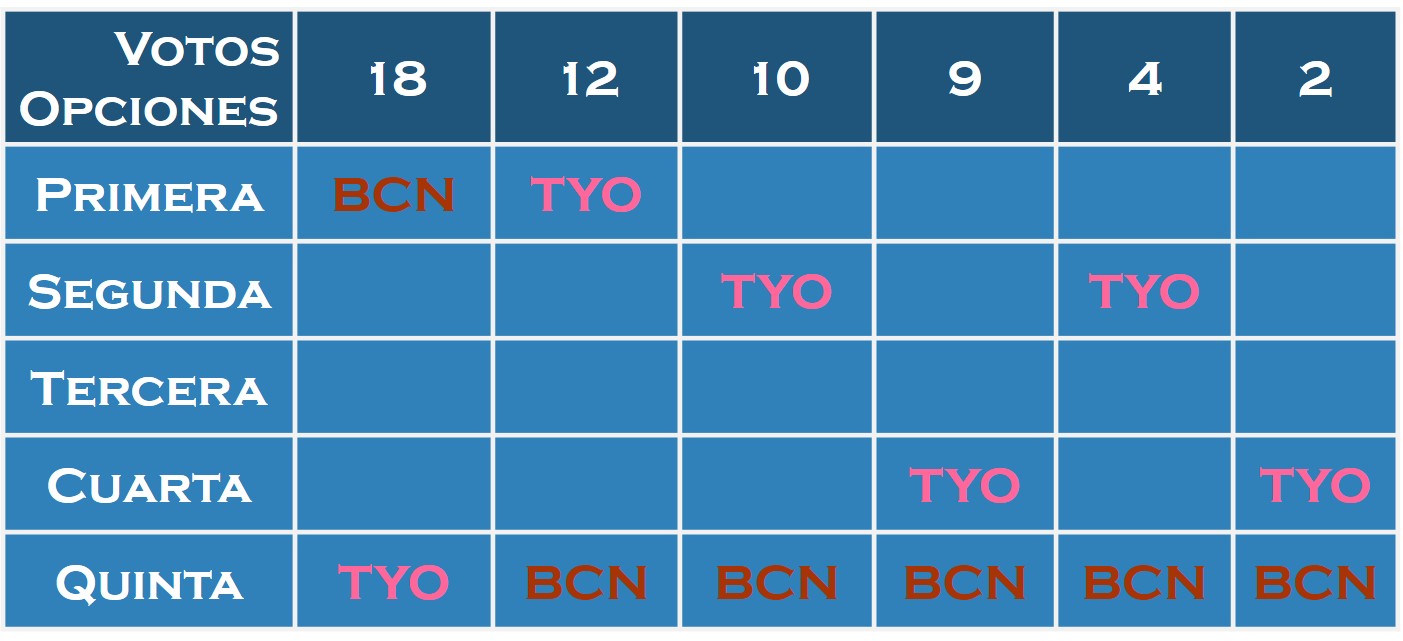

Es decir, en la vida real la cuestión es más complicada que en este ejemplo, donde ya tenemos la intención de voto en la segunda vuelta marcada por las preferencias de la votación realizada. En cualquier caso, si miramos a la tabla de preferencias anterior y vemos cuales son las preferencias de los compromisarios en la votación entre Barcelona y Tokio (en la siguiente tabla hemos dejado solamente las dos ciudades) …

… observamos que el resultado de la segunda vuelta será: Barcelona, 18 votos, y Tokio, 37 votos, puesto que todos los compromisarios que no votaron por Barcelona en la primera vuelta, prefieren Tokio a Barcelona. La ciudad ganadora y, en consecuencia, sede de los siguientes JJ.OO. será

C. Método de votación “eliminación de los perdedores”.

Este es el sistema que utiliza realmente el Comité Olímpico Internacional, con la salvedad de que nosotros estamos contando con la intención de voto desde el inicio para determinar lo que votará cada compromisario en las diferentes vueltas que se van a producir, mientras que, en la realidad, entre una votación y la siguiente, cada compromisario puede cambiar de opinión, ya sea de forma libre, con la intención de manipular el resultado a favor de una opción débil e intentando eliminar alguna candidatura rival con posibilidades o como consecuencia del juego político que se desarrolla en esos momentos “entre bastidores”.

El método de “eliminación de los perdedores” consiste en lo siguiente. Cada votante da su voto a la candidatura que piensa que es la mejor de todas, como en las anteriores, pero después del recuento de votos se elimina la candidatura menos votada. Entonces, se produce la segunda ronda, en la que se vota entre todas las candidaturas, menos la que ha sido eliminada, se cuentan los votos y se elimina la candidatura con menos votos. Así se continúa hasta que solamente queda una candidatura, que será la ganadora de la votación.

Por ejemplo, en octubre de 2009 se produjo la elección de la sede de los JJ.OO. de 2016. Las ciudades candidatas fueron Río de Janeiro, Madrid, Tokio y Chicago. En la primera vuelta los resultados de la votación dentro del COI fueron:

Río de Janeiro, 26 votos; Madrid, 28 votos; Tokio, 22 votos; y Chicago, 19 votos.

Por el método de la mayoría simple habría ganado Madrid. Sin embargo, como utilizan el método de la “eliminación del perdedor” se eliminó a Chicago en esa primera ronda. Los resultados de la segunda votación fueron:

Río de Janeiro, 46 votos; Madrid, 29 votos; Tokio, 20 votos .

Observemos que Tokio no solo no subió en votos, sino que perdió dos de los votos de la primera ronda. Pasaron a la siguiente ronda Río de Janeiro y Madrid, donde perdió Madrid por 66 frente a 32 votos.

En nuestro ejemplo, tenemos que los resultados de las votaciones en cada una de las rondas, siguiendo la intención de voto que han manifestado inicialmente (véase el cuadro de arriba), serían…

Las ciudades eliminadas en cada ronda serían Los Ángeles, Johannesburgo, Tokio y finalmente Barcelona, quedando como ciudad ganadora y, en consecuencia, sede de los siguientes JJ.OO.

D. Método de votación “recuento de Borda”.

Este sistema de votaciones, propuesto por el matemático, físico, navegante y político francés Jean-Charles de Borda (1733-1799), se utiliza, por ejemplo, en las elecciones primarias de Podemos, en las elecciones presidenciales de Kiribati en el océano Pacífico, o se utilizó también en el proceso de pacificación de Irlanda.

Este método consiste en darle peso a las preferencias de los votantes sobre las candidaturas, mediante la asignación de puntos según el orden de preferencia. De esta forma se prima a las primeras preferencias sobre las últimas.

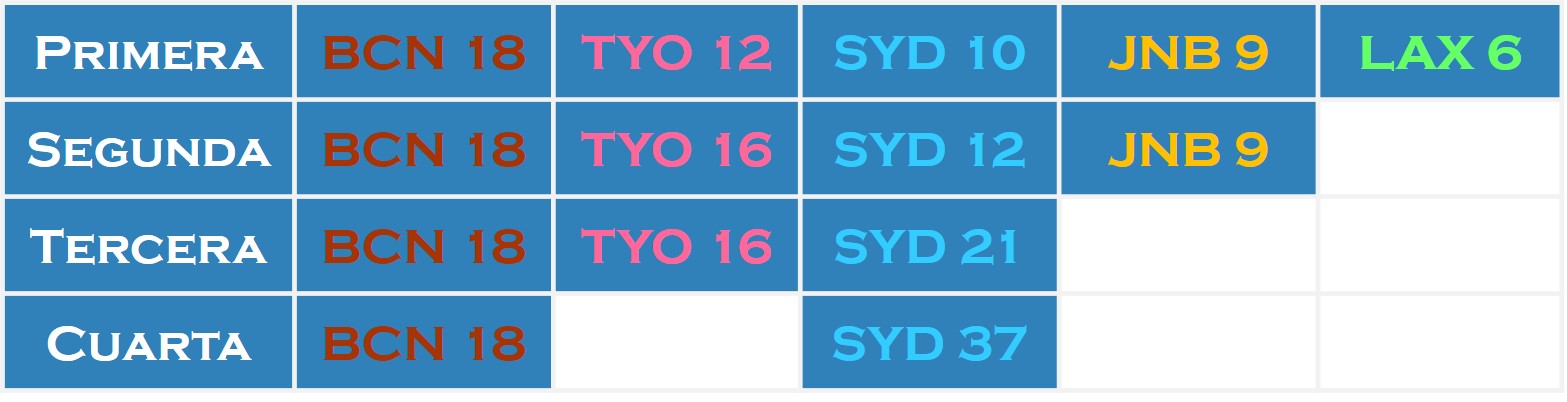

Así, en nuestra votación para la sede de los JJ.OO. se conceden 5 puntos a la ciudad preferida del votante, 4 puntos a la segunda opción, 3 puntos a la tercera, 2 puntos a la cuarta y 1 punto a la última, como se observa en la imagen.

De esta forma, el número de puntos de cada candidatura es:

En consecuencia, la ciudad ganadora y sede de los siguientes JJ.OO. sería

E. Método de votación “de Condorcet”.

El método de Condorcet, como ya se anticipaba en la paradoja que lleva su nombre, es el de los enfrentamientos dos a dos, por parte de todas las candidaturas, es decir, cada candidatura se compara con el resto de candidaturas, y la que “gane” más enfrentamientos gana las elecciones.

En nuestro ejemplo, como tenemos 5 ciudades candidatas a sede de los siguientes juegos olímpicos, el número de enfrentamientos dos a dos será 10. Cada ciudad se enfrenta a cuatro ciudades.

Por ejemplo, si enfrentamos a Los Ángeles y Sydney, el resultado de la votación de los compromisarios si solo votan por una de las dos es (miremos la tabla anterior de preferencias): Los Ángeles, 36 votos; Sydney, 19 votos.

La única ciudad que, en este ejemplo, gana todos sus enfrentamientos es Los Ángeles. En concreto, LAX 28 – JNB 27; LAX 36 – SYD 19; LAX 33 – TYO 22; y LAX 37 – BCN 18. Por lo tanto, la ciudad ganadora de estas elecciones y sede de los siguientes JJ.OO. sería

Cuadro “Voting Line” del artista americano Charly “Carlos” Palmer

Este ejemplo nos ilustra como el ganador de la anterior votación no lo determinan únicamente las preferencias individuales de los votantes, sino también el método de votación elegido. Con unas mismas preferencias individuales (las que hemos recogido en la tabla inicial) se obtiene que cada ciudad candidata podría ganar las elecciones en función del sistema de votación elegido.

Por lo tanto, habrá que tratar de elegir el método de votación que permita determinar la preferencia colectiva que mejor represente las preferencias individuales de los votantes. Este será el tema de nuestra siguiente entrada del Cuaderno de Cultura Científica.

Para terminar, una cita del filósofo, matemático y político francés, Nicolás de Condorcet. Tras la Revolución Francesa, la Asamblea Nacional estuvo trabajando sobre los Derechos del Hombre y del Ciudadano, dejando fuera a las mujeres. Una de las personas que pidió el reconocimiento de los derechos de las mujeres fue precisamente el Marqués de Condorcet.

Quien vota en contra del derecho de otro ser, sean cuales sean su religión, el color de su piel o su sexo, renuncia a los suyos desde ese preciso momento.

“Sobre la admisión de las mujeres al derecho de ciudadanía”

Marqués de Condorcet, 1790

Bibliografía

1.- VV. AA., Las matemáticas en la vida cotidiana, Addison-Wesley/Universidad Autónoma de Madrid, 1999.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El disputado voto del Señor Condorcet (I) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- “La cultura científica o la misteriosa identidad del señor Gauss” por Raúl Ibáñez

- La insoportable levedad del TRES, o sobre la existencia de sistemas numéricos en base 3

- Uno, dos, muchos

Ez omen gara sinesteko jaioak

Urte askotan, bereziki soziologoak, antropologoak eta filosofoak erlijioaren jatorria aurkitzen saiatu dira. Modu batean ala bestean, gizarte guztietan garatu den sinesmen hauek gizateriaren bilakaera baldintzatu dute.

Erabateko erantzuna topatzea, aldiz, arras zaila da. XIX. mendean Friedrich Nietzsche filosofoak Jainkoaren heriotza iragarri zuen, eta, era berean, heriotza horrek “izakiaren bakardadea” ekarriko zuela ohartarazi zuen: gizakiak erlijioaz gaindiko giza balore propioak sortu behar zituen, bere bizitzak helburu jakin bat ez zuela onartu, eta jainko baten babesik gabe bizitzen ikasi behar zuen. XX. mendean, mendebaldeko gizarteetan bederen, balore horiek indarra galdu zuten, eta soziologoak sekularizazioari buruz hitz egiten hasi ziren. Halere, eta erlijioak boterea galtzen zuela bazirudien ere, denborarekin ikusi zen prozesu hori ez zela hain jarraitua izango. Anthony Giddens soziologoak, adibidez, horretaz ohartarazi zuen bere Sociology liburu klasikoan: “Ez dago argi erlijioaren eragina desagertzeko bezainbeste urritu denik”. Gaur egun, hedabideetako albisteak edota inguruan dauden pentsamendu magikoaren adibideak ikustea baino ez dago horretaz jabetzeko.

1 irudia: Erlijioaren jatorria argitzeko saiakera asko egin dira, batez ere gizarte zientzien eta humanitateen aldetik. (Argazkia: Juanma Gallego)

Durkheim soziologoarentzat, erlijioaren atzean gizarte bakoitzaren balore identitarioak zeuden, eta gizarte modernoetan elementu zibilek betetzen zuten erlijioaren rola (aberria, bandera, ereserkiak…). Max Weberrek, berriz, erlijioak gizarteak eraldatzeko ahalmen adina zuela proposatu zuen, eta kapitalismoaren garapenean protestantismoak izan zuen rola bereziki aztertu zuen.

Gizarte zientziek eskaintzen dituzten tresnez gain, orain psikologiak eta neurozientziak tresna gehiago jartzen dituzte mahai gainean; diziplina anitzeko taldeek erantzunak bilatzen kolaboratzen dute.

Psikologoen kasuan, noski, abiapuntuak norbanakoa izan behar du. Arlo horretan azken urteetan bereziki sinesmen intuitiboaren hipotesia zabaldu da. Horren arabera, naturaz gaindiko sinesmena pentsamendu intuitiboan oinarritzen da, eta pentsamendu analitikoa martxan jartzen denean, aldiz, sinesmena gutxitu egiten da. Hortaz, hipotesi horren arabera, sinesmen sustraituak dituzten lagunak, analitikoak baino, intuitiboagoak dira.

Coventryko eta Oxfordeko unibertsitateetako (Erresuma Batua) neurologoek eta filosofoek egindako ikerketa batek hipotesi hori kolokan jarri du orain. Ikertzaile hauek diote erlijio sinesmenak ez daudela intuizioari edo pentsamendu arrazionalari lotuta. Scientific Reports aldizkarian argitaratu dituzte emaitzak.

Erromesak, akuriBesteak beste, Done Jakue bidea egin duten erromesak aztertu dituzte ikerketa abiatzeko. Artikuluan azaldu dute arrazoia: “Done Jakue bidean ikerketa egiteak naturaz gaindiko sinesmenekin izandako hartu-emanak neurtzeko aukera eman digu; bestalde, erlijio eta nazionalitate desberdinetako parte-hartzaileen multzo aproposa izateko aukera eman digu”.

Erromesen arrazoinamendua aztertzeko, galdeketa bat egin diete. Besteak beste, euren sinesmenen sakontasunari buruz eta erromesaldiari eskainitako denborari buruz galdetu diete. Ikerketan 89 lagunek parte hartu dute. Ingelesez, gazteleraz eta portugaleraz egin dituzte galdeketak. % 71 kristauak ziren, % 20 “espiritualak, baina ez erlijiosoak”, eta % 8 ateoak. Budismoa praktikatzen zuen lagun bat ere bazegoen (hortik gainerako % 1).

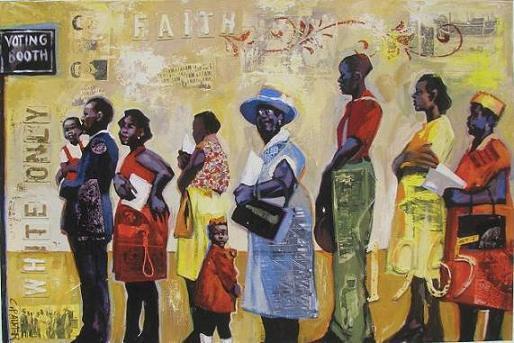

2 irudia: Erromesei galdeketa egin diete, eta baita, begiak itxita, koloretako beira-aleak lortzeko ataza jarri ere. Horrekin intuizioa eta pentsamendu analitikoa neurtu dituzte. (Argazkia: Scientific Reports)

Bestetik, saiatu dira neurtzen erromesen pentsamendua norainokoa den intuitiboa ala arrazionala. Horretarako, ataza bat jarri diete. Erromesek logikan eta intuizioan oinarritutako bi aukeren artean hautatu behar izan dute. Pentsamendu intuitiboak azkar prozesatzen du informazioa, deliberazio gutxi eginda. Pentsamendu analitikoan, berriz, geldoagoa eta deliberazio asko egiten da.

Parte-hartzaileei beira-aleak dituzten bi ontzi erakutsi dizkiete. Helburua izan da koloretako beira-aleak lortzea, baina nahastuta aurkeztu dizkiete. Handiagoa den ontzi batean beira-ale asko sartu dituzte; horietatik, %6-9 kolorekoak izan dira. Beste ontzi batean, berriz, hamar ale sartu dituzte, tartean koloretako ale bakarra. Horretan, koloretako alea eskuratzeko aukera %10ekoa izan da. Behin hori ikusita, begiak itxi eta koloretako alea non bilatu erabaki behar izan dute. Emaitzetatik ondorioztatu dute berez ez dagoela intuizioaren eta naturaz gaindiko sinesmenen arteko loturarik.

Erromesak ez diren lagunei egindako beste proba baten bidez berretsi dute ideia hori. Kasu honetan, matematika buru-hausgarriak baliatu dituzte “intuizioa handitzeko”, eta erlijio sinesmenekin loturarik ez dagoela ikusi dute.

Azkenik, garunaren estimulazioa erabili zuten inhibizio kognitiboaren maila handitzeko, prozesu honek pentsamendu analitikoa arautzen dutela uste da eta. Estimulazio hori lortzeko, bi elektrodo ezarri dizkiete garunean, inhibizioaren kontrola arautzen duen eremuan eragiteko (zehazki, eskuineko beheko zirkunboluzio frontala izeneko eremuan). Emaitzen arabera, estimulazioak inhibizio kognitiboa indartzea lortu du, baina naturaz gaindiko sinesmenak ez dira aldatu. Beraz, kasu honetan ere, bi aldaera horien arteko harreman zuzenik ez dagoela ondorioztatu dute.

Hortaz, pentsamenduak antolatzeko moduan ez, baino beste nonbaiten bilatu behar omen dira erantzunak. Coventryko Unibertsitatean lan egiten duen Miguel Farias psikologoaren arabera, “eskura dauden datu soziologikoek eta historikoek erakusten dutenez, sinesten duguna batez ere hezkuntza eta gizarte faktoreetan oinarritzen da, eta ez pentsamendu intuitibo edo analitiko bezalako estilo kognitiboetan”.

Erreferentzia bibliografikoa:

Farias, M. et al. Supernatural Belief Is Not Modulated by Intuitive Thinking Style or Cognitive Inhibition. Scientific Reports 7, Article number: 15100 (2017) DOI:10.1038/s41598-017-14090-9

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Ez omen gara sinesteko jaioak appeared first on Zientzia Kaiera.

Sistemas respiratorios: la emergencia de un doble sistema circulatorio

No todos los animales cuentan con lo que puede considerarse, con propiedad, un sistema circulatorio. Y muchos animales, aunque tienen bomba o bombas de impulsión, tienen sistemas circulatorios abiertos. En los sistemas abiertos la sangre o hemolinfa bombeada se vierte a una amplia cavidad interna a través de un sistema de arterias que se ramifican de forma sucesiva. Luego es recogida por un sistema de venas equivalente al anterior y devuelto a la bomba de impulsión. Los sistemas abiertos ejercen un menor control que los cerrados sobre el flujo de sangre a los diferentes órganos, aunque en cualquier caso las demandas de los tejidos son satisfechas de manera conveniente.

El sistema abierto más complejo que se conoce es el de algunos crustáceos, que alcanzan un desarrollo muy similar al de los sistemas cerrados. El sistema arterial llega hasta el final de las extremidades, la hemolinfa se vierte en pequeños espacios abiertos y de ellos es recogida por unos senos a modo de pequeños canales que la devuelven al corazón, no sin antes pasar por las branquias. Así pues, en estos crustáceos la sangre se oxigena en su trayecto de vuelta a la bomba de impulsión.

Las cosas son diferentes en los animales que tienen sistemas cerrados. Los cefalópodos son los únicos moluscos con sistema cerrado. En estos la sangre también pasa por las branquias antes de alcanzar el corazón sistémico o corazón principal, de donde se distribuye al resto de órganos y tejidos. A diferencia de los crustáceos, los moluscos cefalópodos tienen dos corazones branquiales que bombean la sangre venosa procedente de los tejidos a las branquias. Así se oxigena y se descarga de CO2 antes de llegar al corazón sistémico. Una característica notable de este sistema es que al trabajar con sangre venosa, los corazones auxiliares trabajan en condiciones virtualmente anóxicas, con muy escaso aporte de oxígeno.

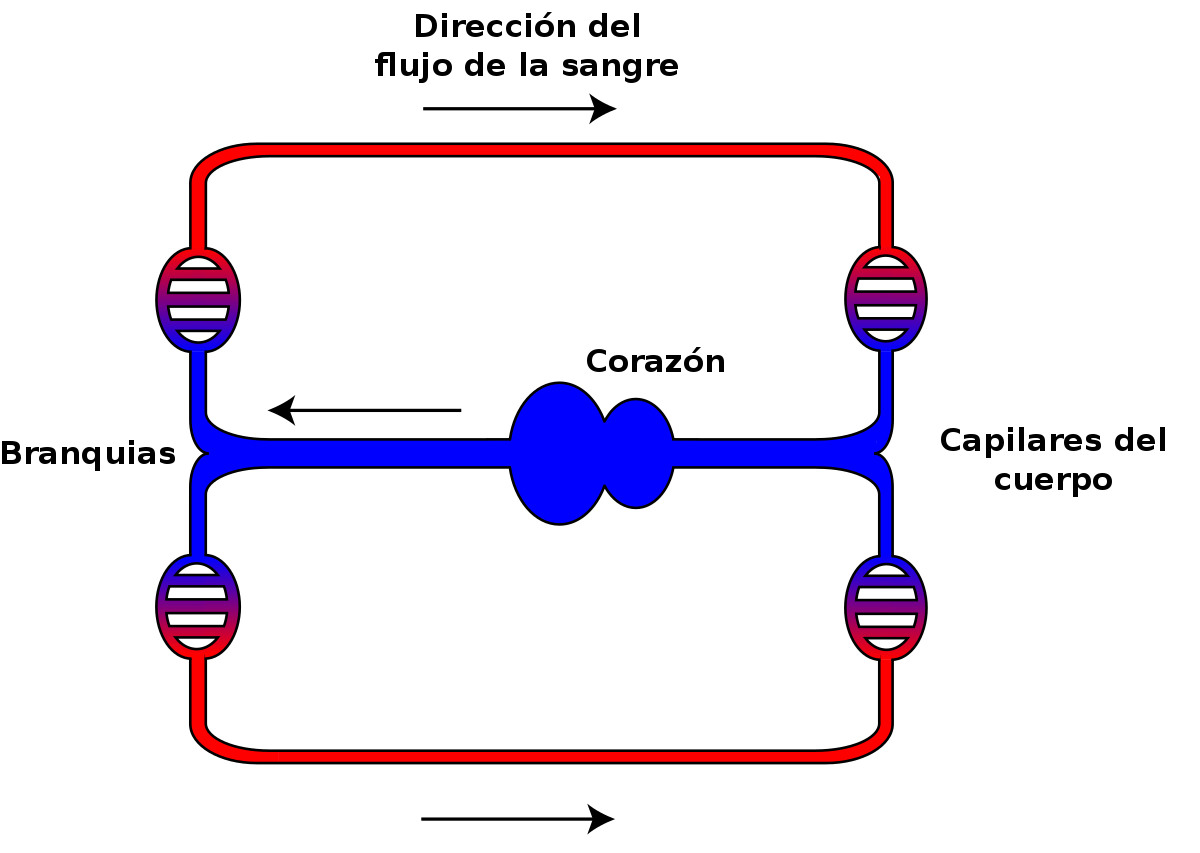

Esquema del sistema circulatorio de los peces. Fuente: Lennert B. / Wikimedia Commons

Los sistemas circulatorios cerrados más desarrollados son los de los vertebrados, y hay una gran variedad de disposiciones anatómicas en este grupo. Lo más probable es que los de los primeros vertebrados consistieran en un circuito muy simple que siguiera, más o menos, la secuencia: corazón, arteria, branquias, aorta, arterias, arteriolas, capilares, vénulas, venas y corazón. Este sistema es diferente de los anteriores porque en aquellos la sangre circulaba de las branquias al corazón y en este circula del corazón a las branquias. Es un buen dispositivo a efectos de oxigenar la sangre, pero reduce mucho la velocidad de circulación desde el corazón a los tejidos, porque al pasar por los capilares branquiales, estos, por su pequeño calibre, ofrecen una gran resistencia al paso de la sangre y la ralentizan. Los peces mantienen las características generales de este sistema, aunque en algunos casos incorporan alguna bomba auxiliar antes del corazón sistémico.

La transición al medio terrestre trajo importantes novedades. La aparición de órganos respiratorios distintos de las branquias complicó de forma notable la arquitectura del circuito. Como vimos aquí, hay peces que son capaces de respirar en aire a través de estructuras tales como la cavidad bucal, el intestino, la vejiga natatoria o la cloaca. En los primeros que desarrollaron esa capacidad el órgano respiratorio recibe sangre del circuito sistémico, lo que da lugar a que, una vez oxigenada, se mezcle con la desoxigenada que procede del resto de los tejidos antes de entrar en el corazón. Por lo tanto, cuando respiran en aire los tejidos sistémicos reciben sangre parcialmente oxigenada, porque las branquias, en caso de ser funcionales, aportan muy poco oxígeno. Esa particularidad, que ha sido tradicionalmente considerada una desventaja de esos peces, tiene sin embargo una ventaja por comparación con los que respiran en agua a través de las branquias: como la sangre que llega al corazón está parcialmente oxigenada, el corazón toma de ella el oxígeno que necesita.

A diferencia de los anteriores, en los peces pulmonados –y en concreto, en el respirador aéreo obligado Protopterus aethiopicus– la sangre procedente de los pulmones no se mezcla con la procedente de los tejidos antes de entrar en el atrio (aurícula) del corazón, sino que entra en este directamente. Y por otro lado, la configuración anatómica del corazón de estos peces es tal que permite que la sangre procedente de los pulmones y la que llega del resto de los tejidos solo se mezclen en una pequeña proporción, de manera que la que viene de los pulmones se dirige preferentemente a la circulación sistémica, y la que procede de los tejidos a los pulmones. Aunque anatómicamente no hay una separación clara entre los dos circuitos, el sistémico o general, y el pulmonar, funcionalmente se produce una cierta diferenciación, lo que constituye un anticipo de los sistemas totalmente diferenciados que aparecieron posteriormente en otros vertebrados.

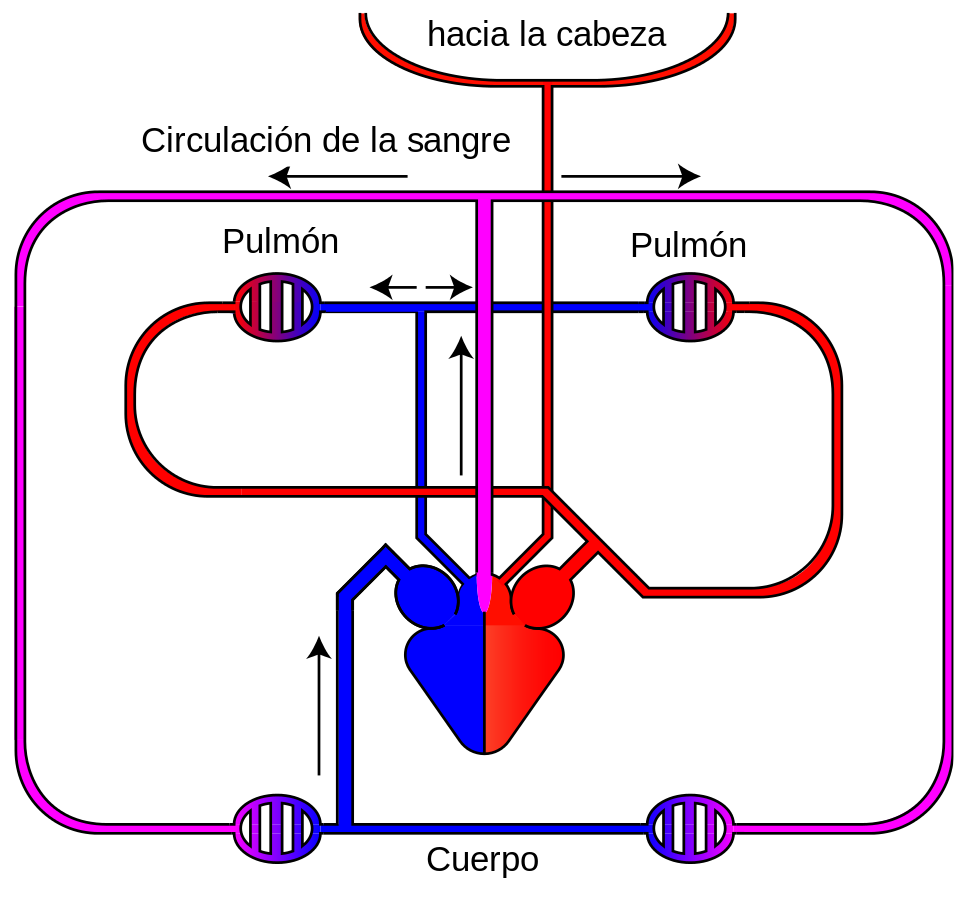

Esquema del sistema circulatorio de los anfibios. Fuente: Lennert B. / Wikimedia Commons

Los anfibios que respiran en aire tienen ya dos cámaras auriculares separadas. La sangre oxigenada procedente de los pulmones entra en la aurícula izquierda, mientras la sangre sistémica venosa entra en la derecha a través del seno venoso. Ambas sangres están separadas hasta que llegan al ventrículo. Pero, gracias a las características ventriculares, tampoco en este se mezclan en una medida significativa. En anfibios, además, hay que introducir la irrigación de la piel en el análisis, dado que puede contribuir de forma significativa al intercambio de gases. El caso de la rana toro (Rana catesbeiana) es muy ilustrativo. Prácticamente toda la sangre oxigenada procedente de los pulmones llega a la aurícula izquierda y sale hacia la circulación sistémica, se descarga de O2 en los tejidos y vuelve al corazón, donde entra por la aurícula derecha; la mayor parte de esa sangre venosa desoxigenada se dirige a la vía pulmo-cutánea (dos tercios a los pulmones, y el otro tercio a la piel). Lo curioso es que la sangre (oxigenada) que procede de la piel se mezcla con la procedente de los tejidos antes de llegar al corazón.

Esquema del sistema circulatorio de los reptiles. Fuente: Basquetteur. / Wikimedia Commons

Los reptiles no cocodrilianos (tortugas, serpientes y lagartos) tienen el ventrículo parcialmente separado en tres cámaras, y aunque la separación no es total, también en estos hay poca mezcla de sangre oxigenada y desoxigenada. No se conoce bien el mecanismo, pero las arterias pulmonares reciben preferentemente sangre desoxigenada. En los cocodrilianos el ventrículo está completamente dividido en dos cámaras por un septo. Del ventrículo izquierdo sale la arteria pulmonar y una arteria sistémica, la izquierda, y del ventrículo izquierdo sale la aorta sistémica derecha; sendas válvulas controlan el flujo a través de ambas aortas y están, además, conectadas nada más salir del corazón. Ese sofisticado dispositivo no solo propicia una distribución selectiva de la sangre desoxigenada a los pulmones prácticamente perfecta, sino que durante el buceo permite limitar el flujo de sangre a los pulmones cuando estos se han quedado sin oxígeno.

Los diferentes dispositivos vistos en peces (de respiración aérea), anfibios y reptiles son funcionales en animales que no tienen garantizado un alto contenido en oxígeno en sus pulmones de manera permanente. Permiten dirigir la sangre desoxigenada y oxigenada hacia diferentes destinos dependiendo de las circunstancias; por ejemplo, dependiendo de la disponibilidad ambiental de O2 y, por ello, de su concentración en el órgano respiratorio. Por eso, la adquisición de un doble sistema, pulmonar y sistémico, por parte de aves y mamíferos no debe entenderse como un “último” paso en la evolución de los sistemas respiratorios hacia una hipotética configuración ideal. La disposición en serie del circuito sistémico y del pulmonar obliga a que los flujos hacia uno y el otro sean idénticos. Ello impide generar flujos diferentes en un y otro circuito, pero en aves y mamíferos no hay tal necesidad, pues, como se ha dicho, estos grupos tienen elevadas concentraciones de oxígeno en sus pulmones de forma permanente.

Por otro lado, esa configuración permite generar presiones hidrostáticas muy diferentes en cada circuito: en el sistémico son necesarias altas presiones para vencer la resistencia que ofrece el sistema capilar, pero en el pulmonar la presión no ha de ser muy alta, pues de lo contrario saldría plasma sanguíneo hacia los espacios extracelulares e, incluso, al interior de los alveolos, lo que aumentaría peligrosamente la longitud de la vía de difusión. Como consecuencia de esa disposición en serie, ambos circuitos se mantienen completamente separados en el corazón. En animales con muy altas demandas metabólicas, como aves y mamíferos, eso es ventajoso pues permite garantizar que sangres con diferentes contenidos de O2 no se mezclan en ningún momento, lo que favorece el transporte de oxígeno a los tejidos. Pero que ese dispositivo resulte muy ventajoso para aves y mamíferos no quiere decir que los animales que carecen de él tengan, a esos efectos, una configuración incompleta. Como hemos visto, el resto de vertebrados que respiran en aire en la práctica también han conseguido evitar la mezcla de sangres, aunque no de forma completa, y disponen, además de otras funcionalidades de las que carecen los dos grupos homeotermos.

Nota:

En las siguientes anotaciones hemos tratado otros aspectos de los sistemas circulatorios que complementan lo expuesto aquí:

La distribución del agua animal y el curioso caso del potasio

Un viaje a través del sistema circulatorio humano

El flujo sanguíneo se reorganiza en respuesta a las necesidades

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: la emergencia de un doble sistema circulatorio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un viaje a través del sistema circulatorio humano

- Sistemas respiratorios: el pulmón de los mamíferos

- Sistemas respiratorios: los límites a la difusión de los gases

La teoría de la invariancia

El color del oro es inexplicable si no se tiene en cuenta la relatividad

Tras el triunfo de Newton, su forma de plantear la ciencia física se expandió no solo a la mecánica, sino también a las otras ramas de la ciencia, en especial a la electricidad y el magnetismo. Este trabajo culminó a finales del siglo XIX con una nueva teoría de la electricidad y el magnetismo basada en la idea de campos eléctricos y magnéticos. James Clerk Maxwell, quien formuló la nueva teoría del campo electromagnético, demostró que lo que observamos como luz puede entenderse como una onda electromagnética.

La física de Newton y la teoría de Maxwell explican casi todo lo que observamos en el mundo físico cotidiano que nos rodea. Los movimientos de los planetas, los automóviles y los proyectiles, la luz y las ondas de radio, los colores, los efectos eléctricos y magnéticos y las corrientes, ya sean eléctricas o de masas de agua, encajan dentro de la física de Newton, Maxwell y sus contemporáneos. Además, su trabajo hizo posible las muchas maravillas de la nueva era eléctrica que extende por gran parte del mundo desde finales del siglo XIX. No es de extrañar que para 1900 algunos físicos muy distinguidos creyeran que la física estaba casi completa, y que solo eran necesarios algunos ajustes menores.

Albert Einstein en 1904