Historia de la primera red social

Las redes sociales son aplicaciones o herramientas que sirven para publicar, difundir y compartir contenido entre los miembros de una comunidad y propiciar la interacción y conexión entre quienes las usan. Las redes sociales son habituales en nuestro día a día, sin embargo, ¿cómo comenzaron?

En 1995 vio la luz la web SixDegrees. SixDegrees es considerada la primera red social. Esta red permitía poner en contacto a amigas y amigos, agrupándolos según el grado de relación que tuvieran, para que interactuaran a través del envío de mensajes. SixDegrees estaba basada en la teoría de los seis grados de separación del psicólogo Stanley Milgram. Esta teoría sustenta que vivamos donde vivamos estamos conectadas y conectados, entre nosotros, a través de seis pasos. SixDegrees señalaba en su presentación: “Only social network where you will meet amazing people based on your interests” (red social donde conocerás gente increíble según tus intereses). Esta descripción dejó al descubierto el nexo de unión entre quienes usamos las redes sociales, el compartir intereses comunes.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia de la primera red social se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La cámara de niebla

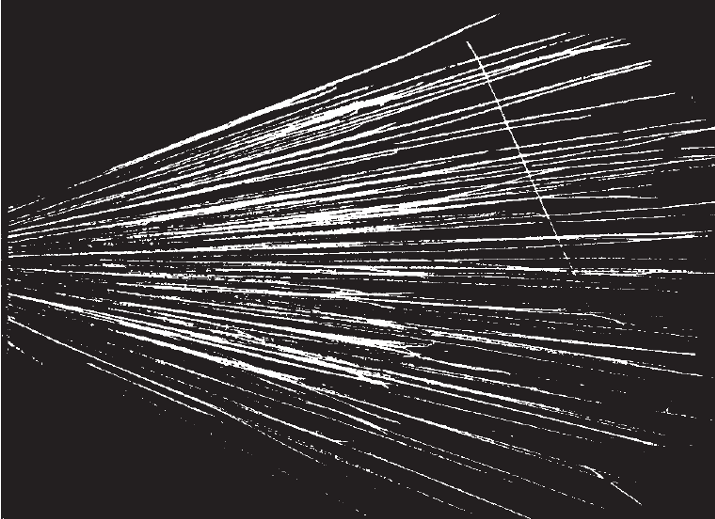

Cámara de niebla Wilson empleada en 1955 en el Brookhaven National Laboratory para el estudio de rayos cósmicos.

Cámara de niebla Wilson empleada en 1955 en el Brookhaven National Laboratory para el estudio de rayos cósmicos.Fue posible distinguir experimentalmente entre las dos hipótesis posibles para explicar la desintegración artificial mediante el uso de un dispositivo llamado «cámara de niebla», que permite visualizar la trayectoria de cada partícula cargada. La cámara de niebla fue inventada por C.T.R. Wilson y perfeccionada por él a lo largo de los años. A partir de 1911 se convertiría en un importante instrumento científico para estudiar el comportamiento de las partículas subatómicas.

En el caso de la desintegración artificial, recordemos, las dos hipótesis eran:

(a) El núcleo del átomo bombardeado pierde un protón, que se “desprende” como resultado de una colisión con una partícula alfa especialmente rápida.

(b) La partícula alfa es “capturada” por el núcleo del átomo al que ha golpeado, formando un nuevo núcleo que, inmediatamente después, emite un protón.

Si la hipótesis (a) es válida, el protón “desprendido” sería la cuarta trayectoria en la fotografía de una desintegración en una cámara de niebla: observaríamos la de una partícula alfa antes de la colisión, la de la misma partícula alfa después de la colisión, la del núcleo que que se desplaza tras la colisión y la del protón desprendido.

En el caso de que la (b) fuese la válida, en cambio, la partícula alfa incidente debería desaparecer en la colisión, y solo se verían tres trayectorias en la fotografía: la de la partícula alfa antes de la colisión y las del núcleo desplazado tras la colisión y el protón emitido.

La cuestión se resolvió en 1925 cuando P.M.S. Blackett estudió las trayectorias producidas cuando las partículas atravesaban gas nitrógeno en una cámara de niebla. Encontró que las únicas trayectorias en las que se podía ver la desintegración artificial eran las de la partícula alfa incidente, un protón y el núcleo desplazado. La ausencia de una trayectoria correspondiente a una partícula alfa tras la colisión demostró que la partícula desaparecía por completo y que el caso (b) es la interpretación correcta de la desintegración artificial: la partícula alfa es capturada por el núcleo del átomo que golpea, formando una nuevo núcleo que luego emite un protón.

Trayectorias de partículas alfa atravesando (de izquierda a derecha) gas nitrógeno. Una de ellas ha golpeado un átomo de nitrógeno, convirtiéndolo en oxígeno y emitiendo un protón. ¿Ves las tres trayectorias? Fuente: Cassidy Physics Library

Trayectorias de partículas alfa atravesando (de izquierda a derecha) gas nitrógeno. Una de ellas ha golpeado un átomo de nitrógeno, convirtiéndolo en oxígeno y emitiendo un protón. ¿Ves las tres trayectorias? Fuente: Cassidy Physics LibraryEl proceso en el que una partícula es absorbida por un núcleo de nitrógeno y se emite un protón puede representarse mediante una «ecuación». La ecuación expresa el hecho de que el número de masa total es el mismo antes y después de la colisión (es decir, hay conservación del número de masa) y el hecho de que la carga total es la misma antes y después de la colisión (hay conservación de carga).

![]()

Esta reacción muestra que ha tenido lugar la transmutación de un átomo de un elemento químico en un átomo de otro elemento químico. La transmutación no se ha producido de forma espontánea, como ocurre en el caso de la radiactividad natural; se produce exponiendo átomos (núcleos) objetivo a proyectiles emitidos por un nucleido radiactivo. Es, pues, una transmutación artificial. En el artículo en el que informó sobre esta primera reacción nuclear producida artificialmente, Rutherford dijo:

Los resultados en su conjunto sugieren que, si se dispusiera de partículas alfa, o proyectiles similares, de energía aún mayor para experimentar, podríamos esperar que se descompusiera la estructura nuclear de muchos de los átomos más ligeros.[1]

El estudio posterior de las reacciones que involucran núcleos ligeros condujo al descubrimiento de una nueva partícula y a un modelo muy mejorado de la constitución del núcleo. Se han observado muchos tipos de reacciones con núcleos de todas las masas, desde los más ligeros hasta los más pesados, y las posibilidades indicadas por Rutherford han ido mucho más allá de lo que jamás podría haber imaginado en 1919.

Nota:

[1] Este llamamiento a conseguir mayores energías de «proyectiles» fue respondido no mucho después con la construcción de aceleradores de partículas.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La cámara de niebla se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El descubrimiento de la desintegración artificial

- El problema de la estructura nuclear

- La hipótesis protón-electrón de la composición nuclear

Txertoen segurtasuna erdigunean

Koronabirusarengatiko pandemia kontrolatu ahal duen txertoaren informazioa hurbiltzen den heinean, gizartearen zati handi batek dio ez dutela lehenengoak izan nahi txertoa jartzen eta, beharbada, ez direla txertatuko ere. Ez dira benetako negazionistak, baina konfiantza falta dago SARS-CoV-2 birusaren kontrako txertoekiko, arin egin direlako eta, hortaz, seguruak izango ote diren beldurra dago agian.

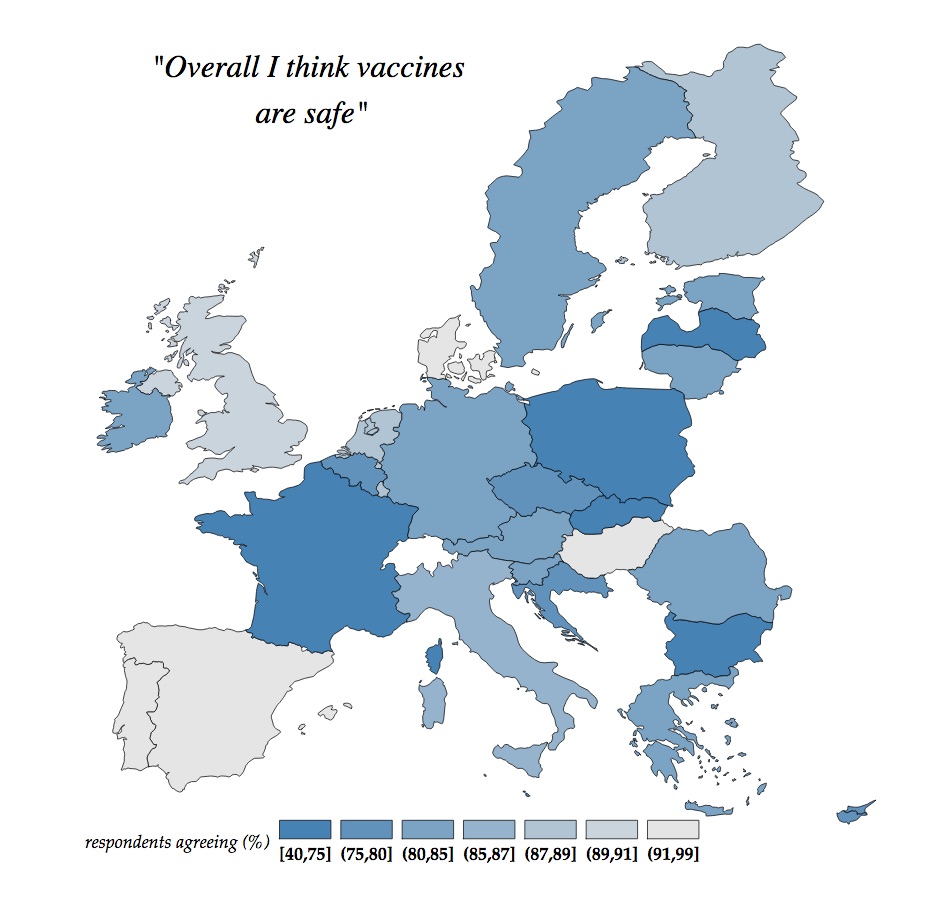

Europar Batasunean 2018an egindako inkesta batean galdetu egin zen ea bakoitzaren ikuspuntutik txertoak seguruak ote ziren. Inkestatutakoen % 82,1ek hala direla uste zuen, eta Espainiar Estatuan % 91,6raino igo zen ehuneko hori: emaitza askoz altuagoa gertuko herrialde batzuekin alderatuta.

Historikoki, txertoak inoiz egin diren osasun publikoko neurririk arrakastatsuenen artean daude. Urtero 6 milioi heriotza inguru saihesten dute mundu osoan.

Osasunari buruz hitz egiterakoan, zero arriskua ez da inoiz existitzen. Baina dudarik ez dago handiagoa dela txertorik ez jartzeko arriskua, eta beraz, gaixotasuna pairatzeko arriskua, txertoak daukana baino. Esate baterako, elgorria gaitza pairatzen duten 20tik batek pneumonia izateko arriskua du; 2000tik batek, entzefalitisa izateko; eta 3000tik batek, hiltzeko. Elgorriaren kontrako txerto hirukoitzak duen arriskua, aldiz, hauxe da: milioi bat hartzailetik batek entzefalitis izan dezakeela.

1. irudia: “Txertoak seguruak direla uste dut” adierazpenaren erantzuna Europar Batasunean egindako inkestan. (Iturria: Europako Batzordea – State of vaccine confidence in the EU 2018)Garapenean segurtasuna erdigunean

1. irudia: “Txertoak seguruak direla uste dut” adierazpenaren erantzuna Europar Batasunean egindako inkestan. (Iturria: Europako Batzordea – State of vaccine confidence in the EU 2018)Garapenean segurtasuna erdigunean

Txertoa garatzeko egiten diren entsegu klinikoetan segurtasuna bermatzea da abiapuntu nagusietakoa. Txerto berri bat merkatuan jartzeko baimena eman aurretik aztertu egiten dira sortzen dituen ondorio kaltegarriak. Alde batetik, interes bereziko kontrako ondorioen identifikazioa egiten da eta, bestetik, segurtasun klinikoaren analisi metatuak; hau da, neurtu egiten da egin diren entsegu kliniko horietan zenbat arazo agertu diren txertatu diren boluntarioetan.

Baina, aldi berean, behin txertoa baimenduta dagoelarik eta merkatuan dagoelarik gizarteko edonork erabili ahal izateko, segurtasunaren zainketak jarraitzen du uneoro alerta-seinaleak lehenbailehen emateko prest txertoa jarri ondoren kontrako ondorioren bat agertuz gero.

Kontuan hartu behar da entsegu klinikoen kontrol zorrotzek ez dutela uzten, kasu guztietan, nahi ez den ondorioren bat dagoela egiaztatzen, boluntario kopurua mugatua baita, nahiz eta hori handitzen joan den urteekin. Laurogeiko hamarkadan, esate baterako, B hepatitisaren aurkako txertorako 800 boluntario erabili ziren; 2000n, aldiz, pneumokokoaren aurkako txertorako 60.000 haur izan ziren boluntarioak, eta gaur egungo COVIDaren aurkako txertoetarako 40.000-60.000 boluntariotan probatzen ari dira txerto bakoitza. Populazio kopuru handietan (milioi pertsona) txertoek izan dezaketen eragina ezagutzeko aukera bakarra txertoa jarri eta behatzea da, eta, horretarako, zainketa hurbiletik egin behar da, eta berehala.

Kontrako ondorioakAlbo-ondorioen % 90 baino gehiago txertoa eman ondoko 40 egunetan agertzen dira. Txertoak eragindako kontrako ondorio gehienak arinak eta iragankorrak dira, eta ziztatu den lekuko minera, gorritasunera edo edemara mugatzen dira. Lehenengo 4 orduetan agertu eta ordu gutxiren ondoren desagertzen dira. Batzuetan ere, gorputz osoko erreakzioa ager daiteke, hala nola sukarra.

Bigarrenik, biltegiratze, manipulazio edo administrazio akatsekin lotutako erreakzioak ager daitezke. Kasu horiek saihesteko ezinbestekoa da txertoa jartzen duten osasun-langileek administrazio-tekniken berri izatea eta erabilitako txerto-prestakinekin trebatuta egotea.

2. irudia: Onartutako txerto guztiei proba zorrotzak egiten zaizkie entsegu klinikoen faseetan, eta jarraiko ebaluazioa egiten zaie merkaturatu ondoren ere. (Argazkia: Willfried Wende – Pixabay lizentziapean. Iturria: pixabay.com)

2. irudia: Onartutako txerto guztiei proba zorrotzak egiten zaizkie entsegu klinikoen faseetan, eta jarraiko ebaluazioa egiten zaie merkaturatu ondoren ere. (Argazkia: Willfried Wende – Pixabay lizentziapean. Iturria: pixabay.com)Hirugarrenik, badira, horrez gain, kontrako ondorio larriak edo oso larriak. Zorionez horiek oso bakan agertzen dira (100 txertatutatik 0,001ean ager daiteke). Ondorio horietariko bat erreakzio alergikoa izatea da txertoak duen konposatu baten aurrean, baina halako erreakzioa sarritan milioi bat txerto jarri ondoren atzeman daitezke. Horregatik, txertoa eman ondoren, komeni da 15-30 minutuko zaintza-aldi bat egitea, txertatutakoak ondorio kaltegarriak izango balitu berehala artatzeko.

Horrez gain, batzuetan aldi-baterako erreakzioak ager daitezke. Hau da, txertoaren administrazioarekin aldi berean agertzen diren erreakzioak, baina pazienteak txertoa jaso ez balu ere adieraz zitezkeenak. Horiek, beraz, ez daude txertoarekin erlazionatuak.

Txertoen segurtasuna zaintzeko sistemakOsasunaren Mundu Erakundeak badu txertoen segurtasunari buruzko aholku-batzorde orokor bat. Modu lokalean autonomia-erkidego bakoitzak botika guztien ondorio kaltegarriak aztertzen ditu, txertoak barne, eta gero Espainiako Medikamentuen eta Osasun-produktuen Agentziako farmakozaintza-sistemari jakinarazten zaizkio. Nazioarteko beste agentzia batzuekin kontaktuan jarriz, ustezko ondorio kaltegarri horiek aztertzen dira.

Azterketa horretan begiratzen da ea txertoa ematearen eta kontrako ondorioa agertzearen artean denbora-harremana dagoen. Horrez gain, ikusi egin behar da kontrako eragina txertoaren toxikotasunarekin lotuta ote dagoen edo ebidentzia zientifikoak erakutsi ote duen kontrako ondorioak izateko arrisku handiagoa dagoela txertoa jarri zaien pertsonetan txertatu gabeetan baino.

Aurreikusitako bigarren mailako ondorio baten eta txertoaren artean loturaren bat dagoela ziurtatzen denean, osasun-agintariek berehalako erabakia hartzen dute, arriskuak eta onurak egiaztatuz eta aztertuz, eta txertoen gomendioak aldatu behar ote diren erabakitzen dute, aukeretako bat delarik txertoa bertan behera uztea ere.

Agentzia arautzaileek eskatzen dituzten baldintza zientifiko-teknikoak gainditu ondoren, onartu egiten da aztergai den txertoa segurua eta eraginkorra dela. Gainera, txertoa merkaturatu ondoren, etengabe zaintzen da haren segurtasuna. Txertoen segurtasunarekin lotutako arazo errealek edo sumatuek eragin negatiboa dute txertaketa-programetan, eta oihartzun handia dute biztanlerian eta komunikabideetan.

Bukatzeko, historiak eta, beraz, esperientziak erakutsi diguna hauxe da:

TXERTORIK EZ JARTZEKO arriskua txertoari lotutako arriskua baino HANDIAGOA dela. Iturriak:- Europako Batzordea: State of vaccine confidence in the EU 2018.

- Osasunaren Mundu Erakundea (OME): Global Vaccine Safety.

Miren Basaras Ibarzabal, UPV/EHUko Medikuntza eta Erizaintza Fakultateko, Immunologia, Mikrobiologia eta Parasitologia Saileko ikertzailea eta irakaslea da.

The post Txertoen segurtasuna erdigunean appeared first on Zientzia Kaiera.

La senescencia celular: el gran desafío para entender y tratar el cáncer

Manuel Collado Rodríguez

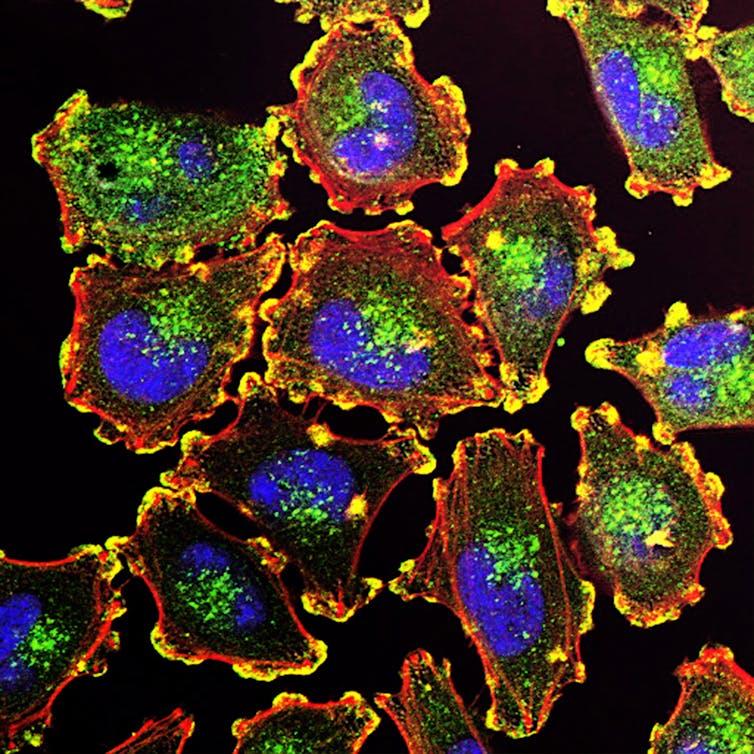

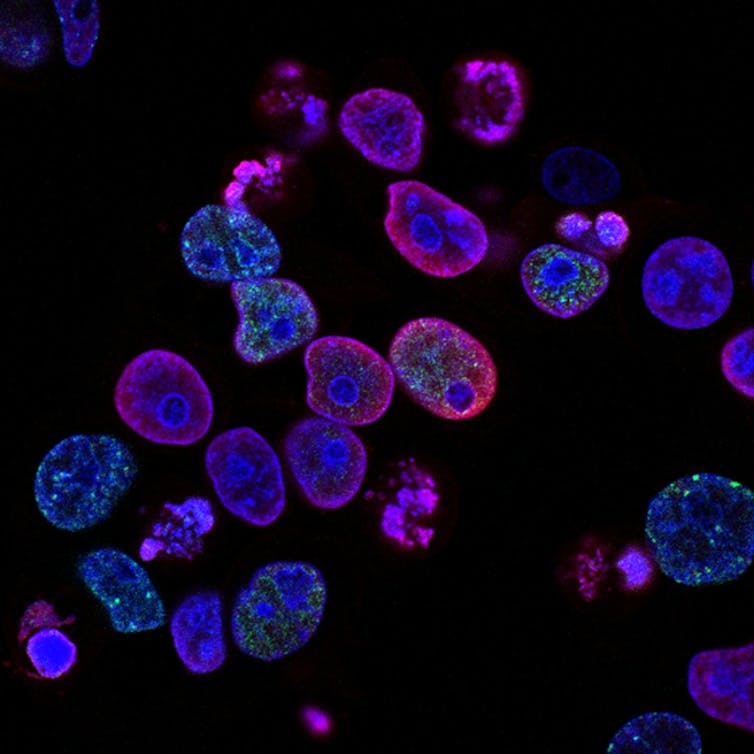

Células metastáticas. Fuente: Unsplash / National Cancer Institute

Células metastáticas. Fuente: Unsplash / National Cancer Institute

Hace 50 años el presidente estadounidense Richard Nixon declaró la “guerra al cáncer”. Seguía así la estela de otros exitosos programas que concentraron esfuerzos para alcanzar un objetivo que pusiera al país a la cabeza del progreso mundial. Años antes, los recursos se habían puesto para desarrollar la bomba atómica y llegar a la Luna. En el caso del cáncer, la iniciativa pretendía promover centros de investigación que reuniesen a los mejores investigadores para encontrar tratamientos contra una enfermedad que suponía una amenaza cada vez mayor para la sociedad.

Multitud de éxitos y fracasos después, asistimos ahora a un nuevo esfuerzo por impulsar la investigación biomédica contra el cáncer. Esta es la base de la iniciativa Grandes Desafíos del Cáncer, que arrancó en 2015. Su objetivo es mejorar nuestra capacidad de prevención, detección y tratamiento de la enfermedad. Para ello, busca identificar las cuestiones clave pendientes de resolver.

Un comité de sabios plantea cuáles son esas grandes preguntas que necesitan ser respondidas antes de continuar avanzando. Uno de estos grandes retos es entender y explotar en nuestro favor la senescencia celular.

¿Qué es la senescencia celular?

La división celular es el proceso que hace que una célula dé lugar a dos hijas idénticas. Esta es la base de la proliferación celular. La senescencia consiste en la incapacidad de llevar a cabo este ciclo.

Durante la senescencia, las células sufren unos cambios en su morfología y en su patrón de expresión de genes, y muestran unas secreciones extracelulares (que denominamos SASP). A este estado se llega como respuesta a daños en la integridad de la célula. Diversas agresiones celulares ponen en marcha este proceso.

La apoptosis (el proceso de suicidio celular) y la senescencia celular son los dos programas de defensa esenciales del organismo ante daños irreparables que ponen en peligro la transmisión íntegra de la información genética y la actividad correcta de las células. Si estos mecanismos fallan y permitimos que las células dañadas continúen proliferando, las células aberrantes crecerán desordenadamente hasta formar un tumor.

Por tanto, ambos son mecanismos de defensa antitumorales esenciales. Ahí tenemos una primera razón de peso para considerar que la investigación en senescencia celular es clave para entender el cáncer.

A lo largo de la vida se suceden todo tipo de agresiones a las células y, en muchas ocasiones, esto resulta en la inducción de senescencia. Esto contrasta con el hecho de que el cáncer es fundamentalmente una enfermedad del envejecimiento, mucho más frecuente en adultos y cuya incidencia aumenta claramente con la edad.

Si un organismo envejecido acumula células que han activado una respuesta de protección frente al cáncer con éxito, ¿cómo es que el cáncer se da más en personas de edad avanzada cuyos órganos y tejidos se están ya defendiendo? Una posibilidad es que la acumulación de daño con la edad termine por deshabilitar la respuesta protectora de la senescencia. Otra, inquietante, es que las células senescentes que no pueden dividirse alteren al resto hasta convertirlas en tumorales.

Así, lo que inicialmente nos protege podría volverse en nuestra contra y facilitar la enfermedad.

Las células dañadas que disparan la senescencia echan el freno para impedir su proliferación descontrolada. Además, secretan el SASP para enviar señales complejas a su entorno. Creemos que pueden estar destinadas a promover la reparación y regeneración del tejido dañado.

Así, una agresión celular es respondida mediante la parada en seco de la proliferación de la célula –ahora dañada– para impedir que pueda dividirse hasta formar un grupo de células aberrante. Además de dejar de proliferar, esas células secretan mensajes moleculares al exterior que por una parte avisan a su entorno, por otra llaman a la reparación y finalmente estimulan su propia eliminación.

Este sería el sistema cuando funciona a la perfección.

Demasiadas agresiones o un sistema ineficaz de eliminación de células dañadas puede conducir a una señalización de reparación constante y perjudicial que cause enfermedades. Este es el caso de patologías asociadas al envejecimiento como la osteoartritis, la fibrosis pulmonar y renal, el alzhéimer y el cáncer. Conocemos aspectos de esta compleja respuesta y tenemos indicios de la asociación entre acumulación de células senescentes y desarrollo de enfermedad, pero necesitamos concretar aún más cómo se desarrolla el proceso para entenderlo mejor y poder manipularlo en nuestro beneficio.

En ciencia, lo que no se ve no existe. O, al menos, se le asigna una menor importancia de la que pueda tener. En el caso de la senescencia celular, y tras décadas de estudio, carecemos de “marcadores” específicos del proceso, biomoléculas cuya aparición se asocie con la aparición de la senescencia y su evolución. Esto dificulta el trabajo en el laboratorio y su aplicación a la enfermedad humana. Debemos avanzar en este aspecto. Para ello, necesitamos emplear todos los recursos que puedan ofrecer diversas disciplinas y que, con enfoques novedosos, permitan el desarrollo de nuevas herramientas.

Fuente: Unsplash / National Cancer Institute

Fuente: Unsplash / National Cancer InstituteCómo eliminar células senescentes

En los últimos años hemos aprendido que es posible eliminar las células senescentes. Esto no parece perjudicar al organismo y ha demostrado, de momento en animales, una capacidad asombrosa para mejorar enfermedades asociadas al envejecimiento. Todas ellas tienen como base la acumulación de células senescentes que alteran los tejidos en los que residen y se han acumulado.

Una de las aproximaciones terapéuticas más avanzada, en experimentación clínica en humanos para conocer su potencial terapéutico, son los compuestos senolíticos. Esta es la denominación genérica que reciben los compuestos capaces de inducir la muerte específica de células senescentes, dejando intactas a las células normales. Pero quizá sea poco realista plantear una terapia contra el cáncer mediante la administración de senolíticos de manera preventiva para eliminar estas células dañadas, según vayan surgiendo, para evitar su acumulación. Se requerirá mucho conocimiento para asegurarse de que una estrategia así está exenta de peligros y puede usarse sin temor a causar un perjuicio mayor que el que se quiere evitar.

Una línea de investigación más directa para explotar nuestro conocimiento de la senescencia celular en la terapia frente al cáncer consiste en intentar controlar el crecimiento tumoral. ¿Cómo? Reactivando esta respuesta protectora del organismo en las células tumorales que proliferan sin control. Dar con fármacos que induzcan este estado de incapacidad proliferativa puede evitar la progresión de los tumores. De hecho, reevaluando algunos de los fármacos antitumorales usados en la actualidad en la quimioterapia, desarrollados con el objetivo de inducir la muerte de las células tumorales, nos encontramos con que en muchas ocasiones inducen senescencia en las células tumorales.

Hasta qué punto la senescencia es nuestro aliada contra el cáncer es algo que por el momento desconocemos. Una posibilidad que manejamos es que la inducción de senescencia durante el tratamiento antitumoral pueda limitar la eficacia de la terapia. La única célula tumoral buena es la célula tumoral muerta, y dejar células tumorales zombis en el organismo puede ser beneficioso a corto plazo, pero desembocar en efectos posteriores perjudiciales. Para muchos, las células tumorales senescentes producidas por la quimioterapia suponen la base de las recaídas tan frecuentes en pacientes tras terapia. En muchas ocasiones, estas recaídas se producen por tumores que muestran unas características aún más agresivas que las originales.

Fuente:Unsplash / National Cancer Institute

Fuente:Unsplash / National Cancer InstituteLa estrategia “uno-dos”

En este contexto surge la estrategia “uno-dos”. Esta pretende detener: primero, el crecimiento tumoral mediante la inducción de senescencia celular de la célula tumoral. Segundo, inducir de forma selectiva su muerte mediante la aplicación de un senolítico. Esta estrategia ha comenzado ya a ensayarse en modelos animales de cáncer y lo que hemos observado es que el efecto de la combinación de quimioterapia inductora de senescencia junto al senolítico es más eficaz que la quimioterapia sola.

Existe un aspecto positivo extra nada desdeñable en esta estrategia. Los agresivos tratamientos provocan desagradables efectos secundarios en los pacientes sometidos a quimioterapia. Al parecer, en muchos casos estos efectos secundarios derivan de la inducción de senescencia en células no tumorales que quedan dañadas. Estas pueden ser eliminadas eficazmente por los agentes senolíticos al mismo tiempo que las tumorales senescentes generadas por la quimioterapia, lo cual podría proporcionar un efecto terapéutico beneficioso con mínimos efectos secundarios.

Todos estos aspectos mencionados en el artículo son el objetivo de multitud de grupos de investigación en el mundo. Definir los objetivos prioritarios de esta investigación, plantear nuevas iniciativas para resolver las dudas y desarrollar nuevas y más eficaces intervenciones terapéuticas basadas en el uso de la senescencia celular constituyen el esfuerzo en el que se han embarcado numerosos grupos. Estos tratan de reunir fuerzas en consorcios internacionales multidisciplinares para buscar el apoyo financiero de la iniciativa Grandes Desafíos del Cáncer, que nos permita dar un gran salto hacia adelante en nuestro conocimiento y manejo del cáncer.![]()

Sobre el autor: Manuel Collado Rodríguez, Investigador, director del laboratorio de investigación en Células Madre en Cáncer y Envejecimiento, SERGAS Servizo Galego de Saúde

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La senescencia celular: el gran desafío para entender y tratar el cáncer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los supermicrobios amenazan con ser más letales que el cáncer

- Nanopartículas recubiertas para el tratamiento localizado del cáncer por hipertermia magnética

- Lo que la búsqueda de inteligencia extraterrestre nos enseña para entender la pandemia

Super Glue itsasgarriaren historia

Joan den mendeko 40ko hamarkadaren hasieran, Harry Wesley Coover kimikariak Super Glue itsasgarria aurkitu zuen istripuz. Bigarren Mundu Gerra zen, eta Cooverrek eta haren taldeak Kodak enpresan lan egiten zuten, su-armen bisoreetarako plastiko garden bat garatzen. Akrilatoekin esperimentatzen ari zen, itsasgarri oso itsaskorra (zianoakrilatoa) aurkitu zuenean.

Alde batera utzi zuten aurkikuntza, harik eta 1951n Cooverren taldean zebilen Fred Joyner ikertzaileak konposatu bera erabili zuen arte. Hegazkin-kabinetarako tenperaturarekiko erresistentea zen estaldura bat bilatzen ari zirela, ikertzaileak errefraktometroaren bi lentetan zabaldu zuen itsasgarria, errefrakzio-indizea neurtzeko. Kontua da lenteak ez zirela askatzen, elkarri itsatsita mantentzen ziren eta produktu hark irtenbide komertziala izan zezakeela pentsatu zuen.

Handik urte gutxira, lehen Super Gluea iritsi zen merkatura, eta Eastman 910 deitu zioten. Hala ere, itsasgarriak ez zuen arrakasta handirik izan harik eta 70eko hamarkadaren amaieran zianoakrilatozko lurrunak askatzen zituela ikusi arte. Konturatu ziren lurruna larruazaleko koipeari itsasten zitzaiola eta ondoren gure erkainen markak agerian jartzen zituela.

“Zientziaren historia” ataleko bideoek gure historia zientifiko eta teknologikoaren gertaerak aurkezten dizkigute labur-labur. Bideoak UPV/EHUko Kultura Zientifikoko Katedrak eginak daude eta zientzia jorratzen duen Órbita Laika (@orbitalaika_tve) telebista-programan eman dira gaztelaniaz.

The post Super Glue itsasgarriaren historia appeared first on Zientzia Kaiera.

Genética eres tú

Rosa García-Verdugo, autora

Hoy vengo a hablar de mi libro. Siempre quise decir esta frase. Y hoy, puedo por fin usarla. Y es que desde el 17 de noviembre está a la venta mi primer libro de la serie Para Curiosos de la Editorial Paidós (Grupo Planeta).

Hace ya casi dos años que mi editor, Sergi, me llamó preguntándome si me había planteado escribir un libro de ciencia, y me dio libertad total para elegir la temática. Como soy bioquímica, y desde niña tengo una fascinación total con el mundo de la genética, no lo dudé, mi libro tratará de genética. Y escribí el libro de genética que a mi me gustaría leer si no supiera nada del tema.

Un libro que empieza con un viaje por el pasado de la genética y los consabidos guisantes de Mendel y las observaciones de Darwin, pero que en vez de quedarse ahí como la mayoría de libros de texto del tema, pasa a explicar de una manera práctica –y cercana, creo– para qué sirve la genética hoy en día y que podemos esperar de ella en el futuro. Aunque este libro llevaba ya prácticamente un año escrito cuando estalló la crisis del COVID-19, no pude mantenerme al margen y por supuesto, el libro también incluye un breve capítulo dedicado a la reina de la actualidad, pero desde la perspectiva de la genética.

Son casi trescientas páginas de lectura amena, donde intento traer referencias cercanas para hacer más fácil la comprensión de conceptos, que de primeras pueden confundir hasta los expertos, además de pequeñas notas y curiosidades que poder llevar a la mesa el domingo para compartir con la familia o los amigos.

El libro se titula Genética eres tú, y es una referencia al comienzo del primer capítulo, que trata sobre el pasado de la genética. Ese capítulo comienza con una reflexión en cuanto a lo que la genética significa, no solo para los científicos, sino para todos los seres vivos, incluidos naturalmente nosotros. Y la forma en que se me ocurrió expresarlo fue adaptando un poema clásico. ¿Reconocéis la referencia?

¿Qué es genética?

Me preguntas mientras clavas en mi pupila tu pupila azul…

¿Qué es genética?

¿Y tú me lo preguntas?

Genética eres tú.

Como digo en el libro, espero que el autor, Gustavo Adolfo Bécquer, no se revuelva en su tumba al ver lo que hice con su poema, pero espero me perdone la licencia por la causa.

He pensado que para abrir boca, voy a copiar por aquí el contenido de uno de los llamados datos curiosos del libro, que por cierto ¡también tiene dibujos! y es que he podido contar con un ilustrador de lujo: Javier Pérez de Amézaga Tomás. Espero que este aperitivo os deje con las ganas de hincarle el diente al libro y que aprovechando que las fiestas se acercan y este año preveo que pasaremos mucho tiempo en casa, lo pongáis en la carta a los Reyes Magos.

Científicos colocados

Pues si os creíais que el inventor de la PCR ha sido el único científico o inventor con afición por las drogas, siento decepcionaros, porque no estaba solo. De hecho, forma parte de un grupo más que numeroso de mentes de reconocido prestigio a las que también les gusta irse «de viaje» de vez en cuando. Apuesto a que algunos de los nombres de esta lista van a sorprenderos…

Según sus preferencias por una droga en concreto:

LSD. Steve Jobs y Bill Gates tienen algo más en común que ser rivales en el mundo de la informática. Francis Crick, uno de los descubridores de la estructura tridimensional del ADN dijo que la vio en un viaje de LSD.

Cocaína. Al inventor de la bombilla incandescente Thomas Edison le iba la coca, lo mismo que al padre del psicoanálisis Sigmund Freud y a mi héroe de la infancia, que aunque sea solo un genio literario, también se merece un puesto en esta lista: el señor Sherlock Holmes.

Marihuana. Entre aquellos a los que les gustaba fumar a lo Bob Marley tenemos al biólogo evolucionista Stephen Jay Gould y al astrofísico Carl Sagan.

Combinación de diferentes sustancias. Por último, tenemos a los que les gusta mezclar drogas, como Richard Feynman (físico célebre), al que le iba la marihuana y el LSD, o el neurocientí co John C. Lilly, que consumía LSD y ketamina.Seguro que esta lista se queda corta y hay muchos otros que también se «colocan» porque, a excepción de la cocaína, las otras drogas tienen entre sus efectos el liberar la creatividad del yugo del control prefrontal y por ello es posible que hayan sido las preferidas —y una ayuda— en momentos de «eureka» para alguno de estos genios.

Ficha:

Autora: Rosa García-Verdugo

Editorial: Ediciones Paidós

Año: 2020

Colección: Para curiosos.

ISBN: 978-8449336584

Sobre la autora: Rosa García-Verdugo estudió bioquímica en Oviedo, terminando dichos estudios con un proyecto de investigación en la Universidad de Leiden (Países Bajos). Después comenzó su periplo por varios laboratorios en Madrid, Barcelona y finalmente Múnich donde en 2015 consiguió su doctorado en Neurobiología en el Instituto Max-Planck. Tras diez años dedicados a la ciencia, decide colgar la bata y ahondar en su otra pasión: la comunicación científica. Actualmente trabaja como escritora freelance y asesora de comunicación para empresas de biotecnología. Es colaboradora habitual de Mapping Ignorance.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Genética eres tú se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las herramientas de edición genética CRISPR y los ratones avatar

- Sobre la predisposición genética a padecer enfermedades

- Sobre la predisposición genética a padecer enfermedades (II)

Asteon zientzia begi-bistan #326

SARS-CoV-2arekin lotura dute beste bi koronabirus aurkitu dituzte Japonian eta Kanbodian, Elhuyar aldizkariak azaldu digunez. Bata Japonian aurkitu dute eta bestea Kanbodian. Japoniako laborategian ikusi dute bere genomaren %81 dela SARS-CoV-2 birusaren parekoa. Bigarrena oraindik ez dute guztiz sekuentziatu.

Mikel Baza familia medikua elkarrizketatu dute Berrian, izurriak eragin duen egoeraren ondorioz kontsulta telematikoen aldeko apustua egin baita. Haren esanetan, kontsulta birtualek “muga handiak” dituzte. Horretaz gain, aurrez aurreko artaren garrantziaz mintzo da. Ez galdu!

Gorka Oribe ikertzailea elkarrizketatu dute Alea-n, zientziak pandemia honetan izan duen rolaz eta txertoez mintzatu da. Horretaz gain, alzheimerraren detekzio goiztiarra ahalbidetzea helburu duen Geroa Diagnostics enpresako kidea ere bada eta horri buruzko azalpenak eman ditu. Elkarrizketa mamitsua hemen irakurgai.

Iker Badiola zientzietan doktoreak berriki publikatu du Cangrejo de Troya. Las bases celulares y moleculares del cáncer al alcance de todos, minbizia zen de ulertzeko azterlana, hain zuzen. Berriako elkarrizketa honetan liburuaren nondik norakoak azaldu ditu: asmoa, egitura eta edukia, besteak beste.

Sedentarismoaren aurrean, Osasunaren Mundu Erakundeak ariketa fisikoa egitea gomendatzen du. Orain gomendioak berritu dituzte: egiten den ariketa fisiko guztia osasungarria dela nabarmendu dute. Elhuyar aldizkarian aurkituko dituzue xehetasunak.

BiologiaEspezie inbaditzaileen aferari helduz, ikertzaile talde batek identifikatu ditu zeintzuk diren Europan ahalik eta lasterren arreta berezia behar dutenak eta horiekin ranking bat osatu dute. Estrategiak garatu ahal izateko, hainbat faktore ezarri dituzte: eraginkortasuna, kostua, gizartean desagerrarazte estrategia horrekiko dagoen onarpen maila, iraupena eta, azkenik, behin akabatu ondoren populazio hori berriro agertzeko dagoen probabilitatea.

GenetikaAfrikan behiak nola etxekotu ziren aztertu du artikulu honetan Koldo Garciak. Afrikan 150 behi-arrazatik gora daude eta arraza horiek askotariko ezaugarri eta moldaketak dituzte. Behien gene-historia zein izan den eta jaso dituzten moldaketak ikusteko ikertzaile talde batek aztertu du behi afrikarren 16 arraza garrantzitsuenen 172 genoma.

Zer dira retroiak? Koldo Garcian Edonola blogean azaltzen digun moduan, “hainbat bakteriok dituzten gene-osagai arraro batzuk dira”. Bi ikertzaile taldek horiek aztertu eta ondorioztatu dute retroiak bakterioen babes-mekanismo bat direla birusen aurrean.

SariakTxiotesia lehiaketan, Ainhoa Gonzalez eta Eider Urkola izan dira irabazleak. Lehiaketa honen erronka da tesia sei txiotan azaltzea. Guztira, 74 ikertzailek hartu dute parte bosgarren edizioan. Berriak eman du albistea.

PaleontologiaNazioarteko ikertzaile talde batek buztana zuten eta mugitzeko ahalmena zuten mikroorganismoen aztarna fosilak aurkitu dituzte. Aztarnak 3.400 milioi urtekoak dira. Oraindik beste adituek aztertzea falta da emaitzak aldizkari batean publikatu aurretik.

Aurreko astean jakin genuen duela 80 urte Koskobiloko aztarnategian (Olaztin) aurkitutako fosilak berriro aztertu dituztela UPV/EHUko ikertzaile batzuek eta duela 220 mila urteko faunaren ebidentziak aurkitu dituztela: errinozero baten arrastoez gain, hartzak, orein erraldoiak, makakoak eta kuoiak ere topatu dituzte. Honi buruz gehiago irakurtzeko, hemen duzue Berriako artikulua.

DibulgazioaJames Randiren bizitzari errepasoa eman dio Josu Lopez-Gazpiok honetan. Pentsamendu kritikoaren aldarria izan zen. Zientziaren arloan, gezurtiak agerian uzteko lan bikaina egin zuen.

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

Egileaz:Uxue Razkin (@UxueRazkin) kazetaria da.

The post Asteon zientzia begi-bistan #326 appeared first on Zientzia Kaiera.

Elisa Sainz de Murieta – Naukas Pro 2019: Impactos del cambio climático

Foto: Tiko Giorgadze / Unsplash

Foto: Tiko Giorgadze / UnsplashUna introducción a qué es y qué factores afectan al cambio climático y como abordarlos, incluyendo los aspectos socioeconómicos. Esto es lo que ofrece Elisa sainz de Murieta al presentar el trabajo que se realiza en el Basque Centre for Climate Change (BC3) en esta charla de 2019.

Elisa Sainz de Murieta es geóloga e investigadora principal del BC3 en varios proyectos H2020 relacionados con la evaluación de los costes del cambio climático y la adaptación a los efectos costeros del cambio climático en la ciudad de Dakar.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Elisa Sainz de Murieta – Naukas Pro 2019: Impactos del cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Los ecosistemas acuáticos de África y el cambio climático

- Dani y Fiti sobre el cambio climático

Ezjakintasunaren kartografia #329

SARS-COV-2 koronabirusa, covid-19aren eragilea, gorputzeko hainbat organotan ditu efektuak, sintoma eta ondorio andanarekin. Oraindik ikasten gabiltza, baina gauza batzuk ezagutzen hasi gara, eta ez dira berri onak. José Ramón Alonsoren Coronavirus in the brain

Apurtutako bihotzaren eta ondo ez dabilen buruaren arteko harremana egon, badago. Rosa García-Verdugoren Broken heart, disconnected brain

Fotonikan egiten ari diren ikerketa asko erabilgarri izan daitezen, material fotonikoan gertatzen dena kanpoaldearekin harremana izan behar du eta harreman hori balioa izan behar du. Eta espektroskopioa txip batean muntatzea? Funtzionamenduaren printzipioa posible dela frogatu dute DIPCkoek: Strong coupling between propagating phonon polaritons and organic molecules observed for the first time

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #329 appeared first on Zientzia Kaiera.

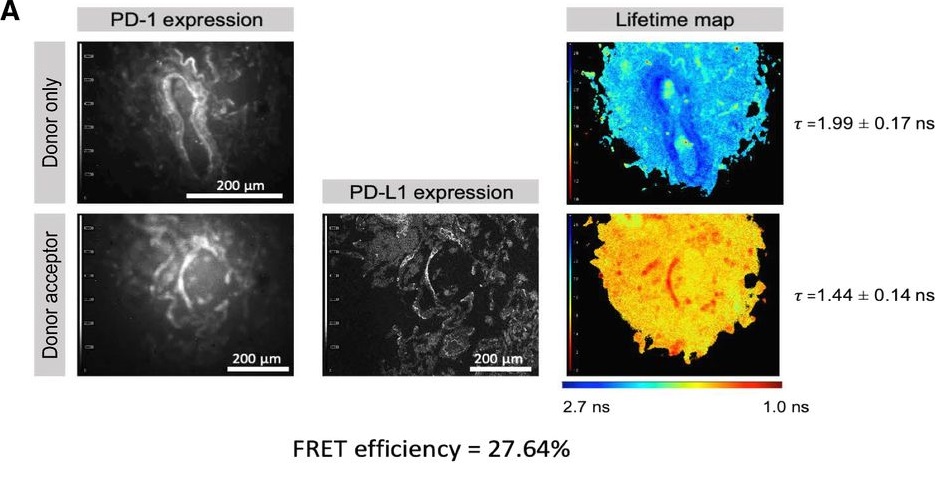

Cómo pronosticar el éxito del tratamiento del cáncer con inmunoterapia

Un grupo internacional liderado por la doctora Banafshe Larijani, investigadora Ikerbasque adscrita al Instituto Biofisika (UPV/EHU, CSIC), ha desarrollado un nuevo método de diagnóstico que permite pronosticar con precisión qué pacientes de cáncer responderán positivamente a la inmunoterapia. Este método permitirá a los oncólogos adecuar el tratamiento a cada paciente y evitar las terapias que no vayan a tener éxito.

La inmunoterapia es un tipo de tratamiento del cáncer que ayuda al sistema inmunológico del paciente a combatirlo y tiene un impacto profundamente positivo en los tratamientos oncológicos, si bien no funciona en todos los casos: tiene mucho éxito en algunos pacientes, mientras que en otros tiene poco o ningún efecto. Dados los riesgos inherentes a estos procedimientos, se ha establecido una necesidad creciente de definir qué pacientes tienen más probabilidades de beneficiarse, evitando la exposición innecesaria a aquellos que no lo harán.

En el grupo liderado por la doctora Larijan, quien también es directora del Centro de Innovación Terapéutica (CTI) de la Universidad de Bath (Reino Unido), han colaborado colegas de otros centros en Euskadi (Biocruces, PIE, BCAM), europeos y la empresa FASTBASE Solutions Ltd. La nueva herramienta de pronóstico ha sido desarrollada utilizando una plataforma de microscopía avanzada que identifica las interacciones de las células inmunes con las células tumorales y también informa sobre el estado de activación de los puntos de control inmunitarios que amortiguan la respuesta antitumoral.

En una persona sana, los llamados puntos de control inmunológico regulan estrechamente la respuesta inmunitaria del cuerpo, actuando como un interruptor para prevenir enfermedades autoinmunes e inflamatorias. El equipo de la doctora Larijan ha analizado un punto de control inmunológico que consta de dos proteínas: PD-1 (presente en células inmunitarias llamadas linfocitos T) y PD-L1 (presente en otros tipos de células inmunitarias y en la superficie de muchos tipos diferentes de tumores).

Por lo general, cuando el PD-1 en la superficie de los linfocitos T se acopla con el PD-L1 en la superficie de otras células inmunes, apaga eficazmente la función inmunológica de la célula T. Y eso es lo que hacen las células tumorales: al expresar PD-L1 en su superficie, activan PD-1 en el linfocito T, con lo que desactivan su función antitumoral y permiten la supervivencia y el crecimiento del tumor. Los inhibidores empleados en la inmunoterapia funcionan interrumpiendo la interacción entre el PD-L1 en el tumor y el PD-1 en la célula T, y así restablecen la actividad antitumoral del paciente. Esta nueva herramienta determina el alcance de la interacción PD-1 / PD-L1 en una biopsia del tumor, prediciendo si es probable que la terapia con inhibidores del punto de control tenga un beneficio clínico significativo.

“Actualmente, las decisiones sobre si proceder con el tratamiento con inhibidores de puntos de control se basan simplemente en si PD-1 y PD-L1 están presentes en las biopsias, más que en su estado funcional. Sin embargo, nuestro trabajo ha demostrado que es mucho más importante saber que las dos proteínas realmente interactúan y, por lo tanto, es probable que tengan un impacto funcional en la supervivencia del tumor», indica la profesora Larijani.

Referencia:

Lissete Sánchez-Magraner, James Miles, Claire L. Baker, Christopher J. Applebee, Dae-Jin Lee, Somaia Elsheikh, Shaimaa Lashin, Katriona Withers, Andrew G. Watts, Richard Parry, Christine Edmead, Jose Ignacio Lopez, Raj Mehta, Antoine Italiano, Stephen G. Ward, Peter J. Parker and Banafshé Larijani (2020) High PD-1/PD-L1 checkpoint interaction infers tumour selection and therapeutic sensitivity to anti-PD-1/PD-L1 treatment Cancer Research doi: 10.1158/0008-5472.CAN-20-1117

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Cómo pronosticar el éxito del tratamiento del cáncer con inmunoterapia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Inmunoterapia contra el cáncer

- Magnetosomas para el tratamiento del cáncer

- Nanopartículas recubiertas para el tratamiento localizado del cáncer por hipertermia magnética

Asier Ruiz: “Kaltzioak ezinbesteko funtzio ugari betetzen ditu zeluletan” #Zientzialari (141)

Ikerketa askoren arabera, neuronen eta zenbait glia zelulen heriotzaren ondorioz sortzen diren gaixotasun neurodegeneratibo guztiek (edo gehienek behintzat) osagai komun bat dute: kaltzio-homeostasiaren, edo zelulen kaltzioaren erregulazioaren, galera. Izan ere, kaltzioak ezinbesteko funtzioa betetzen du hainbat zeluletan eta oso nabarmena da nerbio-sisteman.

Badaude fenomeno batzuk kaltzio-homeostasi hori apurtzen dutenak: gaixotasun neurodegeneratiboak. Gaixotasun mota hauek lehen mailako arazoa bihurtu dira gizartean, sekulako inpaktua dutelako eremu pertsonalean eta ekonomikoan ere.

Kaltzio-homeostasiaren eta bere haustura dakarren arazoen inguruan gehiago jakiteko Asier Ruizekin, Achucarro Center for Neuroscience zentroko ikertzaile eta UPV/EHUko Neurozientziak saileko ikertzaile eta irakaslearekin, batu gara.

“Zientzialari” izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Asier Ruiz: “Kaltzioak ezinbesteko funtzio ugari betetzen ditu zeluletan” #Zientzialari (141) appeared first on Zientzia Kaiera.

Un genio desconocido del Renacimiento

Ilustración basada en una foto de Wikimedia Commons

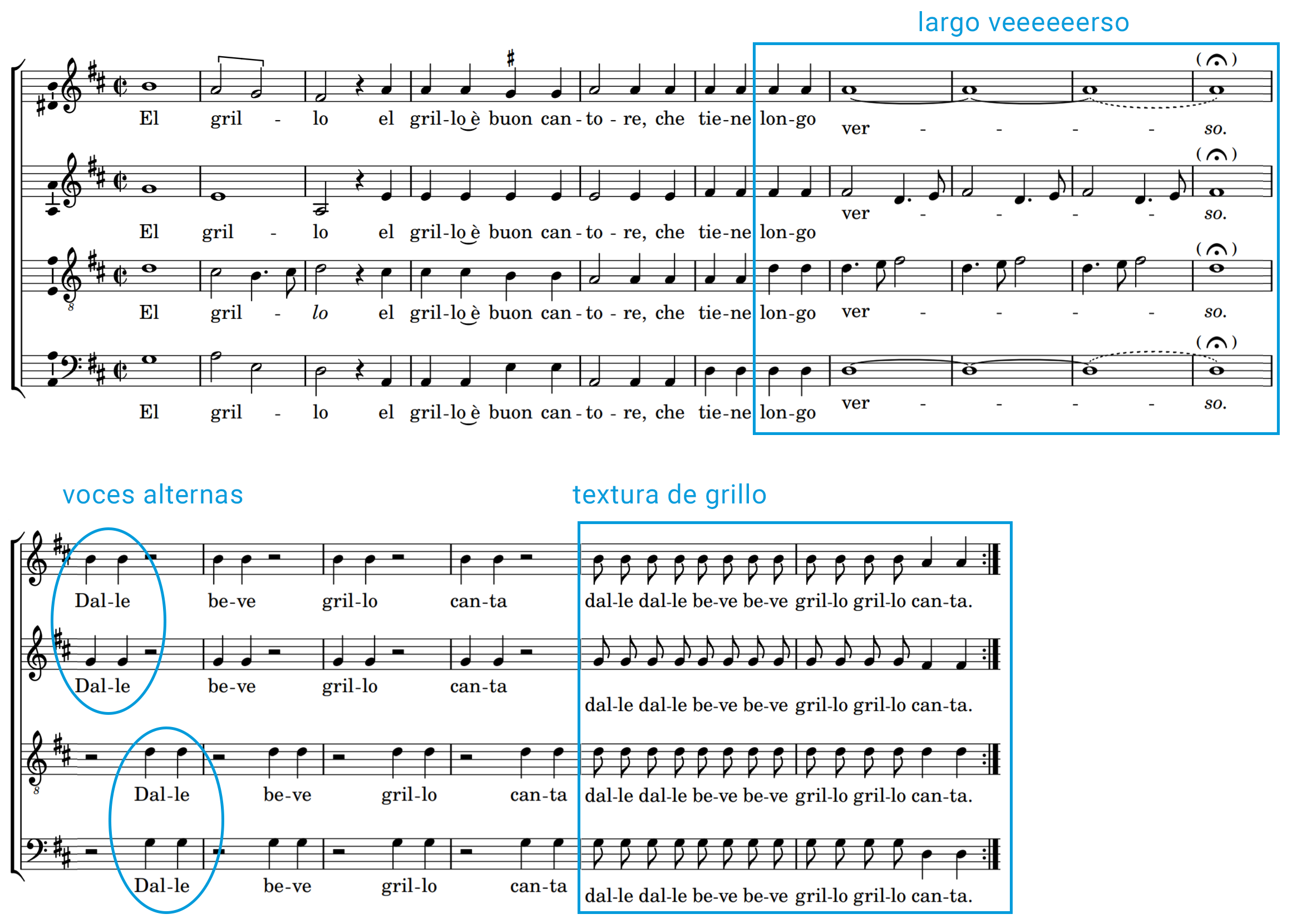

Ilustración basada en una foto de Wikimedia CommonsFue contemporáneo de Leonardo da Vinci, solo un poco mayor que Miguel Ángel y, quizás, el único creador renacentista comparable a ellos dos en cuanto a talla artística y relevancia histórica. Y, sin embargo, es probable que nunca hayas escuchado siquiera su nombre. Me refiero al compositor Josquin Desprez. Pocos músicos a lo largo de la historia han gozado de mayor prestigio entre sus contemporáneos o han ejercido una influencia más profunda y duradera sobre los que les siguieron. Desprez fue aclamado en vida como “el mejor compositores de nuestro tiempo”, el “padre de los músicos”, “el amo de todas las notas” —como se refirió a él Martín Lutero.

Josquin desarrolló su carrera en una etapa de grandes cambios musicales, que darían paso a un lenguaje musical internacional dentro de Europa. Él fue uno de los artistas que ayudó a guiar esta transición, incorporando los valores humanistas del Renacimiento en el mundo de la música. Frente a la música teórica, cerebral y erudita de la etapa anterior, sus composiciones muestran la influencia de formas populares del momento, como la frottola, un tipo de canción con una textura simple (generalmente homofónica, lo que significa que todas las voces se mueven a la vez y complementan a la principal, siguiendo el mismo ritmo), melodías fáciles de seguir, estribillos pegadizos y un texto laico generalmente alegre, desenfadado o hasta irónico. Dentro de este afán por simplificar la música y acercarla a su público, Josquin fue conocido por su don para la melodía y su capacidad de ligarla al texto para hacerlo más comprensible. Para él y otros compositores renacentistas, la música había dejado de ser una creación puramente intelectual, el resultado de complejas relaciones numéricas y mudas. La música era, ante todo, una extensión de las emociones humanas y como tal, debía imitar la entonación de los actores que con su voz eran capaces de conmover al público.

Y por qué os cuento todo esto, os preguntaréis. Pues porque tengo un problema. Tengo una canción pegadiza que me invade la cabeza cada dos por tres y que fue compuesta hace más de 500 años. La melodía es esta:

El grillo es, probablemente, la frottola más popular de Josquin Desprez. Irónica y tierna, habla de lo “buon cantore” que es el pequeño insecto y lo bien que aguanta las notas largas. Aunque también se ha especulado que Josquin podría estar refiriéndose a su amigo el cantante Carlo Grillo. Grillo formaba parte de la capilla musical del cardenal Ascanio Sforza que, al parecer, era bastante rácano a la hora de remunerar a sus músicos. Desprez podría estar al tanto de los aprietos económicos de su compañero y por ello compone esta frottola con un doble sentido, a modo de canción protesta. Léase: señor cardenal, pague usted al buen Grillo, que al contrario que muchos pájaros, él es un músico fiel y canta por amor.

El grillo è buon cantore,Che tienne longo verso,

Dalle beve grillo canta.Ma non fa come gli altri uccelli,

Come li han cantato un poco,

Van’ de fatto in altro loco

Sempre el grillo sta pur saldo,Quando la maggior è’l caldo

Al’ hor canta sol per amore. El grillo es un buen cantante

de verso y notas largas

¡Vamos, grillo, bebe, canta!No hace como los otros pájaros.

Que cantan un poco

Y luego se van a otro sitio,

El grillo se mantiene donde está …Si el mes de mayo es cálido

él canta solo por amor.

Lo más llamativo de la canción es que la música ilustra el texto en varios momentos ¡e imita incluso el canto del simpático bicho! Nada más empezar, por ejemplo, cuando la letra que el grillo es capaz de cantar notas o versos largos (longo verso), la melodía principal se detiene obstinadamente sobre una nota exageradamente larga, mientras las voces intermedias se alternan para dibujar una especie de vaivén: el cantar rugoso del propio grillo. Más adelante, los distintos cantantes se van turnando en una textura cada vez más rápida de notas repetidas que, de nuevo, recuerda al sonido vibrante del propio grillo.

No es un ejemplo aislado, otras frottole de la época1 imitan el sonido del gato, el cisne y la grulla. Algunos se han referido a este fenómeno como música onomatopéyica o, de manera más general, figuralismo: música que “pinta” su propia letra o que imita el sonido de los eventos que habitualmente solo representa simbólicamente. Es un tipo de imitación sonora que se da también en el lenguaje. En concreto, es común que algunos nombres de animales se parezcan al sonido que hace el bicho al que representan. La propia palabra “grillo” es un buen ejemplo de ello. Grillo en castellano, cricket en inglés, kilkerra en euskera, ikhilikithi en zulu, jangkrik en indonesio, Kuriketto (クリケット) en japonés, keulikes (크리켓) en koreano, kirikiti en maorí… parece que el sonido rugoso y agudo del grillo se repite allí donde los humanos pronuncian su nombre. Y, gracias a Josquin, también allí donde lo cantan.

Nota:

1Colección impresa de frottole de Ottaviano Petrucci. El grillo figura en el tercer libro Frottole III publicado en 1505.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Un genio desconocido del Renacimiento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Inbaditzaileei aurre egitea, lehentasun kontua

Dagoeneko Europara sartu diren espezie inbaditzaileak desagerrarazteko eta etorkizunean sartu daitezkeenak uxatzeko, aditu talde batek lehentasunetan oinarritutako zerrenda bat osatu du. Espezie bakoitzaren araberako estrategia garatzea funtsezkotzat jo dute.

Espezie inbaditzaileen afera biologoen eremu hutsa gainditu eta gizartean dezente txertatu den gai horietako bat da. Gaur egun, gure artean, sakonki sartuta dago zebra-muskuilua arazo iturri delako ideia, eta berdina gertatzen da liztor asiarrarekin. Umetxoen artean ere kuriositatea eta beldurra parean eragiten dituen intsektua da, eta abuztuko arratsalde luzeetan, erredakzioetara berri askorik iristen ez diren horietan, albiste iturri izan daiteke ere, suhiltzaileek Asiatik etorritako liztorraren habi bat kentzen dutenean.

1. irudia: Oraindik asko zabalduta ez dagoen arren, Nasua nasua espezieko koatia Europara iritsi da. Maskota gisa ekarrita, ingurune naturalera sartu da. Espezie hori Europako naturaguneetatik desagerrarazi beharreko lau espezie garrantzitsuenen artean kokatu dute. (Argazkia: Dennis Jarvis / CC BY-SA 2.0 lizentziapean)

1. irudia: Oraindik asko zabalduta ez dagoen arren, Nasua nasua espezieko koatia Europara iritsi da. Maskota gisa ekarrita, ingurune naturalera sartu da. Espezie hori Europako naturaguneetatik desagerrarazi beharreko lau espezie garrantzitsuenen artean kokatu dute. (Argazkia: Dennis Jarvis / CC BY-SA 2.0 lizentziapean)Baten batek esan lezake agian munduan hedatuen dagoen espezie inbaditzailea gizakia bera dela, eremu polar hotzenetatik basamortu beroenetara zabalduta baitago, eta munduan dagoen ia ekosistema orotan gailentzeko gai izan delako, gainerako espezie gehienen kalterako. Aparteko animalia da sapiensa, bai onerako zein txarrerako.

Baina kalekumeok ezagutzen ditugun espezieez kezkatzen hasten garenerako, biologoek eta ekologoek urteak daramatzate oraindik gehiegi zabaltzeke dauden espezieei adi. Batzuetan, horiei begirako kanpainetan ere parte hartzen dute. Hori gertatzen da, adibidez, bisoiekin. Bisoi amerikarraren (Mustela vison) erruz ur-ipurtatsak (M. lutreola) desagertzerako bidea hartu ez dezan, ahalegin izugarriak egiten ari dira. Gehienetan, adituak eta teknikariak estu eta larri ibili behar izaten dira, esku hartzeak hasten direnerako kaltea atzerapausorik gabekoa baita.

Hori gerta ez dadin, ikertzaile talde batek identifikatu ditu zeintzuk diren Europan ahalik eta lasterren arreta berezia behar duten inbaditzaileak. Horrez gain, eta arlo praktikoari begira, ranking bat osatu dute, espezie horien aurkako estrategiak ezartzerakoan lehentasunak argi izateko. Global Change Biology aldizkarian argitaratutako zientzia artikulu batean eskuragarri dago zerrenda hori, modu irekian.

Europako 34 ikertzaileren artean ebaluazioak partekatu dituzte, eta adostasuna bilatu dute zerrenda egiteko. Aurreko ikerketa batean ebaluatu zuten espezie bakoitzak Europan ezartzeko zuen arriskua, eta, horren ondorioz, egon litekeen inpaktua. Oraingo ikerketan, berriz, aukeran egon daitezkeen desagerrarazte estrategiekin alderatu dute espezieen zerrenda. Estrategia horien ebaluazioan, hainbat faktore kontuan hartu dituzte: eraginkortasuna, kostua, gizartean desagerrarazte estrategia horrekiko dagoen onarpen maila, iraupena eta, azkenik, behin akabatu ondoren populazio hori berriro agertzeko dagoen probabilitatea.

Aukeran egon daitezkeen desagerrarazte estrategien gaineko azterketa egin dute, jakin ahal izateko estrategia horiek zer inpaktu eta zer eraginkortasun izan zezaketen. Dagoeneko kontinentean dauden espeziak kontuan hartu dituzte, baina berdina egin dute iristear egon daitezkeen espezieekin. Bide hori jarraituta, gauzak are gehiago okertu baino lehen, administrazioek bederen ezin izango dute esan abisatuta ez zeudenik.

95 espezie aztertu dituzte. Horietatik, 60 oraindik Europan txertatuta ez dauden espezieak dira, eta gainerako 35 dira goraka ari direnak; azken horiek lurraldean ezarrita daude, baina, momentuz, banaketa mugatua dute. Bi talde horietatik, aukeraketa bat egin dute, eta nolabaiteko ranking bat osatu dute, ahalik eta lasterren mugatu behar diren espezieez osatutakoa. Txertatuta ez daudenetatik 17 aukeratu dituzte; dagoeneko Europan daudenei dagokienez, 14 aukeratu dituzte. Horiek dira, ikerketan parte hartu duten adituen ustetan, lehentasun gehien izan behar dituzten espezieak.

2. irudia: Arrisku potentzialen artean, lehenengo postua eman diote Faxonius rusticus karramarroari. Ipar Amerikako ekosistemetan triskantza handiak egiten ari da, eta Europara sartzea ekidin nahi dute. (Argazkia: Ashour Rehana / CC BY-NC-ND 2.0 lizentziapean)

2. irudia: Arrisku potentzialen artean, lehenengo postua eman diote Faxonius rusticus karramarroari. Ipar Amerikako ekosistemetan triskantza handiak egiten ari da, eta Europara sartzea ekidin nahi dute. (Argazkia: Ashour Rehana / CC BY-NC-ND 2.0 lizentziapean)Ezarritako espezieen zerrendaren goiko aldean daude, hurrenez hurren, Acridotheres tristis txoria, Bufo mauritanicus apoa, Nasua nasua koatia eta Pycnonotus cafer txoria. Lau horiei lehentasun altuko estatusa eman diete, eta ikertzaileen aburuz, agintariek horiek desagerrarazteari ekin beharko liekete. Oraindik ezarrita ez dauden espeziei dagokienez, gehienei lehentasun berdina eman diete, baina bati lehentasun mailarik altuena eman diote: Faxonius rusticus espezieko karramarro herdoilduari, Ameriketan ematen dioten izen arruntaren arabera. Espezie hau luze eta zabal hedatzen ari da Ipar Amerikatik, eta 2019an aurrenekoz aurkitu zuten Frantzian. Zerrenda hauek FBIk landutako Most wanted horietako bat izango balira, karramarro hori agertuko litzateke Public Enemy Number One gisa. Kontua ez da soilik jatorrizko beste espezieentzako izan dezakeen arriskua, baizik eta lehen momentuetan Europan erraz akabatzeko modukoa izango litzakeela, oraindik hedatuta ez dagoelako.

“Hoberena litzateke espezie inbaditzaile guztiak desagerraraztea, baina baliabideak, bai jendez zein diruz, urriak dira; are gehiago orain, beste lehentasun batzuk daudela”, adierazi du prentsa ohar batean Kordobako Unibertsitateko Pablo Gonzalez Moreno ikertzaileak. Gaiaren inguruan administrazioek hartu behar dituzten erabakietan ikerketa hau lagungarri izatea espero dute zientzialariek. Behar hau zientzia artikuluan bertan azpimarratu dute, kudeaketa egiteko garaian datuak eskura izatearen garrantzia nabarmenduta: “Espezie asko izanda, eta baliabideak mugatuak direnez, erabakiak hartzen dituztenek tentuz ebatzi beharko dute zein espezieren kudeaketari eman lehentasuna, eta nola”.

Ikerketak argi utzi du egoera gero eta konplexuagoa dela. Batetik, momentuz zenbait espezieri buruzko informazio nahikorik ez dagoelako. Bestetik, espezie bakoitzaren ezaugarrien arabera estrategia bat garatu behar delako. Adibidez, espezie batzuen aurrean, prebentzioa egitea oso zaila dela nabarmendu dute egileek. Plotosus lineatus arrainaren adibidea jarri dute. Itsaso Gorritik Mediterraneora igaro da espeziea, Suezko kanalen bitartez, eta bereziki Israel inguruko itsasoko ekosistemetan kalte nabarmenak eragiten ari da. Itsaso zabalean dabilen arraina izanik, ez da batere erraza izango arrainaren zabalpena mugatzea. Antzeko zerbait gertatzen da Pterois miles arrainarekin: Suezetik sartu da Mediterraneoan, eta, behin ezarrita, espeziea uxatzea oso zaila izango da.

Horretaz jakitun, zientzialariek ohartarazi dute oraindik iritsi ez diren zenbait espezierekin prebentzioa bai izan daitekeela guztiz beharrezkoa. Homarus americanus otarrainaren kasua jarri dute adibidetzat: Europan sartuko balitz, espeziea akabatzea guztiz zaila izango litzateke, eta, horregatik, prebentzioa lehenetsi beharko litzateke. Kasu honetan, eta Atlantikoaren beste aldekoa den krustazeoa izanik, ez gara hitz egiten ari kanal artifizial batetik etor daitekeen espezie bati buruz, gizakiak nahita mugiarazitako krustazeo bati buruz baizik. Hortaz, mugimendu artifizial hori ekiditea premiazkoa izan daiteke.

Aurrean aipatutako kasu horiek guztiak itsas espezieak dira, eta mota horretakoak dira, hain justu, kudeatzeko zailenak. Adituek diote itsas espezieen populazioak eskala txikietan kudeatzea erraza dela, baina, behin zabalduta daudela, arras zaila da horiek kontrolpean edukitzea. Lur espezieen kasuan, ostera, errazagoa omen da kudeaketa, lurraldean zabalduta egon arren. Horregatik nabarmendu dute espezie baten zabalpena ez dela zertan izan behar irizpide nagusia arazoa jorratzerakoan.

Erreferentzia bibliografikoa:Booy, Olaf et al. (2020). Using structured eradication feasibility assessment to prioritize the management of new and emerging invasive alien species in Europe. Global Change Biology, 26 (11), 6235-6250. DOI: https://doi.org/10.1111/gcb.15280

Egileaz:Juanma Gallego (@juanmagallego) zientzia kazetaria da.

The post Inbaditzaileei aurre egitea, lehentasun kontua appeared first on Zientzia Kaiera.

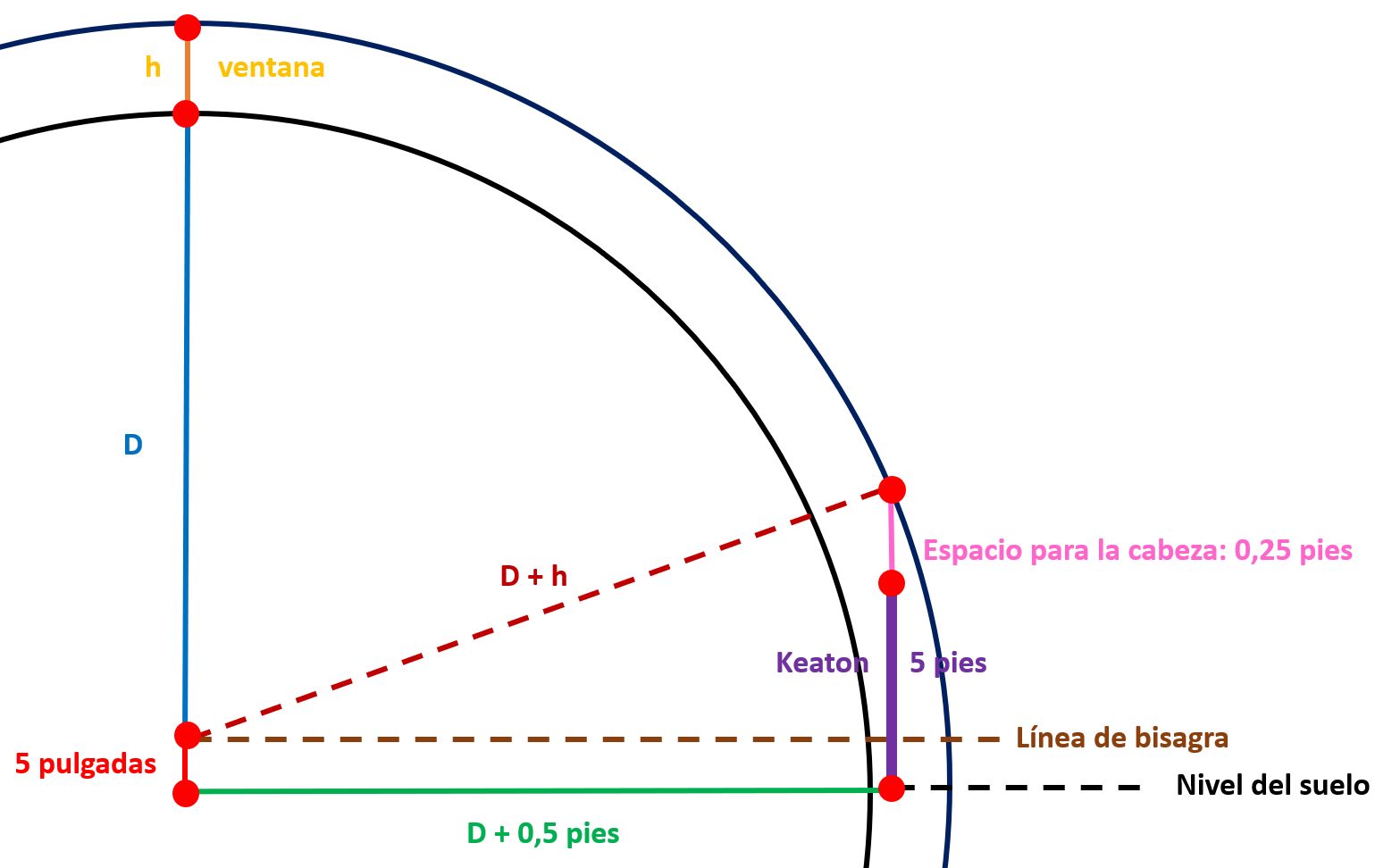

En el lugar correcto en el momento adecuado

El héroe del río es un largometraje cómico (mudo) estrenado en 1928. Está codirigido y protagonizado por Buster Keaton que hace el papel de William, el hijo de Bill Canfield. Canfield es propietario de un barco fluvial que compite con el empresario John James King por el control del transporte de mercancías en el río Mississippi. William y Kitty (la hija de King) están enamorados, provocando el enfado de los padres de ambos.

Casi al final de la película un huracán atraviesa la ciudad. William lucha contra el viento que lo arrastra sin cesar. Tras recibir un golpe en la cabeza, desorientado, permanece en pie, aturdido delante de una casa. La fachada cae sobre él, pero una ventana providencialmente abierta lo salva de morir aplastado (la escena puede verse aproximadamente en el minuto 59:00 de la película). Parece que el actor no permitía que se le doblara en las escenas peligrosas y, en esta, asumió un enorme riesgo. ¿Realizaría algún ensayo antes de filmarla? Desde luego, el protagonista permanece inmutable durante la escena…

Seis fotogramas de la escena de la caída de la fachada. Extraídas de Steamboat Bill Jr. / Wikimedia Commons.

Seis fotogramas de la escena de la caída de la fachada. Extraídas de Steamboat Bill Jr. / Wikimedia Commons.

Esta secuencia se ha versionado en numerosas ocasiones, desde un episodio de la serie MacGyver hasta alguna película de Jackie Chan, pasando por Deadpan (1997) del cineasta Steve McQueen, en la que él mismo reproduce la escena protagonizada por Keaton casi 70 años antes. Durante casi 20 minutos, desde diferentes ángulos, se puede ver la fachada de una casa que cae sobre McQueen que, al igual que Keaton en 1928, no muestra ninguna reacción.

Consulto cada día la magnífica página Futility Closet que comparte historias sorprendentes sobre temas diversos, entre ellos, la matemática recreativa. En una de sus entradas, Greg Ross introduce un artículo de James Metz publicado en la revista Mathematics Teacher, en el que el autor propone diferentes y sencillos cálculos basados en esta escena de El héroe del río. Es decir, realiza un estudio matemático de la escena, fijándose en algunos de sus fotogramas.

Metz comenta en su artículo que el espacio alrededor de Keaton cuando la ventana “lo atraviesa” es realmente escaso… y tiene razón. Y propone una serie de reflexiones y cálculos para entender con precisión los detalles de la escena. Debajo reproducimos algunas de sus observaciones.

Supongamos que Keaton permanece de pie en el suelo que está situado a 5 pulgadas (1 pulgada = 2,54 centímetros) por debajo de la “bisagra” de la pared que cae. Keaton mide 5 pies y 5 pulgadas (1 pie = 30,48 centímetros; es decir, Keaton mide aproximadamente 165 centímetros). Dejando un margen de 3 pulgadas (7,62 centímetros) por encima de su cabeza, la ventana de altura h debe pasar sobre él a 5,25 pies (1 pie = 12 pulgadas) por encima de la línea de la bisagra. Viendo la escena de El héroe del río, tras la caída completa de la pared, la parte posterior de sus pies está aproximadamente a 0,5 pies (15,24 centímetros) delante de la parte inferior de la ventana. Antes de la caída, la parte inferior de la ventana está a una distancia D de la bisagra de la casa (sobre ella, por supuesto). Resumimos en un diagrama lo anteriormente expuesto:

Imagen 2: Esquema de la escena basada en los anteriores datos y siguiendo el esquema incluido en el artículo de Metz.

Imagen 2: Esquema de la escena basada en los anteriores datos y siguiendo el esquema incluido en el artículo de Metz.

¿Cuál es la relación entre h y D? Se trata de una simple relación entre la hipotenusa y los catetos de un triángulo rectángulo:

(D + h)2 = (D + 0,5)2 + 5,252.

Si la anchura de los hombros de Keaton es de 1,5 pies (unos 45,72 centímetros) y los lados de la ventana pasan a 3 pulgadas (unos 7,62 centímetros) por cada lado de Keaton, ¿cuál es el ancho de la ventana? Como 3 pulgadas son 0,25 pies, la ventana tiene una anchura de 1,5 + (2 x 0,25) = 2 pies.

Observando de nuevo la escena, supongamos que la relación entre la altura y el ancho de la ventana es de 7/11. ¿Cuál es la altura h de la ventana? Como 7/11 = 2/h, despejando, es h= 22/7, es decir, unos 3 pies (unos 91,45 centímetros).

Ahora podemos calcular D usando la relación entre h y D obtenida antes. Despejando, D = 3,76 pies (unos 114,6 centímetros).

Estos son solo unos pequeños cálculos que nos ayudan a analizar la situación. ¿Serán similares a los realizados por el equipo de Keaton antes de filmar la escena? Como indica Metz en su artículo, se puede generalizar este análisis y hacerse distintas preguntas de tipo «¿qué pasaría si…?».

Referencias:

- Clearence, Futility Closet, 28 agosto 2020

- Steamboat Bill Jr. (1928), película completa, Wikimedia Commons

- James Metz, The Right Place at the Right Time, Mathematics Teacher 112:4 (2019) 247-249

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo En el lugar correcto en el momento adecuado se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cinco motivos por los que sin jirafas el mundo sería un lugar peor

- Trigonometría para piratas

- La ‘reverosis’ de Pablo

Behi afrikarren etxekotzearen gene-aztarnak

Behiak, animalia maitagarriak izateaz gain, haragia edota esnea ekoizteko etxekotu ditugun animaliak dira. Etxekotze-prozesua aski ezaguna da Europan, behien gene-materialean nahiz gizakien gene-materialean utzi dituen aztarnengatik; eta bi espezieen arteko koeboluzioaren adibidetzat jotzen delako. Baina beste kontinente batzuetan ez da hain ezaguna behien etxekotzea. Afrikara begira jarriko gara, ikerketetan ahaztu ohi den kontinentera, alegia, eta gene-informazioaren bidez, behiak bertan nola etxekotu ziren aztertuko dugu.

Afrikan 150 behi-arrazatik gora daude eta arraza horiek askotariko ezaugarri eta moldaketak dituzte. Afrikako behi gehienak guretzat ezagunak diren behien (Bos taurus) eta asiar jatorria duten zebuen (Bos indicus) arteko gurutzaketak dira. Bi behi mota horien arteko ezberdintasuna da zebuek beren sorbaldetan konkor handi bat dutela. Konkor horretan gantzak metatzen dituzte eta zebuak klima lehor eta tenperatura altuak jasateko moldatuta daude. Bi behi mota horiek –luze eztabaidatu izan da bi espezie ezberdin ote ziren baina badirudi espezie berdineko azpitaldeak direla– desagertuta dagoen uroaren (Bos primigenius) ondorengoak dira. Baina etxekotutako behiek ez dute afrikar jatorria, ez dira bertakoak.

1. irudia: Behiak. (Argazkia: Peggy_Marco – Pixabay lizentziapean. Iturria: pixabay.com)

1. irudia: Behiak. (Argazkia: Peggy_Marco – Pixabay lizentziapean. Iturria: pixabay.com)Afrikan behien gene-historia zein izan den eta jaso dituzten tokiko moldaketak zeintzuk izan ziren ezagutzeko, ikerketa berri batek aztertu ditu behi afrikarren 16 arraza garrantzitsuenen 172 genoma. Hori horrela egin ahal izateko, lan horretako ikertzaileek sekuentziatu zituzten Afrikako 12 behi-populaziotako 114 behiren genoma osoak eta 2 bufalo afrikarren (Syncerus caffer caffer) genomak. Bufaloen genomak erabili ziren konparaketak errazteko. Genoma horietaz gain, jada eskuragarri zeuden beste 4 arrazetako 58 genoma erabili zituzten. Aztertutako behien arraza horiek honako herrialdeetakoak ziren: Etiopia, Sudan, Kenia, Uganda, Gambia eta Nigeria. Horrela lortu zuten –gene-informazioari dagokiola– Afrikako behien ordezkaritza zabala.

Hasteko, aztertu zuten zein zen behi eta zebu arteko nahasketa afrikar behietan eta noiz gertatu zen. Bi behi-taldeen arteko nahasketa-gertaera garrantzitsu bat orain dela 750 eta 1.050 urte artean gertatu zen, orain dela 150 behi-belaunaldi inguru, hain zuzen ere. Gertaera horrek gaur egun Afrikako Adarrean bizi diren behi-arrazen genomak moldatu zituen, bertatik sartu baitziren zebuak Asiatik Afrikara. Kontuan izan behar da, aztertu ziren 16 arrazetatik, 14 Afrikako Adarrekoak direla eta, ondorioz, bertan gertatu den etxekotzea sakonago azter daitekeela.

2. irudia: Zebuak. (Argazkia: Bishnu Sarangi – Pixabay lizentziapean. Iturria: pixabay.com)

2. irudia: Zebuak. (Argazkia: Bishnu Sarangi – Pixabay lizentziapean. Iturria: pixabay.com)Erregistro historikoetan oinarrituta, zebua Afrikako Adarrera heldu zen aipatutako nahasketa-gertaera baino 200-300 urte lehenago, Swahili zibilizazioaren sorreraren ostean, hain zuzen ere. Hortaz, ikerketaren egileek iradokitzen dute, hasieran zebuak mugatu zirela Afrikako ekialdeko kostaldera; eta geroago behiekin nahastu zirela, giza populazioen mugimenduen eta dispertsioaren, eta klimaren gorabeheren ondorioz. Mendebaldeko Afrikan ere nahasketa-gertaerak detektatu ziren: esate baterako, orain dela 500 urte halako gertaera bat egon zen, Afrikako Ekialdetik Mendebaldera egindako mugimenduen ondorioz; edota orain dela hogei bat belaunaldi gertatutako nahasketa berriak Borgou eta N’Dama arrazetan, behi-izurriarekin lotura izan dezaketen gertaerak.

Behia nahiz zebua Afrikara sartu ziren beste leku batzuetan etxekotu ostean. Behia Ekialde Hurbilean etxekotu ostean sartu zen Afrikan; eta zebua, berriz, Indiako azpikontinentean etxekotu ostean. Hortaz, pentsa daiteke animalia horientzat erronka izan zela ingurune berrietara egokitzea. Egokitzapen horren zantzuak genoman aztertu ziren, hautespenean egon ziren gene-eskualdeak detektatzeko eta, horrela, hautatutako ezaugarriak zeintzuk izan ziren ondorioztatzeko. Hautespena izan zuten gene-aldaerak batez ere zebu jatorriko gene-sekuentzietan detektatu ziren.

3. irudia: Behi afrikarrak. (Argazkia: Clarence Alford – Pixabay lizentziapean. Iturria: pixabay.com)

3. irudia: Behi afrikarrak. (Argazkia: Clarence Alford – Pixabay lizentziapean. Iturria: pixabay.com)Behi afrikarrek zebutik jasotako gene-aldaeren artean zeuden erantzun immunean parte hartzen duten geneak eta beroarekiko tolerantzian parte hartzen duten geneak. Erantzun immuneari dagokiola, ikertzaileek hautespena detektatu zuten kaparrekin eta kaparrek sortzen dituzten gaixotasunekin –esate baterako, Ekialdeko Kostaldeko sukarrarekin– lotura izan dezaketen geneetan; edota birusen aurkako erantzunean –esate baterako, Rift Haraneko sukarrarekiko tolerantzian– parte hartzen duten geneetan. Beroarekiko tolerantziaren kasuan, ikertzaileek hautespena detektatu zuten bai ingurune beroei erantzuteko geneetan, bai eta ura berxurgatzeko geneetan. Izan ere, zebuak ingurune beroetara moldatuta daudenez, Afrikako inguruneetara errez zuen moldatzea eta, ondorioz, Afrikako behietan gene-aztarna hori nabarmena izatea.

Behietan jatorria izan zuten gene-aldaerak, aldiz, izan ziren hanturan parte hartzen duten geneak eta tripanosomiasiarekiko –protozoo bizkarroiekiko– tolerantzian parte hartzen duten geneak. Hantura modu eraginkorrean kontrolatzeko gaitasunak infekzioen kalteak mugatzea eragin lezake, adibidez, lehenago aipatutako Ekialdeko Kostaldeko sukarraren edota Rift Haraneko sukarraren kasuetan. Tripanosomiasiak Afrikako behien produktibitatea murrizten du eta Afrikako hainbat ingurune halako parasitoez beteta daude. Hortaz, infekzio horiek kontrolatu ahal izatea –bai parasitoen kopurua, bai infekzioaren efektuak– abantaila da behientzat eta beren produktibitatea emendatzen du.

Hortaz, ondoriozta daiteke zebuak Afrikara heltzeak ahalbidetu duela Afrikan behien abeltzaintza arrakastatsua izatea. Hori dela eta, ikerketaren egileek iradokitzen dute afrikar kontinentearen elikagai-segurtasuna bermatzeko ideia ona izan daitekeela Afrikako behiekin beste lekuetako arrazak gurutzatzea.

Laburbilduz, Afrikan zebuen eta behien nahasketak gene-dibertsitatea handitu zuen eta, horren eraginez, Afrikako behiek ingurunera hobeto moldatzeko gaitasuna izan zuten. Badirudi gizakien eta behien arteko harremanak kontinente bakoitzean bere bilakaera izan duela, baina leku guztietan arrastoak utzi ditu bai abeltzaintzan, bai gene-ondarean.

Erreferentzia bibliografikoak:Koch, L. (2020). African cattle adaptations. Nature Reviews Genetics, 21, 718–719. DOI: https://doi.org/10.1038/s41576-020-00293-w

Kim, K., Kwon, T., Dessie, T. et al. (2020). The mosaic genome of indigenous African cattle as a unique genetic resource for African pastoralism. Nature Genetics, 54, 1099-1110. DOI: https://doi.org/10.1038/s41588-020-0694-2

Egileaz:Koldo Garcia (@koldotxu) Biodonostia OIIko ikertzailea da. Biologian lizentziatua eta genetikan doktorea da eta Edonola gunean genetika eta genomika jorratzen ditu.

The post Behi afrikarren etxekotzearen gene-aztarnak appeared first on Zientzia Kaiera.

Historia de la bombilla

Las bombillas incandescentes nos alumbraron en el siglo XX. Sin duda, la bombilla ha sido uno de los avances más importantes de la historia y junto a ella, probablemente, nos vendrá a la mente el nombre de Thomas Edison. Sin embargo, la invención de la lámpara incandescente tiene una extensa lista de aportaciones. Los historiadores Robert Friedel y Paul Israel han llegado a contabilizar hasta 22 inventores de lámparas incandescentes. Lo que sí señalan ambos es que la versión de Edison fue capaz de superar a las demás debido a las mejoras realizadas lo que convirtieron su bombilla es más eficaz, resistente y económicamente viable.

Edison, cuyo mérito no discute nadie, fue lo que hoy llamamos un emprendedor, lo que de toda la vida ha sido un empresario. Eso no le desmerece en absoluto, pero sí es necesario tenerlo en cuenta para entender su forma de actuar, siempre con ánimo de lucro y en términos de competencia en un mercado limitado. Edison creaba, mejoraba lo que hacían otros y sobre todo, ponía en el mercado magistralmente productos revolucionarios. Todo lo anterior es para mencionar que la primera bombilla de filamento de carbono la creó el físico, químico e inventor Joseph Swan en febrero de 1879, quien también fue el primero en suministrarlas para un uso comercial, en concreto para iluminar el Hotel Savoy de Londres en 1881.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia de la bombilla se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La bombilla de colores (y el método científico)

- Historia del cura rompecristales

- Historia de Nicolas Bourbaki

El descubrimiento de la desintegración artificial

Foto: Naufal Ardi Santoso / Unsplash

Foto: Naufal Ardi Santoso / UnsplashLa serendipia que condujo a una mejor comprensión de la composición nuclear ocurrió en 1919. Ese año Rutherford se dio cuenta de que, cuando bombardeaba gas nitrógeno con partículas alfa procedentes de bismuto-214, se producían partículas rápidas que podían viajar más lejos en el gas que las propias partículas alfa. Cuando estas partículas golpeaban una pantalla de centelleo producían destellos de luz más débiles que los producidos por las partículas alfa. Unos cálculos rápidos indicaban que esa intensidad era aproximadamente la intensidad que se esperaría que produjesen los iones positivos de hidrógeno [1].

Las mediciones del efecto que un campo magnético tenía en las trayectorias de estas partículas apuntaban a que, en efecto, eran protones. Con el escepticismo que caracteriza a toda buena investigación científica, Rutherford descartó, mediante cuidadosos experimentos, la posibilidad de que los protones procedieran del hidrógeno presente como impureza en el nitrógeno.

Dado que los átomos de nitrógeno del gas eran la única fuente posible de protones, Rutherford llegó a la conclusión de que una partícula alfa, al chocar con un núcleo de nitrógeno, ocasionalmente puede expulsar una partícula más pequeña (un protón) del núcleo de nitrógeno. En otras palabras, Rutherford dedujo que una partícula puede provocar la desintegración artificial de un núcleo de nitrógeno, siendo el protón uno de los productos de esta desintegración. Pero este proceso no ocurre fácilmente. Los resultados experimentales mostraban que solo se producía un protón por aproximadamente cada millón de partículas alfa que atraviesan el gas.

Entre 1921 y 1924 Rutherford y su colega James Chadwick ampliaron el trabajo sobre el nitrógeno a otros elementos y encontraron pruebas de que era posible producir la desintegración artificial de todos los elementos ligeros, desde el boro al potasio, con la excepción del carbono y el oxígeno [2].

El siguiente paso era determinar la naturaleza del proceso nuclear que conduce a la emisión del protón. Se sugirieron dos hipótesis para este proceso:

(a) El núcleo del átomo bombardeado pierde un protón, que se “desprende” como resultado de una colisión con una partícula alfa especialmente rápida.

(b) La partícula alfa es “capturada” por el núcleo del átomo al que ha golpeado, formando un nuevo núcleo que, inmediatamente después, emite un protón.

¿Cómo distinguir experimentalmente entre ambas hipótesis? Un nuevo instrumento marcaría toda la investigación nuclear desde entonces hasta nuestros días: la cámara de niebla.

Notas:

[1] El nombre protón para el ion positivo del hidrógeno se adoptaría al año siguiente, en 1920, a sugerencia del propio Rutherford.

[2] Años más tarde y con mejor tecnología se demostró que estos elementos también se podían desintegrar artificialmente.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El descubrimiento de la desintegración artificial se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las series de desintegración radiactiva

- El problema de la estructura nuclear

- La transformación radiactiva

Organismo mugikor zaharrenak?

Parisko Sorbona Unibertsitateko Frédéric Delarue zientzialaria buru duen nazioarteko talde batek adierazi duenez, zartailu baten antzeko buztana zuten eta modu aktiboan mugitzeko gai ziren mikroorganismoen aztarna fosilak aurkitu dituzte. Aztarnak duela 3.400 milioi urtekoak dira (hemendik aurrera m.a.).

Irudia: Nazioarteko ikertalde batek mugitzeko ahalmena omen zuten mikroorganismo buztandunen fosilak aurkitu dituzte. (Argazkia: Centers for Disease Control and Prevention (CDC) – Unsplash)

Irudia: Nazioarteko ikertalde batek mugitzeko ahalmena omen zuten mikroorganismo buztandunen fosilak aurkitu dituzte. (Argazkia: Centers for Disease Control and Prevention (CDC) – Unsplash)Orain arte zeuden lehenengo bizitza arrastoak duela 3.800 milioi urte inguruko harri batzuk ziren. Harri horietan dagoen grafitoko karbono isotopoen proportzioak nolabaiteko jarduera biologikoa islatzen du bere formazioan. Baliteke oinarrizko bizitza formak lehenago agertu izana ere, agian duela 4.000 milioi urte, planeta sortu zenetik 500 milioi urtera, oraindik asteroideek maiz kolpatzen zuten garaian. Hala ere, ezagutzen diren organismo zelulabakarren fosil zaharrenak duela 3.500 milioi urte ingurukoak dira.

Ustezko egitura eragileak dituzten mikrofosilak aurkitu dira Strelley aintziraren formazioan, Australiako mendebaldean. Hosto formako mikroorganismoetatik abiatuz osatuko ziren –30-84 µm-ko luzerakoak eta zabalera erdikoak–. Arrasto inorganiko hutsak ez zirela baieztatzeko, mikrofosiletan fosforoa eta nitrogenoa zegoela frogatu dute paleontologoek, hau da, izaki bizidunen ezaugarri diren elementuak. Aurkitutako bostehunetatik, lauk bastoi moduko bat daukate zelularen ertzetako batean, eta egitura hori jotzen dute ikertzaileek apendize eragiletzat, egitura osatugabeak direla susmatzen duten arren. Arrasto gehienetan apendizea ez egotea edo aurkitutako lauretan zatirik ez egotea formatu zirenetik igarotako denbora luzean galdu izanaren ondorioa izango litzateke. Gaur egungo mikroorganismo askok, mugitzeko, antzeko egiturak erabiltzen dituzte, adibidez, flageloak –ingurune likidoan horiek biratuz mugitzen dira– edo beste batzuk.

Ikertzaileek bioRxiv gordailuan –biozientzien arloko biltegi librea– argitaratutako dokumentu batean eman dute beren aurkikuntzaren berri eta beste aditu batzuek aztertzea falta da aldizkari batean argitaratu aurretik. Beraz, oraindik ez du txosten zientifikoek formalki egiazko ikerketa produktu gisa onartuak izateko gainditu behar duten iragazkia pasatu. Gainera, aditu batzuek aurkikuntzen interpretazioaren inguruko zalantzak adierazi dituzte, beraz, tentuz hartu behar dira.