Naukas Bilbao 2021: Almudena M. Castro e Iñaki Úcar – El metrónomo de Beethoven

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

¿Cómo debería sonar realmente la música de Beethoven? Puede que no se esté interpretando bien porque el compositor se hizo un lío con un instrumento que acababa de salir al mercado y que fue de los primeros en reconocer su utilidad, el metrónomo. Almudena M. Castro e Iñaki Úcar lo investigaron y aquí cuentan sus hallazgos.

Almudena lo contó en la sección Fronteras del Cuaderno: Beethoven y el metrónomo: los titubeos de un genio

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Almudena M. Castro e Iñaki Úcar – El metrónomo de Beethoven se ha escrito en Cuaderno de Cultura Científica.

Nuestro comportamiento ante un desastre natural y la importancia de la psicología de emergencias

César San Juan

Una mujer observa la erupción del nuevo volcán de La Palma desde un tejado el 20 de septiembre de 2021. Fuente: Wikimedia Commons / Eduardo Robaina, CC BY-SA

Una mujer observa la erupción del nuevo volcán de La Palma desde un tejado el 20 de septiembre de 2021. Fuente: Wikimedia Commons / Eduardo Robaina, CC BY-SA

La terrible situación que está sufriendo la isla de La Palma tras una devastadora erupción volcánica ha hecho más visible el papel de la denominada psicología de emergencias. Sobre todo, considerando el carácter errático, continuado e imparable de la lava contra cuyo avance no hay forma de hacer nada.

La investigación sobre desastres ha cuestionado las visiones tradicionales del comportamiento colectivo que se asocia a respuestas de pánico irracional, comportamientos antisociales, saqueos, etc.

Cabe pensar que, muy posiblemente, el éxito del cine de catástrofes sea, en alguna medida, responsable de la imagen social del comportamiento humano en situaciones críticas o catastróficas. Películas como El coloso en llamas, Poseidón, Terremoto y Vulcano, entre otras, han exagerado el lado más oscuro e irracional del comportamiento humano, solo dignificado en contadas excepciones por esos héroes que siempre aparecen corriendo en sentido contrario a una enloquecida muchedumbre.

Efectivamente, la evidencia empírica sostiene que la mayor parte de las personas afectadas por un desastre natural disponen de los suficientes recursos psicosociales para afrontarlo aunque, obviamente, habrá una casuística muy diversa en función del grado de exposición al desastre. Dicho en otras palabras, es muy distinto perder a un ser querido, perder la vivienda o, en una esfera más periférica, observar con inquietud, pero desde la lejanía, las explosiones de lava.

Los cuadros clínicos más frecuentes

En todo caso, es absolutamente imperativo que las administraciones garanticen las necesidades básicas materiales de los damnificados y la atención a las personas que, por diferentes motivos, van a precisar un acompañamiento más directo y, eventualmente, apoyo psicológico ya que, en caso contrario, se acabaran identificando cuadros de relevancia clínica, siendo los más frecuentes los siguientes:

- Síndrome de estrés postraumático. Reexperimentación del acontecimiento traumático. Evitación de los estímulos asociados al acontecimiento. Aumento de la activación motora. Puede aparecer ideación suicida.

- Síndrome de aflicción por catástrofe. Para las personas que han sufrido pérdidas considerables, las reacciones emocionales más probables son el dolor por la pérdida de seres queridos, de posesiones, de sustento, que se manifiesta en forma de tristeza, ira, ansiedad, nostalgia, sentimiento de desgracia, etc.

- Síndrome del superviviente. La irritabilidad, la ira y la agresión, que aumentan en los años siguientes al desastre, pueden cebarse con algunos supervivientes que no han podido gestionar lo que el resto de personas de su círculo se ha empeñado en considerar “buena suerte”. También los desórdenes físicos y la tasa de mortalidad aumentan entre los supervivientes.

- Efectos en los niños. En niños afectados por desastres se constatan comportamientos regresivos y un gran aumento de la dependencia.

Los recursos propios de los afectados

En definitiva, lo esencial para entender el impacto psicológico de una crisis de esta naturaleza es el desequilibrio que se produce entre las demandas planteadas al sujeto, enfrentado a una circunstancia excepcional, y sus propios recursos o capacidades para afrontarlo apropiadamente. Es muy característica la desazonante sensación de impotencia e ineficacia para resolver los problemas derivados del desastre y controlar las emociones desatadas en el propio sujeto.

Dicho esto, no obstante, tenemos que ser especialmente cuidadosos al interpretar las respuestas ante una situación catastrófica. Por ejemplo, sentimientos como temor, ansiedad, ira, frustración o culpabilidad inmediatamente después de la catástrofe, o durante su evolución, como el caso que nos ocupa, debemos interpretarlos como normales ante una situación anormal, y constituyen la parte dinamizadora de la reacción ante lo que está ocurriendo. Por tanto, se trata de una respuesta adaptativa. Una respuesta catatónica, pasiva o excesivamente dependiente tiene, en este sentido, un peor pronóstico.

También es muy habitual la búsqueda intensiva, pero irreflexiva, de soluciones. El sujeto focaliza su atención en el problema sobrevenido de manera abusiva, con las consiguientes pérdidas de atención respecto a otros asuntos vitales relacionados con el bienestar de los suyos o incluso su propia seguridad.

“¿Por qué me ha sucedido a mí esto?”

También dirige el sujeto su actividad cognitiva y fiscalizadora hacia sí mismo, haciéndose preguntas aparentemente esenciales pero objetivamente carentes de toda lógica como, por ejemplo, “¿por qué me ha sucedido a mí esto?” o “¿qué he hecho para ser merecedor de esta situación?”. Este tipo de reacciones son a las que nos referíamos con la necesidad de que reciban respuestas adecuadas en forma de acompañamiento y apoyo psicológico con el fin de evitar la vulneración del sujeto más a largo plazo.

Desde esta perspectiva, debemos señalar como flagrantes malas prácticas el insistente debate de estos días acerca de la idoneidad de construir viviendas en las faldas de volcanes activos o potencialmente activos.

Dejando al margen que las faldas de los volcanes de La Palma conforman, de hecho, prácticamente toda la superficie de la isla, sea como fuere, este momento es sin lugar a dudas el más inapropiado para debatir sobre el particular ya que solo puede contribuir a generar desolación e impotencia.

Ahora lo que toca es atender todas las necesidades materiales y psicosociales de la población afectada. Debe hacerse sin tregua porque el volcán no la está dando.![]()

Sobre el autor: César San Juan es profesor de psicología criminal en el Departament de Psicología Social de la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Nuestro comportamiento ante un desastre natural y la importancia de la psicología de emergencias se ha escrito en Cuaderno de Cultura Científica.

La distancia a las estrellas

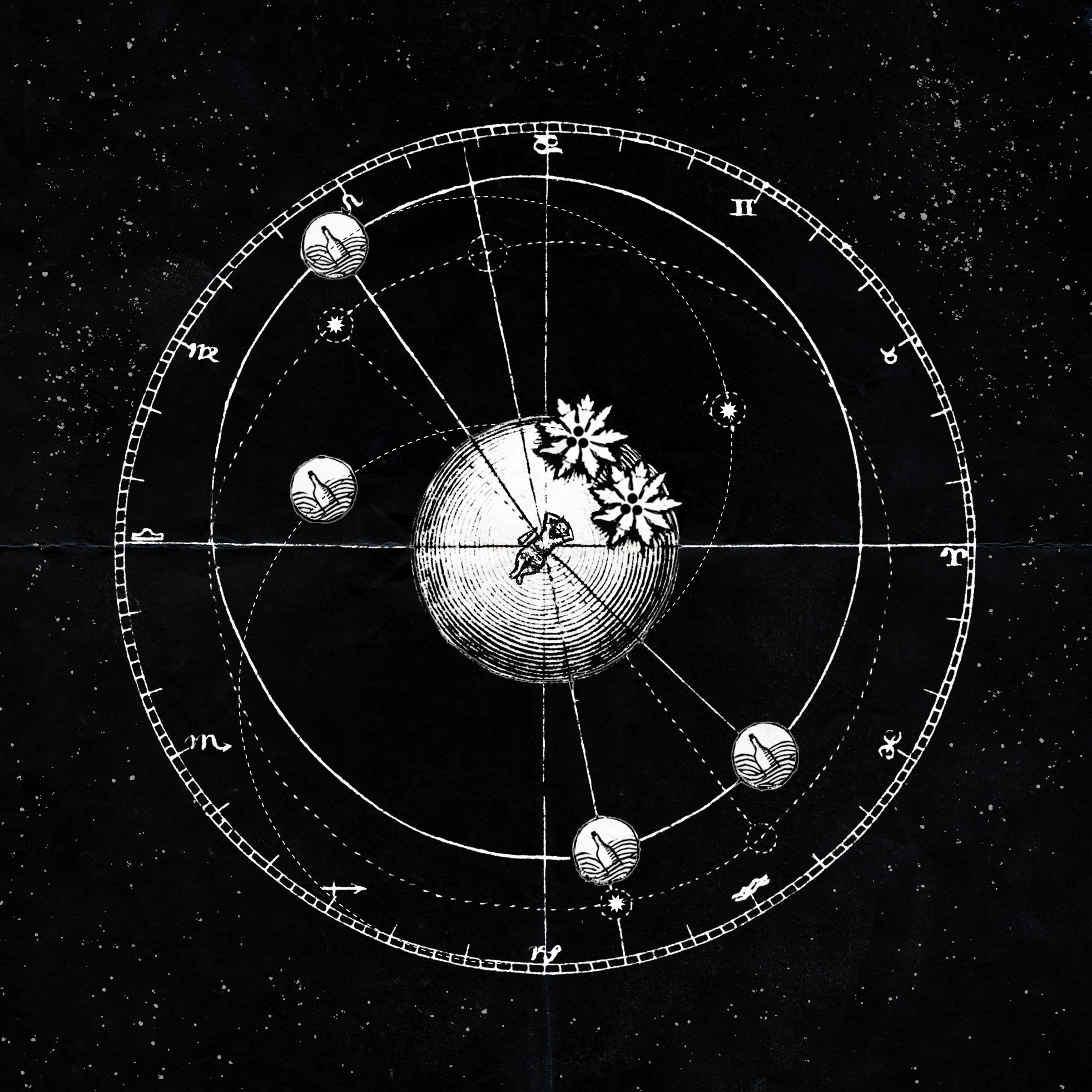

Náufragos. Ilustración: Almudena M. Castro.

Náufragos. Ilustración: Almudena M. Castro.El reto al que se enfrentan los astrónomos podría compararse, en muchos sentidos, al de un náufrago perdido en una isla desierta. Carcomido por la curiosidad, el pobre intenta averiguar cómo es el mundo que lo rodea, a qué distancia se encuentran los países y los continentes al otro lado del océano. Pero para ello solo cuenta con las botellas que van llegando a su orilla.

Como en el caso del náufrago, el objeto de estudio de los astrónomos está fuera de su alcance. La distancia de la mayoría de las estrellas a la Tierra es equiparable a la de un océano que solo se pudiese cruzar a nado. Pero incluso si algún día la tecnología (o la ciencia ficción) nos permitiesen llegar hasta ellas, superando las distancias de años luz, otros obstáculos nos impedirían alcanzarlas: la temperatura de su atmósfera o su enorme gravedad acabarían con la curiosidad del pobre náufrago.

Quizás por todos estos motivos, en 1835 el filósofo Auguste Compte escribió1:

“En cuanto a las estrellas, […] nunca podremos, de ningún modo, estudiar su composición química o su estructura mineralógica. Considero que cualquier idea sobre la verdadera temperatura media de alguna estrella nos será siempre negada”.

En efecto, todas estas cuestiones parecían irresolubles en la primera mitad del siglo XIX. Hasta entonces, el estudio de la astronomía se había basado en el movimiento y la posición relativa de las estrellas en el firmamento. El pobre náufrago se había pasado milenios anotando en sus cuadernos el punto exacto de la costa al que llegaban las distintas botellas y la variación de este punto respecto al tiempo. Así, dibujado sobre la arena, el cosmos era bidimensional. Una cáscara de naranja salpicada de pecas luminosas.

Este mapa del cielo nos permitió conocer la posición relativa de las estrellas respecto a la Tierra (nuestra pequeña isla azulada). Pero ni siquiera servía para esclarecer la distancia a la que se encuentran la mayoría de los astros. Y, por supuesto, no revelaba nada acerca de su “composición química o su estructura mineralógica”. Incluso un concepto tan básico y tan antiguo como el de las constelaciones, agrupa estrellas que nada tienen que ver entre sí, más allá de su cercanía aparente en el cielo nocturno. Responde al modelo mental de un náufrago, que va agrupando las botellas según se encuentran más próximas sobre la arena de su playa.

A pesar de las dificultades, algunos pensadores consiguieron calcular algunas de las distancias más próximas de este mapa. En el siglo III a.C. Aristarco de Samos logró estimar los tamaños relativos del Sol, la Luna y la Tierra, así como las distancias que los separan. Razonó que, durante la media luna, los tres cuerpos celestes deben situarse formando un ángulo recto con su vértice en la Luna. A continuación midió el ángulo entre el Sol y la Luna desde la Tierra y usó trigonometría para calcular el tamaño relativo de los lados del triángulo resultante. Su lógica era correcta, pero no contaba con los medios apropiados para medir en ángulo con suficiente precisión. Aristarco midió 87º cuando en realidad son 89º50’ (un ángulo mucho indistinguible de 90º a simple vista). Por eso concluyó, erróneamente, que el Sol estaba 19 veces más lejos del planeta que la Luna, y, puesto que el tamaño angular de ambos astros sobre el firmamento es similar, que debía de ser también 19 veces más grande. De hecho, el Sol es unas 400 veces más grande que la Luna.

Aristarco también calculó el tamaño relativo de la Tierra y la Luna. Para ello, se basó en la sombra del planeta sobre nuestro satélite durante un eclipse. Poco después, Eratóstenes pudo estimar el radio de la Tierra comparando la sombra proyectada por el sol a la misma hora en dos ciudades distintas. Ya en la Edad Moderna, el astrónomo Christiaan Huygens calculó la distancia de la Tierra al Sol basándose en las fases de Venus, usando un método similar al de Aristarco. Otros astrónomos lograron utilizar técnicas similares y otras, como la paralaje, para estimar la distancia a los demás planetas.

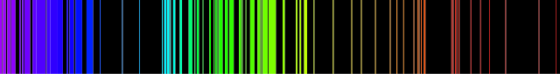

Sin embargo, todas estas técnicas eran relativamente limitadas en su alcance y no demasiado precisas. Por suerte, a mediados del siglo XIX, el panorama cambió radicalmente. Gracias a los avances de la óptica, fue posible estudiar por primera vez los espectros luminosos de las distintas estrellas y su brillo relativo. El náufrago decidió abrir las botellas de su playa y dentro encontró lo que casi todos encontramos al abrir el buzón: facturas de la luz.

Facturas de la luz. Espectro de emisión en la región visible del vapor de hierro. Imagen: Wikimedia Commons

Facturas de la luz. Espectro de emisión en la región visible del vapor de hierro. Imagen: Wikimedia CommonsReferencia:

1A. García Hernández. El camino hacia el interior de las estrellas. Revista IAA 34 (CSIC). 2011. Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científicaEl artículo La distancia a las estrellas se ha escrito en Cuaderno de Cultura Científica.

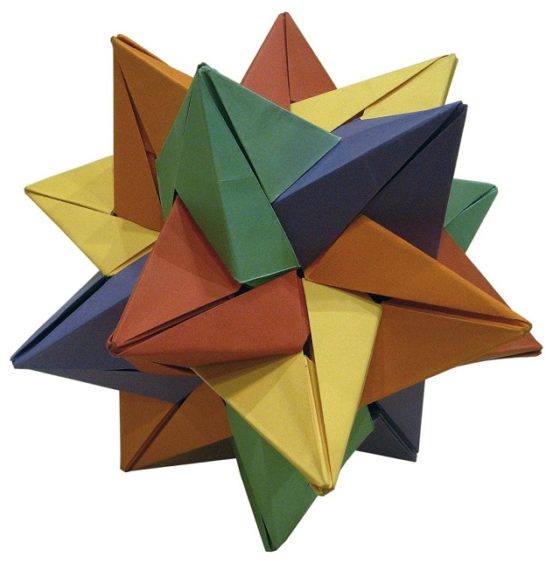

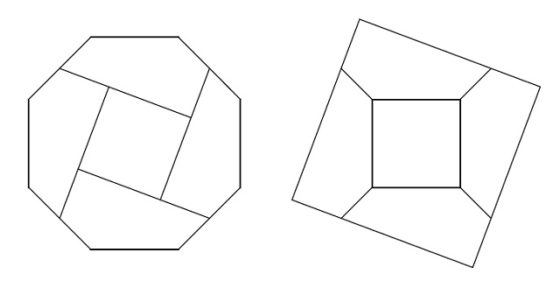

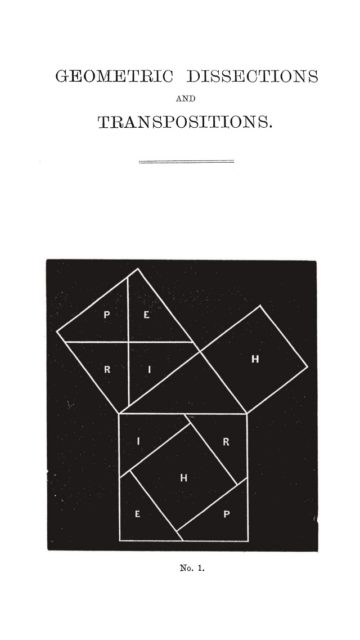

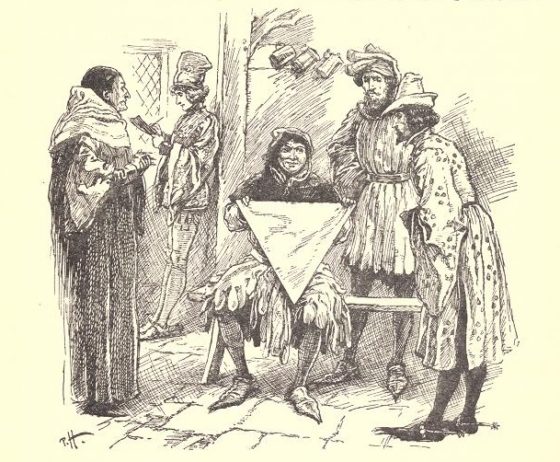

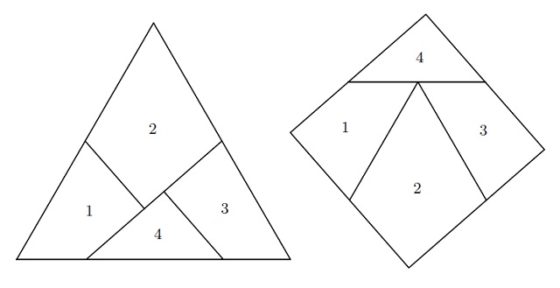

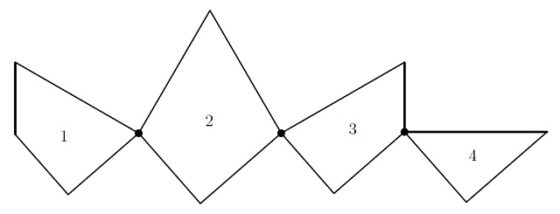

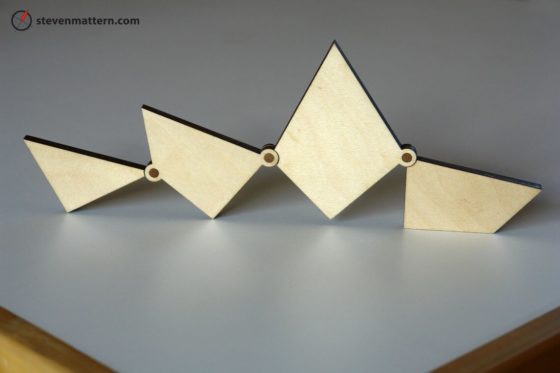

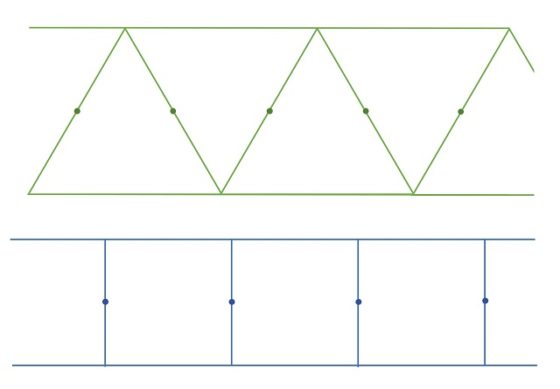

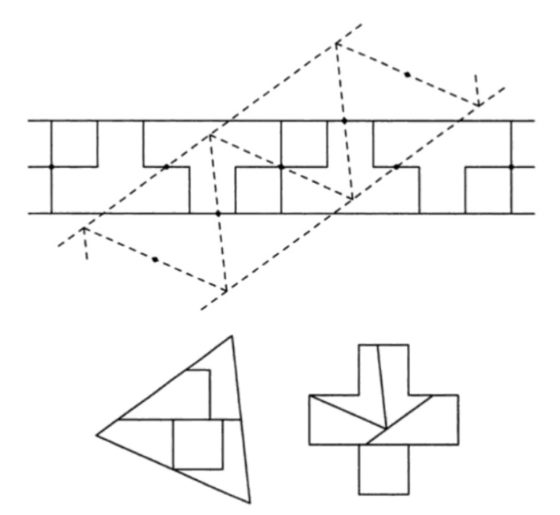

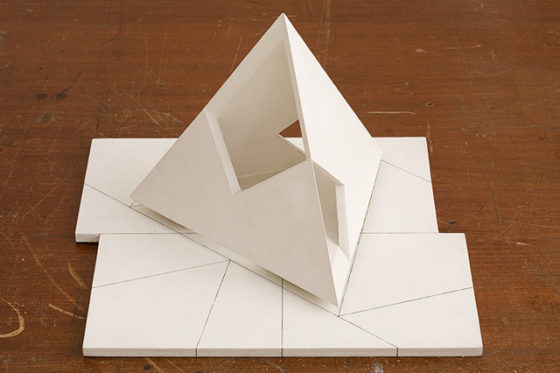

Construir un triángulo pitagórico doblando papel

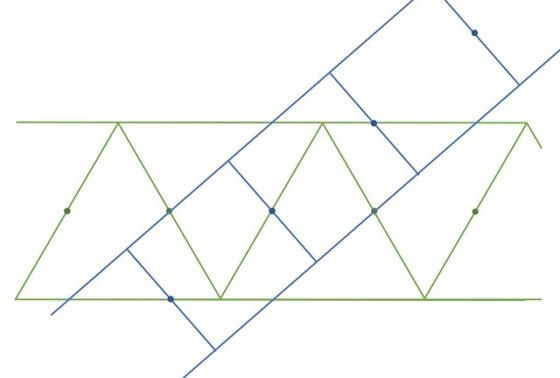

Estos días estaba yo buscando información sobre los triángulos pitagóricos cuando he descubierto un curioso resultado geométrico, el conocido como primer teorema de Haga, un sencillo método para construir un triángulo pitagórico doblando una hoja de papel cuadrada. El objetivo de esta entrada del Cuaderno de Cultura Científica es explicar esta hermosa construcción.

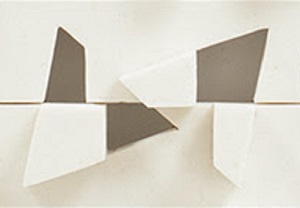

Cinco tetraedros cruzados que forman un dodecaedro, realizados con la técnica de la papiroflexia modular. Imagen de José Ignacio Royo

Cinco tetraedros cruzados que forman un dodecaedro, realizados con la técnica de la papiroflexia modular. Imagen de José Ignacio Royo

Para empezar, recordemos que un triángulo pitagórico es un triángulo rectángulo, es decir, cuyos lados (a, b, c), siendo a y b los catetos y c la hipotenusa, no solo verifican la igualdad derivada del teorema de Pitágoras a2 + b2 = c2 (véase la entrada Pitágoras sin palabras), sino que son números enteros, como las ternas (3, 4, 5), (5, 12, 13) o (8, 15, 17).

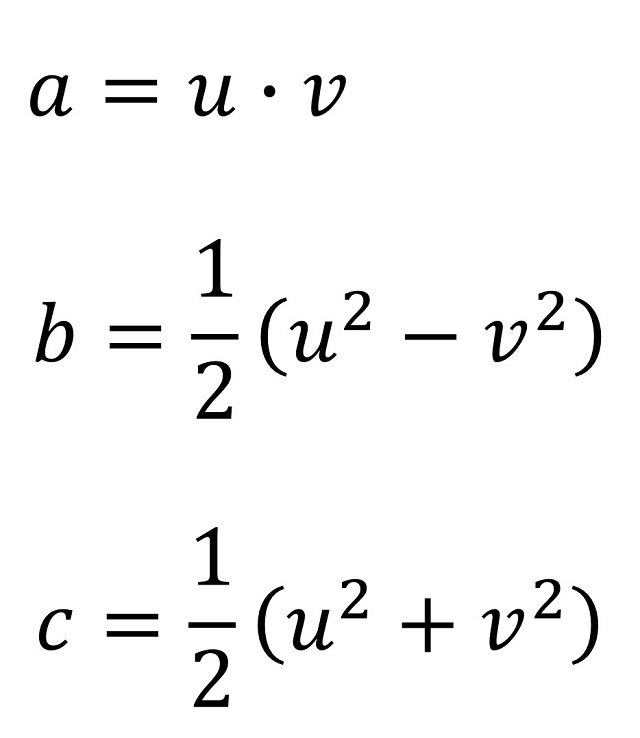

Aunque debemos el estudio general del resultado geométrico conocido como teorema de Pitágoras y su demostración al matemático griego Pitágoras (aprox. 585-500 a.n.e.), lo cierto es que el resultado ya era conocido anteriormente en Babilonia, Egipto, India o China, quienes desarrollaron métodos para obtener ternas pitagóricas (números naturales (a, b, c) que satisfacen la ecuación a2 + b2 = c2) y las utilizaron para trazar ángulos rectos en construcción y agrimensura. Por ejemplo, el método chino consistía en coger dos números u y v (el primero mayor que el segundo) y obtener la terna pitagórica mediante las expresiones:

Para u = 3 y v = 1 se obtiene la terna pitagórica (3, 4, 5) que da lugar al triángulo egipcio o para u = 5 y v = 1 se obtiene la terna (5, 12, 13) cuyo triángulo rectángulo asociado se conoce como triángulo indio.

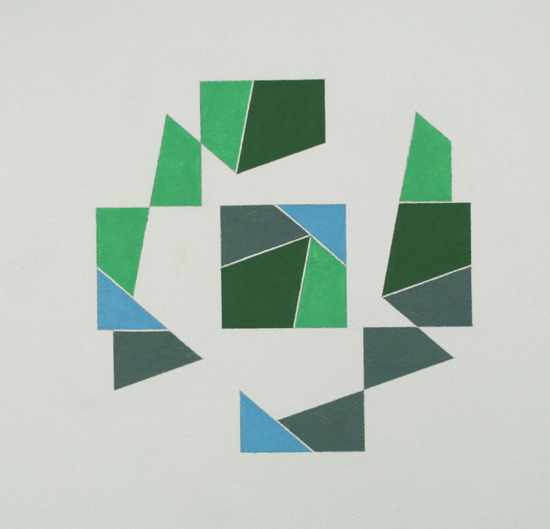

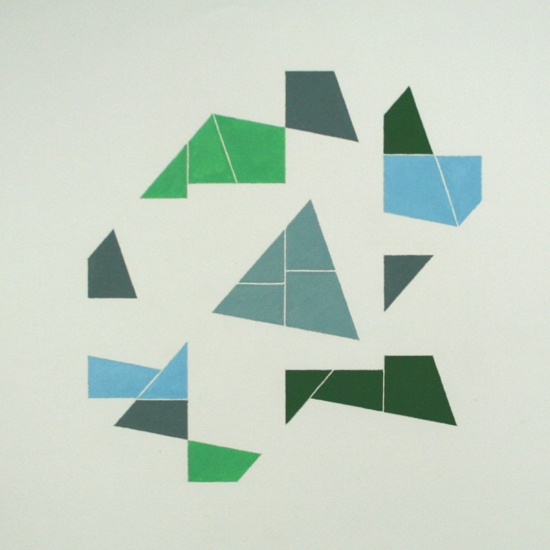

Pythagoräisches dreieck in quadrat II (1980), “Triángulo pitagórico en el cuadrado II”, del artista concreto suizo Max Will. Imagen de WikiArt

Pythagoräisches dreieck in quadrat II (1980), “Triángulo pitagórico en el cuadrado II”, del artista concreto suizo Max Will. Imagen de WikiArt

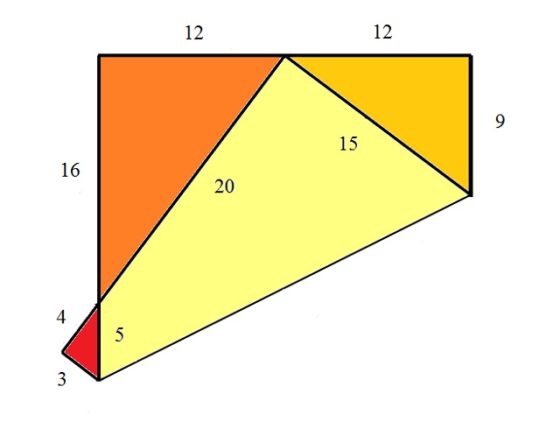

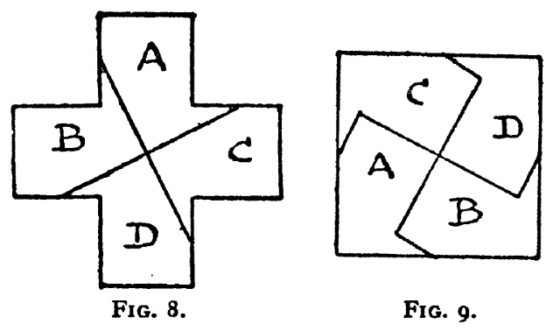

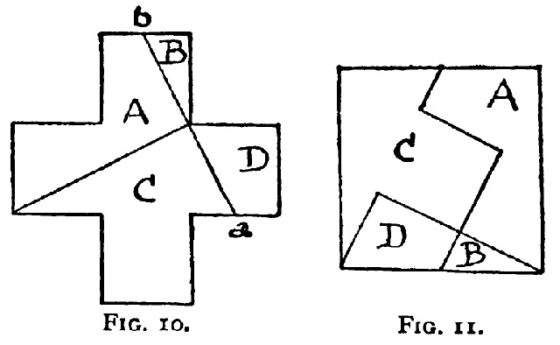

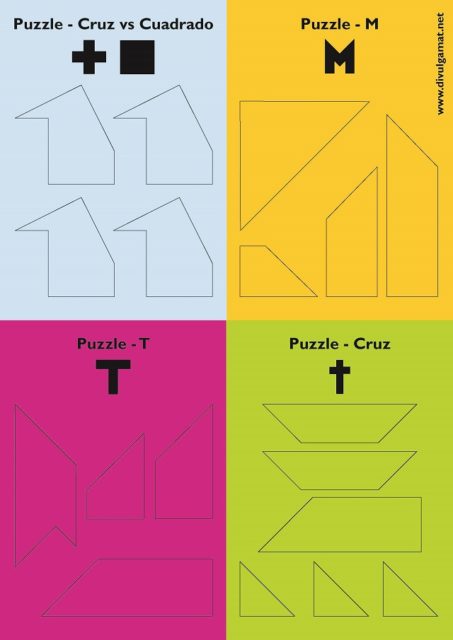

Pero vayamos con la construcción de un triángulo pitagórico doblando una hoja de papel cuadrada, el primer teorema de Haga, extraída del libro del octogenario biólogo japonés Kazuo Haga, Origamics, Mathematical Explorations through Paper Folding.

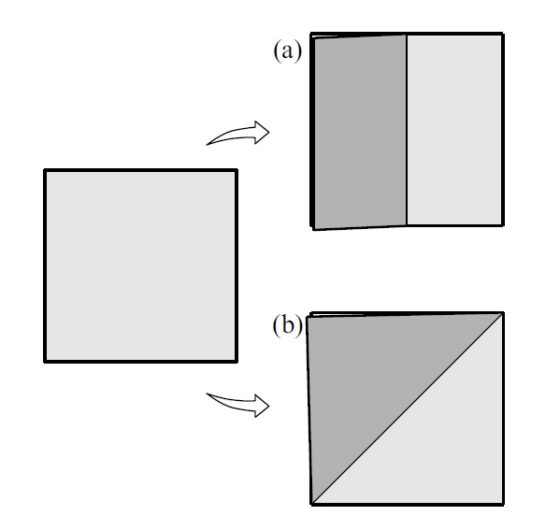

Para empezar, necesitamos una hoja de papel cuadrada. De forma natural, esto quiere decir que el plegado es reproducible, su resultado lo podemos obtener en cualquier otra hoja cuadrada, podemos doblarla de dos maneras distintas. Un plegado consiste en unir un lado del cuadrado con su opuesto lo cual da lugar a un pliegue por la mitad de la hoja, mientras que el otro consiste en unir un vértice del cuadrado con el vértice opuesto dando lugar a un plegado por la diagonal del cuadrado.

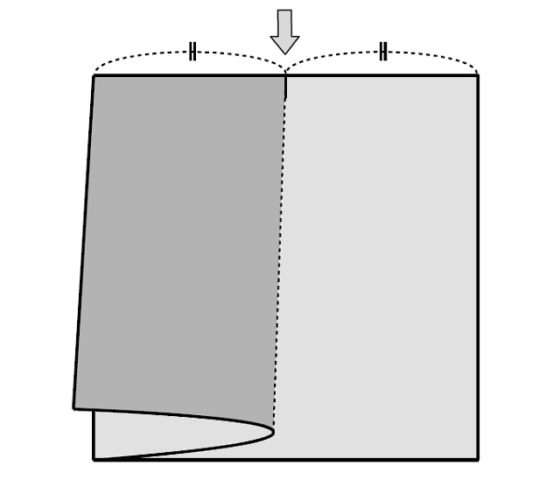

Para la construcción de Haga necesitamos marcar el punto medio de uno de los lados, lo cual se consigue fácilmente con el primer plegado comentado anteriormente, como se muestra también en la siguiente imagen (para quien quiera realizar la construcción en su casa), y después volver a desplegar la hoja volviendo a su posición cuadrada original.

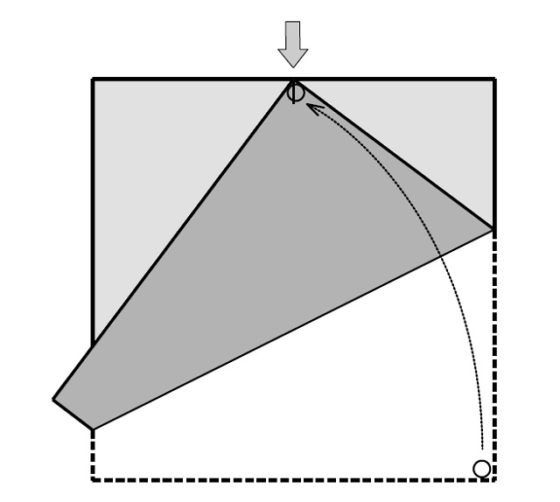

El plegado que nos va a dar lugar al triángulo pitagórico consiste en coger el vértice de abajo a la derecha, cuando tenemos la hoja cuadrada desplegada, y situarlo sobre el punto medio del lado de arriba (como se muestra en la siguiente imagen), lo cual nos genera el plegado de la hoja cuadrada sobre una línea que va desde lado izquierdo al derecho.

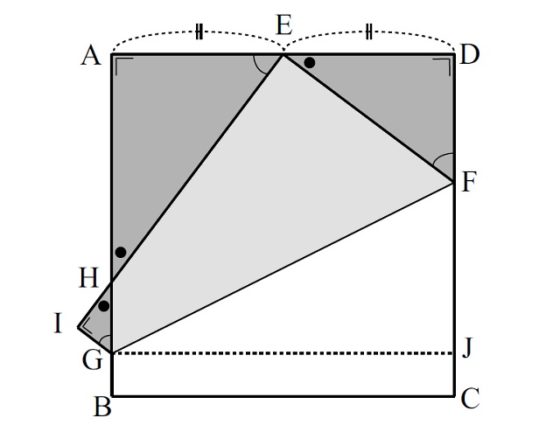

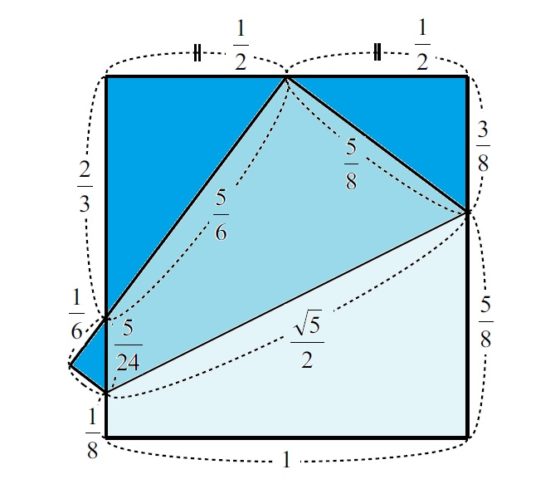

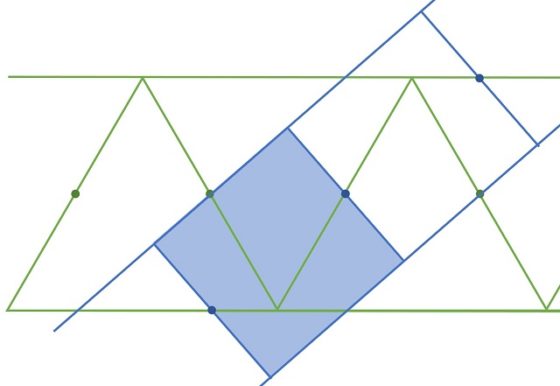

El plegado realizado es el único que se necesita, pero vamos a comprobar que hemos generado tres triángulos rectángulos cuyos lados son proporcionales al triángulo egipcio 3:4:5. Para demostrar esto vamos a marcar una serie de puntos en la figura: los vértices del cuadrado A, B, C, D (empezando arriba a la izquierda y siguiendo el sentido contrario a las agujas del reloj), el punto medio E del lado AD, los puntos F, G en los que la línea de plegado toca a los lados laterales del cuadrado y el punto H marcado por la intersección del lado CB (que se convierte al plegarse en CI) con el lado BA al ser plegado sobre el anterior.

Lo primero que se podría observar en la imagen anterior es que los tres triángulos rectángulos generados sobre el papel cuadrado con el pliegue, AHE, DEF y IGH, son semejantes. Recordemos que dos triángulos son semejantes si tienen la misma forma, es decir, tienen los tres ángulos iguales, solo se diferencian por su tamaño.

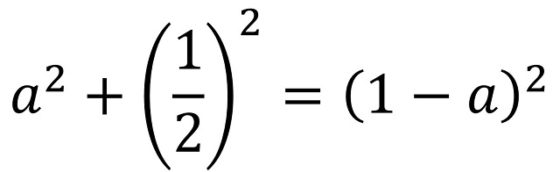

Pero empecemos por el triángulo DEF y veamos que es proporcional al triángulo egipcio 3:4:5, es decir, tomando la hoja de papel cuadrada de un cierto tamaño obtendríamos el triángulo pitagórico 3:4:5. Consideremos que la longitud de los lados de la hoja de papel cuadrada es la unidad, 1. Si llamamos a (es nuestra incógnita) a la longitud del lado DF, entonces la longitud de FC es 1 – a, pero como FE = FC, por el plegado, tenemos que la hipotenusa del triángulo rectángulo DEF, el lado FE, tiene longitud 1 – a. La longitud del lado ED la conocemos, ya que E es el punto medio de AD, es 1/2. Si aplicamos ahora el teorema de Pitágoras al triángulo rectángulo DEF se tiene que

de donde se puede despejar y obtener el valor de a, que es a = 3/8. Por lo tanto, los lados del triángulo rectángulo tienen longitud 3/8, 1/2 y 5/8. Estas longitudes son proporcionales al triángulo 3:4:5, para lo cual basta multiplicar por 8, o dicho de otra forma, si el cuadrado original tiene lado igual a 8, las longitudes del triángulo rectángulo originado por esta doblez son 3, 4 y 5. ¡El triángulo pitagórico egipcio!.

Resultado 1 (teorema de Haga): el triángulo rectángulo DEF es proporcional a un triángulo pitagórico 3:4:5.

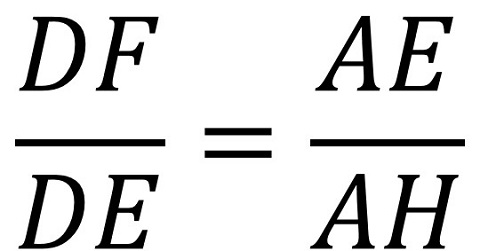

A continuación, razonemos sobre el triángulo AHE. Para empezar, el ángulo BCD, que es un ángulo recto, se ha convertido mediante el plegado en el ángulo IEF, luego también es recto. Por lo tanto, los ángulos DEF y AEH son complementarios, de donde se deduce que los triángulos DEF y AHE son semejantes, como se comentaba más arriba, es decir, uno es una ampliación –mediante un cierto factor- del otro. En consecuencia, el triángulo AHE es proporcional al triángulo DEF, luego también lo es un triángulo rectángulo con lados proporcionales a 3:4:5. Pero calculemos cual es esa proporción.

Por la proporcionalidad, tenemos que:

Como conocemos tres de las longitudes AE = 1/2 = DE y DF = 3/8, se obtiene la cuarta, AH = 2/3. Por lo tanto, BH = 1/3 y el punto H nos marca la trisección del lado BA (obteniendo así, de paso, una manera mediante plegado de dividir un segmento –en este caso BA– en tres partes iguales, ya que BH = 1/3 y si M es el punto medio de HA, entonces HM = MA = 1/3).

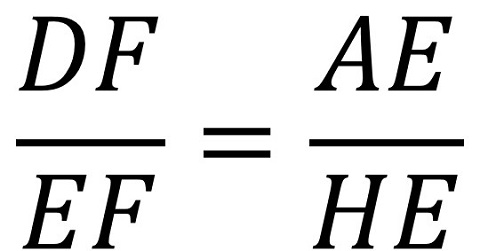

De nuevo, por la proporcionalidad de los lados de los triángulos AHE y DEF se obtiene que:

Conocemos tres de las longitudes, DF = 3/8, EF = 5/8 y AE = 1/2, luego se puede calcular la otra, HE = 5/6. Por lo tanto, las medidas del triángulo AHE, si el cuadrado original tiene lado 1, son 1/2, 2/3 y 5/6, proporcional al triángulo 3:4:5 multiplicando por 6. Más aún, el punto H nos da la sexta parte del segmento IE, ya que HI = 1 – 5/6 = 1/6.

Resultado 2 (teorema de Haga):

a) el triángulo rectángulo AHE es proporcional a un triángulo pitagórico 3:4:5;

b) el punto H es un punto de trisección del lado BA, BH = 1/3;

c) el punto H es un punto de “hexasección” del lado IE, HI = 1/6.

Finalmente, utilizando argumentos similares, es decir, la proporcionalidad de los triángulos semejantes y el teorema de Pitágoras, podemos obtener las medidas del tercer triángulo rectángulo IGH. En concreto, HI = 1/6, IG = 1/8 y GH = 5/24, que también es proporcional al triángulo 3:4:5, multiplicando por 24. Más aún, como GB = IG = 1/8, el punto G nos da la octava parte del segmento BA.

Resultado 3 (teorema de Haga):

a) el triángulo rectángulo IGH es proporcional a un triángulo pitagórico 3:4:5;

b) el punto G es un punto de “octosección” del lado BA, BG = 1/8.

Incluso, utilizando el teorema de Pitágoras podemos obtener la longitud del segmento GF, que es la hipotenusa del triángulo JFG (véase la imagen anterior), cuyo cálculo os dejo para vosotros.

En resumen, si consideramos una hoja de papel cuadrada de longitud 1, las medidas obtenidas tras el pliegue aparecen en la siguiente imagen.

Como hemos visto a lo largo de esta entrada, el primer teorema de Haga nos dice que mediante el plegado “del vértice al punto medio de uno de los lados contrarios” se obtienen tres triángulos rectángulos proporcionales al triángulo egipcio 3:4:5 cuyas medidas son a) 3/8, 1/2 y 5/8; b) 1/2, 2/3 y 5/6; c) 1/8, 1/6 y 5/24, de la longitud del cuadrado original. Por lo tanto, si tomamos una hoja de papel cuadrada de longitud 24 se obtienen tres triángulos pitagóricos de tamaño (9, 12, 15), (12, 16, 20) y (3, 4, 5), como aparece en la imagen.

Más aún, podemos observar que también es cierta la siguiente igualdad:

Resultado 4 (teorema de Haga): La suma de los perímetros de los triángulos DEF y IGH es igual al perímetro del triángulo AHE.

Este resultado, el primer teorema de Haga, a caballo entre el origami y la geometría euclídea, fue descubierto por Kazuo Haga en 1978, cuando trabajaba como biólogo especializado en morfología de artrópodos y utilizaba el origami como método para relajarse. Un año más tarde el físico japonés Koji Fushimi publicó en una revista japonesa el resultado de Haga etiquetándolo por vez primera como el “teorema de Haga”.

Bibliografía

1. Pedro Miguel González Urbaneja, Pitágoras, el filósofo del número, Nivola, 2001.

2. Kazuo Haga, Origamics, Mathematical Explorations through Paper Folding, World Scientific, 2008.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Construir un triángulo pitagórico doblando papel se ha escrito en Cuaderno de Cultura Científica.

El enamoramiento como droga de abuso

Dante y Beatriz (1884) por Henry Holiday (1839 – 1927). Óleo sobre lienzo. 142.2 × 203.3 cm. Walker Art Gallery, Liverpool, Reino Unido. Fuente: Wikimedia Commons

Dante y Beatriz (1884) por Henry Holiday (1839 – 1927). Óleo sobre lienzo. 142.2 × 203.3 cm. Walker Art Gallery, Liverpool, Reino Unido. Fuente: Wikimedia CommonsEs hielo abrasador, es fuego helado,

es herida, que duele y no se siente,

es un soñado bien, un mal presente,

es un breve descanso muy cansado.

Es un descuido, que nos da cuidado,

un cobarde, con nombre de valiente,

un andar solitario entre la gente,

un amar solamente ser amado.

Es una libertad encarcelada,

que dura hasta el postrero paroxismo,

enfermedad que crece si es curada.

Este es el niño Amor, este es tu abismo:

mirad cuál amistad tendrá con nada,

el que en todo es contrario de sí mismo.

Este texto es un soneto de Francisco de Quevedo. En lo que solemos llamar “cultura” un comentario del mismo podría ser algo tal que así. Habrá quien, leyendo esto, alabe la capacidad analítica del comentarista y su conocimiento de la teoría literaria. Sin embargo, la cultura científica aporta otra dimensión al poema que no le resta un ápice de su belleza formal y sí pone en valor la agudeza de su autor. Algo que hoy día lamentablemente solo es valorado por unos pocos. En lo que sigue vamos a intentar explicar en qué consiste esa otra dimensión.

Explicando el enamoramiento

Cupido, el niño arquero y enredante al que el poema se refiere como niño Amor, se supone que dispara flechas que hacen que la gente se enamore; pero hay poca evidencia científica de que esto sea así. Platón, en su línea, proponía una explicación muy bonita sobre la pérdida de la “otra mitad” que todavía atormenta a muchos adolescentes, y a otros que no lo son tanto, en forma de media naranja ideal; sin embargo, este argumento no pasa la revisión por pares. Otra posibilidad es recurrir a pociones al estilo de Tristán e Isolda, pero que nadie espere más resultados de este remedio que de los adivinos de la tele. Hasta aquí, las letras.

El hecho cierto es que el enamoramiento y sus síntomas, que Quevedo describe magistralmente, existen. Los antropólogos han llegado a la conclusión de que es una constante universal (o casi, siempre hay algo por comprobar): no existe cultura humana conocida en el planeta que no sepa de primera mano lo que es el enamoramiento.

Entonces, si es universal, debe existir una base biológica para él. En otras palabras, no puede ser simplemente una tradición cultural como el fútbol o los tatuajes. Habrá que echar un vistazo pues, sin ánimo de ser exhaustivos, a la acción de genes, neuronas y hormonas si queremos empezar a comprender el síndrome de enajenación mental transitoria al que se refiere Quevedo y que llamamos enamoramiento.

Casanovas y Marcillas

En este punto, y antes de seguir adelante, conviene dejar claro un aspecto importante. En lo que sigue se habla de apareamiento y de enamoramiento indistintamente, porque el enamoramiento no es más que la vestidura con la que disfrazamos el apareamiento. Como apuntábamos más arriba, el enamoramiento es una alteración mental (una enajenación) que dura un tiempo (transitoria) que idealiza al otro, rebaja el riesgo percibido y favorece, en última instancia, la procreación.

Todos conocemos especies en las que las parejas se forman para toda la vida de los individuos y otras en las que la promiscuidad es la regla. Los humanos oscilamos entre el “amor cortés” (platónico) de Dante por Beatriz (en la imagen) y todo lo contrario. Esta “elección”, ¿es algo espiritual, platónico, trascendente o es biológico, genético?

Naturalmente, si hay un fenómeno biológico que se encuentra entre la inmensa mayoría de los individuos de una especie lo que cabe pensar es que esté predeterminado de una forma o de otra en los genes. El problema con el enamoramiento es que es un fenómeno complejo, muy probablemente controlado por interacciones entre muchos productos genéticos distintos. Esto dificulta mucho su estudio como ocurre con el alzhéimer o las dolencias cardíacas. Si, además, por razones éticas muy comprensibles, no se pueden hacer experimentos con humanos, la cosa se complica.

Gracias a la teoría de la evolución, sabemos que estamos relacionados genéticamente con muchas especies, con la que compartimos mucho más que un antepasado común. Esto permite que los estudios genéticos en animales, si bien no pueden responder a cuestiones humanas complicadas, sí den respuesta a preguntas más simples.

Así, por ejemplo, existen dos especies relacionadas de ratones de campo que viven en Norteamérica: una es monógama y vive en la pradera (Microtus ochrogaster) y la otra es promiscua y vive en los montes (Microtus montanus). Un estudio descubrió un gen en los de la pradera que estaba sospechosamente ausente entre los montaraces. Los investigadores insertaron el gen en cuestión en los machos de las especie de montaña y esta simple manipulación convirtió a los que tenían que haber sido Giacomo Casanova en Diego Marcilla. Un indicio de que lo que pensamos que es elección propia de esa persona ideal(izada), esto es, la monogamia total o la poligamia como monogamia en serie, no sería más que predisposición genética.

Loco de amor

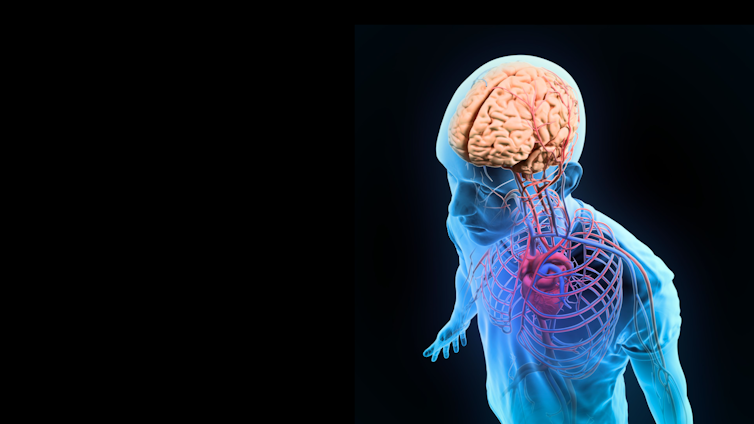

Pero si el enamoramiento es, como decimos, una enajenación mental transitoria, toda la influencia genética tendrá su correlato en el encéfalo. Veamos qué encontramos.

Un grupo de investigadores se dispuso a descubrir cuáles eran las manifestaciones neurológicas de los primeros estadios del amor romántico. Básicamente, lo que querían descubrir era si el enamoramiento es una emoción fundamental como el miedo o si está producida por bucles de retroalimentación del sistema de recompensa del encéfalo de la misma forma que funciona la adicción a la cocaína.

Su conclusión es que hay una serie de regiones encefálicas que parecen estar involucradas en los sentimientos románticos. Específicamente registraron la activación del mesencéfalo ventral derecho, alrededor del área tegmental ventral y el cuerpo dorsal y la cola del núcleo caudado. Todas estas regiones no están relacionadas con instintos y emociones primitivos como el miedo, sino que están ligadas al sistema de recompensa que hace que nos volvamos adictos a las drogas.

Cuando ponemos estos resultados en contexto se llega a la conclusión de que el enamoramiento es fundamentalmente un sistema de recompensa, que conduce a varias emociones, más que una emoción específica. Es muy característico que no se pueda ligar una expresión facial de forma inequívoca a estar enamorado. Además las primeras etapas del enamoramiento, cuando este es más intenso, difieren tanto de la atracción sexual como del desarrollo del afecto característicos de las fases posteriores de la relación, que activan áreas diferentes del encéfalo.

¿Y qué pasa si la cosa sale mal? ¿Y si no eres correspondido o te abandonan?

Cuando se mira una foto de alguien que te acaba de abandonar suceden muchas cosas en el encéfalo, incluyendo la activación de regiones habitualmente asociadas al dolor físico, a comportamientos compulsivos-obsesivos, al control de la ira y áreas que se activan cuando elucubramos sobre lo que otro está pensando. No solo eso, en vez de desactivarse las acciones del amor romántico, parece como si se activaran aún más: el enamoramiento se exacerba por el rechazo.

Moléculas enamoradas

Muchas veces se suele hablar de que el enamoramiento es química. Efectivamente, muchas de los circuitos involucrados en el amor romántico incluyen a una hormona que también es un neurotransmisor, la dopamina. Pero este no es el único compuesto involucrado en el enamoramiento.

Al igual que los pacientes con comportamientos obsesivos-compulsivos los enamorados presentan unos niveles anormalmente bajos de serotonina en sangre, lo que se correlaciona bastante bien con la obsesión con el objeto del enamoramiento.

También se han detectado cambios en los niveles de cortisol, hormona estimulante del folículo y testosterona. Algunos de estos cambios dependen del sexo del sujeto. Por ejemplo, la testosterona aumenta en las mujeres enamoradas y disminuye en los varones. Pero lo mejor viene cuando los enamorados que se han jurado amor eterno vuelven a medir sus niveles hormonales 12 meses después, aunque la relación se mantenga: las diferencias hormonales han desaparecido completamente. Esto es, desde el punto de vista endocrino, una pareja que sobrevive a la fase de enamoramiento (recordemos que es una enajenación mental transitoria) lo hace en base a fundamentos bioquímicos diferentes: después de doce meses la química desaparece, solo para ser sustituida por otra, en la que por ejemplo, interviene la oxitocina.

Quevedo etólogo

Vemos pues que el elegir a un solo objeto de nuestra obsesión amorosa tiene una base genética, neurológica y fundamentalmente química y que todo ello se manifiesta en un comportamiento similar al del adicto a una droga.

Prueba ahora a leer el soneto del inicio pensando que está dedicado a una droga de abuso o al objeto de una adicción en general. Apreciarás mucho mejor el genio de Quevedo y advertirás, quizás, que un comentario literario estándar puede quedarse muy corto.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este texto se publicó en Experientia docet el 1 de febrero de 2013.

El artículo El enamoramiento como droga de abuso se ha escrito en Cuaderno de Cultura Científica.

Eletanolamina en el espacio y el origen de la vida

José Mora Perujo y Delphine Pott

El centro de la Vía Láctea capturado por el telescopio Spitzer Space de la NASA.

El centro de la Vía Láctea capturado por el telescopio Spitzer Space de la NASA.NASA/JPL-Caltech/S. Stolovy (Spitzer Science Center/Caltech)

Si hay una pregunta que estremece a la mayoría de las personas es el origen de la vida. Múltiples teorías se han enfrentado a esta pregunta dando respuestas plausibles y, en varios casos, se ha planteado la posibilidad de que nuestra vida no sea única en el vasto universo.

Etanolamina en la Vía Láctea

Mediante el uso de radiotelescopios podemos descubrir moléculas en zonas lejanas del universo. Cualquier onda puede interactuar con átomos y moléculas para provocar en ellos ciertos cambios, dependiendo de la energía de la onda en cuestión.

Estos cambios pueden observarse y jugar a quién es quién hasta dar con la molécula elegida. Un pequeño ejemplo: si alguien nos empuja, dependiendo de la fuerza con la que lo haga, reaccionaremos de una forma u otra. Pues una cosa parecida pasa con las moléculas, solo que el empujón es la onda y la reacción es lo que estos radiotelescopios captan.

El grupo de Víctor M. Rivilla han usado los radiotelescopios IRAM de Pico Veleta (Granada) y del Observatorio de Yebes (Guadalajara). Esto les ha servido para encontrar etanolamina en una nube de moléculas llamada G+0.693-0.027, cerca del centro de nuestra galaxia, la Vía Láctea.

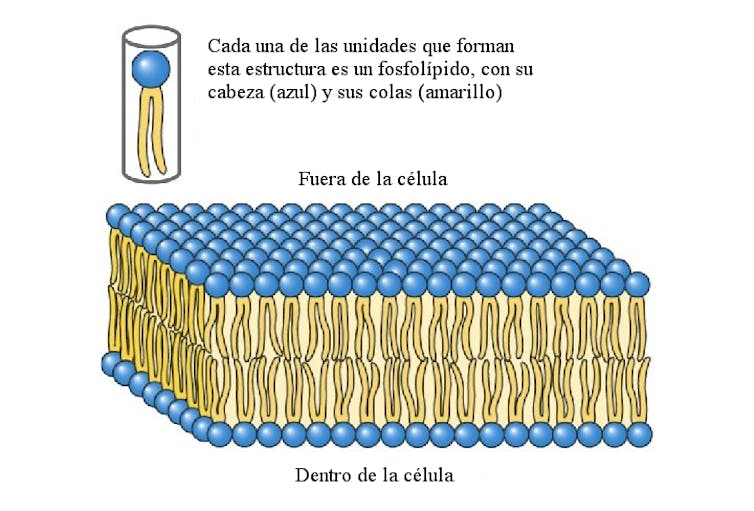

¿Qué es la etanolamina?

Esta simpática molécula es realmente simple y ahí radica parte de su belleza. La etanolamina no es más que etanol (2 carbonos, 1 oxígeno y 6 hidrógenos) y una amina (1 nitrógeno y 2 hidrógenos) unidos. Esto hace una molécula de fórmula C₂H₇NO, cuya importancia es debida a la presencia de nitrógeno y oxígeno: es polar.

Que una molécula sea polar significa que, dentro de la misma, los electrones no se sienten atraídos de igual forma por unos núcleos de átomos que por otros. Respecto a lo que atañe a la vida es mucho más fácil: las sustancias polares se llevan bien con el agua, nuestro disolvente universal y la base de nuestra vida.

Importancia biológica de la etanolamina

Esta molécula no se presenta sola en los seres vivos, normalmente está unida a otros tipos de biomoléculas. Su pareja perfecta son los ácidos grasos, pero para unirse con ellos necesita de otra molécula: el glicerol-3-fosfato.

Digamos que esta molécula es como una especie de puente entre la etanolamina y los ácidos grasos. Esta unión (etanolamina, glicerol-3-fosfato y ácidos grasos) da lugar a un grupo de moléculas llamadas fosfolípidos muy particulares, tanto que estos compuestos son esenciales para la vida tal y como la conocemos.

Los ácidos grasos, como el aceite, son moléculas largas no polares (apolares). Por tanto, no se llevan bien con el agua (a fin de cuentas, el agua y el aceite no se mezclan).

Entonces, en el caso de los fosfolípidos tenemos una situación muy especial: los ácidos grasos no se mezclan con el agua, como hemos dicho, pero la etanolamina sí. Esto hace que nos podamos imaginar los fosfolípidos como moléculas que tienen una cabeza que interactúa con el agua y unas colitas que huyen de ella.

Estructura de los fosfolípidos y su agrupación en membranas lipídicas.

Estructura de los fosfolípidos y su agrupación en membranas lipídicas.Modificado de Principios de Bioquímica, Lehninger, 5ª Edición. W. H. Freeman and Company

El fenómeno interesante es que las cabezas se alinean y las colas también (como en la imagen). Esto no es ni más ni menos que una membrana, el principio de una célula. Esta membrana es una especie de cercado que delimita la célula. Por tanto, sin etanolamina no habría fosfolípidos y, sin ellos, no habría células y, por tanto, vida.

¿Acaso no es de vital importancia la etanolamina?

El origen de la etanolamina

En muchos casos se especula con la posibilidad de que, antes de que existiese la vida, las moléculas necesarias para el origen de la misma podrían haber llegado a la Tierra transportadas en meteoritos. Estos meteoritos impactarían en nuestro planeta y dejarían esas moléculas libres para que se combinasen con otras e ir construyendo paso a paso la vida que conocemos.

En el caso de la etanolamina, los autores de este estudio creen que mil billones de litros de esta podrían haber llegado a la Tierra en meteoritos. Por tanto, la etanolamina en la Tierra fue extraterrestre hace millones de años y, gracias a este hecho, estaba disponible para formar nuevas moléculas.

Una vez más, como nos hacía pensar Carl Sagan, somos hijos de las estrellas y del universo. Una parte de nosotros proviene de fuera de la Tierra, de lugares que todavía desconocemos.

Entender el cómo se forman estas semillas de vida en el espacio es clave para entender el origen de la vida, como dice Rivilla. Este pensamiento nos siembra la duda de si estamos solos en el universo, si somos la única vida que existe. Esta idea ha sido explorada varias veces por el investigador Carlos Briones. Concretamente, en esta entrevista habla sobre la posibilidad de encontrar vida fuera en el espacio:

Quizás haya que empezar a pensar en la posibilidad que dice Briones: “A lo mejor el Cosmos está lleno de vida”. Puede que, en parte, sea debido a estas moléculas presentes por todo el universo.![]()

Sobre los autores: José Mora Perujo es investigador predoctoral y Delphine Pott investigadora postdoctoral en el departamento de Biología Molecular y Bioquímica de la Universidad de Málaga

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Eletanolamina en el espacio y el origen de la vida se ha escrito en Cuaderno de Cultura Científica.

El cuarto ángel

Tocó el cuarto ángel… Entonces fue herida la tercera parte del sol, la tercera parte de la luna y la tercera parte de las estrellas; quedó en sombra la tercera parte de ellos; el día perdió una tercera parte de su claridad y lo mismo la noche.

Juan de Patmos (siglo I e.c.) Apocalipsis 8: 12.

La gente abandona las ciudades (detalle) (2010) de Zbigniew Libera. Fuente: Muzeum Sztuki Nowoczesnej w Warszawie

La gente abandona las ciudades (detalle) (2010) de Zbigniew Libera. Fuente: Muzeum Sztuki Nowoczesnej w WarszawieNormalmente pensamos en el colapso o extinción de la humanidad asociándola a catástrofes de origen natural, como las que ocurren tras los toques del segundo (supervolcanes) o del tercer ángel (asteroides o cometas), o también por las de origen antropogénico, como las que anuncian el primer ángel (catástrofe ambiental) o el sexto (guerra nuclear). Sin embargo, también son concebibles colapsos por razones sociales. No conllevarían la extinción humana pero sí la imposibilidad de optar por futuros alternativos, que es otra forma de agotamiento del potencial de desarrollo y progreso del ser humano. No me refiero a progreso material, aunque, muy probablemente, la parálisis intelectual lo anularía. Ciertas distopías, de las que no nos podríamos recuperar, nos abocarían a esa forma de colapso.

La sociedad que describe George Orwell en su novela 1984 sería una de ellas. Bajo determinadas circunstancias, quizás facilitadas por la inacción de una mayoría de seres humanos, un poder totalitario podría llegar a ejercer un control absoluto del destino de la humanidad. A partir del momento en que eso ocurriese, dejaríamos de tener el más mínimo control o capacidad de incidir sobre nuestro futuro. La humanidad quedaría abocada a un porvenir sin margen alguno para optar por diferentes alternativas. Sería una distopía generada por la fuerza del poder totalitario.

Otra forma de distopía podría surgir debido a la acción de fuerzas sociales alimentadas por decisiones individuales o grupales bajo el efecto de ciertos incentivos, pero que conducirían a un nuevo equilibrio indeseado para el conjunto de la humanidad. La forma más fácilmente concebible de esta modalidad de humanidad distópica es la que podría resultar de un proceso conducente a una tragedia de los bienes comunes de ámbito mundial o casi mundial.

La tragedia de los bienes comunes -o comunales- se produce cuando un conjunto de individuos -pueden ser los vecinos de una comunidad, los nacionales de un país o gran parte de los habitantes del mundo- que actúan de forma racional e independiente, destruyen un recurso común (los bienes comunales), aunque tal destrucción no interese a ninguno de esos individuos. El bien común puede ser material (una fuente, los pastos, el suelo del portal o las pesquerías del mundo) o inmaterial (la democracia, un sistema educativo, o la paz entre las naciones). De un modo similar, ciertos procesos automáticos o semiautomáticos podrían conducir a sociedades cerradas y, eventualmente, a una humanidad sin alternativas. Se trataría de una distopía provocada por acciones individuales y grupales voluntarias, pero cuyo resultado no sería deseado por quienes, con sus decisiones, la habrían propiciado.

Estarían, por último, las distopías deseadas. Serían, por ejemplo, las provocadas por sistemas ideológicos -políticos o religiosos- que serían asumidos con carácter universal, aun cuando condujesen a una humanidad cerrada, que ha decidido autolimitar su potencial hasta perder el control sobre su propio destino. Ejemplos de esta variedad de humanidad distópica serían, por ejemplo, la que renuncia al desarrollo científico o tecnológico, la que no reconoce bienes o males morales con resultados dañinos para ciertos grupos, o la que profesa un credo religioso único y obligatorio para todos. También lo sería la que describió Ray Bradbury en Fahrenheit 451, una sociedad que ha decidido prescindir de los libros. En ella el día, como la noche, habrían perdido, al menos, la tercera parte de su claridad.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El cuarto ángel se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2021: Oskar Gonzalez – No venderás cuadros a los nazis

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

Un juicio por alta traición termina desvelando uno de los grandes engaños de la historia del arte. Oskar Gonzalez nos cuenta el papel pionero de la ciencia en la constatación de la falsedad de la que pasaba por ser la gran obra maestra de Vermeer.

El propio Oskar escribió sobre esta historia en su sección del Cuaderno, kimikArte: El pintor que engañó a los nazis, pero no a la química

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Oskar Gonzalez – No venderás cuadros a los nazis se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2021: Oskar Gonzalez – No venderás cuadros a los nazis

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

Un juicio por alta traición termina desvelando uno de los grandes engaños de la historia del arte. Oskar Gonzalez nos cuenta el papel pionero de la ciencia en la constatación de la falsedad de la que pasaba por ser la gran obra maestra de Vermeer.

El propio Oskar escribió sobre esta historia en su sección del Cuaderno, kimikArte: El pintor que engañó a los nazis, pero no a la química

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Oskar Gonzalez – No venderás cuadros a los nazis se ha escrito en Cuaderno de Cultura Científica.

Un termómetro óptico para entornos industriales extremos

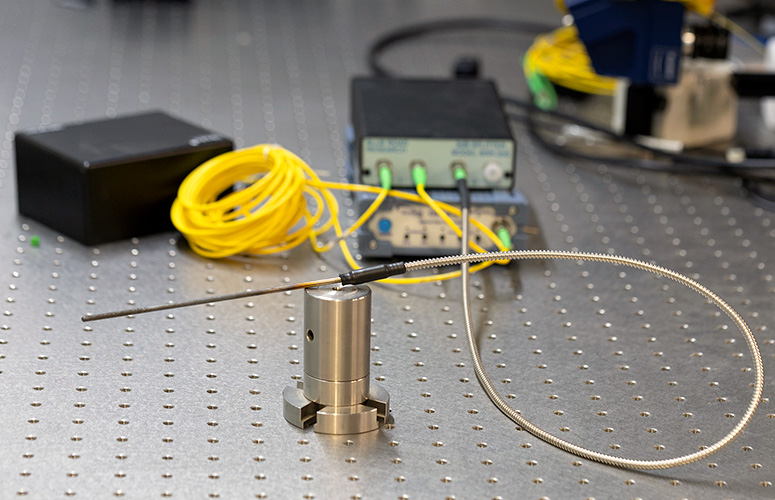

El grupo de investigación Applied Photonics Group de la UPV/EHU ha desarrollado un termómetro óptico para el sector industrial basado en una fibra óptica capaz de medir la temperatura en un amplio rango térmico con una alta sensibilidad sin interacción con el entorno.

La temperatura siempre ha sido una variable muy importante en muchos sectores industriales. Ciertas aplicaciones industriales requieren además una alta sensibilidad ya que existen procesos críticos en los que la medición precisa de la temperatura en tiempo real es esencial para la calidad del producto o para evitar accidentes o averías. Además, habitualmente, los entornos en los que se llevan a cabo estas mediciones provocan que los dispositivos estén sometidos a altos niveles de estrés que pueden reducir su vida útil. Así, por ejemplo, las altas temperaturas en el interior de las turbinas de los motores de aviación; la producción de productos petroquímicos, muchos de ellos inflamables o directamente explosivos, que hay mantener dentro de estrictos rangos de temperatura; o la industria alimentaria donde algunos productos deben conservarse a temperaturas bajo cero.

Existe pues una demanda de termómetros altamente sensibles y robustos capaces de operar en amplios rangos térmicos. Hoy en día, los termómetros electrónicos son los dispositivos más extendidos para la detección de la temperatura en la industria. Entre ellos, los termopares son una tecnología fiable y barata. Pero pueden no ser los mejores candidatos cuando hay que utilizarlos en entornos con gases inflamables, por ejemplo, porque pueden interactuar de forma indeseada con esos gases. En las últimas décadas han aparecido varios sensores basados en fibra óptica como alternativa para superar dicha limitación gracias a su pasividad y su sensibilidad intrínseca a la temperatura.

Por ello, “en este trabajo hemos desarrollado un termómetro basado en una fibra óptica muy especial capaz de soportar condiciones de trabajo extremadamente exigentes. Se trata de la fibra óptica multinúcleo que obtenemos gracias a un acuerdo de colaboración con la Universidad Central de Florida. La fibra óptica común, por ejemplo, es la fibra que nos llega a casa. Se trata de una carretera convencional con un solo carril por sentido de marcha. La fibra óptica multinúcleo sería equivalente a una autopista en la que hay múltiples carriles en cada sentido por los que puede ir la luz. De ahí que las propiedades tanto de transferencia de datos como de cantidad de luz que puede transmitirse se multiplican”, explica Josu Amorebieta investigador del grupo de investigación Applied Photonics Group de la UPV/EHU.

“Para desarrollar el termómetro hemos analizado teóricamente y en detalle cómo afecta la temperatura a las fibras multinúcleo para predecir de esta forma la geometría más sensible a la temperatura. El diseño del termómetro le permite funcionar en un amplio rango térmico (desde los -25 hasta los 900 grados Celsius) y su construcción es lo suficientemente compacta y robusta como para soportar entornos adversos”, añade Josu Amorebieta.

Según el personal investigador del grupo Applied Photonics Group de la UPV/EHU, “los resultados sugieren que el nuevo termómetro óptico es tan preciso como cualquier termómetro electrónico con la ventaja de ser inerte, compacto y fácil de fabricar”. Este prototipo es un importante paso en el camino hacia los termómetros ópticos comercialmente viables.

Referencia:

Josu Amorebieta, Angel Ortega-Gomez, Rubén Fernández, Enrique Antonio-Lopez, Axel Schülzgen, Joseba Zubia, Amezcua-Correa, Gaizka Durana & Joel Villatoro (2021) Sensitivity-optimized strongly coupled multicore fiber-based thermometer Optics and Laser Technology DOI: 10.1016/j.optlastec.2021.107532

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un termómetro óptico para entornos industriales extremos se ha escrito en Cuaderno de Cultura Científica.

En las entrañas de nuestro planeta

En 1864 Julio Verne publicó su novela “Viaje al centro de la Tierra”, en la que imaginaba nuestro planeta como una especie de queso gruyère en donde era posible encontrar pasadizos que nos conducían, directamente, al interior hueco de nuestro planeta. Sin embargo, y gracias a siglo y medio de avances en las técnicas de estudio geológicas, hoy sabemos que esta fantástica idea no era muy acertada.

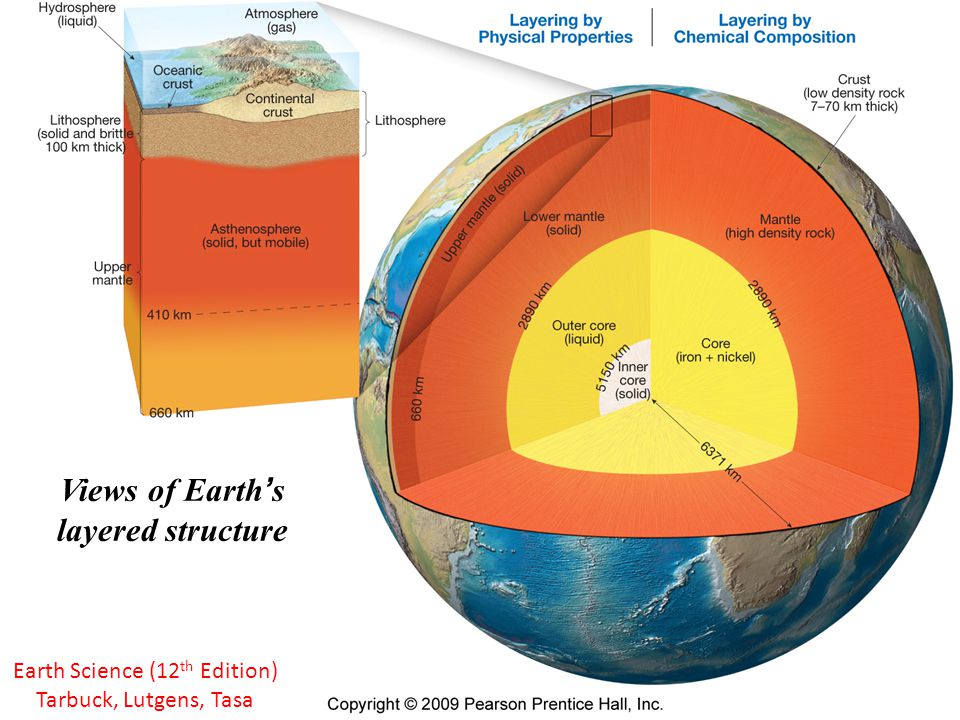

Aunque solemos representar a la Tierra como una esfera casi perfecta, en realidad, debido a la rotación que realiza sobre sí misma, se asemeja más a un elipsoide de revolución que se encuentra parcialmente achatado por los polos, por lo que tiene un diámetro máximo de 12.756 km y un diámetro mínimo de 12.714 km, con un radio promedio de unos 6370 km. Y en cuanto a su estructura interna, que es el tema que nos ocupa hoy, podríamos definir nuestro planeta como una cebolla, ya que está formado por diversas capas concéntricas superpuestas una encima de la otra. Pero a la hora de nombrar y describir cada una de esas capas, nos encontramos con dos divisiones diferentes de acuerdo a qué propiedades físicas de los materiales queramos hacer alusión.

Divisiones internas de la Tierra de acuerdo a la composición química y a las propiedades físicas de los materiales. Autoría: Tarbuck, E.J., Lutgens, F.K. y Tasa, D.G. (2009). Earth Science, 12th Edition. Ed. Pearson Prentice Hall, Estados Unidos. Fair use.

Divisiones internas de la Tierra de acuerdo a la composición química y a las propiedades físicas de los materiales. Autoría: Tarbuck, E.J., Lutgens, F.K. y Tasa, D.G. (2009). Earth Science, 12th Edition. Ed. Pearson Prentice Hall, Estados Unidos. Fair use.La primera división interna que hacemos de nuestro planeta responde a la composición química de los materiales que lo conforman, que tiene que ver directamente con la densidad de los elementos químicos. Cuando nuestro planeta estaba comenzando a formarse, los elementos más densos, es decir, los más pesados, se quedaron en el interior de la Tierra, mientras que los menos densos y, por tanto, más ligeros, migraron hacia la parte más externa. Por este motivo, tenemos composiciones químicas diferentes según aumentamos en profundidad, lo que nos permite definir tres grandes capas en nuestro planeta:

La corteza, que es la capa más externa o superficial de la Tierra y está formada principalmente por silicatos de aluminio y magnesio. Podemos dividirla en corteza oceánica, que se encuentra por debajo de la columna de agua de los océanos y tiene un espesor de entre 7 y 12 km, y corteza continental, que posee un espesor promedio de unos 30 km, aunque llega hasta profundidades de 70 km por debajo de las grandes cordilleras, como el Himalaya. Al límite inferior de la corteza, cuya profundidad oscila entre los 7 y los 70 km, se le denomina discontinuidad de Mohorovicic, o “la Moho”, como la conocemos de manera cariñosa en geología.

Justo por debajo de la corteza y hasta los 2900 km de profundidad nos encontramos con el manto, que está compuesto mayoritariamente por silicatos de hierro y magnesio. También aquí podemos hacer una diferenciación en dos partes, el manto superior y el manto inferior, cuyo límite se encuentra aproximadamente a 660 km de profundidad y se conoce como discontinuidad de Repetti.

Finalmente tenemos el núcleo, formado por hierro y níquel y que está separado del manto por la discontinuidad de Gutenberg. El núcleo también se divide en dos subcapas, el núcleo externo y el núcleo interno, cuyo límite aparece a unos 5150 km de profundidad en la discontinuidad de Lehmann.

La otra división que hacemos de la estructura interna de nuestro planeta se corresponde con las propiedades mecánicas de los materiales que lo componen. En este caso, los principales parámetros físicos a tener en cuenta son la presión y la temperatura. Resulta que, según aumentamos en profundidad hacia el interior de la Tierra, tanto la presión como la temperatura son cada vez más altas, por lo que la acción combinada de ambos parámetros físicos provoca un cambio en el comportamiento mecánico de los materiales que nos vamos encontrando. De esta manera, se puede subdividir nuestro planeta en cuatro capas:

La litosfera, que es la capa sólida y rígida exterior y abarca toda la corteza y parte del manto superior. También se divide en litosfera oceánica y litosfera continental, por lo que su espesor oscila entre los 70 km y los 150 km.

A continuación tenemos la astenosfera, que es un semisólido plástico y viscoso que comprende el resto del manto superior.

Por debajo aparece la mesosfera, algo más sólida que la astenosfera pero cuyos materiales mantienen un comportamiento plástico. Se corresponde con el manto inferior.

Y, por último, encontramos la endosfera, en la que podemos diferenciar el núcleo externo que es líquido y el núcleo interno que es sólido.

De esta manera, utilizaremos una nomenclatura u otra para las capas internas de la Tierra dependiendo de a qué propiedades de los materiales nos queramos referir. Si hacemos alusión a la composición química, usaremos los términos corteza, manto y núcleo para dividir nuestro planeta. Sin embargo, si queremos referirnos al comportamiento mecánico, emplearemos los conceptos de litosfera, astenosfera, mesosfera y endosfera. Incluso, podemos mezclar ambas divisiones y usar términos compuestos tales como manto astenosférico si queremos reseñar tanto la composición como las propiedades mecánicas de los materiales. Pero recordad que estos términos ni son sinónimos ni son intercambiables, por lo que no es lo mismo hablar de la corteza que hablar de la litosfera.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo En las entrañas de nuestro planeta se ha escrito en Cuaderno de Cultura Científica.

Tomás Rodríguez Bachiller: matemático, ingeniero y traductor de textos científicos

En su habitual sonrisa, aparentemente ingenua, casi infantil, destellaba, en efecto, suavemente, esa lumbre de benévola ironía que hemos visto lucir en otras nobles y selectas personalidades, y que revela, junto a ese fondo de milenario saber humano que no se hace ilusiones, la más amplia y exquisita tolerancia.

Fragmento de la necrológica de Tomás Rodríguez Bachiller por Antonio Rodríguez Huéscar, El País, 30/10/1980

Tomás Rodríguez Bachiller. Imagen extraída de la Gaceta de la RSME.

Tomás Rodríguez Bachiller. Imagen extraída de la Gaceta de la RSME.

Tomás Rodríguez Bachiller nació en Hong Kong el 10 de noviembre de 1899. Su padre, Tomás Rodríguez, era vicecónsul de España en la entonces colonia británica. Su madre era Julia Bachiller. Era el tercero de dos hermanas (Julia y Pilar, nacidas del primer matrimonio de su padre) y tres hermanos (él, Ángel y Jesús). Su madre falleció al dar a luz a Jesús.

Estudió en el Instituto Cardenal Cisneros de Madrid, graduándose en 1916. Se matriculó después en la Universidad Central de Madrid: deseaba estudiar matemáticas. Pero su padre pensaba que estos estudios no le proporcionarían una carrera exitosa. Así, en 1918, Rodríguez Bachiller comenzó sus estudios en la Escuela de Ingenieros de Caminos, Canales y Puertos de Madrid, sin abandonar por ello sus estudios de matemáticas. Algunos de sus profesores fueron Luis Octavio de Toledo (1857-1934), Julio Rey Pastor (1888-1962) y José Ruiz Castizo (1857-1929) que le enseñaron Análisis Matemático, y Cecilio Jiménez Rueda (1858-1950), Miguel Vegas (1865-1943) y José Gabriel Álvarez Ude (1876-1958) fueron sus profesores docentes de Geometría. También estudió Mecánica Celeste con José María Plans (1878-1934).

En enero de 1921, Tullio Levi-Civita (1873-1941) visitó Madrid para dictar un curso sobre Mecánica clásica y relativista. Rodríguez Bachiller, que tenía conocimientos de alemán, francés, inglés e italiano, tomó notas durante las lecciones del matemático italiano y las tradujo al castellano, aunque nunca llegaron a publicarse.

En 1923, el físico Albert Einstein (1879-1955) visitó España para impartir una serie de conferencias públicas sobre relatividad. Rodríguez Bachiller fue uno de los invitados a asistir; debía tomar notas y preparar unos resúmenes de las conferencias. En aquel momento había terminado sus estudios de matemáticas, aunque continuaba con los de ingeniería. Los resúmenes preparados por el matemático español se publicaron en el periódico El Debate, con la satisfacción del físico, que le confesó que«en ningún otro país del mundo se había hecho tan bien».

Gracias a una beca de la Facultad de Ciencias de Madrid, Rodríguez Bachiller pasó el curso académico 1923-1924 en Francia. Allí asistió a los cursos de Émile Borel (1871-1956) sobre elasticidad, de Jules Drach (1871-1949) sobre transformaciones de contacto, de Charles Émile Picard (1856-1941) sobre curvas y superficies algebraicas, de Élie Cartan (1869-1951) sobre mecánica de fluidos, de Jacques Hadamard (1865-1963) sobre ecuaciones diferenciales, de Claude Guichard (1861-1924) sobre geometría diferencial y transformaciones de Laplace, de Henri Lebesgue (1875-1941) sobre topología y de Ernest Vessiot (1865-1952) sobre ecuaciones diferenciales parciales y teoría de grupos.

Al regresar a Madrid en 1924, Rodríguez Bachiller dictó el primer curso de topología impartido en España.

En octubre de 1925 fue nombrado profesor ayudante en la Facultad de Ciencias de Madrid. Además, fue un activo colaborador de la Revista de la Sociedad Matemática Española. Su conocimiento de idiomas le permitió revisar varios trabajos de matemáticos europeos, en particular los artículos sobre topología de Maurice Fréchet (1878-1973), las tesis doctorales de Luigi Fantappié (1901-1956) sobre geometría algebraica y de Louis Antoine (1888-1971) sobre topología, o la monografía L’Analysis situs et la Géométrie algébrique de Solomon Lefschetz (1884-1972). También se ocupaba de la correspondencia con matemáticos extranjeros que publicaron en los primeros números de la Revista de la Sociedad Matemática Española, además de traducir algunos de sus artículos a castellano.

En octubre de 1932, Rodríguez Bachiller se convirtió en profesor interino de la Facultad de Ciencias de Madrid al quedar vacante la Cátedra de Ecuaciones Diferenciales. En 1935, tras pasar las pruebas correspondientes, fue nombrado profesor de Teoría de Funciones, aunque al carecer de un doctorado, le informaron de que debía presentar una tesis antes de poder ocupar la Cátedra. Presentó su tesis Axiomática de la dimensión y la defendió el 27 de agosto de 1935, aunque nunca fue publicada.

Al final de la Guerra Civil, debido a su simpatía por el bando republicano, fue tratado con recelo por el régimen franquista y descalificado para ocupar cargos de dirección y confianza. Aunque pudo volver a ocupar su Cátedra en diciembre de 1939.

En 1941 escribió Comentarios sobre álgebra y topología y, al año siguiente, Sulle superficie del quarto ordine contenenti una conica. Fueron sus últimos trabajos de investigación, aunque mantuvo su interés por la topología e impartió docencia sobre esta disciplina en muchas ocasiones.

En 1947 realizó una visita de cinco meses a Estados Unidos gracias a una beca de Junta de Relaciones Culturales del Ministerio de Relaciones Exteriores. En la Universidad de Illinois en Urbana trabajó con Oscar Zariski (1899-1986), y en Princeton con Solomon Lefschetz (1884-1972), Emil Artin (1898-1962) y Claude Chevalley (1909-1984).

En 1954 comenzó una serie de estancias en la Universidad de Puerto Rico, un lugar especial para el matemático ya que allí había nacido su hermano Jesús y estaba enterrada su madre.

En 1969 se retiró, falleciendo con 80 años, el 9 de julio de 1980.

Referencias

-

Luis Español González y María Ángeles Martínez García, Hacia la matemática abstracta: Tomás Rodríguez Bachiller (1899–1980), Gaceta de la Real Sociedad Matemática Española 13 (4) (2010) 769–795

-

J J O’Connor and E F Robertson, Tomás Rodríguez Bachiller, MacTutor History of Mathematics archive, University of St Andrews

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Tomás Rodríguez Bachiller: matemático, ingeniero y traductor de textos científicos se ha escrito en Cuaderno de Cultura Científica.

Alfred Werner, químico hasta la extenuación

Imagen oficial de Werner que se conserva en la Biblioteca del Politécnico de Zúrich (ETH Zürich)

Imagen oficial de Werner que se conserva en la Biblioteca del Politécnico de Zúrich (ETH Zürich)Alfred Werner nació en 1866 en uno de esos lugares marcados por la guerra en la vieja Europa, una de esas ciudades en la frontera entre imperios que cambiaba de manos según soplase el viento. Mulhouse tenía tendencia a ser francesa, la mayoría de sus habitantes se sentían franceses, a pesar de que sus apellidos eran una mezcolanza de prusianos y galos. Siendo Alfred niño, la guerra franco-prusiana de 1870 hizo que la ciudad cambiase de nuevo de manos, siendo anexada al recién formado Reich Alemán diseñado por Otto von Bismarck para mayor gloria del káiser Wilhelm.

Muchos ciudadanos con lazos franceses abandonaron la ciudad, no así los padres de Alfred, que prefirieron quedarse y resistir, hablando francés en casa aunque estuviese expresamente prohibido. Ya adulto, Alfred recordaría cómo disparaba su fusil de juguete contra los soldados alemanes y su mesa de despacho en Zúrich estaba presidida por un trozo de bomba que recogió cerca de su casa siendo niño.

Alfred no fue precisamente un alumno ejemplar y, como precaución, solía llevar trozos de cartón dentro de sus pantalones con la idea de aliviar el castigo físico que suponía saltarse clases. Los biógrafos de Werner hablan de rebeldía frente a la extrema rigidez del sistema de enseñanza alemán, la misma que años después mostraría Einstein. Sin embargo, Alfred era muy experimental a la par que teórico: sus escapadas las empleaba en hacer experimentos químicos detrás de un granero cercano y está documentada al menos una explosión en su habitación.

Entre 1885 y 1886 Alfred tuvo que hacer el servicio militar en Karlsruhe, donde aprovechó para asistir a las conferencias que Engler daba en el Politécnico local. En 1886 toma la decisión de alejarse de conflictos y se matricula en el Politécnico de Zúrich. En 1889 se diploma en química técnica y, a pesar de suspender varios exámenes de matemáticas en su primer intento, consigue su doctorado en 1892, tras una estancia de casi dos años en París, con una tesis sobre la disposición espacial de moléculas que contienen nitrógeno, con Arthur Hanztsch como director y Marcellin Berthelot como codirector. Al igual que Einstein, si bien realizó su trabajo en el Politécnico el doctorado se lo otorgó la Universidad de Zúrich.

Los años 1892 y 1893 fueron de subsistencia para Alfred, trabajando como privat dozent, profesor sin sueldo (lo que sus alumnos le pagasen), en la Universidad de Zúrich. En 1893 se convirtió e profesor asociado de la Universidad con un modesto salario, sucediendo a Victor Merz como profesor de química orgánica. En 1895 adquiriría la nacionalidad suiza y, a pesar de tener ofertas de Viena, Basilea o Wurzburg, decide quedarse en la Universidad de Zúrich aceptando la plaza de catedrático con sólo 29 años. Pero, ¿qué había hecho Alfred en este tiempo para escalar así de rápido?

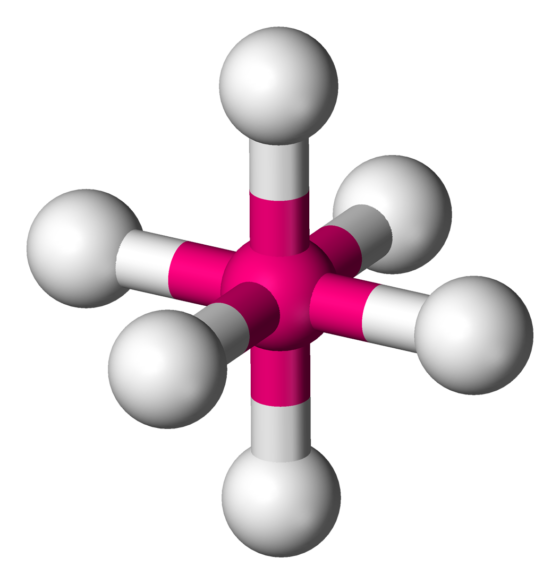

Alfred hizo su primera investigación química independiente con 18 años y su interés siempre había estado en la frontera entre la química orgánica y la inorgánica, alrededor del problema de la valencia y la estructura de los compuestos químicos. Un par de años después de su doctorado, obsesionado como estaba con el problema, cuenta la leyenda que una noche se despertó sobresaltado a las dos de la madrugada, saltó de la cama y se puso a escribir. A las cinco había terminado “Contribución a la constitución de los compuestos inorgánicos”, el artículo que sentaba las bases de la teoría actualmente aceptada sobre los compuestos de coordinación, también llamados complejos.

Alfred proponía flexibilizar las ideas de Kekulé, de una valencia rígida en una dirección, a una esfera de fuerza con el centro en el átomo. Sugería la existencia de un número de coordinación, que sería el número de ligandos que un determinado átomo metálico buscaría adquirir. Estas ideas eran controvertidas pero lo suficientemente interesantes como para asegurarle un puesto en la universidad.

Con el futuro asegurado, se dejó barba y bigote para intentar conseguir un poco de respeto por parte de los alumnos y colegas, se casó con una chica suiza y se dispuso a fundar una familia y a probar su teoría. La familia estuvo completa 8 años después. Probar la teoría le costaría 20 años de trabajo incansable.

La rutina era siempre la misma: sugería una estructura para un compuesto y predecía sus propiedades a partir de ella. Después una laboriosísima serie de síntesis muy meticulosas hasta conseguir el compuesto. Finalmente caracterizar el compuesto, asegurarse de que era el que se quería obtener y comprobar que sus propiedades correspondían a las predichas. Por ejemplo, proponía que los compuestos octaédricos tenían átomos en posiciones fijas alrededor de un centro, lo que significaba que tenían quiralidad y, por tanto, podían rotar la luz polarizada. Si se encontraban los compuestos mediante síntesis, su actividad óptica vendría a confirmar las ideas de Alfred.

En química, se llama geometría molecular octaédrica a la forma de los compuestos en los que seis ligandos (átomos, moléculas o iones) se disponen alrededor de un átomo o ion central, definiendo los vértices de un octaedro.

En química, se llama geometría molecular octaédrica a la forma de los compuestos en los que seis ligandos (átomos, moléculas o iones) se disponen alrededor de un átomo o ion central, definiendo los vértices de un octaedro.A diferencia de los compuestos que usó Pasteur, las moléculas ópticamente activas de Alfred no formaban cristales que se pudiesen separar con pinzas. Empleó 18 años en perfeccionar el método para conseguir separarlas con la ayuda inestimable de su alumno de doctorado Victor King.

Pero siempre hay críticos, y eso no es necesariamente malo. Se pensaba que la quiralidad era algo propio de los átomos de carbono y, como en los compuestos de Alfred había carbono, sugerían que la actividad óptica era consecuencia de la presencia de estos. En 1914, un año después de recibir el Nobel por sus logros, con la ayuda de otra estudiante de doctorado, Sophie Matissen, Alfred consiguió preparar un compuesto ópticamente activo en el que solo había nitrógeno, hidrógeno y oxígeno, despojando al carbono de sus derechos exclusivos en lo que a quiralidad se refiere.

Werner, maestro

Todos los avances químicos de Alfred Werner están disponibles en múltiples recursos en la red (por ejemplo). Sin embargo, en pocos lugares encontraréis su otra gran contribución a la ciencia. Su labor como enseñante y director de personas, en lo que fue un avanzado a su tiempo.

Alfred era un orador magnífico y profesor vocacional. El aula en el que daba clases Alfred solía contener de forma rutinaria del orden del doble de personas de las que se suponía que era su capacidad: se sentaban en los pasillos, se aglomeraban alrededor del banco de demostraciones. En verano había desmayos y los rectores de la institución mostraban su preocupación por los riesgos de incendio o explosión. Un chascarrillo de la época era “¿cuándo ocupa un estudiante de química el volumen mínimo? En una clase de Nunwiegeht’s”. Ni que decir tiene que Nunwiegeht’s era uno de los motes de Alfred, por su costumbre de saludar con un ¿cómo te va?.

Alfred dirigió más de 200 tesis doctorales y, siendo la Universidad de Zúrich pionera en admitir mujeres para el doctorado, él fue pionero en admitirlas en ciencia, aplicando una meritocracia estricta. Buena parte de sus más 200 tesis dirigidas fueron escritas por mujeres. No es de extrañar que personas de toda Europa y Estados Unidos fuesen a Zúrich a estudiar con él.

El laboratorio de Alfred en Zúrich era extraoficialmente conocido como “las catacumbas”, celdas semisubterráneas donde siempre era necesaria la iluminación artificial. Según una revista humorística de la universidad, una muestra del aire de las catacumbas contenía de forma típica “un 50% de ácidos evaporados, 30% de olores nauseabundos de preparados, 10% de humo de cigarrillo, 5% de alcohol y 5% de gas de iluminación mal quemado, lo suficiente para enviar al más resistente de los individuos al gran más allá”. La universidad, consciente de la necesidad de un nuevo edificio para albergar los laboratorios, lo acabó concediendo, con lo que Alfred trabajó incansablemente en su diseño y construcción mientras seguía dirigiendo elementos fundamentales de su investigación. Alfred empezó a dormir muchos días en su despacho de la universidad y a buscar en el alcohol una manera rápida de relajarse.

El precio que Alfred pagó fue muy alto. El estrés, el exceso de trabajo, su consumo excesivo de tabaco y alcohol le llevaron al colapso nervioso. No mucho después de recibir su nuevo edificio fue obligado a dimitir.

Alfred Werner murió en un hospital psiquiátrico de Zúrich poco después de cumplir los 53 años.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Alfred Werner, químico hasta la extenuación se ha escrito en Cuaderno de Cultura Científica.

¿Por qué la carne de los atunes es roja y la de los lenguados, blanca?

Cola de atún y cabeza de lenguado.

Cola de atún y cabeza de lenguado.Shutterstock / Natasha Breen

El color de los atunes tiene importancia económica: existen casos de fraude en los que se enrojece la carne de ejemplares de otras especies para hacerlas pasar por atún rojo (Thunnus thynnus) o para que las piezas parezcan frescas y no deterioradas por una conservación deficiente. Pero ¿por qué la carne de estos animales es roja?

El color de la carne de los túnidos (género Thunnus) varía entre especies, pero tiende a ser más oscuro que el del resto de peces. Por un lado, es una carne con un alto contenido en mioglobina, un pigmento que se encuentra en las células musculares de muchos vertebrados y que hace las veces de depósito celular de oxígeno para cuando se necesita.

Por otro lado, es una musculatura con alta densidad de vasos sanguíneos, en especial la del atún rojo. Como norma general, cuando un animal tiene músculos muy irrigados es que es muy activo. Así son los atunes, fuertes, capaces de nadar a velocidades asombrosas y hacerlo de forma sostenida. Recorren por ello grandes distancias. Además, la sangre de los túnidos –la del atún rojo en especial– tiene un contenido muy alto en hemoglobina.

La razón de todos estos rasgos –alto contenido muscular de mioglobina, musculatura muy irrigada, alto contenido de hemoglobina en la sangre– es que la gran actividad que desarrollan exige un suministro permanente e intenso de nutrientes y, sobre todo, de oxígeno. Lo cierto es que la musculatura de los atunes alcanza prestaciones metabólicas difícilmente superables.

Pero hay más. Hay una zona en el tronco de los túnidos que es más oscura, tiene más vasos sanguíneos y una consistencia casi esponjosa. De hecho, los atunes pierden mucha sangre por esa zona cuando sufren un corte. Esa zona oscura, sanguinolenta incluso, es lo que se conoce como rete mirabile.

La red maravillosa —su nombre en español– es un dispositivo que permite que la sangre (arterial) fría procedente de las branquias se caliente antes de llegar a los músculos. Recibe el calor de la sangre (venosa) procedente de la musculatura, donde se ha calentado por efecto del metabolismo. Ese intercambio de calor se produce entre vasos sanguíneos dispuestos en íntima proximidad unos con otros, pero en cuyo interior la sangre circula en sentidos opuestos. Esa forma de circular –contracorriente– permite una transferencia óptima de calor entre los dos subsistemas circulatorios. Es un ejemplo fisiológico de lo que se denomina un “intercambiador contracorriente”. En el mundo animal no son raros intercambiadores así, de calor, de gases o de iones.

Nosotros utilizamos intercambiadores contracorriente –no biológicos, por supuesto– para termostatizar instalaciones, por su gran eficiencia. Aunque hay ingenieros que creen que son una creación de la mente humana, en realidad fueron diseñados por la naturaleza hace millones de años, gracias a la selección natural.

Así pues, el calor generado por la potente actividad muscular de los atunes no se pierde por las branquias cuando la sangre llega a ellas. Se ha transferido a la sangre arterial. Se podría decir que ha quedado preso en una jaula fisiológica. Y gracias a ello, el interior de los atunes –parte de su musculatura, los ojos y el encéfalo– se encuentra, en aguas frías, hasta diez grados más caliente que el agua en que nadan. Desarrollan así niveles metabólicos muy altos, acordes con los de la actividad física que despliegan.

Atún fresco.

Atún fresco.Shutterstock / Mark Watts

Llegados a este punto se habrán acordado de los lenguados o peces similares cuya carne es blanca. En efecto, esos peces no dan un palo al agua, son lo que en inglés se denomina depredadores sit and wait, porque se “sientan” a esperar.

Durante la mayor parte del tiempo permanecen sobre el sustrato, quietos, mimetizados con el fondo o semicubiertos con partículas de arena o fango. Pasan así inadvertidos por sus posibles presas. Los ojos de los peces planos se encuentran en uno de los lados de la cabeza mirando hacia arriba. Cuando ven que pasa alguna posible presa por encima, realizan un movimiento veloz, como un latigazo, se lanzan hacia ella. Si tienen suerte, la capturan.

Lo interesante es que los músculos que ejecutan ese movimiento no utilizan oxígeno, son anaerobios, músculos que obtienen su energía (el ATP) únicamente de la glucolisis, sin completarse, por lo tanto, la ruta estándar del metabolismo aerobio –a través del ciclo de Krebs y la cadena respiratoria en el interior de las mitocondrias– característico de otros tejidos.

Lenguado fresco.

Lenguado fresco.Shutterstock / seeshooteatrepeat

La glucolisis es una vía muy rápida aunque ineficiente. Proporciona energía a gran velocidad, que es de lo que se trata en este caso. Surte de ATP a músculos rápidos y por eso la utiliza el lenguado para atrapar a sus presas. Así pues, como no es necesario un aporte permanente de oxígeno, no hace falta que llegue mucha sangre a esa musculatura. A ello se debe que los peces planos y especies con un modo de vida similar tengan la carne tan blanca.

La carne de los atunes es roja; la de los peces planos, blanca, apenas sangra al cortarla. Esas diferencias obedecen al modo de vida de las especies. No son caprichosas, como no lo son gran parte de los fenómenos de la naturaleza, aunque creamos lo contrario.![]()

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Por qué la carne de los atunes es roja y la de los lenguados, blanca? se ha escrito en Cuaderno de Cultura Científica.

Introducción a Bitcoin

Mikel Lezaun Iturralde

Bitcoin es la primera moneda nativa digital. Como moneda digital, Bitcoin no tiene ninguna componente física, simplificando mucho, se puede afirmar que los bitcoin son registros informáticos y claves para realizar transacciones. Bitcoin opera en una extensa red de ordenadores abierta a quien lo desee, descentralizada (todos los nodos son iguales, no hay un nodo central que gestiona la red) y en la que los nodos tienen una copia de la gran base de datos de todas las transacciones. La red Bitcoin funciona con la tecnología blockchain, que garantiza por sí misma la seguridad de su gran base de datos. Bitcoin emite su propia moneda sin ningún respaldo de una entidad financiera o banco central. La emisión de moneda la hace Bitcoin en tiempo, número y destino siguiendo unas reglas fijas, independientemente del valor de cambio de bitcoin y de la coyuntura económica. En este artículo se describe los principales procesos del sistema blockchain, o cadena de bloques, y Bitcoin.

Foto: Executium / Unsplash

Foto: Executium / Unsplash-

Introducción

En el sistema bancario tradicional, para hacer una transferencia de una cuenta de un banco a otro banco, se cursa la orden, el banco comprueba si la cuenta del ordenante tiene fondos, resta del saldo de su cuenta el dinero de la transferencia y comunica al otro banco que debe sumar esa cantidad al saldo de la cuenta del destinatario. Esta gestión no mueve billetes de un lado a otro, simplemente es un cambio en los saldos de las cuentas. En realidad, todo esto lo hace un programa informático. Los bancos son los intermediarios y garantes de las transacciones, son quienes mantienen de forma segura toda la información en sus bases de datos y por ello cobran sus comisiones.

Ya en 1996, el Premio Nobel de economía Milton Friedman apuntó la necesidad de que se creara un protocolo específico para transferir valor por Internet, para trasferir dinero electrónico de un usuario A a uno B, sin que A tenga por qué saber la identidad de B o B quien es A.

En 2008, Satoshi Nakamoto, del que hasta la fecha no se sabe nada, ni quien, quienes o qué es, publicó un artículo en la lista de correo Cryptography de Internet, en el que definía un protocolo de comunicaciones para transmitir valor, basado en una red en la que todos los nodos se comportan como iguales, sin jerarquías. El año siguiente, él mismo publicó la primera versión del software Bitcoin, creó la red del mismo nombre y las primeras unidades de moneda, que también denominó bitcoin. En 2010, una vez puesto en marcha el sistema Bitcoin, Nakamoto se apartó y desapareció del mapa.

Características de la red Bitcoin

Las características más destacables de las monedas digitales, en particular de la red blockchain (cadena de bloques) de Bitcoin son las siguientes.

-

La red blockchain de Bitcoin es abierta, todo el que quiera puede participar, no se necesita autorización ni identificación.

-

La red es transfronteriza, se puede transferir de un punto a cualquier otro punto del mundo. En realidad, los bitcoin no residen en ningún sitio, no son algo físico.

-

La red es neutral, no hay que dar ninguna explicación a una transferencia. La red procesa cualquier transacción independientemente del ordenante, destinatario y cantidad.

-