Biringuccio, la química práctica y rentable del XVI

Los profesionales de las artes químicas de la primera mitad del siglo XVI, salvo algunos conversos muy concretos a las doctrinas y prácticas de Paracelso, se caracterizaron por una aproximación muy práctica, en lo que coincidían con él, pero por un alejamiento total en su forma de comportarse y en la forma en que transmitían el conocimiento: libros producidos a un precio asequible gracias a la imprenta de tipos móviles que cualquier lector interesado podía comprar.

Primera edición de “De la pirotechnia” de Biringuccio, Venecia (1540). Nótese que está escrito en italiano, no en latín.

El siglo XVI fue testigo de grandes avances en la tecnología química que se plasmaron en varios libros impresos que trataron el tema. Libros que se distinguieron de los de sus predecesores alquímicos, incluidos los de Paracelso, por centrarse en aspectos exclusivamente prácticos, sin que mencionaran teoría alguna más que de pasada.

El objetivo de estos libros no era el avance del conocimiento, sino recoger de forma sistemática una tecnología compleja que no se parecía en casi nada a la que se había empleado de forma prácticamente inamovible durante buena parte de la Edad Media.

De forma general hablaban solo de aparatos y reactivos, y de las recetas necesarias para llevar a cabo los métodos de destilación. Muchas recetas, especialmente las relacionadas con los pigmentos y tintes empleados por los artistas, siguen siendo llamativamente parecidas a las recogidas en documentos alquímicos del siglo III, lo que representa una continuidad en las recetas de los artesanos a la hora de fabricar joyas de imitación, tintes textiles, tintas, pinturas y “trucos” químicos, baratos, pero espectaculares.

Uno de los libros destacados escrito por un contemporáneo de Paracelso fue De la pirotechnia de Vannoccio Biringuccio, publicado póstumamente en 1540. En él se recogía todo lo conocido sobre la metalurgia más avanzada de la época, la fabricación de armas y el uso de máquinas que empleaban la energía hidráulica.

Ensayando en el laboratorio antes de llevarlo a la practica industrial. Nótese la balanza.

En De la pirotechnia aparece primera vez de forma explícita la importancia de los ensayos como una guía llevar las operaciones a una escala mayor y se proporcionan, también por primera vez, los valores cuantitativos para llevar a cabo las distintas recetas.

Biringuccio también aporta una visión distinta de la alquimia precedente y de muchos de los aspectos esotéricos asociados, esoterismos que aún cultiva Paracelso, por cierto. Da su opinión a partir de su observación personal y de su experiencia, escribiendo (énfasis nuestro):

[…] me motivan razones mas poderosas, o quizás la inclinación natural, a seguir el camino de la minería con más voluntariamente que el de la alquimia, aunque la minería es una tarea más ardua, tanto física como mentalmente, es más cara, sus promesas son menores a primera vista y en palabras de las que hace la alquimia; y tiene como como su ámbito la observación de los poderes de la naturaleza más que los del arte, o, en verdad, más los de ver lo que realmente existe más que lo que uno piensa que existe.

O dicho de otra manera, De la pirotechnia representa que para la primera mitad del siglo XVI las menas metálicas naturales, así como sus separaciones y transformaciones por medio del calor, ácidos y destilaciones, se han convertido en algo más interesante y financieramente fructífero que el tiempo empleado esterilmente en las transmutaciones especulativas.

Edición en francés de “De la pirotechnia” de Biringuccio, París (1572)

El libro se convertirá en el estándar para mineros y metalúrgicos durante lo que resta del siglo XVI y buena parte del XVII. Y a ello contribuyó su publicación no en latín, sino en italiano, y su posterior traducción a otras lenguas modernas. Sin alharacas, Biringuccio también contribuyó a la reforma idiomática del conocimiento.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Biringuccio, la química práctica y rentable del XVI se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Dejad de propagar el mito de los estilos de aprendizaje

Paul A. Kirschner

Resumen

Los seres humanos nos diferenciamos unos de otros en multitud de formas, y como tal, nuestras preferencias varían en cuanto a música, alimentación o aprendizaje, por ejemplo. Como resultado, a muchos estudiantes, padres, profesores, administradores, e incluso investigadores, les parece intuitivamente correcto decir que como laspersonas prefieren aprender de forma visual, auditiva, cinestética, u otras, deberíamos adaptar la enseñanza, las situaciones y los recursos educativos a estas preferencias. ¿Es esto un problema? La respuesta es un rotundo ¡Sí! En términos generales hay varios problemas importantes con respecto a los estilos de aprendizaje. En primer lugar, hay una gran diferencia entre el modo en que alguien prefiere aprender y lo que realmente le lleva a un aprendizaje eficaz y eficiente. En segundo lugar, las preferencias de estudio no son estilos de aprendizaje. La mayoría de los llamados estilos de aprendizaje están basados en clasificar a las personas en grupos. Sin embargo, los estudios objetivos pocas veces tienen en cuenta que una persona se puede asociar a distintos grupos. Finalmente, casi todos los estudios que presentan pruebas sobre estilos de aprendizaje, no satisfacen los criterios elementales de validez científica. Basado en la evidencia científica, este artículo pide a profesores, administradores e investigadores, que dejen de propagar el mito de los estilos de aprendizaje.

“Ninguna suma de creencias hace de algo un hecho” – James Randi

“Todo hombre tiene derecho a su propia opinión, pero ningún hombre tiene derecho a equivocarse en sus actos” – Bernard Baruch1

A continuación un comentario invitado para esta revista, que además pretende servir de carta abierta a todos mis colegas académicos que investigan en esta área de conocimiento, a editores, a miembros de consejos editoriales y/o a revisores de revistas científicas como esta. En 2013 publiqué un artículo en Educational Psychologist con mi buen amigo y colega Jeroen van Merriënboer titulado “¿Saben realmente los estudiantes lo que es mejor para ellos? Leyendas urbanas en educación”. En dicho artículo discutimos una serie de leyendas urbanas que influyen en la enseñanza y la educación, tales como los estilos de aprendizaje, los nativos digitales, la multitarea, la pirámide de aprendizaje, entre otras. Basado en un tuit mío relacionado con un artículo publicado en Computers & Education, los editores se dirigieron a mí de la siguiente manera:

El 18 de agosto usted tuiteó: “¡La revista científica Computers & Education publica bulos sobre estilos de aprendizaje! ¿Cuándo los editores van a parar este absurdo?” Esto se relacionó con el reciente artículo de [Autor y otros] sobre estilos de aprendizaje [URL] en nuestra revista.

Creemos que los lectores de nuestra revista estarán interesados en una indagación más detallada sobre los estilos de aprendizaje, por lo que queremos pedirle que escriba un “comentario invitado” sobre este tema.

La esencia de mi crítica a los estilos de aprendizaje es que no hay una base científica real para la proposición (más bien debería ser considerada una creencia) de que (1) un alumno tiene realmente cierto estilo de aprendizaje óptimo, (2) este es consciente de cuál es su estilo de aprendizaje personal y/o hay una manera confiable y válida para determinar este estilo, y (3) un aprendizaje e instrucción óptimos implican, primero determinar este estilo de aprendizaje, y luego alinear la instrucción en consecuencia.

El supuesto en que se basan los estilos de aprendizaje es que los profesores, instructores, diseñadores educativos, desarrolladores pedagógicos, etc., deben adoptar el estilo de aprendizaje que, (1) los estudiantes dicen que tienen o (2) el determinado por alguno de los instrumentos existentes (por ejemplo, cuestionarios de estilos de aprendizaje), lo cual determina qué se debe tener en cuenta con respecto al estudiante, al diseñar, desarrollar, e impartir la instrucción. Al hacer esto, se facilitará un aprendizaje óptimo y se permitir el pleno desarrollo del estudiante para lograr resultados óptimos. Aunque esta idea parece intuitivamente atractiva y suena como si tuviera cierto grado de validez, hay dificultades fundamentales tanto en el diagnóstico de los estilos de aprendizaje como en la alineación de la instrucción con estos estilos. En el resto de este comentario intentaré aclarar cuáles son estos problemas.

En nuestro artículo (Kirschner y van Merriënboer, 2013) planteamos primero que los estilos de aprendizaje clasifican mal (en realidad encasillan) a los estudiantes. La mayoría de los estilos que se han “determinado” se basan en tipos. El estudiante no se asocia a un estilo basado en un conjunto de medidas en diferentes dimensiones, sino que se clasifica en un grupo específico, a menudo exclusivo (para una panorámica sobre estilos de aprendizaje véase Cassidy, 2004; Coffield, Moseley, Hall y Ecclestone, 2004,). El primer problema aquí es que la gente no puede simplemente agruparse en grupos específicos y distintos como muestran varios estudios (véase, por ejemplo, Druckman & Porter, 1991). La mayoría de las diferencias entre personas en cualquier dimensión que uno pueda imaginar son graduales y no nominales. Incluso la clasificación sexo/género que hasta hace poco se consideraba dicotómica ha demostrado ser más matizada que eso. Los defensores del uso de estilos de aprendizaje tienden a ignorar esto y usan criterios arbitrarios, como una mediana o una media en una cierta escala para asociar a una persona con un estilo específico.

Con respecto a este simple encasillamiento de los estudiantes, Barbara Prashnig (2005), quien podría ser considerada partidaria de los estilos de aprendizaje, y quien ha desarrollado instrumentos de estilos de aprendizaje, escribe que en uno de los instrumentos de estilos de aprendizaje más complejos y detallados del mercado [el Analizador de Estilos de Aprendizaje (Learning Style Analysis, LSA)] hay al menos

49 elementos diferentes… [con]… complejas combinaciones de estilos, matizadas por grados de necesidades que van desde preferencias claras a ninguna preferencia, pasando por preferencias flexibles. Dados los numerosos componentes de los estilos… no es posible etiquetar a los estudiantes simplemente seleccionando un rasgo de un estilo como predominante (p. 2).

En cuanto al número de clasificaciones (encasillamientos) que se han creado, Coffield y otros (2004) escriben que “el gran número de dicotomías en la literatura transmite algo de la confusión conceptual actual” (p. 136). En su revisión se refieren a 30 estilos de aprendizaje dicotómicos diferentes en la literatura2 (ver Tabla 1).

El segundo problema tiene que ver con la validez, confiabilidad y poder predictivo de las pruebas de estilos de aprendizaje que se están utilizando. Stahl (1999) reportó inconsistencias y baja confiabilidad en la medición de estilos de aprendizaje cuando los individuos realizan una prueba específica en dos momentos diferentes. En otras palabras, la fiabilidad entre pruebas es bastante baja. Esto también está relacionado con la información que se utiliza frecuentemente para evaluar los estilos de aprendizaje. El método más utilizado es la autoevaluación. Infortunadamente, la idoneidad de la autoevaluación para evaluar un estilo de aprendizaje es muy dudosa (véase por ejemplo Veenman, Prins, & Verheij, 2003).

La razón es que los estudiantes no son capaces de y/o no están dispuestos a informar lo que en realidad hacen, o lo que creen que hacen. Para ilustrar la falta de fiabilidad de la autoevaluación, Rawson, Stahovich y Mayer (2016) les preguntaron a un grupo de estudiantes cuándo hicieron su tarea y cuánto tiempo trabajaron en ella. También les dieron a estos estudiantes un “bolígrafo inteligente”, el cual indicaba cuándo y cuánto tiempo trabajaban en su tarea. Si bien hubo una significativa correlación positiva (r=,44) entre la cantidad de tiempo que los estudiantes pasaron trabajando en su tarea (medido por el “bolígrafo inteligente”) y la nota obtenida por los estudiantes en el curso, no hubo correlación significativa (r=-,16) entre la nota y el tiempo que los estudiantes dijeron haber dedicado a la tarea. En otras palabras, no hubo una correlación real entre la autoevaluación subjetiva y la medición objetiva. Además, la mayoría de los estudiantes (88%) sobrevaloraron el tiempo que dedicaron la tarea. Por último, Massa y Mayer (2006), encontraron que cuando los estudiantes informaban su preferencia por la información verbal en lugar de la información visual, esta preferencia solo estaba débilmente relacionada con sus habilidades reales medidas objetivamente (es decir, su capacidad espacial).

Además, la forma aprendizaje preferida según las autoevaluaciones suele ser un mal indicador de la forma más eficaz de aprender; lo que las personas prefieren no es, por definición, lo mejor para ellos. Knoll, Otani, Skeel y Van Horn (2016) concluyen que los estilos de aprendizaje están asociados con aspectos subjetivos del aprendizaje, y no con aspectos objetivos. En otras palabras, cabe preguntarse si realmente los estudiantes saben lo que es mejor para ellos. Clark (1982) publicó un metaanálisis crítico con respecto a la preferencia del alumno a la hora de elegir un cierto tipo de instrucción, y encontró que con frecuencia dicha preferencia tenía una correlación negativa con el qué y el cuánto se aprendió, y que en el mejor de los casos, no existía correlación alguna. Dicho de otra manera, aquellos estudiantes que dijeron preferir una forma particular de aprender, en la mayoría de los casos no tuvieron mejores resultados usando dicha forma, o incluso mostraron peor rendimiento. Este autor usó el término matematántico3(del griego mathema = un estudio donde algo es aprendido + thanatos = muerte) para describir un método de instrucción que por un lado coincide con la forma favorita de aprender del alumno, pero que a la vez es improductivo o perjudicial para su aprendizaje (Clark, 1989). En tal caso, un modelo de instrucción compensatorio o incluso remedial (véase Salomon, 1971, así como Berliner & Cahen, 1973, cuando discuten las interacciones rasgo-tratamiento) es probablemente un mejor enfoque, encaminado a compensar los efectos no deseados de una predisposición o preferencia específica (van Merriënboer, 1990). Para ponerlo en un contexto diferente, mientras que la mayoría de las personas prefieren los alimentos dulces, salados y/o grasos, creo que todos estaremos de acuerdo en que esa no es la mejor dieta a seguir, salvo que pretendamos poner en riesgo nuestra salud y ganar peso.

Tabla 1. 30 Estilos de aprendizaje discutidos en Coffield y otros (2004)

- Convergentes vs. divergentes

- Verbales vs. visuales

- Holísticos vs. seriados

- Profundos vs. superficiales

- Activos vs. reflexivos

- Pragmáticos vs. teóricos

- Adaptadores vs. innovadores

- Asimiladores vs. exploradores

- Dependiente vs. independiente del campo

- Globalistas vs. analistas

- Asimiladores vs. acomodadores

- Imaginativos vs. analíticos

- No comprometidos vs. pujantes

- Estudiantes de sentido común vs. dinámicos

- Estudiantes concretos vs. abstractos

- Estudiantes aleatorios vs. secuenciales

- Iniciadores vs. razonadores

- Intuicionistas vs. analistas

- Extrovertidos vs. introvertidos

- Detección vs. intuición

- Pensamiento vs. sentimiento

- Juzgar vs. percibir

- Cerebral izquierdo vs. derecho

- Significado-directo vs. indirecto

- Teóricos vs. humanistas

- Activos vs. teóricos

- Pragmáticos vs. reflexivos

- Organizadores vs. innovadores

- procesadores secuenciales izquierdo/analíticos/inductivos vs. procesadores simultáneos derechos/globales /deductivos

- Ejecutivo, jerárquico, conservador vs. legislativo, anárquico, liberal

Con respecto a la fiabilidad y validez de determinar el estilo de aprendizaje de una persona, Coffield y otros (2004) revisaron los 13 instrumentos más utilizados para determinar los estilos de aprendizaje con respecto a criterios psicométricos elementales, o sea, consistencia interna, fiabilidad entre pruebas, validez del constructo y validez predictiva (véase Tabla 2; Tabla 44 en su artículo).

Tabla 2. Trece modelos/instrumentos de estilos de aprendizaje y su cumplimiento de criterios elementales. (Coffield y otros, 2004; las referencias a estos instrumentos pueden encontrarse en dicho artículo).

Fig. 1. Interacción cruzada

Los autores concluyen que tres de los modelos (Jackson, Riding, e inteligencias múltiples de Sternberg) no se asociaron con ninguno de los cuatro criterios, cuatro (Dunn & Dunn, Gregorc, Honey & Mumford, y Kolb) se correspondieron con un solo criterio, tres (Entwistle, Herrmann, e indicador de tipo de personalidad de Myers-Briggs) con dos criterios, dos (Apter y Vermunt) con tres criterios y uno solo se asoció con los cuatro criterios (indicador de estilo cognitivo de Allinson & Hayes), pero este instrumento midió estilos cognitivos y no estilos de aprendizajes.

Nosotros concluimos en nuestro artículo (Kirschner y van Merriënboer, 2013):

Cuando en el diseño de la enseñanza se tienen en cuenta las diferencias entre los estudiantes, se debería evaluar las habilidades cognitivas más que los estilos de aprendizaje preferidos, porque las habilidades predicen mejor cómo las personas aprenden más eficazmente. Además, estas habilidades cognitivas deben ser medidas objetivamente en una escala ordinal, más que por autoevaluaciones subjetivas que son usadas para asociar personas con tipos en base a uno o más criterios arbitrarios.

Como un experimento imaginario, ignoremos todas las dificultades discutidas en relación con la medición y la determinación de los estilos de aprendizaje, y entonces preguntémonos si deberíamos adaptar la instrucción a los estilos de aprendizaje preferidos o determinados. Aquí, la hipótesis de los estilos de aprendizaje (Pashler, McDaniel, Rohrer, y Bjork, 2009) es importante, o sea, que se encontrará una interacción cruzada (véase Fig. 1) en la cual un tipo específico de estudiante aprende significativamente mejor con un método de enseñanza adaptado a su estilo de aprendizaje, mientras que otro tipo específico diferente de estudiante con un estilo de aprendizaje opuesto, aprende mejor con un método de instrucción adaptado a su estilo.

Por ejemplo, de acuerdo a esta hipótesis, los estudiantes que prefieren aprender de forma verbal, aprenderán mejor cuando se les enseña a través de métodos de instrucción verbales (por ejemplo, cuando se les da a leer un libro o un artículo), pero tendrán un bajo rendimiento al aprender con vídeos. En cambio los que prefieren aprender de manera visual, aprenderán mejor cuando se les enseña a través de métodos de instrucción visuales (por ejemplo, cuando se les orienta que vean un video) que cuando aprenden leyendo un libro. Lo importante aquí es que no es suficiente que se encuentre una interacción estadísticamente significativa entre un estilo y un método. Solo una interacción cruzada real se puede usar para confirmar las hipótesis de los estilos de aprendizaje.

Teniendo en cuenta todo lo anterior, cabe cuestionarse si existen suficientes estudios que presenten interacciones cruzadas robustas entre estilo y método, independientemente de si se usa un modelo preferencial, correctivo o compensatorio como base de las interacciones. Infortunadamente para los partidarios de los estilos de aprendizaje, este no es el caso (véase Coffield y otros, 2004, Pashler y otros, 2009, y Rohrer & Pashler, 2012). Pashler y otros (2009, p. 105) concluyen que “actualmente, no existe una base de evidencias adecuadas para justificar la incorporación de las evaluaciones de los estilos de aprendizaje en la práctica educativa general. Por lo tanto, sería mejor dedicar los limitados recursos educativos a la adopción de otras prácticas educativas que tengan una sólida base en evidencias, de las cuales hay un número cada vez mayor”.

En contraste, una serie de estudios recientes, bien diseñados, contradicen la hipótesis de los estilos de aprendizaje. Pashler y otros (2009) afirmaron que una investigación rigurosa sobre los estilos de aprendizaje debe seguir tres pasos:

-

Comenzar examinando el supuesto estilo de aprendizaje de los encuestados en el estudio Rogowsky, Calhoun y Tallal (2015), por ejemplo, examinando los estilos de aprendizaje visual versus auditivo.

-

Distribuir aleatoriamente los participantes en grupos donde la mitad debe recibir una instrucción que coincida específicamente con su estilo de aprendizaje y la otra mitad, una instrucción que coincida con el estilo opuesto (por ejemplo, los estudiantes visuales de un grupo deben leer, mientras que los alumnos visuales del grupo de control deben escuchar).

-

Asignar a todos los participantes la misma prueba.

Teniendo en cuenta estos tres pasos, Constantidinou y Baker (2002), por ejemplo, no encontraron relación alguna entre tener un supuesto estilo de aprendizaje visual y el aprendizaje de elementos verbales presentados de manera visual o auditiva. Massa y Mayer (2006) tampoco encontraron nada que apoyara la idea de que los diferentes métodos de enseñanza, enfatizando la información pictórica o verbal, eran de beneficio, de forma cruzada, para los visualizadores y verbalizadores, respectivamente. Se han encontrado resultados negativos similares para otros estilos de aprendizaje. En la enseñanza médica, Cook, Thompson, Thomas y Thomas (2009), no encontraron apoyo para la premisa de que trabajar desde los problemas a la teoría (es decir, siguiendo un enfoque inductivo) o de la teoría a los problemas (es decir, siguiendo un enfoque deductivo), conduciría a un mejor aprendizaje para los estudiantes sensores/concretos y los estudiantes intuitivos/abstractos, respectivamente. Por último, Rogowksy, Calhoun y Tallal (2015) no encontraron relación alguna estadísticamente significativa entre la preferencia por un estilo de aprendizaje particular (por ejemplo, auditivo, visual) y el aprendizaje (por ejemplo, la comprensión auditiva y la comprensión lectora).

La lista de estudios que demuestran el absurdo de los estilos de aprendizaje es abrumadora. A continuación dos interesantes citas relacionadas con el gran número de estudios sobre estilos de aprendizaje:

Para Morrison, Ross, Kalman, y Kemp (2011, p. 59), “a pesar de la extensa bibliografía sobre estilos de aprendizaje, subsisten interrogantes sobre el grado en que tales estilos pueden adaptarse a los métodos de enseñanza con algún beneficio para el aprendizaje (Knight, Halpin, & Halpin, 1992; Park & Lee, 2004; Snow, 1992). “

Para Dembo y Howard (2007, p.107), “… los instrumentos de estilo de aprendizaje no han demostrado ser válidos y confiables, no hay beneficio en adaptar la instrucción al estilo de aprendizaje preferido y no hay evidencia de que comprendiendo su estilo de aprendizaje mejore su aprendizaje y sus resultados… Rogamos a los educadores que reconsideren sus prácticas de instrucción, especialmente el consejo que dan a sus estudiantes sobre los estilos de aprendizaje, y basen sus prácticas en una investigación sólida”.

Para terminar, hay cuatro conclusiones que se pueden plantear con respecto a los estilos de aprendizaje y los estudios asociados a estos:

-

La premisa de que hay estudiantes con diferentes estilos de aprendizaje y que deben recibir instrucción utilizando métodos que coincidan con esos estilos, no es un hecho “probado”, sino más bien una creencia respaldada por escasa, si acaso alguna, evidencia científica.

-

Hay muchos problemas fundamentales en cuanto a la medición de los estilos de aprendizaje.

-

La base teórica para las interacciones entre los estilos de aprendizaje y los métodos de enseñanza es muy escasa.

-

La evidencia empírica significativa para la hipótesis de los estilos de aprendizaje es casi inexistente.

En otra referencia, Coffield y otros (2004) afirman que el concepto de estilos de aprendizaje está tan mal definido que es prácticamente inútil para la instrucción. Wheeler (2011) resumió esta afirmación así: “Probablemente la única razón por la que algunos profesores (y muchas instituciones educativas) se aferran a la idea de experimentar con estilos de aprendizaje, es que es conveniente hacerlo, y que de abandonar la idea por completo, tendrían que trabajar más duro con los estudiantes”.

A esto solo puedo añadir que cuando los maestros dicen que tienen pruebas de que el uso de estilos de aprendizaje funciona, la “prueba” que dan es principalmente anecdótica. Según Rosenthal y Jacobson (1992), lo que ven y/o experimentan es, probablemente, que cuando los maestros esperan un mejor desempeño de sus estudiantes, el desempeño es mejorado. Esto se conoce como efecto Pigmalión o Rosenthal, donde unas expectativas más altas conducen a un aumento en el rendimiento. Rosenthal sostiene que tales expectativas sesgadas afectan la realidad y crean profecías auto-realizables. Relacionado con esto, Reiner y Willingham (2010) declaran:

… la teoría de estilos de aprendizaje ha logrado convertirse en “conocimiento común”. Su amplia aceptación sirve como una razón, lamentablemente, para creer en ella. Esto se acompaña de un conocido fenómeno cognitivo llamado confirmación sesgada. Al evaluar nuestras propias creencias, tendemos a buscar información que confirme nuestras creencias e ignorar la información contraria, incluso cuando la encontramos repetidamente. Cuando vemos a alguien que profesa ser un aprendiz visual y sobresale en geografía y un alumno auditivo sobresale en música, no buscamos la información que refute nuestra interpretación de estos eventos (¿Puede el alumno auditivo aprender geografía a través de la escucha? ¿Puede el alumno visual mejorar en la música viéndola?) (np)

Newton (2015) encontró que una abrumadora mayoría (89%) de los recientes artículos de investigación, con el rango de fechas del 23 de julio de 2013 al 23 de julio de 2015, que figuran en las bases de datos de investigación ERIC y PubMed, apoyan implícita o directamente el uso de estilos de aprendizaje en la educación superior. Queremos hacer un llamamiento a la comunidad científica en esta área a hacer las cosas como corresponde. Howard-Jones (2014), presentando un estudio que llevó a cabo con Dekker, Lee, Howard-Jones y Jolles en 2012, encontró que el 95% de los profesores en Gran Bretaña, Holanda, Turquía, Grecia y China, estaban convencidos de que “[L]os individuos aprenden mejor cuando reciben información en su estilo de aprendizaje preferido (por ejemplo, visual, auditivo o cinestético)”.

Somos creadores y guardianes de nuevos conocimientos. Lo que estudiamos y/o publicamos puede y debe tener un impacto tanto en el mundo científico en el que nos desempeñamos como en el mundo educativo al que servimos. Como tal, es nuestro deber solemne investigar y publicar siguiendo buenas prácticas científicas, independiente de resultados positivos significativos, y combatir la difusión de la pseudociencia, los mitos y las mentiras abiertas. No hay beneficio que se pueda obtener al adaptar y diseñar la educación y la instrucción a estos denominados estilos. De hecho, de acuerdo con los efectos matematánticos de los enfoques preferidos en la instrucción, puede incluso suceder que de aplicar esta práctica, los administradores, maestros, padres, e incluso estudiantes, influyan negativamente en el proceso de aprendizaje, y por ende en los resultados educativos. Con esto en mente, considero necesario, e incluso nuestro deber como investigadores y/o editores y revisores de revistas, no propagar tales mitos. Debemos salvaguardar nuestra credibilidad como investigadores, como (portavoces de la) comunidad científica y trabajar en beneficio de aquellos a quienes servimos, a saber, la comunidad científica y la ciudadanía en general, especialmente educadores y estudiantes.

Agradecimientos

Estoy en deuda de gratitud con Jeroen van Merriënboer, con quien escribí el artículo en que se basa este comentario. También me gustaría agradecer a Pedro de Bruyckere, compañero de batallas quijotescas contra los mitos y las leyendas urbanas en la enseñanza y aprendizaje, quien leyó y comentó la primera versión de este artículo.

Referencias

Berliner, D. C., & Cahen, L. S. (1973). Trait-treatment interaction and learning. In F. N. Kerlinger (Ed.), Vol.1. Review of research in education (pp. 58-94). Itasca. IL: Peacock.

Cassidy, S. (2004). Learning styles: An overview of theories, models, and measures. Educational Psychology, 24, 419-444. http://dx.doi.org/10.1080/0144341042000228834.

Clark, R. E. (1982). Antagonism between achievement and enjoyment in ATI studies. Educational Psychologist, 17(2), 92-101.

Clark, R. E. (1989). When teaching kills learning: Research on mathemathantics. In H. Mandl, N. Bennett, E. De Corte, & H. Friedrich (Eds.), Learning and Instruction: European Research in an International Context (Vol. 2, pp. 1-22). London, UK: Pergamon.

Coffield, F., Moseley, D., Hall, E., & Ecclestone, K. (2004). Learning styles and pedagogy in post-16 learning: A systematic and critical review. London, UK: Learning and Skills Research Centre.

Constantidinou, F., & Baker, S. (2002). Stimulus modality and verbal learning performance in normal aging. Brain and Language, 82, 296e311. http://dx.doi.org/10.1016/S0093-934X(02)00018-4.

Cook, D. A., Thompson, W. G., Thomas, K. G., & Thomas, M. R. (2009). Lack of interaction between sensing-intuitive learning styles and problem-first versus information-first instruction: A randomized cross-over trial. Advances in Health Sciences Education, 14, 79e90. http://dx.doi.org/10.1007/s10459-007-9089-8.

Dekker, S., Lee, N. C., Howard-Jones, P. A., & Jolles, J. (2012). Neuromyths in education: Prevalence and predictors of misconceptions among teachers. Frontiers in Psychology, 3, 429. http://dx.doi.org/10.3389/fpsyg.2012.00429.

Dembo, M. H., & Howard, K. (2007). Advice about the use of learning styles: A major myth in education. Journal of College Reading and Learning, 37(2), 101 – 109.

Druckman, D., & Porter, L. W. (1991). Developing careers. In D. Druckman, & R. A. Bjork (Eds.), In the mind’s eye: Enhancing human performance (pp. 80-103). Washington, DC: National Academy Press.

Howard-Jones, P. A. (2014). Neuroscience and education: Myths and messages. Nature Reviews Neuroscience, 15, 817e824. http://dx.doi.org/10.1038/nrn3817.

Kirschner, P. A., & van Merriënboer, J. J. G. (2013). Do learners really know best? Urban legends in education. Educational Psychologist, 48(3), 169e183. http://dx.doi.org/10.1080/00461520.2013.804395.

Knight, C. B., Halpin, G., & Halpin, G. (1992). The effects of learning environment accommodations on the achievement of second graders. Paper presented at the annual meeting of the American Educational Research Association, San Francisco, CA.

Knoll, A. R., Otani, H., Skeel, R. L., & Van Horn, K. R. (2016). Learning style, judgements of learning, and learning of verbal and visual information. British Journal of Psychology. http://dx.doi.org/10.1111/bjop.12214.

Massa, L. J., & Mayer, R. E. (2006). Testing the ATI hypothesis: Should multimedia instruction accommodate verbalizer-visualizer cognitive style? Learning and Individual Differences, 16, 321-336. http://dx.doi.org/10.1016/j.lindif.2006.10.001.

Morrison, G. R., Ross, S. M., Kalman, H. K., & Kemp, J. E. (2011). In Designing effective instruction (6th ed.). Hoboken, NJ: John Wiley & Sons, Inc.

Newton, P. M. (2015). The learning styles myth is thriving in higher education. Frontiers in Psychology, 6, 1908. http://dx.doi.org/10.3389/fpsyg.2015.01908.

Park, O., & Lee, J. (2004). Adaptive instructional systems. In D. H. Jonassen (Ed.), Handbook of research on educational communications and technology (2nd ed., pp. 651-684). Mahwah, NJ: Lawrence Erlbaum Associates.

Pashler, H., McDaniel, M., Rohrer, D., & Bjork, R. (2009). Learning styles: Concepts and evidence. Psychological Science in the Public Interest, 9(3), 105-119. http://dx.doi.org/10.1111/j. 1539-6053.2009.01038.x.

Prashnig, B. (2005, Autumn). Learning styles vs. multiple intelligences (MI): Two concepts for enhancing learning and teaching (Vol. 9, pp. 8-9). expertise, com. Retrieved from: www.teacher http://www.creativelearningcentre.com/downloads/LS%20vs%20MI%20TEX9_p8_9.pdf.

Rawson, Stahovich, & Mayer. (2016). Homework and achievement: Using smartpen technology to find the connection. Journal of Educational Psychology. http://dx.doi.org/10.1037/edu0000130 (in press).

Reiner, C., & Willingham, D. (2010). The myth of learning styles. Change Magazine (Sept-Oct.).

Rogowsky, B. A., Calhoun, B. M., & Tallal, P. (2015). Matching learning style to instructional method: Effects on comprehension. Journal of Educational Psychology, 107, 64-78.

Rogowksy, B. A., Calhoun, B. M., & Tallal, P. (2015). Matching learning style to instructional method: Effects on comprehension. Journal of Educational Psychology, 107(1), 64-78. http://dx.doi.org/10.1037/a0037478.

Rohrer, D., & Pashler, H. (2012). Learning styles: Where’s the evidence? Medical Education, 46, 630-635.

Rosenthal, R., & Jacobson, L. (1992). Pygmalion in the classroom. New York, NY: Irvington.

Rothkopf, E. Z. (1970). The concept of mathemagenic activities. Review of Educational Research, 40, 325-336.

Salomon, G. (1971). Heuristic models for the generation of aptitude-treatment interaction hypotheses. Review of Educational Research, 2, 327-343.

Snow, R. E. (1992). Aptitude theory: Yesterday, today, and tomorrow. Educational Psychologist, 27, 5-32.

Stahl, S. A. (1999). Different strokes for different folks? A critique of learning styles. American Educator, 23(3), 27-31.

Van Merriënboer, J. J. G. (1990). Instructional strategies for teaching computer programming: Interactions with the cognitive style reflection-impulsivity. Journal of Research in Computing Education, 23, 45-53. http://dx.doi.org/10.1080/08886504.1990.10781942.

Veenman, M. V. J., Prins, F. J., & Verheij, J. (2003). Learning styles: Self-reports versus thinking-aloud measures. British Journal of Educational Psychology, 73, 357-372. http://dx.doi.org/10.1348/000709903322275885.

Wheeler, S. (November, 2011). A convenient untruth. Learning with ‘e’s [blog]. Retrieved from http://steve-wheeler.blogspot.ca/2011/11/convenient-untruth.html.

Notas:

1 Una variante de este planteamiento es atribuida a Daniel Patrick Moynahan como “Cada cual tiene derecho a sus propias opiniones, pero no a sus propios hechos”, salvo que la referencia de Baruch se realizó hace 24 años.

2 Si hay “solo” 30 variables dicotómicas que se pueden aplicar a los estudiantes, entonces hay 230 combinaciones diferentes de estos 30 estilos dicotómicos, lo cual significa que hay al menos 1,073,741,824 estilos de aprendizaje diferentes. Si solo contamos los niño(a)s aquí (estimados en 2 billones), esto significa un estilo por cada dos niño(a)s

3 Ernst Rothkopf había acuñado ya en 1970 (Rothkopf, 1970) el término actividades matemagénicas (gigneshai = nacer) para referirse a aquellas actividades que dan lugar a un proceso de aprendizaje.

Sobre el autor: Paul A. Kirschner es catedrático de psicología educativa en la Open University of the Netherlands (Países Bajos) y profesor visitante de la University of Oulu (Finlandia)

Traducido y adaptado por: Héctor Pijeira Diaz y Raidell Avello Martínez

Artículo Original (Source): Kirschner, P. A. (2017). Stop propagating the learning styles myth. Computers & Education, 106, 166-171. http://www.sciencedirect.com/science/article/pii/S0360131516302482

Blog Original: http://tinyurl.com/jnnmgks y https://onderzoekonderwijs.net/2017/02/26/dejad-de-propagar-el-mito-de-los-estilos-de-aprendizaje/

El artículo Dejad de propagar el mito de los estilos de aprendizaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El aprendizaje del inglés es mejor si se usa para aprender otra cosa

- #Naukas16 Mito(bio)logía griega

- Otro mito desacreditado: la peligrosidad de las viudas negras

El corpus de confusión consistente del inglés oral

En la percepción del habla con ruido de fondo a menudo se producen errores en los que el oyente cree haber escuchado una palabra distinta de la pronunciada. Este fenómeno se ha llamado “deslices del oído” (slips of the ear). Un grupo en el que trabaja la profesora de la UPV/EHU María Luisa García Lecumberri ha generado el primer gran corpus de errores de percepción coincidentes para el inglés, que abarca más de 3.000 términos y está disponible on line.

Normalmente no oímos en condiciones óptimas -hay ruidos de fondo como tráfico, máquinas, otras conversaciones- pero, como hablantes nativos y ayudados por el contexto, tenemos capacidad para reconstruir la parte de la señal que no nos ha llegado. Sin embargo, ello no evita que cometamos errores. El grupo que integran María Luisa García Lecumberri, el profesor Ikerbasque de la UPV/EHU Martin Cooke y los investigadores de la Universidad de Sheffield Jon Barker y Ricard Marxer ha identificado 3.207 percepciones erróneas coincidentes para el inglés, es decir, errores en los que un número significativo de oyentes coinciden. Estas concordancias tienen valor como tests de los modelos de percepción del habla y para comprender mejor cómo funcionan los mecanismos de percepción de los humanos.

Para ello realizaron un estudio a gran escala con 212 participantes y más de 300.000 presentaciones de palabras, que los investigadores sacaban de contexto, es decir, las presentaban de forma aislada con ruido de fondo. El estudio logró identificar 3.207 percepciones erróneas coincidentes y las ha reunido en un corpus, único en su categoría y que está disponible online: http://spandh.dcs.shef.ac.uk/ECCC/. Para cada una de las percepciones erróneas, el corpus presenta las ondas sonoras de la palabra pronunciada y del ruido de fondo que generó el error, las respuestas aportadas por los oyentes y las transcripciones fonémicas de la palabra pronunciada y de la percibida. Se observó que hay distintos tipos de confusiones. En algunos casos está claro que el ruido ocultaba parte de la palabra y los oyentes imaginaban otra palabra que coincidía con las partes audibles (“wooden –> wood” o “pánico” –> “pan”) o sustituían las partes inaudibles por otros sonidos (“ten” –> “pen” y “valla –>falla”). En otros casos se reconstruían la palabra incorporando fragmentos del ruido o conversaciones de fondo, (“purse –> permitted” o “ciervo” –> “invierno”). Finalmente se encontraban percepciones extrañas pero con coincidencia de varios hablantes, en las que no había ninguna similitud entre la palabra emitida y la que creían haber óido, (“modern –> suggest” o “guardan –> pozo”). En estos casos la interacción entre habla y ruido es bastante más compleja y, por lo tanto, interesante.

“Estos estudios nos ayudan a comprender mejor los mecanismos de percepción del habla, y cuanto mejor conozcamos dichos mecanismos, mejor se podrá ayudar, a nivel técnico y clínico, a los que padecen problemas de percepción”, indica la investigadora. El grupo publicó anteriormente un corpus de deslices de oído del castellano, que también puede ser consultado en el mismo sitio web. “Entre ambos hay similitudes y diferencias: el castellano es una lengua con más flexión, lo cual provoca que haya más confusiones en las terminaciones; el inglés tiene más monosílabos y más riqueza consonántica en posición final, donde se producen más errores en los que se sustituye una consonante por otra”, añade. Coinciden ambas lenguas en que, dependiendo del tipo de ruido, sobreviven mejor unos tipos de sonidos y sílabas que otros.

Ricard Marxer, Jon Barker, Martin Cooke, and Maria Luisa Garcia. A corpus of noise-induced word misperceptions for English. The Journal of the Acoustical Society of America Volume 140, Issue 5. doi: 10.1121/1.4967185.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El corpus de confusión consistente del inglés oral se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El aprendizaje del inglés es mejor si se usa para aprender otra cosa

- Las plantas como aislantes acústicos

- La percepción del propio peso es peor en las chicas que en los chicos

Mundos imaginados

Rover Curiosity (Imagen: NASA)

EL pasado 22 de febrero se anunció un descubrimiento que entusiasmó a los especialistas, fascinó a los amantes de la astronomía y cautivó la atención del público. A 39 años luz -no demasiado lejos- de nuestro sistema solar, donde se pensaba que había un sistema con una enana roja (su masa es el 8% de la de nuestro sol) y tres planetas, han descubierto que en realidad hay siete planetas. Y lo que es más importante: son de dimensiones parecidas a las de la Tierra y tres de ellos se encuentran en la zona de habitabilidad. O sea, podrían contener agua líquida, condición considerada esencial, si se cumplen otras -como la existencia de algún tipo de atmósfera, por ejemplo-, para el desarrollo de alguna forma de vida.

A la misma hora que se anunciaba ese descubrimiento, el profesor Madariaga, catedrático de química analítica de la Universidad del País Vasco, exponía en Bilbao los trabajos que desarrolla la NASA, y en los que su equipo participa en aspectos científico-tecnológicos claves, para poner sobre la superficie de Marte un vehículo con un laboratorio equipado para detectar la existencia, presente o pasada, de vida en el planeta rojo. El público siguió fascinado sus explicaciones.

Es la vida, su búsqueda más allá de los límites de nuestro planeta, lo que nos cautiva, la posibilidad de que no estemos solos en el universo. La ciencia ficción ha explotado esa fascinación en muchas ocasiones. Y las agencias científicas se dedican a ello, tanto mediante la búsqueda de enclaves en nuestro sistema solar o en otros que sean propicios para la vida, como mediante la detección de señales que, procedentes de muy lejos, indiquen la existencia de otras formas de vida inteligente en el cosmos.

Según las últimas estimaciones, en el universo observable hay entre doscientos mil millones y dos billones de galaxias. Y en una galaxia puede haber desde unos pocos miles de millones de estrellas hasta un centenar de billones. Por eso, aunque la probabilidad de la existencia de planetas que reúnan las condiciones para la vida sea ridículamente baja, deben de existir millones de planetas en los que se dan esas condiciones. Los recién descubiertos no son los primeros exoplanetas de los que sabemos que pueden reunir condiciones para la vida, pero sí los más próximos. Esa relativa cercanía, así como otros rasgos del sistema, han disparado el interés de los especialistas y del público. Y lo que es más importante: genera nuevas y prometedoras expectativas en la exploración del cosmos.

Estos descubrimientos nos fascinan, sí. Pero también hay quienes, legítimamente, dudan que deban destinarse recursos a la exploración del universo. Les parecen caros y no perciben sus beneficios. Se equivocan. Los costes de las sondas a Marte o al espacio exterior, de los telescopios y, en general, de la exploración espacial son ridículos al lado de lo que nos gastamos en armas, por ejemplo. Y la inversión proporciona, por el desarrollo tecnológico que exige, valiosísimos retornos en conocimiento aplicable a corto plazo. Aunque no evidentes a primera vista, son argumentos poderosos para los que dudan de su “utilidad”.

Otros tenemos razones tan poderosas o más que las anteriores: descubrimientos como el de los nuevos exoplanetas abren nuevas puertas, incluso si son pequeñas, a nuevo conocimiento, algo de gran “utilidad” per se. Porque frente a un futuro intrínsecamente incierto, no neutralizaremos los peligros que adivinamos para nuestra supervivencia y bienestar con medidas que limiten la capacidad de actuación. La única actitud sensata ante la incertidumbre es atesorar cada vez más conocimiento. También acerca de esos mundos que hoy solo podemos imaginar.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————————

Este artículo fue publicado en la sección #con_ciencia del diario Deia el 26 de febrero de 2017.

El artículo Mundos imaginados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La aburrida pluralidad de mundos habitados

- Hacedores de mundos

- #Naukas16 Exoplanetas: mundos de ciencia ficción

#Naukas16 Big Van Science

BigVan o, mejor, una muestra representativa, se subió al escenario del Bizkaia Aretoa para hablar de la que es, sin duda, la disciplina científica más importante…

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Big Van Science se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 ¿Cómo saber si tu funeraria te estafa?

- #Naukas16 De profesión, futurólogo

- #Naukas16 Mito(bio)logía griega

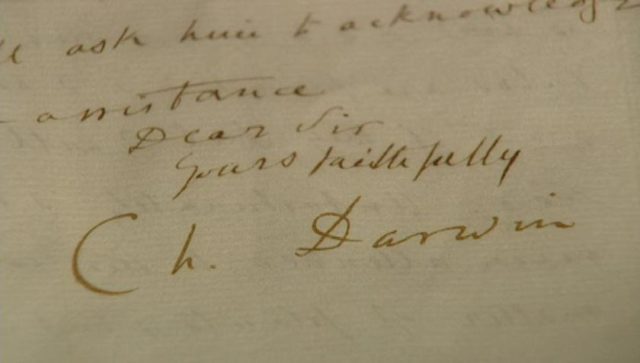

Las Cartas de Darwin: El sueño truncado de Canarias

Las cartas de Darwin, una serie para conocer aspectos sorprendentes de la vida del naturalista

En enero de 1828, cuando aún no había cumplido 20 años, Darwin llega a Cambridge después de un infructuoso paso por la Universidad de Edimburgo donde supuestamente debía convertirse en médico como su padre. El joven se mareaba cada vez que veía la sangre y parecía claro que ese no era el camino para el que estaba destinado. No obstante en Escocia se apañó bastante bien en las asignaturas de historia natural, de química e incluso recibió clases particulares de taxidermia de un esclavo liberado llamado John Edmonstone de quien aprendió a disecar.

En Cambridge se inscribe en el Christ’s College con la intención de estudiar el grado ordinario de teología, algo que podría contentar a su padre ya que ser clérigo era algo socialmente considerado en esa época y de paso le permitiría dedicarse a su afición de naturalista. De hecho, durante estos siglos gran parte de los naturalistas y geólogos eran reverendos anglicanos.

En estos casi cuatro años que dura su estancia en Cambridge (1828-1831) entabla amistad con dos figuras que serán fundamentales en la futura vida de Darwin y en su viaje en el Beagle: los reverendos John Stevens Henslow (profesor de botánica) y Adam Sedgwick (profesor de geología). Estos dos profesores y su pasión por la lectura de las aventuras naturalistas de Von Humboldt le empujarán a organizar lo que realmente iba a ser el viaje de sus sueños: Visitar las Islas Canarias.

Carta a su primo William Darwin Fox [07de abril de 1831]

“Por ahora, hablo, pienso y sueño en el plan que he cocinado para ir a las islas Canarias. Hace tiempo que tengo el deseo de ver paisajes y vegetaciones tropicales y, según Humboldt, Tenerife es un buen ejemplo de ellos”

“The Charles Darwin Sculpture Garden, Cambridge” Escultura de bronce realizada por Anthony Smith como pieza central del jardín. Captura el momento, a principios del verano de 1831, cuando Charles Darwin, un joven de 22 años en este College, estaba planeando una expedición a Tenerife en las islas Canarias. Esperaba seguir los pasos de uno de sus héroes, el explorador y naturalista Alexander von Humboldt” | Imagen Javier Peláez.

Carta a su hermana Caroline Darwin [28 de abril de 1831]

“Mientras te escribo mi mente le da vueltas a los trópicos. Por la mañana voy y contemplo las palmeras del invernadero y regreso a casa y leo a Humboldt: mi entusiasmo es tan grande que apenas si me puedo quedar quieto en mi silla. Henslow y otros profesores apoyan nuestro plan: Henslow me promete meterme la geología a la fuerza. Nunca me sentiré tranquilo hasta no ver el pico de Tenerife y el árbol drago [Dracaena draco]; las deslumbrantes llanuras arenosas y el silencioso bosque sombrío son lo que más alterna en mi cabeza. Trabajo regularmente en mi español; Erasmus me aconsejó decididamente que dejara el italiano. Me he trazado un esplendor tropical”.

Carta a su primo William Darwin Fox [11 de mayo de 1831]

“En cuanto a mi plan para las Canarias, es imprudente que me hagas tantas preguntas. Mis otros amigos desean sinceramente que ya me encuentre ahí, de tanto que los atosigo con mi plática sobre los paisajes tropicales, etc., etc. Eyton irá en el próximo verano, y ya estoy aprendiendo español”.

Carta a su primo William Darwin Fox [09 de julio de 1831]

“El plan de las Canarias va viento en popa. Trabajo como un tigre para conseguirlo, en este momento con el español y la geología, y mientras que al primero lo encuentro intensamente estúpido, la segunda es de lo más interesante”.

Carta a John Stevens Henslow [11 de julio de 1831]

“Y ahora, lo que toca a las Canarias. Le escribí al señor Ramsey dándole la poca información que pude conseguir en la ciudad. Pero como posiblemente dejó Cambridge, lo intentaré por mí mismo. Pasaje: 20 libras. Los barcos van y vuelven durante los meses de junio a febrero, aunque como no he visto aún al agente, las dos preguntas más importantes quedan sin responder, o sea si significa junio inclusive y con qué frecuencia navegan. No tardaré en enterarme de todo ello. Espero que usted siga alimentando su fervor canario. He leído y releído a Humboldt, así que haga lo mismo y estoy seguro de que nada impedirá que veamos el árbol del gran drago”.

Escultura de Darwin en el Christ’s College de Cambridge | Imagen Javier Peláez.

Como vemos la idea original era que Henslow acompañara a Darwin en su viaje, sin embargo el profesor atado por obligaciones personales se fue distanciando del proyecto.

Carta a su primo William Darwin Fox [01 de agosto de 1831]

“El plan de las Canarias no tendrá lugar antes del próximo junio, y lamento saber que la posibilidad de que Henslow venga es muy remota. Esperaba que conforme pasaran los días las cosas fueran arreglándose”.

Paradójicamente serían estas obligaciones familiares de su profesor de botánica las que terminarían llevando a Darwin a tomar su puesto en el Beagle puesto que la invitación fue en primer lugar para Henslow quien, al no poder embarcarse en un viaje tan largo propuso que fuera el joven Darwin el que ocupara su lugar.

Y es que, apenas unos días después de esta carta de Darwin fechada el 01 de agosto, los acontecimientos iban a dar un giro inesperado para todos. Sin que él supiera nada, el futuro de Charles Darwin estaba a punto de cambiar radicalmente gracias a una carta de la que ni siquiera era consciente.

Esta carta representa probablemente el momento clave de toda su vida. Una hoja de apenas cuatro párrafos, escrita por el profesor de matemáticas George Peacock a Henslow, y que terminaría cambiando el plan de Darwin las Canarias por otro aún más ambicioso:

Carta de George Peacock a John Stevens Henslow [13 de agosto 1831]

Querido Henslow: El capitán FitzRoy partirá para inspeccionar la costa de Tierra del Fuego, visitar más tarde muchas de las islas del mar del Sur y regresar por el archipiélago indio. El barco ha sido habilitado expresamente con fines científicos, en combinación con la exploración. Por lo tanto proporcionará una rara oportunidad para un naturalista y sería muy infortunado que se perdiera… […] ¿Habría alguna persona a quien usted pudiera recomendar ampliamente? Debe ser una persona tal que dé satisfacción a nuestra recomendación. Piense en esto: sería una grave pérdida para la causa de las ciencias naturales que se perdiera esta preciosa oportunidad. El barco partirá a finales de septiembre. […] Escriba inmediatamente y dígame qué puede hacerse”.

Más adelante en esta serie de artículos analizaremos con más detalle las diferentes cartas que llevaron a Darwin a embarcarse en el HMS Beagle, pero por ahora diremos que esta nueva aventura reunía todas sus expectativas puesto que la primera parada prevista de este gran viaje también eran las islas Canarias.

“Cuadro físico de las Islas Canarias. Geografía de las Plantas de Tenerife.” Extraído del Volumen 1 de los Viajes a las regiones equinocciales del nuevo continente de Humboldt.

A pesar de que septiembre era el mes previsto para el inicio del viaje, el arduo trabajo de acondicionamiento del Beagle hizo que la partida se retrasara hasta el 27 de diciembre de 1831. A partir de este día, y ya embarcado, Darwin se pasó las primeras semanas enfermo por el “mal de mar” y, recluido en el camarote, estuvo casi siempre mareado y vomitando.

Hasta el 08 de febrero apenas tuvo un momento para volver a escribir, y al primero a quien envió una carta fue a su padre, Robert Waring Darwin, explicando los vaivenes del viaje y la llegada, por fin, a su sueño dorado: Las islas Canarias.

Carta a Robert Waring Darwing [08 de febrero 1832]

“[…] Nos hicimos a la vela, como usted sabe, el 27 de diciembre. […] En el golfo de Vizcaya nos topamos con una larga y continuada mar crecida y la infelicidad que soporté por el mal de mar llegó mucho más allá de todo lo que esperaba. […] No logré que nada me aliviara más que tenderme en mi hamaca. Debo exceptuar su envío de uvas, pues es la única comida que soporta mi estómago.

El 04 de enero estábamos a unas millas de Madeira, pero como había un mar alborotado y la isla estaba a barlovento, no valía la pena pensar en abordarla. Yo estaba tan enfermo que ni siquiera pude levantarme para ver su contorno en la distancia.

El 06 de enero por la tarde llegamos al puerto de Santa Cruz (de Tenerife). Al principio me sentía moderadamente bien y me representaba a mí mismo todas las delicias de fruta fresca creciendo en bellos valles y leyendo las descripciones de Humboldt de las gloriosas vistas de las islas.

Quizá pueda usted imaginar nuestra desilusión cuando un hombrecito pálido nos informó que debíamos observar una estricta cuarentena de 12 días. Hubo un silencio de muerte en el barco hasta que el capitán gritó: “¡Larguen el foque!” y abandonamos este lugar tan deseado”.

Pico Teide en Tenerife. Imagen Javier Peláez

Hace unos años el periódico Diario de Avisos contactó conmigo y me pidió una columna semanal sobre historia y ciencia. Acepté y titulé a aquella sección “Desde la cubierta del Beagle” puesto que fue así como Darwin vio realmente las islas Canarias. Nunca llegó a pisarlas y al final tuvo que contentarse con contemplar sus paisajes desde el mar… desde la cubierta de su barco.

“Tuvimos mar en calma por un día entre Tenerife y la Gran Canaria y aquí experimenté por primera vez un gran placer: la vista era magnífica. El pico de Tenerife se veía entre las nubes como de otro mundo. Nuestra única desventaja era el deseo extremado de visitar esta espléndida isla. Padre, dígale a Eyton que no olvide nunca cualquiera de las islas canarias, que con toda seguridad la molestia necesaria valdrá la pena y que debe tener en mente encontrarse con una buena cantidad de problemas. Sin embargo estoy seguro de que se arrepentirá si no hace el intento”.

Este post ha sido realizado por Javier Peláez (@irreductible) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Las Cartas de Darwin: El sueño truncado de Canarias se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: 50 años para un proyecto titánico

- Bilbao celebrará el día de Darwin

- La unidad de selección en la evolución y el origen del altruismo (1): En el comienzo fue Darwin

#Naukas16 ¿Cómo saber si tu funeraria te estafa?

La ciencia forense también descubre fraudes funerarios. JM Mulet lo ilustra.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 ¿Cómo saber si tu funeraria te estafa? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 Arqueología funeraría: la fama y el olvido

- #Naukas16 Cómo escribir un libro de ciencia para niños

- #Naukas16 La nutrición está sobrevalorada (y cómo me jode)

Pozos de conocimiento: el problema de la profundidad

Un especialista, dice un proverbio con muchas atribuciones, es alguien que cada vez sabe más sobre cada vez menos hasta que los sabe todo sobre nada. Y esto es un problema, como bien describió el científico e inventor Nikola Tesla: “Hoy los científicos piensan profundamente en lugar de con claridad. Uno tiene que estar cuerdo para pensar con claridad, pero se puede pensar profundamente y estar bastante loco”. Desde la invención de la escritura que tanto preocupara a Platón y en especial desde el descubrimiento de la lectura en silencio por San Ambrosio la cultura occidental ha confundido el conocimiento con la profundidad, haciéndolos sinónimos. Es así como se han desarrollado unas ciencias en las que la especialización en nichos cada vez más estrechos conocidos en cada vez mayor detalle se ha convertido en la norma. La única manera de avanzar es profundizar; la carrera profesional y la aportación de un científico sólo son posibles cuando este excava empujando los límites del conocimiento unos milímetros más allá de donde estaban.

Y así hemos construido silos de saber de inconcebible profundidad haciendo extenso uso de la cuchilla separadora como única herramienta: hemos desmontado la naturaleza en sus partes constituyentes, y según los conocimientos sobre cada parte iban aumentando y se hacía imposible que una única persona los tuviese en su cabeza las ciencias se fueron separando y especializando cada vez más. De los filósofos naturales del siglo XVIII que hacían aportaciones en matemáticas, astronomía, física, arquitectura, medicina y química hemos pasado a los científicos actuales que trabajan en resolver un enigma dentro de una subdisciplina dentro de una especialidad que es sólo una parte de un amplio campo de conocimiento. En ocasiones utilizan herramientas de corte titánicas como aceleradores de partículas, microscopios confocales, tomógrafos de radiación sincrotrón o telescopios en órbita terrestre, pero en su caja de herramientas mental trabajan de la misma forma: separando la realidad en pedacitos y estudiando cada uno en profundidad.

No se puede dudar de que este enfoque ha proporcionado un enorme caudal de conocimiento a la Humanidad, tanto que la idea del científico universal capaz de conocer todos los campos lo bastante como para poder hacer aportaciones en todos ellos es hoy poco realista. Está claro que la profundidad ha sido rentable y que nos ha permitido conocer el universo como jamás antes. Pero también es cierto que lo profundo tiene sus inconvenientes y que tres siglos largos de creciente especialización nos han llevado a una situación casi límite. Para colmo el método de conocimiento basado en fragmentar para saber fracasa cuando la clave del funcionamiento de un rincón del cosmos es la integración de sistemas.

Las especialidades científicas se han hecho tan profundas, separadas y aisladas que un profesional puede pasar toda su carrera, desde el principio de su formación a la cúspide de su desempeño profesional, dentro de un mínimo sector de conocimiento sin necesidad de mirar fuera lo más mínimo. Los campos de estudio se convierten en silos de conocimiento aislados unos de otros en los que establecer relaciones entre enfoques o disciplinas es casi imposible. Cada silo desarrolla su propia metodología y hasta su propia jerga; la separación es tan completa que a veces los científicos tienen dificultades para explicar su trabajo a los científicos del laboratorio de enfrente. Las posibles conexiones entre disciplinas que estudian los mismos fenómenos desde diferentes puntos de vista se hacen así casi imposibles de modo que resulta difícil comprender sistemas complejos. El método de cortar filetes cada vez más estrechos de realidad fracasa a la hora de explicar el funcionamiento en conjunto de un sistema u organismo.

El hecho de que en los últimos años hayan proliferado las iniciativas interdisciplinares es un reconocimiento de este hecho: el aislamiento entre las diferentes especialidades de la ciencia contribuye a dificultar el avance del conocimiento y es necesario romper las paredes de los silos para que el saber se mezcle y enriquezca. Pero no basta con contemplar la interdisciplinariedad en la evaluación de proyectos o con crear institutos pluridisciplinares si a la hora de publicar o de evaluar el rendimiento de un profesional no se tienen en cuenta estos factores. Las revistas siguen siendo especializadas; las publicaciones siguen siendo incomprensibles excepto para los especialistas y los trabajos que intentan establecer puentes entre diversas disciplinas no son premiados, sino castigados en la práctica. Los profesionales que se desvían de la estricta disciplina de lo abisal encuentran dificultades en su carrera, y se premia la dedicación a la máxima profundidad por ciega y estéril que pueda resultar. Y como resultado de esta obsesión por la profundidad el conocimiento de la Humanidad sobre el universo sufre.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Pozos de conocimiento: el problema de la profundidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 La transferencia de conocimiento, ¿nos lleva a la pobreza?

- El conocimiento tácito de Polanyi

- Xurxo Mariño: “Nuestro sistema nervioso no es un máquina fiable para acceder al conocimiento”

De guijarro a asteroide en una trampa de polvo

Nuestro Sistema Solar, como cualquier otro sistema planetario, comenzó a formarse a partir de discos de gas y granos de polvo que orbitaban una estrella. Los procesos que convierten estos granos minúsculos, cada uno con un tamaño que no supera unas pocas millonésimas de metro (una micra) de diámetro, en agregados de unos pocos centímetros, y el mecanismo por el que los “planetesimales” de kilómetros pasan a ser los núcleos de planetas, se entienden bastante bien.

Ahora bien, la etapa intermedia, esa que va de guijarro a asteroide, no está tan clara. De hecho es algo que se asume que ocurre “de alguna manera”, después de todo, con más de 3500 planetas descubiertos orbitando otras estrellas, el proceso debe ser algo bastante común en el universo.

Trampa de polvo en un disco protoplanetario representada como una banda brillante. El polvo aparece en rojo y el gas en azul.

Ahora un grupo de investigadores, encabezado por Jean-François Gonzalez, del Centro de Investigación Astrofísica de Lion (Francia), ha desarrollado un modelo que permite explicar el capítulo que falta en la historia de la formación de los planetas: desde el gas y el polvo hasta los planetesimales.

Existen dos barreras principales que impedirían que un grupo de guijarros se convierta en un planetesimal. En primer lugar la atracción gravitatoria de la estrella unida a el efecto de resistencia aerodinámica que provoca el gas en los granos de polvo, hacen que los granos de polvo tiendan a ir rápidamente hacia la estrella, donde son aniquilados. En segundo, los granos de polvo que chocan entre sí pueden romperse a poco que la colisión con otro grano sea mínimamente energética, lo que los convierte en un número mayor de piezas más pequeñas, disgregando más que agregando.

Una solución a ambos problemas es que formen “trampas de polvo”: zonas en los discos que formarán los planetas en los que la alta presión hace que la velocidad se rebaje, permitiendo que los granos de polvo se acumulen. La velocidad baja hace menos probable que ocurran colisiones con energía suficiente como para romper los granos.

Fases de la formación de una trampa de polvo. Las flechas indican el sentido de las fuerzas ejercidas por el gas (rojas) y el polvo (azul).

Hasta ahora se pensaba que las trampas de polvo solo podían existir en entornos muy concretos, pero las simulaciones por ordenador llevadas a cabo por el equipo de investigadores apuntan a que son mucho más comunes de lo que se pensaba. En el modelo la interacción gas-polvo se considera que actúa en ambos sentidos, esto es, en un entorno en los que la concentración de polvo es importante sus efectos en la velocidad del gas son importantes.

Una de las consecuencias de esta interacción es que el gas se ve expulsado hacia el exterior y forma la zona de alta presión, esto es, la trampa de polvo como tal. Estas trampas, que se forman espontáneamente, concentran los granos que vienen de las regiones más externas del disco protoplanetario, creando un anillo muy denso de sólidos. Una vez que son lo suficientemente grandes, los granos se convierten en amos de su destino y el gas ya no influye significativamente en su movimiento.

Observatorios como el ALMA en Chile ya han observado anillos brillantes y oscuros en sistemas planetarios en formación que se cree que son trampas de polvo.

Referencia:

J.-F. Gonzalez, G. Laibe, S. T. Maddison (2017) Self-induced dust traps: overcoming planet formation barriers Mon Not R Astron Soc doi: 10.1093/mnras/stx016

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo De guijarro a asteroide en una trampa de polvo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Polvo de estrellas

- El asteroide 2012DA14, visto desde Bilbao

- Artazu VII, una trampa mortal del Pleistoceno que es un tesoro

Incendios, los grafos de visibilidad y la conjetura de Collatz

“Hay verdades que sólo pueden ser reveladas a condición de ser descubiertas.”

Carta final de Nawal Marwan a sus hijos gemelos Jeanne y Simon

En septiembre de 2016 se representó por primera vez en castellano Incendios del dramaturgo Wajdi Mouawad; la obra de teatro está dirigida por Mario Gas y cuenta con un gran elenco de actrices y actores.

Lamentablemente, no me ha sido posible ir a verla, pero he leído más de una vez el texto en el que se basa la obra, una durísima historia que trata sobre la violencia (sobre todo ejercida contra las mujeres), la venganza, la importancia de lo escrito y de lo hablado, la recuperación de la memoria, la búsqueda de los orígenes, las huellas que dejan lo vivido… Lo que comentaré en esta nota se basa, por lo tanto, en el libro [1].

Incendios, la historia

Nawal Marwan acaba de morir, tras haberse negado a hablar durante cinco años. Por medio del notario Hermile Lebel, deja a su hija y a su hijo –los gemelos Jeanne y Simon– un testamento en forma de misión: la de entregar una carta a un padre que creían muerto y otra a un hermano del que desconocían la existencia. Tras cumplir con este cometido, podrán poner su nombre sobre la tumba de su madre y abrir otras dos misivas que explicarían el silencio de Nawal durante los últimos años de su vida.

Jeanne y Simon deben dejar Canadá –país en el que creen haber nacido– para regresar al Líbano y encontrar sus orígenes. En esta búsqueda se esconde la necesidad de comprender la historia de su madre, y por lo tanto la suya propia.

Poco a poco van conociendo la historia de Nawal a la que, con tan sólo quince años, arrebatan al hijo nacido de la relación con su amado Wahab. Nawal debe abandonar su poblado y regresa años más tarde para buscar al niño robado. Se encuentra en mitad de una sangrienta guerra, en la que los refugiados huyen perseguidos por milicianos que violan y asesinan de manera impune.Hay un verdadero incendio en la historia, el de un autobús del que Nawal consigue salir de manera milagrosa; Nawal es encarcelada tras matar a un miliciano en defensa propia, y en la prisión de Kfar Rayat es sometida a terribles torturas por parte de Abou Tarek. Fruto de las continuas violaciones de este hombre, Nawal queda embarazada y da a luz a los dos gemelos.

Como parte del legado de su madre, Jeanne y Simon deben encontrar a su padre –al que creían muerto– y a su hermano mayor, y entender el motivo del incomprensible silencio de Nawal.

Las matemáticas de Incendios

Jeanne enseña teoría de grafos en la universidad, y así habla de la matemática básica durante una de sus clases:

Las matemáticas que habéis conocido hasta ahora han tenido como objetivo encontrar una respuesta estricta y definitiva a problemas estrictos y definitivos. Las matemáticas en las que os embarcáis al seguir este curso de introducción a la teoría de grafos son de naturaleza completamente diferente, porque se tratará con problemas insolubles que os llevarán siempre a otros problemas igualmente insolubles. La gente de vuestro entorno os repetirá que eso en lo que os obstináis es inútil. Cambiará vuestra manera de hablar, y más aún, vuestra forma de callar y de pensar. Esto es precisamente lo que menos os perdonarán. Os reprocharán a menudo el malgastar vuestra inteligencia en ejercicios teóricos absurdos en vez de ponerla al servicio de la investigación contra el SIDA o de un tratamiento contra el cáncer. No tendréis ningún argumento para defenderos, ya que vuestros argumentos son en sí mismos de una complejidad teórica absolutamente agotadora. Bienvenidos a las matemáticas puras, es decir, al país de la soledad. Introducción a la teoría de grafos.

Poco después, Jeanne explica lo que es un grafo de visibilidad, aludiendo a las relaciones familiares. Volverá a hablar de este objeto matemático, cuando ‘deba añadir a su propio grafo de visibilidad –el que representa su familia– a su padre y a su hermano mayor’.

Consideremos un polígono simple con cinco lados etiquetados A, B, C, D y E. Llamamos a este polígono, el polígono K. Ahora imaginemos que este polígono representa el plano de una casa donde vive una familia. Y en cada rincón de la casa se sitúa uno de los miembros de esta familia. Reemplacemos por un instante A, B, C, D y E por la abuela, el padre, la madre, el hijo, la hija que viven juntos en el polígono K. Nos planteamos entonces la cuestión de quien –desde el punto de vista que ocupa– ve a quien. La abuela ve al padre, a la madre y a la hija. El padre ve a la madre y a la abuela. La madre ve a la abuela, al padre, al hijo y a la hija. El hijo ve a la madre y a la hermana. Por último, la hermana ve a su hermano, a la madre y a la abuela. […] Ahora, quitemos las paredes de la casa y unamos mediante caminos sólo los miembros de la familia que se ven. El dibujo al que llegamos se llama grafo de visibilidad del polígono K. […] El problema es el siguiente: para cualquier polígono simple, se puede trazar fácilmente –como hemos demostrado– su grafo de visibilidad y su aplicación teórica. Ahora, ¿cómo se puede –partiendo de una aplicación teórica, ésta por ejemplo–, dibujar el grafo de visibilidad y así encontrar la forma del polígono concordante? ¿Cuál es la forma de la casa en la que viven los miembros de la familia representada por esta aplicación? Intentad dibujar el polígono. […] No lo conseguiréis. La teoría de grafos se basa esencialmente en este problema, de momento imposible de resolver. Ahora bien, es esta imposibilidad la que es bella.

Tras recoger la carta destinada a su padre de las manos del notario, Jeanne dice a Lebel:

En matemáticas, 1+1 no son 1,9 o 2,2. Son 2. Ya se esté de buen humor o se sea infeliz, 1 y 1 son 2. Todos pertenecemos a un polígono, Sr. Lebel. Pensé que conocía mi lugar en el interior del polígono al que pertenezco. Creía ser el punto que sólo ve a su hermano Simon y a su madre Nawal. Ahora, me entero de que, desde el lugar que ocupo, es posible que pueda ver también a mi padre; me entero además de que existe otro miembro de este polígono, otro hermano. El grafo de visibilidad que siempre he dibujado es falso. ¿Cuál es mi lugar en el polígono? Para saberlo, tengo que resolver una conjetura. Mi padre está muerto. Ésa es la conjetura. Todo lleva a pensar que es verdadera. Pero nada la demuestra. No he visto su cadáver, no he visto su tumba. Es posible, por lo tanto, entre el 1 y el infinito, que mi padre esté vivo.

El descubrimiento de la verdad sobre el padre y el hermano mayor rompe esas certezas en las que cualquiera cree sin dudar –como la de que uno más uno son dos–. A través de la conjetura de Collatz la terrible realidad –que no vamos a decir de manera explícita– sale a la luz:

Simon (S): Siempre me has dicho que uno más uno son dos. ¿Es verdad?

Jeanne (J): Sí… Es verdad.

S: ¿No me has mentido?

J: ¡No! ¡Uno y uno son dos!

S: ¿Nunca es uno?

J: ¿Qué has descubierto, Simon?

S: Uno más uno ¿puede ser uno?

J: Sí.

S: ¿Qué?

[…]

S: Explícame como uno más uno puede ser uno, siempre me has dicho que no entendía nada, así que ¡ahora es el momento! ¡Explícame!

J: ¡De acuerdo! Hay una conjetura muy extraña en matemáticas. Una conjetura que nunca se ha demostrado. Me vas a dar un número, cualquiera. Si el número es par, se divide por dos. Si es impar, se multiplica por tres y se suma uno. Haremos lo mismo con el número que se obtiene. Esta conjetura afirma que cualquiera que sea el número de partida, por este procedimiento se llega siempre a uno. Di un número.

S: Siete.

J: Bueno siete es impar. Lo multiplicamos por tres y le añadimos uno, da…

S: Veintidós.

J: Veintidós es par, se divide por dos.

S: Once.

J: Once es impar, se multiplica por tres, y se añade uno:

S: Treinta y cuatro.

J: Treinta y cuatro es par. Se divide por dos, diecisiete. Diecisiete es impar, se multiplica por tres, y se suma uno, cincuenta y dos. Cincuenta y dos es par, se divide por dos, veintiséis. Veintiséis es par, se divide por dos, trece. Trece es impar. Se multiplica por tres y se suma uno cuarenta. Cuarenta es par, se divide por dos, veinte. Veinte es par, se divide por dos, diez, diez es par, se divide por dos, cinco. Cinco es impar, se multiplica por tres y se suma uno. Dieciséis. Dieciséis es par, se divide por dos, ocho, ocho es par, se divide por dos, cuatro, cuatro es par, se divide por dos, dos, dos es par, se divide por dos, uno. Independientemente de la cifra inicial, se llega a… ¡No!

Aunque no se dice explícitamente en el texto, se reconoce en la historia la cruel guerra del Líbano que tuvo lugar entre 1975 y 1989. Por ejemplo, se alude al incendio del autobús en 1975 y las masacres de los campos de refugiados de Sabra y Chatila.

Nota: Las traducciones de los extractos elegidos de la obra (ver [1]) son de la autora de esta anotación.

Referencias

-

Wajdi Mouawad, Incendies, Actes Sud, 2011

-

Marta Macho Stadler, Incendies, de Wajdi Mouawad, DivulgaMAT, Teatro y matemáticas, diciembre 2012

-

Página de Wajdi Mouawad dedicada a Incendies

-

Alfonso Jesús Población Sáez, La conjetura de Siracusa, reseña sobre la película Incendies basada en la obra de W. Mouawad, DivulgaMAT, Cine y Matemáticas, mayo 2011

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Incendios, los grafos de visibilidad y la conjetura de Collatz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La conjetura de Goldbach

- La teoría de grafos y “Così Fan Tutte”

- La conjetura de Poincaré-Perelman-Miander

#Naukas16 Aquí no se opina, aquí se mide

Javier Fernández Panadero tiene un don para la comunicación en general, y para la científica del día a día en particular. Como además usa “cacharritos” salen cosas como esta cuando habla de sesgos cognitivos, que operan aunque los conozcas.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Aquí no se opina, aquí se mide se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 ¿Cifras o encriptas? Siempre con la ayuda de tus primos

- #Naukas16 Sandman, tócala otra vez

- #Naukas16 Pianos, torpedos y lo inesperado

Paracelso, el antisistema

Las clases que comenzó a impartir Paracelso en la Universidad de Basilea supusieron una ruptura completa con la tradición. De entrada las daba en alemán, en vez de en latín (algo en común con Lutero, que fue la primera persona que se atrevió a publicar la Biblia en un idioma, el alemán, que no fuera el latín), y contenían muchas más información práctica que teórica.

No solo despreciaba en ellas las obras de Galeno y Avicena verbalmente; su falta de aprecio adquiría tintes dramáticos, como cuando el día de san Juan de 1527 unos estudiantes necesitaban combustible para la hoguera y Paracelso no dudó en arrojar a ella una copia del Canon de Avicena, expresando su esperanza de que el autor se encontrase en las mismas circunstancias. Y de nuevo encontramos otra similitud con Lutero: cuando éste recibió la amenaza de excomunión por una bula papal, quemó públicamente la bula.

Las curas de Paracelso ganaban rápidamente fama, como también crecía el número e importancia de sus pacientes. Ello conllevó que el número de sus enemigos creciese exponencialmente. Entre esto estaban los médicos que afirmaban que no tenía título de medicina alguno y, por lo tanto, no estaba cualificado y los farmacéuticos, que veían cómo disminuían sus ingresos habida cuenta que Paracelso fabricaba sus propios tratamientos. Por ello, cuando su protector Froben murió dos años después de que lo curase Paracelso (no se sabe si por la misma causa), sus enemigos empezaron a sentirse poderosos.

La crisis estalló cuando el canónigo Cornelius von Lichtentels prometió a Paracelso la cantidad exorbitante de dinero que éste le exigía como pago por aliviar el agudísimo dolor abdominal que sentía; promesa que olvidó cuando unas cuantas píldoras de opio de Paracelso lo eliminaron. Paracelso lo llevó a los tribunales y los tribunales dieron la razón al canónigo. Paracelso, de todo menos prudente, dejó constancia allí mismo de su opinión de los tribunales en general, de los miembros de ellos en particular, y tuvo algo de tiempo para acordarse de familia y amigos. Los pocos que aún conservaba convencieron a Paracelso de que era el momento ideal para dejar Basilea a toda prisa.