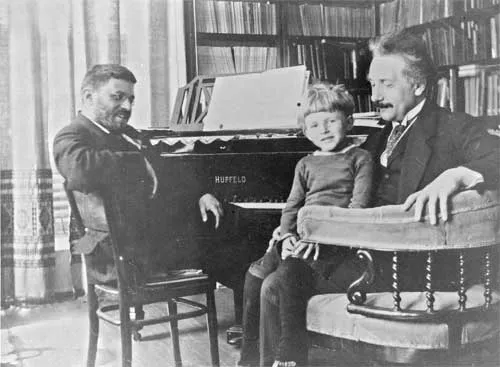

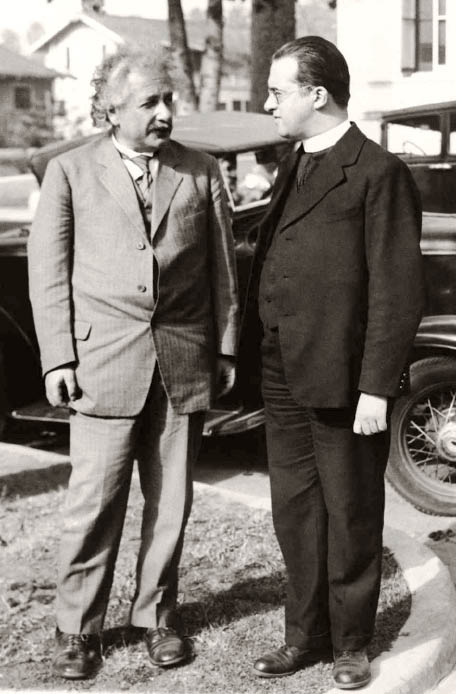

Einstein y Paul Ehrenfest

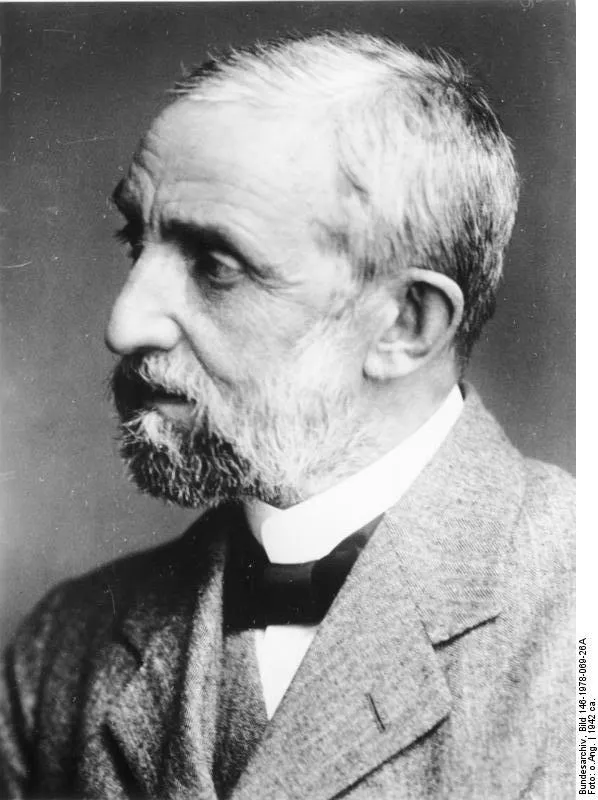

El físico austriaco Paul Ehrenfest fue un íntimo amigo de Einstein. Fue un hombre con una personalidad efusiva, dado a hablar entre signos de exclamación, y bastante emocional. Su disgusto fue enorme cuando Einstein se negó a aceptar ciertos aspectos de la ciencia moderna, y su pasión le llevó a la autodestrucción, acosado por sus tragedias personales.

Foto tomada en la casa de Ehrenfest en Leiden. El niño sentado en las rodillas de Einstein es Paul (Pavlik), el mayor de los dos hijos varones de Ehrenfest y que llegaría a ser físico como su padre. Su hija Tatyana sería matemática como su madre. Fuente: Wikimedia Commons

Foto tomada en la casa de Ehrenfest en Leiden. El niño sentado en las rodillas de Einstein es Paul (Pavlik), el mayor de los dos hijos varones de Ehrenfest y que llegaría a ser físico como su padre. Su hija Tatyana sería matemática como su madre. Fuente: Wikimedia CommonsEinstein pasó menos de dos años enseñando en la universidad alemana de Praga, pero fue en esta época cuando conoció a Ehrenfest y a muchos de sus futuros colegas en la comunidad de físicos. Como joven físico Ehrenfest tuvo, como Einstein, muchas dificultades para asegurarse un puesto académico. De hecho, Ehrenfest estaba en una de las etapas de lo que sería un periplo por varias universidades europeas a la búsqueda de una posición estable cuando comenzó su amistad con Einstein.

Los dos hombres se conocieron en la estación de trenes de Praga un día de febrero. En su diario, Ehrenfest recogió sus impresiones del momento en su estilo telegráfico: “Por fin llegada a Praga, gris. Bajo [del tren]. Einstein (puro en la boca) allí, con esposa. Derechos al café… Hablamos de Viena, Zúrich, Praga…De camino al instituto primera discusión acerca de todo. Lluvia en la calle, lodo, discusión todo el rato. Instituto: salón de clases, escaleras a física teórica. Discusión constante con Einstein”.

Esas discusiones ayudaron a Einstein a formular su revolucionaria teoría general de la relatividad. Einstein y Ehrenfest, siendo ambos de lengua afilada, disfrutaron de tener alguien con quien discutir acaloradamente sobre física. Ehrenfest se hospedó con los Einstein, y, según el diario de Ehrenfest, emplearon una gran cantidad de tiempo en “discusión”. “Te. De 12-2:30. Discusión con Einstein. A la cama muy tarde”. Al día siguiente, “Empezamos a discutir inmediatamente…Tarde Einstein me habla de su artículo sobre gravitación”.

Tanto Ehrenfest como Einstein se vieron muy influenciados, y construyeron sobre las ideas, de dos viejos maestros de la física de su tiempo, el matemático francés Henri Poincaré y el físico holandés Hendrik Antoon Lorentz. La odisea de Ehrenfest por las universidades de Europa terminó con éxito cuando se le ofreció el puesto de Lorentz de catedrático de física matemática en la Universidad de Leiden en 1912.

Solo unos meses antes, Einstein había aceptado un nuevo puesto de profesor creado expresamente para él en el Politécnico de Zúrich. Einstein escribió por aquella época que se sentía aliviado por haber ya aceptado el puesto de Zúrich antes de saber de la jubilación de Lorentz, y quizás haberse visto forzado a aceptar su puesto. Pero es muy posible que Einstein estuviese intentando quedar bien: parece que Einstein y Ehrenfest eran un poquito competitivos el uno con el otro, y fue una sorpresa para la toda la comunidad científica que Ehrenfest ganase una cátedra tan prestigiosa como la de Leiden.

A pesar de estar en ciudades distintas, Einstein y Ehrenfest se escribían y veían a menudo. En 1913 Ehrenfest y su esposa, la matemática rusa Tatiana Alekséyevna Afanásieva, visitaron Zúrich y, aunque se suponía que iban a ser unas vacaciones, Ehrenfest pasó casi cada hora en discusión profunda con Einstein. Sólo una vez registró en su diario: “Un día sin Einstein”.

La rigurosa correspondencia entre Einstein y Ehrenfest da una visión desde dentro del desarrollo de la teoría general de la relatividad. Cuando Einstein se estaba preparando para remitir la teoría a la asociación científica de Alemania, escribió a Ehrenfest que su nueva teoría de la gravitación podría hacer que le internasen en un sanatorio psiquiátrico. “Espero que no tengáis uno en Leiden”, escribió, “para que os pueda visitar con seguridad”. Einstein no necesitaba preocuparse. La nueva teoría cimentó su papel como uno de los principales físicos del mundo, y poco después Ehrenfest intentó tentarle para que se uniera a él en la Universidad de Leiden. En una carta de 1919 le dice “De repente estamos todos de acuerdo en que tenemos que atarte a Leiden”, carta que cierra con esta posdata: “¡Realmente es un incordio que tú tengas algo que decir en una cuestión que nosotros estamos en mucha mejor posición para decidir que tú mismo!” Sin esperar a la respuesta de Einstein, envió otra carta: “Aquí no hay más que gente que te quiere a ti y no solo a tu corteza cerebral”.

Einstein, sin embargo, declinó la invitación, y los dos hombres continuaron con sus cartas llenas de bromas en las que discutían física teórica y, a veces, asuntos religiosos. Al igual que Einstein Ehrenfest era judío, y por eso Einstein encontró en él alguien con quien discutir no solo de física sino también de sionismo. Ehrenfest prestaba los oídos comprensivos que Einstein no encontraba en Berlín. Einstein le escribió: “Tú no me regañas por mis escarceos sionistas. Aquí hay bastante indignación, lo que, sin embargo, me es indiferente. Incluso los judíos asimilados se lamentan de mí o me reprenden”.

Pero, como dos de los principales físicos de su tiempo, Einstein y Ehrenfest no podían dejar de discutir a menudo sobre el tema más controvertido del momento: la mecánica cuántica. El campo surgió en buena medida de las propias teorías de Einstein, y Ehrenfest organizó en Leiden el primer congreso sobre mecánica cuántica durante la conmemoración de los 50 años del doctorado de Lorentz, el 11 de diciembre de 1925. Si bien ambos amigos comprendían la relatividad de manera similar, en cuestiones de mecánica cuántica estaban claramente enfrentados. Ehrenfest la admitía sin reservas; Einstein tenía muchos prejuicios. El que hubiese tenido que elegir estar en contra de las posiciones de su amigo fue muy doloroso para Ehrenfest. Emotivo como era, el asunto era capaz de llenar sus ojos de lágrimas. En vano señaló Ehrenfest a Einstein que una vez él mismo había presentado una teoría completamente nueva, la relatividad especial, y que también tuvo que convencer a los físicos veteranos de su veracidad. Einstein, ahora en el papel de veterano, rehusaba aceptar las nuevas teorías.

Tristemente, Ehrenfest no participaría en las discusiones sobre la mecánica cuántica durante mucho tiempo. Einstein y Ehrenfest parecían vivir vidas paralelas, compartiendo tragedias similares. El hijo pequeño de Einstein, Eduard, desarrolló esquizofrenia y pasó sus últimos días en una clínica. El hijo pequeño de Ehrenfest, Vassily, nació con síndrome de Down. Ante la angustia de Ehrenfest por tener que internar a su hijo en una institución, Einstein intentó consolarlo, compartiendo con él el frío razonamiento que él había aplicado a su propia tragedia: “Los individuos valiosos no deben ser sacrificados en aras de casos perdidos, ni siquiera en estas circunstancias”. Por otra parte, Einstein, plenamente consciente de la situación personal de su amigo, escribió al consejo rector de la Universidad de Leiden expresándoles su preocupación y rogándoles que disminuyesen la carga de trabajo de Ehrenfest.

A pesar de todo, Ehrenfest, el pasional, no encontraba consuelo. Escribió una carta a sus colegas en septiembre de 1933, que transcribimos íntegra:

“¡Mis queridos amigos: Bohr, Einstein, Franck, Herglotz, Joffé, Kohnstamm y Tolman!

Realmente ya no sé como llevar durante los próximos meses la carga de mi vida que se ha vuelto insoportable. No puedo soportar más que mi cátedra en Leiden se vaya por el sumidero. Debo abandonar mi posición aquí.

Quizás pueda ocurrir que pueda usar el resto de mis fuerzas en Rusia…Si, sin embargo, no se aclara pronto el que lo pueda hacer, entonces está claro que me mataré. Y, si eso ocurre alguna vez, me gustaría saber que os he escrito, con calma y sin prisas, a vosotros cuya amistad ha jugado un papel tan importante en mi vida.

…Perdonadme.”

Esta carta y otra dirigida a sus estudiantes nunca fueron enviadas. En una depresión profunda, el 25 de septiembre de 1933 Ehrenfest mató a su amadísimo hijo Vassily de un disparo en la sala de espera del médico y acto seguido se disparó a sí mismo, muriendo al instante.

En la necrológica de su amigo, Einstein escribió:

“No era sólo el mejor maestro de nuestra profesión que yo haya conocido; también estaba apasionadamente preocupado por el desarrollo y destino de los hombres, especialmente de sus estudiantes. Comprender a los demás, ganar su amistad y confianza, ayudar a cualquiera inmerso en luchas internas o externas, alentar el talento de la juventud, este era su verdadero elemento, casi más que la inmersión en problemas científicos”.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 13 de septiembre de 2009.

El artículo Einstein y Paul Ehrenfest se ha escrito en Cuaderno de Cultura Científica.

Ideología, política y cambio climático

“Somos la primera generación en sentir el efecto del cambio climático y la última generación que puede hacer algo al respecto.”

Barack Obama, 23 septiembre 2014

“Esta muy costosa mierda del calentamiento global tiene que parar. El planeta se está congelando, registra bajas temperaturas, y nuestros científicos del calentamiento global están atrapados en el hielo.”

Donald Trump, 1 enero 2014

Foto: William Bossen / Unsplash

Foto: William Bossen / UnsplashEs sorprendente que, mientras que el 97% de los científicos y expertos en cambio climático consideran que es un hecho demostrado provocado por la actividad humana y que el 97% de los artículos científicos publicados sobre este asunto lo apoyen, solo el 50% de los estadounidenses acepten el cambio climático, y todavía son menos los que creen que lo provoca la actividad de nuestra especie.

Una revisión diez años después y publicada en 2021, Krista Myers y su grupo, de la Universidad Estatal de Louisiana en Baton Rouge, con respuestas a una encuesta enviada a geocientíficos de Estados Unidos y Canadá, con 2780 respuestas, entre l 91% y el 100% apoyan que la causa del cambio climático es la actividad humana. Las respuestas de los 153 expertos más reconocidos y con el currículo científico más amplio es la que llega al 100%.

En España, en 2013, el 80% afirma que el cambio climático es un hecho científico, solo el 8.5% lo rechaza y el 86% acepta que es el resultado de la actividad humana. Los universitarios estudiantes de Biología e Ingeniería Química de la Universidad de Santiago de Compostela, en más de un 80%, consideran que es la actividad humana la causa del cambio climático. El estudio, firmado por Pablo Meira y Mónica Arto, se basa en entrevistas a 284 alumnos y se publicó en 2014.

En 2013, John Cook y su grupo, de la Universidad de Queensland, en Australia, revisaron 11944 artículos publicados sobre el clima entre 1991 y 2011. El 97% de los artículos que expresan una opinión sobre el cambio climático provocado por la actividad humana apoyan su existencia. Solo el 1.9% lo rechaza, y el 1.0% plantea dudas sobre que su causa sea nuestra especie. Y en encuestas a 1372 expertos en cambio climático, en 2010, el 98% acepta a nuestra especie y sus actividades como causa, según el estudio de William Anderegg y sus colegas de la Universidad de Stanford. Para John Cook, los estudios que rechazan el cambio climático provocado por la actividad humana son cada vez más escasos y su número disminuye según pasan los años.

Un par de años después, el grupo de J.S. Carlton, de la Universidad Purdue, encuestó sobre el cambio climático a 698 biofísicos de diez de las más prestigiosas universidades de Estados Unidos. Los resultados son parecidos a los del trabajo de Cook: el 93.6% afirma que el calentamiento global es un hecho, y el 91.9% apoya que su causa es la actividad humana. La conclusión de los autores del estudio es que la ciencia del cambio climático es creíble y está consolidada.

Foto: Juan Manuel Sanchez / UnsplashNo hay sesgos científicos detectables…

Foto: Juan Manuel Sanchez / UnsplashNo hay sesgos científicos detectables…

Se puede argumentar que la publicación de artículos que apoyan el consenso sobre el cambio climático está favorecida por los editores de revistas científicas, pero la investigación de Christian Harlos y sus colegas, de la Universidad de Lund, en Suecia, demuestra que el sesgo no existe. Revisan los artículos sobre clima publicados entre 1997 y 2013 e identifican 120 textos, en revistas de gran difusión, con los resultados de 1154 experimentos. No detectan ningún sesgo, ninguna omisión de resultados sobre el cambio climático, sea a favor o en contra.

Desde la Universidad de California en Merced, Alexander Petersen y su grupo compararon la difusión de las publicaciones de 386 autores contrarios al cambio climático y de 386 expertos científicos en el mismo tema. Encontraron dos resultados diferentes en la difusión en los medios. Los contrarios al cambio climáticos tienen un 50% más de presencia que los expertos científicos. Pero en los medios de mayor difusión la diferencia de visibilidad es solo del 15. Son los nuevos medios en las redes sociales los que contribuyen a la producción y consumo de desinformación sobre el cambio climático.

Sin embargo, la desconexión entre el consenso científico y la percepción social, que se observa en Estados Unidos y en muchos otros países, se atribuye a la ideología, a aceptar la información sobre el cambio climático que no esté en contra de la ideología propia y a construir la interpretación de lo que ocurre según esa información. Lo contrario de lo que aconsejaba Sherlock Holmes cuando decía aquello de que “uno comienza a deformar los hechos para hacerlos encajar en la teoría en lugar de encajar la teoría en los hechos”.

…pero sí sesgos ideológicosLa ideología política puede tener mucha influencia no solo en la comunidad científica sino, sobre todo, en el público en general al que llegan, en muchos casos, informaciones sesgadas según el medio de comunicación que las difunda. Juan Ignacio Pérez y Joaquín Sevilla comentan como la negación de la existencia del cambio climático se vincula a la ideología conservadora. Según explican, la base ideológica se relaciona con una visión optimista del mundo, con la creencia de una naturaleza sin límites, incluso capaz de asimilar los cambios provocados por las actividades de la especie humana. Además, los efectos del cambio climático, según afirman los expertos, siempre se sitúan en el futuro, en un tiempo que nuestra especie no es muy capaz de calibrar.

Cuando Toby Bolsen y James Druckman, de las universidades Estatal de Georgia y del Noroeste, estudiaron los factores que influían en la aceptación por los ciudadanos del cambio climático y de la actividad humana como su causa, encontraron que la ideología del receptor era un factor importantes. Reúnen encuestas de 1329 voluntarios, en julio de 2014, y el análisis de sus respuestas revela que la difusión de información sobre el consenso científico sobre el cambio climático entre los ciudadanos consigue que aumente la aceptación de la actividad humana como causa, excepto para los republicanos que se consideran bien informados.

Por todo ello, Ridley Dunlap y sus colegas, de la Universidad Estatal de Oklahoma, han revisado esta polarización ideológica y, en consecuencia, política y partidaria en Estados Unidos cuando se trata el cambio climático.

Durante la década de los noventa, la brecha entre demócratas y republicanos al tratar asuntos relacionados con el medio ambiente no dejó de crecer. Hasta entonces las votaciones en el Congreso y en el Senado estaban relativamente cercanas y, a menudo, se aprobaban o rechazaban propuestas con los votos de ambos partidos. Para aprobar propuestas sobre el medio ambiente, los porcentajes de apoyo variaban entre el 30% de los republicanos y el 60% de los demócratas. Pero, a partir de esa década, los porcentajes comenzaron a separarse y, en 2015, llegaban al 5%-15% de aprobación por los republicanos y el 80%-90% en los demócratas. Son la ideología y el programa de los partidos quienes dirigen las votaciones.

Si nos centramos en el cambio climático, cerca del 80% de los demócratas aceptan el calentamiento global. Entre los republicanos, el porcentaje llega al 40%. Parecidos porcentajes, del 80% y del 40%, se obtienen en respuesta a la pregunta de si el calentamiento se debe a la actividad humana. Los resultados se invierten si se pregunta si los medios exageran los peligros del calentamiento: lo afirma el 60% de los republicanos y el 10% de los demócratas. Solo el 40% de los republicanos acepta que la mayoría de los científicos del clima han llegado al consenso respecto al cambio climático mientras que, entre los demócratas, el porcentaje llega al 80%.

Todo intento de politizar el cambio climático elimina el efecto que produce la información sobre el consenso científico. Politizar el debate disminuye la credibilidad del consenso y su aceptación se filtra a través de la ideología del receptor. Entonces cuenta más la ideología que las evidencias científicas.

Sin embargo, el estudio de Sander van der Linden y sus colegas, de la Universidad de Cambridge, con encuestas a 6301 voluntarios de Estados Unidos, muestra que resaltar el consenso científico sobre el cambio climático aumenta la aceptación del cambio climático tanto en conservadores como en liberales. Entre los conservadores sube del 60% al 80%, y entre los liberales del 80% al 90%. Para los autores, más que convencer sobre el cambio climático, lo que implica politizar el debate, lo adecuado es promover la ciencia y sus valores, destacando el consenso científico sobre el cambio climático.

Es evidente que la ideología personal influye en el debate sobre la aceptación del cambio climático. Por tanto, lo que los líderes políticos opinen o apoyen públicamente será importante en el proceso de aceptación. Lo estudiaron, en Australia, con encuestas a 1211 voluntarios, Thad Kousser y Bruce Tranter, de las universidades de California en San Diego y de Tasmania. En concreto, en las encuestas se pedía el apoyo a políticas públicas relacionadas con el cambio climático como la disminución las emisiones de dióxido de carbono o la promoción de las energías renovables. Cuando los líderes políticos discrepan, los ciudadanos reaccionan según su ideología: los conservadores se oponen y los liberales lo apoyan. Cuando los líderes están de acuerdo, los ciudadanos apoyan esas políticas y lo hacen sea cual sea su ideología.

También en Australia, Colvin y Jotzo, de la Universidad Nacional Australiana de Canberra, después de encuestar a 2033 votantes en las elecciones de 2019, detectan que la mayoría piensan que es importante para Australia disminuir las emisiones de gases con efecto invernadero. Pero la importancia que dan a las acciones para conseguirlo es mayor en los votantes de partidos políticos considerados progresistas, con un mayor nivel de educación y, también, en los más jóvenes.

Foto: Matt Palmer / UnsplashEl efecto de la temperatura de ayer sobre la opinión de hoy

Foto: Matt Palmer / UnsplashEl efecto de la temperatura de ayer sobre la opinión de hoy

Tanto influye la ideología en las opiniones sobre el calentamiento global que Lawrence Hamilton y Mary Stampone, de la Universidad de New Hampshire en Durham, han encontrado que, después de una encuesta, y sea cual sea la temperatura de los días anteriores, casi el 80% de los demócratas acepta el cambio climático mientras que el 70% de los republicanos lo rechaza. Y los que se declaran independientes lo aceptan o lo niegan según la temperatura de los días anteriores a la encuesta: lo niegan si han estado a 6ºC bajo cero y lo aceptan si ha sido de 12ºC sobre cero.

Y no solo influye el tiempo de los días anteriores, también lo hace el de los últimos meses y años. En el estudio de Jeremiah Bohr, de la Universidad de Wisconsin, analiza el clima en 2013 y 2014 y lo compara con la aceptación del cambio climático y la ideología política según cuatro encuestas de la CBS y del New York Times.

El tiempo de los últimos cinco años amplia la percepción de los impactos del cambio climático y la polarización política en cuanto a si ha sido causado por la actividad humana o no. Esta reacción es más evidente entre los demócratas. Lo que ocurre, según el estudio de Hamilton y Stampone sobre la influencia del tiempo de los días anteriores, también se da para lo que ocurre en los años anteriores. Los demócratas se reafirman en su convicción de que la causa del cambio climático es la actividad humana si las temperaturas han sido altas, y los republicanos en su negación del cambio climático si ha hecho frío. Así, la polarización política de las creencias sobre el cambio climático crece si se dan temperaturas extremas poco habituales.

En la revisión publicada en 2017 que trata de esta relación entre ideología y medio ambiente, de Wanyum Shao, de la Universidad de Auburn, en Estados Unidos, con datos de 2012 los resultados se mantienen, con los demócratas aceptando el cambio climático y la intervención humana, y los republicanos lo niegan y, además, con la orientación más extremista del grupo Tea Party.

Incluso hay una diferencia similar entre demócratas y republicanos, en Nueva York, respecto a los desastres provocados por el clima como, por ejemplo, las inundaciones del huracán Sandy en 2012. La percepción de los demócratas de la probabilidad de sufrir inundaciones es mucho mayor que para los republicanos, con porcentajes del 70% para los primeros y casi del 50% en los segundos.

Un aspecto curioso de estas diferencias ideológicas sobre la aceptación del cambio climático lo explican Karen Douglas y Robbie Sutton, de la Universidad de Kent, en Inglaterra. Hacen una revisión que demuestra que, para muchos ciudadanos, el cambio climático no es un hecho científico sino, más bien, una creencia que, además, tiene mucho que ver con lo llamamos conspiraciones. Es típico de nuestra cultura digital y globalizada que cualquiera puede proponer que detrás de algo, de lo que sea, hay una conspiración que lo explica y justifica. En poco tiempo, miles de internautas difunden la conspiración y millones la aceptan y se la creen.

La actuación personal depende de la moralidad personalLa ideología indica lo que la persona piensa y acepta, pero su moral influye en cómo actúa según esas ideas. En la ideología se basa la conducta pero es la moralidad la que fundamenta su comportamiento, como definen Janis Dickinson y sus colegas, de la Universidad Cornell de Ithaca, al estudiar el compromiso de cada ciudadano sobre el cambio climático. Mencionan cinco ejes principales de la moralidad: compasión, justicia, honradez, autoridad y lealtad al grupo.

Trabajan con encuestas telefónicas a 1000 voluntarios hechas entre agosto y octubre de 2014. De los cinco ejes de la moral que estudian, los que mejor predicen el compromiso de cambio de vida para mitigar el cambio climático son la compasión y la justicia. Destacan estos dos ejes en los progresistas y, por ello, su aceptación de la existencia del cambio climático es mayor que en los conservadores. Estos muestran apoyo al cambio climático con honradez, autoridad y lealtad al grupo.

El contexto lo es todo en las noticias sobre cambio climáticoPero la información sobre cambio climático y sobre la ciencia, en nuestra cultura global, llega a los ciudadanos por los medios de comunicación. Los resultados de Toby Bolsen y Matthew Shapiro, de la Universidad Estatal de Georgia y del Instituto de Tecnología de Illinois en Chicago, muestran cómo influye en los lectores el marco en que se incluyen las noticias sobre el cambio climático. Esas noticias cambian si aparece el cambio climático en noticias de ciencia con el consenso científico o, por el contrario, con las incertidumbres de la ciencia. O hablar de desastres naturales y de que su número puede aumentar con el cambio climático. O de economía y afirmar que la lucha contra el cambio climático puede suponer beneficios económicos o, por el contrario, destruir industria y empleo. Y así, mencionan los autores, el marco en que se incluye la noticia o la información sobre cambio climático puede influir en su aceptación o no por los ciudadanos. Aunque, como cuentan William Anderegg y Gregory Goldsmith, de las universidades de Princeton y Oxford, y con datos del número de consultas, en Google y entre 2004 y 2014, hay picos de interés, como en 2007 y 2010, pero, en general, el interés del público se sostiene durante la década analizada.

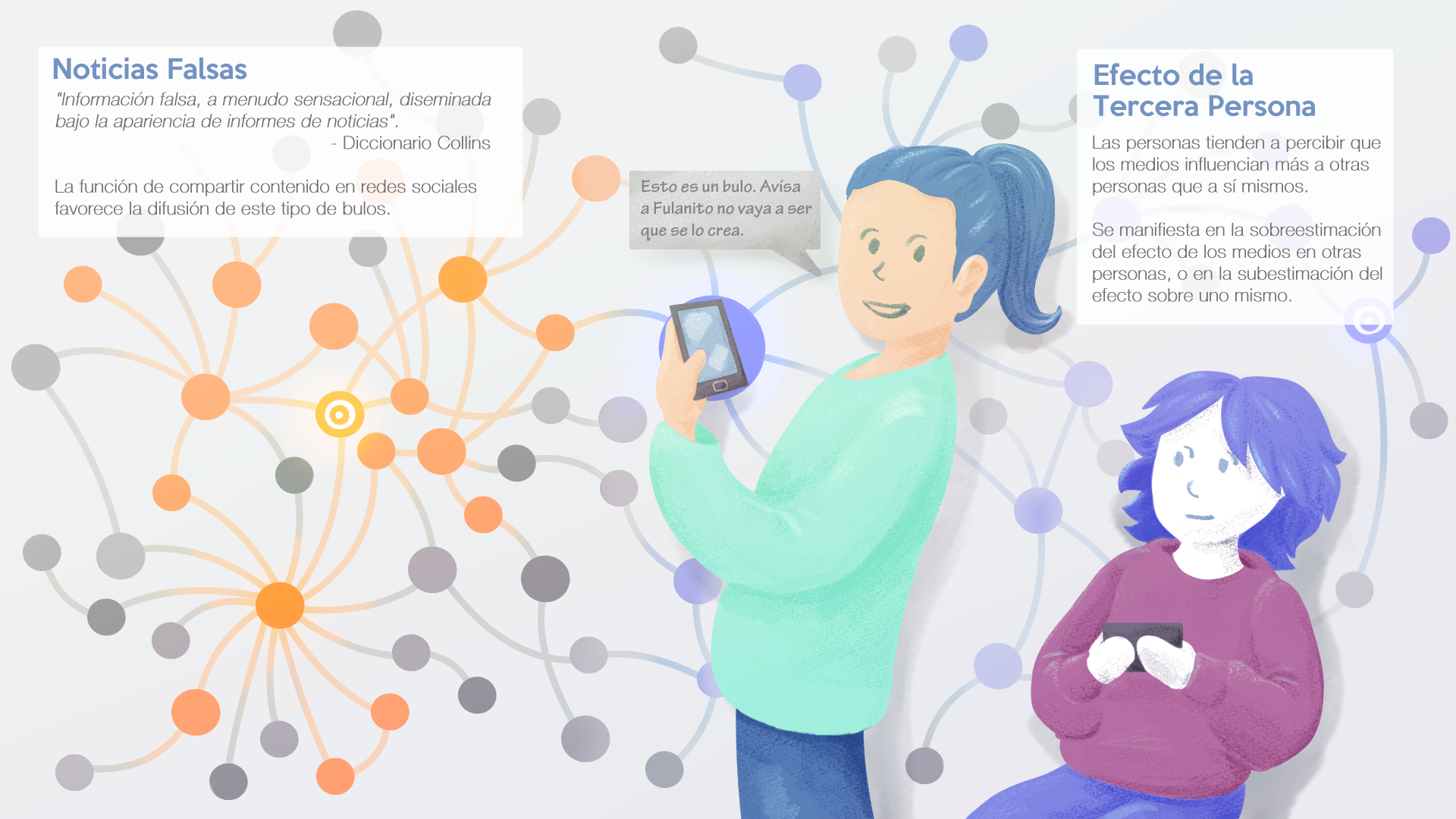

Y, además, estamos en la era de las noticias falsas, de las fake news. Pero no solo cuenta en que marco se incluyen las noticias sobre el cambio climático, también actúan las noticias falsas que llegan a los medios. Es un debate que, como ocurre con temas muy sensibles, incita a la invención y la falsedad. Así se manipula la opinión pública para desinformar, provocar debates innecesarios, difundir verdades alternativas, como diría Donald Trump, … El editorial de Nature Communications, de 20 de abril de 2017, avisaba de lo que estaba, y está, ocurriendo y de la necesidad de que los científicos y periodistas expertos en cambio climático se comprometan a desmontar noticias falsas. Solo así llegará la ciencia del cambio climático a los ciudadanos y, además, contribuirán a que el público se eduque en ciencia y pueda tomar, cuando sea necesario, las decisiones adecuadas.

Foto: Matt Palmer / UnsplashSe rechaza la ciencia por extensión

Foto: Matt Palmer / UnsplashSe rechaza la ciencia por extensión

Esta manera de pensar y aceptar los hechos puede llevar a rechazar no solo el cambio climático sino, además, la ciencia. Stephen Lewandowsky y Klaus Oberauer, de las universidades de Bristol, en Inglaterra, y de Zurich, en Suiza, comentan que el rechazo a los hallazgos científicos es más habitual en la derecha que en la izquierda aunque, realmente, el mecanismo de rechazo es igual en ambas ideologías. Es el procesamiento superficial de evidencias y el rechazo de toda evidencia que no encaje con las creencias de cada persona. Una buena educación e, incluso, una cultura científica suficiente no ayudan a mitigar el rechazo. Pero los autores también detectan que un conocimiento científico profundo del tema de que se trate, en este caso del cambio climático, ayuda en su aceptación. Erik Nisbet y su grupo, de la Universidad Estatal de Ohio en Columbus, añaden a esta investigación que una mentalidad abierta, sea cual sea el entorno, ayuda a cambiar de opinión y, en el caso concreto del cambio climático, a entender los costes y beneficios que supone la política gubernamental en relación con el clima.

Sobre esto de las conspiraciones y sobre el cambio climático, incluso se habla de una poderosa organización conspiratoria que recibe el nombre de Gran Conspiración del Cambio Climático, así escrito, con muchas mayúsculas. La forman científicos, periodistas y políticos que inventaron lo del calentamiento global en primer lugar y, después, asustaron con sus consecuencias. Los científicos lo hicieron para aumentar su influencia social y política y, claro está, para conseguir más fondos. También hay implicados ecologistas para promover las energías renovables. O empresarios relacionados con la energía nuclear para promover su construcción y erradicar los combustibles fósiles. Por supuesto, creer en esta conspiración es habitual entre quienes no aceptan el cambio climático y la intervención humana como su causa.

Todos, demócratas y republicanos, hablan del mismo planeta, en la misma época de la historia, y sobre el mismo tema, y nos dan una muestra exacta de cómo influyen las interpretaciones individuales basadas, está claro, en creencias que blindan las ideologías. Además, ni a demócratas ni a republicanos les gusta escuchar opiniones de otros. Jeremy Frimer y su grupo, de la Universidad de Winnipeg, en Canadá, lo han estudiado con más de 2400 voluntarios y con encuestas sobre diferentes temas. Concluyen que las personas comprometidas con su ideología están igualmente motivadas para evitar la información transversal, es decir, que no esté comprometida con ninguna ideología. Por ejemplo, la información científica. Y lo hacen porque es cansado, requiere esfuerzo y provoca frustración, y socava el sentido de la realidad compartida con quien piensa igual y con el grupo al que pertenece. No hay diferencias, concluyen, en el deseo de demócratas y republicanos de permanecer en sus respectivas burbujas ideológicas.

El efecto paísPor los analizado hasta ahora es evidente que los expertos encuentran conclusiones contradictorias. El estudio de Matthew Hornsey y su equipo, de la Universidad de Queensland, en Australia, muestra que los datos estudiados hasta 2018 provienen, en su gran mayoría, de Estados Unidos y son los que revelan la influencia de la ideología conservadora y la creencia en conspiraciones. Así se justifica el rechazo a la existencia del cambio climático. Pero el estudio de Hornsey incluye 24 países y es, precisamente, en Estados Unidos donde más influye la ideología. En el resto de los países no aparecen los mismos resultados y, como ejemplo, en España, la ideología de no aceptación del cambio climático se sitúa ligeramente a la derecha del espectro político y es tres veces menor que en Estados Unidos. Además, hay una relación menor entre el escepticismo sobre el cambio climático y la creencia en conspiraciones para promocionarlo.

La respuesta a la pregunta de quienes son responsables del cambio climático cambia según el país. El estudio de Ruxandra Malina Petrescu-Nag y sus colegas, de la Universidad Babes-Bolyai de Cluj-Napoca, en Rumania, nos sirve de ejemplo pues compara las respuestas de belgas y rumanos. Para los primeros, los responsables son todos los ciudadanos, incluso cada uno de ellos. En cambio los rumanos apuntan a las grandes compañías, los gobiernos y los consumidores en general. Además, los rumanos destacan que el cambio climático a menudo se utiliza con exageración e intención política.

Referencias:

Anderegg, W.R.L. et al. 2010. Expert credibility in climate change. Proceedings of the National Academy of Sciences USA 107: 12107-12109.

Anderegg, W.R.L. & G.R. Goldsmith. 2014. Public interest in climate change over the past decade and the effects of the “climagate” media event. Environmental Research Letters 9: 054005.

Bohr, J. 2017. Is it hot in here or is it just me? Temperature anomalies and political polarization over global warming on the American public. Climatic Change DOI: 10.1007/s10584-017-1934-z.

Bolsen, T. & J.N. Druckman. 2018. Do partisanship and politicization undermine the impact of a scientific consensus message about climate change? Processes & Intergroup Relations 21: 389-402.

Bolsen, T. & M.A. Shapiro. 2017. The US news media, polarization on climate change, and pathways to effective communication. Environmental Communication doi: 10.1080/17524032.2017.1397039.

Botzen, W.J.W. et al. 2016. Political affiliation affects adaptation to climate risks: Evidence from New York City. Climatic Change DOI: 10.1007/s10584-016-1735-9.

Carlton, J.S. et al. 2015. The climate change consensus extends beyond climate scientists. Environmental Research Letters 10: 094025.

Colvin, R.M. & F. Jotzo. 2021. Australian voters’ attitudes to climate action and their social-political determinants. PLOS One 16: e0248268.

Cook, J. et al. 2013. Quantifying the consensus on anthropogenic global warming in the scientific literature. Environmental Research Letters 8: 024024.

Dickinson, J.L. et al. 2016. Which moral foundations predict willingness to make lifestyle changes to avert climate change in USA? PLOS One 11: e163852.

Douglas, K.M. & R.M. Sutton, 2015. Climate change: Why the conspiracy theories are dangerous. Bulletin of the Atomic Scientists 71: 98-106.

Dunlap. R.E. et al. 2016. The political divide on climate change: Partisan polarization widens in the U.S. Environment. Science and Policy for Sustainable Development 58: 4-22.

Editorial. 2017. Fake news threatens a climate literate world. Nature Communications 8: 15460.

Frimer, J.A. et al. 2017. Liberals and conservatives are similarly motivated to avoid exposure to one another’s opinions. Journal of Experimental Social Psychology 72: 1-12.

Hamilton, L.C. & M.D. Stampone. 2013. Blowin’ in the wind: Short-term weather and belief in anthropogenic climate change. Weather, Climate, and Society 5: 112-119.

Harlos, C. et al. 2017. No evidence of publication bias in climate change science Climatic Change 140: 375-385.

Hornsey, M.J. et al. 2018. Relationships among conspirational beliefs, conservatism and climate scepticism across nations. Nature Climate Change 8: 614-620.

Kousser, T. & B. Tranter. 2018. The influence of political leaders on climate change attitudes. Global Environmental Change 50: 100-109.

Lewandowsky, S. & K. Oberauer. 2016. Motivated rejection of science. Current Directions in Psychological Science 25: 217-222.

Meira-Cartea, P.A. & M. Arto-Blanco. 2014. Representaciones del cambio climático en estudiantes universitarios en España: aportes para la educación y la comunicación. Educar em Revista, Curitiba, Brasil 3: 15-33.

Myers, K.F. et al. 2021. Consensus revisited: quantifying scientific agreement on climate change and climate expertise among Earth scientists 10 years later. Environmental Research Letters 16: 104030.

Nisbet, E.C. et al. 2013. Attitude change in competitive framing environments? Open-/closed-mindedness, framing effects, and climate change. Journal of Communication 63: 766-785.

Pérez, J.I. & J. Sevilla. 2022. Los males de la ciencia. Next Door Publ. Pamplona. 284 pp.

Petersen, A.M. et al. 2019. Discrepancy in scientific authority and media visibility of climate change scientists and contrarians. Nature Communications 10: 3502.

Petrescu-Mag, R.M. et al. 2022. How climate change science is reflected in people’s minds. A cross-country study on people’s perceptions of climate change. International Journal of Environmental Research and Public Health 19: 4280.

Shao, W. 2017. Weather, climate, politics, or God? Determinants of American public opinions toward global warming. Environmental Politics 26: 71-96.

van der Linden, S. et al. 2017. Scientific agreement can neutralize politicization of facts. Nature Human Behaviour doi: 10.1038/s41562-017-0259-2.

Para saber más:

Ciencia, creencias, política y matar al mensajero

«El cambio climático: ciencia, política y moral» por José Manuel Sánchez Ron

Certezas e incertidumbres sobre el cambio climático

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Ideología, política y cambio climático se ha escrito en Cuaderno de Cultura Científica.

Cómo nos cambió la Iglesia medieval

La Iglesia Católica modificó las relaciones familiares en la Edad Media y, como consecuencia, pudo haber influido en los patrones psicológicos contemporáneos

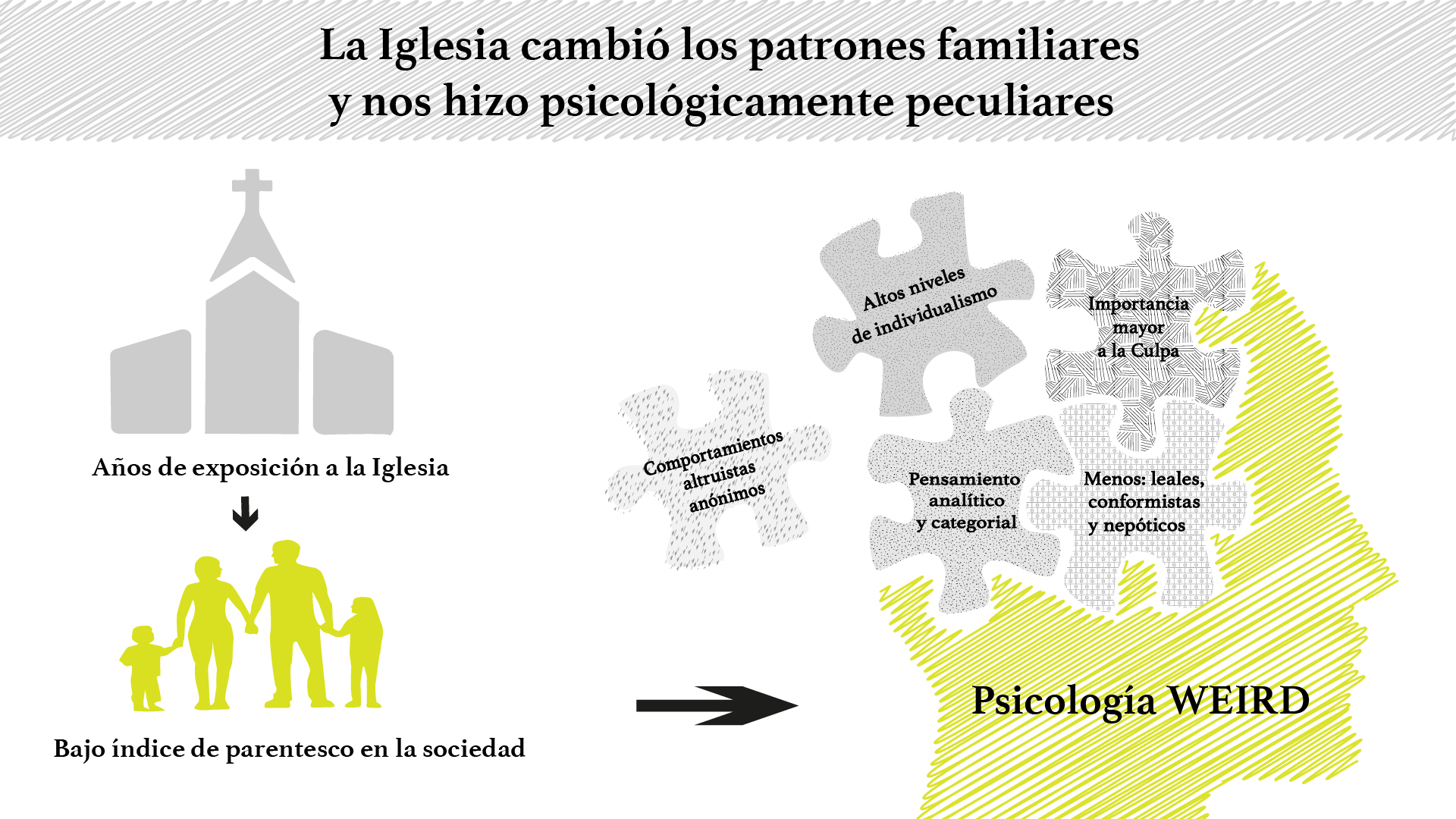

Ilustración: Elena Andreu

Ilustración: Elena Andreu

Jonathan F. Schulz, economista asociado a la Universidad de Harvard en el departamento de biología evolutiva humana y colegas, publicaron en noviembre de 2019 en la revista Science, un artículo que argumenta que hay una variación sustancial en los atributos psicológicos entre las culturas. Examinaron si la difusión del catolicismo en Europa generó gran parte de esta variación. En concreto, echaron la mirada atrás, a la política matrimonial y la estructura familiar que favorecía la Iglesia Occidental en la Edad Media (la rama del cristianismo que luego se convirtió en la Iglesia Católica Romana). Comprobaron, que la Iglesia tuvo el poder de desglosar las instituciones extendidas basadas en el parentesco y alentar una estructura familiar nuclear. Tanto es así, que los países con más siglos de influencia de la Iglesia (antes de 1500 de la era común) tienen hoy rasgos psicológicos característicos de las que han llamado sociedades WEIRD.

Hace algo así como una década, el antrópologo Joseph Henrich, en un artículo titulado «The weirdest people in the world” usaba la palabra “WEIRD” para describir nuestras sociedades. Además de extraño en inglés es el acrónimo de occidental, educada, industrializada, rica y democrática.

¿Pero entonces, qué rasgos tiene una persona de una sociedad WEIRD?

- Priorizan comportamientos prosociales impersonales, definidos como aquellos que benefician a un anónimo Otro; por ejemplo, ser voluntario o donante.

- Muestran altos niveles de individualismo y están insertos en intensos procesos de movilidad, cambio social y volcados en su éxito personal.

- La cultura occidental promueve formas de pensamiento más analítico y categorial, mientras que la asiática (y otras muchas) lo hace con un pensamiento más holístico y relacional.

- Se centran en las intenciones, creencias, y deseos, juzgándolas moralmente en lugar de enfatizar sus acciones. Se da importancia a la Culpa. Así en muchas sociedades No-WEIRD los castigos penales para homicidio accidental y premeditado eran las mismas mientras que en las sociedades WEIRD las penas dependen del estado mental del asesino sus intenciones y creencias.

- Son menos conformistas, menos obedientes, menos leales al grupo, y tienen menos nepotismo.

La Iglesia pudo influir en la psicología de muchas maneras y en concreto a través de los sistemas de parentesco.

La expresión “sistemas de parentesco” designa todo sistema de relaciones sociales donde se combina consanguinidad con afinidad o alianza. Es decir, de una parte intervienen elementos biológicos de filiación, término que hace referencia a los lazos de los padres con los hijos y entre hermanos, y, de otra, elementos sociales. Es decir, los lazos derivados de la relación conyugal, que son lazos de alianza que son determinados por acuerdos o conveniencias sociales.

La iglesia prohibió prácticas corrientes como la adopción, la poligamia, el divorcio, el concubinato, las segundas nupcias de los viudos, el matrimonio en el seno del parentesco y puso el acento sobre el consentimiento mutuo de los esposos en el matrimonio, su amor.i Reduciendo así la intensidad de parentesco de la sociedad.

Cuando los investigadores tuvieron que buscar datos sobre los sistemas de parentesco se basaron en el conjunto de datos del Atlas Etnográfico, elaborado a partir de observaciones de antropólogos sobre 1.291 poblaciones previas a la industrialización. Partiendo de estos datos crearon un índice de intensidad de parentesco en el que incluían la tendencia de la sociedad a contraer de matrimonios entre primos, la poligamia o a la convivencia con la familia del nuevo matrimonio. De forma adicional, tomaron los datos de prevalencia de matrimonio entre primos en el siglo XX. Así pudieron correlacionar los atributos psicológicos recopilados en variedad de pruebas, a la intensidad de parentesco de la sociedad y a los años de influencia de la Iglesia. A nivel regional, entre países y entre la primera generación de hijos de migrantes.

Concluyeron que las regiones con mayor tiempo de exposición a la Iglesia, tenían menos intensidad de parentesco y más rasgos de psicología WEIRD. Cabe preguntarse si la psicología WEIRD es solo una delgada capa que ante circunstancias adversas se rompe para desvelar a un ser humano que favorece a sus allegados por encima de todo.

Por otro lado asumir que la prosperidad occidental se debe a esta psicología es arriesgado, ya que no tiene en cuenta todos los actos inmorales no WEIRD que se han dado para que occidente haya prosperado como por ejemplo el colonialismo.

Referencias consultadas:

i Juan F. Gamella Ana María Núñez Negrillo Entre marido y mujer. Discursos eclesiásticos en las causas de dispensa de los matrimonios consanguíneos celebrados en la diócesis de Granada (1892-1963) DOI: 10.30827/Digibug.6741 https://www.ugr.es/~pwlac/G26_39Juan_Gamella-Ana_Nunez-Elisa_Carrasco.html

Schulz, J. F., Barahmi-Rad, D., Beauchamp, J., & Henrich, J. (2018, June 22). The Origins of WEIRD Psychology. https://doi.org/10.31234/osf.io/d6qhu

Jonathan F. Schulz, Duman Bahrami-Rad, Jonathan P. Beauchamp and Joseph Henrich (2019): The Church, intensive kinship, and global psychological variation. Science 366 (6466), eaau5141. DOI: 10.1126/science.aau5141.

Autora: Elena Andreu Rubert (IG: @elena_andreu_ilustra) es graduada en farmacia, e ilustradora científica. Alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2020/21

Artículo original: Pérez Iglesias, J.I. (2020) Así nos hizo la Iglesia: Individualistas, independientes y prosociales si no es personal Cuaderno de Cultura Científica

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión centrada en la propia ilustración

El artículo Cómo nos cambió la Iglesia medieval se ha escrito en Cuaderno de Cultura Científica.

Las pruebas de la educación: Lucas Gortazar – El puzle de la repetición de curso

Bilbao volvió a acoger el pasado 20 de mayo de 2022 “Las pruebas de la educación”, una jornada que abordará diversas cuestiones educativas con la evidencia científica existente. Esta quinta edición está organizado por la Cátedra de Cultura Científica de la UPV/EHU y la Fundación Promaestro con la colaboración del Consejo Escolar de Euskadi, y se celebró en el Bizkaia Aretoa – UPV/EHU de la capital vizcaína.

La jornada consta de cinco ponencias de media hora de duración en la que se tratan temas como la problemática relacionada con los juegos de azar en el ámbito escolar, el impacto de la inmigración en el rendimiento del alumnado o el debate sobre la jornada escolar continua o partida, entre otras cuestiones. La dirección del seminario corrió de nuevo a cargo de Marta Ferrero profesora de la Facultad de Formación del Profesorado y Educación de la Universidad Autónoma de Madrid.

En esta charla Lucas Gortazar, director de investigación y senior fellow de Educación del Centro de Políticas Económicas de Esade además de consultor en el Departamento de Educación del Banco Mundial, aborda “el puzle de la repetición de curso”, medida “poco efectiva, cara y desigual” como se concluye tras estudiar los datos administrativos de decenas de miles de alumnos vascos de Educación Primaria y la ESO.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Las pruebas de la educación: Lucas Gortazar – El puzle de la repetición de curso se ha escrito en Cuaderno de Cultura Científica.

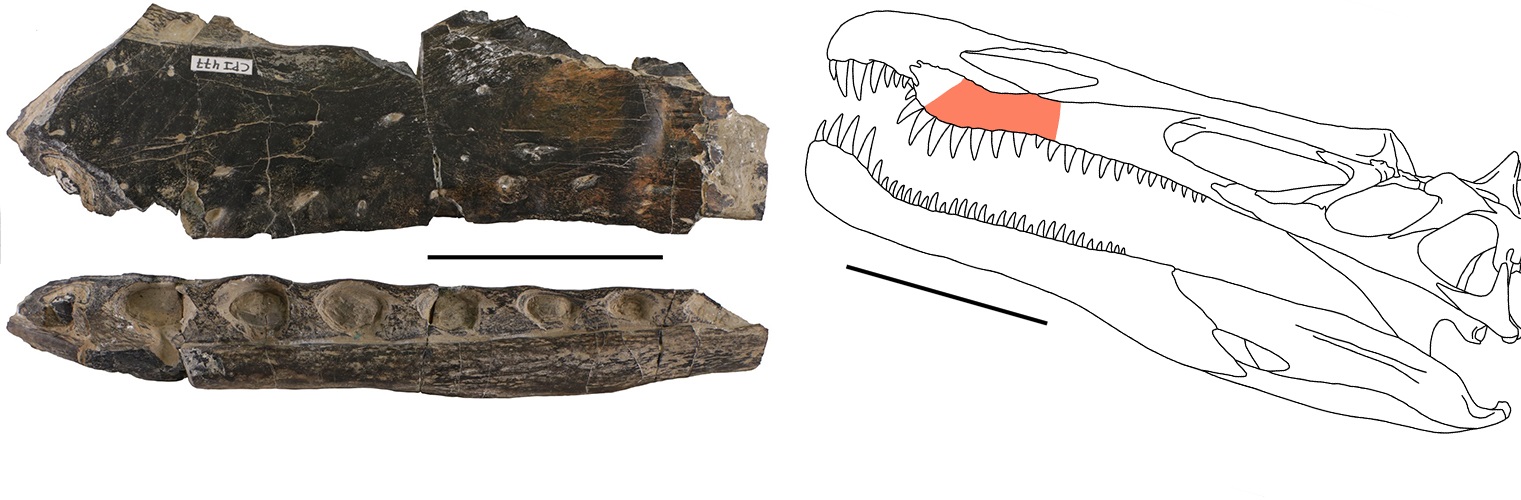

Por qué se encuentran tantos dientes de espinosáuridos

Los dinosaurios espinosáuridos podían desarrollar hasta tres generaciones de dientes al mismo tiempo, una alta tasa de reemplazo que explicaría por qué se han encontrado tantas piezas de este tipo en yacimientos del Cretácico.

Detalle de la dentadura de un fósil de Suchomimus tenerensis. Fuente: Wikimedia Commons

Detalle de la dentadura de un fósil de Suchomimus tenerensis. Fuente: Wikimedia CommonsLos científicos han reestudiado un resto fósil de mandíbula hallado en 1983 en un yacimiento del Cretácico Inferior en Igea (La Rioja, España). Se trata del fragmento de un maxilar izquierdo de dinosaurio carnívoro que preserva 8 alvéolos. En uno de estos huecos dentales han descubierto, mediante técnicas de microTAC, restos de varios dientes desarrollándose de forma simultánea.

“Hemos reconocido en un mismo alvéolo hasta tres generaciones de dientes: el diente funcional del animal; otra pieza en formación que reemplazaría al primero, y el germen del que acabaría sustituyendo a este segundo”, explica Pablo Navarro, de la Universidad de La Rioja.

Resto fósil estudiado y ubicación en el cráneo. Escala: 5 cm. | Foto: Centro de Interpretación Paleontológica de La Rioja en Igea.

Resto fósil estudiado y ubicación en el cráneo. Escala: 5 cm. | Foto: Centro de Interpretación Paleontológica de La Rioja en Igea.Ello implica un reemplazo dental muy rápido y es, probablemente, una de las razones de que encuentren tantos dientes de espinosáuridos en la península ibérica durante el Cretácico Inferior”, añade el coautor del artículo.

Hasta ahora se sabía que algunas especies de espinosáuridos –dinosaurios carnívoros de tamaño medio/grande, que poseían un cráneo alargado y unos dientes cónicos semejantes a los de los cocodrilos- podían cambiar de dientes más rápido que otros terópodos, en apenas dos meses (se estima una tasa de reemplazo de entre 60 y 68 días); esta investigación confirma que se trata de un rasgo común a todo el grupo y aporta evidencias de cómo se producía este cambio, gracias al desarrollo de varios dientes de sustitución al mismo tiempo.

“Estos animales generaban, a lo largo de toda su vida, nuevos dientes que iban reemplazando el diente original y provocando su caída. Esto implica que un mismo animal podía generar multitud de dientes”, asegura Pablo Navarro.

Reconstrucción artística de la cabeza de un espinosáurido. Fuente: Wikimedia Commons

Reconstrucción artística de la cabeza de un espinosáurido. Fuente: Wikimedia Commons“Estos dientes, de forma más o menos cónica y de tamaño centimétrico, eran transportados por los ríos y acumulados en zonas lacustres y, con el tiempo, quedaban fosilizados –indica el investigador-. Son uno de los restos de vertebrados más comunes en los yacimientos ibéricos del Cretácico Inferior (entre 145 y 113 millones de años)”.

Aunque no se conoce con precisión por qué cambiaban de dientes tan a menudo, se cree que esto les permitía poseer un mayor número de dientes funcionales en todo momento. Una ventaja decisiva para resistir el importante esfuerzo que les suponía sujetar a sus presas atrapándolas entre las mandíbulas.

Además de estos hallazgos, la investigación ha permitido matizar la clasificación del maxilar estudiado: los expertos no lo atribuyen, como se creía, al género Baryonix, sino a otro tipo de espinosáuridos muy cercano, un barioniquino indeterminado.

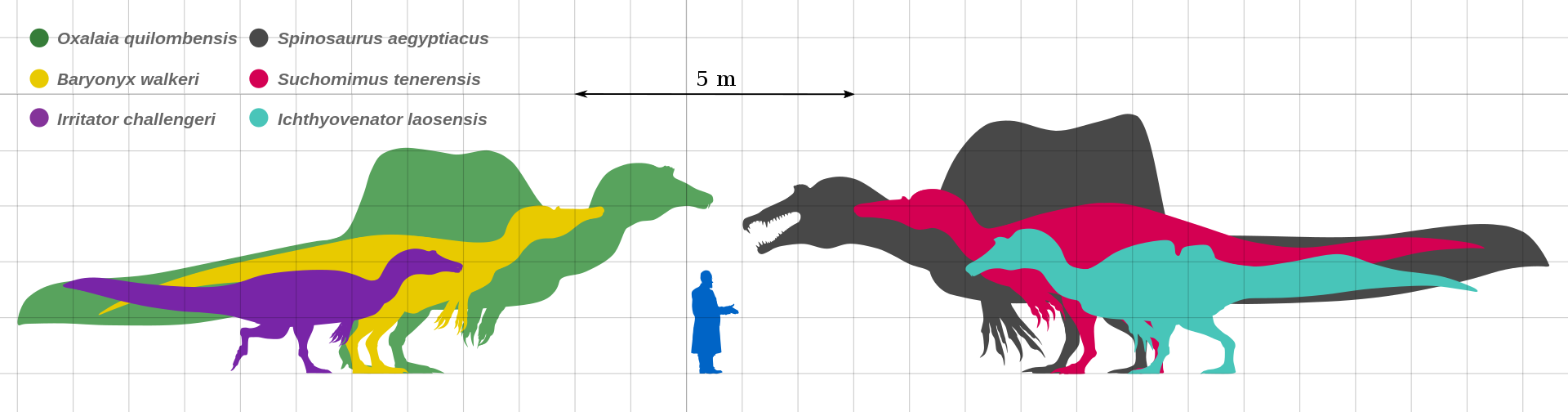

Tamaño de algunas especies de espinosáuridos. Fuente: Wikimedia Commons

Tamaño de algunas especies de espinosáuridos. Fuente: Wikimedia CommonsLos estudios paleontólogicos desarrollados hasta la fecha en Igea son relevantes por la presencia de numerosos restos óseos de espinosaurios, incluyendo esqueletos parciales pertenecientes a varios individuos. «La investigación actual permitirá mejorar nuestro conocimiento sobre la diversidad de este grupo tan particular de dinosaurios carnívoros. Es probable que al menos dos especies distintas estén representadas en los yacimientos de Igea», afirman Erik Isasmendi y Xabier Pereda-Suberbiola, paleontólogos del Departamento de Geología de la UPV/EHU, lo que convierte a esta localidad riojana en uno de los lugares destacados en el mundo en el estudio de los espinosaurios.

Referencia:

Erik Isasmendi, Pablo Navarro-Lorbés, Patxi Sáez-Benito, Luis I. Viera, Angelica Torices, Xabier Pereda-Suberbiola (2022) New contributions to the skull anatomy of spinosaurid theropods: Baryonychinae maxilla from the Early Cretaceous of Igea (La Rioja, Spain) Historical Biology doi: 10.1080/08912963.2022.2069019

Para saber más:

Veinte años de dinosaurios con plumas

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Por qué se encuentran tantos dientes de espinosáuridos se ha escrito en Cuaderno de Cultura Científica.

Los diapasones que miden nuestro tiempo

Koenig ha muerto, y sus amigos lo recordarán con cariño y respeto. Su devoción por la ciencia acústica fue única. Su vida fue la del bachiller recluso, y sus últimos años le trajeron ansiedad y privaciones porque su ciencia había perdido su valor como medio de sustento. No será olvidado pronto, pero tampoco nadie aspirará a ocupar su lugar.

W. Le Conte Steven, 19011.

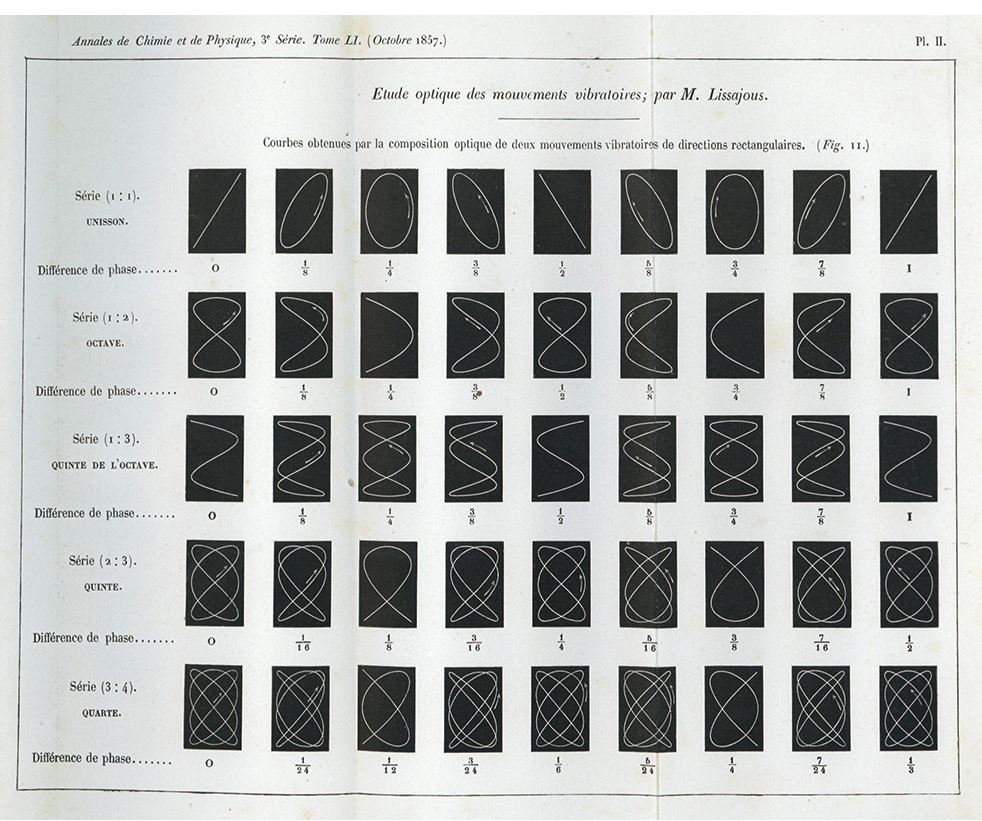

Los experimentos ópticos de Lissajous permitieron visualizar por primera vez las vibraciones del sonido con una gran precisión y se convirtieron en una herramienta clave en las investigaciones acústicas de finales del siglo XIX. Sin embargo, el diapasón como instrumento de laboratorio aún presentaba una grave limitación, y es que tras golpearlo, su sonido se desvanecía muy rápidamente. Entre los científicos que intentaron sortear este inconveniente, Rudolph Koenig dio con la solución más práctica. Este luthier y físico de origen alemán ideó un mecanismo que permitía prologar la voz de lo diapasones, pero también medir con precisión su frecuencia de vibración. En el camino, y sin saberlo ni buscarlo, cambió para siempre la manera en que medimos el tiempo. Su legado aún se encuentra en el corazón de casi todos los relojes que usamos hoy en día, en forma de diapasón.

Ciertamente, Koenig no es un científico muy conocido. Durante su adolescencia, estudió física y matemáticas en Königsberg pero nunca llegó a ir a la universidad. Al terminar el instituto (o “gymnasium”, según el nombre que le daba entonces), se mudó a París para trabajar como aprendiz de un prestigioso luthier llamado Jean Baptiste Vuillaume. Fue en el taller musical, mientras aprendía a fabricar instrumentos de todo tipo, donde Koenig perfeccionó su talento para trabajar la madera y el metal.

Debió de ser entonces cuando adquirió también su pasión por la acústica. Tras siete años construyendo máquinas de hacer sonido, Koenig decidió montar su propio negocio pero, al hacerlo, le dio un giro a su carrera. Decidió dedicarse al diseño de instrumentos de laboratorio y a la investigación acústica. Sus diseños ya no servirían para generar sonidos musicales sino para estudiarlos.

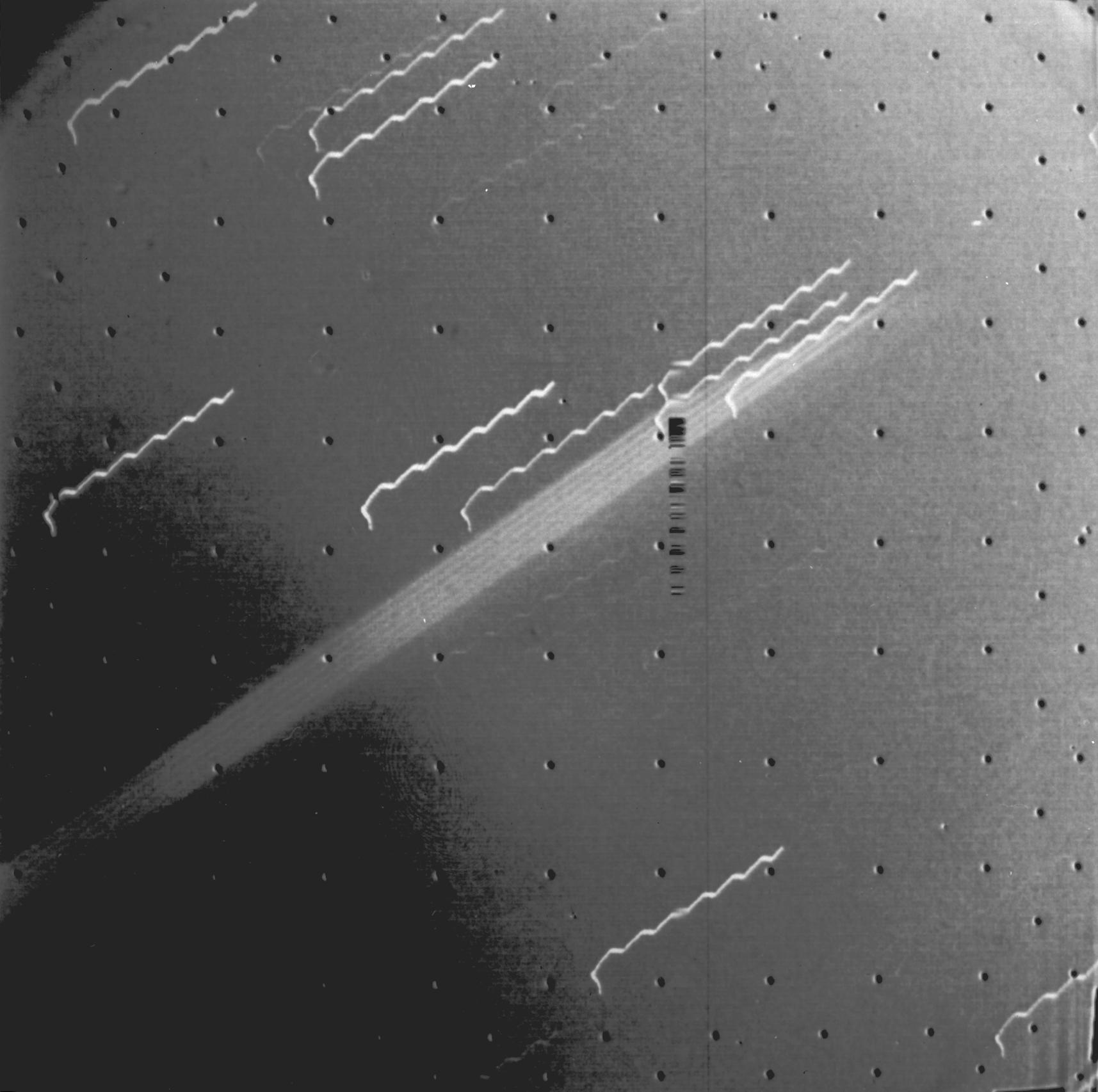

Koenig alcanzó una fama legendaria como acústico y fabricante de diapasones de precisión, entre otros aparatos físicos. Colaboró estrechamente con Helmholtz, y a finales del siglo XIX, sus diseños se encontraban en todos los laboratorios acústicos del mundo. Entre ellos, había un curioso diapasón que se mantenía en constante vibración con la ayuda de un mecanismo de relojería. El conjunto era muy similar a un reloj estándar, solo que utilizaba un diapasón en el lugar que normalmente habría ocupado un péndulo, para marcar la frecuencia. Este diseño permitía además medir la frecuencia del diapasón elegido con total precisión. Bastaba con comparar el tiempo marcado por las agujas del dispositivo respecto al de un reloj bien calibrado. Fue así como Koenig comprobó que el diapasón estándar de Lissajous, ese gran aspirante a «la universal”, no producía las 435 vibraciones por segundo declaradas, sino 435,4(5)2.

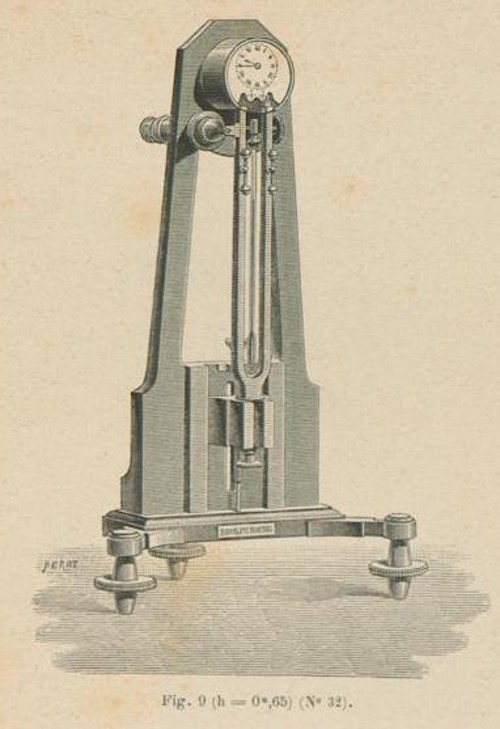

Dibujo de un reloj del catálogo Koenig de 1889 tal y como aparece en Catalogue des appareils d’acoustique. Paris: L. Landry, 1889, p. 19, Fig. 9 (No. 32). Fuente: Sound & Science: Digital Histories / Universidad Humboldt de Berlín / Instituto Max Planck de Historia de la Ciencia

Dibujo de un reloj del catálogo Koenig de 1889 tal y como aparece en Catalogue des appareils d’acoustique. Paris: L. Landry, 1889, p. 19, Fig. 9 (No. 32). Fuente: Sound & Science: Digital Histories / Universidad Humboldt de Berlín / Instituto Max Planck de Historia de la Ciencia

El reloj-diapasón de Koenig tuvo especial relevancia por otro motivo. Mientras que el mecanismo mantenía la vibración constante, la obstinada afinación del diapasón (la misma propiedad que lo convierte en una excelente herramienta para los músicos) mantenía las agujas del reloj moviéndose siempre a la misma velocidad, de manera exacta. Esto lo convertía en un fantástico aliado para medir el tiempo.

Este concepto se incorporaría a los relojes de pulsera un siglo más tarde, para producir modelos con una precisión sin precedentes. En 1960, salió a la venta el Accutron, un reloj que utilizaba un diapasón de acero de 360 hercios para marcar el tiempo. Como esta frecuencia estaba en el rango audible humano, sus usuarios podían oír un leve zumbido en fa sostenido al acercar el reloj a su oreja. Si os digo la verdad, me parece una oportunidad perdida para la poesía que no usasen un diapasón a 440 Hz, pero el hecho es que aquella innovación mejoró enormemente la precisión de los relojes. Probablemente por eso, la marca de relojes Bulova, fabricante original del Accutron, aún conserva un diapasón en su logotipo.

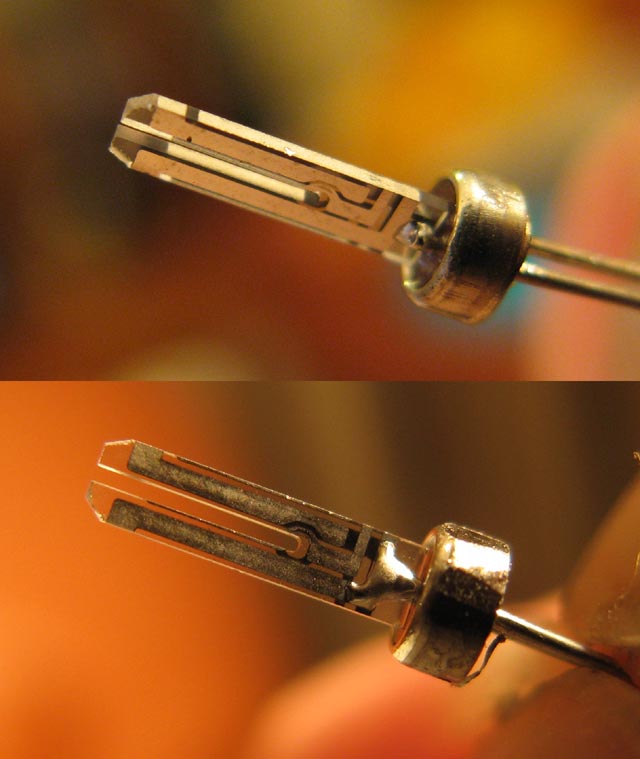

Con el tiempo, los procesos de fabricación fueron mejorando, así como los materiales. Cambiamos los muelles por pilas y aprendimos a dominar la electrónica. Hoy en día, en casi todos los relojes de pulsera late un diminuto diapasón en forma de horquilla. Está hecho de cuarzo y oscila a 32768 Hz. Y aunque nosotros ya no lo oímos, es posible que nuestras mascotas aún tengan muy presente su origen sonoro y musical.

Resonador de cristal de cuarzo en forma de diapasón de un reloj «de cuarzo» moderno. Fuente: Wikimedia Commons

Resonador de cristal de cuarzo en forma de diapasón de un reloj «de cuarzo» moderno. Fuente: Wikimedia CommonsReferencias:

1Le Conte, Steven W. “Rudolph Koenig.” Science, vol. 14, no. 358, 1901, pp. 724-727. https://www.science.org/doi/10.1126/science.14.358.724.

2Feldmann, H. (1997). History of the tuning fork. I: Invention of the tuning fork, its course in music and natural sciences. Pictures from the history of otorhinolaryngology, presented by instruments from the collection of the Ingolstadt German Medical History Museum. Laryngorhinootologie, 76(2), 116–122. DOI: 10.1055/s-2007-997398

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Los diapasones que miden nuestro tiempo se ha escrito en Cuaderno de Cultura Científica.

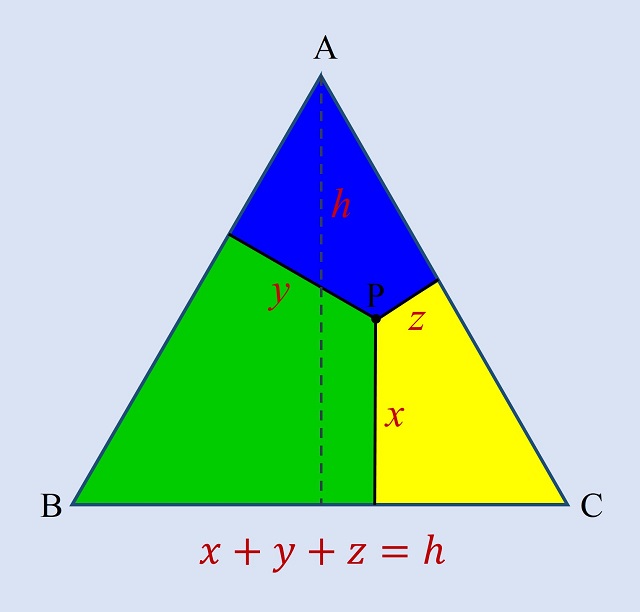

Teoremas geométricos sin palabras: Conway

Con la anterior entrada del Cuaderno de Cultura Científica titulada Teoremas geométricos sin palabras: Viviani iniciamos una pequeña serie estival de demostraciones sin palabras de interesantes y hermosos teoremas geométricos. El teorema de la anterior entrada era un teorema clásico de la geometría del plano sobre triángulos equiláteros, el conocido teorema de Viviani. Este resultado del matemático italiano Vincenzo Viviani (1622-1703) dice que “la suma de las distancias de un punto cualquiera en el interior de un triángulo equilátero (o en alguno de sus lados) a cada uno de sus lados es igual a la altura del mismo.”

En esta entrada, vamos a pasar de un extremo al otro, de un teorema clásico, el teorema de Viviani, de hace más de 300 años, a un teorema actual, el teorema de la circunferencia de Conway. El matemático británico John Horton Conway (1937-2020), fallecido recientemente como consecuencia del covid-19, fue un prolífico e imaginativo matemático que trabajó en muchas áreas de las matemáticas, entre ellas la teoría de grupos algebraicos, las matemáticas de los juegos, la teoría de nudos, la teoría de números, la geometría o la teoría de códigos, que escribió interesantes libros, como la trilogía Winning Ways for your Mathematical Plays (Estrategias ganadoras para tus juegos matemáticos), junto a Richard K. Guy y Elwyn Berlekamp, o The Book of Numbers (El libro de los números), con Richard K. Guy, y que es conocido por temas como el autómata celular denominado el juego de la vida, los números surreales o la regla del fin del mundo, entre muchos otros.

Fotografía del matemático británico John H. Conway realizada por Thane Plambeck en el congreso Combinatorial Game Theory (2005), celebrado en Banff International Research Station (Canada)

Fotografía del matemático británico John H. Conway realizada por Thane Plambeck en el congreso Combinatorial Game Theory (2005), celebrado en Banff International Research Station (Canada)

Pero antes de adentrarnos en el teorema de la circunferencia de Conway, vayamos a la resolución del problema que dejamos planteado en la anterior entrada y que podía resolverse con una sencilla prueba sin palabras.

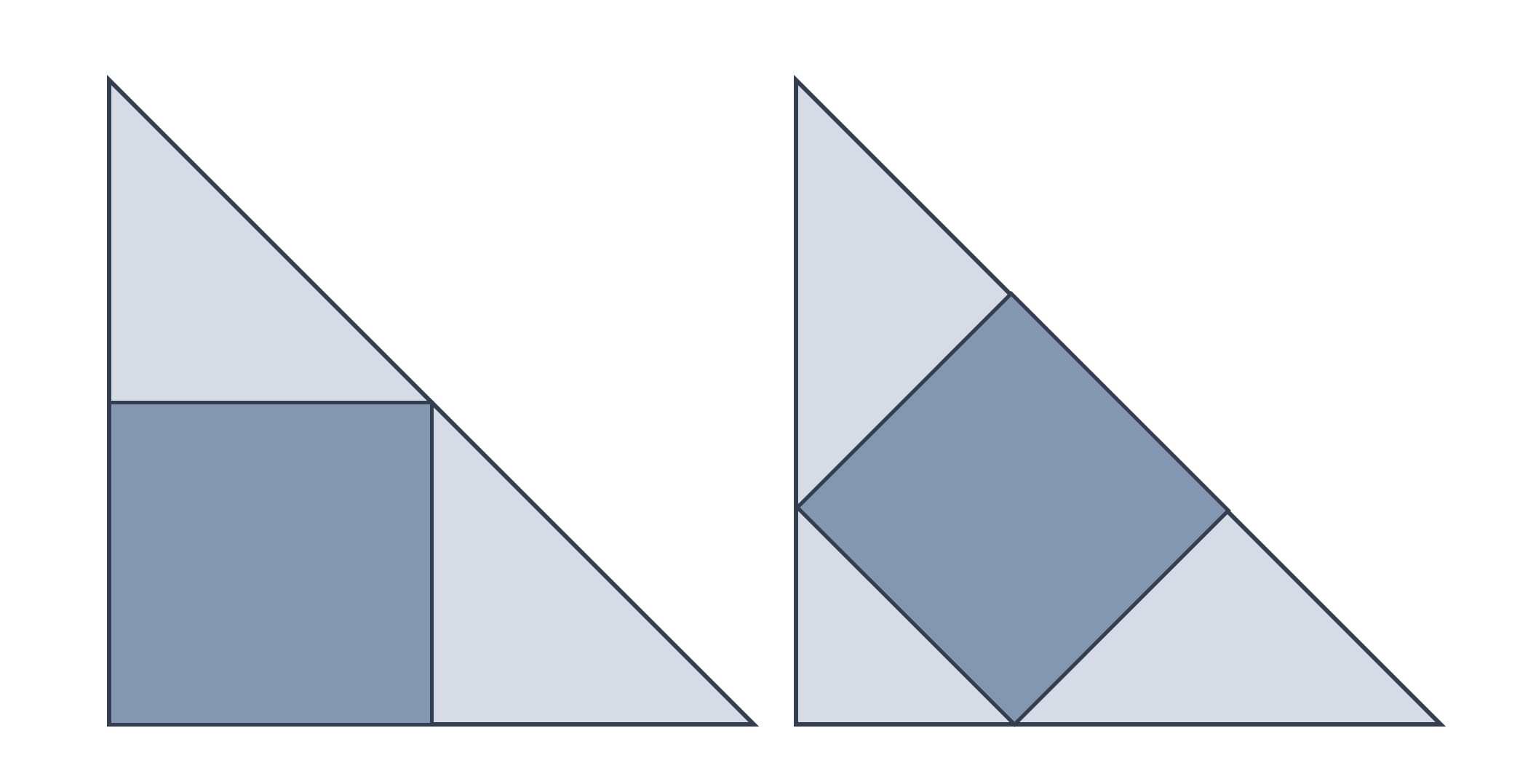

El cuadrado dentro del cuadradoEl problema, que habíamos planteado en la anterior entrada y que dejamos pendiente para todas aquellas personas que quisierais intentar resolverlo de una forma sencilla, es el siguiente.

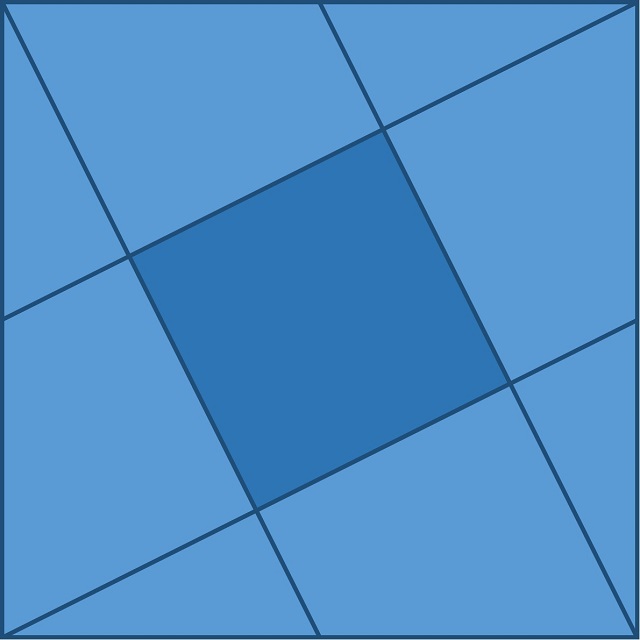

Problema (El cuadrado dentro del cuadrado): Demuéstrese que si se trazan rectas que unen los vértices del cuadrado con los puntos medios de uno de los lados opuestos, como se muestra en la siguiente imagen, entonces el área del cuadrado central es un quinto del área del cuadrado original.

Como hemos comentado, este problema se puede resolver fácilmente de forma visual. Si nos fijamos en el siguiente dibujo, deduciremos que, como se afirma en el problema, el área del cuadrado central es igual la quinta parte del área del cuadrado grande.

El 15 de abril de 2020, con motivo de la muerte del matemático británico John H. Conway unos días antes, el 11 de abril, el matemático Matt Baker escribió en su blog Matt Baker’s Math Blog una entrada titulada Some Mathematical Gems from John Conway (Algunas joyas matemáticas de John Conway), en la que hacía un repaso personal de algunas de las contribuciones de este genial matemático. Una de esas contribuciones, que yo no conocía y que llamó mi atención, es uno de esos curiosos resultados geométricos que entraría de lleno en los objetivos de esta serie estival, puesto que es sorprendente, interesante e incluso se ha realizado una hermosa demostración sin palabras del mismo.

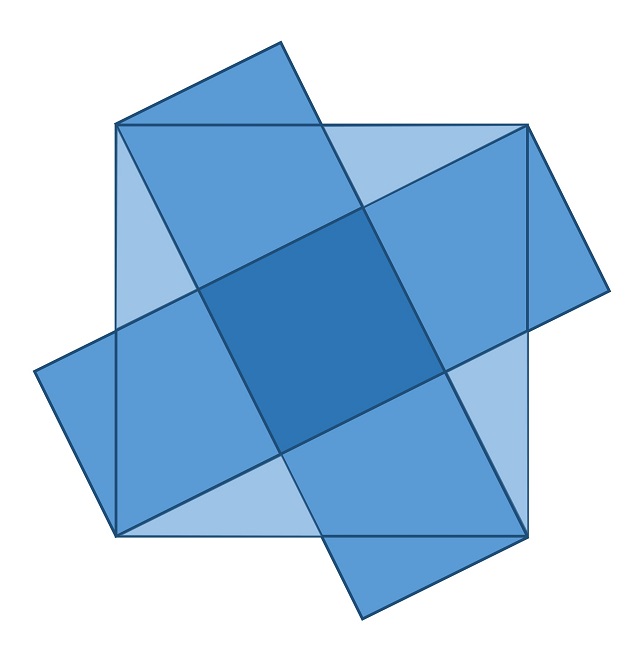

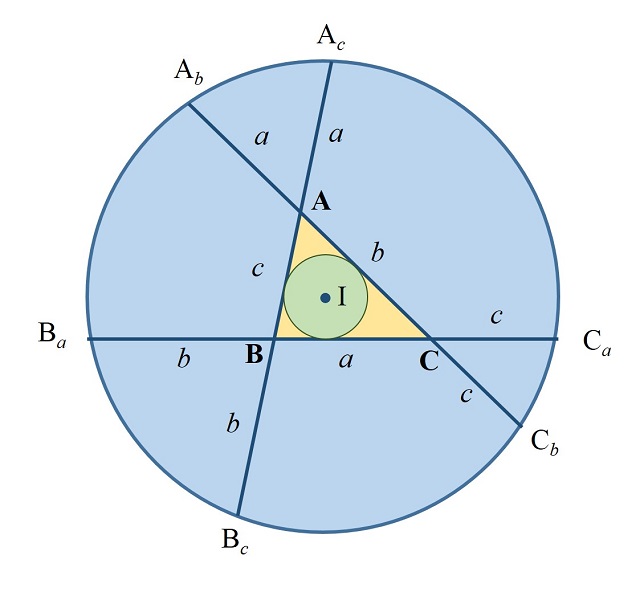

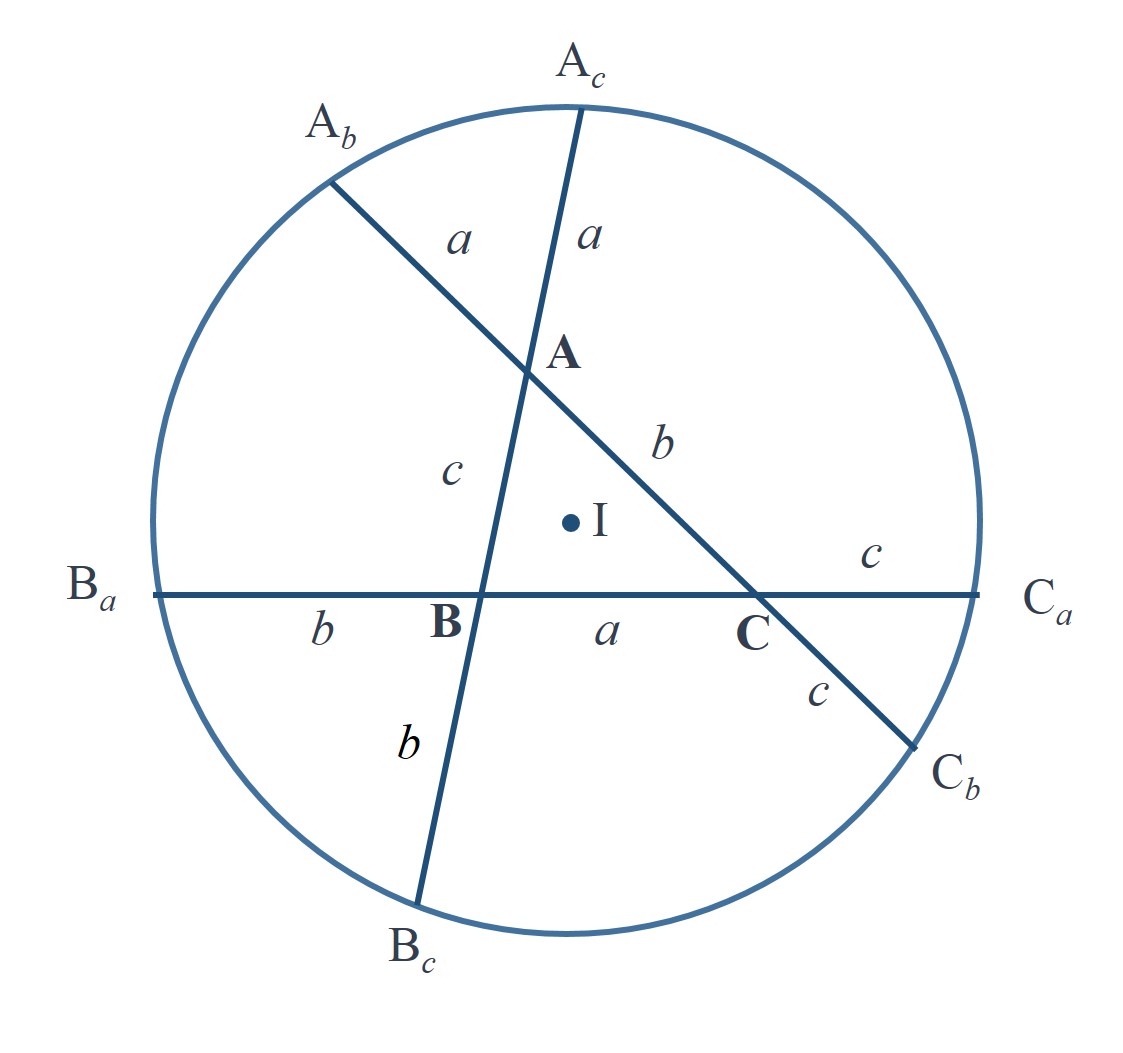

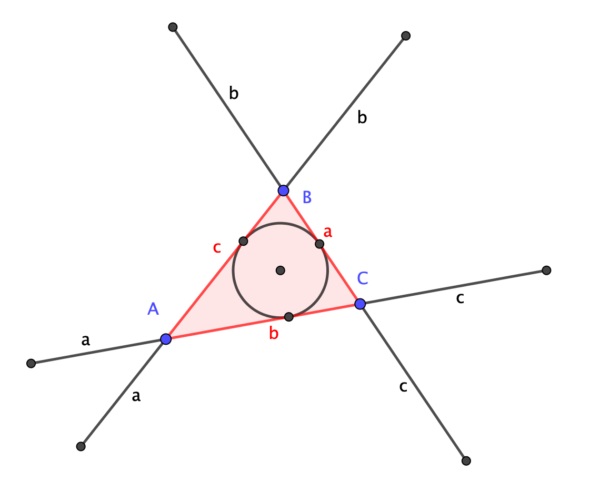

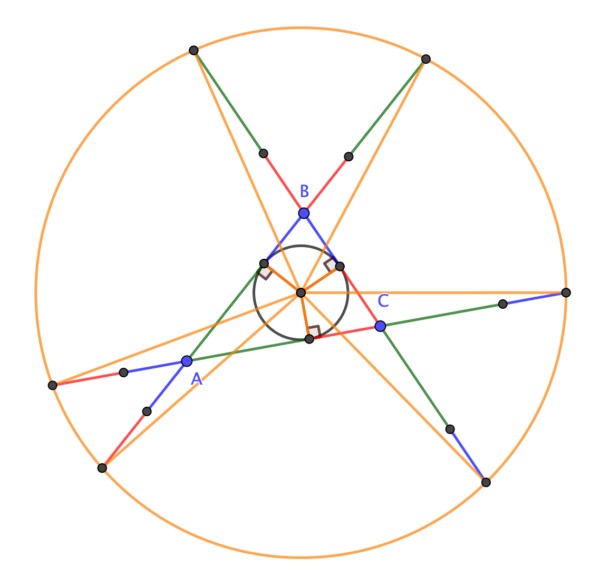

El inventor del juego de la vida descubrió la siguiente propiedad geométrica de los triángulos, en concreto, observó que, si los lados de un triángulo que se encuentran en un vértice son extendidos por una longitud igual al lado opuesto, los seis puntos finales de los seis segmentos rectos resultantes se encuentran en una misma circunferencia cuyo centro es, además, el incentro del triángulo, es decir, el centro de la circunferencia inscrita en el triángulo.

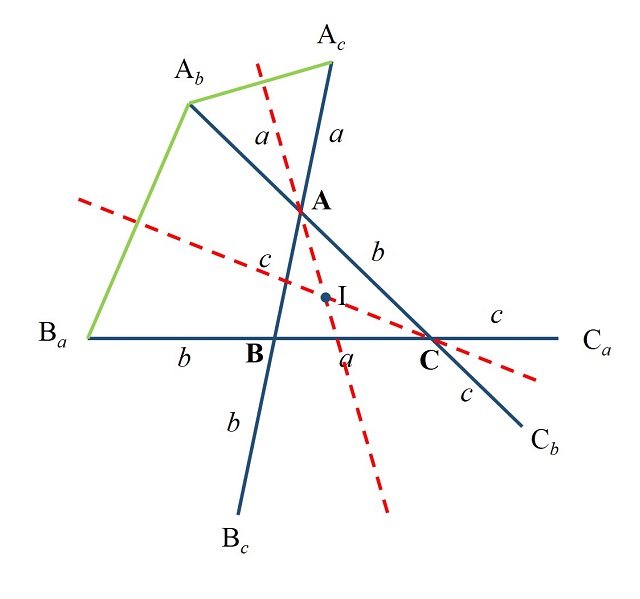

Teorema de la circunferencia de Conway: Dado un triángulo ABC, de lados a = BC, b = AC y c = AB (como se muestran en la imagen), se extienden los lados a, b y c, y se consideran los puntos Ab y Ac, que están a una distancia a en las rectas extensión de b y c, es decir, AAb = AAc = a, de igual forma se consideran los puntos Ba y Bc, que están a una distancia b en las rectas extensión de a y c, y Ca y Cb, que están a una distancia c en las rectas extensión de a y b, entonces los puntos Ab, Ac, Ba, Bc, Ca y Cb son concíclicos, es decir, están en una misma circunferencia, a la cual se denomina “circunferencia de Conway”. Más aún, el centro de la circunferencia de Conway es el incentro del triángulo ABC.

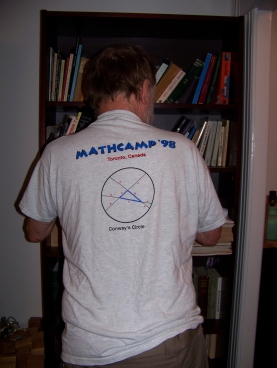

Al parecer John Conway nunca publicó nada de este resultado geométrico. Según aparece recogido en el blog de la matemática Tanya Khovanova (Tanya Khovanova’s Math Blog), el matemático tenía una camiseta del campamento de verano de matemáticas Mathcamp de 1998 en el que aparecía una ilustración de este teorema con la expresión “la circuferencia de Conway”, que vemos en la siguiente imagen. Es probable que Conway solo lo presentara de forma oral en estos campamentos o en algún evento similar.

Fotografía de John Conway con su camiseta con el denominado teorema de la circunferencia de Conway del Mathcamp’98. Imagen de Tanya Khovanova en su blog

Fotografía de John Conway con su camiseta con el denominado teorema de la circunferencia de Conway del Mathcamp’98. Imagen de Tanya Khovanova en su blog

Sobre esta fotografía su autora comenta que “el pobre John Conway tuvo que estar de espaldas a mí hasta que descubrí la prueba del teorema y me di cuenta de qué punto debía ser el centro de la circunferencia de Conway”.

A partir del fallecimiento de Conway y la publicación del matemático Matt Baker en su blog, empezaron a publicarse diferentes demostraciones del teorema de la circunferencia de Conway, como se recoge en la página web del matemático irlandés Colm Mulcahy. Por ejemplo, la matemática estadounidense Doris Schattschneider obtuvo dos demostraciones en 2020 (abril y mayo), de la segunda de las cuales dijo que “es mucho más bonita y convincente. Una demostración que creo que Conway habría sido más propenso a realizar él mismo”, basada en un hexágono y que puede leerse en la página de Colm Mulcahy.

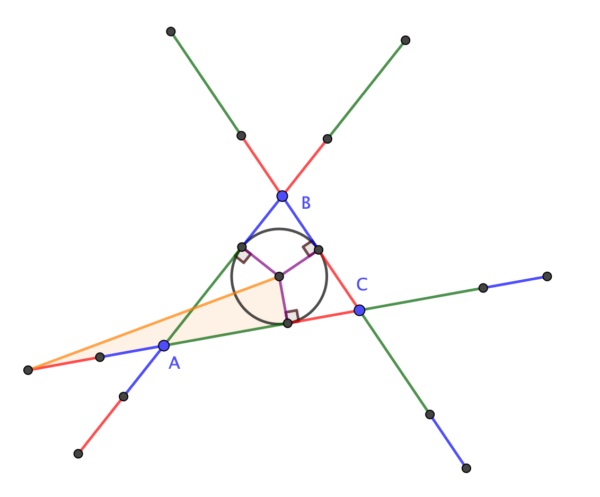

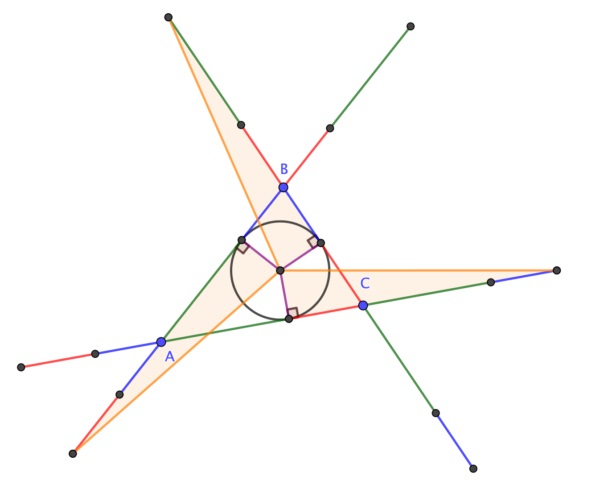

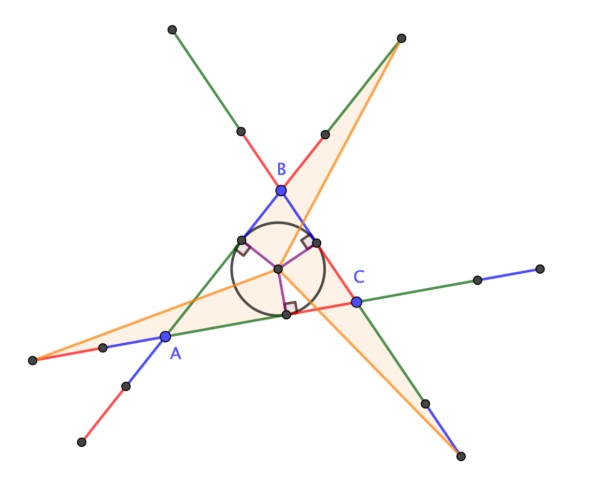

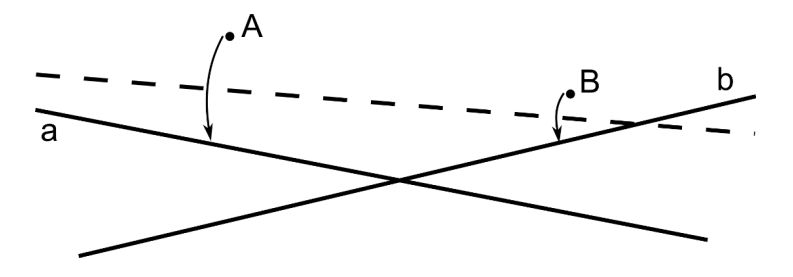

Sin embargo, la demostración que recogemos aquí fue obtenida por el matemático británico Alex Ryba, en mayo de 2020. Es una demostración sencilla basada en triángulos isósceles. Mostramos una ilustración con el triángulo ABC y las extensiones de longitudes a, b y c en los vértices A, B y C, con los puntos extremos Ab, Ac, Ba, Bc, Ca y Cb, que son los que hay que demostrar que están en una circunferencia de centro I, el incentro del triángulo ABC, es decir, que todos ellos equidistan del punto I.

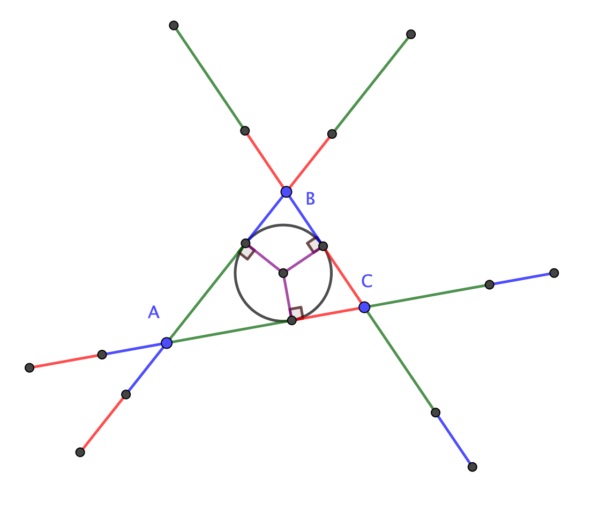

La demostración de Ryba es la siguiente: Los triángulos AbAAc y BaCAb son triángulos isósceles, con ápices (es decir, los vértices formados por los lados iguales) A y C, por lo tanto, las rectas mediatrices de las bases AbAc y BaAb (en rojo en la imagen) son además las rectas que bisecan los ángulos en los ápices A y C (llamadas bisectrices), luego son las bisectrices de los ángulos en A y C del triángulo ABC, luego se intersecan en el incentro I del triángulo ABC (esto es debido a que el incentro del triángulo es también el punto en el que se intersecan las tres bisectrices del mismo). Además, puesto que las rectas son las mediatrices de las bases AbAc y BaAb, y se cortan en I, entonces los puntos Ba, Ab y Ac equidistan de I. Argumentos similares nos determinan que los puntos Cb, Bc y Ba equidistan de I, así como Ac, Ca y Cb. Y el resultado queda probado.

Y han ido apareciendo más demostraciones del resultado, pero también se han descubierto demostraciones anteriores, como la publicada por el matemático cordobés Francisco Javier García Capitán en Forum Geometricorum, en 2013, en el artículo A Generalization of the Conway Circle. En este artículo se menciona que “esta configuración también apareció en el Problema 6 de la Olimpiada Matemática Iberoamericana de 1992”.

Respecto a la demostración sin palabras de este resultado geométrico, en 2020 el matemático británico Colin Beveridge, autor de libros como La biblia de las matemáticas, Guía para comprender y disfrutar el mundo de las matemáticas (Gaia, 2016) o Lo que las Matemáticas Esconden… Descubre las Matemáticas del Día a Día (Libsa, 2019), publicó en el blog The Aperiodical una hermosa demostración sin palabras del teorema de la circunferencia de Conway. Esta demostración consiste en una serie de seis imágenes que incluimos a continuación, que os dejamos para que seáis vosotros mismos quienes comprobéis que efectivamente demuestra el teorema de la circunferencia de Conway.

Al igual que en la anterior entrada, vamos a terminar esta con otro sencillo problema que puede ser resuelto con un razonamiento visual. Este problema, como el de la primera entrada de esta serie estival, es otro problema sobre cuadrados que aparece recogido en el artículo A Round-Up of Square Problemas (Una recopilación de problemas con cuadrados), de los matemáticos Duane Detemple y Sonia Harold, publicado en Mathematics Magazine en 1996.

Problema (Un cuadrado inscrito en un triángulo rectángulo isósceles): Estos dos cuadrados han sido inscritos en un mismo triángulo rectángulo isósceles, pero de dos formas distintas, como se muestra en la imagen. ¿Cuál de los dos cuadrados tiene una mayor superficie?

Bibliografía:

1.- Roger B. Nelsen, Proofs without Words: Exercises in Visual Thinking, Mathematical Association of America, 1997.

2.- Roger B. Nelsen, Proofs Without Words II: More Exercises in Visual Thinking, Mathematical Association of America, 2001.

3.- Claudi Alsina y Roger B. Nelsen, Charming Proofs, A Journey Into Elegant Mathematics, Mathematical Association of America, 2010.

4.- Wolfram MathWorld: Conway circle (Darij Grinberg y Eric W. Weisstein)

5.- Francisco Javier García Capitán, A Generalization of the Conway Circle, Forum Geometricorum, vol. 13, pp. 191-195, 2013.

6.- Duane Detemple y Sonia Harold, A Round-Up of Square Problemas, Mathematics Magazine 69, no. 1, pp. 15-27, 1996.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Teoremas geométricos sin palabras: Conway se ha escrito en Cuaderno de Cultura Científica.

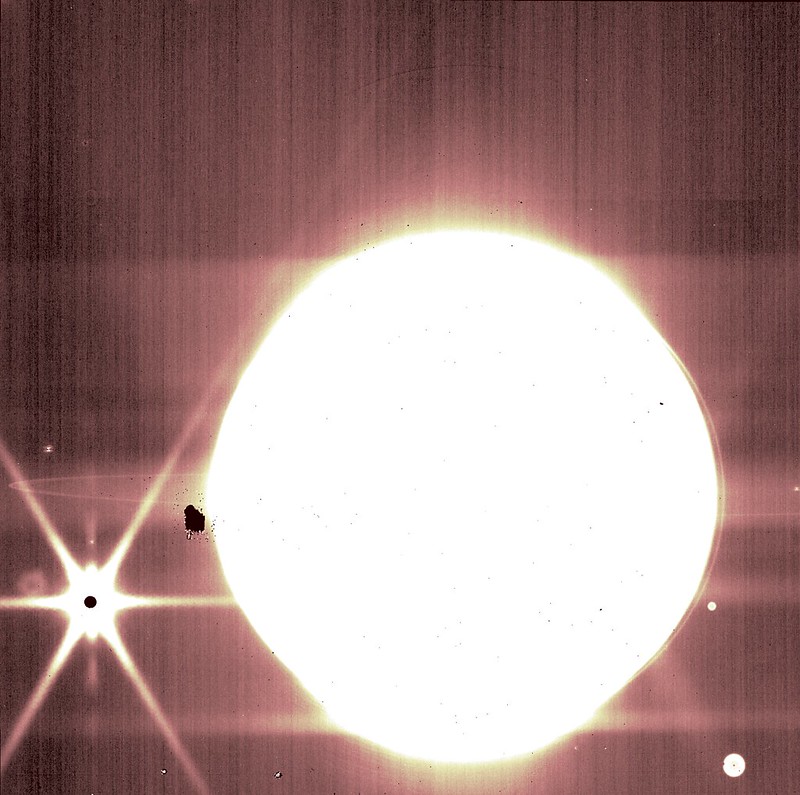

Einstein y Georges Lemaître

El astrónomo y sacerdote jesuita Georges Lemaître fue el primero en sugerir que la totalidad del universo comenzó a partir de un solo “átomo primigenio” en algún momento en el tiempo; esta sería la primera versión de lo que ha llegado a ser la teoría actual del Big Bang*. Einstein menospreció el modelo de Lemaître, como hizo con todos los modelos en los que el universo se expandía, pero al final tuvo que admitir que Lemaître podía tener razón.

Einstein y Lemaître tras la conferencia mencionada en el texto, en 1933. Fuente: KU Leuven

Einstein y Lemaître tras la conferencia mencionada en el texto, en 1933. Fuente: KU LeuvenTras ordenarse presbítero en 1923, Lemaître continuó sus estudios de astronomía con Arthur Eddington en la Universidad de Cambridge (Reino Unido) para después completarlos con Harlow Shapley en el Observatorio del Harvard College (EE. UU.). Para finalizar su formación académica se inscribió para el doctorado en el Instituto de Tecnología de Massachusets (MIT, por sus siglas en inglés; EE. UU.). Fue aquí donde Lemaître comenzó a pensar acerca de la historia del universo.

De hecho, Lemaître no estaba familiarizado con las ecuaciones de la relatividad de Einstein: él no creó un modelo de la historia del universo basándose en ideas sobre la estructura del universo como habían hecho Willem de Sitter o Alexander Friedmann. Lemaître se basó en la termodinámica, en concreto en la segunda ley y su concepto de entropía: todo sistema se mueve de un estado de orden a otro de desorden. Otra forma de interpretar la entropía es que toda la energía que se puede usar del sistema se pierde en el transcurso del tiempo, hasta que toda la energía termina desapareciendo. Si esto es cierto para cualquier sistema, también lo es para el universo.

El universo, por tanto, debe haber empezado en un estado de máxima energía, perdiendo energía paulatinamente hasta que finalmente muera. La conclusión lógica de la termodinámica, dijo Lemaître, era un modelo del universo en el que éste se expandiese con el tiempo: un universo que comenzó mucho más pequeño de lo que es ahora, tan pequeño que todo el universo estaba originalmente comprimido en un minúsculo átomo. Nuestro universo “estalló” a partir de esta increíblemente densa primera partícula y este universo continuaría expandiéndose, perdiendo energía y hasta llegar gradualmente a detenerse. Lemaître publicó su teoría de lo que él llamaba el “átomo primigenio” en 1927, nada más volver a Bélgica para enseñar astrofísica en la Universidad de Lovaina.

La cosmovisión de LemaîtreEn esa época, la mayoría de los científicos asumían que el universo siempre había existido tal y como es en la actualidad. Creer en un universo cambiante, es decir, creer en “un momento de creación”, parecía demasiado cercano a la religión y al misticismo. El mismo Lemaître, a pesar de su profunda cosmovisión católica, también pensaba que la ciencia y la fe no deben confundirse entre sí; según él se emplean metodologías diferentes en cada una y, al menos el propio Lemaître, nunca usó una disciplina para confirmar o negar la otra.

En cualquier caso, la familiaridad de Lemaître con la historia del génesis en la Biblia judeo-cristiana y su evidente creencia en un creador influyeron probablemente en la facilidad con la que aceptó una teoría que sugería un universo que había “empezado” en un momento dado. A diferencia de muchos de los contemporáneos de Lemaître, él creía que su teoría del átomo primigenio era una verdadera realidad física, no un simple modelo matemático, como habían dicho de Sitter y Friedmann de los suyos.

En el momento en que Lemaître publicó sus teorías por primera vez, Einstein ya había dejado bastante claras sus ideas sobre un universo en expansión. Ya había publicado sus críticas a los modelos en expansión de de Sitter y Friedmann, y su respuesta al de Lemaître no fue diferente. Einstein se vio obligado a admitir que las matemáticas parecían funcionar, pero se quejaba de que la física era “abominable”. Al igual que con la mecánica cuántica, las matemáticas parecían no poder desmentir a sus prejuicios, y Einstein despreció la idea de un universo en expansión sin más.

Como decíamos más arriba, a diferencia de de Sitter y Friedmann, Lemaître no creó un modelo solo con objetivos intelectuales. Creía que se correspondía con la realidad. Basándose en los conocimientos físicos de la época, Lemaître lanzó la hipótesis de que el átomo primigenio estaba formado por elementos radioactivos que comenzaron una reacción en cadena. La energía liberada en esta reacción en cadena habría forzado una expansión inmediata y espectacular del universo; en el proceso también habría creado vida. Lemaître era plenamente consciente de que su versión del origen del universo sería modificada a lo largo del tiempo conforme los principios de la física atómica y nuclear fuesen mejor comprendidos.

No fue hasta los años 60 que la versión moderna de la teoría del Big Bang fue aceptada y, tal y como Lemaître predijo, la teoría de lo que existía en el momento del Big Bang y por qué comenzó a expandirse era muy diferente a sus ideas originales. Lemaître fue, sin embargo, el primer científico en aceptar verdaderamente el concepto de que el universo tuvo un principio.

También Einstein, tuvo que aceptar las ideas de Lemaître. El anuncio en 1929 por parte de Edwin Hubble de que las observaciones efectivamente apuntaban hacia un universo en expansión, convenció finalmente a Einstein de que debía abandonar su noción preconcebida de un universo estático. Unos años después, en 1933, Einstein dio a Lemaître el mérito debido. En una conferencia en el Instituto Tecnológico de California en la que Lemaître describió el universo en expansión, Einstein se levantó a la conclusión, aplaudió y dijo “Esta es la explicación más hermosa y satisfactoria de la creación que haya escuchado jamás”.

Nota:

[*] Las expresiones y planteamientos que se mencionan en el texto corresponden a la visión original de Lemaître de finales de los años 20 y comienzo de los 30 del siglo pasado. La teoría actual del Big Bang es mucho más elaborada y compleja y existen conceptos, como los de tiempo o de composición, que difieren de forma radical de los expresados hace casi un siglo. Para más información sobre el modelo actual puede consultarse el enlace.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 27 de septiembre de 2009.

El artículo Einstein y Georges Lemaître se ha escrito en Cuaderno de Cultura Científica.

¿Por qué Júpiter no tiene unos anillos tan espectaculares como Saturno?

Uno de los hechos más llamativos –al menos visualmente- de los gigantes gaseosos de nuestro Sistema Solar es que el sistema de anillos de Júpiter es mucho más tenue de lo que cabría esperar, especialmente si lo comparamos con los majestuosos anillos de Saturno. Tanto es así que fue el tercer sistema de anillos descubierto en nuestro Sistema Solar, concretamente después de los de Saturno y Urano, gracias a las observaciones realizadas por la sonda Voyager 1 en 1979 durante su visita al sistema joviano y el único que ha necesitado de una sonda espacial para su descubrimiento.

Anillos de Júpiter observados por primera vez desde la Voyager 1. Cortesía de la NASA/JPL

Anillos de Júpiter observados por primera vez desde la Voyager 1. Cortesía de la NASA/JPLEs también destacable que, al menos en nuestro sistema planetario, todos los gigantes gaseosos tengan anillos, como si de alguna forma fuese una característica común a este tipo de planetas, algo que podremos verificar en el futuro observando los planetas extrasolares y comprobando si efectivamente se cumple esta regla.

Incluso es posible que en los últimos días hayas visto por primera vez los anillos de Júpiter gracias a las imágenes del telescopio espacial James Webb, que durante su etapa de calibración apuntó al planeta tomando un espectacular retrato en infrarrojo en el que estos son visibles, algo que llama poderosamente la atención, especialmente si comparamos esta imagen con otras similares tomadas por el Hubble, aunque en luz visible, en las que no hay rastro del anillo.

Imagen de Júpiter en el infrarrojo tomada por el JWST. Se aprecian sutilmente los anillos y a la izquierda, la “estrella” brillante es Europa, un satélite de Júpiter. Cortesía de NASA, ESA, CSA, B. Holler y J. Stansberry (STScI)

Imagen de Júpiter en el infrarrojo tomada por el JWST. Se aprecian sutilmente los anillos y a la izquierda, la “estrella” brillante es Europa, un satélite de Júpiter. Cortesía de NASA, ESA, CSA, B. Holler y J. Stansberry (STScI)Pero vayamos al grano del asunto: ¿Por qué los anillos de Júpiter son tan diferentes a los de Saturno? Tenemos que ser conscientes que los mecanismos de formación de los anillos, así como los mecanismos que afectan a su longevidad -desconocemos con certeza si en todos los casos los sistemas de anillos son más o menos permanentes o si tienen una duración determinada por distintos factores- no se comprenden del todo y hay diferentes teorías que podrían explicarlos.

El caso es que nuevo artículo apunta a que, muy probablemente, los responsables de la escasa densidad de los anillos de Júpiter han sido sus satélites. Los científicos han realizado simulaciones físicas en las cuales la existencia de grandes satélites dificultaba la capacidad del planeta para mantener un gran sistema de anillos.

Esto nos hace pensar que Júpiter tuvo en el pasado unos anillos más densos, aunque quizás no en el sentido que lo son los de Saturno, pero la presencia de los satélites galileanos fue barriendo de sus órbitas las partículas de hielo y polvo que conformaban este sistema, ya fuese dándoles más velocidad y acabando por ser expulsadas del sistema joviano o atrayéndolas hacia los satélites, acabando sobre la superficie de estos.

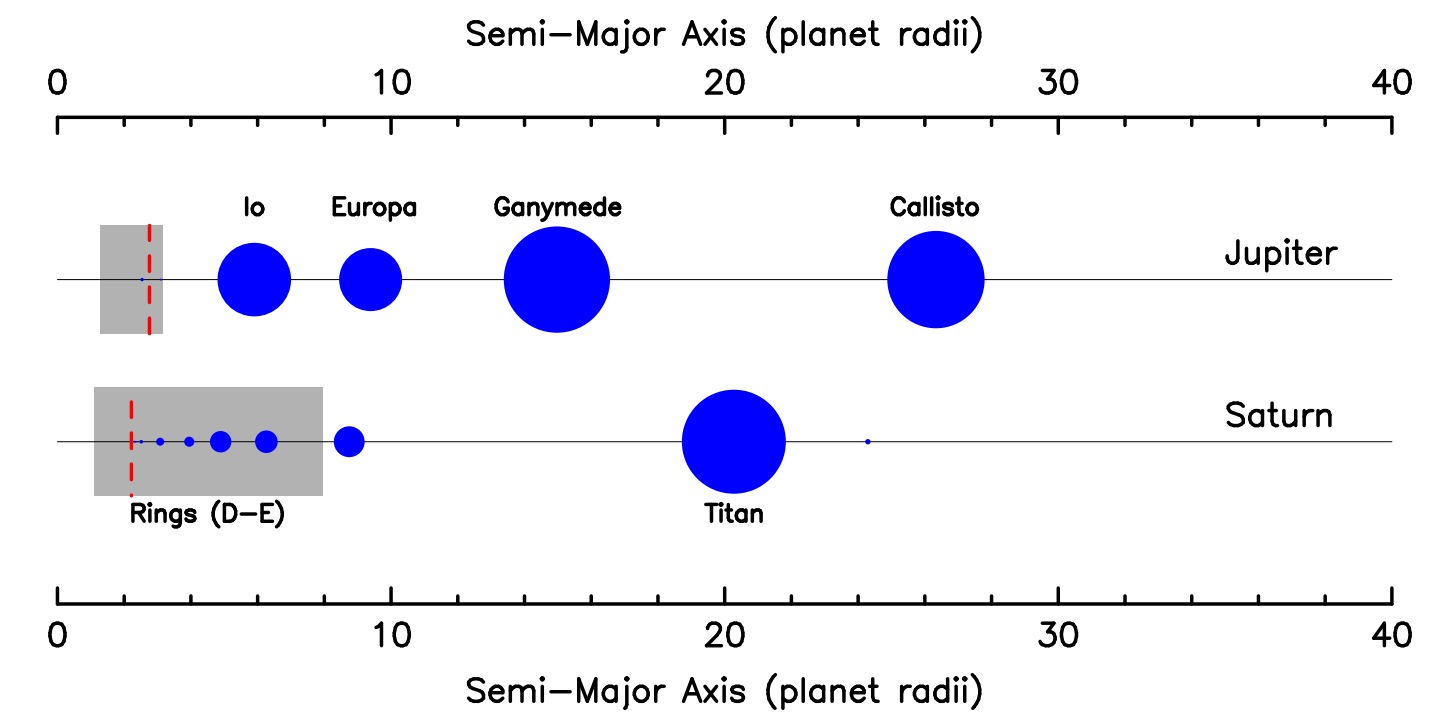

Distribución de satélites por tamaño y distancia en Júpiter y Saturno. En gris, la región donde se encuentran los anillos en cada uno de los planetas. Cortesía de Kane et al (2022)

Distribución de satélites por tamaño y distancia en Júpiter y Saturno. En gris, la región donde se encuentran los anillos en cada uno de los planetas. Cortesía de Kane et al (2022)Saturno también tiene satélites, pero el papel de los satélites en su sistema de anillos es diferente por diversos factores: el primero, la masa de los satélites en el entorno e interior del sistema de anillos es mucho menor que en el sistema joviano, que tiene muy cerca de los anillos a los satélites galileanos, y, por otro, los pequeños satélites que hay dentro de los anillos de Saturno ayudan por el efecto de la gravedad que ejercen sobre las partículas del anillo, a mantenerlos estables.

Además, estos satélites incluso pueden contribuir a mantener la densidad de partículas de los anillos, ya que los impactos que sufren estas lunas pueden lanzar partículas a la órbita de Saturno y que acaben formando parte de estos.

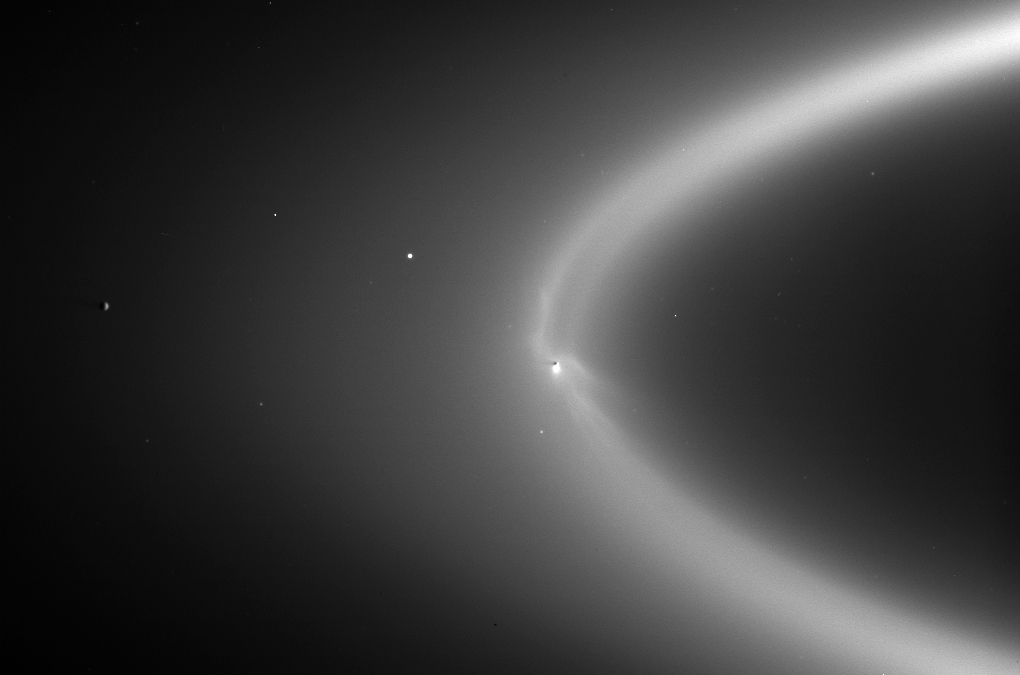

El anillo E de Saturno está compuesto principalmente por partículas expulsadas de Encélado, una de las de mayor actividad geológica de nuestro Sistema Solar, contribuyendo a la longevidad del propio anillo, que va recibiendo un aporte continuo de material. Imagen cortesía de la NASA/JPL

El anillo E de Saturno está compuesto principalmente por partículas expulsadas de Encélado, una de las de mayor actividad geológica de nuestro Sistema Solar, contribuyendo a la longevidad del propio anillo, que va recibiendo un aporte continuo de material. Imagen cortesía de la NASA/JPL¿Por qué son tan interesantes los anillos desde el punto de vista de la geología? Puesto que es muy difícil conocer el interior de los gigantes gaseosos debido a sus tremendas condiciones de presión, temperatura, vientos y gravedad, la oscilación de las partículas de los anillos nos puede ayudar a descubrir la distribución de las masas en el interior de los planetas.

Pero también pueden ser un reservorio de partículas primigenias de la formación de nuestro Sistema Solar, especialmente en algunas regiones que pueden haber sufrido menos perturbaciones gravitatorias por parte de los distintos satélites, y que nos servirían para muestrear su composición.

Incluso podrían servirnos para desentrañar la historia de la evolución dinámica de los mini sistemas “planetarios” que tienen, por norma general, a su alrededor los gigantes gaseosos, abriéndonos también una ventana a estudiar las causas de la actividad interna de algunos de estos satélites.

Así que tenemos que ver los anillos como algo más que un bonito adorno planetario y maravillarnos no solo con el reflejo de su luz y sus discontinuidades, sino como una verdadera fuente de información de la que podremos aprender detalles

Bibliografía:

Kane, S. R., & Li, Z. (2022). The Dynamical Viability of an Extended Jupiter Ring System (Version 2). arXiv. doi: 10.48550/ARXIV.2207.06434

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo ¿Por qué Júpiter no tiene unos anillos tan espectaculares como Saturno? se ha escrito en Cuaderno de Cultura Científica.

Herramientas biológicas multiusos

Ictidomys tridecemlineatus Fuente: Wikimedia Commons

Ictidomys tridecemlineatus Fuente: Wikimedia CommonsLos mamíferos que viven en nuestra latitud y más al norte han de afrontar una situación difícil si permanecen activos durante el invierno. Por un lado, deben gastar mucha energía para contrarrestar la pérdida de calor que experimentan al bajar la temperatura ambiental. Por el otro, al haber poca comida, difícilmente pueden obtener del alimento la energía que necesitan gastar para producir el calor necesario que les permita mantener su temperatura corporal constante. Han de recurrir, para ello, a metabolizar las reservas almacenadas.