#Naukas16 Aquí no se opina, aquí se mide

Javier Fernández Panadero tiene un don para la comunicación en general, y para la científica del día a día en particular. Como además usa “cacharritos” salen cosas como esta cuando habla de sesgos cognitivos, que operan aunque los conozcas.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Aquí no se opina, aquí se mide se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 ¿Cifras o encriptas? Siempre con la ayuda de tus primos

- #Naukas16 Sandman, tócala otra vez

- #Naukas16 Pianos, torpedos y lo inesperado

Paracelso, el antisistema

Las clases que comenzó a impartir Paracelso en la Universidad de Basilea supusieron una ruptura completa con la tradición. De entrada las daba en alemán, en vez de en latín (algo en común con Lutero, que fue la primera persona que se atrevió a publicar la Biblia en un idioma, el alemán, que no fuera el latín), y contenían muchas más información práctica que teórica.

No solo despreciaba en ellas las obras de Galeno y Avicena verbalmente; su falta de aprecio adquiría tintes dramáticos, como cuando el día de san Juan de 1527 unos estudiantes necesitaban combustible para la hoguera y Paracelso no dudó en arrojar a ella una copia del Canon de Avicena, expresando su esperanza de que el autor se encontrase en las mismas circunstancias. Y de nuevo encontramos otra similitud con Lutero: cuando éste recibió la amenaza de excomunión por una bula papal, quemó públicamente la bula.

Las curas de Paracelso ganaban rápidamente fama, como también crecía el número e importancia de sus pacientes. Ello conllevó que el número de sus enemigos creciese exponencialmente. Entre esto estaban los médicos que afirmaban que no tenía título de medicina alguno y, por lo tanto, no estaba cualificado y los farmacéuticos, que veían cómo disminuían sus ingresos habida cuenta que Paracelso fabricaba sus propios tratamientos. Por ello, cuando su protector Froben murió dos años después de que lo curase Paracelso (no se sabe si por la misma causa), sus enemigos empezaron a sentirse poderosos.

La crisis estalló cuando el canónigo Cornelius von Lichtentels prometió a Paracelso la cantidad exorbitante de dinero que éste le exigía como pago por aliviar el agudísimo dolor abdominal que sentía; promesa que olvidó cuando unas cuantas píldoras de opio de Paracelso lo eliminaron. Paracelso lo llevó a los tribunales y los tribunales dieron la razón al canónigo. Paracelso, de todo menos prudente, dejó constancia allí mismo de su opinión de los tribunales en general, de los miembros de ellos en particular, y tuvo algo de tiempo para acordarse de familia y amigos. Los pocos que aún conservaba convencieron a Paracelso de que era el momento ideal para dejar Basilea a toda prisa.

Expulsado de Basilea, adoptó su sobrenombre, Paracelso, en 1529, y retomó su vida errática y vagabunda. Sus correrías por Europa acabaron en 1541 cuando Ernst, arzobispo de Salzburgo, le invitó a establecerse en la ciudad bajo su protección. Unos meses después, en septiembre de ese mismo año, Paracelso moría a los 47 años, sin que se sepa muy bien de qué. Hay quien dice que murió arrojado desde lo alto de un edificio por sus enemigos; otros que murió de una intoxicación etílica descomunal; y otros que murió plácidamente en el albergue para indigentes en el que vivía. Esta última versión, aunque sea la que cuadre menos con la vida que llevó, parece la más verosímil.

Aunque hubo otras autoridades químicas contemporáneas que afirmaban, como Paracelso, que era necesario combinar el conocimiento químico práctico con la investigación teórica, y que ésta debería ser pragmática, ninguna de ellas quiso que se asociara su nombre con el de Paracelso, dada su rebeldía y a los excesos que proponía y, sobre todo, llevaban a cabo sus discípulos.

Entre estos excesos se encontraban algunos tratamientos, digamos, radicales. Así, tratar la epilepsia con sulfuro de mercurio; sulfato de zinc para la miopía; sulfuro de plomo para las enfermedades del bazo; sulfuro de hierro para tratar la diabetes; y el óxido de mercurio para tratar cualquier mal inespecífico, todo ello cuando los síntomas del envenenamiento por mercurio (dientes sueltos, parálisis, desórdenes nerviosos y muerte) eran conocidos en la época.

Esas otras autoridades químicas tomaron un camino diferente. Se dedicaron a componer libros, una actividad que tenía sentido intelectual y económico desde el momento en que en 1455 se empieza a popularizar la imprenta de tipos móviles. Como consecuencia el conocimiento químico comienza a poder estandarizarse, dejaba de estar sujeto a los errores de los copistas y se ponía a disposición de muchas más personas a un coste mucho menor.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Paracelso, el antisistema se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Paracelso y los médicos espagiritas (3)

- Paracelso, el Lutero de la alquimia (1)

- Paracelso, el sistemático borrachín que trató la sífilis (2)

Ingredientes para la receta: El arroz

Ya que tratamos del arroz, Oryza sativa de nombre científico, lo más oportuno es comenzar con la paella, plato de fama universal cocinado con este cereal, o así nos lo parece en nuestra cultura muy de sol, playa y paella. Así abrimos el apetito. Se conoce con este nombre desde mediados del siglo XIX y, antes, se describe en los recetarios como “Arroz cocido a la valenciana”. Tiene su primera aparición como tal en 1513, en un folleto del agrónomo Francisco de Paula Martí. Pero, por ahora, nos vale con la receta que firma “Un Gastrónomo Jubilado” en su libro “La Gran Economía de las Familias”, editado en Madrid en 1869. Dice así:

“El arroz a la Valenciana se hace friyendo el aceite o manteca en el que se echa un diente de ajo, que se saca cuando este empieza a quemarse. Enseguida se echa el arroz y antes se ha mezclado en seco la sal, la pimienta y un polvo de azafrán para darle color. En el momento en que el aceite se ha empapado en el arroz y comienzan los granos a tostarse, se echa sobre él el agua o caldo que inmediatamente lo empieza a levantar. Después que los granos del arroz se han esponjado y adquirido todo su grueso consumiendo el agua o caldo en que hervían se aparta del fuego, se le deja reposar una media hora, colocando encima de la tapadera de la cazuela o cacerola brasas encendidas que doran la pasta superior del arroz.

El mérito del arroz a la Valenciana consiste en que los granos de él estén blandos pero secos al mismo tiempo y desprendidos entre sí.

Al arroz se le pueden añadir toda clase de carnes, aves y pescados que deberán echársele momento antes de ponerle el caldo después de haber dorado el arroz, aprovechando en esto las sobras de aves, jamón y carnes del día anterior.”

Y, después del apetitoso almuerzo, al arroz. España es un país exportador de arroz, según datos del Ministerio de Agricultura para la campaña de 2010-2011. En estos años, la exportaciones triplican las importaciones. La producción se centra en Andalucía, Extremadura, Cataluña y Valencia. Y, sin embargo, parte del arroz que comemos viene de muy lejos, a miles de kilómetros, y, sobre todo, de muy lejos en el tiempo, de miles de años atrás. Esta es la historia de ese arroz lejano en el tiempo.

Para conocer su lugar de origen en el tiempo, el área geográfica donde fue domesticado, seguiremos los trabajos del botánico y genético ruso Nikolai Vavilov. Estableció que aquellos lugares con más variedades y más especies cercanas, las regiones genéticamente más ricas, son el lugar de origen de una planta domesticada, son lo que llamamos centros Vavilov.

Según Colin Khoury y sus colegas, de la Universidad de Wageningen, en Holanda, no hay muchos centros Vavilov de especies domesticadas en el planeta. Son América Central y México; parte de los Andes y Chile, Brasil y Paraguay; el Mediterráneo; Oriente Próximo; Etiopía; Asia Central; China; y el área entre la India y Malasia.

En la actualidad, muchos de los países del mundo se alimentan de plantas que no se originaron y domesticaron en ellos. Por ejemplo, el arroz viene de del sur, sudeste y este de Asia. La media a nivel planetario del uso de alimentos originados en otro lugar es del 68.7% para cada país. Incluso la media de cultivo en cada país de plantas de origen exterior es del 71%. Los países con menos plantas extrañas en cultivo y como alimento son los que se encuentran en los centros Vavilov, como Camboya, con solo el 19.1% de plantas de origen exterior; Bangladesh, con el 20%; o Nigeria, con el 20.1%. Con el mayor uso de plantas de origen exterior están los países más ricos y más lejanos de los centros Vavilov como Estados Unidos, Brasil, Argentina, Europa o Australia, que están entre el 80% y el 95% de plantas de otro origen en su mesa.

El arroz alimenta a más de la mitad de la población mundial y entre China y la India cultivan y consumen la mitad de la producción, unos 480 millones de toneladas al año de media. Es la única planta cultivada de la que se utiliza el grano que casi exclusivamente se dedica a la alimentación humana. Entre el sur, el este y el sureste de Asia, se produce el 90% del arroz cultivado en el mundo, con un consumo de más de 110 kilogramos por persona y año. En España no llegamos a los 20 kilogramos por persona y año.

También se domesticó una segunda especie de Oryza, esta vez en África, en las llanuras del río Níger. Es la Oryza glaberrima y ocurrió hace unos 3000 años. En la actualidad solo se cultiva en esta zona de África, mientras que Oryza sativa, el arroz de Asia, se siembra en más de 100 países de todos los continentes excepto en la Antártida. Casi todo el arroz sembrado se consume en el país en que se siembra y solo el 7% del total se comercia entre países.

El arroz que cultivamos, comemos y exportamos, viene de oriente, del este y sur de Asia., y llegó a España en el siglo VIII, con los árabes. Ya se cocinaba desde, quizá, el siglo I en Grecia y Roma, pero en pequeña cantidad. Marco Gavio Apicio, el reputado gastrónomo romano del siglo I, en su libro De re coquinaria, solo cita una vez el arroz y como fécula para espesar salsas. Fueron los árabes los que perfeccionaron y extendieron su cultivo y su utilización como alimento.

No es fácil su cultivo e, incluso, es peligroso ya que necesita mucha agua y los lodazales donde se siembra son lugares idóneos para la cría de mosquitos que, a su vez, con sus picaduras transmiten enfermedades tan peligrosas como el paludismo. Cuando el rey Jaume I conquistó Valencia a los árabes, prohibió el cultivo del arroz en los campos cercanos y lo confinó a la Albufera, zona inundada y acostumbrada a los mosquitos y a la malaria.

La evidencia más antigua de arroz domesticado la ha encontrado el grupo de Yunfei Zheng, del Instituto Provincial de Arqueología y Reliquias Culturales de Zhejiang, en China. Aparecieron granos de arroz, fechados hace entre 8400 y 9000 años, en el yacimiento de Huxi, en el valle del río Yangtze. Son granos de arroz domesticado mezclados con granos de arroz salvaje y semidomesticado. Para los autores, se estaba haciendo la selección del arroz domesticado que ahora conocemos. Parece que su origen está en la especie Oryza rifipogon, que todavía se encuentra en el sur y sudeste de Asia, como es típico de un centro Vavilov. Los expertos proponen que la domesticación ocurrió antes, hace entre 10000 y 14000 años, y aunque no hay evidencias directas se han hecho estudios genéticos de las variedades que ahora se cultivan que apoyan esta hipótesis.

Hace 4000 años ya se sembraba y consumía en la India y arroz fechado hace 2000 años se ha encontrado en el Japón, en Oriente Medio y en Egipto. Como decía antes, en el siglo VIII llegó a la Península con los árabes y en el siglo XIII se consumía en el norte de Europa. A Estados Unidos lo llevaron los esclavos negros desde África en el siglo XVIII.

Una curiosa investigación se ha publicado hace unos años, en 2014, liderada por T. Talhelm, de la Universidad de Virginia, que trata de las diferencias psicológicas y de conducta en China entre los cultivadores de arroz y los que siembran cereales, en concreto, trigo. Entrevistan a 1162 agricultores de la etnia Ham de seis procedencias geográficas y que siembran trigo o arroz. Encuentran que el arroz, que se cultiva en el sur de China, provoca comportamientos más interdependientes y sus cultivadores tiene un pensamiento más holístico. Los cultivadores de trigo, en áreas más al norte, son más independientes e individualistas.

Proponen que la siembra de arroz obliga a la cooperación para asuntos relacionados con el cultivo como, por ejemplo, el reparto de agua o el mantenimiento adecuado de las parcelas. En el trigo, la buena práctica se puede conseguir con una conducta más individual.

Y, para terminar, un postre, un “Arroz con leche” nada menos que del siglo XVII, de 1611, y de Francisco Martínez Motiño, el que fuera Cocinero Mayor de Felipe II y de los Austrias que le sucedieron. Todo un personaje y esta es su receta:

“Después de lavado el arroz con cuatro aguas, se ha de enjugar del agua, y para doce escudillas de arroz, se echará libra y media de arroz; y después de enjuto se echará a cocer en un azumbre de agua y sal; y estando cocido que esté bien seco, se le echará un azumbre de leche y una libra de azúcar, se pondrá a cocer con muy poca lumbre porque no se esture, meneándolo, porque no se pegue; y estando embebida la leche se raspará para que repose, y se harán las escudillas, y se echará por encima azúcar y canela.”

Que aproveche.

Referencias:

Chang, T.-T. 2000. Rice. En “The Cambridge world history of food, Vol 1”, p. 132-149. Ed. por K.E. Kiple & K.C. Ornelas. Cambridge University Press. Cambridge. 1120 pp.

Girona, P. 1968. Valores agroecológicos de la agricultura tradicional valenciana: el arroz. Actas del III Congreso de la SEAE, Valencia, p. 31-39.

Khoury, C.K. et al. 2016. Origins of food crops connect countries worldwide. Proceedings of the Royal Society B 283: 20160792

Martínez Motiño, F. 1611. Arte de cozina, pastelería, bizcochería y conservería. Barcelona. 1763.

Molina, J. et al. 2011. Molecular evidence for a single evolutionary origin of domesticated rice. Proceedings of the National Academy of Sciences USA 108: 8351-8356.

Muthayya, S. et al. 2014. An overview of global rice production, supply, trade, and consumption. Annals of New York Academy of Sciences 1324: 7-14.

Swaminathan, M.S. 1984. Arroz. Investigación y Ciencia marzo: 52-62.

Talhelm, T. et al. 2014. Large-scale psychological differences within China explained by rice versus wheat agricultue. Science 344: 603-608.

Un Gastrónomo Jubilado. 1869. La gran economía de las familias. Impr. F. López Vizcaíno. Madrid . 93 pp.

Zheng, Y. et al. 2016. Rice domestication revealed by reduced shattering of archaeological rice from the Lower Yangtze valley. Scientific Reports 6: 28136

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Ingredientes para la receta: El arroz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El robo de los barriles de arroz

- Preparados para matar: algunas ideas para el debate

- Llega la segunda generación de ingredientes funcionales

Membranas de celulosa nanoestructurada como sensores de metales

Valiéndose de materiales renovables, azúcar y una fuente de celulosa, como los periódicos, investigadores de la UPV/EHU han desarrollado un sensor para la detección de presencia de determinados metales que, además, puede ser útil en la creación de bioimágenes.

Erlantz Lizundia experto en celulosa, dio comienzo a la investigación en una estancia que realizó en Canadá. El grupo de investigación en el que estuvo está especializado en la organización en forma de hélice de un producto extraído de la celulosa, los nanocristales de celulosa (CNC por sus siglas en inglés). En unas condiciones específicas, los cristales pueden adquirir forma helicoidal, o lo que es lo mismo, formar estructuras quirales nemáticas, mediante la organización de los cristales en capas ordenadas, y así lograr membranas con propiedades muy especiales: “En función de la distancia que hay entre las capas de nanocristales de celulosa que conforman la hélice, o estructura quiral nemática, la membrana presenta un color distinto. Se da una interacción entre la estructura y la luz, y, como consecuencia, cambia la longitud de onda de la luz, y se consiguen materiales de colores vivos”, explica Lizundia.

Esta capacidad de cambiar de color que presenta la estructura “puede ser muy útil para utilizar estas membranas como sensores; por ejemplo, al ponerlas en un entorno húmedo, la estructura se hinchará y aumentará la distancia entre las capas, y cambiará de color”, añade. Ese efecto es conocido como color estructural, y es muy común en la naturaleza. El color de multitud de animales (serpientes, camaleones) y plantas es consecuencia directa de su estructura supramolecular, y no está relacionado, en contra de lo que se podría pensar, con la presencia de pigmentos.

Queriendo ir un paso más allá de lo aprendido en Canadá, Lizundia pensó en incorporar otras nanopartículas funcionales en esa estructura quiral nemática, unas partículas que cambian de propiedades ante estímulos externos. Escogió los llamados nanopuntos de carbono, por un lado, porque son fluorescentes, es decir, emiten color al excitarlos con luz ultravioleta, y, por otro, porque pudo conseguirlos utilizando como materia prima azúcar: “Logré estas nanopartículas sometiendo a la glucosa a un tratamiento hidrotermal, utilizando únicamente agua y calor, y mediante un proceso rápido y barato”, comenta el investigador.

El material final presenta las características que buscaba Lizundia: Por un lado, “es un material respetuoso con el medioambiente, ya que no es tóxico y sus materias primas son de carácter renovable, y el proceso de síntesis es rápido, simple y escalable. Por otro lado, además, el hecho de ser fluorescente dota al material de propiedades interesantes para poder ser utilizado como sensor”, concreta Lizundia.

El haber introducido puntos de carbono dentro de la estructura quiral nemática de los nanocristales de celulosa convierte a este material en especialmente apropiado como detector de la presencia de hierro, por lo que, tal como explica Lizundia, “resulta muy útil para detectar la polución medioambiental o la presencia de metales en el cuerpo. Yo, concretamente, estudié la respuesta del material frente al cinc y el hierro, al ser los dos muy abundantes tanto en temas medioambientales como biológicos. Pude observar que la interacción de los iones metálicos con las nanopartículas de carbono influye en el nivel de fluorescencia que emiten las nanopartículas. En presencia de hierro, disminuye su fluorescencia, y en presencia de cinc, sin embargo, aumenta”.

Otra posible aplicación de ese material puede ser el utilizarlo para formar bioimágenes. En la investigación realizada, Lizundia no llegó más que a probar que, efectivamente, ofrece esa posibilidad. “En breve pondré en marcha una investigación para profundizar en este tema, y utilizar estas nanopartículas para la creación de bioimágenes”. La bioimagen consiste en crear imágenes mediante métodos no invasivos de procesos biológicos, como procesos celulares, así como medir la interacción entre moléculas en tiempo real, en el lugar donde están sucediendo esas interacciones.

Referencia:

E. Lizundia, T.D. Nguyen, J. L. Vilas, W. Y. Hamad, M. J. MacLachlan.. (2016) Chiroptical luminescent nanostructured cellulose films. Materials Chemistry Frontiers. DOI: 10.1039/C6QM00225K.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Membranas de celulosa nanoestructurada como sensores de metales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Nanopartículas lipídicas como vectores en terapia génica

- La contaminación por metales pesados no llega a los tomates

- Los sedimentos fluviales, una reserva dinámica de metales contaminantes

El caso de la mujer barbuda

En la estancia de V.Re. estaba un pintor muy famoso haciendo el retrato de una señora de los Abruzzos casada y madre de muchos hijos, cuyo rostro era totalmente viril, con más de un palmo de barba negra muy hermosa, el pecho lleno de pelo, si vuestra Excelencia me permite verlo, como cosa maravillosa, lo es verdaderamente.

Carta del Embajador de Venecia en Nápoles con fecha 11 de febrero de 1631.

“La mujer barbuda (Magdalena Ventura con su marido)” José de Ribera (1631). Óleo sobre lienzo 196 x 127 cm

Se llamaba Maddalena Ventura, había nacido hacia 1580 en Accumoli, pueblo de la región de los Abruzzos, en Italia, y en 1631 fue la figura central del cuadro “La Mujer Barbuda”, de José de Ribera, conocido como “El Españoleto”. En aquella época, en los siglos XVI y XVII, gustaban los mecenas de la pintura encargar retratos de enanos y personas con cualquier discapacidad. Fue el Virrey de Nápoles, Duque de Alcalá, Don Fernando Afán de Ribera y Téllez-Girón, quien se enteró de la existencia de una mujer con barba en su virreinato, la nombrada Maddalena Ventura, y la invitó a su palacio de Nápoles para que Ribera, su protegido, la pudiera retratar. El título original de la obra, en italiano, sería “Maddalena Ventura con il marito e suo figlio”. En la actualidad, el cuadro pertenece a la colección del Duque de Medinaceli y está depositado en el Museo del Prado.

Maddalena Ventura tenía 52 años cuando sirvió de modelo a Ribera. Estaba casada con Felici di Amici y tenía tres hijos. En el cuadro aparece amamantando al menor de ellos, nacido 15 años después de la aparición de la barba. Fue a los 37 años cuando le comenzó a crecer la barba, junto a otros signos de masculinización como la calvicie y la voz grave. Es, según todos los síntomas, un caso de hirsutismo.

“Brígida del Río, la barbuda de Peñaranda” de Juan Sánchez Cotán (1590). Óleo sobre lienzo. 102 x 61 cm

Hay otro cuadro en el Museo del Prado con una mujer barbuda. Lo pintó Juan Sánchez Cotán hacia 1590 por encargo, quizá, del propio Felipe II. La mujer se llamaba Brígida del Río, y era conocida como “la mujer barbuda de Peñaranda”, parece ser que Peñaranda de Bracamonte, provincia de Salamanca, aunque está sin confirmar. Cuando sirvió de modelo al pintor tenía 50 años y, en parte, se ganaba la vida cobrando por mostrarse al público o, mejor, a los nobles que podían pagar lo que recaudaba.

El hirsutismo es el crecimiento excesivo de pelo en la mujer, con un patrón masculino de distribución en la barba, las patillas, el cuello, el tórax, el ombligo, los muslos, la espalda, además de la calvicie y de irregularidades en la regla.

Tienen hirsutismo, más o menos, entre el 5% y el 10% de las mujeres en edad fértil, y puede ser leve y, solo en casos raros, llegar a ser un trastorno grave. La causa está en la producción en exceso de hormonas masculinas o en la sensibilidad aumentada a esas hormonas. El receptor de las hormonas, sobre todo de testosterona, están en los folículos pilosos, estructuras de la piel donde se sintetiza el pelo. Si hay un exceso de producción se activan los receptores de los folículos o, también, puede aumentar la sensibilidad de esos receptores y activarse con menos concentración de testosterona. En ambos casos, el vello que se produce en los folículos acelera su crecimiento y se transforma en pelo terminal, más grueso y visible. Además, tanto en el hombre como en la mujer, hay del cuerpo con folículos más sensibles a la testosterona y, por eso, la distribución de este pelo terminal es parecida en hombres y en mujeres con hirsutismo y, por supuesto, destaca por ser más visible, la aparición de barba como ocurría con Magdalena Ventura.

La testosterona en las mujeres se sintetiza en el ovario o en las glándula suprarrenales y, cuando ocurre en exceso, se debe a causas como el síndrome de los ovarios poliquísticos, tumores en las glándulas suprarrenales, hiperplasia suprarrenal, o el uso de fármacos como la difenilhidantoína, los tratamientos con testosterona, el damazol y otros.

En el caso de aumento de la sensibilidad de los folículos pilosos a la testosterona, tenemos lo que se llama hirsutismo idiopático y no se conoce con exactitud la causa de su aparición. Lo tienen el 20% de las mujeres afectadas de hirsutismo. Tienen niveles normales de testosterona y mantienen la función normal de los ovarios. Entre este tipo de hirsutismo más el provocado por el síndrome de los ovarios poliquísticos afectan al 90% de las mujeres con hirsutismo.

Harnaam Kaur

Para acabar, un caso de hirsutismo más cercano a nuestro tiempo y cultura. En 2015, hace algo más de un año, ganó el Festival de Eurovisión Conchita Wurst, conocida como “La mujer barbuda”, aunque, en realidad, era el disfraz público de travesti del joven austríaco Thomas Neuwirth. Pero, en las mismas fechas llegó a los medios la historia real de una verdadera mujer barbuda, Harnaam Kaur. A los 18 años desarrolló el síndrome del ovario poliquístico que, ya hemos visto, provoca el hirsutismo en las mujeres. Con la aparición de la barba, la joven sintió el rechazo de su entorno e, incluso, el bullying de sus compañeros estudiantes. Se convirtió al sijismo, religión hindú que prohíbe cortarse la barba. Harnaam se aceptó a sí misma y se dejó crecer la barba, como le pedían sus nuevas creencias. Ahora, su barba es, también, no una enfermedad sino una opción personal.

Referencias

Akter, N. & N.K. Qureshi. 2016. Hirsutism – Evaluation and treatment. Delta Medical College Journal 4: 35-44.

Díez, P.M. 2015. La historia de la auténtica mujer barbuda. ABC 21 marzo.

Oranges, C.M. & M. Matucci-Cerinic. 2016. Maddalena Ventura: an impressive case of hirsutism in a painting of Jusepe De Ribera (1631). Journal of Endocrinological Investigation 39: 123.

Turnbridge, W.M.G. 2011. La Mujer Barbuda by Ribera, 1631: a gender bender. QJM: An International Journal of Medicine 104: 733-736.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo El caso de la mujer barbuda se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El caso de Kitty Genovese

- El caso de Henrietta Lacks

- El caso de Juan Díaz de Garayo, el Sacamantecas

#Naukas16 Por qué el descubrimiento de las ondas gravitacionales no confirma la relatividad general…¿o sí?

César Tomé López hace algunas reflexiones sobre el descubrimiento del año 2016

Edición realizada a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Por qué el descubrimiento de las ondas gravitacionales no confirma la relatividad general…¿o sí? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La detección de ondas gravitacionales: el nacimiento de una nueva astronomía

- #Naukas16 Cómo escribir un libro de ciencia para niños

- #Naukas16 Aproximadamente

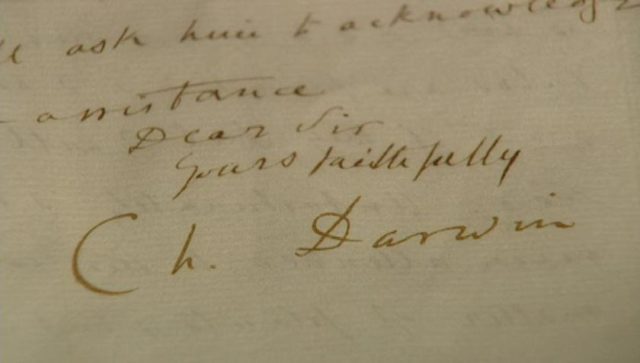

Las cartas de Darwin: 50 años para un proyecto titánico

Las cartas de Darwin, una serie para conocer aspectos sorprendentes de la vida del naturalista

En 1974 la Universidad de Cambridge inició un proyecto titánico. La idea surgió a petición de un académico retirado, Frederick Burkhardt, que con la ayuda de su esposa Anne y el zoólogo Sydney Smith, planteó al centro una tarea ardua y casi imposible: Recopilar, ordenar y publicar toda la correspondencia de Charles Darwin.

A primera vista puede parecer un proyecto sencillo. Al fin y al cabo, Darwin es una de las figuras más célebres de la Historia y tanto su trabajo como su vida son bien conocidos. Sin embargo, el naturalista era un escritor metódico e incansable que intercambió correspondencia con más de dos mil personas diferentes a lo largo de su vida. Las proporciones del proyecto se incrementan aún más si tenemos en cuenta que se incluyen no solo las cartas que Darwin escribió sino también, y esto es importante, las que recibió.

La estimación que hicieron los responsables de este proyecto superó por mucho sus expectativas puesto que actualmente se calcula que la cantidad total de textos a analizar supera ampliamente los 20.000 documentos.

Por supuesto, antes de la recopilación de Burkhardt, ya existían diversas publicaciones con diferentes cartas y notas de Charles Darwin. El ejemplo más significativo es la edición que la editorial John Murray, el sello que publicó originalmente toda la obra de Darwin, lanzó cinco años después de la muerte del naturalista y que llevó por título “Life and letters” [F1452.1,2 y 3].

3 volúmenes del Life and Letters (1887) | Imagen Javier Peláez

Aquella obra, editada en tres extensos volúmenes por su propio hijo Francis Darwin se publicó en 1887 y significó tan solo el pistoletazo de salida, puesto que en los siguientes años se vio acompañada por una segunda recopilación, con dos nuevos tomos, titulada “More letters” en 1903. [F1548.1 y 2]. Sin embargo, estas ediciones originales de Murray, junto con las posteriores a lo largo de los siguientes años, escasamente abarcan un 5% del total de cartas escritas y recibidas por Charles Darwin.

2 volúmenes del More Letters (1903) | Imagen Javier Peláez

Desde que se inició el proyecto de Cambridge University Press en 1974 se han publicado ya 24 tomos y los actuales responsables del trabajo (puesto que Burkhardt falleció en 2007) estiman que la colección completa alcanzará los 30 volúmenes y podría estar terminada en el año 2022.

Las razones que justifican un proyecto tan longevo son variadas. En primer lugar la extensa correspondencia de Darwin: sin contar con las cartas que se han perdido con el paso del tiempo, se estima que existen unos 15.000 escritos enviados o recibidos por Darwin dispersos por todo el mundo. Una buena parte de esa correspondencia se encuentra en museos, universidades o fundaciones a los que es más fácil acceder… pero el resto es propiedad de coleccionistas privados, muchos de ellos anónimos.

Otra razón que dificulta el trabajo de transcripción y edición de los textos es el inevitable paso del tiempo que ha dejado ilegibles muchos documentos. Sin contar con que la letra de Darwin tampoco facilita la tarea (es frecuente encontrar palabras o incluso frases enteras que no se entienden por la caligrafía del propio naturalista).

Ejemplo de algunas de las cartas recuperadas por el proyecto de Cambridge

Sin embargo este enorme y complicado proyecto tiene sus satisfacciones, muchas de ellas al alcance de cualquiera con un solo click de ratón. Actualmente el Darwin Correspondence Proyect ofrece públicamente más de 8.000 cartas, notas, dibujos y grabados, que se pueden consultar online en su web.

La cantidad de información disponible es inmensa y la idea de inaugurar esta serie titulada “Las cartas de Darwin” tiene como objetivo el conocer algunos aspectos poco conocidos de la biografía del naturalista inglés, utilizando la vasta colección de correspondencia que dejó a lo largo de vida.

Este post ha sido realizado por Javier Peláez (@irreductible) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Las cartas de Darwin: 50 años para un proyecto titánico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El proyecto BRAIN y sus implicaciones para la ciencia, medicina y sociedad

- Proyecto Mohole, un fracaso que no hacía falta

- Bilbao celebrará el día de Darwin

#Naukas16 Un monumento invisible

En París hay un monumento invisible. O visible por partes. Manu Arregi nos lo descubre auqnue al principio parezca que no lo va a hacer.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Un monumento invisible se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 Pianos, torpedos y lo inesperado

- #Naukas16 ¿Cifras o encriptas? Siempre con la ayuda de tus primos

- #Naukas16 ¿Que te chupe la qué?

La flamante historia del celuloide

Fotograma de “Cinema Paradiso” (1988) de Giuseppe Tornatore.

En 1990 el cineasta Martin Scorsese creó The Film Foundation, una fundación sin ánimo de lucro encomendada a la preservación y restauración de películas de cine clásico.

Probablemente esta fundación no existiría si Scorsese no hubiese tenido un momento revelador de la problemática cuestión de la preservación del patrimonio cuando, en un pase doble de cine al que asistió en su juventud, le chocó el triste estado en el que se encontraba la copia emitida de una importante película. Esa era La tentación vive arriba (1955), la famosa obra de Billy Wilder protagonizada por Marilyn Monroe. Una copia maltrecha de esa película se emitió justo después de una magnífica copia de Niágara, donde también aparecía Monroe y que se conservaba en mucho mejor estado pese a que ambas producciones contaban con dos años de diferencia. Así lo relató Scorsese durante la celebración del Festival de Cine de Nueva York en 2015 [1].

Scorsese asegura que más de la mitad de las películas realizadas antes de 1950 se han perdido, y sólo se conserva un 10% del cine mudo. Incluso películas más recientes se están deteriorando[2].

Uno de los motivos de estas pérdidas es que hasta 1950 el soporte de las películas se hacía con un material altamente inflamable, por lo que muchas películas se perdieron en incendios o se quemaron durante la proyección.

Solo en un incendio de 1965 en el depósito de la Metro Goldwing Mayer se perdieron más de 100 películas para siempre, entre ellas London after midnight de Tod Browning. Muchos de los cortometrajes de Georges Méliès, el mago-fundador del cine, se encuentran desaparecidos pese al empeño personal de Scorsese que ha conseguido recuperar y restaurar algunas de sus cintas[3].

En España, un incendio de un depósito en Madrid en 1944 destruyó buena parte del material rodado en la Guerra civil y muchas películas republicanas.

La historia del descubrimiento del material con el que se hacían las películas no tiene nada que ver con el cine. Es una curiosa historia que sirve para ilustrar cómo funciona la ciencia y la deriva de sus aplicaciones.

En 1860, los fabricantes estadounidenses de billares Phelan y Collander ofrecieron un cuantioso premio a quien consiguiese un material capaz de sustituir al costoso y escaso marfil que por aquel entonces se utilizaba para fabricar bolas de billar. John Wesley Hyatt, inventor estadounidense, se puso manos a la obra y descubrió un nuevo material: el celuloide.

El celuloide es un plástico a base de nitrato de celulosa y alcanfor. El nitrato de celulosa se obtiene tratando la celulosa extraída de las plantas con ácido nítrico. Esta sustancia plástica adquiría la forma deseada antes de endurecerse. Aparentemente era un material idóneo para fabricar bolas de billar; aun así, no consiguió ganar. Hyatt no había probado sus bolas de billar hasta el día del concurso. La sorpresa llegó en forma de estallidos y pequeñas explosiones que se producían durante el juego cada vez que las bolas de billar chocaban con fuerza entre sí. Había descubierto que el celuloide es inflamable [4].

El invento de Hyatt no servía para el billar, pero era un material muy versátil que acabaría teniendo mucho éxito por ser traslúcido y porque puede moldearse con calor reiteradamente, es decir, es un material termoplástico.

El celuloide se utilizó para fabricar mangos de cuchillos, monturas de gafas, peines y demás objetos de uso cotidiano. En México, a las muñecas elaboradas con celuloide se las denomina muñecas de sololoy. Sololoy es una transliteración de palabra inglesa celluloid. Las muñecas se fabricaron con ese material desde 1920 hasta 1979[5]. Todavía hoy, aunque cada vez con menos frecuencia, en México suele escucharse la expresión muñequita de sololoy para referirse de forma cariñosa a una niña, por comparación con la hermosura y delicadeza de aquellas muñecas de antaño.

Donde el celuloide tuvo una mayor aceptación fue en la industria cinematográfica, ya que durante muchos años los rollos de fotografía y cine se fabricaron con este material. Por este motivo a la industria del cine se le sigue llamando industria del celuloide.

El celuloide, por su flexibilidad y su transparencia óptica, resultaba un soporte idóneo para las películas. Sobre este soporte se suspende una emulsión coloidal gelatinosa de haluro de plata que es fotosensible y, por tanto, la responsable de la formación de imágenes.

El celuloide, por su flexibilidad y su transparencia óptica, resultaba un soporte idóneo para las películas. Sobre este soporte se suspende una emulsión coloidal gelatinosa de haluro de plata que es fotosensible y, por tanto, la responsable de la formación de imágenes.

El impacto de la luz sobre la suspensión del haluro de plata es suficiente como para movilizar electrones capaces de reducir alguno de los átomos de plata oxidada (de color blanco) a plata reducida (de color negro), generando lo que se llama una imagen latente. Esta imagen es imperceptible para el ojo humano, pero es la responsable de crear los núcleos a partir de los cuales se seguirá reduciendo la plata adyacente en el proceso de revelado.

En el caso de la película en color, aquí aparecen tres capas de haluro de plata las cuales están mezcladas con filtros que determinan el paso, en cada caso, de un espectro específico de la luz. De este modo, se terminan creando una capa amarilla, otra cian y otra magenta en el negativo después del revelado.

A partir de 1952 el celuloide cae en desuso y se comienza a utilizar el acetato de celulosa como soporte, un poco más opaco, pero más estable. En la actualidad, las películas de Kodak y Eastman son de un polímero de poliéster sintético denominado ESTAR, que es prácticamente inalterable.

Esta historia es muy representativa de cómo funciona la ciencia y lo dispares que pueden llegar a ser sus aplicaciones. A veces esas aplicaciones llegan inmediatamente. A veces tardan años, décadas. A veces no llegan nunca. A veces ni se pretenden. Lo hermoso de esta historia es que un uso inesperado de un material que perdió el concurso que pretendía ganar, es el material que le dio nombre al cine y el que, a la vez, truncó y posibilitó su existencia.

Fuentes:

[1] Martin Scorsese on Fighting For Film Preservation and Not Believing in ‘Old Movies’. Wil Barlow, octubre de 2015. Indie Wire.

[2] Save that Movie! Susan King, octubre de 1997. Los Angeles Times.

[3] La frágil vida del séptimo arte. Esteban Ramón, septiembre de 2013. RTVE.

[4] Todo es cuestión de química. Deborah García Bello, 2016. Ed. Paidós.

[5] Muñequita de Sololy. Arturo Ortega Morán, febrero de 2012. Cápsulas de lengua.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo La flamante historia del celuloide se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La historia de la humanidad en una isla

- #Naukas16 La verdadera historia de la penicilina

- Historia de un héroe inmune

Un poco más allá del modelo estándar

El modelo estándar

El conocido como modelo estándar de partículas es una de las teoría científicas de más éxito de la historia, tal es la cantidad de cosas que explica y el número de veces que ha sido puesto a prueba. De hecho, pocas teorías físicas tienen la robustez del modelo estándar en términos estadísticos. Desde que se propusiese hace cuarenta años ha pasado todos los ensayos ampliamente.

Con todo, y como les ocurre a todos los modelos, tiene algunos problemas que no son precisamente fáciles de responder. Por ejemplo, no explica por qué hay más materia que antimateria en el universo, cuando en principio no existe ninguna razón para que una fuese más abundante que la otra.

Pero a grandes males, grandes remedios. Los científicos a los largo de la historia han especulado con distintas posibilidades que podrían solucionar un problema desde el punto de vista teórico y después han realizado experimentos y observaciones para comprobar que ello era así. Lo hizo Einstein cuando desarrolló su teoría general de la relatividad y lo hizo Pauli cuando llegó a la conclusión que tenía que existir una partícula que hoy conocemos como neutrino.

Ahora, cuatro físicos teóricos, Guillermo Ballesteros, Javier Redondo, Andreas Ringwald y Carlos Tamarit, han desarrollado un nuevo modelo, al que llaman SMASH, que extiende mínimamente el estándar con resultados espectaculares: soluciona cinco de los problemas del modelo estándar de una tacada.

SMASH. APS/Alan Stonebraker

En SMASH se añaden 6 nuevas partículas a las 17 existentes. Las nuevas partículas son tres neutrinos pesados diestros, un fermión con triplete de color, una partícula llamada ro que le da masa a los neutrinos diestros y que, junto con el bosón de Higgs, es la responsable de la inflación cósmica, y un axión, que es una partícula candidata a ser la constituyente de la materia oscura.

Con estas 6 partículas el SMASH hace 5 cosas: produce el desequilibrio observado materia-antimateria que hay en el universo; crea las misteriosas masas diminutas de los neutrinos zurdos; explica la simetría tan extraña que presenta la interacción fuerte que es la que mantiene a los quarks en los núcleos de los átomos; incluye el origen de la materia oscura; y, por si fuera poco, explica la inflación cósmica.

¿Irá a alguna parte este modelo? ¿Conseguirán sus autores el Nobel?¿Será esto el ansiado cambio de paradigma de la física? No hay que correr tanto. De momento hay cosas que SMASH no explica, como el llamado problema de jerarquía o la constante cosmológica.

Pero una cosa sí tiene muy buena el nuevo modelo: hace predicciones claras y medibles. Por ejemplo, SMASH dice que la masa de los axiones tiene que estar entre 50 y 200 microelectronvoltios. Nuevas observaciones del fondo cósmico de microondas y los resultados de los experimentos que buscan axiones pueden decir más pronto que tarde si esta nueva hipótesis es nuestro mejor modelo del universo o hay que descartarla completamente.

Referencia:

Guillermo Ballesteros, Javier Redondo, Andreas Ringwald, and Carlos Tamarit (2017) Unifying Inflation with the Axion, Dark Matter, Baryogenesis, and the Seesaw Mechanism Phys. Rev. Lett. doi: 10.1103/PhysRevLett.118.071802

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Un poco más allá del modelo estándar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La verdadera composición última del universo (I): Más allá del modelo estándar

- El Higgs aún podría no ser el bosón de Higgs del modelo estándar

- Del modelo estándar

Un problema clásico de pesas

Los problemas de pesas y balanzas son muy frecuentes en la matemática recreativa. Revisando el libro 100 Great Problems of Elementary Mathematics – 100 grandes problemas de matemática elemental he recordado un problema clásico de pesas del siglo XVII y me ha parecido interesante, por su atractivo, su interés y su sencillez, recordarlo en esta sección del Cuaderno de Cultura Científica.

El problema fue propuesto por el matemático, lingüista, filósofo y poeta francés Claude Gaspard Bachet de Méziriac (1581-1638), quien realizó la traducción al latín y la edición, en 1621, de la obra Arithmetica del matemático griego Diofanto (siglo III), dentro de su libro Problèmes Plaisants et Délectables, qui se font par les nombres – Problemas placenteros y deliciosos que se plantean con los números (1612).

Cuadro, de autor desconocido, del matemático francés Claude Gaspard Bachet de Méziriac

El problema propuesto por el matemático francés dice así:

Problema de pesas de Bachet de Méziriac: Determinar el menor número de pesas, y su peso en kilos*, necesarias para pesar cualquier cantidad de kilos entre 1 y 40, ambas incluidas (sin admitir fracciones).

[* En el texto original son libras]

Aunque no se dice explícitamente en el texto del problema, se está refiriendo a que las pesadas se realizan con una balanza de dos brazos, o respectivamente de dos platos, de forma que los pesos se pueden colocar en cualquiera de los dos platos para conseguir obtener el peso que se desea (similar a la que podemos ver en la siguiente imagen, aunque con la licencia de que la de la imagen no aguantaría los pesos de los que estamos hablando). Así, si se tiene una pesa de 9 kilos y otra de 5 kilos, se pueden pesar 4 kilos de naranjas, poniendo en uno de los platos la pesa de 9 kilos y en el otro la pesa de 5 kilos con las naranjas. Matemáticamente, estamos realizando la operación resta, 9 kilos – 5 kilos = 4 kilos.

Es decir, dadas unas pesas con unos determinados pesos, se puede conseguir pesar cualquier cantidad obtenida como suma o resta de los valores de las pesas.

Balanza de dos brazos, o dos platos

En el libro 100 Great Problems of Elementary Mathematics se plantea esencialmente el mismo problema, aunque en el enunciado se incluye ya la información de que son 4 pesas, con una literatura un poco más atractiva para un lector general.

Problema: Un mercader tenía una pesa de 40 kilos*, pero se le cayó y se rompió en 4 piezas distintas. Cuando se pesaron las piezas se comprobó que cada una pesaba una cantidad exacta de kilos y que entre las cuatro se podía pesar cualquier cantidad de kilos* entre 1 y 40. ¿Cuántos kilos* pesan cada una de las piezas?

Portada del libro de Claude Gaspard Bachet de Méziriac, “Problèmes Plaisants et Délectables, qui se font par les nombres” (1612)

Razonemos de forma similar a como lo hizo Bachet hace 400 años. La idea de Bachet es empezar con dos pesas de formas que podamos pesar cualquier cantidad entre 1 y n, para n lo más grande posible. Es evidente que la solución son dos pesas de 1 y 3 kilos, con las que se pueden conseguir los pesos entre 1 y 4 kilos:

1 = 1, 2 = 3 – 1, 3 = 3 y 4 = 1 + 3.

Recordemos que sumar significa poner las pesas en el mismo plato, mientras que restar significa ponerlas en platos distintos.

Sin embargo, para otras cantidades habríamos tenido la misma cantidad de pesos, pero no comprendidos entre 1 y n. Por ejemplo, con pesas de 2 y 3 kilos se obtienen 1, 2, 3 y 5 kilos, pero no 4 kilos.

Ahora, habría que ver que pesa añadir para obtener todos los pesos entre 1 y n, para n más grande que 4. Como tenemos ya las dos pesas de 1 y 3 kilos, y hemos conseguido pesar todos los pesos entre 1 y 4 kilos, tenemos que tomar una pesa cuya diferencia con el máximo conseguido hasta ahora, 4 kilos, sea el siguiente peso, 5 kilos (por lo tanto, 9 kilos, ya que 9 – 5 = 4, o lo que es igual, 9 = 2 x 4 + 1), ya que así se consiguen todas las cantidades desde 5 kilos hasta dicha cantidad, 9 kilos, al ir restando de 9 kilos (es decir, poniendo en el otro plato) todas las cantidades desde 1 hasta 4:

5 = 9 – 4 = 9 – (1 + 3), 6 = 9 – 3,

7 = 9 – 2 = 9 + 1 – 3, 8 = 9 – 1, 9 = 9.

Pero además, también podemos conseguir todos los pesos entre 9 y 9 + 4 = 13 kilos:

10 = 9 + 1, 11 = 9 + 2 = 9 + 3 – 1,

12 = 9 + 3, 13 = 9 + 4 = 9 + 3 + 1.

Por lo tanto, con 3 pesas de 1, 3 y 9 kilos se consiguen todos los pesas entre 1 y 13 kilos.

El número 13 en una tipografía creada por Jamie Clarke, con Elliot Jay Stocks, para 8 Faces Magazine

De hecho, estamos estableciendo el método general. Supongamos que tenemos pesas A, B, C,… con las que conseguimos pesar desde 1 a n kilos. Ahora consideramos una nueva pesa P de p kilos, que excederá a n en exactamente n + 1 kilos (para poder conseguir todas las cantidades intermedias), es decir, p – n = n + 1, o equivalentemente, p = 2 n + 1. Y de esta forma es posible pesar desde 1 hasta p + n = 3 n + 1 kilos.

En consecuencia, la siguiente pesa, la cuarta, tendrá 2 x 13 + 1 = 27 kilos, y nos permitirá contar hasta 3 x 13 + 1 = 40 kilos. Por lo tanto, la solución del problema es que se necesitan 4 pesas, cuyos pesos son 1, 3, 9 y 27 kilos, respectivamente.

Página del libro de Claude Gaspard Bachet de Méziriac, Problèmes Plaisants et Délectables, qui se font par les nombres (1612), en el que se propone y resuelve el problema de las pesas

Como la construcción que hemos dado es general, podemos plantearnos cuál sería el valor de la siguiente pesa y hasta que cantidad conseguiríamos pesar. La pesa tendría un valor de 2 x 40 + 1 = 81 kilos y se podría pesar con las 5 pesas hasta 3 x 40 + 1 = 121 kilos.

Llegados a este punto seguro que nos hemos dado cuenta de que las cantidades de las pesas son las potencias de 3, es decir, 1 = 30, 3 = 31, 9 = 32, 27 = 33 o 81 = 34. De hecho, no es difícil demostrar que las pesas van a ser de 30, 31, 32, …, 3k kilos y el peso máximo que se puede conseguir con ellas es 30 + 31 + 32 + … + 3k. Además, esta última expresión, utilizando la formula de la suma finita de potencias, es igual a (3k+1 – 1) / 2.

Con cinco pesas cuyos valores sean 1, 3, 9, 27 y 81 se pueden pesar todas las cantidades entre 1 y 121 kilos. Números representados con la fuente Tropical, diseñada por Alejandro Paul Joluvian, en 2017

Pero podemos plantear la solución del problema de pesas de Bachet de Méziriac de otra forma, como aparece en el excelente libro Famous puzzles of Great Mathematicians. Teniendo en cuenta que si ponemos las pesas en un plato u otro la cantidad de las mismas se suma o se resta, la idea es representar cualquier cantidad C, entre 1 y 40, de la siguiente forma

C = a1p1 + a2p2 + … + ampm,

donde p1, …, pm son los valores de las pesas y los coeficientes ai toman los valores -1 (si se coloca la pesa de valor pi en el plato de la balanza en el que está el objeto que queremos pesar), 0 (si no se utiliza la pesa pi) y 1 (si se coloca la pesa de valor pi en el plato contrario al que está el objeto que queremos pesar).

Como los coeficientes ai pueden tomar tres valores diferentes, -1, 0, 1, la expresión anterior nos sugiere que utilicemos un sistema en base 3. Es decir, los pesos serían p1 = 30 = 1, p2 = 31 = 3, p3 = 32 = 9,… y las cantidades obtenidas serían (las colocamos ahora en orden inverso)

C = am 3m – 1 + am – 1 3m – 2 + … + a3 32 + a2 31 + a1 30,

que como número en el sistema en base 3 se representa (amam – 1 … a3 a2 a1)3. Y permite representar todos los números hasta (1 1 … 1 1 1)3. Por ejemplo, para m = 5 pesas, el máximo número representado es (1 1 1 1 1)3 = 34 + 33 + 32 + 31 + 30 = (35 – 1) / 2 = 121.

Por ejemplo, el número 65 se representaría como

65 = 1 x 81 + (– 1) x 27 + 1 x 9 + 1 x 3 + (– 1) x 1.

Página del libro Mathematical recreations and essays (1892), de W. W. Rouse Ball, en la que se incluye el problema de las pesas de Bachet, con sus dos variantes, y se inicia su resolución

El matemático y abogado británico W. W. Rouse Ball recoge el “problema de las pesas de Bachet” en su célebre libro Mathematical recreations and essays – Recreaciones matemáticas y ensayos (1892). En el mismo plantea dos opciones para el problema, la original en la que se pueden colocar las pesas en ambos platos de la balanza, y cuya solución sabemos que está formada por pesas con valores potencias de 3, es decir, 1, 3, 9, 27, y la otra en la que solo se pueden colocar las pesas en el plato opuesto al plato en el que se coloca el objeto que se quiere pesar. En esta segunda variante las pesas se pueden poner o no, luego solo tenemos la opción de que se sumen o no, pero no que se resten, en conclusión tenemos un sistema binario y la solución son las potencias de 2 para las pesas, 1, 2, 4, 8, 16, 32.

Sin embargo, el problema de las pesas de Bachet de Méziriac tiene un origen mucho más lejano en el tiempo. La primera vez que aparece, que se tenga constancia, es en el Liber Abaci – Libro del ábaco (1202) de Leonardo de Pisa, conocido como Fibonacci. En la edición de 1857 de Baldassarre Boncompagni es el problema “De IIIIer pesonibus, quorum pondus erat librarum quadraginta” que aparece en la página 297 del volumen 1.

Página de la edición de Baldassarre Boncompagni de 1857 del “Liber Abaci” (1202) de Leonardo de Pisa, en la que aparece el problema de las cuatro pesas para conseguir todos los pesos entre 1 y 40

“Bosque de números” (2017), de Emmanuelle Moureaux en The National Art Center, Tokyo. Gracias a @molinos1282

Bibliografía

1.- Heinrich Dörrie, 100 Great Problems of Elementary Mathematics, their history and solution, Dover, 1965.

2.- Claude Gaspard Bachet de Méziriac, Problèmes Plaisants et Délectables, qui se font par les nombres, 1612.

3.- Miodrag S. Petrovic, Famous Puzzles of Great Mathematicians,AMS, 2009.

4.- W. W. Rouse Ball, Mathematical recreations and essays, Macmillan and Co., 1892.

5.- Leonardo de Pisa, Liber Abaci (1202), volumen 1 de la edición Baldassarre Boncompagni, 1857.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Un problema clásico de pesas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El problema del experimento ZZZ

- Metros o millas… Houston, tenemos un problema!

- El problema de las estudiantes de Kirkman

#Naukas16 Viajando en el tiempo y en el espacio

Uno de los grandes acontecimientos científicos de 2016 fue la detección de ondas gravitacionales. Y Francis Villatoro lo tenía que contar.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Viajando en el tiempo y en el espacio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Paracelso y los médicos espagiritas (3)

No está claro de dónde se sacó Paracelso el tratamiento para la sífilis a base de mercurio. Pudo haberlo aprendido en alguno de sus viajes; hay indicios, por ejemplo, de que en la India algunos iatroquímicos recomendaban mercurio para la enfermedad de los portugueses (sífilis). Pero perfectamente el descubrimiento pudo ser un caso de serendipia dado que Paracelso había extendido la dualidad mercurio-azufre tan habitual en los textos alquímicos musulmanes a la tria prima (la Santísima Trnidad), consistente en mercurio (alma), azufre (espíritu) y sal (cuerpo), y experimentaba con ella siempre que tenía ocasión.

Pero, si bien había tenido un éxito mayúsculo con el tratamiento de la sífilis, no se suele hacer mención de la cantidad considerable de gente a la que pudo perjudicar haciendo experimentos con pócimas y mezclas que, no solo no eran efectivas, sino manifiestamente tóxicas.

Con todo, Paracelso era un gran observador y algo aprendía siempre de todos los pacientes a los que trataba. Por ejemplo, describió la relación existente entre niños con cretinismo (una enfermedad congénita asociada a una deficiencia en la glándula tiroides) y padres con bocio (un aumento de tamaño de la glándula tiroides). De hecho, la mayor contribución de Paracelso a la medicina, sin duda, es la idea de que los médicos deben actuar sobre lo que observan más que seguir ciegamente lo que diga la autoridad.

Sus éxitos le dieron la confianza (algo de lo que, por otra parte, nunca anduvo escaso) para criticar abiertamente a los médicos de su época y señalar públicamente su ignorancia y codicia. Sin embargo, de los iatroquímicos (a los que él se refiere como médicos espagiritas, donde espagiria es un término inventado por él para referirse a la producción de medicamentos por métodos alquímicos) dice lo siguiente:

“Alabo a los […] médicos espagiritas, porque no se asocian con gandules o van por ahí majestuosos en su satenes, sedas y terciopelos […] sino que están a su trabajo junto al fuego pacientemente noche y día. No se dedican a pasearse, sino que buscan su entretenimiento en el laboratorio, usan vestidos sencillos de piel y mandiles de cuero en los que limpian sus manos [porque] introducen sus dedos entre los carbones, en la suciedad y la basura y no en anillos de oro. Están manchados de hollín y suciedad como los herreros y los carboneros, y por tanto lucen poco […] no alaban sus remedios sin mesura, ya que saben que el trabajo debe alabar al maestro y no el maestro al trabajo. […] Por tanto se dejan de todas esas cosas y se ocupan de trabajar con sus fuegos y de aprender los pasos de la alquimia”

Frobenius poco antes de caer enfermo

Entonces, alrededor de 1525, cuando Paracelso se acercaba a los cuarenta, tuvo la fortuna de ser llamados a consultas a Basilea por Johann Froben (Frobenius) a causa de una importante infección en la pierna, un humanista y editor de enorme influencia. La infección era de tal entidad que se consideró la amputación para salvar su vida, pero Paracelso recomendó un tratamiento mucho menos drástico y Frobenius, por la razón que fuese, sobrevivió, llevándose Paracelso el mérito. Esto junto a los consejos médicos que dio a un buen amigo de Frobenius, y visitante en esos momentos, llamado Erasmo de Rotterdam, fue lo que le consiguió a Paracelso el puesto de médico municipal en Basilea.

Poco después comenzó a dar clases de medicina en la universidad. Y aquello fue la revolución.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Paracelso y los médicos espagiritas (3) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Paracelso, el sistemático borrachín que trató la sífilis (2)

- Paracelso, el Lutero de la alquimia (1)

- Ciencia en la cocina: crujiente de mandioca con queso de Paracelso

Los animales

Los animales –humanos incluidos, por supuesto- son sistemas orgánicos autoorganizados cuya estructura permanece en el tiempo, o se modifica a lo largo de su desarrollo de acuerdo con un patrón preestablecido. Hasta que mueren, claro está.

El genoma porta, de forma codificada, las instrucciones a partir de las cuales se forma y funciona cada individuo. Incluye, por lo tanto, las instrucciones que determinarán, en interacción con las condiciones ambientales, el modo en que desempeñe sus funciones. Éstas pueden agruparse en las siguientes categorías: (1) mantenimiento de la integridad estructural y funcional del organismo; (2) adquisición y procesamiento de los recursos necesarios para producir copias de sí mismos; y (3) control de los procesos implicados en las funciones anteriores y en las relaciones (del tipo que fueren) con el resto de organismos del mismo o de otros linajes.

Hay muy pocas características animales que puedan ser consideradas realmente universales. Todos son organismos pluricelulares; sus células son eucariotas; y tienen un modo heterótrofo de alimentación, o sea, necesitan materia orgánica procedente de otros organismos. Casi todos se reproducen sexualmente (aunque unos cuantos son capaces de hacerlo asexualmente también) y unos pocos sólo se reproducen mediante partenogénesis. La inmensa mayoría han de ingerir el alimento, ya que no pueden absorberlo directamente del exterior, como hacen los hongos. Casi todos tienen metabolismo aerobio. Y casi todos disponen también de un sistema de control e integración. Muchos tienen capacidad de desplazamiento.

Los animales intercambian materia y energía con el exterior y sobre ese intercambio ejercen grados variables de control. El intercambio de materia puede estar relacionado con la economía de agua y sales. También puede tratarse de procesos implicados en la renovación de los componentes estructurales y la generación de nuevas estructuras (somáticas o reproductivas), o de la provisión del oxígeno y la energía necesarios para generar las moléculas de alto contenido energético –ATP principalmente- con las que alimentar las actividades propias del animal, tanto internas como externas.

Como en el resto de seres vivos, para comprender la biología de los animales es preciso tener en cuenta que los que existen hoy son el (hasta ahora) último eslabón de un linaje que se remonta a un antepasado común en el origen de la vida. No es posible fijar con exactitud el momento en que aparecieron pero se puede aventurar que ocurrió hace unos sesicientos millones de años. A lo largo de los tiempos han ido apareciendo nuevos linajes, a los que agrupamos bajo diferentes categorías a efectos taxonómicos, y han ido despareciendo otros. La categoría taxonómica básica es la especie, y está formada por el conjunto de individuos que pueden reproducirse entre sí dando lugar a descendencia fértil1. Los individuos de un mismo linaje presentan siempre una cierta variabilidad genética, provocada por efecto de las mutaciones y de la recombinación entre los genomas de los gametos que se unen para dar lugar a un nuevo individuo. Y pueden aparecer nuevos linajes por efecto de la selección natural y la deriva genética.

Decimos que los animales (individuos o linajes) se adaptan a unas determinadas condiciones cuando sus características fenotípicas son más adecuadas (para su desempeño bajo las referidas condiciones) que las anteriores a producirse la adaptación en cuestión. Ésta puede consistir en una respuesta de carácter fenotípico (de tipo fisiológico o etológico) de un individuo a un cambio ambiental, o en la aparición de una variante génica más adecuada que la anterior para el desempeño de los animales que la poseen; esta segunda modalidad, al contrario que la primera, se refiere a procesos que cursan a través de generaciones. En ambas acepciones del término es clave la noción de “adecuación” o, más propiamente, “aptitud”. Una adaptación siempre conlleva una mejora de la aptitud, y como consecuencia de ello, el individuo o el linaje que experimenta esa mejora se ve favorecido en términos de potencial reproductivo. O sea, es capaz de producir un mayor número de descendientes.

Teniendo en cuenta lo anterior, decimos que un determinado rasgo o una respuesta biológica tienen valor adaptativo cuando propician una mejora de la aptitud. No todos los rasgos animales son consecuencia de una adaptación. También decimos que sobre los animales actúan presiones selectivas; una presión selectiva es un factor, del tipo que sea, susceptible de inducir variaciones en el grado de aptitud de los individuos pertenecientes a un determinado linaje y, por ello, favorecer las variantes génicas que proporcionan mayor aptitud, provocando un aumento de su frecuencia en ese linaje.

La adecuación (o aptitud) no es estable a lo largo del tiempo, sino que depende de las circunstancias ambientales a las que se encuentran sometidos los animales. Si esas circunstancias cambian, la aptitud también puede hacerlo. Bajo esas condiciones pueden producirse adaptaciones, en forma de respuestas biológicas en plazos de tiempo cortos (en todo caso inferiores al periodo de vida de los individuos), que permitan mantener o mejorar la aptitud. Y en plazos más extensos de tiempo (más que el periodo vital de los individuos) también pueden producirse adaptaciones de base genética, si alguno o algunos individuos de un determinado linaje cuentan con una variante genética que proporciona un mayor grado de aptitud. Como consecuencia de ello, esa variante acabaría siendo la más abundante en los miembros del linaje o, incluso, la única, pues esos individuos tendrían una mayor descendencia y el rasgo ventajoso se acabaría extendiendo a todo el grupo.

Nota:

1No obstante, esa definición de especie tiene algunos problemas a la hora de llevarla a la práctica.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Los animales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La talla de los animales domésticos ha aumentado

- #Naukas15 ¿Es necesario usar animales en investigación?

- Animales emocionales

Bacterias hospitalarias: resistentes e indetectables

Las infecciones adquiridas en el hospital suponen un problema de salud importante, por los problemas que generan y por la alta resistencia de las bacterias que las ocasionan. Una investigadora de la UPV/EHU ha descubierto que al someter a una de esas bacterias a diferentes procesos de desinfección, algunas células siguen vivas, pero en un estado en el que no son capaces de crecer en medios de cultivo tradicionales. Esto las hace indetectables por los métodos de evaluación de la desinfección, que están basados en ese crecimiento.

Imagen microscópica de la bacteria Acinetobacter baumannii. Foto: UPV/EHU

La bacteria Acinetobacter baumannii es un microorganismo responsable de un gran número de brotes epidémicos en los hospitales de todo el mundo, que es capaz de persistir bajo condiciones adversas durante largos periodos de tiempo, debido a su sorprendente resistencia a la desecación y a antibióticos y desinfectantes. Con el fin de conocer su comportamiento en el medio en el que vive, la microbióloga Zaloa Bravo ha estudiado sus estrategias de supervivencia en diferentes condiciones propias del ambiente hospitalario. Aunque era conocida su resistencia, esta investigadora ha constatado que “mantiene una gran estabilidad y viabilidad en condiciones hostiles durante largos periodos de tiempo, más de 30 días”.

Por todo ello, se considera de vital importancia la utilización y la garantía de los métodos de desinfección de los microorganismos en los hospitales. En su investigación, analizó la efectividad de diferentes métodos de limpieza, tanto métodos que utilizan radiación como el uso de desinfectantes. “Los resultados obtenidos tras la exposición de A. baumannii a estos agentes demostraron que ninguno de los desinfectantes estudiados es capaz de eliminar totalmente a este microorganismo”, explica la investigadora.

Más allá de las bacterias que se eliminan y las que no, uno de los resultados destacables de este estudio es que observó que las radiaciones y ciertos agentes oxidantes provocan la entrada de este microrganismo en el estado Viable No Cultivable (VNC), estado en el que las células no son capaces de crecer en medios de cultivo tradicionales pero sí retienen cierta actividad metabólica, sinónimo de que son células activas. “Se trata del primer trabajo que demuestra la adopción del estado Viable No Cultivable por parte de Acinetobacter baumannii“, declara Bravo. Los microorganismos patógenos en estado VNC, generalmente, no son capaces de producir una enfermedad, pero sí retienen la virulencia y la infección puede comenzar si revierten dicho estado. De hecho, “hay estudios que han demostrado que otros microorganismos son capaces de resucitar de ese estado y comenzar una infección, aunque es cierto que existe cierta controversia sobre este tema entre la comunidad científica”, añade.

La detección de células en estado Viable No Cultivable (VNC) lleva a Bravo a realizar la siguiente reflexión en relación a la evaluación de los desinfectantes: “En los controles que se llevan a cabo en los centros sanitarios, se detecta la presencia de bacterias infecciosas mediante la observación de su crecimiento en medios de cultivo. Pero si quedan células en estado viable no cultivable, es decir, que no son capaces de crecer en esos medios, y por eso consideramos que no están presentes, pero en realidad no es así, quizá ni los desinfectantes ni los métodos de control estén funcionando como se esperaba”.

En este punto, Bravo propone que en los hospitales no tendrían que limitar los análisis de presencia de microorganismos patógenos en el ambiente a determinaciones basadas en el crecimiento en medios de cultivo; “habría que utilizar otros métodos que detecten viabilidad, como la expresión génica, por ejemplo, para poder determinar si están presentes”. También habría que saber si esta bacteria es capaz de revertir el estado VNC y, potencialmente, iniciar un proceso infectivo.

Referencia:

Bravo Z., Orruño M., Parada C., Kaberdin V. R., Barcina I., Arana I. (2016) The long-term survival of Acinetobacter baumannii ATCC 19606T under nutrient-deprived conditions does not require the entry into the viable but nonculturable state. Archives of Microbiology, vol. 198: 398-407. doi: 10.1007/s00203-016-1200-1.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Bacterias hospitalarias: resistentes e indetectables se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Descubierto el proceso por el que las bacterias fabrican nanoimanes

- Bacterias emisoras de rayos X

- Microcápsulas biomiméticas de células madre

No están todas las que son

Imagen: En primer lugar, arriba a la izquierda, Yulua Lermontova, química. Junto a ella, Trinidad Arroyo, oftamóloga. En la imagen inferior Elisa Leonida Zamfirescu, ingeniera. A la derecha de la imagen, Lina Stern bioquímica y fisióloga.

Yulua Lermontova nació en 1847 en San Petersburgo, Rusia. Intentó ingresar en la Academia Agrícola de Petrovskaya pero no fue aceptada por ser mujer. La matemática Sofía Kovaleski convenció a Yulua para que la acompañase a Alemania y seguir allí sus estudios. Fue admitida en el laboratorio de Robert Bunsen. En 1871 se trasladó a Berlín y estudió Química Orgánica en el laboratorio de August W. Hofmann; lo hizo de forma privada pues, pese a las brillantes referencias de los científicos de Heidelberg, en la capital alemana no se le permitió asistir a clase ni trabajar en los laboratorios. Allí se doctoró con Magna cum laude; fue la primera doctora en Química de la historia. A los 28 años Yulua regresó a Rusia y en 1875 fue nombrada miembro de la Sociedad Rusa de Química.

Trinidad Arroyo Villaverde nació en 1872 en Palencia. Quiso matricularse en la Facultad de Medicina de Valladolid pero el rector se negó, contraviniendo la Disposición Real que permitía a las mujeres realizar estudios universitarios desde ese mismo año. El padre de Trinidad recurrió ante la Dirección General de Instrucción Pública y se pudo matricular. Tras licenciarse en Medicina se trasladó a Madrid, donde defendió su tesis sobre oftalmología. A partir de entonces alternó o compaginó la práctica profesional con la docencia e investigación en la Universidad Central, hasta que la Guerra Civil la obligó exiliarse.

Lina Stern nació en Liepaja, en la actual Letonia, en 1878, en una familia judía. Debido a las políticas antisemitas de la Rusia zarista hubo de emigrar a Ginebra, en cuya facultad de Medicina cursó estudios universitarios. En 1925 se trasladó a Moscú, y a partir de entonces dirigió diversas instituciones científicas. En 1939 entró a formar parte de la Academia de Ciencias de la URSS, siendo la primera mujer galardonada con tal reconocimiento. Contribuyó a salvar la vida de miles de combatientes durante la II Guerra Mundial, y en parte por ello -desarrolló un medicamento contra la meningitis tuberculosa- recibió en 1943 el Premio Stalin. En 1949 fue detenida por ser judía y hasta 1952 permaneció en prisión, donde fue torturada en numerosas ocasiones. Conmutada la pena de muerte, fue desterrada a Asia central. A su regreso a Moscú, retomó la labor académica en el Instituto de Biofísica. La URSS silenció sus últimos años de vida.

Elisa Leonida Zamfirescu nació en 1887, en Galati, Rumanía. Intentó cursar estudios de ingeniería en su país pero, por ser mujer, no fue aceptada. No se arredró; fue a Berlín y no sin dificultades -de la misma índole que las anteriores- consiguió matricularse en su Universidad Técnica. En 1912 se graduó con honores, siendo denominada por el decano como “la más diligente de los diligentes”. Zamfirescu llegó a ser nombrada directora de los laboratorios del Instituto Geológico de Rumanía. Ella fue una de las primeras mujeres ingenieras reconocidas de la historia.

El pasado día 11 celebramos el Día Internacional de la Mujer y la Niña en la Ciencia; por eso he traído hoy aquí a estas mujeres. No son más que cuatro ejemplos de las muchas damas brillantes y esforzadas que superaron obstáculos enormes para poder desarrollar una carrera científica o tecnológica. Además de las que forman la breve lista de las que solemos recordar, como Lovelace, Curie, Franklin, Montalcini, Rubin y unas pocas más, en la historia de la ciencia ha habido muchas grandes científicas de las que apenas sabemos nada. Yulua, Trinidad, Lina y Elisa son cuatro de ellas. Representan aquí a esas grandes científicas que lo fueron y lo son, pero que ni estuvieron ni están.

Notas:

(1) Estas breves notas biográficas se han basado en lo publicado en Mujeres con Ciencia sobre Yulua Lermontova, Trinidad Arroyo Villaverde, Lina Stern y Elisa Leonida Zamfirescu.

(2) La publicación de esta anotación se enmarca en las actividades de celebración del Día Internacional de la Mujer y la Niña en la Ciencia que se han desarrollado entre el 6 y el 19 de febrero.

—————————————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————————————–

Una versión previa de este artículo fue publicada en la sección #con_ciencia del diario Deia el 12 de febrero pasado.

El artículo No están todas las que son se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:#Naukas16 The Scottish Book

Si eres capaz de convertir café en teoremas lo mismo ganas un kilo de bacon, o algo así. José A. Prado Bassas lo explica mucho mejor.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 The Scottish Book se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 La ciencia de la pasión

- #Naukas16 Alucinaciones lingüísticas: los engaños de tu lengua materna

- #Naukas16 Metaestudios comparativos sobre nasciturus

El hidrógeno en el Universo (V): Cartografiando las galaxias en hidrógeno atómico

En la investigación en Astrofísica cada vez es más evidente que la información que proviene en “otras frecuencias” diferentes a las que detectamos con los telescopios ópticos convencionales es indispensable a la hora de entender el Cosmos. En las últimas décadas, y gracias a los telescopios espaciales, hemos empezado a explorar el Universo en rayos gamma, rayos X, ultravioleta e infrarrojo medio y lejano, descubriendo cosas fascinantes, desde violentas explosiones de estrellas muy masivas a distancias cosmológicas a la peculiar distribución del polvo interestelar dentro de nuestra Galaxia. Aún así, siguen siendo las observaciones en ondas de radio, que también se pueden observar desde la superficie de la Tierra, las que están cambiando muchas de nuestras concepciones previas de cómo funciona el Universo.

El objetivo de esta serie de artículos ha sido enseñar y describir la enorme importancia que las observaciones radioastronómicas en la línea de 21 cm (equivalente a 1420 MHz) del hidrógeno neutro han tenido y tienen en la actualidad. Gracias a ellas hemos empezado a entender la estructura de la Vía Láctea, hemos investigado la cantidad de gas y la dinámica de las galaxias cercanas (que nos permite medir muy bien la cantidad de materia oscura en ellas) e incluso explorado lo que ocurre en el espacio intergaláctico y cómo interaccionan las galaxias.

No obstante, el entender las características generales del gas neutro existente en las galaxias precisa no observaciones radioastronómicas de unas pocas galaxias individuales sino de datos de cientos, miles, decenas de miles, de galaxias. Los grandes números y los estudios estadísticos son muy importantes en Astrofísica a la hora de encontrar relaciones entre distintos observables que sean consecuencia de los fenómenos y las leyes físicas que gobiernan el Universo. Aquí quiero recordar algo importante: la Astrofísica es distinta al resto de las ciencias. No podemos hacer experimentos. Los astrofísicos observamos la luz que nos llega del Cosmos y, usando los modelos y las simulaciones por ordenador, intentamos explicar lo que vemos. Quizá el ejemplo más famoso de estos “estudios de multitud de objetos astronómicos” es el cartografiado SDSS (Sloan Digital Sky Survey) que, usando un “modesto” telescopio de 2.5 metros de tamaño (Observatorio Apache Point, Nuevo México, EE.UU.) proporciona datos ópticos de millones de estrellas y galaxias. El cartografiado de galaxias de SDSS es, en la actualidad, uno de los trabajos astrofísicos más citados en la literatura científica.

Por este motivo, desde finales del siglo pasado se empezaron a desarrollar catálogos y cartografiados de galaxias observadas en la línea de 21 cm del hidrógeno atómico. Aquí es donde entra en juego el cartografiado HIPASS (“HI Parkes All Sky Survey”). Usando un potente y novedoso receptor (el “21 cm multibeam system”) instalado para tal efecto en el famoso radiotelescopio de 64 metros de Parkes (Australia), HIPASS cartografió casi todo el cielo observable desde este radiotelescopio (71% de todo el cielo) buscando la emisión de HI de galaxias cercanas. HIPASS supuso una revolución para los astrofísicos extragalácticos: se pudieron obtener las propiedades del gas neutro (distancia, cantidad de masa de gas, cantidad de materia oscura, velocidad del gas, como describimos en el tercer artículo de esta serie) de más de 5000 galaxias cercanas.

(Vídeo 1: Visualización que muestra la posición de las galaxias detectadas según la emisión en 21 cm del hidrógeno atómico (en azul), muchas de ellas usando el cartografiado HIPASS, con nuevas galaxias escondidas detrás de la Vía Láctea y descubiertas en 2016 por el equipo liderado por Lister Stavely-Smith (en colores verde-anaranjados). El centro del diagrama representa nuestra Vía Láctea. Crédito: ICRAR.)

Aunque el cartografiado HIPASS se completó en 2002 el análisis de los datos (algo muy complejo para las observaciones en radio) ha llevado más de una década. Aún hoy día se siguen publicando descubrimientos que surgen de estos datos, por ejemplo, nubes de gas difuso alrededor de la Vía Láctea que habían pasado desapercibidas antes, o la detección difusa de gas hidrógeno en galaxias ultra-enanas cercanas descubiertas por cartografiados ópticos profundos como el “Dark Energy Survey” (DES, usando el Telescopio Blanco del Observatorio Inter-Americano de Cerro Tololo, Chile).