Einstein y el efecto fotoeléctrico

El trabajo de Einstein sobre el efecto fotoeléctrico fue tan revolucionario como el de la relatividad, convirtiéndose en una de las teorías que darían un impulso definitivo a la creación de la mecánica cuántica. Aunque no tan llamativa como la teoría de la relatividad, fue el logro por el que mereció oficialmente el premio Nobel en 1921.

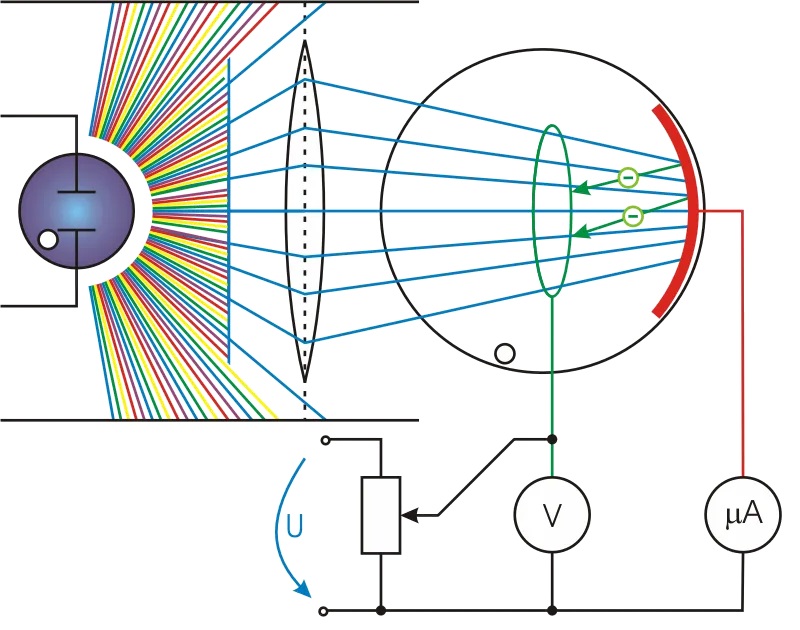

Cuando la luz incide sobre una placa de metal es capaz de arrancar electrones, provocando una corriente eléctrica, en esto consiste el efecto fotoeléctrico. Pero a principios del siglo XX, la teoría vigente de cómo la luz se movía no encajaba con lo que sucedía cuando se realizaba un experimento fotoeléctrico. En 1905, el “annus mirabilis” de Einstein, este publicó un artículo en el que ofrecía una solución que se basaba en la hipótesis de que la luz está formada por partículas discretas. Esta era una idea radical, pero que hoy se acepta completamente.

Heinrich Hertz fue el primero que se dio cuenta de la existencia del efecto fotoeléctrico en 1887, cuando bloqueó toda la luz que no necesitaba para un experimento eléctrico que estaba realizando. Hertz descubrió que las chispas eléctricas creadas por el aparato eran más débiles sin la luz adicional; por tanto, la luz misma que incidía en la placa de metal estaba induciendo electricidad. A finales del siglo XIX se tenía asumido que esta electricidad estaba específicamente constituida por los electrones que se habían arrancado de los átomos por la energía aportada por la luz incidente.

En 1902, el físico alemán Philipp Lénárd identificó algunos problemas con la idea de Hertz. Lénárd creía, al igual que sus contemporáneos, que la luz era una onda. Consecuentemente, podrían esperarse algunos resultados: más cantidad de luz aportaría más cantidad de energía a los electrones; una luz débil necesitaría un tiempo para transmitir suficiente energía a los electrones del metal como para arrancar algunos; y las dos afirmaciones anteriores serían independientes de la frecuencia de la luz incidente. Lénárd descubrió que no pasaba nada de todo esto. Cuando hizo que rayos de luz cada vez más intensos incidiesen sobre el metal, la cantidad de electrones arrancados aumentaba, pero siempre parecían tener la misma cantidad de energía. Además, los electrones comenzaban a escaparse en el momento en que la luz alcanzaba la placa, a no ser que la luz fuese de baja frecuencia, en cuyo caso no pasaba nada de nada. Lénárd hizo que estos problemas, con todo lujo de detalles y datos experimentales, fuesen conocidos públicamente (y ganó un premio Nobel por ello), pero no fue él el llamado a resolver el misterio.

Por otro lado, Max Planck también estaba trabajando con la radiación. Para resolver un conjunto de problemas completamente diferente, lanzó la hipótesis de que, quizás, la energía estuviese constituida por paquetes de tamaños específicos. En vez de un flujo continuo, la radiación estaría formada por “cuantos” de energía. En otras palabras, la radiación en vez de ser como un chorro de agua sería como una serie continua de pelotas de ping-pong. Al introducir esta idea, Planck consiguió que las matemáticas del trabajo que estaba realizando cuadrasen. Esto no quiere decir que Planck creyese necesariamente que la energía viniese realmente en paquetes discretos, al menos al principio pensó que esto no era más que un truco matemático que le había permitido salir de un atolladero.

Un truco matemático era la explicación física del efecto fotoeléctricoEinstein, por su parte, estaba dispuesto a aceptar que este truco matemático podría representar la realidad física. El 17 de marzo de 1905 publicó un artículo en el que partía de la hipótesis de que la luz no era una onda, sino que estaba constituida por partículas no demasiado diferentes a los propios electrones. Si se adoptaba este salto conceptual todo parecía tener sentido. En vez de que el rayo de luz añadiese energía continuamente a los electrones de la placa metálica, ahora había que interpretar el efecto fotoeléctrico como si cada fotón (el nombre que le daría en 1926 Gilbert Lewis al cuanto de luz) pudiese afectar solamente a un electrón cada vez. Esto explicaba los tres problemas fundamentales que planteaba el efecto fotoeléctrico.

El primer problema era que la incidencia de luz con mayor energía no correspondía a la expulsión de átomos con más energía. Con la solución de Einstein, se puede apreciar que cambiar la intensidad de la luz simplemente significa que hay más fotones. Más fotones significa que hay más electrones expulsados del metal, pero ello no implica que un electrón en concreto tenga más energía.

El segundo problema era que las ondas de baja intensidad no necesitaban más tiempo para arrancar los electrones del metal, sino que lo hacían inmediatamente. Esto podía interpretarse como que había menos fotones en el rayo de luz incidente. Si bien menor número de fotones significa menor número de electrones, un fotón individual no va a tener problemas expulsando a un electrón en el momento en que golpee la placa metálica. No hay necesidad de que múltiples ondas de energía se acumulen a lo largo del tiempo dándole finalmente al electrón energía suficiente para liberarse.

El tercer problema era que, en el marco de la teoría ondulatoria de la luz, uno no esperaría que un cambio en la frecuencia afectase al resultado, pero sí lo hacía. La explicación está en el hecho de que la cantidad de energía de cada fotón individual es directamente proporcional a su frecuencia. Por debajo de cierta frecuencia, un fotón simplemente no tiene energía suficiente como para arrancar un electrón, no importa el número de fotones que se estrelle contra la placa de metal (recordemos que el electrón no acumula la energía).

La teoría de Einstein no solo proporcionaba explicaciones a los problemas planteados por el efecto fotoeléctrico; también daba formas de ser comprobada experimentalmente. Su teoría implicaba que había una correlación entre la frecuencia de la luz y la energía dada a los electrones. Esta correlación era algo que podía medirse.

A pesar del hecho de que la correlación era verificable y que la hipótesis de Einstein explicaba satisfactoriamente el efecto fotoeléctrico, llevó bastante tiempo a la comunidad científica aceptar que no era solo un truco matemático. Incluso Einstein necesitó varios años hasta que se comprometió con la idea de que la luz era realmente un haz de partículas. Robert Millikan, una década más tarde, llevó a cabo experimentos con objeto de probar que la teoría era falsa y, a pesar de que los resultados apoyaban continuamente la hipótesis de los cuantos, Millikan siguió durante años negándose a creer que no existiese una explicación alternativa.

Para los años 20 del siglo pasado, se aceptaba (casi) universalmente que la luz estaba constituida por cuantos, a pesar de que también pareciera comportarse como una onda. Esta dualidad onda-corpúsculo fundamental se convirtió en uno de los pilares de la teoría cuántica, algo que ocupó mucho más la cabeza de Einstein que la propia teoría de la relatividad en los siguientes 30 años.

Referencia:

Einstein, A. (2005). Über einen die Erzeugung und Verwandlung des Lichtes betreffenden heuristischen Gesichtspunkt [AdP 17, 132 (1905)] Annalen der Physik, 14 (S1), 164-181 DOI: 10.1002/andp.200590004

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 27 de junio de 2010.

El artículo Einstein y el efecto fotoeléctrico se ha escrito en Cuaderno de Cultura Científica.

Termoplásticos basados en resinas PAEK para la aviación eléctrica

El E-Fan_X es un modelo experimental de Airbus, en el que uno de sus cuatro motores es eléctrico. Lanzado en 2017, ha supuesto un paso de gigante hacia la aviación eléctrica. Fuente: Airbus

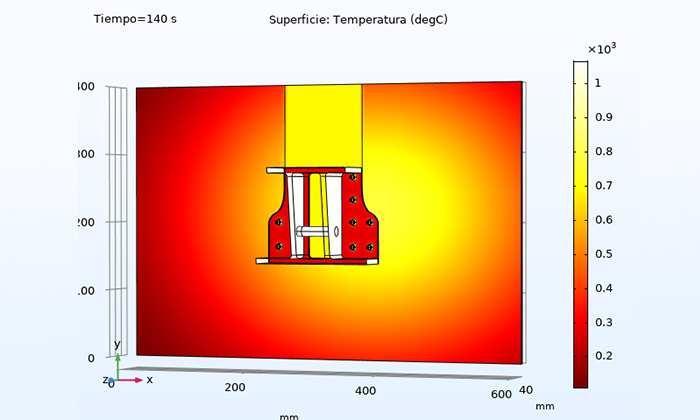

El E-Fan_X es un modelo experimental de Airbus, en el que uno de sus cuatro motores es eléctrico. Lanzado en 2017, ha supuesto un paso de gigante hacia la aviación eléctrica. Fuente: Airbus El sector aeroespacial europeo emplea habitualmente materiales compuestos de plástico termoestable —también conocidos como composites basados en resina epoxi—, de bajo peso y alto rendimiento, en muchas aplicaciones. Sin embargo, estos materiales no son tan resistentes a las altas temperaturas como los componentes metálicos de las aeronaves, lo cual puede comprometer la seguridad en situaciones en las que se alcancen temperaturas extremas. Con el objetivo de mejorar el comportamiento de los actuales composites termoestables ante las exigencias de la cada vez mayor electrificación de la aviación, el equipo de investigación HITCOMP (High Temperature Characterization and Modelling of Thermoplastic Composites), coordinado por la Universidad Carlos III de Madrid (UC3M) ha planteado una alternativa: el uso de nuevos materiales termoplásticos basados en resinas PAEK.

Las resinas PAEK (siglas en inglés de poliariletercetona) constituyen una familia de plásticos semicristalinos en la que se forman cadenas de anillos de benceno con dos sustituciones (grupos arilo, fenilenos) unidos por eslabonaes que contienen oxígeno: alternativamente éter (R-O-R) y cetona (R-CO-R). Su temperatura de procesamiento está en el rango de 350-450 ºC. Suelen emplearse en impresoras 3D. Esta técnica ya tiene amplio uso aeroespacial.

«El sector aeroespacial está en proceso de transición hacia un avión más eléctrico. Esto implica más fuentes de calor y eventualmente de fuego, aumentando el efecto térmico sobre la estructura. En este marco, nuestro proyecto tiene como objetivo establecer una metodología innovadora que permita una caracterización de los termoplásticos que implique menos recursos y mejore la predicción de su comportamiento y resistencia cuando se someten a cargas mecánicas o a eventos de fuego y altas temperaturas».

Fernando López, investigador principal y coordinador del proyecto HITCOMP. Departamento de Física de la UC3M

En el transcurso del proyecto HITCOMP se ha demostrado que los componentes fabricados con una base termoplástica son más eficientes, desde el punto de vista de sus propiedades térmicas, que los composites termoestables. Una propiedad conocida que los hace muy útiles es que se pueden volver a fundir, moldear, procesar y reciclar, sin necesidad de ningún proceso de curado adicional para endurecerse y fraguar. Además, son materiales más versátiles, baratos y ecológicos que los composites termoestables convencionales y tienen una vida útil mayor, gracias a su alta capacidad de recuperación —pueden reciclarse o repararse con mayor facilidad— y su resistencia a la fatiga —el desgaste por uso— y la corrosión. La introducción de estos materiales supondría contar con aviones más seguros y ligeros, que consuman menos combustible, aprovechen mejor la energía y reduzcan sus emisiones.

Para sacar el máximo partido a los termoplásticos en la industria aeroespacial, dada su tendencia a fundirse y deformarse a altas temperaturas, hay que caracterizar su comportamiento cuando son sometidos a sobrecalentamientos, al fuego y a cargas mecánicas. Para conseguir mediciones precisas y no intrusivas de la temperatura real de los materiales durante las pruebas de fuego, el proyecto HITCOMP ha desarrollado un laboratorio de ensayos con técnicas novedosas de termografía infrarroja. El objetivo final es realizar ensayos virtuales de los termoplásticos y comparar sus prestaciones en aplicaciones reales con las de los composites termoestables convencionales.

Las medidas obtenidas mediante termografía infrarroja permiten realizar simulaciones por ordenador, que virtualizan los ensayos para seleccionar este tipo de materiales en la industria aeronáutica. Se espera que con su aplicación «disminuya notablemente el número de ensayos de validación, que son obligatorios y que encarecen y retrasan enormemente la aprobación de este tipo de materiales en la industria». A día de hoy, ya se han transferido a Airbus los modelos y equipos infrarrojos para que pueda estudiar su aplicación industrial.

Durante el proceso de investigación, el equipo también ha desarrollado un nuevo método —inspirado en los resultados previos del Laboratorio de Sensores, Teledetección e Imagen en el Infrarrojo de la UC3M (LIR-InfraRed LAB)— que permite utilizar estas técnicas de imagen infrarroja para determinar, a distancia y sin contacto, las propiedades térmicas de estos materiales.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Termoplásticos basados en resinas PAEK para la aviación eléctrica se ha escrito en Cuaderno de Cultura Científica.

La exploración de Zelandia, el continente sumergido

Laia Alegret

El buque de perforación oceánica Joides Resolution en el mar de Tasmania (océano Pacífico), durante la expedición a Zelandia. Foto: Adam Kurtz, IODP, CC BY-NC-ND

El buque de perforación oceánica Joides Resolution en el mar de Tasmania (océano Pacífico), durante la expedición a Zelandia. Foto: Adam Kurtz, IODP, CC BY-NC-ND

Zelandia es todo un continente oculto bajo las aguas del Pacífico, del que únicamente aflora una mínima parte: las islas de Nueva Zelanda y Nueva Caledonia.

El séptimo continente, que aún no figura en los libros de texto, se separó de Australia y de la Antártida hace unos 80 millones de años. Tras aquella separación sufrió importantes movimientos verticales, con momentos en los que estuvo sumergido a miles de metros de profundidad y otros en los que ascendió hasta la superficie. En la actualidad está escondido bajo el mar en un 94 %.

En 2017 se reconoció oficialmente como un continente, y ese mismo año España participó en una expedición internacional para explorarlo en detalle.

Entonces recibí una carta aceptando mi solicitud para participar como científica en una expedición internacional para explorar ¡un continente!

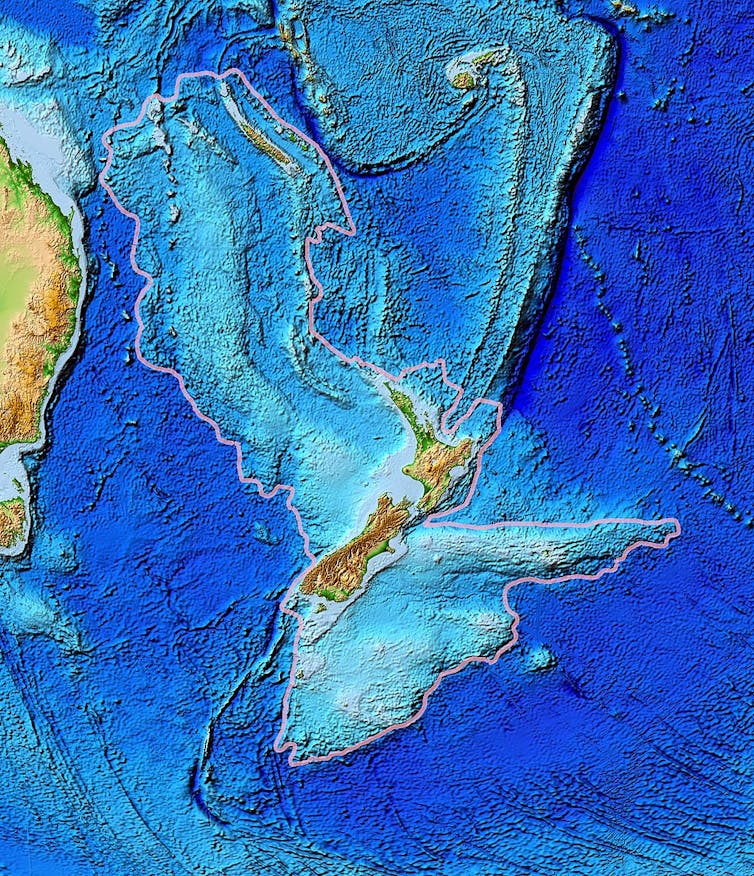

Zelandia, el séptimo continente, en gris en el mapa, está casi en su totalidad sumergido bajo las aguas del Pacífico. Sólo afloran sus montañas más altas: las islas de Nueva Zelanda y Nueva Caledonia. Imagen: Laia Alegret, modificada de Mortimer et al. (2017).

Zelandia, el séptimo continente, en gris en el mapa, está casi en su totalidad sumergido bajo las aguas del Pacífico. Sólo afloran sus montañas más altas: las islas de Nueva Zelanda y Nueva Caledonia. Imagen: Laia Alegret, modificada de Mortimer et al. (2017).En pleno siglo XXI, cuando la atención general está puesta en las misiones espaciales, parecía impensable que todavía quedara un continente prácticamente desconocido: Zelandia.

La razón por la que no se conocía es que se encuentra sumergido, casi por completo, a más de 1 000 m de profundidad bajo las aguas del Pacífico. Solo afloran sus montañas más altas, las islas de Nueva Zelanda y Nueva Caledonia, que apenas constituyen un 6 % de su superficie.

Extensión de Zelandia (delimitada por una línea rosa), y su topografía. La mayor parte del continente se encuentra sumergido a profundidades de entre 1 000 m y 3 000 m.

Extensión de Zelandia (delimitada por una línea rosa), y su topografía. La mayor parte del continente se encuentra sumergido a profundidades de entre 1 000 m y 3 000 m.Imagen: World Data Center for Geophysics & Marine Geology (Boulder, CO), National Geophysical Data Center, NOAA, Public domain / Wikimedia Commons

Como geóloga, la participación en esta expedición era una oportunidad única, comparable a las gestas de los descubridores de siglos pasados cuando exploraban mares y tierras desconocidos.

Pero en aquel momento quizás no fui consciente de la gran suerte que tuve de ser aceptada en el equipo como investigadora española. Algo que no podrá volver a repetirse. En 2022, la participación de España en el consorcio que financia estas expediciones de perforación submarina ha sido suspendida, tras 5 años sin abonar su cuota. Esto frena nuestra participación en un mar de descubrimientos.

La expedición a bordo del Joides ResolutionEl 27 de julio de 2017 el buque Joides Resolution partía del puerto de Towsnville (Australia) para extraer sondeos del fondo marino y estudiar en detalle el séptimo continente. Los otros seis, desde el punto de vista geológico, son Eurasia, África, Norteamérica, Sudamérica, Australia y la Antártida. A bordo, 32 científicos de 12 países diferentes, técnicos de laboratorio, sondistas, el personal y la tripulación del barco… hasta un total de 146 personas.

Participantes de la expedición a Zelandia, en la proa del buque Joides Resolution. Foto: Tim Fulton, IODP/JRSO

Participantes de la expedición a Zelandia, en la proa del buque Joides Resolution. Foto: Tim Fulton, IODP/JRSODurante dos meses navegamos por el mar de Tasmania perforando sondeos, lanzando cilindros huecos al fondo marino y recuperándolos rellenos del sedimento depositado a lo largo de 70 millones de años. Trabajamos en turnos de 12 horas, los 7 días de la semana, haciendo frente a los fenómenos meteorológicos y a los problemas técnicos derivados de una campaña que fue pura exploración.

Técnicos de laboratorio, introduciendo en el barco uno de los sondeos extraídos del fondo del océano. Foto: IODP

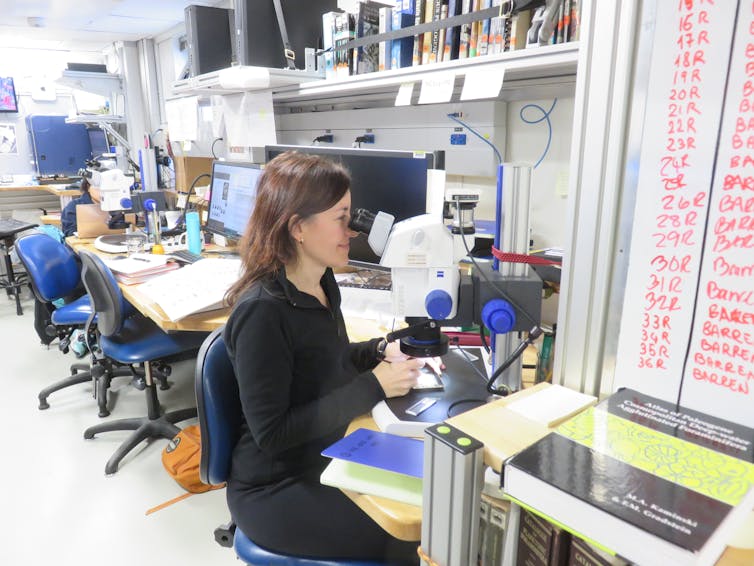

Técnicos de laboratorio, introduciendo en el barco uno de los sondeos extraídos del fondo del océano. Foto: IODPCada científico estudiaba un aspecto de las muestras en los laboratorios del barco. Los paleontólogos estudiábamos los miles de fósiles microscópicos que aparecían, mientras reforzábamos los abdominales al tratar de mantenernos erguidos frente al microscopio con el fuerte oleaje del mar de Tasmania. Pero siempre con la convicción de que estábamos haciendo un nuevo descubrimiento con cada núcleo de sedimento que llegaba al barco.

La autora, Laia Alegret, observando fósiles microscópicos en el laboratorio de Paleontología del buque Joides Resolution, durante la expedición a Zelandia. Foto: Debra Beamish

La autora, Laia Alegret, observando fósiles microscópicos en el laboratorio de Paleontología del buque Joides Resolution, durante la expedición a Zelandia. Foto: Debra BeamishRecuperamos más de 3 kilómetros de sondeos y llegamos a perforar a casi 5 kilómetros de profundidad bajo la columna de agua.

El 26 de septiembre de 2017 desembarcamos en Hobart (Tasmania). Aún recuerdo las bromas sobre la novedad de volver a caminar y vivir en tierra firme. Desde entonces, los 32 científicos hemos seguido colaborando en el estudio de Zelandia.

Los análisis del sedimento depositado a lo largo de millones de años en los fondos marinos han permitido reescribir la historia geológica de un continente, Zelandia, y entender su relación con los movimientos de las placas tectónicas, los riesgos geológicos y el cambio climático.

Reescribiendo la historia de ZelandiaAl contrario de lo que se pensaba, hemos demostrado que, desde que Zelandia se separó de Australia y de la Antártida hace 80 millones de años, ha sufrido grandes movimientos verticales, con momentos en los que hubo tierra firme y otros en los que se hundió a miles de metros de profundidad.

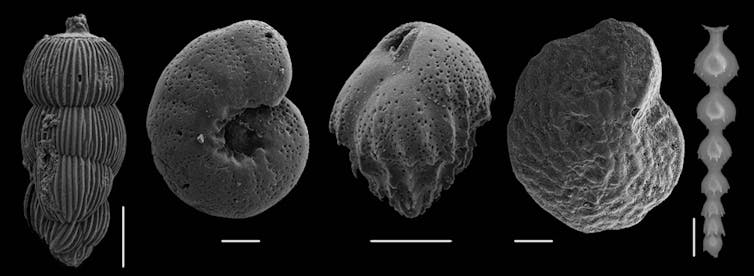

Esto lo hemos deducido a partir de los fósiles microscópicos encontrados. El grupo estrella para reconstruir la profundidad de las aguas es el de los foraminíferos bentónicos, unos organismos unicelulares que protegen su única célula mediante una concha. Ocupan el mayor hábitat del planeta, los fondos marinos desde las playas hasta las llanuras abisales, y sus miles de especies son diagnósticas de la profundidad. Algunas de las muestras de Zelandia contienen especies típicas de medios profundos, mientras que en otras muestras predominan las especies características de playas someras, e incluso otros fósiles procedentes de tierra firme como restos de plantas, polen, esporas e insectos.

Conchas fosilizadas de foraminíferos bentónicos de Zelandia. Fotografías tomadas mediante microscopía electrónica de barrido (Servicio General de Apoyo a la Investigación-SAI, Universidad de Zaragoza). Las barras de escala corresponden a 100 micras.

Conchas fosilizadas de foraminíferos bentónicos de Zelandia. Fotografías tomadas mediante microscopía electrónica de barrido (Servicio General de Apoyo a la Investigación-SAI, Universidad de Zaragoza). Las barras de escala corresponden a 100 micras.Laia Alegret

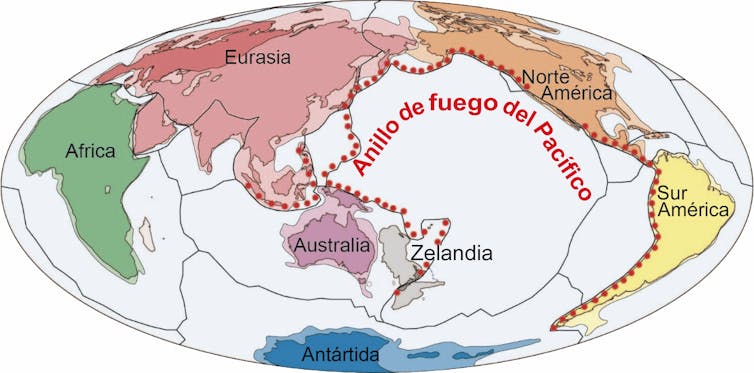

Estos movimientos se han relacionado con la subducción de la corteza oceánica del Pacífico por debajo de la corteza continental, un proceso que genera fricción de materiales, calor, riesgos geológicos como terremotos, maremotos y vulcanismo, y que también conduce a la formación de recursos minerales.

El océano Pacífico está prácticamente rodeado por zonas de subducción, que conforman el Anillo de Fuego del Pacífico. Los procesos de subducción se producen hoy en día en multitud de lugares del planeta, incluido el Mediterráneo, y el estudio de Zelandia ha sido fundamental para conocer mejor cómo se desarrollan.

En Zelandia encontramos también sedimentos clave para la investigación sobre el cambio climático. En los sondeos hemos identificado eventos de calentamiento global ocurridos en el pasado y que pueden ser empleados para mejorar los modelos predictivos del actual cambio climático. Estos y otros resultados se están publicado en revistas científicas de primer nivel y han propiciado el desarrollo de más proyectos y colaboraciones internacionales. La investigación de las muestras de Zelandia sigue en marcha, y dará lugar a muchos más descubrimientos.

Punto final a la participación de EspañaDesde 1968, los programas internacionales de perforación oceánica han recuperado sondeos de los fondos oceánicos para dar respuesta a preguntas fundamentales sobre el funcionamiento de nuestro planeta, las fuerzas que lo gobiernan, los cambios climáticos, la vida y la evolución.

La colaboración internacional contribuye no sólo a financiar las expediciones, sino también a formar grupos multidisciplinares de científicos que trabajan con objetivos comunes. Dicen que la unión hace la fuerza, y estos programas benefician a la comunidad global, a los países que participan y a los científicos, que establecen lazos de colaboración muy estrechos en redes internacionales.

España participa en los programas internacionales de perforación oceánica a través del consorcio europeo ECORD, que recibe aportaciones económicas de cada uno de sus países integrantes. La contribución española era de las más modestas del consorcio, pero permitía que científicos de centros españoles participaran en las expediciones y en los comités científicos asesores.

En 2017 dejó de contribuir al programa y desde entonces el Ministerio de Ciencia e Innovación no ha solventado la situación, por lo que la participación de España ha sido finalmente suspendida en marzo de 2022. Sería deseable que el Gobierno de España llegara pronto a un acuerdo que nos permita volver a participar en todo un mar de descubrimientos.![]()

Sobre la autora: Laia Alegret es catedrática de paleontología de la Universidad de Zaragoza

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La exploración de Zelandia, el continente sumergido se ha escrito en Cuaderno de Cultura Científica.

Día de Pi con BCAM Naukas 2022: Nicolás Moreno – Dime quién eres y te diré cómo te mueves

La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática: 3-14 martxoaren 14 en euskara / 3-14 March, 14th en inglés. En los últimos años, la conmemoración del Día de Pi se ha ido extendiendo, hasta tal punto que el 26 de noviembre de 2019 la UNESCO proclamó el 14 de marzo Día Internacional de las Matemáticas.

Un año más, el Basque Center for applied Mathematics-BCAM y la Cátedra de Cultura Científica de la UPV/EHU se han suamdo a la celebración, organizando la tercera edición del evento BCAM-NAUKAS, que se desarrolló a lo largo del 14 de marzo en el Bizkaia Aretoa de la UPV/EHU.

Nicolás Moreno, que es investigador postdoctoral en el BCAM, se dedica, entre otras cosas, a las simulaciones de flujos en nanocanales. En esta charla nos cuenta una historia basada en hechos virales (de virus), en la que cualquier parecido con la realidad es pura ciencia.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Día de Pi con BCAM Naukas 2022: Nicolás Moreno – Dime quién eres y te diré cómo te mueves se ha escrito en Cuaderno de Cultura Científica.

Biomarcadores para determinar los hábitos del pastoreo neolítico

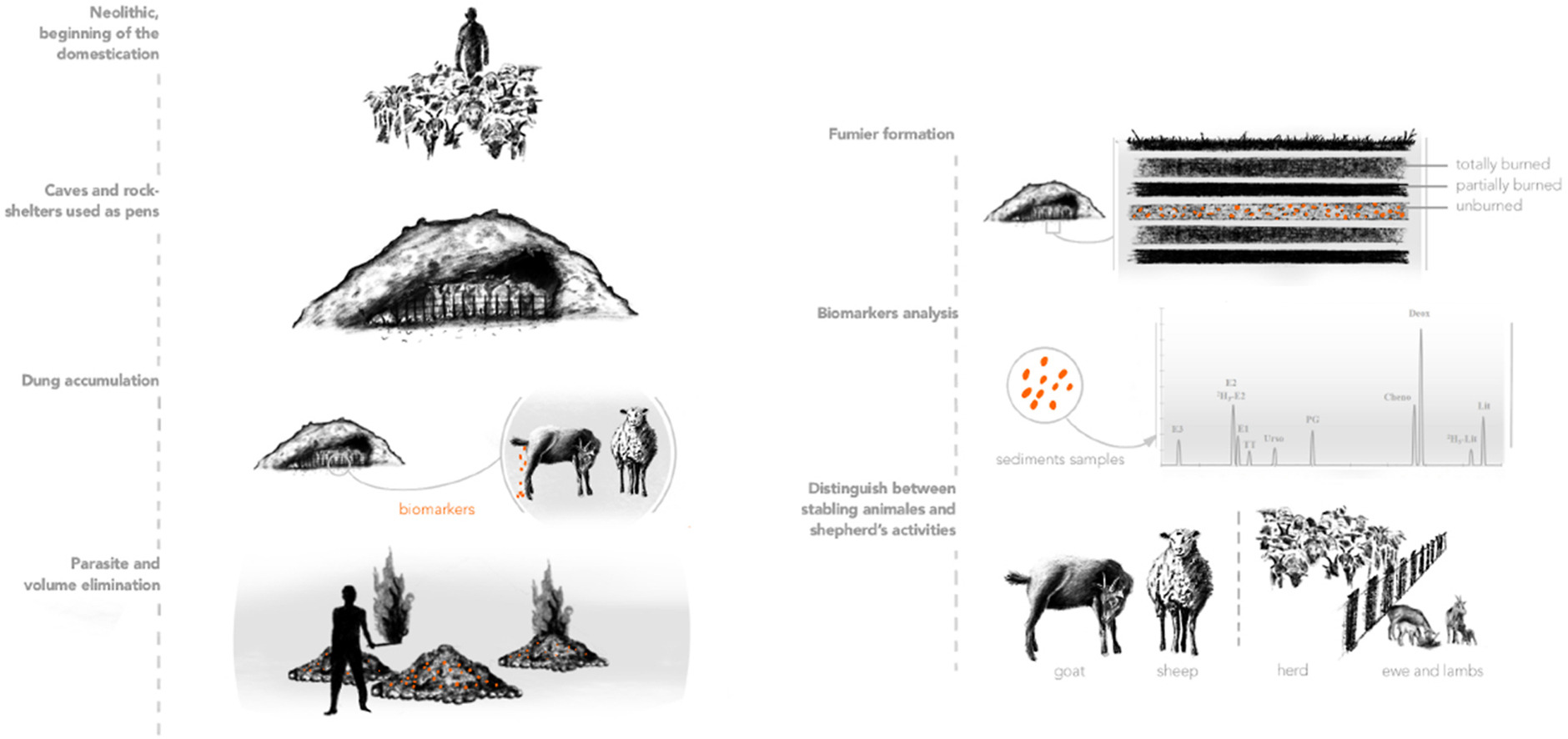

El grupo de investigación METABOLOMIPs de la UPV/EHU ha utilizado como biomarcadores los ácidos biliares y las hormonas de los depósitos de la cueva de El Mirador de Atapuerca, empleada como redil en la prehistoria, para determinar los hábitos del pastoreo neolítico.

Toma de muestras en El Mirador. Foto: UPV/EHU

Toma de muestras en El Mirador. Foto: UPV/EHUEn el Neolítico surgieron y se generalizaron la agricultura y el pastoreo, y a través de ellos se desarrollaron las sociedades agrarias. Las cuevas y abrigos rocosos comenzaron a utilizarse como corrales para el ganado. Una práctica de pastoreo habitual en todo el Mediterráneo, desde el Neolítico hasta la Edad del Bronce, era la quema del estiércol acumulado en las cuevas y abrigos rocosos de los rebaños para limpiar estos lugares, eliminar los parásitos, etc. Esta quema continua produjo una acumulación de diversas capas de sedimentos orgánicos y minerales que se denominan fumiers.

Los ácidos biliares de las capas que quedaron sin quemar en los fumiers permiten a los investigadores saber qué especies resguardaban en el redil, debido a que la composición de los ácidos biliares es diferente en cada especie. También dan una idea del tamaño el rebaño porque existe una proporcionalidad con la cantidad de ácidos biliares.

Por otra parte, el grupo de investigación METABOLOMIPs de la UPV/EHU ha empleado biomarcadores hormonales para conocer mejor cómo manejaban los rebaños los pastores prehistóricos. “Las proporciones hormonales son diferentes si las ovejas están en periodo de gestación, lactancia o cualquier otra situación”, explica Asier Vallejo, doctor de la UPV/EHU.

Fuente: Vallejo et al (2022)

Fuente: Vallejo et al (2022)“En los trabajos arqueológicos de la cueva de El Mirador, situada en la Sierra de Atapuerca (Burgos), se habían encontrado muchos restos óseos animales, y presumían que se dividía el rebaño, porque en una parte de la cueva hay una mayor cantidad de huesos de cordero”, explica el autor principal del estudio. El análisis de los biomarcadores hormonales permitiría saber “si realmente la actividad hormonal era mayor en dicha parte. Y así fue”, añade.

El método analítico utilizado para ello no es especialmente novedoso, pero “la idea ha sido innovadora. Es la primera vez que se estudian biomarcadores hormonales para predeterminar cómo era el manejo de los rebaños de hace 6.000-7.000 años”, comenta el Dr. Vallejo. Los análisis de los ácidos biliares proporcionan una idea de la cantidad de cabezas de ganado del rebaño: “Cuanto más ácido biliar haya habido, más cabezas de ganado. Esto lo utilizamos para normalizar la concentración de progesterona en el estiércol. Si el rebaño es grande, el nivel de progesterona también será alto; sin embargo, si el rebaño es pequeño y el nivel de progesterona es alto, esto quiere decir que en esa parte de la cueva se situaban las ovejas en periodo de gestación y lactancia”. Por lo tanto, “hemos cruzado las hipótesis de los estudios arqueológicos y las nuestras, y coinciden. Hemos confirmado sus hipótesis”, afirma.

Actualmente, se está realizando un estudio similar en una zona de Sicilia. El grupo quiere avanzar buscando biomarcadores más precisos que permitan, por una parte, reconocer fácilmente el tipo de animales que estabulaban en los abrigos prehistóricos, ya que “a menudo los animales estaban entremezclados y en algunos casos no es fácil diferenciar entre sí los biomarcadores”, y, por otro parte, determinar más fácilmente su estado hormonal.

Referencia:

Asier Vallejo, Jaime Gea, Ane Gorostizu-Orkaiztegi, Josep Maria Vergès, Patricia Martín, M. Carmen Sampedro, Alicia Sánchez-Ortega, M. Aranzazu Goicolea, Ramón J. Barrio (2022) Hormones and bile acids as biomarkers for the characterization of animal management in prehistoric sheepfold caves: El Mirador case (Sierra de Atapuerca, Burgos, Spain) Journal of Archaeological Science doi: 10.1016/j.jas.2022.105547

Para saber más:

La química analítica como base para el estudio de las prácticas pastoriles prehistóricas

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Biomarcadores para determinar los hábitos del pastoreo neolítico se ha escrito en Cuaderno de Cultura Científica.

Ártico y Antártico se calientan a la vez

Fernando Prieto

Las temperaturas récord en el Ártico y en el Antártico, unidas al desprendimiento de la plataforma Conger de 1.200 kilómetros cuadrados el 15 de marzo en la Antártida oriental, son una seria llamada a priorizar las medidas para proteger el clima. Este hecho nunca había sucedido. Es una advertencia que debería poner en alerta a los políticos y decisores para, de una vez, reducir las emisiones de gases de efecto invernadero y tomar medidas de adaptación de una vez por todas.

En Groenlandia, las anomalías alcanzaron los 10 ºC por encima de la media, y en la región Ártica llegaron hasta los 30ºC. Además en el Ártico esta subida de temperaturas continuada, unida al aumento de olas de calor registrado, está relacionada con el deshielo del permafrost. Foto: Pixabay

En Groenlandia, las anomalías alcanzaron los 10 ºC por encima de la media, y en la región Ártica llegaron hasta los 30ºC. Además en el Ártico esta subida de temperaturas continuada, unida al aumento de olas de calor registrado, está relacionada con el deshielo del permafrost. Foto: PixabayLa ola de calor de la segunda semana de marzo tanto en el Ártico como en el Antártico llevó a temperaturas de hasta 40 °C por encima de lo habitual para esta época del año. Hasta ahora este fenómeno se había registrado solo en el Ártico, pero no había llegado a la Antártida y jamás en los dos polos a la vez. Así lo señala una de las autoridades mundiales en el campo, Carlos Duarte, de la Tarek Ahmed Juffali Research Chair in Red Sea Ecology.

En Groenlandia, las anomalías alcanzaron los 10 °C por encima de la media, y en la región Ártica llegaron hasta los 30 °C por encima de los valores habituales. La disminución del albedo hace que aumente la radiación absorbida y, como consecuencias, las temperaturas.

En el Ártico, esta subida de temperaturas continuada, unida al aumento de olas de calor registrado, está relacionada con el deshielo del permafrost que aumentará las emisiones de metano y puede desencadenar uno de los temidos puntos de no retorno.

En la Antártida, en la base de Concordia, situada a 75 grados sur de latitud, se registraron 40 grados de temperatura por encima de la media. Si por esas fechas lo habitual son unos -55 °C, el pasado 18 de marzo los termómetros marcaron -12 °C. Si este aumento de temperaturas sucede de manera continuada produciría una fusión masiva del hielo que aumentaría la cantidad de agua líquida en el océano y, en consecuencia, un aumento del nivel del mar.

Así como en el Ártico no existe ninguna duda sobre el proceso, en la Antártida sí ha habido polémica entre la comunidad científica sobre la variación de las masas de hielo, si bien las últimas investigaciones publicadas en Nature entre 1992 y 2017 apuntan a que a largo plazo existe una disminución del hielo.

La Antártida perdió 2.720 ± 1.390 mil millones de toneladas de hielo entre 1992 y 2017, lo que corresponde a un aumento del nivel medio del mar de 7,6 ± 3,9 milímetros. El desprendimiento citado de la plataforma de hielo coincide con el hecho de que la extensión de hielo marino en la Antártida mostró su nivel más bajo desde que hay registros para el mes de febrero de 2022. Se encontraría por debajo de los 2 millones de kilómetros cuadrados, según cita la Oficina Meteorológica de Australia.

Efectos cascada en otras partes del planetaLa consecuencia de que se desestabilice el clima en las zonas polares puede ser un efecto dominó de cambios a escala planetaria. Esto puede generar un cambio climático abrupto, ya que estas regiones tienen un papel crítico en la regulación al sistema climático global, así como respecto al nivel del mar.

Los eventos meteorológicos extremos son pruebas del calentamiento global y como este puede originar cambios irreversibles. Si se mantiene en el tiempo el aumento de las temperaturas detectadas en los polos, cambiará la circulación de las masas de aire y tendrá repercusiones en latitudes medias.

En concreto, en la Península y en el Mediterráneo, además del aumento de temperaturas generalizado, puede haber un aumento de los fenómenos meteorológicos extremos como olas de calor, inundaciones, mayor irregularidad de precipitaciones, sequías o inundaciones.

La ciencia climática es todavía incapaz de predecir los puntos de no retorno, pero estas señales sí pueden indicar que podemos estar cerca de alguno de ellos, que como su propio nombre sugiere, pueden ser graves para la humanidad.

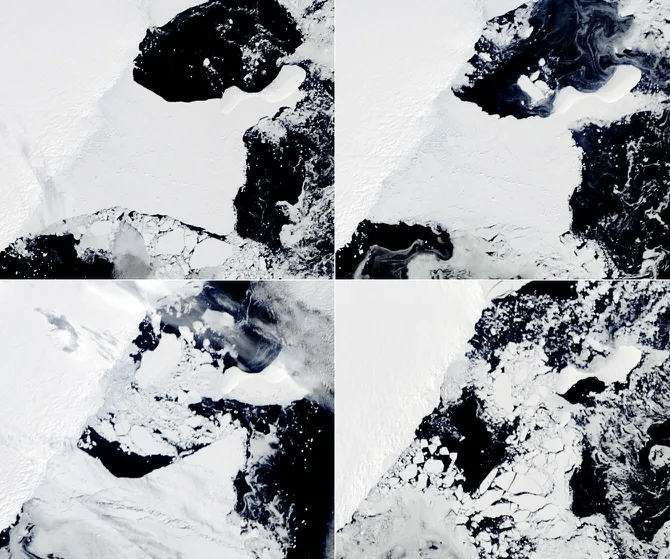

Evolución de la plataforma Conger entre el 22 de febrero y el 21 de marzo de 2022. Fuente: NASA Earth ObservatoryLas consecuencias climáticas de la guerra en Ucrania

Evolución de la plataforma Conger entre el 22 de febrero y el 21 de marzo de 2022. Fuente: NASA Earth ObservatoryLas consecuencias climáticas de la guerra en Ucrania

Por otra parte, las primeras estimaciones de las consecuencias de la guerra en Ucrania indican que las emisiones pueden subir un 14 % en el año 2022. Asimismo, ha determinado una falta de interés en todo el proceso del cambio climático, lo que ha generado una ruptura de acuerdos internacionales y de medidas conjuntas climáticas por parte de todos los países.

El primer informe importante del Panel Intergubernamental de Expertos sobre el Cambio Climático (IPCC) es de 1990 y desde entonces y hasta abril de 2022 se han sucedido hasta seis grandes de ellos recogiendo las mejores investigaciones mundiales con los mejores científicos sobre el clima. En 1997 se firmó el protocolo de Kioto con la finalidad de reducir las emisiones. En 2015 el Acuerdo de París y se aprobaron los 17 Objetivos de Desarrollo Sostenible. En noviembre de 2021 se celebró la 26 Cumbre del Clima de Glasgow con el mismo objetivo y en los últimos meses se ha presentado el último informe del IPCC con resultados cada vez más alarmantes.

Mientras, en 1990 la concentración de CO₂ en la atmosfera era de 350 ppm (partes por millón), lo que se considera un valor seguro. En la actualidad ya son más de 419, lo cual ya es un valor preocupante y no hace más que incrementar los efectos del cambio climático que se hacen notar en todos los rincones del mundo.

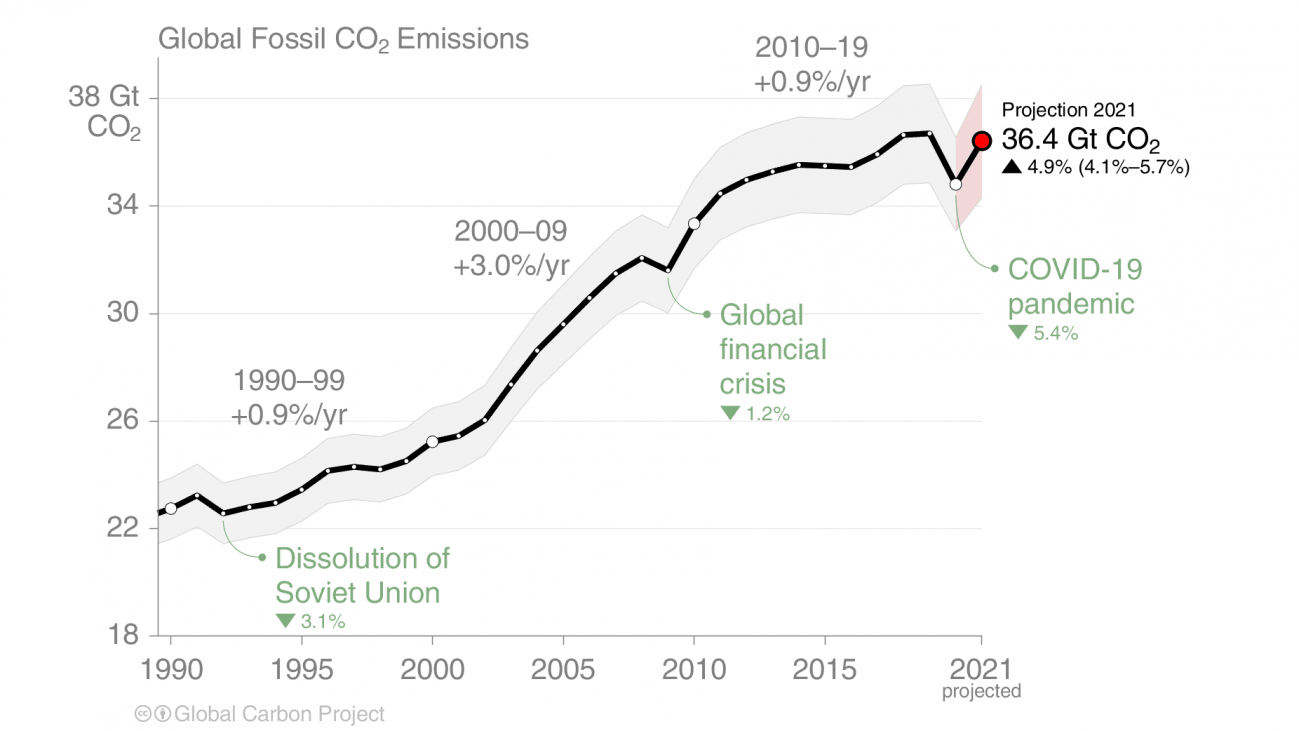

Las emisiones de CO₂ en 1990 a la atmosfera eran de 22,7 gigatoneladas (Gt) según Carbon Project y en 2020 ya se han alcanzado más de 36.4 Gt de CO₂, solo un 0.8 % menor que los valores pre pandemia que fueron de 36,7 Gt CO₂ en 2019. Con la guerra ya se está quemando mucho más carbón, más gas y países como el Reino Unido ya han anunciado que volverán a las perforaciones para extraer más petróleo del Mar del Norte.

Fuente: Global Carbon ProjectLa historia de un fracaso

Fuente: Global Carbon ProjectLa historia de un fracaso

Es sabido que las emisiones de combustibles fósiles son responsables de estos récords de temperaturas y del cambio climático. Sin embargo, las emisiones han seguido aumentando desde que existen datos, excepto en periodos muy puntales como la crisis de la antigua Unión Soviética, la crisis de Lehman Brothers o la reciente pandemia de la covid-19. Por todo ello, es evidente que es necesario reducir todas estas emisiones y volver a mirar arriba para replantearse los temas realmente importantes.

En resumen, hasta la actualidad, es la historia de un gran fracaso. Es hora de reducir las emisiones de una forma radical y sobre todo de adaptarnos con políticas valientes y basadas en la ciencia, para aumentar la resiliencia sobre todo con señales tan alarmantes como anomalías térmicas en ambos polos simultáneamente, señal clara de disrupciones del sistema climático global. Parar la guerra y mirar arriba para resolver los problemas del sistema climático son, sin duda, la única salida y la opción más inteligente.

Sobre el autor: Fernando Prieto es doctor en Ecología y director del Observatorio de la Sostenibilidad.

Una versión de este artículo se publicó en SINC.

El artículo Ártico y Antártico se calientan a la vez se ha escrito en Cuaderno de Cultura Científica.

El arte de la sencilla baldosa de Truchet

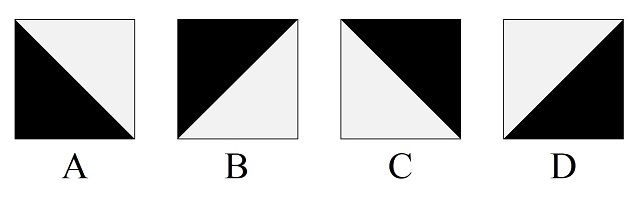

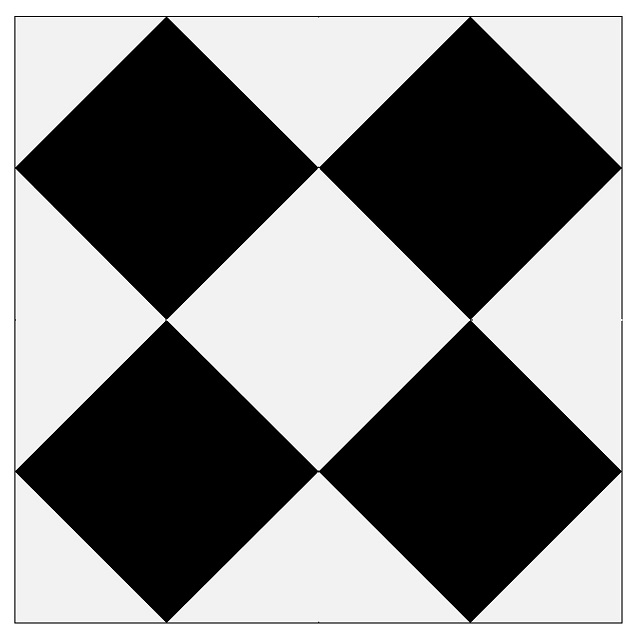

En la anterior entrada del Cuaderno de Cultura Científica Los embaldosados de Truchet y el puzle del diamante estuvimos hablando del diseño de patrones de embaldosado realizados con una sencilla baldosa, la conocida con el nombre de “baldosa de Truchet”. Esta es una baldosa cuadrada dividida por la diagonal en dos zonas triangulares de dos colores distintos, por ejemplo, gris y negro, como la que aparece en la imagen.

Baldosa de Truchet

Baldosa de Truchet

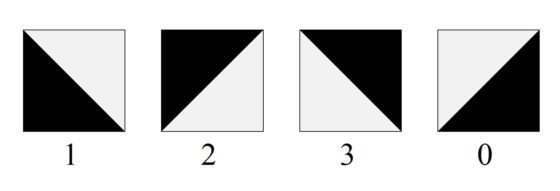

En el siglo XVIII los religiosos franceses, interesados por las matemáticas, Sébastien Truchet –en su artículo Memoria sobre las combinaciones (1704)– y Dominique Doüat –en su libro Método para hacer una infinidad de diseños distintos con cuadrados de dos colores separados por una línea diagonal (1722)– tomaron las cuatro orientaciones posibles de esta baldosa cuadrada bicolor, que vemos en la siguiente imagen, y realizaron un análisis combinatorio de los posibles patrones de teselados que se podían construir con ellas, del que hemos hablado en la anterior entrada.

Las cuatro orientaciones posibles de la tesela de Truchet, nombradas por Doüat como A, B, C y D

Las cuatro orientaciones posibles de la tesela de Truchet, nombradas por Doüat como A, B, C y D

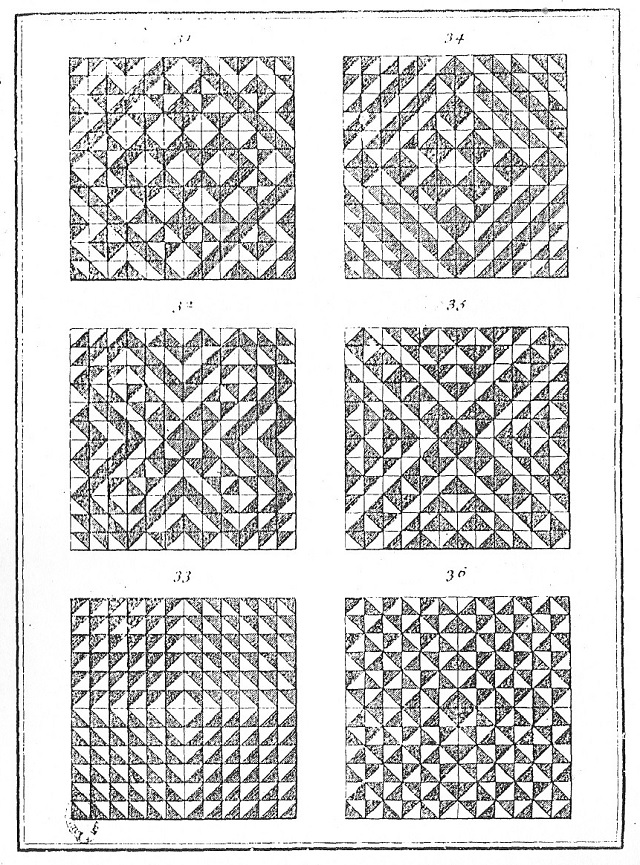

Y como comentábamos entonces, el estudio de los patrones de embaldosado o teselado, y en particular también los realizados con la baldosa de Truchet, es un tema con interés tanto en el ámbito de la ciencia y la tecnología, como del arte y el diseño. De hecho, tanto Truchet, como Doüat, no solo realizaron el estudio combinatorio de estos patrones de teselados, sino que se preocuparon de mostrar hermosos diseños realizados con esta baldosa, como los que aparecen en la siguiente imagen.

Una página del libro Método para hacer una infinidad de diseños distintos con cuadrados de dos colores separados por una línea diagonal (1722), de Dominique Doüat, con ilustraciones de patrones de embaldosado, con una baldosa de Truchet

Una página del libro Método para hacer una infinidad de diseños distintos con cuadrados de dos colores separados por una línea diagonal (1722), de Dominique Doüat, con ilustraciones de patrones de embaldosado, con una baldosa de Truchet

Es sorprendente como con un elemento tan sencillo se pueden realizar tan hermosos y complejos diseños de patrones de embaldosado. El propio Sébastien Truchet explicaba en su artículo Memoria sobre las combinaciones (1704) que para su estudio combinatorio se había inspirado en las baldosas de cerámica utilizadas para la decoración de un castillo que había visitado en uno de sus viajes, como hemos recogido en la entrada Los embaldosados de Truchet y el puzle del diamante. En la siguiente imagen se muestran, aunque no los azulejos que vio el religioso matemático en su viaje, sí unos azulejos decorativos antiguos. Pertenecen a la Catedral Santa María de la Huerta de Tarazona, edificio religioso que empezó a construirse a mediados del siglo XII, que como en la mayoría de edificaciones de este tipo tuvo sus etapas de destrucción y reconstrucción. Los azulejos pertenecen a las reconstrucciones de los siglos XV y XVI, de estilo mudéjar.

Fotografía de los azulejos de la Catedral Santa María de la Huerta de Tarazona, perteneciente a la entrada Simetrías I en la Catedral de Tarazona del blog MateTurismo, de Angel Requena

Fotografía de los azulejos de la Catedral Santa María de la Huerta de Tarazona, perteneciente a la entrada Simetrías I en la Catedral de Tarazona del blog MateTurismo, de Angel Requena

Así mismo, en la anterior entrada comentamos la presencia de estos cuadrados bicolor en el arte textil de los quilts. Pero también podemos ver como algunas artistas contemporáneas han utilizado, y siguen utilizando, estas ideas en sus obras de arte.

Las baldosas de Truchet en el arte contemporáneoPor ejemplo, la artista noruega Josefine Lyche ha diseñado dos instalaciones con los patrones de teselado de las baldosas de Truchet que están relacionadas con el teorema del diamante en su versión 2 x 2 (véase Los embaldosados de Truchet y el puzle del diamante), que son The 2×2 Case (Diamond Theorem). After Steven H. Cullinane (2011) y The 2×2 Case (Diamond Theorem) II. After Steven H. Cullinane (2011). Estas obras consisten en la realización de los 24 diseños de embaldosados cuadrados de tamaño 2×2 que contienen las cuatro orientaciones distintas (A, B, C y D) de la baldosa cuadrada bicolor. La primera de ellas –que vemos en la siguiente imagen- realizada sobre una pared blanca con espejos que reflejan la luz dirigida hacia ellos en el lugar de exposición, una sala a oscuras, mientras que la segunda versión consiste en piezas realizadas en pintura acrílica sobre lienzo, en lugar de espejos.

The 2×2 Case (Diamond Theorem). After Steven H. Cullinane (2011), de la artista noruega Josefine Lyche. Imágenes de la página web de Josefine Lyche

The 2×2 Case (Diamond Theorem). After Steven H. Cullinane (2011), de la artista noruega Josefine Lyche. Imágenes de la página web de Josefine LycheLa artista abstracta estadounidense Heather Jones, cuyo trabajo está inspirado en los diseños geométricos de los quilts tradicionales elaborados por las mujeres de ciertas regiones de Estados Unidos, ha creado algunas obras con esta estructura cuadrada dividida en dos triángulos coloreados. Por ejemplo, en la reciente exposición Storytellers / Contadoras de historias (2022) en el centro de arte contemporáneo de Dayton (Ohio), The Contemporary Dayton, dedicada a las mujeres desarrollaron el arte textil de los quilts, se ven algunas de estas obras, como las que vemos en la siguiente imagen: One way or another / De una manera u otra (2021), realizada en algodón cosido, destacando el color negro, y A time for change / Un tiempo para el cambio (2021), también en algodón cosido, destacando el color rojo.

Fotografía de la exposición Storytellers / Contadoras de historias (2022) en The Contemporary Dayton, en la que se pueden ver las obras One way or another / De una manera u otra (2021) y A time for change / Un tiempo para el cambio (2021), de la artista abstracta estadounidense Heather Jones

Fotografía de la exposición Storytellers / Contadoras de historias (2022) en The Contemporary Dayton, en la que se pueden ver las obras One way or another / De una manera u otra (2021) y A time for change / Un tiempo para el cambio (2021), de la artista abstracta estadounidense Heather Jones

O también, en la reciente exposición To Hold Tender This Land / Mantener joven esta tierra (2022) en la Galería David Richard de Nueva York se ha podido disfrutar de obras como la siguiente, titulada There was always light / Siempre hubo luz (2022).

Fotografía de la exposición To Hold Tender This Land (2022), de la artista estadounidense Heather Jones, en la Galería David Richard de Nueva York. La obra de la derecha es There was always light / Siempre hubo luz (2022). Imagen de la página GalleriesNow

Fotografía de la exposición To Hold Tender This Land (2022), de la artista estadounidense Heather Jones, en la Galería David Richard de Nueva York. La obra de la derecha es There was always light / Siempre hubo luz (2022). Imagen de la página GalleriesNow

Otra artista que utiliza este tipo de teselaciones es la francesa Ode Bertrand (1930) cuyo trabajo artístico está relacionado con la abstracción geométrica y el arte concreto, y que según sus palabras pretende “poner orden en el caos”. En una serie de obras, como la pintura Sin título (2015) que podemos ver en la siguiente imagen, añade a las cuatro teselas cuadradas bicolor blanco/negro, las dos teselas monocromáticas relacionadas, la tesela blanca y la negra.

Sin título (2015), de la artista francesa Ode Bertrand. Imagen de la Galerie Wagner

Sin título (2015), de la artista francesa Ode Bertrand. Imagen de la Galerie Wagner

Una artista que sigo a través de Instagram y cuyas obras, realizadas en lápiz sobre papel, son de una belleza geométrica inspiradora es la alemana Christiane Kaufmann (1983). Muchas de sus sencillas y hermosas creaciones nos recuerdan a la baldosa de Truchet, aunque muchos de sus cuadrados a lápiz son monocolor. En particular, la serie de obras titulada azul/rojo, de la que destaco esta pieza azul/rojo [25/10/2021],

Pintura azul/rojo [25/10/2021], de la artista alemana Christiane Kaufmann, realizada con lápices de colores sobre papel

Pintura azul/rojo [25/10/2021], de la artista alemana Christiane Kaufmann, realizada con lápices de colores sobre papel

que nos recuerda al diseño con baldosas de Truchet siguiente.

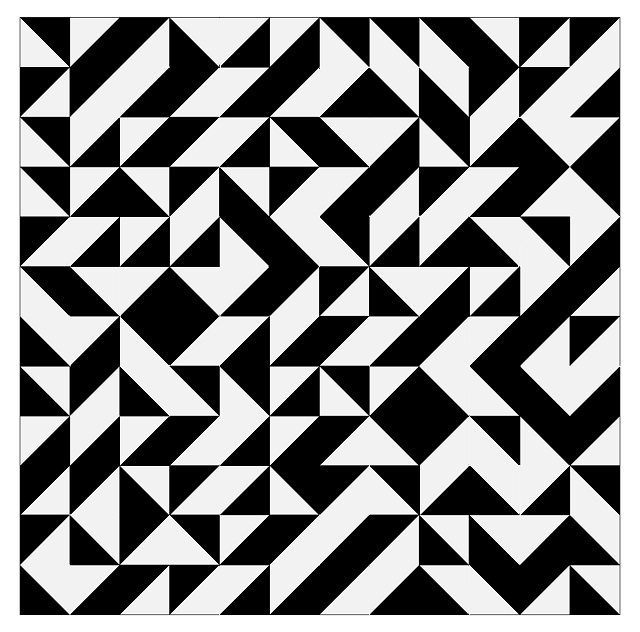

Preparando esta entrada del Cuaderno de Cultura Científica se me ocurrió una idea para realizar una obra plástica basada en la baldosa de Truchet y el número pi, cuyo boceto explico en las siguientes líneas. Para empezar, renombramos las cuatro orientaciones de la baldosa cuadrada tricolor –antes nombradas A, B, C y D- como 1, 2, 3, 0, como se muestra en la imagen.

La idea es realizar un patrón de embaldosado cuadrado de tamaño 12 x 12 que formará la estructura visual de la obra. Para determinar la colocación de las cuatro baldosas de Truchet orientadas utilizaré el número pi, es decir, el diseño no depende de mis preferencias personales. Con este fin, consideramos la expresión decimal de esta constante matemática (sobre esta puede leerse la entrada ¿Es normal el número pi?), pero no en la base decimal que utilizamos normalmente, sino en base cuatro (en la que utilizamos las cuatro cifras básicas 1, 2, 3, 0), ya que solo tenemos cuatro orientaciones posibles. La expresión del número pi en base cuatro es la siguiente (en una futura entrada del Cuaderno de Cultura Científica explicaremos cómo determinar la expresión del número pi, o cualquier otro número, en una base de numeración cualquiera, por ejemplo, cuatro):

3,02100333122

220202011220

300203103010

301212022023

200031300130

310102210002

103200202022

121330301310

000200232332

221203230103

212302021101

102200201321…

Solo hemos incluido los 144 primeros dígitos del número pi, en base cuatro, ya que nuestro patrón es un cuadrado de tamaño 12 x 12 y utilizaremos 12 x 12 = 144 baldosas cuadradas. Estas estarán determinadas por el correspondiente dígito de pi, en base cuatro, recorriendo el cuadrado fila a fila, de arriba a la izquierda, hacia la derecha en cada fila, hasta abajo a la derecha. Así la primera fila de nuestro diseño de embaldosado utiliza las baldosas que se corresponden con los primeros doce dígitos 3 0 2 1 0 0 3 3 3 1 2 2, como puede observarse en el diseño final que hemos obtenido y que se muestra en la siguiente imagen.

Idea para una obra basada en los patrones de embaldosado con baldosas de Truchet y el número pi.

Idea para una obra basada en los patrones de embaldosado con baldosas de Truchet y el número pi.

En esta entrada solamente hemos considerado el caso de los diseños con la sencilla baldosa de Truchet, aunque podríamos considerar las baldosas de Truchet en un sentido más amplio, pero eso será en otra ocasión. Mientras os animo a realizar vuestros propios diseños con cuadrados bicolor, ya sea con telas, lápices de colores, pinturas o con el ordenador.

Bibliografía:

1.- Cyril Stanley Smith (con la traducción del texto de Truchet por Pauline Boucher), The Tiling Patterns of Sebastian Truchet and the Topology of Structural Hierarchy, Leonardo, vol. 20, n. 4, pp. 373-385, 1987.

2.- Dominique Doüat, Méthode pour faire une infinité de desseins différents avec des carreaux mi-partis de deux couleurs par une ligne diagonale : ou observations du Père Dominique Doüat, Religieux Carme de la Province de Toulouse, sur un mémoire inséré dans l’Histoire de l’Académie Royale des Sciences de Paris l’année 1704, présenté par le Révérend Père Sébastien Truchet religieux du même ordre, Académicien honoraire [Método para hacer una infinidad de diseños distintos con cuadrados de dos colores separados por una línea diagonal], París, 1922.

* Facsímil (extractos) e introducción de Jacques André

* Obra completa en Gallica – Bibliothèque nationale de France

3.- Sebastien Truchet, Memoir sur les Combinaisons, Histoire de l’Académie Royale des Sciences de Paris, 363-372 (1704).

* Obra completa en Gallica – Bibliothèque nationale de France

4.- Angel Requena, Simetrías I en la Catedral de Tarazona, del blog MateTurismo, 2018.

5.- Página web de Josefine Lyche

6.- Página web de Heather Jones

7.- Página web de Christiane Kaufmann

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El arte de la sencilla baldosa de Truchet se ha escrito en Cuaderno de Cultura Científica.

Einstein y su educación formal

En contra de las leyendas populares, Einstein fue en realidad un buen estudiante. Lo que sí es cierto es que el sistema de educación convencional, que él calificaba como dictatorial, le frustraba y que su rebeldía contra él era una manifestación de su propia creatividad. Muchas de las personas que intentaron enseñar a Einstein durante su educación formal se encontraron frente a un joven muy inteligente, pero quizás demasiado aficionado a discutir.

Antes siquiera de que Einstein empezase el colegio, su madre, con objeto de darle un empujoncito para que comenzase con buen pie, contrató a una profesora particular. Einstein se aburría mortalmente con las lecciones y, todavía en esa época de la vida en la que las rabietas se entienden como normales, le tiró una silla a la maestra. No volvería y la madre terminó contratando a otra.

En el Volksschule (colegio público de primaria), para alegría de su madre, le fue bastante bien y, aunque la leyenda quiere que suspendiese matemáticas, la realidad es que fue un estudiante muy bueno.

Las cosas cambiaron un poco cuando empezó a asistir al Luitpold Gymnasium (colegio de secundaria que prepara para la universidad) en Múnich. Según Einstein, los profesores tenían “una naturaleza dictatorial”. Uno de ellos llegó a decir que la sonrisa arrogante de Einstein ya era irrespetuosa. Pero, a pesar del hecho de que Einstein, al igual que muchas personas de inclinaciones intelectuales, odiaba el deporte (área fundamental en la educación alemana), pasó por el colegio bastante bien.

Mucho del estímulo intelectual lo conseguía Einstein fuera de clase. Su tío Jakob procuraba que su sobrino se distrajese enseñándole álgebra. Un amigo de la familia, Max Talmey (en aquella época, Max Talmud), un pobre estudiante de medicina en la Universidad de Múnich, judío polaco acogido por la comunidad judía local, cenaba muchas noches con la familia Einstein, y le hablaba al joven Albert de medicina, matemáticas, ciencia y filosofía. No sólo eso, sino que también le prestaba libros: entre ellos el “sagrado librito de geometría” (los Elementos de Euclides) y la Crítica de la razón pura de Kant. [Talmey, ya con su apellido adaptado al ambiente anglosajón, terminaría siendo oftalmólogo en la ciudad de Nueva York y un gran divulgador de la obra científica de Einstein.]

La educación de Einstein tuvo un giro inesperado en 1894. El negocio de su padre quebró, por lo que la familia partió hacia Pavía (Italia) donde había un encontrado un empleo. Einstein se quedó en Múnich con la idea de terminar la educación secundaria. El joven Albert, sin guía y expuesto a la rigidez militar de sus profesores, no lo soportó mucho tiempo, por lo que dejó el colegio y sorprendió a sus padres presentándose en la puerta de su casa en Italia.

La educación universitaria de EinsteinSu madre, posiblemente preocupada porque su vástago no triunfase en la vida como le correspondía por su valía, movió todos los hilos que pudo para conseguir que a Einstein se le permitiese presentarse al examen de entrada del Eidgenössische Technische Hochschule (ETH), la Escuela Politécnica Federal de Zúrich (Suiza). Estos hilos no eran fáciles de mover. Fue finalmente un amigo de la familia, Gustav Maier, el que convenció al director, Albin Herzog, de que merecía la pena dejar que aquel “niño prodigio” lo intentase. Einstein se presentó al examen y, a pesar de tener dos años menos de la edad habitual de entrada (18) y carecer de un certificado de escuela secundaria, aprobó las secciones de matemáticas y ciencia, pero suspendió las demás.

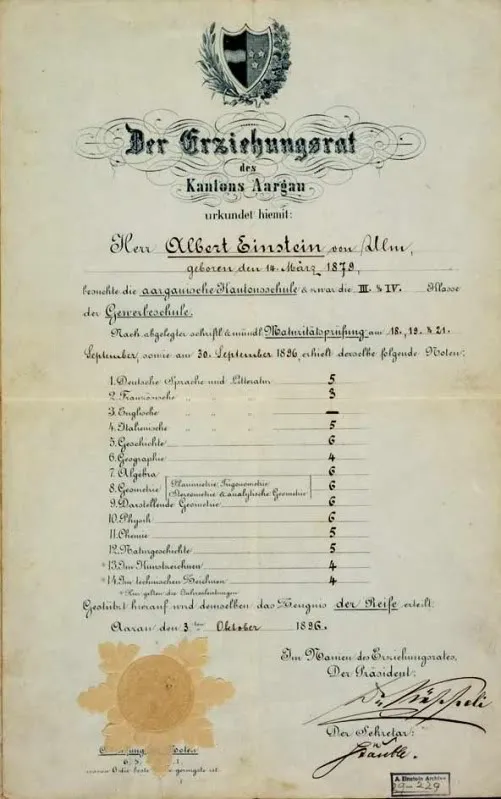

La familia decidió entonces que Einstein se matricularía en la escuela cantonal de Argovia (Suiza) [Aargau en alemán]. Tras un año de estudios en el que se hospedó en casa de su profesor Jost Winteler, consiguió aprobar la Maturitätsprüfung, la prueba de madurez establecida como final de la educación secundaria y que le daba acceso al ETH [en la imagen el certificado; usa el sistema de calificación suizo de la época, en el que la máxima nota posible es un 6].

Einstein se unió al Departamento VI, la “Escuela de profesores especializados en las asignaturas de matemáticas y ciencias” del ETH, cuando todavía le faltaban seis meses para tener la edad mínima oficial de acceso. Einstein era uno de los cinco estudiantes de física en la universidad. La Politécnica había sido fundada en 1855 y en la época en la que se inscribió Einstein se la consideraba de inferior categoría a otras escuelas, especialmente a las alemanas, aunque fuera por el solo hecho de que no podía otorgar doctorados.

Los primeros años fueron muy buenos para el joven Einstein. Los resultados de los exámenes lo colocaban siempre en los primeros puestos de su clase pero, conforme se acercaba el final de sus estudios, su incapacidad para soportar la autoridad volvió a aparecer. Especialmente difícil fue su relación con Heinrich Weber que, según Einstein contase a su biógrafo Carl Seelig, llegó a decir: “Es usted un muchacho inteligente, Einstein, muy inteligente. Pero tiene usted un gran defecto: no deja usted que se le diga nada”.

Einstein había comenzado ya una relación amorosa con Mileva Marić cuando en 1900 la pareja dedicó las vacaciones de primavera a preparar sus disertaciones finales de graduación. Sus calificaciones fueron de mediocres a malas. Sobre un máximo de 6, Einstein obtuvo un 4,5 y Mileva un 4,0. Los exámenes finales no fueron mejores. El sistema de evaluación final tenía en cuenta las calificaciones en exámenes y los trabajos presentados. Einstein aprobó, el cuarto de cinco alumnos, con un 4,91. Mileva suspendió con un 4,0.

El testarudo y joven físico se sintió desilusionado con el mundo académico, pero sí continuó trabajando en su tesis doctoral. La ETH no ofrecía doctorados, pero se podía obtener uno simplemente mandando una tesis a la Universidad de Zúrich. En septiembre de 1901 Einstein envió una tesis sobre un tema de la teoría cinética de gases. Esta tesis no prosperó. Se desconoce si Einstein la retiró o si no fue aceptada (los historiadores no han podido encontrar la respuesta de la universidad).

Mientras Einstein luchaba por encontrar un empleo, y subsistía dando clases particulares, siguió trabajando en su segunda tesis. El tema esta vez era sobre cómo usar el movimiento browniano para medir el tamaño de los átomos. Con la estabilidad que le daba el empleo que había encontrado en la Oficina Federal de Patentes en Berna, pudo avanzar en ella. Envió finalmente la tesis a la Universidad de Zúrich a comienzos de 1905. Paralelamente, Einstein mandó una versión de la misma a la principal revista alemana, Annalen der Physik, que fue publicada prácticamente a la vez que era aceptada por la Universidad de Zúrich, en abril de 1905. Einstein tenía finalmente su doctorado.

Einstein le contó la siguiente anécdota a Seelig: “Un día recibí un sobre grande en la oficina [de patentes], que contenía una elegante hoja de papel con algunas palabras en una tipografía pintoresca (creo incluso que era latín) que me pareció impersonal y carente de interés, por lo que terminó en la papelera”. Solo más tarde alguien le diría que aquella hoja de papel era su título de doctor y que, además, en el sobre había una carta invitándole a la ceremonia de graduación.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 4 de julio de 2010.

El artículo Einstein y su educación formal se ha escrito en Cuaderno de Cultura Científica.

¿Por qué las caras de la Luna son tan diferentes?

Creo que sin excepción todos hemos mirado alguna vez a nuestra Luna y nos ha llamado la atención las irregularidades que incluso a simple vista son evidentes. Quizás la más vistosa de todas es la presencia de dos colores bien diferenciados, el blanco y el gris, que salpican la superficie creando formas caprichosas, acompañadas de numerosos cráteres de impacto.

Pero desgraciadamente, desde la Tierra solo podemos ver una parte de la superficie, la que conocemos como «cara visible», y menos de un veinte por ciento de la que llamamos «cara oculta”, cuya geografía y geología es muy diferente de la primera.

No fue hasta el año 1959 cuando pudimos ver por primera vez la cara oculta de la Luna gracias a las imágenes tomadas por la sonda soviética Luna 3. A lo largo de los años sesenta, especialmente a partir de la segunda mitad, la pudimos estudiar con un mayor nivel de detalle gracias al creciente número de misiones lunares y una mejor tecnología.

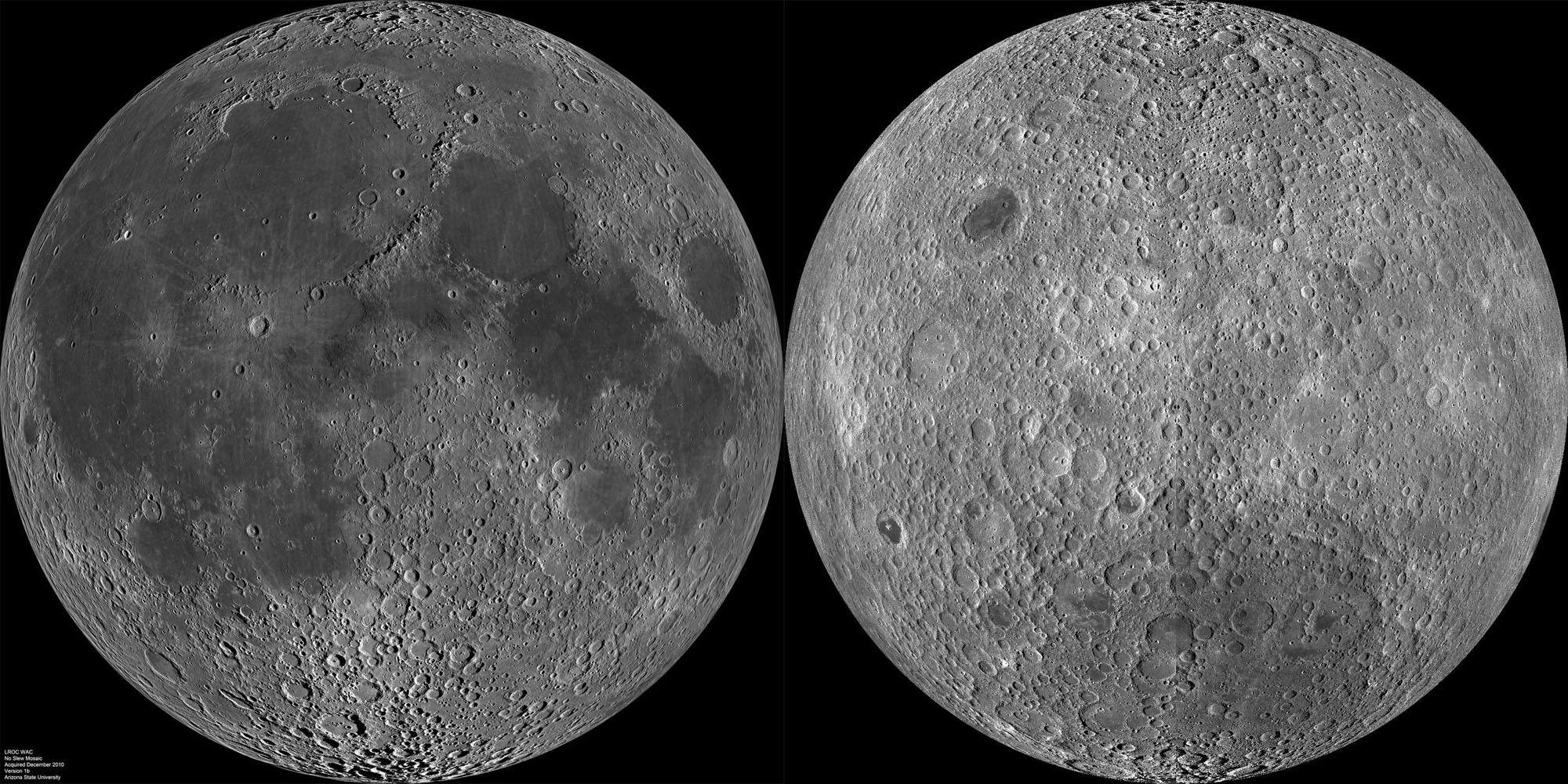

Las diferencias entre las caras de la Luna Comparación entre las caras visible y oculta de la Luna con imágenes de la Lunar Reconaissance Orbiter. Imagen cortesía de NASA/GSFC/Arizona State University.

Comparación entre las caras visible y oculta de la Luna con imágenes de la Lunar Reconaissance Orbiter. Imagen cortesía de NASA/GSFC/Arizona State University.

Al examinar estas imágenes los científicos se dieron cuenta de que había grandes diferencias entre ambas caras. Propusieron distintas explicaciones a este hecho, a veces no exentas de controversia, pero que anticipaban que la historia de la Luna iba a ser mucho más interesante de lo que habíamos pensado a priori.

¿Y cuáles son estas diferencias? La más evidente es la proporción entre los mares lunares y las zonas más claras del terreno. Mientras que en la cara visible los mares representan aproximadamente un tercio de su superficie, en la cara oculta únicamente cubren alrededor de un uno por ciento. Además, la menor presencia de mares lunares hacía de la geografía de la cara oculta un lugar mucho más agreste y aparentemente con un mayor número de cráteres.

¿Pero qué son los mares? Los mares lunares, lejos de ser mares de agua como serían los de nuestro planeta, en realidad son grandes llanuras cubiertas por lava formadas como resultado de grandes colisiones de asteroides contra la superficie de la Luna y las erupciones volcánicas provocadas por estos.

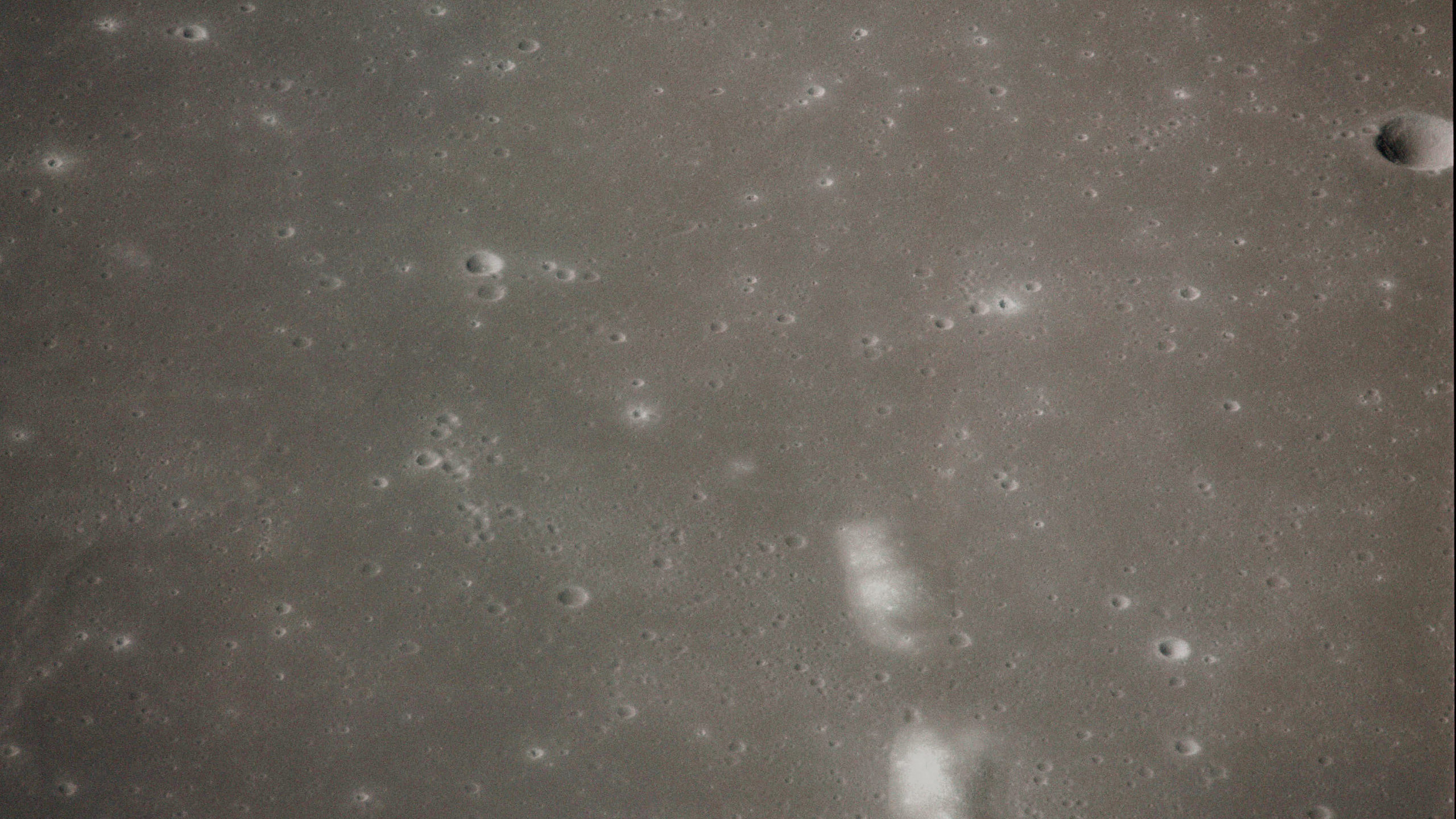

Salvo por cráteres de impacto posteriores a su formación y algunas montañas, los mares lunares son extraordinariamente llanos, como podemos ver en esta imagen tomada desde el módulo de comando de la misión Apolo XVI. Imagen cortesía de NASA.

Salvo por cráteres de impacto posteriores a su formación y algunas montañas, los mares lunares son extraordinariamente llanos, como podemos ver en esta imagen tomada desde el módulo de comando de la misión Apolo XVI. Imagen cortesía de NASA.

Tenemos que imaginarnos que las colisiones más energéticas y violentas eran capaces no solo de crear cráteres de grandes dimensiones, sino que podían fracturar la corteza lunar, facilitando que partes fundidas del manto fluyesen hacia la superficie, y rellenando estos cráteres con el material que ascendía.

Pero, entonces, ¿cómo podemos explicar esta diferencia? ¿Acaso no habrían ocurrido grandes impactos en la cara oculta de la Luna o es que hay otro mecanismo en juego y que no hemos podido atisbar hasta ahora?

El misterio de la Cuenca AitkenLa pasada semana se publicaba un artículo en la revista Science Advances que intenta dar una respuesta definitiva a estas preguntas: En el polo sur de la Luna existe la llamada Cuenca Aitken, un gigantesco cráter de impacto que alcanza los casi 2500 kilómetros de diámetro por más de 6 kilómetros de profundidad, y que se formó hace unos 4300 millones de años. De hecho, es el cráter más grande de la Luna y uno de los más grandes del Sistema Solar, probablemente el segundo más grande de todos los que conocemos.

Los autores afirman que la virulencia de este impacto fue tan grande que la energía liberada en forma de calor habría sido suficiente para alterar los patrones de circulación del manto lunar, debido a que el brusco aumento de la temperatura se habría ido propagando desde el lugar del impacto a todo el interior de la Luna.

A pesar de que fue un impacto de dimensiones realmente grandes, provocado por un cuerpo en el entorno de los 100 kilómetros de diámetro, sabemos que no llegó a profundizar más allá de la corteza lunar y, por lo tanto, llegar hasta el manto.

¿Cómo sabemos este detalle? Pues bien, las distintas misiones espaciales que han podido analizar la composición de esa zona de la Luna han podido comprobar que realmente todas las rocas que se ven tienen un mayor parecido composicional a las de la corteza que a las del manto, por lo que, de haber sido un impacto que realmente hubiese llegado hasta el manto, veríamos rocas con una composición diferente tanto dentro del cráter como desperdigadas hacia afuera del cráter, expulsadas por la brutal energía del impacto.

Esto quiere decir que el impacto probablemente ocurrió con un ángulo muy oblicuo y no “de frente”. Si se hubiese producido con un ángulo mucho más vertical, probablemente si hubiese llegado hasta el manto, haciendo que numerosas rocas quedasen exhumadas y otras fueran lanzadas a gran distancia.

Contados estos detalles del impacto, puede parecer que no tienen nada que ver con nuestra historia, pero probablemente condicionaron lo que ocurrió posteriormente. Justo debajo de la corteza lunar se estaban acumulando un conjunto de elementos químicos que conocemos como KREEP, y que se llaman así porque agrupan al potasio (K), tierras raras (REE) y fósforo (P). Junto a estos, también viajarían otros capaces de generar calor por el efecto de la desintegración radioactiva, como, por ejemplo, el torio.

Como dijimos antes, al ocurrir el impacto, el calor producido por este alteraría la circulación normal en el manto lunar, de tal manera que estos elementos que justo se acumulaban debajo de la corteza “se montaron” en esa nueva corriente de circulación por el manto y habrían llegado hasta la cara visible de la Luna.

Este hecho casa muy bien con las observaciones de la geoquímica lunar, tanto que concentraciones anómalas de estos elementos se pueden encontrar en algunos lugares de nuestro satélite, como Oceanus Procellarum, uno de los mares lunares más grandes.

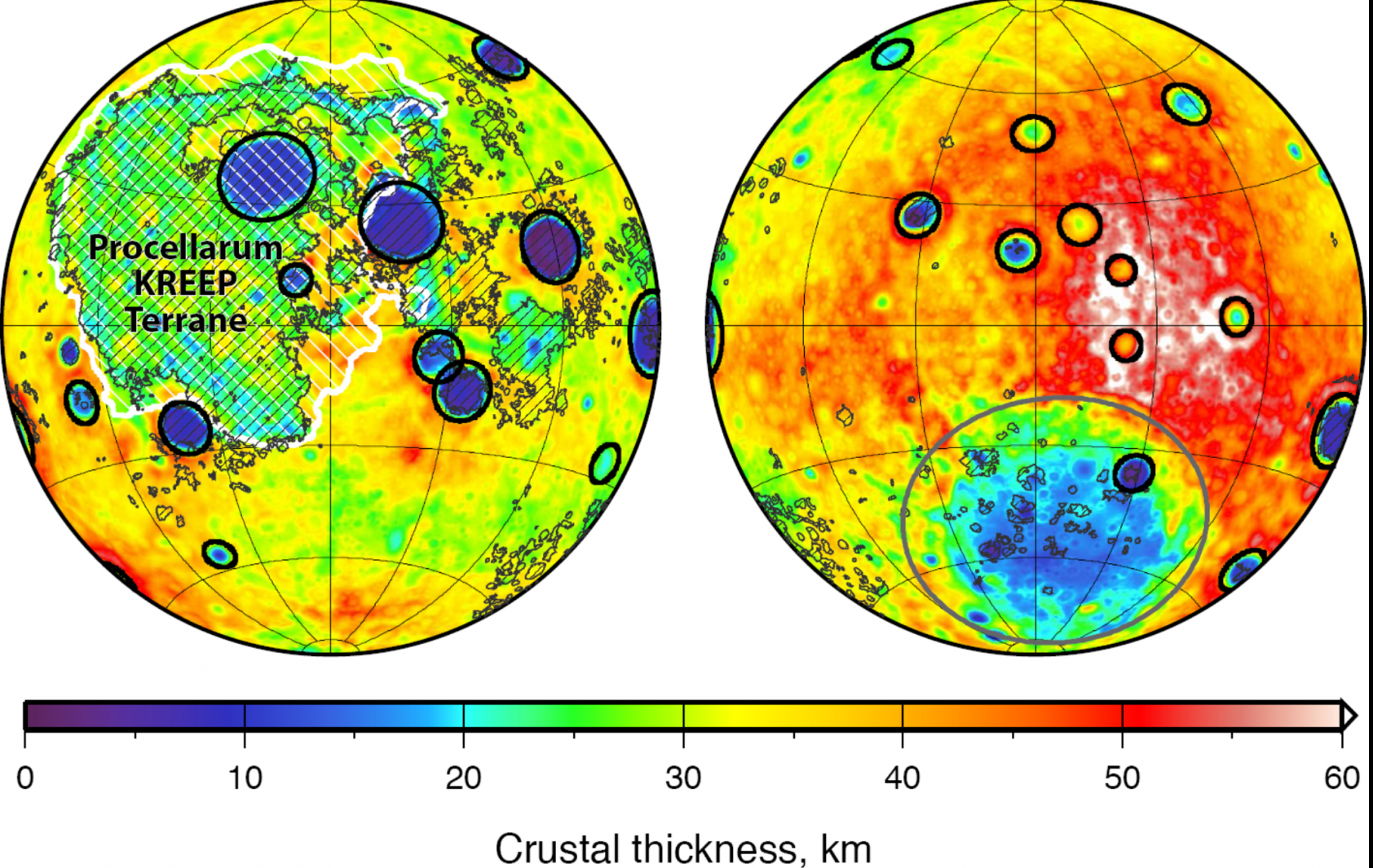

Mapa de espesor cortical de la Luna. En este puede apreciarse como en la cara visible, además de los grandes cráteres de impacto, la zona de Océanos Procellarum destaca por su menor espesor. Imagen cortesía de NASA/JPL-Caltech/S. Miljkovic.

Mapa de espesor cortical de la Luna. En este puede apreciarse como en la cara visible, además de los grandes cráteres de impacto, la zona de Océanos Procellarum destaca por su menor espesor. Imagen cortesía de NASA/JPL-Caltech/S. Miljkovic.

Y es que, gracias al calor extra aportado por estos elementos, se habría producido un mayor grado de fusión en los materiales del manto, lo que, a su vez, habría generado un mayor volumen de magma disponible para salir a la superficie y acabar formando los mares a través de los sistemas de fracturas generados por los impactos de asteroides.

Sin duda es una hipótesis muy interesante y que a grandes rasgos parece cuadrar muy bien con las observaciones, aunque todavía falta mucho por conocer de la geología lunar, y por ejemplo, comprender por qué el espesor de la corteza de nuestro satélite es mayor en la cara oculta que en la visible, y si esto también fue un factor importante a la hora de que una esté más cubierta por mares que la otra.

Referencia:

Jones, M. J., Evans, A. J., Johnson, B. C., Weller, M. B., Andrews-Hanna, J. C., Tikoo, S. M., & Keane, J. T. (2022). A south pole–aitken impact origin of the lunar compositional asymmetry. Science Advances, 8(14).doi: 10.1126/sciadv.abm8475

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo ¿Por qué las caras de la Luna son tan diferentes? se ha escrito en Cuaderno de Cultura Científica.

Solo respira el domingo

Foto: Vitaly Sokol / Wikimedia Commons

Foto: Vitaly Sokol / Wikimedia Commons“Por anómalo que parezca este es el caso exactamente de la ballena, que vive sistemáticamente con intervalos de una hora entera y más (cuando está sumergida) sin inhalar un solo respiro, ni absorber de ningún modo una partícula de aire, pues recordemos que no tiene branquias.” (Moby Dick, capítulo LXXXV).

La historia de la obsesión del capitán Ahab con la gran ballena blanca que al final provocó su muerte, el naufragio del Pequod, así como la pérdida de la tripulación (salvo Ismael), es una epopeya trágica. Pero es también una crónica de la vida en los balleneros del siglo XIX y, aunque pueda sorprender, un tratado de historia natural. Quizás por reunir en una sola obra tal diversidad temática, la novela de Herman Melville es el texto de mayor densidad de vocabulario de que se tiene constancia. En ningún otro hay tantas palabras diferentes en comparación con el total de vocablos. Moby Dick contiene abundante y, en gran parte, correcta información biológica, como la que encabeza este texto.

Los cachalotes se sumergen, en promedio, a unos 400 m de profundidad, inmersiones que se prolongan alrededor de 40 minutos. Pero pueden llegar hasta los 3000 m y permanecer bajo el agua casi dos horas. Gracias a ello dan caza, incluso, a calamares gigantes. Son grandes depredadores. A pesar de haber sido diezmados de forma severa por la caza a que fueron sometidos durante el siglo XIX y gran parte del XX, consumen, en la actualidad, unas cien mil toneladas de pescado al año, el equivalente a lo que pescamos los seres humanos.

Se necesitan características muy especiales para conseguir esas inmersiones, algunas compartidas con el resto de mamíferos, aunque desarrolladas en mayor grado, como el reflejo de inmersión. Al sumergirnos, el corazón late más lentamente y consume así menos oxígeno. A la vez, la circulación periférica se limita o suprime, dirigiéndose la sangre, sobre todo, al encéfalo, pulmones y corazón; la subida de presión arterial que podría producirse la contrarresta la menor frecuencia de latido y, en los mamíferos marinos, una expansión de la aorta que funciona como cámara de compensación. Además, el bazo, que alberga en su interior muchos glóbulos rojos llenos de oxígeno, se contrae y los vierte al sistema circulatorio.

En comparación con otros mamíferos, los cetáceos exhiben rasgos específicamente adaptados al buceo a gran profundidad. Antes de sumergirse respiran varias veces y, a continuación, expulsan todo el aire de sus pulmones. Minimizan así la formación de burbujas de nitrógeno en la sangre al despresurizarse en el retorno a la superficie. A cambio, cuentan con varios “depósitos de oxígeno”. Ya hemos citado los glóbulos rojos extra que aporta el bazo. Además, tienen más sangre que los demás mamíferos; y esa sangre tiene un hematocrito -concentración de glóbulos rojos- muy alto. Su concentración de mioglobina es diez veces más alta que la nuestra; la mioglobina es una proteína similar a la hemoglobina, localizada en las células musculares. Lo mismo cabe decir de la citoglobina (en diferentes tejidos) y neuroglobina (en el tejido nervioso).

Los cachalotes pasan la mitad de su tiempo haciendo inmersiones profundas, la cuarta parte sumergiéndose a poca profundidad, y la otra cuarta parte algo por debajo o por encima de la superficie del agua. Moby Dick era un cachalote de tamaño enorme, por lo que seguramente superaba los periodos de una hora de inmersión que le atribuye Melville y, lo que es más significativo, resulta ser cierto, metafóricamente, lo que el propio autor escribió en el mismo capítulo LXXXV: “el cachalote solo respira cerca de la séptima parte, el domingo de su tiempo.”

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Solo respira el domingo se ha escrito en Cuaderno de Cultura Científica.

Día de Pi con BCAM Naukas 2022: María Ángeles García-Ferrero – Imágenes matemáticas

La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática: 3-14 martxoaren 14 en euskara / 3-14 March, 14th en inglés. En los últimos años, la conmemoración del Día de Pi se ha ido extendiendo, hasta tal punto que el 26 de noviembre de 2019 la UNESCO proclamó el 14 de marzo Día Internacional de las Matemáticas.

Un año más, el Basque Center for applied Mathematics-BCAM y la Cátedra de Cultura Científica de la UPV/EHU se han suamdo a la celebración, organizando la tercera edición del evento BCAM-NAUKAS, que se desarrolló a lo largo del 14 de marzo en el Bizkaia Aretoa de la UPV/EHU.

María Ángeles García Ferrero, que es investigadora postdoctoral en el BCAM, se dedica, entre otras cosas, a los problemas inversos. En esta charla nos presenta algunos en forma de imágenes, desde ingeniosos pasatiempos japoneses a sistemas biológicos.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Día de Pi con BCAM Naukas 2022: María Ángeles García-Ferrero – Imágenes matemáticas se ha escrito en Cuaderno de Cultura Científica.

Párkinson en una lágrima

Un estudio piloto liderado por la Dra. Elena Vecino, catedrática de Biología Celular y directora del grupo de investigación GOBE de la UPV/EHU, ha detectado potenciales biomarcadores de diagnóstico del párkinson en tan solo una lágrima.

Foto: Luis Gálvez / Unsplash

Foto: Luis Gálvez / UnsplashLa enfermedad de Parkinson es la segunda enfermedad neurodegenerativa más común después de la enfermedad de Alzheimer. Uno de los principales retos en el tratamiento de las enfermedades neurodegenerativas es encontrar marcadores clínicos que permitan la clasificación temprana de los pacientes y ayuden a monitorizar la progresión de la enfermedad. Actualmente una de las pruebas de detección de marcadores de párkinson se realiza mediante punción lumbar y extracción de líquido cefalorraquídeo, pero un estudio dirigido por la UPV/EHU intenta detectarlo por otra vía menos invasiva. “Como el párkinson afecta a varios sistemas no motores y a los nervios periféricos, la secreción lagrimal podría estar alterada en estos pacientes, y la composición de las proteínas lagrimales podría mostrar un perfil característico en estos pacientes que podría servir como biomarcador de diagnóstico”, explica la Dra. Elena Vecino, catedrática de Biología Celular de la UPV/EHU.

El grupo de investigación GOBE ha analizado por primera vez las lágrimas de pacientes con párkinson con el fin de detectar biomarcadores tempranos de la enfermedad. Se trata de un estudio pionero en la detección en cantidades muy pequeñas (unos 5 microlitros), dirigido por la Dra. Elena Vecino y codirigido por la Dra. Arantxa Acera, investigadora Ikerbasque, en el que ha sido fundamental la participación del neurólogo del Hospital de Cruces Dr. Juan Carlos Gómez y su equipo además de especialistas en Oftalmología del Hospital de Cruces, y el servicio de proteómica del CIC Biogune (la proteómica es el estudio a gran escala de las proteínas).

Este estudio piloto se ha realizado mediante el análisis comparado de las lágrimas de 27 personas control y 27 pacientes con párkinson en distintos estadios de la enfermedad. Los resultados apuntan a una alteración en una serie de proteínas implicadas en la función de los lisosomas, orgánulos celulares responsables de la degradación de sustancias en el interior de la célula. “Hemos localizado estos marcadores (proteínas) sobreexpresados en las lágrimas de pacientes con párkinson”, señala Vecino.

Según explica la catedrática, “la córnea, la parte transparente del ojo, es la estructura más inervada del organismo; la lágrima que baña esta estructura retiene, entre otras sustancias, las proteínas necesarias para mantener el estado de lubricación de nuestros ojos. Entre los cientos de proteínas, casi miles de proteínas, que se pueden detectar en una lágrima, hemos visto que hay una tendencia en unas cuantas a sobreexpresarse, es decir, que aparecen en mayor cantidad en los pacientes de párkinson”.

Detectar el párkinson en una lágrimaEste estudio ha sido el germen de un Proyecto Elkartek, liderado por la UPV/EHU, en el que, además del Hospital de Cruces, se han incorporado los servicios de Neurología y Oftalmología del Hospital Donostia para ampliar el número de pacientes participantes. Además, también se ha incorporado la empresa Tecnalia, con el objetivo de desarrollar un test de detección temprana de la enfermedad con los biomarcadores que sean caracterizados en el estudio de proteómica. Vecino destaca que en el estudio es fundamental la participación de los pacientes; “en particular es de especial importancia la participación de familias afectadas por párkinson congénito. En el País Vasco hay varias familias afectadas por mutaciones que inducen esta enfermedad y el conocimiento de los marcadores tempranos son de especial importancia para el conocimiento de las causas y posterior estudio del tratamiento”.

En opinión de la doctora, “la novedad de este estudio estriba en el análisis individualizado, porque vamos hacia la personalización de la detección de las enfermedades”. Pero afirma que todavía queda mucho por hacer: “Ahora tenemos que mirar por qué sucede la citada sobreexpresión, por qué las neuronas de los pacientes bloquean el mecanismo de los lisosomas. Pero eso lo tenemos que demostrar con más pacientes”. La investigadora se muestra optimista: “Hemos sido los primeros en detectar en una lágrima todas las proteínas que hay y queremos llegar a poder detectar precozmente la patología”. Asimismo, la investigadora afirma que “si esta metodología funciona, el siguiente paso sería poderla aplicar a alzhéimer y a otras enfermedades neurodegenerativas”, concluye.

Referencia:

Arantxa Acera, Juan Carlos Gómez-Esteban, Ane Murueta-Goyena, Marta Galdos, Mikel Azkargorta, Felix Elortza, Noelia Ruzafa, Oliver Ibarrondo, Xandra Pereiro, and Elena Vecino Potential Tear Biomarkers for the Diagnosis of Parkinson’s Disease—A Pilot Study Proteomes 2022 10,4 DOI: 10.3390/proteomes10010004

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Párkinson en una lágrima se ha escrito en Cuaderno de Cultura Científica.

Taxones, paranormal activity en paleontología

En ciencia en general y en geología en particular, cuando queremos ponerle un nombre a algún proceso o estructura, buscamos un término que sea auto-explicativo. Es decir, que ya solo con oírlo, nos hagamos una idea de lo que estamos hablando, sin necesidad de una descripción más profunda. Pero, a veces, somos demasiado literales a la hora de elegir esos nombres. Y aquí os voy a mostrar unos ejemplos, con los que no sabremos si estamos hablando de términos paleontológicos o si queremos contar una película de terror con tintes rockeros.

Pero antes de entrar en detalles, es necesario que haga algunas aclaraciones. Los estudios paleontológicos se basan en la información preservada en el registro fósil, es decir, en los restos de organismos del pasado que se han conservado transformados en rocas. Pero es extremadamente difícil que un resto orgánico se convierta en fósil, la mayor parte de ellos acaban desapareciendo sin dejar huella. Por eso solemos decir que el registro fósil es “incompleto”. Con esto no pretendemos afirmar que sea malo o que no sirva para nada, más bien al contrario, es una manera de recordarnos que nos faltan muchas piezas del puzle que, poco a poco, tenemos que ir completando. Y esto cobra especial relevancia en los estudios evolutivos basados en organismos del pasado, por ese motivo se siguen descubriendo especies fósiles nuevas cada día y se van corrigiendo algunas creencias, incluso certezas, que pensábamos que teníamos ya aseguradas. Es aquí donde entran los protagonistas de hoy.

Taxones Elvis, Lázaro y hasta zombisComo buena amante de la música heavy metal y hard rock, voy a empezar hablando del Rey del Rock, el gran Elvis Presley. Aunque el Rey fue único e inigualable, desde su muerte no han dejado de aparecer cientos de imitadores por medio mundo. Pues esto también les puede suceder a los taxones, que es el término científico para referirse a los grupos faunísticos, a lo largo de la historia evolutiva de nuestro planeta. Podemos encontrarnos con organismos más modernos que son muy similares, casi idénticos a veces, a otros organismos más antiguos. Esto nos lleva a pensar que se trata de sus descendentes evolutivos, pero en realidad no tienen nada que ver. Sus semejanzas morfológicas son fruto de un proceso denominado convergencia evolutiva, mediante el cual dos organismos desarrollan estructuras morfológicas muy parecidas y con unas funciones casi iguales, pero sus líneas evolutivas se han desenvuelto por separado. A estos organismos más modernos que desarrollan esas semejanzas con los grupos más antiguos, llegando incluso a imitarlos, y que nos llevan a la confusión de creer que están estrechamente emparentados, se les conoce como taxones Elvis.

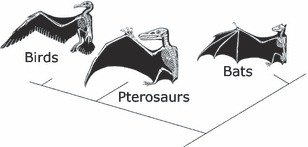

Convergencia evolutiva en las alas de las aves, los pterosaurios (reptiles) y los murciélagos (mamíferos). Los tres grupos han desarrollado un elemento morfológico muy similar y con unas funciones prácticamente idénticas, pero tienen líneas evolutivas diferentes. Imagen tomada de: Seed, A., Emery, N. y Clayton, N. (2009). Intelligence in Corvids and Apes: A Case of Convergent Evolution? Ethology 115, 401-420.