El Puente Bizkaia, icono de la era industrial

Foto: jarnogz / 123rf

Foto: jarnogz / 123rfBizkaia tuvo un enorme desarrollo económico, tecnológico y social en la segunda mitad del siglo el siglo XIX, y alcanzó su máximo esplendor a finales de ese siglo y a principios del siglo XX. Este desarrollo fue consecuencia de la confluencia de varios factores, entre los que se encontraba la explotación eficiente de los recursos minerales del territorio. Clave en esta explotación estuvo el uso de la ría del Nervión como medio de transporte. El crecimiento en habitantes e instalaciones en sus márgenes llevó a la necesidad de construir sistemas que permitieran pasar personas y mercancías de una margen a la otra. Ahí surge la idea del puente Bizkaia en 1888. El Puente de Bizkaia está reconocido por la UNESCO como Patrimonio Mundial de la Humanidad.

En este vídeo se recogen los hitos más importantes en la construcción del Puente de Bizkaia actual, así como algunas de sus características estructurales. El vídeo forma parte del proyecto «La Ría del Nervión a la vista de las ciencias y las tecnologías».

Edición realizada por César Tomé López

El artículo El Puente Bizkaia, icono de la era industrial se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Por qué hay hierro en Bizkaia?

- La ría de Bilbao como medio de transporte de mineral

- Cuando por Bizkaia corrían rinocerontes

Más del 80 % de los varones del País Vasco desciende de antepasados varones que llegaron a la zona en la Edad del Bronce

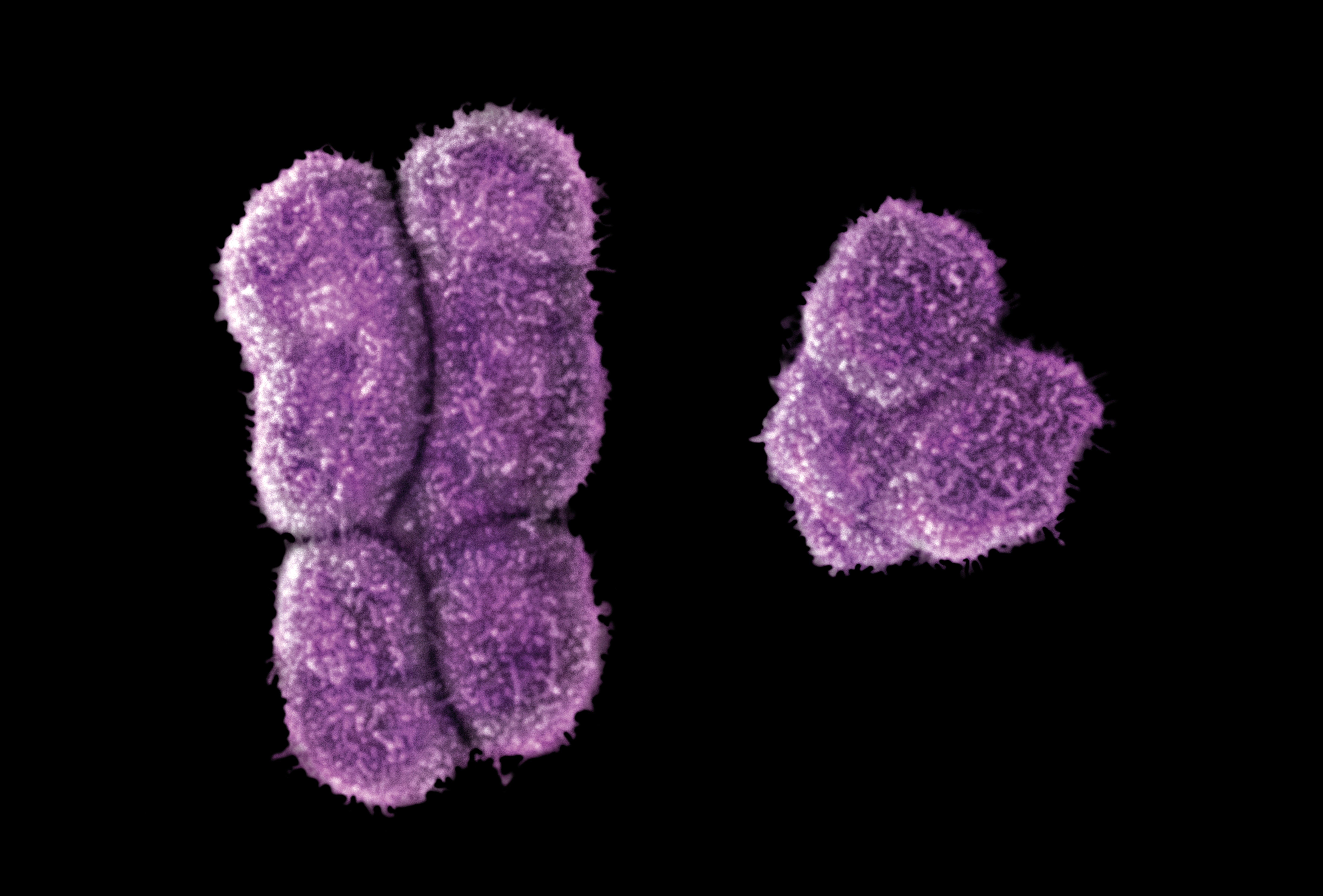

El cromosoma Y (derecha) es más pequeño que el cromosoma X. Fuente: Clark, A. The vital Y chromosome. Nature 508, 463–464 (2014). https://doi.org/10.1038/508463a

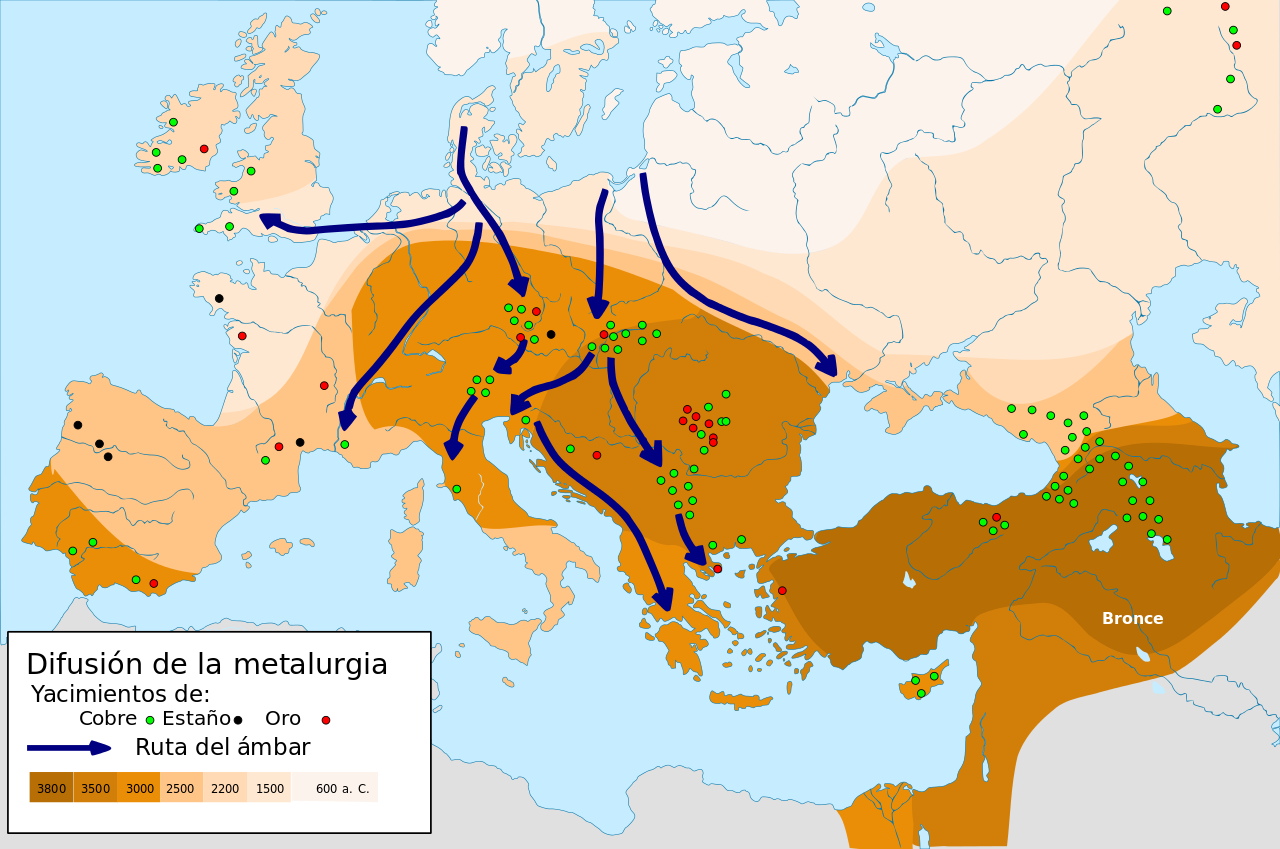

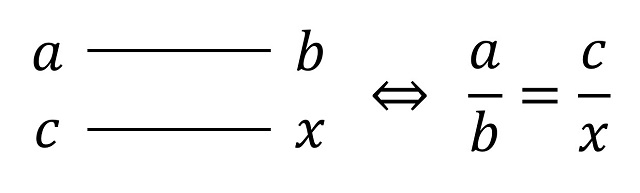

El cromosoma Y (derecha) es más pequeño que el cromosoma X. Fuente: Clark, A. The vital Y chromosome. Nature 508, 463–464 (2014). https://doi.org/10.1038/508463aMás del 80 % de los varones del País Vasco desciende de antepasados varones que llegaron a la zona hace 4.500 años, en la Edad del Bronce.

Los cromosomas son las estructuras que contienen la mayor parte del material genético de cada individuo. El cromosoma Y es un cromosoma que solo está presente en los varones. “Se transmite únicamente de padres a hijos varones y se trata de un marcador de linaje patrilineal que nos permite seguir la evolución de la población”, explica Marian M. de Pancorbo, investigadora del grupo BIOMICs de la UPV/EHU.

Además, “el cromosoma Y tiene ciertas variantes que surgen en un individuo y a partir de él pasan a sus descendientes porque se mantienen muy estables a lo largo de las generaciones. Es el caso de la variante R-S116 en la población del País Vasco, marca característica de más del 80 % de los varones vascos”, explica. “El objetivo de este trabajo, realizado en colaboración con el personal investigador de la Universidad de Santiago de Compostela y de la Escuela Universitaria de Colorado, ha sido realizar un cálculo ajustado para conocer cuándo puede haber surgido esa variante del cromosoma Y centrándonos únicamente en la población del País Vasco”, añade la catedrática de Biología Celular de la UPV/EHU.

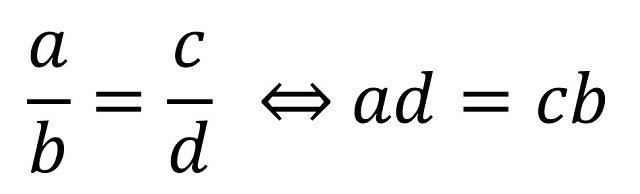

“Para ello se ha analizado un grupo de individuos con la variante característica R-S116 tanto en Álava (75 %), Guipúzcoa (86,7 %) y Vizcaya (87,3 %), y a través de ciertas fórmulas estadísticas en las cuales se tienen en cuenta la tasa de mutación y el tiempo que transcurre de una generación a la siguiente, se calcula el tiempo hasta el ancestro común más reciente”, cuenta Martínez Pancorbo. “El tiempo que transcurre de una generación a otra es muy variable, de ahí que los cálculos de la antigüedad sean orientativos y en lugar de situarse en unos años concretos se sitúan más bien en un periodo, en este caso, por ejemplo, en la Edad del Bronce, alrededor de hace unos 4.500 años”, añade.

“Si estudiamos el linaje materno vemos que en el País Vasco se mantiene el linaje del Paleolítico, es decir, las mujeres siguen transmitiendo el ADN mitocondrial antiguo del Paleolítico entre generación y generación. Sin embargo, al estudiar el cromosoma Y nos hemos encontrado que no procede del Paleolítico, sino que se trata de una variante nueva del Neolítico; como si hace 4.500 años en la Edad del Bronce, surgiera una variante y reemplazara a todos los linajes del cromosoma Y de los varones que vivían en el País Vasco: los antiguos cazadores, recolectores…”, indica Marian Martínez de Pancorbo. “Hemos observado que desde la Edad del Bronce no se siguen transmitiendo aquellos linajes de los varones vascos y los descendientes nuevos que aparecen son hijos de estas nuevas variantes que han llegado. Se trata de un dato muy curioso que llama mucho la atención y que no se comprende muy bien el por qué”, subraya Martínez de Pancorbo.

“Una de las hipótesis que se baraja es que posiblemente cuando llegó aquella población más avanzada tecnológicamente procedente de la estepa euroasiática, los varones tuvieran mayores posibilidades de tener descendientes con las mujeres vascas. Pero insisto —subraya Martínez de Pancorbo— no deja de ser una hipótesis puesto que no hay evidencias de que se eliminara a los varones que en aquel entonces estaban en el territorio que hoy conocemos como País Vasco, porque no hay evidencias de guerras, ni masacres…”. Además, “no deja ser muy curioso que en tan poco tiempo lleguen a reemplazar todo lo que había alrededor”, recalca la investigadora. Podría haberse debido a que los nuevos pobladores, tecnológicamente más avanzados, tuvieran mejores posibilidades para alimentar a sus progenies y por tanto dejasen un mayor número de descendientes que fueran transmitiendo cromosoma Y de tipo R-S116.

Sin embargo, “personalmente tengo otra hipótesis —comenta la catedrática de Biología Celular de la UPV/EHU—que nos gustaría comprobar y quizás nos ayudaría a comprender mejor esto. Tal vez la fertilidad, o la probabilidad de tener hijos varones de aquellos individuos con la variante R-S116 del cromosoma Y era mayor que en los varones con otros tipos de cromosoma Y, y por eso el número de descendientes masculinos que dejan es mayor en cada generación”. “Se podría realizar un estudio y ver simplemente si actualmente los individuos portadores de esa variante del cromosoma Y tienen un número de descendientes varones más alto que el número de hijos varones que tienen otros individuos con otros tipos de variantes del cromosoma Y. Pero no podemos remontarnos a las condiciones de vida de la Edad del Bronce, y puede que los datos actuales no reflejen la realidad antigua, ya que en distintas condiciones de vida los individuos somos más o menos eficientes biológicamente”, señala Martínez de Pancorbo.

Referencia:

Luis, J.R., Palencia-Madrid, L., Mendoza, V.C., Garcia-Bertrand, R., M. de Pancorbo, M. & Herrera, R.J. (2021) The Y chromosome of autochthonous Basque populations and the Bronze Age replacement. Sci Rep 11, 5607 doi:10.1038/s41598-021-84915-1

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Más del 80 % de los varones del País Vasco desciende de antepasados varones que llegaron a la zona en la Edad del Bronce se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El 70% de los varones del País Vasco desciende de un antepasado que vivió hace 4.500 años

- Nuevos neandertales del País Vasco (y algunos que dejan de serlo)

- Estudio de eficacia escolar en el País Vasco

Certezas e incertidumbres sobre el cambio climático

Josep Lluís Pelegrí Llopart

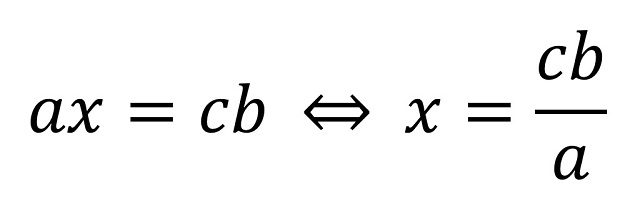

Escultura de Lorenzo Quinn en Venecia.Fuente: Shutterstock / Alena Veasey

Escultura de Lorenzo Quinn en Venecia.Fuente: Shutterstock / Alena Veasey

A mediados del siglo pasado, las primeras voces de la comunidad científica advirtieron sobre la posibilidad de que el clima de la Tierra se modificase por la continua emisión de dióxido de carbono a la atmósfera como resultado de la quema de combustibles fósiles. Esta preocupación llevó, durante la década de los 80, a la creación primero del Programa de Investigación del Clima Global (1980) y posteriormente del Panel Intergubernamental de Cambio Climático (IPCC, 1988).

El IPCC es una entidad de las Naciones Unidas encargada de valorar la ciencia relacionada con el cambio climático. Desde 1990 ha preparado numerosos trabajos relacionados con el cambio climático, entre los que destacan los Informes de Evaluación producidos cada 5-7 años, el último de ellos publicado entre 2013 y 2014 (Quinto Informe de Evaluación). En 2018 y 2019 se publicaron otros tres informes intermedios: el calentamiento global de 1,5 °C, los océanos y la criosfera en el cambio climático y el cambio climático y las zonas terrestres.

Ahora el IPCC acaba de publicar el primer volumen del Sexto Informe de Evaluación, dedicado a las ciencias físicas del cambio climático. Esta evaluación nos envía un contundente mensaje: el aumento de los gases invernadero en la atmósfera ha tenido, tiene y tendrá un grave impacto sobre el clima de la Tierra.

La certeza

La certeza básica –lo que podríamos llamar el punto de partida– es que el rápido aumento de los gases de tipo invernadero es de origen antrópico. Para el periodo 1960-2019, los dos principales gases de efecto invernadero han sido el dióxido de carbono (CO₂) y el metano (CH₄). Su contribución al efecto radiativo es del 63 % para el CO₂ y del 11 % para el CH₄. En el caso del CO₂, aproximadamente 2/3 partes corresponden a la quema de combustibles fósiles y 1/3 parte al uso de la tierra. En el caso del CH₄, la situación se invierte, con 1/3 parte proveniente de los combustibles y las 2/3 partes provenientes de la agricultura y la gestión de residuos.

Esta evidencia indiscutible, conduce a otra realidad que también se considera irrefutable: el aumento de gases invernadero hace que la superficie del planeta haya recibido y siga incorporando un exceso de calor. La radiación de onda larga que emite nuestro planeta no es suficiente para deshacerse de este exceso de energía y la diferencia se almacena principalmente en los océanos (el 91 %). Este desbalance hace que la temperatura del planeta –no solo la de la superficie del globo sino también del océano profundo– haya aumentado sobradamente por encima de los cambios planetarios naturales.

El incremento medio de temperatura del aire en la superficie de la Tierra, entre 1850-1900 y 2011-2020, ha sido de 1,09 °C (1,29 °C entre 1750 y 2019). Sobre las zonas terrestres este aumento ya ha alcanzado 1,61 °C, siendo un 45 % superior a la media planetaria y un 80 % superior al incremento experimentado en la superficie de los océanos.

El desbalance radiativo actual hace que, incluso si dejásemos de emitir gases invernadero, la temperatura del planeta continuaría aumentando. Con el fin de detener este incremento de temperatura lo antes posible, la única solución es eliminar la emisión de gases invernadero. El nuevo informe del IPCC nos advierte que cualquier alternativa de reducción progresiva en la emisión de estos gases ocasionará que la temperatura de la Tierra aumentará durante un periodo más largo.

Los daños colaterales

El Sexto Informe de Evaluación explora detenidamente los posibles impactos colaterales, de alcance global, asociados a la subida de la temperatura del planeta. A lo largo de todo el informe, se valora la confianza y grado de probabilidad de las predicciones. La confianza se determina a partir de la robustez de las evidencias disponibles y por medio del grado de concordancia entre investigadores y metodologías diversas. En la verisimilitud de futuros cambios, se destacan aquellos que tienen un grado de probabilidad muy elevado (90 %) o de casi total certeza (99 %).

Unos de las consecuencias indiscutibles es el aumento del nivel del mar, causado tanto por la expansión del agua que se calienta como por la pérdida de glaciares y hielo continental. El aumento para finales del siglo XXI dependerá del escenario de emisiones. Para un escenario realista se prevé un incremento de entre 0,55 y 0,90 m para finales de siglo, relativo al nivel del mar durante el periodo 1995-2014. Debido al deshielo y el calentamiento de las aguas profundas, el nivel del mar continuará aumentando durante varios siglos, pudiendo perfectamente alcanzar varios metros para el año 2300.

Otro impacto esperado es el incremento en la frecuencia de eventos extremos, tanto las tormentas con fuertes vientos y lluvias extremas como las sequías prolongadas. La combinación del incremento del nivel del mar y las tormentas más extremas reforzará el impacto sobre muchas zonas costeras.

El aumento de la temperatura superficial también conllevará una mayor cantidad de agua en la atmósfera. En particular, se prevé un incremento en precipitación de entre un 2 y un 8 % para finales de siglo, dependiendo del escenario de emisiones de gases invernadero. Sin embargo, las precipitaciones se distribuirán de forma irregular, con sequías en zonas de climas mediterráneos y mucha más lluvia a altas latitudes. La variabilidad interanual también aumentará.

A estos dos ejemplos se le añaden otros como la acidificación y desoxigenación de grandes regiones oceánicas, un considerable aumento en la estratificación de las aguas superficiales y las oleadas de calor marino en regiones costeras. Todo ello con un importante impacto sobre la biodiversidad y salud de los ecosistemas marinos. También vale la pena destacar la previsión de que, durante el verano austral, en el año 2050 ya no habrá hielo ártico, con consecuencias importantes no solo en la biodiversidad de estas regiones sino también en la disminución del albedo polar.

Las incertidumbres

El sexto informe nos dice que el cambio ya es imparable, lo que nos queda por saber es qué niveles alcanzará. Una gran parte del informe se dedica a analizar cuál será la magnitud de estos cambios para diferentes escenarios de emisión de gases invernadero. El informe concluye que si el equilibrio radiativo se logra con aumentos de temperatura moderados, entre 1,5 y 2,0 °C, el impacto sobre el clima tendrá consecuencias mucho menos drásticas.

Para llegar a esta conclusión el informe analiza multitud de factores, en cada caso valorando cuál es la respuesta más probable del sistema climático y a menudo reconociendo un elevado grado de incertidumbre. Se trata de aspectos del sistema climático cuya evolución futura no se conoce con suficiente confianza, a pesar de que tienen un papel muy importante en el aumento de la temperatura.

Un primer factor es la cantidad de dióxido de carbono que terminará en la atmósfera. Durante las seis últimas décadas aproximadamente el 56 % del CO₂ ha terminado en el océano y en la biosfera terrestre. Sin embargo, el informe anticipa que este porcentaje disminuirá progresivamente hasta el extremo de que incluso podría revertirse, de modo que océano y masas terrestres podrían convertirse en fuente de CO₂ en lugar de sumidero.

Otro aspecto de importancia clave es la cinta transportadora global, encargada de distribuir energía hacia altas latitudes y de intercambiar las aguas superficiales y profundas. El informe indica que hay una alta probabilidad de que esta cinta se debilite, incluso previendo la posibilidad de su colapso total, pero con baja fiabilidad.

También se apunta hacia una reducción de las regiones con permafrost, que es la capa de suelo permanentemente congelada que ha acumulado grandes cantidades de materia orgánica. Su efecto parece estar muy por debajo del impacto que ocasiona la quema de combustibles fósiles pero el grado de incertidumbre es elevado.

Otro factor importante e incierto para el clima futuro de nuestro planeta es la evolución de las grandes masas de hielo antártico, localizadas en zonas emergidas sobre este continente. A diferencia de la región ártica, su posible deshielo vendrá condicionado no por la temperatura del aire sino sobre todo por la temperatura de las aguas subsuperficiales.

Finalmente, el ciclo de agua, especialmente en lo relativo a la formación de nubes y sus efectos albedo e invernadero, se mantiene como uno de los elementos con mayor incertidumbre. El fortalecimiento del ciclo del agua, con cambios significativos en la cantidad de vapor de agua en la atmósfera, podría ocasionar diferencias regionales importantes en las tasas de evapotranspiración.

La mayor incertidumbre

El clima de la Tierra está cambiando y cambiará aún más como resultado de un ritmo de vida insostenible que mantiene una parte de la población planetaria. A corto plazo experimentaremos fuertes sequías y lluvias torrenciales. A medio plazo viviremos una progresiva desertización de grandes regiones planetarias y nuestras costas y sus habitantes sufrirán fuertes temporales marinos superpuestos a un nivel de mar en lento pero progresivo aumento. A largo plazo, dejaremos a las generaciones futuras, a los nietos de nuestros nietos, un litoral inundado y en continuo retroceso.

El cambio climático conllevará también un fuerte impacto sobre los ecosistemas terrestres y marinos, deteriorando la salud de ecosistemas regionales y la resiliencia del sistema climático tal como lo conocemos. En el horizonte se vislumbra, como una realidad casi inminente, un sistema climático distinto al actual, para el cual la especie humana no se encuentra bien adaptada.

Sin duda es un aviso que nos dice que no estamos en el buen camino. ¿Cuál será nuestra respuesta? ¿Miraremos con amor y empatía a nuestros vecinos amenazados, con menos posibilidades de adaptarse que nosotros, y a esos nietos lejanos que no conoceremos? ¿Nos imaginaremos formando parte del planeta? ¿O seguiremos actuando como sus dueños y usuarios, con nuestras comodidades y lujos absurdos?

¿Seremos capaces de reinventarnos en nuestros pequeños gestos diarios? Reciclar, reutilizar, reducir… desde el consumo sostenible hasta nuestro goce armónico junto con la naturaleza. La respuesta está en nuestras manos, todos tenemos nuestra responsabilidad personal diaria y todos tenemos la oportunidad de exigir esta misma responsabilidad a nuestros gobernantes.

La humanidad ha ocasionado el cambio climático actual, y la humanidad también, paradójicamente, es la mayor incertidumbre en el futuro climático que nos espera.![]()

Sobre el autor: Josep Lluís Pelegrí Llopart esoceanógrafo, profesor de investigación y director del Instituto de Ciencias del Mar (ICM-CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Certezas e incertidumbres sobre el cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Geología, Antropoceno y cambio climático

- Dani y Fiti sobre el cambio climático

- Los ecosistemas acuáticos de África y el cambio climático

En agosto, como en abril, refranes mil

En la reciente trilogía de entradas del Cuaderno de Cultura Científica «Las emocionantes aventuras del número tres» (primera parte, segunda parte y tercera parte), se recogían algunos refranes y expresiones que contenían al número tres, como No hay dos sin tres, o Los números nones son los mejores, y el número tres el mejor (de todos) es. Pensando en estos refranes, me ha parecido interesante dedicar esta entrada estival a refranes en los que aparezcan números.

Portada del hermoso cuento infantil ilustrado La guerra de los números (OQO editora, 2009), de Juan Darién, Premio Ilustración 2008 de la Fundación Cultural CJ

Portada del hermoso cuento infantil ilustrado La guerra de los números (OQO editora, 2009), de Juan Darién, Premio Ilustración 2008 de la Fundación Cultural CJ

La verdad es que no soy una persona de refranes, pero sí he vivido rodeado de personas que lo eran, como mi abuelo materno, que conocía muchos y a quien siempre le gustaba citar algún refrán si la situación lo permitía. Aunque, como la mayoría de las personas, conozco una buena cantidad de refranes, ya que algunos son tan populares que su uso suele ser muy cotidiano.

Empezaremos con algunos refranes sobre el número dos. Por ejemplo, el refrán que dice:

Dos no discuten (riñen) si uno no quiere.

Este refrán nos viene a decir que si no entramos en las provocaciones de otras personas no discutiremos, o nos pelearemos, con ellas, o que por mucho que se empeñe una persona en discutir con otra, si esta no quiere, no habrá discusión. El refrán admite muchos enunciados similares, como Cuando uno no quiere, dos no barajan (como se indica en el diccionario de la RAE, una de las acepciones, en desuso, del verbo “barajar” es “reñir, altercar o contender con otros”) o Cuando uno no quiere, dos no pelean. Este refrán aparece mencionado en el libro Refranes que dicen las viejas tras el fuego (1508), de Íñigo López de Mendoza, Marqués de Santillana, así como en el Tesoro de la lengua castellana o española (1611), de Sebastián de Covarrubias Orozco.

El refrán es bastante universal y nos lo encontramos en varios idiomas. Así en gallego se dice Cando un non quere, dous non barallan (cuando uno no quiere, dos no disputan), en euskera Idia ez da bakarrik uztartzen (el buey no se unce solo), en inglés se dice It takes two to make a quarrel (hacen falta dos para una pelea), en francés Pour se battre il faut être deux (para luchar hacen falta ser dos), en alemán Wer allein zankt, zankt nicht lange (quien discute solo, no discute mucho tiempo), aunque el refrán es antiguo y nos lo encontramos ya en latín, Duo sunt ad litem necessarii (dos son necesarios para reñir).

En la novela Don Quijote de la Mancha (1605 y 1614), del escritor madrileño Miguel de Cervantes Saavedra (1547-1616), aparecen citados muchos refranes. Uno de los cuales es:

Más vale un ‘toma’ que dos ‘te daré’.

Este refrán transmite la idea de que es mejor disfrutar de lo que nos ofrece el presente, que esperar a un posible futuro mejor. Aunque es un refrán que ya no se utiliza mucho. De nuevo, como muchos otros refranes, es bastante universal, en algunos idiomas con la misma expresión, como en francés, pero en otros con variaciones. En inglés se dice One today is worth two tomorrows (Uno de hoy vale dos de mañana), en griego Κάλλιο το σημερινό ψωμί, παρά την αυριανή πίτα (Mejor el pan de hoy que la tarta de mañana) y en algunos casos se cambia el número dos por cien, como en italiano.

El número 2 en diferentes tipografías: Arial Black, Batang, Bodoni MT Black, Broadway, Cooper Black, Century, Gigi, Goudy Stout, Jokerman y Stencil

El número 2 en diferentes tipografías: Arial Black, Batang, Bodoni MT Black, Broadway, Cooper Black, Century, Gigi, Goudy Stout, Jokerman y Stencil

Otro refrán conocido en alguna de sus formas es:

Al que no quiere caldo, dos tazas.

También se dice Si no quieres caldo, toma tres tazas, Si no quieres caldo, taza y media, y otras expresiones similares. En euskera se dice Nahi ez duen mandoak, bi zaldare (A mulo que no quiere pienso se le da el doble) o en catalán No vols brou?, tassa i mitja (¿No quieres caldo?, taza y media). Como se menciona en el Centro Virtual Cervantes, que recoge muchos estudios sobre refranes populares en lengua española, el significado de este refrán es que “resulta conveniente contentarse con aceptar las cosas como vienen, porque, de lo contrario, se corre el riesgo de recibir lo que no se desea, pero en una cantidad mayor o duplicada”.

Seguimos con refranes que utilizan el número dos, como:

Quien se enfada, dos trabajos (problemas) tiene.

En una de las variantes de este refrán se explica incluso cuáles son esos trabajos, ya que dice así El que se enoja tiene dos trabajos: enojarse y contentarse. En ocasiones se utiliza a modo de broma con una persona que se está empezando a picarse, para que se le pase el cabreo. Otra variación de este refrán parece tener relación con los enfados de los niños y niñas, en particular, a la hora de comer, ya que dice así: Quien se enoja, dos trabajos tiene, y tres si no come.

El siguiente refrán es el título de una comedia del dramaturgo madrileño Calderón de la Barca (1600-1681):

Casa con dos puertas, mala es de guardar.

En Refranes que dicen las viejas tras el fuego (1508), del Marqués de Santillana, aparece expresado de la siguiente manera Todo te haré, mas casa con dos puertas no te guardaré. Este mismo refrán Casa con dos puertas, mala es de guardar aparece en varios idiomas con la misma expresión, mientras que en otros se utilizan pequeñas variaciones, como en italiano Se vuoi guardar la casa, fai un uscio solo (Si quieres guardar la casa, haz una sola puerta) o griego Για να φυλάξεις το σπίτι σου, έχε μόνο μια πόρτα (Para cuidar tu casa, ten sólo una puerta).

Hay muchos refranes, la mayoría desconocidos para mí, que contienen al número dos, como: a) Dos pájaros en una espiga hacen mala compañía (que alude al hecho de que es difícil dirigir algo entre varias personas); b) Dos que duermen en un colchón, se vuelven de la misma condición; c) Entre dos muelas cordales, nunca metas tus pulgares (que según el Centro Virtual Cervantes “No es aconsejable entrar en conflictos familiares, porque los que son de la misma sangre suelen después entenderse y pueden achacar a los extraños una culpa que no les corresponde y, de esa forma, se pierde la amistad” y es otro de los que aparecen en Don Quijote de la Mancha); d) Entre dos que se quieran con uno que coma basta (nos habla del sacrificio por la persona amada); e) Hombre prevenido, vale por dos; f) Quien da primero da dos veces (que aparece en la siempre presente novela de Miguel de Cervantes); g) Quien se pone debajo de la hoja, dos veces se moja; h) Dos aguas de abril y una de mayo, valen los bueyes y el carro (que como explica el CVC quería decir que “la abundancia de las cosechas depende de las lluvias y las templanzas de estos dos meses, concretamente de las lluvias de primavera”); i) Freídle un huevo, que dos merece; j) La una mano lava la otra, y las dos al rostro (que como explica el CVC “alude a la necesidad de ayudarse unos a otros para conseguir las cosas, al tiempo que recuerda la obligación de corresponder a las ayudas que nos prestan. Se refiere también al alivio o a la ventaja de que alguien nos ayude para acabar antes y con menos esfuerzo”).

El número 3 en diferentes tipografías: Vineta BT, Viner Hand ITC, Times New Roman, Stencil, Snap ITC, Segoe Script, Rockwell Condensed, Goudy Stout, Playbill y Magneto

El número 3 en diferentes tipografías: Vineta BT, Viner Hand ITC, Times New Roman, Stencil, Snap ITC, Segoe Script, Rockwell Condensed, Goudy Stout, Playbill y Magneto

Un refrán muy conocido que nos liga los números dos y tres es:

Dos es compañía, tres es multitud.

Como se explica en el Centro Virtual Cervantes “se dice cuando es preferible limitar el número de personas para conseguir que reine la concordia” o que muchas personas en una misma actividad o negocio, no traen nada bueno. También se suele utilizar en relación a las parejas. En euskera cuando hay una tercera persona que molesta se dice Hara bi zu bat eta bestea ni (He aquí dos, uno tú y otro yo); en gallego se dice Compañía de tres fíxoa o demo (Compañía de tres la hizo el demonio); en catalán Més de dos són massa (Más de dos son demasiados).

Sobre el número tres ya hemos citado algunos refranes más conocidos, ahora mostraremos algunos otros que lo son menos. El primero:

A pan de quince días, hambre de tres semanas,

que ya está en desuso y que aludía a que cuando las cosas vienen mal dadas hay que aceptar lo que nos viene. Una versión más moderna sería Para el hambriento no hay pan duro.

Seguimos con otro refrán con el número tres:

El huésped y el pez, a los tres días hiede.

En Cuba se dice El invitado y el pescado al tercer día apestan o en Colombia La visita y la pesca a los tres días apesta, que además tiene rima. En gallego es parecido O hóspede e o peixe aos tres días feden (El huésped y el pez a los tres días hieden), así como en catalán L’hoste i el peix menut, més de tres dies put (El huésped y el pez pequeño, más de tres días hiede) y en euskera se dice Arraina eta arrotza, heren egunak karatzez, (usain txarrez) kanpora deragotza (bota) (que podríamos traducir –gracias al traductor- como El invitado, como el pescado, al tercer día empieza a apestar, mejor deshacerse de él). Y casi con la misma expresión existe en muchos más idiomas.

Otro refrán que ya está en desuso es:

Secreto de uno, de ninguno; de dos, sábelo Dios; de tres, secreto no es,

cuyo significado no hace falta explicar mucho. Es difícil guardar un secreto si lo conocen más de dos personas. La versión que aparece en el Vocabulario de refranes y frases proverbiales (1627), de Gonzalo Correas es Secreto de dos, sábelo Dios; secreto de tres, toda res (donde “toda res” significa todo el mundo). La versión de este refrán en euskera era Hiru belarritan igaran hitz isila, orotan lasterka dabila (El secreto que ha recorrido tres orejas va corriendo por todas partes); en catalán Secret d’un és secret, secret de dos és dificultós[,] i secret de tres descobert és (Secreto de uno es secreto, secreto de dos es dificultoso, y secreto de tres descubierto es); y en gallego Segredo de dous sábeo Deus; segredo de tres sábeo quen quer (Secreto de dos lo sabe Dios; secreto de tres lo sabe cualquiera). La versión del refrán en inglés tiene su coña, ya que dice así Three may keep a secret, if two of them are dead (Tres pueden guardar un secreto, si dos de ellos están muertos); en francés es Secret de trois, secret de tous (Secreto de tres, secreto de todos); y en alemán Zum Geheimnis ist einer zu wenig und drei schon zu viel (Para el secreto uno es demasiado poco y tres son demasiados).

Unos pocos refranes más con el número tres: a) Un médico cura, dos dudan, tres muerte segura (que no deja muy bien parados a los médicos y recomienda no visitarles mucho, o también no acudir a varios médicos para una misma dolencia); b) Dios, dame dos, y si me das tres, no te pido otra vez; c) Nueve meses de invierno y tres de infierno (en referencia al clima de Castilla); d) Con tres pes abrirás camino: pan, paciencia y padrino; e) Al muerto y al consorte, a los tres días ya no hay quien los soporte; f) Ninguna maravilla dura más de tres días; luego con otra se olvida.

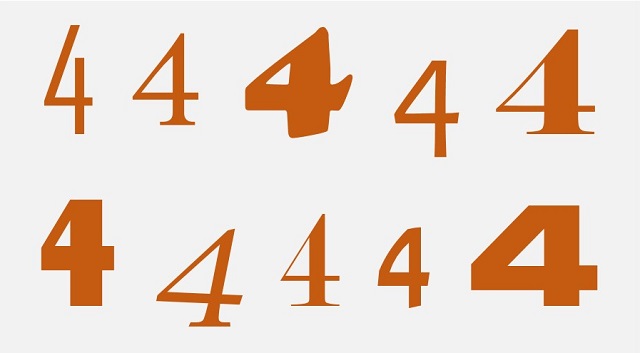

El número 4 en diferentes tipografías: Agency FB, Andalus, Goudy Stout, Candara, Elephant, Gill Sans Ultrabold Condensed, Lucida Calligraphy, Modern n. 20, Narkisim y Swis 721 Blkex BT

El número 4 en diferentes tipografías: Agency FB, Andalus, Goudy Stout, Candara, Elephant, Gill Sans Ultrabold Condensed, Lucida Calligraphy, Modern n. 20, Narkisim y Swis 721 Blkex BT

Vayamos a por refranes con el número cuatro. Empezamos con un refrán conocido:

Cuatro ojos ven más que dos.

Este refrán nos viene a decir que dos personas, o más, encuentran mejor solución a los problemas, y mucho antes. De hecho, en ruso el refrán es Одна голова хорошо, а две лучше (Dos cabezas valen más que una), aunque en la mayoría de los idiomas el enunciado es exactamente como en castellano.

Otro refrán más o menos usado es

Donde comen tres, comen cuatro,

o también, Donde comen cuatro, comen cinco, aunque el refrán entero es En la mesa de San Francisco, donde comen cuatro comen cinco. En francés se dice Quand il y en a pour deux il y en a pour trois (Cuando hay para dos hay para tres); en alemán Wo vier essen, wird auch der fünfte satt (Donde comen cuatro también se sacia el quinto); como vemos el significado es el mismo en los distintos idiomas, aunque varían los números dos, tres, cuatro, cinco, de hecho, en inglés el refrán dice Always room for one more (siempre hay sitio para uno más).

Todos los refranes encierran cierto tipo de sabiduría, o aprendizaje, como este otro refrán:

Si haces barato, venderás más que cuatro,

que nos habla de la relación entre el precio del producto y la cantidad que se vende. De hecho, el refrán en alemán es más explícito Wer wohlfeil verkauft, hat viel Zuspruch (Quien vende a buen precio tiene mucha demanda).

Un refrán bastante popular pero que ha caído en desuso por la desaparición de la peseta, por la llegada del euro, es el siguiente:

Nadie da duros a cuatro pesetas.

Para quienes no la conocieron, la moneda de un duro valía cinco pesetas, por lo tanto, el refrán quería decir que nadie da nada de forma gratuita, sin recibir nada a cambio. Y nos advierte ante los timos, en los que “nos ofrecen duros a cuatro pesetas”.

Otro refrán económico:

Quien tiene cuatro y gasta cinco, no ha menester bolsico (o bolsillo).

Este refrán nos dice claramente que si gastamos más de lo que tenemos o ganamos, nunca ahorraremos, de hecho, acabaremos con deudas.

El número 5 en diferentes tipografías: Wide Latin, Tempus Sans, FreesiaUPC, Castellar, Georgia, Script MT Bold, PMingLiU-ExtB, Cooper Black, Copperplate Gothic Bold y BankGothic Lt BT

El número 5 en diferentes tipografías: Wide Latin, Tempus Sans, FreesiaUPC, Castellar, Georgia, Script MT Bold, PMingLiU-ExtB, Cooper Black, Copperplate Gothic Bold y BankGothic Lt BT

En el libro Diccionario de refranes comentado, de Regino Etxabe, encontramos algún refrán más con el número cinco, como:

Árbol de buen natío, toma un palmo y paga cinco,

es decir, un buen árbol ocupa poco espacio y da mucho fruto, que se utiliza para que no nos dejemos llevar por las apariencias.

Y un refrán deportivo:

El mejor perder un día 5-0, que cinco días 1-0,

que nos transmite la idea de que en el ámbito deportivo muchas veces hay que arriesgar y jugar al ataque, aunque eso pueda conllevar una abultada derrota.

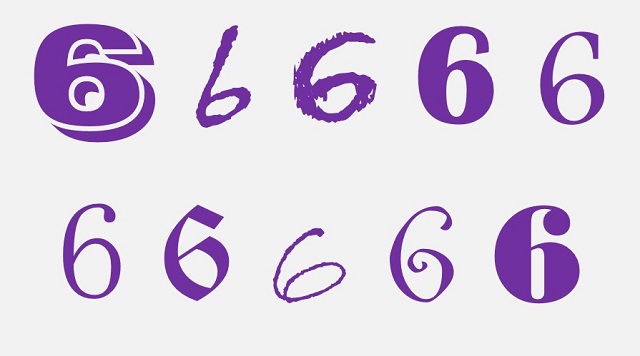

El número 6 en diferentes tipografías: Vineta BT, Viner Hand ITC, Eraser, Britannic Bold, Footlight MT Light, MS Mincho, Old English Text MT, Bradley Hand ITC, Curlz MT y Bodoni MT Black

El número 6 en diferentes tipografías: Vineta BT, Viner Hand ITC, Eraser, Britannic Bold, Footlight MT Light, MS Mincho, Old English Text MT, Bradley Hand ITC, Curlz MT y Bodoni MT Black

Existen muchos refranes referidos al tiempo y ahí encontramos algún refrán con el número seis, como este:

Cuando a las seis veas oscurecer, otoño seguro es.

Otra versión referida al mes de diciembre dice Cuando en diciembre empieza a llover, la noche se oscurecerá a las seis. Y uno más meteorológico:

El que compra el paraguas cuando llueve, valiendo seis le cobran nueve.

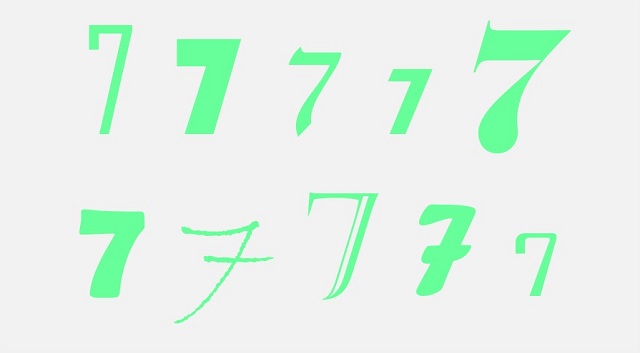

El número 7 en diferentes tipografías: Agency FB, Bauhaus 93, David, Aharoni, Elephant, Berlin Sans FB Demi, Bradley Hand ITC, Castellar, Forte y IrisUPC

El número 7 en diferentes tipografías: Agency FB, Bauhaus 93, David, Aharoni, Elephant, Berlin Sans FB Demi, Bradley Hand ITC, Castellar, Forte y IrisUPC

Empezamos los refranes que contienen al número siete con un refrán que nos aconseja la calidad antes de la cantidad:

Más valen dos bocados de vaca que siete de patata.

De hecho, en francés es un refrán explícito, sin metáfora, La qualité vaut mieux que la quantité (Más vale la calidad que la cantidad), aunque me gustan más los refranes menos literales. En alemán se dice Besser ein Lot Gold als ein Pfund Blei (Más vale media onza de oro que una libra de plomo), pero no aparece en muchos más idiomas.

Otros refranes con el número siete: a) Un año bueno da para siete malos; b) Año de siete, deja España y vete (asociando al siete con la mala suerte); c) No alabes ni desalabes hasta siete navidades (nos habla de que no es bueno prejuzgar a una persona o dejarse llevar por la primera impresión, en general se puede utilizar como apelación a la prudencia); d) No era nada la meada, y calaba siete colchones y una frazada, aunque también se utiliza y una manta (este refrán se utiliza cuando alguien quita importancia a algo que sí la tiene y mucho, otro similar es ¡No es nada lo del ojo… y lo llevaba en la mano!).

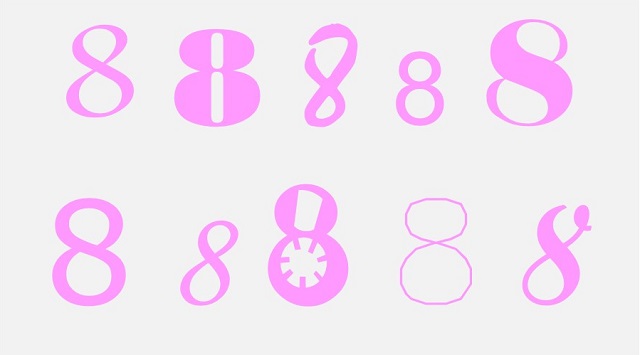

El número 8 en diferentes tipografías: Andalus, Bodoni MT Black, Mistral, Utsaah, Elephant, MS Reference Sans Serif, Monotype Corsiva, Jokerman, GDT y Script MT Bold

El número 8 en diferentes tipografías: Andalus, Bodoni MT Black, Mistral, Utsaah, Elephant, MS Reference Sans Serif, Monotype Corsiva, Jokerman, GDT y Script MT Bold

Un par de refranes con el número ocho son:

Tan contenta va una gallina con un pollo, como otra con ocho,

que habla del amor de una madre por sus hijos, ya sea uno o muchos; y un refrán más agrícola:

Cebada granada, a los ocho días segada.

El número 9 en diferentes tipografías: Dutch801 Rm BT, Bernard MT Condensed, Swis721 BlkOul BT, JasmineUPC, Felix Titling, Blackadder ITC, Tw Cen MT, Gigi, Cooper Black y Bradley Hand ITC

El número 9 en diferentes tipografías: Dutch801 Rm BT, Bernard MT Condensed, Swis721 BlkOul BT, JasmineUPC, Felix Titling, Blackadder ITC, Tw Cen MT, Gigi, Cooper Black y Bradley Hand ITC

No hay muchos más refranes sobre el número nueve que los vistos anteriormente. A continuación, veamos uno con el número diez, que en su versión larga menciona también al nueve, este es:

A las diez en la cama estés,

que recomienda acostarse pronto, así se podrá descansar bien y afrontar mejor el siguiente día y que en su versión más extendida dice A las diez en la cama estés, y si puede ser, a las nueve. En euskera se dice Munduen nahi dabenak luzeroen bizi, olluekin erretirau ta , txoriekin jagi (Quien quiere vivir durante mucho tiempo, que se acueste con las gallinas y que se levante con los pájaros); en inglés Early to bed, early to rise, makes a man healthy, wealthy and wise (Acostarse temprano y levantarse temprano hacen al hombre sano, rico y sabio) o en francés Si tu veux bien te porter, couche-toi tôt et lève-toi tôt (Si te quieres encontrar sano, acuéstate pronto y levántate temprano).

Un refrán relacionado con este es:

A las diez, deja la calle para quien es,

que nos habla de los peligros de la noche. Y seguimos con algunos refranes más con el número diez que he encontrado en el libro Refranero: refranes y expresiones populares, de Pierre Marie Mouronval Morales: a) Lo que desenredan diez hombres buenos, lo vuelve a enredar un picapleitos (que no habla precisamente bien de los abogados); b) Una vez salí y diez me arrepentí; c) El amigo que está presente vale por diez ausentes; d) Mucho más trabajo cuesta hacer un libro que hacer diez hijos; e) Más aprende un pobre en un mes, que un rico en años diez.

El número 0 en diferentes tipografías: Bradley Hand ITC, Bodoni MT, Vani, Imprint MT Shadow, Curlz MT, BankGothic Md BT, Vineta BT, Batang, Freestyle Script y Gill Sans Ultra Bold

El número 0 en diferentes tipografías: Bradley Hand ITC, Bodoni MT, Vani, Imprint MT Shadow, Curlz MT, BankGothic Md BT, Vineta BT, Batang, Freestyle Script y Gill Sans Ultra Bold

Algunos refranes con el número cien. Este primero es muy conocido, e incluso ha dado título a una película:

Quien roba a un ladrón, tiene cien años de perdón,

que disculpa a quien comete una mala acción contra alguien malvado. En La Celestina () se cita como Quien engaña al engañador cien años de perdón. Este es otro refrán ampliamente difundido. En inglés se dice It’s no crime to steal from a thief (No es un crimen robar a un ladrón); en francés C’est une bonne action de volerle larron (Es una buena acción robar a un ladrón); en italiano Chi ruba a un buon ladron ha cent’anni di perdon (Quien roba a un buen ladrón tiene cien años de perdón); o en alemán Wer einen Betrüger betrügt und einen Dieb bestiehlt, erhält hundert Jahr Ablass (Quien engaña a un timador y roba a un ladrón consigue cien años de indulgencia). Pero incluso nos lo encontramos en latín, Dolus cum dolo compensatur (Engaño con engaño se compensa).

Otro refrán muy conocido es:

Más vale pájaro en mano, que ciento volando,

que pone en valor lo que tenemos, aunque sea normal o escaso, frente a aquello más perfecto que deseamos, pero que es posible que nunca consigamos. Entre las diferentes versiones de este refrán tenemos Más vale pájaro en la barriga que ciento en la liga. La versión en euskera es Aireko txoriarentzat eskuakoa es utz (No dejes el pájaro de la mano para cazar el del aire).

Y otro muy conocido:

No hay mal que cien años dure.

Algunos refranes más: a) Si una puerta se cierra, ciento se abren; b) Dios me dé cien enemigos y no me dé un falso amigo; c) El bien hacer abre cien puertas y el mal agradecer las cierra; d) Quien come la vaca del rey, a cien años paga los huesos; e) Más caga un buey que cien golondrinas; f) Más discurre un hambriento que cien letrados.

Y terminemos con dos refranes con el número mil,

Antes de mil años todos seremos calvos,

y el que da título a esta entrada del Cuaderno de Cultura Científica,

En abril, aguas mil.

Bibliografía

1.- Jesús Cantera Ortiz de Urbina, Julia Sevilla Muñoz, Refranes que dizen las viejas tras el fuego, los refranes recopilados por el Marqués de Santillana, Centro Virtual Cervantes Instituto Cervantes, 2018.

2.- Centro Virtual Cervantes, del Instituto Cervantes.

3.- Regino Etxabe, Diccionario de refranes comentado, Ediciones de la Torre, 2012.

4.- Buscapalabra: Refranes y dichos

5.- Pierre Marie Mouronval Morales, Refranero: refranes y expresiones populares, CreateSpace Independent Publishing Platform, 2017.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo En agosto, como en abril, refranes mil se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Abril comienza con matemáticas y bromas

- Y tú, ¿cómo cuentas con los dedos? (1)

- La simetría como estrategia ganadora: la margarita y bloqueado

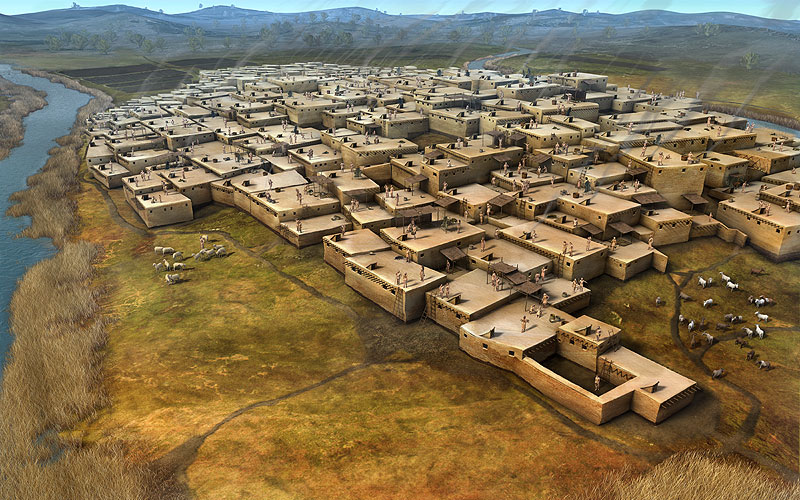

Antes del hierro

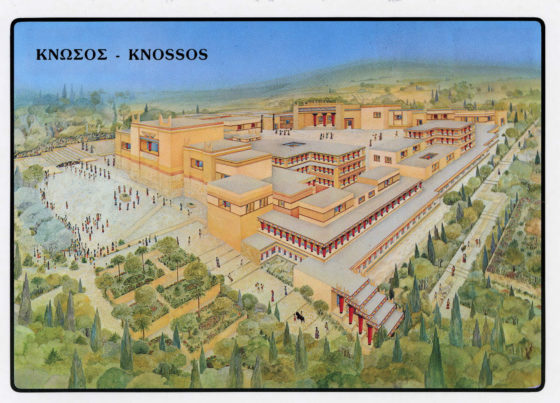

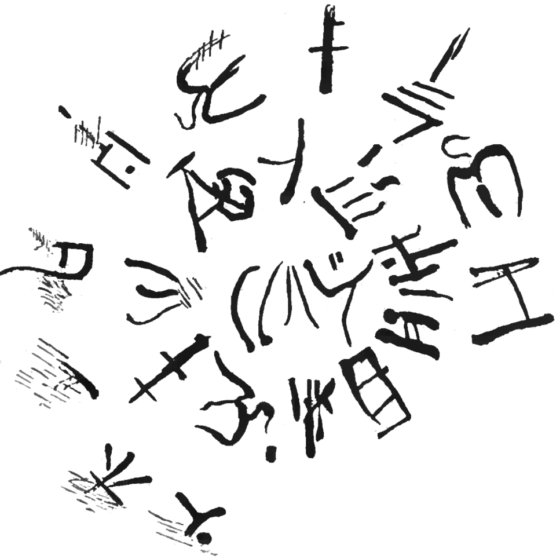

Grecia y las islas del Egeo estuvieron inicialmente sujetas al imperio de Creta antes de obtener la independencia a mediados del segundo milenio a.e.c. Esta civilización, centrada en el Peloponeso griego, era desconocida hasta su descubrimiento por Heinrich Schliemann en el siglo XIX. Schliemann ya había descubierto la antigua Troya en el noroeste de Turquía. Afirmó haber descubierto la patria del rey Príamo y el príncipe Héctor de Troya y los reinos de Menelao y Agamenón, hermanos y reyes de Esparta y Micenas y Argos. Schliemann se refirió a las culturas de la Edad del Bronce del Egeo y Grecia como la civilización micénica, mientras que actualmente se prefiere el término periodo heládico.

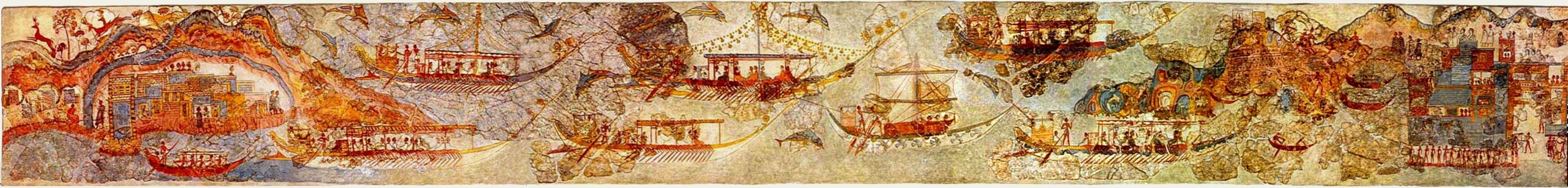

Los micénicos eran similares a los minoicos en su sofisticación en distintas técnicas, desde la metalurgia a la construcción de barcos, y estaban muy avanzados en el comercio y en las cuestiones militares, incluida la construcción de fortalezas. Poseían una forma de escritura, quizás derivada de la civilización minoica, la Lineal B. Los reyes y los aristócratas gobernaban, y la mayor parte de la población eran agricultores y pastores, si bien existía una clase media de artesanos, escribas, médicos y comerciantes.

El consejo de los dioses (1517-18) por Raffaello Sanzio «Rafael». Fresco, Villa Farnesina (Roma).

El consejo de los dioses (1517-18) por Raffaello Sanzio «Rafael». Fresco, Villa Farnesina (Roma).La civilización micénica era patriarcal, como se refleja en sus deidades, dominada por el dios masculino Zeus. La gente de Grecia, como la de Creta, trató de explicar el funcionamiento de la naturaleza, pero no pasó de imaginar fuerzas sobrenaturales trabajando de forma invisible tras la inmensidad del cielo, en las profundidades del mar o en el interior de la tierra, produciendo rayos, proporcionando la fertilidad del suelo y de los humanos, jugando con las emociones humanas e interviniendo en la enfermedad y la muerte. Los dioses griegos, que gobernaban desde el Monte Olimpo, personificaban las fuerzas de la naturaleza para estos pueblos de la Edad del Bronce.

A principios del siglo XII a.e.c. se produjo un hecho que alteraría para siempre las civilizaciones del Mediterráneo oriental. Invasores del norte de Europa con armas de hierro emigraron a los Balcanes y a Asia Menor y al sur a Palestina y Egipto. Eran nómadas y primitivos, analfabetos y violentos, pero habían encontrado el secreto de la fundición del hierro, lo que los hacía poco menos que imparables. Los griegos llamaron dorios a los invasores; destruyeron la civilización micénica y tomaron el control especialmente de Grecia occidental y del Peloponeso. Es incluso posible que tuviesen un papel en la caída de Troya.

Hoplita (soldado de infantería pesada) del siglo V a.e.c. Posiblemente represente a un dorio, el rey Leónidas I de Esparta, quien moriría junto a sus tropas defendiendo el paso de las Termópilas frente a la invasión del imperio aqueménida encabezado por Jerjes durante la segunda guerra médica.

Hoplita (soldado de infantería pesada) del siglo V a.e.c. Posiblemente represente a un dorio, el rey Leónidas I de Esparta, quien moriría junto a sus tropas defendiendo el paso de las Termópilas frente a la invasión del imperio aqueménida encabezado por Jerjes durante la segunda guerra médica.Estos mismos invasores conquistaron el imperio hitita de Asia Menor, posiblemente fuesen los que amenazaron a los judíos de Palestina (los filisteos) y atacaron a los egipcios. Aunque fueron rechazados por Egipto, los egipcios estaban aterrorizados por esta gente del mar. En ocasiones, se hace referencia a estos invasores como los «pueblos del mar».

Los habitantes de las ciudades y pueblos micénicos huyeron ante el avance dórico, migrando hacia el este hasta las penínsulas extremas del continente, las islas del Egeo y la costa occidental de Turquía. Estos migrantes, posteriormente llamadas jonios, fundaron ciudades-estado jónicas: Atenas, Mileto, Quíos, Samos, Halicarnaso, Cos, Colofón o Éfeso son algunas de ellas.

Los jonios y dorios de los siglos posteriores siempre se consideraron diferentes. Tenían tradiciones e idiomas similares y adoraban dioses y diosas similares, pero el nivel y la sofisticación de sus respectivas culturas eran muy diferentes. Los dorios eran más militaristas y sus ciudades se centraban en la guerra y la defensa en lugar del arte, la poesía y la ciencia. Los jonios, por otro lado, se dedicaron al pensamiento, la cultura, la investigación de la naturaleza y la expresión de sus ideas. Con el tiempo, los jonios se convirtieron en los líderes de la ciencia griega durante las eras arcaica, clásica y helenística de Grecia. Las ciudades de Atenas, Mileto, Cos y Quíos se convirtieron en centros de filosofía y ciencia. Homero, Tales, Anaxágoras, Anaximandro, Hipócrates, Sócrates y Platón fueron representantes de los filósofos, científicos y médicos jonios.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Antes del hierro se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:¿Estamos solos en el universo?

Si hay un tema que ha fascinado a todos por igual desde el inicio de los tiempos ese ha sido la necesidad de saber si estamos solos en el universo o si al igual que nosotros hemos poblado la Tierra, hay también vida en otros planetas.

Imagen: Herbert York, Emil Konopoinsky, Edward Teller y Enrico Fermi esperando, una vez más, celebrar la existencia de vida inteligente extraterrestre. (Ilustración: Nuria Hernández Pintor)

Imagen: Herbert York, Emil Konopoinsky, Edward Teller y Enrico Fermi esperando, una vez más, celebrar la existencia de vida inteligente extraterrestre. (Ilustración: Nuria Hernández Pintor)Era un día de verano de 1950 y los físicos Enrico Fermi, Edward Teller, Herbert York y Emil Konopinsky se dirigían a tomar el almuerzo. Iban charlando sobre supuestos avistamientos de OVNIS, pero a Enrico Fermi algo no le cuadraba, así que minutos después, sentados alrededor de la mesa y después de haber hablado ya sobre el tema, gritó: “¿Pero dónde diablos están todos?”. El resto del grupo entendió a qué se refería. Si hay vida fuera del planeta Tierra, ¿por qué aun no nos han visitado? Según Fermi, la probabilidad de que hubiera otras civilizaciones en la Vía Láctea y vida en ellas, era alta, entonces, ¿por qué no tenemos alguna prueba de su existencia? Fermi no fue el primero en formularse esa pregunta, sin embargo gracias a él, a esa contradicción, se le conoce como la paradoja de Fermi.

Numerosos profesionales de la ciencia se han interesado también por esta problemática. En 1961 el astrofísico Frank Drake, con la intención de generar debate, diseñó una ecuación que permitiría estimar con cuántas de las civilizaciones de nuestra galaxia podríamos tener contacto. A él le siguieron, en 1975, el astrofísico Michael Hart con un artículo científico sobre el argumento de Fermi y la astrofísica Sara Seager proponiendo en 2013 una versión paralela a la ecuación de Drake.

Se sabe que en la Vía Láctea hay millones de estrellas similares al Sol y entonces sería muy probable que alguna, o muchas de esas estrellas tuvieran planetas similares al nuestro y que, al igual que ocurre en la Tierra, se hubiera desarrollado vida inteligente en ellos. Si esto fuera así, no sería osado pensar que alguno de esos seres inteligentes hubieran desarrollado la posibilidad de realizar viajes interestelares, con lo que nuestro planeta debería haber sido visitado ya, si no en persona, al menos a través de sondas. Sin embargo, aún no poseemos pruebas de ello ni tenemos certezas sobre la existencia de vida fuera de nuestro planeta. Aunque, es verdad que cada vez contamos con más y mejor tecnología para explorar el espacio, por lo que, si hay vida ahí fuera encontrarnos con ella será cuestión de tiempo.

Autora: Nuria Hernández Pintor (@somos.visuales), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2019/20

Artículo original: ¿Pero dónde diablos están todos? Juan Ignacio Pérez, Cuaderno de Cultura Científica, 5 de enero de 2020.

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo ¿Estamos solos en el universo? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La evolución nos dice que es probable que seamos la única vida inteligente del universo

- El Universo en un día: El final del Universo, por Aitor Bergara

- Hay más estrellas masivas de lo que se creía y lo que eso implica para la historia del universo

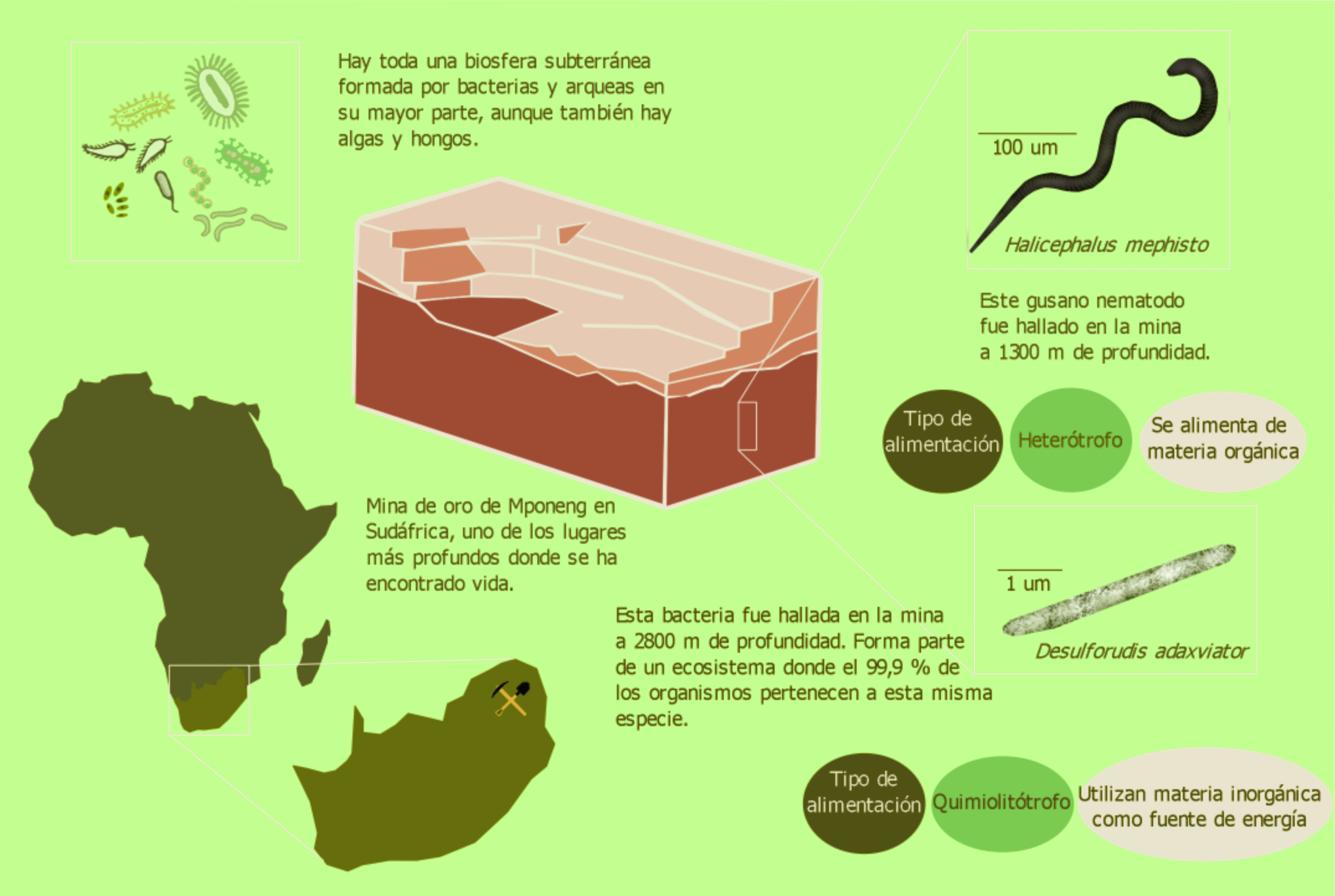

Babosas marinas que conservan la cabeza y pierden el cuerpo

Esta historia comenzó hace unos años cuando Sayaka Mitoh, de la Universidad de Mujeres de Nara, en Japón, hacía su doctorado. Su tema de tesis doctoral era conocer los efectos de la fotosíntesis de los cloroplastos de las algas que son el alimento de los nudibranquios o babosas marinas. Estaba revisando los acuarios con la colección de babosas marinas de su laboratorio e hizo un descubrimiento sorprendente. Las babosas marinas o nudibranquios son moluscos gasterópodos sin concha con colores muy llamativos. Destacan por llevar las branquias o sistema respiratorio en apéndices hacia el exterior.

Elysia marginata.

Elysia marginata.Sayaka Mitoh encontró un cuerpo de la especie Elysia marginata sin cabeza, y, revisando el acuario, encontró la correspondiente cabeza sin cuerpo. Se movía por el tanque y se alimentaba de algas como es habitual.

Al examinar la cabeza, Mitoh vio que la herida del corte era autoinflingida, era una amputación voluntaria conocida como autotomía. Es una conducta bien conocida en varias especies animales. En la revisión de Patricia Fleming y sus colegas, de la Universidad de Murdoch, en Australia, se menciona que se ha encontrado en cnidarios, como algunas medusas, en anélidos como las lombrices, moluscos, como nuestros nudibranquios, artrópodos, en equinodermos y en vertebrados.

Fleming, como característica habitual en la autotomía, menciona que es una estrategia defensiva en la que, perdiendo una parte del cuerpo, se evita su destrucción completa por algún depredador. La amputación ocurre en un plano concreto del cuerpo como, por ejemplo, en las lagartijas cuando se desprenden de la cola. El proceso se describe con detalle en la revisión de Timothy Higham y su grupo de la Universidad de California en Riverside. Quizá es la autotomía más conocida y popular estudiada por los zoólogos.

Otra característica de la autotomía que menciona Fleming, y quizá la más interesante, es que se trata de una conducta muy controlada por el individuo. La pérdida de parte del cuerpo está bajo algún tipo de control central, hormonal o nervioso, y la parte que se desprende lo hace con rapidez y exactitud.

Hay conductas de autotomía en varios nudibranquios aunque no tan excepcionales como las descritas por Sayaka Mitoh. Hay especies que pierden parte de los apéndices o papilas respiratorias de las branquias que, como ocurre con la cola de las lagartijas, mantienen el movimiento después de desprenderse para centrar la atención del depredador y facilitar la huida.

Sayaka Mitoh encontró en el acuario que cinco de quince ejemplares, todos criados en el laboratorio, de la especie Elysia marginata, y un individuo de la misma especie recogido en la costa, habían perdido el cuerpo y conservado la cabeza. Incluso uno de los ejemplares lo hizo dos veces.

La cabeza se movía inmediatamente después del corte y, en un día, la herida se cerraba. A las pocas horas, tres de las cabezas comenzaron a alimentarse con algas, como es habitual en esta especie. En siete días regeneraron el corazón y en tres semanas lo hicieron con el cuerpo entero.

Todo el proceso lo consiguen los ejemplares más jóvenes, con menos de un año de vida. Los que pasan del año y medio mueren en los diez días siguientes a la amputación. Los cuerpos desechados se mueven y reaccionan a los toques de los investigadores desde varios días a meses después de la separación de la cabeza. Sin embargo, ningún cuerpo regenera la cabeza.

Los autores hicieron una nueva recogida de 82 ejemplares de otra especie, Elysia atroviridis, que estaban parasitados por un copépodo. Tres de los ejemplares cortaron el cuerpo y dos de ellos lo regeneraron en una semana. Del grupo inicial de 82 ejemplares, 39 perdieron por autotomía partes del cuerpo. Parece que es el método de esta especie para deshacerse de los copépodos es perder parte o todo el cuerpo, incluyendo los parásitos. De los 39, fueron 13 los que regeneraron las partes perdidas y, el resto, murieron. Junto con los 82 ejemplares con copépodos, los investigadores recogieron 64 sin parásitos y ninguno de ellos perdió partes del cuerpo.

Las dos especies muestreadas, Elysia marginata y Elysia atroviridis, cortan el cuerpo por una zona concreta y determinada del cuello que funciona como plano de ruptura y separación. Un plano similar se localiza en la base de la cola de las lagartijas. En Elysia parece que en ese plano de corte se acumulan células madre que intervendrán en la regeneración del cuerpo.

El proceso de autotomía es lento y, por tanto, no es eficaz para huir de depredadores como, por ejemplo, hacen las lagartijas. La hipótesis es que, más bien, es una conducta para deshacerse de los parásitos. O, también se ha propuesto, para expulsar contaminantes tóxicos acumulados en el cuerpo. Así consiguen un cuerpo nuevo, limpio y sano.

Por otra parte, mientras regeneran el cuerpo y solo tienen la cabeza, no tienen sistema digestivo y no se pueden alimentar por los procesos habituales. Mitoh y Yusa sugieren que, en el corto periodo de tiempo que dura la regeneración del cuerpo, se alimentan de los productos de la fotosíntesis que se hace en los cloroplastos tomados de las algas que ingieren. Este proceso de alimentación y supervivencia con los azúcares de cloroplastos de algas ingeridas se denomina cleptoplastia.

Referencias:

Aoki, R. & S. Matsunaga. 2021. A photosynthetic animal: A sacoglossan sea slug that steals chloroplasts. Cytologia 86: 103-107.

Avila Casanueva, A.B. 2021. Una cabeza a la deriva: babosas marinas que regeneran sus cuerpos. Lado B 8 marzo.

Fleming, P.A. et al. 2007. Leave it all behind: a taxonomic perspective of autotomy in invertebrates. Biological Reviews 82: 481-510.

Higham, T.E. et al. 2013. Integrative biology of tail autotomy in lizards. Physiological and Biochemical Zoology 86: 603-610.

Mitoh, S. & Y. Yusa. 2021. Extreme autotomy and whole-body regeneration in photosynthetic sea slugs. Current Biology 31: R233-R234.

Roth, A. 2021. Estas babosas marinas pasan por la guillotina para conseguir un cuerpo nuevo. New York Times 9 marzo.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Babosas marinas que conservan la cabeza y pierden el cuerpo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cucarachas sin cabeza

- ¿Cuántas células hay en el cuerpo humano?

- Las babosas y el undécimo aniversario

La ría de Bilbao como medio de transporte de mineral

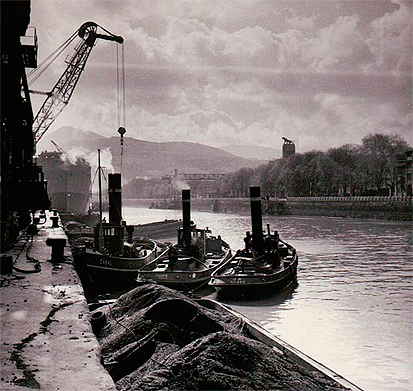

Gabarras con mineral de hierro en la ría de Bilbao. Fuente: Peña Gabarra Athletic

Gabarras con mineral de hierro en la ría de Bilbao. Fuente: Peña Gabarra AthleticBizkaia tuvo un enorme desarrollo económico, tecnológico y social en la segunda mitad del siglo el siglo XIX, y alcanzó su máximo esplendor a finales de ese siglo y a principios del siglo XX. Este desarrollo fue consecuencia de la confluencia de varios factores, entre los que se encontraba la explotación eficiente de los recursos minerales del territorio. Clave en esta explotación estuvo el uso de la ría del Nervión como medio de transporte. En este video repasamos como fluía el hierro del mineral de las montañas a donde fuese necesario. El vídeo forma parte del proyecto «La Ría del Nervión a la vista de las ciencias y las tecnologías».

Edición realizada por César Tomé López

El artículo La ría de Bilbao como medio de transporte de mineral se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Geología, industrialización y transporte del mineral de hierro en el entorno de la Ría de Bilbao

- De las minas a los puertos. Transporte tradicional del mineral

- ¿Por qué hay hierro en Bizkaia?

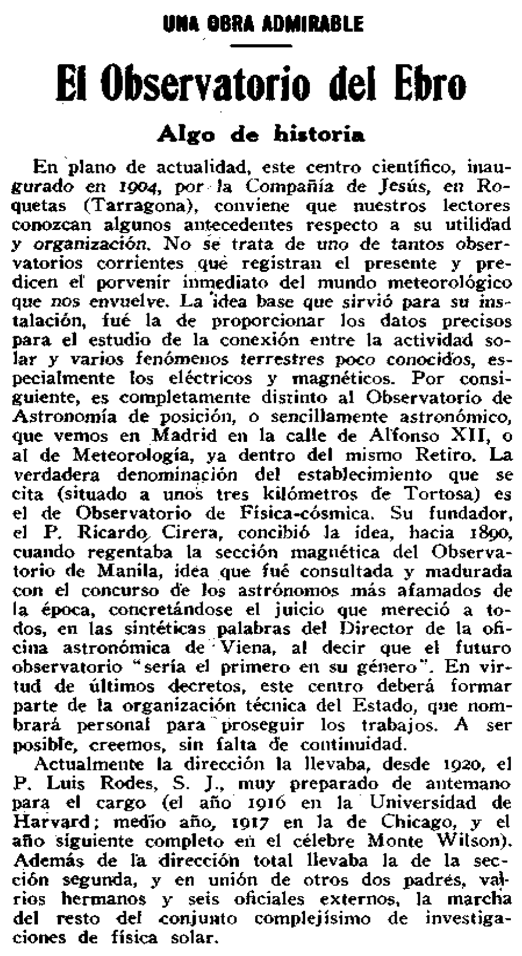

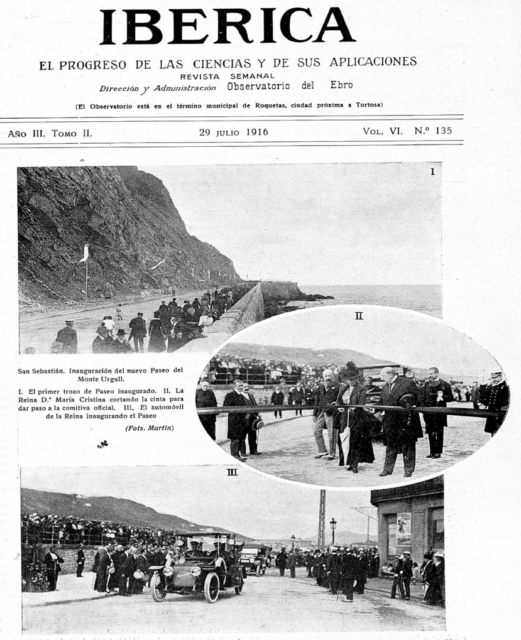

Divulgación Científica e Ingenieros en la España del Regeneracionismo (III): Polémicas y conflictos

Jaume Navarro y Javier Sierra de la Torre

Tras explicar las características de la nueva revista, el editorial del primer número de Ibérica, de noviembre de 1913, termina advirtiendo que “no estará satisfecho aquel racionalista que con pretexto de ciencia ande buscando cómo atacar la verdad revelada, ya fundándose en hechos falsos, ya sosteniendo teorías contrarias a la realidad de los fenómenos. Pero el que de verdad ame la ciencia sin ningún prurito tendenciosa, puede recorrer confiado las paginas de esta Revista”. Su redactor, el geofísico y jesuita catalán Ricardo Cirera, fundador y primer director del Observatorio del Ebro, y con una larga trayectoria científica en Filipinas, quería de este modo posicionarse frente a las polémicas que habían acompañado el discurso sobre la ciencia en la España del último tercio del siglo XIX y principios del XX. De hecho, la historiografía de la Edad de Plata de la ciencia española suele incluir tres elementos de conflicto que se presentan como centrales en los proyectos de desarrollo científico y tecnológico del país: la conocida como “Polémica” de la ciencia española, las reformas educativas y el conflicto ciencia-religión. En esta tercera entrega nos proponemos elucidar hasta qué punto las dos revistas tratadas, Ibérica y Madrid Científico, fueron o no actores relevantes en estas disputas.

La teleología, la creencia de que el universo en su conjunto y cada uno de sus componentes obra con un fin, es algo común a Aristóteles, Tomás de Aquino y las teologías cristianas. (Nota del editor)

La teleología, la creencia de que el universo en su conjunto y cada uno de sus componentes obra con un fin, es algo común a Aristóteles, Tomás de Aquino y las teologías cristianas. (Nota del editor)Brevemente, la “Polémica” se refiere a la percepción de una parte de la intelectualidad local del retraso científico del país y a la explicación de sus causas. Desde que, a finales del siglo XVIII, el enciclopedista francés Masson de Morvilliers describiera a España como un país atrasado, holgazán y bueno para nada, la idea del retraso cultural, tecnológico y científico fue un arma arrojadiza para muchos de los reformadores españoles. En los primeros años de la Restauración (a partir de 1874), y tras el fracaso de los ideales de la Primera República, la Polémica se convirtió en un lugar común para los defensores del liberalismo frente a las fuerzas conservadoras. Es importante señalar que, salvo alguna excepción, todos los actores de esta disputa eran filósofos, políticos y literatos, y no gente de ciencia, como Marcelino Menéndez Pelayo y Gumersindo Laverde, en un lado, y Nicolás Salmerón y Manuel de la Revilla, en el otro. Además, las discusiones acerca de la veracidad del supuesto retraso español y de las causas de éste se llevaron a cabo en diarios y semanarios generalistas. Se trataba, pues, no tanto de una disputa científica sino de un conflicto acerca de qué era la ciencia y cuál era su papel en la sociedad.

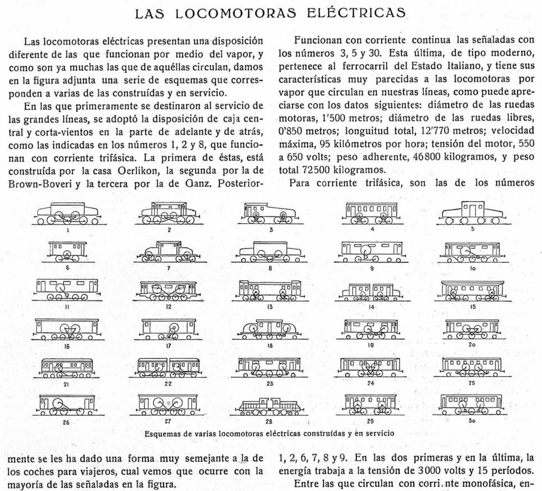

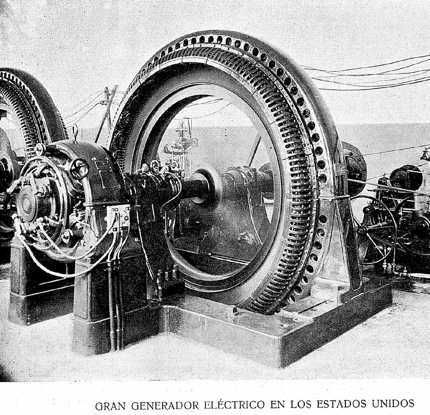

Tal como hemos apuntado en la entrega anterior, el Regeneracionismo fue una ocasión para que científicos e ingenieros decidieran participar activamente en la modernización del país y se implicaran en la vulgarización de sus actividades. De este modo promovían la difusión del conocimiento y sus aplicaciones, a la par que se presentaban como patriotas en la misión de reconstruir el país. De ahí que tanto Madrid Científico como Ibérica se convirtieron en intentos por legitimar las actividades de ingenieros y científicos como empresas patrióticas al servicio de la sociedad. Tal y como ya hemos visto, la vulgarización científica de ambas revistas se explayaba en la descripción de nueva maquinaria, infraestructuras y armamento, todas ellas presentadas como servidoras de la construcción nacional tras la derrota del ’98. Por citar un ejemplo explícito, durante la Gran Guerra, empresas españolas pudieron desarrollar tecnologías relacionadas con la aviación civil. En este contexto, un redactor de Ibérica sostenía en octubre de 1914 que

“sabemos que la más alta encarnación de la Patria aspira, con voluntad decidida, a que deje España de ser tributaria del extranjero en estos productos, los más refinados, de la cultura moderna, los cuales, sobre ser testimonio fehaciente de adelanto del país que es capaz de producirlos, es de esperar sean base de desenvolvimientos de la sociedad, de los cuales aun la imaginación más viva es, acaso, incapaz de medir de antemano el alcance y las consecuencias”.

Más explícita fue la participación de ambas revistas de divulgación científica en los debates acerca de las reformas educativas del país. Mucho se ha hablado, desde la historia de la ciencia española, del importante papel que jugó la Institución Libre de Enseñanza en los intentos de democratizar y transformar la instrucción primaria, secundaria y universitaria. Pero, como se lee constantemente en Madrid Científico, los ingenieros también quisieron participar en esos debates.

En 1910, en la Sociètes Savantes, André Pelletan pronunció una conferencia que tituló “La formación de los ingenieros”. En ella, el ingeniero de minas francés repasó la historia reciente de la formación de los ingenieros franceses en el siglo XIX, aseverando la excesiva importancia que se le había dado a la abstracción cuando las escuelas de enseñanza técnica se convirtieron en superiores. Al llegar la noticia a Madrid Científico, uno de sus autores se lamentó de que un tema de capital importancia no interesara en la península. O, más bien, sintió que no interesara a quien debía interesar. Previamente, Vicente Machimbarrena -ingeniero de caminos y profesor en la Escuela Especial del cuerpo- había expuesto en un discurso las malas prácticas de la enseñanza en las escuelas especiales de ingenieros.

Pelletan y Machimbarrena hablaron de temas similares en contextos diferentes. Después de la Guerra hispano-estadounidense de 1898, las élites españolas entraron en un proceso que ellos mismos denominaron “de regeneración”. Aunque el objetivo fuera la regeneración, no existía un proyecto único para dicho fin. Aun así, el de la educación fue un tema central sobre el que los ingenieros españoles no callaron sus opiniones. La enseñanza fundamental -primaria y secundaria- solía traerse a colación en Madrid Científico, donde los autores denunciaban el abandono en el que el estado tenía al maestro. Criticaban su escasa remuneración, la cual, en muchas ocasiones, no llegaba para cubrir la carestía de la vida. El maestro se veía forzado a subsistir gracias a la caridad de los padres de los alumnos, y esto provocaba su desmotivación y convertía la profesión en un destino en absoluto atractivo. El atraso del pueblo español se achacaba superficialmente a un general espíritu vago y simplón, incapaz para la ciencia y superficial. Los ingenieros plasmaban estas narrativas en sus artículos, pero afirmaban que el problema educativo no era una incapacidad para aprender, sino una incapacidad para enseñar. Y esta incapacidad era para ellos más palpable en la enseñanza superior en universidades y escuelas especiales de ingenieros.

Sobre las primeras denunciaron los abusos cometidos por catedráticos de todas las disciplinas: el amparo en la libertad de cátedra (que los ingenieros defendieron a capa y espada) para no actualizar lo que se enseñaba; el poder para nombrar sucesores que convertía al que llamaban el estudiante más veterano (el catedrático) en dueño de una finca en la que reinaba; y la ineptitud a la hora de escribir libros de calidad ya que adolecían de una falta de estudios positivos. De las segundas, además, solían censurar la ausencia de una enseñanza práctica.

Los ingenieros hablaban de desprecio histórico por los estudios positivos. Uno de ellos diría en 1908, a propósito de El realismo en la enseñanza, que habían llevado a una pérdida del brío intelectual (a un “sueño metafísico” en el que se sumía a los alumnos, según Pelletan, y en el que no se permitía luchar por la vida, según el Reporter que le cita en Madrid Científico). Pero este desprecio, acusado en las universidades, también lo veían en sus propias escuelas especiales: la práctica escaseaba en la enseñanza del ingeniero. Afirmaron en varias ocasiones que un ingeniero industrial se graduaba sin tocar una máquina, que un futuro ingeniero de minas no entraba en ninguna explotación (minera, agrícola, ganadera, etc.) antes de graduarse, y que los obreros instruidos en las Escuelas de Artes y Oficios recibían más formación práctica que ningún otro profesional. La polémica en torno a la formación matemática en las escuelas especiales también era un tema recurrente: “¿cuántas matemáticas tiene que saber el ingeniero?; ¿acaso tantas como el doctor en matemáticas?”. De hecho, en 1910 reformaron el reglamento de los estudios en ingeniería de caminos, y Madrid Científico celebró que los estudios propedéuticos para acceder a la escuela se devolvieran a la escuela misma, “de dónde nunca tendrían que haberse ido”. En el siglo XIX se sucedieron varios proyectos para organizar una escuela politécnica, y el tiempo dedicado a unas u otras asignaturas fue motivo constante de polémica entre miembros de las Escuelas.

Otro ejemplo, quizás un poco más minoritario, pero no irrelevante, fue el uso de Ibérica como altavoz para la promoción de reformas educativas en el seno de la Compañía de Jesús. Sus editores, como el ya mencionado Ricardo Cirera o el químico Eduardo Vitoria, eran científicos con una larga trayectoria en la práctica de la geofísica y la bioquímica, respectivamente. Para ellos, las ciencias debían ser un elemento esencial de la educación moderna, y sus intentos de reformar los planes de estudios en sus escuelas y seminarios no siempre encontraban el eco esperado dentro de la orden. De ahí que podamos leer manifiestos que, bajo el disfraz de la eficacia en la misión evangelizadora, lo que realmente proponían era la incorporación de más estudios científicos entre la juventud. Así, encontramos al Padre Vitoria clamar por

“una modificación en el plan de estudios de Ciencias naturales en los Seminarios. Por de pronto, dando a estas materias más importancia que hasta aquí (…). Hoy, como decíamos en otro articulo, ha tomado todo un rumbo marcadamente científico: la misma Agricultura, antes rutinaria, se ha ennoblecido: en la marcha de sus cultivos y en la realización de sus múltiples industrias, ha entrado por el sendero científico, y nadie duda que una de las Ciencias naturales que mas la auxilian, es la Química. Pues bien, el Sacerdote que salga del Seminario con suficiente formación científica, en particular química, podrá ser un buen consejero para sus feligreses en su parroquia, (…) Hemos de persuadirnos de que para muchas inteligencias atrofiadas, el gran argumento, el que mas les convence, es el que toca a su manutención y bienestar material: o hay que empezar, pues, por ahí, o, por lo menos, hay que aprovechar, para nuestro trabajo de apóstoles de Jesucristo, una palanca de tanta eficacia.”

Este último ejemplo nos sirve para mencionar la tercera de las disputas típicas del periodo estudiado: la del supuesto conflicto entre ciencia y religión. Esta cita revela cómo la tensión entre educación científica y educación humanista, entre educación práctica y educación teórica, no era necesariamente paralela a la disputa entre educación religiosa y educación laica. El artículo del Padre Vitoria nos muestra sus esfuerzos por introducir más conocimientos científicos, en este caso de química, en la formación del sacerdote y en las escuelas llevadas por religiosos, no a pesar de ser religiosos sino precisamente como parte de su misión religiosa.

El manifiesto de supuesta neutralidad con el que Ibérica se presentó en sus inicios era su manera particular de participar en las discusiones acerca del conflicto entre la religión y la ciencia. Junto a disquisiciones filosóficas acerca de la compatibilidad entre la verdadera ciencia y la verdadera religión (la católica), la revista solía enaltecer el trabajo de católicos como Pasteur y sus polémicas con el anticlerical Berthelot, o el de los propios miembros de la Compañía. Ibérica también es un lugar interesante para explorar las posturas, muy diversas y generalmente bien informadas, acerca del evolucionismo y la singularidad humana que había entre los redactores de la revista.

Más interesante es ver cómo una revista secular como Madrid Científico participaba, o no, en la retórica del conflicto ciencia-religión. En general, las menciones a esta oposición están prácticamente ausentes en comparación a los otros temas que sí abordaron. Es difícil, como dijimos en las dos entradas anteriores, encontrar un campo de conocimiento que no tocaran los autores, y por eso sorprende que sea complicado encontrar reflexiones en torno a cuestiones de la relación entre fe y ciencia, tan comunes en la época en otro tipo de publicaciones. Puede haber varios motivos que expliquen esta ausencia: falta de interés, decisiones editoriales, o que fuera un tema “candente” que los autores preferían evitar por ser una publicación sin apoyos institucionales y dependiente de sus socios lectores.

La falta de interés es difícil de justificar: en estas revistas se publicaba sobre cualquier tema. Se perciben cambios en preferencias por campos de conocimiento, pero lo religioso está muy ausente en todos estos cambios. Es, por eso, relevante mencionar algunos de los pocos casos en los que publicaron artículos sobre religión ya que apenas se presentaba en clave de conflicto. En una sección titulada “palabras olvidadas”, el editor publica un artículo de Leopoldo Alas “Clarín”. En él, Clarín defiende que no se debe separar a la iglesia del estado, afirmando que

“Es mejor injertar … Injertar en la España católica la España liberal, no consiste en falsificar la libertad, ni en corromper a los católicos por el soborno del presupuesto repartido. Tampoco se trata de una obra de seducción pérfida, de una propaganda inoportuna en terreno mal preparado; se trata de practicar de veras la tolerancia”. Lo científico no aparece mencionado en este artículo. Sí se menciona en un número diferente, en un artículo titulado El significado de ciencia, donde el autor asegura que “No hay antagonismo entre la poesía y la ciencia. No debe haberlo entre la religión y la ciencia. Hay muchos caminos para llegar a la verdad; el de la ciencia es uno de ellos”.

Otro ejemplo es el del ingeniero militar Carlos Mendizábal, quien en 1920 firma un artículo en el que busca poner la ciencia al servicio de la fe, y propone usar el cinematógrafo para averiguar si un supuesto milagro es, efectivamente, tal cosa. Al principio de su artículo indica a los lectores que

“Los que, llevando recorrida la mayor parte de una vida consagrada a tareas científicas, vemos que lejos de haber hallado incompatibilidades entre ellas y la fe que recibimos en la infancia la han robustecido, a veces, impensadas relaciones de mutuo apoyo y auxilio entre creencias y conocimientos. No hay que sorprenderse de ello, ya que unas y otros, realmente, son manifestaciones de una misma verdad (…) emanación de la verdad absoluta, aún cuando nuestra mente la reciba por caminos diferentes: el de la revelación y el de la indagación”.

En años posteriores, los ingenieros de Madrid Científico alabaron la obra de Ibérica, indicando que “(…) esta solida publicación científica continúa llevando al cabo un intenso y patriótico esfuerzo cultural que se ha puesto ahora más de relieve con la aparición de un número extraordinario, dedicado a la actividad científica nacional”. Carlos Barutell, Ingeniero Militar, aplaudió años después la labor astronómica y sismológica del Observatorio del Ebro. De sus palabras destaca la afirmación de que puede ser un lugar desconocido porque “este establecimiento trabaja muy seria y silenciosamente, como la generalidad de los centros verdaderamente científicos”. Concluye una detallada descripción del Observatorio y sus labores con una cita de P. Puig (director del Observatorio) en la que este pide al cielo que permita continuar con la labor de investigación de la naturaleza porque su estudio “ha de contribuir en hacernos penetrar más y más en los arcanos de la divinidad ”.

En definitiva, cuando la religión y la ciencia se traen a colación en Madrid Científico, no era necesariamente para señalar un conflicto. Los ingenieros, cuando se referían a estos temas en Madrid Científico, huían de la retórica anticlerical del conflicto, típica de otras publicaciones del momento.

Sobre los autores: Jaume Navarro es Ikerbasque Research Professor en el grupo Praxis de la Facultad de Filosofía de la UPV/EHU y dirige el doctorado que Javier Sierra de la Torre está realizando sobre la divulgación científica en España a finales del XIX y principios del XX.

This publication was made possible through the support of a grant from Templeton Religion Trust, awarded via the International Research Network for the Study of Science and Belief in Society (INSBS). The opinions expressed in this publication are those of the author(s) and do not necessarily reflect the views of Templeton Religion Trust or the INSBS

El artículo Divulgación Científica e Ingenieros en la España del Regeneracionismo (III): Polémicas y conflictos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Divulgación científica e ingenieros en la España del Regeneracionismo (II): Temas

- Divulgación científica e ingenieros en la España del Regeneracionismo (I): Ibérica y Madrid Científico

- La divulgación científica, un cuento inexacto; por Ana Montserrat Rosell

La estufa encefálica de los cetáceos

Marsopa común (Phocoena phocoena). Ilustración: María Lezana

Marsopa común (Phocoena phocoena). Ilustración: María LezanaLos cetáceos tienen encéfalos muy grandes, tanto en términos absolutos como relativos. Por eso, se les atribuyen capacidades cognitivas superiores a las de la mayoría de los mamíferos, dado que se asume que ambos rasgos -tamaño encefálico y capacidad cognitiva- están relacionados. Esa atribución tiene un origen curioso: el encéfalo humano. Dado que los seres humanos tenemos una cabeza de grandes proporciones y nos consideramos particularmente bien dotados cognitivamente, tendemos a pensar que la cabeza grande -el encéfalo grande, para hablar con propiedad- es condición necesaria y, quizás, suficiente para atribuir a un animal altas capacidades cognitivas.

Sin embargo, recientemente se ha publicado un estudio que pone en cuestión esa interpretación del gran tamaño encefálico de los cetáceos y lo atribuye a un factor que tiene muy poco que ver con la cognición. Según los autores de la investigación, ese gran tamaño se ha desarrollado en la evolución de los cetáceos porque es condición necesaria para que el calor que producen sus células sea suficiente para permitir que el encéfalo se mantenga a la temperatura óptima de funcionamiento incluso en las aguas gélidas que, a menudo, frecuentan. Hay que tener en cuenta que el agua tiene una gran conductividad térmica, por lo que los mamíferos tendemos a perder mucho calor cuando nos sumergimos. Además, el pelaje no es efectivo como aislamiento dentro del agua; por esa razón, los mamíferos acuáticos tienden a acumular una gruesa capa de grasa subcutánea.

Los autores de la investigación apoyan su tesis en tres observaciones. La primera es que en casi todas las neuronas de la corteza de los cetáceos hay una mayor presencia de la enzima UCP1 que en las de los artiodáctilos, un grupo de mamíferos muy próximos a los cetáceos. La UCP1 es una enzima con efectos termogénicos. Su función es convertir en calor la energía química procedente de los sustratos metabólicos; también recibe el nombre de termogenina y me ocupé de ella aquí, porque es característica de la grasa parda.

Así pues, dado que, a diferencia de los mamíferos artiodáctilos, casi todas las neuronas corticales presentan una densidad alta de UCP1, debe deducirse que la mayoría de esas neuronas funcionan como unidades termogénicas en caso de necesidad.

La segunda observación se refiere a la presencia de otras dos proteínas desacoplantes UCP4 y UCP5, en numerosas células gliales de los encéfalos de cetáceos. Lo cierto es que entre un 30 y un 70% de esas células pueden funcionar como unidades productoras de calor. La importancia de esas unidades queda refrendada por el hecho de que el encéfalo de los cetáceos tiene una alta proporción de células gliales.