¿Mi hijo tiene autismo o este comportamiento es “normal”?

Adam McCrimmon

![]()

Para muchos padres distinguir entre las rarezas del comportamiento infantil “normal” de los síntomas de un trastorno del espectro autista puede provocar ansiedad.

Criar a un hijo es a menudo uno de los acontecimientos más desafiantes y felices en la vida de una persona. Ver a tu hijo crecer y desarrollarse es una fuente de placer. Sin embargo, algunos padres se preocupan cuando su hijo parece desarrollarse de manera diferente a los demás.

En ocasiones, los padres pueden preocuparse por la posibilidad de un trastorno del espectro autista o TEA.

Como profesor asociado y psicólogo colegiado en la Werklund School of Education de la Universidad de Calgary (Canadá), me especializo en la evaluación diagnóstica del TEA tanto en niños y como en adultos.

Muchas familias me hablan de sus preocupaciones (o de las preocupaciones de los demás) por sus hijos y se preguntan acerca de la posibilidad de un TEA.

Descubrí que informar a los padres sobre los síntomas del TEA puede ayudarlos a decidir si sus preocupaciones están justificadas. Además, muchos padres desconocen cómo se caracteriza actualmente el trastorno y, por lo tanto, les cuesta entender si una evaluación puede beneficiar a su hijo.

Los síntomas individuales son únicos

El TEA es, de acuerdo con la descripción utilizada por la mayoría de los médicos en América del Norte, un “trastorno del neurodesarrollo“, lo que significa que se hace patente durante el desarrollo temprano de un niño y se traduce en dificultades en su funcionamiento personal, social, académico u ocupacional.

Las personas con TEA típicamente muestran síntomas a los dos a tres años de edad. Sin embargo, en muchas habrá signos antes en el desarrollo y el TEA se puede diagnosticar de manera fiable alrededor de los 18 meses de edad.

Algunos niños con TEA son muy sensibles a los estímulos sensoriales y se angustian mucho con los ruidos de la casa.

Los sujetos deben presentar dificultades en dos áreas de funcionamiento: 1) comunicación social y 2) patrones de conducta restringidos y/o repetitivos.

Es importante destacar que las personas con TEA se encuentran en un “espectro”, lo que significa que pueden experimentar una variedad de dificultades dentro de cada área. Esto significa que los síntomas específicos de cada persona serán únicos.

Problemas de comunicación social

En el área de la comunicación social, los niños pueden demostrar un retraso en el desarrollo del habla, ya sea por no usar palabras sueltas a los 18 meses o por la inexistencia de frases de dos a tres palabras a los 33 meses de edad.

Es posible que no dirijan la atención de los demás (p. ej., señalando o mirando a los ojos), que no sigan lo que otro señala o que no respondan a su nombre. A veces carecen de la capacidad, o tienen habilidades limitadas, de jugar a juegos de simulación.

Otros signos pueden incluir poco interés en jugar con los compañeros, no enseñar o llevar objetos a otros para compartir un interés, sonreír con poca frecuencia a los demás o no hacer gestos para expresar sus necesidades, por ejemplo asintiendo o levantando los brazos para que los cojan.

Muchos niños muestran síntomas consistentes con TEA pero crecen hasta eliminarlos de forma natural

Muchos niños que son diagnosticados de TEA no imitan los comportamientos de los demás. Por ejemplo, es posible que no respondan a alguien que los saluda con la mano. O les cuesta comprender el lenguaje de los demás o muestran un variedad limitada de expresiones faciales.

Algunas veces usan las manos de otros como una herramienta, por ejemplo, usando la mano de un padre para señalar las imágenes de un libro en vez de señalarlas ellos mismos. Y pueden repetir las palabras de los demás en lugar de usar su propio lenguaje para expresar necesidades o deseos.

Patrones de comportamiento repetitivos

Con respecto a los patrones de comportamiento restringido / repetitivo, algunos niños muestran una fuerte preferencia por, o aversión a, estímulos sensoriales. Por ejemplo, un niño puede ansiar el estímulo visual al mirar fijamente a un ventilador durante largos períodos de tiempo. O pueden sentirse muy angustiados por los ruidos típicos de la casa, por cortarse el pelo o por que los toquen.

Los niños a menudo se apegan a objetos específicos, como un bloque [de madera o plástico] o una libreta que deben llevar consigo, pero muestran poco interés por los juguetes. Pueden interesarse intensamente en cosas como los pomos de las puertas o los asientos de los inodoros, o pueden obsesionarse con un personaje de dibujos animados familiar o un juguete.

Sonreír poco a los demás puede ser un síntoma de TEA

Pueden agitar los brazos o las manos, mecerse o girar repetitivamente cuando están excitados. Algunos niños repiten acciones una y otra vez, como encender y apagar una luz. Algunos se centran en los componentes pequeños de un objeto (la rueda de un coche de juguete) en lugar de en todo el objeto (el coche).

Otros pueden alinear los objetos con insistencia, como los juguetes o los zapatos de los miembros de la familia, y se angustian si alguien mueve los objetos. Pueden ser agresivos con los demás o pueden lastimarse a sí mismos. A menudo anhelan la previsibilidad y lo pasan mal cuando se rompen sus rutinas.

La identificación temprana es clave

Es importante destacar que ningún síntoma concreto es necesario o suficiente para un diagnóstico. Sin embargo, más síntomas sí aumentan la probabilidad de un diagnóstico.

Además, muchos niños muestran síntomas consistentes con TEA pero crecen hasta eliminarlos de forma natural y no reciben un diagnóstico. Los médicos experimentados toman en cuenta el desarrollo infantil típico al determinar si se justifica un diagnóstico.

La identificación temprana permite a los niños y sus familias acceder a intervenciones y apoyos que tienen su mayor impacto durante la primera infancia.

Si le preocupa que su hijo pueda tener TEA, un primer paso importante es hablar con su médico o pediatra. Autism Canada [en España, Autismo España] es un recurso excelente que proporciona información sobre las posibilidades de evaluación e intervención.

La evaluación a menudo involucra a equipos de profesionales que trabajan juntos para identificar como se ajusta un niño con los síntomas de TEA y generalmente incluye la observación del niño en diferentes entornos, entrevistas con los padres y la realización de tareas de evaluación para valorar el desarrollo del niño.

La identificación temprana es clave. Este reconocimiento permite a los niños y sus familias acceder a intervenciones y apoyos que tienen su mayor impacto durante la primera infancia.

Sobre el autor:

Adam McCrimmon es profesor asociado de la facultad de educación de la Universidad de Calgary (Canadá)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 8 de enero de 2018 bajo una licencia Creative Commons (CC BY-ND 4.0)![]()

El artículo ¿Mi hijo tiene autismo o este comportamiento es “normal”? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Natacha Aguilar: “Necesitamos que el mar esté en equilibrio para que el planeta también lo esté”

- Una nueva investigación muestra que explicar cosas a la gente “normal” puede ayudar a los científicos a ser mejores en su trabajo

- ¿Tiene límite el tamaño de un agujero negro?

Agua cruda, la nueva moda antiprogreso del primer mundo

En Silicon Valley (California) se encuentran las mayores corporaciones de tecnología del mundo, hasta tal punto que Silicon Valley se ha convertido en el metónimo para el sector de la alta tecnología (a la manera de Hollywood para el cine). Marcan tendencias a escala global: moda, estilo de vida, pensamiento… Incluso alimentación. La última idea feliz que ha triunfado en Silicon Valley es la de beber «agua cruda», agua sin tratar y sin analizar.

Siendo justos, ya existía en el mercado agua sin tratar que se embotella directamente extraída del manantial. Es el agua mineral natural que todos conocemos y que podemos comprar por unos 30 céntimos el litro. Sin embargo, si un agua no se trata, o se trata mínimamente, es porque no lo necesita. Periódicamente se analiza su composición química y biológica para determinar si es segura. Si no se analiza, sencillamente no se puede vender.

En cambio, el «agua cruda» (raw water), aunque también es agua sin tratar como la mineral, no se analiza. Ahí está la diferencia fundamental: no sabes qué estás bebiendo, si es agua segura o no. La comercializan embotellada, a una media de 6 € el litro (20 veces más que el agua mineral natural), empresas como Live Water, en Oregón, y Tourmaline Spring, en Maine. Zero Mass Water, en Arizona, es una empresa que instala en los hogares sistemas para captar agua de la atmósfera y evitar así beber agua del grifo. Liquid Eden, en San Diego, ofrece, entre otras opciones, agua libre de flúor y libre de cloro, según publicaba recientemente The New York Times.

-

Los supuestos beneficios del agua cruda son disparates

Los absurdos motivos que han llevado a que estas empresas generen ingresos comercializando agua cruda son de naturaleza muy diversa. Apuntan a la desconfianza en la calidad del agua que sale del grifo, principalmente por los compuestos de cloro y flúor que se agregan durante el tratamiento, sustancias a las que les atribuyen efectos tóxicos sin parangón e incluso la conspiranoica idea de que esas sustancias sirven para volvernos dóciles y controlarnos. Otros alegan que el agua corriente contiene restos de medicamentos y fitosanitarios capaces de producirnos enfermedades. Algunos creen que durante el filtrado se eliminan minerales beneficiosos y probióticos saludables. Otros hablan de disparates mayores, como que el agua cruda ayuda a los chacras y está impregnada de energías de piedras preciosas.

-

Potabilización del agua: uno de los mayores progresos en salud pública de la historia

En 1997 la revista Life publicó que «la filtración de agua potable y el empleo de cloro es probablemente el avance en salud pública más significativo del milenio».

A lo largo de la historia hemos ido desarrollando métodos cada vez más eficaces para garantizar la seguridad del agua que consumimos. Hay registrados métodos para mejorar el sabor y el olor del agua 4.000 años antes de Cristo. Se han encontrado escritos griegos en los que se hablaba de métodos de tratamiento de aguas por filtración a través de carbón, exposición a los rayos solares y ebullición.

En el antiguo Egipto el agua se decantaba. Se dejaba reposar en vasijas de barro hasta que precipitasen las impurezas, quedándose con la parte superior del agua. También añadían alumbre para favorecer la precipitación de las partículas suspendidas en el agua.

A principios del siglo XIX algunas ciudades ya contaban con sistemas de abastecimiento de aguas y filtrado. Sin embargo, estos métodos eran insuficientes. Algunos agentes patógenos sobrevivían tras estos tratamientos.

En 1854, el médico británico John Snow, descubrió que el cólera era causado por el consumo de aguas contaminadas con materias fecales, al comprobar que los casos de esta enfermedad se agrupaban en las zonas donde el agua consumida estaba contaminada con heces. La OMS publicó un monográfico en el que se contabilizaron seis pandemias de cólera en el siglo XIX que se cobraron la vida de millones de personas en todo el mundo.

En 1908 se emplearon compuestos de cloro por primera vez como desinfectantes primarios del agua potable de New Jersey. La cloración causa alteraciones en la pared celular de las células bacterianas. Las deja indefensas, de modo que disminuyen sus funciones vitales hasta llevarlas a la muerte, por lo que son incapaces de producir enfermedades. Estos compuestos clorados, que bien pueden utilizarse como gas cloro, hipoclorito o dióxido de cloro, son oxidantes. Esto hace que además sean germicidas, eliminando mohos, algas y otros microorganismos además de bacterias.

Antes de la llegada de la cloración para el tratamiento de agua potable la gente se contagiaba fácilmente de enfermedades mortales como el cólera, la fiebre tifoidea, la disentería o la poliomielitis. Actualmente conocemos otros muchos oxidantes con cualidades similares, como los halógenos, el permanganato o el ozono.

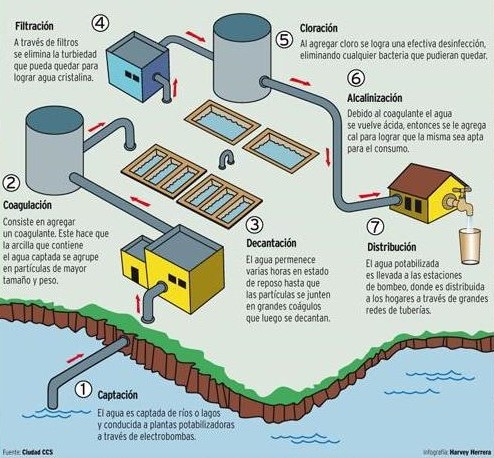

Hoy en día, en las estaciones de tratamiento de agua potable (ETAP) se realizan los procesos necesarios para que el agua natural procedente de embalses y otras captaciones se transforme en agua potable. En ellas se llevan a cabo procesos físicos, químicos y biológicos complejos capaces de lograr un agua segura, con buen olor y sabor. Además de tratar el agua, ésta se analiza periódicamente, es decir, se mide su calidad y su composición química y biológica.

Sin lugar a duda, el tratamiento del agua ha sido uno de los mayores avances en salud pública de la historia. Ha salvado una cantidad ingente de vidas. Rechazar el tratamiento del agua es rechazar el progreso. Es rechazar la salud. Incluso es rechazar un derecho humano fundamental.

-

El agua potable es un derecho humano fundamental

El 28 de julio de 2010 la Asamblea General de las Naciones Unidas declaró que el acceso al agua potable segura y limpia y al saneamiento era un derecho humano esencial para el pleno disfrute de la vida y de todos los demás derechos humanos. Además, expresó su profunda preocupación por el hecho de que casi 900 millones de personas en todo el mundo carecen de acceso al agua potable. Esta carencia provoca la muerte de 3,5 millones de personas cada año. El doble de fallecimientos que se producen por accidentes viales y casi el triple de los ocasionados por el VIH.

-

Un problema inventado del primer mundo.

La escasez de agua potable y de saneamiento es la causa principal de enfermedades en el mundo. El 42% de los hogares carece de retretes y una de cada seis personas no tiene acceso a agua potable.

La mortandad en la población infantil es especialmente elevada. Unos 4.500 niños y niñas mueren a diario por carecer de agua potable y de instalaciones básicas de saneamiento. En los países en vías de desarrollo, más del 90% de las muertes por diarrea a causa de agua no potable y la falta de higiene se producen en niños y niñas menores de cinco años. Preguntadles a sus familias qué opinan del agua cruda, si están preocupados por los probióticos, por el control mental por cloración o por los chacras del agua.

La moda de beber agua cruda sólo la pueden seguir aquellos que cuentan con una nevera llena, buena cobertura sanitaria y, sobre todo, agua corriente potable. Ellos son los que lideran el movimiento antiprogreso, los que no tienen nada que temer y con insultante esnobismo, se lo inventan.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Agua cruda, la nueva moda antiprogreso del primer mundo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Puedes presumir de tener la mejor piel del mundo.

- Libavius y el primer libro de texto químico

- Una proteína humana para potabilizar agua

Kakalardo bonba-jaurtitzailea

Juan Ignacio Pérez eta Miren Bego Urrutia Defentsak eta erasoak

Juan Ignacio Pérez eta Miren Bego Urrutia Defentsak eta erasoak ———————————————————————————————————–

Carabidae familiakoak ditugu beren babes kimikorako mekanismoa dela eta izen xelebre hau hartzen duten 500 intsektu-espezietik gorako taldeko kideak. Zerbaitek, normalean apo, inurri edo armiarma edo antzeko harrapariren batek, kalte egingo diela antzematen dutenean, kakalardo hauek narritagarria den esprai kimikoa jaurtitzen diote etsaiari. Babes-modua bera deigarria bada ere, are harrigarriagoa da jaurtitzen duten substantziaren tenperatura 100°C-tik gorakoa izatea; beraz, oso arma indartsua da ia edozein harraparirentzat.Kakalardo bonba-jaurtitzaileak 100ºC-tik gorako esprai kimikoa jaurtitzen du mehatxatuta dagoenean. Iturria: KQED San Francisco telebista publikoa.

Nola ekoizten dute horren kaltegarria izan daitekeen konposatu hori? Eta nola lortu dute eurei kalterik ez eragitea?

Kontua oso konplexua da, eta horrexegatik erabili izan dute adibide modura kreazionismoaren eta diseinu adimendunaren aldekoek, horren konplexua den zerbait hautespen naturalez ezin gara daitekeela azaltzeko. Utz ditzagun funts zientifikorik gabeko kontu hauek alde batera eta azter dezagun eraso kimiko honen oinarrian dagoena.

Kakalardo hauen sabelaren atzealdeko muturrean kokatzen diren guruin berezietan ekoizten da aerosol babesgarria. Espraia jaurtitzen dutenean, laino bat bezala ikus daiteke, eta leherketak hots berezia eta entzuteko modukoa sortzen du.

Bi ganbarek osatzen dituzte sekrezio-guruin berezi hauek: ganbara handienean, barrurago kokatzen dena, animaliaren bi guruin berezitutan ekoitzitako hidrokinona eta hidrogeno peroxidoa nahasten dira; kanporago kokatzen den ganbara txikiagoan, berriz, epitelioko zelulek jariatzen dituzten katalasaz eta peroxidasaz osatutako nahaste entzimatiko bat dago. Hidrokinona intsektu askoren metabolismoaren produktuetako bat da, kitinaren sintesian erabiltzen dena, eta hidrogeno peroxidoa, bestalde, denok ezaguna dugun ur oxigenatua da.

Intsektu hauek mehatxua hautematen dutenean, zenbait muskulu uzkurtuz ganbara handiko likidoa ganbara txikiagoan sarrarazten dute, eta orduan gertatzen da leherketa, hidrogeno peroxidoa bat-batean hidrolizatzen hasten delako eta hidrokinonak oxidatzen, oso erreakzio bortitza eraginez, non bero kantitate handiak askatzen diren. Sortutako gasen presioaren eraginez, alde batetik ganbara handiko balbula itxita mantentzen da, eta horrela babestuta gelditzen, eta bestetik nahaste erasotzailea esprai fin bat bezala kanporatzen da beste balbula batetik. Ateratzen den benzokinona eta lurrunaren nahasteak erre egiten du, uraren irakite-puntuaren tenperaturaren ingurura heltzen baita, eta normalean harrapariak uxatu egiten ditu.

Kakalardoek hainbat aldiz erakuts dezakete babes-erantzun hau eta gainera bonba-jaurtiketa ia edozein noranzkoan zuzendu dezaketela ikusi da, harrapariaren mugimenduen arabera eraso kimikoaren norabidea aldatuz. Afrikako zenbait kakalardo bonba-jaurtitzailek 270 graduko errotazio-ahalmena dute, eta, beraz, guruinaren irekitze-gunea ia edonorantz bideratu dezakete.

Animalia hauek erabiltzen duten lehertze-mekanismoa hain da eraginkorra, ezen 2004 urtean Leeds-eko Unibertsitatean 135.000 liberako finantziazioa jaso zuen proiektu bat abiatu baitzen, animalia hauen konbustio-mekanismoak industria aeronautikoan izan ditzakeen aplikazioak aztertuko dituena. «Learning from controlled explotions in nature: modelling the catalytic explosion device of bombardier beetles» da ikerketa-lanaren izena, eta gero eta gehiago garatzen ari den biomimetikaren arloan sakonduko du.

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso du.

The post Kakalardo bonba-jaurtitzailea appeared first on Zientzia Kaiera.

Hay más estrellas masivas de lo que se creía y lo que eso implica para la historia del universo

Un equipo internacional de astrónomos ha descubierto que hay muchas más estrellas masivas en una galaxia satélite de la Vía Láctea de las que se pensaba. El descubrimiento, realizado en la gigantesca región de formación estelar 30 Doradus (número de catálogo NGC 2070) en la Gran Nube de Magallanes, tiene consecuencias muy importantes para nuestra comprensión de cómo las estrellas transformaron el Universo primitivo en el que vivimos hoy.

30 Doradus (NGC 2070), también llamada Nebulosa de la Tarántula

El equipo utilizó el Very Large Telescope del Observatorio Europeo Austral (ESO) para observar cerca de 1,000 estrellas masivas en 30 Doradus, un gigantesco vivero estelar también conocido como la nebulosa de la Tarántula. Realizó análisis detallados de alrededor de 250 estrellas con masas de entre 15 y 200 veces la masa de nuestro Sol para determinar la llamada función de masa inicial (FMI), esto es, una función empírica que describe la distribución de las masas iniciales de una población de estrellas, en este caso, 30 Doradus.

Las estrellas masivas son particularmente importantes para los astrónomos debido a la enorme influencia que ejercen en su entorno. Además, pueden explotar en espectaculares supernovas al final de sus vidas, formando algunos de los objetos más exóticos del Universo, como las estrellas de neutrones y los agujeros negros.

En los resultados se obtiene una sorprendente población actual abundante en estrellas de 200 masas solares; aún es más chocante que también se encuentra una FMI con un alto porcentaje de estrellas supermasivas. Y es chocante porque, hasta hace poco, afirmar la existencia de estrellas de hasta 200 masas solares era algo muy controvertido, y este trabajo ha encontrado que una masa de nacimiento máxima de entre 200 y 300 masas solares no solo es posible, sino probable.

En la mayoría de las zonas del universo estudiadas por los astrónomos hasta la fecha se ha encontrado que cuanto mayor es la masa estelar, menos abundantes son las estrellas. La FMI predice habitualmente que la mayor parte de la masa acumulada en forma de estrellas se encuentra en estrellas de baja masa y que menos del 1% de todas las estrellas nacen con masas que superan diez veces la del Sol.

La Gran Nube de Magallanes al completo. ¿Eres capaz de encontrar la Nebulosa de la Tarántula?

Medir la proporción de estrellas masivas es extremadamente difícil, debido precisamente a su escasez, y solo hay un puñado de lugares en el universo observable donde se puede hacer. Uno de estos lugares es 30 Doradus, la mayor región local de formación de estrellas, que alberga algunas de las estrellas más masivas que se han encontrado. La gran muestra de estrellas de esta región analizada por los investigadores ha permitido a los astrónomos demostrar que las estrellas masivas son mucho más abundantes de lo que se pensaba. De hecho, estos resultados sugieren que la mayor parte de la masa estelar no está en estrellas de baja masa, sino que una fracción significativa estaría en estrellas muy masivas.

Implicaciones importantísimas para nuestra comprensión de la evolución del universo.

Las estrellas han producido la mayoría de los elementos químicos más pesados que el helio, desde el oxígeno que respiramos todos los días hasta el hierro que está en los glóbulos rojos de nuestra sangre. Durante sus vidas, las estrellas masivas producen cantidades gigantescas de radiación ionizante y de energía cinética en forma de fuertes vientos estelares. La radiación ionizante de las estrellas masivas fue crucial para volver a iluminar el Universo después de la llamada Épocas Oscuras, y su efecto cinético impulsa la evolución de las galaxias. Saber por tanto la proporción y número de estrellas masivas es fundamental.

Con estos resultados en la mano podríamos estar hablando de que habría un 70 % más de supernovas en el universo, de que la producción de elementos químicos pesados podría ser el triple y de que se estaría emitiendo cuatro veces más radiación ionizante de lo que se pensaba. Por si esto no fuese suficiente, la tasa de formación de agujeros negros sería un 180 % mayor, lo que se traduciría directamente en un aumento de las fusiones de agujeros negros binarios como las recientemente detectadas por LIGO en forma de ondas gravitacionales.

Los resultados como vemos tienen una importancia potencial enorme. La cuestión es, ¿son extrapolables al conjunto del universo? Y, si es así, ¿cuáles serían las consecuencias para el actual modelo de evolución de nuestro universo?

Referencia:

F.R.N. Schneider et al (2018) An excess of massive stars in the local 30 Doradus starburst Science doi: 10.1126/science.aan0106

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Hay más estrellas masivas de lo que se creía y lo que eso implica para la historia del universo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Está la materia oscura detrás de las extinciones masivas?

- El universo en un día: La vida de las estrellas, por Natalia Ruiz Zelmanovitch

- La estructura en común de estrellas de neutrones y aparcamientos

Blaise Pascal, Dios y la cicloide

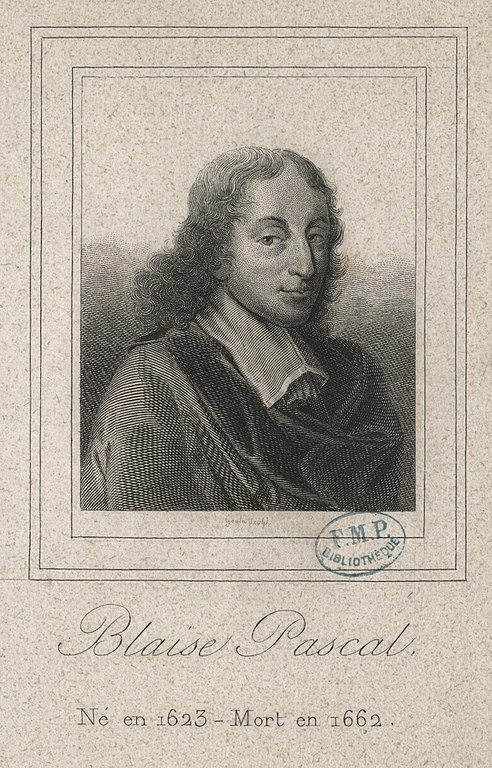

Siempre me ha gustado una anécdota del matemático francés Blaise Pascal (1623-1662) del periodo de su vida en el que abandonó la ciencia y se dedicó por completo a Dios, pero se le cruzaron en el camino un dolor de muelas y la cicloide. En esta entrada del Cuaderno de Cultura Científica me gustaría contaros esta anécdota, junto con otra sobre su precoz talento para las matemáticas, y en particular, para la geometría.

Grabado del matemático Blaise Pascal (1623-1662), realizado por el grabador Goulou. Fuente: Bibliothèque Interuniversitaire de Santé/Wikimedia Commons

Blaise Pascal nació el 19 de junio de 1623 en Clermont, hoy en día Clermont-Ferrand, (Francia). Su padre fue Etienne Pascal (1588-1651), jurista francés que fue consejero del rey por la Baja Auvernia, vicepresidente de la Cour des aides, una corte suprema encargada de los impuestos y otros temas fiscales, de Clermont y posteriormente, presidente de la Cour des aides de Normandia, quien además hizo sus pinitos en matemáticas, como el estudio de la curva llamada “el caracol de Pascal”. Su madre, Antoinette Begon, murió cuando Blaise tenía tan solo tres años, tras el nacimiento de su hermana Jaqueline. Tenía otra hermana, Gilberte, tres años mayor que Blaise.

Obra “Caracol de Pascal” (2017), de la serie MathArt (Wiskunst), del artista holandés Bart Mulckhuijse

Se tiene mucha información sobre la niñez del matemático Blaise Pascal debido a que su hermana Gilberte, de casada Gilberte Périer, escribió una biografía sobre su hermano. Por ejemplo, sabemos que su padre se encargó de la educación de sus tres hijos, y muy especialmente de la de Blaise. Así, Gilberte escribió, como se recoge en el libro Blaise Pascal: la certeza y la duda,

“…al morir mi madre en 1626, cuando mi hermano no tenía más que tres años, mi padre, al quedarse solo, se entregó con mayor dedicación al cuidado de la familia; y como Blaise era su único hijo varón, esta cualidad y las demás que en él observó [las grandes pruebas de inteligencia que observó en él] le llenó hasta tal punto de afecto paternal que decidió no encargar a nadie la tarea de su educación y tomó la resolución de instruirle él mismo, como en efecto hizo, pues mi hermano no tuvo nunca otro maestro que mi padre…”

Más aún, en 1631, Etienne decidió marcharse con sus dos hijas y su hijo, que tenía 8 años, a vivir a París, pensando especialmente en la educación de su hijo varón.

Blaise era un niño enfermizo por lo que su padre decidió darle una educación más clásica, centrada en las lenguas y la filosofía, y alejada completamente de las matemáticas, con el objetivo de mantenerlo en una relativa tranquilidad y no forzar su salud. Más aún, Etienne evitaba hablar de matemáticas en presencia de su hijo, incluso cuando sus amigos (entre ellos estaba, por ejemplo, el matemático Gilles Personne de Roberval o Marin Mersenne) le visitaban en casa. Pero la prohibición de incluir las matemáticas en su educación, solo consiguió despertar en Blaise la curiosidad por las mismas, y terminó preguntándole a su padre, cuando tenía 12 años, sobre la geometría. Etienne le explicó, según narra Gilberte en su bografía, que “… en general, [la geometría] es el medio de construir las figuras exactas y de encontrar las proporciones entre ellas”, pero le prohibió volver a hablar, o pensar, sobre el tema.

“Alegoría de la geometría” (1649), del pintor francés Laurent de la Hyre (1606-1656)

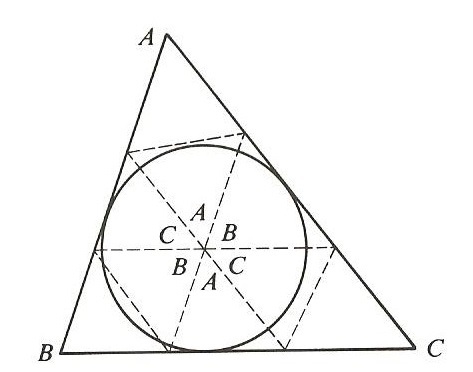

Estimulado por la descripción que su padre hizo de la geometría, y a pesar de su prohibición, Blaise empezó a estudiarla a escondidas en su habitación. Descubrió por su cuenta muchas propiedades de figuras geométricas, por ejemplo, que la suma de los ángulos de un triángulo es lo mismo que dos ángulos rectos, es decir, 180º. Según Howard W. Eves, esto fue realizado después mediante algún proceso que consistía en el plegado de un triángulo de papel, del estilo de plegar los vértices del triángulo sobre el centro de una circunferencia inscrita en el triángulo o el plegado de los vértices sobre uno de los lados del triángulo, procesos que se muestran en la siguiente imagen.

Cuenta la hermana mayor de Blaise que como tampoco conocía los términos matemáticos de los objetos geométricos que estudiaba, se fue inventando los nombres de los mismos. Por ejemplo, al círculo le llamó “aro” y a la línea recta “barra”.

Cuando su padre le sorprendió estudiando las figuras geométricas y vio los resultados que había obtenido por su cuenta lloró de alegría al ver la capacidad que tenía su hijo para las matemáticas. Entonces le regaló una copia del gran libro de las matemáticas griegas Los Elementos del matemático Euclides (aprox. 325 – 265 a.c.), un compendio de todo el saber geométrico, aunque también de aritmética y álgebra, de la matemática griega y que fue el libro de texto de matemáticas por antonomasia durante más de dos mil años, que devoró rápidamente con gran placer.

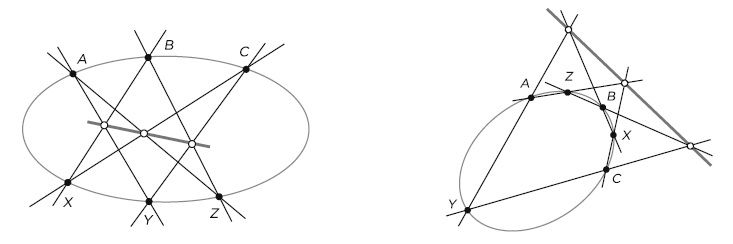

A la edad de 14 años ya empezó a participar, con su padre, en las reuniones de un grupo de matemáticos de París, organizadas por el matemático Marin Mersenne (1588-1648), conocida como la “Academia de Mersenne” y germen de lo que sería la Academia de Ciencias de París, fundada en 1666. Con tan solo 16 años, escribió su Essai pour les coniques –Ensayo sobre las cónicas- (1640), un artículo con una única página que contenía uno de los grandes resultados geométricos de la historia de las matemáticas, hoy en día un resultado clásico de la geometría proyectiva, el conocido como teorema de Pascal o como lo denominó el joven Pascal, el hexagrama místico.

Teorema de Pascal: Sean A, B, C, X, Y, Z seis puntos sobre una cónica Q del plano proyectivo. Si las líneas AY, BZ, CX intersecan a las líneas BX, CY, AZ, respectivamente, entonces los tres puntos de intersección son colineales, es decir, pertenecen a una misma recta (que se suele denominar recta de Pascal).

El resultado también se puede formular de la siguiente forma: si un hexágono (que puede ser estrellado, como en la imagen anterior) está inscrito en una cónica del plano proyectivo, entonces los puntos de corte de las rectas que continúan a los lados opuestos del hexágono son colineales, de ahí el nombre de “hexagrama místico” (de Pascal).

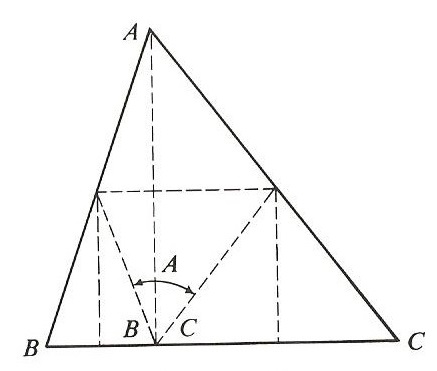

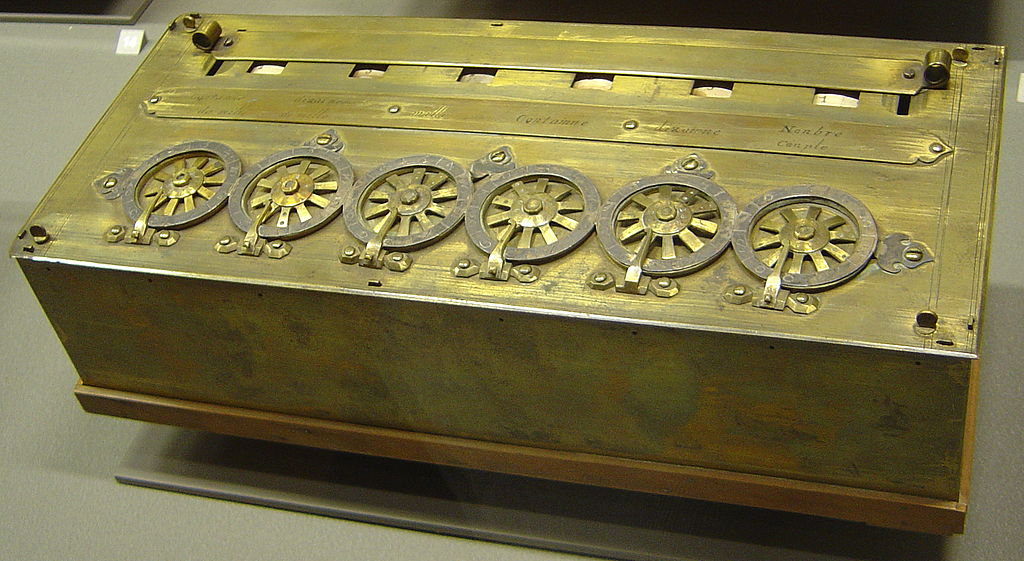

Cuando Pascal tenía 18 o 19 años inventó la primera calculadora mecánica, la pascalina, que funcionaba con ruedas y engranajes. Después de realizar muchos prototipos, la pascalina fue presentada en público en 1645.

Pascalina, calculadora mecánica diseñada por Blaise Pascal, con seis rodillos, conservada en el Museo de artes y oficios de París y firmada personalmente por el matemático francés. Fotografía de David Monniaux / Wikimedia Commons

Blaise Pascal de interesaría después, hacia 1648, por el estudio de la hidrostática, demostrando la existencia de la presión atmosférica mediante el experimento de Puy-de-Dôme, confirmando la teoría y los ensayos del físico y matemático italiano Evangelista Torricelli (1608-1647) o la ley de Pascal sobre los vasos comunicantes, es decir, el estudio de la presión ejercida por un fluido.

Hacia 1653, el caballero de Méré, amigo de Blaise, le planteó algunas cuestiones como la siguiente. Supongamos que dos jugadores de dados determinan jugarse un cierto dinero a apostar quien saca mejor puntuación después de un número dado de partidas, por ejemplo siete, pero el juego se interrumpe antes de esas siete partidas ¿Cómo debería repartirse el dinero apostado si, por ejemplo, uno ha ganado tres partidas y el otro una? Pascal le escribió al matemático (en realidad jurista) francés Pierre de Fermat (1607-1665) sobre estas cuestiones y la correspondencia entre ambos se considera hoy en día el origen de la teoría de probabilidades.

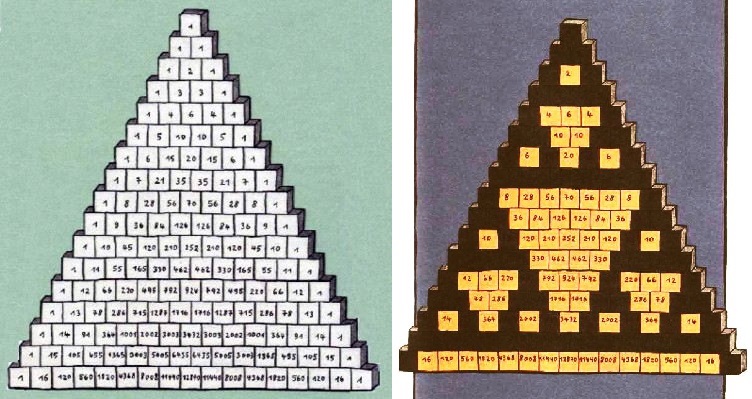

En 1654 publicaría varias obras estudiando otras cuestiones matemáticas, entre ellas el Traité du triangle arithmétique en la que estudia el famoso triángulo de Pascal, que es la representación de los coeficientes binomiales en forma triangular o el Traité des ordres numériques acerca de los órdenes de los números.

En el libro “El diablo de los números” (Siruela, 1988), de Hans Magnus Enzensberger, se explica el triángulo de Pascal y algunas de sus interesantes propiedades. Estas dos ilustraciones pertenecen al libro, la primera es el triángulo de Pascal en el cual cada número es la suma de los dos inmediatamente por encima, y en la segunda se muestran los patrones triangulares que aparecen cuando solo se muestran los números pares

Pero en otoño de 1654 Blaise Pascal sufre una profunda depresión. Su padre había muerto en 1651 y su hermana Jaqueline había ingresado en un convento. Entonces, se produce su conversión religiosa, tras un “accidente de tráfico”.

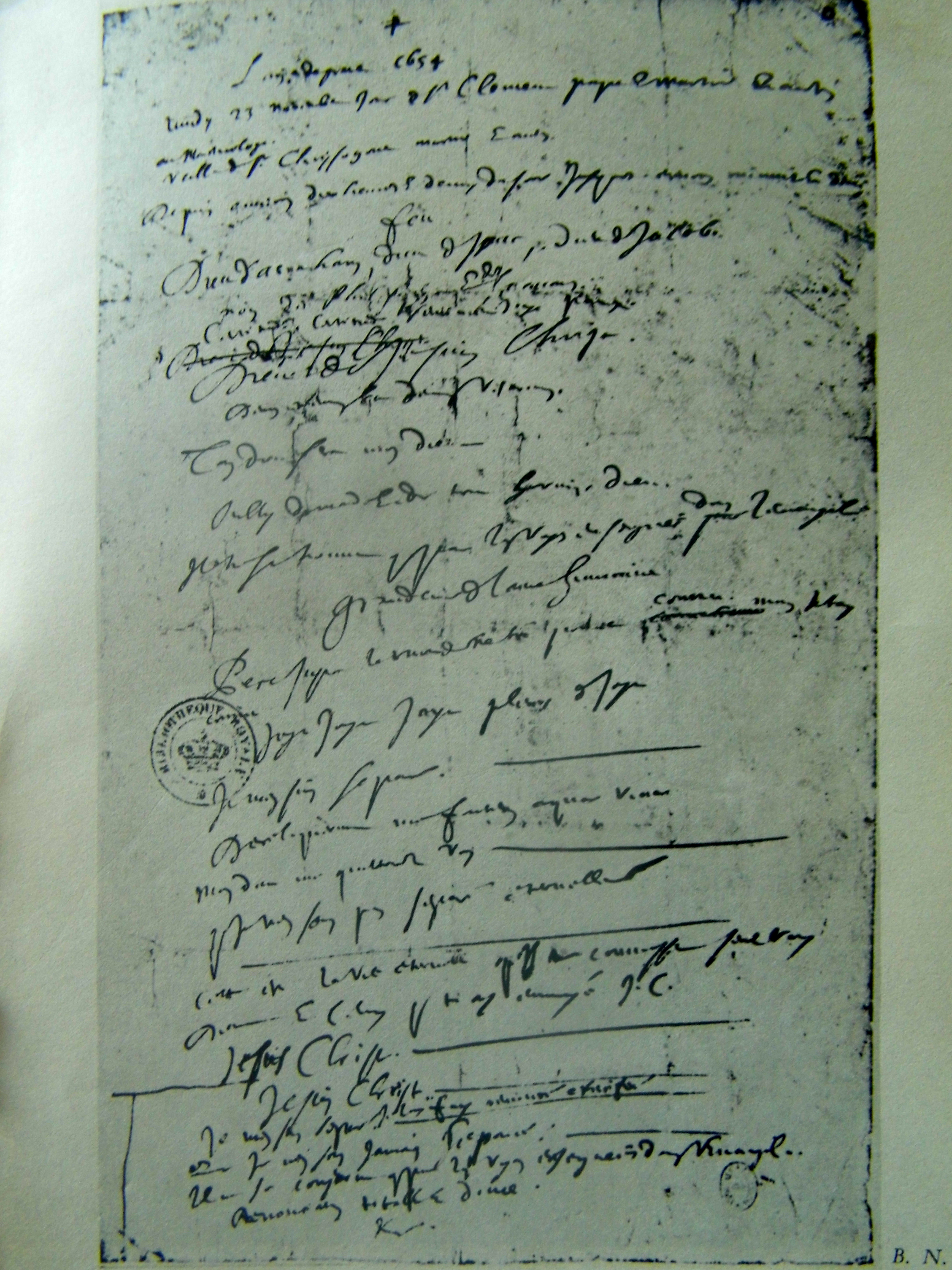

La noche del 23 de noviembre de 1654 Blaise Pascal iba dando uno de sus habituales paseos en coche de caballos al Pont de Neully. Al entrar en el puente los caballos se espantaron saltando el muro del mismo, pero antes de que estos en su caída arrastraran al carruaje, y a Blaise que estaba dentro, los enganches cedieron, quedando el carruaje, y en consecuencia también su pasajero, sobre el puente. El matemático se salvó de milagro.

Pascal vio este suceso como un mensaje de Dios y experimentó una especie de éxtasis religioso (esa misma noche del 23 de noviembre escribió su pensamiento sobre la experiencia en un texto de una hoja conocido como el Memorial, que está plagado de menciones a Dios), abandonando a partir de ese momento las matemáticas y la ciencia, para dedicarse por entero a la teología.

En ese periodo de tiempo dedicado a la religión escribe sus obras Lettres provinciales –Cartas provinciales- (1656-57) y los Penseés –Pensamientos- (se publicaría póstumamente en 1669), una defensa de la religión cristiana y una reflexión sobre el ser humano.

Memorial de Blaise Pascal, del 23 de noviembre de 1654. Bibliothèque Nationale de France / Wikimedia Commons

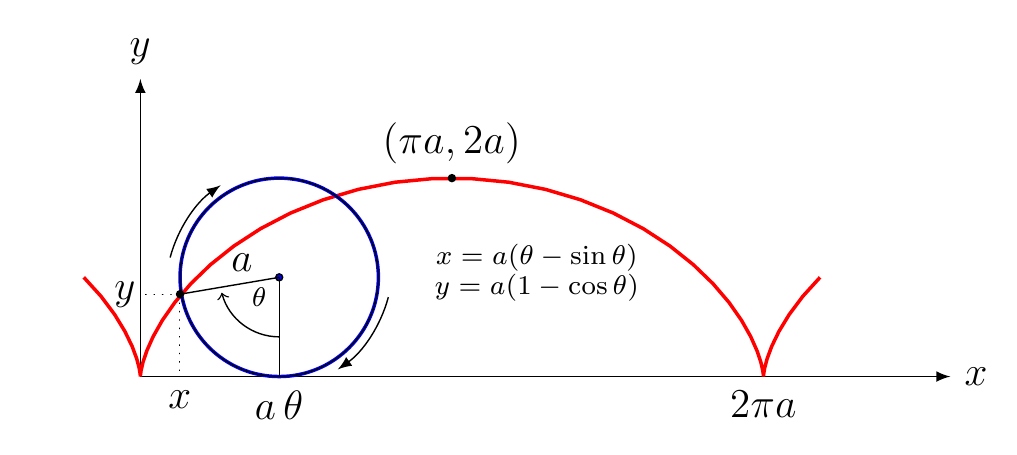

Pascal había abandonado completamente el estudio de las matemáticas. Pero ocurrió que una noche de 1658 sufría un terrible dolor de muelas, o quizás uno de los primeros dolores de cabeza que serían permanentes en sus últimos años de vida, y para intentar distraerse del dolor que sufría decidió dedicarse al estudio de la curva cicloide. La cicloide es la curva geométrica que describe un punto de una circunferencia que rueda sobre una línea recta.

La cicloide. Fuente: LaTeX Stack Exchange

Mientras trabajaba esa noche en la cicloide, el dolor de muelas cesó, lo cual fue interpretado por Pascal como que el estudio de las matemáticas no desagradaba a Dios y volvió de nuevo a dedicar parte de su tiempo a la investigación científica.

Por desgracia, en 1659 la salud de Blaise Pascal se deterioró mucho, por lo que tuvo que abandonar definitivamente el estudio de las matemáticas. Finalmente, el 19 de agosto de 1662, a la edad de 39 años, murió este gran científico, del que siempre se ha especulado sobre lo mucho que podría haber hecho, dado su gran talento para las matemáticas, si su vida hubiese transcurrido de otra forma. A pesar de ello, a Pascal le debemos grandes contribuciones a las matemáticas y la ciencia en general, y es uno de los grandes personajes de la historia de las matemáticas.

“Cicloides” (2004), del artista estadounidense Michael Schultheis

Bibliografía

1.- Howard W. Eves, Mathematical Circles (volume I), MAA, 2003.

2.- Carl B. Boyer, Historia de la matemática, Alianza Universiadad Textos, Alianza, 1992.

3.- Francisco Díez Del Corral, Blaise Pascal: la certeza y la duda, Vision Libros, 2009.

4.- Gilberte Périer, La vie de Monsieur Paschal, escrite par Madame Perier, sa sœur, femme de Monsieur Perier, conseiller de la Cour des Aides de Clermont, 1663. Este libro se puede consultar on line en wikisource

5.- Raúl Ibáñez, Cayley, el origen del álgebra moderna, Genios de las Matemáticas, RBA, 2017.

6.- Página web del artista Michael Schultheis

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Blaise Pascal, Dios y la cicloide se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Triangulando: Pascal versus Sierpinski

- La traba de Pascal: geometría proyectiva y literatura

- Matemáticas y mundo físico (y III): los pensamientos de dios

Kodetu al daiteke Historia? Kliodinamika baiezkoan dago

Historia ezagutu beharra dago, behin egindako akatsak berriro ez errepikatzeko. Mendetan zehar errepikatu izan den mantra da. Ideia horren atzean dagoen filosofia da, nonbait, iragana ezagututa etorkizuna aurreikus daitekeela. Halere, ia hori bezain zaharra da beste galdera bat: zientzia al da Historia?

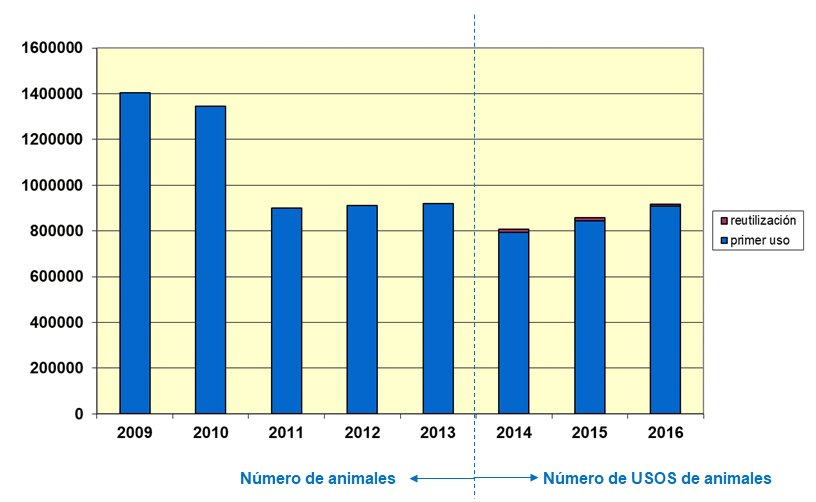

1. irudia: Historiaren izaera dinamikoa izanda ere, datuetan oinarritutako emaitza zientifikoak lor daitezkeela aldarrikatzen dute Kliodinamika babesten dutenek. (Argazkia: Juanma Gallego)

Ezetz esango dute gehienek, eta arrazoia izango dute, seguruenera. Baina ondorengo galderek erantzun zailagoa dute. Metodo zientifikoa erabil al daiteke Historia lantzerakoan? Humanitateak horrela aztertu ahal dira? Kasu honetan, zalantza gehiago agertzen dira. Bereziki arkeologoek aldarrikatzen dute haien jardunaren balio zientifikoa. Objektuak aztertu, eta sailkatu egiten dituztelako, txukuntasun zientifikoarekin. Halere, jakina da askoz harago doala arkeologia, “trastelogia” izan nahi ez badu bederen. Traste horien interpretazioa egin behar da, eta, askoren ustez, horretan dago diziplina horren funtsa: “Arkeologia antropologia da edo ez da ezer”, Gordon Willey eta Philip Phillips arkeologoen esanetan. Interpretazio horretan, beraz gauzak zaildu egiten dira.

Zientziak aldagaiak kodetzea gustuko du. “Ezaugarritzea” da zientzialarien aitagurean gehien aipatzen den hitzetako bat. Fenomenoak behatzea, ezaugarritzea, sailkatzea, eta aldagaien arteko loturak bilatzea; finean, errealitatea azaltzeko gai den teoria bat osatzeko. Ez edonolako teoria, gainera. Beste edonork, antzeko baldintzatan, errepikatu ahal izango duen teoria bat baizik. Jakinda, gainera, teoria hori kolokan jartzea dela beste zientzialarien beharra. Horrela urratzen baita zientziaren bidezidorra. Baina hau ia ezinezkoa da Historiaren alorrean. Ala agian bai?

Seshat “Historia globalaren datu-basea” izeneko tresnaren atzean dauden ikertzaileek baietz uste dute. Gizarteek dituzten konplexutasunak kodetzeak zaila badirudi ere, egile hauek lanari ekin diote. Planteamendu filosofikoetan murgiltzeari baino, praktikari ekin diote, gizarte desberdinak kodetzen dituen datu-basea sortuz eta elikatuz.

Egiptoko jainkosa baten izena du martxan jarri duten datu-baseak. Liburutegien eta idazketaren jainkosa da Seshat. Egiptoko mitologiaren arabera, iraganean gertatutakoari buruz, eta, era berean, etorkizunean gertatu behar zenari buruz idazten zuen Seshatek. Izen ezin aproposagoa, beraz, Historiari buruzko teoriak garatzea helburu duen tresna baterako.

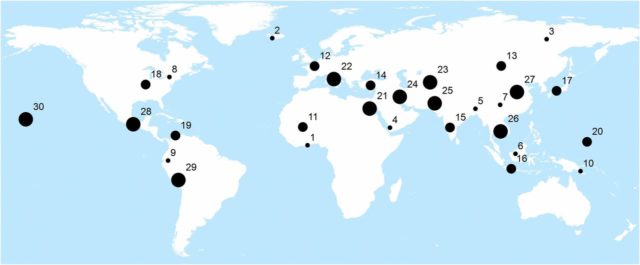

70 adituk baino gehiagok parte hartu dute historia eta arkeologiari buruzko datuak biltzen dituen tresnaren sorreran. Azken 10.000 urteetan 30 erregiotako informazio historikoa eta arkeologikoa biltzen ditu datu-baseak. 414 gizarte, orotara. Egileen esanetan, orain arte gaiari buruz munduan garatu den datu-baserik osatuena da.

Mundua 10 eremutan bereizi dituzte, eta, horietako eremu bakoitzean hiru lokalizazio hautatu dituzte, “eremu geografiko natural” izenaren pean. Hiru lokalizazio horiek gizarteen garapen mailaren adierazgarri dira: hasierako gizarteak, erdikoak eta, azkenik, zentralizazio politikoa duten gizarteak. “Gure helburua da iraganeko gizarteei buruz dagoen ezagutza biltzea, baita informazioa ziurra ez denean eta adituen arteko desadostasunak daudenean ere”, zehaztu dute PNAS aldizkarian argitaratutako artikulu batean.

Analisirako unitatea gisa “polity”-a ezarri dute (gobernua edo estatua esan nahi du, ingelesez). Unitate horrek maila guztietako batasun independenteak biltzen ditu; berdin maila lokalean aritzen diren komunitate independenteak, zein etnia anitz biltzen dituzten inperio hedakorrak. Eremu geografiko natural bakoitzean, denbora 100 urteko tarteetan banandu dute. Horrela, toki eta une bakoitzean adierazgarria den “polity”-a identifikatu dute, analisia egin ahal izateko (adibidez, hemen, Erresuma Ostrogotikoaren “polity”-aren fitxa).

Konplexutasun sozialaren adierazle desberdinak kontuan hartu ahal izateko, 51 aldagai ezarri dituzte. Aldagai horiek bederatzi multzotan bildu dituzte.

- Populazioa

- Lurraldea

- Hiriburua

- Hierarkia adierazten duten aldagaiak (erabakitze guneak, erlijioa…)

- Gobernua

- Azpiegiturak

- Informazio sistemak

- Literatura

- Garapen ekonomikoa

Aldagai hauek kontuan hartuta, datuen analisi estatistikoa egin dute. Besteak beste, eta horrenbeste aldagaien artean korrelazioak bilatu ahal izateko, osagai nagusien analisia baliatu dute. Hasierako hiru multzoen arteko korrelazioa aurkitzea espero zuten -populazioa, lurraldea, eta hiriburua-, eta hala izan da, baina gainerako aldagaien artean ere harremana aurkitu dute. Diotenez, aldagai batzuk ezagututa, posible da beste aldagaiak aurreikustea. Bereziki populazioaren aldagaia da besteekin harreman gehien omen duena. “Emaitza honek berresten du hipotesietako bat: konplexutasun soziala neurketa bakar baten bitartez adieraz daitekeela”, diote zientzia artikuluan.

2. irudia: Ikertzaileek munduan zehar aukeratu dituzten 30 eremuak. Puntuetako lodierak gizarteen antzinatasuna adierazten du. (Irudia: PNAS)

Horrez gain, berretsi dute ere kontinente desberdinetan dauden gizarteek bidea ematen dutela konparaketak egiteko. Europarren eta amerikarren arteko talka jarri dute adibidetzat. “PC1an [populazioa azaltzen duen aldagaia] dauden desberdintasunek adierazten dute Ameriketako gizarteak ez zirela Eurasiako gizarteak bezain konplexuak gizarte hauek kontaktuan jarri zirenean. Horrek lagun dezake azaltzen zergatik Europako gizarteak gai izan ziren Amerika inbaditu eta kolonizatzeko”.

Bestalde, zenbait gizarte txikik beste handiagoen ohiturak berenganatzen dituzte gizarte horiekin harremanetan egoteko, baina horrek ez dakarkie aldaketarik beste arloetan. Diruaren eta idazketaren adibidea jarri dute. “Hautapen selektibo horrek ez du esan nahi halabeharrez beste ezaugarri konplexuak garatuko dituztenik”.

Kliodinamika, historia eta matematikaEgileek argudiatu dutenez, iraganeko gizarteei buruz dagoen ezagutza kolektiboa “historialarien garunetan gordeta edota ohar eta argitalpen heterogeneotan sakabanatuta” dago. Era berean egileek diote ezagutza potentzial honi guztiari etekinik ez zaiola atera, eta, hortaz, ezin izan direla erabili garapen politikoaren edota ekonomikoaren inguruko teoriak osatzeko.

Exeterreko Unibertsitateak (Erresuma Batua) zabaldutako prentsa ohar batean, Thomas Currie antropologoak nabarmendu du “azaleko desberdintasunen gainetik, gizarteek duten eboluzionatzeko moduan oinarrizko antzekotasunak” badirela. Gizarte guztiek antzeko egiturak dituztela uste dute ikertzaileek, ez du axola garatu diren espazioa edo garaia zein den.

Ikerketan egile askok parte hartu badute ere, Peter Turchin Connecticuteko Unibertsitateko (AEB) biologoa da egile nagusia. Matematika eta zientzia sozialak uztartzeko egin dituen ahaleginei esker ezaguna da Turchin. Kliodinamika metodoaren sortzailea da. Indikatzaile desberdinak erabilita, gizarteen garapena aztertu nahi du Kliodinamikak, eta, ahal den heinean, garapen hori aurreikusi. (Isaac Asimoven Foundation liburua irakurri dutenei, berehala etorriko zaie burura psikohistoria izeneko diziplina).

2017. urtearen hasieran Turchinen ikerketa batek oihartzun mediatiko handia izan zuen. Bertan babesten zuen munduan eliteak handitzen ari direla, eta gero eta lagun gehiago jasaten ari direla baldintza ekonomikoen txirotze bat. Horrek gero era biolentzia gehiago ekarriko duela proposatu zuen.

Erreferentzia bibliografikoa:

Turchin et alia. Quantitative historical analysis uncovers a single dimension of complexity that structures global variation in human social organization. PNAS 2017:1708800115v1-201708800. DOI: 10.1073/pnas.1708800115

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Kodetu al daiteke Historia? Kliodinamika baiezkoan dago appeared first on Zientzia Kaiera.

Sistemas respiratorios: la curva de disociación de un pigmento respiratorio

Sangre desoxigenada, a la izquierda, frente a sangre oxigenada, derecha.

El oxígeno se combina con la molécula del pigmento respiratorio uniéndose a sus átomos metálicos. En las hemoglobinas, por ejemplo, hay cuatro grupos hemo y en cada uno de ellos, un átomo de hierro, con cada uno de los cuales puede combinarse una molécula de oxígeno, aunque esas proporciones son diferentes en otros pigmentos. El grado de oxigenación del pigmento es una función de la tensión parcial del oxígeno (tO2) en la sangre, hemolinfa o medio respiratorio de que se trate.

La tensión parcial de un gas disuelto en un medio líquido es, por definición, la presión parcial que tiene ese gas en la fase atmosférica con la que ese líquido se encuentra en equilibrio. Eso no quiere decir que para poder referirnos a una determinada tensión parcial el líquido en el que se encuentra disuelto el gas haya de estar en equilibrio con una fase atmosférica, sino que su tensión parcial es la presión parcial que tendría el gas en una atmósfera con la que hipotéticamente se encontrase en equilibrio. Y aunque, para una presión parcial determinada, la concentración de un gas disuelto puede variar en función de la temperatura y de la presencia y concentración de otros solutos, en condiciones fisiológicas normales la tensión parcial de un gas es proporcional a su concentración. Por lo tanto, el grado de oxigenación de un pigmento respiratorio es una función de la concentración de oxígeno disuelto en la sangre. Analizaremos ahora la naturaleza de la dependencia entre el grado de oxigenación del pigmento (magnitud que expresaremos como porcentaje de saturación) y la tensión parcial de oxígeno en el medio circulatorio. En lo sucesivo solo nos referiremos a la hemoglobina (Hb).

La concentración de hemoglobina combinada con el oxígeno [HbO2] es proporcional al producto de la concentración de hemoglobina no combinada [Hb] y de la concentración de oxígeno [O2], de manera que [HbO2] = K [Hb] [O2], siendo K un coeficiente denominado constante de equilibrio.

El porcentaje de saturación (y) es la fracción porcentual de hemoglobina combinada con respecto a la hemoglobina total (la suma de la combinada y la no combinada); o sea,

y = 100 · [HbO2]/{[Hb] + [HbO2]},

por lo que

y = 100 · K [Hb] [O2]/{[Hb] + K [Hb] [O2]};

de donde

y = 100 · K [O2]/{1 + K [O2]},

y dado que como antes se ha dicho, tO2 es proporcional a [O2], tenemos que

y = 100 · K tO2/(1+tO2).

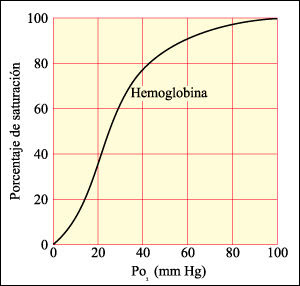

Curva teórica de disociación de la hemoglobina

Esa expresión define la denominada curva de disociación (o de saturación) del pigmento; es una función hiperbólica con un valor asintótico de 100. La ecuación nos dice que (1) a bajas tensiones parciales de oxígeno la probabilidad de que una molécula del gas se combine con una molécula de hemoglobina es muy alta, porque la mayor parte de los átomos metálicos de los grupos hemo se encuentran disponibles para ello, pero que (2) conforme aumenta la tensión parcial y las moléculas de hemoglobina van combinándose con las de oxígeno, cada vez quedan menos átomos metálicos disponibles, por lo que es necesario que haya cada vez más moléculas de oxígeno en disolución (mayor tO2) para que siga aumentando la fracción del pigmento combinado. Al tratarse de una curva asintótica, nunca se alcanza el 100%, o sea, nunca se satura el pigmento en su totalidad.

El valor de K refleja la propensión que tiene el pigmento a combinarse con el oxígeno. Cuanto más alto es ese valor con mayor facilidad se combinan ambos y más difícil resulta para el oxígeno desprenderse del pigmento. Por eso, un pigmento cuya curva de disociación tiene un valor alto de K, capta oxígeno con facilidad y lo cede difícilmente. Gráficamente estaría representado por una curva hiperbólica que se aproxima rápidamente al valor de 100.

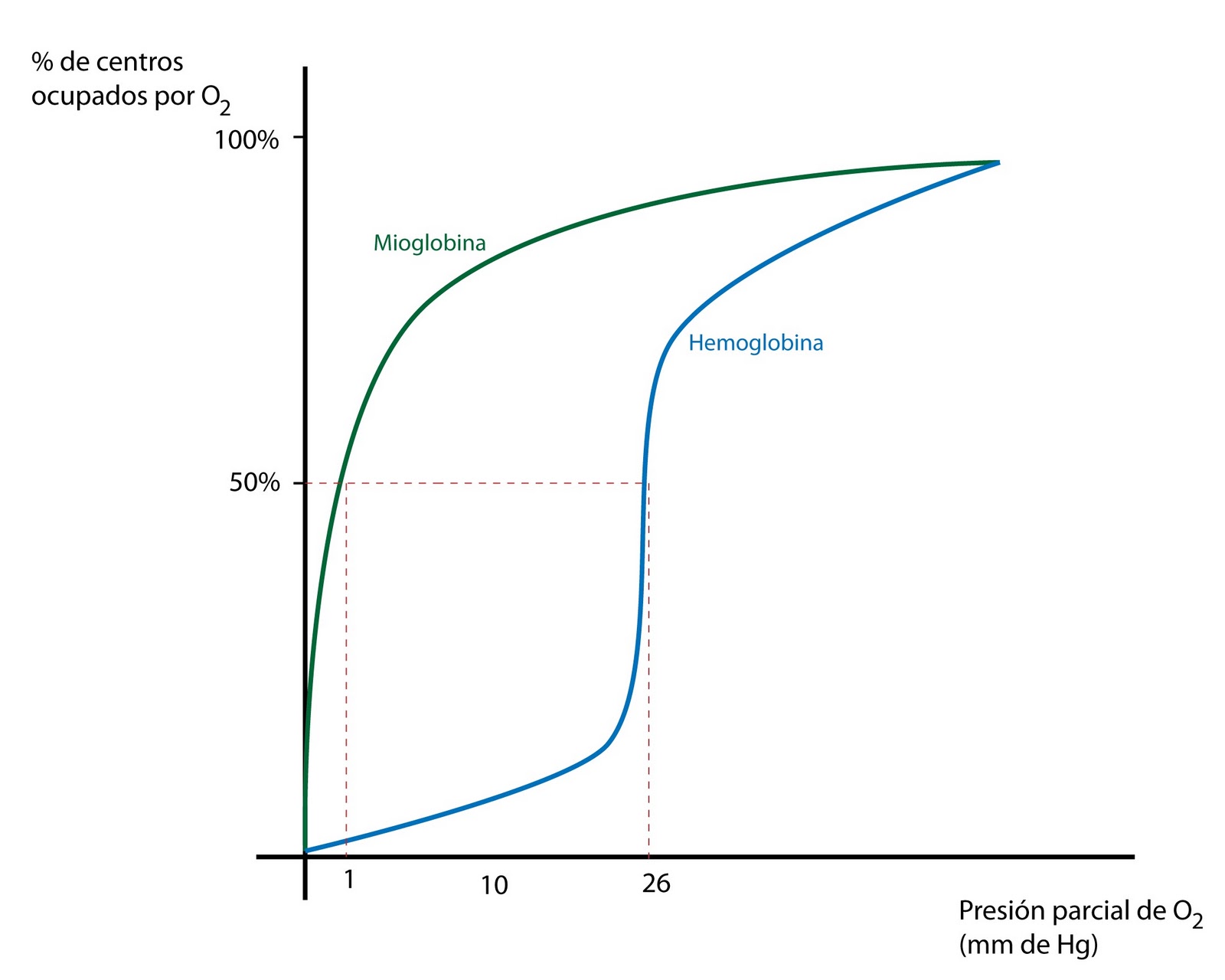

En pigmentos reales, sin embargo, las cosas son algo más complejas. En multitud de ocasiones se ha comprobado experimentalmente que la curva de disociación, más que hiperbólica, es sigmoidea; o sea, tiene forma de s. Y matemáticamente viene expresada por la denominada ecuación de Hill:

y = 100 x K tO2n/(1+tO2n),

que es similar a la anterior, pero en la que el término independiente (tO2) viene afectado por una potencia, n, que es el coeficiente de sigmoidicidad. Cuando n vale 1, tenemos la curva de disociación anterior. Y si toma valores superiores se trata de curvas sigmoideas; o sea, curvas con una primera fase de elevación relativamente lenta pero creciente para valores bajos de tO2, una segunda de elevación más rápida, y la tercera de aproximación asintótica al valor de 100.

Curvas de disociación de la mioglobiba (hiperbólica) y de la hemoglobina (sigmoidea, con forma de “s”)

La sigmoidicidad se produce como consecuencia de la existencia de fenómenos de cooperatividad. Al unirse una molécula de O2 a la molécula de hemoglobina, se altera levemente la conformación de esta y facilita, como consecuencia, las subsiguientes combinaciones. Eso explica que a muy bajos valores de tO2 la curva ascienda lentamente, porque la molécula de O2 que se une a la hemoglobina con mayor dificultad es la primera, pero una vez combinada esta, las siguientes lo hacen con facilidad creciente, razón por la cual la curva pasa a elevarse rápidamente a tensiones parciales de oxígeno intermedias, hasta aproximarse a los valores cercanos a 100, en los que el crecimiento es necesariamente lento y decreciente. La potencia n refleja la intensidad de las interacciones que dan lugar a la cooperatividad, de manera que cuanto mayor es, más intensa es esa cooperatividad y la curva de disociación es más sigmoidea.

Una noción clave en el estudio de los pigmentos respiratorios es la de “afinidad” del pigmento por el oxígeno. Nos hemos referido a esta noción de pasada antes, sin nombrarla. La afinidad de un pigmento refleja la intensidad con la que se combina con el oxígeno o, expresado en otros términos, la propensión o facilidad para combinarse. Un pigmento de alta afinidad se combina con el O2 con facilidad y se desprende con dificultad. O sea, capta oxígeno muy fácilmente y le cuesta cederlo. Por ello, a bajas tensiones parciales de oxígeno gran parte del pigmento se encuentra combinado en un gran porcentaje; lo contrario ocurre con un pigmento de baja afinidad. No hay un parámetro que mida directamente esa característica, aunque suele utilizarse el denominado p50, como indicador. El p50 es el valor de tensión parcial de oxígeno al que el pigmento ha alcanzado el 50% de su valor de saturación.

Quien haya llegado hasta aquí quizás piense que lo lógico es que un buen pigmento respiratorio tenga una gran afinidad por el O2. En la próxima anotación podrá comprobar que esa idea es incorrecta.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: la curva de disociación de un pigmento respiratorio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: los pigmentos respiratorios

- Sistemas respiratorios: distribución de los pigmentos

- Sistemas respiratorios: los límites a la difusión de los gases

La relatividad del tiempo (2)

La dilatación del tiempo explica por qué en la Estación Espacial Internacional el tiempo va más lento, con un retraso de 0,007 segundos cada seis meses.

¿Cuánto más lento parece un reloj que se mueve respecto de un observador? La relación exacta entre el intervalo de tiempo transcurrido registrado por un reloj que está estacionario con respecto al observador (Mónica) y el intervalo de tiempo transcurrido para el mismo fenómeno medido por alguien que observa el reloj en movimiento a una velocidad constante v (Esteban), la relatividad del tiempo, viene dada por una ecuación muy sencilla,

Δte = Δtm /√(1-v2/c2).

Lo que puede hacer que la ecuación para la dilatación del tiempo parezca complicada es el término en la raíz cuadrada, que es el que contiene gran parte de la física. Sin embargo, es muy simple. El símbolo c es la velocidad de la luz en el vacío, y v es la velocidad del reloj que se mueve en relación con el observador que mide el intervalo de tiempo transcurrido Δte. Para los objetos reales, no imaginarios, v es siempre menor que c. Por lo tanto, v/c es siempre menor que uno y, por consiguiente, también lo es v2/c2. Como v2/c2 se resta de 1, el resultado de esta resta siempre es un número positivo menor que 1. La raíz cuadrada de un número positivo menor que 1 es siempre un numero menor que uno [1]. De ahí que podamos afirmar que si Mónica se mueve, esto es, para una velocidad v no nula, Δte será mayor que Δtm. En otras palabras, el tiempo pasa más rápido para Esteban que está estacionario observando cómo Mónica se mueve a velocidad v, o, visto de otra manera, Esteban observa que el reloj en movimiento que acompaña a Mónica se mueve más lentamente. Obviamente, si v = 0 entonces Δte = Δtm, esto es,dos observadores en reposo uno respecto al otro miden el mismo paso del tiempo.

¿Qué sucede a velocidades muy altas?

Asumamos que la velocidad del reloj en movimiento (o cualquier proceso repetitivo) es extremadamente alta, digamos 260,000 km/s, relativa a otro marco de referencia inercial. La velocidad de la luz c en el vacío es constante y, redondeando, de 300,000 km/s. Cuando el reloj en movimiento registra un intervalo de tiempo de 1 s en su propio marco inercial (Δtm = 1 s), ¿cuál es el intervalo de tiempo para alguien que mira el reloj pasar a la velocidad de 260,000 km/s? Resolvamos la ecuación Δte = Δtm /√(1-v2/c2) paso a paso:

v/c = 260.000/300000 = 0,867

v2/c2 = [0,867]2 = 0,75

1 – 0,75 = 0,25

√0,25 = 0,5

Por lo tanto, como Δtm = 1 s,

Δte = Δtm/ 0,5 = 1s /0,5 = 2 s

Este resultado dice que un reloj que se mueve a 260,000 km/s y que registra un intervalo de 1 s en su propio marco inercial, a un observador en reposo en relación con el reloj le parece que va muy lento. Mientras la persona que viaja con el reloj registra un intervalo de 1 s, el observador en reposo medirá (con respecto a su propio reloj) el doble de tiempo, 2 s. Recordemos que el reloj no parece ralentizarse en absoluto a la persona que se mueve con el reloj; pero para el observador externo el intervalo de tiempo se dilata considerablemente.

¿Qué sucede a velocidades ordinarias?

Es de señalar que en la situación anterior obtenemos un efecto de dilatación del tiempo de “solo” dos veces con una velocidad relativa de 260,000 km/s, casi el 87% de la velocidad de la luz. Para velocidades mucho más bajas, el efecto disminuye muy rápidamente, hasta que a velocidades ordinarias no es apreciable salvo en experimentos muy delicados.

Por ejemplo, veamos una situación de la vida real, digamos un reloj marcando un intervalo de 1 s dentro de un avión a reacción, volando a la velocidad del sonido de aproximadamente 0.331 km/s. ¿Cuál es el intervalo de tiempo correspondiente observado por una persona en reposo en tierra? Si repetimos la operativa, tenemos:

v/c = 0,331/300000 = 1,10 ·10-6

v2/c2 = [1,10 ·10-6]2 = 1,22 ·10-12

1 – 1,22 ·10-12 = 0,99999999999878

√0,99999999999878 = 0,99999999999938

Por lo tanto, como Δtm = 1 s,

Δte = Δtm/ 0,99999999999938 = 1s /0,99999999999938 = 1,00000000000061 s

Con una cantidad tan increíblemente pequeña de dilatación del tiempo, no es de extrañar que este efecto nunca se hubiese observado antes. Debido a que el efecto es muy pequeño, la física de Newton todavía es útil para el mundo cotidiano de las velocidades normales para el que se construyó. Es falso afirmar (Einstein jamás dijo nada parecido) que la teoría de la invariancia [2] demuestre que la física de Newton deja de ser válida; tan falso como afirmar que los calibres (pies de rey) demuestren que los metros de carpintero no sirven, lo que ocurre es que sirven a determinada escala.

En cualquier caso, la dilatación del tiempo en los relojes en movimiento está ahí, y de hecho fue confirmado en un famoso experimento que involucraba un reloj atómico muy preciso que volaba alrededor del mundo en un avión de pasajeros. Si bien se vuelve significativo solo a velocidades relativas cerca de la velocidad de la luz, que es el caso en experimentos de laboratorio de alta energía y en algunos fenómenos astrofísicos, también es importante en medidas de precisión que toman mucho tiempo. Así, los satélites del sistema GPS se desplazan a 4 km/s, lo que representa una ralentización de 7 microsegundos por día, solo debido al efecto que hemos visto [3]; este efecto debe tenerse en cuenta en el diseño.

Notas:

[1] Estrictamente la raíz cuadrada de un número no es unívoca, no da un solo resultado, sino dos, uno positivo y otro negativo. Así la raíz cuadrada de 4 es tanto +2 como -2, ya que tanto (+2)·(+2) como (-2)·(-2) dan 4. En este caso descartamos la raíz negativa por carecer de sentido físico.

[2] Popularmente, teoría de la relatividad.

[3] Existe también un efecto debido a la relatividad general. Ambos efectos combinados harían que los observadores de la Tierra vieran los relojes de los satélites GPS 38 microsegundos por día más rápidos que los relojes en la Tierra (en el satélite la atracción gravitatoria es menor que en la superficie del planeta y el reloj “corre más” compensando el efecto debido a la velocidad relativa). Las posiciones calculadas por GPS se desviarían rápidamente, acumulándose unos nada despreciables ¡10 kilómetros por día!. Esto se corrige en el diseño del GPS.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La relatividad del tiempo (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La relatividad del tiempo (1)

- El principio de relatividad (y 4): la versión de Einstein

- El principio de relatividad (3): la invariancia de Galileo

Gizakia izarretara bidean

Breakthrough Starshot proiektuan lan egiten dutenen ustean, bai. Horien artean dira Mark Zuckerberg (Facebook-en sortzailea) moduko enpresariak, alde batetik, eta Stephen Hawking moduko zientzialariak, bestetik. Unibertsoaren inguruan garrantzi handiko galderak erantzun nahirik ari diren Breakthrough Initiatives izeneko egitasmoetako bat da Startshot. Gizakia izarretara joan daitekeen ala ez jakin nahi du.

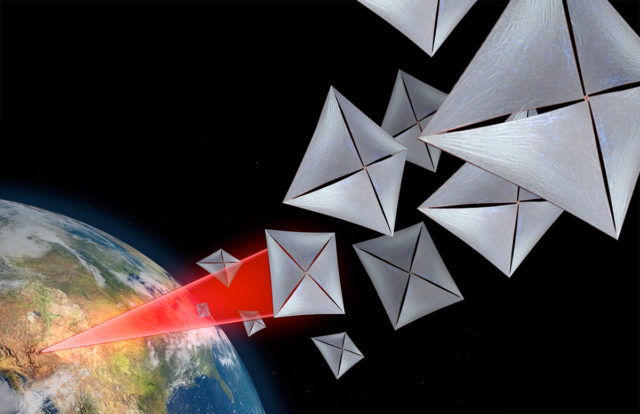

1. irudia: Breakthrough Starshot proiektuaren baitan garatzen ari diren nano-ontziak Lurretik jaurtitako laser batez bultzatuko dira Alpha Centauri izarrerantz 200 milioi km/h-ko abiaduran. (Argazkia: Breakthrough Initiatives )

Espazio-agentzia batek izarretara joateko misio bat mahaigaineratu ahal izateko, halako bidaia bat egitea posible dela frogatu behar da lehenengo. Hau da, horretarako gai dela gaur egun dugun teknologia, edo epe laburrean garatu dezakegun teknologia. Hori da Starshoten helburu nagusia, izar batera joan ahal izateko teknologia garatzea.

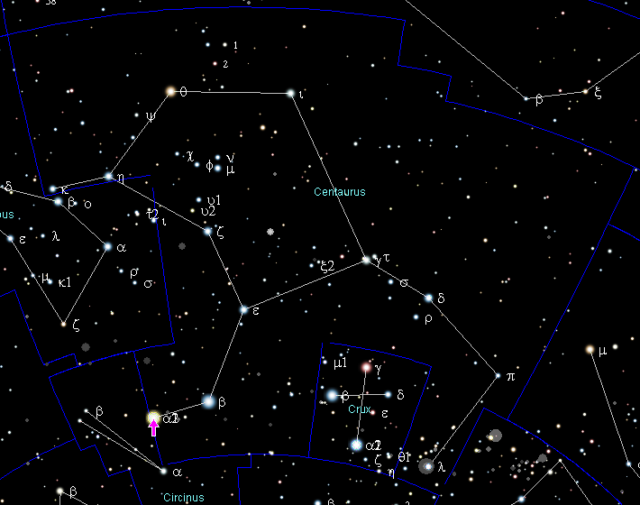

Alpha Centauri da gertuen dugun izar-sistema. Centaurus konstelazioan kokatua (ikus 2. irudia), gugandik 4,36 argi-urtera edo 41 bilioi kilometrora dago. Egungo espazio-ontzietan ehunka mila urte beharko genituzke bertara iristeko. Gehiegi. Abiadura handiagoa behar da, askoz handiagoa. Argiaren abiaduran (1080 milioi km/h) edo ia abiadura horretan joan beharko genuke urte kopuru ez oso handi batean Alpha Centaurira iristeko.

2. irudia: Alpha Centauri izar-sitema Centaurus konstelazioan topatzen da. (Argazkia: Wikipedia / Jabego publikoko argazkia)

Halere, espazioaren esplorazioan ohikoa den moduan, gizakia nonbaitera joan aurretik robotak bidaltzen ditugu, espazio-ontziak. Kasu honetan, nano-ontziak. Milaka nano-ontzi.

Gaurko espazio-ontziak handiegiak, edo hobe esanda, pisutsuegiak dira halako abiadura hartzeko. Baina Breakthrough Starshot proiektuko partaideek uste dute potentzia handiko izpi-jaurtigailu batekin nano-ontziak bultzatu eta argiaren abiaduraren %15-20ko abiaduran (gutxi gorabehera 200 milioi km/h) jarri ahalko genituzkeela, gramo gutxi batzuetako espazio-ontziak sortzeko gai bagina. Honela, Alpha Centaurirako bidaia 20 urtera murriztuko litzateke. Hori bai, ezin dugu ahaztu 20 urte horiei beste 4,36 urte gehitu beharko genizkiekeela bertako informazioa (argazki edo datu zientifiko) gugana itzultzeko. Nano-ontziari bidali nahiko geniokeen edozein motatako informazioak bertara heltzeko ere denbora hori beharko luke.

Jaurtiketa2036an jaurti nahi dituzte lehen nano-ontziak, mila nano-ontzi batera. Ontzi handiago baten barnean jaurtiko lirateke Lurretik, eta, ondoren, espazioan direla, banan-banan aterako lirateke ontzi-nagusitik. Bestalde, Lurrean, potentzia handiko izpi-jaurtigailu bat eraikiko litzateke laser multzo handi batez osatuta (ikus animazioa). Jaurtigailu horrek nano-ontzi bakoitzaren bela (“haize”-oihala) jo eta ontzia norabide zuzenean azeleratuko luke.

Erronka handiak dira hauek, ordea. Bai espazio-ontzi hain txikiak egitea, bai izpi-jaurtigailu indartsua egitea.

Nano-ontzi bakoitzak izango duen oihalak, adibidez, 4 metroko zabalera izan beharko du, Lurretik laserrak ondo lerrokatu ahal izateko. Ezin du ordea ia masarik izan, nano-ontziaren osoko masa handiegia ez izateko. Bestalde, nano-ontziek Alpha Centaurira iritsitakoan, zientzia egin behar dute, hau da, irudiren bat hartu, adibidez. Horretarako, gutxienez kamera bat eraman behar dute. Kamera hori hornituko duen energia-iturria ere eraman behar dute. Ondoren, irudi hori Lurrera bueltan bidaltzea nahi dute, eta beraz, telekomunikazio-sistema bat ere eraman behar dute. Eta abar, eta abar. Dena gramo gutxi batzuetan, zentimetro gutxi batzuetan.

Izpi-jaurtigailuak potentzia handia izan beharko du nano-ontziak 200 milioi km/h-ko abiadurara arte azeleratzeko. Hori dela eta, izpiaren uhin-luzera eta fasea oso garrantzitsuak izango dira, ahalik eta erradiazio gehien iris dadin espaziora eta, ondorioz, nano-ontziek jasotako bultzada ahalik eta handien izan dadin. Eta garrantzitsuena, laser guztiak lerrokatuta eta sinkronizatuta egon beharko dira. Izpi-jaurtigailua non eraiki ere ondo pentsatu behar da. Izan ere, alde batetik, atmosferak erradiazio asko xurgatzen du, espaziora iristen den energia gutxiagotzen delarik. Bestetik, atmosferaren turbulentziak izpiaren sekzioa zabal dezake. Beraz, jaurtigailua altuera handitan kokatzea komeni da, izpiak atmosfera gutxiago zeharka dezan.

Alpha CentauriAlpha Centauri izarra aukeratu da Starshot egitasmorako. Izatez, izar-sistema bat da. Alpha Centauri A eta Alpa Centauri B izarrak elkarri lotuta daude grabitate indarragatik. Biek masa-zentro beraren inguruan biratzen dute, 80 urteko orbita eliptikoetan. Lehenengoa Eguzkia baino apur bat handiagoa eta distiratsuagoa da, eta bigarrena Eguzkia baino apur bat txikiagoa eta apalagoa. Baina bada hirugarren izar bat, Proxima Centauri nano gorria, beste bien inguruan biraka egon daitekeena. Hala balitz, bere orbita ehunka urtekoa izango litzateke.

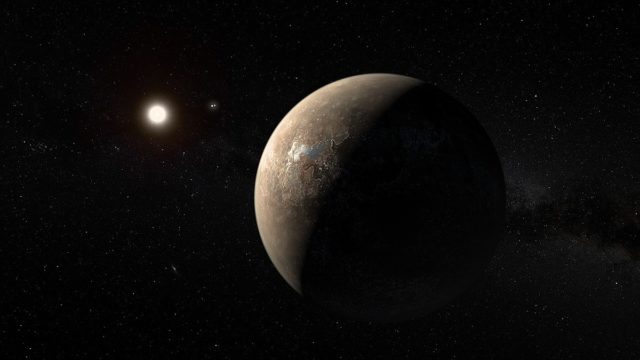

Proxima Centauri izarra da, hain zuzen, gugandik gertuen dagoen izarra. Eta badu beste ezaugarri interesgarri bat gainera, Proxima Centauri b exoplaneta. 2016ko abuztuan aurkitua, Lurra-moduko (Earth-like) exoplaneten artean sailkatzen da. Lurraren masa eta erradio oso antzekoak izan ditzakeela uste da, eta izarrarekiko duen distantzia egokia da exoplanetaren gainazalean ur likidoa egon dadin. Halere, Proxima Centauri izarrak haize bortitzak jaurti ditzakeela uste da, eta horrek zaila egingo luke planetaren inguruan atmosfera bat mantentzea. Beraz, bizia baldin bada Proxima Centauri b-n, gainazalaren azpian izan beharko da.

3. irudia: Artista batek eginiko Proxima Centauri b exoplanetaren ilustrazioa. Orbitatzen duen Proxima Centauri nano gorria eta izar-sistema bereko Alpha Centauri izar binarioa ikus daitezke urrunean. (Argazkia: ESO – Euopean Southern Observatory/M. Kornmesser)

Izugarrizko suertea da gertuen dugun izarra izar-sistema baten parte izatea eta, gainera, “Earth-like” exoplaneta bat izatea. Ikaragarria litzateke nano-ontzi bakar batek lortuko balu Alpha Centaurira iritsi, bertan argazki bat atera (edota bestelako datu zientifikoren bat hartzea) eta informazio hori Lurrera bidaltzea. Teknologia aldetik sekulako garrantzia luke lorpenak, baina zientzia aldetik ez luke parekorik izango izar-sistema bat eta exoplaneta bat gertutik ikertu ahal izateak.

Antza, gauza bera uste dute Breakthrough Starshot egitasmokoek ere.

—————————————————–

Egileez: Naiara Barrado Izagirre (@naierromo) UPV/EHUko Fisika Aplikatuko irakaslea da eta Zientzia Planetarioen Taldeko kidea. Itziar Garate Lopez (@galoitz) Fisikan doktorea da eta Parisko Meteorologia Dinamikoaren Laborategiko ikertzailea.

—————————————————–

The post Gizakia izarretara bidean appeared first on Zientzia Kaiera.

La verdaderamente divertido es hacer Ciencia

Haydée Valdés González

A menudo tengo la sensación de que buscando acercar la Ciencia a la sociedad y pretendiendo que la ciudadanía “pierda el miedo” a la Ciencia y se sienta más atraído y predispuesto hacia ella, recurrentemente se deja entrever el mensaje de que “la Ciencia es fácil y divertida”.

Sin embargo, este eslogan puede ser un arma de doble filo. Permítanme que me explique.

En lo que a la “facilidad” de la Ciencia se refiere, es necesario hacer hincapié en tres aspectos fundamentales: la asimilación de los contenidos científicos, el ejercicio de la Ciencia y el espíritu investigador.

En primer lugar, en lo que a los contenidos científicos se refiere, es importante aclarar que, ciertamente, el conocimiento científico es comprensible para todo aquella persona que lo desee pero creo que es importante matizar que no es, necesariamente, fácilmente comprensible. Al contrario, suele ser difícilmente comprensible puesto que requiere de mucho esfuerzo y muchas horas de dedicación al estudio para poder asimilarlo correctamente.

Lo que ocurre entonces es que para “hacer fáciles los contenidos científicos” y poder transferir conocimiento a la sociedad muchas veces se ha de recurrir a una simplificación excesiva de dichos contenidos científicos. Esta acción, como todo en la vida, tiene sus ventajas e inconvenientes. En esta ocasión me gustaría centrarme en los inconvenientes.

Presentar la Ciencia a través de conceptos demasiado simples o, bien, presentar la Ciencia a través de conceptos muy complejos de forma simple, probablemente deja al espectador con un dulce sabor de boca pero también con grandes lagunas de conocimiento y posiblemente engañado al creer que, en unos pocos minutos, ha logrado comprender teorías o conceptos científicos que en realidad son muy complejos.

Al permitir que el ciudadano se marche a su casa con la sensación general de que “la Ciencia es fácil”,se corre el gravísimo riesgo de que éste no sepa poner en verdadero valor a la Ciencia y no la perciba como lo que realmente es, un proceso que requiere mucho esfuerzo, dedicación estudio y conocimiento. Esto puede implicar a su vez que dicha persona no sepa apreciar en su justa medida el verdadero valor de los estudios científicos ni distinguirlos del resto de informaciones pseudocientíficas que están a la orden del día.

En segundo lugar, la Ciencia no sólo abarca el conjunto de conocimientos científicos derivados de su ejercicio. La Ciencia es también la actividad ejercitada por los científicos para la obtención de dicho conjunto de conocimientos y llevar a cabo dicho proceso con la seriedad y el rigor que le caracteriza tampoco es necesariamente fácil. Hay que tener en cuenta que la actividad científica es un ejercicio que habitualmente se prolonga bastante en el tiempo, para lo que se requiere mucha constancia y paciencia, y que se ha de ejecutar siempre de una forma organizada, meticulosa y precisa lo que no siempre resulta una tarea fácil.

Y en tercer y último lugar, también es importante matizar que el ejercicio de la Ciencia conlleva una transformación fundamental en el carácter y personalidad del ser humano que lo practica, lo que lógicamente entraña una cierta dificultad. Un buen científico debería poseer un espíritu científico, lo que significa que esa persona debería realizar un importante esfuerzo personal para desarrollar un conjunto de valores, habilidades y aptitudes que no siempre le son innatas. Así por ejemplo, un científico debería poseer apertura mental, ser escéptico o estar libre de prejuicios, capacidades, todas ellas, cuyo desarrollo puede llegar a entrañar una enorme dificultad dado que en muchas ocasiones puede provocar importantes conflictos con los sentimientos, deseos o creencias propias del individuo.

Por otro lado, la afirmación de que “la Ciencia es divertida” también habría que matizarla.

Seguro que todos nosotros conocemos a personas de nuestro entorno cotidiano que son felices haciendo deporte. Cuando les preguntamos por qué continúan practicando deporte a pesar de por ejemplo, las lesiones, el cansancio físico o las condiciones climatológicas, una de las razones que normalmente argumentan es que hacer deporte “les divierte”, en alusión a la diversión derivada de la propia naturaleza del proceso.

Bien, pues con la Ciencia pasa lo mismo.

La actividad científica, la práctica del ejercicio de la Ciencia, es divertida por sí misma. La Ciencia resulta entretenida y apasionante porque su fin último es comprender el mundo que nos rodea, lo que satisface el anhelo de curiosidad que ha acompañado al ser humano a lo largo de toda su existencia.

Ahora bien, no se vayan a creer ustedes que estar en el laboratorio es una fiesta continua. La actividad investigadora, como cualquier otra profesión, también puede ser rutinaria y, en ocasiones, hasta aburrida. Lo que ocurre es que hay personas para las que el proceso de investigación científica y todo lo que éste conlleva, incluidos los aspectos negativos, resulta fascinante y atractivo, de la misma manera que hay personas que disfrutan haciendo ejercicio físico a pesar de, como digo, las lesiones o el cansancio.

Otra cosa bien distinta es que además sea posible disfrutar con el conocimiento científico derivado del ejercicio de la Ciencia asistiendo a eventos de divulgación científica.

Pero resulta evidente que se trata de dos formas de disfrutar completamente diferentes.

Eva María Wara Álvarez Pari, durante su máster en química en la Friedrich-Alexander-Universität, Erlangen-Nürnberg (Alemania). Foto: Lindau Nobel Laureate Meetings

Mientras que el espectador de un evento de divulgación científica es un agente pasivo que disfruta de los contenidos científicos sentado en una butaca, el científico es un agente activo que disfruta haciendo Ciencia y generando conocimiento científico (aunque en ocasiones también pueda actuar como espectador de eventos científicos, evidentemente).

En línea con esta afirmación cabría matizar entonces que el principal inconveniente de que a la ciudadanía se le otorgue sistemáticamente el papel de espectador es que, probablemente, acabará por tener una comprensión limitada de lo que es la diversión en la Ciencia ya que nunca experimentará la diversión asociada al trabajo deinvestigación.

En este sentido, resultaría sumamente interesante que se llevaran a cabo más iniciativas que permitiesen a los ciudadanos que así lo desearan (especialmente los niños y los más jóvenes) tomar parte activa en procesos de investigación reales otorgándoles el papel protagonista del ejercicio de la Ciencia y alejándolos por completo del papel de espectador.

Esta iniciativa satisfaría además otras necesidades importantes como son las de desarrollar el espíritu científico de la población, para que puedan aplicarlo en sus vidas y beneficiarse de todo lo que éste implica, y la de permitir a los ciudadanoscomprobar en primera persona el esfuerzo, dificultad, rigor y seriedad que entraña la actividad científica, lo que incuestionablemente influiría en una percepción más positiva y respetuosa de la misma.

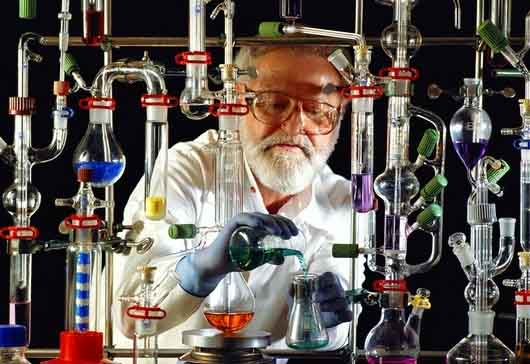

Otra deriva de lo que es el concepto de “Ciencia divertida” es el de los espectáculos de Ciencia que en ocasiones tenemos la oportunidad de presenciar.

Los actores de las performances científicas eligen experimentos llamativos a sabiendas de que van a resultar fascinantes y espectaculares, casi mágicos y milagrosos, lo que indiscutiblemente resulta altamente lúdico, entretenido e irresistible pero también considerablemente alejado de la realidad científica.

En estos espectáculos, la Ciencia se equipara al contenido que ha sido cuidadosamente “enlatado” con un formato atrayente para el consumo del gran público a costa de alejarla de su propia esencia como proceso de búsqueda del conocimiento, lo que tiene un efecto devastador al banalizar la Ciencia y convertirla en un producto de consumo más dentro de la oferta del sector de ocio y entretenimiento.

Incuestionablemente,es imprescindible acercar la Ciencia a la sociedad y transferir el conocimiento científico a la ciudadanía por lo que todas las posibles iniciativas tienen cabida, pero es importante recalcar la necesidad de cuidar adecuadamente las formas y el fondo para no desvirtuar a la Ciencia y conseguir así que su verdadero valor e importancia no pasen desapercibidos a la sociedad.

Sobre la autora: Haydée Valdés González es doctora en ciencias químicas.

El artículo La verdaderamente divertido es hacer Ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo hacer ciencia en un periódico: la experiencia de ‘Público’

- ¿Una charla? ¿de ciencia?, prefiero el bar…

- Ciencia para todos a través del cine y la literatura de ciencia ficción

Más competidores, menos competición

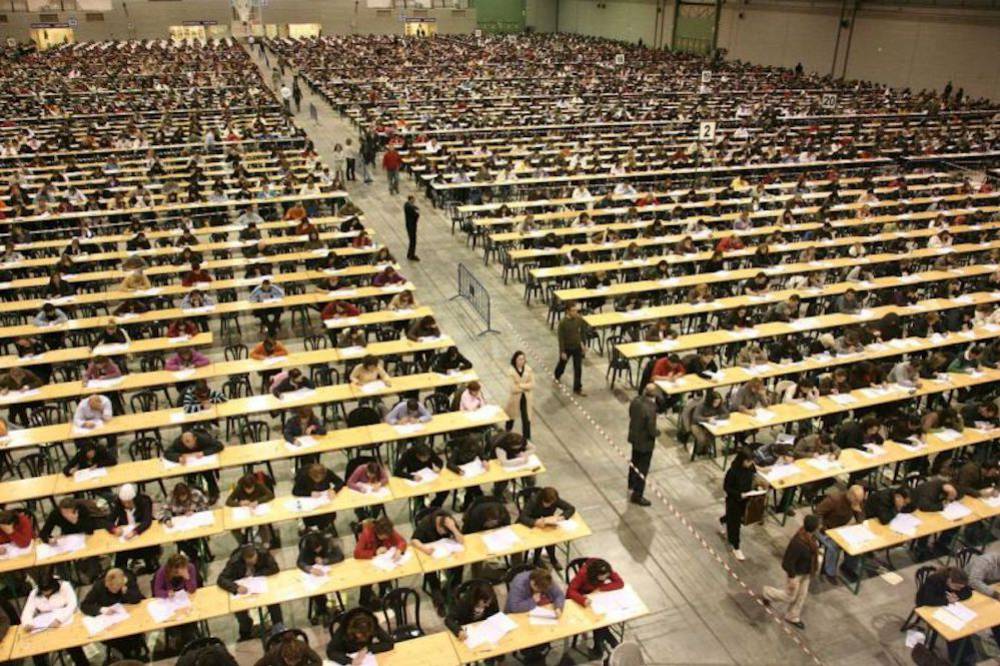

Analizando los resultados de la prueba SAT que se realiza en los Estados Unidos para acceder a los estudios universitarios, S. García (Michigan, EEUU) y A. Tor (Haifa, Israel) han observado que dichos resultados son peores cuanto mayor es el número de personas que realizan la prueba en una misma dependencia. También han observado el mismo fenómeno al analizar los resultados de una prueba analítica muy sencilla, denominada “Cognitive Reflection Test”.

Ese fenómeno podría tener más de una explicación. Podría deberse a que en los sitios con mucha gente hay más ruido y, en general, más distracción, o ser consecuencia del modo en que quienes se examinan reaccionan a la percepción del número de posibles competidores.

Tras esos primeros resultados, hicieron estudios adicionales. Pidieron a un conjunto de estudiantes universitarios que realizaran una prueba sencilla lo más rápido que pudiesen, sin preocuparse demasiado por la corrección de las respuestas y ofrecieron una recompensa económica al 20% que lo hiciesen en menos tiempo. A la mitad de los que iban a hacer la prueba les dijeron que competían contra otros diez y a la otra mitad, que lo hacían contra otros cien. Pues bien, la mitad que pensaban que competían contra diez respondieron al test en 29 s y la otra mitad en algo más de 33 s, una diferencia de más de un 10%. Nótese que el resultado difirió entre los dos grupos por el simple hecho de variar el número de competidores, aunque el porcentaje premiado fuese el mismo en ambos casos, el 20%, como se ha dicho.

En una siguiente prueba pidieron a unos estudiantes que imaginasen que participaban en una carrera de 5 km; unos creían que corrían en un grupo formado por 50 corredores y los otros que el grupo era de 500, y en ambos casos se les dijo que el 10% que obtuviese mejores posiciones se llevaría un premio de 1.000 dólares. Y lo que se les preguntaba era por el esfuerzo que estaban dispuestos a hacer en cada caso. El esfuerzo se expresaba en términos relativos, con un mínimo de 1 (correr algo más rápido que lo normal) y un máximo de 7 (la carrera más rápida de su vida). Resultó que los que creían correr contra 50 estaban dispuestos a realizar un esfuerzo mayor (5’4 en la escala de 1 a 7) que los que creían correr contra 500 (4’9 en esa misma escala).

Los autores del trabajo denominaron efecto “n” (n de número) a la influencia que ejerce la percepción del número de competidores sobre el esfuerzo que se está dispuesto a hacer para obtener unos resultados en un entorno competitivo. Las implicaciones prácticas de estos resultados, de confirmarse, son evidentes, aunque no lo es tanto su significado. Es comprensible que se gradúe el esfuerzo en función de lo fácil o difícil que se perciba obtener recompensa cuando el número de recompensados es fijo, pero carece de sentido que esa misma graduación se haga cuando es un porcentaje el que recibe premio. Aunque en realidad podría ocurrir que, dado el proverbial anumerismo de la mayoría de los miembros de nuestra especie, los sujetos encuestados respondiesen sin una noción clara de esa diferencia y pensando que la existencia de muchos competidores disminuye de suyo las posibilidades de obtener recompensa. De ser así, cabe pensar que la evolución nos ha dotado de una curiosa herramienta mental para economizar esfuerzos, sobre todo cuando pensamos que esos esfuerzos pueden ser baldíos. Pero la confusión número-porcentaje, a la que tan dada es nuestra especie, engaña una vez más.

Fuente: Stephen M. García & Avishalom Tor (2009): The N-Effect-More Competitors, Less Competition. Psychological Science 20 (7): 871-877.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Más competidores, menos competición se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Menos felices y menos insatisfechos a medida que envejecemos

- Conviene que los hijos se parezcan a su padre

- Cuantas menos ecuaciones…. ¿mejor?

Ohiz kanpoko egonkortasun kimikoa duen materiala