Una tabla de multiplicar japonesa de 1300 años de antigüedad

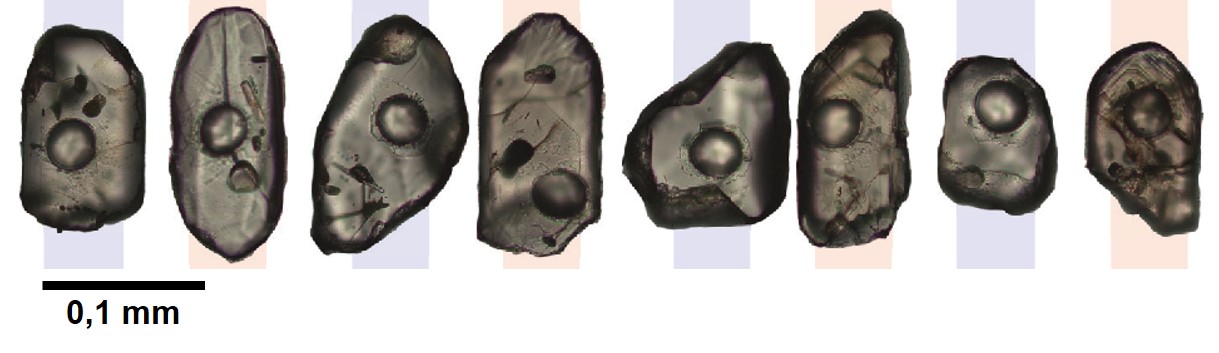

El 4 de septiembre de 2024, el Instituto Nacional de Investigación de Bienes Culturales de la prefectura de Nara (Japón) anunció que había descubierto un fragmento de madera de unos 1300 años de antigüedad que contenía una tabla de multiplicar que sería la más antigua de Japón.

De izquierda a derecha: fotografía en color de la parte superior del fragmento de la tablilla encontrada, fotografía con infrarrojos de la misma parte de la tablilla (donde aparecería escrito «9 x 9 = 81») y multiplicaciones que aparecería en la tablilla completa. Fuente: Arkeonews.

De izquierda a derecha: fotografía en color de la parte superior del fragmento de la tablilla encontrada, fotografía con infrarrojos de la misma parte de la tablilla (donde aparecería escrito «9 x 9 = 81») y multiplicaciones que aparecería en la tablilla completa. Fuente: Arkeonews.En realidad, ese fragmento fue hallado en 2001 en el sitio de Fujiwara-kyo, la capital imperial de Japón entre los años 694 y 710, al final del periodo Asuka. Se encontró en lo que se cree que fue el lugar donde se ubicaba una oficina de guardias Emon-fu (Cuartel General de la Guardia de la Puerta Exterior del Palacio) del gobierno central de Fujiwara-kyo.

Las excavaciones arqueológicas de este sitio comenzaron en 1934; se han encontrado desde entonces unas 13 000 tablillas de madera, las mokkan, con inscripciones en chino clásico.

Un descubrimiento que llega gracias a la tecnologíaAl principio, en 2001, este fragmento de madera (de 16,2 cm de largo y 1,2 cm de ancho) no llamó la atención de los investigadores, que pensaban que se trataba de un simple tablero de práctica.

Se observaban en ella tres columnas de caracteres kanji (los sinogramas utilizados en la escritura en japonés) escritos verticalmente en una línea, con cinco caracteres legibles a simple vista: «10», «1», «6», otro «6» y «8». Inicialmente, el instituto de Nara planteó la hipótesis de que la primera columna decía «9 x 9 = 81» y la tercera «6 x 8 = 48”.

En julio de 2023, Kuniya Kuwata, investigador jefe de historia antigua del Instituto Nacional de Investigación de Bienes Culturales en Nara, volvió a analizar la tablilla con el equipo de observación infrarroja más moderno, que reveló el contenido de la segunda columna que no se había leído anteriormente: «4 x 9 = 36». Al observar el patrón de estas tres columnas, concluyó que la tablilla no era una nota, sino la sección superior derecha de un tablero de cálculo (un kuku). Kuwata comentaba en una entrevista:

Si la tabla de multiplicar estuviera completa, la tablilla de madera tendría 33 centímetros de largo con todas las ecuaciones escritas.

La tabla original enumeraría 37 datos clave de multiplicación desde «1 x 1 = 1» hasta «9 x 9 = 81». Kuwata concluyó (observar la imagen arriba) que estos datos se habrían escrito en la tablilla original en cinco filas y ocho columnas, de mayor a menor, de derecha a izquierda.

La más antigua tabla de multiplicar japonesaEsta tablilla presenta una estructura de multiplicación más compleja que la observada anteriormente en Japón. Como hemos comentado, posee cinco líneas de ecuaciones, escritas de derecha a izquierda. Evocan directamente los métodos matemáticos utilizados durante las dinastías Qin (desde 221 a. C. hasta el 206 a. C) y Han (desde 206 a. C. hasta el 220 d. C.) en China. Estas dinastías establecieron sistemas matemáticos estructurados para gestionar las tareas administrativas y fiscales de sus imperios. En Corea también se utilizaban sistemas similares en aquella época.

En palabras de Kuwata:

Al principio pensaba que las tablas de multiplicar japonesas solo tenían de dos a tres ecuaciones por línea, por lo que me sorprendió genuinamente encontrar una con tantas, similar a las de China y Corea.

En efecto, las tablillas descubiertas anteriormente en Japón mostraban ecuaciones organizadas en sólo dos o tres líneas, lo que sugería un enfoque más elemental para los cálculos. De aquí se comprende la importancia de este descubrimiento.

Este vínculo con los modelos chino y coreano sugiere, además, la existencia de una fuerte influencia cultural y técnica entre estas civilizaciones y el antiguo Japón.

Una herramienta en las funciones administrativasEsta tabla encontrada en Fujiwara-kyo parece haber sido una herramienta importante en las funciones administrativas de la época, en particular en la oficina de guardia de Emon-fu. Este cuartel se encargaba de la seguridad en la corte imperial y en los alrededores del palacio Fujiwara-kyo; no solo garantizaba la protección física de los locales, sino también la gestión de diferentes tareas administrativas relacionadas con la organización diaria del gobierno. Entre otros, era responsable de planificar la jornada laboral de los funcionarios y coordinar los servicios dentro de la corte imperial; de allí la necesidad de calcular. Estas tablas de multiplicar habrían permitido la gestión eficaz del tiempo de trabajo, de las ausencias y de la rotación del personal.

Los cálculos rigurosos y normalizados habrían ayudado también a supervisar la recaudación de impuestos.

Aunque la fecha del fragmento de esta tablilla está bien establecida, algunos expertos especulan que podría remontarse al período Kofun (desde el año 250 al 538), período se caracteriza por la construcción de túmulos monumentales, entierros destinados a la élite japonesa.

El dominio de las matemáticas podría haber desempeñado un papel clave en el diseño de estas gigantescas estructuras en las que los cálculos de proporciones, volúmenes y alineaciones eran imprescindibles. Esta hipótesis refuerza la idea de que la cultura matemática estaba establecida en la antigua sociedad japonesa.

Kuwata comentaba al anunciar este descubrimiento:

Este artefacto demuestra que en Fujiwara-kyo, el kuku no solo lo utilizaban ciertos ingenieros, sino también los funcionarios comunes en su trabajo diario. Al igual que hoy, gestionar los turnos en las antiguas oficinas gubernamentales era una tarea difícil, y los empleados debían tener dificultades para hacer los cálculos, utilizando la tablilla como referencia.

Referencias

- Tablet unearthed in Japan’s Nara Pref. was 13-century-old multiplication chart: research, The Mainichi, 11 septiembre 2024

- Laurie Henry, Trouvaille d’une importance majeure : la plus ancienne table de multiplication japonaise découverte, Science&Vie, 9 septiembre 2024

- Nathan Falde, Piece of 1,300-Year-Old Wood Came from Japanese Multiplication Table, Ancien Origins, 9 septiembre 2024

- oguz kayra, Japan’s Oldest Multiplication Table Discovered in Nara, Dating Back 1,300 Years, Arkeonews, 7 septiembre 2024

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

El artículo Una tabla de multiplicar japonesa de 1300 años de antigüedad se ha escrito en Cuaderno de Cultura Científica.

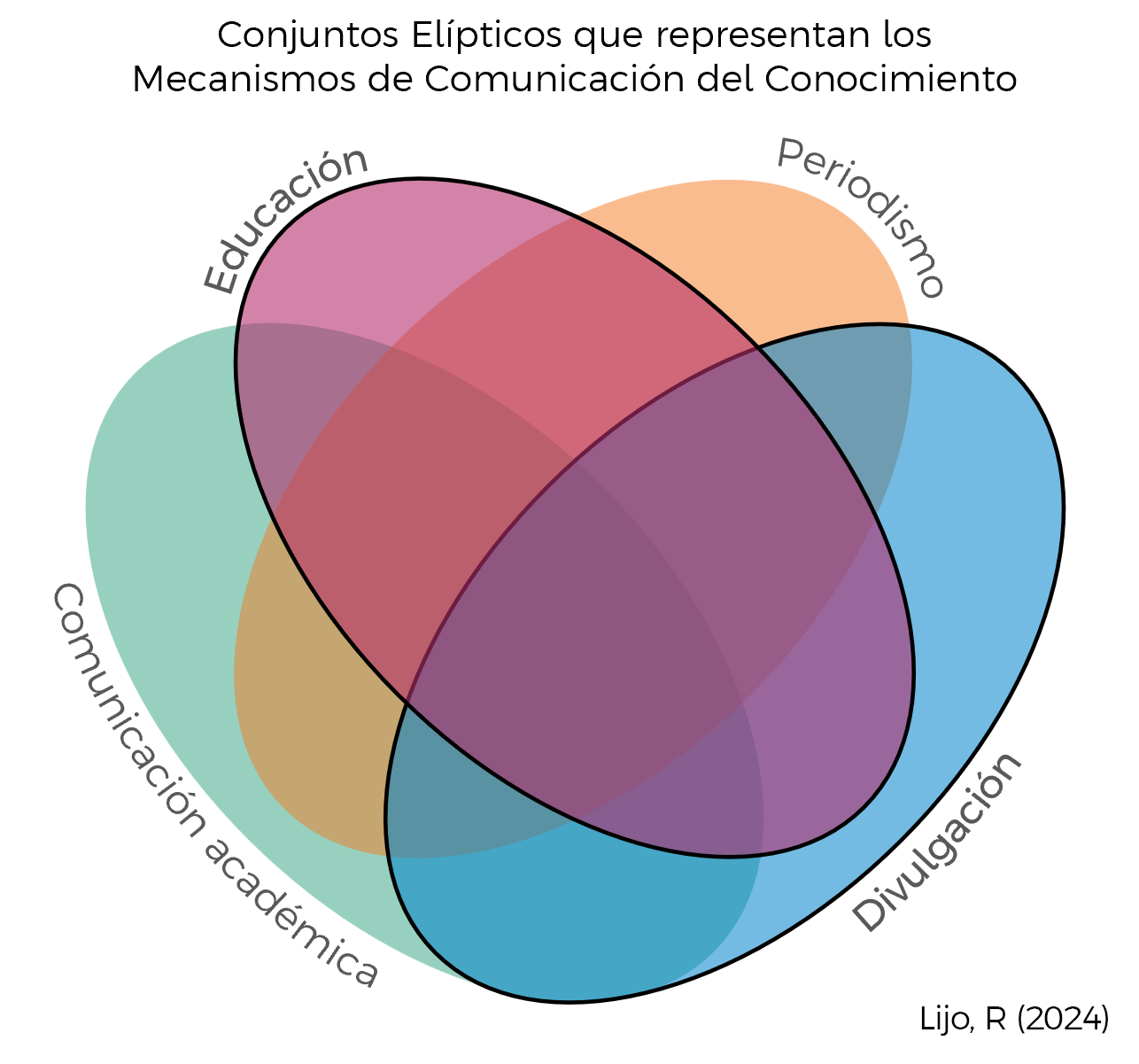

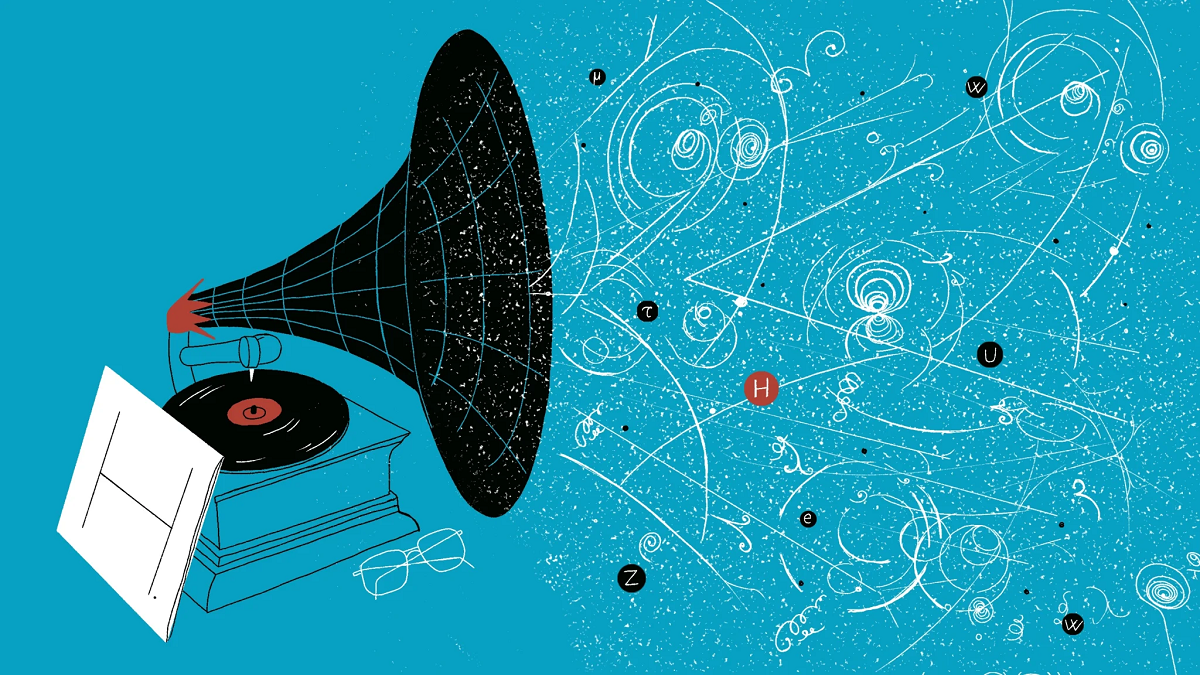

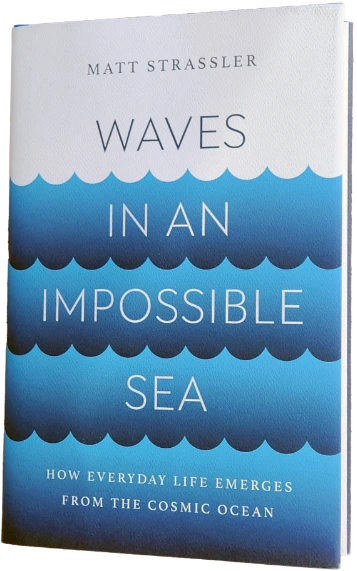

El origen cuántico del efecto invernadero

El poderoso efecto de retención de calor del dióxido de carbono se ha encontrado que se debe a una peculiaridad de su estructura cuántica. El hallazgo podría explicar el cambio climático mejor que cualquier modelo informático.

Un artículo de Joseph Howlett. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

https://culturacientifica.com/app/uploads/2024/09/Video-CO2.mp4 Una coincidencia numérica ayuda a que las moléculas de CO2 se muevan de una determinada manera, atrapando mucha más radiación infrarroja de la Tierra de lo que lo harían de otra forma. Fuente: Kristina Armitage/Quanta Magazine; Matt Twombly para Quanta MagazineEn 1896, el físico sueco Svante Arrhenius se dio cuenta de que el dióxido de carbono (CO2) atrapa el calor en la atmósfera terrestre, fenómeno que hoy se denomina efecto invernadero. Desde entonces, los modelos climáticos modernos, cada vez más sofisticados, han confirmado la conclusión central de Arrhenius: cada vez que se duplica la concentración de CO2 en la atmósfera, la temperatura de la Tierra aumenta entre 2 y 5 grados Celsius.

Aun así, la razón física por la que el CO2 se comporta de esta manera había seguido siendo un misterio hasta hace poco.

En primer lugar, en 2022, los físicos resolvieron una disputa sobre el origen de la “escala logarítmica” del efecto invernadero, es decir, la forma en que la temperatura de la Tierra aumenta en la misma cantidad en respuesta a cualquier duplicación del CO2, sin importar las cifras brutas.

Esta primavera, un equipo dirigido por Robin Wordsworth, de la Universidad de Harvard, descubrió por qué la molécula de CO2 es tan eficaz para atrapar el calor. Los investigadores identificaron una extraña peculiaridad de la estructura cuántica de la molécula que explica por qué es un gas de efecto invernadero tan potente y por qué el aumento de la emisión de carbono al cielo impulsa el cambio climático. Los hallazgos aparecieron en The Planetary Science Journal.

“Es un artículo realmente interesante”, comenta Raymond Pierrehumbert, un físico atmosférico de la Universidad de Oxford que no ha participado en el trabajo. “Es una buena respuesta a todas aquellas personas que dicen que el calentamiento global es simplemente algo que surge de modelos informáticos impenetrables”.

Por el contrario, el calentamiento global está ligado a una coincidencia numérica que involucra dos formas diferentes en las que el CO2 puede moverse.

“Si no fuera por este accidente”, afirma Pierrehumbert, “muchas cosas serían diferentes”.

Una vieja conclusión Robin Wordsworth, científico del clima de la Universidad de Harvard, recurrió a la mecánica cuántica para comprender el espectro de absorción del dióxido de carbono. Fuente: ETH Zurich

Robin Wordsworth, científico del clima de la Universidad de Harvard, recurrió a la mecánica cuántica para comprender el espectro de absorción del dióxido de carbono. Fuente: ETH Zurich¿Cómo pudo Arrhenius comprender los conceptos básicos del efecto invernadero antes de que se descubriera la mecánica cuántica? Todo empezó con Joseph Fourier, un matemático y físico francés que se dio cuenta hace exactamente 200 años de que la atmósfera de la Tierra aísla al planeta del frío helado del espacio, un descubrimiento que dio inicio al campo de la ciencia del clima. Luego, en 1856, una estadounidense, Eunice Foote, observó que el dióxido de carbono es particularmente bueno para absorber la radiación. A continuación, el físico irlandés John Tyndall midió la cantidad de luz infrarroja que absorbe el CO2, mostrando el efecto que Arrhenius luego cuantificó utilizando conocimientos básicos sobre la Tierra.

La Tierra irradia calor en forma de luz infrarroja. La esencia del efecto invernadero es que parte de esa luz, en lugar de escapar directamente al espacio, choca con las moléculas de CO2 de la atmósfera. Una molécula absorbe la luz y luego la vuelve a emitir. Luego, otra lo hace. A veces, la luz vuelve a bajar hacia la superficie. A veces, sube al espacio y deja la Tierra un ápice más fría, pero sólo después de recorrer un camino irregular hasta las frías capas superiores de la atmósfera.

Utilizando una versión más rudimentaria del mismo enfoque matemático que utilizan los científicos del clima hoy en día, Arrhenius concluyó que agregar más CO2 haría que la superficie del planeta se calentara. Es como agregar aislamiento a las paredes para mantener la casa más cálida en invierno: el calor de la caldera entra al mismo ritmo, pero se escapa más lentamente.

Sin embargo, unos años después, el físico sueco Knut Ångström publicó una refutación. Argumentaba que las moléculas de CO2 solo absorben una longitud de onda específica de radiación infrarroja: 15 micras. Y ya había suficiente gas en la atmósfera para atrapar el 100% de la luz de 15 micras que emite la Tierra, por lo que agregar más CO2 no haría nada.

De lo que Ångström no se dio cuenta fue que el CO2 puede absorber longitudes de onda ligeramente más cortas o más largas que 15 micras, aunque con menos facilidad. Esta luz se captura menos veces a lo largo de su viaje al espacio.

Pero esa tasa de captura cambia si la cantidad de dióxido de carbono se duplica. Ahora la luz tiene que esquivar el doble de moléculas antes de escapar, y tiende a ser absorbida más veces en el camino. Escapa de una capa más alta y más fría de la atmósfera, por lo que la salida de calor se reduce a un goteo. Es la mayor absorción de estas longitudes de onda cercanas a las 15 micras la responsable de nuestro clima cambiante.

A pesar del error, el artículo de Ångström generó suficientes dudas sobre la teoría de Arrhenius entre sus contemporáneos como para que el debate sobre el cambio climático prácticamente dejase de ser relevante durante medio siglo. Incluso hoy, los escépticos del consenso sobre el cambio climático a veces citan el argumento erróneo de Ångström sobre la “saturación” de carbono.

De vuelta a lo básicoA diferencia de aquellos primeros tiempos, la era moderna de la ciencia climática ha avanzado en gran medida gracias a modelos computacionales que capturan las múltiples facetas complejas y caóticas de nuestra atmósfera desordenada y cambiante. Para algunos, esto hace que las conclusiones sean más difíciles de entender.

“He hablado con muchos físicos escépticos y una de sus objeciones es: ‘Ustedes simplemente ejecutan modelos informáticos y luego aceptan las respuestas de este cálculo de caja negra, y no lo entienden en profundidad’”, explica Nadir Jeevanjee, físico atmosférico de la Administración Nacional Oceánica y Atmosférica de los Estados Unidos (NOAA, por sus siglas en inglés). “Es un poco insatisfactorio no poder explicarle a alguien en una pizarra por qué obtenemos los números que obtenemos”.

Jeevanjee y otros como él se han propuesto construir una comprensión más sencilla del impacto de la concentración de CO2 en el clima.

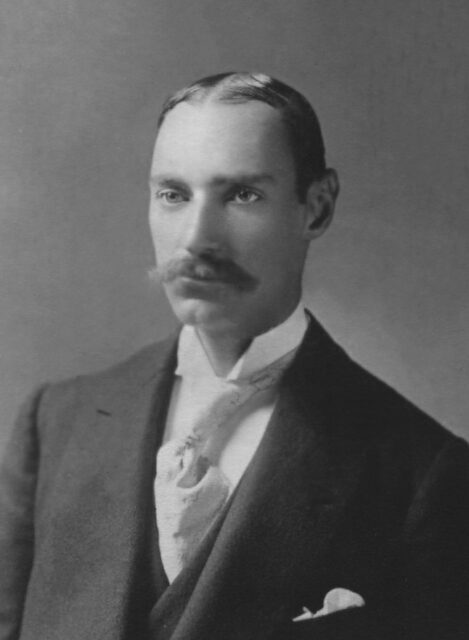

El científico sueco Svante Arrhenius fue, en 1896, la primera persona que determinó la sensibilidad de la temperatura de la Tierra a los cambios en los niveles de dióxido de carbono en la atmósfera. Fuente: Chronicle/Alamy

El científico sueco Svante Arrhenius fue, en 1896, la primera persona que determinó la sensibilidad de la temperatura de la Tierra a los cambios en los niveles de dióxido de carbono en la atmósfera. Fuente: Chronicle/AlamyUna pregunta clave fue el origen de la escala logarítmica del efecto invernadero (el aumento de temperatura de 2 a 5 grados que los modelos predicen que ocurrirá por cada duplicación del CO2). Una teoría sostenía que la escala se debía a la rapidez con la que la temperatura bajaba con la altitud. Pero en 2022, un equipo de investigadores utilizó un modelo simple para demostrar que la escala logarítmica se debía a la forma del “espectro” de absorción del dióxido de carbono (cómo su capacidad para absorber la luz varía con la longitud de onda de la luz).

Volvemos a aquellas longitudes de onda que son ligeramente más largas o más cortas que 15 micras. Un detalle crítico es que el dióxido de carbono es peor (pero no mucho peor) a la hora de absorber la luz con esas longitudes de onda. La absorción cae a ambos lados del pico a la velocidad justa para dar lugar a la escala logarítmica.

“La forma de ese espectro es esencial”, afirma David Romps, físico climático de la Universidad de California en Berkeley, coautor del artículo de 2022. “Si la cambias, no obtienes la escala logarítmica”.

La forma del espectro del carbono es inusual: la mayoría de los gases absorben un rango mucho más estrecho de longitudes de onda. “La pregunta que tenía en el fondo de mi mente era: ¿por qué tiene esta forma?”, cuenta Romps. “Pero no podía precisar la razón”.

Movimientos consecuentesWordsworth y sus coautores Jacob Seeley y Keith Shine recurrieron a la mecánica cuántica para encontrar la respuesta.

La luz está formada por paquetes de energía llamados fotones. Las moléculas como el CO2 pueden absorberlos solo cuando los paquetes tienen exactamente la cantidad de energía adecuada para llevar a la molécula a un estado mecánico cuántico diferente.

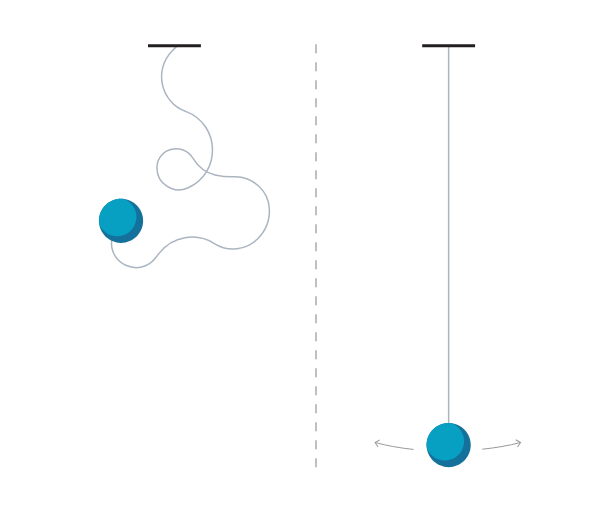

El dióxido de carbono suele encontrarse en su “estado fundamental”, en el que sus tres átomos forman una línea con el átomo de carbono en el centro, equidistante de los otros. La molécula también tiene estados “excitados”, en los que sus átomos ondulan o se balancean.

Un fotón de luz de 15 micras contiene la energía exacta necesaria para que el átomo de carbono gire alrededor del punto central en una especie de movimiento de hula-hula. Los científicos del clima han culpado durante mucho tiempo a este estado de hula-hula del efecto invernadero, pero, como anticipó Ångström, el efecto requiere una cantidad de energía demasiado precisa, como han descubierto Wordsworth y su equipo. El estado de hula-hula no puede explicar la disminución relativamente lenta de la tasa de absorción de fotones más allá de las 15 micras, por lo que no puede explicar el cambio climático por sí solo.

La clave, según han descubierto, es otro tipo de movimiento, en el que los dos átomos de oxígeno se mueven repetidamente hacia y desde el centro de carbono, como si estiraran y comprimieran un resorte que los conecta. Este movimiento requiere demasiada energía para ser inducido por los fotones infrarrojos de la Tierra por sí solos.

Pero los autores han encontrado que la energía del movimiento de estiramiento es casi el doble de la del movimiento de hula-hula, por lo que ambos estados de movimiento se mezclan. Existen combinaciones especiales de ambos movimientos que requieren un poco más o un poco menos de la energía exacta del movimiento del hula-hula.

Este fenómeno único se llama resonancia de Fermi en honor al famoso físico Enrico Fermi, quien lo dedujo en un artículo de 1931. Pero su conexión con el clima de la Tierra solo se ha establecido por primera vez el año pasado en un artículo de Shine y su estudiante, y el artículo de esta primavera es el primero en exponerlo por completo.

“El momento en que escribimos los términos de esta ecuación y vimos que todo encajaba, fue increíble”, dijo Wordsworth. “Es un resultado que finalmente nos muestra cuán directamente se vincula la mecánica cuántica con la visión de conjunto”.

En cierto modo, dice, el cálculo nos ayuda a entender el cambio climático mejor que cualquier modelo informático. “Parece ser algo fundamentalmente importante poder decir en un campo que podemos demostrar a partir de principios básicos de dónde proviene todo”.

Joanna Haigh, física atmosférica y profesora emérita del Imperial College de Londres, está de acuerdo y añade que el artículo agrega poder retórico a la defensa del cambio climático al mostrar que está “basado en conceptos fundamentales de la mecánica cuántica y la física establecida”.

En enero de este año, el Laboratorio de Monitoreo Global de la NOAA informó que la concentración de CO2 en la atmósfera aumentó desde su nivel preindustrial de 280 partes por millón a un récord de 419,3 partes por millón en 2023, lo que ha provocado un calentamiento estimado de 1 grado Celsius hasta el momento.

El artículo original, Physicists Pinpoint the Quantum Origin of the Greenhouse Effect, se publicó el 7 de agosto de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo El origen cuántico del efecto invernadero se ha escrito en Cuaderno de Cultura Científica.

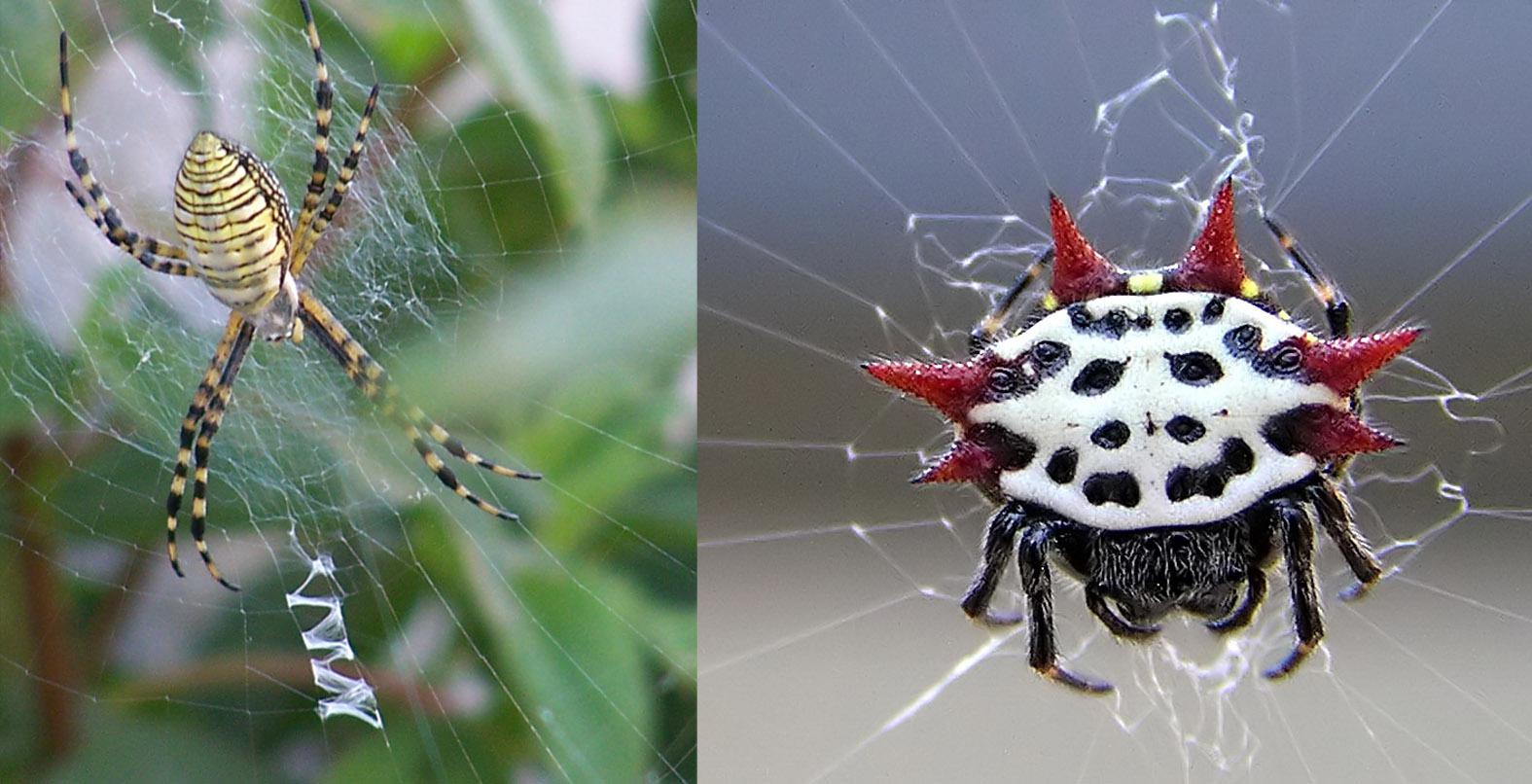

Blastocystis, ¿parásito intestinal o buena noticia para tu salud?

La microbiota intestinal es la comunidad de organismos microscópicos que viven en nuestro intestino, una comunidad compuesta por numerosas variedades de bacterias, virus, hongos y protistas unicelulares (eucariotas). Se trata de un ecosistema esencial para nuestra salud, ya que protegen contra patógenos, sintetizan vitaminas (K, ácido fólico), neurotransmisores (serotonina) y otros metabolitos beneficiosos. Además, son esenciales para la digestión de carbohidratos complejos. En los últimos años se está prestando mucha atención a la composición de la microbiota, ya que sus alteraciones pueden estar asociadas a enfermedades muy diversas: autoinmunes, inflamatorias, metabólicas o neurodegenerativas.

Los estudios sobre la microbiota intestinal se centran sobre todo en las bacterias, su principal componente. En nuestro intestino hay alrededor de cien billones de bacterias de unas mil especies diferentes. Los virus pueden ser cinco veces más abundantes, mientras que los hongos son una décima parte de esa cifra. Los protistas son mucho menos abundantes y están menos estudiados. Algunos de ellos causan enfermedades como la amebiasis o la giardiasis, mientras que otros no suponen ningún inconveniente.

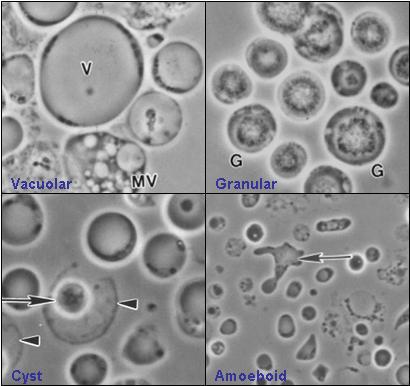

Figura 1. Cuatro formas en las que se presenta Blastocystis: vacuolar, granular, ameboide y quística. Todavía no se conocen las razones de esta variabilidad morfológica. De Valentia Lim Zhining (Valzn) – Trabajo propio, CC BY-SA 3.0

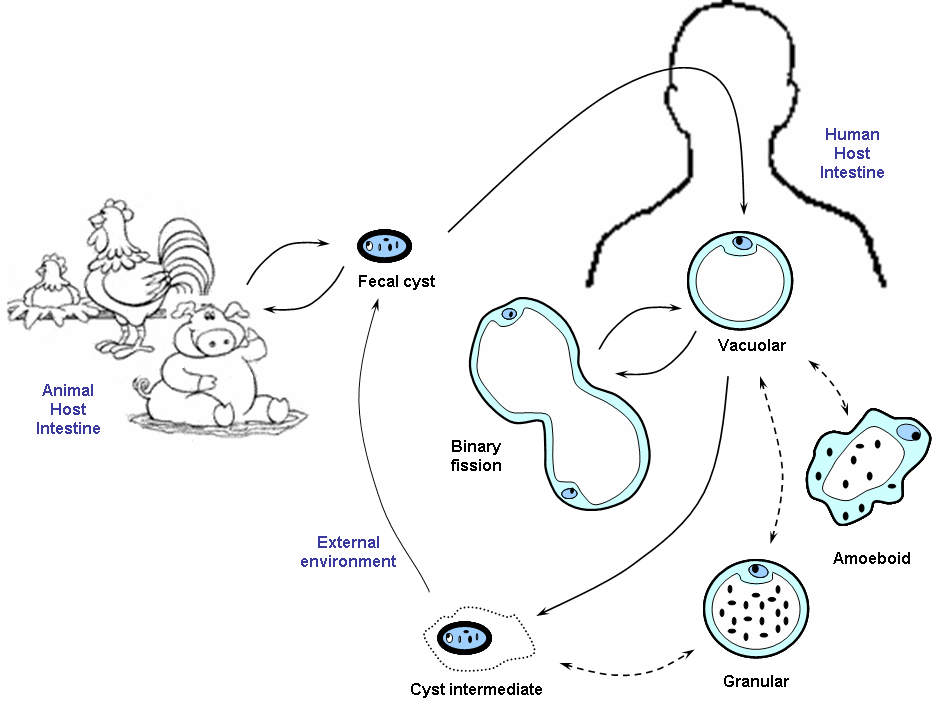

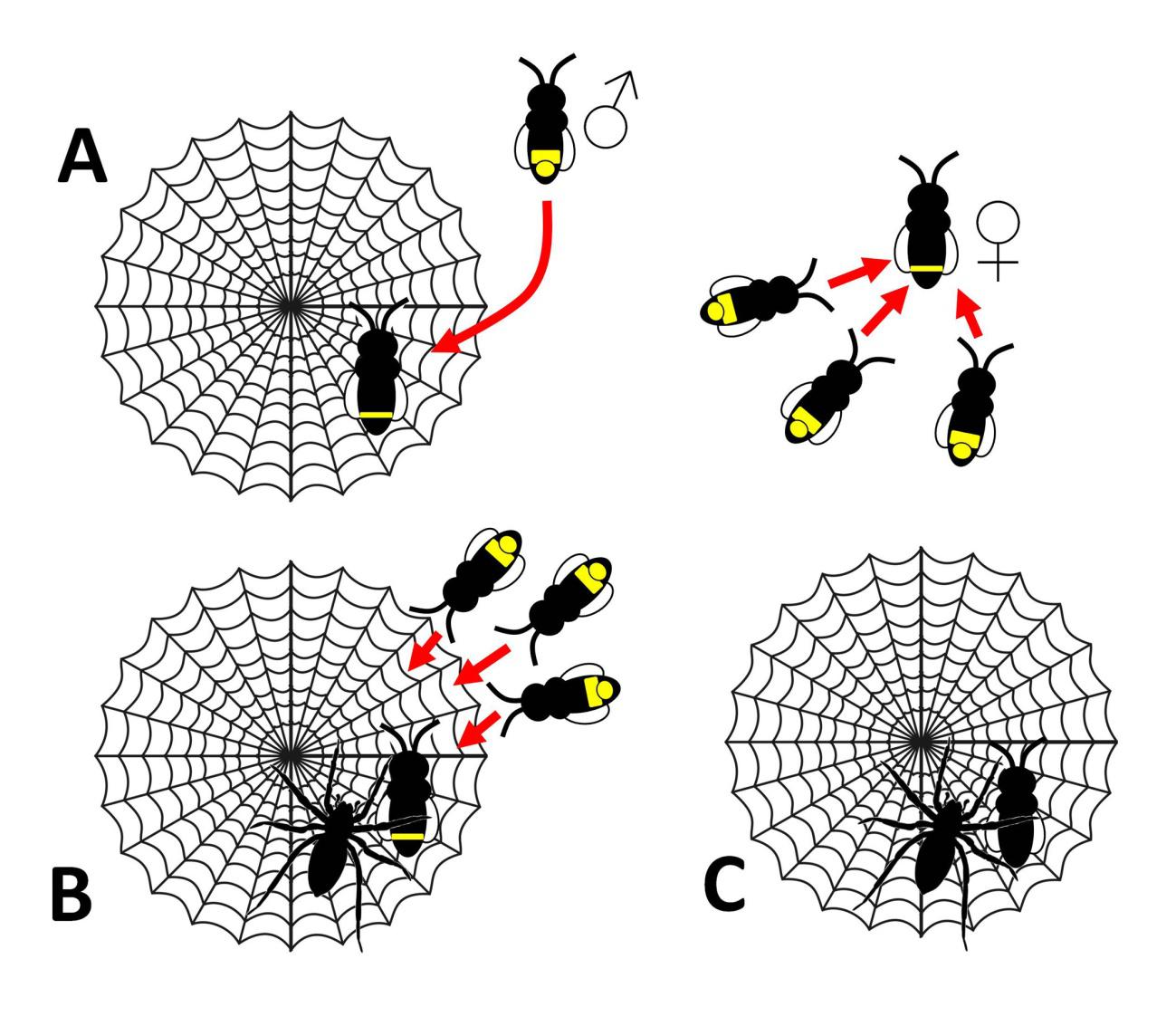

Figura 1. Cuatro formas en las que se presenta Blastocystis: vacuolar, granular, ameboide y quística. Todavía no se conocen las razones de esta variabilidad morfológica. De Valentia Lim Zhining (Valzn) – Trabajo propio, CC BY-SA 3.0Vamos a ocuparnos del protista intestinal más abundante en la población mundial, llamado Blastocystis hominis. Se trata de un pequeño organismo (5-40 micrómetros) que despliega una gran variabilidad morfológica (Figura 1), y cuyo ciclo vital es todavía poco conocido (Figura 2).

Figura 2. Ciclo vital de Blastocystis propuesto por el microbiólogo Kevin Tan Shyong-Wei. De Valentia Lim Zhining (Valzn) – Trabajo propio, CC BY-SA 3.0

Figura 2. Ciclo vital de Blastocystis propuesto por el microbiólogo Kevin Tan Shyong-Wei. De Valentia Lim Zhining (Valzn) – Trabajo propio, CC BY-SA 3.0Nuestros lectores tienen un 25% de probabilidades de albergarlo en su intestino, como veremos luego. Si buscan información en Internet sobre este organismo se inquietarán, ya que se le ha achacado ser el causante de una enfermedad, la blastocistosis, caracterizada por diarrea, dolor abdominal, náuseas y pérdida de peso. Sin embargo, otras fuentes indican que su patogenicidad es muy dudosa. El tema acaba de ser aclarado por un artículo recién publicado en la revista Cell que ha dado un sorprendente giro de guion a este asunto. Blastocystis podría ser incluso beneficioso para la salud de sus portadores.

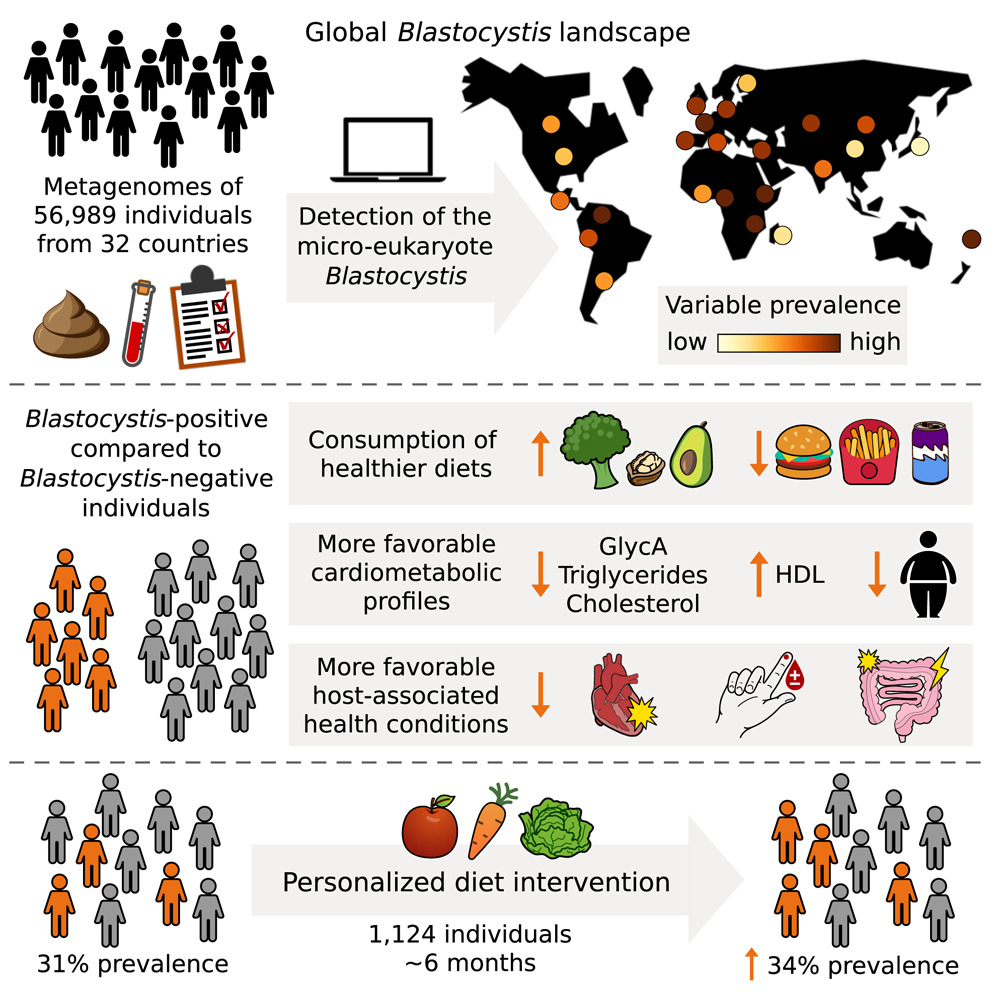

La investigación ha sido realizada por un equipo internacional liderado desde la universidad de Trento (Italia). El estudio incluyó 56 989 metagenomas (conjunto de genomas de la microbiota) secuenciados a partir de heces de individuos de 32 países. 41 428 de los individuos fueron considerados sanos, mientras que 15 561 padecían algún tipo de patología.

Blastocystis fue detectado en 8 190 muestras. La prevalencia media fue por tanto del 14,4%, una cifra que ascendía al 16% considerando solo los individuos sanos. Esta cifra varió mucho entre continentes y países. América del Norte no llegó al 7%, mientras la media europea fue del 22%, similar a la de África y América del Sur. Asia ocupó una posición intermedia, con el 16% de portadores. Entre los países, los valores extremos se dieron en Fiji (56%) y Japón (2,5%). En España, Blastocystis fue detectado en un 25,4% de las muestras. Prevalencias muy altas (>35%) fueron halladas en países como Etiopía, Camerún y Tanzania.

Podría pensarse a primera vista que la presencia de Blastocystis en el intestino humano estaría asociada a un menor nivel de desarrollo, pero la situación se reveló más compleja cuando se analizaron otros datos de las poblaciones estudiadas. Existía una relación significativa entre la presencia de Blastocystis y el tipo de alimentación. Las personas vegetarianas y veganas mostraban una mayor prevalencia de Blastocystis que las omnívoras. Además esa prevalencia se asociaba positivamente al consumo de verduras, aguacate, frutos secos o legumbres, y negativamente a la ingesta de pizza, hamburguesas o bebidas azucaradas.

Más sorprendente resultó la asociación positiva de la presencia de Blastocystis con indicadores de buena salud cardiometabólica, como colesterol total y triglicéridos bajos, elevado HDL-colesterol (el llamado “bueno”) o reducidos marcadores de inflamación. Los individuos con un índice de masa corporal correcto tenían más probabilidad de portar Blastocystis que los que tenían sobrepeso u obesidad.

Los investigadores diseñaron un experimento de intervención de la dieta en un total de 1 124 individuos. Tras seis meses de dieta saludable, tanto la prevalencia como la abundancia de Blastocystis aumentaron significativamente en la población, de forma paralela a una mejora en indicadores de salud cardiometabólica.

Estos resultados parecen descartar que Blastocystis constituya un problema desde el punto de vista clínico. Más aventurado resulta considerarlo un agente beneficioso. La asociación con mejores marcadores de salud cardiometabólica se puede interpretar de dos formas. Por un lado sería la dieta sana la que genera un estado favorable de salud en el que Blastocystis prolifera cómodamente, sin ser responsable directo de los beneficios. Pero los autores del artículo plantean otra interesante hipótesis, ya que comprobaron que la presencia de Blastocystis se asocia a una composición más saludable de la microbiota. Según esta idea, Blastocystis podría favorecer la proliferación de microorganismos intestinales más convenientes para la salud o prevenir la expansión de microbios perjudiciales.

Una forma de comprobar esto sería el transplante de Blastocystis en humanos o al menos en modelos animales. De hecho, una serie de patologías se están tratando en la actualidad mediante el transplante de microbiota intestinal. Curiosamente, la presencia de Blastocystis en las muestras de microbiota las invalidaba hasta ahora para ser trasplantadas, por las sospechas de que pudiera ser un patógeno. El estudio publicado en Cell abre nuevas posibilidades para la intervención en la microbiota intestinal con fines clínicos.

No obstante, ¡prudencia! Es importante recordar que correlación no implica causalidad. Un profesor y buen amigo explicaba en sus clases que existía una correlación negativa y significativa entre el número de paraguas desplegados en París y el precio de las sardinas en sus mercados. El nexo es obvio, el mal tiempo implica menos barcos faenando. Lo que no tendría sentido es creer que abriendo paraguas puede abaratarse el pescado.

Referencias

Piperni, E., Nguyen, L.H., Manghi, P., et al. (2024). Intestinal Blastocystis is linked to healthier diets and more favorable cardiometabolic outcomes in 56,989 individuals from 32 countries. Cell. doi: 10.1016/j.cell.2024.06.018

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

El artículo Blastocystis, ¿parásito intestinal o buena noticia para tu salud? se ha escrito en Cuaderno de Cultura Científica.

Cómo hacer un queso de pasta blanda y corteza tratada en casa

Comparándolos con los quesos duros, la fabricación de quesos de pasta blanda en sí es un proceso más sencillo. A cambio, su affinage puede ser más complejo y el trato a sus cortezas da lugar a múltiples variedades de quesos, dependiendo de las levaduras, mohos y bacterias que se incluyen y las técnicas que se utilizan.

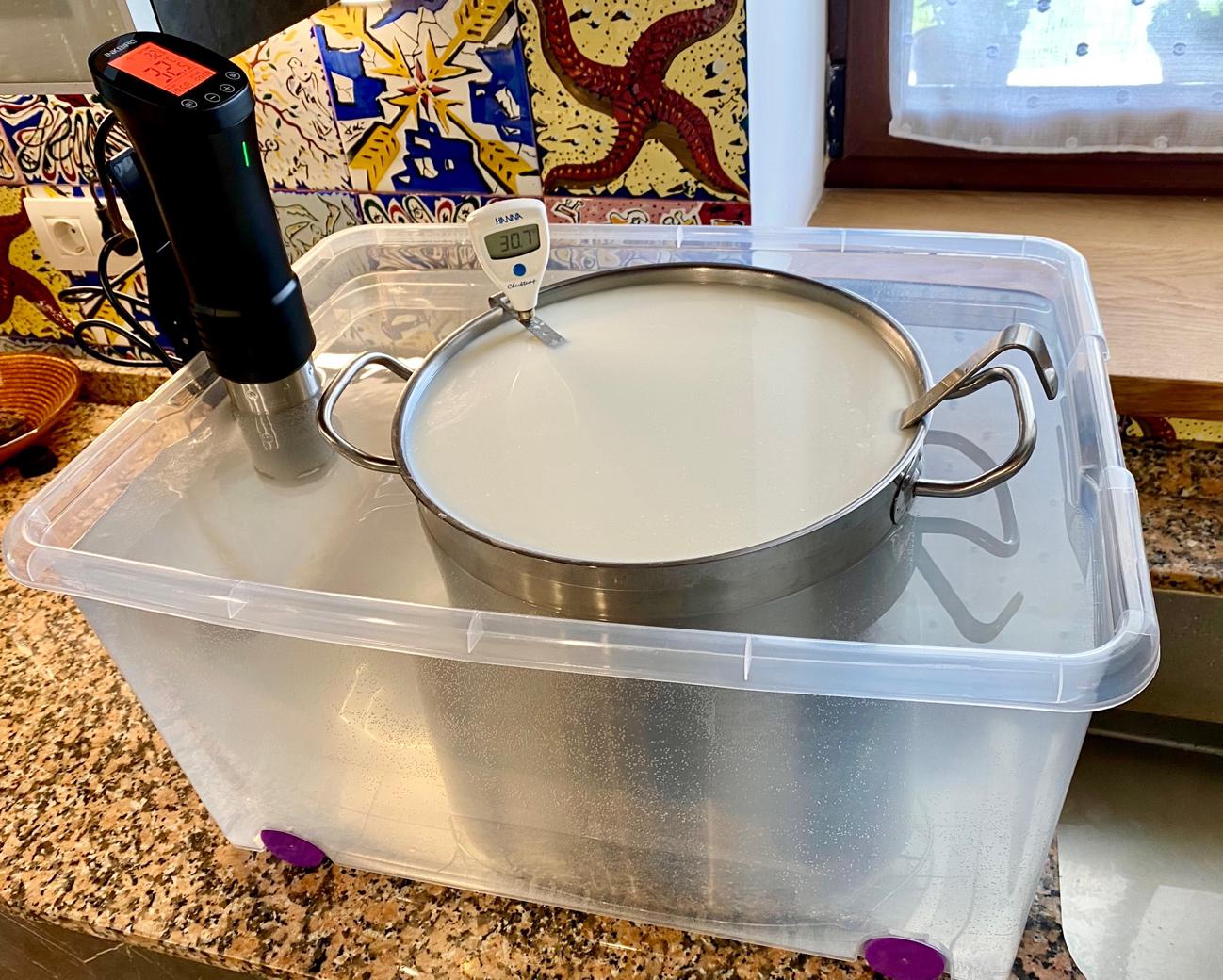

Templado de la leche al baño maría a 30.7ºC constantes, para efectuar la siembra. Foto: Victor Etxebarria

Templado de la leche al baño maría a 30.7ºC constantes, para efectuar la siembra. Foto: Victor Etxebarria

De la misma manera que comenzamos el proceso de fabricación de quesos duros, partimos del laboratorio perfectamente ordenado y limpio, y usamos el baño maría mostrado en la Figura 1 para colocar la leche a una temperatura cercana a los 30ºC, ideal para los Lactococcus mesófilos, que comienzan a consumir lactosa y acidificar la leche a pleno rendimiento. Para regular la acidificación, añadimos a la leche al menos Lactococcus lactis, cremoris y quizás diacetylactis, que son las lactobacterias más utilizadas en la fabricación de queso y las más fáciles de obtener en el mercado. La dosis aproximada es un gramo de fermento por cada 10 litros de leche.

Incorporamos ahora también los mohos y levaduras que usaremos para tratar la superficie de la corteza del queso. Uno de los casos más comunes es la adición de hongos Penecillium camemberti y Geotrichum candidum, utilizados en los conocidos quesos Brie o Camembert, entre muchos otros. Dependiendo del tipo de queso que queremos obtener, se pueden incluir en este caso otros hongos e incluso bacterias aerobias. Microorganismos muy empleados en este momento son Brevibacterium aurantiacum, Arthrobacter nicotianae y Debaryomyces hansenii. La posterior técnica del lavado de la corteza que a veces se lleva a cabo emplea típicamente estas bacterias y hongos.

Distribuimos la siembra completa en la leche templada con la espumadera y dejamos actuar a los microorganismos añadidos alrededor de una hora, lo cual nos debe permitir detectar un ligero descenso inicial del pH de la leche, primer indicador fácilmente medible de la actividad de los fermentos lácticos.

Una vez detectado el inicio de fermentación de la leche, es el momento de coagularla. Un paso adicional justo antes de ello es rectificar el balance químico de la leche añadiendo cloruro cálcico saturado en agua. Sobre todo, si se emplea leche procesada (homogeneizada o pasteurizada), esta sal de calcio es ingrediente imprescindible para garantizar una coagulación firme, ya que los iones de calcio Ca++ forman sólidos puentes entre moléculas de proteínas de la leche.

Preparada una dosis de 1ml de cloruro cálcico saturado en agua por cada 4l de leche, más un extra de 10-20 ml de agua no clorada, se añade esta mezcla a la leche y se distribuye con la espumadera. Ahora se trata de cuajar la leche mediante la quimosina o el cuajo natural. Estas peptidasas -en misma dosis que el cloruro cálcico- se distribuyen también por todo el volumen de la leche con la espumadora durante un minuto. Después se tapa y se deja todo en reposo absoluto durante 45 minutos.

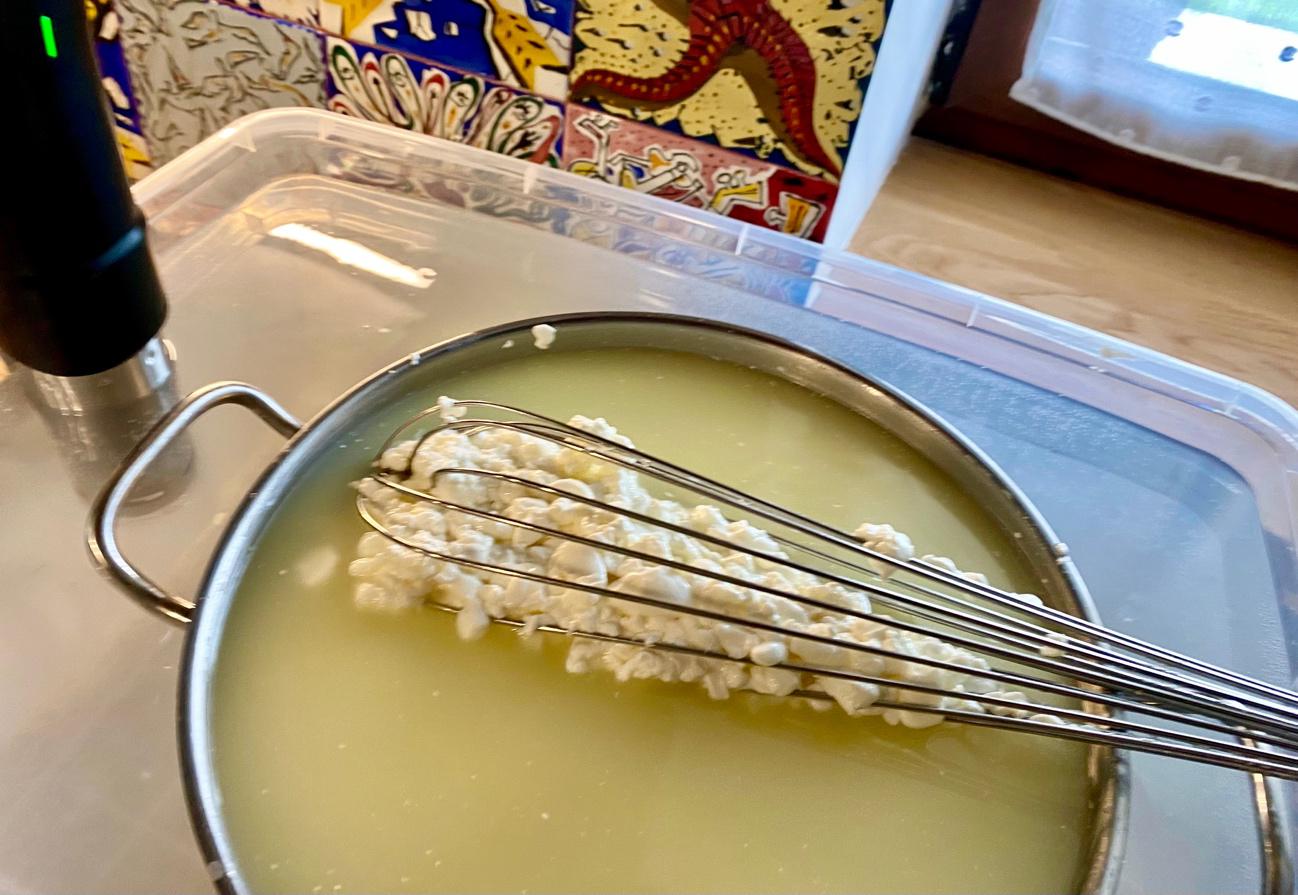

Como en todos los quesos, debemos probar la firmeza de la cuajada con la espátula. Si la coagulación es aún débil, se debe aumentar unos 10 minutos el tiempo. Obtenida la cuajada firme, la cortamos en grandes cubos de 2-3 cm de lado con la misma espátula. Dejamos reposar los cuajos unos 30 minutos y verificamos que el pH continúa descendiendo. Si el pH del suero es 6.4 o inferior, observamos que los Lactococcus están acidificando el queso a buen ritmo.

Removemos muy suavemente los cuajos con la espumadera durante 10 minutos, dejando al baño maría descender la temperatura lentamente por debajo de 30ºC. De esta forma los cuajos se van homogeneizando. Después de otro reposo de pocos minutos, podemos pasar ya los cuajos a los moldes. Si se quiere, puede retirarse directamente la parte superior del suero sobrante, aunque no es necesario.

Cuajos transvasados a moldes cilíndricos y separación del suero sobrante por gravedad. Foto: Victor Etxebarria

Cuajos transvasados a moldes cilíndricos y separación del suero sobrante por gravedad. Foto: Victor Etxebarria

El paso de la delicada cuajada a los moldes se realiza como se ilustra en la Figura 2. Se usan moldes cilíndricos ligeramente agujereados y sin tapa inferior ni superior. Para comenzar el proceso, se cubren las bases con rejillas de plástico aptas para la alimentación. Con cuidado y usando la espumadera llenamos los moldes hasta el borde. Observamos que, de esta forma, el suero va separándose por gravedad y los quesos van compactándose.

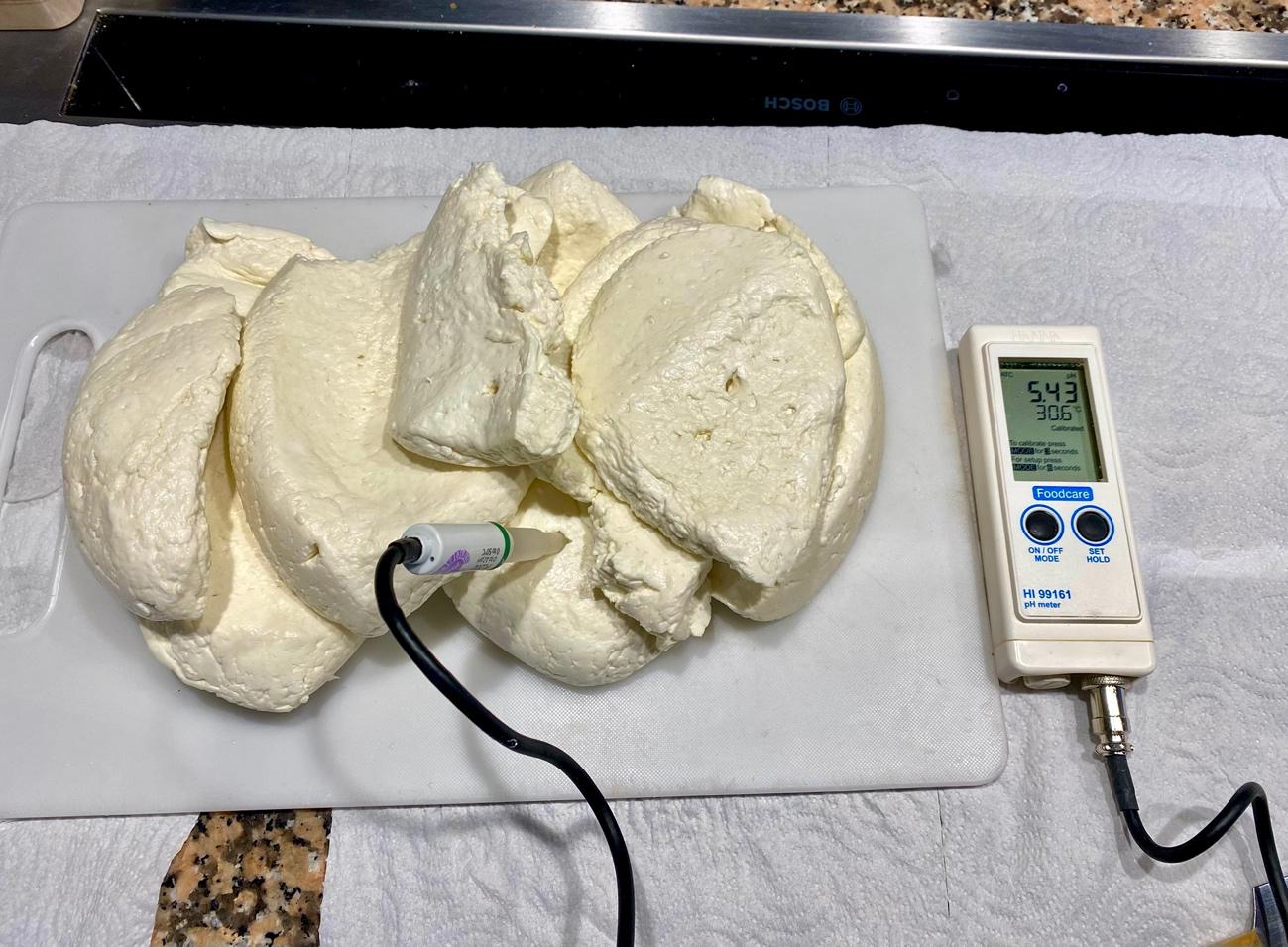

Una vez llenos los moldes, a intervalos de una o dos horas los volteamos cubiertos por rejillas y vamos así igualando la forma y la humedad de ambas caras de los quesos, a medida que se va escurriendo el suero sobrante por gravedad. En 24 horas los quesos resultan unos discos sólidos, compactos, ligeramente húmedos y elásticos. En este tiempo el pH habrá descendido hasta menos de 5 y la acidificación habrá terminado, puesto que las Lactococcus dejan de reproducirse en este ámbito ácido.

Los quesos pueden ahora salarse en seco, frotando sal común gruesa no yodada por todas sus superficies. La dosis de sal es 2% de la masa de cada queso que se sala. Se observa que la sal se adhiere fácilmente, se disuelve y se absorbe en pocos minutos. Los quesos están ya fabricados (pero no terminados).

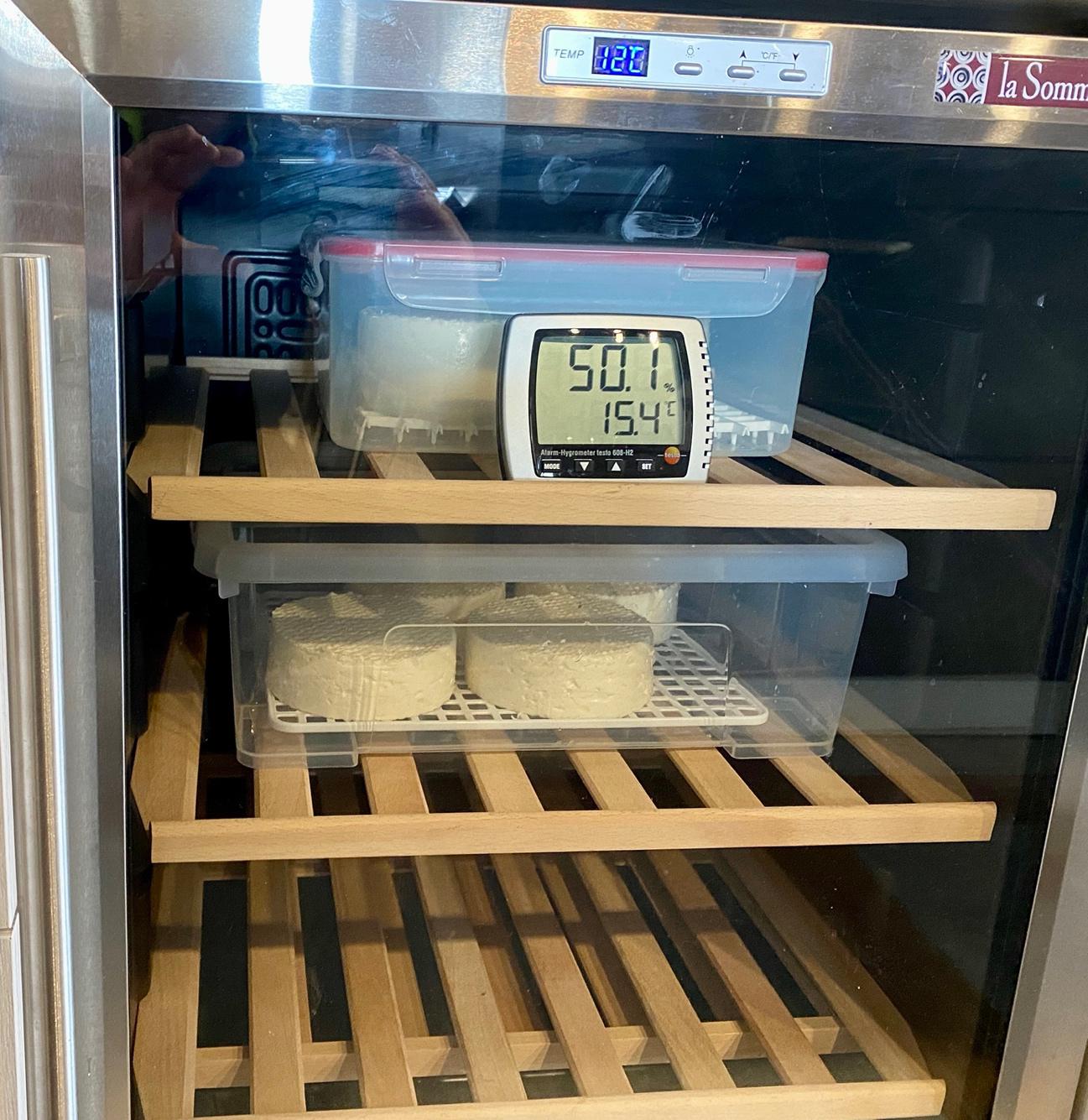

Inicio de la maduración de la corteza y de la masa de los quesos en vinoteca. Temperatura en torno a 15ºC y humedad superior al 90% en las cajas cerradas. Foto: Victor Etxebarria

Inicio de la maduración de la corteza y de la masa de los quesos en vinoteca. Temperatura en torno a 15ºC y humedad superior al 90% en las cajas cerradas. Foto: Victor Etxebarria

El siguiente paso es el afinado (affinage) de estos quesos de masa blanda. En primer lugar, los introducimos en cajas de plástico bien desinfectadas y usamos una rejilla plástica como base, para que cierta cantidad de suero que aún pueda separarse quede en el fondo de la caja. Tal y como se ilustra en la Figura 3, se introducen estas cajas en una cava o en una vinoteca a 15ºC. Esta cava puede emplearse simultáneamente para madurar quesos duros y para afinar la corteza de los quesos de masa blanda. La humedad del interior de las cajas de plástico cerradas es superior al 90%, pero no afecta al exterior.

Cada uno o dos días los quesos deben voltearse para garantizar su desarrollo uniforme. Dependiendo de los hongos y bacterias aerobias añadidas para afinar su corteza, en menos de dos semanas se comenzará a observar su desarrollo por toda la superficie del queso. Estos microorganismos no se desarrollan en el interior, sino solo en la corteza. Normalmente, con las manos desinfectadas abrimos las cajas, observamos la evolución de mohos y levaduras y volteamos los quesos.

Inspección visual, táctil y olfativa del desarrollo de las cortezas, volteo de los quesos y renovación de la atmósfera de las cajas. Foto: Victor Etxebarria

Inspección visual, táctil y olfativa del desarrollo de las cortezas, volteo de los quesos y renovación de la atmósfera de las cajas. Foto: Victor Etxebarria

En la Figura 4 se ilustra un proceso de supervisión del desarrollo de la corteza de quesos blandos. Los mohos se visualizan rápidamente, el tacto resbaladizo o pegajoso de las levaduras y el aroma generado por todos los microorganismos nos indican la evolución del afinado. El volteo uniformiza todas las superficies, y alrededor de tres o cuatro semanas la corteza debería haberse desarrollado por completo.

Una técnica especial para producir quesos de pasta blanda de fuerte sabor y aroma es el lavado de la corteza. Como decíamos, los simples quesos mohosos como el Brie o Camembert no necesitan lavado. Sin embargo, los quesos de fuerte aroma y sabor como Epoisses, Reblochon o Stinking Bishop basan sus características en el lavado de sus cortezas. Para ello se emplea una salmuera débil (5% de sal no yodada disuelta en agua no clorada) a la que se añaden los mismos microorganismos (mohos, levaduras y bacterias aerobias) que decidimos utilizar en el sembrado de la leche. Así, aunque los hongos pueden comenzar a aparecer en la superficie, el lavado refuerza el desarrollo de la corteza, incluyendo olorosos gases característicos producidos por las bacterias aerobias introducidas, al descomponer aminoácidos azufrados presentes en las proteínas de los quesos.

Técnica de lavado de la corteza para quesos de fuerte aroma y sabor. Foto: Victor Etxebarria

Técnica de lavado de la corteza para quesos de fuerte aroma y sabor. Foto: Victor Etxebarria

En la Figura 5 se muestra el proceso del lavado de la corteza. Se empapa un pañuelo limpio en la salmuera débil con los microorganismos elegidos y se lavan las cortezas. Ello -dos veces por semana- mantiene la corteza dando prioridad a las levaduras, mohos y bacterias aerobias deseadas. En la Figura 5, se utiliza un baño salino débil con Brevibacterium aurantiacum, Arthrobacter nicotianae, Debaryomyces hansenii y Geotrichum candidum. Este lavado produce un fuerte aroma (olor a pies, más interesante de lo que parece) cuando va desarrollándose.

El affinage por tanto incluye el tratamiento de las cortezas, proceso de la máxima importancia en el desarrollo de distintas variedades de quesos de masa blanda. Sea con lavado de corteza o sin ello, falta un último paso para un afinado completo de estos quesos. Dependiendo de la textura interior final que se desea para consumir el queso, la maduración puede durar varias semanas más.

El proceso de la afinación de la masa interior se produce mediante una serie de reacciones químicas muy interesantes. Una vez formada la corteza, los hongos metabolizan el ácido láctico generado (o su versión ionizada, el lactato) en dióxido de carbono y agua (en presencia de oxígeno). Esto aumenta el pH de la superficie. Cuando el lactato superficial se consume, el lactato interno comienza a moverse hacia la superficie y va consumiéndose también.

El aumento de pH hace que las proteínas del queso pierdan su punto isoeléctrico y dejan de ser hidrofóbicas (vuelven a ser cada vez más solubles en agua cuanto más se alejan de su punto isoeléctrico). Así, este pH de la superficie va haciendo más cremosa la masa interior del queso. Globalmente el pH de la superficie es cercano a 7, el interior inmediato es algo más ácido (6.5) y cremoso, y el núcleo central del queso puede ser más ácido (5.5) y sólido, si el afinado no ha durado el tiempo suficiente.

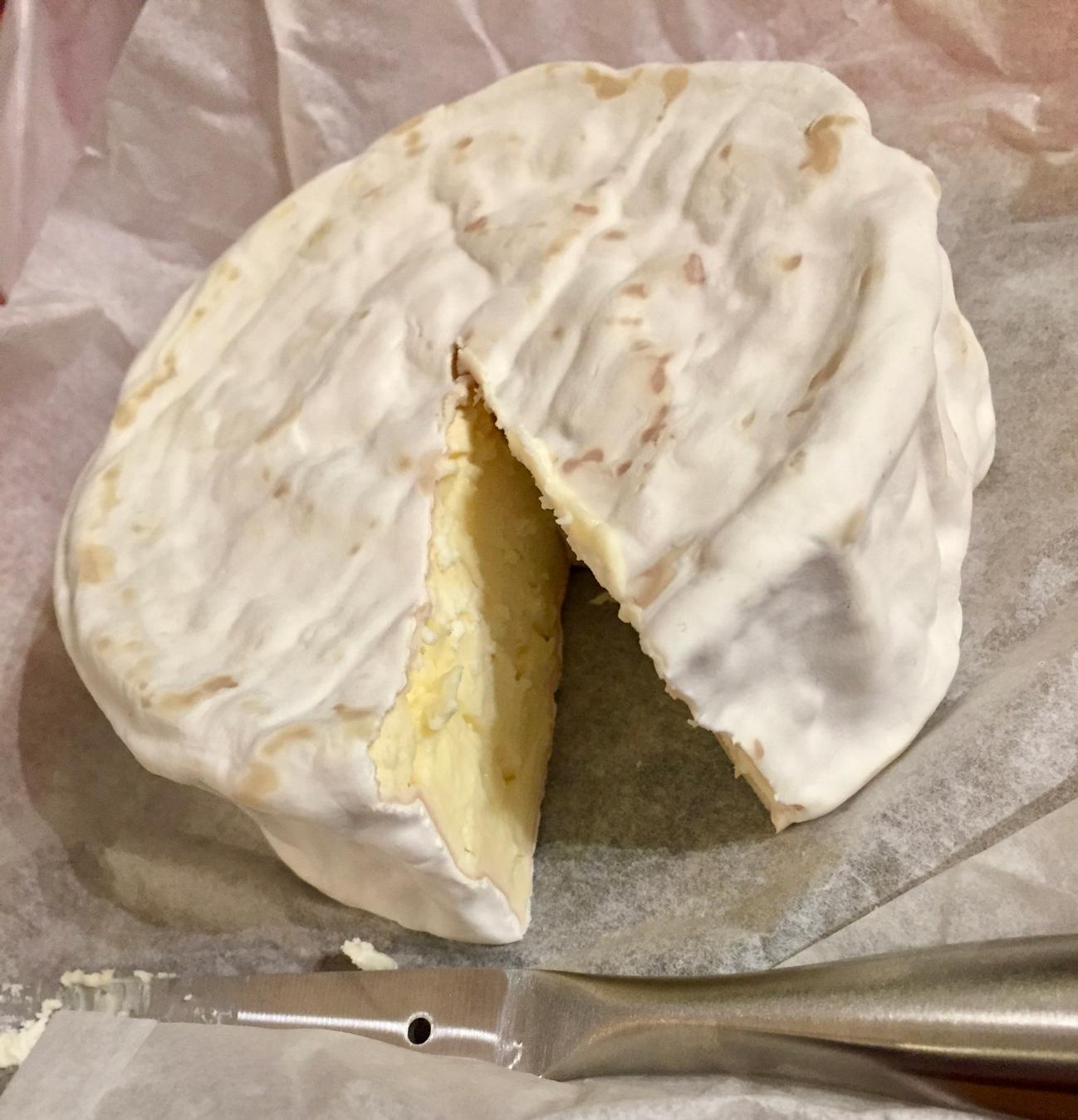

Queso tipo camembert semi-affiné (afinado corto) para sabor y aroma suave. Foto: Victor Etxebarria

Queso tipo camembert semi-affiné (afinado corto) para sabor y aroma suave. Foto: Victor Etxebarria

Dependiendo del nivel de afinado que queremos, este proceso de maduración interior puede durar típicamente entre dos y cinco semanas (siempre contando tras formar la corteza). Cuando es corto el afinado interior, como el mostrado en la Figura 6 de un camembert, el sabor y aroma que se obtiene no es tan fuerte y el interior es blando pero sólido. Esto puede llamarse un camembert semi-affiné que muchas personas prefieren.

Queso blando de cabra affiné à point (en su punto) para sabor y aroma excelentes. Foto: Victor Etxebarria

Queso blando de cabra affiné à point (en su punto) para sabor y aroma excelentes. Foto: Victor Etxebarria

Cuando el afinado es más largo, el sabor y aroma es más fuerte, como el mostrado en la Figura 7, en un queso de cabra con el interior más cremoso, en un afinado à point. La corteza y la masa cremosa amplifican los sabores y olores del queso y durante unos pocos días está en su mejor momento.

Los quesos de pasta blanda y corteza tratada pueden degustarse suaves, más fuertes -en su punto- o hay personas que prefieren mantener aún más tiempo la maduración en el frigorífico. Esto implica que los hongos descompongan los aminoácidos de las proteínas, generen amoniaco y por tanto ambiente aún más alcalino en el interior del queso. Esto puede dar lugar a un sabor extrafuerte, una textura casi líquida y un olor cuyo carácter quesero empieza a alterarse, al dominar el amoniaco. Esta situación es del gusto de amantes de sabores fuertes, pero pasado de este límite, el queso deja de ser comestible.

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

El artículo Cómo hacer un queso de pasta blanda y corteza tratada en casa se ha escrito en Cuaderno de Cultura Científica.

Estamos en Naukas Bilbao. Síguelo en directo

El evento de divulgación científica de referencia vuelve a Bilbao los días 20 y 21 de septiembre. Un año más la ciencia vuelve a subirse al escenario del Euskalduna Bilbao en una nueva edición de NAUKAS Bilbao en el que las breves charlas científicas llenas de humor volverán a ser las protagonistas.

A lo largo de la mañana y la tarde del viernes y el sábado, decenas de conferenciantes hablarán sobre los temas científicos más variados respetando siempre el formato NAUKAS: charlas breves (10 minutos por persona) y amenas. Este es el programa definitivo.

La entrada es libre hasta completar aforo y, además, puedes seguir el evento en streaming en el canal Kosmos de EITB.

El artículo Estamos en Naukas Bilbao. Síguelo en directo se ha escrito en Cuaderno de Cultura Científica.

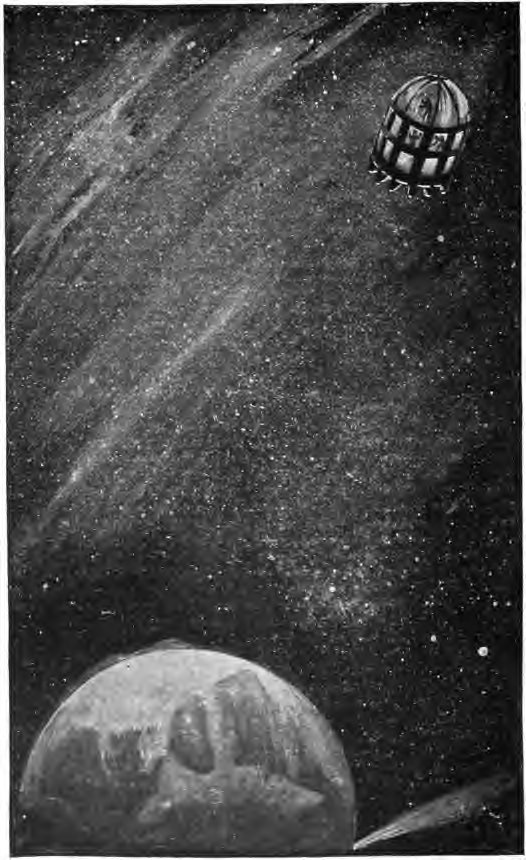

El proyecto Orión y un señor de Murcia

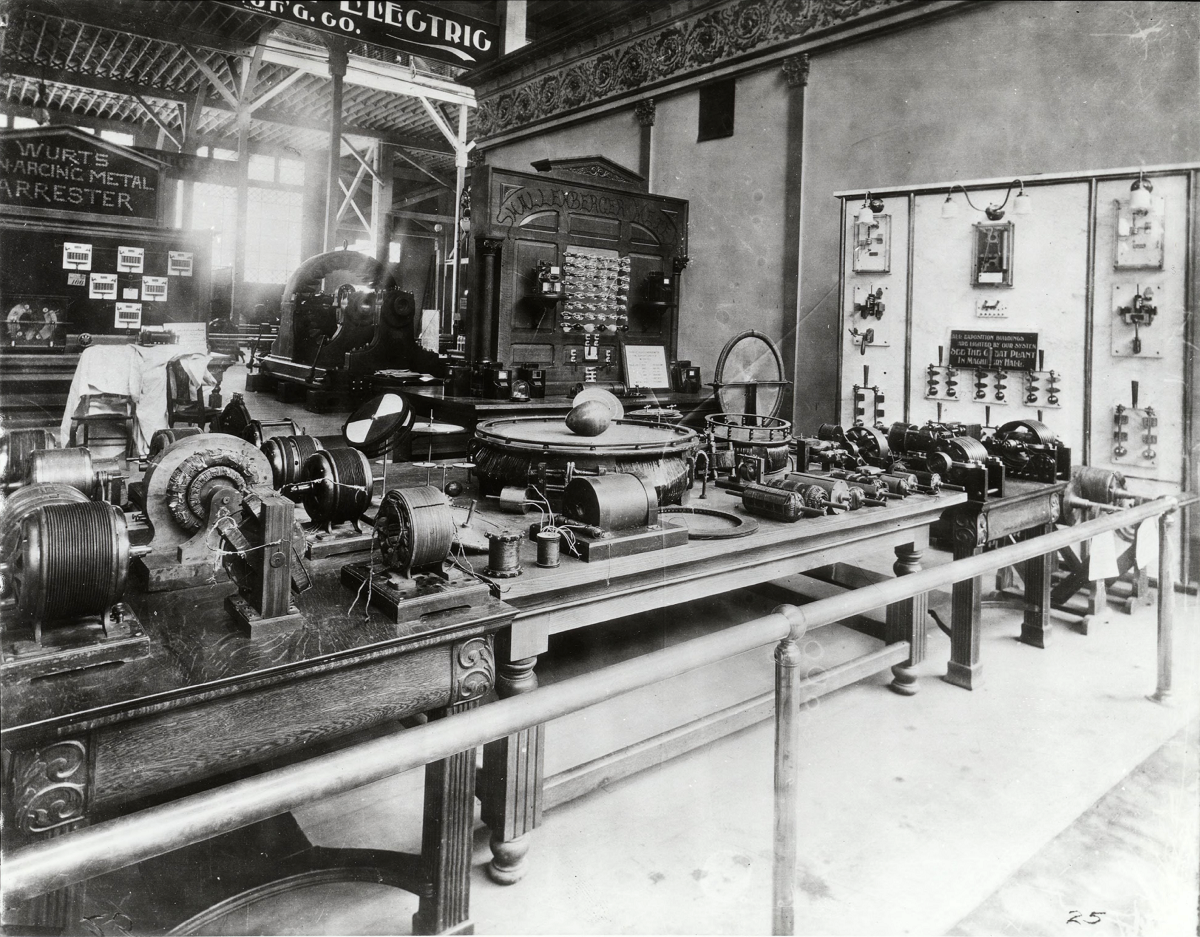

A caballo entre la invención de la bomba atómica y el comienzo de la carrera espacial, el año 1946 contaba con los dos principales ingredientes que llevaron al matemático de origen polaco Stanislaw Ulam a imaginar uno de los métodos de propulsión de naves más… ¿originales? ―no sé ni cómo describirlo―de la historia: la propulsión nuclear de pulso. Y es que… ¿Qué podría salir mal si intentamos viajar por el espacio utilizando explosiones atómicas para desplazar nuestro vehículo? Es posible que todo, y, sin embargo, ese no fue el motivo por el que la idea que, de hecho, demostró no ser mala del todo, se descartó. Aún más: aunque en su momento se presentó como algo completamente innovador, ni siquiera lo era tanto. Esta es la historia del Proyecto Orión y del señor de Alhama de Murcia que ya pensó algo similar unos cincuenta años antes.

La idea de utilizar explosiones nucleares como modo de propulsión de naves estelares se le ocurrió al matemático polaco Stanislaw Ulam en 1946. Un año después de los ataques de Hiroshima y Nagasaki.

La idea de utilizar explosiones nucleares como modo de propulsión de naves estelares se le ocurrió al matemático polaco Stanislaw Ulam en 1946. Un año después de los ataques de Hiroshima y Nagasaki.Créditos: Los Alamos National Laboratory

Los cálculos preliminares de la idea de la propulsión nuclear a pulso a la que Ulam le había estado dando vueltas a lo largo de 1946 quedaron plasmados en un breve memorándum que escribió junto con Fred Reines al año siguiente, pero no quedó ahí la cosa. Años después, en 1955 ―antes del lanzamiento del Sputnik―, amplió esos cálculos y publicó con Cornelius Everett un documento mucho más detallado, On a method of propulsion of projectiles by means of external nuclear explosion, en el que se evidenciaba que aquella locura, podría no serlo tanto, y daban una descripción más pormenorizada de la idea:

El esquema propuesto en el presente informe implica el uso de una serie de reactores desechables (bombas de fisión) que se van expulsando y detonando a una distancia considerable del vehículo y que liberan la energía necesaria en un «motor» externo que consiste esencialmente en espacio vacío. La cuestión crítica sobre este método gira en torno a su capacidad para aprovechar las reservas reales de energía nuclear liberada a las temperaturas de la bomba sin destruir o derretir el vehículo.

Que la nave pudiera acabar destruida o las posibles consecuencias que la radiación resultante de las explosiones pudiera tener sobre los ocupantes del vehículo se planteaba más como una cuestión de ingeniería que de física. La ciencia, en principio, no ponía ninguna objeción a priori. En aquellos años en los que el espacio dejó de pertenecer al mundo de la fantasía y las historias de ciencia ficción para convertirse en una posibilidad,Stanislaw Ulam promovió incansablemente su idea, hasta que, tal vez apremiados por el éxito del Sputnik y la ventaja que el primer satélite artificial le dio a la URSS en la carrera espacial, ARPA ―la Agencia de Proyectos de Investigación Avanzados, hoy DARPA― decidió financiarlo con 999 750 $.

En junio de 1958, el Proyecto Orión empezó a pasar del papel a la práctica de la mano de los físicos Ted Taylor, de General Atomic, y Freeman Dyson, que se tomó un año sabático a instancias del primero en el Instituto de Estudios Avanzados de Princeton. Un año después, en 1959, se llevaban a cabo las primeras pruebas del diseño en la base militar de Point Loma (San Diego, California); eso sí, con explosivos convencionales. Y llegó a funcionar relativamente bien.

Tal fue así que uno de los prototipos se encuentra en el Museo Nacional del Aire y el Espacio, en Washington.

Prototipo de la nave del Proyecto Orión que se conserva en el Museo Nacional del Aire y el Espacio.

Prototipo de la nave del Proyecto Orión que se conserva en el Museo Nacional del Aire y el Espacio.Créditos: Gulf General Atomics Division, General Dynamics Corporation. Fuente.

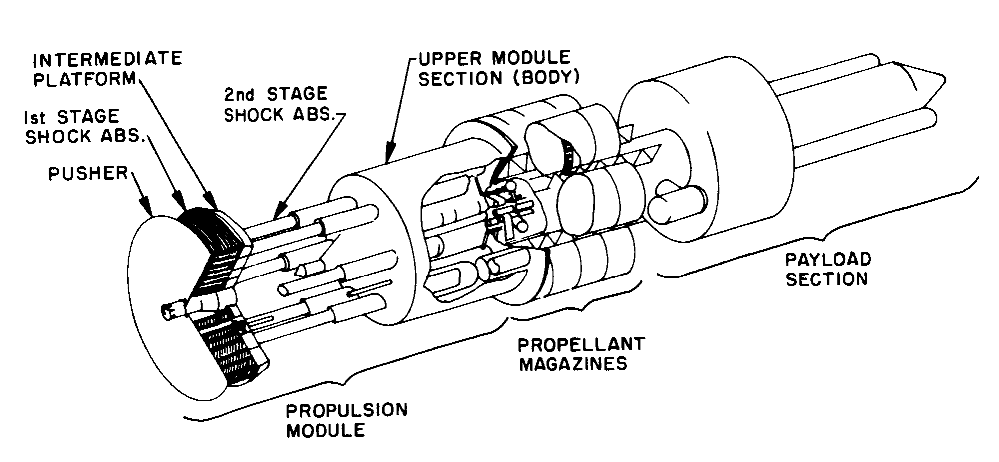

El sistema, a muy grandes rasgos, funcionaba así: las explosiones nucleares liberarían una gran cantidad de energía en forma de radiación y partículas que moverían un amortiguador de inercia que, a su vez, transmitiría el impulso a la nave ―recomiendo muchísimo este artículo de Daniel Marín donde explica de manera mucho más exhaustiva todos los detalles―.

Diseño de la NASA de un posible vehículo con propulsión nuclear de pulso. Créditos: Dominio Público/NASA

Diseño de la NASA de un posible vehículo con propulsión nuclear de pulso. Créditos: Dominio Público/NASA

¿Por qué terminó entonces el proyecto? Por varios motivos, pero, principalmente, debido al Tratado de Prohibición Parcial de Ensayos Nucleares en la Atmósfera, en el Espacio Exterior y Bajo el Agua que 113 países firmaron en 1963. ¿Cómo hubiera sido una nave que hubiera utilizado este sistema si se hubiera construido? Algunos la han imaginado. Aquí podemos ver la simulación de funcionamiento de una nave así:

No solo eso, las relaciones entre el Proyecto Orión y la literatura de ciencia ficción pueden encontrarse casi por todas partes. Muchos de los ideólogos y participantes, entre ellos el propio Stanislaw Ulam o Freeman Dyson, mencionaron en su momento las obras de Julio Verne o las aventuras de Buck Rogers como fuente de inspiración. Y, por supuesto, este método de propulsión apareció en las historias de Robert A. Heinlein, Arthur C. Clarke, Larry Niven y Jerry Pournelle, y, más recientemente, de Charles Stross o en la famosa trilogía de los Tres Cuerpos de Liu Cixin.

Bueno, todo esto está muy bien y ya se ha escrito mucho sobre ellos, pero… ¿Qué tiene que ver el Proyecto Orión con un señor de Murcia? Que, si bien cuando vivió dicho señor todavía quedaba mucho para el desarrollo de la energía atómica ―J. J. Thomson acababa de descubrir el electrón apenas en aquel momento―, tuvo la idea de utilizar explosivos para alimentar un motor ya a finales del siglo XIX.

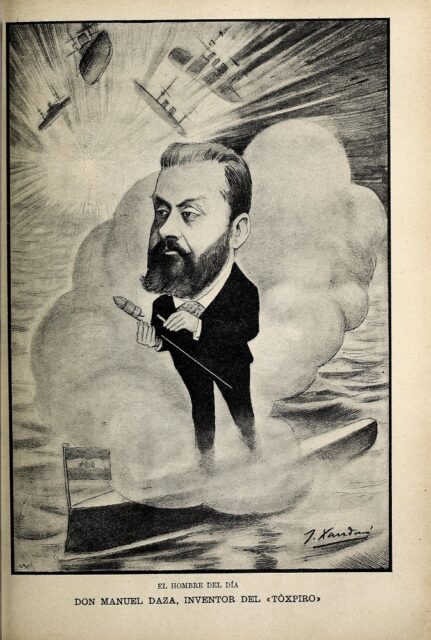

A juzgar por esta caricatura que Joaquín Xaudaró le dedica en la revista Blanco y Negro en junio de 1898, Manuel Daza no fue un desconocido en su época. Créditos: Dominio Público/Joaquín Xaudaró

A juzgar por esta caricatura que Joaquín Xaudaró le dedica en la revista Blanco y Negro en junio de 1898, Manuel Daza no fue un desconocido en su época. Créditos: Dominio Público/Joaquín Xaudaró

Manuel Daza y Gómez fue un ingeniero e inventor español nacido en Alhama de Murcia en 1853 al que se le ocurrieron cosas tan locas como «el Toxpiro […], el fuego venenoso, la venganza española, una supuesta máquina infernal capaz de disparar proyectiles explosivos a gran distancia», según explica Alejandro Polanco en su blog. Entre esas locuras, existe una patente suya fechada en 1898 de un motor que utiliza principios muy similares, aunque utilizando pólvora como detonante de las bombas, a los del Proyecto Orión:

Componen este motor dos organismos esenciales, un generador, en el que se desarrolla la energía, y un receptor, donde con ella se obtiene un movimiento circular con las condiciones convenientes para su aplicación a obtener un trabajo cualquiera.

El generador figuras 1.ª y 2.ª es un cilindro de hierro o acero cerrado por una de sus bases y lleno de pólvora que detrás de él se comprime en la medida necesaria el tiempo que debe durar la combustión.

Y acompaña la descripción con los planos del dispositivo.

Existen más de una veintena de patentes a nombre de este ingeniero ya, en gran medida, olvidado, que nada tienen que envidiar a las de sus pares estadounidenses de la época. Entre ellas, se pueden encontrar, entre otros ingenios, generadores, pilas, limitadores de corriente, «un bastón encendedor eléctrico» ―no estoy segura de si esto es exactamente lo que parece, una especie de bastón-mechero―, motores de viento, bicicletas de madera, trituradores y hasta procesos de aprovechamiento de materiales que hoy podrían ayudar al tan necesario reciclaje. Y no fue el único que tuvo visiones innovadoras y disruptivas en aquella época en nuestro país.

Aunque estoy convencida de que muchos habían oído ya hablar del Proyecto Orión, seguramente muy pocos habían oído hablar de Manuel Daza. Sin embargo, lo cierto es que en España hubo, como él, muchos más ingenieros e inventores que, sin llamarse Thomas (Edison), Alexander (Graham Bell) o Charles (Babbage), y con nombres como Leonardo (Torres Quevedo), Elia (Garci-Lara Catalá) o Emilio (Herrera Linares), no tenían nada que envidiarles.

Agradecimiento:

Quiero dar las gracias a Alejandro Polanco Masa por su gran labor de investigación en todo lo referente a infinitud de inventos españoles olvidados, y por poner a mi disposición los documentos de la patente de Manuel Daza para poder escribir este artículo.

Bibliografía

Daza y Gómez, M. (1898). Motor Daza. N.º de patente ES22411. Ministerio de Fomento.

Dyson, G. (2003). Project Orion: the true story of the atomic spaceship. Holt paperbacks.

Everett, C. J. Y Ulam S. M (1955). On a method of propulsion of projectiles by means of external nuclear explosions. Part I. Los Alamos Scientific Laboratory of the University of California.

Marín, D. (14 de octubre de 2010). Orión: la nave imposible. Eureka.

Palao Poveda, G. y Sáiz González, J. P. (2004). Las patentes de invención de Manuel Daza. Revista de Estudios Yeclanos. Yakka, 14, 177-180.

Polanco Masa, A. (2024). 365 inventos made in Spain. Glyphos.

Polanco Masa, A. (7 de agosto de 2008). Manuel Daza y su arma secreta. Tecnología Obsoleta.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo El proyecto Orión y un señor de Murcia se ha escrito en Cuaderno de Cultura Científica.

La circunferencia de los nueve puntos

La entrada del Cuaderno de Cultura Científica titulada La recta de Euler estaba dedicada al resultado geométrico conocido como el teorema de la línea de Euler, que dice que tres de los puntos notables asociados a un triángulo cualquiera, el ortocentro, el circuncentro y el baricentro, se encuentran en una misma línea, que se conoce con el nombre de línea de Euler. Además, al final de la entrada se comentaba que, junto al ortocentro, el circuncentro y el baricentro de un triángulo, existen otros puntos definidos con relación al triángulo que también están en la recta de Euler, uno de ellos era el centro de la circunferencia de los nueve puntos. La entrada de hoy la vamos a dedicar precisamente a esta figura geométrica, la circunferencia de los nueve puntos.

Squared Rectangle and Euler Line / Rectángulo cuadrado y línea de Euler (1972), del dibujante e ilustrador infantil estadounidense Crockett Johnson (1906-1975). Imagen de la página web de The National Museum of American HistoryLa línea de Euler

Squared Rectangle and Euler Line / Rectángulo cuadrado y línea de Euler (1972), del dibujante e ilustrador infantil estadounidense Crockett Johnson (1906-1975). Imagen de la página web de The National Museum of American HistoryLa línea de Euler

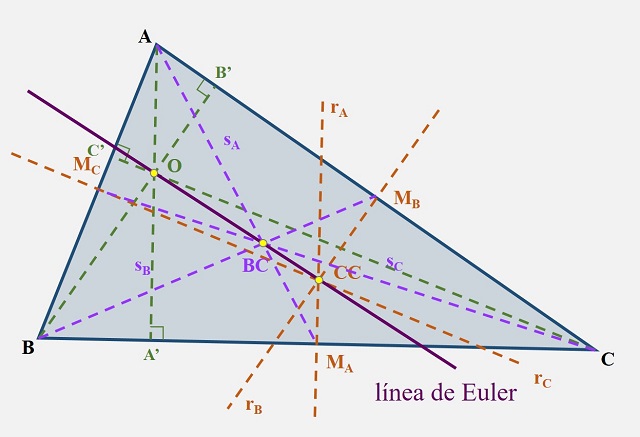

Antes de nada, vamos a recordar brevemente el teorema de la línea de Euler que, aunque no se necesita para explicar qué es la circunferencia de los nueve puntos, sí está relacionado con ella, como se ha comentado.

Dado un triángulo cualquiera, los tres puntos notables asociados al triángulo que se mencionan en el teorema de la línea de Euler son el ortocentro, el circuncentro y el baricentro. El ortocentro es el punto de intersección de las tres alturas del triángulo (o las rectas que las extienden), el circuncentro es el punto de intersección de las tres mediatrices (la mediatriz de un segmento es la recta perpendicular al mismo que pasa por su punto medio) de los lados del triángulo y el baricentro es el punto de intersección de las tres medianas (una mediana de un triángulo es el segmento de recta que pasa por un vértice y el punto medio del lado opuesto) del triángulo. Esos tres puntos del plano podrían no estar alineados, como ocurre en general para tres puntos cualesquiera, sin embargo, estos tres puntos sí van a estar sobre una misma línea recta, como afirma este teorema.

Teorema de la línea de Euler: Dado un triángulo cualquiera ABC, el ortocentro O, el circuncentro CC y el baricentro BC son colineales (a la recta que incluye a los tres puntos se la denomina línea de Euler). Además, la distancia del ortocentro O al baricentro BC es igual a dos veces la distancia del baricentro BC al circuncentro CC.

El ortocentro O, el circuncentro CC y el baricentro BC de un triángulo ABC están alineados y la recta que los contiene es la línea de Euler

El ortocentro O, el circuncentro CC y el baricentro BC de un triángulo ABC están alineados y la recta que los contiene es la línea de Euler

El matemático suizo Leonhard Euler (1707-1783), el matemático más prolífico de todos los tiempos, incluía este resultado en su artículo titulado Solutio facilis problematum quorundam geometricorum difficillimorum / Soluciones fáciles para algunos problemas geométricos difíciles y, que fue publicado en la revista Novi Commentarii academiae scientiarum Petropolitanae en 1767, aunque se presentó a la Academia de Ciencias de San Petersburgo en diciembre de 1763.

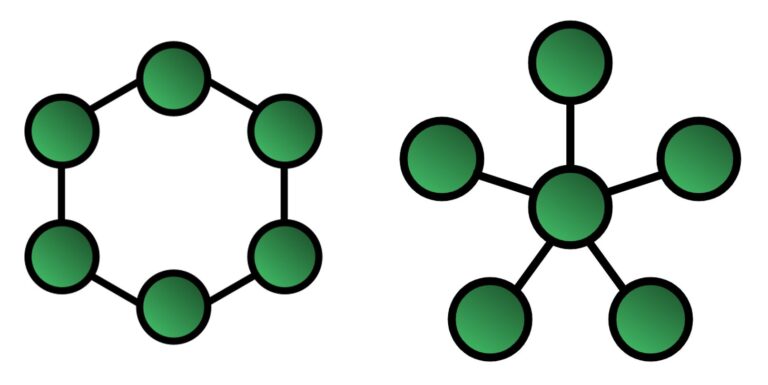

La circunferencia de los nueve puntosDado un triángulo cualquiera, vamos a considerar tres grupos de tres puntos, luego nueve puntos en total, definidos geométricamente en relación con el triángulo.

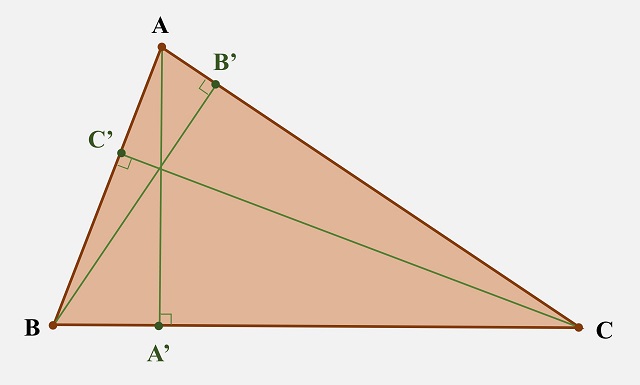

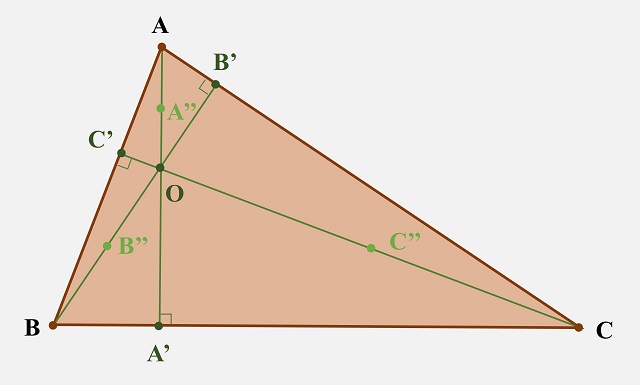

El primer grupo de tres puntos consiste en los pies de las tres alturas del triángulo. Por ejemplo, en la siguiente imagen tenemos un triángulo ABC cualquiera. Desde el vértice A se traza la recta que pasa por A y corta perpendicularmente al lado opuesto del triángulo (o a la recta que lo contiene), el lado BC, que es la altura del triángulo ABC desde el vértice A y se denota A’ al punto de corte, que es el pie de esa altura. Desde el punto B se traza la correspondiente altura, es decir, la recta que corta perpendicularmente al lado opuesto AC y se considera el punto de corte, B’, el pie de esta altura. Y desde C se traza también la altura y se denota por C’ el pie de la misma.

Un triángulo ABC cualquiera, sus alturas y los pies de las mismas A’, B’ y C’

Un triángulo ABC cualquiera, sus alturas y los pies de las mismas A’, B’ y C’

Ya tenemos el primer grupo de tres puntos, los pies de las tres alturas. Para considerar el siguiente grupo de tres puntos, vamos a tomar la intersección de las tres alturas (o de las rectas que las contienen), el ortocentro. Entonces, los puntos que nos interesan son los puntos medios de los segmentos que unen cada vértice con el ortocentro, que se denominan puntos de Euler. Si consideramos el triángulo ABC anterior, O es el ortocentro, los puntos de Euler son A’’, B’’ y C’’, que son los puntos medios de los segmentos OA’, OB’ y OC’.

Un triángulo ABC cualquiera, los pies de las alturas A’, B’ y C’, el ortocentro O y los puntos de Euler A’’, B’’ y C’’, que son los puntos medios de los segmentos OA’, OB’ y OC’

Un triángulo ABC cualquiera, los pies de las alturas A’, B’ y C’, el ortocentro O y los puntos de Euler A’’, B’’ y C’’, que son los puntos medios de los segmentos OA’, OB’ y OC’

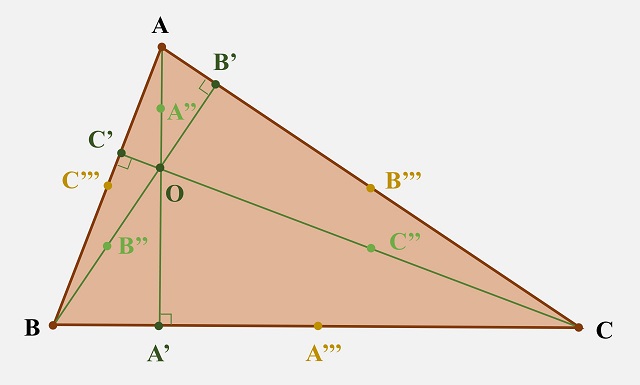

El siguiente grupo de tres puntos son los puntos medios de los lados del triángulo. Si volvemos al triángulo ABC, el punto medio del segmento AB es C’’’, el punto medio del segmento BC es A’’’ y el punto medio del segmento CA es B’’’.

Nueve puntos destacados de un triángulo ABC: los pies de las alturas A’, B’ y C’, los puntos de Euler A’’, B’’ y C’’, y los puntos medios de los lados del triángulo A’’’, B’’’ y C’’’

Nueve puntos destacados de un triángulo ABC: los pies de las alturas A’, B’ y C’, los puntos de Euler A’’, B’’ y C’’, y los puntos medios de los lados del triángulo A’’’, B’’’ y C’’’

Ya están establecidos los tres grupos de tres puntos asociados a un triángulo y que aparecen en el teorema de la circunferencia de los nueve puntos, que enunciamos a continuación.

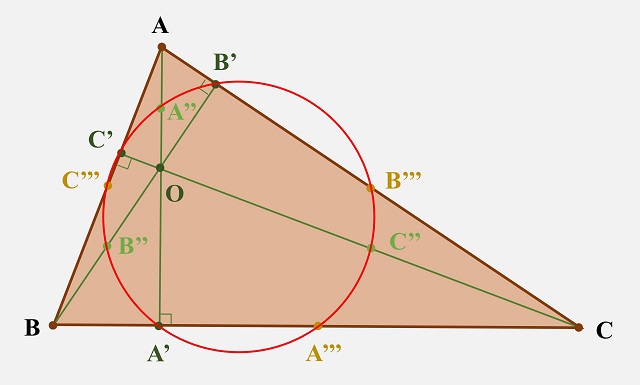

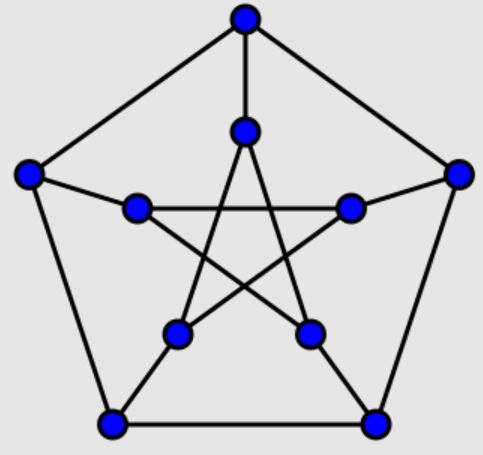

Teorema de la circunferencia de los nueve puntos: Dado un triángulo cualquiera ABC, los pies de las alturas del triángulo, los puntos de Euler y los puntos medios de los lados del triángulo están en una misma circunferencia, conocida como circunferencia de los nueve puntos.

Los nueve puntos destacados del triángulo ABC, los pies de las alturas A’, B’ y C’, los puntos de Euler A’’, B’’ y C’’, y los puntos medios de los lados del triángulo A’’’, B’’’ y C’’’, están en una misma circunferencia (roja en la imagen)

Los nueve puntos destacados del triángulo ABC, los pies de las alturas A’, B’ y C’, los puntos de Euler A’’, B’’ y C’’, y los puntos medios de los lados del triángulo A’’’, B’’’ y C’’’, están en una misma circunferencia (roja en la imagen)La circunferencia de Feuerbach

Uno de los muchos nombres que recibe la circunferencia de los nueve puntos es circunferencia de Euler, puesto que según algunos autores ya era conocida por el matemático suizo, entre otros Heinrich Dorrie, autor del interesante libro 100 Great Problems of Elementary Mathematics: Their History and Solutions. Sin embargo, como explica el matemático John Sturgeon Mackay (1843-1904) en su artículo History of the nine-point circle / Historia de la circunferencia de los nueve puntos, no hay ninguna referencia a esta circunferencia en las obras de Euler:

El primer autor al que se ha atribuido el descubrimiento del círculo de nueve puntos es Euler, pero nadie ha dado nunca una referencia a ningún pasaje de los trabajos de Euler en el que se afirme, o se implique, la propiedad característica de esta circunferencia. La atribución a Euler es simplemente un error, y el origen del error puede, creo, explicarse.

Según Mackay, el error viene de un texto del matemático Eugène Charles Catalan (1814-1894), el libro Théorèmes et Problèmes Géométrie élémentaire, que en sus quinta y sexta ediciones atribuye el resultado a Euler, al malinterpretar dos artículos del matemático francés Olry Terquem (1782-1862) que tienen prácticamente el mismo título, lo que provoca la confusión. El primero titulado Considerations sur le triangle rectiligne, d’apres Euler / Consideraciones sobre el triángulo rectilíneo, según Euler (1842) y el segundo con el mismo título, salvo la expresión “según Euler”, y publicados además en el mismo número de la misma revista. Mientras que en el primero se recogían resultados de Euler, el segundo se dedicaba a resultados desarrollados por el propio Terquem y empezaba con el teorema de la circunferencia de los nueve puntos.

La primera vez que se menciona explícitamente la circunferencia de los nueve puntos es en un artículo publicado por el matemático, químico y militar francés Charles Julien Brianchon (1783-1864) y el matemático e ingeniero francés Jean-Victor Poncelet (1788-1867), en la revista Annales de Mathematiques, en 1821.

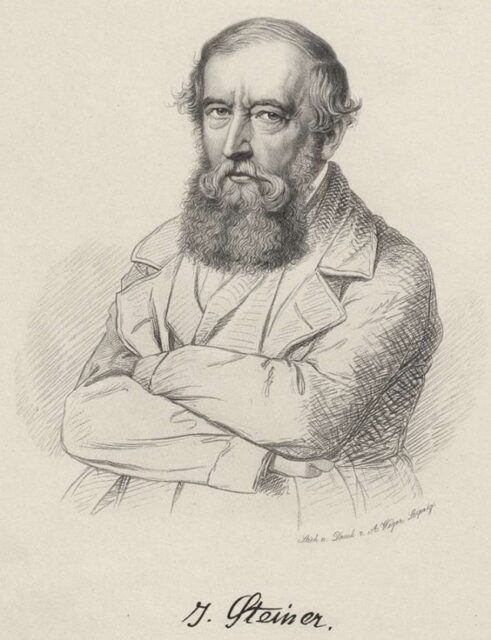

Dibujo del matemático alemán Karl Wilhelm Feuerbach

Dibujo del matemático alemán Karl Wilhelm Feuerbach

Un año después, el matemático alemán Karl Wilhelm Feuerbach (1800-1834) demostró la existencia de esta circunferencia, pero mencionando que pasa por seis puntos, los puntos medios de los lados del triángulo y los pies de las alturas (por este motivo en ocasiones se llama circunferencia de los seis puntos), en su pequeño libro Eigenschaften einiger merkwürdigen Punkte des geradlinigen Dreiecks und mehrerer durch sie bestimmten Linien und Figuren / Propiedades de algunos puntos peculiares del triángulo rectilíneo y de varias rectas y figuras determinadas por ellos (1822). Así mismo, demostró un resultado relacionado con esta circunferencia, que se conoce como teorema de Feuerbach y que presentamos más adelante. De manera que a la circunferencia de los nueve puntos se la suele conocer como circunferencia de Feuerbach, que es un nombre que se utiliza frecuentemente, y a su centro como centro de Feuerbach.

Además, el centro de Feuerbach, o centro de la circunferencia de los nueve puntos, se encuentra sobre la recta de Euler, que se presentó en la anterior entrada La recta de Euler.

El teorema de FeuerbachPor lo tanto, dado un triángulo cualquiera la circunferencia que pasa por los pies de las alturas, por los puntos de Euler y por los puntos medios de los lados recibe muchos nombres, desde circunferencia de Euler, que resulta ser confuso e incorrecto, hasta el más habitual, circunferencia de los nueve puntos, pasando por circunferencia de los seis puntos y circunferencia de Feuerbach, entre otros que ya comentaremos.

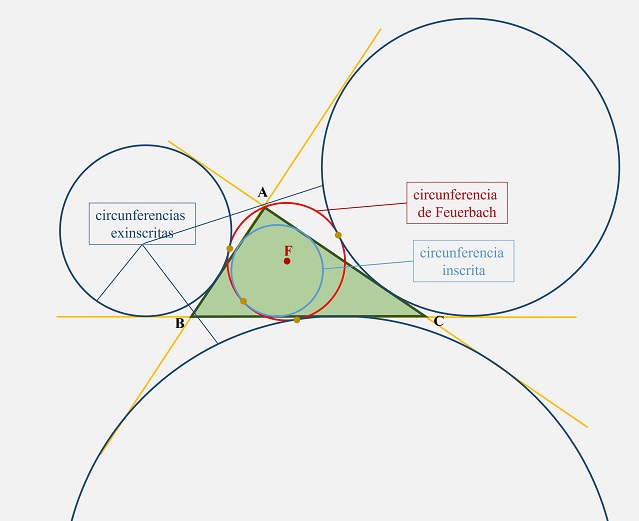

La existencia de la circunferencia de los seis puntos no fue lo único que demostró el matemático alemán, también probó, entre otros resultados relacionados con esta circunferencia, el conocido teorema de Feuerbach, que enunciamos a continuación.

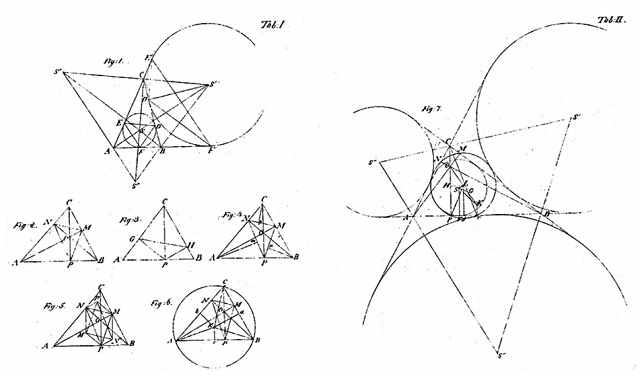

Teorema de Feuerbach: Dado un triángulo cualquiera ABC, la circunferencia de los seis puntos es tangente a las circunferencias inscrita y exinscritas del triángulo.

Dado un triángulo cualquiera ABC, la circunferencia de los seis puntos (en rojo en la imagen) es tangente a las circunferencias inscrita (azul claro) y exinscritas (azul oscuro) al triángulo

Dado un triángulo cualquiera ABC, la circunferencia de los seis puntos (en rojo en la imagen) es tangente a las circunferencias inscrita (azul claro) y exinscritas (azul oscuro) al triángulo

Como escribe el matemático estadounidense Howard H. Eves (1911-2004) en su clásico Mathematical circles / Círculos matemáticos (2003), “Los geómetras consideran universalmente que el llamado teorema de Feuerbach es sin duda uno de los teoremas más bellos de la geometría moderna del triángulo”. De hecho, después de Feuerbach muchos otros matemáticos demostraron este resultado o generalizaciones del mismo. Por ejemplo, el matemático británico Thomas S. Davies (1795-1851) en su artículo Symmetrical properties of plane triangles (1827), que ya añadía los puntos de Euler a los seis considerados por Feuerbach, el matemático suizo Jakob Steiner (1796-1863), que publicó algunos resultados generalizando el teorema de la circunferencia de los nueve puntos en el artículo Developpement dune serie de theoremes relatifs aux sections coniques (1828) y en el libro Die geometrischen Constructionen, ausgefuhrt mittelst der geraden Linie und eines festen Kreises (1833), en el cual demostraba que la circunferencia de los nueve puntos pasaba por tres puntos notables más, doce en total (motivo por el cual esta circunferencia se conoce también con el nombre de circunferencia de los doce puntos) o el matemático francés Olry Terquem, que es quien le pone nombre a la circunferencia, llamándola “circunferencia de los nueve puntos”, en su artículo de 1842, en el que da una nueva demostración analítica del teorema de Feuerbach.

Grabado de Jakob Steiner realizado por el grabador August Weger en 1881

Grabado de Jakob Steiner realizado por el grabador August Weger en 1881¿Qué fue de Feuerbach?

Vamos a terminar esta entrada del Cuaderno de Cultura Científica con la triste historia de Karl Feuerbach, el matemático que demostró de uno de los teoremas más hermosos de la geometría moderna, por el cual ha pasado a formar parte de la historia de las matemáticas, pero que no ha destacado por ninguna otra gran contribución. Por este motivo, el matemático Howard Eves, en Mathematical circles, se pregunta cuál es el motivo por el cual no ha producido más resultados matemáticos relevantes, qué fue de su vida y por qué murió tan joven, a la edad de 33 años (casi 34).

Ilustraciones al final del pequeño libro Propiedades de algunos puntos peculiares del triángulo rectilíneo y de varias rectas y figuras determinadas por ellos (1822), de Karl W. Feuerbach, en las que podemos apreciar una ilustración del conocido teorema de Feuerbach

Ilustraciones al final del pequeño libro Propiedades de algunos puntos peculiares del triángulo rectilíneo y de varias rectas y figuras determinadas por ellos (1822), de Karl W. Feuerbach, en las que podemos apreciar una ilustración del conocido teorema de FeuerbachKarl W. Feuerbach nació en la ciudad alemana de Jena el 30 de mayo de 1800. Su padre fue un famoso jurista y Karl fue el tercero de un total de once hermanos, entre ellos el filósofo Ludwig Feuerbach. Estudio en las universidades de Erlangen y Freiburg, doctorándose en esta última a la edad de 22 años. Entonces se convirtió en profesor en el Gymnasium (instituto de educación secundaria) de Erlangen. Fue entonces, en 1822, cuando publicó el pequeño libro que contenía el hermoso teorema al que hemos dedicado esta entrada.

En mayo de 1824, mientras se dirigía al Gymnasium, fue detenido. Karl, junto a otros diecinueve jóvenes, fue encarcelado en Munich, donde permanecieron incomunicados durante varios meses. Fueron detenidos por el carácter político de algunas de las actividades organizadas por una asociación a la que pertenecieron cuando eran estudiantes.

Parece ser que durante el encarcelamiento se obsesionó con la idea de que solo con su muerte podía conseguir que liberasen a sus compañeros, por lo que intentó suicidarse en dos ocasiones. La primera se cortó las venas de los pies, pero antes de morir desangrado fue descubierto y trasladado en estado inconsciente a un hospital. Mientras que en la segunda ocasión saltó por una ventana después de escaparse por un pasillo, pero la nieve que había en el exterior amortiguo la caída y no consiguió quitarse la vida, aunque quedó lisiado. Tras este incidente, Karl fue puesto en libertad condicional, bajo la custodia de un antiguo profesor amigo de la familia.

Uno de sus compañeros sí murió durante su encarcelamiento, pero nadie fue liberado. Permanecieron bajo arresto hasta que se celebró el juicio catorce meses después, cuando fueron declarados inocentes y puestos en libertad.

La hipérbola de Feuerbach, que es una hipérbola que pasa por el ortocentro y cuyo centro es el punto de tangencia entre la circunferencia de los nueve puntos y la circunferencia inscrita del triángulo

La hipérbola de Feuerbach, que es una hipérbola que pasa por el ortocentro y cuyo centro es el punto de tangencia entre la circunferencia de los nueve puntos y la circunferencia inscrita del triángulo

Tras salir de prisión volvería a trabajar de profesor, esta vez en el Gymnasium de Hof, pero al poco tiempo sufrió una crisis nerviosa y tuvo que dejar el centro. En 1828, recuperado ya de la crisis nerviosa volvió a la docencia en el Gymnasium de Erlangen, en el que ya había trabajado. Sin embargo, un día se presentó en clase con una espada y amenazó con decapitar a aquellos estudiantes que no resolvieran unas ecuaciones que había escrito en la pizarra. Después de este episodio fue obligado a jubilarse de forma permanente.

Como comenta Eves, poco a poco se fue alejando de la realidad, se dejó crecer el pelo, la barba y las uñas, y se redujo a un estado de mirada perdida y murmullos ininteligibles. Vivió seis años retirado en Erlangen, tras los cuales murió el 12 de marzo de 1834, a la edad de 33 años.

Nine Point Circle and Euler Line for an Acute Triangle / Circunferencia de los nueve puntos y línea de Euler para un triángulo agudo (2017), del profesor de matemáticas de secundaria jubilado Stephen Kenney. Lápiz de color sobre papel. Presentado en la exposición de arte del 2019 Joint Mathematics Meetings

Nine Point Circle and Euler Line for an Acute Triangle / Circunferencia de los nueve puntos y línea de Euler para un triángulo agudo (2017), del profesor de matemáticas de secundaria jubilado Stephen Kenney. Lápiz de color sobre papel. Presentado en la exposición de arte del 2019 Joint Mathematics MeetingsBibliografía

1.- David Wells, The Penguin Dictionary of Curious and Interesting Geometry, Penguin, 1991.

2.- Heinrich Dorrie, 100 Great Problems of Elementary Mathematics: Their History and Solutions, Dover, 1965.

3.- Howard Eves, A Survey of Geometry, Allyn and bacon, 1972.

4.- John Sturgeon Mackay, History of the nine-point circle,Proceedings of the Edinburgh Mathematical Society 11, pp. 19-61, 1892.

5.- Howard H. Eves, Mathematical Circles, The Mathematical Association of America (MAA), 2003.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La circunferencia de los nueve puntos se ha escrito en Cuaderno de Cultura Científica.

Buscando materia oscura con un observatorio de ondas gravitacionales

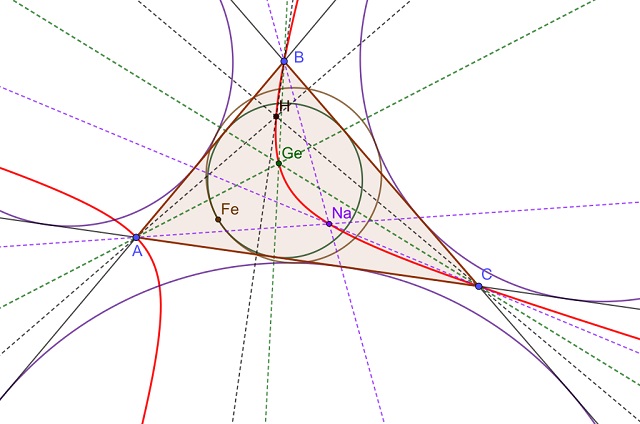

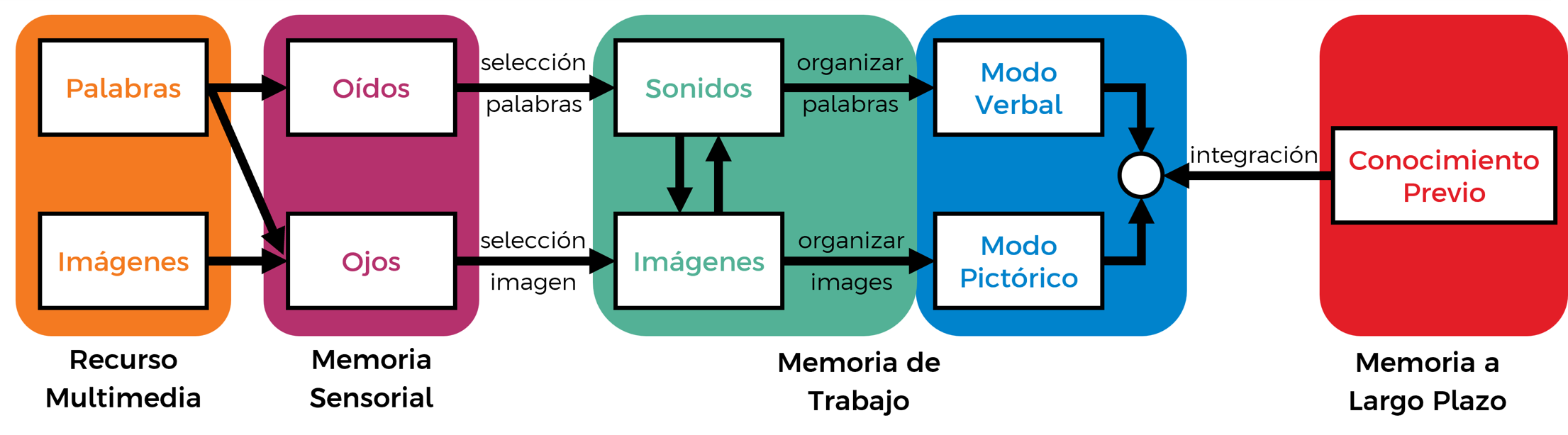

Instalaciones del observatorio LIGO en Hanford (estado de Washington). Fuente: LIGO Laboratory / Wikimedia Commons

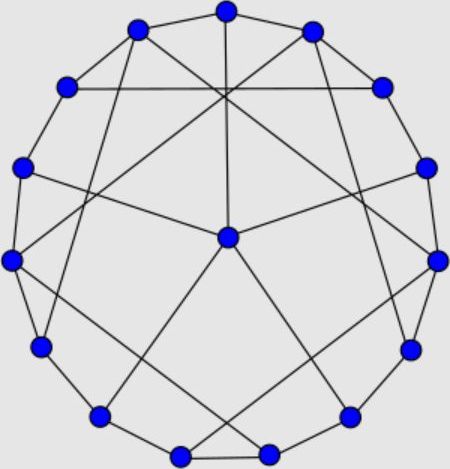

Instalaciones del observatorio LIGO en Hanford (estado de Washington). Fuente: LIGO Laboratory / Wikimedia CommonsEn la actualidad, el consenso científico es que la mayor parte de la materia del universo es materia oscura compuesta de partículas exóticas invisibles desde la Tierra. Muchas predicciones del modelo convencional de la materia oscura fría coinciden con las observaciones, pero una de las discrepancias de la teoría es su incapacidad para describir con precisión la estructura de las galaxias enanas. En 2000 se propuso que si las partículas de materia oscura tuvieran una masa extremadamente pequeña, su naturaleza cuántica, ondulatoria por tanto, distribuiría automáticamente la masa en los centros de las galaxias enanas y el modelo se acercaría más a las observaciones. Según esta idea, denominada “materia oscura del campo escalar” (o, a veces, “materia oscura fría difusa”), dichas partículas formarían un gigantesco condensado de Bose-Einstein –un estado normalmente asociado con átomos ultrafríos en los laboratorios de física– dentro y alrededor de cada galaxia.

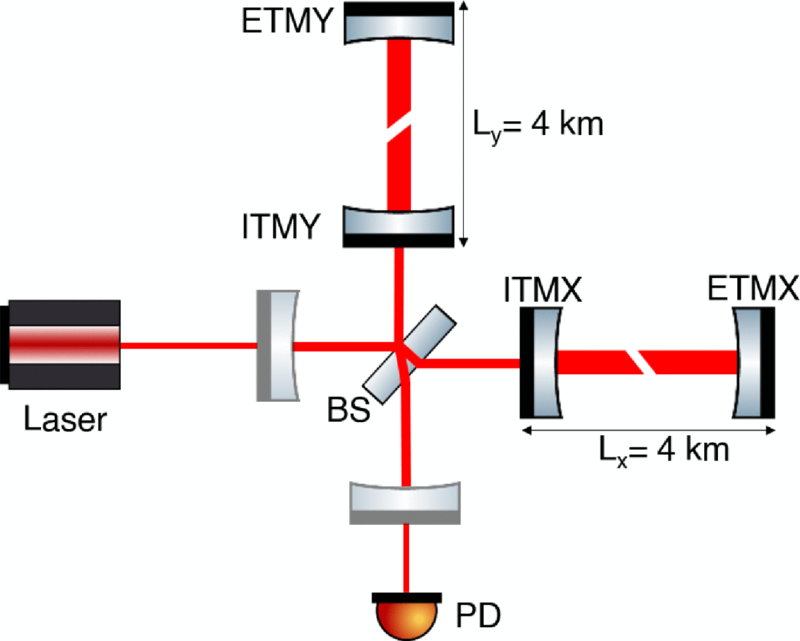

¿Cómo comprobar un modelo así? Usando observatorios como LIGO. LIGO y otros observatorios de ondas gravitacionales detectan las ondas gravitacionales a través de cambios minúsculos (tan pequeños como la millonésima parte del ancho de un núcleo atómico) en la longitud de los brazos del interferómetro, de un kilómetro de longitud.

Esquema del interferómetro de LIGO. El divisor de haz (beam splitter) está marcado como BS en el centro de la figura. Fuente: Göttel et al (2024).

Esquema del interferómetro de LIGO. El divisor de haz (beam splitter) está marcado como BS en el centro de la figura. Fuente: Göttel et al (2024).El modelo predice que la materia oscura del campo escalar debería causar oscilaciones en las constantes fundamentales, a saber, la masa del electrón y la constante de estructura fina. Dichas oscilaciones podrían hacer que la materia se encoja y se expanda a una velocidad que depende de la masa de la partícula del campo escalar. Los detectores de ondas gravitacionales podrían por ello ser sensibles a la materia oscura del campo escalar, ya que debería causar cambios de tamaño en el equipo del interferómetro. Un nuevo análisis de los datos de LIGO no encuentra señales de cambio de tamaño, lo que implica nuevas limitaciones para este modelo de materia oscura.

El equipo de investigadores ha buscado efectos de oscilación en los datos del tercer ciclo de observación de LIGO (2019-2020). No son los primeros en realizar una búsqueda de este tipo, pero su análisis da cuenta de una gama más amplia de efectos. Si bien toda la materia se vería influenciada por el campo escalar, la mayoría de los efectos se cancelarían en LIGO, excepto la señal del divisor de haz (beam splitter, BS en el centro de la figura). El divisor de haz se encuentra en el centro del detector y cualquier cambio en su tamaño cambiaría el patrón de interferencia del láser. Los investigadores no encuentran ninguna señal a una frecuencia de 10 Hz, lo que establece los límites más fuertes hasta ahora para la materia oscura del campo escalar con una masa de 10–13 eV/c2. Planean seguir buscando en futuros conjuntos de datos de LIGO y detectores de próxima generación.

Referencias:

Wayne Hu, Rennan Barkana, and Andrei Gruzinov (2000) Fuzzy Cold Dark Matter: The Wave Properties of Ultralight Particles Phys. Rev. Lett. doi: 10.1103/PhysRevLett.85.1158

Alexandre S. Göttel, Aldo Ejlli, Kanioar Karan, Sander M. Vermeulen, Lorenzo Aiello, Vivien Raymond, and Hartmut Grote (2024) Searching for Scalar Field Dark Matter with LIGO Phys. Rev. Lett. doi: 10.1103/PhysRevLett.133.101001

Michael Schirber (2024) Dark Matter Search in Gravitational-Wave Data Physics 17, s101

Para saber más:

Ondas gravitacionales en la materia oscura

Los púlsares imponen un nuevo límite a la materia oscura ultraligera

La materia oscura auto-interactuante y las curvas de rotación de las galaxias

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Buscando materia oscura con un observatorio de ondas gravitacionales se ha escrito en Cuaderno de Cultura Científica.

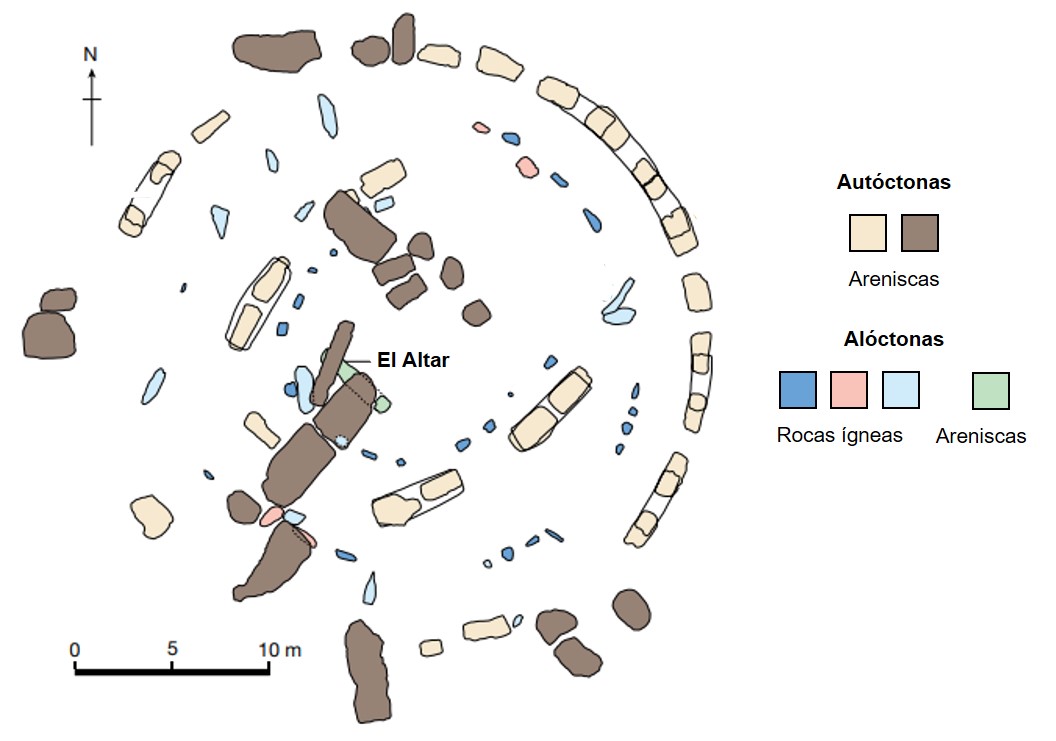

¿De dónde proceden los meteoritos de Marte?

De los más de 80.000 meteoritos que tenemos registrados hoy día en las bases de datos científicas, apenas tenemos contabilizados algo menos de 390 meteoritos cuya procedencia se pueda adscribir con cierto grado de certidumbre al planeta Marte. O lo que es lo mismo, los meteoritos marcianos apenas representan un 0.5% del total de meteoritos que hemos encontrado hasta la fecha.

Esto no quiere decir que estén incluidos todos los que se han podido localizar o hayan caído sobre nuestro planeta, sino que, y remarco esto, son los que de manera fehaciente hemos podido asignar al planeta rojo como su lugar procedencia. E incluso es probable que alguno que haya caído en el pasado todavía no se haya podido encontrar -especialmente si cayó en alguna zona remota o de difícil acceso- y aguarde a ser descubierto algún día.

A la vista de lo dicho en los párrafos anteriores, la pregunta que da título a este artículo puede parecer absurda, pero no lo es. Marte es un planeta “muy” grande -al menos si lo comparamos con la mayoría de asteroides de los que suelen proceder los meteoritos- y hay diferencias geológicas y geoquímicas sustanciales entre unas zonas y otras del planeta, por lo que estos se sitúan como una pieza fundamental para comprender la historia del planeta, como si estuviésemos completando una especie de complicado puzle en el que no solo tenemos que situar todas las piezas como si fuesen un mapa en dos dimensiones, sino que probablemente también representen momentos diferentes de la historia del planeta, añadiendo una tercera dimensión que puede complicar más la interpretación de estos meteoritos y el contexto geológico del que provienen.

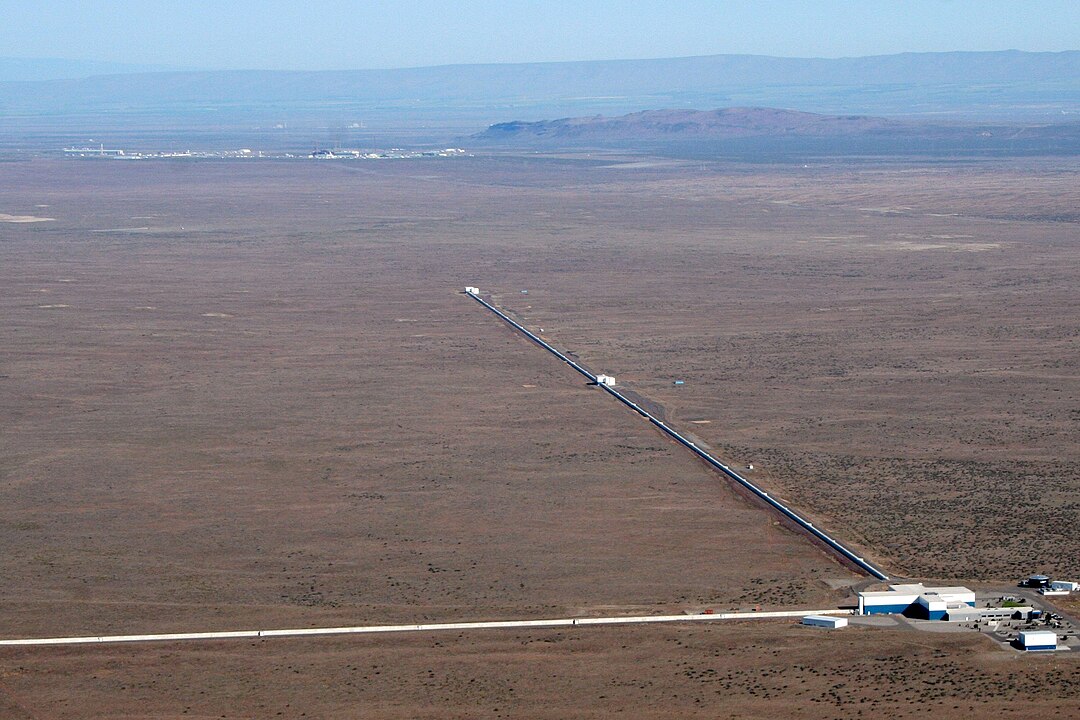

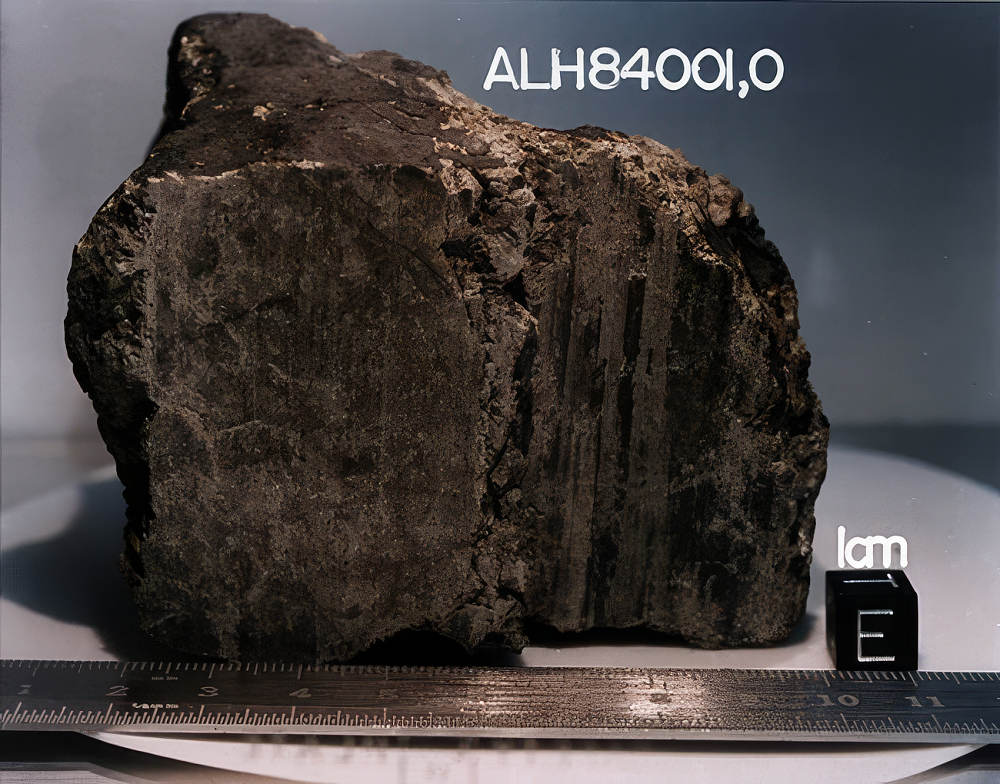

Imagen del archiconocido meteorito marciano ALH84001, encontrado en la Antártida en el año 1984. Cortesía de NASA/JSC/Universidad de Stanford.

Imagen del archiconocido meteorito marciano ALH84001, encontrado en la Antártida en el año 1984. Cortesía de NASA/JSC/Universidad de Stanford.¿Qué tipo de meteoritos hemos encontrado? Pues en su inmensa mayoría están compuestos por rocas ígneas, formadas por la solidificación de un magma en el interior del planeta o en su superficie y cuyos grupos principales son las Shergotitas -siendo estas a su vez la que da nombre al grupo más numeroso de meteoritos marcianos, formando un ~75% de los meteoritos que tenemos identificados-, las Nakhlitas, las Chasignitas (estos tres tipos forman el supergrupo SNC de meteoritos marcianos) y las ortopiroxenitas. Por cierto, dentro de este último grupo se encuentra el archiconocido meteorito ALH 84001, que saltó a la prensa a mediados de la década de los 90 por encontrarse unas formas en él que “recordaban” a posibles fósiles de bacterias y que generaron una gran controversia en el mundo científico.

Pero volvamos al asunto que hoy nos trae hasta aquí. Marte es un planeta complejo, cuya superficie ha estado marcada por erupciones volcánicas, la presencia de hielo y agua, la formación de cráteres de impacto y, por supuesto, la erosión, que continúa hoy en día. Estos procesos han marcado una evolución que puede provocar que, incluso meteoritos que provengan de una misma zona, puedan tener características diferentes, complicando mucho su interpretación y averiguar su verdadera procedencia.

Una nueva investigación publicada en Science Advances por Herd et al. (2024) podría suponer un importante cambio en nuestro conocimiento sobre la procedencia de los meteoritos marcianos que ya tenemos y los que vayamos a encontrar: Combinando los datos de modelos físicos de impacto, datos de teledetección -los que toman las sondas desde la órbita marciana- y las cronologías de los cráteres -las que nos permiten calcular la edad de la superficie de Marte- han podido identificar los posibles lugares de donde algunos de los meteoritos que tenemos en la Tierra fueron eyectados.

Otro punto interesante del estudio es como han interpretado los distintos aspectos observados en los minerales de los meteoritos y que aparecen como consecuencia de la inmensa energía del impacto. Gracias a este detalle los investigadores han podido estimar el tamaño de los cráteres de los que podrían provenir los meteoritos e incluso la profundidad de los materiales -dentro de la corteza del planeta- antes de ser expulsados, lo que ha ayudado a restringir los posibles cráteres de los que podrían proceder.

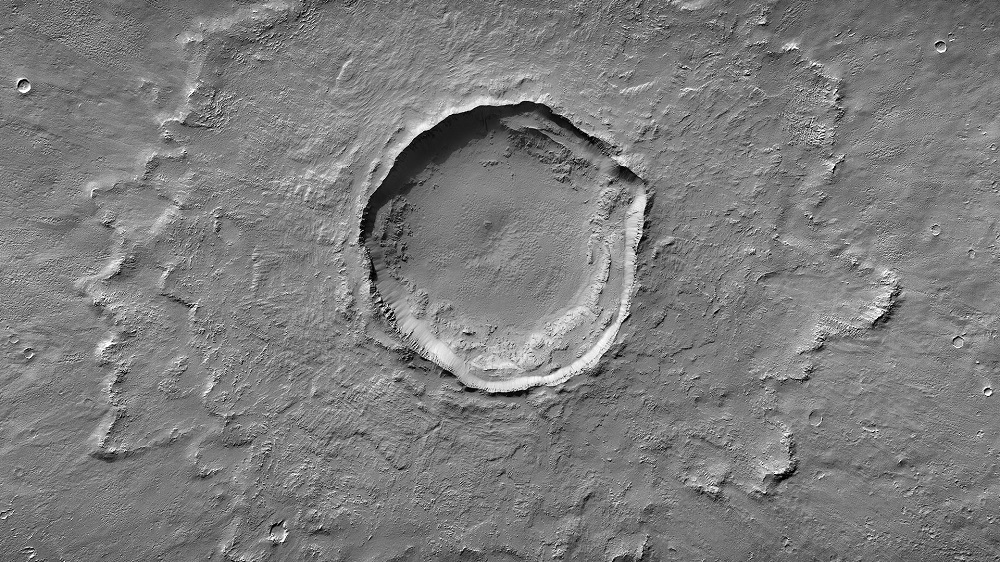

Aquí podemos ver uno de los posibles cráteres marcianos, en este caso el Corinto, que serían responsables de “enviarnos” meteoritos a nuestro planeta. Obsérvese la particular forma en “huevo frito” o cráter de tipo Rampart. Cortesía de NASA/JPL/ASU.

Aquí podemos ver uno de los posibles cráteres marcianos, en este caso el Corinto, que serían responsables de “enviarnos” meteoritos a nuestro planeta. Obsérvese la particular forma en “huevo frito” o cráter de tipo Rampart. Cortesía de NASA/JPL/ASU.Con estos datos han identificado unos cráteres concretos como fuente de algunos de los meteoritos marcianos. Entre los más destacables tenemos Chakpar, Domoni, Kotka, Tooting y Corinto. Este último, por cierto, es un cráter de “récord” ya que se estima que su formación dio lugar a unos 2000 millones de cráteres secundarios en Marte, es decir, cráteres formados por el impacto del material expulsado durante un evento de impacto.

Pero más allá de la procedencia, los autores hacen una serie de anotaciones muy interesantes sobre la geología de Marte: haciendo esta unión entre los meteoritos y sus cráteres “progenitores”, se puede intentar reconstruir la historia volcánica del planeta Marte, lo que nos permite conocer mejor manera los procesos que han transformado el planeta.