El tripos matemático, el examen más duro que jamás existió

Hace unos años, escribiendo la biografía Cayley, el origen del algebra moderna (RBA, 2017) sobre el matemático británico Arthur Cayley (1821-1895), tuve la oportunidad de leer mucho sobre un curioso examen de matemáticas que se realizaba en la Universidad de Cambridge (Gran Bretaña), denominado tripos matemático (en inglés, Mathematical Tripos), un examen que, en los siglos XVIII y XIX, todos los estudiantes de esta universidad debían de aprobar si querían recibir el título de graduado. El objetivo de esta entrada del Cuaderno de Cultura Científica es mostrar algunas de las particularidades de este examen, que era capaz de causar crisis nerviosas a algunos estudiantes.

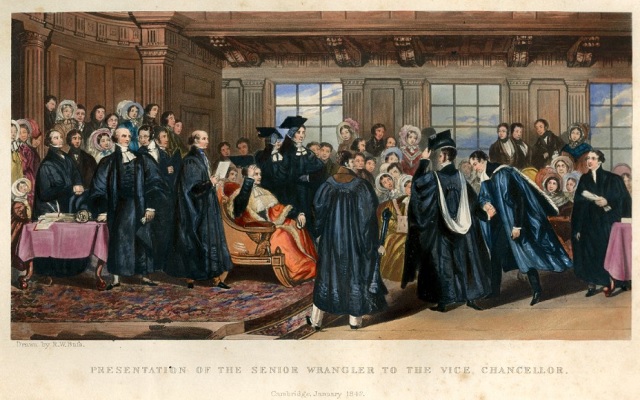

Grabado del artista Robert W. Buss de la presentación del senior Wrangler (estudiante con mejor nota del examen tripos matemático) de 1842, que fue el estudiante, futuro matemático, Arthur Cayley, ante el rector de la Universidad de Cambridge. Imagen de la University of St Andrews Libraries and Museums

Grabado del artista Robert W. Buss de la presentación del senior Wrangler (estudiante con mejor nota del examen tripos matemático) de 1842, que fue el estudiante, futuro matemático, Arthur Cayley, ante el rector de la Universidad de Cambridge. Imagen de la University of St Andrews Libraries and MuseumsUn examen de matemáticas para todos

Los tripos son los exámenes para obtener el grado en la Universidad de Cambridge, una de las universidades más antiguas del mundo, fundada en 1209. Aunque en la actualidad cada grado tiene su propio examen, durante siglos todos los estudiantes de la Universidad de Cambridge debían de pasar una misma prueba, que durante mucho tiempo fue un examen de matemáticas.

En el siglo XV todos los candidatos tenían que realizar un debate oral en latín (de donde deriva el término wrangler, persona que toma parte en una discusión) con un representante de la universidad que se sentaba en un taburete de tres patas (en latín, trypus).

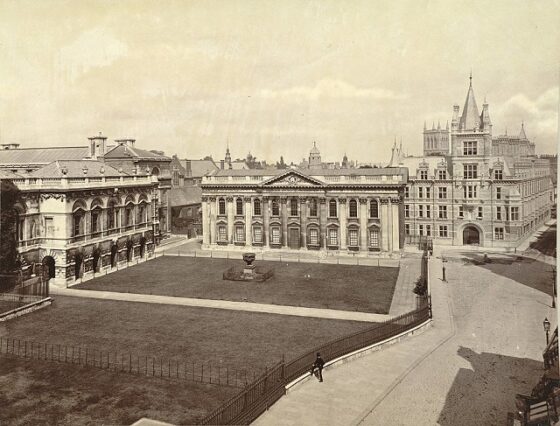

Hacia 1725 el debate oral fue sustituido por un examen escrito de matemáticas, el tripos matemático (inicialmente denominado “Examen de la Casa del Senado”, por el lugar en el que se desarrollaban los exámenes), aunque se mantuvo una parte de discusión oral en inglés. Se consideraba que las matemáticas eran un conocimiento básico importante para los jóvenes estudiantes, puesto que su estudio fortalecía y desarrollaba las facultades de la mente y los preparaba para su posterior desarrollo intelectual. El examen se realizaba en enero, tras los diez trimestres oficiales, más de tres cursos, en la universidad.

Fotografía de la casa del Senado en la Universidad de Cambridge, junto al Gonville College y al Caius College, alrededor de 1870. Fotografía de la Cornell University Library. Imagen de la colección A. D. White Architectural Photographs, Cornell University Library Accession Number

Fotografía de la casa del Senado en la Universidad de Cambridge, junto al Gonville College y al Caius College, alrededor de 1870. Fotografía de la Cornell University Library. Imagen de la colección A. D. White Architectural Photographs, Cornell University Library Accession NumberGrado ordinario y grado con honores

La mayoría de estudiantes de la Universidad de Cambridge que aprobaban tenían un grado ordinario, sin honores, mientras que algunos ni siquiera pasaban el examen. Según el físico y matemático irlandés George G. Stokes (1819-1903), hacia 1850, el 38% de los que graduados obtenían puestos de honor, mientras que el resto obtenía un grado ordinario. Y sobre un sexto de los aspirantes suspendían el examen.

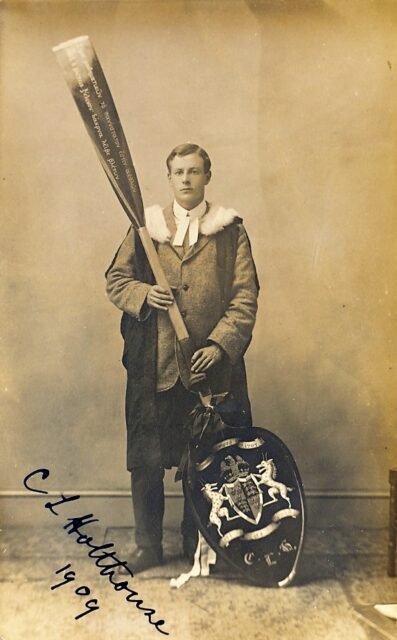

Desde 1753 hasta 1909 se publicaron las listas de honor del tripos matemático por orden de mérito en tres categorías, wranglers, senior optimes y junior optimes. El primer puesto de honor, senior wrangler, figura que sigue existiendo en el tripos matemático actual, era reconocido como un gran logro intelectual en todo Gran Bretaña y abría muchas puertas para una carrera exitosa. De hecho, en ese tiempo los cursos académicos en Cambridge se recordaban por la persona que había sido senior wrangler ese curso. Cada año la noticia sobre el examen aparecía en los periódicos. El último de los estudiantes de la lista de honor recibía el apodo de “cuchara de madera” y se hacía una celebración en la que se le entregaba una enorme cuchara de madera.

El último estudiante que fue “cuchara de madera” fue Cuthbert Lempriere Holthouse, en 1909. Imagen de la Universidad de Cambridge

El último estudiante que fue “cuchara de madera” fue Cuthbert Lempriere Holthouse, en 1909. Imagen de la Universidad de CambridgeEscasez de matemáticos

El objetivo del tripos matemático no era enseñar una herramienta fundamental para la formación de los futuros científicos, ni la preparación de los nuevos matemáticos, sino que se consideraban un mero entrenamiento para la mente de los estudiantes, necesarias para su formación intelectual como graduados.

En más de 150 años, este sistema dio lugar a pocos matemáticos puros destacados, solo Arthur Cayley (1821-1895) –senior wrangler–, James J. Sylvester (1814-1897) –segundo wrangler–, William K. Clifford (1845-1879) –segundo wrangler–, Godfrey H. Hardy (1877-1947) –cuarto wrangler– y John E. Littlewood (1885-1977) –senior wrangler–, en contraste con la considerable cantidad de físicos o físicos matemáticos, entre ellos, James C. Maxwell (1831-1879) –segundo wrangler–, William Thomson, Lord Kelvin (1824-1907) –segundo wrangler–, George G. Stokes –senior wrangler–, John W. Strutt (1842-1919) –senior wrangler–, John C. Adams (1819-1892) –senior wrangler– o J. J. Thompson (1856-1940) –segundo wrangler–.

Además, entre los altos wranglers no solo se encontraban científicos, sino también ilustres personajes en ámbitos como la política, la iglesia, el derecho o la medicina.

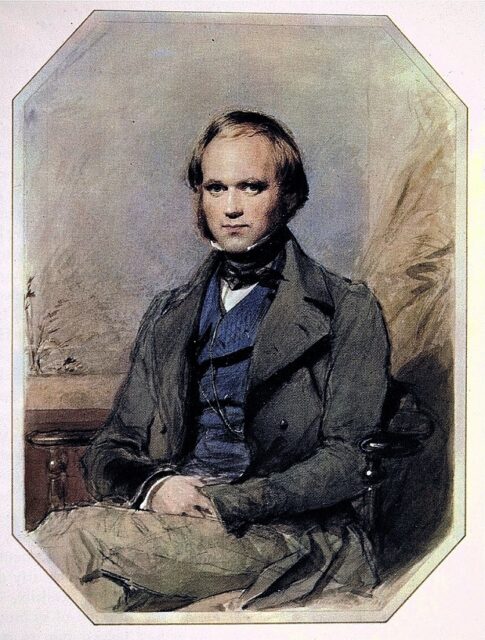

Retrato del naturalista Charles Darwin, realizado por el artista George Richmond (1809-1896) en 1840

Retrato del naturalista Charles Darwin, realizado por el artista George Richmond (1809-1896) en 1840

Por otra parte, no a todos los estudiantes se les daban bien las matemáticas, así el escritor y político Thomas Macaulay (1800-1854) las aborrecía y el naturalista Charles Darwin (1809-1882) no estaba interesado en ellas. Por ese motivo, ambos aspiraron solo a un grado ordinario.

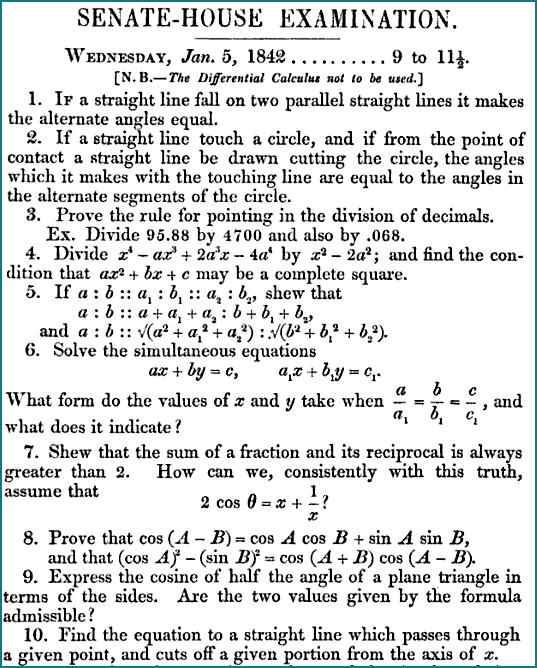

El tripos matemático, el examenEl tripos matemático constaba de dos partes, el workbook, que consistía en memorizar teoremas y demostraciones, y la parte de resolución de problemas. El contenido y duración iría variando a lo largo del siglo XIX. En la década de los años 1840 cubría cuestiones de matemática pura y aplicada, y tenía una duración de 6 días, con jornadas de 6 horas, pero llegó a durar 8 días.

Por ejemplo, el año que se presentó Arthur Cayley al tripos matemático, el año 1842, el examen de la Casa del Senado empezó el miércoles 5 de enero y terminó el martes siguiente, con descanso el domingo. Entre todos los estudiantes que se presentaron, ciento veinte eran candidatos a la lista de honor. Soportando el duro frío que hacía en el interior del edificio, los candidatos se enfrentaron a ciento diecisiete problemas distribuidos en dos exámenes cada una de las seis jornadas. Cada college tenía su candidato favorito, aunque los dos estudiantes con más opciones para ser senior Wrangler ese año eran Arthur Cayley (Trinity College) y Charles Simpson (St. Johns College). La expectación era máxima y el ambiente de Cambridge festivo.

Hoja con problemas del tripos matemático de 1842

Hoja con problemas del tripos matemático de 1842

Aunque el mathematical tripos cambió de estructura y contenido a lo largo de todo este tiempo, en el artículo The Mathematical Tripos in the University of Cambridge / El tripos matemático en la Universidad de Cambridge, publicado en la revista Science, en 1883, se puede leer que constaba de tres partes. La primera era la básica y solía hacerse a principios del mes de junio. Su contenido era el siguiente: varios de los libros de Los Elementos de Euclides, aritmética, álgebra básica y las tres primeras secciones de los Principia (Philosophiæ naturalis principia mathematica / Principios matemáticos de la filosofía natural) de Isaac Newton, con partes elementales de trigonometría, secciones cónicas, mecánica, dinámica, hidroestática, óptica y astronomía.

Entre los aprobados de este examen, que ya tenían el grado ordinario, la universidad realizaba un listado de los estudiantes que podían presentarse a la segunda parte, para acceder a la lista de honor del tripos matemático, que se celebraba también en el mes de junio. Para este examen las materias eran: algebra, trigonometría (plana y esférica), teoría de ecuaciones, geometría analítica (plana y sólida, incluyendo curvatura de curvas y superficies), cálculo diferencial e integral, ecuaciones diferenciales, mecánica, hidroestática, dinámica de partículas, dinámica rígida, óptica y astronomía esférica.

Como consecuencia de los exámenes I y II, la universidad de Cambridge realizaba el listado de estudiantes por orden de méritos en las tres categorías mencionadas, wranglers, senior optimes y junior optimes. Y solamente los wranglers realizaban la última parte del examen, la más dura, que se realizaba en el mes de enero del siguiente año, como hemos mencionado en el caso de Arthur Cayley.

Entrenadores para preparar el examenEl matemático y lógico Augustus de Morgan (1806-1871) describe el tripos matemático como una «gran carrera de escritura», mientras que el matemático Godfrey H. Hardy (1877-1947), de quien recomiendo su libro Apología de un matemático (1940), se sintió como «un caballo de carreras para correr una carrera de ejercicios matemáticos». Era necesario un duro entrenamiento, memorizando teoremas, estudiando técnicas de resolución de problemas y trabajando los de cursos anteriores. Los estudiantes contrataban a «entrenadores» privados, no a profesores de la universidad, y dedicaban todo su tiempo a prepararse, por lo que no asistían a las clases regulares.

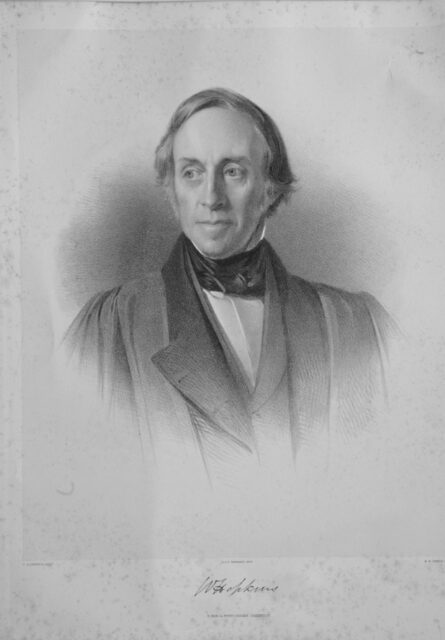

Consciente de su importancia, el estudiante y futuro matemático Arthur Cayley, como hacían también los demás estudiantes que aspiraban a la lista de honor, contrató a un «entrenador», William Hopkins (1793-1866), para preparar el «gran» examen. Hopkins era considerado el mejor entrenador y era conocido como «fabricante de wranglers»: en veintidós años obtuvo diecisiete senior wranglers y veintisiete segundos o terceros wranglers.

Grabado de William Hopkins, de alrededor de 1850. Imagen del Peterhouse College de la Universidad de Cambridge

Grabado de William Hopkins, de alrededor de 1850. Imagen del Peterhouse College de la Universidad de Cambridge

El entrenamiento de Hopkins consistía en clases teóricas donde enseñaba las matemáticas puras y aplicadas que formaban parte del contenido del examen, desde Los Elementos, de Euclides, aritmética, álgebra, trigonometría, secciones cónicas o el binomio de Newton, hasta cálculo de variaciones, instrumentos astronómicos, hidrostática y dinámica, teoría lunar y planetaria, u óptica, sonido y luz. Así mismo, suministraba montones de hojas de problemas de años anteriores a sus estudiantes, que estos debían hacer sin descanso, trimestre tras trimestre, hasta el examen final.

Sin embargo, Hopkins no se limitaba al entrenamiento clásico, sino que inculcaba a sus pupilos el espíritu de la investigación matemática y les animaba a mantenerse al día leyendo las nuevas teorías, en particular, las provenientes del continente. Por ejemplo, el joven Cayley, tras la lectura de algunas obras del matemático y físico Joseph-Louis de Lagrange (1736-1813), demostró un nuevo teorema sobre integrales múltiples que publicó en dos artículos en la revista Cambridge Mathematical Journal (CMJ) en 1841.

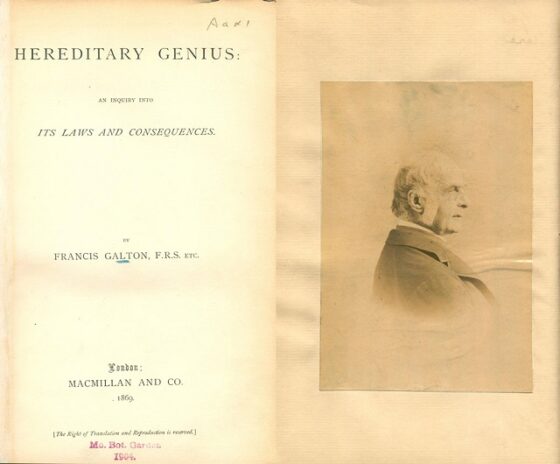

La dureza del tripos matemáticoComo ya se ha comentado, el tripos matemático, era un examen muy difícil. El científico Francis Galton (1822-1911), en su libro Genio hereditario (1869), menciona que un año de la década de 1860 de los 17.000 puntos en juego en el examen, el senior wrangler obtuvo 7.634, el segundo wrangler 4.123 y el estudiante junior optime con la puntuación más baja, tan solo 237 (aunque este no realizó la tercera parte del examen). Y estos eran los mejores, los de la lista de honor. Si trasladamos estas puntuaciones a un examen actual, puntuado sobre 10, la mejor nota era un 4,49, ni siquiera llega al 5, al “aprobado”, y la peor de las notas, pero del grupo de honor, la de los mejores de la universidad ese año, era un 0,14, ¡¡un 0,14!!.

Dos páginas del libro Genio hereditario (1869), del científico Francis Galton, una de ellas con un retrato del autor

Dos páginas del libro Genio hereditario (1869), del científico Francis Galton, una de ellas con un retrato del autorGalton sufrió una crisis nerviosa y acabó con un grado ordinario. El erudito estadounidense Charles A. Bristed (1820-1874) sufrió un colapso físico, quedando en los últimos lugares de la lista de junior optimes. El político y economista Henry Fawcett (1833-1884), favorito para senior wrangler, acabó siendo séptimo wrangler tras sufrir trastornos nerviosos e insomnio. El senior wrangler de 1859, James Wilson (1836-1931), sufrió una crisis nerviosa tras los exámenes y al recuperarse había olvidado todas las matemáticas estudiadas. O el también senior wrangler James Savage fue encontrado muerto en una zanja tres meses después del examen, el motivo de la muerte fue un derrame cerebral, posiblemente producido por el enorme esfuerzo realizado. Estos son solo algunos casos de la historia negra de este sistema.

Las mujeres en el tripos matemáticoHasta finales del siglo XIX las mujeres no podían asistir a la universidad en Gran Bretaña. Las universidades de Cambridge y Oxford empezaron a realizar exámenes de acceso a la universidad para mujeres en 1869, aunque estas solamente podían asistir a clase como oyentes y realizar exámenes con el permiso del profesor. Además, no se les concedía el título de graduadas.

A partir de 1880, las mujeres pudieron presentarse, con un permiso especial, al tripos matemático, aunque no recibían título o reconocimiento alguno. En 1880, la futura matemática Charlotte A. Scott (1858-1931) obtuvo una puntuación que se correspondía con el octavo wrangler. A partir de su logro, en 1882, se permitió a las mujeres participar oficialmente en el tripos y desde entonces se publicaban sus resultados en una lista complementaria a la de los hombres. Y en 1890, la futura matemática y educadora Philippa G. Fawcett (1868-1948) obtuvo la máxima distinción “por encima del senior wrangler”.

La matemática y educadora Philippa G. Fawcett

La matemática y educadora Philippa G. FawcettHacia el final de la hegemonía matemática

En 1822 se crearía el tripos clásico, pero hasta el año 1850 solo se podían presentar aquellos que habían obtenido honores en el matemático. Los siguientes tripos en crearse, en la década de 1860, fueron los de ciencias morales y ciencias naturales. En la actualidad existen 28 tripos modernos, es decir, exámenes para obtener el título de graduado por la universidad de Cambridge.

Camuflaje binario de la Casa del Senado, de la Universidad de Cambridge. Fotografía de Keith Edkins, en 2009

Camuflaje binario de la Casa del Senado, de la Universidad de Cambridge. Fotografía de Keith Edkins, en 2009

Bibliografía

1.- Raúl Ibáñez, Cayley, el origen del algebra moderna, RBA, 2017.

2.- Tony Crilly, Arthur Cayley, Mathematician Laureate of the Victorian Age, The Johns Hopkins University Press, 2006.

3.- R. Flood, A. Rice, R. Wilson, (editores), Mathematics in Victorian Britain, Oxford University Press, 2011.

4.- Revista Sciencia: The Mathematical Tripos in the University of Cambridge, Science, Vol. 1, No. 15, pp. 412-415, 1883.

5.- César Tomé López (2015) El Tripos y la profesionalización (serie Las matemáticas como herramienta) Cuaderno de Cultura Científica

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El tripos matemático, el examen más duro que jamás existió se ha escrito en Cuaderno de Cultura Científica.

El entrelazamiento perfecto no existe en el ruidoso mundo físico

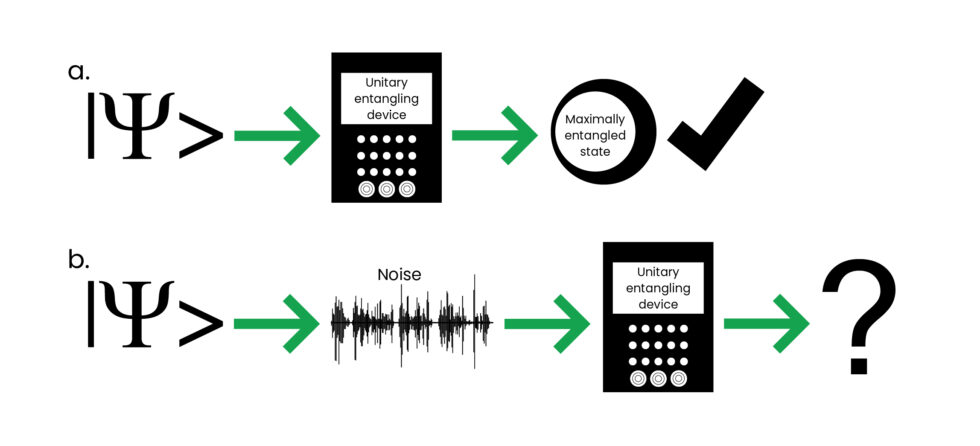

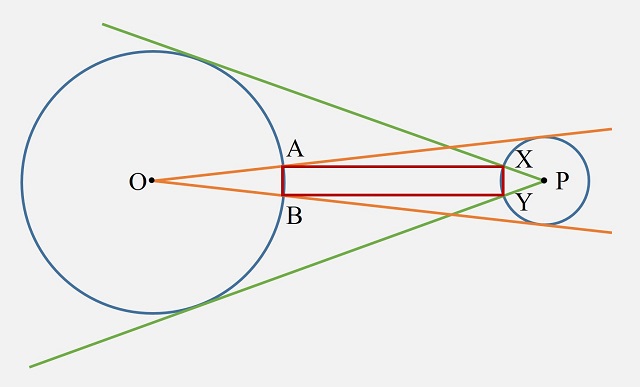

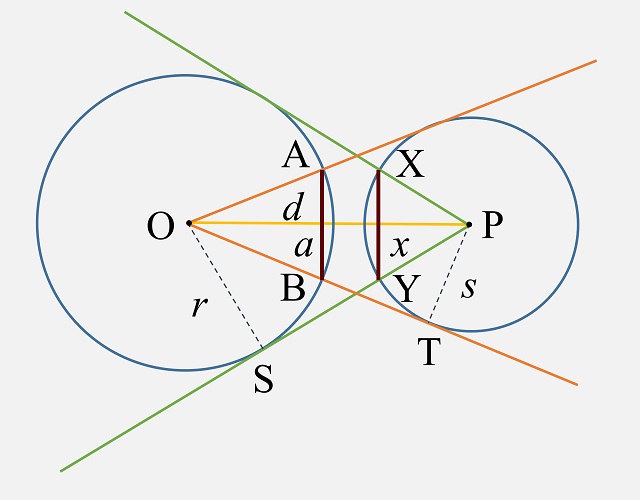

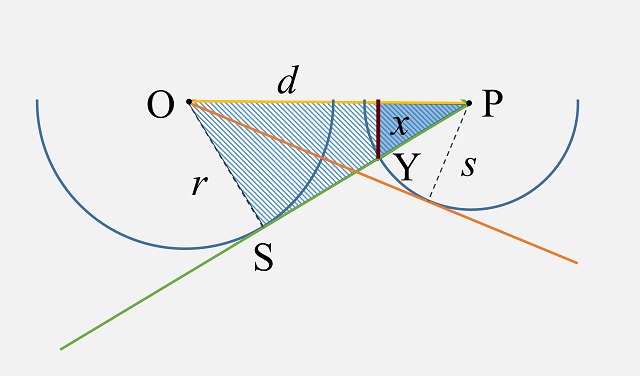

Los físicos tienen una larga lista de problemas abiertos que consideran importantes para avanzar en el campo de la información cuántica. El problema 5 se planteó en 2001 y aborda la cuestión de si un sistema puede existir en su estado de máximo entrelazamiento en un escenario realista, en el que hay ruido.

Ahora Julio de Vicente, de la Universidad Carlos III de Madrid y el Instituto de Ciencias Matemáticas (ICMAT), ha respondido a esta pregunta cuántica fundamental con un rotundo “no”. De Vicente dice que espera que su trabajo “abra una nueva vía de investigación dentro de la teoría del entrelazamiento”.

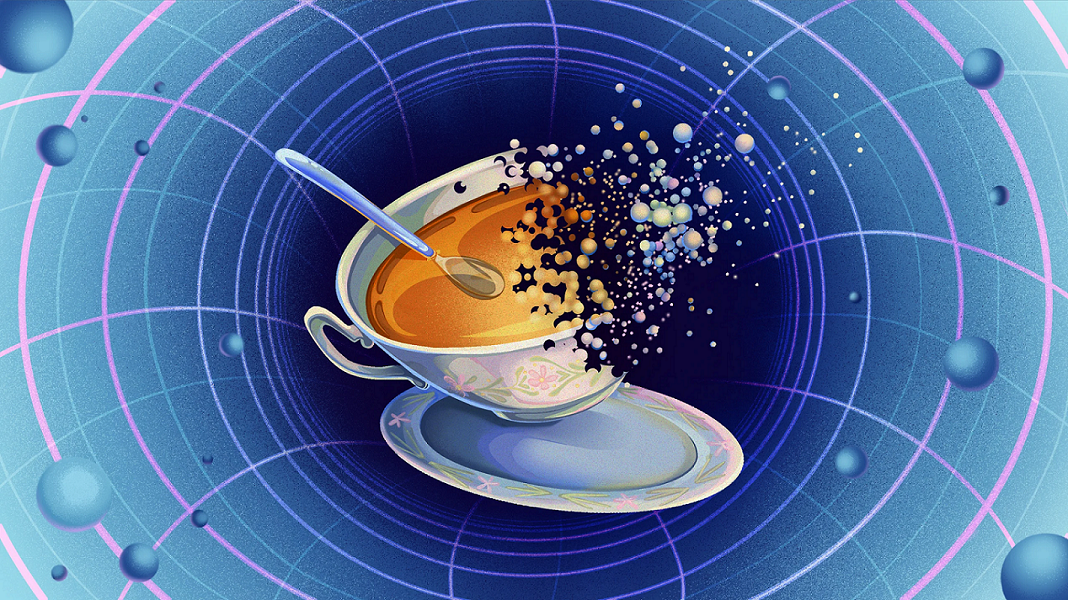

Ilustración: Laura Moreno-Iraola / ICMAT

Ilustración: Laura Moreno-Iraola / ICMATDe los sensores cuánticos a los ordenadores cuánticos muchas tecnologías requieren partículas entrelazadas mecanocuánticamente para funcionar. Las propiedades de estas partículas están correlacionadas de una manera que no sería posible en la física clásica.

Idealmente, para las aplicaciones tecnológicas estas partículas deberían estar en el llamado estado de máximo entrelazamiento, uno en el que se maximizan todas las posibles medidas de entrelazamiento. Los científicos predicen que las partículas pueden existir en este estado en ausencia de ruido experimental, ambiental y estadístico. Pero no estaba claro si las partículas también podrían existir en un estado de máximo entrelazamiento en situaciones del mundo real, donde el ruido es inevitable.

Para encontrar una respuesta de Vicente recurrió a las matemáticas. Ha demostrado que, si se introduce ruido en un sistema cuántico, es imposible maximizar simultáneamente todas las medidas de entrelazamiento del sistema, y, por tanto, el sistema no puede existir en un estado de máximo entrelazamiento.

Si bien el hallazgo de de Vicente resuelve un problema abierto, plantea muchos problemas más, incluyendo el problema tecnológico fundamental: qué condiciones se requieren para maximizar simultáneamente las múltiples medidas de entrelazamiento de un sistema.

Referencias:

Julio I. de Vicente (2024) Maximally Entangled Mixed States for a Fixed Spectrum Do Not Always Exist Phys. Rev. Lett. doi: 10.1103/PhysRevLett.133.050202

Ryan Wilkinson (2024) Long-Standing Quantum Problem Finally Solved Physics 17, s83

Ágata Timón García-Longoria (2024) Demuestran que el entrelazamiento perfecto no existe en el mundo real ICMAT

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El entrelazamiento perfecto no existe en el ruidoso mundo físico se ha escrito en Cuaderno de Cultura Científica.

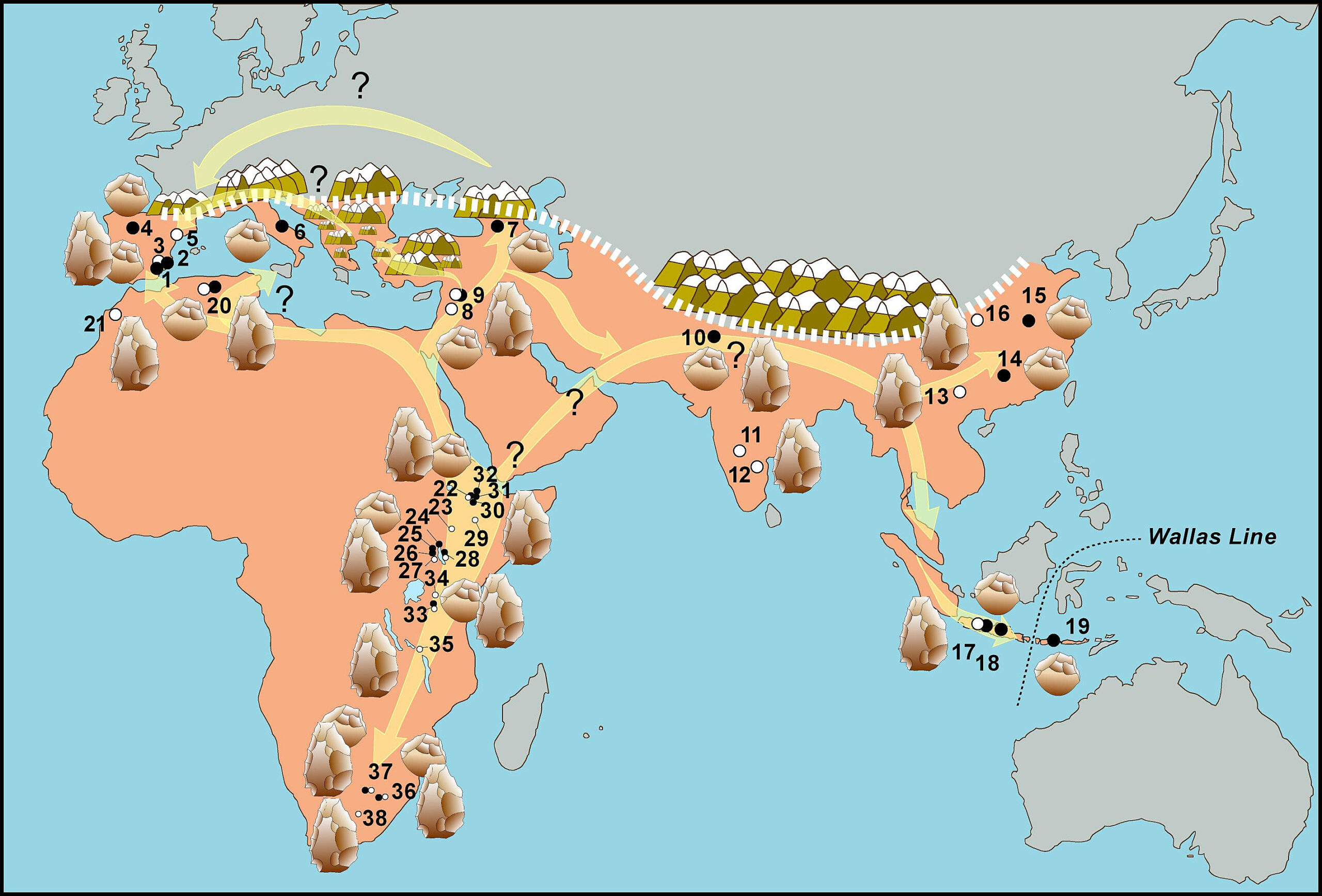

El océano de Ariel

Los satélites que orbitan los gigantes de hielo de nuestro Sistema Solar son una verdadera caja de sorpresas a nivel geológico: en ellos encontramos una gran diversidad geológica, procesos activos e incluso ciclos “hidrológicos”. Pero todavía nos queda mucho por saber, especialmente de los de Urano y Neptuno, ya que han sido sistemas que todavía no hemos podido visitar de una manera más permanente como sí que hemos hecho en Júpiter y Saturno.

Pero mientras podamos volver allí -nada indica que será antes de la década de 2040- podemos hacer estudios gracias a los numerosos avances tecnológicos y a los telescopios, pero también con modelos físicos y geoquímicos que nos ayuden a conocer como puede ser el interior y si son capaces de albergar un océano por debajo de su superficie y cuáles podrían ser las fuentes de energía que todavía los mantengan en estado líquido a pesar del tiempo que ha pasado tras su formación.

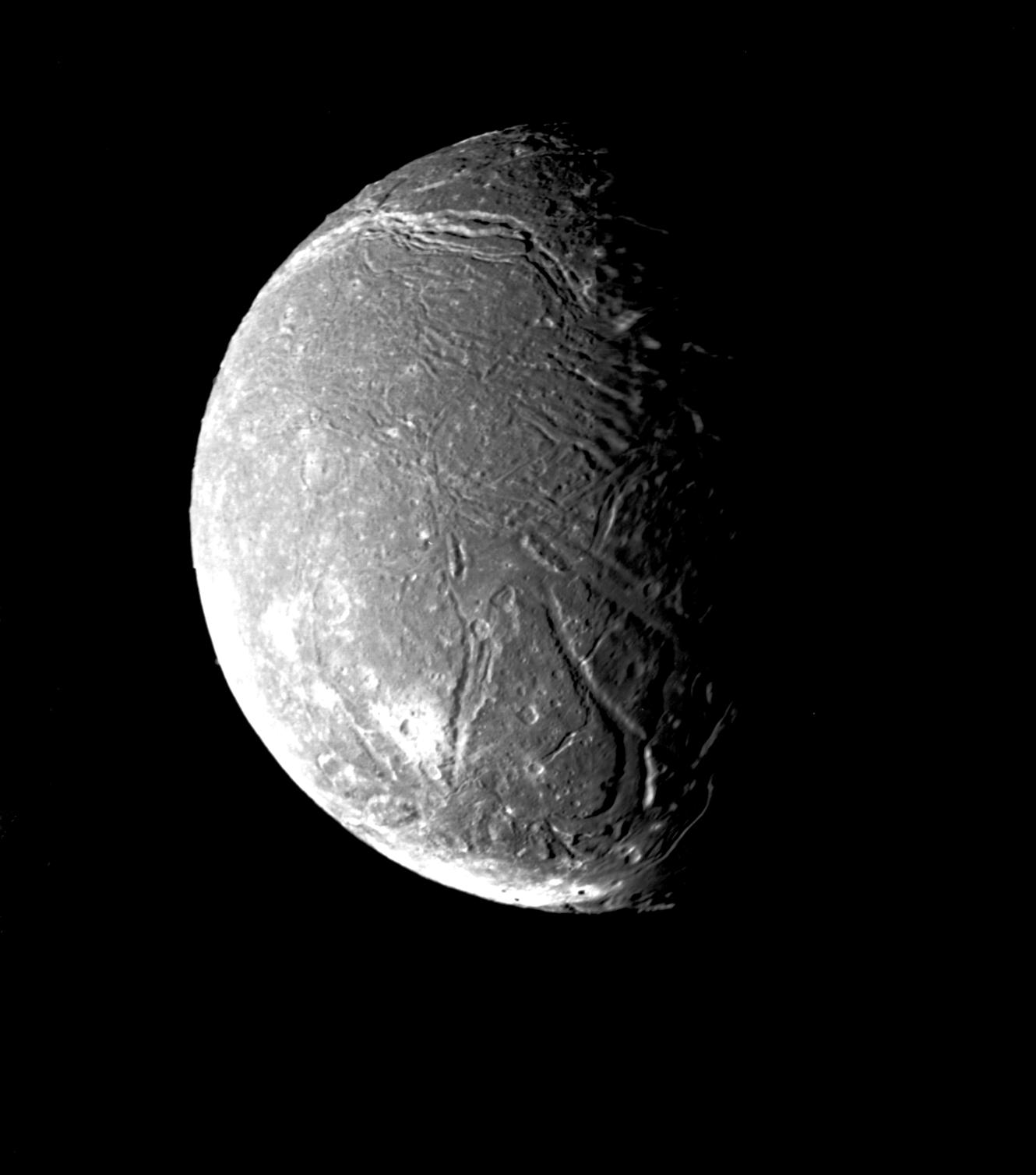

Ariel, observado por la Voyager 2 en Enero de 1986. Desde entonces no hemos vuelto a ver su superficie de cerca. Pero es que, además, solo hemos podido tomar imágenes de aproximadamente un tercio de su superficie. Cortesía de NASA/JPL.

Ariel, observado por la Voyager 2 en Enero de 1986. Desde entonces no hemos vuelto a ver su superficie de cerca. Pero es que, además, solo hemos podido tomar imágenes de aproximadamente un tercio de su superficie. Cortesía de NASA/JPL.Ariel, el satélite de Urano, es un firme candidato a albergar un océano subterráneo y, poco a poco, se empiezan a acumular pruebas a favor de esta teoría. Hay zonas de su superficie que exhiben chasmatas –chasmata es el plural de chasma, que en geología planetaria hacen referencia a depresiones alargadas y no muy anchas- así como otros detalles que sugieren la actividad criovolcánica. De hecho, algunos estudios sugieren que hay zonas de Ariel cuya edad sería inferior a los mil millones de años, lo que indicaría procesos de rejuvenecimiento de su superficie posteriores a su formación.

¿Qué hay de nuevo respecto a Ariel? Un equipo de científicos ha usado el telescopio espacial JWST para estudiar la composición de su superficie gracias al uso de uno de sus instrumentos, el espectrógrafo NIRSpec, que permite con mucha precisión detectar distintos compuestos -algunos de ellos de hielo- sobre la superficie del satélite.

El primer hallazgo destacado es la presencia de depósitos de hielo de dióxido de carbono más potentes -potentes en el sentido geológico, de espesor de la capa- de lo esperado y que podrían llegar a formar una capa superficial de 10 milímetros en determinadas zonas del satélite.

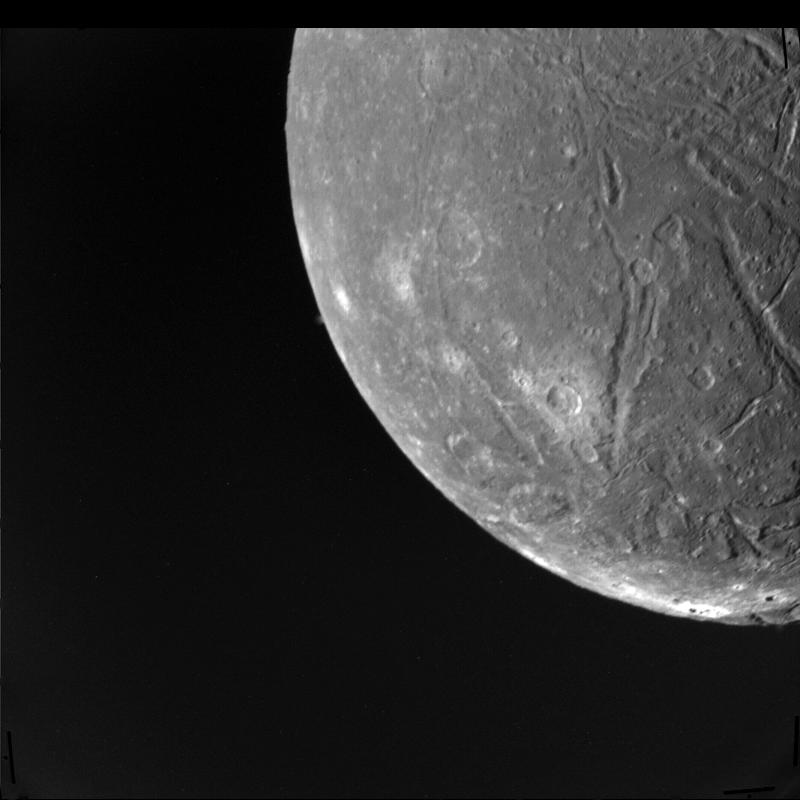

En su superficie, además, podemos ver zonas más claras y oscuras… ¿Están relacionadas las zonas más claras con materiales que salen desde el interior del satélite hacia la superficie a través de impactos y de fenómenos criovolcánicos?. Imagen cortesía de NASA/JPL.

En su superficie, además, podemos ver zonas más claras y oscuras… ¿Están relacionadas las zonas más claras con materiales que salen desde el interior del satélite hacia la superficie a través de impactos y de fenómenos criovolcánicos?. Imagen cortesía de NASA/JPL.Pero además también se ha encontrado una capa de monóxido de carbono, algo que ha desconcertado un poco a los científicos. Y es que a las temperaturas que encontramos en la superficie de Ariel, aproximadamente entre -180 °C y -190 °C, el hielo compuesto de monóxido de carbono tendría que sublimarse -pasar del estado sólido al gaseoso sin pasar por el líquido- de una manera muy rápida. Esto podría indicar que hay mecanismos geológicos que van reponiendo el hielo de monóxido de carbono o que de alguna manera ocurren reacciones con el dióxido de carbono que lo estabilizan y lo hacen más resistente a la sublimación.

Otro de los detalles que nos aporta este estudio es que no aparecen determinadas especies químicas, como compuestos con amoniaco o el peróxido de hidrógeno, que a veces se forman por efecto de la radiación sobre el hielo de agua. Esta marcada ausencia podría significar dos cosas: O bien que la superficie está bien aislada por capas potentes de hielo de dióxido de carbono -y limitando las interacciones del hielo de agua con la radiación- o bien, la radiación del entorno que existe en la órbita de Ariel es menos intenso de lo que se piensa.

En esta imagen podemos apreciar perfectamente los chasmatas, formando depresiones alargadas que atraviesan la superficie de Ariel. Imagen cortesía de NASA/JPL.

En esta imagen podemos apreciar perfectamente los chasmatas, formando depresiones alargadas que atraviesan la superficie de Ariel. Imagen cortesía de NASA/JPL.Pero todavía queda un aspecto más a mencionar de este nuevo artículo: los científicos sugieren la presencia de carbonatos en la superficie de Ariel, una serie de minerales que se pueden formar por la interacción del agua líquida y las rocas, algo que de confirmarse, podría ocurrir en la interfaz entre el océano subterráneo y el núcleo rocoso del satélite, indicando unas condiciones de habitabilidad que podrían ser similares a las de océanos subterráneos como el que podría existir bajo Encélado o Europa.

¿Y qué nos quiere decir todo esto a nivel geológico? Pues que las capas de hielo de dióxido y de monóxido de carbono probablemente tengan un origen geológico, es decir, que estén formadas como consecuencia de procesos geológicos activos, como por ejemplo el criovulcanismo, que también sería el responsable de “subir” los carbonatos hasta la superficie. Y si es un mundo activo, ese mecanismo de “transmisión” del calor y de la materia desde el interior a la superficie podría ser un océano subterráneo algo que, de nuevo, aumenta las perspectivas astrobiológicas sobre este mundo.

Así que, aunque los satélites de los gigantes de hielo nos puedan parecer mundos algo anodinos lo cierto es que quizás lo que nos hace falta es poder visitarlos de nuevo y quizás descubrir así mundos fascinantes y con actividad geológica en el presente.

Referencias:

Cartwright, R. J., Holler, B. J., Grundy, W. M., Tegler, S. C., Neveu, M., Raut, U., Glein, C. R., Nordheim, T. A., Emery, J. P., Castillo-Rogez, J. C., Quirico, E., Protopapa, S., Beddingfield, C. B., Hedman, M. M., De Kleer, K., DeColibus, R. A., Morgan, A. N., Wochner, R., Hand, K. P., . . . Mueller, M. M. (2024). JWST Reveals CO Ice, Concentrated CO2 Deposits, and Evidence for Carbonates Potentially Sourced from Ariel’s Interior. The Astrophysical Journal Letters, 970(2), L29. doi: 10.3847/2041-8213/ad566a

El artículo El océano de Ariel se ha escrito en Cuaderno de Cultura Científica.

Un paso más hacia el robot aéreo autónomo: evitar colisiones

El Grupo de Inteligencia Computacional (GIC) de la UPV/EHU ha diseñado una nueva tecnología de bajo coste reproducible para todo tipo de robot aéreo.

Fuente: Referencia

Fuente: ReferenciaUn estudio que ha realizado el Grupo de Inteligencia Computacional (GIC) de la UPV/EHU con un grupo de drones ha verificado que, “a pesar del reducido coste de la tecnología, la solución que hemos desarrollado ha sido validada con éxito en drones comerciales. Utilizando un equipo sencillo de bajo coste y un algoritmo basado en visión artificial, empleando la identificación de colores, hemos desarrollado una tecnología robusta para evitar satisfactoriamente la colisión entre drones que puede ser fácilmente extrapolable a la mayoría de los robots aéreos comerciales y de investigación; además, proporcionamos el código software completo de la solución”, señala Julián Estévez, investigador de la Universidad del País Vasco.

Hacia el robot aéreo autónomoLa mayoría de los drones que conocemos están tripulados, incluso aunque estén más allá de la vista del operador. Para que un dron sea totalmente autónomo tiene que ser capaz de tomar decisiones de vuelo por su propia cuenta y sin intervención humana, es decir, decidir por sí mismo cómo evitar las colisiones, cómo mantener rumbos frente a ráfagas de viento, controlar la velocidad de vuelo, esquivar edificios, árboles…

“Este trabajo es un pequeño paso hacia la navegación completamente autónoma —sin ninguna intervención humana—, y que los drones decidan qué maniobra realizar, qué dirección tomar y así evitar colisiones entre ellos o con otros obstáculos aéreos. Si asumimos que, en un futuro, nuestro espacio aéreo estará mucho más poblado por servicios comerciales realizados por estos drones, nuestro trabajo es una pequeña contribución en esta dirección”, indica Julián Estévez.

El autor del estudio explica que “nuestra propuesta de evitar colisiones no requiere que los drones intercambien información entre ellos; en su lugar, dependen únicamente de los sensores y cámaras de a bordo”. “Obtenemos la señal de la cámara que está a bordo de los drones y mediante el procesamiento de las imágenes ajustamos las reacciones de los robots para que vuelen con suavidad y precisión”, añade Estévez.

En los experimentos han tratado de imitar condiciones realistas de los drones, es decir, escenarios que pueden darse en un área urbana habitual en condiciones de iluminación no controladas, drones volando en diferentes direcciones, etc., por lo que sus aportaciones están enfocadas a aplicaciones en el mundo real, a pesar del trabajo inicial en laboratorio.

Algoritmos basados en el color“Hemos equipado cada dron con una tarjeta roja que permite al algoritmo software detectar la presencia de un dron que se aproxima y medir su proximidad”, explica Julián Estévez. “Nuestra propuesta —continúa el investigador— es muy sencilla: cada dron lleva equipada una cámara a bordo, cuya pantalla está dividida en dos mitades (izquierda y derecha). Esta cámara busca en todo momento el color rojo de las tarjetas que hemos indicado anteriormente. Mediante sencillos procesamientos de imágenes, podemos saber qué porcentaje de la cámara está ocupada por el color rojo, y si la mayor parte de esta región roja está a la izquierda o a la derecha de la pantalla. Si la mayor parte de la zona roja está en la parte izquierda de la pantalla, el dron volará hacia la derecha para evitar la colisión. Si la zona roja está en la derecha, lo hará hacia la izquierda. Y esto ocurre con todos los drones que se encuentran en el aire”.

Además, “cuando el porcentaje de color rojo en la pantalla vaya aumentando, esto significará que los drones se están aproximando de frente. De manera que cuando se supere un umbral, el robot sabrá que debe realizar la maniobra de evasión. Todo esto ocurre de manera autónoma, sin intervención del operador humano. Es una manera sencilla de evitar choques, capaz de realizarse mediante sensores y equipamiento low cost”, recalca Julián Estévez. Algo parecido a lo que ocurre cuando una persona va caminando por la calle y ve que alguien se le acerca por su izquierda, en ese caso la persona intenta retirarse hacia la derecha para no chocarse.

Referencia:

Julian Estevez, Endika Nuñez, Jose Manuel Lopez-Guede & Gorka Garate (2024) A low-cost vision system for online reciprocal collision avoidance with UAVs Aerospace Science and Technology doi: 10.1016/j.ast.2024.109190

El artículo Un paso más hacia el robot aéreo autónomo: evitar colisiones se ha escrito en Cuaderno de Cultura Científica.

La Geología, disciplina olímpica

Durante estas semanas, la mirada de todo el mundo se concentra en una misma ciudad europea: París. La capital de Francia se ha convertido en el centro de atención gracias a albergar el mayor evento deportivo mundial, ese que ocurre cada cuatro años (pandemia mediante) y que nos permite descubrir deportes que no sabíamos ni que existían y países que nunca habríamos podido posicionar en el mapamundi, los Juegos Olímpicos. Pero incluso entre largos en la piscina, triples saltos mortales en el pabellón de gimnasia o tiros libres en el pabellón de baloncesto, también podemos aprender algo de Geología. Para ello, no vamos a fijarnos en los metales con los que se forjan las medallas, sino en lo que se encuentra bajo los pies de las estrellas del deporte y de todas las sedes olímpicas del centro de Francia: la cuenca de París.

Geológicamente hablando, una cuenca es una zona deprimida del terreno en la que se acumulan sedimentos. Y eso es exactamente lo que sucede no solo en París, sino en toda la zona central de Francia, desde hace millones de años. Así que, para entenderlo, debemos viajar al pasado.

250 millones de años acumulando sedimentosTodo comenzó hace unos 250 millones de años, a finales del Periodo Pérmico y comienzos de Periodo Triásico, cuando el último gran supercontinente de la historia de nuestro planeta, Pangea, empezó a romperse. Desde entonces, debido a los movimientos tectónicos que han culminado con la actual disposición de los continentes en la superficie terrestre, toda la zona central de Francia ha sufrido un proceso de subsidencia más o menos continuo. Como ya os comenté en otra ocasión, la subsidencia es un término geológico que se refiere a un hundimiento continuado y relativamente lento del terreno, lo cual genera una zona deprimida que puede actuar como una excelente piscina olímpica que ha estado recibiendo el depósito de sedimentos durante estos últimos 250 millones de años prácticamente sin descanso.

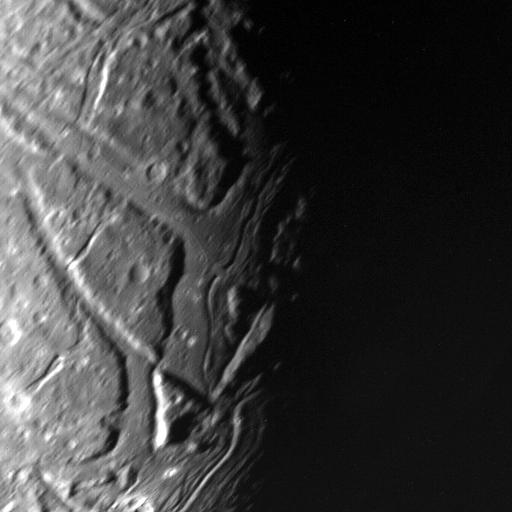

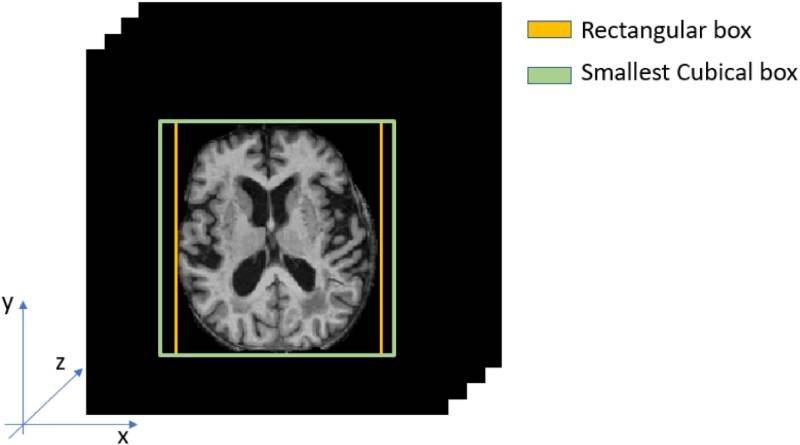

Mapa geológico de la cuenca de París y reconstrucción de una sección transversal de los materiales en profundidad con orientación oeste (W)-este (E). Imagen tomada de Mas, P., Calcagno, P., Caritg-Monnot, S., Beccaletto, L., Capar, L. y Hamm, V. (2022). A 3D geomodel of the deep aquifers in the Orléans area of the southern Paris Basin (France). Sci Data 9, 781.

Mapa geológico de la cuenca de París y reconstrucción de una sección transversal de los materiales en profundidad con orientación oeste (W)-este (E). Imagen tomada de Mas, P., Calcagno, P., Caritg-Monnot, S., Beccaletto, L., Capar, L. y Hamm, V. (2022). A 3D geomodel of the deep aquifers in the Orléans area of the southern Paris Basin (France). Sci Data 9, 781.Esto se observa claramente al mirar el mapa geológico de Francia, sobre todo si prestamos atención a la reconstrucción que se ha realizado de cómo se distribuyen esos materiales en profundidad, por debajo del suelo. Aquí se remarca con mucho detalle cómo la parte central del país vecino está hundida con respecto a sus márgenes, lo que ha permitido una gran acumulación de materiales geológicos desde comienzos del Triásico, situados en la parte inferior, hasta la actualidad, que recubren la superficie. Además, esta representación gráfica nos permite definir la morfología de la cuenca de París, que recuerda a los platos que sirven de objetivo al sobrevolar el foso de tiro o a los discos que lanzan sobre la pista de césped en el estadio de atletismo. Por ese motivo y gracias a que, como ya sabéis, en Geología no nos gusta comernos la cabeza a la hora de ponerle nombre a las cosas, a este tipo de cuencas sedimentarias se las conoce como “de tipo platillo”.

La de París, cuenca de referenciaLa cuenca de París, gracias a sus grandes dimensiones, la enorme acumulación casi continuada de sedimentos durante las Eras Mesozoica y Cenozoica y, sobre todo, al situarse en Francia una de las cunas de la Geología europea, se ha convertido en el modelo teórico de referencia para comprender cómo se comportan y evolucionan con el tiempo las cuencas sedimentarias de tipo platillo. Pero, además, tiene otra característica geológica que la convierte en un referente a nivel mundial y que se encuentra escondida entre los materiales de comienzos de la Era Cenozoica, pintados con esos colores anaranjados en el mapa.

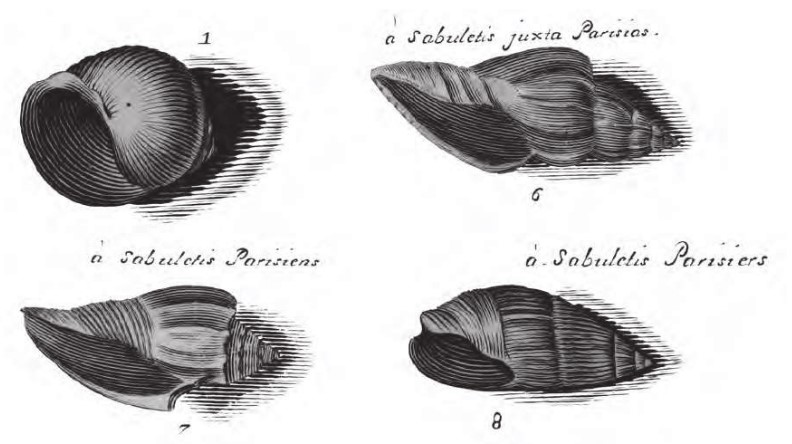

Lámina con ilustraciones de varios fósiles de gasterópodos del Luteciense de París, dibujada por las hermanas Lister en 1692. Imagen tomada de Merle, D. (2008). Les grands auteurs de la paléontologie du Lutétien. En: Stratotype Lutétien: Un peu d’histoire (Merle, D. ed.). Publications Scientifiques du Muséum, Paris; Biotope Mèze; BRGM La Source, pp. 35-46.

Lámina con ilustraciones de varios fósiles de gasterópodos del Luteciense de París, dibujada por las hermanas Lister en 1692. Imagen tomada de Merle, D. (2008). Les grands auteurs de la paléontologie du Lutétien. En: Stratotype Lutétien: Un peu d’histoire (Merle, D. ed.). Publications Scientifiques du Muséum, Paris; Biotope Mèze; BRGM La Source, pp. 35-46.Cuando a comienzos del siglo XIX Charles Lyell, uno de los padres de la Geología, estuvo trabajando en el sur de Francia, pudo estudiar los materiales más recientes de la cuenca de París. A partir de sus observaciones en los fantásticos afloramientos de toda esta zona, el geólogo se atrevió a subdividir la entonces llamada Era Terciaria (nombre ya obsoleto en el ámbito geológico) en tres periodos: Eoceno, Mioceno y Plioceno. Pero no fue el primero en analizar la Geología de esta zona. Otros pioneros franceses, desde finales del siglo XVIII, se habían centrado en recopilar miles de ejemplares fósiles de los numerosos yacimientos encontrados en las afueras de París, sobre todo de gasterópodos marinos del Periodo Eoceno. Con estos fósiles en la mano, el barón Georges Cuvier empezó a elucubrar sus ideas sobre la anatomía comparada, o Jean Baptiste Monet, caballero de Lamarck, le fue dando forma a su particular hipótesis sobre la evolución. Incluso, a finales del siglo XIX, Albert de Lapparent fue más allá que Lyell y propuso una subdivisión del Periodo Eoceno basado en estos yacimientos parisinos. Así nació el segundo Piso del Periodo Eoceno, cuyos límites temporales actualmente oscilan entre hace 47,8 y 41,3 millones de años y que ha sido nombrado en honor a la capital francesa. Pero no, no se llama Parisiense, Lapparent propuso emplear el nombre antiguo de la ciudad, ese que todo el mundo conocemos gracias a los cómics de Astérix: Lutecia. Había nacido el piso Luteciense.

Espero que, cuando sigáis los Juegos Olímpicos en la radio o la televisión, os acordéis de que los cimientos de las sedes olímpicas se sustentan sobre los materiales de una cuenca sedimentaria de record. Porque ahora el deporte es el protagonista en la capital francesa, pero la Geología ha sido y siempre será la principal estrella de París.

Agradecimientos:

Me gustaría dedicar este artículo a Daniel Ampuero y Gonzalo Da Cuña, dos de los periodistas de Radio Nacional de España que están dando cobertura a los Juegos Olímpicos de París, por compartir conmigo su amor por el deporte.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo La Geología, disciplina olímpica se ha escrito en Cuaderno de Cultura Científica.

Los números vistos como bosques

Todo el que tiene cuerpo

tiene un árbol.

Y dos que se juntan, bosque.

La suavidad sumaria de la hoja.

El rostro informe de la lluvia.

La tierra que se expande

como un pétalo

nocturno.

Un instante febril cuando el sol cae.

Fuente: Freepik.

Fuente: Freepik.

En matemáticas, también existen bosques con árboles variados que viven en ellos…

Árboles y bosquesSe denomina bosque a un grafo acíclico, es decir, un grafo sin ciclos (un ciclo es un camino cerrado de aristas uniendo vértices, en los que no se repite ninguno salvo el primero y el último).

Los bosques matemáticos, como los naturales, están compuestos por árboles. Un árbol es un grafo en el que dos vértices cualesquiera están conectados por exactamente un camino. De otro modo, es un grafo conexo (es decir, “de una pieza”) acíclico. Observar que, en un árbol, la diferencia entre la cantidad de vértices y aristas es 1.

Así, los bosques son uniones disjuntas de árboles que pueden estar desconectados, es decir, un bosque puede ser un grafo disconexo. Los ejemplos más sencillos de bosques son precisamente los árboles, incluyendo el grafo vacío (sin vértices) y el grafo formado sólo por un vértice. De otro modo, los árboles son las componentes conexas (subgrafos conexos maximales) de los bosques.

¿Cuántos árboles tiene un bosque? Si denotamos por V el número de vértices de un bosque y por A su número de aristas, V − A es precisamente el número de árboles que forman un bosque. Esto se debe a que, como hemos comentado antes, en el caso de un árbol, V – A = 1.

Claramente, un bosque con K árboles y N vértices posee N – K aristas. En la página On-Line Encyclopedia of Integer Sequences (OEISA005195) se puede ver la cantidad de bosques diferentes que existen con una cantidad dada de vértices V; los primeros son:

Número de vértices V

Número de bosques

1

1

2

2

3

3

4

6

5

10

6

20

7

37

8

76

9

153

10

329

11

710

12

1601

13

3658

14

8599

14

20514

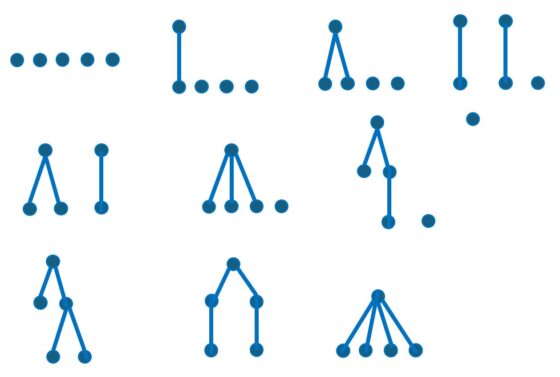

Por ejemplo, un bosque con 5 vértices tiene 10 configuraciones posibles, que se muestran en la imagen de debajo:

Los 10 posibles bosques formados por 5 vértices. En la primera fila aparecen los que tienen 5, 4 y 3 componentes conexas; en la segunda los posibles bosques con 2 árboles; en la tercera los bosques que poseen un único árbol (es decir, los árboles diferentes formados por 5 vértices).

Los 10 posibles bosques formados por 5 vértices. En la primera fila aparecen los que tienen 5, 4 y 3 componentes conexas; en la segunda los posibles bosques con 2 árboles; en la tercera los bosques que poseen un único árbol (es decir, los árboles diferentes formados por 5 vértices).Los números son bosques

En A Puzzle Forest se hace alusión a una bonita manera de representar la factorización de un número entero positivo mediante un bosque.

Cada primo es un árbol y cada entero positivo es un bosque cuyos árboles corresponden a los primos de su factorización. Explicamos este proceso a continuación:

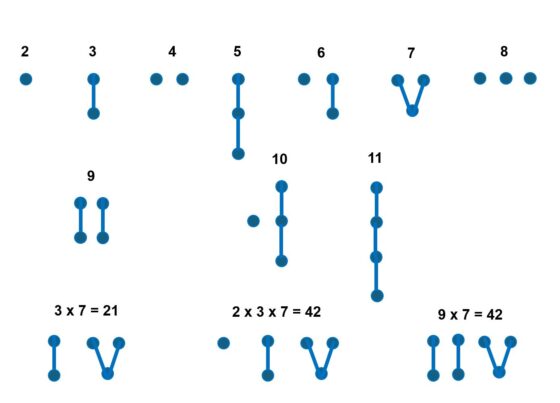

- El número 2 es primo, que se representa como un árbol con un único vértice.

- El número 3 es primo, es el segundo número primo. Se representa como un árbol con dos vértices unidos por una arista.

- El número 4 se descompone como 22. Se representa como un bosque no conexo con dos vértices (la representación del primo 2 duplicada).

- El número 5 es el tercer número primo. Se representa mediante un árbol que se construye tomando un vértice raíz que se une al árbol que representa al 3.

- El número 6 se descompone como 2 x 3. Se representaría como un bosque formado por los árboles que representan al 2 y al 3.

- El número 7 es el cuarto número primo. Se representa entonces como un vértice raíz unido a la representación del número 4.

- El número 8 se descompone como 22 Se representa como un bosque no conexo con tres vértices.

- El número 9 se descompone como 32, así que se representa como un bosque con dos árboles iguales que corresponden al número 3.

Debajo se muestran varios ejemplos de representación de primos y algunos números enteros.

Representaciones de algunos números mediante bosques.

Representaciones de algunos números mediante bosques.

En general, un primo se representa a través de un vértice raíz que se conecta al bosque que representa su lugar en el conjunto de los números primos. Por ejemplo, 11 es el quinto número primo, así que se representa mediante un vértice raíz que se une a la representación del 5.

Es decir, la representación de cada número se obtiene recursivamente conociendo su factorización en primos y la cantidad de primos menores o iguales a un primo dado. Por supuesto, es preciso conocer la función contadora de números primos que calcula la cantidad de números primos menores o iguales a cualquier número entero positivo dado.

Robé a los bosques,

los confiados bosques.

Los árboles desprevenidos

mostraron sus frutos y sus musgos

para agradar a mis delirios.

Escudriñé, curiosa, sus adornos;

se los arrebaté, me atreví a robar.

¿Qué dirá el solemne abeto?

Y el roble, ¿qué dirá?

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

El artículo Los números vistos como bosques se ha escrito en Cuaderno de Cultura Científica.

El vacío del espacio se desintegrará antes de lo esperado (pero no pronto)

Uno de los campos cuánticos que permea el universo es especial porque su valor por defecto parece estar destinado a terminar cambiando, transformándolo todo.

Un artículo de Matt von Hippel. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Una burbuja de vacío de menor energía crecería a la velocidad de la luz, destruyendo todos los átomos en su camino. Ilustración: Nico Roper / Quanta Magazine

Una burbuja de vacío de menor energía crecería a la velocidad de la luz, destruyendo todos los átomos en su camino. Ilustración: Nico Roper / Quanta MagazineLa desintegración del vacío, un proceso que podría acabar con el universo tal como lo conocemos, podría ocurrir 10.000 veces antes de lo esperado. Afortunadamente, no ocurrirá hasta dentro de muchísimo tiempo.

Cuando los físicos hablan del “vacío”, el término suena como si se refiriera al espacio vacío, y en cierto sentido es así. Más específicamente, se refiere a un conjunto de valores predeterminados, como los ajustes de un tablero de control. Cuando los campos cuánticos que permean el espacio se encuentran en estos valores predeterminados, se considera que el espacio está vacío. Los pequeños ajustes en los valores predeterminados crean partículas: si se aumenta un poco el campo electromagnético, se obtiene un fotón. Los grandes ajustes, por otro lado, es mejor considerarlos como un conjunto de nuevos valores predeterminados. Crean una definición diferente de espacio vacío, con características diferentes.

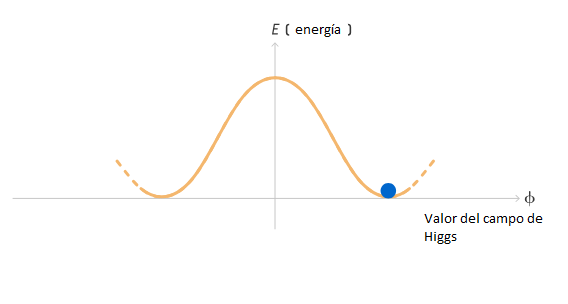

Un campo cuántico en concreto es especial porque su valor por defecto puede cambiar. Se llama campo de Higgs y controla la masa de muchas partículas fundamentales, como los electrones y los cuarks. A diferencia de todos los demás campos cuánticos que ha descubierto la comunidad física, el campo de Higgs tiene un valor por defecto superior a cero. Si se aumenta o disminuye el valor del campo de Higgs, la masa de los electrones y otras partículas aumentaría o disminuiría. Si el valor del campo de Higgs fuera cero, esas partículas no tendrían masa.

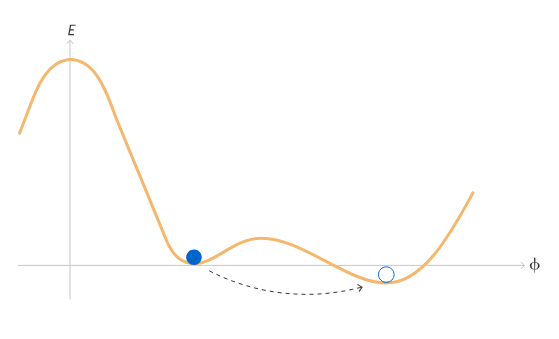

Podríamos permanecer en el valor por defecto distinto de cero por toda la eternidad si no fuera por la mecánica cuántica. Un campo cuántico puede “hacer un túnel”, saltando a un nuevo valor de energía más bajo incluso si no tiene suficiente energía para pasar por los valores intermedios de energía más altos, un efecto similar al de atravesar una pared sólida.

Para que esto suceda, es necesario tener un estado de energía más bajo al que llegar mediante el túnel. Y antes de construir el Gran Colisionador de Hadrones, se pensaba que el estado actual del campo de Higgs podría ser el más bajo. Esta creencia ha cambiado ahora.

Siempre se ha sabido que la curva que representa la energía necesaria para diferentes configuraciones del campo de Higgs se parece a un sombrero con el ala hacia arriba. La configuración actual del campo de Higgs puede representarse como una bola que reposa en la parte inferior del ala.

Ilustración: Mark Belan para Quanta Magazine

Ilustración: Mark Belan para Quanta MagazineSin embargo, correcciones cuánticas sutiles pueden cambiar la forma de la curva. Los campos cuánticos se retroalimentan energía entre sí. Las interacciones cuánticas entre los electrones y el campo electromagnético cambian los niveles de energía de los átomos, por ejemplo, un efecto descubierto en la década de 1940.

En el caso del campo de Higgs, la curvatura del ala del sombrero está determinada por la masa del bosón de Higgs, la partícula elemental que transmite los efectos del campo de Higgs, que se descubrió en el Gran Colisionador de Hadrones en 2012. Otras correcciones a la forma de la curva provienen de partículas que interactúan fuertemente con el bosón de Higgs: aquellas con masa alta, como el cuark cima, la partícula elemental más pesada conocida. Al comparar la masa del bosón de Higgs con la del cuark cima, los físicos ahora piensan que lo más probable es que el sombrero se hunda otra vez. En un valor por defecto mucho más alto del campo de Higgs, hay un estado de energía más bajo.

Ilustración: Mark Belan para Quanta Magazine

Ilustración: Mark Belan para Quanta MagazineEn ese caso, el campo de Higgs acabaría por atravesar ese túnel, o “se desintegraría”, hasta llegar a ese estado. Esta desintegración empezaría en un lugar y luego se extendería, formando una burbuja esférica que crecería a la velocidad de la luz transformando el universo. Las partículas fundamentales se volverían mucho más pesadas, de modo que la gravedad las atraería más que las otras fuerzas las mantienen separadas. Los átomos colapsarían.

Sin embargo, no llegaremos a ese valor por defecto del Higgs más alto en un futuro próximo. Los físicos calculan las probabilidades de desintegración del vacío de distintas maneras. En el método más directo, llevan un registro de las distintas transformaciones que serían necesarias para que el campo pasara de un valor a otro (transformaciones que violan la conservación de la energía, algo que la mecánica cuántica permite que ocurra brevemente), ponderando cada escenario según en qué medida viola reglas como la conservación de la energía. Según estas estimaciones, un gigapársec cúbico de espacio verá desintegrarse el vacío una vez cada 10794 años, o el dígito 1 seguido de 794 ceros, un lapso de tiempo inimaginable. Hasta ahora solo han pasado 1010 años desde el Big Bang.

Recientemente, un grupo de físicos de Eslovenia afirmó haber encontrado un pequeño error en el cálculo, que acelera el fin del universo tal como lo conocemos a 10790 años, en lugar de 10794. Si bien un cambio de un factor de 10.000 puede parecer enorme, es mucho menor que la incertidumbre de otras partes del cálculo. Lo más importante: ninguna de estas incertidumbres es lo suficientemente grande como para reducir los eones que se encuentran entre nosotros y los horrores de la desintegración del vacío.

El artículo original, Vacuum of Space to Decay Sooner Than Expected (but Still Not Soon), se publicó el 22 de julio de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo El vacío del espacio se desintegrará antes de lo esperado (pero no pronto) se ha escrito en Cuaderno de Cultura Científica.

Las células cristal transportan oxígeno en Drosophila

Seguro que recuerdan alguna película en la que aparecen insectos gigantescos. Por ejemplo, la espléndida La humanidad en peligro (1954) nos muestra cómo las pruebas nucleares en el desierto han provocado mutaciones en las hormigas, que se convierten en descomunales amenazas.

Este escenario no es demasiado realista, ya que el tamaño de los insectos está constreñido por la forma en que respiran. En los libros de texto se nos explica que los insectos tienen respiración traqueal, mediante un sistema de finísimos tubos huecos que llevan el aire a todos los rincones de su cuerpo. Esto impone un tamaño limitado por los problemas de la difusión del aire dentro de las tráqueas. Curiosamente, el aire rico en oxígeno del periodo Carbonífero permitió que los insectos alcanzaran los mayores tamaños de su historia. La libélula Meganeura, por ejemplo, llegó a los 70 cm de envergadura.

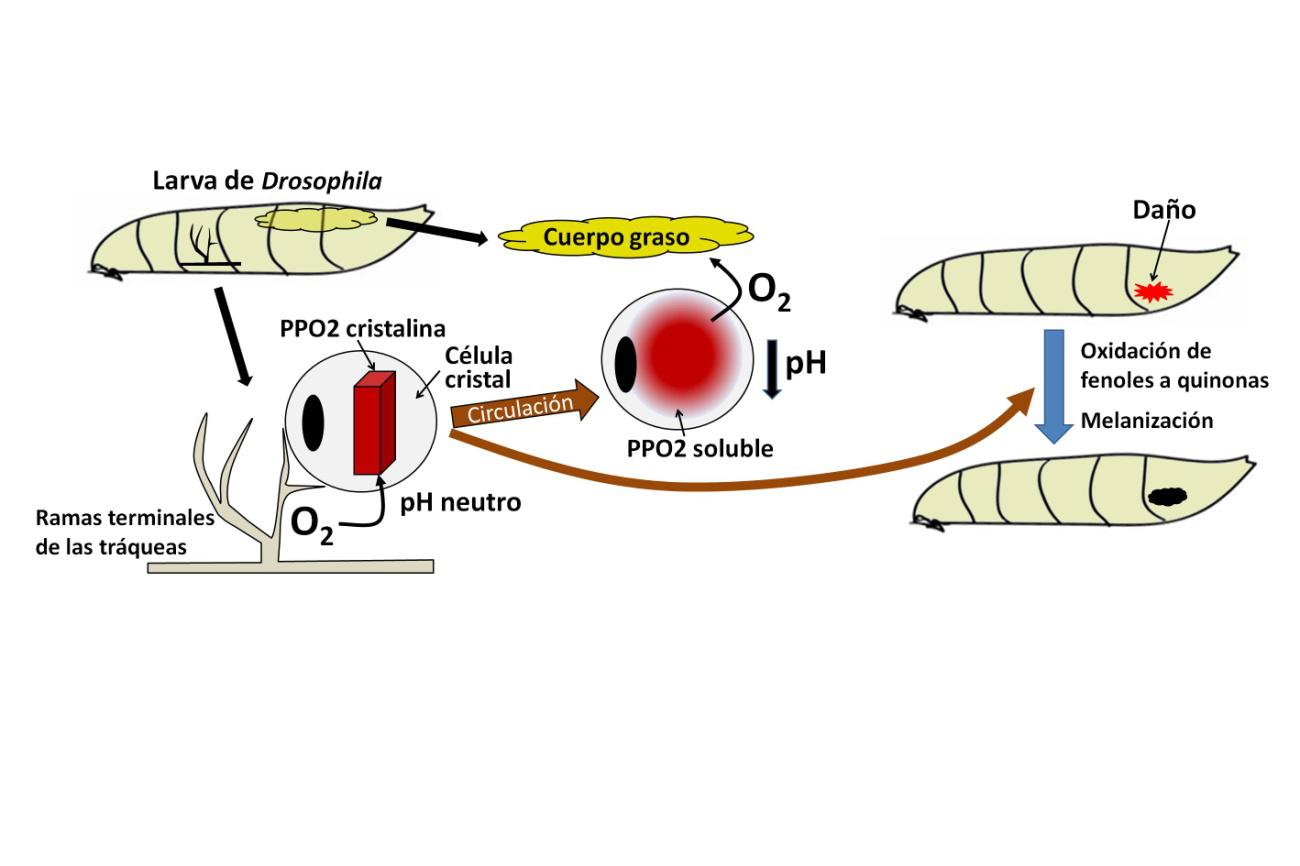

Un reciente descubrimiento, publicado en la revista Nature por un equipo surcoreano, ha revelado que, además de las tráqueas, existen células sanguíneas en la larva de Drosophila capaces de transportar oxígeno mediante un mecanismo sorprendente. Se trata de las células cristal, así llamadas por contener estructuras cristalinas en su interior.

Las células cristal son uno de los tres tipos de hemocitos o células sanguíneas de Drosophila, y representan alrededor del 5% del total. Los más abundantes son los plasmatocitos (95%) una especie de células fagociticas, y el tercer tipo son los lamelocitos que sólo aparecen durante la activación del sistema inmune.

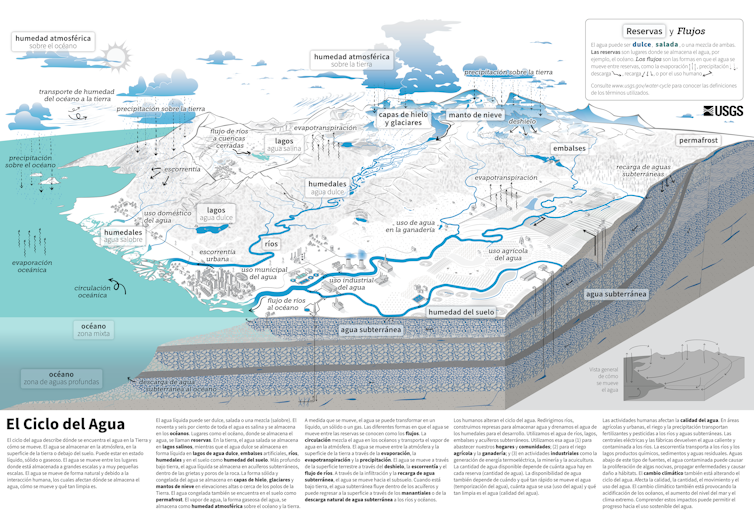

Figura 1. La función hasta ahora atribuida a las células cristal era la melanización, oxidación de fenoles para formar polímeros de melanina capaces de englobar patógenos y cicatrizar heridas (derecha). La nueva función descrita por Shin y cols. consiste en el transporte de oxígeno desde las tráqueas a tejidos como el cuerpo graso, alejados de ellas. El transporte implica un cambio de fase en la profenoloxidasa-2 (PPO2), que almacena oxígeno en estado cristalino y lo libera en la fase soluble, inducida por un descenso del pH.

Figura 1. La función hasta ahora atribuida a las células cristal era la melanización, oxidación de fenoles para formar polímeros de melanina capaces de englobar patógenos y cicatrizar heridas (derecha). La nueva función descrita por Shin y cols. consiste en el transporte de oxígeno desde las tráqueas a tejidos como el cuerpo graso, alejados de ellas. El transporte implica un cambio de fase en la profenoloxidasa-2 (PPO2), que almacena oxígeno en estado cristalino y lo libera en la fase soluble, inducida por un descenso del pH.Los cristales que dan nombre a las células cristal están formados por una proteína que contiene cobre, la profenoloxidasa-2 (PPO2). Esta enzima se encarga de oxidar fenoles y formar polímeros que engloban microorganismos patógenos y contribuyen a la cicatrización de heridas, la función principal que se atribuía a las células cristal hasta ahora (Figura 1). Como los polímeros tienen color oscuro, esta reacción defensiva se conoce como melanización. De hecho, nuestra síntesis de melanina responde a un mecanismo muy similar.

El grupo surcoreano utilizó tres cepas de larvas de moscas mutantes, carentes de células cristal, con ausencia de PPO2 o bien con una PPO2 incapaz de unirse al cobre en su sitio activo. Todas estas larvas muestran alta mortalidad en condiciones de laboratorio y un aumento en el número de ramas terminales de las tráqueas. Este incremento también se produce en larvas normales cultivadas en hipoxia, por lo que se considera una respuesta a la falta de oxígeno.

Estos defectos revierten si se aumenta la concentración de oxígeno en el aire hasta el 60%. De forma más sorprendente, también se rescatan los defectos de las larvas mutantes si se fuerza en las células cristal la expresión de la hemocianina del cangrejo de herradura. Recordemos que esta proteína transporta oxígeno en muchos crustáceos y algunos quelicerados, dando a su sangre color azul debido a su contenido en cobre. Todos estos resultados indican que la PPO2 contenida en las células cristal es indispensable para mantener los niveles de oxígeno en las larvas de las moscas.

Un transportador de oxígeno debe ser capaz de combinarse con esta molécula de forma reversible. En el caso de la hemoglobina o la hemocianina, la fijación se produce en el sitio activo que contiene hierro y cobre, respectivamente. Lo que reveló el estudio de los investigadores surcoreanos es que la combinación reversible de PPO2 con el oxígeno implicaba un cambio de fase en la organización de la proteína (Figura 1). Cuando la célula cristal está próxima a las ramas terminales de las tráqueas, su PPO2 en forma cristalina fija oxígeno. Para ello el pH del interior celular debe ser neutro. Luego, la célula cristal viaja por la cavidad circulatoria y alcanza tejidos alejados de las tráqueas. Allí, el pH citoplasmático disminuye por acción de la enzima anhidrasa carbónica, la proteína pasa de la forma cristalina a una variante soluble, y el oxígeno se libera. La célula cristal regresa a las ramas terminales de las tráqueas y el ciclo comienza de nuevo.

Este proceso ha explicado, por fin, cómo es posible el funcionamiento de un órgano larvario conocido como cuerpo graso, que tiene funciones detoxificadoras y de almacenamiento de lípidos. Su carencia de tráqueas planteaba la cuestión de cómo se satisfacía su demanda metabólica de oxígeno. Ahora sabemos que las células cristal se encargan de transportar el oxígeno desde las tráqueas hasta las proximidades del cuerpo graso.

El sorprendente descubrimiento de células transportadoras de oxígeno en la larva de Drosophila como complemento de la respiración traqueal plantea apasionantes preguntas. ¿Sucede esto en otros insectos, o en insectos adultos? ¿Interviene este tipo de mecanismo en el altísimo consumo de oxígeno que demanda el vuelo de los insectos?

Referencias:

Luschnig, S. (2024) Flies use blood cells to take a deep breath. Nature. doi: 10.1038/d41586-024-01649-6.

Shin, M., Chang, E., Lee, D., et al. (2024) Drosophila immune cells transport oxygen through PPO2 protein phase transition. Nature. doi: 10.1038/s41586-024-07583-x.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

El artículo Las células cristal transportan oxígeno en Drosophila se ha escrito en Cuaderno de Cultura Científica.

Métodos matemáticos para armonizar la poesía

La Camerata Fiorentina fue un grupo de músicos, poetas y humanistas, bajo el patrocinio en Florencia del conde Giovanni Bardi y reunidos en su palacio entre los años 1572 y 1587 aproximadamente. Algunos de los más importantes miembros de la Camerata, como el músico Vincenzo Galilei, los cantantes Giulio Caccini y Jacopo Peri y el poeta Ottavio Rinuccini fueron quienes fundaron las bases intelectuales, teóricas y prácticas de lo que hoy llamamos la ópera.

Patio del Palazzo Bardi en Florencia, atribuido a Bruneleschi, lugar de reunión de la Camerata Fiorentina. Foto: Francesco Bini / Wikimedia CommonsArmonizar la poesía: recitativos y tonemas

Patio del Palazzo Bardi en Florencia, atribuido a Bruneleschi, lugar de reunión de la Camerata Fiorentina. Foto: Francesco Bini / Wikimedia CommonsArmonizar la poesía: recitativos y tonemas

La Camerata heredó de la antigüedad importantes poemas o dramas clásicos que querían modernizar, musicalizar y representar en teatros. El recitativo de versos y diálogos fue un extraordinario invento musical de Giulio Caccini y Jacopo Peri, concebido para elevar la voz humana de actores y cantantes. Ello lo basaron en la entonación ordinaria de los lenguajes humanos, pero tratando -por medio de acertadas inflexiones de voz- de dotarles de mejor expresividad, comunicación, sentimiento y musicalidad.

En Fonética podemos sistematizar la entonación de una frase a través de los tonemas, que definen elevaciones o descensos del tono de la voz. La misma frase, entonada con diferentes tonemas, puede dar lugar a una expresión asertiva, o bien introducir una duda o una pregunta, o puede mostrar enfado, alegría, tristeza u otros sentimientos diferentes. Estas importantes inflexiones expresivas de la voz la formalizaron Caccini y Peri escribiendo notas musicales en un texto para recitar musicalmente los versos de un poema o la frase de una obra teatral. La técnica del Recitativo es por tanto el inicio de musicalizar la poesía y la literatura, esencial para desarrollar la ópera.

Matemáticas: melodía, entonación, eufonía y resoluciónSi queremos armonizar un poema, debemos introducir más de una voz, de forma que ambas a la vez suenen eufónicas. Vincenzo Galilei, en su obra Della musica antica et della moderna explicó matemáticamente la disonancia y la consonancia de dos notas sonando simultáneamente, basado en las ideas del teórico musical Gioseffo Zarlino. El discurso de dos frases musicales simultáneas fue descrito a través de unas sencillas reglas matemáticas de resolución de dichas frases. Ello consistía en una progresión ordenada de notas con mayor o menor eufonía que terminaba por medio de un salto tenso entre dos notas seguido por un regreso relajado a la nota final esperada por el lenguaje humano.

Así pues, mediante estas sencillas reglas matemáticas horizontales (melodía y entonación) y verticales (eufonía y resolución), se explica la más simple y conocida armonía entre dos personas cantando intuitivamente a dos voces, mediante intervalos de terceras, quintas, octavas o unísonos, que ya los Pitagóricos atesoraban por su pureza. Para más de dos voces simultáneas se siguen las mismas normas.

El ejemplo de HändelLas personas dedicadas a la música suelen considerarse “de letras”, quizás porque no les han explicado que las artes y especialmente la música beben de las matemáticas. Como ejemplo ilustrativo de cómo armonizar la poesía, mostraremos una sencilla práctica de uno de los pocos grandes compositores que adquirió en vida enorme éxito, reconocimiento y fortuna: Georg Friedrich Händel, que fue venerado en su país de adopción y fue enterrado en la Abadía de Westminster con honores de Estado.

Rinaldo fue la primera ópera que Händel estrenó en Londres el 24 de febrero de 1711 en el Queen’s Theatre de Haymarket. El estilo operístico italiano que el autor había aprendido, y el libreto en italiano del poeta Giacomo Rossi tuvo un éxito arrollador.

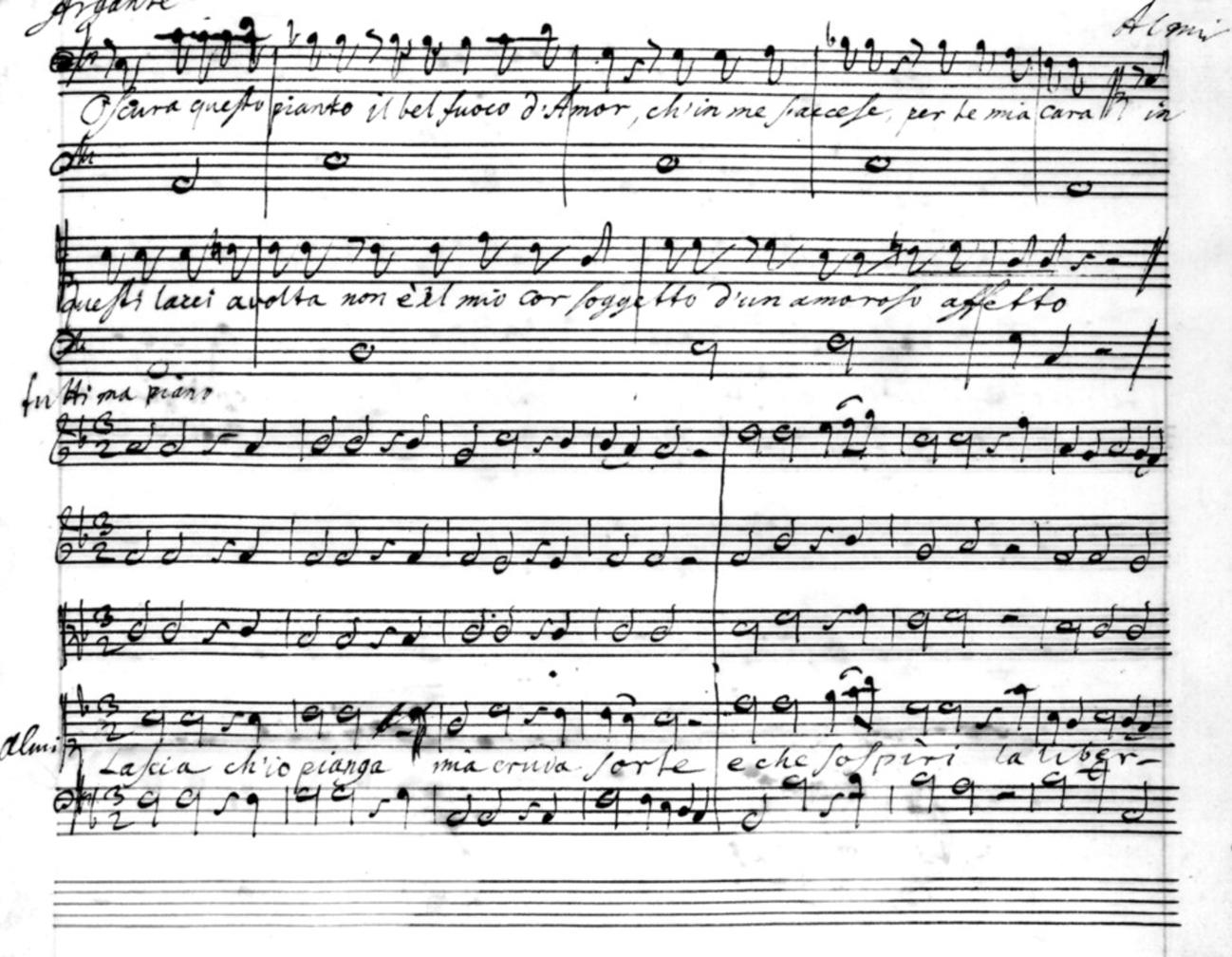

En la Figura 1 se muestra un fragmento del manuscrito original del Acto II de Rinaldo. Comienza un Recitativo de Argante: Oscura questo pianto il bel fuoco d’amor, ch’in me s’accese per te, mia cara. Responde Almirena: In questi lacci avvolta, non è il mio cor soggetto d’un amoroso affetto. En ambos recitativos, al puro estilo de la original invención musical de Giulio Caccini y Jacopo Peri, Händel coloca los tonemas mediante notas musicales para apropiada entonación de las frases.

Figura 1: Manuscrito original de Rinaldo de G.F. Händel (Acto II, Escena IV): recitativos de Argante (Oscura questo pianto) y de Almirena (In questi lacci avvolta) y primeros compases de una de las arias más famosas de Almirena (Lascia ch’io pianga). Wikimedia Commons.

Figura 1: Manuscrito original de Rinaldo de G.F. Händel (Acto II, Escena IV): recitativos de Argante (Oscura questo pianto) y de Almirena (In questi lacci avvolta) y primeros compases de una de las arias más famosas de Almirena (Lascia ch’io pianga). Wikimedia Commons.La parte baja del manuscrito de la Figura 1 es la armonización completa de los primeros compases de una de las arias más famosas de esta ópera y de todo el repertorio operístico de Händel. La simplicísima armonización de los versos

Lascia ch’io pianga mia cruda sorte,

e che sospiri la libertà.

podemos pasarla a limpio para mostrar el ejemplo de ocho compases (cuatro para cada verso). Si no sabe usted leer música, no importa para entender lo escrito que explicaremos a continuación.

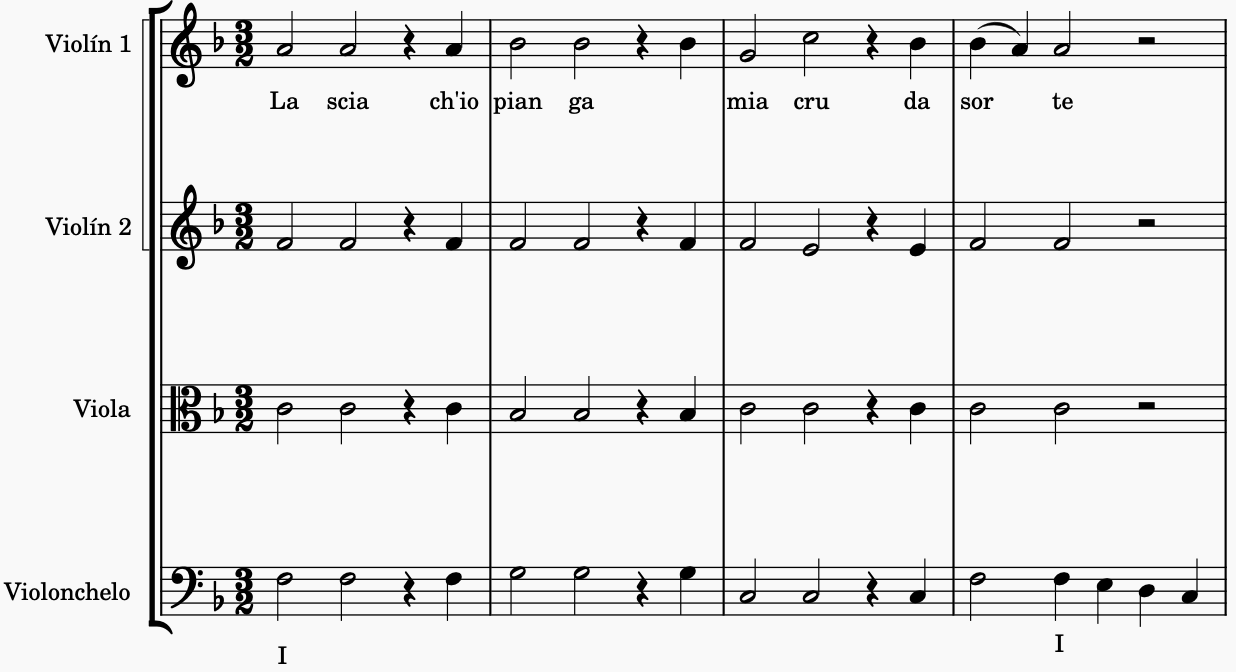

Figura 2: Primer verso del aria a cuatro voces (el violín 1 equivale a la soprano)

Figura 2: Primer verso del aria a cuatro voces (el violín 1 equivale a la soprano)

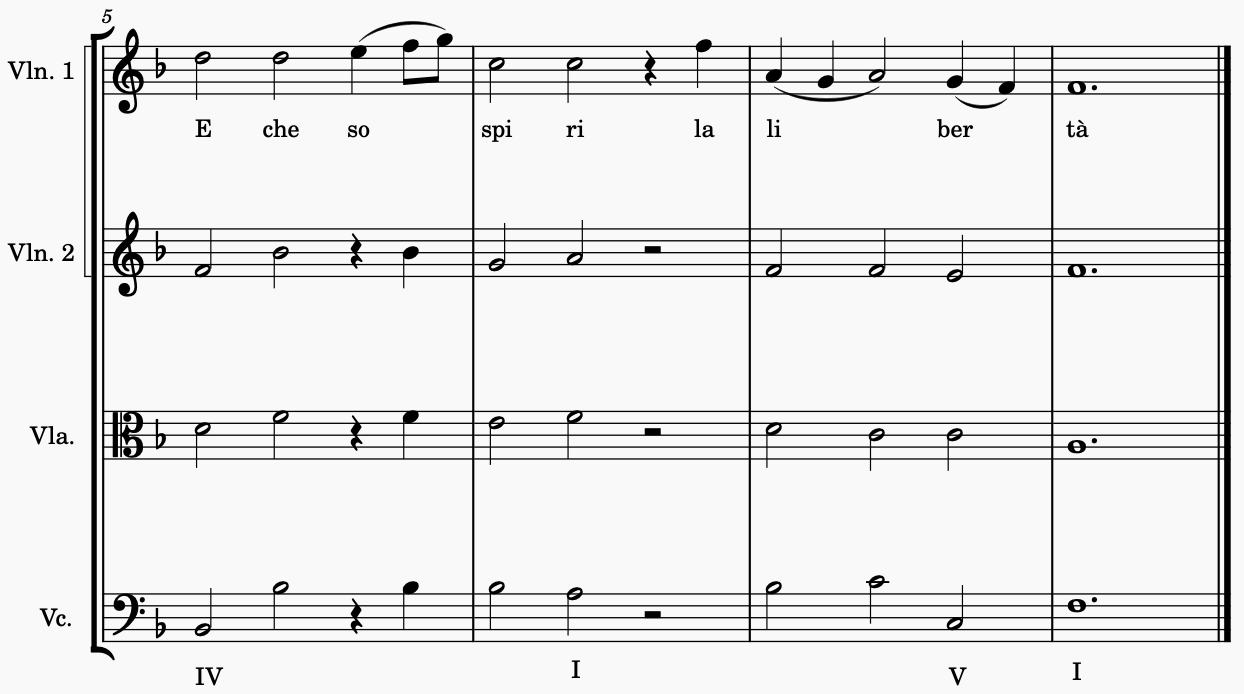

Figura 3: Segundo verso del aria a cuatro voces (el violín 1 equivale a la soprano)

Figura 3: Segundo verso del aria a cuatro voces (el violín 1 equivale a la soprano)

Diremos para empezar que el aria de Almirena está en tonalidad de Fa Mayor. La armonización está realizada a cuatro voces, que hemos colocado como si fuera un cuarteto de cuerda, o bien una pequeña orquesta de cuerda, donde la línea más aguda son los primeros violines o la soprano, que canta la letra.

Lectura horizontal y verticalEn las Figuras 2 y 3, leyendo horizontalmente la primera línea, la soprano canta la melodía. Además, sus dos versos cadenciosos están marcados por la combinación de sus importantes acentos de entonación en puntos expresivos clave (cru-da) y sus esenciales pausas rítmicas, que son los silencios.

Si ahora leemos verticalmente la Figura 2, vemos un primer compás con base en la primera nota de la tonalidad (Fa). Este acorde eufónico, muy Pitagórico, es Fa-La-Do, y lo rotulamos con un número romano (I). Las sencillas reglas matemáticas Galileanas -de progresión ordenada de acordes y la resolución de dichas frases- las podemos seguir mirando los números romanos en la parte del bajo de la partitura, que apenas se mueven, salvo algunas ligeras disonancias en el segundo y tercer compás. Ello nos deja el primer verso sin terminar, con carácter casi interrogativo, solicitando una respuesta.

Si ahora vamos a la Figura 3, continuamos leyendo verticalmente y si seguimos los números romanos, vemos que esta progresión del segundo verso cierra la frase con una tríada tensa (V) seguida por un regreso relajado a la nota final (I) esperada por el lenguaje humano, tal y como explicaba la Camerata Fiorentina. Este cierre V-I es lo que en música se llama cadencia (caída) auténtica, y que cierra frases en casi cualquier estilo musical.

Un poema armonizado no es solo “de letras”. Es también “de ciencias”: sus reglas matemáticas expresan sentimientos, y narran una conmovedora historia. Escuchemos el resultado de esta sencilla armonización que explica por qué Händel fue tan apreciado en vida:

Sobre el autor: Victor Etxebarria Ecenarro está diplomado como lutier por el Conservatorio Juan Crisóstomo de Arriaga (Bilbao) y es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

El artículo Métodos matemáticos para armonizar la poesía se ha escrito en Cuaderno de Cultura Científica.

Día de pi 2024: Demostraciones visuales en dimensiones superiores

El número Pi, representado por la letra griega π, es una de las constantes matemáticas más famosas e importantes que existen en el mundo. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

La fascinación que ha suscitado durante siglos es tal, que se viene estudiando desde hace más de 4.000 años e, incluso, cuenta con su propio día en el calendario: el 14 de marzo. Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien en 1988 lanzó la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática: 3-14 martxoaren 14 en euskara / 3-14 March, 14th en inglés. En los últimos años, la conmemoración del Día de Pi se ha ido extendiendo, hasta tal punto que el 26 de noviembre de 2019 la UNESCO proclamó el 14 de marzo Día Internacional de las Matemáticas.

Un año más, el Basque Center for applied Mathematics-BCAM y la Cátedra de Cultura Científica de la UPV/EHU nos sumamos a la celebración, organizando la quinta edición del evento BCAM NAUKAS, que se desarrolló a lo largo del 14 de marzo en el Bizkaia Aretoa de UPV/EHU.

Una demostración visual es una prueba matemática que no necesita de manipulación algebraica. En el Cuaderno de Cultura Científica hemos visto este tipo de demostraciones en la serie que hizo Raúl Ibáñez al respecto llamada Teoremas sin palabras. Pero, ¿pueden emplearse en dimensiones mayores que tres? Este es el fascinante (para las personas aficionadas a las matemáticas y matemáticas) tema de esta charla que nos trae Urtzi Bujis Martín.

Urtzi Bujis Martín es profesor de topología algebraica en la Universidad de Málaga y divulgador de las matemáticas en Archimedes Tub.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Día de pi 2024: Demostraciones visuales en dimensiones superiores se ha escrito en Cuaderno de Cultura Científica.

La capacidad de interpretar metáforas se desarrolla por completo a los 6 años

La investigadora de la Universidad del País Vasco Isabel Martín ha analizado con menores de 3 a 9 años la capacidad para interpretar las metáforas, y ha concluido que las comprenden completamente a los 6 años. En edades más tempranas muestran cierta intuición para captar el significado figurado, pero su capacidad no está totalmente desarrollada. La investigadora y sus colaboradoras han llegado a esta conclusión combinando las metodologías de selección de imágenes y de seguimiento de movimientos oculares.

Fuente: ReferenciaMetáforas en neurotípicas y neurodivergentes

Fuente: ReferenciaMetáforas en neurotípicas y neurodivergentes

Un estudio que ha realizado el equipo de investigación Lindy Lab de la UPV/EHU con 80 niños y niñas de 3 a 9 años ha llegado a la conclusión de que la interpretación total de las metáforas se alcanza a partir de los 6 años. A pesar de ello, los resultados indican que la capacidad para intuir los significados no literales comienza a desarrollarse antes. “Se aprecia que en edades más tempranas captan en cierto modo el lenguaje figurado, pero no lo dominan y su capacidad es limitada. A los 6 identifican correctamente su significado y, es más adelante, hacia los 10, cuando parece que son capaces de explicar las metáforas”, aclara Isabel Martín. Los resultados de esta investigación se enmarcan dentro de la tesis que está realizando la doctoranda sobre la comprensión del lenguaje metafórico en personas tanto de desarrollo típico (neurotípicas) como con el llamado trastorno del espectro autista (neurodivergentes), con el objetivo de comparar lo que sucede en ambos grupos y poder comprender mejor la mente de personas con autismo.

La autora del estudio explica que para llegar a las citadas conclusiones se han servido de una investigación innovadora: “Hemos iniciado una nueva tendencia metodológica en psicología experimental y psicolingüística que nos ha permitido extraer conclusiones más matizadas que los trabajos ya existentes”. Y es que cabe recalcar, que hay diversos estudios que han analizado esta cuestión, pero sus resultados son dispares. El grupo de la Universidad del País Vasco ha logrado aportar información más completa al debate científico combinando dos metodologías diferentes de una manera que no se había hecho antes.

Selección de imágenes y desplazamiento de los ojosPor un lado, han empleado la metodología de la selección de imágenes. Han puesto en práctica un experimento en el que cada niño o niña escucha un audio en el que se dicta una metáfora (p. ej.: “Los saltamontes saltan mucho; ese niño es un saltamontes”), a la vez que visualizan cuatro imágenes (un niño saltando, un niño corriendo, un escarabajo y un saltamontes saltando). Entonces, los y las participantes deben elegir el dibujo que representa el mensaje que han oído (el niño saltando). “Esta metodología nos ha permitido saber que los participantes de 6 años comprenden los significados figurados, porque es en esa edad cuando se ve claramente que eligen la representación adecuada”, indica la investigadora.

Sin embargo, la selección de imágenes no ofrece información sobre cómo ha procesado cada participante los mensajes y en qué medida ha contemplado otras opciones. Para conocer esos detalles, el equipo de investigación de la Universidad del País Vasco ha aprovechado cada ejercicio planteado para analizar también sus movimientos oculares.

Mientras ven las imágenes, escuchan el estímulo auditivo y eligen el dibujo definitivo, una cámara de infrarrojos mide los desplazamientos de los ojos; tanto los sacádicos (movimientos rápidos del globo ocular e imperceptibles a simple vista) como las trayectorias y las fijaciones en cada imagen. Isabel Martín explica que estos datos permiten conocer cómo han procesado lo que han visto y oído: “La cámara capta cómo se han movido los ojos de una imagen a otra y nos da información sobre lo que está pasando dentro de sus cabezas antes de elegir el dibujo que consideran correcto: si han tenido dificultades, entre qué opciones han dudado… Dado que la imagen que finalmente seleccionan es el resultado de una decisión, que ha seguido todo un proceso”. El registro de los movimientos oculares les permite asomarse a ese proceso en sí y matizar los resultados obtenidos a través de la selección de imágenes.

Precisamente es gracias a la combinación de ambas metodologías que han podido saber que, aunque los niños y niñas menores de 6 años no interpretan con claridad las metáforas porque seleccionan con menos frecuencia la imagen correcta, sí que tienen cierta intuición para detectar los significados figurados. Y es que a través del seguimiento ocular han detectado que han dudado a la hora de elegir el dibujo. “Cuando tienen clarísimo qué significa la frase, no le dan más vueltas y fijan su mirada en la opción que consideran correcta. Pero cuando tienen dudas, miran a otros lugares. Y eso es lo que hemos podido percibir en menores de edades tempranas”, concreta la investigadora.

Referencia:

Isabel Martín-González, Camilo R. Ronderos, Elena Castroviejo, Kristen Schroeder, Ingrid Lossius-Falkum, Agustín Vicente (2024) That kid is a grasshopper! Metaphor development from 3 to 9 years of age Journal of Child Language doi: 10.1017/S0305000924000187

El artículo La capacidad de interpretar metáforas se desarrolla por completo a los 6 años se ha escrito en Cuaderno de Cultura Científica.

Un pequeño paso para Neil Armstrong, un gran salto para la ciencia ficción

El 20 de julio de 1969, Neil Armstrong y Buzz Aldrin se convertían en los primeros seres humanos en pisar la Luna, mientras un estoico Michael Collins permanecía, a la espera de la pena o la gloria de la misión, orbitando nuestro satélite. Todos conocemos esta historia, y algunos de los que estén leyendo este artículo, probablemente, también la vivieron en primera persona gracias a la colosal cobertura mediática que recibió el acontecimiento. Se estima que 600 millones personas lo vieron en directo en sus televisores, pero ¿y si no se hubiera retransmitido en vivo ni hubiera habido ese colosal despliegue mediático?, ¿hubiera impactado tan profundamente la llegada a la Luna en nosotros? Para muchos tal vez no, pero para algunos otros sí, y mucho. O, al menos, para los escritores de ciencia ficción que durante décadas habían estado imaginando y esperando ese momento.

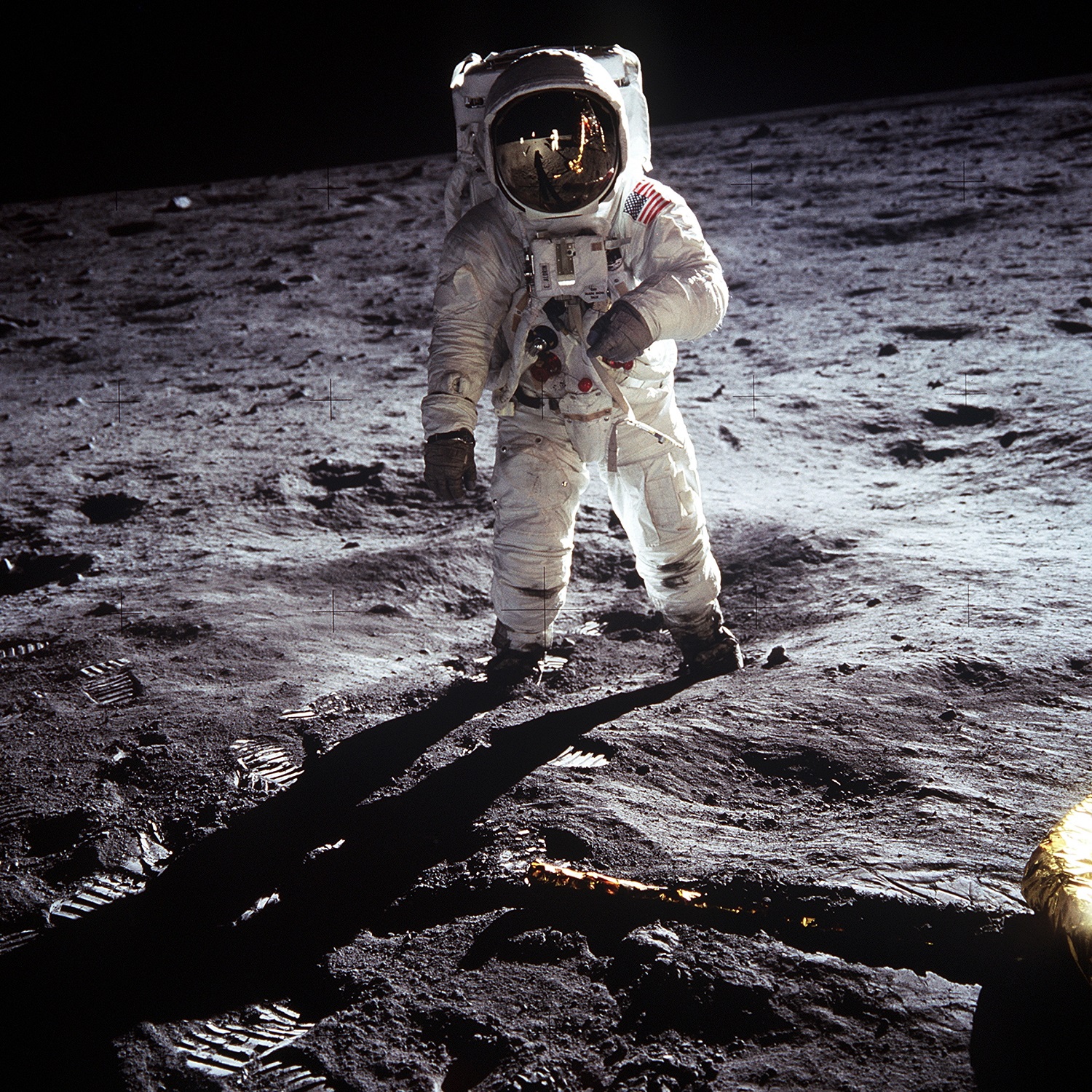

Buzz Aldrin fotografió su propia huella sobre el regolito lunar con fines científicos, pero esta imagen se ha convertido en un símbolo del logro de haber llegado a la luna. Fuente: NASA/Buzz Aldrin

Buzz Aldrin fotografió su propia huella sobre el regolito lunar con fines científicos, pero esta imagen se ha convertido en un símbolo del logro de haber llegado a la luna. Fuente: NASA/Buzz Aldrin

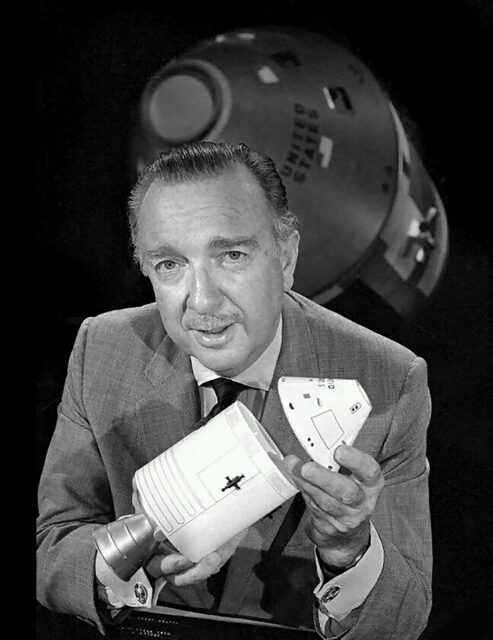

Hubo dos coberturas informativas de la misión Apolo 11 que tuvieron especial relevancia en ese sentido: la de la CBS (Columbia Broadcasting System) y la de la ABC (American Broadcasting Company). La programación especial de CBS News comenzó el 16 de julio de 1969, día del lanzamiento, a las seis de la mañana. Empezaban ocho días de retransmisiones en directo, casi sin descanso, bajo el título de: El hombre en la Luna: el viaje épico del Apolo 11.

La cara visible del despliegue informativo fue Walter Cronkite, uno de los periodistas más respetados del país. Corresponsal en Europa durante la Segunda Guerra Mundial, cubrió el Desembarco de Normandía y otras misiones de bombardeo sobre Alemania, así como los juicios de Núremberg durante los años posteriores. Y su carrera se extendería con éxito durante algunas décadas más. Era la elección lógica por parte de la cadena para cubrir el que sin duda se convertiría en uno de los mayores acontecimientos de la historia de la humanidad.

El periodista de informativos Walter Cronkite fue el encargado de la cobertura de la misión Apollo 11 para CBS News. Fuente: CC BY-NC-SA 2.0/CBS News

El periodista de informativos Walter Cronkite fue el encargado de la cobertura de la misión Apollo 11 para CBS News. Fuente: CC BY-NC-SA 2.0/CBS News

Pero Walter Cronkite no estuvo solo, el desfile de corresponsales y expertos fue infinito. Y, entre esos expertos, ¿qué mejor que los escritores de ciencia ficción que habían estado especulando durante décadas con ese momento? Arthur C. Clarke apareció en antena hasta en doce ocasiones, pero la intervención más interesante se produjo el día del alunizaje. Aquel día, la CBS hizo una emisión de treinta horas ininterrumpidas, veintisiete de las cuales Cronkite estuvo en directo. En los momentos anteriores y posteriores al aterrizaje tuvo dos acompañantes de lujo: el propio Clarke, que lo acompañaba en el estudio de Nueva York, y Robert A. Heinlein, en conexión desde California, acompañado por Bill Stout.

La entrevista, que se puede ver completa en YouTube (abajo aparece un resumen de 10 minutos), es un documento maravilloso para los amantes de la carrera espacial y la ciencia ficción, sobre todo por el optimismo y la emoción que transmitían ambos escritores en aquel momento. Heinlein llega a decir en un momento de su intervención, visiblemente emocionado:

Este es el acontecimiento más grandioso de la historia de la humanidad hasta el momento. Esto es… hoy es el día de año nuevo del año uno.1 Si nosotros no modificamos el calendario, los historiadores lo harán […]. E iremos allá fuera, no solo a la Luna, sino a las estrellas: nos expandiremos […]. Nos vamos a expandir por todo el universo.

En aquello consistió la magia del momento: la ciencia ficción había soñado durante décadas con lo imposible y lo imposible sucedió el 20 de julio de 1969, ¿qué motivo habría para pensar que, una vez pisada la Luna, nos detendríamos ahí?

La cadena ABC recurrió, por otro lado, a Isaac Asimov, Frederik Pohl y John R. Pierce2 que participaron en una mesa redonda moderada por Rod Serling, guionista y productor televisivo conocido, sobre todo, por la serie The Twilight Zone. Tampoco ninguno de ellos mostró ninguna duda de que, desde que tenían uso de razón, la llegada del ser humano a la luna era una cuestión de tiempo. Parte de aquella intervención se puede ver también en YouTube.

La participación mediática de Isaac Asimov, Arthur C. Clarke, Robert A. Heinlein, Frederik Pohl y John R. Pierce, entre otros, en el que probablemente fue el logro tecnológico más importante del siglo XX fue, por un lado, el testimonio de que el sueño de la Edad de Oro de la ciencia ficción podía cumplirse. Por otro, un ejemplo del poder que la ciencia ficción puede ejercer en la manera en la que entendemos nuestra realidad e imaginamos nuestro futuro. Desde los tiempos de Julio Verne ―incluso antes―, sin las constricciones y formalismo de la ciencia, y con mucho sentido de la maravilla, aquellos escritores, y también divulgadores en muchos casos, inspiraron a varias generaciones de científicos, ingenieros y exploradores de lo desconocido, sembrando en ellos la idea de que un día sería posible pisar la Luna.

Buzz Aldrin en la superficie de la Luna, fotografiado por Neil Armstrong. Fuente: NASA/Neil Armstrong

Buzz Aldrin en la superficie de la Luna, fotografiado por Neil Armstrong. Fuente: NASA/Neil Armstrong

Aunque es difícil calibrar el grado de influencia que la ciencia ficción de principios a mediados del siglo XX tuvo sobre el desarrollo de la carrera espacial, todo indica que la tuvo. Wernher von Braun y Arthur C. Clarke fueron grandes amigos. Tal vez eso signifique que, al fin y al cabo, la ciencia y la ciencia ficción ―science fact and science fiction― no se encuentren tan alejadas la una de la otra.

Bibliografía

Hsu, T. (15 de julio de 2019). The Apollo 11 mission was also a global media sensation. https://www.nytimes.com/2019/07/15/business/media/apollo-11-television-media.html

Knoll, S. (16 de julio de 1969). First man on the moon has TV network in orbit. Variety. https://variety.com/1969/biz/news/first-man-on-the-moon-has-tv-networks-in-orbit-1201342630/

Jeffrey, J. (11 de julio de 2019). Apollo 11: ‘The greatest single broadcast in television history’. BBC. https://www.bbc.com/news/world-us-canada-48857752

McAleer, N. (1992). Arthur C. Clarke. The authorized biography. Contemporary Books.

NASA (s. f.). Walter Cronkite. NASA. https://www.nasa.gov/people/walter-cronkite/

O’Donell, Norah (16 de julio de 2019). “Say something, I’m Speechless!”: Inside the CBS News coveragie of Apollo 11. CBS News. https://www.cbsnews.com/news/say-something-im-speechless-inside-the-cbs-news-coverage-of-apollo-11/