Gizaki modernoen sorlekua eta abiapuntua dantzan

Marokon dagoen Jebel Irhoud izeneko aztarnategia egin dute paleoantropologiaren mundua, beste behin ere, irauli duen aurkikuntza. Alemaniako Max Planck Institutuko ikertzaileek egindako ikerketaren arabera, bertan topatu diren bost homininoren arrastoak Homo sapiens espeziekoak dira, eta duela 300.000 – 350.000 urte bitartekoak omen dira. Nature aldizkarian argitaratu dituzte emaitzak.

Proposamen berriak 100.000 urte baino gehiago atzeratu ditu gure espeziearen existentziaren lehen frogak, eta jatorri geografikoa ere lekuz aldatu du. Izan ere, orain arte, gizaki modernoaren lehen ordezkariak Etiopian bizi izan zirela uste izan da. Egindako datazioen arabera, aztarna horiek 200.000 urte zituzten. Orain arteko teoriaren arabera, Afrikako ekialdean eta hegoaldean zeuden Homo sapiensak. Proposamen berriaren arabera, Afrikatik atera baino lehen, kontinente osoan zehar barreiatu ziren gizaki modernoaren lehen arbaso horiek.

1. irudia: Aurkitutako fosilen eskanerretan oinarrituta, arkeologoek egin duten simulazioa. (Argazkia: Nature)

1960ko hamarkadan ezagutu ziren Jebel Irhoud aztarnategiko fosilak, baina Afrikan zeuden Neandertalgo gizakien aldaeratzat jo ziren. Inguruan aurkitu ziren harrizko tresnek ere Europan neandertalei lotuta dagoen mousteriar aldiko kulturaren parekoak zirela zehaztu zen orduan. Hau guztia zela eta, topatu zituztenean, arrasto horiek duela 40.000 urtekoak zirela kalkulatu zuten ikerlatzaileek. Halere, orain egindako analisi berriek kolokan jarri dituzte lehen emaitza horiek. Indusketa berriek, gainera, fosil eta harrizko tresna berriak azaleratu dituzte. Besteak beste, garezur baten zatia eta beheko baraila bat. Horien azterketan abiatuta, Jean-Jacques Hublin paleoantropologoak gidatutako taldeak dio fosil horiek gizaki modernoaren eboluzioaren lehen fase bati dagokiela.

Beste lantalde batek harrizko tresnen analisiaren emaitzak aurkeztu ditu, Nature aldizkariaren ale berean. Europakoekin baino, Afrikako industriekin lotu dituzte material horiek. Era berean, termolumineszentziaren teknika baliatu dute aztarnategian topatutako suharrien data zehazteko. Horren arabera proposatu dute 300.000 eta 350.000 urte arteko tartea. Kuartzoa duten harrien data zehazteko tresna aproposa da termolumineszentzia. Sinplifikatuz, mineral hori asko berotzen denean, kristaletako barne egitura aldatzen da. Gerora, eta urtez urte material horrek jasotzen duen erradiazio kopurua jakinda, zientzialariak gai dira jakiteko material hori noiz erre zen.

“Data ondo zehaztuta duten aro honetako aztarnategiak oso urriak dira Afrikan, baina guk zortea izan dugu, Jebel Irhoud aztarnategian topatu ditugun suharrizko tresna asko iraganean berotuak izan zirelako”, esan du geokronologian aditua den Daniel Richter ikertzaileak Max Planck Institutuak zabaldutako ohar batean. Horrez gain, aurretik eginda zegoen giza baraila baten inguruko datazio bat aldatu dute. Lehen 160.000 urte zituela uste bazen ere, orain emaitza horiek doitu eta berrikusi dituzte, aztarnategiko sedimentuen erradiazioarekin alderatuz. Kasu honetan, erresonantzia elektronikoaren ekorketaren metodoa erabili dute.

2. irudia: Jean-Jacques Hublin paleoantropologoa, Marokoko Jebel Irhoud aztarnategian.

Fosilen azterketatik abiatuta, ikertzaileek diote aurpegiak, barailak eta hortzek lotura dutela gizaki modernoekin, baina garunaren morfologia, berriz, primitiboagoa omen dela. Horren arabera diote gure espezieko lehen ordezkaritzat jo daitezkeela Marokon aurkitutako arrastoak.

Afrikako teknologiaNaturek argitaratutako beste artikulu batean, Londresko Historia Naturalaren Museoan ikertzen duten Chris Stringer eta Julia Galway-Witham antropologoek aurkikuntzaren egileek diotena babestu dute. Analisi morfologikoaz gain, genetikaren argudioa mahai gainean jarri dute ere: “orain arte egin diren bizidunen eta fosilen DNA azterketen arabera, gure leinua gertueneko ahaideengandik -Eurasiako neandertalak era Denisovako gizakiak alegia- duela 500.000 urte baino lehenago aldendu zen. Data hori, ezagutzen den lehen Homo sapiens baino askoz zaharragoa da”. Funtsean, beste paleoantropologo askok pentsatzen duten modu berean, erregistro fosilean galdutako fosil horiek agertu behar direla argudiatzen dute. Gizaki modernoen eboluzioari dagokionez, Atapuercako (Burgos) Hezurren Osina neandertalen eboluzioa zehazteko izan duen garrantziarekin alderatu dute Marokoko aztarnategia.

Hala ere, eta analisi genetikotan oinarrituta, beste zientzialari askok uste dute gaur egungo giza espeziaren aniztasuna duela 200.000 urte inguru hasi zela, eta, hortaz, bat datorrela orain arte gizaki modernoaren abiapuntutzat jotzen den hasierako datarekin.

Ohi bezala, eta ikerketa berriak heldu bitartean, hedabideetan zalantzak agertu dituzte paleoantropologiari zein genetikari lotutako hainbat adituk. Finean, aztarna bat espezie batekin edo bestearekin lotzeak interpretazio anitzerako bidea ematen duelako, eta gizakiaren historia ebolutiboa zehaztea buruhauste galanta izan ohi delako zientzialarientzat. Halere, sapiens izan ala ez, argi dirudien bakarra da zuhaitzen babespetik atera eta mundu berrietara egokitzeko gai izan ziren hominidoek abentura epikoa abiatu zutela, eta, gaur egun, Marteko hautsetan oinatzak marrazteko bidean daudela.

Erreferentzia bibliografikoak:

Hublin et al. New fossils from Jebel Irhoud, Morocco, and the pan-African origin of Homo sapiens. Nature 546, 289–292. DOI: 10.1038/nature22336

Richter et al. The age of the hominin fossils from Jebel Irhoud, Morocco, and the origins of the Middle Stone Age. Nature 546, 293–296. DOI: 10.1038/nature22335

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Gizaki modernoen sorlekua eta abiapuntua dantzan appeared first on Zientzia Kaiera.

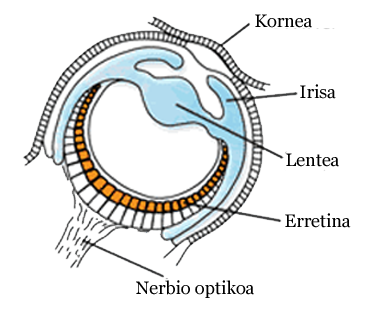

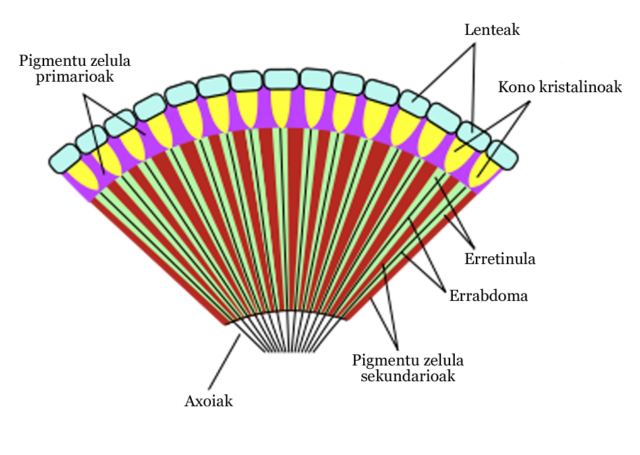

Evolución de los sistemas nerviosos: anélidos y artrópodos

Muchos invertebrados segmentados tienen sistemas nerviosos centrales “distribuidos”: están formados por los ganglios de cada segmento corporal. Cada ganglio se ocupa del control del segmento en el que se encuentra y además, quizás, de parte de los adyacentes. Los ganglios intercambian información a través de dos haces o troncos de axones, denominados conectivos. Esa disposición da lugar a un cordón nervioso ventral característico de anélidos y artrópodos. En el extremo anterior una o varias grandes agrupaciones de cuerpos celulares neuronales dan lugar a la formación de un cerebro. Ese cerebro recibe información de los sistemas sensoriales localizados en la cabeza y controla sus movimientos, pero los axones de varios somas neuronales del cerebro se extienden a lo largo del cordón ventral y ejercen un cierto control sobre sus ganglios; así coordina el cerebro los movimientos del conjunto del organismo.

Los anélidos fueron el primer gran grupo zoológico con un sistema nervioso central condensado de un modo significativo. En algunas especies los ganglios están fusionados. Merece la pena citar una curiosa excepción a la disposición general del sistema nervioso central en este grupo: las sanguijuelas tienen, además del cerebro anterior, un cerebro caudal, en el extremo posterior, que es de mayor tamaño que el anterior. En lo que se refiere al sistema nervioso periférico, muchos anélidos cuentan con un sistema somatogástrico muy desarrollado y en los gusanos de tierra hay además una extensa red subepidérmica de nervios finos.

Las formas de comportamiento mejor estudiadas en anélidos son las siguientes: (1) Las respuestas de huida, que son patrones de acción fijados en los que participan interneuronas y motoneuronas del sistema nervioso central con axones gigantes. (2) La regulación del latido cardiaco en los corazones tubulares de sanguijuelas, que constituyen un ejemplo de control nervioso de comportamiento rítmico. En éste participan motoneuronas del sistema periférico cuya actividad puede ser influenciada por inputs sensoriales directos o por interneuronas del sistema central que permiten ajustar el latido a las necesidades del animal. (3) Movimientos locomotores, que están bajo el control de una red del sistema central que recibe señales de receptores sensoriales periféricos (nociceptores, barorreceptores y receptores táctiles).

Los sistemas nerviosos de los artrópodos se asemejan a los de los anélidos. En las formas más primitivas consisten en una cadena de ganglios ventrales unidos por conexiones horizontales. En muchas especies, los ganglios de la cabeza y los del segmento abdominal terminal se forman por fusión de los ganglios de varios segmentos. Los artrópodos más evolucionados, como cangrejos y algunos insectos, presentan una única masa ganglionar torácica, además de la de la cabeza. Se trata de un sistema nervioso muy complejo, con numerosas neuronas y, por lo tanto, muchas conexiones sinápticas. Por ello, es capaz de desarrollar una gran variedad de comportamientos de gran complejidad.

Muchos movimientos de ajuste de la posición corporal y del movimiento de las extremidades están controlados por señales sensoriales que son sometidas a una integración considerable por parte del sistema central, aunque también hay circuitos de ámbito local.

En artrópodos hay comportamientos rítmicos motores y digestivos. Las actividades rítmicas correspondientes a la locomoción, la natación y el vuelo dependen de Generadores Centrales de Modelos formados por redes de neuronas del sistema nervioso central. En estos casos, la retroalimentación sensorial juega un papel importante. En las respuestas rítmicas de huida, como los rápidos movimientos abdominales de los cangrejos de río, participan dos neuronas gigantes motoras cuyos axones recorren toda la longitud del cuerpo y que establecen conexión sináptica mutua en el cerebro, además de otros tres pares de interneuronas con axones gigantes. El vuelo de las langostas es otra forma de comportamiento rítmico que está controlado por un Generador Central de Modelos. Se trata de un comportamiento controlado por el sistema nervioso central y dependiente de inputs sensoriales.

El sistema somatogástrico controla las actividades rítmicas implicadas en el procesamiento del alimento en el sistema digestivo. Estas actividades están reguladas por conjuntos de interneuronas y motoneuronas del ganglio somatogástrico. Su funcionamiento garantiza la correcta secuenciación de los movimientos implicados en la conducción y tratamiento mecánico del alimento.

Además de los rítmicos, los artrópodos tienen comportamientos que no lo son. Los movimientos de huida de las cucarachas constituyen el comportamiento no-rítmico mejor conocido en este filo. En él participan pares de neuronas con axones gigantes, cuyos cuerpos celulares radican en los últimos ganglios abdominales, pero cuyos axones terminan probablemente en los ganglios subesofágicos en la cabeza. Además de estos, la presencia de axones gigantes que participan en movimientos de huida está muy extendida en otros grupos de artrópodos.

Otro ejemplo de comportamiento no-rítmico es el de los movimientos de amartillamiento y salto en langostas y saltamontes. En éstos participan inputs sensoriales de diferentes tipos (visuales, auditivos y táctiles) a través del sistema nervioso central, a la vez que propioceptores y receptores cuticulares del sistema periférico. La red nerviosa implicada, en la que se producen fenómenos de inhibición cruzada, da lugar a la contracción alternativa de músculos flexores y extensores a cargo de sus correspondientes motoneuronas.

En la mayor parte de los comportamientos anteriores participan tan solo unos pocos ganglios. Sin embargo, en los artrópodos se producen comportamientos muy elaborados y se ha demostrado capacidad de aprendizaje. Todos aquellos aspectos del comportamiento que requieran una valoración del inicio, mantenimiento y duración o selección, precisan del concurso de la principal masa nerviosa del cerebro, que suele estar dividido en dos partes, el ganglio subesofágico y el superesofágico. Aunque se desconoce el funcionamiento preciso de estos órganos, se ha comprobado que el superesofágico inhibe la actividad del subesofágico, quien, a su vez, ejerce un efecto excitatorio en muchos comportamientos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: anélidos y artrópodos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: cnidarios y gusanos no segmentados

- Evolución del tamaño animal

- Historia mínima de la complejidad animal

Carnot y los comienzos de la termodinámica (2)

La máquina ideal de Carnot, tan sencilla como es, explica algunos aspectos fundamentales del funcionamiento de máquinas y motores de todo tipo y permite formular un principio fundamental de la naturaleza.

Las chimeneas anchas de la derecha en realidad son torres de refrigeración. las chimeneas auténticas por las que salen los gases de la combustión del carbón de esta planta de generación eléctrica son las altas y delgadas.

Cualquier máquina que derive su energía mecánica del calor se debe enfriar para eliminar el “desperdicio” de calor a una temperatura más baja. Si hay alguna fricción u otra ineficiencia en la máquina, agregarán más calor residual y reducirá la eficiencia por debajo del límite teórico de la máquina ideal.

Sin embargo, a pesar de las ineficiencias de todas las máquinas reales, es importante saber que nada de la energía total se destruye. Lo que ocurre con la parte de la energía de entrada que llamamos residual es que no se puede emplear para hacer trabajo útil. Así, el calor residual no puede ser reciclado como energía de entrada para hacer funcionar la máquina para producir más trabajo útil y así aumentar la eficiencia del motor a base de reducir la cantidad de energía residual, porque el depósito de calor de entrada está a una temperatura más alta que el de salida, y el calor no fluye por sí mismo de frío a caliente.

La observación de Carnot, que parece tan obvia, esa de que el calor no fluye por sí solo de un cuerpo frío a uno caliente, y que la necesidad de acondicionadores de aire y refrigeradores ilustra tan bien, no es más, si se generaliza, que una forma de expresar un principio fundamental de la naturaleza: la segunda ley de la termodinámica. Esta ley es una de las más potentes que conocemos, dada su capacidad para explicar cosas: desde cómo y en qué sentido ocurren los fenómenos naturales a los límites fundamentales de la tecnología. Volveremos a ella repetidamente en esta serie.

Un ejemplo paradójico del resultado de Carnot

Si quemamos gasóil para calefacción en una caldera en el sótano de nuestro edificio, sabemos que parte del calor se pierde por la chimenea en forma de gases calientes y otra como calor perdido porque el propio quemador no puede estar aislado por completo. Con todo, los recientes avances en tecnología de calderas han dado como resultado calderas con una eficiencia nominal de hasta 0,86, o 86%.

Ahora bien, si preferimos radiadores eléctricos, nos encontramos con que es probable que la compañía de energía eléctrica todavía tenga que quemar petróleo, carbón o gas natural en una caldera, Y después conseguir que esa electricidad generada llegue a nuestra casa. Debido a que los metales se funden por encima de una cierta temperatura (por lo que la sustancia caliente no puede superar la temperatura de fusión de su contenedor) y debido a que el agua de refrigeración nunca puede bajar por debajo del punto de congelación (porque entonces sería sólida y no fluiría, lo que pone un límite inferior de temperatura a nuestra sustancia fría), el hallazgo de Carnot hace imposible que la eficiencia de la generación eléctrica supere el 60%. Dado que la caldera de la compañía de energía también pierde parte de su energía por la chimenea, y dado que existen pérdidas de electricidad en el camino desde la planta que la genera, sólo alrededor de un cuarto a un tercio de la energía que había originalmente en el combustible llega realmente a tu casa. Una eficiencia, en el mejor de los casos, del 33 %. Paradójicamente, la calefacción eléctrica es mucho menos sostenible que una caldera de gasóil si las plantas que generan energía emplean combustibles fósiles.

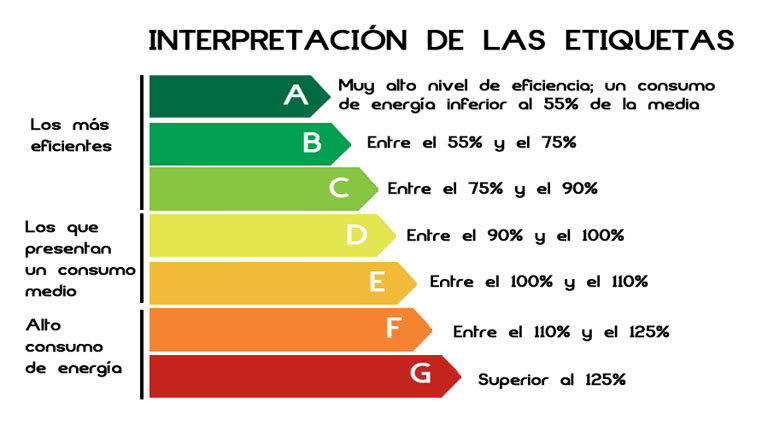

Debido a los límites encontrados por Carnot para las máquinas térmicas, a veces es importante no sólo dar la eficiencia real de una máquina térmica, sino también especificar lo cerca que está del máximo posible. Los aparatos de calefacción domésticos y muchos aparatos eléctricos de gran potencia, como frigoríficos y acondicionadores de aire, vienen ahora con una etiqueta que indica la eficiencia relativa del aparato y el potencial de ahorro anual en coste de electricidad.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Carnot y los comienzos de la termodinámica (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Carnot y los comienzos de la termodinámica (1)

- Potencia y eficiencia de una máquina

- La máquina de vapor (1)

Jo eta ke minbiziaren aurka

Osatzeko ez ezik, gaixotasunak saihesteko ere jotzen dute zenbaitek horrelako baliabideetara. Dieta batzuk, tumoreak ekiditen dituztelakoan iragartzen dira ageri-agerian.

Azkenean, oso lotsagabeak eta gaiztoak dira batzuk, aldarrikatzen baitute gaixoak beraiek baitira beren gaixotasunaren eragile: ozen esaten dute arazo psikologikoren bat dutela gaixoek, eta ez direla behar bezala bizi.

Irudia: Minbizia gaixotasun hedatuenetariko bat da herrialde garatuetan. Denboraren poderioz, gure gorputzeko zelulak zahartuz joaten dira eta, halako batean, akatsen batengatik edo zahartu direlako, gaixotasunak ager daitezke. Beraz, minbizia, nolabait esan, norberaren zelulak gaiztotzea da.

Gero eta ugariagoak dira “minbiziaren aurkako” dietak. Dieta alkalinoa da ezagunenetakoa. Adibide gisa erabiliko dut hemen dieta hau, agerian utzi nahi dudalako jokabide hauen guztien zentzugabekeria. Gauza ondo ulertzeko, kontuan hartu behar da minbizi-zelulen ingurunea azidoa izaten dela, eta dieta hau bultzatu nahi dutenek aldarrikatzen dutela azidotasun hori dela minbiziaren eragile. Horrela ba, pentsatzen dute ezabatu egin behar dela azidotasun hori, dieta alkalino bat hartuta.

Izan ere, zelula osasuntsuek baino glukosa gehiago erabiltzen dute minbizi-zelulek, energia lortzeko. Glukolisi izeneko metabolismo-bidezidor bat erabiltzen dute horretarako. Berez, zelula hauetan ez dira gertatzen beste animali ehun batzuetan oxigenoaz baliatuta gauzatzen diren prozesuak, eta produktu azidoak ematen dituzte glukolisiaren ondorio modura; horretxegatik da azidoa zelula hauen ingurunea. Antzera gertatzen da gure muskuluetako zeluletan, ahalegin fisiko handia egiten dugunean: baldintzapen horietan ere glukosak hainbat aldaketa pairatzen ditu, eta azkenean azido laktiko bihurtzen da.

“Warburg efektua” deritzo minbizi-zelulek lehentasunez glukosa erabiltzeari, Otto Warburgek deskribatu zuelako prozesua 1924.ean. Berak proposatu zuen azidotasunaren ondorio izan litekeela minbizia, baina ikusia dugu ordea alderantziz gertatzen dela eta minbizia dela azidotasuna eragiten duena. Edonola ere, argi esan behar da ingurunearen azidotasun maila ezin dela dietaren bidez aldatu. Fisiologikoki zorrotz erregulatua dagoelarik, dietak ez dio inola ere eragiten azidotasun mailari.

Egia da izugarri kostatzen zaiola jendeari minbizia duela onartzea, eta are gehiago kostatzen zaio kimioterapia bezalako tratamendu agresiboak eman behar direnean. Hori dela eta, ez da hain bitxia gaixoak terapia alternatiboetara jotzea, baldin eta ohiko medikuntzak ezarriko badio tratamendu gogorra, albo efektu oso ezatseginekoa eta zenbaitetan jarduteko ezintasuna. Gainera, gaixoen sufrimenduez baliatuz, batzuek tratamendu leunak eskaintzen dituzte, ohiko bide onkologikoetatik kanpo. Argi esan behar da ordea gure osasun-sistemako medikuak direla terapia eraginkorrena agintzeko gai diren bakarrak. Bidea gogorra denean, ulergarria da bide errazetara jotzeko gogoa, baina minbiziaren aurka bide errazik ez dago.

Adenda:Testu hau Deia aldizkariaren Con ciencia atalean argitaratu zen urtarrilaren 29an. Aurkako kritikak gertatu ziren, argudiatu izan zutelako Jobsen pankrea-minbizia ohikoa baino arinagoa zela eta horretxegatik onartu behar zitzaiola bide alternatiboak hartu izana. Hau idazten ari dena ez da ez onkologoa, ez eta medikua ere. Horrela ba, ingelesetik itzuliko dut Wikipediak dioskuna, norberak bere ondorioak har ditzan:

“2003ko urrian, minbizia antzeman zitzaion Jobsi. 2004.aren erdialdean, bere langileei esan zien minbizi-tumorea zuela pankrean. Oro har, oso pronostiko txarra izaten dute tankera honetako minbiziek, baina Jobsek argitu zuen berak tumore bitxia zuela, arinagoa, pankreako uhartexketako karzinoma modura ezagutzen dena.

Jobsek ez zien jaramonik egin medikuei bederatzi hilabetean zehar eta ez zuen ebakuntza onartu nahi izan. Horren ordez, gezurrezko mediku-dieta batez fidatu zen, eta gaixotasunaren aurkako tratamendu natural bat hartu zuen. Harvard ikerlari den Ranzi Amrik uste du alferrik laburtu ziola bizitza tratamendu horrek. Minbizia ikertzen duen David Gorski ere, medikuntza alternatiboaren aurkakoa da baina berak pentsatzen du bakar-bakarrik apur bat laburtu zitzaiola bizitza. Barri R.Cassileth, bestalde, buru da Memorial Sloan Kettering Cancer Center izenekoaren Medikuntza Integratiboaren Sailean eta bere ustez, Jobsi bizitza kendu zion medikuntza alternatiboan zuen sinesmenak. Funtsean, bere buruaz beste egin zuen. Jobsen biografo den Walter Isaacsonen hitzetan “bederatzi hilabetean zehar uko egin zion pankrea-minbiziaren aurkako kirurgiari, eta gero damutu egin zen bere erabaki horretaz, bere osasunak txarrera egin zuenean. Kirurgiaren ordez, dieta beganoa hartu zuen, eta akupuntura eta belar batzuk erabili zituen, Interneten aurkituta. Igarle bati ere galde egin zion. Berak fede handia izan zuen klinika baten zuzendari zen batengan, eta hor enemak eta ganorarik gabeko zenbait kontu erabiltzen zituzten. Azkenean, 2004.ean egin zioten ebakuntza tumorea kentzeko. Jobsek ez zuen hartu ez erradioterapiarik, ez kimioterapiarik”.

———————————————————————————-

Egileaz: Juan Ignacio Pérez Iglesias (@Uhandrea) UPV/EHUko Fisiologiako katedraduna da eta Kultura Zientifikoko Katedraren arduraduna.

———————————————————————————

The post Jo eta ke minbiziaren aurka appeared first on Zientzia Kaiera.

Dudas sobre las vacunas: problemas y soluciones

Ignacio López Goñi

Cada vez hay más padres que dudan de los beneficios de la vacunación. ¿Debería ser obligatoria? Los profesionales de la salud son la mejor herramienta contra los anti-vacunas.

Los programas de vacunación han contribuido a que el número de casos y de muertes por enfermedades infecciosas hayan disminuido de forma significativa en el último siglo. Las vacunas han salvado millones de vidas humas, son responsables de la erradicación de la viruela del planeta y de que la polio esté apunto de serlo. En general, las coberturas vacunales o tasas de vacunación infantil siguen creciendo a nivel mundial, lo que indica que la vacunación es una medida de salud pública ampliamente aceptada.

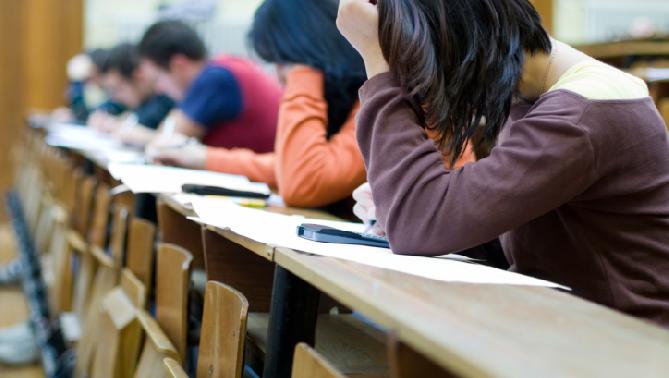

Sin embargo, un número cada vez más creciente de padres (*) perciben la vacunación como algo insano e innecesario. Como las vacunas se administran cuando el niño está sano, nuestro umbral del riesgo es muy bajo. Cualquier duda, aunque sea teórica, sobre la seguridad de las vacunas puede causar que los padres rechacen o retrasen la vacunación de sus hijos. Incluso algunos padres que vacunan a sus hijos suelen tener dudas y temores acerca de la vacunación. Los movimientos anti-vacunas han sido responsables de la disminución de las tasas de aceptación de las vacunas y del aumento de brotes de enfermedades infecciosas que se pueden prevenir con las vacunas. Entre los extremos de los movimientos anti-vacunas que rechazan totalmente la inmunización y los entusiastas pro-vacunas, cada vez hay más padres que dudan: padres que rechazan alguna de las vacunas pero que aceptan otras, que retrasan la vacunación de su hijo porque dudan del calendario vacunal recomendado, o que se sienten inseguros cuando vacunan a sus hijos.

En África entierran a los niños, en Europa enterramos a los ancianos

Por supuesto, la situación es diferente según el contexto y el país. En los países de altos ingresos donde los programas de vacunación están bien establecidos y en gran parte son gratuitos, las vacunas son víctimas de su propio éxito. Como gracias a las vacunas han disminuido radicalmente la frecuencia de enfermedades infecciosas, los padres no perciben el riesgo de esas enfermedades y no ven la necesidad de las vacunas: “¿para que voy a vacunar a mi hijo si ya no hay varicela?”. Se tiene más miedo a la vacuna que a la propia enfermedad. Sin embargo, en los países con ingresos medios o bajos, donde este tipo de enfermedades son todavía más frecuentes, la duda de la inmunización es menor. En países donde la mortalidad infantil es todavía muy alta debido a las enfermedades infecciosas, todavía da más miedo la enfermedad que la vacuna.

Anti-vacunas: desde Jenner hasta Twitter

Los movimientos anti-vacunas no son algo nuevo. Nada más empezar Edward Jenner, a principios de 1800, sus demostraciones de que la viruela de las vacas protegía contra la viruela humana, y a pesar de que más del 30% de los casos de viruela eran mortales, comenzaron las campañas contra la vacuna. Son famosos los dibujos satíricos publicados en 1802 en los que se ridiculizaba la vacunación de Jenner y se mostraban los bulos de sus opositores: que al vacunarte con la viruela de las vacas te salían por el cuerpo apéndices de vaca.

Caricatura publicada en 1802 en “The Punch” por James Gillray de una escena de la inoculación de la vacuna de Jenner en el Hospital de St. Pancras (Londres).

Durante el siglo XIX, en el Reino Unido primero, luego en el resto de Europa y en EE.UU. después, se crearon las primeras Ligas Anti-Vacunación y hubo varias campañas anti-vacunas que lucharon activamente contra las leyes que obligaban a la vacunación y en defensa de la libertad personal. Sin embargo, ya en pleno siglo XX, llegó la edad de oro de las vacunas en las décadas de los 50 y 60, durante las cuáles la aceptación de la inmunización fue máxima. En esos años se introdujeron las vacunas contra la poliomielitis, el sarampión, las paperas y la rubéola, con gran aceptación al comprobar cómo los casos de enfermedades y muertes se reducían de forma espectacular. En los años 70 se comenzó un gran esfuerzo internacional para expandir los programas de vacunación también a los países de bajos ingresos, con el objetivo de acabar con seis grandes asesinos: polio, difteria, tuberculosis, tosferina, sarampión y tétanos. Entonces menos del 5% de la población mundial infantil menor de un año estaba inmunizada contra estos patógenos. En los años 90 cerca del 75% de la población mundial infantil estaba vacunada contra la polio difteria, tétanos y tosferina. Sin embargo, ese periodo de aceptación entusiasta de las vacunas duraría poco tiempo.

A mediados de los 70 los movimientos anti-vacunas resurgieron con fuerza. La controversia comenzó en el Reino Unido con la vacuna contra la tosferina (pertussis en inglés, por estar causada por la bacteria Bordetella pertussis), al publicarse un trabajo que relacionada serios trastornos neurológicos en 36 niños después de haber sido vacunados con la tripe difteria-tétano-pertusis (vacuna DTP). Este trabajo tuvo una gran repercusión mediática e hizo que la cobertura vacunal en el Reino Unido bajara del 77 al 33%, con el consiguiente aumento de los casos de tosferina, algunos de ellos mortales. En EE.UU. la controversia comenzó en 1982 con la emisión de un emotivo documental periodístico “DTP: vaccination roulette” que acusaba al componente pertusis de la DTP de causar daños cerebrales severos y retraso mental. A raíz de tal escándalo se crearon grupos de presión anti-vacunas, se investigaron las empresas fabricantes de vacunas, aumentaron los precios y se redujeron las tasas de vacunación. A pesar de los estudios que se hicieron posteriormente que demostraban que no había relación alguna entre la vacuna DTP y los trastornos neurológicos, la preocupación sobre su seguridad fue un estimulo para el desarrollo de una nueva vacuna de pertusis acelular, menos reactiva y, por lo que se está viendo con el tiempo, con un menor poder protector contra la enfermedad. Quizá lo único bueno de todo aquello fue la creación del Vaccine Adverse Event Report System (VAERS), un programa nacional del CDC y la FDA para recoger, evaluar y publicar de forma transparente todo tipo de información sobre los efectos adversos que puedan ocurrir por la administración de las vacunas en EE.UU.

Unos 25 años después de la controversia sobre la vacuna DTP, el Reino Unido volvió a ser el origen de una de las mayores crisis sobre las vacunas, en esta ocasión relacionando la vacuna tripe vírica sarampión/rubeola/paperas (SRP) con el autismo. La revista The Lancet publicó en 1998 un artículo firmado por Andrew Wakefield y otros doce colegas en el que se sugería una posible asociación entre la vacuna y el autismo. Aunque en el artículo no se probaba una relación causal, las afirmaciones posteriores de Wakefield no dejaban lugar a duda de su opinión y pidió la retirada de la vacuna hasta que se hicieran más estudios. Años después se demostró que los datos de la publicación habían sido sesgados, y que Wakefiled recibió dinero para publicar estos datos contra las empresas farmacéuticas. En 2004, 10 de los 12 coautores del trabajo se retractaron de la publicación. En 2010 el Consejo General Médico inglés expulsó a Wakefield y le prohibió ejercer la medicina en el Reino Unido, y The Lancet tomó la decisión de retirar y retractarse de lo publicado en 1998. Pero habían pasado ya doce largos años. Se han evaluado y revisado más de 20.000 artículos relacionados con esta vacuna y más de 14 millones de casos de niños vacunados y no hay ningún indicio de que la vacuna SRP tenga alguna relación con el autismo infantil. A pesar de ello, la relación de las vacunas con el autismo sigue siendo una de las principales preocupaciones de muchos padres que dudan.

Como hemos comentado, en general las vacunas son mucho mejor recibidas en los países de bajos ingresos. Sin embargo, en los últimos años ha habido también algunas controversias que han hecho disminuir las coberturas vacunales y han supuesto un serio problema para las campañas mundiales de inmunización. En 1990 en Camerún se extendieron rumores de que el objetivo de las campañas de vacunación era la esterilización de las mujeres y en 2003 se boicoteó la vacuna de la polio en el norte de Nigeria también con rumores de que la vacuna era una estrategia para extender el VIH y reducir la fertilidad entre los musulmanes. A consecuencia de estos rumores, la polio resurgió en Nigeria y se extendió en 15 países africanos que ya habían sido declarados libres de la enfermedad.

Desde el año 2000, Internet ha supuesto un cambio de paradigma en la relación médico/paciente. Internet ha acelerado la velocidad de la información y ha roto barreras: la web proporciona información gratis, inmediata y disponible todo el tiempo y anónima. Internet es una oportunidad sin precedentes para los activistas anti-vacunas, para difundir su mensaje a una audiencia cada vez más amplia y reclutar nuevos miembros. Las personas que son contrarias a las vacunas, aunque sean minoría, generan una cantidad desproporcionada de contenidos anti-vacunas.

Cada mes son miles los contenidos que se vierten al ciberespacio sobre la vacunación, la inmensa mayoría subjetivos y de contenido emocional. Internet es una de las principales fuentes de información que emplean los padres para consultas sobre el tema de la vacunación. Desgraciadamente si se examinan los contenidos relacionados con la vacunación en la web o en las redes sociales sobresale la información inexacta e incorrecta. Esto hace que muchos padres pasen de dudar de las vacunas a ser resistentes a la vacunación o incluso claramente opuestos. Muy probablemente ver una web anti-vacunas aumenta los sentimientos negativos contra la inmunización, mientras que las webs pro-vacunas suelen tener un efecto mínimo.

En España no existen movimientos anti-vacunas como en EE.UU. pero el número de padres que dudan aumenta

En España no existen movimientos anti-vacunas bien organizados y beligerantes como los que hay en EE.UU. o en el Reino Unido, pero el número de padres que ponen en duda la efectividad y seguridad de las vacunas aumenta. Además, cada vez tienen más relevancia pública algunos claros anti-vacunas como Josep Pamiés o la monja Forcades, incluso sorprendentemente con la colaboración de grandes medios de comunicación y poderes públicos. También, en los últimos años se han publicado varios libros que claramente ponen en tela de juicio el valor de las vacunas: Vacunas, una reflexión crítica (Enric Costa), Los peligros de las vacunas (Xavier Uriarte), Vacunaciones sistemáticas en cuestión, ¿son realmente necesarias? (Manuel Marín Olmos), o Vacunas las justas (Miguel Jara).

La duda sobre las vacunas es ya un problema de salud pública

Los padres que mantiene una posición claramente anti-vacunas son una minoría, pero la proporción de los que dudan va en aumento. Esto es preocupante porque para el éxito de las campañas de vacunación se debe mantener una cobertura vacunal alta. Se debe conseguir que lo normal sea que un padre vacune a su hijo según el calendario que le corresponde. La vacunación es una medida individual pero que beneficia a la comunidad. A diferencia de otras intervenciones preventivas, si un padre rechaza las vacunas de su hijo no solo pone en riesgo la vida de su hijo sino también de los que le rodean, de los más débiles, otros niños, los enfermos y los ancianos. Luchar contra la oposición o la duda de las vacunas es un problema comunitario.

¿Qué impacto clínico tiene el fenómeno de los anti-vacunas? Quizá el de mayor actualidad sea el aumento de los casos de sarampión, una de las enfermedades infecciosas más contagiosas (ver El sarampión aumente en Europa, en microBIO). Las autoridades sanitarias han alertado que desde febrero de 2016 han aumentado los casos de sarampión en Europa, la mayoría en niños pequeños sin vacunar. La situación en este momento es que de los 53 países de toda la región europea solo han conseguido erradicar la enfermedad 15 países, y en 6 todavía sigue habiendo transmisión endémica. Desde enero de 2017 ya ha habido incluso algunos casos de muertes en Rumanía, Italia y Portugal. La ECDC alerta de que la probabilidad de que se extienda el sarampión a otros países es alta. Casos similares también han ocurrido en el continente americano, libre de sarampión desde el año 2002. En EE.UU. hubo tres grandes brotes en 2013 y lo mismo ocurrió en Canadá. De forma similar en los últimos años ha habido brotes de rubéola, paperas y pertusis en Polonia, Suecia, Holanda, Rumania, Bosnia EE.UU., etc. por la misma causa: personas que no habían sido vacunadas. En 2010, la OMS estimó el número de muertos por enfermedades infecciosas prevenibles por las vacunas (difteria, sarampión, tétanos, pertusis y polio) en unas 400.000. Estas muertes se podrían haber evitado con las vacunas. Es cierto, que más de la mitad ocurren en países donde los problemas de infraestructuras son responsables de la falta de vacunación, pero en otros casos es el rechazo a las vacunas la causa.

Entender las causas y el contexto del que duda

Los grupos anti-vacunas de hoy en día son en su mayoría gente de clase media (o media-alta) con estudios superiores que reclaman su derecho a una decisión informada acerca de las vacunas, prefieren soluciones “naturales”, no les gusta que les califiquen como anti-vacunas (el término “anti” es negativo) y prefieren términos neutros, como grupo pro vacunas seguras. Pero algunos de sus argumentos son los mismos que en 1800: las vacunas no son efectivas; causan enfermedades; son un negocio y se fabrican sólo para beneficio de las farmacéuticas; las vacunas contienen aditivos tóxicos peligrosos para la salud; los daños de las vacunas son ocultados por las autoridades (teorías conspiratorias); la vacunación obligatoria es contraria a la libertad y a los derechos civiles; la inmunidad natural es mucho mejor que la que inducen las vacunas; las vacunas son muchas y se dan demasiado pronto; los productos naturales y alternativos (vida “sana”, homeopatía, vitaminas) son mejores que las vacunas para prevenir las enfermedades; etc. En muchos casos se presentan datos incorrectos, hechos sacados de contexto, ambiguos o medias verdades. En muchas ocasiones apelan a las emociones y presentan historias muy duras del legitimo sufrimiento de padres que creen seriamente que sus hijos han padecidos enfermedades graves por culpa de las vacunas.

El contexto a veces no ayuda. En los últimos años ha aumentado el número de nuevas vacunas, lo que ha complicado los calendarios vacunales. El que no exista un mismo calendario vacunal en distintos países o, lo que es peor, en distintas comunidades autónomas de un mismo país genera percepciones negativas. La falta de transparencia de algunos gobiernos y empresas farmacéuticas y los errores en la forma de afrontar e informar sobre crisis sanitarias también provoca desconfianza y susceptibilidades: la crisis de las vacas locas, la pandemia de gripe aviar o el último brote de Ébola, por ejemplo. Hoy en día los pacientes quieren estar involucrados y participar en sus propias decisiones de salud.

¿Debería ser obligatoria la vacunación?

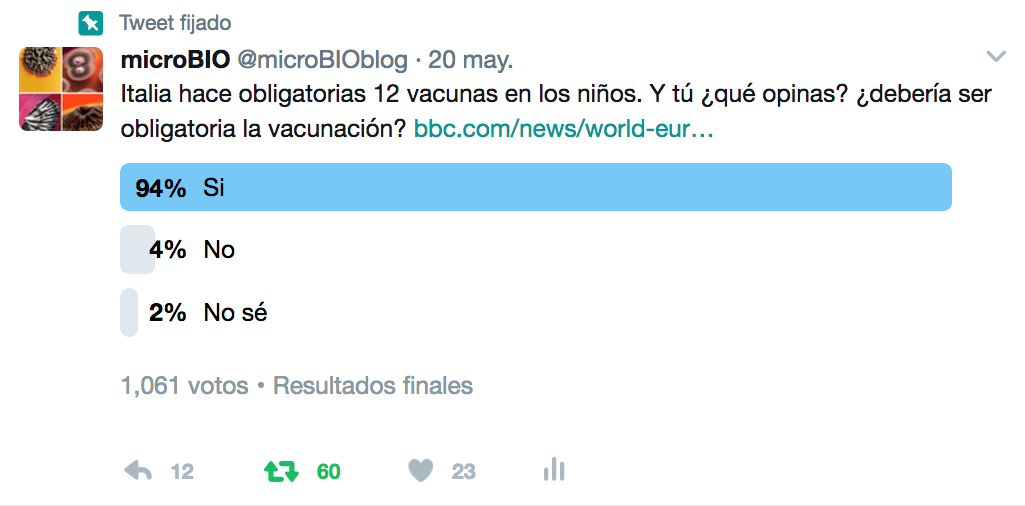

Esta es la pregunta que hace unos días lance desde mi cuenta de Twitter, y el 94% de las respuestas fue afirmativa. Es verdad que el resultado está sesgado y no es significativo: la mayoría de los seguidores de esa cuenta de Twitter son claramente pro-vacunas, pero algunos comentarios fueron muy sugerentes: “si la vacuna de la rabia es obligatoria para los perros, ¿por qué vacunar a los niños no lo es?”, “si llevar cinturón de seguridad en el coche es obligatorio, ¿por qué no las vacunas?”, “si fumar está prohibido en muchos lugares porque es malo para la salud, ¿por qué las vacunas no son obligatorias si son buenas para la salud?”, “si una persona no vacunada puede poner en riesgo la salud de mi hijo, ¿por qué no obligan a vacunarse en las guarderías?”

Resultado de la encuesta “¿Debería ser obligatoria la vacunación?” en Twitter.

Los recientes brotes de sarampión y de otras enfermedades evitables por las vacunas han hecho que algunos países cambien su legislación. En Italia ya es obligatoria la vacunación contra doce enfermedades infecciosas para poder matricular a tu hijo en el colegio. En Portugal no son obligatorias, pero sí gratuitas y están preparando una ley para exigir la vacunación. En Alemana, no son obligatorias, pero preparan también una ley para poder multar si no vacunas a tus hijos. En Francia son obligatorias las del tétanos, difteria y polio, y en Bélgica solo la de la polio. ¿Y en España? La vacunación es voluntaria, nuestro ordenamiento no incorpora explícitamente el deber de vacunación y nadie puede, en principio, ser obligado a vacunarse. Ahora bien, hay determinadas situaciones que permiten que los poderes públicos competentes impongan la vacunación forzosa, en caso de brotes o epidemias y de peligro para la salud pública. ¿Debería cambiarse la ley y que la vacunación fuera obligatoria?

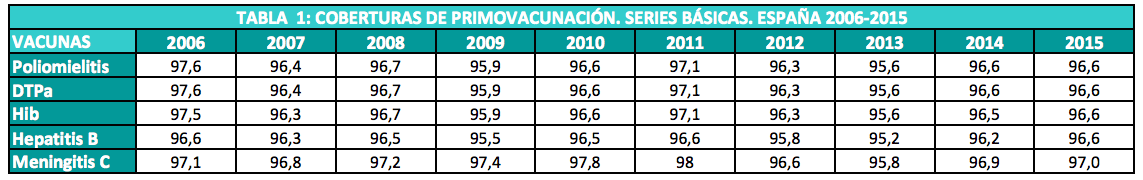

Para controlar e incluso llegar a erradicar una enfermedad infecciosa, la OMS recomienda que la cobertura vacunal para esa enfermedad sea de al menos el 95%. Según datos oficiales, las tasas de vacunación en nuestro país en los últimos años son elevadas, superiores al 95%.

Coberturas vacunales en España desde 2006 hasta el 2015. Para más información consultar la web del MSSSI.

En España, a pesar de la no obligatoriedad, la tasa de vacunación es incluso superior a la de países en los que la vacunación es obligatoria. Por ello, el debate planteado podría ser útil si hubiera un descenso de las tasas de vacunación que pusieran en compromiso la protección del efecto rebaño y afectara a la salud pública. Adelantar cambios normativos que impusieran de forma coercitiva la vacunación, podría generar un efecto contrario al pretendido. Obligar quizá, de momento, no sea la solución.

¿Qué podemos hacer?

Para responder a los movimientos anti-vacunas o convencer a los que dudan, algunas estrategias se han basado en campañas de educación (folletos “oficiales” o similar) con información sobre la efectividad y seguridad de las vacunas. Si embargo, aunque necesaria, no parece que ésta sea la forma más efectiva. Educar a la gente tiene poco efecto o impacto en cambiar la actitud anti-vacunas. La información y educación no suelen cambiar por si solas las percepciones. Todos tenemos la tendencia de recibir mejor la información que confirma lo que pensamos y solemos rechazar lo que contradice nuestras creencias. Para muchas personas lo que convence no son los hechos, sino la credibilidad o autoridad de quién lo dice. En este sentido, la pieza fundamental para conseguir la aceptación y confianza pública de las vacunas son los profesionales de la salud (de la medicina y la enfermería). La gente cree y confía más en su médico o enfermera de lo que nos imaginamos. Muchas gente dice que la primera razón para vacunar a su hijo es la recomendación del profesional de la salud en la consulta de pediatria. Promover una buena relación con el paciente es fundamental.

Se han publicado algunas recomendaciones para estos profesiones de la salud, pero que nos pueden ayudar a todos cuando nos enfrentamos a una persona que duda: ¿cómo convencer a unos padres de que no vacunar supone un riesgo mayor?

1. Recuerda por qué nos vacunamos. Hay que explicar cómo las vacunas nos protegen de las infecciones y nos ayudan mantener la salud; reforzar la idea de que la vacunación es una norma social, porque la gente hace lo que cree que todo el mundo debe hacer. Da por hecho que va a vacunar a su hijo, ni si quiera ponlo en duda. Felicítale por vacunarlo (y concreta la fecha para la siguiente cita).

2. No intentes asustar a la gente con mensajes catastrofistas, ya que te puede salir el tiro por la culata. Explica cómo se controla de forma rigurosa la seguridad de las vacunas, algo que no se suele contar a la gente. Las vacunas son uno de los agentes farmacéuticos mejor estudiados y más seguros del mercado. Es frecuente confundir correlación con causalidad: que dos cosas ocurran al mismo tiempo no quiere decir que una sea la causa de la otra. Que el autismo se manifieste los primeros años de vida al mismo tiempo que el calendario vacunal, no demuestra que las vacunas sean la causa del autismo. Pero el sufrimiento de unos padres con un niño autista, … es tremendo.

3. Ten empatía. Evita ser despectivo. Hazte cargo de sus preocupaciones. Si tiene dudas, escucha, deja que hable, deja que acabe de hablar, reconoce el derecho que tiene para dudar y hacerse esas preguntas, sé positivo, responde de forma simple, sencilla, que se te entienda (“Hay más formaldehido en una pieza de fruta que en todas las vacunas que recibe tu niño”). Dedícale tiempo, con respeto, paciencia y confianza. Recuerda aquello de “siempre positivo, nunca negativo”.

4. La verdad es la piedra angular de la aceptación de las vacunas. Explica claramente las posibles reacciones adversas que pueda haber, que no le coja por sorpresa las reacciones locales de la vacuna. Su hijo ha ido a vacunarse estando sano, sin fiebre y las reacciones locales pueden alarmar si no se han explicado antes. La fiebre, el malestar general, un pequeño sarpullido o enrojecimiento local no significan que la vacuna no funcione sino todo lo contrario. Es señal de que la vacuna está activando las defensas. Y explica las posibles reacciones adversas graves muy raras que puede haber (menos de un caso por millón de dosis administradas). Se honesto y claro. Ningún medicamento es 100% seguro y todos tienen efectos secundarios. Reconoce los riesgos, también hay riesgo en tomar un paracetamol, pero distingue claramente las reacciones locales de los casos graves y muy raros. Hay que dar la información a medida, según las dudas y las preocupaciones de los padres.

5. Cuenta tu historia, tu propia experiencia, como profesional de la salud o como padre que vacuna a sus hijos: aquel viejo amigo del colegio que tuvo polio, o por qué tus hijos no han tenido rubéola. Y cuéntalo como una historia de ciencia. Explica que no hay nada más natural que las vacunas que inducen una inmunidad natural, al estimular a tu propio sistema inmune a producir su propia protección. Los anticuerpos que te protegen los produce tu propio cuerpo. La gente que está en riesgo es la que no hace nada.

6. Utiliza las redes sociales. Involúcrate de forma proactiva con los medios de comunicación y en las redes sociales. Proporcionarles información, comentarios independientes, ayuda a los periodistas a entender los datos. Da información, respuestas, historias, videos. Internet puede ser una herramienta muy útil para luchar contra la duda. Los algoritmos que usa Google no ayudan. Google puede darte una información sesgada. Las palabras “clave” que te sugiere y los contendidos web que te ofrece puede estar condicionados por tus propias preferencias y consultas previas. Así, Google puede contribuir a crear, mantener o aumentar tus dudas o a creer que lo que opina una minoría es mucho más frecuente que lo que realmente es. Por ejemplo, los contendidos negativos tienden a proliferar más en internet. ¿Por qué una madre que ha vacunado a su hijo y todo ha ido fenomenal y están los dos sanos y felices va a escribir su experiencia en un blog o va a dejar un comentario en Internet? Por el contario, si ha habido el menor problema, esa madre compartirá sus dudas en fórums o redes sociales y su testimonio se extenderá cómo la pólvora, generando una percepción errónea del problema. Como ya hemos dicho, los contenidos relacionados con la vacunación en la web y redes sociales son principalmente inexactos e incorrectos. Por eso, uno de los “campos de batalla” se libra en internet. Difundir mensajes en blogs, redes sociales, YouTube, … está muy bien, pero es complicado. El reto no solo es que los padres tengan acceso a la información, sino que esta se entienda y sea inteligible para cualquiera. Usa un lenguaje coloquial, muestra empatía y escucha al público.

Conclusión: En España no hay grandes movimientos anti-vacunas pero sí un aumento de padres que dudan de la seguridad y eficacia de las vacunas. De momento, las coberturas vacunales son altas y no se compromete el efecto rebaño. Por ello, imponer de forma coercitiva la vacunación, podría tener un efecto contrario al pretendido. No obstante, es necesaria una vigilancia estrecha del fenómeno anti-vacunas y su efecto en la salud pública. Los profesionales de la salud son la principal fuente de información para los padres que dudan y la forma más efectiva de convencerles de lo peligroso que es no vacunar a sus hijos.

Referencias y más información:

Las vacunas funcionan. Ignacio López-Goñi y Oihana Iturbide. 2015. Phylicom ediciones, Valencia. Colección Pequeñas Guías de Salud. ISBN: 978-84-943440-0-8

Vaccine hesitancy, vaccine refusal and the anti-vaccine movement: influence, impact and implications. Dubé, E., y col. (2015). Expert Rev Vaccines. 14(1):99-117. doi: 10.1586/14760584.2015.964212.

Identifying and addressing vaccine hesitancy. Kestenbaum, L.A., y col. (2015). Pediatr Ann. 44(4):e71-5. doi: 10.3928/00904481-20150410-07.

Promoting vaccine confidence. Smith, M.J. (2015). Infect Dis Clin North Am. 29(4):759-69. doi: 10.1016/j.idc.2015.07.004.

Vaccine hesitancy: A vade mecum v1.0. Thomson, A., y col. (2016). Vaccine. 34(17):1989-92. doi: 10.1016/j.vaccine.2015.12.049.

The impact of the web and social networks on vaccination. New challenges and opportunities offered to fight against vaccine hesitancy. Stahl, J.P., y col. (2016). Med Mal Infect. 46(3):117-22. doi: 10.1016/j.medmal.2016.02.002.

Vaccine Adverse Event Reporting System (VAERS)

El sarampión aumenta en Europa

Coberturas de vacunación en España (MSSSI)

Nota:

(*) Cuando me refiero a “padres” e “hijos” empleo los términos en plural que según el Diccionario de Lengua Española de la Real Academia significan “padre y madre de una persona” y “descendientes”, respectivamente.

Sobre el autor: Ignacio López Goñi es catedrático de microbiología de la Universidad de Navarra y autor del blog microBio.

El artículo Dudas sobre las vacunas: problemas y soluciones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

- Vacunas: El arte de salvar vidas

- Sobre la predisposición genética a padecer enfermedades

Euskarazko denbora-informazioaren azterketa eta prozesamendua

Irudia: Euskaraz, aztertutako beste hizkuntzetan bezala, denbora-informazioa adierazteko hiru elementu nagusi daude: gertaerak, denbora-adierazpenak eta denborazko erlazio-eraikuntzak. (Argazkia: Gabriel Aresti euskaltegia)

Bada, hiru denbora-egitura motak osatzen du denbora-informazioa:

- Gertaerak, hau da, gertatzen diren ekintzak eta egoerak (adibidez, galdetzea, leherketa, haurdun egotea)

- Denborako une eta iraupenak adierazten dituzten denbora-adierazpenak (adib., atzo, bost minutu, arratsaldeko lauretan

- Horien artean sortzen diren erlazioak (adib., hiruretan, lan egin ondoren bazkaldu dugu). Hau da, denborazko erlazio-eraikuntzak.

Hizkuntzaren prozesamendurako azterketa linguistikoa egitean, elementu horien ezaugarriak erauzi eta era normalizatuan antolatu behar dira, bestela esan, testuko denborek kronologiako zer une zehatzi egiten dioten erreferentzia azaleratu behar da, ekintzen ezaugarri gramatikalak eta semantikoak sailkatu behar dira eta loturetan elementu parte-hartzaileen segida erabaki behar da. Erabaki horiek guztiak EusTimeML markaketa lengoaian eta etiketatze-gidalerroetan adierazi ditugu. Esaterako, “bost minutu” iraupena bost minutu adieraziko da.

Behin denbora-egiturak nola sailkatu eta normalizatu erabaki ostean, corpus etiketatuak sortu ditugu. Corpusetan albisteak eta historia testuak batu eta testuko denbora-egiturak eskuz markatu ditugu eta beren ezaugarriak gehitu dizkiegu. Horrela denbora-informazioa duen corpusa sortu dugu. Corpus hau etiketatzaileen trebakuntzarako, etiketatze-irizpideen ebaluaziorako, ikasketa automatikorako eta tresna automatikoen ebaluaziorako urre patroi gisa erabili da.

Aurretik azaldutako guztia baliatuta, denbora-informazioan gertaeren, denbora-adierazpenen eta erlazioen inguruan ari gara lanean. Denbora-adierazpenei dagokienez, erregela bidezko EusHeidelTime tresna garatu dugu. EusHeidelTimek testuko denbora-adierazpenak identifikatu eta balio normalizatuak ematen dizkie. Horretarako testuetan aurki daitezkeen denbora-adierazpenen egiturak aztertu ditugu eta egitura bakoitzarentzat erregela bat sortu. Ez dugu, ordea, adierazpen bakoitzarentzat erregela bat sortu, egituraren zatiak (urteak, hilabeteak, asteko egunak, etab.) multzokatu ditugu eta multzo horiek idatzi ditugu erregeletan.

EusHeidelTimeren erregelak eta hizkuntza baliabideak—egitura zerrendak eta bakoitzaren balio normalizatuak—sortu ostean, denbora-informazioa lantzeko sortutako corpusaren lagin bat automatikoki etiketatu dugu eta lagin hori eskuz etiketatuarekin konparatu dugu. Denbora-adierazpenen % 90 inguru antzemateko gai izan gara; aurrera egitera animatzen gaituen emaitza. Hala ere, denbora-adierazpenak ez dira denbora-informazioa adierazten duten egitura bakarrak eta gertaerak eta erlazioak automatikoki prozesatzeko lanean jarraitu behar da.

Denbora-informazioa era zabalean tratatzeko gai garenean, informazio hori kronologien sorrera automatikoan, gertaeren aurreikuspenean edo etorkizunaren iragarpenean erabili ahal izango dugu. Ondorioz, euskarazko denbora-informazioaren prozesamendua oso erabilgarria izango da etorkizun hurbilean medikuntzan, ekonomian eta beste hainbat arlotan.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 30

- Artikuluaren izena: Euskarazko denbora-informazioaren tratamendu automatikoa TimeMLren eta HeidelTimeren bidez.

- Laburpena: Hizkuntzaren prozesamenduan (HP), denbora-informazioa beharrezkoa da testuak ulertzeko, testuko gertaerak noiz jazotzen diren edo zenbat irauten duten adierazten baitu. Artikulu honetan, euskarazko denbora-informazioaren azterketa eta prozesamendua aurkezten dira. Lehenik, denbora-egituren deskribapena egin da. Bigarren, informazio egituratua emateko markaketa-lengoaia eta horren bidez etiketatutako corpusak azaldu dira. Ondoren, etiketatzeko tresna automatikoa ere deskribatzen da eta lehen etiketatze automatikoaren saiakera bat eta horren emaitzak ere ematen dira.

- Egileak: Begoña Altuna, Mª Jesús Aranzabe eta Arantza Díaz de Ilarraza

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 153-165

- DOI: 10.1387/ekaia.16362

—————————————————–

Egileaz: Begoña Altuna eta Arantza Díaz de Ilarraza UPV/EHUko Hizkuntza eta Sistema Informatikoak saileko ikertzaileak dira eta Mª Jesús Aranzabe UPV/EHUko Euskal Hizkuntza eta Komunikazioa saileko ikertzailea da.

—————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Euskarazko denbora-informazioaren azterketa eta prozesamendua appeared first on Zientzia Kaiera.

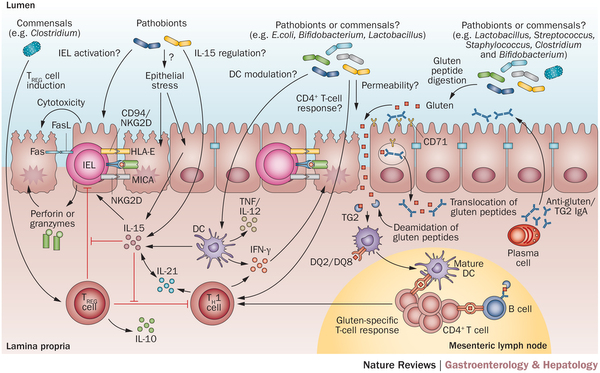

Un nuevo mecanismo de resistencia antifúngico

El grupo de investigación de la UPV/EHU Fungal and Bacterial Biomics ha demostrado la existencia de un nuevo mecanismo de resistencia que se desconocía hasta el momento en el hongo Lomentospora prolificans (L. prolificans). Este microorganismo es multirresistente a los antifúngicos (antibióticos desarrollados frente a hongos) utilizados actualmente y provoca una mortalidad de entre el 80 y el 100% en pacientes con el sistema inmunológico debilitado. Gracias al estudio se podrán diseñar fármacos más efectivos para luchar contra este hongo.

El microorganismo L. prolificans (antes conocido como Scedosporium prolificans) es un hongo filamentoso que pertenece a un grupo conocido vulgarmente como mohos, algunos de los cuales podemos observar creciendo en la comida en mal estado (fruta, pan, etc.) y que se diferencian de las levaduras unicelulares, tales como Candida albicans o Saccharomyces cerevisiae, que son relevantes en práctica clínica o en la industria alimenticia, respectivamente. El hongo L. prolificans es también común y bastante habitual en suelos de ciudades o en zonas industriales. A pesar de estar en contacto con él, no suele producir dolencias en individuos sanos, gracias al sistema inmunológico.

Sin embargo, explica Andoni Ramirez, uno de los autores del artículo, produce “infecciones muy graves” en pacientes con alguna enfermedad subyacente, como la “fibrosis quística”, o con el “sistema inmunológico debilitado”, como es el caso de pacientes que están siendo tratados con quimioterapia debido a padecer algún tipo de cáncer, pacientes en los que se ha llevado a cabo algún trasplante de órgano, o que sufren el Síndrome de la Inmunodeficiencia Adquirida (SIDA) por VIH.

Este hongo, revela la investigación, muestra una gran resistencia a los antifúngicos más habituales como el voriconazol, que es uno de los “fármacos de elección para el tratamiento” de las infecciones causadas por hongos filamentosos. “Este trabajo es muy relevante porque demuestra la existencia de un nuevo mecanismo de resistencia que se desconocía hasta el momento en hongos. Así, observamos una gran modificación de la pared celular en respuesta al antifúngico voriconazol, que es el que se utiliza preferentemente frente a este hongo y frente a otras especies fúngicas. Estas modificaciones se producen tanto en el tamaño como en la composición de su pared celular”, explica.

Este trabajo supone la primera descripción de estas respuestas como mecanismo de defensa frente a un antifúngico, abriendo un nuevo campo de posibilidades de cara al diseño de nuevas moléculas que permitirán un mejor tratamiento de ésta y otras infecciones fúngicas. “A diferencia de lo que ocurre con los agentes antibacterianos, la variedad de los compuestos antifúngicos es muy escasa, y funcionan con pocos mecanismos de acción diferentes. Así, en caso de aparición de cepas o especies resistentes, las opciones que tienen en los hospitales pueden ser a veces muy limitadas. Por tanto, el hallazgo de nuevos mecanismos de resistencia podría, en primer lugar, aumentar el número de dianas frente a las que dirigir fármacos; y en segundo lugar, explicar la resistencia tanto intrínseca como adquirida en otras especies de hongos patógenos”, advierte.

Por el momento, la investigación que está llevando a cabo el grupo de la UPV/EHU Fungal and Bacterial Biomics es básica, es decir, están generando el conocimiento necesario para que en un futuro se puedan diseñar nuevas terapias. “En este sentido, el siguiente objetivo es el de identificar los enzimas necesarios para los cambios que produce el hongo L. prolificans en su pared en respuesta al antifúngico, para así estudiarlos y generar nuevas estrategias terapéuticas”.

Aunque, hay que tener en cuenta que como en cualquier área de la biomedicina, el camino desde el laboratorio hasta el paciente es largo (de varios años) y difícil debido a la cantidad de pruebas que deben hacerse. “Además, al igual que sucede con las denominadas enfermedades raras, las infecciones causadas por este tipo de hongos tienen una baja incidencia en la población y, por tanto, a pesar de la elevada mortalidad que presentan, resulta difícil que haya agentes interesados en invertir en su investigación. Por ello, el avance siempre resulta más dificultoso y lento”, señala Ramírez.

Referencia:

Aize Pellon, Andoni Ramirez-Garcia, Idoia Buldain, Aitziber Antoran, Aitor Rementeria, Fernando L. Hernando.. Molecular and cellular responses of the pathogenic fungus Lomentospora prolificans to the antifungal drug voriconazole. PLOS ONE 12(3): e0174885. DOI: 10.1371/journal.pone.0174885.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un nuevo mecanismo de resistencia antifúngico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una nueva vía para la lucha contra la resistencia a los antibióticos

- La catálisis geométrica como mecanismo de fisión celular

- El mecanismo que bloquea receptores de membrana celular

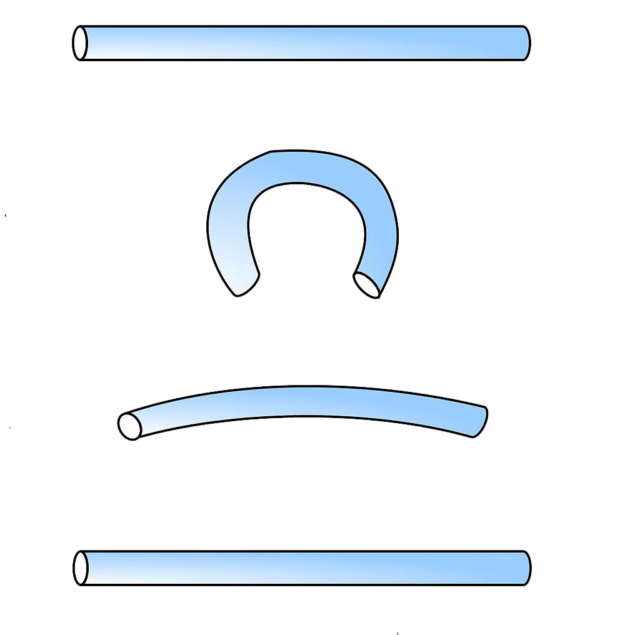

Lehenengo aleazio superelastiko nanometrikoa

Deformatu ostean jatorrizko egoerara bueltatzeko gaitasuna da elastikotasuna; asko deformatzeko gaitasuna duten materialen propietate fisikoa da superelastikotasuna. Guztiz demostratuta dago superelastikotasuna material makroskopikoetan; lehen aldia da, baina, eskala mikrometriko eta nanometrikoan aztertzen dela.

Superelastikotasunaren froga nahiko sinplea da: haga zuzen bati tentsio bat aplikatzen zaio, U itxura har badezake eta, tentsioa kentzean, hagak erabat berreskuratzen badu hasierako forma positiboa da emaitza.

1. irudia: Superelastikotasunaren froga. (Ziortza Guezuragak egina Fongsen irudian oinarritua).

Superelastikotasunaren tentsio kritikoarekin lotutako propietateak nabarmen aldatzen direla mikrometro batetik beherako diametroetan jakin da ikerketari esker. Cu-14Al-4Ni aleazioa erabili dute, memoria-forma eta giro-tenperaturan superelastikotasuna ageri duen aleazioa da.

Aleazio zutabeak dimentsio nanometrikoetaraino zizelkatuta aztertu dituzte eskala nanometrikoan superelastikotasuna. Hala, mikrometro bateko diametrotik behera materialak portaera desberdina duela eta askoz ere tentsio handiagoa aplikatu behar zaiola deformatu ahal izateko baieztatu dute. Aleazioak superelastikotasuna izaten jarraitzen du, baina tentsio handiagoetan.

MetodologiaFocused Ion Beam izeneko ioi kanoia erabili dute materia eskala nanometrikoraino zizelkatzeko, aleazioaren mikro eta nanozutabeak (2 µm eta 260 nm bitartekoak) eraikitzeko. Zutabe horiei tentsioa aplikatu zaie indar txiki-txikiak aplikatzea baimentzen duen nanoindentazio (materialen gogortasuna neurtzeko teknika) bidez, horrela, materialaren portaera neurtu eta aztertu dute.

Aurkitutako portaera superelastikoak bide berriak zabaltzen dizkie elektronika malguko mikrosistemen eta giza gorputzean jar daitezkeen mikrosistemen aplikazioei. Elektronika malgua erabilia da jantzietan, kirol-oinetakoetan eta hainbat pantailatan, besteren artean. Gorputzean erabil daitezkeen mikrosistemei dagokienez, gailu adimendun mediko-sanitarioetan garrantzi handia izan dezake, Lab on a chip moduko gaileuetan. Mikroponpa edo mikroeragingailu txikiak eraiki ahal izango dira, askotariko tratamendu medikoetarako giza gorputzaren barnean substantzia bat askatu eta erregulatu ahal izateko.

Erreferentzia bibliografikoa

Jose F. Gómez-Cortés, Maria L. Nó, Iñaki López-Ferreño, Jesús Hernández-Saz, Sergio I. Molina, Andrey Chuvilin and Jose M. San Juan. Size effect and scaling power-law for superelasticity in shape-memory alloys at the nanoscale. Nature Nanotechnology. May 2017. DOI: 10.1038/nnano.2017.91.

Iturria: Dimentsio nanometrikoko lehenengo aleazio superelastikoa garatu du UPV/EHUk

The post Lehenengo aleazio superelastiko nanometrikoa appeared first on Zientzia Kaiera.

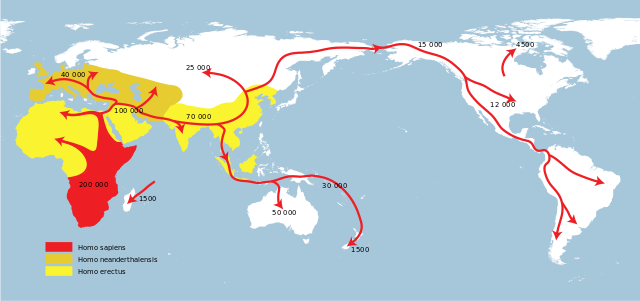

Migraciones

Los seres humanos modernos aparecieron en el este de África hace unos 200.000 años. Hace 75.000 alcanzaron el Oeste del continente. Aunque hubo otros movimientos anteriores hacia Oriente Próximo, hasta hace unos 60.000 no salieron del continente africano para, poco a poco, extenderse hacia otras zonas del planeta. Hace 46.000 años llegaron a Australia y 2.000 después, a Europa. Hace 16.000 años llegaron al continente americano. Hace 11.000 los asentados en el continente europeo avanzaron hacia el Norte el retirarse los hielos de la última glaciación. Y 3.000 después llegaron a nuestro continente los primeros pueblos de agricultores y ganaderos. Hace 1.500 años los seres humanos empezaron a poblar la Polinesia. La mayor parte de esas expansiones eran, seguramente, de carácter “démico”; esto es, fueron ocupaciones graduales de territorios vecinos que iban siendo colonizados poco a poco.

Hace 6.000 años, en Sumeria, las ciudades se convirtieron en los primeros focos de atracción de emigrantes procedentes de localidades de menor tamaño o asentamientos rurales. Y ese proceso impulsó innovaciones culturales, incluidas las tecnológicas. Hace 4.500 años los pastores yamnaya invadieron Europa procedentes de las estepas de Eurasia, y los hunos hicieron lo propio hace unos 1.650, provocando el desplazamiento de pueblos germánicos hacia el interior del Imperio Romano.

Hace unos 1.570 años, anglos y sajones procedentes del norte de Europa colonizaron Gran Bretaña. Los vikingos, 350 años después, siguieron el mismo camino, y en el 980 de nuestra era, viajaron a Islandia, Groenlandia y Terranova. Antes, los árabes ya se habían expandido por Asia Occidental y Norte de África a partir del 632. Y hace ocho siglos los mongoles ocuparon gran parte de Asia.

En 1492 Colón llegó a las Américas, propiciando a partir de esa fecha grandes movimientos migratorios hacia ese continente. En 1520, barcos europeos empezaron a llevar a América esclavos capturados en el África Occidental. En 1820, cuando todavía no se habían producido las migraciones masivas que vendrían más adelante, ya vivían en América 2,6 millones de personas de origen europeo. En 1847, millón y medio de irlandeses huyeron de la hambruna en dirección a Gran Bretaña y Norteamérica. En 1913 la emigración europea hacia las Américas alcanzó su máximo histórico: ese año se desplazaron algo más de dos millones de personas. La revolución bolchevique de 1917 provocó el desplazamiento de más de un millón de seres humanos hacia Europa Occidental. Y en 1945 la Segunda Guerra Mundial desplazó a 30 millones de personas. En 1947 se movieron entre India y Paquistán 18 millones, como consecuencia de la partición india de acuerdo con criterios étnico-religiosos.

Hasta aquí hemos relatado los grandes movimientos de población que se han producido en la historia de la humanidad y de los que tenemos información precisa o, al menos, constancia. Pero, como es sabido, los desplazamientos siguen produciéndose a gran escala. En la actualidad, alrededor de 245 millones de personas viven en países distintos de los que nacieron y, de esos, más de 65 millones han tenido que abandonar su país huyendo de conflictos, violencia o vulneraciones de derechos humanos. Parte de los emigrantes -menos del 10%- son refugiados. El Alto Comisionado de Naciones Unidas para los Refugiados (ACNUR) informa de la existencia de 16,1 millones de personas bajo su jurisdicción, a los que hay que añadir otros 5,2 millones que están al amparo de la Agencia de Naciones Unidas para los Palestinos. En total son más de 21 millones.

Las personas no han dejado de moverse en el Mundo y siempre lo ha hecho por las mismas razones: huyen de la violencia y la persecución o, sencillamente, buscan una vida mejor.

Nota: Las fechas consignadas en el primer párrafo de esta anotación tienen carácter tentativo, por lo que no han de tomarse como definitivas. Cada cierto tiempo se hacen propuestas diferentes para las expansiones. El origen de la especie también está sometido a revisión; esta misma semana Nature ha publicado el hallazgo de fósiles que podrían modificar tanto el origen geográfico como temporal de nuestra especie. La paleoantropología no deja de dar sorpresas.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 26 de marzo de 2017.

El artículo Migraciones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Asteon zientzia begi-bistan #158

Paleontologia

Asteko berria (eta baliteke urtekoa izatea) dakargu igandean ontzen dugun gehigarri honi hasiera emateko: 300.000 urteko Homo sapiens-en fosilak aurkitu dituzte Marokon. Gure espeziea duela 200.000 urte inguru sortu zela uste izan dute orain arte. Orain, aurreko hipotesia iraultzen duen bi ikerketa gauzatu dira. Elhuyarrek azaltzen digu: Jebel Irhoud aztarnategian (Maroko) aurkitutako fosil batzuetan oinarritzen dira ikerketak. Adituen ustez, Homo sapiens espeziaren sorlekua ez legoke Afrikako ekialdean, baizik eta iparraldean. Handik hedatuko zen kontinente osora, lehenik, eta gero Europa aldera (Out of Afrika edo Afrikatik kanpora hipotesia). Max Planck Institutuko Antropologia Ebolutiboko ikertzaileek gidatu dituzte ikerketok eta, datazioaz gain, gure espeziearen eboluzioari buruzko zantzuak ere eman dituzte.

Sustatuk eman du horren berri ere. Ikertzaile guztiak ez dira hipotesi berri honen alde agertu. John Hawks paleoantropologoak, besteak beste, Homo Naledi espezia aurkitu zuen taldeko ikertzaileak, artikulu eszeptiko bat idatzi du: bere ustez, “aurpegi modernoa” izate hutsagatik, Atapuercan aurkitutako Homo Antecessor ere izenda zitekeen Sapiens-aren “aldagai” bezala, eta hori ez da posible (1.2 eta 0.8 milioi arteko Europako espezie bat da Antecessor hau, agian Neandertalen arbasoa, ez ordea gu Sapiens-tarrona.) Halaber, astean agertu den beste azterketa –Hego Afrikako zenbait giza-genoma zahar eta berriren konparaketa– baten berri eman du.

NeurozientziaBadira monogamoak diren animaliak eta ikerketa batek horiek hartu ditu hizpide. Zehazki, Ipar Amerikako lursagua hartu dute aintzat Emory Unibertsitateko (Atlanta, Georgia, AEB) ikertzaile batzuek, “maitasunaren kode neurala” argitzeko. Hau da, bikotekide leiala bilatu eta aurkitzeko prozesu horretan, animalion garunean zer gertatzen den aztertu dute. Zunda elektrikoak baliatuta, lursagu emeen garuneko bi erregio –kortex prefrontal mediala (erabakiak hartzearekin zerikusia duen atala) eta accumbens nukleoa (sari sistema, plazera…)– arteko komunikazio neurala grabatu eta entzun zuten ikertzaileek, arrekin hartu-emanetan zeuden bitartean. Jarraian, ikertzaileek artifizialki aktibatu zuten garuneko bi erregioen arteko zirkuitu neurala. Horren ondorioz, ar horrekin bizi arteko harreman sendoa izango balu bezala hasi zen jokatzen emea.

Medikuntza eta osasunaMin kronikoa tratatzeko garrantzitsua izan daiteke neuronen barrura iristea. Nazioarteko ikertzaile-talde batek arratoiekin egindako esperimentu batzuetan ikusi duenez, neuronen azaleko minaren hartzaile batzuek zelularen barnealdera migratzen dute eta ohiko botikak ez dira gai horraino iristeko. NK1R izeneko hartzaileek lotura dute min kronikoarekin; horiek aktibatzean, hantura eta mina eragiten baitute. Hartzaile horiek blokeatzen dituzten konposatuei lipido bat erantsi diete, zelularen mintza zeharkatu ahal izan dezaten, eta ikusi dute horrela mina kentzea lortzen dela.

Medikuntza arloan badugu beste albiste bat. Gelatinazko matrizea garatu du UPV/EHUko NanoBioCel taldeak, hezurren osatze prozesuan euskarri fisiko funtzioa izateaz gain, hazkuntza-faktoreak askatzeko aukera ematen duena, gorputzak modu naturalean egiten duenari jarraiki. Biodegradagarria izateaz gain, gorputzak errefusatzeko oso arrisku baxua du. Artikulu osoa irakurtzea gomendatzen dizuegu.

Xiringei beldurra diotenek pozarren hartuko dute albiste hau. Izan ere, azken urteotan odola biltzeko teknika berri bat garatzen ari da: Odol Tanta Lehorra. Zer da? Kotoiaz egindako txartel batean odol tanta batzuk ipintzen dira, horretarako gorputzeko edozein tokitan (atzamarra, orpoa edo belarria) orratz batekin ziztada bat eginez. Odola lehortu denean txartel hauek oso erraz gorde daitezke eta edonora eraman. Gero, laborategian odola duen paper zati bat zulatzen da, odola erauzten da eta interesatzen zaigun metabolitoa edo droga analiza daiteke. Baina zergatik ez du azken honek baztertu guztiz xiringa bidezko odol ateratzea? Teknika “berria” 1963. urtean erabiltzen hasi zen eta oraindik gutxik izan dute ospitaletan ikusteko aukera. Arrazoi nagusietariko bat analisiak burutzeko behar diren metodo analitikoen mugak izan dira.

Felipe Aizpuru, Osakidetzako Arabako ikerketa unitateko burua elkarrizketatu du Berriak. Bihotz gutxiegitasunaren bilakaera iragarri ahal izateko ikerketa lanetan ari da. 2011. urtetik, gaitz hori duten 13.000 lagunen datuak aztertu dituzte. Big data osasungintzan “aukera” bat dela dio, baina ez du gizateria salbatuko. Zuzentzen ari den ikerketa lanak badu helburu jakin bat, Azipuruk azalduta: “Etorkizunean aurreikuspenak egiteko modeloak landu nahi ditugu. Alegia, medikuek edo erizainek gaixoaren bilakaera zein izango den iragar dezaten. Bestalde, kasuen artean konparazioak egin nahi ditugu, ondorioak ateratzeko”.

AstrofisikaAlbert Einsteinek erlatibitatearen teoria orokorra landu zuzenean, aurreikusi zuen argia kurbatu egiten dela masa baten eraginez. Fenomeno horren froga esperimentala lortu dute oraingoan Estatu Batuetako Space Telescope Science Instituteko ikertzaileek. Ez da argiaren desbiazio hori esperimentalki frogatzen den aurreneko aldia, baina. Jada 1919ko eguzki-eklipse batean ikusi zuten. Eguzkiaren atzean zegoen izar bat desplazatuta azaltzen zela ikusi zuten, Eguzkiaren beraren presentziagatik. Orain fenomeno hori Eguzkia ez den beste izar batekin frogatu ahal izan da. Esperimentu horren nondik norakoa ezagutzeko, jo ezazue Einsteinek ezinezkotzat jo zuena lortu zuen artikulura.

KIC 8462852 izarra dugu protagonista albiste honetan. Lurretik 1.300 bat argi-urtera dago eta Tabbyren izarraz ezagutzen da. Portaera bitxia du: izugarrizko iluntzeak gertatzen dira han, baina zientzialariek ez dakite zergatik. Izan ere, distira aldaketa horiek ez dute jarraitzen inolako eredu ezagunik. Marian Martinez, Kanariar Uharteetako (Espainia) Astrofisika Institutuko ikertzaileak dio: “ikertzen ari garen guztiok ez dakigu oso ondo zehazki zeren bila ari garen”. Martinezek azaltzen du orain arte irakurri duen “azalpenik zentzuzkoena” dela honakoa: asteroidez inguratuta dagoen planeta erraldoi batek sortzen dituela iluntzeak.

NanoteknologiaMaterial superelastikoak gai dira % 10 deformatu eta atzera jatorrizko itxura hartzeko. Ezaugarri hori ezaguna da eskala makroskopikoan; orain, kobre-aluminio-nikel aleazio bateko gailu oso txikiak ere ezaugarri izan dezaketela frogatu dute EHUko Materia Kondentsatuaren Fisika Saileko eta Fisika Aplikatua II Saileko ikertzaileek. Ikerketa honek aplikazio interesgarriak ekar ditzake, hala nola jantzietan, pantailetan eta abar, eta haientzat osagaiak sortzeko baliagarria izan daiteke, baita osasun-arloan ere, organismo barruan txertatuko liratekeen txipak egiteko, adibidez.

GeodinamikaLurralde igneo erraldoiak “bolkanismo anomaloaren” egitura adierazgarrienak dira. “Bolkanismo anomalotzat” jotzen da plaken arteko mugetatik urrun gertatzen dena. LIPek zuten ezaugarrietako bat da geologian laburtzat hartzen den epean azaltzen direla, eta onartu ohi da 1 ma baino arinago garatzen direla. Horren epe laburrean horrenbeste arroka igneo azaleratzen delarik, atmosferara gas kantitate izugarriak igortzen dira. Ondorioz, eragina dute bai Lurreko batezbesteko tenperaturan, bai klimatologian, bai eta ozeanoetako baldintzetan, eta zenbait suntsipen biologiko orokor sustatu dituzte. Mendearen hasieran eztabaida sutsua izan zen LIPen jatorria azaltzeko. Bi hipotesi gailendu ziren: batak mantuko luma gorakorren jarduera (lumen eredua) erabiltzen du eragile gisa, eta besteak, kontinenteko litosferaren lodiera-ezberdintasunetan sortutako, tokian tokiko, konbekzio-korronteak eta mantuaren heterogeneotasuna (plaken eredua). Egindako azken ikerketek indartu egin dute luma gorakorraren eredua.

BiologiaKolibriak hegazti txikienak dira eta nektarra da haien janari nagusia. 12 ordutan zurrupatu behar duten ur kantitatea haien masaren halako 5 baino gehiago da. Ur gehiegi edaten duten animalietan hiperhidratazioa gerta daiteke. Naturan animalia gutxi egon daitezke hori pairatzeko arriskuan. Artikuluaren egileek adibide batzuk aipatu dituzte: anfibioak egon litezke egoera horretan, larruazal iragazkorra dutelako, baina gernu-bolumen handiak ekoitziz konpontzen dute arazoa; anfibioen gernua, bestalde, oso diluitua da, kasik ez du gatzik, haien giltzurruna oso eraginkorra baita gernutik gatzak berreskuratzen. Kolibriek badute urarekin arazoa. Zurrupaturiko uraren % 80 xurgatzen dute kolibriek eta, beraz, giltzurrunak kanporatu behar du ur gehiena. Bada, giltzurrunak mugak ditu. Litekeena da kolibriak toki beroetan bizitzera behartuta egotea. Toki hotzetan animalia homeotermoek bero gehiago galtzen dute eta, ondorioz, toki hotzetan beroetan baino gehiago jan behar dute. Baina kolibriek nekez jan lezakete jaten dutena baino gehiago, giltzurrunak askoz ere ur gehiago prozesatu beharko bailuke orduan.

———————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

Egileaz: Uxue Razkin Deiako kazetaria da.

———————————————————————–

The post Asteon zientzia begi-bistan #158 appeared first on Zientzia Kaiera.

Arte & Ciencia: Conservación de obras con componentes tecnológicos

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Primera jornada. 2ª conferencia.

Aitziber Velasco, técnica de Conservación del Museo Guggenheim Bilbao: Conservación de obras con componentes tecnológicos

Las ciencias experimentales juegan un papel esencial en el análisis, tratamiento y conservación de las obras de arte. Estos procesos nos ofrecen, además, información valiosa sobre el contenido de la obra y las circunstancias en las que fue creada. Ciencia y arte tienen una relación mucho más íntima de lo que imaginamos, ya que el conocimiento científico es una herramienta imprescindible para artistas, restauradores y analistas. Les permite conocer las cualidades de los materiales para optar por unos u otros, prever cómo se degradarán los pigmentos o determinar la mejor manera para conservar una escultura.

Conservación de obras con componentes tecnológicosEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: Conservación de obras con componentes tecnológicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Ciencia, naturaleza y arte: la química y sus metáforas, por Fernando Cossío

- Curso de verano “La ciencia de nuestras vidas”: Arte, literatura y ciencia, por Gustavo A. Schwartz

Ezjakintasunaren kartografia #163

Zelan eragiten du gure garunaren entrenamenduak berorrek esan diezaion gure buruari zer gogoratu? Ignacio Amigok ematen dizkigu azalpenak Learning to remember artikuluan.

Erabili daiteke LSD bezalako droga bat autismoa tratatzeko? José Ramón Alonsok garatzen du gaia: LSD as a therapeutic agent for autism.

Elektronika elektroien kargan oinarritzen da, spintronika haren spinean, eta “harantronika” (valleytronics)? Gure zalantza argitzen dute DIPCko ikertzaileek: A link between straintronics and valleytronics in graphene.

–—–