Alice Bache Gould, la matemática e historiadora estadounidense con una calle en Simancas

Alice Bache Gould se graduó en matemáticas e inicio una tesis doctoral en geometría que no consiguió terminar. La mayor parte de su vida la dedicó a la historia. Fue precisamente esa ocupación la que la llevó a Simancas (Valladolid) donde descubrió numerosos detalles sobre los viajes de Colón.

Alice Bache Gould. Fuente: Archivo Digital Nacional de Puerto Rico.

Alice Bache Gould. Fuente: Archivo Digital Nacional de Puerto Rico.Una infancia entre Estados Unidos y Argentina

Alice Bache Gould nació el 5 de enero de 1868 en Cambridge, Massachussets (Estados Unidos). Era la tercera de los cinco hijo e hijas de Mary Apthorp Quincy y Benjamin Apthorp Gould.

Su padre había estudiado matemáticas y astronomía en la Universidad de Harvard. Gracias a la fortuna privada y al apoyo de su esposa Mary pudo llevar adelante su trabajo astronómico. Estaba interesado en observar el cielo del sur por lo que en 1865 se puso en contacto con el gobierno de Argentina para presentarles su plan para establecer un observatorio en Córdoba. Aunque ese proyecto no llegó a buen término por falta de financiación, cuatro años más tarde fue invitado por el entonces presidente de Argentina, Domingo Faustino Sarmiento, para fundar el Observatorio Nacional de Argentina en Córdoba. En mayo de 1870, la familia Gould emprendió el viaje hacia Argentina. A finales de 1871, tras la inauguración oficial del observatorio en Córdoba, Alice fue enviada de nuevo a Massachussets para vivir al cuidado de sus tías maternas.

La educación primaria de Alice tuvo lugar entre Estados Unidos y Argentina; en este último país aprendió la historia, la cultura y la lengua del país. Su educación secundaria se desarrolló en parte en Estados Unidos y en parte en Inglaterra.

La madre de Alice falleció en Boston en 1883, durante una estancia en la que Benjamin Apthorp Gould estaba organizando el estudio de las placas fotográficas que había tomado en el Observatorio de Córdoba. El astrónomo regresó a Córdoba, dejando a Alice y a sus dos hijos pequeños en un internado en Boston (en febrero de 1874 las dos hermanas mayores de Alice fallecieron en un accidente mientras nadaban en un río en Río Primero, Córdoba).

Los estudios de matemáticas y una tesis inacabadaEn 1885, Alice regresó a Estados Unidos y, poco después, ingresó en la Society for the Collegiate Instruction of Women (más tarde pasó a llamarse Radcliffe College), una institución creada para que las mujeres, que no podían estudiar en la Universidad de Harvard, pudieran recibir formación. Allí estudió matemáticas, y un año más tarde ingresó en el Bryn Mawr College, una universidad privada que ofrecía formación de posgrado a mujeres. Alice se graduó con una licenciatura en matemáticas y física en 1889.

Entre 1890 y 1893, estudió matemáticas en el Instituto Tecnológico de Massachusetts y en Inglaterra, en el Newnham College de Cambridge. Aunque este centro permitía a las mujeres asistir a las clases, no recibían ningún título.

Alice enseñó matemáticas en Carleton College en Northfield (Minnesota) durante el curso académico 1893/1894 y dejó la docencia al obtener una beca para estudios de posgrado en matemáticas en la Universidad de Chicago. Allí, en 1894, comenzó sus estudios tutorizada por Eliakim Moore. Gould comenzó a preparar su trabajo de doctorado en geometría con un trabajo de Henri Brocard como punto de partida. Sus avances eran lentos debido a sus problemas de salud.

Benjamin Apthorp Gould falleció en 1896 y Alice dedicó gran parte de sus esfuerzos a crear una beca en la Academia Nacional de Ciencias en honor de su padre y destinada a personas trabajando en astronomía de precisión. Ella misma donó veinte mil dólares a esa institución para conseguir su objetivo.

En 1900, mientras avanzaba lentamente con su tesis (que nunca consiguió finalizar), comenzó a escribir una biografía del naturalista estadounidense Louis Agassiz. Se publicó en 1901 y obtuvo muy buenas reseñas.

Entusiasmada con la historia de la colonizaciónEn 1903, tras sufrir una fuerte gripe, Gould decidió viajar a Puerto Rico y pasar allí un tiempo recuperándose de su afección pulmonar. Finalmente, permaneció durante siete años. Allí se interesó por la historia de la colonización de la isla y comenzó sus investigaciones. También colaboró en la mejora del sistema educativo creando el «Fondo de Maestros de Puerto Rico» que recaudó dinero para fundar una escuela de enfermería.

Tras regresar a Boston, en 1911, emprendió un viaje a Roma con una amiga. Ésta enfermó durante el trayecto y cuando el barco atracó en Gibraltar rumbo a Italia, ambas mujeres decidieron quedarse. Alice encontró allí la oportunidad de continuar sus investigaciones sobre la colonización de las Indias Occidentales y visitó el Archivo General de Indias de Sevilla. Aunque su amiga regresó a Estados Unidos tras recuperarse, Gould se quedó en España y se centró en explorar el recorrido de los viajes de Cristóbal Colón e indagar sobre las personas que le acompañaban.

En 1914, cuando estalló la Primera Guerra Mundial, Gould estaba en España estudiando documentos en el Archivo General de Simancas. Cuando Estados Unidos entró en la guerra en abril de 1917, Alice ofreció sus servicios a la Embajada de su país en Madrid. Debido a la preocupación de su familia, regresó a Boston en marzo de 1918. Para apoyar el esfuerzo bélico, aceptó un puesto en la Universidad de Chicago en el que enseñó matemáticas en un curso de navegación para personal de la Marina.

Gould regresó a España en 1925 y retomó sus investigaciones sobre los viajes de Colón. Durante la guerra civil española volvió a su país y después regresó a España para vivir en Simancas, donde, entre otros, fundó una escuela para niñas y niños sin recursos.

Alice trabajaba en un libro sobre Colón cuando falleció repentinamente en julio de 1953. Aunque no llegó a publicar sus investigaciones, en 1984 salió a la luz el documento Nueva lista documentada de los tripulantes de Colón en 1492 que elaboró tras estudiar los registros del Archivo General de Simancas. Alice buscaba documentos con cualquier información sobre los viajes de Colón, en particular sobre quienes formaban parte de su tripulación. Entre otros, ratificó la presencia judía en los viajes de descubrimiento, como Luis de Torres, el intérprete de Colón, o Rodrigo Sánchez de Segovia. Identificó a 87 de los 90 tripulantes, demostrando que solo cuatro de ellos tenían problemas con la justicia, desmintiendo la versión aceptada hasta entonces que aseguraba que la mayor parte de la tripulación estaba formada por criminales. Se le atribuye, además, haber salvado documentos que de otro modo habrían sido ignorados e incluso destruidos.

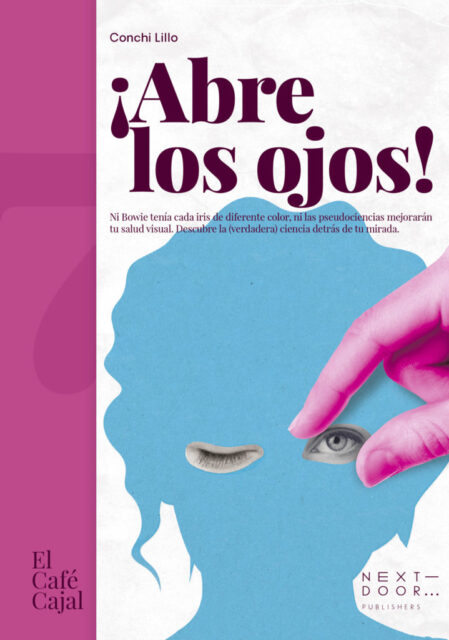

Portada de “Nueva lista documentada de los tripulantes de Colón en 1492”. Fuente: Bibliotheca Sefarad.

Portada de “Nueva lista documentada de los tripulantes de Colón en 1492”. Fuente: Bibliotheca Sefarad.

Entre otros reconocimientos, Gould fue elegida miembro correspondiente de la Real Academia Española de la Historia en 1942, y obtuvo la Orden de Isabel la Católica en 1952.

Tras su repentina muerte (por un derrame cerebral el día 25 de julio de 1953) en el jardín del castillo de Simancas, cerca de los archivos, se colocó en la entrada del edificio una placa en su honor:

A miss Alice B. Gould, ilustre investigadora norteamericana y gran amiga de España. Trabajó en este archivo durante cuarenta años y murió a su entrada el día 25 de julio de 1953.

En Simancas, una calle lleva su nombre.

Referencias

- Alice Bache Gould, MacTutor History of Mathematics Archive, St Andrews University

- Edgardo Ronal Minniti Morgan (2011) Alice Bache Gould. La convergencia de la astronomía, la historia, la matemática y el espionaje, Historia de la astronomía

- Deborah Kent, Alice Bache Gould: mathematician in search of war work, 1918, BSHM Bulletin: Journal of the British Society for the History of Mathematics Volume 27, Issue 1, 2012

- Alice Bache Gould, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Alice Bache Gould, la matemática e historiadora estadounidense con una calle en Simancas se ha escrito en Cuaderno de Cultura Científica.

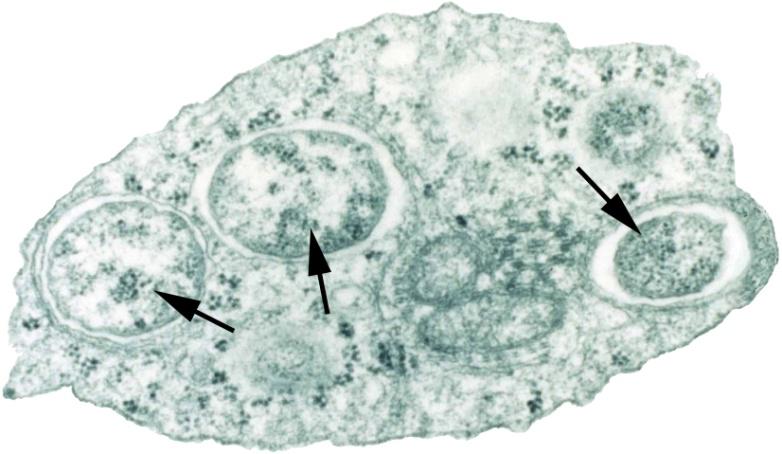

La mayor parte de la vida en la Tierra está aletargada

Muchos microbios y células están en un sueño profundo, esperando el momento adecuado para activarse. Los biólogos han descubierto una proteína muy extendida que detiene abruptamente la actividad de una célula y la vuelve a activar con la misma rapidez.

Un artículo de Dan Samorodnitsky. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Cuando las cosas se ponen difíciles, muchos microbios quedan inactivos. Una nueva investigación ha descubierto una proteína ubicua que detiene la producción de proteínas de una célula en un instante. Fuente: Nico Roper/ Quanta Magazine

Cuando las cosas se ponen difíciles, muchos microbios quedan inactivos. Una nueva investigación ha descubierto una proteína ubicua que detiene la producción de proteínas de una célula en un instante. Fuente: Nico Roper/ Quanta MagazineSe ha informado recientemente del descubrimiento de una proteína natural, llamada Balon, que puede detener por completo la producción celular de nuevas proteínas. Balon se ha encontrado en bacterias que hibernan en el permafrost ártico, pero también parece ser que es producida por muchos otros organismos y podría ser un mecanismo de letargo pasado por alto en todo el árbol de la vida.

Para la mayoría de las formas de vida, la capacidad de aislarse es una parte fundamental de mantenerse con vida. Las condiciones duras como la falta de alimentos o el clima frío pueden aparecer de la nada. En esta situación desesperada, en lugar de desplomarse y morir, muchos organismos han dominado el arte del letargo. Ralentizan su actividad y metabolismo. Luego, cuando vuelven tiempos mejores, se reaniman.

Permanecer en un estado latente es en realidad la norma para la mayoría de la vida en la Tierra: según algunas estimaciones, el 60% de todas las células microbianas están hibernando en un momento dado. Incluso en organismos cuyo cuerpo entero no está inactivo, como la mayoría de los mamíferos, algunas poblaciones celulares dentro de ellos descansan y esperan el mejor momento para activarse.

«Vivimos en un planeta aletargado», afirma Sergey Melnikov, biólogo molecular evolutivo de la Universidad de Newcastle. «La vida se trata principalmente de estar dormido».

Pero, ¿cómo logran las células esta hazaña? A lo largo de los años, los investigadores han descubierto una serie de «factores de hibernación», proteínas que las células utilizan para inducir y mantener un estado latente. Cuando una célula detecta algún tipo de condición adversa, como hambre o frío, produce un conjunto de factores de hibernación para detener su metabolismo.

Algunos factores de hibernación desmantelan la maquinaria celular; otros impiden que los genes se expresen. Los más importantes, sin embargo, desactivan el ribosoma, la máquina celular para construir nuevas proteínas. La producción de proteínas representa más del 50% del uso de energía en una célula bacteriana en crecimiento. Estos factores de hibernación arrojan arena en los engranajes del ribosoma, impidiéndole sintetizar nuevas proteínas y ahorrando así energía para las necesidades básicas de supervivencia.

A principios de este año, en una publicación en Nature, un equipo de investigadores ha informado del descubrimiento de un nuevo factor de hibernación, al que han llamado Balon. La proteína es sorprendentemente común: una búsqueda de su secuencia genética descubrió su presencia en el 20% de todos los genomas bacterianos catalogados. Y funciona de una manera que los biólogos moleculares nunca antes habían visto.

Anteriormente, todos los factores de hibernación conocidos que alteraban los ribosomas funcionaban pasivamente: esperaban a que un ribosoma terminara de construir una proteína y luego le impedían iniciar una nueva. Balon, sin embargo, tira del freno de mano. Se introduce en cada ribosoma de la célula, incluso interrumpiendo los ribosomas activos en mitad de su trabajo. Antes de Balon, los factores de hibernación sólo se habían observado en ribosomas vacíos.

«El artículo Balon es sorprendentemente detallado», comenta el biólogo evolutivo Jay Lennon, que estudia la latencia microbiana en la Universidad de Indiana y que no ha participado en el nuevo estudio. «Ampliará nuestra visión de cómo funciona el letargo».

Karla Helena-Bueno descubrió un factor de hibernación común cuando accidentalmente dejó una bacteria del Ártico en el hielo durante demasiado tiempo. «Traté de buscar en un rincón poco estudiado de la naturaleza y encontré algo», cuenta. Fuente: Karla Helena-Bueno

Karla Helena-Bueno descubrió un factor de hibernación común cuando accidentalmente dejó una bacteria del Ártico en el hielo durante demasiado tiempo. «Traté de buscar en un rincón poco estudiado de la naturaleza y encontré algo», cuenta. Fuente: Karla Helena-BuenoMelnikov y su estudiante de posgrado Karla Helena-Bueno descubrieron Balon en Psychrobacter urativorans, una bacteria adaptada al frío nativa de los suelos helados y recolectada del permafrost ártico. (Según Melnikov, la bacteria se encontró por primera vez infectando un paquete de salchichas congeladas en la década de 1970 y luego fue redescubierta por el famoso geneticista Craig Venter en un viaje al Ártico). Estudian P. urativorans y otros microbios inusuales para caracterizar la diversidad de herramientas de construcción de proteínas utilizadas en todo el espectro de la vida y para comprender cómo los ribosomas pueden adaptarse a ambientes extremos.

Debido a que el letargo puede ser desencadenado por una variedad de condiciones, incluyendo el hambre y la sequía, los científicos llevan a cabo esta investigación con un objetivo práctico en mente: «Probablemente podamos usar este conocimiento para diseñar organismos que puedan tolerar climas más cálidos», apunta Melnikov. “y por lo tanto resistir el cambio climático”.

Presentamos: BalonHelena-Bueno descubrió Balon por pura casualidad. Estaba intentando convencer a P. urativorans para que creciera felizmente en el laboratorio. En lugar de eso, hizo lo contrario. Dejó el cultivo en una cubeta de hielo durante demasiado tiempo y logró aplicarle un golpe de frío. Para cuando recordó que estaba allí, las bacterias adaptadas al frío ya estaban en letargo.

No queriendo desperdiciar el cultivo, los investigadores persiguieron de todos modos sus intereses originales. Helena-Bueno extrajo los ribosomas de las bacterias afectadas por el frío y los sometió a crio-EM. Abreviatura de microscopía electrónica criogénica, crio-EM es una técnica para visualizar estructuras biológicas minúsculas en alta resolución. Helena-Bueno vio una proteína atascada en el sitio A del ribosoma paralizado, la «puerta» por donde se entregan los aminoácidos para la construcción de nuevas proteínas.

Helena-Bueno y Melnikov no reconocieron la proteína. De hecho, nunca antes se había descrito. Tenía similitud con otra proteína bacteriana, una que es importante para desmontar y reciclar partes ribosomales, llamada Pelota en referencia al término en español. De ahí que llamaran a la nueva proteína Balon, por el homónimo español a “pelota”, “balón”.

La capacidad de Balon para detener la actividad del ribosoma es una adaptación crítica para un microbio bajo estrés, comenta Mee-Ngan Frances Yap, microbióloga de la Universidad Northwestern que no ha participado en el trabajo. «Cuando las bacterias crecen activamente, producen muchos ribosomas y ARN», continúa. «Cuando se encuentran con estrés, una especie podría necesitar detener la traducción» del ARN en nuevas proteínas para comenzar a conservar energía para un período de hibernación potencialmente largo.

Llamativamente, el mecanismo de Balon es un proceso reversible. A diferencia de otros factores de hibernación, se puede insertar para detener el crecimiento y luego expulsarlo rápidamente como una cinta de casete. Permite que una célula entre rápidamente en estado de letargo en caso de emergencia y que resucite con la misma rapidez para readaptarse a condiciones más favorables.

Balon puede hacer esto porque se adhiere a los ribosomas de una manera única. Cada factor de hibernación ribosómica descubierto previamente bloquea físicamente el sitio A del ribosoma, por lo que cualquier proceso de producción de proteínas que esté en progreso debe completarse antes de que el factor pueda unirse para desactivar el ribosoma. Balon, por otro lado, se une cerca del canal, pero no a través de él, lo que le permite ir y venir independientemente de lo que esté haciendo el ribosoma.

A pesar de la novedad mecánica de Balon, es una proteína extremadamente común. Una vez identificada, Helena-Bueno y Melnikov encontraron parientes genéticos de Balon en más del 20% de todos los genomas bacterianos catalogados en bases de datos públicas. Con la ayuda de Mariia Rybak, bióloga molecular de la Rama Médica de la Universidad de Texas, caracterizaron dos de estas proteínas bacterianas alternativas: una del patógeno humano Mycobacterium tuberculosis, que causa la tuberculosis, y otra de Thermus thermophilus, que vive en el último lugar en el que econtrarías a P. urativorans, en las ultracalientes fuentes hidrotermales submarinas. Ambas proteínas también se unen al sitio A del ribosoma, lo que sugiere que al menos algunos de estos parientes genéticos actúan de manera similar a Balon en otras especies bacterianas.

Balon está notablemente ausente en Escherichia coli y Staphylococcus aureus, las dos bacterias más comúnmente estudiadas y los modelos más utilizados para el letargo celular. Al centrarse sólo en unos pocos organismos de laboratorio, los científicos habían pasado por alto una táctica de hibernación generalizada, afirma Helena-Bueno. «Traté de buscar en un rincón poco estudiado de la naturaleza y encontré algo».

Todo el mundo hibernaCada célula necesita la capacidad de permanecer aletargada y esperar su momento. Melnikov explica que el modelo de laboratorio de la bacteria E. coli tiene cinco modos diferentes de hibernación, cada uno de los cuales por sí solo es suficiente para permitir que el microbio sobreviva a una crisis.

«La mayoría de los microbios se están muriendo de hambre», comenta Ashley Shade, microbióloga de la Universidad de Lyon que no ha participado en el nuevo estudio. “Existen en un estado de necesidad. No se están duplicando. No están viviendo su mejor vida”.

Pero el letargo también es necesario fuera de los períodos de hambruna. Incluso en organismos, como la mayoría de los mamíferos, cuyo cuerpo entero no queda completamente inactivo, las poblaciones celulares individuales deben esperar el mejor momento para activarse. Los ovocitos humanos permanecen inactivos durante décadas esperando ser fertilizados. Las células madre humanas nacen en la médula ósea y luego permanecen inactivas, esperando que el cuerpo las llame para crecer y diferenciarse. Los fibroblastos del tejido nervioso, los linfocitos del sistema inmunitario y los hepatocitos del hígado entran en fases latentes, inactivos y sin división y se reactivan más tarde.

«Esto no es algo exclusivo de bacterias o arqueas», afirma Lennon. “Cada organismo del árbol de la vida tiene una forma de lograr esta estrategia. Pueden pausar su metabolismo”.

Los osos hibernan. Los virus del herpes se lisogenizan. Los gusanos tienen una etapa dauer. Los insectos entran en diapausa. Los anfibios estivan. Los pájaros entran en torpor. Todas estas son palabras para exactamente lo mismo: un estado de letargo que los organismos pueden revertir cuando las condiciones son favorables.

«Antes de la invención de la hibernación, la única forma de vivir era seguir creciendo sin interrupciones», dice Melnikov. “Poner la vida en pausa es un lujo”.

También es un tipo de seguro a nivel poblacional. Algunas células persiguen el estado de letargo detectando cambios ambientales y respondiendo en consecuencia. Sin embargo, muchas bacterias utilizan una estrategia estocástica. «En entornos que fluctúan aleatoriamente, si a veces no entras en estado de letargo, existe la posibilidad de que toda la población se extinga» a través de encuentros aleatorios con desastres, explica Lennon. Incluso en los cultivos de E. coli más sanos, felices y de más rápido crecimiento, entre el 5% y el 10% de las células permanecerán inactivas en cualquier caso. Son los supervivientes designados que vivirán si algo les sucede a sus primos más activos y vulnerables.

En ese sentido, el letargo es una estrategia de supervivencia ante catástrofes globales. Por eso Helena-Bueno estudia la hibernación. Le interesa saber qué especies podrían permanecer estables a pesar del cambio climático, cuáles podrían recuperarse y qué procesos celulares, como la hibernación asistida por Balon, podrían ayudar.

Más fundamentalmente, Melnikov y Helena-Bueno esperan que el descubrimiento de Balon y su ubicuidad ayude a las personas a replantear lo que es importante en la vida. Todos nos quedamos inactivos con frecuencia y muchos de nosotros lo disfrutamos bastante. «Pasamos un tercio de nuestra vida durmiendo, pero no hablamos de ello en absoluto», comenta Melnikov. En lugar de quejarnos de lo que nos perdemos cuando dormimos, tal vez podamos experimentarlo como un proceso que nos conecta con toda la vida en la Tierra, incluidos los microbios que duermen en las profundidades del permafrost del Ártico.

El artículo original, Most Life on Earth is Dormant, After Pulling an ‘Emergency Brake’, se publicó el 5 de junio de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo La mayor parte de la vida en la Tierra está aletargada se ha escrito en Cuaderno de Cultura Científica.

Los hongos carnívoros “olfatean” a sus presas

Estoy seguro de que este título ha sorprendido a los lectores. Primero, por el concepto de “hongo carnívoro” bastante opuesto a lo que conocemos sobre estos seres. Segundo, porque atribuimos un cierto sentido del olfato a organismos carentes de sistema nervioso. Lo explicamos a continuación.

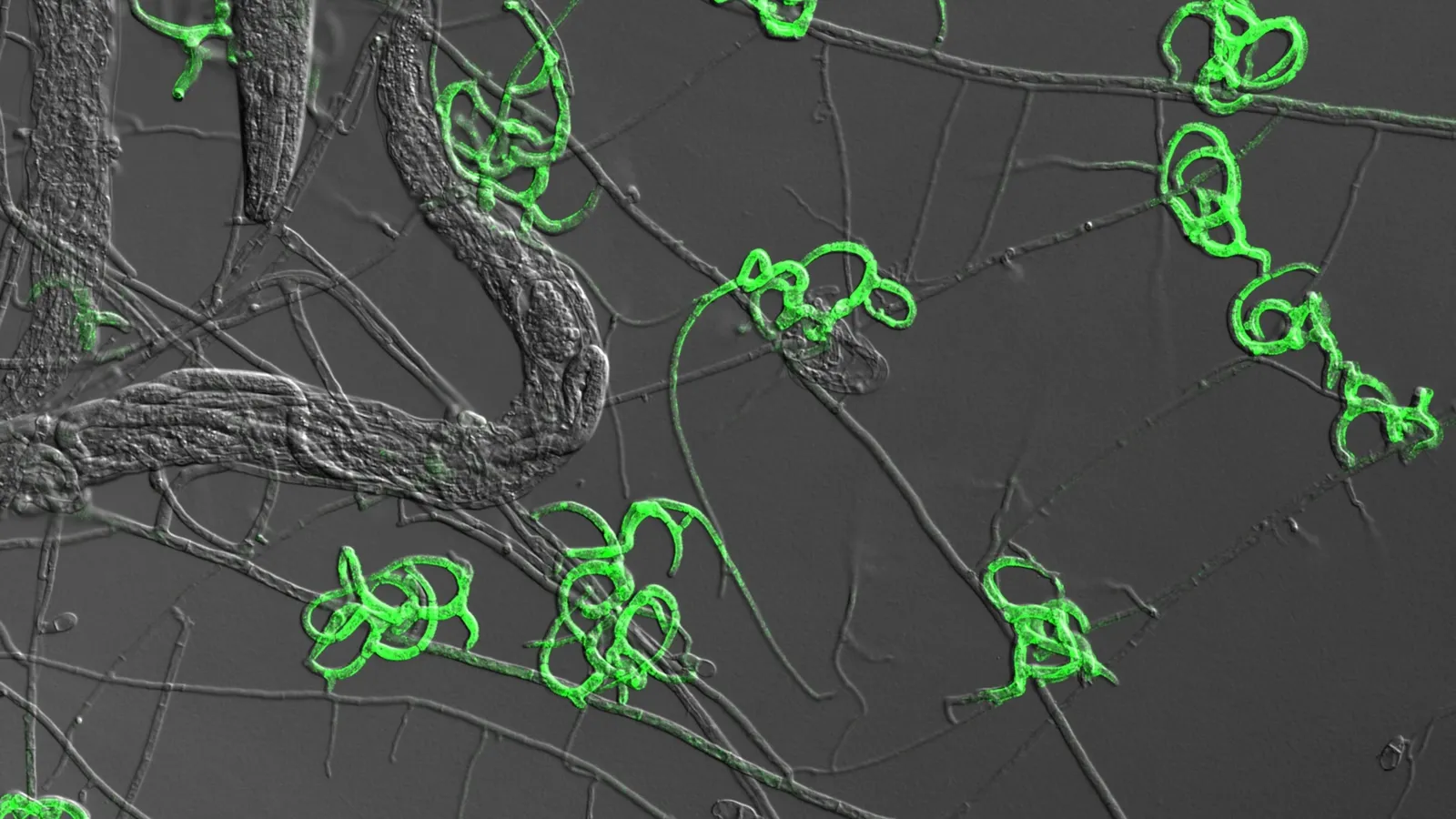

En verde, las células producidas por el hongo hambriento ayudan a atraer y atrapar gusanos nematodos. Las líneas grises en forma de hilo son micelio, las hebras conectivas que forman un solo hongo.

En verde, las células producidas por el hongo hambriento ayudan a atraer y atrapar gusanos nematodos. Las líneas grises en forma de hilo son micelio, las hebras conectivas que forman un solo hongo.Foto: Yen-Ping Hsueh

Los hongos y los animales compartimos algunas características importantes. Somos pluricelulares y heterótrofos. Esto quiere decir que estamos formados por multitud de células organizadas que obtienen su energía a partir de la oxidación de materia orgánica. Esto nos distingue de seres autótrofos como las plantas, que son capaces de utilizar energía de fuentes no orgánicas como la luz.

Hongos y animales también somos diferentes en ambos aspectos. La pluricelularidad se alcanza en los animales a través de un desarrollo embrionario. Esto no sucede en los hongos, cuyo micelio crece a partir de esporas, sin formar tejidos ni órganos. Por otro lado, la alimentación de los hongos es fundamentalmente pasiva, por crecimiento del micelio sobre una fuente de materia orgánica. Los animales (salvo esponjas y placozoos) desarrollamos un sistema nervioso que nos permite desplegar un comportamiento proactivo de detección y obtención del alimento.

La capacidad evolutiva de los seres vivos produce innovaciones insólitas que rompen estos esquemas simples. Hay un grupo de hongos, conocidos genéricamente como NTF (nematode trapping fungi), que en condiciones de inanición y presencia de nematodos son capaces de desarrollar rápidamente unos filamentos adhesivos que atrapan al gusano, causan su muerte y les proporcionan alimento.

Los mecanismos que regulan este sorprendente comportamiento están siendo revelados por una serie de estudios sobre el NTF Arthrobotrys oligospora, liderados por la investigadora taiwanesa Yen-Ping Hsueh. Este hongo ya era conocido por su capacidad de producir compuestos químicos que actuaban como cebo para atraer a los nematodos, simulando el olor de fuentes de alimento o incluso feromonas para la atracción sexual.

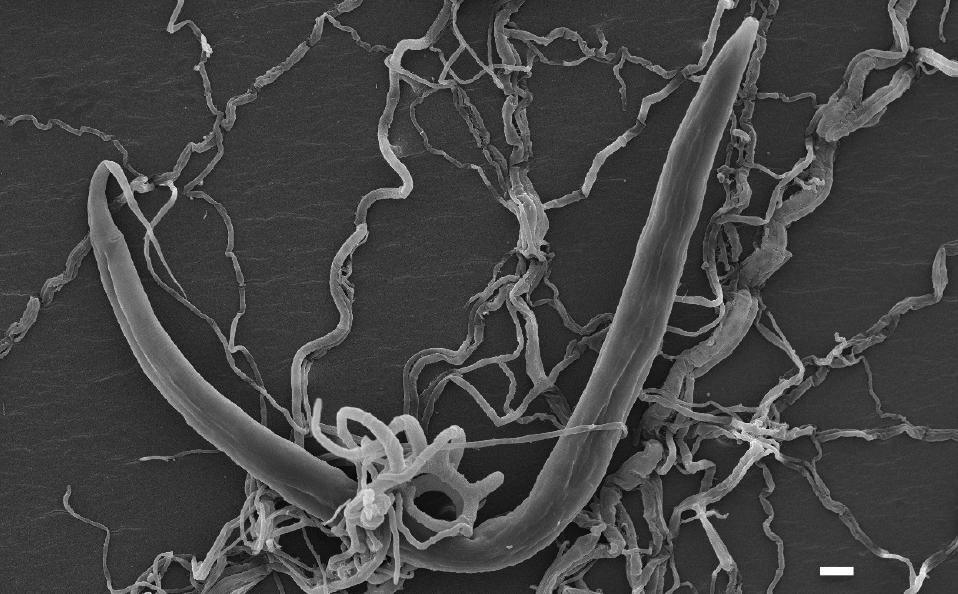

Figura 1. El nematodo C. elegans atrapado por el hongo A. oligospora. Escala=10 μm. Fuente: Hsueh et al. (2017) eLife 2017;6:e20023

Figura 1. El nematodo C. elegans atrapado por el hongo A. oligospora. Escala=10 μm. Fuente: Hsueh et al. (2017) eLife 2017;6:e20023Más recientemente, el grupo de Yen-Ping Hsueh mostró que la presencia del nematodo Caenorhabditis elegans provocaba en el hongo la activación de un gran número de genes. Esta respuesta inducía cambios morfológicos, sobre todo el crecimiento rápido de los filamentos de las trampas (Figura 1). Al mismo tiempo se expresaban proteínas adhesivas para dificultar la huida del gusano, y finalmente se secretaban enzimas, en concreto metaloproteasas, que digerían al infortunado C. elegans haciendo posible su absorción por el hongo. El proceso se puede ver en este espectacular vídeo del laboratorio de la Dra. Hsueh1.

¿Cómo se regula a nivel molecular la rápida respuesta de A. oligospora a la presencia del nematodo? El equipo taiwanés identificó la vía AMPc-PKA como la activadora de este proceso. El adenosín monofosfato cíclico (AMPc) es un “segundo mensajero”. Cuando una célula recibe una señal externa a través de un receptor es habitual que se desencadene una cascada de reacciones en el interior que culmine en una respuesta fisiológica, por ejemplo, la expresión de determinados genes. Este proceso se conoce como “transducción de señales” y en él intervienen muchas veces segundos mensajeros, es decir, pequeñas moléculas como el AMPc o iones como el calcio (Ca2+). En concreto el AMPc activa la proteína kinasa A (PKA), activadora a su vez de otras proteínas que regulan la respuesta celular.

Yen-Ping Hsueh y sus colaboradores mostraron que la inactivación de esta vía de señalización hacía que los hongos fueran indiferentes a la cercanía de sus presas potenciales. Pero todavía quedaba una cuestión por resolver, ¿cómo detecta un hongo sin sistema nervioso la presencia de C. elegans?

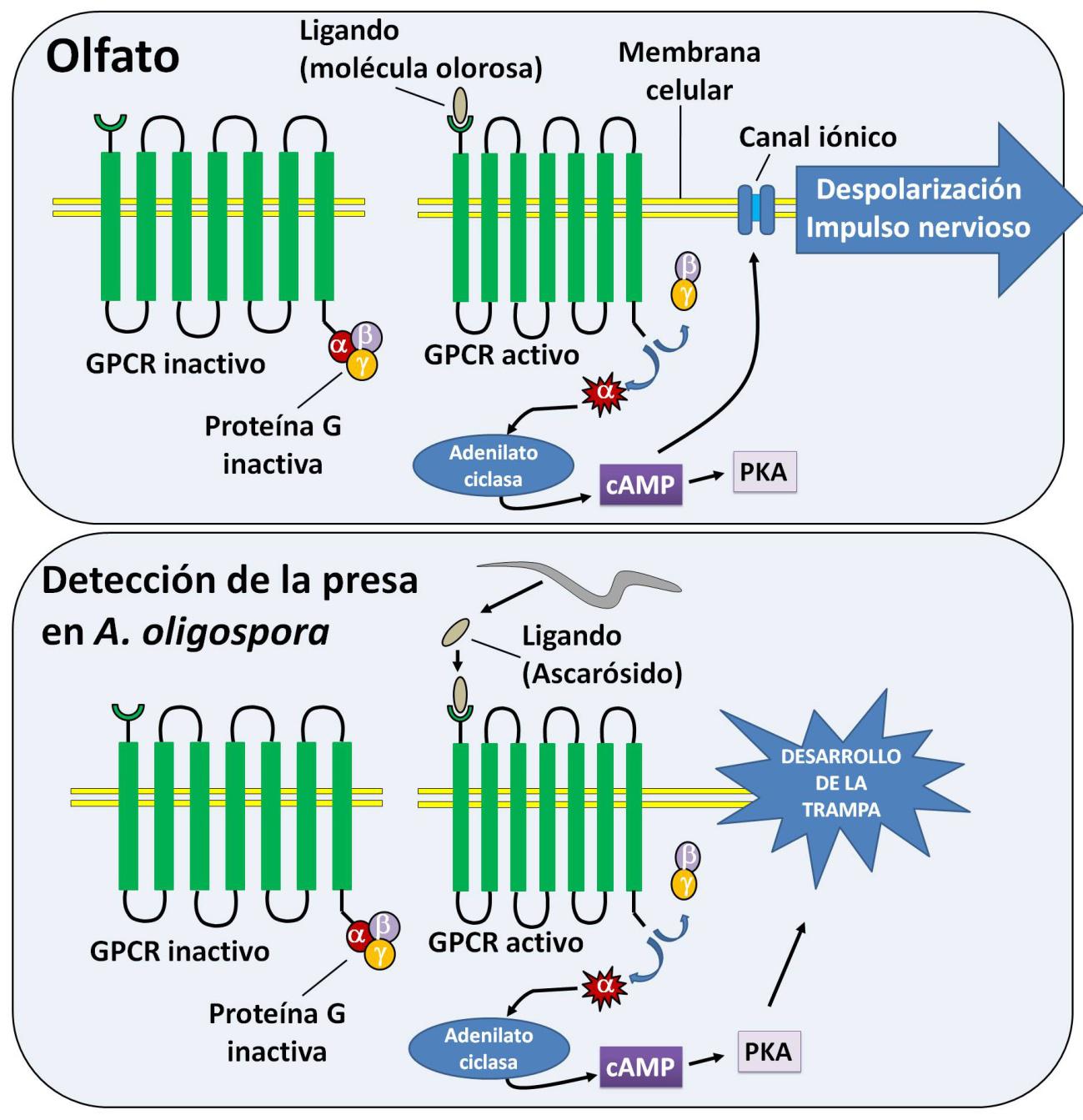

Figura 2. Nuestra sensación olfativa se genera cuando un receptor GPCR del epitelio olfativo capta un ligando (molécula olorosa) y cambia su configuración. Esto provoca la disociación y activación de la proteína G cuya subunidad α activa la enzima sintetizadora de AMPc. Esta molécula provoca la apertura de canales iónicos, la despolarización de la membrana celular y la generación del impulso nervioso. En el caso del hongo A. oligospora el ligando de las GPCRs es un ascarósido segregado por el nematodo. La elevación de los niveles de AMPc activa la proteína kinasa A y se dispara el mecanismo de desarrollo de la trampa

Figura 2. Nuestra sensación olfativa se genera cuando un receptor GPCR del epitelio olfativo capta un ligando (molécula olorosa) y cambia su configuración. Esto provoca la disociación y activación de la proteína G cuya subunidad α activa la enzima sintetizadora de AMPc. Esta molécula provoca la apertura de canales iónicos, la despolarización de la membrana celular y la generación del impulso nervioso. En el caso del hongo A. oligospora el ligando de las GPCRs es un ascarósido segregado por el nematodo. La elevación de los niveles de AMPc activa la proteína kinasa A y se dispara el mecanismo de desarrollo de la trampa

En cierto sentido A. oligospora “huele” al nematodo. Evidentemente no existen órganos olfativos en los hongos, pero el mecanismo que utilizan es sorprendentemente parecido al que usamos nosotros para percibir los olores (Figura 2).

Nuestro sentido del olfato se basa en receptores acoplados a proteína G (GPCRs, por G protein-coupled receptors). Se trata de proteínas cuya cadena atraviesa siete veces la membrana celular. Cuando su porción extracelular detecta las señales adecuadas (hormonas, péptidos, diverso tipo de moléculas…) cambia la configuración del receptor disociando la proteína G unida a su dominio intracelular, lo que desencadena la transducción de la señal.

Estos receptores son importantísimos en la detección de señales. Para hacernos una idea, los humanos tenemos más de 800 GPCRs que intervienen en multitud de procesos sensoriales y de respuesta a hormonas o neurotransmisores. Por esto son la principal diana de los fármacos que utilizamos.

En un reciente artículo, el equipo de Yen-Ping Hsueh acaba de identificar dos familias de GPCRs usadas por A. oligospora para detectar la presencia de nematodos. Una de estas familias detecta ascarósidos, pequeños glicolípidos que secretan continuamente los nematodos a modo de feromonas. La segunda familia detecta otras moléculas segregadas por los nematodos y que todavía no han sido identificadas. En ambos casos la activación de las proteínas G dispara la vía AMPc-PKA y pone en marcha el programa de construcción de las trampas.

En resumen, los hongos NTF no “huelen” al nematodo en un sentido estricto de la palabra, pero el paralelismo entre el uso de GPCRs para la detección de presas y el funcionamiento de nuestro olfato es extraordinariamente llamativo.

Referencias:

Chen SA, Lin HC, Hsueh YP. (2022) The cAMP-PKA pathway regulates prey sensing and trap morphogenesis in the nematode-trapping fungus Arthrobotrys oligospora. G3 (Bethesda). doi: 10.1093/g3journal/jkac217.

Hsueh YP, Gronquist MR, Schwarz EM, Nath RD, Lee CH, Gharib S, Schroeder FC, Sternberg PW. (2017) Nematophagous fungus Arthrobotrys oligospora mimics olfactory cues of sex and food to lure its nematode prey. Elife. doi: 10.7554/eLife.20023.

Kuo CY, Tay RJ, Lin HC, Juan SC, Vidal-Diez de Ulzurrun G, Chang YC, Hoki J, Schroeder FC, Hsueh YP. (2024) The nematode-trapping fungus Arthrobotrys oligospora detects prey pheromones via G protein-coupled receptors. Nat Microbiol. doi: 10.1038/s41564-024-01679-w.

Lin HC, de Ulzurrun GV, Chen SA, Yang CT, Tay RJ, Iizuka T, Huang TY, Kuo CY, Gonçalves AP, Lin SY, Chang YC, Stajich JE, Schwarz EM, Hsueh YP. (2023) Key processes required for the different stages of fungal carnivory by a nematode-trapping fungus. PLoS Biol. doi: 10.1371/journal.pbio.3002400.

Nota:

1 En la primera parte. En una segunda parte se muestra la estrategia de otro hongo carnívoro, Pleurotus ostreatus, que produce una toxina volátil que paraliza al nematodo.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

El artículo Los hongos carnívoros “olfatean” a sus presas se ha escrito en Cuaderno de Cultura Científica.

Las mentiras visuales de la IA

Federico Kukso

A medida que se expande la inteligencia artificial en cada rincón de nuestras vidas, un cliché se consolida: el de representar visualmente estos sistemas como robots humanoides blancos, cerebros destellantes o con referencias a la ciencia ficción. Un grupo cada vez mayor de especialistas se opone a esta iconografía cargada de sesgos históricos sobre género, etnia y religión que genera expectativas poco realistas y enmascara los efectos sociales de estas tecnologías.

Las imágenes mediáticas que representan la IA como robots humanoides blancos y sensibles enmascaran la responsabilidad de los humanos que realmente desarrollan esta tecnología. Foto: Jezael Melgoza / Unsplash

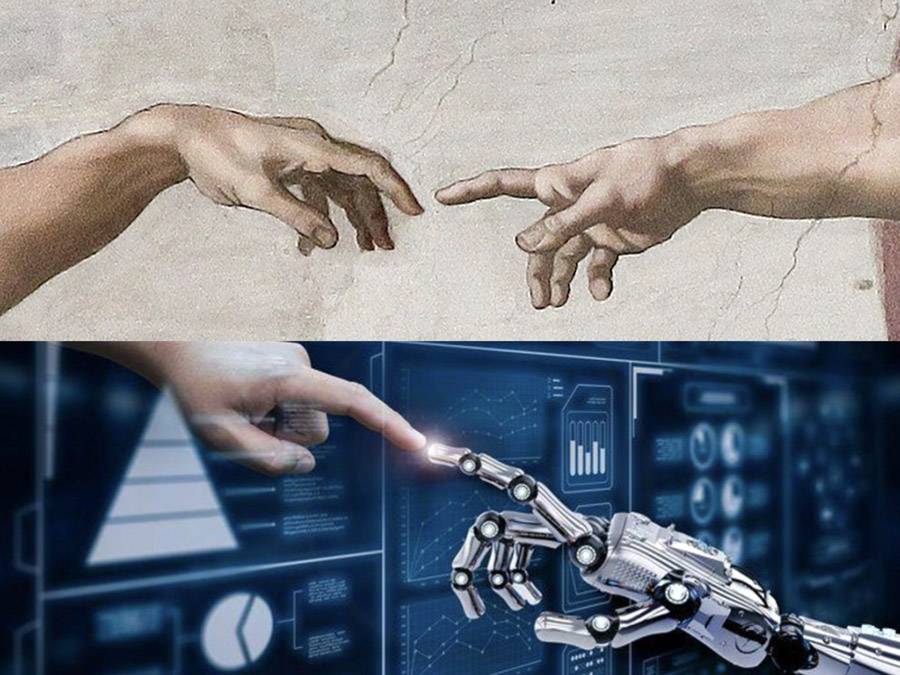

Las imágenes mediáticas que representan la IA como robots humanoides blancos y sensibles enmascaran la responsabilidad de los humanos que realmente desarrollan esta tecnología. Foto: Jezael Melgoza / UnsplashEl 25 de abril de 2018, la Comisión Europea publicó un documento que marcó el inicio de su camino hacia la primera ley regulatoria de la inteligencia artificial del mundo. En él, se detallaban las recomendaciones presentadas por un grupo de expertos, se enumeraban los pasos a seguir y se proponían directrices éticas para una IA confiable. Sin llamar mucho la atención, una atractiva imagen acompañaba al texto: una mano humana y una mano robótica –brillante y metálica– se extendían delante de un fondo azul y gris, casi tocándose con las yemas de los dedos.

Inspirada en La creación de Adán de Miguel Ángel, fresco que desde el siglo XVI adorna el techo de la Capilla Sixtina en el Vaticano, esta composición que presenta a la IA como una fuerza creativa divina o como una chispa, una conexión entre lo humano y lo divino, se ha convertido en uno de los pósteres oficiales de la inteligencia artificial.

Imágenes que recrean ‘La creación de Adán’ de Miguel Ángel son usadas con frecuencia para ilustrar la IA, como hizo la Comisión Europea en 2018. Fuente: Michelangelo / Comisión Europea

Imágenes que recrean ‘La creación de Adán’ de Miguel Ángel son usadas con frecuencia para ilustrar la IA, como hizo la Comisión Europea en 2018. Fuente: Michelangelo / Comisión EuropeaSe la ve una y otra vez en sitios de noticias y revistas, en publicidades, en portadas de libros, en comunicados de empresas, en afiches de cursos y conferencias, a la par de retratos pintorescos de robots humanoides siempre blancos, cerebros azules brillantes, placas de circuitos, código binario y trilladas referencias a personajes de ciencia ficción como Terminator.

Conforman la iconografía actual de la IA, su traducción visual, cada vez más criticada por especialistas que advierten sobre sus peligros y las suposiciones estereotipadas y potencialmente discriminatorias que arrastran sobre género, etnia y religión.

“Estas imágenes tergiversan completamente las realidades de la IA”, advierte a SINC la investigadora en ética Tania Duarte, fundadora de We and AI, una organización sin fines de lucro del Reino Unido que busca mejorar la alfabetización en inteligencia artificial para la inclusión social e impulsar el pensamiento crítico. “Refuerzan mitos sobre la IA –subraya–, ideas falsas sobre la infalibilidad, la sensibilidad y el misticismo religioso que envuelve a estas tecnologías y no ayudan al público a desarrollar una comprensión de lo que está en juego”.

El poder de la imagenComo hace tiempo explicó la escritora Susan Sontag, las imágenes son elementos poderosos. Enmarcan nuestra percepción del mundo, confirman, refuerzan o disipan estereotipos. Influyen en la forma en que la sociedad piensa y comprende temas que retratan. En el caso de la IA, ciertas ilustraciones exageran las capacidades de estos sistemas informáticos cada vez más ubicuos.

Otras, en cambio, siembran miedo, aumentan la desconfianza pública, enmascaran la responsabilidad de los humanos y perpetúan un entendimiento demasiado limitado y temeroso de la IA pero también misterioso, al no mostrar su contexto real, ni sus procesos y ni sus aplicaciones o limitaciones. Y desvían el debate sobre las consecuencias potencialmente significativas para la investigación, la financiación, la regulación y la recepción de estos sistemas cada vez más ubicuos.

Para combatir estos clichés y distorsiones, Duarte y un equipo de más de cien ingenieros, artistas, sociólogos y especialistas en ética impulsan un programa conocido como Better Images of AI.

Con el apoyo del Alan Turing Institute, el Centro Leverhulme para el Futuro de la Inteligencia y del departamento de investigación y desarrollo de la BBC, exponen cómo estas representaciones dominantes refuerzan conceptos erróneos y limitan la comprensión pública del uso y funcionamiento de los sistemas de IA.

“Necesitamos imágenes que retraten de manera más realista la tecnología y las personas detrás de ella y que señalen sus fortalezas, debilidades, contextos y aplicaciones”, indican sus promotores, que ofrecen un repositorio gratuito de mejores imágenes de IA y una guía de consejos para un uso responsable.

Una de las imágenes del colectivo ‘Better Images of AI’. Fuente: Alan Warburton / BBC / Better Images of AIImperios visuales

Una de las imágenes del colectivo ‘Better Images of AI’. Fuente: Alan Warburton / BBC / Better Images of AIImperios visuales

Una parte importante de las fotografías e ilustraciones que se emplean en publicidades, marketing corporativo, diseño de sitios web y también en sitios de noticias provienen de “fábricas de imágenes”: el negocio de las fotografías de archivo o de stock, una industria global de miles de millones de dólares, dominada por un puñado de corporaciones transnacionales –Getty Images, Corbis, Alamy, Shutterstock, Adobe Stock, Science Photo Library (SPL), entre otras–, con una fuerza poderosa en la cultura visual contemporánea.

Como indican los investigadores Gaudenz Urs Metzger y Tina Braun de la Escuela Superior de las Artes de Zúrich (Suiza) en un estudio publicado en el Journal of Death and Dying, estas imágenes influyen en cómo se imagina un tema, así como en lo que se puede decir y no decir en una sociedad.

A medida que las empresas periodísticas invierten cada vez menos en fotógrafos y diseñadores de infografías, las imágenes de stock expanden su presencia.

Por lo general, se trata de montajes, gráficos o ilustraciones genéricas, con un estilo realista, aunque más simbólico que documental, que buscan atraer la atención del lector al representar visualmente temas complejos como las tijeras moleculares de la técnica CRISPR de edición genética, el mundo subatómico, el interior del cuerpo humano, la computación cuántica, el blockchain (cadena de bloques) o la computación en la nube.

En el caso de la IA, el robot humanoide blanco ha sido elevado en el último tiempo al rol de embajador visual de estas tecnologías complejas por directa influencia de la cultura popular. Como registró el AI Narratives Project de la Royal Society de Londres, existe una fuerte tendencia a concebir las máquinas inteligentes con forma humana.

Una IA con formas hipersexualizadas“Cuando las personas imaginan a otros seres inteligentes, estas imaginaciones tienden a tomar forma humanoide”, destaca el documento principal de esta iniciativa. “Una consecuencia de este antropomorfismo es que los sistemas de IA son con frecuencia representados con género: sus formas físicas a menudo no son andróginas, sino que tienen las características sexuales secundarias estereotipadas de hombres o mujeres. De hecho, a menudo están hipersexualizados: tienen cuerpos masculinos exageradamente musculosos y tendencias agresivas, como Terminator, o formas femeninas convencionalmente hermosas como Ava en la película Ex Machina”.

La IA y sus ramas, como el aprendizaje automático, no son temas sencillos de explicar ni de ilustrar. Pero imaginar estas tecnologías como androides es problemático: desinforma, plantea expectativas demasiado altas, sugiere que su fin último es el de reemplazar a los humanos y dificulta que se consideren sus beneficios reales. Además, cuanto más humanos se ven estas representaciones, más étnicamente blancas son sus características.

De ahí que Stephen Cave y Kanta Dihal, investigadores de la Universidad de Cambridge (Reino Unido), señalen en su ensayo The Whiteness of AI que la representación de la IA sufre de un problema racial. “Imaginar máquinas que sean inteligentes, profesionales o poderosas es imaginar máquinas blancas porque el marco racial blanco atribuye estos atributos predominantemente a la blancura”, dicen los también autores de Imagining AI: How the World Sees Intelligent Machines.

“En las sociedades europeas y norteamericanas, la blancura está normalizada hasta tal punto que la vuelve en gran medida invisible. Al centrar la blancura como el color predeterminado del futuro, estas imágenes contribuyen a imaginar un futuro tecnológico que excluye a las personas de color de la misma manera que lo hacen las grandes empresas tecnológicas en la actualidad”, apuntan.

Clichés visuales y confusión sobre la IALos clichés visuales son varios: placas de circuitos, código binario descendente, brillantes cerebros situados en un espacio oscuro y vacío, aislados de las necesidades de un cuerpo, es decir, una clara alusión a la inteligencia, si bien gran parte de la IA y el aprendizaje automático que se utilizan hoy en día están muy alejados de la inteligencia humana. “Las personas que no entienden qué es la IA no pueden defender las formas en que la tecnología debería o no impactar a la sociedad”, señala Duarte.

Cerebros brillantes y robots blancos conforman la iconografía actual de la IA. Fuentes: Wiley / Routledge / Apress

Cerebros brillantes y robots blancos conforman la iconografía actual de la IA. Fuentes: Wiley / Routledge / ApressAdemás de la prevalencia de robots blancos, el color favorito de las empresas de tecnología para representar sus sistemas es el azul, usualmente asociado con inteligencia, confianza, seriedad, eficiencia pero también con masculinidad, como destaca la historiadora Alexandra Grieser en Blue Brains: Aesthetic Ideologies and the Formation of Knowledge Between Religion and Science.

“Existe una gran brecha entre la realidad de la IA y la percepción que tiene el público general, que es alimentada por representaciones en los medios y películas que a menudo presentan la IA como robots autónomos con capacidades casi humanas”, indica la desarrolladora de software mexicana Yadira Sánchez, asesora de Better Images of AI.

“Esta distorsión es preocupante porque impide que el público comprenda y participe efectivamente en debates cruciales sobre cómo la IA está remodelando áreas esenciales como la atención médica, la agricultura y la vigilancia estatal. Además –añade–, estas imágenes inexactas crean pensamientos futuristas muy optimistas o muy pesimistas sobre la IA y esto es peligroso porque generan expectativas y miedos en la sociedad”.

Otras imágenes para minimizar la confusiónPara minimizar la confusión, sostienen los investigadores de Better Images of AI, es importante utilizar imágenes que representen honestamente la realidad de la IA, como los recursos naturales y materiales que se consumen en su desarrollo. Por ejemplo, la extracción de litio en América Latina, o el agua y los ríos que se usan para mantener centros de datos en funcionamiento.

“Deberíamos mostrar cómo la IA se integra y afecta nuestros entornos naturales y sociales”, agrega Sánchez, “y cómo su infraestructura impacta directamente en el ecosistema y la vida cotidiana de las personas”.

“La enfermedad de la fotografía de stock de la IA ha alcanzado el estado epidémico”, señaló hace unos años el investigador Adam Geitgey, especialista en aprendizaje automático y reconocimiento facial. Aunque la IA no es la única rama científica que sufre estas tergiversaciones visuales. Más bien, todas las disciplinas, en algún grado u otro, las padecen cuando son representadas en periódicos, avisos publicitarios, campañas públicas o en webs de instituciones.

“Los medios optan por la solución más sencilla: utilizar imágenes que la gente reconozca y asocie rápidamente con la ciencia”, apunta la socióloga portuguesa Ana Delicado, quien estudió las representaciones visuales de la ciencia durante la pandemia de la covid-19 en sitios web de instituciones políticas y medios de comunicación en Portugal y España.

“Las imágenes de stock siempre se basan en estereotipos. Son productos comerciales: su objetivo es vender, no reflexionar sobre los temas que venden. Las imágenes estereotipadas en los medios de comunicación contribuyen a perpetuar representaciones estereotipadas en la opinión pública”, recalca.

En su análisis, publicado en la revista Frontiers in Communication, esta investigadora del Instituto de Ciencias Sociales da Universidad de Lisboa registró el abuso de ilustraciones del coronavirus SARS-CoV-2 con sus púas y pintado de rojo, haciéndolo parecer más amenazador.

También detectó una gran lista de elementos visuales que aluden a la actividad científica: hélices de ADN, células, moléculas, radiografías, equipos de laboratorio como microscopios, tubos, placas de Petri y pipetas, a menudo sostenidos por manos incorpóreas enguantadas, así como la presencia de personas con batas blancas, gafas protectoras y mascarillas, pero sin diversidad étnica, lo que refleja la subrepresentación de las minorías en la comunidad científica.

“La elección de imágenes para ilustrar la ciencia de la covid-19 tiende a reproducir nociones estereotipadas de la investigación científica como una actividad centrada en el laboratorio”, indica Delicado.

Nuevos generadores del imágenesAhora, con el auge de los sistemas de IA generadores de imágenes, como Stable Diffusion, Midjourney y DALL·E, se teme que empeoren las distorsiones sobre la realidad de la IA y la actividad científica en general. Como ya han demostrado algunas investigaciones, estas herramientas que producen imágenes a partir de indicaciones de texto suelen dar resultados racistas y sexistas.

Es decir, reproducen y amplifican sesgos raciales y de género, pues son entrenadas con imágenes utilizadas por medios de comunicación, organizaciones mundiales de salud y bases de datos de internet. “Estas imágenes son utilizadas sin crítica, sin reflexión”, advierte la socióloga portuguesa, “y la IA va a seguir perpetuando los estereotipos sobre la ciencia y las tecnologías”.

Una versión de este artículo fue publicada originalmente en SINC el 3 de mayo de 2024.

El artículo Las mentiras visuales de la IA se ha escrito en Cuaderno de Cultura Científica.

El protagonismo de los cuidados en la evolución humana

Los cambios del cerebro durante el embarazo y la maternidad, cómo el estrés ha pasado de ser un mecanismo de supervivencia a un eventual elemento de riesgo para nuestra salud o cuál ha sido el papel que ha jugado el suicidio en la evolución del ser humano fueron algunos de los temas que se tratarán en la VI Jornada Nacional sobre Evolución y Neurociencias.

La jornada tuvo lugar el Bizkaia Aretoa de la UPV/EHU los pasados 25 y 26 de abril y estuvo dirigida por Eva Garnica y Pablo Malo, de la Red de Salud Mental de Bizkaia, institución que organizó la jornada junto a la Cátedra de Cultura Científica de la UPV/EHU.

El encuentro, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolutivo y divulgar de un modo accesible para todos los públicos.

¿Cuándo comenzamos a cuidarnos entre los humanos? ¿Cómo se encuadra este comportamiento en nuestra evolución? Los orígenes de los cuidados están estrechamente vinculados al desarrollo de comportamientos que consideramos emblemáticamente humanos: en particular, nuestra disposición a cooperar por un bien mayor y nuestras habilidades de organización social. Explorar cuándo y por qué surgió este rasgo es un reto apasionante, y debe hacernos reflexionar sobre el impacto que su estudio debe producir, y produce, en la ciencia y en la sociedad actual. Estos son los temas que trata la conferencia El protagonismo de los cuidados en la evolución humana. La imparte Roberto Sáez, Doctor en Antropología, Máster en Ingeniería Industrial y divulgador científico, experto en Evolución Humana y en la Bioarqueología del Cuidado. Sáez es el autor del blog Nutcracker man.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El protagonismo de los cuidados en la evolución humana se ha escrito en Cuaderno de Cultura Científica.

Uso y abuso de la pregabalina

Envase de Lyrica (pregabalina) comercializado en Finlandia. Fuente: Acdx / Wikimedia Commons

Envase de Lyrica (pregabalina) comercializado en Finlandia. Fuente: Acdx / Wikimedia CommonsEl pasado mes de marzo, una noticia llegada desde Reino Unido generó cierta alarma respecto a la seguridad de la pregabalina, medicamento utilizado frecuentemente para el tratamiento del dolor crónico y la ansiedad. Una investigación del periódico británico The Sunday Times relacionaba el consumo de este fármaco con la muerte de 3 400 personas en los últimos años y describía los problemas de abuso y adicción que puede generar.

Dada la gravedad de la crisis sociosanitaria que sufre EE. UU. por la adicción a los opioides, los problemas de seguridad que puede plantear el uso de medicamentos como la pregabalina constituye un tema de especial interés.

Usos no contemplados en la ficha técnicaLa pregabalina es un medicamento con una estructura química similar a la del neurotransmisor GABA (ácido gamma-amino-butírico), sustancia que regula de forma inhibitoria la actividad del cerebro. Junto con la gabapentina, forma un grupo de medicamentos denominado gabapentinoides.

En España, el primer medicamento con pregabalina lo lanzó al mercado el laboratorio farmacéutico Pfizer, con el nombre comercial Lyrica. Inicialmente, fue aprobado para tratar la epilepsia y el dolor neuropático, y después se autorizó para tratar el trastorno de ansiedad generalizada.

Con el tiempo, el uso de Lyrica se amplió para tratar otras patologías que no contaban con la autorización sanitaria, como el dolor crónico, el dolor lumbar, la prevención del dolor postoperatorio, la fibromialgia y la profilaxis de la migraña. Esta aplicación se conoce como off-label o fuera de ficha técnica. En ocasiones, dichos usos pueden estar médicamente justificados si no existen alternativas terapéuticas autorizadas, y en todo caso se encuentran regulados por ley.

Lo que está prohibido es publicitarlo, y esto condenó a Pfizer a pagos de multas millonarias. Es conveniente recordar que el uso off-label de los medicamentos puede constituir un problema de seguridad, incrementar los costes del tratamiento o, directamente, resultar ineficaz, ya que se ha demostrado que su beneficio terapéutico es insuficiente.

Sin embargo, distintos estudios concluyen que más de la mitad de las recetas de gabapentinoides se realizan para indicaciones no autorizadas; mayoritariamente para tratar distintos tipos de dolor, a pesar de que los estudios científicos no recomiendan su uso.

Un consumo disparadoHoy en día, disponemos de 168 medicamentos que contienen pregabalina, incluidos los llamados genéricos. Los datos de consumo se pueden consultar en la página web de la Agencia Española de Medicamentos y Productos Sanitarios (AEMPS), concretamente en el informe sobre la utilización de analgésicos no opioides.

Esta información se expresa en DHD, es decir, en la dosis diaria definida (DDD) por cada 1 000 habitantes y día. Así sabemos que en los últimos 10 años el consumo de pregabalina se ha incrementado un 66 %, puesto que entre 2012 y 2022 el DHD pasó de 3,56 a 5,92. Este último dato significa que cada día un promedio de 5,92 personas de cada 1 000 recibe una DDD de pregabalina. Actualmente, se encuentra en el tercer puesto de fármacos analgésicos no opioides con mayor consumo en España, por detrás del paracetamol y el metamizol.

¿Es seguro tomar pregabalina?La pregabalina, como todos los medicamentos, no está libre de producir efectos adversos, es decir, efectos que no deseamos pero que en muchos casos no se pueden evitar. Por suerte, los más frecuentes, que aparecen en al menos una de cada 10 personas, son leves. Entre ellos destacan los mareos, la somnolencia y el dolor de cabeza.

También pueden manifestarse otros con menor frecuencia. Todos ellos pueden ser consultados en la ficha técnica en la página web del centro de información de la AEMPS, de acceso abierto, o en el prospecto del medicamento. Es importante señalar que los efectos adversos son más frecuentes cuando la pregabalina se toma en dosis altas y de forma crónica. Y en cualquier caso, este tipo de uso no ha demostrado aliviar mejor del dolor.

Entre los efectos más graves encontramos el riesgo de reducir la respiración, debido a que actúan sobre la zona del cerebro que controla esa función. Es importante tener esto en cuenta si el paciente ya está tomando otros medicamentos que tienen el mismo efecto, ya que su combinación en dosis altas podría llegar a paralizar la respiración y causar la muerte.

Estos otros medicamentos depresores son los analgésicos opioides (como la morfina), que utilizamos para aliviar dolores fuertes, y las benzodiazepinas (como el orfidal), que tomamos para dormir o calmar los nervios. Diversos estudios indican que el 60 % de los pacientes que usa gabapentinoides toma también los otros depresores. Una combinación fatal podría estar detrás del incremento de muertes asociadas al uso de pregabalina que describía el The Sunday Times.

Ese mismo efecto depresor de la pregabalina, pero ejercido sobre el sistema límbico del cerebro, produce una sensación de euforia y bienestar que puede conducir a comportamientos de abuso y dependencia. El concepto de dependencia se refiere a la necesidad de seguir tomando una sustancia para experimentar sus efectos deseados o aliviar el malestar que causa no consumirla (síndrome de abstinencia).

Si no se ingiere el medicamento, aparecen síntomas que provocan malestar y empujan a seguir tomándolo, a pesar de los posibles efectos negativos; es lo que coloquialmente llamamos “estar enganchado”. Son especialmente vulnerables aquellas personas que han sufrido con anterioridad problemas de adicción.

Siempre bajo supervisión médicaLos riesgos asociados al abuso de pregabalina pueden minimizarse con un seguimiento adecuado de la pauta médica, valorando periódicamente la necesidad de mantener o retirar el tratamiento según criterios de eficacia, tolerabilidad, efectos adversos y adherencia. Si la valoración recomienda suspender el tratamiento, se realizará de forma gradual y con supervisión médica.

En todo caso, la pregabalina está autorizada para tratar el dolor neuropático –que se produce por el daño de un nervio–, la epilepsia y la ansiedad porque los estudios indican que los beneficios del tratamiento superan los riesgos. En este contexto, la evaluación de la relación riesgo-beneficio del tratamiento con pregabalina corresponde a los profesionales médicos y cuentan con el apoyo de la AEMPS.

Finalmente, no podemos olvidar el papel de la ciudadanía en la gestión activa de su salud: es fundamental seguir las indicaciones médicas y comunicar si sufrimos efectos adversos y si notamos que el tratamiento no está funcionando. Transmitir toda esta información en las visitas a la consulta es clave para que el médico o la médica evalúe correctamente la utilidad del tratamiento y su seguridad.![]()

Sobre las autoras: María Torrecilla Sesma y Cristina Bruzos Cidón son Profesoras de Farmacología en la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Uso y abuso de la pregabalina se ha escrito en Cuaderno de Cultura Científica.

Un coloso de la informática

El 18 de enero de 1944, llegó a Bletchley Park un camión con una carga muy especial: una máquina de cálculo que pesaba una tonelada, medía 2,13 x 5,18 x 3,35 metros, estaba construida con alrededor de 1600 válvulas termoiónicas y era capaz de operar a una velocidad de 5000 caracteres por segundo. La llamaron Colossus, se considera la primera computadora electrónica, programable y digital de la historia… y estuvo a punto de no existir.

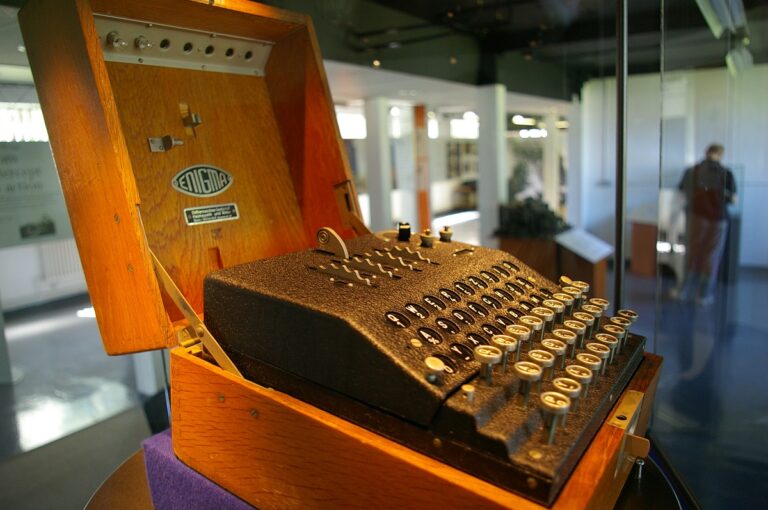

Durante la Segunda Guerra Mundial, Bletchley Park fue uno de los centros neurálgicos de los servicios de inteligencia británicos. Bajo el nombre en clave de Ultra, allí se descifraban todas las comunicaciones que Inglaterra interceptaba al Ejército y la diplomacia de la Alemania nazi y pasó a la historia, sobre todo, por el duelo que tuvo lugar allí entre el matemático inglés Alan Turing y la supuestamente impenetrable Enigma naval de la Kriegsmarine que utilizaban los U-Boote del Atlántico.

Máquina enigma de cuatro rotores expuesta en Bletchley Park. Funete: Tim Gage / CC BY-SA 2.0

Máquina enigma de cuatro rotores expuesta en Bletchley Park. Funete: Tim Gage / CC BY-SA 2.0

En 1941, casi a la par que la Enigma naval quedaba al descubierto tras un arduo trabajo por parte del barracón 8 que dirigía Turing, las estaciones de escucha británicas comenzaron a interceptar una nueva clase de mensajes indescifrables que no se estaban retransmitiendo en morse, como los de Enigma, sino en el código internacional del teletipo. Alemania había puesto en escena una nueva máquina de cifrado automática y mucho más sofisticada que Enigma para las comunicaciones diplomáticas: la Lorenz SZ, a la que apodaron Tunny.

En este caso, fue el coronel John Tiltman quien consiguió descifrar un mensaje de Tunny por primera vez a finales de aquel mismo año. Con el trabajo de este, el matemático Bill Tutte dedujo cómo debía de ser el funcionamiento de la máquina. Por último, Alan Turing ideó un método algorítmico, la «turingería» ―de «Turing» e «ingeniería»― que permitió acotar sustancialmente las posibles configuraciones de los doce rotores de los que constaba el disposivo y… entonces se marchó a Estados Unidos.

Máquina de cifrado Lorenz SZ40, sin la carcasa, en el US National Cryptologic Museum. En ella se pueden apreciar los doce rotores. Fuente: Mark Pellegrini / CC BY-SA 2.5

Máquina de cifrado Lorenz SZ40, sin la carcasa, en el US National Cryptologic Museum. En ella se pueden apreciar los doce rotores. Fuente: Mark Pellegrini / CC BY-SA 2.5

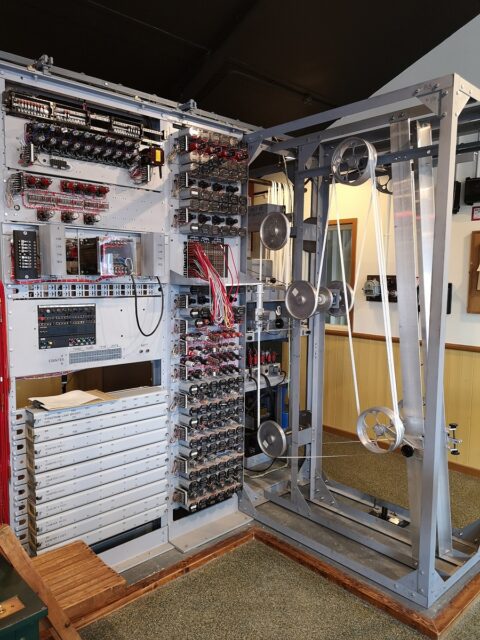

Fue Bill Tutte el que continuó trabajando en nuevos métodos de descifrado de Tunny, pero, a medida que Alemania aumentó la extensión aquella red de comunicaciones, que los aliados bautizaron como Fish, y mejoró la seguridad, los cálculos empezaron a volverse inabarcables: se iba a necesitar algún tipo de dispositivo electromecánico para realizarlos, al igual que se habían necesitado las Bombe para poder romper Enigma.

El primer intento de mecanizar el descifrado de Tunny vino de la mano de Max Newman y sus «Heath Robinson» unos cacharros llamados así en honor a William Heath Robinson, un ilustrador que solía hacer dibujos de inventos bizarros dada la lentitud, imprecisión y tendencia al sobrecalentamiento que tenían. Pero un ingeniero eléctrico de Bletchley Park, al que, en un principio, habían reclutado como ayudante de Alan Turing, tenía en mente desde hacía algún tipo una idea de máquina mucho más rápida, precisa y eficiente.

Réplica de una de las Heath Robinson de Max Newman en el National Museum of Computing, de Bletchley Park. Fuente: TedColes / CC BY-SA 4.0

Réplica de una de las Heath Robinson de Max Newman en el National Museum of Computing, de Bletchley Park. Fuente: TedColes / CC BY-SA 4.0

Tommy Flowers había nacido en una familia humilde en uno de los distritos más pobres de Londres, Poplar, muy cerca de Whitechapel, y ya desde muy pequeño le había llamado la atención la ingeniería. Estuvo durante un tiempo como aprendiz en el Arsenal Real de Londres hasta que encontró trabajo en el departamento de ingeniería de Correos mientras se sacaba el título en la escuela nocturna. Allí conoció y empezó a investigar las posibilidades que ofrecía un nuevo componente electrónico que podía realizar tareas de interruptor a una velocidad mucho más alta de la habitual: la válvula termoiónica o de vacío.

Tommy Flowers. Fuentes: Dominio público

Tommy Flowers. Fuentes: Dominio público

Aunque ya se estaban utilizando en algunos dispositivos ―y las Heath Robinson eran uno de ellos, aunque solo parcialmente―, el uso de las válvulas de vacío aún era bastante limitado. Tommy Flowers fue el primero al que se le ocurrió que podían utilizarse en un número mucho mayor para fabricar máquinas de computación completamente electrónicas. Pero, como sucede casi siempre que alguien presenta una idea demasiado disruptiva, en Bletchley Park aquello les pareció una locura.

Sin el apoyo que necesitaba, pero convencido de que un computador completamente electrónico era posible, pese a las dificultades de diseño que presentaba, Flowers reunió a cincuenta científicos, ingenieros y técnicos del laboratorio de la oficina de Correos de Dollis Hill donde trabajaba y se pusieron manos a la obra, trabajando doce horas al día, seis días y medio a la semana para crear, en un tiempo récord de diez meses, el primer computador electrónico: Colossus. Cuando se presentaron con él en Bletchley Park y, más aun, cuando lo pusieron en funcionamiento, el personal no daba crédito a lo que tenía delante.

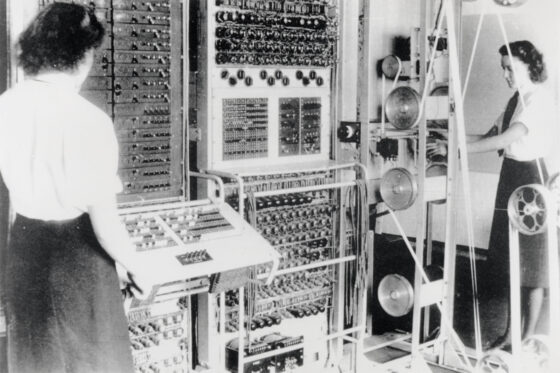

El primer prototipo de Colossus que llegó a Bletchley funcionaba muy bien, pero no lo todo lo rápido que se necesitaba, así que Tommy Flowers y su equipo se pusieron de nuevo a trabajar contrarreloj en una versión mejorada que el Gobierno quería tener lista, como muy tarde, para el 1 de junio: aquella iba a ser la fecha inicial en la que iba a tener lugar el Día-D y se necesitaba que la máquina estuviera ya operativa. Colossus Mark II, con 2400 válvulas y una velocidad de 25 000 caracteres por segundo, lo estuvo y, de hecho, el 5 de junio se descifró con ella un mensaje de Adolf Hitler dirigido al mariscal Erwin Rommel en el que los aliados pudieron confirmar que la maniobras de los servicios secretos para desviar la atención del Führer lejos de las playas de Normandía había funcionado. Al día siguiente, el Ejército aliado tomó la costa francesa y comenzó la ofensiva por la liberación de Europa occidental. Mientras tanto, una Colossus tras otra iba llegando a Bletchley Park a medida que las fuerzas aliadas penetraban en el continente. Veinticuatro horas al día, siete días la semana, un ejército de WRENs ―mujeres pertenecientes al Women’s Royal Naval Service― averiguaba sin descanso la configuración diaria de la las máquinas Tunny y dejaba al descubierto las comunicaciones enemigas.

Colossus Mark II en Bletchley Park, operada por las WRENs (Women’s Royal Naval Service) Dorothy Du Boisson y Elsie Booker en 1943.

Colossus Mark II en Bletchley Park, operada por las WRENs (Women’s Royal Naval Service) Dorothy Du Boisson y Elsie Booker en 1943.

A menudo se ha tratado de establecer el impacto que todo el trabajo de criptoanálisis de Bletchley Park tuvo sobre el desarrollo de la guerra. Hay quienes dicen que ayudó a acortar el conflicto en unos dos o tres años, por ello, resulta bastante inquietante pensar que Colossus fue posible gracias a una serie de serendipias que podrían, perfectamente, no haber tenido lugar.

A finales de agosto de 1939, y con las tensiones en Europa a punto de hacer estallar todo, algún superior no muy centrado envió a Tommy Flowers a Berlín en viaje de trabajo. Tan pronto como este puso el pie en la capital alemana, la Embajada británica lo llamó para advertirle de que abandonara el país lo antes posible. Flowers consiguió cruzar a Holanda apenas unas horas antes de que se cerraran las fronteras de Alemania, evitando así, seguramente, acabar como prisionero del régimen nazi. También fue providencial que luego la oficina de Correos lo enviara a él, y no a otro, a ayudar a Alan Turing con Enigma y las Bombe, porque cuando alguien iba a consultarle al matemático cualquier tema de ingeniería o problema con los equipos, Alan simplemente respondía: «Flowers»… Lo que llevó a este hasta Newman, luego hasta Tunny, luego hasta Colossus y, finalmente, a marcar ―casualidades que pasan― el primer gran hito de la historia de la computación.

Referencias:

Copeland, B. Jack, et. al. (2006). Colossus. The secrets of Bletchley Park’s codebreaking computers. Oxford University Press.

Copeland, B. Jack (2021 [2013]). Alan Turing. El pionero de la era de la información. Turner.

Para saber más:

Marian Rejewski, el matemático que «rompió» la Máquina Enigma

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Un coloso de la informática se ha escrito en Cuaderno de Cultura Científica.

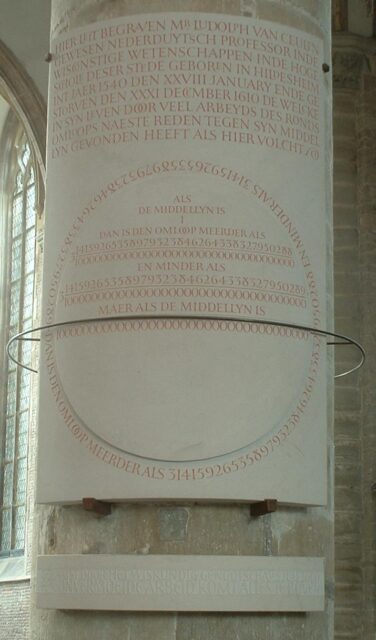

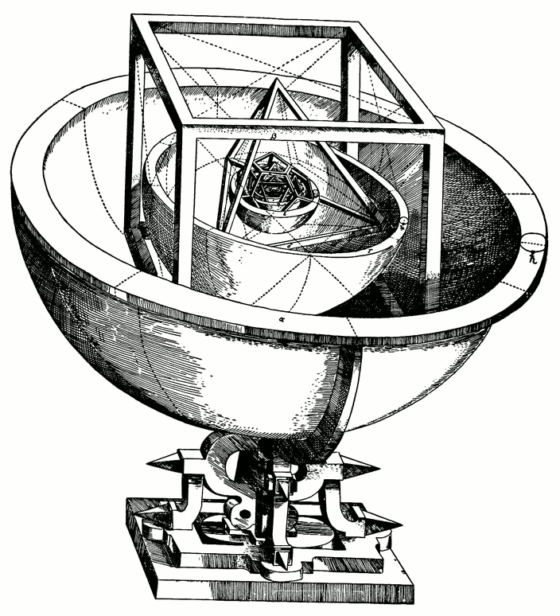

El infinito en un segmento (3)

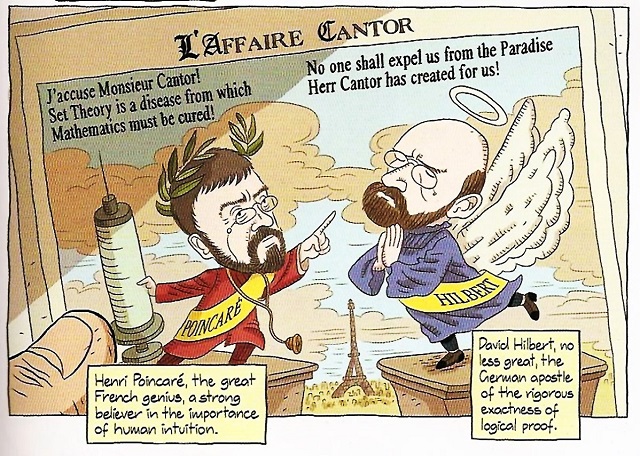

A finales del siglo XIX, el matemático ruso-alemán Georg Cantor (1845-1918) conmocionó al mundo de las matemáticas, rompiendo las creencias existentes sobre el concepto de infinito. Entre los revolucionarios resultados que demostró están que existe más de un infinito o que la cantidad de puntos de un segmento es la misma que la cantidad de puntos de un cuadrado. A esta revolución matemática hemos dedicado, en el Cuaderno de Cultura Científica, la miniserie titulada El infinito en un segmento.

Página de la novela gráfica Logicomix, de Apostolos Doxiadis y Christos H. Papadimitiou, Bloomsbury, 2009. En la viñeta se muestra una noticia con motivo del Congreso Internacional de Matemáticos de 1900, con una caricatura de dos matemáticos enfrentados, el francés Henri Poincaré, con su frase “¡Le acuso Señor Cantor! ¡La teoría de conjuntos es una enfermedad de la que hay que curar a las matemáticas!”, y el alemán David Hilbert, con su frase “Nadie nos expulsará del paraíso que Herr Cantor ha creado para nosotros”

Página de la novela gráfica Logicomix, de Apostolos Doxiadis y Christos H. Papadimitiou, Bloomsbury, 2009. En la viñeta se muestra una noticia con motivo del Congreso Internacional de Matemáticos de 1900, con una caricatura de dos matemáticos enfrentados, el francés Henri Poincaré, con su frase “¡Le acuso Señor Cantor! ¡La teoría de conjuntos es una enfermedad de la que hay que curar a las matemáticas!”, y el alemán David Hilbert, con su frase “Nadie nos expulsará del paraíso que Herr Cantor ha creado para nosotros”

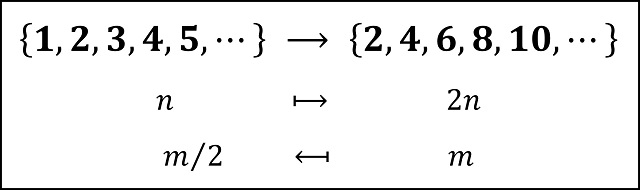

La primera entrega de esta miniserie, El infinito en un segmento (1), se centró en cómo resolvió el matemático ruso-alemán el problema de comparar dos conjuntos con infinitos elementos. La respuesta es sencilla y está en la base del origen del concepto de número. Dos conjuntos tienen la misma cantidad de elementos cuando se puede establecer una “correspondencia uno-a-uno” entre los elementos de los dos conjuntos. De esta forma, llegamos a la paradoja de que para un conjunto infinito existen subconjuntos propios del mismo que tienen la misma cantidad de elementos que el propio conjunto. Por ejemplo, el conjunto de los números pares tiene la misma cantidad de elementos que el conjunto de los números naturales (que está formado por los números pares y los números impares).

Existe una correspondencia uno-a-uno entre el conjunto de los números pares y el conjunto de los números naturales

Existe una correspondencia uno-a-uno entre el conjunto de los números pares y el conjunto de los números naturales

De hecho, Georg Cantor tomó esta paradoja del ininfito como definición de “conjunto infinito”, es decir, un conjunto es infinito si existe un subconjunto propio suyo que tiene la misma cantidad de elementos que el conjunto.

En esta primera entrega de la serie se demostró también que los conjuntos de los números enteros y de los números racionales son conjuntos numerables, es decir, tienen la misma cantidad de elementos que el conjunto de los números naturales.

En la segunda entrega de esta miniserie, El infinito en un segmento (2), se mostró que el conjunto de los números reales (de forma explícita, en la demostración se consideró el intervalo (0,1), es decir, los números reales entre 0 y 1) no es numerable, no se puede poner en correspondencia uno-a-uno con los números naturales. Por lo tanto, existe más de un infinito, al menos, el infinito de los números naturales (cuyo cardinal se denomina aleph-zero) y el infinito de los números reales (cuyo cardinal se denomina cardinal del continuo, c).

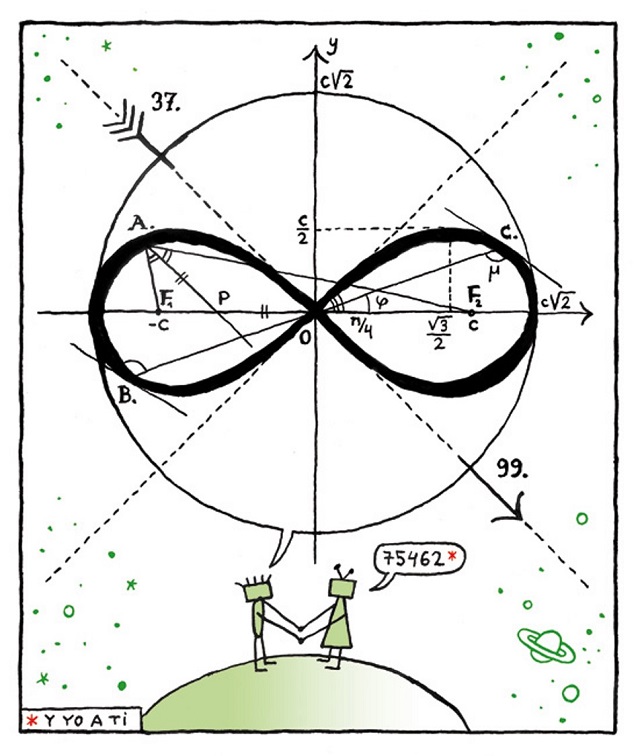

El bueno de Cuttlas (4MOR, 37 & 99), de Calpurnio, publicado en 20 MinutosEl infinito en un cuadrado

El bueno de Cuttlas (4MOR, 37 & 99), de Calpurnio, publicado en 20 MinutosEl infinito en un cuadrado

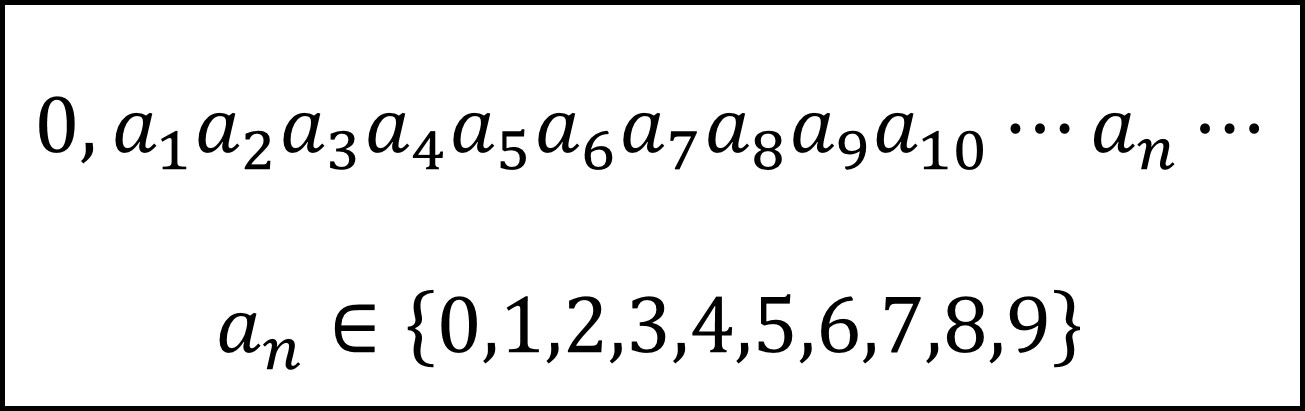

Como se comentó al final de la segunda entrada de esta miniserie, una vez demostrado que el cardinal del continuo c (el infinito de los números reales) es mayor que aleph-zero (el infinito de los números naturales), Georg Cantor se planteó si el plano (de dimensión 2) tiene una mayor cantidad de puntos que la recta (de dimensión 1), es decir, si el infinito del plano es mayor que el infinito del continuo. Simplificando la cuestión.

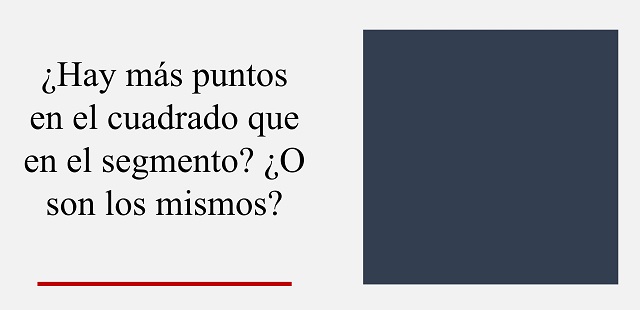

Problema: ¿Hay la misma cantidad de puntos en el segmento unidad [0,1] que en el cuadrado unidad [0,1] x [0,1]?

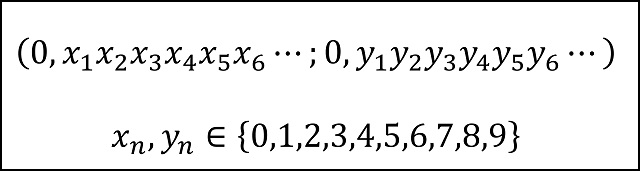

Para abordar el anterior problema, primero recordemos un par de cuestiones básicas. La primera es que los números reales del intervalo [0,1], es decir, mayores que 0 y menores que 1, se escriben en forma decimal como

donde, si todos los dígitos son 0 se obtendría el número cero (0), y si todos los decimales son 9 se obtendría el número uno (1), ya que, como se comentó en la anterior entrada, el número 1 se puede representar de dos formas distintas 1,00000000… (infinitos ceros) y 0,99999999… (infinitos nueves). Por ejemplo, el número pi menos 3, que es un número real del intervalo (0,1) se expresa como 0,1415926535…

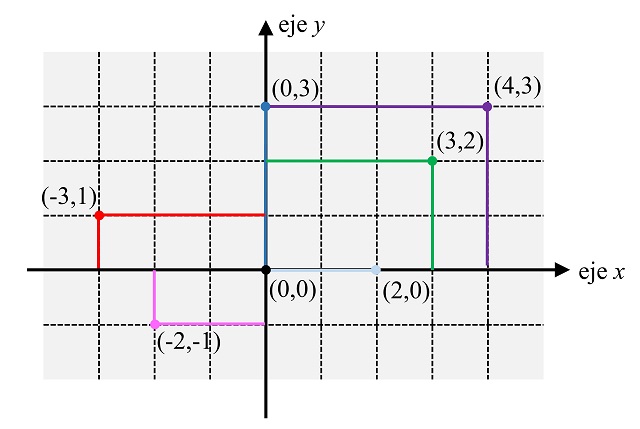

La segunda cuestión básica es que todo elemento del plano real se puede identificar con sus coordenadas cartesianas, es decir, con un par (x, y), donde x e y son números reales, como se muestra en la siguiente imagen (aunque en ella solamente se han utilizado puntos cuyas coordenadas x e y son números enteros).

De manera, que los elementos del cuadrado [0,1] x [0,1], serán los puntos del plano (x, y), donde x e y son números reales del intervalo [0,1]. Es decir, son de la forma

(Nota: hemos utilizado el punto y coma “;” para separar las coordenadas, en lugar de la tradicional coma “,”, con la intención de que quede más clara la separación entre las dos coordenadas)

(Nota: hemos utilizado el punto y coma “;” para separar las coordenadas, en lugar de la tradicional coma “,”, con la intención de que quede más clara la separación entre las dos coordenadas)

Ahora, una cuestión técnica. Antes de entrar en la construcción de la buscada correspondencia uno-a-uno entre el segmento y el cuadrado, vamos a tener en cuenta lo siguiente, de cara a dicha construcción. Como se puede demostrar (aunque no quiero meterme ahora en esta cuestión para no complicar más esta entrada) que los segmentos [0,1], es decir, los números reales mayores o iguales que 0 y menores o iguales que 1; (0,1], es decir, los números reales mayores que 0 y menores o iguales que 1; y (0,1), es decir, los números reales mayores que 0 y menores que 1, tienen la misma cantidad de elementos (existen correspondencias uno-a-uno entre ellos), es equivalente demostrar que existe una correspondencia uno-a-uno entre el segmento [0,1] y el cuadrado [0,1] x [0,1], que entre el segmento (0,1] y el cuadrado (0,1] x (0,1] o que entre el segmento (0,1) y el cuadrado (0,1) x (0,1). Por motivos técnicos, nosotros vamos a centrarnos en construir una correspondencia uno-a-uno entre el segmento (0,1] y el cuadrado (0,1] x (0,1], es decir, los puntos (x, y) tales que sus coordenadas x e y pertenecen a (0, 1].

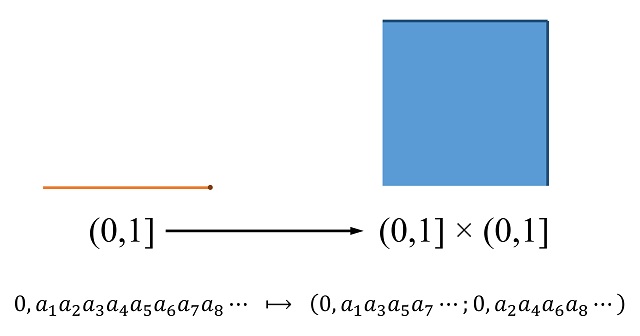

Por lo tanto, ya estamos en condiciones de mostrar la construcción de Georg Cantor de la correspondencia uno-a-uno entre los elementos del segmento (0,1] y los elementos del cuadrado (0,1] x (0,1], que prueba que ambos conjuntos tienen la misma cantidad de elementos. La idea básica es asignar a cada elemento A del intervalo (0,1], es decir, un número real con su expresión decimal (por ejemplo, 0,1234567891011…), un elemento (B, C) del cuadrado (0,1] x (0,1] tal que los decimales de la primera coordenada B son los decimales en las posiciones impares de A y los decimales de la segunda coordenada C son los decimales en posiciones pares de A, como se muestra en la imagen.

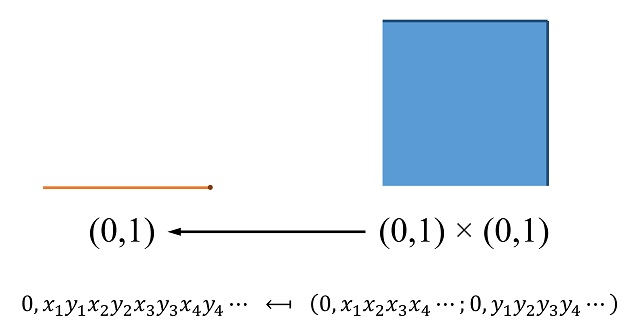

Y cuya aplicación inversa, es decir, que envía los elementos del cuadrado (0,1] x (0,1] en elementos del segmento (0,1], está definida mediante la construcción inversa, juntando los decimales de ambas coordenadas e intercalándolos en posiciones impares y pares.

Por ejemplo, la imagen de la conocida “constante de Champernowne”, que es el número real, entre 0 y 1, cuyos decimales son los números naturales ordenados de izquierda a derecha, es decir,

0,123456789101112131415161718192021…

es el punto del cuadrado (0,1] x (0,1] cuyas coordenadas son

(0,135790123456789012…; 0,24681111111111222…).

Por otra parte, si tomamos el punto del cuadrado (0,1] x (0,1] dado por las coordenadas (x, x), donde x es la raíz de 2 menos 1, es decir, el punto

(0, 41421356237309…; 0, 41421356237309…),

su imagen, mediante la aplicación inversa, es el elemento del segmento (0,1] dado por la siguiente expresión

0, 4411442211335566223377330099…

Resolviendo algunas cuestiones técnicasLa idea de Cantor es ingeniosa, sin embargo, el hecho de que haya números reales, en concreto, los números racionales con un número finito de decimales (incluido en caso en el que no hay decimales, es decir, los números enteros) que tienen dos representaciones genera algunos problemas en la anterior aplicación, que hay que resolver.

Problema 1. Como decíamos, hay números que tienen dos representaciones decimales, por ejemplo, el número racional 11/20 se puede representar como 0,55 (o si lo preferimos 0,55000000…) y 0,54999999… Esto es un problema, ya que ese número racional tendría dos posibles imágenes mediante la anterior construcción

(0,500000…; 0,500000…) y (0,599999…; 0,499999…).

Por lo tanto, lo que hizo Cantor fue quedarse con una única representación de las dos, la que tiene infinitos nueves, en este caso, 0,54999999… De esta forma, solo existe, a priori, una imagen en (0,1] x (0,1] de cada número real de (0,1], que, en el ejemplo anterior, es (0,599999…; 0,499999…).

Problema 2. Pero al elegir una única representación de las dos se genera un problema añadido, ya que puede haber números reales de (0,1] cuya imagen contenga una expresión de las primeras y ya no sea válida, como 118/275 = 0,429090909…, cuya imagen sería, por la construcción de Cantor, el punto del cuadrado (0,49999…; 0,20000…), que ya no es un punto válido puesto que para el número 0,2 se ha elegido la representación 0,199999… Notemos que si se admitiesen aquí las dos representaciones se tendría que dos números reales distintos 0,429090909… y 0,4199999999… tendrían la misma imagen (0,49999…; 0,20000…) = (0,49999…; 0,19999…), es decir, la correspondencia no sería uno-a-uno.

Este nuevo problema lo resuelve Cantor de una forma ingeniosa. En la aplicación del segmento (0,1] en el cuadrado (0,1] x (0,1], en lugar de separar dígitos en posiciones pares e impares (y en la aplicación inversa intercalar los dígitos de las dos coordenadas del punto), lo que propone es separar (respectivamente, intercalar) grupos de dígitos, de manera que los ceros consecutivos dentro de la representación decimal se “pegan” al siguiente dígito no nulo. Por ejemplo, los grupos de dígitos de 118/275 = 0,429090909… serían

4 / 2 / 9 / 09 / 09 / 09 …

Por lo tanto, su imagen mediante la aplicación de Cantor sería ahora

(0,49090909…; 0,2090909…).

De hecho, el punto (0,49090909…; 0,2090909…) sería el único punto de (0,1] x (0,1] cuya imagen es 118/275 = 0,429090909…

Veamos otro ejemplo. El número real 0,01002000300004000005… tendría los siguientes grupos de dígitos

01 / 002 / 0003 / 00004 / 000005 …

por lo que su imagen sería el punto del cuadrado de coordenadas (0,010003000005…; 0,002000040000006…). Y ese punto del cuadrado es el único cuya imagen inversa es el número real 0,01002000300004000005…

Por supuesto, los números que no tienen ceros entre sus decimales funcionan como antes. Así, 1/2 = 0,4999999… tiene como imagen (0,4999999…, 0,9999999) y este punto es el único cuya imagen inversa es 1/2 = 0,4999999…

En conclusión, Cantor demostró que existen tantos puntos en el intervalo (0,1], como en el cuadrado (0,1] x (0,1].

Retrato del matemático ruso-alemán Georg Cantor, de alrededor de 1910. Imagen obtenida de “Library of Congress, courtesy AIP Emilio Segrè Visual Archives”

Retrato del matemático ruso-alemán Georg Cantor, de alrededor de 1910. Imagen obtenida de “Library of Congress, courtesy AIP Emilio Segrè Visual Archives”Bibliografía

1.- R. Ibáñez, La gran familia de los números, Libros de la Catarata – FESPM, 2021.

2.- David Foster Wallace, Todo y más, Breve historia del infinito, RBA, 2013.

3.- J. Stillwell, The Real Numbers: An Introduction to Set Theory and Analysis, Undergraduate Texts in Mathematics, Springer, 2013.

4.- Eli Maor, To infinity and Beyond, A Cultural History of Infinity, Birkhauser, 1987.

5.- José A. Prado-Bassas, Historia del infinito (el apasionante relato de uno de los conceptos más profundos y enigmáticos de las matemáticas), Pinolia, 2023.

6.- Erich Kamke, Theory of Sets, Dover, 1950.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El infinito en un segmento (3) se ha escrito en Cuaderno de Cultura Científica.

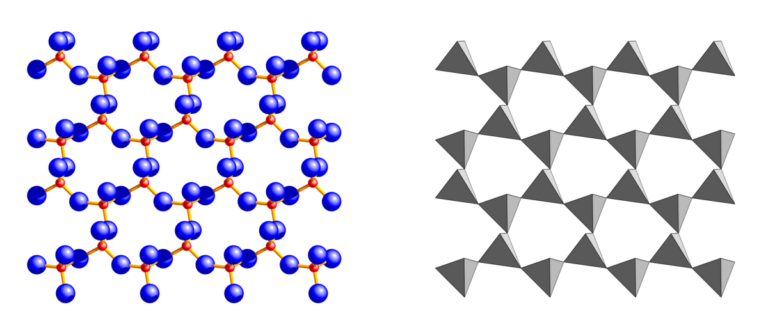

La carga efectiva del protón depende del isospín

Al calcular las propiedades de los núcleos pesados los teóricos suelen centrarse en un subconjunto de los nucleones (protones y neutrones) y suponen que estas partículas tienen “cargas efectivas” que de alguna manera compensan todos los nucleones que se ignoran. Sin embargo, elegir las cargas efectivas adecuadas puede resultar complicado. Ahora Andrea Jungclaus, del Instituto de Estructura de la Materia (IEM-CSIC), y sus colegas han proporcionado la primera evidencia experimental clara de que las cargas efectivas dependen del isospín (groseramente, la proporción neutrón-protón) y han medido esta dependencia de forma inequívoca. La nueva información debería mejorar la precisión de los cálculos para núcleos pesados y ricos en neutrones, para los cuales existen datos experimentales limitados.

El Radioactive Isotope Beam Factory de RIKEN, donde se realizaron los experimentos. Fuente: RIKEN

El Radioactive Isotope Beam Factory de RIKEN, donde se realizaron los experimentos. Fuente: RIKENLas partículas subatómicas que interaccionan a través de la interacción fuerte se conocen como hadrones. Esta categoría incluye a los protones, los neutrones y los piones. El espín isotópico o isospín es un número cuántico que se aplica a los hadrones para diferenciar los elementos de un conjunto de partículas que difieren en sus propiedades electromagnéticas pero que, por lo demás, son indiscernibles. Así, si se ignoran las interacciones electromagnéticas y débiles, el protón no puede distinguirse del neutrón por sus interacciones fuertes: el isospín se introdujo para distinguirlos.