La Ría del Nervión a vista de ciencia y tecnología

Alrededor de un millón de personas vivimos en las localidades situadas en los márgenes de la Ría del Nervión o en poblaciones próximas a aquellas. Muchas de esas personas hemos pasado la mayor parte de nuestras vidas en ese entorno, transitando, además, de manera frecuente entre las dos orillas. Y sin embargo, es muy poco lo que sabemos acerca de la Ría, aunque durante el último medio siglo se ha atesorado una cantidad de conocimiento enorme sobre ella.

La Cátedra de Cultura Científica de la UPV/EHU se ha propuesto mostrar a la ciudadanía del Territorio de Bizkaia y a quienes nos visitan una pequeñísima parte de ese conocimiento. Y lo hace, además, llevándolo a uno de los enclaves más transitados de nuestra metrópoli: el metro. Hemos contado, como es natural, con la inestimable colaboración de Metro Bilbao, que se ha implicado a fondo en este proyecto conjunto.

Mediante una colección de diez paneles con infografías se presenta su desarrollo histórico, la geología del entorno, la ecología, las consecuencias del saneamiento, el Puente de Bizkaia, el metro y otros elementos. Y se presentan a la luz de la ciencia y la tecnología, ofreciendo una visión diferente, más comprensiva, del entorno en el que vivimos y trabajamos. Las infografías han sido realizadas por el estudio NorArte, gracias al asesoramiento de un nutrido grupo de investigadoras e investigadores y expertas y expertos en diversas áreas.

Mediante esta exposición la Cátedra inicia el año en que cumplirá su primera década de vida, y lo hace abriendo una nueva línea de actuación que busca acercar el conocimiento a la gente. Hasta ahora hemos, sobre todo, convocado a la ciudadanía a los actos de difusión social de la ciencia que organizamos. Con esta iniciativa pretendemos recorrer el viaje de vuelta, dirigirnos al público, a los lugares por los que transita y donde se encuentra sin abandonar, lógicamente, nuestras actividades habituales.

Los paneles han estado expuestos desde el 16 de diciembre al 1 de enero en la estación de Moyua. Entre el 2 y el 31 de enero estarán en la estación de Indautxu. Y durante el mes de febrero reclarán en la estación de Portugalete. No te lo pierdas.

https://culturacientifica.com/app/uploads/2020/01/ccc2.mp4Vídeo de EiTB de la mano del periodista Aitor Zabaleta, sobre la exposición de infografías .

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La Ría del Nervión a vista de ciencia y tecnología se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Presentación del estudio «Percepción social de la ciencia y la tecnología en el País Vasco»

- Visión de los jóvenes vascos sobre la ciencia y la tecnología

- Ciencia y tecnología

Ingredientes clave a la hora de enseñar a leer

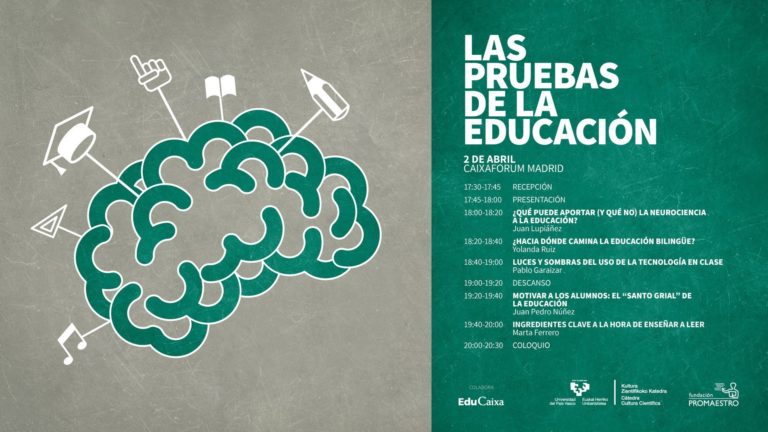

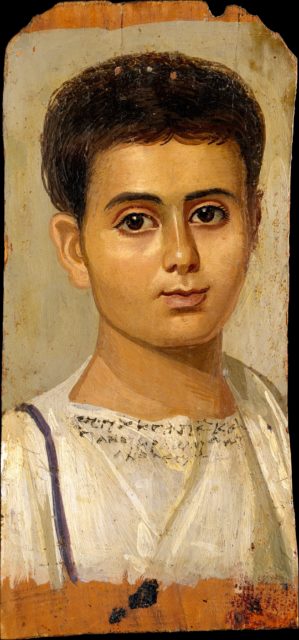

Érase una vez… en el País Vasco, un congreso tan oportuno y tan útil, y tan bien recibido en Bilbao y en Donostia-San Sebastián, que muchos pensaron que tenía que viajar a más lugares. Así que la Cátedra de Cultura Científica y la Fundación Promaestro se pusiron de acuerdo y, con la ayuda de EduCaixa, lo llevaron a Madrid: casi un centenar de personas con espíritu crítico y bien informadas llenaron el pasado 2 de abril la modesta y acogedora sala de CaixaForum en la que se celebró.

Marta Ferrero, investigadora de la Universidad de Deusto, nos hace experimentar, “oligodendroglia” mediante, cómo un lector inicial puede aprender con éxito una nueva palabra: exponiéndose repetidamente a ella en contextos diversos y recibiendo información sobre su morfología. Y es que sobre cómo enseñar a leer a los niños, “la evidencia es robusta: el método más eficaz es aquel que explica la relación entre las letras y los sonidos”.

Por tanto, el método fonético es mejor que el famoso método global, y lo es por una cuestión de justicia social, según indicó la ponente: “la mayoría de los niños aprenden a leer con cualquier método, pero hay una pequeña parte de los niños que solo aprenderán a leer correctamente si se les enseña con el método fonético. Por el contrario, con el método global algunos niños convertirán el acto de leer en un acto de adivinar”.

Ferrero termina dando unos consejos para conseguir que los más pequeños se conviertan, en un futuro, en buenos lectores: llenad el aula (y la casa) de libros; cuidad las bibliotecas escolares y visitadlas; enseñadles las partes de un libro; haced lecturas compartidas; dejad que sean ellos los que elijan qué leer (y si quieren leer el mismo libro diez veces, que lo hagan); y, por último, recordó que “no pasa nada porque un niño salga de la etapa de infantil sin saber leer. A veces, dejando pasar el verano, esos niños van a aprender a leer con mucho menos esfuerzo. No los machaquemos; disfrutemos leyendo con ellos y convirtamos la lectura en algo placentero”.

Edición realizada por César Tomé López a partir de materiales suministrados por Fundación Promaestro.

El artículo Ingredientes clave a la hora de enseñar a leer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- Cómo leer un artículo científico

- Por qué los colegios no deberían enseñar habilidades de pensamiento crítico generales

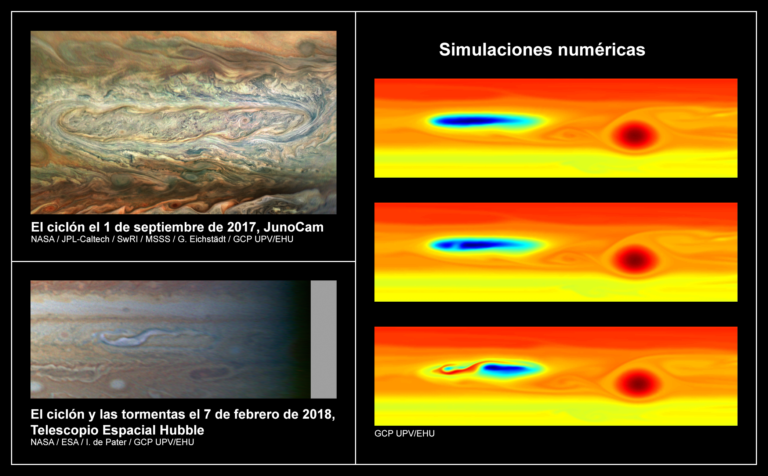

Tormentas convectivas de agua muy energéticas en Júpiter

El grupo de Ciencias Planetarias de la UPV/EHU ha estudiado durante un año una serie de tormentas convectivas que se dieron dentro de un ciclón de gran escala de Júpiter. Las tormentas fueron tan energéticas que perturbaron la estructura y la dinámica del ciclón durante meses. Al simular el fenómeno la única conclusión es tormentas de esa magnitud solo pueden ser generadas por la convección de agua.

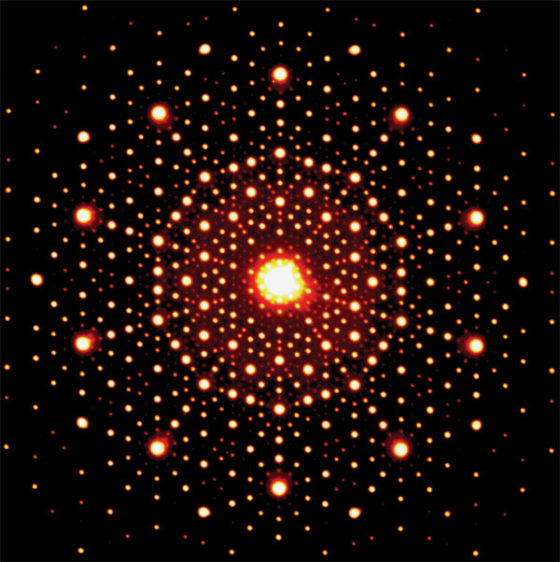

Imagen: Peio Iñurrigarro, UPV/EHU

Imagen: Peio Iñurrigarro, UPV/EHU

En febrero de 2018 sucedieron en Júpiter una serie de tormentas convectivas, tormentas con fuertes movimientos verticales y gran desarrollo de precipitación, que fueron tan energéticas que cambiaron por completo la región en la que sucedieron: un ciclón de 28.000 km de longitud denominado ciclón fantasma por su débil contraste que lo hace difícil de distinguir en observaciones desde la Tierra. “Tuvimos conocimiento de estas tormentas gracias a las observaciones de personas aficionadas a la astronomía, que ciertamente nos proveen de un seguimiento prácticamente continuo de la actividad meteorológica de Júpiter”, comenta Peio Iñurrigarro Rodriguez, miembro del grupo de Ciencias Planetarias del Departamento de Física Aplicada I de la Escuela de Ingeniería de Bilbao de la UPV/EHU, y uno de los autores del estudio.

Las primeras observaciones de este fenómeno fueron obtenidas por astrónomos aficionados y en seguida llamaron la atención de los investigadores. “Se trata de un fenómeno no muy habitual; las tormentas se suelen desarrollar en regiones ciclónicas, pero no dentro de ciclones específicos, y eso fue lo que llamó nuestra atención, porque nos interesó ver la interacción que tenían las tormentas con el propio ciclón”, detalla Iñurrigarro. Las tormentas no estuvieron activas más que unos pocos días, pero fueron tan energéticas que modificaron totalmente la estructura del ciclón, generando una gran cantidad de turbulencia en su interior, e incluso terminaron por romper el ciclón en dos estructuras.

Para el estudio, los investigadores han contado con imágenes procedentes de diferentes fuentes, además de las tomadas por astrónomos aficionados, como las que captó el telescopio espacial Hubble, y la cámara JunoCam, de la misión Juno que actualmente está orbitando el planeta Júpiter. También utilizaron observaciones realizadas por los propios miembros del grupo de Ciencias Planetarias con el instrumento PlanetCam UPV/EHU, una cámara de alta resolución instalada en uno de los telescopios del observatorio de Calar Alto en Almería, mediante el que monitorizan la actividad atmosférica de los planetas del Sistema Solar. “Cada uno de los instrumentos toma las imágenes a través de diferentes filtros, por lo que la información que recibimos de unos y otros es complementaria. Además en este caso era necesario hacer un seguimiento durante meses de la actividad producida en el ciclón”, explica el investigador.

Al mismo tiempo que han analizado las numerosas imágenes obtenidas, han realizado simulaciones numéricas tanto del ciclón como de la perturbación que sufrió éste como consecuencia de las tormentas. Utilizaron para ello un modelo numérico de circulación atmosférica adecuado a las características de la atmósfera de Júpiter. Una de las características que quisieron determinar mediante las simulaciones fue la naturaleza de las tormentas, es decir, cuánta energía liberaron las tormentas y cuál fue la fuente de esta energía. En las tormentas convectivas los movimientos producidos son consecuencia de la energía que se libera en la condensación de los diferentes gases que pasan a formar las nubes en expansión observadas. “Los candidatos más importantes eran el amoniaco, principal componente de las nubes visibles del planeta, y el agua, mucho más profunda en la atmósfera y difícil de observar», cuenta Iñurrigarro.

«Mediante las simulaciones fuimos capaces de calcular la energía que debíamos introducir en el sistema simulado para reproducir el fenómeno. Y a través de esa energía suministrada a las estructuras atmosféricas, determinamos que la única fuente posible era la condensación de agua, porque la condensación de agua libera muchísima más energía que la del amoniaco. Entonces, simplemente por comparación, vimos que la cantidad que necesitaríamos de amoniaco para generar esa energía suministrada era imposible de obtener, porque se requeriría recolectar el amoniaco de un área muy superior a la del propio ciclón en el que se produjo la actividad de las tormentas. En cambio, con el agua, al ser mucho más energética, se obtenía un área razonable. Nuestras simulaciones muestran que para reproducir las observaciones es necesario que las tormentas sean muy energéticas y los cálculos detallados nos permiten determinar que las tormentas que se formaron en el ciclón fantasma fueron tormentas convectivas formadas por la condensación de agua proveniente de al menos 80 km por debajo de las nubes visibles”, concluye el físico.

Referencia:

P. Iñurrigarro, R. Hueso, J. Legarreta, A. Sánchez-Lavega, G. Eichstädt, J. H. Rogers, G. S. Orton, C. J. Hansen, S. Pérez-Hoyos, J. F. Rojas, J. M. Gómez-Forrellad (2019) Observations and numerical modelling of a convective disturbance in a large-scale cyclone in Jupiter’s South Temperate Belt Icarus doi: 10.1016/j.icarus.2019.113475

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Tormentas convectivas de agua muy energéticas en Júpiter se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La importancia del agua en un biomarcador contra el cáncer

- Juno, Júpiter, arte y amoniaco

- Los castillos de arena en Titán no necesitan agua

La promoción de las vocaciones científico-tecnológicas: la profecía autocumplida de Poincaré

Foto: Science in HD / Unsplash

Foto: Science in HD / Unsplash

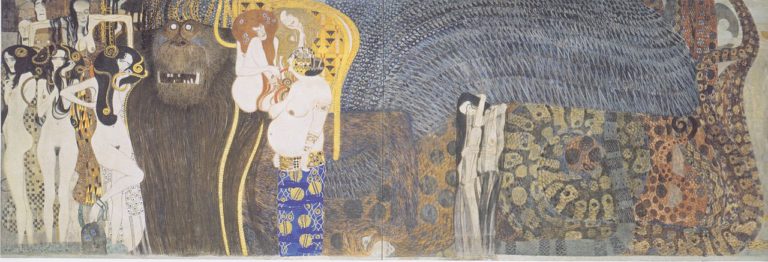

Se dice que las profesiones científico-tecnológicas serán las mejor remuneradas y las más demandadas en un futuro inmediato. La promoción de vocaciones STEM está a la orden del día. Estas actitudes conviven con una notable precarización de la profesión científica, sobre todo para quienes se dedican a la ciencia básica. Estos hechos contienen un fondo social, político y filosófico sobre el que es importante reflexionar.

El científico y filósofo Henri Poincaré en su ensayo El valor de la ciencia divide a los científicos entre «prácticos» y «curiosos». Los primeros se dedican a lo útil y los segundos a lo inútil. Poincaré entiende lo útil como todo aquello que atiende solamente al beneficio. Así lo útil puede definirse como lo que pretende resolver problemas: desde curar una enfermedad a desarrollar sistemas de captación de CO2. Lo útil se corresponde con la definición clásica de «ciencia aplicada». En cambio, lo inútil se define como el saber en sí. Así lo inútil puede definirse como una aproximación sensible al mundo: desde describir un fenómeno natural a ofrecer una definición estética del tiempo. Lo inútil se corresponde con la definición clásica de «ciencia básica».

Tanto en ese ensayo de Poincaré como en el ensayo posterior Ciencia y método, defiende a los científicos curiosos a la vez que menosprecia a los científicos prácticos. El manifiesto La utilidad de lo inútil del filósofo Nuccio Ordine sigue la misma línea de pensamiento. A lo largo de todo el texto se refiere a la utilidad como una suerte de perversión consecuencia del capitalismo. Por ejemplo, en el capítulo dedicado a las universidades critica el hecho de que las universidades funcionen como empresas y que el conocimiento se transmita como un utensilio profesionalizador y tecnificador. También en La idea de una universidad de John Henry Newman se rechaza la idea de que la formación universitaria priorice la utilidad. Para Newman la tarea principal de la universidad es generar y transmitir conocimiento, no formar a técnicos. No obstante, Newman se refiere a la utilidad como una consecuencia ventajosa, no como una perversión.

Tanto Ordine como Abraham Flexner en La utilidad de los conocimientos inútiles caen en la misma incoherencia: defienden a los científicos curiosos citando ejemplos de ciencia básica que culminaron en ciencia aplicada. Uno de los ejemplos que citan ambos es cómo los estudios sobre electricidad y magnetismo de Clerk Maxwell posibilitaron la invención de la radio. Es incoherente defender la ciencia básica a través de su conversión en ciencia aplicada. Aunque la una no es posible sin la otra, la defensa de la una sí es posible sin la otra. También es posible defender la ciencia básica sin menospreciar la ciencia aplicada y viceversa.

Polarizar las ideas —lo blanco contra lo negro— a menudo es una trampa retórica. De la misma forma que se han mostrado las dos culturas —ciencias y humanidades— como si entre ellas existiese una guerra; Ordine, Flexner y Poincaré, entre otros, plantean la misma dicotomía útil/inútil entre la ciencia aplicada (prácticos) y la ciencia básica (curiosos). En este caso los tres se posicionan a favor de los científicos curiosos y en contra de los científicos prácticos. Además, es una nueva vuelta de tuerca al dilema planteado por Montesquieu entre lo útil y lo moral.

Para Poincaré lo útil es el camino hacia la inmoralidad. En La inesperada utilidad de las ciencias inútiles, Ordine concuerda con Poincaré. Según él, los crecientes fraudes en las investigaciones científicas han sido perpetrados por científicos prácticos. Pone como ejemplo el famoso artículo antivacunas de Wakefield que fue retirado de The Lancet en 1998. No obstante, la experiencia nos ha enseñado que la inmoralidad puede manifestarse tanto en los científicos curiosos como en los prácticos.

Para Poincaré y Ordine, el beneficio económico es el verdadero germen de la inmoralidad. Esa es la razón por la que la ciencia aplicada, según ellos, predispone al fraude. Por el contrario, los científicos curiosos, «locos desinteresados que murieron pobres y que no pensaron jamás en la utilidad» (Ciencia y método, Poincaré) practican una vida de virtud y principios. Como si asumiese que el ejercicio de la ciencia básica no debiera remunerarse. Como si el voto de pobreza garantizase la virtud.

Tener en cuenta estas ideas es importante para hacer un análisis provechoso de la actualidad. Por ejemplo, la promoción de vocaciones científicas y tecnológicas, principalmente ingenierías, responde a un ejercicio de ingeniería social. Lo vemos en los medios de comunicación y en la publicidad de las enseñanzas superiores: «Los ingenieros informáticos serán los profesionales más demandados, la profesión del futuro, los que tendrán mayores salarios». La mercadotecnia social responde a criterios útiles: se necesitan resolutores de problemas. Es la profecía autocumplida de Poincaré.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo La promoción de las vocaciones científico-tecnológicas: la profecía autocumplida de Poincaré se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Errar es humano, y científico

- La conjetura de Poincaré-Perelman-Miander

- Pena de muerte contra el fraude científico

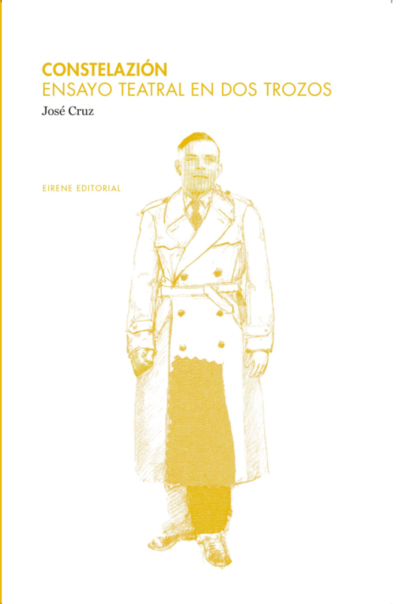

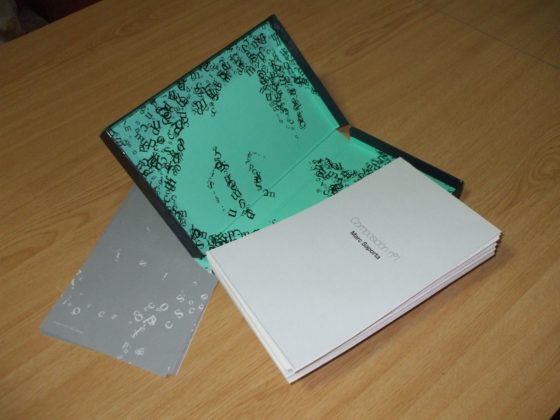

Constelazión : homenaje a Alan Turing

Cuando José Cruz puso el punto y final a ‘Constelazión’, su ordenador estaba llorando.

María Velasco, prólogo de ‘Constelazión. Ensayo teatral en dos trozos’

Alan Mathison Turing (1912-1954) es probablemente uno de los matemáticos más conocidos por el gran público. El cine se ha encargado de inmortalizarlo con películas como Breaking the Code —Descifrando el código— (1996), o la más reciente The Imitation Game —Descifrando Enigma— (2014), en las que la azarosa vida del científico se novela con mayor o menor fidelidad.

Recordemos que, durante la Segunda Guerra Mundial, Turing fue convocado a Bletchley Park para trabajar en el descifrado de mensajes procedentes del ejército nazi —mensajes codificados por medio de la máquina alemana Enigma—. Entre sus aportes a la ciencia de la computación y a la inteligencia artificial, destacan los conocidos test de Turing o la máquina de Turing.

Su carrera se vio truncada al ser procesado por homosexualidad en 1952. Dos años después de su condena, falleció —¿Se suicidó? ¿Fue asesinado?— contribuyendo al misterio alrededor de su figura.

Portada de Constelazión de José Cruz.

Portada de Constelazión de José Cruz.

Traemos a este Cuaderno de Cultura Científica una propuesta teatral sobre Alan Turing, Constelazión. Ensayo teatral en dos trozos del dramaturgo José Cruz.

Sinopsis

Una misteriosa mujer con problemas de amnesia, un puntilloso regidor que supervisa la escena como quien juega una partida de ajedrez y un científico visionario obsesionado con la matemática del amor. Esta pieza teatral es una invitación al universo de Alan Turing (1912-1954), una de las mentes más privilegiadas e influyentes del pasado siglo, padre de la informática, precursor de la geometría fractal y víctima de una sociedad intolerante incapaz de comprender la diferencia. ¿Conseguirá esta noche Sibila cambiar el curso de su desgraciada historia? ¿Podrá el Desconocido llevar a buen puerto su misterioso plan? ¿Descubrirá Alan el por qué uno más uno a veces suma uno?

Los personajes de Constelazión se presentan en la obra como Alan Turing –un científico–, Sibila –una actriz– y Desconocido –un regidor. Los dos trozos a los que se alude en el título y de los que se compone la pieza son Inspirazión y Expirazión. Ambos trozos juegan continuamente con saltos en el tiempo. Y ambos incorporan realidades vividas en distintos momentos para hacer coincidir personajes y buscar respuestas, aclaraciones, excusas o disculpas.

La obra comienza con Alan Turing sentado en un escenario vacío, con una manzana en la mano y leyendo un libro: es el 7 de junio de 1954, la noche de su muerte.

El libro que lee es una especie de diario en el que el matemático tiene anotados metódicamente los encuentros con sus amantes y sus hábitos de conducta. A través de ellos y sus recuerdos intenta conocerse mejor a sí mismo: Fred, Paul, Henry, Morgan, Ernesto, Bert,… y el joven Arnold Murray que acaba desencadenando el fatal desenlace de la vida del científico.

Sibila es una mujer, una sombra, una intrusa que se introduce en el espacio vital de Turing. Actúa de enlace entre el público y el matemático, ejerce como motor de los recuerdos del protagonista, adelanta los acontecimientos que van a seguir y evoca fragmentos de la biografía de Turing. Aunque pretende intervenir tan solo como narradora, acaba implicándose en la vida del matemático, al que escucha y consuela.

Desconocido es un regidor. Monta y desmonta escenarios para simular el despacho o la casa del científico. También personifica a los amantes de Turing, que van a apareciendo a medida que el matemático lee fragmentos de su diario.

Conocer es siempre regresar.

Alan Turing en ‘Constelazión’

Esta bella frase del científico dibuja la manera en la que, durante la obra, se retorna incesantemente a situaciones pasadas, se analizan obsesivamente los momentos vividos o se ahonda en la identidad del protagonista.

Las matemáticas no son una ciencia exacta. Uno más uno jamás sumará dos. La mayor parte de las veces el resultado es cero. Y, si hay suerte, uno. Las relaciones humanas operan según un estricto código binario.

Alan Turing en ‘Constelazión’

Turing recurre a sus matemáticas para hablar del amor y el desamor. ¿Le amaba Arnold realmente, o solo se acercó a él por interés?

“Constelazión” es una de mis obras más personales. Escrita entre 2011 y 2014, estrenada en mayo de ese último año y publicada unos meses después, constituye, además de un encendido homenaje a la figura del visionario Turing, un “ensayo dramático” acerca de la naturaleza matemática del amor. Esa vocación cientificista se traslada a una estructura relativamente compleja que juega con la repetición como recurso e intenta valerse de las propias paradojas del teatro para demostrar, a la manera de un experimento de laboratorio, el poder del amor para trascendernos y salvarnos.

José Cruz, Contexto teatral

Más información:

-

José Cruz, Constelazión. Ensayo teatral en dos trozos, Eirene Editorial, 2014

-

Marta Macho Stadler, «Constelazión. Ensayo teatral en dos trozos», de José Cruz, DivulgaMAT, mayo 2015

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Constelazión : homenaje a Alan Turing se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- «Alan Turing, un genio incomprendido» por Alfonso Jesús Población

- Homenaje de Google a Euler

- El teorema de Morcom

Construyendo la mecánica cuántica

Imagen: Gerd Altmann / Pixabay

Imagen: Gerd Altmann / PixabayA mediados de la década de 1920 estaba claro que las «cosas» (electrones, átomos, moléculas) consideradas durante mucho tiempo como corpúsculos también muestran propiedades de onda. Este hecho es la base de la teoría actualmente aceptada de la estructura atómica. Esta teoría, la mecánica cuántica, se introdujo en 1925. Sus fundamentos se desarrollaron muy rápidamente durante los años siguientes, principalmente por Born, Heisenberg, Schrödinger, Bohr, Jordan y Dirac.

Al principio, la teoría apareció en dos formas matemáticas diferentes, propuestas independientemente por Werner Heisenberg y Erwin Schrödinger. Heisenberg enfatizó el aspecto corpuscular de los objetos cuánticos, mientras que Schrödinger enfatizó el aspecto ondulatorio. Finalmente, Schrödinger demostraría que, de hecho, estas dos formas de la mecánica cuántica son equivalentes, es decir, diferentes formas de expresar las mismas relaciones. La formulación de Schrödinger ahora es la predominante, aunque los símbolos utilizados en sus ecuaciones ahora se interpreten de manera algo diferente al uso original de Schrödinger. Este predominio en última instancia se debe exclusivamente a la base matemática, el cálculo diferencial, mucho más manejable que la forma de Heisenberg, basada en el cálculo matricial.

Schrödinger buscó expresar matemáticamente la naturaleza dual de onda-corpúsculo de la materia. Maxwell había formulado la teoría electromagnética de la luz en términos de una ecuación de onda. Los físicos estaban familiarizados con esta teoría, sus aplicaciones y sus matemáticas. Schrödinger razonó que las ondas de de Broglie asociadas con los electrones podrían describirse de forma análoga a las ondas de luz clásicas. Por lo tanto, debe haber una ecuación de onda que se mantenga para las ondas de materia, al igual que existe una ecuación de onda para las ondas electromagnéticas. [2]

Schrödinger obtuvo una ecuación para las ondas de materia (ondas de de Broglie) asociadas con los electrones en movimiento. Esta ecuación, que lleva su nombre, ecuación de Schrödinger, define las propiedades de onda de los electrones y también predice su comportamiento corpuscular. La ecuación de Schrödinger para un electrón unido en un átomo tiene una solución solo cuando una constante en la ecuación tiene los valores de números enteros 1, 2, 3.. . . Estos números se corresponden con diferentes energías. Por lo tanto, la ecuación de Schrödinger predice que solo ciertas energías de electrones son posibles en un átomo. [3] Además, estos estados energéticos se corresponden con la imagen de ondas electrónicas estacionarias en los diversos estados estacionarios.

En el modelo de Schrödinger estos resultados se derivan directamente de la formulación matemática de la naturaleza de onda y corpúsculo del electrón. Bohr tuvo que asumir la existencia de estos estados estacionarios al principio y no hacer suposiciones sobre las órbitas permitidas. En el modelo de Schrödinger, sin embargo, los estados estacionarios y sus energías se derivan de la teoría. El nuevo modelo arroja todos los resultados de la teoría de Bohr, sin ninguna de las hipótesis inconsistentes de la teoría de Bohr. La nueva teoría también explica cierta información experimental que la teoría de Bohr no tuvo en cuenta. Por ejemplo, permite calcular la intensidad de una línea espectral, que se entiende como la probabilidad de que un electrón cambie de un estado de energía a otro. [5]

Tras la unificación de la mecánica de ondas de Schrödinger con la formulación de Heisenberg, la mecánica cuántica pasa a estar representada por la ecuación de Schrödinger, que ya no proporcionaba un modelo materializable o una imagen visualizable del átomo. El modelo planetario del átomo tiene que abandonarse pero no ha sido reemplazado por otra imagen simple. Ahora hay un modelo matemático para el átomo de un éxito enorme, pero no hay un modelo físico fácilmente visualizable. Los conceptos utilizados para construir la mecánica cuántica son mucho más abstractos que los del modelo de Bohr. [6] A pesar de ello la formulación matemática de la mecánica cuántica es mucho más poderosa que la empleada en el modelo de Bohr para predecir y explicar fenómenos. Muchos problemas que antes no se podían resolver se resolvieron rápidamente con la mecánica cuántica.

La comunidad física ha aprendido que el mundo de los átomos, los electrones y los fotones no puede pensarse en los mismos términos mecánicos que el mundo de la experiencia cotidiana. En cambio, el estudio de los átomos presenta algunos conceptos nuevos fascinantes, como los que veremos a continuación. Lo que se ha perdido en fácil visualización se compensa con un aumento en la comprensión de la naturaleza al nivel más fundamental.

Notas:

[1] Dado que la forma de la teoría de Schrödinger está más cerca de las ideas de De Broglie, a menudo se la conoce como mecánica ondulatoria.

[2] Esta parte matemática de la mecánica ondulatoria no puede discutirse adecuadamente sin usar matemáticas avanzadas, pero las ideas físicas involucradas requieren solo unas matemáticas muy simples y son esenciales para comprender la física moderna. Por lo tanto, el resto de esta serie se centrará en tratar algunas de las ideas físicas de la teoría para indicar que son realmente razonables y algunos de sus resultados más importantes.

[3] En el átomo de hidrógeno, la energía del electrón resulta tener los valores numéricos En = k22π2me2/n2h2 , donde n toma los valores 1, 2, 3, … Estas energías se corresponden a los valores experimentales y ¡son los mismos del modelo de Bohr!

[4] Esta idea es clave y muy simple. Si no la terminas de entender repasa Las ondas electrónicas y la estructura de la materia.

[5] Véase Las limitaciones del modelo de Bohr

[6] A este respecto véase El universo ametafórico

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Construyendo la mecánica cuántica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Más allá del modelo de Bohr

- El comportamiento corpuscular de la luz: momento lineal del fotón

- El modelo de Bohr explica la fórmula de Balmer

Los dueños del conocimeinto

Logo Sci-Hub

Logo Sci-HubLa mejor –quizás única- forma de garantizar que los hallazgos científicos pueden ser escrutados por cualquiera y así contrastar su validez es permitir que a tales hallazgos tenga acceso el conjunto de la comunidad científica, con independencia de qué parte de los descubrimientos han sido hechos por unos u otros científicos. Además, todos deberían tener el mismo acceso a los bienes científicos y debería haber un sentido de propiedad común al objeto de promover la colaboración.

El conocimiento publicado

Sin embargo, el acceso al conocimiento se encuentra limitado por diferentes motivos, principalmente de carácter económico. Si nos limitamos al conocimiento que se crea en instituciones públicas, lo lógico sería que dado que los recursos utilizados para su obtención son de carácter público, también lo fueran los productos en que se plasma tal conocimiento. Nos referimos a los artículos que se publican en las revistas científicas.

Las revistas se han convertido en un magnífico negocio para algunas entidades y, sobre todo, empresas editoriales. Tal y como está configurado el sistema en la actualidad, además, en ciertas áreas una o dos editoriales funcionan en un régimen muy cercano al monopolio, con lo que las instituciones científicas se ven obligadas a pagar un alto precio por el acceso a las correspondientes revistas.

Los autores no cobran por publicar, los revisores no cobran por revisar y el producto final se ofrece a precios muy altos. Eso genera beneficios enormes. En apariencia no es lógico que quienes se dedican a la ciencia profesionalmente se presten a esto. A fin de cuentas, colectivamente, ellos son los autores, los revisores y los lectores de esas publicaciones. La respuesta a esa aparente contradicción es que esas publicaciones son las que constituyen sus principales méritos profesionales. Dejar de participar en el sistema tal y como está significa ser excluido del competitivo entorno profesional de la ciencia porque, para empezar, las posibilidades de conseguir financiación para los proyectos disminuirían muchísimo o, sencillamente, desaparecerían; también verían seriamente obstaculizadas sus posibilidades de estabilización, promoción o progreso académico.

El problema es que de esa forma no todo el mundo puede tener acceso a la información científica porque no todo el mundo puede permitirse pagar los precios de las suscripciones a las revistas de alto nivel. La magnitud de este problema no ha dejado de aumentar con el tiempo. Hay instituciones científicas que, por esa razón, han debido anular suscripciones a ciertos medios.

Como la mayor parte de la investigación cuyos resultados se publican en esas revistas se ha financiado con cargo a fondos públicos, se da la paradoja de que la ciudadanía ha de pagar por partida doble. Paga para producir los resultados de las investigaciones y ha de volverlo a hacer para que las instituciones científicas tengan acceso a esos resultados.

Diferentes iniciativas han surgido para dar respuesta a ese problema. Por un lado, han aparecido algunas publicaciones de acceso abierto, como PlosOne y otras del grupo, en las que los costes de la publicación corren a cargo de los autores. Muchos investigadores recurren a publicar sus manuscritos (antes de su aceptación para publicación en una revista) en repositorios digitales, como ArXiv. Y ha habido iniciativas individuales de grandísimo éxito aunque, por razones legales, de incierto futuro, como el repositorio Sci-Hub, creado por la científica Alexandra Elbakyan.

Algunos gobiernos también han reaccionado promoviendo la publicación en repositorios públicos de los resultados obtenidos mediante los proyectos financiados por ellos. Y muchas instituciones, universitarias y gubernamentales, se proponen diseñar mecanismos que permitan poner la producción científica pagada con fondos públicos al alcance de todos. La Universidad de California –con sus diez campus una de las instituciones universitarias más grandes y prestigiosas del mundo ha cancelado la suscripción a las revistas científicas del todopoderoso grupo Elsevier para promover así el llamado “acceso abierto”.

El conocimiento secreto

El secretismo es lo opuesto a la norma mertoniana del comunalismo, puesto que el conocimiento que se oculta, que no se hace público no es de ninguna ayuda en el cumplimiento del objetivo de la comunidad, que el conocimiento certificado crezca. Hay dos tipos de investigación cuyos resultados han de mantenerse en secreto. Uno es, por razones obvias, la investigación militar. Y el otro la realizada o contratada por empresas que se proponen explotar comercialmente sus resultados.

El secretismo de la investigación en asuntos militares tiene el comprensible propósito de impedir que potenciales rivales tengan acceso a sistemas de armamento o cualquier otro elemento que pueda dar ventaja en caso de conflicto armado o, incluso, a los solos efectos de la disuasión.

Por otro lado, y como hemos señalado al tratar la financiación de la investigación, hay empresas que hacen investigación científica (o tecnológica) o que la contratan con centros de investigación y cuyos resultados, por su valor comercial, no se hacen públicos.

Cuando la investigación se produce en los contextos dichos, el principio del comunalismo se incumple de forma clara. Y por lo mismo, también se impide que los resultados de la investigación puedan ser sometidos a contraste por parte de la comunidad científica: no puede verificarse ni refutarse. Por lo tanto, también el escepticismo deja de tener en este caso posibilidad de ser ejercido.

Esa limitación no es una dificultad menor, sobre todo con investigaciones como la de productos farmacéuticos, por su elevado coste y sus implicaciones en términos de salud pública. En esos casos, y dadas las posibles consecuencias que se derivan de la comercialización de un médicamente o la implantación de algún procedimiento, las administraciones públicas son las que, en última instancia, establecen las condiciones que los productos en cuestión han de cumplir para que se autorice su comercialización. Ahora bien, sea como fuere, la intervención administrativa no puede considerarse, desde el punto de vista científico, equivalente al control público por parte de la comunidad científica.

Por lo tanto, las limitaciones a la difusión de los resultados de investigación que se derivan de los objetivos de las investigaciones citadas (la militar y ciertas investigaciones de carácter empresarial) conllevan fuertes restricciones del ámbito de acceso, por lo que tanto el carácter comunal como el ejercicio del escepticismo se ven más que entorpecido, prácticamente impedidos. Y si ambas normas se considerasen requisitos para la consideración de la investigación como científica, las investigaciones citadas no podrían ser consideradas así.

El conocimiento patentado

A medio camino entre la publicación y el secreto está la patente. El conocimiento nuevo con un eminente carácter práctico se puede patentar. Una patente es un título de propiedad que reconoce a su titular el derecho exclusivo de utilización práctica del conocimiento allí expuesto. Las patentes son documentos públicos, por tanto, ese conocimiento no es secreto, cualquiera puede leerlo, pero no puede utilizarlo.

En general el sistema de patentes se considera una pieza indispensable en el proceso de desarrollo de la ciencia aplicada, dado que las empresas pueden invertir dinero en investigación con la tranquilidad de que los resultados de esas investigaciones los van a poder explotar adecuadamente y recuperar con ello esa inversión. Sin embargo, no son pocos los problemas que este sistema genera, especialmente para conocimientos en la frontera de la ciencia.

Uno de los casos que se suele citar es el de James Watt, científico que contribuyó al desarrollo de la máquina de vapor (y en cuyo honor se nombra la unidad de potencia del sistema internacional) y cuyas patentes y litigios se dice que retrasaron 30 años la revolución industrial. Si bien esa afirmación es controvertida y puede ser excesiva, no hay duda de que el uso de las patentes por parte de Watt influyo significativamente en el desarrollo comercial de máquinas de vapor.

A la hora de investigar la cura de algunas enfermedades, los proyectos de investigación buscan la mejor estrategia pro no de entre las posibles, sino de entre las que no rozan patentes en vigor. Una situación difícil que puede llevar a la desesperación a quien tiene que desarrollarlo. Esta situación la describe el investigador Lucas Sánchez durante su tesis concluyendo: “¿Esto es lo que le espera al desarrollo de la ciencia? ¿Estas son las normas inamovibles para curar enfermedades? ¿Vamos a vernos siempre obligados a hacer ciencia con normas anticientíficas?”

La posibilidad de que se puedan patentar genes humanos, que parte de lo que conforma la esencia biológica de un ser humano pueda ser “propiedad” intelectual de otro es, cuando menos, sorprendente. Esta cuestión llegó a la actualidad de los medios de comunicación con los genes de predisposición al cáncer de mama BRCA1 y BRCAC, y pone de manifiesto un importante dilema moral. Más recientemente, la técnica de edición genética CRISPR también está generando unas importantes batallas legales sobre su propiedad intelectual que pueden determinar el rumbo de muchas investigaciones con tan potente herramienta.

Los anteriores ejemplos sirven para ilustrar la dificultad que entraña establecer el nivel de protección intelectual adecuado sobre los resultados de la ciencia. Una protección que no desincentive la inversión pero que tampoco ponga barreras al desarrollo de conocimiento nuevo, especialmente en temas de clara repercusión en vidas humanas.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo Los dueños del conocimeinto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El ethos de la ciencia

- Lo que la ciencia puede enseñarnos a los dueños de perros y gatos

- Los valores en la filosofía de la ciencia

¿Pero dónde diablos están todos?

Foto: NASA/ESA Hubble Space Telescope

Foto: NASA/ESA Hubble Space TelescopeUn día de verano de 1950, mientras se dirigían a almorzar, los físicos Enrico Fermi, Edward Teller, Herbert York y Emil Konopinsky charlaron, entre otras cosas, acerca de las especulaciones sobre supuestos avistamientos de OVNIs. Hacía ya rato que habían cambiado de tema cuando, mientras almorzaban, Fermi, sin explicación previa dijo “¿Pero dónde diablos están todos?” Ninguno de los comensales necesitó preguntar a qué se refería; enseguida se dieron cuenta de que seguía pensando en la posible existencia de vida extraterrestre inteligente.

Lo que expresaba la exclamación del físico ítalo-americano era la extrañeza por no haber recibido aún la visita de seres de otros mundos. Fermi pensaba que había una probabilidad relativamente alta de que hubiesen florecido otras civilizaciones en la Vía Láctea y le parecía, por tanto, extraño que no hubiese pruebas de su existencia. Aunque él no fue el primero en formular esa impresión contradictoria, es conocida en la actualidad como la paradoja de Fermi.

En 1961, el astrofísico Frank Drake diseñó una ecuación que permitiría estimar el número de civilizaciones de nuestra galaxia con las que podríamos llegar a comunicarnos; el principal motivo de este ejercicio, no obstante, era promover el debate sobre la búsqueda de vida inteligente. Y en 1975 el también astrofísico Michael Hart elaboró en detalle el argumento de Fermi en un artículo científico.

Por un lado, sabemos que en la Vía Láctea hay miles de millones de estrellas similares al Sol y, además, muchas de ellas se formaron millones de años antes. Por otro lado, es muy probable que una parte de esas estrellas tengan planetas similares al nuestro, por lo que no sería extraño que se haya desarrollado vida inteligente en ellos. Llegados a ese punto, no sería improbable que esos seres inteligentes realizasen viajes interestelares, de manera que nuestro planeta debería haber sido visitado ya por seres de otros mundos o, al menos, por sondas enviadas por ellos. Y sin embargo, no hay pruebas de que haya ocurrido nada de eso. De ahí la pregunta de Fermi: “¿Pero dónde diablos están todos?”

Como es lógico, se han ofrecido diferentes argumentos que podrían explicar la paradoja. Se ha propuesto que ciertas transiciones -de materia inerte a viva, de células simples a complejas, o de seres individuales a sociales, por ejemplo- han necesitado mucho tiempo en otros mundos o, incluso, quizás no se han llegado a producir. Según la hipótesis de la Tierra Extraña, quizás las condiciones de nuestro planeta son excepcionales y hay muy pocos de similares características. Por otro lado, la vida inteligente tiene una historia muy breve en la Tierra, por lo que no sabemos hasta qué punto podría tratarse de un hecho realmente excepcional o único, y esta razón se puede extrapolar a la posesión de tecnología, mucho más limitada aún. Una propuesta de carácter apocalíptico sugiere que, a la vista de la hipotética propensión de los seres humanos a matarse unos a otros, la vida inteligente tienda quizás a destruirse a sí misma. O quizás tiende a aniquilar a otras formas de vida inteligente, haciendo esta mucho más efímera. Otros suponen que la capacidad de una civilización para expandirse por la galaxia está limitada por el agotamiento de los recursos necesarios. O puede, sencillamente, que no estemos buscando de la forma apropiada.

Sea como fuere, cada vez contamos con mejor tecnología para explorar el espacio y hay programas específicos para tratar de encontrar vida ahí fuera. Me daría verdadero vértigo si la encontrásemos. Pero me daría más vértigo aún si supiésemos que no la hay, que nos encontramos absolutamente solos en el Universo.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo ¿Pero dónde diablos están todos? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los siete pequeños diablos

- Las siliconas son seguras y útiles, pero no convienen a todos los cabellos

- En el mar, allí donde todo comienza

Luces y sombras del uso de la tecnología en clase

Érase una vez… en el País Vasco, un congreso tan oportuno y tan útil, y tan bien recibido en Bilbao y en Donostia-San Sebastián, que muchos pensaron que tenía que viajar a más lugares. Así que la Cátedra de Cultura Científica y la Fundación Promaestro se pusiron de acuerdo y, con la ayuda de EduCaixa, lo llevaron a Madrid: casi un centenar de personas con espíritu crítico y bien informadas llenaron el pasado 2 de abril la modesta y acogedora sala de CaixaForum en la que se celebró.

Algo desalentadoras son las evidencias que Pablo Garaizar presenta sobre el uso (y abuso) de la tecnología en las aulas. Muchas veces asociamos los buenos resultados a la supuesta bondad de una metodología cuando, en realidad, dichos resultados se explican mejor atendiendo a otros factores, principalmente al nivel socio-económico de las familias de los alumnos. Es lo que suele ocurrir con las apuestas tecnológicas en educación: “el tiempo de pantalla no se puede medir «al peso» y las pantallas se usan de manera diferente en unos contextos y en otros», por lo que tampoco es igual el aprovechamiento de la tecnología en unas familias y en otras.

Ciertos programas innovadores y conocidos, como Escuela 2.0, no han funcionado y, en todo caso, los efectos positivos encontrados en ellos se suelen limitar “al uso moderado de las TIC a la hora de hacer los deberes, es decir –matizó el profesor de la Universidad de Deusto– a usar la tablet o el ordenador una o dos veces al mes”.

A la pregunta de si merece la pena invertir en tecnología para mejorar la educación, la respuesta de Garaizar es igual de clara: “los principales estudios muestran que un poco de tecnología es bueno, pero mucha no ayuda e incluso puede empeorar la educación”. Lo que sucede, reconoce el ingeniero informático, “es que la educación es un sector económico muy jugoso”, y las empresas tecnológicas están introduciéndose en él valiéndose de los maestros y de los deseos de las familias. En respuesta a esta deriva, el investigador cierra su ponencia con un recordatorio: “la educación no es un producto, los estudiantes no son nuestros clientes, los profesores no somos herramientas y la universidad no es una fábrica de titulados”.

Edición realizada por César Tomé López a partir de materiales suministrados por Fundación Promaestro

El artículo Luces y sombras del uso de la tecnología en clase se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas14 Luces y sombras en películas de animación

- #Naukas14 El camino no tomado: azar y tecnología

- Modelado matemático: del legado de Galileo al ambiente, la medicina y la tecnología

Entrenan a las máquinas para reconocer la belleza y edad de las caras

Ignacio Arganda. Foto: UPV/EHU.

Ignacio Arganda. Foto: UPV/EHU.Los investigadores Ikerbasque Fadi Dornaika e Ignacio Arganda del Departamento de Ciencias de la Computación e Inteligencia Artificial de la UPV/EHU proponen avances en la visión por ordenador y el aprendizaje automático. Concretamente, han obtenido muy buenos resultados utilizando técnicas semisupervisadas en el campo de predicción de la belleza facial, y, por otra parte, han estudiado qué funciones de error ayudan a entrenar mejor a las redes para mejorar la estimación de la edad facial.

La investigación en inteligencia artificial abarca muchísimos campos con el objetivo de conseguir la que podría ser la máquina inteligente ideal que percibe su entorno y lleva a cabo acciones que maximicen sus posibilidades de éxito en algún objetivo o tarea. El grupo Computer Vision and Pattern Discovery de la UPV/EHU se dedica a la visión por ordenador y al aprendizaje automático. “Básicamente, utilizamos técnicas modernas de inteligencia artificial para resolver problemas de imagen muy diversos, en imágenes de todo tipo: 2D, 3D, vídeos, etc.”, explica Ignacio Arganda, investigador Ikerbasque del Departamento de Ciencias de la Computación e Inteligencia Artificial de la UPV/EHU.

De hecho, el grupo de investigación está especializado en temas tan diversos como imágenes biomédicas (detección de células, tejidos, tumores…), imágenes faciales (percepción de la belleza, estimación de la edad) o imágenes de la calle (localización de vehículos, peatones…), que abordan en colaboración con investigadores de otras entidades y centros de investigación. “En general, son técnicas de aprendizaje automático, porque normalmente partimos de un conjunto de datos, imágenes o vídeos etiquetados (en los que se conoce dónde están los objetos o qué tipo de categoría tienen), con los que enseñamos o entrenamos a nuestros modelos estadísticos o de inteligencia artificial a asignar esas mismas etiquetas a ejemplos que no habían visto antes”, explica Arganda.

¿En qué se fija la red para deducir la edad de una persona o dar una puntuación de belleza?

En sendas investigaciones relacionadas con las imágenes faciales, los investigadores han propuesto mejoras en relación con la predicción de la belleza y la estimación de la edad. “En la investigación de la predicción de la belleza, intentamos replicar las puntuaciones de belleza dadas en diferentes bases de datos, utilizando técnicas semisupervisadas (en las que no todas las imágenes están etiquetadas) —explica el doctor Arganda—. Para eso, utilizamos redes en las que se extraen diferentes características que se utilizan para entrenar a los modelos con los que predecir la belleza”. En esta línea, los miembros del equipo han demostrado que “el aprendizaje semisupervisado, nunca utilizado hasta ahora para este tipo de problema, da tan buenos resultados o incluso mejores que el supervisado (en el que todas las imágenes están etiquetadas)”, apunta.

“Para la estimación de la edad, se utilizan redes neuronales convolucionales (CNN): lo que se tiene es una imagen de entrada; una serie de filtros van extrayendo características que ayudan a tomar la decisión final, o sea un número, en este caso la edad”, añade. En esta línea, “hicimos un estudio empírico para ver qué funciones de error ayudan a entrenar mejor a las redes en este ámbito, porque el error en las estimaciones se puede minimizar de maneras diferentes”, explica el investigador. Los resultados experimentales obtenidos han demostrado la manera en la que se puede mejorar la estimación de la edad.

Para este tipo de predicciones y estimaciones se utilizan redes neuronales profundas: “Redes con muchísimas conexiones, muchísimos filtros, millones de datos… Pero es importante entender en qué se está fijando la red para predecir la edad de una persona, o hacer cualquier otro tipo de predicción. Actualmente, existe otro campo de investigación, en el que estamos sumergidos, llamado inteligencia artificial explicable o interpretable, que estudia técnicas con las que dilucidar en qué pone la red su atención”, explica Arganda.

Asimismo, el investigador alerta de que “las técnicas de aprendizaje automático nos afectan en la vida más de lo que pensamos. Se están generando muchísimos datos y se están tomando decisiones de alto nivel en función de estos sistemas. Es muy importante tener en cuenta el factor ético. De hecho, en el aprendizaje automático se utilizan bases de datos gigantescas con las que se entrenan los modelos, y todos los sesgos que contienen estos datos se replican en las predicciones y estimaciones que hacen los modelos, y puede ser realmente nocivo. En ese sentido, hay investigaciones abiertas en la que se estudia cómo quitar los diferentes sesgos de los datos”. En opinión de Arganda, “estamos en un momento apasionante en este campo”.

Referencia:

Fadi Dornaika, Kunwei Wang, Ignacio Arganda-Carreras, Anne Elorza, Abdelmalik Moujahid (2019) Toward graph-based semi-supervised face beauty prediction Expert Systems With Applications Expert Systems with Applications doi: 10.1016/j.eswa.2019.112990

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Entrenan a las máquinas para reconocer la belleza y edad de las caras se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Aprendiendo de las máquinas

- Máquinas inteligentes (II): Inteligencia artificial y robótica

- Algoritmos de triaje para readmitidos en urgencias

Receta de un Adagio (1)

Sentía la pobre oscuramente, sin darse de ello clara cuenta, que la música es preparación eterna, preparación a un advenimiento que nunca llega, eterna iniciación que no acaba cosa.

Miguel de Unamuno. Niebla.

Foto: Uriel Soberanes / Unsplash

Foto: Uriel Soberanes / UnsplashHay muchas formas de componer la tristeza. Si uno toma el top dramones de la encuesta de la BBC por ejemplo, puede resultar sorprendente que las obras incluidas ni siquiera parecen comparables entre sí. Sólo en 5 piezas encontramos desde un tema de jazz de 3 minutos cantado por Billy Holiday, hasta una obra para cuerda de media hora de duración compuesta por Richard Strauss. Y si uno le pregunta a Twitter, el abanico de posibilidades se vuelve todavía más extenso.

Hay muchas formas de componer la tristeza. No existe una única pieza clave, una nota dolorosa, ni una fórmula mágica que haga brotar las lágrimas. Pero como el vinagre y el aceite, existen ingredientes que se repiten en casi todas las ensaladas (tristes ensaladas). Para componer la tristeza no se usan aliños sino sonidos que se parecen a los que emite un humano triste y sonidos que se parecen a los de un humano que gotea.

Elige un tempo lento.

Es difícil encontrar un patrón que se repita en todas las obras que nos producen tristeza. Pero si hubiese que elegir uno, sería este: casi todas las canciones tristes son lentas. Basta alterar la velocidad y el carácter de la pieza cambia por completo.

El tempo (la velocidad a la que interpreta una pieza de música) se encuentra, de hecho, en la base de las emociones y es, probablemente, el ingrediente más importante a la hora de determinar el carácter de la música. Tanto es así que muchas de las palabras que utilizamos para designarlo corresponden a estados anímicos expresados en italiano (o, más raramente, en francés): Allegro, Tranquillo, Moderato espressivo, Afettuoso, Grave…

El término Adagio no es una excepción. Proviene del italiano ad agio que significa “con facilidad”. En este caso, el contagio se dio a la inversa y un término que en principio hacía referencia a una velocidad de interpretación cómoda, hoy está empapada de matices emocionales. Un Adagio es lento, sí, pausado como un humano triste. Pero es más que eso… también es noble, amable, amplio, a veces elegíaco, siempre expresivo. Un Adagio canta con voz redonda y sostiene una mirada serena. Encarna todos los antónimos que se puedan pensar de la palabra frívolo. Y, a estas alturas… un Adagio ya no es fácil.

El Adagio de Barber, de hecho, resulta engañosamente sencillo. Y uno de los mayores retos que plantea de su interpretación radica, justamente, en elegir y mantener el tempo adecuado. Ni demasiado rápido —arruinaría el carácter de la pieza— ni demasiado lento —acabaría por ahogarla. “Con intensidad creciente”—escribió Toscanini de su puño y letra en su partitura de ensayo— “pero sin correr”. Aunque desde fuera un tempo rápido puede parecer más díficil de ejecutar (a todos nos impresionan los grandes virtuosos con sus malabarismos digitales), la lentitud plantea sus propios retos. Es difícil sostener la tensión de la música, controlar las propias emociones para que la música no se desparrame hacia delante siguiendo el pulso acelerado de quien la interpreta. Pero incluso a nivel puramente técnico: un movimiento demasiado lento del arco sobre el violín puede hacer más difícil mantener una presión constante sobre las cuerdas, o calcular que el arco no se acabe antes de la cuenta.

Tampoco las pausas deben extenderse más de la cuenta: un rubato excesivo (las pequeñas variaciones que se hacen sobre el tempo base) podría llevar a que el pulso, ya de por sí lento y difícil de seguir, se perdiera por completo. Intuitivamente, como dice Zubin Mehta: “si uno exprime cada cadencia, puede acabar un poco mareado”.

A veces me imagino el Adagio de Barber como una escultura de agua. Un montón de líneas de flujo laminar suspendidas sin roturas en el aire: inmóviles gracias al constante movimiento de las moléculas del agua, transparente sólo si se consigue fijar la velocidad perfecta.

Elimina las esquinas.

Los humanos tristes balbucean, arrastran los pies, se mueven despacio y odian los saltos. Los humanos tristes no tienen esquinas.

Por eso, las piezas de música triste suelen dar pocos saltos y prefieren las melodías suaves, también en su articulación: la alegría a menudo utiliza sonidos breves, saltarines, cortantes (pizzicato, staccato…). La tristeza, en cambio, prefiere fundir sus sonidos en un continuo legatto (o diluirlo todo al piano, con un buen pedal de resonancia).

La ausencia de esquinas se hace evidente en el Adagio de Barber, que desliza su melodía por grados contiguos y pinta toda la armonía a base de gradientes y acuarelas. En el Adagio, los acordes se desbordan de cada compás mediante retardos y apoyaturas. Todo es fluido, ambiguo y curvo… como una escultura de agua.

Esto puede provocar que la coordinación de los músicos se vuelve complicada: en Barber, el pulso a veces es tan lento que puede llegar a perderse por completo. La ausencia generalizada de líneas nítidas hace difícil colocar hitos temporales sobre los que coordinarse con los demás. Es como quedar a pasear en un día con niebla. Los intérpretes de la orquesta deben prestar atención a lo que hacen los demás para ubicarse y reubicarse, y andar a la par.

Los finales de frase tienden a relajar tempo. Es ahí donde la música se para a respirar. Así, con los pulmones llenos, las frases pueden hacerse más largas. Pero, en palabras del director William Schrickel, “no tendría sentido si fuesen tan lentas que nadie las pudiese cantarlas en realidad”. Por supuesto, los violines no tienen nada que limite su capacidad pulmonar… pero toda música es, con perspectiva, la sofisticación de algún tipo de canto. Los violines del Adagio, encarnan su voz.

El artículo Receta de un Adagio (1) se ha escrito en Cuaderno de Cultura Científica.

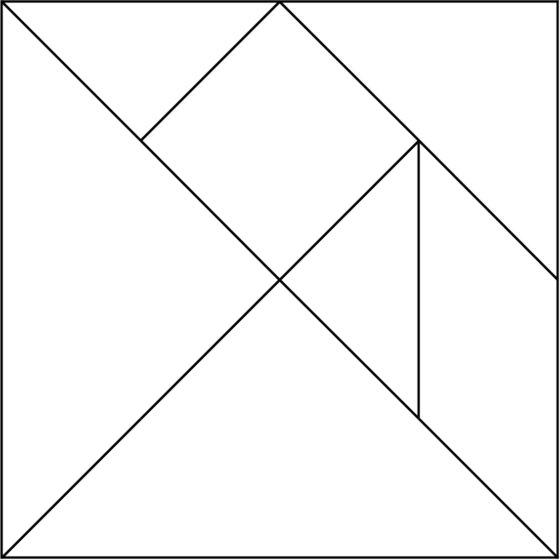

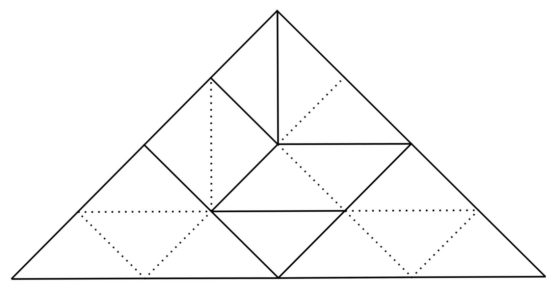

Entradas relacionadas:Un teorema sobre el Tangram

En la entrada del Cuaderno de Cultura Científica titulada El arte contemporáneo mira al Tangram estuvimos viendo como algunos artistas contemporáneos utilizaban el Tangram como un elemento fundamental en el desarrollo de algunas de sus obras de arte.

En particular, pudimos observar que, entre las configuraciones posibles con las siete piezas de este rompecabezas geométrico, un grupo que llamaba especialmente la atención de estos artistas era la familia de configuraciones convexas, quizás por ser una familia muy matemática. En la entrada de hoy vamos a hablar precisamente de este tipo de configuraciones, en qué consisten y cuántas existen.

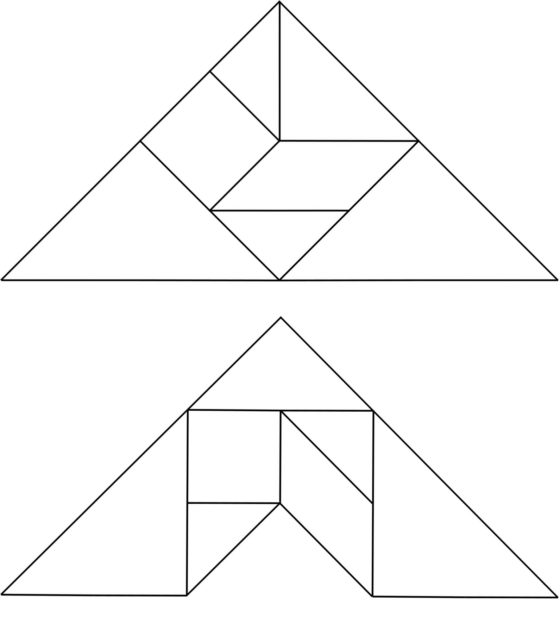

Tangram convexo 007 (2014), del artista Kaufman, pseudónimo artístico de James Marr, realizado con madera reciclada. Imagen de la página web del artista

Tangram convexo 007 (2014), del artista Kaufman, pseudónimo artístico de James Marr, realizado con madera reciclada. Imagen de la página web del artista

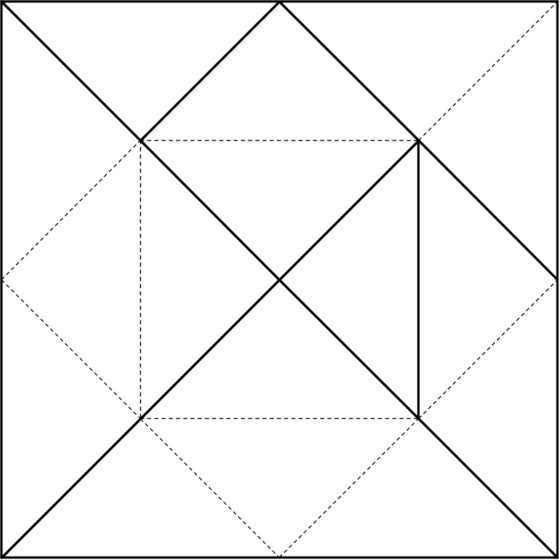

Puesto que esta entrada va a ser algo más matemática, volvamos a introducir y observar, desde una óptica más geométrica, el rompecabezas Tangram y las siete piezas poligonales que lo componen.

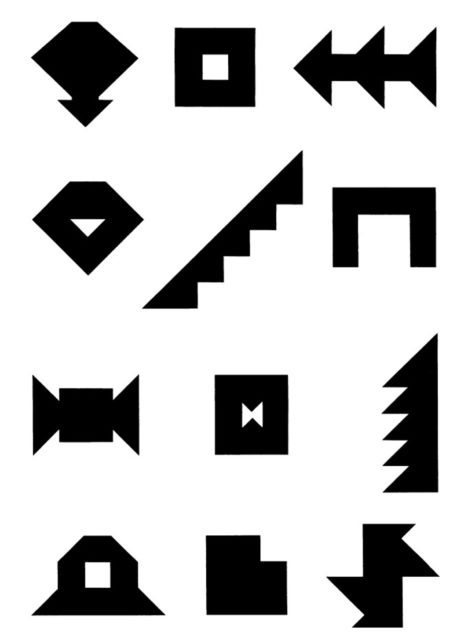

Para empezar, volvamos a observar las siete piezas poligonales que forman el Tangram, dos triángulos pequeños, un triángulo mediano y dos triángulos grandes, todos ellos con la misma forma –triángulo rectángulo isósceles–, pero distintos tamaños (sus ángulos son 90, 45 y 45 grados), un cuadrado (con cuatro ángulos de 90 grados) y un romboide (cuyos ángulos son 45, 135, 45 y 135 grados, pero observemos que 135 = 90 + 45). Todas las piezas son “simétricas”, en el sentido de que si se voltean no cambian de forma, son la misma figura (tienen simetría especular), salvo el romboide, que si se voltea cambia su orientación. Por lo tanto, el romboide tiene dos posibilidades a la hora de ser utilizado para realizar una configuración, como la original del cuadrado.

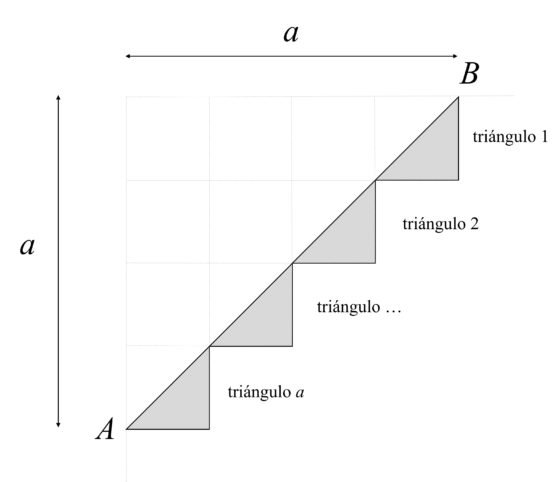

Una cuestión interesante de las piezas del Tangram, que además va a ser fundamental en el estudio de las configuraciones convexas, es que las piezas del Tangram pueden ser divididas en triángulos rectángulos isósceles, del mismo tamaño que las dos piezas triangulares pequeñas del Tangram, como se muestra en la siguiente imagen. De esta forma, las piezas del Tangram pueden dividirse en 16 triángulos rectángulos isósceles iguales.

Si consideramos que los dos lados iguales de estos triángulos rectángulos isósceles, que son los catetos, miden 1 (son nuestra unidad de medida), entonces la hipotenusa medirá, por el teorema de Pitágoras, raíz de 2. Es decir, bajo esta premisa podemos considerar que dos lados del triángulo rectángulo isósceles son “lados racionales” y el otro es un “lado irracional”.

Además, teniendo en cuenta esto podemos ver, en la siguiente imagen, las medidas de las piezas del Tangram. Así mismo, podemos calcular sus áreas. El área de los triángulos pequeños es 0,5, el área del cuadrado, el triángulo mediano y el romboide es 1, y el área de los triángulos grandes es 2.

El objetivo del rompecabezas geométrico es buscar la forma de colocar las piezas para obtener una configuración dada del mismo, como el cuadrado básico, pero también otras configuraciones, ya sean figurativas (personas, animales, árboles, flores, edificios, letras, números, etc) o geométricas (polígonos convexos, estrellas, poliominós, etc), o incluso diseñar nuevas configuraciones. Puede ocurrir que una configuración dada no tenga ninguna solución, en cuyo caso hay que buscar la forma de demostrar que no la tiene, o en caso de tener solución puede analizarse cuántas formas distintas de conseguir esa configuración existen.

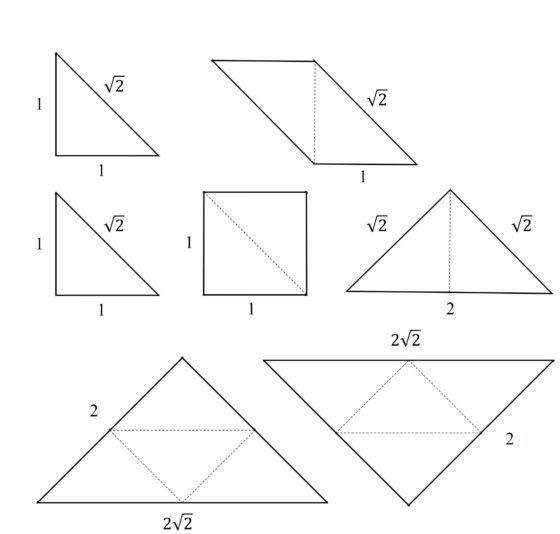

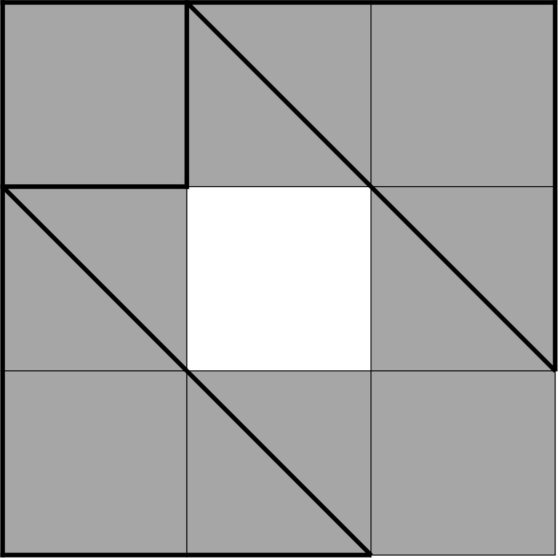

Por ejemplo, si tomamos la configuración básica del Tangram solo existe una solución de la misma, salvo rotaciones y reflexiones (dar la vuelta), que se extendería a 8 soluciones si admitiésemos como distintas las rotaciones y reflexiones (dar la vuelta), como se muestra en la siguiente imagen.

Ocho soluciones simétricas del cuadrado con las piezas del Tangram, que constituyen la única solución, salvo rotaciones y reflexiones

Ocho soluciones simétricas del cuadrado con las piezas del Tangram, que constituyen la única solución, salvo rotaciones y reflexiones

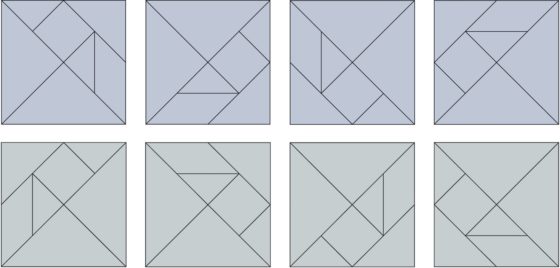

El gran divulgador de las matemáticas Martin Gardner (1914-2010), en su primer artículo sobre el Tangram de su columna Mathematical Games de la revista Scientific American, titulado On the fanciful history and the creative challenges of the puzzle game of tangrams, mostraba una colección de configuraciones con el reto de obtenerlas con las siete piezas, pero una de ellas no era posible y la cuestión era, además, demostrar por qué no era posible. A continuación, mostramos estas configuraciones.

Reto: Obtener estas configuraciones con las siete piezas del Tangram y demostrar que una de ellas es imposible (la demostración al final de la entrada).

Desde el punto de vista matemático, los problemas más interesantes son los de tipo combinatorio. Cuestiones como las siguientes: ¿cuántos polígonos convexos pueden formarse con las piezas del Tangram?, ¿cuántos polígonos de tres, cuatro o cinco lados pueden construirse?, ¿cuántos poliominós (donde un poliominó es una figura geométrica plana formada conectando dos o más cuadrados por alguno de sus lados, como vimos en la entrada Embaldosando con L-triominós (un ejemplo de demostración por inducción)?, ¿cuántas formas estrelladas pueden formarse?, etc.

Antes de continuar, recordemos que un polígono convexo es un polígono cuyos ángulos interiores miden menos de 180º, es decir, no hay zonas que externas metidas hacia dentro. En general, en matemáticas, se dice que un conjunto es convexo, si dados dos puntos cualesquiera del conjunto se verifica que los puntos del segmento que une esos dos puntos está también dentro del conjunto.

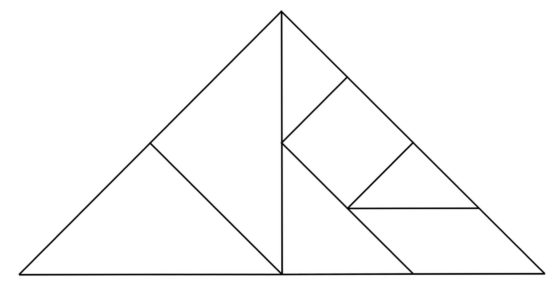

Dos figuras realizadas con las piezas del Tangram, la primera es convexa (sus ángulos interiores miden, desde arriba y en el sentido de las agujas del reloj, 90, 45 y 45 grados), mientras que la segunda no lo es (sus ángulos interiores miden, desde arriba y en el sentido de las agujas del reloj, 90, 45, 135, 270, 135 y 45 grados

Dos figuras realizadas con las piezas del Tangram, la primera es convexa (sus ángulos interiores miden, desde arriba y en el sentido de las agujas del reloj, 90, 45 y 45 grados), mientras que la segunda no lo es (sus ángulos interiores miden, desde arriba y en el sentido de las agujas del reloj, 90, 45, 135, 270, 135 y 45 grados

Antes de entrar en el teorema sobre el Tangram referido al número de configuraciones convexas que existen, primero pensemos cuántos triángulos, polígonos de tres lados, se pueden construir con las piezas del Tangram. La respuesta es sencilla, únicamente el triángulo de la imagen anterior, que es un triángulo rectángulo isósceles (con ángulos de 45, 45 y 90 grados). El motivo es que los ángulos de las piezas del Tangram son 45, 90 y 135 grados, como la suma de los ángulos de un triángulo es 180 grados, la única opción posible es 45, 45 y 90 grados, es decir, el triángulo rectángulo anterior.

Observemos ahora que la solución anterior de la configuración triangular del Tangram no es la única, en contraposición a lo que ocurría con el cuadrado básico. Por ejemplo, otra posible solución es la que mostramos a continuación.

Otra solución de la configuración triangular del Tangram

Otra solución de la configuración triangular del Tangram

Si nos planteáramos qué ocurre con las figuras cuadriláteras, si es posible que existan figuras no convexas de cuatro lados, la respuesta es negativa. La única opción posible para los cuatro ángulos es tres ángulos de 45 grados y uno de 225 grados, el problema es que no se puede realizar esta figura con 16 triángulos rectángulos isósceles del tamaño de las piezas triangulares pequeñas del Tangram. Luego todos los cuadriláteros que se puedan construir serán convexos.

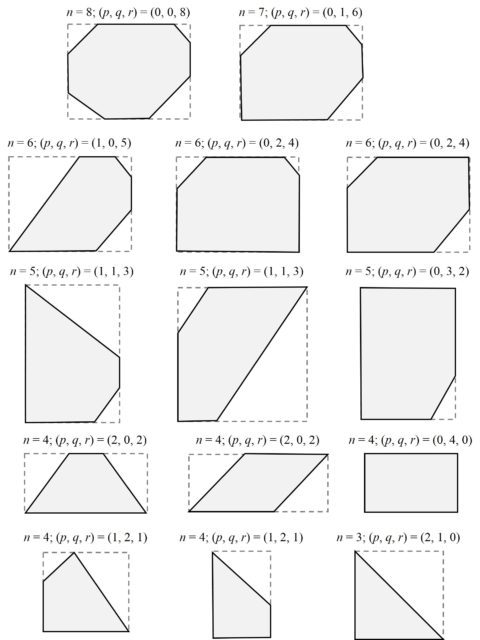

Pero vayamos al resultado importante respecto a las configuraciones convexas del Tangram, la existencia únicamente de 13 polígonos convexos realizados con las figuras del rompecabezas.

Teorema (F.T. Wang, Ch. Hsiung, 1942): Utilizando las piezas del Tangram se pueden formar exactamente trece polígonos convexos.

Los matemáticos chinos Fu Traing Wang y Chuan-Chih Hsiung, en su artículo publicado en The American Mathematical Monthly en 1942, demostraron primero algunos lemas (resultados técnicos previos) que tenían en cuenta fundamentalmente el carácter racional e irracional de los lados de los dieciséis triángulos rectángulos isósceles y que nos permiten entender mejor la situación, así como simplificar la demostración del resultado matemático.

Lema 1. El primer lema dice que, si utilizamos dieciséis triángulos rectángulos iguales para formar un polígono convexo, entonces un lado racional de un triángulo no puede apoyarse en un lado irracional de otro triángulo, como en la imagen siguiente.

Si nos fijamos en la imagen de arriba, los dos triángulos apoyados uno en otro, racional frente a irracional, la figura es claramente no convexa con solo esas dos piezas. Si dibujamos la recta que extiende el lado compartido de los triángulos, podemos observar que:

1. No hay forma de que ninguna pieza atraviese esa línea;

2. Si en la parte superior colocamos triángulos con el lado racional apoyado en la recta, como el que está, y en la parte inferior colocamos triángulos con el lado irracional apoyado en la recta, no hay forma de que coincidan los vértices sobre la recta, ya que una cantidad racional, la suma de los lados de arriba, no puede ser igual a una cantidad irracional, la suma de los de abajo, por lo que siempre quedará una situación no convexa, similar a la de la imagen;

3. La única forma de igualar las longitudes de las piezas que se apoyan en la parte superior e inferior de la recta, es apoyando desde arriba un triángulo con su lado irracional y desde abajo un triángulo con el racional, como se muestra en la imagen.

Pero, en este caso, para romper la no convexidad de la figura formada hay que incluir más triángulos en las zonas con una estrella, lo que nos lleva a volver a poner necesariamente otro lado irracional sobre uno racional y volver a la misma situación inicial, luego de no convexidad.

Lema 2. Si se tiene en cuenta el primer lema, en particular, el argumento del punto 3, se tiene que, si utilizamos dieciséis triángulos rectángulos iguales para formar un polígono convexo, entonces los lados del polígono están formados por lados del mismo tipo (racionales o irracionales) de los triángulos. Además, se dice que un lado del polígono convexo es racional, o irracional, cuando está formado por lados racionales, o irracionales (respectivamente), de los triángulos. En general, los lados racionales e irracionales del polígono convexo alternan, pero si un ángulo del polígono es recto, los lados adyacentes son ambos racionales o irracionales.

Si miramos a la solución del Tangram con forma triangular, pero vista como formada por los dieciséis triángulos rectángulos isósceles del mismo tamaño, observamos que efectivamente se cumple este lema. Los dos lados adyacentes al ángulo recto son racionales, mientras que el otro, entre ellos, es irracional.

Lema 3. Este lema nos establece un número máximo de lados que puede tener un polígono convexo formado por dieciséis triángulos rectángulos isósceles del mismo tamaño. Por una parte, tiene en cuenta que la suma de los ángulos interiores de un polígono convexo de n lados es (n – 2) x 180 grados (este resultado se puede demostrar fácilmente tomando un punto interior del polígono convexo y dividiendo este en triángulos con uno de sus vértices ese punto interior, con solo tener en cuenta que la suma de los ángulos de un triángulo es 180 grados y que los ángulos alrededor del punto interior suman 360 grados) y, por otra parte, que en cada uno de los n vértices del polígono convexo la suma máxima que pueden alcanzar los ángulos que proporcionan los triángulos es 135 grados. Considerando ambas informaciones se tiene que la suma de los ángulos interiores del polígono convexo, (n – 2) x 180 grados, es menor o igual que n x 135 grados, de donde, n es menor o igual que 8.

En conclusión, no hay polígonos convexos de más de 8 lados que puedan ser formados con 16 triángulos rectángulos isósceles iguales.

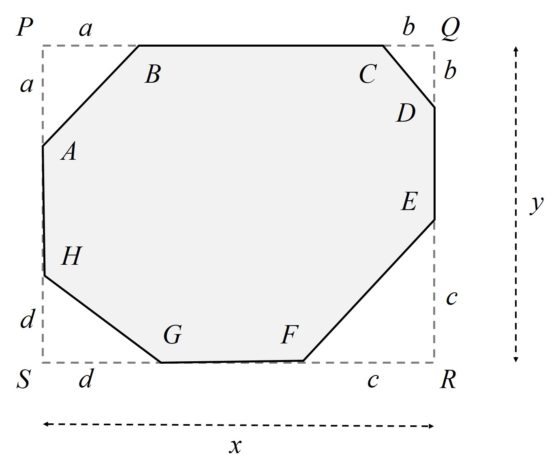

Lema 4. Teniendo en cuenta los lemas anteriores y que los ángulos del polígono convexo solo pueden tener los valores 45, 90 y 135 grados, se obtiene que, si utilizamos dieciséis triángulos rectángulos iguales para formar un polígono convexo, entonces este polígono está inscrito en un rectángulo con todos los lados racionales, o irracionales, del polígono apoyados en los lados del rectángulo.

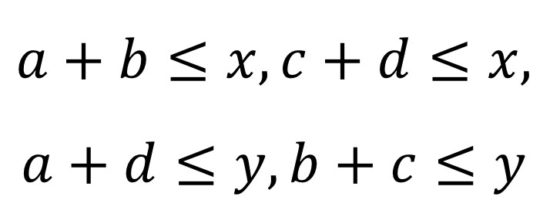

Si consideramos que el polígono convexo tiene p ángulos de 45 grados, q de 90 grados y r de 135 grados, y que la suma de los ángulos del polígono convexo es (n – 2) x 180 grados, se tiene que 2p + q = 8 – n, luego como el polígono tiene como mucho 8 lados, entonces se tienen las siguientes posibilidades para los valores de (p, q, r):

Con los anteriores resultados, ya estamos en condiciones de demostrar este teorema sobre el Tangram.

Demostración del teorema. Para empezar, podemos asumir que el polígono convexo generado con los dieciséis triángulos rectángulos isósceles iguales es un octógono, que denotamos de la siguiente forma ABCDEFGH (sus vértices), ya que podemos considerar que los polígonos con menos lados son octógonos degenerados, en los que algunos lados tienen longitud cero, es decir, son solo vértices. Por otra parte, podemos suponer que el polígono está inscrito en un rectángulo PQRS tal que los lados racionales del polígono BC, DE, FG y HA son los que se apoyan en los lados del rectángulo.

A continuación, llamamos a, b, c y d al número de lados irracionales de los triángulos rectángulos isósceles que forman los lados irracionales del octógono AB, CD, EF y GH, respectivamente. Si seguimos con la convención de que los lados racionales de los dieciséis triángulos rectángulos isósceles iguales miden 1 (por el teorema de Pitágoras, los irracionales miden raíz de 2), entonces resulta que los números naturales a, b, c y d (que podrían valer 0 en el caso de un octógono degenerado) son las longitudes de los catetos de los triángulos rectángulos APB, CQD, ERF y GSH, cuyas hipotenusas son los lados irracionales del octógono, como puede observarse en la anterior imagen. El siguiente diagrama nos muestra la justificación de lo anterior.

Y llamamos x e y a las longitudes de los lados del rectángulo en el que está inscrito el octógono, como se indica en la imagen de más arriba. Ahora, por un simple razonamiento de áreas en el diagrama del octógono inscrito en el rectángulo, tenemos que los números naturales a, b, c, d, x, y (que pueden tomar también el valor 0) satisfacen la siguiente ecuación:

![]()

con las restricciones naturales siguientes

Por lo tanto, hemos reducido la demostración del resultado sobre las configuraciones convexas del Tangram a la búsqueda de soluciones enteras (no negativas) de la anterior ecuación, con sus restricciones y de las mismas (ya que estas se corresponden a disposiciones con los 16 triángulos rectángulos isósceles iguales) determinar cuáles son posibles mediante las piezas del Tangram.

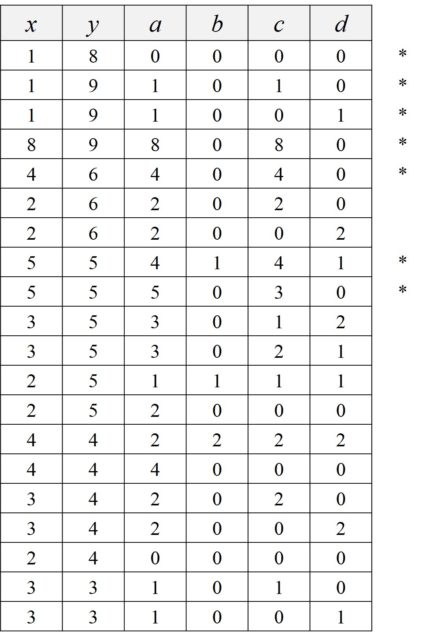

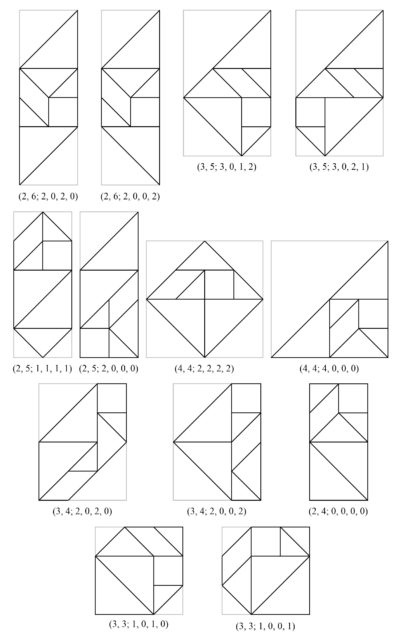

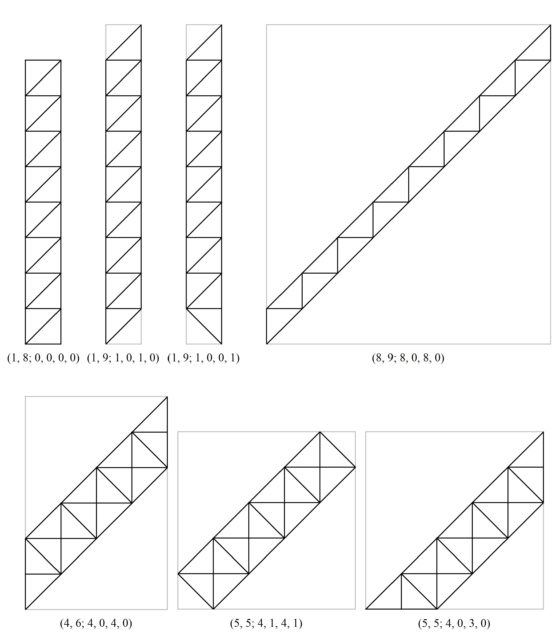

En esta entrada nos vamos a saltar la parte de la demostración que consiste en buscar las soluciones enteras, no negativas, de la anterior ecuación. Para las personas que estén interesadas les remitimos al artículo original A theorem on the Tangram, de Wang y Hsiung, o al artículo Finding all convex tangrams, de T.G.J. Beelen, que se incluyen en la bibliografía. A continuación, mostramos una tabla con las soluciones para las incógnitas a, b, c, d, x, y, además, están marcadas con un asterisco aquellas que no se corresponden con configuraciones del Tangram.

De donde podemos construir los trece poliedros convexos posibles con las siete piezas del Tangram.

Las 13 configuraciones convexas posibles con el rompecabezas Tangram

Las 13 configuraciones convexas posibles con el rompecabezas Tangram

Por otra parte, las siete construcciones posibles con dieciséis triángulos rectángulos isósceles iguales, pero que no son realizables con las piezas del Tangram son las siguientes.

Las 7 configuraciones convexas realizables con los 16 triángulos rectángulos isósceles iguales, pero no con las piezas del Tangram

Las 7 configuraciones convexas realizables con los 16 triángulos rectángulos isósceles iguales, pero no con las piezas del Tangram

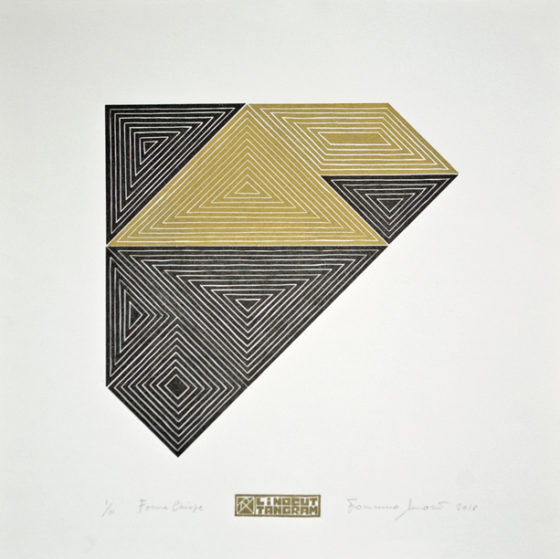

Vamos a terminar con un grabado basado en una de las trece construcciones poligonales convexas del Tangram, realizada por el artista italiano Francesco Moretti, de quien ya hablamos en la anterior entrada El arte contemporáneo que mira al Tangram.

Forma cerrada 02 (2018), de Francesco Moretti. Linograbado en 2 colores, de tamaño 50 x 50 cm. Imagen extraída de la página del artista Francesco Moretti

Forma cerrada 02 (2018), de Francesco Moretti. Linograbado en 2 colores, de tamaño 50 x 50 cm. Imagen extraída de la página del artista Francesco Moretti

Pero no hemos terminado del todo, aún nos queda la solución del reto que habíamos planteado.

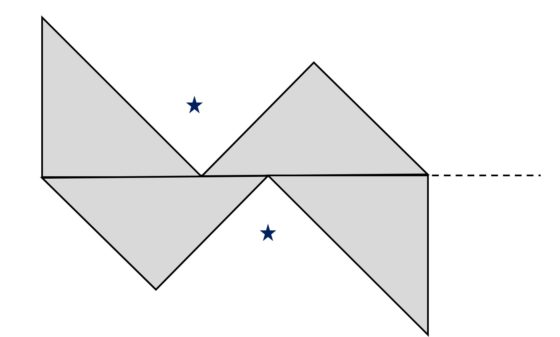

Solución del reto: Para terminar, resolvamos la parte del reto de la configuración que es imposible de realizar. Esta es el cuadrado con un agujero cuadrado en el centro. Demostremos que no es posible realizarla con las siete piezas del Tangram. Si observamos bien la configuración, vemos que efectivamente la superficie de la misma está formada por 8 cuadrados, es decir, 16 triángulos rectángulos isósceles, como las 7 piezas del Tangram. Si vemos donde pueden ir colocadas las piezas triangulares grandes, resulta que solo pueden ir colocadas en dos esquinas opuestas de la configuración, como se muestra en la imagen de abajo. Además, la pieza cuadrada solo podrá ir en una de las dos esquinas libres.

El problema es que la pieza romboide solo puede ir pegada a la única esquina que queda libre, pero entonces no hay sitio para poder colocar la pieza triangular mediana. En conclusión, es imposible realizar esta configuración.

Bibliografía

1.- Fu Traing Wang, Chuan-Chih Hsiung, A theorem on the Tangram, The American Mathematical Monthly, vol. 49, no. 9, pp. 596-599, 1942.

2.- Martin Gardner, Viajes en el tiempo y otras perplejidades matemáticas, RBA, 2010 (los dos artículos originales de Martin Gardner sobre el Tangram que aparecen en este libro fueron publicados originalmente en la columna Mathematical Games de la revista Scientific American en 1974)

3.- Paul Scott, Convex Tangrams

4.- T.G.J. Beelen, Finding all convex tangrams, CASA-report Vol. 1702, Technische Universiteit Eindhoven, 2017.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Un teorema sobre el Tangram se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El arte contemporáneo que mira al Tangram

- El teorema del pollo picante (o sobre particiones convexas equitativas)

- Tangram

Las ondas electrónicas y la estructura atómica

Foto: Paulo Carrolo / Unsplash

Foto: Paulo Carrolo / UnsplashBohr había postulado que la cantidad mvr, que llamaremos «momento angular» [1] del electrón que orbita en el átomo de hidrógeno, donde r es el radio de la órbita del electrón, m es la masa de los electrones y v es su velocidad lineal [2], puede tener solo ciertos valores cuantizados. Estos valores cuantizados permiten definir los estados estacionarios.

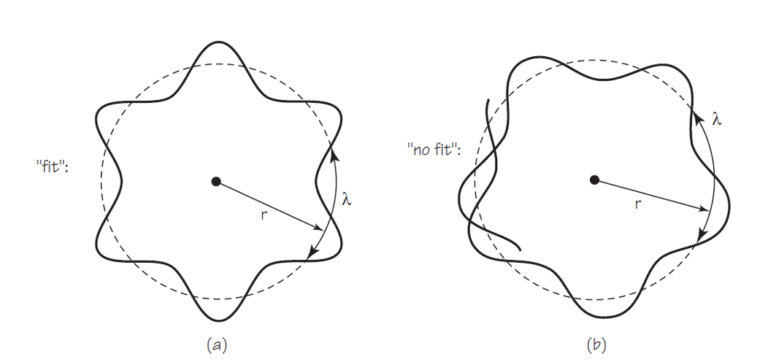

La relación de de Broglie, λ = h/mv, esto es, el comportamiento ondulatorio de los electrones tiene una aplicación interesante y extremadamente simple que respalda este postulado [3] y ayuda a explicar la existencia de unos estados estacionarios y no otros. Veámoslo.

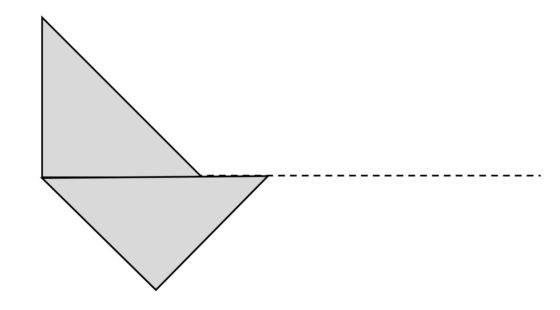

Bohr asumió que mvr solo puede tener los valores mvr = nh/2π [4], donde h es la constante de Planck y n un número natural que solo puede adoptar los valores n = 1, 2, 3, . . . .

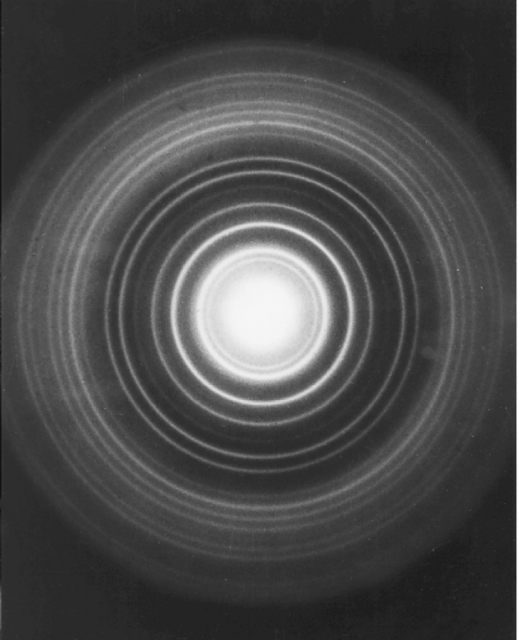

Bien. Supongamos ahora que la onda asociada al electrón se extiende, de alguna forma, por la órbita circular de radio r, de tal forma que ocupa toda la órbita. Si esto es así la longitud de la circunferencia de la órbita, 2π tiene que ser igual a una longitud de onda o a un número entero n de longitudes de onda. En cualquier otro caso la onda se autoanula. Lo vemos en la figura: a la izquierda, encaja (fit), a la derecha no lo hace (no fit) y las ondas se anulan.

Fuente: Cassidy Physics Library

Fuente: Cassidy Physics LibrarySi esto mismo lo reemplazamos por símbolos tenemos que 2πr, la longitud de la circunferencia, ha de ser igual a un número natural de longitudes de onda, nλ, o sea, 2πr = nλ. Por la relación de de Broglie sabemos que λ = h/mv, por tanto 2πr = nh/mv; que no es más que el postulado de Bohr escrito de otra manera ya que, simplemente reordenando obtenemos mvr = nh/2π.

La relación de Broglie para las ondas electrónicas unida a la idea de que los electrones tienen órbitas que permiten ondas estacionarias nos permite derivar la cuantización de las órbitas electrónicas que Bohr tuvo que asumir.

De lo que hemos visto resulta que uno se puede imaginar electrón que orbita en el átomo tanto como un corpúsculo que se mueve en una órbita con un cierto valor cuantizado del producto mvr como una onda tipo de Broglie estacionaria que ocupa una cierta región alrededor del núcleo.

Ya tenemos los mimbres básicos con los que construir la mecánica cuántica.

Notas: