Rayos X y neutrones para descubrir el origen del agua en la Tierra

A lo largo de todas estas entradas de Planeta B hemos remarcado la importancia de los meteoritos en el conocimiento de la geología de nuestro Sistema Solar, ya que nos abren la puerta a estudiar no solo la composición, sino también algunos procesos ocurridos a lo largo de la historia en aquellos cuerpos de los que proceden, y de los que en la mayoría de las ocasiones carecemos de muestras traídas directamente.

Pero no solo eso, los meteoritos nos pueden aportar una visión histórica sobre nuestro planeta -y el Sistema Solar en general- más prolongada que las rocas que hoy día podemos encontrar en la Tierra, ya que esas primeras rocas desaparecieron fruto de los impactos de los asteroides, la erosión y la tectónica de placas.

Una condrita carbonácea, un tipo de meteorito que en algunos casos puede contener un gran porcentaje de agua. Imagen cortesía de NASA / Eric James.

Una condrita carbonácea, un tipo de meteorito que en algunos casos puede contener un gran porcentaje de agua. Imagen cortesía de NASA / Eric James.Dicho esto, si queremos conocer mejor como fueron esos ladrillos fundamentales que dieron lugar a nuestro planeta para intentar reconstruir con mayor detalle cómo pudo ser esa infancia de la Tierra, tenemos que recurrir, sin duda, al estudio de los asteroides y los meteoritos.

Y es que, aunque las últimas décadas nos han sido muy gratas en cuanto a descubrimientos, nos quedan todavía muchos interrogantes. Uno de estos, y que de algún modo sigue sujeto a gran debate científico, es ¿de dónde proviene el agua de nuestro planeta? ¿Formaba parte de la Tierra durante su formación o llegó después a partir de los impactos de cometas y asteroides?

Estudios recientes sugieren que alrededor del cinco por ciento de la masa de nuestro planeta podría provenir de las zonas más externas de nuestro Sistema Solar, un lugar dominado por gases y elementos volátiles -como el agua-, pero cuya proporción puede haber ido variando a lo largo del tiempo, especialmente tras el impacto que dio lugar a la formación la Luna.

Pero con estos estudios surgen nuevas dudas… ¿incorporó la Tierra estos elementos volátiles antes o después de su formación? Quizás está aquí el quid de la cuestión.

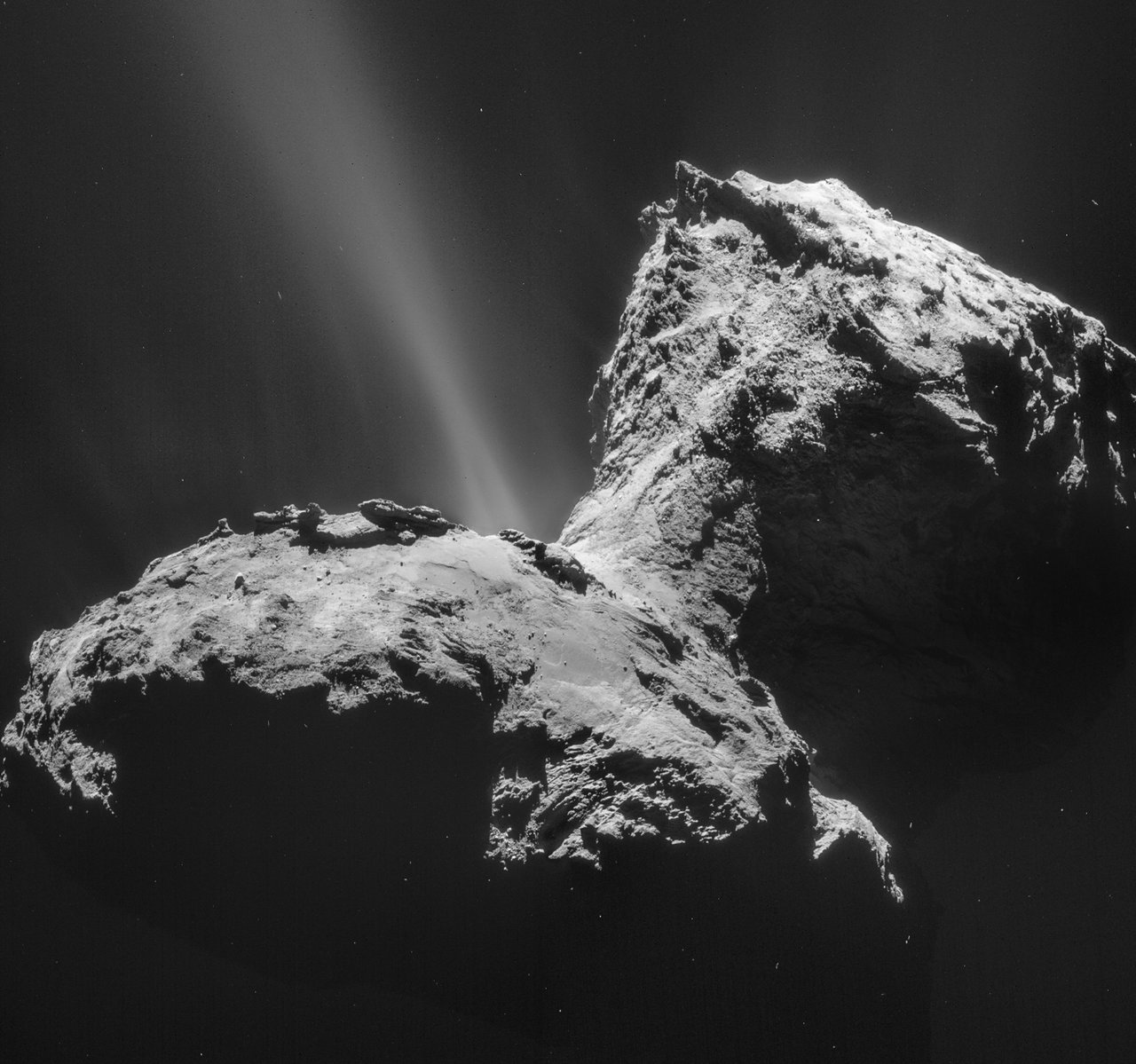

¿Proviene el agua del impacto de cuerpos ricos en hielo como los cometas, y que impactaron sobre nuestro planeta en etapas tardías? Imagen cortesía de ESA/Rosetta/NAVCAM

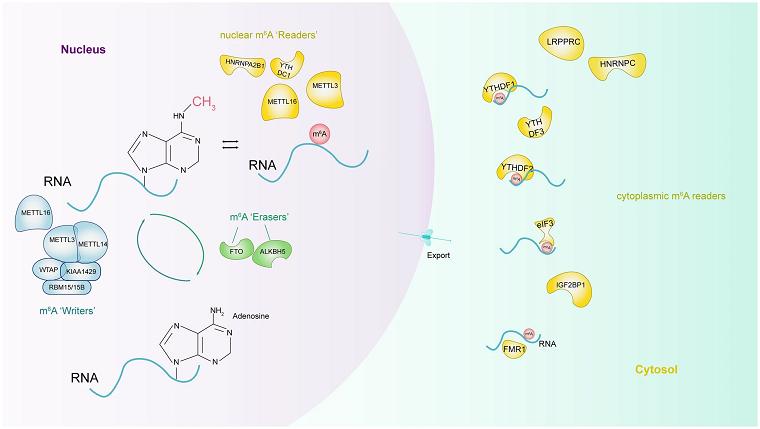

¿Proviene el agua del impacto de cuerpos ricos en hielo como los cometas, y que impactaron sobre nuestro planeta en etapas tardías? Imagen cortesía de ESA/Rosetta/NAVCAMPara poder responder a estas preguntas, los científicos están intentando conocer con precisión las ratios isotópicas de los distintos elementos, ya que pequeñas variaciones en estas proporciones podrían significar que provienen de lugares diferentes o incluso que fueron incorporados a nuestro planeta en momentos diferentes, entre otros procesos.

Al intentar resolver el origen del agua en la Tierra tenemos que contar con el estudio de meteoritos que contengan agua, porque los isótopos del hidrógeno del agua podrían tener una de las claves, pero el agua no se encuentra distribuida de una manera homogénea dentro del meteorito.

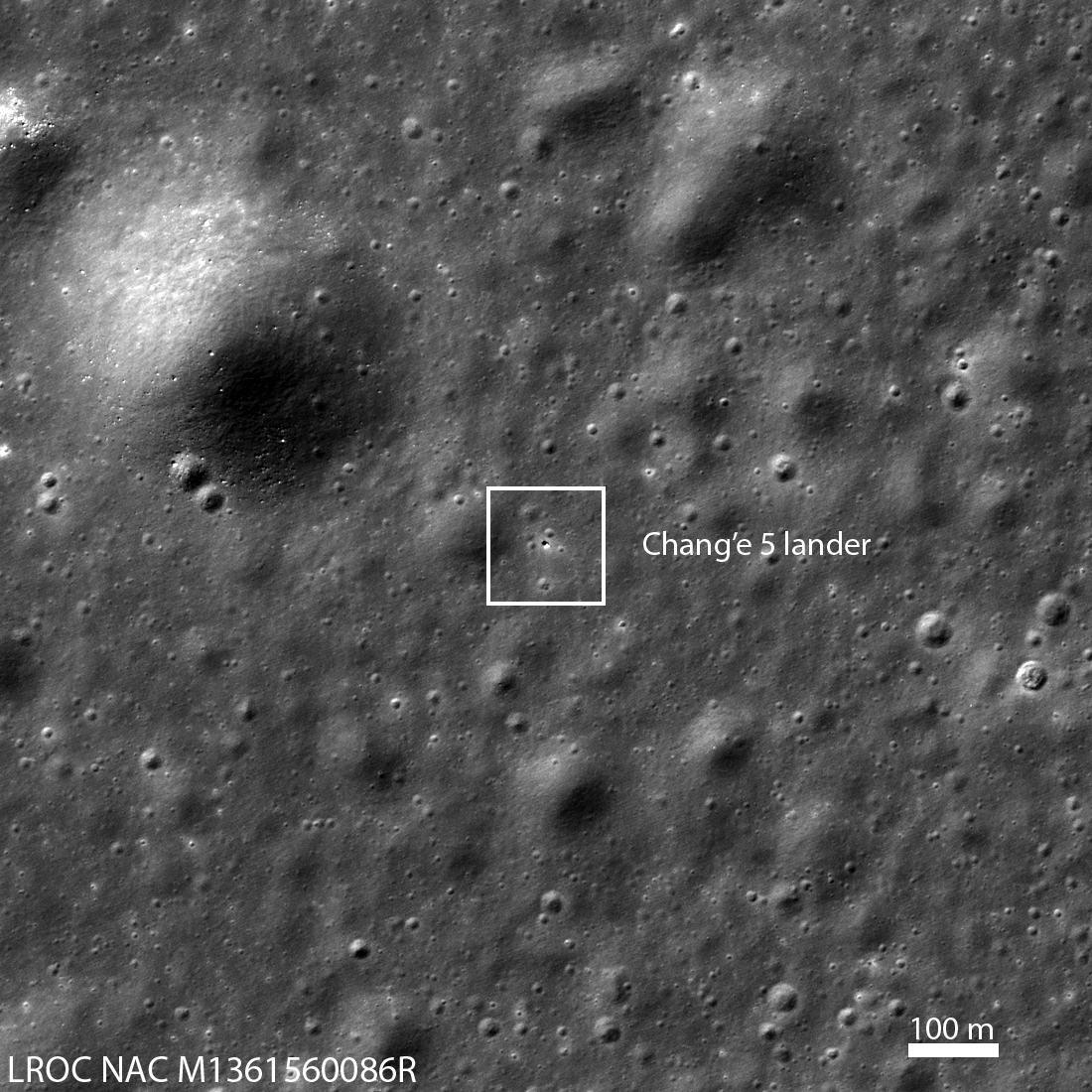

¿Y qué tienen que ver los rayos X y los neutrones con el origen del agua? Un nuevo estudio publicado esta pasada semana nos abre una puerta a estudiar los meteoritos de una manera no invasiva antes de que sean usados para tomar muestras, ayudándonos a seleccionar los lugares más interesantes del meteorito combinando ambas técnicas.

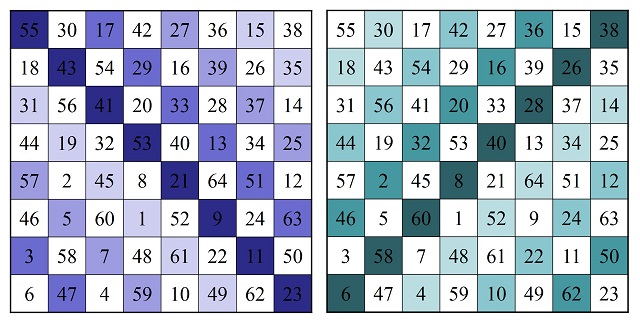

Vídeo del interior del meteorito GRA 06100, recogido en la Antártida. Los colores azules muestran los compuestos con hidrógeno, como el agua. Los rojos muestran compuestos ricos en hierro. Vídeo cortesía de NIST.El estudio con neutrones nos permite, dentro del meteorito, buscar las zonas con mayor contenido en agua y compuestos del hidrógeno, mientras que los rayos X nos permiten ver mejor compuestos con elementos de mayor peso atómico, como los metálicos. Estas dos técnicas combinadas permiten realizar un modelo tridimensional del interior del meteorito con las que los científicos podrían decidir que zonas son más adecuadas para el análisis para medir las ratios isotópicas del hidrógeno y así, quizás, conseguir mejores respuestas de cara al origen del agua.

Esta técnica, además, permitirá elaborar mapas composicionales que nos permitirán conocer, sin tener que cortar, la relación entre los distintos elementos que hay en el interior de los meteoritos, estudiar el alcance de la alteración física y química que estos han sufrido y su estructura sin necesidad de destruir la muestra para su estudio, preservándolas para estudios futuros.

Sin lugar a dudas, esta técnica no solo será útil para el estudio de los meteoritos, sino que podrá abrirse a otros campos de la geología e incluso, quien sabe, si a las muestras que seamos capaces de traer de Marte en la década de 2030.

Para saber más:

Métodos no destructivos para analizar muestras marcianas

Las últimas gotas de agua en el meteorito

Bibliografía:

Borg, L.E., Brennecka, G.A. and Kruijer, T.S. (2022) “The origin of volatile elements in the earth–moon system,” Proceedings of the National Academy of Sciences, 119(8). doi:: 10.1073/pnas.2115726119.

Treiman, A.H. et al. (2022) “Coordinated Neutron and x‐ray computed tomography of meteorites: Detection and distribution of hydrogen‐bearing materials,” Meteoritics & Planetary Science, 57(10), pp. 1820–1835. doi: 10.1111/maps.13904.

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Rayos X y neutrones para descubrir el origen del agua en la Tierra se ha escrito en Cuaderno de Cultura Científica.

La hormona de la maternidad y de la paternidad

Foto: Alex Bodini / Unsplash

Foto: Alex Bodini / UnsplashSi le digo que la prolactina es la hormona de la que depende la producción de leche en los mamíferos, pensará, inmediatamente, que es una hormona femenina. Pero en biología, máxime en materia de sexo, a menudo las cosas no son lo que parecen. Sus funciones más importantes tienen que ver con la reproducción, pero cumple, además, papeles esenciales en otros procesos.

La pituitaria, o hipófisis, es el principal órgano endocrino que produce prolactina. Ese órgano, de muy pequeño tamaño, se encuentra en la base del encéfalo. La zona concreta que produce prolactina recibe señales del hipotálamo, una región encefálica que constituye, por así decir, la interfase entre el sistema nervioso y el sistema hormonal. Las señales procedentes del hipotálamo llegan a la hipófisis, mediante un servicio de mensajería química a través de su propio sistema de vasos y capilares sanguíneos. De esa forma, el control último de la liberación de la hormona corresponde al sistema nervioso. La arquitectura y organización de todo este dispositivo de control es, a la vez, compleja y elegante.

Un grupo importante de funciones en las que interviene la prolactina tiene que ver con el cuidado parental, esto es, con la atención y, sobre todo, la alimentación de las crías. En el caso de la producción de leche, esa función es clara. Durante el embarazo aumenta la concentración sanguínea de prolactina, las células de las glándulas mamarias empiezan a acumular reservas y, como consecuencia, las mamas se agrandan. Al final del embarazo, con el parto, desciende la concentración sanguínea de progesterona y estrógenos. Ese descenso, junto con las señales de succión en los pezones, hacen que las glándulas mamarias empiezan a producir leche. La oxitocina, otra hormona, provoca su eyección en respuesta a la succión por el bebé.

Pero no solo las hembras de mamífero se ven influidas por la prolactina. A los machos también nos afecta, y lo hace de manera que favorece las tendencias a cuidar de la prole. Los hombres, con la paternidad, experimentamos un descenso en la concentración sanguínea de testosterona y un aumento de la de prolactina. No producimos leche, claro está, pero nuestro comportamiento se modifica, reduciéndose la agresividad y adquiriendo una actitud “paternal” para con nuestras criaturas. No somos los únicos mamíferos en los que ocurren estas cosas. En general y hasta donde se ha investigado, se trata de respuestas fisiológicas propias de los machos que intervienen en el cuidado y atención de su prole.

Hay comportamientos aún más extremos que el masculino humano. El tití Callithrix jacchus y el tamarino Saguinus oedipus son primates, monos del Nuevo Mundo, y monógamos. No es muy habitual que los primates sean monógamos, pero estos lo son. Los machos de estas especies se ocupan de su progenie a fondo, hasta el punto de que, tras el parto, le dedican más tiempo de atención y cuidados que las madres. No hay ningún comportamiento semejante en el mundo mamífero. El fenómeno es tan relevante, que el cuidado de la cría hace que el padre pierda peso. Hasta tal punto es importante que, para poder estar preparados para la paternidad, estos monos ganan peso durante el embarazo de sus parejas. Desde que la mona se queda embarazada hasta que da a luz, el padre gana un 15% de peso, ganancia que más adelante se esfumará. Pues bien, la hormona que participa en este fenómeno es –ya lo habrá adivinado– la prolactina, la hormona que, entre otras funciones menos llamativas, interviene en el cuidado maternal de las crías y, dependiendo de las circunstancias, también del paternal.

Para saber más:

El enamoramiento como droga de abuso

Fuente: Ziegler, T. E., Prudom, S. L., Schultz-Darken, N. J., Kurian, A. V., Snowdon, Ch. T. (2006): Pregnancy weight gain: marmoset and tamarin dads show it too. Biol. Lett. 2: 181–183. doi: 10.1098/rsbl.2005.0426

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La hormona de la maternidad y de la paternidad se ha escrito en Cuaderno de Cultura Científica.

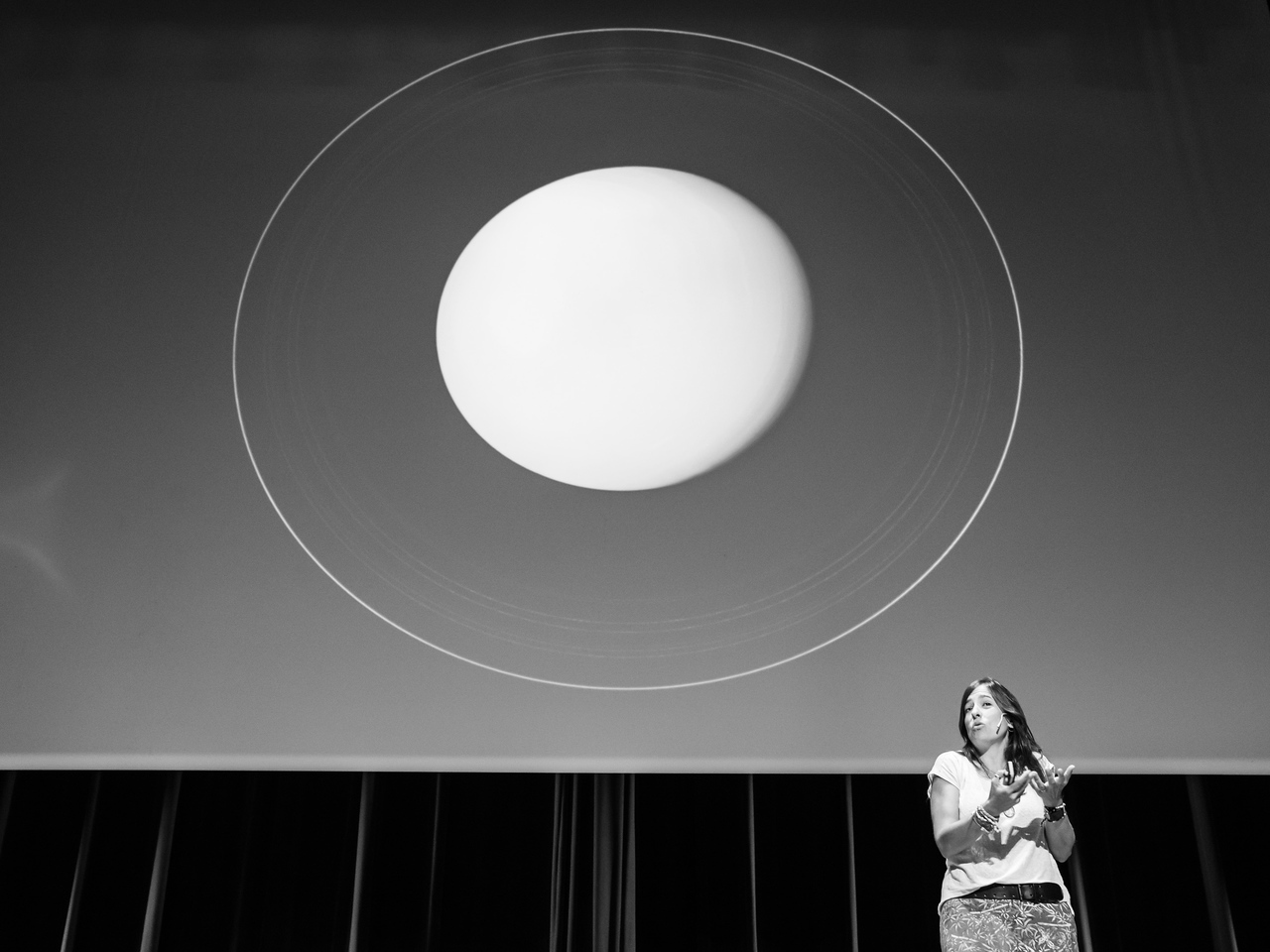

Las pruebas de la educación: Rocío Garrido Martos – La dimensión afectiva y la didáctica de las matemáticas

Bilbao volvió a acoger el pasado 20 de mayo de 2022 “Las pruebas de la educación”, una jornada que abordará diversas cuestiones educativas con la evidencia científica existente. Esta quinta edición está organizado por la Cátedra de Cultura Científica de la UPV/EHU y la Fundación Promaestro con la colaboración del Consejo Escolar de Euskadi, y se celebró en el Bizkaia Aretoa – UPV/EHU de la capital vizcaína.

La jornada consta de cinco ponencias de media hora de duración en la que se tratan temas como la problemática relacionada con los juegos de azar en el ámbito escolar, el impacto de la inmigración en el rendimiento del alumnado o el debate sobre la jornada escolar continua o partida, entre otras cuestiones. La dirección del seminario corrió de nuevo a cargo de Marta Ferrero profesora de la Facultad de Formación del Profesorado y Educación de la Universidad Autónoma de Madrid.

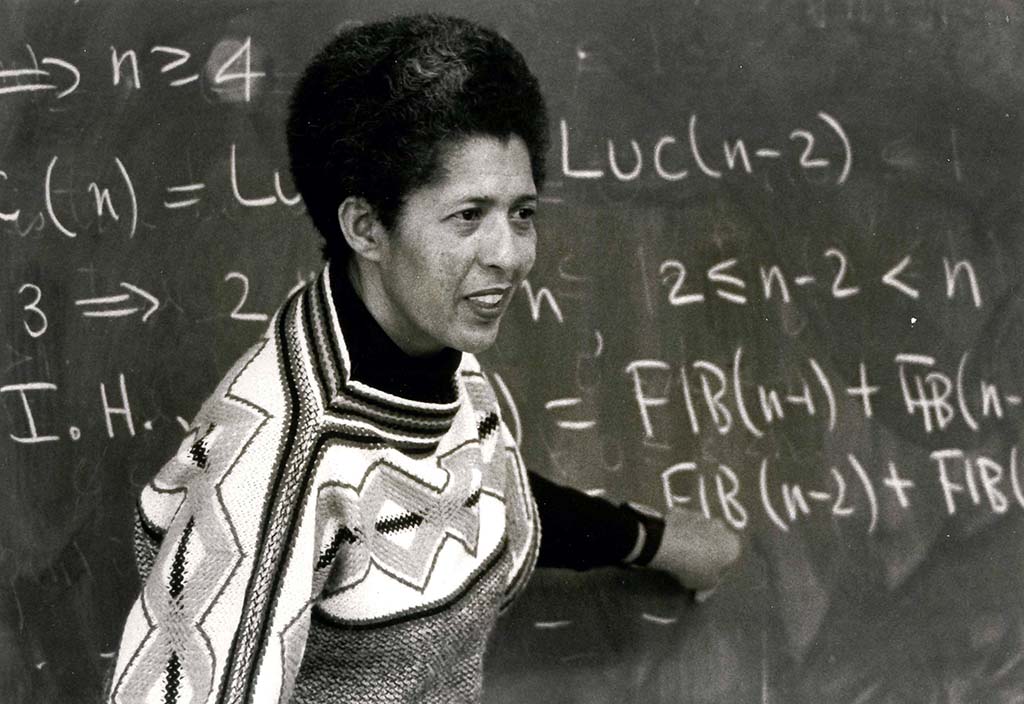

El hecho de que un gran porcentaje de docentes de Educación Primaria sufran un rechazo por las Matemáticas condicionan su manera de abordarla. En esta conferencia Rocío Garrido-Martos, profesora de Didáctica de las Matemáticas en la Universidad Autónoma de Madrid (UAM), analiza algunas de las posibles razones de este rechazo y como condiciona la dimensión afectiva en el aprendizaje y enseñanza de estas ciencias.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Las pruebas de la educación: Rocío Garrido Martos – La dimensión afectiva y la didáctica de las matemáticas se ha escrito en Cuaderno de Cultura Científica.

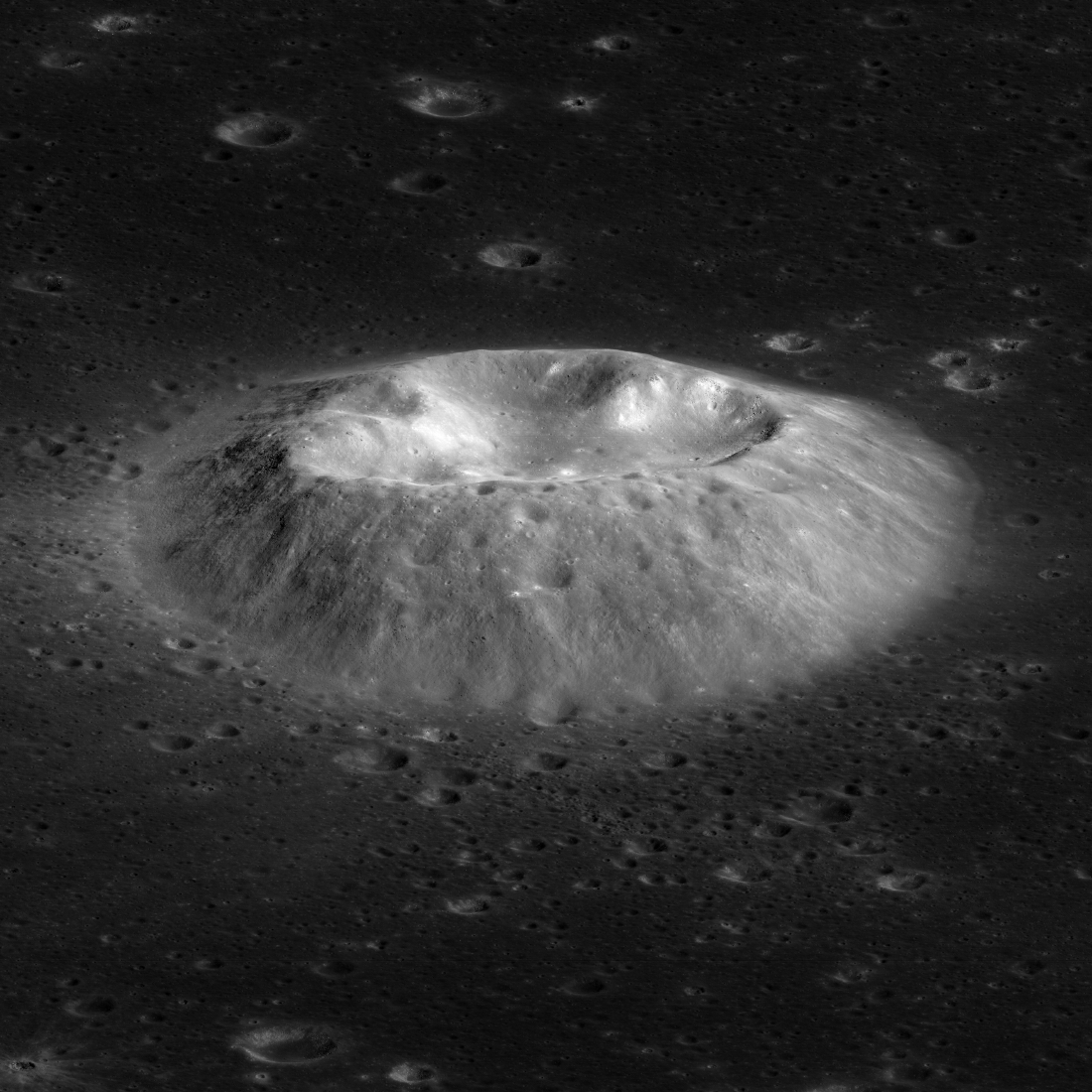

Las lentes gravitacionales permiten observar la aparición de una supernova varias veces

Una supernova es una explosión estelar que se produce al final de la vida de algunas estrellas muy masivas. En este violento epílogo, una onda de choque expulsa el material de las capas exteriores de la estrella, lo que permite observar los diferentes elementos de los que estaba compuesta.

Un equipo internacional, en el que ha participado Tom Broadhurst, Investigador Ikerbasque de la Universidad del País Vasco (UPV/EHU) y asociado del Donostia International Physics Center (DIPC), ha obtenido tres imágenes, cada una en una frecuencia diferente, de una misma supernova en el universo distante, gracias al poder magnificador de una galaxia ubicada en primer plano.

El equipo de investigación desarrolló un modelo del campo gravitacional de la galaxia que sirvió de lente y así se pudo determinar que la luz de estas tres imágenes recorrió tres caminos diferentes, que difieren en distancia por unos pocos días (la distancia se mide en tiempo porque la velocidad de la luz es constante). Esto explica las tres frecuencias obtenidas en las imágenes, ya que a medida que el gas de la supernova se expande y se enfría existe una variación en la frecuencia emitida. A mayor temperatura, la luz emitida es más violeta (incluso ultravioleta), y a medida que la temperatura va disminuyendo, la luz emitida va tendiendo al rojo. Así, la imagen azul corresponde a una fotografía de la supernova unas pocas horas después de la explosión estelar, mientras que las imágenes verde y roja corresponden a 2 y 8 días tras la explosión respectivamente.

Esta información permitió determinar el radio de la estrella original, una supergigante roja con un radio equiparable a 500 veces el del Sol, y que explotó hace 11.500 millones de años, mucho antes de que existiera la Tierra, en la época en la que se considera que se formó nuestra Galaxia. Las imágenes de esta supernova, captadas con el Telescopio Espacial Hubble, están muy magnificadas por el campo gravitacional de una galaxia más cercana que actúa como lente, lo que nos permite ver mucho más lejos en distancia, y en el tiempo, que todas las supernovas locales en galaxias cercanas.

El estudio de las explosiones de estas estrellas supergigantes rojas encaja con la idea actual de cómo los núcleos de los elementos más pesados se habrían creado dentro de las estrellas y liberados al espacio durante las explosiones de supernovas. De esta manera los elementos forjados en el interior de las estrellas tras estas explosiones de supernova se convierten en la siguiente generación de gas y polvo a partir de los cuales se crean los sistemas solares y la vida tal y como la conocemos. Sin las supernovas el gas en las galaxias actuales solo incluiría hidrógeno, helio y algo de litio que se formaron en el Big Bang y no soportaría la vida compleja que requiere de otros elementos químicos más pesados.

Es importante destacar que esta supernova observada a través de una lente gravitacional demuestra que un evento ocurrido en el universo lejano se puede presenciar varias veces, por lo que, en principio, cuando se detecte una nueva supernova podríamos enfocar nuestros instrumentos con anticipación para ver en detalle la aparición de esa misma supernova.

Para saber más:

Referencia:

W. Chen, P. L. Kelly, M. Oguri, T. J. Broadhurst, J. M. Diego, N. Emami, A. V. Filippenko, T. L. Treu, A. Zitrin (2022) Shock cooling of a red super-giant supernova at redshift 3, in lensed images Nature doi: 10.1038/s41586-022-05252-5

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Las lentes gravitacionales permiten observar la aparición de una supernova varias veces se ha escrito en Cuaderno de Cultura Científica.

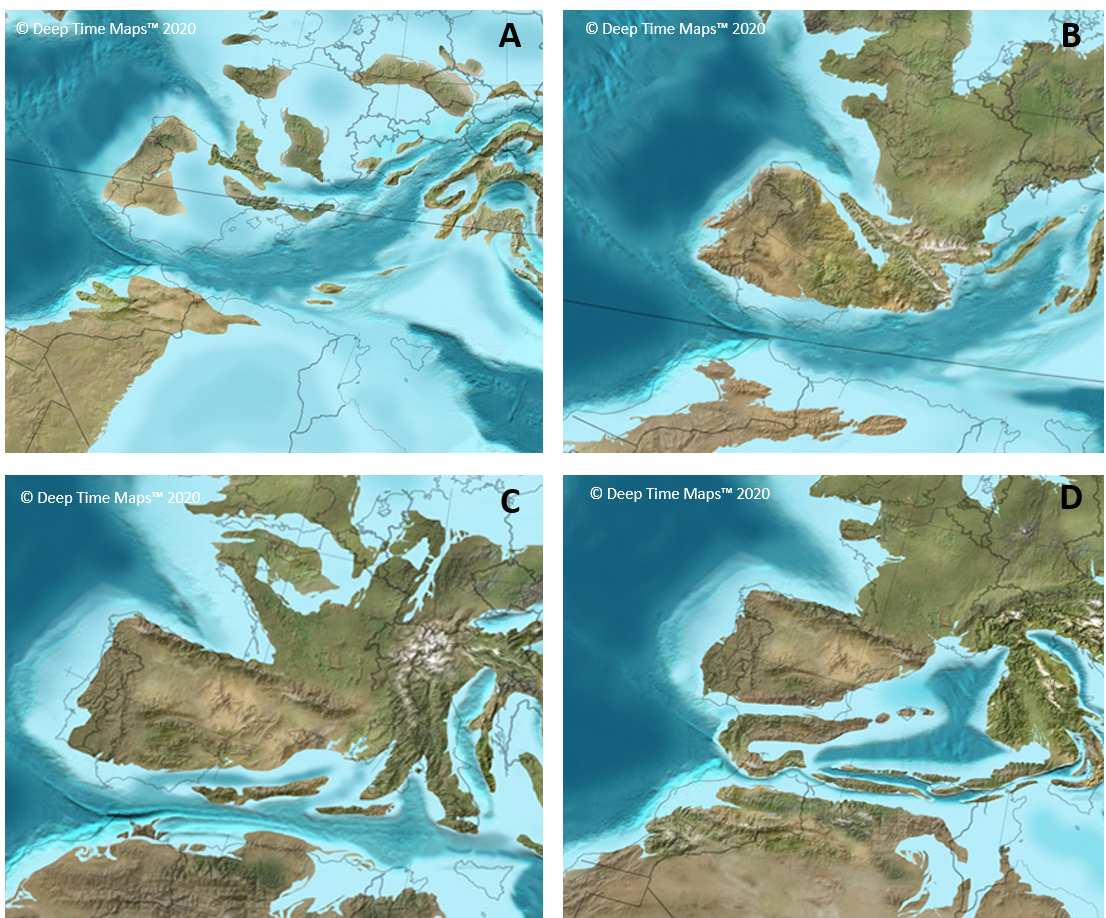

Geometría fractal y geología, morfologías que se repiten al modificar la escala

Ahora que cierta serie inspirada en el universo creado por J. R. R. Tolkien se ha convertido en un fenómeno de masas me he acordado de una curiosa anécdota que tuve junto a varias amigas y amigos geólogos hace unos años, cuando fuimos al cine a ver el estreno de “El Hobbit: La Batalla de los Cinco Ejércitos”. En la parte de la película que ALERTA SPOILER sucede en Dol Guldur, cuando Lady Galadriel se enfrenta a Sauron, ocurre un curioso efecto visual con la imagen del nigromante, que parece repetirse al cambiar la escala y de manera cíclica hasta ser expulsado a Mordor. En ese instante dijimos en mitad del cine, reconozco que igual con voz demasiado elevada, “¡Anda mira, Sauron fractal!” FIN DEL SPOILER.

La verdad es que no se trataba de un fractal en sentido estricto, pero nos dio pie a una interesante discusión sobre la relación entre la geometría fractal y la geología.

No voy a explicar lo que es un fractal, ya que es un concepto matemático que, ni de lejos, es mi especialidad, pero, de manera muy resumida, se caracterizan por dos propiedades: 1- se trata de morfologías muy complejas que no pueden explicarse con la geometría euclídea tradicional; y 2- estas morfologías se repiten al modificar la escala, es decir, mantienen la misma forma independientemente de si las observamos al microscopio o a tamaño kilométrico. Y estas morfologías fractales son muy comunes en la naturaleza, pudiendo encontrar muchos ejemplos en el ámbito geológico.

Muestra del mineral pirita, cuya composición química es FeS2, cristalizado en el sistema cristalino cúbico. La longitud de la arista es de 7cm.

Muestra del mineral pirita, cuya composición química es FeS2, cristalizado en el sistema cristalino cúbico. La longitud de la arista es de 7cm.Uno de los más evidentes lo observamos en la estructura cristalina de los minerales. Un mineral no aparece de la nada, sino que tiene un nacimiento, por así decirlo, que se produce cuando se unen varios átomos o moléculas con una composición química concreta. Si este embrión mineral tiene suficiente tiempo y espacio, va a ir agregando más elementos o moléculas químicas, lo que le permite crecer en tamaño. Pero este crecimiento lo hace siempre manteniendo la misma estructura cristalina, es decir, la misma morfología, por ejemplo, un cubo. De esta manera, nos podemos topar con cristales de un mismo mineral que sean cubitos de apenas unos milímetros de longitud de arista, o con cristales que puedan llegar a medir varios centímetros o metros de longitud, teniendo unos cubos de categoría. Vamos, que conservan la misma forma independientemente del tamaño final que alcance el cristal.

Río braided o trenzado de Islandia a vista de dron. Fotografía de Iurie Belegurschi / Iceland Photo Tours

Río braided o trenzado de Islandia a vista de dron. Fotografía de Iurie Belegurschi / Iceland Photo ToursVoy a pasarme ahora al mundo de la geomorfología. Seguro que os habéis dado cuenta de que no todos los ríos del mundo tienen la misma forma. Esta morfología depende del clima, el caudal de agua que transportan y las características geológicas del terreno que atraviesan. Pues hay un tipo de ríos donde la geometría fractal es más que evidente. Se trata de los ríos braided, que podríamos traducir como de tipo trenzado. Son unos ríos de grandes dimensiones cuya forma recuerda mucho a las ramas de los árboles o al sistema circulatorio, ya que tienen un canal principal y muchos canales secundarios que se van ramificando en canales cada vez más pequeños. Pues este patrón de distribución sigue una geometría fractal, ya que se repite a cualquier escala de observación que utilicemos. De tal manera que, si hacemos un zoom sobre uno de los canales secundarios, veremos cómo parten de él canales menores formados por otros canales cada vez más pequeños.

Fósil de la concha de un ammonites con sutura ammonítica.

Fósil de la concha de un ammonites con sutura ammonítica.Y no podía dejar pasar la oportunidad de hablar de fósiles, así que voy a terminar con un tercer ejemplo también bastante curioso. Los ammonites son un grupo de cefalópodos marinos ya extintos que formaban una concha carbonatada que iba creciendo con forma de espiral. Este crecimiento, debido a su vez al crecimiento del propio organismo, se producía por la adicción de una nueva cámara más grande que albergaba las partes blandas. La unión entre las cámaras se denomina sutura que, a modo de símil, representaría las costuras entre las cámaras. Pues hay un tipo de sutura conocida como ammonítica que tenía una morfología sinuosa formada por curvas superpuestas una sobre la otra, que recuerda mucho a las suturas craneales. De nuevo, resulta que este patrón de curvas superpuestas se repite a diferentes escalas, manteniendo una morfología fractal.

Aquí solo he usado tres ejemplos muy evidentes, pero existen decenas de procesos, estructuras y eventos geológicos que pueden cuantificarse y explicarse empleando la geometría fractal. Os invito a que los busquéis, porque son realmente curiosos. Y, por supuesto, esto no es más que una simple muestra de la estrecha relación que existe entre la Geología y las Matemáticas y de cómo se mantiene la armonía en la naturaleza.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Geometría fractal y geología, morfologías que se repiten al modificar la escala se ha escrito en Cuaderno de Cultura Científica.

El efecto Will Rogers

Will Rogers (1879-1935) fue un actor cómico estadounidense a quien se atribuye la mordaz frase: «When the Okies left Oklahoma and moved to California, they raised the average intelligence level in both states» («Cuando los habitantes de Oklahoma se mudaron a California, aumentaron el nivel de inteligencia medio en ambos estados»).

Will Rogers. Fuente: Wikimedia Commons.

Will Rogers. Fuente: Wikimedia Commons.

Por este motivo se conoce como “efecto Will Rogers” (o paradoja de los Okies) a una familia de situaciones contraintuitivas que vamos a explicar en esta anotación.

Una paradoja con medias aritméticasConsideremos dos conjuntos de números enteros positivos A = {5, 6, 7, 8, 9} y B = {1, 2, 3, 4}. La media aritmética de A es (5 + 6 + 7 + 8 + 9) / 5 = 7 y la de B es (1 + 2 + 3 + 4) / 4 = 2,5. Si trasladamos el número 5 de A hacia B, obtenemos los conjuntos A’ = {6, 7, 8, 9} y B’ = {1, 2, 3, 4, 5}. La media de A’ es (6 + 7 + 8 + 9) / 4 = 7,5 y la de B’ es (1 + 2 + 3 + 4 + 5) / 5 = 3. ¡Ambas medias aritméticas han aumentado! ¿No es esto paradójico?

Aparentemente lo es. Pero fijaos que en el conjunto A se ha eliminado en número menor, que es mayor que todos los enteros positivos del conjunto B…

El efecto Will Rogers y la salud públicaEl efecto Will Rogers salva vidas… Y lo hace sin necesidad de tratar a ningún paciente. En efecto, supongamos que, gracias a la investigación científica y técnica, se amplían los criterios o la capacidad para identificar una enfermedad. Por este motivo, un grupo de personas pasa de la lista de “individuos sanos” al registro de “individuos enfermos”. Como esas personas padecían ciertamente esa enfermedad, estaban más enfermas que una persona sana promedio. Al retirarlas de la lista de “individuos sanos” aumenta la esperanza de vida (o la salud general) de la lista de personas sanas.

Por otro lado, estas personas diagnosticadas gracias a esos avances en investigación están menos enfermas que los pacientes más graves de la lista de “individuos enfermos”. Y es así, porque están en una etapa temprana o su afección es leve. Hasta que los criterios de evaluación de esa enfermedad no cambiaron, no se consideraban como personas enfermas, y ahora lo son. Pero como están en mejores condiciones de salud que los “individuos enfermos” según el método anterior, la esperanza de vida de este último registro sube.

Lo sorprendente de este fenómeno es que nadie ha recibido ningún tratamiento, por lo tanto, ninguna persona ha mejorado su salud por haberle diagnosticado esta enfermedad. Sin embargo, esta reclasificación implica que las personas de ambas listas han aumentado su esperanza de vida.

En el artículo de Feinstein et al. explican precisamente el caso de un grupo de pacientes con cáncer de pulmón tratados por primera vez en 1977. En ese momento tenían unas tasas de supervivencia (a los seis meses) más altas para el grupo total y para los subgrupos en cada uno de los tres estadios principales (tumor, ganglios y metástasis) que un grupo tratado entre 1953 y 1964 en las mismas instituciones. ¿Qué había sucedido? Que el grupo más reciente se había sometido a nuevos procedimientos de diagnóstico por imágenes, con lo que el pronóstico mejoró. Además, se observaron metástasis que antes no se podían identificar, con lo que los nuevos datos procedentes de la mejora de la tecnología médica llevaron a estos pacientes a un cambio de etapa. Muchos de esos individuos que previamente habrían sido diagnosticados en una fase “buena” fueron entonces asignados a una fase “mala”. En el nuevo grupo al que habían sido asignados, su estado de salud era mejor que el de la mayoría de las personas. Así, la tasa de supervivencia aumentó en cada grupo sin cambios en cada paciente individual. Además, antes de utilizar esos nuevos métodos diagnósticos, los dos grupos tenían tasas de supervivencia similares.

En una situación como la descrita arriba, el mero hecho de reordenar no cambia nada ni para el conjunto de la población, ni para cada individuo. Sin una acción adicional, no hay ningún beneficio real para ningún paciente.

En el ámbito de la medicina, muchas personas son conscientes de posibles sesgos en la interpretación estadística de los datos y en la posibilidad de estar a merced del efecto Will Rogers. Existen numerosos artículos que tratan de este tema; algunos de ellos están relacionados con el cáncer de próstata, el cáncer de mama, el cáncer de estómago, la esclerosis múltiple y muchas otras dolencias.

Volviendo a la frase de Will RogersParece que con esta frase Will Rogers se refería a la época de la Gran Depresión de 1929. Cuando algunos trabajadores Okies se fueron a California a buscar empleo, en Oklahoma aumentó el coeficiente intelectual debido a la emigración (aludiendo a la falta de oportunidades de estas personas para estudiar y formarse). Rogers era originario de Oklahoma y, orgulloso de sus orígenes, insinuaba de manera jocosa que cualquier habitante de Oklahoma era más inteligente que el californiano medio… ¡Probablemente este comentario no hizo demasiado gracia en el estado de California!

Referencias

-

Alvan R. Feinstein, M.D., Daniel M. Sosin, M.D., and Carolyn K. Wells, M.P.H., The Will Rogers Phenomenon — Stage Migration and New Diagnostic Techniques as a Source of Misleading Statistics for Survival in Cancer, N Engl J Med 312 (1985) 1604-1608

-

Will Rogers phenomenon, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo El efecto Will Rogers se ha escrito en Cuaderno de Cultura Científica.

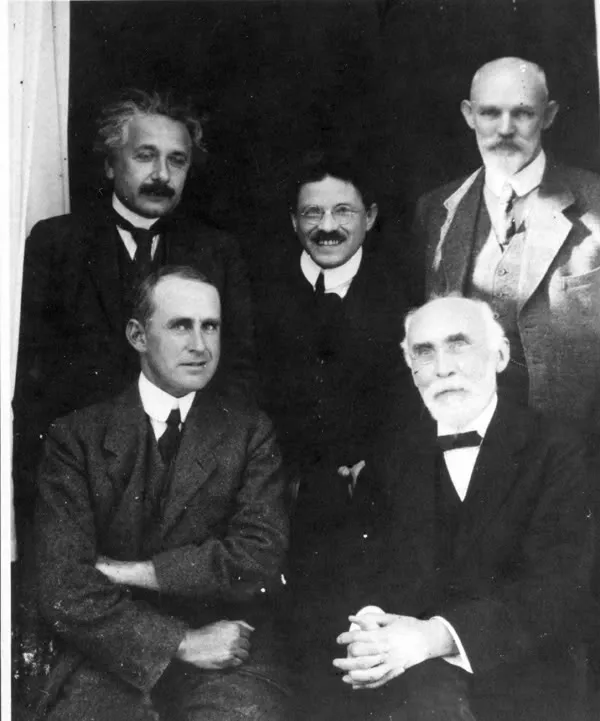

Einstein y Arthur Eddington

Arthur Eddington creyó en las teorías de Einstein desde el principio, y fueron sus datos tomados durante el eclipse solar de 1919 los que dieron el primer indicio experimental de que la teoría general de la relatividad podría ser correcta. La amplia cobertura informativa de los resultados de Eddington llevó a la teoría de la relatividad, y al propio Einstein, a unos niveles de fama sin precedentes.

En la imagen, tomada en Leiden en 1923, podemos ver de arriba abajo y de izquierda a derecha a Albert Einstein, Paul Ehrenfest, Willem de Sitter, Arthur Eddington y Hendrik Lorentz. Fuente: Wikimedia Commons

En la imagen, tomada en Leiden en 1923, podemos ver de arriba abajo y de izquierda a derecha a Albert Einstein, Paul Ehrenfest, Willem de Sitter, Arthur Eddington y Hendrik Lorentz. Fuente: Wikimedia CommonsArthur Eddington está considerado uno de los más importantes astrónomos ingleses del siglo XX. Se especializó en la interpretación de las observaciones de los movimientos de las estrellas en el Observatorio de Greenwich. En 1913, fue uno de los primeros científicos no alemanes en entrar en contacto con las primeras versiones de la teoría general de la relatividad, e inmediatamente se convirtió en un declarado partidario.

Cuando Einstein empezó a publicar sobre la teoría general de la relatividad, Eddington, como otros muchos científicos, estaba convencido de que era correcta; simplemente tenía tanto sentido que sentían que tenía que ser correcta. Pero eso no significaba que no quisiesen ver una prueba concreta, experimental. Dado que la teoría de la relatividad general se centra en la idea de que las masas gigantescas (estrellas, planetas, etc.) deforman el mismísimo espacio (estrictamente, el espaciotiempo), la única forma de comprobar la teoría era la observación astronómica. Los científicos querían medir si la luz de una estrella se desviaba al pasar cerca de una masa como la del Sol. El problema era que esa observación de la débil luz de una estrella no se podía hacer con el Sol brillando con toda su intensidad. Era necesario un eclipse.

Y así en 1912, 1914 y 1916, se enviaron expediciones a varias localizaciones alrededor del mundo para estudiar eclipses solares. Pero cada una de ellas no pudo aportar datos: en la primera llovió y las segundas fueron detenidas por motivos geopolíticos (la Primera Guerra Mundial había comenzado en 1914). Sin embargo, esto terminó siendo una suerte ya que, si bien hoy sabemos la teoría de Einstein era correcta, en esas fechas un cálculo clave era erróneo. En la primera publicación de la teoría en 1911, Einstein había calculado mal el valor de la curvatura de la luz debida a la gravedad; se había descuidado a la hora de incluir todos los efectos del espacio curvado. Si los datos de los eclipses hubiesen estado en desacuerdo con las predicciones de Einstein, como probablemente habría ocurrido, la teoría podría haber sido desechada por incorrecta.

En 1915 Einstein corrigió el modelo matemático de la teoría, proporcionando un valor revisado para el arco de la luz. Hubo un intento de medición en 1918 en los Estados Unidos pero los resultados no fueron concluyentes.

Durante todos estos intentos, Eddington simplemente aceptó la teoría general de la relatividad, sin necesitar más pruebas que su razón, pero el director del Observatorio de Greenwich y Astrónomo Real, Frank Watson Dyson, quería ver los datos de una prueba “concluyente”[1]. Así, Dyson ordenó dos expediciones para 1919. Eligió a Andrew Crommelin del Observatorio Real para liderar una a la ciudad de Sobral (Brasil) y a Eddington para la otra. La elección de Eddington tuvo toda una historia detrás.

En 1917, el gobierno británico comenzó una nueva tanda de reclutamiento y, aunque la Universidad de Cambridge había movido los hilos para que no tocasen a su profesor, la crianza cuáquera de Eddington le llevó a denunciar formalmente la guerra. Dyson intervino y, usando toda su influencia, convenció al Ejército Británico de que se olvidase del científico bocazas. A cambio de no ir a un campo de prisioneros, el compromiso que adquirieron Eddington y Dyson fue que Eddington “encabezaría una expedición que aseguraría la tradición británica de estar a la vanguardia de la física de manera que el brillo de Newton no se viese empañado”. De esta forma Eddington fue el encargado de dirigir la expedición a la isla portuguesa de Príncipe (actualmente parte de Santo Tomé y Príncipe) en el Golfo de Guinea en África.

La expedición de Eddington fue todo un éxito mediáticoTan pronto como supo del éxito de los científicos británicos, Einstein mandó una postal a su madre. Decía: “Querida madre, felices noticias hoy. H.A. Lorentz me ha telegrafiado diciendo que las expediciones británicas han demostrado de hecho la deflexión de la luz por el Sol”. Los científicos también saludaron con entusiasmo los resultados, y posiblemente gracias a un profundo deseo de superar las divisiones de la Gran Guerra, el resto del mundo se alegró de que unos británicos hubiesen confirmado las teorías de un alemán. Eddington fue el encargado de presentar los resultados ante una reunión conjunta de la Royal Society y la Royal Astronomical Society. Los periódicos estaban encantados con la noticia. [2]

El Times de Londres afirmaba en sus titulares del 17 de noviembre de 1919. “Revolución en la ciencia – Nueva teoría del universo – Las ideas de Newton derrocadas”. Y antes incluso de que las noticias se difundiesen por Europa, el New York Times en los Estados Unidos escribía una serie de seis artículos con titulares como: “Luces torcidas en los cielos”; “Los hombres de ciencia más o menos convulsionados: la teoría de Einstein triunfa”. Eddington también pasó al primer plano. Era requerido para que diese conferencias continuamente y, en ellas, hablaba a menudo de la relatividad.

En 1920, Eddington publicaría una obra de divulgación “Espacio, tiempo y gravitación”. En 1923, la magistral “Teoría matemática de la relatividad”. Hasta su muerte ya no publicaría ningún trabajo relevante más, dedicando sus últimos 20 años de vida, al igual que Einstein, a la búsqueda infructuosa de una teoría unificada. En 1946 aparecería póstumamente su “Teoría fundamental”. La diferencia principal entre Einstein y Eddington estuvo en que Einstein era consciente de que ninguno estaba teniendo éxito en su búsqueda de la teoría del campo unificado.

Notas:

[1] Todo este relato tiene unas profundas implicaciones filosóficas. Sobre la necesidad de una prueba concluyente véase: El experimento crucial que nunca existió

[2] ¿Una sola medición echa por tierra todo el marco físico newtoniano? ¿O son los medios de comunicación los que elevan a absoluto un hallazgo preliminar en su búsqueda del titular impactante? Véase Desviación de la luz y falsabilidad y, para más detalle técnico, Comprobaciones experimentales de la relatividad general (y 2)

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 15 de noviembre de 2009.

El artículo Einstein y Arthur Eddington se ha escrito en Cuaderno de Cultura Científica.

Un llamamiento histórico para proteger África de la crisis climática

Sossusvlei, Namibia. Foto: Parsing Eye / Unsplash

Sossusvlei, Namibia. Foto: Parsing Eye / UnsplashLa crisis climática, por el progresivo aumento de las temperaturas del planeta Tierra, es un fenómeno global del que nadie está a salvo. Sin embargo, su impacto no es ni será igual para todos. Determinados países son especialmente vulnerables a las consecuencias del calentamiento global porque apenas tienen recursos para hacerles frente. Además, sus poblaciones cuentan con condiciones de vida ya de por sí muy precarias y sus economías dependen en gran medida del clima. Se calcula que la crisis climática ha destruido un 20 % del producto interior bruto de los países más vulnerables. Precisamente por ello, de entre todas las regiones, el África es la más vulnerable frente a los diferentes escenarios que se plantean ante un calentamiento por encima de los 1,5 ºC desde la época preindustrial.

A pesar de que África apenas ha contribuido con un 3 % en las emisiones globales de dióxido de carbono, en comparación con el 62 % de Europa y América del Norte desde la Revolución Industrial, es la zona del planeta que más está sufriendo las consecuencias del calentamiento global. Unos daños que irán a más con el progresivo aumento de las temperaturas a lo largo de los años.

Se estima que torno al 95 % de los cultivos del África subsahariana dependen del agua de lluvia y que el 41 % de la población vive en tierras secas, proclives a las sequías. Desde 1970-79 hasta 2010-2019 las sequías en esta región se han triplicado. Esto ha acentuado la pobreza (por las pérdidas de las cosechas y del ganado) y provocado inseguridad alimentaria, enfermedades y muertes por desnutrición entre las personas más vulnerables de múltiples países africanos.

En torno a 1,7 millones de personas mueren cada año en África por las razones anteriores y los casos de desnutrición han aumentado un 50 % desde 2012 según la Organización de Naciones Unidas (ONU). Además, los ciclones, las inundaciones y la aparición de vectores han provocado migraciones masivas, millones de muertos y potenciado la aparición de diversas enfermedades infecciosas: malaria, ébola, fiebre de Lassa, dengue, enfermedad de Lyme, virus del Nilo Occidental…

Justicia climática para ÁfricaAnte la catástrofe climática que acecha a África en el futuro próximo, más de 250 revistas científicas sanitarias, entre las que destacan The Lancet y The British Medical Journal, han publicado de forma simultánea un editorial en la que instan a los líderes mundiales a impartir justicia climática a dicho continente. Nunca antes tantas revistas científicas se habían organizado para lanzar un mensaje conjunto, con vistas a la Conferencia de las Naciones Unidas sobre el Cambio Climático (COP27). Este evento se está celebrando entre el 6 y el 18 de noviembre y será decisivo para que los dirigentes establezcan compromisos para mitigar el calentamiento global y establecer acciones para adaptarse y protegerse frente a este.

En el comunicado conjunto de las revistas sanitarias, los editores sostienen que dejar a los países a merced de los impactos medioambientales crea inestabilidad que tendrá, más temprano que tarde, graves consecuencias sobre todas las naciones: «La crisis climática es producto de la inacción global y conlleva un gran coste no solo a países africanos afectados de forma desproporcionada, sino también a todo el mundo. África está unida con otras regiones en primera línea para instar a las naciones ricas a dar, por fin, un paso adelante […]».

El documento sostiene que las naciones en desarrollo no han recibido compensación por una crisis que no han provocado: «No es solo injusto, sino que también impulsa una espiral de desestabilización global, mientras los países destinan dinero a responder a los desastres, no pueden permitirse pagar una mayor resistencia o reducir la raíz del problema a través de las reducciones de las emisiones».

Los autores defienden la gran importancia mundial de cumplir con el objetivo, prometido en el Acuerdo de París de 2015, de destinar 100 mil millones de dólares cada año para financiar a los países en desarrollo frente a la crisis climática y evitar los riesgos sistémicos de dejarlos a su suerte. Esta financiación que, sostienen, debería ser en subvenciones y no en préstamos, se dirigiría a incrementar la resistencia de dichas naciones a los previsibles impactos del cambio climático y también como apoyo en los procesos de reducción de emisiones de gases invernadero.

Una combinación equilibrada entre la adaptación y la mitigación, en la que los sistemas sanitarios deben estar por delante, ya que las consecuencias de las crisis climáticas se manifiestan con frecuencia en problemas de salud agudos. «Financiar la adaptación será más costo-efectivo que centrarse en la ayuda de catástrofes».

El primer autor del comunicado, el profesor y decano de la Facultad de Medicina de África Oriental Lukoye Atwoli, declara que «Es la hora de que la comunidad global se dé cuenta de que la crisis climática, aunque afecte de forma desproporcionada al continente [africano], es una crisis global. Las acciones deben empezar ahora y hacerlo donde se está sufriendo más, en África. Fracasar en actuar hará que la crisis se convierta en el problema de todos muy pronto».

Para saber más:

Del cambio climático

Los ecosistemas acuáticos de África y el cambio climático

Lo prudente es hablar de emergencia climática

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo Un llamamiento histórico para proteger África de la crisis climática se ha escrito en Cuaderno de Cultura Científica.

La caja de resonancia del violín

Sabemos muy bien cómo empujar a una criatura en el columpio del parque: podemos aumentar la amplitud de oscilación de la barquilla sincronizando nuestros empujones con la frecuencia natural de este péndulo. En física se puede fácilmente modelar esta dinámica mediante una sencilla ecuación diferencial y predecir cuál es la frecuencia de resonancia del columpio cargado. Dicho de otra manera: deducimos con exactitud a qué ritmo debemos empujar para que la oscilación del columpio se amplifique; y además sabemos que intentar empujar por encima o por debajo de la frecuencia de resonancia que hemos deducido es inútil, porque la oscilación del péndulo se atenuará. La caja de resonancia de un violín no es más que un columpio algo más complejo que el que acabamos de describir. Debido a sus características constructivas y mecánicas, la caja contiene decenas de frecuencias de resonancia en el rango de las vibraciones sonoras.

Foto: Roberto Delfanti / Unsplash

Foto: Roberto Delfanti / UnsplashSin una caja de resonancia en un violín, las vibraciones de sus cuerdas apenas son audibles. Así, la transmisión de las vibraciones de las cuerdas al cuerpo hace que tanto la caja como el volumen de aire de su interior empiecen a vibrar también. Debido a las frecuencias naturales de cada uno de los elementos del instrumento y a la unión de todos ellos en el violín, ciertas frecuencias y armónicos superiores de las ondas acústicas se amplifican o se atenúan en mayor o menor medida. De esta manera, se crea el carácter tonal individual de cada violín, que incluye el volumen y el timbre del sonido musical que este consigue.

La invención del violín modernoLa caja de resonancia de los violines fue mejorando a lo largo de los siglos. La lutería es tanto un arte como una ciencia, y todos los maestros artesanos constructores de instrumentos fueron desde sus inicios también científicos empíricos, capaces de aprender y avanzar en su área de conocimiento mediante continuos métodos experimentales de ciencia acústica, prueba y error.

El violín moderno fue construido en Europa a principios del siglo XVI. Entre las principales regiones europeas aspirantes al título de invención del violín están Füssen, en Algovia (hoy parte de Alemania), Sklenařice en la República Checa, Cracovia en Polonia, y, en Italia, Venecia, Brescia y Cremona. De todas ellas, fue Lombardía la cuna de los mejores lutieres, y más en concreto Brescia, con las violas encabezadas por Gasparo da Salò, y Cremona, con los violines representados por Andrea Amati. Este último es quien quizás pueda ser considerado el inventor del violín moderno, si debemos ceder semejante mérito a una única persona.

Árbol «genealógico» de la escuela de lutería de Cremona. Fuente Wikimedia Commons

Árbol «genealógico» de la escuela de lutería de Cremona. Fuente Wikimedia CommonsCómo medir el carácter tonal del violín

La acústica musical puede modelar el carácter tonal de un violín midiendo distintos parámetros importantes en la caja de resonancia. La forma más completa de caracterizar la calidad de un instrumento es medir la movilidad de su caja al recibir vibraciones de las cuerdas a través del puente.

La movilidad de la caja se denomina también admitancia mecánica (inverso de la impedancia mecánica) que se define como el cociente entre la velocidad que se produce y la fuerza que se aplica en un sistema mecánico. Para medir la respuesta en frecuencia de la movilidad de un violín, debemos ejercer sobre la caja una fuerza oscilante barriendo todas las frecuencias audibles, y medir las velocidades con las que responde dicha caja para cada una de estas frecuencias.

Con un computador se puede emitir un ruido blanco a través de una bobina que induce oscilaciones mecánicas a todas las frecuencias en el cuerpo del violín. A su vez, puede medirse con un acelerómetro la respuesta mecánica de la caja a todas estas frecuencias, y efectuar un cálculo de la transformada de Fourier y un gráfico en el dominio de la frecuencia de todo el mapa de resonancias del instrumento [1].

Método sencillo de medida del carácter tonal de un violín. Fuente: UPV/EHU, Dept Electricidad y Electrónica

Método sencillo de medida del carácter tonal de un violín. Fuente: UPV/EHU, Dept Electricidad y Electrónica

Las resonancias del cuerpo de los violines pueden caracterizar la acústica de todo tipo de instrumentos, incluyendo piezas históricas de gran calidad musical fabricadas hace siglos por los grandes lutieres [2].

Ejemplo del espectro sonoro medido en un violín Fuente: Referencia [2]

Ejemplo del espectro sonoro medido en un violín Fuente: Referencia [2]

Las medidas acústicas de la caja de un violín pueden distinguir varias resonancias de esencial importancia para el sonido que podemos extraer del instrumento. La cavidad del aire de la caja vibra a una frecuencia propia que podemos excitar fácilmente soplando por una de las aberturas acústicas en forma de f del violín y escuchar la nota que surge de la otra f. Otras resonancias de la caja debidas a la madera, espesores, curvas, geometría y construcción nos permiten completar el espectro sonoro del instrumento, así como su firma y carácter tonal.

Referencias:

[1] Victor Etxebarria and Iratxe Riera (2002) Measuring the frequency response of musical instruments with a PC-based system. Catgut Acoustical Society Journal, vol 4, n. 6, (Series II), pp. 26-30.

[2] F Leccese, G Salvadori, G Bernardini and P Bernardini (2018) The bowed string instruments: acoustic characterization of unique pieces from the Italian lutherie. IOP Conf. Series: Materials Science and Engineering vol. 364 pp: 012022

Sobre el autor: Victor Etxebarria Ecenarro está diplomado como lutier por el Conservatorio Juan Crisóstomo de Arriaga (Bilbao) y es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

El artículo La caja de resonancia del violín se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2022: La maravillosa labor investigadora de las moscas

¿Consideras que las moscas son criaturas “maravillosas”? ¿O que puedan tener un papel protagonista en la investigación contra enfermedades como el cáncer? ¿Alguna vez has llegado a reflexionar sobre la virginidad de estos insectos?

El investigador, doctor en Biología y profesor del departamento de Biología Celular de la Universidad de Sevilla Luis M. Escudero Cuadrado abordó estas cuestiones en su charla en Naukas Bilbao para responder que sí, que las tres son ciertas. ¿Por qué?

En primer lugar porque, aunque cueste trabajo creerlo, la mosca conocida como Drosophila melanogaster es muy parecida al ser humano. Tanto, que se utiliza para estudiar los procesos que llevan a la formación de nuestros órganos, hacer experimentos genéticos e intentar extraer conclusiones que resulten provechosas para la Humanidad. Para llevar a cabo estos experimentos los investigadores utilizan las moscas por varias razones: “Son pequeñas, manejables y tienen un ciclo de vida corto. En 10 días las moscas pasan del embrión a la larva y a la pupa; se produce la metamorfosis y tenemos nuevas moscas, y con una alta descendencia. Además, trabajar con ellas es barato”, explicó el científico.

Y es precisamente en este punto donde entra en juego la virtud de las hembras. Las moscas de este sexo tienen un órgano llamado espermateca que conserva un poco del esperma de cada uno de los machos con los que copula. Por eso, a la hora de garantizar que la información genética de las moscas no se vea alterada con el esperma de varios machos, es necesario que la hembra sea virgen e inducir la copulación en tubos de ensayo.

“Lo que hacemos es coger el tubo, dejar solo las pupas y esperar unas horas para que emerjan las nuevas moscas y tengamos así una guardería de vírgenes”, ilustró el investigador en lo que él mismo denominó “un curso completo de mamporrerismo de moscas en cuatro minutos”.

La finalidad de este “mamporrerismo” es encontrar genes que ayuden a descubrir aspectos que contribuyan a mejorar la vida del ser humano. ¿De qué manera? Luis M. Escudero se remontó a principios del siglo pasado, a los tiempos de Thomas H. Morgan, un genetista experto en investigación con moscas para responder a esta pregunta. Morgan quería resolver el enigma de la transmisión de la herencia genética entre generaciones cuando comenzó a cruzar una mosca con ojos blancos con otras con ojos rojos y se dio cuenta de que la información genética se hallaba en los cromosomas. Un hallazgo que le valió el Nobel de Medicina y Fisiología en 1933.

Morgan denominó white (blanco en inglés) a ese gen que daba la coloración blanca a los ojos de estos insectos, e inauguró la tradición de poner nombre a sus genes, hasta el punto de que hoy en día hay cientos de ellos. Por ejemplo, el gen tinman, que significa “hombre de hojalata”, es el que hace que se forme el corazón de forma correcta. Este gen tiene muchas similitudes con los genes humanos que participan en el proceso de formación del corazón.

Esta introducción permitió al investigador andaluz afirmar que la Drosophila es “maravillosa” ya que “las moscas han servido para investigar un montón de cosas que nos afectan, y para elaborar modelos de Alzheimer, Parkinson y cáncer”. ¿Cómo?

En concreto, el biólogo mencionó el ejemplo de un paciente con cáncer de colon a quien los tratamientos de cirugía, radioterapia y quimioterapia no le sirvieron para controlar la enfermedad e incluso comenzó a sufrir metástasis. Los investigadores identificaron los genes que estaban alterados en los tumores del paciente y crearon una serie de moscas con hasta ocho mutaciones diferentes que producían tumores muy parecidos a los suyos. Para intentar combatir estos tumores probaron en los insectos infinidad de combinaciones de compuestos hasta que dieron con una que conseguía que las moscas sobrevivieran. El resultado fue que después de 27 semanas de tratamiento el tamaño de las lesiones del paciente se redujo un 45%. Lamentablemente, el tratamiento se tuvo que suspender debido a un problema de efectos secundarios, pero abrió la puerta a nuevas investigaciones similares a las que se han desarrollado durante los últimos años.

Investigaciones como la que arrancó en La India hace 50 años con el descubrimiento de un gen, denominado wingless, que posibilita el crecimiento de las alas de una mosca han hecho que se avance muchísimo en la investigación biomédica. En aquella época la tasa de supervivencia en casos de cáncer de colon no superaba el 50%. “Ahora sabemos que los genes de esa familia están mutados en su gran mayoría de los tumores de colon”, explicó Escudero.

Los estudios de este tipo de genes en moscas, ratones y humanos han llevado a que hoy en día tengamos una tasa de supervivencia superior al 90% en este tipo de cáncer. El investigador concluyó su charla con un alegato optimista. “Trabajos como el que os acabo de comentar van a seguir aumentando esta estadística de cara a futuro. Seguro que sí”.

Si no ve correctamente el vídeo use este enlace.

Para saber más:

La inevitable ciencia de los bichos raros

Crónica de Roberto de la Calle / GUK

El artículo Naukas Bilbao 2022: La maravillosa labor investigadora de las moscas se ha escrito en Cuaderno de Cultura Científica.

Los usos terapéuticos de la psilocibina de los hongos alucinógenos

La psilocibina es un alcaloide que una vez ingerido en el cuerpo se convierte en psilocina, un compuesto alucinógeno responsable del efecto psicoactivo de ciertos hongos comestibles. La psilocibina se encuentra en fases avanzadas de ensayos clínicos dirigidos al tratamiento de diferentes patologías psiquiátricas, tales como la depresión o las adicciones. Investigadores del grupo de neuropsicofarmacología de la UPV/EHU han estudiado en profundidad el mecanismo de acción de la psilocibina en ratones.

Psilocybe semilanceata. Fuente: Wikimedia Commons

Psilocybe semilanceata. Fuente: Wikimedia CommonsLa psilocibina se ha convertido en un fármaco potencialmente útil para varias enfermedades neuropsiquiátricas, presentando un inicio rápido de la actividad terapéutica. Sin embargo, los mecanismos responsables de tales efectos siguen siendo poco conocidos. El trabajo del grupo es relevante para comprender tanto el mecanismo de acción subyacente a los efectos terapéuticos como los potenciales efectos secundarios no deseados de esa sustancia psicodélica.

La psilocibina, naturalmente presente en algunas especies de hongos alucinógenos (hongos del género ‘Psilocybe’, entre otros), fue estudiada durante la década de los 60 para el tratamiento de diversos trastornos mentales, pero su uso y distribución quedaron prohibidos a partir de 1972. No obstante, en los últimos años, la comunidad científica ha retomado las investigaciones relacionadas con esa y otras sustancias de características similares, como el MDMA o el LSD.

Los ensayos clínicos desarrollados tanto en Europa como en América están dando resultados prometedores. “Esos estudios han sido el desencadenante para la descriminalización de la psilocibina y otros alucinógenos con potencial terapéutico en los Estados Unidos, lo que supone un avance para una futura aprobación para su uso clínico por las diferentes agencias reguladoras, principalmente la Food & Drug Administration (FDA) y la European Medicines Agency (EMA)”, explica Ines Erkizia, investigadora predoctoral del grupo y primera autora del artículo.

Los efectos agudos de la psilocibina y de su metabolito activo, psilocina, han sido ampliamente descritos tanto en entornos clínicos como por parte de usuarios en ambientes recreativos. Estos incluyen cambios en la percepción, como alucinaciones auditivas o visuales, y experiencias místicas o espirituales. Entre los efectos a largo plazo, los usuarios perciben cambios positivos en el humor y el estado de ánimo, lo cual podría suponer una mejora en la sintomatología de ciertas enfermedades psiquátricas. Los mecanismos que subyacen a esos efectos no son del todo conocidos, pero se han relacionado con incrementos de la plasticidad neuronal que parecen conllevar alteraciones en la conectividad de la corteza cerebral.

“Hemos confirmado un perfil farmacológico similar de psilocina en humanos y roedores -comenta la investigadora-. Además, se realizó un estudio farmacológico exhaustivo para identificar las dosis óptimas a utilizar en futuros estudios científicos de investigación básica y clínica. Nuestros hallazgos aportan datos valiosos sobre la implicación del sistema serotonérgico en los efectos de la psilocibina”, recalca Ines Erkizia.

Los resultados de esta investigación pueden proporcionar una nueva perspectiva sobre las dianas terapéuticas del fármaco para futuros estudios clínicos.

Para saber más:

Consumo de cannabis y desarrollo de esquizofrenia

Del metabolismo (y II)

Referencia:

I. Erkizia-Santamaría, R. Alles-Pascual, I. Horrillo, J.J. Meana, J.E. Ortega (2022) Serotonin 5-HT2A, 5-HT2C and 5-HT1A receptor involvement in the acute effects of psilocybin in mice. In vitro pharmacological profile and modulation of thermoregulation and head-twitch response Biomedicine & Pharmacotherapy doi: 10.1016/j.biopha.2022.113612

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Los usos terapéuticos de la psilocibina de los hongos alucinógenos se ha escrito en Cuaderno de Cultura Científica.

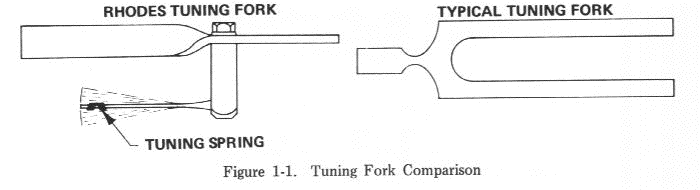

El piano que surgió de los restos de la guerra

Saltó a la fama gracias a The Doors y su sonido conquistó la música de finales de los 60 y principios de los 70. Se podía oír en todo tipo de música funk, rock y pop. Fue fundamental para el desarrollo del jazz-rock y de artistas como Miles Davis, Joe Zawinul, Chick Corea y Herbie Hancock. El piano Rhodes es ya un símbolo de toda una época. Lo que quizás no sabías es que en sus entrañas se encuentra la magia acústica del diapasón, y en sus orígenes, el horror de la guerra y bombarderos reciclados. Hoy te cuento su historia.

Viajemos hasta 1942. Europa se desangra bajo el peso de la Segunda Guerra Mundial, y han pasado pocos meses desde que Estados Unidos decidió enviar a sus soldados a la contienda. Entre las filas de estos recién llegados se encuentra un curioso personaje. Harold Rhodes ha sido reclutado para entrenarse como piloto de las fuerzas aéreas del ejército estadounidense1. Aunque todos le llaman oficial, él se define a sí mismo como profesor de piano —lo seguiría haciendo durante el resto de su vida—. Por eso, entre vuelo y vuelo, se dedica a dar clases de música a sus compañeros. Pronto, estas lecciones se vuelven tan populares, que el personal médico del ejército solicita su ayuda y Harold no se lo tiene que pensar dos veces. Equipado con su mejor arma, decide que su misión en medio del horror de la guerra será traer rehabilitación y consuelo a los soldados heridos, a través de la música.

Sin embargo, su tarea no era nada fácil. Para empezar, porque conseguir un piano para hacer musicoterapia de vanguardia no era precisamente una prioridad médica en medio de la Segunda Guerra Mundial —por lo que sea—. Pero además, muchos de los soldados que llegaban a sus manos se encontraban postrados en sus camas, sin posibilidad de moverse. Rhodes se vio forzado a inventar una nueva manera de impartir sus clases. En tiempos más felices, antes de la guerra, había puesto mucho empeño en enseñar a sus alumnos la mecánica de su instrumento, convencido de que entender el lenguaje de la música y cómo se produce el sonido era clave en su formación. Ahora, todo ese bagaje le ayudaría en su nuevo reto.

Rhodes se dispuso a crear un nuevo instrumento, un teclado portable y ligero, que los soldados pudieran tocar desde sus camillas, o sobre su regazo. Y ¿de dónde podía sacar el material necesario para construirlo? ¡De la propia guerra! Haciendo uso de su ingenio, decidió recurrir a una fuente insospechada de piezas de metal: aviones B-17 averiados. Las alas de estos bombarderos tenían unos tubos de aluminio que se podían cortar para crear láminas vibrantes de diferentes tonos. El “Xylette” —como llamó a su instrumento— tenía 29 teclas y era parecido a un xilófono, solo que con teclas. Una especie de piano de juguete. Y a pesar de ser bastante rudimentario, a los soldados les encantó. De hecho, el instrumento tuvo tanto éxito que Rhodes fue puesto a cargo del programa de rehabilitación de instrucción musical en todos los hospitales de la fuerza aérea. Se estima que el Xylette fue utilizado en hospitales de la Fuerza Aérea por miles de soldados.

El prepiano Rhodes (1950) es uno de los más antiguos, un modelo muy anterior al famoso piano eléctrico Fender Rhodes (1965). Fuente: Wikimedia Commons

El prepiano Rhodes (1950) es uno de los más antiguos, un modelo muy anterior al famoso piano eléctrico Fender Rhodes (1965). Fuente: Wikimedia Commons

Después de la guerra, Rhodes siguió trabajando en su idea. Como buen profesor de piano, su objetivo era llevar su nuevo teclado a las aulas, para seguir enseñando música. Así que se le ocurrió amplificar su sonido electrónicamente y adaptarlo para estudiantes. El “Pre-Piano” contaba incluso con un asiento adjunto, como una especie de pupitre sonoro. Una década más tarde, Rhodes se asoció con Leo Fender para desarrollar y fabricar el piano Fender Rhodes que hoy conocemos. El primer modelo fue lanzado en 1959 y contaba solo con el registro más grave. Fue el modelo que popularizó The Doors. Raymond Manzarek, el teclista, lo utilizaba en sustitución del tradicional bajo eléctrico. Poco más tarde, salió al mercado el primer teclado completo de 73 notas: el Fender Rhodes Mk1.

¿Pero cómo funciona exactamente este piano eléctrico? Bien, el mecanismo no es muy diferente al de un piano real, solo que, en lugar de cuerdas, tiene unas piezas de metal que vibran a distinta frecuencia. Cuando el martillo las golpea, su vibración es capturada por un transductor que convierte su energía acústica en una señal eléctrica, como sucede en una guitarra eléctrica.

Pues bien, esas piezas de metal que sustituyen a las cuerdas son diapasones. ¡Sí, diapasones! Bueno, quizás un tipo de diapasón un tanto más asimétrico que el que solemos imaginar, pero instrumentos perfectamente equivalentes desde un punto de vista físico. En este caso, las patas de las varillas tienen distinta forma, masa y tamaño, pero son iguales en el tono. Y al igual que los diapasones, su sonido tiene propiedades especialmente interesantes para los músicos.

Piano Rhodes sin la tapa de forma que las piezas de metal (diapasones) quedan visibles. Fuente: Wikimedia Commons

Piano Rhodes sin la tapa de forma que las piezas de metal (diapasones) quedan visibles. Fuente: Wikimedia CommonsDe hecho, el piano de Rhodes resultó revolucionario en su época. Por primera vez en la historia, los teclistas podían llevar su propio piano portátil de viaje. Bueno, todo lo “portátil” que puede ser un piano, entiéndase. Nadie les libraba de cargarlo en una camioneta cada noche. Pero gracias a las propiedades del diapasón, el Rhodes apenas se desafinaba. Y como alternativa era mucho mejor, que el piano destartalado de turno que pudieran encontrarse en los clubes donde tocaban.

Pronto este instrumento conquistó el mundo del rock y de la música. A mí me cuesta oír su sonido sin que me venga a la cabeza de inmediato The Doors. Pero muchos otros artistas recurrieron a este piano electrónico, desde Herbie Hancock a los Beatles o Michael Jackson. No está nada mal para un piano de juguete fabricado con aviones reciclados.

Referencia:

1Elaine Woo, 2001. “Harold B. Rhodes; Inventor of Electric Piano”. Los Angeles Times. Consultado el 1 de noviembre de 2022.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El piano que surgió de los restos de la guerra se ha escrito en Cuaderno de Cultura Científica.

¿Existen recorridos mágicos del caballo en el tablero de ajedrez?

Mis dos últimas entradas del Cuaderno de Cultura Científica han estado dedicadas a un problema clásico que relaciona matemáticas y ajedrez, el conocido problema del recorrido del caballo sobre el tablero de este juego. La primera de esas entradas, titulada El problema del recorrido del caballo en el tablero de ajedrez la dedicábamos a explicar el problema y a analizar la existencia de recorridos sobre tableros de ajedrez generales, no solo el clásico tablero cuadrado 8 x 8, sino tableros cuadrados o rectangulares de diferentes tamaños. Mientras que la segunda entrada, titulada El problema del recorrido del caballo en el tablero de ajedrez (II), se centraba en algunos métodos (algoritmos) históricos (de matemáticos como los franceses Abraham de Moivre (1667-1754) y Pierre Rémond de Montmort (1678-1719), o el suizo Leonhard Euler (1707-1783), entre otros) para construir dichos recorridos.

Jaque mate (alrededor de 2010), del artista canadiense Paul Ygartua. Véase la obra en su página web, Imagen de su página web: Paul Ygartua

Jaque mate (alrededor de 2010), del artista canadiense Paul Ygartua. Véase la obra en su página web, Imagen de su página web: Paul YgartuaEn esta entrada, vamos a relacionar el rompecabezas del recorrido del caballo con la construcción de cuadrados mágicos, dos cuestiones que no tienen aparentemente ninguna conexión.

El problema del recorrido del caballoLo primero, como no puede ser de otra manera, es recordar el rompecabezas del que estamos hablando.

Problema del recorrido del caballo: Buscar un recorrido de la figura del caballo sobre el tablero de ajedrez (considerado este en un sentido general, es decir, tableros de diferentes formas y tamaños, principalmente cuadrados y rectangulares) que consista en mover esta pieza del juego, desde una casilla inicial, de forma sucesiva a través de todas las casillas del tablero, pasando una sola vez por cada una de ellas, y terminando en la casilla inicial (recorrido cerrado) o en otra casilla distinta (recorrido abierto).

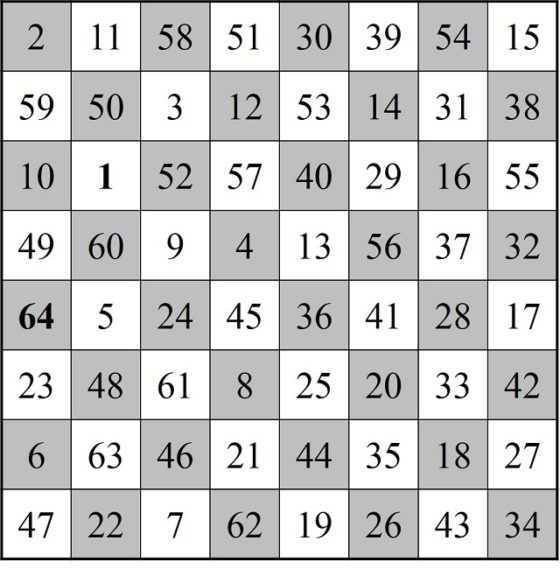

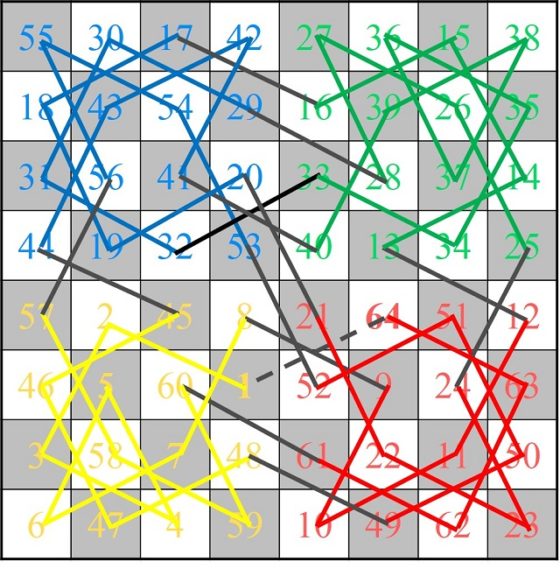

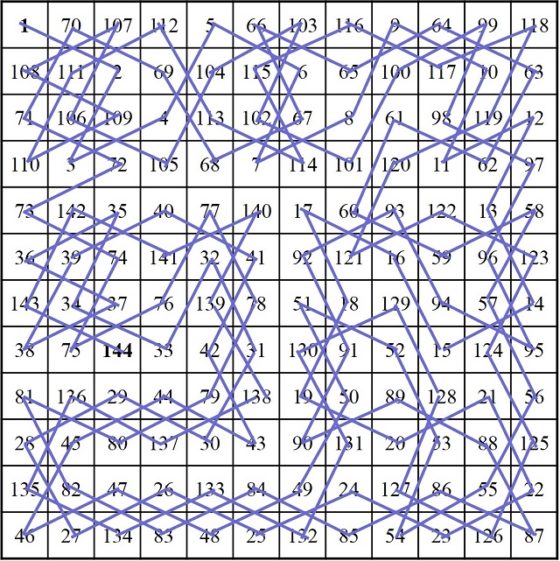

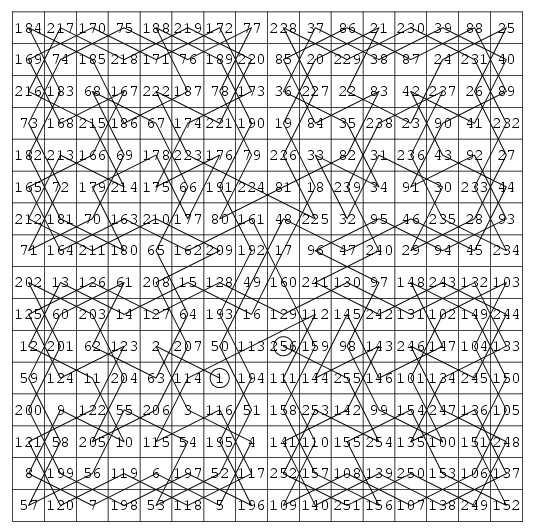

Por ejemplo, en la siguiente imagen mostramos dos soluciones de este juego, una con un recorrido abierto y otra con un recorrido cerrado, que obtuvimos en la anterior entrada con la técnica de De Moivre y De Montmort.

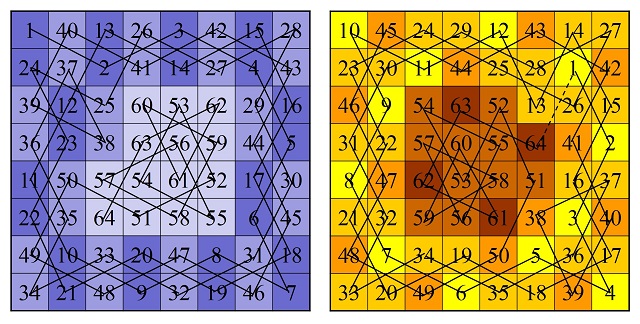

Recorridos abierto y cerrado obtenidos con el algoritmo de De Moivre-De Montmort

Recorridos abierto y cerrado obtenidos con el algoritmo de De Moivre-De Montmort

Además, recordemos que hemos numerado las casillas del tablero de ajedrez generalizado según el orden del recorrido del caballo, es decir, la casilla inicial esta numerada como 1, la siguiente sobre la que salta el caballo 2, después 3, y así hasta la casilla 64. De forma que, al resolver el problema del recorrido del caballo, hemos generado una retícula cuadrada con los números del 1 al 64, en general, del 1 al número de casillas del tablero.

Ya el matemático más prolífico de todos los tiempos, Leonhard Euler (1707-1783), que, como comentamos en la anterior entrada, fue el primero en realizar un análisis matemático riguroso del juego del recorrido del caballo en su artículo Solución a una cuestión ingeniosa que parece que no ha sido analizada (Memoria de la Academia de Ciencias de Berlín, escrito en 1759 y publicado en 1766), observó que los números pares e impares se distribuyen de forma alternada sobre el tablero de ajedrez. Si tenemos pintadas de blanco y negro las casillas del tablero con su típica distribución alternada, cada color alberga a todos los números pares o impares.

Los cuadrados mágicosLos cuadrados mágicos son unos objetos matemáticos que han cautivado a matemáticos y no matemáticos a lo largo de la historia. Se pueden encontrar, normalmente, en libros de divulgación de las matemáticas, de matemática recreativa o incluso de magia, pero también, como mostraremos hoy, en libros de ajedrez. Sobre ellos investigaron grandes matemáticos como el francés Pierre de Fermat (1607-1665) o Leonhard Euler, y hasta personalidades como el político, científico e inventor Benjamin Franklin (1706-1790), se atrevieron con ellos. Los cuadrados mágicos ya se conocían desde la antigüedad (quizás más allá del año 2.200 a.n.e.), y se les relacionaba con los planetas y con la alquimia, con la magia y la astrología, con la numerología, y también se utilizaban para sanar o como amuletos.

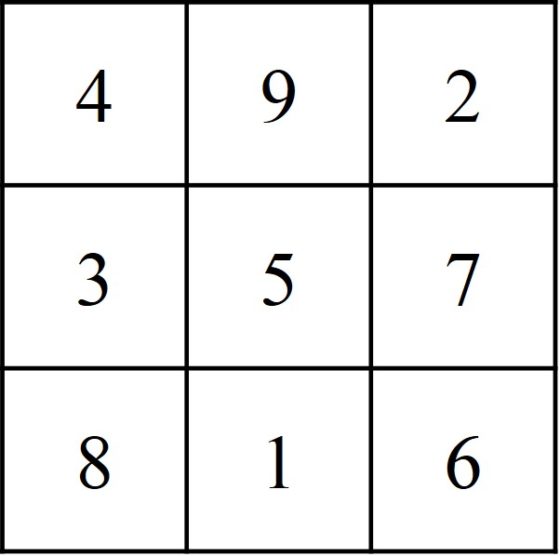

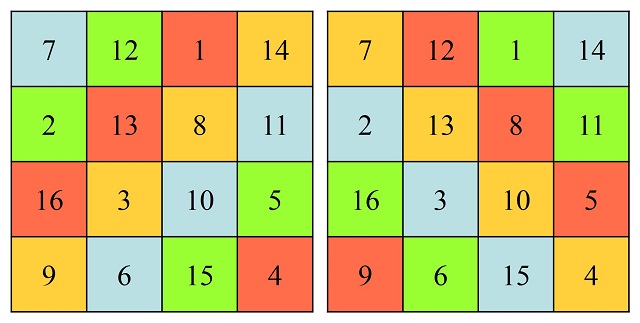

Pero vayamos con la definición de cuadrado mágico. Primero empecemos con un ejemplo, el cuadrado mágico más sencillo, que es el cuadrado mágico de orden 3. Se trata de un retículo cuadrado de tamaño 3 x 3, en el que se han colocado los números del 1 al 9, por ejemplo, como se muestra en la siguiente imagen.

Cuadrado mágico de orden 3, conocido como Lo-Shu

Cuadrado mágico de orden 3, conocido como Lo-Shu

Como se puede observar la primera fila 4 – 9 – 2, la segunda fila 3 – 5 – 7 y la tercera 8 – 1 – 6 están formadas, cada una de ellas, por tres números cuya suma es la misma en los tres casos, en concreto, 15. Efectivamente, 4 + 9 + 2 = 3 + 5 + 7 = 8 + 1 + 6 = 15. Por otra parte, si sumamos los números de cada columna, suman de nuevo 15. La primera columna 4 + 3 + 8 = 15, la segunda 9 + 5 + 1 = 15 y la tercera 2 + 7 + 6 = 15. Más aún, la suma de los números de las dos diagonales principales suma de nuevo 15, como se comprueba fácilmente, 4 + 5 + 6 = 8 + 5 + 2 = 15. ¡Esto es exactamente un cuadrado mágico de orden 3!

Este cuadrado mágico 3 × 3, conocido como Lo-Shu, aparece por primera vez en uno de los cinco libros clásicos de la Antigua China, el I-Ching o Libro de las permutaciones (sobre el siglo 1.200 a.n.e), aunque una leyenda afirma que es mucho más antiguo, que fue visto por el emperador chino Yu, hacia el 2.200 a.n.e., en el caparazón de una gran tortuga. Sobre esta leyenda y algunas otras cuestiones relacionadas con los cuadrados mágicos las podéis leer en la serie de entradas del Cuaderno de Cultura Científica titulada Habibi y los cuadrados mágicos (primera parte, segunda parte y tercera parte).

En general, un cuadrado mágico de orden n (en el caso anterior, n = 3), es una distribución de los n2 primeros números (para orden 3, los 9 primeros números, 1, 2, 3, 4, 5, 6, 7, 8, 9), sobre las casillas de una retícula cuadrada n x n, (en el ejemplo anterior, 3 x 3), de forma que la suma de cada fila, cada columna y cada diagonal sea siempre la misma (para orden 3 es 15) y a ese número se le llama constante del cuadrado mágico.

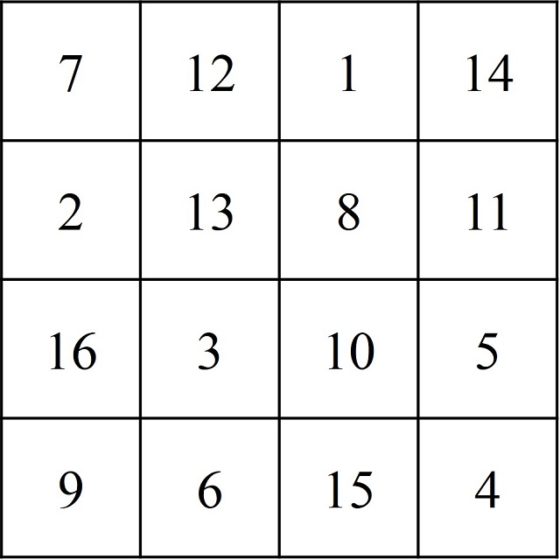

Un ejemplo de cuadrado mágico de orden 4 lo vemos en la siguiente imagen. En el mismo la suma de cada fila, cada columna y cada diagonal es 34.

Cuadrado mágico de orden 4 que aparece en un pilar de un templo de Khajurado (India), y que es la primera representación gráfica de la que se tiene constancia en la que aparece un cuadrado mágico de orden 4

Cuadrado mágico de orden 4 que aparece en un pilar de un templo de Khajurado (India), y que es la primera representación gráfica de la que se tiene constancia en la que aparece un cuadrado mágico de orden 4Los cuadrados mágicos y el recorrido del caballo

Teniendo en cuenta que cada recorrido del caballo sobre el tablero de ajedrez genera una retícula de números, que en el caso de tableros cuadrados de tamaño n x n es una retícula cuadrada, es posible plantearse si esta podría ser un cuadrado mágico.

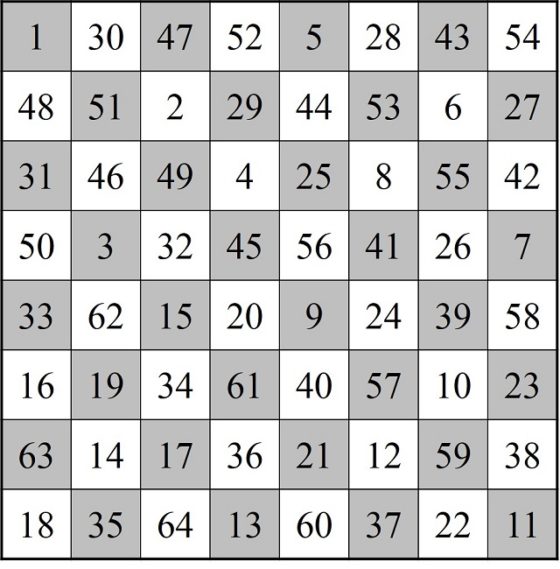

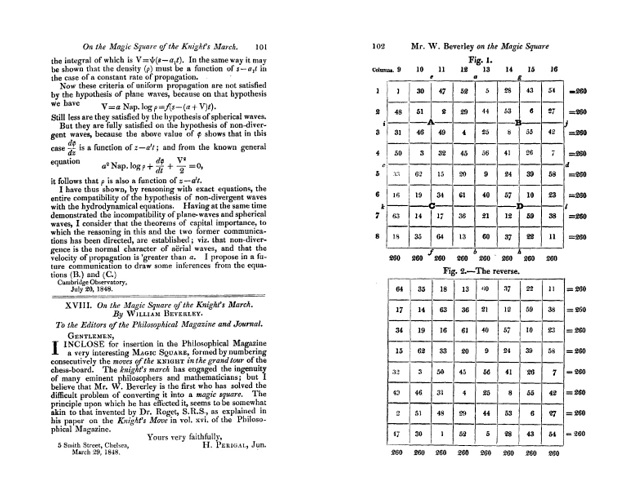

La primera persona que se planteó esta cuestión, que tengamos constancia de ello, sobre el tablero de ajedrez clásico fue William Beverly (no está clara la identidad de William Beverly, pero se cree que podría ser el pintor William Roxby Beverley (aprox. 1814-1889)) en el artículo On the Magic Square of the Knight’s March (Sobre el cuadrado mágico del camino del caballo), publicado en la revista The London, Edinburgh, and Dublin Philosophical Magazine and Journal of Science (vol. 33, no. 220, pp. 101–105, 1848). En el mismo presentaba el siguiente retículo cuadrado numérico generado por un recorrido abierto del caballo sobre el tablero de ajedrez.

Recorrido abierto del caballo sobre el tablero de ajedrez, con curiosas propiedades numéricas, publicado por William Beverley en 1848

Recorrido abierto del caballo sobre el tablero de ajedrez, con curiosas propiedades numéricas, publicado por William Beverley en 1848

Este cuadrado numérico, en ocasiones erróneamente atribuido a Leonhard Euler, cumple la propiedad de que la suma de los números de cada fila y de cada columna es la misma, en concreto, 260. Es lo que se conoce como cuadrado semi-mágico de orden 8, ya que la suma de los números de las diagonales no es 260, sino 210 y 282.

La constante mágica para orden 8 es 260, como ocurre con el ejemplo de Beverley, ya que en general, la constante de un cuadrado semi-mágico de orden n es igual, como se puede deducir fácilmente, a:

Una sencilla propiedad de los cuadrados semi-mágicos obtenidos mediante el recorrido del caballo es que el recorrido inverso, es decir, que empieza por el final y termina en el principio, también es un cuadrado semi-mágico. El propio William Beverley pone de manifiesto este hecho en su ejemplo, como se puede ver en su publicación (siguiente imagen).

Las dos primeras páginas del artículo On the Magic Square of the Knight’s March, publicado en la revista The London, Edinburgh, and Dublin Philosophical Magazine and Journal of Science, con la introducción del matemático amateur Henry Perigal, Junior (1801–1898) y el recorrido del caballo, y su reverso, cuyas filas y columnas suman 260

Las dos primeras páginas del artículo On the Magic Square of the Knight’s March, publicado en la revista The London, Edinburgh, and Dublin Philosophical Magazine and Journal of Science, con la introducción del matemático amateur Henry Perigal, Junior (1801–1898) y el recorrido del caballo, y su reverso, cuyas filas y columnas suman 260

Aunque este cuadrado semi-mágico cumple algunas propiedades más (puede verse el artículo original de William Beverley), sigamos con el problema de la relación de los recorridos del caballo con los cuadrados mágicos.

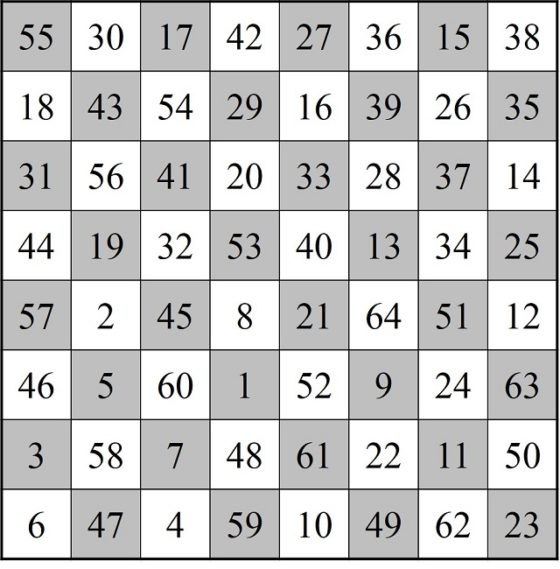

El primer cuadrado semi-mágico generado por un recorrido cerrado del caballo se debe al húngaro Carl Wenzelides (tampoco está clara su identidad, según el matemático y experto en ciencias de la computación Donald Knuth (1938) sería un historiador, que además escribió sobre poesía y música, y vivió entre los años 1770 y 1852) y apareció en el artículo Bemerkungen über den Rösselsprung (Observaciones sobre el salto del caballo), publicado en 1849 en la revista de ajedrez Schachzeitung.

Cuadrado semi-mágico de Carl Wenzelides generado por un recorrido cerrado del caballo

Cuadrado semi-mágico de Carl Wenzelides generado por un recorrido cerrado del caballo

En este cuadrado numérico, las sumas de cada una de las diagonales no es 260, luego tampoco es un cuadrado mágico, pero cumple una curiosa propiedad, que la suma de los números de las dos diagonales es el doble de 260, 304 + 216 = 520.

En los siguientes años fueron apareciendo algunos ejemplos más de cuadrados semi-mágicos generados mediante recorridos del caballo sobre el tablero de ajedrez. Entre otros, el siguiente debido al jugador y teórico del ajedrez ruso-finlandés Carl Ferdinand Jaenisch (1813–1872), que aparecía en el artículo De la solution la plus parfaite du problème du cavalier (Sobre la solución más perfecta del problema del caballo), publicado en 1859 en la revista de ajedrez The Chess Monthly.

La perfección viene por dos motivos. El primero es que, si dibujamos, con segmentos, el camino realizado por el caballo, este tiene simetría rotacional (180 grados), como se observa en la imagen.

El otro motivo es que, aunque los números de las diagonales no son 260, sino 256 y 264, la suma da de nuevo 520, el doble de 260, pero además se verifica otra curiosa propiedad relacionada con las diagonales no principales, las diagonales fragmentadas. Para explicarlo mejor, vayamos de nuevo al ejemplo del cuadrado mágico de orden 4 que habíamos mostrado anteriormente, cuyas filas, columnas y diagonales principales sumaban 34. Pero, además, ese cuadrado mágico, cumple otra propiedad, que las diagonales fragmentadas descendentes y ascendentes (que mostramos con el mismo color en la siguiente imagen, también suman 34).

En el cuadrado semi-mágico de Jaenisch ocurre algo similar, pero solo parcialmente. Los números de la diagonal principal descendente (azul oscuro en la siguiente imagen) suman 256, así como las diagonales fragmentadas paralelas (diferentes tonos de azul). Por otra parte, la suma de la diagonal principal ascendente (verde oscuro en la siguiente imagen) es 264, así como las diagonales fragmentadas paralelas (diferentes tonos de verde).

Siguieron encontrándose ejemplos de cuadrados semi-mágicos obtenidos mediante el recorrido del caballo (recorridos semi-mágicos). En 1951, el pedagogo, inspector de educación e historiador del ajedrez británico Harold J. R. Murray (1868 – 1955), autor del libro Historia del ajedrez, escribió la monografía The Magic Knight’s Tours. A Mathematical Recreation (Los recorridos del caballo mágicos, una recreación matemática), que recogía los 126 semi-mágicos obtenidos mediante recorridos del caballo, 59 de ellos cerrados, que se conocían hasta ese momento. Pero esta monografía se quedó en el cajón, por lo que el listado de estos cuadrados semi-mágicos no fue publicado hasta 1986. Apareció en el artículo Catalogue of 8 x 8 magic knight’s tours (Chessics 26, pp. 122-128), del matemático y editor británico George P. Jelliss, quien es el autor de una página web muy exhaustiva sobre el problema del recorrido del caballo.

A raíz de la publicación de este catálogo de 126 cuadrados semi-mágicos, se descubrió que aún había más recorridos semi-mágicos. Entre 1987 y 1988, el aficionado a las matemáticas británico Thomas W. Marlow (1927-2011) encontró, utilizando métodos computacionales, 5 cuadrados semi-mágicos más. A los que se les añadió 2 más, en 2003, por parte del australiano Timothy S. Roberts, profesor del Departamento de Informática y Comunicación de la Central Queensland University.

Sin embargo, ninguno de ellos era un cuadrado mágico, por lo que aún seguía abierto, tras más de 150 años, el problema de si existían recorridos (abiertos o cerrados) del caballo en el tablero de ajedrez que generaran un cuadrado mágico.

Finalmente, Hugues Mackay (Canada), Jean-Charles Meyrignac (Francia) y Günther Stertenbrink (Alemania) decidieron unir sus fuerzas y desarrollar un software que analizara computacionalmente todos los posibles recorridos del caballo en el tablero 8 x 8. El resultado, obtenido en 2003, fue que:

¡no hay recorridos del caballo que generen cuadrados mágicos!

Además, obtuvieron 7 nuevos cuadrados semi-mágicos, tres abiertos y cuatro cerrados, que no se habían obtenido antes. De esta forma, se cerró el catálogo de recorridos del caballo que generan cuadrados semi-mágicos, con una extensión de 140, de los cuales 63 son cerrados.

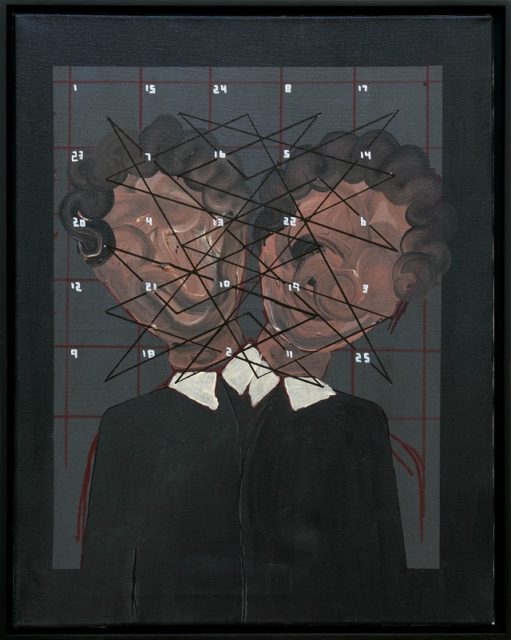

A. O. Magic Square Face #B2 (2019), del artista alemán Thomas Zipp (1966), que forma parte de la instalación The Church of the Magic Square (2020), para la galería Blank Projects [blankprojects.com] de Sudáfrica

A. O. Magic Square Face #B2 (2019), del artista alemán Thomas Zipp (1966), que forma parte de la instalación The Church of the Magic Square (2020), para la galería Blank Projects [blankprojects.com] de Sudáfrica

Los recorridos del caballo mágicos en tableros de cualquier tamaño

Puesto que se pueden obtener retículos cuadrados numéricos para recorridos del caballo sobre tableros cuadrados de cualquier tamaño n x n, es lógico preguntarse si sería posible construir cuadrados mágicos con recorridos del caballo para grados distintos de 8.

La primera reflexión que podemos realizar es que no van a existir tales cuadrados mágicos, ni semi-mágicos, para ordenes n impares. El motivo es muy simple.

Si tomamos el tablero de ajedrez cuadrado, de tamaño n x n, y pintamos sus casillas de blanco y negro, de forma alterna, como es habitual, el caballo en su salto va a pasar de una casilla negra a una blanca, y viceversa, pero cuando contamos las casillas del recorrido después de un número par viene uno impar, y viceversa, luego todos los números pares estarán en las casillas de un mismo color y los impares en las casillas del otro, como podéis comprobar además en los ejemplos mostrados más arriba para el tablero 8 x 8. Por lo tanto, si nuestro tablero n x n es tal que n es impar (n = 2k + 1), tendremos que dos columnas cualesquiera, respectivamente filas, contiguas tendrán una de ellas k casillas negras y k + 1 blancas, mientras que la otra tendrá k casillas blancas y k + 1 negras. Como la paridad está asociada al color, entonces la suma de los números de una de esas dos columnas (resp. filas) será par, mientras que la suma de la otra será impar. Por lo tanto, no pueden coincidir.

¡No existen recorridos (semi-)mágicos en los tableros de tamaño n x n, con n impar!