El camión solar: ¿una posibilidad real?

Los cálculos son tercos y apuntan a que todavía estamos muy lejos de ver circulando por la carretera un camión solar.

Gama de soluciones de movilidad apoyada por energía solar fotovoltaica propuesta por Sono Motors. Fuente: Sono Motors

Gama de soluciones de movilidad apoyada por energía solar fotovoltaica propuesta por Sono Motors. Fuente: Sono MotorsLa movilidad del futuro se presenta fascinante y llena de novedades. En los últimos años hemos visto emerger nuevos actores y viejos conocidos con ímpetus renovados. En el extremo ligero de las soluciones de transporte encontramos los patinetes y las bicicletas eléctricas. Para desplazarnos más rápidamente disponemos de turismos eléctricos en diferentes configuraciones y con distintos resultados al respecto de la reducción de emisiones de gases: motorizaciones híbridas, híbridas enchufables y cien por cien eléctricas. En el horizonte inmediato esperan las pilas de combustible, con el potencial de crear un nuevo sector de la economía con el hidrógeno como vector energético. Quizá más allá se encuentren sistemas pesados basados en el ciclo de oxidación-reducción del hierro, con usos prospectivos en el campo naval. Y en el aire encontramos los combustibles de origen vegetal de segunda generación que prometen ciclos casi cerrados y, por tanto, una gran reducción en las emisiones de CO2. La electrificación en el aire espera aún un gran salto en las capacidades de almacenamiento de energía de las baterías eléctricas, que está tardando en darse y no está, bajo ningún concepto, garantizado.

Vehículos con apoyo fotovoltaicoLa movilidad solar ha sido tradicionalmente una curiosidad, limitada a ejemplos experimentales. La realidad es tozuda y se muestra inflexible por lo que respecta a permitir que un vehículo sea independiente de cualquier infraestructura de carga o repostaje. Las aventuras ingenieriles que han buscado derivar toda su capacidad motriz de la energía del sol mediante paneles fotovoltaicos embarcados han fallado una y otra vez. Incluso conseguir que parte de la energía consumida sea de origen solar supone, por lo general, mucha más molestia de la que merece la pena a la luz (exigua) de los resultados.

Sin embargo, entre las propuestas de movilidad que aparecen prácticamente a diario en las noticias tecnológicas empiezan a verse ejemplos de coches solares. Destacan, por su cercanía al mercado, dos modelos: el Sono Sion y el Lightyear 0 (el número cero, no la letra o mayúscula). Ambos utilizan superficies cubiertas de paneles solares poco o nada frecuentes en un vehículo. Capó, techo y portón trasero en el caso del Lightyear [1], una berlina de casi 5,10 metros de longitud, con un total de 5 metros cuadrados de paneles curvados según la aerodinámica de la carrocería. El Lightyear 0 promete nada menos que 70 kilómetros diarios de movilidad solar sin coste, aunque la letra pequeña afirma que el cálculo está hecho para una ubicación no especificada del sur de España y solo es válido durante el 10 por ciento del año más favorable, alrededor del solsticio de verano. Este dato sin duda será interesante para los potenciales compradores de la berlina que vivan más cerca de la sede de la marca, en Eindhoven (Países Bajos).

Lightyear 0. Fuente: Lightyear

Lightyear 0. Fuente: LightyearEn cuanto al Sono Sion [2], un monovolumen de 4,47 metros de longitud, ofrece ocho metros cuadrados de paneles fotovoltaicos integrados en todas las superficies expuestas de la carrocería. No solo capó y techo, sino también puertas y aletas. El cálculo de la autonomía solar que permite sus paneles está dado por el fabricante en 35 kilómetros diarios en el mes de junio, suponiendo días perfectamente soleados. A su favor hay que decir que esta estimación no corresponde a la Costa del Sol: el fabricante Sono Motors está radicado en Múnich (Alemania), y esa es precisamente la ubicación a la que se refieren. Las tablas con el histórico meteorológico de Múnich indican que un mes de junio normal tiene 11 días soleados. Sin embargo; esta información no aparece en la web de Sono Motors.

Sono Sion. Fuente: Sono Motors

Sono Sion. Fuente: Sono MotorsEstá por ver que estos turismos con apoyo solar —llamarlos coches solares es, a todas luces, engañoso— resulten rentables a largo plazo. La integración de los paneles fotovoltaicos en la carrocería, a pesar de intentar aprovechar las superficies de menor curvatura, resulta compleja y hace una verificación independiente de sus capacidades reales, cuanto menos, difícil. No obstante, sería interesante disponer de una idea de la magnitud del apoyo que puedan proporcionar unos paneles solares en un vehículo electrificado capaz de llevarlos. Para lograr este objetivo, es interesante centrarse en un caso de cálculo particularmente favorable: el camión con apoyo solar. Han aparecido propuestas de camiones electrificados, total o parcialmente, que obtienen cierto apoyo en su autonomía de paneles fotovoltaicos montados sobre las paredes laterales y superior de su zona de carga. Esta disposición permite disponer de grandes espacios, en principio diáfanos, para la instalación de los colectores solares. Espacios que, además, son planos. Se evita de este modo un problema común que aumenta el coste de los paneles en techos u otras superficies de turismos: las curvaturas guiadas por la aerodinámica.

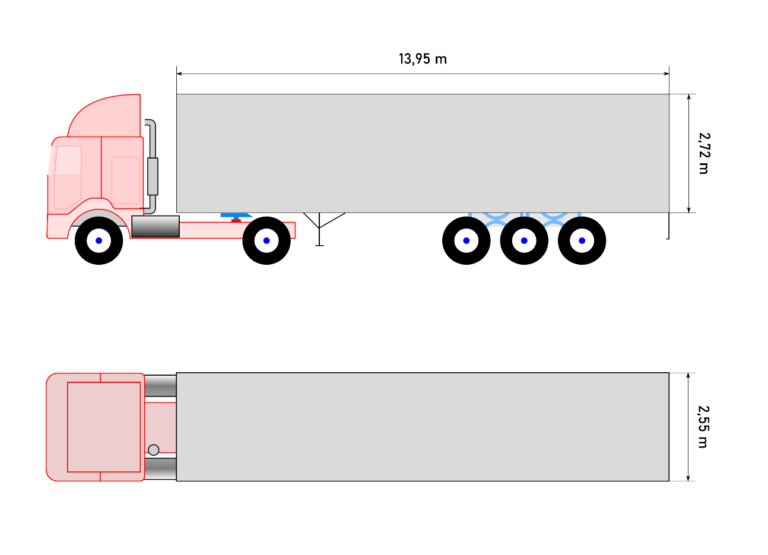

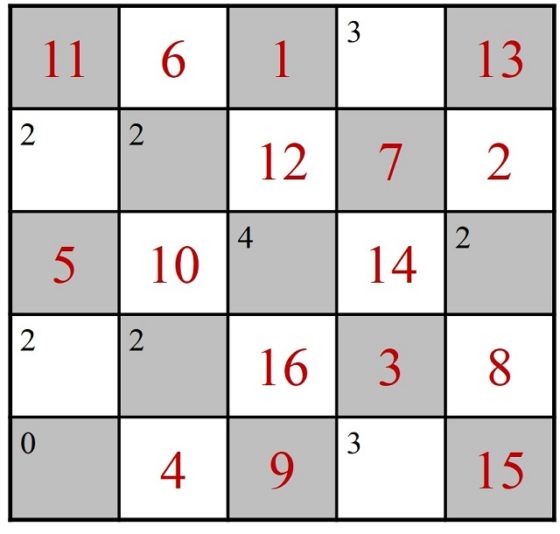

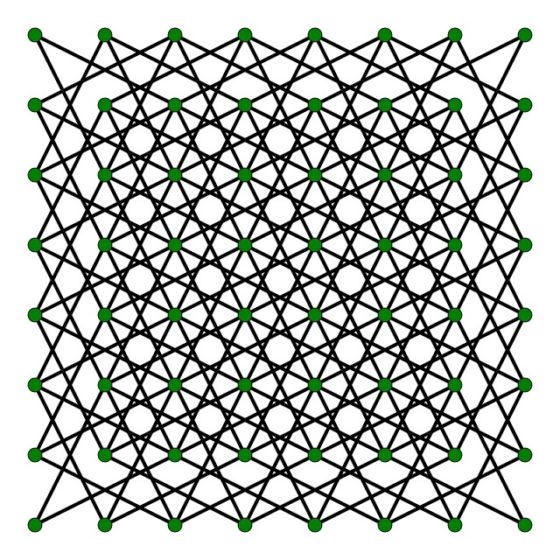

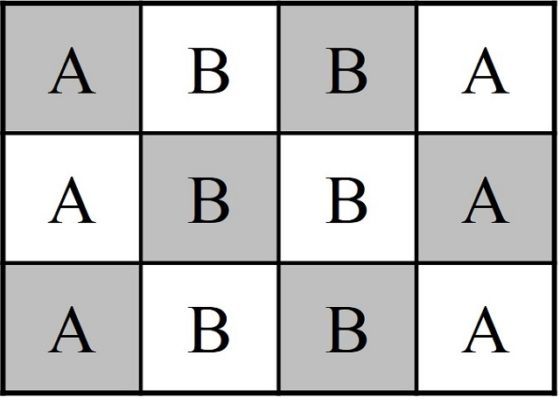

Modelo de cálculo de apoyo solar para camiónPara crear un modelo de cálculo simplificado [3] nos centraremos en un camión con semirremolque de cinco ejes al que dotaremos de paneles fotovoltaicos en los laterales y techo de su semirremolque. El primer paso será calcular las superficies disponibles dadas unas dimensiones típicas.

Camión de cinco ejes típico con medidas del semirremolque. Imagen modificada por el autor a partir del diagrama CC BY-SA 3.0 de H Padleckas / Orinoco / Malyszkz, Wikimedia Commons

Camión de cinco ejes típico con medidas del semirremolque. Imagen modificada por el autor a partir del diagrama CC BY-SA 3.0 de H Padleckas / Orinoco / Malyszkz, Wikimedia Commons

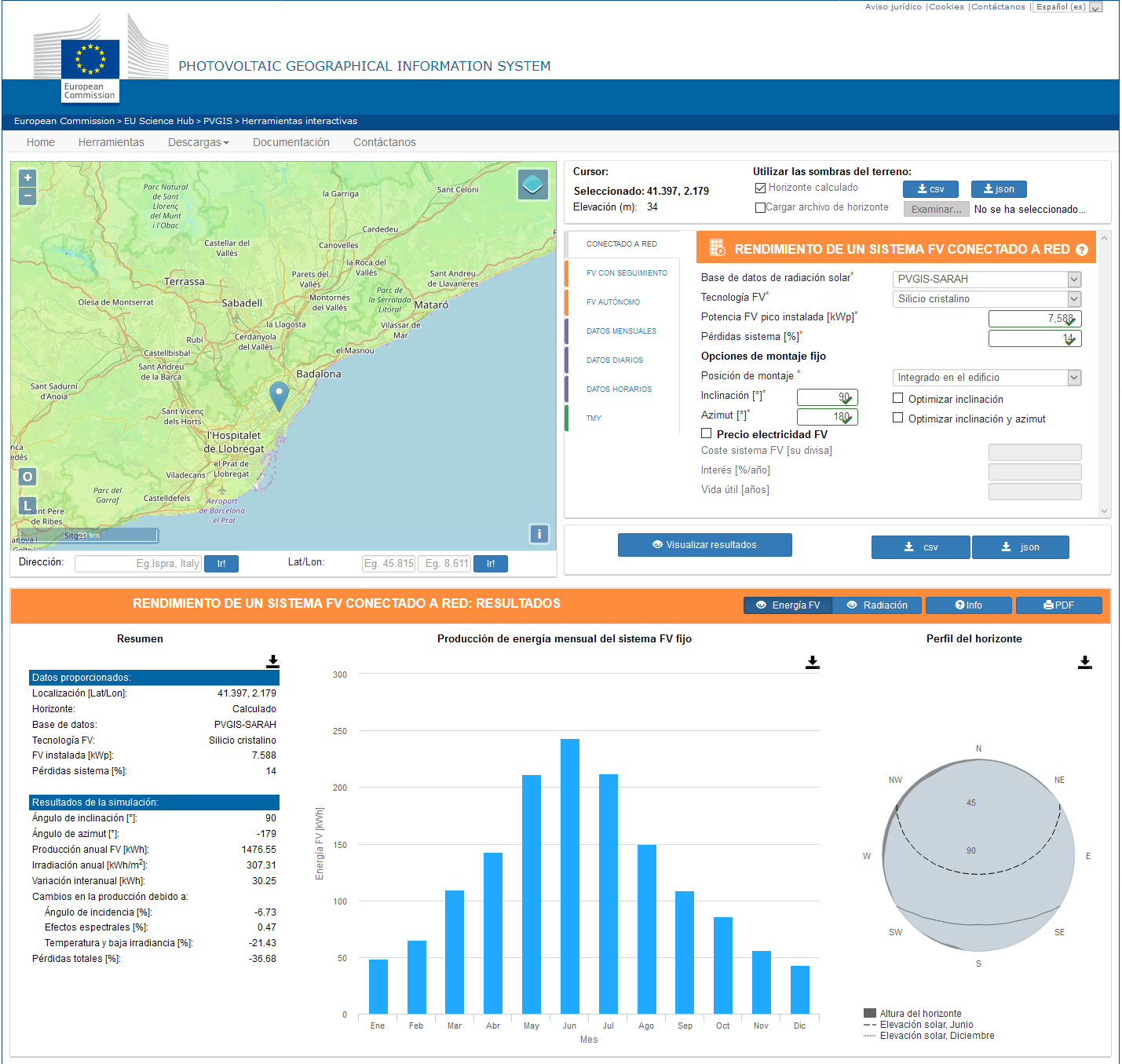

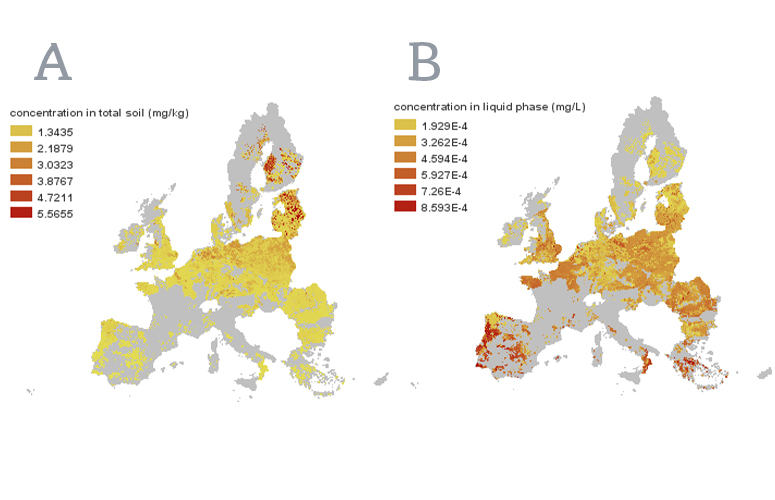

A partir de las medidas de la superficie disponible, procedemos a calcular la superficie total expuesta, lo que para un semirremolque típico excede los 110 metros cuadrados. En el siguiente paso, seleccionamos una ubicación y preparamos una consulta a la base de datos PVGIS de la Comisión Europea [4]. Usaremos el cálculo para el sistema más sencillo, el de un panel fotovoltaico conectado a la red, ya que no vamos a tener en cuenta datos de las baterías montadas en el vehículo.

Como quiera que el dimensionamiento de una instalación solar en PVGIS se realiza con su potencia en vatios-pico (los vatios que puede producir una instalación solar fotovoltaica bajo condiciones óptimas de iluminación solar, sin cobertura de nubes y a una temperatura de panel de 25 °C), utilizamos un parámetro común para ligar esta unidad a la superficie unitaria de paneles: un metro cuadrado de panel fotovoltaico ofrece 0,2 kilovatios-pico.

Avanzando en las características del modelo, calcularemos por un lado la energía producida para la ubicación dada por la superficie de paneles del techo de la caja del semirremolque, cuya inclinación, que asumiremos siempre cenital, es fija e igual a cero grados, y su acimut es indiferente. Por otro, tendremos en cuenta un movimiento aleatorio del vehículo a lo largo del año. Computaremos el valor de la energía producida por uno de los laterales, considerando su inclinación como 90 grados y su acimut como una variable aleatoria de distribución uniforme. orientado en cuatro direcciones perpendiculares (–90°, 0°, 90° y 180°, es decir, este, sur, oeste y norte); el resultado será la media aritmética de estos cuatro valores, multiplicada por dos para tener en cuenta ambos lados de la caja.

Captura de pantalla de la herramienta PVGIS de la Comisión Europea. Fuente: Comisión Europea

Captura de pantalla de la herramienta PVGIS de la Comisión Europea. Fuente: Comisión EuropeaPara que este valor de energía producida sea correcto, tendremos que imponer la condición de que el camión no visite recintos cerrados ni se encuentre en zonas sombreadas nunca; esto anularía o reduciría significativamente la producción de energía durante el tiempo en el que se viera afectado por esta reducción de la iluminación ambiental. Esta suposición, fácil de hacer para un camión, es mucho más aventurada para un vehículo más pequeño como un turismo. Con todo esto, podemos ya intentar estimar la producción de energía anual del sistema. Los cálculos anuales permiten uniformizar el impacto de la variación día-noche y estacional en la radiación solar incidente.

Estimación del consumo de energía en un camión eléctricoPodemos comprobar que, en el centro de la península Ibérica, instalar paneles fotovoltaicos en las superficies disponibles de un semirremolque de las medidas consideradas permitirá producir más de 19 megavatios-hora en un año. Parece mucho, pero para estar seguros tendremos que comparar esa cifra con cuánta energía consumiría ese mismo camión en su funcionamiento normal, y comprobar que fracción representa la producción solar. ¿El problema? Que, hoy, no existen camiones eléctricos de ese tamaño en producción con los que poder ofrecer cifras fiables. Tanto el Tesla Semi como el Mercedes eActros LongHaul están, según las noticias recientes, a uno y dos años respectivamente de estar disponibles en el mercado.

Tesla Semi (izquierda) y Mercedes-Benz eActros LongHaul. Fuentes: izquierda, CC BY 2.0 Steve Jurvetson; derecha, MBpassion.de / Philipp Deppe

Tesla Semi (izquierda) y Mercedes-Benz eActros LongHaul. Fuentes: izquierda, CC BY 2.0 Steve Jurvetson; derecha, MBpassion.de / Philipp DeppeSin embargo, sí es posible comparar con el consumo de camiones actuales de motorización térmica, bajo el supuesto de que la energía necesaria para su movimiento será aproximadamente la misma. Un camión del tipo que estamos considerando puede consumir, bajo condiciones de conducción económica y recorridos mayoritariamente sin pendientes, 32 litros de combustible diésel cada cien kilómetros [5]. Este consumo responde al uso total, primario, de energía del camión, pero no nos está dando la información que necesitamos. Hay que ponerlo en términos de energía neta. Para ello, habrá que minorar la parte de la energía que se pierde por las limitaciones termodinámicas de los motores de combustión; con ello tendremos la energía neta que llega finalmente a las ruedas y sistemas auxiliares. Después, imaginaremos que la energía ha sido extraída de una fuente compatible con los paneles solares, de manera que podamos compararla. Por último, añadiremos la parte de pérdidas de un motor eléctrico, que, como veremos, es mucho menos significativa que en el caso del motor de combustión.

Los valores que emplearemos para realizar el cálculo serán:

Densidad energética del combustible diésel: 36,05 MJ/L

En kilovatios-hora/litro: 10,01 kW·h/L

Rendimiento del motor térmico: 45 %

Rendimiento del motor eléctrico equivalente: 90 %

Consideraremos además un kilometraje anual típico de 120000 kilómetros. El camión diésel considerado consumirá 375000 litros de combustible, mientras que un hipotético camión eléctrico equivalente deberá usar del orden de 210 megavatios-hora, arrojando un gasto de energía por kilómetro de 1,75 kilovatios-hora por kilómetro. Como comparación, Tesla afirma que su futuro Tesla Semi tendrá un consumo de 1,24 kilovatios-hora por kilómetro [6], un 29 por ciento menos, lo que es consistente con las diferencias habituales observadas entre consumos declarados y reales en otros vehículos.

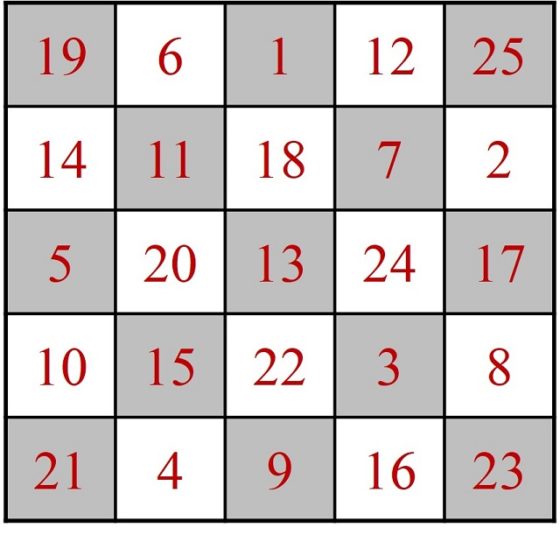

Los paneles, según el cálculo de nuestro modelo, ofrecerán algo menos de 20 megavatios-hora, del orden del 9 por ciento de la energía requerida. En términos de distancia, más de 11000 kilómetros «gratuitos». Ahora bien, ¿compensa el montaje? ¿En cuánto tiempo se recuperará la inversión necesaria?

Plazo de retorno de la inversiónEn este momento, sin una disponibilidad real de camiones para modificar, solo es posible hacer estimaciones. La instalación de los paneles fotovoltaicos sobre las superficies de la caja de un semirremolque no se antoja como especialmente compleja, pero es un problema diferente al de un montaje sobre el tejado de un edificio. El sistema no necesitará estar dotado de un inversor, un componente que habitualmente justifica aproximadamente el veinte por ciento del coste de un sistema fotovoltaico de esta magnitud; las baterías de un camión eléctrico almacenan corriente continua. Será necesario, naturalmente, instalar la circuitería necesaria para realizar la adaptación del voltaje de las placas al de las baterías, así como todos los elementos de control necesarios. Al tratarse de una instalación en movimiento, es de prever que los requisitos mecánicos y normativos de seguridad serán más onerosos de cumplir.

Entre factores que disminuyen el precio y otros que lo aumentan, vamos a simplificar considerando que el coste unitario por metro cuadrado de instalación del sistema será similar al disponible hoy para edificios, cuyo límite inferior se encuentra alrededor de los 600 euros. Esto fijaría el coste del sistema fotovoltaico en unos 67000 euros, una magnitud comparable a la de los costes típicos de la cabeza tractora. Una cifra habitual de referencia en las motorizaciones diésel sería 100000 euros, pero con seguridad el coste final será superior para los futuros camiones eléctricos de gran tonelaje). Por su parte, es casi el doble que el coste del propio semirremolque, para el que una cifra típica podría ser 36000 euros.

Ahora estamos en condiciones de calcular un tiempo de retorno de la inversión, si tenemos en cuenta el coste del kilovatio-hora para la carga de las baterías del camión. Considerando un coste de 0,19 euros por kilovatio-hora, no se recuperaría la inversión hasta casi los dieciocho años. La vida media de un camión de gran tonelaje se estima en unos diez años, y aunque es de suponer que las mecánicas más sencillas de las motorizaciones eléctricas conllevarán un aumento considerable del tiempo útil de estos vehículos, dieciocho años parecen un plazo completamente inasumible.

Gráfico de análisis de coste para camiones de cinco ejes con apoyo solar para una vida máxima del vehículo de 20 años. Fuente: Iván Rivera (elaboración propia)

Gráfico de análisis de coste para camiones de cinco ejes con apoyo solar para una vida máxima del vehículo de 20 años. Fuente: Iván Rivera (elaboración propia)Haciendo un análisis para diferentes escenarios considerando las dos variables clave en esta situación (el coste unitario de instalación de los paneles fotovoltaicos y el coste por kilovatio-hora de la energía de recarga, encontramos que, si establecemos de forma muy conservadora los diez años como el periodo mínimo de retorno aceptable para la inversión de instalar paneles fotovoltaicos en el semirremolque, encontramos que los costes de instalación unitarios deben disminuir hasta los 500 euros por metro cuadrado y el precio medio de la energía aumentar hasta los 0,3 euros por kilovatio-hora. Para costes de instalación unitarios más bajos, el precio medio de la energía aceptable en todo el periodo disminuye también. Para un valor similar al considerado inicialmente de 0,19 euros por kilovatio-hora, el coste unitario de instalación tendría que bajar a la mitad (300 euros por metro cuadrado) para que el tiempo de retorno bajara de los nueve años.

De modo un tanto alarmante, el precio por metro cuadrado del panel fotovoltaico, que ha mostrado un comportamiento histórico de disminución exponencial hasta 2019 [7], parece haberse estabilizado e incluso aumentado en los últimos tres años [8], a pesar del crecimiento constante en su capacidad productiva en todo el mundo.

El futuro del camión con apoyo fotovoltaicoEn conclusión: no vemos paneles solares en camiones por un conjunto de razones. Para empezar, los camiones tienen que evolucionar en motorización: sin al menos una motorización híbrida con una capacidad suficiente de baterías, no tiene sentido la instalación de placas fotovoltaicas salvo para alimentar sistemas secundarios (la refrigeración aparece aquí como una oportunidad a considerar). Por otro lado, es necesario que el coste de las instalaciones fotovoltaicas disminuya de forma clara, algo que podría suceder aún pese al comportamiento reciente del mercado, achacable al menos en parte a las turbulencias logísticas inducidas por la crisis de la COVID-19. Y, por último, este tipo de instalaciones tienen más sentido cuanto mayor sea el coste del kilovatio-hora para la recarga. Lamentablemente, todas las señales apuntan en este sentido a corto y medio plazo.

El caso de negocio para empresas del tipo de Sono Motors, que ha propuesto adaptaciones para camiones de este estilo [9], está en el aire. Y esto, sin responder a una pregunta más: ¿aceptarán los operadores de camiones ceder el espacio de los laterales de los semirremolques para un fin diferente a anunciarse en letras de dos metros de altura?

Bibliografía[1] Lightyear. (2022). Long Range Solar Electric Vehicle – Lightyear 0. Visitado el 29/09/2022 en

[2] Sono Motors. (2022). The Sion – the car that charges itself. Visitado el 29/09/2022.

[3] Rivera, I. (29/09/2022). Modelo de cálculo de apoyo solar para camiones. Google Spreadsheets.

[4] Comisión Europea. (01/03/2022). PVGIS Photovoltaic Geographical Information System. EU Science Hub. Visitado el 29/09/2022.

[5] Instituto para la Diversificación y el Ahorro de Energía. (2009). Guía para la gestión del combustible en las flotas de transporte por carretera. Centro de Publicaciones, Ministerio de Fomento. Visitado el 29/09/2022.

[6] García, G. (15/02/2021). Ya sabemos la capacidad del tesla semi: 500 KWH, ¿Escasa para un camión eléctrico? Híbridos y Eléctricos. Visitado el 29/09/2022.

[7] Oxford Martin School, University of Oxford. (2020). Solar PV module prices. Our World in Data. Visitado el 29/09/2022.

[8] Gifford, J. (04/01/2022). Higher PV module prices may point to stable demand and more sustainable pricing trends. PV Magazine International. Visitado el 29/09//2022.

[9] Sono Motors. (08/09/2022). Sono Motors presents financial results for the second quarter of 2022. Sono Motors. Visitado el 29/09//2022.

Sobre el autor: Iván Rivera es ingeniero especializado en proyectos de innovación de productos y servicios para ferrocarriles.

El artículo El camión solar: ¿una posibilidad real? se ha escrito en Cuaderno de Cultura Científica.

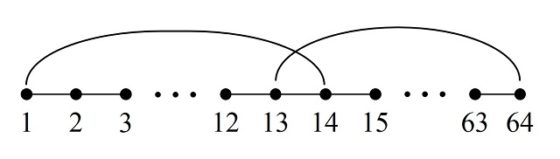

El problema del recorrido del caballo en el tablero de ajedrez (II)

En la anterior entrada del Cuaderno de Cultura Científica titulada El problema del recorrido del caballo en el tablero de ajedrez, iniciamos una pequeña serie sobre este clásico problema en el que se relacionan ajedrez y matemáticas, el problema de recorrer todas las casillas de un tablero de ajedrez con la figura del caballo, pasando una vez y sólo una vez por cada casilla. En particular, en esa entrada centramos nuestra atención en la cuestión de la existencia de solución al problema para tableros rectangulares de tamaño n x m, mientras que en esta entrada nos centraremos en la cuestión de cómo construir esos recorridos.

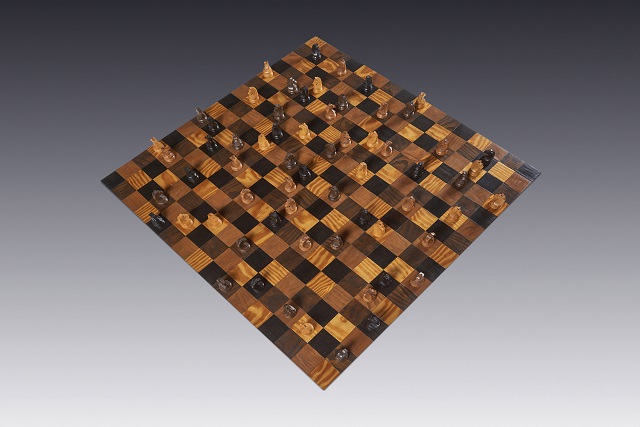

El reino del ajedrez (2008), del artista mexicano Carlos Orduña Barrera. Imagen de su página web: Carlos Orduña BarreraEl problema del recorrido del caballo

El reino del ajedrez (2008), del artista mexicano Carlos Orduña Barrera. Imagen de su página web: Carlos Orduña BarreraEl problema del recorrido del caballo

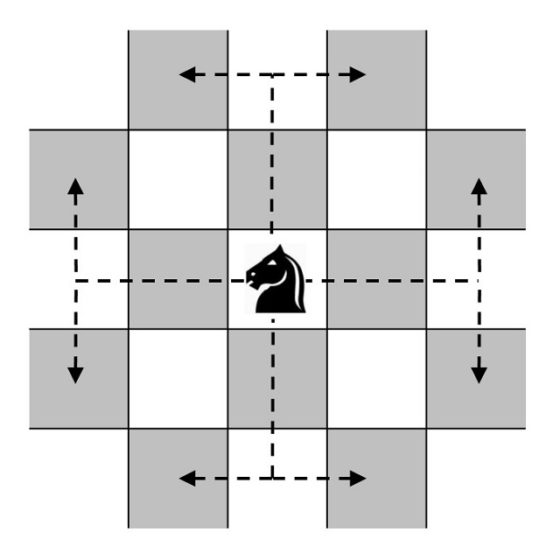

Empecemos recordando exactamente qué nos plantea este juego o problema.

Problema del recorrido del caballo: Buscar un recorrido de la figura del caballo sobre el tablero de ajedrez que consista en mover esta pieza, desde una casilla inicial, de forma sucesiva a través de todas las casillas del tablero, pasando una sola vez por cada una de ellas, y terminando en la casilla inicial.

Aunque el juego del recorrido del caballo se plantea sobre el tablero clásico, de tamaño 8 x 8, desde el inicio se interesaron en la solución para tableros cuadrados de diferentes tamaños n x n, para tableros rectangulares de tamaño n x m, e incluso, para tableros de formas diversas.

Por otra parte, se distinguieron dos tipos de soluciones. Los recorridos como el planteado en el enunciado anterior, que se denomina recorrido cerrado, ya que empieza y acaba en la misma casilla, aunque se puede plantear la variante del problema que consiste en que las casillas inicial y final no sean las mismas, en cuyo caso se habla de recorrido abierto.

En la entrada anterior, como comentábamos, dedicamos nuestra atención al problema de la existencia de recorridos (abiertos y cerrados) sobre un tablero rectangular. Analizamos con un poco más de detalle los tableros de tamaño 3 x m (dejamos abierto el problema 3 x 4 que resolveremos en otra entrada de esta serie), así como el tablero 4 x 4, y recordamos cual era el resultado general: para un tablero n x m, con n menor o igual que m, existen recorridos de caballos cerrados si no se da alguno de los casos siguientes: i) n y m impares; ii) n = 1, 2 o 4; iii) n = 3 y m = 4, 6 o 8.

En esta entrada se van a analizar algunos métodos clásicos de construcción de recorridos del caballo sobre el tablero de ajedrez.

El método de los matemáticos De Moivre y De MontmortEl matemático y abogado británico Walter William Rouse Ball (1850-1925) menciona en su libro Recreaciones matemáticas y ensayos (1892) que el primer método, del que él tiene conocimiento, para obtener recorridos del caballo sobre el tablero de ajedrez, es de los matemáticos franceses Abraham de Moivre (1667-1754) y Pierre Rémond de Montmort (1678-1719).

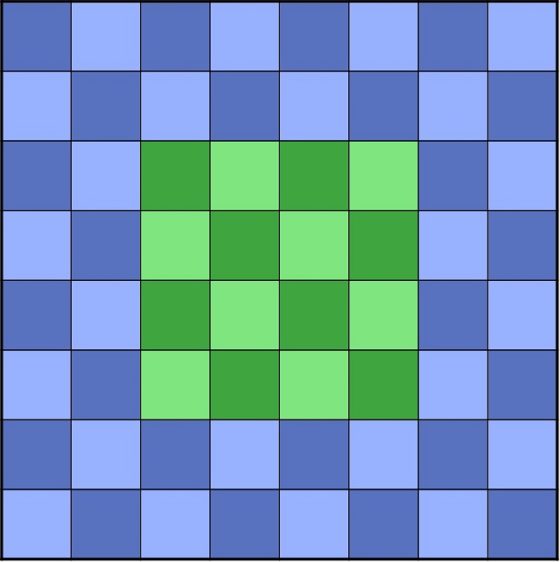

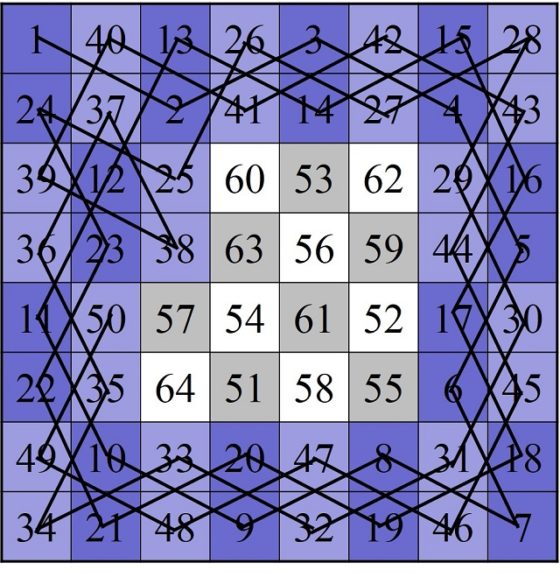

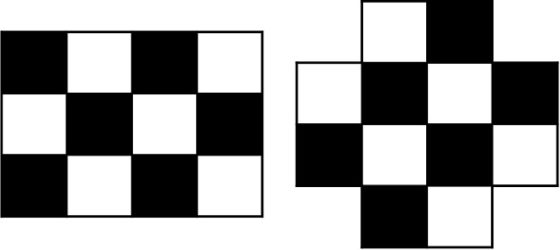

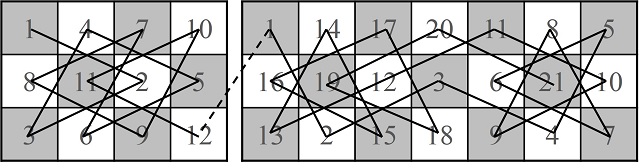

Este método consiste en dividir el tablero en dos partes, un anillo exterior de una anchura de dos celdas y un cuadrado interior 4×4, de forma que primero se recorra con el caballo la zona exterior, solo entrando en la zona interior si es completamente necesario, y después de recorrer el anillo exterior, continuar con el trayecto por la parte interior.

Zonas interior –verde– y exterior –azul– del tablero de ajedrez para el método de De Moivre y De Montmort

Zonas interior –verde– y exterior –azul– del tablero de ajedrez para el método de De Moivre y De Montmort

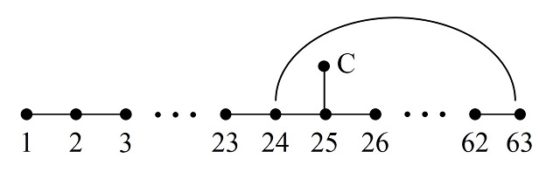

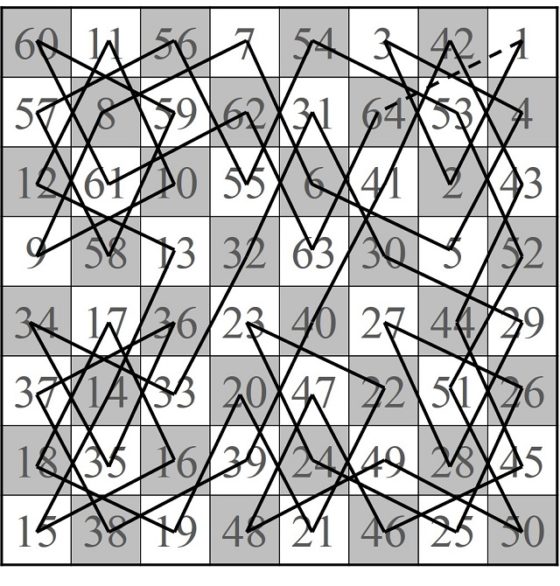

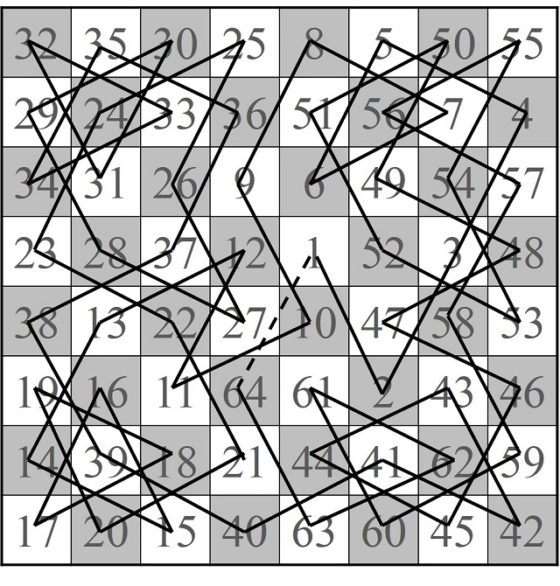

Podemos empezar a buscar un itinerario del caballo empezando en una esquina del tablero y recorriendo el anillo exterior de forma circular, por ejemplo, en el sentido de las agujas del reloj (véase la siguiente imagen), de forma que se van saltando las casillas que hemos numerado 1, 2, 3, así hasta la casilla 24, desde la cual no podemos seguir saltando a una casilla de la zona exterior (véase la siguiente imagen).

Como en la casilla 24 nos hemos bloqueado en nuestro recorrido por el anillo exterior, hay que apoyarse en la zona interior (casilla 25) para poder continuar el trayecto por el anillo exterior. Así seguimos saltando hasta la casilla 37, en la que nos volvemos a bloquear, y hay que volver a entrar puntualmente en la zona interior para poder seguir. El recorrido por el anillo exterior se termina en la casilla 50 (véase la siguiente imagen).

Para terminar el recorrido del caballo solo queda saltar por las casillas de la zona interior. Al empezar en la casilla de la esquina es imposible alcanzar esa esquina desde la zona interior, luego el recorrido será abierto. En la imagen siguiente se muestra el final del mismo.

Por el comentario anterior, las esquinas no se conectan con la zona interior, para conseguir un camino cerrado con la técnica de De Moivre y De Montmort habría que empezar en una casilla desde la que sí se pueda acceder desde la zona exterior. Una pequeña diversión para las personas que estáis leyendo esta entrada podría ser analizar cómo construir recorridos del caballo utilizando la técnica aprendida de los matemáticos franceses del siglo XVIII, empezando en diferentes casillas del anillo exterior, y ver si en algunos casos se pueden conseguir recorridos cerrados o modificar los recorridos abiertos obtenidos para convertirlos en cerrados.

A continuación, se muestra un camino cerrado partiendo de una casilla de una de las diagonales principales del tablero, que no está en ninguna esquina del mismo, y que está en el anillo exterior.

Aunque nos estamos refiriendo a la técnica de De Moivre y De Montmort para resolver el problema del recorrido del caballo sobre el tablero de ajedrez, lo cierto es que esta técnica aparece ya varios siglos antes. El pedagogo, inspector de educación e historiador del ajedrez británico Harold J. R. Murray (1868.1955) en su libro Historia del ajedrez muestra un recorrido abierto de un ajedrecista árabe desconocido, del que se sabe que se llamaba Ali Ibn Mani, que es esencialmente la misma solución que hemos mostrado al describir el método de los matemáticos franceses. Aunque el problema es datar dicha construcción ya que aparece recogida en un manuscrito, de alrededor del año 1350, sobre ajedrez de Abu Zakariya Yahya ben Ibrahim al-Hakim, titulado El deleite de los inteligentes, una descripción del ajedrez, y que también recoge el primer recorrido cerrado de Al-Adli (hacia el 840), que se comenta en la anterior entrada.

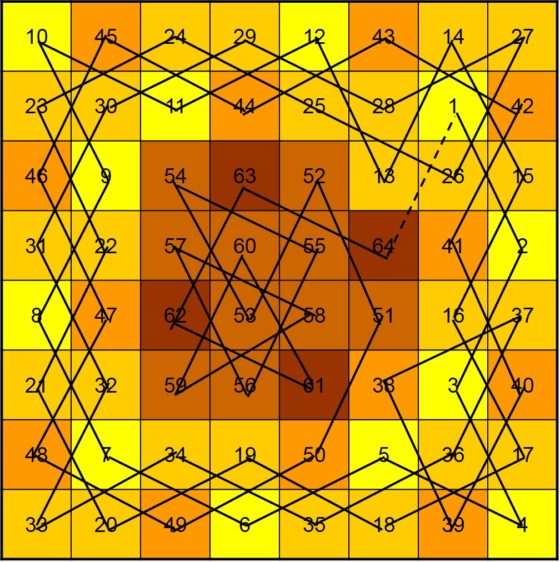

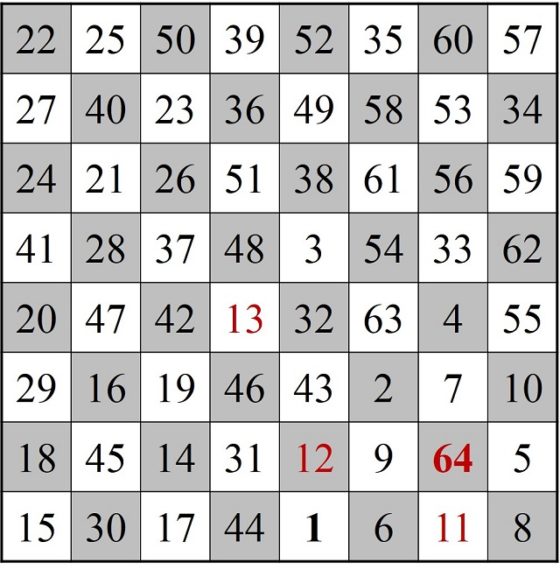

El método del matemático Leonhard EulerEl matemático suizo Leonhard Euler (1707-1783) fue el primero en realizar un análisis matemático riguroso del juego del recorrido del caballo en su artículo Solución a una cuestión ingeniosa que parece que no ha sido analizada (Memoria de la Academia de Ciencias de Berlín, escrito en 1759 y publicado en 1766).

Las dos primeras páginas del artículo de Leonhard Euler Solución a una cuestión ingeniosa que parece que no ha sido analizada (1759)

Las dos primeras páginas del artículo de Leonhard Euler Solución a una cuestión ingeniosa que parece que no ha sido analizada (1759)

En particular, en este artículo desarrolló el siguiente método para obtener recorridos cerrados. Esta técnica consistía en buscar de forma aleatoria un recorrido del caballo sobre el tablero de ajedrez lo más largo posible, que dejara una cantidad pequeña de casillas sin recorrer, para después intercalar estas casillas en diferentes partes del mismo con el objetivo de construir un recorrido cerrado que cubra todas las casillas del tablero.

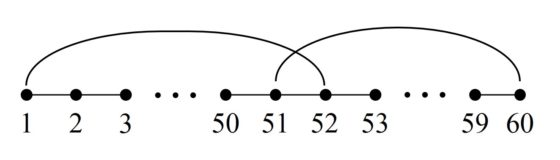

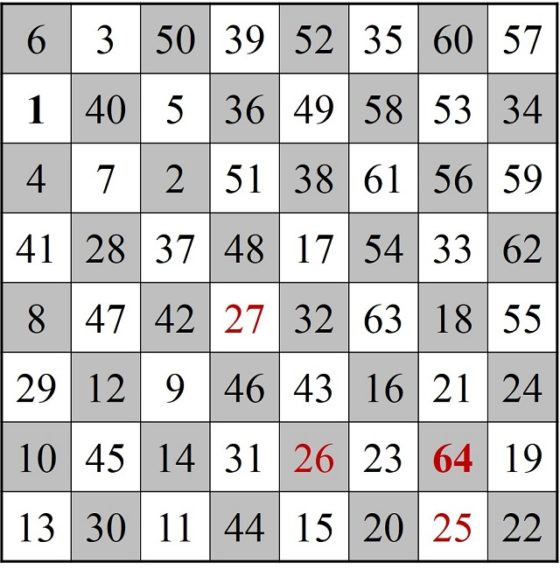

A continuación, mostramos el ejemplo que aparece en el libro Recreaciones matemáticas y ensayos (1892), de W. W. Rouse Ball, que según se menciona es un ejemplo que el matemático francés Adrien-Marie Legendre (1752-1833) considera especialmente difícil. Supongamos que, en esa búsqueda aleatoria de una solución del problema, se ha construido un recorrido que consta de 60 casillas, que nombramos 1, 2, 3, …, 59, 60, como estamos haciendo a lo largo de estas entradas, y se han dejado fuera cuatro casillas, que nombramos A, B, C y D, que son las que aparecen en la siguiente imagen (en negrita los números inicial y final del camino abierto y en rojo los de las casillas por las que no se ha pasado).

Lo primero que se hace es intentar cerrar el recorrido, aunque no tenga las 64 casillas. Nos fijamos entonces en la casilla 1 (la primera del recorrido), que es “adyacente” a las casillas numeradas como 2, 32 y 52, es decir, se llega a ellas con el salto del caballo desde la casilla 1, y en la casilla 60 (la última del recorrido), que es adyacente a 29, 51 y 59. Como las casillas 51 (cercana a la casilla 60) y 52 (cercana a la casilla 1) son adyacentes entre sí, vamos a poder construir un recorrido cerrado. Veamos cómo hacerlo.

Sencilla representación del recorrido del caballo desde la casilla 1 a la 60, junto con las dos adyacencias comentadas de la casilla 51, con la 60, y la casilla 52, con la 1

Sencilla representación del recorrido del caballo desde la casilla 1 a la 60, junto con las dos adyacencias comentadas de la casilla 51, con la 60, y la casilla 52, con la 1

Entonces, podemos determinar un recorrido cerrado que consiste en saltar por las casillas desde la 1 hasta la 51, de esta saltar a la 60, y seguir en orden inverso, desde la 60 hasta la casilla 52, que es adyacente a la casilla 1, cerrando así el paseo. Para que nuestro recorrido siga en orden, podemos renombrar las celdas 60, 59, 58, …, 53, 52 como 52, 53, … 58, 59, 60, es decir, en orden inverso. Si hacemos esto el recorrido que nos queda es el que aparece en la siguiente imagen y como vemos es un itinerario cerrado del 1 al 60, que aún no incluye las cuatro casillas A, B, C y D.

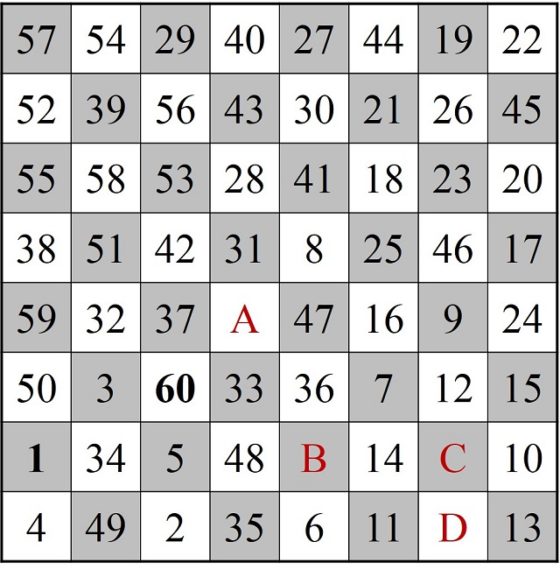

Ahora se trata de ver cómo añadir las casillas no recorridas. Las casillas A, B y D están conectadas mediante el salto del caballo, luego se trata de crear un nuevo recorrido abierto a partir de la ruta cerrada 1–60, que además incluya a A, B y D. Como resulta que la casilla A está conectada con las casillas 3, 5, 7, 25, 41, 51 y 53, podemos conectar la casilla 51 con las casillas A, B y C, y tendremos el recorrido abierto 52, 53, …., 60, 1, 2, …, 50, 51, A, B, C.

Sencilla representación del recorrido cerrado del caballo desde la casilla 1 a la 60, junto con el recorrido A-B-D adyacente a la casilla 51

Sencilla representación del recorrido cerrado del caballo desde la casilla 1 a la 60, junto con el recorrido A-B-D adyacente a la casilla 51

Ahora, para mantener nuestro recorrido (abierto) de 63 casillas en orden, vamos a renombrar las casillas 52, 53, …., 60, 1, 2, …, 50, 51, A, B, C, como 1, 2, 3, …, 59, 60, 61, 62, 63, como aparece en la siguiente imagen.

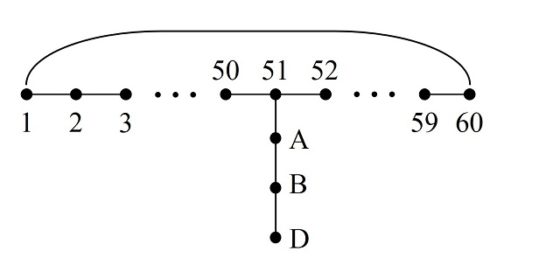

Por lo tanto, tenemos un recorrido abierto que va de la casilla 1 a la 63 y queda por saltar por la casilla C y cerrar el camino. Como resulta que C es adyacente a 25 y 63 es adyacente a 24, vamos a poder intercalar la casilla C consiguiendo así un recorrido abierto con las 64 casillas del tablero

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 63, con las adyacencias de la casilla C con la 25 y la casilla 24 con la 63

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 63, con las adyacencias de la casilla C con la 25 y la casilla 24 con la 63

Por lo tanto, el recorrido buscado empezaría en la casilla 1 e iría saltando hasta llegar a la casilla 24, de ahí se saltaría a la 63 y se iría saltando hacia atrás hasta la 25, de la cual se pasaría a la casilla C. Y de nuevo renombramos las casillas 1, 2, 3, …, 23, 24, 63, 62, …, 26, 25, C, para que quede el recorrido abierto del 1 al 64, como aparece en la siguiente imagen.

Ahora ya solo nos queda cerrar el recorrido, pero resulta que las casillas inicial (1) y final (64) están bastante alejadas la una de la otra, lo que dificulta poder realizar el cierre. Por lo tanto, Euler modifica el recorrido abierto por obtener otro que tenga las casillas inicial y final más cercanas. Para ello, Euler elige una celda que sea adyacente con la celda 1, en concreto, la celda 28, y que es adyacente a la celda 27, la cual está más cerca de la casilla 64.

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 64, con la adyacencia de la casilla 1 con la 28

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 64, con la adyacencia de la casilla 1 con la 28

Entonces, se considera el recorrido abierto que empieza en la casilla 27, va hacia atrás hasta la casilla 1, de donde salta a la 28 y sigue hasta la 64. Así tenemos un itinerario abierto, con el inicio y el final más próximos, pero antes renombremos nuestras casillas 27, 26, … 2, 1, 28, 29, …, 64 como 1, 2, 3, …, 61, 62, 63, 64 (imagen siguiente).

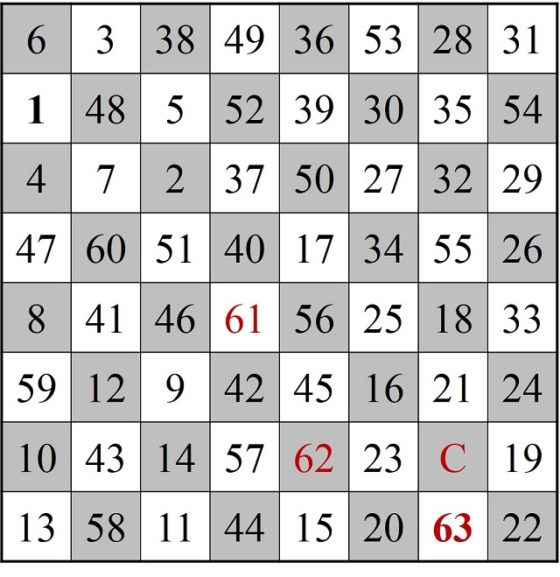

Finalmente vamos a poder cerrar el recorrido abierto, ya que las casillas inicial y final, ahora sí, están cercanas. Por ejemplo, la casilla inicial (1) es adyacente a la casilla 14, mientras que la casilla final (64) es adyacente a la casilla 13, y podemos hacer la misma jugada que hicimos al cerrar el primer camino.

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 64, junto con las dos adyacencias comentadas de la casilla 1, con la 14, y la casilla 64, con la 13

Sencilla representación del recorrido abierto del caballo desde la casilla 1 a la 64, junto con las dos adyacencias comentadas de la casilla 1, con la 14, y la casilla 64, con la 13

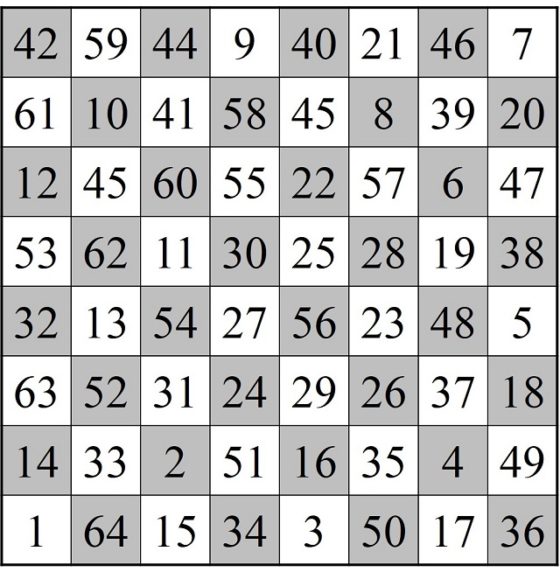

De la misma manera que al principio de la descripción de esta técnica, el recorrido cerrado será empezar con el 13 e ir saltando en sentido inverso hasta 1, de ahí saltar a la casilla 14 y seguir saltando hasta la casilla 64 (que cierra con la casilla 13). Solo nos falta renombrar el recorrido 13, 12, …, 2, 1, 14, 15, …, 64 como 1, 2, …, 63, 64, como vemos en la siguiente imagen.

Recorrido cerrado del caballo por el tablero de ajedrez, obtenido mediante la técnica de Euler

Recorrido cerrado del caballo por el tablero de ajedrez, obtenido mediante la técnica de EulerLa técnica de H. C. von Warnsdorff

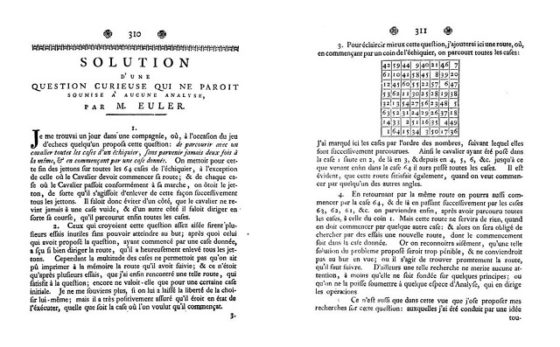

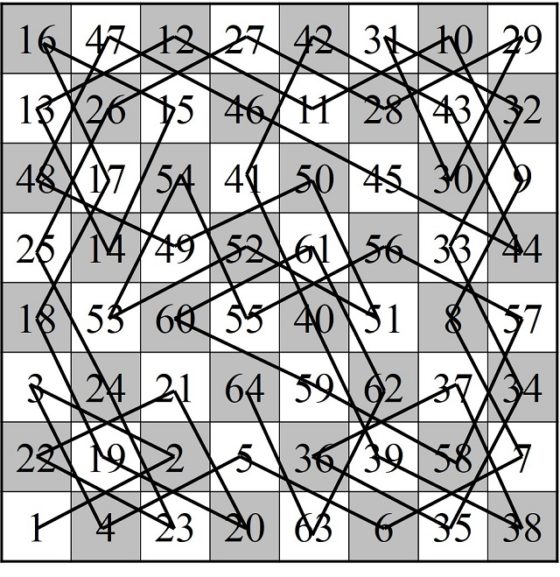

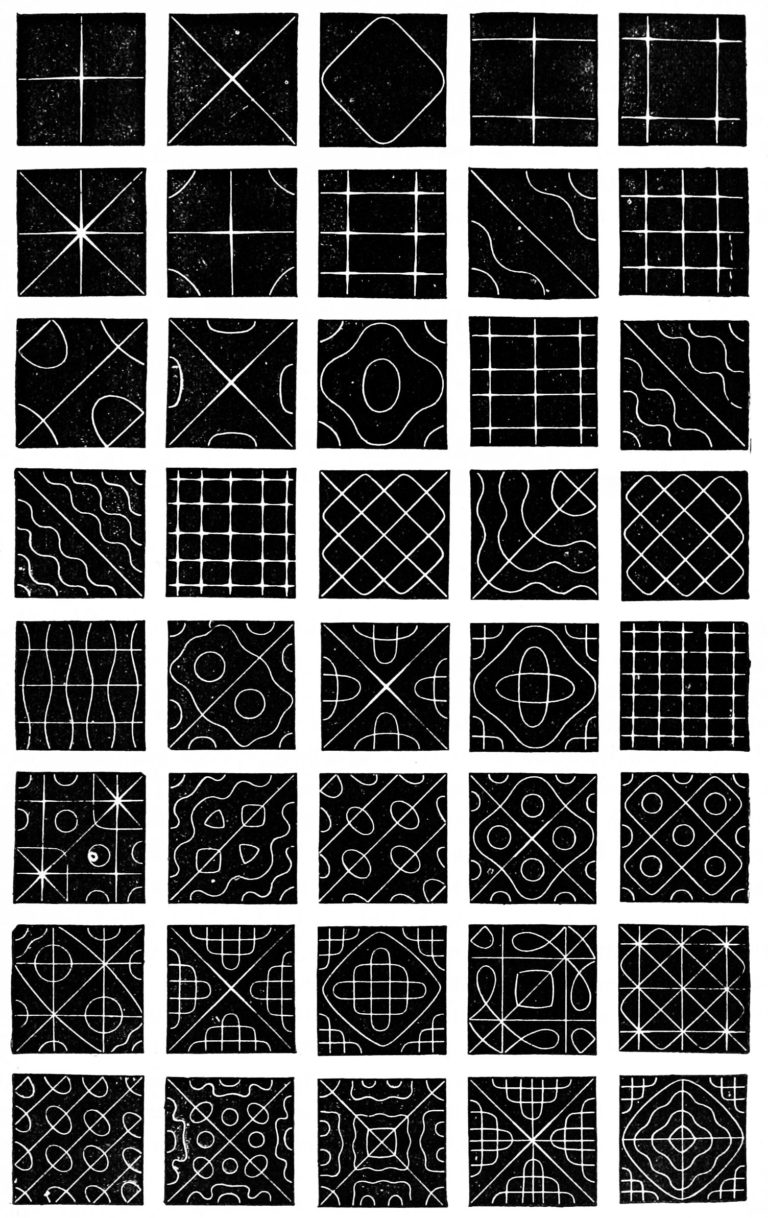

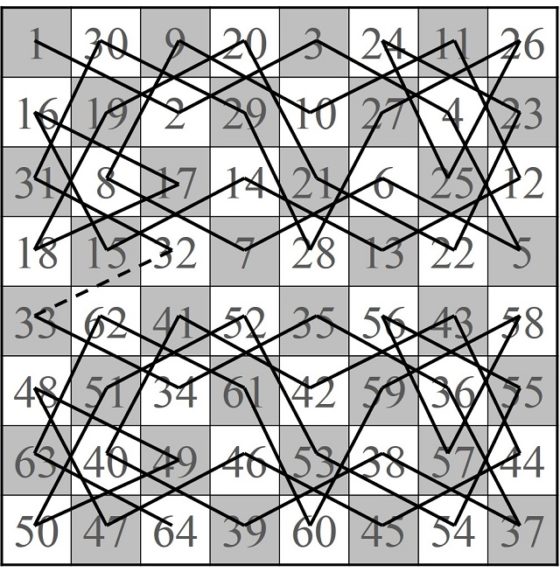

El alemán H. C. von Warnsdorff propuso un método sencillo y elegante de resolver el problema del recorrido del caballo, en su publicación titulada La solución más sencilla y general al salto del caballo (1823), que podéis encontrar en internet.

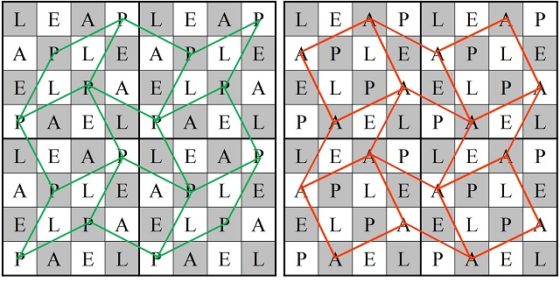

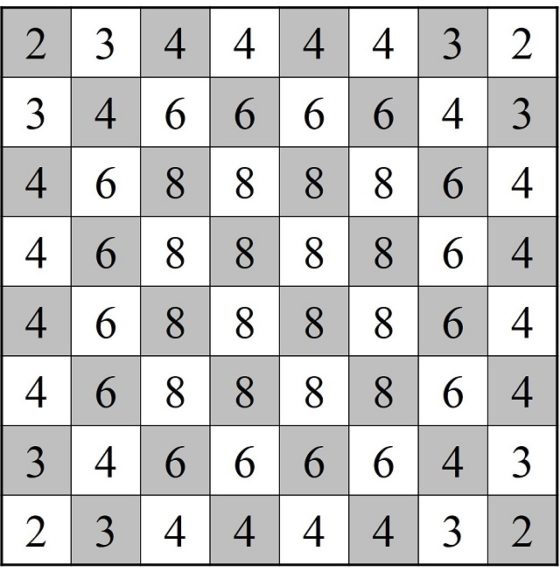

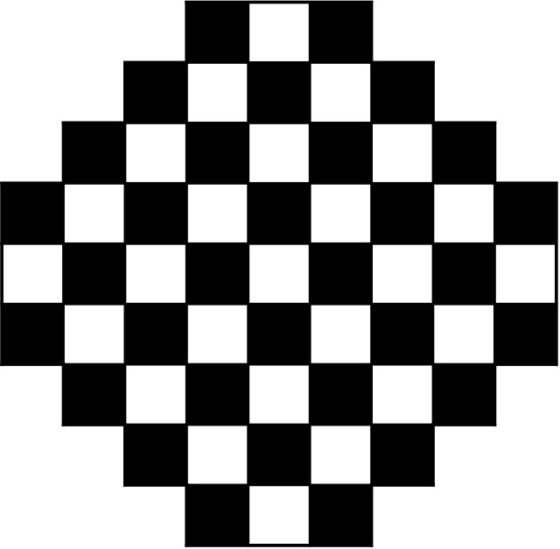

La técnica de H. C. von Warnsdorff para encontrar recorridos del caballo sobre el tablero 8 x 8 es la siguiente: Mueve el caballo a una casilla adyacente (es decir, a la que se llegue con el movimiento del caballo), que no haya sido visitada ya y que tenga el menor número de casillas adyacentes libres. Si se da un empate, elegir de forma arbitraria.

Esta es una regla intuitiva, puesto que indica que hay que visitar primero las casillas con menos conexiones, que son aquellas que si no se recorren en ese momento quizás, por la falta de conexiones, no se pueda regresar después a pasar por ellas, que realmente se puede utilizar para todo tipo de tableros rectangulares, que es bastante eficaz a la hora de buscar algunos recorridos particulares del caballo, aunque no es válida para una búsqueda exhaustiva, por ejemplo, los recorridos anteriores de Euler o Al-Adli sobre el tablero clásico no verifican la regla de von Warnsdorff.

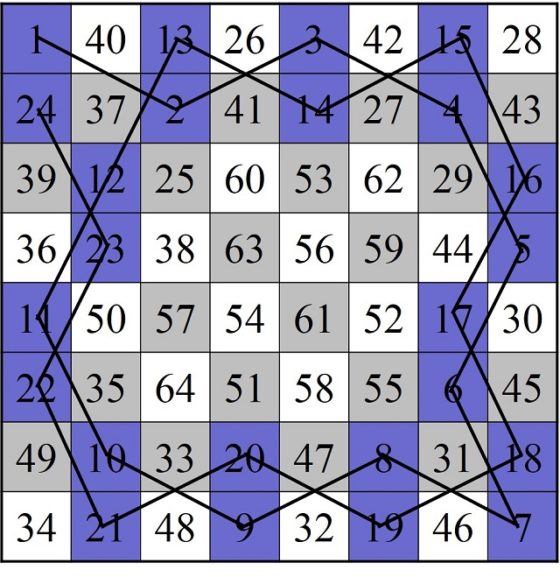

Recorrido del caballo sobre un tablero 8 x 8 obtenido mediante el método de von Warnsdorff

Recorrido del caballo sobre un tablero 8 x 8 obtenido mediante el método de von Warnsdorff

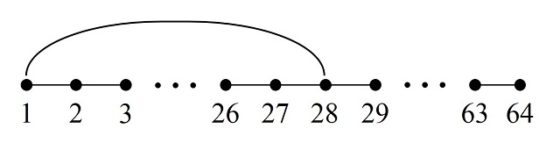

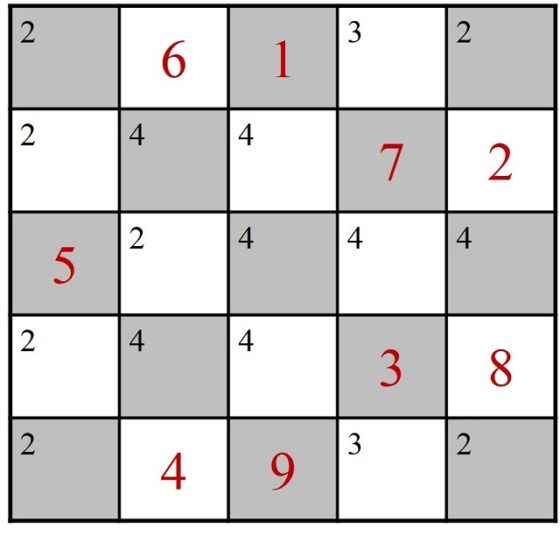

Sin embargo, el método no resuelve bien los casos en los que hay empates en el número de casillas adyacentes libres. Si se elige al azar la casilla en la que continuar, como sugiere Warnsdorff, puede ocurrir que el recorrido se pare en un momento intermedio y no pase por todas las casillas del tablero, como se muestra en el siguiente ejemplo 5 x 5.

Si utilizamos la regla de Warnsdorff para un tablero 5 x 5, empezando en la casilla del medio de la primera fila, el primer empate se produce al llegar a la casilla 9, que tiene dos opciones de continuidad, dos casillas con número de casillas adyacentes libres igual a 2, en el lateral y debajo de la casilla número 5.

Inicio de un recorrido construido con la técnica de von Warnsdorff, donde se indica con números rojos grandes las casillas recorridas, del 1 al 9, y con números pequeños negros las casillas libres conectadas con dicha casilla mediante el salto del caballo

Inicio de un recorrido construido con la técnica de von Warnsdorff, donde se indica con números rojos grandes las casillas recorridas, del 1 al 9, y con números pequeños negros las casillas libres conectadas con dicha casilla mediante el salto del caballo

Si se continúa con la casilla lateral, el recorrido se estanca después de la casilla 16, como se muestra en la siguiente imagen, puesto que si el caballo salta a la esquina de abajo a la izquierda (como indicaría la regla), ya no puede salir, pero si continuase por otra casilla, no volvería nunca a esa casilla que tiene 0 casillas adyacentes libres.

Inicio de un recorrido construido con la técnica de von Warnsdorff que se ha bloqueado en la casilla 16

Inicio de un recorrido construido con la técnica de von Warnsdorff que se ha bloqueado en la casilla 16

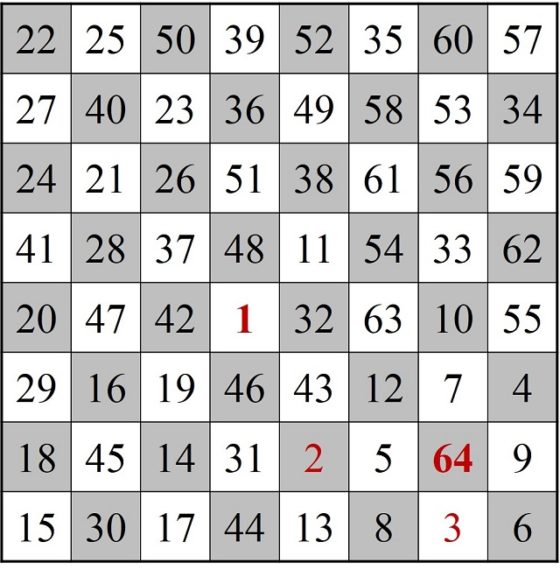

Sin embargo, si se continúa, tras el empate, con la casilla de debajo de la 5, existen varias soluciones continuando con la regla, una de ellas la mostrada en la imagen.

Recorrido final construido con la técnica de von Warnsdorff

Recorrido final construido con la técnica de von Warnsdorff

Puede verse en la literatura sobre el tema, que diferentes autores han modificado la regla de Warndorff mediante el diseño de métodos para determinar la mejor elección de una casilla cuando se produce un empate. El más sencillo de los cuales consiste en la elección, en caso de empate, de la casilla más alejada (con la distancia euclídea) al centro del tablero, que es el método que yo he utilizado para deshacer los empates en el recorrido mostrado anteriormente sobre el tablero 8 x 8.

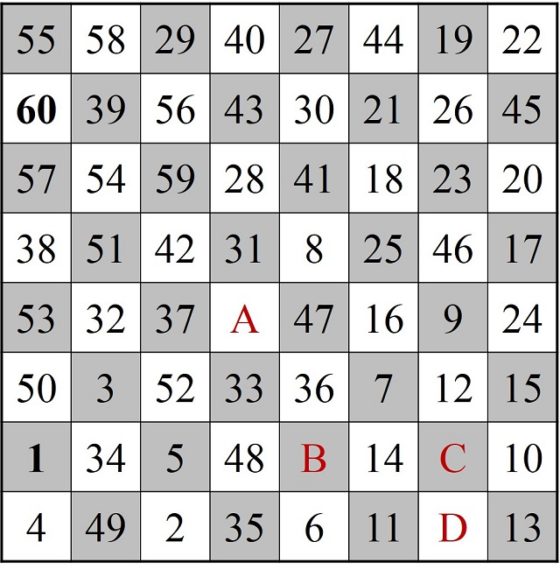

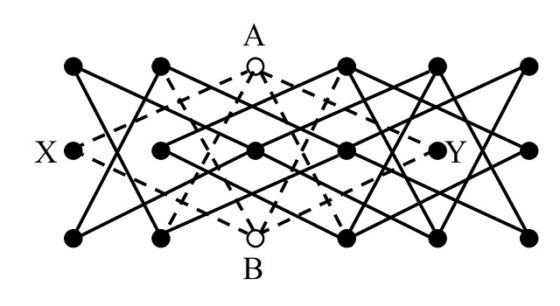

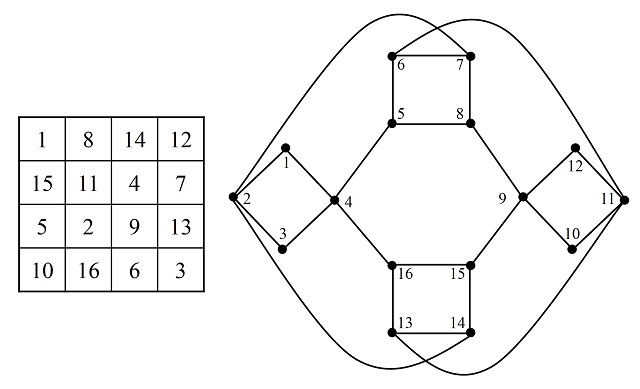

La construcción de RogetVamos a terminar esta entrada con el método que propuso el médico, matemático, físico, teólogo y lexicólogo británico Peter Mark Roget (1779-1869), en un artículo de la revista Philosophical Magazine en 1840.

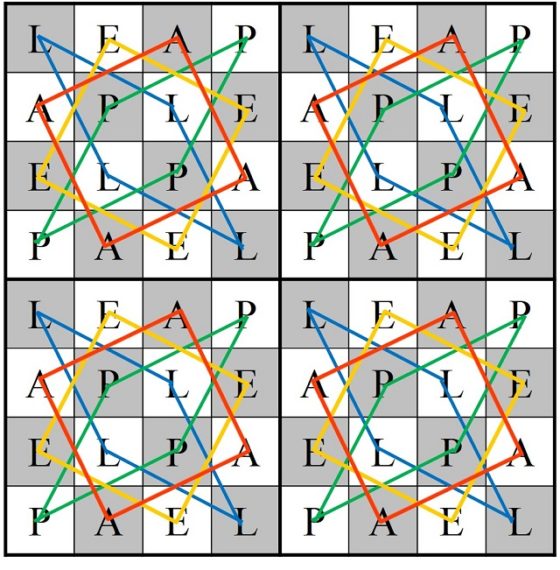

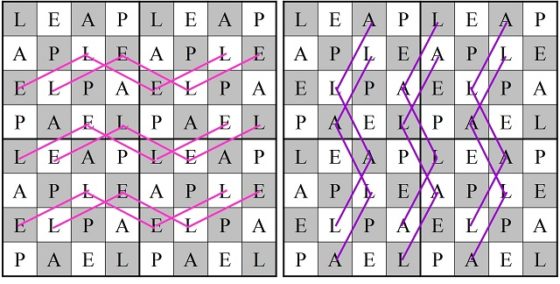

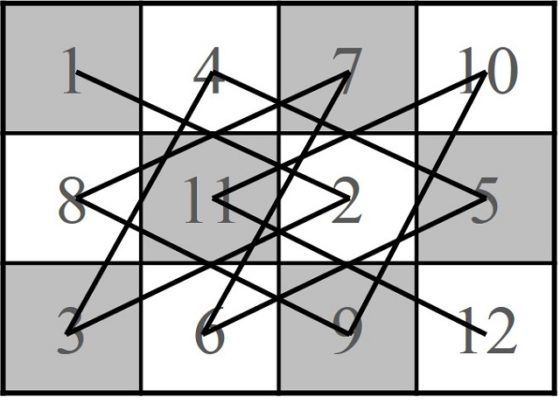

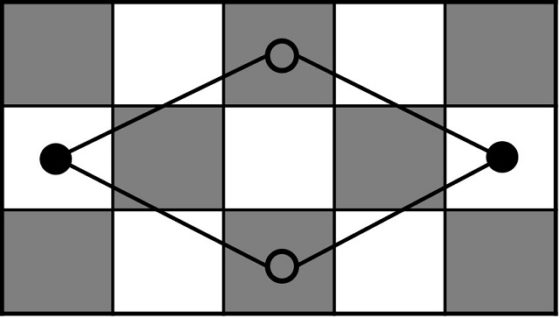

Roget divide el tablero 8 x 8 en cuatro zonas, cada una de ellas formada por un cuadrado 4 x 4, y las 16 casillas de cada cuarto de tablero las separa en cuatro grupos de 4 casillas, que forman un recorrido cerrado sobre esa zona 4 x 4. A cada una de las casillas de esos grupos, o recorridos cerrados, las nombra con una misma letra L, E, A, P (la palabra leap, en inglés, significa “salto”). Los recorridos de las letras L y P tienen forma de diamante, mientras que los de las letras A y E de cuadrado.

Entonces, Roget considera movimientos del caballo que son de tipo LL, EE, AA, PP (de una casilla de una letra a otra de la misma letra) y movimientos de tipo EL, AL, EP, AP (de una casilla con una letra vocal a una casilla con una letra consonante, o viceversa), como se muestra en las siguientes imágenes.

Movimientos de tipo LL y AA sobre el tablero de ajedrez

Movimientos de tipo LL y AA sobre el tablero de ajedrez

Movimientos de tipo EL y AL sobre el tablero de ajedrez

Movimientos de tipo EL y AL sobre el tablero de ajedrez

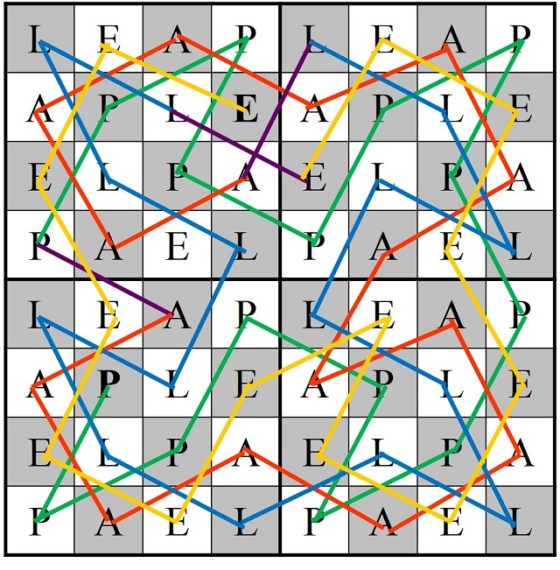

Con las 16 casillas de cada una de las letras se puede construir un circuito cerrado, luego disponemos de cuatro tipos de circuitos cerrados con 16 casillas, cada uno con cada una de las letras. Ahora para construir el recorrido de las 64 casillas se combinan cuatro circuitos de una sola letra de forma que después de un circuito de una vocal va uno de una consonante, y viceversa. En el siguiente ejemplo, hemos empezado con el circuito de la letra P, después el circuito de la letra A, luego L y finalmente E, creando un recorrido abierto.

Recorrido abierto del caballo sobre el tablero de ajedrez realizado con la técnica de Roget

Recorrido abierto del caballo sobre el tablero de ajedrez realizado con la técnica de Roget

Y no podía faltar un poco de arte para terminar la entrada.

Caballo negro (2006), del artista mexicano Carlos Orduña Barrera. Imagen de su página web: Carlos Orduña Barrera

Caballo negro (2006), del artista mexicano Carlos Orduña Barrera. Imagen de su página web: Carlos Orduña Barrera

Bibliografía:

1.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

2.- Édouard Lucas, Recreaciones Matemáticas, vol. 1 – 4, Nivola, 2007, 2008.

3.- Miodrag S. Petrovic, Famous Puzzles of Great Mathematicians, AMS, 2009.

4.- Harold J. R. Murray, A History of Chess (Historia del ajedrez), Oxford University Press, 1913.

5.- W. W. Rouse Ball, H. S. M. Coxeter, Mathematical Recreations and Essays, Dover Publications, 1987 (originalmente publicada por W. W. R. Ball en 1892 –la versión original puede encontrarse en el Proyecto Gutenberg – y extendida por el geómetra H. S. M. Coxeter en 1974)

6.- John J. Watkins, Across the Board: The Mathematics of Chessboard Problems, Princeton University Press, 2004.

7.- H. C. von Warnsdorf, Des Rösselsprunges einfachste und allgemeinste Lösung, Verhagen, 1823.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El problema del recorrido del caballo en el tablero de ajedrez (II) se ha escrito en Cuaderno de Cultura Científica.

Einstein y Newton

En el siglo XVII Isaac Newton básicamente creó la física del mundo moderno, desarrollando modelos acerca de la gravedad, la luz, la inercia, la masa, e incluso las matemáticas necesarias para comprender estos conceptos. La mecánica de Newton fue considerada como la descripción definitiva del universo, hasta que Einstein vino a cambiarlo todo.

Newton / Einstein Proxxi Composite (2003) de Daniel Rozin. Para ver correctamente la imagen debes tener en cuenta que la realidad depende del observador: aléjate de la pantalla (o minimiza el tamaño) hasta que veas a Newton; acércate (o aumenta el tamaño) para ver a Einstein. Fuente: Daniel Rozin / smoothware.com

Newton / Einstein Proxxi Composite (2003) de Daniel Rozin. Para ver correctamente la imagen debes tener en cuenta que la realidad depende del observador: aléjate de la pantalla (o minimiza el tamaño) hasta que veas a Newton; acércate (o aumenta el tamaño) para ver a Einstein. Fuente: Daniel Rozin / smoothware.comEinstein fue el que comenzó la revolución de la física moderna que terminaría derrocando el viejo paradigma de la física newtoniana, por lo que tanto Einstein como Newton crearon las bases de nuevas formas de pensar. Efectivamente, hay grandes paralelismos entre ambos físicos. Los dos tuvieron lo que ha dado en llamarse un “año maravilloso” cuando tenían veintitantos años. El de Newton fue el que él llamó “año de la plaga”, en 1666. Ese año creó el cálculo diferencial e integral, descubrió la ley de gravitación universal y determinó cómo la gravedad hace que los planetas se muevan en elipses. El de Einstein fue en 1905, durante el que publicó la teoría especial de la relatividad, la solución al problema del efecto fotoeléctrico (para la que aplicó la hipótesis cuántica a la luz), una explicación del movimiento browniano y la ecuación E = mc2.

Hay, sin embargo, una pequeña diferencia entre Einstein y Newton a la hora de tratar estos descubrimientos: Newton no publicó la mayoría de sus primeros trabajos hasta décadas después pero, cuando lo hizo, todo el mundo los aclamó como correctos inmediatamente. Los dos hombres también están unidos por el hecho de que ambos llegaron a ser tremendamente famosos durante sus vidas. Newton fue una figura tan iconográfica durante su época como Einstein lo fue en la suya, solo hay que sustituir una formal peluca británica por la melena alborotada de Einstein.

A lo largo de los siglos, la fama de Newton como fundador de la física moderna le había incrustado en la consciencia de la sociedad como el genio que había creado la ciencia tal y como se conocía. Surgieron, sin embargo, varias discrepancias, las más evidentes tenían que ver con la luz y la óptica.

Newton había lanzado la hipótesis de que la luz estaba constituida por “corpúsculos”, partículas como pequeñas bolas. En el siglo XIX varios físicos, entre ellos, más notablemente, James Clerk Maxwell, habían determinado que la luz era de hecho una onda. Pero los problemas para la mecánica newtoniana estaban solo comenzando. La teoría de Maxwell cuestionaba otras facetas de la visión del mundo de Newton. Para la época en que Einstein estaba haciendo el doctorado estaba claro para los físicos más perceptivos de que se estaba en medio de una crisis: o Newton estaba equivocado o lo estaba Maxwell. La publicación por Einstein en 1905 de la teoría especial de la relatividad fue el golpe decisivo: Maxwell era el ganador y la mecánica newtoniana, con su dependencia del tiempo y del espacio absolutos, era incorrecta. Pero Einstein no se paró ahí. Si bien no tenía un plan premeditado para desmantelar el edificio que Newton había construido, él fue el que vino a cambiar el concepto aceptado, mecánico y determinista, del mundo.

Einstein abordó la cuestión de la gravedad, dándose cuenta de que la forma en la que era comprendida no era compatible con su teoría de la relatividad. En 1911 publicaría su primera aproximación a la teoría general de la relatividad, que reformaba otra de las grandes teorías de newton: la ley de la gravedad universal. Newton había dicho que todos los objetos del universo se atraían entre sí con una fuerza proporcional a sus masas. Pero sabía que no podía ofrecer una idea de por qué esto era así. “Non fingo hypotheses”, no formulo hipótesis, fue su comentario ante su falta de una teoría. Con la relatividad general Einstein ofrecía una solución a por qué la gravedad funcionaba: dos objetos se atraían entre sí porque la masa distorsiona el espaciotiempo alrededor de ella de tal manera que cualquier otra masa en su cercanía se “desliza” hacia ella. En su forma más sencilla las ecuaciones de Einstein son equivalentes a las de Newton; las de Newton no son expresiones equivocadas, sino incompletas, y las de Einstein son más completas. Algún día aparecerá una teoría que complete aún más las de Einstein.

A pesar de haber contribuido tanto a bajar del pedestal en el que se encontraban las ideas de Newton, Einstein siempre profesó una gran admiración por el inglés. En 1940, en un artículo que escribió para Science titulado “Consideraciones acerca de los fundamentos de la física teórica”, Einstein dijo de Newton que fue la primera persona en “establecer una base teórica uniforme” para el mundo de la ciencia. Einstein seguía: “Esta base newtoniana probó ser sumamente fructífera y fue considerada definitiva hasta finales del siglo XIX. No solamente proporcionó resultados para los movimientos de los cuerpos celestes, hasta los más pequeños detalles, sino que también suministró una teoría de la mecánica de las masas continuas y discretas, una explicación sencilla del principio de conservación de la energía y una teoría completa y brillante del calor”. Newton había producido un conjunto de reglas, sistemático y omnicomprensivo, que unía todos los fenómenos conocidos en su época. Encontró que la mecánica era una forma tan buena de explicar la naturaleza que la aplicó a todo lo que vio; como lo hizo todo el mundo los doscientos años siguientes, hasta que llegó Einstein para cambiar de nuevo la visión del mundo.

Referencia:

Einstein, A. (1940). Cnsiderations concerning the fundaments of theoretical physics Science, 91 (2369), 487-492 DOI: 10.1126/science.91.2369.487

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 6 de junio de 2010.

El artículo Einstein y Newton se ha escrito en Cuaderno de Cultura Científica.

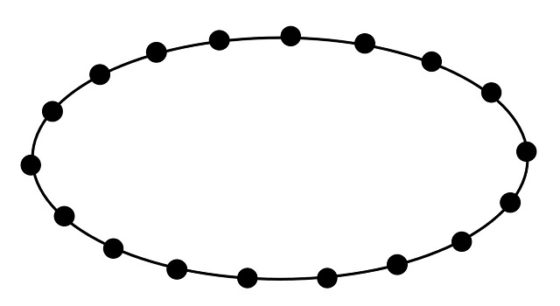

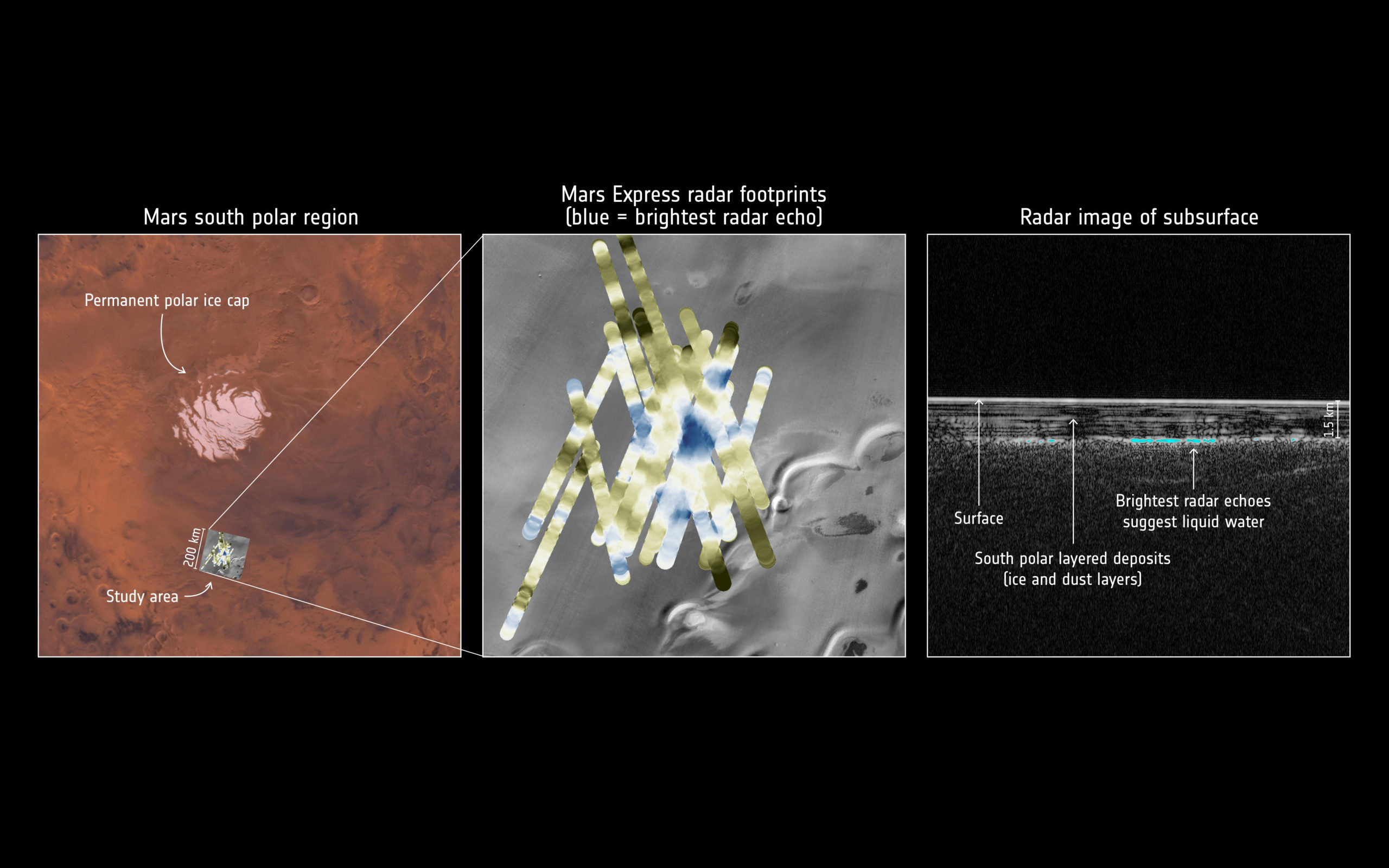

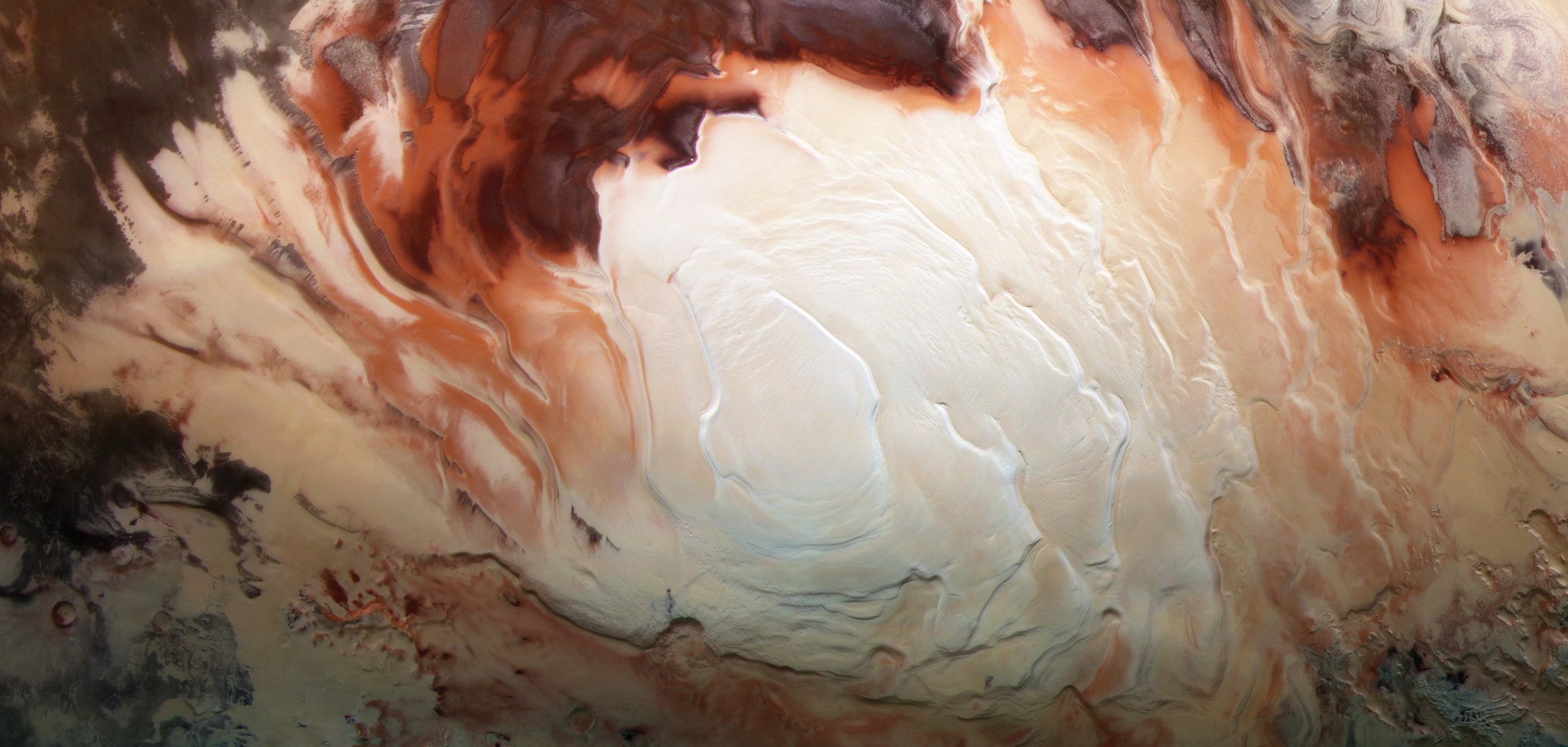

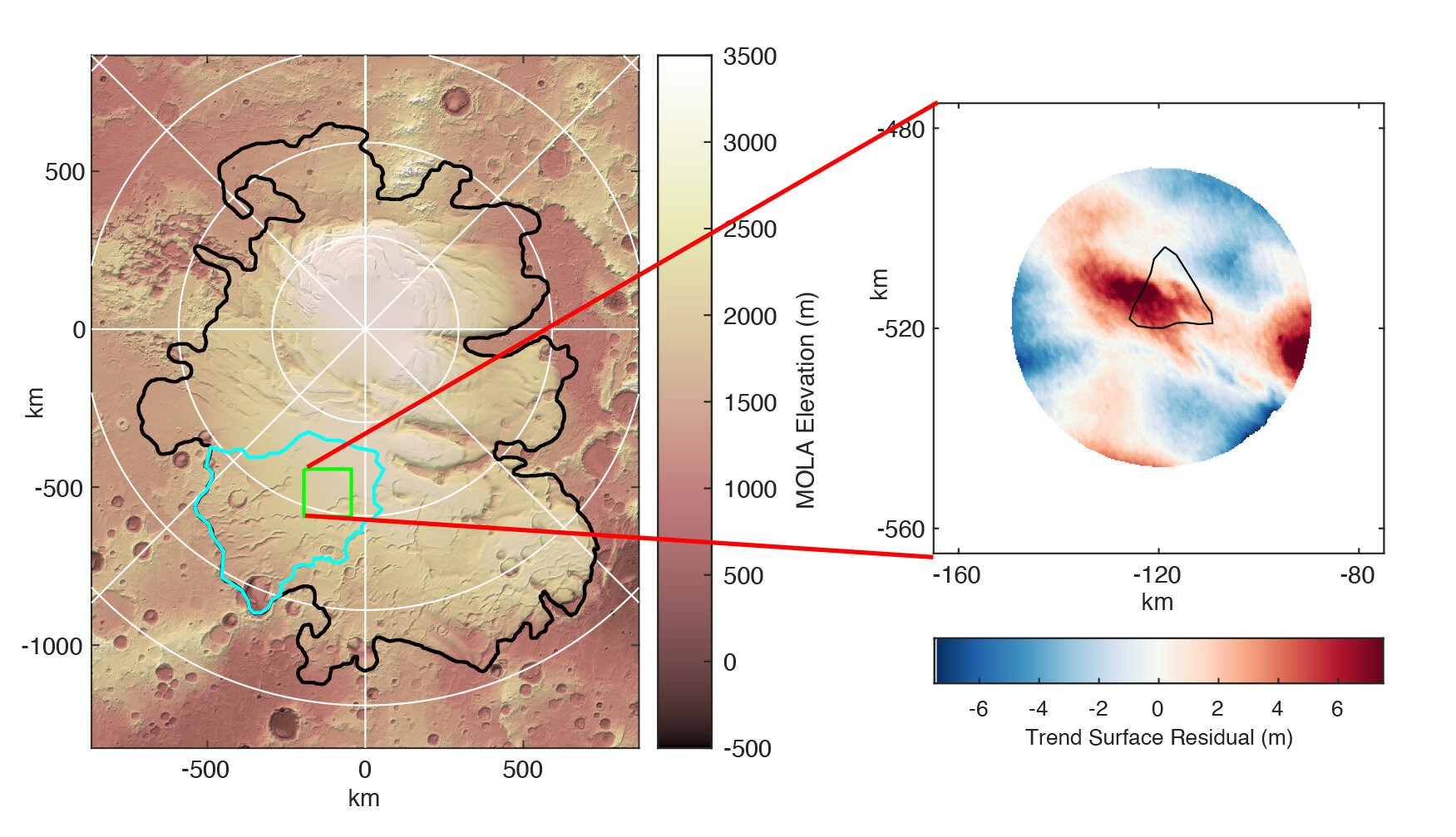

Lagos en(tre) el hielo de Europa

En el último artículo hablábamos de los lagos en Marte y su importancia a nivel astrobiológico, ya que supondrían una fuente relativamente estable de agua líquida, algo fundamental para el origen y desarrollo de la vida. Pero siempre que hablamos de lagos en nuestro Sistema Solar -más allá de la Tierra, claro está- las condiciones en las que el agua está líquida no tienen que ver en absoluto con las que existen en nuestro planeta, adecuadas para que haya un continuo ciclo hidrológico en superficie, algo que no ocurre en ningún otro cuerpo. Por ello, y por las grandes perspectivas que nos abre el agua a la hora de buscar ambientes habitables, nos hemos fijado en los denominados mundos océano, cuerpos de nuestro Sistema Solar en los que debajo de su corteza formada principalmente por hielo -frente a la rocosa de los planetas interiores- existe un océano de agua líquida. Incluso a nivel geodinámico, eso sí, tomándonos ciertas licencias, podríamos decir que estos océanos se comportan de algún modo como el manto de la Tierra, transfiriendo esa energía interna hacia el exterior, dando lugar a distintos procesos que transforman la superficie de estos cuerpos. Este sería el caso de Europa, la luna de Júpiter.

Una de las dudas que tenemos es si, además de los océanos subterráneos, existen otras masas de agua intermedias en la corteza, a modo de grandes bolsas de agua y que, de nuevo, tengan permanencia a lo largo del tiempo, ya que nos podrían servir de algún modo para poder estudiar ese océano más profundo sin la dificultad técnica que supondría llegar hasta él, puesto que esa agua vendría directamente desde las profundidades, emplazándose en la corteza.

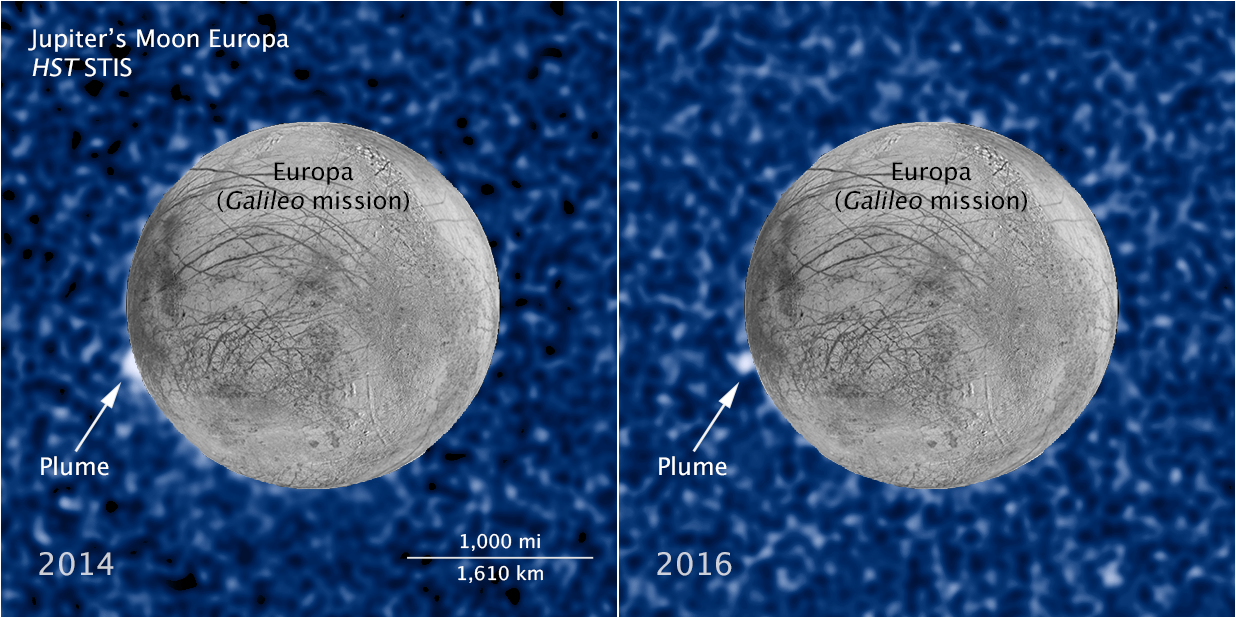

Detección de los posibles géiseres de vapor de agua por parte del Telescopio Espacial Hubble. Fuente: NASA, ESA, and W. Sparks (STScI).

Detección de los posibles géiseres de vapor de agua por parte del Telescopio Espacial Hubble. Fuente: NASA, ESA, and W. Sparks (STScI).Aunque todavía nos falta una confirmación más fehaciente de la existencia de fenómenos criovolcánicos en Europa, como pueden ser los géiseres detectados por el telescopio espacial Hubble, la existencia de una corteza con un espesor entre los 15 a los 25 kilómetros haría más complicadas las erupciones directamente desde un océano subterráneo.

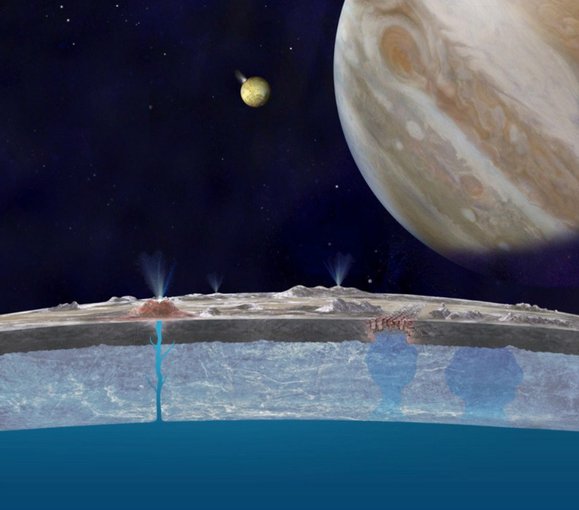

Un equipo de científicos acaba de publicar un artículo en The Planetary Science Journal en el que ha realizado distintos modelos en los que aparecen bolsas de agua en el interior de la corteza a profundidades que van desde los 4 a los 8 kilómetros de profundidad. El hielo tendría un comportamiento rígido y frágil, lo que facilitaría su fractura y permitiendo que el agua contenida en estas hipotéticas reservas fluyese con mayor facilidad a la superficie como vapor o como criolavas.

Distintos modelos para la formación de fenómenos criovolcánicos en Europa. Fuente: NASA.

Distintos modelos para la formación de fenómenos criovolcánicos en Europa. Fuente: NASA.¿Cómo ocurriría esto? Al ir congelándose estas bolsas de agua, se logra un aumento de volumen de esta agua que puede fracturar el hielo que las rodea, permitiendo salir al agua contenida. Este fenómeno es muy importante porque más que dar lugar a un continuo de géiseres como, por ejemplo, vemos en Encélado, permitiría tener una actividad intermitente y de ahí que sea más difícil de detectar.

Y, por supuesto, es un mecanismo compatible con una corteza de gran espesor, en la que no es necesaria la existencia sistemas de fracturas que atraviesen la corteza por completo, aunque tampoco un mecanismo excluiría la existencia del otro, e incluso haber coexistido en otros momentos de la historia geológica de Europa.

¿Cuándo tendremos respuesta a si este modelo es correcto? Muy probablemente a partir de la década de 2030, cuando la sonda Europa Clipper llegue al sistema joviano y sea capaz de estudiar con detalle la corteza de Europa, pudiendo detectar estas reservas de agua en la corteza de Europa y confirmar (o descartar) este nuevo modelo gracias a su instrumento REASON, un radar cuyas ondas serán capaces de penetrar en la corteza de hielo y aportarnos pistas sobre su estructura.

Referencias:

Lesage, E., Massol, H., Howell, S., & Schmidt, F. (2022). Simulation of Freezing Cryomagma Reservoirs in Viscoelastic Ice Shells. The Planetary Science Journal, 3(7), 170. doi: 10.3847/psj/ac75bf

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Lagos en(tre) el hielo de Europa se ha escrito en Cuaderno de Cultura Científica.

Motivos para el altruismo

Colonia de Demodus rotundus

Colonia de Demodus rotundusLos seres humanos compartimos comida y otros bienes. No lo hacemos con cualquiera, ni bajo cualquier circunstancia, pero es un comportamiento habitual. Por eso nos parece normal, aunque, a decir verdad, sea algo sorprendente, al menos desde un punto de vista evolutivo. Al ceder alimento, el que lo da pierde un recurso que podría darle una ventaja competitiva con relación a otros miembros del grupo.

Se suelen considerar tres posibles motivos por los que puede merecer la pena compartir alimento. Por un lado está la selección por parentesco, en virtud de la cual es ventajoso ser altruista con las personas (parientes) con las que se comparte una parte de los genes porque, ayudándolas, se facilita que una parte del patrimonio genético perdure. También se puede compartir por gorroneo tolerado (o consentido); se produce cuando quien tiene comida no es capaz de monopolizarla debido a los costes que le imponen quienes no la tienen y que, aunque no le obliguen a compartirla, pueden hacer que le resulte muy costoso no hacerlo. En tercer lugar está la reciprocidad, ya que quien hoy dispone de comida quizás haya recibido en el pasado ayuda de otro o podrá necesitarla en el futuro; esto es, sería ventajoso compartir comida en situaciones en las que la reciprocidad por parte de quien recibe puede acabar resultando conveniente en el futuro para quien comparte.

Nosotros no somos los únicos primates que compartimos comida. Los tres motivos citados en el párrafo anterior parecen estar en la base del comportamiento generoso de seres humanos y otros primates, como chimpancés, bonobos, capuchinos y tamarinos. Los dos motivos que más influyen son el gorroneo consentido y la reciprocidad, mientras que el de la selección de parentesco es algo menor.

En la especie humana las diferencias entre poblaciones en el grado de reciprocidad de sus miembros parecen estar relacionadas con el nivel de predictibilidad de la cantidad de alimento disponible. En aquellas en que es más incierta la posibilidad de disponer de comida de forma regular, la reciprocidad tiende a ser más importante.

El altruismo tampoco se limita a los primates. Desmodus rotundus se alimenta de sangre; es un vampiro de los de verdad, esto es, un murciélago hematófago. Además, comparte con otros vampiros de su mismo grupo la sangre que obtiene. Mediante experimentos diseñados a tal efecto se ha podido verificar que, al compartir la sangre, los murciélagos de esta especie establecen vínculos duraderos con sus congéneres, en virtud de los cuales adoptan el hábito de compartir comida entre ellos. Los individuos con los que lo hacen pueden ser de su misma familia o no serlo, por lo que no parece que su altruismo obedezca a la selección de parentesco. Por otro lado, dada la especial forma de compartir la sangre -regurgitándola-, tampoco es explicable este comportamiento por gorroneo tolerado.

En Desmodus rotundus hay altruismo recíproco. Cuando un vampiro da parte de su alimento a otro y establece así un vínculo con él, ambos salen beneficiados de esa relación, porque unas veces es uno el que consiga alimentarse y otras es el otro. Así, la probabilidad de que pasen privación en un entorno de posibilidades de alimentación inciertas disminuye para ambos. La pequeña cantidad de sangre que se comparte en cada ocasión puede representar, para el que la recibe, la diferencia entre reproducirse o no hacerlo, o entre sobrevivir o perecer, mientras que el que dona pierde solo una parte de lo conseguido. Por ello, el altruismo tiene en estos animales -que son, además, sociales- un altísimo valor adaptativo: la continuidad de todo el grupo depende de ello.

Fuentes:

Carter, G. G., Wilkinson, G. S., 2015, Social benefits of non-kin food sharing by female vampire bats. Proc. R. Soc. B.282 20152524 20152524

Jaeggi, A. V. y Gurven, M., 2013, Reciprocity explains food sharing in humans and other primates independent of kin selection and tolerated scrounging: a phylogenetic meta-analysis. Proc. R. Soc. B.280 20131615 20131615

Para saber más:

La unidad de selección en la evolución y el origen del altruismo

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Motivos para el altruismo se ha escrito en Cuaderno de Cultura Científica.

Naukas Pro 2022: Alimentos alternativos y sostenibles

“Quiero cambiar el mundo”. Si esta frase la pronunciara alguien de corta edad, probablemente se consideraría un golpe de entusiasmo propio de la juventud. Pero salida de la cabeza de un doctor en Física de Materiales e investigador de la NASA, en plena pandemia, podría considerarse un anticipo de algo realmente ambicioso. El dueño de aquel deseo fue Eneko Axpe, un científico baracaldés experto en la investigación de nuevos alimentos, a quien el COVID-19 clausuró los laboratorios en los que trabajaba y le dio la oportunidad de disfrutar de “tiempo para pensar”. Y lo hizo: reflexionó sobre cómo resolver uno de los principales problemas de la Humanidad, el cambio climático, y las consecuencias que este fenómeno tiene sobre aspectos como la alimentación y la sostenibilidad a nivel global.

De todo ello dio cuenta el propio científico en el Naukas Pro celebrado en el Palacio Euskalduna de Bilbao, donde expuso los esfuerzos investigadores que él mismo y que otras organizaciones llevan a cabo para diseñar alimentos alternativos y sostenibles capaces de asegurar las necesidades de la población de una forma saludable y respetuosa con el medioambiente.

Axpe compartió varios de los datos que, según sus palabras, le dejaron “anonadado” a la hora de abordar su sueño: el más impactante tenía mucho que ver, precisamente, con la relación entre la alimentación y la contaminación global. Según explicó, la comida es responsable del 26% de las emisiones de gases de efecto invernadero del planeta, muy por delante de otras fuentes contaminantes como la actividad aérea (el 1,9%) y el resto de los medios de transporte (el 11,8%).

También recordó que los 7.800 millones de personas que viven hoy en el planeta pasarán a ser 11.000 millones a finales de siglo, un hecho que contribuirá a esquilmar las fuentes de alimentación, y que los recursos que utilizamos para alimentarnos, como la agricultura y la ganadería, ocupan cerca de la mitad de la tierra habitable en el planeta, algo que consideró “terrible para la biodiversidad”. De hecho, afirmó que mientras el ser humano supone el 34% de la biomasa global de mamíferos, los animales encargados de nuestra alimentación, como el ganado bovino y los cerdos, acaparan el 35% y el 12%, respectivamente, muy por delante del 4% que suponen los animales salvajes o silvestres. “Se ha destruido biodiversidad para favorecer la cría de ganado”, constató.

Para completar esta relación entre la producción de alimentos, el consumo global y la sostenibilidad del planeta, Eneko Axpe ofreció un dato clarificador: una persona ingiere la misma cantidad de proteína en tres días consumiendo filetes de carne que a lo largo de todo un año comiendo guisantes. Y apostilló: “La mayoría de los productos beneficiosos para el medioambiente lo son también para la salud, hasta el punto de que su consumo puede llegar a incrementar nuestra esperanza de vida en 10 años”.

Con estos datos sobre la mesa, Eneko Axpe lanzó una pregunta al aire: “¿Cómo puede un científico de materiales ayudar a resolverlo?”.

A partir de ese momento reivindicó la importancia de la Física a la hora de diseñar alimentos alternativos saludables y sostenibles, y mencionó algunas de las investigaciones que él mismo y otras organizaciones han llevado a cabo en este campo. El investigador recordó un proyecto en el que consiguió crear hamburguesas y bacon a base de plantas en el laboratorio, con características organolépticas similares a las de la carne, y mencionó el “impacto positivo” que supuso esta ingesta para los consumidores.

A continuación recordó el resultado de otra investigación con la que se consiguió reproducir carne de vaca, sin sacrificar al animal, a través del cultivo celular obtenido de una simple biopsia, una opción que exige la construcción de grandes fermentadores que en la actualidad desarrollan varias empresas, entre ellas una donostiarra. Axpe explicó que el consumo de esta carne “crecida en laboratorio” ya fue aprobado en Singapur, con unos nuggets de pollo a los que siguieron salmón y otros productos de carne de vacuno como filetes y carne picada, con resultados prometedores.

El investigador mencionó otra estrategia que ya está en marcha y que consiste en crear carne con micelio, una sustancia similar a la raíz de un hongo que se cultiva en 3D y que genera tejidos similares a los de aquel alimento. Se trata de una iniciativa que también ha explorado la NASA pero con objetivos diferentes. En concreto, para diseñar productos con propiedades mecánicas como la madera de cara a la creación de futuros asentamientos en la luna o en otros planetas.

Eneko Axpe dejó para el final de su intervención “el proyecto más divertido e innovador”, un microbio que captura el CO2 para generar proteínas, una iniciativa que ya abordó la NASA en el proyecto Apolo de los años 60 con el objetivo de alimentar a los astronautas.

Estas iniciativas muestran la necesidad que tiene el ser humano de dar respuesta a las necesidades de alimentación de la población mundial de una forma sostenible.

Si no ve correctamente el vídeo use este enlace.

Para saber más:

¿Qué es realmente una dieta saludable y sostenible?

¿Realmente necesitamos insectos, microalgas o carne de laboratorio como fuentes alternativas de proteína?

Crónica de Roberto de la Calle / GUK

El artículo Naukas Pro 2022: Alimentos alternativos y sostenibles se ha escrito en Cuaderno de Cultura Científica.

Biojardineras o cómo depurar el agua con piedras, plantas y microorganismos

Biojardinera en el distrito de Santa Rita de Nandayure (provincia de Guanacaste, Costa Rica). Foto: Guillermo A. Durán / Flickr, CC BY-NC-ND

Biojardinera en el distrito de Santa Rita de Nandayure (provincia de Guanacaste, Costa Rica). Foto: Guillermo A. Durán / Flickr, CC BY-NC-NDCuando nos dijeron que era posible depurar aguas residuales cultivando plantas sobre un lecho de grava nos costó creerlo. Pero todavía nos sorprendió más conocer de primera mano el caso de la comunidad de El Rodeo, en El Salvador, donde recientemente se han instalado 60 biojardineras * para tratar las aguas grises de más de 80 familias y reutilizarlas en el riego.

Las aguas grises son las aguas residuales que proceden de la ducha, lavamanos y bañera, y se diferencian de las aguas negras, que provienen del inodoro.

Según datos de Naciones Unidas, más del 80 % de las aguas residuales se vierten en ríos, lagos o mares sin tratamiento previo, lo que provoca la contaminación de los recursos hídricos.

El sector agrícola representa aproximadamente el 70 % del consumo global de agua, por lo que crece el interés por la reutilización de las aguas grises para el regadío, especialmente en comunidades del sur global.

Pero ¿cómo se puede promover la instalación de sistemas de tratamiento de aguas residuales en comunidades con escasos recursos económicos y materiales?

El desarrollo de tecnologías alternativas apropiadas es fundamental para asegurar que todas las personas dispongan de un sistema de saneamiento adecuado y así contribuir a alcanzar algunas de las metas que se establecen en el sexto eje de los Objetivos de Desarrollo Sostenible de Naciones Unidas.

Entre otras opciones, las biojardineras o humedales artificiales acaparan mucha atención por ser sistemas accesibles, económicos, eficientes y sencillos de instalar y mantener.

Biojardinera instalada en la comunidad de El Rodeo (El Salvador). Foto aportada por las autoras.¿Cómo funcionan las biojardineras?

Biojardinera instalada en la comunidad de El Rodeo (El Salvador). Foto aportada por las autoras.¿Cómo funcionan las biojardineras?

Estos sistemas de saneamiento buscan replicar e incluso mejorar las condiciones que se dan en los humedales naturales para así aprovechar su capacidad de depuración. Combinan procesos físicos, químicos y biológicos.

A la entrada del sistema, las aguas se introducen en uno o varios tanques de pretratamiento, también llamados trampas de grasas, donde aceites y grasas se separan por flotación, y donde los sólidos pesados se recogen en el fondo del tanque.

A continuación, el agua pasa a una balsa rellena con grava. Es aquí donde ocurre la magia (o mejor dicho, la ciencia). Todos los elementos que se emplean en estos sistemas se combinan para lograr que las aguas salgan limpias y listas para reutilizarse.

Balsa rellena con grava para depurar las aguas. Foto aportada por las autoras.

Balsa rellena con grava para depurar las aguas. Foto aportada por las autoras.En la primera sección de la balsa se colocan piedras más gruesas con la misión de retener los sólidos gruesos suspendidos que no se han retenido en el pretratamiento.

La grava fina, que ocupa la mayor parte de la balsa, sirve para favorecer el crecimiento y la fijación de los microorganismos: pequeños organismos unicelulares que son los responsables de la digestión de la materia orgánica suspendida en el agua, el principal contaminante en las aguas residuales domésticas. Estos microorganismos están presentes en el suelo y en las aguas, y proliferan de forma natural cuando se dan las condiciones adecuadas, que es lo que se pretende replicar en el lecho de grava de la biojardinera.

Por último, las raíces de las plantas ayudan a retener pequeños sólidos suspendidos y sobre todo absorben los nutrientes generados por los microorganismos en la digestión de la materia orgánica.

Por tanto, cuando construimos una biojardinera tenemos que escoger unas plantas que se adapten al clima y puedan vivir con las raíces permanentemente inundadas (plantas acuáticas locales) y una grava que permita el paso del agua y la fijación de los microorganismos. Y si nos aseguramos de que los microbios no pasan hambre, la naturaleza se encargará del resto.

También un elemento decorativoAunque el logro principal de la biojardinera es garantizar un nivel de depuración de las aguas grises suficiente para que sea posible su reutilización o su vertido sin alterar el equilibrio de sistemas hídricos naturales, este sistema tiene otras ventajas.

La parte aérea de las plantas es decorativa y tiene un impacto visual positivo, lo que facilita su integración paisajística en cualquier ubicación.

Además debido al elevado nivel de eliminación de carga orgánica, el agua que sale de la biojardinera se puede emplear para regar jardines, árboles frutales o para asegurar la producción hortícola durante la época seca en las regiones tropicales.

En la mayoría de casos las biojardineras se utilizan para el tratamiento de aguas grises procedentes de hogares, por lo que se adaptan muy bien a entornos domésticos. No obstante, se han instalado con éxito a mayor escala, como por ejemplo para el tratamiento de las aguas procedentes de los comedores de la Universidad de El Salvador.

La ciencia de los humedales artificialesAunque el interés por los humedales artificiales como solución natural para el tratamiento de aguas comenzó en los años 80, hasta hace unos años estos sistemas no llamaron la atención de la comunidad científica.

En la última década la necesidad de ahondar en el conocimiento de los mecanismos de depuración para optimizar el diseño y aprovechar todo el potencial de estos sistemas ha despertado el interés por este tipo de soluciones naturales.

Recientemente, miembros del Departamento de Ingeniería Química de la Universidad del País Vasco hemos estudiado la polivalencia de estos sistemas mediante el modelado matemático y simulación de su funcionamiento. Hemos demostrado que son capaces de soportar cambios de caudal y composición de las aguas grises e incluso las variaciones estacionales de las regiones tropicales.

Biojardineras en su jardínUna de las ventajas que hace más atractiva la implantación de los humedales artificiales es la facilidad de construcción y mantenimiento de la instalación durante su vida útil. Es por ello que muchas comunidades del sur global están apostando por este sistema para el tratamiento de aguas grises domésticas, como por ejemplo en El Salvador y en Costa Rica.

Si son tantas las ventajas de las biojardineras, ¿por qué no instalar este sistema en nuestro jardín?

Actualmente hay disponibles numerosos manuales sobre cómo construir y mantener biojardineras. Así que si disponemos de un terreno y podemos hacer acopio de algunos materiales de construcción sencillos (como tuberías de plástico y bidones), en unas pocas semanas podremos disponer de nuestro propio sistema sostenible para el tratamiento de aguas residuales domésticas.![]()

Sobre las personas autoras: Onintze Parra Ipiña es investigadora predoctoral en Ingeniería Química en la UPV/EHU y secretaria de la junta directiva de Mugarik Gabeko Ingeniaritza / Ingeniería Sin Fronteras País Vasco., y Roberto Aguado es catedrático de Ingeniería Química de la UPV/EHU.

Nota:

[*] El proyecto de construcción de biojardineras en El Salvador fue financiado por el Ayuntamiento de Bilbao (proyectos 2019-017085 y 2020-015220) y coordinado por Ingeniería Sin Fronteras País Vasco.

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Biojardineras o cómo depurar el agua con piedras, plantas y microorganismos se ha escrito en Cuaderno de Cultura Científica.

Heráldica geológica

Suelo insistir mucho en la idea de que la Geología se encuentra en todo lo que nos rodea y que nos ha condicionado como especie y como sociedad, aunque muchas veces no sea tan sencillo darnos cuenta. Por eso, en esta ocasión os traigo a colación un tema curioso donde también la Geología tiene mucho que decir. Se trata de la heráldica, es decir, los escudos de muchas localidades del mundo.

Cuando un pueblo o una ciudad tiene que crearse su propio escudo heráldico elige como tema central alguna cosa que sea característica de dicha localidad. Puede ser un castillo enorme que se hizo famoso por alguna batalla antigua, un árbol milenario que ya se encontraba ahí antes de los primeros asentamientos humanos de la zona o un puente sin cuya presencia no habría sido posible la conexión comercial con otros pueblos de su alrededor. Pero, ¿qué sucede cuando lo más característico de una localidad es alguna cosa geológica? Pues que se incluye en su escudo. Así que vamos con algunos ejemplos muy curiosos y relativamente cercanos.

Escudo de la localidad de Murero, provincia de Zaragoza, con un trilobites de color dorado. Fuente

Escudo de la localidad de Murero, provincia de Zaragoza, con un trilobites de color dorado. FuenteEn la provincia de Zaragoza se encuentra una localidad llamada Murero que posee un yacimiento paleontológico del periodo Cámbrico que se ha convertido, científicamente hablando, en uno de los más importantes del mundo, llegando a describirse numerosas especies nuevas desconocidas para la ciencia. Este yacimiento de trilobites le ha dado fama mundial al pueblo, convirtiéndose en una de sus mayores características distintivas, lo que ha provocado que uno de estos fósiles sea el protagonista del escudo de la localidad.

Escudo de Tejada (Burgos), en el que aparecen dos ammonites. Fuente

Escudo de Tejada (Burgos), en el que aparecen dos ammonites. FuenteUna historia similar la encontramos en Tejada, provincia de Burgos. En los alrededores de esta localidad se encuentran un buen número de afloramientos de los periodos Jurásico y Cretácico con abundante contenido fósil, siendo los más llamativos los ejemplares de ammonites que llegan a alcanzar varios centímetros de diámetro. Hace algo más de una década, dicha localidad quiso potenciar su turismo como un recurso económico, dándose cuenta de que uno de sus recursos más llamativo era su patrimonio geológico, así que crearon un museo, un centro de interpretación y varios recorridos geológicos, llegando a modificar su escudo añadiéndole dos fósiles de ammonites.

Pero no solo de paleontología vive la heráldica. Numerosas provincias españolas tienen una historia minera muy antigua y variada que ha llegado a caracterizar su desarrollo social e industrial durante siglos. Y eso también se ve reflejado en los escudos de muchas localidades muy ligadas a la minería.

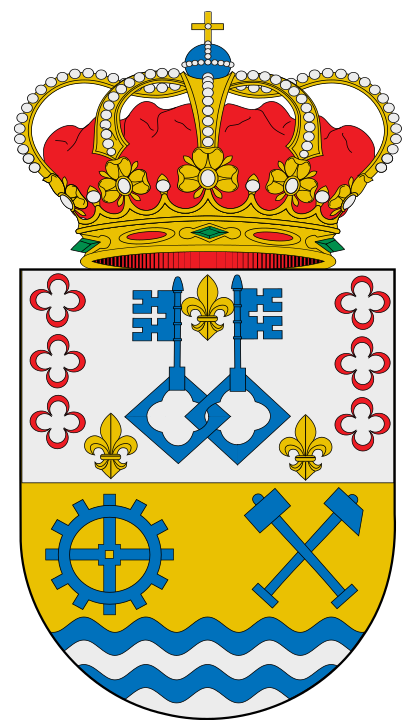

Escudo del Ayuntamiento de Minas de Riotinto, provincia de Huelva, con dos martillos cruzados y ondas blancas y rojas que representan al río Tinto. Fuente

Escudo del Ayuntamiento de Minas de Riotinto, provincia de Huelva, con dos martillos cruzados y ondas blancas y rojas que representan al río Tinto. FuenteEn la provincia de Huelva se encuentra el Ayuntamiento de Minas de Riotinto, cuyos yacimientos de sulfuros de hierro, cobre, plomo y cinc fueron explotados en diversas minas desde tiempos remotos, incluso antes de que los romanos se asentasen en la Península Ibérica. De hecho, la alteración superficial de estas mineralizaciones, que cuenta con una buena ayuda de bacterias extremófilas, ha provocado la típica coloración rojiza del río que atraviesa la zona, de ahí que se llame río Tinto. Pues en el escudo de este ayuntamiento encontramos dos martillos cruzados, uno de aspecto antiguo y otro más moderno, y unas ondulaciones en las que se alternan ondas de color blanco y de color rojo que representan al río Tinto.

Escudo de Mieres (Asturias) con los símbolos de la minería del carbón y la siderometalurgia. Fuente

Escudo de Mieres (Asturias) con los símbolos de la minería del carbón y la siderometalurgia. FuenteOtra de las cuencas mineras más famosas de toda la Península Ibérica son los yacimientos de carbón de Asturias, que marcaron el desarrollo social e industrial de muchas localidades desde su descubrimiento a comienzos del siglo XVII hasta no hace demasiadas décadas. Y esta eventualidad también ha quedado reflejada en varios escudos heráldicos. Un ejemplo lo encontramos en el escudo del Concejo de Mieres, que se caracteriza por presentar una maza y un martillo cruzados junto a una rueda dentada, símbolo de la industria siderometalúrgica que se impulsó en toda esta zona.

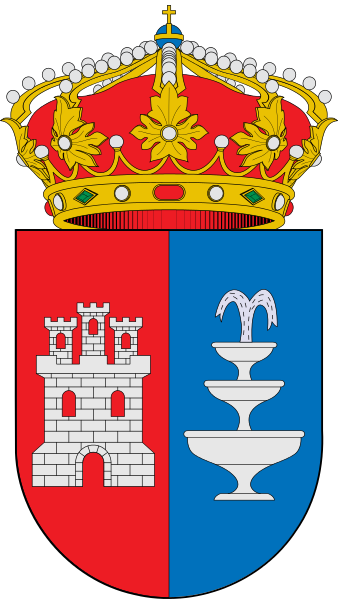

Escudo de Lanjarón (Granada) con la representación de Sierra Nevada y sus famosas aguas. Fuente

Escudo de Lanjarón (Granada) con la representación de Sierra Nevada y sus famosas aguas. FuenteTambién existen recursos geológicos a priori menos obvios de identificar, pero que también han sido y son muy importantes para el avance de muchas localidades y que forman parte indispensable de sus heráldicas. Me estoy refiriendo al agua minero-medicinal. En el escudo de la localidad de Lanjarón, en la provincia de Granada, aparecen una montaña y una pequeña fuente de la que fluyen dos chorros de agua. De manera similar, en el escudo del Ayuntamiento de Medio Cudeyo, al que pertenece la localidad de Solares, en Cantabria, encontramos una gran fuente de la que sale a presión un chorro de agua que se bifurca en dos. En ambos casos queda en evidencia la importancia del agua hidrotermal en el desarrollo económico y social de estas localidades.

Escudo de Medio Cudeyo (Cantabria), con una fuente de la que fluye un chorro bifurcado de agua. Fuente

Escudo de Medio Cudeyo (Cantabria), con una fuente de la que fluye un chorro bifurcado de agua. FuenteY es que, tal y como decía al principio, la Geología nos rodea y nos condiciona tanto que ya ni nos damos cuenta de su impronta en nuestra sociedad. Pero siempre está ahí y, en muchas ocasiones, bien visible.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Heráldica geológica se ha escrito en Cuaderno de Cultura Científica.

Frances Chick Wood, de la química a la estadística médica

Frances Chick Wood comenzó a trabajar como química en temas relacionados con la polimerización y con la fermentación de la uva. Pronto sus intereses giraron hacia la estadística médica, disciplina en la que realizó destacadas aportaciones.

Frances Wood. Fuente: Significance

Frances Wood. Fuente: SignificanceFrances Chick nació el 25 de diciembre de 1883 en Londres en el seno de una familia metodista. Fue la sexta de las siete hermanas que llegó a la vida adulta en una prole de doce niñas y niños. Como el resto de sus hermanas, fue educada de manera estricta y asistió al Notting Hill High School, una escuela femenina célebre por su esmerada educación en ciencias.

Cinco de las hermanas, incluida Frances, continuaron sus estudios superiores y obtuvieron grados universitarios. Entre ellas se encuentra la reconocida nutricionista Harriette Chick (1875-1977).

Frances estudió en el University College de Londres, graduándose con honores en química en 1908. Ese mismo año obtuvo un puesto de investigadora química en el Instituto Lister de Medicina Preventiva, institución en la que en ese momento ya trabajaba su hermana Harriette.

En 1910, el Instituto Lister contrató al epidemiólogo y estadístico Major Greenwood (1880-1949) para inaugurar en la institución un Departamento de Estadística. Frances asistió a una serie de conferencias impartidas por el médico y, a partir de 1911, comenzó a trabajar a tiempo completo en estadística médica. Entre otros trabajos, Chick comenzó a investigar la correlación entre las condiciones de los hogares y el desarrollo mental de los estudiantes de las escuelas primarias. Tan solo tuvo tiempo de recopilar los datos e iniciar su análisis. Al estallar la Primera Guerra Mundial en 1914 fue destinada a la Cámara de Comercio. Posteriormente fue transferida al Ministerio de Municiones donde permaneció hasta marzo de 1919, momento en el que renunció debido a su embarazo. En 1911 se había casado con Sydney Wood, un inspector de la Junta de Educación. A finales de septiembre de 1919 dio a luz a una niña, Barbara. Frances falleció dos semanas más tarde, el 12 de octubre, por una septicemia tras su parto por cesárea.

Frances Chick Wood como estadística médicaLa carrera estadística de Frances Wood fue breve, pero de gran relevancia.

En 1913 publicó dos artículos en solitario. En el primero de ellos, «The course of real wages in London, 1900–12», documentó de manera detallada cómo los números índice (medida estadística utilizada para comparar una o varias magnitudes en distintas situaciones temporales o espaciales) usados por la Cámara de Comercio para medir los cambios a lo largo del tiempo en los salarios, los precios minoristas y el alquiler no eran satisfactorios. En su segundo artículo «The construction of index numbers to show changes in the price of the principal articles of food for the working classes» ampliaba el anterior estudio. Volvió a este tema en 1916 en su publicación «The increase in the cost of food for different classes of society since the outbreak of war» en la que subrayaba que las clases medias podían amoldarse al aumento de los precios de los alimentos cambiando la composición o la calidad de su dieta, mientras que las clases trabajadoras no tenían esta flexibilidad. “Queda perfectamente claro que, con creces, el mayor aumento en el coste de los alimentos, durante los últimos dos años, ha recaído en la clase menos capaz de soportarlo”, afirmaba la investigadora en este trabajo.