Microscopios petrográficos y libros de geoquímica

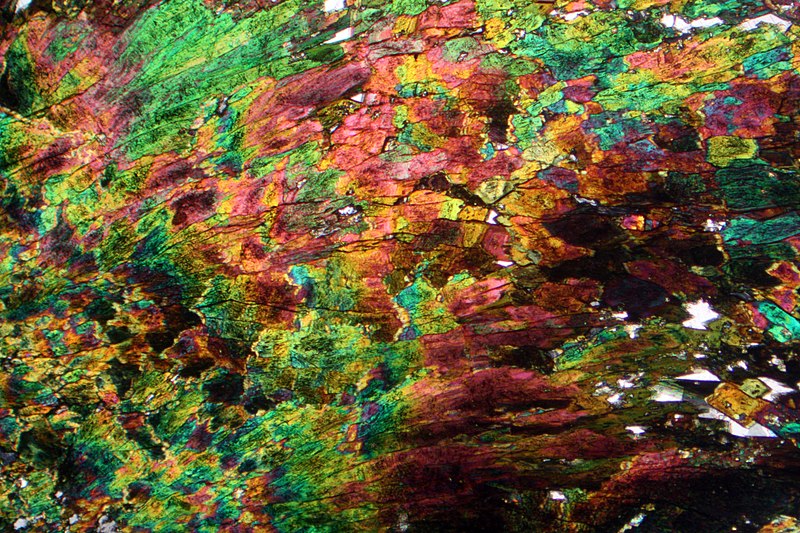

Sección delgada de una roca siberiana en la que se aprecia la presencia de egirina, en verde. Fuente: Strekeisen / Wikimedia Commons

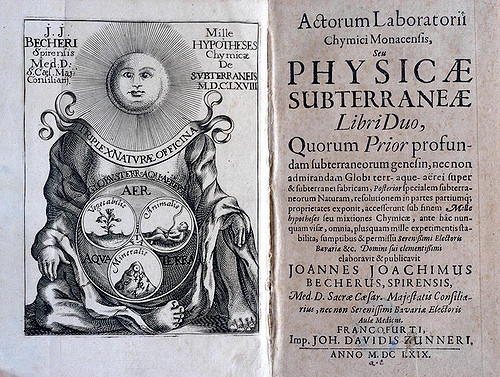

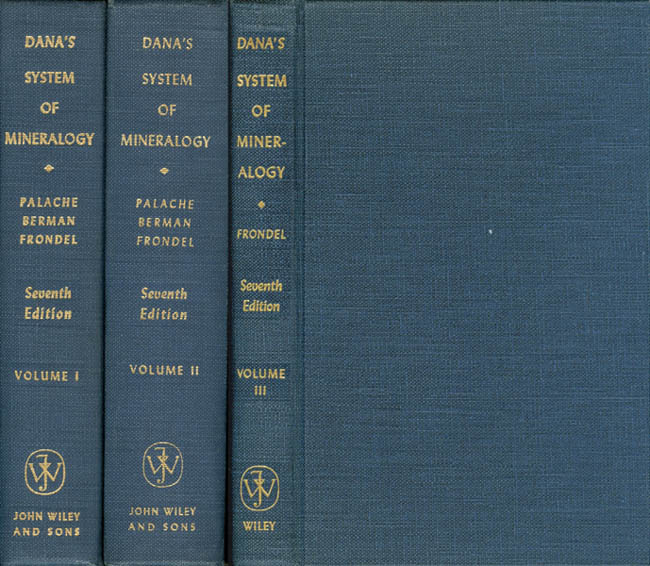

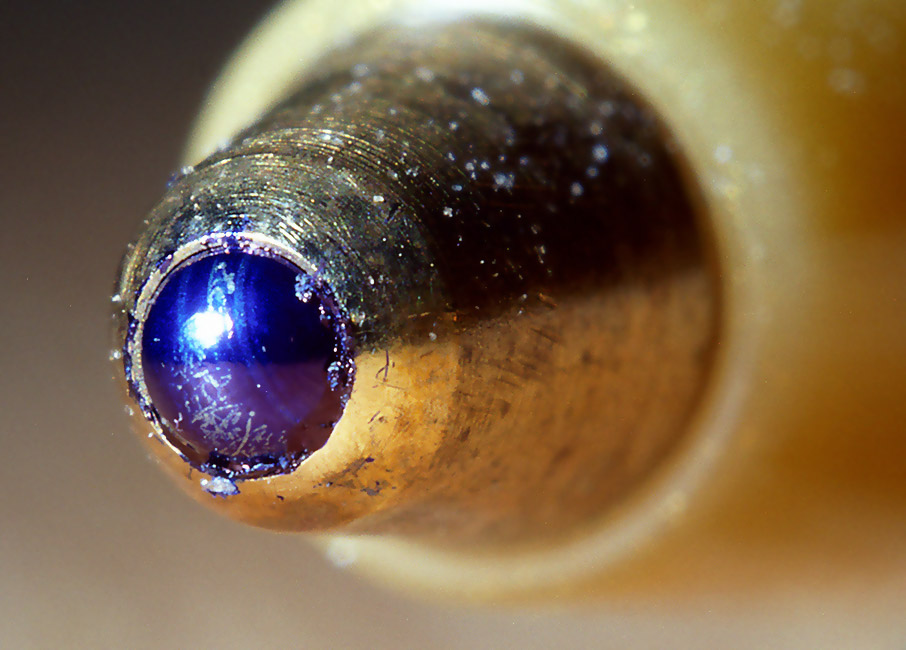

La química, como hemos visto, fue la principal herramienta mineralógica durante los tres primeros ciartos del siglo XIX. En 1858 Henry Clifton Sorby publica On the Microscopical Structure of Crystals en lo que supone la adpatación al uso mineralógico de un instrumento que se había desarrolado en la primera mitad del siglo: el microscopio de luz polarizada.

Colección de secciones delgadas “C. G. S.” (José Ramírez del Pozo y M. Aguilar). Litoteca de sondeos del Instituto Geológico y Minero de España (IGME). Peñarroya (Córdoba, España). Fuente: PePeEfe /Wikimedia Commons

En el microscopio petrográfico, como terminó conociéndose el microscopio de luz polarizada, se colocan una secciones delgadas del mineral o de la roca en unos soportes que pueden rotarse bajo unas lentes que polarizan la luz. Los cambios de color característicos que se producen al rotar el soporte permiten identificar los minerales presentes.

Extición de un cristal de cuarzo por la rotación de los filtros polarizadores en una roca de ortogneis, formada por una deformación seguida de una cristalización en el granito. Fuente: Chmee2 / Wikimedia Commons

Esta nueva técnica permitió a los mineralogistas ver e identificar por primera vez agrupaciones minerales que hasta ese momento eran invisibles para el ojo desnudo. El microscopio petrográfico proporcionó un impulso enorme a la mineralogía y a la petrografía, y sus consecuencias tecnológicas y económicas fueron de la mayor importancia al revolucionar la producción de materiales y las prospecciones mineras. Así, por ejemplo, el trabajo pionero del propio Sorby con el microscopio transformaría completamente la industria del acero, pasando de estar basada en un arte a tener una base científica.

Microscopio tipo Rosenbusch en la exposición “Laboratoire d’Europe Strasbourg, 1880-1930” en el “Musée d’art moderne et contemporain” de Estrasburgo. Fuente: Ji-Elle / Wikimedia Commons

Karl Heinrich Rosenbusch desarrolló tanto el uso del microscopio como su diseño. Su trabajo tendría como resultado un libro de texto que marcaría un antes y un después en la mineralogía, convirtiéndose en un clásico: Mikroskopische Physiographie der petrographisch wichtigen Mineralien (1873).

En paralelo a los avances técnicos la discusión sobre los orígenes de las rocas no paraba. A lo largo del siglo XIX las teorías, eso sí, se hacen mucho más sofisticadas. Probablemente la aportación más significativa a la discusión la proporciona el británico Charles Lyell, quien sugiere que, además de rocas primarias (volcánicas, plutónicas) y secundarias (sedimentarias), los geólogos necesitan una cuarta categoría para entender lo que ven, que él llama rocas metamórficas. Éstas surgirían por la transformación de las otras clases debido a la acción del calor y la presión.

Pero las teorías petrológicas y cosmogónicas, como la filosofía, estaban separadas por el Canal de la Mancha. Si bien los mineralogistas de la Europa continental podían admitir que los gneises, los esquistos y, quizás, el granito podrían ser problemáticos, no por ello renunciaban a sus posiciones neptunianas [*], esto es, su creencia en que el agua, quizás con la intervención del calor, la temperatura y la presencia de determinadas sustancias químicas muy reactivas, era la clave para el cambio petrológico.

Carl Gustav Bischof, resumió el estado de la cuestión, desde el punto de vista continental, en lo que se convertiría en el primer libro de texto, en sentido estricto, de geoquímica Lehrbuch der chemischen und physikalischen Geologie (1847-1871).

La resolución del conflicto vendría del otro lado del Atlántico, gracias al trabajo de un físico matemático: Josiah Willard Gibbs.

Nota:

[*] Veremos más adelante con algo más de detalle, como ya hemos comentado en otra parte, las discusiones entre neptunianos y plutonianos.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Microscopios petrográficos y libros de geoquímica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Qué puedes hacer tú para proteger a las abejas

Este domingo 20 de mayo se ha celebrado el primer Día Mundial de las Abejas, una iniciativa impulsada por la ONU a petición de Eslovenia para llamar la atención sobre la importancia que este insecto tiene en miles de ecosistemas, el desastre que puede suponer su desaparición y la necesidad de impulsar medidas para conservarlo. Eslovenia está especialmente implicada en esta iniciativa porque las abejas forman parte de su cultura hasta el punto de haber puesto en marcha una industria en torno al apiturismo.

Salvar a las abejas es, según defiende esta iniciativa, un esfuerzo en manos de todos, tanto de los gobiernos nacionales que manejan las políticas agrarias y climáticas que afectan a los hábitats y el bienestar de las abejas como de los organismos municipales y también los particulares que cuidan y diseñan parques y jardines públicos o privados. Incluso las personas que cuidan plantas en sus ventanas y balcones pueden poner su granito de arena para cuidar de las abejas y demás polinizadores que son parte imprescindible de nuestros ecosistemas.

Si tienes un jardín, o si de alguna forma puedes influir en el diseño y mantenimiento de los parques de tu municipio, incluso si estás pensando con qué decorar las macetas de tu edificio, aquí van algunas ideas directas de las cuidadoras del Pollinator Garden, perteneciente al Smithsonian, que se encargan de crear el ambiente perfecto para que las abejas sobrevivan y se reproduzcan en las mejores condiciones.

1. Aprende a apreciar lo silvestre

Este es quizá el más valioso de los consejos que dan las cuidadoras del Pollinator Garden: cuidar de las abejas es cosa de todos y quizá para ello tengas que renunciar a la pulcritud extrema de tu jardín.

Porque es raro encontrarse con alguien a estas alturas que no esté familiarizado con el riesgo que sufren las abejas en todo el mundo, y las catastróficas consecuencias que podría tener para los ecosistemas de todo el mundo su desaparición. A eso hay que añadir las consecuencias puramente económicas: desde la apicultura hasta diversas industrias agrarias dependen de que estos pequeños animales cumplan con eficacia la labor de polinización.

Y aunque todos lo tenemos muy claro, algunos seguimos pensando que es un problema de otros, y pulimos hasta el extremo nuestros parques y jardines eliminando de ellos cualquier resquicio acogedor para esos animales que tenemos tan claro que hace falta proteger. ¿No es esto un poco contradictorio?

2. Más jardines y menos céspedes

Empecemos por poner en práctica ese amor por lo ligeramente silvestre en el mismo estilo del jardín.

Un césped verde brillante y bien cortado es la imagen idílica de un jardín cuidado, pero es todo lo contrario de lo que necesitan las abejas, para las que toda esa extensión se verde homogéneo es el equivalente a un desierto. Si se puede, un jardín diverso y de plantas que generen polen es mucho más nutritivo para las abejas, que se alimentan de ese polen. Así que si por cuestiones estéticas o pragmáticas cubres grandes áreas de césped, intenta que haya otras zonas cercanas donde crezcan plantas diversas y, si es posible, con flores.

3. Planta flores locales

A menudo plantas e insectos evolucionan en paralelo para especializarse y sobrevivir a la vez. Elegir plantas autóctonas con flores es una buena forma de preservar la flora local y además alimentar a las abejas y otros polinizadores locales, que a menudo se ven amenazadas por otras especies de insectos invasores. Al hacerlo se producirá un aumento en la eficiencia de polinización y con ello mejorarán las perspectivas de supervivencia de las especies locales, tanto de las plantas como de los insectos.

4. Planta especies diversas en tamaño, color y forma

En la variedad está el gusto, también en las plantas que pueblan tu jardín si lo que quieres es favorecer la supervivencia de insectos y abejas, que también a su vez son diversos en tamaños y formas. Además, un jardín con diversidad de especies es más resistente a amenazas como plagas o contaminación, asegurando así una mayor fuente de alimentos para sus polinizadores.

5. Aprovecha toda la estación de floración

Pensamos en las flores como algo de la primavera, pero algunas especies florecen en verano, y las últimas pueden llegar incluso hasta octubre (que se lo digan a los alérgicos de otoño). Si se incluyen en parques y jardines especies que florezcan en distintos momentos del año, las abejas y otros polinizadores encontrarán alimento durante un periodo más amplio, facilitando su supervivencia.

6. Proporciónales agua y alojamiento

Piensa en tu jardín menos como en un adorno o paisaje que mirar y más como en un ecosistema donde puedan vivir distintas especies. Entre otras cosas, puede tratar de incorporar una fuente de agua, aunque sea pequeña, y también algunos rincones donde puedan anidar los polinizadores. Si tienes en la cabeza la imagen de una colmena colgando de un árbol, olvídate. Una tinaja de barro, unas cajas de madera o una zona de tierra despejada para que construyan su colmena bajo ella pueden ser igual de acogedoras.

7. Reduce la frecuencia con la que cortas el césped

No hace falta que tu jardín se convierta en un prado, pero si tienes césped, dale un poco de margen para crecer y asilvestrarse un poco. Como decíamos al principio, un jardín es un entorno mucho más amigable que un césped homogéneo para que habiten las abejas, pero si tienes uno, siempre puedes permitir que crezca un poco más de lo habitual para que las colonias de insectos puedan establecerse y sobrevivir en él.

8. Cuidado con los pesticidas

Para eliminar pulgones y otras plagas a menudo se emplean pesticidas sin control y sin cuidado. Los compuestos fitosanitarios son parte esencial de una agricultura eficaz, pero a la hora de cuidar de un parque o jardín es importante tener en cuenta el impacto que su uso tendrá no solamente en la especie o plaga a eliminar, sino en todas las demás que conforma su ecosistema. Algunos estudios, incluido un informe de la Agencia Europea de Seguridad Alimentaria, han confirmado que determinados tipos de pesticidas suponen un riesgo para las abejas. A veces solo basta que una se contamine para que viaje de vuelta a su colonia y termine intoxicando a todas las demás.

Si tienes un jardín o cuidas de un parque, considera utilizar otros métodos contra las plagas, como por ejemplo, la introducción de otros insectos que actúen como depredadores: mariquitas, mantis religiosas o avispas entre otros. Por si acaso consulta a un especialista en plagas, pero muchas veces, cuantos más insectos, mejor.

Referencias

Fall in love with bees in a ‘apiturism’ trip to Slovenia – The New York Times

How to protect your local polinators in ten easy ways – Smithsonian Magazine

Neonicotinoids: risk to beed confirmed – EFSA

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Qué puedes hacer tú para proteger a las abejas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo mejorar a las abejas con fractales

- Una ecuación para hacer un submarino indetectable

- La menopausia… ¿para qué sirve? Seguimos sin respuesta

Indispensable, discreta y sin dueño

Si alguien les pregunta cuáles son los principales productos sobre los que se ha erigido nuestra civilización, es probable que respondan que el petróleo. También es posible que citen el hierro. Quizás alguien nombre el plástico. Y yo añadiría el papel. Pero pocos pensarían en la arena, ese producto formado por granos principalmente de cuarzo (sílice) -aunque la composición varía dependiendo de su origen- y cuyos tamaños se encuentran entre los 0,06 y 2 milímetros. La arena no es tan conspicua como el petróleo, el hierro o el plástico, por lo que quizás no seamos muy conscientes de hasta qué punto dependemos de ella. Pero nos es indispensable: con arena se fabrica el hormigón, los ladrillos y el yeso con los que se han levantado las aldeas, ciudades y urbes modernas, y construido las vías que las conectan. Con arena se fabrica el vidrio que ha hecho accesible la luz a nuestros hogares. Y los microchips.

La arena es discreta pero la usamos en cantidades ingentes: sólo en 2010 se utilizaron en el mundo once mil millones de toneladas para fabricar hormigón, lo que representa alrededor de dos terceras partes del gasto de arena total. Se estima que en la actualidad se emplean cuarenta mil millones de toneladas de arenas y gravas. Es un recurso que, como el petróleo, ha hecho falta mucho tiempo para formarse y no se renueva. De hecho, cada vez es más difícil conseguirla y su extracción causa daños graves a los ecosistemas marinos. Y no, la arena del Sahara y otros desiertos no sirve; sus granos son muy finos y están demasiado redondeados por la erosión del viento. La mejor arena para fabricar hormigón es la que se deposita en los lechos fluviales; la marina no es adecuada porque los cloruros que contiene son corrosivos para las armaduras de acero.

La necesidad de arena es tal que en Italia la mafia ha entrado en el negocio, y en India hay numerosos grupos mafiosos a su alrededor. En Marruecos, Argelia, Vietnam, Indonesia y Malasia están documentadas extracciones ilegales de arena, pero se estima que son habituales en 70 países. Al menos 24 islas han desaparecido en Indonesia por la acción de los piratas de la arena, que la venden en Singapur para arrebatar espacio al mar.

En tanto no se hallen alternativas, lo más conveniente sería reducir las necesidades de hormigón tratando de disminuir la construcción de nuevas edificaciones e infraestructuras, pero hace falta incluso para poder mantener en buenas condiciones las actuales. Se ensayan procedimientos para la conservación del hormigón basados en la capacidad de ciertas bacterias y hongos para producir carbonato cálcico, que actuaría rellenando las grietas que surgen con el paso del tiempo, pero esa vía no puede ofrecer soluciones en plazos razonables. Otra posibilidad consiste en su reciclaje, pero el volumen que permiten reciclar las demoliciones no va más allá del 20% de las necesidades.

Es muy posible que haya que cambiar los métodos actuales de construcción y hay quien piensa que quizás la impresión en tres dimensiones de grandes estructuras con materiales diseñados ad hoc pueda ser la solución. Aunque lo más probable es que las soluciones no lleguen de ninguno de los métodos o materiales en los que se piensa ahora, sino de algún procedimiento radicalmente nuevo.

El número de granos de arena que hay en el mundo es una socorrida metáfora para expresar grandes cantidades. Pero no es infinito. Es un recurso sin dueño, escaso y del que todos pueden aprovecharse, un recurso afectado por una “tragedia de los bienes comunes” de extensión planetaria.

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 11 de marzo de 2018.

El artículo Indispensable, discreta y sin dueño se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Matemática discreta y trasplantes cruzados de riñones

- Animación suspendida

- Los castillos de arena en Titán no necesitan agua

Naukas Bilbao 2017 – Javier de la Cueva: Proyecto Richfields, un ejemplo de proyecto 2020

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Los proyectos Horizon 2020 son proyectos de integración europeos en los que participan instituciones y empresas de varios países. Javier de la Cueva, usando el ejemplo del proyecto Richfields, reflexiona sobre lo que estos proyectos enseñan sobre la investigación y los investigadores en Europa.

Javier de la Cueva: Proyecto Richfields: Un ejemplo de Horizon 2020Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Javier de la Cueva: Proyecto Richfields, un ejemplo de proyecto 2020 se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Francisco R. Villatoro: El espín para irreductibles

- Naukas Pro 2017: Javier Burgos y el alzhéimer

- Naukas Bilbao 2017 – Carolina Jiménez: Ciencia y cine, avanzando de la mano

Estimación del umbral de lactato usando ‘machine learning’

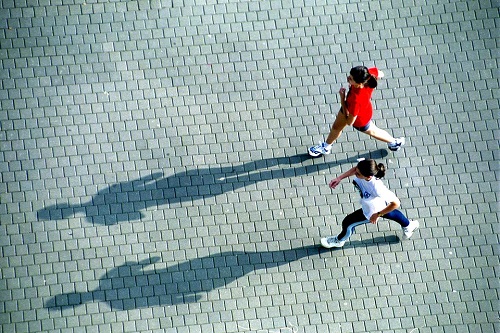

El umbral de lactato es considerado una variable fisiológica de gran utilidad tanto para estimar el rendimiento de atletas de resistencia como para apoyar la prescripción de sus entrenamientos. Una investigación llevada a cabo por los grupos de investigación GCIS de la Escuela de Ingeniería de Bilbao y el Departamento de Fisiología de la UP/EHU propone un sistema para calcularlo de manera no invasiva y accesible.

Hasta ahora se han propuesto múltiples métodos para calcular el umbral de lactato. Algunos de ellos se basan en la utilización de equipamiento especializado y/o personal cualificado para su cálculo; otros utilizan test de campo para estimarlo. Mientras que los primeros son costosos y poco accesibles, los segundos no consiguen alcanzar la fiabilidad necesaria para su aplicación. Es precisamente aquí donde se sitúa este proyecto desarrollado en la UPV/EHU, con el objetivo de crear un sistema accesible, no invasivo y fiable que ayude a la toma de decisiones del atleta y/o entrenador.

Para ello, en esta investigación se ha propuesto un sistema de aprendizaje automático que encuentra la relación entre variables fisiológicas fácilmente medibles y el umbral de lactato. De esta manera, por medio de la relación aprendida, el sistema es capaz de estimar el umbral de lactato de nuevos atletas.

Para desarrollar este sistema, el proyecto ha contado con una muestra de más de 140 corredores de diferentes niveles y características, de manera que representa lo mejor posible la población objetivo de atletas recreacionales de resistencia.

“El principal objetivo del proyecto es crear un sistema que realmente sea aplicable y útil para atletas y entrenadores. Por lo tanto, pretende ser una herramienta de apoyo a la toma de decisiones que sea fácil de integrar en la caja de herramientas del entrenador o del atleta, para que pueda utilizarlo como complemento a su conocimiento”, explica Urtats Etxegarai.

En un sistema tan complejo como el cuerpo humano, las diferencias interindividuales son grandes, incluso dentro de lo que a priori puede parecer una población bien definida como los atletas recreacionales de resistencia. Es por ello que, el principal reto de este proyecto es conseguir un sistema válido para una población tan diversa.

Dado que la información recogida en una base de datos es siempre limitada, la capacidad de aprendizaje está igualmente limitada. “El planteamiento que hacemos en este proyecto es utilizar esta información para conseguir nuestro objetivo principal, la fiabilidad. En igualdad de condiciones, los modelos más simples son más probables de ser ciertos y es por ello que en este primer trabajo hemos centrado nuestros esfuerzos en crear un modelo lo más simple posible que obtuviese resultados satisfactorios”, añade Etxegarai.

Así, los resultados muestran que son capaces de estimar el umbral de lactato dentro de los límites establecidos con un 89% de acierto, todo ello utilizando un modelo relativamente simple.

El grupo trabaja actualmente en validar este primer modelo e implementarlo, en colaboración con la empresa Grupo Campus S.L. para crear un primer producto funcional. A continuación, tratarán de mejorar la fiabilidad del sistema creando modelos personalizados.

Referencia:

Etxegarai, Urtats;, Portillo, Eva; Irazusta, Jon; Arriandiaga, Ander; Cabanes, Itziar (2018) Estimation of lactate threshold with machine learning techniques in recreational runners Applied Soft Computing (2018) doi: 10.1016/j.asoc.2017.11.036.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Estimación del umbral de lactato usando ‘machine learning’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo mecanizar una pieza de cobre usando bacterias

- Acumuladores térmicos domésticos más pequeños usando parafinas

- Cómo sintetizar casi cualquier biomaterial usando ADN

Algunas cosas que los científicos pueden aprender de los programadores

Mi carrera científica tuvo un parón en 2012. O al menos entonces pensé que era un parón. Nada más licenciarme en física, en lugar de continuar directamente hacia un doctorado (como me hubiese gustado), las circunstancias me obligaron a buscar un empleo a tiempo completo. Tuve la suerte de encontrar uno, concretamente de ingeniero en una empresa de diseño de lentes.

Reconozco, con cierta vergüenza, que entonces pensaba que en el sector privado no podría aprender gran cosa en comparación con lo que podría aprender si hubiese continuado en la Universidad. Sin embargo hoy, retornado a la investigación desde 2015, utilizo a diario muchas de las herramientas que aprendí en mi etapa como ingeniero.

Dos destacan sobre el resto: los tests unitarios y el control de versiones. Son herramientas enormemente obvias y de dominio público. Tanto, que he dudado sobre la utilidad de publicar o no el presente artículo. Si al final me he decidido a hacerlo es debido al convencimiento, basado en mi experiencia personal, de que muchos profesionales del mundo científico desconocen por completo su existencia.

Si hay algo en el mundo real que se parece al concepto fantástico de “palabras mágicas” es el de comando en programación. Escribes las palabras correctas, y el ordenador hace lo que quieres. Se parece, pero no es igual. Para empezar, en programación no hay ninguna magia de por medio. Y quizá más importante, lo realmente relevante es la lógica detrás de los comandos y no los propios comandos. Sin embargo, hay un paralelismo con las “palabras mágicas” sobre el que quiero llamar la atención: basta un error tipográfico, o un comando mal utilizado, para que todo se vaya al traste. Sabido esto, sorprende que existan programas informáticos con miles e incluso millones de líneas, escritos entre varios programadores, con diferentes versiones a lo largo de los años y a menudo dependiendo de otros programas y submódulos, … y que a pesar de todo funcionen. ¿Cuál es su secreto?, ¿cómo hacen para no meter la pata?

Bien pensado, la pregunta tiene especial relevancia para los investigadores científicos. Para empezar, muchos de nosotros programamos en nuestro día a día. Pero es que además nos enfrentamos a un problema similar al de un proyecto de ingeniería cada vez que escribimos una publicación: al fin y al cabo, una publicación también es un proyecto complejo, que debe tener consistencia interna (como poco), a menudo con varios autores y con varias versiones a lo largo del tiempo.

Los programadores acumulan décadas de experiencia en este tipo de problemas. Sus métodos y herramientas son notoriamente públicos y, a pesar de ello, sorprendentemente desconocidos para una enorme fracción de los profesionales científicos. Quizá valga la pena aprender de ellos.

El propósito de este artículo es llamar la atención sobre la mera existencia de este tipo de herramientas. Usaré como ejemplo dos de ellas, aquellas que me resultaron más útiles. Concretamente los tests unitarios y el control de versiones.

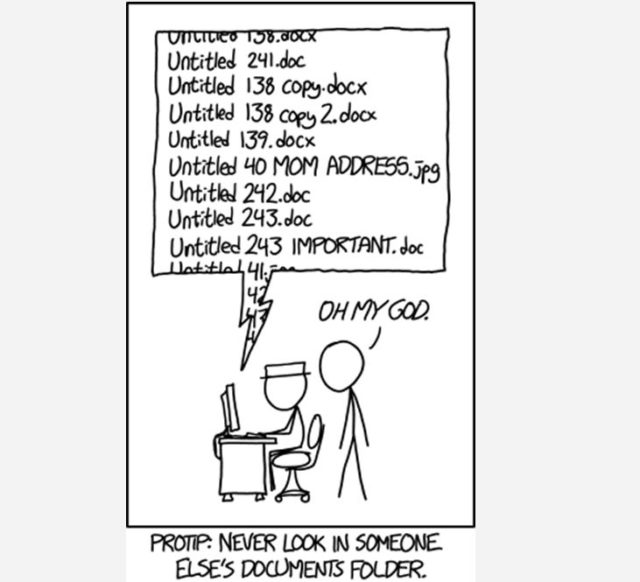

Espero con ello que, como mínimo, la próxima vez que pierdas una tarde buscando un error en un trozo de código que ayer funcionaba perfectamente, o la próxima vez que abras una carpeta con doce versiones de tu tesis (y te sientas sucio), o tengas cualquier otro problema relacionado con la gestión de información, sepas que no estás sólo… que casi seguro alguien ha tenido el mismo problema antes que tú, y ha creado herramientas para evitarlo. Y como máximo, que quizá nunca más te vuelva a suceder algo así.

Ejemplo extraído de XKCD cómics

Tests unitarios

La idea detrás de los tests unitarios consiste en escribir mini programas que se aseguren de que todo funciona cómo esperamos.

Veamos un ejemplo: imagina que quieres escribir una (sencillísima) función para sumar dos números, algo como:

suma(x, y):

return (x + y)

Un test obvio sería, por ejemplo:

asegúrate de que suma(2, 3) = 5

Otros menos obvios serían, por ejemplo, probar a sumar un número negativo:

asegúrate de que suma(2, -3) = -1

O un número no entero:

asegúrate de que suma(1.1, 2.3) = 3.4

O probar a introducir valores extraños, como texto:

asegúrate de que suma(1, “abc”) = Error

Esta pequeña batería de tests se guarda para que las comprobaciones puedan ser repetidas cada vez que se quiera. Cualquier edición futura de la función deberá pasar, al menos, los mismos tests y quizá otros nuevos. Si en el futuro alguien, por error, modifica la función suma así:

suma(x, y):

return (x – y)

los tests nos indicarán inmediatamente que algo va mal con nuestra función suma.

Nuestro ejemplo parece (y es) bastante tonto, pero no olvidemos que el código está vivo. Lo que hoy empieza como una o dos funciones facilonas, mañana puede crecer, y en un año contener cincuenta funciones interrelacionadas entre sí. Un solo error en una de ellas puede producir un desastroso efecto dominó. Los tests, cuando están bien escritos, facilitan muchísimo la tarea de localizar errores.

Como ventaja adicional, leer los tests correspondientes a una función que no esté bien documentada puede ayudarnos a entender qué pretendía el autor (a menudo nosotros mismos hace seis meses) al escribirla.

Por otro lado, programar sabiendo que cada función que escribamos deberá ser comprobada por los tests nos forzará a programar de un modo más lógico y modular.

Por último, si compartes tu código con un potencial usuario (que probablemente seas tú mismo en un futuro), lo primero que hará este será comprobar que todos los tests se pasan con éxito también en su equipo. Si la respuesta es no, probablemente signifique que el programa no se ha instalado correctamente. Sea como sea, el nuevo usuario estará alertado, y encontrar el problema será relativamente sencillo.

Me interesa, ¿cómo empiezo?

Aunque la idea detrás de los tests unitarios es muy general, la forma específica de implementarlos de forma práctica dependerá del lenguaje de programación concreto que uses. ¿Cómo empezar a usarlos?… sí, lo has adivinado, googlea “unit testing” + .

Control de versiones

Los programas informáticos (y también los textos) evolucionan en el tiempo. Crecen, cambian, se actualizan, … La idea básica detrás del control de versiones es llevar un registro ordenado y comentado de todos los cambios que se han realizado sobre el código, con la posibilidad de, por ejemplo, comparar el mismo archivo en dos momentos distintos o volver a una versión antigua en caso de que “rompamos” algo en la actual.

A diferencia de, por ejemplo, las copias de nuestro código guardadas en servicios como Dropbox o Google Drive, el control de versiones implica registrar solamente aquellas actualizaciones que se consideran importantes, junto con una descripción de la lógica detrás del cambio o conjunto de cambios.

Como bola extra, servicios como github o bitbucket permiten publicar fácilmente en la red el conjunto de código + control de versiones. Esto es especialmente útil en situaciones como las siguientes:

- Si estás escribiendo código con varios colaboradores.

- Si has usado tu código en un artículo científico y quieres enlazarlo. Si quieres que los resultados sean reproducibles por parte de un lector interesado, es condición necesaria (pero no suficiente) enlazar exactamente a la misma versión que tú utilizaste en tu análisis.

- Si quieres dar a conocer tu código.

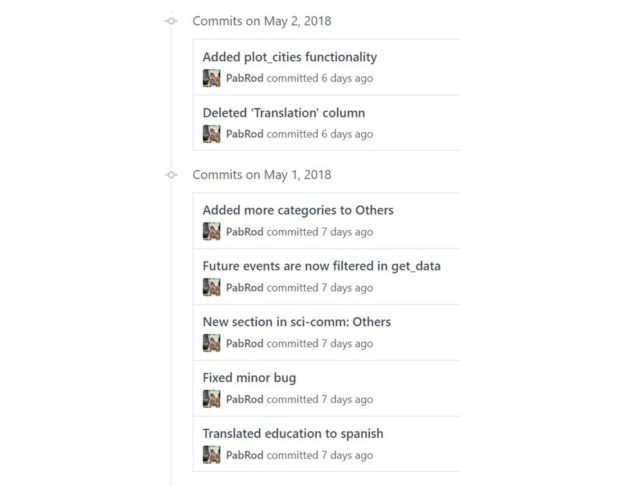

Ilustración 1 Ejemplo de un registro de GitHub. Los “commits” aparecen ordenados cronológicamente, y cada uno corresponde a una modificación lo suficientemente importante como para merecer ser comentada. Haciendo click sobre los commits (Fuente aquí) se pueden ver en todo detalle los cambios efectuados.

Me interesa, ¿cómo empiezo?

El sistema de control de versiones más popular actualmente es git, y se puede obtener gratuitamente. El primer encontronazo puede ser un poco impactante si no estás acostumbrado a las aplicaciones de consola. El uso de interfaces gráficas puede ayudar bastante durante las primeras etapas. En particular, yo utilicé una llamada SourceTree hasta que me acostumbré a usar solamente la consola de comandos.

No quiero complicarme

La primera reacción de la mayoría de científicos que conozco al saber de estos métodos es considerarlos demasiado complejos y/o alejados de sus especialidades. Irónicamente, suelen desarrollar sus propios métodos “ñapa”, que acaban siendo igual de complicados (o más), pero mucho más inseguros e ineficientes.

El hecho es que escribir un artículo científico, un trozo de software científico o una tesis son procesos complejos. Y lo son independientemente de las herramientas que uno use. Los programadores tienen décadas de experiencia en este tipo de problemas de gestión de la información… ¿por qué no usar sus herramientas de probada eficacia en lugar de reinventar la rueda?

Este post ha sido realizado por Pablo Rodríguez (@DonMostrenco) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Algunas cosas que los científicos pueden aprender de los programadores se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Aprender ciencia conociendo a los científicos

- Una nueva investigación muestra que explicar cosas a la gente “normal” puede ayudar a los científicos a ser mejores en su trabajo

- Científicos, animalistas y el uso de animales para investigación

El ir y venir de las modas educativas

Marta Ferrero

No hay que confundir innovación educativa con moda educativa pero, ¿cómo hacerlo?

Las modas educativas han existido siempre. Por moda educativa se entiende aquí a cualquier propuesta metodológica o recurso educativo que, en un momento dado, se cuela con furor en un determinado distrito escolar y, transcurrido un tiempo más o menos extenso, desaparece sin dejar prueba sólida alguna de haber contribuido al aprendizaje de los alumnos.

No todas las modas educativas son iguales. Hay modas “inofensivas”, ya que no implican cambios ni medidas significativas de ningún tipo, como aquella que introdujo la música de Mozart en las aulas para mejorar el rendimiento cognitivo de los alumnos. Y hay modas claramente perjudiciales, bien porque suponen un gasto sustancial de tiempo y dinero que pueden dedicarse a metodologías con eficacia probada (Busso y Pollack, 2014), bien porque pueden dificultar o impedir el aprendizaje de todo el alumnado o, como mínimo, de una parte del mismo (Carnine, 2000). Un ejemplo del primer caso, en referencia a las modas perjudiciales, es la aplicación de la teoría de las Inteligencias Múltiples en las aulas (Hodge, 2005). Mientras que un ejemplo del segundo caso es (o, quiero pensar, fue) la adopción del método global para la enseñanza inicial de la lectura (Stahl, 1999). Son estas últimas modas las que centran el contenido de este post.

Antes de continuar, conviene aclarar que el término moda educativa no es irremediablemente sinónimo de innovación educativa. Una moda educativa no se apoya en ninguna teoría válida ni está respaldada por estudios científicos que demuestren su eficacia. Habitualmente, su difusión viene de la mano de determinadas empresas o personas afines que logran popularizarla entre los responsables de la formación continua del profesorado, las autoridades educativas o los propios docentes a través de libros, publicaciones periódicas o estudios preliminares de baja calidad (Slavin, 1989). Por el contrario, una innovación educativa puede referirse a cualquier elemento novedoso que se introduce en un sistema educativo o colegio y conduce a un cambio en las ideas, prácticas, productos o servicios del mismo (Carrier, 2015). Este cambio puede estar o no respaldado por la evidencia.

¿Cómo se popularizan las modas educativas?

En el año 2017, Nathalie Carrier publicó un trabajo fruto de su tesis doctoral que tenía como objetivo determinar qué estrategias se habían utilizado para difundir siete modas educativas concretas y qué lugar ocupaba la evidencia en este fenómeno, aunque ella emplea el término innovación. Los medios que examinó para determinar cómo se difunden las modas educativas fueron revistas de divulgación educativa y comerciales, periódicos locales y blogs. Para analizar el contenido de estos medios, utilizó seis criterios de persuasión recogidos en la literatura sobre psicología social: Compatibilidad con las ideas previas, accesibilidad para su uso mediante explicaciones claras, practicidad para el trabajo en el aula, evidencia o calidad de la investigación que lo avala, credibilidad de las fuentes de las que procede la información y atractivo, referido a si la innovación resulta profesional, personalizada y/o divertida. Para ser consideradas populares, las modas analizadas tenían que cumplir al menos cuatro de un total de seis requisitos como, por ejemplo, poseer una entrada en diez blogs diferentes, contar con un hashtag en Twitter o una página en Facebook o haber sido empleadas por 10.000 individuos, 10 colegios o 5 distritos escolares.

A continuación, se presentan las conclusiones principales de su trabajo. En general, las dos estrategias más utilizadas para promocionar las modas educativas fueron, en primer lugar y a gran distancia del resto, el atractivo y en segundo lugar la credibilidad percibida, por delante de la evidencia, la practicidad, la accesibilidad y la compatibilidad. Junto a esto, los medios recurrían a un lenguaje emotivo o descriptivo, más que a uno basado en la evidencia disponible, para publicitar la moda en cuestión. Además, apenas unos pocos documentos citaban estudios de investigación sobre las modas anunciadas para determinar la efectividad de las intervenciones y ninguno de ellos describía o exploraba en profundidad dichos estudios. Más bien, el tipo de evidencia en la que se apoyaban los documentos consultados eran estudios informales, anécdotas basadas en experiencias personales o datos estadísticos generales sobre los problemas que abordaban las modas o sobre su uso.

La información sobre un determinado método educativo puede sonar convincente al mostrarse adornada con historias y anécdotas emotivas o referencias a fuentes afines creíbles. Pero, a la vez, esta información puede no estar corroborada sino simplemente basada en argumentos incorrectos y rudimentarios. Por esta razón, la autora recomendaba a los docentes estar alerta ante las influencias y sesgos que pueden producir las estrategias usadas para difundir las modas educativas. Junto a esto, les aconsejaba ser prudentes y formular preguntas críticas sobre dichas modas como, por ejemplo, qué estudios cuestionan su eficacia o, al menos, cuestionan los inconvenientes potenciales de la misma. Para terminar, Carrier sentenciaba que las estrategias detectadas a través de su trabajo de investigación pueden conducir a la difusión de modas ineficaces, inútiles e incluso perjudiciales para los alumnos.

En 1989, Robert E. Slavin describía las etapas por las que pasan las modas educativas hasta popularizarse dentro de la comunidad educativa. A modo de resumen, este investigador situaba como primera etapa la publicación de un método concreto en un libro, publicación periódica popular o evento educativo, seguida por la presentación de resultados preliminares y prometedores, aunque frecuentemente con pruebas muy deficientes. A pesar de ello, el método se expande entre algunos distritos escolares, más tarde entre otros colegios entusiastas de la innovación para hacerlo más tarde entre los responsables de la formación del profesorado, inspectores de educación, etc. Por último, el método termina expandiéndose rápidamente al resto de colegios a través de breves talleres impartidos o bien por los propios creadores del método o bien por formadores profesionales o bien por personal del centro formado ex profeso para ello. Desafortunadamente, solamente cuando el programa ya está de moda y muchos profesores lo están aplicando en sus aulas, comienzan a hacerse evaluaciones rigurosas de su eficacia. De hecho, para cuando comienzan a publicarse estudios de calidad y revisiones, con resultados a menudo negativos, ya es tarde. También ocurre con frecuencia que, a estas alturas, el interés por el método ya ha disminuido y es otra moda la que ha comenzado a despertar entusiasmo entre el profesorado.

¿Qué se puede hacer para evitar que las modas educativas se cuelen en los colegios?

La forma de frenar este péndulo, este ir y venir de las modas educativas, sostiene Slavin (1989), es cambiar las reglas del juego bajo las que las innovaciones educativas son elegidas, implementadas, evaluadas e institucionalizadas. El autor afirma que la comunidad educativa tiene que demandar evaluaciones rigurosas sobre las propuestas educativas que se ofertan antes de adoptarlas. También subraya la necesidad de reemplazar los cursos y talleres de formación breves por otros más extensos que incluyan un seguimiento a medio y largo plazo para comprobar si una determinada propuesta educativa está funcionando o no. Este seguimiento, esta evaluación de la eficacia de la propuesta, ha de incluir grupo experimental y control, con medidas de pre y postest (a poder ser estandarizadas) y garantizando que la aplicación de la propuesta en el aula se ha evaluado bajo condiciones reales y durante períodos de tiempo realistas. Además, sería recomendable que esta evaluación se hicieran primero a pequeña escala y después a gran escala.

Ya en el año 2006, Ben Goldacre, científico y divulgador, advertía de la necesidad de dotar al profesorado de las herramientas y autonomía suficientes para juzgar críticamente si un método educativo dispone o no de pruebas suficientes y válidas para su implementación en las aulas, lo cual favorecería que los docentes dejaran de depender de las injerencias externas (opiniones de expertos, ideologías de uno y otro color, etc.). Sin embargo, son varias las señales que ponen de relieve que aún estamos lejos de este objetivo. Por poner solamente algunos ejemplos, los profesores tanto en formación como en activo, dentro y fuera de nuestro país, albergan hoy en día un elevado número de ideas erróneas sobre teorías y métodos educativos (Cunningham, Perry, Stanovich & Stanovich, 2004; Dekker, Lee, Howard-Jones, & Jolles, 2012; Echegaray-Bengoa & Soriano-Ferrer, 2015; Ferrero, Garaizar, & Vadillo, 2016; Fuentes & Risso, 2015; Tardif, Doudin, & Meylan, 2015; Washburn, Mulcahy, Musante, & Joshi, 2017). Además, consultan más revistas divulgativas que científicas (Ferrero et al., 2016), a las que por cierto consideran menos fiables, accesibles y útiles que los talleres y cursos de formación (Landrum, Cook, Tankersley & Fitzgerald, 2002). Por último, la formación que reciben los estudiantes de educación en métodos de investigación, estadística, búsqueda en bases de datos o lectura de artículos científicos es insuficiente (Ferrero, 2018) y puede impedir que los futuros maestros puedan beneficiarse de los avances científicos en materia educativa.

Si nuestra sociedad aspira a una educación basada en las mejores pruebas disponibles y no en modas que vienen y van, es fundamental mejorar la cultura científica de todos los agentes de la comunidad educativa. Mientras esto ocurre, se presentan a continuación diez señales de alerta que pueden emplear los docentes para detectar prácticas educativas sin pruebas válidas sobre su eficacia (Lilienfeld, Ammirati & David, 2012).

Fotograma de “The Simsons”, serie creada por Matt Groening para Fox Broadcasting Company

Diez señales de alerta para detectar prácticas pseudocientíficas

1. Falta de falsabilidad y uso excesivo de hipótesis ad hoc

La falsabilidad se refiere a la capacidad de refutar una teoría con la ayuda de la evidencia. Una forma de convertir una teoría en irrefutable es usando hipótesis ad hoc. Esto es, invocando nuevas hipótesis sobre un determinado fenómeno a los resultados obtenidos para explicar por qué no se han confirmado las predicciones de la teoría. Por ejemplo, ante la inferioridad del método global frente al alfabético en la enseñanza de la lectura, los defensores del primero podrían alegar que las tareas empleadas para medir la velocidad y precisión lectoras no son las adecuadas.

2. Falta de autocorrección

Frente a las correcciones graduales que se hacen constantemente a las afirmaciones científicas, las pseudociencias tienden a mantenerse estancadas a pesar de que cada vez haya más evidencia en contra de lo que defienden. Un ejemplo de esta falta de autocorrección se puede observar en torno a la teoría de los estilos de aprendizaje. A pesar de la cada más abundante y sólida evidencia sobre su invalidez, su uso está aún muy generalizado en las escuelas.

3. Énfasis en la confirmación

El sesgo de confirmación consiste en buscar únicamente evidencia que apoya las hipótesis propias a la vez que se ignoran o reinterpretan de forma selectiva aquellas que van en contra. Este sería el caso, por ejemplo, del método Berard, Para defender su eficacia ante múltiples problemas de aprendizaje y conducta (ver la última señal de alerta), sus creadores aportan en la web oficial diversos testimonios de clientes que afirman que el método ha cambiado sus vidas. Sin embargo, esta web no contiene ninguna mención sobre la posibilidad de que el método puede no funcionar en todos los niños.

4. Evasión de la revisión por pares

Aunque no es perfecta, la revisión por pares proporciona cierta protección frente a la investigación de baja calidad. Brevemente, ésta consiste en la revisión de los trabajos de investigación por parte de varios investigadores independientes, a menudo tres o más, antes de su publicación. Sin embargo, no todas las revistas exigen una revisión por pares para publicar un trabajo de investigación. Este es el caso, por ejemplo, de Brain Gym. Este método de gimnasia cerebral, que llegó a utilizarse en más de 80 países (Hyatt, 2007), incluye en su web oficial una pestaña con un extenso listado de estudios de investigación que supuestamente demuestran su eficacia. Sin embargo, la mayoría son estudios cualitativos. Y, entre los que son experimentales, solamente dos han sido publicados en revistas de revisión por pares.

5. Confianza excesiva en pruebas basadas en anécdotas y testimonios

La suma de anécdotas no equivale a hechos. Las anécdotas son difíciles de verificar, tienen una representatividad muy cuestionable y siempre son muy vulnerables a múltiples explicaciones alternativas. Un claro ejemplo del uso de anécdotas aisladas para defender la eficacia de una intervención la encontramos en torno al método Doman. No hay estudios empíricos válidos sobre su eficacia pero sí múltiples testimonios de usuarios particulares, normalmente familias, que defienden el “a mí me funciona” y que son presentadas por los promotores del método como pruebas irrefutables de su éxito.

6. Ausencia de conexión

La conexión se refiere a si un conjunto de afirmaciones están edificadas sobre o conectadas con afirmaciones o hallazgos previos válidos. Las pseudociencias a menudo carecen de esta conexión. Un ejemplo de ello es la idea de que las diferencias en el hemisferio dominante (cerebro izquierdo, cerebro derecho) pueden ayudar a explicar las diferencias individuales entre estudiantes. Los defensores de esta idea ignoran la gran cantidad de investigación que muestra que los dos hemisferios cerebrales siempre trabajan juntos así como que ambos hemisferios son mucho más similares que diferentes a la hora de procesar la información.

7. Afirmaciones extraordinarias

Las afirmaciones extraordinarias requieren de hechos extraordinarios. Sin embargo, muchas pseudociencias no cumplen esta premisa. Un ejemplo de ello lo encontramos en los llamados niños índigo, de los que los creadores del método Asiri (que ha aterrizado en nuestro país) hacen bandera. Según ellos, estos niños irían más allá en la evolución humana desde el punto de vista espiritual y mental. Sin embargo, no aportan ninguna prueba que demuestre esta sorprendente afirmación.

8. Falacia ad antequitem

Consiste en apelar a la antigüedad, al “se ha hecho siempre”, para defender la validez de una práctica concreta. Esto sucede en muchas escuelas de educación infantil de nuestro país que llevan décadas empleando el método Doman y el método patterning (del mismo autor) en las aulas. Otro ejemplo claro es el uso de ciertas pruebas proyectivas, como el dibujo de la figura humana, en el ámbito de la psicología escolar a pesar de la falta de pruebas sobre su validez.

9. Uso de un lenguaje hipertécnico

Dentro de la comunidad científica, con frecuencia es preciso introducir nuevos términos para describir un hallazgo reciente. Sin embargo, desde el campo de las pseudociencias, se hace un abuso de la jerga técnica para dotar de mayor credibilidad a sus afirmaciones. Por ejemplo, los partidarios de las terapias auditivas, como el método Tomatis o Berard, recurren a menudo a un lenguaje hipertécnico, con expresiones como “hipersensibilidad al sonido” o “interferencia con un procesamiento eficiente de las señales sonoras” a la hora de describir los problemas que supuestamente remedian.

10. Ausencia de condiciones límite

En contra de lo que hacen los científicos, los defensores de prácticas pseudocientíficas no definen los límites de las prácticas que defienden. Esto es, no especifican en qué casos es o no eficaz una intervención. De hecho, defienden su uso para un abanico excesivamente amplio de condiciones. Este es el caso por ejemplo del método Irlen, cuyos promotores defienden su utilidad para innumerables problemáticas tanto físicas (por ejemplo, confort y sensibilidad a la luz) como psicológicas (por ejemplo, atención y concentración).

Nota: Aunque para cada alerta se han aportado uno o dos ejemplos concretos, prácticamente todos ellos podría utilizarse para ejemplificar muchas de las diez alertas.

Referencias:

Busso, D. S., & Pollack, C. (2014). No brain left behind: Consequences of neuroscience discourse for education. Learning, Media and Technology, 1-19. doi:10.1080/17439884.2014.908908

Carnine, D. (2000). Why education experts resist effective practices (and what it would take to make education more like medicine). Recuperado de http://www.wrightslaw.com/info/teach.profession.carnine.pdf

Carrier, N. (2017). How educational ideas catch on: The promotion of popular education innovations and the role of evidence. Educational Research, 59, 228-240.

Carrier, N. (2015). What catches on? The role of evidence in the promotion and evaluation of educational innovations (tesis doctoral). Universidad de Toronto, Ontario, Canadá.

Cunningham, A. E., Perry, K. E., Stanovich, K. E., & Stanovich, P. J. (2004). Disciplinary knowledge of k-3 teachers and their knowledge calibration in the domain of early literacy. Annals of Dyslexia, 54,139-167.

Dekker, S., Lee, N. C., Howard-Jones, P., & Jolles, J. (2012). Neuromyths in education: Prevalence and predictors of misconceptions among teachers. Frontiers in Psychology, 3, 429.

Echegaray-Bengoa, J., & Soriano-Ferrer, M. (2016). Conocimientos de los maestros acerca de la dislexia del desarrollo: Implicaciones educativas. Aula Abierta, 44, 63-69.

Ferrero, M. ¿Qué saben los estudiantes de educación sobre métodos de investigación? Un estudio de los programas docentes españoles (en preparación).

Ferrero, M., Garaizar, P., & Vadillo, M. A. (2016). Neuromyths in education: Prevalence among Spanish teachers and an exploration of cross-cultural variation. Frontiers in Human Neuroscience, 10, 496.

Fuentes, A., & Riso, A. (2015). Evaluación de conocimientos y actitudes sobre neuromitos en futuros/as maestros/as. Revista de Estudios de Investigación en Psicología y Educación, 6, 193-198.

Goldacre, B. (2006). Brain Gym – Name & Shame [Blog post]. Recuperado de http://www.badscience.net/2006/03/the-brain-drain/

Hodge, E. E. (2005). A best-evidence synthesis of the relationship of multiple intelligence instructional approaches and student achievement indicators in secondary school classrooms (tesis doctoral). Universidad Cedarville , Ohio, Estados Unidos.

Hyatt, K. J. (2007). Brain Gym®: Building stronger brains or wishful thinking? Remedial and Special Education, 28, 117-124.

Landrum, T. J., Cook, B. G., Tankersley, M., & Fitzgerald, S. (2002). Teacher perceptions of the trustworthiness, usability, and accessibility of information from different sources. Remedial and Special Education, 23, 42-48.

Lilienfeld, S. O., Ammirati, R., and David, M. (2012). Distinguishing science from pseudoscience in school psychology: science and scientific thinking as safeguards against human error. Journal of School Psychology, 50, 7-36.

Tardif, E., Doudin, P-A., & Meylan, N. (2015). Neuromyths among teachers and student teachers. Mind, Brain and Education, 9, 50-59.

Slavin, R. E. (1989). PET and the pendulum: Faddism in education and how to stop it. Phi Delta Kappan, 752–758

Stahl, S. A. (1999). Why innovations come and go (and mostly go): The case of whole language. Educational Researcher, 28, 13-22.

Washburn, E. K., Mulcahy, C.A., Musante, G., Joshi, R. M. (2017). Novice teachers’ knowledge of reading-related disabilities and dyslexia. Learning Disabilities: A Contemporary Journal, 15, 169-191.

Sobre la autora: Marta Ferrero es psicopedagoga y doctora en psicología. Actualmente es investigadora posdoctoral en el Deusto Learning Lab de la Universidad de Deusto. Es autora del blog Si tú supieras…

El artículo El ir y venir de las modas educativas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La evaluación mejora el aprendizaje

- Tres historias italianas: vacunas, homeopatía, niños y derechos humanos

- La curva de la atención, ¿una leyenda urbana?

El ácido hialurónico no sirve para todo, aunque lo parezca

Desde hace unos años el ácido hialurónico está por todas partes, es la molécula estrella. Lo encontramos en cremas hidratantes y antiedad, lo usamos en tratamientos estéticos, en tratamientos de artrosis, en suplementos alimenticios para deportistas y para combatir las arrugas. Cuando algo sirve para tantas cosas, en apariencia tan diferentes entre sí, saltan las alarmas. ¿El ácido hialurónico es tan versátil y efectivo como lo pintan?

-

El origen del ácido hialurónico

Los farmacéuticos Karl Meyer y John Palmer aislaron por primera vez el ácido hialurónico en 1934 mientras estudiaban la composición del humor vítreo de los ojos de las vacas. Resultó que esta sustancia de aspecto tan viscoso —es un polisacárido del tipo de glucosaminoglucanos— tenía una función estructural, es decir, es la responsable de mantener la forma del ojo.

Estos farmacéuticos decidieron llamarlo ácido hialurónico porque hialos proviene del griego υαλώδη, que significa vítreo, y urónico por la alta concentración de ácido urónico que contiene (producto de la oxidación de los monosacáridos).

En 1942 empezó a utilizarse el ácido hialurónico con fines comerciales como sucedáneo del aglutinante de clara de huevo usado en pastelería. A partir de entonces comenzó a extraerse de la cresta de algunas aves, ya que lo contienen en gran cantidad. Aunque hoy conocemos métodos de obtención más eficientes que ese, la cresta de las aves se continúa utilizando como fuente. En los años setenta se descubrieron nuevas aplicaciones relacionadas con la cirugía ocular. Empezamos a probarlo con infiltraciones para el tratamiento de patologías articulares y, poco después, se descubrieron aplicaciones cosméticas.

-

Hialurónico para las articulaciones

El ácido hialurónico forma parte del líquido sinovial que lubrica las articulaciones. Algunos mamíferos contienen más que otros. Una persona de 70 kg alberga en su cuerpo unos 15 g de hialurónico. Aproximadamente un tercio se degrada y se recupera parcialmente a lo largo del día. Con la edad, la destrucción del hialurónico es más rápida que su recuperación.

Una de las aplicaciones médicas del ácido hialurónico se hace por medio de infiltraciones en las cápsulas sinoviales —los cojinetes de las articulaciones—. Estas infiltraciones favorecen la lubricación de la articulación y reducen el desgaste del cartílago, lo que minimiza el dolor derivado de la artrosis y otras patologías de sintomatología similar.

Esta molécula es viscosa y de baja densidad. Sus propiedades derivan de su estructura química. El ácido hialurónico es un polisacárido. Esto quiere decir que está formado por la unión de moléculas de azúcar pequeñas formando cadenas. Estas cadenas experimentan cierta repulsión eléctrica unas de otras. El resultado de esto es que pocas moléculas ocupan mucho volumen, por eso tiene baja densidad, y en lugar de apelmazarse al ser sometidas a presión, unas moléculas se deslizan sobre las otras.

Además, el ácido hialurónico es biodegradable. Esto es a la vez una ventaja y una desventaja. Por un lado, es un compuesto que encontramos de forma natural en nuestro cuerpo, por lo que es improbable que dé problemas de incompatibilidad o rechazo. Por otro lado, se va degradando, así que hay que repetir las infiltraciones cada cierto tiempo.

-

Hialurónico en inyecciones estéticas

El ácido hialurónico forma parte de la estructura de la piel. Es la sustancia que mantiene el colágeno en su sitio, por lo que además de una función estructural, desempeña un papel importante en la estética de nuestra piel. La mantiene tersa y rellena.

Con la edad se ralentiza la síntesis natural de hialurónico, mientras que su destrucción sigue un ritmo constante. Esa es una de las razones por las que aparecen arrugas y la piel pierde volumen.

Las inyecciones de hialurónico se hacen bajo la dermis y se dirigen hacia los surcos de las arrugas. El efecto de relleno es inmediato.

Para evitar problemas de alergia, rechazo u otras reacciones autoinmunes, el hialurónico empleado tiene que ser muy puro, sin rastro de proteína animal. Por este motivo se utiliza hialurónico biosintético. Éste se produce a partir de la fermentación bacteriana de ciertos vegetales.

-

Cremas hidratantes y antiedad con ácido hialurónico

Una de las cualidades del ácido hialurónico es que es muy higroscópico. Esto significa que es capaz de retener una gran cantidad de agua —miles de veces su peso—. Esta propiedad se utiliza como activo de hidratación en los productos cosméticos.

Uno de los factores que más afectan al aspecto, salubridad y envejecimiento de nuestra piel es la hidratación. La piel tiende a perder agua de forma natural. Lo que hacen los activos hidratantes es evitar la excesiva pérdida de agua. Algunas de estas sustancias pueden ser simplemente oclusivos (taponan la piel), otras como el hialurónico son humectantes, actúan como una capa de agua que previene la deshidratación de la piel.

La hidratación superficial nos la proporciona cualquier tipo de hialurónico. Sin embargo, dependiendo de su peso molecular, el ácido hialurónico tiene una actividad diferente. El peso molecular también afecta al precio de la materia prima y, por tanto, al precio del cosmético.

El hialurónico de alto peso molecular suele ser de procedencia animal. Al ser una molécula tan grande, no tiene capacidad de penetración en la piel. Permanece en la superficie y actúa como un potente hidratante.

El hialurónico de bajo peso molecular suele ser de origen sintético. Producirlo es más costoso, por eso lo encontramos en productos cosméticos de gama media-alta. En la lista de ingredientes se denomina hialurónico «fragmentado» o «hidrolizado». Éste sí tiene capacidad de penetración. Es capaz de llegar hasta la dermis, por lo que tiene una función rellenadora que atenúa las arrugas. Además, se ha comprobado experimentalmente que promueve la síntesis de hialurónico natural de la piel.

El peso molecular del hialurónico que encontramos en los cosméticos es muy diverso, y eso hace que unos productos sean mejores que otros y más adecuados a cada piel. La unidad de medida que se emplea en el sector cosmético es el KDa (kilodalton). El hialurónico de 320 KDa o más no garantiza el efecto relleno, pero sí la hidratación. El hialurónico de 20 kDa o menos tiene tal capacidad de penetración que puede resultar irritante para algunas personas. Por ese motivo existen productos que combinan el hialurónico de alto peso con el de bajo peso. Para evitar posibles irritaciones, en los productos formulados para pieles sensibles se utiliza hialurónico de bajo peso de 50 kDa.

-

Suplementos alimenticios con ácido hialurónico

Los suplementos alimenticios con ácido hialurónico se publicitan tanto para personas con artrosis, como para deportistas, como para combatir el envejecimiento de la piel.

El dicho popular «de lo que se come se cría» no hay que tomárselo al pie de la letra. De la misma manera que comer sesos no hace que te crezca el cerebro, comer hialurónico no hace que tu piel o tus articulaciones ganen hialurónico. Todo lo que ingerimos se metaboliza, se transforma en otras moléculas más simples y éstas se distribuyen en nuestro organismo. Cuando consumimos hialurónico, éste se fragmenta en azúcares simples y lo metabolizamos como cualquier otro polisacárido. Es decir, no viaja como azúcares libres a nuestra piel y se vuelve a recomponer allí como hialurónico. El metabolismo es algo mucho más complejo que eso. Esa es la razón por la que no sirve para nada consumir suplementos con ácido hialurónico.

Habitualmente estos suplementos además contienen colágeno, por aquello de la relación estructural que mantiene el hialurónico con el colágeno. Ni el colágeno ni el hialurónico favorecen la síntesis de más hialurónico ni más colágeno. Para poder publicitar que sí lo hacen, estos suplementos suelen contener vitamina C, que sí ha sido aprobada por las autoridades. Incluir una cantidad ridícula de vitaminas y minerales con declaraciones saludables verificadas es una de las tretas permitida y fomentada por las autoridades.

No todos los suplementos son iguales. Algunos contienen diferentes principios activos que conjuntamente promueven la síntesis natural de hialurónico y frenan su destrucción. Desgraciadamente las autoridades no evalúan los alimentos ni los suplementos en su conjunto, sino como ingredientes individuales. Esa es la razón por la que tanto buenos y malos incluyen vitamina C en su composición, para que sea legal publicitarlos como beneficiosos para la piel y las articulaciones.

-

Conclusión

El ácido hialurónico es una molécula estrella. Es versátil y eficaz, pero no para absolutamente todo.

Inyectado en las articulaciones sí es capaz de minimizar el dolor, de conservar el cartílago y aumentar la lubricación. Inyectado bajo la epidermis, sí rellena las arrugas y fomenta la síntesis del hialurónico propio de la piel. Al ser biodegradable hay que inyectarlo periódicamente.

Por vía tópica también cumple varias funciones cosméticas. El hialurónico de alto peso molecular hidrata la piel, y el de bajo peso molecular tiene capacidad de penetración. No es tan efectivo e inmediato como las inyecciones, pero funciona como rellenador y activa la síntesis del hialurónico propio de la piel de forma menos invasiva.

Ingerido en suplementos alimenticios o formando parte de alimentos funcionales no aporta ningún beneficio, ya que se metaboliza como cualquier otro polisacárido. Los suplementos que promueven la síntesis de hialurónico o frenan su destrucción tienen otros principios activos, ninguno de ellos será el ácido hialurónico.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo El ácido hialurónico no sirve para todo, aunque lo parezca se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La potencia sin control no sirve de nada

- Con los edulcorantes artificiales (casi) todo son ventajas

- Aunque tengas colesterol, podrás desayunar huevos

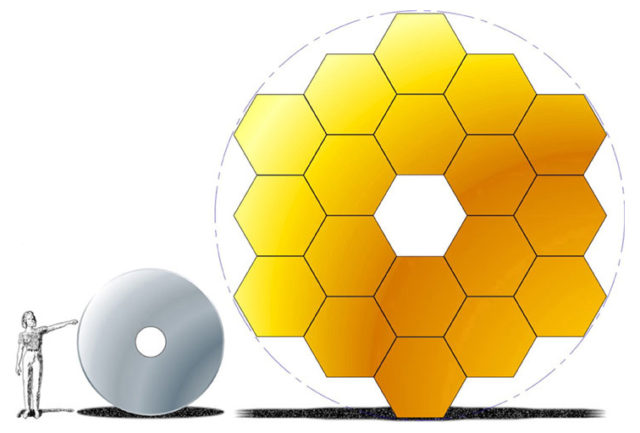

¿Y si la desintegración del neutrón produjese materia oscura?

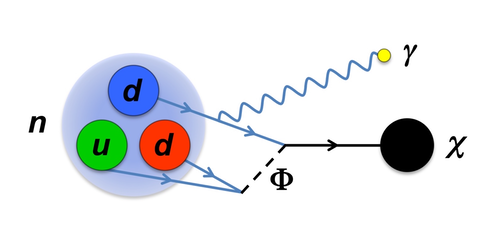

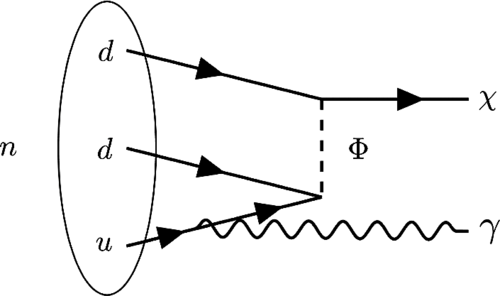

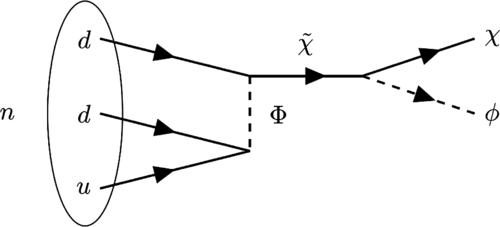

B. Fornal and B. Grinstein/University of California, San Diego

Los neutrones, esas partículas neutras que se encuentran en el núcleo de los átomos, no son partículas elementales, ya que tienen estructura. Si bien son estables cuando están en el núcleo atómico, se desintegran cuando están libres. Un neutron libre tarda en desintegrarse de media unos 881,5 segundos, segundo y medio arriba o abajo, y el hecho de que no se disponga de un valor con una precisión muchísimo mayor se debe a que según cómo se haga el experimento se obtienen unos resultados u otros.

La fuente de la discrepancia entre los dos tipos de experimentos que se realizan podría ser perfectamente algún tipo de error sistemático aún no identificado. Pero otra posibilidad podría ser que los neutrones se desintegrasen en esas partículas invisibles en cualquier parte del espectro electromagnético que llamamos materia oscura, y que permiten que las galaxias existan tal y como las conocemos.

Esta nueva hipótesis, como es lógico, ha despertado mucho interés, y ya se han realizado experimentos intentando comprobarla. Los resultados de éstos no descartan la idea, aunque sí imponen limites a qué variantes de la hipótesis son viables. Veamos.

Fuera del núcleo, el neutrón se descompone en un protón, un electrón y un neutrino electrónico. Los estudios de este proceso de desintegración son de dos tipos, que van podemos llamar de “botella” y de “haz”. En un experimento de botella, los investigadores colocan un conjunto de neutrones ultrafríos en un recipiente (la botella) y cuentan cuántos quedan tras un cierto intervalo de tiempo. En un experimento de haz, los investigadores observan un flujo de neutrones y cuentan la cantidad de protones creados a partir de las desintegraciones. La vida media del neutrón en un experimento de haz puede ser hasta 9 s más larga que la medida en uno de botella.

Bartosz Fornal y Benjamin Grinstein de la Universidad de California en San Diego (EE.UU.), proponen una solución a esta discrepancia que asume que los neutrones se desintegran un 1% de las veces en partículas de materia oscura. Debido a que los experimentos de haz no detectarían estas desintegraciones, eso explicaría que estos experimentos midan una vida media de los neutrones mayor que en los de botella, que darían valores más próximos al valor correcto.

Desintegración del neutrón dando lugar a un rayo gamma

Fornal y Grinstein investigaron varias posibilidades con neutrones que se desintegran dando diferentes combinaciones de materia oscura y partículas visibles. En uno de estos escenarios, las desintegraciones “oscuras” de neutrones van acompañadas de la emisión de un rayo gamma. Inspirado por esta posibilidad, Christopher Morris del Laboratorio Nacional de Los Alamos, Nuevo México (EE.UU.), y sus colegas controlaron la posible emisión de rayos gamma en una botella de neutrones ultrafríos. No encontraron ninguna señal, lo que parece descartar este canal de desintegración propuesto en el rango de energía de fotones de entre 782 y 1664 keV.

Desintegración del neutrón sin que se produzca un rayo gamma

Pero otros posibilidades de desintegración, que producen rayos gammas de energía más baja o que no producen este tipo de radiación, siguen siendo posibles y podrían probarse buscando anomalías en las desintegraciones nucleares.

Referencia:

Bartosz Fornal & Benjamín Grinstein (2018) Dark Matter Interpretation of the Neutron Decay Anomaly Physical Review Letters doi: 10.1103/PhysRevLett.120.191801

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo ¿Y si la desintegración del neutrón produjese materia oscura? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los supermateriales aumentan la sensibilidad 10.000 veces en los detectores de materia oscura

- Un neutrino estéril como candidato a materia oscura

- ¿Y si lo que detectó LIGO fue materia oscura?

Quipu y yupana, instrumentos matemáticos incas (I)

Una de mis pasiones, en relación con la historia de las matemáticas, es la lectura sobre los diferentes sistemas de numeración, las distintas aritméticas y, en general, las matemáticas que han desarrollado los diferentes pueblos, las diferentes culturas, de todo el planeta, a lo largo de la historia de la humanidad.

Por una parte, cada pueblo ha desarrollado unas matemáticas muy particulares, relacionadas con su propia identidad, con su forma de vida, con el lugar y el tiempo en el que se han existido, con sus circunstancias concretas, lo que hace que estas matemáticas tengan sus propias características, diferentes de las de los demás pueblos. Sin embargo, al mismo tiempo podemos observar cómo existe una parte esencial de dichas matemáticas que es muy similar en todas las culturas, como si de alguna forma cada una inventara su propio descubrimiento de unas matemáticas ya existentes.

Tabla babilónica de multiplicar del 9, en base 60, encontrada en Nippur, del periodo 1400-1100 a.C. Colección Hilprecht, Universidad de Jena, Alemania

Las siguientes entradas de la sección Matemoción del Cuaderno de Cultura Científica me gustaría dedicarlas a conocer un poco sobre las matemáticas de los incas, y más concretamente, sobre su sistema de numeración y su aritmética.

El imperio inca –llamado Tawantinsuyu, “las cuatro regiones” en la lengua Quechua– se fundó aproximadamente hacia el año 1200 d.C. y estaba en su máximo apogeo cuando los conquistadores españoles, dirigidos por Francisco Pizarro (1478-1541), iniciaron la conquista de Perú, que acabaría con la anexión del imperio Inca a España. En ese momento, el imperio Inca se extendía de norte a sur de la zona del Pacífico de América del Sur, desde las actuales Argentina y Chile hasta Bolivia, Ecuador y Perú, alcanzando una extensión de unos 2.000.000 de kilómetros cuadrados.

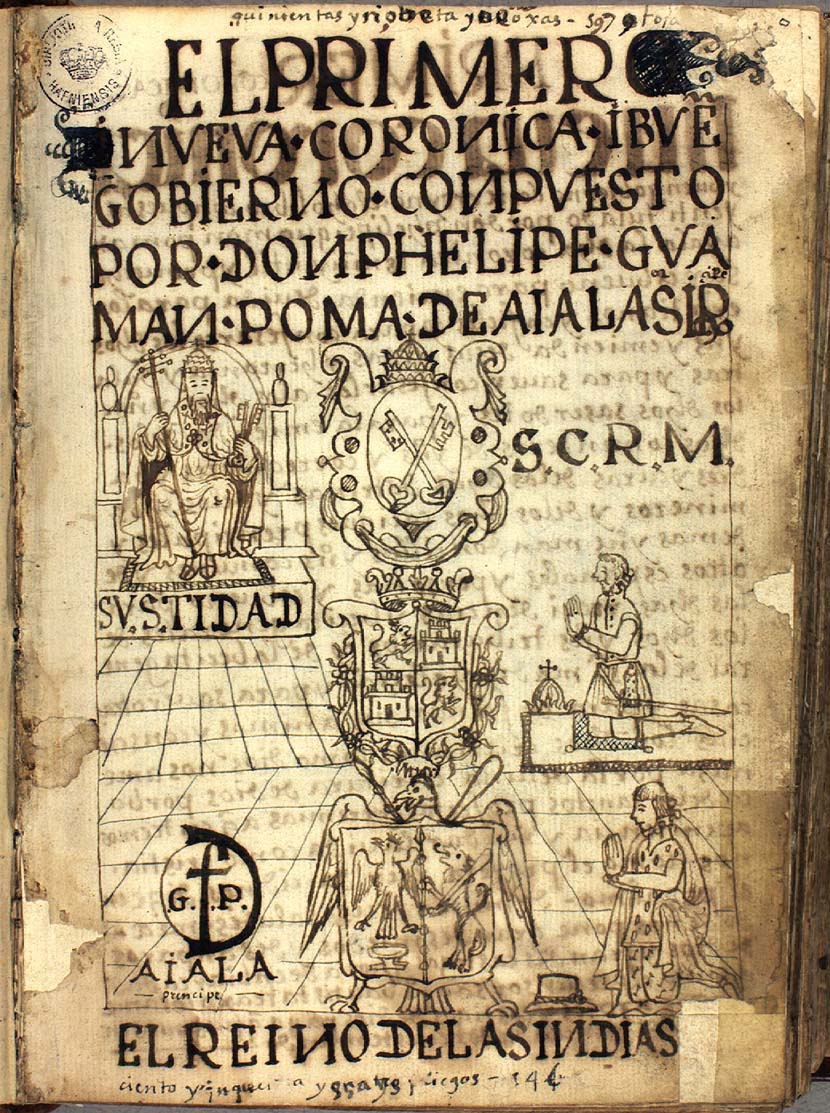

Los conocimientos que hoy en día tenemos de la cultura incaica, y en particular, los de carácter científico y técnico, nos han llegado a través de las diferentes crónicas que se escribieron en la época por parte de cronistas “españoles” (algunos indígenas al servicio del imperio español), como Felipe Guamán Poma de Ayala (1534-1615), Gómez Suárez de Figueroa, apodado como Inca Garcilaso de la Vega (1539-1616), Pedro Cieza de León (1520-1554) o Martín de Murúa (1525/1540-1616/17).

Portada de la obra “Nueva corónica i buen gobierno” (1615), de Felipe Guamán Poma de Ayala

Pero centrémonos en las matemáticas del pueblo inca. Su sistema de numeración era, como para muchos otros pueblos que utilizaron sus manos para empezar a desarrollar el concepto de número y su aritmética, decimal. Además, era un sistema posicional, como nuestro sistema de numeración indo-arábigo, con la característica especial de que los números se representaban, como veremos, por medio de cuerdas, de los quipus.

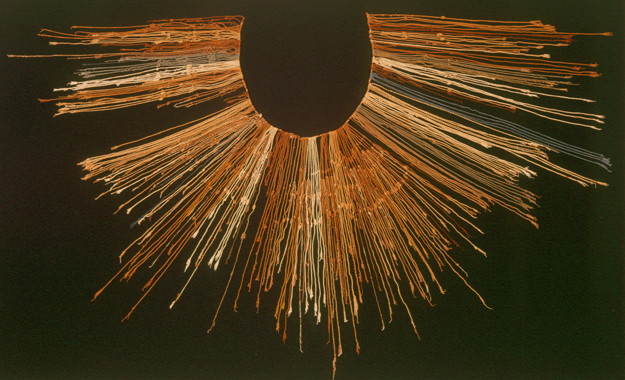

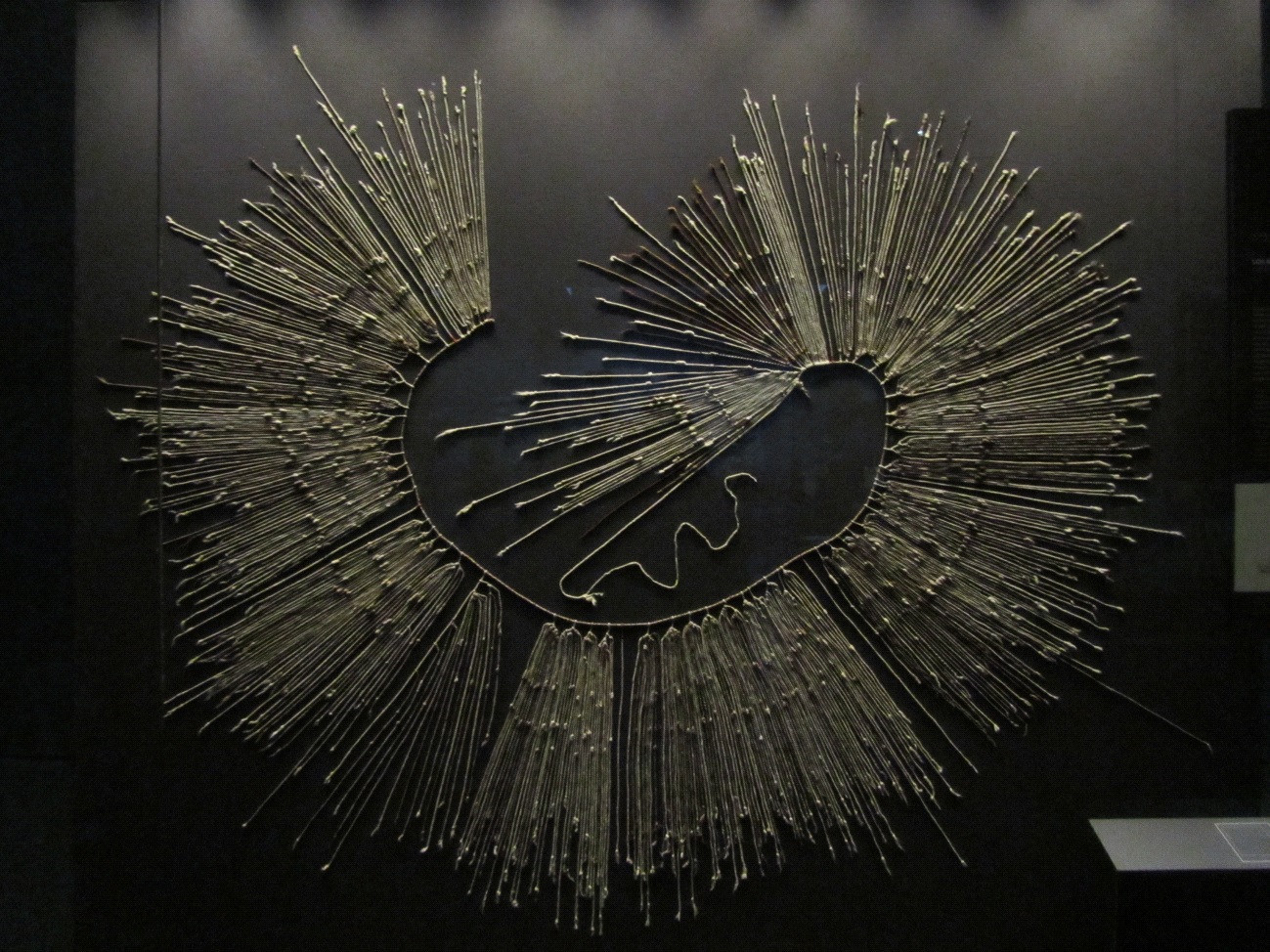

Quipu inca del Museo Larco, de Lima (Perú), sobre el 1400 d.C. Fotografía: Claus Ableiter / Wikimedia Commons

El sistema decimal no solamente se utilizó para representar los números, sino que se utilizó como parte de la organización social del imperio. En la base de la estructura social estaban los puric, que eran los indios trabajadores, que además eran los que tributaban (campesinos, ganaderos, artesanos y soldados). Los purics se organizaban en grupos de diez (10), una cancha, que estaban bajo el mando de un cancha-camayo. A su vez, cada diez cancha-camayos, eran supervisados por un capataz, o pachaca-curaca, que tenía bajo su mando, a través de los 10 cancha-camayos, a 100 trabajadores, una pachaca.

Subiendo un poco más en la pirámide estaban los supervisores, guaranca-curacas, de una decena (10) de pachaca-curacas, una centena (100) de cancha-camayos y un millar (1.000) de indios tributarios, lo que se conocía como una waranqa. Y seguía la jerarquía, cada responsable con el control de diez personas de un rango inferior al suyo, con el huno-curaca o jefe de la tribu, con un total de 10.000 purics, lo que se conocía como un huno, a su cargo.

Por encima del huno-huraca estaba el gobernador de la provincia y más arriba el mandatario de cada uno de los cuatro cuarteles en los que se dividía el imperio. Y arriba de la gran pirámide estaba el Inca, el soberano del imperio inca.

Por ejemplo, en el texto Historia Natural y Moral de las Indias, del jesuita José de Acosta (1540-1600), podemos leer el siguiente párrafo:

“…es de saber que, la distribución que hacían los Incas de sus vasallos era tan particular, que con facilidad los podían gobernar a todos, siendo un reino de mil leguas de distrito, porque en conquistando cada provincia, luego reducían los indios a pueblos y comunidad, y contábanlos por parcialidades, y a cada diez indios ponían uno que tuviese cuenta con ellos, y a cada ciento, otro, y a cada mil, otro, y a cada diez mil, otro, y a éste llamaban Huno [huno-curaca], que era cargo principal; y sobre todos éstos en cada provincia un gobernador del linaje de los Incas, al cual obedecían todos, y daba cuenta cada un año de todo lo sucedido por menudo; es, a saber, de los que habían nacido, de los que habían muerto, de los ganados, de las sementeras.”

Dibujos de Cinchiroca, segundo Inca del imperio, y de su mujer Chympo Coya, del libro “Historia General del Perú. Origen y descendencia de los incas” (1616), del fraile vasco Martín de Murúa. Digital image courtesy of the Getty’s Open Content Program

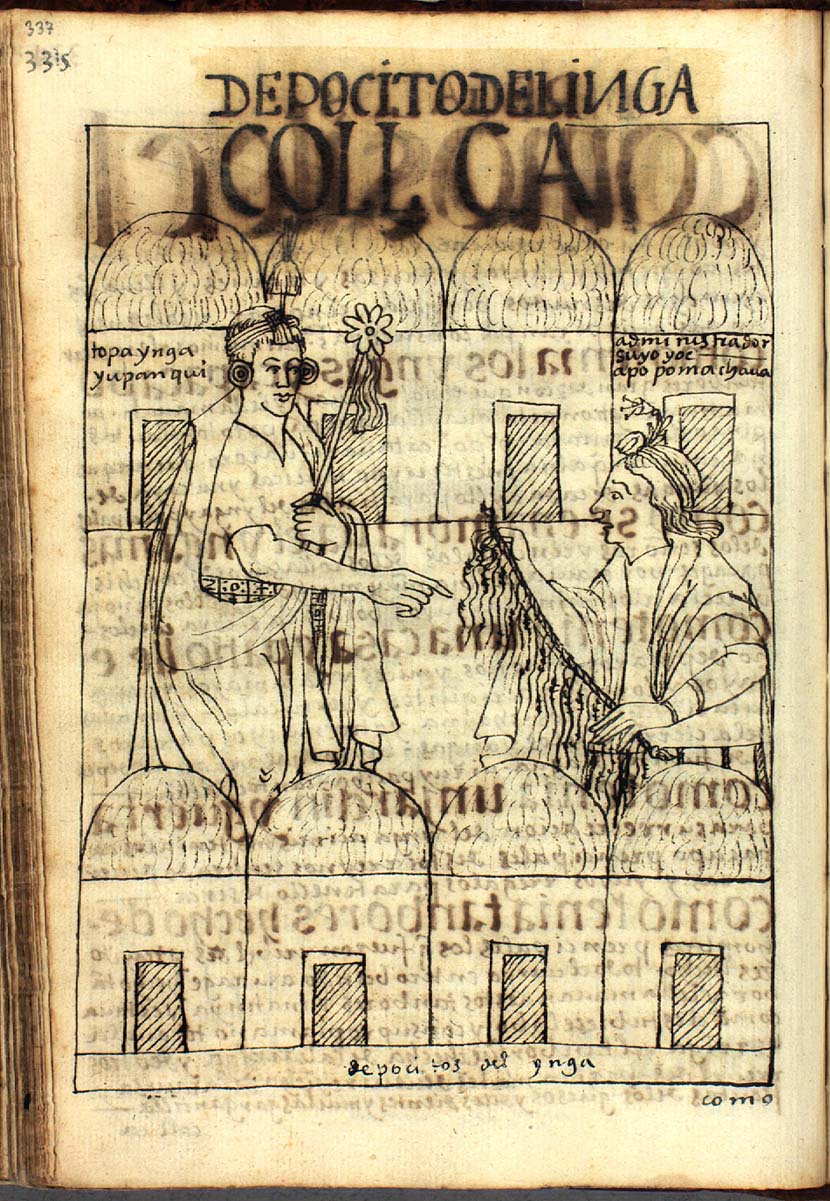

Efectivamente, el sistema de numeración de los incas era decimal, como lo confirma, por ejemplo, el cronista Felipe Guamán Poma de Ayala en su texto Nueva corónica i buen gobierno (1615), al referirse a los quipu-camayos, los funcionarios de imperio que manejaban los quipus, dice así:

“…numeran de cien mil y de diez mil [y de mil] y de ciento y de diez hasta llegar a uno.”

Y también explica cuáles son las palabras utilizadas en la lengua Quechua para designar a los números:

“Suc [uno], yscay [dos], quinza [tres], taua [cuatro], pichica [5], zocta [6], canchis [7], puzac [8], yscon [9], chunga [10], yscay chunga [20], quinza chunga [30], taua chonga [40], pisca chunga [50], zocta chunga [60], canchis chunga [70], pozac chunga [80], yscon chunga [90], pachaca [100], uaranga [1000].

Chunga uaranga [10000][es un]huno, pachaca huno [100 x 10000], uaranranga [sic] huno [1000 x 10000], pantacac huno [incontable]”

Los incas utilizaban un dispositivo con cuerdas, el quipu (palabra que en Quechua significa “nudo”), para representar los números. Pero el quipu era más que un sistema de escritura numérica, era un instrumento para registrar información, como datos estadísticos relacionados con los datos de censo, la contabilidad tributaria, registros económicos y de producción, e informaciones numéricas similares relacionadas con el imperio Inca y su gobierno, que permitía conservar de forma duradera dichas informaciones numéricas.

Quipu del Museo Chileno de Arte Precolombino, como nos cuenta Marta Macho en su entrada El quipu: ¿algo más que un registro numérico?, “contiene 586 cuerdas organizadas en 8 sectores de 10 conjuntos de cuerdas, cada uno con hasta 13 niveles de información; almacena 15.024 datos cuyo significado se desconoce”. Fotografía de Inés Macho

Los Quipus podrían registrar también otro tipo de informaciones, como información histórica, poemas y canciones, genealogías, temporales, o incluso funcionar como calendario. Como podemos leer en el mencionado texto de José de Acosta:

“Fuera de esta diligencia, suplían la falta de escritura y letras, parte con pinturas, como los de Méjico, aunque las del Perú eran muy groseras y toscas; parte, y lo más, con quipos. Son quipos unos memoriales o registros hechos de ramales, en que diversos nudos y diversos colores significan diversas cosas. Es increíble lo que en este modo alcanzaron, porque cuanto los libros pueden decir de historias, y leyes, y ceremonias y cuentas de negocios, todo eso suplen los quipos tan puntualmente, que admiran. Había para tener estos quipos o memoriales oficiales diputados, que se llaman hoy día Quipocamayo, los cuales eran obligados a dar cuenta de cada cosa, como los escribanos públicos acá, y así se les había de dar entero crédito; porque para diversos géneros, como de guerra, de gobierno, de tributos, de ceremonias, de tierras, había diversos quipos o ramales; y en cada manojo de estos nudos y nudicos y hilillos atados, unos colorados, otros verdes, otros azules, otros blancos, y finalmente tantas diferencias, que así como nosotros de veinte y cuatro letras, guisándolas en diferentes maneras, sacamos tanta infinidad de vocablos, así éstos de sus ñudos y colores sacaban innumerables significaciones de cosas.”

Y como dice el texto de José de Acosta, los funcionarios del imperio encargados de manejar los quipus eran los quipucamayos, que tenían como trabajo construir los quipus, registrar las informaciones e informar de las mismas (es decir, interpretar los quipus) a los gobernantes. Había distintos quipucamayos que se dedicaban a recoger diferentes tipos de informaciones.

Dibujo de un quipucamayo, de hecho, el “contador mayor y tesorero” que informaba directamente al Inca, del libro “Nueva corónica i buen gobierno” (1615), de Felipe Guamán Poma de Ayala, que aparece con los dos instrumentos matemáticos incas, el quipu y la yupana, o ábaco inca

Cada aldea, provincia, región tenía sus propios quipucamayos. Loa gobernantes utilizaban estas informaciones para el gobierno de aldeas, provincias, regiones o todo el imperio inca. Como escribe el cronista Poma de Ayala “con los cordeles gobernaban todo el reino”.

Dibujo “los depósitos del inca”, del libro “Nueva corónica i buen gobierno” (1615), de Felipe Guamán Poma de Ayala, en el que se ve al administrador de los depósitos del inca, con un quipu en las manos, haciendo inventario del contenido de los depósitos ante el décimo Inca Topa Ynga Yupanqui

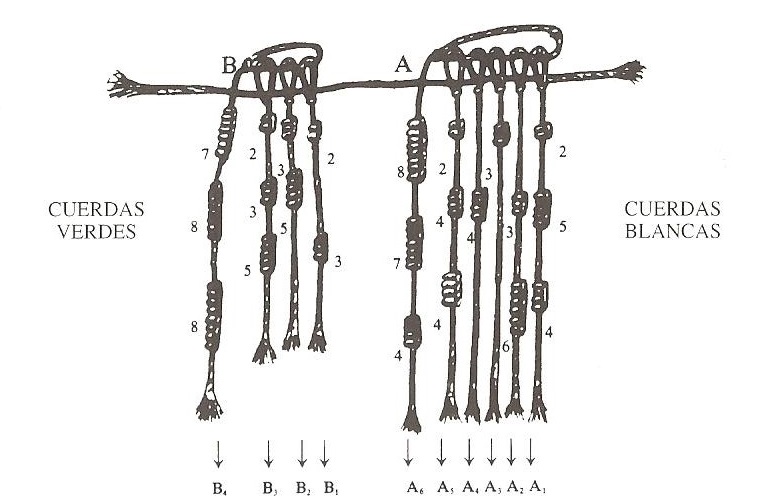

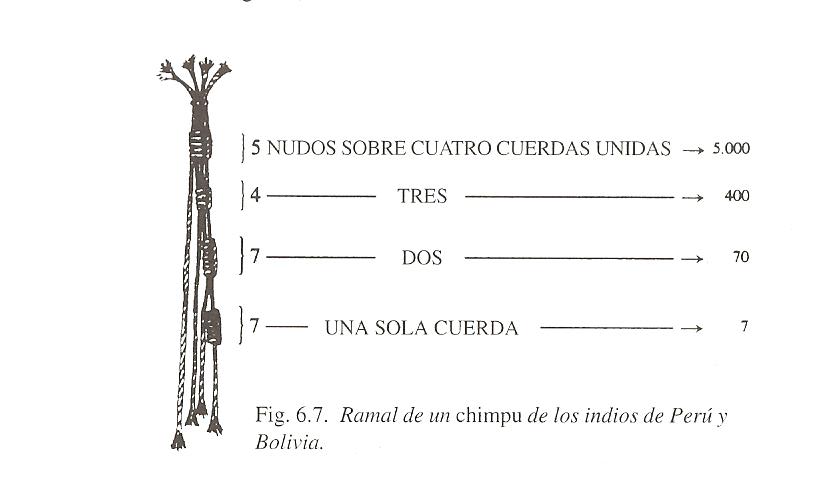

Los quipus eran cuerdas, normalmente fabricadas con algodón o fibra de camélido (obtenida de las llamas y alpacas), que solían constar de una cuerda principal, que era la columna vertebral del quipu, del que colgaban, anudadas a la cuerda principal, una serie de cuerdas colgantes sobre los que se realizaban los nudos que representaban los números. De estas cuerdas colgantes podían a su vez colgar otras cuerdas colgantes secundarias o incluso podían existir cuerdas superiores.

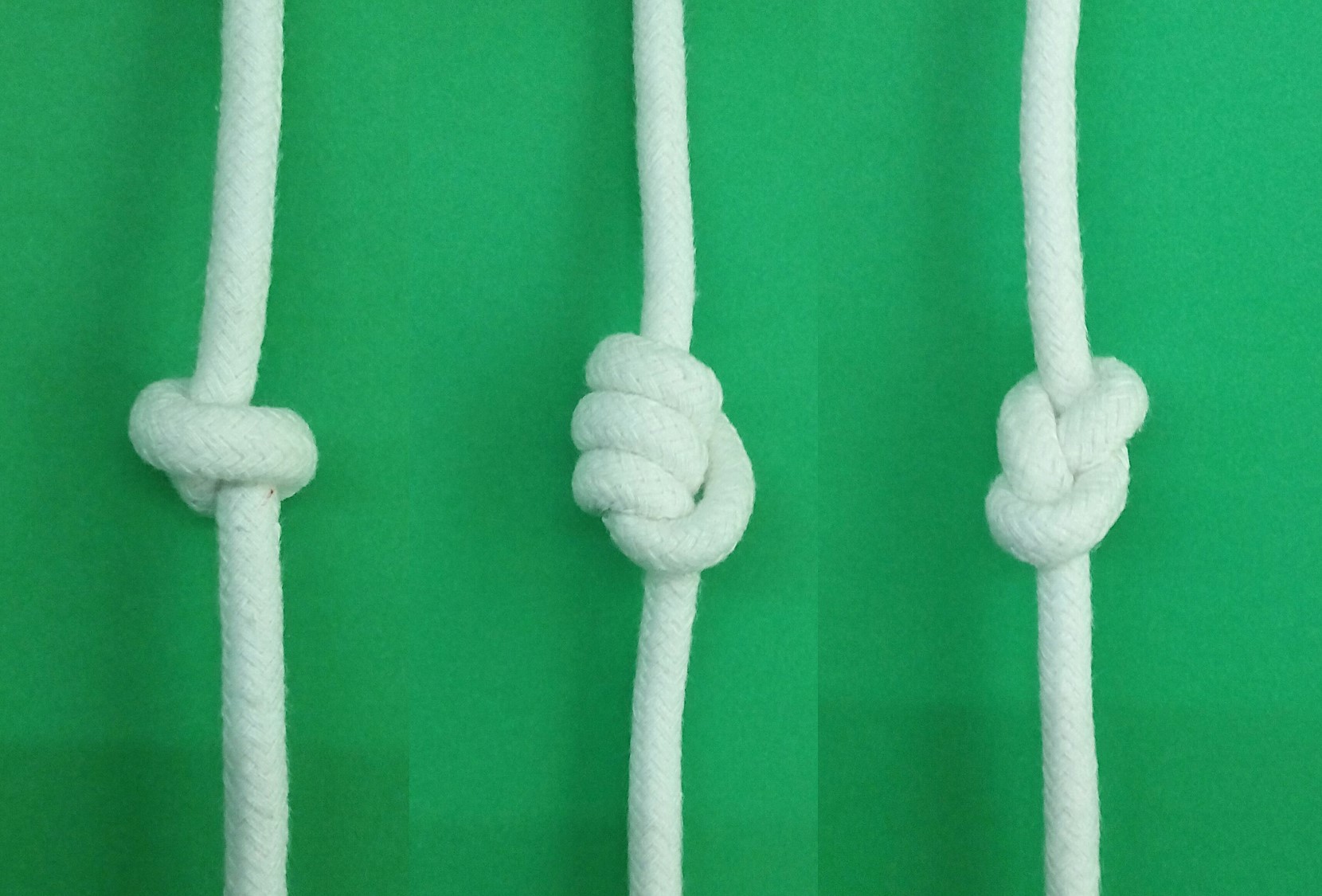

¿Cómo se representaba un número, mediante nudos, en cada uno de las cuerdas colgantes? Existían tres tipos de nudos, los nudos simples, los nudos largos y los nudos en forma de ocho.

Ejemplos de un nudo simple, un nudo largo (triple) y un nudo en forma de 8

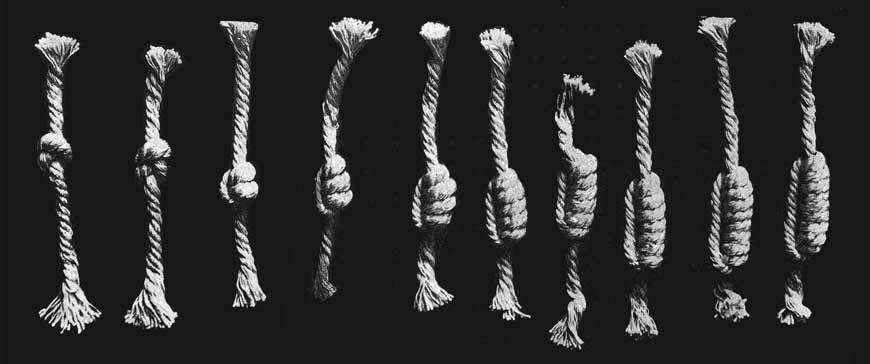

Imagen con una secuencia de nudos que se inicia con dos nudos simples, realizados en las dos direcciones, que representan a 1 y nudos largos de dos a nueve giros, que representan a las cifras del 2 al 9, del artículo “Q’eros: a Study in Survival” –Natural History Magazine 1957–, de John Cohen

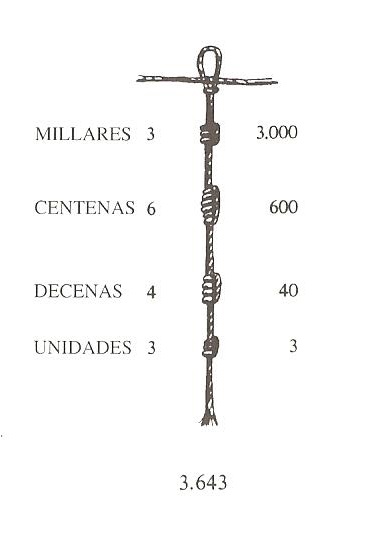

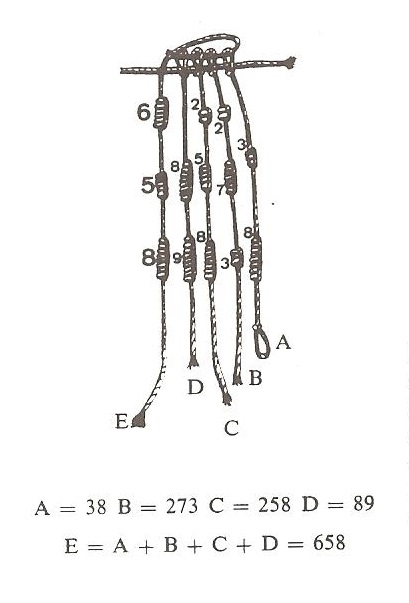

El nudo con forma de 8 representa al 1, pero solamente en la que va a ser la zona o posición de las unidades, los nudos largos representan los números del 2 al 9, en la zona de las unidades, y cada uno de los nudos simples representa una unidad en las posiciones de las decenas, centenas, millares, etcétera, de forma que si queremos representar cualquier cifra del 1 al 9 en una de estas zonas se hacen tantos nudos simples como indique la cifra, por ejemplo, 5 nudos para la cifra 5.

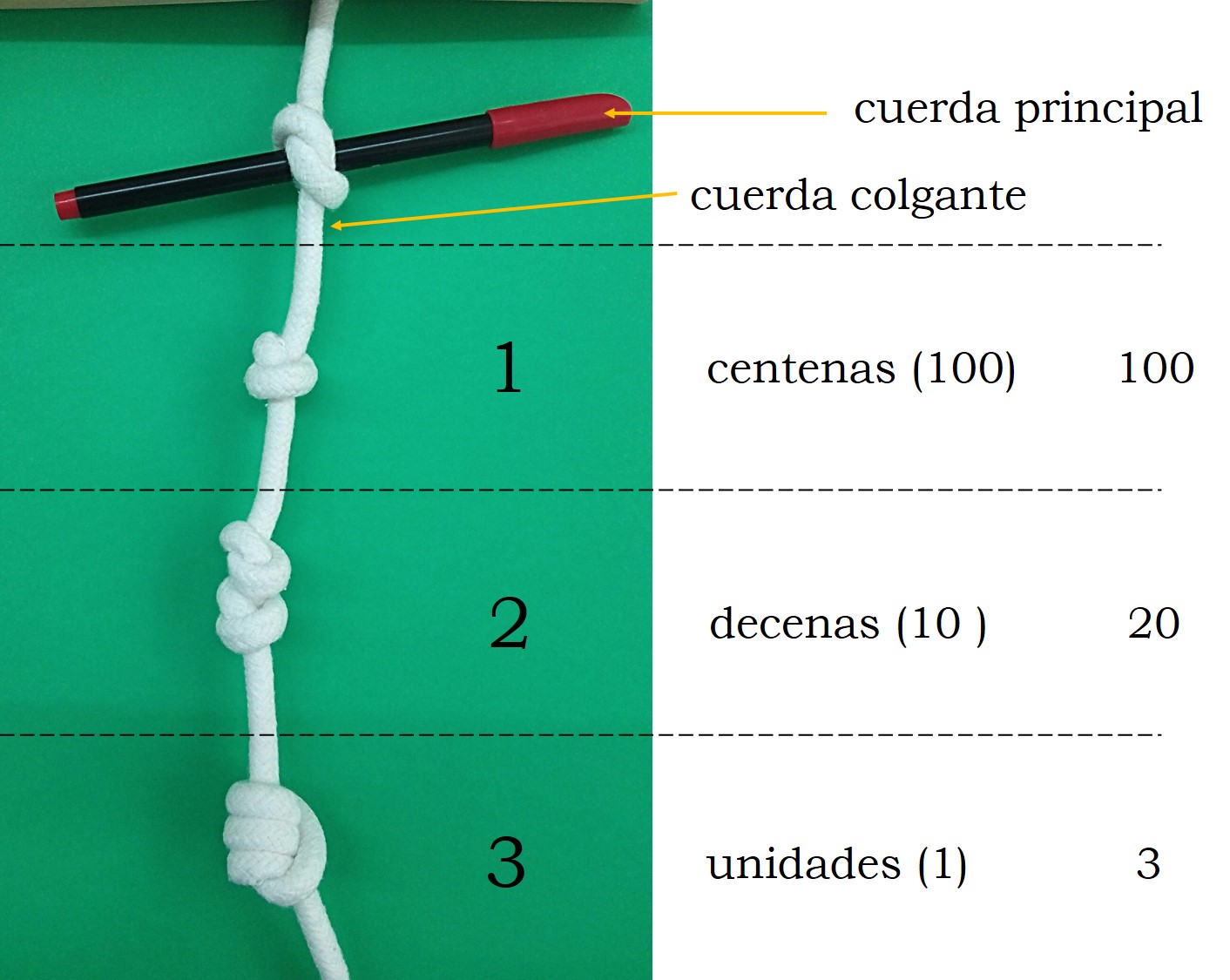

En la cuerda colgante en la que queremos representar nuestro número se marcan zonas numéricas equidistantes en función de las necesidades. La zona de las unidades sería la zona más alejada de la cuerda principal, la siguiente zona, hacia la cuerda principal, serían las decenas, la siguiente las centenas y así hasta la cantidad de zonas que se necesiten para representar nuestro número.

En el siguiente ejemplo de cuerda colgante de un quipu que he simulado, el número representado es el 123, ya que, en la zona más baja, por lo tanto la de las unidades, hay un nudo largo triple, luego nos marca un 3 en las unidades, en la siguiente zona, la de las decenas, tenemos dos nudos simples, luego nos marca un 2 × 10 = 20, y en la zona más cercana a la cuerda principal, la de las centenas en este caso, hay un nudo simple, luego marca un 1 × 100 = 100, y el número representado es el 3 + 20 + 100 = 123.

Representación del número 123 en un quipu simulado, con un nudo largo triple en las unidades, dos nudos simples en las decenas y un nudo simple en las centenas

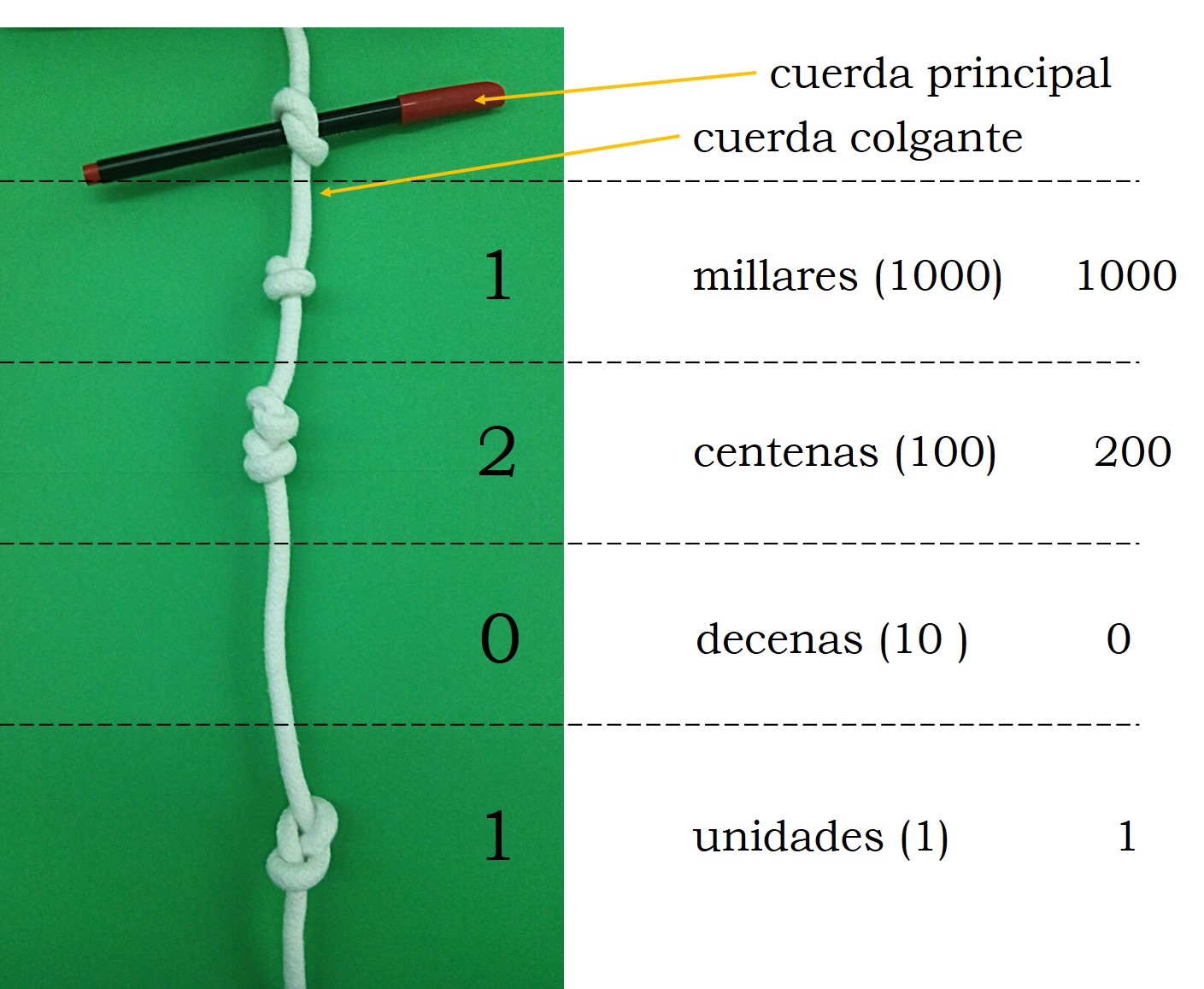

No existía una cifra específica para el cero, pero los incas sí eran capaces de utilizar el vacío en la cuerda para representar que en esa posición no había ningún valor, es decir, se correspondía con el valor cero. Lo cual es esencial para cualquier sistema posicional, como pueda ser este o el indo-arábigo. En el siguiente ejemplo hemos representado el número 1.201, ya que en la zona de las unidades hay un nudo de 8, luego toma el valor 1, en la zona de las decenas no hay nudo, por lo tanto, el valor cero, en la zona de las centenas hay dos nudos simples, luego toma el valor 2 × 100 = 200, y en la zona de los millares hay un nudo simple, esto es, 1 × 1.000 = 1.000, luego el número representado en este quipu simulado es el 1 + 200 + 1.000, es decir, el número representado por 1.201 en nuestro sistema de numeración indo-arábigo.

El hueco vacío en la zona de las decenas indica que no hay decenas, y el número representado es el 1 + 200 + 1.000 = 1.201