La tentación de la explicación única

Una de las principales y quizá más importantes características del cerebro humano es esa incomodidad, esa especie de ‘picor’ metafísico que sufre cuando desconocemos la explicación a un fenómeno observado. Esa inquietud que nos lleva a perseverar en buscar explicaciones y que nos recompensa con un instante de placer, un destello de gozo y bienestar cuando descubrimos la solución a un problema o la explicación a un enigma: la razón de que los humanos consideremos los rompecabezas, puzzles y todo tipo de juegos de adivinanzas como algo agradable en lugar de como una maldición. A nuestra mente le gusta descubrir cosas, y esto hace que tengamos un irresistible impulso curioso que nos mueve a buscar y a preguntar.

Aunque como casi todas las características que podemos considerar ‘naturales’ esta tendencia irreprimible a la curiosidad también puede provocar efectos paradójicos que nos lleven justo en la dirección contraria a la que queremos llevar. La naturaleza y nuestros impulsos morales muchas veces no tienen un encaje sencillo, y si nuestra querencia por ese momento ‘ahá’ del descubrimiento y la comprensión nos puede llevar a practicar la ciencia y a buscar el conocimiento también nos puede empujar a una de las tentaciones intelectuales más comodonas y cobardes, como es la explicación única: inventar una teoría o concepto que, como una navaja suiza intelectual, sirve para explicarlo TODO.

Un ejemplo simple es la cosmogonía de todas y cada una de las religiones que en el mundo hay y ha habido, para las cuales la historia humana y prehumana se explica entera con un concepto simple: porque la [inserte deidad] así lo quiere. ¿La distribución de los animales y plantas y sus características? La divinidad así lo dispuso. ¿Algo que no encaja en física, geología, meteorología? Es voluntad de la deidad. ¿Problemas sociales, históricos, sorpresas evolutivas? Nuestro dios lo quiso así. Con un mínimo de flexibilidad que permita incorporar (como subunidades de la divina voluntad) cualquier explicación racional y lógica esta versátil herramienta no hay fenómeno, causa o consecuencia que no sea capaz de explicar. Con la ventaja de que incluso puede usarse para construir relaciones causales tan barrocas y complejas como para satisfacer a las mentes más inquisitivas: la historia de la escolástica demuestra la cantidad de esfuerzo intelectual que se puede dedicar (¿perder?) en tratar de seguir los vericuetos de la voluntad divina, si uno se empeña en ello.

La así llamada ‘teoría de los antiguos cosmonautas’ es una versión más moderna del mismo principio; en este caso la explicación multiusos se resume en una única palabra, que es ‘alienígenas’. ¿No entendemos los detalles nimios de cómo los egipcios construyeron las pirámides, los habitantes de la britania prehistórica erigieron Stonehenge o los incas crearon los magníficos templos de Cuzco o Machu Picchu? Los extraterrestres. ¿Hay parecidos entre algunos edificios erigidos por civilizaciones dispersas a grandes distancias en el espacio y el tiempo? Claro, porque los alienígenas. ¿Algunos símbolos de lenguajes separados por decenas de miles de kilómetros y otros tantos años se parecen, si los miramos asá? Lógico: es cosa de los Grises y su (oculta, casi indescifrable, misteriosa, constante) intervención en la historia humana. Como las cosmogonías religiosas se trata de crear una explicación única que sirve para tapar cualquier hueco en nuestro conocimiento y que rellena cualquier grieta, real o imaginaria. Teniendo una explicación, única, polivalente y sin posible discusión, hay quien se da por satisfecho y a otra cosa. Todas las ventajas del conocimiento sin necesidad ninguna de trabajar para conseguirlo: un verdadero chollo.

Las cosas, por supuesto, son mucho más complejas, difíciles de comprender e interesantes que todo eso. Las explicaciones únicas sólo satisfacen el principio de economía de esfuerzo: contempladas con espíritu crítico las numerosas simplificaciones y renuncias intelectuales que conllevan quedan dolorosamente claras. Cuando se aplica un mínimo de rigor las juntas de las grietas salen a la superficie, las dudas vuelven y los hechos no encajan; la realidad siempre es mucho más sutil e interesante que las explicaciones polivalentes que al igual que las herramientas multiuso sirven para todo, pero todo lo hacen mal. Lo más curioso es que sí hay una explicación subyacente que es real a muchas de las coincidencias en las que se apoyan los partidarios de las teorías únicas del universo, una que es tan obvia que raras veces se subraya y que es tan simple como caer en que hay un factor común en muchos fenómenos y misterios, que no es otro que el factor humano.

Si hay paralelismos entre edificios, momentos históricos, imágenes o decoraciones entre diferentes civilizaciones es porque todas ellas estaban compuestas por seres humanos, que comparten limitaciones, capacidades e inteligencia. Si muchos edificios antiguos tienen forma de pirámide es porque todos ellos fueron construidos por sociedades de humanos, que por definición miran, piensan y trabajan de formas paralelas, ya que pertenecen a la misma especie. Si existen similitudes entre representaciones gráficas de distintas civilizaciones y tiempos es porque todas las civilizaciones comparten un hecho común, que no es que fueran visitadas por deidades o extraterrestres, sino que estaban compuestas por personas. Extraer este factor común es suficiente casi siempre para que las teorías de la Explicación Única se derrumben como si estuviesen hechas de arena. Que, intelectualmente, es de lo que son.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La tentación de la explicación única se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La tentación de la posesión

- Por qué los niños preguntan “por qué” y qué constituye una buena explicación

- Pseudociencia y arrogancia

Los amiloides y el origen de la vida

Suponiendo que reconozcas la palabra amiloide, si te pido que la asocies con algo lo más probable es que ese algo sea el alzhéimer. Si por alguna razón te interesa el mundo de las enfermedades neurodegenerativas es probable que también la asocies al párkinson o a la enfermedad de Creutzfeldt-Jacobs. Lo que es menos probable es que la asocies con el origen de la vida. Y de esto precisamente es de lo que vamos a hablar.

Los amiloides son agregados fibrosos de unas moléculas llamadas péptidos. Hasta hace poco no se sabía que los amiloides aparecen como elementos estructurales y funcionales en una amplia gama de formas de vida, desde bacterias, levaduras y hongos hasta humanos. En los vertebrados intervienen en la producción del pigmento melanina (en los humanos este es la molécula que los broncea al exponerse al sol), mientras que las células de levadura usan agregados amiloides para formar un tipo de memoria molecular (sí, eso existe).

Las fibras de amiloide están compuestas de aminoácidos unidos de una forma concreta, la parte ácido de uno con la amino del siguiente, formando lo que se conoce como enlace peptídico; por ello se dice que los amiloides son péptidos cortos. Las proteínas son cadenas largas de péptidos (polipéptidos) y las enzimas son proteínas que aceleran y regulan las reacciones bioquímicas. Resulta que las fibras de amiloide pueden acelerar las reacciones bioquímicas de una forma similar a como lo hacen las enzimas. Este hecho ha sido clave para que algunos investigadores aventurasen la posibilidad de que los amiloides participasen activamente en el origen de la vida como precursores de las moléculas de la vida, la llamada abiogénesis. Pero faltaba algo evidente en esta hipótesis: la capacidad de autorreplicarse.

Ahora, investigadores del Instituto Federal Politécnico de Zúrich (Suiza) han realizado un experimento en el que demuestran que los amiloides pueden servir como plantilla química para la síntesis de péptidos cortos. De donde se deduce que esta capacidad también se aplicaría potencialmente al amiloide mismo, él mismo un péptido corto; por lo tanto las moléculas podrían autorreplicarse.

Hace dos años este mismo grupo de investigación demostró experimentalmente que las estructuras amiloides pueden formarse espontáneamente con asombrosa facilidad, a partir de aminoácidos simples que probablemente ya existían cuando la Tierra aún carecía de vida, y bajo condiciones de reacción que parecen muy plausibles que pudiesen existir en aquella época. Lo mismo aplica para la síntesis de péptidos cortos: el mecanismo de reacción es general, es estable en un rango amplio de condiciones de temperatura y salinidad, y lo es tanto en medios ácidos como básicos. Todo esto junto refuerza la idea de que los amiloides pudiesen haber jugado un papel relevante en la historia evolutiva química, tanto como portadores de información como como catalizadores.

Hasta ahora la hipótesis más aceptada para los comienzos moleculares de la vida ha sido la del ARN, que ve al ácido ribonucleico (ARN) como el único elemento clave en la sopa prebiótica primordial. Esto se debe a que, al igual que el ADN, las moléculas de ARN pueden codificar información y también pueden autorreplicarse.

Estos resultados harían de la hipótesis amiloide una idea claramente competitiva frente a la hipótesis del mundo de ARN por dos motivos fundamentalmente. El primero porque las moléculas de ARN con función biológica son mucho más grandes y complejas que los amiloides, por lo que es menos fácil que se formen en condiciones prebióticas. Por otra parte, los amiloides son mucho más estables y tienen una ruta de síntesis abiótica mucho más simple que las versiones catalíticas del ARN.

No se podrá probar nunca a ciencia cierta cual es la hipótesis correcta. Pero no parece demasiado aventurado afirmar que pudieron existir procesos moleculares múltiples que participaron en el origen de la vida.

Referencia:

Rout SK, Friedmann MP, Riek R, Greenwald J (2018) A prebiotic template-directed peptide synthesis based on amyloids. Nature Communications doi: 10.1038/s41467-017-02742-3

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Los amiloides y el origen de la vida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Carlos Briones y el origen de la vida

- ¿Y si la Gran Oxidación tuvo un origen geológico?

- Un origen químico de la vida elegantemente simple

Pierre Fatou, un matemático poco (re)conocido

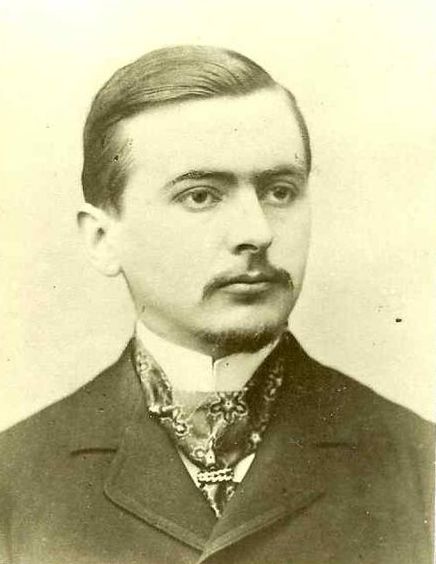

Pierre Joseph Louis Fatou (1878-1929) nació tal día como hoy, hace 140 años.

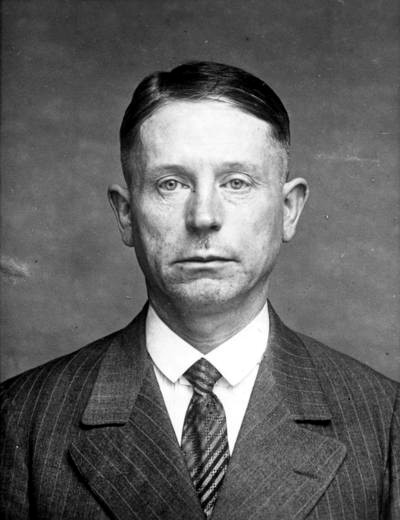

Pierre Fatou. Fuente: Wikimedia Commons

Fue un matemático y astrónomo francés. Ingresó en la École Normale Supérieure de París en 1898 para estudiar matemáticas, y se graduó en 1901. Intentó obtener un puesto como matemático –en el Collège de France, en La Sorbona, etc.– sin éxito: trabajó durante casi toda su vida como astrónomo adjunto de Observatorio de París, hasta el año 1928 en el que se convirtió en astrónomo titular. Como cualquier astrónomo que trabajaba por la noche, vivía cerca del Observatorio, en el boulevard Montparnasse, cerca del Bal Bullier, un salón de baile en el que pasaba bastante tiempo practicando una de sus pasiones –le gustaba la música, la fotografía, caminar por París, los paseos por la montaña… y el baile: incluso asistió a clases de tango–.

Fue un científico activo, que escribió numerosos artículos de matemáticas sobre temas variados de análisis y geometría, realizó observaciones astronómicas –se especializó en el análisis de estrellas dobles– y obtuvo importantes resultados sobre mecánica celeste.

También estuvo integrado en medio científico de su tiempo, siendo miembro activo de las comunidades matemática y astronómica. Fue –entre otros– presidente de la Association amicale des personnels scientifiques des observatoires français y participó en las actividades de la Société mathématique de France desde 1907 hasta su muerte –fue su presidente en 1926–.

¿Qué aportaciones matemáticas realizó? Es muy conocido –cualquier persona que ha estudiado teoría de la medida lo debería recordar– el lema de Fatou. Su tesis doctoral, defendida en 1907, llevaba por título Séries trigonométriques et séries de Taylor.

Las personas que trabajan en dinámica compleja saben, además, que Fatou fue uno de los creadores de su disciplina. Su carrera fue lenta y modesta, como él mismo admitía a su amigo Paul Montel (1876-1975) hacia 1920:

En cuanto a mí, me he resignado de antemano a no llegar nunca, continuaré tranquilamente mi profesión de suborden […]; no es muy glorioso, pero mi filosofía se acomoda y eso no me impedirá hacer matemáticas en la medida de mis posibilidades (traducido de [1]).

Desde 1906, Fatou empezó a interesarse en los procesos iterativos, y aunque obtuvo resultados sorprendentes, no publicó nada sobre este tema.

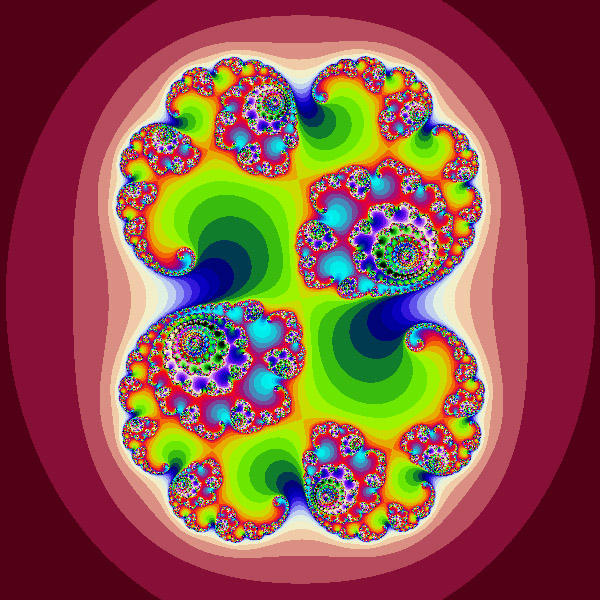

En 1915, la Académie des sciences convocó precisamente un Grand Prix des sciences mathématiques –para 1918– sobre este tema. Fatou empezó a trabajar en ello a partir de 1917 y publicó sus resultados en forma de notas en los Comptes rendus. En junio de 1917, Paul Montel publicó una nota en esta misma revista científica sobre otro tema: contenía una idea de la que Fatou se adueñó, y que sesenta años más tarde Benoît Mandelbrot (1924-2010) denominaría conjuntos de Julia.

Un conjunto de Julia. Fuente: Wikimedia Commons

El matemático Gaston Julia (1893-1978) también había visto la nota de Montel, y tuvo ideas análogas a las de Fatou… reclamó la prioridad sobre ellas y la Académie des sciences se la concedió. Fatou continuó trabajando tranquilamente sobre el tema, y Julia envió su candidatura para el Grand Prix des sciences mathématiques y lo ganó. Aunque Fatou no presentó su candidatura para el premio, la Académie des sciences le mencionó en el informe que atribuía el premio a Julia, y posteriormente le concedió un reconocimiento por sus trabajos en este tema.

¿Por qué la Academia se posicionó a favor de Julia? En [1], Michèle Audin comenta que quizás la situación de Gaston Julia pudo ayudar. El joven Julia tuvo que partir a la guerra en 1914 tras su brillante carrera en la École normale supérieure de París. En enero de 1915 fue gravemente herido en la cara –tuvo que llevar toda su vida una máscara de cuero–. Muchos jóvenes científicos franceses fallecieron en aquella guerra y, quizás Julia representaba un icono para la comunidad matemática francesa.

En el libro [2] de Michèle Audin ([3] en su traducción al inglés), la autora habla precisamente sobre como Fatou y Julia inventaron los hoy llamados conjuntos de Julia. Habla de las matemáticas, los conflictos y las personalidades de estos dos científicos… y también un poco de dinámica compleja. ¡Muy recomendable!

Referencias

[1] Michèle Audin, Pierre Fatou, mathématicien et astronome, Images des Mathématiques, CNRS, 2009

[2] Michèle Audin, Fatou, Julia, Montel, le Grand Prix des sciences mathématiques de 1918, et après…, Springer, 2009

[3] Michèle Audin, Fatou, Julia, Montel. The Great Prize of Mathematical Sciences of 1918, and Beyond, Springer, 2011

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Pierre Fatou, un matemático poco (re)conocido se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un convite matemático ‘de altura’

- El problema matemático de las cartas extraviadas

- Del nudo gordiano al nudo de los enamorados, por territorio matemático

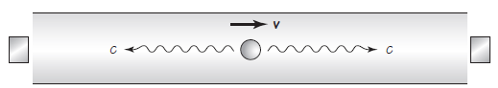

Corazones miogénicos y neurogénicos

Los iones como Na+, Cl–, K+, Ca2+ y otros no se distribuyen de forma simétrica a ambos lados de la membrana celular. Además, esta no es igualmente permeable para con unos iones y otros, y esa diferencia de permeabilidad determina que unos la puedan atravesar con facilidad y otros no. En las células animales la distribución de los iones a los dos lados de la membrana y la permeabilidad diferencial de esta para con unos y otros electrolitos da lugar a la existencia de una diferencia de potencial eléctrico entre el interior y el exterior celular. Llamamos “potencial de membrana” a esa diferencia de potencial, y suele ser negativa, lo que quiere decir que en el lado interno se acumulan cargas negativas y positivas en el externo.

Las células musculares se contraen en respuesta a despolarizaciones o cambios de polaridad de la membrana celular. O sea, la membrana celular puede pasar a tener más cargas positivas en el lado interno de la membrana y más cargas negativas en el externo. Esas despolarizaciones, denominadas potenciales de acción, son transitorias y, como se ha señalado, son los estímulos que provocan la contracción de las células musculares y, en consecuencia, el acortamiento del músculo1. Esto vale para todo tipo de musculatura, incluido el músculo cardiaco.

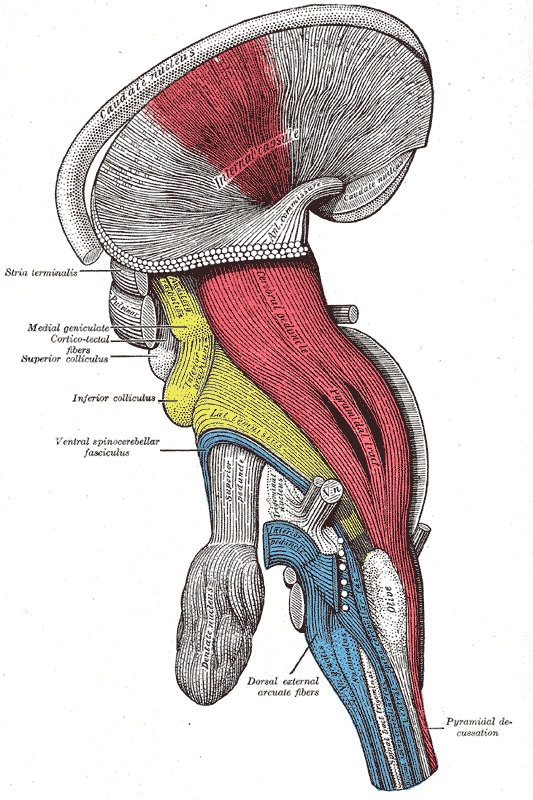

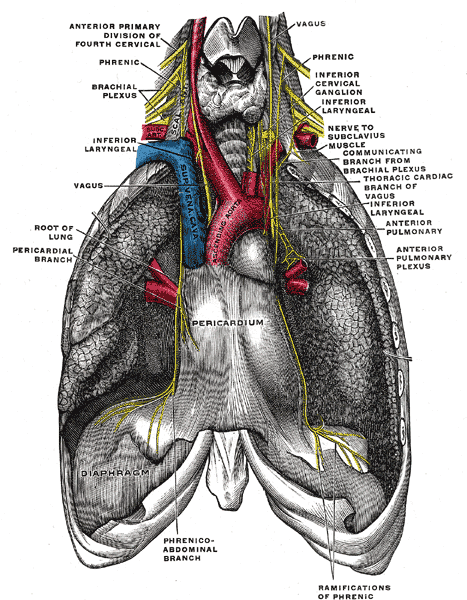

Un corazón se contrae rítmicamente porque sus células se contraen de esa forma. Eso quiere decir que en los corazones se están produciendo despolarizaciones de forma permanente con carácter rítmico. Por otro lado, la despolarización puede tener su origen en las mismas células cardiacas -en los corazones miogénicos-, o en células nerviosas -en los corazones neurogénicos-. Los corazones de vertebrados son del primer tipo, mientras que los de algunos artrópodos (crustáceos decápodos, cangrejo en herradura, arañas y escorpiones) son del segundo.

Corazones miogénicos

La mayor parte de los corazones de vertebrados reciben señales del sistema nervioso autónomo y está sometido a un cierto control por su parte, pero si se aísla uno de estos corazones, no deja de latir enseguida, lo que quiere decir que es capaz de hacerlo sin necesitar impulsos externos.

Las células cardiacas de vertebrados se hallan conectadas eléctricamente unas a otras mediante uniones gap, que son estructuras propias de ciertas membranas celulares que proporcionan continuidad citoplasmática a células adyacentes y que se encuentran en regiones especializadas denominadas discos intercalares. Las cargas eléctricas (en forma de iones) se mueven libremente por esas uniones gap, por lo que las despolarizaciones pueden transmitirse de unas células a otras a su través. Por ello, una vez se produce una despolarización en una célula, esta se extiende progresivamente al resto del corazón.

Las células cardiacas de vertebrados tienen la facultad de contraerse rítmicamente de forma espontánea. Pero si se dejase a cada célula contraerse por su cuenta, el conjunto del corazón no lo haría de forma coordinada, porque cada célula tendría su propio ritmo. Hay un grupo de células musculares especializadas, denominado marcapasos, que controla el ritmo de las demás células del miocardio (músculo cardiaco). En los vertebrados ectotermos el marcapasos se encuentra en la pared del seno venoso, la primera cámara cardiaca o en la unión entre el seno venoso y la aurícula. En aves y mamíferos, en los que el seno venoso ya se ha incorporado a la aurícula2, el marcapasos se halla en la pared de la aurícula derecha y es conocido como nodo seno-auricular. Las células del marcapasos son de naturaleza muscular pero apenas tienen capacidad para contraerse. Son las que tienen la frecuencia de despolarización espontánea más alta de todas las células del miocardio. Gracias a ese rasgo son las primeras en despolarizarse en cada latido, de manera que son las que inician la onda de despolarización que se expande por todo el corazón; y por ello el de esas células es el ritmo de contracción que seguirá todo el corazón.

Las aurículas están separadas de los ventrículos por una capa de tejido conjuntivo fibroso que no permite el paso de las señales eléctricas pues carecen de las uniones gap propias de las células musculares. En los mamíferos hay un sistema de conducción, una vía de conexión entre ambas zonas, las aurículas y los ventrículos. Está formado por células musculares especializadas, y empieza en un grupo de células situadas en la pared de la aurícula derecha que se denomina nodo aurículo-ventricular. De este nodo parte un conjunto de células denominado fascículo aurículo-ventricular, o fascículo de His, que atraviesa la capa de tejido conectivo y penetra en la pared o septo interventricular (pared que separa los dos ventrículos), donde se separa en dos ramas. Las ramas se deslizan por las superficies izquierda y derecha de la pared hasta conectar con las fibras de Purkinje, que se ramifican en el fondo de cada ventrículo.

El dispositivo descrito provoca que la onda despolarizante surgida en el nodo seno-auricular se extienda, en primer lugar, por las aurículas; una vez se han contraído estas, la onda se transfiere a los ventrículos a través del fascículo de His. De esa forma los ventrículos no comiencen su contracción hasta que no la han completado las aurículas, garantizándose así un flujo de sangre normal de las aurículas a los ventrículos.

Homarus gammarus

Corazones neurogénicos

Al contrario que en los corazones miogénicos, en los neurogénicos la despolarización rítmica no tiene su origen en células musculares, sino en células nerviosas. Un ejemplo magnífico de este tipo de corazones es el del bogavante. En este las células musculares funcionan de forma similar a como lo hacen las del músculo esquelético, ya que todas ellas se encuentran inervadas por células nerviosas que son las que les transmiten los impulsos que dan lugar a la despolarización de la membrana que desencadena el mecanismo de la contracción.

El tejido nervioso que genera las despolarizaciones rítmicas es el ganglio cardiaco, que consta de nueve neuronas y se halla situado en la superficie interna del lado dorsal del corazón. Los axones de cinco de esas neuronas inervan las células musculares. Y las otras cuatro, las que conforman el ganglio propiamente dicho son las que generan el ritmo de despolarizaciones; es una de sus neuronas, en concreto, la que asume esa función. Actúa como un generador central de patrones, produciendo de forma espontánea y periódica trenes de potenciales de acción (impulsos nerviosos). Esas señales se transmiten a través de las otras cinco neuronas a las células musculares, contrayéndose todas ellas casi al unísono. Al contrario que las células de los corazones miogénicos de vertebrados, si al corazón del bogavante se le priva del ganglio, sus células musculares no son capaces de contraerse de manera espontánea.

Fuente:

Richard W. Hill, Gordon A. Wyse & Margaret Anderson (2004): Animal Physiology. Sinauer Associates, Sunderland

Notas:

1 Conviene aclarar que bajo determinadas circunstancias puede producirse contracción de las células musculares pero el músculo no llega a acortarse. Es a lo que se llama contracción isométrica.

2 Aquí puede consultarse una descripción muy somera de los diferentes configuraciones cardiacas en vertebrados.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Corazones miogénicos y neurogénicos se ha escrito en Cuaderno de Cultura Científica.

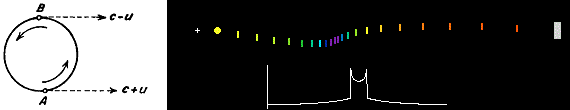

Entradas relacionadas:Confirmación experimental de la teoría de la relatividad especial (y 2)

La relatividad de longitud

Recuerdemos que una de las ideas básicas de la teoría de la invariancia es que toda velocidad es relativa al observador que mide la velocidad. Con esto en mente, volvemos al rompecabezas de los muones de larga vida, pero esta vez desde la perspectiva del desventurado muón que atraviesa la atmósfera de la Tierra. Desde el punto de vista del muón está en reposo, mientras que es la superfive de la Tierra la que está volando hacia él a una velocidad cercana a la velocidad de la luz. Dado que la Tierra se está moviendo ahora con respecto al propio marco de referencia del muón, la distancia desde la parte superior de la atmósfera hasta el suelo sufre una contracción de la longitud cuando se ve desde el punto de vista del muón. La contracción es tan grande que, desde la perspectiva del muón, no tiene problemas para cubrir esta distancia corta en los tan solo 2,2·10-6 segundos corta vida que tiene en su marco de referencia “estacionario”. Una vez más, las observaciones están en completo acuerdo con las predicciones de la teoría de la relatividad especial.

La relatividad de la masa

La teoría de la invariancia predice que la masa observada de un objeto aumentará a medida que aumente la velocidad relativa del objeto. Curiosamente, este efecto se había observado incluso antes de la teoría de Einstein, cuando los científicos se sorprendieron al notar un aumento en la masa de los electrones de alta velocidad en los tubos de vacío. Este efecto se observa fácilmente hoy en día en los aceleradores de partículas, donde las partículas elementales cargadas, como los electrones o los protones, se aceleran mediante campos electromagnéticos a velocidades tan altas como 0,9999999 de la velocidad de la luz. Las masas de estas partículas aumentan exactamente la cantidad predicha por la fórmula de Einstein. A esa velocidad, el aumento de su masa mm es aproximadamente 2236 veces la masa en reposo. De hecho, los aceleradores circulares deben diseñarse para tener en cuenta este aumento de masa.

A medida que las partículas se aceleran a altas velocidades por los campos eléctricos, los campos magnéticos las curvan en una trayectoria circular para hacerlas volver al principio y permitir que los campos eléctricos las aceleren repetidamente. Para impedir que la partícula que se mueve en una trayectoria circular salga en línea recta se requiere una fuerza centrípeta. Esta fuerza viene dada por la ecuación F = mv2 / R., donde R es el radio del círculo, que es constante; v es la velocidad de la partícula, que va aumentando aumenta; y m es la masa en movimiento, que también aumenta según la teoría de la relatividad.

Si los ingenieros no toman en cuenta el aumento de masa a la hora de diseñar los aceleradores de partículas, la fuerza magnética no sería suficiente para mantener las partículas en la trayectoria circular del acelerador, golpearían la pared y se acabó el acelerador. Un acelerador circular simple se llama ciclotrón. Pero cuando el aumento de la fuerza de aceleración (la frecuencia del campo eléctrico) se sincroniza con precisión con los aumentos de velocidad y masa relativistas, se llama sincrociclotrón.

La equivalencia de masa y energía

Einstein consideró la equivalencia de masa y energía, tal y como se expresa en la ecuación E = m·c2, como un resultado teórico significativo de la relatividad especial, pero no creía que tuviera ninguna importancia práctica cuando anunció su hallazgo. Y ahí se equivocó. Quedó patente en las explosiones nucleares (mejor que “atómicas”) de 1945. La tremenda energía liberada en una bomba de ese tipo se deriva de la transformación de una pequeña cantidad de la masa de los núcleos de uranio o plutonio en su enorme cantidad equivalente de energía.

Las bombas y los reactores nucleares se basan en la energía liberada por la división de átomos pesados. Un proceso opuesto, una reacción de fusión, tiene lugar cuando se unen núcleos de elementos ligeros. De nuevo, una pequeña cantidad de la masa se convierte en energía de acuerdo con la fórmula de Einstein. Aún no ha sido posible controlar este proceso de fusión a una escala suficiente para producir electricidad para uso doméstico e industrial; este proceso sí tiene uso militar. Con todo, el proceso de fusión nuclear tiene una importancia muy práctica: es la base de la producción de energía del Sol y todas las demás estrellas del Universo. Sin él, la vida no podría existir en la superficie de la Tierra.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Confirmación experimental de la teoría de la relatividad especial (y 2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Confirmación experimental de la teoría de la relatividad especial (1)

- La primera confirmación experimental de la teoría de Maxwell

- La relatividad de la masa

“Si todos tus amigos se tiran por un puente, ¿tú también te tiras?”: los adolescentes, los amigos y los riesgos

Fuente: Pixabay

En un experimento cuyos resultados se publicaron en 2014, se colocó a 66 chavales de entre 16 y 18 años en un simulador de conducción para medir lo temerario de sus decisiones. A veces conducían solos y a veces lo hacían acompañados por otro adolescente. Los resultados demostraron lo que cualquier padre cree saber por intuición: que un chaval de esa edad es mucho más sensato cuando está solo que cuando le ven sus amigos.

La forma en que los adolescentes se exponen a determinados riesgos es un quebradero de cabeza para cualquier progenitor: alcohol, tabaco, drogas, sexo sin protección, peleas, accidentes de tráfico, comportamientos temerarios en general… ¿Por qué estos hijos nuestros (vuestros) parecen olvidar todo lo aprendido sobre seguridad y autocuidado cuando llegan a la adolescencia y se rodean de la banda de cabestros (con perdón) que pueden llegar a ser sus amigos?

Que los adolescentes son más temerarios no es solo una intuición. Según datos de la OMS la tasa de muerte entre los 15 y los 19 años es un 35% mayor que entre los 10 y los 14, y los comportamientos de riesgo están asociados a muchas de las amenazas para la vida durante este periodo: los accidentes de carretera es la principal causa de muerte para adolescentes en todo el mundo, seguidos por las autolesiones y otras formas de violencia. Además, algunas prácticas que pueden llevar a problemas de salud más adelante, como el tabaquismo, el alcoholismo o una vida sedentaria muchas veces provienen de malas elecciones hechas durante la adolescencia.

Fuente: Pixabay

Más allá del “tú no me mandas”

Asociamos esa forma de asumir riesgos sin pensar en las consecuencias a la rebelión de la edad, el “tú ya no me mandas”, pero algunas investigaciones recientes que recoge la revista Nature en su especial Ciencia adolescente han empleado un enfoque neurocientífico más profundo para entender este fenómeno.

Porque entender la forma en que los adolescentes interactúan con el riesgo es interesante. Es cierto que asumen más peligros que los adultos, algunos de ellos con graves consecuencias: heridas, lesiones, enfermedades o problemas de salud de por vida, antecedentes penales y encontronazos con la justicia… Pero hay otros tipos de riesgos, como los riesgos sociales, por ejemplo, a los que pueden ser mucho más adversos que las personas de más edad, y otros, como los riesgos positivos (hacer exámenes o pruebas que den acceso a niveles educativos superiores, por ejemplo) con los que se relacionan de forma más habitual que nosotros.

Y cada uno de estos comportamientos parece tener diferentes efectos en el cerebro. Tener esto en cuenta puede ser importante por ejemplo para decidir si hay que reducir o no la edad mínima para conducir, o cómo debe tratarse a un adolescente que haya cometido un crimen. Saber cómo el cerebro adolescente evalúa y maneja las situaciones de riesgo puede servir para diagnosticar enfermedades como la esquizofrenia o la depresión, a que a menudo empiezan a asomar la patita durante la estos años.

No es un campo nuevo. El cerebro adolescente y su relación con el riesgo lleva años analizándose. Las primeras teorías apuntaban a un posible desequilibrio durante el desarrollo cerebral: las áreas asociadas con la impulsividad y con la sensibilidad a la recompensa, especialmente la recompensa social, se desarrollan mucho antes y del tirón, mientras que el control de los procesos cognitivos, como la memoria de trabajo (cómo almacenamos y elaboramos la información), siguen un proceso más lento pero continuado durante todo el crecimiento. La metáfora habitual era la de un coche con el acelerador pulsado a fondo pero con los frenos defectuosos.

Y esto encajaba con algunos datos, pero no con el hecho de que algunos adolescentes no son tan proclives a asumir riesgos, algo que debería ser generalizado si hablamos de una cuestión asociada con la edad y el proceso de desarrollo. Por eso ahora la mayoría de los neurocientíficos consideran que diferentes sistemas desarrollándose a diferentes velocidades no significan que el cerebro esté desequilibrado.

Fuente: Pixabay

La influencia de los iguales

Así que la investigación se orienta a un mayor abanico de riesgos y de influencias del ambiente. Para muchos adolescentes el riesgo no es solo lo que les puede causar daño físico o repercusiones legales: hay situaciones relativamente benignas, como pedir una cita a una persona que les gusta o dar la cara ante un progenitor o un profesor, que parecen para ellos mucho más arriesgadas.

En 2009, una investigación de la Universidad Temple, en Philadelphia, llevó a cabo una versión del experimento con el que abrimos este artículo: pidió a voluntarios adolescentes que se sometiesen a un escáner cerebral a la vez que jugaban a un videojuego en el que conducían un coche que pasaba por la enervante cantidad de 20 semáforos en 6 minutos. Algunos de ellos comenzaban a acelerar con la luz en ámbar mientras otros esperaban a que se pusiese en verde. A veces acelerar antes salía bien, pero otras terminaba en un accidente.

Los investigadores observaron que cuando los chavales jugaban a solas, asumían el riesgo de tener un accidente con la misma frecuencia que los adultos. Pero cuando se les decía que sus amigos les estaban viendo jugar desde la habitación de al lado, lo hacían con mucha más frecuencia. En otro experimento parecido, los chavales asumían muchos menos riesgos cuando se les decía que quien les estaba viendo jugar desde la sala contigua era su madre.

Mientras tanto, el escáner reveló una actividad muy intensa en las zonas del cerebro relacionadas con la recompensa, como la llamada núcleo estriado, cuando asumían riesgos mientras les veían sus amigos; cuando era su madre la que observaba, era la zona del córtex prefrontal, relacionada con el control cognitivo, la que se ponía a funcionar.

Fuente: Pixabay

La influencia del grupo no siempre es negativa

Así que se pudo comprobar una vez más que la propensión a asumir riesgos en los adolescentes depende en gran medida de las relaciones sociales con sus iguales, y del miedo a quedar aislados. Esto, de nuevo, es una realidad casi palpable para todos aquellos padres preocupados porque los amigos de sus hijos puedan ser para ellos una mala influencia.

Pero no todo es malo, porque algunos experimentos han demostrado un efecto positivo en esta presión de sus iguales. En un estudio se pidió a varios adolescentes que jugasen un juego en el que tenían que elegir entre donar dinero a una buena causa o quedárselo, mientras otros adolescentes les veían. Los resultados mostraron que si el sujeto hacía una donación y los otros aprobaban el gesto, éste tendía a hacer más donaciones durante el resto del juego. Así que, aunque solemos asumir que la influencia del grupo es siempre algo negativo, la realidad parece ser algo más compleja.

Y es aun más interesante observar que el mismo sistema cerebral que empuja a los adolescentes a asumir riesgos insanos les empuja también a asumir riesgos positivos: la actividad en el núcleo estriado, concretamente un aumento en los receptores de dopamina de esas zonas, se ha relacionado con una mayor sensibilidad a recompensas por actos positivos, así como peligrosos.

Las limitaciones de estos estudios

Como casi todos, estos estudios tienen sus limitaciones porque es difícil reproducir en un laboratorio los estímulos, las actividades y las condiciones sociales y de comportamiento en las que se ven envueltos los adolescentes en su día a día. Como mucho se puede captar la inclinación a asumir riesgos de los chavales que participan en ellos, pero eso queda algo lejos de cómo afrontan riesgos cotidianos concretos.

Hay que tener en cuenta también que los adolescentes de estos estudios, igual que la media, solo se exponen a riesgos moderados, mientras que existen algunos individuos que están dispuestos a exponerse a riesgos muy elevados (violencia juvenil, acceso a lugares peligrosos por caídas o accidentes…), y estos podrían procesar esos riesgos de una forma muy distinta.

Pero teniendo en cuenta lo que estos estudios revelan y lo que podemos aprender de estos adolescentes medios, quizá debamos replantearnos esas ideas preconcebidas sobre la adolescencia y la presión del grupo: existe y funciona para mal, pero también para bien, algo de lo que se habla mucho menos.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo “Si todos tus amigos se tiran por un puente, ¿tú también te tiras?”: los adolescentes, los amigos y los riesgos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Y si el cambio climático nos termina haciendo a todos más simpáticos?

- El sensacionalismo en las noticias clave en la concienciación sobre los riesgos de Internet

- La familia, los amigos, los jóvenes y la ciencia

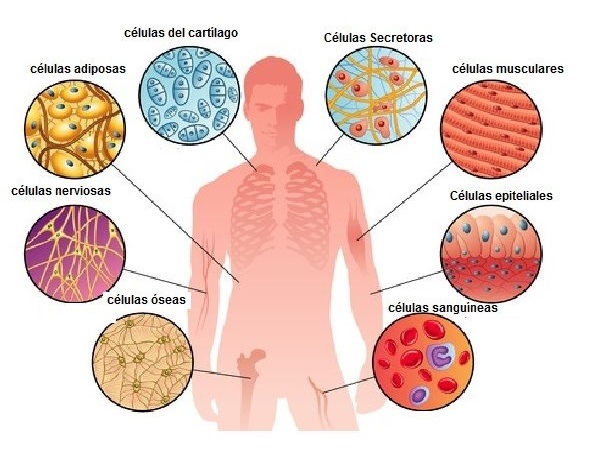

¿Cuántas células hay en el cuerpo humano?

La respuesta no es fácil y, de hecho, hasta hace poco no ha habido estimaciones mínimamente fiables. Los primeros cálculos con cierto rigor se publicaron en 2013, pero en 2016 se hicieron estimaciones más precisas de los seis tipos celulares que se tenían por más abundantes. Esos tipos daban cuenta del 97% del número total de células. Según los últimos cálculos, en el cuerpo de un hombre joven de unos 70 kg y 170 cm de estatura hay aproximadamente 30 billones de células. Y las cifras no serían muy diferentes para una mujer de similares características.

Las células más abundantes, con gran diferencia, son los glóbulos rojos. Hay del orden de veintiséis billones de estos y una cantidad ligeramente inferior en una mujer. Ese número representa el 84% de todas las células. Las plaquetas, aunque mucho menos numerosas, también son muy abundantes, un 4,9% del total. Si tenemos en cuenta que además de glóbulos rojos y plaquetas, en la sangre hay leucocitos, casi el 90% de las células del cuerpo humano se encuentran en la sangre. Y dado que tanto los glóbulos rojos como las plaquetas carecen de núcleo, resulta que casi el 90% de nuestras células -veintiséis billones- son enucleadas.

La médula ósea también contribuye con un elevado número al total: utilizando métodos histológicos, se ha estimado que contiene setecientos cincuenta mil millones de células (2,5%). Otro tipo abundante es el de las endoteliales vasculares, que son las células que tapizan el interior de los vasos sanguíneos. No es fácil determinar su número; lo han calculado a partir del volumen total de sangre que hay en los diferentes tipos de vasos (arterias, venas, capilares), estimando la longitud de cada tipo de vaso a partir de sus diámetros medios. De esa forma calcularon la superficie interna de los vasos, y la dividieron por la superficie media de las células endoteliales. Hay del orden de seiscientos mil millones de estas células (2,1%).

Los linfocitos –del sistema inmunitario- representan un 1,5% del total de células y los hepatocitos –del hígado-, un 0,8%. En el sistema nervioso hay neuronas y células de la glía; estas segundas son las que dan soporte a las anteriores. Pues bien, aunque antes se pensaba que había diez veces más células gliales que neuronas, parece ser que hay muchas menos de las primeras de lo que se creía y el número de unas y de otras es similar. Según las últimas estimaciones, tenemos alrededor de ochenta y cinco mil millones de neuronas y otras tantas células gliales; en conjunto suponen un 0,6% del total. El resto de tipos representan proporciones aún menores del acervo celular humano.

Las cifras anteriores expresan la cantidad de células, su número, pero la imagen cambia mucho si atendemos a la masa de cada tipo. El 25% del peso humano corresponde a líquidos extracelulares (plasma sanguíneo y líquido intersticial) y otro 7% son sólidos extracelulares. Por lo tanto, a una persona de 70 kg le corresponden 46 kg de masa celular. Esa masa se reparte del modo siguiente: 20 kg de células musculares; 13 kg de adipocitos (células con depósitos de grasa); 3 kg de glóbulos rojos. La masa del resto es, en total, de 10 kg. Así pues, las proporciones en términos de masa son muy diferentes, por la sencilla razón de que hay grandes diferencias en los volúmenes de unas células y otras.

Y por supuesto, también tenemos bacterias, en el colon principalmente, pero muchas menos de las que se pensaba: son del orden de 38 billones pero solo pesan unos 200 g en total.

Fuente: Ron Sender, Shai Fuchs & Ron Milo (2016): Revised Estimates for the Number of Human and Bacteria Cells in the Body. PLOS Biology

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 19 de noviembre de 2017.

El artículo ¿Cuántas células hay en el cuerpo humano? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuantas menos ecuaciones…. ¿mejor?

- Cómo criopreservar células madre

- Sistemas circulatorios: células sanguíneas

Naukas Bilbao 2017 – Laura Morrón: La gran divulgadora

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Laura Morrón presenta a su candidata al título de mejor divulgador/a de la historia: Jane Haldimand Marcet

Laura Morrón: La gran divulgadoraEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Laura Morrón: La gran divulgadora se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Naukas Bilbao 2017 – Mónica Lalanda: Una muerte de cómic

- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

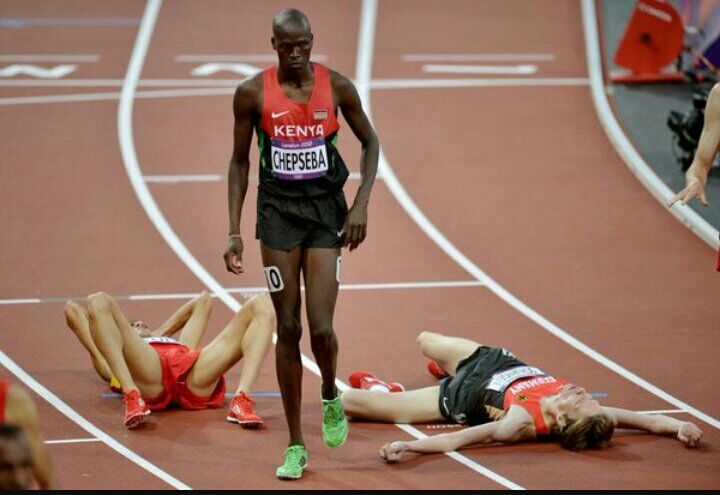

La sorprendente densidad ósea de los atletas kenianos

Los resultados del análisis de la densidad mineral ósea en atletas kenianos de élite es verdaderamente sorprendente. Está muy por debajo de lo esperado para hombres de su edad según las guías de la Sociedad Internacional de Densitometría Clínica.

Uno de los factores clave para alcanzar el éxito en el mundo del deporte de élite es minimizar el riesgo de lesiones de los deportistas. En el caso del atletismo de fondo, hay especial prevalencia en las fracturas óseas por estrés, ya que los corredores se someten a grandes cargas de entrenamiento que acaban por llevar sus cuerpos al límite.

Aunque aún no se conoce exactamente el vínculo, parece que existe cierta predisposición a las fracturas de estrés en aquellos individuos con una baja densidad mineral ósea. A diferencia de lo que ocurre con la cadera, o el cuello del fémur (donde los impactos repetitivos que supone la carrera a pie pueden incluso ayudar a incrementar la densidad ósea), la zona lumbar se ve menos expuesta a los impactos. Además, está compuesta mayoritariamente por hueso trabecular, su recambio óseo es mayor y depende más de factores hormonales y metabólicos. Todo eso hace que se suela usar como indicador de la salud ósea de los deportistas.

En el estudio ‘Bone health in elite Kenyan runners’, publicado por la revista Journal of Sports Sciences y en el que ha participado el doctor Jordan Santos-Concejero, del Departamento de Educación Física y Deportiva de la Universidad del País Vasco/Euskal Herriko Unibertsitatea, se analizó la densidad mineral ósea en atletas kenianos de élite y se compararon sus valores con sujetos control sudafricanos sanos de edad y antropometría similar. Para ello, midieron parámetros relacionados con la densidad mineral ósea y composición corporal en atletas kenianos de élite por absorciometría dual de rayos X con un escáner DXA, tanto en la zona del cuello del fémur y cadera como en la región lumbar. Además, se analizaron distintos parámetros biomecánicos con un sistema Vicon de captura del movimiento en 3D para valorar su posible influencia en la densidad ósea de los atletas estudiados.

Los resultados confirmaron, en parte, lo esperado, ya que los atletas kenianos presentaron una mayor densidad ósea en la región proximal del fémur y, de hecho, esa mayor densidad ósea parecía asociada a la carga de entrenamiento y la mayor rigidez articular de los atletas kenianos.

Sin embargo, en la zona lumbar, los resultados fueron muy distintos. “El 40% de los kenianos analizados presentaron valores de densidad ósea muy por debajo de la media esperable para hombres de su edad, según las guías de la Sociedad Internacional de Densitometría Clínica. Hasta el punto de ser clasificados como en riesgo de padecer osteoporosis por la Organización Mundial de la Salud”, comenta el profesor de la UPV/EHU.

Una de las posibles explicaciones para estos valores es un desequilibrio entre gasto y aporte calórico en esos atletas, que se ha visto repetidamente en la literatura que es negativo. Además, la alta carga de entrenamiento parece jugar un papel fundamental en esos bajos valores de densidad ósea en la zona lumbar.

Sin embargo, a pesar de esos valores aparentemente patológicos, la incidencia de fracturas de estrés en kenianos es relativamente baja. Una posible explicación son las menores fuerzas de contacto de estos atletas, tal y como se ha visto en estudios previos (como este o este) o, incluso, es posible que las guías estándar que se utilizan actualmente no sean representativas para una población tan especial como esos atletas, ya que no existen guías específicas para africanos del Este (a pesar de la influencia de la etnicidad en la incidencia de las fracturas de estrés). “Los resultados de este estudio vuelven a poner de relieve la complejidad del fenómeno africano en las pruebas de fondo, ya que un nuevo factor, en este caso su sorprendente densidad ósea, debe ser añadida a la ecuación”, concluye el doctor Santos-Concejero.

Referencia:

N. Tam, J. Santos-Concejero, R. Tucker, R.P. Lamberts, L.K. Micklesfield (2018) Bone health in elite Kenyan runners Journal of Sports Sciences, 36(4):456-461. 2018 doi: 10.1080/02640414.2017.1313998

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La sorprendente densidad ósea de los atletas kenianos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los corredores de élite kenianos oxigenan su cerebro de forma diferente

- La importancia del ritmo en la carrera de fondo

- El sorprendente penacho de Marte

¿Cuánto cuesta realmente investigar en biomedicina?

¿Cuánto cuesta investigar?

¿Cuánto cuesta un proyecto para investigar en biomedicina? Probablemente la gente diría que mucho dinero. Pero, ¿cuánto es mucho dinero? En los proyectos de investigación se habla de miles, de centenares de miles, hasta de millones de euros con aparente soltura. Cifras que son extrañas a la mayoría de la gente, que bastante tiene con llegar a fin de mes y cubrir gastos, cuando lo consiguen. Puede por ello parecer inoportuno o desconsiderado hablar de lo que cuesta investigar, cuando una parte importante de la sociedad tiene problemas esenciales para sobrevivir dignamente.

Sin embargo, creo que aportar cifras a este debate puede ser útil para entender lo que realmente cuesta llevar a cabo un proyecto de investigación en biomedicina. Creo que así puede comprenderse mejor lo que representan los presupuestos dedicados a la investigación por entidades públicas o privadas, las campañas solidarias llevadas a cabo heroicamente por asociaciones de pacientes o por grupos afectados por una determinada enfermedad, las colectas de fondos, las donaciones, etc… En definitiva, las iniciativas varias en favor de la ciencia. Y creo que puede servir para poner en valor lo que significa que estas iniciativas consigan miles, centenares de miles o quizás millones de euros para invertir en proyectos científicos en biomedicina.

Tras muchos años liderando proyectos de investigación y también evaluando proyectos para diversas fundaciones, agencias y administraciones nacionales e internacionales, he pensado que podría ser interesante compartir lo que yo considero que podría costar un proyecto “tipo” en el ámbito de la biomedicina, que es el que conozco.

El coste de un proyecto de investigación en biomedicina depende de muchos factores. Entre otros depende del número de años necesarios para su ejecución (suelen ser proyectos de 3 años, pero los hay de 1 año y hasta de 5 años), del área concreta de investigación (inmunología, oncología, metabolismo, enfermedades raras, neurociencias, etc…), del tipo de experimentos que vayan a acometerse, del número de personas involucradas en el equipo, si es necesario o no adquirir nuevos instrumentos, si es necesario o no contratar a personas para llevar a cabo los objetivos del proyecto, si es necesario o no usar modelos animales, del centro en el cual vaya a ejecutarse el proyecto, de la existencia o no de servicios de apoyo a la investigación en el centro de ejecución, etc.. innumerables factores que pueden hacer variar el coste final del proyecto.

Sin embargo, a pesar de las variaciones consubstanciales a cualquier proyecto de investigación, lo cierto es que todo proyecto científico, también en biomedicina, consta de dos apartados principales: costes directos y costes indirectos.

Los costes directos incluyen los gastos de personal, de adquisición de instrumental o equipos, de fungibles o consumibles, de servicios de apoyo a la investigación, de viajes y otros gastos (gastos de publicación, de telefonía, correos y mensajería, etc…).

Los costes indirectos corresponden a un porcentaje de los costes directos (habitualmente en nuestro país este porcentaje es del 21% para los proyectos financiados desde el denominado Plan Nacional de I+D+i) y es la parte que las instituciones destinan para sufragar los gastos de funcionamiento y mantenimiento de los centros de investigación (luz, agua, gas, calefacción y ventilación, servicio de limpieza, servicio de seguridad, servicio de mantenimiento, de instrumentación, servicios de apoyo científicos y administrativos, personal de apoyo, etc…).

Supongamos un grupo de tamaño medio en un centro de investigación público español que solicita un proyecto de investigación de biomedicina para los próximos 3 años. El grupo estaría formado por unas 5 personas: un/a investigador/a principal, un/a técnico/a de investigación, un/a investigador/a postdoctoral y dos estudiantes de doctorado. Muy probablemente los salarios del investigador postdoctoral, del técnico y de alguno (o los dos) investigadores predoctorales estarán vinculados a los fondos de investigación, a proyectos científicos que son los que sufragan, en su mayor parte o en su totalidad, los gastos de funcionamiento del laboratorio.

El primer apartado a considerar dentro de los costes directos es el capítulo de personal. Hay que recordar que, en los organismos públicos de investigación, los salarios están establecidos institucionalmente. Y son idénticos para hombres y mujeres, naturalmente. Por ejemplo, en el CSIC para contratar un titulado superior (licenciado o graduado, sea doctor o no) el coste de contratación anual, incluyendo las 14 pagas y la cuota patronal de la Seguridad Social, es de unos 36.000 Euros. De forma similar, el coste anual para contratar un técnico de apoyo es de unos 23.000 Euros. Por lo tanto, si proponemos en el proyecto la contratación de un investigador y de un técnico durante los tres años, algo totalmente razonable para poder abordar un nuevo proyecto de investigación en condiciones óptimas, entonces el coste de personal se nos pone ya en: (36.000 x 3) + (23.000 x 3) = 177.000 Euros.

¡Casi 180.000 Euros en Personal… y todavía no hemos gastado nada más ni hemos empezado a hacer ningún experimento! Este es el mundo real, con números reales.

Es probable que tengamos que adquirir algún instrumento específico, algún equipo que no tengamos o que debamos reemplazar o actualizar. Quizás una centrifuga de tamaño medio, un microscopio sencillo o un equipo de análisis de muestras. Aquí los precios pueden ser muy variables, pero algo razonable, para un equipo medio, sería presupuestar unos 30.000 Euros para la adquisición de estos equipos que son necesarios para abordar el proyecto de investigación en condiciones óptimas.

Seguidamente hay que contemplar los gastos fungibles, los denominados consumibles: material de plástico, de vidrio, reactivos varios de biología celular y biología molecular, productos químicos, kits para su uso inmediato, anticuerpos, medios de cultivo para las células, etc… De nuevo este capítulo puede ser muy variable, pero de nuevo, algo razonable, por experiencia, que se ajusta bastante bien a los gastos reales anuales promedio de un grupo de investigación en biomedicina, es considerar un gasto de 6.000 Euros por persona y año. Es decir, para un grupo de 5 personas le correspondería un presupuesto estimado de consumibles de 6.000 x 5 = 30.000 Euros/año, y, por lo tanto, para 3 años este apartado se elevaría a 90.000 Euros.

Supongamos que el grupo de investigación en biomedicina va a generar y utilizar modelos animales en el servicio de animalario del centro, y, además, va a requerir los servicios de genómica, de microscopía, de citometría, de histología y otros de apoyo a la investigación en el centro. Estos gastos pueden llegar a ser muy importantes, en particular los de generación y mantenimiento de modelos animales (generalmente ratones). Una cantidad mensual razonable para este capítulo de servicios sería de por lo menos 2.800 Euros al mes (de los cuales un 80% pueden perfectamente corresponder a los gastos de animalario). Con estos valores este gasto en servicios representa, para un proyecto de 3 años, 2.800 x 12 x 3 = 100.800 Euros.

Deberemos considerar un presupuesto para viajes, para la asistencia a reuniones nacionales e internacionales donde presentar los resultados que se obtienen y donde enterarse o ponerse al día de lo que están haciendo otros grupos que trabajan en temas similares o relacionados. La asistencia regular a estos congresos, cursos o talleres es esencial para mantenerse regularmente informado de cómo evoluciona un campo determinado, las técnicas que se están usando, las que ya han quedado obsoletas, descubrir nuevas ideas, etc… Asumiendo que una persona del grupo puede ir a una reunión internacional y otra a una reunión nacional por año, y asumiendo que un coste razonable de registro, viaje, alojamiento y dietas para una reunión internacional es de 1.750 Euros, y para una reunión nacional es de hasta 750 Euros, este apartado correspondería a unos 2.500 Euros por año, o un total de 7.500 Euros para los tres años.

Finalmente, también habrá que considerar un apartado relativamente indeterminado de “otros gastos”, en el que incluiremos los gastos de telefonía, mensajería, correos, gastos para tramitar patentes, gastos de publicación, gastos de revisión de manuscritos, etc… Este apartado puede suponer fácilmente unos 2.500 Euros al año. Por lo tanto, para 3 años este apartado sumaría por lo menos otros 7.500 Euros.

Si sumamos todas las cantidades anteriores completaremos el apartado de costes directos del proyecto. Así pues, sumando Personal (177.000 Euros), Equipos (30.000 Euros), Consumibles (90.000 Euros), Servicios (100.800 Euros), Viajes (7.500 Euros) y Otros gastos (7.500 Euros) nos saldrá una cifra de 412.800 Euros.

Para contemplar el apartado de costes indirectos calculamos el 21% de los costes directos previamente detallados. En el ejemplo considerado, para 412.800 Euros, el 21% representan 86.688 Euros.

Finalmente, el coste total de este ejemplo-tipo de proyecto de 3 años de investigación en biomedicina sería la suma de los costes directos e indirectos, es decir 412.800 + 86.688 = 499.488 Euros. Es decir, en números redondos, un proyecto ideal de biomedicina con una duración de 3 años en nuestro país desde un centro público de investigación realizado por un grupo de investigación de tamaño medio (5 personas) vendría a costar aproximadamente medio millón de euros. Aproximadamente unos 167.000 Euros por año.

De forma similar, si se dice que se destinarán 5 millones de euros a una iniciativa en Biomedicina y tenemos en cuenta el ejemplo anterior fácilmente se puede convertir esa cifra para llegar a deducir que son fondos suficientes para financiar óptimamente por lo menos unos 10 proyectos de investigación. Si fueran 50 millones de euros entonces la cantidad correspondería a unos 100 proyectos de investigación. 500 millones de euros darían para 1.000 proyectos de investigación.

El ejemplo anterior ilustra, en mi opinión, el coste lógico, razonable para la ejecución óptima de un proyecto de investigación en biomedicina de 3 años, en una situación ideal. Sin embargo, este no suele ser el importe habitual con el que se financian los proyectos de investigación.

Desafortunadamente, debido a la limitación en los fondos destinados a investigación, atendiendo también a la calidad científico-técnica de los proyectos (su impacto previsible en el campo y/o en la sociedad, la trayectoria del investigador principal, la del grupo), a la voluntad de intentar financiar el máximo número de proyectos de investigación con el máximo posible de financiación, y todo ello en función del presupuesto global disponible, lo que en realidad sucede es que pocos proyectos financiados apenas llegan o superan la mitad del ideal calculado, esto es, unos 250.000 Euros. Y, generalmente, la mayoría acaban financiándose por debajo de esa cifra, con importes de alrededor de 150.000-180.000 Euros, o incluso cantidades inferiores.

¿Qué se puede hacer cuando se reciben menos fondos que los inicialmente presupuestados para ejecutar el proyecto de investigación? Lo primero que la agencia financiadora asume y pide al investigador principal es que el grupo deberá poder acometer todos los objetivos que pretendía con una financiación sensiblemente inferior, aunque parezca bastante obvio que es prácticamente imposible. No queda otra que activar la imaginación, la austeridad y los sacrificios. Y por supuesto acudir a otras agencias o fuentes de financiación con otro proyecto, más o menos relacionado, para compensar el déficit presupuestario. Aunque con ello estemos comprometiendo el tiempo de escritura, desarrollo y justificación de diversos pequeños proyectos (y, sobre todo, el tiempo administrativo, la burocracia que requiere cada uno de ellos), tiempo que el investigador principal deja de poder destinar a los aspectos directamente relacionados con la investigación.

¿Qué hacemos con 180.000 Euros para 3 años cuando nuestro proyecto estaba presupuestado en 500.000 Euros? Para empezar, hay que tener en cuenta que no recibiremos 180.000 Euros, sino unos 150.000 Euros (exactamente 148.760 Euros), tras detraer el 21% de costes indirectos. Esto corresponde aproximadamente a 50.000 Euros de gastos directos por año.

Para recortar el presupuesto, lo primero que tendremos que revisar es el capítulo de Personal. Ya no va a ser posible contratar al técnico, y ya no vamos a poder contratar al investigador que pretendíamos durante 3 años. A lo sumo podremos contratarle por 1 año, es decir 36.000 Euros. Seguidamente, ya no compraremos ningún equipo nuevo. Nos apañaremos con los que tenemos o usaremos los equipos de nuestros colaboradores. Tendremos que apretarnos el cinturón y gastar mucho menos por persona y año, quizás la mitad (3.000 Euros/persona/año, para un grupo de 5 personas, 45.000 Euros).

También tendremos que limitar mucho los gastos de servicios, y, en particular, disminuir significativamente los gastos de nuestro animalario, a aproximadamente un total de servicios de 20.000 Euros por año, que corresponde a 60.000 Euros para los 3 años. Sumando estas cantidades: 36.000 + 45.000 + 60.000 = 141.000 Euros nos quedarían unos 9.000 Euros para viajes y otros gastos. Ya no podremos hacer todos los viajes que teníamos previstos, quizás solamente uno internacional y tres nacionales, por un total de 4.000 Euros. Y nos quedarían 5.000 Euros para los 3 años para “otros gastos”.

Ahora quizás se entiendan mejor las reacciones agridulces que se suceden en los centros de investigación cuando se conocen las listas de los proyectos financiados. En primer lugar, en el mejor de los casos, la alegría de saber que tu proyecto está en la lista de los seleccionados, de los propuestos para su financiación. E inmediatamente después, la tristeza y la preocupación, al constatar que la cantidad asignada es sensiblemente inferior a la que fue inicialmente presupuestada y, por ello, deberemos acometer fuertes ajustes económicos a nuestro proyecto, recortando aquí y allá, para poder ejecutar gran parte de los objetivos previstos.

Una persona no relacionada con la investigación puede que no comprenda el por qué de la aparente mezcla de alegría, tristeza y preocupación de un investigador al que le acaban de otorgar 180.000 Euros para los próximos 3 años, cuando probablemente lo que ocurra es que el coste presupuestado para el proyecto era bastante mayor, y lo que preocupa ahora al investigador es cómo abordar los experimentos planeados con una menor financiación.

Este post ha sido realizado por Lluis Montoliu (@LluisMontoliu) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo ¿Cuánto cuesta realmente investigar en biomedicina? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- “Nanobiosensores: Aplicaciones en la frontera entre las nanociencias y la biomedicina” por Luis Liz-Marzán

- “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

- Proyecto Mohole, un fracaso que no hacía falta

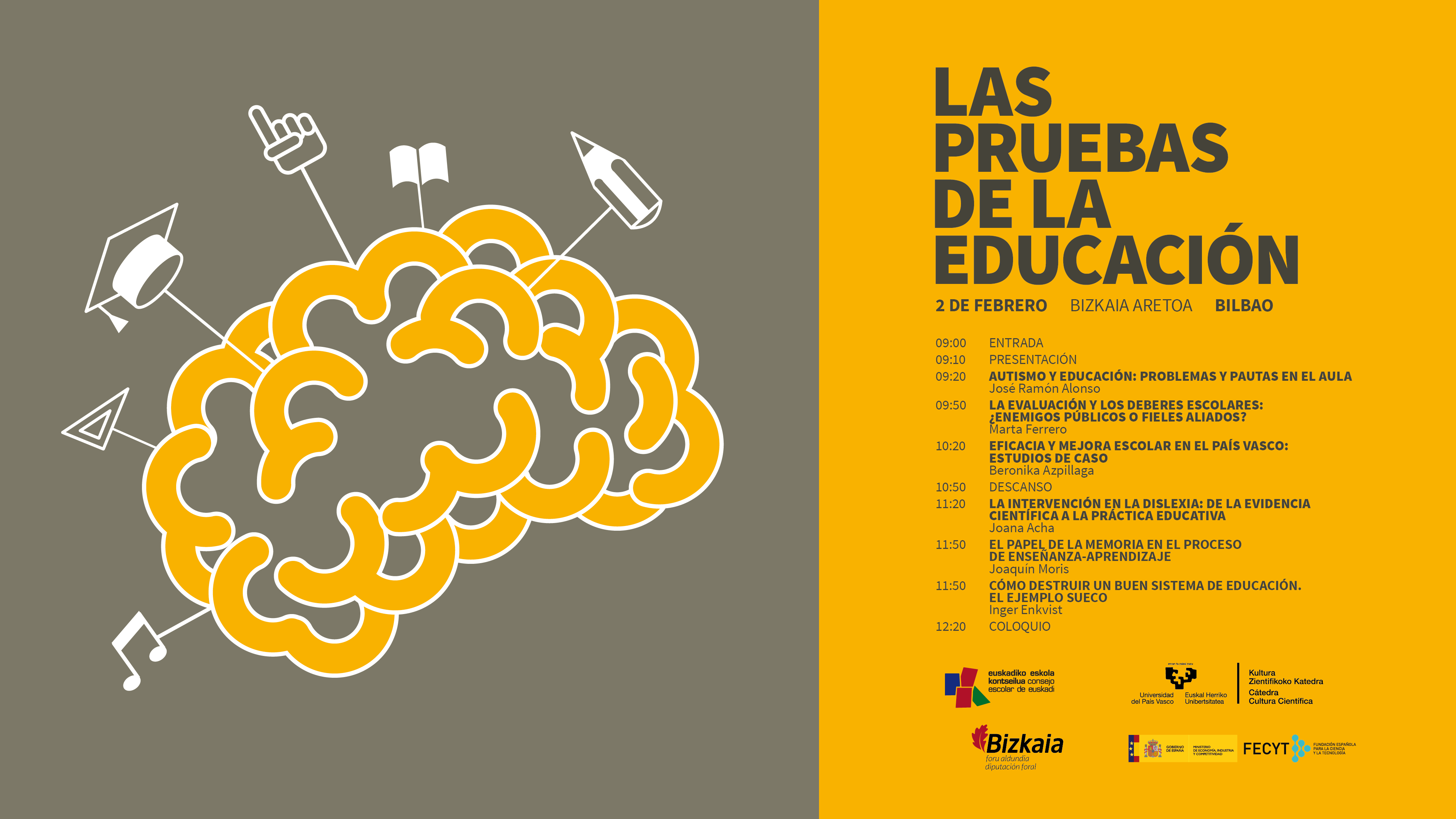

La intervención en la dislexia: de la evidencia científica a la práctica educativa

¿Cómo se tratan algunos de los trastornos cognitivos más frecuentes en las aulas? ¿Son efectivos los programas y herramientas del sistema educativo actual? ¿Carecen de eficacia algunas de las prácticas educativas más populares?

Estas son algunas de las cuestiones que se debatieron en la jornada “Las pruebas de la educación”, que se celebró el pasado 2 de febrero de 2018 en el Bizkaia Aretoa de Bilbao. El evento, en su segunda edición, estuvo organizado por la Cátedra de Cultura Científica de la UPV/EHU y el Consejo Escolar de Euskadi, con la colaboración de la Fundación Española para la Ciencia y la Tecnología (FECYT).

Las ponencias de los expertos que expusieron múltiples cuestiones relacionadas con la educación, basándose siempre en las pruebas científicas existentes. Los especialistas hicieron especial hincapié en destacar cuál es la mejor evidencia disponible a día de hoy con el objetivo de abordar las diferentes realidades que coexisten en las aulas y en el sistema educativo en general.

“Las pruebas de la educación” forma parte de una serie de eventos organizados por la Cátedra de Cultura Científica de la UPV/EHU para abordar cuestiones del día a día como la educación o el arte desde diversos ámbitos de la actividad científica. La dirección del seminario corre a cargo de la doctora en psicología Marta Ferrero.

Joana Acha, profesora en el departamento de Procesos Psicológicos Básicos y su Desarrollo de la UPV/EHU, revisa los métodos de prevención e intervención más efectivos para el desarrollo de las habilidades básicas implicadas en la dislexia. La especialista en procesos cognitivos infantiles aporta evidencias de los cambios cerebrales que acompañan a la adquisición de dichas habilidades.

Joana Acha: ''La intervención en la dislexia''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo La intervención en la dislexia: de la evidencia científica a la práctica educativa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Autismo y educación: problemas y pautas en el aula

- Prohibir los herbicidas con glifosato es anteponer la ideología a la evidencia científica

- La evaluación y los deberes escolares

Aunque tengas colesterol, podrás desayunar huevos

Las enfermedades cardiovasculares son la principal causa de muerte en el mundo. Cada año mueren más personas por enfermedades cardiovasculares que por cualquier otra causa. Por eso cuando el médico nos alerta de que tenemos el colesterol alto, nos entra el miedo.

¿Recuerdas aquello de que no debemos tomar más de tres huevos a la semana? Pues olvídalo. La culpa de tu colesterol no la tienen los huevos.

¿Qué es el colesterol?

El colesterol es un tipo de lípido denominado esterol. Lo encontramos en los tejidos y en la sangre. Pese a su mala fama en cuestiones de salud, el colesterol es esencial para la vida. Forma parte de las membranas de nuestras células y ayuda a controlar qué entra y qué sale de ellas, es un precursor de la vitamina D, por tanto, es fundamental para el metabolismo del calcio, es precursor de las hormonas sexuales, etc.

Colesterol bueno y colesterol malo

El colesterol no se disuelve ni se mezcla con la sangre. El modo que tiene de permanecer en el torrente sanguíneo es formando parte de una especie de cápsulas denominadas lipoproteínas. Cuando estas cápsulas tienen más proteínas que lípidos, son más densas. Esta propiedad es la que se utiliza para clasificarlas: HDL (lipoproteína de alta densidad) y LDL (lipoproteína de baja densidad). El HDL lo conocemos como colesterol bueno y el LDL como colesterol malo.

Que uno sea el bueno y el otro sea el malo tiene que ver con la ateroesclerosis. La ateroesclerosis se caracteriza por la acumulación de placa en el interior de las arterias, haciéndolas más rígidas y pudiendo llegar a taponarlas (produciendo una isquemia o infarto). Cuando analizamos esta placa solo encontramos LDL. Es decir, solo el LDL es capaz de adentrarse en nuestras arterias y causarnos problemas cardiovasculares, por eso le hemos llamado colesterol malo.

Estudios recientes han ido todavía más allá. Lo más relevante con respecto al riesgo cardiovascular no es tanto la cantidad de colesterol que contengan esas lipoproteínas, sino la cantidad de lipoproteínas LDL que haya, independientemente de si contienen más o menos colesterol en su interior. Esto no implica que deberíamos dejar de preocuparnos por el colesterol, al menos no en todos los casos. La evidencia nos dice el colesterol malo aumenta el riesgo cardiovascular si además va unido a otros factores como la obesidad, niveles altos de triglicéridos, hipertensión, niveles altos de glucosa, estrés o bajo nivel de colesterol bueno.

Los alimentos que contienen colesterol no hacen subir el colesterol

Además del huevo y los quesos, los alimentos que más colesterol contienen en su composición son los que tienen más grasas saturadas: las mantecas, la nata, algunos mariscos, los patés, el hígado, etc.

Numerosos estudios han demostrado que el colesterol que consumimos apenas repercute en los niveles de colesterol en sangre. De hecho, el colesterol que ingerimos es un factor poco relevante, ya que nuestro cuerpo sintetiza por sí solo la mayor parte del colesterol que utiliza. Si no comiésemos nada de colesterol, nuestro cuerpo lo fabricaría por sí mismo.

A esto hay que sumarle que la mayor parte del colesterol que ingerimos ni se absorbe ni se metaboliza, sino que se expulsa directamente. Esto es debido a que el colesterol de la mayoría de los alimentos está esterificado (es químicamente diferente al colesterol libre) y eso afecta a su biodisponibilidad. Solo podríamos absorber el colesterol libre (no esterificado) y éste es difícil de encontrar en los alimentos. Por lo tanto, en la mayor parte de las personas la cantidad de colesterol ingerido tiene poca relación con el nivel de colesterol que se queda en su cuerpo.

Es un mito que consumir huevos suba el colesterol

En los años 70 se empezó la lucha contra las grasas, especialmente contra los alimentos con colesterol, en gran medida a causa de una interpretación un tanto alarmista de este estudio. Para más inri, en 1973 la Asociación Americana del Corazónpropuso limitar la ingesta de huevos a un máximo de tres por semana.

Actualmente sabemos que aquella recomendación era innecesaria, y que por su culpa este mito se ha perpetuado hasta nuestros días. La realidad es que consumir un huevo al día no aumenta el riesgo cardiovascular en comparación con tres huevos semanales.

En enero de 2014 la Fundación Española del Corazón publicó una nota de prensa en la que decía que no es necesario restringir la ingesta de huevosen la dieta de las personas sanas.

Hay indicios de que el huevo, además de colesterol, contiene unas sustancias que bloquean su entrada en el organismo. Por eso, a la luz de la evidencia científica, ninguna organización nutricional desaconseja su consumo por miedo a que nos suba el colesterol.

Alimentos funcionales para bajar el colesterol

Los alimentos funcionales formulados para bajar el colesterol contienen esteroles y estanoles añadidos. Estas dos sustancias forman parte de las plantas, donde desarrollan funciones análogas a las de nuestro colesterol. Cuando consumimos esteroles y estanoles, estos bloquean la absorción intestinal del colesterol, impidiendo que más adelante lleguen a la sangre.

Estas sustancias las encontramos en frutas, verduras, aceites vegetales, legumbres, frutos secos, etc. Pero están presentes en cantidades tan pequeñas que no afectan al nivel de colesterol. Sin embargo, los alimentos funcionales multiplican por 10 o más la cantidad de esteroles y estanoles. Contienen una media de 3 g por cada 100 g de producto.

Una de las funciones de la Agencia Europea de Seguridad Alimentaria (EFSA) es verificar si las alegaciones saludables publicitadas de un alimento son válidas. A la luz de los estudios presentados, la EFSA ha confirmado que «los alimentos funcionales que contienen esteroles o estanoles contribuyen a mantener los niveles normales de colesterol sanguíneo». Tanto es así, que estos productos van exclusivamente dirigidos a personas con problemas de colesterol, no se debe consumir más de 3 g al día de esteroles y estanoles, no lo pueden tomar los menores de 5 años, ni las embarazadas, por lo que es aconsejable que sea el médico el que paute su consumo.

Según publica la EFSA, tomar entre 1,5 y 3 g de esteroles o estanoles al día durante 2-3 semanas puede reducir el colesterol malo en un 11,3 u 11,4 % respectivamente. Todavía queda por analizar si esta reducción de los niveles de colesterol malo es tan relevante como se cree con respecto a la salud cardiovascular.

Qué dice la ciencia para bajar el colesterol

Lo que sí sabemos que disminuye el riesgo cardiovascular, mantiene a raya nuestro nivel de colesterol y la cantidad de lipoproteínas portadoras de colesterol malo, es seguir una dieta basada en unas sencillas recomendaciones: tomar frutas y verduras, suficientes proteínas y grasas saludables, apostar por las harinas integrales y evitar las harinas refinadas. También deberíamos evitar los alimentos procesados de alto índice glucémico como los dulces y la bollería, especialmente el azúcar y los siropes.

Además de seguir una dieta saludable, los estudios confirman que la actividad física es fundamental para controlar el colesterol malo y la cantidad de lipoproteínas portadoras.

Conclusión

Si tenemos que lidiar con el colesterol, lo primero es seguir las indicaciones de nuestro médico. Como hay otros factores que regulan la síntesis de colesterol, no siempre es posible controlarlo a través de la dieta. Si esto sucede, será el médico quien nos pondrá un tratamiento.

Si éste no es nuestro caso, la solución a nuestro colesterol no será emprender una batalla contra los huevos, sino en apostar por una dieta saludable. La batalla, como casi siempre, la deberíamos mantener con los alimentos procesados, aquellos que contienen harinas refinadas, azúcares y grasas saturadas. Si a esto le sumamos actividad física, no sólo estaremos combatiendo el colesterol, sino que ganaremos en muchos otros frentes.

Si eres de los que desayunan huevos revueltos o cenan tortilla francesa, no cambies esos hábitos por miedo al colesterol. Ya lo estás haciendo bien.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Aunque tengas colesterol, podrás desayunar huevos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Colores vivientes: nanoestructuras que se cultivan, no se fabrican.

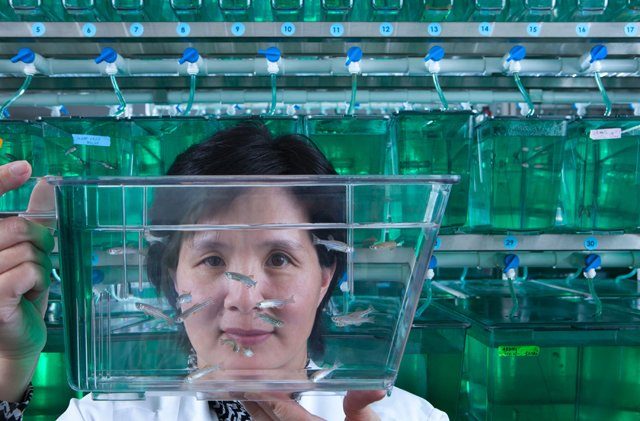

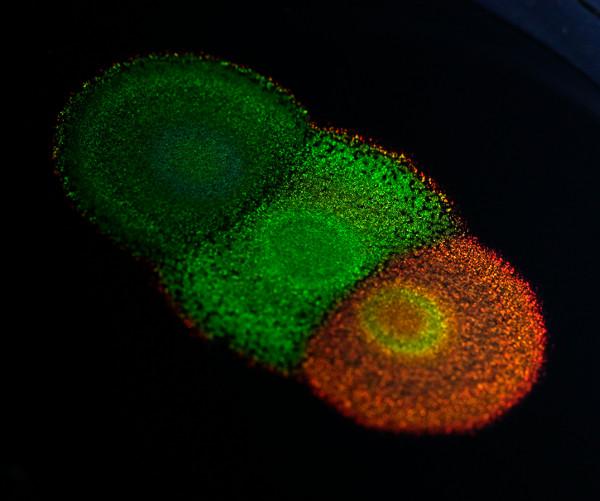

Fuente: University of Cambridge

Una nueva investigación muestra cómo la genética puede cambiar el color y la apariencia de ciertos tipos de bacterias que crecen en colonias de colores llamativos. Este sería uno de los primeros estudios, si no el primero, de la genética del color estructural, ese que se manifiesta espectacularmente en las alas de las mariposas o en las plumas de los pavos reales. Los resultados abren la vía para la investigación genética de toda una variedad de organismos coloreados estructuralmente. Desde un punto de vista práctico cosechar estas bacterias para la fabricación a gran escala de materiales nanoestructurados se convierte ahora en una posibilidad; es decir, que las pinturas biodegradables y no tóxicas podrían “cultivarse” y no fabricarse, por ejemplo.

Flavobacterium es un tipo de bacteria que se agrupa en colonias que producen llamativos colores metálicos. Estos colores no provienen de la existencia de pigmentos, sino de su estructura interna, que refleja la luz a ciertas longitudes de onda. Sin embargo, la ciencia aún no tiene muy claro cómo la genética afecta a estas estructuras. De ahí el interés de este trabajo, que estudia por primera vez los genes que provocan estas estructuras de color en un sistema vivo.

Los investigadores, encabezados por Villads Egede Johansen, de la Universidad de Cambridge (Reino Unido), compararon la información genética con las propiedades ópticas y la anatomía de colonias bacterianas sin mutar y mutadas para comprender cómo regulan los genes el color de la colonia.

Al mutar genéticamente la bacteria, los investigadores cambiaron sus dimensiones o su capacidad de movimiento, lo que alteró la geometría de las colonias. Al cambiar la geometría, cambiaron el color: cambiaron el color verde metálico original de la colonia en todo el rango visible de azul a rojo. También fueron capaces de crear una coloración más opaca o hacer que el color desapareciese por completo.

Desde el punto de vista práctico, y usando el lenguaje no de la biología genética sino de la nanotecnología, esto significa que se pueden diseñar estructuras fotónicas del color deseado y que estas estructuras se pueden autorreproducir en abundancia, todo ello evitando los laboriosos métodos tradicionales de la nanofabricación.

Para darnos cuenta de lo que esto significa, pensemos que estamos hablando de la posibilidad de usar colonias bacterianas como pigmentos fotónicos que pueden optimizarse fácilmente para cambiar la coloración bajo estímulos externos y que pueden interactuar con otros tejidos vivos, adaptándose así a entornos variables. La potencialidad de aplicaciones es tan amplia como la imaginación.

Referencia:

Villads Egede Johansen el al. (2018) Living colors: Genetic manipulation of structural color in bacterial colonies, PNAS doi: 10.1073/pnas.1716214115

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Colores vivientes: nanoestructuras que se cultivan, no se fabrican. se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Usando ADN para sintetizar nanoestructuras de oro

- Descubierto el proceso por el que las bacterias fabrican nanoimanes

- Paneles solares orgánicos…y de colores

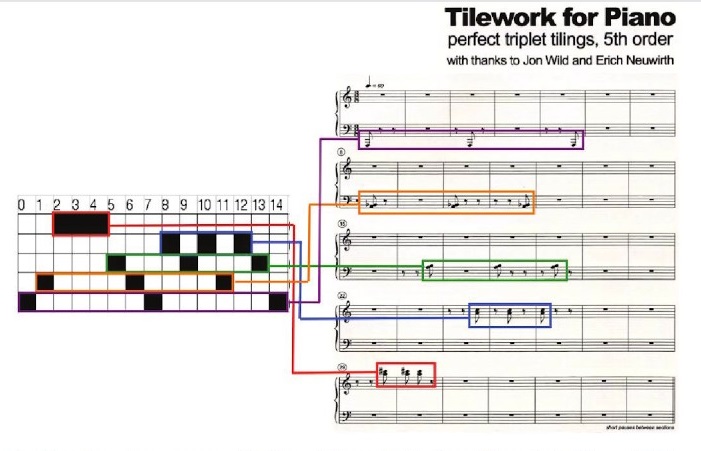

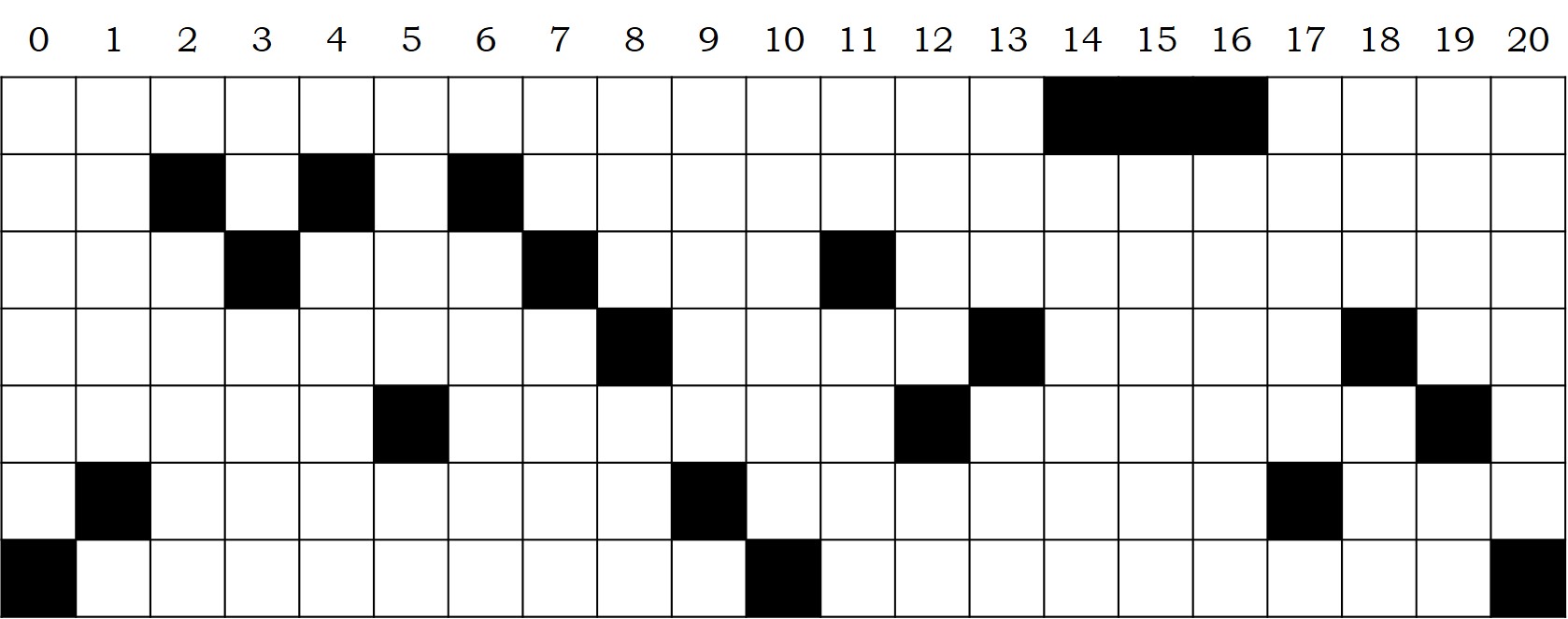

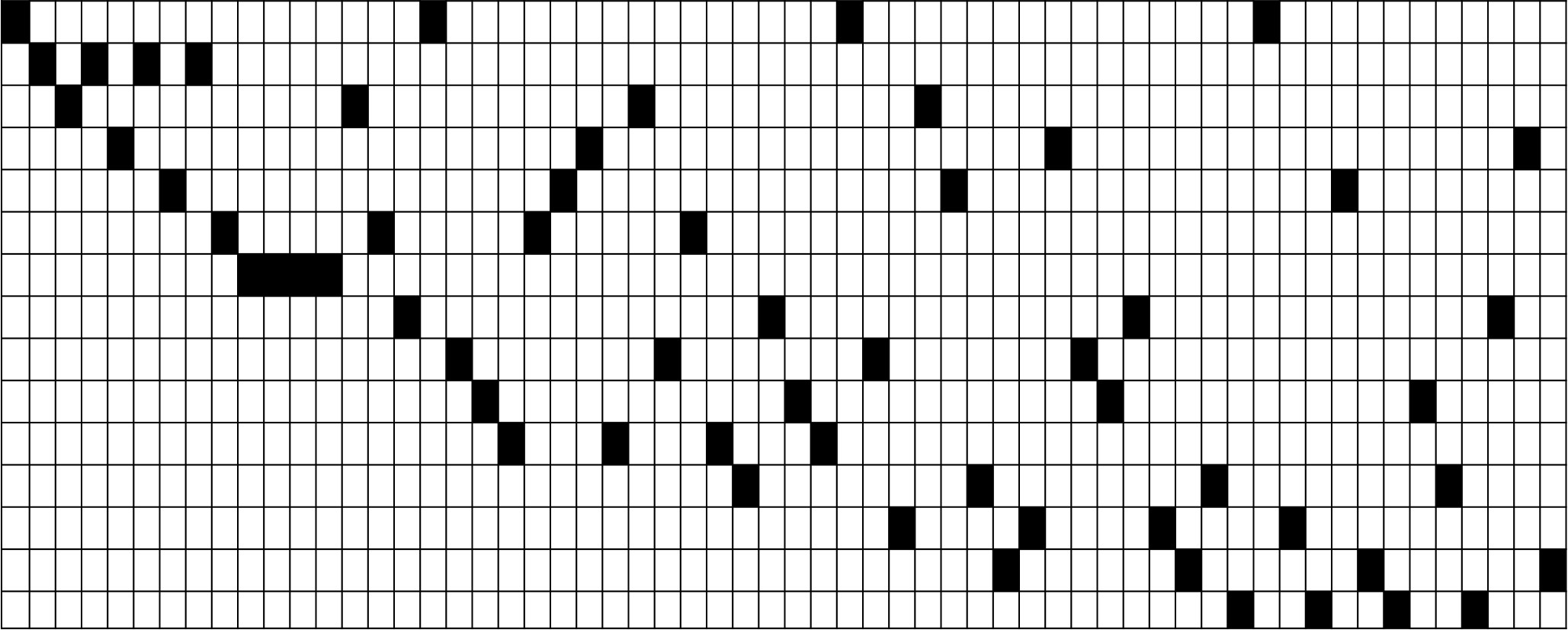

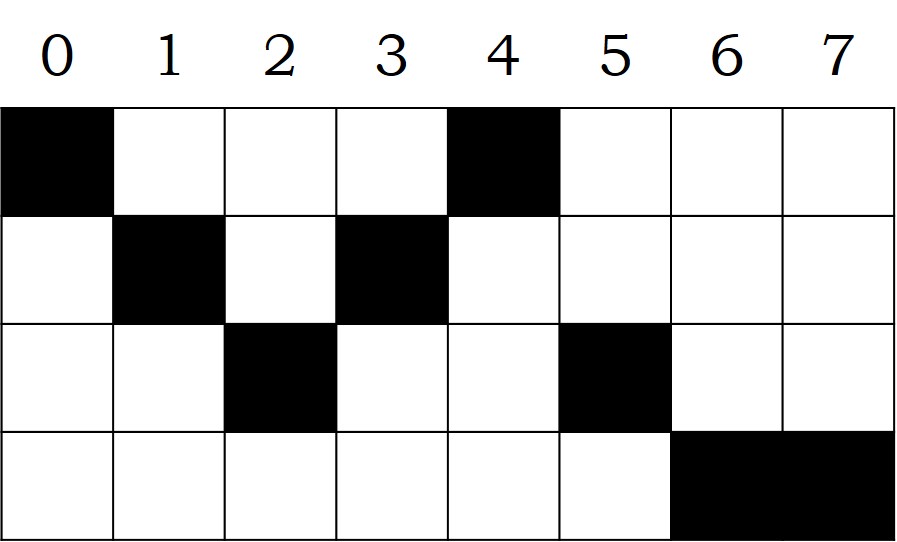

Teselaciones rítmicas perfectas

En mi anterior entrada del Cuaderno de Cultura Científica, titulada Las vacas de Narayana, la versión hindú de los conejos de Fibonacci , estuvimos hablando de una curiosa sucesión de números, la sucesión de las vacas de Narayana, y de cómo el compositor minimalista estadounidense Tom Johnson (Greeley, Colorado, EE.UU., 1939), la había utilizado para componer una obra musical de título homónimo.

Portada del disco “Rational Music”, de Tom Johnson, interpretado por Dedalus, New World Records, 2010

En el proceso creativo de su música, Tom Johnson busca encontrar la belleza de una forma objetiva, alejándose de la subjetividad de la música romántica y expresionista, que lo hace a través de los sentimientos. El compositor minimalista utiliza las matemáticas, es decir, la simetría, la combinatoria, las sucesiones numéricas, los números binarios, las funciones matemáticas, los fractales o la geometría, en su búsqueda de una belleza musical objetiva.

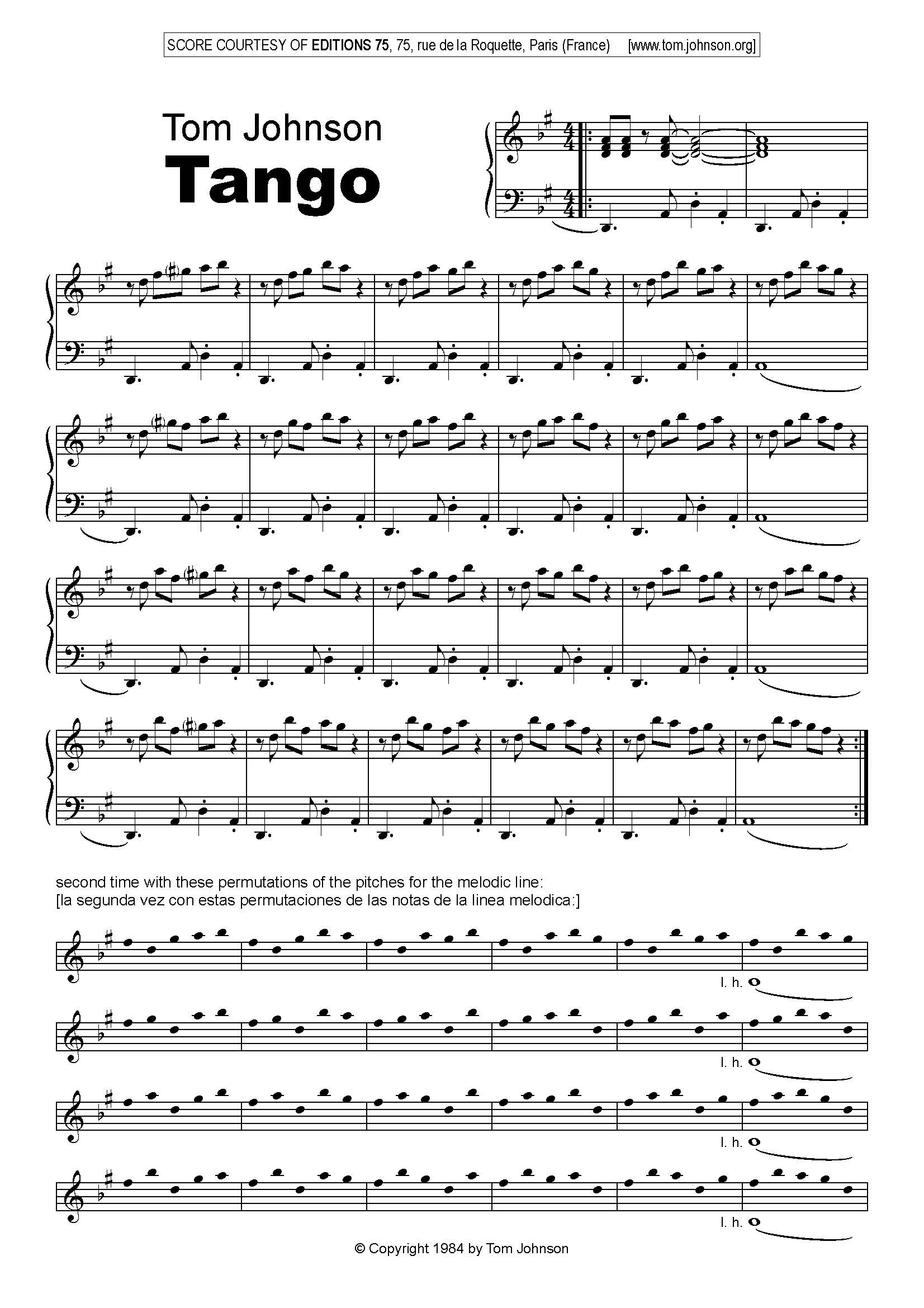

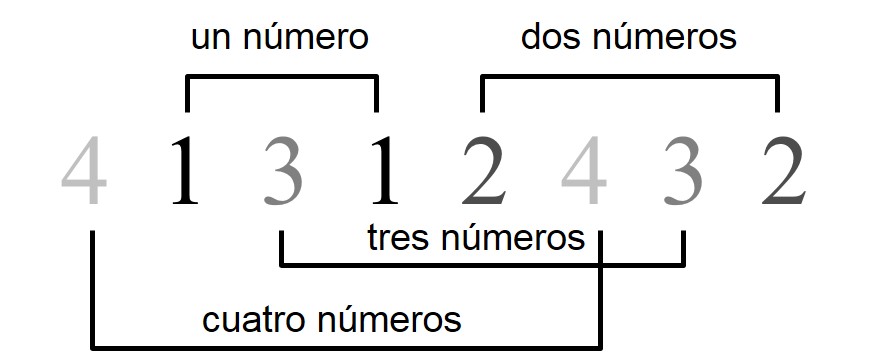

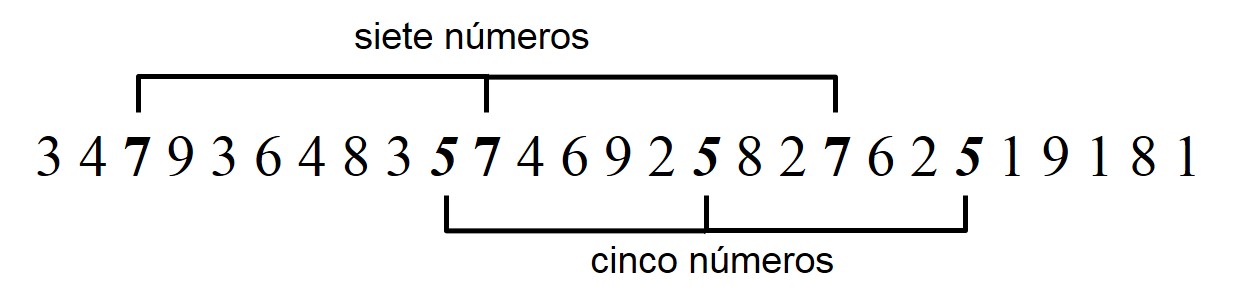

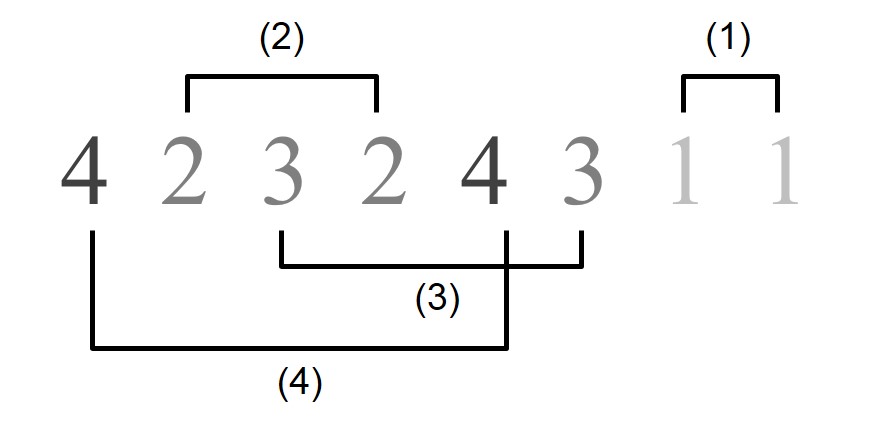

Un ejemplo ilustrativo podría ser la pieza musical Tango, que Tom Johnson compuso en 1984 para el virtuoso pianista estadounidense Yvar Mikhashoff, y para la cual utilizó el concepto matemático de las permutaciones. Si se toman cinco objetos cualesquiera, ya sean cinco números o cinco notas, existen 120 formas diferentes de colocarlos en orden, es decir, 120 permutaciones de los mismos. En concreto, el factorial de 5, 5! = 5 × 4 × 3 × 2 × 1 = 120, como ya explicamos en las entradas Cuadrados latinos, matemáticas y arte abstracto y El problema matemático de las cartas extraviadas o en el video La combinatoria, de la sección Una de Mates, en el programa de TV2 Órbita Laika.

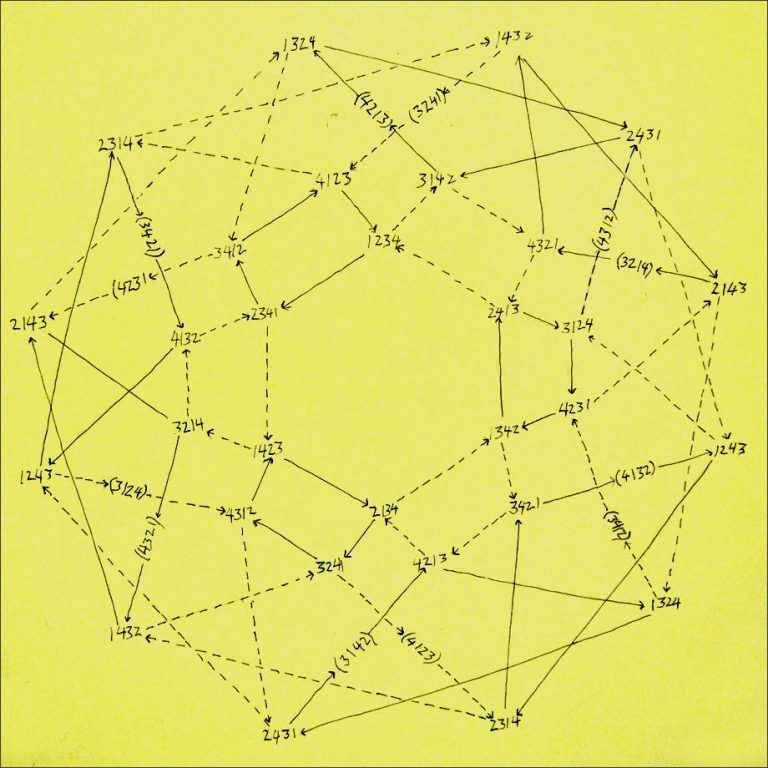

Por lo tanto, si se toman cinco notas, hay 120 permutaciones distintas de esas cinco notas. Como puede apreciarse en la imagen de la partitura que mostramos más abajo, las cinco notas de partida son [Re, Fa, Sol(#), La, Si(Ь)], y estas se van permutando [Re, Fa, Sol(#), Si(Ь), La], [Re, Fa, La, Sol(#), Si(Ь)], [Re, Fa, La, Si(Ь), Sol(#)], [Re, Fa, Si(Ь), Sol(#), La], [Re, Fa, Si(Ь), La, Sol(#)], y así hasta las 120 permutaciones que utiliza el compositor Tom Johnson para crear esta hermosa pieza, cuyo título es Tango, y que tiene un acompañamiento con ritmo argentino.

Primera parte de la partitura de la obra “Tango” (1984), de Tom Johnson. La partitura la podéis encontrar gratis en la página del compositor Tom Johnson.