Annus horribilis

.

.

En 2016 hemos sabido que existen las ondas gravitacionales y que se han podido detectar. Ha sido una grandísima hazaña científico-tecnológica gracias a la cual se ha podido verificar una de las predicciones de la teoría de general de la relatividad, formulada por Einstein hace un siglo. Y sobre todo, ha abierto la vía a la observación del universo mediante esos “nuevos ojos” –las ondas-, ojos que nos enseñarán aspectos hasta ahora desconocidos de lo que hay “ahí afuera”. Ha habido otros grandes avances, por supuesto, aunque sólo añadiré aquí, por los miles de vidas humanas que salvará, el de la vacuna contra el ébola que ha demostrado una eficacia del 100%.

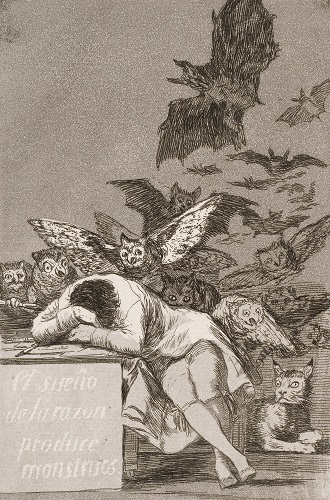

Y sin embargo, este curioso observador del mundo que acude ante sus lectores cada dos semanas deja el año con una sensación de pesar y cierto –o mucho- pesimismo. Porque las victorias de los partidarios de la salida del Reino Unido de la Unión Europea y del candidato Donald Trump en las elecciones norteamericanas han sido dos severas derrotas de la ciencia, al haberlo sido del pensamiento crítico, pilar fundamental de aquélla.

Aunque ha sido objeto de críticas y chanzas, la palabra “posverdad” -tomada del inglés postruth– puede ser usada de forma adecuada para calificar el sustantivo “época”. De esa forma, podemos referirnos a nuestro tiempo como “época posverdad”. Esa expresión no denomina un fenómeno ya conocido, sino que nombra algo nuevo, algo acerca de lo que había ciertas pistas, elementos fragmentarios, manifestaciones parciales o anticipos, pero que no había adquirido aún verdadera carta de naturaleza. Siempre ha habido mentiras, por supuesto, pero quizás no haya habido antes tantas en el discurso público y, sobre todo, quizás nunca como ahora la falsedad o veracidad de una proposición había tenido tan poca trascendencia. En eso radica, a mi juicio, la novedad: en la “época posverdad” las verdades no importan, en la “época posthechos” (como prefiero denominarla) los hechos fehacientes no importan. Importa, más que nunca, que las proposiciones, verdaderas o falsas, se acomoden a nuestros gustos, preferencias o intereses.

Esa disposición mental no surge de manera espontánea. No nace de la nada. Aparece, en gran parte al menos, como consecuencia de la influencia que a la larga ha acabado ejerciendo el pensamiento posmoderno. El posmodernismo cuestionó de forma radical la distinción entre lo verdadero y lo falso; atribuyó a la ciencia la condición de constructo social, despojándola así de cualquier pretensión de objetividad y superioridad epistemológica; negó, en sus manifestaciones más extremas, la misma existencia de una realidad. Pues bien, ese ha sido el caldo de cultivo intelectual en que se ha desarrollado el desprecio a las nociones contrastadas, las proposiciones verdaderas e, incluso, los hechos fehacientes. Lo que no era sino el delirio de una minoría intelectual enemiga de la razón y partidaria del “todo vale”, ha acabado por convertirse en una patología social de consecuencias potencialmente devastadoras. El pensamiento posmoderno ha socavado así las bases del pensamiento crítico y de la razón.

La comunidad científica norteamericana está preocupada porque el señor Trump ha manifestado su propósito de tomar decisiones ajenas a los hechos contrastados y porque creen que su política se opondrá al progreso del conocimiento. Y los científicos del Reino Unido creen que la salida de la Unión Europea debilitará de forma significativa a la ciencia británica. De confirmarse esos temores, el avance del conocimiento se vería frenado en dos de los países con mayor tradición y potencia científica del mundo. Dejarían así un mayor espacio al avance de la sinrazón. Habría comenzado a formarse de ese modo un círculo vicioso de imprevisibles consecuencias.

—————————————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————————————–

Este artículo fue publicado en la sección #con_ciencia del diario Deia el 31 de diciembre de 2016.

El artículo Annus horribilis se ha escrito en Cuaderno de Cultura Científica.

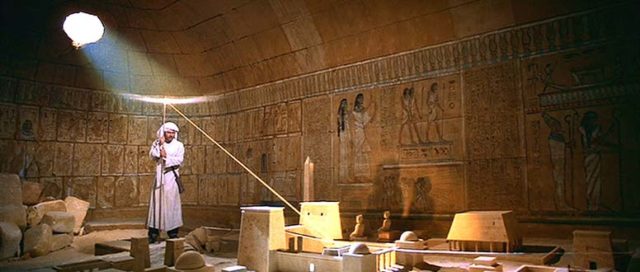

Entradas relacionadas:#Naukas16 Cuando Indiana Jones se hizo astrónomo

Ángel López Sánchez, astrofísico cordobés que trabaja en Australia, nos cuenta algunos resultados de su investigación de la mano de uno de sus personajes favoritos, Indiana Jones.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Cuando Indiana Jones se hizo astrónomo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 Qué pasa cuando le das un péndulo a una máquina

- #Naukas14 Arqueología de datos

- #Naukas16 ¿Perdemos el sentido cuando perdemos los sentidos?

El ocaso de la teoría de cuerdas

Hubo una época en la que el hombre puso la Tierra en el centro del Universo. Todos los cuerpos celestes, incluido el Sol, describían órbitas a nuestro alrededor. Hoy sabemos que en realidad no lo hacen, así que los movimientos de los planetas en la bóveda celeste no se correspondían a lo predicho por la teoría geocéntrica pura. Suele decirse que, en un caso así, hay que descartar la teoría, pero quizá ésta siga manteniéndose con algunas modificaciones. Comenzaron los ajustes. Quizá los planetas no giran en torno a la Tierra de forma directa sino que describen circunferencias (epiciclos) cuyo centro, a su vez, giraba en torno a la Tierra. Quizá los planetas no giran exactamente en torno a nosotros sino a otro punto cercano. Quizá esos puntos son diferentes para cada planeta. Quizá los epiciclos giran en torno a epiciclos que giran en torno a epiciclos.

Cuando fuimos capaz de observar y medir con suficiente exactitud, la teoría geocéntrica se vino abajo. No lo hizo de un día para otro, porque los geocéntricos siguieron refinando y añadiendo complicaciones a su modelo, pero a la postre se vieron forzados a ceder: Galileo demostró que algunos cuerpos se encuentran muy cómodos girando alrededor de Júpiter y no de la Tierra, Kepler se atrevió a sugerir que quizá las órbitas planetarias no fuesen circulares, y finalmente Newton trajo la paz y la claridad a nuestra galaxia. En la actualidad la teoría geocéntrica solamente pervive en los libros de Historia y en algunos nostálgicos que todavía defienden que Bilbao es, literalmente, el centro del Universo.

El ocaso y caída de la teoría geocéntrica no es sino una expresión de un fenómeno habitual en la conducta humana: cuando un proyecto crece y se complica, existe la tendencia a mantenerlo pase lo que pase, arriesgándose a perder la perspectiva y olvidar el objetivo. Geocéntricos, detractores de la teoría atómica, constructores emblemáticos, amantes del “constrúyelo y ellos vendrán,” escritores de la gran novela moderna inacabada… es fácil caer en la tentación. Menos mal que eso ya no pasa en Ciencia.

¿Alguien ha dicho Teoría de Cuerdas?

Desde hace casi un siglo se sabe que la Mecánica Cuántica y la Relatividad General son teorías incompatibles, que funcionan perfectamente bien por separado pero se llevan fatal si intentamos unificarlas. Como consecuencia, carecemos de una teoría que explique todos los fenómenos del Universo. Lo mejor que tenemos para explicar la composición de la materia es el llamado Modelo Estándar, que postula un conjunto de partículas con distintas propiedades. Pero parece demasiado caprichoso y arbitrario. ¿Por qué el electrón tiene esa masa y no otra? ¿Guarda alguna relación con la masa de las demás partículas, o con alguna constante fundamental? Deberíamos buscar algo mejor, más sencillo, más compacto.

Uno de los intentos más famosos por obtener esa “teoría de todo” y avanzar más allá del Modelo Estándar se denomina Teoría de Cuerdas. En su génesis la idea no podía ser más sencilla: las partículas elementales no son puntuales sino que se componen de minúsculas cuerdas que vibran. Los diferentes modos de vibración dan lugar a las partículas conocidas, y explican propiedades como su masa o su carga eléctrica. Pronto se descubrió que uno de los modos de vibración daba una partícula de características similares al llamado gravitón, que transporta las fuerzas gravitatorias. ¿Significaba ello que por fin se podía unificar la gravedad con las demás fuerzas básicas? La cosa prometía.

Pronto comenzaron los problemas. Uno de ellos es que la teoría de cuerdas inicial requería la existencia de un espacio multidimensional, y nuestro Universo solamente tiene cuatro dimensiones (las tres espaciales y el tiempo). Bueno, no hay demasiado problema conceptual en ello. Ya en los años veinte el dúo Kaluza-Kelin postuló la existencia de una dimensión adicional para intentar unificar la gravedad y el electromagnetismo. Si no podemos verla, decían, es porque esa nueva dimensión es muy pequeña en tamaño y además está enrollada, o como dicen los habituales del tema, “compactificada.”

Para entender esto, piense el lector en una manguera de jardín. Vista desde gran distancia aparece como un objeto que solamente tiene longitud, pero al acercarnos podemos apreciar que tiene grosor y altura. De modo similar, Kaluza y Klein imaginaron una dimensión compactificada de un tamaño muy inferior al radio de un núcleo atómico. Sus esfuerzos no dieron fruto en su momento pero la teoría de cuerdas recuperó el concepto, y lo hizo a lo grande: ahora el Universo no tiene cuatro dimensiones sino 26. Parece un despilfarro de dimensiones, pero si están compactificadas y son minúsculas, no molestan.

Un segundo problema con la teoría de cuerdas inicial era que solamente funcionaba para algunos tipos de partículas, los llamados bosones; los fermiones (entre los que se incluyen quarks, electrones y otras partículas interesantes) se quedaban fuera. Eso sí que es un fallo grave de la teoría. Para arreglarlo, los teóricos de cuerdas postularon que cada fermión existente en la naturaleza está asociado a un compañero bosón, en un fenómeno llamado supersimetría. Por ejemplo, el electrón tendría una partícula asociada supersimétrica llamada selectrón. De ese modo, los compañeros supersimétricos podrían encajar en la teoría de cuerdas, que al añadirle esta propiedad de supersimetría pasó a denominarse teoría de supercuerdas. Como ventaja adicional, el número de dimensiones del espacio de cuerdas se redujo desde 26 a 10.

Parecía que la teoría de supercuerdas (que pronto volvería a llamarse teoría de cuerdas por eso de simplificar) iba por buen camino, pero el precio a pagar fue grande: nada menos que la aparición de toda una familia de partículas supersimétricas que, además, nunca habían sido observadas. No pasa nada, dijeron, seguro que los nuevos aceleradores de partículas las encontrarán. No fue así, y en la actualidad seguimos buscándolas. No pasa nada, dijeron, quizá es que tienen tanta masa que escapan a nuestras posibilidades de detección.

Mientras se buscaban pruebas experimentales, los teóricos de cuerdas continuaron su trabajo y la teoría, inicialmente tan sencilla, siguió complicándose. Las cuerdas ya no eran suficientes y se vieron acompañadas por nuevos y extraños bichos llamados branas. Aparecieron cinco grandes teoría de cuerdas con nombres extraños: Tipo I, Tipo IIA, Tipo IIB, heterótica SO(32), heterótica E8xE8, y como grandes corrientes disidentes de un partido político o una religión comenzaron a enfrentarse unas a otras en pos del título de Teoría de Todo. Edward Witten sugirió que todas eran manifestaciones parciales de lo que llamó Teoría M, pero la guerra continuó. Los principales centros de física teórica continúan investigando y gastando hojas de papel, los gurús del campo escriben libros divulgativos dando a entender que la teoría de cuerdas está lista salvo algunos pequeños detalles, pero lo cierto es que a la teoría de cuerdas le falta un hervor. Y le falta desde hace medio siglo.

Es en este punto cuando los científicos acuden al experimento para interrogar a la naturaleza y que ésta, como jueza implacable, decida. Es aquí donde la teoría de cuerdas muestra su cara más diabólica. El detalle es la compactificación de las dimensiones ocultas. Si tengo un bloque de corcho, puedo aplastarlo para conseguir una superficie bidimensional y luego enrollarlo para obtener una línea unidimensional. También puedo hacerlo al revés: primero enrollo y luego aplasto. Pero en la teoría M tenemos siete dimensiones nuevas. ¿Cómo se compactifican? O dicho de otro modo, ¿de cuántas formas podemos enrollarlas unas respecto a otras?

La respuesta es: nadie lo sabe. Ni siquiera los teóricos de cuerdas pueden dar algo más que una respuesta aproximada, pero todo indica que el número de posibles compactificaciones es enorme; giganteouse, que diría Forges. Las cifras sugeridas superan con mucho la del número de partículas existentes en nuestro Universo. Digamos, por fijar conceptos, que ese número es del orden de un plexollar (101000). Cada una de esas posibilidades de compactificar daría lugar a un Universo distinto, con leyes físicas distintas y con partículas de masa distinta.

Cuando tenemos dos teorías y queremos saber cuál es la correcta, no hay más que realizar un experimento en el que ambas teorías arrojen resultados diferentes. Si la teoría A nos dice que las piedras amarillas flotan en el agua y la B nos dice que se hunden, no hay más que tirar una piedra amarilla al agua y salir de dudas. ¿Pero y si tenemos tantas teorías que pueden reproducir todos los resultados experimentales imaginables? En tal caso el proceso de eliminación falla. Puede que tirar una piedra amarilla al agua y ver que flota elimine medio plexollar de posibles teorías de cuerdas, ¿pero qué pasa con el otro medio plexollar?

Y ahí está el gran problema. Por muchos experimentos que hagamos, por muchas propiedades que determinemos en el laboratorio, por mucha caña que le demos al LHC, siempre habrá una cantidad ingente de posibles compactificaciones capaces de explicar todo lo que vemos. Nunca podremos decir “la teoría de cuerdas no funciona;” pero tampoco podremos predecir nada porque todo lo que pueda suceder tendrá explicación en alguna versión de la teoría de cuerdas. Sería como un vidente que tiene una gran cantidad de visiones: alguna acertará, ¿pero qué significa eso? Exactamente nada.

Pero imaginemos por un momento que hemos tenido un gran golpe de suerte, y que un experimento permite descartar todo el plexollar de compactificaciones menos un solo caso. Tenemos finalmente una combinación de dimensiones enrolladas, y solamente una, que concuerda con lo que vemos a nuestro alrededor. La pregunta evidente es ¿por qué esa y no alguna de las demás? ¿Acaso tiene algo extraordinario, alguna propiedad basada en principios fundamentales que la distingue de las otras? Quizá es como el número ganador de la lotería de navidad, que no tiene nada especial pero que salió porque… bueno, porque alguno tenía que salir.

De ese modo, y a lo largo de cincuenta años, los físicos de cuerdas han edificado una gran teoría, pero en lugar del edificio sencillo y de líneas elegantes de los diseños iniciales han acabado con una fea aglomeración de construcciones sin orden ni concierto, que no pegan ni con cola, no sirven su propósito y ni siquiera permite al político local hacerse una foto inaugurando algo. La edificación carece de agua corriente o luz, no tiene conexión para el wifi, los paneles del techo se caen y no hay visos de que vaya a servir algún día para algo. Si hasta el propio Sheldon Cooper abandonó la teoría de cuerdas en The Big Bang Theory, por algo será.

Por supuesto, puede que dentro de veinte años, o mañana mismo, el nuevo Newton tenga la gran inspiración que le permita construir finalmente una teoría de cuerdas eficaz y elegante; pero también es posible que nunca llegue ese día. Quizá en el futuro los historiadores examinen el caso de la teoría de cuerdas igual que ahora lo hacemos con la teoría geocéntrica. El tiempo dirá si la teoría de cuerdas será una nueva senda hacia un futuro brillante o tan sólo una autopista cara que no llega a ninguna parte.

Este post ha sido realizado por Arturo Quirantes (@Elprofedefisica) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo El ocaso de la teoría de cuerdas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Elogio de la teoría

- Arthur Cayley, la teoría de grafos y los isómeros químicos

- La primera confirmación experimental de la teoría de Maxwell

#Naukas16 La cultura

Foto: Mikel Uzkudun

Foto: Mikel Uzkudun

Déborah García Bello, aúna ciencia química y arte en sus charlas. En esta, “El peine del viento XV” le permite reflexionar sobre qué es la cultura.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 La cultura se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 Astrofotografía

- #Naukas16 ¿Que te chupe la qué?

- #Naukas16 La nutrición está sobrevalorada (y cómo me jode)

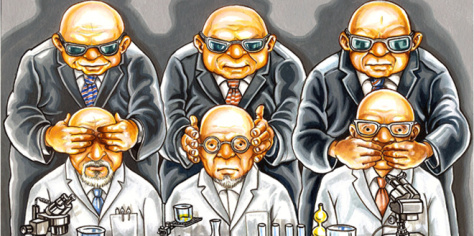

Ciencia, poder y comercio

.

.

De entre las concepciones erróneas sobre la ciencia la más perniciosa es la que confunde el conocimiento científico con el poder y con el dinero, considerando así que la ciencia como método y los científicos como profesionales están a la venta y participan de modo deliberado en las estrategias de los poderosos. El éxito de la ciencia y la tecnología sistematizadas a la hora de proporcionar armas y potencia económica a los países y el tentador prestigio que tienen las afirmaciones científicas como herramienta de propaganda justifican que haya quien considere sospechoso cualquier conocimiento aportado por el método científico. Cuando la ciencia se financia con dinero público, y mucho peor aún cuando es privado, las sospechas crecen y los conflictos abundan. La confusión, cuando no es interesada, proviene de una distinción fundamental entre los objetivos de las distintas partes de la ecuación.

El objetivo de los países a la hora de crear estructuras científicas es claro: aumentar el poder económico y militar del estado y (secundariamente) su prestigio en la escena internacional. Para las empresas el objetivo de hacer ciencia es crear nuevos productos o aumentar las ventas de los ya creados aprovechando el prestigio de la ciencia como reclamo. Tanto estados como empresas pueden ser determinantes a la hora de marcar la carrera profesional de un científico, o a capacidad de investigación de un laboratorio o de un centro; a través de estos mecanismos pueden presionar para que se investiguen ciertas cosas y no otras, y tienen la capacidad de influir (incluso de determinar) qué hipótesis se ponen a prueba y cuáles no. Como los historiadores de la ciencia han demostrado con numerosos ejemplos los científicos, como personas que son, no son inmunes a las presiones económicas ni a la cultura de su momento histórico; a menudo las hipótesis que se crean vienen marcadas por la realidad socioeconómica y política que rodea al científico. De este modo los intereses políticos y económicos pueden determinar las preguntas que la ciencia hace.

Lo que no pueden es modificar las respuestas, por mucho poder o dinero que haya en juego, y este es el error básico. Ni las presiones del poder ni los intereses económicos pueden modificar la realidad del universo. Pueden ocultar, durante algún tiempo; pueden ofuscar y crear confusión, a menudo mucha y demasiado extendida en el tiempo. Pero no pueden cambiar la realidad o el conocimiento de esa verdad, por mucho que se empeñen. Porque el interés de la ciencia como construcción social no es el avance de las carreras de los científicos ni su medro económico, sino la comprensión del universo y su funcionamiento. Las hipótesis se pueden sesgar y los resultados se pueden ocultar o incluso falsificar, pero al final se acabará descubriendo la verdad.

Con todo su poder y recursos la industria del tabaco no pudo suprimir el vínculo entre su producto y el cáncer de pulmón como Stalin no consiguió hacer desaparecer la genética mendeliana; los conflictos que surgen entre los científicos y quienes respaldan su trabajo como mucho pueden retrasar el conocimiento de los hechos, pero no hacerlos desaparecer. Algunos científicos pueden estar a la venta, pero la ciencia en su conjunto entendida como recopilación de conocimiento sobre el cosmos no lo está. Porque al universo le da igual lo que opinen los poderosos sobre su funcionamiento, y en última instancia a la ciencia también. Las hipótesis pueden deformarse, los científicos pueden corromperse, pero al final sus errores serán descubiertos con certeza.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Ciencia, poder y comercio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Curso de verano “Las dos culturas y más allá”: Ciencia y Poder

- #Naukas16 El poder de las brujas

- La ciencia y los objetivos del milenio (I): Ciencia y desarrollo I

Econofísica: ¿puede la economía tratarse como un sistema físico?

De vez en cuando surge el debate de si la economía es una ciencia. Si bien es innegable que la economía moderna surge en la misma revolución que hemos dado en llamar científica, parece que carece de algunos aspectos fundamentales que sí están presentes en las ciencias, como la capacidad de predecir, la reproducibilidad o el estar libre de escuelas de pensamiento como guía a la hora de interpretar los resultados. Los partidarios del no terminan afirmando que no reúne, ni por aproximación, las características definitorias de una ciencia como la física. Sin embargo, puede que el acceso a cantidades ingentes de datos y a la capacidad de analizarlos terminen convirtiendo la economía en una de las ciencias físicas: la econofísica.

Un ejemplo típico de la falta de capacidad de predecir de la economía es la evolución de los mercados (no nos engañemos, el llamado análisis técnico es poco menos que astrología), sobre todo los pánicos y las euforias. Un físico podría estudiarlo usando un modelo desarrollado originalmente para para tratar muchas partículas que interactúan dando lugar a fenómenos como el magnetismo, algo que para un economista podría sonar a chino. Después de todo tanto los fenómenos físicos como los económicos podrían poseer características universales que podrían ponerse de manifiesto usando las herramientas de la física, tal y como se ponen de manifiesto en el estudio de los llamados sistemas complejos. La principal diferencia entre física y economía la introducen los humanos (y es la que hace inválido el análisis técnico como herramienta útil en bolsa): en los mercados financieros, y en los sistemas económicos en general, las acciones de hoy se ven influenciadas por la percepción de los acontecimientos futuros.

Esto puede parecer muy teórico y lejano. Pero el debate sobre la viabilidad de la econofísica está encima de la mesa. Tanto es así que el European Physical Journal ST le ha dedicado un número monográfico.

Hasta la fecha la econofísica se ha centrado mayoritariamente en elucidar las propiedades de mercados financieros, redes económicas complejas, distribución de ingresos/riqueza y toma de decisiones estratégicas, con la idea en mente de desarrollar una teoría de los sistemas económicos como las que describen los fenómenos críticos en los sistemas físicos. Una teoría que pueda explicar su funcionamiento en las proximidades de un punto crítico independientemente de las características concretas a nivel micro.

Una de las conclusiones que parecen surgir de los artículos de este número especial es que la idea de universalidad puede que sea la excepción más que la regla en los sistemas económicos y sociales. Otra, no menos importante, es que hasta ahora los modelos de la econofísica han sido simplistas más que simples, tanto es así, que ningún modelo econofísico ha demostrado ser superior a un modelo económico estándar.

¿Significa esto que la econofísica no tiene sentido? En absoluto. El acceso a gigantescas cantidades de datos y la mayor disponibilidad de capacidad de cálculo computacional hace que ahora la econofísica tenga más sentido que nunca.

Ya existen las primeras historias de éxito de la econofísica. Entre ellas la ley de la inversa del cubo para la distribución de las fluctuaciones de los precios de acciones e índices bursátiles (por cierto, en el electromagnetismo también aparece el inverso del cubo) y el análisis de redes económicas basado en los análisis físicos de grandes redes complejas.

Puede que con el tiempo y los modelos adecuados la econofísica tenga la misma capacidad predictiva que otras ramas físicas que estudian sistemas complejos, como la meteorología.

Referencia:

Can economics be a physical science? S. Sinha, A. S. Chakrabarti, and M. Mitra (Eds.), Eur. Phys. J. Special Topics 225/17 (2016)

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Econofísica: ¿puede la economía tratarse como un sistema físico? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fórmulas matemáticas y números: cómo ayuda la economía al fútbol

- Cómo diseñar un sistema para comunicarse con el otro lado de la galaxia

- Ellen Richards: la economía doméstica como cultura científica

El ‘truelo’ de «el bueno», «el feo» y «el malo»

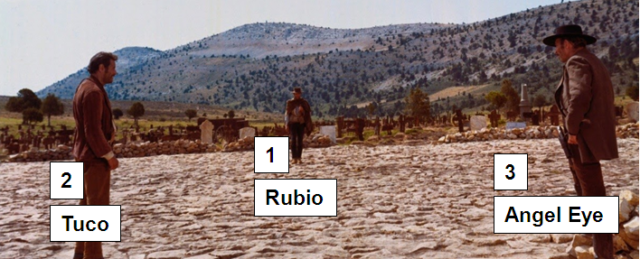

Imagen del duelo final de la película “El bueno, el feo y el malo” de Sergio Leone.

Imagen del duelo final de la película “El bueno, el feo y el malo” de Sergio Leone.

Rubio –«el bueno»–, Tuco –«el feo»– y Angel Eye –«el malo»– se enfrentan en un duelo a tres, que llamaremos un ‘truelo’.

Deciden que disparará en primer lugar Rubio, luego Tuco y por último Angel Eye; después de nuevo –«el bueno», y así sucesivamente, por turnos, hasta que sólo quede uno de ellos vivo. Si uno de ellos muere, se pasa al siguiente en este orden de disparos.

Rubio es el que peor puntería tiene de los tres: tiene una probabilidad de 1/3 de matar a su adversario al disparar. Tuco acierta con 1/2 de probabilidad, y Angel Eye nunca falla el tiro.

Todos ellos conocen la probabilidad de éxito al disparar del resto de los contrincantes, y sólo buscan ganar el duelo, es decir, sobrevivir.

Cada uno de ellos puede elegir su estrategia como desee, incluso disparar al aire.

¿Qué debe hacer «el bueno»?

Vamos a argumentar las tres elecciones que puede realizar para ver con cuál de ellas tiene la mayor probabilidad de sobrevivir.

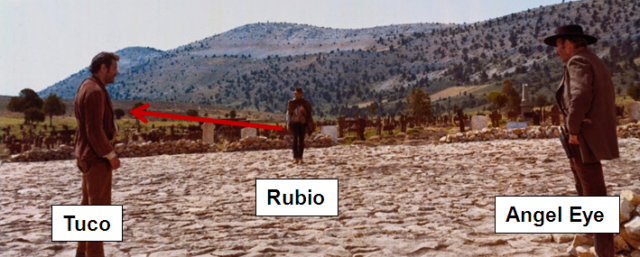

1) Rubio dispara a Tuco

Esta estrategia no es buena. Si acierta en su tiro, se encuentra frente a Angel Eye, y morirá con toda seguridad, ya que «el malo» nunca falla.

Si no acierta en su tiro, es decir, si Tuco sobrevive, tiene la misma probabilidad de sobrevivir que si hubiera tirado al aire.

Es decir, la probabilidad de sobrevivir es inferior a la probabilidad de sobrevivir si erra su disparo, con lo que esta opción no es buena.

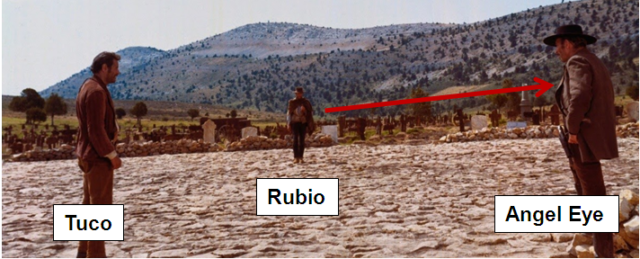

2) Rubio dispara a Angel Eye

Eliminar al adversario más peligroso parece, intuitivamente, la mejor opción. Supongamos entonces que Rubio dispara a «el malo». Independientemente de lo que suceda, el siguiente en disparar es Tuco.

¿Cuál es la probabilidad p de que Rubio sobreviva? Es decir, p es la probabilidad de que Rubio gane frente a Tuco, si Tuco dispara primero. Sea q la probabilidad de que Rubio gane frente a Tuco, disparando él primero.

Entonces p = 1/2 q, ya que o Tuco mata a Rubio o le proporciona una probabilidad de q de ganarle.

Por otro lado, q = 2/3 p + 1/3, ya que Rubio tiene una probabilidad sobre 3 de matar a Tuco y dos probabilidades sobre tres de encontrarse en la situación en el que Tuco tire en primer lugar.

De las dos ecuaciones,

p = 1/2 q

q = 2/3 p + 1/3

se deduce que p = 1/4.

Esta estrategia es interesante sólo p es superior a la probabilidad de que Rubio dispare al aire, que ahora calcularemos.

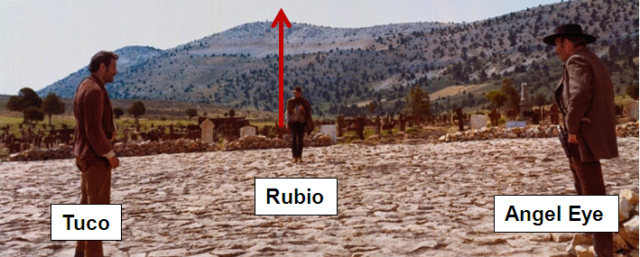

3) Rubio dispara al aire

«El bueno» decide fallar sistemáticamente su tiro hasta que se encuentre con un único adversario.

Tuco y Angel Eye no tienen ningún interés en disparar a Rubio si los tres continúan vivos. En efecto, si Tuco dispara sobre Rubio, sería un suicidio (el siguiente en disparar es Angel Eye, que lo matará). Y si «el malo» dispara sobre «el bueno» tendría una probabilidad de ganar de 1/2 (porque lo mataría, y el siguiente en disparar sería Tuco), mientras que puede conseguir una de 2/3 si dispara sobre «el malo». Así que en este caso, todo sucedería como si se tratara de un duelo entre Tuco y Angel Eye.

Así que comienza Tuco disparando. Si mata a Angel Eye, Rubio se encuentra frente a Tuco con probabilidad q de ganar. Si Tuco falla al disparar a «el malo», éste le dispara a su vez (y le mata) y le toca a Rubio disparar a Angel Eye, y no puede fallar (recordar que Angel Eye nunca falla), pero sólo tiene una probabilidad sobre tres de ganar. Así, la probabilidad de ganar con esta estrategia es de:

p’ = p + 1/2 x 1/3 = 1/4 + 1/6,

que es mayor que 1/4. Es decir, es la mejor estrategia.

En resumen, Rubio debe disparar al aire.

Nota 1: Este problema está extraído de Guillaume Deslandes y Clément Deslandes, Énigmes mathématiques corrigées, Ellipses (2014).

Nota 2: En la larga escena del duelo de El bueno, el feo y el malo no es esto lo que sucede…

Puede encontrarse un análisis matemático de esta escena en José María Sorando, Aventuras matemáticas en el cine, Gualdamazán (2015), páginas 117 a 144.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo El ‘truelo’ de «el bueno», «el feo» y «el malo» se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- No todo ha sido malo este año: la ciencia nos dejó algunas buenas noticias

- Una de mates: La probabilidad de que llueva el fin de semana

- Cómo acabar con el desprecio a los fotones

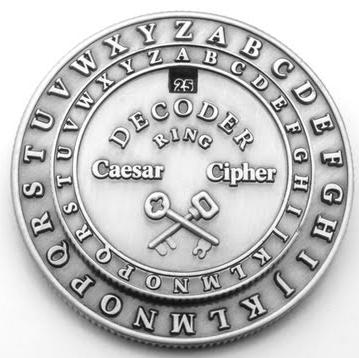

#Naukas16 ¿Cifras o encriptas? Siempre con la ayuda de tus primos

.

.

Fernando de la Cuadra, aunque parezca un talibán del léxico, ha venido a hablar de lo suyo, de seguridad informática.

El artículo #Naukas16 ¿Cifras o encriptas? Siempre con la ayuda de tus primos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas15 Mitos y realidades de la seguridad informática

- #Naukas16 Entramos en M1

- Fórmulas matemáticas y números: cómo ayuda la economía al fútbol

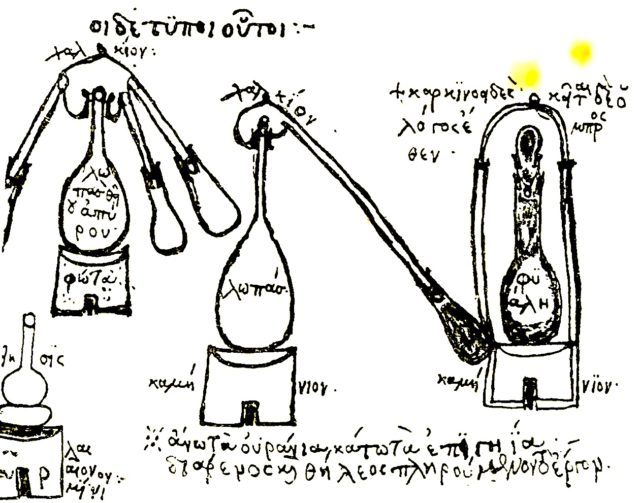

Ácidos minerales y alquimistas europeos

El redescubrimiento por parte de los europeos de los ácidos minerales fue hito en la historia de la alquimia y de la química. En palabras de Isaac Asimov (“Breve historia de la química”, Alianza Editorial):

“El descubrimiento de los ácidos minerales fuertes fue el adelanto más importante después de la afortunada obtención del hierro a partir de su mena unos tres mil años antes.”

Los ácidos orgánicos comunes (acético del vinagre y cítrico del limón) se venían usando desde tiempo inmemorial, pero estos ácidos son muy débiles y su capacidad para disolver sustancias es muy limitada. Los ácidos minerales (sulfúrico, nítrico, clorhídrico), obtenidos calentando ciertas sales y condensando la fase vapor (en presencia de vapor de agua, que el alquimista no tenía forma de evitar aunque hubiese sabido de su existencia), eran ácidos mucho más fuertes con gran capacidad de disolución.

Fue al-Razi, entre otros alquimistas musulmanes, el que habló de forma sistemática de aguas agudas. Aunque, siendo estrictos, estos productos obtenidos por disolución y destilación de mezclas de vitriolos (sulfatos), alumbre, sal, nitro (o salitre) o sal amoniacal es dudoso que fuesen algo más que disoluciones de sales ácidas. Con todo, se suele atribuir a al-Razi la primera obtención de ácido sulfúrico.

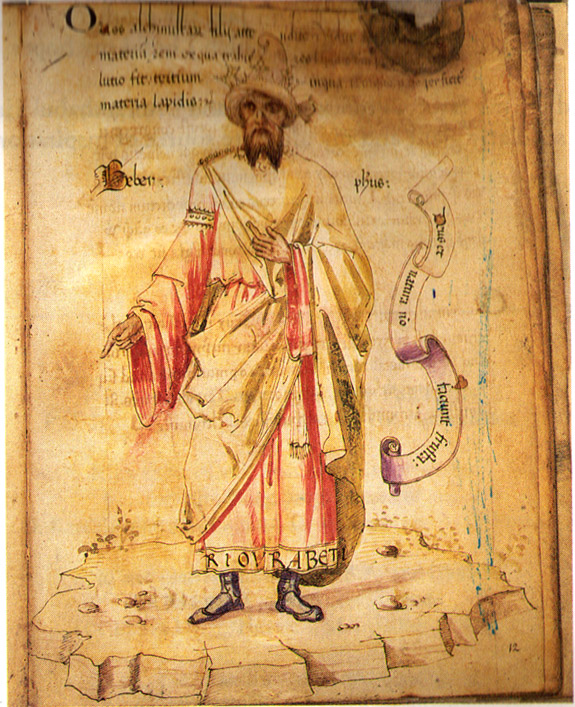

Retrato de “Geber” del siglo XV, Codici Ashburnhamiani

Retrato de “Geber” del siglo XV, Codici Ashburnhamiani

Si bien al-Razi fue probablemente el primero que lo obtuvo y el pseudo-Llull el primero que proporcionó una receta “moderna” para obtenerlo, el primero en describir el ácido sulfúrico fue el que para algunos es el alquimista musulmán más influyente Abu Mūsa Ŷābir ibn Hayyan (s. IX), latinizado Geber, o mejor, el o los europeos que usaron su nombre en los siglos posteriores para firmar textos alquímicos (pseudo-Geber).

De lo que parece que no cabe duda es de que el empleo de los métodos descritos por al-Razi y la modificación del diseño de los dispositivos de destilación los alquimistas en Europa obtuvieron por primera vez ácido sulfúrico, nítrico y clorhídrico en el siglo XIII, tal y como los describe pseudo-Geber. Un proceso paralelo al que siguió la obtención del alcohol absoluto.

“Aqua regia” disolviendo oro

“Aqua regia” disolviendo oro

Los experimentos con los nuevos ácidos llevaron muy pronto a descubrimientos increíbles y de gran significado para unos alquimistas cada vez más místicos. Mezclando ácido nítrico y ácido clorhídrico en las cantidades adecuadas se obtenía un “agua”, el aqua regia, capaz de disolver el mismísimo oro. Este fenómeno alimentó la imaginación de los europeos que habían estado leyendo acerca de la teoría de la transmutación y sobre cómo, con la combinación de ingredientes apropiados uno podía obtener una fortuna con una tinaja y poco más instalada en la cuadra.

Si bien la Iglesia se había resistido inicialmente, la información química de los paganos griegos y de los musulmanes se terminó abriendo paso hasta las estanterías y los laboratorios de los estudiosos europeos. Éstos ahora disponían de información sobre la pólvora, el alcohol y los ácidos minerales, información que se reunió en textos enciclopédicos, y que era saboreada, digerida e interpretada dentro de nuevas escuelas de pensamiento; algunos atrevidos incluso harían nuevos experimentos.

Los nuevos productos y la nueva mentalidad estaban listos para ver nacer a una nueva generación de alquimistas místicos: los alquimistas europeos.

El artículo Ácidos minerales y alquimistas europeos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Implantes orales profilácticos

Las infecciones orales son consideradas hoy en día el principal motivo de fracaso o fallo de los implantes dentales. Una investigación de la UPV/EHU ha logrado desarrollar unos recubrimientos capaces de evitar una posible infección bacteriana, y en el caso de producirse, eliminarla, además de dotar a los implantes de propiedades osteointegradoras, es decir, que favorecen su correcto anclaje al hueso.

La búsqueda de superficies que sean capaces de evitar la adhesión y colonización bacteriana en la zona que rodea el implante “es un tema de indudable interés, y buena muestra de ello es la gran cantidad de publicaciones que se han ido desarrollando en este campo”, explica Beatriz Palla, investigadora del grupo de Biomateriales del Departamento de Ciencia y Tecnología de Polímeros de la UPV/EHU. De hecho, “aproximadamente el 10% de los implantes debe ser eliminado por problemas de osteointegración, o por la aparición de infecciones”, añade.

A la hora de diseñar estrategias para combatir estos problemas, hay que tener en cuenta el desafío que supone dotar a la superficie de los implantes de titanio de propiedades antibacterianas, y a su vez, la gran resistencia que son capaces de desarrollar las cepas bacterianas a las terapias convencionales con antibióticos.

Ese fue el reto que quiso superar el grupo de la UPV/EHU, que lleva un tiempo desarrollando materiales orientados a los implantes dentales. “Ya habíamos conseguido unos recubrimientos que favorecen la generación de hueso alrededor del implante, para de esta forma favorecer su anclaje al hueso. Queriendo ir un paso más allá, buscamos la forma de convertir esos recubrimientos en bactericidas”, comenta la investigadora.

El método que utilizaron para ello fue la síntesis sol-gel. La síntesis sol-gel se basa en la preparación de un disolución (sol) de los precursores que, tras un período de reposo, se convierte en un gel con el que se recubre la superficie del tornillo de titanio y, tras el tratamiento térmico a alta temperatura en estufa, queda adherido definitivamente al tornillo que será implantado. “Utilizamos el silicio como precursor, porque en muchos estudios se ha demostrado que este compuesto es osteoinductor, por lo que favorece uno de los objetivos que queríamos lograr. Además, para dotar a los materiales de características antibacterianas, añadimos diferentes agentes antibacterianos”.

En el estudio llevado a cabo, Palla desarrolló tres tipos de recubrimientos, en función de los diferentes agentes antibacterianos elegidos, cada uno de los cuales tiene un mecanismo de actuación contra las infecciones bacterianas, bien de manera profiláctica impidiendo la adhesión inicial bacteriana y la posterior infección, o bien eliminándola una vez formada.

En el caso de los recubrimientos profilácticos, era necesario “un material con un tiempo de degradación muy largo para que se mantenga el adherido al tornillo y actúe el mayor tiempo posible, impidiendo la adhesión bacteriana”, comenta Palla. En los recubrimientos que están destinados a erradicar una infección ya formada, sin embargo, “se requiere un material con una degradación rápida que sea capaz de liberar el agente antibacteriano lo más rápido posible atacando la infección”. Uno de los recubrimientos desarrollados para este fin, además, “está diseñado para ser utilizado in situ en la propia consulta odontológica, sobre el tornillo infectado sin necesidad de retirar el implante del paciente. Este nuevo material está en proceso de patente y bajo secreto industrial”, destaca la investigadora.

Vistos los resultados, Palla considera que “se puede afirmar que se han desarrollado recubrimientos con capacidad antibacteriana que no afectan a la correcta integración del implante en el hueso mandibular”. Aunque también reconoce que queda mucho trayecto por recorrer hasta una posible aplicación y utilización en las consultas odontológicas: “Además de todos los ensayos que quedarían por hacer, también sería conveniente seguir un poco más con las investigaciones, para conseguir optimizar más los resultados”.

Referencia:

Romero-Gavilán, F., Barros-Silva, S., García-Cañadas, J., Palla, B., Izquierdo, R., Gurruchaga, M., & Suay, J.. Control of the degradation of silica sol-gel hybrid coatings for metal implants prepared by the triple combination of alkoxysilanes. Journal of Non-Crystalline Solids, 453, 66-73. doi: 10.1016/j.jnoncrysol.2016.09.026

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Implantes orales profilácticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El efecto de los biovidrios en la degradación de los implantes óseos

- Recubrimientos funcionales

- Nanopartículas de hierro contra el lindano

Casos de corrupción

Corrupción: Definición ampliamente aceptada por los expertos: “Uso indebido de la función pública, la confianza o el poder para obtener beneficios privados”.

Diccionario de la Lengua: Definición 4ª: En las organizaciones, especialmente en las públicas, práctica consistente en la utilización de las funciones y medios de aquellas en provecho, económico o de otra índole, de sus gestores.

Comenzaré con un par de ejemplos de estudios publicados recientemente sobre la corrupción, para que nos vayamos haciendo al tema. Primero, una interesante investigación del grupo de Tarek Jaber-López, de la Universitat Jaume I de Castellón. Trabajan con 93 universitarios voluntarios, incluyendo 47 mujeres. Para detectar su reacción en los experimentos, miden la conductividad en la piel, que aumenta al sentir mayor emoción y estrés, ya que mide el paso de electricidad por la piel que, a su vez, crece con la secreción de sudor.

Se les ofrece actuar de jurado en un ayuntamiento para la concesión de obras públicas a empresas constructoras. Se presentan dos empresas y una de ellas ofrece un soborno en dinero al voluntario. Le avisa que el dinero que le ofrece, lo descontarán del proyecto de obra pública con lo que bajará la calidad final. El 82% de los voluntarios acepta el soborno y solo el 18% lo rechaza. Si se avisa que un inspector revisará el resultado del concurso y, si descubre irregularidades, habrá castigo, el número de voluntarios que acepta baja al 44% y, así, por miedo al castigo, el 56% no lo acepta. Nos queda la esperanza del 18% que no acepta, aún en el caso de no haber amenaza de castigo.

Cuando los autores miden las emociones con la conductividad de la piel, encuentran que los que rechazan el soborno se sienten estresados por hacerlo. Es decir, es más sencillo y menos estresante aceptar el soborno. Duele menos ser corrupto. Alguien dijo hace tiempo que la especie humana tiende biológicamente a la corrupción, o sea, a conseguir recursos como se pueda para el individuo y para el grupo al que pertenezca. Quizá por ello hay tantos familiares de corruptos implicados en estos asuntos.

La segunda investigación la publicaron Beatriz López Valcárcel y sus colegas, de la Universidad de Las Palmas. Crearon una base de datos, tomados entre 2001 y 2010, con municipios y sus características locales, factores económicos y corrupción a nivel municipal.

Cuando hacen el estudio estadístico y relacionan todos estos datos, descubren que un municipio sin corrupción tiene un 3.1% de posibilidades de caer en ella por cada municipio vecino que sea corrupto. Pero también encuentra la tendencia contraria y, así, un municipio sin corrupción aumenta en un 6.7% sus denuncias por corrupción a los tribunales por cada municipio vecino que sea corrupto. Solo hay que intentar promover esta segunda respuesta más que la primera. Aunque, como contaba el trabajo de la Jaume I de Castellón, sea más sencillo, fácil, menos estresante y agradable caer en la corrupción.

.

.

En fin, volvamos al principio. La corrupción de la cosa pública para el beneficio personal se da en todos los países, y da igual la época o el régimen político. En la mayoría de los casos y, como decía antes, se busca el beneficio personal y para parientes y amigos. En los países más ricos hay menos corrupción por la existencia de más leyes y mejor control policial y judicial y de los presupestos, además de que hay más riqueza a repartir. Pero si se encuentra corrupción suele aparecer según se baja en la escala jerárquica, a grupos más pequeños, a la familia y los amigos, al grupo más cercano. Y, por ello, es típica la corrupción en los municipios. La evolución, durante miles de años, nos juntó en grupos no muy grandes, familiares o tribales, y lo seguimos aplicando aunque, creo, se ha quedado anticuado, si se puede decir algo así de los resultados de la evolución. Nuestra sociedad es ahora enorme, incontrolable según los métodos que nos dio la selección natural. Algo hay cambiar con educación y control de las leyes y de las estructuras, como en la policía y en los tribunales, que prometen castigo que, como vimos antes, en el estudio de Jaber-López, ayudan contra la corrupción.

Lo que busca el corrupto es lo habitual, es decir, supervivencia y reproducción o, en concreto, recursos para ambos objetivos. En una sociedad desarrollada, cuenta para conseguir recursos, y mucho, el estatus social y económico que permitirá el acceso a esos recursos. Como ejemplo de este estatus que, da la posibilidad de evitar o dilatar el castigo, tan importante como veíamos antes, es el aforamiento de los políticos. Además, la psicología del corrupto incluye la carencia de conciencia social o, en concreto, de empatía y altruismo. Y, es de destacar, en la psicología de la corrupción está extendida la sensación de impunidad, de que nunca serán descubiertos.

Podemos plantear la hipótesis de que en un sistema democrático, los implicados en corrupción que conozcan los ciudadanos, recibirán un castigo en las elecciones. Juan Luis Jiménez, de la Universidad de Las Palmas, escribe que, entre 1999 y 2011, más de 200 municipios han sido acusados formalmente de corrupción: los datos electorales de estos municipios demuestran que los efectos en cuanto a castigo en las votaciones son relativamente modestos. Incluso hay algunos municipios en los que la corrupción premia con votos a los corruptos.

En las elecciones municipales entre 2003 y 2011, la caída media de votos del partido acusado de corrupción es del 9%, con el máximo en el 11.8%. En la mayoría de los municipios, el porcentaje de votos para cada partido no cambia, aunque, en casos extremos, cae, pero hay otros municipios donde los votos al partido corrupto aumentan.

En la bibliografía revisada por Jiménez, hay casos en que los votos caen un 4% pero, si hay atención de los medios a la corrupción en el municipio, la caída puede llegar al 14%. Y, es curioso, pero hay varios estudios en que, si la corrupción es en el PSOE, los votos pueden caer hasta el 2%, y, si es en el PP, los votos crecen hasta un 3%.

Nos podemos preguntar cómo es posible que no se castigue la corrupción e, incluso, que se premie. Quizá la respuesta está en Costa Rica y en el estudio de María del Mar Martínez Resón, de la Universidad de Burgos. Los datos los tomó del Barómetro de las Américas de 2006, con preguntas sobre honestidad, capacidad y buenas ideas de los políticos que cada encuestado responde.

La mayoría de los encuestados, el 76.8%, prefiere al político honesto aunque lo considere un incapaz. Pero hay un 23.2% que prefiere al deshonesto si está capacitado. Esta elección corresponde a hombres con pocos conocimientos políticos, a jóvenes y a los ciudadanos con más ingresos.

Además, en la investigación de Pablo Fernández Vázquez y su grupo, de la Universidad Vanderbilt en Nashville, y con datos, de nuevo, de elecciones municipales en España en los años 2007 y 2011, en más de 8000 municipios, confirman que, como hemos visto, el castigo electoral a los corruptos es más bien tibio. Así, el partido cuyo alcalde está implicado en casos de corrupción es reelegido en el 62.7% de los municipios en que se presenta. No es muy diferente del 67.9% de reelección de los partidos cuyo alcalde no está implicado en corrupción. En general, hay algunos candidatos que están acusados de corrupción cuyos resultados bajan pero lo habitual es que suban, incluso, un 10% o más.

Para los autores, estas diferencias en los resultados y la falta de influencia de la corrupción en las elecciones está causada por la sensación de los electores de sentirse perjudicados o beneficiados por la corrupción de sus dirigentes. En muchos municipios y en esas fechas, la corrupción se debe al urbanismo y al boom inmobiliario. Los electores consideran que esta corrupción no perjudica a nadie, excepto al erario público que, por otra parte, consideran que no les pertenece. En cambio, trae dinero al municipio, beneficia a muchos y, en último término, algo toca a todos.

La pertenencia al grupo es, ya lo hemos visto, típico de nuestra especie y, más todavía, de los que se dedican a política. Es uno de los caminos de la corrupción y Eva Anduiza y sus colegas, de la Universitat Autónoma de Barcelona, lo han estudiado, con una encuesta por internet a la que respondieron 2300 voluntarios, de 15 a 45 años, en 2010. Se les envía un recorte de prensa en el que se anuncia el inicio de una investigación de un fiscal sobre un alcalde por tráfico de influencias, acusado de colocar a familiares en el ayuntamiento. Al azar, en el recorte se indica, en unos casos, que el alcalde es del PSOE y en otros que es del PP. Se les pide que puntúen la gravedad de la situación entre 1 y 10, y que indiquen si simpatizan con el PSOE o con el PP.

La puntuación media de la corrupción, si se refiere al partido que nos gusta, es de 7.6. Si el voluntario no tiene una adscripción política definida, es de 7.7. Y si se refiere al partido contrario, es de 8.1. Si el voluntario se declara del PP, puntúa a su partido con 7.4, y al PSOE con 7.95. Si se declara al PSOE, puntúa al PP con 8.15 y al PSOE con 7.75. Como queda claro, el grupo al que uno pertenece sigue tirando.

Cuando se han hecho estudios en el laboratorio, incluyendo análisis de saliva para conocer las concentraciones de hormonas en sangre, el grupo de Jooa Julia Lee, de la Universidad de Harvard, ha encontrado que las concentraciones de testosterona y de cortisol, relacionadas con la agresividad y el estrés, deben ser altas para llevar al engaño y al fraude. Y lo han estudiado en 82 voluntarios, con el 54% de mujeres. En cuanto al apego al grupo, el grupo de Shaud Shalvi, desde la Universidad del Negev en Israel, explica que también la oxitocina, la hormona que lleva a las relaciones entre personas, ayuda a la corrupción.

A veces, estás investigaciones sobre corrupción descubren relaciones insospechadas. Por ejemplo, Aksel Sundström y Lena Wängnerud, de la Universidad de Goteborg, en Suecia, han estudiado la corrupción en 18 países europeos y su relación con la presencia de mujeres en los ayuntamientos. Y han descubierto que la corrupción supone un obstáculo para las mujeres en la política municipal. Los autores suponen que hay un previo acuerdo en la sombra por grupos de poder que son, mayoritariamente, de hombres, para elegir a los candidatos dentro de los partidos políticos. Y eligen, sobre todo, a personas que conocen de antes y de quienes se fían, es decir, hombres.

Por cierto, España se desvía en parte de las tendencias generales pues aparece en la mitad de la lista en corrupción, con Dinamarca a la cabeza y Bulgaria en la cola, y está muy arriba en presencia de mujeres, en segundo lugar detrás de Suecia y con Rumania en la cola.

Referencias:

Anduiza, E. et al. 2013. Turning a blind eye: Experimental evidence of partisan bias in attitudes toward corruption. Comparative Political Studies 46: 1664-1692.

Costas Pérez, E. et al. 2012. Corruption, scandals, voter information, and accountability. European Journal of Political Economy 28: 469-484.

Hernández-Vázquez, P. et al. 2015. Rooting out corruption or rooting for corruption? The heterogeneous electoral consequences of scandals. Political Science Research and Methods doi: 10.1017/psrm.2015.8

Jaber-López, T. et al. 2014. Physiological and behavioral patterns of corruption. Frontiers in Behavioral Neuroscience doi: 10.3389/fnbeh.2014.00434

Jiménez, J.L. 2013. Corrupción local en España. Cuadernos Económicos de ICE 85: 23-42.

Lee, J.J. et al. 2015. Hormones and ethics: Understanding the biological basis of unethical conduct. Journal of Experimental Psychology: General DOI: 10.1037/xge0000099

López-Valcárcel, B.G. et al. 2015. Danger: local corruption is contagious! Cátedra Pasquall Maragall Working Paper 1: 21 pp.

Martínez –Resón, M.M. 2016. Yo prefiero al corrupto: el perfil de los ciudadanos que eligen políticos deshonestos pero competentes. Revista Española de Investigaciones Sociológicas 153: 77-94.

Riera, P. et al. 2013. The electoral consequences of corruption scandals in Spain. Crime, Law and Social Change DOI: 10.1007/s10611-013-9479-1

Shalvi, S. & C.K.W. De Dreu. 2014. Oxytocin promotes group-serving dishonesty. Proceedings of tha National Academy of Sciences USA 112: 10651-10656.

Sundström, A. & L. Wängnerud. 2014. Corruption as an obstacle to women’s political representation: Evidence from local councils in 18 European countries. Party Politics DOI: 10.1177/1354068814549339

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Casos de corrupción se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los 2 casos del síndrome de Hikikomori en España

- Técnicas de demostración para casos ‘desesperados’

- Limpieza promueve limpieza

#Naukas16 Entramos en M1

.

.

Rosario Luque ha venido a hablar del DefCon1, ese estado de alerta militar que autoriza el uso de armas de destrucción masiva, a nivel celular y del papel que en él juegan los macrófagos.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Entramos en M1 se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Las tres conquistas del Polo Norte

La expedición noruega de Amundsen coronando el Polo Sur

La expedición noruega de Amundsen coronando el Polo Sur

Siempre me ha resultado curioso saber que, después de miles de años de Historia, el ser humano finalmente consiguió alcanzar los cuatro puntos más extremos de nuestro planeta en apenas medio siglo. El lapso de tiempo que va de 1911 hasta 1960 fue testigo de la victoria final, y casi consecutiva, sobre los Polos, el Everest y la Fosa de las Marianas… o dicho de otra manera: el punto más alto, el más profundo, el más al norte y el más al sur de nuestro planeta.

Estos prodigiosos cincuenta años se inician con la conquista del Polo Sur por parte de la expedición noruega, liderada por Roald Amundsen, el 14 de diciembre de 1911. En mayo de 1953 el neozelandés Edmund Hillary y el sherpa Tenzing Norgay fueron los primeros seres humanos en ascender los 8848 metros de altura del Everest. En enero de 1960 el ingeniero Jacques Picard y el militar Don Walsh se posaron por primera vez en el fondo marino de la fosa de las Marianas a bordo del submarino Trieste.

Las dos últimas fechas, separadas apenas por unos años, situaban al hombre en el punto más alto y el más profundo del planeta, y si las comparamos con julio de 1969, momento en el que la humanidad consiguió poner un pie en la Luna, nos dan una idea de la extrema dificultad de las gestas alcanzadas.

Doodle conmemorativo del 125 aniversario de la conquista del Polo Sur

Doodle conmemorativo del 125 aniversario de la conquista del Polo Sur

Hace unos días, Google nos recordaba en su portada el 125 aniversario de la conquista del Polo Sur, sin embargo si tuviese que crear uno de sus populares “doodles” y dedicarlo al Polo Norte, el asunto sería bastante más complicado. De hecho, y a raíz de esta celebración tuve en twitter un pequeño debate sobre el tema puesto que, a pesar del tiempo transcurrido, la gente no tiene aún muy claro quién fue el primer hombre que alcanzó el Polo Norte… Incluso si volvemos a acudir al célebre buscador para encontrar una respuesta nos encontraremos con una muy equivocada.

No siempre hay que fiarse de Google

No siempre hay que fiarse de Google

La historia de la conquista del Polo Norte se ha visto envuelta en numerosos errores (y mentiras, por qué no decirlo) que condicionaron su exploración y la relegaron al olvido, simplemente porque todos pensaron que ya se había completado. Para complicarlo aún más, aparte de las consideraciones históricas, la pregunta de quién fue el primero en llegar al Polo Norte tiene sus propias connotaciones semánticas… ¿Qué se considera llegar? ¿Hay que pisar físicamente el lugar, hay que llegar de alguna manera concreta?

Dos siglos antes, cuando comenzó la exploración polar, a nadie se le hubiera ocurrido avanzar hacia el Polo… allí no había nada, y al igual que Colón, lo que buscaban los navegantes en realidad era un paso comercial, el célebre Paso del Noroeste (o del Nordeste). Poco a poco el deseo comercial se fue transformando en exploración, más tarde en pasión y finalmente en obsesión.

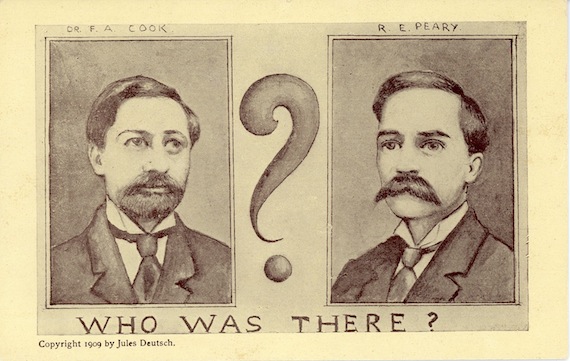

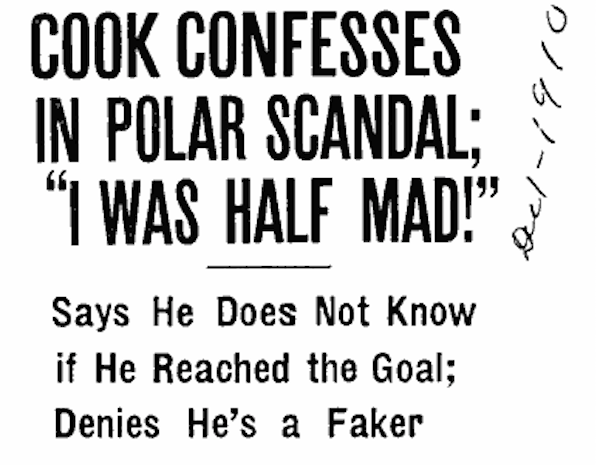

¿Peary o Cook? Hoy sabemos que ninguno.

¿Peary o Cook? Hoy sabemos que ninguno.

Obsesión como la de Robert Peary, explorador estadounidense que durante más de veinte años realizó casi una docena de intentonas, hasta que en abril de 1909 pudo gritar: ¡Al fin el Polo Norte, el premio a tres siglos, mío al fin!.

Ya sea porque mintió o porque se equivocó en sus mediciones (yo soy más partidario de la primera opción), Peary jamás llegó al Polo Norte. Pero tuvo la suerte de toparse con un adversario aún más mentiroso que él, Frederick Cook, otro aventurero que también se proclamaba como la primera persona en llegar a los 90ºN, casualmente el mismo año en que Peary regresaba de su expedición.

Ninguno de los dos lo consiguió, dejémoslo bien claro: Ni Peary, ni Cook.

Sin embargo, la fama de mentiroso de Cook (a quién unos años antes ya habían pillado falseando logros, como una fingida escalada al Denali) empujó a muchos a darle crédito a la gesta de Peary. Para auparle aún más, en noviembre Cook confesó y admitió que no había llegado, lo que aumentó aún más la apariencia de vencedor de su contrincante. Esta errónea creencia de que Robert Peary fue el primero en llegar al Polo Norte se mantuvo durante décadas, e incluso hoy en día, muchas webs aún mantienen esa información falsa en sus contenidos.

Cook confiesa

Cook confiesa

Para lo que a nosotros nos atañe, el hecho de que a principios de siglo se diera por sentado que Peary era el gran ganador tuvo consecuencias inesperadas. La más importante fue que, al dar por finalizada la carrera hacia los 90ºN, muchos exploradores olvidaron el Polo Norte para dedicar sus esfuerzos a ganar otros objetivos. El más destacado, el propio Amundsen que, al conocerse la noticia de que el Ártico ya tenía Rey, desvió sus esfuerzos y su expedición hacia el Polo Sur.

La autoproclamación de Peary en 1909 como conquistador del Norte hizo que durante casi veinte años y, exceptuando alguna expedición danesa de exploración por Groenlandia, el Ártico apenas tuviera visitantes. Tuvimos que esperar hasta mediados de la década de los ’20 para que volviera la fiebre ártica, esta vez utilizando nuevos métodos y transportes.

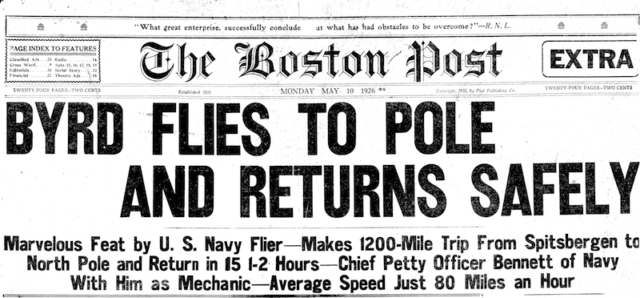

En 1926, el piloto estadounidense Richard Byrd volvió a poner sobre la mesa una nueva hazaña ártica afirmando que había sobrevolado el Polo Norte subido en su fokker. Otro “bluff” que sumar al de Peary y Cook puesto que hoy sabemos con total seguridad que Byrd también mintió: Tergiversó las coordenadas en su diario y se inventó los datos para aparentar, sin mencionar su demencial historia de haber divisado desde el aire entradas a un mundo intraterrestre bajo el Polo.

Richard Byrd… tampoco.

Richard Byrd… tampoco.

Seguimos en mayo de 1926 y a pesar de lo que todo el mundo piensa, el Polo Norte continúa virgen: Nadie lo ha alcanzado aún. Sin embargo, tan solo unos días después del vuelo en avión de Byrd, despegaba desde el archipiélago de Svalbard la primera expedición que de verdad iba a alcanzar el Polo Norte.

A bordo del dirigible Norge se embarcan dieciséis personas, encabezadas por el italiano Umberto Nobile, y… tachán… el rey del Sur, Roald Amundsen. Se sitúan sobre los 90ºN, abren la ventanilla del dirigible y lanzan tres banderas, italiana, noruega y estadounidense. Todos ellos, el 12 de mayo de 1926, se convierten, por fin, en las primeras personas en alcanzar el Polo. Admundsen además atesora el honor de ser el primero en conquistar el Polo Sur y también el Norte.

Por supuesto habrá quien considere que el sobrevuelo del Norge por parte de Nobile y Amundsen no es una conquista total puesto que, aunque no cabe duda de que fueron los primeros en llegar, en realidad, no “pisaron” el Polo Norte…

Oficialmente ya tenemos ganadores, sin embargo aún queda pendiente la cuestión semántica a la que me refería en párrafos anteriores, de quién fue el primer hombre que “pisó” el Polo Norte. Para alcanzar este honor aún tendríamos que esperar más de veinte años.

En abril de 1948, tres aviones Lisunov Li-2 soviéticos aterrizan en el Polo Norte llevando a bordo una expedición científica Sever-2, compuesta por veinticuatro personas lideradas por el explorador Alexander Kutnesov. Su misión principal era determinar mediante sonar si debajo del hielo ártico había montañas submarinas, por lo que en ningún momento supieron que eran los primeros seres humanos que pisaban el lugar más septentrional del planeta.

Es posible que también en esta ocasión haya gente que considere que llegar en avión al Polo y regresar cómodamente por aire, no merece el tratamiento de “conquista”, sobre todo si tenemos en cuenta las gestas de Hillary en el Everest o la carrera entre Scott y Amundsen en la Antártida. Dicho de otro modo: tanto el Norge como la expedición soviética alcanzaron los 90ºN mediante medios aéreos y hay quien puede pensar (no es mi caso) que estos logros son como si Hillary hubiese conquistado el Everest descendiendo en un helicóptero…

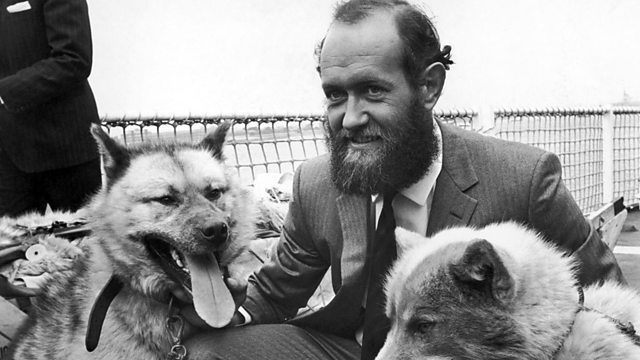

Wally Herbert, su expedición es la única en llegar a pie al Polo Norte atravesando el mar Ártico

Wally Herbert, su expedición es la única en llegar a pie al Polo Norte atravesando el mar Ártico

Para estos “tiquismiquis” que esperan una gesta tradicional, por tierra, aún queda una tercera conquista del Polo Norte, aunque eso sí… habrá que esperar más de veinte años.

En 1969, y el año es significativo de la dureza del reto si lo comparamos con la fecha de llegada a la Luna, una expedición de tres hombres, comandada por el explorador británico Wally Herbert dará cumplida cuenta de lo que representa alcanzar el Polo Norte sin utilizar medios aéreos. Más de un año de travesía, más de un centenar de perros para los trineos y una gesta que jamás nadie ha vuelto a repetir: Alcanzar los 90ºN cruzando el océano Ártico a pie.

Estas son las tres conquistas del Polo Norte, las verdaderas.

Nobile, Amundsen, Ellsworth, Wisting a bordo del Norge fueron los primeros en llegar.

Kutnesov y sus científicos de la expedición Sever-2 fueron los primeros en pisar.

Herbert y su equipo de la British Trans-Arctic Expedition fueron los primeros en conquistar.

Este post ha sido realizado por Javier Peláez (@irreductible) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Las tres conquistas del Polo Norte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sorpresas en la atmósfera del polo sur de Venus

- ¿Qué hago yo si papá viaja hacia al norte y mamá hacia el sur?

- Las tres dimensiones del sonido

#Naukas16 Exoplanetas: mundos de ciencia ficción

Los exoplanetas descubiertos superan a todo lo imaginado por los creadores de ciencia ficción. Daniel Marín nos da una vuelta por ellos.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Exoplanetas: mundos de ciencia ficción se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas13 Naves de ciencia y no de ficción

- #NaukasKids14 Física y ciencia ficción

- #Naukas16 Cómo escribir un libro de ciencia para niños

No todo ha sido malo este año: la ciencia nos dejó algunas buenas noticias

Donald Trump

Donald Trump

Francamente, debimos plantearnos adelantar el cambio de año cuando el 14 de enero fallecía Alan Rickman. 2016 no podía traer nada bueno. Tras ello llegó el brexit, la elección de Donald Trump, las muertes de David Bowie, Leonard Cohen, Umberto Eco, Darío Fo, Bud Spencer, Johan Cruyff, el huracán Mathew, el terremoto de Italia… Efectivamente, nada bueno.

¡Error! Aunque han pasado más desapercibidas, este año también ha traído buenas noticias, muchas de ellas por cortesía y gracia de los científicos e investigadores de todo el mundo. Si tener en cuenta lo bueno ya es una costumbre saludable de por sí, en un año que vamos a cerrar como un continuo borrón chubascoso se antoja una necesidad vital.

No están todas las que son, pero todas las que están, lo son: buenas noticias que nos ha dejado la ciencia.

Una mujer recibe la vacuna del ébola en Conakri (Guinea). Foto: Cellou Binani – AFP

Una mujer recibe la vacuna del ébola en Conakri (Guinea). Foto: Cellou Binani – AFP

Una vacuna para el ébola

En la misma semana de Navidad llegó la que probablemente es la mejor noticia de todas: la Organización Mundial de la Salud anunciaba que la vacuna experimental sometida a la fase de ensayos clínicos en Guinea durante 2015 demostraba una eficacia del 100% para proteger a los seres humanos de la enfermedad.

La noticia llegaba tarde para todos los que fallecieron en la epidemia de ébola en África Occidental del año pasado, pero suponía una esperanzadora diferencia para la próxima vez que algo así ocurra de nuevo.

El virus del ébola se identificó por primera vez en 1976 y desde entonces ha habido brotes esporádicos de la enfermedad. El que se vivió en África entre 2013 y este 2016 ha sido el más grave de todos con más de 11.000 muertes.

El doctor John Zhang con el niño cuyo embrión fue creado por reemplazamiento mitocondrial: óvulo (y sus mitocondrias) de una donante, núcleo del óvulo de la madre y esperma del padre.

El doctor John Zhang con el niño cuyo embrión fue creado por reemplazamiento mitocondrial: óvulo (y sus mitocondrias) de una donante, núcleo del óvulo de la madre y esperma del padre.

Un niño con tres padres

En el mes de septiembre conocíamos la noticia: cinco meses antes nacía el primer bebé con código genético de tres personas distintas. Ocurrió en Estados Unidos y el objetivo era evitar que el bebé naciese con el síndrome de Leigh, una patología genética que afecta al desarrollo del sistema nervioso.

La madre del bebé porta la carga genética responsable de este síndrome. Aunque ella no ha desarrollado la enfermedad, ésta causó la muerte de sus primeros dos hijos, así que ella y su marido buscaron la ayuda de John Zhang, especializado en la técnica de los ‘tres padres’ para evitar este tipo de enfermedades.

Hay varias formas de evitar esto. La más habitual es fertilizar el óvulo de una donante y de la madre con el esperma del padre, y antes de que ambos comiencen a dividirse se extrae el núcleo de ambos, se descarta el de la donante y se sustituye por el de la madre. En este caso, por motivos religiosos, la pareja se negó a destruir un embrión, así que el proceso fue diferente: Zhang extrajo el núcleo de un óvulo de la madre y lo introdujo en uno de la donante para ser fertilizado a posteriori.

Esto abre una nueva puerta a la manipulación de óvulos para evitar enfermedades sin afectar a embriones, un punto que causa serios dilemas éticos y morales en muchos casos.

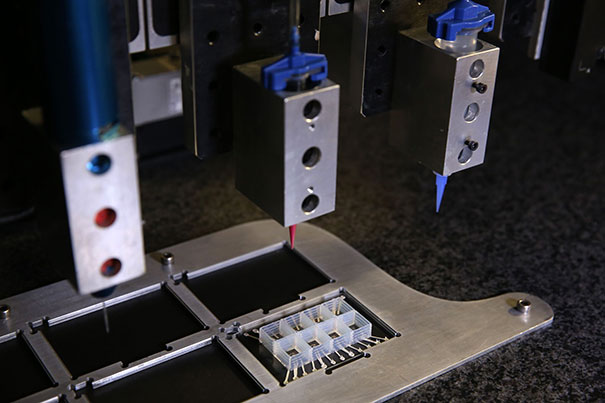

Impresora 3D

Impresora 3D

Un corazón en un chip

En el mes de octubre, científicos de Harvard anunciaban que habían logrado por primera vez reproducir los elementos y funcionamiento del corazón humano en un pequeño chip fabricado con una impresora 3D de forma que se pueda utilizar para investigación médica sin necesidad de utilizar modelos animales.

Se trata de un paso más en la rama de la microfluídica, que trata de fabricar pequeños chips de plástico en los que se ensayen las reacciones químicas que ocurren en cada órgano humano al entrar en contacto con distintos medicamentos o sustancias y llevar así a cabo parte de la investigación sobre enfermedades y sus curas.

Además, utilizar una impresora 3D para fabricarlos tiene ventajas añadidas, ya que el diseño se puede modificar rápidamente para adaptarse a enfermedades o alteraciones concretas de un paciente y aplicar así una investigación y medicina personalizadas.

Nathan Copeland y su brazo robótico

Nathan Copeland y su brazo robótico

Un brazo robótico que siente

Una noche de 2004, Nathan Copeland, de 18 años, iba conduciendo bajo la lluvia cuando perdió el control de su coche y tuvo un accidente. Desde entonces, su cuerpo perdió toda sensibilidad del cuello para abajo. Hasta que este mes de octubre recuperó el sentido del tacto en un brazo.

Claro que el brazo no es suyo. Es un brazo robótico conectado con una cirugía directamente a su cerebro, de forma que recibe las señales eléctricas de forma similar a como sentimos habitualmente que algo nos roza un dedo.

No es la primera prótesis robótica que se fabrica, pero aquí la clave está en el sistema de señales bidireccionales. A Copeland se le colocó un implante neuronal y durante seis meses entrenó para aprender a dominar el dispositivo: por un lado, los electrodos recogían las señales enviadas por la zona motora del cerebro para mover el brazo robótico, mientras que por otro estimulaban eléctricamente otra región relacionada con los sentidos. para crear la sensación del tacto. Según Copeland, la sensación es prácticamente la de tener la mano y el brazo de nuevo funcionales.

Posible presentación de los anticonceptivos masculinos

Posible presentación de los anticonceptivos masculinos

Un anticonceptivo masculino

Queda aún mucha investigación por delante, pero los primeros resultados son prometedores: en el estudio clínico de una inyección anticonceptiva masculina, los resultados demostraron una eficacia prácticamente igual a la de la píldora anticonceptiva femenina. Si bien el estudio tuvo que ser suspendido temporalmente por los efectos secundarios que sufrieron los voluntarios, se trata de un primer paso hacia un reparto equitativo del control del embarazo entre ambos miembros de una pareja.

En el estudio participaron 350 hombres con pareja estable que recibieron estas inyecciones hormonas. El efecto fue una bajada en el número de espermatozoides durante el tiempo que duró el tratamiento, recuperándose después los niveles habituales igual que ocurre con la píldora.

Sin embargo, las inyecciones presentaron efectos negativos, como acné, depresión y un incremento de la libido que causaron que el 20% de los participantes abandonase el tratamiento y por tanto el estudio se detuviese antes de lo previsto. Son aspectos que deben mejorar antes de que este anticonceptivo masculino pueda salir al mercado, pero se trata de un paso adelante en un camino que traerá una alternativa más para evitar embarazos no deseados.

Los ratones parecen estar un paso más cerca de la inmortalidad

Los ratones parecen estar un paso más cerca de la inmortalidad

Un ratón rejuvenecido

En el futuro, el envejecimiento no será una consecuencia inevitable del paso del tiempo, sino un factor que, como cualquier enfermedad, será posible tratar y curar. Eso asegura el equipo que a finales de este año anunció que, por primera vez, había aplicado en un ratón vivo la técnica de la reprogramación celular para revertir los efectos del envejecimiento.

La reprogramación consiste en manipular las células de cualquier tejido del cuerpo (del cerebro, de un músculo, del hígado…) para revertir su especialización y convertirlas en células madre pluripotentes, con la capacidad de convertirse en cualquier otra célula. Esto, que supondría una ventaja obvia ante la necesidad de un trasplante, es de momento una técnica demasiado compleja, cuyos resultados terminan a menudo desarrollando tumores.

En el caso del ratón, la clave fue dejar la reprogramación a medias: en vez de completar el proceso, los investigadores lo aplicaron de forma parcial y lo detuvieron antes de que terminase. De esa forma las células de los tejidos seguían especializadas, pero los efectos del paso del tiempo se habían corregido. Hará falta más investigación, pero pasar de los modelos in vitro, donde se había probado la reprogramación hasta ahora, a un animal vivo es un paso adelante en el dominio de una técnica que servirá para salvar vidas y ayudarnos a luchar contra las enfermedades causadas por la vejez.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista en El Confidencial

El artículo No todo ha sido malo este año: la ciencia nos dejó algunas buenas noticias se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En la ciencia todo se desarrolla vigoroso, obvio y estupendo como en un cuento de hadas

- Migraciones culturales: La costumbre de usar palillos llegó al este de China hace 500.000 años

- Fraude científico (IV). Algunas consecuencias

Un 5 % de materia oscura menos

La naturaleza de la materia oscura sigue siendo uno de los grandes misterios de la ciencia. Tanto es así que hay científicos que consiguen gran eco mediático simplemente proponiendo teorías en las que la materia oscura no aparece. Pero ninguna de estas teorías termina de explicar las cosas tan bien como lo hace la materia oscura.

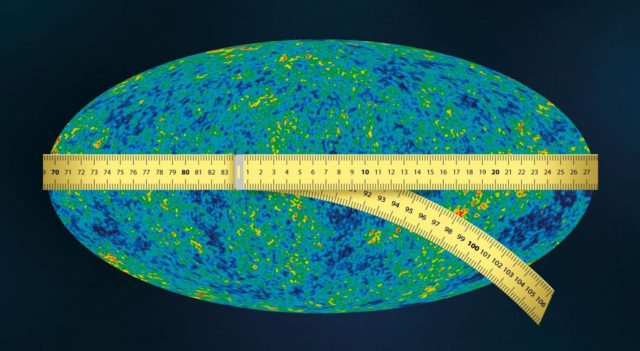

Mientras se dilucida de qué está compuesta, las propiedades atribuibles a la materia oscura, aparte de su masa, podrían ayudar a explicar algunas anomalías detectadas en el fondo cósmico de microondas. El telescopio Planck midió con precisión las fluctuaciones en la temperatura de éste y con estas mediciones los científicos pudieron calcular algunos parámetros cosmológicos clave.

Los valores de dos de estos parámetros, la constante de Hubble, que describe la velocidad de expansión del universo, y el asociado con el número de galaxias en cúmulos, discrepan con los obtenidos a partir de la observación de la velocidad de expansión de las galaxias y el estudio de los cúmulos. La discrepancia es significativamente mayor que los márgenes de error y los errores sistemáticos conocidos. Caben entonces dos posibilidades: o existe un error desconocido o la composición del universo en la época del fondo cósmico de microondas era diferente a la del universo posterior y que podemos observar hoy.

Una forma de explicar la discrepancia es asumir que la materia oscura se desintegra por lo que en el universo primitivo habría habido más materia oscura que ahora. Pero, ¿es esto posible?

Para resolver esta cuestión tres investigadores de la Academia Rusa de Ciencias, Igor Tkachev, Dmitry Gorbunov y Anton Chudaykin, han analizado los datos de Planck y los han comparado con un modelo basado en la hipótesis de la materia oscura que se desintegra y con el modelo estándar ΛCDM con materia oscura estable. La comparación muestra que el modelo que incluye materia oscura inestable es más consistente con los datos observacionales. Sin embargo, también encontraron que el efecto de lente gravitacional limita mucho la proporción de materia oscura que se desintegra en el modelo.

Usando datos de observaciones de varios efectos cosmológicos, los investigadores fueron capaces de dar una estimación de la concentración relativa de los componentes de la materia oscura que se desintegran, limitándola a entre un 2 y un 5 %.

En otras palabras, esto significa que en nuestro universo habría ahora hasta un 5 % de materia oscura menos de la que había 378.000 años después del Big Bang, en la llamada era de la recombinación. Lo que aún no podemos decir es ni a qué velocidad desapareció esta materia oscura, ni si sigue desintegrándose actualmente.

Referencia:

A. Chudaykin, D. Gorbunov, & I. Tkachev (2016) Dark matter component decaying after recombination: Lensing constraints with Planck data Physical Review D doi: 10.1103/PhysRevD.94.023528

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Un 5 % de materia oscura menos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Y si lo que detectó LIGO fue materia oscura?

- Los supermateriales aumentan la sensibilidad 10.000 veces en los detectores de materia oscura

- Materia oscura entre nubes intergalácticas

6943, protagonista de un cuadro de Boccioni

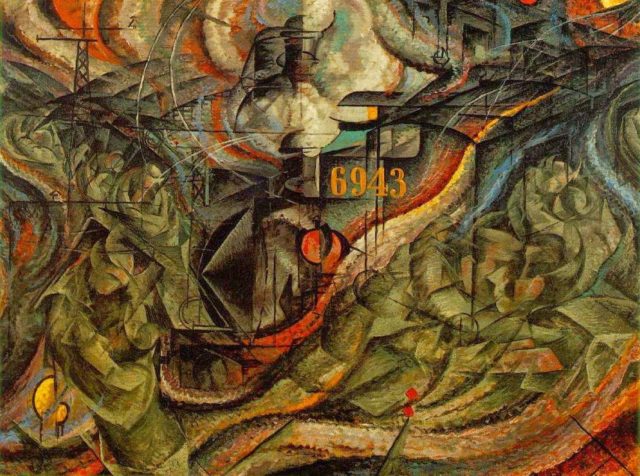

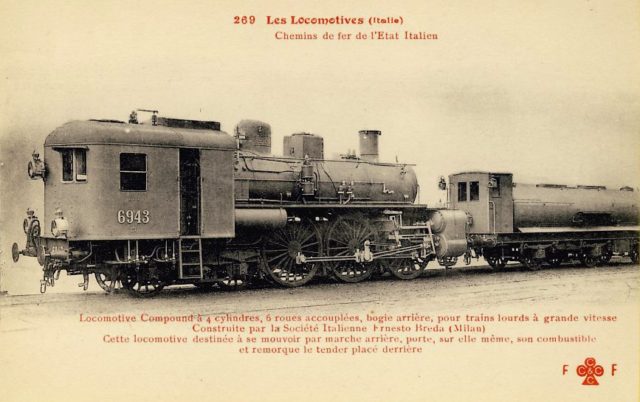

Mientras que en las anteriores entradas del Cuaderno de Cultura Científica Matemática pop y Vi el número cinco en oro mostrábamos obras de arte en las cuales los números son los protagonistas principales de las mismas, hoy vamos a mostrar el ejemplo de un cuadro en el que un número, en concreto el 6943, es uno de los elementos destacados de la obra. Nos estamos refiriendo a Estados de ánimo, las despedidas (1911), del futurista italiano Umberto Boccioni.

“Estados de ánimo, las despedidas” (1911), óleo sobre lienzo, de Umberto Boccioni, en el MoMA de Nueva York

“Estados de ánimo, las despedidas” (1911), óleo sobre lienzo, de Umberto Boccioni, en el MoMA de Nueva York

Nos encontramos frente a una obra que pertenece al movimiento artístico denominado futurismo. Este es un movimiento literario, artístico y social, que surge en Italia con el Manifiesto Futurista de 1909 (publicado en Le Figaro por Filippo T. Marinetti), y que junto al cubismo dan inicio a las vanguardias artísticas, que suponen el inicio del arte moderno.

Algunas de las características fundamentales del movimiento futurista son:

i) no se limita a ser un movimiento artístico, sino que es todo un movimiento cultural, e incluso social, muy relacionado con lo literario pero que también se manifestó en la arquitectura, la música o el cine;

ii) las ideas y la filosofía del movimiento se publican en manifiestos, libros y artículos;

iii) rompe, junto al cubismo, con la tradición artística anterior (como se explica, por ejemplo, en el libro La cuarta dimensión [2]), lo que se manifiesta a través de una ruptura con la perspectiva (cubismo –estática– y futurismo –dinámica–) introduciendo diferentes puntos de vista, pero también con la utilización de técnicas novedosas y revolucionarias, como el “collage” (en estos las letras, las palabras y los números se convierten en elementos importantes, tanto por su significado, como por su imagen);

iv) la característica estética fundamental del futurismo es el dinamismo y el movimiento –para lo cual utilizan magistralmente las formas y los colores–, los futuristas querían crear un nuevo arte, y una nueva sociedad, y tomaron como referencia la nueva tecnología y las máquinas, símbolos del futuro, su fuerza, su velocidad, su energía, su movimiento, aunque también creían en la guerra y en la violencia como paso hacia ese futuro.

“Bailarina azul” (1912), óleo sobre lienzo con lentejuelas, de Gino Severini, en la Peggy Guggenheim Collection de Venecia

“Bailarina azul” (1912), óleo sobre lienzo con lentejuelas, de Gino Severini, en la Peggy Guggenheim Collection de Venecia

“El vuelo de golondrinas” (1913), témpera sobre papel, de Giacomo Balla, en el MoMA de Nueva York

“El vuelo de golondrinas” (1913), témpera sobre papel, de Giacomo Balla, en el MoMA de Nueva York