El futuro es inescrutable, sus amenazas también lo son

Foto: Louis Reed / Unsplash

Foto: Louis Reed / UnsplashEn 1971, dos años después de haber sido elegido presidente de los Estados Unidos, Richard Nixon firmó la denominada National Cancer Act, una ley mediante la que se proponía acabar con el cáncer. Aunque la ley en cuestión no la recogía en su tenor literal, la expresión “guerra al cáncer” fue profusamente utilizada para referirse al plan federal de actuaciones. Junto con otras medidas, se destinaron al plan 1.500 millones de dólares y Nixon prometió que lo “derrotarían”.

Otros gobiernos, el español incluido, declaran ahora la “guerra” a otra enfermedad, la provocada por el coronavirus SARS-CoV-2. Además de las medidas implantadas para contener la expansión de la pandemia, los planes contienen actuaciones de política científica, con una importante inyección de recursos económicos para investigar sobre el coronavirus y posibles tratamientos para “vencerlo”.

En medio de tanta zozobra, dolor e incertidumbre como está causando la pandemia, gobernantes y prescriptores de opinión parecen depositar su confianza en la ciencia como instrumento para resolver el reto más formidable que afrontan generaciones. Porque parece haber calado la idea de que, como decíamos hace dos semanas, solo el conocimiento permitirá superarlo.

Conviene, no obstante, ser cautos. El pasado lunes 23 la revista Science publicó un editorial en el que advertía del riesgo de que se le pida demasiado a la ciencia o de que, incluso, la propia comunidad científica genere más expectativas de las debidas. El editorial utilizaba, a tal efecto, el caso del VIH: fueron necesarias décadas de esfuerzo en virología, epidemiología y desarrollo de nuevos fármacos para empezar a obtener resultados. Y si bien es cierto que desde hace tiempo el SIDA se ha convertido en una enfermedad crónica, tan solo ahora, cuatro décadas después, están empezando a curarse algunos enfermos.

Algo parecido cabe decir de las investigaciones sobre el cáncer y sus resultados. Hoy sabemos más sobre los procesos implicados en las diferentes enfermedades que se engloban bajo esa denominación, y desde 1971 se han hecho progresos en el conocimiento de cuestiones tales como los factores de riesgo, los tratamientos y la prognosis de algunos tipos. Pero muchos siguen siendo incurables y la mortalidad se ha reducido solo levemente desde entonces. Recuperando la metáfora bélica, el cáncer sigue sin haber sido “derrotado”.

El contraejemplo de esas “guerras” es el proyecto Manhattan -este sí, de carácter bélico-, que se saldó con la producción de la bomba atómica. La comunidad científica contaba con suficiente conocimiento acerca de la estructura del átomo y la naturaleza de la materia. Y eso permitió a los norteamericanos disponer, en tiempo récord, del arma más mortífera que ha creado la humanidad.

Es importante, por supuesto, que se destinen recursos a la investigación sobre coronavirus y sobre epidemias en general. Pero la conclusión que cabe extraer de lo anterior debe llevarnos más allá.

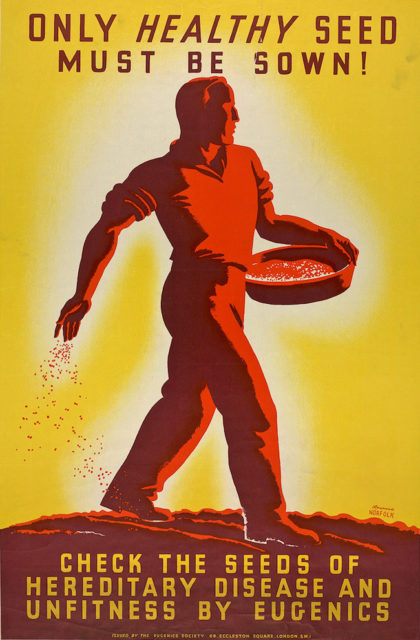

No sabemos qué nos deparará el futuro. Si bien es cierto que algunos peligros posibles son demasiado probables como para ignorarlos, también lo es que otros son completamente impredecibles, de la misma forma que desconocemos en qué materias o en qué campos necesitaremos generar conocimiento en el futuro próximo. También ignoramos aspectos fundamentales que subyacen a algunos de los problemas del presente, como pone de manifiesto la historia del cáncer. Por eso, la estrategia más útil consiste en aumentar y diversificar el esfuerzo, sembrando en terrenos diferentes, porque desconocemos hoy lo que necesitaremos mañana. Es importante atesorar conocimiento en materias diversas porque cuanto más sepamos, mejor pertrechados estaremos para hacer frente a los retos que, en forma de pandemias o de cualquier otra naturaleza, esperan a la humanidad.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El futuro es inescrutable, sus amenazas también lo son se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:¡Leamos poesía astronómica en las rocas!

Los fósiles, los minerales o las rocas son, entre otras cosas, en lo primero que pensamos al hablar de geología, pero lo cierto es que la física es un ámbito científico que difícilmente se puede desvincular de la geología. Y es que el fundamento físico resulta clave a la hora de explicar algunos procesos geológicos que suceden tanto en el océano como en la superficie terrestre.

Con el fin de poner sobre la mesa la estrecha relación entre la geología y la física, los días 27 y 28 de noviembre de 2019 se celebró la jornada divulgativa “Geología para poetas, miopes y despistados: La Geología también tiene su Física”. El evento tuvo lugar en la Sala Baroja del Bizkaia Aretoa de la UPV/EHU en Bilbao.

La segunda edición de esta iniciativa estuvo organizada por miembros del grupo de investigación de Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Geoparque de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

En las rocas se puede leer la historia climática de la Tierra. Pero si se hace con los ojos de un poeta y se busca inspiración en la astronomía te encuentras con que puedes leer poesía en las rocas, como los que explica Aitor Payros, profesor del departamento de estratigrafía y paleontología de la Universidad del País Vasco.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo ¡Leamos poesía astronómica en las rocas! se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las mareas del pasado leídas en las rocas del presente

- Terremotos en la gran pantalla: algunas verdades y diversas mentiras

- La eternidad en un grano de arena

La supervivencia siempre tiene un coste: la prevalencia del haplogrupo H en Europa

Esqueleto de uno de los individuos enterrados en la necrópolis de la ermita de San Miguel de Ereñozar. Foto: Mikel Neira.

Esqueleto de uno de los individuos enterrados en la necrópolis de la ermita de San Miguel de Ereñozar. Foto: Mikel Neira.Entre el siglo XIV y el XIX se produjo un período de inestabilidad climática conocido como la Pequeña Edad de Hielo que afectó principalmente al hemisferio norte. Durante este período se produjo un incremento de la actividad tormentosa y un descenso de la temperatura, que, aunque no fue muy severo, entre 1º y 2ºC, tuvo consecuencias devastadoras. El clima benigno de siglos anteriores, que había provocado un aumento notable de la población, se transformó en otro más duro y conllevó la destrucción de cosechas, la muerte de animales y, en definitiva, hambre. Y con las hambrunas, la salud de las poblaciones se debilitó y se propagaron las enfermedades. Basta recordar la pandemia de peste negra que asoló Europa en el siglo XIV, acabando con aproximadamente un tercio de su población.

¿Influyeron ese cambio climático y las consiguientes enfermedades en la genética humana? En la población europea actual el linaje del ADN mitocondrial, es decir, el material genético que se transmite por vía materna, más frecuente es el H. ¿Por qué?

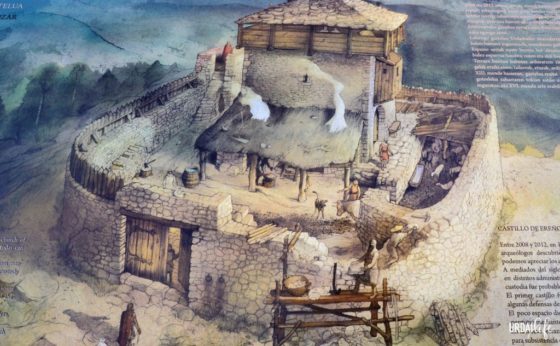

Reconstrucción del Castillo-Ermita de San Miguel de Ereñozar en época medieval. Fuente: Urdailife. Abajo, vídeo con el estado actual y la ubicación de la ermita.

Reconstrucción del Castillo-Ermita de San Miguel de Ereñozar en época medieval. Fuente: Urdailife. Abajo, vídeo con el estado actual y la ubicación de la ermita.

En el yacimiento medieval de San Miguel de Ereñozar el grupo de Biología Evolutiva Humana de la Facultad de Ciencia y Tecnología de la UPV/EHU, ha encontrado elementos que podrían servir para esclarecerlo. En esa necrópolis de la comarca vizcaína de Busturialdea-Urdaibai, en uso del siglo XIII al XVI, hay enterrados 163 individuos, de los que un 73% pertenecen al haplogrupo H, una frecuencia más alta que la que se da hoy en día en Europa.

“En la bibliografía ya se había postulado que algunos linajes mitocondriales podrían tener una relación con diferentes tipos de enfermedades y además, presentar un comportamiento diferencial con respecto al desarrollo de las mismas”, explica Imanol Martín, quien ha desarrollado la investigación como parte de su tesis. Así, los haplogrupos J y T protegerían frente al desarrollo de la osteoartritis, mientras que el haplogrupo H incrementaría el riesgo a desarrollar enfermedades reumáticas.

Así, que los investigadores de la UPV/EHU buscaron manifestaciones reumáticas en los esqueletos de los 163 individuos enterrados en Ereñozar, y los encontraron en 47. Y, puesto que para que las enfermedades reumáticas dejen signos óseos es necesario que pase el tiempo, se eligieron los restos de otras 43 personas de más de 45 años de edad de la misma necrópolis como grupo de control. En ambos grupos se llevaron a cabo análisis de los distintos linajes mitocondriales. “El haplogrupo H fue más frecuente entre los individuos con manifestaciones reumáticas que en el grupo control y, a su vez, fue este haplogrupo mitocondrial el más frecuente entre los individuos afectados con espondiloartritis (grupo de enfermedades reumáticas e inflamatorias de las articulaciones)”, añade Martín.

En definitiva, el estudio confirma la relación entre las enfermedades reumáticas y el haplogrupo H, y también da pistas sobre la elevada frecuencia de este haplogupo en la población europea: “En esa época de déficit de alimentos los individuos del haplogrupo H tenían una ventaja selectiva frente a los que tuvieran otros haplogrupos, ya que el H es más eficiente a la hora de obtener energía de la dieta”. Sin embargo, ese metabolismo altamente eficiente también genera las llamadas especies reactivas de oxígeno (radicales libres, iones de oxígeno…), que desencadenan la disfunción y apoptosis celular y provocan, a la larga, la degradación del cartílago y el desarrollo de enfermedades de carácter reumático. La supervivencia siempre tiene un coste.

Referencia:

I.M. Laza, M. Hervella, M. Neira Zubieta & C. de-la-Rúa (2019) Environmental factors modulated ancient mitochondrial DNA variability and the prevalence of rheumatic diseases in the Basque Country Scientific Reports doi: 10.1038/s41598-019-56921-x

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La supervivencia siempre tiene un coste: la prevalencia del haplogrupo H en Europa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fotovoltaicos siempre a máxima potencia

- El planeta enano Haumea tiene anillo

- La selección positiva de la piel clara en el sur de Europa

Lienzos y partituras para crear nuevas vacunas

![]()

José de la Fuente, Juan José Pastor Comin y Sara Artigas Jerónimo

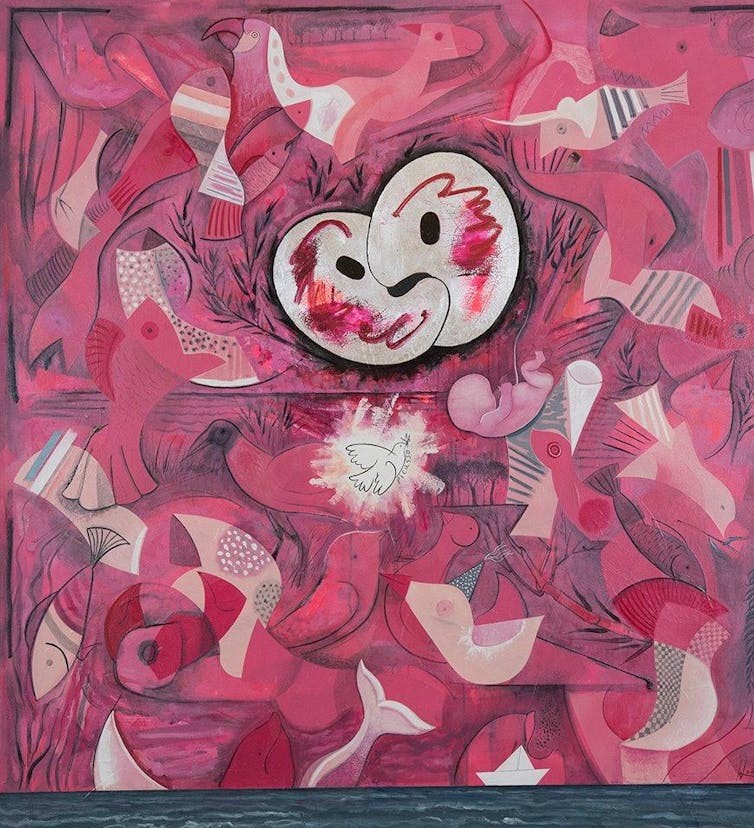

“El beso”, de Israel León Viera, que representa la nueva e inexplorada interacción de AKR con AKR o de SUB con SUB.

“El beso”, de Israel León Viera, que representa la nueva e inexplorada interacción de AKR con AKR o de SUB con SUB.KGJ Colección, Author provided

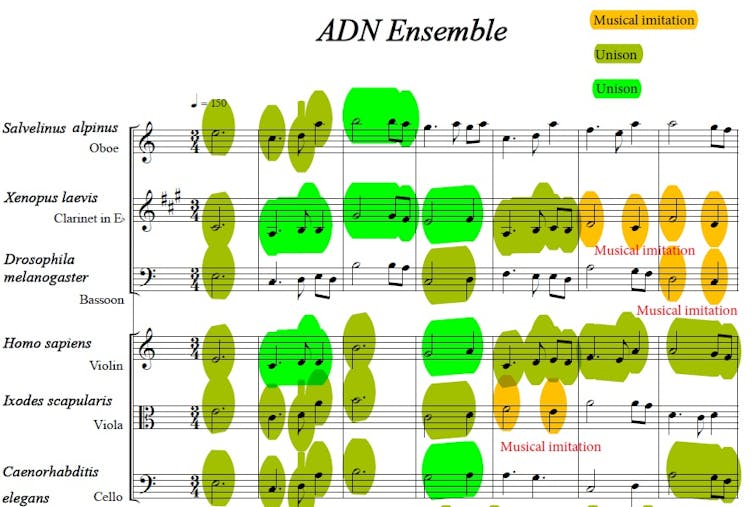

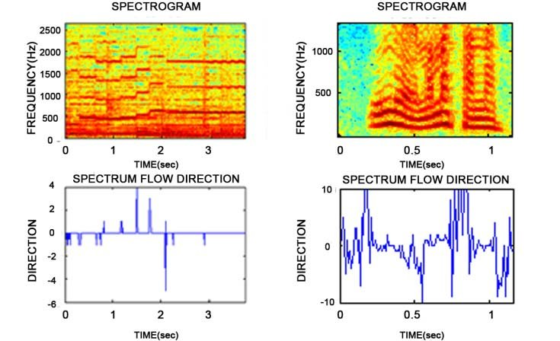

¡Que suene la música! La trucha alpina al oboe. Una rana al clarinete. El fagot para la mosca del vinagre. La única persona de esta peculiar banda toca el violín, mientras que una garrapata se encarga de la viola. Completa el sexteto de viento y cuerda un Caenorhabditis elegans, un pequeño gusano de un milímetro que hará que suene un imponente chelo.

¿Puede un compositor procurar una banda sonora que transcriba los datos que emergen de la rutina experimental de tubos de ensayo y probetas? Todos los componentes de la banda tienen algo en común: una proteína en su ADN. ¿Puede la información genética trasladarse a una partitura?

Secuencias de AKR/SUB dispuestas polifónicamente. Recurrencias y motivos.

Secuencias de AKR/SUB dispuestas polifónicamente. Recurrencias y motivos.Juan José Pastor., Author provided

La ciencia consiste en plantear nuevos interrogantes. Innovar es romper con lo establecido ¿Pueden el arte y la música ayudarnos a comprender la respuesta de nuestro organismo a una infección? ¿Y si los diseños de los artistas plásticos pudieran recoger sobre un lienzo los caminos que la ciencia debe abordar en el diseño de nuevos experimentos? ¿Podría una composición musical ayudar a entender con el comportamiento de sus voces, sus líneas melódicas, su forma y su estructura, las interacciones de las proteínas cuando estas responden ante la amenaza de un nuevo patógeno?

Para responder a esto tenemos que abrir nuestra mente. Y experimentar.

Científicos y artistas

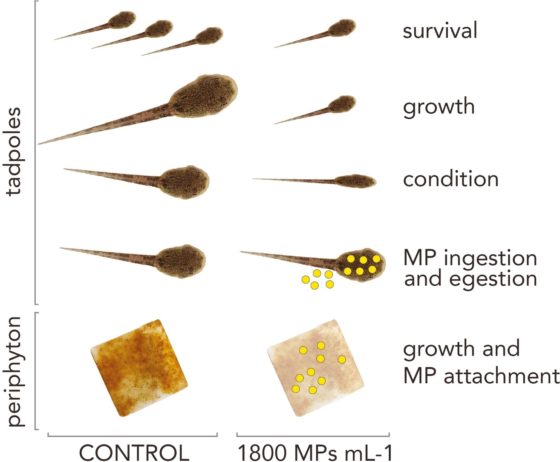

Investigadores del área de Genómica, Proteómica y Biotecnología del grupo SaBio en el Instituto de Investigación de Recursos Cinegéticos, centro mixto de la Universidad de Castilla-La Mancha y el CSIC, hemos desarrollado a través de un equipo interdisciplinar de científicos, artistas y músicos una nueva metodología. Esta nueva aproximación, publicada en el último número de la revista Vaccines, reúne el enfoque artístico y científico en la caracterización de la akirina (AKR), una proteína también conocida como subolesina (SUB) en garrapatas, para avanzar en el estudio del papel que juegan estas moléculas en la regulación de la respuesta inmune.

De esta forma, se identifican los mecanismos y genes que son expresados en nuestras células y se convierten en proteínas con un papel funcional en respuesta a la infección. Estas proteínas están muy conservadas a través de la evolución en distintas especies y han sido eficaces en el desarrollo de vacunas. Este conjunto de proteínas interactúa física y funcionalmente entre ellas en respuesta a algún estímulo, como podría ser su comportamiento ante una infección en células humanas.

La colaboración entre científicos y artistas proporcionó dos resultados:

- Un algoritmo que utiliza conjuntos musicales, basados en la akirina y secuencias de proteínas que interactúan, como un nuevo método para caracterizar la evolución y las interacciones entre proteínas.

- La sugerencia de artistas visuales de propiedades previamente inexploradas.

Este planteamiento proporciona un enfoque combinado para comprender algunas de las preguntas desafiantes de la biología molecular.

Del ADN a la partitura

Tradujimos las secuencias del ADN de la akirina de distintas especies animales a motivos musicales. Para ello utilizamos un primer algoritmo modificado que atendía a la altura y el ritmo. Esto permitió generar el patrón melódico de cada especie animal y su configuración motívica, y también observar las similitudes presentes entre las secuencias en distintas especies y la identificación de los motivos repetidos.

La representación musical no solo permitió una comprensión lineal –-melódica-– de la singularidad de cada especie estudiada, sino que permitió su visión polifónica –conjunta y simultánea-–, como una composición compleja y lógica. El análisis del contrapunto –cómo unas voces o especies se imitan unas a otras-– aportó una textura musical llena de correspondencias, que se mostraba viva a través del sonido.

Ciencia sobre lienzo

En el caso de la pintura, trasladamos al artista una hipótesis científica de partida que sirvió al pintor para expresar un problema biológico sobre los materiales artísticos elegidos y que este tratara de resolverlo a través de formas, composición, trazos y color sobre la tela y el bastidor.

Esta contribución creativa nos ayudó a representar su propia teoría de una forma original y desde un punto de vista completamente diferente, no conceptual, lejos de la organización estadística de los datos recogidos.

La nueva representación visual constituye un nuevo contexto de referencias aperturista que estimula la imaginación y la creatividad y que permite establecer nuevas hipótesis que, a la única luz de los datos experimentales obtenidos, tal vez no hubieran surgido. La representación artístico-visual sirvió no solo para identificar problemas conocidos en las formas de expresión de un lenguaje artístico, sino también para suscitar nuevas ideas divergentes.

KGJ Colección, Ciudad Real, España., Author provided

KGJ Colección, Ciudad Real, España., Author providedLos resultados mostraron de un modo plural e interdisciplinar que la interacción entre varías moléculas de AKR y SUB y las interacciones físicas con diferentes proteínas simultáneamente están involucradas en la regulación de varios procesos biológicos. Además, ayudaron a entender, a través de estas nuevas formas de representación artística y musical, el papel de las interacciones estudiadas en la regulación positiva y negativa de respuesta inmune. Así entendimos cómo se activa o suprime la expresión de algunos genes concretos.

¿Qué implicaciones alcanza esta colaboración? No solo contribuye a la investigación, sino que puede lograr el desarrollo de vacunas para el control de infestaciones por garrapatas, así como para el estudio de patógenos transmitidos por estas.

Este puede ser un avance esencial en contextos de exclusión social en un mundo que cuenta con un importante índice poblacional situado bajo el umbral de pobreza. Ahí es donde científicos y artistas pueden avanzar juntos y de la mano, iluminando el avance de la investigación ante los nuevos desafíos científicos que permitan construir un mundo mejor.![]()

Sobre los autores: José de la Fuente es profesor de investigación en el Instituto de Investigación en Recursos Cinegéticos (CSIC – Universidad de Castilla-La Mancha) y profesor adjunto en el departamente de patobiología veterinaria de la Universidad Estatal de Oklahoma (Estados Unidos); Juan José Pastor Comin es es profesor titular del área de Música en la Universidad de Castilla-La Mancha y co-director del Centro de Investigación y Documentación Musical (CIDoM); Sara Artigas Jerónimo es investigadora predoctoral en el Instituto de Investigación en Recursos Cinegéticos.

Este artículo fue publicado originalmente en The Conversation. Artículo original

El artículo Lienzos y partituras para crear nuevas vacunas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Dudas sobre las vacunas: problemas y soluciones

- Nuevas tecnologías para el estudio del cerebro: Desde Cajal a nuestros días

- Desmitificando: Vacunas peligrosas

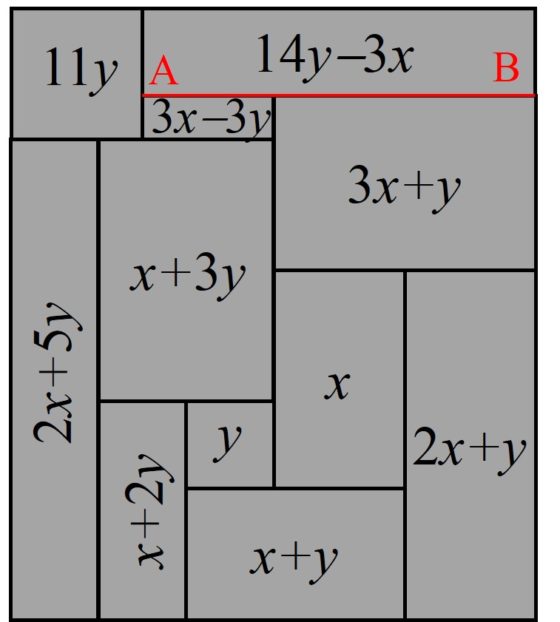

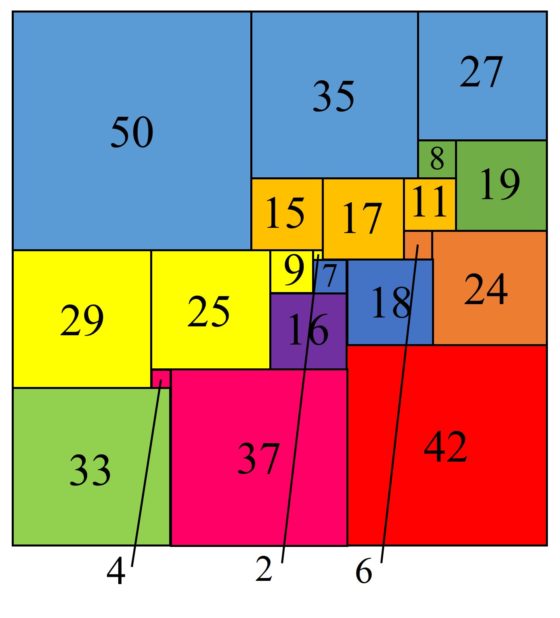

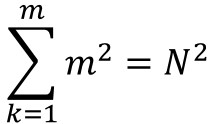

La cuadratura del cuadrado: las redes eléctricas de Kirchhoff

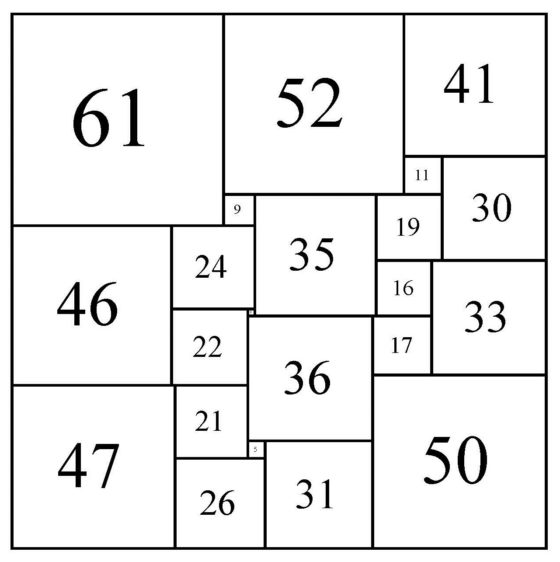

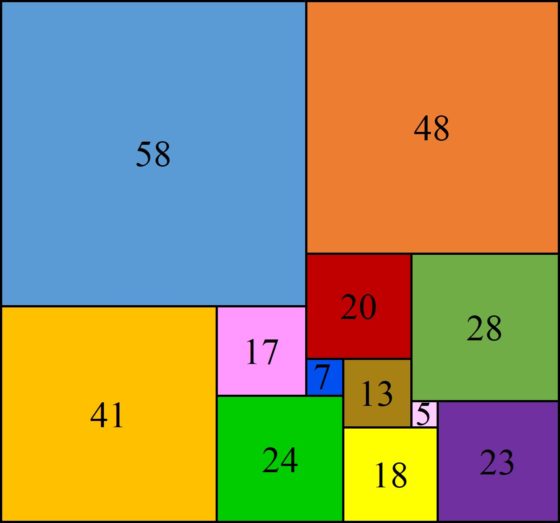

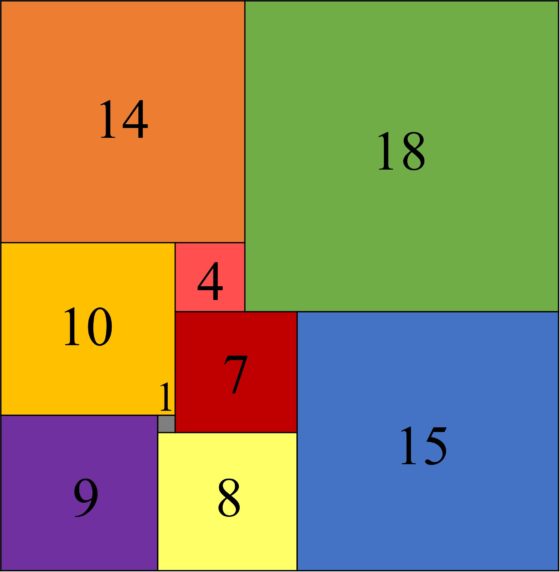

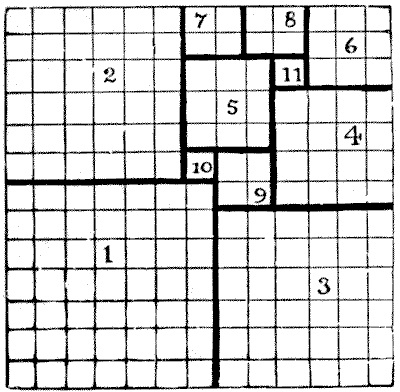

En mi anterior entrada del Cuaderno de Cultura Científica La cuadratura del cuadrado: en busca del santo grial estuvimos hablando de un hermoso rompecabezas matemático, el problema de la cuadratura perfecta del cuadrado, que recuerdo a continuación:

Problema de la cuadratura perfecta del cuadrado (o rectángulo): Dividir un cuadrado (o rectángulo) en un número finito de cuadrados más pequeños, todos de distintos tamaños.

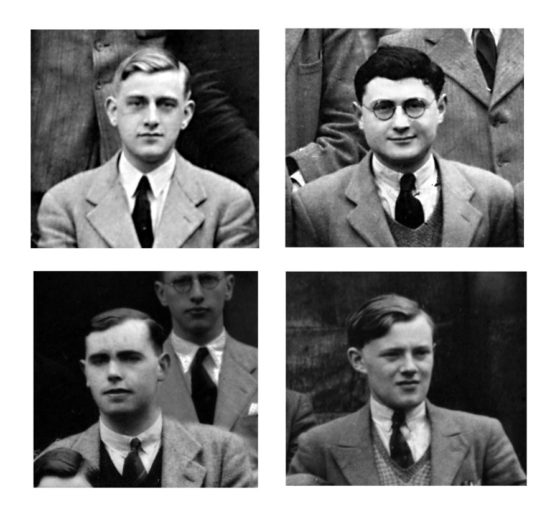

Este problema, que durante mucho tiempo se pensó que no tenía solución para cuadrados, lo que se conoció como la conjetura de Luzin, fue finalmente resuelto en positivo, alrededor del año 1939, por dos grupos de matemáticos. Por una parte, el matemático alemán Roland P. Sprague (1894-1967) construyó un cuadrado con una cuadratura perfecta, pero compuesta (recordemos que eso significa que contiene la cuadratura de algún sub-rectángulo), de orden 55. Mientras que los cuatro estudiantes del Trinity College de la Universidad de Cambridge (Reino Unido), Rowland L. Brooks (1916-1993), Cedric A. B. Smith (1917-2002), Arthur H. Stone (1916-2000) y William Th. Tutte (1917-2002), consiguieron construir el primer cuadrado perfecto simple (no compuesto), también de orden 55. Para ello, los cuatro de Trinity (puede leerse más sobre ellos en la entrada Blanche Descartes y la cuadratura del cuadrado) relacionaron el problema de las disecciones cuadradas de los rectángulos, en particular, de los cuadrados, con la teoría de las redes eléctricas de Kirchhoff, que es de lo que vamos a hablar en esta entrada.

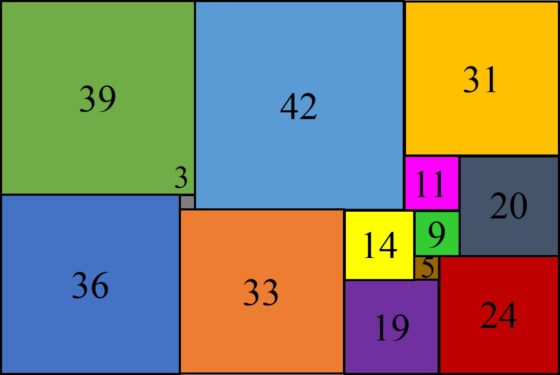

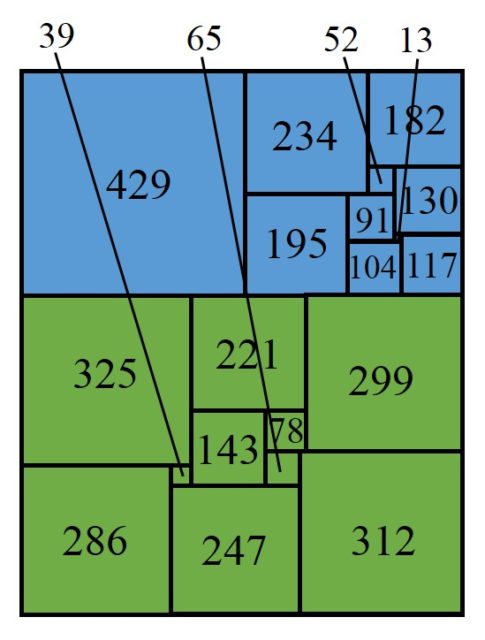

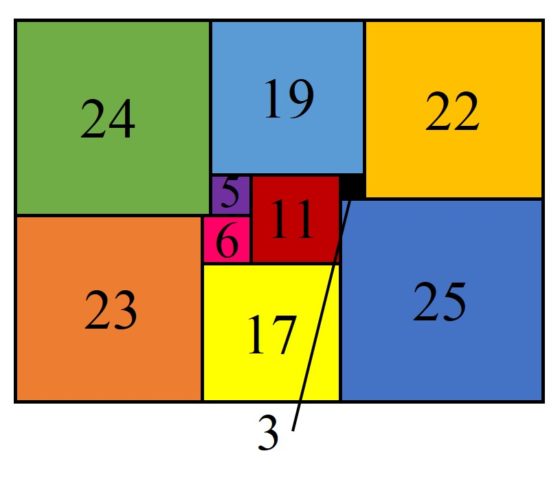

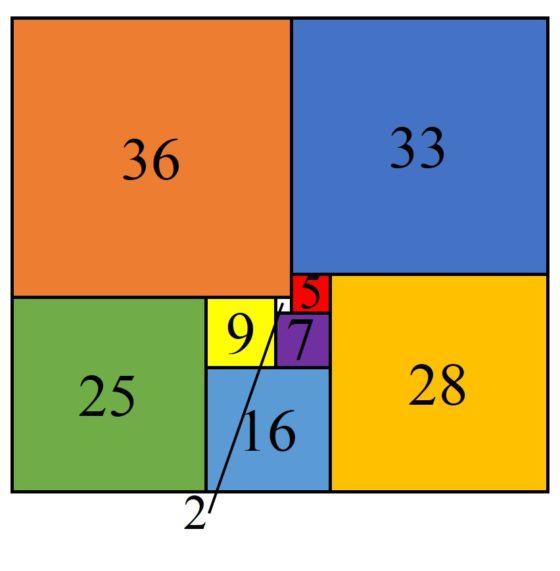

Una de las ocho cuadraturas perfectas simples del cuadrado de orden 22 que existen. Imagen de la página Tiling by squares, de Stuart Anderson

Una de las ocho cuadraturas perfectas simples del cuadrado de orden 22 que existen. Imagen de la página Tiling by squares, de Stuart AndersonComo explicamos en la anterior entrada, La cuadratura del cuadrado: en busca del santo grial, el primer acercamiento de los jóvenes estudiantes de Cambridge, Brooks, Smith, Stone y Tutte, fue experimental. Intentaron construir mediante una sencilla técnica algebraica algún ejemplo de disección de un cuadrado en cuadrados más pequeños de diferentes tamaños. Con esta técnica sí consiguieron construir algunos ejemplos de cuadraturas perfectas de rectángulos, pero no de cuadrados. Este método experimental dependía demasiado de la suerte y podrían no encontrar nunca el ansiado grial, una cuadratura perfecta del cuadrado. Era como encontrar una aguja en un pajar, sin saber además si había aguja. Por este motivo, abandonaron el camino experimental a favor de un enfoque más teórico, que además les permitiera conocer más sobre el problema.

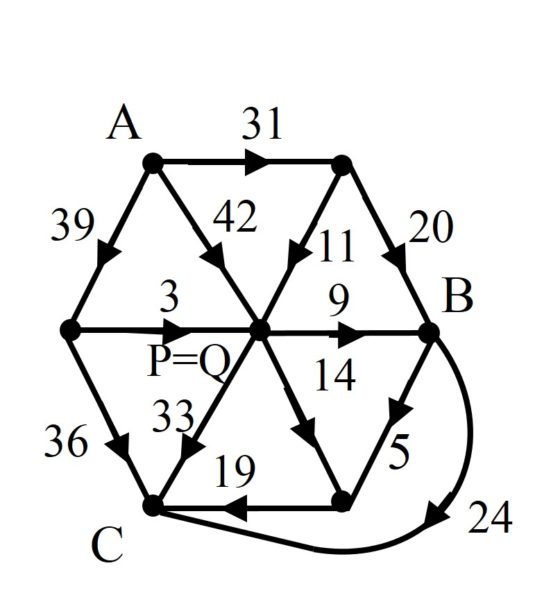

Entonces, empezaron a asociar diferentes tipos de diagramas a las cuadraturas de los rectángulos. Hasta que llegaron a un diagrama propuesto por Cedric Smith, que sus compañeros no dudaron en llamar el “diagrama de Smith”, que asociaba cada cuadratura de un rectángulo con el grafo de una red eléctrica.

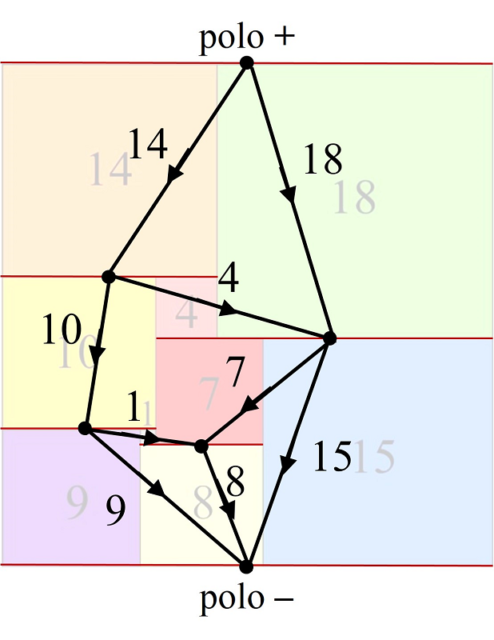

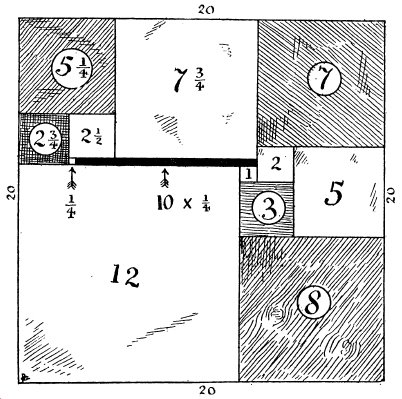

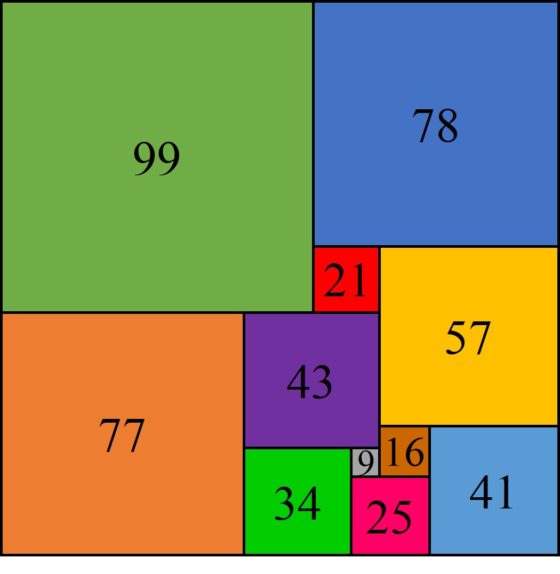

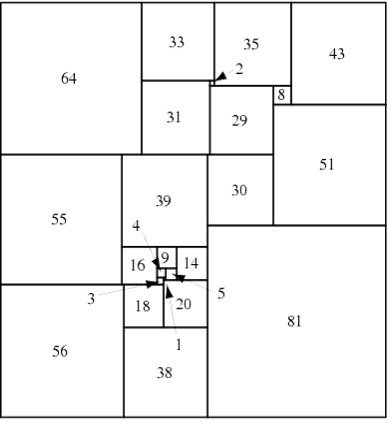

Para ilustrar la construcción de la red eléctrica asociada a una cuadratura, consideraremos el ejemplo de la división de un rectángulo de dimensiones 32 x 33 en 9 cuadrados de distintos tamaños, de lados 1, 4, 7, 8, 9, 10, 14, 15 y 18, luego de orden 9, obtenida por el matemático polaco Zbigniew Moron en 1925, que aparece en la siguiente imagen. Cada segmento horizontal se representará como un vértice del grafo y dos vértices estarán unidos mediante una arista si existe un cuadrado que tiene su lado superior apoyado en el segmento horizontal correspondiente a uno de los vértices y su lado inferior apoyado en el segmento horizontal del otro vértice. Además, el grafo está dirigido, como se muestra mediante las fechas de las aristas, de arriba hacia abajo, que es el orden de la corriente eléctrica, del polo positivo (que consideramos el vértice del lado horizontal superior) al polo negativo (el vértice del lado horizontal inferior). Más aún, es un grafo etiquetado, ya que asociamos a cada arista el valor del lado del cuadrado correspondiente, que será el valor de la corriente eléctrica.

Diagrama de Smith de la cuadratura perfecta del rectángulo de dimensiones 32 x 33 en 9 cuadrados de distintos tamaños, de lados 1, 4, 7, 8, 9, 10, 14, 15 y 18

Diagrama de Smith de la cuadratura perfecta del rectángulo de dimensiones 32 x 33 en 9 cuadrados de distintos tamaños, de lados 1, 4, 7, 8, 9, 10, 14, 15 y 18

Lo curioso es que el diagrama de Smith cumple las leyes de Kirchhoff para las redes eléctricas, asumiendo que la resistencia de cada arista es igual a 1. La primera ley de Kirchhoff establece que en cada nodo (vértice) del circuito eléctrico, con excepción de los polos, la suma de las corrientes debe ser cero, es decir, la suma de las corrientes que entran en el nodo es igual a la suma de las corrientes que salen del mismo. Por ejemplo, si miramos a la red eléctrica anterior, en el primer vértice después del polo positivo, entra una corriente de 14 y salen dos de 10 y 4, o en el siguiente entran dos corrientes de 4 y 18, mientras que salen dos corrientes de 7 y 15. Esto es debido a que, en un segmento horizontal (vértice) cualquiera de la cuadratura del rectángulo, la suma de los lados de los cuadrados que se apoyan en el segmento desde arriba (la suma de las corrientes que entran) es igual a la suma de los lados de los cuadrados que se apoyan en el segmento desde abajo (la suma de las corrientes que salen), que en ambos casos es la longitud del segmento horizontal.

Teniendo en cuenta que, por la ley de Ohm de los circuitos eléctricos, la diferencia de potencial de cada arista del circuito es igual al producto de la resistencia, que en este caso hemos asumido que es 1, por la corriente, ambas –diferencia de potencia y corriente- son iguales. Por lo tanto, la segunda ley de Kirchhoff establece que la suma algebraica de las corrientes –diferencias de potencial- de cualquier circuito cerrado es cero. En el ejemplo de arriba, en el primer circuito cerrado tenemos que 14 + 4 – 18 = 0 o en el segundo 10 + 1 – 7 – 4 = 0. Esto es debido a que cada segmento vertical de la cuadratura del rectángulo se corresponde con un circuito cerrado, y la suma de las longitudes de los lados de los cuadrados a izquierda y derecha del segmento valen lo mismo, la longitud del segmento vertical.

La corriente que entra en el circuito eléctrico por el polo positivo, que es igual a la que sale por el polo negativo, es la longitud de los lados horizontales del rectángulo. En el ejemplo de arriba, 14 + 18 = 9 + 8 + 15 = 32. Por otra parte, la diferencia de potencial entre los dos polos es igual a la longitud de los lados verticales del rectángulo. De nuevo, en el ejemplo la diferencia de potencial la podemos calcular a través de cualquiera de los recorridos entre el polo positivo y el negativo, 14 + 10 + 9 = 14 + 4 + 7 + 8 = 18 + 15 = 33, entre otros. Por lo tanto, si la corriente que entra por el polo positivo, y sale por el negativo, es igual a la diferencia de potencial, estaríamos ante un circuito eléctrico que se corresponde con la cuadratura del cuadrado.

Diagrama de Smith asociado a una cuadratura perfecta de un rectángulo

Diagrama de Smith asociado a una cuadratura perfecta de un rectángulo

En conclusión, cada cuadratura de un rectángulo se corresponde con una red eléctrica, lo cual les permitió utilizar los conocimientos de la teoría de redes eléctricas para estudiar el problema de la cuadratura de los rectángulos, y del cuadrado. Por ejemplo, en la imagen anterior tenemos una red eléctrica, os dejo como divertimento el construir la cuadratura del rectángulo asociada (solución al final de la entrada).

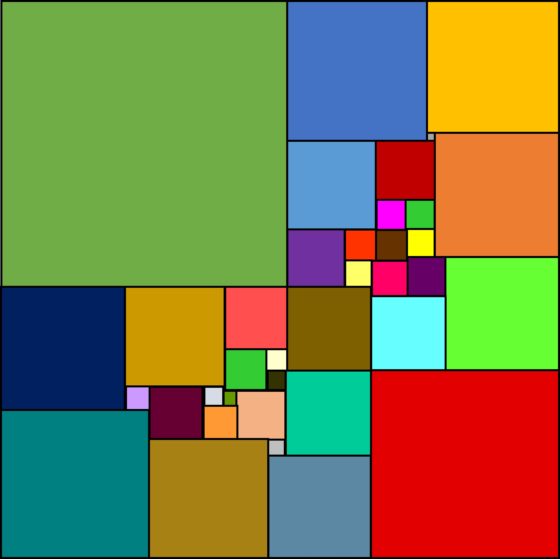

En particular, esto simplificó el problema de construir y clasificar las cuadraturas perfectas simples de rectángulos. Por ejemplo, analizaron todos los circuitos eléctricos con hasta 11 aristas y construyeron las cuadraturas de rectángulos asociadas. Así probaron que no existen cuadraturas perfectas simples de rectángulos de orden menor que 9, que solo hay dos de orden 9 (mostradas en la anterior entrada La cuadratura del cuadrado: en busca del santo grial, una de ellas es la asociada al primer circuito eléctrico que hemos mostrado más arriba), seis de orden 10 y veintidós de orden 11. Y siguieron clasificando las cuadraturas de orden 12, que hay sesenta y siete, y después de orden 13. Este fue el inicio de una fructífera investigación sobre las cuadraturas perfectas de rectángulos. Pero como veremos, también del cuadrado.

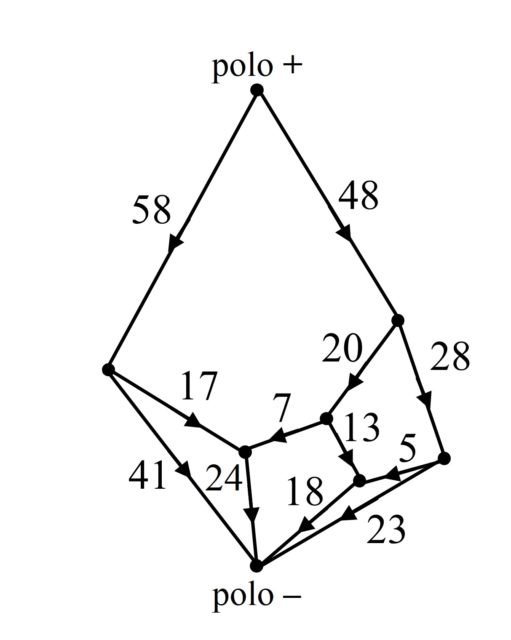

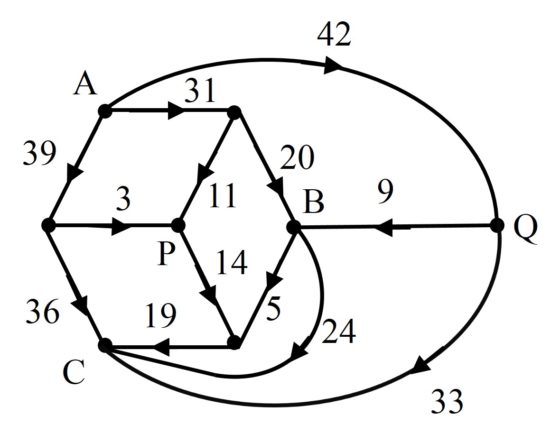

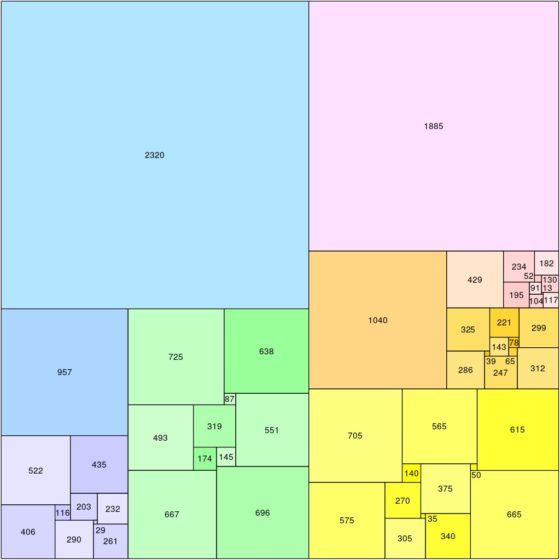

Uno de los estudios que realizaron fue el análisis de redes eléctricas con ciertas simetrías. Por ejemplo, consideraron el circuito eléctrico asociado a un cubo, vértices y aristas, que no proporcionaba cuadraturas perfectas de rectángulos, pero cuando se añadía una de las diagonales de una de las caras del cubo, se obtenía el diagrama de Smith de la siguiente imagen y la correspondiente cuadratura perfecta simple del rectángulo, que se muestra después.

Red eléctrica definida sobre un cubo, junto con una diagonal de una de sus caras, introducida por Brooks, Smith, Stone y Tutte, para construir cuadraturas perfectas simples de rectángulos

Red eléctrica definida sobre un cubo, junto con una diagonal de una de sus caras, introducida por Brooks, Smith, Stone y Tutte, para construir cuadraturas perfectas simples de rectángulos

Cuadratura perfecta simple de un rectángulo de dimensiones 112 x 75 obtenida a través del circuito eléctrico anterior

Cuadratura perfecta simple de un rectángulo de dimensiones 112 x 75 obtenida a través del circuito eléctrico anterior

Una bonita historia relacionada con esta cuadratura del rectángulo es la siguiente. Leonhard Brooks estaba tan satisfecho con este ejemplo que decidió construirse un rompecabezas geométrico cuyas piezas eran los cuadrados de la cuadratura del rectángulo anterior, es decir, de lados 3, 5, 9, 11, 14, 19, 20, 24, 31, 33, 36, 39 y 42, con el que jugar a realizar el rectángulo original. Entonces su madre cogió el rompecabezas para jugar con él y consiguió formar el rectángulo con ellas, pero resultó que no era la misma solución anterior, las piezas estaban colocadas de forma diferente. Con la ayuda de la madre de Brooks, habían encontrado dos disecciones perfectas simples del rectángulo 112 x 75 realizadas con los mismos cuadrados.

Segunda cuadratura perfecta simple del rectángulo de dimensiones 112 x 75 realizada con los mismos cuadrados que la anterior

Segunda cuadratura perfecta simple del rectángulo de dimensiones 112 x 75 realizada con los mismos cuadrados que la anterior

La red eléctrica asociada a esta nueva descomposición perfecta y simple del rectángulo 112 x 75 se puede obtener a partir del primer circuito eléctrico (que está representado arriba) identificando los vértices P y Q, lo cual es posible ya que tienen la misma diferencia de potencial, en concreto, 42.

Red eléctrica asociada a la anterior descomposición perfecta simple del rectángulo 112 x 75, que se puede obtener a partir de la anterior identificando P y Q

Red eléctrica asociada a la anterior descomposición perfecta simple del rectángulo 112 x 75, que se puede obtener a partir de la anterior identificando P y Q

Analizaron el motivo por el cual se producía este fenómeno y tenía que ver con la simetría de algunas redes eléctricas, aunque no entraremos en los detalles técnicos en esta entrada, por este motivo empezaron a analizar circuitos eléctricos en los cuales cogían la red eléctrica anterior, que habían obtenido a partir del cubo, y sustituyeron la parte simétrica central (el hexágono plano que contiene a los vértices A, B, C y centro P) por otras estructuras simétricas. Así consiguieron obtener más ejemplos de dobles cuadraturas perfectas simples de un mismo rectángulo con los mismos cuadrados.

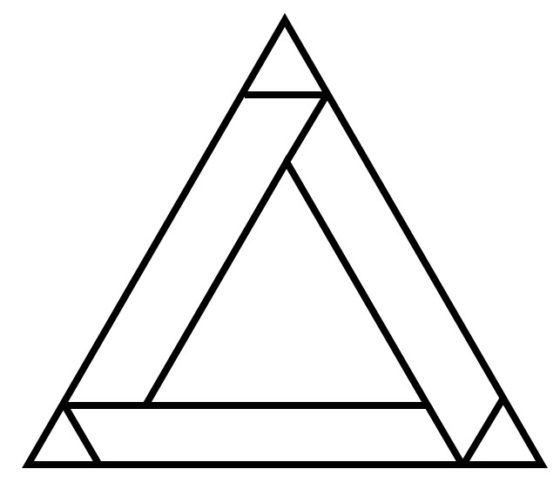

Esta técnica, después de seguir investigando y obtener otros ejemplos, les llevó a encontrar su primer ejemplo de cuadratura perfecta de un cuadrado. La pieza central simétrica tenía la siguiente forma.

La cuadratura perfecta, que era compuesta, que obtuvieron era de orden 39, es decir, formada por 39 cuadrados de diferentes tamaños, que componían un cuadrado de lado 4.639. Utilizando el código de Bouwkamp que explicamos en la anterior entrada, esta era la cuadratura [2.378, 1.163, 1.098], [65, 1.033], [737, 491], [249, 242], [7, 235], [478, 259], [256], [324, 944], [219, 296], [1.030, 829, 519, 697], [620], [341, 178], [163, 712, 1.564], [201, 440, 157, 31], [126, 409], [283], [1231], [992, 140], [852]. Como cada corchete del código de Bouwkamp nos dice qué cuadrados, su lado, están debajo de cada segmento horizontal, de arriba abajo, podemos ver qué cuadratura prefecta del cuadrado, de lado 4.639, habían construido.

Cuadratura perfecta, compuesta, de un cuadrado de lado 4.639, de orden 39, construida por Brooks, Smith, Stone y Tutte utilizando la teoría de las redes eléctricas

Cuadratura perfecta, compuesta, de un cuadrado de lado 4.639, de orden 39, construida por Brooks, Smith, Stone y Tutte utilizando la teoría de las redes eléctricas

Poco después, encontrarían el primer ejemplo de cuadratura perfecta simple de un cuadrado de orden 55, utilizando las mismas técnicas.

Como hemos podido ver, relacionar las cuadraturas perfectas de los rectángulos con redes eléctricas se demostró una técnica muy fructífera en la resolución del problema de la cuadratura del cuadrado, y del rectángulo, y en el estudio general de estas cuestiones.

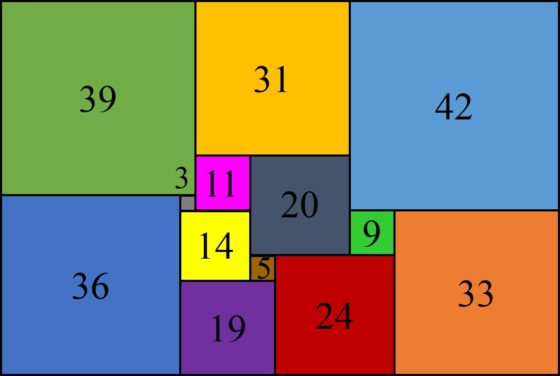

Y, por cierto, la solución a la cuestión planteada arriba sobre cuál es la cuadratura perfecta asociada a la red eléctrica que habíamos mostrado, es la siguiente.

Cuadratura perfecta simple de un rectángulo de tamaño 106 x 99 de orden 12, que es la solución al divertimento que os he dejado arriba de encontrar la cuadratura asociada a la red eléctrica mostrada

Cuadratura perfecta simple de un rectángulo de tamaño 106 x 99 de orden 12, que es la solución al divertimento que os he dejado arriba de encontrar la cuadratura asociada a la red eléctrica mostrada

Bibliografía

1.- Wolfram MathWorld: Perfect Square Dissection.

2.- Stuart Anderson, Tiling by squares.

3.- Martin Gardner, The 2nd Scientific American Book of Mathematical Puzzles and Diversions, University of Chicago Press, 1987. Contiene el capítulo de W. Th. Tutte Squaring the square.

4.- Wikipedia: Kirchhoff’s circuit laws

5.- Arkadiusz Maciuk, Antoni Smoluk, Tiling by squares, Kirchhoff’s Laws and a Flow Problem in the Economy, Didactics of Mathematics, n. 14 (18), 2017.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La cuadratura del cuadrado: las redes eléctricas de Kirchhoff se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La cuadratura del cuadrado: en busca del santo grial

- Blanche Descartes y la cuadratura del cuadrado

- ¿Sueñan los babilonios con multiplicaciones eléctricas?

Sólidos cuánticos

Foto: Pixabay

Foto: PixabayUno de los primeros grandes éxitos de la hipótesis cuántica de Planck surgió, no del estudio de la radiación, sino de la teoría de los sólidos. Una vez más, Albert Einstein fue la vanguardia.

Después de presentar la hipótesis de los cuantos de luz que explicaba el efecto fotoeléctrico en 1905, Einstein demostró en 1906 que los resultados anteriores de Planck sobre la distribución de energía en la radiación electromagnética podrían derivarse utilizando dos supuestos. El primero, ya presente en su artículo de 1905, fue que la luz se compone de cuantos de luz; el segundo fue que los cuantos de luz son emitidos y absorbidos por cargas oscilantes dentro de la materia que vibran solo con ciertas energías cuantificadas. Esto significa que la luz es emitida por cargas oscilantes dentro de la materia, como podría esperarse de la teoría de Maxwell, pero las energías tanto de la luz emitida como de los osciladores están restringidas a ciertos valores permitidos, lo que contradice la teoría clásica. Los osciladores se comportaron como cargas unidas a resortes, oscilando de un lado a otro solo con ciertas frecuencias correspondientes a ciertas energías cuánticas.

En 1904, Paul Drude había propuesto un modelo de sólido cristalino en el que los átomos están dispuestos en una red tridimensional de tal manera que cada átomo está unido a sus átomos vecinos por enlaces que pueden actuar como pequeños muelles (osciladores). Drude demostró, utilizando la física clásica, que la oscilación tridimensional de los átomos de la red puede explicar la absorción observada de la radiación infrarroja por algunos sólidos, si se supone que los átomos están ionizados. Una oscilación similar de los electrones, unidos a los átomos o iones, explicaba la absorción observada de la radiación ultravioleta en estos sólidos.

Figura 1. Modelo de Drude de átomos y muelles. Fuente: Wikimedia Commons

Figura 1. Modelo de Drude de átomos y muelles. Fuente: Wikimedia CommonsEn 1907, Einstein aplicó la hipótesis cuántica a los osciladores clásicos de Drude. Incluso antes del modelo de Drude, Einstein había especulado desde 1901 con la idea de que la energía cinética interna de los sólidos y líquidos podría considerarse como la energía de los «resonadores eléctricos». Un enigma considerable en ese momento era el comportamiento del calor específico, c, de los sólidos a medida que la temperatura disminuía. Normalmente se supone que el calor específico es una constante en la relación entre la transferencia de calor y el cambio de temperatura de una sustancia ΔQ = m·c·ΔT [2]. Y la aplicación de la física clásica al modelo de red de átomos y muelles de Drude llega a la conclusión de que, efectivamente, el calor específico c debe ser una constante para los sólidos a todas las temperaturas.

Sin embargo, cuando Einstein aplicó la hipótesis cuántica a los osciladores en el modelo de Drude obtuvo una expresión para el calor específico que afirmaba que el valor del calor específico debería cambiar con la temperatura. Para ser precisos, decía que debería ser constante a temperatura ambiente o algo menos, pero que el calor específico debería caer rápidamente a cero conforme la temperatura se va a cero (absoluto), como se muestra en la figura 2. Visto de otra forma: partiendo desde 0 K, el valor de Einstein para el calor específico de una sustancia cristalina en función de su temperatura debe acercarse a un valor constante que se alcanza más o menos a temperatura ambiente.

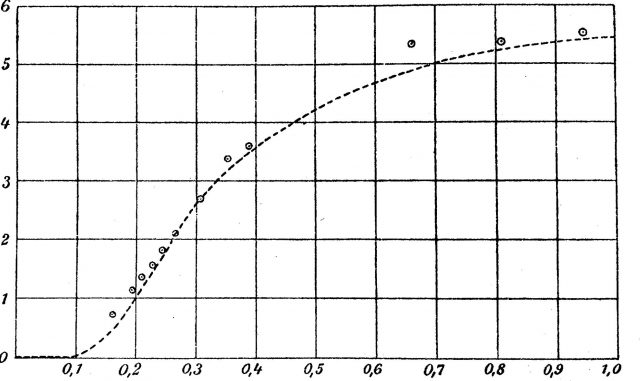

Figura 2. Gráfica original del artículo de Einstein de 1907

Figura 2. Gráfica original del artículo de Einstein de 1907Es importante recalcar esto: las predicciones de Einstein para el comportamiento del calor específico de los sólidos en función de la temperatura se basaron en una aplicación de la hipótesis cuántica a un modelo de un sólido cristalino en el que los átomos de la red se comportan como osciladores tridimensionales que vibran con energías cuantificadas. Los físicos Walther Nernst y Frederick A. Lindemann, que trabajan en un laboratorio de bajas temperaturas en Berlín, asombraron a la comunidad científica con una confirmación completa de la predicción de Einstein sobre la forma en la que el calor específico de un sólido cristalino cambia con la temperatura. Fue la primera confirmación de la hipótesis cuántica fuera del campo de radiación, y demostraba inequívocamente que los sólidos cristalinos pueden considerarse como una red tridimensional de átomos oscilantes sujetos a los requisitos de la hipótesis cuántica y, más tarde, de la mecánica cuántica.

Este modelo ha servido como modelo básico de sólido cristalino desde entonces. Como escribieron Nernst y Lindemann:

«[…] que las observaciones en su totalidad suponen una confirmación brillante de la teoría cuántica de Planck y Einstein es obvio».

Notas:

[1] Este artículo es una adaptación de nuestro Einstein and quantum solids

[2] Nosotros lo asumimos en El misterio de la temperatura constante, por ejemplo. En el ejemplo que usamos en ese texto es suficientemente cierto.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Sólidos cuánticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los experimentos de Joule

- La teoría cinética y la segunda ley de la termodinámica

- La ley del gas ideal a partir del modelo cinético

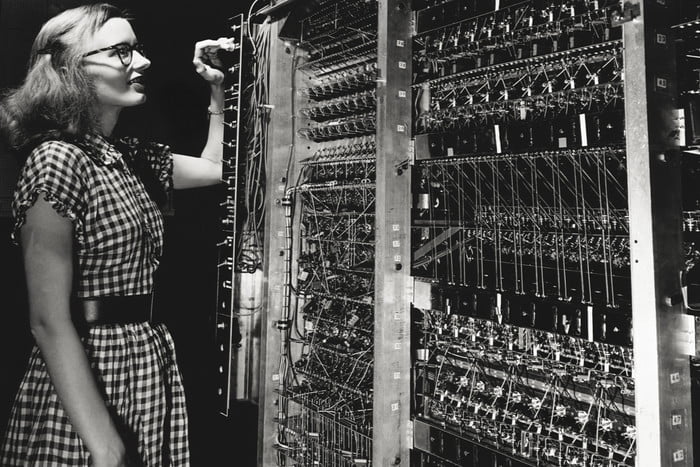

La ciencia al servicio de la guerra

Lois Cook-Leurgan examinando la unidad aritmética principal del MANIAC ( Mathematical Analyzer, Numerical Integrator And Computer). El ordenador jugó un papel importante en los cálculos termonucleares que se llevaron a cabo en el Los Alamos Scientific Laboratory de la Universidad de California dentro del Proyecto Manhattan. Klara Dan von Neumann fue la autora de los primeros programas.

Lois Cook-Leurgan examinando la unidad aritmética principal del MANIAC ( Mathematical Analyzer, Numerical Integrator And Computer). El ordenador jugó un papel importante en los cálculos termonucleares que se llevaron a cabo en el Los Alamos Scientific Laboratory de la Universidad de California dentro del Proyecto Manhattan. Klara Dan von Neumann fue la autora de los primeros programas.En las guerras siempre se ha utilizado el conocimiento del que se disponía en la época. Por tanto, la ciencia y la tecnología, en tanto que formas de conocimiento, no han sido ajenas a los conflictos bélicos. Más bien habría que decir que las guerras han incentivado la generación de conocimiento científico y tecnológico, y lo siguen haciendo en la actualidad.

A Arquímedes (s III aec) se le atribuye haber inventado un dispositivo basado en espejos ustorios para concentrar rayos de luz solar y producir suficiente calor como para dar fuego a las naves que transportaban las tropas romanas que pretendían ocupar la ciudad de Siracusa. Aunque en realidad, no sabemos si esa atribución es correcta.

Si nos limitamos al siglo XX y lo que llevamos del XXI, está claro que laboratorios y despachos de científicos han tenido un protagonismo determinante en los conflictos bélicos.

Fritz Haber fue galardonado con el premio Nobel por su descubrimiento del proceso llamado de Haber-Bosch, para la síntesis catalítica de amoniaco a partir de hidrógeno y nitrógeno atmosférico bajo condiciones de alta presión y temperatura. Ese proceso abrió la era de la producción industrial de fertilizantes y, en general, de la industria química. Pues bien, él fue el químico al frente del programa de producción de gases letales que utilizó Alemania en la I Guerra Mundial. F Haber puso sus conocimientos al servicio del esfuerzo bélico alemán por su forma de entender el patriotismo; llegó a decir que «en tiempo de paz, un científico pertenece al mundo, pero en tiempo de guerra pertenece a su país».

No solo él, James Franck, Gustav Hertz y Otto Hahn, futuros premios Nobel, también formaron parte de la unidad de Haber. Y en el bando galo, otro galardonado con el Nobel, Victor Grignard, participó en el esfuerzo francés para producir gases venenosos.

El radar, invención basada en la patente obtenida por Robert Watson-Watt (descendiente de James Watt), fue seguramente determinante del curso que siguió la II Guerra mundial. El invento, de 1935, de Watson-Watt se basaba en el uso de ondas de radio para detectar y alertar de movimientos de objetos invisibles con la vista. En este caso se trató de una invención de carácter defensivo (sirvió, entre otras cosas, para poder anticipar los bombardeos alemanes sobre la población civil británica), pero en lo relativo a su influencia sobre el curso de la guerra, a largo plazo no es posible diferenciar la función defensiva de la ofensiva.

El ejemplo más evidente de contribución científica a la guerra es el proyecto Manhattan, nombre clave con el que se conocía el proyecto que desarrolló Estados Unidos para fabricar la bomba atómica durante la II Guerra Mundial. El objetivo del proyecto era producir la bomba antes de que los nazis lo consiguieran. Lo lograron, como es bien sabido. Y como consecuencia de ello, lanzaron sendas bombas sobre las ciudades japonesas de Hirosima y Nagasaki, provocando de esa forma la rendición del Japón. El proyecto, en su parte científica, fue dirigido por el físico Julius Robert Oppenheimer y de una u otra forma, participaren numerosos científicos e ingenieros. También estos científicos tomaron parte en el proyecto por una causa. Todos ellos quisieron colaborar en la derrota de las potencias del Eje.

En las guerras del siglo XXI los científicos e ingenieros siguen teniendo una función determinante en el perfeccionamiento del armamento clásico y en las innovaciones. Drones, robots, inteligencia artificial, sistemas de telecomunicaciones, invisibilidad a los sistemas de detección son áreas en las que los ejércitos más poderosos del mundo invierten enormes cantidades de recursos. Muchos científicos e ingenieros participan en el desarrollo de nuevas ideas con fines militares.

Tanto Haber como Oppenheimer ejemplifican bien el tipo de dilemas éticos al que se han de enfrentar los científicos que toman parte activa en el desarrollo de armas de gran potencial para segar vidas humanas. Ambos actuaron motivados por su compromiso con el destino de los conflictos bélicos en que se vieron involucrados. Haber por patriotismo y Oppenheimer para frenar el avance del fascismo. Sus casos son especiales porque el resultado de su trabajo científico tuvo como consecuencia la pérdida de miles de vidas humanas, pero en rigor, nada los diferencia de la actuación de otros científicos que han desarrollado y desarrollan su actividad al servicio del ejército de sus países.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo La ciencia al servicio de la guerra se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El límite entre la vida y la muerte en las neuronas

![]()

Jorge Valero Gómez-Lobo y Amanda Sierra

La apoptosis de la neurona es un tipo de muerte autoinducida.

La apoptosis de la neurona es un tipo de muerte autoinducida.Kateryna Kon / Shutterstock

“Hasta que la muerte nos separe”. Esa es la fecha de caducidad que tienen la mayoría de nuestras neuronas. Estas células, encargadas de transmitir el impulso nervioso en el cerebro, son de las más longevas de nuestro organismo. Nacen prácticamente a la vez que nosotros y, por lo general, no se renuevan.

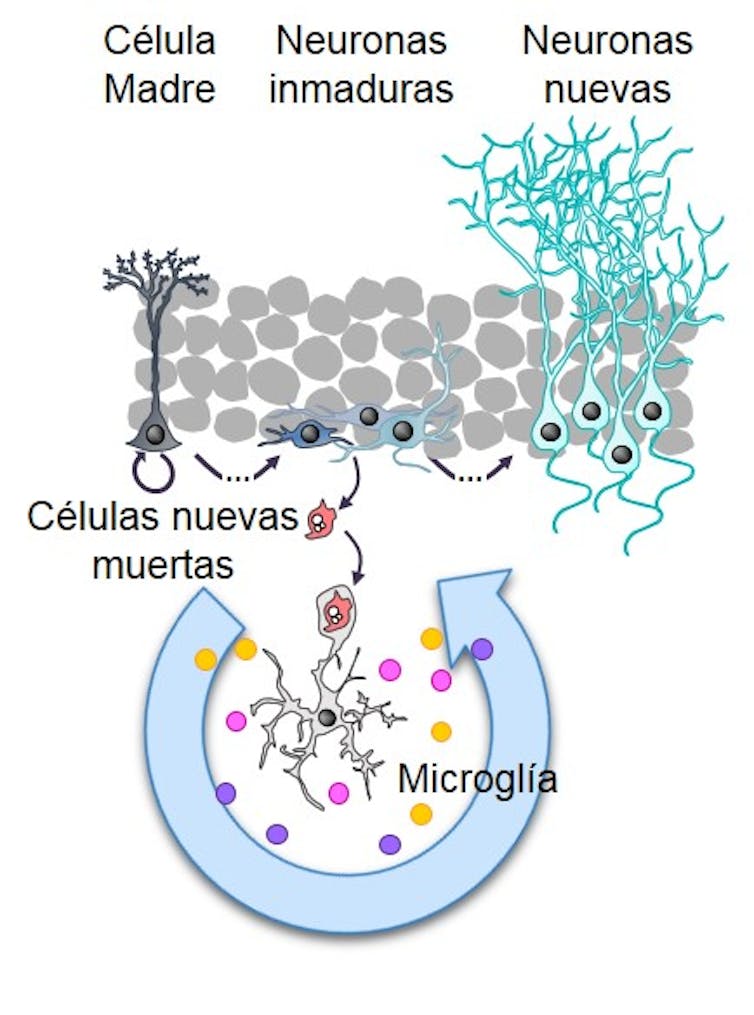

Pero existe una excepción a toda regla, y esta no iba a ser menos. No hace mucho que sabemos que en el cerebro de la mayoría de los mamíferos se producen nuevas neuronas a lo largo de toda la vida. Este fenómeno, que conocemos como neurogénesis adulta, sólo ocurre en unas pocas regiones del cerebro. Entre ellas el hipocampo, una región especializada en procesos de memoria y aprendizaje.

Las conexiones que establecen las neuronas dan forma a nuestros pensamientos y manera de ser, haciéndolas únicas e insustituibles. De ahí que la pérdida de neuronas que sufrimos al envejecer, o cuando caemos en las garras de una enfermedad neurodegenerativa, suela ser irreparable.

Lo normal es morir

Las neuronas mueren cuando envejecemos debido a que acumulan residuos y defectos que hacen que pierdan su función y degeneren. Este proceso natural se limita a unas pocas neuronas pero se ve agravado en enfermedades neurodegenerativas como las enfermedades de Parkinson o Alzheimer. Sin embargo, también hay mucha muerte neuronal al inicio de la vida.

De hecho, antes del nacimiento se producen muchas más neuronas de las necesarias. Tantas que la mayoría no sobreviven al no establecer las conexiones adecuadas. No solo eso, sino que gran parte de las neuronas que se generan en la vida adulta y sus precursores mueren sin llegar a incorporarse a los circuitos cerebrales. Esta muerte temprana no es patológica: todo lo contrario. Estos procesos de muerte neuronal se producen de forma normal y están destinados a mantener el buen funcionamiento del cerebro.

Una muerte limpia

La muerte temprana de las neuronas se produce de manera controlada a través de un proceso que llamamos apoptosis. Para entendernos, la apoptosis es una tipo de muerte autoinducida y limpia, que no genera desechos tóxicos dispersos y evita daños mayores. Solo deja atrás un residuo: los restos de las células que acaban de morir. Estos “cadáveres neuronales” son eliminados por unas células del cerebro llamadas microglía.

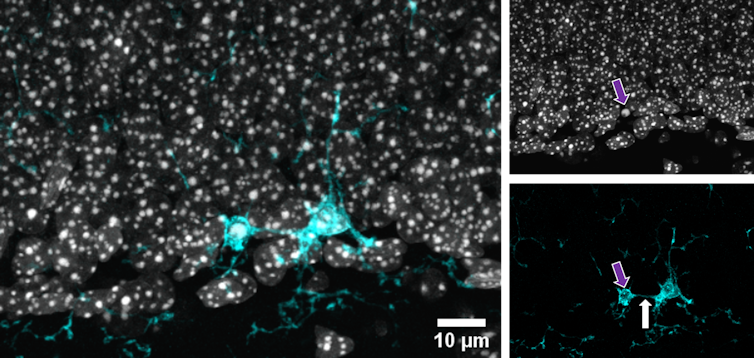

Microglía (cian) fagocitando una célula muerta, apoptótica. Arriba a la derecha una imagen de los núcleos celulares. La flecha morada señala a la célula muerta, apoptótica. La célula apoptótica tiene un tamaño menor que el resto de núcleos debido a que su contenido se ha compactado. En la imagen inferior derecha se ve la microglía, la flecha blanca señala la prolongación que la microglía extiende hasta la célula muerta.

Microglía (cian) fagocitando una célula muerta, apoptótica. Arriba a la derecha una imagen de los núcleos celulares. La flecha morada señala a la célula muerta, apoptótica. La célula apoptótica tiene un tamaño menor que el resto de núcleos debido a que su contenido se ha compactado. En la imagen inferior derecha se ve la microglía, la flecha blanca señala la prolongación que la microglía extiende hasta la célula muerta.Author provided

Las células de la microglía son células muy dinámicas cuyos cuerpos tiene prolongaciones finas que escanean continuamente el cerebro. Su misión es contener cualquier tipo de daño. Y como parte de esta función se encargan de detectar, englobar y destruir los restos de células muertas.

A este proceso por el que la microglía “se come” a las células muertas y “las digiere” lo llamamos fagocitosis. La fagocitosis es necesaria para evitar que los restos celulares degeneren y produzcan residuos tóxicos. La fagocitosis, por tanto, constituye el último paso en la gestión de la muerte de las neuronas: su eliminación definitiva. Pero, ¿qué ocurre después de la fagocitosis? ¿Acaba ahí, con la eliminación de los residuos?

Microglía en movimiento. Imagen “en vivo” del cultivo de una rodaja de hipocampo. El punto rojo representa la zona en la que se generó daño con un láser.La microglía regula la producción de nuevas neuronas

Los resultados de nuestra investigación muestran que la microglía no se limita a retirar los residuos del sistema sin más. Por el contrario, cuando la microglía se “come” a las células muertas comienza un proceso de auto-reprogramación que cambia la expresión de sus genes. Este cambio en la expresión génica se da, entre otros, en genes que codifican para sustancias que pueden regular la propia neurogénesis. Es decir, que las células de microglía fagocítica liberan factores que limitan la formación de nuevas neuronas. Pero, ¿cuál puede ser el sentido de todo esto?

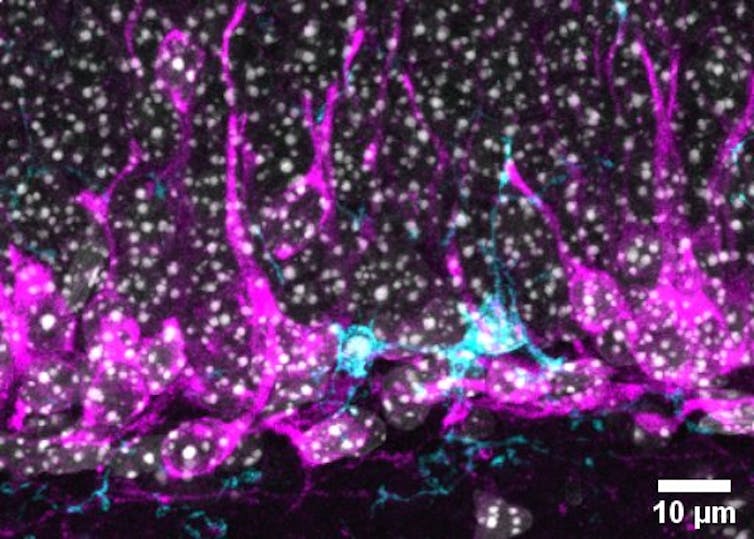

Microglía (cian) fagocitando una célula muerta y rodeada de nuevas neuronas (magenta).

Microglía (cian) fagocitando una célula muerta y rodeada de nuevas neuronas (magenta).Author provided

La formación de nuevas neuronas en el cerebro adulto tiene un coste. Estas neuronas se generan a partir de células madre que se activan y se agotan en el proceso. Producir un exceso de nuevas neuronas cuando no son necesarias agotaría la reserva de células madre rápidamente y la capacidad de formar neuronas cuando realmente se necesite.

La microglía detecta un exceso en la producción de neuronas al fagocitar a aquellas que mueren y, mediante las moléculas que secreta, le indica al hipocampo que frene la producción porque está gastando recursos sin sentido. De esta manera, podemos especular que la microglía fagocítica regula el equilibrio entre la oferta y la demanda, y ajusta la tasa de producción de nuevas neuronas en función de cuántas se mueren y cuántas se pueden incorporar al circuito neuronal.

La microglía tras fagocitar libera sustancias que regulan la producción de nuevas neuronas.

La microglía tras fagocitar libera sustancias que regulan la producción de nuevas neuronas.Author provided

Estos hallazgos tienen implicaciones en el campo de las enfermedades neurodegenerativas. En estas patologías, las neuronas mueren y la microglía es la encargada de retirarlas del tejido cerebral. En ocasiones, como hemos observado en anteriores estudios sobre la epilepsia, la naturaleza de la enfermedad impide a la microglía ejercer su función fagocítica y retirar los residuos celulares. Estos resultados nos llevan a plantear lo siguiente: incrementar la actividad fagocítica de la microglía

puede constituir una nueva vía terapéutica.

En los próximos años determinaremos si potenciar los mecanismos de auto-reparación devuelve al cerebro el adecuado equilibrio entre la vida y la muerte en las enfermedades neurodegenerativas.![]()

Sobre los autores: Jorge Valero Gómez-Lobo y Amanda Sierra son investigadores del Achúcarro Basque Center for Neuroscience

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo El límite entre la vida y la muerte en las neuronas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Más allá de las neuronas

- La microglía es un sensor de mortalidad neuronal

- Muerte entre las ecuaciones (Historias de muerte y matemáticas 1)

Las mareas del pasado leídas en las rocas del presente

Los fósiles, los minerales o las rocas son, entre otras cosas, en lo primero que pensamos al hablar de geología, pero lo cierto es que la física es un ámbito científico que difícilmente se puede desvincular de la geología. Y es que el fundamento físico resulta clave a la hora de explicar algunos procesos geológicos que suceden tanto en el océano como en la superficie terrestre.

Con el fin de poner sobre la mesa la estrecha relación entre la geología y la física, los días 27 y 28 de noviembre de 2019 se celebró la jornada divulgativa “Geología para poetas, miopes y despistados: La Geología también tiene su Física”. El evento tuvo lugar en la Sala Baroja del Bizkaia Aretoa de la UPV/EHU en Bilbao.

La segunda edición de esta iniciativa estuvo organizada por miembros del grupo de investigación de Procesos Hidro-Ambientales (HGI) de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Geoparque de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

Las mareas, esos movimientos de mares y océanos provocados por la Luna, dejan su marca en el proceso de formación de las rocas sedimentarias. Estas marcas las podemos leer hoy para saber que ocurrió hace millones de años. Lo explica en esta conferencia Isabel Emma Quijada, profesora del departamento de geología de la Universidad de Oviedo.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Las mareas del pasado leídas en las rocas del presente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La eternidad en un grano de arena

- Geotermia urbana

- Los ecos del fondo submarino: imágenes de las estructuras geológicas.

Estimación de la edad en obras de arte contemporáneas

Obra de Jesús Mari Lazkano empleada en la investigación. Fuente: UPV/EHU

Obra de Jesús Mari Lazkano empleada en la investigación. Fuente: UPV/EHUEl comercio ilícito de arte se ha convertido en el tercer mercado ilegal a escala mundial después de las drogas y las armas. Una investigación de la UPV/EHU ha desarrollado un novedoso método para la datación de obras de arte contemporáneo, hasta la fecha no existía ninguno, a través del estudio del proceso de envejecimiento de las pinturas acrílicas.

El objetivo era conseguir una correcta identificación y datación precisa de los materiales utilizados en las obras que pudiese ayudar en la detección de trabajos falsificados o mal atribuidos. “El punto de partida del estudio es conocer cómo envejecen las pinturas acrílicas en el arte contemporáneo, y determinar que llevan depositadas el mismo tiempo que el que se supone que tiene la obra, para poder así decir si esa obra tiene 20 años por ejemplo o está hecha antes de ayer”, cuenta Itxaso Maguregi, profesora de Bellas Artes y coautora del trabajo.

“El principal problema del arte contemporáneos es que los materiales utilizados para las obras se pueden encontrar a día de hoy fácilmente, por tanto, las falsificaciones son más sencillas, de ahí la importancia de este estudio”, explica Luis Bartolomé, otro de los coautores.

Para ello, las pinturas fueron sometidas a ensayos de envejecimiento acelerado, mediante el uso de cámaras con condiciones de luz, temperatura y humedad controladas que permiten recrear el paso del tiempo en las pinturas. “50 horas en la cámara equivaldría a un año de envejecimiento natural, y se monitorizó su evolución química a fin de desarrollar modelos matemáticos de predicción de edad. Básicamente lo que se ha realizado ha sido un estudio controlado del envejecimiento de una pintura acrílica, mediante un time lapse de la pintura”, señala Luis Bartolomé.

Tras la realización del ‘envejecimiento artificial’ se logra una serie de patrones, de muestras, que sirven para comparar con la obra original. “Una vez que creamos nuestra ‘serie patrón de muestras artificiales’, incorporamos muestras reales para compararlas. Así, hemos visto que nuestro modelo funcionaba correctamente porque estimaba justamente la edad que tenían las obras reales. Por ejemplo, se pudo ratificar que un cuadro cedido por el pintor vasco Jesús Mari Lazkano y realizado en el año 2015 tenía 4 años de antigüedad”, asegura Bartolomé.

Esta correlación ha podido utilizarse para fechar obras de hasta 22 años, conservadas en condiciones comparables y creadas con el mismo tipo de pintura. “Esta metodología podría ser un primer paso para fechar obras pictóricas contemporáneas. Asimismo, este trabajo puede resultar de ayuda en el desarrollo de otras metodologías apropiadas de conservación y restauración en pintura contemporánea”, exponen las investigadoras Laura Ortiz-Herrero e Irene Cardaba.

Referencia:

L.Ortiz-Herrero, I.Cardaba, S.Setien, L.Bartolomé, M.L.Alonso, M.I.Maguregui (2019) OPLS multivariate regression of FTIR-ATR spectra of acrylic paints for age estimation in contemporary artworks Talanta doi: 10.1016/j.talanta.2019.120114

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Estimación de la edad en obras de arte contemporáneas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

- Arte & Ciencia: Conservación de obras con componentes tecnológicos

- Técnicas «low cost» para el estudio de obras de arte

Tomanowos: el meteorito que sobrevivió a las megainundaciones y a la insensatez humana

Tomanowos en el Museo de Historia Natural de Nueva York.

Tomanowos en el Museo de Historia Natural de Nueva York.Daniel García-Castellanos, Author provided

La roca con la historia más fascinante que conozco tiene un nombre milenario: Tomanowos. Significa el visitante del cielo en el extinto idioma de los indios clacamas, para quienes Tomanowos vino para unir el cielo, la tierra y el agua.

Hoy yace en el Museo de Historia Natural de Nueva York. Sin embargo, cuando los colonos europeos la encontraron hace más de cien años junto a Portland (Oregón), protagonizó una de las historias más hilarantes en geología, fruto de la atracción fatal que una roca rara como esta produce en los humanos.

¿Qué sabemos sobre sus orígenes?

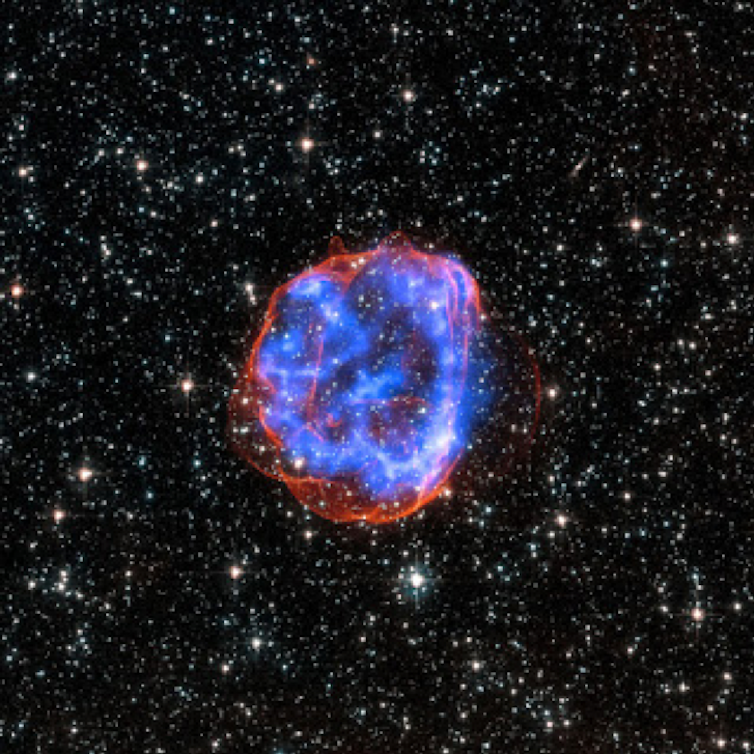

Tomanowos es un raro meteorito de 15 toneladas compuesto de hierro y níquel (Fe 91 %, Ni 7,6 %). Estos átomos de Fe y Ni se formaron mediante fusión nuclear en el núcleo de estrellas. Convertidas en supernovas, sufrieron gigantescas explosiones que los esparcieron por el espacio.

Las explosiones de supernovas esparcen por el espacio el hierro producido en las estrellas más pesadas. Este hierro termina en nebulosas de partículas que eventualmente producen nuevas estrellas y protoplanetas como el que formó Tomanowos.

Las explosiones de supernovas esparcen por el espacio el hierro producido en las estrellas más pesadas. Este hierro termina en nebulosas de partículas que eventualmente producen nuevas estrellas y protoplanetas como el que formó Tomanowos.X-ray: NASA/CXC/Rutgers/J.Hughes; Optical: NASA/STScI

Hace unos 4 500 millones de años, estos átomos pululaban en una nebulosa de detritos cósmicos que comenzaba a agregarse para formar protoplanetas en el sistema solar. Tomanowos fue parte del núcleo de uno de estos protoplanetas, en cuyo centro se acumulan siempre los metales más pesados.

Más tarde, hace unos 4 000 millones de años, una colisión entre dos de esos protoplanetas devolvió nuestra pieza de museo a la soledad espacial. Lo sabemos porque un choque es la única manera conocida de extraer una masa de 15 toneladas del centro de un protoplaneta.

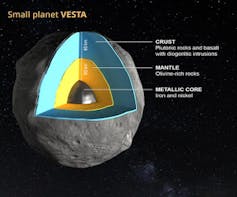

Vesta, un protoplaneta superviviente del sistema solar primigenio. Debido a su gran tamaño, los protoplanetas desarrollan una estructura de capas por densidades con elementos más pesados como el hierro concentrados en el núcleo. Tomanowos es un pedazo del núcleo expulsado por una colisión de un protoplaneta similar.

Vesta, un protoplaneta superviviente del sistema solar primigenio. Debido a su gran tamaño, los protoplanetas desarrollan una estructura de capas por densidades con elementos más pesados como el hierro concentrados en el núcleo. Tomanowos es un pedazo del núcleo expulsado por una colisión de un protoplaneta similar.EPFL/Jamani Caillet, Harold Clenet

Hace apenas 17 000 años, la órbita de Tomanowos finalmente se cruzó con la terrestre. Como resultado de este billar cósmico, el meteorito entró en nuestra atmósfera, con la suerte de aterrizar plácidamente en un casquete glaciar en Canadá. El hielo glaciar suele ser una importante fuente de meteoritos bien preservados.

La acción del agua y el hielo

Durante las siguientes décadas, el glaciar transportó lentamente a Tomanowos hacia una lengua glaciar que en ese momento bloqueaba el río Fork en Montana (EE. UU.).

El hielo obstruía el valle fluvial formando una barrera de 600 m de altura que dio lugar aguas arriba el enorme lago Missoula. Aunque ya no quedan restos de esa barrera, conocemos su existencia porque Joseph Pardee encontró en la década de 1920 los sedimentos del enorme lago que ocupó el valle.

Arrastrada por el glaciar, la roca llegó a la presa de hielo justo el año en que esta colapsó por la presión del agua. Provocó una de las mayores inundaciones jamás documentadas: las inundaciones de Missoula, que dieron forma a los Scablands y transformaron el paisaje del estado de Washington. El fenómeno alcanzó una intensidad equivalente a varios miles de cataratas del Niágara.

Al caer el dique glaciar, el meteorito quedó atrapado en un bloque de hielo y fue arrastrado flotando en la inundación. Cruzó los estados de Idaho, Washington y Oregón siguiendo el cauce del desbordado río Columbia a velocidades de más de 20 m/s, según simulaciones numéricas del evento. Cuando flotaba ya a la altura de la actual Portland, la carcasa de hielo se rompió y la roca se hundió bajo las aguas.

Tras la inundación, Tomanowos quedó expuesto a la atmósfera. Durante miles de años, la lluvia reaccionó con un mineral raro en la Tierra pero común en los meteoritos, la troilita (FeS). El agua disolvió lentamente el hierro, formando las cavidades de la roca.

La llegada del hombre

Los clacamas llegaron a Oregón probablemente poco después de la inundación. ¿Sabían que las rocas de níquel provienen del cielo? ¿Les intrigaba la ausencia de un cráter en el lugar del meteorito? ¿Vislumbraron la posibilidad de que una inundación lo llevara al lugar, una teoría que tardaría miles de años en ser desarrollada por la geología? En cualquier caso, el nombre que le dieron al meteorito nos recuerda que las culturas precientíficas no eran tontas. O al menos no lo eran más que las posteriores.

La historia que sigue confirma de alguna manera esta hipótesis. En 1902 un colono llamado Ellis Hughes decidió apropiarse en secreto de la roca de hierro trasladándola a sus tierras. Pero no es fácil mover 15 toneladas más de un kilómetro sin despertar sospechas, ni siquiera en Oregón. Durante los tres meses de penoso transporte nocturno, el meteorito sufrió severas mutilaciones.

Después de acabar con la mudanza de Tomanowos, Hughes construyó una cabaña alrededor del meteorito, anunció que lo había encontrado en su propiedad y comenzó a cobrar veinticinco centavos por verlo.

Después de acabar con la mudanza de Tomanowos, Hughes construyó una cabaña alrededor del meteorito, anunció que lo había encontrado en su propiedad y comenzó a cobrar veinticinco centavos por verlo.En otro despliegue de insensatez, un vecino demandó a Hughes alegando que la roca había aterrizado en su propiedad. Y para respaldar su reclamación mostró a los investigadores un enorme cráter en su terreno. El caso hubo de ser desestimado cuando un tercer vecino de la zona informó de una gran explosión escuchada unos días antes.

Irónicamente, el propietario legítimo del lugar del meteorito resultó ser la Compañía de Hierro de Oregón. La empresa desconocía su existencia hasta el momento, pero pronto contrató a un guardia que se sentó encima de la roca con un arma hasta que la vendió al museo de Nueva York.

Las autoridades, que ya habían decidido relocalizar a los Clacamas en una reserva, decidieron también reubicar a Tomanowos en la otra costa de los EE. UU. Hoy, los descendientes de los clacamas conservan aún el derecho a visitar al visitante que reunió al cielo, el agua y la tierra en la última parada de su billar cósmico.![]()

Sobre el autor: Daniel Garcia-Castellanos es investigador del Instituto de Ciencias de la Tierra Jaume Almera (ICTJA – CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Tomanowos: el meteorito que sobrevivió a las megainundaciones y a la insensatez humana se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La extraordinaria capacidad poética de las matemáticas

Las matemáticas también son un mundo de imaginación, no sólo los caminos de letras. […] Las matemáticas me han hecho más consciente de la importancia de la estructura y por otro me han educado en la síntesis. En mis obras existen ciertas simetrías, repeticiones que se dan en un mismo texto que de algún modo se puede decir que son una matemática oculta.

Juan Mayorga en [2]

En la entrada Personas famosas que estudiaron matemáticas: literatura y cine, Raúl Ibáñez citaba al premiado dramaturgo Juan Mayorga, licenciado en matemáticas y doctor en filosofía, que también ejerció como profesor de matemáticas durante cinco años. En 2010, cuando la revista Matematicalia aún se publicaba, tuvimos la suerte de poder concertar una entrevista con Mayorga; el título de esta entrada alude precisamente a una frase de la conversación mantenida con la periodista Leticia Fernández Abejón (Divulga). La reportera preguntaba al dramaturgo sobre la relación entre las matemáticas y el teatro:

A mi modo de ver, primero las matemáticas son una escritura de precisión, y así ha de ser también la del teatro: una escritura sin un gramo de grasa. Segundo, porque las matemáticas y el teatro coinciden en su búsqueda de síntesis significativas: igual que para un matemático una fórmula define toda una clase de objetos, para un dramaturgo una frase puede definir un personaje o incluso una época, así como un objeto puede definir un espacio, por ejemplo, un banco puede ser todo un parque.

Portada del libreto de El chico de la última fila.

Portada del libreto de El chico de la última fila.

Mayorga comentaba en la entrevista que su El chico de la última fila era una obra en la que «las matemáticas sirven como elemento dramático e hilo conductor. Se establece una relación entre dos alumnos; uno ofrece al otro enseñar matemáticas y el segundo le enseña al primero filosofía. […] Un motivo poético de la obra es el mundo de los números imaginarios. En ese sentido, creo que las matemáticas tienen una capacidad poética extraordinaria: la noción de matriz, elipse, tienen una poesía propia y un mundo.».

Los personajes de El chico de la última fila pertenecen a tres familias distintas: Claudio García –el chico de la última fila– y su padre; el profesor de Lengua y Literatura Germán y su esposa Juana y “Los Rafa”, familia burguesa formada Rafael Artola padre, Ester –ama de casa– y Rafa hijo, compañero de Claudio.

Claudio es uno de los alumnos de Germán. Se sienta en la última fila de clase. Desde allí observa lo que sucede dentro y fuera del aula. No es un mal estudiante, excepto en la asignatura de filosofía. Rafa también es alumno de Germán. No se le dan bien las matemáticas, pero si la filosofía. Claudio encuentra en esta situación la ocasión para colarse en casa de Rafa: propone a su compañero ayuda en matemáticas a cambio del apoyo de Rafa en filosofía. Se trata solo de una estratagema de Claudio para espiar a esta familia perfecta: él no tiene madre y su padre es un extraño personaje al que ni siquiera se le da nombre en la obra.

Germán es profesor de Lengua y Literatura. Propone a su alumnado una redacción sobre Mi pasado fin de semana. Entre las simplezas escritas por sus estudiantes, Germán descubre un texto distinto, el de Claudio, que explica en su escrito cómo su deseo de entrar en casa de Rafa le llevó a vivir su primer día con la familia de su compañero:

A las once toqué el timbre y la casa se abrió ante mí.

Su atracción por la vivienda –que esconde los secretos, las miserias, las alegrías y los anhelos de sus habitantes– se muestra también al final de la obra:

Algo necesitarán. Siempre habrá un modo de entrar. Siempre hay un modo de entrar a cualquier casa.

Intrigado, Germán decide hablar con Claudio para saber si ese relato es real o ficticio. Claudio le confirma que no inventa, que solo expone lo que está viviendo. Germán no puede –¿o quizás no desea?– frenar a Claudio, que prosigue redactando sus vivencias en la casa de “los Rafa”, finalizando cada nuevo episodio con un desafiante Continuará.

Claudio pasa de ser un simple cronista a desencadenar voluntariamente situaciones para escrutar, analizar, embaucar, burlarse y escribir para Germán todo lo que observa. Los escritos de Claudio van mostrando su gradual injerencia en la vida de “los Rafa” ante la progresiva incomodidad de Germán. Entre el profesor y el alumno prospera un ambiguo juego de seducción, disgusto, arrogancia, recelo, apego y rivalidad. Claudio se hace con la victoria final en un sorprendente desenlace.

Mientras que a Germán y Claudio les une el amor por la literatura, la conexión entre Claudio y Rafa se realiza a través de las matemáticas y la filosofía. A Claudio le gustan las matemáticas, mientras que Germán está obsesionado por Tolstoi y Dostoievski:

– Claudio: El de Filosofía está empeñado en convencernos de que su asignatura es útil. Siempre empieza planteándonos un caso, él lo llama “dilema moral”, y luego nos explica el filósofo, Platón, Hegel, lo que toque. Todos quieren convencernos de que enseñan cosas útiles. Todos menos el de Matemáticas. Ése ya nos advirtió el primer día que las Matemáticas no sirven para nada.

– Germán: Las Matemáticas son importantes. También la Filosofía. Aunque ni las Matemáticas ni la Filosofía tengan respuesta para la gran pregunta.

– Claudio: ¿La gran pregunta?

– Germán: ¿Tolstoi o Dostoievski? Ésa es la gran pregunta, la que resume todas las demás.

Cartel de una representación de El chico de la última fila.

Cartel de una representación de El chico de la última fila.

Claudio explica a su amigo ejercicios sobre cónicas –Rafa debe aprender a distinguirlas a través de sus ecuaciones– o sobre números imaginarios:

– Rafa: Raíz cuadrada de menos uno. Por más que lo pienso, no le veo el sentido.

– Claudio: No es un número real. Por eso se les llama números imaginarios: raíz de menos cinco, raíz de menos siete… Sólo existen en la cabeza. Pero se les puede sumar, multiplicar… ¡dibujar! Se puede hacer cosas con ellos, aunque no existan.

– Rafa: No consigo memorizar las fórmulas. Las aprendo y se me van.

– Claudio: No tienes que memorizarlas, tienes que comprenderlas. (Le pone tres ejercicios.) Le pongo tres ejercicios: uno fácil, para animarlo; otro no tan fácil; y otro difícil, para que se atasque. Mientras él combate con los números imaginarios, yo doy una vuelta por la casa.

Los números imaginarios, ¿permiten al protagonista deambular por la casa de Rafa con completa libertad o quizás aluden a esa delgada línea entre lo auténtico y lo inventado?

– Germán: Hay algo de lo que todavía no hemos hablado. Hasta ahora hemos evitado hablar de ello, pero no podemos postergarlo más tiempo. El título. El título compromete. El título establece un pacto con el lector. El título le orienta acerca de qué ha de valorar, en qué ha de fijarse: “Guerra y paz”, “Los hermanos Karamazov”… ¿Qué tal “El chico de la última fila”?

(Silencio.)

– Claudio: Yo he pensado“Los números imaginarios”.

Cuando Rafa descubre que Claudio ha enviado una poesía a su madre, corta radicalmente con él. El joven escritor encuentra refugio en las matemáticas:

Ahora estudio solo. Matemáticas. Las Matemáticas nunca defraudan.

Más información:

[1] Juan Mayorga, El chico de la última fila, Ed. Ñaque, 2006

[2] Leticia Fernández Abejón, Las matemáticas tienen una capacidad poética extraordinaria, Entrevista a Juan Mayorga, Matematicalia, Cultura, Vol. 6, no. 1, 2010

[3] Marta Macho Stadler, El chico de la última fila de Juan Mayorga, DivulgaMat, julio 2010

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La extraordinaria capacidad poética de las matemáticas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las dos culturas de las matemáticas: construir teorías o resolver problemas

- FUN WITH MATHS, diversión con matemáticas

- Artistas que miran a las matemáticas

Tipos de materia sólida

Foto: Wolfgang Hasselmann / Unsplash

Foto: Wolfgang Hasselmann / UnsplashA medida que se forma un sólido a partir de un líquido, el tipo de disposición ordenada que se crea depende de los tipos de constituyentes (moléculas, átomos o iones) y de la naturaleza de la atracción eléctrica entre ellos.

Los estados de entropía más bajos implicarían el mayor número posible de enlaces (conexiones) entre los constituyentes. Esto ocurre en la formación de cristales, disposiciones muy ordenadas de miles y miles de millones de constituyentes [1]. En los cristales una estructura básica que involucra solo un pequeño número de constituyentes se repite muchas veces. El agua, la sal y muchos metales forman estructuras cristalinas. Muchas aleaciones metálicas, que implican una mezcla de diferentes metales, forman lo que se llama sólidos «policristalinos» («muchos cristales»). [2]

Los cristales se suelen clasificar según el tipo de constituyente. Así, los cristales iónicos están formados por iones positivos y negativos que se mantienen unidos por la atracción eléctrica entre ellos. La sal común es un ejemplo típico. En los cristales metálicos los electrones de los átomos que forman la red cristalina están deslocalizados, manteniendo el metal unido. Las redes no-metálicos, o cristales covalentes, son redes de átomos que se mantienen unidos por enlaces covalentes (que pueden ser polares) no existiendo moléculas individuales. El diamante, el grafito (ambos carbono puro), el silicio (Si) o la sílice (SiO2) son ejemplos de cristales covalentes.

En cristales iónicos, metálicos o covalentes no es posible hablar de moléculas individuales. El cristal completo es una única molécula gigante. En los llamados cristales moleculares, sí se puede hablar de moléculas individuales. Los átomos de las moléculas se mantienen unidos por enlaces covalentes, y las moléculas entre sí por fuerzas intermoleculares relativamente débiles [3]. El ejemplo prototípico para hablar de cambios de estado, el agua, resulta ser un cristal molecular.

Sin embargo, no todos los sólidos son cristales. Hay otros tres tipos importantes de materia sólida: cuasicristalina, amorfa y compuesta. El tipo de constituyente involucrado, e incluso cómo se forma el sólido, determinan el tipo de estructura resultante.

Si el enfriamiento del líquido ocurre demasiado rápido, los constituyentes que normalmente podrían formar un cristal perfecto no tienen tiempo para organizarse en una estructura cristalina de baja entropía. Podríamos decir que se congelan donde estaban mientras aun formaban un líquido [4]. En este caso, solo se observa un orden local de corto alcance y no una matriz repetitiva de largo alcance. Estos son los llamados sólidos amorfos (sin forma). Algunos sólidos son intrínsecamente amorfos, incluso cuando se enfrían lentamente. Son amorfos el caucho, el vidrio [5] y la mayoría de los plásticos [6]. El carbono en forma de carbón es amorfo, pero en forma de grafito o diamante es altamente cristalino.

Los cuasicristales se descubrieron en 1983. Las moléculas están dispuestas en un patrón tridimensional muy ordenado, pero el patrón no se repite en todo el cristal como lo hace en una estructura completamente cristalina. [7]

Finalmente, tenemos los sólidos compuestos, que implican la unión de diferentes materiales con diferentes estructuras. Los ejemplos son abundantísimos: la madera, el cemento, la fibra de vidrio, y muchos materiales biológicos como el hueso, la carne o el músculo. La investigación en los últimos años para desarrollar materiales que puedan actuar como «repuestos» biológicos ha experimentado una revolución debido al descubrimiento de la posibilidad de fabricar sólidos compuestos artificiales (composites).

Notas:

[1] Para explorar el mundo de los cristales puede verse nuestra serie Introducción histórica a la mineralogía, especialmente las entregas de la 9 a la 23 dedicadas específicamente a la cristalografía.

[2] Los aficionados al programa de televisión “Forjado a fuego” están muy familiarizados con este concepto, pues es la estructura policristalina del acero templado la que da sus características de dureza, flexibilidad y fragilidad a las hojas. De hecho, en ocasiones, cuando se rompe alguna durante las pruebas, los jueces suelen mostrar a cámara las estructuras policristalinas que han provocado el “fallo catastrófico”.

[3] Fuerzas de van der Waals (por ejemplo, hielo de CO2) o enlaces de hidrógeno (por ejemplo, hielo de agua).

[4] Esta afirmación es tan matizable que debe considerarse solo como una imagen útil para visualizar qué ocurre.

[5] El vidrio es sílice y otros materilaes enfriados rápidamente. La sílice enfriada lentamente forma un cristal covalente.

[6] Algunos polímeros, como el polietieleno, pueden considerarse cristales covalentes en una red monodimensional. Estos polímeros tienen en común que son de cadena larga. Hay casos es los que se puede establecer una red tridimensional de polímeros por un fenómeno llamado entrecruzamiento, y seguiría siendo un cristal covalente, pero esto ya se sale del ámbito de esta serie.

[7] La definición estricta de cuasicristal implica conocimientos matemáticos que se escapan de nuestro objetivo. Bástenos saber que en los cuasicristales existen simetrías centrales (respecto a un punto), como ocurre en dos dimensiones con el pentágono, por ejemplo, cosa que no existe en los cristales.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Tipos de materia sólida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un modelo simple de gas

- El demonio de Maxwell

- Otras predicciones del modelo cinético. Movimiento browniano