¿Quién llorará por los animales feos cuando desaparezcan?

El pez gota ostenta el dudoso honor de ser considerado el animal más feo del mundo (Fuente: FishesOfAustralia)

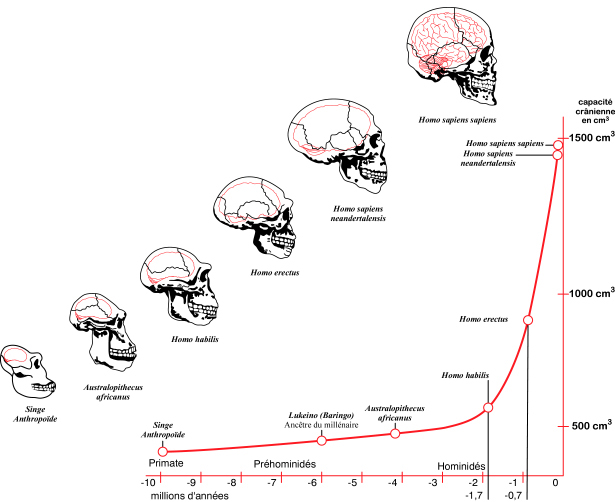

Hace apenas unos días murió Sudán, el último rinoceronte blanco del norte macho. Es una de las cinco especies de rinocerontes que hay en el mundo, y con la muerte del último macho, podemos darla oficialmente por extinta. Quedan con vida aun dos hembras, una hija y una nieta de Sudán, y se espera que utilizando técnicas de fecundación in vitro haya una posibilidad, aunque sea pequeña, de recuperar algún día la especie.

Pero la muerte de Sudán es un símbolo de nuestro fracaso en la conservación de la biodiversidad. La hemos fastidiado, queridos congéneres, y Sudán es la última prueba que nos ha llegado, un mensaje alto y claro. Ojalá sirva como toque de atención y nos pongamos las pilas con esto. La Tierra es hogar de millones de especies y nosotros somos la única con conciencia y responsabilidad para preservarla para todas las demás.

Sudan, el último rinoceronte blanco del norte macho, vivió sus últimos años custodiado para protegerle de los cazadores furtivos (Fuente: Ol Pejeta Conservancy)

Y digo todas. Insisto en ello porque cuando pensamos en conservación de especies solemos pensar en lindos koalas, gorilas imponentes, tigres majestuosos o simpáticos delfines. Y aunque es loable querer proteger a los cetáceos, ¿quién se acuerda de todas esas otras especies, las feas, las antipáticas, las despeluchadas, las viscosas, las patéticas? ¿Es que no merece el pez gota, nombrado una vez el animal más feo del mundo, sobrevivir igual que lo merece el lince o el águila imperial?

¿Puede el marketing salvar a los animales poco conmovedores?

Bob Smith es director del Instituto Durrell de Conservación y Ecología de la Universidad de Kent. En un artículo publicado en The Conversation a medias con Diogo Verissimo, de la Universidad de Oxford, comentaba que “nosotros como científicos conservacionistas queríamos comprobar si quizá el marketing podría salvar a estas otras especies. Si las empresas consiguen vender productos como fregonas y otros productos monótonos, ¿por qué no íbamos a poder recaudar dinero para salvar al poco glamuroso topo dorado gigante, incluso aunque parezca un pequeño cojín peludo con una pequeña nariz pegada?”.

Así que Smith y Verissimo compararon dos estrategias de recaudación de fondos para la conservación de especies, una de WWF y otra de la Sociedad Zoológica de Londres a través de su programa EDGE of Existence (al borde de la existencia). Ambas campañas eran muy diferentes: la de WWF trataba de recaudar dinero para un amplio abanico de proyectos que iban desde hacer frente al cambio climático y el comercio ilegal de animales salvajes a la conservación de los océanos y los bosques, mientras que la de EDGE estaba centrada en salvar a 100 mamíferos en peligro de extinción.

“Dado los diferente de ambas campañas queríamos ver si el marketing suponía alguna diferencia”, explican los autores, y para eso había que tener en cuenta qué animales se utilizaban como reclamo y cuál era su grado de atractivo, algo que depende de distintas cosas, como por ejemplo de si son bonitos, adorables, grandes o famosos.

Para crear una escala de atractivo animal se eligió a 850 personas involucradas en la conservación y se les enseñó una selección de imágenes, escogidas al azar, de entre las que ambas campañas estaban utilizando, y se les pidió que las clasificasen.

Comenzaron por la campaña de WWF, que recauda dinero a través de la adopción de los animales. Cuando la gente dona dinero, otorgan su apoyo a especies bien conocidas, y a cambio consiguen un animal de peluche, fotos de esos animales y certificados de adopción. El dinero donado va a acciones y proyectos que no solo benefician a los animales adoptados, sino a todo el ecosistema en general.

¿Cómo no iba a conmovernos la penosa situación de los adorables pandas? Solo un corazón de hielo se resistiría a intentar salvarlos (Fuente: Wikipedia Commons)

Los científicos determinaron que dos factores en concreto influían las elecciones de los donantes a WWF: el atractivo del animal y el grado de amenaza de extinción que sufrieran. “Las campañas de marketing no tenían ningún efecto. Daba igual como estuviesen descritas o presentadas, las especies más atractivas siempre reciben más donaciones, probablemente porque la gente ya las conoce y le gustan”.

Es posible salvar a ratas y murciélagos si sabes cómo

El programa EDGE funciona de forma diferente. Aunque apoya algunas especies mundialmente conocidas, como el elefante asiático, muchas otras son mucho menos atractivas, incluyendo un amplio grupo de ratas y murciélagos. Cada una de estas especies aparece en su web y los usuarios pueden aprender cuanto quieran sobre ellas.

En este caso, los resultados de Smith y Verissimo muestran que si bien la gente en general se muestra más interesada por donar para especies atractivas, en este caso las estrategias de marketing sí que influyen en la decisión. Los animales a los que se daba más visibilidad y se promocionaba conseguían más atención de los donantes.

No es tan lindo como un koala, pero ¿es que acaso el jerbo orejudo no merece nuestra ayuda? (Fuente: Wikipedia Commons)

Al comparar las dos campañas, los resultados muestran que entre 2011 y 2017 los animales que más dinero recaudaron en la web de WWF fueron el oso polar, el oso panda, el tigre y el leopardo de las nieves, mientras que en la web de EDGE fueron el delfín chino de río (ya extinto), el jerbo orejudo, el loris esbelto rojo y el murciélago de hocico de cerdo.

Los autores creen por tanto que utilizar técnicas de marketing con habilidad puede ayudar a recaudar fondos no solo para los animales que a todos nos derriten el corazón, sino también para los que no querríamos encontrarnos trepando por la pared de nuestra casa. Para estimar el impacto que podrían tener esas técnicas de marketing, crearon un modelo matemático basado en los datos recogidos del proyecto EDGE, una ecuación capaz de predecir las donaciones basándose en el atractivo del animal (algo que es fijo) y si fue o no promocionado por la organización en su web (algo que es variable).

Utilizando esa fórmula simularon distintas situaciones para los 10 animales más atractivos y los 10 menos atractivos según la clasificación hecha por los voluntarios del estudio. Si el marketing no intervenía, el modelo estimaba que las especies más adorables recaudarían hasta diez veces más que las más desagradables o feas. Pero al introducir el marketing que podía llevar a cabo la organización (situar las diez especies menos atractivas en las zonas destacadas de su web), el modelo predecía que las donaciones se multiplicarían por 26.

Sin un poquito de ayuda, un topo dorado gigante nunca tendrá el éxito de recaudación de un delfín, un tigre o un águila (Foto: Globalspecies.org)

Esto quiere decir, aseguran los dos autores del artículo, que las especies feas, al menos en lo que se refiere a ratones, murciélagos y similares, no lo tienen todo perdido y que hay mucho trabajo que los activistas y conservacionistas pueden hacer para echarles una mano.

Pero eso no es todo. El éxito de una campaña de marketing para salvar una especie, o un entorno, depende también de otros factores. El estudio Asignación Óptima de Recursos entre Especies Amenazadas: un Protocolo de Priorización de Proyectos, publicado en 2009, analizaba cuál es la mejor forma de gestionar el dinero dedicado a conservación, que por desgracia nunca es suficiente, para que sea lo más eficiente posible. “La literatura académica dedicada a la asignación sistemática de prioridades normalmente recomienda hacer un ranking de especies basándose en varios criterios, incluyendo el nivel de amenaza y el valor de esa especie en términos de distinción evolutiva, importancia ecológica y significado social. Pero este enfoque ignora dos aspectos cruciales: el coste del proyecto y las probabilidades de que el proyecto sea un éxito”.

Aclaran Smith y Verissimo que su estudio no analizó si una u otra estrategia de marketing sirvió para aumentar el número total de donaciones, pero sí que fue muy útil para aumentar el número de especies que la población reconoce y en cuya supervivencia se implica. No solo los gorilas o los osos panda tienen derecho a sobrevivir, ¿o es que nadie llorará al pez gota cuando desaparezca, igual que estamos todos ahora llorando por Sudán?

Referencias:

Increased conservation marketing effort has major fundraising benefits for even the least popular species. Diogo Verissimo, Robert J. Smith et al. Biological Conservation, Julio 2017.

Asignación Óptima de Recursos entre Especies Amenazadas: un Protocolo de Priorización de Proyectos. Liana N. Joseph, Richard F. Maloney, Hugh P. Possingham. Conservation Biology. Marzo 2009.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo ¿Quién llorará por los animales feos cuando desaparezcan? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El tamaño relativo de los órganos animales

- Las actividades animales

- Los animales que respiran en agua

Umami

Saccharina japonica

En 1909 el profesor de química Kikunae Ikeda publicó en japonés un artículo en el que propuso la existencia de un sabor básico no reconocido antes como tal: el umai (sabroso en japonés). Hasta ese momento se pensaba que los seres humanos teníamos receptores sensoriales gustativos específicos para los sabores dulces, salados, ácidos y amargos. Esos eran los considerados cuatro sabores básicos, cada uno con su receptor. El umai es muy característico del caldo (dashi) que preparan en Japón con bonito deshidratado y konbu, que es el nombre común del alga marrón Saccharina japonica. Ikeda denominó umami al nuevo sabor básico; el sufijo mi en japonés significa esencia.

Mediante un procedimiento de extracción que constaba de trenta y ocho pasos, Ikeda obtuvo del alga una sustancia cuyos cristales tenían su mismo sabor; la identificó como ácido glutámico. Su sal de sodio -el glutamato sódico- fue la forma del compuesto que proporcionó el mejor y más intenso sabor a umami. El ácido glutámico es un aminoácido, una de las sustancias de las que están formadas las proteínas, solo que este cumple, además, otras funciones en los seres vivos. Ocupa una posición central como intermediario en numerosas vías metabólicas. Y es un importante neurotransmisor (molécula que transmite información entre neuronas), el más abundante en el sistema nervioso de los vertebrados.

El glutamato está presente en muchos alimentos ricos en proteínas, como la carne. Además, somos capaces de detectar su presencia en la comida incluso en concentraciones ínfimas, por lo que es un indicador excelente de su valor nutricional. Pero hay más alimentos ricos en este aminoácido, como el tomate cocinado y ciertos alimentos fermentados, como el queso. Y la leche humana tiene 10 veces más concentración de glutamato que la de vaca, lo que da una idea de la gran importancia que este aminoácido tiene para los seres humanos ya desde que nacemos.

Tras el hallazgo del papel e importancia gustativa del glutamato, un discípulo de Ikeda extrajo del bonito deshidratado otra sustancia, el inosinato, que también contribuye al umai propio del dashi. El inosinato es un nucleótido cuya presencia en el alimento refuerza el efecto del glutamato. El mismo efecto ejerce el guanilato -otro nucleótido- que fue extraído de levaduras algunos años después por otro investigador japonés. El guanilato se encuentra en vegetales y hongos, y además de en las levaduras, pueden extraerse cantidades importantes de setas shitaki deshidratadas. Tanto el inosinato como el guanilato son, como lo es el glutamato, indicadores del valor nutricional del alimento; por esa razón tenemos receptores específicos para esas sustancias.

Tras su descubrimiento, Ikeda patentó un método para producir glutamato monosódico y desde entonces ha sido muy utilizado como potenciador de sabor. En la actualidad se extrae del konbu. Con ese propósito se cosechan anualmente dos mil quinientos millones de toneladas del alga en las costas de China. Entre el 2 y el 3% de la masa seca de Saccharina japonica es glutamato. Tan alto contenido es debido a que su presencia en el interior de las células del alga permite a estas igualar su concentración interna de solutos con la del agua de mar y evitar así la deshidratación. Lo interesante de ese fenómeno es que hay animales marinos que acumulan en sus tejidos glutamato y otros aminoácidos exactamente por la misma razón que lo hacen las algas: impiden así que el agua salga de su interior debido al efecto osmótico. He aquí un hermoso capricho de la naturaleza: ante un mismo problema, animales y vegetales recurren a una misma solución, solución que, además, encierra el secreto de nuestra predilección por ciertos alimentos.

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Este artículo fue publicada en el diario Deia el 17 de diciembre de 2017.

El artículo Umami se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuando las algas rojas no pueden gestionar los radicales libres

- Los invasores

- Identificada la proteína que provoca la inflamación tras un ictus

Naukas Bilbao 2017 – Déborah García Bello: Saboer

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

El grafiti es un arte efímero que para poder saborearlo hay que saber. Deborah García Bello conseguirá que lo mires de otra manera en apenas 10 minutos.

Deborah García: SaboerEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Déborah García Bello: Saboer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Mónica Lalanda: Una muerte de cómic

- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

- Naukas Bilbao 2017 – Laura Morrón: La gran divulgadora

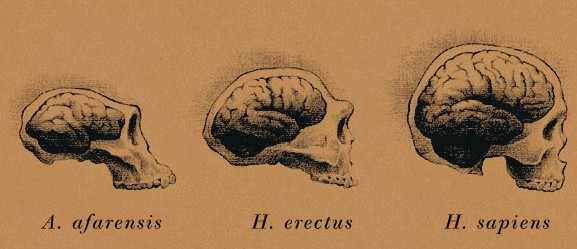

Salud ósea en estudiantes universitarios

La osteoporosis es una enfermedad asociada habitualmente con la edad y la mujer, aunque cada vez hay más varones que la padecen. Esta enfermedad se trata farmacológicamente en el momento en que se detecta. Sin embargo, la prevención en la juventud es una estrategia a tener en cuenta para llegar a la madurez con huesos bien mineralizados y de calidad.

Un estudio llevado a cabo por un grupo de investigación de los departamentos de Fisiología y Enfermería de la UPV/EHU ha analizado la salud ósea de 156 estudiantes de entre 18 y 21 años. Esta es una de las escasas investigaciones realizadas sobre la calidad del hueso de personas adultas que aún no han llegado al punto álgido de madurez ósea (21-30 años). Hasta ahora lo que se han realizado son principalmente estudios retrospectivos de los factores que se cree que son determinantes de la calidad ósea.

Idoia Zarrazquin, una de las autoras, explica que “la mayoría de los estudios realizados hasta el momento están centrados en la edad adulta y en el inicio de la decadencia ósea, traducida en osteoporosis, sobre todo entre las mujeres a partir de los 50 años. Nosotras consideramos que es importante hacer estos estudios previos para conocer qué influye positivamente en la calidad del hueso, porque el margen de mejora es más amplio ya que por delante hay más de una década para incrementar la mineralización lo antes posible”.

Ejercicio y nutrición equilibrados

En este estudio, se ha analizado la actividad y condición física, la composición corporal y la nutrición de sujetos jóvenes (61 varones y 95 mujeres) desde septiembre de 2016 hasta mayo de 2017. Se registraron sus características antropométricas, el consumo dietético, la capacidad aeróbica, la fuerza muscular y la actividad física que realizan habitualmente. Además, se midió su estado óseo mediante ultrasonidos, una técnica no invasiva y sencilla de utilizar.

El conjunto de jóvenes estudiantes que ha participado en la investigación presentan en general una buena calidad ósea. Son estudiantes que en su mayoría realizan deporte: de forma más vigorosa los varones, de manera más moderada las mujeres. Respecto al calcio, los hombres consumen una media de 1.080 mg/día, es decir, por encima de las recomendaciones de la Organización Mundial de la Salud (1000 mg/día), mientras que las mujeres no llegan a este valor (814 mg/día). En cuanto a la vitamina D, ni varones (3,88 mg/día) ni mujeres (3,10 mg/día) alcanzan lo recomendado por la OMS (5mg/día).

Actividad física sí, pero sin pasarse

Aunque los jóvenes analizados presentan una buena calidad ósea general, ésta puede ser mejorable para ralentizar la disminución ósea que se dará con la edad. En este sentido, Gotzone Hervás, primera firmante del estudio, concreta que el conocer los factores que ayudan a la formación ósea puede servir para prevenir estas enfermedades. “Sabemos que la actividad física mejora el músculo y fortalece el hueso. Existe una interconexión entre ellos y, si la actividad es intensa, ambos mejoran, resistirán mejor el paso de los años y afrontarán mejor la decadencia ósea”.

Por tanto, la actividad moderada-intensa y los deportes de impacto son recomendables, pero hay que equilibrarlos con la adecuada nutrición otra de las autoras, Fátima Ruiz-Litago. “La tensión y fuerza muscular mejora la mineralización del hueso, pero eso no significa que cuanto más mejor, porque está demostrado que deportistas de élite también sufren osteoporosis. Es decir, la actividad física tiene que ser moderadamente intensa, sin sobrepasarse; sobre todo, entre las mujeres. Cuando el ejercicio es muy intenso las necesidades nutricionales también son muy elevadas y, en el caso de las mujeres deportistas, muy difíciles de cubrir por sus propias características físicas y hormonales. Es por ello que es más habitual de lo pensado que entre deportistas de élite se den casos de osteoporosis”.

En definitiva, los investigadores de la UPV/EHU concluyen que, además de una correcta nutrición en calcio y vitamina D, la actividad física contribuye a acumular minerales óseos de manera que al llegar a la madurez el índice de rigidez ósea sea alto y se contrarreste la decadencia que se produce a partir de los 30/35 años y sobre todo a partir de los 50. “Las futuras recomendaciones para prevenir la osteoporosis también pasarán por favorecer la fuerza muscular”, asegura Idoia Zarrazquin.

Referencia:

Hervás, G.; Ruiz-Litago, F.; Irazusta, J.; Fernández-Atutxa, A.; Fraile-Bermúdez, A.B.; Zarrazquin, I. (2018) Physical Activity, Physical Fitness, Body Composition, and Nutrition Are Associated with Bone Status in University Students Nutrients doi: 10.3390/nu10010061

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Salud ósea en estudiantes universitarios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La sorprendente densidad ósea de los atletas kenianos

- La gestión de la salud y seguridad en el trabajo de las mujeres

- El método Feldenkreis y las personas con discapacidad intelectual

¿Qué permitió las increíbles fosilizaciones de Burgess Shale?

Hace algo más de una década, una joven Chenoa cantaba aquello de “Estoy cansada de cuerpos duros”. Probablemente, escribió la letra de la canción pensando en todos aquellos paleontólogos que se dedican al estudio de organismos (o parte de ellos) fósiles que no tenían ninguna parte dura.

Y es que si eres una almeja tendrás muchas más posibilidades de pasar al registro fósil, esa suerte de posteridad geológica que hoy usamos para completar el árbol de la vida, que una grácil medusa gracias precisamente a esos cuerpos duros y mineralizados de los que se quejaba amargamente la cantante marplatense.

Bromas aparte, el registro fósil tiene un sesgo de conservación brutal hacia la preservación de las partes duras de los organismos, como pueden ser los huesos o las conchas, mientras que los organismos formados exclusivamente por partes blandas suelen descomponerse mucho antes de fosilizar sin dejar rastro alguno de su existencia.

Figura 1. Este pariente de la avispa lo tuvo realmente difícil para fosilizar, pero tras su muerte cayó en un ambiente muy favorable para su fosilización.

Afortunadamente para nosotros, existe lo que conocemos como Lagerstätte, un grupo de yacimientos fosilíferos entre los que se encuentran aquellos que permiten una preservación excepcional de los organismos, tanto de sus partes blandas, como de organismos completos.

Uno de los detalles que hoy día desconocemos con exactitud es que permite precisamente la existencia de este tipo de yacimientos: ¿Será un rápido enterramiento de los fósiles? ¿Tendrá que ver con la mineralogía existente? ¿Influirá el tamaño de grano de la roca? ¿O quizás hay algún factor que no hemos tenido en cuenta hasta ahora?

En las últimas décadas se ha puesto mucho énfasis en la búsqueda de biomarcadores3, moléculas orgánicas complejas formadas por la actividad de los organismos vivos, que podemos encontrar en las rocas y que atestigüen la presencia de vida no solo en nuestro planeta sino, por ejemplo, en Marte, donde cada vez somos capaces de enviar instrumentos más sensibles, capaces de caracterizar con gran detalle la composición química de las rocas.

No sabemos si se desarrolló o existe vida en otros lugares más allá de nuestro planeta. Pero si esto ocurrió en algún momento, es probable que también comenzase su andadura con cuerpos blandos, sin mineralizaciones.

Si fuésemos capaces de conocer las condiciones, los procesos y los ambientes que permitieron en nuestro planeta la aparición de las Lagerstätte, podríamos comenzar a buscar esta suerte de geomarcadores1 también en otros puntos del Sistema Solar, con vistas a decidir los lugares de aterrizaje de futuras misiones que tengan la posibilidad de estudiar la existencia de vida en el pasado.

Un nuevo estudio2 llevado a cabo por científicos de distintas universidades británicas y norteamericanas ha abordado este problema estudiando una de las mejores Lagerstätte conocidas, la de Burgess Shale, que toma su nombre de un yacimiento Canadiense descubierto a principios del siglo XX y que data de hace unos 500 millones de años, en el Cámbrico, momento en el que ocurre una gran diversificación evolutiva en el reino animal.

Gracias a este tipo de yacimientos, de los que se conocen varias docenas en todo el mundo, se ha podido completar de una manera mucho más exhaustiva el árbol de la vida en el Cámbrico ya que sin estos, más del 80% de los organismos aparecidos en este periodo, no habrían dejado rastro alguno en el registro fósil.

¿Qué hace a este tipo de yacimientos tan especiales que permiten la excepcional preservación de las partes blandas?

Desde hace un par de décadas, sabemos que algunas arcillas son capaces de facilitar la fosilización ya que son capaces de adherirse a cierto tipo de enzimas encargadas de romper la célula tras la muerte del organismo, dejándolas inactivas y por lo tanto ralentizando la descomposición.

Pero en los últimos años, diversos experimentos han mostrado como la presencia de arcillas como la caolinita y la bertierina son capaces de interferir en el crecimiento de algunas bacterias encargadas de la putrefacción de los organismos muertos… ¿Podría la presencia de cierto tipo de arcillas tener una relación fundamental con la aparición de yacimientos del tipo de Burgess Shale?.

Para resolver esta cuestión, este equipo de científicos ha analizado en detalle la mineralogía de más de 200 muestras de fósiles del Cámbrico provenientes de 19 yacimientos de cuatro continentes, de las cuales 131 correspondieron a fosilizaciones del tipo de Burgess Shale, y 82 en las que solo aparecen restos mineralizados.

Los resultados muestran que los fósiles de partes blandas se conservan mejor en rocas que contienen bertierina, que en estudios anteriores ya se había demostrado su efecto contra las bacterias que provocan la putrefacción de los tejidos.

Hoy en día esta arcilla se forma principalmente en ambientes tropicales, con aguas ricas en hierro, lo que probablemente sirva como indicador para interpretar que el ambiente en el que vivieron estos organismos también fue las aguas de algún mar u océano tropical del Cámbrico.

Aunque este nuevo análisis mineralógico consigue predecir con una tasa de éxito de alrededor del 80% la posibilidad de fosilización de tipo Burguess Shale en rocas sedimentarias de grano fino formadas durante el Cámbrico, es manifiesto que hay otros factores que también son importantes para una buena preservación, como puede ser un enterramiento rápido, la presencia de aguas pobres en oxígeno o la composición de las aguas.

Este estudio abre la puerta a la búsqueda de nuevos yacimientos de tipo Burgess Shale en nuestro planeta que hayan podido pasar desapercibidos, pero quizás pueda ser también el pistoletazo de salida para localizar rocas favorables a la fosilización en lugares como Marte, donde sabemos que hubo un ambiente mucho más adecuado para el desarrollo de la vida al principio de su historia, y de haber existido esta, quien sabe si también quedó registrada en las rocas como ocurrió en con la que habitaba aquellos mares tropicales del Cámbrico.

Este artículo lo ha escrito Nahum Méndez Chazarra y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU

Referencias:

[1] J. Martinez-Frias, E. Lázaro, A. Esteve-Núñez, and C. M. B. L. Beard. Biogeochemical cycling of iron isotopes. Science. CrossRef PubMedJohnson, Geomarkers versus Biomarkers: Paleoenvironmental and Astrobiological Significance, vol. 36. 2009.

[2] R. P. Anderson, N. J. Tosca, R. R. Gaines, N. M. Koch, and D. E. G. Briggs, “A mineralogical signature for Burgess Shale – type fossilization,” vol. 46, no. 4, pp. 2–5, 2018.

[3] M. Gargaud and W. M. Irvine, Encyclopedia of Astrobiology. 2015.

El artículo ¿Qué permitió las increíbles fosilizaciones de Burgess Shale? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La aparición de los tejidos musculares y el registro fósil

- Del zumo de naranja a la selva, un ejemplo de reciclaje extremo

- Las cartas de Darwin: ¡La geología por encima de todo!

Catástrofe Ultravioleta #23 TOTALIDAD

Catástrofe Ultravioleta #23 TOTALIDAD

El pasado 21 de agosto de 2017 tuvo lugar uno de los eclipses totales de Sol más seguidos de la historia. Millones de personas pudieron contemplar aquel apasionante momento y desde Catástrofe Ultravioleta no quisimos quedarnos atrás. Aprovecharemos este eclipse para conocer infinidad de curiosidades sobre nuestra estrella y descubrir qué fenómenos ocurren durante los mágicos minutos en los que el Sol queda oculto tras la Luna. Un viaje que nos llevará desde los descubrimientos de Galileo hasta las futuras misiones espaciales.

Agradecimientos: Carolina Jiménez (OKinfografia), José Miguel Viñas (Divulgameteo), Miquel Serra-Ricart (IAC), Expedición Sheilos, GOAT (Grupo de Observadores Astronómicos de Tenerife), Alejandra Godell, Héctor Socas (IAC), José Carlos del Toro Iniesta (IAA)

** Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #23 TOTALIDAD se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Preparados para una Catástrofe Ultravioleta

- Catástrofe Ultravioleta #13 LEVIATÁN

- Catástrofe Ultravioleta #01 Expedición

El falso pan integral tiene los días contados

assortment of baked bread on wood table

El pan integral es una opción más saludable que el pan blanco, sin embargo, no todos los panes que lucen la palabra integral en su etiquetado son realmente integrales. La normativa vigente lo permite, cosa que no ocurre en otros países. Desde el Ministerio de Agricultura y Pesca, Alimentación y Medio Ambiente (Mapama) se ha presentado un borrador que pretende derogar la normativa actual para que llamemos a cada cosa por su nombre y no nos sigan vendiendo, al amparo de la ley, falso pan integral.

Diferencias entre harina integral y refinada

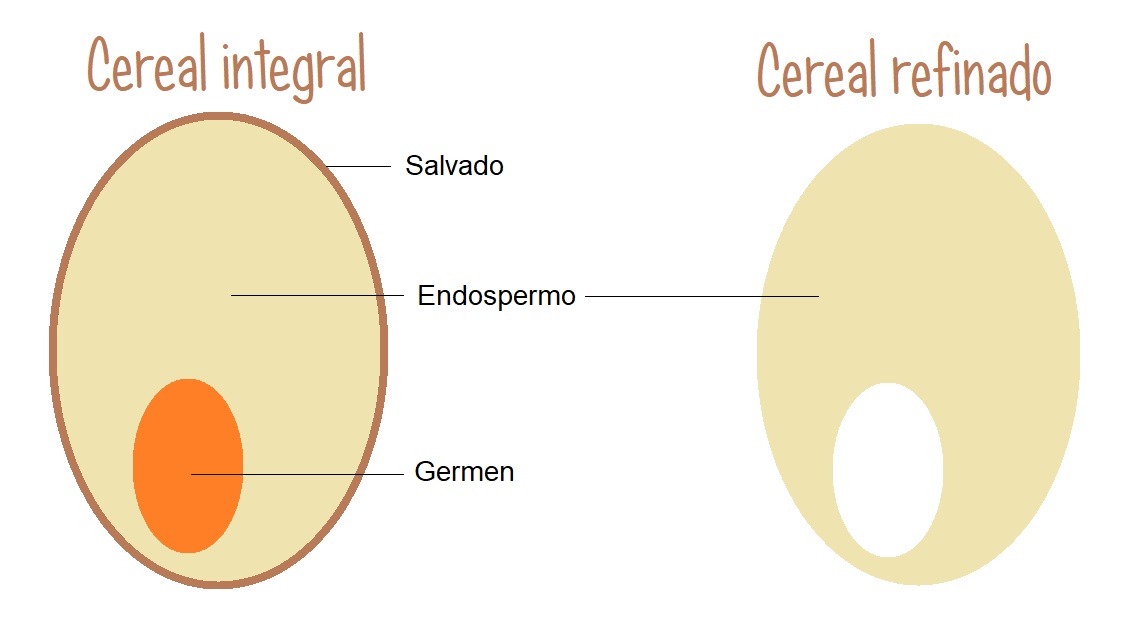

Las harinas integrales son aquellas que se fabrican moliendo el cereal entero. Los cereales tienen tres partes: la cáscara del cereal es el salvado, donde está la mayor parte de la fibra, la parte central es el endospermo, compuesto mayoritariamente por almidón, y el núcleo es el germen, donde se concentra la fracción grasa del cereal.

Las harinas integrales de mayor calidad son las que se muelen a la piedra. La razón es que no se desperdicia ni se separan las diferentes partes del grano. Estas harinas pueden tamizarse para separar parte de salvado y así elaborar una semi-integral.

Según el tipo de molienda que se utilice, obtendremos harinas con diferente tasa de extracción. La tasa de extracción indica los kilos de harina que se obtienen moliendo 100 kilos de cereal. Así, una harina con tasa de extracción del 100% es una harina 100% integral, con el grano entero, y una harina con una tasa de extracción del 70% será, para los panaderos, una harina refinada.

En cambio, la mayor parte de las harinas que encontramos en el mercado suele ser fruto de un tipo de molienda por fases. Normalmente en cada una de estas fases se separan las diferentes partes del grano. Por un lado conseguimos una harina blanquísima que solo contiene endospermo, una harina oscura hecha con el salvado y, por otro lado, el germen, que suele retirarse porque su contenido graso hace que la harina se ponga rancia con más facilidad.

Las harinas integrales fabricadas a partir de molienda en fases se fabrican mezclando en la proporción deseada la harina blanca con la harina de salvado. A veces están tan poco logradas que las fases pueden separarse utilizando un colador. Los panaderos suelen llamar a estas harinas de mezcla ‘falsa integral’. Algunos fabricantes de harina integral lo indican en el envase como dos ingredientes: harina y salvado.

Los panaderos la prefieren integral

Los panaderos que elaboran el pan de forma tradicional, empleando masa madre, suelen usar harinas integrales. La razón es que las levaduras se encuentran en mayor proporción en el salvado. Estas levaduras rompen el almidón en azúcares simples y los fermentan formando las características burbujas del pan.

En cambio, al hacer pan con harina integral, la fibra absorbe más agua y esto obstaculiza el desarrollo del gluten, es decir, se tarda más en conseguir una masa elástica.

El manejo de harinas integrales para elaborar pan requiere más destreza que el manejo de harinas refinadas. No obstante, la complejidad de la elaboración del pan integral repercute en un producto con mejores cualidades nutricionales.

El pan integral es más saludable que el pan blanco

Las harinas integrales contienen todas la vitaminas y nutrientes del cereal completo, siendo especialmente interesante para nuestra salud su alto contenido en fibra. La fibra favorece el tránsito intestinal y además hace que el pan sea más saciante.

El pan integral tiene las mismas calorías que el pan refinado, así que es un mito eso de que ‘engorda menos’, pero al resultar más saciante necesitaremos comer menos cantidad.

La fibra también hace que el pan integral tenga menor índice glucémico, es decir, hace que metabolicemos los carbohidratos lentamente y que no nos suba la glucosa en sangre. Por el contrario, los panes blancos tienen alto índice glucémico, lo que significa que se metabolizan muy rápido dando elevados y repentinos picos de glucosa en sangre y, en consecuencia, picos de insulina. Este es el motivo por el que el pan blanco es poco saciante y por el que las personas con diabetes limitan su consumo.

La ley actual permite llamar integral a casi cualquier pan

En la normativa vigente sobre fabricación y comercio del pan, el pan integral se define como «el elaborado con harina integral», sin especificar el porcentaje que debe llevar este producto para ser considerado integral. La harina integral, por su parte, «es el producto resultante de la molturación del grano de cereal y cuya composición corresponde con la del grano del cereal íntegro», sin indicar qué porcentaje de grano entero debe llevar.

Así, un pan con un bajo contenido de harina integral puede llevar en su envase la palabra integral. La normativa se lo permite. También puede indicar «fuente de fibra» si contiene más de 3 g de fibra por cada 100 g de producto, o «alto contenido en fibra» si tiene 6 g de fibra. Tenemos que tener en cuenta que 100 g de pan elaborado con 100% harina integral de trigo contendrá más de 8 g de fibra.

Existe, por tanto, una especie de vacío legal respecto a la denominación integral del pan. Algunos productos lucen en su etiqueta la frase «elaborado con harina 100% integral», cuando en realidad llevan un porcentaje ínfimo de harina integral. Claro que no es lo mismo decir «elaborado con harina 100% integral» que «elaborado con 100% harina integral». El primero solo dice que contiene harina integral (y que esa parte de harina integral es 100% integral) y el segundo dice que el 100% de la harina empleada es integral.

Una nueva normativa para los panes integrales

El Gobierno quiere acabar con estas tretas y por eso ha propuesto un cambio de normativa a través de un proyecto presentado por el Ministerio de Agricultura y Pesca, Alimentación y Medio Ambiente (Mapama). El objetivo es, entre otros, proporcionar una información adecuada al consumidor que facilite su elección de compra. Este proyecto se ha escrito a semejanza del de los países nórdicos, donde ya está regulado que solo pueden denominar pan integral a aquel que contenga más del 80% de harina integral.

La futura normativa concretará las características que deberá tener el pan integral y unificará criterios: «Se denominarán ‘pan 100% integral’ o ‘pan integral’ los panes elaborados con harina exclusivamente integral, excluyendo de dicho porcentaje las harinas procesadas/malteadas. Los panes en los que la harina utilizada en la elaboración no sea exclusivamente integral incluirán en la denominación la mención ‘elaborado con harina integral X%’». Si el porcentaje es inferior al 100%, el porcentaje exacto deberá figurar en el frontal del envase con la misma tipografía, tamaño y color que la palabra integral.

Los panes elaborados con harinas diferentes al trigo, como espelta, kamut, centeno, etc. podrán denominarse ‘pan de…’ siempre y cuando contengan al menos un 50% de ese cereal.

Cómo saber si el pan que compramos es realmente integral

Hasta que la nueva normativa se aplique, todavía nos encontraremos panes en el mercado que se llaman integrales aun cuando contienen cantidades irrisorias de harina integral. A veces contienen semillas que los hacen parecer integrales.

Como en todos los alimentos envasados, la realidad del producto no esta en los eslóganes del frontal del envase, sino en la lista de ingredientes y en la tabla nutricional. Tenemos que prestar atención a la lista de ingredientes.

Los ingredientes van ordenados de mayor a menor cantidad en el producto. Así, un pan cuyo primer ingrediente contenga la palabra integral o grano entero, quiere decir que el ingrediente mayoritario sí es una harina integral. Además, entre paréntesis lucirá el porcentaje exacto de harina integral.

En los ejemplos mostrados en la imagen superior encontramos tostadas de pan con diferentes contenidos de harina integral, a pesar de que en el frontal todos se denominan integrales. En el primer producto el ingrediente principal es harina integral. Es, por tanto, el ingrediente mayoritario, aunque solo sea un 58% del producto. El ingrediente que le sigue es «harina de trigo», es decir, harina refinada. En el segundo producto, el ingrediente mayoritario es «harina de trigo», es decir, harina refinada. La integral es solo un 46%. En el tercer producto el ingrediente mayoritario sí es harina integral y en un porcentaje elevado: 88%. Además, el resto de los ingredientes son semillas, levadura, sal… No contiene ni azúcares ni harinas refinadas.

Para conocer la realidad de un pan integral debemos buscar un producto cuyo primer ingrediente sea «integral» o «grano entero». Si indica el porcentaje, será mejor cuanto mayor sea. Lo ideal es que tenga al menos un 80% de integral. Si en el resto de los ingredientes no aparecen ni azúcares ni otras harinas, estaremos ante una buena opción de compra.

Conclusión

La normativa actual permite llamar pan integral a cualquier pan que contenga harina integral, sea cual sea esa cantidad. El proyecto presentado por el Mapama pretende cambiar la normativa para que solo se pueda denominar integral al pan elaborado con un 100% de harina integral. Hasta que la normativa no cambie tendremos que seguir fijándonos en la lista de ingredientes. Y, si compramos pan fresco sin envasar, le preguntaremos a los panaderos.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo El falso pan integral tiene los días contados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El mejor lacón con grelos tiene su ciencia

- El buen turrón tiene su ciencia

- La pantalla de tu móvil solo tiene tres colores

Destruyendo asteroides con bombas atómicas

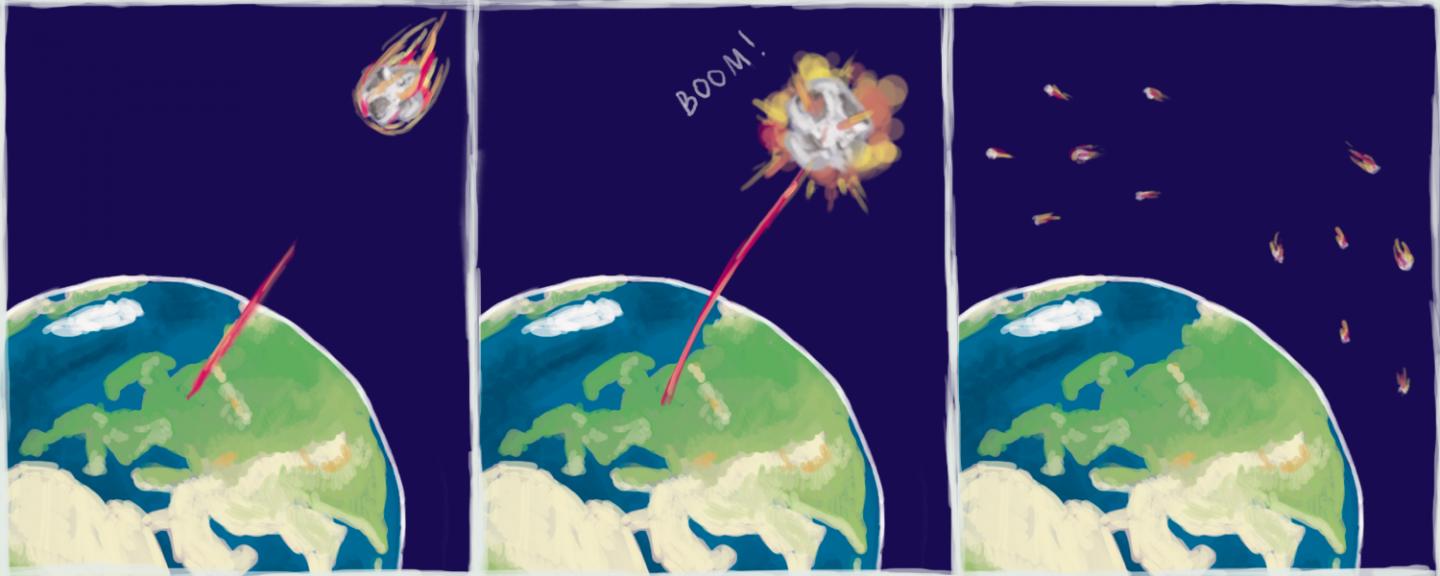

Ilustración: Elena Khavina

Un numeroso equipo de físicos e ingenieros encabezados por A. Y. Arasova, del Instituto de Investigación Científica de Física Experimental Panruso (VNIIEF), el principal centro de investigación del complejo militar-industrial de Rusia en armas nucleares, ha modelado el impacto de una explosión nuclear en un asteroide que amenazase la Tierra. Para ello se fabricaron asteroides en miniatura y los bombardearon con un láser. La técnica de modelado desarrollada en este estudio es una forma de evaluar experimentalmente los criterios de destrucción de asteroides, así como la energía de la explosión necesaria para eliminar un objeto peligroso en curso de colisión con la Tierra.

Los asteroides son cuerpos celestes compuestos principalmente de carbono, silicio, metales y, algunas veces, hielo. Habitualmente se clasifican los objetos de más de 1 metro como asteroides, aunque este límite inferior aún está en discusión. En el otro extremo de la escala, los asteroides alcanzan los 900 kilómetros de diámetro. Viajando a 20 kilómetros por segundo, estos gigantes representan una amenaza creíble de aniquilar toda la vida en la Tierra.

Hay dos opciones básicas cuando se trata de proteger el planeta de la colisión con un asteroide: o se le desvía o se vuela en pedazos de tal manera que la mayoría n impacte con la atmósdfera y, los que lo hagan, se quemen en ella de tal modo que lleguen a la superficie sin causar daños catastróficos. Los autores de este estudio se han centrado en la segunda opción, creando un modelo experimental con el que comprobar los efectos de una poderosa onda de choque liberada por una explosión nuclear en la superficie del asteroide. El equipo de investigación demuestra que un breve pulso láser dirigido a una réplica en miniatura de un asteroide produce efectos destructivos similares a los de una explosión nuclear en una roca espacial real. Las distribuciones de calor y presión predichas para el evento real generalmente coinciden con las medidas en el experimento de laboratorio.

Para que el modelo de láser fuera preciso, los investigadores se aseguraron de que la densidad y rigidez del asteroide de laboratorio, e incluso su forma, imitaran las reales. Gracias a esta correspondencia precisa, los investigadores obtuvieron una forma de calcular directamente la energía requerida de una explosión nuclear en el asteroide real a partir de la energía de un pulso láser que destruye su réplica en miniatura.

La composición de los asteroides artificiales para las pruebas se corresponde a la de los meteoritos condríticos (básicamente de carbono), que representan aproximadamente el 90 por ciento de los restos de asteroides que alcanzan la superficie de la Tierra. Las réplicas se hicieron usando los datos sobre el meteorito recuperado del fondo del lago Chebarkul. Es el fragmento más grande del asteroide que entró en la atmósfera de la Tierra en febrero de 2013, explotando sobre el Óblast de Cheliábinsk, Rusia. El material del asteroide se fabricó usando una combinación de sedimentación, compresión y calentamiento, imitando el proceso de formación natural. A partir de muestras cilíndricas se hicieron asteroides de prueba esféricos, elipsoidales y cúbicos.

Estela del bólido de Cheliábinsk fotografiado desde Ekaterimburgo

Para estimar los criterios de destrucción de asteroides, los investigadores analizaron los datos disponibles del meteorito de Cheliábinsk. Ingresó a la atmósfera de la Tierra como un asteroide de 20 metros y se fracturó en pequeños fragmentos que no causaron daños catastróficos. Por lo tanto, tiene sentido afirmar que un asteroide de 200 metros ha sido eliminado si se fractura en pedazos con diámetros 10 veces más pequeños y masas 1.000 veces más pequeñas que la roca inicial. Por razones obvias, esta conclusión solo se cumple para un asteroide de 200 metros que entra en la atmósfera en un ángulo similar y para fragmentos que viajan a lo largo de trayectorias similares a la del meteoro de Cheliábinsk.

Los experimentos indican que para eliminar un asteroide de 200 metros, la bomba necesita liberar la energía equivalente a 3 megatones de TNT. A este dato se llegua porque los investigadores midieron que es necesario un pulso láser de 500 julios para destruir un modelo de 8-10 milímetros de diámetro. Para poner el dato en perspectiva, 3 megatones vendría a ser equivalente a la energía de todas y cada una de las bombas detonadas durante la Segunda Guerra Mundial, incluidas las bombas atómicas que se lanzaron sobre Hiroshima y Nagasaki; por otro lado tampoco es tanto: el explosivo más poderoso jamás detonado, la bomba Zar, construida por la Unión Soviética en 1961, liberó 58,6 megatones (aunque los números varían algo según las fuentes; este dato es el oficioso ruso); las bombas de hidrógeno estadounidenses de la Guerra Fría se estima que liberaban 25 megatones.

El equipo de investigación ahora planea expandir el estudio experimentando con réplicas de asteroides de diferentes composiciones, incluidas las que contienen hierro, níquel y hielo. También pretenden identificar con mayor precisión cómo la forma del asteroide y la presencia de cavidades en su superficie afectan el criterio de destrucción general.

De momento no hay amenazas inminentes de asteroides, por lo que el equipo tiene tiempo de perfeccionar esta técnica para evitar un desastre planetario.

Referencia:

Aristova, E.Y., Aushev, A.A., Baranov, V.K. et al. (2018) J. Exp. Theor. Phys. doi 10.1134/S1063776118010132

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Destruyendo asteroides con bombas atómicas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Choques de asteroides, arte islámico y cuasicristales

- Asteroides, ¿de la amenza a la oportunidad?

- Los meteoritos ya no son lo que eran desde hace 466 millones de años

Ilustraciones artísticas de un matemático

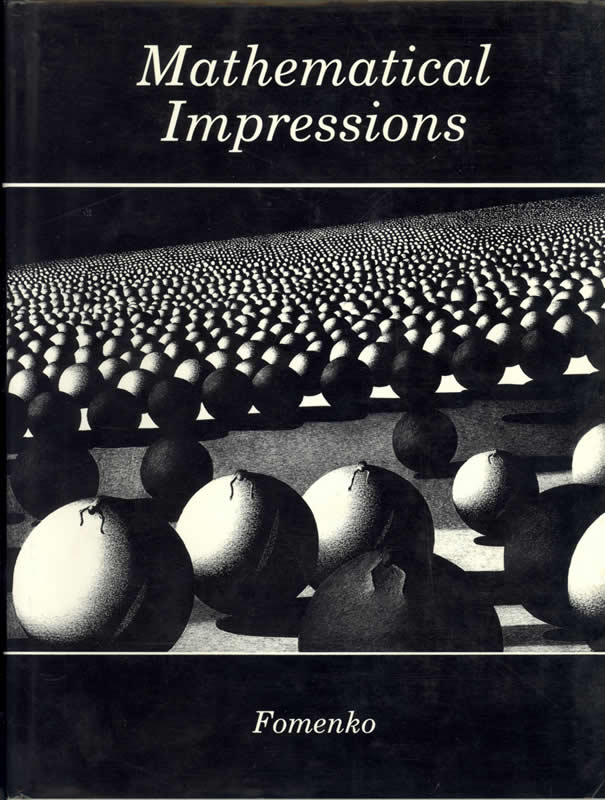

El año 1990 la American Mathematical Society (Sociedad Matemática Americana) publicó un curioso libro que, bajo el título de Mathematical Impressions, recogía más de ochenta ilustraciones artísticas del matemático ruso Analoty T. Fomenko.

Portada del libro “Mathematical Impressions” del matemático A.T. Fomeko

Mi primer contacto con A. T. Fomenko fue a través de sus libros de Geometría Diferencial y Topología Algebraica, relacionados con mi área de investigación. Libros como Modern Geometry. Methods and Applications (1984, 1985 y 1990), Symplectic Geometry. Methods and Applications (1988) o Homotopic topology (1986), entre muchos otros.

El matemático ruso Anatoly Timofeevich Fomenko, que nació el 13 de marzo de 1945 en la ciudad ucraniana de Donetsk, por aquel entonces Stalino (URSS), fue un conocido topólogo y geómetra diferencial de la Universidad Estatal de Moscú, así como miembro de la Russian Academy of Sciences (Academia Rusa de Ciencias).

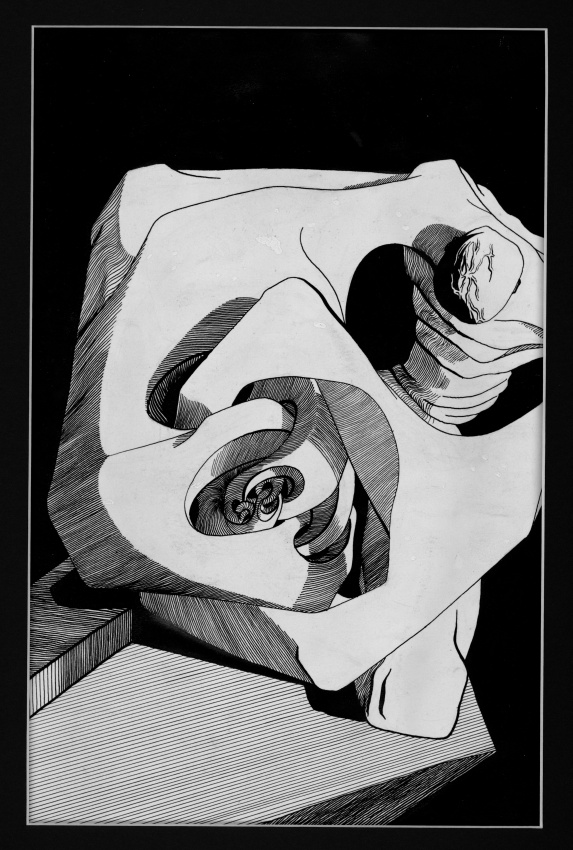

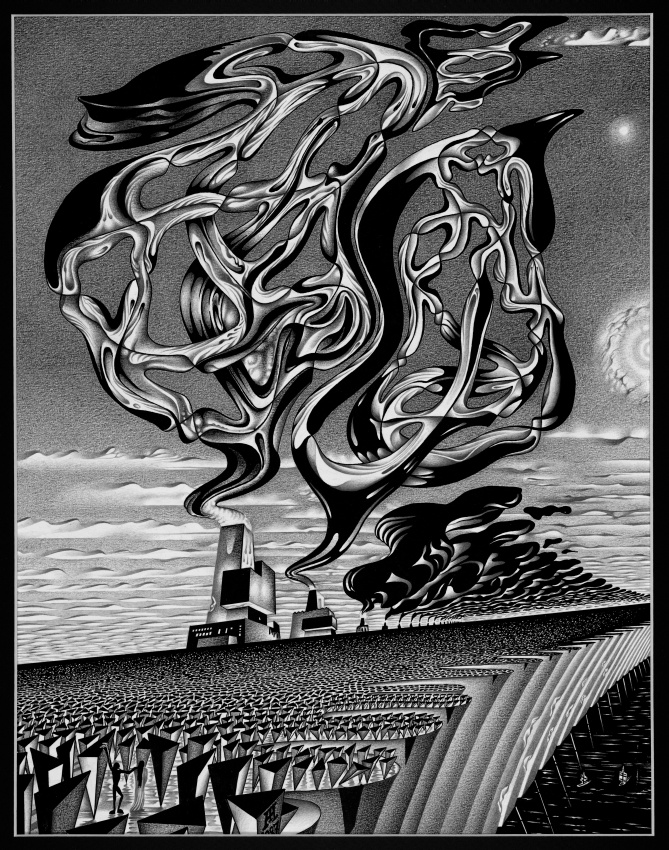

En 1969 publicó en ruso, junto con Dimitry B. Fuchs y Victor L. Gutenmacher, su libro Homotopic topology, que sería traducido al inglés en 1987. Las personas que leyeron este libro matemático se quedaron sorprendidas al encontrarse en el mismo una serie de ilustraciones artísticas en blanco y negro, y del tamaño de una página, que pretendían explicar visualmente algunos conceptos matemáticos muy complejos, pero que, al mismo tiempo, utilizando una estética oscura y expresionista, tenían un marcado carácter artístico. Una versión moderna de ese libro fue publicada en 2016 por Springer (GMT 273).

Veamos algunas de las ilustraciones que formaron parte de este libro. La primera de ellas, que inicia el libro es Esfera con cuernos de Alexander (1967), que ilustra un concepto topológico extraño como son las esferas con cuernos de Alexander (véase la entrada James Waddell Alexander de Marta Macho, para más información).

“Esfera con cuernos de Alexander” (1967), ilustración perteneciente al libro “Homotopic Topology”, que también fue recogida en el libro “Mathematical Impressions”

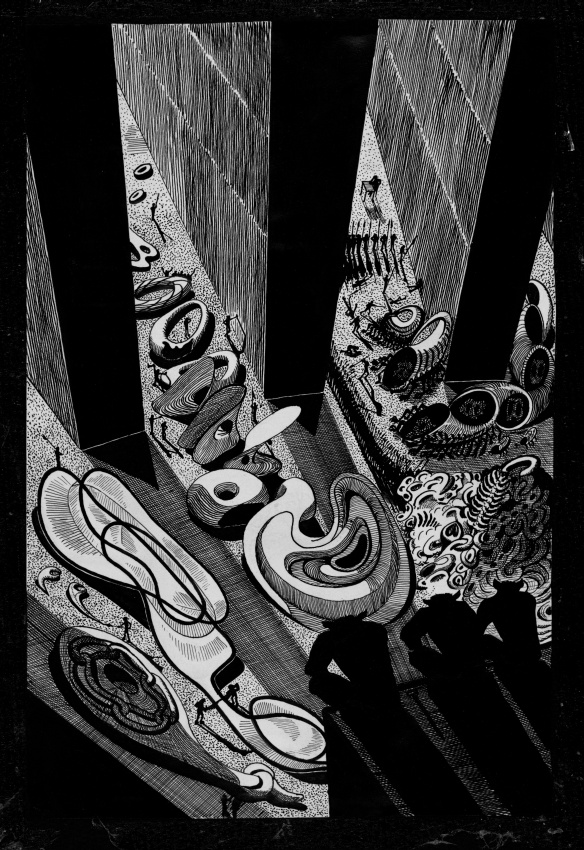

“Zoo topológico” (1967), ilustración perteneciente al libro “Homotopic Topology”, que también fue recogida en el libro “Mathematical Impressions”

La segunda ilustración de arriba es Zoo topológico (1967). La explicación que acompaña a la misma dice así:

“En este espacio cavernoso, la galería de un gran castillo austero, tres seres observan desde arriba como otras criaturas pasan el tiempo en una colección de magníficas formas matemáticas, cada una siendo una perturbación diferente del espacio físico. Arriba a la derecha, un poliedro animado cobra vida y comienza a descomponerse en sus componentes, las conchas, como escorpiones, de las que está hecho. Observe la cola del aparente escorpión, arqueándose hacia arriba y hacia la cabeza de las conchas, revelando intuitivamente las facetas de la estructura y forma del objeto. Vea cómo las conchas finalmente se unen para crear un único poliedro infinito. Mientras tanto, en el centro del gran hall, un enorme toro, es decir, un objeto con forma de donuts, se está dando la vuelta (el interior pasa a ser exterior, y al revés), transformándose a sí mismo y al espacio que lo rodea. Curiosamente, a pesar de que el toro, que ha sido cortado o perforado, se retuerce en el espacio y se está dando la vuelta, el nuevo objeto sigue siendo un toro, aunque las superficies interna y externa se han intercambiado.

En la parte inferior izquierda, a la sombra de un gran pilar, yace un objeto llamado el collar de Antoine, bastante familiar en topología. A su derecha, descansa una película de jabón, que se extiende a través de un cable circular. Compuesto por la unión de una banda normal de Moebius con una banda triple de Moebius, esta superficie minimal es notable ya que puede contraerse continuamente a lo largo de su límite sin romperse. Incluso se puede transformar en otro objeto, conocido en topología como una casa de Bing con un agujero. Finalmente, en el centro hay un solenoide 2-adico.”

Para las personas que el anterior texto solamente les parece un cúmulo de términos matemáticos incomprensibles, diremos que es una galería de imágenes de superficies topológicas interesantes. Entre los términos mencionados están “el collar de Antoine” del que podéis leer en la entrada Louis Antoine y su fabuloso collar, de Marta Macho, la famosa “banda de Moebius”, sobre la que podéis ver el video La banda de Moebius, de la sección Una de Mates del programa de TV Órbita Laika, o las películas de jabón, que son superficies minimales, sobre las que podéis ver este otro video Matemáticas con jabón, de Una de Mates.

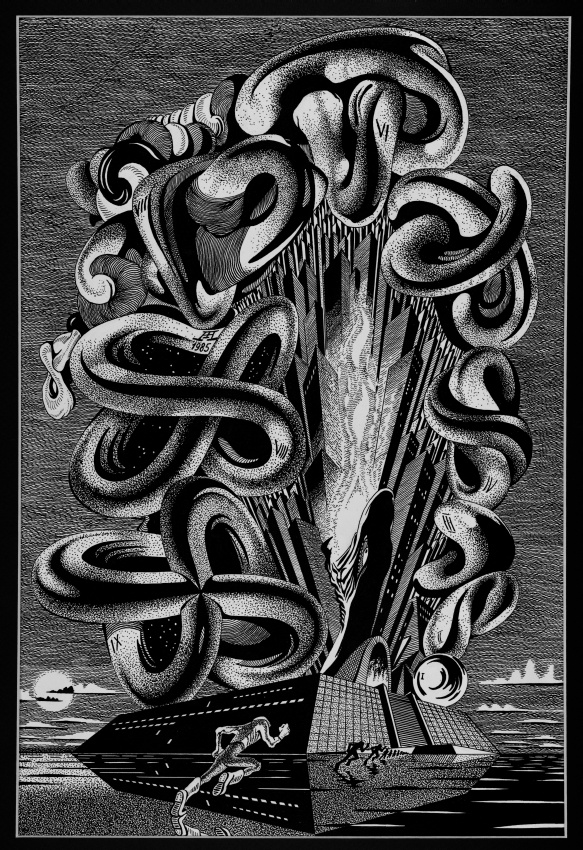

Otra ilustración en la que se intenta explicar un proceso matemático es la siguiente, cuyo título es ¿Es posible darle la vuelta (el interior pasa a ser exterior, y al revés) a una esfera (de dimensión 2) en el espacio euclídeo tridimensional ambiente dentro de la clase de las inmersiones diferenciables (“suaves”)? (1985, aparece en la versión inglesa).

“¿Es posible darle la vuelta (el interior pasa a ser exterior, y al revés) a una esfera (de dimensión 2) en el espacio euclídeo tridimensional ambiente dentro de la clase de las inmersiones diferenciables (“suaves”)?” (1985), ilustración perteneciente al libro “Homotopic Topology”, que también fue recogida en el libro “Mathematical Impressions”

Para visualizar el proceso de darle la vuelta (el interior pasa a ser exterior, y el exterior pasa a ser interior) a una esfera (de dimensión 2) en el espacio euclídeo tridimensional, que se ilustra en la anterior imagen, puede verse el siguiente video… How to turn a sphere inside out:

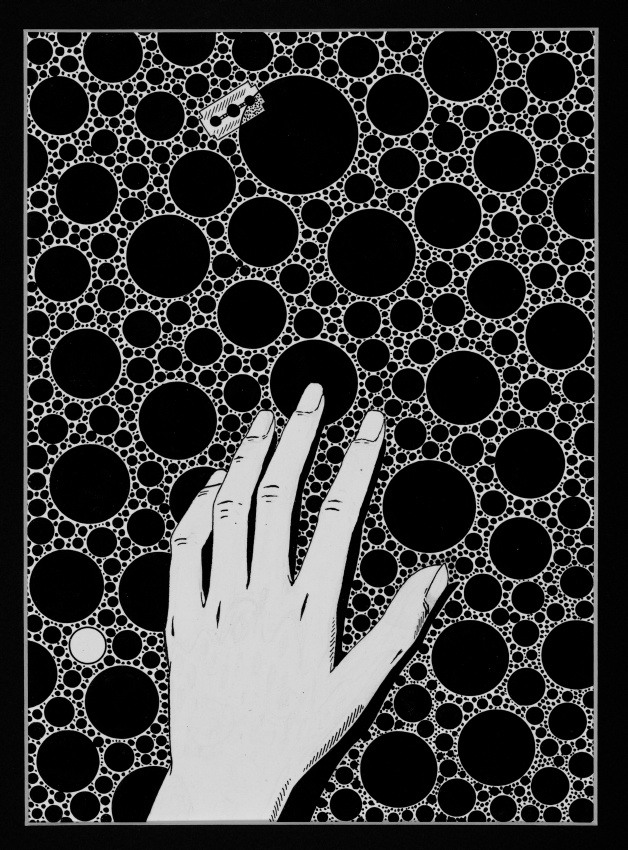

Disfrutemos de un par de ejemplos más de ilustraciones de la publicación Homotopic Topology. La primera (aunque de su versión más moderna) tiene el título Fantasía sobre el tema de los fractales, análogos a los conjuntos de Cantor, y dimensión de Hausdorff no entera (1986).

“Fantasía sobre el tema de los fractales, análogos a los conjuntos de Cantor, y dimensión de Hausdorff no entera” (1986), ilustración perteneciente al libro “Homotopic Topology”, que también fue recogida en el libro “Mathematical Impressions”

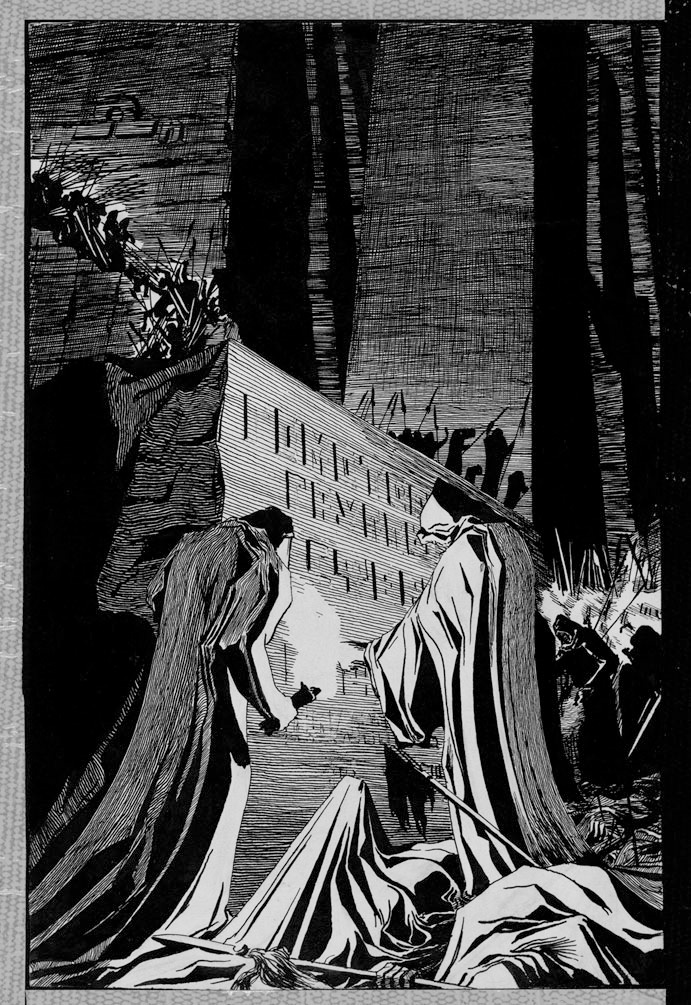

Y la última ilustración que incluimos de Homotopic Topology tiene el enigmático título, para aquellas personas de fuera del mundo de las matemáticas, o más concretamente, de la topología algebraica, El problema de un algoritmo efectivo de cálculo de los grupos de homotopía de las esferas no está resuelto (ya aparece en la publicación de 1986).

“El problema de un algoritmo efectivo de cálculo de los grupos de homotopía de las esferas no está resuelto”, ilustración perteneciente al libro “Homotopic Topology”, que también fue recogida en el libro “Mathematical Impressions”

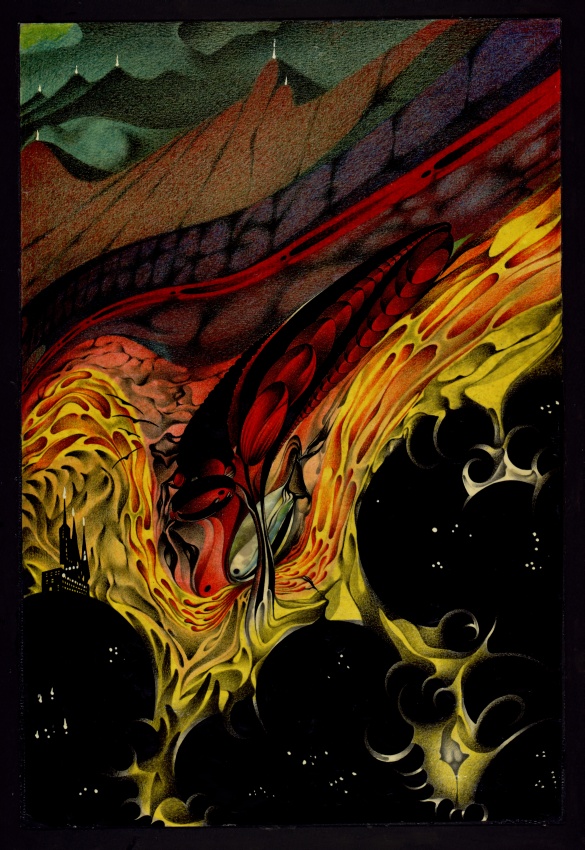

El matemático ruso continuó trabajando en la misma línea durante los siguientes años, llegando a realizar al menos 280 ilustraciones artísticas de conceptos y resultados matemáticos, no solamente de geometría y topología, sino también de otros tópicos como estadística, probabilidad o teoría de números.

En el libro Mathematical Impressions, publicado por la American Mathematical Society, en 1990, se incluyeron 84 ilustraciones, 23 de las cuales eran en color.

En la introducción de este libro A. T. Fomenko escribe: “Pienso en mis dibujos como si fueran fotografías de un mundo extraño, pero real, y la naturaleza de este mundo, uno de objetos y procesos infinitos, no se conoce bien. Claramente, existe una conexión entre el mundo matemático y el mundo real…. Esta es la relación que yo veo entre mis dibujos y las matemáticas.“

A continuación, mostraremos algunas ilustraciones incluidas en este libro tan especial, que es Mathematical Impressions.

“Una superficie algebraica de Kummer y sus puntos singulares” (1971), del libro “Mathematical Impressions”, de A. T. Fomenko

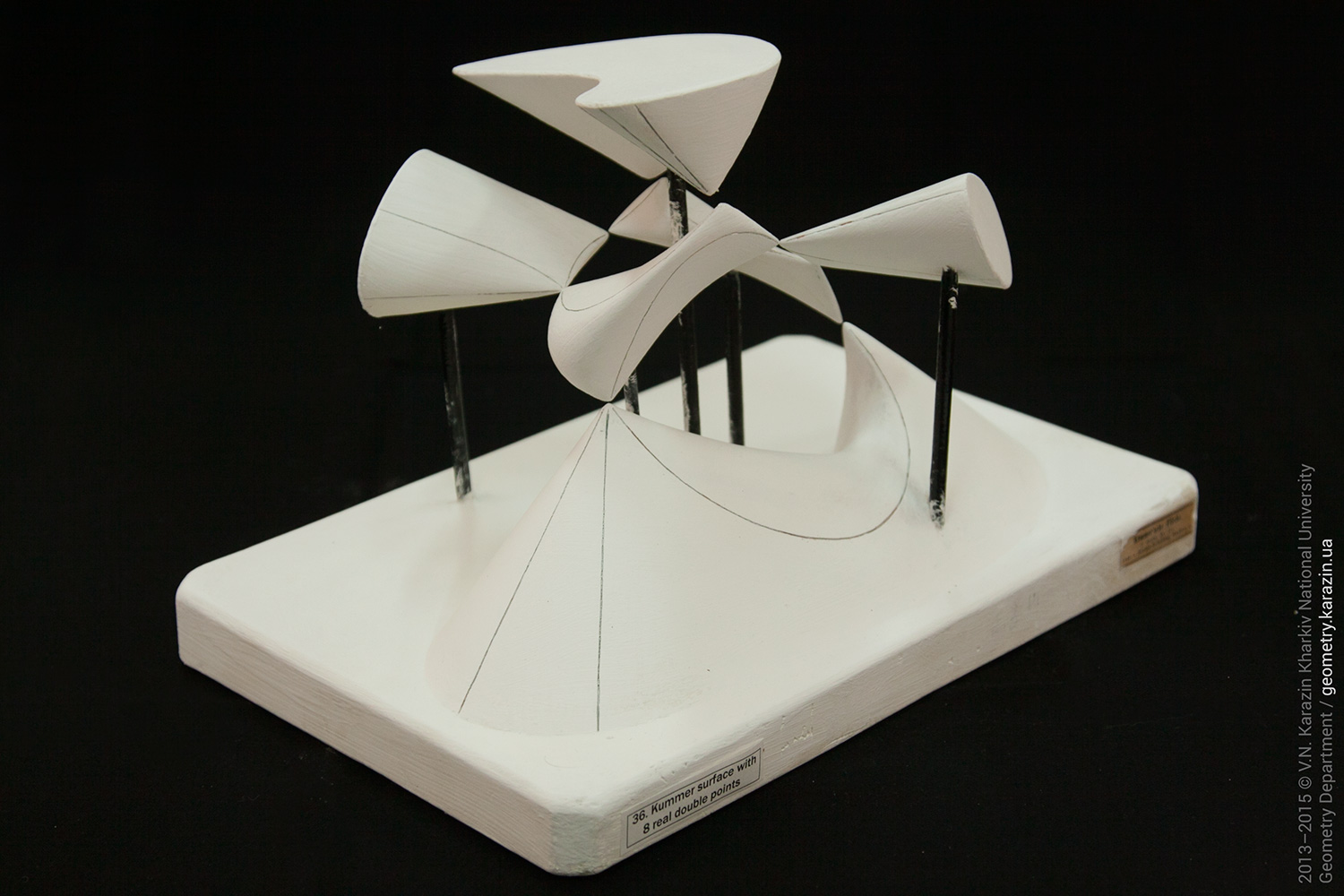

Las superficies de Kummer son superficies algebraicas que tienen dieciséis puntos singulares. El ejemplo de Fomenko tiene 8 puntos singulares reales, como la superficie cuyo modelo físico (del Touch Geometry Project) mostramos a continuación.

Modelo físico de una superficie der Kummer con 8 puntos dobles reales, del proyecto Touch Geometry Project, de la Universidad Nacional de V. N. Kazarin Kharkiv

La siguiente obra recibe el título Fantasía geométrica sobre el tema de las funciones analíticas (1971).

“Fantasía geométrica sobre el tema de las funciones analíticas” (1971), del libro “Mathematical Impressions”, de A. T. Fomenko

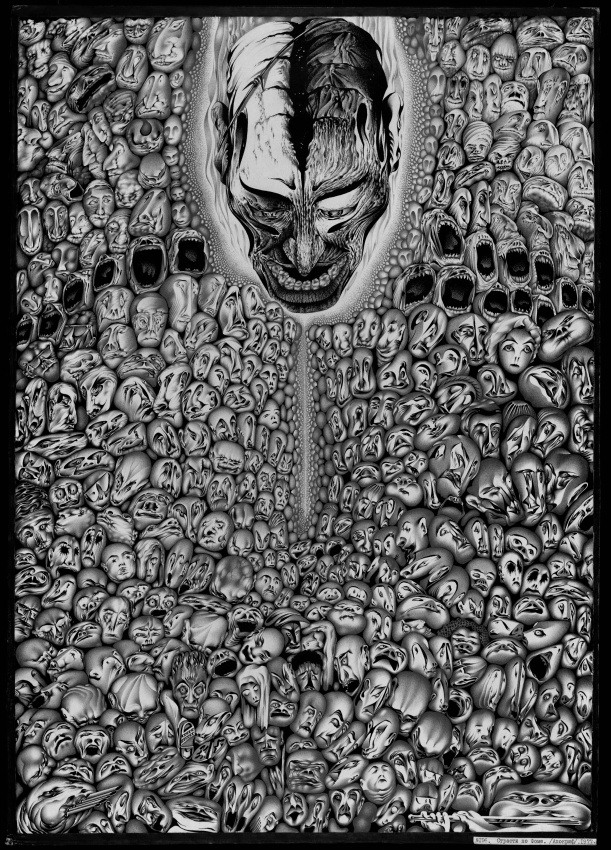

También nos encontramos con una representación del infinito en la obra Infinito matemático (1977). El texto que acompaña la imagen es el siguiente:

“Miles de caras en una multitud gritan, rodeando una sola cabeza ominosa. De hecho, esta imagen refleja las meditaciones de los matemáticos sobre el infinito, un concepto que acompaña a muchas teorías y que aparece de diferentes maneras en geometría, lógica, teoría de números y muchas otras áreas. Infinito potencial y real, paradojas de lógica, problemas irresolubles, la hipótesis del continuo y sus diversas versiones, matemáticas constructivas, intuicionismo (en el espíritu de Poincaré) -todos estos cobran vida mediante la existencia del infinito matemático, cuyo estudio presenta fascinantes problemas filosóficos sobre el conocimiento del mundo que nos rodea. En cuanto a las personas, un homeomorfismo adecuado puede identificar a diferentes seres humanos desde un punto de vista geométrico, comenzando con un único sujeto ideal. Todo esto también recuerda a los muchos artistas medievales que trataron de reflejar sus interpretaciones de infinitos físicos y morales sobre lienzos dedicados a los sufrimientos de Jesucristo.”

“Infinito matemático” (1977), del libro “Mathematical Impressions”, de A. T. Fomenko

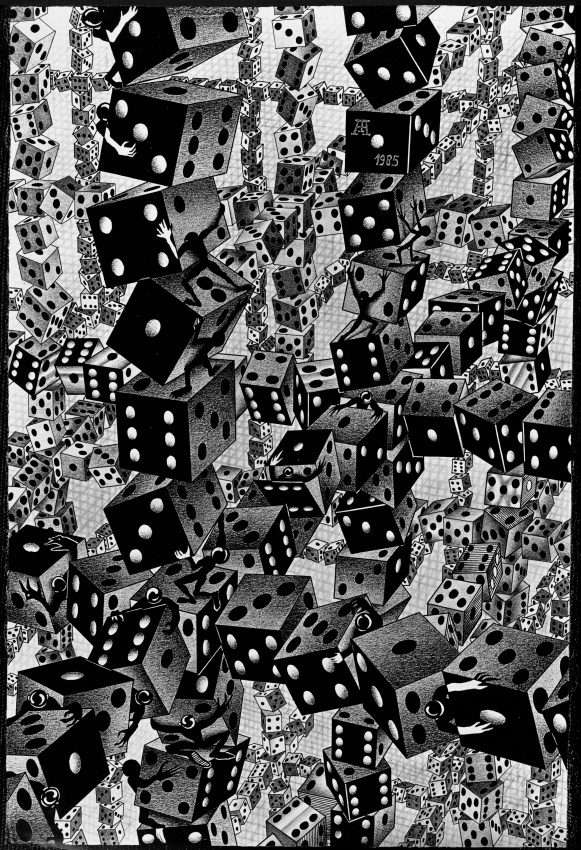

También realizó ilustraciones relacionadas con la probabilidad, como esta obra titulada Procesos aleatorios en probabilidad (1985).

“Procesos aleatorios en probabilidad” (1985), del libro “Mathematical Impressions”, de A. T. Fomenko

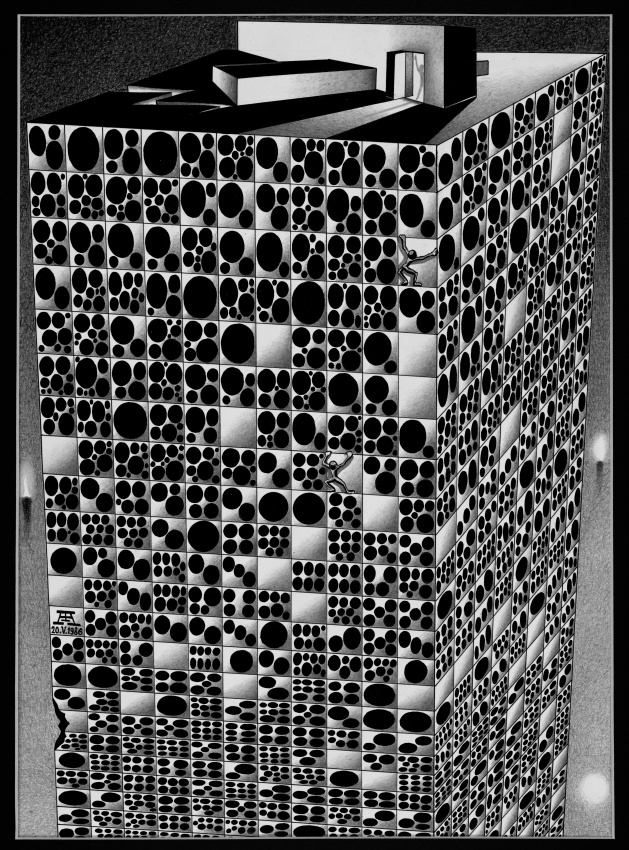

También reflexiones visuales sobre los importantes números irracionales π y e, como la obra Los remarcables números π y e (1985), en la que vemos los primeros decimales del número π (3,1415926535 8979323846 2643383279…), en la cara frontal del edificio, y los del número e (2,7182818284 5904523536 0287471352…), en la cara lateral.

“Los remarcables números π y e (1985)”, del libro “Mathematical Impressions”, de A. T. Fomenko

Y terminemos, casi, con dos ilustraciones con títulos incomprensibles para las personas que no trabajan en estos temas.

“Espines de dos variedades hiperbólicas cerradas compactas de dimensión 3” (1987), del libro “Mathematical Impressions”, de A. T. Fomenko

“Puntos singulares de campos de vectores y la capa frontera en el flujo de un líquido alrededor de un cuerpo rígido” (1980), del libro “Mathematical Impressions”, de A. T. Fomenko

Y para terminar, esta vez sí, una obra relacionada también con temas no matemáticos.

“La tentación de San Antonio” (1979), del libro “Mathematical Impressions”, de A. T. Fomenko

Bibliografía

1.- Anatoly T. Fomenko, Mathematical Impressions, AMS, 1990.

2.- B. A. Dubrovin, S. P. Novikov, A. T. Fomenko, Modern Geometry. Methods and Applications. Springer-Verlag, GTM 93 (Part 1), 1984; GTM 104 (Part 2), 1985; GTM 124 (Part 3) 1990.

3.- A. T. Fomenko Symplectic Geometry. Methods and Applications. Gordon and Breach, 1988.

4.- A. T. Fomenko, D. B. Fuchs, V. L. Gutenmacher, Homotopic topology, Akademiai Kiadó, 1986.

5.- Anatoly Fomeko, Dimitry Fuchs, Homotopical Topology, Akademiai Kiadó, 1989 (Springer, GTM 273, 2016).

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Ilustraciones artísticas de un matemático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Variaciones artísticas del teorema de Napoleón

- Pierre Fatou, un matemático poco (re)conocido

- El problema matemático de las cartas extraviadas

Respuesta de los sistemas respiratorio y cardiovascular al ejercicio físico

Cuando el organismo humano pasa de encontrarse en condiciones de reposo a desarrollar una actividad física intensa, sus sistemas respiratorio y cardiovascular modifican sus prestaciones para dar respuesta a las demandas metabólicas elevadas que impone la actividad física. Ya vimos aquí como se regula la respiración, y aquí y aquí, la circulación sanguínea, que son las dos funciones que permiten ajustar el suministro de oxígeno a las necesidades. Veremos a continuación cuáles son las magnitudes propias del funcionamiento del sistema respiratorio y del sistema cardiovascular en condiciones de reposo, primero, y de actividad intensa después.

Reposo

En condiciones de reposo respiramos entre unas catorce y dieciséis veces (ciclos completos de inspiración y espiración) por minuto; o sea, nuestra frecuencia respiratoria (fr) se encuentra entre 14 y 16 min-1. Un hombre inspira en cada ocasión (VC: volumen corriente) alrededor de 0,5-0,6 l y una mujer 0,4-0,5 l; en otras palabras, en cada una de esas inspiraciones introducimos alrededor de medio litro de aire nuevo en los pulmones. Por lo tanto, el volumen de medio respiratorio inspirado y espirado por unidad de tiempo (V: tasa ventilatoria) es de unos 7,5 l min-1.

No obstante, a los 300 millones de alveolos (similares a microburbujas de 0,3 mm de diámetro y cuya superficie total equivale a 100 m2) no llegan los 7,5 l-1, sino 5,4 l min-1, ya que la diferencia corresponde al volumen inspirado que llena los conductos (bronquios y bronquiolos) que no participan en el intercambio respiratorio y son, por lo tanto, espacio muerto.

Por otro lado, en caso de necesidad, pueden introducirse mayores volúmenes de aire en los pulmones (VIR: volumen inspiratorio de reserva): hasta tres litros (VIR = 3 l) los hombres y dos litros (VIR = 2 l) las mujeres. También pueden expulsarse mayores volúmenes en la espiración. Ese volumen adicional que puede ser exhalado (VER: volumen espiratorio de reserva) es de 1,2 l, en los hombres, y 0,8 l, en las mujeres, aproximadamente. Pero hay un volumen residual (VR) que no es posible desalojar: 1,2 l y 1 l en hombres y mujeres, respectivamente. La capacidad pulmonar total (CPT) masculina es de 6 l y la femenina de 4,2, aproximadamente.

El aire inspirado tiene una presión parcial de oxígeno (pO2) de 158,8 mmHg pero la del oxígeno de los alveolos se encuentra entre 100 mmHg y 105 mmHg.

En condiciones de reposo a la sangre pasan 0,3 l min-1 en los hombres. Esa es su tasa de consumo de oxígeno (VO2 = 0,3 l min-1) en reposo.

En esas condiciones, el corazón late setenta veces por minuto (frecuencia cardiaca: fh= 70 min-1) y el volumen impulsado en cada latido (volumen sistólico: VS) es de 71 ml. El gasto cardiaco –volumen de sangre impulsado por el corazón por unidad de tiempo- es de 5 l min-1. Como tienen alrededor de 5 l de sangre, necesitan alrededor de un minuto para hacer pasar toda su sangre por el corazón. Esas cifras corresponden a hombres sin entrenar; si se trata de atletas de resistencia, VS rondaría los 100 ml y fh sería de unos 50 min-1, aunque puede ser incluso inferior.

La tensión parcial de oxígeno en la sangre arterial (tO2A) es de unos 95 mmHg, y la de la que llega procedente de los tejidos (tO2V), de unos 40 mmHg, y la diferencia entre las concentraciones arterial y venosa de oxígeno (CA –CV) es de 0,06 l O2 por litro de sangre.

Actividad intensa

Durante la realización de ejercicio físico intenso la frecuencia respiratoria puede pasar de 16 min-1 a 40-60 min-1, dependiendo del individuo y de la intensidad del esfuerzo.

El volumen inspiratorio puede llegar a valores máximos de 2 l (en reposo era de 0,5 l), y la tasa ventilatoria pasa de los 7,5 l min-1 del estado de reposo a valores de entre 90 y 120 l min-1 en condiciones de intensa actividad. En esas condiciones el consumo de oxígeno (VO2)puede llegar a 3 o 4 l min-1 en hombres jóvenes no entrenados, y a 5 l min-1 en jóvenes con entrenamiento de resistencia.

La presión parcial de oxígeno en condiciones de actividad intensa puede aumentar hasta pO2 = 115 mmHg dependiendo del nivel de actividad y, por lo tanto, de demanda metabólica; cuanto mayor es la demanda más alta es la presión parcial alveolar porque, como hemos visto, la frecuencia respiratoria y tasa ventilatoria aumentan, elevándose de esa forma la renovación de aire y, en consecuencia, su presión parcial de oxígeno.

Para poderlo sostener, el corazón puede bombear hasta 20 l min-1 (en hombres jóvenes no entrenados) y para ello, ha de latir a frecuencias cardiacas que pueden alcanzar los 190 latidos por minuto (min-1), y el volumen sistólico pasar a unos 105 ml. Los hombres con entrenamiento de resistencia pueden alcanzar valores de gasto cardiaco de 35 l min-1, con frecuencias cardiacas (fh) similares o algo inferiores a las de los hombres no entrenados, pero volúmenes sistólicos (VS) de cerca de 180 ml.

Conforme aumenta la demanda de oxígeno por parte de la musculatura esquelética, la diferencia entre las concentraciones de oxígeno de la sangre arterial y la sangre venosa (CA –CV) aumenta de los 0.06 l por litro de sangre de las condiciones de reposo a máximos de 0,14 l O2 por litro de sangre para consumos de oxígeno de 5 l min-1.

Bajo condiciones de reposo los músculos reciben muy poca sangre, pero en condiciones de trabajo máximo, 1 kg de músculo esquelético puede llegar a recibir 2,5 l min-1. Dado que esa cifra representa más de un 10% del gasto cardiaco, no es posible mantener más de 10 kg de músculo (la tercera parte de toda la musculatura) trabajando a máximo nivel, puesto que hay que seguir irrigando e encéfalo y el corazón, en primer lugar, y otros órganos y tejidos aunque estos recibiendo muy poca sangre. Aquí puedes encontrar una descripción detallada de cómo se reorganiza el flujo sanguíneo al pasar de reposo a la actividad intensa.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Respuesta de los sistemas respiratorio y cardiovascular al ejercicio físico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El flujo sanguíneo se reorganiza en respuesta a las necesidades

- La curva de disociación de un pigmento respiratorio

- Regulación de la circulación (1): control del sistema cardiovascular

Generalización de la invariancia: principios de covariancia y equivalencia

En la nave “Avalon”, que aparece en la película “Passengers”, la aceleración que produce el giro alrededor del eje central de la nave proporciona un efecto idéntico al de la gravedad para los pasajeros; ese es el principio de equivalencia. A pesar de ello, las leyes de la física siquen siendo las mismas dentro de la nave; ese es el principio de covariancia.

Entre 1907 y 1916 Einstein empleó buena parte de su tiempo y esfuerzos en la generalización de la teoría de la invariancia a marcos de referencia no inerciales [1]. Si bien el resultado de estos trabajos, la que después se conocería como teoría general de la relatividad, es sustancialmente más compleja que la teoría especial, en lo que sigue emplearemos lo que ya hemos aprendido de la teoría especial para comprender algunos aspectos importantes de la teoría general y después explorar algunas de sus implicaciones.

Sabemos que la teoría especial se basa en dos principios básicos, el principio de relatividad y la constancia de la velocidad de la luz. De forma similar, la teoría general también se basa en dos principios: el principio de covariancia [2] y el principio de equivalencia. Vamos a ver que los dos son muy fáciles de plantear y entender, otra cosa mucho más complicada es expresar sus consecuencias matemáticamente, algo en lo que no entraremos.

El principio de covariancia se puede resumir diciendo que las leyes de la física son las mismas en todos los marcos de referencia. Una afirmación que nos retrotrae al principio de relatividad de la teoría especial:

Todas las leyes de la física son exactamente las mismas para cada observador en cada marco de referencia que está en reposo o moviéndose con una velocidad relativa uniforme. Esto significa que no hay ningún experimento que se pueda realizar dentro de un marco de referencia que revele si éste está en reposo o moviéndose a una velocidad uniforme.

El principio de covariancia es pues una generalización del principio de relatividad [3]: mientras que éste se limita a los marcos de referencia inerciales, el principio de covariancia dice que las leyes de la física son las mismas en cualquier marco de referencia, independientemente de cómo se esté moviendo respecto a otro. Es en este sentido cómo las teorías de la relatividad se distinguen en especial y general: mientras que la teoría especial se aplica cuando se dan ciertas circunstancias especiales (siempre que estemos tratando con marcos de referencia inerciales), la teoría general carece de esta restricción.

El otro principio básico de la teoría general es el principio de equivalencia que viene a decir que los efectos debidos a la aceleración y los debidos a la gravedad son indistinguibles. Puede parecer una afirmación huera, porque ya sabíamos que la gravedad provoca una aceleración en física newtoniana y la relación ya la conocía el propio Newton.

¿Qué novedad introduce Einstein entonces? En la física de Newton aceleración y gravedad son tratadas como dos fenómenos separados y la relación entre ellas como una coincidencia. Pero el principio de equivalencia afirma que esencialmente no existe diferencia entre ambos efectos: no podemos distinguir entre ellos.

Esta equivalencia esencial entre aceleración y gravedad se suele ilustrar con el experimento mental del ascensor. Imagina que estás en una caja de ascensor sin ventanas, y que la caja está depositada en la superficie de la Tierra estática, pero tú no lo sabes. Comienzas a hacer experimentos físicos para ver qué puedes averiguar de tu situación. ¿Qué mides? Pues mides que los objetos que dejas libres a la altura de tu hombro se mueven con movimiento uniformemente acelerado hacia el suelo (sabes que es el suelo porque hay una fuerza que te empuja hacia esa superficie y, por eso, la llamas suelo) con una aceleración constante de 9,8 m/s.

Ahora supongamos que, de nuevo sin que tú sepas nada, la caja de ascensor se mueve por el espacio interestelar (y, por tanto, no le influye significativamente ningún campo gravitatorio) con una aceleración uniforme de 9,8 m/s en la dirección perpendicular a lo que tú antes llamabas suelo y sentido “del suelo al techo”. De nuevo, tus experimentos te llevarían en estas circunstancias exactamente a los mismos resultados. Es decir, los efectos prácticos de aceleración y gravedad son idénticos y no puedes distinguir una situación de otra.

Notas:

[1] Los marcos de referencia que están en reposo o se mueven con velocidad uniforme en relación con otro marco de referencia son llamados marcos de referencia inerciales, ya que la ley de inercia de Newton se cumple en ellos. Los marcos de referencia que se aceleran respecto a otros se denominan marcos de referencia no inerciales.

[2] Recibe varios nombres según el texto que consultemos: principio de covariancia, de covariancia general o general de la relatividad. Nosotros preferimos el nombre más eficiente.

[3] Einstein se refería a él como principio general de la relatividad.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Generalización de la invariancia: principios de covariancia y equivalencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de relatividad (3): la invariancia de Galileo

- El principio de relatividad (y 4): la versión de Einstein

- ¿La teoría de la invariancia es física o metafísica?

Ingredientes para la receta: El garbanzo

“-Lo que real y verdaderamente tengo son dos uñas de vaca que parecen manos de ternera, o dos manos de ternera que parecen uñas de vaca; están cocidas con sus garbanzos, cebollas y tocino, y la hora de ahora están diciendo: “¡Cómeme! ¡Cómeme!”

-Por mías las marco desde aquí –dijo Sancho-, y nadie las toque, que yo las pagaré mejor que otro, porque para mí ninguna otra cosa pudiera esperar de más gusto, y no se me daría nada que fuesen manos, como fuesen uñas.”

Miguel de Cervantes, Don Quijote de La Mancha, 1605.

Oda al garbanzo

Si a pensar en los males de Castilla

y en su miseria y desnudez me lanzo,

como origen fatal de esta mancilla,

te saludo, ¡Oh garbanzo!

Tú en Burgos, y en Sigüenza, y en Zamora,

y en Guadalajara, capital del hielo,

alimentas la raza comedora,

y así le crece el pelo.

Esa tu masa insípida y caliza,

que de aroma privó naturaleza,

y de jugo y sabor, ¿qué simboliza?

vanidad y pobreza.

En El Practicón, de Ángel Muro, “de un eminente poeta” anónimo, 1894.

Siempre podemos empezar a tratar del garbanzo con una buena receta, esa de las manos de vaca de El Quijote que, como solo él sabe hacer, degustará con entusiasmo Sancho, que para eso se apellida Panza.

Limpiamos, raspamos, cortamos las manos de vaca y las maceramos en vinagre con zumo de limón. Las sacamos, lavamos y al puchero a cocer con cebolla, unos pimientos choriceros, laurel, perejil, pimienta, azafrán, garbanzos que han estado a remojo la noche anterior, y vinagre. Cocer hasta que todo esté tierno y, si se necesita, añadir agua caliente. Y a la mesa.

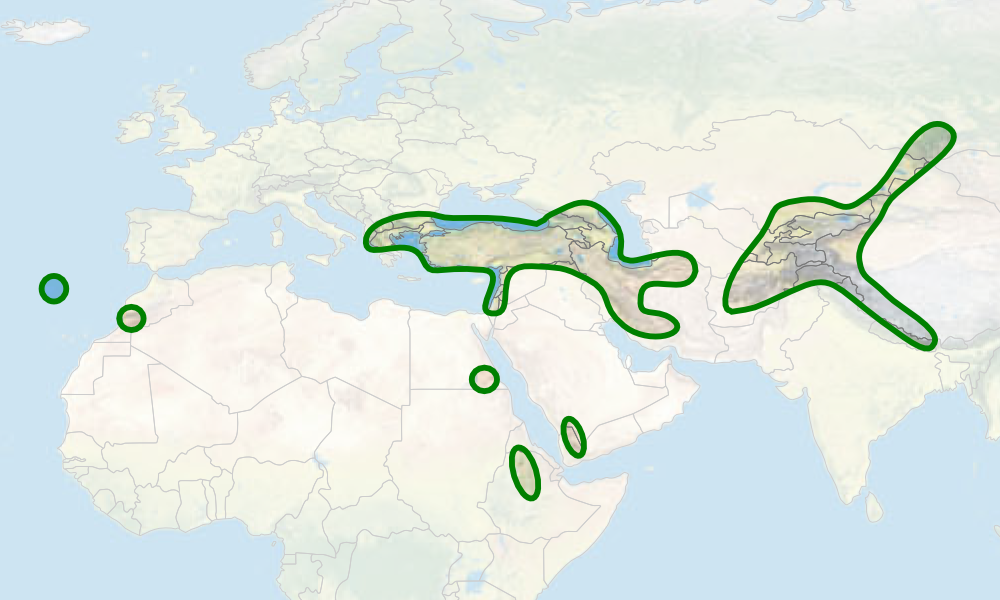

El garbanzo, de nombre científico Cicer arietinum y perteneciente a la familia Fabaceae, es una planta que crece en climas cálidos, con pluviometría superior a 400 milímetros, aunque tiene problemas de cultivo con exceso de agua. Es una herbácea anual, de unos 50 centímetros de altura, con tres o cuatro granos como máximo en cada pie. Tiene muchas variedades pero destacan dos como origen de otras: el tipo Kabuli, de grano medio o grande, liso, redondeado, de color crema y que se cultiva en el Mediterráneo y Asia occidental, y procedente de Kabul, en Afganistán, llegó a la India en el siglo XVIII; y el tipo Desi, rugoso, más pequeño y de color marrón oscuro, y se siembra entre Irán y la India. El tipo Desi tiene más variabilidad genética que el Kabuli y, por ello, los expertos suponen que este deriva de aquel y que su aparición es relativamente reciente. Además, el Desi se parece más al Cicer reticulatum, el antecesor silvestre del garbanzo domesticado. Sin embargo, algunos de los estudios genéticos parecen indicar que el tipo Kabuli también deriva directamente del Cicer reticulatum, tal como sugiere Deepak Ohri, de la Universidad de Uttar Pradesh, en la India.

Por otra parte, como ocurre en muchas especies domesticadas, el garbanzo doméstico tiene poca variabilidad genética, tal como dijo Vavilov. En varios momentos del proceso de domesticación, ha pasado por cuellos de botella que han reducido su población y su variabilidad. Solo algunas variedades han superado estos cuellos de botella y han llegado a nuestros campos.

Garbanzo kabuli (izquierda) y desi (derecha)

Según Shahal Abbo, han sido cuatro estos cuellos de botella. En primer lugar, partimos de una especie antecesora, Cicer reticulatum, con una distribución geográfica restringida y, por tanto, y, en segundo lugar, con escasa variabilidad genética. En tercer lugar, el garbanzo pasó por un proceso selectivo muy fuerte para convertirse en cultivo de verano. Y, finalmente, se eliminaron muchas variedades locales cuando se seleccionaron, por su eficacia en el cultivo, los dos grandes tipos, Desi y Kabuli.

En España y por hibridación y selección se han obtenido muchas variedades: Fardón, Puchero, Alcazaba, Bujeo, Pedrosillano, Lechoso, Blanco Andaluz, el de Fuentesaúco, el de Pico Pardal, y otras más. Escriben José del Moral y su grupo, del Servicio de Investigación y Desarrollo Tecnológico de la Junta de Extremadura, que, en España, la superficie dedicada al cultivo del garbanzo ha pasado por grandes variaciones en el último siglo. Entre 1919 y 1936, de media eran unas 2400000 hectáreas al año, para subir hasta casi 4000000 de hectáreas durante la Guerra Civil y los diez años siguientes. Desde 1950, la superficie disminuye hasta las 44000 hectáreas en 1993, con un aumento hasta casi 150000 hectáreas en 1996 cuando se empieza aplicar la Política Agraria Común de la Unión Europea. En 2015, la disminución de la superficie dedicada al garbanzo es notable y quedan 38000 hectáreas. Sin embargo, la productividad llega a las dos toneladas de garbanzos por hectárea.

Se ha secuenciado el genoma de 90 genotipos de garbanzo, con más de 28000 genes y ha servido para encontrar hasta 77 variantes que mejoran diversos aspectos de su cultivo.

Es la segunda o tercera especie de legumbre más cultivada, según los años, y se siembra desde la cuenca mediterránea, al oeste, y Etiopía, al sur, hasta la India, en el este. Es la India el primer productor mundial y allí, de media y entre 2000 y 2004, se recogió el 63% de la cosecha. Le siguen Turquía, con el 8%, Pakistán, con el 7%, e Irán, con el 4%. También son zonas de cultivo de garbanzo Australia, el Mediterráneo, Asia occidental, y en las Grandes Llanuras de Estados Unidos. En el año 2013, la cosecha mundial de garbanzos fue de algo más de 13 millones de toneladas, con casi 9 millones recogidas en la India.

Además, la India es también el mayor importador, con 133000 toneladas en 2004. En cuarto lugar está España con 58000 toneladas en 2004. Sin embargo, solo entre el 5% y el 10% de la producción mundial entra en el comercio internacional. El garbanzo es un cultivo muy consumido por las comunidades que lo cultivan. El mayor exportador es Australia, con 150000 toneladas en 2004, seguido de Turquía, con 133000 toneladas, e Irán, con 85000 toneladas.

Presentación de hummus con aceite de oliva

Es un alimento habitual desde Oriente Próximo hasta la India y el ingrediente básico del hummus, del falafel y es habitual en el cuscús. El garbanzo se come asado, cocido, frito y molido para obtener harina.

Destaca, entre otros cultivos domésticos del Oriente Próximo, por ser de verano y no de invierno. Es resistente a la sequía y con pocas necesidades de agua. Shahal Abbo, de la Universidad Hebrea de Jerusalén, indica que le basta con el agua del rocío.

Lo habitual en esas plantas domesticadas del Creciente Fértil es que germinen en otoño, florezcan al final del invierno y principio de la primavera, y maduren al comienzo del verano. Es lo típico en los ancestros del trigo, la cebada, la lenteja, el guisante e, incluso, del garbanzo silvestre, el Cicer reticulatum. En la actualidad, todos mantienen este ciclo excepto el garbanzo. Es una planta que se siembra en primavera y se recoge en verano. Fueron griegos y romanos quienes nos dan las evidencias más antiguas del garbanzo como planta que se siembra en marzo y abril.

Planta en flor

En Oriente Próximo, en el Crecente Fértil, más del 80% de la lluvia anual cae entre diciembre y enero, y el largo verano es cálido y seco. El cultivo que necesite agua en verano solo tiene la que queda en el suelo. Es este ciclo anual de lluvias el que ha seleccionado las plantas a sembrar en otoño y recoger al inicio del verano. Abbo plantea la incógnita que supone cambiar del garbanzo silvestre de invierno y de éxito por el cultivo más arriesgado del garbanzo de verano, doméstico y actual. Durante milenios ha sido, en el entorno de Asia, Oriente y el Mediterráneo uno de los escasos cultivos de verano. Además, con este paso de invierno a verano se evita el daño que produce un hongo, Didymella rabiei, que provoca la llamada rabia del garbanzo. El hongo necesita humedad y en el cálido y seco verano no la tiene.

El garbanzo silvestre, antecesor del cultivado, solo se localiza en el sudeste de Turquía y, en concreto, en solo 18 localidades. Es la especie Cicer reticulatum. Además, el garbanzo es la única especie cultivada del género Cicer.

Con fecha de hace 13000 a 11000 años, el garbanzo se encuentra en yacimientos del Oriente Próximo, en Tell Abu Hureyra, en el norte de la Siria actual. De hace 10500 años ha aparecido en Cayonii, en el sudeste de Turquía, en Jericó, en Israel, y en Tell Ramad, en el sur de Siria, yacimientos situados lejos del área de distribución del garbanzo silvestre y, por ello, quizá cultivados aunque todavía sin seleccionar el garbanzo actual. Se considera que fue domesticado hace entre 7000 y 10000 años en Asia occidental.

Distribución del garbanzo según Maesen et al (2007): “Taxonomy of the genus Cicer revisited”.

Para Deepak Ohri, la fecha más temprana a la que conocemos con certeza la existencia del garbanzo doméstico es de 10600 a 12250 años en el yacimiento de Tell el-Kerkh, en el noroeste de Siria, donde se encuentra a la vez y se distinguen claramente granos de garbanzo silvestre y de garbanzo domesticado. En esta excavación, Ken-Ichi Tanno y George Willcox, del centro Archeorient del CNRS en Minneapolis, en Francia, recogieron un centenar de granos de garbanzo con una morfología variable y que iba del reticulatum al arietinum, es decir, del silvestre al domesticado. Como este yacimiento está lejos del área de distribución original del garbanzo silvestre, los autores consideran que la domesticación ocurrió mucho tiempo antes de esta fecha de hace 10000 años.

Hace 7500 años aparece en yacimientos en Jericó, en Israel, y en Cayonii y Hacilar, en Turquía. Por su presencia en los yacimientos, hace 6000 años eran alimento habitual en Palestina. Y de hace casi 7000 años aparece en la cueva L’Abenrador, en Francia.

Son los garbanzos de consumo habitual en la Palestina de hace 6000 años, según los restos encontrados en los yacimientos. En la India, los restos más antiguos son de hace 5000 años.

También hace unos 5000 años, en la Edad del Bronce de Grecia, se han encontrado garbanzos en yacimientos del la isla de Creta. En estos años ya se encuentra el garbanzo en la cuenca mediterránea y Oriente Próximo y, en la misma época, ha alcanzado la cultura Harapa, entre los actuales estados de la India y Pakistán. En la Edad del Hierro, con fechas entre 3300 y 2500 años, aparece por primera vez en Etiopía, uno de los mayores cultivadores y consumidores actuales.

Hay un curioso e inexplicable lapso de hallazgos de garbanzo doméstico hace entre 8000 y 11000 años. Algunos autores han propuesto que se debe a que entonces se estaban seleccionando las variedades para el actual cultivo de verano del garbanzo.