Montañeros, espeleólogos y mineros

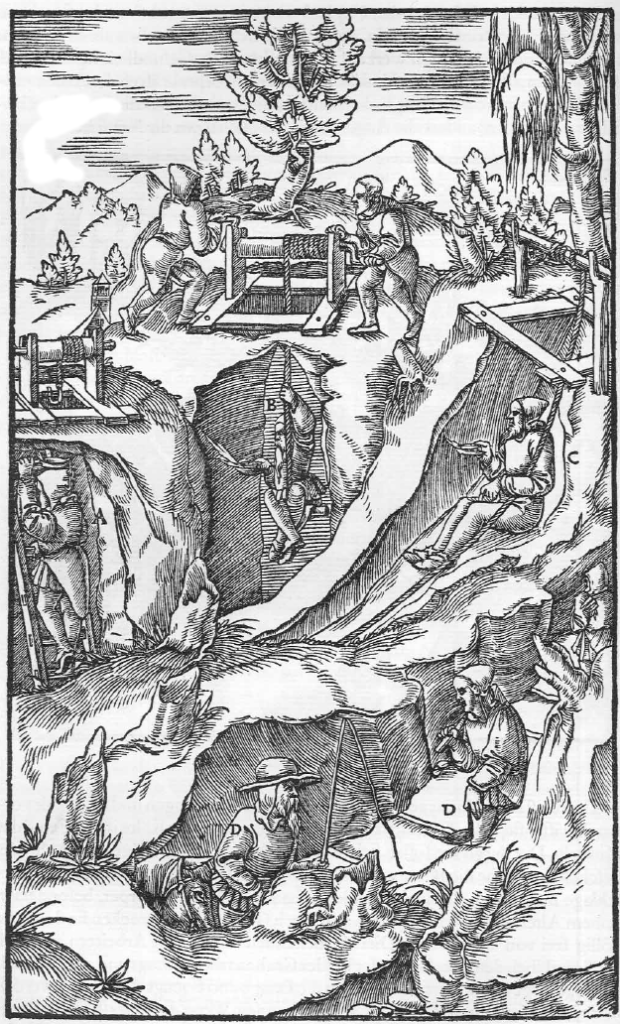

Ilustración del libro XII de “De re metallica” (1556) de Georg Bauer “Agricola”

Desde el Renacimiento has el siglo XVIII produjeron clasificaciones de minerales y rocas una tras otra. Entre las más importantes cabe mencionar la del ingeniero de minas y alquimista alemán Georg Pawer (también Bauer), más conocido como Agricola, la del químico sueco Johan G. Wallerius (considerado el padre de la química agrícola, por cierto) o la del geólogo alemán Abraham Gottlob Werner (otro padre, en este caso del neptunismo, algo de lo que nos ocuparemos más adelante).

Todas estas clasificaciones tenían un trasfondo alquímico y todas tenían en común la clasificación general en cuatro grupos en función de sus “químicas”, más concretamente en su relación con el calor y los fluidos: tierras, metales, sales y combustibles. Así, las tierras resistían el calor y el agua, los metales se volvían fluidos al calentarse, las sales se disolvían en los fluidos y los combustibles (como el carbón, por ejemplo) generaban calor al arder.

Como la química era la base de la clasificación de las rocas y minerales, los aprendices y estudiantes pasaban más tiempo en talleres, fundiciones, gabinetes y laboratorios trabajando con sustancias y aparataje químicos que sobre el terreno.

La Calzada del Gigante (Irlanda) está formada por duras columnas de basalto.

Después de siglos de clasificaciones minerales, Werner sería el primero en expresar la frustración que producía el estudio de minerales y rocas desde el punto de vista científico a principios del siglo XIX, concluyendo que no existían y, por tanto, no podían encontrarse, principios teóricos consistentes para la clasificación de los minerales. Una consecuencia de este convencimiento es que Werner empieza a dar instrucciones a sus estudiantes de clasificar las rocas en función del tiempo de su formación (lo que se enmarca en lo que se conoce como estratigrafía, que también veremos más avanzada la serie) y los minerales aparte de la clasificación general se asocian al tipo y antigüedad de las rocas en las que aparecen, algo que estrá relacionado con el origen mismo de esas rocas.

La creciente industrialización junto a la aparición de estados nacionales ilustrados lleva a que los gobiernos comiencen a contratar inspectores de minas, especialistas en sondeos mineros y mineralogistas para que estudien el territorio nacional concienzudamente en busca de riquezas y recursos. Los mineralogistas abandonan sus cubículos para convertirse en montañeros, espeleólogos y mineros.

La blanda piedra arenisca del Cañón del Antílope (Arizona, Estados Unidos) está formada por arena (cuarzo, blanco); los colores los porporcionan mayoritariamente los minerales hematites (rojo), goetita (pardo / amarillo ocre) y limonita (pardo / amarillento claro).

En la segunda mitad del siglo XVIII, estos mineralogistas de aire libre, entre ellos, Lazzaro Moro y Giovanni Arduino en Italia, Johann Lehmann en Alemania o Guillaume-François Rouelle en Francia, encuentran conveniente clasificar las rocas en dos tipos fundamentales: primarias y secundarias.

Las rocas primarias eran duras, a menudo cristalinas, y la matriz en la que se encontraban los metales y minerales preciosos; constituían el núcleo de las cadenas montañosas.

Las rocas secundarias eran relativamente blandas y granulares, a menudo formaban capas o estratos en las laderas de las montañas cuyos núcleos eran las rocas primarias. A menudo, las rocas secundarias contenían fósiles, que ya entonces los mineralogistas consideraban restos endurecidos de animales y plantas.

Esta clasificación tenía que ver con la cosmogonía: el estudio del desarrollo del planeta.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Montañeros, espeleólogos y mineros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Clasificación y origen, los dos problemas de la mineralogía

- Esa pesadilla científica llamada mineralogía

- Potencia y eficiencia de una máquina

La polilla que se parecía a Donald Trump: más allá del chascarrillo

La polilla bautizada en honor a Donald Trump. Imagen: Wikimedia Commons

Con todos ustedes, bajo estas líneas, el escarabajo acuático Grouvellinus leonardodicaprioi, bautizado como habrán podido deducir mis avezados lectores, en honor del actor Leonardo DiCaprio como homenaje a su activismo en favor de la conservación del medio ambiente y para conmemorar el 20 aniversario de la Leonardo DiCaprio Foundation, creada por el actor con este fin.

Leonardo DiCaprio junto al escarabajo que lleva su nombre. Imagen: Wikimedia Commons

Este recién descubierto escarabajo fue encontrado en la cascada en la remota zona de Maliau Basin, en el Borneo Malasio, y su descubrimiento es un logro de la llamada ciencia ciudadana: fue un grupo de excursionistas aficionados el que encontró el espécimen nunca antes descrito. En total descubrieron tres nuevas especies de escarabajos acuáticos, y uno de ellos quisieron dedicarlo a DiCaprio, que ha dedicado sus esfuerzos a proteger el medio ambiente, y en concreto los hábitats vírgenes e inexplorados, como el propio lugar donde su escarabajo vive. “Pequeño y negro, este nuevo escarabajo nunca ganará un Oscar por su carisma, pero en la conservación de la biodiversidad, todas las criaturas cuentan”, ha dicho la entomóloga Iva Njunjic.

Permítanme que les presente a otra amiga. Pueden verla al comienzo de este texto y si se fijan bien en su aspecto quizá puedan adivinar su nombre. Presten atención sobre todo a esas escamas pálidas sobre su cabeza y a su parecido con el proceloso flequillo del hombre a su lado: están ustedes ante un ejemplar de Neopalpa donaldtrumpi bautizada, como no podía ser de otra manera, en recuerdo del actual presidente de Estados Unidos, Donald Trump.

Shakira y sus movimientos de cadera dan nombre a esta avispa. Imagen: Wikimedia Commons

Pero esperen, que traigo más amigos a esta pequeña reunión nuestra. Esta curiosa avispa se llama Aleiodes shakirae en honor a la cantante colombiana Shakira. No es porque se le parezca, o porque Shakira haya hecho nada concreto por ella y su entorno. No, en este caso el homenaje se debe a que “el parasitismo por esta especie causa que la oruga anfitriona doble y retuerza su abdomen de forma muy particular, y Shakira también es famosa por su habilidad en la danza del vientre”, explicaban los bautizadores del insecto.

La tarántula bautizada en honor a Johnny Cash. Imagen: Wikimedia Commons

Y aquí está la araña Aphonopelma johnnycashi. Dado que se puede encontrar en los alrededores de la prisión Folsom, en California, y que los machos a partir de determinada edad son de color negro completamente, sus descubridores decidieron que no había nombre más apropiado para esta especie que un homenaje al cantante Johnny Cash. Y yo coincido en ese juicio.

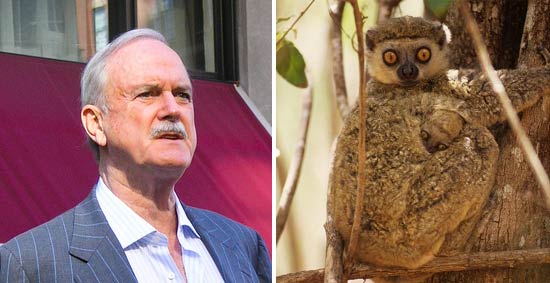

Jonh Cleese y ‘su’ lemur. Imagen: Wikimedia Commons

En 2005 este simpático lemur fue descrito por primera vez y bautizado como Avahi cleesei en honor al actor inglés John Cleese, que en la película Criaturas feroces interpretaba a un cuidador de lemures y que después dio voz y presentó a un afamado documental sobre estos animales.

Para no extenderme, pero no queriendo dejar a nadie atrás, dejad simplemente que mencione a los trilobites Avalanchurus simoni y Avalanchurus garfunkeli (en homenaje a Simon y Garfunkel), al escarabajo Cheguevaria (que recuerda al Che Guevara), al pterosaurio Coloborhynchus spielbergi (bautizada en honor al director Steven Spielbergh), la araña Filistata maguirei (para recordar a Tobey Maguire, actor en tres películas de Spiderman), el mamífero extinto Gagadón (que homenajea a Lady Gaga), la polilla Hellinsia pizarroi (que recuerda al conquistador Francisco Pizarro) o la rana Hyloscirtus princecharlesi (en honor al príncipe Carlos de Inglaterra).

¿Cómo se bautiza a una especie?

Imaginarse a una polilla con un pelucón a lo Donald Trump tiene su gracia. ¿Cómo se convierte eso en el nombre oficial de una nueva especie?

Lo primero que hace falta es asegurarse de que lo que tenemos entre manos es efectivamente una nueva especie lista para ser bautizada. Para eso hace falta designar un holotipo, esto es, un ejemplar que sirva como identificación de esa nueva especie descubierta. También son de ayuda los paratipos, ejemplares complementarios, por ejemplo un macho si el holotipo es una hembra, o una cría de la misma especie, de forma que se puedan reunir y observar todas las características distintivas de la especie descubierta.

Esta rana recibe su nombre del Príncipe Carlos, ya que este siempre utiliza una rana como símbolo en sus campañas para la conservación tropical. Imagen: Wikimedia Commons

Normalmente estos especímenes se conservan en un lugar donde puedan ser examinados por otros científicos, a fin de determinar con seguridad si se trata de una especie nueva o no. La taxonomía es una disciplina en constante discusión y reexaminación, y no son pocas las veces que un ejemplar ha obtenido y perdido después el estatus de especie independiente.

También hace falta una descripción: una recolección de las características que dan forma a una nueva especie. Y aquí las cosas pueden empezar a ponerse delicadas porque el ojo y las palabras son muchas veces subjetivos y por tanto dificultan la diferenciación ente dos animales lo suficientemente parecidos. Características contables, como el número de vértebras o de crías en cada camada, por ejemplo, son aquí más útiles que la descripción de colores o de cantos.

Una vez seguros de que lo descubierto es una especie nueva, entonces llega el momento de nombrarla, puesto que lo que no se nombra no existe. El nombre de una especie (por ejemplo, Homo sapiens) está compuesto por el género al que pertenece (Homo) y después por el apelativo concreto que la identifica (sapiens), ambos latinizados. El proceso de bautizar una nueva especie se completa cuando el nombre y descripción se publica de forma que quede internacionalmente accesible y sea consultable. Esto antes implicaba a revistas científicas de renombre, pero ahora internet ha hecho las cosas más fáciles. Curiosamente el proceso por el que se otorga nombre a nuevas especies es uno de los pocos relacionados con la ciencia que no depende del peer-review, lo que en ocasiones causa confusión si dos nombres se parecen demasiado o si algún nombre no se clasifica correctamente dentro de su género.

Bautizar una especie con el nombre de un famoso: más allá del chascarrillo

Los científicos llevan bautizando animales con nombres de famosos desde el siglo XVIII. Carl Linnaeus, científico suizo que sentó las bases de la taxonomía actual, lo hacía ya para ganarse el favor, y con ello el dinero, de los patrones ricos que así podían ayudarle a continuar con sus investigaciones.

La abeja nombrada en honor a Beyoncé. Imagen: Wikimedia Commons

Algo parecido ocurre hoy: el descubridor de la abeja Scaptia beyonceae sabía perfectamente que relacionando el trasero redondeado y dorado de este animal con el de la cantante Beyoncé se asegura la atención del público, aunque sea solo durante unos pocos pero valiosos segundos. Se trata por tanto de llamar la atención para que, junto con el chistecito del nombre y la gracia que nos hace latinizar el nombre de Shakira hablemos también de algunas de las características de la avispa que ahora lleva su nombre, del hábitat en el que vive el animal en cuestión, de los riesgos que la amenazan, de los esfuerzos de conservación que se realizan pero aun más de los que todavía tenemos que hacer.

Así que se trata de marketing: una estrategia para conseguir que se hable de sus animales, su trabajo (lo que puede a su vez convertirse en más fondos para su investigación) y la conservación del medio ambiente. Hace unas semanas hablábamos aquí mismo de cómo el marketing es una buena opción para la supervivencia de especies que no son majestuosas como un águila o imponentes como un gorila. Los animales feos, sosos o desagradables pueden beneficiarse de una buena campaña de comunicación. Y si eso incluye ser bautizado en honor a Donald Trump, habrá que hacer de tripas corazón y llevar el nombre con dignidad. O con toda la dignidad posible.

Referencias:

Three new species of Grouvellinus Champion, 1923 from Maliau Basin, Sabah, Borneo, discovered by citizen scientists during the first Taxon Expedition – Hendrik Freitag, Clister V. Pangantihon, Iva Njunjić.ZooKeys, 2018; 754: 1 DOI: 10.3897/zookeys.754.24276

How a new species is named – Dr. David Hone, The Guardian

List of organisms named after famous people – Wikipedia

It’s funny to name species after celebrities, but there’s a serious side too – Kevin Thiele, The Conversation

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo La polilla que se parecía a Donald Trump: más allá del chascarrillo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Kim Jong-un, Donald Trump y la geología de la aniquilación

- Naukas Bilbao 2017 – Aitor Sánchez: Si Donald Trump fuese nutricionista

- Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos

Las aves de Prometeo

Milanos negros sobrevolando un fuego que podrían haber iniciado ellos mismos. Imagen: Bob Gosdorf

Las aves tienen capacidades asombrosas. Los pájaros cantores, por ejemplo, tienen excelentes habilidades vocálicas, algunos extraordinarias. El caso más espectacular es el de una especie cuyos machos, para cortejar a la hembra, aprenden un canto nuevo cada año. Los pergoleros macho fabrican pérgolas muy complejas y de gran cromatismo; también lo hacen para conquistar a su pareja. Otras aves fabrican instrumentos, como ganchos para extraer lo que les interesa de lugares de difícil acceso. Hay cuervos que reconocen personas y son capaces de recordarlas durante largo tiempo, sobre todo si, por lo que fuese, las temen. También hay aves que juegan. Como es bien sabido, muchas migran, y algunas de sus migraciones son verdaderas heroicidades, tanto desde el punto de vista físico como cognitivo. Y de algunos pájaros sabemos que son capaces de posponer las gratificaciones a una tarea bien completada a la espera de una recompensa mejor.

Desde hace tiempo los indígenas de las sabanas del norte de Australia sostienen que hay aves que ayudan a propagar fuegos. Algunos bomberos también afirman haber visto a ciertas aves de presa reavivar incendios ya controlados. Algunas de esas observaciones datan de los ochenta del pasado siglo. Pero casi nadie las creía. Hace dos años el ornitólogo Robert Gosford sugirió que esos testimonios podían ser correctos, pero la mayoría de sus colegas manifestaron serias dudas al respecto. Como mucho pensaban que podía tratarse de hechos fortuitos. Sin embargo, las dudas parecen estar disipándose. Un grupo formado por ornitólogos y bomberos han recogido veinte testimonios -considerados fidedignos- de observaciones de aves de presa que propagaban incendios de manera intencionada, y han dado a conocer su investigación en la revista científica Journal of Ethnobiology.

Las observaciones se refieren a las especies Milvus migrans (milano negro), Haliastur sphenurus (milano silbador) y Falco berigora (halcón berigora) y se han realizado en las sabanas septentrionales australianas, aunque los autores del trabajo afirman haber recibido informaciones en el mismo sentido de otras zonas del país. El comportamiento observado consiste en el traslado de pequeñas ramas encendidas de zonas ya quemadas a zonas a las que no ha llegado el fuego. Llevan las ramas de un sitio a otro en el pico o las patas. A veces son actos individuales y en ocasiones son varios los individuos que actúan de forma cooperativa. Aunque no siempre lo consiguen, con frecuencia logran extender el fuego hacia zonas que no habían ardido. Al parecer, solo se comportan así cuando un fuego se ha detenido al llegar a una barrera o por haber sido apagado por los servicios contra incendios. Y solo unos pocos individuos aprenden a hacerlo.

Que hay aves que se valen de los incendios para atrapar presas que huyen de zonas en llamas era algo ya sabido. La novedad que aportan los testimonios recogidos consiste en la participación activa de milanos y halcones en la extensión del fuego. Se trata de un comportamiento de importantes requerimientos cognitivos.

Solemos pensar que los pájaros son animales estúpidos, de escasa inteligencia, entre otras cosas porque nos parece que tienen la cabeza pequeña. Pero eso no es cierto; en la evolución su encéfalo se redujo mucho menos que el resto del cuerpo en relación con el de sus antecesores, los dinosaurios. Además, sabemos muy poco del funcionamientos de ese encéfalo. Y quizás seamos incapaces de valorar de forma adecuada la capacidad cognitiva de las aves, simplemente porque utilizamos la nuestra como referencia y modelo. Prometeo robó el fuego a los dioses y se lo entregó a los mortales. Pero es posible que entre los mortales también incluyera aves de presa.

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 28 de enero de 2018.

El artículo Las aves de Prometeo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Naukas Bilbao 2017 – Sergio Palacios: Precausión, amigo conduztó

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Dolor, aceleraciones y extraterrestres de la mano del inefable Sergio Palacios.

Sergio L. Palacios: Precausión, amigo conduztóEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Sergio Palacios: Precausión, amigo conduztó se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Naukas Bilbao 2017 – Mónica Lalanda: Una muerte de cómic

- Naukas Bilbao 2017 – Laura Morrón: La gran divulgadora

Entrelazamiento cuántico entre dos nubes de átomos ultrafríos

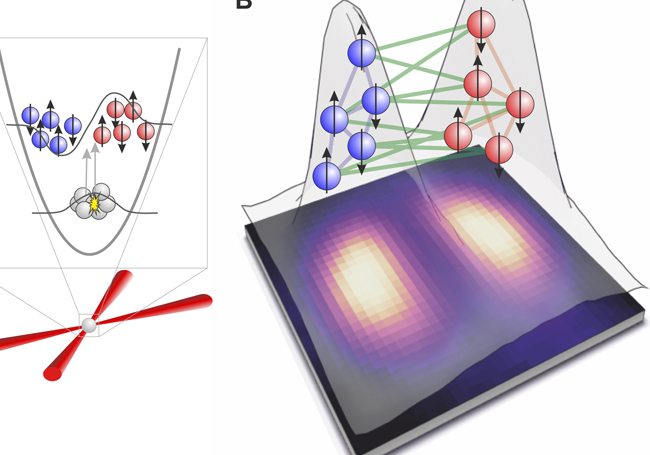

Science publica los resultados de un experimento en el que han colaborado varios miembros del grupo de investigación Quantum Information Theory and Quantum Metrology del Departamento de Física Teórica e Historia de la Ciencia de la Facultad de Ciencia y Tecnología de la UPV/EHU, liderados por Géza Tóth, Ikerbasque Research Professor, y llevado a cabo en la Universidad de Hannover. En el experimento, han conseguido el entrelazamiento cuántico entre dos nubes de átomos ultrafríos, conocidos como condensados de Bose-Einstein, donde los dos conjuntos de átomos estaban espacialmente separados entre sí.

El entrelazamiento cuántico es un fenómeno que no tiene análogo en la física clásica. Los conjuntos de partículas que están entrelazadas pierden su individualidad y se comportan como una sola entidad. Cualquier cambio en una de las partículas conduce a una respuesta inmediata en la otra, incluso si están espacialmente separadas. “El entrelazamiento cuántico es indispensable en aplicaciones como la computación cuántica, ya que permite la resolución de ciertas tareas de forma mucho más rápida que en computación clásica”, explica Géza Toth.

A diferencia de la forma en que se ha creado hasta ahora el entrelazamiento cuántico entre nubes de partículas, utilizando conjuntos de partículas incoherentes y térmicas, en este experimento utilizaron conjuntos de átomos en estado de condensado de Bose-Einstein. Tal como explica Toth, “los condensados de Bose-Einstein se consiguen al enfriar los átomos utilizados a temperaturas muy bajas, cercanas al cero absoluto. A esa temperatura, todos los átomos comparten el mismo estado cuántico, con gran coherencia; se podría decir que todos ocupan la misma posición en el espacio. En ese estado se da el entrelazamiento cuántico entre los átomos del conjunto”. Posteriormente, lo que hicieron fue separar en dos nubes de átomos ese conjunto. “Dejamos una distancia entre las dos nubes de átomos, y pudimos demostrar que seguía habiendo entrelazamiento cuántico entre ellas”, continúa.

La demostración de que se puede crear el entrelazamiento entre dos nubes en estado de condensado de Bose-Einstein puede dar lugar a una mejora en muchos campos en los que se utiliza la tecnología cuántica, como la computación cuántica, la simulación cuántica y metrología cuántica, dado que estas requieren de la creación y el control de un gran número de conjuntos de partículas entrelazadas. “La ventaja que ofrecen los átomos ultra fríos es que se pueden conseguir estados fuertemente entrelazados que contienen cantidades de partículas superiores en varios órdenes de magnitud a otros sistemas físicos, lo cual podrá ser la base para la computación cuántica a gran escala”, relata el investigador.

Referencia:

Karsten Lange, Jan Peise, Bernd Lücke, Ilka Kruse, Giuseppe Vitagliano, Iagoba Apellaniz, Matthias Kleinmann, Geza Toth, Carsten Klempt (2018) Entanglement between two spatially separated atomic modes Science (2018) DOI: 10.1126/science.aao2035

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Entrelazamiento cuántico entre dos nubes de átomos ultrafríos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Física de partículas en un simulador cuántico

- Materia oscura entre nubes intergalácticas

- Un observador cuántico de lo más útil

¡Cuidado! Publicación depredadora a la vista

La historia la contaba Kelly Cobey en una pasada columna para Nature: un colega investigador, ya con tablas y algunas canas, había caído en uno de los más extraños, peligrosos y agresivos timos del mundo científico. Aunque esta estafa lleva bebiendo de las sangres del “publica o muere” muchos años ya, parece que es capaz de atrapar hasta al más experimentado de los investigadores.

Hablamos, nada menos, que de las “revistas depredadoras”, más conocidas como Predatory Journals o, en casos concretos, Open Access Predatory Journals (OAPJ). Esta peligrosa práctica puede bloquear nuestra investigación o hacernos perder una cantidad ingente de dinero. ¿En qué consiste esta engañifa? ¿Cómo podemos reconocer una publicación de este tipo?. Entender cómo operan y qué consecuencias trae el caer en sus garras es crucial para poder defender nuestro paper en el peor de los casos.

¿Qué son los ‘Predatory Journals’?

El nombre de “revista depredadora” fue acuñado por Jeffrey Beall para describir una serie de journals científicos (publicaciones) que se hacen pasar por revistas típicas del ámbito especializado pero que en realidad esconden prácticas abusivas y que en muchos casos rozan la pura estafa. El término “depredador” refleja la naturaleza intencionalmente engañosa de estas revistas, que “cazan” a los investigadores y sus estudios con artimañas diversas.

Entre las estratagemas, y haciéndonos eco de las investigaciones realizadas por el propio Beall o Cobey (et al), estas entidades afirman, por ejemplo, realizar una exhaustiva revisión por pares, cosa que no hacen. También ofrecen un servicio de acceso Open Access, pero más adelante, cuando ya es demasiado tarde para los autores, no cumplen con la conocida como Declaración de Bethesda a la hora de darle acceso gratuito a los investigadores y lectores, faltando en varios puntos a los derechos de autor.

Como guinda de este pastel, los Predatory Journals utilizan tácticas agresivas y trucos sucios para obligar a los autores a enviarles el manuscrito, incluso si estos se han dado cuenta del lío en el que se estaban metiendo. De esta manera, los investigadores se encuentran en una tesitura muy difícil. Para muestra un botón: el encontronazo del que hablábamos resultó ocurrir como sigue.

De investigador a “presa”

Parafraseando a la Dra. Cobey, en 2017 recibió un correo de un colega explicándole su problema con cierta publicación. Al parecer, meses antes había llegado una “invitación” para que publicara el material de cierto estudio en forma de artículo. Unos meses antes, este investigador había hecho una presentación oral mostrando parte de sus resultados. Esta “invitación” parecía la oportunidad perfecta para convertir este esfuerzo en un paper que contara en su currículum.

Tanto el título de la revista como el tema al que se refería el correo que recibió encajaban a la perfección con su especialización. “Qué diablos”, pensaría nuestro desdichado científico. Poco después, tras algunas correcciones menores, el investigador recibió un email explicando que el artículo había sido aceptado para su publicación. “¡Albricias!”. Pero no, no había motivo para alegrarse. Un poco más abajo, en ese mismo mensaje, se incluía un albarán de casi mil dólares por la publicación del artículo en el dichoso journal. “Un momento, a mi nadie me había avisado de esto”.

Así que, molesto por la argucia, el investigador decidió pasar de la publicación y, ya que el trabajo estaba hecho, enviarlo a una publicación legítima y que no tratara de timarle. Durante los siguientes meses le siguieron llegando mensajes de la anterior publicación, claramente depredadora, donde se le seguía solicitando el dinero de la publicación. Cuando su paper fue admitido en la otra editorial (esta vez sí, con una correcta revisión por pares), se alegró. “Albricias, ahora de verdad”. Pero el problema estaba lejos de acabar.

Así son las tácticas depredadoras

Resulta que una vez aceptado y todo preparado para la publicación, los investigadores (y la nueva publicación) se encontraron con que el paper ya había sido expuesto en la web del Predatory Journal de marras. Esto, como cualquiera familiarizado con la publicación científica, la revisión por pares y los embargos sabe, es un problema muy gordo.

Porque una vez publicada la información ya no es susceptible de ser publicada de nuevo en otra revista científica. La única manera posible de hacerlo es eliminando dicho documento. Al solicitarlo formalmente, explicaba Cobey en su artículo, los editores (mal eufemismo para estos estafadores), indicaron que el coste de la retirada del artículo era de unos 300 dólares, aproximadamente.

De esta manera, habían puesto al investigador y a su equipo en jaque: “¿Quiere que lo publiquemos? Bien, son mil dólares. ¿No quiere que lo publiquemos? Bien, son 300 dólares”. Y ante la tesitura, ¿qué haría cualquiera? Este investigador, aconsejado por la Dra. Cobey, contactó con los supuestos miembros editores del Journal y, para su sorpresa, estos indicaron que poco o nada tenían que ver con él, una muestra más de la estafa.

Finalmente, y para alivio del investigador (y a pesar de las semanas de esfuerzo y sufrimiento causadas) la publicación legítima decidió publicar el artículo sin que existiera “perjuicio” para los investigadores, reconociendo las prácticas del Predatory Journal como una vulgar estafa alejada de la ética editorial de cualquier publicación real.

¿Cómo se si mi ‘paper’ está en manos de un ‘Predatory Journal’?

Existen pocas universidades que cuenten con unidades y especialistas dedicados, casi exclusivamente, a la publicación. Esto, explican algunos expertos como Beall o la propia Cobey, es un problema muy serio ya que muchos (muchísimos investigadores) carecen de la experiencia (o incluso formación) sobre cómo funciona el mundo de las editoriales científicas. En otras ocasiones es la presión por publicar la culpable de una mala decisión.

En cualquier caso, los datos indican que no importa la formación o la carrera del investigador, cualquiera es susceptible a caer en las garras de un Predatory Journal. Hablamos de miles de investigaciones que son extorsionadas por estas mal llamadas publicaciones. Según los datos recogidos por Cobey, tras analizar unos 2.000 papers dispuestos en este tipo de revistas, ni tan siquiera el tipo de subvención, la procedencia de la investigación o el origen del equipo investigador libra a nadie de ser objeto de este tipo de prácticas. Por cierto, los países con más presencia de publicaciones depredadoras, con diferencia, son la India y Estados Unidos, aunque también se encuentran en Nigeria, Egipto, Turquía o incluso Japón y Reino Unido.

¿Cómo podemos esquivar a estos depredadores de la información? Para identificar este tipo de publicaciones varios hechos deberían hacer sonar nuestras alarmas alarmas. En primer lugar, la afiliación editorial. Una afiliación editorial dudosa, o la falta de información sobre la empresa que la maneja, son buenas razones para dudar. En segundo, una publicación legítima jamás pondrá tasas absurdas. Por ejemplo, el recargo por “retirar” un artículo no aparecerá en ninguna publicación que cumpla con una buena ética editorial.

Según el criterio de Jeffrey Beall para identificar a este tipo de Predatory Journals, estos se caracterizan por no seguir, o simplemente violar, el “Código de conducta de los editores de publicaciones científicas” o los “Principios de transparencia y buenas prácticas de las publicaciones académicas“. En ellas, por ejemplo, se recogen asuntos tan variados como la información que se intercambia entre autores y editores, la cuestión de las tasas o los derechos de autor.

Las razones son muchas y muy variadas, demasiadas para recogerlas aquí. Por otro lado, estos criterios están bien recapitulados y arduamente resumidos en el documento preparado por el propio Beall, el cual podría servir como código genérico para detectar este tipo de publicaciones. Este documento, de hecho, surge a la par que una lista de publicaciones listadas en su web, con lo que revisar si el journal en cuestión entra dentro de estos criterios puede ser tan sencillo como comprobar que no haya sido mencionado en la “Lista Beall de Predatory Journals“. i

Una piedra más en esto de “hacer ciencia”

Si algo queda cada vez más claro es que la ciencia y el proceso para generar conocimiento científico está viviendo una profunda crisis. Desde cuestiones socioeconómicas a políticas, pasando por técnicas o humanas, el proceso de revisión por pares y la publicación en revistas científicas se encuentra ahora mismo con graves problemas.

Cada año son más los papers retirados debido a un sinfín de razones (en el peor de los casos porque sus investigaciones no se sustentan); los investigadores se ven envueltos en condiciones inasumibles de trabajo, cobrando poco y trabajando demasiado. Y lo peor es que en la mayoría de los casos se ven envueltos en una especie de “carrera de la reina roja” en los que han de publicar cada vez más para mantener su financiación o el apoyo institucional.

Al final, dentro de este círculo vicioso, se busca la publicación con el mayor índice de impacto para poder optar a la financiación y, mientras tanto, los artículos que no cumplen con las expectativas de los editores de grande publicaciones o, sencillamente, los resultados negativos se pierden el el frenesí del “publica o muere”.

Volviendo al tema de las grandes editoriales, y aunque a muchos no les gusta escucharlo, los investigadores viven regidos por un índice de impacto que ha sido decidido de forma interna y cuasi secreta por las mismas compañías que deciden qué papers son mejores o peores. Al final, todo el mundo científico danza al son de unas pocas marcas que contienen el 90% del haber científico del mundo.

Y en todo este maremagnum, los predatory journals acechan para hacerse con la carroña que puedan desgarrar de este tejido intelectual científico. Pero las víctimas no son solo los incautos investigadores que caen en sus artimañas. También lo son, y probablemente de forma más amarga, las pequeñas publicaciones. Esos journal que, sin tratar de acercarse a la sombra de los titanes editoriales, pretenden hacerse un hueco en la literatura científica especializada.

Estos son los primeros en sufrir las consecuencias en forma de rechazo y suspicacia, probablemente inmerecida, por culpa de otros estafadores sin escrúpulos. Por desgracia, los Predatory Journals han aumentado su número en las últimas décadas, lo que complica muchísimo más el trabajo a la hora de publicar, tanto para los científicos como para las pequeñas editoriales. Pero admitiremos una cosa: no hay mal que por bien no venga. Si al menos, tras el mal trago de gente como la que ha llegado a conocer Cobey el resto de la comunidad científica se pone las pilas, algo bueno sacaremos de esto. Y es que nos hace falta ser más conscientes de cómo funciona el mundo de la publicación científica si queremos mejorar la manera que tenemos de “hacer ciencia”.

Este post ha sido realizado por Santiago Campillo (@ScruzCampillo) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo ¡Cuidado! Publicación depredadora a la vista se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La contradicción de la publicación

- ¿Puede ser culto alguien de Letras?

- La estrella individual más lejana jamás vista

Las absurdas declaraciones saludables de algunos alimentos están amparadas por las autoridades

Cada vez hay más alimentos que muestran en su etiquetado alguna declaración saludable. Desde postres lácteos que «contribuyen al normal funcionamiento del sistema inmunitario» a bollería industrial que «aumenta la capacidad de atención y memoria». Este tipo de declaraciones hacen que algunos alimentos de bajo interés nutricional aparenten ser saludables. Ante esta vorágine de caretas saludables, da la impresión de que todo está permitido y que no hay ninguna autoridad al mando que lo regule.

-

Las declaraciones saludables se regulan

En los años 90 se pusieron de moda los anuncios de patés ricos en hierro y zumos ultravitaminados que nos harían crecer fuertes y sanos. El reglamento que prevalecía en aquel momento permitía alegar casi cualquier cosa con tal de que una porción de alimento (100 g o 100 ml) contuviese al menos el 15% de la cantidad diaria recomendada de vitaminas o minerales.

Para poner un poco de orden, en 2006 se publicó un nuevo reglamento en el que se decía que para incluir una alegación saludable en un alimento, primero había que probar que alguno de sus ingredientes ayudaba de alguna manera a mantener nuestra salud. Eso propició una avalancha de peticiones que la Autoridad Europea de Seguridad Alimentaria (EFSA) se encargaba de revisar para dar el visto o bueno o no. Esto sigue funcionando así. Cada vez que se descubre alguna propiedad saludable de un ingrediente, se envían los informes pertinentes a la EFSA y desde aquí revisan la evidencia científica aportada para aceptar o rechazar una nueva declaración saludable.

Como consecuencia de todo esto, las declaraciones saludables relativas a cada ingrediente se recogen periódicamente en el Diario Oficial de la EFSA y se detallan en los anexos de los reglamentos específicos que se han ido publicando a continuación (como en éste de 2012).

Si todo esto está regulado, ¿cómo es posible que un alimento atiborrado de azúcares y harinas refinadas pueda mostrar alguna declaración saludable?

-

Las declaraciones saludables se regulan, pero se regulan mal

Por ejemplo, para poder declarar que un alimento «contribuye a la formación normal de colágeno para el funcionamiento normal de la piel» tiene que poder ser considerado «fuente de vitamina C» según el reglamento de 2006. A su vez, este reglamento hace referencia al reglamento de 1990, en el que se recoge el dichoso mínimo del 15% de la cantidad diaria recomendada (CDR).

La cantidad diaria recomendada de vitamina C según el reglamento de 1990 era de 60 mg. En el Real Decreto 1669/2009 fue modificada estableciéndose una cantidad diaria recomendada de vitamina C de 80 mg. Por tanto, si un alimento contiene 12 mg de vitamina C (el 15% de 80 mg), ya sea añadida o formando parte de alguno de sus componentes, está permitido que muestre cualquier declaración referida a las bondades de la vitamina C, incluida la formación normal de colágeno.

Lo mismo ocurre con una larga lista de declaraciones saludables autorizadas para vitaminas, minerales y otros nutrientes cuyas propiedades individuales han sido avaladas por la EFSA.

Así que lejos de la intención inicial de poner orden en la publicidad de los alimentos, el reglamento sirve de coladero para incluir legalmente casi cualquier declaración saludable. Añadiendo una cantidad irrisoria de vitaminas o minerales a un alimento, se permite decir casi de todo. No estamos mucho mejor que en los años 90.

-

El reglamento se fundamenta en el maldito nutricionismo

Una de las consecuencias de todo esto es que es legal que un alimento sin interés nutricional, como puede ser la bollería industrial o un refresco cargado de azúcar, puede publicitarse de forma que parezca saludable. La razón es que el reglamento no tiene en consideración el alimento en su conjunto, sino sus ingredientes individuales. La única excepción son las bebidas alcohólicas de más de 1,2 % en volumen de alcohol. Estas no pueden contener declaraciones saludables en su etiqueta ni en su publicidad. Aun así, algunos medios de comunicación publicitan indirectamente las bondades del consumo de alcohol, a pesar de ser siempre falsas.

Un alimento no se debe considerar más o menos saludable atendiendo a sus ingredientes individuales. Hay que tener en cuenta el alimento en su conjunto. La matriz del alimento puede disminuir, potenciar o anular completamente las bondades de sus ingredientes. Ese es el principal motivo por el que el reglamento actual y, por tanto, la evaluación que hace la EFSA aprobando o rechazando declaraciones saludables es absurda.

Valorar un alimento en función de sus ingredientes individuales, y no como conjunto, se llama nutricionismo. El nutricionismo es un error. Entre otras cosas alienta el consumo exagerado e innecesario de suplementos alimenticios y la elección de alimentos insanos creyendo que son beneficiosos solo porque contengan tal o cual ingrediente.

Otra consecuencia no menos importante es que en el reglamento no se contempla la posibilidad de declarar las virtudes de un alimento en su conjunto, o de declarar las virtudes de la suma de una serie de ingredientes que interactúan entre sí. Por esa razón, aunque un alimento estuviese perfectamente formulado y demostrase su eficacia, solo podría mostrar la declaración de salud que el reglamento le permita. Por ese motivo algunos suplementos alimenticios contienen ingredientes con virtudes previamente aprobadas por la EFSA, a pesar de que las bondades del suplemento sean propiciadas por otros. O lo que es lo mismo, un suplemento alimenticio mediocre puede alegar las mismas bondades que uno bien formulado si contiene la misma cantidad de ingrediente avalado por la EFSA.

Para publicitar la efectividad de un suplemento alimenticio, da igual si haces ciencia o no, el reglamento te permite decir lo que quieras si incluyes el dichoso 15% de la cantidad diaria recomendada de alguna vitamina o mineral.

El maldito nutricionismo nos ha llevado a repetir durante años mentiras como que los frutos secos son insanos o engordan, atendiendo exclusivamente a la cantidad de grasas que contienen. Los estudios confirman que no podemos juzgar a un alimento por sus ingredientes individuales, sino en su conjunto. Siguiendo con el ejemplo, a pesar de las calorías de los frutos secos y su elevado aporte de grasas, la evidencia científica nos dice lo contrario, que el consumo de frutos secos es saludable y que se relaciona con menores tasas de obesidad.

Lo mismo ocurre con algunos productos lácteos que contienen grasas saturadas y que por ello creíamos que afectaban al aumento del colesterol. La evidencia científica nos dice lo contrario, que algunos ayudan a prevenir enfermedades cardiovasculares.

-

Conclusiones

El reglamento de 2006 (incluidas sus modificaciones posteriores) pretendía poner orden en las declaraciones saludables que se publicitan en los alimentos, sin embargo, ha incurrido en el grave error del nutricionismo. Esa es la razón por la que alimentos insanos y de bajo interés nutricional pueden disfrazarse de alimentos saludables. La legislación les ampara.

Esa también es la razón por la que se permite anunciar las bondades de los suplementos alimenticios o de los alimentos funcionales, porque no tienen que probar su eficacia, sino contener una cantidad irrisoria de tal o cual ingrediente previamente avalado por la EFSA. De nada sirve formular un buen suplemento, porque las autoridades no contemplan las virtudes del alimento completo, sino de sus ingredientes individuales. Aunque los resultados de unos y otros deberían condicionar las ventas a largo plazo, la realidad es que buenos y malos pueden lanzarse legalmente al mercado publicitando lo mismo. Los que invierten en I+D para desarrollar sus productos y los que no, pueden alegar las mismas bondades. El coste de la declaración saludable es tan pequeño como unos cuantos gramos de vitaminas añadidas.

La consecuencia de todo esto es que, si no replanteamos el reglamento, su aplicación y la forma en la que la EFSA avala las declaraciones saludables, será posible publicitar cualquier virtud del alimento, sea cierta o no. Hoy en día es legal vender refrescos azucarados y bollería industrial como si fuesen saludables. O esto cambia, o al final acabaremos por creer que cualquier alegación saludable es una farsa legitimada por las autoridades.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Las absurdas declaraciones saludables de algunos alimentos están amparadas por las autoridades se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El azúcar oculto en los alimentos

- Dani y Fiti sobre los alimentos

- #Naukas14 Algunos curiosos experimentos

Una explicación a la existencia de películas de carbono tipo diamante (DLC)

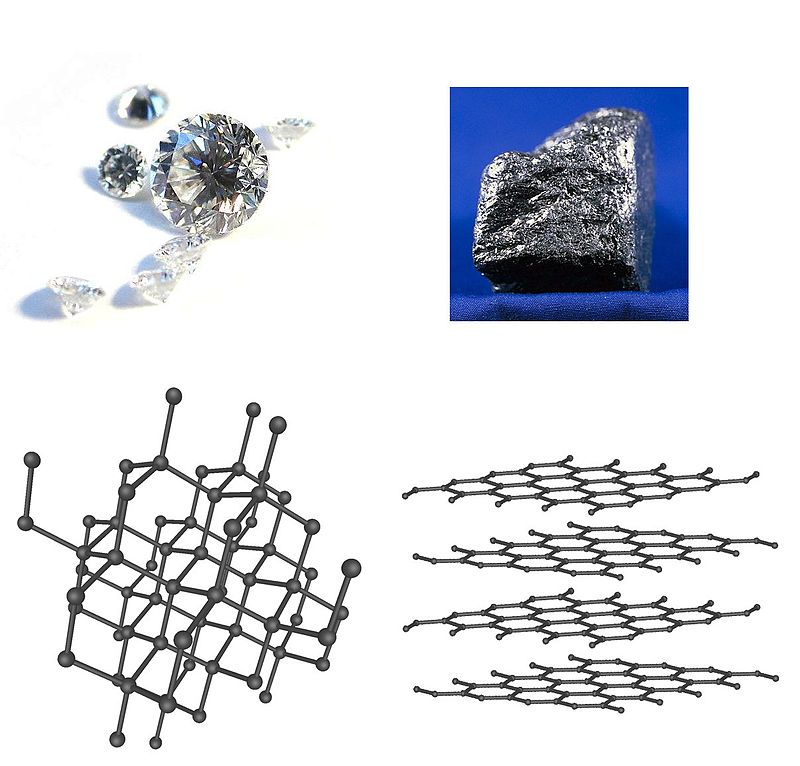

Las películas muy densas de carbono amorfo pueden presentar unas propiedades, como una dureza excepcional, la ausencia de reactividad química o ser ópticamente transparentes que habitualmente se asocian al carbono pero con una estructura cristalina muy concreta, esa que llamamos diamante. Pensemos esto un segundo, ¿películas de diamante? Pues sí, aunque parezca sacado de una película de ciencia ficción de serie B de los sesenta. Precisamente explicar cómo es posible que algo tan extraordinario ocurra es lo que ha conseguido un equipo de investigadores encabezado por el español Miguel A. Caro, que trabaja en la Universidad de Aalto (Finlandia).

Diamante, grafito y sus estructuras.

La alotropía es la capacidad que tienen algunos elementos de poseer estructuras atómicas o moleculares diferentes. Cada una de estas formas se llama alótropo. El carbono es capaz de formar muchos alótropos diferentes debido a su capacidad de formar distintos tipos de enlaces químicos. Las formas más conocidas de carbono incluyen el diamante y el grafito (la mina de los lápices). En las últimas décadas se han descubierto e investigado muchos más alótropos y formas de carbono, incluidas formas esféricas como el buckminsterfullereno, láminas como el grafeno o las nanocintas y tubulares como los nanotubos. Se estima que existen del orden de 500 alótropos del carbono.

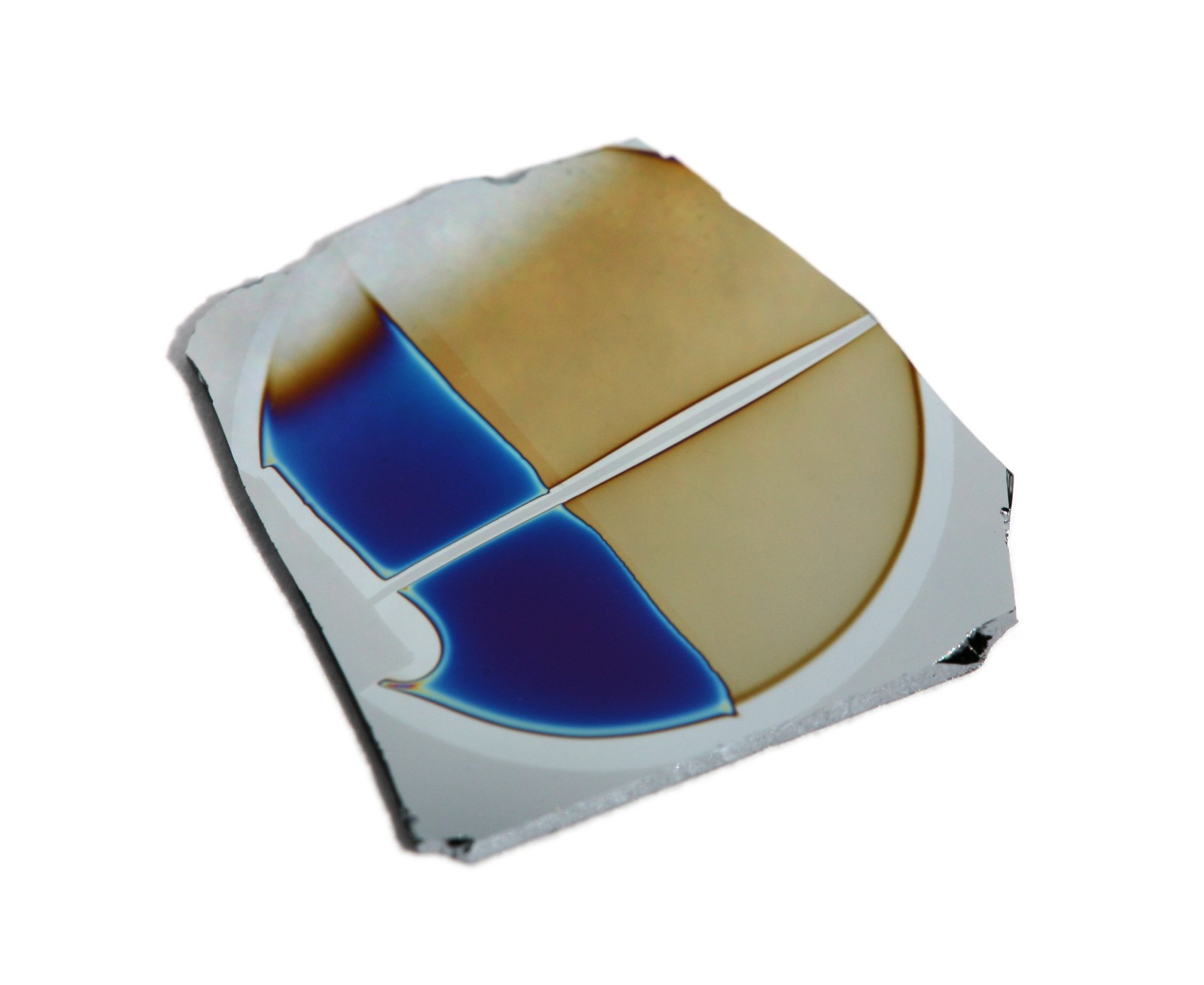

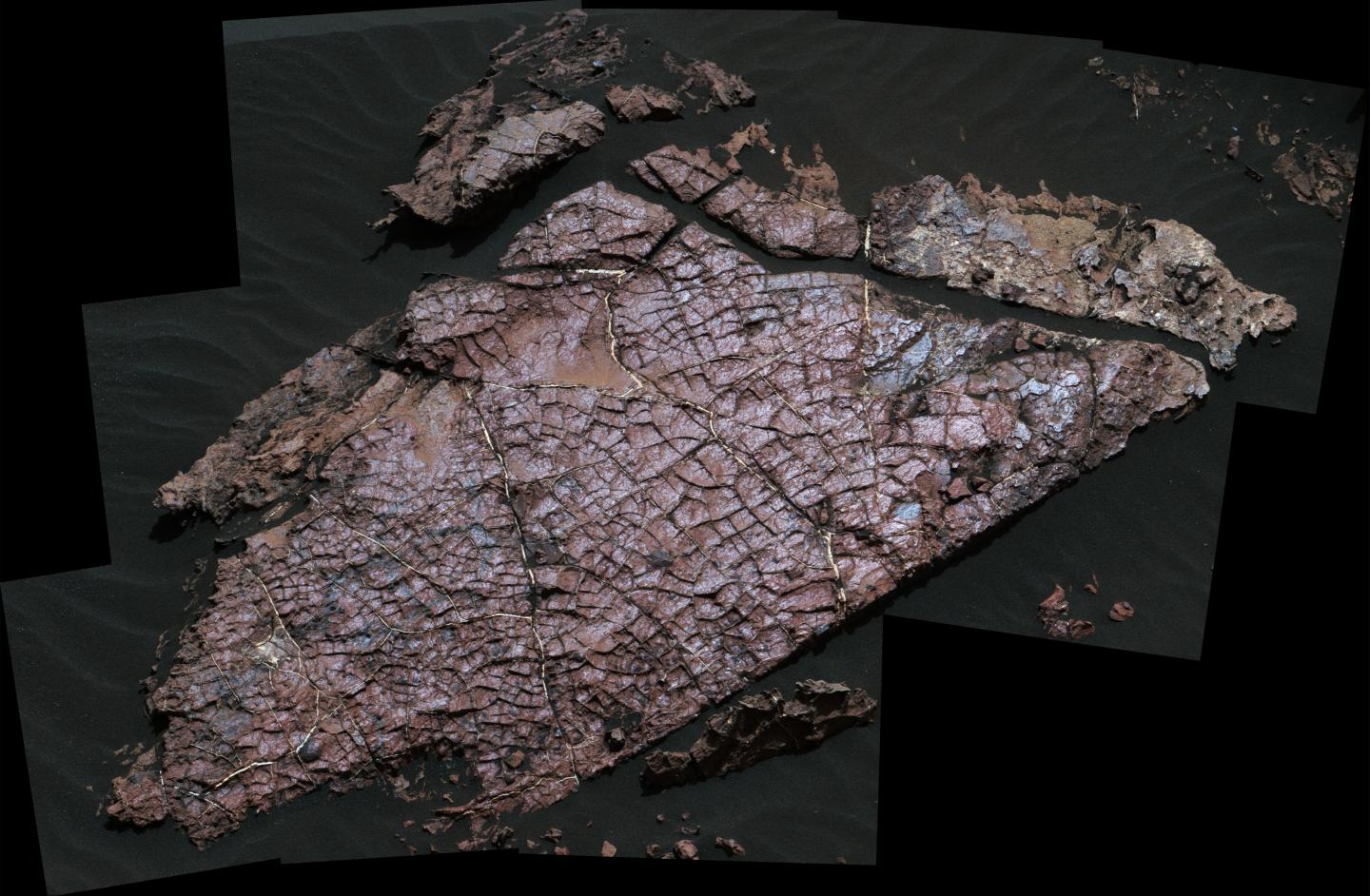

Lámina de carbono tipo diamante (DLC) sobre silicio

El carbono amorfo es el alótropo del carbono que no tiene una estructura cristalina. Como con todos los materiales vítreos (los llamados vidrios), puede presentarse algún orden de corto alcance, pero no hay patrones de largo alcance de las posiciones atómicas. Una variedad de carbono amorfo es el llamado carbono tipo diamante, más comúnmente conocido en la industria por sus siglas en inglés, DLC (diamond-like carbon)

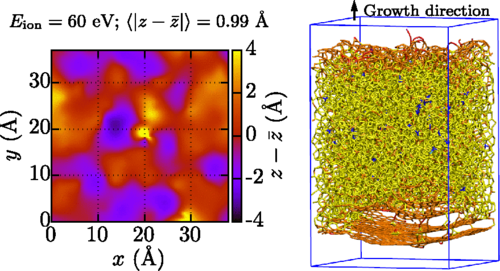

Los químicos e ingenieros han aprendido mediante ensayo y error a crear películas de DLC a base de depositar átomos de carbono en un sustrato de carbono. El uso del ensayo y error se debe precisamente a que no se entiende teóricamente cómo se forman estas películas. Ahora, combinando un algoritmo de aprendizaje automático con simulaciones de dinámica molecular, Caro y sus colegas han demostrado que las películas de DLC se forman a través de un mecanismo de “granallado”.

Si en el granallado de un taller de chapa y pintura, se trata la carrocería de un automóvil con un “chorro de granalla” (o “de arena”) para dejar la superficie completamente limpia y lista para recibir la imprimación previa a la pintura, en el caso del DLC el impacto de un átomo de carbono sobre la superficie induce ondas de presión que cambian localmente la densidad de la película y, a su vez, la hibridación orbital, es decir, el tipo de enlaces químicos que pueden formar los átomos en la película.

Rugosidad de la superficie (izquierda) y estructura atómoca de la película de DLC (derecha)

El equipo simuló la deposición secuencial de átomos de carbono individuales en un sustrato de carbono. Utilizando un algoritmo de aprendizaje automático desarrollado previamente calcularon los potenciales interatómicos entre los átomos e introdujeron esa información en las simulaciones de dinámica molecular. Este procedimiento les permitió mapear la densidad de las películas después de cada impacto. Descubrieron que los átomos entrantes creaban una onda de presión que alejaba los átomos del sitio de impacto, de modo que cada impacto disminuía la densidad de los átomos en la superficie de la película y la aumentaba en el interior de la película. En el interior de la película, el cambio de densidad causó que una alta fracción de átomos de carbono adquiriese una hibridación tetraédrica: exactamente el mismo estado que tienen los átomos de carbono en el diamante. Los perfiles de densidad simulados concuerdan con los que se derivan experimentalmente.

La películas de DLC ya se emplean industrialmente como recubrimientos de piezas expuestas a alto rozamiento. Lo que estos resultados pueden hacer es ayudar a los químicos a optimizar el crecimiento de películas DLC, lo que puede ser extremadamente interesante para la construcción de dispositivos electrónicos implantables en el cuerpo humano. Y es que el DLC, al ser químicamente inerte, es biocompatible.

Referencia:

Mguel A. Caro et al (2018) Growth Mechanism and Origin of High sp3 Content in Tetrahedral Amorphous Carbon Physical Review Letters doi: 10.1103/PhysRevLett.120.166101

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Una explicación a la existencia de películas de carbono tipo diamante (DLC) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un diamante ultraduro a partir de cebollas de carbono

- Nanotubos de carbono y regeneración neuronal

- Combustibles solares por un tubo

Crímenes áureos

Me gusta leer. Me gusta todo tipo de literatura, pero, en especial, leo muchas novelas. De todos los estilos. En estos momentos estoy terminando de leer la magnífica, aunque dura, novela Manual para mujeres de la limpieza (Alfaguara, 2016) de Lucia Berlin, antes de este libro he leído la excelente novela gráfica de Paco Roca, Las calles de arena (Astiberri, 2015) y Las normas de la casa (Temas de Hoy, 2012), de Jodi Picoult, y mis dos siguientes lecturas, salvo que se cruce alguna otra en el camino, serán Solenoide (Impedimenta, 2017), de Mircea Catarescu, cuyas primeras páginas te enganchan y es difícil dejar de leer (aunque antes tenía que terminar el magnífico libro de Lucia Berlin), y La torre de Babel (Alfaguara, 2011), de A. S. Byatt, un interesante descubrimiento que hice mientras preparaba una conferencia sobre la sucesión de Fibonacci.

Portada del libro “Manual para mujeres de la limpieza” (Alfaguara, 2016), de Lucia Berlin

Pero, en especial, me gusta la novela policiaca. Desde las clásicas novelas de raciocinio, como los relatos de Edgar Allan Poe, las historias de Sherlock Holmes, de Arthur Conan Doyle, o las sencillas novelas de Agatha Christie, hasta la novela negra actual, que es mucho más realista y social. Y si estas novelas tienen alguna referencia matemática, entonces mi interés y disfrute es mucho mayor aún.

En esta entrada del Cuaderno de Cultura Científica vamos a ver un pequeño ejemplo de presencia de las matemáticas en una novela negra. No es un caso aislado, existen muchos ejemplos, como la novela La chica que soñaba con una cerilla y un bidón de gasolina, del escritor sueco Stieg Larsson (Destino, 2008), de la que ya hablamos en la entrada La chica que soñaba con una cerilla y un bidón de gasolina. En esta ocasión, se trata de la novela La mano del diablo (Plaza & Janés, 2005), de los escritores Douglas Preston y Lincoln Child.

Portada de la novela “La mano del diablo” de Douglas Preston y Lincoln Child, publicada por Plaza & Janés en 2005, un año después de su publicación en inglés

Los escritores estadounidenses Douglas Preston y Lincoln Child suelen escribir juntos, a cuatro manos, novelas policiacas, de misterio y de aventuras. Son dos escritores de éxito, aunque tengo que confesar que no están entre mis escritores preferidos. Su primer éxito fue El ídolo perdido (1995), novela en la cual se inspiró la película The Relic (Peter Hyams, 1997). Esta novela, como muchas de las que han escrito juntos, está protagonizada por el agente del FBI, Aloysius Pendergast, acompañado del teniente de la policía, Vicent D’Agosta.

La novela La mano del diablo es la primera novela de la trilogía de Diogenes, el hermano de Aloysius. En esta historia, el agente del FBI Aloysius Pendergast y el teniente de la policía Vicent D’Agosta investigan una serie de asesinatos que parecen implicar al propio Lucifer.

En la novela aparece un periodista del Post, Bryce Harriman, que investiga también estas misteriosas muertes. El periodista decide entrevistar, para recabar información sobre esta serie de asesinatos relacionados con el diablo, al profesor Friedrich Von Menck, doctor en filosofía por la Universidad de Heidelberg (Alemania), en medicina por la Universidad de Harvard (EE.UU.) y en teología por la Universidad de Canterbury (Nueva Zelanda), pero que siempre se había interesado por el misticismo, lo paranormal y lo inexplicable, lo cual le hace un candidato ideal, según el periodista, para hablar de los “asesinatos del diablo”. Una mezcla de científico y apasionado de los temas esotéricos.

Leamos la parte de la novela en la que el periodista Harriman está en casa de Von Menck preguntándole por los “asesinatos del diablo”.

“—Lo de menos son las personas y la manera. Lo decisivo es el momento.

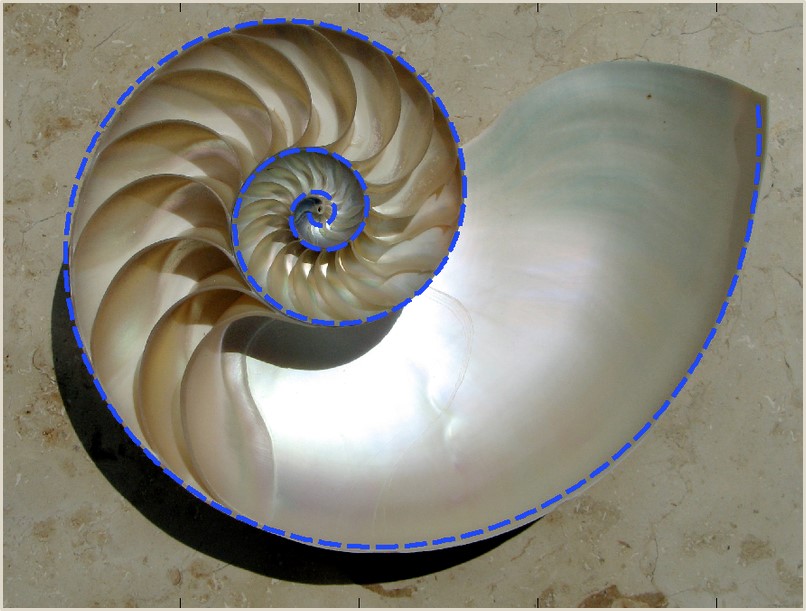

Von Menck se levantó para abrir una de las vitrinas y sacar algo, Lo trajo y lo dejó sobre la mesa, delante de Harriman. Era una sección de concha de nautilo, con sus celdas de crecimiento formando una espiral de hermosa regularidad.

—Señor Harriman, ¿sabe qué hay en común entre esta cocha, el Partenón, los pétalos de una flor y las pinturas de Leonardo da Vinci?

Harriman negó con la cabeza.

—Que encarna la proporción más perfecta de la naturaleza, la proporción áurea.

—No sé si le entiendo.

—Es la proporción que se obtiene al dividir una línea de modo que el segmento más corto sea al segmento más largo, lo mismo que el segmento más largo a la línea entera.

Harriman lo anotó con la esperanza de entenderlo más tarde.

—El segmento más largo es 1,618054 veces más largo que el segmento más corto. El segmento más corto representa el 0,618054 por ciento del más largo. Son dos números exactamente recíprocos, que solo se diferencian en el primer dígito. Se trata de los dos únicos números que presentan esta propiedad.

—Ah, claro.

Las matemáticas nunca habían sido su fuerte.

—Y tienen otras propiedades muy notables. Se considera que un rectángulo construido con lados de estas longitudes es la forma más agradable a la vista. Recibe el nombre de rectángulo áureo. La planta del Partenón se construyó según esta figura. Y en ella se basan catedrales y pinturas. Estos rectángulos tienen otra propiedad destacable: si se recorta un cuadrado en cada lado se obtiene un rectángulo áureo de menor tamaño, pero con las mismas proporciones. Se pueden recortar cuadrados y obtener rectángulos dorados más pequeños hasta el infinito.

—Comprendo.

—Bueno, pues si parte de un rectángulo grande y lo reduce a una serie infinita de rectángulos áureos más pequeños, y si después conecta todos los centros de los rectángulos, obtendrá una espiral logarítmica natural perfecta. Es la espiral que está viendo en la cocha del nautilo, la misma que forman las semillas en la cabeza del girasol, y de la armonía musical. La proporción áurea es una característica básica del mundo natural.

—Ajá.

—Es una proporción que forma parte de la estructura del universo.”

Paremos un momento en este punto, en el cual el periodista Harriman piensa que ha perdido el tiempo al ir a entrevistar al profesor Von Menck. No entiende nada y no cree que las personas que van a leer el Post entiendan tampoco nada. Paremos un momento para recordar algunos de los conceptos matemáticos que aparecen citados.

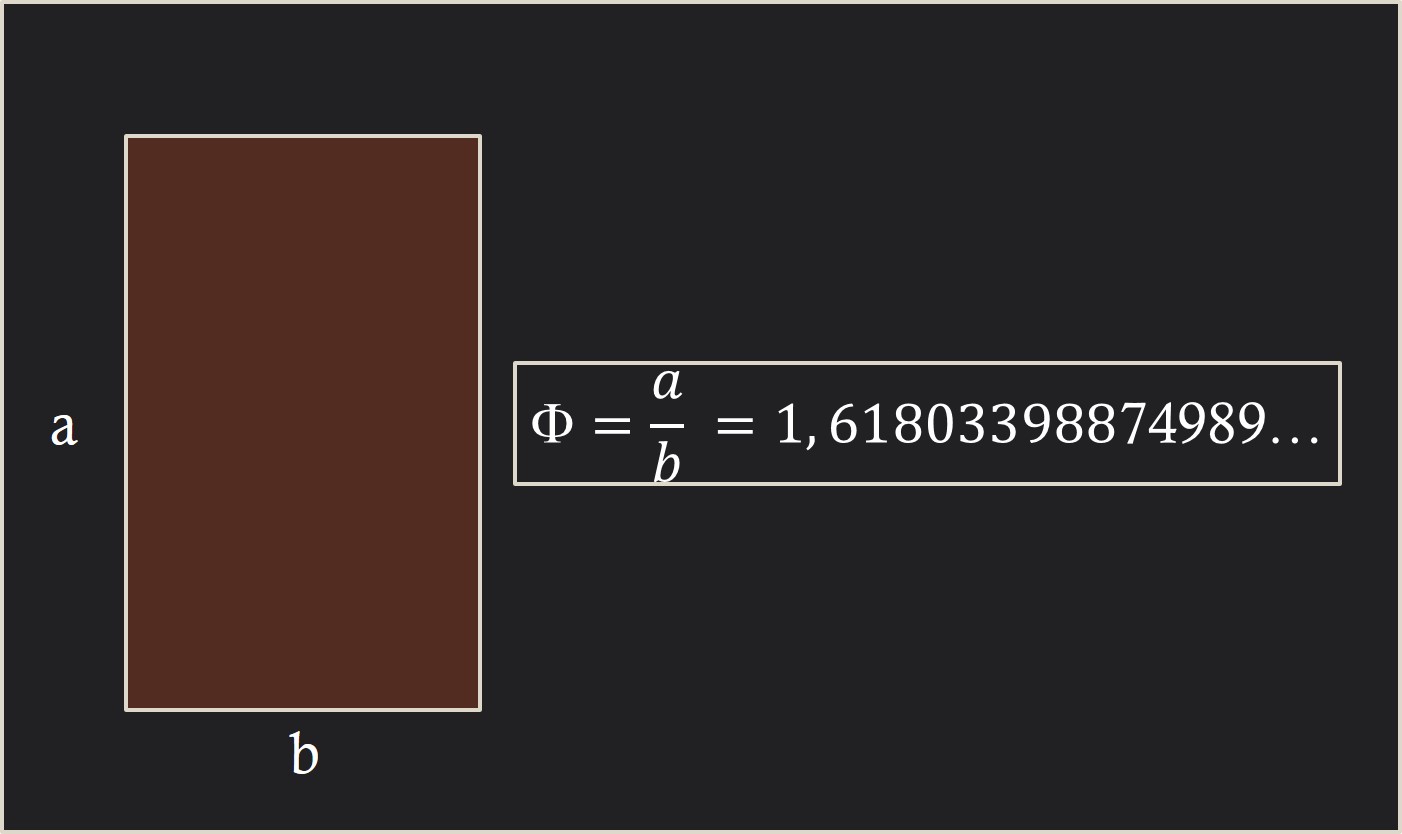

Para empezar, recordemos que es el número áureo, que ya hemos introducido en el Cuaderno de Cultura Científica, por ejemplo, en la entrada Visitad los museos, también en clave matemática y en la entrada ¿Es áureo el Aston Martin de James Bond?. La proporción áurea es un concepto matemático muy antiguo, que ya fue estudiado por los griegos, en particular, por los pitagóricos. La definición de esta proporción aparece recogida en el gran texto matemático, Los Elementos de Euclides (aprox. 325-265 a.c.). Y dice así:

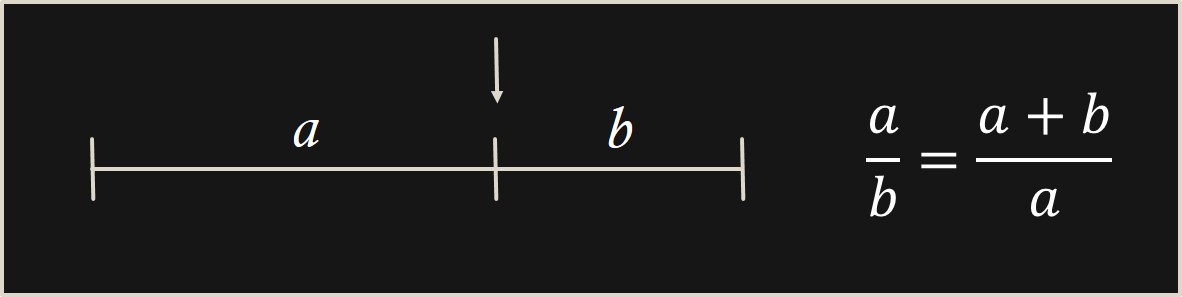

“Se dice que un segmento está dividido en media y extrema razón cuando la longitud del segmento total es a la parte mayor, como la de esta parte mayor es a la menor”.

Es decir, si tenemos un segmento como el que aparece en la siguiente imagen, buscamos el punto del mismo que divide al segmento en dos partes, de longitudes a y b, de forma que la proporción o razón (división) entre la parte mayor y la menor, a/b es igual a la proporción entre la longitud del segmento y la parte mayor (a + b)/a.

Ahora, si llamamos Φ al cociente a/b, la condición anterior se puede escribir como la ecuación algebraica siguiente:

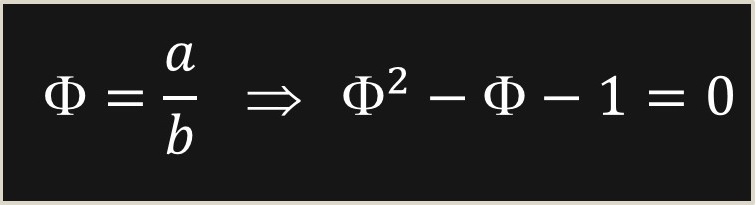

Esta es una ecuación algebraica de segundo grado, cuyas soluciones, sin más que utilizar la conocida fórmula de resolución de la ecuación de segundo grado que estudiamos en el instituto, son:

Si tenemos en cuenta que la inversa de Φ, es decir, Φ-1, es b/a, entonces la propia expresión de la definición nos dice que

Φ = 1 + Φ-1,

es decir, que ambas soluciones se diferencian en 1, como se comenta en la novela. Aunque el número que aparece citado en la misma, “1,618054”, no es exactamente el número áureo, que más bien, por aproximación sería “1,618034”, ahí se ha colado un 5, en lugar de un 3.

Un pequeño error. Cuando se dice que “El segmento más corto representa el 0,618054 por ciento del más largo”, lo correcto sería que “El segmento más corto representa el 0,618054 del más largo”, sin la expresión “por ciento”.

Sigamos. Un rectángulo áureo es un rectángulo de dimensiones a (alto) y b (ancho), tal que la proporción entre ambas, a/b, es el número áureo, Φ = 1,618033…, como aparece en la siguiente imagen y no como está escrito en la novela, es decir, que los lados del rectángulo sean “1,618034” (Φ) y “0,618034” (Φ-1),… “Se considera que un rectángulo construido con lados de estas longitudes es la forma más agradable a la vista. Recibe el nombre de rectángulo áureo”. En cuanto a que sea el rectángulo más bello que existe, esa es una creencia basada en la supuesta demostración estadística del sicólogo alemán Gustav Fechner (1801-1887).

Una interesante reflexión sobre las supuestas relaciones del rectángulo áureo con la belleza, el Partenón, el arte de Leonardo da Vinci y algunas otras cuestiones, la encontramos en el artículo Misconceptions about the Golden Ratio (Ideas erróneas sobre la proporción áurea), del matemático, de la Universidad de Harvard, George Markowsky.

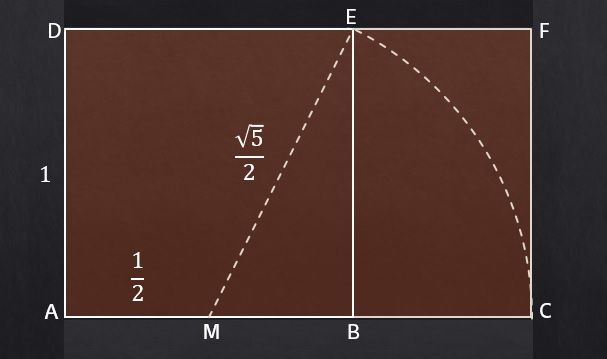

Una propiedad interesante de los rectángulos áureos es que se pueden construir fácilmente a partir de un cuadrado, como se muestra en la siguiente imagen. Se parte de un cuadrado ABDE (en la imagen se ha considerado de lado 1) y se traza un arco de circunferencia, con centro el medio M del lado del cuadrado AB y de radio igual al segmento ME, determinando así el punto C (la intersección de la recta que pasa por A y B, con el arco de circunferencia), de forma que el rectángulo generado ACDF resulta ser un rectángulo áureo.

Esta es una forma sencilla de construir rectángulos áureos, que puede ser desarrollada por personas dedicadas, por ejemplo, al arte o la jardinería.

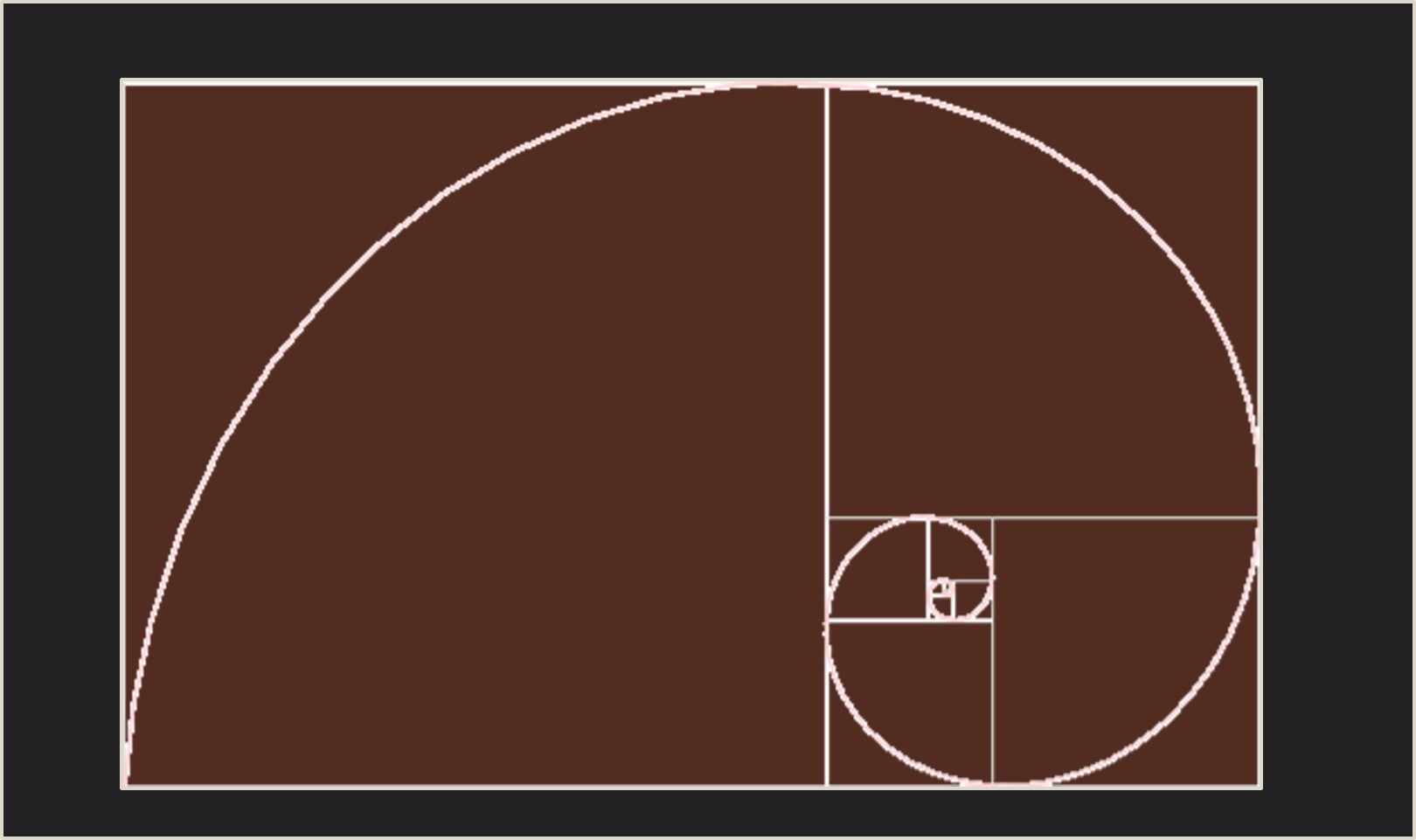

Pero esta propiedad pone de manifiesto, como se expresa en la cita anterior (aunque de una forma un poco confusa), que un rectángulo áureo puede descomponerse en un cuadrado y un rectángulo más pequeño, con la sorprendente propiedad de que resulta ser también un rectángulo áureo. Ahora, con este rectángulo áureo más pequeño podríamos, a su vez, descomponerlo en un cuadrado y un rectángulo áureo, así hasta el infinito.

Si se considera un trozo de circunferencia en cada uno de los cuadrados de la descomposición, como aparece en la siguiente imagen, se construye lo que se conoce como “espiral áurea”.

A pesar de lo que se suele leer en muchos sitios, ni esta espiral, ni la construida con segmentos rectos, al unir los centros de los cuadrados, según la novela, son la espiral logarítmica o espiral del crecimiento que aparece en el nautilus.

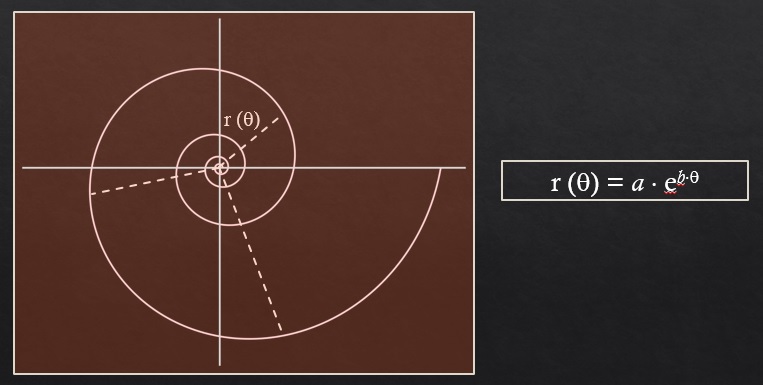

La espiral logarítmica, que aparece en la siguiente imagen, se define como aquella espiral cuyo radio aumenta de forma exponencial según va creciendo el ángulo de giro (θ en la imagen), es decir, matemáticamente la longitud del radio es igual a r(θ) = a ebθ.

Y esta espiral sí modeliza la sección de la concha del nautilus.

Disculpad que me haya entretenido un poco con estos conceptos iniciales y algunas cuestiones relacionadas. Volvamos a la novela La mano del diablo, de la pareja de escritores Preston y Child. La persona que este leyendo la novela se preguntará en el punto en el que habíamos dejado la cita, al igual que el periodista del Post, … ¿todo esto para qué? ¿qué tiene que ver con los “asesinatos del diablo”? Para dar respuesta a esta cuestión volvamos a la novela, puesto que toda la cita anterior es una introducción a lo que es el asunto principal, que explica el profesor Von Meck a continuación.

“—Se lo voy a explicar. He dedicado toda mi vida a estudiar lo misterioso y lo inexplicable. En muchos casos, la solución del misterio me ha satisfecho del todo. Otros misterios, casi siempre los de mayor importancia, se me siguen resistiendo.

Von Menck cogió un papel de la mesa, hizo unas anotaciones y se lo puso delante de Harriman: 3243, 1239. Dio un golpecito en la hoja.

—Para mí, estos números siempre han representado el mayor de los misterios. ¿Los reconoce?

Harriman negó con la cabeza.

—Identifican los dos mayores cataclismos que ha sufrido la civilización humana. En 3243 a.C., la explosión de la isla Santorini produjo un maremoto que barrió la gran civilización minoica de Creta y devastó todo el Mediterráneo. Es la fuente tanto de la leyenda de la Atlántida como de la del Diluvio Universal. En 1239 a.C., las ciudades gemelas de Sodoma y Gomorra fueron reducidas a cenizas por una lluvia de fuego.

—¿La Atlántida? ¿Sodoma y Gomorra?

La cosa empeoraba.”

Tras una larga explicación sobre la Atlántida y Sodoma y Gomorra, el profesor Von Menck continúa con su teoría, para lo cual es necesario saber que la novela transcurre en el año 2004, luego ese es el año de los “asesinatos del diablo”.

“Von Menck cogió la hoja de papel y escribió otro número debajo de los dos primeros: 3243, 1239, 2004

—2004 d.C., señor Harriman. Constituye el término de la proporción áurea. Han pasado exactamente 5246 años desde 3243 a.C.: la proporción áurea. La siguiente fecha de la serie es 2004 d.C. Resulta que también es el número exacto de años que separan los desastres anteriores. ¿Una coincidencia?

Harriman se quedó mirando el papel. “¿Está diciendo lo que creo?”, pensó. Parecía increíble, una locura.”

Lo que está diciendo Von Menck, entre otras cosas, es que si se toma el segmento de tiempo que va desde el año 3243 a.C. hasta el año 2004 d.C., el punto que está en “media y extrema razón”, es decir, el que produce la proporción áurea, es el año 1239 a.C., como se muestra en la siguiente imagen.

Continuemos leyendo.

“Se acercó a otra vitrina y sacó una cartulina blanca que tenía dibujada una espiral de grandes dimensiones, como la concha de un nautilo. En la parte inferior había una anotación en lápiz rojo: “3243 a.C. – Santorini/Atlántida”. A dos tercios de la curva, otra anotación en rojo: “1239 a.C. – Sodoma/Gomorra”. En otros puntos de la espiral, una serie de marcas en negro componían una lista de decenas de fechas y lugares:

79 d.C. – La erupción del Vesuvio destruye Pompeya/Herculano.

426 d.C. – Caída de Roma, saqueada y destruida por los bárbaros.

1321 d.C. – La peste azota Venecia. Mueren dos tercios de la población.

1665 d.C. – Gran incendio de Londres.

Y justo en el centro, donde la espiral se cerraba sobre si misma y terminaba en un gran punto negro, había otra anotación en rojo, la tercera: 2004 d.C. ¿…?

Von Menck dejó la cartulina en equilibrio sobre la mesa.

Como ve, he levantado acta de muchos desastres y todos coinciden con puntos exactos de la espiral logarítmica natural. Todos están perfectamente alineados en proporciones áureas.”

Lo importante del anterior comentario es que las fechas de los desastres “están perfectamente alineados en proporciones áureas” y la continua mención a la “espiral logarítmica natural” es más bien metafórica, salvo por la idea de que esas fechas de desastres van aproximándose a la fecha límite, la fecha final, el año 2004, que es cuando se desarrolla la historia de la novela.

Mientras que las tres primeras fechas mencionadas por el profesor 3243 a.C., 1239 a.C. y 2004 d.C. efectivamente están situadas en proporción áurea, en el sentido explicado arriba, no sucede lo mismo cuando se consideran las nuevas fechas de desastres presentadas por Von Menck. Contrariamente a lo expresado por el profesor, las cuentas no salen, no están en proporción áurea.

Los autores de la novela, Preston y Child, son conscientes de ello, solamente quieren darle un aire de misterio satánico a los acontecimientos que se desarrollan en la novela, a los “asesinatos del diablo”. Y que los autores son conscientes de que las cuentas no salen para las demás fechas lo sabemos leyendo los agradecimientos, en los que han escrito:

“Para acabar, queremos pedir disculpas […] de la aplicación incorrecta de la proporción áurea del profesor Von Menck.”

La razón áurea, divina proporción o número de oro aparece en muchas novelas policiacas y de misterio, como la famosa El código Da Vinci (Umbriel, 2004), de Dan Brown.

“Canto de espigas” (1929), de Maruja Mallo. Toda la estructura de esta obra está realizada mediante la razón áurea

Bibliografía

1.- Douglas Preston, Lincold Child, La mano del diablo, Plaza & Janés, 2005.

2.- Mario Livio, La proporción áurea, La historia de phi, el número más sorprendente del mundo, Ariel, 2006.

3.- George Markowsky, Misconceptions about the Golden Ratio, The College Mathematical Journal 23, n. 1, 1992.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Crímenes áureos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El diablo y Simon Flagg, una lectura ligera para el verano

- Las vacas de Narayana, la versión hindú de los conejos de Fibonacci

- ¿Es normal el número pi?

Animales eurihalinos

Tiburón toro (“Carcharius taurus”). Foto: Jeff Kubina / Wikimedia Commons

La mayor parte de los animales acuáticos son estenohalinos, no toleran cambios en la concentración de sales del medio externo y están, por lo tanto, obligados a vivir en un medio osmóticamente estable, ya sea el mar o las aguas dulces. En ese grupo se encuentran tanto animales osmoconcordantes (u osmoconformadores) como osmorreguladores. De los primeros ya nos ocupamos aquí; baste recordar que se encuentran en equilibrio hídrico y osmótico con el medio externo; son, de hecho, isosmóticos con el agua de mar. Pero han de realizar una cierta regulación iónica, porque las concentraciones de solutos inorgánicos no son las mismas dentro y fuera del organismo. Y de los segundos hemos tratado aquí (de agua dulce) y aquí (de agua de mar).

Pero aunque son una minoría, también hay animales acuáticos eurihalinos. Algunos son peces elasmobranquios, como el tiburón toro y otros de su mismo grupo, de los que nos ocupamos aquí. Pero también hay invertebrados y teleósteos eurihalinos. Y los mecanismos que ponen en juego para poder hacer frente a los cambios ambientales de salinidad o para poder vivir en medios de concentración muy diferente (aunque en la práctica esa concentración no varíe) son muy distintos dependiendo, principalmente, de si son osmoconcordantes (poiquilosmóticos) u osmorreguladores (homeosmóticos).

Aunque la mayor parte de los invertebrados marinos osmoconcordantes son estenohalinos, hay unas pocas especies que toleran cambios en la salinidad ambiental. Los mejor estudiados son, quizás, los bivalvos. Numerosos miembros de este grupo viven en zonas costeras sometidas a la influencia de los ríos (bahías, ensenadas, lagunas costeras) o penetran, incluso, en los estuarios. Muchas especies de mejillones, berberechos, almejas u ostras, se encuentran en ese grupo. Estos animales permiten que su medio interno se diluya cuando lo hace el externo, y por ello, también el medio intracelular se diluye en la misma medida. Pero esa dilución no es pasiva; no es consecuencia de una invasión de agua de sus células, ya que si ello ocurriera podrían llegar a estallar o, cuando menos, a ver alterados gravemente todos los procesos que dependen de la estructura de la membrana celular. Además, también la concentración intracelular de potasio se reduciría, con los consiguientes daños al funcionamiento de las proteínas celulares, cuya integridad funcional depende precisamente de la concentración del principal catión intracelular. La dilución del medio intracelular se produce mediante una reducción activa de la concentración de solutos orgánicos como aminoácidos, taurina y otros, los denominados efectores osmóticos, sustancias gracias a las cuales las células de los invertebrados marinos pueden mantenerse isosmóticas con el medio interno, sin que el K+ tenga por qué alcanzar concentraciones intracelulares inconvenientes.

Y luego tenemos animales eurihalinos que regulan activamente la concentración osmótica de su medio interno, aunque lo suelen hacer en rangos limitados de salinidad. Estos suelen asignarse, a su vez, a dos grandes categorías, los reguladores hiper-isosmóticos y los reguladores hiper-hiposmóticos.

Los del primer grupo mantienen su concentración interna por encima de la ambiental, aunque la diferencia se reduce conforme aumenta la concentración osmótica exterior. A este grupo pertenecen especies predominantemente dulceacuícolas que tienen la capacidad para adentrarse en aguas salobres, como algunos peces de la familia Cyprinidae, y otras propias de zonas costeras y estuarinas, como algunos anfípodos y crustáceos. La adaptación a aguas de diferente concentración, pero siempre igual o inferior a la interna, se basa en la capacidad para modificar la intensidad con que funcionan los mecanismos propios de la regulación hiperosmótica (grado de dilución y tasa de producción de orina, así como tasas de recuperación de solutos a través de las branquias).

Los reguladores hiper-hiposmóticos son animales que mantienen su concentración interna constante en condiciones tanto hiper como hiposmóticas. En otras palabras, a bajas concentraciones ambientales, su concentración interna se encuentra por encima de la externa, y lo contrario ocurre a altas concentraciones ambientales. Esta forma de regulación es característica de ciertos crustáceos que habitan zonas intermareales, como algunos cangrejos violinistas y especies próximas.

Por último tenemos a los peces diádromos, pero de esos nos ocuparemos en una próxima anotación, porque es dudoso que deban ser considerados eurihalinos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Animales eurihalinos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Animales en equilibrio osmótico: invertebrados marinos y peces bruja

- La regulación osmótica de los animales de agua dulce

- Relaciones hídricas y salinas de los animales

Clasificación y origen, los dos problemas de la mineralogía

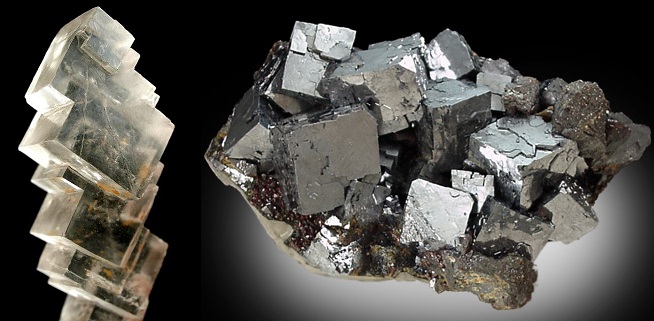

Fluorita. Fluoruro cálcico, CaF2; sistema cúbico; color violeta; raya blanca; dureza de Mohs 4; peso específico 3,1; brillo vítreo; opaco; fractura lisa a concoidea; exfoliación perfecta; en macla; fluorescente.

A pesar de los cambios en estatus como disciplina desde el siglo XVIII hasta la actualidad la mineralogía se ha concentrado en dos problemas principales: la clasificación y el origen de los minerales.

El primero, la clasificación, aunque pueda parecer un tecnicismo, es fundamental tanto para la teoría geológica como para los aspectos más prácticos y económicamente relevantes de la ingeniería de minas: encontrar vetas rentables.

Por su importancia se han dedicado a lo largo de los siglos importantes esfuerzos a desarrollar clasificaciones coherentes, relevantes y útiles, lo que ha probado ser de todo menos fácil. Digámoslo claramente, las clasificaciones minerales han sido tan numerosas como arbitrarias.

Clasificar algo depende de la capacidad de hacer distinciones claras a distintos niveles de organización. En el caso de los animales y plantas distinguir entre especies no es tan difícil y siempre existe un criterio último que dirime la cuestión de si un especimen es de la especie A o B: la capacidad de reproducirse con A o B.

En el siglo XVIII Carl Nilsson Linnæus (castellanizado, Linneo) se atrevió osadamente a aplicar los principios de clasificación que con tanto éxito había aplicado a animales y plantas a los minerales. Todo ese esfuerzo para fracasar estrepitosamente: aparecían tantas categorías casi como minerales conocidos, tantas excepciones había.

Isomorfismo. tanto la halita (NaCl) a la izquierda y la galena (PbS) a la derecha cristalizan en el sistema cúbico, sin embargo, a pesar de compartir sistema cristalino sus composciones difieren completamente.

Tras ese escarmiento los mineralogistas han oscilado principalmente entre el uso de la composición química y la forma cristalográfica. Para complicar la cosa hay que decir que estos dos tipos de clasificaciones no casan entre sí, ya que dos minerales con la misma composición pueden tener distinta forma cristalina y al revés, dos minerales con la misma forma cristalina pueden tener composiciones completamente dispares. Para añadir más dificultad, la composición química de un mineral no corresponde necesariamente a una fórmula exacta. De hecho, la mayoría de los minerales tienen un rango de variación en la composición.

Polimorfismo. Calcita (izquierda) y aragonito (derecha) tienen la misma composición, carbonato cálcico (CaCO3), sin embargo, la primera cristaliza en el sistema trigonal y el segundo en el ortorrómbico.

Esto ha llevado a ingenieros, geólogos y aficionados ha desarrollar suplementos a la clasificacón que se esté usando en forma de características macroscópicas para poder decidir más o menos rápidamente y con cierta seguridad ante que se está. Así en una guía moderna siguen apareciendo criteros de identificación como el color (aunque no sirva de mucho), la raya [1], la dureza de Mohs [2], el peso específico, el brillo [3], la brillantez (que no es lo mismo que el brillo), irisaciones (que tampoco hay que confundir con el brillo ni con la brillantez) [4], transparencia, fractura [5], exfoliación (si el mineral se rompe en hojas planas) y muchas más.

Sistema portátil para determinar la dureza en la escala de Mohs [2].

El segundo problema mineralógico clave es cómo se originaron los minerales y las rocas. Como aparecen mezclados unos con otros, desde el siglo XVII lo mineralogistas asumieron que se originaban a partir de fluidos y que se endurecían en las posiciones y localizaciones en las que se encontraban. El estado de de fluidez podía deberse al calor, al agua o a alguna combinación de ambos.Los mineralogistas han librado batallas recurrentes en lo que parece una guerra interminable sobre la importancia relativa de todos estos factores. En cualquier caso, siempre han mantenido la esperanza de que serían capaces de usar sus conocimientos de química para reconstruir una narración de la génesis histórica de las rocas: una geogonía basada en una invariable secuencia de reacciones químicas a partir de un estado inicial. Buena parte de esos relatos están más próximos a la leyenda que a la realidad, que se ha mostrado exasperantemente tozuda.

Notas:

[1] La raya es el color “propio” de mineral que aparece al rayar una porcelana sin vidriar

[2] La escala de Mohs es una relación de diez minerales ordenados por su dureza, de menor a mayor. Se utiliza como referencia de la dureza de un material dado. Es necesario, por tanto, poseer una caja con minerales de referencia para poder determinar el valor de dureza.

[3] El ojo entrenado distingue entre vítreo, sedoso, nacarado, adamantino, graso y metálico

[4] Hay expertos que a simple vista disciernen entre ojo de gato, adularescencia, irisación propiamente dicha, labradorescencia y opalescencia

[5] O cómo se rompe un mineral; la fractura puede ser concoidea, astillosa, fibrosa, desigual y terrosa

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Clasificación y origen, los dos problemas de la mineralogía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Esa pesadilla científica llamada mineralogía

- ¿Y si la Gran Oxidación tuvo un origen geológico?

- Los amiloides y el origen de la vida

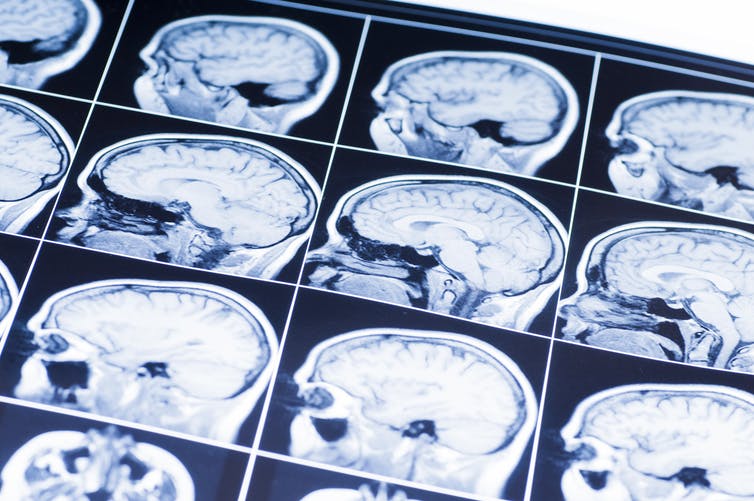

El nivel socioeconómico familiar influye en el desarrollo del encéfalo infantil

El entorno familiar influye de forma marcada en el desarrollo del encéfalo infantil. Los bebés tienen similares volúmenes de materia gris al nacer y en su más temprana infancia, pero al cabo de unos pocos meses de vida los que pertenecen a familias de bajo estatus socio-económico tienen menos que los de nivel medio o alto. Las diferencias no tienen relación con el peso al nacer, con la salud en las primeras semanas de vida o con diferencias en el tamaño de la cabeza en el momento del nacimiento. Y sabemos, por otro lado, que las diferencias en la cantidad de materia gris están relacionadas con problemas de comportamiento en los años anteriores a la escolarización.

Esas son las principales conclusiones de un estudio en el que se compararon los volúmenes de materia gris en varias áreas encefálicas de bebés y niños y niñas de edades preescolares procedentes de diferentes familias de los Estados Unidos. En el estudio se utilizaron imágenes obtenidas por resonancia magnética de encéfalos de bebés a los que se les siguió a lo largo de su desarrollo hasta los tres años edad, aproximadamente. Los análisis de imagen se hicieron con niños y niñas de los que se conocía su historial médico, no habían sido adoptados, no habían estado expuestos a sustancias nocivas durante el embarazo de la madre, el parto había sido normal, habían tenido un desarrollo normal y en la familia no había antecedentes psiquiátricos.

Las diferencias observadas se localizaron específicamente en las áreas frontal y parietal del cerebro, con menores volúmenes de estas áreas en los niños de familias de menores recursos. El lóbulo frontal está implicado en funciones ejecutivas, tales como planificación, control de impulsos y atención. El lóbulo parietal participa en la integración de señales sensoriales y aspectos relativos a la atención visual. Además, el desarrollo del lóbulo parietal parece ser importante para la conectividad entre diferentes áreas encefálicas.

No son los primeros resultados que ponen de manifiesto la relación entre las condiciones en que se desenvuelve el desarrollo temprano ligadas al nivel socioeconómico familiar y la posterior salud y capacidad de adaptación de los niños. Y al parecer, que el volumen de determinadas áreas dependa de las circunstancias ambientales experimentadas por los individuos tiene que ver con el establecimiento en ellas de diferente número de conexiones sinápticas, así como con diferencias en la producción de tejido de soporte (capilares sanguíneos y glía).

La variable de referencia utilizada para determinar el estatus socioeconómico fue el volumen de ingresos con relación al “nivel de pobreza federal”, que varió desde un 4% de dicho nivel hasta valores que lo cuadriplicaban. En los Estados Unidos, un 19% de las personas viven por debajo de esa línea. Los autores del trabajo descartan establecer relaciones causales concretas, porque el estatus socioeconómico lleva emparejado muchas otras condiciones ambientales, como el nivel cultural o educativo de los padres, el estilo de vida, la calidad de la alimentación, el ruido, la incidencia de enfermedades infecciosas, el ambiente familiar u otros. Y es muy posible que sea alguno de esos factores o determinada combinación de ellos lo que dé lugar a los efectos observados.

Conviene tener en cuenta que los criterios utilizados para seleccionar a los niños y niñas incluidos en los análisis conducen, de hecho, a atenuar las diferencias que cabría esperar encontrar, pues es sabido que los factores de exclusión (del estudio) están sobrerrepresentados en las personas de bajos recursos económicos. Por lo tanto, las conclusiones obtenidas en este trabajo deben considerarse conservadoras. Las diferencias reales son, con toda seguridad, de una magnitud muy superior.