Las actividades animales

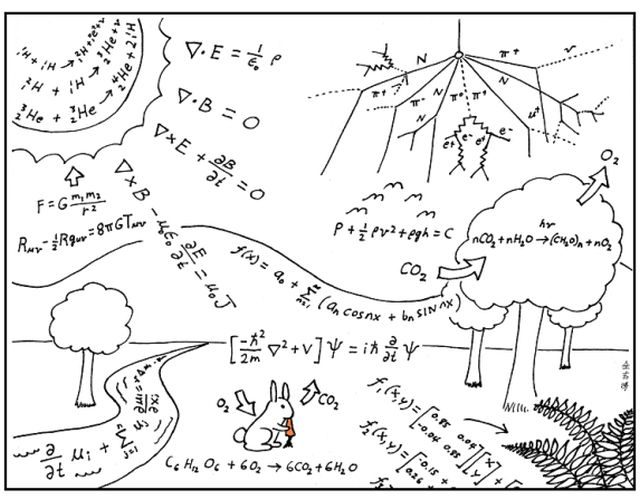

Los animales pueden ser tratados como sistemas abiertos que intercambian materia y energía con su entorno y que ejercen un cierto control sobre esos intercambios. Agua, sales, elementos estructurales, energía química, oxígeno, calor, así como los restos químicos de sus actividades (CO2, sustancias nitrogenadas,…) son objeto de un trasiego continuo. La capacidad de un animal para que ese flujo, en una y otra dirección (hacia dentro y fuera del organismo), rinda el máximo beneficio energético posible, a la vez que las condiciones estructurales y fisico-químicas internas permiten el mantenimiento de su integridad funcional, es lo que determina su éxito reproductor y, por lo tanto, su aptitud biológica en términos darwinianos.

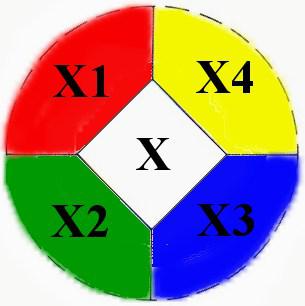

Cualquier clasificación que se quiera hacer de las actividades animales de acuerdo con las funciones a cuyo servicio se encuentran contiene, necesariamente, algún criterio arbitrario. Eso es así porque varias de esas actividades cumplen funciones en más de un ámbito. A los efectos de lo que nos interesa exponer aquí, las actividades pueden agruparse en las siguientes tres grandes categorías: (1) mantenimiento de la integridad estructural y funcional del organismo; (2) adquisición y procesamiento de los recursos necesarios para producir copias de sí mismo; y (3) control e integración de los procesos implicados en las funciones anteriores y en las relaciones (del tipo que fueren) con el resto de organismos del mismo o de otros linajes.

La primera categoría engloba las actividades implicadas en el mantenimiento de las condiciones que permiten que los procesos fisiológicos cursen de tal forma que el sistema animal en su conjunto mantenga su integridad. En rigor cabría atribuir a esta categoría casi todas las actividades –todas con la única excepción de las reproductivas-, pero algunas de ellas tienen cometidos más específicos, por lo que serán tratadas de acuerdo con su especificidad. La integridad funcional depende de los siguientes elementos: (1) mantenimiento del balance de agua y solutos en las células y en el individuo en su conjunto, incluyendo el concurso del sistema excretor; (2) equilibrio ácido-base de los líquidos corporales; (3) funcionamiento del sistema cardio-vascular como sistema de distribución y transporte de información, gases, nutrientes, deshechos y calor; (4) tareas de defensa; y (5) sistema de captación de O2 y eliminación de CO2 y transporte de estos gases.

La segunda categoría comprende las actividades mediante las cuales se adquieren y procesan los recursos que proporcionan: (1) la energía química que alimenta el conjunto de las actividades animales; y (2) los elementos estructurales que se necesitan para elaborar nuevos tejidos, ya sean para la línea somática o la línea germinal. Incluye, por lo tanto, (1) funciones de adquisición, digestión y absorción del alimento; (2) el metabolismo en su conjunto en su doble vertiente de indicador del nivel de actividad global del organismo y de gasto de energía en forma de calor disipado; y (3) balance energético de los procesos de ganancia y pérdida de energía, del que depende el crecimiento y la reproducción del individuo.

Y en la tercera categoría se incluyen las actividades que permiten: (1) recibir información del estado del organismo y del entorno; (2) procesar esa información y elaborar respuestas; y (3) ejecutar esas respuestas mediante cambios en las funciones fisiológicas internas o mediante actuaciones sobre el entorno. Esta categoría comprende el funcionamiento de los sistemas nervioso, endocrino y de los órganos efectores, especialmente los sistemas musculares.

Para concluir debemos remarcar una idea presentada al comienzo: los animales del presente son los herederos actuales de antecesores que, bajo las específicas circunstancias ambientales en que vivieron, han dejado mayor número de réplicas (parciales) de su información genética que otros muchos miembros de su linaje. Son, por lo tanto, herederos de los animales con mayor aptitud biológica de sus respectivas generaciones. Es a la luz de ese hecho como debe valorarse el modo en que cada individuo animal desarrolla sus actividades.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Las actividades animales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El tamaño relativo de los órganos animales

- Los animales

- El sistema de la difusión social de la ciencia: Efecto de las actividades de difusión científica

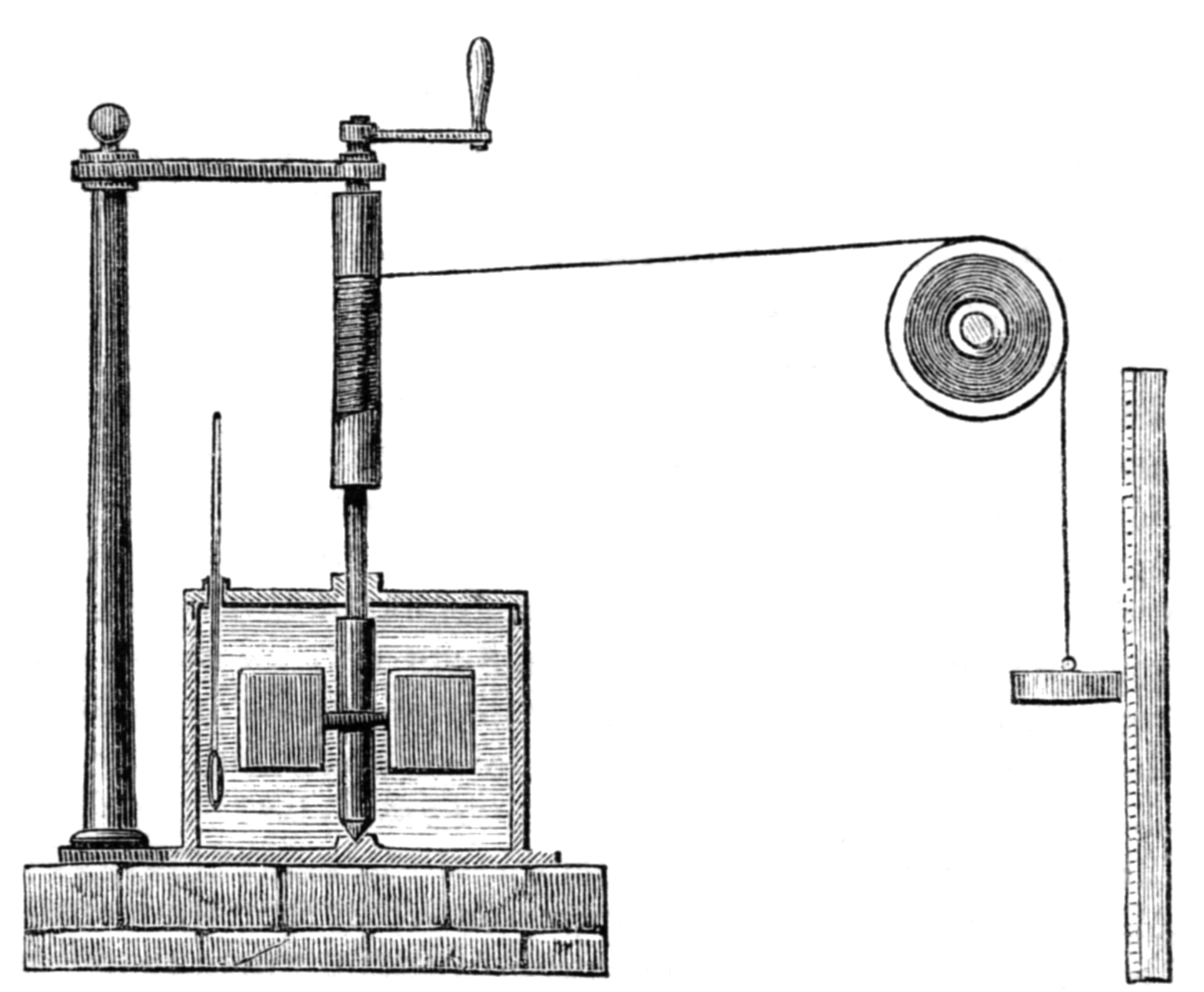

La máquina de vapor (1)

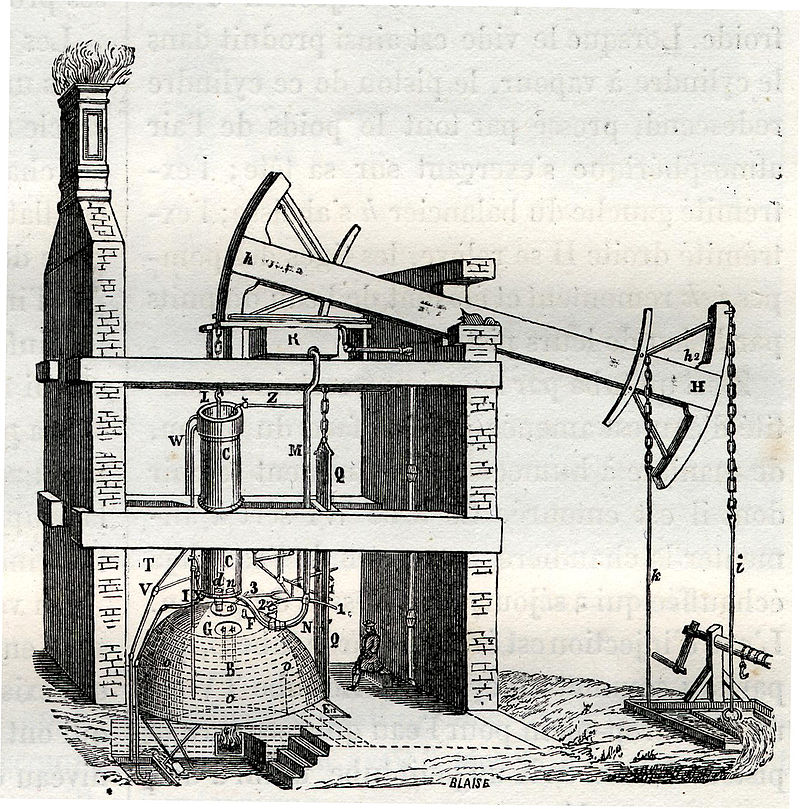

Segunda máquina de vapor construida por Newcomen (1714)

El desarrollo de la ciencia moderna del calor estuvo estrechamente ligado al desarrollo de la tecnología moderna de máquinas diseñadas para realizar trabajo. Durante milenios y hasta hace dos siglos la mayor parte del trabajo se realizaba por animales (humanos y de otras especies). El viento y el agua también proporcionaban trabajo mecánico, pero en general no son fuentes de energía fiables, ya que no siempre está disponibles cuando y donde se necesitan.

En el siglo XVIII, los mineros comenzaron a cavar cada vez a más profundidad en su búsqueda de mayores cantidades de carbón. El agua tendía a filtrarse e inundaba estas minas más profundas. Se planteó la necesidad de un método económico para bombear el agua y sacarla de las minas. La máquina de vapor se desarrolló inicialmente para satisfacer esta necesidad concreta.

La máquina de vapor es un dispositivo para convertir la energía térmica del calor que produce un combustible en trabajo mecánico. Por ejemplo, la energía química de la madera, el carbón o el petróleo, o la energía nuclear del uranio, pueden convertirse en calor. La energía térmica a su vez se utiliza para hervir el agua para formar vapor, y la energía en el vapor se convierte en energía mecánica. Esta energía mecánica puede ser utilizada directamente para realizar trabajo, como en una locomotora de vapor, o utilizada para bombear agua, o para transportar cargas, o se transforma en energía eléctrica. En las sociedades post-industriales típicas de hoy, la mayor parte de la energía utilizada en las fábricas y en los hogares proviene de la energía eléctrica. Parte viene de saltos de agua y del viento pero la fuente que garantiza el suministro continuo y a demanda sigue siendo la proveniente de generadores.

Existen otros dispositivos que convierten el combustible en energía térmica para la producción de energía mecánica, como los motores de combustión interna utilizados en automóviles, camiones y aviones, por ejemplo. Pero la máquina de vapor sigue siendo un buen modelo para el funcionamiento básico de toda la familia de los llamados motores térmicos y la cadena de procesos desde la entrada de calor hasta la salida de trabajo y el escape de calor residual es un buen modelo del ciclo básico involucrado en todos los motores térmicos.

Modelo moderno de eolípila

Desde la antigüedad se sabe que el calor se puede utilizar para producir vapor que, a su vez, puede realizar trabajo mecánico. Un ejemplo fue la eolípila, inventada por Herón de Alejandría alrededor del año 100. Se basaba en el mismo principio que hace que giren los aspersores de jardín, excepto en que la fuerza motriz era el vapor en vez de la presión del agua. La eolípila de Herón era un juguete, hecho para entretener más que para hacer un trabajo útil. Quizás la aplicación más “útil” del vapor en el mundo antiguo fue otro de los inventos de Herón. Este dispositivo asombraba a los fieles congregados en un templo al hacer que una puerta se abriera cuando se encendía un fuego en el altar.

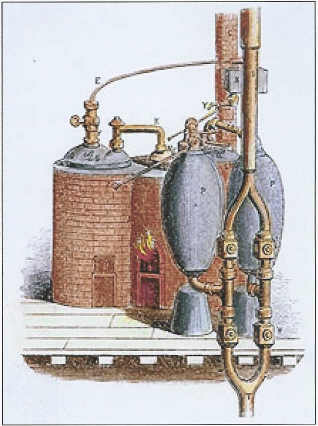

No fue hasta finales del siglo XVIII que los inventores empezaron a producir máquinas de vapor con éxito comercial. Thomas Savery (1650-1715), un ingeniero militar inglés, inventó la primera máquina de este tipo, a la que dio en llamarse “la amiga del minero”. Podía bombear el agua de una mina llenando alternativamente un tanque con vapor de alta presión, lo que llevaba vaciaba el agua del tanque empujándola hacia arriba, condensando después el vapor, lo que permitía que entrase más agua en el tanque.

Máquina de Savery (1698)

Desafortunadamente, el uso de vapor de alta presión por parte de la máquina Savery implicaba unimportante riesgo de explosiones de calderas o cilindros. Thomas Newcomen (1663-1729), otro ingeniero inglés, solucionó este defecto. Newcomen inventó una máquina que utilizaba vapor a menor presión. Su máquina era mejor también en otros aspectos. Por ejemplo, podía elevar cargas distintas al agua. En lugar de usar el vapor para forzar el agua dentro y fuera de un cilindro, Newcomen utilizó vapor para forzar un pistón hacia adelante y presión de aire para forzarlo hacia atrás. El movimiento del pistón podía utilizarse para mover una bomba u otro tipo de máquina.

Principio de funcionamiento de la máquina de Newcomen

El movimiento del pistón en una máquina de vapor, hacia adelante y hacia atrás, es uno de los orígenes de la definición de trabajo mecánico, W, como fuerza (F) x distancia (d), W = F·d.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La máquina de vapor (1) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El terrorismo como sacerdocio

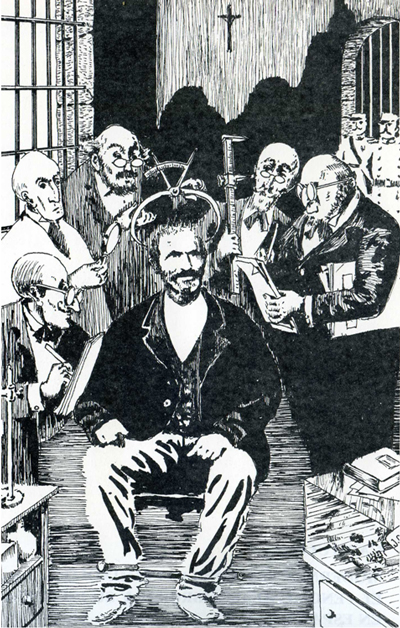

El sufrimiento por las creencias propias facilita que otros compartan las mismas creencias, religiosas y de otro tipo, porque les otorga credibilidad. Esta es la tesis que sostiene Joseph Henrich, de la Universidad de la Colombia Británica (Canada). El prestigio de una persona en el seno de su comunidad facilita considerablemente que las costumbres, ideas y creencias de esa persona sean adoptadas por el resto de sus miembros. Si además de eso, la persona en cuestión está dispuesta a realizar actos costosos o que acarrean sufrimiento en pro de esas costumbres, ideas o creencias, su credibilidad es aún mayor, porque otorgamos mucho valor a ese tipo de actos. Por eso, en las primeras fases de las religiones que tienen éxito suelen aparecer personas de prestigio que los realizan. La gente se fija, sobre todo, en modelos o referencias comunitarias y la credibilidad de su fe es mayor si están dispuestas a sufrir o pasarlo mal para demostrarlo.

Esa es la razón por la que el martirio se convierte en una poderosa herramienta para que las creencias del mártir sean aceptadas por otras personas y para que éstas se comprometan, a su vez, con la causa. Es también el mecanismo que subyace a los votos de castidad y pobreza, o al ayuno, de los líderes religiosos, porque la renuncia (real o aparente) a los correspondientes bienes, supone una muestra de lo genuino de las creencias y promueve su adopción por parte de otras personas.

El mismo argumento vale para los terroristas, sobre todo si son suicidas. Por esa razón, las medidas que puedan adoptar las autoridades para punir determinados comportamientos pueden, en la práctica, servir de estímulo para la aparición de nuevos seguidores de la causa. Los mártires del primer cristianismo son ejemplos claros de ese fenómeno. No es que los terroristas hagan votos de castidad o pobreza, o que ayunen de forma voluntaria, pero ante los potenciales adeptos a su causa aparecen como personas dispuestas a renunciar a bienes, como la libertad o el bienestar material, de los que muchos disfrutan y que tienen en alta estima. Desde ese punto de vista y en sus modalidades menos exageradas, la militancia terrorista bien podría asimilarse a una especie de sacerdocio. Y si los terroristas están dispuestos a arriesgar sus vidas o, incluso, se la quitan a sí mismos como consecuencia inevitable de sus actos, más que sacerdotes, alcanzan la condición de mártires.

Fuente:

Joseph Henrich (2015): The secret of our success. Princeton University Press.

El trabajo original fue publicado por el autor en Evolution and Human Behavior (2009) y se puede consultar aquí.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El terrorismo como sacerdocio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Del relativimo al cientifismo, por Experientia Docet

- La prolongación de la juventud como precarización de lo adulto

- El óxido de grafeno que se mueve como una oruga y coge cosas como una mano

Un espectrómetro Raman portátil mide el punto óptimo de maduración del tomate

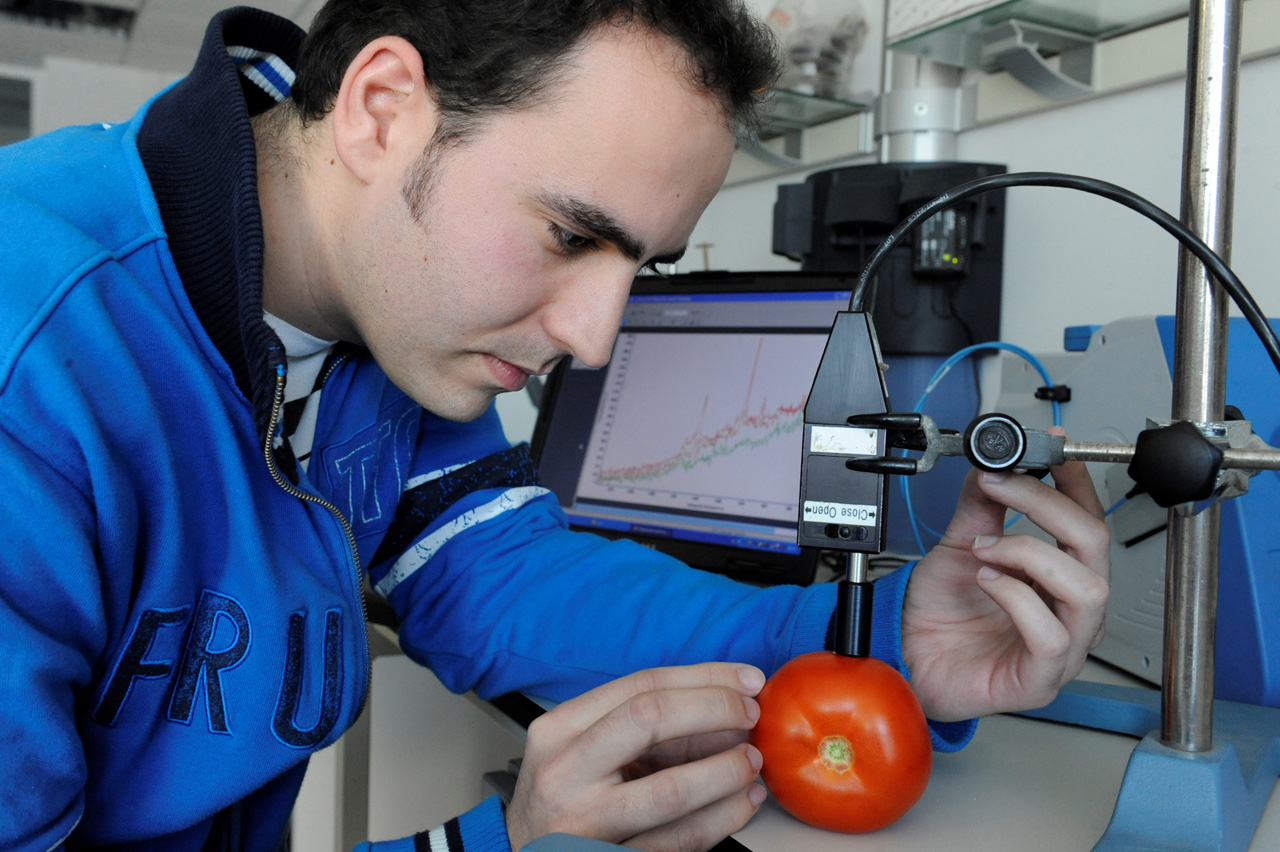

Un espectrómetro Raman portátil

El espectrómetro Raman portátil, un equipo que se utiliza en campos tan diversos como la metalurgia, la arqueología o el arte, permite obtener datos sobre la variación de la composición del fruto del tomate en sus diferentes fases de maduración, según los resultados de un estudio realizado en el Departamento de Química Analítica de la UPV/EHU.

El espectrómetro Raman portátil es un instrumento muy utilizado en sectores muy diferentes, ya que es una técnica no invasiva que sirve, por ejemplo, para observar los pigmentos que contiene un cuadro o una escultura sin tener que extraer muestra alguna, preservando así la integridad de la obra en cuestión. En este caso, los investigadores han aplicado el espectrómetro Raman a la investigación culinaria. Según Josu Trebolazabala, autor del estudio, “se trata de un trasvase de esta tecnología, que tenía un uso concreto, a la cocina. Nuestra idea era crear una herramienta que pudiera ayudar al productor a saber cuál es el punto óptimo de maduración del tomate. Con esta técnica se consigue, además, hacerlo sin destruir el fruto”.

Josu Trebolazabala analiza en el laboratorio la composición de un tomate mediante el espectrómetro Raman. Foto: Txetxu Berruezo.

Los resultados ofrecidos por este instrumento portátil han sido comparados con los ofrecidos por un instrumento similar de laboratorio, y “aunque la calidad de los espectros Raman del instrumento de laboratorio ha resultado ser superior, la información obtenida con la instrumentación portátil puede considerarse de suficiente calidad para el objetivo propuesto, es decir, que el productor pueda ir a la huerta con este equipo y, posando la sonda Raman de contacto sobre el fruto del tomate, pueda saber si el tomate está en un punto de recogida óptimo o hay que dejarlo madurar más tiempo”, comenta Josu Trebolazabala.

La monitorización de la composición del fruto del tomate en sus fases de maduración ha permitido observar los cambios que se producen en la composición del tomate en su tránsito desde su estado inmaduro hacia el estado maduro. “Cuando el tomate está verde, los pigmentos mayoritarios son la clorofila (de ahí su color verde) y las ceras cuticulares, que se encuentran en el exterior”, explica Trebolazabala. Pero la presencia de dichos compuestos desciende a medida que el fruto alcanza su punto óptimo de maduración. “Una vez que el color pasa al anaranjado, se observan otro tipo de compuestos; se activan los compuestos carotenoides. El tomate va adquiriendo nutrientes hasta llegar al punto óptimo, es decir, cuando el licopeno (carotenoide de color rojo) está en su máximo. Después, el tomate empieza a perder contenido en carotenoides, como demuestran los análisis realizados en tomates excesivamente maduros”.

Esta innovadora técnica es extrapolable a cualquier otro alimento que cambie de coloración durante su etapa de maduración. “Se han realizado pruebas con el pimiento y con la calabaza, por ejemplo, y también es posible obtener datos sobre su composición”, aclara.

Referencia:

J. Trebolazabala, M. Maguregui, H. Morillas, A. de Diego, J.M. Madariaga.. Portable Raman spectroscopy for an in-situ monitoring the ripening of tomato (Solanum lycopersicum) fruits. Spectrochimica Acta Part A: Molecular and Biomolecular Spectroscopy 180: 138-143. DOI: 10.1016/j.saa.2017.03.024.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un espectrómetro Raman portátil mide el punto óptimo de maduración del tomate se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La pantalla de tu móvil solo tiene tres colores

- Otra pieza en el puzle de la fotosíntesis

- La contaminación por metales pesados no llega a los tomates

Sin atajos frente al cáncer

El archiconocido empresario norteamericano Steve Jobs murió a consecuencia de un cáncer de páncreas que no fue operado a tiempo. Si hubiese sido intervenido cuando le fue diagnosticada la enfermedad, el desenlace podría haber sido otro. Sin embargo, Jobs optó por recurrir a terapias alternativas, y retrasó la intervención que, realizada a tiempo, podría quizás haberle salvado. Ese no es, desgraciadamente, el único caso en que la renuncia a las terapias más eficaces de que disponemos conduce a un desenlace fatal.

Aparte de para curarse, también hay quien recurre a remedios supuestamente preventivos. Se promocionan dietas con la pretensión declarada de prevenir la aparición de tumores. Y en el colmo de la desfachatez –por no decir, directamente, de la maldad- hay quienes atribuyen a los enfermos la responsabilidad de su situación, al afirmar que el cáncer tiene origen en algún problema psicológico no resuelto mediante alguna práctica o modo de vida supuestamente indicado a tal efecto.

Proliferan ahora dietas “anti-cáncer”. Una de las más populares es la llamada “dieta alcalina”, que usaré aquí, a modo de ejemplo, para ilustrar el sinsentido de esta y otras falsas terapias. Para entender el fundamento en que supuestamente se basa, hay que tener en cuenta que el entorno de las células cancerosas suele ser ácido y que los promotores de la dieta milagrosa sostienen que esa acidez es la que provoca el cáncer. Creen que hay que neutralizarla ingiriendo una dieta alcalina.

La razón de que las células cancerosas se encuentren en un entorno ácido es que, para obtener energía, tienden a utilizar más glucosa que las sanas, haciendo uso de una vía metabólica llamada glucolisis, sin que esa ruta sea complementada por otras que son las que en muchos tejidos animales proporcionan más energía y acaban requiriendo el concurso del oxígeno que respiramos. En esas condiciones, los productos finales de la glucolisis son sustancias ácidas, y es por eso por lo que el entorno de esas células se acidifica. Algo parecido ocurre, por cierto, con las células de nuestros músculos cuando los sometemos a un esfuerzo muy intenso; bajo esas condiciones la glucosa, tras una serie de etapas, acaba convirtiéndose en ácido láctico.

A la utilización preferente de glucosa por las células cancerosas se le denomina “efecto Warburg”, pues fue Otto Warburg quien lo describió en 1924. De hecho, fue él quien sugirió que el cáncer podía ser una consecuencia del fenómeno descrito. Sin embargo, como hemos visto, la secuencia causal es la opuesta: son las células cancerosas las que provocan la acidificación del entorno, y no al revés. Y en todo caso, conviene aclarar que el grado de acidez del organismo no puede modificarse con la dieta, puesto que está regulado fisiológicamente de forma muy estricta, sin que la acidez de aquélla ejerza ningún efecto.

Los diagnósticos de cáncer son difíciles de aceptar, sobre todo cuando el tratamiento prescrito es agresivo, como suele ocurrir con la quimioterapia. Y por esa razón no es raro que a la hora de afrontar un tratamiento duro, de efectos secundarios muy desagradables e incluso temporalmente incapacitantes, haya quien valore la posibilidad de probar terapias alternativas. No faltan, además, personajes que, valiéndose del sufrimiento de los enfermos, les ofrecen remedios sin los duros efectos de los tratamientos oncológicos habituales. Pues bien, conviene tener siempre presente que son los médicos de nuestro sistema de salud los únicos capacitados para prescribir la terapia más eficaz posible. Cuando el camino a recorrer es muy duro, la tentación de tomar atajos es muy fuerte, también frente a la enfermedad. Pero tampoco frente al cáncer hay atajos.

Adenda:

Tras su publicación en la sección con_ciencia del diario Deia el 29 de enero pasado, este texto recibió comentarios críticos con la idea de que el cáncer que sufría Jobs tuviese mejor pronóstico que la mayoría de los que afectan al páncreas, razón por la cual no debía criticarse su opción por explorar tratamientos alternativos a los que le ofrecía la medicina. Quien suscribe no es especialista en oncología; ni siquiera es médico. Recurro, por ello, a lo que señala la Wikipedia en inglés a ese respecto y que cada cual juzgue:

En octubre de 2003 a Jobs se le diagnosticó cáncer. A mediados de 2004 él anunció a sus empleados que tenía un tumor canceroso en el páncreas. El pronóstico para el cáncer de páncreas es normalmente muy negativo. Jobs especificó que él tenía un tipo de tumor raro, no tan agresivo, conocido como carcinoma de los islotes pancreáticos.

A pesar del diagnóstico, durante nueve meses Jobs no hizo caso a las recomendaciones de sus médicos de que se operase, confiando, por el contrario, en una dieta pseudo-médica para intentar un tratamiento natural para combatir la enfermedad. De acuerdo con el investigador de Harvard Ramzi Amri, su opción por un tratamiento alternativo le condujo a una muerte innecesariamente temprana. El investigador en cáncer y crítico de la medicina alternativa David Gorski disentía de la opinión de Amri, y manifestó que “según mi criterio, Jobs probablemente solo redujo de manera modesta sus posibilidades de sobrevivir”. Barrie R. Cassileth, el jefe del departamento de medicina integrativa del Memorial Sloan Kettering Cancer Center dijo que “la fe de Jobs en la medicina alternativa probablemente le costó la vida…. Él tenía el único tipo de cáncer de páncreas que es tratable y curable… Él, básicamente se suicidó.” De acuerdo con el biógrafo de Jobs, Walter Isaacson, “durante nueve meses él rehusó someterse a una cirugía para su cáncer de páncreas, una decisión que más tarde lamentaría conforme su salud empeoró. En vez de ello, probó una dieta vegana, acupuntura, hierbas y otros tratamientos que encontró en internet, e incluso, consultó a un vidente. El estaba muy influido por un médico que dirigía una clínica que prescribía enemas, ayunos y otros tratamientos carentes de fundamento antes de ser operado en julio de 2004 y de serle extirpado el tumor. Jobs no recibió radioterapia ni quimioterapia.”

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sin atajos frente al cáncer se ha escrito en Cuaderno de Cultura Científica.

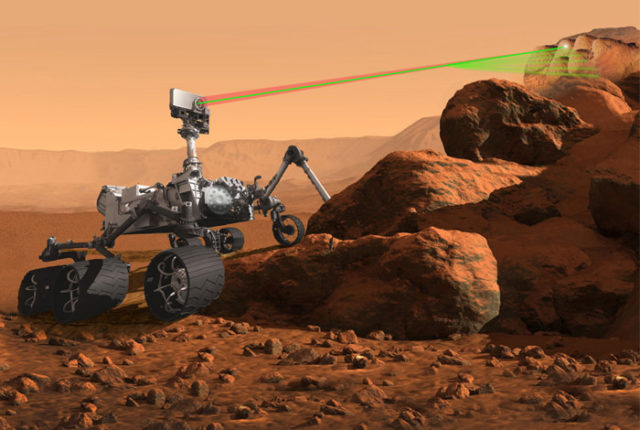

Entradas relacionadas:Los ojos que explorarán la superficie de Marte (Mars2020)

Un equipo de investigación de la UPV/EHU está participando en la misión de la NASA Mars2020, que pretende transportar un nuevo vehículo científico a Marte para explorar potenciales signos de vida, analizar su habitabilidad y mejorar el estudio del clima, la atmósfera y la geología marciana. Estos investigadores se encargarán de calibrar una cámara que, mediante diferentes mediciones espectroscópicas, analizará el suelo del planeta rojo para buscar señales orgánicas y determinar la mineralogía y la composición química, atómica y molecular de las muestras localizadas.

El director de este equipo de investigación, Juan Manuel Madariaga, habló sobre este proyecto en una charla que tuvo lugar el pasado 22 de febrero en Azkuna Zentroa (Bilbao). Esta charla forma parte del ciclo de conferencias Zientziateka, que organizan todos los meses la Cátedra de Cultura Científica de la UPV/EHU y Azkuna Zentroa para divulgar asuntos científicos de actualidad.

Los ojos que explorarán la superficie de MarteEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Los ojos que explorarán la superficie de Marte (Mars2020) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Investigación con medicamentos en seres humanos: del laboratorio a la farmacia

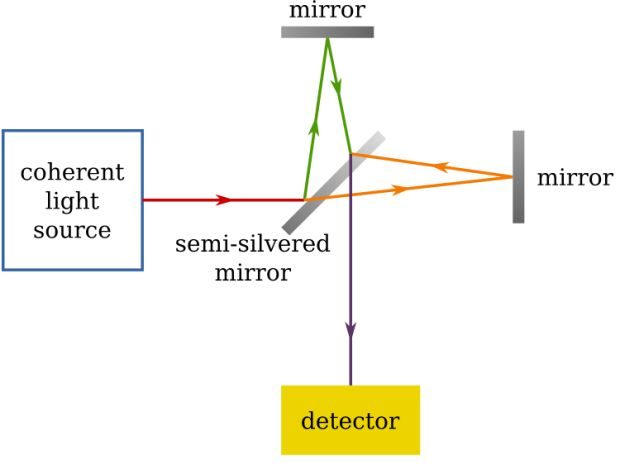

- La detección de ondas gravitacionales: el nacimiento de una nueva astronomía

- La batalla contra el cáncer: la importancia de la alimentación

Las cartas de Darwin: El capitán y el filósofo

Las cartas de Darwin, una serie para conocer aspectos sorprendentes de la vida del naturalista

Carta de Charles Darwin a John Stevens Henslow [15 septiembre 1831]

“El capitán FitzRoy es todo lo que puede ser de grato, si fuera a alabarlo solo la mitad de lo que me siento inclinado, a pesar de haberlo visto solo una vez, le parecería a usted absurdo…[…] No puede usted imaginar nada más grato, gentil y abierto que las maneras del capitán FitzRoy para conmigo. Si no congeniamos seguramente será por mi culpa”.

Así de optimista y elogioso se mostraba el joven Charles Darwin tras su primer encuentro con el capitán que iba a dirigir su expedición durante los próximos años. A ojos del naturalista, FitzRoy aparecía como un hombre experimentado (a pesar de tener solamente cuatro años más que Darwin), una persona disciplinada, de trato afable y dispuesta a agradar. Darwin mantuvo esta favorable opinión del capitán durante gran parte del viaje y, aunque no se puede decir que se convirtieran en amigos, sí que hubo una relación correcta durante los cinco largos años que tuvieron que compartir un pequeño camarote y las incomodidades de un barco de esas características.

Carta de Charles Darwin a su hermana Susan Darwin [09/14 de septiembre 1831]

“Te daré una prueba de que FitzRoy es un buen capitán: todos los oficiales serán los mismos del anterior viaje y dos tercios de su tripulación y los ocho infantes de marina que fueron antes con él, todos se han ofrecido a volver de nuevo, así que el servicio no puede ser tan malo”.

Unos días más tarde y tras algunos encuentros más con el capitán para la organización del viaje, Darwin vuelve a escribir a su hermana reiterando su admiración por FitzRoy.

“Por mis cartas anteriores, quizá llegaste a pensar que admiraba yo a mi bello ideal de capitán, pero todo ello no es nada respecto de lo que siento ahora. Todo el mundo lo alaba y, si juzgamos por el poco tiempo que he compartido con él, no hay duda que lo merece. Esto no quiere decir que una admiración tan intensa como la que siento por él pueda durar para siempre. Nadie es un héroe para su ayuda de cámara, como dice el dicho, y desde luego que me encontraré en el mismo predicamento con el tiempo”.

Además, en la primera carta a su hermana, Darwin hace una pequeña profecía que, como comprobaremos más adelante, no se iba a cumplir:

“No creo que nos peleemos por la política, aunque Wood (como debe esperarse de un irlandés de Londonderry) advirtió solemnemente a FitzRoy que yo era liberal”.

El capitán Robert FitzRoy en uno de los pocos retratos de joven

Mucha gente cree que las escasas, aunque potentes, discusiones que tuvieron Darwin y FitzRoy durante el viaje en el Beagle se debieron a motivos religiosos, y no es cierto. Tanto el capitán como el filósofo (así llamaba la tripulación al joven Darwin) se enfrascaron en varias disputas pero siempre por motivos políticos y sociales. Las desavenencias religiosas llegaron mucho más tarde, casi 30 años después, a raíz de la publicación en 1859 del Origen de las especies.

En el barco, no obstante, la gran discusión entre Darwin y FitzRoy se produjo por un asunto que imprimió una profunda huella en el naturalista: la esclavitud.

Carta de Charles Darwin a John Maurice Herbert [01 de junio de 1832]

“[Durante su estancia en Brasil] No me había dado cuenta de cuán íntimamente está conectada la que podríamos llamar parte moral con el goce del paisaje. Tales ideas, al igual que la historia del país, la utilidad de los productos y más especialmente la felicidad de la gente, nos acompañan. Pero cambia al trabajador inglés por un pobre esclavo que trabaja para otro y ya no reconoces el mismo paisaje”.

A pesar de lo que se pudiera pensar, sobre todo por las grandes ilusiones que Darwin se hizo al inicio del viaje, nuestros dos personajes nunca llegaron a ser grandes amigos. De hecho, si tuviésemos que juzgar su relación por las cartas que se escribieron en toda su vida tendríamos muchas dificultades puesto que apenas se intercambiaron un puñado de ellas.

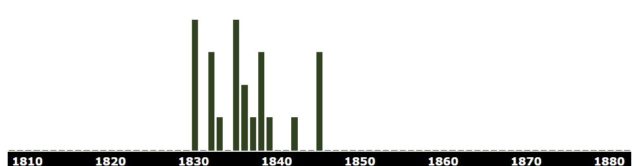

Darwin y FitzRoy tan solo intercambiaron 22 cartas (diez escritas por Darwin, doce por FitzRoy) entre los años 1831 y 1846, año en el que dejaron de escribirse.

Para conocer a fondo la intensa relación entre Darwin y el capitán, lo más eficaz es acudir a la “Autobiografía” que el propio naturalista escribió haciendo gala de una sinceridad en muchos aspectos implacable.

“FitzRoy poseía un carácter singular dotado de muchas facetas muy nobles: era un hombre entregado a su deber, generoso hasta el exceso, audaz, decidido, de una energía indomable y amigo apasionado de todo el que se hallase bajo su autoridad. Sería capaz de asumir cualquier tipo de inconveniente para dar su ayuda a quien pensaba que la merecía”

“El temperamento de FitzRoy era de lo más desventurado. Así lo demostraban no solo su apasionamiento sino sus accesos de prolongada taciturnidad con quienes le habían ofendido. Solía empeorar en las primeras horas de la mañana, y con su vista de águila era, por lo general, capaz de detectar cualquier cosa que estuviese mal en el barco, y a continuación se mostraba implacable con sus acusaciones. Cuando se turnaban antes del mediodía, los oficiales de menor rango solían preguntarse “Cuánto café caliente se había servido aquella mañana”, con lo que se referían al humor del capitán. Era también un tanto suspicaz, y de vez en cuando, muy depresivo, hasta el punto de rayar la locura en cierta ocasión. A menudo me parecía que carecía de sensatez o de sentido común”.

“Conmigo se portó con una amabilidad extrema, pero era un hombre con el cual resultaba muy difícil convivir con la intimidad derivada necesariamente del hecho de comer solos en el mismo camarote”.

“Tuvimos varias peleas y cuando perdía los estribos era absolutamente irrazonable. Al comienzo del viaje, por ejemplo, en la localidad brasileña de Bahía, defendió y elegió la esclavitud, que a mí me parecía abominable, y me dijo que acababa de visitar a un gran propietario de esclavos que, tras convocar a muchos de ellos, les había preguntado si eran felices y deseaban ser libres, a los que todos habían respondido con un: “No”. Yo le pregunté, quizá con cierta sorna, si pensaba que las respuestas dadas por unos esclavos en presencia de su dueño tenían algún valor. Esto lo sacó de quicio y me dijo que, si dudaba de su palabra, no podríamos seguir viviendo juntos. Pensé que se me obligaría a dejar el barco, pero en cuanto se difundió la noticia, el capitán mandó llamar al primer teniente para calmar su furia insultándome a mí, me sentí profundamente gratificado al recibir una invitación de los oficiales de la sala de armas para que comiera con ellos.

No obstante, al cabo de unas horas, FitzRoy demostró su habitual magnanimidad enviándome a un oficial con sus disculpas y una petición para que siguiéramos compartiendo su camarote”.

Robert FitzRoy con su uniforme de la marina británica en la que llegó a ser ViceAlmirante

De esta tensa relación, y también de la disputa a cuenta del espinoso asunto de la esclavitud, Darwin se explicaba así en una carta a Henslow:

Carta de Charles Darwin a John Stevens Henslow [16 junio 1832]

“El capitán hace todo lo que está en su mano para ayudarme, y nos llevamos bien, pero doy gracias a mi buena fortuna que no me haya convertido en un renegado de los principios liberales. No seré un conservador aunque tan solo sea a cuenta de sus fríos corazones acerca del escándalo de todas las naciones cristianas: la esclavitud”.

Finalizando el viaje, y tras cinco años embarcado, Darwin escribe a su hermana Susan resumiendo el estado de la relación con el capitán en los últimos meses.

Carta de Charles Darwin a su hermana Susan Darwin [28 de enero 1836]

“En los últimos doce meses he estado en muy buenos términos con él. Es un hombre extraordinario y de noble carácter, aunque por desgracia afectado por ciertas peculiaridades de su temperamento, de lo cual nadie se da tanta cuenta como él mismo, lo cual se demuestra en sus intentos por controlarlo.

A menudo dudo de cuál sea su fin: bajo muchas circunstancias estoy seguro de que será brillante, pero por otras me temo que no será feliz”.

En esta ocasión, Darwin sí acertaría de pleno con su profecía. FitzRoy fue un hombre brillante, al que bien podemos considerar hoy como el padre de la meteorología moderna, pero que tuvo un final trágico y suicida, como él mismo temió durante su vida.

Una vez finalizada la travesía del Beagle, Darwin y FitzRoy apenas mantuvieron el contacto, salvo en algunas cartas sueltas, una de ellas escrita con indignación y enfado por parte del capitán a cuenta de los créditos en el prólogo de la obra Zoology of the voyage of HMS Beagle.

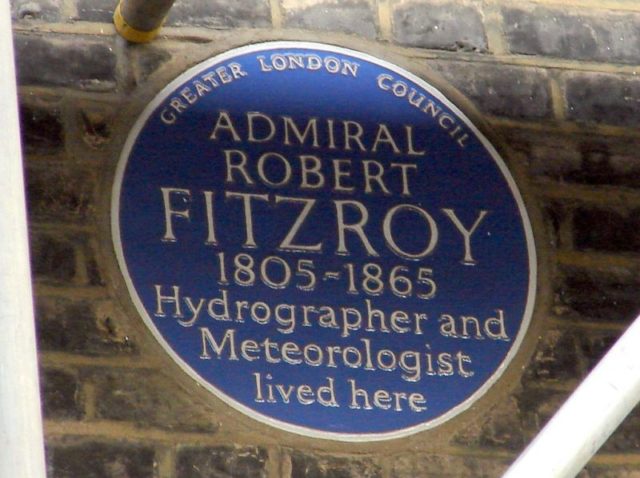

Placa conmemorativa en Londres dedicada a FitzRoy como hidrógrafo y meteorólogo

El final, y abrupto desencuentro, entre los dos personajes lo resume mejor que nadie el propio Darwin en su Autobiografía:

“Tras mi vuelta a Inglaterra, solo vi a FitzRoy de vez en cuando, pues temía siempre ofenderle sin querer, como lo hice realmente en un caso sin posibilidad de reconciliación”.

Darwin se refiere aquí a la carta de FitzRoy de 16 de noviembre de 1837, aunque el colofón final llegaría en 1859 con la publicación de su obra más célebre.

“Más tarde se mostró muy indignado conmigo por haber publicado un libro tan heterodoxo como El origen de las especies, pues en esa época Fitzroy se había vuelto muy religioso. Me temo que hacia al final de su vida se empobreció mucho, debido en gran parte a su generosidad. De todos modos, tras su muerte se organizó una suscripción para pagar sus deudas. Tuvo un triste final, por suicidio, exactamente igual que su tío Lord Castlergah, a quien se parecía mucho en modales y aspecto.

Su carácter fue, en varios sentidos, uno de los más nobles que he conocido, aunque empañado por graves imperfecciones”.

Para finalizar, me gustaría recomendar el libro “FitzRoy, capitán del Beagle” de John y Mary Gribbin, en cuya introducción se recogen las que posiblemente sean las palabras más célebres de Darwin sobre su compañero de viaje:

“A mi entender, es un individuo extraordinario. No había jamás a un hombre de convertirse en un Napoleón o un Nelson. No le llamaría listo, aunque estoy convencido de que no hay misión demasiado noble o ambiciosa para él. Su influencia sobre los demás es muy curiosa: antes de conocerle me habría resultado incomprensible el grado al que cada oficial y marinero siente la menor reprimenda elogio. Su peor fallo como compañero es un silencio austero, producto de su carácter excesivamente pensativo. Tiene muchas y muy importantes cualidades positivas: en conjunto es la persona con el carácter más fuerte con el que haya congeniado en mi vida”.

Este post ha sido realizado por Javier Peláez (@irreductible) y es una colaboración deNaukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Las cartas de Darwin: El capitán y el filósofo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: La vida a bordo de un balandro ataúd

- Las cartas de Darwin: Casi me vuelvo a casa antes de las Galápagos

- Las cartas de Darwin: ¿Dejamos que el chaval se vaya de viaje?

¿Jugar al ajedrez te hace más inteligente? Un vistazo a las pruebas

Giovanni Sala & Fernand Gobet

![]()

El estereotipo del jugador de ajedrez es alguien que es inteligente, lógico y bueno en matemáticas. Esta es la razón por la que muchos padres de todo el mundo desean que sus hijos jueguen al ajedrez, con la esperanza de que el juego pueda ayudar a aumentar los niveles de inteligencia de su hijo o hija y ayudarlos a tener éxito en una amplia variedad de asignaturas.

Pero aparte de que el ajedrez sea un gran juego, su historia arraigada en los ejércitos de la India oriental, ¿hay alguna evidencia que demuestre que jugar al ajedrez puede hacerte más inteligente?

En un artículo anterior, mostramos que los jugadores de ajedrez exhiben, en promedio, una capacidad cognitiva superior en comparación con los jugadores que no son ajedrecistas. Y las habilidades necesarias para jugar al ajedrez también se ha demostrado que se correlacionan con varias medidas de la inteligencia – como el razonamiento fluido, la memoria y la velocidad de procesamiento.

Pero si bien la existencia de una relación entre la habilidad cognitiva general y la capacidad ajedrecística es clara, ¿es esto simplemente porque las personas inteligentes son más propensas a jugar al ajedrez, o jugar al ajedrez hace que la gente sea más inteligente?

Juego mental

La noción de que jugar ajedrez te hace más inteligente va más o menos así: el ajedrez requiere concentración e inteligencia, y como las matemáticas y las capacidades lectora y escritora requieren las mismas habilidades generales, entonces practicar el ajedrez también debe mejorar tu rendimiento académico.

Con esta idea en mente, el Instituto de Educación [del University College London] llevó a cabo una gran investigación para comprobar los efectos de la instrucción en ajedrez sobre las habilidades académicas de casi 4.000 niños británicos.

Club de ajedrez en un colegio. Imagen: Pexels

Los resultados publicados recientemente fueron decepcionantes – parece que el ajedrez no influye en los niveles de logros de los niños en matemáticas, capacidades lectora y escritora o ciencia.

Rápidamente, la comunidad ajedrecista cuestionó la fiabilidad de los resultados, sobre todo teniendo en cuenta que otros estudios ofrecen un panorama más optimista sobre los beneficios académicos de la instrucción en ajedrez.

Evaluando las evidencias

La comunidad ajedrecista probablemente tiene razón al criticar el estudio reciente, ya que sufre de varias deficiencias metodológicas que probablemente invalidan los resultados.

Antes de que se publicasen los resultados, llevamos a cabo una revisión de todos los estudios en el campo. Nuestros resultados muestran algunos efectos moderados de la instrucción en ajedrez sobre la capacidad cognitiva y el rendimiento académico – especialmente matemáticas.

¿Requiere inteligencia el ajedrez? Imagen: Shutterstock

Y, sin embargo, todavía tenemos que ser cautelosos en la interpretación de estos resultados como una indicación positiva del poder del ajedrez sobre las habilidades cognitivas o académicas. Esto se debe a que la mayoría de los estudios revisados compararon el efecto del ajedrez con grupos que no realizaron actividades alternativas.

Esto es un problema porque la investigación ha demostrado que la excitación y la diversión inducidas por actividades novedosas pueden causar un efecto temporal positivo en los resultados de las pruebas – un efecto placebo.

Llamativamente, cuando se le compara con una actividad alternativa – como los damas o los deportes – el ajedrez no muestra ningún efecto significativo en las habilidades de los niños. Por lo tanto, podría muy bien ser sólo que los efectos positivos observados de la instrucción en ajedrez sean meramente debido a efectos placebo.

Notas de ajedrez

Lo que todo esto demuestra es que es improbable que el ajedrez tenga un impacto significativo en la capacidad cognitiva general. Así que aunque puede sonar como una victoria rápida – que un juego de ajedrez puede mejorar una amplia gama de habilidades – desafortunadamente no es este el caso.

El fracaso de la generalización de una habilidad particular, de hecho, ocurre en muchas otras áreas más allá del ajedrez, como la formación musical, que se ha demostrado que no tiene ningún efecto sobre las habilidades cognitivas o académicas no musicales. Lo mismo se aplica al entrenamiento con videojuegos, al entrenamiento mental [brain training], y al entrenamiento de la memoria de trabajo, entre otros.

¿Inteligencia antigua o solo un buen juego?

El hecho de que las habilidades aprendidas por entrenamiento no se transfieran a diferentes dominios parece ser un universal en la cognición humana. En otras palabras, mejoras, en el mejor de los casos, en lo que entrenas – lo que puede sonar a sentido común de toda la vida.

Pero aunque esperar que el ajedrez mejore la capacidad cognitiva de los niños y el rendimiento académico en general es sólo una ilusión, esto no significa que no pueda agregar valor a la educación de un niño.

Claramente, jugar al ajedrez implica algún nivel de habilidad aritmética y geométrica, y el diseño de juegos matemáticos o ejercicios con material de ajedrez puede ser una forma sencilla y divertida de ayudar a los niños a aprender.

Sobre los autores:

Giovanni Sala está realizando su tesis doctoral en psicología cognitiva en la Universidad de Liverpool y Fernand Gobet es catedrático de toma de decisiones y conocimiento en esa misma universidad

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 9 de mayo de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0)

![]()

El artículo ¿Jugar al ajedrez te hace más inteligente? Un vistazo a las pruebas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Crónica de la jornada “Las pruebas de la educación”

- Jugar a ser dios

- Por qué los colegios no deberían enseñar habilidades de pensamiento crítico generales

Ciencia y política: el papel de la verdad

La ciencia, se suele decir, no debe ser política; debe ser independiente, ajena a los tejemanejes del gobierno, tan sólo dedicada a su tarea principal de comprender el funcionamiento del Universo. El único punto de contacto debiera ser la financiación de un sistema público de ciencia, basada en la comprobable observación de que los países que ponen los medios para cultivar la ciencia terminan siendo más ricos y poderosos que aquellos que no lo hacen. Es decir, en razones puramente prácticas, complementadas en el mejor de los casos por un reconocimiento del valor cultural del avance científico. La política debería por tanto mantenerse alejada de la ciencia, limitándose a financiarla y a liberar un espacio de independencia en el que pueda medrar.

Lo malo es que garantizar la independencia de la ciencia es una decisión política, y la decisión de financiarla, con cuánto y cómo es una práctica política por excelencia. De ahí los actuales conflictos entre determinados gobiernos y determinados campos científicos: los políticos se han dado cuenta de que cuando la ciencia contradice sus ideologías y con sus datos se niega a reforzar sus argumentos tienen un modo de contraatacar: presionar política y económicamente hasta amenazar los sistemas científicos en su esencia.

Los científicos, por supuesto, son de cualquier color político: los hay radicales y conservadores, de izquierdas y de derechas, partidarios de Keynes y de Friedman. Cada uno de ellos tiene su opinión sobre el papel de la religión en la vida pública, sobre la mejor forma de regular el mercado eléctrico o de mejorar la vida de las clases menos privilegiadas. Aunque pueda haber tendencias generales derivadas de su educación, carrera profesional y ocupación no hay una única orientación política entre quienes trabajan en ciencia. Y sin embargo sí que tienen algo abrumadora, aplastantemente en común en lo que se refiere a las relaciones entre ciencia y política: son partidarios de los hechos y los datos sobre las emociones y las movilizaciones a la hora de tomar decisiones, también cuando se trata de cómo gobernar un grupo humano.

Está claro que la política no es un simple asunto de toma de decisiones racional y basada en datos: cuando se trata de guiar a un grupo humano grande y complejo hay otros factores a tener en cuenta. Los datos tienen siempre un cierto grado de incertidumbre, pero esa no es la principal diferencia: la cuestión es que en política los sentimientos y las pasiones son también determinantes. La política no es el reino de la razón y la desapasionada toma de decisiones; antes al contrario, es un campo en el que rutinariamente se azuzan las más bajas pasiones y se utilizan simpatías y antipatías, querencias y rechazos para aglutinar voluntades y apoyos y generar capacidad de acción.

Por eso sucede que política y ciencia a veces colisionan, cuando la gestión de pasiones de la política se encuentra con hechos que le resultan inconvenientes y carga contra ellos. En esos casos se producen enfrentamientos entre lo que la política quiere y lo que la ciencia sabe. Y las consecuencias pueden ser devastadoras. Lo estamos viendo actualmente en cuestiones como los organismos genéticamente modificados, la resistencia a las vacunas, la negación del cambio climático de origen antropogénico o el supuesto riesgo de las ondas electromagnéticas como el Wifi.

Cuando la política se enfrenta a la ciencia no sólo niega los hechos, sino que emplea contra quienes los han creado las mismas tácticas que se usan en la contienda ideológica: acusar al contrario de malas intenciones, asumir que usa las mismas formas de propaganda, descalificar y buscar trapos sucios, manchar por asociación con ‘malos’ reconocidos, deslegitimar sus móviles, etc. Es una contienda que los científicos tienen muy mal para ganar, o siquiera empatar, ya que no hay nada en su formación o en sus carreras profesionales que les prepare para ello. En una batalla política con políticos la ciencia lleva todas las de perder, puesto que carece del armamento necesario.

Pero las peores consecuencias no las sufre la ciencia, sino la sociedad en su conjunto. Por supuesto que la ciencia pública recibe los golpes en forma de descalificaciones, recortes presupuestarios, deterioro de las carreras profesionales e incluso destrucción de datos acumulados, como ha ocurrido en el caso del calentamiento global. El avance de la ciencia se resiente, hay menos futuros científicos y el prestigio social de la actividad decae. El impacto es muy real y muy doloroso para una comunidad que no está acostumbrada a defenderse, mucho menos en términos de política.

Aun así, la principal pérdida la sufrimos todos cuando se ataca el papel de los hechos a la hora de tomar decisiones políticas, porque eso lleva a las sociedades a cometer errores terribles. Es cierto que la política no es, ni debe ser, exclusivamente una cuestión de datos y toma racional de decisiones. Creerlo así es ingenuo, ya que los humanos tenemos emociones y cuando nos juntamos en grandes grupos tenemos el derecho, si queremos, de saltarnos la realidad en la búsqueda de una realidad diferente (y mejor). La política puede, y debe, aspirar a cambiar el mundo, y para ello a veces es imperativo que desprecie o aspire a superar los hechos de hoy. No se puede cambiar la realidad sin prescindir, hasta cierto punto, de la realidad tal como es hoy.

Lo cual no quiere decir que prescindir por completo de los hechos y los datos sea una buena idea: al contrario, es un error fatal. La política puede y debe superar los datos pero a partir de ellos, no prescindiendo de ellos. La realidad se puede cambiar, pero desde el conocimiento de cuál es la realidad actual. Cuando los políticos atacan el papel de la ciencia e incluso de los datos para avanzar sus posiciones ideológicas están contribuyendo a destruir la mejor herramienta que tienen las sociedades para conocer la realidad; que luego pueden decidir (si así lo quieren) cambiar.

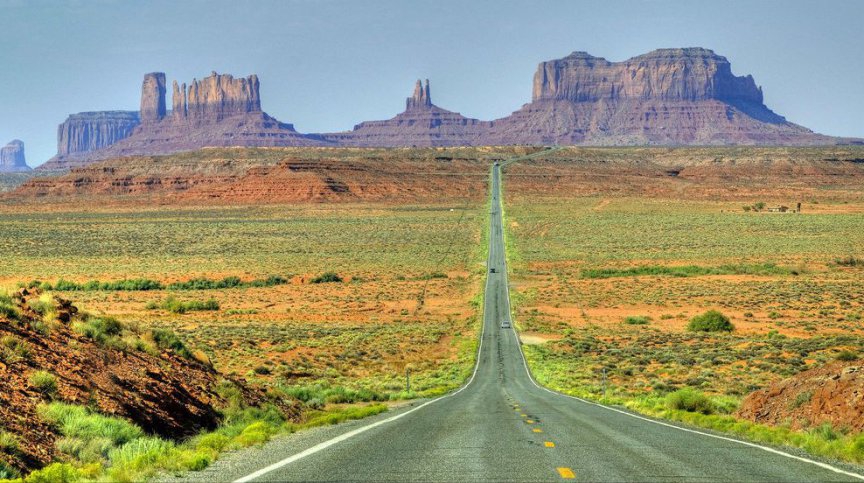

Los datos, los hechos y la razón no tienen por qué ser los únicos participantes en la toma de decisiones políticas, pero si se prescinde de ellos estas decisiones estarán equivocadas con seguridad. La política es el arte de usar un mapa, la ideología, para llegar a un destino mejor. Pero para orientarte lo primero que necesitas es saber dónde estás, porque de lo contrario jamás podrás trazar un rumbo. Ése es el papel de la ciencia y de los datos: darle a la sociedad la mejor estimación de dónde está, para que luego la política decida a dónde quiere ir. Si por conveniencia política de corto plazo atacamos y desprestigiamos a quien nos informa de dónde estamos nunca podremos saber qué dirección debemos tomar. El papel de la verdad, de los datos y de la razón es proporcionar ese punto de partida.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Ciencia y política: el papel de la verdad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Un equipo de alta fidelidad de ciencia ficción

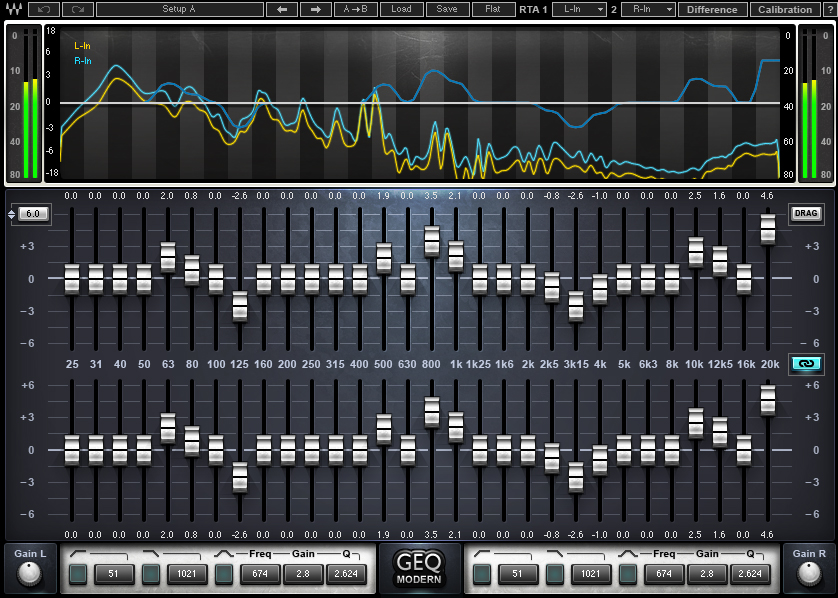

Ecualizador gráfico

Cuando se habla de nanomateriales siempre o casi siempre hablamos de posibilidades futuras. De propiedades y características que, quizás algún día, puedan ser tan útiles que revolucionen una parte de nuestro mundo. Pero es cierto que pocas veces podemos presenciar el nacimiento de toda una nueva forma de hacer las cosas. Hoy es diferente.

Hace un par de décadas un altavoz de alta fidelidad era fácil que tuviese una altura y anchuras variables, pero lo que era seguro, y lo sigue siendo, es que tuviese una profundidad respetable. Ello es debido a que necesitan una caja acústica, igual que una guitarra. El uso de nanopartículas magnéticas y de nanotubos de carbono en altavoces ha sido históricamente para el lucimiento de los materiales, no porque nadie tuviese intención de usar esos altavoces. Eso cambió drásticamente el año pasado cuando se presentó en Korea [1] un altavoz completamente plano (no necesita caja acústica) basado en grafeno para producir un sonido de calidad.

Hace un par de décadas un altavoz de alta fidelidad era fácil que tuviese una altura y anchuras variables, pero lo que era seguro, y lo sigue siendo, es que tuviese una profundidad respetable. Ello es debido a que necesitan una caja acústica, igual que una guitarra. El uso de nanopartículas magnéticas y de nanotubos de carbono en altavoces ha sido históricamente para el lucimiento de los materiales, no porque nadie tuviese intención de usar esos altavoces. Eso cambió drásticamente el año pasado cuando se presentó en Korea [1] un altavoz completamente plano (no necesita caja acústica) basado en grafeno para producir un sonido de calidad.

Dos investigadores de la Universidad de Exeter (Reino Unido) le han dado una vuelta de tuerca a la idea [2]: ahora el grafeno produce el sonido termoacústicamente. En vez de depender de las vibraciones de un material dentro de una caja acústica, la termoacústica hace uso de la idea centenaria de que el rápido calentamiento y enfriamiento de un material puede producir sonido. Y esto, que podría no parecer muy diferente de lo que hicieron los koreanos sí lo es: además de altavoz, el nuevo dispositivo funciona como amplificador y ecualizador gráfico, todo ello en una pastilla plana del tamaño de un pulgar.

Composición en la que se aprecia el tamaño del nuevo dispositivo.

Los investigadores pudieron comprobar que cuando el grafeno se calienta y enfría rápidamente por medio de una corriente eléctrica alterna, transfiere esas vibraciones al aire circundante. El aire se expande y contrae, generando ondas de sonido. La clave para controlar las capacidades multitarea del dispositivo está en controlar la corriente eléctrica que llega al grafeno. Este control permite no solo cambiar el volumen, también especificar cómo se amplifica cada frecuencia.

Siendo tan pequeño lo normal es que se piense en su aplicación en teléfonos móviles. Pero ese uso es el trivial y no explota las verdaderas posibilidades de la idea. Como el grafeno es casi completamente transparente, los investigadores creen que esta tecnología podría usarse para generar imágenes además de sonidos. Una de las aplicaciones de confirmarse esa posibilidad sería médica: imágenes por ultrasonido en dispositivos portátiles y muy compactos. Tan compactos que nada impediría que se empleasen como monitores inteligentes en tiempo real que tendrían forma de vendas que llevaría el paciente, dada la flexibilidad del grafeno.

Pero hasta que estas aplicaciones de película se hagan realidad hay una aplicación muchísimo más inmediata en la industria de las telecomunicaciones. Ésta hace un uso intensivo de la mezcla de frecuencias empleando métodos bastante complejos, lo que es sinónimo de caro; el nuevo dispositivo lo hace de una forma simple y controlable, y muchísimo más barata.

Referencias:

[1] Choong Sun Kim et al (2016) Application of N-Doped Three-Dimensional Reduced Graphene Oxide Aerogel to Thin Film Loudspeaker ACS Appl. Mater. Interfaces, doi: 10.1021/acsami.6b03618

[2] M. S. Heath & D. W. Horsell (2017) Multi-frequency sound production and mixing in graphene Scientific Reports doi: 10.1038/s41598-017-01467-z

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Un equipo de alta fidelidad de ciencia ficción se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia para todos a través del cine y la literatura de ciencia ficción

- La robustez de la red oscura

- #NaukasKids14 Física y ciencia ficción

El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

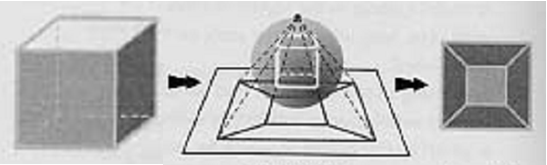

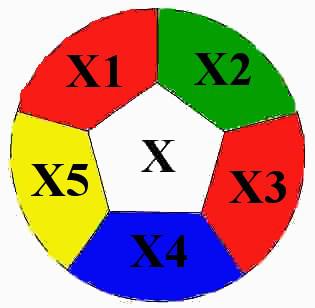

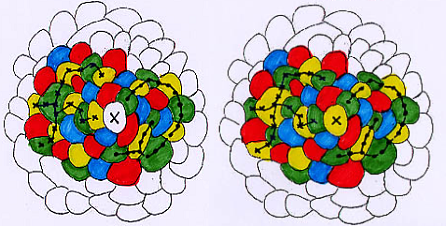

Antes de continuar con la historia iniciada en [1], es conveniente destacar que el teorema de los cuatro colores sobre mapas planos equivale al mismo enunciado sobre mapas esféricos: se demuestra fácilmente usando la proyección estereográfica.

La propiedad clave en la demostración del teorema de los cuatro colores es el teorema de poliedros de Euler que afirma que:

c – a + v = 2,

donde c es el número de caras, ael de aristas y v el de vértices del poliedro estudiado.

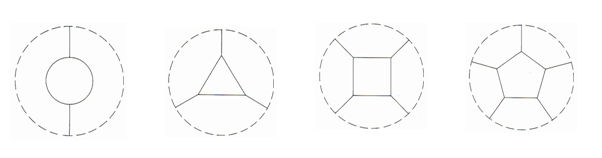

Este teorema puede trasladarse a mapas planos. En efecto, dado un poliedro arbitrario, se infla sobre una esfera, se proyecta estereográficamente, y se obtiene su proyección sobre el plano (figura 1).

Figura 1: Pasando de poliedros a mapas planos.

Así, puede hablarse del teorema de Euler para mapas:

r – l + p = 2,

donde r es el número de regiones del mapa, l el de líneas frontera y p el de puntos de encuentro entre dos líneas frontera. En esta fórmula, la región exterior del mapa debe contarse: es la que corresponde a la cara más cercana al polo norte antes de realizar la proyección estereográfica.

Ya podemos continuar con nuestra historia. El abogado Alfred Kempe (1849-1922) se interesó por el problema de los cuatro colores tras la pregunta de Arthur Cayley en la London Mathematical Society en 1878 (ver [1]).

Figura 2: Alfred Kempe.

En 1879, Kempe publicó una solución al problema en la revista Nature. Al año siguiente publicó una versión simplificada en los Proceedings of the London Mathematical Society, corrigiendo algunas erratas de su prueba original.

Kempe utilizó la fórmula de Euler para mapas cúbicos (ver [1]) para probar que: Todo mapa tiene al menos una región con como mucho cinco regiones vecinas, es decir, cada mapa contiene al menos un digon, un triángulo, un cuadrado o un pentágono.

Figura 3: Digon, triángulo, cuadrado y pentágono.

La demostración de Kempe es ahora fácil de entender: si X es una región de un mapa cúbico M, denotamos por v(X) el número de las comarcas que le son colindantes. La prueba se hace por inducción sobre el número de regiones del mapa. ComoMes un mapa cúbico, sabemos que existe una región X con v(X) menor o igual que5. Si suponemos que el mapa M-{X} es 4-coloreable, se trata de ver que entonces M también lo es. Hay tres casos posibles:

CASO 1. Si v(X)= 1, 2 ó 3, disponemos de al menos un color para colorear X con él.

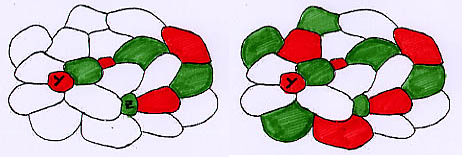

CASO 2. Supongamos que v(X)=4. Antes de continuar, debemos introducir dos nuevos términos. Si Z e Y son dos regiones, por ejemplo, Y de color rojo y Z de color verde en un mapa 4-coloreado, se llama cadena de Kemperojo-verde de Y a Z a un camino que va de Y a Z, alternando los colores rojo y verde. Una componente rojo-verde de Y es el conjunto de todas las regiones Z del mapa, tales que existe una cadena de Kempe rojo-verde de Y a Z.

Figura 4: Cadena y componente de Kempe.

En una componente rojo-verde cualquiera de un mapa 4-coloreado se pueden invertir los colores rojo y verde para obtener un nuevo 4-coloreado, respetando las condiciones del problema de los cuatro colores (ver figura 5).

Figura 5: Cartas original y obtenida invirtiendo la componente rojo-verde.

Como v(X)=4, un entorno de X es de la forma indicada en la figura 6:

Figura 6.

Distinguimos dos posibilidades:

a) X3 no está en la componente rojo-azul de X1. Entonces se invierten el rojo y el azul en esta componente y se libera un color (en la figura 7, el rojo) para X.

Figura 7.

b) X3 está en la componente rojo-azul de X1. Entonces X2no está en la componente amarillo-verde de X4, y se hace un cambio en la componente de X4, rescatando un color (en la figura 8, el amarillo) para X.

Figura 8.

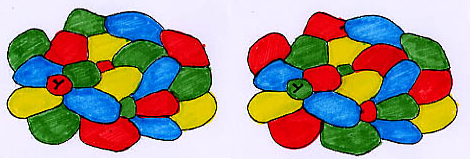

CASO 3. Finalmente, supongamos que v(X)=5; un entorno de X es de la forma indicada en la figura 9:

Figura 9: Entorno de X.

Se distinguen, de nuevo, dos posibilidades:

a) X2 no pertenece a la componente amarilla-verde de X5 o X2 no pertenece a la componente azul-verde de X4. En el primer caso (el otro se hace análogamente) se invierten el amarillo y el verde en esta componente y queda libre un color (en la figura 10, el amarillo) para X.

Figura 10.

b) X2 pertenece a la componente amarilla-verde de X5 y X2 pertenece a la componente azul-verde de X4. Entonces, se invierten las componentes roja-azul de X1 y roja-amarilla de X3, para liberar el rojo para X.

Figura 11.

Así concluye la demostración de Kempe, prueba aceptada por la comunidad matemática, hasta 1890. En ese año, Percy John Heawood (1861-1955) publicó el artículo Map Colour Theorem en el Journal of Pure and Applied Maths: había encontrado –muy a su pesar– un mapa en el que la prueba de Kempe no funcionaba (ver figura 12).

Figura 12.

En efecto, en la prueba dada por Kempe (caso v(X)=5, b) de la discusión anterior), las componentes amarilla-verde (y-g) de X5 y azul-verde (b-g) de X4 pueden cruzarse. Y entonces, las componentes rojo-azul (r-b) de X1 y rojo-amarillo (r-y) de X3 no pueden invertirse simultáneamente…

Kempe admitió su error en los Proceedings of the London Mathematical Society, y el 9 de abril de 1891, en un encuentro de la citada sociedad afirmó: “My proof consisted of a method by which any map can be coloured with four colours. Mr. Heawood gives a case in which the method fails, and thus shows the proof to be erroneous. I have not succeded in remedying the defect, though it can be shown that the map which Mr. Heawood gives can be coloured with four colours, and thus his criticism applied to my proof only and not to the theorem itself”.

A pesar de este error, Heawood usó el argumento de las cadenas de Kempe para probar el teorema de los 5 colores. Demostró también el llamado problema de coloreado de mapas de Heawood que acota superiormente el número de colores necesarios para colorear un mapa dibujado sobre una superficie sin borde, exceptuando el caso de la esfera (ver [3]).

En 1968, Gerhard Ringel y Ted Youngs (ver [3]) probaron que el problema de coloreado de mapas de Heawood daba el número exacto de colores para toda superficie, excepto la botella de Klein. En 1986, Thomas L. Saaty (ver [4]) demostró que para colorear un mapa sobre la botella de Klein se necesitan como mucho 6 colores.

¡Sólo quedaba por resolver el caso de mapas esféricos (equivalentemente, el de mapas planos)!

Conoceremos la solución en El teorema de los cuatro colores (3): Tras más de un siglo de aventura… ¿un ordenador resuelve el problema?

Referencias

[1]Marta Macho Stadler, El teorema de los cuatro colores (1): una historia que comienza en 1852, Cuaderno de Cultura Científica, 26 abril 2017

[2] Marta Macho Stadler, Mapas, colores y números, Descubrir las matemáticas hoy: Sociedad, Ciencia, Tecnología y Matemáticas 2006 (2008) 41-68

[3] Robin Wilson, Four colors suffice: how the map problem was solved, Princeton University Press, 2002.

[4] J.L. Saaty, P.C. Kainen, The four colour problem: assaults and conquest, Dover, 1986.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (1): una historia que comienza en 1852

- La bombilla de colores (y el método científico)

- La pantalla de tu móvil solo tiene tres colores

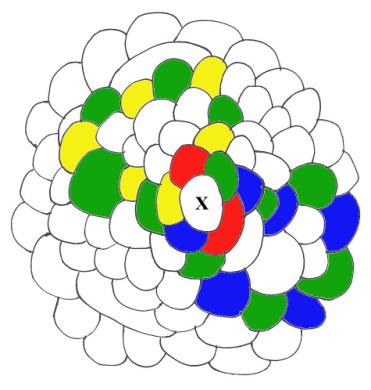

El tamaño relativo de los órganos animales

Los animales grandes no son como los pequeños. No es solo que difieran en tamaño, su anatomía es diferente y también lo es su fisiología; no funcionan igual. Eso es así tanto si consideramos las distintas dimensiones que pueden tener los ejemplares de una misma especie como si lo que nos ocupa son animales pertenecientes a especies de tamaños dispares. Aunque pueda parecerlo, esto no es una obviedad. No se trata de que un animal de mayor tamaño tenga órganos más grandes, coma más, disipe más calor o corra más rápido. De hecho, todo eso es así en términos generales. Pero cuando se dice que unos y otros son diferentes y que funcionan de forma diferente no se hace alusión a nociones tan triviales.

El fenómeno que nos interesa es otro, porque lo interesante es que si comparamos animales de distintas dimensiones podemos comprobar que el tamaño relativo de sus órganos no es el mismo. El tegumento, por ejemplo, representa una fracción menor de la masa corporal en los animales grandes que en los pequeños. Y un bebé disipa, por unidad de masa, mucho más calor que su madre; y también come mucho más por unidad de masa. Hoy nos ocuparemos de los órganos y sistemas, ciñéndonos a aves y mamíferos en nuestro análisis, porque para el resto de animales la información es demasiado escasa. Además, aves y mamíferos son grupos próximos y comparten muchos rasgos fisiológicos importantes.

La proporción que representan la mayor parte de órganos con relación a la masa total del animal disminuye al aumentar aquella. La más importante de las secciones corporales en la que se observa ese fenómeno es el tegumento. Tanto en aves como en mamíferos de muy pequeño tamaño (50 g) representa alrededor de un 17 o 18% de la masa corporal, pero desciende a un 12% en individuos de 5 kg, y a un 8% en mamíferos de 500 kg. Hay una lógica geométrica en esa disminución, ya que la masa del tegumento es proporcional a su grosor (que depende de forma lineal de la masa total) y a la superficie corporal (que depende de la masa según una función potencial en la que el valor de la potencia es de 2/31).

El tubo digestivo, por su parte, representa alrededor de un 10% en aves y mamíferos de pequeño tamaño (50 g o menos), pero esa proporción es menor en animales más grandes, sobre todo en mamíferos (en aves apenas varía), de manera que el de un individuo de 500 kg tendría un 5% de la masa del animal. Con el hígado pasa algo similar; pasa de representar casi un 5% en un ave o mamífero de 50 g, y llega a no ser más de un 1,5% en uno de 500 kg.

Y para completar el repaso de los órganos cuya importancia relativa disminuye en animales grandes, nos quedan el encéfalo y los riñones. El encéfalo representa un 2,3% y un 2,5% en mamíferos y aves, respectivamente, de muy pequeño tamaño; un 0,8% y 0,9% en los de 5 kg; y un 0,24% en los grandes mamíferos. Los riñones también disminuyen de forma notable su proporción en animales grandes: 1,3% (mamíferos) y 1,5% (aves) en individuos pequeños (50 g); 0.5% (mamíferos) y 0,8% (aves) en animales de 5 kg, y 0,2% en mamíferos de 500 kg.

La proporción que representa el corazón, la sangre y los pulmones apenas cambia con el tamaño; y tampoco lo hace la musculatura de los mamíferos. El corazón viene a ser un 0,6% de la masa de un mamífero y un 0,9% de la de un ave. También tienen menos sangre los primeros (7%) que las segundas (9%). Y en los pulmones se observa una diferencia relativa similar, aunque estos representan fracciones menores en ambos grupos: algo más del 1% en mamíferos y alrededor de un 1,3% en aves. La capacidad pulmonar de las aves es, en cierta consonancia con lo anterior, un 12% mayor que en mamíferos. Seguramente, esas diferencias en el tamaño del corazón, la cantidad de sangre y la capacidad pulmonar tienen que ver con las altas demandas metabólicas que impone el vuelo y, por ello, con la necesidad de las aves de disponer de más oxígeno y combustible para poder volar. El vuelo proporciona ventajas pero sale caro.

Como se ha señalado, la musculatura de los mamíferos representa una fracción de la masa total muy similar en animales de distinto tamaño: un 45% aproximadamente. Conviene aclarar, no obstante, que hay grandes diferencias entre diferentes especies aunque no estén relacionadas con sus tamaño. Los que tienen más musculatura son felinos: leones y linces; en ellos, entre un 56% y un 59% de su masa corporal corresponde a la musculatura esquelética. Se trata de porcentajes impresionantes, pero no llegan a ser los más musculosos del reino animal; sin salir del grupo de los cordados los hay con más masa muscular, como los peces escómbridos (en Katsuwonus pelamis representa un 68%) que, no en balde, son reputados viajeros marinos.

En las aves, sin embargo, la importancia relativa de la musculatura sí aumenta con el tamaño; en las más pequeñas representa un 38% de la masa total, mientras que en las grandes llega a ser de un 55%. Esa diferencia quizás tenga que ver con los requerimientos biomecánicos del vuelo, si la fuerza necesaria para volar crece desproporcionadamente al aumentar la masa.

El esqueleto es el elemento corporal cuya masa aumenta en mayor proporción que la del conjunto del cuerpo tanto en aves como en mamíferos. Representa alrededor de un 5% en los de pequeño tamaño; se eleva a un 7% en los de 5 kg, y los mamíferos de 500 kg tienen esqueletos de unos 50 kg de masa, o sea, un 10% del total. El aumento de la proporción que representa el esqueleto en animales de mayor tamaño obedece, seguramente, a que los huesos son las estructuras de sostén, que su resistencia es proporcional a la sección superficial y que esa sección aumenta con el cuadrado del radio (y, en definitiva, la longitud) del hueso. Por eso, los animales grandes tienden a tener huesos de mayor grosor relativo que los pequeños; por eso una gacela de Thompson tiene un aspecto mucho más grácil que un elefante, y también por eso Godzilla o King Kong son monstruos de imposible anatomía. Y que los huesos sean mucho más gruesos implica también que son mucho más pesados.

Si se sumasen los porcentajes que hemos ido deslizando a lo largo del texto, no se llegaría a completar el 100%. Faltan órganos: faltan las mamas, las gónadas, el tejido conjuntivo, los ojos y unas cuantas estructuras de menor tamaño. Sin embargo, ninguna de esas estructuras es de mayor dimensiones relativas en los animales grandes. Sigue faltando un componente, uno que, además, es mucho más importante cuanto mayor es el animal. Y ese componente es el de los depósitos de grasa.

Las reservas de energía tienen mucha más importancia en los animales de tamaño grande que en los de tamaño pequeño. Un mamífero o un ave de 50 g de masa destina alrededor de un 4% a sus reservas energéticas; en los de tamaño medio (5 kg) ese porcentaje es de un 10%, y alcanza el 25%, aproximadamente, en los grandes mamíferos.

El aumento de los depósitos de grasa con el tamaño de los ejemplares de una misma especie es algo lógico, ya que esas reservas suelen destinarse a alimentar la reproducción, y suele ocurrir que los pequeños son los más jóvenes y esos no se reproducen. Pero si la comparación se hace entre individuos de diferentes especies de dimensiones dispares, también en esa comparación se observan diferencias en función del tamaño. Las especies cuyos ejemplares llegan a ser grandes o muy grandes suelen ser conservadoras desde el punto de vista reproductivo, dedican a la progenie importantes volúmenes de recursos, y almacenan energía para hacer frente a épocas de escasez. Por todas esas razones es normal que cuanto mayor es el tamaño de un animal mayor sea su volumen de reservas de energía. Y por esa razón no deben interpretarse en términos funcionales todos los casos en que se observa una disminución de la proporción que representa un órgano o sistema al aumentar el tamaño.

Unos riñones más pequeños, un bazo menor, un tubo digestivo o un hígado de menores dimensiones relativas no significa necesariamente que en los animales de mayor tamaño esos órganos tengan menor importancia o trabajen menos; lo que ocurre es que como nos estamos refiriendo a proporciones, sus menores contribuciones relativas a la masa total obedecen a la mayor presencia relativa de depósitos de grasa en animales de gran tamaño. No olvidemos, tampoco, que una vez se alcanza un cierto tamaño, en aves y mamíferos casi todo el excedente energético que se genera se destina a la reproducción o a almacenar reservas.

Tras este repaso podemos concluir que el tamaño es una variable biológica fundamental o, dicho de forma más simple y directa: en biología animal el tamaño sí importa.

Nota:

1 Porque la masa es proporcional al volumen y este lo es al cubo de la dimensión lineal, mientras que la superficie es proporcional al cuadrado de la dimensión lineal. Así, cuando aumenta el tamaño de un cuerpo, su superficie aumenta con la masa (o el volumen) de acuerdo con una función cuya potencia es 2/3.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El tamaño relativo de los órganos animales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Los experimentos de Joule

Cerca de medio siglo después james Prescott Joule repetiría los experimentos de Rumford a una escala menor. Comenzó en los años cuarenta del siglo XIX y los repitió durante muchos años, refinando cada vez más sus aparatos y sus técnicas. En todos los casos, cuanto más cuidadoso era más exacta encontraba la proporcionalidad de la cantidad de calor, medida como cambio en la temperatura y la cantidad de trabajo realizado. Como Joule hacía sus experimentos con agua, como el resto de investigadores de la época, asumía que la proporcionalidad que encontraba entre la cantidad de calor producida, simbolizada por la letra Q (Q es un símbolo habitual para el calor) era igual a la cantidad de agua expresada como su masa, m, multiplicada por el cambio (que se simboliza con la letra griega Δ, delta) de la temperatura, T; con lo que llegaba a la expresión: Q = m·ΔT.

Hoy sabemos que la cantidad de calor que corresponde a un determinado cambio de temperatura es diferente para diferentes sustancias (incluso que puede variar con la temperatura). Para tener esto en cuenta en la expresión anetrior basta con introducir una constante c, a la llamaremos calor específico de la sustancia en cuestión. Así, la relación entre calor y cambio de temperatura puede escribirse como: Q = m·c·ΔT.

La cantidad de calor puede expresarse en una unidad llamada caloría. La caloría se define como la cantidad de calor que se requiere para elevar la temperatura de 1 g de agua 1 ºC en condiciones estándar. De aquí que el calor específico del agua expresado en calorías sea exactamente 1, es decir, para el agua c = 1 cal /gºC. Por tanto, si estamos hablando en estas unidades, se cumple la relación de Joule: Q = m·ΔT

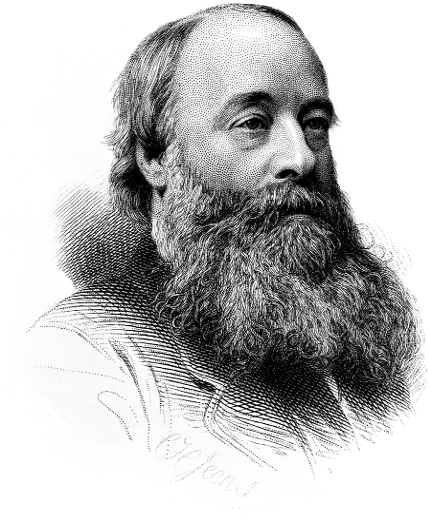

James Prescott Joule

Joule realizó experimentos muy variados y empleando medios diferentes para poder establecer una relación independientemente del sistema empleado.

Para uno de sus primeros experimentos sobre la relación entre calor y trabajo Joule construyó un generador eléctrico sencillo, cuya fuerza motriz era un peso que dejaba caer. Hacía pasar la corriente eléctrica generada así por un cable que estaba sumergido en un contenedor con agua, a la que calentaba. A partir de la distancia que recorría el peso al caer Joule podía calcular el trabajo realizado (recordemos que el trabajo no es más que la fuerza por la distancia, y el peso es una fuerza; también es en este caso, una disminución de la energía potencial, esa que está relacionada con la posición en un campo como el gravitatorio). El producto de la masa de agua, m, en el contenedor por el aumento de su temperatura, ΔT, le permitió a Joule calcular la cantidad de calor producida, Q.

En otro experimento Joule comprimía gas en una botella sumergida en agua, miediendo el trabajo hecho para comprimir el gas por el pistón. Medía después la cantidad de calor aportada al agua por el calentamiento del gas al comprimirse.

Probablemente la serie de experimentos más famosa es aquella que empleaba un aparato en el que unos pesos que descendían lentamente hacían girar una rueda de paletas en un contenedor de agua. Debido a la fricción enre la rueda y el líquido, la rueda realizaba trabajo sobre el líquido, aumentando su temperatura.

Todos estos experimentos, algunos repetidos muchas veces con aparatos cada vez mejores, llevaron a Joule a enunciar dos resultados cuantitativos muy importantes en 1849 que, expresados en lenguaje actual, son:

- La cantidad de calor producida por la fricción de los cuerpos, ya sean sólidos o líquidos, es siempre proporcional a la cantidad de energía gastada.

- La cantidad de calor (en calorías) capaz de incrementar la temperatura de 1 kg de agua en 1 ºC requiere el cambio en la energía mecánica representada por la caída de 1 m de un peso de 4.180 N (newtons)

La primera firmación de Joule es la prueba de que el calor es una forma de energía, en contra de la teoría del calórico de que el calor es un fluido. La segunda da la magnitud numérica de la proporción que había encontrado entre energía mecánica y su energía térmica equivalente. Esta proporción entre energía mecánica, E, y la cantidad equivalente de energía térmica, Q, se llama habitualmente equivalente mecánico del calor. A principios de del siglo XX su valor numérico quedaría establecido en 4,186 J/cal (julios, la unidad de energía, por caloría).

En la época en la que joule realizó sus famosos experimentos, la idea de que es el calor es una forma de energía estaba ganando aceptación. Si bien Joule no fue el único en expresar estas ideas, sus experimentos fueron clave para su consolidación.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los experimentos de Joule se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Los asesinos

No les asesinaron delincuentes

de pasados lastimeros,

ni sádicos sumidos en las simas del sexo.

No fueron bárbaros

habitados por ideas de exterminio,

ni esclavos de sectas que anulan la razón,

sus verdugos.

Tampoco les mató la locura que a veces

engendran las ciudades.

El horror fue obra, la historia se repite,

de escrupulosos funcionarios.

José Ovejero, en “El Estado de la Nación” (2002), tomado de “El eco de los disparos” (2016) de Edurne Portela.

Hay mucho que escribir sobre asesinos, aunque casi siempre basado en textos confusos, a partir de experiencias personales, y con falta de revisiones actuales y ajustadas. Pero algo hay que decir y aquí va, quizá con una cierta falta de orden.

Gary Cooper en una escena de “El sargento York” (1941)

Primero, hay que distinguir entre los criminales habituales y las personas de la sociedad civil que han cometido algún delito en una sola ocasión. Pero nunca hay que olvidar que las personas de la sociedad civil también son capaces de matar, y mucho (repasar la película El Sargento York, de 1941, con Gary Cooper de protagonista). También hay que recordar que estos ciudadanos son los protagonistas del genocidio nazi en el Tercer Reich o de las matanzas xenófobas en guerras como en la antigua Yugoeslavia o Ruanda, por recordar solamente algunas de las más recientes.

Los que asesinaron a lo largo de la historia de nuestra especie fueron, en una gran mayoría, personas normales rodeadas de circunstancias que, por diversas razones, les llevaron a justificar la violencia contra los catalogados como enemigos.

Richard Loeb (izquierda) y Nathan Leopold (derecha)

Nathan Leopold y Richard Loeb: El asesinato del Superhombre

Eran dos genios. Dos niños ricos, inteligentes, universitarios, de buena presencia, a los que sobraban tiempo y dinero, y que quisieron demostrarse a sí mismos que eran más listos que nadie. Planearon y ejecutaron el crimen perfecto. Y cometieron los errores más estúpidos, les pillaron, acabaron en la cárcel y poco faltó para que les ahorcaran.

Ambos de Chicago, Nathan F. Leopold, Jr. nació en 1904 y Richard Loeb en 1905, con sólo unos meses de diferencia. Después del crimen y la condena, Leopold murió en libertad a los 66 años de edad y Loeb, en cambio, murió apuñalado en la cárcel a los 30 años. Fueron condenados a cadena perpetua por el secuestro y asesinato de Bobby Franks, un chaval de 14 años, amigo y vecino, el tercer hijo de una familia feliz. Fue su “crimen perfecto”.

Su defensor en el juicio, el famoso abogado Clarence Darrow, les salvó de la horca con un brillante alegato contra la pena de muerte y a favor de un sistema penal rehabilitador de delincuentes.