Arte & Ciencia: La relación entre el desarrollo de la ciencia y la creación artística

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Segunda jornada. 3ª conferencia

José Ramón Marcaida, especialista en historia de la ciencia e historia del arte de la Edad Moderna de la Universidad de Cambridge : La relación entre el desarrollo de la ciencia y la creación artística

Las primeras ilustraciones de animales y plantas, el coleccionismo de maravillas naturales, el trabajo de los artistas… A lo largo de su historia, el ser humano ha representado la naturaleza de diferentes maneras que han jugado un papel fundamental en la generación de conocimiento científico. Pero esta influencia también se ha dado en la dirección inversa, puesto que los descubrimientos científicos han servido de inspiración y han influido en el desarrollo de técnicas pictóricas y estilos artísticos, marcando el devenir de la historia del arte.

La relación entre el desarrollo de la ciencia y la creación artísticaEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: La relación entre el desarrollo de la ciencia y la creación artística se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: Química y Arte, reacciones creativas

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Arte & Ciencia: Imaginario marino

Sobre la predisposición genética a padecer enfermedades (II)

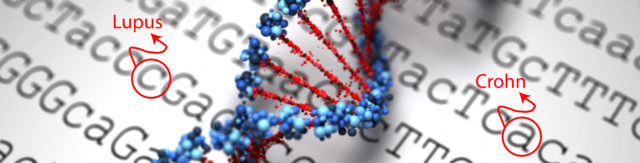

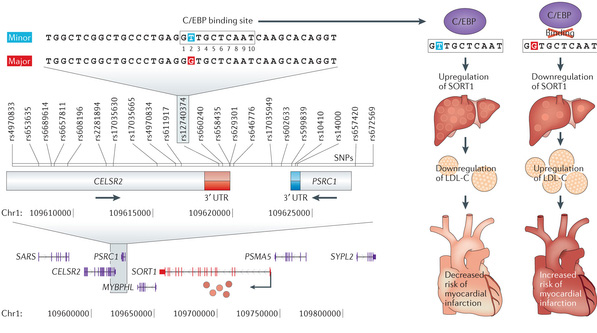

En un artículo anterior hablábamos de cómo se descubren las variantes genéticas (los polimorfismos de un solo nucleótido ‒SNPs‒, ¿recuerdas?) que podemos relacionar estadísticamente con diversas enfermedades o trastornos mediante estudios de asociación del genoma completo (GWAS, Genome-wide association study). Es importante dejar claro que estas asociaciones nos señalan algunos cambios en el ADN que aumentan la probabilidad de que padezcamos una patología, sin que ello signifique que la vayamos a sufrir necesariamente.

Entonces ya apuntábamos a un problema de estas correlaciones SNP-patología: salvo excepciones, no indican de forma clara la causa concreta de la enfermedad. Sabemos que un nucleótido concreto en una posición específica del genoma aumenta la predisposición a padecer un trastorno determinado, pero poco conocemos sobre los mecanismos celulares y rutas metabólicas que llevan de una variación concreta del ADN a la enfermedad. Y esto es importante si queremos investigar tratamientos efectivos.

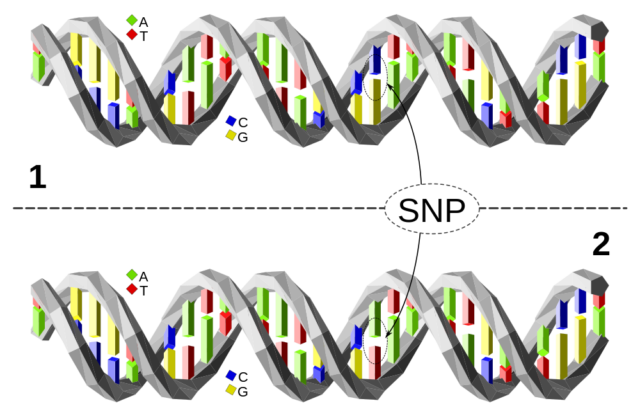

Como ya se explicó en el artículo anterior, un polimorfismo de un solo nucleótido (SNP) no es más que una diferencia en un punto de la secuencia de ADN entre distintos individuos. En la imagen, el individuo 1 tiene un par C-G en la posición señalada, mientras que el individuo 2 tiene el par de nucleótidos A-T. El resto de la secuencia mostrada es idéntica

En algunos casos sí que podemos deducir las causas: si hay un cambio en la secuencia de un gen, este cambio puede afectar a la estructura de la proteína resultante y, según las funciones de esta, podemos tratar de inferir los mecanismos que llevan a sufrir el trastorno. Pero esto sólo ocurre en un 5-10% de los SNPs estudiados y asociados a patologías: el resto de variantes genéticas relacionadas con enfermedades a través de GWAS se encuentran en zonas del genoma que no codifican proteínas (en el mal denominado ADN basura).

¿Qué ocurre en el resto de casos? ¿Cómo puede afectar una variante genética, un pequeño cambio en la secuencia de ADN, al funcionamiento de la célula si no se encuentra directamente implicada en la construcción de proteínas? Pues a través de otros mecanismos, principalmente mediante la regulación de la expresión génica.

Expresión génica

Aunque la secuencia de ADN de todas nuestras células es la misma (salvo mutaciones puntuales), resulta evidente que existen muchos tipos distintos de células: las células que forman los músculos son distintas a las del hígado o el páncreas, a las epiteliales o a las neuronas. Esto se debe a que no se «activan» los mismos genes ni con la misma intensidad en las distintas células.

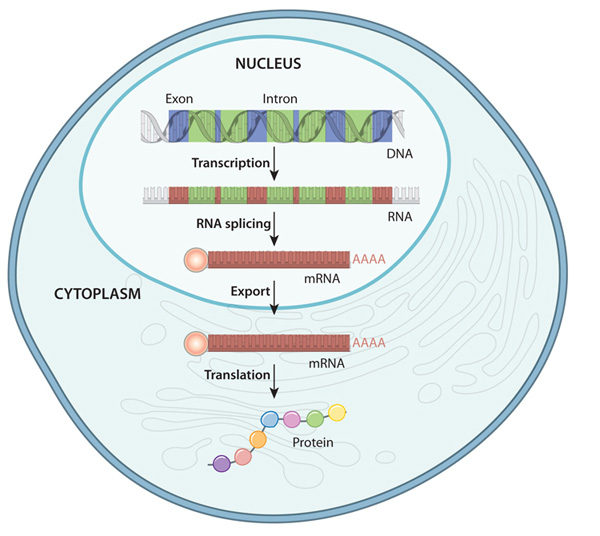

Recordemos que los genes son secuencias de ADN que contienen la información para fabricar una proteína. Para ello, previamente se transcriben a ARN mediante la acción de la enzima ARN polimerasa, se eliminan fragmentos no codificantes de su interior (los denominados intrones) y las secuencias resultantes (denominadas ARNm) se traducen a proteínas. Un cambio en la secuencia de ADN que define un gen puede conllevar que la proteína se fabrique mal y que aparezca una enfermedad grave.

Así pues, un gen contiene la información necesaria para fabricar una proteína, pero no sobre cuándo empezar este proceso, cuánta cantidad de proteína es necesaria y en qué tipo de células se debe llevar a cabo. De esta regulación de la expresión génica, se encargan factores externos, diversos actores en el interior de la célula y, en particular, otras secuencias cromosómicas. Un ejemplo sería la propia secuencia que marca el inicio de transcripción donde se une la enzima ARN polimerasa (promotor). Otros fragmentos de ADN van a actuar como potenciadores de la transcripción o represores. A grandes rasgos, estos fragmentos (que no tienen por qué encontrarse cerca del gen que controlan) regulan el plegamiento de la cadena de ADN como lugares de unión de otros complejos enzimáticos, permitiendo un mejor o peor acceso de la ARN polimerasa al inicio de la transcripción. Una variación en estas secuencias no influye en cómo se construye la proteína, sino en qué condiciones se va a fabricar y en qué magnitud.

Podemos medir la expresión de un gen en un tejido concreto estimando qué cantidad de ARNm se ha fabricado, lo que se conoce como transcriptoma. Avances recientes en secuenciación genética han permitido obtener transcriptomas con una eficacia elevada.

Expression quantitative trait loci

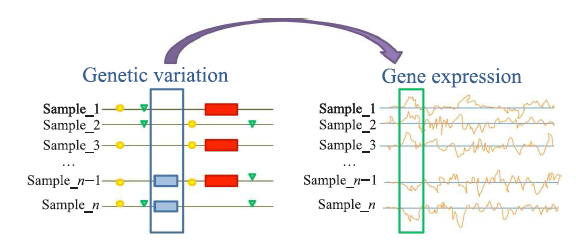

Así pues, resumiendo, podemos utilizar técnicas avanzadas de secuenciación masiva para obtener tanto el genoma de un conjunto de individuos como su transcriptoma. De hecho, empezamos a disponer de grandes bases de datos con ambos datos asociados a patologías y rasgos concretos de los donantes de muestras. Analizando estas bases de datos con potentes herramientas computacionales y estadísticas podemos relacionar variaciones concretas del genoma (en particular, SNPs) en regiones no codificantes, con cambios en la expresión génica. A estas regiones del ADN cuyos cambios afectan a la expresión génica de uno o más genes se les denomina eQTLs (expression quantitative trait loci). Vamos a utilizar esta definición con frecuencia a lo largo de este artículo, así que vamos a explicar con más detalle qué significa.

Imagen modificada de Wikipedia Commons.

Un eQTL es una posición concreta del genoma que, en función del nucleótido que se encuentre en ella, va a influir en la predisponibilidad a poseer algún rasgo o padecer enfermedad concreta. Pero no lo va a hacer modificando la estructura de la proteína codificada por un gen, sino alterando la expresión génica. Es decir, las personas que presenten en su genoma un eQTL determinado van a fabricar proteínas de forma correcta, pero en una cantidad distinta de la adecuada para el funcionamiento adecuado de la célula, pudiendo dar lugar a algún trastorno determinado o rasgo específico.

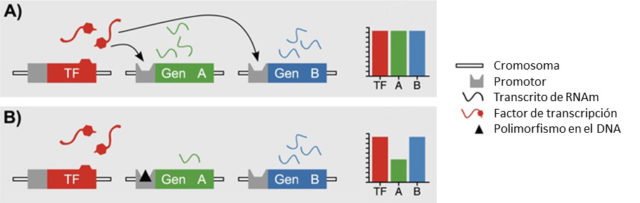

En la figura anterior, un factor de transcripción se une a los promotores de los genes A y B, dando como resultado una cierta cantidad de proteína (A). Si hay una variación en el promotor del gen A (indicada con un triángulo negro en la figura) la cantidad de proteína fabricada disminuye.

Una variante concreta de un eQTL (señalada con un rectángulo azul a la izquierda) lleva consigo un cambio en la expresión de un gen concreto (rectángulo verde a la derecha).

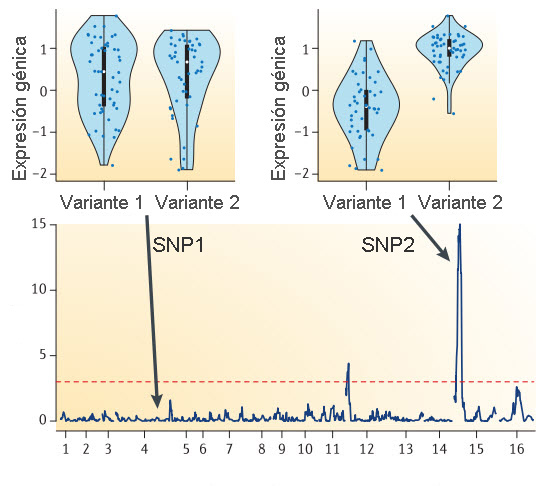

¿Cómo se localizan eQTLs en el genoma? Primero, se obtienen los SNPs de cada uno de los participantes en el experimento como se explicó en el anterior artículo. En la siguiente figura se toman como ejemplo dos polimorfismos de los cromosomas 4 y 14, marcados como SNP1 y SNP2. Recuerda que un SNP varía de individuo a individuo, aunque en este ejemplo sólo consideraremos dos variantes posibles.

A continuación se obtiene una muestra del tejido de interés (recuerda que la expresión génica depende del tipo concreto de células) y se mide la cantidad de ARNm fabricado de distintos genes (con técnicas como RNA-seq). Podemos representar para cada variante de un SNP la cantidad de ARNm expresada de un gen concreto (en la figura, los puntos negros de las gráficas). Se observa que en el primer SNP no hay apenas variación en el nivel de expresión según se posea una variante u otra (fíjate en las formas de las distribuciones de puntos, destacadas en fondo azul), mientras que en el segundo hay una mayor expresión en la variante 2. Por lo tanto, diríamos que el SNP2 tiene asociados cambios destacables de expresión génica según la variante implicada, por lo que sería un eQTL.

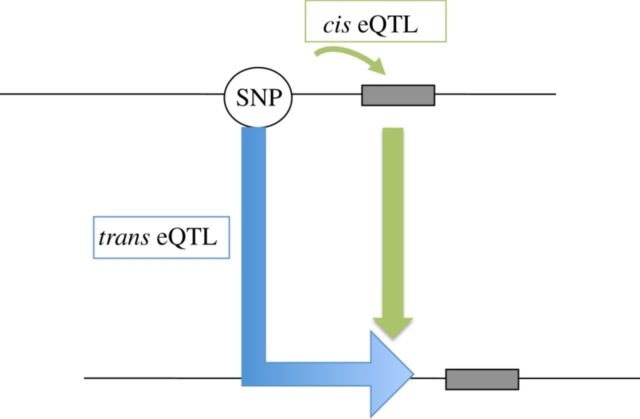

Con este tipo de estudios se han podido localizar un gran número de eQTLs en nuestro genoma. Muchas de estas zonas influyen en la expresión génica por encontrarse cerca del lugar donde se inicia la transcripción del gen: se conocen como cis-eQTL. Hay que tener en cuenta que «cerca» puede significar hasta un millón de nucleótidos de distancia entre el SNP y el inicio del gen. Otras variaciones, sin embargo, son capaces de modificar la expresión de un gen situado a mucha distancia del SNP implicado, e incluso en un cromosoma distinto: son los denominados trans-eQTL.

Empezábamos este artículo comentando que conocer que una variante genética esté asociada a una enfermedad no implica que podamos entender cuál es el mecanismo subyacente, lo cual no nos da pistas de cómo tratar el problema. Si descubrimos que esta variante afecta a la expresión de un gen determinado, y conocemos su función celular, sí que podemos investigar nuevos tratamientos.

Pongamos un ejemplo concreto. Recientemente se descubrió un SNP asociado a un menor riesgo de padecer un infarto de miocardio. Se comprobó que la variante menos común de este SNP (la T destacada en azul en la siguiente figura) promueve la expresión de un gen en el hígado que produce sortilina. Estudios posteriores con ratones demostraron que esta proteína disminuye los niveles de colesterol LDL, asociado a riesgo cardíaco.

Otros ejemplos de eQTLs recientemente descubiertos han contribuido a explicar la asociaciones de variantes genéticas con enfermedades como el asma infantil, la enfermedad de Crohn o el lupus.

Este post ha sido realizado por Guillermo Peris (@Waltzing_piglet) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias- Gene expression. Scitable (Nature Education).

- The role of regulatory variation in complex traits and disease. Albert, F.A. and Kruglyak, L. (2015) Nature Reviews Genetics 16, 197–212. doi:10.1038/nrg3891

- Expression quantitative trait loci: present and future. Nica A.C. and Dermitzakis E.T. (2013). Philos Trans R Soc Lond B Biol Sci.;368: 20120362

doi: 10.1098/rstb.2012.0362 - The study of eQTL variations by RNA-seq: from SNPs to phenotypes. Majewski, J. and Pastinen, T. (2011) Trends in Genetics 27 (2) , 72-79. doi: 10.1016/j.tig.2010.10.006.

El artículo Sobre la predisposición genética a padecer enfermedades (II) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sobre la predisposición genética a padecer enfermedades

- Dani y Fiti sobre la ingeniería genética

- Dudas sobre las vacunas: problemas y soluciones

Pena de muerte contra el fraude científico

Una de las grandes tendencias en el mundo científico durante las últimas décadas ha sido el imparable avance de China. Decidido a ser una potencia de alcance mundial el gobierno chino ha ejecutado una deliberada estrategia de desarrollo de la ciencia y la tecnología que comenzó hace muchos años, cuando de repente los laboratorios del mundo en múltiples especialidades se llenaron de estudiantes doctorales y postdoctorales provenientes de aquel país con especial hincapié en determinados campos que se consideraron estratégicos. Estos estudiantes regresaron a China, donde montaron laboratorios y centros de investigación conectados a la comunidad científica internacional; miles, centenares de miles de nuevos puestos de trabajo se crearon en estos campos, y se comenzó a desarrollar una verdadera invasión de publicaciones de equipos chinos que después se transformó en un diluvio de nuevas revistas especializadas creadas específicamente para este mercado. El país ha ejecutado un salto científico enorme desde finales del siglo XX como parte de una clara estrategia política: el gobierno ha decidido que la ciencia es clave para el estátus de potencia mundial de China.

El problema es que inevitablemente el fomento por parte de un estado de cualquier cosa provoca el desarrollo paralelo de un fenómeno de picaresca: los espabilados de turno se aferran a la tradicional corta visión de las burocracias para aprovecharse de los incentivos (económicos, profesionales, sociales) que se usan para desarrollar un campo, en este caso la ciencia. Y surge el fraude, en múltiples formas y variedades. La ciencia trucha en China se ha convertido en un auténtico problema, y no sólo para el gobierno local y su despilfarro de recursos en resultados falsos: el volumen de publicación es tal que se corre un riesgo real de que acabe contaminando el avance científico en todo el mundo. Para dar una idea según algunas estimaciones de científicos chinos del área de biomedicina hasta el 40% de todas las publicaciones locales de su sector podrían contener algún tipo de fraude. Esto supone un problema colosal, dado el enorme número de publicaciones que salen hoy de aquel país.

Las instituciones chinas han tomado cartas en el asunto, castigando ejemplarmente los casos que han salido a la luz con penas que incluyen la devolución del dinero concedido en forma de proyectos de investigación. Los departamentos encargados de supervisar el sistema de investigación están preocupados por la reputación internacional de China tras escándalos como la reciente retracción en masa de 107 artículos que se habían publicado en una revista (Tumor Biology) tras pasar una falsa revisión por pares en la que los presuntos revisores no existían. El Ministerio chino de Ciencia y Tecnología ha anunciado una política de ‘tolerancia cero’ con las falsificaciones y los fraudes. Una política que en algunos casos puede acabar con duras penas de prisión para los investigadores responsables de malas conductas científicas, y hasta potencialmente en la pena de muerte.

Sí: en el caso de que se pueda demostrar que una falsificación de datos científicos haya dañado a personas, por ejemplo en pruebas clínicas de medicamentos, el castigo podría llegar hasta la ejecución de los culpables. Según sentencias emitidas por algunos tribunales chinos no hay diferencia entre la falsificación de datos científicos y la falsificación de moneda, por lo que las penas de cárcel están garantizadas; pero en caso de que se perjudique a terceros se podría llegar en principio a la pena de muerte. Cosa que en China no es ninguna tontería: se trata del país con mayor entusiasmo con esta institución penal abolida en muchas partes del mundo, pero que allí se sigue practicando. Se calcula que el país ejecuta a más de 2.o00 prisioneros al año por diversos delitos que incluyen casos graves de soborno o corrupción, aunque las cifras exactas no son conocidas.

El fraude científico es, en esencia, una forma de crimen especialmente poco inteligente, ya que la naturaleza no hace trampas y las posibilidades de que las falsificaciones e invenciones no se descubran (tarde o temprano) es cero. La ciencia como cuerpo de conocimiento a la larga no sale dañado porque los datos espurios son eliminados por posteriores investigaciones: cualquier falsificación sobre el comportamiento del universo acaba por colisionar con la realidad y es eliminada. Para la ciencia es una pérdida de tiempo y una molestia que detrae recursos de los investigadores serios y retrasa el avance. Para las burocracias que financian la actividad científica, sin embargo, se trata de una estafa, pura y simple: el robo de unos recursos obtenidos con premisas falsas y un insulto a la autoridad que concede esos recursos. Por el bien de la ciencia como actividad y como conocimiento es necesario luchar contra el fraude, que supone un desperdicio y una pérdida de tiempo y dinero, y en ese sentido la postura de las autoridades chinas es encomiable. Aunque es obvio que la pena de muerte supone un castigo un tanto excesivo para el fraude científico, y rechazable en cualquier caso.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Pena de muerte contra el fraude científico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fraude científico (III). Profundizando en los dos tipos de fraude

- Fraude científico (y V). Resumen y conclusiones

- Fraude científico (I). Una primera aproximación

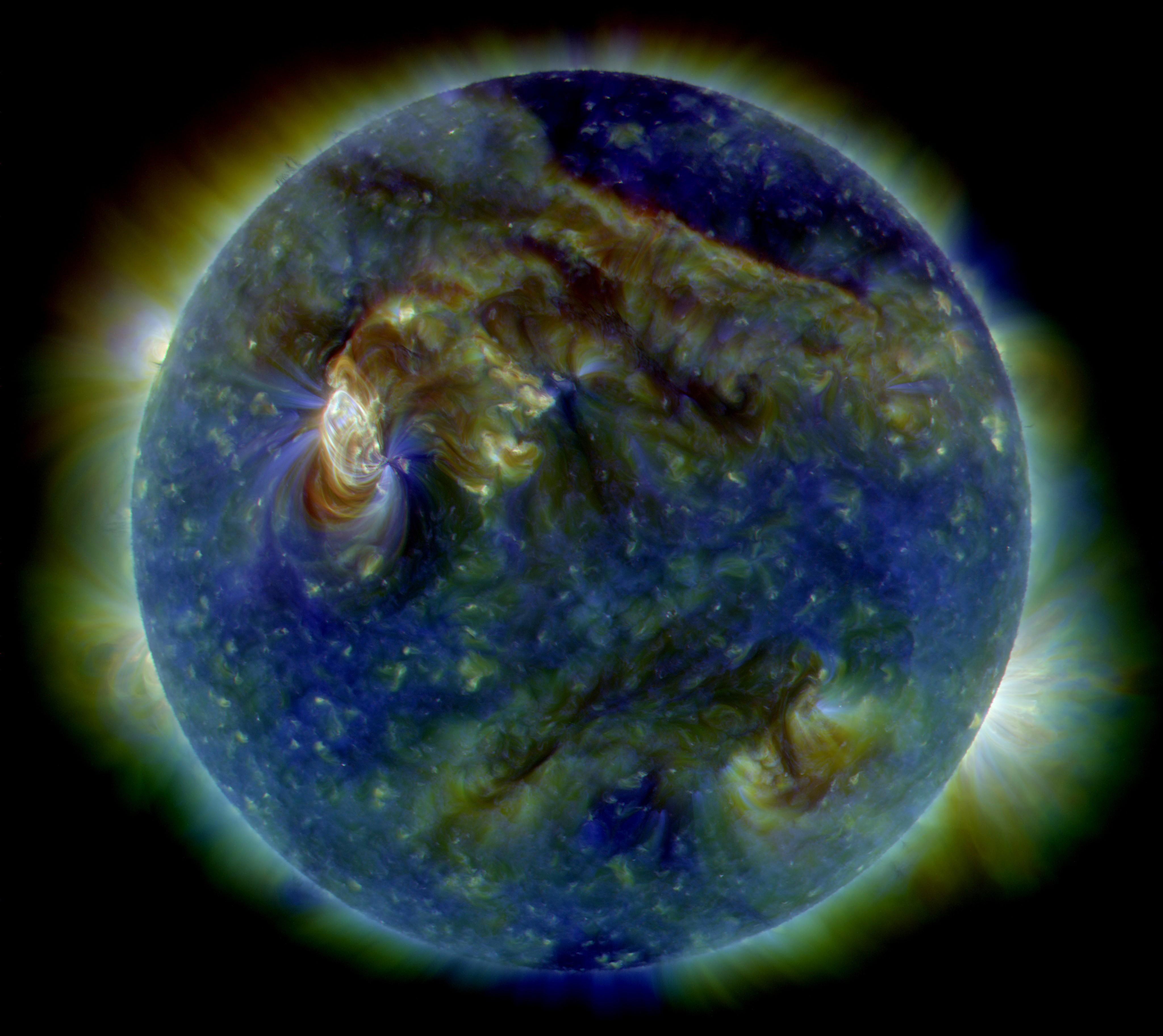

¿Y si el Sol estuviese cambiando de forma fundamental?

Un estudio del Sol usando ondas sonoras utilizando sugiere que la capa en la que se produce la actividad magnética significativa se ha vuelto más fina en los últimos años. La persistencia de este cambio podría indicar que el Sol habría entrado en una fase de transición hacia no se sabe muy bien qué, todavía. Los resultados de este estudio fueron presentados ayer martes 4 de julio por Yvonne Elsworth, profesora de la Universidad de Birmingham, en un congreso que se está celebrando en la Universidad de Hull.

El Sol es muy parecido a un instrumento musical, excepto en que sus notas típicas están a una frecuencia muy baja – unas 100.000 veces menor que el do central. El estudio de estas ondas de sonido utilizando una técnica llamada heliosismología, nos permite descubrir lo que está pasando en el interior del Sol .

El Sol actúa como una cavidad natural que atrapa el sonido, sonido que se genera por la turbulencia existente en unos pocos cientos de kilómetros más exteriores de la zona de convección. La Universidad de Birmingham es uno de los centros pioneros a nivel mundial en el campo de la heliosismología y los investigadores han estado utilizando la Red Birmingham de Oscilaciones Solares (BISON, por sus siglas en inglés) para estudiar el Sol a través de las ondas sonoras desde 1985. Este período abarca tres ciclos de 11 años de actividad del Sol. En estos ciclos se producen fluctuaciones en el ritmo al que se crean partículas energéticas por la interacción entre el campo magnético del Sol y sus capas exteriores calientes y altamente cargadas.

Los investigadores del equipo de Elsworth han encontrado que el interior del Sol ha cambiado en los últimos años, y que estos cambios persisten en el ciclo actual. Estas observaciones, combinadas con modelos teóricos, sugieren que la distribución del campo magnético en las capas más externas podría haberse vuelto algo más delgada. Otros datos seismológicos apuntan a que la velocidad de rotación del Sol también habría sufrido algunos cambios en lo que se refiere a la forma en la que el material del sol rota a distintas latitudes.

Según Elsworth:

“[…] esto no es lo que solía ser, y la velocidad de rotación ha disminuido un poco en las latitudes alrededor de unos 60 grados. No estamos muy seguros de cuáles serán las consecuencias de esto pero está claro qué nos encontramos en tiempos inusuales. ”

Estos resultados hacen que la idea de que la dinamo del Sol esté en proceso de cambiar fundamentalmente sea menos especulativa de lo que era hace unos años.

Referencia:

R. Howe, G. R. Davies, W. J. Chaplin, Y. Elsworth, S. Basu, S. J. Hale, W. H. Ball, R. W. Komm (2017) The Sun in transition? Persistence of near-surface structural changes through Cycle 24 Mon Not R Astron Soc stx1318. DOI: 10.1093/mnras/stx1318

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo ¿Y si el Sol estuviese cambiando de forma fundamental? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo dejar de usar petróleo y seguir consumiendo sus derivados de forma barata

- El estaño beta es como el grafeno pero en 3D

- Encontrando exoplanetas tapando las estrellas

La máquina calculadora de Nicholas Saunderson

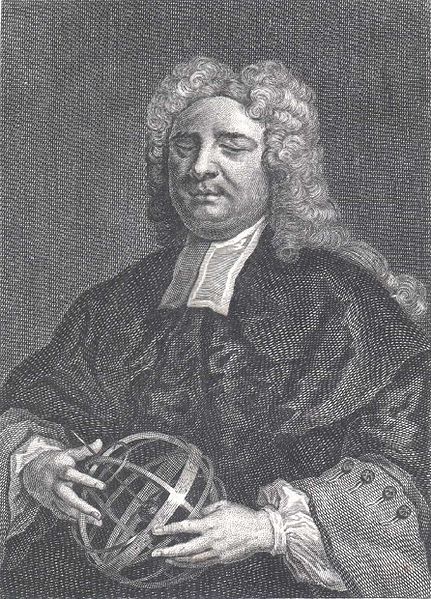

En la entrada Haciendo matemáticas en la oscuridad citábamos al británico Nicholas Saunderson (1682-1739) entre los matemáticos ciegos que, a pesar de su defecto visual, fueron capaces de realizar importantes aportaciones en su disciplina.

Nicholas Saunderson (Wikipedia).

Saunderson perdió la vista al enfermar de viruela con tan solo un año de edad. Su ceguera le permitió adquirir unos excepcionales sentidos del oído y del tacto, y una increíble agilidad mental para los cálculos matemáticos.

Tras muchas negativas, gracias al apoyo del matemático William Whiston y a petición de personajes destacados de la Universidad de Cambridge, la Reina Ana I concedió a Saunderson el cargo de profesor Lucasiano en 1911 –fue el cuarto, tras Isaac Barrow, Isaac Newton y el propio William Whiston–.

Ocupando aquella cátedra, Saunderson enseñó matemáticas con un éxito asombroso; escribió los libros Elements of Algebra (1740, basado en el ábaco del que hableremos más adelante) y The Method of Fluxions (publicado en 1756 por su hijo). Sorprendentemente, dio además clases de óptica, sobre la naturaleza de la luz y de los colores, y acerca de otras materias relativas a la visión y a su órgano.

En 1718, fue admitido en la Royal Society, donde compartió amistad con matemáticos de gran relevancia como Isaac Newton, Edmund Halley, Abraham de Moivre o Roger Cotes.

El filósofo y enciclopedista Denis Diderot le citó en varios fragmentos de su ensayo Lettre sur les aveugles, à l’usage de ceux qui voyent (Carta sobre los ciegos para uso de los que ven, 1749). Al igual que el filósofo William Molyneux (ver [1]), Diderot opinaba que un ciego que empieza a ver de repente –por ejemplo tras una operación– no puede comprender inmediatamente lo que observa, y debería costarle un tiempo hacer el vínculo entre su experiencia con las formas y distancias adquiridas mediantes el tacto, y las imágenes percibidas a través de sus ojos.

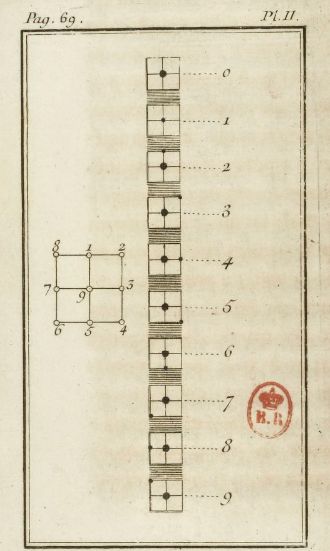

Saunderson ideó una especie de ábaco con una serie de agujeros en los que podía introducir clavijas para facilitar su utilización a personas ciegas. Para describirlo, vamos a utilizar las palabras de Diderot extraídas de [4, página 26 y siguientes]:

Es mucho más rápido usar símbolos ya inventados que inventarlos uno mismo, como se está forzado, cuando nos cogen desprevenidos. ¡Cuánto mejor hubiera sido para Saunderson haber encontrado una aritmética palpable, ya preparada, cuando tenía cinco años, en vez de tener que imaginársela a los veinticinco! […] Cuentan de él prodigios y no hay ninguno que sus progresos en las bellas letras y su habilidad en las ciencias matemáticas no puedan hacer creíble.

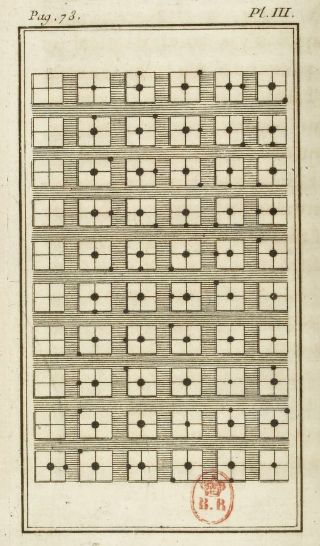

Plancha II (página 69 de [3]).

Una misma máquina le servía para los cálculos algebraicos y para la descripción de las figuras rectilíneas. […] Imaginad un cuadrado como el que veis en la Plancha II, dividido en cuatro partes iguales por líneas perpendiculares a los lados, de suerte que os ofrezca los nueve puntos 1, 2, 3, 4, 5, 6, 7, 8, 9. Suponed este cuadrado perforado por nueve agujeros capaces de recibir alfileres de dos clases, todos de la misma longitud y del mismo grosor, pero unos con la cabeza algo más gruesa que otros. Los alfileres de cabeza gruesa sólo se colocan en el centro del cuadrado; los de cabeza fina, sólo en los lados, excepto en un caso, el del cero. El cero se marca por un alfiler de cabeza gruesa, colocado en el centro del cuadrado pequeño, sin ningún otro alfiler a los lados. La cifra 1 estará representada por un alfiler de cabeza fina, colocado en el centro del cuadrado, sin ningún otro alfiler a los lados. La cifra 2, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 1. La cifra 3, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 2. La cifra 4, por un alfiler de cabeza gruesa colocada en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 3. La cifra 5, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 4. La cifra 6, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 5. La cifra 7, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 6. La cifra 8, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados, en el punto 7. La cifra 9, por un alfiler de cabeza gruesa colocado en el centro del cuadrado y un alfiler de cabeza fina colocado a uno de los lados del cuadrado, en el punto 8.

Estas son diez expresiones diferentes para el tacto, cada una de las cuales responde a uno de nuestros diez caracteres aritméticos. Imaginad ahora una tabla tan grande como queráis, dividida en pequeños cuadrados colocados horizontalmente y separados unos de otros a la misma distancia, como podéis verlo en la Plancha III, y tendréis la máquina de Saunderson.

La máquina calculadora de Nicholas Saunderson

Podréis ver fácilmente que no existen números que no puedan escribirse sobre esa tabla y, por consiguiente, ninguna operación aritmética que no pueda ejecutarse.

Diderot continúa dando un ejemplo de utilización de esta máquina para ilustrar su descripción.

No es el único momento en el que Diderot alude a Saunderson en su ensayo; por ejemplo, para exponer su visión materialista desarrolla un pasaje con una serie de argumentos que atribuye a Saunderson mientras con un sacerdote que intenta demostrar la existencia de Dios a través del espectáculo de la naturaleza (que no puede ver) y posteriormente por la perfección de los órganos humanos.

Referencias

[1] Marta Macho Stadler, Haciendo matemáticas en la oscuridad, Cuaderno de cultura científica, 14 de mayo de 2015

[2] Marta Macho Stadler, Nicholas Saunderson, extraordinario calculador, ZTFNews, 19 de abril de 2014

[3] Lettre sur les aveugles, à l’usage de ceux qui voyent, Gallica

[4] Julia Escobar, Carta sobre los ciegos para uso de los que ven, Fundación ONCE y Editorial Pre-Textos, 2002

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La máquina calculadora de Nicholas Saunderson se ha escrito en Cuaderno de Cultura Científica.

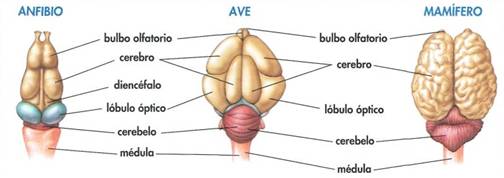

Entradas relacionadas:Evolución de los sistemas nerviosos: el sistema periférico de vertebrados

Como decíamos en la entrega anterior de esta serie, en los sistemas nerviosos diferenciamos el subsistema central y el periférico. Desde un punto de vista funcional, en el sistema periférico se distinguen dos grandes divisiones: la aferente y la eferente. La división aferente es la formada por los nervios que transportan información hacia el sistema nervioso central. En la división eferente la información viaja del sistema central a los órganos efectores, tanto musculares como de otro tipo. Dentro de la división eferente se diferencian, a su vez, dos sistemas, el somático y el visceral o autónomo.

El sistema somático conduce las señales que dan lugar a movimientos corporales y a acciones hacia el exterior del organismo. Está formado por las fibras de las motoneuronas que inervan los músculos esqueléticos; sus cuerpos celulares se encuentran en la médula espinal y un único axón alcanza las fibras musculares que inerva. La acción de estas motoneuronas consiste siempre en la excitación y contracción de los músculos, aunque la actividad muscular puede ser inhibida mediante sinapsis inhibitorias a cargo de neuronas del sistema central. De hecho, la actividad de las motoneuronas puede ser controlada mediante señales presinápticas, tanto excitatorias como inhibitorias. Esas señales pueden proceder de receptores sensoriales periféricos (reflejos espinales) o de diferentes enclaves encefálicos.

El sistema visceral está formado por las fibras que inervan la musculatura lisa, el corazón, las glándulas y otros órganos o tejidos no motores, como la grasa parda. Controla funciones que están sobre todo relacionadas con el mantenimiento de las condiciones del medio interno y también ciertas respuestas de carácter automático a estímulos exteriores. Regula actividades viscerales tales como la circulación, digestión, termorregulación, entre otras. En peces teleosteos, anfibios, aves y mamíferos, el sistema autónomo se subdivide, a su vez en dos divisiones, la simpática y la parasimpática. La mayor parte de los órganos viscerales están inervados tanto por fibras de la división simpática como de la parasimpática. En esos casos suelen ejercer efectos opuestos. Normalmente ambas divisiones mantienen una cierta actividad, pero dependiendo de las circunstancias, se eleva la de uno de los dos a la vez que se reduce la del otro. De esa forma se eleva o se reduce la actividad del órgano en cuestión. Con carácter general se puede decir que la activación de la división simpática prepara al organismo para desarrollar una actividad física muy intensa (eleva la ventilación respiratoria y la actividad cardiaca, activa la circulación periférica, inicia el catabolismo del glucógeno y grasas; dilata las pupilas, ajustando la vista a larga distancia o en oscuridad; en algunas especies promueve la sudoración o el jadeo; y a cambio, reduce las actividades urinaria y digestiva). La división parasimpática domina, por el contrario, en condiciones de tranquilidad, cuando el organismo ha de ocuparse de sus asuntos internos; por esa razón, esta división activa la digestión y la función urinaria.

La inervación a cargo de las dos divisiones proporciona un control más preciso de la funciones reguladas por el sistema autónomo. No obstante, hay unos pocos órganos o glándulas que solo reciben señales de una de las dos divisiones. Arteriolas y venas están inervados por fibras simpáticas (arterias y capilares no están inervados), con la excepción de los vasos que irrigan el pene y el clítoris, que reciben fibras simpáticas y parasimpáticas, lo que permite un control muy preciso de la erección de ambos. La mayoría de las glándulas sudoríparas también están inervadas solo por fibras simpáticas. Y aunque las glándulas salivares reciben fibras simpáticas y parasimpáticas, en este caso sus efectos no son antagonistas; ambas estimulan su actividad.

Algunos textos de fisiología añaden a las dos divisiones anteriores –simpática y parasimpática- una tercera, la división entérica que, aunque mantiene alguna conexión con el sistema central, se halla contenida en el intestino. Consiste en redes neuronales ubicadas en las paredes del intestino. Controla el peristaltismo, la segmentación y otros patrones de contracción de la musculatura lisa de la pared intestinal. Por lo tanto, es la división que se encarga de impulsar el alimento que es procesado dentro del tracto intestinal.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: el sistema periférico de vertebrados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: el sistema central de vertebrados

- Evolución de los sistemas nerviosos: anélidos y artrópodos

- Evolución de los sistemas nerviosos: moluscos

Se establece el principio de conservación de la energía

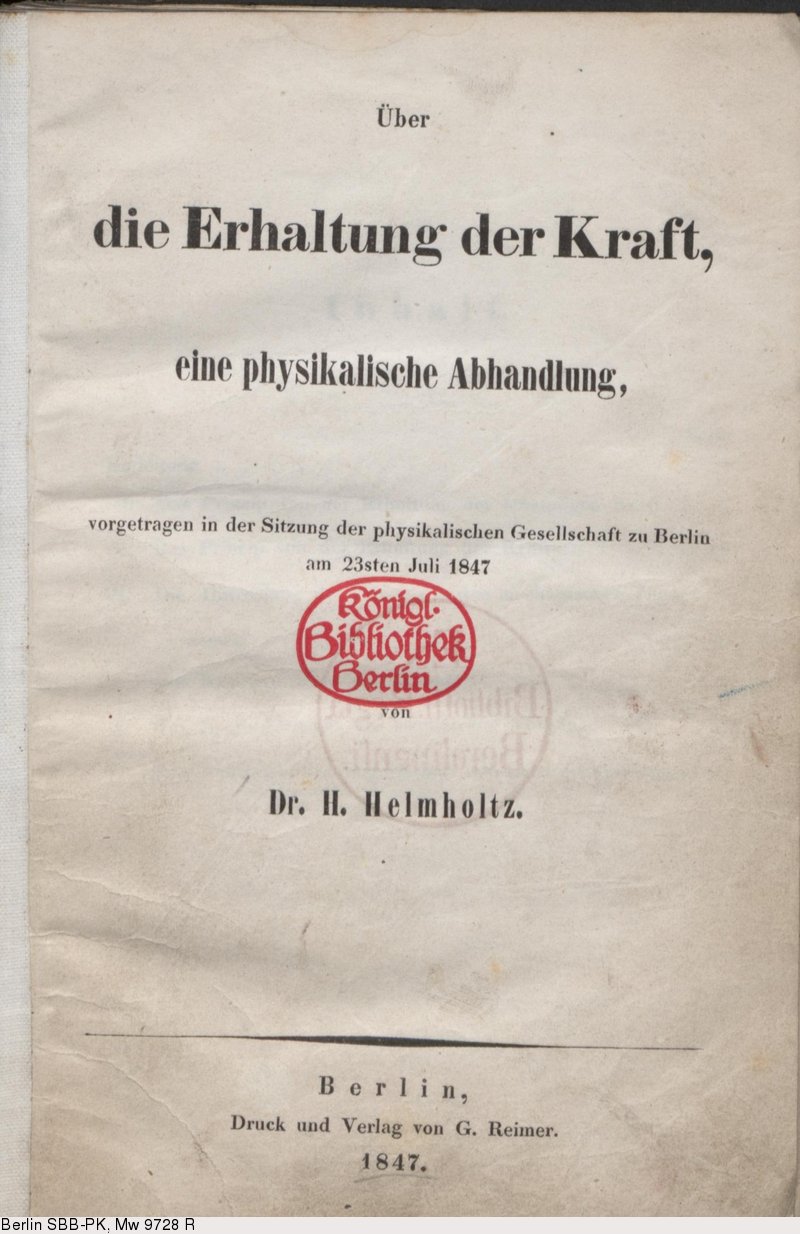

Este mes de julio se cumplen 170 años de un artículo clave en la historia de la ciencia.

Mayer y Joule fueron sólo dos de al menos una docena de personas que, entre 1832 y 1854, propusieron de alguna forma la idea de que la energía se conserva. Algunos expresaron la idea vagamente; otros con toda claridad. Algunos llegaron al convencimiento principalmente a través de la filosofía; otros a partir de consideraciones prácticas en el uso de motores y máquinas o a partir de experimentos de laboratorio; otros más por una combinación de factores. Muchos, entre ellos Mayer y Joule, trabajando independientemente de todos los demás. Una cosa era evidente, la idea de la conservación de la energía estaba, de alguna manera, “en el aire”.

Hermann Ludwig Ferdinand von Helmholtz en 1848

Pero si hemos de poner fecha al inicio de la aceptación mayoritaria de la ley de la conservación de la energía hemos de referirnos a la publicación de uno de los artículos más influyentes de la historia, no ya de la física, sino de la ciencia, lo que no implica que sea de los más conocidos. Se publicó en 1847, dos años antes de que Joule publicase los resultados de sus experimentos más precisos. El autor, un joven médico alemán que estaba estudiando el metabolismo del músculo llamado Hermann von Helmholtz, tituló su trabajo Über die Erhaltung der Kraft (Sobre la conservación de la fuerza). Helmholtz (usando ” fuerza “en el sentido moderno de “energía”), afirmaba audazmente en él la idea que otros sólo expresaban vagamente, a saber, “que es imposible crear una fuerza motriz duradera a partir de nada “.Con esto rechazaba la existencia de una “fuerza vital” necesaria para el movimiento del músculo, una idea la de la necesidad de la fuerza vital directamente extraída de la Naturphilosophie imperante en la fisiología alemana de la época.

Helmhotz volvería sobre este tema aún más claramente muchos años después en una de sus conferencias de divulgación:

Llegamos a la conclusión de que la Naturaleza en su conjunto posee una reserva de fuerza [energía] que no puede de ninguna manera ser aumentada ni disminuida y que, por lo tanto, la cantidad de fuerza en la Naturaleza es igual de eterna e inalterable que la cantidad de materia. Expresado en esta forma, he llamado a la ley general “El Principio de la Conservación de la Fuerza”.

Así pues, a medidados del siglo XIX queda establecido un principio básico y universal de la ciencia con enormes consecuencias prácticas. Cualquier máquina o motor que realice trabajo (proporciona energía) sólo puede hacerlo si la extrae de alguna fuente de energía. O, de otra forma, la máquina no puede suministrar más energía de la que obtiene de la fuente. Cuando se agote la fuente, la máquina dejará de funcionar. Las máquinas y los motores sólo pueden transformar la energía; no pueden crearla o destruirla.

Esto, que hoy día debería estar asumido, no lo está tanto como debiera. En cualquier caso, con lo que llevamos visto en esta serie de forma tan sencilla, ya podemos formular dos de las leyes que rigen el funcionamiento del universo (así, como suena) y que veremos en las dos próximas entregas de la serie.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Se establece el principio de conservación de la energía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Se intuye la conservación de la energía (1)

- Se intuye la conservación de la energía (2)

- De las leyes de conservación (I)

Cómo regular la velocidad de disolución de los biometales de las prótesis

Los biometales se usan desde hace mucho tiempo en medicina, principalmente en prótesis, pero también en elementos de unión para soldar huesos o en los stents que se emplean para solventar problemas cardiovasculares, entre otros. Los metales más utilizados tradicionalmente —el acero inoxidable y las aleaciones de titanio—presentan ventajas, como su resistencia a la corrosión en el medio fisiológico, pero también inconvenientes, como la disminución de la densidad ósea en las inmediaciones de la prótesis, que produce una pérdida de resistencia del hueso. Además, en muchas ocasiones se hace necesario realizar una segunda intervención para eliminar el material una vez que ha cumplido su función.

Para solventar dichos problemas, se están desarrollando numerosas investigaciones con otros materiales, como la familia del magnesio y sus aleaciones. “Lo que hace que este material sea especialmente atrayente es su capacidad de disolverse en el medio fisiológico, es decir, se iría disolviendo progresivamente, hasta que, una vez cumplida su misión, fuera expulsado del cuerpo de forma natural, a través de la orina”, explica Nuria Monasterio, autora del estudio realizado en la Escuela de Ingeniería de Bilbao de la UPV/EHU. Así, se evitarían segundas intervenciones en los pacientes. Otro punto fuerte del nuevo material consiste en que evita la pérdida de densidad ósea localizada que producen otros materiales más resistentes. “Además, al tratarse de un material abundante en la corteza terrestre, la materia prima tiene un costo razonable, aunque su procesado requiere ciertas precauciones que encarecen la fabricación de las aleaciones. Por lo cual, sus costos finales se sitúan a medio camino entre los del acero inoxidable y las aleaciones de titanio”.

Sin embargo, dicho metal también presenta retos, ya que “su velocidad de disolución es mayor de la deseada. Se disuelve antes de cumplir su función; por ello, el reto es alargar su vida para que esté, de alguna manera, regulada a la medida de la aplicación”, afirma Monasterio.

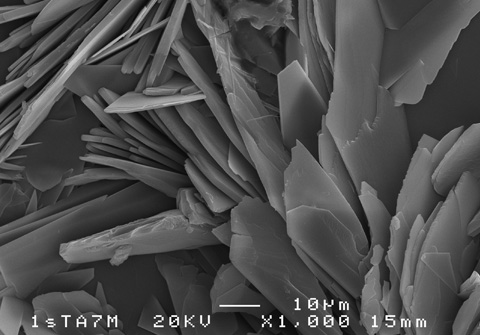

Aspecto de la superficie de la capa de fosfato de calcio. Foto: Nuria Monasterio. UPV/EHU.

Existen varias técnicas para tratar de alargar la vida de las aleaciones de magnesio; esta investigación de la UPV/EHU ha optado por el recubrimiento del material con fosfato de calcio, aunque “la función del fosfato de calcio no solo es alargar la vida del propio magnesio. Se trata, además, de que el cuerpo humano lo tolere mejor y que aumente la velocidad de generación de tejidos adyacentes, una doble función que consiste en alargar la vida del material y conseguir una mejor integración. Hay que tener en cuenta que, por un lado, es el componente principal de los huesos y, por otro, está comprobado que favorece el crecimiento de los tejidos circundantes”, comenta.

Como medio para adherir la capa de fosfato de calcio a la superficie del metal, se ha empleado la electrodeposición. “Lo que perseguíamos era obtener un depósito uniforme, que no se desprendiera, y que pudiéramos variar su espesor de manera eficaz. Para ello, se han estudiado distintas variables eléctricas, para conseguir adecuar los espesores a la medida de lo que requieran las aplicaciones concretas”. Y el resultado ha sido más que satisfactorio: “además de validar el método utilizado, se ha logrado regular la calidad y el espesor de la capa de manera precisa” destaca Nuria Monasterio.

La investigadora de la UPV/EHU menciona varios retos de cara al futuro, “hemos conseguido afinar el sistema electrolítico, por lo que ahora pretendemos probar con otros biometales. Por otro lado, trabajamos en la fabricación de aleaciones de magnesio de composiciones que no supongan riesgo alguno, ya que la aleación de magnesio utilizada en esta investigación contiene aluminio, un metal perjudicial para la salud”.

Referencia:

N. Monasterio, J.L. Ledesma, I. Aranguiz, A.M. Garcia-Romero, E. Zuza.. Analysis of electrodeposition processes to obtain calcium phosphate layer on AZ31 alloy. Surf. Coat. Technol. 319 (2017) 12-22. doi: 10.1016/j.surfcoat.2017.03.060

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Cómo regular la velocidad de disolución de los biometales de las prótesis se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo mecanizar una pieza de cobre usando bacterias

- Cómo sintetizar casi cualquier biomaterial usando ADN

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

Libros para enamorarse

Daniel Torregrosa, lector

Durante prácticamente toda su vida, el científico y popularizador de la ciencia Carl Sagan dio una gran importancia a la generación de entusiasmo y fascinación en la transmisión de la ciencia a la ciudadanía, algo que veía como una obligación necesaria e ineludible para el beneficio de la civilización global y de nuestra supervivencia como especie. Una faceta que Sagan predicaba con el ejemplo y resumía con su famosa sentencia: «Después de todo, cuando estás enamorado, quieres salir a contarlo a todo el mundo».

Y una forma de «salir a contarlo» puede ser la de recomendar algunos libros que pueden enamoraros de la ciencia. O al menos es mi deseo.

Para enamorarse de la Química

El tío tungsteno. Recuerdos de un químico precoz, de Oliver Sacks. Barcelona, 2003. Editorial Anagrama. Colección compactos.

En este delicioso libro de Oliver Sacks nos encontraremos con la autobiografía adolescente de este famoso neurólogo amalgamada con un buen resumen de la historia general de la química. Aparte de disfrutar y maravillarnos con las vivencias de su infancia descubriremos un relato donde la química, como ciencia apasionante como pocas, cobra un valor original y muy personal. Un viaje iniciático donde la curiosidad de Sacks le lleva a la admiración de héroes y heroínas como Carl Wilhelm Scheele, Lavosier, Marie Curie, Mendeléiev, Moseley y otros personajes conocidos de la historia de la ciencia. Una cuestión menor, pero muy curiosa, de este libro es la que nos revela Sacks como motivo de que abandonara el interés por la química cuando apenas había cumplido 14 años. La respuesta, a todas luces reveladora de la irrepetible figura de Oliver Sacks, la encontrará el lector en sus páginas.

Para enamorarse de la Física

Seis piezas fáciles, de Richard Feynman. Barcelona, 2014. Planeta. Colección Booket Ciencia.

Esta obra es una selección del libro de texto Lecciones de Física (1963) de Richard Feynman, uno de los genios más reconocibles del siglo XX. La ciencia no es una aventura fácil y mucho menos la Física, pero viendo cómo la explicaba Feynman dan ganas de matricularse en un curso avanzado de esta disciplina o directamente en el grado de Física. La forma tan clara y magistral de explicar los conceptos básicos, con ejemplos escogidos sacados de nuestro mundo cotidiano, nos embriaga desde el primer capítulo, el de los átomos en movimiento, hasta llegar al clímax final con la mecánica cuántica. Pero mi pieza favorita es la tercera, la que nos cuenta de forma muy original la relación de la física con el resto de ciencias. La épica y la lírica de la ciencia, tan habituales en Feynman, también tiene cabida en este accesible libro, que constituye una delicia absoluta para neófitos o recién iniciados.

Para enamorarse de las Matemáticas

Cartas a una joven matemática, de Ian Stuart. Barcelona, 2016. Crítica. Drakontos bolsillo.

Mediante una serie de cartas dirigidas a la joven Meg (personaje ficticio), Ian Stuart convierte este libro en toda una apología de las matemáticas, emulando al gran matemático Godfrey H. Hardy. Fresco, divertido e inspirador. Un libro que nos convence de la belleza y la importancia de esta disciplina, nos habla de las nuevas áreas de investigación como la teoría del caos o la geometría fractal, e incluso se adentra en vida académica de los matemáticos profesionales. No es uno de esos libros de introducción formal a las matemáticas, ni de paradojas o desafíos matemáticos, no es aparentemente un libro de divulgación de las matemáticas. Es el libro que te lleva a devorar todos los anteriores.

Para enamorarse de la Biología

Botánica insólita, de José Ramón Alonso con ilustraciones de Yolanda González. Pamplona, 2016. Next Door Publishers.

La primera impresión que ofrece este libro, con solo acariciar su portada, es la de estar frente a una obra maestra de la divulgación científica y el arte.

Y cuando nos sumergimos en sus páginas nos encontramos con unas historias extraordinarias y fascinantes sobre las plantas, contadas con un exquisito lenguaje literario de la mano del profesor y divulgador José Ramón Alonso Peña e ilustradas por Yolanda González.

Semillas con alas aerodinámicas, plantas carnívoras aterradoras, árboles descomunales, la inmortalidad surgida del hielo, la alquimia para detectar moléculas en el aire y modificar su comportamiento, las plantas medicinales de los neandertales y así hasta treinta y seis capítulos maravillosamente ilustrados. Goce intelectual y visual absoluto que nos hará mirar con otros ojos al reino Plantae que nos rodea.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Libros para enamorarse se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¡Explora! Libros de divulgación científica para niños

- Cálculo y geometría analítica, de George F. Simmons

- #Naukas16 Big Van Science

Arte & Ciencia: Imaginario marino

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Segunda jornada. 2ª conferencia

Clara Cerviño, bióloga e ilustradora: Imaginario marino

Las primeras ilustraciones de animales y plantas, el coleccionismo de maravillas naturales, el trabajo de los artistas… A lo largo de su historia, el ser humano ha representado la naturaleza de diferentes maneras que han jugado un papel fundamental en la generación de conocimiento científico. Pero esta influencia también se ha dado en la dirección inversa, puesto que los descubrimientos científicos han servido de inspiración y han influido en el desarrollo de técnicas pictóricas y estilos artísticos, marcando el devenir de la historia del arte.

Imaginario marinoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: Imaginario marino se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Arte & Ciencia: Química y Arte, reacciones creativas

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

Parkinsonia parkinsoni

Parkinsonia parkinsoni NHM. Pablo Barrecheguren

Todos tenemos nuestras aficiones y la de James Parkinson eran los fósiles. Nacido en 1755, este médico londinense compaginó su labor médica en Hoxton con los fósiles y llegó a tener una de las colecciones más bellas del país. Es fácil imaginarlo tras una jornada de trabajo paseándose por sus estanterías llenas de piezas bien ordenadas. Como médico ejercía en la zona norte de la ciudad, en un barrio que por la Revolución Industrial pasó de ser una zona ajardinada a una interminable sucesión de edificios de ladrillos. Esto produjo un aumento en la población y por lo tanto de pacientes, entre los cuales James empezó a detectar casos de un trastorno motor desconocido.

- Essay on the Shaking Palsy

En 1817, James Parkinson publicó “Essay on the Shaking Palsy” (Ensayo sobre la parálisis agitante), donde describe la mayoría de los síntomas clásicos motores presentes en la enfermedad de Parkinson. Actualmente es la segunda enfermedad neurodegenerativa, después del alzhéimer, con una prevalencia que aumenta según envejece la población y se estima que afecta al 1-2% de la población mayor de 65 años.

Aunque los temblores son el síntoma que más se suele asociar a la enfermedad, uno de cada cuatro pacientes no desarrolla temblores y además los problemas motores van mucho más allá: rigidez muscular, calambres, dificultad para iniciar o terminar un movimiento, temblores estando en reposo, movimientos lentos, etc. Sin embargo, tal y como el propio James señaló en su ensayo, esta enfermedad es más que un trastorno motor y también existen síntomas no motores como desórdenes en el sueño, y se ha visto que algunos de los pacientes desarrollan demencia o psicosis tras varios años con la enfermedad de Parkinson.

La causa principal de la enfermedad es la degeneración de las neuronas dopaminérgicas en la substantia nigra, que es uno de los núcleos principales de los ganglios basales (los cuales participan en la regulación de la actividad motora). Esta degeneración se debe principalmente a la aparición intracelular de unos depósitos proteicos denominados Cuerpos de Lewy, que interfieren en el funcionamiento neuronal y están compuestos mayoritariamente por α-Sinucleína. Se trata de una proteína presináptica cuya función exacta todavía no está clara, pero las mutaciones que afectan a su regulación son culpables de la mayor parte de casos de Parkinson familiar (que suponen aproximadamente el 5% del total). En el resto de situaciones las causas genéticas de cada caso no están claras, al igual que tampoco lo están los factores ambientales de riesgo (que van desde el consumo de drogas, la exposición a pesticidas o pequeños traumas cerebrales). Pero al igual que en otras enfermedades neurodegenerativas, uno de los factores que más aumenta las posibilidades de desarrollar la enfermedad es la edad: por ejemplo, a los cuarenta padecen la enfermedad aproximadamente el 0,041% de la población mientras que pasados los ochenta se supera el 1,9%.

Pasado el diagnóstico de la enfermedad, que se realiza principalmente mediante la identificación de los síntomas, la esperanza de vida ronda los 15 años. Durante todo ese tiempo el tratamiento principal para atenuar los síntomas es la administración de levodopa. Esta molécula es capaz de llegar al cerebro y allí se convierte en dopamina, por lo que su administración compensa la falta de dopamina provocada por la degeneración de las neuronas dopaminérgicas en la substantia nigra, y como consecuencia los síntomas de la enfermedad remiten. Desgraciadamente, con el paso del tiempo el efecto terapéutico de la levodopa disminuye e incluso es objeto de debate si la administración continuada de levodopa durante años puede también generar problemas en los pacientes. Por ello, también se usan otros fármacos o la estimulación cerebral profunda para combatir los síntomas.

Sin embargo, es importante recordar que todos los actuales tratamientos son paliativos: compensan temporalmente los desajustes pero no actúan sobre la causa del problema. Es como si tuviéramos un coche con el depósito de gasolina agujereado y en vez de arreglar el agujero lo único que pudiéramos hacer es suministrar continuamente más gasolina para que el coche no se pare. Además, hay que tener en cuenta que mantener a un paciente medicado durante años puede generar problemas, especialmente en casos como el párkinson donde es posible que el paciente también desarrolle otro tipo de enfermedades (por ejemplo 1 de cada 3 pacientes con párkinson desarrolla posteriormente alzhéimer) lo cual aumenta la medicación que deben tomar los pacientes, y por lo tanto las posibles complicaciones.

A día de hoy todavía es necesario un gran trabajo en investigación tanto básica como aplicada para comprender mejor la enfermedad y ser capaz de tratar su origen. Y aunque se va a tratar de un trabajo de décadas, tampoco se puede negar que ha habido una mejora sustancial en la calidad de vida de los pacientes gracias a los tratamientos paliativos: hace dos siglos cuando James Parkinson describió la enfermedad no se les podía ofrecer prácticamente ninguna ayuda a los pacientes mientras que ahora, al menos a corto plazo, es posible controlar los síntomas de la enfermedad.

James Parkinson, cuya colección de fósiles por cierto se vendió fragmentada en una subasta tras su muerte en 1824, y la mayoría de las piezas acabaron en un museo geológico de Estados Unidos. Museo donde se perdieron los fósiles a consecuencia de un incendio que destruyó el edificio. James Parkinson, quien moriría sin saber que daría nombre a una de las enfermedades más importantes del siglo XXI pero que curiosamente un año antes de su muerte se le honraría poniendo su nombre a un fósil: Parkinsonia parkinsoni.

Este post ha sido realizado por Pablo Barrecheguren (@pjbarrecheguren) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Parkinsonia parkinsoni se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sobre la predisposición genética a padecer enfermedades

- Una nueva diana terapéutica para el neuroblastoma

- La mutación vasca de la dardarina y el párkinson

Turquía prohíbe la enseñanza de la evolución – pero la ciencia no es un sistema de creencias

James Williams

![]()

Wellcome Images/Wikimedia Commons, CC BY

En los Estados Unidos han habido muchos intentos de eliminar la evolución del currículo escolar o exigir que el creacionismo – la idea de que toda vida fue creada por Dios – se le da el mismo trato en los libros de texto de ciencias. Si bien todos estos han fracasado, el gobierno de Turquía acaba de prohibir la evolución de su plan de estudios nacional.

Los creacionistas estadounidenses quieren que se presenten ambas opiniones, para que los niños decidan qué creer. Los esfuerzos para rechazar esto se caracterizan erróneamente como intentos de coartar el debate o la libertad de expresión para promover una ideología científica, atea, secular, frente a una cosmovisión religiosa más moral, ética y de sentido común.

La decisión de Turquía va mucho más allá. No se trata de reclamar la igualdad de trato, es una prohibición absoluta. El gobierno la justifica alegando que la evolución es “difícil de entender” y “controvertida”. Cualquier controversia, sin embargo, es una fabricada por las comunidades ultra-religiosas que buscan socavar la ciencia. Muchos conceptos en la ciencia son más difíciles que la evolución, pero todavía se enseñan.

Argumentos creacionistas

La evolución, según los creacionistas, es sólo una teoría – no está probada y, por tanto, es debatible. Los árboles evolutivos (especialmente para los seres humanos) se re-dibujan habitualmente después del descubrimiento de nuevos fósiles, demostrando lo pobre que es la teoría. Después de todo, si la teoría fuese correcta, esto no seguiría cambiando. A menudo los creacionistas plantean un reto a la ciencia para que demuestre cómo comenzó la vida, sabiendo que no hay todavía una teoría firme y aceptada. Por último, está el rey de todos los argumentos: si todos evolucionamos de los monos, ¿por qué hay monos todavía?

Estos argumentos están llenos de inexactitudes fácticas y falacias lógicas. La evolución no necesita una explicación de cómo comenzó la vida. Simplemente describe cómo la vida se desarrolla y se diversifica. Los humanos no evolucionaron de los monos – somos grandes simios. Los simios modernos, incluidos los humanos, evolucionaron a partir de especies preexistentes ahora extintas de simios. Estamos emparentados con, no descendimos de, los simios modernos.

Conceptos erróneos fundamentales creacionistas

Darwin lideró un gran avance. Glendon Mellow/Flickr, CC BY-NC-ND

Los creacionistas no comprenden que la evolución misma no es una teoría. La evolución sucede. La vida se desarrolla y diversifica, aparecen nuevas especies. Podemos ver las formas de vida intermedias en este momento, como peces que están en transición de vivir en tierra y los mamíferos terrestres que han realizado la transición a la vida acuática. La “teoría de la evolución” explica cómo se desarrolla la evolución. Charles Darwin y Alfred Russel Wallace describieron por primera vez el mecanismo que impulsa el cambio – la selección natural – en 1858.

Los creacionistas tampoco comprenden la diferencia entre una teoría y una ley en ciencia. Esto es algo que incluso los graduados en ciencia padecen, como he señalado en mi propia investigación. Las teorías explican conceptos científicos. Están respaldadas por pruebas y aceptadas por la comunidad científica. Las teorías son el pináculo de la explicación científica, no sólo un presentimiento o una conjetura. Sin embargo, las leyes tienen un papel diferente, describen fenómenos naturales. Por ejemplo, la ley de la gravedad de Newton no explica cómo ocurre la gravedad, describe los efectos que la gravedad tiene en los objetos. Hay leyes y teorías para la gravedad. En biología, sin embargo, hay pocas leyes, por lo que no hay ley de la evolución. Las teorías no se convierten, si tienen pruebas suficientes, en leyes. No son jerárquicas.

Una tercera cuestión es la falta de comprensión de la naturaleza de la ciencia. La ciencia no pretende encontrar alguna verdad objetiva, sino obtener una explicación de los fenómenos naturales. Todas las explicaciones científicas son provisionales. Cuando se encuentran nuevas pruebas que contradicen lo que pensamos que sabemos, cambiamos nuestras explicaciones, a veces rechazando teorías que antes se creían correctas. La ciencia siempre está trabajando para tratar de falsar ideas. Cuantas más superan esas ideas nuestras pruebas, más robustas son y mayor es nuestra confianza en que son correctas. La evolución se ha comprobado durante casi 160 años. Nunca se ha falsado. La ciencia sólo se ocupa de los fenómenos naturales, no le incumbe ni trata de explicar lo sobrenatural.

¿Por qué la prohibición es peligrosa?

Prohibir la buena ciencia socava toda la ciencia, especialmente teniendo en cuenta el lugar de la evolución como base de la biología moderna, con abundantes evidencias para apoyarla. Para la mayoría de científicos el hecho de que la evolución tenga la lugar no se cuestiona seriamente ni es algo controvertido. Cualquier controversia en las discusiones sobre la evolución trata sobre el papel que la selección natural tiene como motor de la diversidad y el cambio, o el ritmo de ese cambio.

Esta prohibición de enseñar la evolución en las escuelas turcas abre la posibilidad de que ideas alternativas no científicas puedan entrar en la enseñanza de la ciencia, desde aquellos que creen en una tierra plana a los negadores de la gravedad.

¿Cómo tratar el aparente cisma entre la creencia religiosa y la evidencia científica?

Mi investigación y enfoque ha sido distinguir entre religión, un sistema de creencias, y la ciencia, que trabaja en la aceptación de pruebas. Las creencias, incluyendo pero no limitadas a las creencias religiosas, a menudo se mantienen irracionalmente, sin pruebas, y son resistentes al cambio. La ciencia es racional, basada en la evidencia y está abierta al cambio cuando se enfrenta con nuevas pruebas. En ciencia, aceptamos las pruebas, en lugar de “elegir creer”.

La decisión de Turquía de prohibir la enseñanza de la evolución contradice el pensamiento científico y trata de convertir el método científico en un sistema de creencias, como si se tratara de una religión. Busca introducir explicaciones sobrenaturales para los fenómenos naturales y afirmar que existe alguna forma de verdad o explicación para la naturaleza más allá de la naturaleza. La prohibición es anticientífica, antidemocrática y debe oponérsele resistencia.

Sobre el autor:

James Williams es profesor de educación de la ciencia en el Sussex School of Education and Social Work de la Universidad de Sussex (Reino Unido)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 28 de junio de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0)

![]()

El artículo Turquía prohíbe la enseñanza de la evolución – pero la ciencia no es un sistema de creencias se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: el sistema central de vertebrados

- El sistema de la difusión social de la ciencia: Catalizadores del sistema y consideraciones finales

- Ciencia, creencias, política y matar al mensajero

Miel y siropes, ¿son mejores que el azúcar?

A estas alturas, los que nos preocupamos por nuestra salud y tratamos de seguir una dieta equilibrada, sabemos que se consume más azúcar del recomendable, con las consecuencias para la salud que eso acarrea, sobre todo relacionadas con el sobrepeso y la diabetes. Por este motivo, muchos hemos buscado el ansiado sabor dulce en sustitutos del azúcar. Cada vez hay más oferta, desde el azúcar moreno, a edulcorantes como el aspartamo, el eritritol, la sacarina, la estevia, etc.

En el primer artículo de la serie «Azúcar y otros edulcorantes» concluimos que el azúcar moreno no es más saludable que el azúcar blanco. En siguientes artículos analizaremos al resto de edulcorantes. Hoy vamos a ver qué ocurre con los llamados edulcorantes naturales, como la miel y los siropes.

-

¿Qué es la miel?

Las abejas recolectan el néctar de las flores (miel de flores) o las secreciones de partes vivas de plantas o excreciones de insectos chupadores de plantas (rocío de miel), lo transforman gracias a la enzima invertasa que contienen en la saliva y lo almacenan en los panales donde madura hasta convertirse en miel.

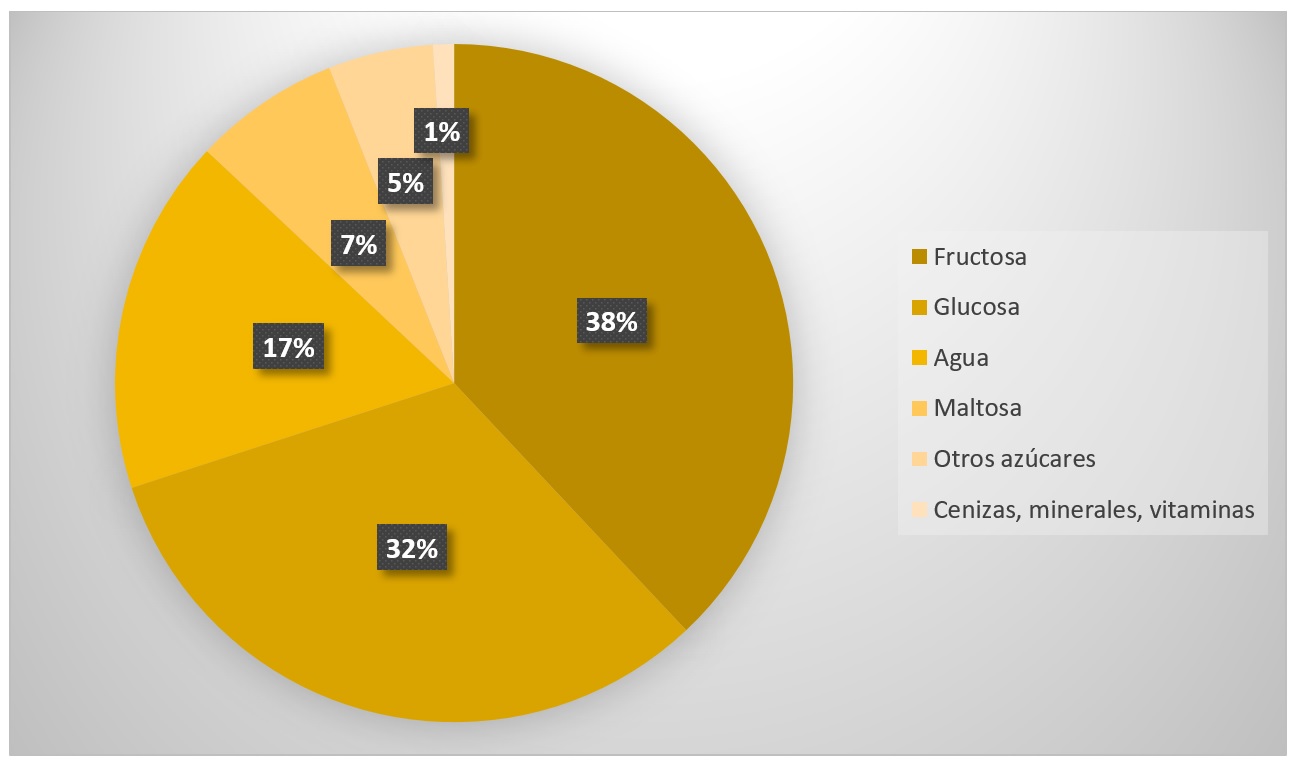

La composición de la miel es la siguiente, aunque varía según el origen del néctar y el clima:

Composición media de la miel

El azúcar blanco y el azúcar moreno son sacarosa al 85-100%. La miel contiene en un 70-80% fructosa y glucosa —los monosacáridos que conforman la sacarosa—. En todos los tipos de miel, los azúcares conforman más de 85% de su composición.

Con respecto al aporte calórico, el azúcar tiene 4 kcal por gramo, mientras que la miel tiene unas 3 kcal por gramo. Esta disminución se debe al agua que contiene.

El índice glucémico (IG) de un alimento es otro valor a tener en cuenta. El IG determina la velocidad con la que un alimento hace aumentar los niveles de glucosa en sangre, de modo que los alimentos de alto IG se restringen en dietas para diabéticos o propensos a padecer diabetes. También reducen la saciedad, por lo que se suelen desaconsejar en dietas para perder peso. La miel tiene un IG de 60-65. El azúcar común tiene un IG de 70. Ambos son valores elevados y similares, así que tampoco es un dato que haga a la miel mejor que al azúcar común.

En la miel encontramos un 1% de otras sustancias que sí tienen valor nutricional, como minerales, vitaminas y aminoácidos, y es por ello por lo que se le atribuyen propiedades antioxidantes, entre otras. También contiene una pequeña porción de agua oxigenada, responsable de que en la antigüedad y en caso de emergencia, se utilizase miel como cicatrizante y bactericida.

La proporción de nutrientes es tan pequeña que necesitaríamos comer grandes cantidades de miel para que el aporte fuera significativo. Y eso es precisamente lo que no debemos hacer. El beneficio que pudiesen suponer sus nutrientes queda eclipsado por la enorme cantidad de azúcares que contiene la miel. Si queremos nutrientes, no los busquemos en la miel.

-

¿Qué son los siropes?

Los siropes o jarabes son jugos que se extraen de diferentes plantas que posteriormente se tratan para eliminar parte del agua y concentrar sus azúcares. Los siropes son disoluciones acuosas con un contenido en azúcares que oscila entre el 70 y el 90%. Los más conocidos son el sirope de arce y el sirope de agave.

El sirope de arce, edulcorante típico canadiense, se extrae del tronco de diferentes tipos de arces. Es el sustituto de la miel que suele emplearse en cocina vegana. Para producir el sirope se extrae el jugo del tronco de los arces y se calienta hasta conseguir la consistencia deseada. Algunos productores además le añaden grasa en forma de manteca.

El sirope de agave se extrae del corazón del agave, planta típica de México. Para su elaboración se corta la planta y se extrae la savia, denominada aguamiel, que es consumida por los nativos como una bebida refrescante. Si la savia se fermenta obtenemos pulque, bebida alcohólica tradicional de México. También se emplea para fabricar tequila. El proceso de obtención del sirope es por degradación enzimática de los carbohidratos, principalmente fructosanos, en azucares simples. Posteriormente se filtra y se concentra por calentamiento hasta alcanzar una viscosidad similar a la miel, de forma muy parecida a cómo se obtiene el sirope de arce o cualquier otro sirope vegetal.

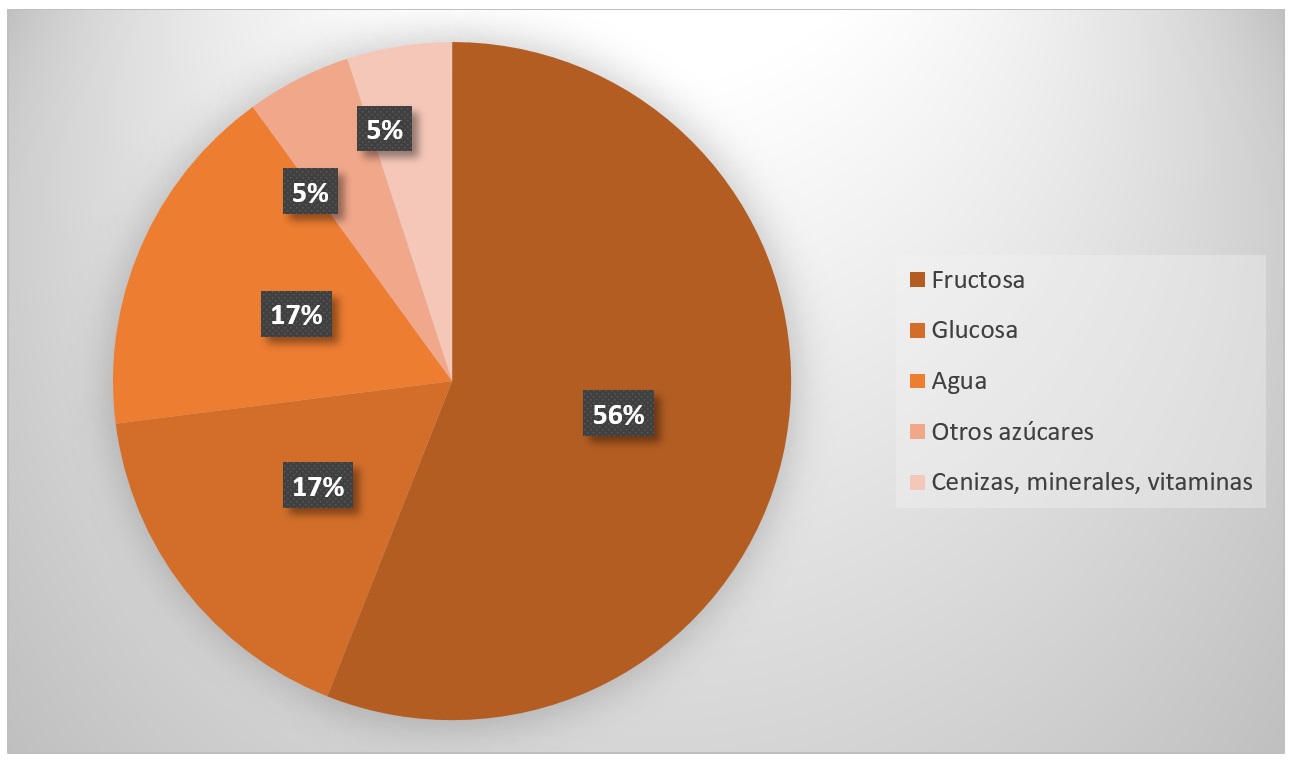

Tanto el sirope de arce como el sirope de agave tienen un IG de 55 y aportan una media de 3 kcal por gramo. La diferencia con el azúcar se debe a la cantidad de agua y a la elevada proporción de fructosa. La composición media de ambos siropes es:

Composición media del sirope de agave y de arce

La principal diferencia entre los siropes y la miel es que los siropes contienen una mayor cantidad media de fructosa. El sirope que más fructosa contiene es el llamado jarabe de maíz, también conocido como jarabe de maíz de alta fructosa. Aunque la fructosa y la glucosa aportan casi las mismas kcal, la fructosa tiene una capacidad edulcorante más potente, por lo que suele emplearse menos cantidad para obtener el mismo dulzor.

De media, el 5% de cualquiera de estos siropes contiene otro tipo de sustancias con valor nutricional, como vitaminas, minerales y aminoácidos, responsables, entre otras cosas, de los diferentes sabores y aromas de los siropes. El porcentaje es muy pequeño como para tenerlo en consideración como aspecto saludable, ya que, como pasaba con la miel o con el azúcar moreno, habría que consumir una elevada cantidad de estos edulcorantes para conseguir una porción significativa de nutrientes. La enorme cantidad de azúcares ensombrece la posible bondad de sus nutrientes.

Para algunos consumidores, la ventaja de este 5% de nutrientes y otras sustancias es organoléptica. De ninguna manera debería aconsejarse el consumo de miel o siropes alegando valor nutricional y otros aspectos saludables, porque no son ni ciertos ni relevantes.

-

Consideraciones metabólicas de siropes, miel y otros edulcorantes de alto contenido en fructosa.

A diferencia de la glucosa, que se absorbe instantáneamente produciendo un aumento y disminución rápida de energía, la fructosa se metaboliza más despacio y en parte es almacenada como reserva por el hígado en forma de glucógeno. El exceso acaba convirtiéndose en grasa. Sin embargo, puesto que la fructosa se transforma en glucosa y produce una elevación glucémica en sangre, no se considera un edulcorante recomendable para las personas con diabetes, tal y como se creía erróneamente en el pasado.

El hecho de que toda la fructosa tenga que ser metabolizada por el hígado (mientras que la glucosa se metaboliza en todo tipo de células) tiene implicaciones sobre la salud. Actualmente se está analizando la relación entre un consumo excesivo de fructosa y algunas patologías como la diabetes tipo II, la obesidad y sus enfermedades cardiovasculares asociadas, el hígado graso no alcohólico y el síndrome metabólico. Patologías que, hasta ahora, asociábamos al consumo excesivo de azúcar común, entre otros, y que hoy en día extendemos a estos otros edulcorantes de elevado contenido en azúcares como la fructosa.

Puede resultar curioso que un alimento con un IG medio, como muchos siropes, esté relacionado con la obesidad. Esto tiene una razón metabólica que lo explica: el hígado focaliza toda la actividad en la fructosa, lo que causa un cese en la actividad digestiva normal. La consecuencia es que se reducen los niveles de insulina y leptina, y aumenta el nivel de la hormona ghrelina, encargada de controlar el apetito, con lo cual, cuando consumimos fructosa, no sentiremos saciedad.

-

Conclusiones

La recomendación de la Organización Mundial de la Salud (OMS) es reducir el consumo de azúcar libre hasta los 25 g diarios (exactamente al 5% de las calorías diarias consumidas). En la recomendación de la OMS se hace una clara distinción entre azúcar libre y azúcar intrínseco. El azúcar intrínseco es el que de serie contienen las frutas y las verduras, y sobre el que no hay restricción de consumo. El azúcar libre es el que sí debemos minimizar. El azúcar libre lo añadimos a los alimentos como azúcar común y es el que se utiliza como un ingrediente más en alimentos procesados (sean aparentemente dulces o no). La OMS también denomina azúcar libre la miel y los siropes, ya que su consumo ocasiona una respuesta metabólica de consecuencias análogas a las que produce el consumo de azúcar común.

Tanto la miel como los siropes tienen un contenido en azúcares elevado, que varía entre el 70% y el 90%. El resto es agua, y una cantidad mínima de nutrientes, vitaminas y minerales. Estos nutrientes son tan escasos que, cualquiera de las propiedades beneficiosas que pudiesen aportarnos, quedan ensombrecidas por el alto contenido en azúcares. Si queremos nutrientes, no los busquemos en la miel o en los siropes.

En definitiva, si la recomendación es disminuir la ingesta de azúcar libre, disminuyámosla, no busquemos soluciones mágicas. Tanto la miel como los siropes son azúcares con nombres y presentaciones atractivas, que evocan salud y naturalidad. Son azúcares con un bonito disfraz.

Principales fuentes consultadas:

- Recomendaciones sobre el consumo de azúcares de la Organización Mundial de la Salud [PDF]

- Wikipedia: Maple syrup.

- Directo al paladar: Qué es el sirope de agave, origen y usos en la cocina.

- Morselli, Mariafranca; Whalen, M Lynn (1996). “Appendix 2: Maple Chemistry and Quality”. In Koelling, Melvin R; Heiligmann, Randall B. North American Maple Syrup Producers Manual. Ohio State University.

- Gominolas de petróleo: ¿Es cierto que la miel no se estropea?

- El comidista: ¿Existen alternativas sanas al azúcar?

- Forristal, Linda (2001). The Murky World of High-Fructose Corn Syrup.

- Teff, K. L.; Elliott, S. S., Tschöp, M., Kieffer, T. J., Rader. D., Heiman, M., Townsend, R. R., Keim, N. L., D’Alessio, D., Havel, P. J. (2004). “«Dietary fructose reduces circulating insulin and leptin, attenuates postprandial suppression of ghrelin, and increases triglycerides in women.» J Clin Endocrinol Metab. 89 (6): 2963-72.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Miel y siropes, ¿son mejores que el azúcar? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El azúcar oculto en los alimentos

- Azúcar moreno, ¿mejor que el azúcar blanco?

- Un modelo para la máquina de coser fluidodinámica, o como untar miel con conocimiento

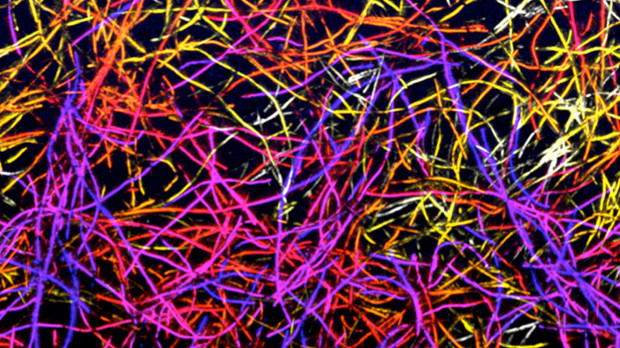

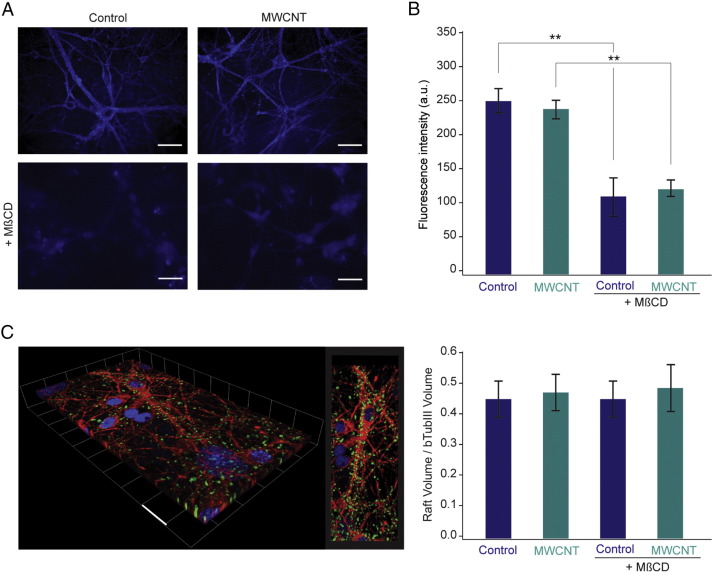

Nanotubos de carbono y regeneración neuronal

Cuando hablamos de nanotecnología aplicada a la medicina surgen preguntas muy básicas, como ¿qué pasa si permitimos que interactúen neuronas con nanotubos de carbono? ¿Será tóxico, pierden las neuronas sus capacidades, mueren? Precisamente un equipo de investigadores en el que participa Maurizio Prato, profesor Ikerbasque en CIC biomaGune, ha investigado los posibles efectos sobre las neuronas de la interacción con los nanotubos de carbono. Y han encontrado algo tremendamente interesante y potencialmente muy importante.

Los científicos han demostrado que estos nanomateriales pueden mediar en la formación de sinapsis, esas estructuras especializadas a través de las cuales las células nerviosas se comunican, y modular mecanismos biológicos, como el crecimiento de las neuronas, como parte de un proceso autorregulado. Este resultado, que muestra hasta qué punto la integración entre las células nerviosas y estas estructuras sintéticas es estable y eficiente, pone de relieve las grandes potencialidades de los nanotubos de carbono como materiales capaces de facilitar la regeneración neuronal o para crear una especie de puente artificial entre grupos de neuronas cuya conexión se haya visto interrumpida. Las pruebas in vivo ya han comenzado.

Tan espectacular como suena, los nanomateriales representan hoy día la mejor esperanza para el tratamiento de personas con daños en su médula espinal. Estos materiales se usan tanto como andamiaje, dando soporte estructural, como interfaces para permitir la comunicación entre neuronas.

Sin embargo, todavía hay que considerar muchas cuestiones. Entre ellas el impacto en la fisiología neuronal de la integración de estas estructuras nanométricas con la membrana celular. Si, por ejemplo, el mero contacto provocara un aumento vertiginoso del número de sinapsis, estos materiales serían esencialmente inutilizables. Esto es precisamente lo que se ha investigado en este estudio.

Los resultados de la investigación son muy alentadores: se ha comprobado que los nanotubos no interfieren en la composición de los lípidos, en particular del colesterol, que constituyen la membrana celular en las neuronas; estos lípidos de la membrana juegan un papel muy importante en la transmisión de las señales a través de las sinapsis. Y los nanotubos no parecen influir en este proceso, lo que es muy importante.

La investigación también ha destacado el hecho de que las células nerviosas que crecen sobre el substrato de nanotubos, gracias a esta interacción, se desarrollan y alcanzan la madurez muy rápidamente, llegando finalmente a una condición de homeostasis biológica, es decir, este crecimiento no es indiscriminado e ilimitado sino que se consigue llegar a un equilibrio fisiológico.

La consecución de este equilibrio es un aspecto de fundamental importancia . Efectivamente, no solo los nanotubos de carbono funcionan excelentemente en términos de duración, adaptabilidad y compatibilidad mecánica con el material biológico, también estamos ante una interacción eficiente.

Si las pruebas in vivo salen bien, se habrá dado un paso en una dirección muy prometedora para recuperar funciones neurológicas perdidas.

Referencia:

Niccolò Paolo Pampaloni, Denis Scaini, Fabio Perissinotto, Susanna Bosi, Maurizio Prato, Laura Ballerini (2017) Sculpting neurotransmission during synaptic development by 2D nanostructured interfaces nanomedicine doi: 10.1016/j.nano.2017.01.020

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con N

El artículo Nanotubos de carbono y regeneración neuronal se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo incorporar nanotubos de carbono a un plástico de aviación

- Nanotubos de carbono como canales iónicos artificiales

- Nadar y guardar la ropa: nanotubos en revestimientos epoxis nanoestructurados

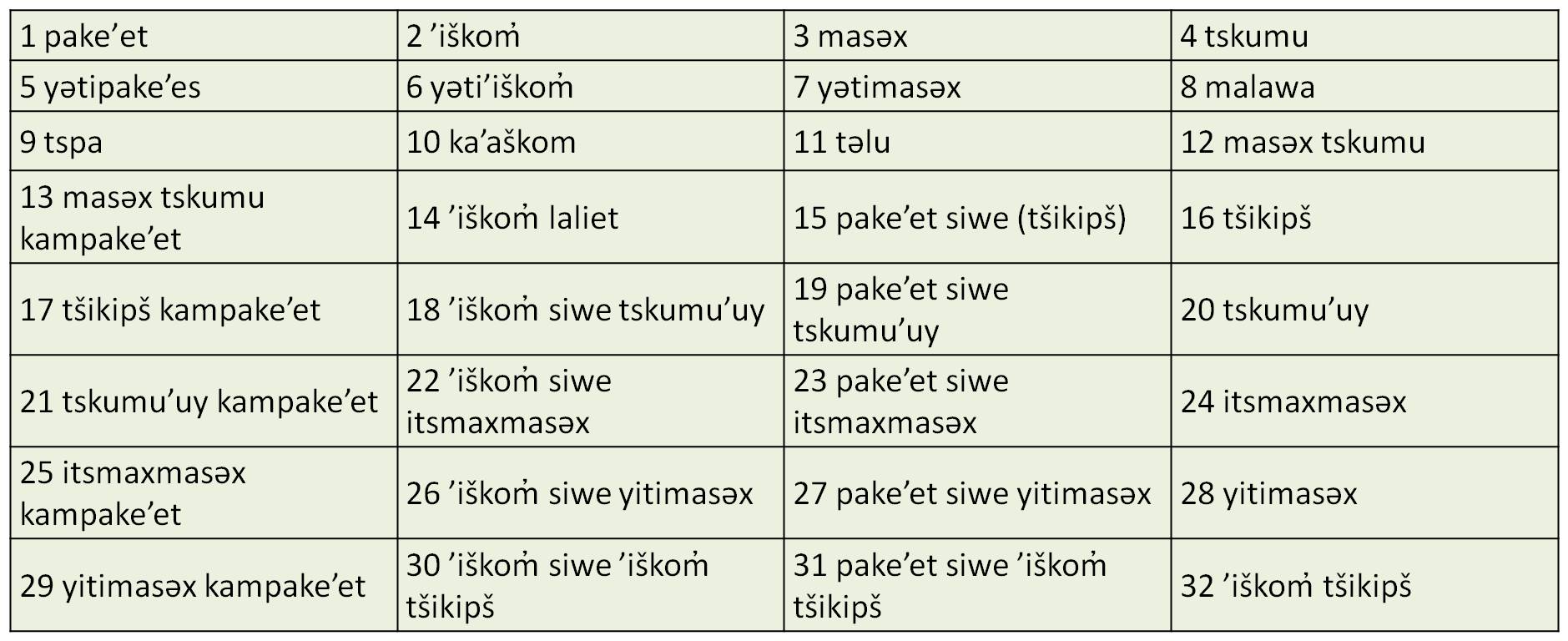

El gran cuatro, o los números siguen estando locos

Teniendo en cuenta que el número cuatro va a ser protagonista de la entrada de hoy en la sección Matemoción del Cuaderno de Cultura Científica, vamos a empezar con una obra de arte relacionada con este número.

“El gran cuatro” (1986), de Robert Motherwell (1915-1991)

Hace tres años publiqué una entrada en el Cuaderno de Cultura Científica que llevaba el título “Los números deben estar locos”. En la misma hablábamos de “pueblos primitivos” (algunos de los cuales siguen existiendo hoy en día, o lo han hecho hasta el siglo XX, como “los bosquimanos del África austral, los zulúes y los pigmeos del África central, los botocudos del Brasil, los indios de Tierra de Fuego, los kamilarai y los aranda de Australia, los indígenas de las Islas Murray o los vedas de Ceilán”) cuyos sistemas para contar eran muy básicos, ya que prácticamente solo disponían de palabras para el “uno” y el “dos”.

Algunos pueblos, como los bergdama – darama– del Sur de África (zona de Namibia), solo tenían tres palabras, para “uno” y “dos “, y para todo lo que fuera mayor que dos utilizaban la palabra “muchos”.

Danza tradicional de los Darama