¿Cómo una bacteria inofensiva de Gambia acaba generando una epidemia en Wisconsin?

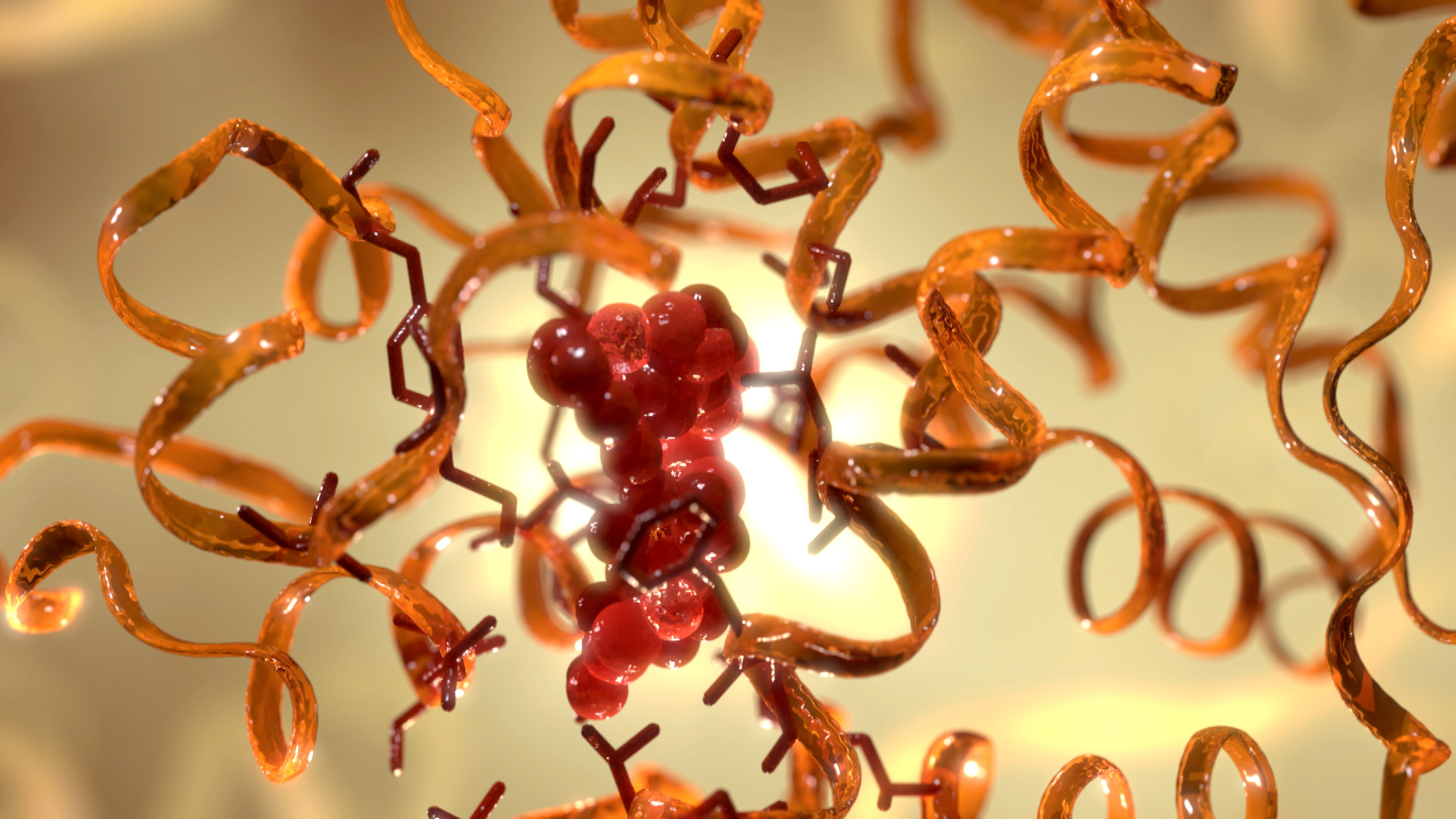

Elizabethkingia anophelis fue aislada en 2011 a partir de muestras del intestino medio del complejo de ciptoespecies al que pertenece el mosquito Anopheles gambiae1. Aunque podría haber quedado olvidada entre las publicaciones de las revistas de taxonomía, la bacteria saltó a la fama en 2016 cuando las noticias de Wisconsin se hicieron eco de su existencia, algo que cuando hablamos de bacterias no suele estar relacionado con buenas nuevas. E. anophelis estaba tras la infección de más de 60 personas y lo que era peor, era la causa de la muerte de 20.

¿Qué hacia una bacteria sin historial como patógeno infectando y matando gente?, una bacteria que además, habitualmente vive en el sistema digestivo de mosquitos. Sin olvidar el dato climático, los mosquitos no son algo común en Wisconsin durante el invierno.

No es una sorpresa ver a microorganismos inofensivos convertidos en patógenos: los cambios en el genoma, los plásmidos y otros mecanismos son capaces de generar esta situación. Por ello el CDC (Centro de control de enfermedades) hizo algo poco común, liberó por twitter el genoma recién secuenciado e imagino que sin procesar, rápidamente algunos microbiólogos como Kat Holt o Sylvain Brisse se unieron para solucionar el problema.

La primera cosa que observaron es que las secuencias procesadas de las muestras de los enfermos eran demasiado distintas. Normalmente las epidemias las causan una misma cepa con una secuencia genética casi idéntica con variaciones mínimas propias de cambios individuales, 40, 50 o incluso 100 pares de bases dentro del total. Sin embargo en esta ocasión las diferencias eran mucho mayores. Así que tras asegurarse por medio de herramientas mucho más potentes como el análisis cgMLST y aproximaciones comparativas de SNP en el genoma completo… Se llegó a la indudable conclusión de que aún siendo tan distintas, eran no sólo la misma especie sino que provenían de una misma cepa-ancestro. La diferencia entre ellas provenía principalmente de una enorme trozo insertado en el medio del gen mutY.

El gen mutY, se encarga de codificar para una proteína encargada de reparar errores en el ADN, así que ahora podéis imaginar que tras llevar un trozo de código más grande que la propia secuencia, la capacidad para producir la proteína desaparece completamente. Sin reparación, tenemos mutación descontrolada, y aunque la mayoría de las mutaciones son negativas o sin función…con el suficiente tiempo un pequeño porcentaje podrán dar habilidades no deseadas (por nosotros) a las bacterias. Y claro, de camino también ayudaría a volver locos a los microbiólogos que trataban de identificar al patógeno.

Aunque resuelto e identificado el culpable, seguía sin estar claro cómo una bacteria de esas características había llegado allí y lo que era más extraño, el modo en el que aparecieron los casos. Normalmente las epidemias aparecen en un hospital o lugar concreto desde el que se expanden, pero en este caso apareció de forma diseminada. El CDC analizó todas las posibles fuentes de esta bacteria dentro del ambiente hospitalario sin dar en ningún comento con la bacteria en el medio. Por lo que el foco se centró en la comunidad.

Cerrada la vía del estudio en el medio ambiente, el esfuerzo se centró en la secuencia genética de las muestras obtenidas de los enfermos2. -Y Ahora empieza quizás la parte más complicada, pero si ha llegado hasta aquí leyendo, no se asuste estimado lector, porque vamos a intentar entender lo básico de algunas técnicas. (Si además queréis saber más de taxonomía bacteriana y sus limitaciones con técnicas de antes de ayer podéis leer mi colaboración en la Cátedra de Cultura Científica).

El árbol filogenético se realizó usando la que es quizás la herramienta más potente en taxonomía microbiona, el cgMLST. Esta técnica está basada en el análisis MLST, pero vayamos poco a poco. En taxonomía microbiana existen muchas aproximaciones a la descripción de especies. Centrándonos en los métodos moleculares, concretamente en los que implican secuencias genéticas, el más conocido es el análsis del ADNr 16S del que hablo en el texto citado en el párrafo anterior. Voy a contarlo de una forma muy sencilla, casi näif:

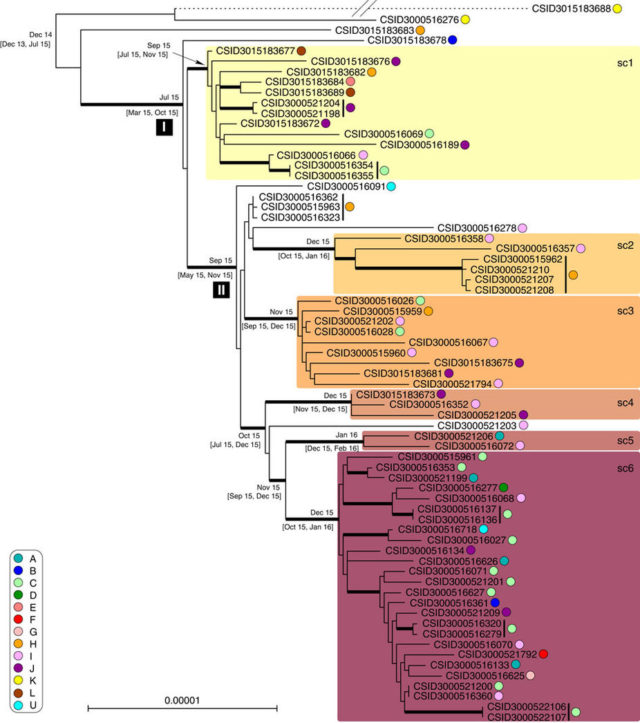

Phylogenetic tree of the outbreak isolates. From: Evolutionary dynamics and genomic features of the Elizabethkingia anophelis 2015 to 2016 Wisconsin outbreak strain

Si queremos describir en base a la secuencia genética necesitamos un código que sea muy similar, que cambie muy poco, y ya sabemos que los seres vivos tienden a mutar y cambiar con las generaciones. Pero existen genes muy muy importantes, tanto que los cambios en ellos son muy pocos. Estos genes, o mejor dicho trozos de ellos, son los candidatos elegidos para secuenciar e identificar mediante multilocus sequence typing (MLST). Cada especie bacteriana tiene un número de genes de este tipo, suelen elegirse siete y en base a ellos se realizan árboles mediante procesos estadísticos (en los que no vamos a entrar). Quizás os preguntéis por qué no usar Whole-genome sequencing (WGS), la secuenciación del genoma completo y la hibridación es el método “final” para publicar una nueva especie microbiana, básicamente alineas el genoma completo de esa especie y la más cercana para demostrar que hay partes que no son iguales y que esas partes son lo suficientemente grandes para considerarse una especie nueva. Sin embargo este método no es útil en epidemiología. Es complicado estandarizar, ya que arroja tantos por ciento de similitud, lo que complica un poco la colaboración entre distintos centros de investigación.

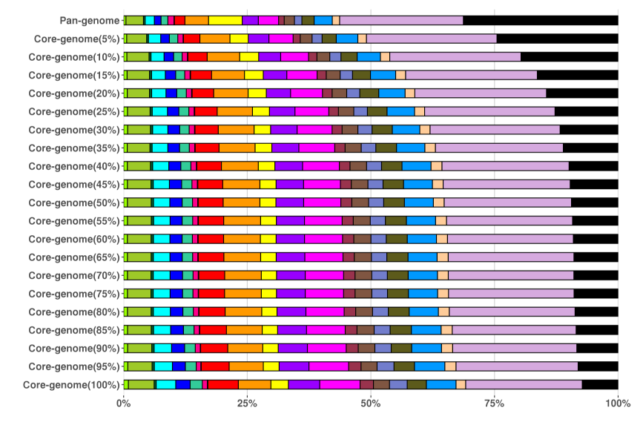

¿La solución?, ya la imagináis core genome MLST (cgMLST). Retrocedamos a los médicos que tomaban muestras de los enfermos, muestras de una bacteria que cambiaba casi cada día…bacterias que siendo responsables de la misma epidemia eran sensiblemente distintas entre ellas. El genoma de las bacterias estudiadas era distinto en gran parte, pero claramente perteneciente a la misma especie. A la suma de todos esos genomas que tenemos es a lo que llamamos pan-genoma,

Pan-genoma vs. Core-genoma.

El Core Genoma sería (simplificando muchísimo) las partes de la secuencia que van caracterizando las similitudes entre cepas de la misma especie. Dejando los “genes únicos” como las zonas que diferencian a cada cepa de las demás. Así que tenemos un Pan-genoma que contiene partes compartidas llamadas Core-genoma, partes distintas llamadas genes únicos. El Pan-genoma por decirlo de otra forma, sería una secuencia consenso entre las cepas.

Pues mezclando ambos conceptos se desarrolló el cgMLST. En el cual se estandarizó y dotó de un sistema numérico a los alelos ayudándose del mapeo de single nucleotide polymorphism (SNP), que son pequeños cambios en el ADN usados también para diferenciar y clasificar. La ventaja de todo este sistema, es su velocidad y usabilidad una vez automatizado. Tomar una muestra de la bacteria, secuenciar los genes MLST, y cotejar con el sistema cgMLST para poder colocar y clasificar.

Se tomaron muestras casi diarias de prácticamente todos los pacientes, y tras procesarlas en el cgMLST se vio que el core-genoma era idéntico excepto por un único SNP encontrado en uno de los aislamientos (en el mismo paciente otros dos aislamientos también fueron distintos para ese SNP) Este dato confirmó lo dicho al inicio de la historia, que se trataba de una bacteria con un origen común pero con una gran capacidad de mutar.

Por si fuera poco sorprendente, los análisis bayesianos demostraron que había una “firma temporal”, lo que implicaba que la cepa de la epidemia se había continuado diversificando de una forma mesurable durante el curso de la epidemia. Se estimó que el ratio de evolución era de 5.98 × 10−6 substituciones nucleotídicas por año y sitio. Atendiendo al ratio de diversificación y a que las muestras fueron tomadas alrededor de julio de 2015. Se pudo determinar la aparición del ancestro de la cepa epidémica aproximaciones a finales de diciembre de 2014. Para asegurarse, los investigadores realizaron un experimento similar pero atendiendo a los SNP del genoma completo y no sólo de los cgMLST, este experimento situó el origen de la cepa en agosto de 2014. Uniendo ambos resultados se confirmó que la cepa apareció un año antes de la epidemia, y evolucionó en un reservorio desconocido para luego generar la epidemia, siguiendo su diversificación durante todo el proceso.

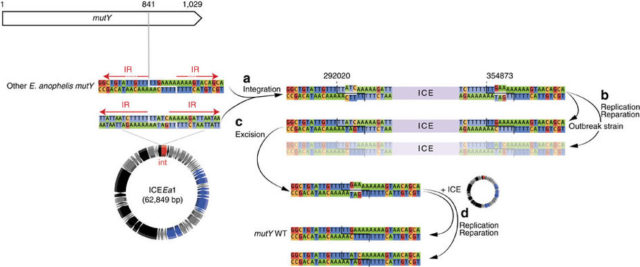

Excision of ICEEa1 can lead to mutY WT in outbreak strains.

Estudiando el elemento externo que se había insertado en el genoma de la bacteria causando este fenómeno de “hipermutación” y patogenia, los investigadores descubrieron que se trataba del elemento, al que bautizaron como ICEEa1 (integrative and conjugative element 1 of E. anophelis). Era en realidad un enorme paquete que originalmente pertenecía a un Sistema de secreción tipo 4 de Bacteroidetes (T4SS-B). El ICEEa1, además de los 12 genes que codificaban para el T4SS, también incluía: un set completo de genes para integración/escisión y conjugación bacteriana, una relaxasa, una ATPasa, la metilasa de ADN N-6 y reguladores para tetraciclinas. Si esto fuese poco, también se encontraron genes para sistemas de producción de sideróforos (para capturar hierro libre) y bombas de transporte para: cobalto, zinc, cadmio, níquel, cobre y mercurio.

La incapacidad de reparar su genoma por tener todo esto en medio del mutY, parece que generó en la cepa original muchos daños por estrés oxidativo. El tipo de mutaciones así lo indicaban, así que observar esta increíble resistencia a metales pesados cuadraba bastante con la hipótesis de que la cepa inicial evolucionó en un ambiente contaminado en la comunidad y no en hospitales.

Aunque lo más sorprendente y preocupante fue descubrir que el ICEEa1 era de “quita y pon”, la bacteria podía llevar insertado el trozo y perder su capacidad para reparar el genoma, pero a cambio convertirse en fenotipo hipermutador, adquirir resistencia a metales pesados y volverse muy patógena. Y en cualquier momento soltar el trozo para recuperar sus capacidades normales manteniendo algunas de las adquiridas. No os imaginéis algo voluntario, más bien pensad en una enorme población de bacterias que van multiplicándose y por transferencia horizontal pasándose el trozo unas a otras generando estas cepas hipermutantes de vez en cuando.

Dicho esto, a los investigadores sólo les faltaba una cosa por contar, ¿por qué se había vuelto patógena ahora si nunca había causado problemas? Pues quizás siempre lo había sido… Como ya se ha dicho muchas veces la taxonomía basada en el ADNr16S y la tipificación por métodos bioquímicos no son por si mismas suficientes, esto es algo que empieza a admitirse lentamente. Los investigadores piensan que muchas de las bacterias identificadas como Elizabethkingia meningoseptica, un típico patógeno de ambientes hospitalarios eran en realidad E. anophelis, por lo que se propuso la actualización de las bases de datos del MALDI-TOF, herramienta usada en la identificación rápida de patógenos. Y se puso en aviso a la comunidad de epidemiólogos pues trozos como el ICEEa1 podían pasar a otras bacterias distintas dejando el aviso de que una nueva epidemia es sólo cuestión de tiempo.

Este post ha sido realizado por José Jesús Gallego Parrilla (@Raven_neo) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias científicas y más información:

1.Kämpfer, P. et al. Elizabethkingia anophelis sp. nov., isolated from the midgut of the mosquito Anopheles gambiae. International Journal of Systematic and Evolutionary Microbiology 61, 2670–2675 (2011).

2.Perrin, A. et al. Evolutionary dynamics and genomic features of the Elizabethkingia anophelis 2015 to 2016 Wisconsin outbreak strain. Nature communications 8, 15483 (2017).

El artículo ¿Cómo una bacteria inofensiva de Gambia acaba generando una epidemia en Wisconsin? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La falta de hierro y cómo un pez acaba con ella

- Sobre la predisposición genética a padecer enfermedades (II)

- Sobre la predisposición genética a padecer enfermedades

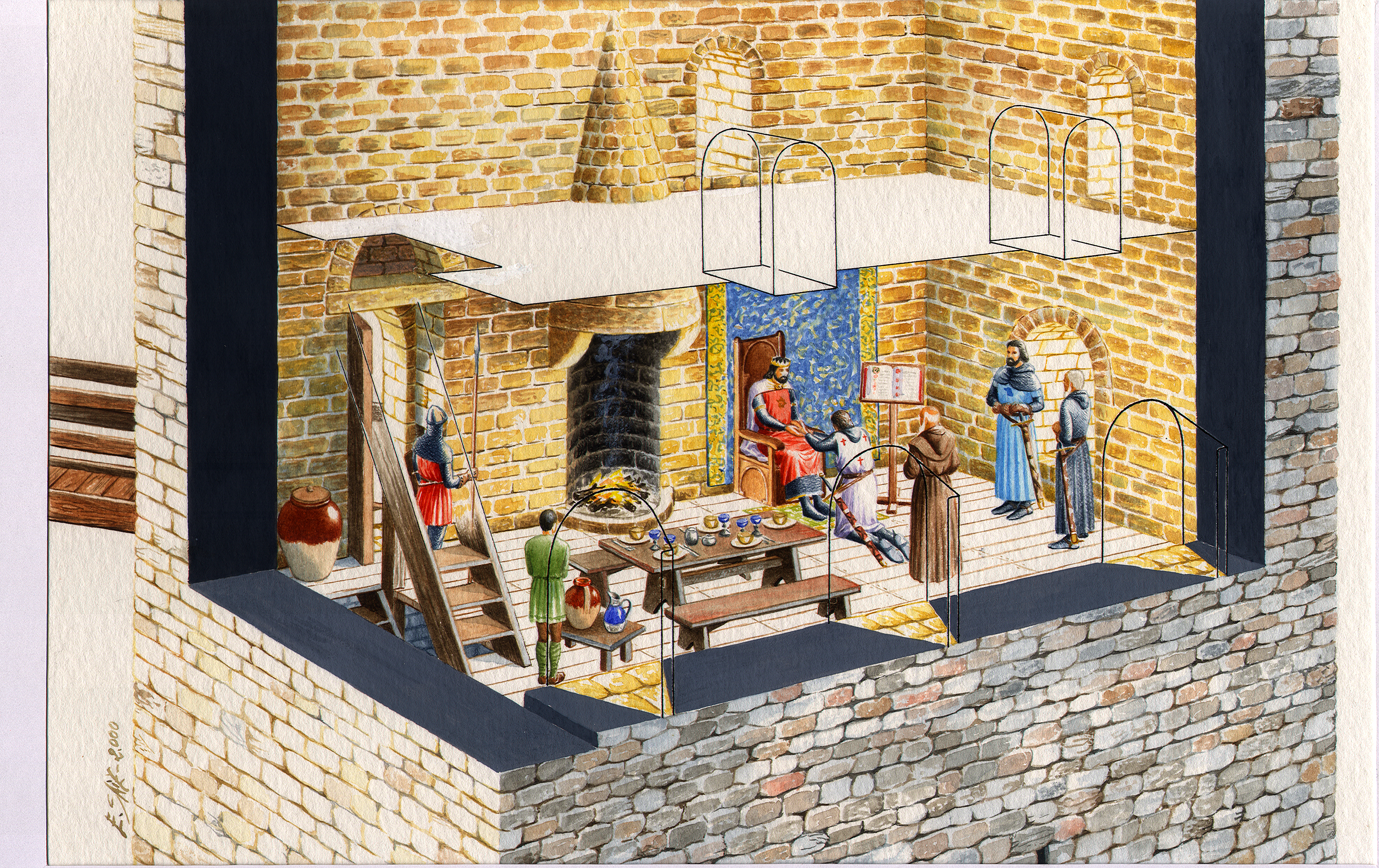

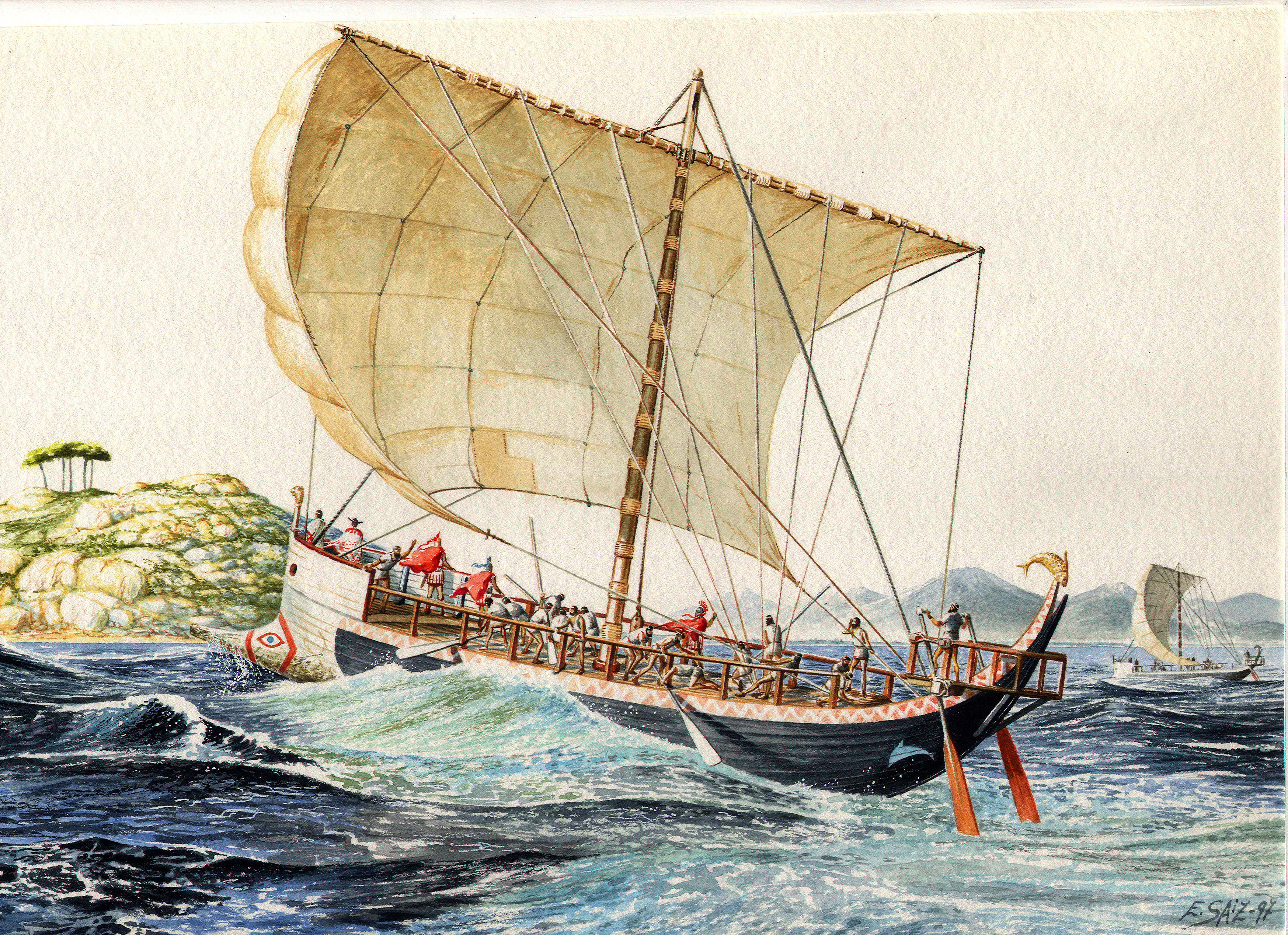

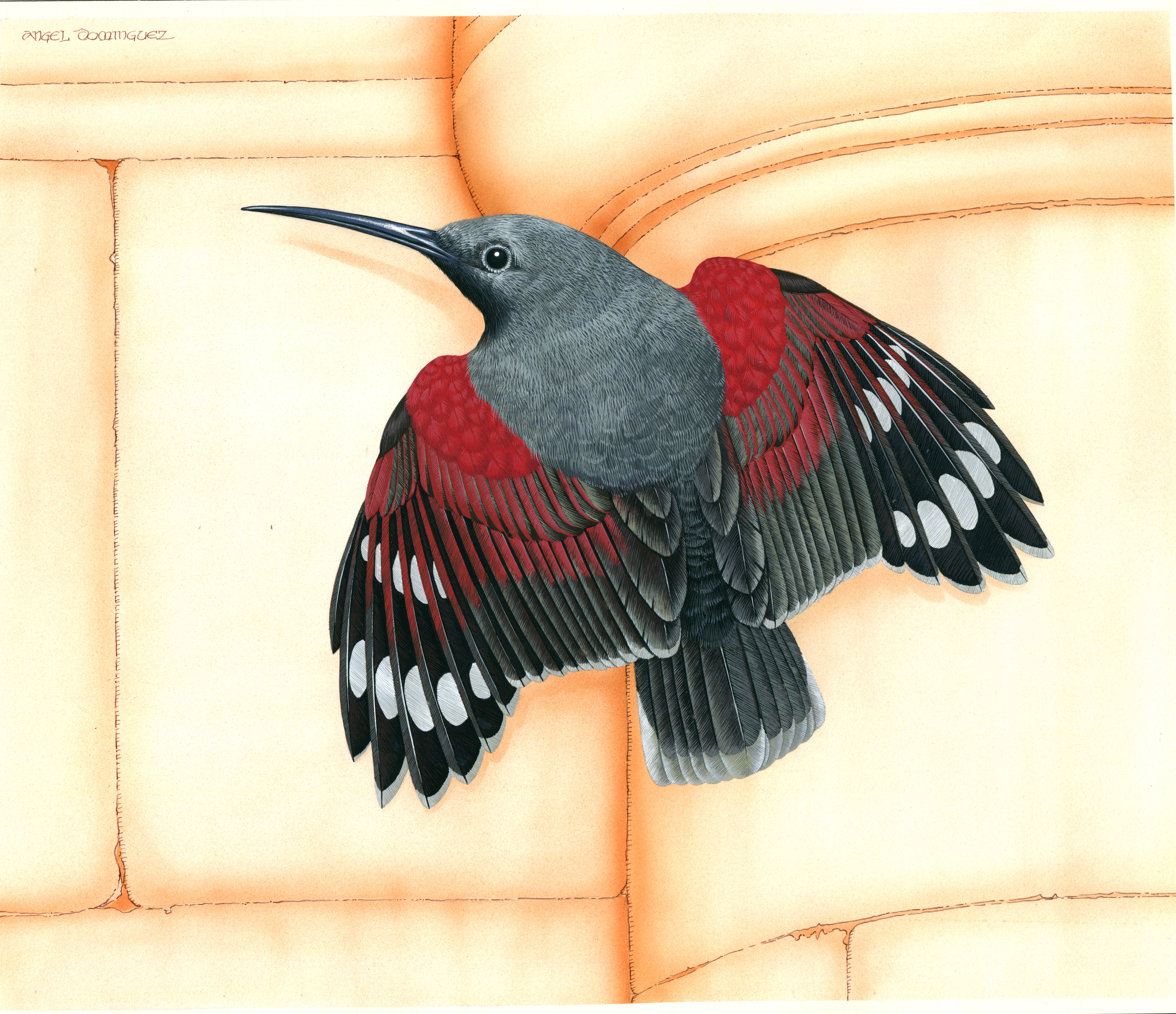

El primer postgrado en Ilustración Científica, esa profesión invisible

Vega Asensio

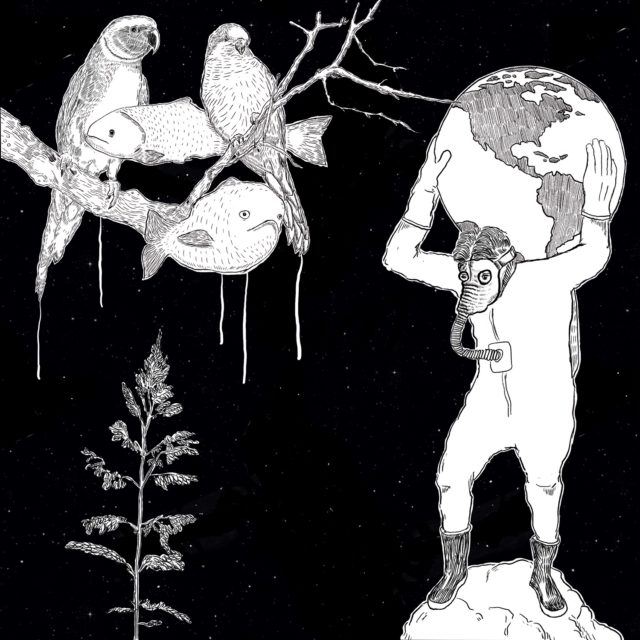

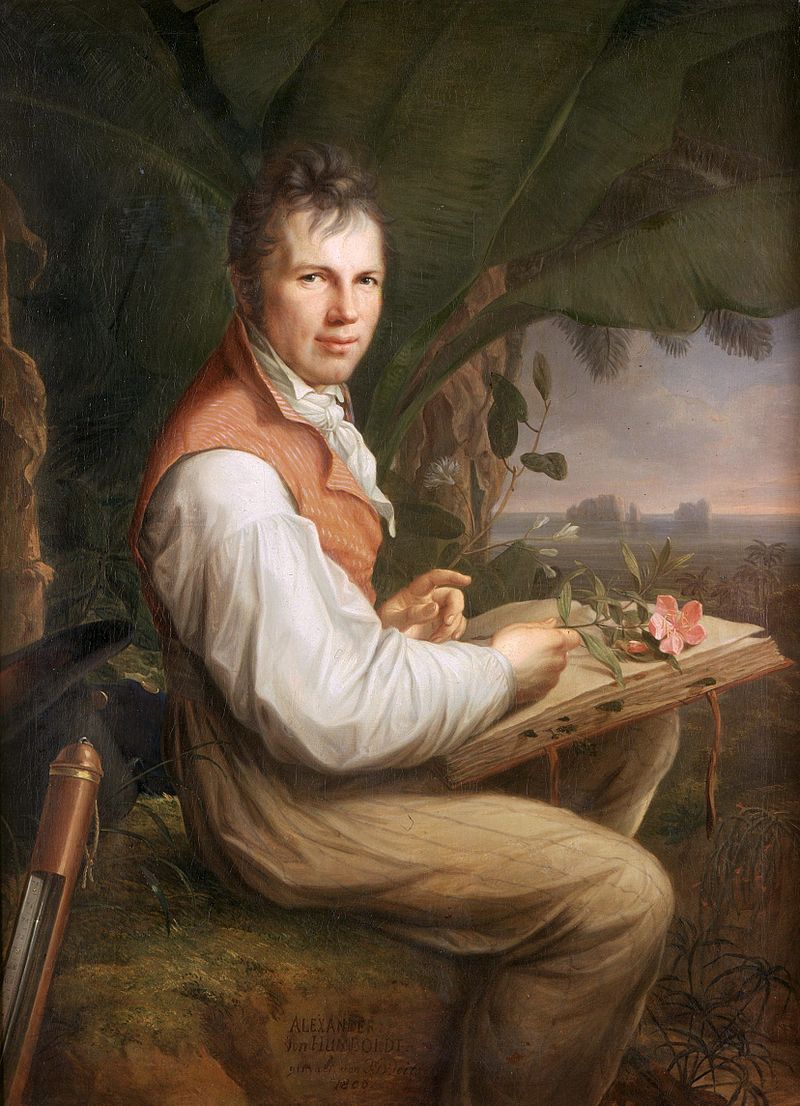

El ser humano es visual. Buena parte de las capacidades cognitivas de nuestro cerebro están orientadas al procesamiento de la imagen. Por ello, para comprender y comunicar la ciencia la imagen es una herramienta fundamental. Dibujos, diagramas, gráficas, ilustraciones,… no sólo están presentes en prácticamente todo artículo, libro, clase, presentación de ciencia sino que las hemos estado disfrutando desde nuestra infancia en todo tipo de formatos: enciclopedias, guías, folletos, museos, periódicos, etc. Los profesionales formados para crear estos materiales son las ilustradoras e ilustradores científicos.

Estos y estas profesionales tienen normalmente formación científica y han virado hacia la ilustración o son profesionales de las bellas artes que se han especializado en ciencia. La ciencia y el arte se unen para crear la profesión de la Ilustración Científica, una de las ramas de la comunicación científica, cuyo objetivo es comunicar la ciencia de forma visual per se o apoyando a la palabra oral o escrita.

Normalmente son profesionales autodidactas ya que la formación reglada en está disciplina es inexistente en España. Puede que este sea uno de los principales factores que hacen de la profesión de Ilustración Científica una desconocida. Pequeños talleres o cursos, principalmente relacionados con la ilustración de la naturaleza, organizados de forma esporádica por museos o ayuntamientos y que no pueden abarcan la complejidad de la disciplina, es lo que podemos encontrar.

En Europa hay muy pocos centros donde se dé formación reglada [1], aunque en estas universidades este tipo de postgrado se oferta desde hace años y se impulsa desde departamentos diferentes: bellas artes o diseño, ciencias o medicina. La universidad pionera en el mundo y una de las más prestigiosas es la Johns Hopkins (http://medicalart.johnshopkins.edu/) de Estados Unidos con más de 100 años de historia.

Sabiendo que la comunicación científica es fundamental para que la ciencia avance, la Facultad de Ciencia y Tecnología (ZTF-FCT) de la Universidad del País Vasco con el apoyo de otras facultades e instituciones oferta por primera vez un título propio de Especialista Universitario en Ilustración Científica. Toda la información referente al postgrado está en www.ehu.eus/ilustracion-cientifica.

El profesorado está compuesto por un grupo variado y equilibrado de excelentes científicos, artistas, juristas y comunicadores reconocidos y galardonados internacionalmente. Este equipo docente está fuertemente motivado para dar lo mejor de sí en este postgrado primicia.

El postgrado cuenta con el apoyo económico del museo Laboratorium de Bergara, el centro tecnológico experto en innovación marina y alimentaria AZTI-Tecnalia y la casa de material de bellas artes Colart y sigue abierto a nuevos patrocinadores que quieran embarcarse en el proyecto.

El postgrado se ofertará el año académico 2017-2018, actualmente está en periodo de prematrícula hasta septiembre y en octubre comenzarán las clases. Los requisitos para entrar en este postgrado son ser graduado o licenciado y tener conocimientos básicos de dibujo. Para garantizar la calidad en la formación del alumnado, sólo un máximo de 15 alumnos serán aceptados por año académico. Esto permitirá realizar un seguimiento individualizado de cada alumno o alumna por parte del profesorado.

El postgrado tiene 40 créditos entre clases presenciales (34,5 ECTS) y el proyecto final (5,5 ECTS) que podrá realizarse en entidades colaboradoras como museos, departamentos universitarios o centros tecnológicos, etc. y aprovechamos la ocasión para invitar a nuevos colaboradores. Estos proyectos serán de provecho reciproco entre el alumnado, que realiza prácticas reales, y estas entidades, que disfrutarán y conocerán de estos y estas profesionales y la profesión en sí misma.

El postgrado formará la primera generación de tituladas y titulados en Ilustración Científica de España. Pero pretende ir más allá y convertirse en un referente en el área de la ciencia visual, ser un nexo de unión para las ilustradoras e ilustradores científicos, dar a conocer y promocionar esta profesión al servicio de la ciencia, la tecnología y la sociedad.

Más información:

www.ehu.eus/ilustracion-cientifica

ilustracioncientifica.fct@ehu.eus

[1]

Maastricht Academy of Fine Arts and Design

Liverpool John Moores University

École Supérieure Estienne des Arts Graphiques

Zurich University of the Arts Scientific Visualization

Hochschule Luzern Design & Kunst

Medical Artists’ Education trust.

Sobre la autora: Vega Asensio, doctora en biología e ilustradora científica profesional, es la directora del título propio de Especialista Universitario en Ilustración Científica de la UPV/EHU

El artículo El primer postgrado en Ilustración Científica, esa profesión invisible se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia moderna y la Ilustración

- Planeta X, en busca del inquilino invisible del sistema solar

- Science + : 1 – La carrera científica I: el doctorado y la investigación académica”

Errar es humano, y científico

Por un clavo se perdió una herradura; por una herradura se perdió un caballo, por un caballo se perdió un reino. A veces los más pequeños detalles puede echar a perder todo un complejo edificio teórico (hermosas teorías asesinadas por feos e insignificantes datos), o dificultar la comprensión de un fenómeno durante décadas. El último caso célebre es justo lo contrario: localizar un error de calibración de un instrumento en un satélite ha permitido dar sentido a un incomprensible dato que se interponia ante la aceptación de un proceso en marcha. Como tal se convertirá seguramente en polémica y se discutirá ferozmente, ya que se trata de un tema políticamente candente como es el calentamiento global. Pero sobre todo subraya una realidad de la práctica científica que a veces no se entiende bien desde fuera: la ciencia no es perfecta, y lo sabe: por eso jamás es permanente y siempre está en proceso de mejora.

En este caso se trataba de explicar el hecho de que una serie de satélites puestos en órbita para medir, con precisión milimétrica, el nivel del mar en el planeta mostraban datos que no encajaban con otros fenómenos conocidos. En la superficie de la Tierra abundan los indicios de que el sistema océano-atmósfera se está haciendo más cálido, con sus lógicas consecuencias que incluyen el retroceso de los glaciares y por tanto el vertido a los mares de mayores cantidades de agua. Se daba por supuesto que esto causaría un aumento del nivel global del mar, y para medirlo con precisión se diseñaron, construyeron y pusieron en órbita estos satélites. Y sin embargo los datos mostraban que el nivel del mar no estaba subiendo; de hecho incluso podría estar bajando en algunos lugares. Un regalo para los negacionistas del cambio climático, y un quebradero de cabeza para los científicos, porque no hay nada que incordie más a una mente que dos juegos de datos incompatibles sobre el mismo fenómeno.

En un artículo recién publicado un grupo de climatólogos han llegado a la conclusión de que un error de calibración del primero de los satélites lanzados ha provocado un sesgo sistemático en las medidas de todos los que vinieron después, contaminando esos datos. Al eliminar este factor de distorsión y corregir otros errores sistemáticos el resultado encaja mucho mejor con el resto de los datos sobre el calentamiento global: el nivel del mar aumenta, y lo hace a ritmo creciente. Las líneas de tendencia ahora encajan con las que muestran otras fuentes de información. La discrepancia ha desaparecido.

La ciencia trabaja con la suposición de que toda hipótesis debe ser confirmada y de que toda medida es susceptible de contener errores. Por eso se desarrollan complejos e ingeniosos sistemas para poner a prueba las hipótesis, y por eso se trabaja denodadamente en localizar y eliminar, a ser posible de antemano, cualquier fuente de error. Por eso también la práctica científica puede ser frustrante cuando diminutas imperfecciones ajenas a propio científico (errores del instrumental, fallos en la composición de los reactivos, pequeñas catástrofes como congeladores desenchufados, etc) echan a perder un experimento en el que se puede llevar trabajando meses, o incluso años. El método científico da por supuesto que todo puede fallar, desde el equipo a los materiales estudiados e incluso el propio científico, y por eso sistemáticamente trabaja para eliminar toda fuente de error.

Algo que, por supuesto, es imposible, porque los científicos son humanos y errar también lo es. Por eso el método científico incorpora el reconocimiento de los errores entre sus herramientas: porque la gente que practica ciencia es consciente de que hay que luchar con denuedo contra los fallos, pero también de que esa lucha puede fácilmente terminar en derrota. Los errores se cuelan en los experimentos, tanto más en cuanto que los actuales aparatos y sistemas de investigación tienen una sensibilidad mucho más elevada que antaño y los fenómenos que se estudian están mucho más cerca del umbral del ruido. Los errores son inevitables, y aunque el científico hace lo que puede por mantenerlos a raya, sabe que nunca podrá estar seguro del todo de haberlo conseguido.

Por eso la ciencia aprende, y cuando se detecta y corrige el error el nuevo dato se incorpora al acervo científico sin demora. Esto a veces supone cambiar teorías completas o adaptar partes de hipótesis tenidas por ciertas durante mucho tiempo, algo que resulta desconcertante desde fuera. A veces puede dar la impresión de que los científicos no tienen bemoles intelectuales; que hoy están dispuestos a confiar en una teoría que ayer consideraban rechazable. Pero no se trata de volubilidad o de falta de principios, sino de honestidad intelectual. La ciencia actúa como un sastre, ajustando sus hipótesis y teorías lo más posible a la realidad; a veces se descubre un desgarrón en la tela o un deshilado, y entonces hay que rehacer el patrón en una parte concreta. El proceso es continuo y no se trata de tropezones, sino de avances sucesivos: en cada prueba el traje ajusta mejor a la realidad del cosmos. Así es como la ciencia avanza: eliminando sus errores y cambiando, cuando es preciso, de opinión. Un empeño humano por antonomasia.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Errar es humano, y científico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Un observador cuántico de lo más útil

De todos es conocida la aparente paradoja del gato de Schrödinger, en la que el papel del observador humano determina el destino del gato encerrado en la caja. Sin embargo el papel del observador en mecánica cuántica es real. Tanto que un grupo de investigadores, encabezado por Robert Biele, de la Universidad del País Vasco (UPV/EHU) ha conseguido controlar los flujos térmicos y eléctricos en un dispositivo de tamaño nanoscópico por medio de observaciones cuánticas locales.

Ilustración artística del papel de un observador cuántico en un nanodispositivo. Al observar solamente la parte derecha de la figura (cubriendo la parte izquierda con la mano), el agua parece fluir hacia abajo del canal, por el contrario, mirando el cuadro entero el agua en fluye hacia arriba, Esta aparente paradoja imita la superposición coherente de dos estados cuánticos (el agua que fluye hacia arriba y hacia abajo) .Al observar en partes específicas de nuestro sistema, somos capaces de elgir entre estos dos estados y por lo tanto cambiar la “respuesta física del nanodispositivo” de forma controlada. Imagen de K. Aranburu

La medición, que no es más que una forma de observación, desempeña un papel fundamental en la mecánica cuántica. La ilustración más conocida de los principios de superposición y entrelazamiento es el gato de Schrödinger. Invisible desde el exterior, el gato se encuentra en una superposición coherente de dos estados, vivo y muerto al mismo tiempo.

Mediante una medición, esta superposición se colapsa en un estado concreto. El gato está muerto o vivo. En este famoso experimento mental, una medición del “gato cuántico” puede ser vista como una interacción con un objeto macroscópico que colapsa la superposición en un estado concreto al destruir su coherencia.

En el trabajo que nos ocupa los investigadores describen cómo un observador cuántico microscópico es capaz de controlar las corrientes térmicas y eléctricas en dispositivos a nanoescala. La observación cuántica local de un sistema puede inducir cambios continuos y dinámicos en su coherencia cuántica, lo que permite un mejor control de las corrientes de partículas y energía en los sistemas a nanoescala.

La termodinámica clásica de no equilibrio se desarrolló para entender el flujo de partículas y energía entre múltiples reservorios de calor y partículas. El ejemplo más conocido e intuitivo es la formulación de Clausius de la segunda ley de la termodinámica, que dice que que cuando dos objetos con diferentes temperaturas se ponen en contacto, el calor fluirá exclusivamente de la más caliente a la más fría.

En objetos macroscópicos, la observación de este proceso no influye en el flujo de energía y partículas entre ellos. Sin embargo, en dispositivos cuánticos, es necesario revisar los conceptos termodinámicos. Cuando un observador clásico mide un sistema cuántico, esta interacción destruye la mayor parte de la coherencia dentro del sistema y altera su respuesta dinámica.

En cambio, si un observador cuántico actúa sólo localmente, la coherencia cuántica del sistema cambia continua y dinámicamente, proporcionando así otro nivel de control de sus propiedades. Dependiendo de lo fuertes que sean y dónde se realicen estas observaciones cuánticas locales, surgen nuevos y sorprendentes fenómenos de transporte cuántico.

Los científicos estudiaron esta idea en una rueda de trinquete cuántica teórica. Dentro de este sistema, los lados izquierdo y derecho están conectados a dos baños térmicos, caliente y frío, respectivamente. Esta configuración fuerza a la energía a fluir de caliente a frío y a que las partículas fluyan en el sentido de las agujas del reloj dentro de la rueda. La introducción de un observador cuántico, sin embargo, invierte la corriente anular de partículas en contra de la dirección natural del trinquete; un fenómeno causado por el estado electrónico localizado y la alteración de la simetría del sistema.

Además, la observación cuántica también es capaz de invertir la dirección del flujo de calor, contradiciendo aparentemente la segunda ley de la termodinámica. Esta capacidad para controlar el flujo de calor y las corrientes de partículas podría encontrar un amplio uso en el diseño de dispositivos termoeléctricos, espintrónicos y fotónicos. La observación podría usarse incluso para escribir en una memoria magnética.

Desde un punto de vista más fundamental, este trabajo resalta el papel del observador cuántico. En contraste con el gato de Schrödinger, donde el estado coherente es destruido a través de la interacción con un “observador” macroscópico, aquí, mediante la introducción de un observador cuántico local, la coherencia se cambia local y dinámicamente, permitiendo a los investigadores seleccionar entre los estados coherentes del sistema . O, dicho de otra manera, esto demuestra cómo la termodinámica es muy diferente en el régimen cuántico.

Referencia:

Robert Biele et al (2017) Controlling heat and particle currents in nanodevices by quantum observation, npj Quantum Materials. doi: 10.1038/s41535-017-0043-6

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Un observador cuántico de lo más útil se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un gato de Cheshire cuántico

- Cómo medir el trabajo cuántico

- Transmisión de voz con cifrado cuántico a larga distancia

Triangulando: Pascal versus Sierpinski

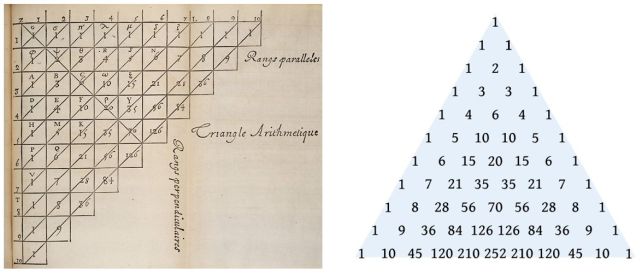

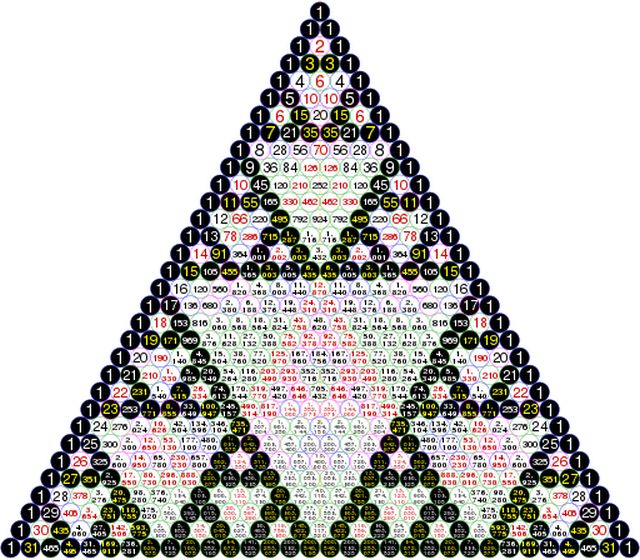

En su Traité du triangle arithmétique (Tratado del triángulo aritmético, publicado por primera vez en 1654), Blaise Pascal iniciaba su texto con una página en la que dibujaba su triángulo aritmético (ver figura 1). Le seguían casi un centenar de páginas en las que el matemático daba diecinueve propiedades de ese triángulo, bastante sencillas de demostrar en general. Pascal probaba algunas de ellas, otras las mostraba mediante un ejemplo y otras quedaban solo enunciadas.

Figura 1: El triángulo de Pascal (figura original de Pascal de 1654 y la usada actualmente).

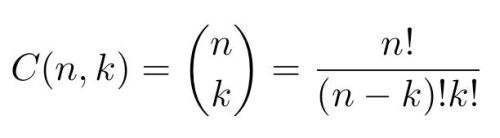

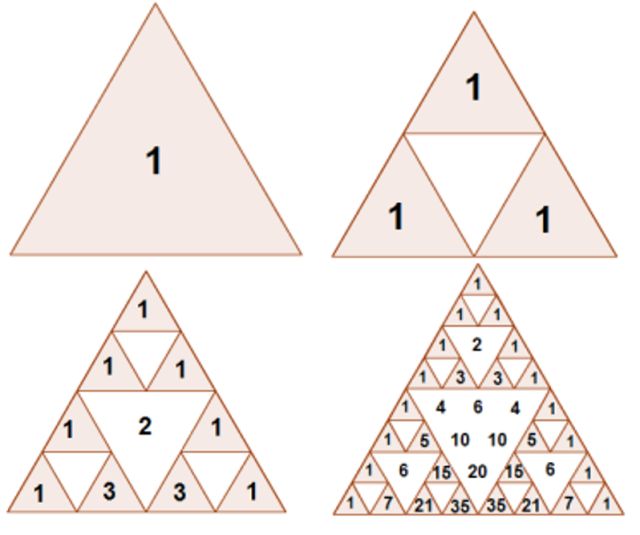

Ese triángulo, conocido hoy en día como triángulo de Pascal –aunque ya era conocido en el siglo X–, proporciona una manera de ordenar los coeficientes binomiales. Recordemos que el coeficiente binomial C(n,k) es el número de grupos de k objetos que pueden elegirse en un conjunto formado por n objetos. En la figura 2 puede verse su expresión:

Figura 2: Coeficiente binomial.

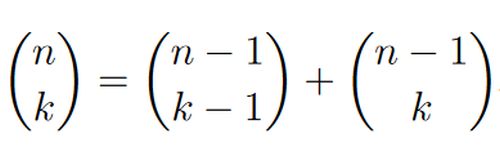

Los coeficientes binomiales también pueden calcularse por recurrencia, utilizando la llamada fórmula de Pascal que aparece debajo.

Figura 3: Fórmula de Pascal.

El triángulo de Pascal Pn es el reordenamiento de los coeficientes binomiales desde el C(0,0) hasta el C(n,n), de manera que en la fila m aparecen (y en ese orden):

C(m,0), C(m,1), C(m,2), …, C(m,m-1) y C(m,m).

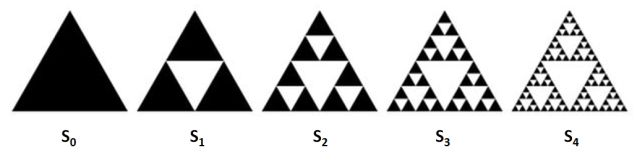

El triángulo de Sierpinski es un conjunto fractal que se construye de manera recurrente como se indica a continuación: se toma un triángulo equilátero ‘lleno’, S0, al que se le quita el pequeño triángulo formado al unir las mitades de sus tres lados (ver la figura 4). Obtenemos S1 formado por tres triángulos ‘llenos’ sobre los cuales se realiza el mismo proceso que acabamos de describir. Logramos así una figura formada por nueve triángulos llenos, S2, a los que se les vuelve a aplicar el mismo procedimiento.

Figura 4: Primeras etapas de la construcción del triángulo de Sierpinski.

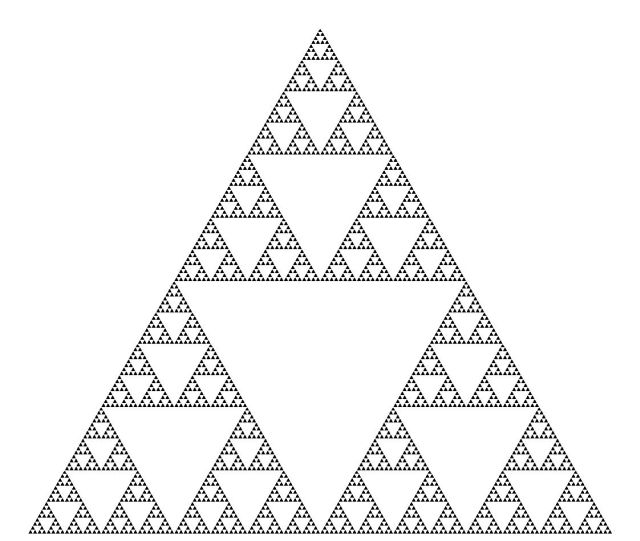

Iterando este procedimiento indefinidamente, se obtiene el triángulo de Sierpinski, que lleva el nombre del matemático Wacław Sierpiński, quien lo describió en 1915 (aunque aparece como elemento decorativo –alguna etapa de su construcción– mucho antes).

Figura 5: El triángulo de Sierpinski.

¿Existe alguna relación entre estos dos triángulos? El primero, el de Pascal, se construye de manera combinatoria y el segundo, el de Sierpinski, de manera geométrica… ¿pueden vincularse de alguna manera?

Como se observa en la figura 6, todos los triángulos ‘llenos’ que modelan cada Sn pueden rellenarse con coeficientes binomiales impares. Y, a su vez, cada coeficiente binomial impar puede colocarse dentro de uno de los triángulos ‘llenos’ en determinada etapa de la iteración en la construcción del triángulo de Sierpinski.

Figura 6: Los triángulos de Pascal y de Sierpinski.

El enunciado preciso que proporciona la propiedad que acabamos de mostrar es la siguiente: “Para cada número natural n, el triángulo de Sierpinski Sn se corresponde con el triángulo de Pascal de 2n filas, del que se han eliminado los coeficientes pares”.

Observar que este resultado ofrece otra manera de construir Sn. En efecto, bastaría con dividir un triángulo equilátero en triángulos equiláteros más pequeños, de modo que cada lado del triángulo original se divida en 2n partes iguales. Superponiendo el triángulo de Pascal de 2n filas, bastaría con colorear únicamente los pequeños triángulos correspondientes a los coeficientes binomiales impares…

Figura 7: Los triángulos de Pascal y de Sierpinski.

¡Una bella y curiosa propiedad!

Referencias

- Blaise Pascal, Traité du triangle arithmétique, avec quelques autres petits traitez sur la mesme matière. Par Monsieur Pascal, G. Desprez, 1665 (en Gallica).

- Sierpiński et Pascal sont dans un triangle, Blogdemaths, 16 julio 2013

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Triangulando: Pascal versus Sierpinski se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La traba de Pascal: geometría proyectiva y literatura

- El juego del Sim

- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

Evolución de los sistemas nerviosos: variación del tamaño de las regiones encefálicas

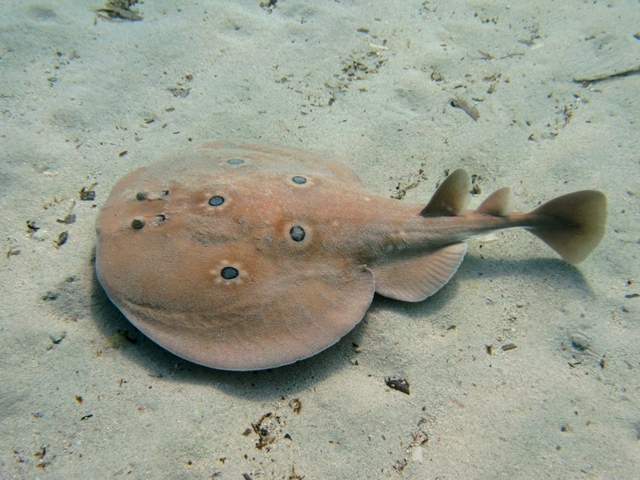

Las neuronas que inervan el órgano eléctrico de las rayas Torpedo ocupan un impresionante 60% de todo el encéfalo. Un ejemplo de evolución en mosaico espectacular.

En los encéfalos se pueden diferenciar conjuntos de neuronas de los que sabemos que están implicados en determinadas funciones. Así, nos referimos a la corteza visual, al área de Broca o a los parches faciales, por ejemplo. Es interesante la cuestión de si las diferentes áreas encefálicas han evolucionado en los vertebrados de forma independiente (evolución en mosaico) o, por el contrario, lo han hecho de forma conjunta o coordinada con el resto de áreas (evolución en concierto). Esto es importante porque si la evolución del encéfalo se produce de forma concertada, sobre cada una de sus áreas actuarían restricciones que impedirían que una de ellas, cualquiera, se desarrollase de manera independiente bajo la acción de presiones selectivas concretas. Sin embargo, en el supuesto de no operar restricciones anatómicas y funcionales provocadas por el conjunto del encéfalo, la evolución en mosaico permitiría que la selección natural actúe sobre determinadas áreas en concreto de manera independiente.

Una forma de abordar esta cuestión consiste en comprobar si el tamaño del área objeto de interés varía de forma homogénea en función del tamaño encefálico total (o, por razones que no vienen al caso, del tamaño del resto del encéfalo) para un amplio conjunto de especies. Cuando la variación es homogénea, ello es indicativo de que el tamaño del órgano ha condicionado el tamaño de las áreas de acuerdo con un patrón general y, por lo tanto, que la evolución ha sido en concierto. De haber sido en mosaico, habría habido especies que se alejen de la tendencia general, seguramente porque sobre ellas han operado presiones selectivas en esa dirección y porque no existen restricciones anatómicas (por configuración) o funcionales (por cómo funciona el encéfalo) que condicionen el tamaño que un área en concreto puede alcanzar.

Al realizar ese análisis para un amplio conjunto de mamíferos (que incluía primates, insectívoros y murciélagos) por ejemplo, se observa que en estos hay una correspondencia muy considerable entre el tamaño de diferentes regiones encefálicas y el del resto del órgano. El 96% de la variación de las áreas encefálicas viene explicado por la variación del tamaño total del encéfalo. La evolución, en este caso, se habría producido en concierto, y el neocortex es el área que más proporción representa en los encéfalos grandes. Al parecer, las diferencias de tamaño relativo se producen porque las áreas que surgen más tarde son las que más aumentan de tamaño. En otras palabras, “tarde” implica “grande”. O sea, el neocórtex es el área encefálica que más tarde empieza su desarrollo y la que, al aumentar su tamaño, su proporción relativa con respecto a la masa encefálica total también aumenta.

No obstante lo anterior, al realizar esos análisis u otros similares hay elementos de la metodología estadística (en cuyo detalle no merece la pena entrar aquí) que han de ser tenidos en cuenta, puesto que el procedimiento que se utiliza puede oscurecer algunos casos en los que ciertas estructuras encefálicas muestran tamaños muy diferentes de lo que cabría esperar a partir del tamaño general del encéfalo. En otras palabras, si bien en los casos comentados las estructuras principales han evolucionado de forma concertada, hay áreas, normalmente de menor tamaño, que han experimentado evolución en mosaico –normalmente implicadas en el procesamiento de determinadas señales (olfativas, visuales, o sonoras)-, muy probablemente porque esas áreas están implicadas en procesos que han sido sometidos a presiones selectivas específicas.

Si nos salimos del grupo de los mamíferos hay ejemplos de evolución en mosaico espectaculares. Las neuronas que inervan el órgano eléctrico de las rayas Torpedo ocupan un impresionante 60% de todo el encéfalo, mucho más que lo que ocupan zonas homólogas en otros peces cartilaginosos. Y en teleósteos también hay algunos casos claros de evolución en mosaico, sobre todo en los lóbulos medulares, aunque sin llegar a los extremos de la raya Torpedo. Es preciso comentar que en vertebrados no mamíferos, al contrario que en estos, la neurogénesis puede ser importante a lo largo de periodos más prolongadas de la vida, y eso introduce un elemento de flexibilidad importante.

La conclusión que se extrae de lo recogido hasta aquí es que muy probablemente la evolución concertada es un principio que tiene una validez muy general en los vertebrados, aunque la evolución en mosaico ha podido ser muy importante en determinados casos. Cuando ésta se ha producido, ello ha dado lugar, seguramente, a cambios importantes en el funcionamiento encefálico y, por ello, ha podido abrir nuevos nichos ecológicos y posibilidades de cambio adicional. Por esa razón, es mucho más probable que la evolución en mosaico haya dado lugar a más diferencias entre clases que entre órdenes, más entre órdenes que entre familias, y más entre familias que entre géneros. En otras palabras, las constricciones propias de la evolución en concierto seguramente operan de forma más clara cuanto menor es el nivel taxonómico y es más probable que las diferencias entre taxones de más nivel puedan deberse a evolución en mosaico.

Fuente: Georg F. Strider (2005): Principles of Brain Evolution, Sinauer Associates, Inc, Sunderland, Massachusetts, EEUU.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: variación del tamaño de las regiones encefálicas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: el tamaño encefálico

- Evolución de los sistemas nerviosos: el sistema central de vertebrados

- Evolución de los sistemas nerviosos: cnidarios y gusanos no segmentados

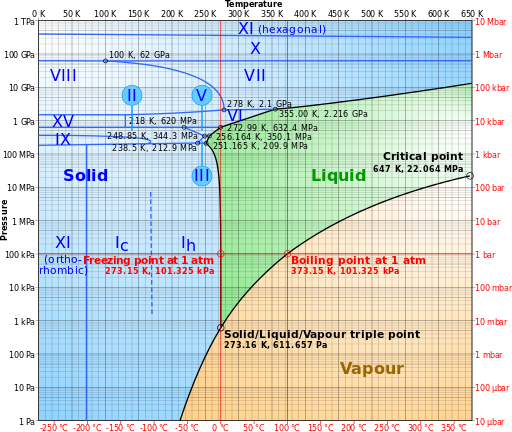

La segunda ley de la termodinámica

Dijimos anteriormente que íbamos a introducir dos leyes fundamentales del universo a partir de elemento muy sencillos. Ya introdujimos la primera ley, y ahora vamos con la segunda, que ilustra cómo estudiar algo muy concreto, como una máquina de vapor, puede tener consecuencias amplísimas.

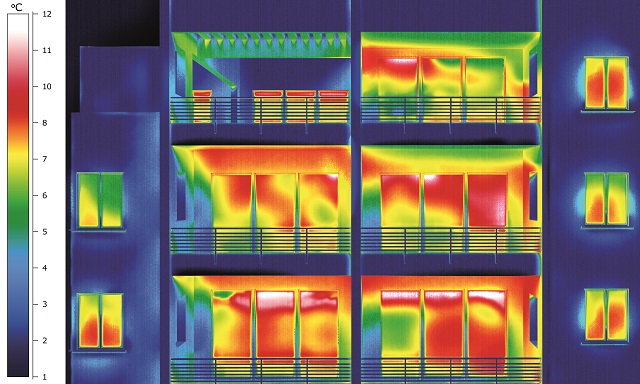

Las personas que habitan en este inmueble están contribuyendo a que la entropía del universo aumente.

La segunda ley de la termodinámica es una generalización de los límites de una máquina térmica y se basa en el trabajo de Carnot. Pero para poder llevarla a cabo necesitamos una idea nueva.

Hemos visto previamente que una máquina reversible es la máquina más eficiente. Cualquier otra máquina no es tan eficiente. Para formular esa idea de manera general y precisa, debe introducirse un nuevo concepto: la entropía. El cambio de entropía de un sistema, ΔS, se define como la energía neta transferida como calor, ΔQ, ganada o perdida por el sistema, dividida por la temperatura (en Kelvin) del sistema, T: ΔS = ΔQ/T

donde el segundo miembro de la igualdad entronca directamente con lo que vimos del ciclo de Carnot (véanse notas 1 y 2). Es importante señalar que, por la forma en la que la hemos definido esta expresión es solamente válida para sistemas cerrados y procesos reversibles (ideales).

Cuando introdujimos el concepto de máquina reversible ideal vimos que una máquina de este tipo trabaja en un ciclo entre cuerpos calientes y fríos (como cualquier motor térmico). Una máquina que trabaje de esta manera debe tener la misma entropía al final de un ciclo que tiene al principio. Esto se debe a que, al final del ciclo, T vuelve a su valor inicial, y la energía transferida como calor o trabajo cedidos en una parte del ciclo deben ganarse en el resto del ciclo; por lo tanto ΔQ en el conjunto durante todo el ciclo es cero. Como el cambio de entropía se define como ΔS = ΔQ/T, el cambio de entropía durante un ciclo es también cero, ΔS = 0.

¿Qué pasa con un motor que no es reversible y deja de ser ideal, como una máquina de vapor real? Sabemos que debe ser menos eficiente que una máquina perfectamente reversible, que tendría un 100% de eficiencia. Por lo tanto, para una máquina real las las pérdidas de energía en forma de calor deben ser mayores que las de una ideal.

Pero si miremos a la máquina desde el punto de vista del entorno resulta que obtenemos un resultado de consecuencias cósmicas. Efectivamente, al final de cada ciclo de trabajo, ΔQ en elentorno de la máquina no será cero sino positivo (véase la nota 3), y ΔS, correspondientemente, tendrá un valor positivo. Es decir, aunque la energía total dentro y fuera de la máquina se conservará (consideramos el entorno como parte del sistema), por la primera ley, la entropía del entorno habrá aumentado. Fijémonos en que esto sucederá una y otra vez cada vez que una máquina no ideal repita su ciclo de trabajo. Por tanto, la entropía del universo aumentará constantemente mientras la máquina no ideal esté funcionando.

Podemos resumir las consecuencias del funcionamiento de las máquinas térmicas en el cambio de entropía del universo de forma muy simple:

ΔSuniverso = 0, si la máquina es ideal

ΔSuniverso > 0, si la máquina es real.

Aunque aquí solo hemos hablado de máquinas térmicas muy sencillas, estos resultados son generales. De hecho, se aplican a todos los procesos térmicos. Por simplicidad, pueden expresarse en una sola línea:

ΔSuniverso ≥ 0

Esta expresión, de hecho, es una formulación matemática que expresa la segunda ley de la termodinámica. Rudolf Clausius, que fue el primero en formular la segunda ley en la forma dada aquí, parafraseó las dos leyes de la termodinámica en 1850 así:

“La energía del universo permanece constante, pero su entropía tiende a un máximo.”

Y todo ello sin entrar a describir qué es energía o entropía más allá de las definiciones macroscópicas que hemos empleado.

Una frase breve, pero de consecuencias vastísimas, obtenida del estudio de cosas muy sencillas como hemos visto. Veremos algunas de estas consecuencias en entregas posteriores.

Notas:

[1] Esta ecuación define sólo los cambios de entropía, ΔS, en lugar del valor absoluto de la entropía. Esto es similar a lo que se encuentra cuando se estudia cualquier energía potencial: lo que interesa es el cambio. Si se necesitan valores absolutos de la entropía basta con definir un estado estándar al que se asigna entropía cero y la diferencia de entropía con cualquier otro estado será el valor absoluto de la entropía para éste.

[2] Creemos que es interesante resaltar que la entropía es una propiedad macroscópica pero no molecular o atómica, a diferencia de la energía. Una molécula individual no tiene entropía, como tampoco la tiene un átomo.

[3] Reiteramos el criterio de signos que establecimos al hablar de la primera ley, aquí, y nuestra recomendación a los estudiantes de ser muy escrupulosos con el uso de signos que hagan sus profesores o libros de texto, que puede ser diferente.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La segunda ley de la termodinámica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Carnot y los comienzos de la termodinámica (1)

- Carnot y los comienzos de la termodinámica (2)

- La primera ley de la termodinámica

Catástrofe Ultravioleta #18 INVASORES

Catástrofe Ultravioleta #18 INVASORES

Nuestro planeta no es demasiado grande y está lleno de vida. A veces unas especies llegan a nuevos lugares viajando y a veces somos los humanos quienes las llevamos. En este intercambio se producen todo tipo de situaciones, a veces con riesgo para los ecosistemas locales y a veces para que la vida prolifere donde no esperábamos. En el capítulo de hoy os enseñamos el revoltijo que es la vida y hablamos con los expertos que tratan de evitar que el asunto se nos vaya de las manos.

Agradecimientos: Antonio Quesada, Javier Benayas, Carlos Briones, SEO BirdLife. Con las voces invitadas de Severine Beata, Inés Almirón, Lalo, Katita, Siddhartha Montoya, Mariana Cancela, Diego Briones, Jose María del Río, Celine y Ana González.

La Cumparsita es una versión del tango original de Gerardo Matos Rodríguez.

* Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el apoyo de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

Puedes conocernos en nuestra web: Catastrofeultravioleta.com y seguirnos en el twitter Catastrofe_UV. También puedes encontrar todos los capítulos en este enlace.

El artículo Catástrofe Ultravioleta #18 INVASORES se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Preparados para una Catástrofe Ultravioleta

- Catástrofe Ultravioleta #14 VULCANO

- Catástrofe Ultravioleta #13 LEVIATÁN

La condición física de los árbitros de fútbol

El interés científico por conocer el rendimiento físico durante los partidos y el perfil de condición física de los árbitros de fútbol ha crecido de forma sustancial a lo largo de las últimas dos décadas. En ese sentido, la tesis doctoral de Daniel Castillo Alvira, que lleva por título ‘Cuantificación de las respuestas físicas y fisiológicas y análisis de la fatiga inducida por los partidos oficiales en árbitros de fútbol’, se ha elaborado a partir de cuatro estudios científicos publicados en revistas internacionales indexadas en la lista JCR. Todos los estudios presentados en esta tesis siguen una misma temática basada en la descripción de las respuestas físicas y fisiológicas y el análisis de la fatiga producida por los partidos oficiales en árbitros de fútbol.

Los árbitros, independientemente de la categoría en la que arbitren, han de superar unas pruebas físicas en distintos momentos a lo largo de la temporada, cuyos resultados, junto con los informes técnicos de los partidos elaborados por los Comités de Árbitros correspondientes (internacionales, nacionales, autonómicos o provinciales), les habilitan para ejercer su actividad y, en su caso, ascender o descender de categoría.

Los estudios que conforman esta investigación demuestran que los árbitros de campo recorren más distancia y registran un valor de velocidad media mayor que los árbitros asistentes durante el desarrollo de los partidos oficiales. Se observa, además, un descenso en la capacidad de esprintar en distancias de 15 y 30 metros después del partido cuando se compara con el rendimiento registrado antes del mismo, tanto en árbitros de campo como en árbitros asistentes. El descenso observado en el rendimiento de esprint podría ser considerado como un indicador de fatiga ocasionada por el partido. Sin embargo, no se encuentra una pérdida de rendimiento en la capacidad de salto vertical bilateral y unilateral.

También se ha comprobado un descenso en el rendimiento de otros parámetros medidos o que los árbitros asistentes tienen una fatiga muscular más acentuada en la pierna derecha al final del partido. “Este hecho –explica Daniel Castillo-, podría sugerir que los árbitros asistentes pueden tener una mayor implicación durante el juego de la extremidad inferior derecha y, en consecuencia, una fatiga debido a que las acciones específicas y más relevantes que realizan se producen hacia su lado derecho donde se encuentra el área de penalti”.

Dado que una inadecuada preparación física en este colectivo podría limitar sus acciones durante los partidos y también podría influir negativamente en un descenso de categoría, la tesis sugiere la necesidad de diseñar programas de entrenamiento específicos tanto para árbitros de campo como para árbitros asistentes, con el fin de mejorar su rendimiento físico durante la competición. “Aunque la FIFA ha establecido unos test para valorar la capacidad de esprintar en árbitros de campo y árbitros asistentes, parece interesante valorar esta cualidad en distancias más cortas especialmente en categorías provinciales. Además, los preparadores físicos deberían incluir entrenamiento específico, basado en mejorar la capacidad de aceleración, atendiendo a las demandas físicas que les supone a los árbitros de campo y a los árbitros asistentes arbitrar los partidos de fútbol”, indica Daniel Castillo.

Referencias:

Castillo, D., Yanci, J., Cámara, J., Weston, M. ‘The influence of soccer match play on physiological and physical performance measures in soccer referees and assistant referees’. Journal of Sports Sciences (2016) 34(6), 557-563. doi: 10.1080/02640414.2015.1101646

Castillo, D., Cámara, J., Sedano, S., Yanci, J. ‘Impact of official matches on soccer referees’ horizontal-jump performance’. Science and Medicine in Football. Pages 1-6. Accepted 23 Apr 2017, Published online: 01 Jun 2017. doi: 10.1080/24733938.2017.1330549

Castillo, D., Weston, M., McLaren, S.J., Cámara, J., Yanci, J. ‘Relationships between internal and external match load indicators in soccer match officials’. International Journal of Sports Physiology and Performance (2016) Dec 5:1-21. DOI: 10.1123/ijspp.2016-0392. doi: 10.1123/ijspp.2016-0392

Castillo, D., Cámara, J., Castellano, J., Yanci, J. ‘Football match officials do not attain maximal sprinting speed during matches‘. Kinesiology (2016) 48(2), 207-212.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La condición física de los árbitros de fútbol se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fórmulas matemáticas y números: cómo ayuda la economía al fútbol

- La ciencia del balón de fútbol

- La conferencia improvisada que cambió la física

Una buena muerte

“En más de una ocasión, cuando me entrevistan por mis novelas, ha llegado un periodista y me ha dicho: “¿Y por qué escribes sobre la muerte?”. Es una pregunta que me deja turulata: ¿es que acaso uno puede dejar de escribir sobre eso? Siempre siento la tentación de responder: lo siento mucho, querido, pero tengo que darte una malísima noticia: te vas a morir.”

Rosa Montero, El País Semanal, 15 enero 2017.

“Soy un hombre a quien la suerte

hirió con zarpa de fiera,

soy un novio de la muerte

que va a unirse en lazo fuerte

con tan leal compañera.”

El novio de la muerte, canción de la Legión, letra de Fidel Prado, música de Juan Cosa, 1925.

“Si la muerte fuera un bien, los dioses no serían inmortales.”

Safo.

Hay mucho escrito sobre la muerte, sobre la buena muerte y sobre cómo aceptarla. Quizá deba comenzar, o terminar, visto el tema que trato, con aquel antiguo proverbio, creo que de Confucio o de algún otro sabio oriental, que decía que “Cuando un problema no tiene solución, deja de ser un problema”. Y asumir, también, como hizo Benjamin Franklin hace dos siglos y medio, que, junto a los impuestos, la muerte es la otra certeza de nuestra vida. Pero podemos luchar por tener una buena muerte, ya que la muerte es nuestra, personal e inevitable.

Los seres humanos somos muy conscientes, quizá sin asumirlo del todo, de nuestra forzosa mortalidad. Es una idea que ataca o, por lo menos, relativiza, nuestra autoestima de transcendencia sin final, y defender con fuerza nuestra visión del mundo y de la vida nos ayuda a mantenerla.

Para entender cómo la muerte influye en nuestra vida, podemos, como ejemplo, comentar la investigación de Marcelo Vinhal Nepomunceno y Michael Laroche, de la Universidad Concordia de Montreal, sobre el consumo y la muerte. Sabemos que en nuestra cultura, los pensamientos sobre la muerte aumentan la propensión a consumir, a consumir lo que sea. Aceptamos que posesiones y bienes materiales nos permiten vivir más felices o, por lo menos, a vivir sin más, aunque cueste aceptar que no ayuda a vivir más. Los pensamientos de muerte nos llevan a una actitud positiva ante artículos de lujo o a consumir de manera impulsiva. Así, el consumo creció en Estados Unidos después del 11-S.

En su investigación, Nepomuceno y Laroche encuentran que a los contrarios al consumo les da igual sentir pensamientos de muerte y siempre consumen poco. En cambio, los consumidores medios, los ciudadanos que no destacan en las compras, la idea de la muerte les empuja a consumir más.

Y, ahora, pasemos a repasar no lo que la muerte hace en nuestra vida, sino a cómo deseamos que sea la inevitable muerte. Primero, una definición de buena muerte que nos da Jacquelin Flaskerud, de la Universidad de California en Los Angeles. Dice así: “Una buena muerte es la que está libre de angustia y sufrimientos evitables para los pacientes, la familia y los cuidadores. Transcurre, en general, de acuerdo con los deseos de los pacientes y de las familias. Y es razonablemente consistente con los estándares clínicos, culturales y éticos.”

Es una definición sencilla, vaga y quizá difícil de llevar en los detalles para cada caso. Vamos a extendernos sobre lo que dice esta definición. Emily Meier y su grupo, de la Universidad de California en San Diego, han revisado lo que respondemos si nos preguntan sobre la buena muerte y han publicado recientemente un meta-análisis sobre ello.

Para ello, recuperan de las bases de datos lo investigado hasta 2015 y encuentran 3434 artículos de los que, tras una primera revisión, rescatan 392 y, después de un repaso más exhaustivo en cuanto a métodos y análisis, quedan 36. La mayoría de los datos vienen de pacientes y de sus familias, además de profesionales sanitarios.

En conclusión, son once cuestiones importantes para llegar a una buena muerte, y las enumero y resumo a continuación:

1.- El 94% de los trabajos revisados mencionan donde y cuando morir, por ejemplo, en casa y durante el sueño y, además, después de dejar bien establecido lo necesario para el funeral y el entierro.

2.- El 81% desea una muerte sin dolor y sufrimiento.

3.- Hasta el 64% menciona como importante el bienestar emocional, con apoyo psicológico si es necesario y, si es posible, con un diálogo sobre el significado de la muerte.

4.- Es importante tener cerca a la familia, preparada y aceptando la muerte del familiar que, además, desea no sentirse una carga para ellos.

5.- Es esencial respetar y mantener la dignidad de la persona que muere.

6.- Debe aceptar que ha cumplido con su vida, despedirse con dignidad y aceptar la muerte.

7.- Si es religioso, debe buscar consuelo espiritual y tener cerca al sacerdote.

8.- No abusar de los tratamientos médicos en un intento de prolongar la vida por medio de todas las terapias posibles. En relación con los tratamientos médicos entra el debate, no resuelto en absoluto, sobre la eutanasia.

9.- Hay que conseguir la mejor calidad de vida posible e intentar vivir como siempre, con esperanza, placer y gratitud y, en resumen, considerar que merece la pena vivir y haber vivido la vida.

10.- Los médicos y enfermeras deben ser un apoyo para el paciente e, incluso, los propios profesionales sanitarios deben aceptar la muerte.

11.- Según la cultura, la educación y el entorno de cada uno, se menciona el sentir el contacto físico con las personas cercanas y, en este apartado, se sugiere la importancia y cercanía de las mascotas.

Es evidente que todo lo dicho hasta ahora trata de la muerte en nuestra cultura en el mundo occidental. Incluso en esta cultura concreta, la muerte ha cambiado a lo largo de la historia, como cuenta David San Filippo, de la Universidad Nacional Louis de Chicago. Sin entrar en detalles de su exposición, su escrito termina con la constatación de que la presencia de la muerte en nuestra sociedad es un recordatorio constante de la propia mortalidad personal de cada uno (como nos recuerda Rosa Montero en la cita inicial de este texto). Todo lo eventualmente vivo, muere. Y la aproximación de la sociedad a la muerte debe ser el reflejo de la actitud colectiva de respeto a las creencias individuales sobre la vida y la muerte. Como dijo Steve Jobs, “Nadie quiere morir… Nadie escapa de ello”.

Es importante conocer nuestras creencias, actitud y prácticas ante la muerte y, también, el cómo vivimos sabiendo que nadie se va vivo de esta vida. Todo ello debe llevar a una vida sin miedo a la muerte, a una vida con propósitos y proyectos. Como escribió en El club de los poetas muertos, Nancy Kleinbaum,“para no descubrir, a la hora de mi muerte, que no había vivido”.

Referencias:

Filippo, D.S. 2017. A historical perspective of death in the Western World. En “Dying and death in Oncology”, p. 99-114. Ed. por L. Berk. Springer, Switzerland.

Flaskerud, J.H. 2017. Individual and dynamic: Western views of a good death. Issues in Mental Health Nursing doi: 10.1080/01612840.2017.1295492

Meier, E.A. et al. 2016. Defining a good death (Successful Dying): Literature review and a call for research and public dialogue. American Journal of Geriatric Psychiatry doi: 10.1016/j.ajgp.2016.01.135

Montero, R. 2017. Arrojar palabras. El País. 15 enero.

Nepomuceno, M.V. & M. Laroche. 2016. Do I fear death? The effects of mortality salience on anti-consumption lifestyles. Journal of Consumer Affairs 50: 124-144.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Una buena muerte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Muerte entre las ecuaciones (Historias de muerte y matemáticas 1)

- La creatividad científica y el arte: La muerte de Sócrates

- Neandertales ¿crónica de una muerte anunciada?, por María Martinón-Torres

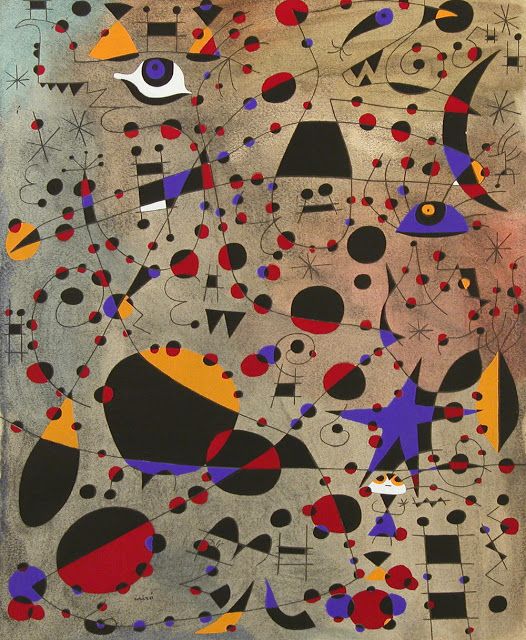

Arte & Ciencia: Sobre la dimensión cognitiva del arte en relación a la ciencia

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Tercera jornada. 1ª Conferencia

Juan Luis Moraza, escultor y Profesor de la Universidad de Vigo: Sobre la dimensión cognitiva del arte en relación a la ciencia

''Sobre la dimensión cognitiva del arte en relación a la ciencia''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: Sobre la dimensión cognitiva del arte en relación a la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: La relación entre el desarrollo de la ciencia y la creación artística

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

La astronomía transformada en arte

A lo largo de nuestra vida, pocas experiencias son comparables a contemplar el cielo estrellado en una noche oscura, a sobrecogernos con un eclipse, a despertar con la impresión del sol naciente. Probablemente estas sensaciones han acompañado a los humanos desde nuestros orígenes, desde aquel lejano día en que por primera vez alzamos la vista para contemplar el cielo y comenzar a hacernos grandes preguntas. Durante milenios, la fascinación por la inmensidad del Cosmos y por los acontecimientos celestes que podíamos observar ha caminado a nuestro lado, sea por el terror que algunos fenómenos astronómicos inspiraron, por la creencia irracional de que nuestro destino pudiera estar escrito en las estrellas, o por la propia inquietud científica que surgió en el munco clásico y cristalizó en el Renacimiento. Todo ello ha quedado plasmado en numerosas obras de arte pertenecientes a diferentes culturas y épocas.

Antes de la llegada de la fotografía y su aplicación al estudio de los cuerpos celestes durante el siglo XIX, los astrónomos con talento artístico tenían una gran ventaja ya que podían representar gráficamente los resultados de sus observaciones del Cosmos. El propio Galileo Galilei ilustró lo que veía a través de su telescopio a partir de 1609, como el relieve de la Luna, los satélites de Júpiter o las fases de Venus. Artistas de su tiempo, entre ellos Pieter Paul Rubens (en su famoso cuadro “Saturno devorando a un hijo”) o Ludovico Cigoli (“Inmaculada”), plasmaron en sus obras los descubrimientos del gran científico italiano.

Saturno devorando a un hijo” (1636-1638; Museo del Prado). Rubens representa el planeta Saturno como una estrella triple, tal y como lo había descrito Galileo Galilei.

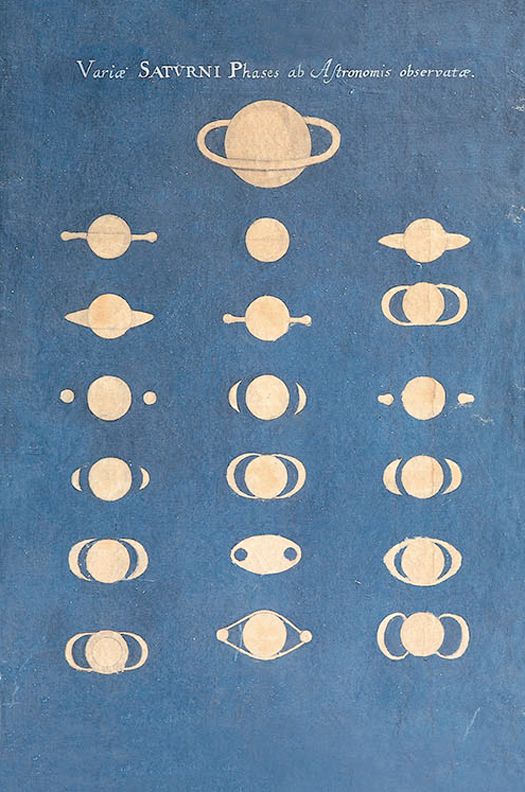

Aunque pocas, también hubo mujeres en aquella época que estudiaron y dibujaron los cielos. Finalizando el siglo XVII, la astrónoma y artista alemana Maria Clara Eimmart realizaba cientos de ilustraciones (a menudo basadas en sus propias observaciones) que mostraban las fases de Mercurio, la superficie de la Luna, la diversa morfología de los cometas y el aspecto cambiante de los anillos de Saturno.

Dibujos de Saturno y sus anillos realizados por Maria Clara Eimmart (1693-1698)

En ocasiones, científicos y artistas colaboraban para dejar constancia del saber astronómico. Así, en 1711 el pintor italiano Donato Creti representó los objetos del Sistema Solar conocidos entonces en la serie de ocho cuadros titulada “Observaciones astronómicas”, siguiendo las directrices del astrónomo Eustaquio Manfredi.

En el siglo XIX la ciencia brillaba ya con luz propia. Fenómenos celestes como los cometas, que durante siglos se consideraron mensajeros de enfermedad y de muerte, habían sido despojados por completo de ese aura de terror. Pintores como el escocés William Dyce (“Pegwell Bay, Kent. Recuerdo del 5 de octubre de 1858”), fascinados por la naturaleza y los mecanismos que subyacen a ella, representaron los cometas como meros elementos presentes en el cielo de sus paisajes. Al mismo tiempo los astrónomos dibujaban minuciosamente su aspecto, que en ocasiones resultaba espectacular. Quedaban atrás las antiguas ilustraciones en las que los cometas auguraban lluvias de sangre, ciudades devastadas o la maldición de animales nacidos con dos cabezas.

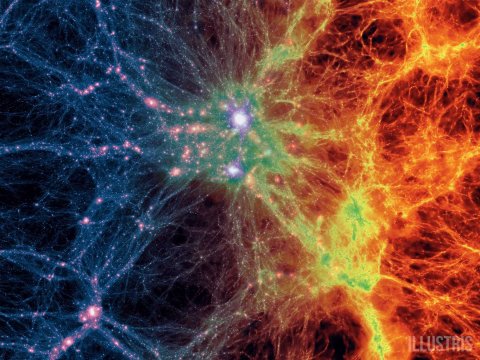

Desde los albores del siglo XX, nuestra visión del Cosmos se ha expandido a escalas de tiempo y tamaño tan gigantescas que son imposibles de imaginar en el contexto de nuestra existencia efímera y de nuestra posición como habitantes del extrarradio de una galaxia vulgar. Sin embargo, para lograr entender la grandiosidad de Universo hemos desarrollado una nueva manera de hacer ciencia, que es también otra forma de crear arte: los programas informáticos. Con el rigor más estricto de las ecuaciones físicas somos capaces de visualizar, utilizando sugerentes simulaciones computacionales, fenómenos imposibles de observar en la naturaleza: procesos tan rápidos o tan lentos, o que suceden en escalas espaciales tan enormes o tan minúsculas, que no pueden reproducirse en los laboratorios. Podemos recrear nada más y nada menos que la historia del Universo desde su origen hasta la actualidad: 13.800 millones de años que transcurren en tres minutos, en una secuencia de imágenes hermosas y coloristas que bien podrían ser la obra de un artista contemporáneo.

Fotograma de la simulación creada por la colaboración Illustris que recrea la evolución del Universo desde poco después de su nacimiento hasta la actualidad

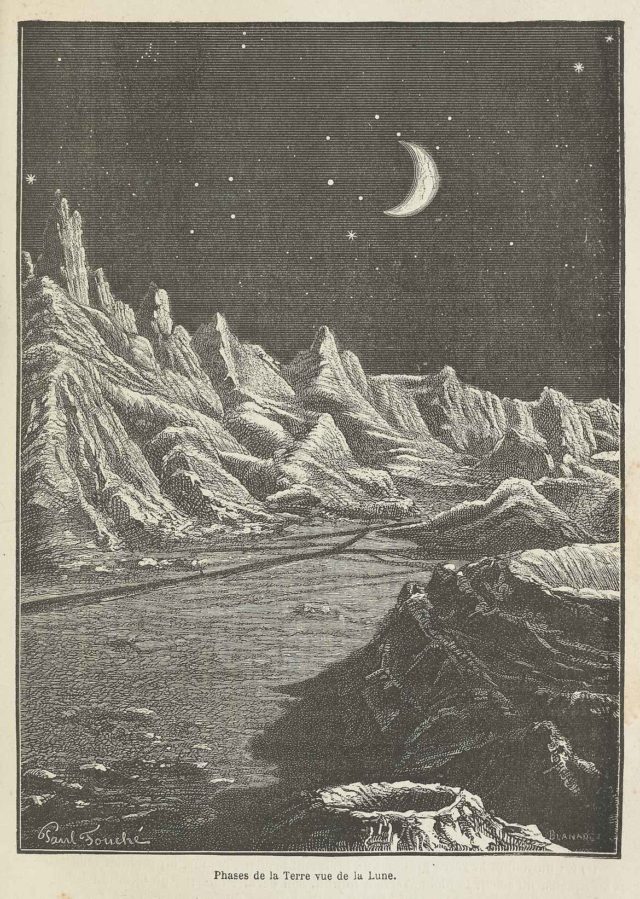

En 2016 se cumplieron 50 años de la obtención de la primera imagen de la Tierra desde la vecindad lunar. Antes de que se produjera aquel logro tecnológico hubo grandes soñadores que imaginaron nuestro planeta visto desde el espacio. Novelas (como “Hector Servadac”, de Julio Verne, publicada en 1877) y libros de divulgación de la astronomía (“Las Tierras del cielo: Viaje astronómico sobre otros mundos”, de Camille Flammarion, 1884) contenían ricas ilustraciones de cómo podría ser la Tierra contemplada desde el espacio.

El paisaje de la Luna con nuestro planeta en la distancia, en aquel retrato icónico de hace medio siglo, inspiró un cambio profundo en la percepción del ser humano acerca del lugar que ocupamos en el Universo: nos hizo comprender que la Tierra no es el único hábitat posible, que aunque singular y extraordinario para nosotros, es un planeta más en la vastedad del Cosmos. Desde entonces, aquellas imágenes han seducido a generaciones, como demuestra la obra “Un cierto eclipse lunar: Proyecto para la humanidad Nº 2 A” (1991) del artista chino Cai Guo Qiang, creador del espectáculo de fuegos artificiales en las ceremonias de apertura y clausura de las Olimpiadas de Pekin en 2008.

Primera imagen de la Tierra desde la vencidad lunar, tomada el 23 de agosto de 1966 (NASA / LOIRP)

La Tierra en cuarto creciente vista desde la Luna. Ilustración de Paul Foché para el libro “Las Tierras del cielo: Viaje astronómico sobre otros mundos” (Camille Flammarion, 1884).

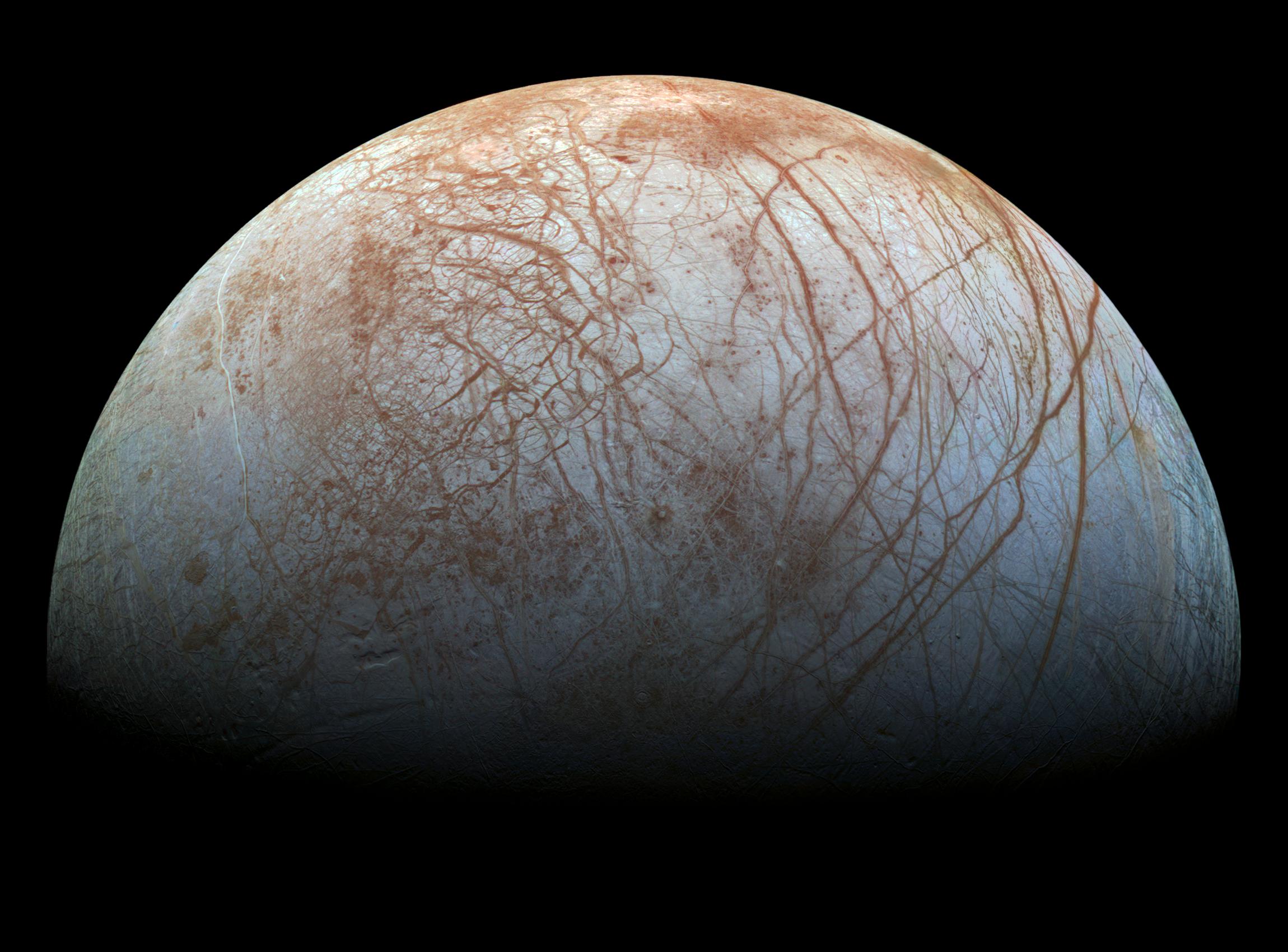

Desde hace varias décadas, diferentes misiones espaciales exploran los astros de nuestro vecindario cósmico, el Sistema Solar. En Marte han descubierto profundos cañones, volcanes imponentes y cráteres que un día fueron lagos: el planeta rojo es un mundo de terrenos y texturas sorprendentes. También hemos podido observar grietas y acantilados en el corazón del cometa 67P/Churyumov-Gerasimenko, cuyo perfil se recorta contra un fondo negro y vacío. Aún más lejos de nosotros, otras misiones nos han mostrado geysers en Encédalo que se proyectan desde su océano interior, y cicatrices en Caronte que revelan un violento pasado. Actualmente, la sonda Cassini de la NASA está enviando, a sólo dos meses del grand finale de esta misión, decenas de fotografías de Saturno y sus anillos con un valioso contenido científico… y cuya belleza es sobrecogedora.

Todas estas imágenes nos hablan de texturas y sombras, de geometrías y contrastes, de hielo y de silencio. Las propias agencias espaciales NASA y ESA colaboran con artistas y fotógrafos para seducir a la humanidad con el sugerente esplendor de estos mundos, mostrando en diversos proyectos tanto las imágenes seleccionadas por su valor estético como la obra de artistas que se han inspirado en ellas. Es el caso de la rusa Ekaterina Smirnova, que ha creado una serie de acuarelas de considerables dimensiones a partir de las imágenes del cometa 67P enviadas por la exitosa misión Rosetta-Philae de la ESA.

Acuarela de la serie “67P” (2015). Ekaterina Smirnova

La belleza hipnótica de las imágenes del planeta Júpiter, obtenidas recientemente por la misión Juno de la NASA, nos ha vuelto a situar en esa frontera difusa entre el arte y la ciencia. Dejándonos llevar sólo por la estética, nos parecería más natural exponerlas en un museo de arte que en uno de ciencia. De hecho, la NASA ha habilitado una página web en la que cualquier persona puede aportar sus propias interpretaciones de los datos de Juno.

Imagen de una zona de la superficie de Júpiter tomada por la misión Juno y procesada por Bjorn Jonsson.

En el procesamiento de las imágenes más hermosas han contribuido ciudadanos de diferentes países, en muchos casos astrónomos aficionados, que a partir de unos datos originales de atractivo visual discutible (aunque con un gran valor científico), han producido resultados de una delicadeza exquisita. Ante estas imágenes cobra especial actualidad la pregunta que se hacía Richard Feynmann, “¿Qué clase de hombres son esos poetas que pueden hablar de Júpiter como si fuera humano, pero deben guardar silencio si se trata de una inmensa esfera de amoniaco y metano en rotación?“

Este artículo ha sido realizado por Montserrat Villar (astrofísica) y Carlos Briones (bioquímico, @brionesci) son investigadores del Consejo Superior de Investigaciones Científicas (CSIC) en el Centro de Astrobiología (CAB), centro mixto del CSIC y del Instituto Nacional de Tecnología Aeroespacial (INTA), asociado al NASA Astrobiology Institute (NAI) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo La astronomía transformada en arte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia, arte, religión

- El Elogio del Horizonte de Chillida, un encuentro entre ciencia y arte

- Goethe, pensar la ciencia con el espíritu del arte

Tomas poca estevia

Reducir el consumo de azúcar no es sencillo. Nos hemos acostumbrado al sabor dulce. En artículos anteriores hemos concluido que consumir miel, siropes o azúcar moreno no es la solución, ya que son como consumir azúcar. Por eso una de las opciones que se nos plantean es sustituir estos azúcares por otros edulcorantes. Los datos de consumo apuntan en esta dirección: «Actualmente el volumen de consumo de azúcar en España es casi 40 veces mayor que el del edulcorante. En cambio, desde 2015 el volumen consumido de azúcar ha disminuido un 13%, mientras que el del edulcorante ha aumentado un 11,7%» [1].

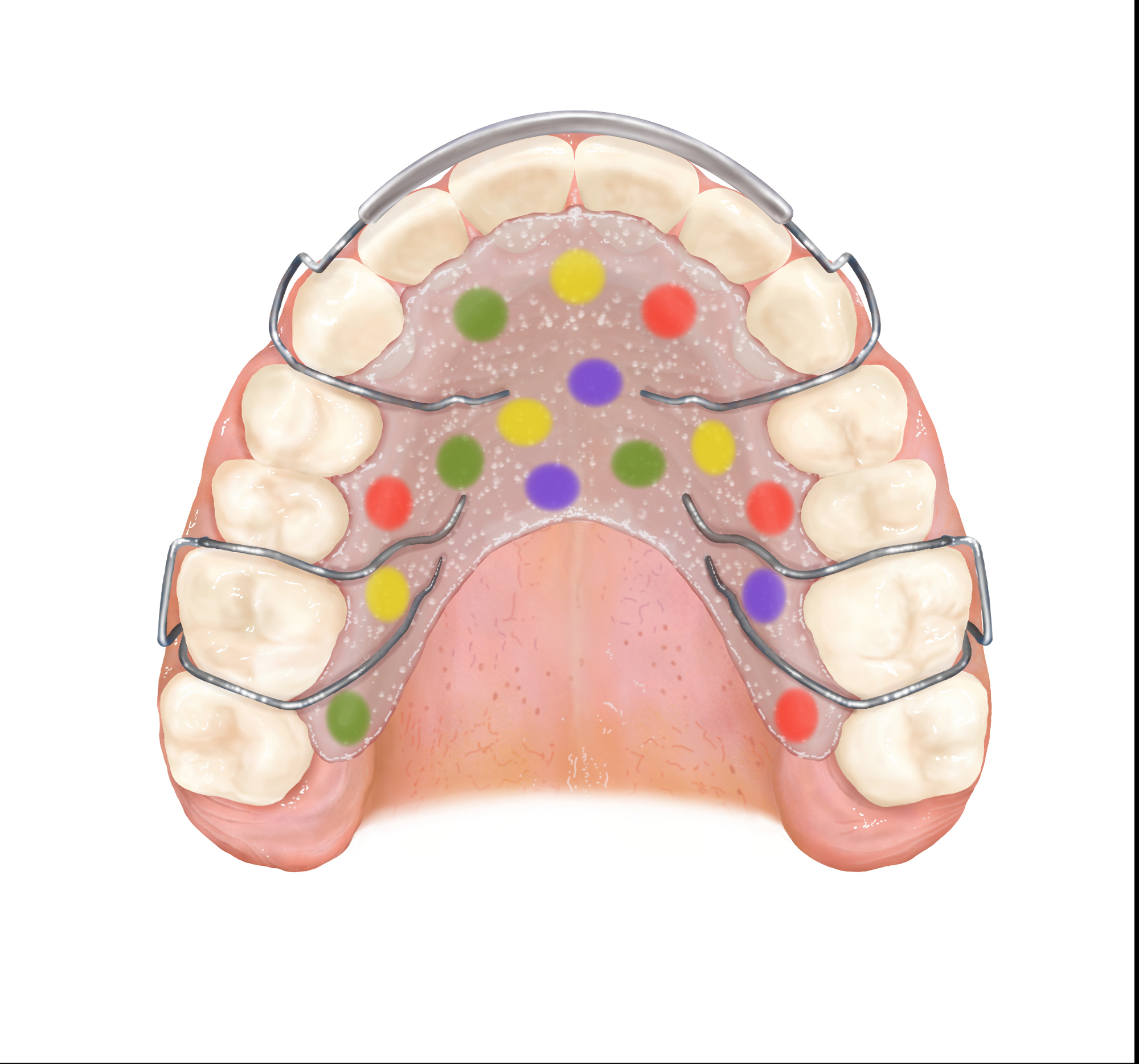

De entre todos los edulcorantes que encontramos en el mercado (aspartamo, sacarina, maltitol, xilitol, acesulfamo, etc.) de los que hablaremos en una próxima entrega de la serie «Azúcar y otros edulcorantes», el que tiene una mejor imagen es la estevia.

-

Qué es la estevia

La sacarina, el aspartamo, y demás edulcorantes suelen denominarse coloquialmente «edulcorantes artificiales», mientras que la estevia suele llamarse «edulcorante natural». Esta distinción no es trivial, sino que atiende a una estrategia publicitaria: aquello que se relaciona con la naturaleza nos resulta más atractivo y saludable.

Los productos denominados estevia que encontramos en el mercado, tienen un aspecto similar al azúcar blanco, aunque en el envase encontremos la imagen de una planta.

Realmente, la estevia no se comercializa en España. Está prohibido vender la planta como alimento, ni siquiera sus hojas secas. La principal razón es que no es un producto de consumo tradicional y, la segunda razón, es que la planta contiene compuestos con actividad farmacológica, entre ellos hipotensores. Lo que se vende como estevia (a veces bajo otros nombres comerciales) se trata de una mezcla de diferentes edulcorantes, entre los cuales se encuentra el E-960 [2].

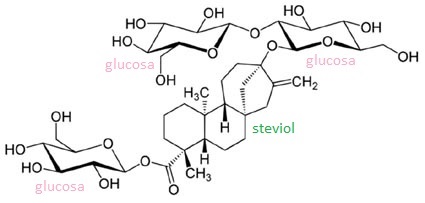

El aditivo E-960 se corresponde con el compuesto rebaudósido A. Este compuesto es un glucósido de esteviol, formado por tres moléculas de glucosa unidas a una molécula de esteviol. Al igual que los demás edulcorantes, tiene su propio número E. Esto significa que se trata de una sustancia que puede emplearse como aditivo alimentario, que ha pasado los controles sanitarios y que es segura para consumo.

-

Cómo se obtiene la estevia

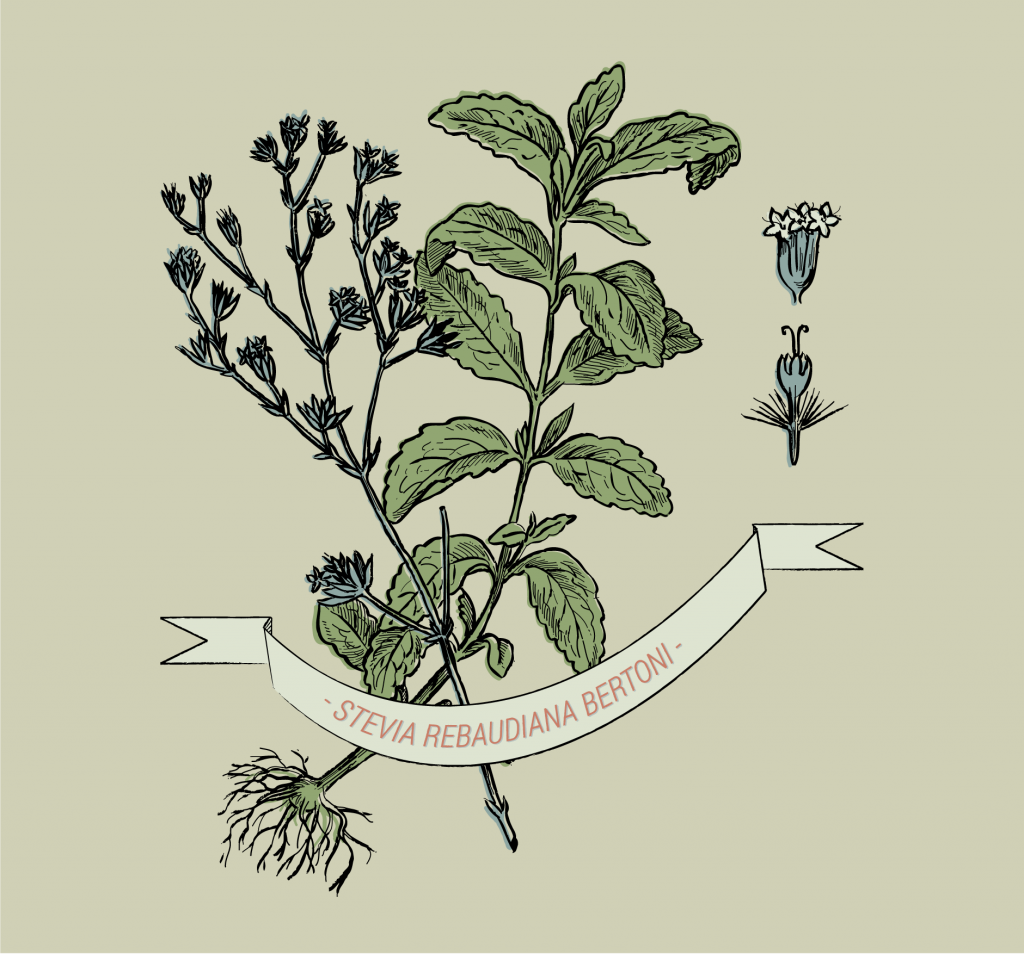

Para la obtención del E-960 se utiliza la planta de stevia rebaudiana, originaria de sudamérica. De ahí el nombre comercial de los productos que contienen este aditivo y de ahí la estrategia de denominarlo «edulcorante natural».

Ilustración cortesía de Tamara Feijoo

El proceso de fabricación del E-960 comienza con una extracción de las hojas de la planta en el que se eliminan los compuestos que no interesan mediante floculación. Posteriormente se pasa la solución que queda por resinas de absorción, para concentrar los glucósidos. Después se recuperan los glucósidos mediante una solución alcohólica. A continuación, se realiza una purificación con una solución hidroalcohólica y se recristaliza [3]. De esta manera se obtiene el E-960 puro.

Los alimentos procesados que dicen contener estevia, como mermeladas, cremas de cacao o refrescos, suelen contener otros edulcorantes además del E-960. Podemos consultar todo lo que llevan revisando la lista de ingredientes.

-

¿Qué llevan los productos llamados estevia?

Los edulcorantes comercializados bajo el nombre de estevia o similares (como stevia, steviva, svetia o truvia) contienen un escaso porcentaje de E-960, la mayoría es otro edulcorante, generalmente eritritol.

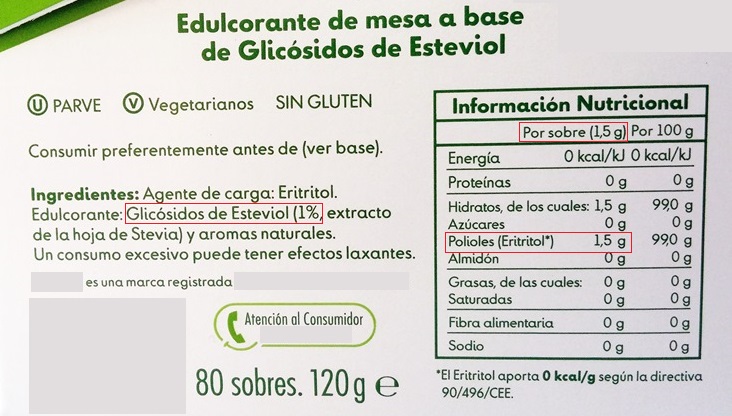

Si nos fijamos en la imagen superior, entre la lista de ingredientes encontramos el glucósido de esteviol (el E-960) por debajo del 1%, de modo que el 99% restante del producto es el otro ingrediente: eritritol. En una porción de 1,5 g de estevia, hay 1,5 g de eritritol.

El eritritol es el aditivo alimentario E-968. Forma pequeños cristales que se disuelven con facilidad, lo que recuerda al azúcar común. Pertenece a de la familia de los polialcoholes, como el xilitol, el sorbitol o el maltitol.

-

Ventajas e inconvenientes de la estevia comercial

El principal inconveniente a corto plazo del uso de polialcoholes como edulcorantes, es que producen efectos laxantes (unos en mayor medida que otros), y por eso figura esa advertencia en los envases de esta clase de productos. A la larga, si el consumo de estos edulcorantes es excesivo, provocarían diarrea, infamación, flatulencias, deshidratación y problemas de malabsorción asociados. De entre todos los edulcorantes, el eritritol es el polialcohol al que tenemos mayor tolerancia. Prácticamente no se metaboliza. El 90% se excreta por la orina sin causar problemas y, el 10% restante fermenta en el intestino y en el colon, pudiendo causar molestias digestivas [4].

Si el azúcar común tiene un poder edulcorante de 1, el E-968 lo tiene de 0,7, y el E-960 lo tiene de 3, con lo que la combinación de ambos edulcorantes da como resultado una sustancia que se utiliza casi en la misma proporción que utilizaríamos azúcar común. La principal ventaja es que la capacidad edulcorante de estos productos es similar a la del azúcar, pero con un aporte calórico prácticamente nulo.

La otra ventaja es que estos productos no fermentan en la boca, con lo que no están relacionados con la aparición de caries, como sí ocurre con los azúcares.

Otra ventaja es que el índice glucémico (IG) tanto del E-968 como del E-960 es nulo, es decir, que no afectan a los niveles de glucosa en sangre. Esto hace que puedan ser consumidos por diabéticos.

Una de las grandes desventajas de este tipo de edulcorantes es que un consumo continuado afecta a la percepción del sabor, aumentando el apetito y la tolerancia al sabor dulce. Las personas que toman habitualmente este tipo de productos aumentan de media un 30% el consumo de calorías frente a aquellas que no toman edulcorantes [5]. Esto se debe al efecto halo de los alimentos light [6], ya que saber que aportan menos calorías y que parecen más saludables, afecta a la conducta y el resultado es que comemos más de lo necesario. Cada vez tenemos más edulcorantes, más alimentos bajos en calorías, pero los índices de obesidad no paran de aumentar.

-

El mito de la estevia

Uno de los mayores mitos que nos encontramos haciendo una búsqueda por internet sobre las bondades de estos edulcorantes, es que la estevia cura la diabetes [7]. Ni cura la diabetes ni ninguna otra enfermedad. La única relación entre estos edulcorantes y la diabetes es que son aptos para diabéticos.

Otras bondades atribuidas a la estevia no se corresponden con ninguna propiedad achacable al E-960. Ni es antioxidante, ni bactericida, ni hipotensor, ni antiácido, ni un largo etcétera de propiedades sobre las que no hay ninguna evidencia.

-

Conclusiones

El producto que se comercializa como estevia no se trata de un edulcorante más natural que cualquier otro edulcorante. Aunque el adjetivo «natural» no significa nada concreto, lo asociamos con sustancias que se encuentran libres en la naturaleza y con sustancias con propiedades beneficiosas para la salud. La estevia no cumple ninguna de estas características. Eso no la hace ni mejor ni peor. La estrategia publicitaria de lo «natural», en oposición a lo «artificial», como si una cosa fuese buena y la otra no, es una estrategia que nace de la incultura y la promueve.

La estevia que se comercializa en España y gran parte de la Unión Europea se basa en una mezcla de diferentes edulcorantes, donde el E-960 (rebaudósido A que se extrae de la planta) es el que está en menor proporción. La mayor parte de estos productos son eritritol, edulcorante E-968.

En conjunto, sí podemos asumir que este edulcorante es mejor para la salud que el azúcar, ya que no afecta a la diabetes, a las caries, y afecta en menor medida a la obesidad y sus enfermedades asociadas. Que no sea malo para la salud, tampoco implica que sea beneficioso.

El gran factor contra del uso de este edulcorante es que perpetúa conductas alimentarias insalubres y la tendencia de consumir todo con un extra de dulzor. Los edulcorantes enmascaran el verdadero sabor de los alimentos y esa es la mayor pérdida de todas.

Principales fuentes consultadas:

[1] Estudio sobre el consumo y el gasto en azúcar y edulcorante de la población española, a partir de datos del Panel de Consumo Alimentario del MAPAMA. Revista Consumer, 2017

[2] ¿Es tan buena la Stevia? Dimetilsulfuro.es, 2015.

[3] Bioquímica, farmacología y toxicología de Stevia rebaudiana Bertoni. Alejandro Gutiérrez Cruz, Paulina Bermejo Benito. Memoria Trabajo Fin de Máster. Facultad de Farmacia. Universidad Complutense de Madrid, 2015.