Naukas Bilbao 2017 – Raúl Gay: Todo sobre mi órtesis

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Raúl Gay habla de discapacidad desde una perspectiva muy diferente a la habitual: llamando a las cosas por su nombre. Posiblemente, una de las charlas más memorables de esta edición de Naukas Bilbao.

Raúl Gay: Todo sobre mi órtesisEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Raúl Gay: Todo sobre mi órtesis se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Naukas Bilbao 2017 – Mónica Lalanda: Una muerte de cómic

- Naukas Bilbao 2017 – Diana González: Identidad digital y robots

Ezjakintasunaren kartografia #202

Minbizi mota jakin bati erasotzeko moduak ezusteko tokietan egon daitezke, D bitaminaren errezeptoreetan, adibidez. NuRCaMein-en Vitamin D receptor, a powerful weapon against colorectal cancer.

Tesla espaziora bidaltzeagatik eta Space X programagatik hain entzutetsu egin den Elon Musk-en beste megaproiektu bati arreta jartzea ideia ona da. Iván Rivera eta The limits of Hyperloop.

Molekula baten egitura intimoa ezagutzea ahalbidetzen duten teknikak gero eta sofistikatuagoak eta eskuragarriagoak dira laborategi normaletan erabiltzeko (orden baten barruan). DIPC Submolecular resolution using inelastic electron tunnelling spectroscopy at 5 K artikuluan.

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #202 appeared first on Zientzia Kaiera.

Traducción automática neuronal sin supervisión

La mayoría de los sistemas de aprendizaje automático requieren supervisión humana, y la traducción automática no es una excepción: el ordenador utiliza millones de traducciones hechas por personas para extraer patrones y, de esta forma, aprender a traducir cualquier texto. Este método funciona bien con pares de idiomas como el inglés y el francés, pues existen muchas traducciones entre ambos. Sin embargo, no es tan efectivo para la gran mayoría de pares de idiomas con recursos limitados, como es el caso del alemán-ruso o el euskera-inglés, por ejemplo.

En este contexto, Mikel Artetxe, Eneko Agirre y Gorka Labaka, investigadores del grupo IXA de la Facultad de Informática de la UPV/EHU, han desarrollado un método de traducción automática basado en el aprendizaje sin supervisión, es decir, sin necesidad de diccionarios o traducciones humanas.

“Imagina que le das a una persona una gran cantidad de libros escritos en chino y otros tantos, distintos, en árabe, con el objetivo de que aprenda a traducir del chino al árabe. A priori parece una tarea imposible para un ser humano. Pero nosotros hemos demostrado que un ordenador es capaz de hacerlo”, afirma Mikel Artetxe, que está realizando su tesis doctoral sobre el procesamiento del lenguaje natural y el aprendizaje automático.

Este nuevo método que proponen los investigadores de la UPV/EHU supone un gran avance en el campo de la traducción automática, ya que abre una nueva línea de trabajo que muestra que las redes neuronales, algoritmos informáticos que se inspiran en el cerebro humano, pueden aprender a traducir sin necesidad de traducciones preexistentes.

Se da la casualidad que otro estudio, desarrollado por un equipo de investigadores de Facebook y la Universidad de la Sorbona de París, ha propuesto un método similar. “Es sorprendente -subraya Artetxe- que nuestros métodos sean tan parecidos. Pero al mismo tiempo es positivo, pues significa que esta nueva aproximación va por el buen camino”.

Los dos estudios, de los que se ha hecho eco la revista científica Science en su sección digital de noticias, fueron publicados en el repositorio virtual arXiv con un día de diferencia, y serán presentados en uno de los congresos más relevantes del área, el sexto encuentro internacional sobre el aprendizaje de representaciones (International Conference on Learning Representations – ICLR), que se celebrará en el mes de abril en Vancouver, Canadá.

En los únicos resultados comparables entre ambos estudios, el método del grupo IXA de la UPV/EHU obtuvo resultados ligeramente superiores, con una puntuación BLEU del 15% entre el francés y el inglés. A modo de comparativa, la máxima puntuación la obtienen métodos supervisados como Google Translate con cerca del 40%, si bien una persona supera el 50%. “Estamos en los inicios -aclara Mikel Artetxe- por lo que no sabemos hasta dónde puede llegar esta nueva línea de investigación”.

Referencia:

Mikel Artetxe, Gorka Labaka, Eneko Agirre, Kyunghyun Cho (2017) Unsupervised Neural Machine Translation arXiv:1710.11041

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Traducción automática neuronal sin supervisión se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Buscando la traducción automática perfecta

- Chatbots de traducción automática profunda

- La hiperactividad neuronal impide que las microglías realicen su trabajo

Nacido para ser autista

Mary Temple Grandin

En los años sesenta, Leo Kanner (uno de los dos primeros descubridores del autismo) defendía su teoría de las “madres nevera/refrigerador”. En ella argumentaba que el autismo de los hijos era consecuencia de la falta de contacto materno adecuado: afirmaba que estas madres de hijos autistas eran distantes, poco afectivas con sus hijos y llegó incluso a decir que esas mujeres se habían “descongelado” lo justo para dar a luz a un hijo. Según Kanner, si una mujer tenía un hijo autista era porque ella había hecho algo mal. Esta idea falsa que directamente culpabilizaba a las madres tuvo un importante calado e incluso hoy en día es posible encontrar personas que argumentan que el origen de los trastornos del espectro autista (TDA) se deben a la educación, traumas, etc. Lo cual significa que hay gente que cree que los TDA son algo adquirido. Mientras que el enfoque opuesto es pensar que los TDA son trastornos del desarrollo: es decir, que su origen está en alteraciones internas producidas durante el propio desarrollo del individuo.

Antes de ver cuál de estos dos planteamientos es el correcto, creo que es importante aclarar qué es exactamente el autismo. Lo primero que debemos saber es que no existe “el autismo” sino los trastornos del espectro autista (TDA), dentro de los cuales hay una gran diversidad. Esto ya se ve en los dos primeros estudios donde se documentan estos trastornos: el trabajo de Leo Kanner (1943) describe niños que mayoritariamente tienen muchas dificultades para hablar y discapacidad intelectual, mientras que en el estudio de Hans Asperger (1944) los niños tienen un uso preciso del lenguaje y no presentan discapacidad intelectual. Hablo de niños porque los TDA afectan principalmente a varones en una proporción que va desde 4 a 1, hasta 8 niños por cada niña según el tipo de TDA. Independientemente del género, algunas de las características principales de los trastornos del espectro autista son problemas en el uso del lenguaje o habilidades sociales. Además, junto con el propio trastorno los pacientes suelen padecer algún tipo de discapacidad intelectual en más de la mitad de los casos o epilepsia (alrededor del 30% de los casos); entre otros problemas.

La primera pista sobre el origen de estos trastornos la tenemos en el incremento de los casos en las últimas décadas, que ahora se sitúa en cerca del 1% de la población y es un porcentaje superior al documentado con anterioridad. Esta subida se debe principalmente a tres motivos: el primero es una mejora de las técnicas diagnósticas que permiten detectar más casos, el segundo es un cambio en lo que entendemos por TDA hacia una definición clínica más amplia que recoge casos que antes no se consideraban TDA, y el tercer motivo es un incremento de la edad a la que las parejas conciben hijos. Aquí está la pista. Muchos estudios están documentando que cuanto más mayores son los progenitores a la hora de concebir un hijo (y en muchos de ellos se señala que es especialmente importante la edad del padre), más probable es que su descendencia tenga un TDA. ¿Por qué? Porque conforme envejecemos nuestra capacidad de generar células reproductoras es peor y los genes que trasmitimos a través de ellas contienen más fallos. Esto indica que los problemas genéticos tienen un papel importante en el desarrollo del TDA, y eso es algo que también se ve si uno estudia árboles genealógicos o trabajos donde se ha documentado casos de gemelos. En ellos se ha visto que si uno de ellos desarrolla un TDA, en el 60-90% de los casos el otro hermano también desarrollará un TDA.

Que la genética tenga un factor decisivo en la aparición de TDA no es suficiente para definirlo como un trastorno que se produce durante el desarrollo del organismo: para ello es esencial ver cuándo aparece el TDA. Los seres humanos nacemos extremadamente poco desarrollados, siendo además el cerebro el tejido más inmaduro y tarda unas dos décadas en acabar de formarse. Trastornos neurológicos que se manifiesten dentro de este espacio de tiempo pueden deberse en parte a anomalías del desarrollo, y cuanto más pronto aparezcan pues es más probable que el desarrollo nervioso esté implicado en su aparición. En el caso de los TDA, los diagnósticos tempranos se sitúan entorno a los dos/tres años de edad. Lo cual ya es muy temprano pero es que además, en estudios con bebés de seis meses ha sido posible analizar el funcionamiento de sus redes neuronales a los seis, doce y veinticuatro meses; encontrándose que aquellos pequeños que a los veinticuatro meses eran diagnosticados con un TDA, a los seis meses ya presentaban alteraciones en el funcionamiento de sus redes neuronales. Y además, se ha hallado una correlación entre la severidad de estas anomalías a los seis meses y la gravedad de los síntomas a los veinticuatro meses.

En resumen, todo esto nos dice que los TDA son intrínsecos a la propia formación del sistema nervioso del paciente y por lo tanto es parte de ellos mismos. No es algo que se adquiera después de nacer sino que se manifiesta después de nacer. Se nace siendo autista. Esto es importante por dos aspectos: en primer lugar para no culpar al entorno, la familia, el calendario de las vacunas infantiles, etc. de los casos que aparezcan. Y en segundo lugar es vital para el tratamiento: actualmente la única posibilidad para intentar mitigar los síntomas del TDA es diagnosticar y tratar a los pacientes cuanto antes, porque los procesos del desarrollo son mayoritariamente irreversibles pero durante las fases iniciales a veces hay un cierto margen para dirigirlos parcialmente en otra dirección.

Este post ha sido realizado por Pablo Barrecheguren (@pjbarrecheguren) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias:

- Constantino, J. N., & Marrus, N. (2017). The Early Origins of Autism. Child and Adolescent Psychiatric Clinics of North America, 26(3), 555–570.

- John D. Lewis*, Alan C. Evans, John R. Pruett Jr, Kelly N. Botteron, Robert C. McKinstry, Lonnie Zwaigenbaum, Annette Estes, Louis Collins, Penelope Kostopoulos, Guido Gerig, Stephen Dager, Sarah Paterson, Robert T. Schultz, Martin Styner, Heather Hazlett, and Joseph Piven, for the IBIS network. (2017). The emergence of network inefficiencies in infants with autism spectrum disorder. Biol Psychiatry. 2017 August 01; 82(3): 176–185.

- Principles of Neural Science, Fifth Edition (2012). Editorial McGraw-Hill Education.

- Swaab D. We are our brains (2014). Penguin Books.

El artículo Nacido para ser autista se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El universo recién nacido

- Luminoterapia para el cambio de estación

- ¿Cuántos animales se usan en España para experimentación?

Ainhoa Plaza-Zabala: “Glia zelulak ezinbestekoak dira giza garunaren funtzionamendurako” #Zientzialari (88)

Neurona bakoitzeko hamar glia zelula daudela kalkulatzen da. Zelula mota hauek ezinbestekoak dira neuronen eta giza garunaren funtzionamendu egokirako. Izan ere, neuronak ezingo lirateke bizi glia zelulek ematen dizkieten baliabiderik gabe.

Azken hamarkadetan egindako ikerketek glia zelulak neuronen euskarri fisiko bat baino gehiago direla aditzera eman dute. Neuronekin batera garuna osatzen duten zelula hauek propietate eta funtzio bereizgarriak dituzte. Besteak beste, glia zelulek neuronen ingurumenaren konposizioa kontrolatzen dute, baliabide energetikoak ematen dizkiete neuronei eta azken hauen arteko komunikazioa kontrolatzen dute.

Baina, zein motatako glia zelulak daude eta zein da bakoitzaren funtzioa? Zein ondorio ekar ditzake glia zelulen funtzionamendu txarrak? Galdera hauei erantzun bat emateko Achucarro Basque Center for Neuroscience zentroan ikertzailea den Ainhoa Plaza-Zabalarekin izan gara.

‘Zientzialari’ izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Ainhoa Plaza-Zabala: “Glia zelulak ezinbestekoak dira giza garunaren funtzionamendurako” #Zientzialari (88) appeared first on Zientzia Kaiera.

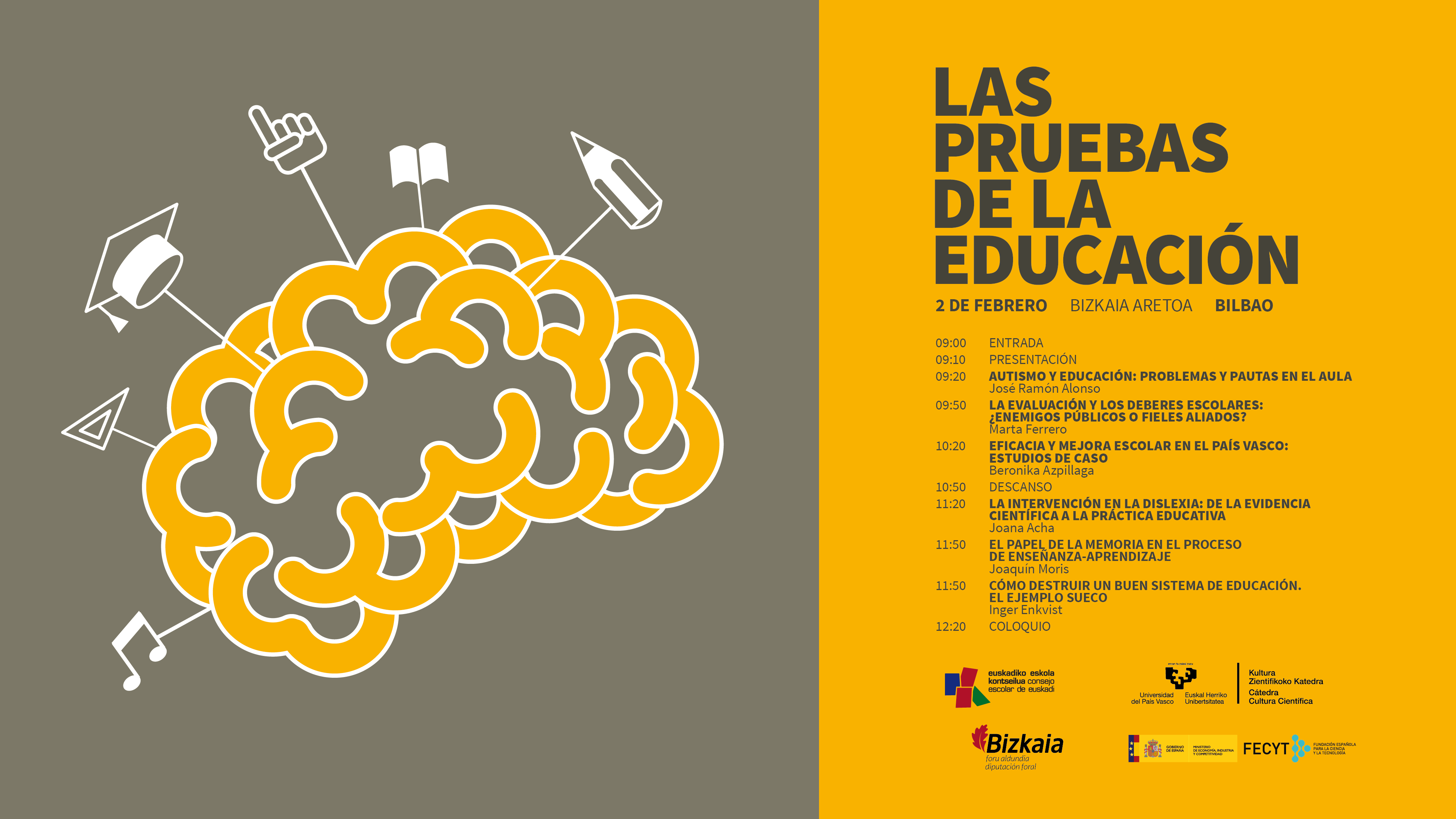

Autismo y educación: problemas y pautas en el aula

¿Cómo se tratan algunos de los trastornos cognitivos más frecuentes en las aulas? ¿Son efectivos los programas y herramientas del sistema educativo actual? ¿Carecen de eficacia algunas de las prácticas educativas más populares?

Estas son algunas de las cuestiones que se debatieron en la jornada “Las pruebas de la educación”, que se celebró el pasado 2 de febrero de 2018 en el Bizkaia Aretoa de Bilbao. El evento, en su segunda edición, estuvo organizado por la Cátedra de Cultura Científica de la UPV/EHU y el Consejo Escolar de Euskadi, con la colaboración de la Fundación Española para la Ciencia y la Tecnología (FECYT).

Las ponencias de los expertos que expusieron múltiples cuestiones relacionadas con la educación, basándose siempre en las pruebas científicas existentes. Los especialistas hicieron especial hincapié en destacar cuál es la mejor evidencia disponible a día de hoy con el objetivo de abordar las diferentes realidades que coexisten en las aulas y en el sistema educativo en general.

“Las pruebas de la educación” forma parte de una serie de eventos organizados por la Cátedra de Cultura Científica de la UPV/EHU para abordar cuestiones del día a día como la educación o el arte desde diversos ámbitos de la actividad científica. La dirección del seminario corre a cargo de la doctora en psicología Marta Ferrero.

En “Autismo y educación: Problemas y pautas en el aula”, José Ramón Alonso, neurobiólogo y catedrático de biología celular en la Universidad de Salamanca, nos acerca al concepto del autismo, sus posibles causas y los tratamientos más empleados, con el objetivo de identificar las pautas concretas que pueden ayudar a maestros y profesores a tratar en el aula este trastorno cognitivo.

José Ramón Alonso: ''Autismo y educación: Problemas y pautas en el aula''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Autismo y educación: problemas y pautas en el aula se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

- La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- Del mito al hecho: hemisferios, gimnasia cerebral y estilos de aprendizaje

Urtaroarteko biltegiratze termikoko sistema baten bideragarritasun tekno-ekonomikoaren azterketa

Espainiako zein Europako hainbat legek energia berriztagarrien erabilera sustatzen dute, Espainiako Kode Teknikoa (CTE) eta Energy Performance of Building Directive (EPBD), besteak beste. Espainiaren kasuan, (CTE), DB-HE agirian, energia aurrezteko eskakizunak betetzeko arauak eta prozedurak azaltzen dira. Horren barnean, HE4 dokumentuan, ur bero sanitarioko (UBS) eskaria asetzeko eguzki energia termikoko kontribuzio minimo bat egin behar dela azaltzen da, Espainiako gune klimatiko ezberdinen araberakoa. Europaren kasuan, ordea, EPBD-ak kontsumo ia nuluko eraikinerantz bideratzen gaitu (NZEB, Nearly Zero Energy Buildings), hau da, eraikinek kontsumitzen duten energiaren kantitate bera produzitu behar dutela.

Europako energiaren kontsumo totalaren %40 eraikinek eragiten dute. Horietan berokuntza eta ur bero sanitarioaren erabilerak nabarmentzen dira batik bat. Espainiaren kasuan, ur bero sanitarioaren kontsumoak %27 suposatzen du eta berokuntzak, ordea, %50a.

Urtaroarteko biltegiratze termikoko sistema (STES: Seasonal Thermal Energy Storage) kalefakzioko eta UBSko beharrak asetzeko erabili ohi da. Eguzki energia termikoa erabiltzen duen sistema da, non udako hilabeteetan, eguzki kolektore termikoen laguntzaz, eguzki energia termikoa (beroa) biltegiratzen den, ondoren, neguko hilabeteetan erabiltzeko helburuarekin. Izan ere, udan, eguzki energia termiko altuagoa biltegira dezakegu neguan baino. Gainera, urteko bero-eskari ia totala neguan ematen da, hau da, udan ia ez dago bero-eskaririk. Bi arrazoi horiek kontuan hartuta, udan (apiriletik urrira arte) soberan dagoen eguzki energia termikoa biltegiratuko da, hala, neguko bero-eskariak asez.

Lau STES mota ezberdin bereizten dira: ur depositua, putzuko biltegiratzea, biltegiratze geotermikoa eta akuiferoak. Horiek biltegiratze ahalmen handiko biltegi termikoak dira eta bertan ur bero kantitate handiak biltegira daitezke. Beraz, distritu baten bero-beharraren zati handi bat asetzeko ahalmena dute. Eguzki kolektoreekin eta biltegiratuta dagoenarekin ase ezin daitekeen eskaria ekipo laguntzaile batek aseko luke. Artikulu honen bitartez ur depositu motako biltegiak izango lukeen ahalmena aztertu izan da.

Simulazioak egiteko, TRNSYS (TRaNsient System Simulation program) sistema iragankorren simulazio programa erabili da. Oro har, energia berriztagarrien ingeniaritzan egiten ditu simulazioak. Programa honek hiri askotako aldagai klimatologikoen data baseak dauzka bere baitan, Espainiako probintzien hiriburuenak barne.

Hortaz, TRNSYS-aren laguntzaz, Espainiako gune klimatiko ezberdineko hainbat hiritan bi distritu tamaina ezberdinak simulatu dira. Bata txikia, 100-200 arteko etxebizitza kopuruarekin eta bestea distritu handia, 1000-2000 arteko etxebizitzekin. Bi kasuetan, tankearen tamaina ezberdinekin eta eguzki kolektore azalera ezberdinekin egin dira simulazioak. Hala, sistema horren bitartez lortzen den eguzki frakzioa (ase daitekeen UBS-ko eskariaren portzentajea) eta hori eraikitzeak suposatuko lukeen inbertsioa ikusi da.

Honakoa ondorioztatu da emaitzei erreparatuz:

Tankearen bolumena eta kolektoreen azalera handituz, eguzki frakzioa handitzen da. Baina eguzki kolektoreen azalerak garrantzi handiagoa du, eta, hortaz, errentagarriago suertatzen da kolektoreen azaleraren tamaina handitzea tankearen bolumena baino.

Alderdi ekonomikoari dagokionez, konprobatu da zenbat eta distritu handiagoa izan, orduan eta inbertsio handiagoa egin beharko dela, baina horrek geroz eta onura gehiago dakartza.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 30

- Artikuluaren izena: Urtaroarteko biltegiratze termikoko sistema baten bideragarritasun tekno-ekonomikoaren azterketa.

- Laburpena: Gaur egun, Europako energiaren kontsumo osoaren %40 eraikinek eragiten dute. Kontsumo horren barnean, eraikinetako berokuntza eta ur bero sanitarioaren (UBS) erabilera nabarmentzen da, batik bat. Espainiaren kasuan, berokuntza %50 da, eta UBSa, berriz, %27.Proiektu honen bitartez, Espainia mailan Urtaroko biltegiratze termikoko sistemen (STES) bideragarritasun ekonomiko zein energetikoa aztertu da. Espainiako hainbat hiritako eskari termikoak simulatu dira, eta STESaren bitartez berogailuko eta UBSko eskari osoaren %45-60 artean asetzeko saiakera egin da. Beraz, ikusita eraikinetan kontsumo energetiko handia izaten dela eta, gainera, jakinda Eraikuntzarako Kode Teknikoak (CTE) ur bero sanitariorako eguzki-energia termikoaren kontribuzio minimoa derrigortzen duela, sistema horien bideragarritasunaren azterketa ezinbestekoa da. Hala, energia berriztagarrien erabilera sustatzen da.

- Egileak: Oihane Setién Echenique eta Carol Pascual Ortiz

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 71-79

- DOI: 10.1387/ekaia.15854

—————————————————–

Egileez:

Oihane Setién Echenique Aula Tecnalian dabil eta Carol Pascual Ortiz Tecnaliako Energia eta Ingurumeneko Dibisioan.————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Urtaroarteko biltegiratze termikoko sistema baten bideragarritasun tekno-ekonomikoaren azterketa appeared first on Zientzia Kaiera.

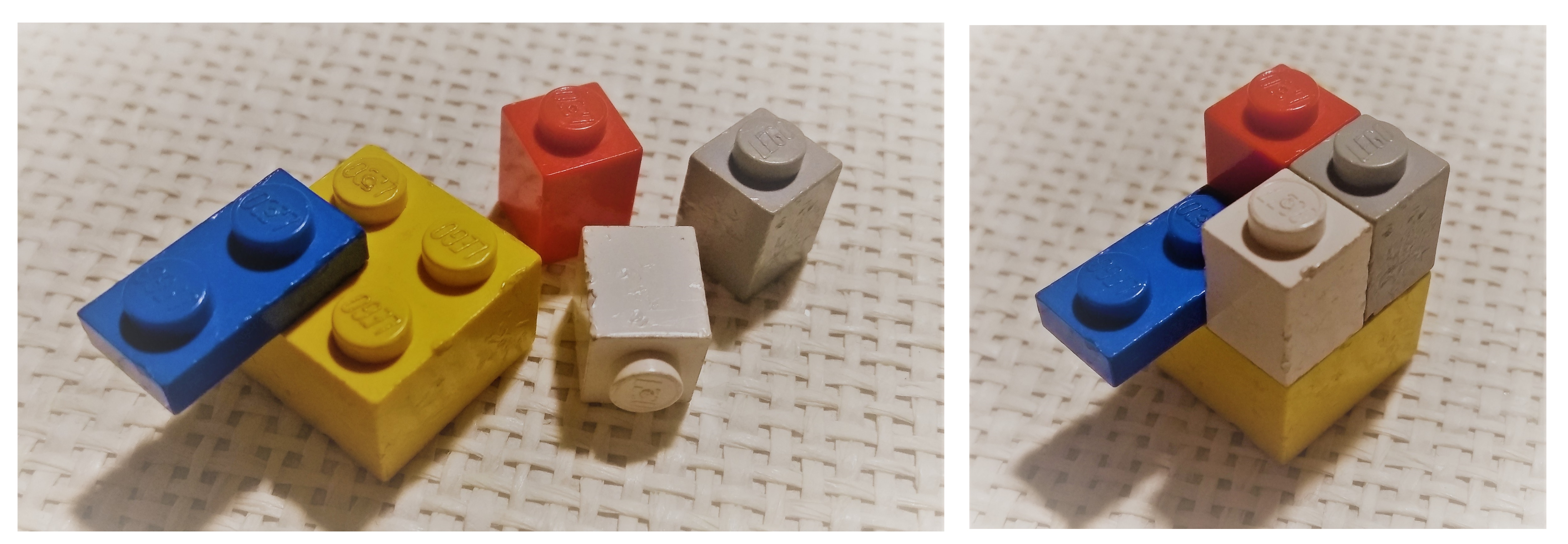

Si hacer fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino

Muchos de los fármacos que conocemos son compuestos muy complejos. Esto quiere decir que están formados por muchos átomos unidos entre sí de una manera concreta. Hacer que estos átomos se unan de una forma y no de otra es una tarea complicada. Al estudio de estos procesos de ensamblaje de átomos se le llama «síntesis química».

Los átomos no se comportan como piezas de Lego. No siempre podemos ensamblarlos y desensamblarlos a nuestro antojo, ya que unos átomos tienen más afinidad por unos que por otros, tienen tendencia a colocarse en unas posiciones y no en otras, a girarse, etc. Por eso es tan importante diseñar una buena ruta de síntesis, en la que cada átomo acabe ocupando la posición deseada.

Uno de los átomos más famosos de los fármacos es el carbono. El carbono está presente en casi todos los fármacos que conocemos. Es capaz de unirse a otros átomos de forma muy diferente. El carbono es como una pieza de Lego con cuatro posiciones de ensamblaje. Desgraciadamente es muy difícil conseguir una pieza solitaria de este carbono. En la naturaleza siempre está unido a más piezas y, en el caso de tener alguna posición libre (formando lo que denominamos radicales libres) son muy inestables y enseguida encuentran a quién unirse.

Esto ha sido un quebradero de cabeza para los químicos que trabajan en síntesis. Al menos hasta ahora. Recientemente, un grupo de investigadores del Instituto Catalán de Investigación Química (ICIQ), liderado por el joven químico Marcos García Suero, acaba de encontrar un método revolucionario que permite conseguir la ansiada pieza solitaria de carbono. Esta pieza sólo tiene una de sus posiciones ocupadas por hidrógeno, el resto están listas para ensamblarse a los átomos que deseemos. Esta pieza se denomina carbino.

El carbino fue una de las primeras moléculas halladas en el espacio interestelar. Los astrofísicos lo detectaron en los años 30 del siglo pasado. Estos carbinos se detectan en eventos astonómicos muy energéticos y violentos, como en la formación de estrellas. Duran muy poco como carbinos porque tienen esa tendencia a unirse rápidamente a otros átomos. Esto es lo que los hace tan escurridizos.

Lo que han hecho los investigadores del ICIQ es sintetizar un equivalente de los carbinos. Este equivalente se llama radical diazometilo. Si seguimos con la analogía de las piezas de Lego, el radical diazometilo sería como una pieza de carbino con sus posiciones ocupadas por piezas de quita y pon, fáciles de intercambiar por piezas definitivas.

Tanto el hallazgo de este carbino equivalente, como la forma de sintetizarlo, ha llevado a estos investigadores a publicar su descubrimiento en la prestigiosa revista científica Nature. Su artículo lleva por título «Generación de carbinos equivalentes por medio de catálisis fotorredox». Para obtener carbino en el laboratorio no se pueden emular los violentos eventos astronómicos. Lo que han hecho estos investigadores es darle un empujón a la reacción de obtención de estos carbinos ayudándose de catalizadores. Los catalizadores que utilizaron son unos compuestos con rutenio sensibles a la luz, de ahí el prefijo foto de catálisis fotorredox. El catalizador, al recibir un fotón de luz LED, da el pistoletazo de salida para que se forme el carbino. Los procesos de fotocatálisis son, de hecho, una de las líneas de investigación más importantes del ICIQ.

Estos investigadores han probado la eficacia del carbino para modificar a antojo algunos medicamentos ya existentes. Así, han modificado con éxito el principio activo del ibuprofeno, del antidepresivo duloxetina, del antitumoral taxol, y del fingolimod, el primer tratamiento oral que existe para la esclerosis múltiple.

Este carbino no solo se podrá usar para mejorar los fármacos que ya conocemos, sino que podrá ayudar a acelerar el diseño y desarrollo de nuevos medicamentos. Si la química del desarrollo de fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino.

Agradezco a Fernando Gomollón Bel su ayuda con este artículo.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Si hacer fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo mecanizar una pieza de cobre usando bacterias

- Otra pieza en el puzle de la fotosíntesis

- Cómo hacer más eficiente un mini aerogenerador

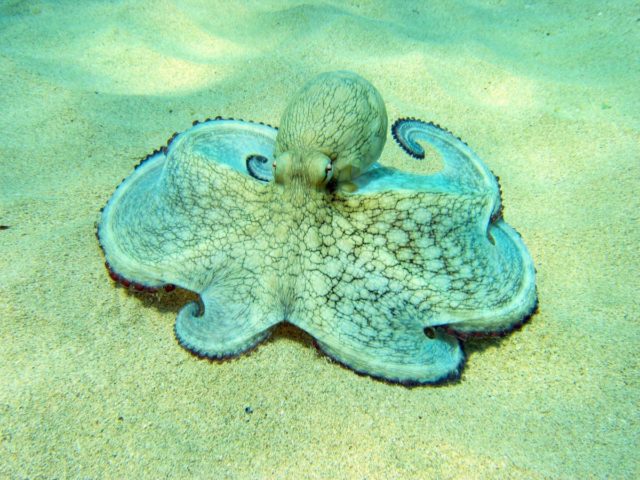

Arrainak vs. zefalopodoak

Juan Ignacio Pérez eta Miren Bego Urrutia Igeri egiten, lasterka egiten, hegan egiten

Juan Ignacio Pérez eta Miren Bego Urrutia Igeri egiten, lasterka egiten, hegan egiten ———————————————————————————————————–

Zefalopodoek milaka urte daramatzate itsasoetan. Arrainak sortu baino lehen, haiek ziren itsasoetako harrapari nagusiak. Zefalopodoak ziren aktibitate-maila altuena garatzen zuten animaliak. Baina gero arrainak sortu ziren, uretako ornodunak, lehen ornodunak, eta gailendu egin zitzaizkien. Sortu eta berehala, sekulako arrakasta lortu zuten; arrainak harrapari nagusi bilakatu, eta zefalopodoak bigarren maila batean geratu ziren.

Arrainen arrakasta horren gakoa da hemen laburki aztertu nahi duguna. Litekeena da oxigenoa izatea gako hori, edo hobeto esanda, oxigenoarekin zerikusi handia duten fisiologia-ezaugarriak.

Zefalopodoen igeri egiteko modua ikusgarria da benetan, oso trebeak dira. Baina ez da batere eraginkorra arrainen igeri egiteko moduaren alboan, zefalopodoen jet-propultsioko igeriketa oso garestia baita. Igeriketa-modu horrek energia asko kontsumitzen du eta, energiarekin batera, oxigeno asko. Izan ere, zefalopodo batek arrain batek baino lau bider oxigeno gehiago kontsumitu behar du abiadura bera lortzeko.

Energia gehiago kontsumitu behar izatea, berez, eragozpena da janaria mugatua denean (eta janaria ia beti izaten da mugatua). Baina baliteke energia baino areago oxigenoa izatea kasu honetan gakoa. Abiadura bera garatzeko zefalopodoek arrainek baino lau bider oxigeno gehiago erabili behar dute. Garrantzi handikoa izan daiteke hori, noski, baina, horrez gain, zefalopodoen odolaren oxigeno-edukiera arrainena baino askoz txikiagoa da: %5ekoa zefalopodoena eta %10ekoa arrainena. Horren ondorioz, arrainek zefalopodoek baino askoz oxigeno gehiago eskura dezakete kanpo-mediotik, bi aldiz gehiago, zehatzagoak izateko.

Zefalopodoen arnas pigmentua hemozianina da, eta arrainena hemoglobina. Arrainek globulu gorrietan gordetzen dute, baina zefalopodoek plasman disolbatuta daramate. Hori dela eta, zefalopodoek ezin dute hemozianina-kontzentrazio altuagorik izan; pigmentua plasman disolbatuta egonik, haren kontzentrazioa handituko balitz odolaren biskositatea gehiegizkoa izango litzateke.

Laburtuz, arrainek garatu zuten igeri egiteko modua, batetik ,eta arnas pigmentuaren ezaugarriak, bestetik, horiek biak izan omen ziren ozeanoetako harrapari nagusi gisa gailendu ahal izateko gakoak.

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso du.

The post Arrainak vs. zefalopodoak appeared first on Zientzia Kaiera.

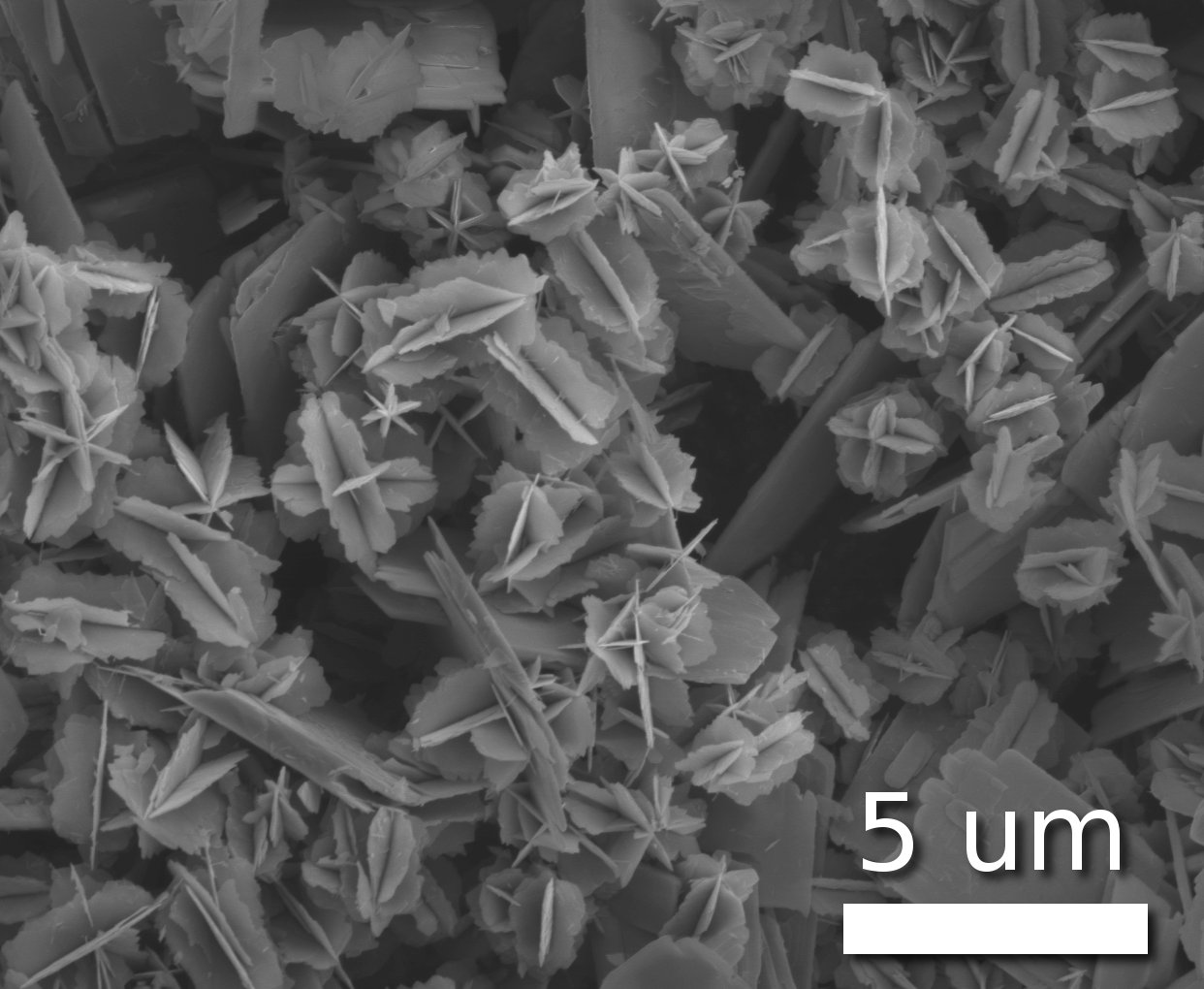

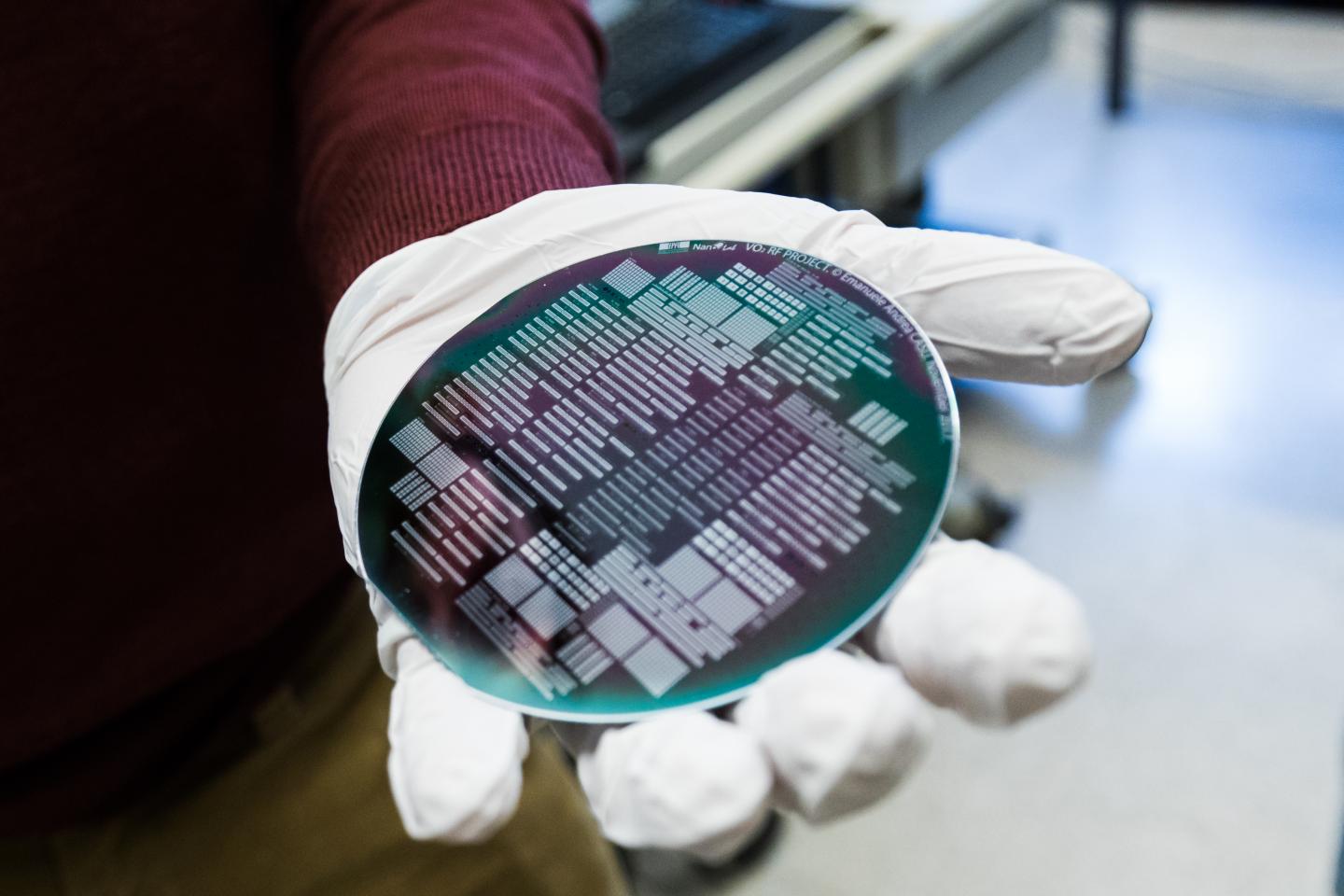

Óxido de vanadio (IV), un material para una revolución de ciencia ficción

Nanoestrellas de óxido de vanadio (IV)

Primero vino el interruptor. Luego el transistor. Ahora otra innovación puede revolucionar la forma en que controlamos el flujo de electrones a través de un circuito: el óxido de vanadio (IV), de fórmula VO2. Una característica clave de este compuesto es que se comporta como un aislante a temperatura ambiente, pero como un conductor a temperaturas superiores a 68 °C. Este comportamiento, también conocido como transición de aislante de metal, podría ser muy útil para una variedad de aplicaciones nuevas y emocionantes.

Los científicos conocen desde hace mucho tiempo las propiedades electrónicas del VO2, pero no han podido explicarlas hasta ahora. Resulta que su estructura atómica cambia de fase a medida que aumenta la temperatura, pasando de una estructura cristalina a temperatura ambiente a una metálica, a temperaturas superiores a 68 ° C.

Lo verdaderamente interesante es que esta transición ocurre en menos de un nanosegundo, algo que lo hace muy útil para aplicaciones electrónicas. No solo eso, además de a la temperatura, resulta que el VO2 también es sensible a otros factores que podrían hacer que cambie de fase, como la inyección de energía eléctrica, determinadas iluminaciones, o la aplicación de un pulso de radiación de terahercios (en el límite entre microondas e infrarrojo). Todo ello implica que el consumo energético del interruptor es minúsculo.

Contrariamente a lo que podamos suponer, 68ºC es una temperatura de transición demasiado baja para la electrónica de los dispositivos actuales, donde los circuitos funcionan sin problemas a unos 100 ºC. Una solución a este problema la propusieron investigadores de la Escuela Politécnica Federal de Lausana (Suiza) en julio de 2017 que consistía en añadir germanio a una lamina de VO2. Simplemnete con esto la transición pasaba a ocurrir a 100 ºC.

Un chip basado en dióxido de vanadio (IV) fabricado en la Escuela Politécnica Federal de Lausana. Imagen: EPFL / Jamani Caillet

Solucionado este problema, investigadores del mismo grupo suizo, que incluye a la ingeniera española Montserrat Fernández-Bolaños, han sido capaces de fabricar por primera vez filtros de frecuencia modulables ultracompactos. Esta tecnología hace uso de las características de interruptor por cambio de fase del VO2 y es especialmente eficaz en un rango de frecuencias que es crucial para las comunicaciones espaciales, la llamada banda Ka. Esta banda es la que se emplea, por ejemplo, para la descarga de datos científicos del telescopio espacial Kepler y es la que se usará en telescopio espacial James Webb. Los filtros pueden programarse para modular entre los 28,2 y los 35 GHz.

Estos primeros resultados es muy posible que estimulen la investigación de las aplicaciones del VO2 en dispositivos electrónicos de potencia ultrabaja. Además de las comunicaciones espaciales que mencionábamos, otras posibilidades podrían ser la computación neuromórfica (computación basada en circuitos analógicos que simulan estructuras neurobiológicas) y los radares de alta frecuencia para automóviles autónomos.

Referencia:

E. A. Casu , A. A. Müller, M. Fernández-Bolaños et al (2018) Vanadium Oxide bandstop tunable filter for Ka frequency bands based on a novel reconfigurable spiral shape defected ground plane CPW IEEE Access doi: 10.1109/ACCESS.2018.2795463

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Óxido de vanadio (IV), un material para una revolución de ciencia ficción se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Siligrafeno, ¿el material para la revolución optoelectrónica?

- Un equipo de alta fidelidad de ciencia ficción

- Ciencia para todos a través del cine y la literatura de ciencia ficción

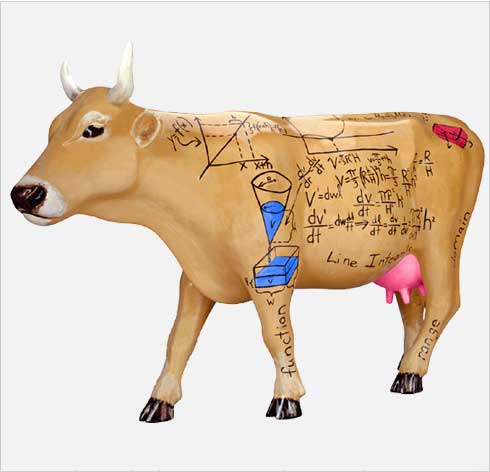

Las vacas de Narayana, la versión hindú de los conejos de Fibonacci

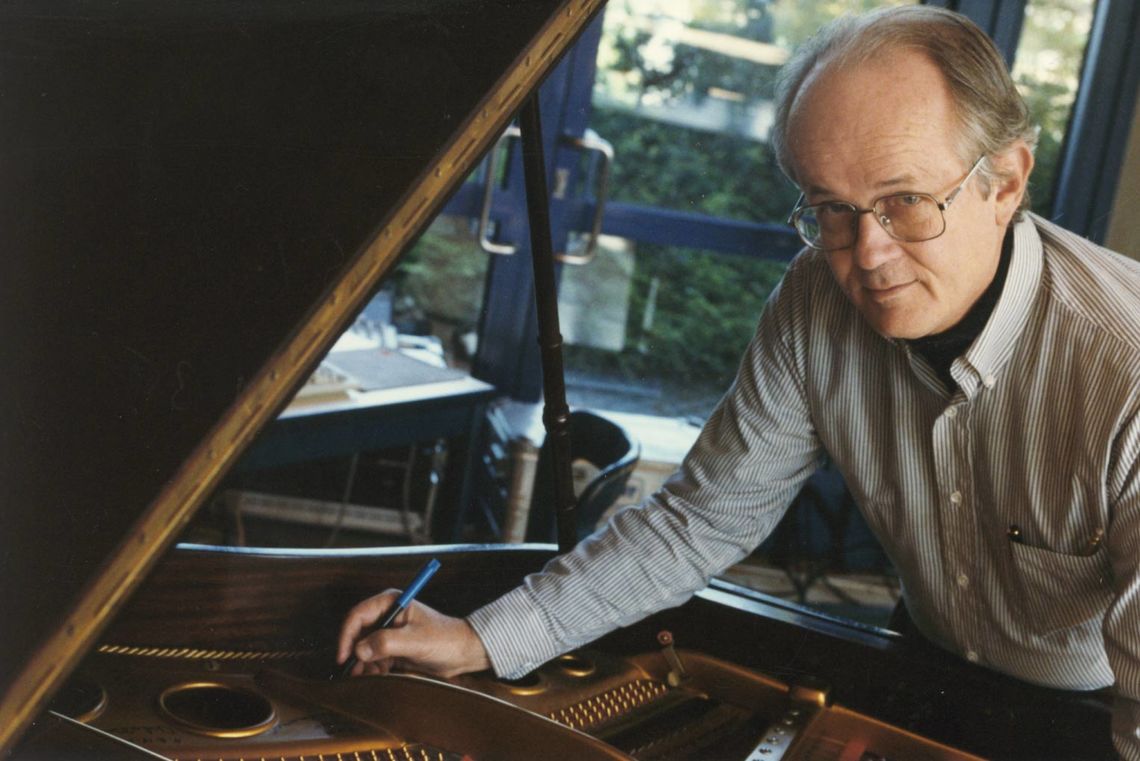

En octubre de 2002, el compositor minimalista norteamericano Tom Johnson visitó la Universidad del País Vasco/Euskal Herriko Unibertsitatea. Durante dicha visita Tom Johnson ofreció dos interesantes seminarios sobre su forma de componer utilizando las matemáticas y se organizaron algunos conciertos. Una de las composiciones musicales que tuve el placer de escuchar entonces fue Las vacas de Narayana (1989), interpretada por los miembros del grupo Kuraia Ensemble (Asociación de Música Contemporánea del País Vasco), Andrea Cazzaniga (violín), Rafael Climent (clarinete) e Iñigo Ibaibarriaga (saxofón).

El compositor minimalista norteamericano Tom Johnson preparando el instrumento para ejecutar la obra “Galileo” (2001), que estrenó en la Facultad de BBAA de la UPV/EHU en 2002

Para componer la obra Las vacas de Narayama, Tom Johnson se basó en el problema homónimo propuesto por el matemático indio Narayana Pandita (1340-1400) en su tratado de aritmética Ganita Kaumudi (1356). Una de las cuestiones estudiadas por Narayana Pandita en esta obra fueron las sucesiones que él llamó “aditivas”, entre las que se encuentra la que nosotros conocemos como sucesión de Fibonacci.

El problema de las vacas de Narayana dice lo siguiente:

Si las vacas tienen una cría cada año, y cada ternera, después de los tres años que necesita para convertirse en una vaca madura, tiene una cría a principio de cada año, ¿cuántas vacas habrá después de 20 años a partir de una primera ternera?

El proyecto artístico “CowParade” es un proyecto internacional que se ha desarrollado en muchas ciudades del mundo, entre ellas Bilbao, Barcelona o Madrid. La vaca “cowculus” fue exhibida en Kansas city (EE.UU.)

Si empezamos con una ternera recién nacida, a principios de año, durante los tres primeros años solamente tendremos una (1) vaca, esa primera ternera. El cuarto año empezará realmente a crecer la población bovina, con la vaca inicial y su primera ternera, luego dos (2) vacas en total. Habrá una ternera más al principio de cada uno de los dos siguientes años, luego tres (3) el quinto año y cuatro (4) el sexto. Al inicio del séptimo, la primera ternera nacida de la vaca original ya puede tener también terneras, por lo que ese año habrá dos vacas adultas y cuatro terneras, en total, seis (6) vacas. El siguiente año una nueva ternera pasa a la madurez y tres vacas tienen una ternera cada una, luego en total hay tres vacas maduras y seis terneras, luego nueve (9) vacas. Al inicio del noveno año, habrá trece (13) vacas, cuatro adultas y nueve terneras. En el siguiente gráfico hemos representado la evolución de vacas en esos nueve primeros años.

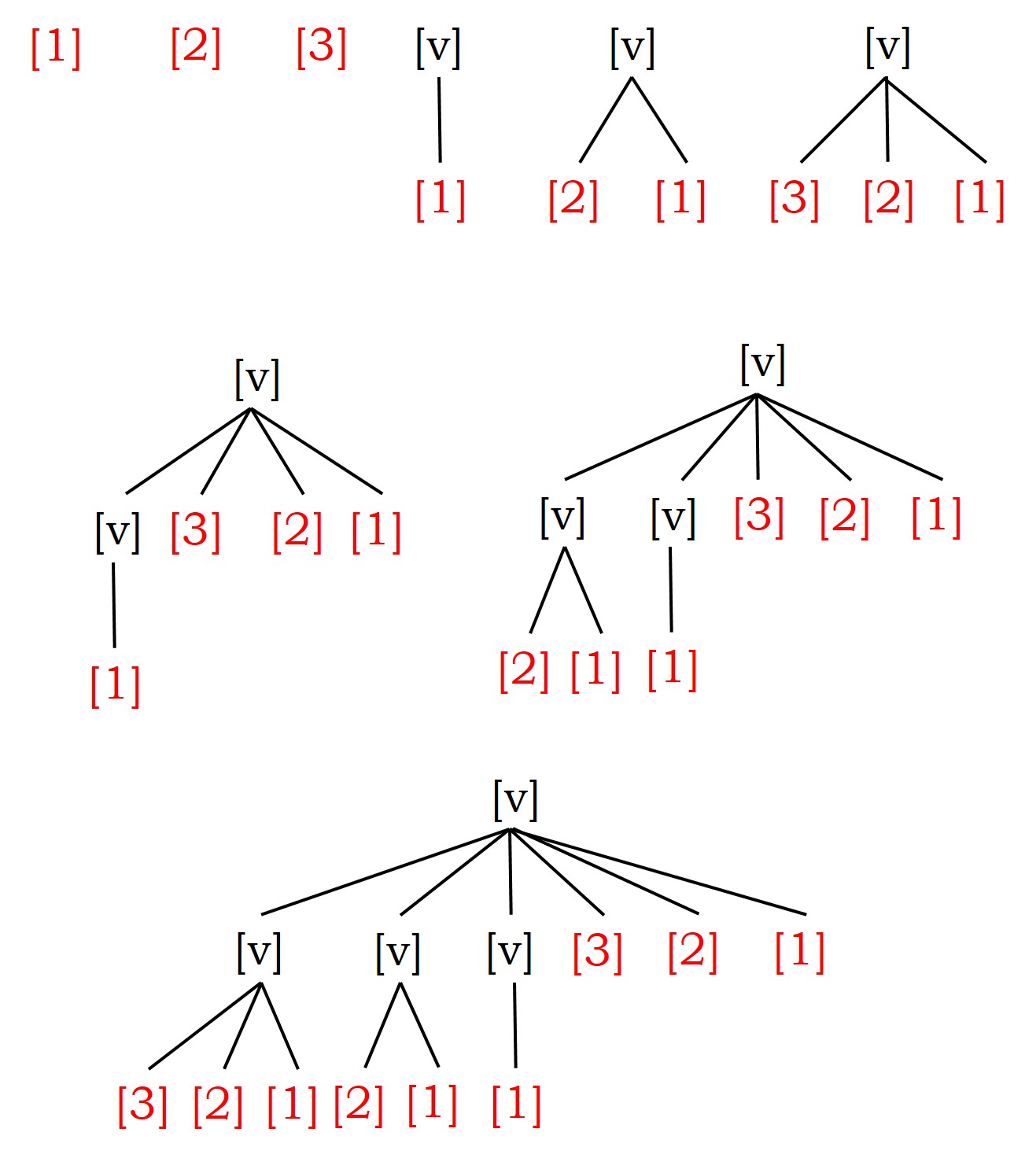

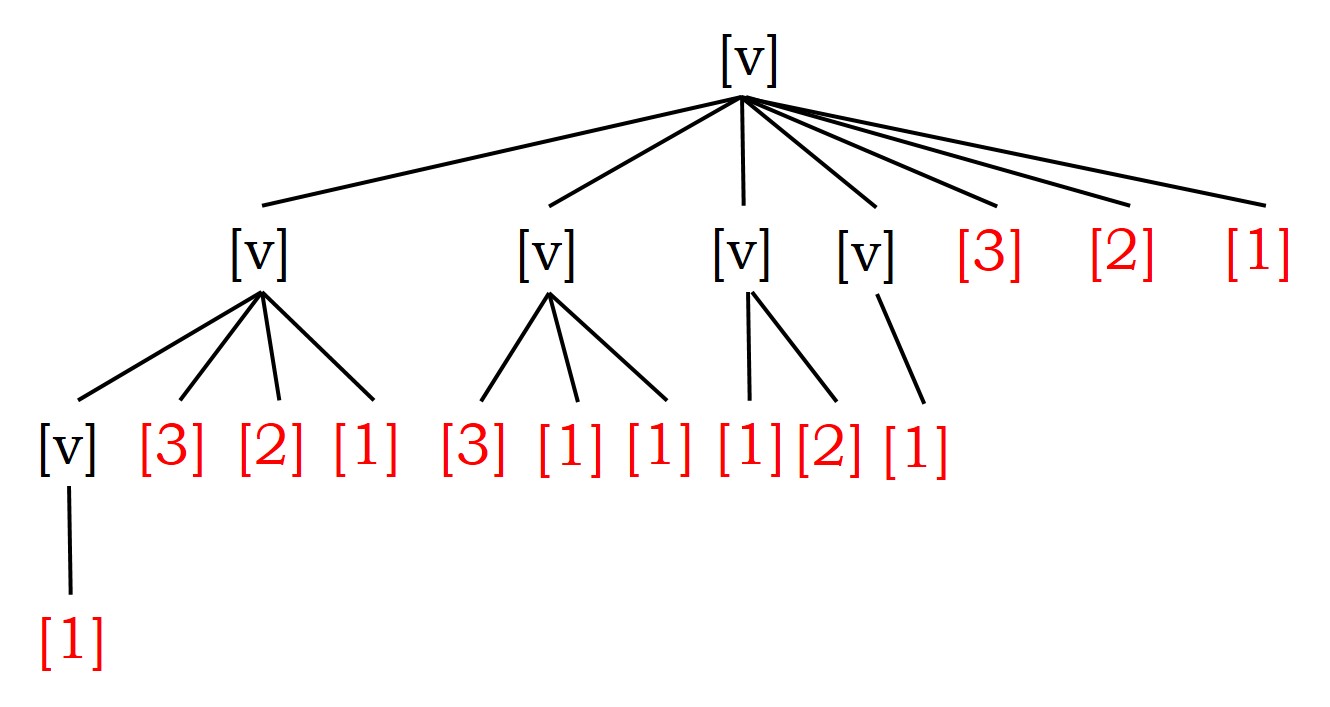

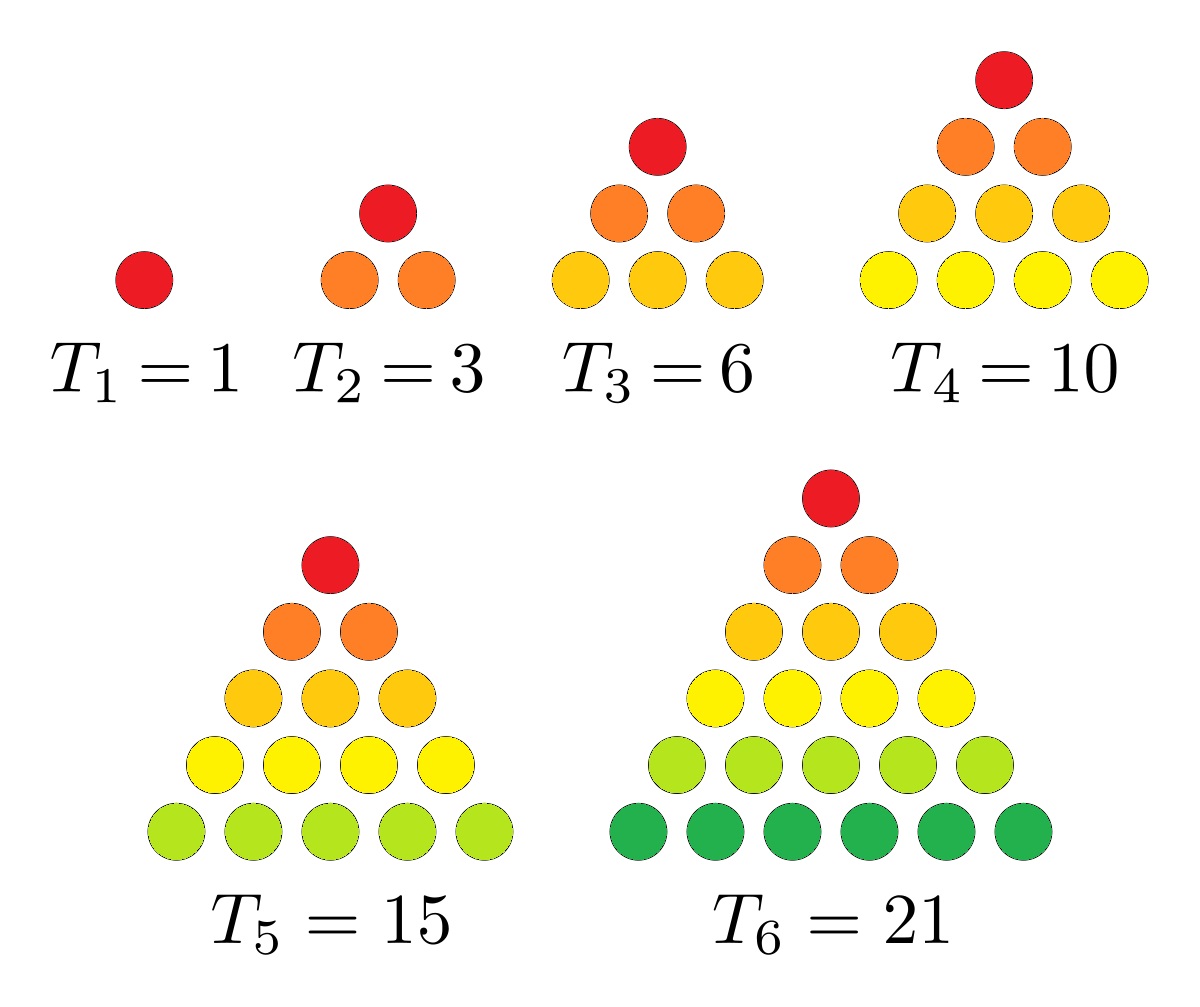

Gráfico del problema de las vacas de Narayana en los nueve primeros años

Pero continuemos… ¿cuántas vacas habrá el décimo año? Estarán las que ya estaban el año anterior, es decir, trece (13) vacas, más las terneras de las vacas que ese año pueden tener crías, que son exactamente las vacas que había hace tres años, seis (6) vacas, en total, diecinueve (13 + 6 = 19) vacas. Como se ve en el siguiente gráfico, seis son vacas maduras y trece son terneras, pero también podemos numerarlas por generaciones, la vaca original es la primera generación, hay siete vacas de la segunda generación, diez de la tercera y una de la cuarta.

Gráfico del problema de las vacas de Narayana en el décimo año

El razonamiento que hemos realizado para obtener el número de vacas al inicio del décimo año es, de hecho, general y realmente nos da una fórmula recursiva para resolver el problema de las vacas de Narayana. Si se denota por v(n) el número de vacas que habrá en el año n, entonces

v(n) = v(n – 1) + v(n – 3),

siendo además, v(1) = v(2) = v(3) = 1.

Por lo tanto, se pueden obtener fácilmente los primeros veinte números de la sucesión de vacas de Narayana,

1, 1, 1, 2, 3, 4, 6, 9, 13, 19, 28, 41, 60, 88, 129, 189, 277, 406, 595, 872, …

Luego, después de veinte años, es decir, al inicio del año veintiuno, habrá 406 + 872 =1.278 vacas.

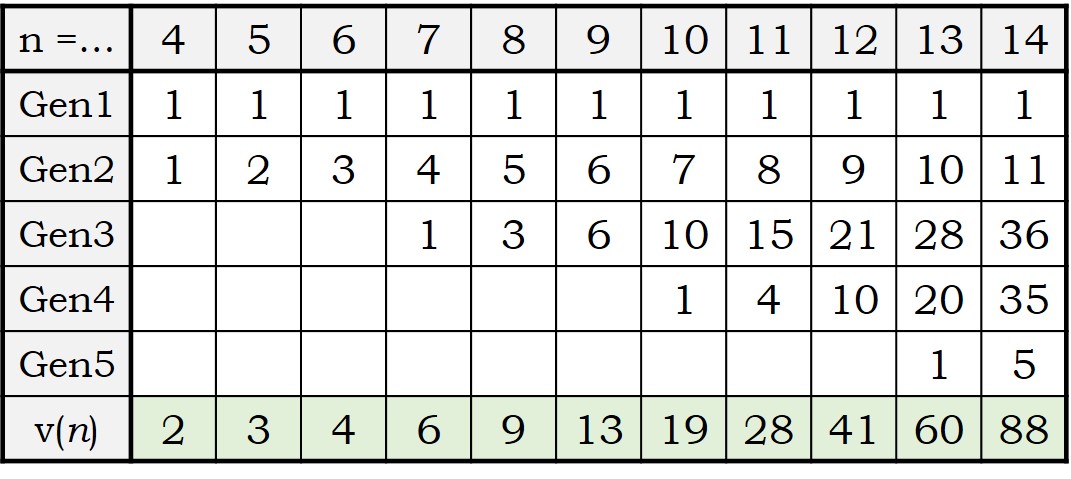

Incluso, podemos hacer una tabla de la sucesión de vacas de Narayana, viendo las vacas que hay de cada generación.

Observando esta tabla con los primeros años ya podemos extraer algunas curiosas conclusiones. Por ejemplo, el número de vacas de la segunda generación son los números naturales, puesto que son las vacas que van naciendo de la vaca original, y cada año tiene una nueva ternera, luego cada año una más, 1, 2, 3, 4, 5, …

En la tercera generación se obtienen los números triangulares, ya que son las sumas de los primeros números naturales, puesto que son las vacas descendientes de las de la generación anterior. Por ejemplo, en el décimo año hemos visto que el número de vacas de la segunda generación eran 1 + 2 + 3 + 4 = 10. Recordemos que los números triangulares T(n), que se llaman así puesto que son los que se obtienen al colocar piedras o discos circulares formando un triángulo equilátero (como se ve en la imagen siguiente), son aquellos que son la suma de los primeros números naturales, T(n) = 1 + 2 + 3 + … + (n – 1) + n.

: Los números triangulares son aquellos que son la suma de los primeros números naturales, 1, 1 + 2 = 3, 1 + 2 + 3 = 6, 1 + 2 + 3 + 4 = 10, 1 + 2 + 3 + 4 + 5 = 15, 1 + 2 + 3 + 4 + 5 + 6 = 21,…

Por el mismo motivo, las vacas de la cuarta generación serán los llamados números tetraédricos, 1, 4, 10, 20, 35, … ya que serán las sumas de los primeros números triangulares, los que aparecen en la tercera generación. Recordemos que los números tetraédricos son el número de bolas que hay en una pirámide triangular (como la de la imagen), es decir, un tetraedro, y que es igual a la suma de los primeros números triangulares, TT(n) = T(1) + T(2) + … + T(n).

Los números tetraédricos son aquellos que son la suma de los primeros números triangulares, 1, 1 + 3 = 4, 1 + 3 + 6 = 10, 1 + 3 + 6 + 10 = 20, 1 + 3 + 6 + 10 + 15 = 35, … Imagen de cults3d.com

Dejemos por un momento la sucesión de las vacas de Narayana y volvamos a la composición musical basada en este problema. Pero antes presentemos brevemente a su autor, el compositor Tom Johnson.

El compositor norteamericano Tom Johnson

Tom Johnson (Greeley, Colorado, EE.UU.), es un compositor minimalista y teórico de la música estadounidense. Se graduó en la Universidad de Yale, donde obtuvo además su grado avanzado en música. Fue alumno del compositor Morton Feldman (1926-1987), uno de los artífices, junto con John Cage (1912-1992), de la música aleatoria.

Es un compositor minimalista, ya que trabaja con formas simples, escalas limitadas y de manera general, con material reducido. Y dentro del minimalismo destaca por el uso de las matemáticas en el proceso creativo. Fórmulas matemáticas, trigonometría, simetrías, teselaciones, combinatoria, sucesiones de números enteros, teoría de números o fractales, son algunas de las teorías matemáticas que utiliza en sus composiciones.

Tom Johnson ha escrito de su música: “quiero encontrar la música, no componerla”, o como decía su maestro Morton Feldman “Deja a la música hacer lo que quiere hacer”. Mientras John Cage, o Morton Feldman, realizan esta búsqueda mediante el azar, Tom Johnson lo hace mediante las matemáticas.

Entre sus obras encontramos óperas como Riemannoper (1988), Trigonometría (1997) o la más famosa La ópera de las cuatro notas (1972), que fue representada en España en 2015 por Vania Produccions bajo la dirección de Paco Mir (que muchos conoceréis por ser uno de los miembros del trío Tricicle) o composiciones musicales muy creativas e interesantes, como Nueve campanas (1973), Simetrías (1981), Melodías Racionales (1982), Melodías infinitas (1986), Música para 88 (1988), Las vacas de Narayana (1889), Galileo (2001), Mosaicos (2002), o Ritmos de Vermont (2008), entre muchas otras.

Ha escrito libros como la colección de artículos de crítica musical The voice of the new music (Apollohuis, 1989), Self-similar Melodies (Editions 75, 1996) o Looking at numbers (Birkhauser, 2014).

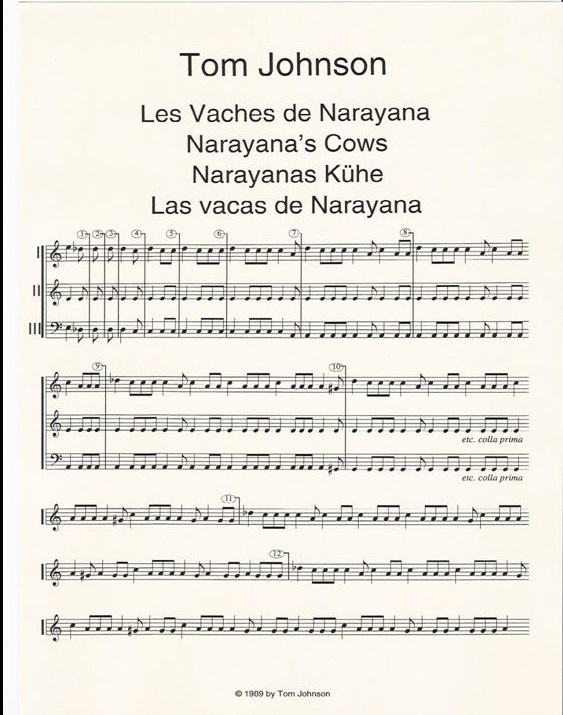

En la composición musical Las vacas de Narayana, Tom Johnson realiza en esta obra una demostración musical del problema matemático. Para ello, divide la pieza en diferentes partes, cada una de las cuales se corresponde con un año del problema de las vacas, y en cada una de esas piezas hay tantas notas como el número de vacas que hay ese año, siendo una nota larga para cada vaca madura y una nota corta para cada ternera.

Aunque antes de seguir hablando de esta composición, lo que debemos hacer es escucharla. Esta pieza está incluida en el álbum Kentzy plays Johnson (2004), con el saxofonista Daniel Kientzy y en el álbum Cows, Chords and Combinations (2011), del grupo Ensemble Klang. Os traemos aquí dos conciertos que están en youtube. Uno es un concierto en Toronto en 2010, organizado por Continuum Contemporary Music.

mientras que el otro es un concierto en 2014, en el Switchboard Music Festival

Como hemos podido observar los conciertos empiezan en el cuarto año, cuando la vaca original tiene su primera ternera. Además, Tom Johnson distribuye las notas largas y cortas, que se corresponden con vacas maduras y terneras en la composición, siguiendo unas estructuras de árbol similares a los que hemos incluido más arriba para los diez primeros años del problema, y leyendo las vacas que hay, de arriba hacia abajo y de derecha a izquierda en esos diagramas de tipo árbol.

Por ejemplo, si escuchamos (o leemos la partitura, cuya primera página hemos incluido más abajo) la sucesión de notas que se corresponde con el quinto año del concierto (el octavo en el problema entero de las vacas de Narayana, o también en la partitura escrita) y miramos al diagrama de árbol de ese año, observaremos que las notas serán

larga – corta – corta – corta – larga – corta – larga – corta – corta

Primera página de la partitura de “Las vacas de Narayana” (1989), de Tom Johnson

Cuando se escucha la obra de Tom Johnson, los primeros años de la composición musical sirven para entender el problema de las vacas de Narayana y la forma en la que el compositor asocia las notas musicales con las vacas maduras y crías, mientras que según van pasando los años vamos percibiendo la estructura, que surge a partir del problema matemático, de la composición musical.

Regresemos de nuevo a las matemáticas de la sucesión numérica de las vacas de Narayana. Es un hecho muy conocido, tanto en la literatura matemática, como por las personas interesadas en la sucesión de Fibonacci (véase alguno de los libros titulados La proporción áurea, de Mario Livio o Fernando Corbalán), que si se toma el cociente entre dos miembros consecutivos de la sucesión de Fibonacci F(n + 1) / F(n), esta sucesión de cocientes, converge (al ir aumentando n) a la proporción áurea, phi = 1,6180339…

1/1 = 1; 2/1 = 2; 3/2 = 1,5; 5/3 = 1,666…; 8/5 = 1,6; 13/8 = 1,625; 21/13 = 1,615…; 34/21 = 1,619…; 55/33 = 1,617…; etc…

¿Ocurrirá algo similar si tomamos la sucesión de los cocientes de números consecutivos de la sucesión de las vacas de Narayana? La respuesta es afirmativa, como vamos a ver a continuación.

Empezamos en la fórmula recursiva de la sucesión de vacas de Narayana

v(n + 1) = v(n) + v(n – 2),

a la que le dividimos por v(n) y además, en el último sumando, multiplicamos y dividimos por v(n – 1), para obtener la expresión

v(n + 1) / v(n) = 1 + v(n – 2) / v(n – 1) × v(n – 1) / v(n).

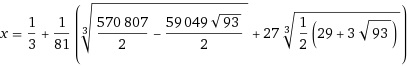

Si llamamos κ al límite, cuando n tiene de infinito, del cociente v(n + 1) / v(n), la anterior expresión nos dice que κ satisface la ecuación de tercer grado κ 3 – κ 2 – 1 = 0, que podemos llamar la ecuación de Narayana. Esta ecuación tiene tres soluciones, dos de ellas imaginarias, y la solución real que buscamos es (calculada con WolframAlfa)

Aproximadamente, κ = 1,46557123187676802665673… que podríamos llamar la proporción de Narayana.

Kodhai. Vaca rescatada del Santuario Dakshin Vrindavan, de la artista Charlotte Gerrard

Vamos a terminar esta entrada del Cuaderno de Cultura Científica mostrando algunas caracterizaciones interesantes de la sucesión de vacas de Narayana.

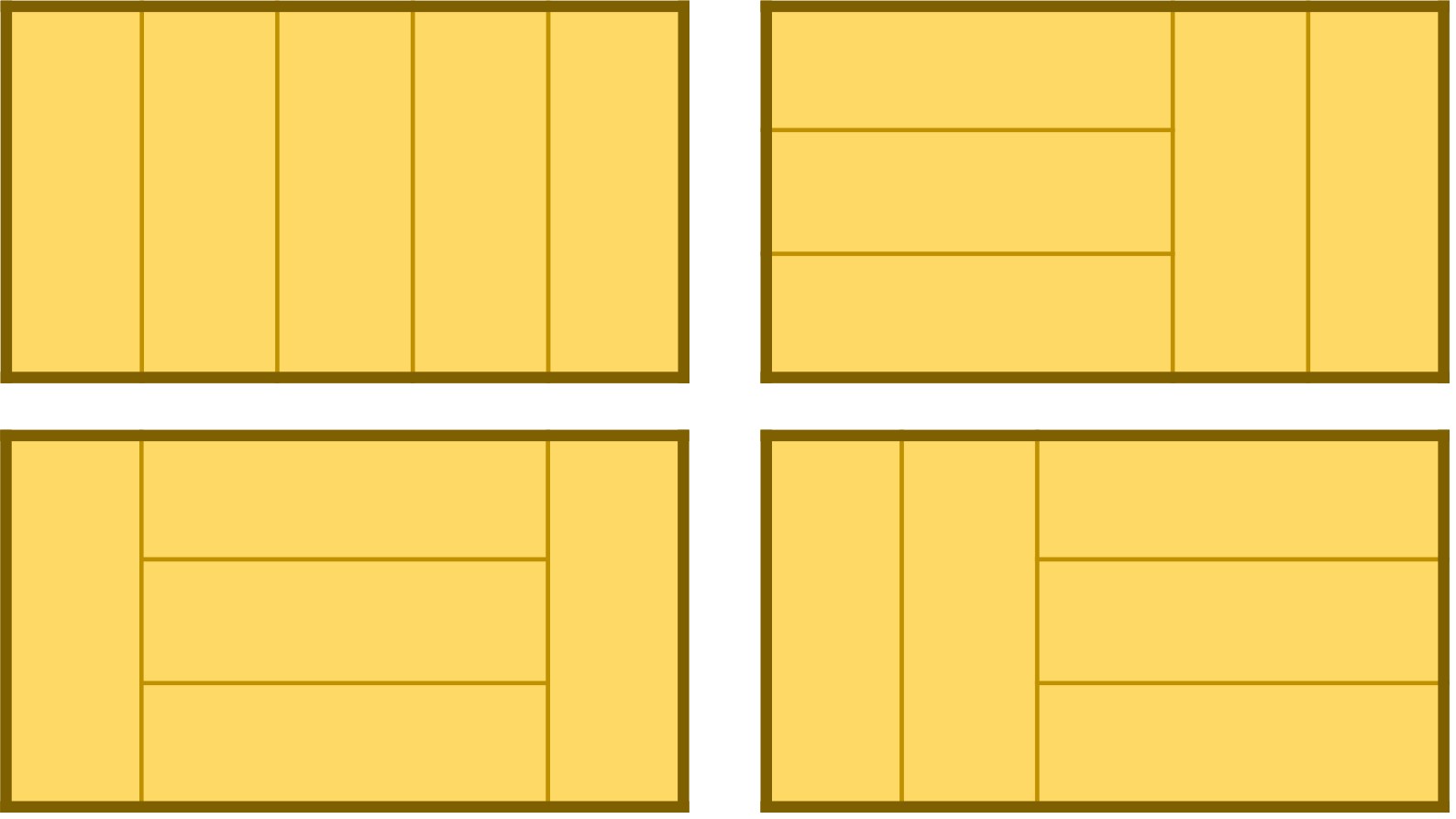

A. Número de embaldosados con triominós rectos de rectángulos 3 × (n – 1).

Consideremos un rectángulo de tamaño 3 × (n – 1), como el que aparece en la imagen de abajo (ese en particular es de tamaño 3 × 5), entonces el número v(n) de la sucesión de vacas de Narayana para el año n, es igual a la cantidad de embaldosados posibles con triominós rectos, fichas de tamaño 1 × 3, también llamados I-triominós (véase la entrada Embaldosados con L-triominós (un ejemplo de demostración por inducción) [https://culturacientifica.com/2014/07/16/embaldosando-con-l-triominos-un-ejemplo-de-demostracion-por-induccion/]), es decir, el número de diferentes maneras que hay de colocar triominós rectos en el rectángulo 3 × (n – 1).

El número de vacas del sexto año, v(6), es 4, al igual que el número de embaldosados con triominós rectos del rectángulo 3 × 5

Esta caracterización es una versión geométrica del siguiente resultado de la Teoría de números relacionado con las particiones de los números.

B. Número de composiciones del número n – 1, con el 1 y el 3.

Recordemos primero dos conceptos básicos de la Teoría de números, como son las particiones y las composiciones. Una partición de un número entero positivo es una forma de expresarlo como suma de números enteros positivos, donde el orden no es relevante. Por ejemplo, el número 3 puede expresarse como suma de tres formas distintas {1 + 1 + 1, 2 + 1, 3}, mientras que existen cinco particiones del número 4 {1 + 1 + 1 + 1, 2 + 1 + 1, 2 + 2, 3 + 1, 4}. Si se denota por p(n) el número de particiones de n, entonces p(3) = 3 y p(4) = 5.

Si en las particiones se tuviera en cuenta el orden, se obtendrían las composiciones, o particiones ordenadas, que se denotan c(n). Así, las particiones ordenadas de 4 son: {1 + 1 + 1 + 1, 2 + 1 + 1, 1 + 2+ 1, 1 + 1 + 2, 2 + 2, 3 + 1, 1 + 3, 4}. Luego, c(4) = 8, mientras que p(4) = 5.

La sucesión de números de Narayama, al igual que la de Fibonacci (véase, por ejemplo, el libro Cayley, el origen del álgebra moderna), se puede relacionar con ciertos tipos de composiciones de números. En particular, la anterior caracterización geométrica es equivalente a que el número v(n) de la sucesión de vacas de Narayana para el año n, es igual al número de composiciones del número n – 1 con únicamente los números 1 y 3. Así, como las composiciones, con 1 y 3, de 6 son {1+1+1+1+1+1, 1+1+1+3, 1+1+3+1, 1+3+1+1, 3+1+1+1, 3+3}, entonces v(7) = 6.

C. Número de formas de colocar n – 2 alfombras tatami en una habitación de tamaño 2 × (n – 2), sin que los vértices de 4 alfombras coincidan.

Recordemos que las alfombras tatami de las casas tradicionales japonesas tienen una relación de tamaño de 1 × 2.

Una distribución de alfombras tatami en una habitación de tamaño 2 × 7

Una distribución no válida de alfombras tatami, ya que los vértices de cuatro alfombras coinciden, en una habitación de tamaño 2 × 7

Existen 13 formas de cubrir una habitación de tamaño 2 × 7 con alfombras tatami, sin que coincidan las esquinas de cuatro de ellas, que es exactamente el número v(9). De hecho, esas 13 maneras pueden describirse de la forma 1111111, 111112, 111121, 111211, 112111, 121111, 211111, 11212, 12112, 21112, 12121, 21121, 21211.

Si lo pensamos un momento, la descripción con 1 y 2 de colocar las alfombras tatami (1 para las verticales, 2 para las horizontales) nos está diciendo realmente que podemos describir el número de la sucesión de vacas de Narayana v(n) como las composiciones de n – 2 con tan solo los números 1 y 2, pero sin que haya dos 2 juntos.

D. Número de composiciones del número n – 2, con el 1 y el 2, sin que haya dos 2 juntos.

Como despedida de esta entrada otra pieza del compositor minimalista norteamericano Tom Johnson, la primera de sus melodías racionales, en mi opinión una hermosa pieza, interpretada por el Gruppo di Musica Contemporanea Steffani, en el Conservatorio Steffani, de Castelfranco Veneto (Italia), en 2009.

Portada del disco Rational Melodies/Bedtime stories, de Tom Johnson, con Roger Heaton al clarinete. El diseño de la portada es la obra de Esther Ferrer, “Project Drawing With Prime Number Series, Spiraling Out From 19.000.041”

Bibliografía

1.- Página web de Editions 75

2.- Tom Johnson, Kientzy plays Johnson (álbum), 2004.

3.- Jean-Paul Allouche, Tom Johnson, Narayana’s Cows and Delayed Morphisms, Cahiers du GREYC Troisiemes Journées d’Informatique Musicale (JIM 96) 4, p. 2-7, 1996.

4.- Parmanand Singh, The so-called Fibonacci Numbers in Ancient and Medieval India, Historia Mathematica 12, p. 229-244, 1985.

5.- Krishnamurthy Kirthi, Subhash Kak, The Narayana Universal Code, ArXiv, 2016.

6.- Tom Johnson, Self-Similar Melodies, Editions 75, 1996.

7.- Tom Johnson, Looking at numbers, Birkhäuser, 2014.

8.- Fernando Corbalán, La proporción áurea, El lenguaje matemático de la belleza, RBA, 2010.

9.- Mario Livio, La proporción áurea, La historia de phi, el número más sorprendente del mundo, Ariel, 2006.

10.- Página web de la artista Charlotte Gerrard

11.- N. J. A. Sloane, La sucesión de vacas de Narayana, A000930 [https://oeis.org/A000930], Enciclopedia on-line de sucesiones de números enteros.

12.- Raúl Ibáñez, Cayley, el origen del álgebra moderna, colección Genios de las matemáticas, RBA, 2017.

13.- Frank Ruskey, Jennifer Woodcock, Counting Fixed-Height Tatami Tilings, The Electronic Journal of Combinatorics 16, 2009.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Las vacas de Narayana, la versión hindú de los conejos de Fibonacci se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un rebaño de vacas pastando como sistema complejo

- Los números (y los inversos) de Fibonacci

- #Naukas14 ¿Por qué explota una granja de vacas?

Faltsutzeei aurre egiteko, lur arraroetan oinarritutako kodetze sistema

Behin baino gehiagotan agertu da gaiaren inguruko kezka: konputazio kuantikoa garatzen den heinean, gero eta errazagoa izango omen da kodeak apurtzea. Azken hamarkadetan eratu den informazioaren gizarteak kode horien beharra du. Izan ere, ia dena lotuta dago Internetera eta sarearen bitartez egiten diren operazioek gutxienezko segurtasuna behar dute. Batzuek diote, ordea, konputazio kuantikoak ere kode hobeagoak ezartzeko bidea emango duela… arrautza ala oiloa, nor ote aurrena?

Informazioa lapurtzeaz gain, produktuak faltsutzeko lehia ere abian da aspalditik. Teknologiak halako iruzurrak sortzeko aukera errazten du. Batzuetan enpresek baino ez dute jasaten kalte ekonomikoa, baina, beste zenbaitetan kontsumitzaileentzako arriskua ere egon daiteke tartean. Adibidez, faltsututako botiken kasuan.

Lehia teknologiko hau argitzen den bitartean, zientzialariek fisika eta kimika elkartzen diren eremu oparoan jarraitzen dute ikertzen; tartean, kode ziurragoak lortzeko ahaleginetan. Norabide horretan, Kopenhageko Unibertsitateko (Danimarka) ikertzaileek aurkeztu dute azken aurrerapena, Science Advances aldizkarian argitaratutako artikulu baten bitartez.

1. irudia: Hasierako probak egiteko erabilitako txartelak. Bakoitzean 200 kode sartzeko aukera dago (Argazkia: Kopenhageko Unibertsitatea)

Sistemaren oinarria lur arraroen bitartez margotutako hondar aleetan datza. Argi mota berezi baten aurrean jartzen direnean, hondar ale horiek kitzikatuak izaten dira, eta argi kode berezia, ia-ia bakarra, sortzen dute. Kontuaren koska, noski, hondar aleen antolaketan datza eta baita espektroskopia bidezko irakurketan.

Taula periodikoan, lur arraroek lantanidoen taldea osatzen dute. Azken urteetan asko erabiltzen ari dira industrian, bereziki elektronikaren alorrean.

Horrelako kode bat sortzeko, ikertzaileek honako prozesua erabiltzen dute: hondar lagin handi bat hartu, eta hondarra hiru hobi desberdinetan banatzen dute. Ondoren, hodi bakoitzean lur arraro zehatz bat sartzen dute: Europioa, Terbioa eta Disprosioa.

Modu horretan, hondar ale bakoitza lur arraro batekin “margotuta” gelditzen da (edo dopatuta, kimikarien hizkera erabilita). Behin hori eginda, hiru laginak nahasten dituzte, eta euskarri batean, bildu dituzten hondar aleekin osatutako geruza fin bat osatzen dute. Uhin-luzera zehatza duen argia jasotzean, lur arraro bakoitzak argia modu desberdinean islatzen du. Hortaz, azalera txiki horrek berezko argi marka berezia izango du. Marka hori irakurtzeko, hiru laser ezberdin dituen gailu bat erabiltzen da. Bakoitzak era selektiboan kitzikatzen ditu lur arraroetako ioiak. Era horretan, ausazko patroi bat sortzen da hondarrez betetako gailuaren azaleran. Kitzikapen horren atzean eratzen den argiaren marka jasotzen da ondoren eta datu-base batean gordetzen da. Produktuaren fabrikatzaileak baino ez du izango datu hori; nahi izanez gero, produktua saltzaileak aukera izango du alderatzeko bere saltokian dagoen produktua benetan fabrikatzaile ofizialak ekoiztu ote duen ala norbaitek ziria sartu dion. Produktu bakoitzak kode bakarra izango du, beraz.

Antzeko bidea jorratu izan diren aurreko teknikekin alderatuz, prozesu berriaren abantailak nabarmendu dituzte ikerketa artikuluan. “Lantanidoetan oinarritutako koloratzaileak guztiz fotoegonkorrak dira, eta argia xurgatzen eta igortzen dute oso ondo zehaztuta dauden espektro elektromagnetikoko eremuetan”.

Diotenez, “hackeatu” ezin den segurtasun neurria da asmatutakoa. Kopenhageko Unibertsitateko ikertzaile Thomas Just Sørensen-en esanetan “munduko ziurrena” litzateke honakoa. Praktikan, eta estatistikaren arabera, marka hori ia bakarra dela adierazi du ikertzaileak prentsa ohar batean. “Bi produktuk ‘hatz marka’ berdina izateko duten probabilitatea hain da txikia ezen, praktikan, existitzen ez dela esan baitaiteke”, ziurtatu du Sørensenek. Guztiz imajinaezin den probabilitate hori 1/6.10104 da, hau da, aukera bat 104 zeroz jarraitutako 6 zenbaki bakoitzeko.

2. irudia: Itxura honetakoak dira argia islatzean sortzen diren patroiak. Horietatik, hasierakoa baino ez da onargarria (Irudia: Science Advances/Kopenhageko Unibertsitatea/ moldatuta)

Bestetik, teknika hau kriptografian erabiltzeko aukera dagoela ere proposatu dute. “Patroi edo giltza digital hau erabil daiteke bai faltsutzeen kontrako giltza fisikoa egiaztatzeko edo edozein mezu enkriptatzeko ere”.

Praktikotasunari begiraUnibertsitateak sistema patentatu du jada eta, ikertzaileek egin duten aurreikuspenen arabera, urtebete barru merkatuan egon daiteke teknologia berria. Une honetan, eskanerrak hobetzeko lanean ari dira.

Zelako kostuan, ordea? Jakina da, askotan, merkatura heltzean, segurtasun neurri txukunek ez dutela arrakastarik lortzen erabilitako gailu bakoitzaren prezioa handiegia delako, babesten duen produktuaren prezioarekin alderatuz. Besteak beste, RFID teknologiaz babestutako alarmekin gertatu izan da hori. Irrati frekuentzia bidezko segurtasun gailu horiei asko kostatu zaie merkatura heltzea.

Kasu honetan, ez dirudi kostua arazo handiegia izango denik, gutxienez, euskarriari dagokionez. Produktuak markatzeko dispositiboaren kostua daniar koro bat baina pixka bat handiagoa izango dela aurreikusten dute ikertzaileek. Egun, 14 euro zentimo inguru balio du daniar koroak. Halere, produktuaren kodea irakurtzeak eta konprobatzeak guztira zenbat balioko duen kalkulatzeke dago oraindik.

Merkea izango omen den teknologia hau ausazkotasunean oinarritzen da. Ikerketa artikuluaren hasieran argitu dutenez, faltsutzeen aurka egun martxan dauden teknologia gehienak prozesu deterministetan oinarritzen dira. Horrek esan nahi du prozesuak bide jakin bat jarraitzen duela. Beraz, bide hori nolakoa den jakinda, aukera dago kodea “apurtzeko”. Horregatik nahiko erraza da, adibidez, softwarea edota WIFI sareak babesteko kodeak sortzeko algoritmoak igartzea. Danimarkako adituek aurkeztutako sistema, berriz, ez da determinista. Hasitako bideak nola jarraituko duen igartzeko modurik ez dago, erabat ausazkoa baita.

Erreferentzia bibliografikoa:

Carro-Temboury M. et al. An optical authentication system based on imaging of excitation-selected lanthanide luminescence. Science Advances 26 Jan 2018: Vol. 4, no. 1, e1701384 DOI: 10.1126/sciadv.1701384

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Faltsutzeei aurre egiteko, lur arraroetan oinarritutako kodetze sistema appeared first on Zientzia Kaiera.

Sistemas respiratorios: almacenamiento y transferencia de oxígeno

En diferentes especies animales y bajo diversas circunstancias, la transferencia de oxígeno desde el medio externo hasta su destino final en las mitocondrias se produce a través de dos pigmentos respiratorios diferentes. En tales casos, los pigmentos suelen mostrar diferente afinidad por el oxígeno y esa diferencia constituye un elemento clave de su funcionamiento. Repasaremos aquí algunos de esos sistemas pigmentarios sin ánimo de exhaustividad.

Sangre fetal y sangre materna

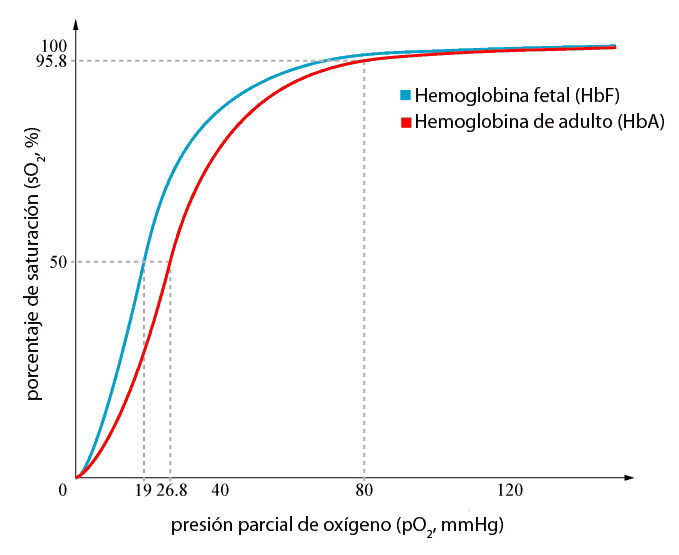

Cuando se comparan las curvas de disociación de la sangre fetal y la sangre materna en mamíferos placentarios, se observa que la curva de la sangre fetal se halla desplazada hacia la izquierda en relación con la de la sangre materna. Quiere decir que la sangre fetal tiene una mayor afinidad por el oxígeno que la materna o, lo que es lo mismo, que para una tensión parcial de oxígeno dada, la fetal se encuentra saturada en un porcentaje mayor que la sangre materna.

Esa diferencia en la afinidad obedece a dos razones. Por un lado, la hemoglobina fetal es algo diferente de la hemoglobina de los adultos, y esa diferencia determina una mayor afinidad. Y además, la concentración de fosfatos orgánicos en los eritrocitos de la sangre fetal es menor que en los de sangre de adultos, por lo que en estos el efecto de esas sustancias moduladoras es mayor. Tras el nacimiento, la hemoglobina fetal es sustituida de forma gradual por hemoglobina de adultos y en los eritrocitos tiende a elevarse la concentración de los fosfatos orgánicos.

La diferente afinidad de las dos hemoglobinas tiene una utilidad evidente para el feto, puesto que de otro modo, la transferencia de oxígeno de la sangre materna a la sangre fetal en la placenta se vería limitada en cierto grado. Y debe tenerse en cuenta que el feto, por su pequeño tamaño y por estar formado por tejidos en pleno desarrollo, tienen una alta demanda de oxígeno.

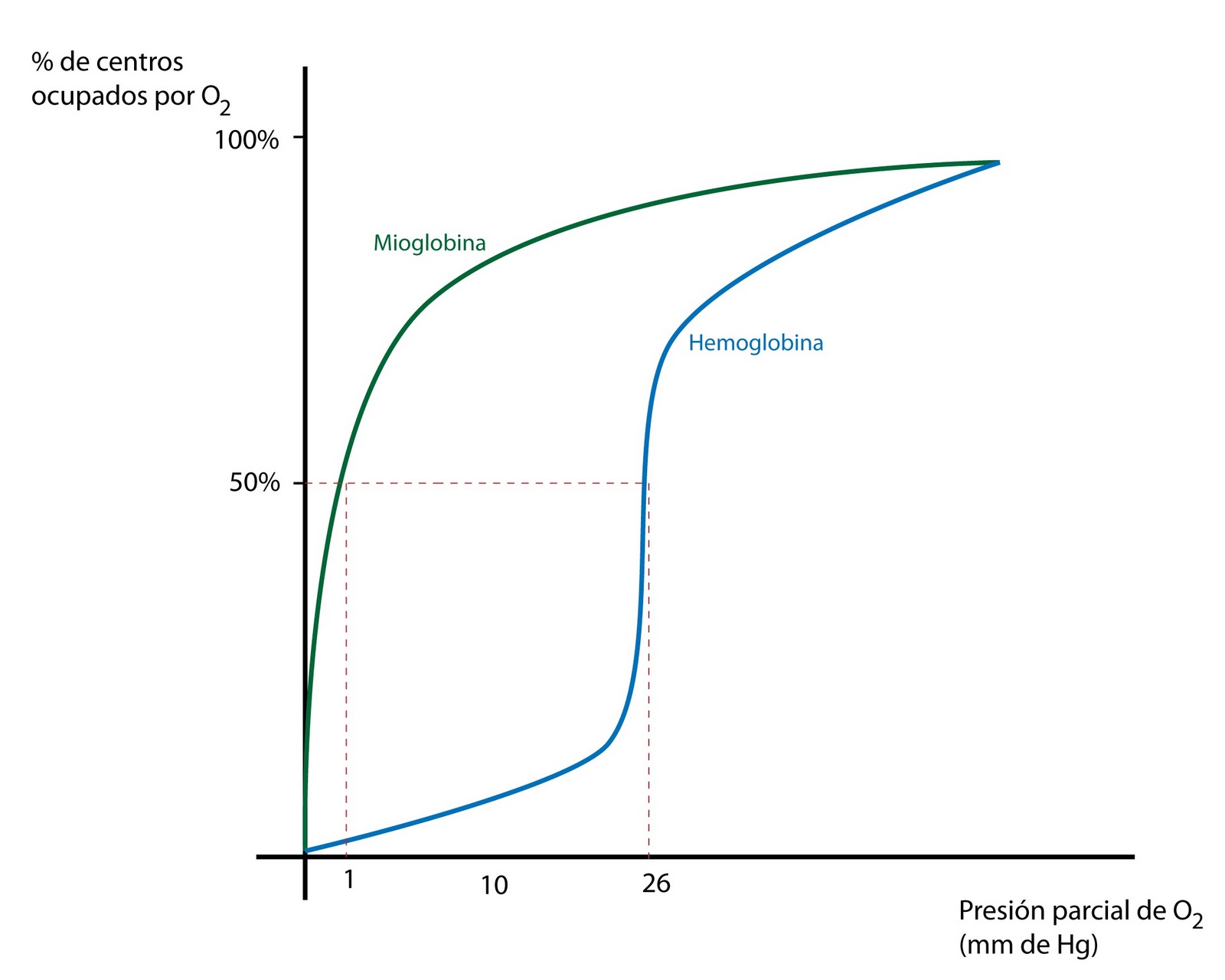

Función de las mioglobinas

Las mioglobinas son pigmentos musculares muy similares a las hemoglobinas sanguíneas. La diferencia es que son de pequeño tamaño puesto que están formadas por una única cadena de aminoácidos. La mioglobina tiene mayor afinidad por el oxígeno que la hemoglobina.

Gracias a esa diferencia de afinidad capta el O2 sanguíneo y facilita su difusión a las mitocondrias musculares. Se ha comprobado experimentalmente la importancia de esta función con ratones a los que se les privó de la posibilidad de sintetizar mioglobina; aunque los ratones pudieron desarrollar una vida normal, hubieron de compensar la falta de mioglobina elevando de forma significativa la densidad de capilares sanguíneos en los músculos. De otra forma no habrían podido suministrar a los músculos el oxígeno necesario para mantener niveles adecuados de metabolismo aerobio.

La mioglobina sirve, además, de almacén de oxígeno. En especies que respiran con normalidad en medios con suficiente disponibilidad de oxígeno, ese almacén garantiza el suministro de O2 a las mitocondrias durante los breves periodos de tiempo (segundos o fracciones de segundo) que, tras iniciarse una actividad muscular intensa, el sistema cardiovascular necesita para hacer llegar a los músculos el oxígeno necesario. Y también cuando los capilares se ocluyen transitoriamente por efecto de las contracciones musculares. La función de almacén es mucho más importante en las especies –como los mamíferos marinos- que dejan de respirar durante periodos de tiempo relativamente prolongados al sumergirse para ir en busca de alimento. De estas especies, no obstante, nos ocuparemos con más detalle en otra ocasión.

La mioglobina no solo se encuentra en la musculatura de vertebrados. El músculo radular del molusco Cryptochiton también tiene mioglobina, y lo llamativo de este caso es que su pigmento vascular no es hemoglobina, sino hemocianina. Es muy probable que este no sea el único caso en que esto ocurre.

Pigmento vascular y pigmento celómico

Se conocen varios sistemas pigmentarios en invertebrados aunque, quizás, el mejor conocido es el del sipuncúlido Dendrostomum. Este sipuncúlido tiene hemeritrina, tanto en su sangre como en el fluido celómico. Los tentáculos rodean la boca y se encuentran bien irrigados de sangre; el gusano vive dentro de la arena y los tentáculos se proyectan hacia el exterior –hacia la masa de agua circundante- y cumplen una función respiratoria. La hemeritrina celómica de Dendrostomum tiene una mayor afinidad por el oxígeno que la sanguínea, lo que quiere decir que el oxígeno captado por la sangre de los tentáculos es transferido con facilidad al fluido celómico. Y del fluido celómico pasa a las células.

———————————————–

Como se ha podido ver aquí, existen en el mundo animal diversas disposiciones anatómicas y funcionales en las que es necesario el concurso de más de un pigmento para que el O2 pueda ser transferido desde el exterior hasta su destino final (feto, músculos, u otros tejidos) y en todas esas disposiciones el juego de afinidades es clave para que tal transferencia pueda cursar con suficiencia y normalidad. En algunos casos, además, uno de los pigmentos cumple funciones de almacenamiento de oxígeno, lo que constituye una garantía de provisión constante ante la existencia de fluctuaciones de diferente intensidad y duración en el suministro al animal (su órgano respiratorio) o a los músculos.

Fuentes:

John D. Jones (1972): Comparative physiology of respiration. Edward Arnold, Edinburgh

Knut Schmidt-Nielsen (1997): Animal Physiology. Adaptation and Environment. Cambridge University Press; Cambridge

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: almacenamiento y transferencia de oxígeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: los pigmentos respiratorios

- Sistemas respiratorios: pigmentos de alta afinidad

- Sistemas respiratorios: pigmentos de baja afinidad

Equivalencia entre masa y energía

El USS Enterprise en 1964 durante la operación “Sea Orbit” en la que dio la vuelta al mundo en 65 días sin repostar, demostrando la capacidad de la tecnología basada en la equivalencia entre masa y energía.

Después de que Einstein completara su artículo sobre la teoría especial de la relatividad en 1905 descubrió una consecuencia más de los postulados de la relatividad que presentó, como una idea de último momento, en un artículo de solo tres páginas posterior ese mismo año. Desde el punto de vista del efecto de la física en la historia mundial, resultó ser el más significativo de todos sus hallazgos: la quivalencia entre masa y energía.

Sabemos que cuando se realiza trabajo sobre un objeto, como golpear una pelota de tenis con una raqueta, el objeto adquiere energía. En la teoría de la relatividad, el aumento de la velocidad y, por lo tanto, el aumento de la energía cinética de una pelota de tenis o de cualquier otro objeto, da como resultado un aumento de la masa (o inercia), aunque en el día a día suele ser solo un aumento infinitesimal.

Al examinar esta relación entre velocidad relativa y masa efectiva con más detenimiento Einstein descubrió que cualquier aumento en la energía de un objeto debería producir un aumento de la masa medida; este incremento de energía daría igual si se hace acelerando el objeto, o calentándolo, o cargándolo con electricidad, o simplemente realizando trabajo elevándolo en el campo gravitacional de la Tierra. En resumen, Einstein descubrió que un cambio en la energía es equivalente a un cambio en la masa.

No solo eso. Descubrió además que la equivalencia funciona en ambos sentidos: un aumento o disminución de la energía en un sistema aumenta o disminuye correspondientemente su masa, y un aumento o disminución de la masa corresponde a un aumento o disminución de la energía. En otras palabras, la masa en sí misma es una medida de una cantidad equivalente de energía.

Dicho de otra manera, un cambio (recordemos que los cambio se expresan con la letra griega delta mayúscula, Δ) en la cantidad de energía, E, de un objeto es directamente proporcional a un cambio en su masa, m. Lo que Einstein hizo en su articulito de tres páginas es demostrar que esa constante de proporcionalidad es el cuadrado de la velocidad de la luz en el vacío, c2. En símbolos, ΔE = Δm·c2, o de forma más genérica, E = m·c2, probablemente la ecuación más famosa de todos los tiempos.

Significa que un cambio de masa observado es equivalente a un cambio de energía, y viceversa. Pero también significa que la propia masa de un objeto, incluso si no cambia, es equivalente a una enorme cantidad de energía, ya que la constante de proporcionalidad, c2, el cuadrado de la velocidad de la luz en el vacío, es un número enorme.

Por ejemplo, la energía contenida en un solo gramo de materia es de E = 0,001 kg · (299792485 m/s)2 = 8,988·1013 kg·m2/s2≈ 9·1013 J. Esta enorme cantidad de energía es aproximadamente la misma que libera la explosión de 20 toneladas de TNT.

La transformación de masa en energía es Es la fuente de las energías liberadas por las sustancias radiactivas, por nuestro Sol y otras estrellas, por las armas nucleares y por los reactores nucleares que producen energía eléctrica.

No solo masa y energía son “equivalentes”, podemos afirmar que la masa es energía. Esto es exactamente lo que concluyó Einstein en 1905: “La masa de un cuerpo es una medida de su contenido energético”. Nada impide que consideremos la masa como “energía congelada”, congelada en el momento en que el Universo se enfrió poco después del Big Bang y la energía se agrupó formando “bolas” de materia, las partículas elementales de las que se compone la materia ordinaria.

Por lo tanto, cualquier energía adicional que se añada a una masa aumentará su masa aún más. Por ejemplo, a medida que aceleramos los protones en el laboratorio a casi la velocidad de la luz, su masa aumenta de acuerdo con la fórmula relativista para mm. Este aumento también se puede interpretar como un aumento en el contenido de energía de los protones.

Estas dos deducciones diferentes de la teoría de la relatividad -aumento de masa y equivalencia de masa de energía- son consistentes entre sí. Esta equivalencia tiene un significado muy importante. Primero, dos grandes leyes de conservación se convierten en dos formas alternativas de una sola ley. En cualquier sistema cuya masa total se conserve, la energía total también se conserva. En segundo lugar, surge la idea de que parte de la energía en reposo podría transformarse en una forma de energía más familiar. Dado que el equivalente energético de la masa es tan grande, una reducción muy pequeña en la masa en reposo liberaría una enorme cantidad de energía, por ejemplo, energía cinética o energía electromagnética.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Equivalencia entre masa y energía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La relatividad de la masa

- Se intuye la conservación de la energía (1)

- Se establece el principio de conservación de la energía

Zenbat gizaki bizi izan dira Lurrean?

Gauzak ordea ez dira beti horrelakoak izan. Garai batean, jaiotze tasa oso handia zen, baina umeen hilkortasun tasa ere oso handia zen, eta bizi-baldintza txarrek eragotzi egiten zuten populazioaren hazkundea. Milaka urtean hainbeste jende jaio eta hil egin delarik, zenbat gizaki bizi izan ote dira Lurrean historian zehar? [1]

1. irudia: Ba al dakigu zenbat gizaki bizi izan diren Lurrean? Zer nolako bilakaera utzi du gizakiaren historiak?

Hasiera-hasieratik esan behar da hau oso gutxi gorabeherako zenbaki-saio bat baizik ez dela izango. Zenbaki handietan aritzen garelarik, hipotesi bat baino gehiago erabili beharko ditugu ohi bezala: ez dugu hain erraz egiazkotzat emango kopuru bat, baina gutxienez modu bat aurkituko dugu oso urrun ez gabiltzala baieztatu ahal izateko.

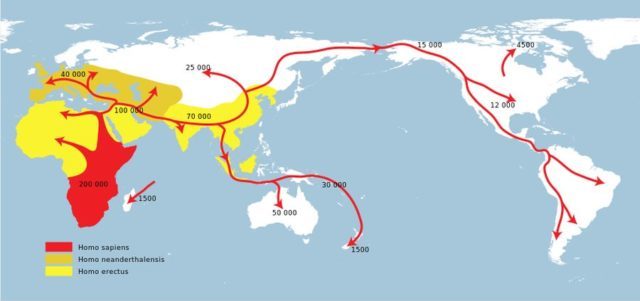

Lehenengo eta behin, abiapuntua ezarri behar da. Erregistro arkeologikoek eta paleontologikoek ezagutzera eman digute Lurrean hainbat hominido egon izan direla gu baino lehenago. Dakigun bezala, onar daiteke gure arbaso zuzenak direla eta dagoeneko desagertu egin direla horietako batzuk. Kalkuluak ahalik eta zehatzen egiteko, Homo sapiens espezieari erreparatuko diogu. Gauzak horrela, duela 50.000 urte izango genuke abiapuntua, uste baita une horretan egin zuela Afrikatik kanpo Homo sapiens espezieak. Zoritxarrez, Miguelón eta Lucy kanpo gelditzen dira [2].

Bigarren urrats batean, kalkulatu egin beharko genuke zenbat Homo sapiens bizi ziren duela 50.000 Lurrean. Hemen ez daukagu aztarnarik, eta beraz, oso badaezpadako estimazioak besterik ezin dugu egin batez ere Homo sapiens modernoaren lehenengo une horietarako.

2. irudia: Homo sapiens espeziearen hedapena.

Zenbait ikertzailek batera onartu dute 5 milioi biztanle zeudela orain 8.000 urte. Une horretan, ia Lurra guztia populatua zegoen, eta nahiko egonkorra zen gainera populazioa. Zenbaki hori erdiesteko, zentzuz pentsa dezakegu 0 edo 2 zenbaki batetik hasiko zela eten gabe populazioa hazten [3].

Lehenengo urtean, ez dago hainbeste adostasunik. Population Reference Bureau izenekoak 300 miloi egongo zirela estimatu du, bi datutan oinarrituta: Erromatar Inperioak 40 edo 50 milioi biztanle izango zituen, eta horretaz gain Asia bazen jadanik Lurreko alde populatuena. Dena dela, beste batzuen estimazioak 170 milioitik 500 milioira doaz.

Une horretatik aurrera, ez daukagu erregistro historikorik, baina informazio gehiago dugu munduko populazioa estimatzeko. Izan ere, gutxi gorabehera bat datoz zenbait iturri desberdinetatik datozen estimazioak. Gauzak errazte aldera, berriz erreparatuko diogu Population Reference Bureau horri.

Hirugarren urratsa da garrantzitsuena, ezartzeko beharrean dugulako zein jaiotze tasa egon den hasieratik gaur arte [4]. Horretarako, asmatu egin beharko dugu beste garai batzuetako umeen hilkortasun tasa [5]. Badakigu kopuru horrek handia behar duela, eta beraz, zentzuz onar dezakegu urte bat bete baino lehen hiltzen zela jaiotzen ziren umeen erdia. Horretaz ezer ez badakigu ere, pentsa daiteke ehiztari eta biltzaile taldeetan hilkortasun handiagoa egongo zela. Berez, baliteke haurrak hil izana, taldearentzat behar besteko baliabiderik ez bazegoen. Baliteke hala gertatu izana, haur jaioberria taldearentzat garrantzitsutzat jotzen ez zutenean behintzat.

Pentsa dezakegu batetik 500/1.000-ko hilkortasun tasa zegoela, eta bizi-itxaropena 10-12 urtekoa zela Brontze eta Burdina Aroetan. Gauzak horrela, onar dezakegu 80/1.000 izango zela jaiotze tasa eta horrela populazioak arinki gora egingo zuela.

Behe Erdi Arotik aurrera, hobetzen joan ziren bizi-baldintzak, eta umeen hilkortasun tasak behera egin zuelarik, jaiotze tasa apalagoa beharko zen belaunaldien ordezkapena bermatzeko. Hala ere, esne pasteurizatua asmatu eta medikuntzaren aurrerapen handiak gertatu arte, ez zen nabarmen jaitsiko umeen hilkortasun tasa. Hortxe hasi zen nonbait munduko populazioaren gorakada izugarria.

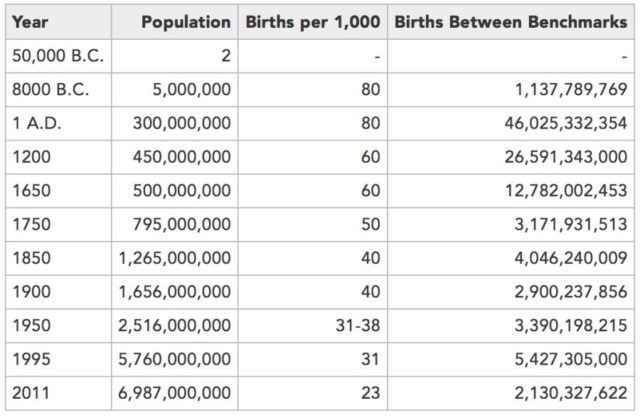

Beraz, hurrengo taula izango genuke abiapuntua, eta unean uneko jaiotze tasak eta estimazioak kontuan hartuta:

3. irudia: Population Reference Bureau izeneko erakundeak emandako datuak.

Estimazio hauek, Carl Haubek [6] egin zituen, erakunde horretan lanean ari zelarik. Haien arabera, 2011. urterako, 107.000 miloi gizaki jaioak egongo ziren jadanik. Bestela esanda, inoiz bizirik egon diren gizakien %6-%7a bizi da egun gure planetan.

Oharrak:

[1]. Historia eta historiaurrea hartuko ditugu kontuan, idatzizko hizkuntzen agerpenak ez diolako kontuari inola eragingo.

[2]. Miguelón Atapuercan aurkitu zen eta Homo heidelbergensis espeziearen 300.000 urteko ale bat da. Lucy Hadarren (Etiopian) aurktu zen, eta Australopithecus afarensis espeziearen 3.2 miloi urteko ale bat da.

[3]. Zenbaki honek ez dauka Adan eta Evaren pertsonaiekin inongo zerikusirik, eta matematika-abiapuntu bat besterik ez da. Onar daiteke ezinbestez egiten dugun oker bat dela hasierako zenbaki hau.

[4]. Jaiotze tasa: jaiotzak/1000 biztanle.

[5]. Umeen hilkortasun tasa: lehenengo urtean hildakoak/urtean jaiotako 1000 umeak.

[6]. How Many People Have Ever Lived on Earth?

———————————————————————————-

Egileaz: Miguel Garcia (@Milhaud) Telekomunikazio-ingeniaria da eta informazio eta teknologi-zerbitzuetan aditua.

———————————————————————————-

—————————————————–

Hizkuntza-begiralea: Juan Carlos Odriozola

——————————————–

The post Zenbat gizaki bizi izan dira Lurrean? appeared first on Zientzia Kaiera.

On Zientzia: E mc2

E=mc2 formulak hiru alderdi ditu:

- E. Energia da, lan bat egiteko ahalmena.

- m. Masa esan nahi du, masa eta ez pisua. Masa berdina da Lurrean zein ilargian.

- c. Argiaren abiadura da, 3·108 m/s.

Hortaz, formulari jarraiki, masa eta energia erlazionaturik daude oso abiadura altuetan.

Einstein fisikariak lortu zuen formula honen azalpen grafikoa dakar Nerea Casasek “E mc2” bideoan, On Zientzia lehiaketaren VII. edizioan euskarazko epaimahaiaren azken errondaren parte izan zena.

—–—–

Elhuyar Fundazioak eta Donostia International Physics Center-ek (DIPC) zientzia eta teknologiaren dibulgaziorako lehiaketa da On Zientzia, jakintza zientifikoa ezagutzera emango duten bideo labur eta originalen ekoizpena bultzatzeko helburuarekin.

Lehiaketaren oinarriek ezarri bezala, bideoek 5 minutu baino gutxiago iraun behar dute eta euskaraz, gaztelaniaz edo ingelesez izan daitezke, gaia librea delarik. Edukiak jatorrizkoak izan behar dira, telebistan inoiz atera ez direnak, eta beste lehiaketaren bat irabazi ez dutenak.

Hiru sari kategoria ditu On Zientzia lehiaketak:

- Gazte saria (18 urtetik beherakoentzat). 1000 €

- Euskarazko bideo onena. 2000 €

- Dibulgazio bideorik onena. 3000 €

2017-2018koa VIII. edizioa da eta parte hartzeko epea zabalik dago jada 2018ko apirilaren 25era arte.

The post On Zientzia: E mc2 appeared first on Zientzia Kaiera.

Inteligencia y ateísmo

Los británicos R. Lynn y J. Harvey, y el danés H. Nyborg, se preguntaron si la idea que Richard Dawkins expresa en The God Delusion de que no es inteligente creer en la existencia de Dios es o no correcta. Y la respuesta a esa pregunta la publicaron en abril de 2008 en la edición digital (en 2009 en papel) de la revista Intelligence en un artículo titulado Average intelligence predicts atheism rates across 137 nations. El estudio da cuenta de la existencia de una correlación negativa significativa entre la inteligencia (expresada mediante el índice “g” de inteligencia general) y el grado de religiosidad de la población de diferentes países.

Los autores, en su introducción, revisaron los trabajos anteriores sobre este mismo tema, e indicaron que las evidencias de la existencia de una relación negativa entre inteligencia y fe religiosa proceden de cuatro fuentes diferentes: 1) Existencia de correlación negativa entre las dos variables; como ejemplo, en un estudio realizado con más de 14.000 norteamericanos jóvenes el IQ varió de la siguiente forma: no religiosos = 103’09; algo religiosos = 99’34; bastante religiosos = 98’28; muy religiosos = 97’14. 2) Menores porcentajes de personas con creencias religiosas entre las personas más inteligentes que en el conjunto de la población. 3) Disminución de las creencias religiosas de niños y adolescentes conforme crecen y desarrollan sus habilidades cognitivas. 4) Disminución de la creencia religiosa durante el siglo XX conforme aumentaba la inteligencia de la población.

Los resultados del estudio se resumen en que la correlación entre el nivel de inteligencia general “g” y la variable “incredulidad religiosa” (religious disbelief) era de 0’60 para un conjunto de 137 países. Si se analizaban por separado los segmentos superior e inferior en que puede dividirse el conjunto de datos (para comprobar si la relación es consistente en todo el rango) se obtenían correlaciones positivas en ambos, aunque esa correlación era alta en el tramo superior y baja en el inferior. O sea, la máxima variación se producía entre los países con mayor nivel de inteligencia y mayor “incredulidad religiosa”.

Un último elemento de interés de ese trabajo es que los autores atribuían las diferencias observadas a factores de naturaleza genética e indicaban que la religiosidad (o creencias religiosas) es altamente heredable (heredabilidad de 0’4-0’5)1.