El Romanticismo contra Newton

Newton (1795) por William Blake. La oposición de Blake a la Ilustración estaba profundamente arraigada y personificada en Newton. La teoría de la óptica de Newton fue especialmente ofensiva para Blake, quien hacía una clara distinción entre la visión del «ojo vegetativo» y la visión espiritual. La visión deísta de Dios como un creador distante que no desempeñaba ningún papel en los asuntos cotidianos era anatema para Blake, quien afirmaba experimentar regularmente visiones de naturaleza espiritual. Contrapone su «visión cuádruple» de la realidad con la «visión única» de Newton, cuya «religión natural» (materialismo científico) consideraba estéril.

Newton (1795) por William Blake. La oposición de Blake a la Ilustración estaba profundamente arraigada y personificada en Newton. La teoría de la óptica de Newton fue especialmente ofensiva para Blake, quien hacía una clara distinción entre la visión del «ojo vegetativo» y la visión espiritual. La visión deísta de Dios como un creador distante que no desempeñaba ningún papel en los asuntos cotidianos era anatema para Blake, quien afirmaba experimentar regularmente visiones de naturaleza espiritual. Contrapone su «visión cuádruple» de la realidad con la «visión única» de Newton, cuya «religión natural» (materialismo científico) consideraba estéril.¿Acaso no vuelan todos los encantos

Al mero toque de la fría filosofía?

Una vez hubo en el cielo un arcoíris tremendo;

Conocemos su trama, su textura; está indicada

En el insulso catálogo de las cosas comunes.

La filosofía cercenará las alas de un Ángel,

Conquistará todos los misterios con la regla y la línea,

Vaciará el aire de fantasmas, y la mina de gnomos,

Destejerá un arcoíris, como antes hizo

que la tierna Lamia se fundiera en sombra.

John Keats, “Lamia”, 18201

Estos son, probablemente, algunos de los versos más famosos que se han escrito sobre ciencia, y por desgracia no dan una valoración demasiado positiva. Fueron escritos por John Keats en 1819. Se trata de una digresión en un largo poema que cuenta cómo Hermes libera a Lamia y la transforma en una hermosa mujer. En su banquete de bodas, Lamia es descubierta por el filósofo Apolonio, el hechizo se rompe y ella regresa a su forma original de serpiente. En este fragmento, sin embargo, la cosa no va sobre mitología. Keats se detiene para criticar de manera no tan velada la teoría óptica de Newton, a quien culpaba de haber “destruido la poesía del arco iris, reduciéndola a los colores de un prisma”2. Debía de tenerle bastante tierra al físico inglés porque también se cuenta que, durante una cena navideña y en compañía de otros escritores y amigos, propuso un brindis3 “¡a la salud de Newton y confusión a las matemáticas!”.

Desgraciadamente, no era el único en pensar de forma parecida. La todavía reciente revolución científica había cambiado la forma en que la gente pensaba sobre el mundo y buscaba conocimiento, y muchos pensadores románticos culpaban a la ciencia, simbolizada por el estudio de la óptica de Newton, de destruir la magia del mundo natural.

No era una crítica unánime, ni falta de matices, por supuesto. Algunos poetas elogiaron a la ciencia. Y algunos científicos del siglo XIX, como Alexander von Humbold, se convirtieron en verdaderos símbolos de su época. El célebre naturalista prusiano fue íntimo amigo de Goethe y se codeó con los artistas más célebres de su tiempo. Sus libros de viajes, su imaginación y su manera holística y multidisciplinar de entender la naturaleza resonaron profundamente con los valores estéticos del Romanticismo4.

Pero es cierto que las ideas de otros científicos, sobre todo en ciertas ramas de la física y las matemáticas, no gozaron de tanta popularidad. En general, los Románticos rechazaban el énfasis en la racionalidad pura que había traído consigo la Ilustración. Acusaba a la ciencia de reduccionismo, de querer explicar el mundo como una suma de átomos, de presentar la naturaleza como un autómata frío y manipulable, sin tener en cuenta las emociones humanas. La ciencia, bajo el legado estético de Newton, era para ellos una máquina apisonadora y sin alma. Los científicos, escribas miopes incapaces de ver más allá de su especialidad, les parecían estatuas de cemento, sin imaginación ni sentimientos, que buscaban maquinalmente la verdad.

En fin, está claro que Romanticismo tuvo sus más y sus menos5. Probablemente, la opinión de unos cuantos poetas de hace doscientos años no tendría la menor importancia, si no fuera porque gran parte de los valores estéticos que compartimos en la actualidad, provienen precisamente de esa época. La forma en la que pensamos y valoramos el Arte se forjó precisamente en el Romanticismo6. Muchas de las ideas que compartimos sobre la ciencia, y la imagen popular de cómo son los científicos, también.

Fueron, en parte, poemas como el de John Keats los que nos contaron que la Física y las Matemáticas son disciplinas frías, ajenas a lo estético, vacías de emoción o imaginación. Personalmente, pasé por la adolescencia convencida de que no había en el mundo nada más gris, mecánico y poco creativo que mover números de ecuación en ecuación. Probablemente, el método de aprendizaje tampoco ayudó, está claro. Pero más allá de eso, sospecho que el estereotipo de científico, tal como nos lo pintaron los poetas del Romanticismo, tuvo mucho que ver con mi decisión: al terminar bachillerato de ciencias, decidí matricularme en Bellas Artes. Años más tarde, y mientras estudiaba Física, me sorprendió descubrir que en esa facultad los profesores exclamaban «¡qué bonito!» con mucha más frecuencia y alegría que en mi primera carrera.

Es una anécdota que suelo contar en mis charlas de divulgación, porque siempre despierta risas y sorpresa entre los asistentes. ¿Qué tendrá que ver la Física con lo “bonito”? ¡Nunca nadie pintó un cuadro al óleo con una ecuación! De nuevo, es el relato Romántico el que habla. Y ese relato contrasta con los cientos de textos, citas y charlas, en que estos científicos han hablado de su interés por la belleza, de la emoción que sienten al descubrir las matemáticas que describen el mundo.

En cualquier caso, y para cerrar la anotación, me gustaría lanzar una pregunta. Más allá de esta anotación, o de la simpatía que cada cual le tenga al Romanticismo: ¿tú cómo lo sientes?, ¿crees que Newton le robó su magia al arcoíris? Saber que los colores que ves en el cielo son trocitos de la luz del Sol, a ti, lector, ¿te emociona más, o te emociona menos?

Notas y referencias:

1John Keats, Lamia en Projecto Gutenberg

2Gigante, Denise (May 2002). «The Monster in the Rainbow: Keats and the Science of Life». PMLA. 117 (3): 433–448. doi:10.1632/003081202X60396. ISSN 0030-8129.

3Nina Martyris (2015). “Does Science Diminish Wonder or Augment It?”. Nautilus

4Sobre este tema, recomiendo leer “The Invention of Nature” de Andrea Wulf

5A veces, me enfado mucho con el Romanticismo. Pero luego escucho a Tchaikovsky y se me pasa.

6Argumentaría que, a menudo, la polémica que suscitan ciertas obras de Arte Contemporáneo (léase, arte académico contemporáneo), está causada por un conflicto entre los valores estéticos populares —esencialmente románticos— y los valores estéticos de la academia. Pero esto daría para otro post.

Para saber más:

La ciencia romántica

¿Qué le debemos a la ciencia del Romanticismo?

Naturaleza, ciencia y cultura en el bicentenario de Henry David Thoreau

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El Romanticismo contra Newton se ha escrito en Cuaderno de Cultura Científica.

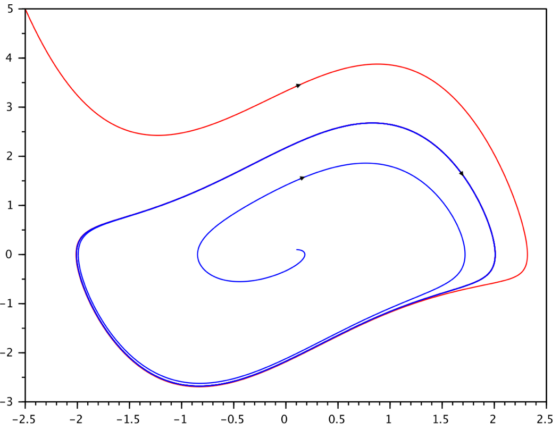

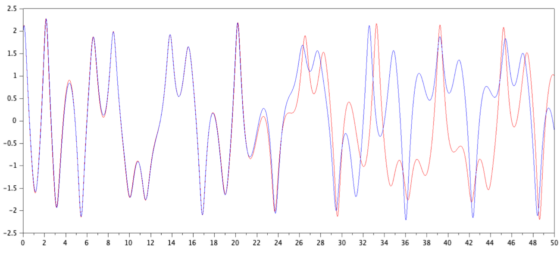

El toro, la botella de Klein y el plano proyectivo real (I)

Cuando escribes un libro una de las tareas necesarias en su desarrollo es la elección del material que tiene que estar incluido necesariamente en el libro y el que debes dejar fuera, aunque te parezca muy interesante. En mi último libro, titulado Las matemáticas como herramienta de creación artística, también me ha tocado dejar fuera muchos materiales muy interesantes. Por ejemplo, en el capítulo titulado Topología: la banda de Moebius, mi idea original era haber incluido obras de arte relacionadas tanto con la banda de Moebius, que son muchas (algunos ejemplos los hemos comentado en las entradas del Cuaderno de Cultura Científica Arte Moebius (I) y Arte Moebius (II), así como en el mencionado libro), como con otras tres superficies relacionadas, que son el toro, la botella de Klein y el plano proyectivo real.

Fotografía de la escultura Doce círculos concéntricos (Girando Moebius), de 1957, de la artista venezolana, nacida en Alemania y de origen judío, Gego (Gertrud Goldschmidt)

Fotografía de la escultura Doce círculos concéntricos (Girando Moebius), de 1957, de la artista venezolana, nacida en Alemania y de origen judío, Gego (Gertrud Goldschmidt)Esta serie de entradas del Cuaderno de Cultura Científica vamos a hablar de estas tres superficies, el toro, la botella de Klein y el plano proyectivo real, y de cómo algunos artistas las han representado en sus obras.

La banda de MoebiusEmpecemos recordando qué es una banda de Moebius, que es uno de los objetos más curiosos de la topología puesto que es una superficie con una sola cara y un solo borde.

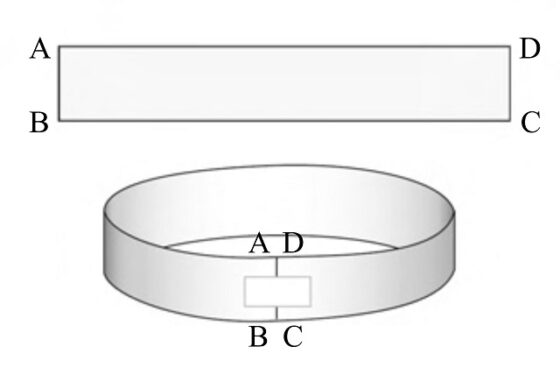

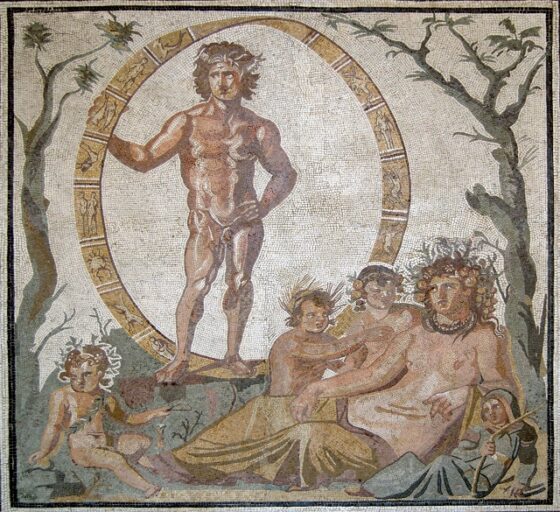

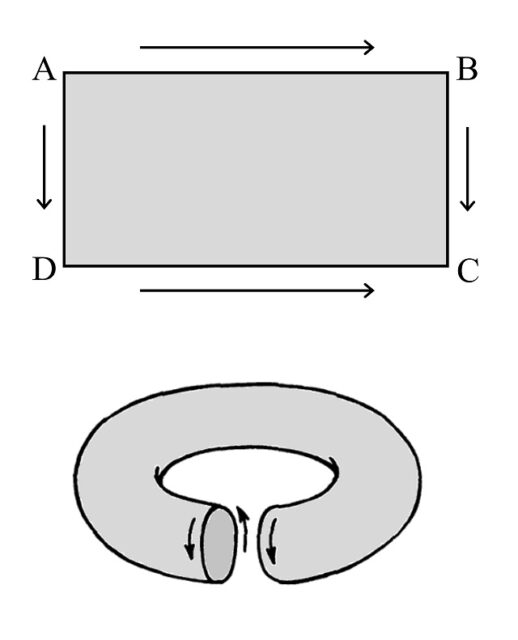

Dada una tira de papel rectangular ABCD (véase la siguiente imagen), si se pegan los extremos (AB con DC) se obtendrá una banda normal, que es una superficie con dos caras –interior y exterior- y dos bordes –arriba y abajo-. Vamos, lo que podemos considerar normal en una superficie, que tenga dos caras (aunque rompiendo esa intuición, ya en la entrada La hoja de papel con cuatro caras, una propuesta de taller mostrábamos cómo construir una mágica “hoja de papel” con cuatro caras).

Una banda normal, con dos caras (exterior e interior) y dos bordes (superior e inferior), construida a partir de una tira de papel alargada ABCD, juntando AB con DC

Una banda normal, con dos caras (exterior e interior) y dos bordes (superior e inferior), construida a partir de una tira de papel alargada ABCD, juntando AB con DC

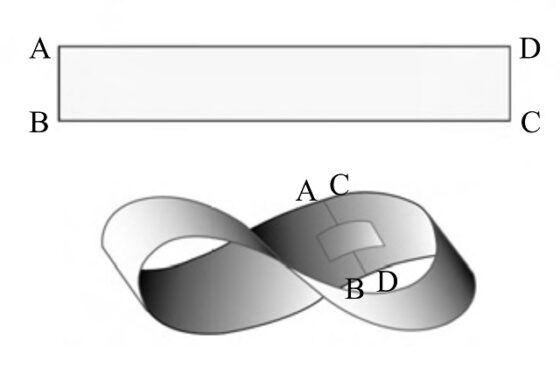

Sin embargo, si primero giramos uno de los extremos del papel media vuelta y después los juntamos (ahora AB se “pega” con CD) se obtiene una banda retorcida, que tiene una sola cara (si se intenta pintar de forma continua la nueva superficie solamente se podrá utilizar un color, mientras que a la anterior se le pueden aplicar dos colores distintos, uno para el interior y otro para el exterior) y un solo borde (que también se puede perfilar de forma continua). Esta es la conocida como superficie de Moebius, que fue descubierta (dentro de las matemáticas), de forma independiente, por los matemáticos alemanes Johann Benedict Listing (1808-1882) y August Ferdinand Moebius (1790-1868).

Una banda de Moebius, con una sola cara y un solo borde, construida a partir de una tira de papel alargada ABCD, juntando AB con DC

Una banda de Moebius, con una sola cara y un solo borde, construida a partir de una tira de papel alargada ABCD, juntando AB con DC

¿Qué ocurre si en lugar de girar uno de los extremos del papel media vuelta se gira una vuelta entera y después se juntan ambos extremos (de nuevo, AB con DC)? Lo que ocurre es que ahora se obtiene una banda retorcida que tiene, de nuevo, dos caras y dos bordes, como podéis comprobar fácilmente simplemente utilizando una tira rectangular alargada de papel.

La banda de Moebius es una superficie con curiosas propiedades y aplicaciones, algunas de ellas se pueden leer en las entradas del Cuaderno de Cultura Científica ya mencionadas o en otras entradas como En busca de la banda de Moebius más corta posible o Dibujando grafos sobre la banda de Moebius, o también en los libros La banda de Moebius, de Clifford Pickover, Experiments in Topology, de Stephen Barr o Festival mágico-matemático, de Martin Gardner. En particular, existen muchos experimentos que consisten en cortar tiras de papel, como los clásicos en los que se corta la banda de Moebius de papel longitudinalmente por la mitad o por un tercio de la anchura, con resultados asombrosos, o algunos algo menos conocidos como el de cómo construir dos corazones entrelazados o un cuadrado, partiendo de dos cintas de Moebius pegadas, o cómo construir un slip de Moebius, que pueden verse como actividades del libro Las matemáticas como herramienta de creación artística.

Página del libro Houdini’s Paper Magic (1922), del ilusionista y escapista austrohúngaro nacionalizado estadounidense Harry Houdini, en la que aparecen bandas de papel, normales, de Moebius o normales retorcidas, que cortadas longitudinalmente dan lugar a diferentes situaciones que son utilizadas en la magia.

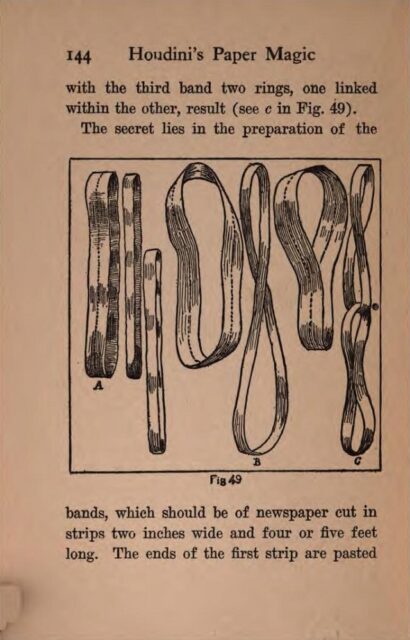

Página del libro Houdini’s Paper Magic (1922), del ilusionista y escapista austrohúngaro nacionalizado estadounidense Harry Houdini, en la que aparecen bandas de papel, normales, de Moebius o normales retorcidas, que cortadas longitudinalmente dan lugar a diferentes situaciones que son utilizadas en la magia.Para finalizar este apartado, mencionaremos que, aunque la superficie de Moebius fue descubierta dentro de las matemáticas en el siglo xix, esta ya era conocida con anterioridad. La banda de una sola cara se encuentra, por ejemplo, en motivos decorativos antiguos, como algunos mosaicos romanos (alrededor del año 200), como se menciona en el artículo The Möbius band in Roman mosaics (Scientific American 61, 1973) de L. L. Larison, o en el artículo Möbius strips before Möbius: Topological hints in ancient representations (The Mathematical Intelligencer 38, 2016), de J. H. E. Cartwright y D. L. González.

Parte central de un mosaico, de la villa romana de Sentinum, situada al lado de la ciudad moderna de Sassoferrato (Italia), aprox. 200 – 250 a.n.e. En el mismo, nos encontramos a Eón, dios romano del tiempo eterno y la prosperidad, sujetando una banda de Moebius -que simboliza el infinito, ya que podemos recorrerlo sin fin, como las hormigas del grabado del artista neerlandés M. C. Escher- con los signos zodiacales

Parte central de un mosaico, de la villa romana de Sentinum, situada al lado de la ciudad moderna de Sassoferrato (Italia), aprox. 200 – 250 a.n.e. En el mismo, nos encontramos a Eón, dios romano del tiempo eterno y la prosperidad, sujetando una banda de Moebius -que simboliza el infinito, ya que podemos recorrerlo sin fin, como las hormigas del grabado del artista neerlandés M. C. Escher- con los signos zodiacalesLa superficie del toro

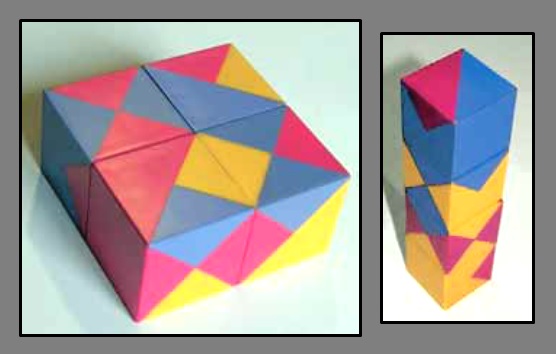

A partir de la definición de las bandas normal (que topológicamente es un cilindro) y de Moebius se pueden definir nuevas superficies que también tendrán una o dos caras, pero que no tendrán bordes. Si volvemos a un rectángulo ABCD, sabemos que pegando los lados AB con DC se obtiene un cilindro, pero en función de cómo se junten los otros dos lados generaremos dos nuevas e interesantes superficies. Si lo hacen de forma directa (AD con BC, como indican las flechas de la siguiente imagen) se obtiene una superficie cerrada -es decir, que no tiene bordes- con dos caras, que tiene forma de rosquilla o flotador, conocida en matemáticas como toro (que no tiene nada que ver con el animal, sino que el término toro, para designar la superficie, viene de la palabra latina “torus”, que tiene un significado de “bulto, protuberancia o nudo”).

Construcción de la superficie del toro

Construcción de la superficie del toro

El toro, tanto geométrico, es decir, la superficie del flotador, que es la superficie de revolución de un círculo alrededor de una recta exterior, como topológico (véase la entrada La topología modifica la trayectoria de los peces para leer más sobre el concepto de topología), esto es, deformaciones “topológicas” (manteniendo cierta continuidad) del toro geométrico, también ha sido utilizado en el arte contemporáneo. A continuación, mostraremos algunos ejemplos.

El toro en la obra artística de Keizo UshioEn la entrada Arte Moebius (II), ya mostrábamos un hermoso ejemplo de escultura que es un toro con una banda de Moebius dentro, es la escultura Moebius en el espacio (2005), del escultor japonés Keizo Ushio (Fukusaki, Prefectura de Hyogo, 1951), un artista con una obra escultórica muy geométrica. En Moebius en el espacio (véase la imagen más adelante), como en algunas otras obras similares, se representa el “espacio exterior” de la superficie de Moebius, mientras que esta no es más que el “espacio vacío”. El problema plástico de esta idea es hacer visible ese espacio vacío en la escultura. Para ello, Ushio trabaja con el toro sólido (realizado en granito), que va a jugar el papel de “espacio exterior” y después perfora una serie de diámetros que van girando, desde un primer diámetro vertical, de manera que al llegar al punto de partida han dado media vuelta, 180 grados, que de nuevo es el diámetro vertical. Ese espacio vacío dentro del toro tiene, por tanto, la forma de la banda de Moebius.

Ilustración de la banda de Moebius dentro del toro, como unión de diámetros del mismo, que van desde el inicial vertical -que se ve enfrente en la imagen- dando media vuelta, un giro de 180 grados, dentro del toro. Imagen generada por Josu Arroyo (UPV/EHU)

Ilustración de la banda de Moebius dentro del toro, como unión de diámetros del mismo, que van desde el inicial vertical -que se ve enfrente en la imagen- dando media vuelta, un giro de 180 grados, dentro del toro. Imagen generada por Josu Arroyo (UPV/EHU)

Ilustración del exterior del toro en el que se han perforado los diámetros construyendo una banda de Moebius vacía dentro del toro. Imagen generada por Josu Arroyo (UPV/EHU)

Ilustración del exterior del toro en el que se han perforado los diámetros construyendo una banda de Moebius vacía dentro del toro. Imagen generada por Josu Arroyo (UPV/EHU)

Esta construcción artística le ha llevado al artista japonés Keizo Ushio a crear hermosas esculturas como la mencionada Moebius en el espacio (2005). En la misma, para destacar aún más la banda de Moebius ausente, ha pintado de naranja la zona del toro que estaría en contacto directo con ella, como se ve en la siguiente fotografía. Una impactante escultura.

Escultura Moebius en el espacio (Granito, 2005), del escultor japonés Keizo Ushio

Escultura Moebius en el espacio (Granito, 2005), del escultor japonés Keizo UshioComo la banda de Moebius tiene una sola cara, el espacio exterior a la misma, que es el toro sólido de granito en la escultura, es único también, luego al perforar la banda de Moebius en el toro, este sigue siendo de una sola pieza, que se corresponde con esa única cara de la “banda de Moebius vacía”. Esto no ocurre si se perforara en el toro una banda con dos caras, como vamos a mostrar a continuación.

Conocí al escultor Keizo Ushio en el International Congress of Mathematicians que organizamos en Madrid en agosto de 2006, cuando le invitamos a realizar una escultura en vivo en el exterior del Palacio Municipal de Congresos de Madrid. Fue una experiencia increíble, que disfrutaron todas las personas que pasaron por allí esos días. La escultura que realizó entonces fue Oushi-Zokei ICM Madrid 2006 (véase la siguiente imagen), que en la actualidad se encuentra en el exterior del ICMAT (Instituto de Ciencias Matemáticas, del CSIC), de Madrid. En esta escultura, en lugar de perforar los diámetros del toro girando media vuelta, lo hizo girando una vuelta entera, por lo tanto, obteniendo una banda normal retorcida en su interior (con dos caras como se ha explicado más arriba). Como el espacio vacío dentro del toro sólido (granito) es una banda con dos caras, entonces la escultura se separa en dos partes, cada una se corresponde con una cara.

Escultura Oushi-Zokei ICM Madrid 2006 (Granito, 2006), del escultor japonés Keizo UshioEl toro en la obra artística de Richard Serra

Escultura Oushi-Zokei ICM Madrid 2006 (Granito, 2006), del escultor japonés Keizo UshioEl toro en la obra artística de Richard Serra

El toro es una superficie con interesantes propiedades que se estudian tanto en geometría, como en topología. Yo enseño esta superficie en la asignatura “Curvas y superficies” del grado de matemáticas, en particular, cuando explico la curvatura de una superficie. El tema de la curvatura de una superficie no es un tema sencillo para tratar en esta entrada, puesto que hay diferentes tipos de curvatura asociados al estudio de las superficies –curvaturas normales, curvaturas principales, curvatura de Gauss y curvatura media- y es necesario conocer algunas herramientas de geometría diferencial para entenderlo, aunque para hablar de las esculturas de Richard Serra nos bastará con explicar el significado del signo de la conocida como curvatura de Gauss (que es una curvatura intrínseca de la superficie).

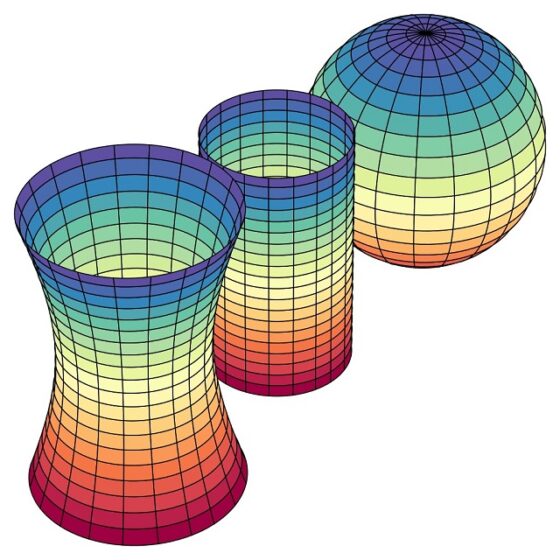

La curvatura de Gauss es un concepto local, es decir, cambia de unos puntos a otros de la superficie, pero para explicar el significado del signo de esta curvatura vamos a considerar superficies con curvatura constante, es decir, con la misma curvatura en todos sus puntos: el plano o el cilindro (este lo podemos ver como un trozo rectangular de plano en el que pegamos dos lados opuestos), que tiene curvatura cero, la esfera, que tiene curvatura positiva, y el hiperboloide de una hoja, que tiene curvatura negativa, cuyo significado explicaremos a continuación. Primero una imagen de estas tres superficies.

Tres superficies de curvatura de Gauss constante, realizadas con el programa Mathematica. De atrás hacia delante: la esfera, el cilindro y el hiperboloide de una hoja

Tres superficies de curvatura de Gauss constante, realizadas con el programa Mathematica. De atrás hacia delante: la esfera, el cilindro y el hiperboloide de una hoja

El plano tiene curvatura de Gauss cero, ya que no se curva de ninguna de las formas, y también el cilindro (esta superficie nos puede despistar ya que aparentemente sí tiene curvatura, pero la curvatura que tiene es la curvatura extrínseca –la llamada curvatura media-, que es no nula, pero la intrínseca, la curvatura de Gauss es cero, ya que el cilindro es como un trozo rectangular de plano en el que pegamos dos lados opuestos).

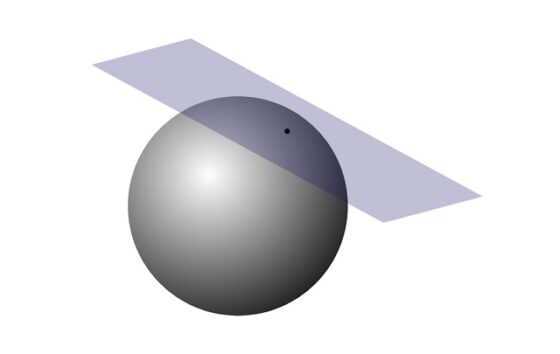

La esfera tiene curvatura de Gauss positiva, lo cual implica que, si tomamos el plano tangente a la esfera en cualquier punto, la esfera queda entera a un lado del plano tangente, como se muestra en la siguiente imagen. Otra forma de verlo –que nos ayudará a entender las esculturas de Richard Serra- es que, si tenemos una esfera gigante y colocamos nuestra cara en un punto de la misma, por ejemplo, en el exterior de la superficie, entonces la esfera se aleja de nosotros en todas las direcciones, es decir, la esfera es convexa en todas las direcciones (si nuestra cara está en el interior de la esfera entonces la esfera nos envuelve en todas las direcciones, esto es, la esfera es cóncava en todas las direcciones).

Esfera con plano tangente en uno de sus puntos

Esfera con plano tangente en uno de sus puntos

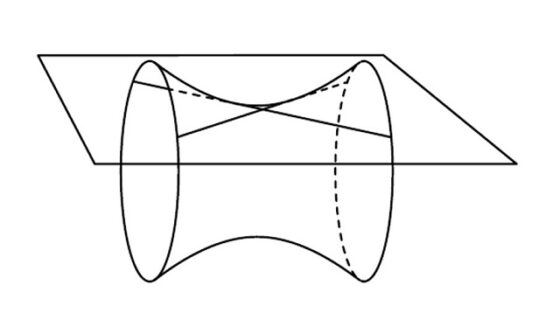

El hiperboloide de una hoja tiene curvatura de Gauss negativa, lo cual implica que, si tomamos el plano tangente al hiperboloide en cualquier punto, este corta al hiperboloide y la superficie tendrá partes a ambos lados del plano tangente, como se muestra en la siguiente imagen. Al igual que para la esfera, otra forma de verlo es que, si tenemos un hiperboloide gigante y colocamos nuestra cara en un punto del mismo, entonces el hiperboloide se aleja en algunas direcciones (será convexo en ellas), mientras que en otras direcciones nos envuelve (es cóncava en las mismas).

Hiperboloide de una hoja con plano tangente en uno de sus puntos

Hiperboloide de una hoja con plano tangente en uno de sus puntos

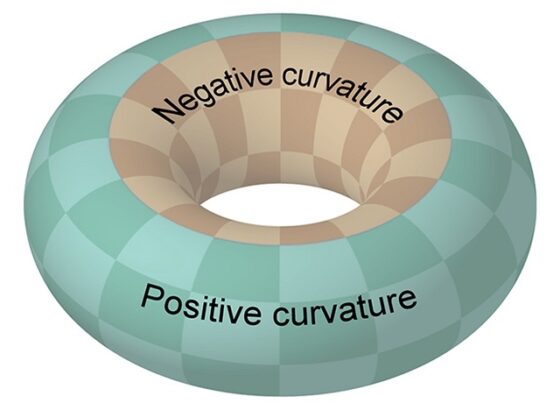

¿Qué ocurre para el toro (geométrico)? Esta superficie tiene puntos con curvatura de Gauss positiva (los del exterior) y puntos con curvatura de Gauss negativa (los del interior), con puntos de curvatura nula en las circunferencias que separan el interior y el exterior, como se muestra en la imagen.

El toro (geométrico) tiene puntos con curvatura de Gauus positiva, los del exterior (verde en la imagen), y puntos con curvatura de Gauss negativa, los del interior (marrón en la imagen)

El toro (geométrico) tiene puntos con curvatura de Gauus positiva, los del exterior (verde en la imagen), y puntos con curvatura de Gauss negativa, los del interior (marrón en la imagen)

Ya estamos en condiciones de entender la importancia de la curvatura de Gauss en algunas de las esculturas del escultor minimalista estadounidense Richard Serra (San Francisco, California, 1938), como New Union / Nueva unión (2003), que durante muchos años pudimos disfrutar en el exterior del Museo de Bellas Artes de Bilbao, o Between the Torus and the Sphere / Entre el toro y la esfera (2003-2005) y Blind Spot Reversed / Punto ciego invertido (2003-2005), que podemos ver en el Museo Guggenheim de Bilbao.

Between the Torus and the Sphere / Entre el toro y la esfera (2003-2005), del escultor estadounidense Richard Serra, en el Museo Guggenheim de Bilbao

Between the Torus and the Sphere / Entre el toro y la esfera (2003-2005), del escultor estadounidense Richard Serra, en el Museo Guggenheim de BilbaoRichard Serra contrapone, en estas esculturas, dos trozos de superficies con distinto signo de la curvatura de Gauss, positivo (esfera) y negativo (interior del toro). Las tres esculturas están formadas por planchas alargadas que son trozos de esfera (curvatura positiva) y planchas alargadas que son trozos de la parte interior del toro (curvatura negativa). Y lo interesantes de ellas es que la curvatura no solo se puede percibir visualmente desde lejos, sino que cuando caminamos entre las planchas de esculturas como Entre el toro y la esfera podemos percibir la curvatura interaccionando con nosotros. Yo suelo recomendar a mis estudiantes, o a las personas a las que les explico esta obra, que se coloquen frente a una plancha esférica, con la nariz tocando la plancha y se den cuenta de que el acero de la misma se aleja (o nos envuelve si estamos en la parte interior de la esfera) en todas las direcciones, lo que ocurre por ser de curvatura positiva. Y que después pasen a una plancha tórica, de nuevo con la nariz tocando el acero y se den cuenta de que en unas direcciones la superficie se aleja de nosotros y en otras nos envuelve, debido a que esa zona del toro tiene curvatura negativa.

El toro anudadoRealmente hay muchos artistas que han realizado esculturas con la forma de un toro geométrico. Pongamos un par de ejemplos más. Uno es el artista británico Jack Eagan y su serie de esculturas Eroded torus / Toro erosionado, dos de las cuales, realizadas en bronce, se muestran en las siguientes imágenes.

Eroded torus / Toro erosionado, del escultor británico Jack Eagan

Eroded torus / Toro erosionado, del escultor británico Jack Eagan Eroded torus / Toro erosionado, del escultor británico Jack Eagan

Eroded torus / Toro erosionado, del escultor británico Jack EaganY el otro ejemplo es el artista británico John Robinson (1935-2007) y su escultura Bonds of Friendship / Lazos de amistad (1980), en la que se representan dos toros entrelazados.

Bonds of Friendship / Lazos de amistad (1980), del escultor británico John Robinson

Bonds of Friendship / Lazos de amistad (1980), del escultor británico John RobinsonPero me gustaría terminar esta entrada del Cuaderno de Cultura Científica con una serie de esculturas más topológicas que tienen al toro como su principal protagonista, y que nos relacionan al toro topológico con la teoría de nudos, que es otra parte muy interesante de la topología (para leer sobre la teoría de nudos os recomiendo las entradas La topología modifica la trayectoria de los peces, La artista Anni Albers, The Walking Dead y la teoría de nudos y Del nudo gordiano al nudo de los enamorados, por territorio matemático).

En matemáticas, un nudo es una curva cerrada en el espacio y la teoría de nudos estudia cuántos nudos distintos, es decir, topológicamente diferentes, existen, así como propiedades topológicas de los mismos. Algunos escultores realizan esculturas de toros anudados, es decir, tienen la forma de nudos, por ejemplo, como el nudo de trébol, pero desde el punto de vista de la topología “son” un toro. Es como si partiéramos de un cilindro, realizáramos un nudo y luego pegáramos los extremos, transformándolo en un toro anudado.

Mostremos dos ejemplos de esculturas de toros anudados. La primera es de la escultora estadounidense E. Calder Powel, que primero estudió matemáticas, que se nota en su trabajo artístico, y después estudió arte. La escultura Nudo de trébol, que se muestra en la siguiente imagen, es un toro anudado con la forma del nudo de trébol.

Escultura Nudo de trébol, de la escultora estadounidense E. Calder Powel

Escultura Nudo de trébol, de la escultora estadounidense E. Calder PowelY terminamos con una escultura que tuve la suerte de ver este verano, cuando fui a visitar la torre del arquitecto Frank Gehry que alberga el centro cultural Luma, en Arlés (Francia). Se trata de un nudo tórico rosa muy llamativo, la escultura Krauses Gekröse (2011), del escultor austriaco Franz West (1947-2012), que vemos en la siguiente imagen. El nudo implicado en esta obra es la unión (en topología “suma conexa”) de dos nudos de trébol, lo que se conoce como nudo de rizo.

Escultura Krauses Gekröse (2011), del escultor austriaco Franz West, que se encuentra en el exterior del edificio de la Funbdacion LUMA (Arlés, Francia). Fotografía de Marian Espinosa

Escultura Krauses Gekröse (2011), del escultor austriaco Franz West, que se encuentra en el exterior del edificio de la Funbdacion LUMA (Arlés, Francia). Fotografía de Marian EspinosaBibliografía

1.- Raúl Ibáñez, Las matemáticas como herramienta de creación artística, colección Miradas matemáticas, Catarata, 2023.

2.- Clifford A. Pickover, La banda de Möbius, Almuzara, 2009.

3.- Martin Gardner, Festival mágico-matemático, Alianza editorial, 1984.

4.- Stephen Barr, Experiments in Topology, Dover, 1989.

5.- Martin Gardner, The Sixth Scientific American Book of Mathematical Puzzles and Diversions, Simon & Schuster, 1971.

6.- Página web del escultor Keizo Ushio

7.- Richard Serra, La materia del tiempo / Denboraren materia, Museo Guggenheim Bilbao, 2006.

8.- Página web de Jack Eagan

9.- Bradshaw Foundation: Symbolic Sculpture. The collected Works of John Robinson

10. Página de la escultora E. Calder Powel

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El toro, la botella de Klein y el plano proyectivo real (I) se ha escrito en Cuaderno de Cultura Científica.

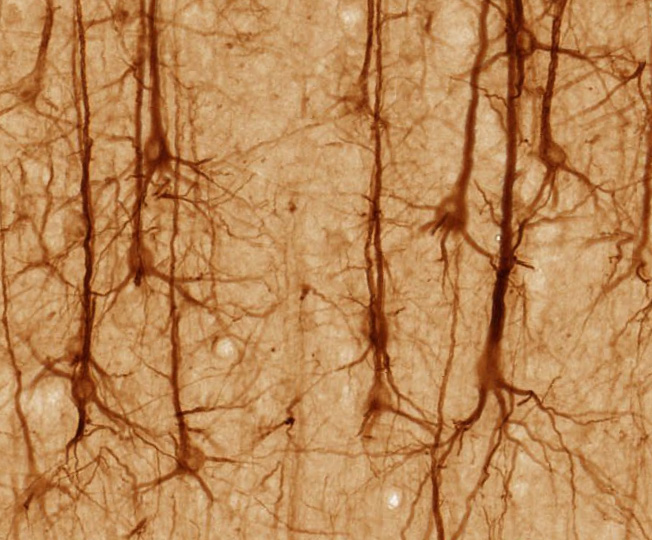

Los patrones emergentes de las colonias de cianobacterias

Foto: Jonathan Larson / Unsplash

Foto: Jonathan Larson / UnsplashUn equipo de investigación ha descrito el mecanismo físico detrás de los patrones geométricos que forman las cianobacterias, una de las formas de vida más antiguas y abundantes de la Tierra, y que ha jugado un papel fundamental en la evolución de nuestro planeta.

Las antiguas cianobacterias fueron la primera forma de vida en desarrollar la fotosíntesis y fueron las responsables de inyectar oxígeno a la atmósfera de la Tierra, sentando así las bases para el surgimiento de las complejas formas de vida que conocemos hoy. Las cianobacterias actuales siguen desempeñando un papel clave en el mantenimiento de la composición de la atmósfera y los océanos actuales.

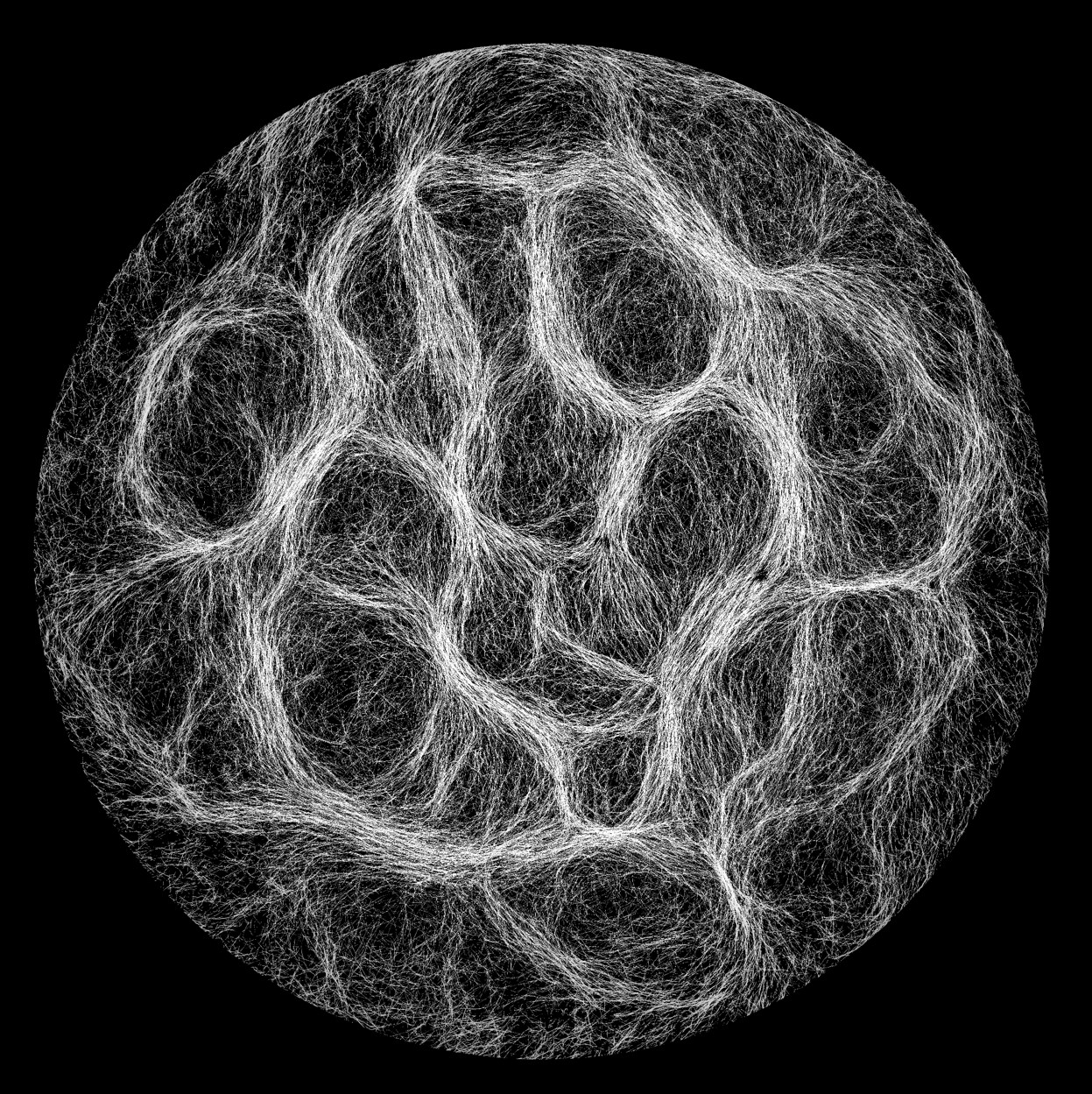

Una estructura reticular formada por cianobacterias. Fuente: Nottingham Trent University

Una estructura reticular formada por cianobacterias. Fuente: Nottingham Trent UniversityPara sobrevivir muchas especies de cianobacterias crecen formando largas cadenas de células que cubren superficies y se entrelazan formando grandes redes de filamentos estrechamente agrupados durante horas o días. Sin embargo, hasta ahora, el origen de estos patrones reticulados había desconcertado a los científicos.

Utilizando técnicas avanzadas de microscopía, simulaciones y modelos teóricos, los investigadores han descubierto cómo las interacciones entre los filamentos de las cianobacterias hacen que se agrupen y construyan estructuras. Cuando las cianobacterias están presentes en una densidad suficientemente alta comienzan a organizarse en su patrón reticulado, y ello como resultado de unas pocas reglas simples.

Las cianobacterias como espaguetis activosA medida que las bacterias se mueven, chocan entre sí. En la mayoría de los casos, los filamentos pasan uno por encima o por debajo del otro, evitando el choque. Pero ocasionalmente se mantienen en el mismo plano, girando para moverse en paralelo durante un tiempo, hasta que uno se separa. Estas interacciones conducen a la formación de haces de filamentos alineados que hacen que las colonias más densas se organicen formando redes extensas. Los investigadores se refieren a este comportamiento de los filamentos como «espaguetis activos».

Los investigadores han desarrollado un modelo que predice con éxito la densidad y escala típicas de los patrones emergentes, incluido el movimiento y las fluctuaciones en la forma de los filamentos. Estos resultados pueden emplearse como base para entender cómo los diferentes tipos de bacterias se autoorganizan para formar estructuras. Esto es especialmente importante porque podría mejorar nuestra comprensión de cómo se forman las biopelículas bacterianas (colecciones de bacterias que se han adherido a una superficie y entre sí), que tienen un papel central en diversos procesos, como las infecciones humanas, la degradación ambiental y la bioingeniería.

Referencia:

Mixon K. Faluweki, Jan Cammann, Marco G. Mazza, and Lucas Goehring (2023) Active Spaghetti: Collective Organization in Cyanobacteria Phys. Rev. Lett. doi: 10.1103/PhysRevLett.131.158303

Edición realizada por César Tomé López a partir de materiales suministrados por Nottingham Trent University

El artículo Los patrones emergentes de las colonias de cianobacterias se ha escrito en Cuaderno de Cultura Científica.

Acotando la edad de los anillos de Saturno

Los anillos de Saturno no son únicamente una fuente de fascinación por su gran belleza y majestuosidad, sino que también siguen cautivando a los científicos a la hora de buscar una explicación no solo a su mecanismo de formación, sino también a su edad. ¿Son un adorno planetario reciente o se formaron hace muchos millones de años?

Ciertamente es muy difícil saber con exactitud la edad de los anillos. Prueba de ello son las distintas estimaciones de edad que se han publicado a lo largo de las últimas décadas, pero también en la diversidad de mecanismos de formación propuestos para explicar su existencia, lo que de nuevo reafirma que no es una tarea fácil el llegar a conclusiones en este ámbito.

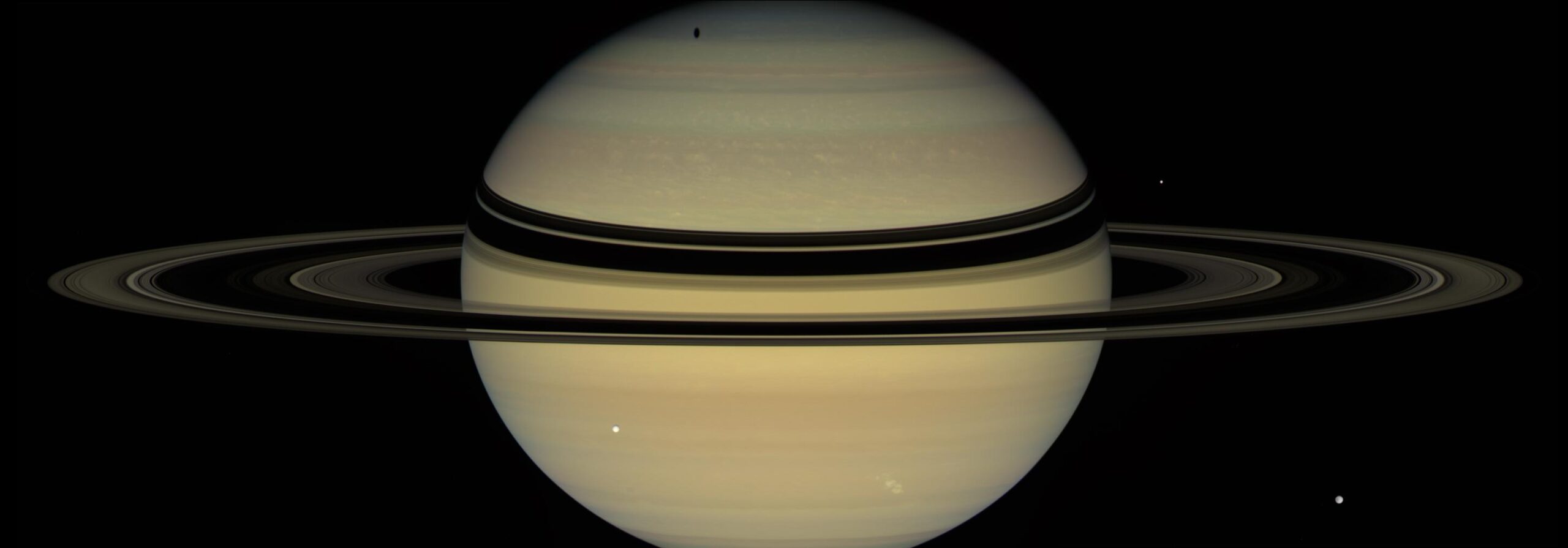

Aunque son realmente impresionantes, los anillos de Saturno tienen un espesor promedio que va desde unas decenas de metros a un kilómetro, pero su densidad y extensión lo hacen un fenómeno espectacular. Imagen cortesía de NASA/JPL-Caltech/Space Science Institute.

Aunque son realmente impresionantes, los anillos de Saturno tienen un espesor promedio que va desde unas decenas de metros a un kilómetro, pero su densidad y extensión lo hacen un fenómeno espectacular. Imagen cortesía de NASA/JPL-Caltech/Space Science Institute.Hablando de las distintas edades de los anillos, algunas sugieren que podrían ser tan antiguos como Saturno, habiéndose formado estos con el material sobrante de la formación del gigante gaseoso y su sistema de satélites. Otros estudios sugieren que pudieron formarse por la desintegración de un satélite hace unos pocos cientos de millones de años -o incluso menos- al haberse acercado demasiado al planeta, quizás por la interacción gravitatoria con otro satélite.

E incluso hay autores que afirman que los anillos podrían ser la consecuencia de la destrucción de distintos cometas que se acercan peligrosamente a Saturno a lo largo del tiempo, y que, mediante este mecanismo de formación, los anillos podrían tener una fuente constante de material que va reemplazando el material que se pierde al caer a Saturno.

En la última década, los datos aportados por la misión Cassini están siendo muy útiles para poder calcular con mayor precisión su edad, algo que está inclinando la balanza hacia una formación reciente de los anillos basándose principalmente en dos evidencias: La primera es que los anillos van perdiendo masa lentamente al caer las partículas que lo conforman sobre Saturno, por lo que los anillos además tienen una esperanza de vida limitada a escala geológica. Esto quiere decir que en el caso de Saturno a los anillos podrían quedarles entre 15 y los 400 millones de años de vida y, si no hay un mecanismo que continuamente aporte material, los anillos irían desapareciendo progresivamente, convirtiendo a estos en un fenómeno efímero y a nosotros en unos afortunados por haber podido observarlos.

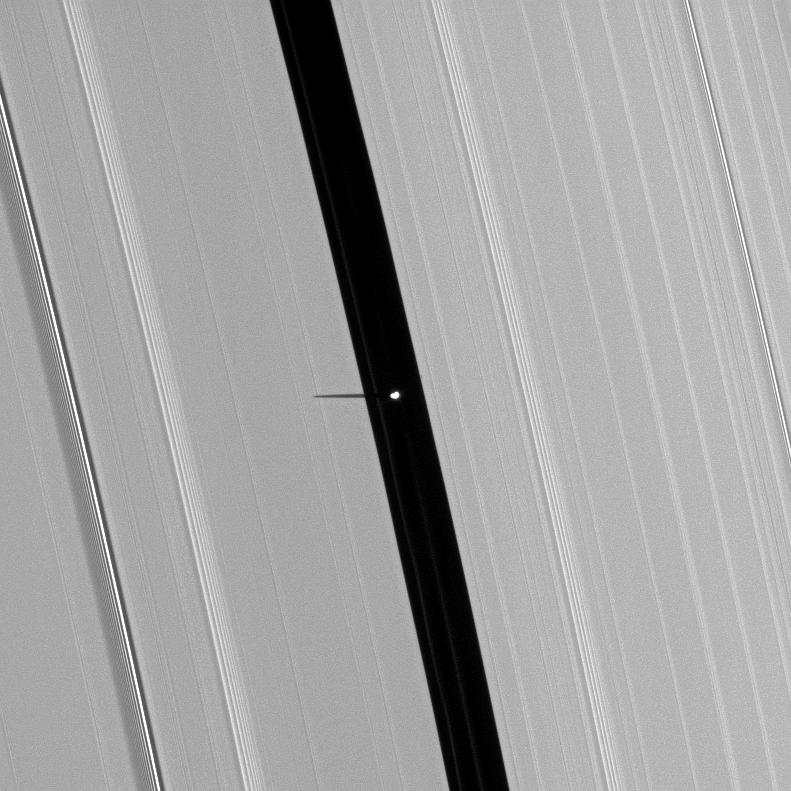

Los anillos de Saturno tienen una compleja estructura concéntrica en la cual, en ocasiones, podemos encontrar huecos o “divisiones” como la que vemos en la imagen, la división de Encke, y en su interior, en este caso, un pequeño satélite denominado Pan. Imagen cortesía de NASA/JPL/Space Science Institute.

Los anillos de Saturno tienen una compleja estructura concéntrica en la cual, en ocasiones, podemos encontrar huecos o “divisiones” como la que vemos en la imagen, la división de Encke, y en su interior, en este caso, un pequeño satélite denominado Pan. Imagen cortesía de NASA/JPL/Space Science Institute.La segunda es que, si suponemos que los anillos están sometidos continuamente a un bombardeo de micrometeoritos como sabemos que ocurre en todo el Sistema Solar, si estos fuesen muy antiguos, tenderían a ser de un color más oscuro a causa de la “contaminación” provocada por parte de partículas rocosas y compuestos orgánicos aportados por estos impactos sobre las partículas de hielo que forman los anillos. En cambio, los anillos de Saturno siguen siendo muy “blancos”, y es que aproximadamente están compuestos en un 99.9% de hielo de agua.

Y aquí es donde vienen las novedades: un nuevo estudio sugiere que los anillos en realidad son el resultado de una colisión entre dos antiguos satélites de Saturno, que como resultado desintegraría los satélites, dejando una gran cantidad de material en la órbita del gigante gaseoso, dando lugar a los anillos. Pero no solo eso, sino que parte de los materiales sobrantes podrían incluso haber formado algunos de los satélites que conocemos hoy día.

Para llegar a esta conclusión los investigadores han creado una serie de simulaciones de alta resolución -superando en más de 100 veces la resolución de modelos anteriores- comprendiendo unos doscientos escenarios diferentes variando distintos parámetros, como el ángulo de colisión, para poder estudiar todas las posibilidades de una manera más precisa.

Estos satélites tendrían una órbita y una masa similar a los actuales Dione y Rea y podrían haber colisionado con ángulos muy diferentes, aunque las simulaciones muestran que para generar la distribución de material necesaria para dar lugar a los anillos la colisión tendría que haber sido directa o con un ángulo intermedio.

El cometa Shoemaker-Levy 9 se fragmentó tras un paso muy cerca de Júpiter, dentro del límite de Roche. Posteriormente sus fragmentos acabarían colisionando con el gigante gaseoso. Imagen cortesía de HA. Weaver, T. ESmith ( Space Telescope Science Institute), and NASA/ESA.

El cometa Shoemaker-Levy 9 se fragmentó tras un paso muy cerca de Júpiter, dentro del límite de Roche. Posteriormente sus fragmentos acabarían colisionando con el gigante gaseoso. Imagen cortesía de HA. Weaver, T. ESmith ( Space Telescope Science Institute), and NASA/ESA.Gracias a este evento, una gran cantidad de material podría haber llegado a las proximidades de Saturno. Uso el término “proximidades” de Saturno, hablando en términos coloquiales, porque este nos da una pista muy interesante. Los anillos de Saturno se encuentran dentro de lo que conocemos como límite de Roche, una distancia alrededor de un planeta o un cuerpo de gran tamaño a partir de la cual la fuerza de la gravedad sería capaz de desintegrar un satélite.

Dicho esto, el material que no formó parte de los anillos pudo llegar a coalescer fuera del límite de Roche formando nuevos satélites a partir de esta colisión. Obviamente, aquí podría haber otra contradicción: ¿Quién dice que no había ya unos anillos y que esto sirvió para rejuvenecer los ya existentes? Pues es, obviamente, otro campo de estudio que se abre a los científicos.

A partir de este punto cabe continuar las investigaciones que puedan confirmar esta teoría, por un lado, modelando la distribución del material dispersado por la posible colisión entre los satélites, pero también el intentar identificar poblaciones de cráteres en los satélites de Saturno cuya distribución y edad coincida con esta nueva teoría.

Referencias:

Teodoro, L. F. A., Kegerreis, J., Estrada, P. R., Ćuk, M., Eke, V. R., Cuzzi, J. N., Massey, R., & Sandnes, T. D. (2023). A recent impact origin of Saturn’s rings and mid-sized moons. The Astrophysical Journal, 955(2), 137. https://doi.org/10.3847/1538-4357/acf4ed

Kempf, S., Altobelli, N., Schmidt, J., Cuzzi, J. N., Estrada, P. R., & Srama, R. (2023). Micrometeoroid infall onto Saturn’s rings constrains their age to no more than a few hundred million years. Science Advances, 9(19). https://doi.org/10.1126/sciadv.adf8537

Dones, L. (1991). A recent cometary origin for Saturn’s Rings? Icarus, 92(2), 194-203. https://doi.org/10.1016/0019-1035(91)90045-u

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Acotando la edad de los anillos de Saturno se ha escrito en Cuaderno de Cultura Científica.

El bienestar subjetivo es heredable, pero no en un alto grado

Al parecer, el sentimiento subjetivo de bienestar es un rasgo heredable, aunque en una pequeña medida. En otras palabras, aunque la herencia genética es responsable de una cierta fracción de la variabilidad de ese sentimiento de bienestar, esa fracción es pequeña; de hecho no supera un 25% de la variabilidad total.

Foto: frank mckenna / Unsplash

Foto: frank mckenna / UnsplashEse es el principal resultado de un estudio basado en encuestas realizadas en Dinamarca y Holanda. A las personas incluidas en la muestra les hicieron dos preguntas. Una era si durante la semana anterior se había sentido contenta (happy), y la otra, si durante la semana anterior había disfrutado de la vida (enjoy).

Para su posterior tratamiento estadístico, transformaron las respuestas en variables binarias (mucho o no mucho) y, además, generaron una tercera variable, combinación de las dos anteriores, de manera que si las anteriores eran afirmativas, entonces la tercera (la combinación) también lo era, y era negativa en cualquier otro caso. El número total de individuos encuestados fue próximo a 11500. Y esos individuos fueron caracterizados genéticamente analizando alrededor de 850.000 polimorfismos de nucleótido único.

El equipo investigador estimó la denominada “heredabilidad estricta (o realizada) común” (o heredabilidad común en sentido estricto), que se define como la fracción de la varianza del carácter en cuestión que es atribuible a los efectos aditivos de los polimorfismos genéticos comunes. Ese término, –heredabilidad estricta–, se utiliza por oposición a la denominada “heredabilidad amplia” (o heredabilidad en sentido amplio), que incluye, además del efecto de los polimorfismos, el de las interacciones entre ellos (epistasia) y sus posibles efectos no lineales (dominancia).

Los especialistas consideran que la heredabilidad “estricta” es más relevante que la “amplia” a la hora de evaluar el poder predictivo de las técnicas de genética molecular, entre otras cosas porque se antoja extremadamente difícil delimitar el conjunto de interacciones epistáticas (interacciones entre los efectos lineales de los diferentes polimorfismos) susceptibles de tener algún efecto. Desde un punto de vista metodológico la tarea se presentaría ardua en extremo en caso de recurrir a la heredabilidad “amplia”, pues haría falta utilizar muestras poblacionales gigantescas para otorgar al análisis el necesario rigor estadístico.

El efecto de los factores genéticos, tal y como se ha determinado en este trabajo, es estadísticamente significativo para las respuestas a la pregunta de si había estado contento (happy) la semana pasada (p = 0,01), y algo menos significativo para la variable generada a partir de las dos primarias (happy y enjoy) (p = 0,03), y en ambos casos la proporción de la varianza explicada por los factores genéticos resultó de un 10% aproximadamente. Se trata de un valor muy bajo, inferior a las estimaciones que se han hecho para otros rasgos de personalidad o características psicológicas, y también por comparación con los obtenidos a partir de estudios de gemelos, hermanos y familiares próximos para este mismo rasgo, el del bienestar subjetivo.

Según los autores, ese bajo valor de heredabilidad se debe, en parte, al error que, por razones metodológicas, se comete en la determinación del sentimiento de bienestar. Una vez corregido el efecto de ese error, el porcentaje explicado por los factores genéticos resulta algo más alto: se encontraría en el rango 12-18%. En todo caso, sigue siendo un valor bajo si se compara con la heredabilidad de otros caracteres o con la heredabilidad “amplia”, que es la que se suele obtener en otros estudios. De hecho, es muy posible que, como ocurre con otros rasgos de personalidad (neuroticismo, apertura a la experiencia, simpatía), haya una importante componente de la heredabilidad no debida a factores aditivos (lo que antes hemos denominado interacciones epistáticas).

Cuando se ha medido la heredabilidad del modo en que se ha hecho en este trabajo, se han obtenido valores de 9% y 12% para el neuroticismo y la extroversión, respectivamente. También es baja la obtenida en este trabajo si se compara con la “heredabilidad estricta” que se determina en estudios con familiares próximos; estos han arrojado valores en el intervalo de 30-40%. Lo que ocurre es que estos estudios dan cuenta de “toda” la heredabilidad estricta, y la medida en este trabajo (heredabilidad estricta común) solo es, como se ha señalado antes, la debida a los polimorfismos comunes. Al corregir las estimaciones de este trabajo de manera que se incorpora el efecto de los polimorfismos raros, se obtienen valores en el entorno de 18%-27% de heredabilidad estricta, una estimación mucho más acorde con los valores obtenidos normalmente con rasgos de personalidad en estudios de familiares próximos.

Dado que la intervención para mejorar el bienestar subjetivo de las personas sólo se puede ejercer a través de factores ambientales (no heredables), es conveniente conocer los límites que pueden tener dichas intervenciones y para eso es esencial determinar, con la mayor precisión posible, las diferentes fuentes de variación, también la de origen genético. Es más, a partir de estos estudios pretenden llegar a identificar el conjunto de polimorfismos concretos que contribuyen de modo más decisivo al sentimiento de bienestar subjetivo.

No obstante, a la hora de valorar estos datos hay que ser cautelosos. Incluso cuando un rasgo es heredable en una alta proporción, ello no tendría por qué reducir la importancia de los factores ambientales. Los niveles basales de serotonina, así como la densidad de receptores de dopamina, inciden en la sensación de bienestar de forma directa, y están, en gran medida, condicionados genéticamente. Y hay otros factores genéticos que inciden en las preferencias, personalidad y habilidades de las personas, lo que influye en la elección de pareja y amistades, fecundidad, etc., elementos todos ellos de carácter ambiental.

Por tanto, los efectos de unos y otros factores son complejos y no es fácil establecer proporciones precisas, porque muchos actúan de modo interactivo. Y por otra parte, aunque estudios realizados en un momento y bajo ciertas condiciones arrojen unos determinados resultados de heredabilidad, esos resultados podrían ser distintos si el mismo estudio se realizase en un momento y bajo condiciones diferentes. Eso es así porque cuando las condiciones ambientales bajo las que se encuentran los sujetos son muy similares, la variabilidad registrada apenas sería atribuible a factores ambientales, de manera que habría de ser atribuida a factores hereditarios.

Para entender lo anterior, pensemos en dos poblaciones, de manera que todos los individuos de una de ellas estuviesen sometidos a restricciones nutricionales y todos los de la otra nadasen en la abundancia. Dentro de cada población se registraría una alta heredabilidad de rasgos tales como la altura o la obesidad, porque no habría apenas efecto de las condiciones alimenticias. Sin embargo, si se comparasen las dos poblaciones, se concluiría que el efecto de las condiciones nutricionales (ambientales) sería muy acusado, mucho más que el que se determina bajo condiciones relativamente homogéneas.

Fuente: Cornelius A. Rietveld, David Cesarini, Daniel J. Benjamin, Philipp D. Koellinger, Jan-Emmanuel De Neve, Henning Tiemeier, Magnus Johannesson, Patrik K. E. Magnusson, Nancy L. Pedersen, Robert F. Krueger, y Meike Bartels (2013): “Molecular genetics and subjective well-being” PNAS 110 (24).

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El bienestar subjetivo es heredable, pero no en un alto grado se ha escrito en Cuaderno de Cultura Científica.

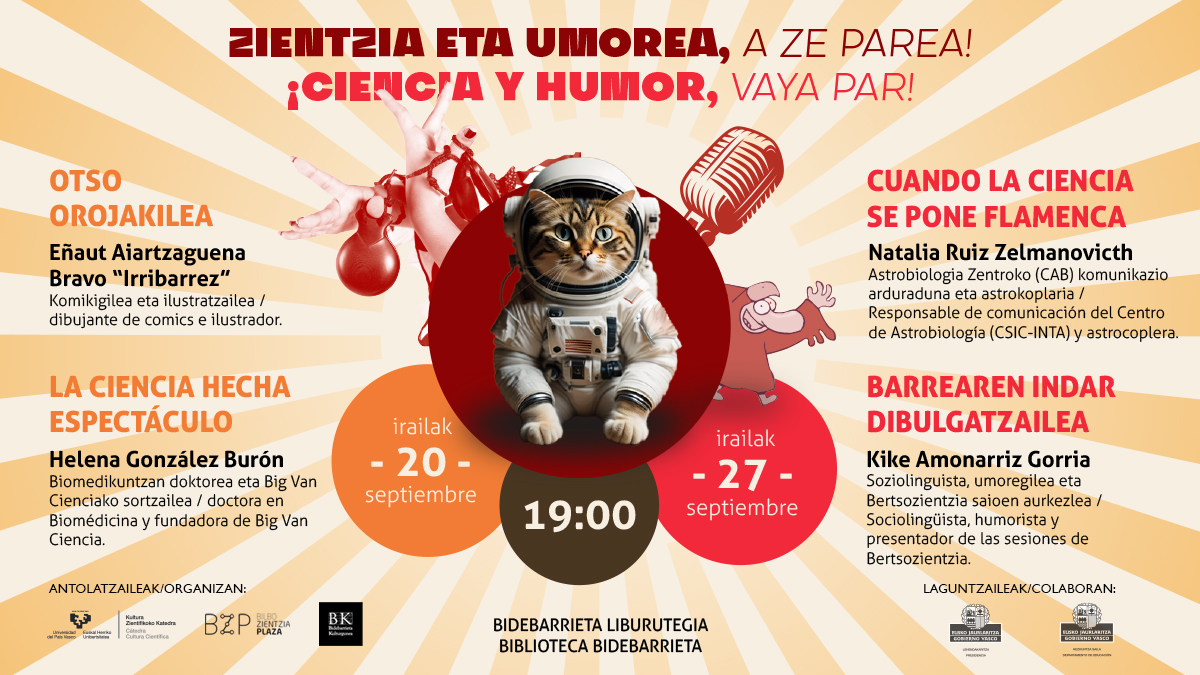

¡Ciencia y humor, vaya par! (1)

La difusión del conocimiento de la ciencia se puede hacer a través de diferentes vías. Muchas veces son caminos que van más allá del ámbito académico y uno de ellos puede ser el uso del humor.

Con tiras publicadas en periódicos o revistas, a través de monólogos humorísticos y chistes o, por qué no, cantando coplas se puede hablar sobre ciencia. Todas estas estrategias son útiles y estas experiencias serán tema de conversación en la serie de conferencias Humor y ciencia, ¡vaya par!, organizadas dentro de Bilbo Zientzia Plaza.

Estas charlas suponen, además, la apertura de un nuevo curso del ciclo de conferencias Bidebarrieta Científica, organizado por la Cátedra de Cultura Científica de la Universidad del País Vasco y la Biblioteca Bidebarrieta.

El miércoles 20 de septiembre a las 19:00 de la tarde Eñaut Aiartzaguena Bravo, Irribarrez, ilustrador y autor de cómics, ofreció la charla Otso orojakilea (con traducción simultánea al castellano). Le acompañará Helena González Burón, doctora en Biomedicina y fundadora de Big Van Ciencia, que impartió la charla La ciencia hecha espectáculo.

Edición realizada por César Tomé López

El artículo ¡Ciencia y humor, vaya par! (1) se ha escrito en Cuaderno de Cultura Científica.

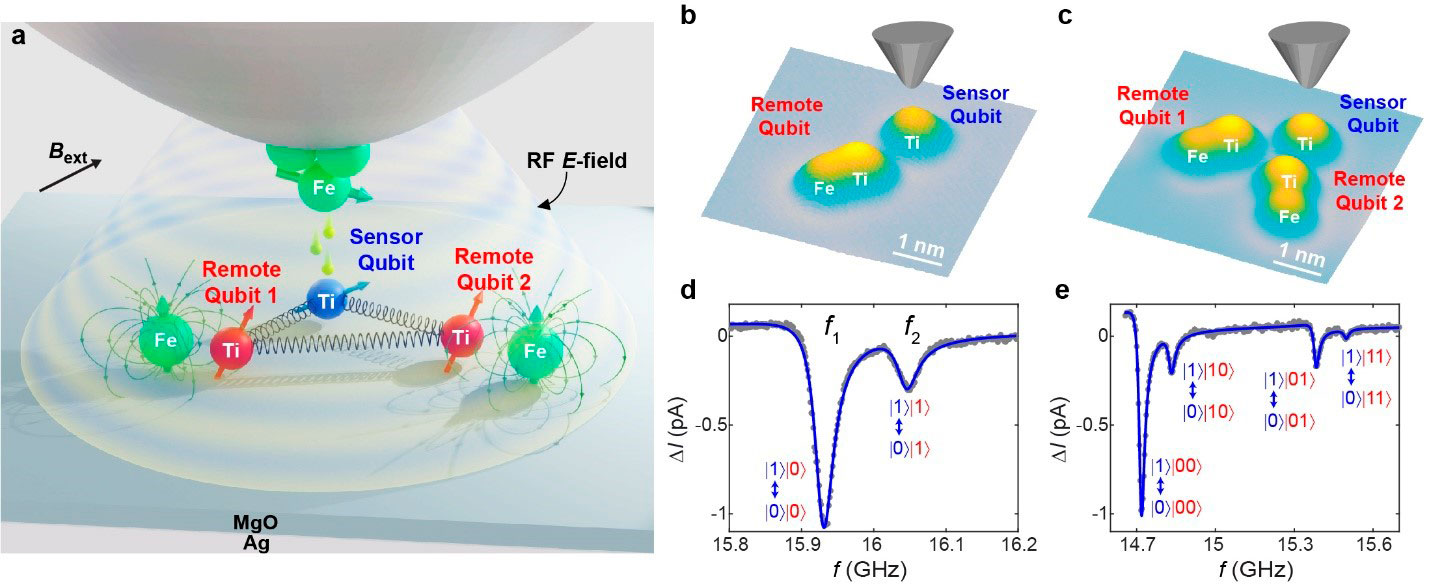

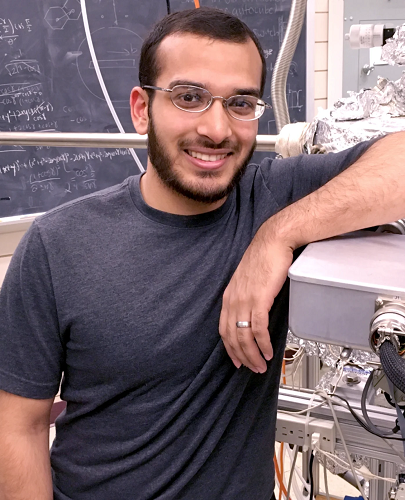

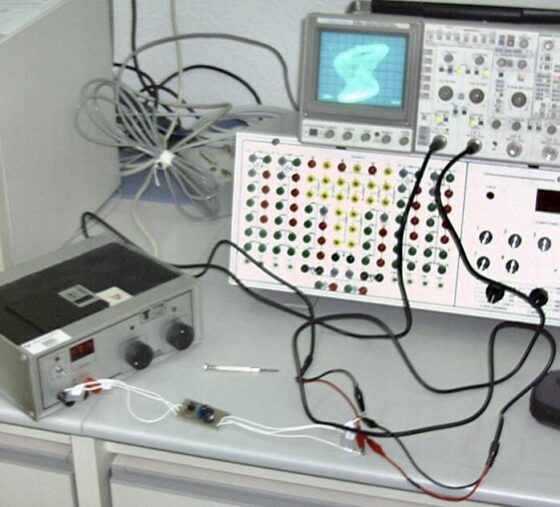

Una nueva plataforma de qubits creada átomo a átomo

Un equipo internacional de investigación liderado por Deung-Jang Choi y Cristina Mier, del Centro de Física de Materiales (CSIC-UPV/EHU) y del Donostia International Physics Center (DIPC), en colaboración con equipos de investigación de Corea, Japón y Estados Unidos, ha presentado una nueva plataforma cuántica que utiliza los espines de electrónicos de átomos individuales sobre una superficie sólida, logrando un sistema de qubits (bit cuántico) múltiple que utiliza tres espines de electrones simultaneamente. Los resultados se han publicado en Science.

La unidad fundamental para el almacenamiento de información y el cálculo en los ordenadores es el bit, que puede tener un valor de 0 ó 1. En cambio, los ordenadores cuánticos funcionan con qubits como unidad fundamental, que pueden realizar cálculos en una superposición de estados 0 y 1, lo que significa que pueden existir simultáneamente en ambos estados, como en la paradoja del gato de Schrodinger. Esta capacidad se traduce en una mejora significativa del rendimiento en términos de almacenamiento de información y velocidad de procesamiento en comparación con los ordenadores clásicos.

Para comercializar los ordenadores cuánticos, se han propuesto varios tipos de qubits utilizando uniones superconductoras, trampas de iones, puntos cuánticos y estados de fase cuánticos. Debido a la relativamente corta historia de la ciencia de la información cuántica, el reto de diseñar un sistema de qubits óptimo sigue pendiente. Durante décadas, los esfuerzos de la ciencia se han concentrado en construir una arquitectura cuántico-coherente a escala atómica, un reino donde las propiedades fundamentales de los átomos, como el espín de los electrones, se abran paso. Un logro así podría revolucionar la ciencia cuántica y la nanotecnología.

De hecho, continúa siendo necesaria una investigación científica fundamental para poner en marcha una nueva plataforma cuántica que subsane las deficiencias de los qubits existentes y, al mismo tiempo, aumente su integración y fiabilidad.

La microscopía de barrido de efecto túnel (STM) ha demostrado ser muy útil para medir y controlar los estados electrónicos de átomos individuales, aprovechando los fenómenos de la mecánica cuántica. En este trabajo, que combina la tecnología STM y la ESR (resonancia de espín electrónico), la proyección de pulsos de microondas sobre átomos individuales de titanio en la superficie permite controlar y medir con éxito los estados de espín. Como resultado, fue posible controlar con precisión el espín de un solo átomo y ajustarlo al estado cuántico deseado. El reto restante era implementar un sistema multiqubit capaz de controlar varios qubits simultáneamente. La plataforma de qubits presentada en este trabajo consiste en múltiples átomos de titanio colocados sobre la superficie de un fino aislante (óxido de magnesio) y ha superado con éxito el reto.

Las investigadoras utilizaron la sonda de un microscopio de barrido en túnel (STM) manipulando con precisión las posiciones de cada átomo, creando una estructura de múltiples átomos de titanio donde sus espines pueden interactuar. Posteriormente, aplicaron un método de control remoto al átomo de titanio que sirve de sensor (qubit sensor) y controlaron y midieron con éxito múltiples qubits (qubits remotos) colocados a distancia con una sola sonda.

Como cada qubit remoto interactúa con el qubit sensor, los cambios en el estado de espín de los qubits remotos afectan al qubit sensor, y este cambio se lee a través de la sonda. En este trabajo también implementaron las operaciones fundamentales del procesamiento cuántico de la información, las puertas «CNOT» (Controlled NOT gate) y «Toffoli», utilizando esta plataforma de qubits. La investigación se llevó a cabo a una temperatura de 0,4 K (-272,6 °C).

«Manipular múltiples qubits a distancia a nivel atómico es realmente extraordinario», afirmó una de las investigadoras. «Hasta ahora, solo podíamos controlar un único qubit en la superficie, pero gracias a esta investigación, hemos dado un salto significativo en la implementación de sistemas de qubits múltiples a nivel atómico».

La plataforma presentada en este estudio tiene la ventaja de controlar con precisión el intercambio de información entre qubits a nivel atómico. También se distingue de las plataformas de qubits existentes porque puede implementar circuitos cuánticos integrados con qubits individuales de menos de 1 nm. Además, a diferencia de otras plataformas que requieren materiales específicos (qubits de uniones superconductoras), permite seleccionar varios átomos como materiales de qubit, además del titanio.

En cuanto a la futura implementación y aplicación de estos resultados, la aplicación del sistema de qubits implementado para el procesamiento práctico de información cuántica, requerirá asegurar un tiempo de operación suficientemente largo para realizar diversas operaciones cuánticas de forma continua mientras se incrementa el número de qubits. Utilizando el método introducido en esta investigación, se espera que se puedan conectar y operar hasta 5-6 qubits, pero es necesario seguir investigando para desarrollar una plataforma que pueda controlar más de 10 qubits simultáneamente mejorando las conexiones y los métodos de medición entre qubits.

Referencia:

Yu Wang, Yi Chen, Hong T. Bui, Christoph Wolf, Masahiro Haze, Cristina Mier, Jinkyung Kim, Deung-Jang Choi, Christopher P. Lutz, Yujeong Bae, Soo-hyon Phark, and Andreas J. Heinrich (2023) An atomic-scale multi-qubit platform Science doi: 10.1126/science.ade5050

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Una nueva plataforma de qubits creada átomo a átomo se ha escrito en Cuaderno de Cultura Científica.

Islas, montañas que emergen del mar

De vez en cuando, los medios de comunicación emiten imágenes de esas acumulaciones de basura y desperdicios flotantes que hemos vertido a los océanos y las corrientes marinas han amontonado en ciertas zonas, a las que llamamos islas de plástico. Pues, aunque sea un nombre muy gráfico y llamativo, en realidad conduce a un error. Y no me refiero a lo de los plásticos, sino a lo de islas.

Asimilando conceptos, podemos llegar a pensar que las islas naturales son acumulaciones de tierra que están flotando en el mar, una idea que nos ha acompañado desde tiempos inmemoriales y que forma parte de muchas de nuestras mitologías. Desde Odiseo, más conocido por su nombre latinizado Ulises, teniendo que evitar con su barco unas enormes rocas erráticas que chocaban entre sí en algún lugar del mar Egeo, hasta Maui, que sacó un enorme trozo de tierra del fondo del mar utilizando su anzuelo mágico y que, al soltarlo y romperse en pedazos quedaron flotando en el océano dando lugar a las islas Hawaii. Por suerte, hoy en día, podemos acudir a la Geología para saber qué son y cómo se forman realmente las islas.

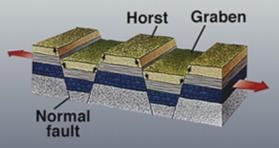

Mecanismo de extensión o separación de dos placas tectónicas (según las flechas rojas) en donde se produce una facturación de la litosfera a favor de fallas denominadas normales (normal fault en la imagen) que generan bloques levantados (horst) y bloques hundidos (graben). Imagen del Servicio Geológico de Estados Unidos de América (United States Geological Service)

Mecanismo de extensión o separación de dos placas tectónicas (según las flechas rojas) en donde se produce una facturación de la litosfera a favor de fallas denominadas normales (normal fault en la imagen) que generan bloques levantados (horst) y bloques hundidos (graben). Imagen del Servicio Geológico de Estados Unidos de América (United States Geological Service)Una isla es una porción de tierra emergida, es decir, que aparece en posición subaérea y está completamente rodeada de agua. Pero eso no quiere decir que flote sobre el mar, más bien todo lo contrario. Todas las islas están enraizadas en el fondo marino y no son más que la parte superior de grandes elevaciones que ascienden hacia la superficie hasta superar el nivel del mar, por lo que podemos verlas en el océano. Así que las islas no serían más que la parte superior de enormes montañas que crecen desde el suelo marino por encima del nivel del agua en ese momento. De hecho, el fondo oceánico no es una superficie plana, existen infinidad de elevaciones de tierra que no llegan a salir a superficie, formando lo que denominamos montes submarinos.

Generalizando un poco, las islas se pueden formar por dos procesos geológicos concretos. Por un lado tenemos los movimientos tectónicos. Como ya he comentado otras veces, la capa más externa, sólida y rígida de nuestro planeta, la litosfera, está partida en pedacitos llamados placas tectónicas. Estas placas se mueven sobre la capa inferior, la astenosfera, que es un sólido plástico. Cuando dos de estas placas se separan una de otra, la litosfera se va adelgazando y fracturando, dando lugar a una serie de bloques hundidos y elevados como si fuesen los peldaños de una escalera que se van a ir cubriendo de agua marina poco a poco. Si el nivel del mar no asciende lo suficiente, algunos de los bloques elevados pueden aflorar en superficie, formando islas.

Pero las placas tectónicas también pueden chocar entre sí. En esos casos, se produce la comprensión de las rocas, que se van levantando lentamente desde el fondo oceánico formando montañas que, de nuevo, pueden llegar a superar el nivel del agua del mar y generar islas en superficie. Para poneros un ejemplo conocido, estos procesos técnicos se produjeron durante el choque de la placa Ibérica con la placa Africana dando lugar a las Cordilleras Béticas y su continuación oriental submarina, las islas Baleares.

Mapa de la topografía submarina (batimetría) de la Península Ibérica donde se observa la elevación de las islas Baleares desde el fondo del Mediterráneo. Imagen modificada del mapa The Mediterranean seafloor, ilustrado por Tiborg G. Toth para la División Cartográfica de la Sociedad Geográfica Nacional de Estados Unidos de América (Cartographic Division, National Geographic Society).

Mapa de la topografía submarina (batimetría) de la Península Ibérica donde se observa la elevación de las islas Baleares desde el fondo del Mediterráneo. Imagen modificada del mapa The Mediterranean seafloor, ilustrado por Tiborg G. Toth para la División Cartográfica de la Sociedad Geográfica Nacional de Estados Unidos de América (Cartographic Division, National Geographic Society).El otro proceso geológico generador de islas más común es el vulcanismo submarino. En este caso, nos encontramos con una cámara magmática en un punto fijo por debajo del fondo oceánico que, en un momento puntual, entra en erupción formando un volcán submarino. Con sucesivas erupciones en la misma zona, ese volcán va a ir creciendo cada vez más hacia la superficie, pudiendo llegar a sobresalir por encima del agua. Entonces formará una isla de origen volcánico, como todas las del archipiélago de las Canarias.

Si los procesos geológicos que han dado lugar a la formación de las islas continúan en el tiempo, estás crecerán, tanto en altitud sobre el nivel del mar como en superficie expuesta de manera subaérea. Pero si dichos procesos se detienen, empezará a actuar la erosión, desmantelando los terrenos emergidos pudiendo llegar a desaparecer las islas quedando sólo unos pequeños remanentes en forma de montes submarinos. Incluso, debido a los ascensos y descensos del nivel marino, algunos territorios emergidos pueden quedar cubiertos por el agua y al revés, elevaciones submarinas pueden aparecer en superficie, encontrándonos con la formación y destrucción de islas de manera continua. Y eso sin entrar en la existencia de algunos eventos extremos que pueden provocar la creación o desmantelamiento de territorios emergidos de manera muy brusca, como la erupción explosiva del volcán Thera durante la época minoica, que se cargó más de la mitad de la isla de Santorini.

En definitiva, las islas, como el resto de montañas de nuestro planeta, no son puñados de tierra flotando en el agua, sino grandes aglomeraciones de rocas bien ancladas al fondo oceánico y que responden a procesos geológicos que modifican nuestro paisaje, también el submarino.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Islas, montañas que emergen del mar se ha escrito en Cuaderno de Cultura Científica.

Sorprendentes promedios

promedios

En la calle Acme 1 hay un edificio de dos plantas.

Las edades de las cinco personas que viven en la primera planta del edificio son 8, 14, 20, 23 y 35 años. Es decir, su edad promedio es:

(8 + 14 + 20 + 23 + 35) / 5 = 100 / 5 = 20 años.

Las seis personas que habitan en la segunda planta del inmueble tienen 25, 30, 35, 40, 45 y 59 años respectivamente. Por lo tanto, su edad promedio es

(25 + 30 + 35 + 40 + 45 + 59) / 6 = 235 / 6 = 39 años.

Juan vive en la primera planta. Tiene 35 años. Harto de soportar los ruidos de sus vecinos, decide mudarse a la segunda planta. Ahora la edad media en la primera planta de la calle Acme número 1 es:

(8 + 14 + 20 + 23) / 4 = 65 / 4 = 16,25 años,

y la edad media en la segunda planta pasa a ser (redondeando con dos decimales):

(25 + 30 + 35 + 35 + 40 + 45 + 59) / 7 = 269 / 7 = 38,43 años.

Sorprendentemente, las edades promedio en las dos plantas han disminuido.

Organizando movimientos de este tipo, ¿podríamos seguir reduciendo la edad media de todas las plantas del edificio y “rejuvenecer” de este modo (en media) a las personas residentes en el inmueble? ¿Qué cambios de este tipo consiguen reducir la edad promedio?

ExplicaciónEsta situación parece contradictoria: tenemos dos conjuntos de números, A y B y, moviendo un elemento de A a B, se ha reducido la media de ambos conjuntos. Raro, ¿no? Pero no hay errores de cálculo. Obviamente, el promedio de las edades de los once habitantes de las dos primeras plantas del edificio se ha mantenido; es:

(8 + 14 + 20 + 23 + 25 + 30 + 35 + 35 + 40 + 45 + 59) / 11 = 334 / 11 = 30,36.

La media ponderada de los dos primeros promedios es:

(5 / 11) x 20 + (6 / 11) x 39 = 334 / 11 = 30,36.

Y, por supuesto, coincide con la media ponderada de las edades tras el cambio de piso de Juan:

(4 / 11) x 16,25 + (7 / 11) x 38,43 = 334,01 / 11 = 30,36.

Esto es, de nuevo, bastante contraintuitivo: cuando tomamos el promedio ponderado de dos números puede permanecer constante, aunque cada uno de los dos números promediados disminuya…

Esta “paradoja” ha sucedido por el siguiente motivo: si en dos conjuntos de números A y B trasladamos de A a B un elemento x mayor que la media de A y menor que la media de B, entonces, las nuevas medias de A y B disminuirán. Pero los promedios ponderados antes y después del cambio permanecerán constantes.

En efecto, la media de los elementos de A disminuye porque se ha eliminado de A un número mayor que la media de A, y eso evidentemente baja su promedio. Además, se ha añadido al conjunto B un número inferior al promedio de los elementos de B; y obviamente esto baja la media de B.

En nuestro ejemplo, Juan tiene 35 años, cantidad que se sitúa entre los dos promedios del primer y el segundo piso (20 < 35 < 39), por eso su cambio de planta produce la disminución de las medias de edad en ambos pisos… ¡Aunque nadie se ha vuelto más joven!

Repitiendo el procesoPor supuesto, el anterior fenómeno no sucede siempre. Si tenemos dos conjuntos de números A y B, ambos con las mismas medias aritméticas, cualquier cambio de uno de los elementos (con valor diferente a la media) de uno a otro conjunto provocará que las medias resultantes varíen en direcciones opuestas.

En el caso de la calle Acme, tras el cambio de Juan, podrían volverse a reducir las edades medias si la persona de 23 años (16,25 < 23 < 38,43) de la primera planta se mudara a la segunda. La nueva edad media en la primera planta sería:

(8 + 14 + 20) / 3 = 42 / 3 = 14 años,

y la edad media en la segunda planta pasaría a ser:

(23 + 25 + 30 + 35 + 35 + 40 + 45 + 59) / 8 = 292 / 8 = 36,5 años.

Y podríamos realizar una nueva disminución de edad si la persona de 20 años del primer piso (14 < 20 < 36,5) se trasladara al segundo piso. La nueva edad media en la primera planta sería:

(8 + 14) / 2 = 22 / 2 = 11 años,

y la edad media en la segunda planta pasaría a ser (redondeando con dos cifras decimales):

(20 + 23 + 25 + 30 + 35 + 35 + 40 + 45 + 59) / 9 = 312 / 9 = 34,67 años.

De nuevo podríamos repetir este “juego” si la persona de 14 años del primer piso (11 < 14 < 34,67) se trasladara al segundo piso. La nueva edad media en la primera planta sería:

8 / 1 = 8 años,

y la edad media en la segunda planta pasaría a ser:

(14 + 20 + 23 + 25 + 30 + 35 + 35 + 40 + 45 + 59) / 10 = 326 / 10 = 32,6 años.

Aunque, por supuesto, la media ponderada en esta última etapa seguiría siendo la misma (redondeando con dos cifras decimales) que al principio:

(1 / 11) x 8 + (10 / 11) x 32,6 = 334 / 11 = 30,36.

Referencia

Jean-Paul Delahaye, Le déménagement miraculeux, Accromath 18.1, hiver – printemps 2023, 30-31.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Sorprendentes promedios se ha escrito en Cuaderno de Cultura Científica.

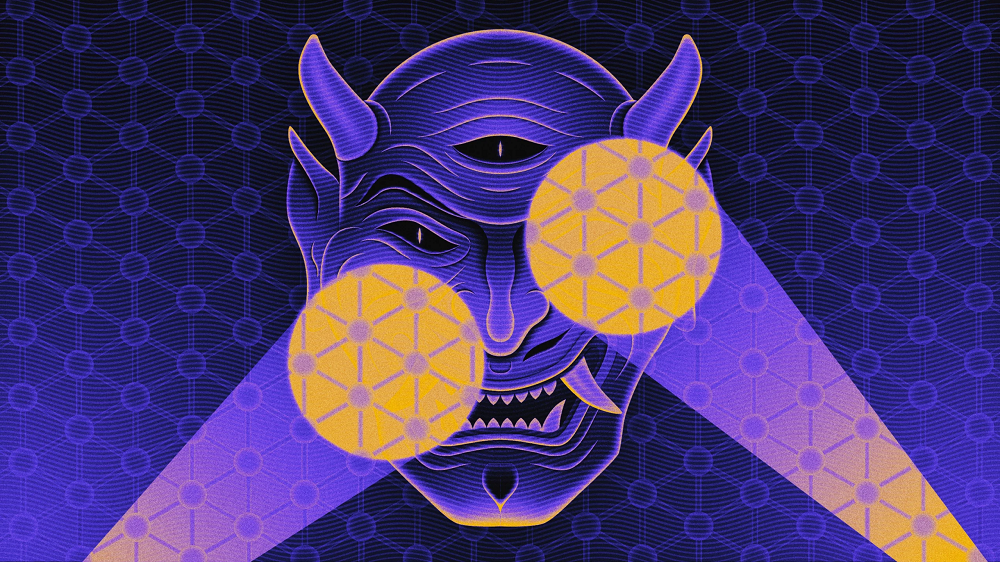

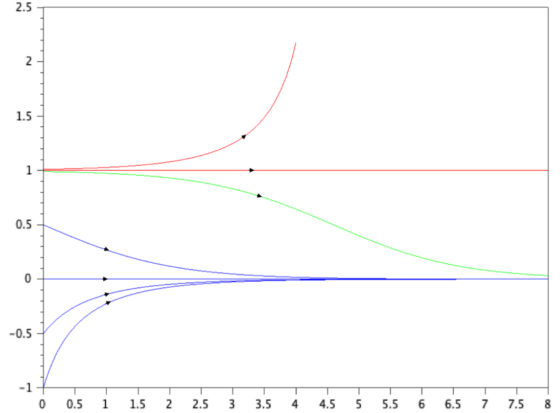

Un «demonio» invisible detectado en un raro superconductor

demonios

Los físicos han sospechado durante mucho tiempo que algunos trozos de metal podrían vibrar de una manera peculiar que sería casi invisible. Ahora los físicos han detectado estos «modos demoníacos».

Un artículo de Charlie Wood. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Los físicos han detectado una inusual onda «demonio» de electrones que es invisible a la radiación electromagnética. Fuente: Kristina Armitage / Quanta Magazine

Los físicos han detectado una inusual onda «demonio» de electrones que es invisible a la radiación electromagnética. Fuente: Kristina Armitage / Quanta MagazineEn 1956, David Pines formuló un fantasma. Predijo la existencia de mares de ondas eléctricas que podrían neutralizarse entre sí, dejando todo el océano inmóvil incluso cuando las olas individuales fluían y refluían. La rareza, que llegó a ser conocida como el demonio de Pines, sería eléctricamente neutra y, por lo tanto, invisible a la luz: la definición de difícil de detectar.

A lo largo de décadas, los físicos lograron vislumbrar variantes de demonios. Pero el demonio original de Pines, que surgiría naturalmente a partir de electrones en bloques metálicos, pasó desapercibido.

Ahora, un equipo de físicos de la Universidad de Illinois en Urbana-Champaign, parece haber detectado el demonio de Pines. Después de perfeccionar una técnica para rastrear con precisión los electrones cuando rebotan en un material, el equipo produjo y detectó una serie de ondas periódicas que se propagan a través de enjambres de electrones. Estas ondas, que los físicos llaman «modos», coinciden en gran medida con los cálculos de Pines. Los investigadores detallaron sus hallazgos en Nature en agosto.

«Estos modos no se habían visto en 70 años», explica Piers Coleman, físico teórico de la Universidad Rutgers. Pero este nuevo experimento, de alguna manera, «recoge estos modos demoníacos».

Imagina demoniosLa década de 1950 fue una época de auge para el estudio de los electrones en los metales. Los físicos ya habían desarrollado una teoría simplista que ignoraba la tendencia de los electrones a alejarse unos de otros, tratándolos colectivamente como si formaran una especie de gas que fluye libremente. En 1952, Pines y su director de tesis doctoral, David Bohm, dieron un paso más. Después de agregar las interacciones de los electrones a esta teoría del “gas de electrones”, descubrieron que los electrones podían agruparse en algunos lugares y dispersarse en otros. Estos electrones agrupados formaban ondas ordenadas de densidad mayor y menor alternadas (y, por lo tanto, regiones de carga eléctrica mayor y menor).

Una onda de electrones (azul) con regiones alternas de alta y baja densidad. Fuente: Merrill Sherman / Revista Quanta

Una onda de electrones (azul) con regiones alternas de alta y baja densidad. Fuente: Merrill Sherman / Revista QuantaLuego, Pines llevaría más lejos aún más la nueva teoría. Imaginó un material que contenía dos gases, cada uno formado por un tipo diferente de partícula cargada. Específicamente, imaginó un metal con electrones «pesados» y electrones «ligeros». (Todos los electrones son idénticos en teoría, pero en el mundo real sus propiedades mensurables dependen de su entorno). Pines descubrió que las ondas del primer gas podían neutralizar las ondas del segundo; donde los electrones pesados se agrupaban, los electrones ligeros disminuían. Luego, a medida que los grupos de electrones pesados se dispersaban, los electrones más ligeros se reunían para llenar las zonas menos ocupadas. Debido a que un gas se espesaba precisamente donde el otro gas se diluía, la densidad electrónica total de ambos tipos juntos (y por lo tanto la carga y el campo eléctrico totales) permanecerían neutrales e invariables. «Las cosas pueden estar moviéndose incluso cuando parece que no lo están», explica Anshul Kogar, físico de materia condensada de la Universidad de California en Los Ángeles.

Ondas superpuestas de dos tipos de electrones (azul y dorado). La densidad de cada color varía, pero la densidad general de las partículas permanece igual en todas partes. Fuente: Merrill Sherman/Revista Quanta

Ondas superpuestas de dos tipos de electrones (azul y dorado). La densidad de cada color varía, pero la densidad general de las partículas permanece igual en todas partes. Fuente: Merrill Sherman/Revista QuantaLa luz se refleja sólo en objetos con una distribución desigual de carga eléctrica, por lo que la neutralidad de la vibración de Pines la hacía perfectamente invisible. La luz viene en paquetes de energía llamados fotones, y Pines bautizó los paquetes de energía de sus ondas como «demonios». El nombre era un guiño al experimento mental demoníaco de James Clerk Maxwell, un físico pionero que, se lamentó Pines, había vivido demasiado pronto como para que una partícula u onda llevara su nombre. «Sugiero que, en honor a Maxwell, y porque estamos tratando aquí con un caso de movimiento definido de electrones (o D.E.M. por sus siglas en inglés), llamemos a estas nuevas excitaciones ‘demonios'», escribió Pines en 1956.

A lo largo de las décadas, los físicos vieron ondas demoníacas en diversos materiales. En 1982, investigadores de los Laboratorios Bell detectaron ondas opuestas en láminas vecinas de arseniuro de galio. Y este año, un equipo dirigido por Feng Wang de la Universidad de California en Berkeley describió un experimento que capturó ondas casi invisibles de electrones latiendo en sincronía con ondas ligeramente más delgadas de objetos similares a partículas cargadas positivamente en una lámina de grafeno.

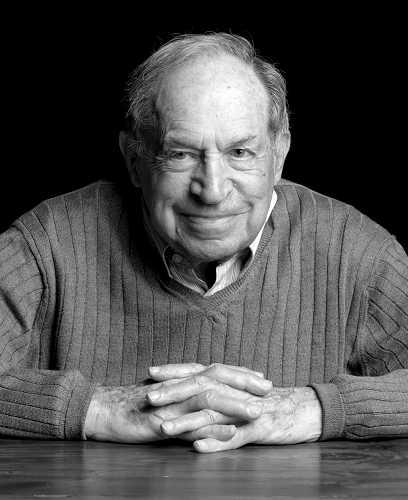

David Pines predijo que podría surgir una onda «demonio» invisible en materiales con dos tipos de electrones. Foto: Minesh Bacrania para SFI

David Pines predijo que podría surgir una onda «demonio» invisible en materiales con dos tipos de electrones. Foto: Minesh Bacrania para SFIPero estos avistamientos ocurrieron en gran medida en sistemas bidimensionales donde una característica demoníaca definitoria era menos llamativa. Debido a una peculiaridad en la dimensionalidad, en 2D puedes desencadenar una onda de carga con un esfuerzo tan pequeño como quieras. Pero en 3D, iniciar una onda requiere una cantidad mínima de energía para que los electrones asociales se agrupen. Los demonios eléctricamente neutros se ahorran esta tarifa de energía 3D. «Ver al demonio en un sólido tridimensional es un poco especial», comenta Kogar, quien realizó su investigación doctoral con el grupo Urbana-Champaign.

Aquí hay demoniosEl equipo de Urbana-Champaign, dirigido por Peter Abbamonte, nunca fue a cazar demonios. El demonio de Pines vino directamente a su laboratorio.

En 2010, el grupo de Abbamonte comenzó a desarrollar una técnica para detectar pequeños temblores que se propagan a través de las hordas de electrones. Lanzaban electrones a un material y registraban con precisión la energía que transportaban y el camino que tomaban cuando rebotaban. Basándose en los detalles de esos rebotes el grupo pudo inferir cómo respondía el material a la colisión, lo que a su vez reveló las propiedades de las ondas creadas por la colisión. Era un poco como determinar si una bañera está llena de agua, miel o hielo arrojándole pelotas de pingpong.

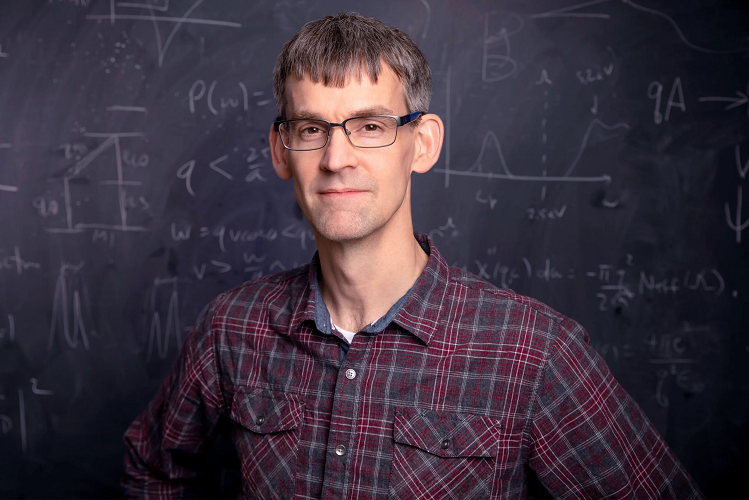

Peter Abbamonte, físico de la Universidad de Illinois, Urbana-Champaign, no fue a buscar al demonio de Pines. Su grupo se topó con esto mientras exploraba una nueva forma de estudiar materiales. Fuente: Universidad de Illinois

Peter Abbamonte, físico de la Universidad de Illinois, Urbana-Champaign, no fue a buscar al demonio de Pines. Su grupo se topó con esto mientras exploraba una nueva forma de estudiar materiales. Fuente: Universidad de IllinoisHace unos años, los investigadores decidieron poner en su punto de mira un metal superconductor llamado rutenato de estroncio. Su estructura es similar a la de una misteriosa clase de superconductores de “cuprato” a base de cobre, pero se puede fabricar de una manera más limpia. Si bien el equipo no aprendió los secretos de los cupratos, el material respondió de una manera que Ali Husain, quien había perfeccionado la técnica como parte de su doctorado, no entendía.

Husain descubrió que los electrones que rebotaban perdían su energía y su momento, lo que indicaba que estaban provocando ondas que drenaban energía en el rutenato de estroncio. Pero las ondas desafiaban sus expectativas: se movían 100 veces demasiado rápidas como para ser ondas sonoras (que se propagan a través de los núcleos atómicos) y 1.000 veces demasiado lentas como para ser ondas de carga propagándose por la superficie plana del metal. También tenían muy poca energía.

«Pensé que debía ser un artefacto», explica Husain. Entonces colocó otras muestras, probó otros voltajes e incluso hizo que diferentes personas tomaran las medidas.

Ali Husain desarrolló una forma de medir con precisión las energías y las trayectorias de los electrones que rebotan; Estas observaciones revelaron modos demoníacos en el rutenato de estroncio. Foto: Mateo Mitrano

Ali Husain desarrolló una forma de medir con precisión las energías y las trayectorias de los electrones que rebotan; Estas observaciones revelaron modos demoníacos en el rutenato de estroncio. Foto: Mateo MitranoLas vibraciones no identificadas seguían ahí. Después de hacer los cálculos, el grupo se dio cuenta de que las energías y los momentos de las ondas encajaban mucho con la teoría de Pines. El grupo sabía que en el rutenato de estroncio los electrones viajan de un átomo a otro utilizando uno de tres canales distintos. El equipo concluyó que en dos de estos canales, los electrones se sincronizaban para neutralizar el movimiento de los otros, desempeñando el papel de los electrones «pesados» y «ligeros» del análisis original de Pines. Habían encontrado un metal con la capacidad de albergar al demonio de Pines.

«Es estable en el rutenato de estroncio», afirma Abbamonte. «Siempre está ahí».