La realidad resulta enigmática porque es no lineal

no lineal

Aunque el origen de la Dinámica se fundó a partir de los experimentos de Mecánica efectuados por Galileo Galilei, el cálculo infinitesimal -inventado por Isaac Newton y Gottfried Leibniz- permitió describir matemáticamente la evolución general de algunas de las más relevantes magnitudes de todas las ciencias. Las maravillosas ecuaciones diferenciales nos permiten describir, predecir e incluso controlar la dinámica de sistemas no sólo basados en las leyes de la mecánica clásica o relativista, el electromagnetismo o la mecánica cuántica, sino en todas las ciencias naturales y sociales, así como en todas las ingenierías.

El gran Henri Poincaré estableció a finales del siglo XIX las propiedades cualitativas de la teoría de ecuaciones diferenciales, con la Mecánica Celeste [1] como ejemplo de aplicación, pero más allá de esto, estableció su teoría matemática generalizada para fundar la Ciencia General de la Dinámica de Sistemas, aplicable a modelar, predecir su evolución en el tiempo y caracterizar las propiedades esenciales de cualquier efecto medible en cualquier tipo de realidad científica.

El mundo a nuestro alrededor es mayormente no lineal. Foto: Jorge Fernández Salas / UnsplashEl principio de superposición

El mundo a nuestro alrededor es mayormente no lineal. Foto: Jorge Fernández Salas / UnsplashEl principio de superposición

La mayoría de los científicos naturales o sociales, muy a menudo consideramos verdadera la hipótesis de que la respuesta neta causada en un sistema por dos o más estímulos es la suma de las respuestas que habría causado cada estímulo por separado. Esto es el Principio de Superposición, que parece ser una cuestión casi de sentido común, y que muchas veces la asumimos sin demasiadas cautelas.

Una función matemática que satisface el principio de superposición se denomina función lineal. Estas funciones lineales, muy utilizadas con gran generalidad en todas las ciencias, incorporan dos propiedades matemáticas muy útiles como la aditividad y la homogeneidad, y nos permiten un análisis e interpretación muy profunda -y bastante sencilla- de leyes que establezcamos, experimentos que realicemos, generalizaciones que propongamos o conclusiones que extraigamos de una investigación.

El principio de superposición se aplica a cualquier sistema lineal, descrito mediante ecuaciones algebraicas o ecuaciones diferenciales lineales. Los estímulos sobre un sistema y las respuestas de éste pueden ser números, funciones, vectores, campos vectoriales, señales variables en el tiempo o cualquier otro objeto que cumpla ciertos axiomas muy comunes. Los Sistemas Lineales son una de las maneras más utilizadas para describir la realidad, aún estudiando situaciones complejas, como aquellas basadas en las leyes de Newton, las ecuaciones de Maxwell, la ecuación de Schrödinger o modelos en econometría, ecología, o cualquier tipo de ciencia para la que tratamos de expresar matemáticamente su funcionamiento. Una ventaja que tenemos es que, cuando escribimos un estímulo muy general en un sistema lineal como la superposición de estímulos de una forma específica y simple, a menudo la respuesta global resulta más fácil de calcular y predecir.

Modelos lineales ordinarios o extraordinariosMuchos sistemas dinámicos, basados en algunas de las leyes más valiosas de la historia de la ciencia, se pueden expresar mediante ecuaciones diferenciales ordinarias lineales con coeficientes constantes. Los matemáticos han suministrado para este tipo de sistemas -llamados autónomos- un verdadero arsenal de medios para resolverlos analíticamente, por muy complejos éstos sean. Por ejemplo, la conocida Transformada de Laplace reduce un complejo sistema de ecuaciones diferenciales ordinarias lineales en un sistema de ecuaciones algebraicas, mucho más fácil de solucionar. Ello además nos permite nos solo conocer al dedillo la evolución en el tiempo del sistema dinámico que hemos resuelto, sino también descubrir sus sorprendentes propiedades en el dominio de la frecuencia, extrayendo nuevo conocimiento que no pensábamos obtener de la mera integración de una sencilla ecuación diferencial.

Las ecuaciones diferenciales ordinarias son un caso particular de las ecuaciones en derivadas parciales, muy comunes también para describir la dinámica en todas las ciencias, y que, en contraposición con las anteriores más sencillas descripciones ordinarias, podemos denominar modelos extraordinarios. Aunque su resolución en este caso es algo más compleja, las ecuaciones diferenciales lineales, sean ordinarias o no, permitieron a los físicos expresar asuntos clave como la dinámica de los planetas, todo el electromagnetismo o la dualidad onda-corpúsculo, entre muchas otras cuestiones. Hoy día científicos e ingenieros de toda especie establecen modelos dinámicos para explicar por qué ocurre la realidad experimentada en su propio ámbito.

La realidad es no linealMuy pocos científicos utilizan ecuaciones diferenciales no lineales. Sentimos una cierta reacción alérgica a su empleo, quizás por la dificultad de resolver la matemática de estas ecuaciones o quizás por abandonar el principio de superposición que tanto apreciamos. En la teoría general de relatividad de Albert Einstein, las ecuaciones son no lineales, y su resolución casi siempre implican métodos matemáticos de linealización o de perturbaciones. Incluso para sistemas mucho más sencillos, descritos en simples ecuaciones diferenciales ordinarias no lineales, nuestra tendencia es linealizar el sistema en torno a unas ciertas condiciones y resolver ecuaciones lineales, para tratar de extraer información -al menos parcial- de la realidad que hemos modelado.

La cuestión es que la realidad es no lineal, y nuestras ecuaciones lineales pueden modelar bastante bien las cosas, pero en ocasiones ocurren fenómenos muy imprevisibles y no intuitivos, tanto en las ciencias naturales como en las ciencias sociales o en las ingenierías. Estos fenómenos no se producen en los modelos lineales, y son por tanto exclusivos de los sistemas no lineales.

Múltiples puntos de equilibrioLos puntos de equilibrio son las soluciones constantes en una ecuación diferencial. En sistemas lineales autónomos, el modelo tiende a un único punto de equilibrio. Uno de los ejemplos más sencillos podemos encontrarlo en la aproximada ley de enfriamiento de Newton: una simple ecuación diferencial lineal de primer orden que explica la transferencia de calor entre dos cuerpos partiendo de diferentes temperaturas. El punto de equilibrio es único y establece igualdad de temperaturas entre ambos cuerpos.

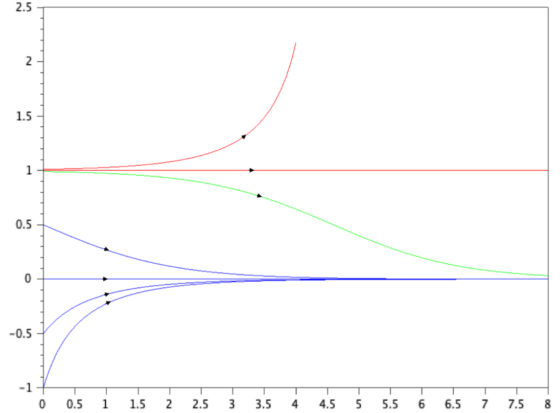

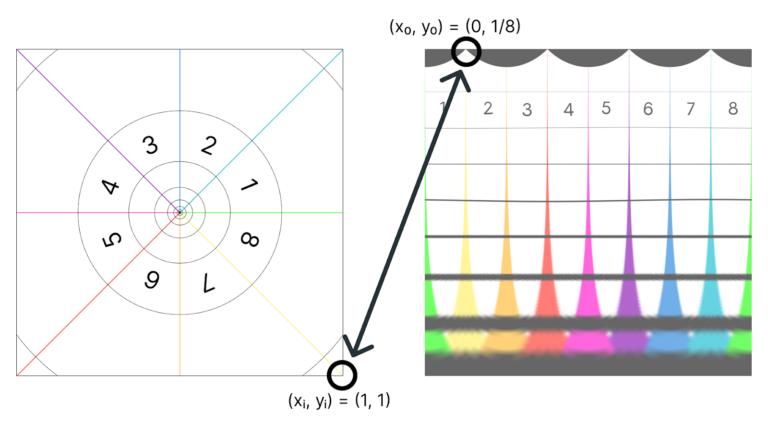

Si a esta sencilla ecuación diferencial añadimos un simple término cuadrático nos encontramos con un básico sistema no lineal, cuya resolución numérica puede observarse en la Figura 1.

Figura 1: Dos puntos de equilibrio en una simple ecuación diferencial ordinaria autónoma no lineal de primer orden: punto de equilibrio estable en 0 y punto de equilibrio inestable en 1. Ecuación =-x+x2 . Fuente: [2] Cap. 1, pp.: 5-6.

Figura 1: Dos puntos de equilibrio en una simple ecuación diferencial ordinaria autónoma no lineal de primer orden: punto de equilibrio estable en 0 y punto de equilibrio inestable en 1. Ecuación =-x+x2 . Fuente: [2] Cap. 1, pp.: 5-6.Vemos que linealizando el sistema en torno a la temperatura 0, la solución (trayectorias azules) tienden al punto de equilibrio previsto por la ley de enfriamiento de Newton, si partimos de las inmediaciones en torno a la cual hemos linealizado. Pero si resolvemos el sistema no lineal completo, descubrimos que partir de otras condiciones iniciales nos puede dar lugar a otras soluciones radicalmente diferentes causadas por un segundo punto de equilibrio en 1. Cualquier perturbación partiendo de esta segunda temperatura hace que el sistema abandone la situación y, o bien tienda al anterior equilibrio 0 (trayectoria verde), o bien la temperatura crezca sin límite (trayectoria roja).

Ciclos límiteLos sistemas no lineales pueden oscilar sin excitación externa, con amplitud y frecuencia fijas. Las oscilaciones lineales como por ejemplo las de un péndulo linealizado en torno a la vertical, puede cambiar la amplitud de sus oscilaciones (por ejemplo, empujando más o menos un columpio). Balthasar Van der Pol, hacia 1920, añadió un término no lineal a la ecuación diferencial lineal del péndulo, haciendo depender su coeficiente de amortiguamiento con su posición. Se trata entonces de una sencilla ecuación diferencial ordinaria no lineal de segundo orden.

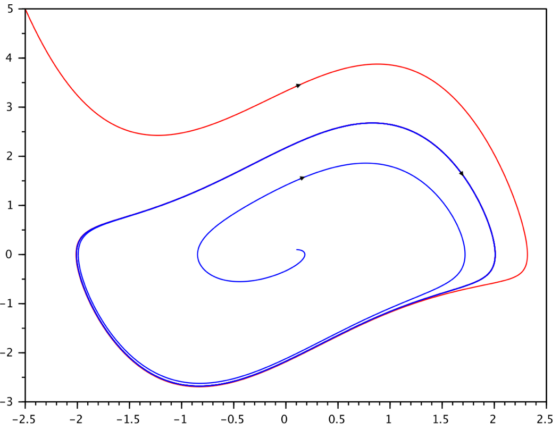

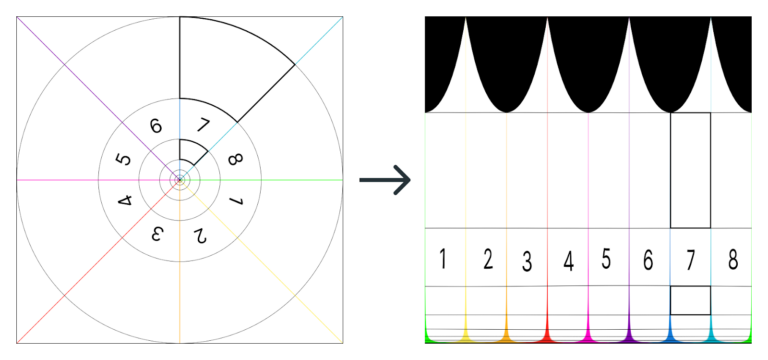

En sistemas dinámicos de orden dos o superior, se emplea muchas veces el espacio de fases para representar los grados de libertad del sistema. En la Figura 2 se muestra la solución de la ecuación de Van der Pol con dos condiciones iniciales diferentes.

Figura 2: Ciclo límite estable en la ecuación de Van der Pol: solución representada en el plano de fase (posición-velocidad). Ecuación +(x2-1)+x=0 . Fuente [2] Cap 5, pp: 95-99.

Figura 2: Ciclo límite estable en la ecuación de Van der Pol: solución representada en el plano de fase (posición-velocidad). Ecuación +(x2-1)+x=0 . Fuente [2] Cap 5, pp: 95-99.Partiendo de posición y velocidad pequeñas (trayectoria azul inicialmente cerca de cero en la Figura 2), el sistema amplifica su oscilación sin excitación externa y tiende a cierta frecuencia y amplitud fijas (ciclo cerrado azul). Partiendo de posición y velocidad amplias (trayectoria roja) el sistema pierde energía y al final tiende a oscilar exactamente igual. En el plano fásico observamos el ciclo cerrado, llamado ciclo límite, efecto causado por la no linealidad añadida por Van der Pol. Ante cualquier perturbación creciente o decreciente que sufra la posición o velocidad de este especial péndulo no lineal, el dispositivo corregirá la situación y volverá a oscilar a la misma frecuencia y amplitud propias. Se trata de un sorprendente ciclo límite estable, exclusivo de los sistemas no lineales, y que nos lleva a un nuevo concepto de región de equilibrio estable, generalización del concepto de punto de equilibrio estable que hemos descrito arriba.

CaosEn sistemas dinámicos lineales estables, la ligera modificación de sus condiciones iniciales da lugar a ligeros cambios en su respuesta. Sin embargo, en sencillos sistemas no lineales se puede observar una extrema sensibilidad a las condiciones iniciales, propiedad exclusiva de la no linealidad, y que se denomina caos.

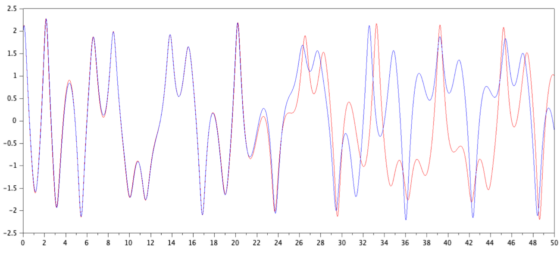

En la Figura 3 se muestran las soluciones de una ecuación diferencial ordinaria no lineal de segundo orden que modela un sistema mecánico con deflexiones elásticas no lineales y forzado con un coeficiente no constante ([2] p.7).

Figura 3: Evolución imprevisible de dos trayectorias en un simple sistema no lineal de segundo orden con dos condiciones iniciales casi idénticas. Ecuación +0,1+x5=6sen t. Fuente: [2] Cap. 1, pp.: 7-8.

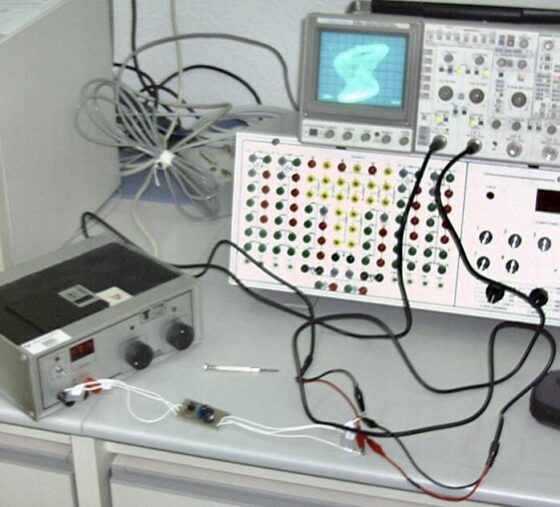

Figura 3: Evolución imprevisible de dos trayectorias en un simple sistema no lineal de segundo orden con dos condiciones iniciales casi idénticas. Ecuación +0,1+x5=6sen t. Fuente: [2] Cap. 1, pp.: 7-8.Puede observarse que, ante condiciones iniciales casi idénticas, las dos trayectorias del sistema (azul y roja) son al principio iguales, pero en pocos instantes se produce una bifurcación radical en el comportamiento del sistema. Nuestro modelo es totalmente determinista, su ecuación puede ser exacta, pero su comportamiento es imprevisible: muy parecido a la imposible previsión del tiempo atmosférico que conocemos. Este ejemplo es aún más sencillo que el famoso modelo de dinámica atmosférica que presentó el conocido matemático y meteorólogo Edward Lorenz. En la Figura 4 se muestra una implementación física del atractor de Lorenz y su medida caótica en el laboratorio.

Figura 4: Circuito electrónico que satisface el modelo del famoso atractor de Lorenz y medida de su respuesta caótica en el plano fásico. Fuente: Dept. de Electricidad y Electrónica UPV/EHU

Figura 4: Circuito electrónico que satisface el modelo del famoso atractor de Lorenz y medida de su respuesta caótica en el plano fásico. Fuente: Dept. de Electricidad y Electrónica UPV/EHU

La dinámica de la naturaleza y las sociedades es inherentemente no lineal. Los sistemas lineales deben entenderse como caso particular de los más generales sistemas no lineales. Los fenómenos impredecibles, anti-intuitivos o sorprendentes los podemos modelar, explicar, predecir, experimentar y controlar en el laboratorio, así como tratar de contribuir a descubrir o solucionar los enigmas de lo que llamamos realidad.

Referencias

[1] Henri Poincaré (1892-1893-1899) Les méthodes nouvelles de la mécanique céleste TOME I, II et III (PDF). Gauthier-Villars et fils, Paris

[2] Victor Etxebarria (1999) Sistemas de control no lineal y robótica. Servicio Editorial de la UPV/EHU, ISBN 8483731924 – 9788483731925, Bilbao

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

El artículo La realidad resulta enigmática porque es no lineal se ha escrito en Cuaderno de Cultura Científica.

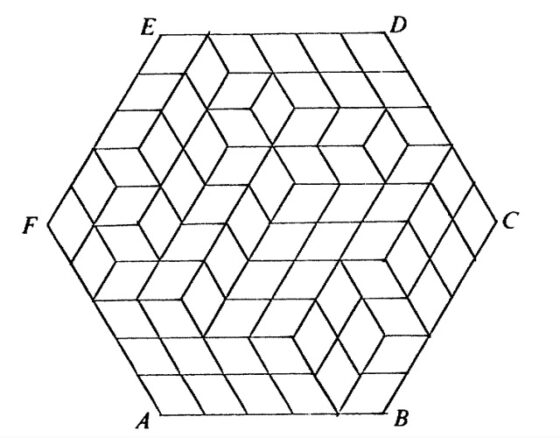

El rompecabezas de los cuatro cubos de Nelson

En una reciente entrada de la sección Matemoción del Cuaderno de Cultura Científica, titulada Los cuadrados de MacMahon, estuvimos hablando de un interesante rompecabezas geométrico, cuyo nombre es precisamente el título de la misma. En esta entrada vamos a ir un poco más allá y con los cuadrados de ese juego de ingenio construiremos cubos que nos permitirán crear un nuevo rompecabezas, conocido primero con el nombre de “el rompecabezas de Nelson”, y después como “el rompecabezas de los cuatro cubos”.

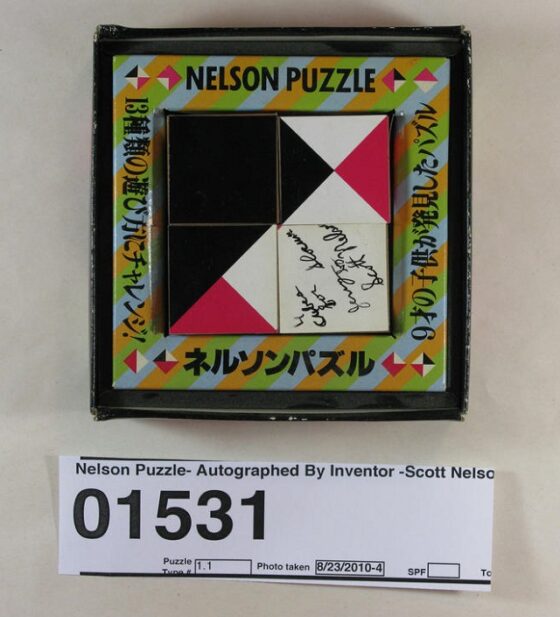

El rompecabezas de Nelson, con la firma de su creador Scott Nelson, comercializado en Japón por el inventor, coleccionista y comunicador de rompecabezas matemáticos y juegos de ingenio japonés Nob Yoshigahara (1936-2004). Imagen de la colección online de rompecabezas mecánicos de Jerry Slocum, cortesía de la Biblioteca Lilly de la Universidad de Indiana.Los cuadrados de MacMahon

El rompecabezas de Nelson, con la firma de su creador Scott Nelson, comercializado en Japón por el inventor, coleccionista y comunicador de rompecabezas matemáticos y juegos de ingenio japonés Nob Yoshigahara (1936-2004). Imagen de la colección online de rompecabezas mecánicos de Jerry Slocum, cortesía de la Biblioteca Lilly de la Universidad de Indiana.Los cuadrados de MacMahon

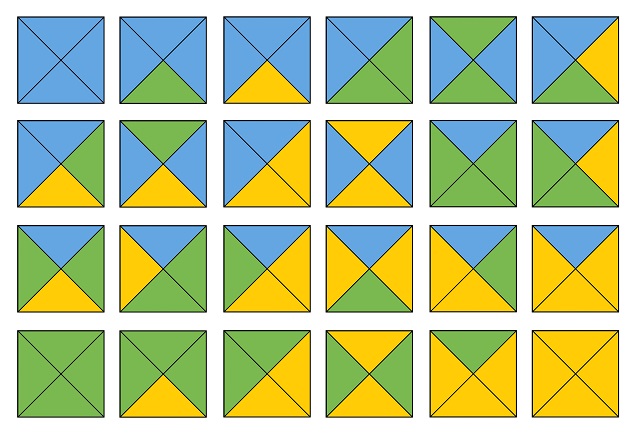

En primer lugar, recordemos el rompecabezas de los cuadrados de MacMahon, y más concretamente, las piezas con las que se juega al mismo. Percy Alexander MacMahon (1854–1929), que fue un militar y matemático británico, se planteó de cuántas formas distintas, salvo rotaciones, se puede colorear el cuadrado dividido en cuatro partes iguales por sus dos diagonales utilizando tres colores distintos y observó que es posible hacerlo de 24 maneras distintas. A partir de esta información, creó el rompecabezas que lleva su nombre, cuyas piezas, que vemos en la siguiente imagen (con los colores verde, azul y amarillo), son la realización de las 24 formas de colorear el cuadrado dividido en cuatro partes iguales por sus dos diagonales utilizando tres colores distintos.

Las 24 fichas que componen el rompecabezas de “los cuadrados de MacMahon”

Las 24 fichas que componen el rompecabezas de “los cuadrados de MacMahon”

El rompecabezas consiste en construir un rectángulo de 4 filas y 6 columnas con las 24 fichas del mismo (si deseas imprimirlas te dejamos aquí el PDF con las 24 fichas), de manera que cuando dos fichas tienen un lado en común el color de las regiones triangulares que comparten ese lado, en los dos cuadrados, tienen que tener el mismo color y, además, todo el perímetro, es decir, todas las regiones triangulares que forman el perímetro del rectángulo, tiene que ser de un mismo color, ya sea este, verde, azul o amarillo (para más información sobre este juego de ingenio puede leerse la entrada Los cuadrados de MacMahon).

Con las 24 fichas se puede jugar al rompecabezas de MacMahon, pero también se pueden plantear otros juegos relacionados con el mismo. Por ejemplo, los miembros del Grupo Alquerque de Sevilla, los matemáticos Juan Antonio Hans Martín, José Muñoz Santonja y Antonio Fernández-Aliseda Redondo, plantearon diferentes retos, con diferentes niveles de dificultad, aunque más sencillos que el original (en los mismos solo se pide que se cumpla la primera condición, esto es, cuando dos fichas son adyacentes tienen el mismo color en las regiones de contacto) en su artículo «MacMahon y las matemáticas en colores», publicado en la revista SUMA. Estos problemas serían los siguientes:

A) de las 24 fichas del rompecabezas, separar las 9 que tienen los tres colores y con ellas formar un cuadrado de lado 3, es decir, con tres filas y tres columnas;

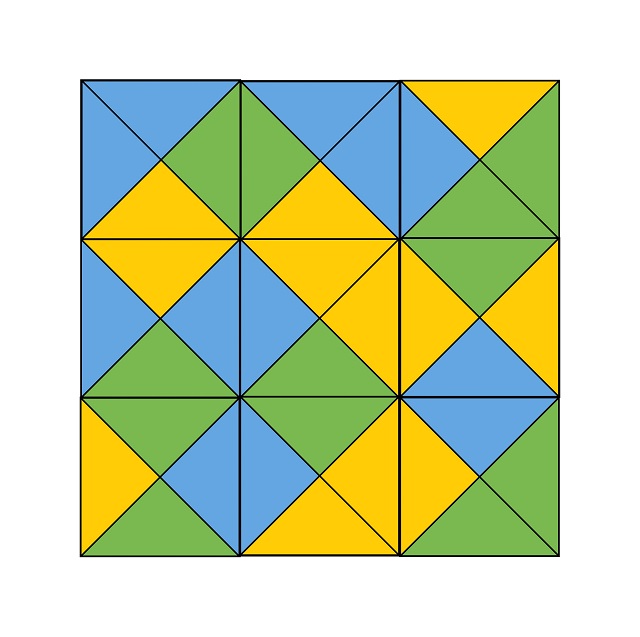

Ejemplo de cuadrado de lado 3 formado por las 9 fichas que tienen los tres colores

Ejemplo de cuadrado de lado 3 formado por las 9 fichas que tienen los tres colores

B) con las 12 fichas que tienen sólo 2 colores construir un rectángulo 3 x 4, tres filas y cuatro columnas;

C) con las 12 fichas complementarias de las anteriores, luego las que tienen 1 o 3 colores, componer también un rectángulo 3 x 4;

D) con las 15 fichas que tienen 1 o 2 colores, construir un rectángulo 3 x 5;

E) con las 15 fichas anteriores (que tienen 1 o 2 colores) y otra cualquiera de las que tienen 3 colores, formar un rectángulo de lado 4, luego con cuatro filas y cuatro columnas;

F) dividiendo primero las 24 fichas en dos grupos de 12 fichas, componer dos rectángulos 3 x 4;

G) con todas las 24 fichas construir rectángulos de tamaños 2 x 12, 3 x 8 y 4 x 6 (si a estos últimos les añadimos la condición del perímetro tenemos el rompecabezas de MacMahon, aunque en los dos tamaños anteriores esta condición nos lleva a que no existan soluciones);

H) con todas las 24 fichas construir rectángulos huecos de tamaños 3 x 11, 4 x 10, 5 x 9, 6 x 8 y 7 x 7 (todos ellos de perímetro igual a 24, que son las piezas que tenemos para construirlos).

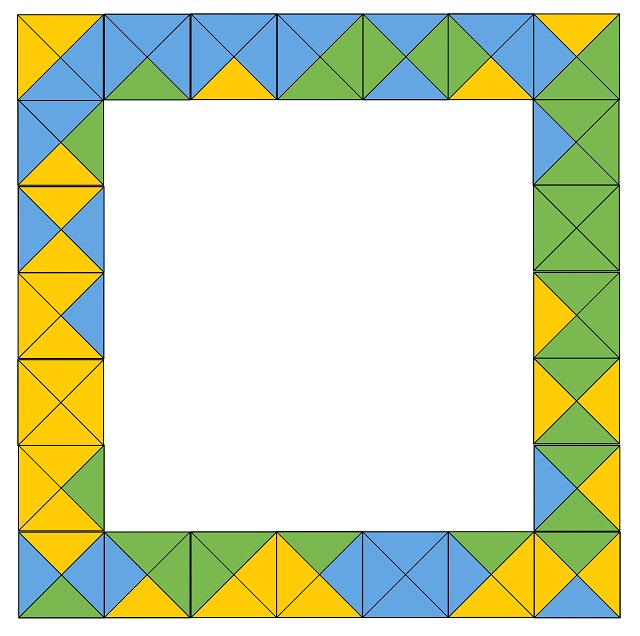

Ejemplo de cuadrado hueco de lado 7 formado por las 24 fichas

Ejemplo de cuadrado hueco de lado 7 formado por las 24 fichasLos cubos de Nelson

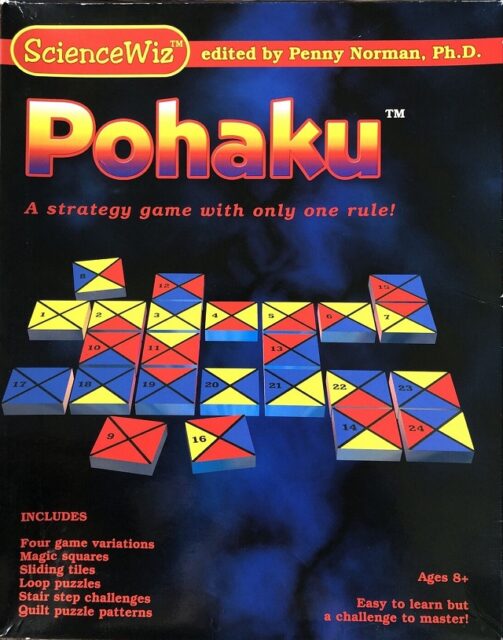

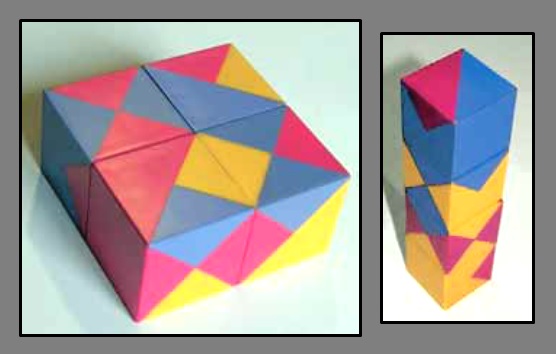

El matemático, programador informático y diseñador de juegos de ingenio estadounidense Harry Lewis Nelson (1932), quien diseñó un juego basado en los cuadrados de MacMahon denominado Pohaku (véanse las siguientes imágenes), planteó la cuestión de si sería posible utilizar las 24 piezas cuadradas de MacMahon como las caras de cuatro cubos (como hay 6 caras por cubo, son 24 caras en total) de manera que, si dos caras comparten una arista, el color de las regiones triangulares de contacto sean del mismo color.

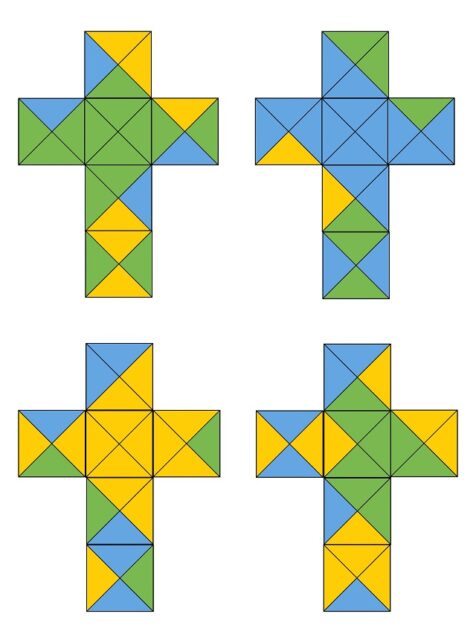

Portada del juego Pohaku, inventado por el matemático estadounidense Harry L. Nelson y comercializado por Penny Norman, que consistía en 5 juegos, para jugar entre dos personas, que utilizaban los 24 cuadrados de MacMahon, denominados Domino Pohaku, Standard Pohaku, 5 x 5 Pohaku y Toroidal Pohaku. Imagen de eBay

Portada del juego Pohaku, inventado por el matemático estadounidense Harry L. Nelson y comercializado por Penny Norman, que consistía en 5 juegos, para jugar entre dos personas, que utilizaban los 24 cuadrados de MacMahon, denominados Domino Pohaku, Standard Pohaku, 5 x 5 Pohaku y Toroidal Pohaku. Imagen de eBay

Reglas de los juegos Domino Pohaku, Standard Pohaku, 5 x 5 Pohaku y Toroidal Pohaku. Imagen de eBay

Reglas de los juegos Domino Pohaku, Standard Pohaku, 5 x 5 Pohaku y Toroidal Pohaku. Imagen de eBay

La cuestión planteada por el matemático fue resuelta por su hijo Scott Nelson en 1970, cuando tenía tan solo 9 años y fue el nacimiento de un nuevo rompecabezas. En la siguiente imagen se muestran los cuatro cubos, cumpliendo las condiciones de Harry Nelson, al desplegar en el plano las seis caras de los mismos.

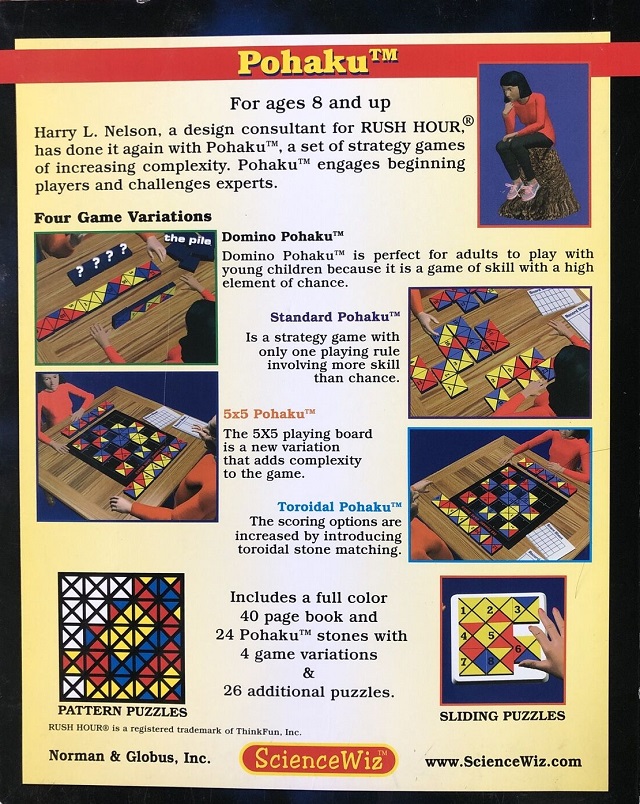

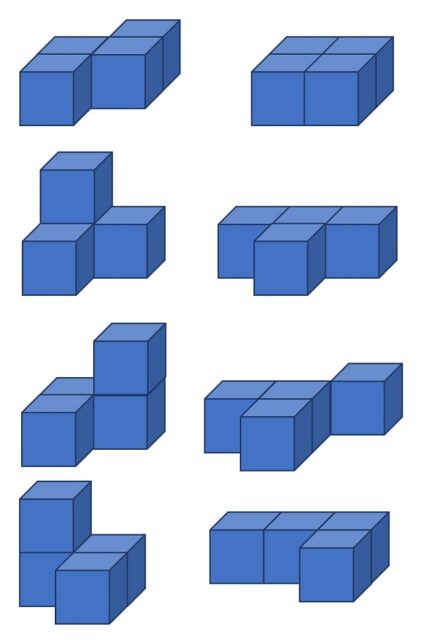

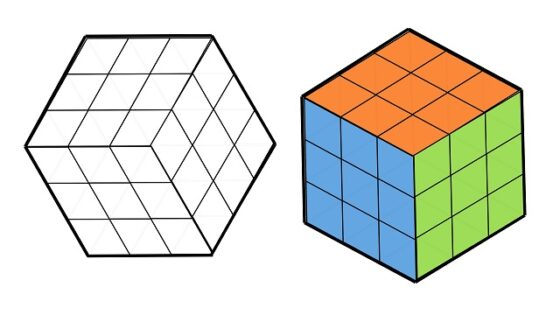

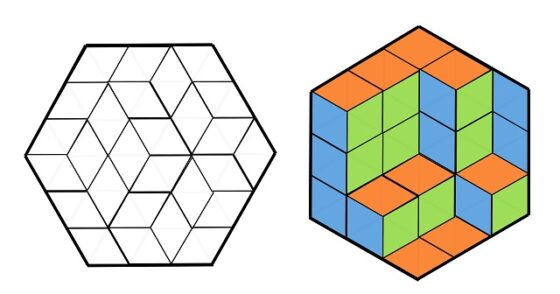

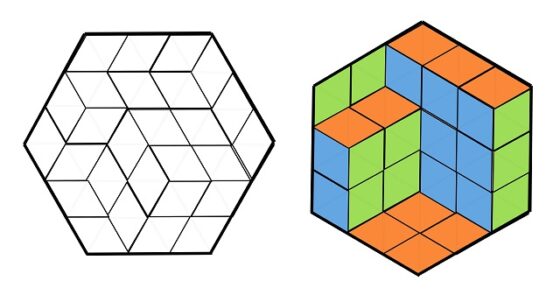

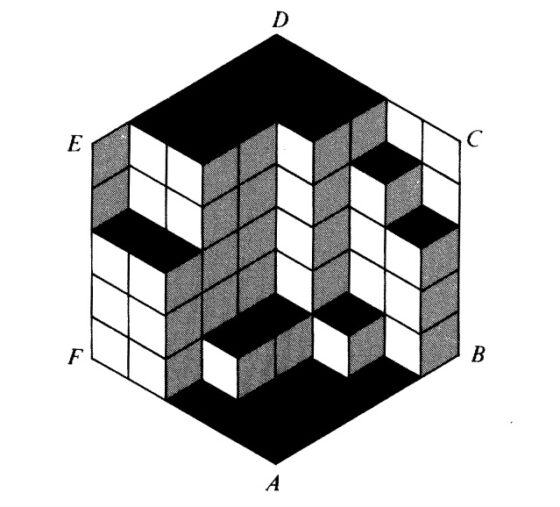

¿En qué consiste el rompecabezas de Nelson? Se trata de crear formas tridimensionales con los cuatro cubos, como una fila de cuatro cubos o los cuatro cubos juntos formando una estructura cuadrada (véase la siguiente imagen), de manera que en las caras visibles se cumpla la condición de que las caras adyacentes tengan el mismo color en las regiones de contacto.

Por ejemplo, las soluciones a las dos figuras anteriores son las siguientes.

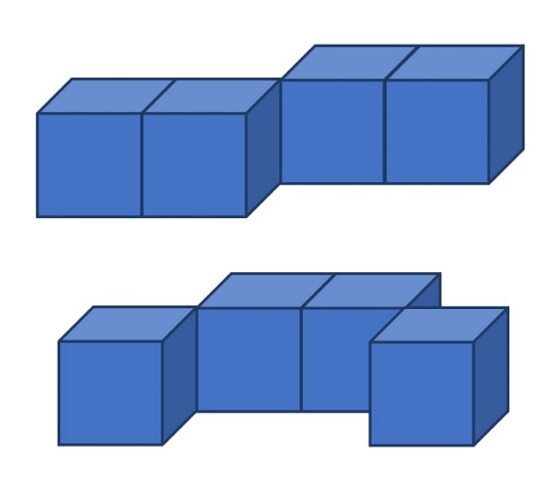

Las formas tridimensionales que aparecían en el juego comercial, divididas por nivel de dificultad, eran las siguientes. Nivel para principiantes:

Nivel intermedio:

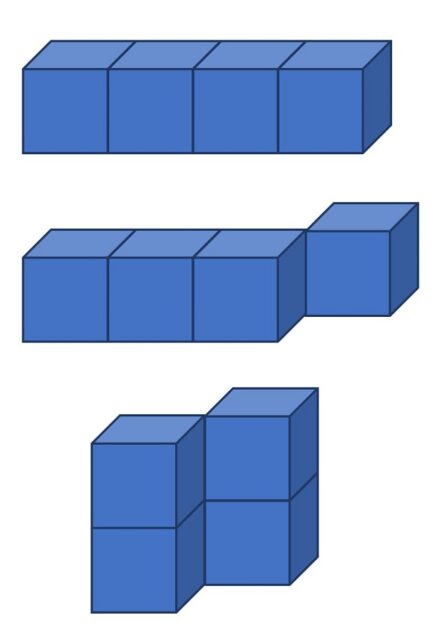

Nivel experto:

Como cada vez que hablamos de rompecabezas, mi consejo es que construyáis los cuatro cubos de Nelson, cuyas caras son los 24 cuadrados de MacMahon, y disfrutéis del juego.

El rompecabezas de Nelson fue comercializado como el rompecabezas de los cuatro cubos por la empresa Binary Arts, que hoy es ThinkFun. Imagen de la colección online de rompecabezas mecánicos de Jerry Slocum, cortesía de la Biblioteca Lilly de la Universidad de Indiana

El rompecabezas de Nelson fue comercializado como el rompecabezas de los cuatro cubos por la empresa Binary Arts, que hoy es ThinkFun. Imagen de la colección online de rompecabezas mecánicos de Jerry Slocum, cortesía de la Biblioteca Lilly de la Universidad de IndianaBibliografía

1.- Percy A. MacMahon, New Mathematical Pastimes, Cambridge University Press, 1921 (puede obtenerse una copia en pdf a través de la biblioteca digital Internet Archive [archive.org]).

2.- Martin Gardner, Nuevos pasatiempos matemáticos, Alianza editorial, 2018.

3.- Juan Antonio Hans Martín, José Muñoz Santonja y Antonio Fernández-Aliseda Redondo, MacMahon y las matemáticas en colores, SUMA 63, pp. 51-57, 2010.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El rompecabezas de los cuatro cubos de Nelson se ha escrito en Cuaderno de Cultura Científica.

Primera observación de la rotación de un agujero negro supermasivo

Ilustración del modelo de disco de acreción inclinado. El eje de giro del agujero negro se alinea verticalmente y la dirección del chorro es casi perpendicular al disco. La desalineación entre el eje de giro del agujero negro y el eje de rotación del disco provocará la precesión (balanceo) del disco y del chorro. Fuente: Yuzhu Cui et al. 2023 / Intouchable Lab@Openverse / Zhejiang Lab

Ilustración del modelo de disco de acreción inclinado. El eje de giro del agujero negro se alinea verticalmente y la dirección del chorro es casi perpendicular al disco. La desalineación entre el eje de giro del agujero negro y el eje de rotación del disco provocará la precesión (balanceo) del disco y del chorro. Fuente: Yuzhu Cui et al. 2023 / Intouchable Lab@Openverse / Zhejiang LabUn equipo científico internacional, con participación del Instituto de Astrofísica de Andalucía (IAA-CSIC), ha analizado datos de 23 años del centro de la galaxia Messier 87 (M87), que alberga un agujero negro supermasivo (6.500 millones de veces más masivo que el Sol), el primero del que se obtuvo una imagen.

Los resultados revelan que el chorro que emerge del agujero negro a altísima velocidad oscila hacia arriba y hacia abajo con una amplitud de unos 10 grados, lo que a su vez confirma que el agujero negro se halla en rotación.

Los agujeros negros absorben grandes cantidades de material debido a su fuerza de gravedad, tan potente que ni siquiera la luz escapa de ellos, e impulsan un flujo de plasma en forma de chorro que se mueve casi a la velocidad de la luz y abarca enormes distancias. La galaxia M87, por ejemplo, presenta un chorro que emerge de sus regiones centrales y se extiende mucho más allá del tamaño de la propia galaxia.

Sin embargo, el mecanismo de transferencia de energía entre los agujeros negros supermasivos, los discos de acreción y los chorros aún se desconoce. La teoría predominante sugiere que se puede extraer energía de un agujero negro en rotación, permitiendo que parte del material que rodea el agujero negro sea expulsado a gran velocidad. A pesar de ello, la rotación de los agujeros negros supermasivos, un factor crucial en este proceso y el parámetro fundamental, además de la masa del agujero negro, nunca se ha observado directamente.

Un chorro en precesiónEl análisis del equipo de investigación, que incluye una comparación con una simulación teórica, indica que el eje de rotación del disco de acreción se desalinea con el eje de giro del agujero negro, lo que genera un chorro en precesión (como el balanceo de una peonza).

La detección de esta precesión constituye una evidencia inequívoca de que el agujero negro supermasivo de M87 se halla, en efecto, girando, lo que abre nuevas dimensiones en nuestra comprensión de la naturaleza de estos objetos.

La desalineación entre el agujero negro y el disco es relativamente pequeña y el período de precesión es de alrededor de once años, por lo que un análisis exhaustivo de los datos de alta resolución de la estructura de M87 acumulados durante dos décadas han sido suficientes para poder detectarla

Pero, ¿qué fuerza puede alterar la dirección de un chorro tan poderoso? La respuesta podría hallarse en el comportamiento del disco de acreción: a medida que los materiales que caen orbitan alrededor del agujero negro, forman una estructura de disco antes de girar gradualmente en espiral hasta que son absorbidos por el agujero negro. Pero si el agujero negro gira, ello ejerce un impacto significativo en el espacio-tiempo circundante, provocando que los objetos cercanos sean arrastrados a lo largo de su eje de rotación, es decir, produciendo el “arrastre de marco” (frame dragging) predicho por la Relatividad General de Einstein.

Si bien este estudio arroja luz sobre cómo funciona un agujero negro supermasivo, también abre grandes incógnitas. La estructura del disco y el valor exacto del giro del agujero negro supermasivo M87* son aún inciertos, y este trabajo predice que existen más factores que intervienen en esta configuración, lo que añade nuevos desafíos a la investigación.

Referencia:

Cui, Y., Hada, K., Kawashima, T. et al. (2023) Precessing jet nozzle connecting to a spinning black hole in M87 Nature doi: 10.1038/s41586-023-06479-6

Edición realizada por César Tomé López a partir de materiales suministrados por IAA-CSIC

El artículo Primera observación de la rotación de un agujero negro supermasivo se ha escrito en Cuaderno de Cultura Científica.

La importancia del dióxido de carbono en la dinámica geológica de Europa

En al menos tres ocasiones, en Planeta B hemos hablado sobre Europa, uno de los satélites más interesantes de Júpiter: “La evolución del interior de la luna Europa”, “Una tectónica de placas más allá de la Tierra” y “¿Y si pudiésemos llegar al océano de Europa sin necesidad de atravesar toda la corteza?”.

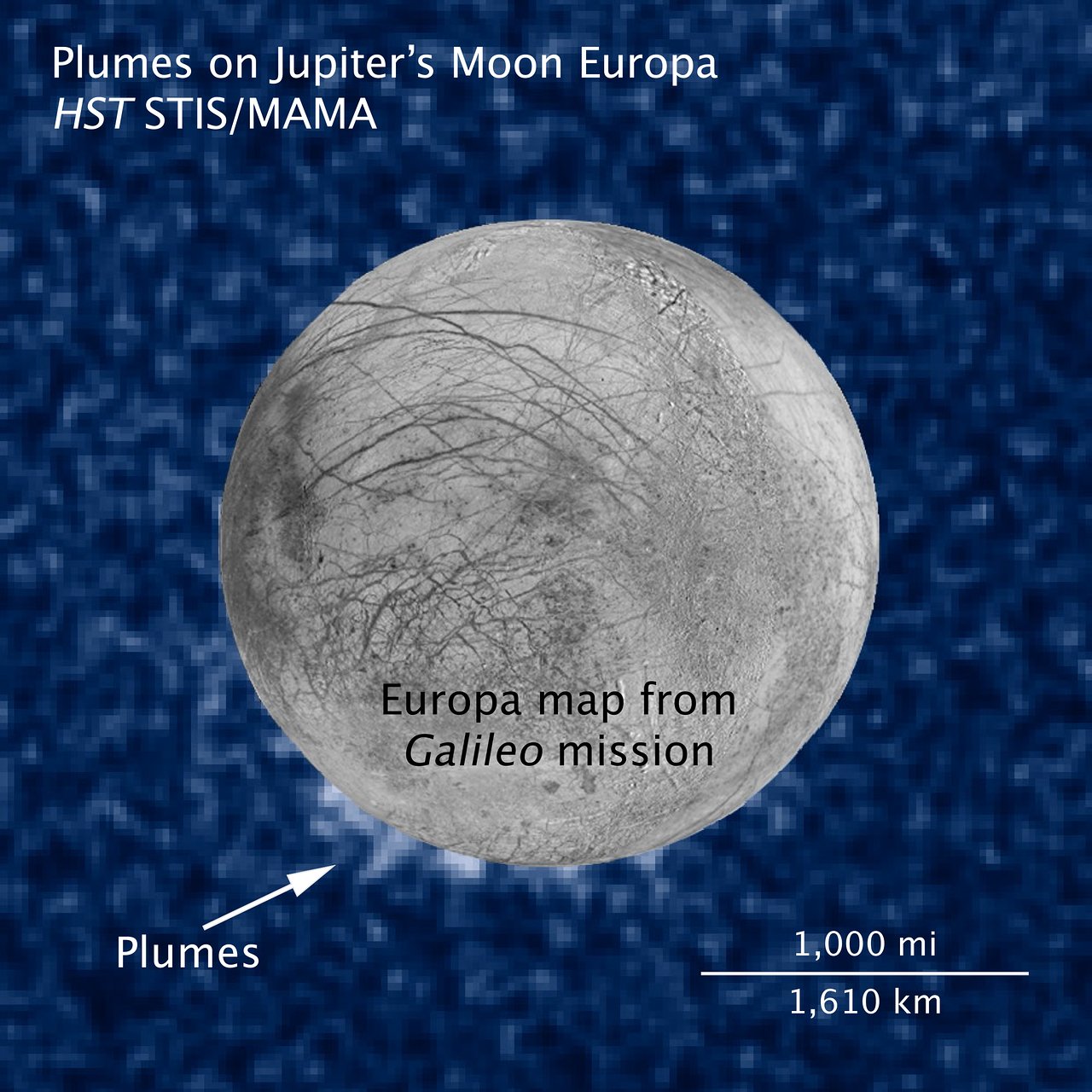

Y es que cuando lo miramos de cerca, su superficie atestigua una historia reciente de actividad geológica, quizás no solo pretérita, sino también en la actualidad, con la posible existencia de procesos que siguen rejuveneciendo el aspecto de este satélite. Además de esa juventud que aparenta en términos geológicos, el Hubble descubrió hace una década la posible existencia de penachos de agua que surgen de su superficie, lo que sería otra prueba a favor de ser un mundo activo, aunque estos serían bastante elusivos.

Los penachos de vapor de agua en Europa tal y como los detectó el telescopio espacial Hubble, abajo a la izquierda, anotados por la palabra “Plumes”. Imagen cortesía de la NASA, ESA, W. Sparks (STScI) y USGS Astrogeology Science Center.

Los penachos de vapor de agua en Europa tal y como los detectó el telescopio espacial Hubble, abajo a la izquierda, anotados por la palabra “Plumes”. Imagen cortesía de la NASA, ESA, W. Sparks (STScI) y USGS Astrogeology Science Center.¿De dónde procede toda esta actividad geológica que observamos? Lo más probable es que el responsable directo sea un océano de agua líquida bastante salado -valga la redundancia- que a su vez está en contacto también con el núcleo rocoso del satélite, de donde procedería la energía para mantener líquido el océano. Este último serviría como una cinta transportadora de materia y energía desde el interior de Europa hacia el exterior, provocando esos cambios que observamos en su superficie.

Una manera indirecta de conocer con mayor grado de detalle la composición química del agua de ese posible océano sería si estuviese de algún modo conectado al exterior, ya que, de momento, carecemos de la tecnología para poder llegar hasta este, que requeriría una sonda capaz de atravesar varios kilómetros de hielo hasta llegar al agua.

Saber qué elementos y compuestos existen en el océano nos abre una puerta a saber si es un océano habitable -habitable para nuestros estándares- puesto que la existencia y abundancia de determinados elementos y compuestos puede ser crucial para el desarrollo de la vida. Por supuesto, esto no quiere decir que haya vida o se pueda haber desarrollado, pero si nos puede indicar si es un lugar hospitalario.

Los lugares más prometedores para “saborear” -me van a permitir que me tome una licencia literaria- este océano serían los penachos de vapor de agua (muestreándolos desde la órbita, por ejemplo- y por supuesto las zonas donde pueda existir actividad geológica reciente en Europa, ya que a través de las fisuras generadas como resultado de la dinámica del satélite podría haberse transportado material desde el océano hasta el exterior. Sería una manera indirecta, pero válida mientras no tengamos una tecnología capaz de llegar al océano.

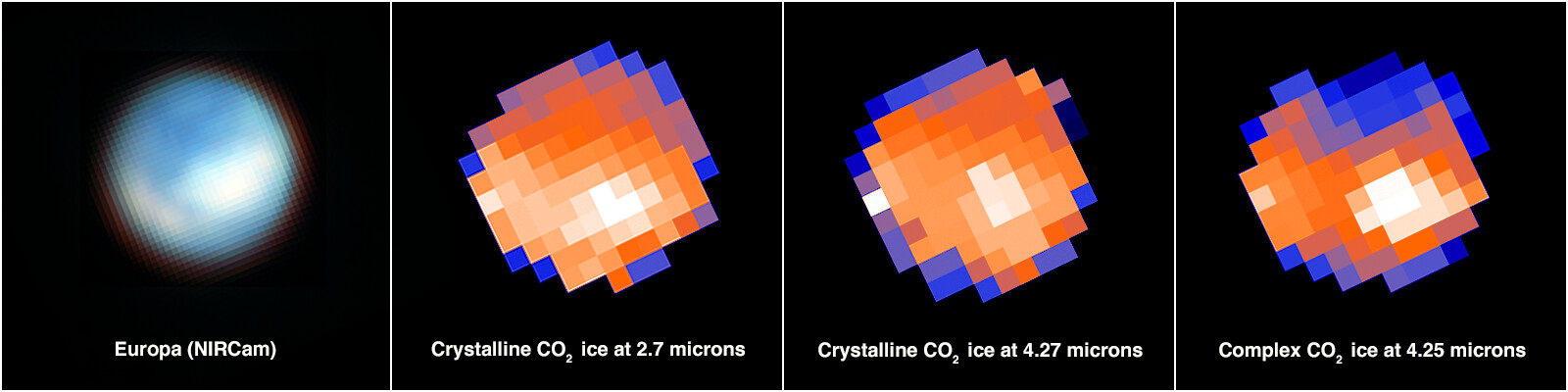

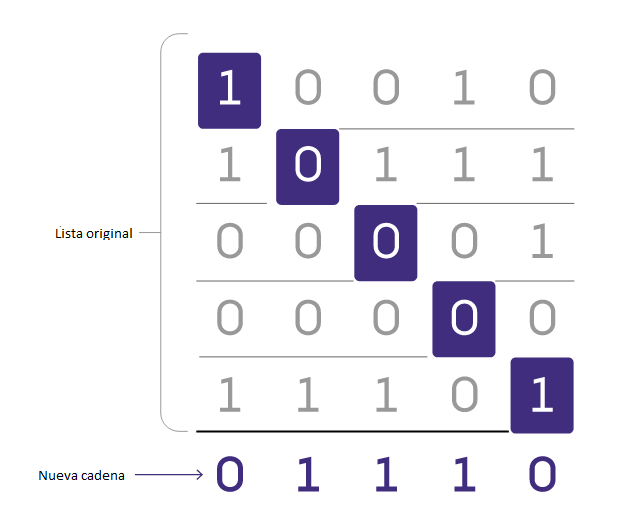

Pero bueno, ¿qué se ha descubierto ahora que ha generado tanto revuelo? Lo cierto es que descubrir -gracias a Jesús Martínez-Frías por su corrección- no se ha descubierto nada en el sentido más estricto de la palabra, sino que se ha podido identificar mejor en que regiones de la superficie de Europa podemos encontrar dióxido de carbono, algo que ya contaba con detecciones previas como podemos leer en Hansen et al. (2008) y McCord et al. (1998).

El dióxido de carbono no es un compuesto que pueda ser estable a lo largo del tiempo geológico en las condiciones de presión y temperatura existentes en la superficie de Europa, por lo que cualquier cantidad de este que quede expuesta, debería de sublimarse y formar parte de la tenue atmósfera del satélite o escaparse al espacio, sin embargo, tanto las observaciones realizadas por la misión Galileo como con el telescopio espacial James Webb han sido capaces de detectar este compuesto en la superficie.

La diferencia entre el descubrimiento original del dióxido de carbono y los datos aportados en el reciente estudio publicado en Science por Trumbo et al. (2023) es principalmente una mejor localización espacial, así como aportar un contexto para su origen, ya que los datos de la Galileo tenían muy poca resolución en comparación con los del James Webb, que ha permitido adscribir la presencia de este compuesto en regiones muy concretas del satélite de Júpiter.

Lo cierto es que el dióxido de carbono no es un compuesto muy raro, y se había detectado previamente en otros lugares del sistema joviano así como en los satélites de Saturno, pero no con una asociación directa a zonas jóvenes de su superficie. Se sospecha que en algunos de estos casos la presencia de este dióxido de carbono podría deberse a factores externos como, por ejemplo, la aportación de compuestos orgánicos por parte de meteoritos o zonas ya ricas en compuestos orgánicos que sufren procesos de degradación a causa de la intensa radiación.

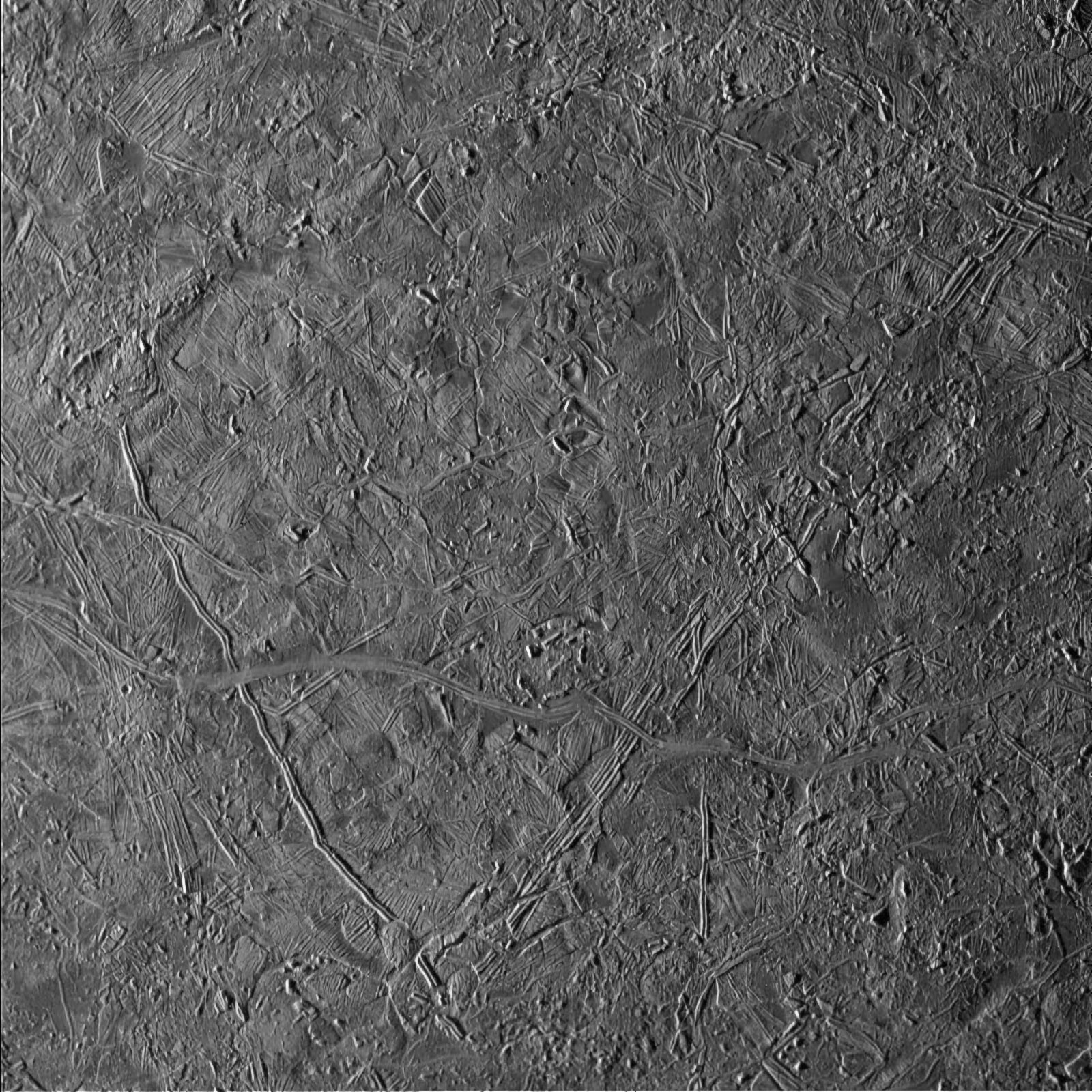

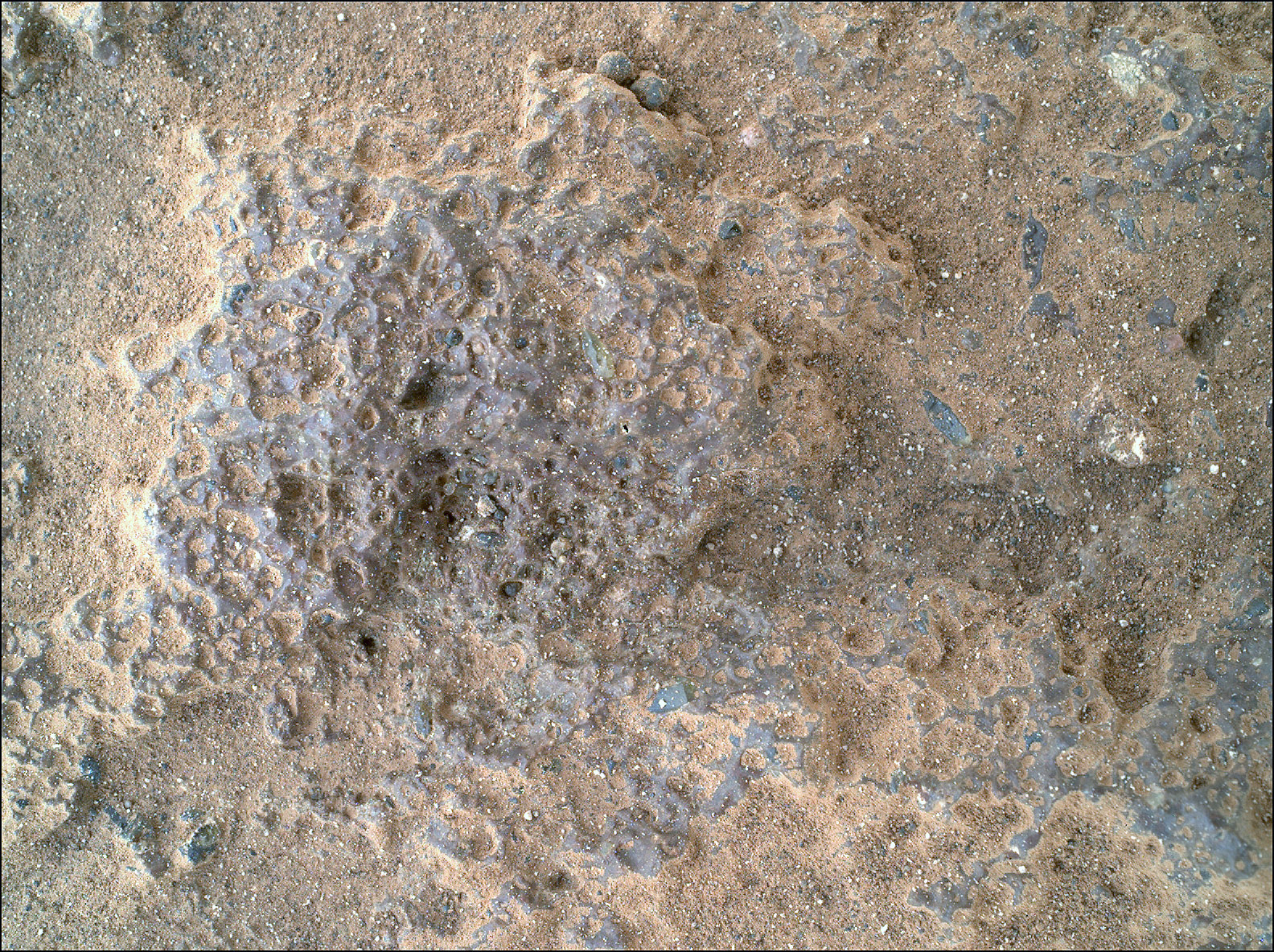

El caso de Europa es diferente, y las concentraciones de dióxido de carbono se encuentran fuertemente asociadas a regiones jóvenes con terreno de tipo chaos -los chaos, explicado de una manera sencilla, son zonas de la superficie de los planetas donde el terreno parece estar agrietado y desordenado- como son Tara Regio y Powys Regio. En el resto de satélites donde se ha detectado, el dióxido de carbono estaba asociado a zonas más oscuras ricas en compuestos orgánicos, cráteres de impacto o las zonas más afectadas por la radiación.

Un detalle de la zona de Tara Regio capturado por la sonda Galileo en septiembre de 1998 a una resolución de 220 metros por píxel. Se aprecia perfectamente la existencia de juegos de grietas, crestas y una forma como de puzle desordenado. Cortesía de NASA/JPL/USGS.

Un detalle de la zona de Tara Regio capturado por la sonda Galileo en septiembre de 1998 a una resolución de 220 metros por píxel. Se aprecia perfectamente la existencia de juegos de grietas, crestas y una forma como de puzle desordenado. Cortesía de NASA/JPL/USGS.Esto nos lleva a la siguiente cuestión. Entonces, ¿de dónde sale el dióxido de carbono? Si en los párrafos anteriores hablábamos del posible origen exógeno -impactos de meteoritos y la degradación de los compuestos orgánicos-, ahora nos toca hablar del origen endógeno de este compuesto. Lo normal es que para que sea estable bajo las condiciones actuales, debe de encontrarse atrapado en el hielo.

Los científicos han estudiado otras posibilidades, como que el dióxido de carbono observado procediese de compuestos orgánicos o de minerales del grupo de los carbonatos, pero no se observan en los espectros señales que hagan pensar en estas dos últimas fuentes -sumada a la radiación- podrían ser una forma plausible de formar las concentraciones de dióxido de carbono encontrados tanto en la asociación a estas regiones jóvenes como en sus proporciones.

Así que solo nos queda una posibilidad, y es que el dióxido de carbono proceda directamente del interior de Europa como dióxido de carbono o como alguna otra molécula precursora de este compuesto desde el océano que hay bajo su superficie. Llegaría a la superficie durante la formación de estas zonas más jóvenes a través del ascenso de materiales del océano -ya sea en estado líquido o como masas de hielo con un comportamiento plástico-, por el colapso del hielo sobre zonas donde exista agua líquida bajo la superficie o por el ascenso de líquidos a través de grietas en la corteza.

Pero todavía hay más: y es que para que observemos las concentraciones de dióxido de carbono que vemos en la superficie, debe de haber un mecanismo continuo que vaya reponiendo este dióxido de carbono que se escapa a la atmósfera o bien la llegada de este compuesto a la superficie ha debido ocurrir en un lapso de tiempo muy reciente a escala geológica.

A la izquierda, una imagen de Europa tomada por el JWST. A la derecha, los mapas de concentración de CO2. Cortesía de NASA, ESA, CSA, G. Villanueva (NASA/GSFC), S. Trumbo (Cornell Univ.) y A. Pagan (STScI).

A la izquierda, una imagen de Europa tomada por el JWST. A la derecha, los mapas de concentración de CO2. Cortesía de NASA, ESA, CSA, G. Villanueva (NASA/GSFC), S. Trumbo (Cornell Univ.) y A. Pagan (STScI).Las implicaciones de estos resultados de cara a la astrobiología son muy importantes: el primero, que el carbono, que es un elemento que es necesario para la vida tal y como la conocemos, se encuentra presente en el océano de Europa, y también que este océano tendría unas condiciones ligeramente oxidantes, lo que coincidiría con una entrada al océano de compuestos oxidantes que se producen en la superficie a causa de la intensa radiación, completando también la cinta transportadora de materia desde la superficie hacia el océano y no solo desde dentro hacia afuera.

Un océano reductor, desde nuestro punto de vista, podría ser menos hospitalario para la vida, porque aunque haya organismos como los anaeróbicos que, capaces de realizar la respiración anaeróbica usando moléculas diferentes al oxígeno, o los quimioautótrofos, capaces de extraer su energía de compuestos inorgánicos, en nuestro planeta sabemos que la falta de oxígeno reduce las posibilidades de formas de vida más complejas.

Todos estos estudios son muy interesantes, ya que podrán servir de base a las futuras investigaciones de la sonda europea JUICE, que ya se dirige al sistema joviano, y la Europa Clipper de la NASA que, si todo va bien, despegará en octubre de 2024, desde donde poder verificar estas observaciones eso sí, desde mucho más cerca y aportarnos nuevos detalles de este cuerpo tan interesante.

Bibliografía:

Hansen, G. B., & McCord, T. B. (2008). Widespread CO2 and other non-ice compounds on the anti-Jovian and trailing sides of Europa from Galileo/NIMS observations. Geophysical Research Letters, 35(1), L01202. doi: 10.1029/2007GL031748

McCord, T. B., Hansen, G. B., Clark, R. N., Martin, P. D., Hibbitts, C. A., Fanale, F. P., Granahan, J. C., Segura, M., Matson, D. L., Johnson, T. V., Carlson, R. W., Smythe, W. D., & Danielson, G. E. (1998). Non‐water‐ice constituents in the surface material of the icy Galilean satellites from the Galileo near‐infrared mapping spectrometer investigation. Journal of Geophysical Research: Planets, 103(E4), 8603-8626. doi: 10.1029/98JE00788

Trumbo, S. K., & Brown, M. E. (2023). The distribution of CO 2 on Europa indicates an internal source of carbon. Science, 381(6664), 1308-1311. doi: 10.1126/science.adg4155

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La importancia del dióxido de carbono en la dinámica geológica de Europa se ha escrito en Cuaderno de Cultura Científica.

Aburrimiento musical

José Manuel González Gamarro

La música, ese hecho cultural transversal a lo largo del planeta, esa gran invención humana que casi empuja a caer irremediablemente en lo interdisciplinar, ha sido estudiada de forma poliédrica. La extensísima literatura que aborda la investigación sobre música tiene casi tantos enfoques como disciplinas del conocimiento existen. Uno de los puntos que más consenso encuentra la investigación es el beneficio que aporta escucharla, estudiarla y/o practicarla. Hay quien, interesadamente sesgado, no duda en atribuirle propiedades casi mágicas con discursos grandilocuentes y atractivos titulares de prensa: «Quítele la pantalla y dele un instrumento musical a su hija o hijo», «La música te hace más inteligente», «¿Quiere envejecer mejor? Practique música», etc. Incluso el refranero popular nos dice que quien canta su mal espanta, pero, como todo en la vida, cabe un gran «depende» en todas estas afirmaciones.

Foto: Manuel Nägeli / UnsplashEfectos negativos de la música

Foto: Manuel Nägeli / UnsplashEfectos negativos de la música

Todos los estudios en pos de los beneficios causados por la música o cómo ésta mejora la sociedad, tienen una consecuencia evidente: el número de estudios de los efectos negativos de la música es mucho menor y solo han suscitado interés en los últimos años. Uno de estos efectos “negativos” puede ser el aburrimiento. Este aburrimiento no siempre se puede considerar negativo ya que algunos autores1 lo consideran como una retroalimentación que provoca un cambio de tarea, por lo que cumple una función importante. Este estado emocional puede ocurrir cuando se interactúa con el arte. De hecho, ocurre con más frecuencia de la que se puede imaginar en un primer momento. Es por esto que un reciente estudio2 dirigido por la investigadora del Instituo Max Planck de Estética Empírica, Julia Merrill ha abordado esta cuestión, poniendo el foco de atención en investigar la prevalencia y las situaciones de aburrimiento al interactuar con la música. Aunque el estudio no es concluyente, aborda cuestiones poco exploradas, como qué características puede tener una música aburrida (por más que esto dependa del juicio del oyente), qué emociones se asocian a esta supuesta música aburrida, la importancia del contexto en la escucha musical, los rasgos de la personalidad del oyente o un constructo que se denomina “sofisticación musical” medida con una escala llamada Gold-MSI3 donde se autoevalúa el compromiso activo con la música, habilidades de percepción musical y la percepción de emociones al oír música.

Para arrojar luz sobre todas estas cuestiones, en el Instituto Max Planck se llevaron a cabo dos estudios diferentes y complementarios, atendiendo a métodos cualitativos y cuantitativos. Para el estudio cualitativo se formularon preguntas abiertas a 266 participantes sobre las situaciones en las que experimentaron aburrimiento al escuchar música atendiendo a la ubicación, el entorno, si estaban solos o acompañados, el tipo de música o la duración de ésta. También se formularon preguntas relativas a los sentimientos y emociones evocados al aburrirse y cómo reaccionaron ante esto. Otra de esas preguntas abiertas abordaba la cuestión de la definición de la música aburrida, es decir, qué características tiene la música con la que la gente se aburre. Para el estudio cuantitativo se usaron 719 participantes donde respondieron a una encuesta con tres preguntas: ¿Con qué frecuencia te aburres cuando escuchas música?, ¿con qué intensidad te aburres cuando escuchas música? y ¿Con qué frecuencia utilizas música para afrontar el aburrimiento? Usando en las respuestas una escala del 1 al 7, siendo el 1 nunca y el 7 siempre. Además, se realizó una lista con 14 estilos musicales que también fueron calificados desde el 1 (muy interesante) hasta el 7 (muy aburrido). A partir de estos datos se escogió el estilo más aburrido y uno ligeramente aburrido y se volvió a pedir a los participantes que valoraran estos dos estilos en la escala de 1 a 7, para a continuación presentar 16 razones por las que la música es aburrida con una escala de 5 puntos. A todos estos datos se le añaden los recopilados por la escala, anteriormente mencionada, Gold-MSI que mide la sofisticación musical de cada participante.

Aburrimiento musicalLos resultados del estudio cualitativo aportaron datos que revelan que, además de experimentar aburrimiento musical en situaciones con cierta monotonía como viajar en coche, en bus, etc. o no tener el control sobre qué música escuchar (bares, radio, etc.), también se experimenta aburrimiento cuando se está solo y la escucha es concentrada. El juicio estético influye de manera determinante cuando no se ajusta a las expectativas del oyente o bien la música no encaja con el estado de ánimo durante la escucha. Las estrategias para evitar el aburrimiento causado por la música dependen de las posibilidades del contexto de la escucha, dependiendo si se puede evitar la situación (salirse de un concierto o cambiar de música) o eso no es posible (ignorar la música o distraerse con otro estímulo). Uno de los resultados que arroja el estudio cuantitativo es el porcentaje de personas que experimentan aburrimiento al escuchar música. Aunque hay un porcentaje muy elevado (76,5 %) de personas que nunca o rara vez experimenta aburrimiento en la escucha, el porcentaje de personas que se aburren en diferentes grados de intensidad y frecuencia no es nada desdeñable.

En cuanto a las características musicales, el aburrimiento ocurre cuando existen ciertos aspectos generales de la música, como la repetición, la monotonía o las letras de las canciones, con una interesante relación entre aburrimiento y significado. Sin embargo, no solo la baja excitación y la subestimulación lo provocan, sino también la sobreestimualción y la alta excitación. La música con un mayor índice de complejidad, con mayor número de disonancias o caótica resulta aburrida por una sobreabundancia de características musicales muy intensa que provocan disgusto. Otra cuestión es que la música que no nos gusta la etiquetemos como aburrida y la identifiquemos como tal antes de su escucha. El gusto musical tiene mucho de vínculo y no tanto de observación y análisis, donde las cuestiones identitarias son un punto clave.

Experiencia estética fracasadaLa finalidad de la escucha musical, en numerosas ocasiones, es, precisamente, la de acabar con el aburrimiento o provocar en nosotros mismos emociones satisfactorias. Por lo tanto, según los autores del estudio se puede afirmar que, si la música nos provoca aburrimiento, es una experiencia estética fracasada con respecto al éxito de esta experiencia, que se produciría cuando hay un equilibrio entre el agrado, el placer, la excitación, la complejidad y la familiaridad. Sin embargo, este “fracaso” también puede significar éxito, puesto que existe el arte (y por lo tanto la música) deliberadamente aburrido4, es decir, algo creado con la firme intención de aburrir y motivado por diferentes razones.

Por otro lado, juzgar cualquier música como aburrida es controvertido, puesto que puede ser contraproducente tanto para el autor de la música como para la persona que la juzga. Se puede entender que una música es aburrida porque la compositora o compositor no ha sido capaz de crear algo emocionalmente satisfactorio, pero también puede ser negativo para quien juzga, por entenderse que no tiene la suficiente formación o sofisticación para comprender cierta música o sentir emociones satisfactorias al escucharla.

Es de suponer que la música con menos índice de aburrimiento, por decirlo de alguna manera, tendrá un mayor éxito en la sociedad. Sin embargo, como ya se ha advertido, el aburrimiento puede ser una consecuencia de escuchar música con unas ciertas características como una predisposición guiada por nuestro prejuicio y preferencia. Es por ello que también existen investigaciones5 que van más allá, buscando la sincronía neuronal en diferentes individuos al someterse a la escucha, con resultados que indican que a mayor sincronía, mayor éxito musical. Sea como fuere el aburrimiento musical y el fracaso de la escucha para evitarlo dependen en gran medida del concepto (filosófico) de belleza, que se podría establecer en la música como una relación compleja entre uniformidad y variedad. La investigación deberá seguir avanzando para tener una mayor comprensión de todos los factores que componen esta relación adversa con la música. Veremos.

Referencias:

1 Fahlman S. A., Mercer-Lynn K. B., Flora D. B., Eastwood J. D. (2013). Development and validation of the multidimensional state boredom scale. Assessment, 20(1), 68–85. https://doi.org/10.1177/1073191111421303

2 Merrill, J., & Niedecken, T. (2023). Music and Boredom: A First Insight Into an Unexplored Relationship. Music & Science, 6. https://doi.org/10.1177/20592043231181215

3 Müllensiefen D., Gingras B., Musil J., Stewart L. (2014). The musicality of non-musicians: An index for assessing musical sophistication in the general population. PLoS ONE, 9(2), 1–23. https://doi.org/10.1371/journal.pone.0089642

4 Elpidorou A., Gibson J. (2022). Really boring art. Ergo an Open Access Journal of Philosophy, 8(0). https://doi.org/10.3998/ergo.2231

5 Leeuwis, N., Pistone, D., Flick, N., & van Bommel, T. (2021). A sound prediction: EEG-based neural synchrony predicts online music streams. Frontiers in psychology, 12, 672980. https://doi.org/10.3389/fpsyg.2021.672980

Sobre el autor: José Manuel González Gamarro es profesor de guitarra e investigador para la Asociación para el Estudio de la Guitarra del Real Conservatorio Superior de Música “Victoria Eugenia” de Granada.

El artículo Aburrimiento musical se ha escrito en Cuaderno de Cultura Científica.

¡Ups! La fiebre amarilla

Aunque a día de hoy sabemos que la fiebre amarilla es una enfermedad vírica aguda y hemorrágica, ocasionada por arbovirus del género Flavivirus y transmitida por mosquitos infectados de los géneros Aedes y Haemogogus, no siempre ha sido así. Esta enfermedad acabó con el 10% de la población de Filadelfia en 1793. Tras aquello, el médico Stubbins Ffirth empezó a buscar la causa de la fiebre amarilla. Imprudentemente experimentó consigo mismo y después de restregarse los vómitos de enfermos e incluso bebérselos y no contagiarse, publicó en una tesis titulada ‘A Treatise on Malignant Fever’ en la que expuso que definitivamente la enfermedad no era contagiosa, un dato erróneo como sabemos actualmente.

Los vídeos de ¡UPS¡ presentan de forma breve y amena errores de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se han emitido en el programa de ciencia Órbita Laika (@orbitalaika_tve), en la 2 de RTVE.

Producción ejecutiva: Blanca Baena

Guion: José Antonio Pérez Ledo

Grafismo: Cristina Serrano

Música: Israel Santamaría

Producción: Olatz Vitorica

Doblaje: K 2000

Locución: José Antonio Pérez Ledo

Edición realizada por César Tomé López

El artículo ¡Ups! La fiebre amarilla se ha escrito en Cuaderno de Cultura Científica.

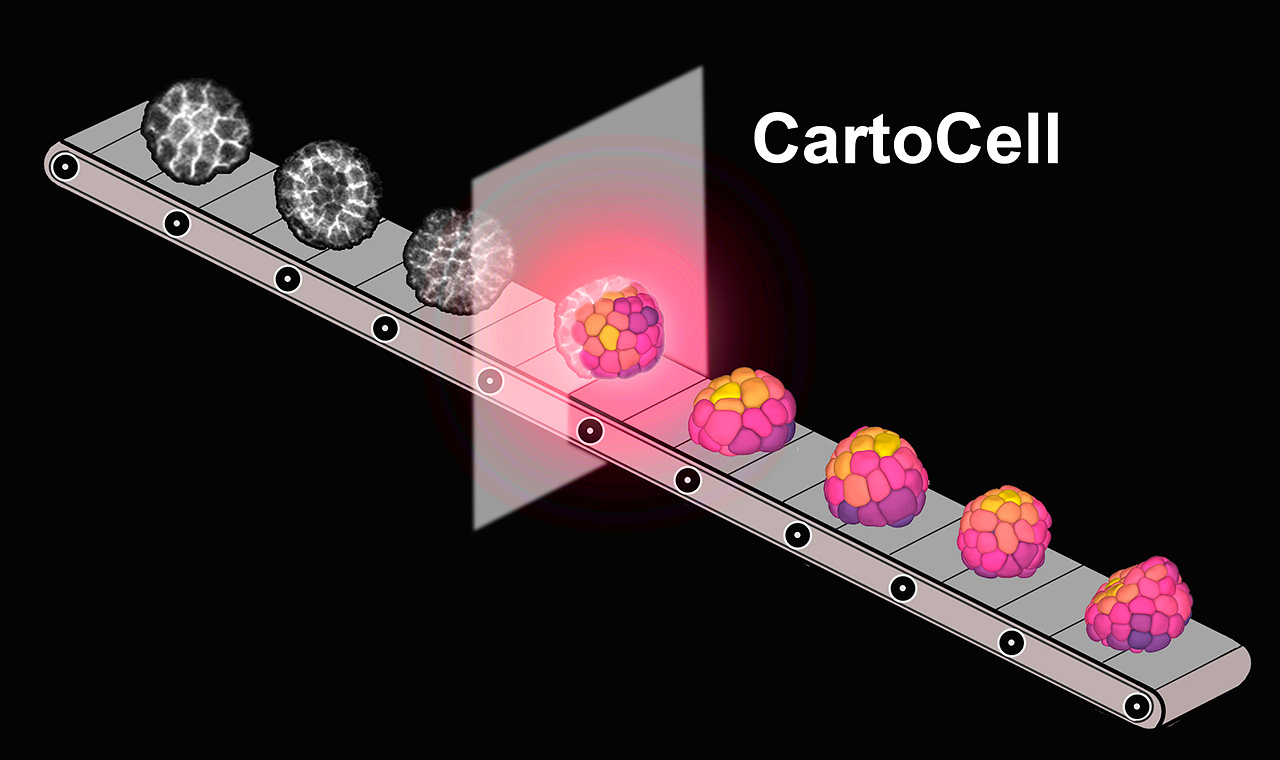

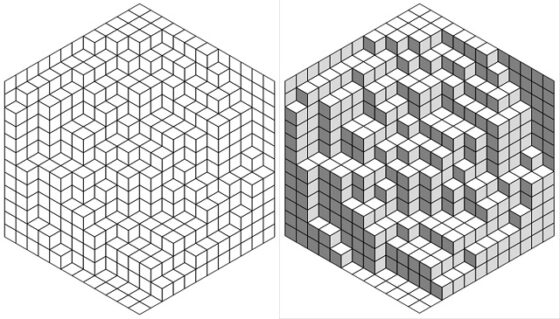

CartoCell o cómo detectar patrones ocultos en tejidos celulares

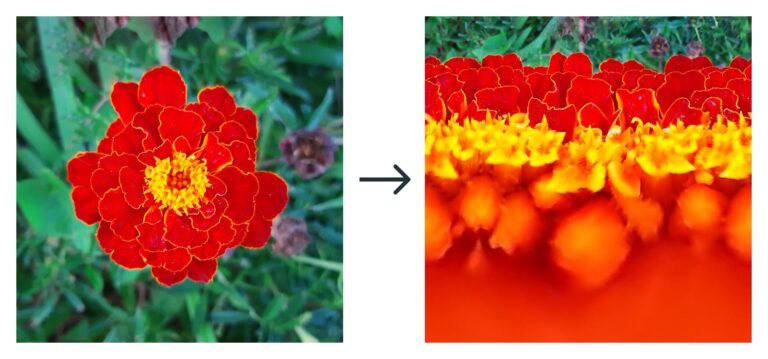

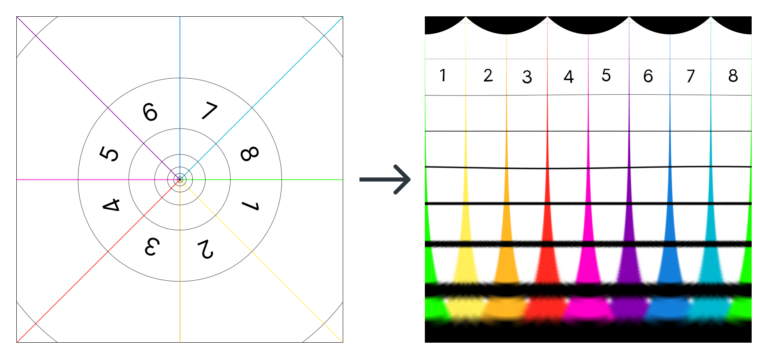

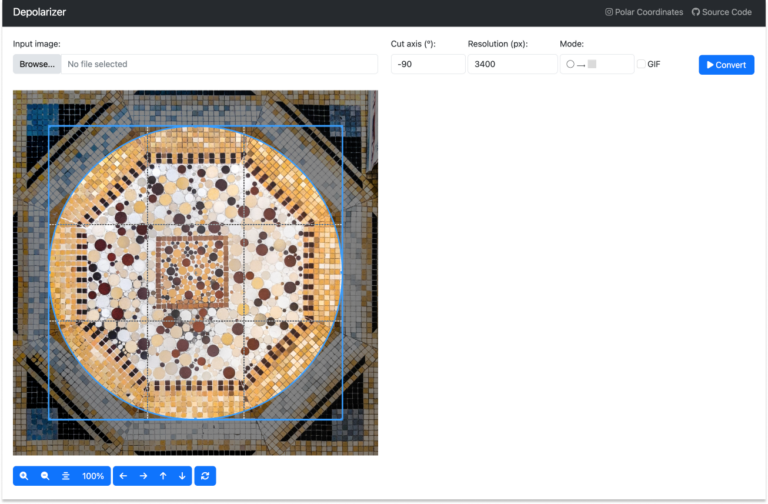

Una reciente colaboración entre el Instituto de Biomedicina de Sevilla con la Universidad del País Vasco, el Instituto Biofisika, el Donostia International Physics Center y otros prestigiosos centros nacionales e internacionales, han dado como resultado CartoCell, una herramienta de análisis de imágenes en 3D de alto contenido que revela patrones de morfología celular escondidos. Este software, de código abierto, tiene un gran potencial de aplicación tanto en ciencia básica, con la que ya ha sido probado, como para el desarrollo clínico y médico.

CartoCell es una red neuronal artificial que procesa de forma automática epitelios en 3D, esto es, permite la reconstrucción automática en 3D de imágenes obtenidas por microscopía.En busca de patrones ocultos

CartoCell es una red neuronal artificial que procesa de forma automática epitelios en 3D, esto es, permite la reconstrucción automática en 3D de imágenes obtenidas por microscopía.En busca de patrones ocultos

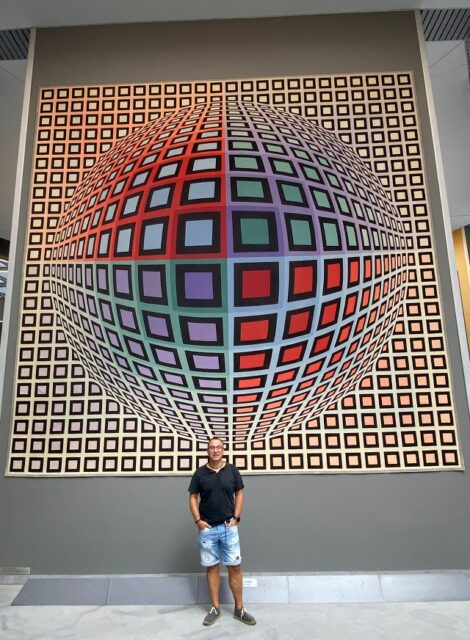

Los animales y plantas, además de otras estructuras de la naturaleza, presentan patrones que podemos detectar fácilmente: las rayas de las cebras, los polígonos de la jirafa o en las conchas de las tortugas, por ejemplo. Todos estos patrones tienen en común que son macroscópicos. Sin embargo, este mismo fenómeno se da a nivel microscópico, en los tejidos. “Estos patrones también aparecen durante el desarrollo embrionario”, explica Luis M. Escudero, uno de los autores e investigador del Instituto de Biomedicina de Sevilla (IBiS) y profesor de la Universidad de Sevilla. “Por ejemplo, hay genes que se expresan en patrones alternos de rayas y que son fundamentales para establecer los segmentos de los insectos”. Muchos de dichos patrones son ya conocidos y muy estudiados, sin embargo, queda mucho por descubrir.

“En nuestro trabajo hemos encontrado patrones que aún estaban escondidos…. Y que solo han podido ser desvelados al usar herramientas de inteligencia artificial para el análisis de imágenes microscópicas de tejidos. Vemos que, incluso en estructuras muy simples, ya hay asimetrías en la morfología de las células. Esta es la forma en que comienza la morfogénesis”. La morfogénesis se refiere al proceso biológico que causa que un organismo desarrolle su forma y estructura. Es una de las etapas fundamentales durante el desarrollo embrionario y se refiere a la organización y distribución espacial de las células diferenciadas para formar estructuras específicas y eventualmente órganos completos.

CartoCell, una herramienta para cartografiar los tejidos epiteliales“CartoCell es una herramienta software que permite procesar de manera rápida y automática una gran cantidad de imágenes 3D obtenidas en el microscopio para la reconstrucción y el análisis de tejidos epiteliales a nivel celular”, prosigue el Dr. Escudero. En otras palabras, esta herramienta digital es capaz de trabajar de forma automática muchísima información, especializándose en buscar patrones, formas, distribuciones y estructuras en los tejidos a partir de imágenes.

Según aclara, CartoCell utiliza la potencia de las redes neuronales, específicamente una red neuronal artificial diseñada para optimizar la identificación de células tridimensionales en imágenes de microscopía. La principal ventaja de CartoCell es que puede identificar y estudiar la forma y distribución espacial de cada célula en el tejido epitelial, permitiendo descubrir patrones asociados a diferentes tipos de tejidos.

“Cada célula del tejido es reconstruida con una gran fidelidad, gracias a lo cual podemos estudiar tanto su forma como su distribución espacial. De este modo, CartoCell nos permite descubrir patrones asociados a los diferentes tipos de tejidos y células, así como estudiar sus reglas de empaquetamiento”. De momento, el software ha sido usado para estudios de ciencia básica, permitiendo cartografiar la morfología de las células con imágenes de diferentes tipos de tejidos. “De este modo, hemos podido encontrar patrones ocultos de una manera sencilla y muy visual”, continúa el investigador, “lo que es fundamental para estudiar la organización de tejidos epiteliales donde las células presentan un contacto estrecho”.

Pero, además de los patrones ocultos, y de la investigación biológica de tejidos, CartoCell también muestra un gran potencial de aplicación clínica. “En el ámbito biomédico, la posibilidad de analizar una gran cantidad de muestras de manera rápida y fiable, como hace CartoCell, es ideal para evaluar la reproducibilidad de cultivos de organoides [pequeños tejidos creados para simular un pequeño órgano] epiteliales y realizar comparativas detalladas entre condiciones normales y patológicas. Por poner un ejemplo sencillo”, continúa el investigador, “el testeo del efecto de fármacos en tejidos animales o humanos podría beneficiarse de nuestro método. Nuestro avanzado análisis de imágenes podría detectar cambios sutiles a nivel celular, que a la larga pueden ser importantes, del efecto de cada fármaco contra una determinada enfermedad”.

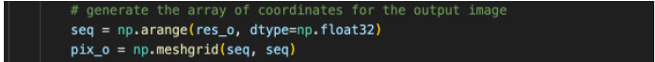

Redes neuronales y código abierto en su núcleoEl corazón de CartoCell es una red neuronal artificial. La arquitectura de la red fue diseñada partiendo de otros modelos desarrollados anteriormente por el grupo de investigación en visión artificial para bioimagen del Instituto Biofisika y el Donostia International Physics Center (DIPC), en el País Vasco, que participa en el proyecto. “Estos modelos ya habían demostrado gran versatilidad y robustez para problemas similares en imagen de microscopía de diferentes modalidades (microscopía electrónica y microscopía confocal, entre otras)”, explica el doctor Ignacio Arganda, líder de dicho grupo e investigador Ikerbasque afiliado también a la Facultad de Informática de la Universidad del País Vasco (UPV/EHU). “En concreto, la arquitectura y las imágenes de salida que genera fueron adaptadas para optimizar la identificación de células tridimensionales adquiridas mediante técnicas de microscopía”.

“Como toda red neuronal artificial”, continúa, “la nuestra necesita del conocido como conjunto de entrenamiento para aprender a realizar la tarea que le propongamos. En nuestro caso, dicha tarea se trata de la identificación (o “segmentación”) de células epiteliales en imágenes tridimensionales”. Normalmente, para que una red neuronal sea capaz de generalizar y realizar esta tarea con precisión, necesita un conjunto de datos muy grande y heterogéneo. Construir dicho conjunto requiere muchísimo trabajo manual, ya que habría que “pintar” una a una todas las células de las imágenes 3D de entrenamiento.

“Sin embargo”, aclara el experto, “CartoCell utiliza un conjunto de entrenamiento inicial de epitelios pintados muy pequeño. Con ese conjunto, entrenamos nuestra red neuronal una primera vez, e intentamos que prediga las identidades celulares en muchas otras imágenes de epitelios. Como es esperado, el resultado no es el ideal, pues muchas identidades no están completas, y quedan huecos entre las células. Para solucionarlo, empleamos un algoritmo de Voronoi que rellena los espacios vacíos entre las células identificadas, consiguiendo así que contacten entre ellas».

“Estas etiquetas celulares transformadas son las que llamamos weak labels [etiquetas débiles], y las utilizamos como nuestro nuevo conjunto de entrenamiento. Aunque estas etiquetas no son totalmente perfectas, capturan de una forma bastante realista la morfología celular (dado que las células epiteliales comparten algunas características de organización con los patrones de Voronoi). Además, al ser muchas y muy heterogéneas, ayudan a mejorar el proceso de re-entrenamiento de la red. Este paso es clave en CartoCell, ya que nos permite conseguir muy buenos resultados en segmentación sin tener que emplear un tiempo excesivo en etiquetar manualmente un conjunto de entrenamiento grande”, completa el investigador.

Una de las características de CartoCell es su versatilidad, según defiende el Dr. Pedro Gómez-Gálvez, autor también del trabajo y actualmente en el Departamento de Fisiología, Desarrollo y Neurociencia de la Universidad de Cambridge (Reino Unido). En concreto, su red neuronal se podría sustituir por cualquier modelo de segmentación del estado del arte (redes neuronales convolucionales 3D o cualquiera de sus variantes), siempre y cuando se utilice el concepto de etiquetado ligero o “weak labels” anteriormente descrito para mejorar el conjunto de entrenamiento. “De hecho, en nuestro artículo probamos con varias arquitecturas de red modernas y, con todas, los resultados fueron muy buenos tras el etiquetado ligero siguiendo el algoritmo de Voronoi”, confirma Gómez-Galvez.

Además, CartoCell es una herramienta de código abierto, lo que brinda la oportunidad a otros expertos de utilizar, mejorar o adaptar libremente su uso. “Todas las personas que hemos participado en la creación de CartoCell creemos firmemente en la idea de ciencia abierta. Consecuentemente, CartoCell ha sido implementado desde el primer día como código abierto, y siempre ha estado disponible para la comunidad. En ese sentido, nuestra intención ha sido crear una herramienta accesible, fácil de instalar y utilizar por personas no expertas, pero también adaptable y ampliable para quien quiera desarrollar nuevas soluciones sobre ella”, concluye.

Referencia:

Jesus A. Andres-San Roman, Carmen Gordillo-Vazquez, Daniel Franco-Barranco, Laura Morato, Cecilia H. Fernández-Espartero, Gabriel Baonza, Antonio Tagua, Pablo Vicente-Munuera, Ana M. Palacios, María P. Gavilán, Fernando Martín-Belmonte, Valentina Annese, Pedro Gómez-Gálvez, Ignacio Arganda-Carreras, Luis M. Escudero (2023) CartoCell, a high-content pipeline for 3D image analysis, unveils cell morphology patterns in epithelia Cell Reports Methods doi: 10.1016/j.crmeth.2023.100597

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo CartoCell o cómo detectar patrones ocultos en tejidos celulares se ha escrito en Cuaderno de Cultura Científica.

Minerales con brillo

brillo

Los minerales, esas sustancias sólidas naturales formadas por elementos químicos ordenados en estructuras cristalinas, presentan una serie de propiedades físicas y químicas que les son únicas y características, lo que nos permite utilizarlas como criterios identificativos y clasificatorios.

Dicho de otro modo y un poco más sencillo. Debido a la composición química de los minerales y la estructura interna que presentan esos elementos químicos, cada mineral tiene unas características concretas que se pueden observar a simple vista y que son propias de cada uno de ellos, lo que nos permite identificarlos rápidamente diferenciándolos de los demás. Si lo asimilamos a los seres humanos, serían esos caracteres heredados que sirven para describir a una persona sin confundirla con otra, como el color del pelo y de los ojos, el tono de la piel, la altura, la presencia de pecas y lunares o el rango de nuestra voz.

Esto nos da mucho juego cuando organizamos actividades de divulgación geológicas, ya que podemos plantear talleres de identificación de minerales de manera muy sencilla y utilizando artilugios de andar por casa, como un trozo de loza, una navaja o un vidrio, que suelen llamar mucho la atención del público asistente. Y, aunque la mayoría de las propiedades físicas y químicas a las que hacemos alusión son muy fáciles tanto de explicar cómo de entender, hay una que se le suele atragantar a la gente. Me estoy refiriendo al brillo.

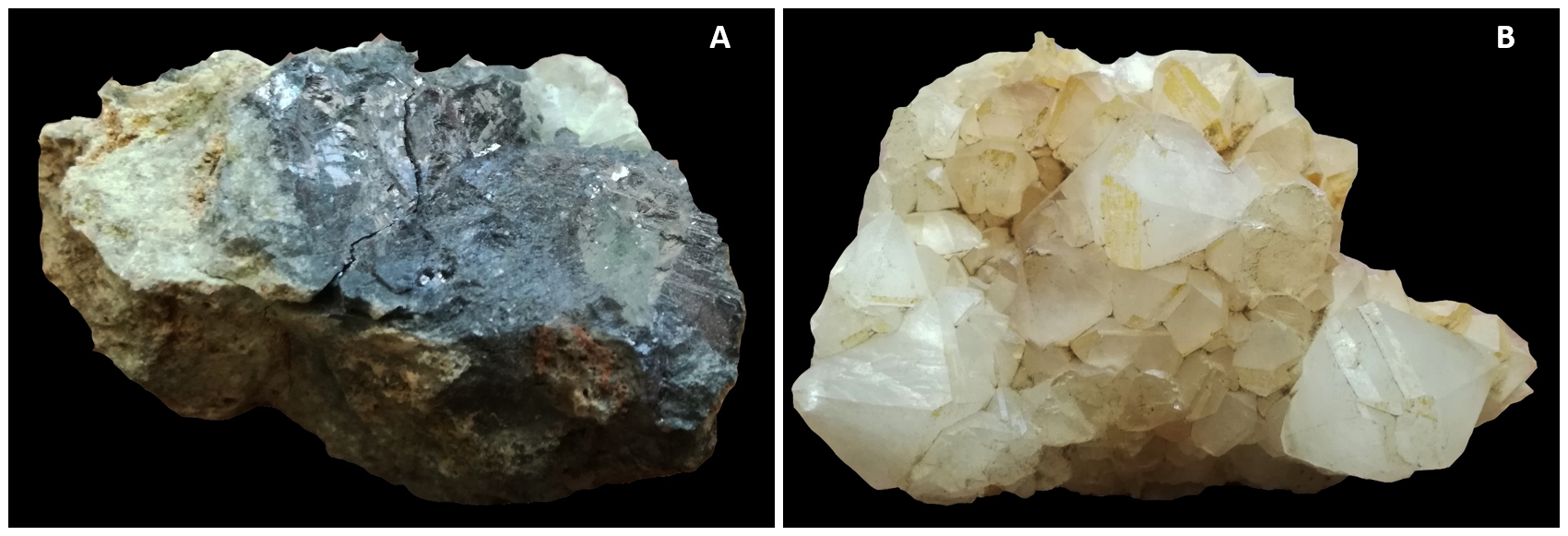

A) Ejemplar de galena, mineral con brillo metálico. B) Cristales de cuarzo, mineral con brillo no metálico.

A) Ejemplar de galena, mineral con brillo metálico. B) Cristales de cuarzo, mineral con brillo no metálico.En una definición rápida, el brillo es el aspecto que adquiere la superficie de un mineral cuando refleja la luz. Y de aquí viene la confusión. Cuando hablamos de reflejar la luz, nos imaginamos a las ondas luminosas rebotando con fuerza contra la cara del mineral y volviendo a la fuente de emisión como un nuevo haz de luz, casi como si ese mineral se convirtiese por sí mismo en emisor y produjese un destello luminoso. Esto es lo que vemos, por ejemplo, cuando el Sol incide en un objeto de metal en la calle, cuyo reflejo se convierte en un resplandor que nos marca exactamente su posición y nos molesta si lo miramos fijamente. Esto nos lleva a pensar que existen minerales que brillan, que serían aquellos que generan este efecto luminoso, y minerales que no brillan, entre los que incluiríamos todos aquellos que no provocan ese destello.

Pues este es el error que comentemos todas las personas la primera vez que nos enfrentamos a tener que describir esta propiedad óptica de los minerales, porque, en realidad, todos y cada uno de los minerales del planeta tienen brillo. Precisamente, esa apreciación visual que os he comentado en el párrafo anterior y que es totalmente intuitiva es la que nos permite clasificar el tipo de brillo de los minerales, diferenciando dos grandes grupos. Por un lado, aquellos minerales que tienen el aspecto brillante de un metal cuando les incide la luz decimos que tienen brillo metálico. Se trata de minerales de colores oscuros y opacos, es decir, que no dejan que les atraviese la luz, como la pirita (sulfuro de hierro, FeS2) o la galena (sulfuro de plomo, PbS). Y, por otro lado, tenemos los minerales de brillo no metálico, que son todos aquellos de colores claros y que se comportan como transparentes o translúcidos, por lo que transmiten la luz bien en parte o bien en su totalidad.

Tabla con la clasificación de los tipos (metálico y no metálico) y subtipos (adamantino, graso, mate, nacarado, perlado, resinoso, sedoso y vítreo) de brillo más comunes en los minerales, con algunos ejemplos característicos. Imagen modificada del original de Minerales de Visu / Universidad de Alicante

Tabla con la clasificación de los tipos (metálico y no metálico) y subtipos (adamantino, graso, mate, nacarado, perlado, resinoso, sedoso y vítreo) de brillo más comunes en los minerales, con algunos ejemplos característicos. Imagen modificada del original de Minerales de Visu / Universidad de AlicantePodemos encontrar diferentes subdivisiones o agrupaciones dentro de los minerales con brillo no metálico, como los de brillo vítreo porque nos recuerdan al brillo que presenta el vidrio de una ventana, que es lo que le ocurre al cuarzo (dióxido de silicio, SiO2), o los de brillo nacarado, que en este caso se asemeja a las irisaciones que se producen en las perlas y es característico del talco (silicato de magnesio hidratado, Mg3Si4O10(OH)2). Pero, por lo general, no entramos en tanto detalle a la hora de clasificar los minerales de acuerdo a su brillo, decimos simplemente que tienen brillo metálico o brillo no metálico.

Sé que he repetido la palabra clave brillo en demasiadas ocasiones a lo largo del texto, pero ha sido totalmente a posta para dejar las ideas bien claras de que todos los minerales tienen esta propiedad y que es una de las características físicas básicas para clasificarlos. Así, cuando os enfrentéis a un apasionante taller divulgativo de identificación de minerales, sabréis la diferencia entre brillo metálico y brillo no metálico y podréis seguir jugando con sus propiedades hasta que acertéis el nombre correcto del ejemplar que tengáis en la mano.

Agradecimiento:

Quiero dar las gracias a Ana Rodrigo, Directora del Museo Geominero del Instituto Geológico y Minero de España (IGME-CSIC), por darme la idea de escribir este artículo tras una interesante conversación sobre cómo mejorar nuestras actividades de divulgación geológicas, resaltando la problemática del público en general a la hora de entender algunas de las propiedades características de los minerales.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Minerales con brillo se ha escrito en Cuaderno de Cultura Científica.

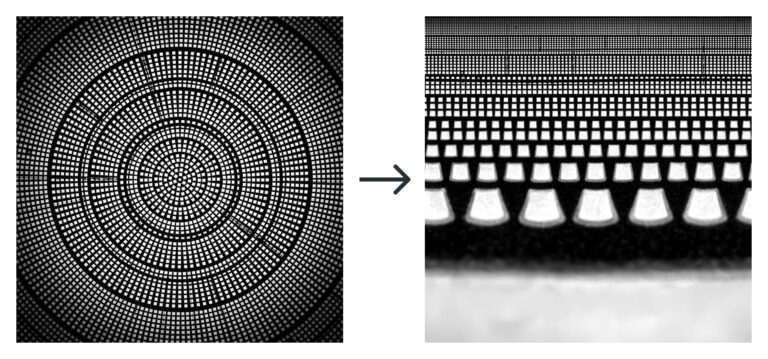

Svetlana Jitomirskaya, la matemática que ganó la mitad de diez martinis

Ella era tan brillante que yo sabía que yo no lo era tanto.

Svetlana Jitomirskaya en [4].

En la anterior cita, la matemática Svetlana Jitomirskaya se refiere a Valentina Borok, su madre, que fue una destacada matemática ucraniana. De ella ya hablamos en este Cuaderno de Cultura Científica.

A pesar de lo brillante que era su madre, Svetlana Jitomirskaya no se queda atrás. Especialista en sistemas dinámicos y física matemática, en 2005 obtuvo el Premio Ruth Lyttle Satter en matemáticas por su trabajo pionero en su especialidad. Y, junto a Artur Ávila, resolvió en 2009 el conocido como problema de los diez martinis en el área de los sistemas dinámicos.

Svetlana Jitomirskaya. Fuente: Springer.

Svetlana Jitomirskaya. Fuente: Springer.Una familia matemática

Svetlana Yakovlevna Jitomirskaya es la hija pequeña de los matemáticos Valentina Mikhailovna Borok y Yakov Yitomirski, que realizaron conjuntamente una parte importante de su investigación.

Su hermano mayor, Michail Zhitomirski (1958) también ha dedicado su vida profesional a las matemáticas. En este momento trabaja en teoría de variedades diferenciables en el Instituto Tecnológico de Israel en Haifa.

Svetlana Yakovlevna Jitomirskaya nació el 4 de junio de 1966 en Járkov (Ucrania). Comentaba sobre sus primeros años (ver [3]):

Cuando yo nací, mis padres ya eran catedráticos (en una sociedad en la que este título inspiraba mucho respeto). Mi madre era sin duda la matemática más destacada del país. Después de haber criado a mi hermano mayor, que estaba claramente dotado para las matemáticas, mis padres pensaron que un matemático más en nuestra familia sería demasiado. Me animaron a interesarme por cosas variadas, y empecé a inclinarme seriamente por las humanidades. Escribí poesía (premiada) y gané algunos concursos nacionales de bachillerato en literatura rusa. Planeé un futuro estudiando (si no escribiendo) poesía rusa.

A pesar de que ni ella ni su familia pensaban que se iba a dedicar a las matemáticas, Svetlana, a sus 14 años, se enamoró durante unas vacaciones de un chico que vivía en Moscú. Sabía que era difícil mantener una relación a distancia y, ya con 16 años, vio que la única manera que tenía de estar cerca de su amado era ingresando en la Universidad Estatal de Moscú. En aquella época esta institución limitaba el número de estudiantes judíos que podían acceder a sus enseñanzas. Para mantener esas cuotas limitantes los aspirantes judíos eran sometidos a preguntas exageradamente difíciles durante los exámenes orales de ingreso. De esta manera intentaban asegurar que el alumnado judío no constituyera más del 0,5 % del estudiantado total. Svetlana sabía que tenía muy pocas posibilidades de aprobar en cualquier disciplina, pero las matemáticas aparecieron como una opción mejor que las humanidades al haber una competencia mucho menor y una mayor objetividad.

Las matemáticas llegan de manera inesperadaCon esta idea en la cabeza dedicó su último año de instituto a preparar el examen oral de matemáticas. En sus propias palabras (ver [3]):

Creo que durante ese año resolví todos los problemas elementales complicados que había, y algunos más. Me tomaba cada problema como algo personal y lo atacaba como si mi felicidad futura dependiera de si lo resolvía o no. Me aceptaron en la Universidad Estatal de Moscú; sin embargo, no puedo considerarlo una victoria personal como me hubiera gustado. No llegué a mostrar ni una fracción de mis habilidades en aquel examen oral, ya que no me sometieron a ese trato «judío» (quizá, debido a las conexiones de mis padres). Sin embargo, algo me ocurrió durante esa extensa preparación, ya que empecé a amar el proceso.

Y de este modo consiguió acercarse a Moscú para no separarse de Vladimir A. Mandelshtam, quien posteriormente se dedicó a la química, con quien se casó en cuanto alcanzó su mayoría de edad.

Jitomirskaya terminó sus estudios universitarios en 1987, graduándose con matrícula de honor. Continuó con su formación doctoral en la Universidad Estatal de Moscú, bajo la supervisión de Yákov Grigórevich Sinái (1935), que también la había asesorado durante sus estudios universitarios. Sinái es un reconocido especialista en teoría de sistemas dinámicos, física matemática y teoría de la probabilidad. Reconocido con el Premio Abel en 2014, fue el principal artífice de la mayoría de los puentes que conectan el mundo de sistemas deterministas (dinámicos) con el mundo de los sistemas probabilísticos (estocásticos).

Svetlana presentó su tesis doctoral en 1991: Spectral and Statistical Properties of Lattice Hamiltonians. Ese mismo año, Vladimir finalizó también su trabajo doctoral.

Antes de finalizar su tesis, en 1990, comenzó a trabajar como investigadora en el Instituto Internacional de Teoría de la Predicción de Terremotos y Geofísica Matemática de Moscú, centro en el que ya trabajaba su marido.

Un año más tarde ofrecieron a Svetlana un puesto postdoctoral en la Universidad de California en Irvine y a Vladimir otro en la Universidad del Sur de California. Aceptaron ambas ofertas de trabajo porque estarían cerca, aunque no fuera en el mismo centro. Lo que pensaron que iba a ser una estancia de un año se convirtió en su lugar de trabajo y residencia definitivos.

Una matemática reconocidaJitomirskaya recibió el Premio Ruth Lyttle Satter 2005 de la American Mathematical Society. Este premio se concede cada dos años en reconocimiento a una contribución destacada a la investigación matemática realizada por una mujer en los cinco años anteriores. El comité de selección destacó (ver [1]):

El Premio Ruth Lyttle Satter de Matemáticas se concede a Svetlana Jitomirskaya por su trabajo pionero sobre la localización cuasiperiódica no perturbativa, en particular por los resultados de sus artículos (1) «Metal-insulator transition for the almost Mathieu operator«, Ann. of Math. (2) 150 (1999), no. 3, 1159-1175, y (2) con J. Bourgain, «Absolutely continuous spectrum for 1D quasiperiodic operators«, Invent. Math. 148 (2002), no. 3, 453-463. En su artículo de los Annals, desarrolló un enfoque no perturbativo de la localización cuasiperiódica y resolvió la vieja conjetura de Aubry-Andre sobre el operador casi Mathieu. Su artículo con Bourgain contiene el primer resultado general no perturbativo sobre el espectro absolutamente continuo.

Además, entre otros reconocimientos, Jitomirskaya ganó en 2020 del Premio Dannie Heineman de Física Matemática que se otorga cada año desde 1959 conjuntamente por la American Physical Society y el American Institute of Physics. Svetlana recibió este galardón:

Por su trabajo en la teoría espectral de operadores de Schrödinger casi periódicos y cuestiones relacionadas en sistemas dinámicos. En particular, por su papel en la solución del problema de los diez martinis, relativo a la naturaleza de conjunto de Cantor del espectro de todos los operadores casi Mathieu y en el desarrollo de los aspectos matemáticos fundamentales de los fenómenos de localización y transición metal-aislante.

El problema de los diez martinis lleva este nombre porque el especialista en teoría de la probabilidad Mark Kac (1914-1984) ofreció diez martinis a quien lo solucionara. Jitomirskaya lo resolvió junto al matemático Artur Avila (1979) en el artículo The Ten Martini Problem publicado en 2009.

A Svetlana Jitomirskaya aún le quedan muchos éxitos matemáticos por conseguir. Su madre fue un modelo extraordinario para ella. Al recibir el premio Ruth Lyttle Satter, comentó lo siguiente en su discurso de agradecimiento (ver [1]):

Debo decir que nunca me he sentido en desventaja por ser una mujer matemática; de hecho, hasta cierto punto ocurre lo contrario. Sin embargo, en comparación con la mayoría de las demás, tuve una ventaja única: un modelo fantástico desde muy pronto: mi madre, Valentina Borok, que habría sido mucho más merecedora de un premio así que yo ahora, si hubiera existido en su época. Para mí, recibir este premio es un homenaje especial a su memoria. Es un placer aprovechar esta oportunidad para darle las gracias.

Referencias

[1] AMS; 2005 Satter Prize, Notices of the AMS 52 (4) 447-448, 2005.

[2] Svetlana Jitomirskaya, Valentina Mikhailovna Borok, MacTutor History of Mathematics archive, University of St Andrews.

[3] John O’Connor and Edmund Robertson, Svetlana Yakovlevna Jitomirskaya, MacTutor History of Mathematics archive, University of St Andrews.

[4] Margarita Rodríguez, Svetlana Jitomirskaya, la matemática detrás de la solución a “el problema de los diez martinis” de la mecánica cuántica, BBC News, 10 de diciembre de 2022.

[5] Valentina Borok, Wikipedia.

[6] Svetlana Jitomirskaya, Wikipedia.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Svetlana Jitomirskaya, la matemática que ganó la mitad de diez martinis se ha escrito en Cuaderno de Cultura Científica.

La ‘repulsión de la especie’ permite una alta biodiversidad en los árboles tropicales

repulsión

Debido a que las plántulas de los árboles no crecen tan bien cuando están cerca de sus progenitores, se pueden concentrar más especies de árboles en los bosques tropicales.

Un artículo de Veronique Greenwood. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons

Vista aérea del bosque tropical en la Isla de Barro Colorado. Fuente: Christian Ziegler / Wikimedia Commons / Gewin V, PLoS Biology Vol. 4/8/2006, e278 doi: 10.1371/journal.pbio.0040278

Vista aérea del bosque tropical en la Isla de Barro Colorado. Fuente: Christian Ziegler / Wikimedia Commons / Gewin V, PLoS Biology Vol. 4/8/2006, e278 doi: 10.1371/journal.pbio.0040278Para los ecólogos, las selvas tropicales encierran muchos enigmas. Una sola hectárea puede contener cientos de especies de árboles, muchas más que en los bosques más cercanos a los polos. De alguna manera estas especies coexisten en una abundancia tan vertiginosa que, como han señalado a veces los naturalistas y ecólogos, los bosques tropicales pueden parecer jardines botánicos, donde cada planta es algo nuevo.

Para que tal multitud de especies esté tan densamente agrupada deben coexistir en un equilibrio muy particular. La evolución parece no favorecer situaciones en las que una sola especie prospera de manera demasiado agresiva, sino que favorece aquellas en las que los organismos están rodeados de especies distintas a la suya. Conciliar estos hechos con lo que se sabe sobre cómo las especies se distribuyen, compiten e influyen entre sí es un desafío.

Para estudiar esta extraordinaria diversidad hace años los científicos comenzaron a establecer parcelas de bosque donde podían registrar y rastrear la ubicación y el estado de cada árbol durante décadas. Una de las primeras parcelas de este tipo, en la isla de Barro Colorado (IBC) en Panamá, tiene 500 metros de ancho por 1.000 metros de largo (el área de unos 70 campos de fútbol) y contiene más de 300 especies. Desde 1980, investigadores de todo el mundo han estudiado minuciosamente los registros detallados de sus habitantes.

En un artículo publicado recientemente en Science, investigadores de la Universidad de Texas en Austin modelaron varios escenarios de distribución y los compararon con datos de IBC. Descubrieron que los patrones en la dispersión de semillas por el viento o por las aves y otros animales salvajes, así como procesos más aleatorios, no eran suficientes para explicar la distribución de los árboles adultos en el bosque. Sugieren que esto es evidencia de una “repulsión específica de la especie”, una teoría de larga data de que los árboles de la misma especie se espacian naturalmente porque el ambiente que rodea inmediatamente a un árbol padre es específicamente hostil a la propia descendencia del árbol.

Distanciamiento social en árbolesEsta idea de repulsión, formalmente conocida como dependencia negativa de la densidad conespecífica, o CNDD (por sus siglas en inglés), se remonta a la década de 1970, cuando los ecólogos Daniel Janzen y Joseph Connell sugirieron de forma independiente que los insectos, herbívoros y patógenos que se alimentan selectivamente de una especie podrían hacer que el área alrededor de un árbol adulto fuese peligrosa para sus semillas. No se impediría con la misma eficacia que otras especies creciesen en la zona, aunque seguirían estando limitadas por problemas no específicos, como la falta de luz solar bajo la copa de un árbol adulto. El resultado sería que los árboles adultos de una especie tenderían a mantener una especie de “distancia social” mínima entre sí.

Los ensayos realizados en las últimas décadas, principalmente con plántulas, apoyan la CNDD, afirma Michael Kalyuzhny, autor principal del nuevo artículo, cuyo trabajo como investigador postdoctoral en la Universidad de Texas en Austin le ha llevado a abrir un laboratorio en la Universidad Hebrea de Jerusalén. Las semillas a menudo no crecen tan bien en el suelo tomado de lugares cercanos a sus árboles progenitores como en el suelo de lugares cercanos a árboles no relacionados.

Sin embargo, incluso una mirada superficial a los datos del IBC muestra que los árboles adultos en ese bosque no parecen repelerse entre sí. En cambio, los árboles se agrupan, formando grupos sueltos de la misma especie en toda la parcela.

Kalyuzhny y Annette Ostling, la ecóloga comunitaria que dirige el laboratorio donde trabaja Kalyuzhny, se propusieron modelar diferentes escenarios que podrían explicar las distribuciones de árboles observadas, para saber si algo podría estar dificultando el papel de la CNDD en el bosque.

El azar por sí solo no es la respuesta: cuando ejecutaron un modelo nulo, en el que los árboles estaban espaciados aleatoriamente, los árboles adultos de una especie se dispersaban demasiado.