Herramientas de luz: de la ciencia ficción a las películas moleculares

Desde su descubrimiento en 1960, los rayos láser han servido de inspiración de películas y series de ciencia ficción. Gracias a desarrollos posteriores algunas de estas fantasías se han hecho realidad. De hecho, ha sido posible crear potentes herramientas de luz de aplicación en ámbitos tan diversos como la biología, la medicina, la industria, las telecomunicaciones o la investigación básica en general.

La conferencia titulada “Herramientas de luz: de la ciencia ficción a las películas moleculares” describe algunas de estas aplicaciones de los rayos láser y abordará las nuevas perspectivas que existen con las fuentes láser de gran intensidad concentrada en pulsos de tiempos muy cortos. Estas fuentes láser permiten filmar los procesos moleculares o incluso adentrarse en el mundo de los electrones, ámbitos antes inexplorables para la ciencia.

Nerea Zabala es la ponente de esta charla del ciclo Bidebarrieta Científica, iniciativa impulsada por la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta. La conferencia ttuvo lugar el pasado 26 de febrero de 2020 en la Biblioteca Bidebarrieta de Bilbao.

Nerea Zabala, doctora en Física, es investigadora asociada en el Centro de Física de Materiales (centro mixto CSIC-UPV/EHU) y en el Donostia International Physics Center (DIPC), y profesora en la Facultad de Ciencia y Tecnología de la UPV/EHU. Actualmente su investigación se centra en el estudio del comportamiento de la luz en la nanoescala.

Edición realizada por César ToméLópez

El artículo Herramientas de luz: de la ciencia ficción a las películas moleculares se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #NaukasKids14 Física y ciencia ficción

- Un equipo de alta fidelidad de ciencia ficción

- Ciencia, arte y cultura callejera: física y música

Lo que la búsqueda de inteligencia extraterrestre nos enseña para entender la pandemia

Unsplash/Donald Giannatti, CC BY-SA

Unsplash/Donald Giannatti, CC BY-SAComprender el significado de los números cuando se refieren a cantidades muy grandes o muy pequeñas es complicado. Esto es algo que experimentamos ahora mismo con la pandemia del COVID-19. La combinación de unos números muy grandes (la población total susceptible de ser contagiada) junto con unas probabilidades ínfimas (las asociadas al contagio individual y a la aparición de determinados síntomas graves) da como resultado unas cantidades de muy difícil interpretación. Sobre todo si ignoramos la disponibilidad de servicios hospitalarios. Así, las diferencias entre el riesgo individual y el comunitario se entremezclan y en ocasiones se oscila entre el excesivo alarmismo y el optimismo injustificado.

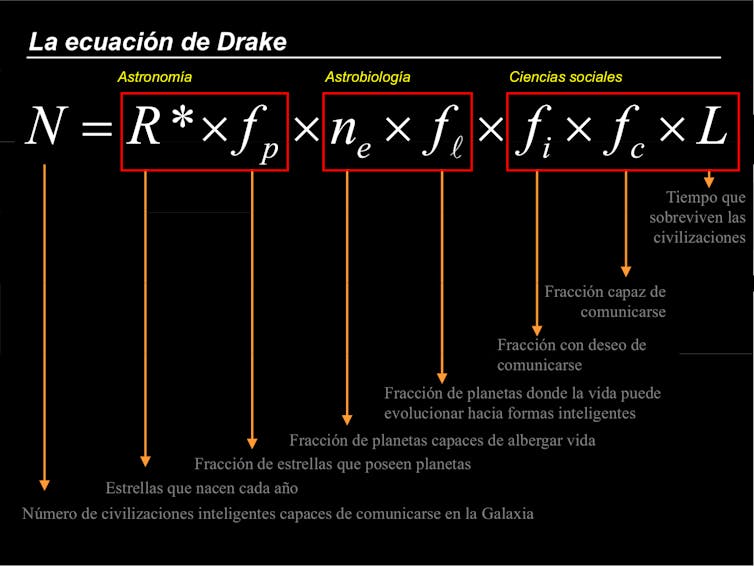

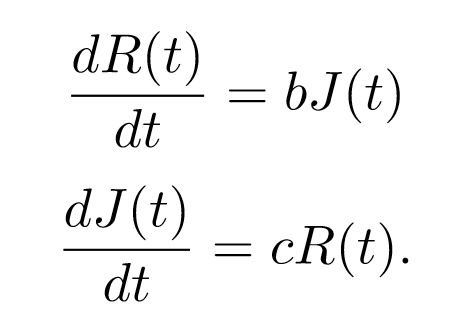

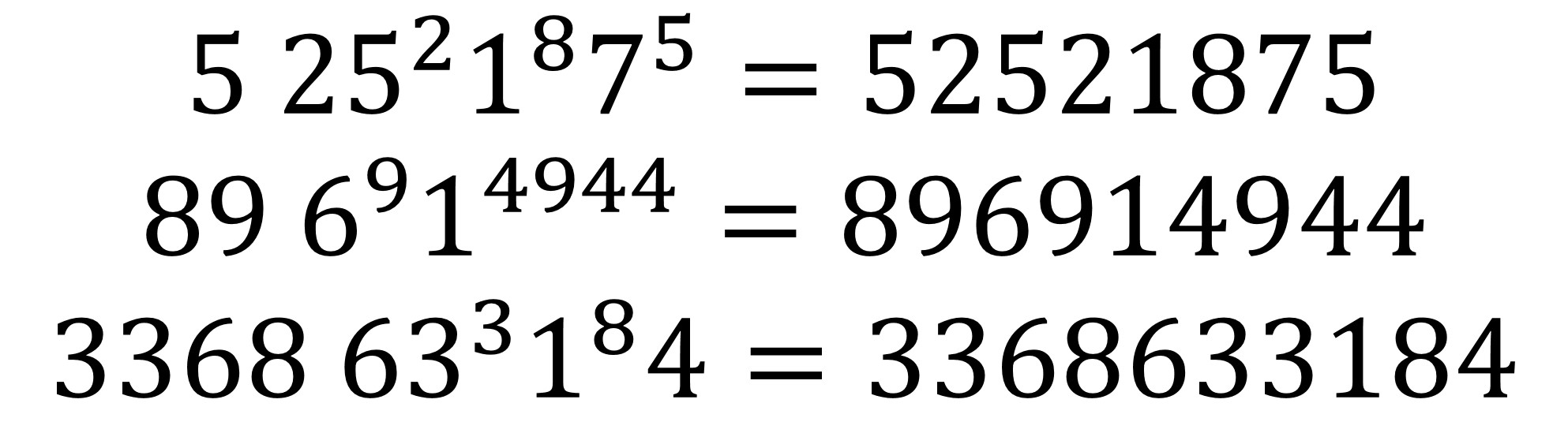

Para ilustrar esta situación en un contexto más amable, podemos utilizar la fórmula presentada en 1961 por el radioastrónomo Frank Drake para dar una base cuantitativa al proyecto SETI (Search for ExtraTerrestrial Intelligence) en la segunda mitad del siglo XX. SETI suponía un intento científico para determinar la probabilidad de establecer contacto con civilizaciones extraterrestres en nuestra galaxia, algo que muchos verán como mera ciencia-ficción pero que podemos abordar con un espíritu analítico.

¿Cómo podríamos determinar el número de eventos de un determinado suceso tan improbable como la comunicación con una sociedad tecnológica extraterrestre? La estrategia consiste en separar los factores que deben concatenarse para lograr un positivo. Asumiremos que todos estos sucesos son independientes y que, por lo tanto, podemos determinar la probabilidad de que se den simultáneamente con una sencilla multiplicación. Añadiendo factores podemos llegar a una estimación razonable sobre la probabilidad del evento final: aquel en el que todos los sucesos se combinan perfectamente.

Esta tarea abarca un buen número de disciplinas que van desde las ciencias experimentales hasta especulaciones de muy discutible fundamento, pasando por áreas del conocimiento más difícilmente mensurables como la historia y las ciencias sociales.

Podríamos comenzar tomando como primeros factores la fracción de estrellas en la galaxia que presentan planetas en su entorno y la cantidad de estos que tienen la composición adecuada y están en la zona de habitabilidad. Estas son cuestiones que las últimas misiones espaciales como Kepler, Gaia y TESS nos permiten cuantificar. Pisamos tierra firme o, al menos, un suelo más firme de lo que Drake pudo hacer en su momento.

Ecuación de Drake.

Ecuación de Drake.¿Cómo cuantificamos la probabilidad de que surja vida en un planeta que aparentemente reúne las condiciones adecuadas? ¿En cuántos de ellos se ha desarrollado la vida inteligente en forma de civilizaciones? Hasta la fecha, aunque Marte o Venus reunieran condiciones habitables en el pasado, solo conocemos un caso positivo: la Tierra. Ninguno de los más de 4 000 planetas extrasolares conocidos ha demostrado de momento sustentar una biosfera como la nuestra.

A partir de aquí la cuestión se complica. Necesitaríamos cuantificar la evolución de las sociedades hacia la tecnología y el deseo de comunicarse con el resto del universo. También influirá el tiempo durante el cual sean capaces de hacerlo: un siglo, mil años o, como sugirió Drake, hasta 10 000 años. Los datos experimentales para establecer estas cantidades son muy escasos y se basan en la historia humana y en la dinámica de las sociedades que solo comenzamos a comprender de una forma cuantitativa.

En el momento en que Frank Drake asignó valores a todos los términos se encontró con un resultado extraordinario: hasta diez civilizaciones deberían ser detectables mediante SETI. Pero, si así fuera, ¿dónde se encuentran? Esta es la llamada Paradoja de Fermi, opuesta al optimismo de Drake. Encontrar las razones de este inquietante silencio, como se le ha llamado, es también una buena manera de explorar nuestro futuro inmediato y tratar de adivinar los riesgos que como civilización nos pueden esperar a la vuelta de la esquina cósmica.

Otros autores discreparon con los números de Drake desde el primer instante, obteniendo valores mucho más bajos que manifestaban la improbabilidad de lograr el contacto gracias al proyecto SETI. Pequeñas variaciones en los términos que se multiplican en esa larga cadena resultaban en cambios notables del resultado final y, peor aún, las incertidumbres se propagaban exponencialmente en el resultado.

De la ecuación de Drake podemos aprender que los eventos individuales pueden ser realmente infrecuentes o improbables pero, aplicados a una población lo suficientemente grande, su aparición es inevitable. Además, cuando los eventos dependen de una larga cadena de condiciones cuyas probabilidades no podemos estimar con total certeza, nuestra capacidad de predecir los eventos futuros se enturbia. La diferencia con la epidemiología es que, en esta, buscamos que los eventos sucedan en el menor número posible y, para ello, podemos actuar sobre algunos de los factores involucrados.

Desde un punto de vista sanitario, la probabilidad de un evento único, como que enfermemos con síntomas graves, puede ser muy baja, casi despreciable. Aplicada sin embargo sobre el conjunto de la población, terminará sucediendo. Y lo hará más de una vez. Los factores que influyen incluyen la biología, fisiología y la sociología, con una transversalidad similar a la de la astrobiología.

La buena noticia es que cambiar esto se encuentra en nuestra manos: alterando unos pocos factores podemos reducir el número a una cantidad, si no nula, al menos manejable. En ello estamos.![]()

Sobre el autor: Santiago Pérez Hoyos es investigador doctor permanente en astronomía y astrofísica en la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original

El artículo Lo que la búsqueda de inteligencia extraterrestre nos enseña para entender la pandemia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La búsqueda de la inteligencia artificial

- Un juego de mesa para entender la irreversibilidad

- La búsqueda de la inteligencia artificial, en la próxima zientziateka

¿Por qué suena triste el modo menor?

Hace cuatro milenios, en Mesopotamia, los sumerios ya utilizaban un sistema musical de siete notas y siete modos para componer sus canciones. Este sistema fue heredado por los griegos que se lo contagiaron al resto de Europa y, desde entonces hasta ahora, —pasando por la larga Edad Media— distintos modos han ido ganando y perdiendo popularidad, según la época. En la actualidad, solemos utilizar preferentemente dos de esos antiguos modos que hemos rebautizado como Modo Mayor y modo menor.

Quizás este desenlace no sea más que un accidente fortuito de la historia. No sabemos si en algún universo paralelo, el reguetón se escribe en el modo frigio y la salsa suena mucho más a mixolidio. Pero, de acuerdo con la hipótesis del profesor David Huron, una vez reducidas las alternativas a dos, su asociación emocional era inevitable: es posible que el modo menor sea, en gran medida un accidente cultural y su asociación con la tristeza deba ser aprendida. Pero esto no significa que sea una asociación arbitraria.

La idea de Huron es que el modo menor suena triste porque suena más triste que el Modo Mayor1. Este, en cambio, saca a relucir su alegría cuando se pone en contraste con su oscuro hermano menor. La clave de esta comparación vuelve a encontrarse en las características de la prosodia humana y cómo esta se ve afectada por nuestras emociones. Pero, para entenderlo, debemos volver a sacar al humano triste de paseo.

Un humano triste, recordemos, es un humano al que le han quitado las pilas. Por eso (y porque tensar las cuerdas vocales también requiere su esfuerzo, aunque no lo parezca), es común que hable bajito, sin cambiar mucho el tono de voz, balbuceando a menudo. Particularmente: es típico que el humano triste produzca sonidos más graves de los que son habituales en él.

Sin embargo, para identificar este cambio en su tono de voz no nos basta con atender a su frecuencia, sin más. Si fuese así, los hombres —que, por lo general, tienen la voz hasta una octava más grave que las mujeres— sonarían siempre tristes, deprimidos, no serían capaces de expresar alegría. Esto, evidentemente, no sucede y el motivo es que, para identificar una voz triste, lo que hacemos es establecer una comparación: entre el tono de esa misma voz en su estado neutro y su tono cuando la invade la tristeza.

Del mismo modo, cuando escuchamos música, realizamos sin darnos cuenta una comparación parecida: entre los tonos que predominan en esa canción y los tonos que se utilizan habitualmente en el resto de nuestra música. O, también, entre los tonos que estamos escuchando en ese momento y los tonos que predominan en el resto de la canción. Y aquí es donde la correspondencia entre los modos Mayor y menor se vuelve relevante, porque si colocamos estas escalas en paralelo, nota a nota, lo que observamos es que el modo menor es una versión oscurecida del Modo Mayor: un modo al que se le han agravado ciertas notas y acortado ciertos intervalos2.

Si bien el uso del modo menor en nuestra tradición musical es, por sí mismo, un accidente cultural, esta especie de tristeza por agravio comparativo parece ser mucho más universal. En 2007, Parag Chordia y Alex Rae quisieron ponerla a prueba utilizando, esta vez, fragmentos musicales procedentes de la India. A través de internet recibieron 22000 respuestas de 500 participantes encargados de clasificar emocionalmente pequeños fragmentos de ragas (los modos melódicos utilizados en la música clásica india). El compendio de todas ellas desvelaba un mismo patrón: los fragmentos con tonos comparativamente más graves e intervalos más pequeños, eran percibidos como más tristes3.

Este es quizás el motivo por el que resulta sorprendente escuchar canciones ya conocidas… a las que alguien ha cambiado el modo (Youtube está lleno de ejemplos). Nuestro recuerdo de la canción original fija un estándar sobre el que inevitablemente superponemos la versión alterada y el contraste saca a relucir la tristeza (o la alegría) percibida

No obstante, mi uso preferido de este contraste se da cuando algún compositor lo establece dentro de una misma canción. Como en esta preciosa canción de El Kanka que, de repente, se quita la ironía y cambia sorpresivamente al modo mayor para hablar de un pasado aparentemente más feliz (se escucha el cambio sobre la misma melodía, en 1’08’’, por ejemplo).

También, me viene a la mente el Lago de los Cisnes de Tchaikovsky. Cuando, en la última escena, después de todo el drama, después de que el tema se haya repetido 500 veces en modo menor, con los protagonistas ya bien muertos y suicidados… el hechizo de los cisnes se rompe y, de repente, escuchamos el mismo tema (2’55’’) ¡pero esta vez triunfante, en Modo Mayor! Parece mentira que pueda tratarse de la misma melodía, cambiando apenas unas pocas notas.

Notas:

1David Huron (2008) A Comparison of Average Pitch Height and Interval Size in Major- and Minor-key Themes: Evidence Consistent with Affect-related Pitch Prosody. Empirical Musicology Review

2El lector que tenga conocimientos musicales quizás se plantee que, al agravar ciertas notas algunos intervalos se harán necesariamente más grandes debido a la estructura cíclica de las escalas. David Huron analizó esta cuestión partiendo de casi 10.000 piezas instrumentales en modo Mayor y menor. Debido a la frecuencia de aparición desigual de los posibles intervalos, el efecto global de cambiar estas notas daba lugar a melodías con intervalos más reducidos en el modo menor.

3Parag Chordia y Alex Rae. “Understanding Emotion in Raag: An Empirical Study of Listener Responses”. Computer Music Modeling and Retrieval. Sense of Sounds, 2008.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo ¿Por qué suena triste el modo menor? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La hoja de papel con cuatro caras, una propuesta de taller

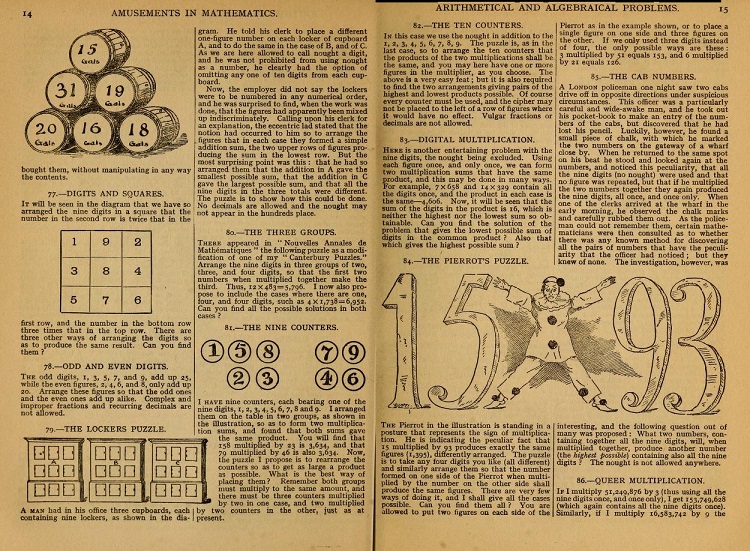

Hace unos cuantos días, pensando en la situación de confinamiento en la que nos encontramos en estos momentos, me pareció que sería una buena idea preparar una actividad sencilla para enviar a la gente y que pudieran realizarla en su casa. Mi idea era que fuese una actividad para personas de cualquier edad, desde pequeños (acompañados si es necesario) hasta mayores. Entonces, me decidí por un taller que hago desde hace algunos años, aunque relacionado con otras cuestiones, y que me gusta mucho. Consiste en construir un objeto matemático sencillo y sorprendente, una hoja de papel con cuatro caras.

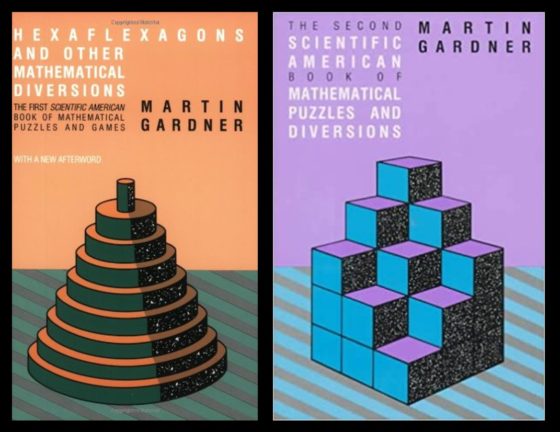

Este objeto matemático, cuyas instrucciones de construcción os voy a explicar en esta entrada del Cuaderno de Cultura Científica, pertenece a la familia de objetos llamados flexágonos y que fue descubierta por el matemático inglés Arthur Stone, de quien ya hemos hablado en relación con el problema de la cuadratura del cuadrado en 1939. Aunque estos objetos fueron dados a conocer y popularizados por el gran divulgador de las matemáticas Martin Gardner (1914-2010) en su columna Juegos matemáticos de la revista Scientific American. En concreto, el objeto matemático que vamos a construir en esta entrada es un tetraflexágono, es decir, un flexágono con cuatro lados (cuadrado o rectángulo), además, como va a poder mostrar cuatro caras, se denomina un tetratetraflexágono.

Portadas de los dos primeros libros de Martin Gardner en los que se recogen los artículos de su columna Juegos matemáticos en la revista Scientific American. En el primero aparece su artículo Hexaflexagons y en el segundo Tetraflexagons

Portadas de los dos primeros libros de Martin Gardner en los que se recogen los artículos de su columna Juegos matemáticos en la revista Scientific American. En el primero aparece su artículo Hexaflexagons y en el segundo Tetraflexagons

Pero vayamos directamente a nuestro objeto matemático, esa hoja de papel de cuatro caras, el tetratetraflexágono, y a su construcción: materiales e instrucciones.

Material básico para el taller: una hoja de papel normal, por ejemplo, din A4, un lápiz y una regla.

Instrucciones para construir el tetratetraflexágono, la hoja de papel con cuatro caras:

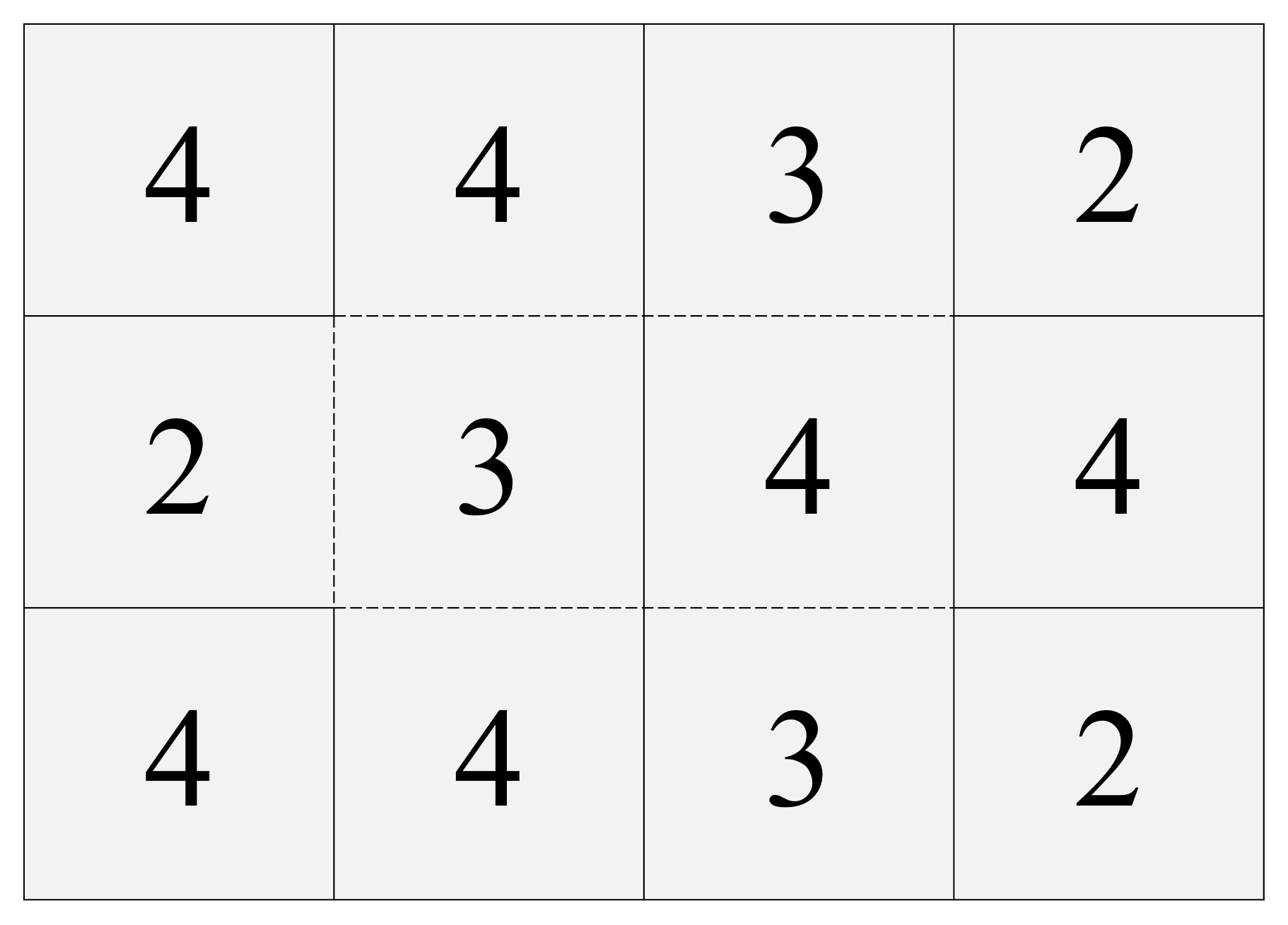

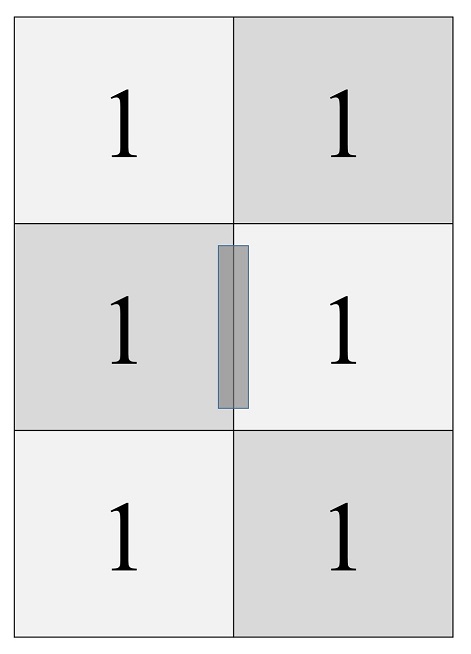

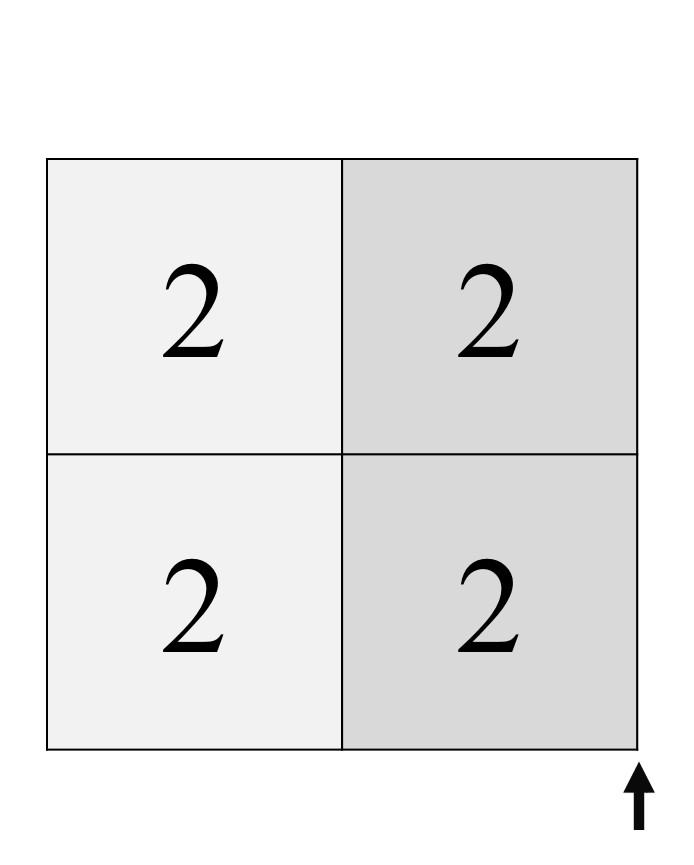

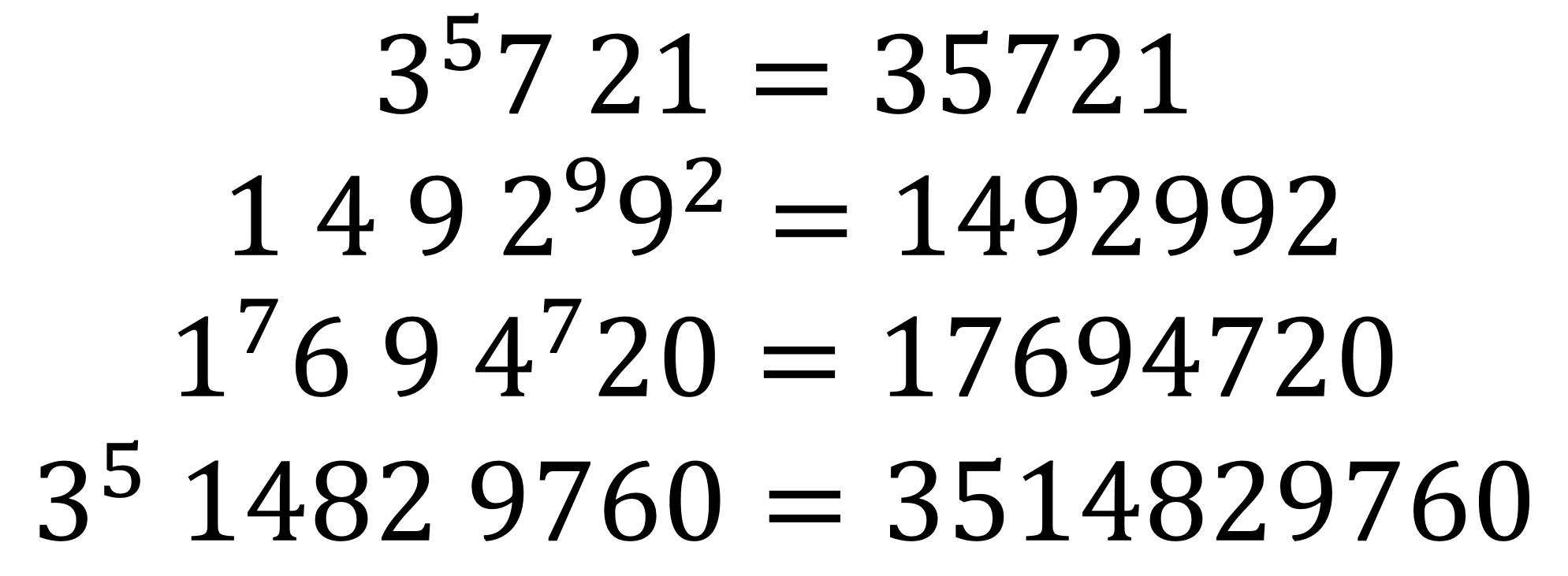

Punto 1. Tomamos la hoja de papel, que colocamos con el lado largo en horizontal, y lo vamos a dividir –por delante y por detrás- en cuatro columnas y tres filas, utilizando líneas trazadas con un lápiz. Generando de esta forma 4 x 3 = 12 casillas rectangulares en cada lado.

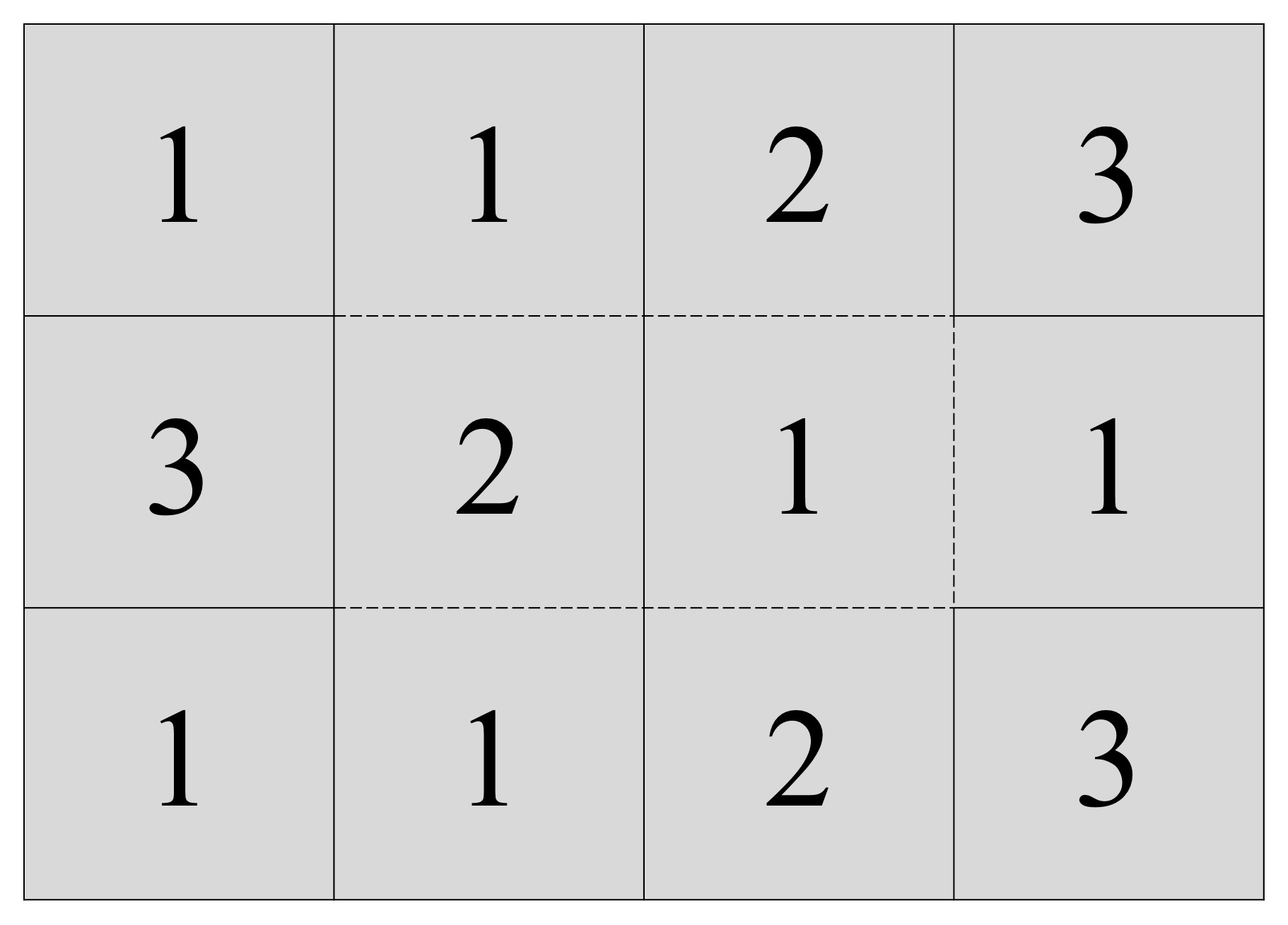

Punto 2. En cada una de las casillas vamos a pintar, centrado, un número. En las 12 casillas de la parte frontal pintamos los números 4, 4, 3, 2 (en la primera fila, la de arriba), luego 2, 3, 4, 4 (en la segunda fila, en medio) y 4, 4, 3, 2 (en la tercera). Ahora en las casillas de la parte trasera pintamos los números 1, 1, 2 y 3 (arriba), 3, 2, 1, 1 (en medio), 1, 1, 2, 3 (abajo). Ojo, aquí quien lo desee puede echarle imaginación y pintar unos números chulos.

Números de las doce casillas de la parte frontal del folio original

Números de las doce casillas de la parte frontal del folio original

Números de las doce casillas de la parte trasera del folio original

Números de las doce casillas de la parte trasera del folio original

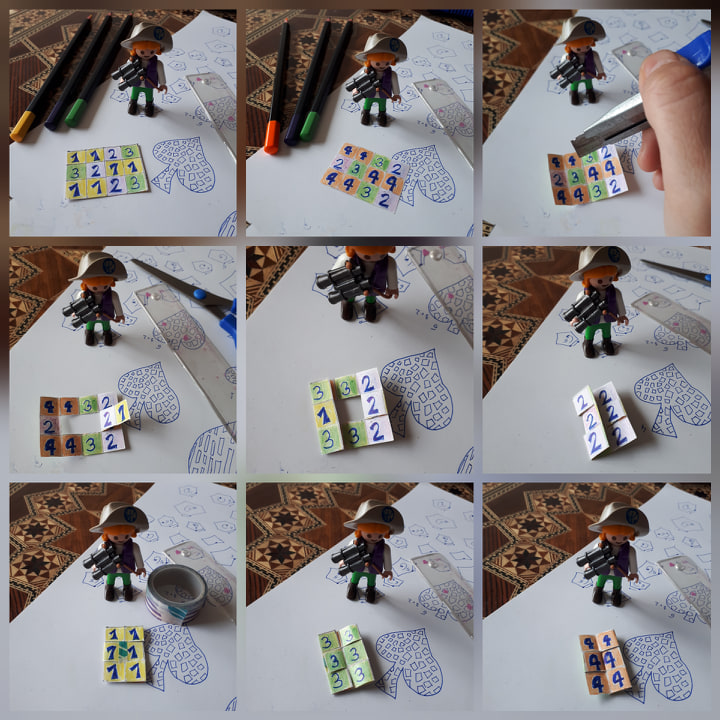

Punto 3. Ahora tenemos que realizar un pequeño corte con unas tijeras, por lo tanto, hay que tener cuidado. Si la actividad la realizan niños y niñas pequeños necesitarán la ayuda, o supervisión, de una persona mayor. Antes de realizar el corte, doblad por las líneas rectas que habéis pintado a lápiz, os ayudará a realizar el corte y además es necesario para la parte final.

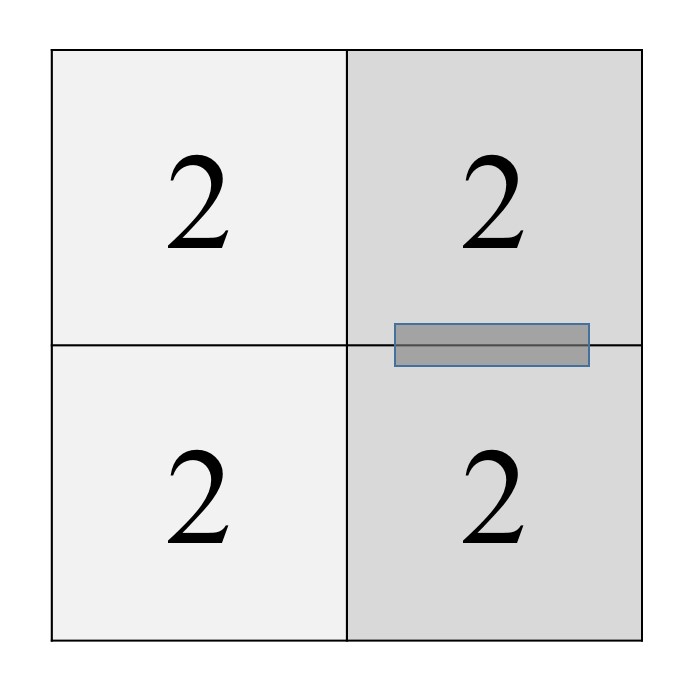

Pero vayamos con el corte. Si consideramos la hoja de papel con la parte frontal, la primera, la que tiene solo doses, treses y cuatros, entonces vamos a cortar el papel para separar las dos casillas del centro –con los números 3 y 4- del resto, pero por todos los lados, salvo uno, el derecho –donde se unen los dos cuatros (véase la siguiente imagen).

Es decir, cortaremos los lados de arriba de las casillas centrales, 3 y 4, el lado izquierdo de la casilla del 3 y los lados de debajo de esas dos casillas centrales. De esta forma, estas dos casillas, 3 y 4, que están unidad entre sí, solo están unidas al resto por el lado derecho, el lado entre los dos cuatros.

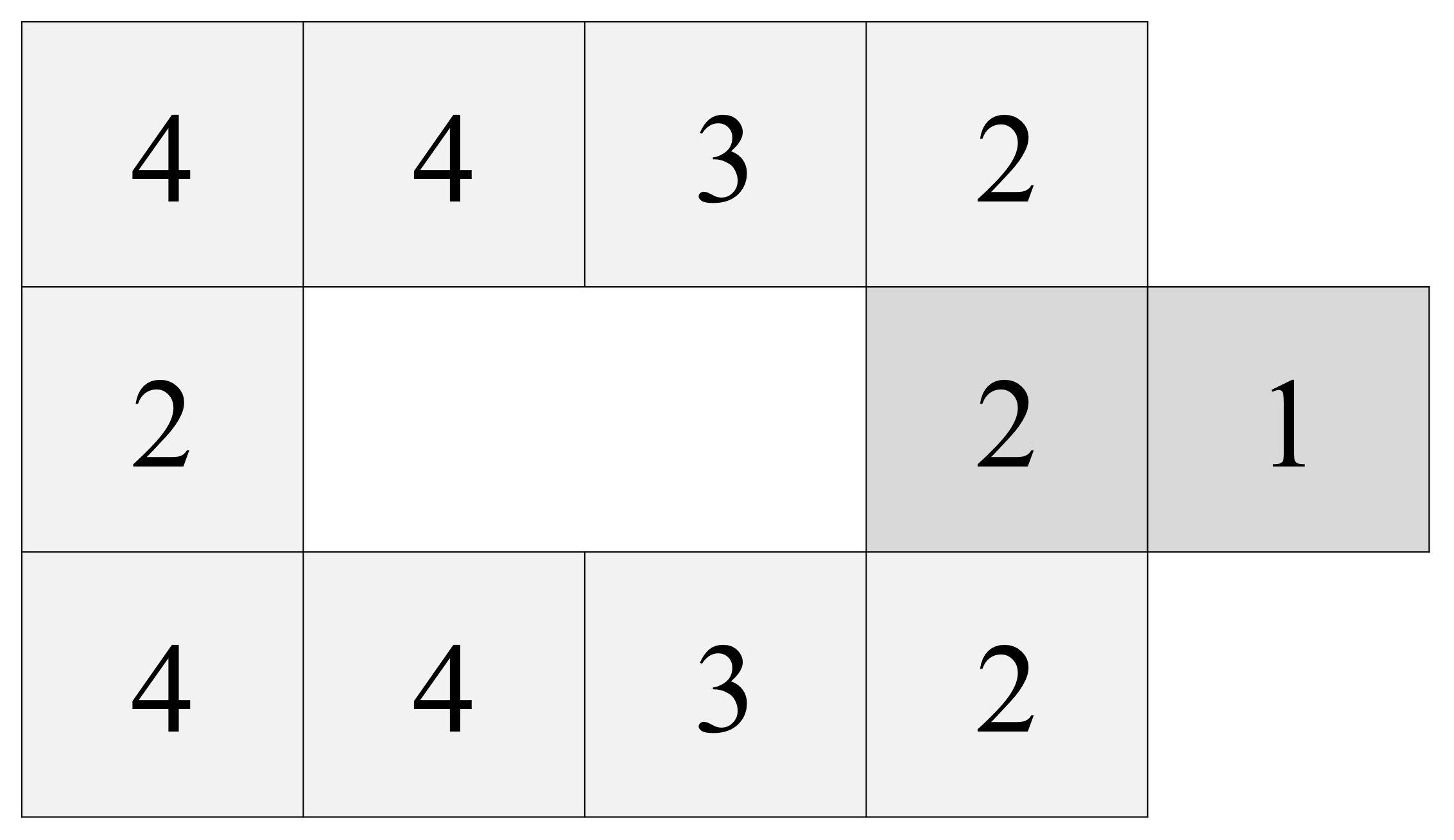

Punto 4. A continuación, vamos a realizar unos cuantos dobleces para generar nuestra nueva hoja de papel, que tendrá 2 x 3 = 6 casillas.

Primero, doblamos esa parte central, de dos casillas, hacia la derecha, de forma que va a quedar un 2 hacia arriba, donde estaba el 4, y el 1 que lo acompaña quedará por debajo de la hoja.

Después, doblamos la columna 4, 2, 4 hacia la derecha, una vez, y después toda la nueva columna (sobre la que ahora vemos los números 3, 1, 3) de nuevo hacia la derecha.

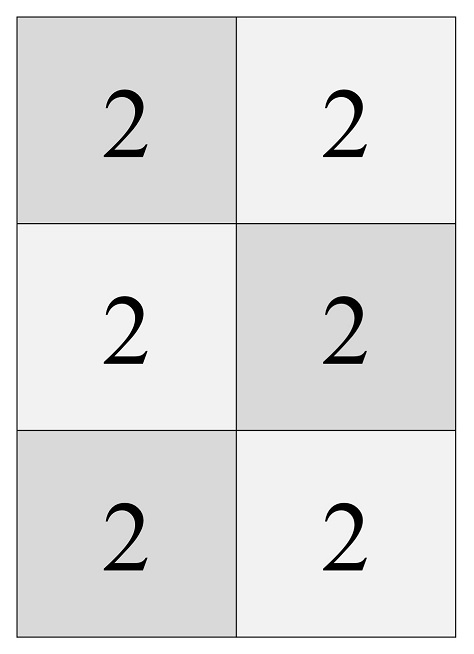

Nos quedará una hoja de papel con 2 x 3 = 6 casillas, con un 2 en todas las casillas, como muestra la siguiente imagen.

Punto 5. Si le dais la vuelta a la nueva hoja de 6 casillas, tendréis una hoja de papel con un 1 en todas las casillas (la imagen de abajo). Estamos entonces en el último paso. Hay que poner un poco de celo uniendo los dos unos de la fila del centro, el de la izquierda con el de la derecha.

Y ya tenéis la “nueva” hoja de papel con cuatro caras. Veámoslo. En la que tenemos delante solo hay unos (1), le damos la vuelta y solo hay doses (2), luego dos caras. Ahora, con los doses mirando hacia nosotros, doblaremos la hoja por la mitad vertical, llevando las dos mitades hacia atrás, y cuando lleguemos a juntar las dos partes veremos que se nos abre la hoja por el medio, la ayudamos a abrirse con nuestros dedos y veremos que la hoja que tenemos delante tiene todo treses (3).

Si volvemos a doblar la hoja por la mitad vertical, hacia atrás, descubriremos una nueva cara con todo cuatros (4). Es decir, tenemos una hoja de papel con cuatro caras, un tetratetraflexágono. Solo un consejo, antes de mostrárselo a las demás personas practicad el paso de una cara a otra.

La parte básica del taller es la que acabamos de describir arriba, pero a partir de ahí cada cual puede echarle imaginación y hacer el flexágono lo más artístico o curioso que considere oportuno. Por ejemplo, Cristina Barcala, una apasionada de la divulgación científica y lectora del Cuaderno de Cultura Científica, nos mandaba su propia versión, de tamaño mini (la siguiente imagen).

Aunque si os ha gustado esta actividad sobre la realización de un tetraflexágono, podemos abordar la realización de los otros dos tetraflexágonos que aparecen en el artículo Tetraflexagons, del libro de Martin Gardner The 2nd Scientific American Book of Mathematical Puzzles and Diversions (1961), uno de tres caras –tritetraflexágono- y otro de seis caras –hexatetraflexágono-.

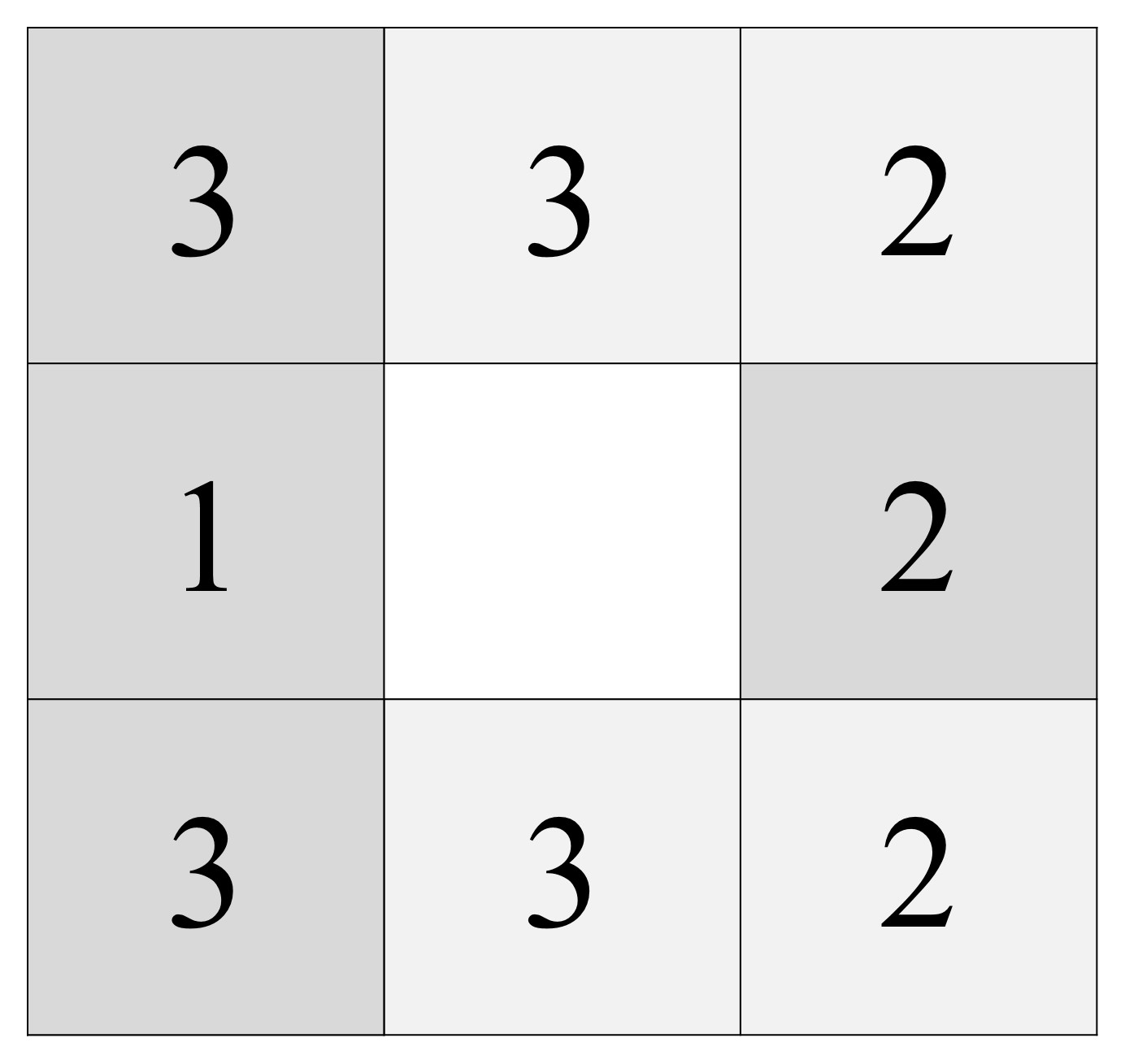

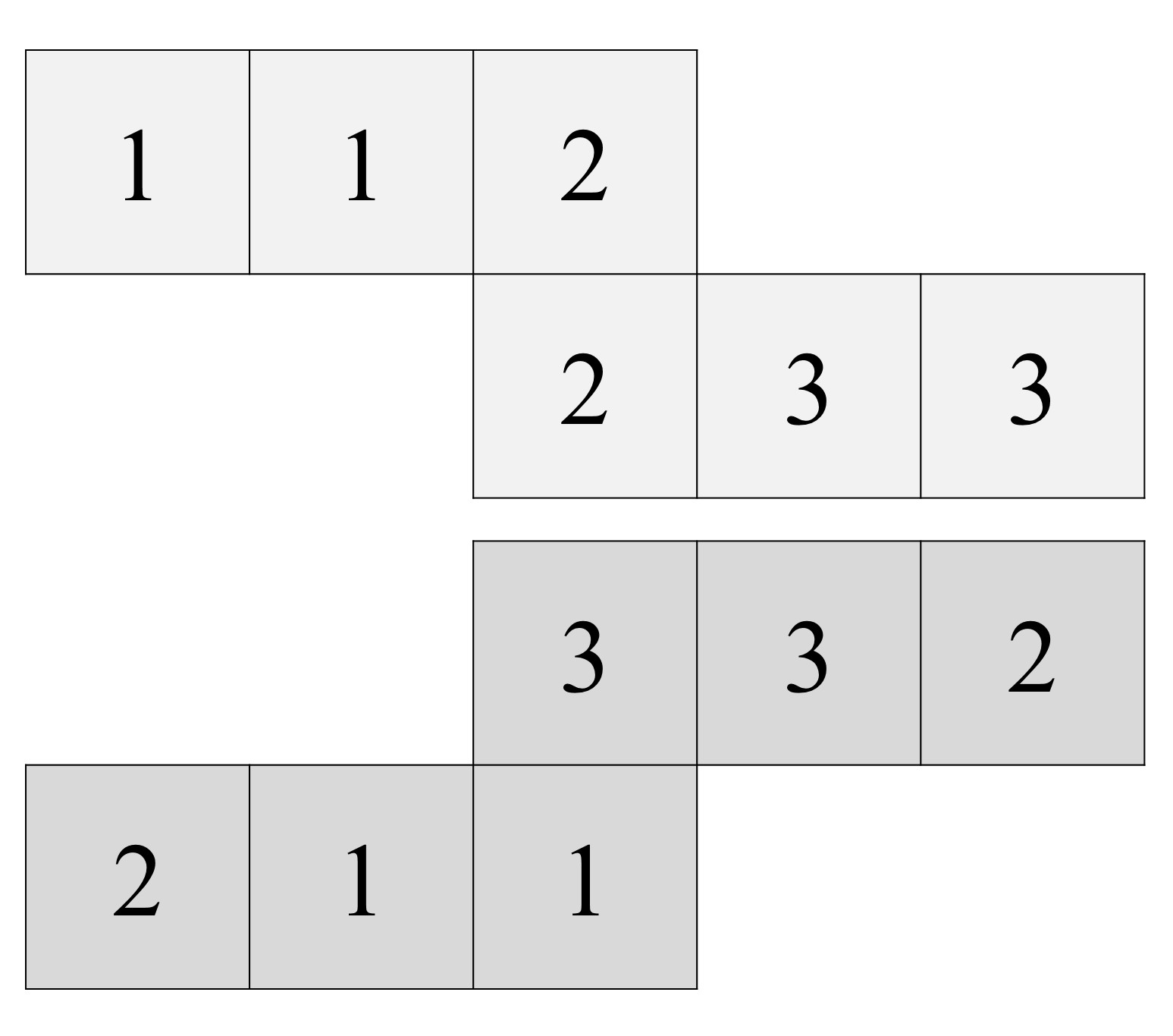

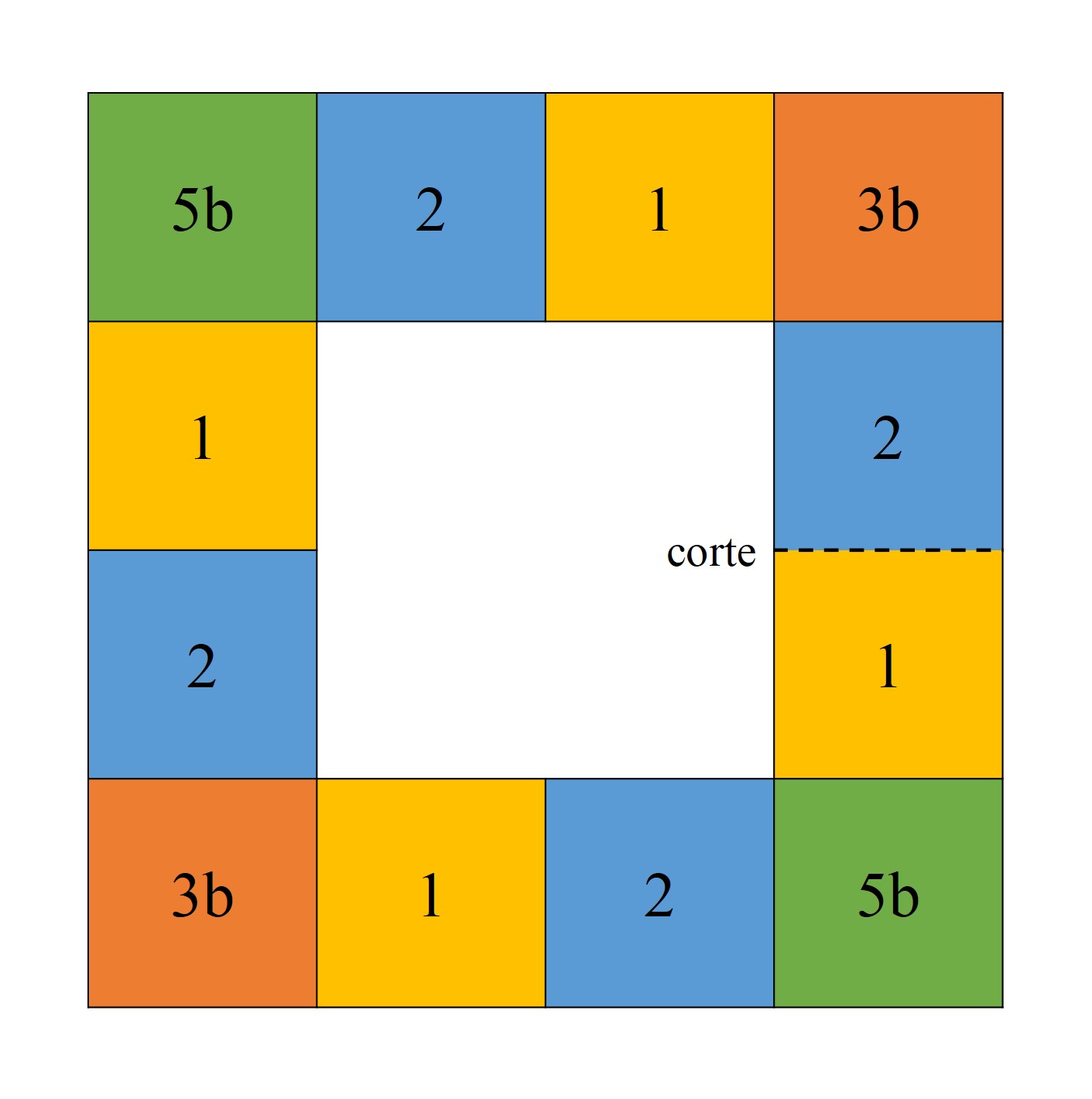

Empecemos con el tritetraflexágono. Para realizarlo hay que construir con una hoja de papel una “tira de papel” de dos filas, como la que aparece en la siguiente imagen, trazar las seis casillas de cada cara y dibujar los números 1, 2 y 3 en las casillas, de la parte frontal y trasera, como aparece en la imagen.

Después doblamos hacia atrás las dos casillas de la izquierda, las que tienen los unos, quedando nuestra tira de papel como se ve en la imagen.

Y doblamos, ahora hacia delante, la casilla de la derecha, la que tiene el tres, quedando así todas las casillas con doses frente a nosotros.

Para finalizar, solo hay que colocar un pequeño trozo de celo entre las dos casillas de la derecha, como se muestra en la imagen.

De esta forma, hemos construido el tritetraflexágono, que tiene tres caras, podemos mostrar en cada una de esas caras, todos unos, doses o treses.

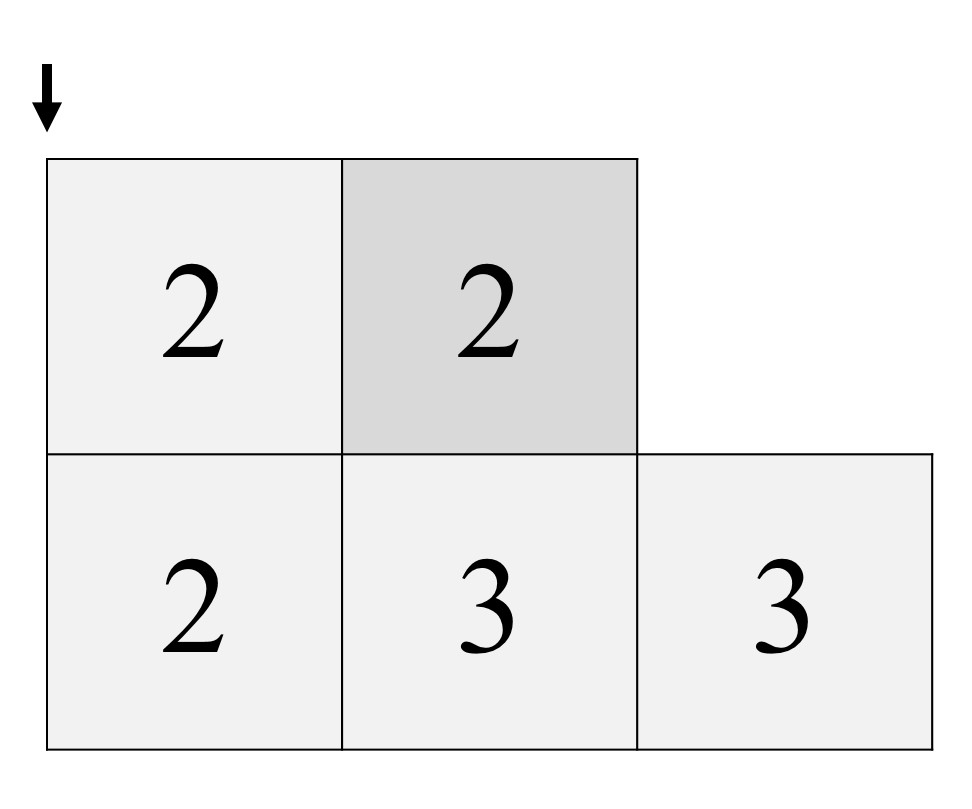

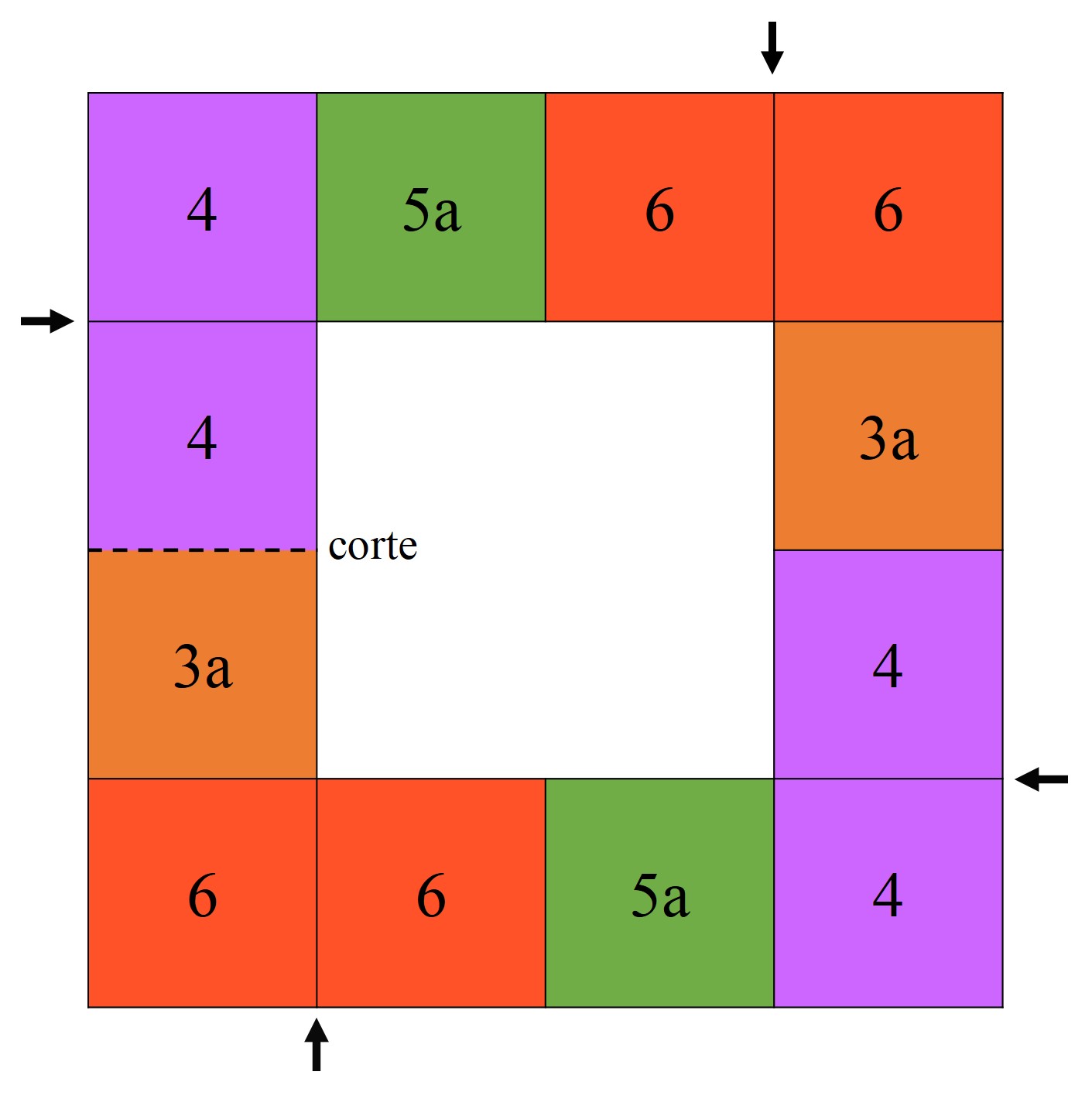

Por último, vamos a terminar con los esquemas para realizar el hexatetraflexágono. Para este flexágono, partimos de una hoja cuadrada, dividida en 16 casillas –cuatro filas y cuatro columnas- en cada cara, a la que le hemos cortado las cuatro casillas del centro. Luego solo le quedan las 12 casillas del exterior. Esta vez vamos a utilizar seis colores (aunque mantenemos los números para seguir las instrucciones de la construcción) para pintar cada casilla, de la parte frontal y trasera, como aparece en las siguientes imágenes.

Las dos casillas de la derecha (en la primera imagen) se separan con un pequeño corte horizontal. Entonces, vamos doblando por donde indican las flechas, empezando por la flecha de abajo y en el sentido de las agujas del reloj, de forma que lo que nos queda al terminar es la siguiente imagen.

De nuevo, doblamos por donde indican las flechas, hasta que quede como la siguiente imagen. Para terminar, solamente hay que añadir un trozo de celo para unir, por arriba, la casilla superior izquierda de delante, con la que tiene atrás.

Y ya tendríamos nuestro hexatetraflexágono.

Bibliografía

1.- Martin Gardner, The 2nd Scientific American Book of Mathematical Puzzles and Diversions, University of Chicago Press, 1987 (publicado originalmente en 1961).

2.- Robert Ghattas, Bricológica, Treinta objetos matemáticos para construir con las manos, RIALP, 2011.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La hoja de papel con cuatro caras, una propuesta de taller se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (3): Tras más de un siglo de aventura… ¿un ordenador resuelve el problema?

- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

- Cuatro leyes consumadas siguiendo una banda de Möbius

La teoría de bandas explica la conducción eléctrica

Foto de Josep Castells / Unsplash

Foto de Josep Castells / UnsplashLa idea básica tras las bandas de Bloch en un sólido es que se crean al unirse los estados cuánticos de los átomos individuales. Bloch y otros ampliaron y refinaron la teoría de bandas de los sólidos durante la década de 1930, hasta el punto de que explica muy bien el comportamiento de conducción eléctrica de los distintos materiales.

Cuando los átomos se unen en un cristal, cada uno de los estados cuánticos individuales de los átomos se une con los estados correspondientes en otros átomos (idénticos) en el cristal para formar las diversas bandas de energía dentro del material. De hecho, si hay un total de N átomos idénticos en el material, entonces hay N estados cuánticos dentro de cada banda. Los electrones en los átomos llenan los estados disponibles dentro de cada banda. Así, si hay N estados en una sola banda, puede haber hasta 2N electrones en cada banda [1].

La física interesante ocurre en la parte superior de las bandas llenas. Cuando se aplica un campo eléctrico externo (voltaje) al material, un electrón puede responder al campo solo si puede moverse a un estado cuántico ligeramente más alto, ya que tendría un poco más de energía al ser afectado por el campo. Esto será posible solo si hay algunos estados libres cercanos a los que el electrón pueda saltar. Este es el caso de los materiales conductores, como el cobre y la plata, ya que sus electrones se llenan en los estados disponibles de modo que la banda más alta está llena solo parcialmente. Los electrones en esta banda, que se llama banda de conducción, son libres de ser conducidos (en realidad, propagados como ondas) por el material, ya que hay estados cuánticos vacíos cercanos en su banda de energía. Pero los electrones en las bandas inferiores llenas no pueden moverse, ya que no hay estados libres cerca.

Por otro lado, si las bandas se llenan de manera que se ocupa exactamente el límite superior de una banda, entonces los electrones no pueden responder a un campo eléctrico, ya que hay una brecha de energía [2] que les impide llegar a un estado cuántico en el que pueden moverse libremente [3]. Un material con estas características es lo que conocemos como aislante. [4]

Finalmente, si estamos ante un caso como el de los aislantes pero la brecha de energía con la banda de conducción no es demasiado grande, puede resultar que la energía térmica sea suficiente como para que algunos electrones salten a ella. Este es el caso de los semiconductores.

Notas:

[1] De acuerdo con una regla en la mecánica cuántica solo dos electrones pueden ocupar un estado de energía cuántica de un solo átomo. El principio de exclusión de Pauli establece que no pueden existir dos partículas en un sistema, electrones en un átomo o quarks en un hadrón, que tengan un conjunto de números cuánticos idéntico. Aplica solo a las partículas llamadas fermiones, no a los hadrones. Los electrones son en todo iguales e indiscernibles salvo porque unos tiene una “cosa” llamada espín con un valor y otros con otro valor. Por eso solo puede haber dos electrones en un estado cuántico de energía: en ese estado todos los números cuánticos son iguales salvo el espín, si hubiese un tercer electrón se violaría el principio de exclusión. Aunque parece un principio inventado para que cuadren los datos, se justifica por el teorema de la estadística del espín de la teoría cuántica de campos relativista.

[2] Una «banda prohibida» por la naturaleza cuántica de las bandas.

[3] Normalmente. Si el voltaje es enorme algunos electrones podrán desplazarse, porque adquirirán energía suficiente como para saltar de la banda de valencia a la banda de conducción. Véase [3]

[4] Un ejemplo es el diamante, en el que el estado cuántico lleno más alto también llena una banda de energía. Esta banda se llama banda de valencia, ya que está ocupada por los electrones de valencia externos de los átomos. La brecha de energía a la siguiente banda, que está vacía, es de aproximadamente 6 eV, por lo que los electrones en el diamante normalmente no pueden alcanzar la banda de conducción y, por lo tanto, el diamante es un buen aislante. En los conductores la banda de conducción se solapa con la llamada banda de valencia, por lo que no hay brecha de energía.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La teoría de bandas explica la conducción eléctrica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las bandas de Bloch

- La teoría de bandas de los sólidos se hace topológica

- El modelo de Bohr explica las regularidades en el espectro del hidrógeno

Los males de la ciencia tienen remedio

Foto: Vlad Tchompalov / Unsplash

Foto: Vlad Tchompalov / UnsplashEn las anotaciones precedentes nos hemos dedicado a repasar los que a nuestro juicio son los males de la ciencia actual. La serie empezó por una presentación de la empresa científica, el marco institucional y económico en el que se desarrolla, y el entramado de las publicaciones científicas como producto principal. Seguimos analizando los valores de la ciencia tal y como los formuló Merton a mediados del siglo pasado. Y a continuación abordamos el repaso de una serie de males que pueden considerarse propios, específicos de la empresa científica. Las últimas anotaciones han tratado de las resbaladizas relaciones entre investigación científica y ética en diferentes planos.

La relación de “males” o “patologías” no ha pretendido ser exhaustiva. Algunas de las malas prácticas presentadas aquí lo son porque vulneran las normas de Robert K Merton, incumplen el ethos de la ciencia en los términos en que él lo definió y que, implícitamente, asumimos gran parte de los científicos. Otras tienen más que ver con aspectos nucleares de la práctica científica o con el sistema de publicaciones o de financiación de la investigación. Son, por lo tanto, diferentes y seguramente los remedios que requieran también lo sean. Pero sospechamos que una gran parte de los problemas se atenuaría si universidades y centros de investigación modificasen el sistema de incentivos que utilizan para reconocer y premiar el trabajo de su personal científico. La cantidad debería perder importancia como criterio, para ir valorando cada vez más la calidad del trabajo y la trascendencia o relevancia de las investigaciones. No se trata de acudir a indicadores de las publicaciones tal y como se utilizan hoy o, al menos, no solo a esos indicadores (basados en métricas de impacto y similares), sino de recurrir a la valoración experta del nivel y alcance del trabajo realizado.

Tenemos por último, todos esos ámbitos en los que el desarrollo de la ciencia se enfrenta a dilemas de naturaleza ética. No se trata de dilemas específicos de la ciencia, o dilemas cuya resolución deba recaer exclusivamente sobre el mundo científico. Son, en su gran mayoría, dilemas sociales. La ciencia es, si acaso, el instrumento, pero es en el ámbito social y político donde se han de resolver. Si se han de exprimir al máximo las posibilidades que nos brinda la biotecnología, o si debemos permanecer pasivos ante la previsible robotización de la sociedad, son cuestiones que no corresponde dirimir a los científicos. Quienes hacen la investigación científica deberán aportar su criterio experto, y tanto la sociedad como los responsables deberían tomar buena nota y tener en cuenta el dictamen experto, pero en última instancia, las decisiones son de carácter social y político. Nos interesa remarcar esta diferencia, porque los males que hemos considerado intrínsecos a la ciencia lo son porque de no neutralizarlos, está en juego el propio funcionamiento del sistema científico, y en ese terreno, los miembros de ese sistema tenemos mucho que decir y que hacer. Precisamente por esa razón, no nos parece saludable que los científicos se desentiendan de las implicaciones sociales de su trabajo. Creemos que tenemos una especial responsabilidad al respecto, precisamente porque somos quienes mejor podemos calibrar el alcance de nuestro trabajo más allá de cómo quede recogido en las publicaciones científicas.

La ciencia sufre de esos y de otros males; son males serios y de graves consecuencias. Las que afectan, con carácter general, al desarrollo del conocimiento son evidentes. Pero esas no son las únicas. También hay consecuencias prácticas de gran trascendencia. En los Estados Unidos se estima que la investigación preclínica no reproducible tiene un coste anual de 28 mil millones de dólares y, por supuesto, retrasa el desarrollo de tratamientos que salvan vidas humanas y mejoran la calidad de vida. Es de suponer que en el resto de potencias científicas las cosas estarán, en su correspondiente proporción, más o menos igual.

Hay investigadores que son reticentes a abordar de forma abierta estas cuestiones, porque temen que pueden conducir a un debilitamiento de la empresa científica porque la sociedad deje de confiar en los científicos. Creo que se trata precisamente de lo contrario. La opacidad sería contraproducente. Una herida que se cierra sin haberla limpiado debidamente, se cierra en falso porque cultiva la infección en su interior y antes o después, aflorará. La vía más eficaz para sanar los males pasa por conocerlos y buscar las medidas para combatirlos. No hay que ser tan ingenuo como para pensar que muchos de los problemas aquí expuestos tienen una solución definitiva. Ningún problema complejo suele tener soluciones definitivas y, desde luego, nunca son soluciones simples. De lo que se trata es de conseguir un funcionamiento de la empresa científica razonablemente mejor que el actual, más sano, con mejores resultados, más eficiente, y que se base más en la realización de interesantes trabajos que en la producción de ingentes cantidades de artículos.

Pero a la vez que han de preocuparnos los males, también debemos congratularnos de que sea la misma comunidad científica la que está tratando de aportar soluciones. Porque han sido científicos profesionales quienes han investigado y dado a conocer las patologías que aquejan a la práctica científica. Han sido científicos profesionales y organizaciones científicas las que han propuesto medidas para afrontar los problemas y resolverlos. Y algunas revistas científicas están adoptando medidas para incentivar la transparencia y la reproducibilidad de los resultados. Esas son las buenas noticias.

Fuentes:

Agin, D (2007): Ciencia basura. Starbooks, Barcelona.

Briggle, A (2012): Scientific Responsability and Misconduct, in Encyclopedia of Applied Ethics, Vol 4, pp.: 41-48, 2nd edition, Academic Press, London

Ferris, Timothy (2010): The Science of Liberty, Harper Collins, Nueva York

Fischer, B A, Zigmond, M J (2012): Scientific Publishing, in Encyclopedia of Applied Ethics, Vol 4, pp.: 32-40, 2nd edition, Academic Press, London

Häyry, M (2012): Genetic Engineering of Human Beings, in Encyclopedia of Applied Ethics, Vol II, pp.: 437-444, 2nd edition, Academic Press, London

Holm, S, Stokes E (2012): Precautionary Principle, in Encyclopedia of Applied Ethics, Vol III, pp.: 569-575, 2nd edition, Academic Press, London

Johnson, J (2012): Ethical Experiments, in Encyclopedia of Applied Ethics, Vol 2, pp.: 149-156, 2nd edition, Academic Press, London

Johnson, S (2012): Nanotechnology, in Encyclopedia of Applied Ethics, Vol III, pp.: 183-185, 2nd edition, Academic Press, London

López Nicolás, J M (2016): Vamos a contar mentiras. Cálamo, Madrid.

Menéndez Viso, A (2005): Las ciencias y el origen de los valores. Siglo XXI.

Merton, R K (1942): “Science and Technology in a Democratic Order” Journal of Legal and Political Sociology 1: 115-126. [Traducción al español como “La estructura normativa de la ciencia” en el volumen II de “La Sociología de la Ciencia” Alianza Editorial 1977, traducción de The Sociology of Science – Theoretical and Empirical Investigations, 1973]

Neri, D (2012): Eugenics, in Encyclopedia of Applied Ethics, Vol 1, pp.: 189-199, 2nd edition, Academic Press, London

Oreskes, N y Conway, E N (2018): Mercaderes de la duda. Cómo un puñado de científicos oscurecieron la verdad sobre cuestiones que van desde el humo del tabaco al calentamiento global. Capitán Swing, Madrid.

Resnik, D B (2012): Developing World Bioethics, in Encyclopedia of Applied Ethics, Vol 1, pp.: 771-778, 2nd edition, Academic Press, London

Solbakk J H, Vidal, S M (2012): Research Ethics, Clinical, in Encyclopedia of Applied Ethics, Vol 3, pp.: 775-785, 2nd edition, Academic Press, London

Spier, R E (2012): Science and Engineering Ethics, Overview, in Encyclopedia of Applied Ethics, Vol 4, pp.: 14-31, 2nd edition, Academic Press, London

Di Trocchio, F (1993): “Las mentiras de la ciencia” Alianza Editorial.

Ziman, J (2000): Real Science: What It Is and What It Means. Cambridge University Press.

Zuk, M (2013): Paleofantasy: What Evolution Really Tells Us about Sex, Diet, and How We Live. Norton & Co, New York.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo Los males de la ciencia tienen remedio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- No todo vale al servicio de la ciencia

- Dilemas éticos en la frontera de la ciencia

- No todas las personas tienen las mismas oportunidades de dedicarse a la actividad científica

Van Eyck al descubierto

Antes de convertirse en el año de la pandemia 2020 iba a servir para homenajear a dos de los pintores más importantes de todos los tiempos: Jan van Eyck y Rafael Sanzio. Hagamos de este espacio un refugio y disfrutemos del arte de estos dos genios durante las próximas entregas. Por deferencia, comenzaremos por el que nació primero. De este modo nos sumamos al tributo que se le estaba rindiendo a van Eyck en Gante, donde se guarda una de sus más emblemática obras: La adoración del cordero Místico. La ciudad belga lucía sus mejores galas y bajo el lema “OMG! Van Eyck was here” había preparado una serie de eventos, incluyendo una exposición de pinturas del artista flamenco como nunca antes se había visto. Afortunadamente las nuevas tecnologías nos permiten disfrutar de estas obras sin tener que salir de casa.

Los “primitivos” flamencos

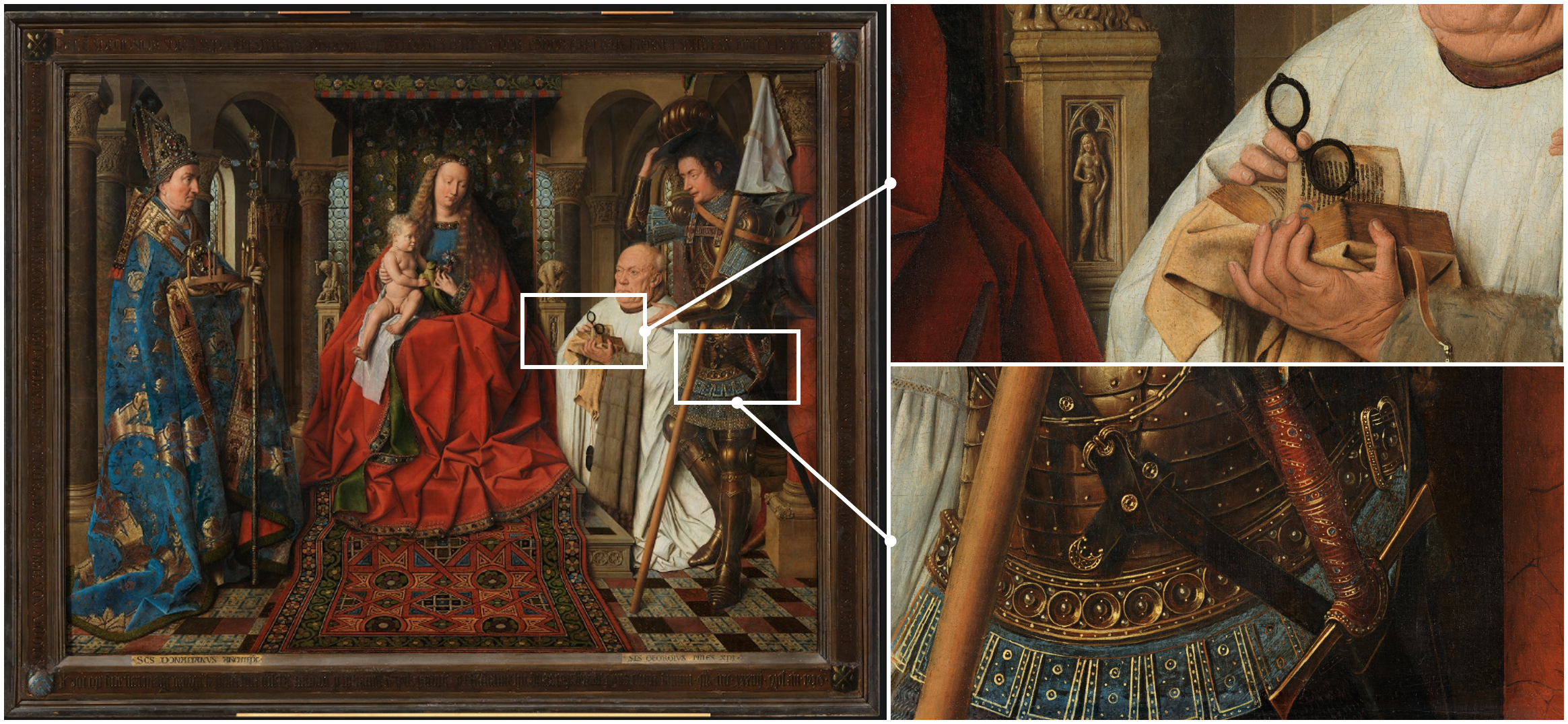

Jan van Eyck y su hermano mayor Hubert fueron, junto a Robert Campin, los primeros de un grupo que ha pasado a la historia del arte con el nombre de los primitivos flamencos. Tomemos ese adjetivo en el sentido de que fueron unos pioneros y no en referencia a un estilo poco desarrollado. ¿Os atreveríais a decir eso de alguien que hace las virguerías que os muestro en la Imagen 1? En la primera mitad del s. XV estos pintores fueron dejando atrás el estilo gótico internacional entonces imperante, en pos de una nueva forma de entender la pintura. Pese a que se trata de un momento crucial de la historia del arte, se ha visto un tanto eclipsado por el coetáneo Renacimiento italiano. A favor de los maestros flamencos hemos de decir que en ciertos aspectos técnicos igualaban o superaban a los italianos, aunque sus nombres no sean tan conocidos como el de Donatello o el de Leonardo, por poner dos ejemplos.

Imagen 1. Virgen del Canónigo Van der Paele (122×158 cm) y detalles. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 1. Virgen del Canónigo Van der Paele (122×158 cm) y detalles. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.El florecimiento de este estilo en la región de los Países Bajos no fue por casualidad. A principios del s. XV urbes como Brujas o Gante habían prosperado gracias al comercio y a la artesanía. Por lo tanto, a la nobleza y al clero se le sumaba una incipiente burguesía con ganas de demostrar su estatus social. En ese entorno destacó Jan van Eyck, quien tras trabajar en diferentes ciudades se instaló en 1425 en la corte de Felipe el Bueno, duque de Borgoña, la gran potencia de la zona en aquel momento. Desde esa fecha hasta su muerte en 1441 realizó las obras que le han colocado en el Olimpo de la pintura. Si algo destaca en van Eyck, más allá de su brillante técnica, es su capacidad de innovación: fue todo un pionero. Su contribución más importante fue la pintura al óleo. Aunque no inventó esta técnica como se afirma en ciertas partes, la perfeccionó y ayudó a popularizarla. Hasta entonces la pintura al temple era la más habitual, pero la posibilidad de aglutinar los pigmentos con aceites abrió nuevas posibilidades, sobre todo gracias a las veladuras, capas de pintura semitransparentes que permiten dar matices y crear juegos de luces.

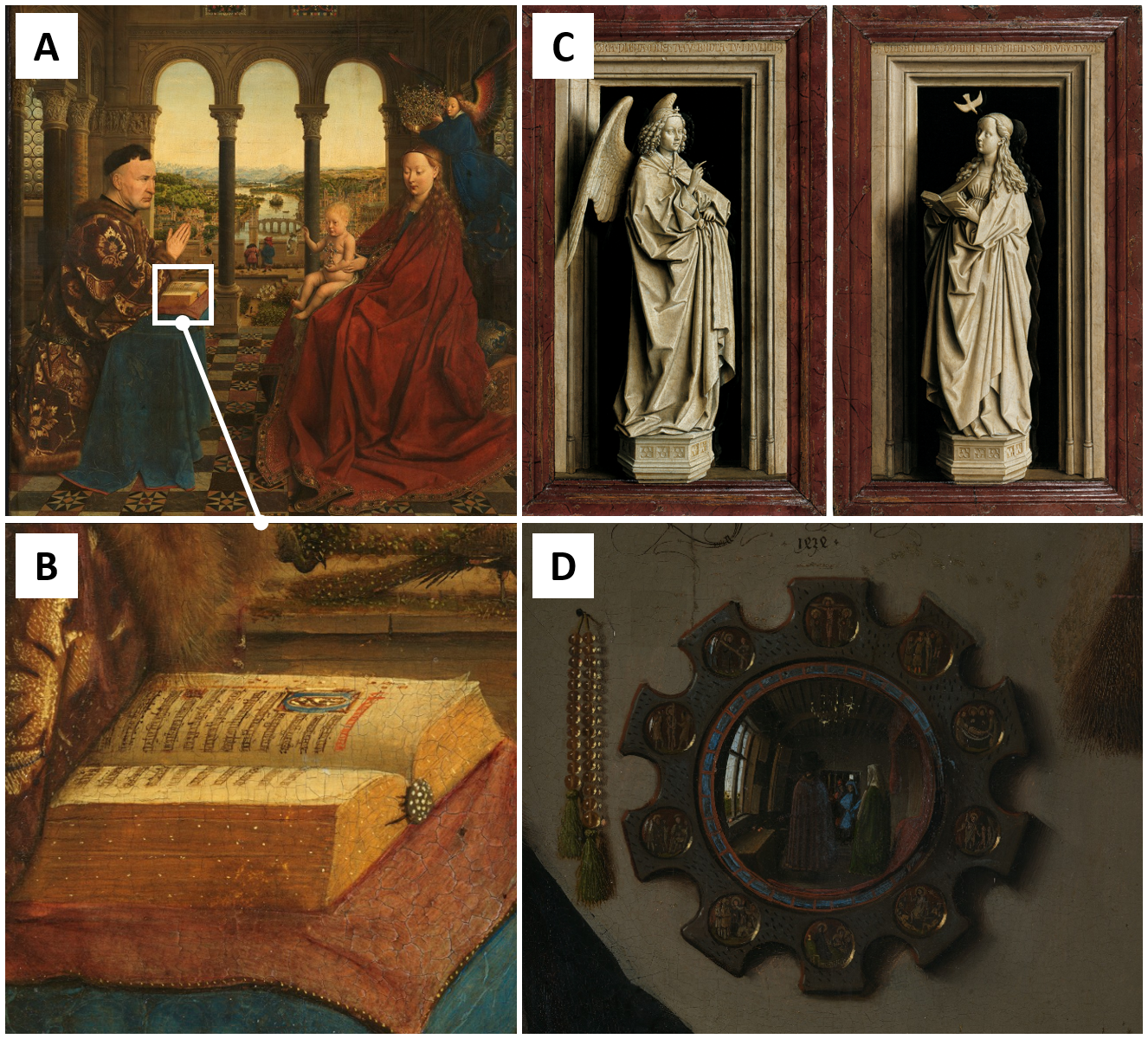

Pero van Eyck fue mucho más que el adalid de la pintura al óleo. También tuvo la capacidad de incorporar el paisaje a sus obras, otorgándoles sensación de profundidad en una suerte de perspectiva atmosférica previa a Leonardo (Figura 2A). Trataba los detalles con una meticulosidad absoluta, posiblemente debido a su pasado como pintor de miniaturas (Figura 2B), y sus óleos recogen hasta el más mínimo pliegue y ornamento de las sofisticadas lanas flamencas o las alfombras orientales. No había ilusión óptica que se escapase a sus afilados pinceles. Una buena muestra es el Díptico de la Anunciación del Museo Thyssen en el que el Arcángel y la Virgen parecen esculturas que se escapan de la hornacina (Figura 2C). Otra, el espejo de El matrimonio Arnolfini, con permiso de Velázquez, el más famoso de la historia del arte (Figura 2D).

Imagen 2. A) Virgen del Canciller Rolin (66×62 cm) y B) detalle C) Díptico de la Anunciación (aprox. 39 x 24 cm cada imagen) D) Espejo de El matrimonio Arnolfini. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 2. A) Virgen del Canciller Rolin (66×62 cm) y B) detalle C) Díptico de la Anunciación (aprox. 39 x 24 cm cada imagen) D) Espejo de El matrimonio Arnolfini. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

A estas alturas espero haberles convencido (si no lo estaban ya) de la importancia que ha tenido van Eyck en la historia del arte. No cabe duda de que su obra merecía ser estudiada empleando los mejores instrumentos a nuestro alcance. Bienvenidos al proyecto VERONA.

El Proyecto VERONA: Van Eyck Research in OpeN Access

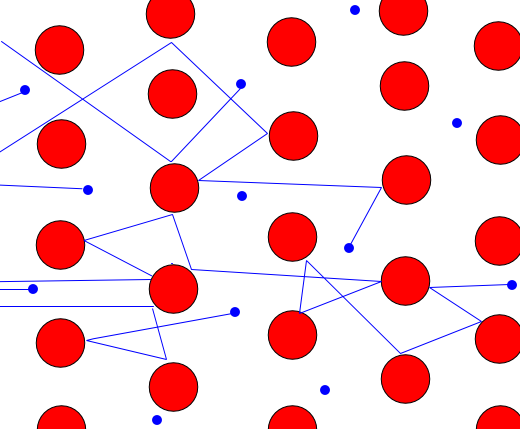

La producción artística de Jan van Eyck fue muy reducida, por lo menos teniendo en cuenta las pinturas que se conservan. Hasta tal punto que sólo existen nueve cuadros que lleven su firma. A lo largo del s. XX los historiadores del arte estudiaron con detalle estas obras y, con menor o mayor polémica, llegaron a atribuir una veintena de obras al genio flamenco. Aun sumando las miniaturas del Libro de Horas de Turín-Milán que se le atribuyen a él y a su hermano Hubert, es un legado escaso. Hemos de tener en cuenta que aquellos estudios estilísticos se hicieron en base a unos recursos técnicos limitados, por lo que se antojaba necesario realizar nuevos análisis adaptándose a los tiempos que corren. Así se podría entender mejor el proceso creativo de van Eyck y revisar su creación artística. De eso se encargaron los expertos del Instituto Real del Patrimonio Cultural de Bélgica (KIK-IRPA) quienes, mediante tecnología puntera y siguiendo un protocolo estandarizado, analizaron la obra de Jan van Eyck y la pusieron a disposición no sólo de los expertos, sino del público en general.

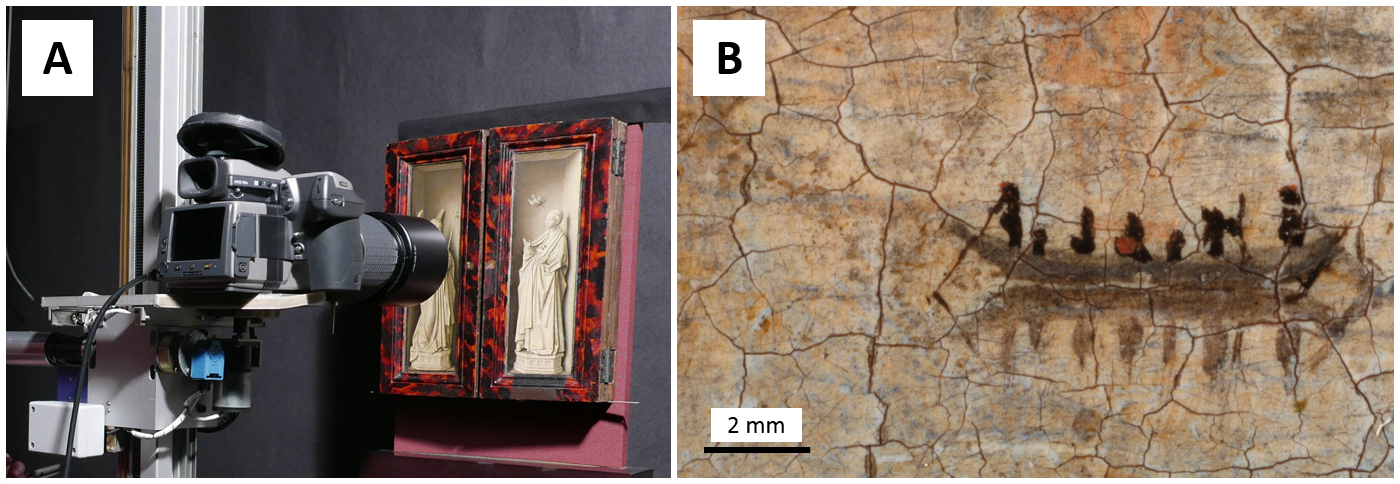

En 2014 cargaron una furgoneta con los instrumentos necesarios y viajaron por toda Europa para documentar las pinturas atribuidas a van Eyck que se hallan desperdigadas por diferentes museos (también hay alguna obra en Estados Unidos). En un trayecto de 12 000 kilómetros recogieron 16 298 imágenes para un total de 1 499 gigas de información. Casi nada. Aquí les tenéis estudiando el Díptico de la Anunciación del Museo Thyssen-Bornemisza, por si les queréis ver con las manos en la masa.

Imagen 3. La instrumentación con la que viajó el equipo del KIK-IRPA. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 3. La instrumentación con la que viajó el equipo del KIK-IRPA. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

El primer paso del proceso consistía en tomar una fotografía de alta resolución, asegurándose de que se usaban siempre las mismas condiciones para todas las obras. Para ello emplearon una cámara Hasselblad H4D-200MS con un sensor de 50 megapíxeles que, obviamente, no sujetaban a pulso. Se colocaba en un soporte mecánico que se podía desplazar por raíles, lo que permitía realizar macrofotografías (15×20 cm o 7.5×10 cm) que luego se montaban digitalmente para ofrecer imágenes en las que podemos apreciar hasta el más pequeño de los detalles (Imagen 4). Además de tomar las fotografías con iluminación normal, las tomaron con luz rasante y bajo luz ultravioleta, algo que ofrece información complementaria como ya vimos en su momento.

Imagen 4. Realización de una macrofotografía sobre el Tríptico de Dresden y una ampliación de San Francisco Recibiendo las Agallas a escala milimétrica en la que podemos observar el craquelado de la pintura. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 4. Realización de una macrofotografía sobre el Tríptico de Dresden y una ampliación de San Francisco Recibiendo las Agallas a escala milimétrica en la que podemos observar el craquelado de la pintura. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

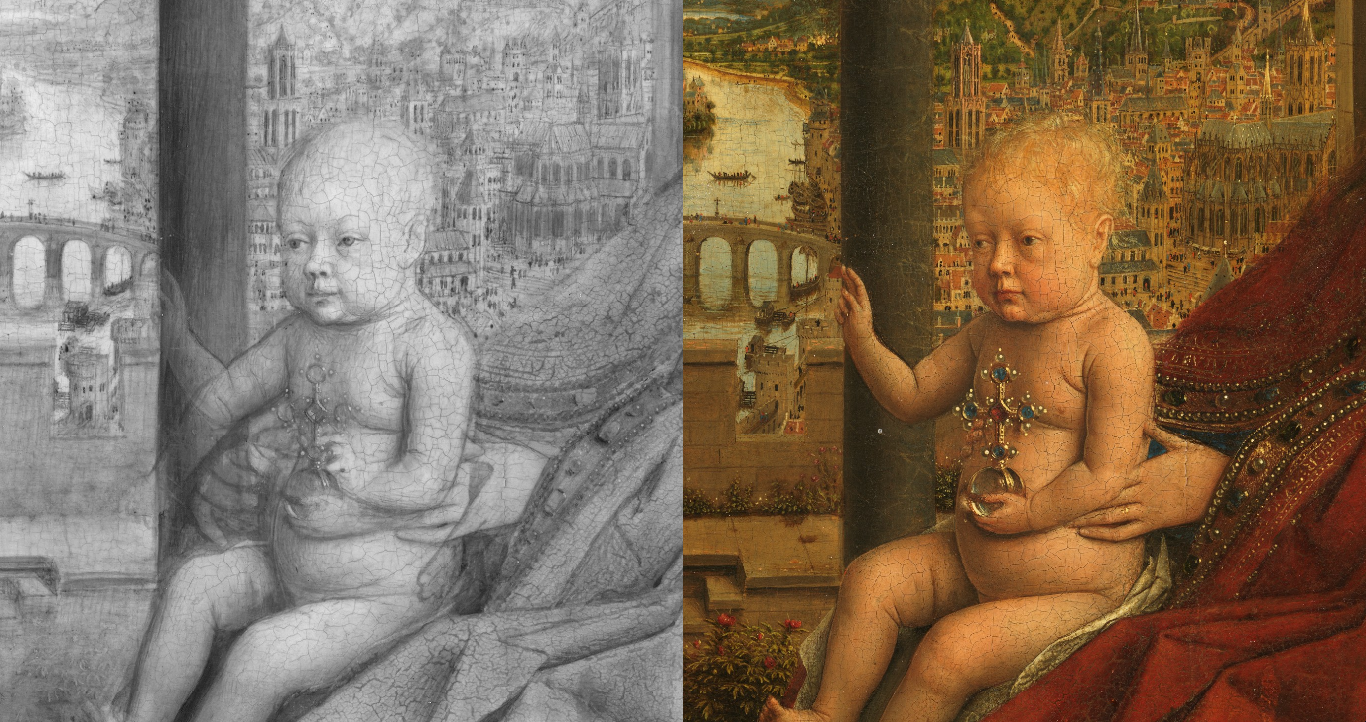

La cámara Hasselblad también estaba equipada para trabajar en el infrarrojo, de modo que se pudiese estudiar el dibujo subyacente de las pinturas. En cualquier caso, para lograr imágenes con una mayor capacidad de penetración se empleó un instrumento de reflectografía infrarroja que permitía trabajar entre los 900 y los 1700 nm. Recordemos que a esas longitudes de onda muchos de los pigmentos no absorben prácticamente energía, mientras que el carbono, tradicionalmente empleado en el dibujo preparatorio, sí lo hace. Gracias a esta técnica se puede conocer mejor el modus operandi de un pintor y ver los cambios realizados a lo largo del proceso de creación. Precisamente uno de los casos paradigmáticos del empleo de la luz infrarroja es El Matrimonio Arnolfini, en cuyo reflectograma se pueden observar los numerosos cambios realizados por van Eyck. Pero quedémonos aquí con un ejemplo que he encontrado trasteando en la web del proyecto VERONA: ¿No os parece que tanto el Niño como la Madre en La Virgen del Canciller Rolin iban a tener los brazos en otra posición?

Imagen 5. Reflectografía infrarroja del Niño de La Virgen del Canciller Rolin en la que se aprecia el cambio de composición respecto al resultado final. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 5. Reflectografía infrarroja del Niño de La Virgen del Canciller Rolin en la que se aprecia el cambio de composición respecto al resultado final. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Siguiendo con la idea de penetrar en la pintura, no se podía dejar de lado el uso de la radiografía. Como la materia absorbe los rayos X en función de los átomos que la componen y la densidad del material, podemos lograr información valiosísima sobre el uso de pigmentos y el estado de la obra. El equipo belga realizó las radiografías mediante instrumentos de rayos X portátiles empleando películas para radiografías (30 x 40 cm) que luego montaron digitalmente. Aquí hemos de decir que el protocolo no está tan estandarizado y que en muchos casos emplearon radiografías realizadas con anterioridad, algo perfectamente comprensible teniendo en cuenta que se trata de una técnica más compleja que las anteriores. Para que os hagáis una idea del tipo de información que se obtiene, os traigo como ejemplo el retrato de Margaret, la mujer del artista (otra de las cosas en las que van Eyck fue un innovador, ya que no era nada habitual este tipo de retratos). Si observáis la Imagen 6, veréis que el tocado ofrece un color claro en la radiografía. Es muy posible que el pintor emplease albayalde, un pigmento blanco que tiene plomo y que por lo tanto absorbe los rayos X.

Imagen 6. Radiografía de El Retrato de Margaret van Eyck (41×34 cm). Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 6. Radiografía de El Retrato de Margaret van Eyck (41×34 cm). Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

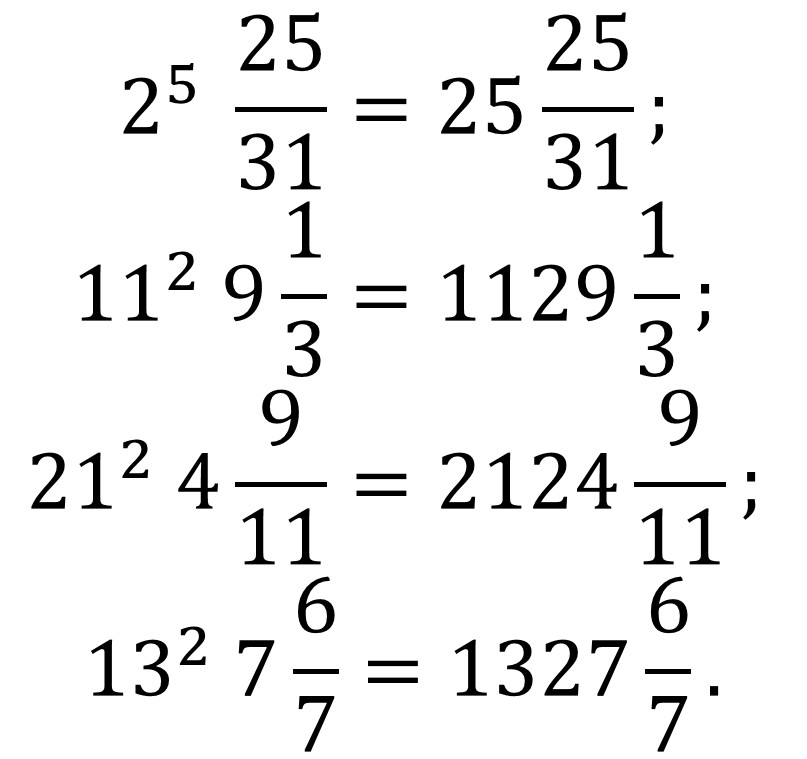

Acabemos este recorrido por los estudios técnicos subrayando que, en algunas de las obras, también se han aplicado análisis más específicos sobre pigmentos gracias al uso de la fluorescencia de rayos X. De momento no están disponibles en la página web del proyecto, pero crucemos los dedos para que pronto lo estén. Lo que sí que podemos hacer en dicha web es juguetear con las macrofotografías (Imagen 7), las imágenes en infrarrojo y las radiografías de más de veinte obras obtenidas con la misma escala en una iniciativa que ojalá sólo sea la primera de muchas.

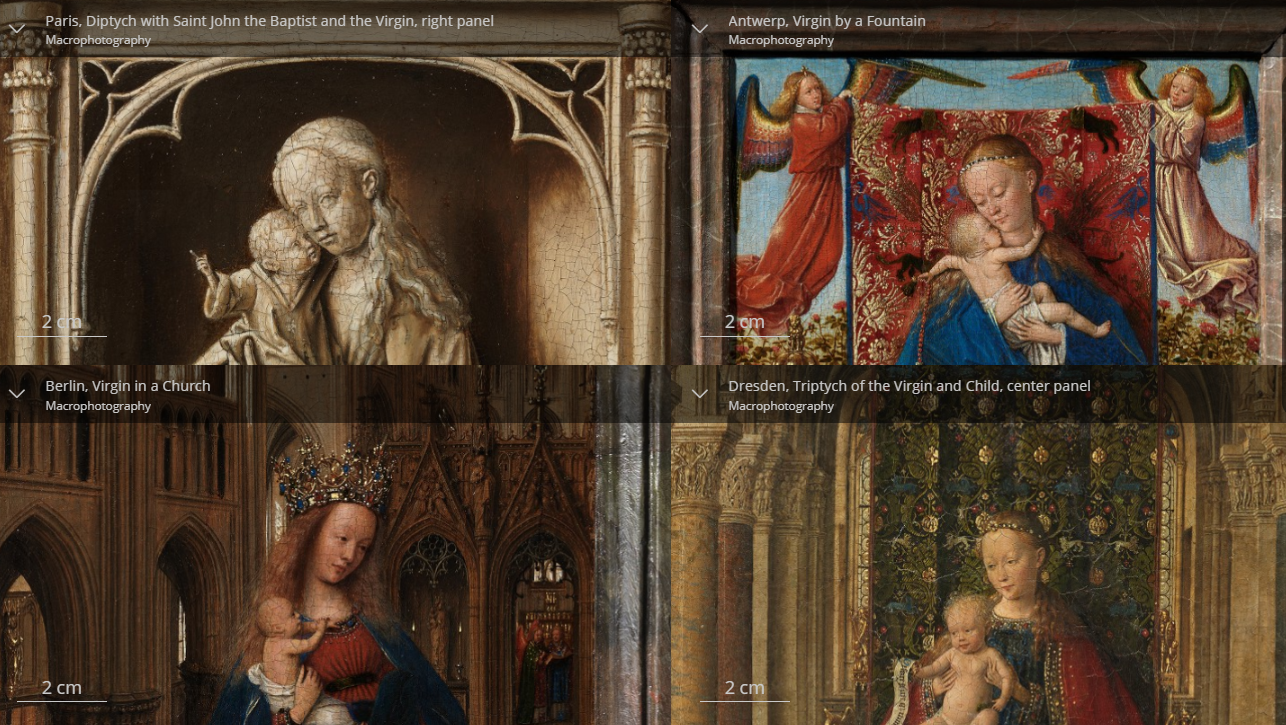

Imagen 7. Apariencia de la página web del proyecto Verona al comparar cuatro macrofotografías de diferentes vírgenes pintadas por van Eyck. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 7. Apariencia de la página web del proyecto Verona al comparar cuatro macrofotografías de diferentes vírgenes pintadas por van Eyck. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

La firma

No quería finalizar el artículo sin llamar la atención sobre un aspecto de las pinturas que suele pasar desapercibido: el marco. En las macrofotografías de algunas de las obras podemos observar los marcos originales que todavía se conservan. Ahí es donde en varias ocasiones el artista flamenco dejó su firma, junto al lema AΛΣ IXH XAN (Als Ich Kan). Esta frase vendría a significar “como (mejor) puedo”, toda una fórmula de humildad, aunque también se ha interpretado como un juego de palabras para decir “como van Eyck (sólo) pudo”, lo que tendría un significado bastante diferente. En cualquier caso, no cabe duda de que van Eyck pudo. Vaya si pudo.

Imagen 8. Marco original de La Virgen de la Fuente con la firma de Jan van Eyck y el lema “AΛΣ IXH XAN” parcialmente visible. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.

Imagen 8. Marco original de La Virgen de la Fuente con la firma de Jan van Eyck y el lema “AΛΣ IXH XAN” parcialmente visible. Fuente: http://closertovaneyck.kikirpa.be, © KIK-IRPA, Brussels.Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

El artículo Van Eyck al descubierto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La tabla periódica en el arte: Cobre

- Descubierto el proceso por el que las bacterias fabrican nanoimanes

- Festín burlesco, una visita al alma del museo

Por qué los biobots no son un problema ético (de momento)

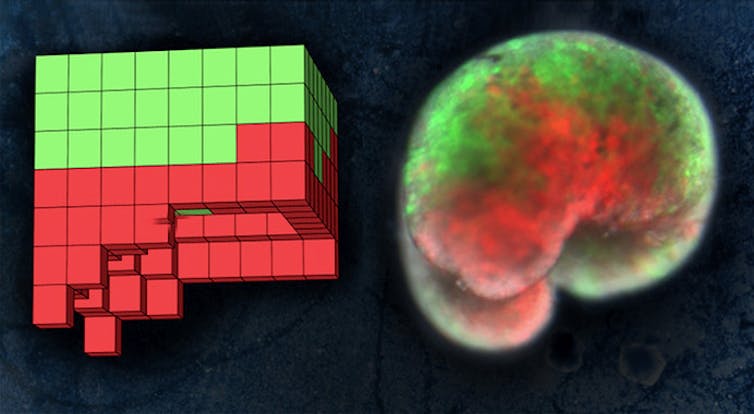

Un organismo 3D diseñado por un algoritmo evolutivo y construido a partir de células vivas.

Un organismo 3D diseñado por un algoritmo evolutivo y construido a partir de células vivas.Douglas Blackiston, CC BY-SA

El pasado 13 de enero se publicó un avance científico que tiene todas las papeletas para convertirse en un hito en la historia de la investigación biotecnológica. Un equipo de cuatro investigadores estadounidenses ha creado un sistema orgánico funcional novedoso, una forma de vida diferente a todas las que existían, algo que jamás se había conseguido antes.

El proceso para llegar a este resultado fue extremadamente arduo. Para empezar, hubo que utilizar un algoritmo evolutivo complejo alojado en un superordenador. Este mecanismo fue el que determinó qué tipo de material biológico – y con qué estructura – habría de emplearse para lograr el objetivo perseguido. A partir de los resultados proporcionados por esa herramienta, se decidió utilizar células procedentes de la piel y el corazón de embriones de ranas africanas, que se moldearon de la forma diseñada por la inteligencia artificial.

La entidad resultante fue una estructura biológica de un milímetro de anchura que se comportaba de manera coordinada en circunstancias hasta ahora esquivas a la acción humana. De hecho, pueden trabajar conjuntamente y sobrevivir incluso semanas sin necesidad de alimento.

Sus posibles aplicaciones incluyen gestionar la contaminación radioactiva, recolectar microplásticos en los océanos e incluso inocular un medicamento en un tumor. Además, estas entidades tienen la ventaja de ser biodegradables, por lo que, en principio, desaparecerían sin dejar rastro una vez cumplido su cometido.

¿Xenobots o biobots?

Nos encontramos ante un descubrimiento de primer orden, que abre las puertas de un mundo desconocido y lleno de promesas, pero tan novedoso que también encierra múltiples interrogantes. Para empezar, ni siquiera está claro cómo tendríamos que denominar a estas criaturas.

En las primeras informaciones facilitadas se ha propuesto el nombre de “Xenobots”, que combina su origen (la denominación científica de las ranas africanas es Xenopus laevis) con el tipo de entidad de la que se trata -– “bots” o robots –.

A mi juicio esta terminología resulta un tanto equívoca, porque la palabra “xeno” significa en griego “extranjero” o “extraño”. Me parece poco afortunado introducir este concepto, que normalmente asociamos a pensamientos negativos, en una nueva tecnología.

Tiene más sentido elegir la denominación de “biobots”, que une a la idea de robotsla de bios, un prefijo que muestra ostensiblemente su carácter de materia viva. Una característica, por cierto, esencial en este caso, ya que es la que dota a las nuevas criaturas tanto de gran plasticidad como de una capacidad a la que suelen ser ajenas las estructuras sintéticas: la de regenerarse a sí mismas en caso de sufrir daño.

A la izquierda, el plano anatómico de un organismo diseñado por ordenador. A la derecha, el organismo vivo, construido a partir de piel de rana (verde) y células del músculo cardíaco (rojo).

A la izquierda, el plano anatómico de un organismo diseñado por ordenador. A la derecha, el organismo vivo, construido a partir de piel de rana (verde) y células del músculo cardíaco (rojo).Sam Kriegman (UVM), CC BY

Los miedos mitológicos no son razonables

Las cuestiones que se entrelazan con la ética requieren un análisis más profundo. Es fácil presuponer que habrá voces que clamen contra los biobots, ya sea porque nos exponen a escalofriantes peligros aún por determinar o porque su creación atenta por sí misma contra la naturaleza.

La fortaleza de estos argumentos proviene de que conectan muy bien con el imaginario colectivo. Al fin y al cabo, tanto la mitología antigua como la ciencia ficción contemporánea se han encargado de infundirnos un considerable temor a todo lo que parece poco natural. Lo han hecho a través de ejemplos de consecuencias que trae la ambición humana cuando se aúpa a un papel hacedor que no le corresponde.

Contamos con visiones muy pesimistas de lo que la biotecnología puede desencadenar sobre la especie humana. Los ejemplos van desde el mito de quimera, que hizo que los romanos exigiesen forma humana a los recién nacidos para considerarlos personas, hasta relatos como los de La isla del doctor Moreau y películas como GATTACA. Hay toda una herencia de miedo a lo artificial, a lo hecho por el ser humano, entre la que es difícil abrir camino a lo razonable.

La realidad se encuentra, al menos en lo que se refiere a los biobots, muy lejos de parecerse a esos escenarios dantescos.

A diferencia de lo que ocurre con otras tecnologías como la edición genética, las quimeras humano-animales y los organoides, en este caso estamos muy lejos de utilizar material humano, al menos de momento.

Aunque algún día llegáramos al punto de usar células embrionarias humanas para constituir estas estructuras vivas seguiríamos sin poder hablar de seres dotados de valor moral (dignidad). Esta frontera solo se avistará si empezamos a introducir estructuras neuronales en estos biobots.

Este escenario está muy lejos, si es que es viable algún día. Por tanto, solo aquellos que defienden la necesidad de valorar todas y cada una de las formas de vida – una línea de pensamiento minoritaria – podrían preocuparse por la aparición de estas nuevas entidades.

¿Sufren los biobots?

Ahora bien, ¿no debería preocuparnos un cambio tan radical en la estructura de la vida, aunque no afecte al material biológico humano? A mi juicio es obvio que no, aunque entiendo la raíz última de estas inquietudes.

Nuestra visión de la naturaleza tiende a idealizarla. Hablamos de la madre naturaleza y su sabiduría innata, algo panteístico. El sistema que nos rodea no posee atributos como la bondad y la inteligencia. Ciertamente, el mundo físico tiene un orden (variable) y unas normas, una forma de organización. No hay nada, sin embargo, que certifique que ese orden sea el óptimo para nosotros. De hecho, llevamos milenios pensando lo contrario, de ahí las alternaciones de la naturaleza que ha provocado el desarrollo de la medicina, la agricultura y el transporte

Introducir otras, como la creación de biobots,no debería resultar inquietante por sí misma. Otra cosa será inferir si la mera existencia como biobot causa sufrimiento a la criatura creada artificialmente. Este es el punto en el que nos hallamos en el caso de los organoides cerebrales, pero cuesta pensar que las dudas sean extrapolables a entidades que carecen de un centro de interpretación de señales nerviosas.

Si en el futuro nos encontramos ante una situación más compleja, será el momento de retomar esta discusión. Por ahora parece superflua.

Sin riesgos (de momento)

Esto no significa que debamos permitir cualquier uso de esta tecnología. La liberación de organismos de este tipo en un entorno no controlado podría entrañar graves riesgos para el ecosistema.

Tampoco parece posible autorizar, en un futuro próximo, experimentos que impliquen su introducción en el cuerpo de seres vivos, sean o no humanos, por razones de seguridad.

Para evitar estos excesos se encuentra ya en vigor toda una normativa que nos protege de usos poco razonables de tecnologías experimentales. Toda una pléyade de organismos, desde las agencias de seguridad hasta los comités de ética de la investigación, se encargan de vetar iniciativas de dudosa utilidad o elevado riesgo. Al menos, mientras no se hayan recorrido todos los pasos que ha de transitar cualquier tecnología nueva antes de su aplicación práctica.

El derecho también tendrá que estudiar qué estatuto proporciona a estos biobots, o si será necesario desarrollar alguna norma concreta que regule su uso, y seguro que su respuesta será más que satisfactoria.

Mientras tanto, quienes han de aplicar las normas tendrán que intentar hallar en su articulado unas guías generales con las que establecer pautas de acción concretas en este momento preciso. Dudo muchísimo que la aparición de formas de vida como estas suponga un desafío a este respecto.

Cabe pensar que este avance tecnológico merece una mirada esperanzada, aunque sea todavía muy pronto para calibrar su impacto en la práctica. No parece que un uso ordenado de esta tecnología plantee problemas éticos o jurídicos preocupantes. Habrá, en todo caso, que estar muy atentos a sus futuros desarrollos. Ellos nos confirmarán (o no) este primer diagnóstico.![]()

Sobre el autor: Iñigo De Miguel Beriain es Ikerbasque Research Professor e investigador distinguido de la Facultad de Derecho, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Por qué los biobots no son un problema ético (de momento) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Pozos de conocimiento: el problema de la profundidad

- El comportamiento corpuscular de la luz: momento lineal del fotón

- Estroncio en la leche

Los retos de geolocalizar a la población española

Rosa Elvira Lillo Rodríguez, Iñaki Úcar y Rubén Cuevas Rumín

shocky / shutterstock

shocky / shutterstock

La utilización de datos de localización es de vital importancia en episodios de pandemia como estos. Ha demostrado su utilidad en países como Corea del Sur o Singapur. España tiene aspectos diferenciales, especialmente en la cultura, que nos confieren particularidades en la adopción de este tipo de estrategias.

Las aplicaciones: ¿funcionan en España?

El uso de apps es una solución válida. Permiten combinar datos de localización precisa (GPS) con datos de contacto físico en distancias cortas (bluetooth) para trazar de manera bastante precisa los patrones de movilidad así como los encuentros de los ciudadanos (en concreto de aquellos infectados).

La utilización de aplicaciones sirve para desarrollar campañas de confinamiento selectivo en lugar del confinamiento global de la población. Estas han demostrado ser más efectivas en el control de la pandemia (como ha quedado patente en Corea del Sur), a la vez que contribuyen a reducir significativamente su impacto en la economía.

Pero las aplicaciones tienen un problema muy importante en un contexto como el de la sociedad española: hay que conseguir que una gran fracción de la población se la instale y todos los desarrolladores de apps saben que ésta es una tarea muy complicada. Solventar este problema (que no es tecnológico) es crítico para que la solución de la utilización de estas herramientas tenga sentido.

Geolocalizar con datos móviles: falta precisión

En el ámbito de la movilidad, el proyecto que se pretende impulsar es semejante al proyecto piloto que lanzó el INE para complementar el censo.

Los operadores móviles disponen de un gran volumen de datos que, si no se tratan de forma agregada, permiten identificar básicamente a cada ciudadano. Pueden utilizarse para estudiar los patrones de movilidad de las personas y evaluar la eficiencia de las medidas de confinamiento.

Sin embargo, existe una limitación importante respecto a la precisión de la localización. En centros urbanos, una antena puede dar cobertura en un radio de centenares de metros, mientras que en zonas menos pobladas pueden dar cobertura hasta decenas de kilómetros. Esto implica que la precisión del dato de localización no es alta y es especialmente insuficiente en zonas rurales.

Para mejorar la precisión, se necesitan datos con granularidad GPS que ofrecen mucha mayor fiabilidad que los datos de operadoras móviles. Existen proveedores como Google, Facebook y Apple que tienen este tipo de datos a escala global, lo que permite no solo estudiar los patrones de movilidad a nivel de un país sino también a nivel internacional. Esto es extremadamente importante en escenarios de pandemias como el que nos estamos enfrentando.

¿Debemos renunciar a la privacidad?

En cualquiera de los dos escenarios (apps o localización), debemos ser conscientes de que si queremos que se exploten este tipo de datos en una estrategia conjunta de estado, los ciudadanos tenemos que estar dispuestos a que nuestros datos se comparta con alguna institución (por ejemplo, los gobiernos o autoridades sanitarias).

Acotar y amparar jurídicamente la utilización de la información personal es una discusión relevante en el ámbito de la ética. La Agencia Española de Protección de Datos ha indicado criterios adecuados en la utilización de datos masivos. Como ha advertido recientemente, su empleo sería solamente imputable a este momento concreto:

“Esta situación de emergencia no puede suponer una suspensión del derecho fundamental a la protección de datos personales. Pero, al mismo tiempo, la normativa de protección de datos no puede utilizarse para obstaculizar o limitar la efectividad de las medidas que adopten las autoridades competentes”.

Tanto las empresas de telecomunicaciones como las tecnológicas pueden desempeñar un papel fundamental en este escenario. Además de aportar sus datos para que se puedan analizar patrones de movilidad, pueden servir de canal de comunicación con los usuarios.

En comparación con la solución de las apps que necesitan que los ciudadanos se instalen las aplicaciones, estas compañías ya tienen un canal directo de comunicación con decenas de millones de usuarios en un país (el caso de las teleco) y miles de millones en el mundo (en el caso de las grandes tecnológicas).

La utilidad de las iniciativas digitales desarrolladas por el Gobierno es incuestionable, pero también es incuestionable que se tienen que arbitrar medidas para garantizar que se dispone de la información personal mínima indispensable, bajo supuestos bien definidos y relegados a la mejora de la situación de la pandemia. Esta última frase puede parecer utópica, pero debe ser el contexto básico en el que se muevan todos los avances que se llevarán a cabo en los próximos días.![]()

Sobre los autores: Rosa Elvira Lillo Rodríguez es catedrática de estadística e investigación operativa además de directora del IBiDat (Instituto de Big Data Universidad Carlos III-Santander), Iñaki Úcar es investigador postdoctoral en el IBiDat y Rubén Cuevas Rumín, profesor titular y subdirector del IBiDat.

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Los retos de geolocalizar a la población española se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una población mejor formada es una población más sana

- La delicada situación de la I+D en la economía española, por Javier García y Abel Fernández

- Marcas de agua digitales, qué son y para qué sirven

Me quiere, no me quiere

El amor ha sido el opio de las mujeres, como la religión el de las masas. Mientras nosotras amábamos, los hombres gobernaban

El matemático Steven H. Strogatz es especialista en el estudio de redes complejas y divulgador científico. En 1988 (ver [1]) publicó un artículo en el que proponía modelizar una determinada situación amorosa —entre, por ejemplo, Romeo y Julieta— usando ecuaciones diferenciales.

Foto: Carlotta Silvestrini / Pixabay

Foto: Carlotta Silvestrini / Pixabay

Tras este artículo, muchas otras personas han escrito sobre este tema, es decir, sobre la modelización matemática de algunas situaciones románticas, intentando prever la evolución en el tiempo de ese vínculo amoroso. Vamos a explicar uno de estos modelos.

Supongamos que R(t) denota el amor de Romeo por Julieta en el tiempo t. Si R(t) tiene valor positivo significa que él la adora, y si es negativo no la soporta demasiado. Del mismo modo, J(t) denota el cariño de Julieta hacia Romeo en el instante t.

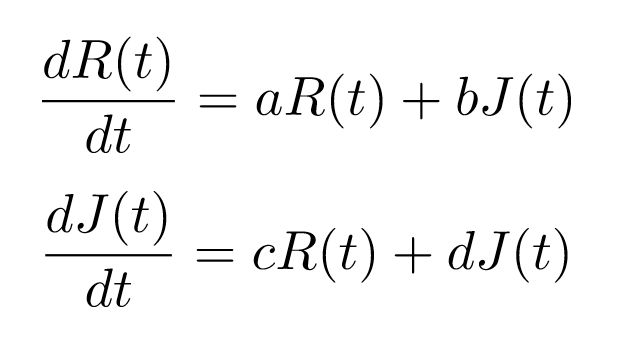

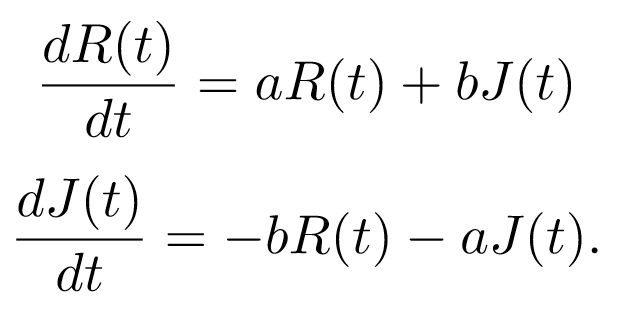

Una manera de plantear las ecuaciones que gobiernan la evolución en el tiempo de la relación entre ambos —un posible modelo para esta relación amorosa—es la siguiente:

donde las constantes a y b determinan el carácter romántico de Romeo, y c y d la manera de querer de Julieta. Que dR(t)/d(t) sea positivo significa que R(t) aumenta al pasar el tiempo, y sucede lo contrario si es negativo.

¿Qué valores tienen las constantes a, b, c y d? Aunque su valor importa —como veremos más adelante— lo realmente relevante es el signo que poseen cada una de ellas. Que a sea positivo significa que Romeo se siente estimulado por sus propios sentimientos, y que sea negativo denota lo contrario. Si pensamos en b, el que sea positivo expresa que Romeo se siente animado por los sentimientos de Julieta, mientras que un valor negativo significaría que se desanima cuando Julieta siente interés por él. Se puede hacer una interpretación similar de c y d con respecto a la evolución del amor de Julieta por Romeo.

A Strogatz y su alumnado se les ocurrió clasificar los posibles “estilos románticos” del siguiente modo:

-

Si a y b son ambos positivos, hablamos de un castor ansioso: Romeo se siente estimulado tanto por sus propios sentimientos como por los de Julieta.

-

Si a es positivo y b es negativo nos encontramos ante un nerd narcisista: Romeo desea más de lo que siente, pero le asustan los sentimientos de Julieta.

-

Si a es negativo y b es positivo tropezamos con un amante cauteloso: Romeo se retrae ante sus propios sentimientos, pero el cariño que le profesa Julieta lo anima.

-

Si a y b son ambos negativos, nos encontramos con un ermitaño: Romeo huye de sus propios sentimientos y también de los de Julieta.

La manera en el que el amor de Julieta varía con el tiempo se puede clasificar de la misma manera: d se corresponde con a en la ecuación de Romeo, y c con b. Existen diferentes tipos de relaciones dependiendo de los valores de las constantes a, b, c y d. Algunos de ellos se muestran a continuación (pueden encontrarse los detalles en [3], [4] y [5]).

Pasión versus indiferencia

Romeo y Julieta se comportan como “polos opuestos” cuando c=–b y a=-d. las ecuaciones quedan entonces del modo

Estas relaciones pueden suceder de dos maneras:

-

Cuando coinciden un castor ansioso y una ermitaña (o viceversa), la evolución en el tiempo de la relación depende de los sentimientos que se priorizan, los propios (|a|>|b|) o los ajenos (|a|). Si Romeo prioriza sus propios sentimientos, la pareja terminará en desacuerdo: uno por siempre enamorado y la otra absolutamente indiferente. Y, en el caso opuesto, la pareja terminará en un ciclo interminable de amor y desamor que sucederán —cada uno de ellos— aproximadamente una cuarta parte del tiempo.

-

Cuando coindicen un nerd narcisista y una amante cautelosa (o viceversa), de nuevo todo depende de la prioridad dada a los sentimientos propios o ajenos. Si |a|>|b|, la pareja finalizará enamorada o en guerra perpetua. Y si |a| terminarán en un eterno ciclo de amor y desamor.

Así que eso de que “polos opuestos” se atraen, no parece que funcione demasiado bien…

Embriagados por los sentimientos ajenos

¿Y si Romeo y Julieta solo se dejan llevar por los sentimientos del otro? Es decir, ¿qué sucede si a=d=0? El sistema de ecuaciones quedaría en este caso del modo siguiente:

Y tres casos son posibles:

-

Si coinciden dos amantes cautelosos (b>0 y c>0), el resultado es el mismo que el de caso del nerd narcisista y la amante cautelosa con |a|>|b|.

-

Si tenemos dos nerds narcisistas (bccastor ansioso y la ermitaña con |a|>|b|.

-

Y si coinciden un nerd narcisista y una amante cautelosa (o viceversa, es decir, bc

Por cierto, el “modelo de Shakespeare” correspondería al caso en el que a=d=0 y b y c son positivos, es decir, al de dos amantes cautelosos.

Y el modelo de Strogatz —el que propone en [1]— supone que a=d=0, b es negativo y c es positivo, es decir, estudia la relación entre un nerd narcisista y una amante cautelosa. En este caso, Romeo es un amante caprichoso: cuanto más lo quiere Julieta, menos ganas tiene Romeo de cortejarla. Y cuando Julieta pierde el interés por él, Romeo empieza a encontrarla extraordinariamente atractiva. Julieta, por el contrario, se deja llevar por los sentimientos de Romeo: su deseo crece cuando él la adora, y se enfría cuando él la ignora. Como ya sabemos, esta triste historia evoluciona como un interminable ciclo de amor y odio…

¿Cómo evolucionan otros posibles casos? ¿Te atreves a dar un modelo alternativo al planteado arriba?

Referencias

[1] Steven H. Strogatz, Love Affairs and differential equations, Mathematics Magazine 61, 35, 1988

[2] Steven H. Strogatz, Loves Me, Loves Me Not (Do the Math), Opinionator, 2009

[3] Omstavan, Love Affairs: A mathematical model using Differential equations!, Steemit, 2018

[4] Fabian Dablander, Love affairs and linear differential equations, R-bloggers, 2019

[5] Isaac Elishakoff, Differential Equations of Love and Love of Differential Equations, Journal of Humanistic Mathematics 9 (2), 2019, 226-246

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Me quiere, no me quiere se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Amelia quiere explorar el desierto

- La ‘reverosis’ de Pablo

- La cuadratura del cuadrado: las redes eléctricas de Kirchhoff

Las bandas de Bloch

Foto: Harli Marten / Unsplash

Foto: Harli Marten / UnsplashEn 1928, solo dos años después de la formulación de la mecánica cuántica, Arnold Sommerfeld modificó el modelo clásico de electrones libres tratando los electrones de acuerdo con la mecánica cuántica. Pero, como antes, Sommerfeld también consideró que los electrones eran pequeñas partículas de materia cargadas. No solo eso, el nuevo modelo aún contenía la suposición poco realista de que los electrones no interactúan con los iones [1] de la red, excepto para colisionar con ellos.

Ese mismo año, Felix Bloch, asistente de Werner Heisenberg en Leipzig, comenzó a hacer suposiciones más razonables en un intento de formular una mecánica cuántica más completa que explicase la conductividad eléctrica.

Primero, Bloch quería asignar un momento y energía definidos a cada uno de los electrones, pero no una posición definida o un intervalo de tiempo, por lo que eligió la faceta de onda de la dualidad onda-corpúsculo [2]. Supuso que los electrones se comportan, no como partículas, sino como ondas de de Broglie infinitamente extensas.

Por lo tanto Bloch no consideraba los electrones dentro de los conductores como un «gas» de partículas, sino más bien como ondas periódicas que se extienden por toda la red cristalina periódica. Este hecho tuvo posteriormente la consecuencia de que permite explicar cómo es que la electricidad puede comenzar a “fluir” por un cable en el mismo instante en que el cable se conecta a una toma de corriente [3].

Bloch hizo una segunda suposición. Supuso que los iones metálicos positivos, que están dispuestos en una matriz periódica infinita (esto es, en un cristal perfecto), ejercen una fuerza eléctrica atractiva sobre los electrones negativos. Esta fuerza atractiva podemos visualizarla como sumideros en el camino de los electrones, técnicamente «pozos de potencial». Los pozos de iones vecinos se superponen de manera que juntos forman una disposición periódica de “baches” que da a las ondas de electrones un recorrido muy irregular por el cable.

Con estas dos suposiciones, Bloch resolvió la ecuación de Schrödinger para averiguar las energías que las de ondas de Broglie de este tipo [4] podrían poseer mientras se movían en este tipo de potencial periódico. Descubrió que las energías permitidas de los electrones en el material se unen en bandas de estados cuánticos, de una forma análoga a como hay ciertos estados estacionarios cuánticos dentro de cada átomo en el que pueden estar los electrones. Entre las bandas, como entre los estados cuánticos, hay un rango de energías en el que los electrones tienen prohibido estar.

Notas:

[1] Un ion tiene carga positiva. Asumir que un electrón cargado negativamente solo interactúa de forma mecánica con ellos es llevar el vacaesferismo hasta casi lo ridículo.

[2] Recordemos esa parte del principio de complementariedad que dice “Cada experimento, o el experimentador que diseña el experimento, selecciona una u otra descripción como la descripción adecuada para ese experimento.”

[3] Démonos cuenta de que, si los electrones se consideran bolitas de materia, la corriente debería emplear un tiempo en llegar a los valores que establece la ley de Ohm.

[4] Recordemos que la ecuación de Schrödinger es una ecuación diferencial y que su solución es, por tanto, una o varias funciones matemáticas llamadas funciones de onda.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Las bandas de Bloch se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría de bandas de los sólidos se hace topológica

- Construyendo la mecánica cuántica

- El principio de complementariedad

Normas de prudencia en el quehacer científico

Foto: Comfreak / Pixabay

Foto: Comfreak / PixabayDados los dilemas vistos en la anotación anterior y otros que no se han recogido aquí, no dejan de hacerse llamadas de atención, tanto desde la propia comunidad científica, como desde fuera de ella, advirtiendo de la necesidad de actuar con prudencia y en algún caso, de establecer moratorias al uso de ciertas tecnologías hasta no tener maás garantías acerca de su inocuidad.

Con carácter general, y en el marco de su tesis doctoral sobre el entramado de ciencia y valores, Menéndez Viso (2005) propone recuperar la noción aristotélica de prudencia (phronesis) para relacionar lo que sabemos y lo que debe hacerse. Propone que la prudencia inspire las decisiones que toman los científicos y quienes hayan de aplicar los productos de la ciencia.

En este terreno, ya desde los años setenta del siglo pasado se ha propuesto la aplicación del llamado Principio de Precaución a la hora de tomar decisiones relativas a la aplicación de las técnicas objeto de controversia.

El Principio de Precaución empezó a tener reconocimiento jurídico de orden internacional cuando la Asamblea General de Naciones Unidas adoptó la Carta Mundial de la Naturaleza. El Protocolo de Montreal lo incorporó en su formulación en 1987. Y a partir de ese momento tuvo acogida en diferentes tratados internacionales (Declaración de Río y Protocolo de Kioto). También se ha ido incorporando a diferentes legislaciones nacionales.

El Principio de Precaución se sustenta en dos ideas principales:

- La necesidad de que quien toma las decisiones anticipen el daño que puede causar una actuación antes de que ocurra. Esta idea lleva implícito el cambio de la carga de la prueba, porque es quien propone la actuación quien ha de demostrar que no causará daño o que es muy improbable que lo cause.

- La proporcionalidad entre el riesgo y los costes y viabilidad de la acción propuesta

El problema de este principio es que hay numerosas y muy diversas formulaciones del mismo, lo que es indicativo de la dificultad real para objetivar y acordar una definición. A pesar de ello, ha tenido reflejo en el Tratado de Funcionamiento de la Unión Europea y en la legislación de algunos de sus estados. El Consejo de Europa lo define así:

Cuando una evaluación pluridisciplinaria, contradictoria, independiente y transparente, realizada sobre la base de datos disponibles, no permite concluir con certeza sobre un cierto nivel de riesgo, entonces las medidas de gestión del riesgo deben ser tomadas sobre la base de una apreciación política que determine el nivel de protección buscado.