¿Por qué los átomos tienen el tamaño que tienen?

Imagen: Berndthaller / Wikimedia Commons

Imagen: Berndthaller / Wikimedia CommonsA escala atómica el principio de incertidumbre se usa principalmente en argumentos generales sobre la teoría atómica más que en problemas numéricos concretos. Por ejemplo, el principio de incertidumbre ayuda a responder una pregunta fundamental que los pensadores se han planteado desde que apareció el concepto de átomo: ¿por qué los átomos tienen el tamaño que tienen? [1]

Los átomos en realidad están compuestos principalmente de espacio vacío. En el centro de cada átomo hay un núcleo muy pequeño, en el que se concentra toda la carga positiva y casi toda la masa del átomo. Alrededor del núcleo hay una cantidad de electrones igual a la carga positiva del núcleo. Los electrones están dispuestos en varias órbitas cuánticas. La más baja se llama el «estado fundamental». Pero incluso la órbita del estado fundamental todavía está lejos del núcleo. En la mayoría de los átomos, el radio del estado fundamental es de unos 10-8 cm, mientras que el radio del núcleo es de unos 10-12 cm. Esto significa que un núcleo ocupa solo una pequeña fracción del espacio dentro de un átomo; el resto está vacío (a excepción de unos pocos electrones que podemos considerar de tamaño puntual) [2].

El modelo de Rutherford, basado en un modelo planetario del átomo, es inestable, ya que el átomo debería colapsar en el núcleo, porque los electrones deberían irradiar su energía y girar en espiral hacia el núcleo. Bohr intentó explicar por qué esto no sucede al postular la existencia de estados cuánticos estacionarios, mientras que la mecánica cuántica asocia dichos estados con ondas estacionarias, teniendo el estado fundamental la onda de electrónica estacionaria más pequeña posible en esa órbita. Pero es el principio de incertidumbre el que explica por qué no podemos tener estados más bajos y por qué los electrones negativos no pueden existir dentro de o sobre el núcleo positivo. Bueno, para ser estrictos, el principio de incertidumbre combinado con el principio de constancia de la velocidad de la luz de la teoría de la relatividad.

Una aplicación simple de la relación de incertidumbre para la posición y el momento (Δx·Δpx≥h/4π) muestra que si un electrón está confinado a un espacio de 10-8 cm, el tamaño de un átomo promedio en centímetros, entonces la incertidumbre en su velocidad es menor que la velocidad de la luz. Pero si se limita a un espacio mucho más pequeño, o incluso al tamaño del núcleo, la incertidumbre en su velocidad excedería la velocidad de la luz, que es, redondeando, 3·1010 cm/s. Pero nada puede superar a la velocidad de la luz [3], ninguna partícula material puede exceder la velocidad de la luz. Por lo tanto, el espacio dentro del átomo entre el núcleo y el primer estado cuántico debe permanecer vacío. [4]

Ya tenemos un tamaño mínimo para el átomo dado por la combinación de incertidumbre y relatividad. ¿Existe algún límite al tamaño máximo?

Para aumentar el tamaño de un átomo, tendríamos que llevar electrones a estados cuánticos mucho más altos. Además de requerir la inyección de una gran cantidad de energía, los estados energéticos más altos no están espaciados uniformemente, sino que están cada vez más separados. Por lo tanto, la probabilidad aumenta enormemente de que los electrones en estos estados superiores puedan escapar del átomo y liberarse, por lo que dicho átomo no existiría durante mucho tiempo debido a la menor atracción electrostática del núcleo, lo que significa que en la práctica la mayoría de los átomos que se pueden estudiar tienen un tamaño de aproximadamente 10-8 cm.

Veremos en su momento que el hecho de que los átomos tengan un tamaño del orden de 10-8 cm ayuda a explicar muchas de las propiedades de la materia que vemos a nuestro alrededor.

Notas:

[1] Veremos que para responder a esta pregunta tendremos que echarmano de lo que hemos visto hasta ahora de Átomos y Cuantos.

[2] Implícitamente estamos considerando el aspecto corpuscular de los electrones. Esta interpretación es la que nos conviene en esta explicación, pero no debemos olvidar la dualidad onda-corpúsculo.

[3] Véase nuestra serie La teoría de la invariancia, una teoría popularmente llamada con un nombre que da lugar a equívocos: teoría de la relatividad.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo ¿Por qué los átomos tienen el tamaño que tienen? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El tamaño del átomo de hidrógeno

- La estructura de la tabla periódica se deduce de la estructura de capas de los átomos

- El tamaño de las moléculas

Ciencia Patológica

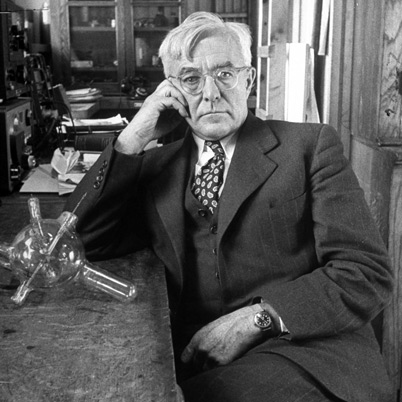

Irving Langmuir. Imagen: Wikimedia Commons

Irving Langmuir. Imagen: Wikimedia CommonsAdemás del fraude, hay otros comportamientos por parte de quienes realizan investigación de vanguardia que pueden conducir a obtener –y en ocasiones anunciar o publicar- conclusiones erróneas o insostenibles. El que da lugar a la denominada “ciencia patológica” es uno de ellos.

La expresión “ciencia patológica” fue acuñada por Irvin Langmuir, químico y físico estadounidense que fue premio Nobel de química en 1932. Se movió entre la ciencia experimental y la teórica, y fue presidente de la Asociación Química Americana.

En la conferencia “Coloquio en el Laboratorio de Investigación Knolls de la General Electric”, impartida el 18 de Diciembre de 1953, Langmuir describió la “ciencia de las cosas que no son”, más tarde conocida como “ciencia patológica”. Esa denominación no hace referencia a una forma particular de pseudociencia, pues esta no tiene pretensión alguna de seguir el denominado “método científico”, sino a un tipo de investigación científica afectada por sesgos inconscientes y efectos subjetivos.

En su conferencia, Langmuir previno contra los peligros del autoengaño y dio cuenta de varios casos famosos, entre ellos: Los Rayos N, (Blondlot, 1903), una prueba experimental contraria a la Teoría de la Relatividad (Kaufmann, 1906), las radiaciones mitogenéticas o rayos Gurwitsch (1923), una verificación prematura del ”corrimiento al rojo” gravitacional (Adams, 1924), y los experimentos dudosos sobre rayos canales de Rupp (1926)*. J M Barandiarán (2017) incluye también en esa relación el caso de Percival Lowell y los “canales” marcianos, a los que dedicó la mayor parte de su actividad en el observatorio (privado) de Flagstaff (Arizona).

La ciencia patológica es un fenómeno que presenta los siguientes rasgos relativos a un supuesto descubrimiento científico:

- El efecto observable máximo es producido por un agente causante de intensidad apenas perceptible, y la magnitud del efecto es sustancialmente independiente de la intensidad de la causa.

- La magnitud del efecto es cercana al límite de la detectabilidad, o muchas medidas son necesarias debido a la baja relevancia estadística de los resultados. Suele ocurrir que el investigador encuentre excusas en estos casos para descartar datos convenientemente.

- Hay afirmaciones de gran exactitud.

- Se proponen teorías fantásticas contrarias a la experiencia.

- Las críticas se resuelven con excusas ad hoc.

- La proporción de partidarios frente a los críticos aumenta y después cae gradualmente al olvido. Los críticos no pueden reproducir los experimentos, sólo pueden los que son partidarios. Al final no se salva nada. De hecho, nunca hubo nada.

Como regla general la ciencia patológica trabaja en los límites difusos, no hay pretensión de fraude, simplemente es mala ciencia, que se practica por no saber reconocer las limitaciones epistemológicas del investigador, sus instrumentos y sus diseños experimentales. Hay mucha más de lo que sería deseable, sobre todo en algunos campos nuevos y de moda. El caso más sonado de ciencia patológica es, quizás, el de la supuesta “fusión fría”.

Si pensamos que para los investigadores constituye un fuerte incentivo la posibilidad de realizar descubrimientos cruciales, nos encontraríamos, paradójicamente, ante un caso en el que el reconocimiento por los hallazgos –que compensa, supuestamente, el carácter desinteresado de la actividad científica-, actuaría como factor principal de esta variedad de mal. Se trata de un efecto similar al de la segunda modalidad de fraude científico. También en este caso, es el escepticismo, la virtud mertoniana que queda en entredicho, no tanto porque se impida su ejercicio, sino porque no se actúa conforme a lo que tal virtud exige.

El contenido de esta anotación se ha basado, sobre todo, en esta otra de César Tomé López (2013) en el Cuaderno de Cultura Científica, y en la de J M Barandiarán (2017) en la web de BC Materials.

Nota:

[*] Rupp tuvo que admitir finalmente que sus extraordinarios resultados se debían, en parte, a una falsificación de datos.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo Ciencia Patológica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ni ciencia, ni pseudociencia, ciencia patológica.

- Ciencia a presión: Ciencia patológica y patología editorial

- El fraude y las malas prácticas en ciencia

El efecto hoy en día

Foto: Cristina Gottardi / Unsplash

Foto: Cristina Gottardi / Unsplash“Ahora los chicos aman el lujo. Tienen malas maneras, desprecian la autoridad; no respetan a los mayores y prefieren la cháchara al ejercicio”. Las personas mayores decimos cosas semejantes con frecuencia. Y eso no es de ahora; se han dicho, al menos, desde que tenemos registros escritos de lo que pensaban nuestros antepasados. La cita entrecomillada con la que se abre este texto, en concreto, se atribuye a Sócrates. Pero si eso fuera cierto, si los jóvenes fuesen cada vez más disolutos, mas irrespetuosos, más holgazanes o más alocados, por citar solo algunos de los defectos que se les suelen atribuir, la juventud y con ella el resto de la humanidad, habría degenerado de una forma difícilmente soportable. Algo falla en esas expresiones.

Una investigación cuyas conclusiones se han dado a conocer recientemente ha abordado este asunto, indagando acerca del fenómeno denominado “efecto hoy en día” (these days effect en inglés). Y para ello ha pulsado la opinión de las personas mayores acerca de cómo han evolucionado tres rasgos en concreto desde nuestros años mozos hasta la juventud de hoy en día. Los rasgos son el respeto a las personas mayores, la inteligencia y el gusto por la lectura.

La conclusión general del estudio es que hay, efectivamente, una tendencia general a hablar mal de la juventud en lo relativo al respeto a los mayores y el gusto por la lectura. Y también una tendencia a valorar de forma negativa a la gente joven en aquellos rasgos en los que uno destaca o cree destacar; esta tendencia es común a los tres rasgos investigados. O sea, cuando una persona adulta es muy respetuosa con la autoridad, tiende a pensar que la gente joven de ahora respeta a los mayores menos que los jóvenes de su época. Y lo propio ocurre con la inteligencia y con la afición a leer. El efecto es, sobre todo, específico de cada rasgo, porque, por ejemplo, alguien muy aficionado a la lectura pero que valora poco la autoridad, no tiende a pensar que los jóvenes de hoy en día no respetan a los mayores como se les respetaba antes. En otras palabras, ese “efecto hoy en día” no consiste en una minusvaloración o mala opinión general de la juventud sino que se circunscribe a dominios relativamente específicos.

Los autores del trabajo identificaron dos mecanismos que subyacen al efecto. Por un lado, observaron que la gente que destaca en algún rasgo tiene una especial tendencia a percibir los fallos en ese mismo rasgo de los demás, tanto en los jóvenes como en los adultos. Y por otra parte, tienden a proyectar sus características actuales hacia el pasado, incurriendo en el error de pensar que cuando eran jóvenes tenían las mismas virtudes o rasgos favorables que en el presente. Por eso se comparan tal y como se ven a sí mismos hoy con los jóvenes, sin caer en la cuenta de que ellos no son ahora como eran hace cuarenta años. Este mismo sesgo ha podido estar actuando durante milenios, con lo que ello implica.

Si llevamos siglos valorando de forma negativa a los “jóvenes de hoy en día”, es muy improbable que los mayores dejemos de hacerlo en adelante. Por esa razón, cuando oiga a sus familiares o colegas, o incluso, se descubra a sí mismo diciendo que los jóvenes de ahora son indisciplinados, no respetan a sus mayores, no leen, antes llegaban mejor preparados a la universidad, o cosas semejantes, antes de asentir o de seguir con la diatriba piense que eso mismo decían los griegos hace casi veinticinco siglos.

Fuente:

John Protzko and Jonathan W. Schooler (2019): Kids these days: Why the youth of today seem lacking Science Advances: 5 (10) eaav5916 DOI: 10.1126/sciadv.aav5916

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El efecto hoy en día se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- No duermas, hay leones

- El efecto escenario: por qué la gente elige la opción de en medio

- El desajuste adolescente

Energía… ¿oscura?

¿Podemos predecir el destino del Universo? Aunque parezca sorprendente, al parecer sí que se puede. Sin embargo, en el intento nos hemos encontrado con el efecto de la llamada ‘energía oscura’. ¿Podemos entender de dónde viene la energía oscura y cuál es su efecto, o debemos simplemente aceptar su existencia?

Ciertamente, nos encontramos ante grandes incógnitas. Para abordar estas cuestiones y reflexionar sobre ellas, el ciclo de conferencias Bidebarrieta Científica acogió la charla titulada “Energía… ¿oscura?” de la mano de Marcos Pellejero Ibáñez, investigador postdoctoral en el Donostia International Physics Center, el pasado 29 de enero de 2020.

Marcos Pellejero habló sobre el Universo y el vacío en esta conferencia del ciclo Bidebarrieta Científica, iniciativa impulsada por la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta y que en esta ocasión se celebrará en el marco de la tercera edición del ciclo de cine y ciencia organizado por la Filmoteca Vasca, el Donostia International Physics Center (DIPC) y el Festival de Cine de San Sebastián.

Edición realizada por César Tomé López

El artículo Energía… ¿oscura? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Prótesis biocompatibles por impresión 3D

Koldo Artola de Domotek y Pedro Guerrero de Biomat. Foto: Nagore Iraola -UPV/EHU.

Koldo Artola de Domotek y Pedro Guerrero de Biomat. Foto: Nagore Iraola -UPV/EHU.La impresión en tres dimensiones (3D) ha constituido un gran avance en la medicina personalizada al desarrollar biomodelos que facilitan en gran medida la labor del profesional de la salud. Un nuevo paso en este camino es el trabajo colaborativo llevado a cabo entre el grupo Biomat de la Universidad del País Vasco y la empresa Domotek que ha permitido la obtención de biomodelos personalizados de colágeno nativo. Gracias a los avances en la obtención de biomateriales procesables por impresión 3D, desarrollados por Biomat, y en la adquisición y procesado de datos para impresoras 3D, llevados a cabo por Domotek, los productos fabricados pueden ser utilizados como piezas de utillaje o prótesis gracias a su biocompatibilidad.

“A partir de imágenes médicas tomadas al paciente, principalmente mediante Tomografía Axial Computarizada (TAC) o Imagen por Resonancia Magnética (MRI), se pueden obtener modelos digitales 3D de gran precisión -explica Pedro Guerrero, investigador del grupo Biomat-. Estos modelos digitales se pueden transformar en datos que pueden ser procesados por las impresoras 3D para imprimir réplicas exactas (biomodelos) de la anatomía del paciente. Estos biomodelos sirven al médico para verificar los procedimientos quirúrgicos y mejoran la comunicación de los médicos con el paciente, mostrándole el biomodelo al paciente para que este comprenda mejor la intervención a realizar. En la actualidad, los implantes personalizados hacen posible la reconstrucción del defecto sin alterar la anatomía del paciente, consiguiéndose una mejora en la eficiencia de la cirugía y reduciendo la duración y los costes de la misma”.

Las impresoras 3D pueden reproducir los biomodelos en plástico o resina, pero estos materiales presentan riesgos de infección o rechazo, por ello el desarrollo de nuevos materiales es clave. “Con el desarrollo llevado a cabo por Biomat y Domotek, los biomodelos se pueden fabricar con colágeno nativo tipo I, un material biocompatible, biodegradable, poroso, adecuado para la adhesión celular y que no presenta citotoxicidad. Por tanto, estos biomodelos fabricados con materiales basados en colágeno nativo pueden ser las prótesis del mañana, ya que, gracias a sus propiedades, pueden comportarse como sustitutos temporales del tejido dañado mientras este se regenera. En el caso de los implantes, la biodegradabilidad es muy importante ya que evita una segunda cirugía para eliminar el implante”, aclara el profesor Guerrero.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Prótesis biocompatibles por impresión 3D se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Polímeros biocompatibles para integrar dispositivos electrónicos en nuestro cuerpo

- Cómo regular la velocidad de disolución de los biometales de las prótesis

- Control adaptativo de robots para rehabilitación

El efecto escenario: por qué la gente elige la opción de en medio

Ante una lista de opciones o elementos similares colocados en fila, los humanos tendemos a descartar los extremos y quedarnos con aquellos situados en medio. Sucede con números, con imágenes e incluso con concursantes de un programa de televisión1. El efecto de preferencia central (“center stage effect” o “centrality preference” en la literatura en inglés) ha sido estudiado por la psicología desde hace décadas y presenta una robusta evidencia23. Los motivos de esta curiosa preferencia no terminan de estar claros 4: podría tratarse de una cuestión perceptiva56 (fijamos nuestra mirada en el centro por lo que tendemos a elegir cosas situadas ahí), cultural7 (el prestigio y la autoridad asociados a una posición central), o una estrategia para reducir el esfuerzo mental que supone elegir8. De un modo u otro, las implicaciones de este efecto resultan de lo más variopintas. Aquí van algunas:

Servicios públicos

En un artículo publicado en 19959, Nicholas Christenfeld presentó una serie de experimentos sobre este curioso sesgo: en uno de ellos, examinó las preferencias de los playeros de California a la hora de ir a mear. Como hubiese sido un poco violento plantarse en la puerta de los servicios públicos a contar visitantes, Christenfeld usó una medida indirecta. Con ayuda del personal de limpieza, registró el uso de papel higiénico de cada una de las cabinas. El resultado confirmó la sospecha: los playeros utilizaban los retretes centrales con bastante más frecuencia de la que cabía esperar por puro azar. Así que la próxima vez, ya sabes… si quieres usar el retrete más limpio, deberías optar por los extremos. No sólo estarán menos usados, además tendrás más posibilidades de encontrar papel higiénico.

¡Compra, compra!

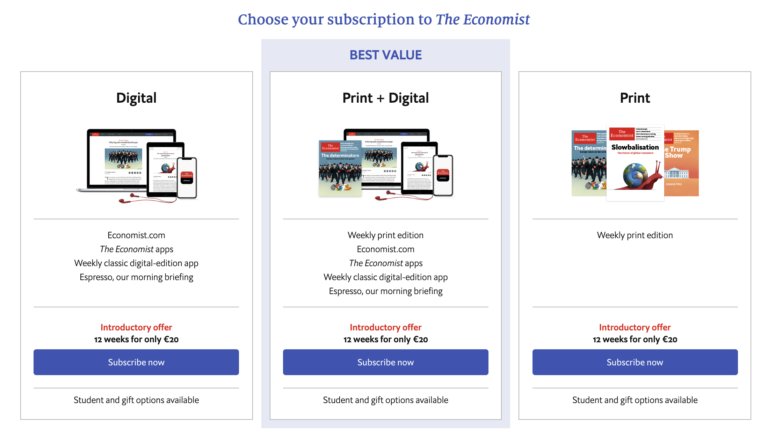

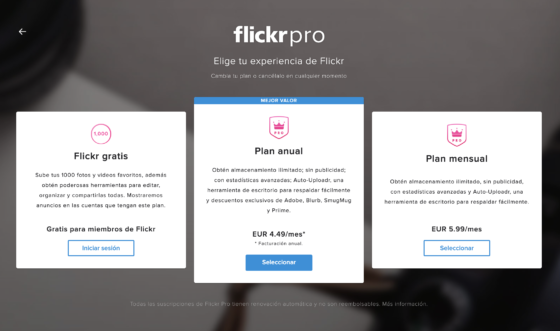

Objetos similares colocados en fila. Está claro que nuestra preferencia por la centralidad tiene muchas ocasiones de salir a relucir cada día. Pero quizás la más clara es la que nos sitúa como compradores ante una colección de productos. Esta colección puede tomar distintas formas: puede ser un escaparate, perfectamente ordenado tras un cristal. También puede tratarse de un catálogo, la balda del supermercado, o las bebidas en la nevera al final de un buffet. Y, claro está, también puede darse en internet: desde la galería de amazon a cualquier página web de venta online. En todos estos casos, los clientes tienden a elegir y gastar más dinero en los elementos situados hacia el centro de su campo visual. Es algo que saben quienes disponen los productos en tiendas físicas y también quienes crean páginas web. De hecho, si recientemente has contratado alguna suscripción o servicio online, es probable que esta distribución te resulte sospechosamente familiar:

Esta es una captura de la página de suscripción a The Economist. Pero la idea no es precisamente original. La misma idea se repite una y otra vez. Sencillamente, porque funciona.

Exámenes tipo test

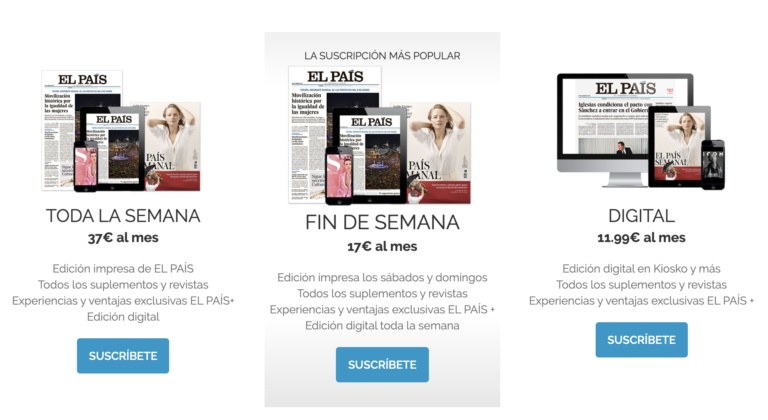

El MIR es, quizás, una de las pruebas más exigentes a las que se enfrenta todo médico durante su carrera. Sin embargo, hasta hace algunos años, los estudiantes recién salidos de la facultad podían contar con una pequeña ventaja. Si algún concepto sobre anatomía humana se les escapaba, siempre podían jugársela con la psicología: debido a los sesgos de quienes habían diseñado el examen, no todas las respuestas eran correctas con igual probabilidad. Según me cuentan los doctores Elena Alvar y Julián Palacios (especialistas en anestesiología y cardiología, respectivamente), este hecho era ampliamente conocido por los estudiantes y se contaba en algunos cursos de preparación a las pruebas. Las respuestas correctas seguían una distribución muy similar a las de las carreras de tortugas. Los examinadores, sin saberlo, tendían a colocar las respuestas correctas con mayor probabilidad hacia el centro. Los estudiantes, incluso sin haberlo sabido, hubiesen optado por ellas también: el sesgo funciona en ambos sentidos y quienes se someten en este tipo de tests, tienden a buscar la respuesta correcta lejos de los extremos.

Esta colaboración no buscada entre examinadores y examinados tiende a darse en todas las pruebas de elección múltiple10. Pero en el caso del MIR tuvo su fin hacia 2010. Desde ese año y hasta 2014, el Ministerio hizo un esfuerzo deliberado por equilibrar la distribución de aciertos entre las 5 respuestas posibles. En 2015, los exámenes pasaron a tener cuatro alternativas en lugar de 5 y parece que los resultados han vuelto a perder el equilibrio favoreciendo ligerísimamente las opciones de en medio. El margen es tan leve que nadie se va a librar de estudiar. Pero ante la duda… siempre mejor quedarse con la segunda o tercera tortuga.

Distribución de las respuestas correctas, según su posición, en las pruebas del MIR, año a año. Fuente.

Distribución de las respuestas correctas, según su posición, en las pruebas del MIR, año a año. Fuente.Referencias:

1Raghubir, P. & Valenzuela. (2006). Centre-of-inattention: Position biases in decision-making. Organisational Behaviour and Human Decision Processes, 99, 66-80

2Paul Rodway Astrid Schepman & Jordana Lambert (2011). Preferring the One in the Middle: Further Evidence for the Centre‐stage Effect. Applied cognitive Psychology.

3Maya Bar-Hillel (2015). Position Effects in Choice From Simultaneous Displays: A Conundrum Solved. Perspectives on Psychological Science.

4Paul Rodway, Astrid Schepman, Volker Thoma (2015). Reachability Does Not Explain the Middle Preference: A Comment on Bar-Hillel

5Benjamin W. Tatler (2007). The central fixation bias in scene viewing: Selecting an optimal viewing position independently of motor biases and image feature distributions. Journal of Vision.

6 A. Selin Atalay, H. Onur Bodur, and Dina Rasolofoarison (2012). Shining in the Center: Central Gaze Cascade Effect on Product Choice. Journal of Consumer Research.

7Valenzuela, Ana & Raghubir, Priya. (2009). Position-based beliefs: The center-stage effect. Journal of Consumer Psychology,

8Jerry I. Shaw, Jon E. Bergen, Chad A. Brown & Maureen E. Gallagher (2000) Centrality Preferences in Choices Among Similar Options, The Journal of General Psychology,

9Nicholas Christenfeld (1995). Choices from Iden tical Options. Psychological Science,

10Attali, Yigal & Bar-Hillel, Maya (2003). Guess Where: The Position of Correct Answers in Multiple‐Choice Test Items as a Psychometric Variable. Journal of Educational Measurement.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El efecto escenario: por qué la gente elige la opción de en medio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Estas Navidades no engordarás medio kilo

- Los números feos de la lotería

- ¿Cuánta gente ha vivido en la Tierra?

Las curvas del espirógrafo

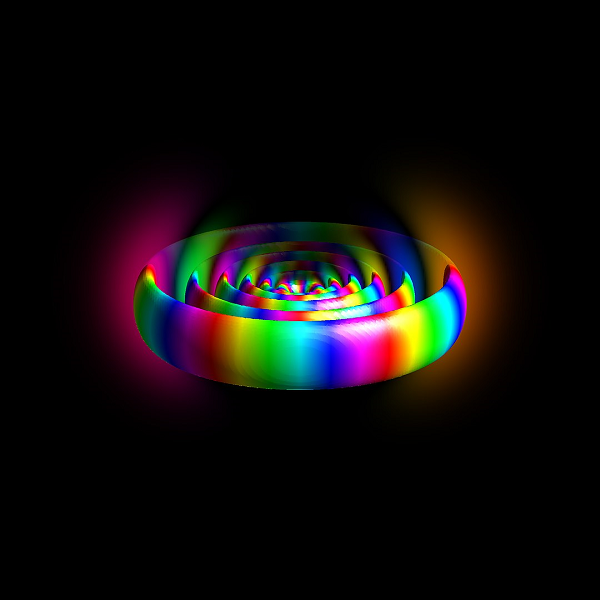

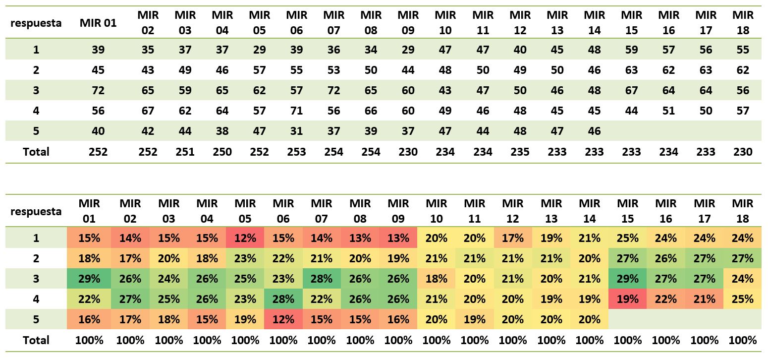

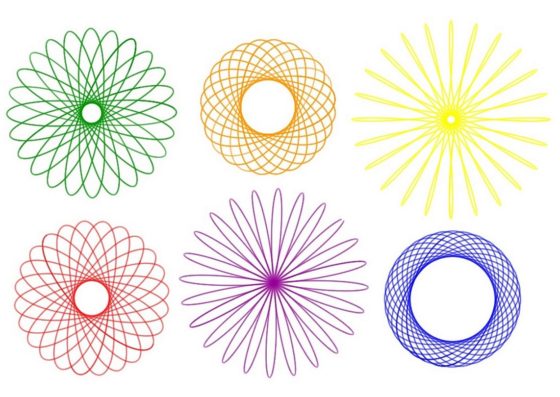

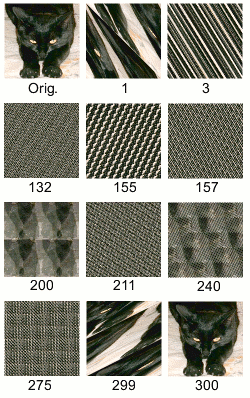

En mi anterior entrada del Cuaderno de Cultura Científica Guía matemática para el cómic ‘Promethea’, sobre las referencias matemáticas que aparecen en Promethea (1999-2005), del guionista Alan Moore y el dibujante James H. Williams III, mencioné que en algunas partes del mismo aparecían “curvas hipotrocoides dibujadas con un espirógrafo”, como las que se pueden ver en la siguiente imagen.

Doble página del cómic Promethea, de Alan Moore (guion) y J.H. Williams III (dibujo)

Doble página del cómic Promethea, de Alan Moore (guion) y J.H. Williams III (dibujo)

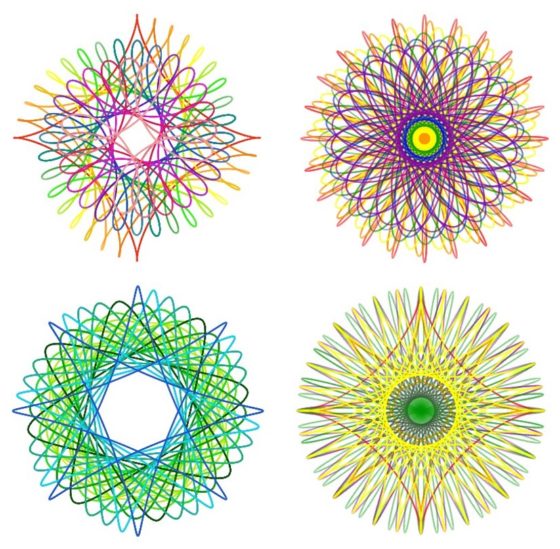

Si nos fijamos en las curvas que aparecen dibujadas en el cómic es posible que nos recuerden a los diseños geométricos realizados con un juguete llamado espirógrafo, con el que tal vez jugamos en nuestra infancia. Diseños geométricos como los que aparecen en la siguiente imagen.

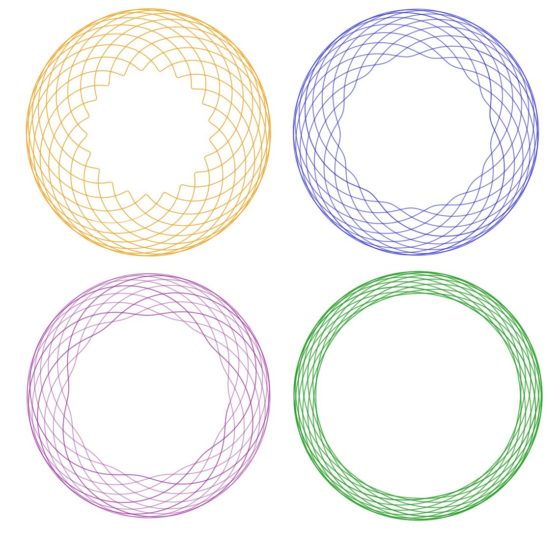

O también los dibujos de esta otra imagen.

Estos diseños geométricos los he realizado con el Inspirograph, que es una réplica digital del espirógrafo desarrollada por el ingeniero canadiense Nathan Friend.

“Kate conocía a todos los tenderos y se llevaba bien con ellos. La verdulería la llevaban Eric y su mujer Mavis. No tenían hijos, pero eran amables con Kate y todas las navidades le compraban un regalo con el que –era increíble– siempre daban en el clavo. El año pasado le habían comprado un espirógrafo, y Kate lo había utilizado para confeccionar un logotipo para sus tarjetas de visita.”

[Katherine O Flynn, Lo que perdimos, Alfaguara, 2009]

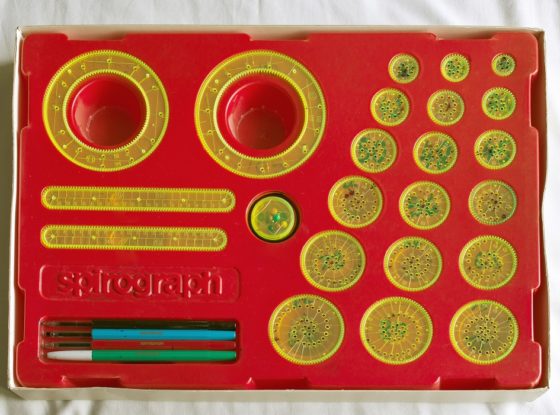

El espirógrafo es un juguete con el que dibujar diseños geométricos que consisten en curvas cíclicas, en concreto, las curvas conocidas con los nombres de hipotrocoides (como los primeros dibujos que hemos trazado) y epitrocoides (como los segundos dibujos), que describiremos matemáticamente más adelante. Este juguete consiste en una serie de engranajes o ruedas dentadas –círculos o coronas circulares en la versión original y más sencilla, pero con formas más complejas en la actualidad–, de tal forma que al girar una rueda dentada sobre la otra, que permanece fija, se producen los diseños geométricos. El dibujo se realiza con un lápiz o rotulador cuya punta se coloca en uno de los agujeros que tiene el interior de la rueda dentada que se hace girar. La rueda dentada fija puede ser tanto una corona circular dentada, de forma que se puede girar la otra rueda dentada tanto por el exterior (generando las curvas epitrocoides), como por el interior (generando las curvas hipotrocoides), de las que solía haber dos en el juego, o un círculo dentado de diferentes tamaños sobre el que solo se puede hacer girar la otra por el exterior (generando hipotrocoides).

Versión del juguete espirógrafo fabricada por Palitoy y vendida en Gran Bretaña en la década de los años 1980. Imagen: Multicherry / Wikimedia Commons

Versión del juguete espirógrafo fabricada por Palitoy y vendida en Gran Bretaña en la década de los años 1980. Imagen: Multicherry / Wikimedia Commons

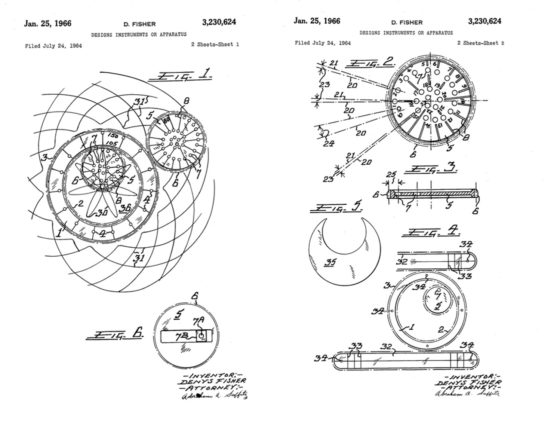

El espirógrafo fue creado por el ingeniero británico Denys Fisher (1918-2002) en los primeros años de la década de 1960. Animado por su familia y amigos, el ingeniero británico fundó Denys Fisher Toys (que en 1970 compraría la empresa Palitoy, la cual acabaría formando parte de Hasbro en 1991) y empezó a comercializar el juguete. Se presentó en la Feria Internacional de Juguetes de Nurenberg en 1965 y fue declarado juguete británico del año en 1967. Fue patentado en 16 países. La siguiente imagen es de la patente de 1966 en Estados Unidos.

Imágenes pertenecientes a la patente en EEUU del espirógrafo de Denys Fisher, US32230624

Imágenes pertenecientes a la patente en EEUU del espirógrafo de Denys Fisher, US32230624

El juego fue todo un éxito. Además, evolucionó rápidamente incluyendo engranajes de formas variadas, que permitían diseños geométricos cada vez más sofisticados y originales. En 2013 la compañía de juguetes Kahootz relanzó el espirógrafo y ganó varios premios, como el Astra Best Toys for Kids de 2013, así mismo fue finalista a juguete del año en 2014.

Pero mencionemos algunos antecedentes de la creación del ingeniero británico Denys Fisher. En 1827 el ingeniero y arquitecto británico Peter Hubert Desvignes (1804-1883) diseñó un mecanismo que llamó “speiragraph” y que servía para dibujar complejas curvas de tipo espiral. El objetivo de este mecanismo era crear diseños que ayudasen a evitar las falsificaciones de los billetes.

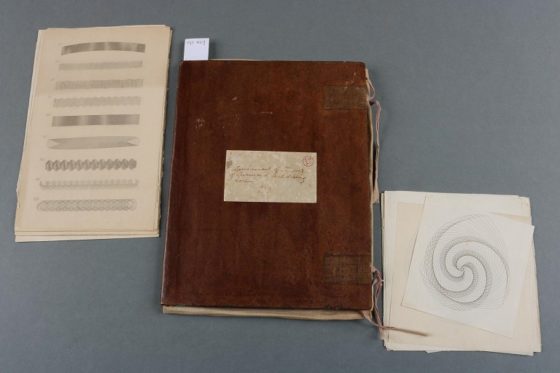

Carpeta con 26 hojas de papel que contienen dibujos realizados con el “speiragraph” de Peter Hubert Desvignes, perteneciente al Science Museum Group. A la izquierda se observa una hoja con una serie de dibujos horizontales de curvas de tipo espiral, mientras que a la derecha hay una hoja con un dibujo de tipo circular de una curva espiral

Carpeta con 26 hojas de papel que contienen dibujos realizados con el “speiragraph” de Peter Hubert Desvignes, perteneciente al Science Museum Group. A la izquierda se observa una hoja con una serie de dibujos horizontales de curvas de tipo espiral, mientras que a la derecha hay una hoja con un dibujo de tipo circular de una curva espiral

El matemático, ingeniero eléctrico e inventor polaco Bruno Abakanowicz (1852-1900), quien inventaría mecanismos como el intégrafo, para representar la integral de una función definida gráficamente, y el parabológrafo, para trazar parábolas, inventó otro mecanismo con el nombre de “spirograh” (espirógrafo), entre 1881 y 1900, que también debía trazar curvas de tipo espiral (spiro + graph), aunque no he podido encontrar ninguna referencia directa del mismo.

El primer juguete precursor del espirógrafo fue el llamado “The Marvelous Wondergraph” con el que realizar diseños geométricos de curvas espirales, pero que pasó bastante desapercibido. En la publicación The Boy Mechanic apareció en 1913 un artículo explicando cómo construir tu propio wandergraph.

Juguete The Marvelous Wondergraph, perteneciente al The Children’s Museum of Indianapolis

Juguete The Marvelous Wondergraph, perteneciente al The Children’s Museum of Indianapolis

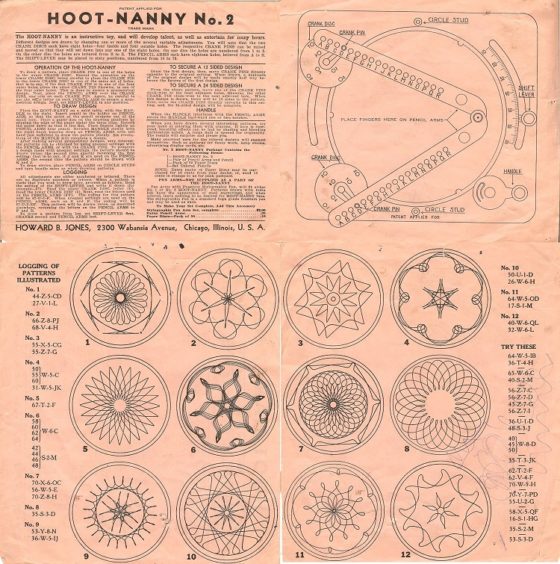

En la década de los años 1930 se comercializó otro juguete para trazar diseños geométricos de curvas, llamado “Hoot-Nanny, The Magic Desiner”, que tuvo más éxito que el anterior y se vendió hasta la década de los años 1950. En la siguiente imagen vemos las instrucciones originales del juguete, con algunas de las curvas que podían trazarse con el mismo. Además, hay un simulador en la red del Hoot-Nanny, con el que podéis divertiros trazando curvas curiosas.

Instrucciones originales del juguete Hoot-Nanny

Instrucciones originales del juguete Hoot-Nanny

Aunque el juguete espirógrafo del ingeniero británico Denys Fisher fue el que más éxito alcanzó, quizás por la sencillez de su diseño y su manejo, por lo que también trazaba curvas más sencillas, o tal vez porque en los años 60 la sociedad estaba más abierta a este tipo de imágenes geométricas, ya que era el tiempo de la psicodelia y del arte pop.

Diseños geométricos realizados con el espirógrafo digital Inspirograph

Diseños geométricos realizados con el espirógrafo digital Inspirograph

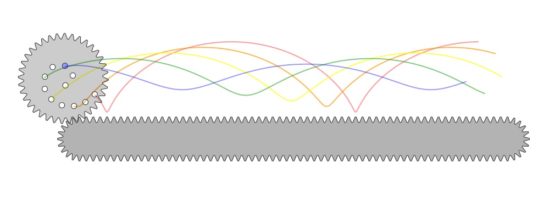

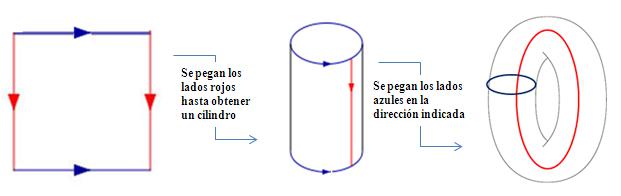

Pero vayamos a las curvas geométricas que dibuja el espirógrafo, las hipotrocoides y epitrocoides, que son dos tipos particulares de curvas cíclicas o “ruletas”. Las curvas cíclicas son las curvas planas descritas por la trayectoria de un punto que pertenece a una curva plana (o relacionado con ella) que rueda, sin deslizarse, sobre otra curva plana. A la familia de las curvas cíclicas pertenecen la cicloide, las trocoides, las epicicloides, las hipocicloides, epitrocoides, hipotrocoides y las involutas.

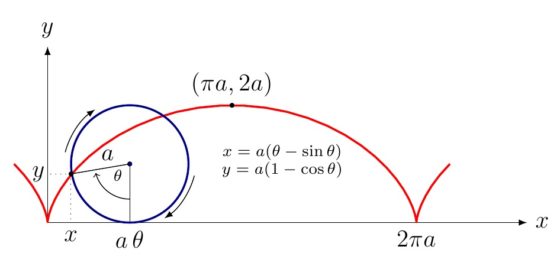

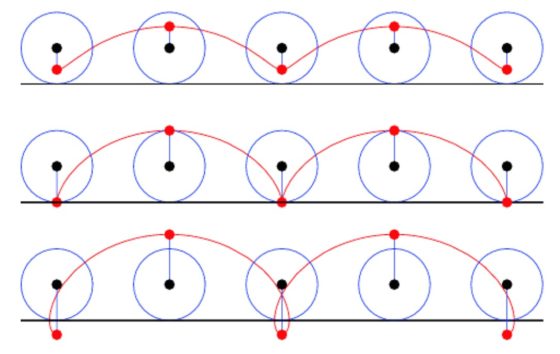

La cicloide es la curva que describe un punto que está en el borde de una rueda circular, es decir, el punto de una circunferencia, que rueda, sin deslizarse, a lo largo de una recta.

Imagen de una de los arcos de la curva cicloide, en rojo, generada por un punto de la circunferencia –azul– que gira, sin deslizarse, sobre la recta horizontal – eje x del plano coordenado–. Imagen de Herman Jaramillo para la web StakExchange

Imagen de una de los arcos de la curva cicloide, en rojo, generada por un punto de la circunferencia –azul– que gira, sin deslizarse, sobre la recta horizontal – eje x del plano coordenado–. Imagen de Herman Jaramillo para la web StakExchange

Esta curva, como las demás que se citan aquí, ya era conocida en la antigüedad, pero fue ampliamente estudiada en el siglo XVII por grandes matemáticos como el francés Marin Mersenne (1588-1648), quien dio la primera definición matemática precisa, el italiano Galileo Galilei (1564-1642), quien estudió la curva durante cuarenta años y a quien le debemos su nombre (que viene de las palabras griegas kuklos, de la que deriva ciclo y que significa círculo, y eidos, que significa forma o imagen), el francés Gilles de Roverbal (1602-1675), quien calculó el área debajo de la curva, el italiano Evangelista Torricelli (1607-1647), Blaise Pascal (1623-1662), que tiene una curiosa relación con la cicloide (puede leerse en la entrada Blaise Pascal, Dios y la cicloide), Christiaan Huygens (1629-1695), quien descubriría que la cicloide es la curva tautócrona, es decir, aquella para la cual el tiempo que tarda una bola en recorrer la cicloide invertida, sin deslizamiento, hasta llegar al punto más bajo de la curva es independiente de la altura desde la que se dejó caer la bola, y utilizó esta propiedad para construir el péndulo cicloidal, el francés Girard Desargues (1591-1661), el matemático alemán Gottfried Wilhelm Leibniz (1646-1716), o el matemático suizo Johann Bernoulli (1667-1748), quien descubrió que la cicloide era la curva braquistócrona, es decir, la curva de recorrido más rápido de una bola que se desplaza de un punto a otro más bajo por el efecto de la gravedad, entre muchos otros.

Experimento del Technoseum, Mannheim, Alemania, demostrando que la cicloide es la curva braquistócrona, de los cuatro caminos que unen la parte superior con la inferior, el que tiene la forma de cicloide es el más rápido, es decir, el camino por el cual la bola llega antes a su destino

Experimento del Technoseum, Mannheim, Alemania, demostrando que la cicloide es la curva braquistócrona, de los cuatro caminos que unen la parte superior con la inferior, el que tiene la forma de cicloide es el más rápido, es decir, el camino por el cual la bola llega antes a su destino

Una cita literaria conocida en la que se menciona a la cicloide y su condición de curva tautócrona es Moby Dick (1851), del escritor estadounidense Hermann Melville (1819-1891):

Algunos marineros viejos y cínicos acostumbran, durante las guardias de noche, introducirse en ellas [las dos ollas de la refinería del barco] y enrollarse en su interior para dormir un rato. Mientras están dedicados a la tarea de lustrarlas –un hombre en cada olla, hombro con hombro– se transmiten muchas comunicaciones confidenciales, por encima de los labios de hierro. El sitio es propicio, también, para la meditación matemática profunda. En la olla izquierda del Pequod, mientras hacía circular dirigentemente la esteatita frente a mí, me sorprendió indirectamente el hecho notable de que en geometría todos los cuerpos que se deslizan en el cicloide, mi esteatita por ejemplo, descienden de cualquier punto exactamente en el mismo tiempo.

Por otra parte, se denomina curva trocoide a la curva que describe un punto conectado con una rueda circular, ya sea porque pertenece al interior de la misma, a su circunferencia o siendo exterior al círculo está conectado con este, que rueda, sin deslizarse, sobre una línea recta. Por lo tanto, la cicloide es una curva trocoide (término que viene de las palabras griegas trhokos, que significa rueda, y eidos, que significa forma o imagen) en la que el punto está sobre la circunferencia de la rueda circular. Si el punto es interior se habla de cicloide reducida y si es exterior de cicloide alargada.

Imagen de los tres tipos de curvas trocoides, la cicloide reducida, la cicloide y la cicloide alargada. Imagen de Wolgram MathWorld

Imagen de los tres tipos de curvas trocoides, la cicloide reducida, la cicloide y la cicloide alargada. Imagen de Wolgram MathWorld

En el espirógrafo clásico hay dos piezas muy alargadas de forma que la parte central es recta, por lo cual, al girar una de las ruedas dentadas por esta parte se obtiene una cicloide reducida.

Diferentes cicloides reducidas obtenidas trabajando con una de las piezas alargadas y una rueda dentada en el espirógrafo digital Inspirograph

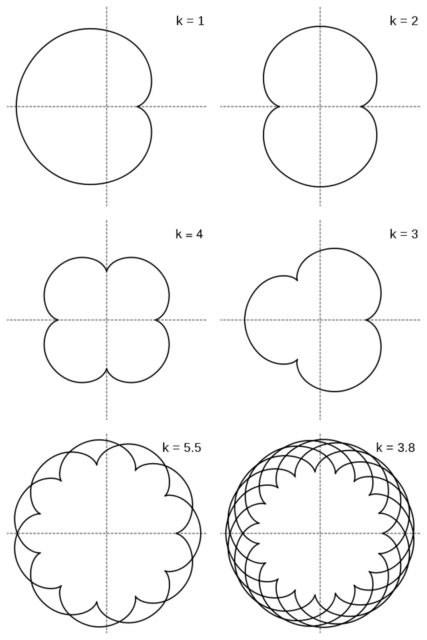

Diferentes cicloides reducidas obtenidas trabajando con una de las piezas alargadas y una rueda dentada en el espirógrafo digital InspirographLa curva epicicloide es la trayectoria de un punto de una circunferencia que rueda, sin deslizarse, por el exterior de una circunferencia fija. En función de la relación que existe entre los radios de ambas circunferencias se obtendrán diferentes curvas. Por ejemplo, si ambos radios son iguales se obtiene una cardioide, si el radio de la circunferencia que rueda es la mitad (1/2) del radio de la rueda fija, la curva es una nefroide.

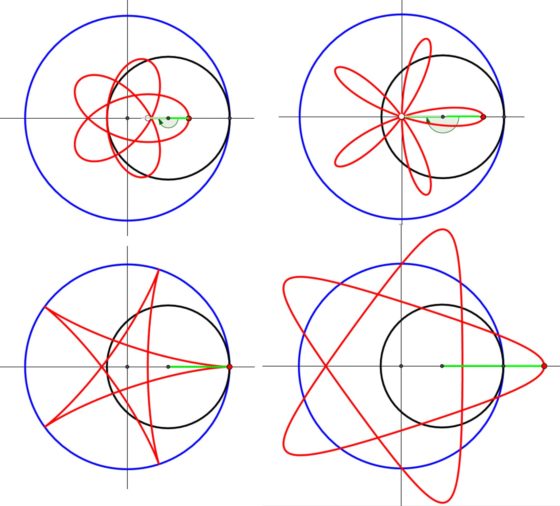

Algunos ejemplos de epicicloides en función de la proporción entre los radios de ambas circunferencias, que incluyen a la cardioide y la nefroide, los dos primeros ejemplos. Imagen de Wikimedia Commons

Algunos ejemplos de epicicloides en función de la proporción entre los radios de ambas circunferencias, que incluyen a la cardioide y la nefroide, los dos primeros ejemplos. Imagen de Wikimedia Commons

Por otra parte, si la circunferencia que rueda lo hace por el interior de la cincunferencia fija la curva que se obtiene es una hipocicloide. Si la relación entre los radios de las circunferencias pequeña –la que rueda– y grande –la que esta fija– es 1/3 se obtiene la curva denominada deltoide, si es 1/4 la curva generada es una astroide y de nuevo en función de esa relación se obtienen diferentes curvas.

Algunos ejemplos de hipocicloides en función de la proporción entre los radios de ambas circunferencias, que incluyen a la deltoide y la astroide, los dos primeros ejemplos. Imagen de Wikimedia Commons

Algunos ejemplos de hipocicloides en función de la proporción entre los radios de ambas circunferencias, que incluyen a la deltoide y la astroide, los dos primeros ejemplos. Imagen de Wikimedia Commons

No hemos mencionado intencionadamente cual es la curva que se obtiene cuando la relación entre los radios de ambas circunferencias es 1/2, ya que esta es una recta, conocida con el nombre de “línea de La Hire”, y que es una forma de obtener un movimiento lineal a partir de un movimiento circular. Como se ve en la siguiente imagen, cuando la circunferencia móvil recorre la mitad del camino, el punto de la circunferencia que gira (color crema en la imagen) recorre el diámetro de la circunferencia fija, y lo vuelve a recorrer en la otra mitad del giro.

En la antigüedad la humanidad pensaba que la circunferencia era una figura geométrica perfecta, relacionada con lo divino, por lo que postularon que el movimiento de los planetas era circular alrededor de la Tierra. Dos de los grandes defensores de este modelo fueron Aristóteles (384–322 a.n.e) y Claudio Ptolomeo (aprox. 100-170). Sin embargo, muchos pensadores postularon que el Sol era el centro natural –el primero en proponerlo fue Aristarco de Samos (aprox. 310-230 a.n.e.)– y se dieron cuenta de que entonces, según las observaciones astronómicas, el movimiento de los planetas alrededor del Sol no podía ser circular. Por lo tanto, introdujeron las curvas epicicloides e hipocicloides para producir curvas que se adaptaran al movimiento observado de los planetas. Y como estos tampoco acababan de describir perfectamente los movimientos, empezaron a introducir curvas más complejas relacionadas con las anteriores. Las dos teorías sobre el movimiento de los planetas, circular o mediante curvas derivadas de epicicloides e hipociclodides, fueron rivales hasta que Johannes Kepler (1571-1630) demostró, a partir de las observaciones de Tycho Brahe (1546-1601), que la órbita de Marte era elíptica, con el Sol en uno de sus focos. Posteriormente, Isaac Newton (1643-1727) demostraría matemáticamente que la órbita de un cuerpo alrededor de un campo gravitatorio son secciones de cónicas.

El estudio de las epicicloides e hipocicloides se reinició en el Renacimiento. Estas curvas fueron estudiadas por Alberto Durero (1471-1528), Girard Desargues, Christian Huygens, Gottfried Wilhelm Leibniz, Isaac Newton, Jacob Bernoulli (1654-1705), Phillipe de La Hire (1640-1718), Johann Bernoulli, Daniel Bernoulli (1700-1782) o Leonhard Euler (1707-1783), que también estudiarían las siguientes curvas que vamos a mostrar en esta entrada del Cuaderno de Cultura Científica.

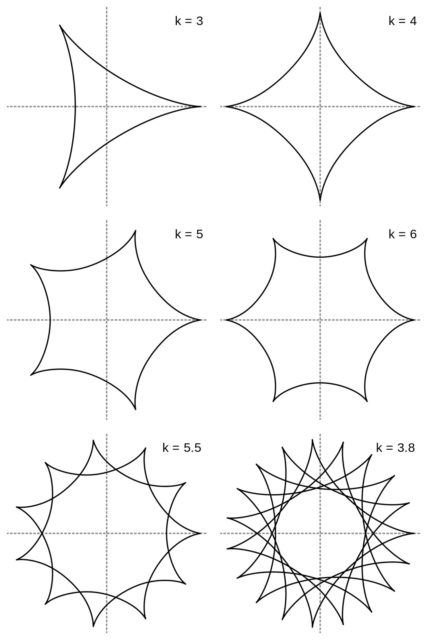

Las últimas curvas cíclicas que vamos a mostrar aquí son las generadas por el espirógrafo clásico, las epitrocoides e hipotrocoides. Una curva epitrocoide es la trayectoria que describe un punto, conectado a un círculo que rueda, sin deslizamiento, sobre el exterior de una circunferencia fija. Si el punto está en el interior del círculo que rueda se obtiene una epitrocoide como algunas de las obtenidas en el espirógrafo clásico (primera curva de la siguiente imagen), si el punto está en la circunferencia es una epicicloide (segunda curva de la imagen), mientras que si el punto es exterior al círculo que rueda (que podemos considerar conectado al centro por un segmento fijo para que ruede con el círculo) se obtiene una epitrocoide que podemos dibujar fácilmente con el ordenador, pero no con el espirógrafo clásico (tercera curva de la imagen).

Tres curvas epitrocoides en las que varía que el punto que describe la curva esté en el interior del círculo que rueda, en su circunferencia o en el exterior. Imagen obtenida del GeoGebra, de la página web GeoGebra Tutorial Movie Bank

Tres curvas epitrocoides en las que varía que el punto que describe la curva esté en el interior del círculo que rueda, en su circunferencia o en el exterior. Imagen obtenida del GeoGebra, de la página web GeoGebra Tutorial Movie Bank

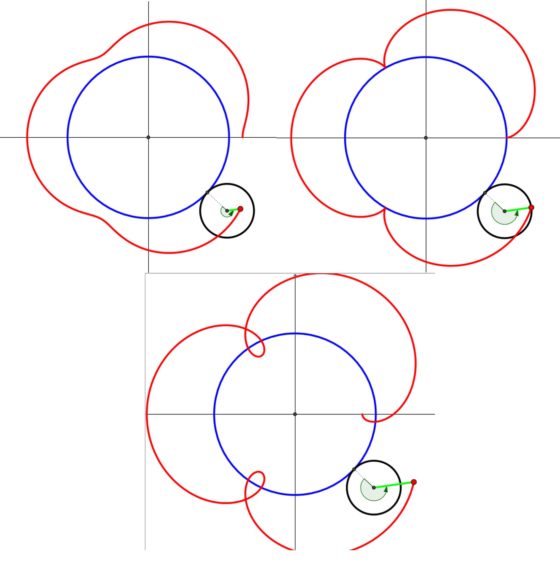

En la siguiente imagen podemos ver una epitrocoide dibujada con el espirógrafo clásico, con una rueda dentada rodando alrededor de otra rueda dentada fija.

Epitrocoide realizada con el espirógrafo digital Inspirograph, en la que hemos dejado las ruedas dentadas para comprobar que es una epitrocoide, obtenida al hacer rodar una rueda dentada –la pequeña en la imagen– alrededor de una rueda dentada fija –la grande en la imagen–

Epitrocoide realizada con el espirógrafo digital Inspirograph, en la que hemos dejado las ruedas dentadas para comprobar que es una epitrocoide, obtenida al hacer rodar una rueda dentada –la pequeña en la imagen– alrededor de una rueda dentada fija –la grande en la imagen–

Mientras que una curva hipotrocoide es la trayectoria que describe un punto, conectado a un círculo que rueda, sin deslizamiento, sobre el interior de una circunferencia fija. De nuevo el punto conectado al círculo que rueda puede ser interior, de la circunferencia o exterior.

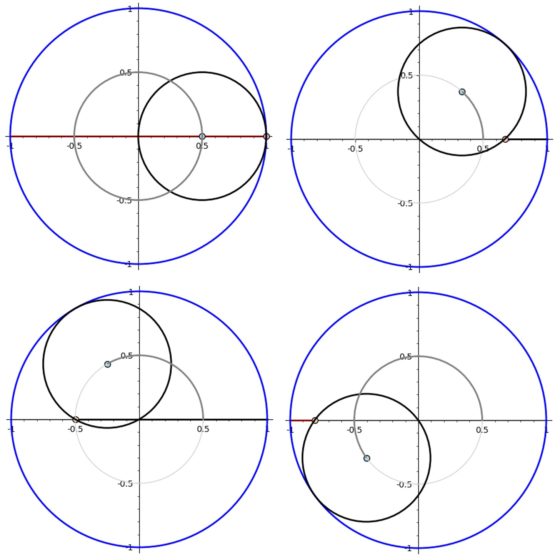

Cuatro curvas hipotrocoides en las que varía que el punto que describe la curva esté en el interior del círculo que rueda (las dos primeras), en su circunferencia o en el exterior. Imagen obtenida del GeoGebra, de la página web GeoGebra Tutorial Movie Bank

Cuatro curvas hipotrocoides en las que varía que el punto que describe la curva esté en el interior del círculo que rueda (las dos primeras), en su circunferencia o en el exterior. Imagen obtenida del GeoGebra, de la página web GeoGebra Tutorial Movie Bank

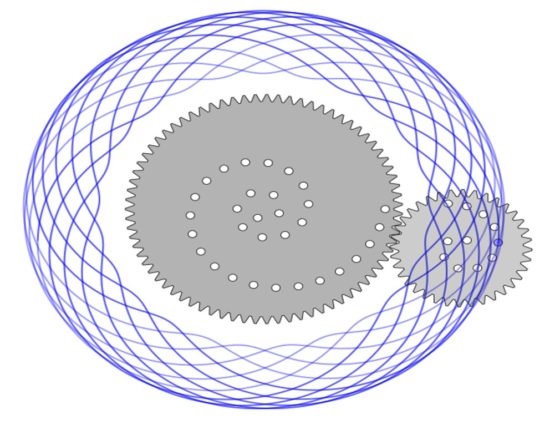

De la misma forma que antes, podemos ver una hipotrocoide dibujada con el espirógrafo clásico, con una rueda dentada rodando en el interior de una corona circular dentada fija.

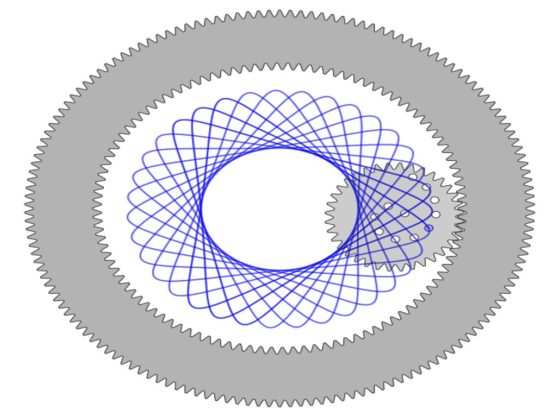

Hipotrocoide realizada con el espirógrafo digital Inspirograph, en la que hemos dejado las ruedas dentadas para comprobar que es una hipotrocoide, obtenida al hacer rodar una rueda dentada –la pequeña del interior en la imagen– en el interior de una corona circular dentada fija –la grande alrededor de la pequeña en la imagen–

Hipotrocoide realizada con el espirógrafo digital Inspirograph, en la que hemos dejado las ruedas dentadas para comprobar que es una hipotrocoide, obtenida al hacer rodar una rueda dentada –la pequeña del interior en la imagen– en el interior de una corona circular dentada fija –la grande alrededor de la pequeña en la imagen–

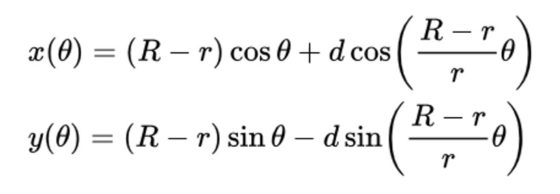

Un ejercicio bonito, relacionado con todas estas curvas cíclicas, es la obtención de las ecuaciones paramétricas de las mismas. Por ejemplo, las ecuaciones paramétricas de las hipotrocoides son:

donde R es el radio de la circunferencia fija exterior, r el radio del círculo interior que rueda y d la distancia al centro del círculo que gira del punto cuya trayectoria estamos considerando (que describe la hipotrocoide). Sin embargo, no lo resolveremos en esta entrada, lo dejaremos para aquellas personas a las que les apetezca enfrentarse al mismo.

Para terminar, mencionaremos que también existen artistas contemporáneos, como ocurrió con Alan Moore y James H. Williams III, autores del cómic Promethea, que han quedado fascinados por la belleza de los diseños de las curvas cíclicas generadas con el espirógrafo. Un ejemplo es la artista estadounidense Robin P. Schlacter, quien utiliza hipotrocoides en muchas de sus obras.

Robin P. Schlacter, Casting Pearls (2013). Imagen de la página web de Robin Schlacter

Robin P. Schlacter, Casting Pearls (2013). Imagen de la página web de Robin Schlacter

Bibliografía

1.- Wikipedia: Spirograph .

2.- Wolfram Mathworld: Spirograph

3.- Nathan Friend, Inspirograph

4.- Toy tales: Spirograph

5.- J. Dennis Lawrence, A catalog of special plane curves, Dover Publications, 1972.

6.- José Manuel Álvarez Pérez, Curvas en la historia 1 y 2, Nivola, 2006.

7.- Wikipedia: Hypotrochoid

8.- Wikipedia: Epitrochoid

9.- Raúl Ibáñez, Construcción de curvas planas, Un paseo por la Geometría 1997/1998.

10. Página web de la artista Robin P. Schlacter.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Las curvas del espirógrafo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La materia oscura auto-interactuante y las curvas de rotación de las galaxias

- Un dulce problema de Paul Erdös

- Construye tu propia calculadora de sumas y restas

El carácter fundamental de las relaciones de incertidumbre

Foto: Franck V / Unsplash

Foto: Franck V / UnsplashEl principio de incertidumbre y las relaciones de incertidumbre resultantes son válidas para cualquier objeto, incluso para un automóvil. Pero las limitaciones que impone el principio de incertidumbre no tienen consecuencias prácticas para objetos tan con tanta masa como coches o pelotas de béisbol que se mueven a velocidades normales para nuestra experiencia humana diaria. Esto se debe a que los valores de incertidumbre involucrados son demasiado pequeños como para ser percibidos. Las limitaciones se hacen evidentes e importantes solo a escala atómica.

Debido a esta discrepancia entre lo que ocurre en el día a día humano y lo atómico es muy importante comprender que las incertidumbres que establece el principio de Heisenberg no son debidas a un defecto del experimentador ni de los instrumentos que usa. Esto debe quedar diáfanamente claro [1]: Nunca, jamás, podremos construir instrumentos para sortear las incertidumbres recíprocas en las mediciones impuestas por las relaciones de incertidumbre.

Esto se debe a que las relaciones de incertidumbre de Heisenberg son una consecuencia directa de la mecánica cuántica y la dualidad onda-partícula. Pero su validez no está completamente ligada a la de la mecánica cuántica. Efectivamente, la mecánica cuántica podría ser sustituida por otro modelo para describir la realidad cuántica [2] y las relaciones de incertidumbre, que emanan de la existencia misma de los cuantos, son más fundamentales que la propia mecánica cuántica.

Desarrollemos esto mínimamente.

Hemos visto el papel que juega la constante h de Planck en la definición del cuanto de luz y en la descripción de los estados estacionarios en el átomo de Bohr. Además, la constante h aparece en las dos ecuaciones básicas para la energía y el momento lineal del fotón, E = hf y p = h/λ, y también en muchas otras ecuaciones cuánticas. También aparece en las relaciones de incertidumbre. Si h fuera 0, eso significaría que la cantidad de energía sería cero, por lo que no habría cuantos de luz, solo ondas continuas.

El momento lineal del fotón también sería cero, y las relaciones de incertidumbre serían Δx·Δpx = 0 o Δt· ΔE = 0 [3]. Por tanto no habría incertidumbres recíprocas en posición y momento, tiempo y energía, y podríamos medir simultáneamente las características de onda y corpúsculo de los objetos cuánticos sin ningún problema.

Pero aunque sea muy pequeña, la constante de Planck no es cero [4], el cuanto existe, nos enfrentamos a la dualidad onda-partícula, la mecánica cuántica sigue siendo un modelo aceptado, y la naturaleza es tal que limita la precisión de nuestras mediciones a escala atómica al nivel más fundamental.

Notas:

[1] Lo que sigue es el tipo de afirmación categórica que los relativistas y postmodernistas varios que en el mundo son prejuzgan como prepotencia de la ciencia. Su postura, como decimos prejuiciosa, se basa en supuestos y asunciones filosóficas, sin contraste con la realidad física. Es este contraste continuo con la realidad el que permite a la ciencia afirmar cosas como esta en estos términos. Los posmodernos optan por la ignorancia. Son indiscernibles de una persona religiosa, a saber, tratan sus afirmaciones como no falsables.

[2] Recordemos: la mecánica cuántica es un modelo teórico para describir los resultados de los experimentos. La realidad de los cuantos es experimental. Podrá cambiar la teoría, pero los hechos son tozudos.

[3] Hay muchísimas relaciones de incertidumbre. Nosotros, para lo que nos interesa, con estas dos para ilustrarlas nos basta y nos sobra.

[4] Su valor está fijado, por ser una de las constantes fundamentales de la naturaleza, desde 2019: 6,62607015·10−34 J·s. El kilogramo se define en función de este valor de h.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El carácter fundamental de las relaciones de incertidumbre se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de incertidumbre, cuantitativamente

- El principio de incertidumbre, cualitativamente

- Construyendo la mecánica cuántica

El fraude y las malas prácticas en ciencia

Fraude y malas prácticas ha habido desde hace mucho tiempo. Hay documentados multitud de casos, incluso entre los científicos más famosos. Hay fundadas sospechas de que Ptolomeo hizo pasar por suyos datos astronómicos que en realidad eran de Aristarco de Samos. Recientemente ha ingresado en prisión Dong-Pyou Han, un investigador en vacunas, condenado por inventar datos en experimentos sobre la vacuna contra el VIH. Los casi 2000 años que separan estos sucesos han estado salpicados de otros muchos casos. Parece ser que Millikan eliminaba de su cuaderno de laboratorio las observaciones que no le interesaban, Mendel y sus guisantes también han resultado polémicos, incluso hay dudas sobre si Galileo realizó realmente los experimentos que relata en sus textos. Hay casos clásicos, como el del hombre de Pitdown, un fósil que se hizo pasar por el eslabón perdido en la evolución entre el hombre y el mono cuando realmente era un engendro creado con trozos de cráneo humano y de chimpancé. Hay multitud de casos bien documentados y diversas compilaciones, como la recientemente publicada por Ángel Abril-Ruiz que, además, se puede consultar en línea.

Resulta especialmente escandaloso oír hablar de fraude en una profesión dedicada fundamentalmente a la búsqueda de la verdad. Ese escándalo ayuda a hacerse un modelo mental de la situación en el que la inmensa mayoría de los científicos son “normales” (totalmente honrados) y una pequeña fracción son “manzanas podridas” (totalmente deshonestos). Sin embargo la realidad dista bastante de este modelo. Según algunos estudios (Fanelli (2009) y resumidas también por uno de nosotros en 2015, aquí), más de dos tercios de los científicos admite realizar algún tipo de malas prácticas y uno de cada 50 admite falsificar o inventar resultados, una de las peores prácticas imaginables. Es interesante notar que cuando se pregunta por las malas prácticas que uno conoce de los compañeros los números salen bastante más altos que cuando se pregunta por las propias.

Fischer y Zigmond (2002) incluyen entre las prácticas abiertamente fraudulentas la fabricación o falsificación de datos, el plagio, y lo que podríamos denominar el cocinado de datos (selección, manipulación y manejo). Pero también consideran como malas prácticas otras formas de proceder entre las que se encuentran lo que denominan –un tanto eufemísticamente- autoría honoraria, el no reconocimiento expreso de las fuentes, la opacidad en la metodología, la publicación fragmentada y la publicación duplicada de los mismos resultados en diferentes artículos. E incluyen malos comportamientos no solo de los autores de los trabajos, sino también de los revisores; entre estas están las revisiones sesgadas de los originales remitidos para su publicación y el uso de información privilegiada tomada de esos originales, entre otros.

De mala práctica debe ser calificada también la pesca de datos o p-hacking. Consiste en ir seleccionando datos o combinaciones de datos hasta que se acaba consiguiendo que los análisis estadísticos arrojen el resultado buscado porque los efectos que interesa destacar alcanzan el nivel de significación estadístico preestablecido. La significación estadística de un efecto se establece sobre la base del valor de p, que normalmente se establece en 0.05. En otras palabras, se considera que se produce un determinado efecto si, asumiendo la hipótesis nula, la probabilidad de obtener los datos que se tienen es inferior al 5%. Las malas prácticas consisten en descartar valores extremos por ser considerados anómalos; también se pueden agrupar de formas diferentes; o modificar el tipo de tratamiento estadístico. Una vez se alcanza el resultado “deseado”, ese es el que se publica. Judith Rich Harris, en su libro The Nurture Hypothesis ha diseccionado de forma brillante un buen número de estas prácticas que han servido para “demostrar” que la educación que proporcionan los padres a sus hijos en el hogar ejerce efectos duraderos sobre el comportamiento de estos en la vida adulta.

Podríamos ordenar un listado de prácticas cuestionables de las más graves a las que apenas suponen un problema. Entre estas últimas tendríamos cuestiones como la autoría honoraria, la opacidad metodológica o el plagio de una frase. Es a la luz de una escala de gravedad de las malas prácticas como pueden entenderse los datos de los estudios antes citados sobre la prevalencia del fraude. Muchos científicos, si no todos, podemos incurrir en malas prácticas de bajo nivel, siendo mucho menos frecuentes las prácticas moralmente más reprobables. En todo caso, cada científico deberá situar sobre una escala de prácticas cuestionables el nivel con el que se siente cómodo, el umbral de lo aceptable. Mientras ese umbral se mantenga dentro de unos márgenes socialmente aceptables, no denominamos propiamente fraude a esas prácticas. Lo que se considera opacidad metodológica, el nivel de lo estadísticamente significativo o el tamaño mínimo de una muestra, por poner algunos ejemplos concretos, son elementos convencionales que pueden variar con el tiempo, y lo que se considerarían niveles intolerables en el pasado pueden ser normales hoy (o viceversa).

Federico di Trochio (1993) estableció dos categorías de fraude, dos motivaciones muy diferentes para que un científico incurra en comportamientos mucho más allá del umbral de lo socialmente aceptable. Curiosamente, se trata de dos categorías provocadas por motivaciones que casi se podrían calificar de opuestas pero que no es extraño que concurran en los miembros de una misma comunidad. Como se ha señalado antes, a quienes nos dedicamos a la ciencia nos mueve el ánimo de ensanchar los límites del conocimiento, de descubrir nuevos hechos y de asignar a esas hechos explicaciones que les otorguen algún sentido; nos hacemos preguntas y aspiramos a responderlas, de una forma tal que las respuestas son el origen de nuevas preguntas. Pues bien, inmersos en esa dialéctica no es difícil anteponer el hallazgo de una “buena” respuesta, de una “buena” explicación o “buena” teoría al cumplimiento de los necesarios estándares de rigor. Cuando eso ocurre se abre una vía por la que no es difícil llegar cada vez más lejos, pues la tolerancia para con las trampas que hace uno mismo es mayor cuantas más hace. Es pues la obnubilación por lo que se cree una buena teoría lo que causa en última instancia esta categoría de fraude. Otro posible resultado de esa obnubilación por el propio resultado es la perseveración empecinada en el mismo incluso cuando las pruebas en su contra son ya clamorosas. A esto se le ha llamado “ciencia patológica” y se describirá en detalle más adelante.

La segunda modalidad se refiere al hecho de que la de científico es una profesión, y como tal dispone de los correspondientes sistemas de acceso, estabilización laboral y promoción. Se trata, además, de una profesión muy exigente en muchos casos, pues la necesidad de obtener resultados y de publicarlos puede llegar a ser muy acuciante. A esa necesidad obedece la expresión “publicar o perecer”, y ante esa perspectiva se puede flaquear y relajar los estándares éticos llegando al fraude en toda regla.

En resumen, en vez de asumir un modelo de manzanas podridas para el fraude, la idea de una gradación de comportamientos cuestionables y un umbral de lo aceptable (socialmente establecido) resulta más adecuada y ayuda a entender los datos sobre incidencia de malas prácticas que muestran los diferentes estudios.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo El fraude y las malas prácticas en ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fraude científico (III). Profundizando en los dos tipos de fraude

- Fraude científico (II). La difusa frontera de la deshonestidad

- #Naukas13 Malas gráficas

Genocidio

Genocidio: “Exterminio o eliminación sistemática de un grupo por motivos de raza, etnia, religión, política o cionalidad».

Diccionario de la lengua española / RAE.

“El Nacionalsocialismo no es otra cosa que Biología Aplicada”.

Rudolf Franz Ferdinand Höss, comandante de Auschwitz.

Fotos de las fichas de niños judíos en Auschwitz. Fuente: DeAgostini / Getty Images vía history.com

Fotos de las fichas de niños judíos en Auschwitz. Fuente: DeAgostini / Getty Images vía history.comEl genocidio, como concepto, definición y delito, es una creación moderna, aunque los antecedentes han acompañado a nuestra especie en toda su historia evolutiva. El término lo utilizó por primera vez el jurista polaco Rafael Lemkin, y lo describió como un crimen de extermino. Tomó carácter oficial en los procesos de Nuremberg a los dirigentes nazis al terminar la Segunda Guerra Mundial. Aparece entre los delitos del acta de acusación de Nuremberg el 8 de octubre de 1945. Cuenta Manuel Ollé Sesé, de la Universidad Complutense, que el Convenio para la Prevención y Sanción del Delito de Genocidio se aprobó en la Asamblea General de las Naciones Unidas con fecha de 9 de diciembre de 1948, y entró en vigor el 12 de enero de 1951. El artículo 607 del Código Penal español establece que los delitos de genocidio tienen “el propósito de destruir total o parcialmente un grupo nacional, étnico, racial, religioso o determinado por la discapacidad de sus integrantes”, según Ley Orgánica aprobada el 23 de noviembre de 1995. Hay que recordar que un grupo, sean cuales sean las razones para que sea un grupo, tiene derecho a existir como una colectividad.

E s más, tal como escribió Hannah Arendt en su crónica sobre el juicio a Eichmann, “el genocidio es un ataque a la diversidad humana como tal, es decir, a una de las características de la “condición humana”, sin la cual los términos “humanidad” y “género humano” carecerían de sentido”. Llega a proponer, como término más adecuado que genocidio, que se denomine “matanza administrativa”.

El concepto de genocidio lo amplió el profesor Baruk, en 1967, cuando añadió que es la destrucción de “todo gen, de toda posibilidad de reproducción, de persistencia, de un pueblo”.

Según solicita Xaimán Aizenstadt, de la Universidad Francisco Marroquín de Guatemala, la definición de genocidio no se debe considerar cerrada sino que debe ser tan flexible e imaginativa como la capacidad humana para el mal.

Aunque el concepto, la definición y la jurisprudencia sobre genocidio comenzó después de la Segunda Guerra Mundial, la historia de nuestra especie está llena de genocidios. Sin entrar en detalles, centraremos el texto en el genocidio nazi, pero hay que recordar la destrucción de Cartago, los anasazi del suroeste del actual Estados Unidos, la cruzada albigense en la Francia del siglo XIII, el exterminio de los armenios al principio del siglo XX, las matanzas de Ruanda o Bosnia … Y, además, aún sin nombre ni concepto, la idea del genocidio viene de lejos en el tiempo y acompaña desde siempre nuestra historia. Y, también, la historia de la evolución biológica. Solo hay que recordar el título completo del libro de Charles Darwin: “Sobre el origen de la especies por medio de la selección natural, o la preservación de razas favorecidas en la lucha por la vida”.

La violación se reconoció como delito de genocidio en el Tribunal Internacional de Ruanda para hechos ocurridos en 1993 y 1994 contra refugiados tutsis. Todo acto de violencia sexual, incluyendo embarazos forzosos, pueden constituir genocidio cuando son cometidos con la intención de destruir un grupo nacional, étnico, racial o religioso.

El Tercer Reich fue un periodo en el que la violencia masiva organizada, a una escala inigualada en la historia moderna, se canalizó contra millones de seres humanos que, según la sociobiología nazi, eran política, racial, étnica y económicamente inferiores. Escribió Zygmunt Bauman que el genocidio nazi no fue un proceso bárbaro sino moderno y civilizado. Los nazis utilizaron muchos de los logros y herramientas de la era industrial –la fábrica, el tren, los productos químicos sintéticos y la organización administrativa de todo el proceso- con efectos letales, confiando en la ciencia moderna y la planificación racional, en la que todo se subordina a un único objetivo limitado y definido. Pelagia Lewinska, comunista polaca que estuvo internada en Auschwitz y sobrevivió, declaró años después que “no me queda otro remedio que admirar la habilidad con que los alemanes habían introducida en la organización de la vida del campo de Auschwitz la ciencia moderna. Habían aplicado no solo un sistema de condiciones materiales que aniquilaba a la gente, sino que empleaban también con precisión la psicología para desorganizar el alma humana, para destruir moralmente al ser racional”.

Los hombres corrientes de la Alemania nazi participaron en el genocidio porque creían que los judíos debían morir, que su aniquilación era socialmente deseable, que eran una raza inferior de infrahumanos. Para los ciudadanos corrientes, el exterminio de los judíos no era un crimen. Era la culminación del antisemitismo que existía desde hace siglos en Europa central.

Kurt Gerstein: El Espía de Dios

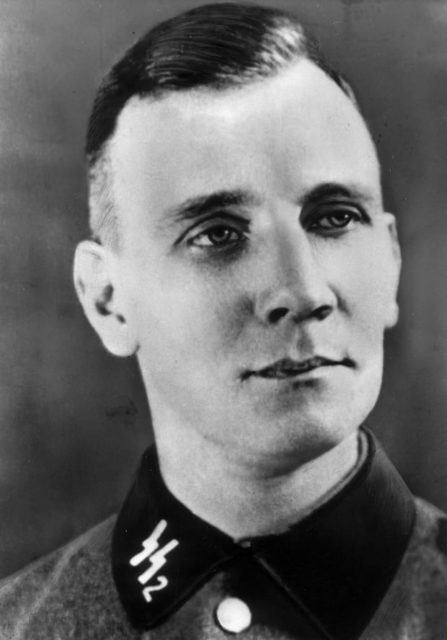

Kurt Gerstein. Fuente: history.com

Kurt Gerstein. Fuente: history.comNació en 1905 en Munster y murió en París en 1945. Ingeniero de minas, se afilió al Partido Nazi el 12 de mayo de 1933, y a las SS y fue destinado al Instituto de Higiene de las SS.

Por su preparación técnica fue destinado a la unidad encargada de la Solución Final y presenció las primeras ejecuciones con gas en agosto de 1942. Fue testigo del exterminio judío en los campos de Sobibor, Belzec y Treblinka y decidió transmitir la información de lo que ocurría a los aliados y a la Iglesia Católica. En Belzec, Gerstein vio morir a 5000 judíos en 1942. El texto que redactó, conocido como Informe Gerstein, fue utilizado en los juicios de Nuremberg. Por su profunda fe religiosa fue conocido como El Espía de Dios. Toda su vida, desde su afiliación al partido, fue una constante lucha entre su fe religiosa y su ideología nazi.

Protestó por la absorción de los movimientos juveniles protestantes en las Juventudes Hitlerianas. Lo hizo ante Baldur von Schirach, líder de las Juventudes, y Monseñor Müller, obispo protestante. En otra ocasión, en 1935, durante el estreno de una obra de teatro pronazi, y con un explícito mensaje anticristiano, protestó en el teatro y recibió una paliza que le costó tres dientes.

También tuvo algún enfrentamiento con las Gestapo por la organización de campamentos juveniles que mezclaban religión y nazismo. Por todo ello, en 1936 fue detenido y expulsado del Partido. Al comenzar la guerra, en 1940, se alistó voluntario en las SS.

Pasó información a diplomáticos a Suecia y Suiza, a la resistencia holandesa, autoridades religiosas e, incluso, intentó una entrevista con el Nuncio de la Santa Sede en Berlín y no lo consiguió. Nadie le creía por lo terrible de lo que contaba. Apuntaba todo lo que veía y sus notas fueron la base del Informe Gerstein.

Fue uno de los encargados de transportar el Zyklon B utilizado en las cámaras de gas. El Zyklon B lo suministraban a los campos de exterminio las empresas Degesch y Testa de I.G. Farben Konzern, y contenía ácido prúsico o ácido cianhídrico, componente esencial de insecticidas que fabricaba desde 1924. Para envenenar a una persona bastaban 0.12 miligramos por litro de aire. La muerte es casi instantánea.

En 1943, las empresas suministraron 12174,09 kilogramos y obtuvieron un beneficio de 127985,79 marcos. Se ha calculado que Gerstein, por su trabajo en el Servicio de Higiene, que incluía los gases tóxicos, suministró 3790 kilogramos de Zyklon B a los campos de Auschwitz y Oranienburg. Bastaban para matar a 450000 personas solo en Auschwitz.

Los crematorios de los campos de concentración los suministró la empresa J.A. Topf & Sohne, de Wiesbaden, que años después, el 5 de enero de 1953, obtuvo en la República Federal Alemana la patente nº 861731 para un “Procedimiento y dispositivo para la incineración de cuerpos, cadáveres y partes de los mismos”.

Desertó al final de la guerra y se entregó a los aliados el 22 de abril de 1945. Ingresó en la prisión de Cherche-Midi, en París, acusado del delito de genocidio. Apareció ahorcado en su celda el 25 de julio de 1945. En 1965 fue rehabilitado en Alemania como resistente por el Canciller Kurt Georg Kiesinger.

Y todo el esfuerzo, por lo menos en los primeros años del régimen nazi, fue contra judíos y gitanos. Ya en enero de 1939, meses antes del inicio de la Segunda Guerra Mundial, Hitler mencionó como objetivo “la destrucción de la raza judía en Europa”.

Más adelante, con la invasión de Rusia, se extendió a los eslavos. Las órdenes incluían ejecutar a los comisarios soviéticos.

De nuevo Pelagia Lewinska nos ofrece sus reflexiones cuando explica que, en Auschwitz, los alemanes “internaban a todos: a los que les parecían inútiles; a los que consideraban como un peso muerto en la obra creadora de la gran Alemania; a los que juzgaban peligrosos; a los que podían constituir una amenaza para el Estado hitleriano; o cuya muerte se hacía necesaria para proveer de oro al Tesoro alemán y procurar a los alemanes bienes y comodidades como era el caso de los judíos … Al lado de los detenidos políticos estaban gentes recogidas en la calle, en los cines, en las iglesias, en los cafés, en los trenes, en el mercado negro y en los lugares de placer. Los había que no eran culpables de actividades políticas conscientes ni contrarios al hitlerismo”.

Para Stephen Chorover, profesor del MIT y judío que perdió a gran parte de su familia en el genocidio nazi, las ideas sociobiológicas ya existentes desempeñaron una función doblemente influyente en el proceso de exterminio. En primer lugar, suministraron el aparato conceptual que médicos y científicos necesitaban para concebir, planificar y realizar la “destrucción de las vidas carentes de valor” o, si se quiere, para la eutanasia de degenerados, desviados, enfermos, … En segundo lugar, ayudaron a construir y ratificar la tesis nazi según la cual la calidad racial es el criterio para juzgar el valor de individuos y países.

Esas ideas habían comenzado con Charles Darwin y su “Origen de las especies”, Herbert Spencer y su naturaleza de “dientes y garras”, Francis Galton y la eugenesia, y tantos otros en Europa y Estados Unidos. Y, no hay que olvidar, que, desde la biología, el genocidio es siempre agresión intraespecífica, o sea, entre individuos de la misma especie.

Konrad Lorenz: El pasado del Premio Nobel

Konrad Lorenz. Fuente: nobelprize.org

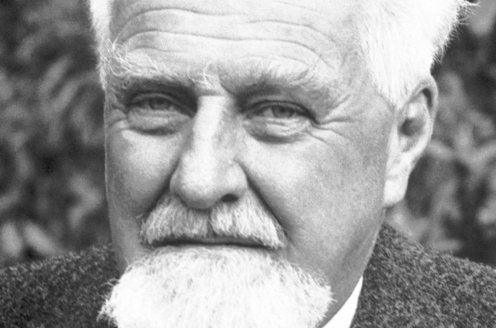

Konrad Lorenz. Fuente: nobelprize.orgNació en Viena en 1903 y murió en Alterberg, Austria, en 1989. Estudió medicina en la Universidad Columbia de Nueva York, y se doctoró en la Universidad de Viena. La lectura de las aventuras de Nils Holgerson, de la autora sueca Selma Lagerlof, le llevó, como a tantos otros, al interés por los animales, las aves en concreto, y al estudio de la zoología. Acepta estudiar medicina para contentar a su padre, y el contacto con los profesores Ferdinand Hochstetter, de anatomía, y Karl Buhler, de psicología, le llevan a utilizar el método comparativo para estudiar el comportamiento. Una vez graduado, en 1939, fue nombrado profesor de psicología con orientación biológica en la Universidad de Konigsberg, en Alemania.

En 1938 se afilió al Partido Nazi, Escribió, en su petición de afiliación, que “puedo decir que todo mi trabajo científico está dedicado a las ideas de los nacionalsocialistas”. Sus escritos de la época apoyaban la ideología nazi de la higiene racial con el apoyo de la terminología científica. Por ejemplo, en junio de 1940, apareció un artículo de Lorenz titulado, en traducción “Alteraciones del comportamiento propio de la raza causadas por la domesticación”. Escribe que “de la amplia analogía biológica de la relación entre el cuerpo y la úlcera cancerosa por una parte, y de un pueblo y sus miembros convertidos en asociales por deficientes por otra, se deducen grandes paralelismos, salvando las naturales diferencias … Todo intento de reconstrucción de los elementos destruidos en relación con la totalidad es, por tanto, desesperado. Por suerte, su extirpación es más fácil para el médico del cuerpo social, y para el organismo supraindividual menos peligrosa que la operación del cirujano en el cuerpo individual”. Terminaba con “la idea racial como base de nuestro estado ya ha logrado mucho en este sentido”. Lorenz jamás escondió esta publicación y repitió las ideas que escribió en muchos de sus libros.

Loren Eisenberg, de la Universidad de Harvard, añade que Lorenz fue explícito en la defensa de los conceptos nazis de pureza racial y, por ejemplo, justificó las restricciones legales al matrimonio con no-arios como medida social para corregir “la degeneración inducida por la domesticación”. Algo similar escribía Lorenz en su libro, publicado en 1975, y titulado “Los ocho pecados mortales de la Humanidad” y, sobre todo, en el capítulo titulado “Decadencia genética”, uno de los “pecados mortales” del título. Menciona que, en un péndulo de ideologías y conductas, en un extremo está que todos los hombres son iguales desde su nacimiento y, en el otro extremo, coloca, literalmente, a ”Eichmann, Auschwitz, la eutanasia y el odio racista”. Para Lorenz, en este péndulo en medio está la virtud o, si se quiere, todos los hombres no son iguales pero ello no nos debe llevar a Eichmann o Auschwitz.

En 1941, una vez comenzó la guerra, fue movilizado como médico militar destinado en Poznan, en Polonia, como neurólogo y psiquiatra, y, en 1944, enviado al frente oriental. Capturado por los rusos, fue su prisionero durante seis años. Allí conoció de primera mano el adoctrinamiento marxista y lo comparó con el nazismo, que conocía en detalle.

Hasta febrero de 1948 no pudo regresar a Austria y declaró su arrepentimiento por su afiliación al Partido Nazi. En principio, negó haber pertenecido al Partido, hasta que se demostró que era cierto. También negó haber conocido el alcance del genocidio, a pesar de su puesto como psicólogo en la Oficina de Política Racial.

Con una financiación escasa y muchos problemas, organizó, en 1949, la estación de investigación de Altenberg. Marchó a Alemania, a la estación de Buldeon, donde fundó el Instituto Max Planck de Fisiología del Comportamiento. En este centro, a comienzos de los sesenta, desarrolló su teoría del comportamiento que unía la evolución, lo innato y lo aprendido. Por todo ello, en 1973 recibió el Premio Nobel.

En su autobiografía, publicada en 1988, Lorenz recordó que, en aquellos años, “estaba asustado, como todavía lo estoy, por la idea de que procesos genéticos de deterioro puedan estar funcionando en la humanidad civilizada. Movido por este miedo, hice algo muy poco aconsejable poco después de que los alemanes invadieran Austria: escribí sobre los peligros de la domesticación y, para ser entendido, expresé mis escritos en la peor terminología nazi. No quiero presentar atenuantes de estos escritos. En realidad, creía que algo bueno vendría del nuevo gobierno … Ninguno sospechaba que la palabra “selección”, utilizada por estos gobernantes, significaba asesinato”.

La Universidad de Salzburgo le retiró, en 2015, el título de Doctor Honoris Causa, concedido en 1983. La universidad argumentó que fue la difusión, por Lorenz, de las ideas nacionalsocialista y, por declarar en aquellos años, que era “siempre un nacionalista”, y utilizar su trabajo para difundir “elementos básicos de la ideología racista del nacionasocialismo”.

Lo había definido Adolf Hitler años antes: “Hemos de crear una técnica de despoblación. Si me pregunta usted lo que entiendo yo por despoblación, le diré a usted que veo la liquidación de unidades raciales, y lo haré, puesto que veo en ella, a grandes rasgos, mi misión fundamental. La Naturaleza es cruel y, por este motivo, también nosotros podemos ser crueles. Si mando a lo mejor del pueblo alemán a la guerra sin lamentos, en ningún momento, el derramamiento de la valiosa sangre alemana en el infierno de la guerra, también tengo el derecho de destruir millones de hombres de razas inferiores, que se multiplican como los parásitos”. Detrás de estas declaraciones está la biología de la época, está el genocidio. Ya lo había expuesto Hitler en 1925 en su libro Mi lucha. Hitler trataba de crear, en el este de Europa, un “espacio vacío”, que era el lugar donde viviría la raza de señores que debía ser creada y organizada por Himmler. Es lo que afirmaba Erich Koch, comisario del Reich y responsable de la administración nazi en Ucrania: “Somos un pueblo de señores que ha de tener en cuenta que el obrero alemán más bajo es mil veces mejor, desde el punto de vista racial y biológico, que cualquier exponente de la población local”.

Detrás de esta ideología supremacista estaba lo que Alfred Rosenberg, ideólogo del Partido Nazi, declaró en el juicio de Nuremberg que “… y finalmente en Munich me especialicé en los estudios de la nueva investigación biológica”. Afirmó que el sentimiento de humanidad iba “contra el proceso de selección natural”. Por ello, consigue que el genocidio se base en la evolución. El mismo Rosenberg escribió que la humanidad trata del individuo y olvida al Estado y al pueblo. Es un concepto que niega las diferencias nacionales y raciales y considera la Humanidad sin diferencias.

Como explicó Heinrich Himmler en una conferencia en enero de 1937, la biología, según los nazis, estaba en el centro de su limpieza étnica, y “no hay mejor ilustración de las leyes de la herencia y de la raza … que un campo de concentración. En el se encuentran hidrocéfalos, bizcos, contrahechos, semijudíos y un número incalculable de productos de razas inferiores”. O, más en extenso y en un lenguaje científico y proponiendo los campos de trabajo, Hans Reiter, médico nazi con cargos en la administración y en el campo de concentración de Buchenwald, declaró en 1941 que “la legislación biológica-hereditaria se preocupa de suprimir, poco a poco, la creación de nuevas generaciones de individuos asociales … El estudio biológico del rendimiento humano debe conducir y reconducir, sin duda, a disponer en la medida de lo posible de esa mano de obra, de manera a desarraigar de una ocupación estéril o de la ociosidad para conducirla por la fuerza a un trabajo real y enteramente provechoso al pueblo y al Estado”. Antes de comenzar la guerra ya se habían esterilizado entre 350000 y 400000 personas.