La música y el entorno natural

José Manuel González Gamarro

La música y la naturaleza es un binomio estudiado desde casi los primeros tratados sobre música. La poética subyacente de la observación del medio ambiente puede casar perfectamente con las emociones que logra provocar la escucha musical. También ha habido múltiples ejemplos de compositores, teóricos e investigadores que han intentado plasmar o transcribir los sonidos de la naturaleza, como el caso paradigmático de Oliver Messiaen con el canto de los pájaros u otros anteriores como fueron Athanasius Kircher o William Gardiner.

Foto: Erica Li / Unsplash

Foto: Erica Li / UnsplashSin embargo, existen otro tipo de investigaciones que no intentan fijar en una partitura aquello que se escucha en el entorno natural, sino más bien averiguar cómo puede influir la música que se escucha en nuestra percepción de ese entorno. Las personas escuchan cada vez más música con auriculares al aire libre, en la naturaleza, mientras pasean o practican algún deporte, así que estudiar las interacciones audiovisuales entre la música y el entorno es significativo tanto para la psicología musical como para la investigación del paisaje sonoro. Es por esto que investigadores como Marek Franěk y Jan Petružálek han profundizado en la influencia que tiene la música que se escucha en la percepción de los entornos naturales1. Tal y como indican estos investigadores, el objetivo de profundizar en esta relación es averiguar si la música que ellos denominan feliz puede aumentar la preferencia ambiental y los sentimientos agradables al ver entornos en comparación con la observación bajo música triste o simplemente sin música.

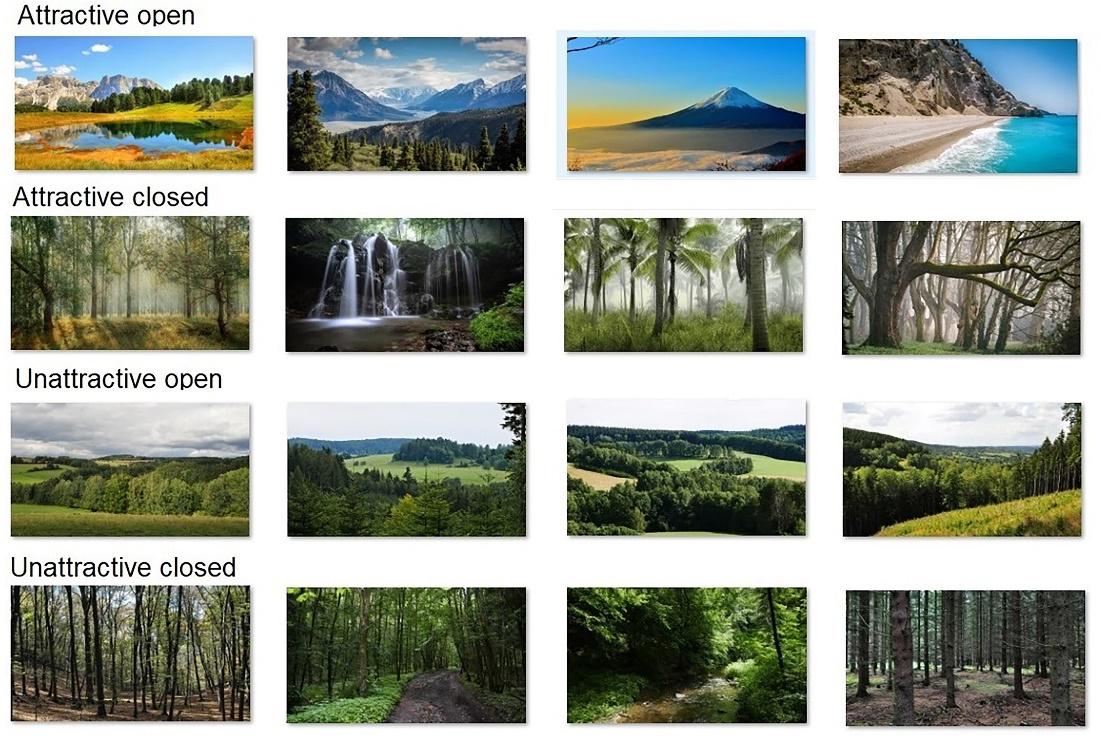

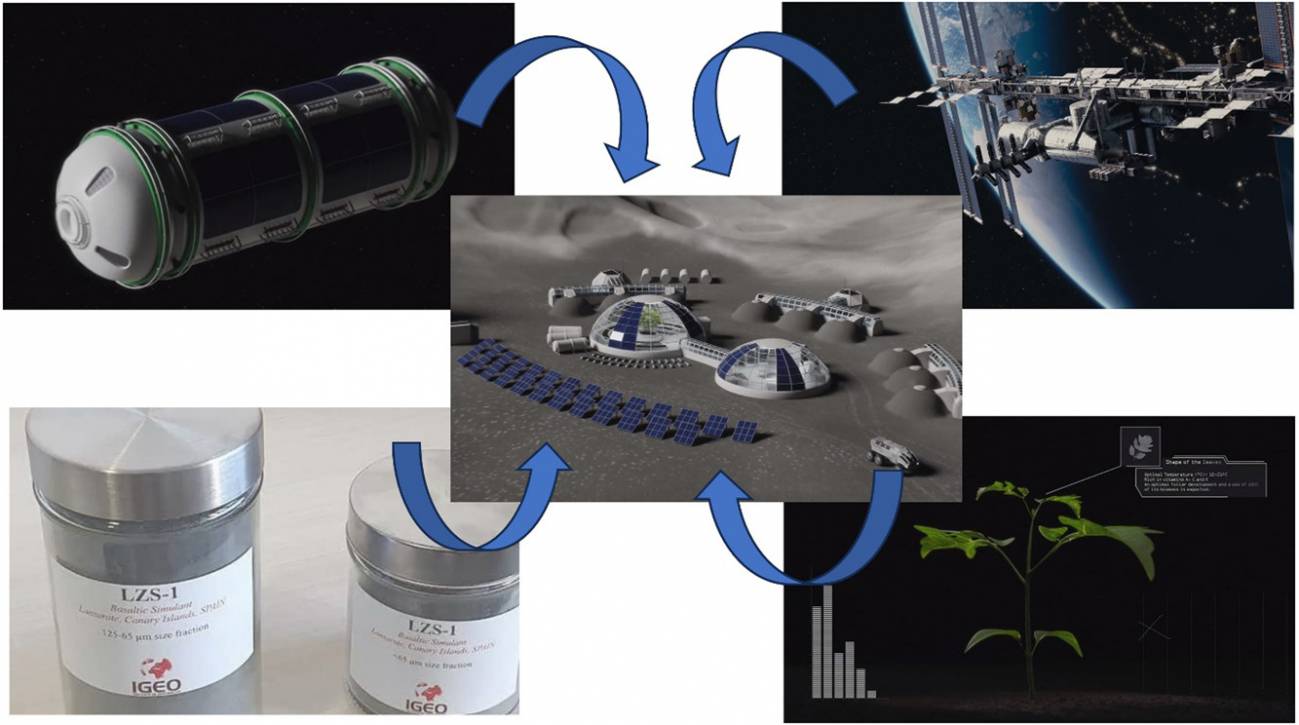

Para ello se plantearon un experimento donde personas visualizaban diferentes tipos de entornos bajo música feliz, música triste y sin música. Los entornos los clasificaron mediante cuatro tipologías: ambientes atractivos abiertos, ambientes atractivos cerrados, ambientes poco atractivos abiertos y ambientes poco atractivos cerrados.

Ilustración 1. Estímulos visuales utilizados en el estudio: entornos abiertos atractivos, entornos cerrados atractivos, entornos abiertos poco atractivos y entornos cerrados poco atractivos. Fuente: Franěk, M., & Petružálek, J. (2024)

Ilustración 1. Estímulos visuales utilizados en el estudio: entornos abiertos atractivos, entornos cerrados atractivos, entornos abiertos poco atractivos y entornos cerrados poco atractivos. Fuente: Franěk, M., & Petružálek, J. (2024)La música feliz estuvo representada por One Fine Day mientras que para la música triste fue usada la canción Mad World de Michael Andrews Estos dos ejemplos salen de una selección de otro estudio anterior donde se pidió a los participantes que seleccionaran y enviaran dos archivos de diferentes tipos de música que les gustaban. Para evaluar en qué medida influía el tipo de música (o la no música) en la visualización y preferencia de los ambientes se usó, por un lado, una autoevaluación con escala tipo Likert para evaluar el gusto por el medio ambiente y los sentimientos al visualizar las imágenes. Por otro lado, se midieron las expresiones faciales mediante grabaciones en vídeo y el posterior análisis con un software capaz de determinar siete emociones básicas (alegría, ira, sorpresa, miedo, desprecio, tristeza y disgusto).

La paradoja de la tristeza agradableLos resultados sacaron a la luz algo nada sorprendente en cuanto a la música feliz, puesto que escuchar música que es agradable y gustada generalmente resulta en respuestas emocionales positivas. El emparejamiento de música alegre con imágenes naturales resultó en un aumento significativo en la preferencia ambiental y sentimientos agradables en todos los entornos. Sin embargo, la música triste no redujo la preferencia ambiental o los sentimientos agradables en comparación con el grupo control al que no se le expuso a música alguna. La explicación más probable a esto es la paradoja de la «tristeza agradable»2, ya que la tristeza evocada por la música puede ser placentera cuando se percibe como no amenazante, es estéticamente agradable o produce beneficios psicológicos como la regulación del estado de ánimo y sentimientos empáticos causados, por ejemplo, por el recuerdo y la reflexión sobre eventos pasados. La música tampoco tuvo el poder de cambiar las preferencias ambientales de los participantes, por lo que la música feliz aumentó las calificaciones de todos los entornos, pero no suprimió las características ambientales. En cualquier caso, la música sí que intensificó la experiencia emocional de la visualización de los entornos.

¿Que ocurriría en un entorno real?Además del debate que puede suscitar la fiabilidad de los métodos de análisis de las expresiones faciales mediante software o la subjetividad del autoinforme, no hay que olvidar que esto es un experimento de laboratorio donde el entorno real no es la imagen que se visualiza. A estímulos visuales se le añaden estímulos sonoros, pero la experiencia en un entorno natural es multisensorial, además de que la música también lo es o puede serlo3. Este tipo de investigación puede ser muy útil para la realización de vídeos relajantes o realidad virtual donde se combinan el entorno natural con la música. Sin embargo, la realidad es bastante más compleja, donde analizar y controlar todas las variables es una tarea muy difícil. La visualización de diferentes entornos naturales no influyó en las preferencias musicales, lo cual en la realidad del entorno podría no ser así. El entorno acústico medioambiental es determinante en muchas cuestiones evolutivas musicales, hasta el punto de haber podido influir en el desarrollo del lenguaje4, por lo que reducir a una visualización la precepción del medio ambiente es un primer paso necesario para la investigación de la interacción de música y entorno natural. Un primer paso que nos adentra en el océano de un nuevo conocimiento en el que, sin embargo, nos hallamos todavía en la orilla.

Referencias:

1 Franěk, M., & Petružálek, J. (2024). Audio-Visual Interactions Between Music and the Natural Environment: Self-Reported Assessments and Measures of Facial Expressions. Music & Science, 7. doi: 10.1177/20592043241291757

2 Sachs, M. E., Damasio, A., & Habibi, A. (2015). The pleasures of sad music: a systematic review. Frontiers in human neuroscience, 9, 404. doi: 10.3389/fnhum.2015.00404

3 Zatorre, R. J., Chen, J. L., & Penhune, V. B. (2007). When the brain plays music: auditory–motor interactions in music perception and production. Nature reviews neuroscience, 8(7), 547-558.doi: 10.1038/nrn2152

4 Gannon, C., Hill, R. A., & Lameira, A. R. (2023). Open plains are not a level playing field for hominid consonant-like versus vowel-like calls. Scientific Reports, 13(1), 21138. doi: 10.1038/s41598-023-48165-7

Sobre el autor: José Manuel González Gamarro es profesor de guitarra e investigador para la Asociación para el Estudio de la Guitarra del Real Conservatorio Superior de Música “Victoria Eugenia” de Granada.

El artículo La música y el entorno natural se ha escrito en Cuaderno de Cultura Científica.

Naukas pro 2024: SAREUS: Red de Varamientos de cetáceos y pinnípedos de Euskadi

Los últimos avances en el ámbito de las energías renovables marinas o la proliferación de los microplásticos fueron algunos de los temas que componen la última edición de NAUKAS PRO. Una cita en la que el personal investigador se sube al escenario del Euskalduna Bilbao para hablar de las investigaciones más destacadas del momento en un ámbito concreto.

En esta ocasión el personal investigador de la Universidad del País Vasco, de la Estación Marina de Plentzia (PiE-UPV/EHU), AZTI, Tecnalia o el CSIC acercaron las últimas investigaciones relacionadas en el ámbito marítimo.

La conferencia SAREUS: Red de Varamientos de cetáceos y pinnípedos de Euskadi corre a cargo de Denis Benito Fernández, investigador de la Estación Marina de Plentzia-Plentziako Itsas Estazioa.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas pro 2024: SAREUS: Red de Varamientos de cetáceos y pinnípedos de Euskadi se ha escrito en Cuaderno de Cultura Científica.

Aceite de palma: ¿aliado tecnológico o enemigo de la salud?

Es probable que haya escuchado hablar sobre el aceite de palma en más de una ocasión, casi siempre acompañado de una connotación negativa. Sin embargo, ¿es tan perjudicial como se dice, o parte de su mala reputación proviene de mitos y/o desinformación?

Foto de Marcelo Verfe / PexelsAceite de palma “hasta en la sopa»…

Foto de Marcelo Verfe / PexelsAceite de palma “hasta en la sopa»…

El principal problema del aceite de palma es que se encuentra como ingrediente en muchos alimentos procesados. Estos van destinados tanto a la población general (sopas instantáneas, helados, galletas y pan de molde) como a colectivos específicos (fórmulas infantiles).

Esta popularidad se debe a que el aceite de palma tiene una composición de ácidos grasos que lo hace estable y semisólido a temperatura ambiente. Además, cuenta con un punto de fusión elevado (temperatura a la que se derrite) y un sabor neutro.

Dichas características lo convierten en un ingrediente ideal para la elaboración de productos de panadería, confitería y aperitivos, donde es frecuente su uso como sustituto de grasas sólidas de mayor valor económico (mantequilla, manteca de cacao) o menos saludables, como las grasas parcialmente hidrogenadas (margarina). La industria alimentaria puede incluso emplearlo como medio de fritura de alimentos que, en principio, no lo contienen.

Todo ello explicaría la omnipresencia del aceite de palma en una gran variedad de alimentos de consumo más o menos habitual.

Pero ¿qué es y de dónde viene el aceite de palma?El aceite de palma es el aceite vegetal más utilizado a nivel mundial y se obtiene a partir del fruto de diferentes ejemplares de plantas del género Elaeis (E. guineensis, E. oleífera o el híbrido entre ambas). Todas ellas son comúnmente conocidas como palma de aceite o palma aceitera. Son originarias de África Occidental, pero en la actualidad los mayores productores a nivel mundial son Indonesia y Malasia.

Aunque solemos hablar de «aceite de palma” de forma general, en realidad se pueden obtener dos tipos diferentes de aceite según la parte del fruto que se utilice.

- El aceite de almendra de palma o aceite de palmiste, que se obtiene de la semilla del fruto.

- El aceite de palma propiamente dicho, que se extrae del mesocarpio (de la pulpa del fruto).

Estos aceites no solo difieren en su procedencia, sino también en su composición lipídica. Así, el aceite de palmiste es rico en ácidos grasos saturados (entre un 72 y un 98 % del total), principalmente ácidos láurico, mirístico y palmítico. En cambio, el aceite de palma presenta una composición mucho más equilibrada de ácidos grasos: casi la mitad de ellos son saturados y la otra mitad son insaturados. Entre los saturados destaca el palmítico (entre un 32 y un 47 %) y entre los insaturados destaca el oleico (ácido monoinsaturado, entre un 40 y un 52 %).

Aparte de su perfil de ácidos grasos, tanto el aceite de palmiste como el de palma contienen elevadas cantidades de componentes lipídicos minoritarios con propiedades antioxidantes, como la vitamina E (especialmente tocotrienoles) y carotenoides precursores de la vitamina A, que le confieren su característico color anaranjado.

Su contenido en estos compuestos lo ha posicionado como alternativa para paliar las deficiencias de vitamina E y A en poblaciones de Asia y África. Sin embargo, el proceso de refinamiento previo a su comercialización provoca que estos componentes bioactivos se pierdan casi en su totalidad, por lo que esta aparente ventaja nutricional en realidad no lo es tanto.

¿Por qué se dice que el aceite de palma es malo?En los últimos años el uso y consumo de aceites y grasas derivados de la planta de la palma de aceite ha causado gran controversia, dado que su alto contenido en ácidos grasos saturados (especialmente ácido palmítico) lo hace difícilmente recomendable desde un punto de vista nutricional.

La capacidad del ácido palmítico para aumentar los niveles circulantes de colesterol LDL (lipoproteína de baja densidad, popularmente conocido como “colesterol malo”) es bien sabida. Dada la relación existente entre niveles aumentados de colesterol LDL y el riesgo de padecer enfermedades cardiovasculares, las recomendaciones dietéticas sugieren reducir o limitar la ingesta de ácidos grasos de la dieta, incluido el ácido palmítico.

También es necesario recalcar la detección de glicidol, 3-monocloropropano-1,2-diol (3-MCPD) y sus ésteres en el aceite de palma refinado, compuestos que resultan tóxicos y para los cuales las autoridades ya han implantado medidas con el fin de reducir su contenido. Cabe recordar que estos compuestos se pueden generar durante el proceso de refinado de cualquier aceite vegetal a temperaturas excesivas (no solo en el procesado del aceite de palma).

No compensaEn conclusión, parece que a día de hoy las ventajas que puede aportar el aceite de palma por sus propiedades tecnológicas no son suficientes para contrarrestar los efectos que puede tener sobre la salud. Por ello, es necesario recalcar la importancia y suerte que tienen países mediterráneos como España de contar con el aceite de oliva virgen extra, que representa una opción mucho más interesante a nivel nutricional por ser rico en ácido oleico y en compuestos fenólicos únicos. Estos son potentes agentes bioactivos antioxidantes que no están presentes en otros aceites y grasas, cuyo consumo se ha relacionado con numerosos beneficios para la salud.![]()

Sobre las autoras: Laura Isabel Arellano García, Investigadora predoctoral del Grupo Nutrición y Obesidad del Centro de Investigación Biomédica en Red de la Fisiopatología de la Obesidad y Nutrición (CiberObn), Universidad del País Vasco / Euskal Herriko Unibertsitatea; Alfredo Fernández-Quintela, Profesor de Nutrición e Investigador del CiberObn; Bárbara Nieva Echevarría, Profesora Ayudante Doctora en el área de Tecnología de Alimentos, UPV/EHU; Encarnación Goicoechea Osés, Profesora Titular de Tecnología de los Alimentos, UPV/EHU; Iñaki Milton Laskibar, Profesor Investigador del CiberObn y del Instituto de Investigación Sanitaria Bioaraba, UPV/EHU, y María Puy Portillo, Catedrática de Nutrición, CIBERobn.

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Aceite de palma: ¿aliado tecnológico o enemigo de la salud? se ha escrito en Cuaderno de Cultura Científica.

¿Y si cae un meteorito?

Los meteoritos son fragmentos de cometas y asteroides que consiguen atravesar la atmósfera terrestre sin destruirse y caen en la superficie de nuestro planeta. Este proceso es mucho más común de lo que nos imaginamos, ya que se ha estimado que miles de estos visitantes extraterrestres llegan a la Tierra cada año, la mayoría de ellos de muy pequeño tamaño, lo que hace que ni nos enteremos de su presencia, aunque alguno consigue alcanzar un tamaño considerable pudiendo provocar ciertos daños materiales al caer en zonas pobladas.

Meteorito de Hoba, encontrado en Namibia. Foto: Patrick Giraud / Wikimedia Commons

Meteorito de Hoba, encontrado en Namibia. Foto: Patrick Giraud / Wikimedia CommonsSin embargo, cuando oímos la palabra meteorito, lo que nos viene a la cabeza es un enemigo gigantesco e implacable acercándose a la Tierra para sembrar caos y destrucción. Esta imagen se nos ha quedado marcada debido a los eventos desencadenados por el impacto meteorítico más famoso de la historia, el acontecido hace unos 66 millones de años, cuando un cuerpo extraterrestre de más de 10 km de diámetro cayó en el actual Golfo de México y provocó la última gran extinción masiva de la historia de la Tierra, en la que desaparecieron el 75% de las especies del planeta, incluidos los dinosaurios no avianos. Y este miedo a que se repita la misma historia ha llegado a formar parte de la cultura popular en forma de numerosas películas de ciencia ficción, como “Deep Impact”, o novelas de terror como “El color surgido del espacio”, de H. P. Lovecraft.

Pero, si echamos un vistazo a la historia geológica de la Tierra, los impactos meteoríticos no han sido siempre tan catastróficos, más bien todo lo contrario. Y para comprobarlo viajaremos a nuestros orígenes… como planeta.

La Tierra se formó hace unos 4567 millones de años gracias a lo que se conoce como acreción de planetesimales. Este proceso consistió en la colisión de varios objetos sólidos con diámetros kilométricos (los planetesimales) que estaban dispersos en una nube de polvo y gases que orbitaba alrededor de una protoestrella que acabó convirtiéndose en nuestro Sol. Tras unos cuantos millones de años de impactos de planetesimales, hace unos 4538 millones de años tuvimos ya formada la Proto-Tierra, una gran bola semisólida cubierta por un océano de lava fruto del enorme calor generado por las colisiones.

Recreación del aspecto de la Tierra primitiva, hace unos 4000 millones de años, mostrando la caída de meteoritos sobre una superficie parcialmente fundida. Ilustración: Simone Marchi & Dan Durda / Southwest Research Institute

Recreación del aspecto de la Tierra primitiva, hace unos 4000 millones de años, mostrando la caída de meteoritos sobre una superficie parcialmente fundida. Ilustración: Simone Marchi & Dan Durda / Southwest Research InstituteMientras nuestro joven planeta recién formado empezaba a enfriarse y parecerse más a lo que vemos hoy en día a nuestro alrededor, no estuvo a salvo de la caída de más meteoritos. En concreto, sufrió un auténtico ataque indiscriminado de proyectiles extraterrestres en dos fases temporales muy concretas: hace entre unos 4400 y 4100 millones de años, en lo que se conoce como Gran Bombardeo Temprano, y hace entre 4100 y 3900 millones de años, durante el Gran Bombardeo Tardío.

Los meteoritos que bombardearon esa Tierra primitiva eran de diferentes tipos: aerolitos o condritas, sideritos, litosideritos y fragmentos de asteroides carbonáceos. Y son los culpables de que, hoy en día, nuestro planeta sea un vergel de vida, ya que aportaron los componentes principales que la caracterizan, elementos químicos como hierro (Fe), níquel (Ni), silicio (Si), oxígeno (O), carbono (C) o hidrógeno (H), algunos de cuales se combinaron para generar moléculas tan importantes como dióxido de carbono (CO2), agua (H2O) y ozono (O3). Sin los cuales, la evolución geológica de nuestro planeta no se habría producido de la manera que lo hizo, propiciando que ahora mismo yo esté escribiendo este texto que estáis cómodamente leyendo.

Si todavía no os he convencido de que los impactos meteoríticos acontecidos en la historia geológica de nuestro planeta han sido más beneficiosos que perjudiciales para el ser humano, quiero que sepáis que, si no se hubiese producido esa extinción de los dinosaurios hace 66 millones de años, los mamíferos no habrían evolucionado hasta dar lugar al ser humano, millones de años después. Así que, ese grandullón surgido del espacio, nos hizo un enorme favor. Además, los meteoritos no dejan de ser fragmentos de cuerpos extraterrestres que nos permiten conocer de primera mano cómo debió ser la Tierra primigenia, aparte de que tener un siderito en las manos, formado principalmente por hierro y níquel, es lo más parecido a poder tocar el propio núcleo de nuestro planeta.

La próxima vez que miréis al cielo en una noche estrellada y veáis una estrella fugaz no quiero que penséis un deseo, sino que os acordéis de que fueron los meteoritos los que pusieron los primeros ladrillos tanto de nuestro planeta como de la vida tal y como la conocemos. Y sí, es posible que, algún día, vuelva a caernos uno lo suficientemente grande como para que la era del ser humano llegue a su fin, pero de eso no tenemos tanta certeza.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿Y si cae un meteorito? se ha escrito en Cuaderno de Cultura Científica.

Benoît Mandelbrot, el padre de los fractales

El matemático Benoît Mandelbrot (1924- 2010) nació tal día como hoy, hace cien años. En un día tan especial, le dedicamos este retrato alfabético.

Benoît Mandelbrot. Fuente: Wikimedia Commons.

Benoît Mandelbrot. Fuente: Wikimedia Commons.

Autosimilitud

En matemáticas, la autosimilitud es la propiedad de un objeto (denominado autosimilar) en el que el todo es exactamente (como, por ejemplo, la curva de Koch) o aproximadamente similar (como en el caso del brócoli) a una parte de sí mismo. La autosimilitud es una propiedad de los conjuntos fractales.

Curva de Koch. Fuente: Wikimedia Commons.

Curva de Koch. Fuente: Wikimedia Commons.

Bourbaki

Aunque formado en Francia, los gustos científicos de Mandelbrot no encajaban con el enorme predominio de la escuela fundacional francesa de Bourbaki; por ello, en 1958, emigró a Estados Unidos de forma permanente.

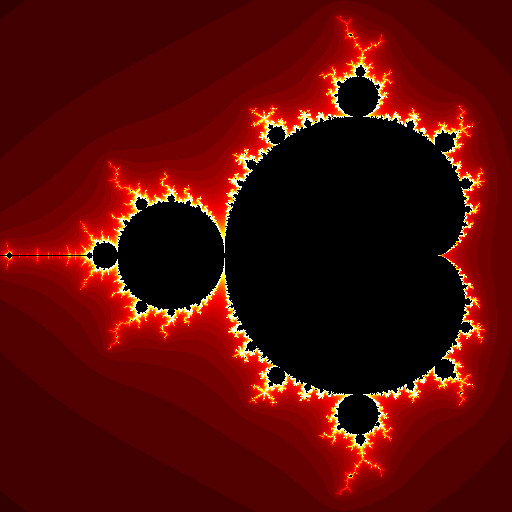

Conjunto (de Mandelbrot)

Benoît Mandelbrot descubrió el conjunto que lleva su nombre en 1980; es un subconjunto del plano complejo.

Conjunto de Mandelbrot. Fuente: Wikimedia Commons.

Conjunto de Mandelbrot. Fuente: Wikimedia Commons.

Diferentes (aspectos y cosas)

En una entrevista realizada en 2004, Mandelbrot cuestionaba la aplicabilidad de la teoría fractal:

¿Cómo es posible que la misma técnica se aplique a Internet, al clima y a la bolsa? ¿Por qué, sin esforzarme demasiado, estoy tocando tantos aspectos diferentes de muchas cosas diferentes?

Escalamiento (en las finanzas)

A finales de los años 1980, Mandelbrot aplicó la teoría fractal al estudio de los mercados. Publicó varios trabajos sobre la ley de escalamiento en las finanzas, ley que muestra propiedades similares a distintas escalas de tiempo.

Fractal (Geometry of Nature)

En 1982 Mandelbrot publicó su libro Fractal Geometry of Nature en el que explicaba sus investigaciones en este área. En 1997 se publicó su traducción al español.

Gran (Bretaña)

En 1967 Mandelbrot publicó en la revista Science su famoso artículo ¿Cuánto mide la costa de Gran Bretaña? donde se exponen sus primeras ideas sobre los objetos fractales. El trabajo examina la paradoja de que la longitud de una línea costera depende de la escala de medida.

¿Cuánto mide la costa de Gran Bretaña? Fuente: Wikimedia Commons.

¿Cuánto mide la costa de Gran Bretaña? Fuente: Wikimedia Commons.

Hausdorff (dimensión)

La dimensión de Hausdorff generaliza el concepto de dimensión topológica y permite definir una dimensión no entera para un objeto fractal. Por ejemplo, la dimensión de Hausdorff del conjunto de Cantor es log(2)/log(3), que es aproximadamente 0,63.

IBM

Desde 1958, y durante 35 años, Mandelbrot trabajó en IBM.

Julia (conjuntos de)

Mandelbrot estudió los llamados conjuntos de Julia que son invariantes bajo ciertas transformaciones del plano complejo. Basándose en trabajos previos de los matemáticos Gaston Julia y Pierre Fatou, Mandelbrot representó gráficamente imágenes de estos conjuntos con ayuda de un ordenador.

Kagan (Aliette)

Mandelbrot se casó con Aliette Kagan en 1955 y se mudó a Ginebra para colaborar con Jean Piaget en el Centro Internacional de Epistemología Genética. En 1958, la pareja se mudó a Estados Unidos, donde Mandelbrot se unió al personal de investigación de IBM.

Lévy (Paul)

Tras realizar sus estudios en la Universidad de Lyon, en 1944, Mandelbrot ingresó en la École polytechnique donde fue tutorizado por el matemático Paul Lévy.

Mandelbrojt (Szolem)

Szolem Mandelbrojt, su tío, fue también matemático. Nació en Varsovia en 1899 en una familia judía procedente de Lituania. En 1920 emigró a Francia y en 1936 ayudó al resto de su familia a dejar Polonia para encontrarse con él. Influyó enormemente en la formación de su sobrino.

Nubes

En su libro Introduction to The Fractal Geometry of Nature, Mandelbrot escribió esta conocida frase sobre las formas geométricas en la naturaleza, comenzando por las nubes:

Las nubes no son esferas, las montañas no son conos, las costas no son círculos, y las cortezas de los árboles no son lisas, ni los relámpagos viajan en una línea recta.

Ordenadores

Gracias a su acceso a los ordenadores de IBM, Mandelbrot fue uno de los primeros en usar gráficos para crear y mostrar imágenes fractales como el conjunto de Mandelbrot y los conjuntos de Julia.

Precios

En sus primeros trabajos sobre mercados financieros, Mandelbrot descubrió que los cambios de precios no seguían una distribución gaussiana, sino distribuciones estables de Lévy con varianza infinita.

Rugosidad

Mandelbrot creó la primera «teoría de la rugosidad» al observar rugosidad en las formas de las montañas y costas, en las estructuras de las plantas, en los vasos sanguíneos y pulmones o en la agrupación de galaxias. Su deseo era establecer matemáticamente una medida de esa rugosidad.

Science

En esta revista, en 1967, publicó ¿Cuánto mide la costa de Gran Bretaña?.

Teoría (Big Bang vs. fractal)

Mandelbrot ofreció en 1974 una nueva explicación de la paradoja de Olbers (¿por qué la noche es oscura?). Postuló que, si las estrellas del universo estuvieran distribuidas de manera fractal (por ejemplo, como el conjunto de Cantor), no sería necesario recurrir la teoría del Big Bang para explicar la paradoja. Su modelo no descartaba un Big Bang, pero permitía un cielo oscuro incluso si el Big Bang no hubiera ocurrido.

Universidades

Fue profesor de diferentes materias en diferentes centros universitarios: impartió docencia en economía en la Universidad Harvard, en ingeniería en la Universidad de Yale, en fisiología en el Colegio Albert Einstein de Medicina y en matemáticas en París y Ginebra.

von Neumann

Mandelbrot defendió su tesis doctoral Contribution à la théorie mathématique des communications en la Universidad de París en 1952, supervisado por Paul Lévy. Después se fue al Instituto Tecnológico de Massachusetts y luego al Instituto de Estudios Avanzados de Princeton, donde fue el último estudiante de postdoctorado del matemático John von Neumann.

Wolf (premio)

Entre muchos otros galardones y reconocimientos, Mandelbrot recibió el Premio Wolf en física en 1993, ya que, según la Fundación Wolf, “al reconocer la aparición generalizada de fractales y desarrollar herramientas matemáticas para describirlos, ha cambiado nuestra visión de la naturaleza”.

XYZ (el final de su carrera y el final de este retrato alfabético)

Benoît Mandelbrot comentaba al final de su carrera:

Ahora que me acerco a los 80, me doy cuenta con melancólico placer de que, en muchas ocasiones estuve diez, veinte, cuarenta, incluso cincuenta años adelantado a mi tiempo.

Referencias

- J J O’Connor and E F Robertson, Benoit Mandelbrot, MacTutor History of Mathematics archive, University of St Andrews

- Benoît Mandelbrot, IBM

- Benoit Mandelbrot, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

El artículo Benoît Mandelbrot, el padre de los fractales se ha escrito en Cuaderno de Cultura Científica.

Detectados tornados cuánticos girando en un “supersólido”

Nuevas observaciones de vórtices microscópicos confirman la existencia de una fase paradójica de la materia que también puede surgir en el interior de las estrellas de neutrones.

Un artículo de Zack Savitsky. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

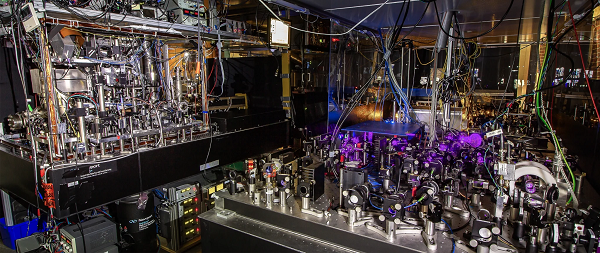

https://culturacientifica.com/app/uploads/2024/11/Supersolids-comprimido.mp4 Cuando se hace girar un supersólido, se forman vórtices de forma espontánea. Vídeo: Ibrahim Rayintakath y Rui Braz para Quanta MagazineEn un laboratorio situado entre los picos escarpados de los Alpes austríacos, los metales de tierras raras se vaporizan y salen de un horno a la velocidad de un avión de combate. Luego, una combinación de láseres y pulsos magnéticos frena el gas hasta casi detenerlo, volviéndolo más frío que las profundidades del espacio. Los aproximadamente 50.000 átomos del gas pierden todo sentido de identidad y se fusionan en un solo estado. Finalmente, con un giro del campo magnético ambiental, pequeños tornados cobran vida y dan vueltas en la oscuridad.

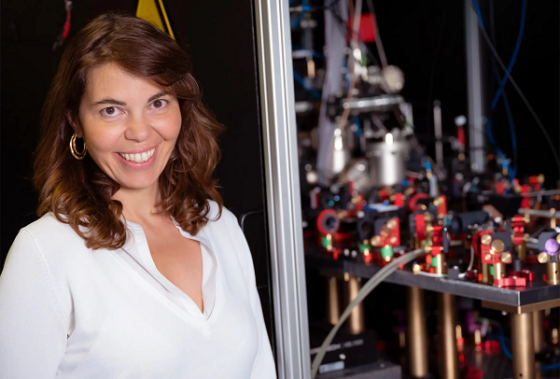

Durante tres años, la física Francesca Ferlaino y su equipo de la Universidad de Innsbruck han trabajado para obtener imágenes de estos vórtices a escala cuántica en acción. “Mucha gente me dijo que esto sería imposible”, contaba Ferlaino durante una visita a su laboratorio este verano. “Pero estaba convencida de que lo lograríamos”.

Ahora, en un artículo publicado en Nature, han publicado instantáneas de los vórtices, confirmando la señal largamente buscada de una fase exótica de la materia conocida como supersólido.

El supersólido, una fase paradójica de la materia que es al mismo tiempo el más rígido de los sólidos y el más fluido de los fluidos, ha fascinado a los físicos de la materia condensada desde su predicción en 1957. Los indicios de esta fase habían ido aumentando, pero el nuevo experimento asegura la última pieza importante de la evidencia de su existencia. Los autores creen que los vórtices que se forman en los supersólidos pueden ayudar a explicar las propiedades en una variedad de sistemas, desde superconductores de alta temperatura hasta cuerpos astronómicos.

Los vórtices podrían mostrar cómo se comporta la materia en algunas de las condiciones más extremas del universo. Se sospecha que los púlsares, que son estrellas de neutrones giratorias (los cadáveres extraordinariamente densos de estrellas quemadas) tienen interiores supersólidos. “En realidad, este es un sistema análogo muy bueno” para las estrellas de neutrones, explica Vanessa Graber, física de Royal Holloway, Universidad de Londres en el Reino Unido, que se especializa en estas estrellas. “Estoy muy emocionada con esto”.

Rígido y fluidoImagina que haces girar un cubo lleno de distintos tipos de materia. Un sólido girará junto con el recipiente debido a la fricción entre el cubo y la red rígida de átomos del material. Un líquido, por otro lado, tiene menos fricción interna, por lo que formará un gran vórtice en el centro del cubo. (Los átomos externos giran con el cubo mientras que los internos se van quedando atrás).

Si se enfrían y dispersan lo suficiente ciertos líquidos, sus átomos comienzan a interactuar a lo largo de distancias mayores y terminan uniéndose en una ola gigante que fluye perfectamente sin fricción alguna. Estos llamados superfluidos fueron descubiertos por primera vez en el helio en 1937 por físicos rusos y canadienses.

Francesca Ferlaino, física de la Universidad de Innsbruck, ha observado la característica distintiva de los supersólidos. Foto: M Vandory/Universidad de Innsbruck

Francesca Ferlaino, física de la Universidad de Innsbruck, ha observado la característica distintiva de los supersólidos. Foto: M Vandory/Universidad de InnsbruckIntenta hacer girar un cubo lleno de superfluido y este permanecerá en reposo incluso mientras el cubo gira a su alrededor. El superfluido sigue rozando el cubo, pero el material es totalmente impermeable a la fricción hasta que el recipiente alcanza una determinada velocidad de rotación. En este punto, al resistir el impulso de girar, el superfluido genera de repente un único vórtice cuántico: un remolino de átomos que rodea una columna de nada que se extiende hasta el fondo del cubo. Continúa acelerando el recipiente y más de estos tornados perfectos se deslizarán desde el borde.

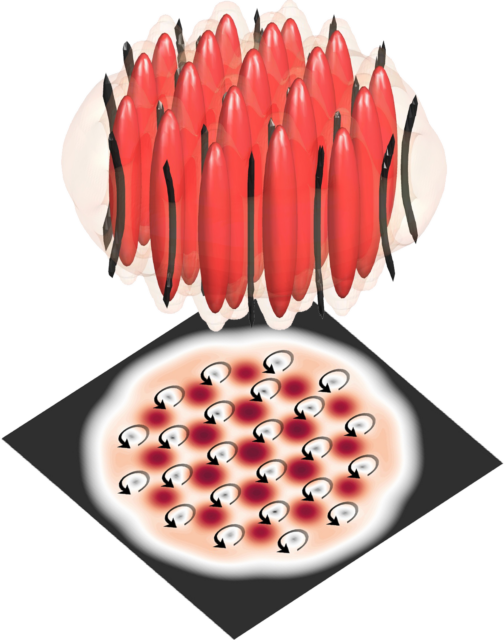

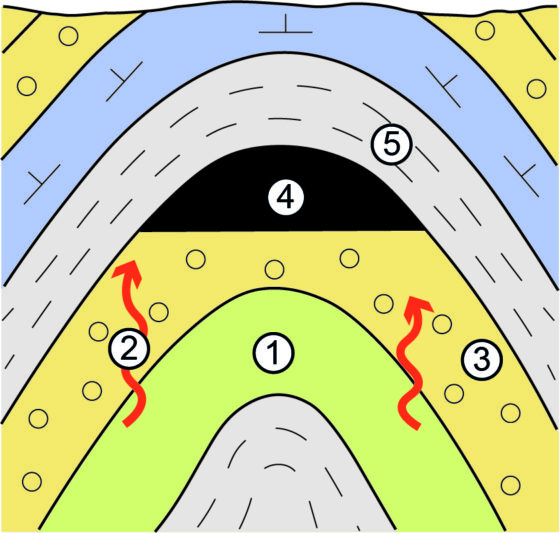

Veinte años después de que se descubrieran los superfluidos, el físico estadounidense Eugene Gross sugirió que el mismo colectivismo cuántico podría surgir en los sólidos. Los físicos debatieron durante décadas si este extraño híbrido de superfluido y sólido podría existir. Finalmente, surgió una imagen teórica del supersólido. Al ajustar el campo magnético alrededor de un superfluido se puede reducir la repulsión entre los átomos de tal manera que comiencen a agruparse. Todos esos grumos se alinearán con el campo magnético pero se repelerán entre sí, autoorganizándose en un patrón cristalino mientras conservan su extraño comportamiento sin fricción.

Si se coloca un supersólido en un recipiente giratorio, los átomos se desplazarán en sincronía, de modo que la red de grumos parecerá girar con el recipiente, como un sólido. Pero, al igual que un superfluido, al girar lo suficientemente rápido, el material se romperá en vórtices, que quedarán atrapados entre los grumos de átomos. El supersólido será rígido y fluido a la vez.

La predicción de Gross dio inicio a una larga búsqueda de los supersólidos en el laboratorio.

Ferlaino Group

Ferlaino GroupLos investigadores anunciaron por primera vez un descubrimiento en 2004, pero luego se retractaron de su afirmación. En 2017 y 2019 se produjeron nuevos estallidos de actividad, cuando grupos de Stuttgart, Florencia e Innsbruck encontraron señales prometedoras de supersolidez en sistemas unidimensionales. Los grupos comenzaron con gases de átomos de disprosio y erbio, que son lo suficientemente magnéticos como para actuar como pequeños imanes de barra. La aplicación de un campo magnético hizo que los átomos se agruparan de forma natural en grupos espaciados regularmente, formando una red cristalina. Luego, cuando los investigadores redujeron la temperatura y la densidad, las interacciones entre los átomos hicieron que oscilaran de forma natural como una onda coherente, con todas las características de un superfluido.

Los experimentos de 2019 vislumbraron las “dos naturalezas en competencia” del supersólido, explica Elena Poli, una estudiante de posgrado del equipo de Innsbruck. Desde entonces, el grupo ha expandido su supuesto supersólido de una dimensión a dos y lo ha investigado para detectar las diferentes propiedades predichas.

Pero “lo que faltaba era básicamente la evidencia irrefutable” de los supersólidos, dice Jens Hertkorn, físico del Instituto Tecnológico de Massachusetts y ex miembro del equipo de Stuttgart. El sello distintivo de la superfluidez es la serie de vórtices que se generan durante la rotación. A pesar de años de intentos, “nadie había logrado hacer girar un supersólido con éxito antes”, cuenta Hertkorn.

Girando un supersólidoPara observar cómo responde su supersólido a la rotación, el equipo de Innsbruck utilizó un campo magnético como una cuchara para retirar los campos magnéticos internos de los átomos unas 50 veces por segundo. Eso es lo suficientemente rápido como para desencadenar vórtices, pero lo suficientemente suave como para preservar la fase cuántica. «Es un estado muy, muy delicado: cualquier pequeño cambio lo destruiría», explica Ferlaino.

Detectar esos pequeños ciclones fue un desafío mayor. El grupo pasó tres años persiguiendo tormentas cuánticas. Finalmente, ejecutaron una propuesta de 2022 de Alessio Recati, un físico de la Universidad de Trento. Sugería formar vórtices en la fase supersólida y luego fundir el material nuevamente en un superfluido para obtener imágenes de los vórtices con mayor contraste.

El laboratorio de Francesca Ferlaino en la Universidad de Innsbruck. Foto: Patscheider

El laboratorio de Francesca Ferlaino en la Universidad de Innsbruck. Foto: PatscheiderUn viernes por la noche, a principios del año pasado, tres estudiantes de posgrado irrumpieron en un pub oscuro cerca del campus de Innsbruck con un ordenador portátil en la mano. Buscaban a dos de los posdoctorados del equipo, quienes verificaron que habían capturado un tornado en su gas cuántico. “Fue excepcionalmente emocionante”, narra Thomas Bland, uno de los posdoctorados. Los estudiantes de posgrado regresaron al laboratorio, y Bland y su colega se quedaron para una ronda de celebración.

“Todos creemos que se trata de un vórtice cuántico”, dice Recati, que no participó en el experimento. Está esperando que los investigadores midan la velocidad de rotación de los tornados para corroborar plenamente las predicciones teóricas, pero las imágenes por sí solas son una validación satisfactoria, afirma. “Esto es muy relevante para toda la comunidad física”.

Hertkorn quiere que otros grupos repitan los resultados y que se haga un seguimiento de cómo cambian las señales en diferentes condiciones experimentales. Aun así, elogia al equipo de Innsbruck por su persistencia a la hora de realizar una medición tan difícil. “Es realmente impresionante, desde el punto de vista experimental, que esto sea observable”, concluye.

Conexiones cósmicasEl pasado mes de mayo, Ezequiel Zubieta estaba almorzando un estofado en un pequeño pueblo de las afueras de Buenos Aires cuando vio cómo una estrella muerta convulsionaba en la pantalla de su portátil. Zubieta, estudiante de posgrado en astronomía de la Universidad Nacional de La Plata, había estado siguiendo la rotación impresionantemente estable del púlsar Vela, el remanente magnetizado de una estrella masiva que explotó hace aproximadamente 11.000 años.

Mientras gira, Vela emite rayos de radiación desde sus polos que destellan en la Tierra 11 veces por segundo, con una regularidad que rivaliza con los mejores relojes que los humanos pueden construir. Pero ese día, la estrella giró 2,4 mil millonésimas de segundo más rápido de lo habitual.

https://culturacientifica.com/app/uploads/2024/11/VelaPulsarTimelapse-comprimido.mp4 Una película del Observatorio de rayos X Chandra de la NASA muestra un chorro de partículas que sale disparado del púlsar Vela, una estrella de neutrones situada a unos 1.000 años luz de la Tierra que gira 11 veces por segundo. Se cree que las formas en forma de arco son ondas expansivas de materia que se aleja de la estrella. Vídeo: NASA/CXC/Universidad de Toronto/M. Durant et alDurante décadas, los astrónomos se han preguntado qué podría provocar que estos objetos masivos aceleren repentinamente su rotación. Muchos esperan que estos fallos técnicos en los púlsares puedan ayudarlos a descifrar el funcionamiento interno de estos peculiares faros cósmicos.

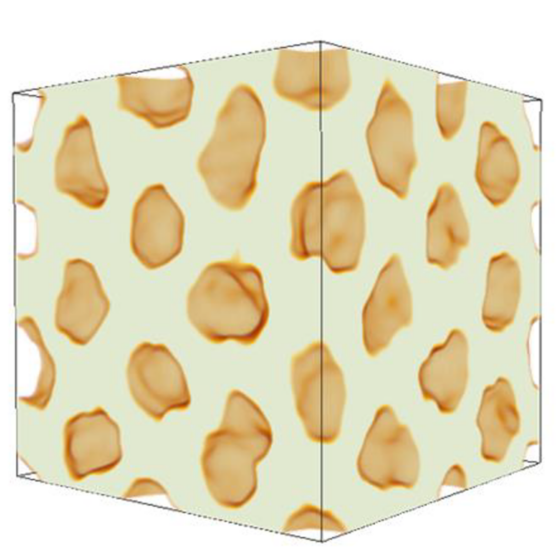

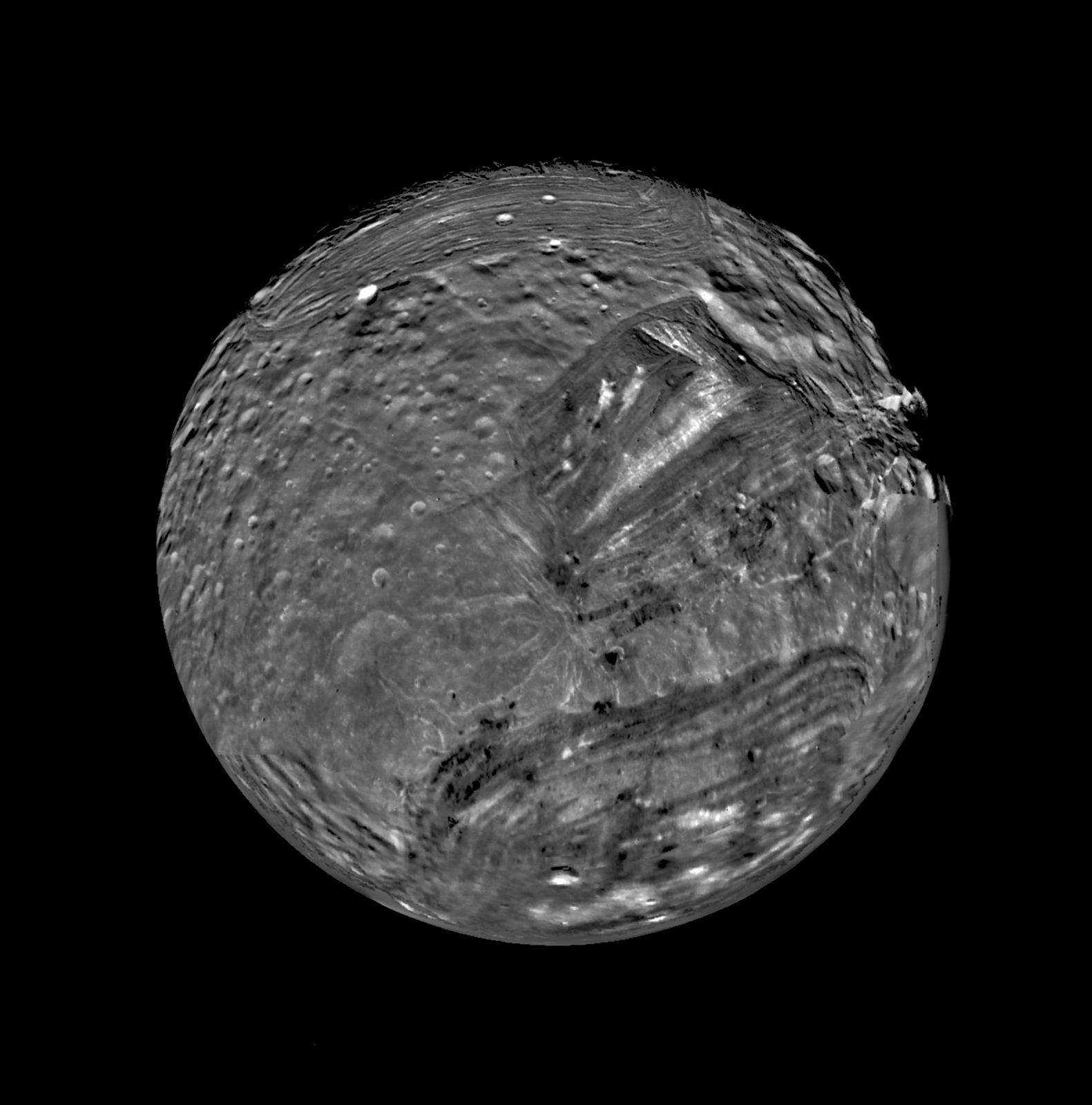

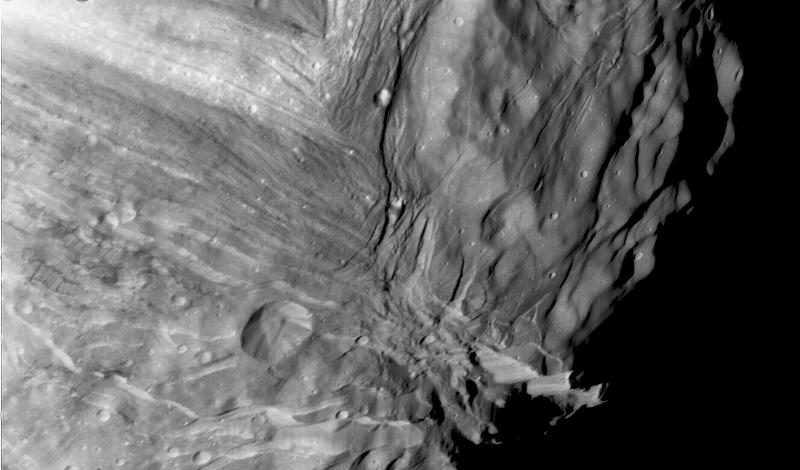

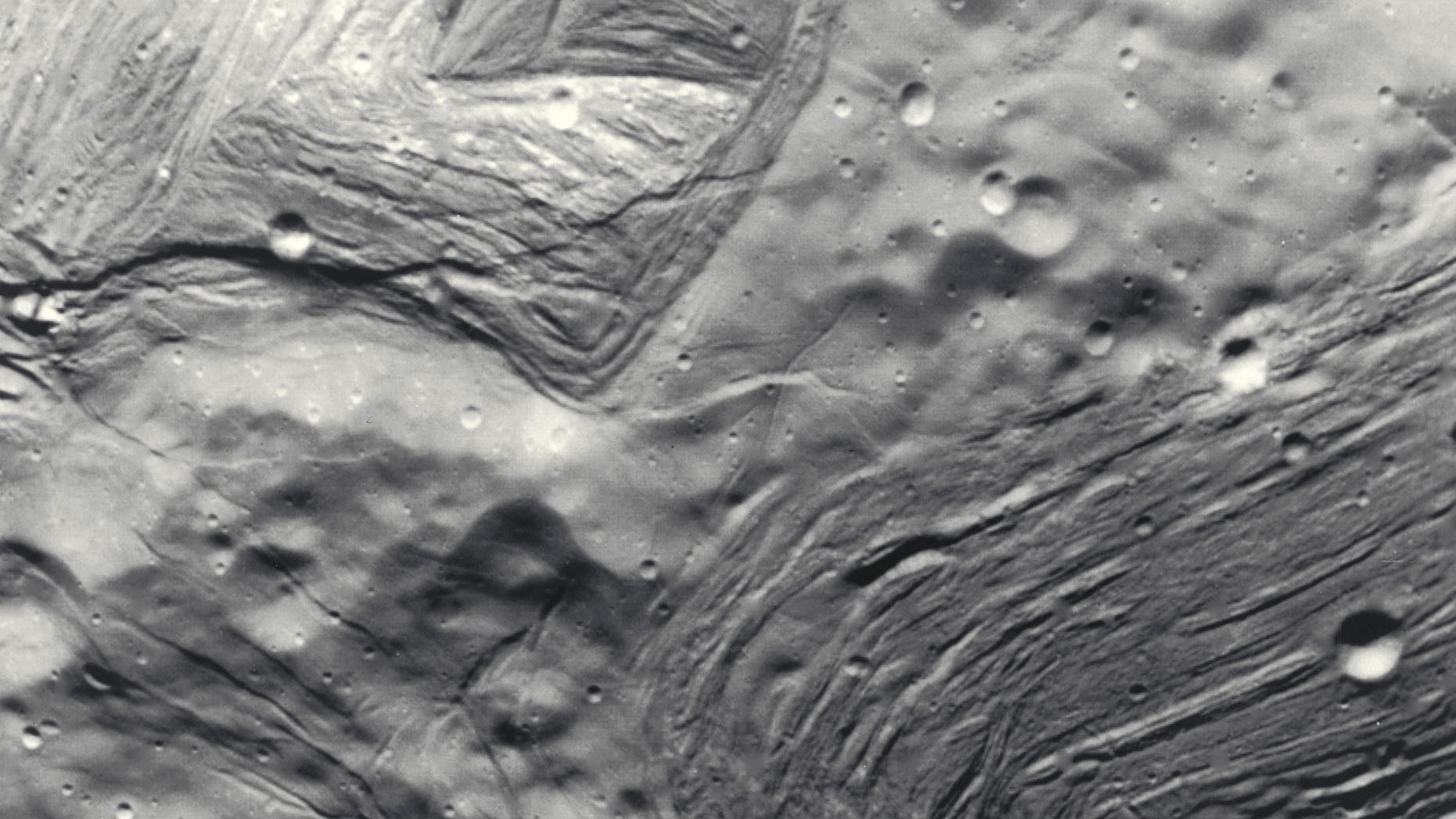

Los científicos saben que los cadáveres estelares están densamente poblados de neutrones (una cucharadita de material de una estrella de neutrones pesaría tanto como el Monte Everest). Nadie está seguro de qué les sucede a los neutrones en esas condiciones, pero los astrónomos sospechan que, en una capa debajo de la corteza sólida exterior de la estrella, los neutrones presurizados forman grumos que adoptan formas inusuales, a las que a menudo se refieren como “pasta nuclear”. Los modelos principales presentan fases que se parecen a ñoquis, espaguetis y lasaña.

En una conferencia celebrada en 2022, Ferlaino escuchó a unos astrónomos hablar sobre las supuestas cualidades de la pasta nuclear. Muchos creen que los grumos de neutrones, parecidos a la pasta, se fusionarían para formar un superfluido, pero no está claro cómo ese material podría dar lugar a los fallos técnicos. Ferlaino sospechó que estos podrían ser una señal de los supersólidos que había estado preparando en su propio laboratorio, por lo que decidió investigar.

Se cree que los neutrones presurizados que llenan las estrellas de neutrones adoptan una variedad de formas posibles conocidas como “pasta nuclear”. Fuente: Grupo Ferlaino

Se cree que los neutrones presurizados que llenan las estrellas de neutrones adoptan una variedad de formas posibles conocidas como “pasta nuclear”. Fuente: Grupo FerlainoEl año pasado, su equipo utilizó una simulación por ordenador de su supersólido para modelar lo que sucedería si existiera un material similar dentro de una estrella de neutrones giratoria. Descubrieron que, después de formarse los vórtices, uno de ellos puede desprenderse y chocar con su vecino, lo que desencadena un tornado y una avalancha que transfiere su energía al contenedor. Según propusieron, una cantidad suficiente de estas colisiones de tornados podría acelerar brevemente la rotación de la estrella de neutrones, lo que daría lugar a un fallo técnico.

Graber, que había publicado una revisión de análogos de laboratorio para estrellas de neutrones varios años antes, se emocionó al encontrar el artículo. “Dios mío, hay algo más por ahí que puedo usar”, recordó que pensó sobre las diversas propiedades de los supersólidos rotatorios descritos en el artículo. “Solo leyendo el texto, pensé: ‘Esto es lo que tengo, y esto es lo que tengo, y esto es lo que tengo’”.

Ahora que el grupo de Ferlaino ha identificado vórtices en su supersólido, planean investigar cómo se forman, migran y se disipan los tornados. También quieren replicar el supuesto mecanismo de los fallos técnicos de los púlsares, para demostrar cómo una avalancha de vórtices podría provocar que un supersólido del mundo real acelere su giro. Los físicos también esperan utilizar estos estudios para descifrar otras fases exóticas de la materia en las que se espera que los vórtices desempeñen un papel clave, como en los superconductores de alta temperatura.

Mientras tanto, astrónomos como Graber y Zubieta esperan que este trabajo permita desarrollar una nueva herramienta de diagnóstico para los púlsares. Con una mejor comprensión de la dinámica de los vórtices, podrían utilizar las observaciones de los fallos técnicos de los púlsares para inferir la composición y el comportamiento de la pasta nuclear.

“Si podemos entender cómo funciona esa física a pequeña escala, eso es realmente valioso para nosotros”, dice Graber. “No puedo usar un telescopio y mirar dentro de la corteza de una estrella de neutrones, pero ellos básicamente tienen esa información”.

Ferlaino, cuyo grupo está buscando otros sistemas que puedan presentar supersolidez, ve las aplicaciones como un reflejo de la conectividad fundamental de la naturaleza. “La física es universal”, afirma, y “estamos aprendiendo las reglas del juego”.

El artículo original, Physicists Spot Quantum Tornadoes Twirling in a ‘Supersolid’, se publicó el 6 de noviembre de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo Detectados tornados cuánticos girando en un “supersólido” se ha escrito en Cuaderno de Cultura Científica.

Los tardígrados resisten radiaciones letales para cualquier otro organismo. Y ya sabemos cómo lo logran

No hay animales tan resistentes a condiciones ambientales extremas como los tardígrados. Estos minúsculos organismos (<1 mm), relacionados filogenéticamente con los artrópodos, viven en ambientes húmedos de todo tipo de climas, especialmente sobre musgos o líquenes como podemos ver en este vídeo:

En condiciones ambientales desfavorables los tardígrados entran en un estado denominado criptobiosis. De un 85% de agua en sus tejidos pasan a tener solo un 3%, y prácticamente detienen su metabolismo. Así pueden resistir sin problemas temperaturas extremas (entre ─200ºC y más de 100ºC) o presiones de 6000 atmósferas. En 2007, la sonda espacial Foton-M3 (Rusia/Agencia Espacial Europea), expuso tardígrados al vacío y a la radiación ultravioleta del espacio exterior en el proyecto TARDIS (tardigrades in space). A su regreso algunos ejemplares sobrevivieron e incluso se reprodujeron. En 2016, investigadores japoneses revivieron tardígrados que habían permanecido congelados durante treinta años en la Antártida.

Pero lo que nos interesa hoy es su increíble resistencia a las radiaciones ionizantes. Son capaces de sobrevivir a una dosis de 3000-5000 grays (Gy). Para hacernos una idea, la dosis letal para un ser humano está entre 5-10 Gy. No hay ser viviente (exceptuando a las bacterias) que pueda sobrevivir a estos niveles de radiación. ¿Cómo es posible? La investigación de un grupo de científicos chinos, recién publicada en Science, parece haber dado con las claves.

Figura 1. El tardígrado Hypsibius dujardini, muy similar a la nueva especie Hypsibius henanensis descrita en el artículo de Science. Su longitud no llega a 1 mm. De Willow Gabriel, Goldstein Lab, CC BY-SA 2.5

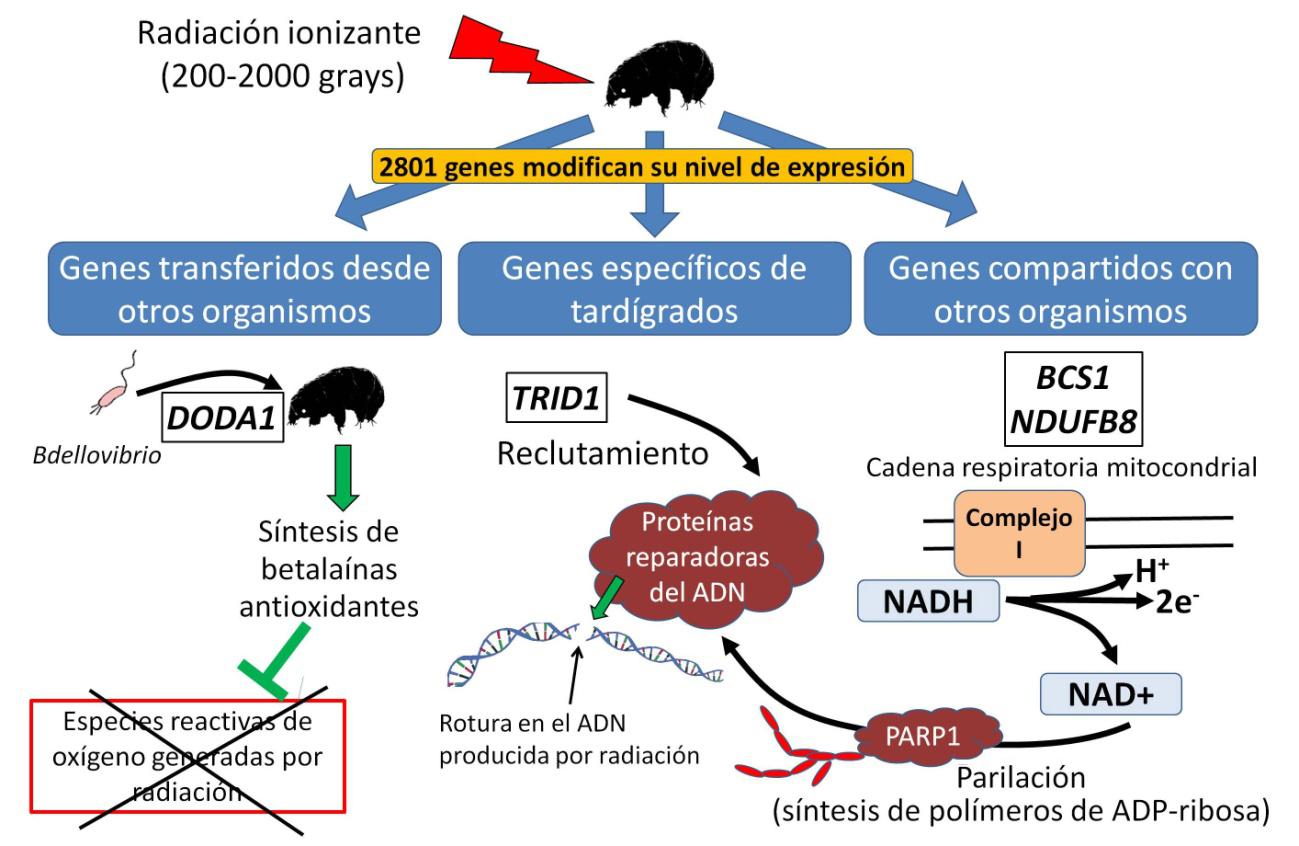

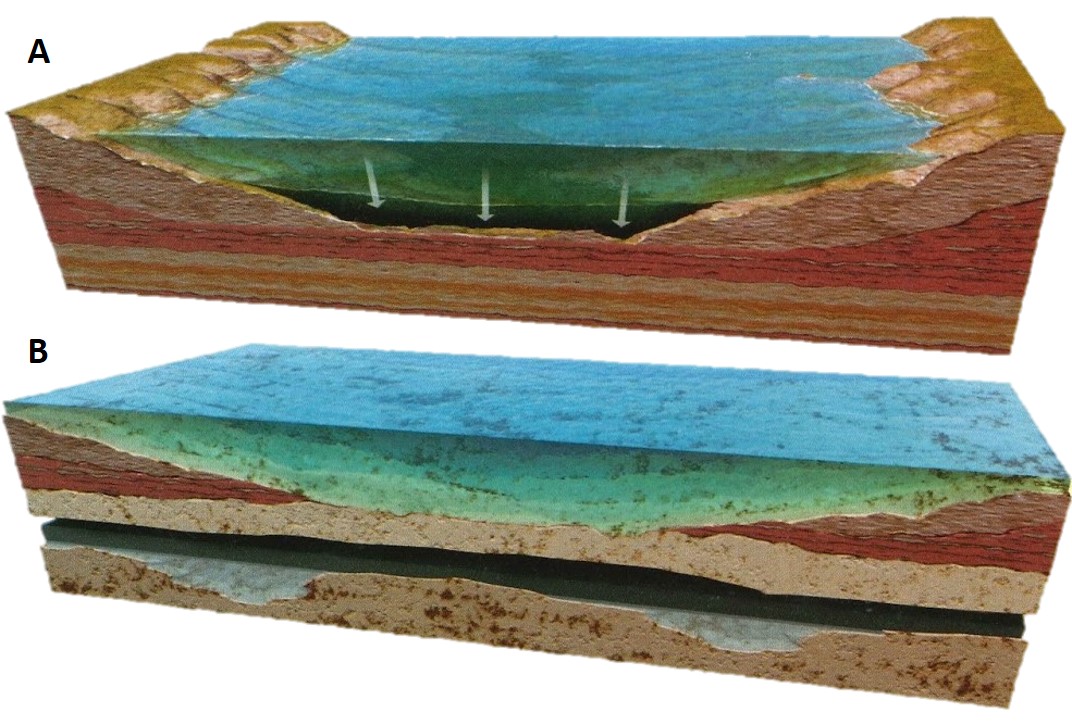

Figura 1. El tardígrado Hypsibius dujardini, muy similar a la nueva especie Hypsibius henanensis descrita en el artículo de Science. Su longitud no llega a 1 mm. De Willow Gabriel, Goldstein Lab, CC BY-SA 2.5Los investigadores secuenciaron el genoma de una nueva especie de tardígrado, Hypsibius henanensis (Figura 1). El grupo identificó un total de 14 701 genes codificantes de proteínas. Tras someter a los tardígrados a dosis de radiación entre 200 y 2000 Gy, comprobaron qué genes habían modificado su nivel de expresión. En total, 2801 genes (un 19%) modificaron su actividad, generalmente con un aumento. Estos genes diferencialmente expresados se podían clasificar en tres grupos (Figura 2).

El primer grupo, podríamos decir el más sorprendente, estaba formado por 459 genes que probablemente derivaban de otros organismos por transferencia genética horizontal. Esto ocurre cuando un organismo incorpora a su genoma genes procedentes de otros seres vivos. Se calculó que entre un 0,5 y un 3% de todo el genoma tardígrado había sido “robado” a otros organismos, 54% a bacterias, 29% a hongos y un 9% a plantas.

Figura 2. Esquema de los resultados obtenidos por Li et al., (2024). La irradiación de Hypsibius henanensis provoca cambios en la expresión de 2801 genes. Un grupo de genes derivan de transferencias desde otros organismos. Entre ellos, DODA1, derivado de una bacteria, permite sintetizar betalaínas antioxidantes que protegen contra la radiación. Entre los genes específicos de tardígrados destaca TRID1, que recluta proteínas reparadoras del ADN a los sitios de rotura de la cadena. Por último, un aumento en la expresión de genes de la cadena respiratoria mitocondrial permite generar grandes cantidades de NAD+, que es usado como sustrato por la enzima PARP1 para sintetizar poli-ADP-ribosa y activar mecanismos de reparación del ADN.

Figura 2. Esquema de los resultados obtenidos por Li et al., (2024). La irradiación de Hypsibius henanensis provoca cambios en la expresión de 2801 genes. Un grupo de genes derivan de transferencias desde otros organismos. Entre ellos, DODA1, derivado de una bacteria, permite sintetizar betalaínas antioxidantes que protegen contra la radiación. Entre los genes específicos de tardígrados destaca TRID1, que recluta proteínas reparadoras del ADN a los sitios de rotura de la cadena. Por último, un aumento en la expresión de genes de la cadena respiratoria mitocondrial permite generar grandes cantidades de NAD+, que es usado como sustrato por la enzima PARP1 para sintetizar poli-ADP-ribosa y activar mecanismos de reparación del ADN.De todos estos genes destacó por su fuerte expresión el denominado DODA1 (DOPA dioxygenase-1), probablemente derivado de una bacteria (Bdellovibrio). DODA1 participa en la síntesis de las betalaínas, pigmentos que aparecen en bacterias y plantas del orden cariofilales. Estas moléculas son las que dan su color rojo a la remolacha. En el caso de los tardígrados, las betalaínas actúan como potentes antioxidantes, eliminando las especies reactivas de oxígeno generadas por la radiación y protegiendo de esta forma al ADN.

El segundo grupo de genes activados por la radiación eran específicos de los tardígrados, ya que no se encontraron equivalentes en otros animales. Constituían el 30% del genoma, y entre ellos destacó TRID1 (por tardigrade-specific radiation-induced disordered protein-1). Se trata de una proteína desestructurada, es decir, sin estructura tridimensional fija, que actúa reclutando proteínas reparadoras del ADN a sitios en los que se ha producido una rotura doble de su cadena. Esta función es tan importante que la inactivación de TRID1 mediante ARN interferente disminuye drásticamente la supervivencia de los tardígrados tras ser irradiados.

Por último, el tercer grupo de genes activados por la radiación se encuentra también en otros animales. Dos de ellos, BCS1 y NDUFB8, destacaron especialmente. Son genes que codifican proteínas de la cadena respiratoria mitocondrial, responsable de la producción de energía en la célula. En el caso de BCS1, se localizaron en distintas especies de tardígrados entre 7-9 copias del gen, frente a la única copia presente en los animales. Todo esto indica una potente aceleración de la fosforilación oxidativa en las mitocondrias tras la irradiación. El objetivo de este proceso sería la regeneración del NAD+ (nicotinamina adenina dinucleótido), una molécula usada como sustrato por la enzima PARP1 para generar polímeros de ADP-ribosa. Estos polímeros facilitan la reparación de daños en el ADN por un proceso llamado parilación.

Lo que resulta intrigante es la razón de que los tardígrados estén equipados con un complejísimo y excepcional sistema de reparación de ADN, teniendo en cuenta de que no se trata de organismos extremófilos. Normalmente no viven sometidos a temperaturas extremas, ni están expuestos al vacío o a la radiación. Es cierto que eventualmente soportan tanto la congelación como la desecación, pero esto también ocurre en otros animales. En cambio, los tardígrados parecen estar preparados para sobrevivir a auténticos cataclismos. En cualquier caso, los nuevos descubrimientos podrían ser valiosos para comprender mejor los mecanismos de supervivencia celular en condiciones de estrés ambiental.

Referencias

Li, L., Ge, Z., Liu, S. et al. (2024) Multi-omics landscape and molecular basis of radiation tolerance in a tardigrade Science doi: 10.1126/science.adl0799.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

El artículo Los tardígrados resisten radiaciones letales para cualquier otro organismo. Y ya sabemos cómo lo logran se ha escrito en Cuaderno de Cultura Científica.

Las ranas de Chernóbil envejecen bien

Macho de Rana de San Antonio oriental (Hyla orientalis). Chernóbil (Ucrania), 2018.

Macho de Rana de San Antonio oriental (Hyla orientalis). Chernóbil (Ucrania), 2018.Germán Orizaola, CC BY

Han transcurrido casi cuatro décadas desde el accidente en la central nuclear de Chernóbil (Ucrania). Durante este tiempo, y para sorpresa de muchos, este lugar se ha convertido en una de las mayores reservas naturales de Europa. A lo largo de los últimos ocho años hemos trabajado para entender la situación de la fauna en el área afectada por este desastre medioambiental.

La radiación es capaz de dañar las células y, en exposiciones extremas, puede incluso causar la muerte de los organismos. Pero la situación de Chernóbil ha cambiado mucho desde el accidente. Allí queda hoy en día menos del 10 % del material radiactivo liberado en 1986. Los isótopos más peligrosos, como los de yodo, desaparecieron hace muchos años.

Estos factores pueden explicar la gran abundancia y diversidad de animales que viven hoy en Chernóbil. Sin embargo, es imprescindible examinar si los organismos experimentan daños que no vemos. Por ejemplo, si acumulan daños que acaben reduciendo su esperanza de vida.

Las ranas de ChernóbilDesde 2016 estudiamos las poblaciones de la rana de San Antonio oriental (Hyla orientalis) en Chernóbil, visitando la zona durante varias semanas cada primavera. Aprovechando la temporada de cría, capturamos machos durante la noche y los llevamos a nuestro laboratorio.

Además de en la zona de exclusión de Chernóbil, trabajamos en otras áreas del norte de Ucrania sin contaminación radiactiva. Estos lugares nos sirven como control para comparar nuestros resultados allí con los de la parte afectada por el accidente.

Durante años hemos examinado la morfología, el estado fisiológico e inmunitario y muchos otros rasgos de estas ranas. Nuestros trabajos han mostrado el aparente buen estado de salud de los anfibios en Chernóbil. Además, descubrimos un ejemplo de evolución rápida en las ranas, que son más oscuras que las de otras zonas sin radiación. Esto se debe, posiblemente, al papel protector de la melanina frente a la radiación.

Quedaba por investigar el efecto a largo plazo de la radiación sobre estos animales. Por eso analizamos la relación entre la radiación, la edad y el envejecimiento de las ranas.

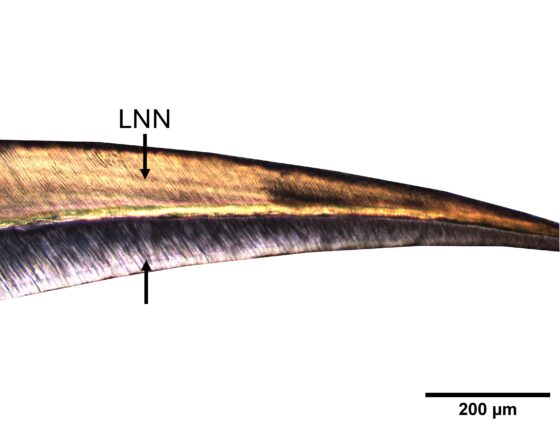

¿Cuánto vive una rana?Podemos calcular la edad de un anfibio contando las líneas de crecimiento en sus huesos. Igual que ocurre con los anillos de los árboles, cada año de vida de una rana queda marcado. Sabemos que algunas especies en zonas de alta montaña pueden vivir más de 20 años. Otras especies, en cambio, apenas llegan a los 2 años.

En nuestro trabajo en Chernóbil examinamos unos 200 ejemplares a lo largo de tres años. Encontramos una edad máxima de 9 años en los machos de rana de San Antonio oriental. La mayoría de individuos que estudiamos tenían entre 3 y 4 años.

Además, queríamos saber si la radiación afectaba al ritmo de envejecimiento de las ranas. Para ello, medimos la longitud de los telómeros, un marcador asociado con la tasa de envejecimiento. Se trata de secuencias de ADN que se encuentran en el extremo de los cromosomas. Su función es proteger el material genético y se van acortando con cada división de la célula.

Para completar nuestro estudio, examinamos también los niveles de hormonas relacionadas con estrés en estas ranas. Medimos el contenido en sangre de corticosterona, una hormona que participa en la regulación del metabolismo y en la activación de la respuesta frente a estrés.

En todas las ranas calculamos también los niveles de radiación absorbida por cada individuo. Medimos el nivel de cesio de sus músculos y de estroncio de sus huesos. Este es uno de los estudios más detallados sobre la exposición actual a radiación en animales de Chernóbil. A nosotros nos permite relacionar de manera precisa los rasgos que medimos con la exposición a radiación en las ranas estudiadas.

El envejecimiento de las ranas de ChernóbilNuestro trabajo revela que vivir en Chernóbil no afecta ni a la edad ni al ritmo de envejecimiento de las ranas estudiadas.

La edad media de los individuos que capturamos fue de 3,6 años y fue similar en los individuos con mayor nivel de radiación y en aquellos de zonas sin radiación. Estos valores son normales para la especie y parecidos a los de otras poblaciones lejos de Chernóbil.

Tampoco observamos ningún efecto de la radiación sobre la velocidad de envejecimiento de las ranas. No detectamos ninguna relación entre la radiación absorbida por las ranas y la longitud de sus telómeros. Ésta se mantuvo bastante constante a lo largo de todos los niveles de radiación estudiados.

Además, los niveles de la hormona corticosterona no se vieron afectados por la radiación absorbida. Las ranas de Chernóbil tampoco parecen estar estresadas.

Estos resultados sugieren que los niveles de radiación presentes hoy en Chernóbil no son suficientes para causar daño crónico en estos organismos. Estas investigaciones son imprescindibles para desmontar el mito de que la Zona de exclusión es un infierno para la vida. En su lugar, estudios como el nuestro demuestran que se ha convertido en un refugio de gran relevancia para la fauna amenazada de Europa.![]()

Sobre los autores: Germán Orizaola, Profesor Titular de Zoología, Universidad de Oviedo y Pablo Burraco, Investigador postdoctoral Juan de la Cierva, Estación Biológica de Doñana (EBD-CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Las ranas de Chernóbil envejecen bien se ha escrito en Cuaderno de Cultura Científica.

Naukas Pro 2024: Las batimetrías, los ojos del fondo marino

Los últimos avances en el ámbito de las energías renovables marinas o la proliferación de los microplásticos fueron algunos de los temas que componen la última edición de NAUKAS PRO. Una cita en la que el personal investigador se sube al escenario del Euskalduna Bilbao para hablar de las investigaciones más destacadas del momento en un ámbito concreto.

En esta ocasión el personal investigador de la Universidad del País Vasco, de la Estación Marina de Plentzia (PiE-UPV/EHU), AZTI, Tecnalia o el CSIC acercaron las últimas investigaciones relacionadas en el ámbito marítimo.

La conferencia Las batimetrías, los ojos del fondo marino corre a cargo de Gemma Ercilla Zarraga, investigadora del Instituto de Ciencias del Mar-ICM-CSIC.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2024: Las batimetrías, los ojos del fondo marino se ha escrito en Cuaderno de Cultura Científica.

El impacto en la Amazonía del petróleo que consumes aquí

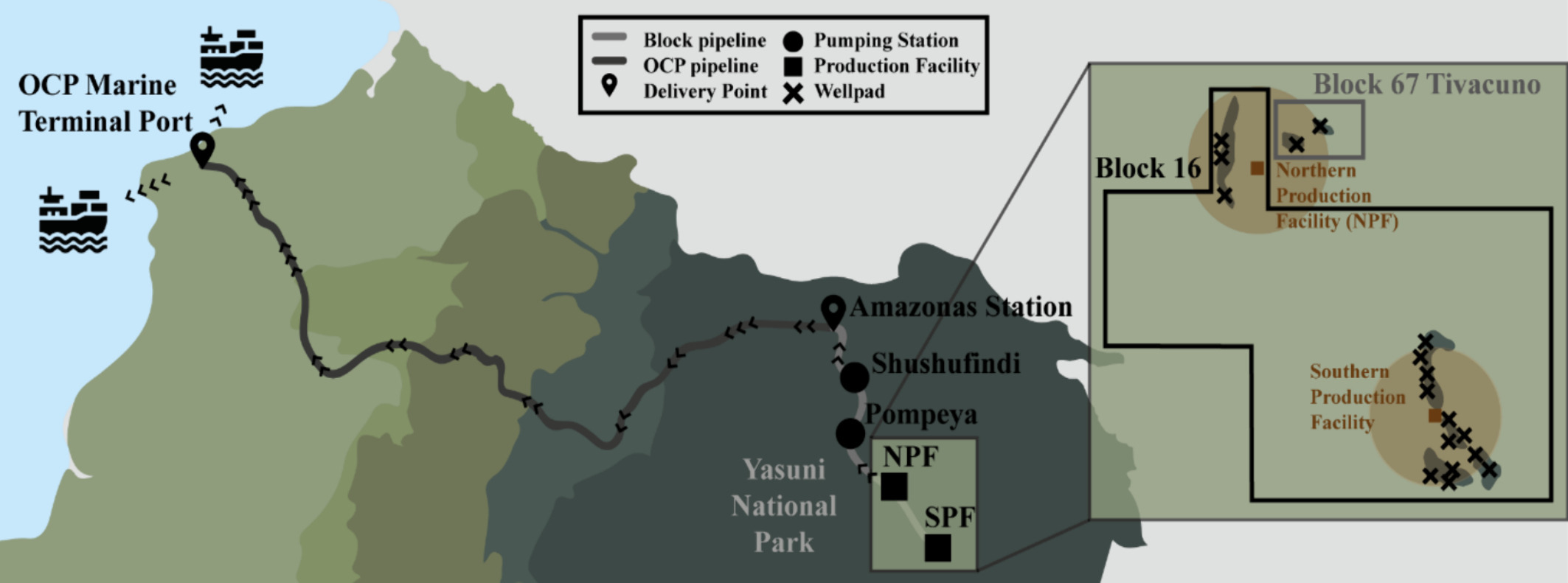

Del petróleo extraído en la Amazonía ecuatoriana por una empresa española, Ecuador apenas se queda con el 21 % de los ingresos. Y ello a pesar de soportar buena parte de los impactos ambientales y las transformaciones culturales en las comunidades indígenas como consecuencia de las extracciones.

Vista aérea de parte de las intalaciones de estracción de petróleo en la Amazonía ecuatoriana. Fuente El Santo Films / Izar Films

Vista aérea de parte de las intalaciones de estracción de petróleo en la Amazonía ecuatoriana. Fuente El Santo Films / Izar FilmsEl último trabajo del grupo de investigación Life Cycle Thinking de la UPV/EHU muestra que el 79 % del dinero procedente del petróleo de los bloques 16 y 67 de Ecuador va a países enriquecidos: el 20 % lo ganan las empresas de extracción, el 21 % las refinerías y los intermediarios en la distribución y el 38 % el gobierno de España a través del impuesto especial sobre hidrocarburos que se aplica por la falta de sostenibilidad. “El hecho de que en el país de origen del recurso, Ecuador, solo se quede el 21 % de los ingresos demuestra que la distribución de beneficios y daños no es equitativa. Nuestro estudio ha convertido en cifras el desigual reparto de los impactos económicos y ambientales de la explotación del petróleo en el norte y en el sur global”, ha explicado Ortzi Akizu Gardoki, investigador de la Escuela de Ingeniería de Vitoria-Gasteiz de la UPV/EHU.

Fuente: Eugenio, C. et al (2024)

Fuente: Eugenio, C. et al (2024)Ecuador produce anualmente unos 175 millones de barriles de petróleo, cuya exportación constituye la principal fuente de ingresos del país. Hay más de 80 bloques repartidos por todo el país, pero los que más polémica generan son los de la selva amazónica, por los daños sociales y ecológicos que provocan. En concreto, los bloques 16 y 67 sobre los que ha incidido la labor de la Universidad del País Vasco se encuentran en el Parque Nacional Yasuní, situado en esa zona, uno de los lugares del mundo con una mayor biodiversidad. Estos pozos han sido elegidos para la investigación por la urgencia de cuantificar el equilibrio entre los impactos y los beneficios que generan las extracciones sobre la naturaleza y sus comunidades indígenas. También porque Repsol ha sido quien ha explotado estos dos bloques durante 24 años: «No se sabe si el combustible que compramos procede de uno de esos dos bloques, pero sí tenemos gasolineras de esa compañía en el País Vasco. El estudio ha servido para impulsar el objetivo de concienciar a los usuarios finales de aquí sobre la responsabilidad que tenemos en los impactos del petróleo que se extrae en la Amazonia”, ha aclarado Akizu Gardoki.

La investigación ha llenado una laguna existente al respecto. De hecho, es la primera vez que se cruzan los datos relativos a los beneficios obtenidos de la explotación de estas dos zonas con la huella ecológica. Se concluye que, de media, la propia Amazonia soporta directamente el 19,6 % de las emisiones equivalentes de CO2 producidas por la producción y el consumo.

El ciclo de vida del petróleoPara lograr estos resultados, el equipo de investigación ha utilizado el análisis del ciclo de vida del petróleo. Con el fin de poder comparar los datos, se ha tenido en cuenta la huella de carbono que se produce cuando lo utilizamos como combustible en vehículos particulares. Es decir, han cuantificado las emisiones de CO2 que se producen desde el momento en que se extrae el petróleo de los dos bloques del Parque Nacional Yasuní, se transporta a las refinerías, se trata y se distribuye a las gasolineras, hasta que sale por el tubo de escape de los coches. Los resultados indican que el 38,7 % de las emisiones se producen directamente por mantener el motor en marcha, el 37,1 % durante la construcción del vehículo y las infraestructuras, y el 24,3 % en los procesos de extracción, refinamiento y distribución.

Akizu Gardoki desea despertar la conciencia de los consumidores finales a través de los siguientes datos: “Se pone de manifiesto la gran responsabilidad de las personas que van al volante. En muchas ocasiones solo miramos el CO2 que sale por el tubo de escape, pero debemos ser conscientes de que la huella ambiental que genera la acción de conducir es más larga y de que también se producen daños en otros países. No somos responsables de los modelos energéticos creados por empresas privadas y gobiernos, pero podemos ser agentes de cambio”.

Impacto social en las comunidades indígenas Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsAdemás del impacto medioambiental, el estudio de la UPV/EHU también ha analizado el impacto social de las extracciones del Parque Nacional Yasuní en los grupos indígenas locales. “Hemos mantenido largas entrevistas con representantes de grupos de la etnia huaorani —señala el investigador— y hemos detectado impactos graves en la calidad de vida. También transformaciones culturales, que no tienen vuelta atrás. Entre otras cosas, hemos visto que se ha producido la dependencia del modelo económico y la pérdida de algunos hábitos, como consecuencia de la civilización”. Por otra parte, el estudio concluye que la explotación del petróleo en la Amazonia ha provocado la aparición del alcoholismo y el aumento de los casos de violencia de género.

Sin embargo, según el líder de Life Cycle Thinking, en el análisis se ha comprobado que las empresas y los gobiernos no cuantifican los daños sociales y ecológicos: “Lo hacen de forma intencionada, porque la falta de medición permite seguir generando impactos y permite pagar una compensación arbitraria por daños no cuantificados”.

El estudio de la Universidad del País Vasco supone una aportación a este primer paso para conocer la relación entre los beneficios y los impactos, pero el autor ha subrayado que es necesario dar más pasos. Por ejemplo, con vistas a reducir los impactos, propone empezar a indicar el origen del petróleo en las gasolineras: “Así como nos hemos acostumbrado a preguntar de dónde procede la fruta que compramos y estamos dispuestos a pagar el doble por las manzanas de productores locales, miremos de dónde viene el combustible que ponemos en los vehículos y de qué manera se produce. La sociedad vasca tiene el potencial de generar cambios en el actual modelo energético”.

Referencia:

Cinta Eugenio, Jacid Montoya-Torres, Ortzi Akizu-Gardoki, Leire Urkidi, Unai Villalba-Eguiluz , Carlos Larrea, Sylvia Pappuccio, Angélica Calle-Calderón, Dania Quirola (2024) Environmental impacts of oil extraction in blocks 16 and 67 of the Yasuní Reserve in the Amazonian Forest: Combined qualitative and Life-Cycle Assessment Science of The Total Environment doi: 10.1016/j.scitotenv.2024.175189

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El impacto en la Amazonía del petróleo que consumes aquí se ha escrito en Cuaderno de Cultura Científica.

Mars Phoenix: la primera biblioteca de Marte

El 25 de mayo de 2008 aterrizó sobre la superficie de Marte la sonda Phoenix y, con ella, muchos de los sueños sobre el planeta rojo que habían alimentado, hasta entonces, la imaginación de varias generaciones. No era la primera vez que llegábamos allí, ni fue la última, pero Phoenix sí fue nuestra Cook o nuestra Peary, esto es, nuestra pionera de la exploración polar marciana.

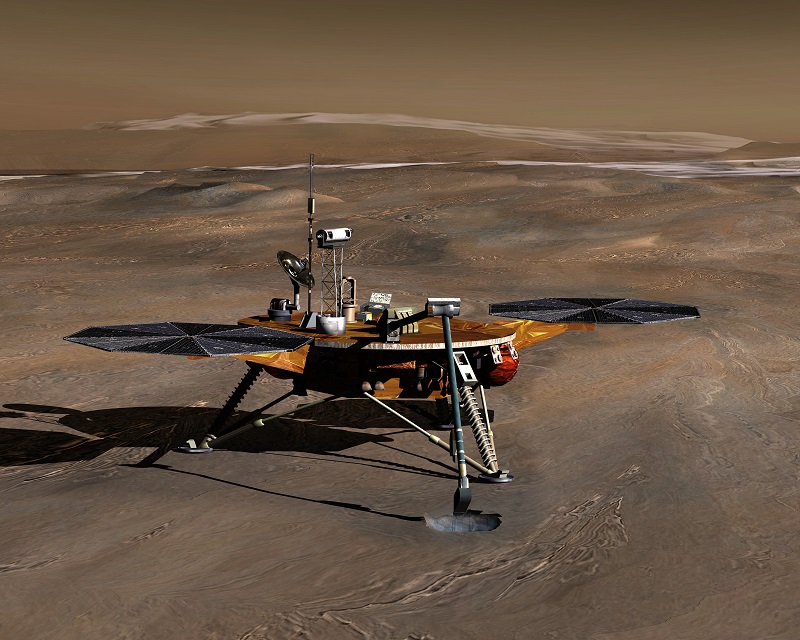

Impresión artística de la sonda Phoenix.

Impresión artística de la sonda Phoenix.Créditos: NASA/JPL/Corby Waste

El objetivo de la misión Mars Phoenix Lander era ayudar a reconstruir la historia geológica del agua en Marte, así como su pasado climático, y estudiar la química del suelo para dilucidar si en algún momento fue capaz de albergar vida. Desde 2001 se sabía, gracias al orbitador Odyssey, que había grandes cantidades de hielo en el subsuelo marciano a latitudes superiores a 55 º, Phoenix —tras el fracaso de la Mars Polar Lander que, en 1999, trató de aterrizar en el polo sur marciano— fue hasta Green Valley, en las planicies septentrionales de Vastitas Borealis, para comprobarlo, pero no solo iba equipada con instrumentos científicos. También llevaba consigo testimonios, historias, visiones y melodías.

Lugar de aterrizaje de la sonda Phoenix: Green Valley, en las tierras bajas septentrionales de Vastitas Borealis, muy cerca del casquete polar norte.

Lugar de aterrizaje de la sonda Phoenix: Green Valley, en las tierras bajas septentrionales de Vastitas Borealis, muy cerca del casquete polar norte.Créditos: NASA/JPL-Caltech/University of Arizona/MSSS

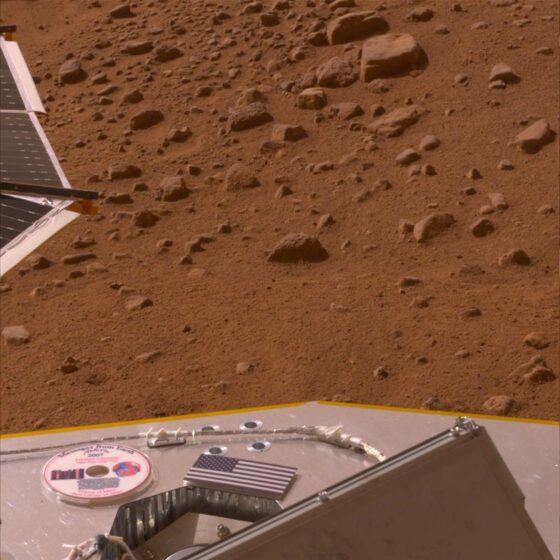

En algunas fotos de la sonda se puede observar sobre la cubierta un miniDVD con el título Visiones de Marte; una versión actualizada —y mucho menos mítica, aunque no menos interesante— del disco dorado de las Voyager. Y sí… como era de esperar, el científico y divulgador Carl Sagan tuvo algo que ver en el proyecto.

El miniDVD Visiones de Marte sobre la cubierta de la Mars Phoenix, fotografiado desde la superficie del planeta.

El miniDVD Visiones de Marte sobre la cubierta de la Mars Phoenix, fotografiado desde la superficie del planeta.Créditos: NASA/Jet Propulsion Lab-Caltech/University of Arizona

La idea, en esta ocasión, nació en 1991 de la mano del ingeniero Louis Friedman, confundador de la Planetary Society junto con el propio Sagan, que en aquel momento era el presidente, y Bruce Murray. Desde finales del siglo XIX y durante gran parte del siglo XX, Marte había sido el protagonista de innumerables aventuras e historias de ciencia ficción y estas, a su vez, habían inspirado a la generación de científicos que había hecho posible que llegáramos hasta nuestro vecino planetario, así que, ¿por qué no recopilar las más significativas y enviarlas allí? Quince años después de las Voyager, la tecnología había avanzado lo suficiente como para poder hacerlo sin un coste prohibitivo: del vinilo se había pasado a las cintas magnéticas, de las cintas magnéticas, al CD y, del CD, al DVD. Ahora se podía almacenar una cantidad de información mucho mayor en mucho menos espacio.

La primera versión de Visions of Mars, cuyo desarrollo corrió a cargo del artista y divulgador Jon Lomberg —colaborador habitual de Carl Sagan y director artístico de Cosmos—, partió a bordo de la misión soviética Mars 96, que acabó en el fondo del Pacífico poco después del despegue. Sin embargo, el proyecto resurgiría de sus cenizas —y no se me ocurre mejor forma de expresarlo— poco más de una década después, cuando se actualizaron y remasterizaron los contenidos para enviarlos al planeta rojo en la misión Mars Phoenix Lander.

Jon Lomberg y John Robert Colombo, con la inestimable ayuda y asesoramiento de la escritora Judith Merril —así como acceso a su extensa biblioteca—, hicieron una selección de obras de ciencia ficción con la que intentaron representar, de la manera más global posible, la historia de nuestras percepciones de Marte a través del tiempo y su influencia en la cultura popular. Así, volvieron a su hogar clásicos anglosajones como Una princesa de Marte, de Edgar R. Burroughs; La guerra de los mundos, de H. G. Wells, o Crónicas marcianas, de Ray Bradbury. Pero también la soviética Estrella Roja, de Alexander Bogdanov (Rusia); Il tre cosmonauti, de Umberto Eco (Italia); Auf zwei Planeten, de Kurd Lasswitz (Alemania), o El atardecer, 2217 d. C., de Ryu Mitsuse (Japón). Y no solo obras de ficción; también se incluyeron algunos de los ensayos más influyentes de la historia de la investigación marciana, como los escritos por Giovanni Schiaparelli y Percivall Lowell. El propio Jon Lomberg diría:

Esta asociación [entre el programa espacial y la ciencia ficción] es lo que nos ha inspirado a enviar este disco a Marte, para honrar y conmemorar el papel que ha desempeñado la ciencia ficción a la hora de alimentar los sueños de las personas que diseñaron, construyeron, volaron y financiaron las misiones que finalmente cruzaron el espacio. ¿Habríamos llegado tan lejos sin estas visiones que nos inspiraron?

Sin embargo, Visiones de Marte no incluía solo textos, sino que en él podemos encontrar todo tipo de expresiones culturales: ilustraciones y fotografías, emisiones de radio —no podía faltar la famosa retransmisión de Orson Welles de La guerra de los mundos, de 1938—… y una lista con los nombres de las 250 000 personas que quisieron formar parte, de alguna manera, de esta misión, incluidos todos los miembros de la Sociedad Planetaria.

Ilustración de 1906 de la edición belga de La guerra de los mundos de H. G. Wells incluida en Visions of Mars.

Ilustración de 1906 de la edición belga de La guerra de los mundos de H. G. Wells incluida en Visions of Mars.

Como si una cápsula del tiempo se tratara, Arthur C. Clarke, Louis Friedman y Judith Merrill dejaorn mensajes para los colonos del futuro. También otra persona que, de haber seguido todavía entre nosotros, hubiera cumplido noventa años el pasado 9 de noviembre:

Cualquiera que sea la razón por la que estáis en Marte, me alegro de que sea así. Y desearía estar con vosotros.

Carl Sagan

Bibliografía

NASA (2008). Phoenix Landing. Mission to the Martian Polar North [press kit].

The Planetary Society (s. f.). Visions of Mars.

The Planetary Society (s. f.). Visions of Mars. Then and now.

.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Mars Phoenix: la primera biblioteca de Marte se ha escrito en Cuaderno de Cultura Científica.

La sucesión del infinito del compositor Per Nørgård

Los fractales son unos curiosos objetos matemáticos que gozan de una cierta popularidad fuera de la comunidad matemática, y científica, desde que el matemático polaco, nacionalizado francés y estadounidense, Benoît Mandelbrot (1924-2010), considerado el padre de la geometría fractal, realizara una importante labor divulgativa sobre ellos, primero con el artículo ¿Qué longitud tiene la costa de Gran Bretaña? (Revista Science, 1967) y posteriormente con los libros Los objetos fractales: forma, azar y dimensión (1975) o La geometría fractal de la naturaleza (1982), entre muchos otros.

En la entrada del Cuaderno de Cultura Científica titulada Sucesiones fractales hablábamos de un tipo de sucesiones de números enteros que compartían con los objetos fractales una de sus propiedades definitorias, la autosemejanza (para una explicación divulgativa de las mismas puede leerse la entrada Fractus, arte y matemáticas). Más aún, en una entrada posterior, titulada Sucesiones fractales: del número a la nota musical, explicábamos como el compositor minimalista estadounidense Tom Johnson (1939) las había utilizado en algunas de sus composiciones musicales, por ejemplo, La melodía racional XV y la pieza La vie est si court, las cuales fueron explicadas en dicha entrada.

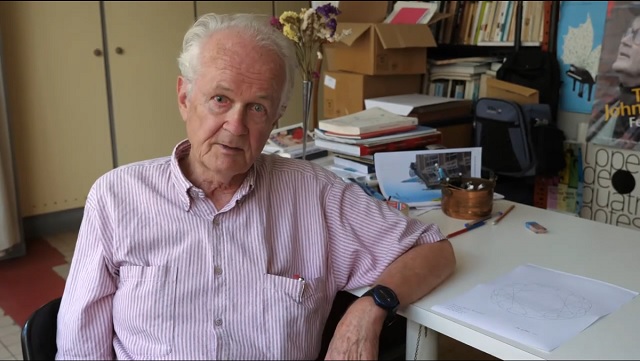

Fotograma del video “Illustrated Music #6, Rational Melody XV” del canal de YouTube del compositor Tom Johnson, al que podemos ver en el mismo

Fotograma del video “Illustrated Music #6, Rational Melody XV” del canal de YouTube del compositor Tom Johnson, al que podemos ver en el mismo

La “sucesión del infinito” que, en particular, es una sucesión fractal y de la que vamos a escribir en esta entrada, fue descubierta por el músico danés Per Nørgård, que la utilizó como base matemática de muchas de sus composiciones musicales.

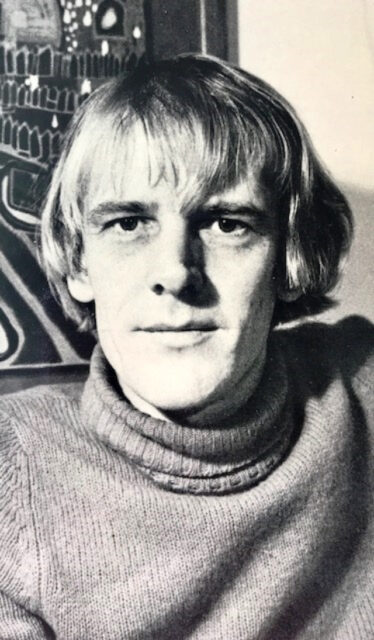

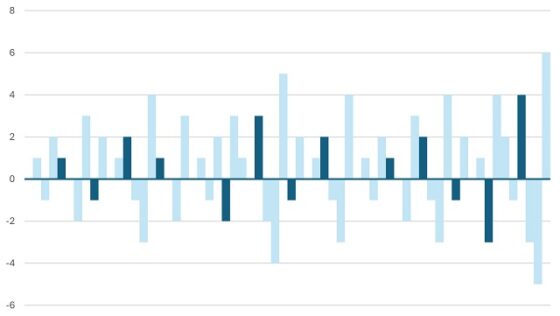

Per Nørgård, descubridor de la sucesión del infinitoEl compositor, teórico de la música y profesor danés Per Nørgård (1932) es una figura fundamental en la música danesa contemporánea. Ha escrito alrededor de 400 composiciones, que incluyen seis operas, ocho sinfonías, tres ballets, música para orquesta, conciertos, obras corales y vocales, música de cámara, piezas para instrumentos solistas y también bandas sonoras para películas. Entre sus composiciones más importantes se podrían citar Voyage into the Golden Screen / Viaje a la pantalla dorada (1968), para orquesta, la Sinfonía no. 2 (1970), para orquesta, la ópera Gilgamesh (1972), premiada con el Nordic Music Prize en 1974, la Sinfonía no. 3 (1972), para dos coros y orquesta, la ópera Siddharta (1979), la pieza para un solo instrumento de percusión I Ching (1982) o la ópera Det Guddommelige Tivoli / El circo divino (1982). Además, ha recibido muchos reconocimientos a lo largo de su extensa carrera, como el Premio (internacional) Ernst von Siemens, conocido como el Premio Nobel de la Música, en 2016, o el Premio (internacional) Wihuri Sibelius, en 2006, por mencionar algunos.

Fotografía del compositor danés Per Nørgård (1932)

Fotografía del compositor danés Per Nørgård (1932)

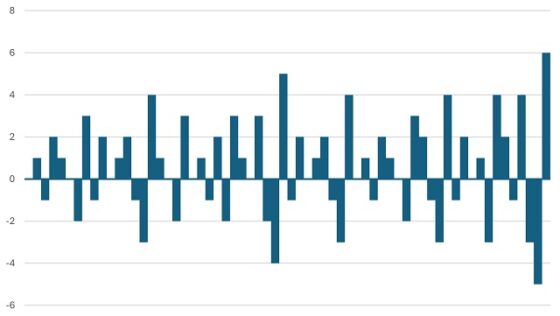

Si consultamos la biografía de Per Nørgård que aparece en la base de datos sobre compositores del Institut de Recherche et Coordination Acoustique/Musique (IRCAM), un instituto francés de investigación sobre música y acústica, asociado al Centro Nacional de Arte y Cultura Georges Pompidou de París (cuya dirección web es brahms.ircam.fr), se mencionan las siguientes cuestiones respecto a su música. “Tras experimentar con collages musicales a finales de la década de 1950, Per Nørgård centró su atención en la música serial en los primeros años de la nueva década, desarrollando su propia técnica conocida como sucesión del infinito”, que es una de las herramientas musicales más importantes del conjunto de su producción musical. Además, no podemos olvidar que esta sucesión del infinito es un objeto matemático, una sucesión de números enteros con una serie de propiedades que la hacían interesante para las composiciones musicales que Per Nørgård quería componer y que utilizó en obras como Viaje a la pantalla dorada (1968), la Sinfonía no. 2 (1970), la Sinfonía no. 3 (1972) o I Ching (1982). Además de la sucesión del infinito, también utilizó el número de oro y la sucesión de Fibonacci, aunque en menor medida.

Por otra parte, “en 1979, durante una exposición en el Museo de Arte Moderno de Luisiana (Dinamarca), el compositor descubrió la obra del pintor suizo, uno de los primeros artistas asociados con el Art Brut (arte marginal), Adolf Wölfli. La interpretación de los criptogramas del artista esquizofrénico atrajo la práctica compositiva de Nørgård hacia el expresionismo. El resultado es un juego de intensidades, cambios bruscos de humor y modificaciones violentas del sonido y, además, un desbordamiento del flujo musical. Esta aparición del conflicto y la irracionalidad en su obra es una respuesta directa a la última década de composiciones matemáticamente regulares”. Entre las obras que pertenecen a este periodo están la Sinfonía no. 4 (1981) y la ópera sobre la vida de Wölfli, El circo divino (1982).

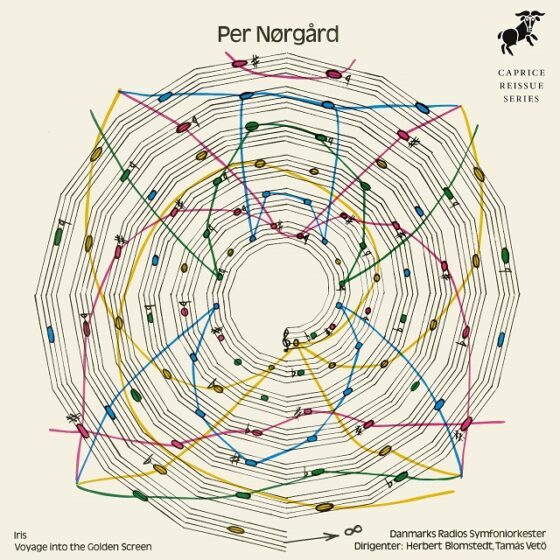

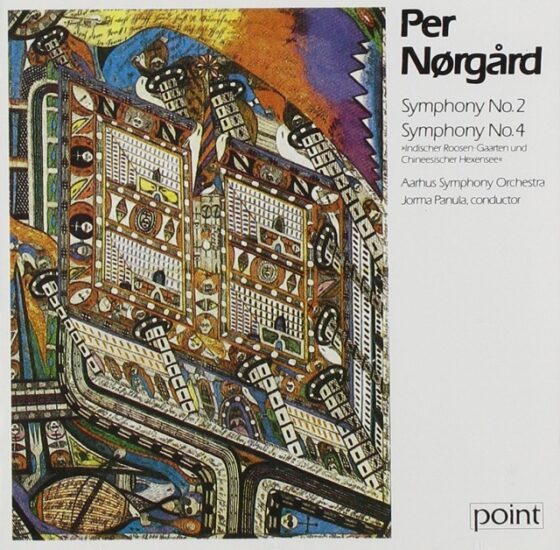

Portada del disco Per Nørgård: Iris/Voyage into the Golden Screen (1973), de la Danish National Symphony Orchestra, dirigida por Herbert Blomstedt y Tamás Vetö, en cuya imagen podemos observar la sucesión del infinito en formato musical y dibujada en espiralLa sucesión del infinito

Portada del disco Per Nørgård: Iris/Voyage into the Golden Screen (1973), de la Danish National Symphony Orchestra, dirigida por Herbert Blomstedt y Tamás Vetö, en cuya imagen podemos observar la sucesión del infinito en formato musical y dibujada en espiralLa sucesión del infinito

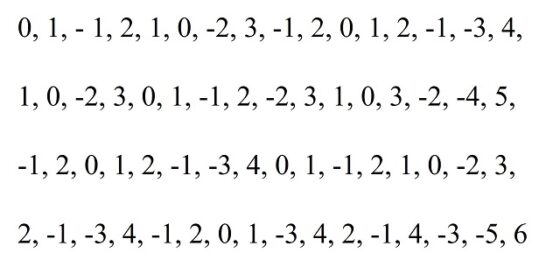

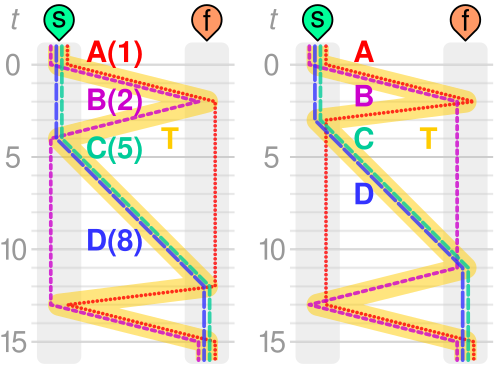

El compositor Per Nørgård descubrió (utilizamos este término y no “inventó”, ya que es el que utilizaba el propio Nørgård) la sucesión de números enteros que bautizó con el nombre de Uendelighedsrækken (en danés), que he traducido para esta entrada como sucesión del infinito, en 1959, años antes de que los fractales se hicieran conocidos a través de la labor divulgativa del matemático Benoit Mandelbrot, y que utilizó en muchas de sus composiciones, especialmente de las décadas de 1960 y 1970. La primera obra en la que utiliza la sucesión del infinito es su obra Viaje a la pantalla dorada (1968), en la cual utiliza 1.024 elementos de la sucesión en su versión musical. La siguiente obra en la que la utilizaría es la Sinfonía no. 2 (1970), con una utilización más compleja con 4.096 elementos de la sucesión.

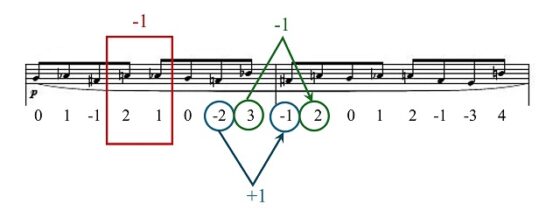

Si consultamos la partitura de la obra Viaje a la pantalla dorada podemos ver una versión musical de la sucesión del infinito, cuyas primeras 64 notas (interpretadas en esta obra por las dos flautas) aparecen en la siguiente imagen.

Las primeras 64 notas de la sucesión musical del infinito extraída de la composición Viaje a la pantalla dorada (1968), de Per Nørgård

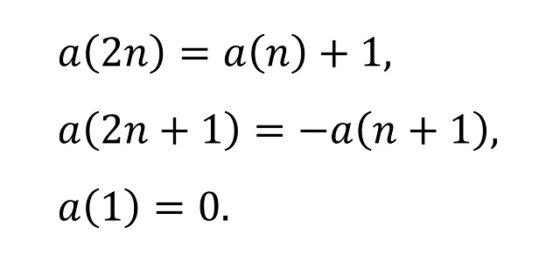

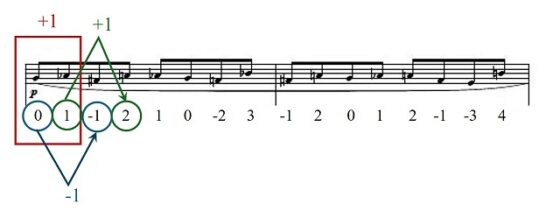

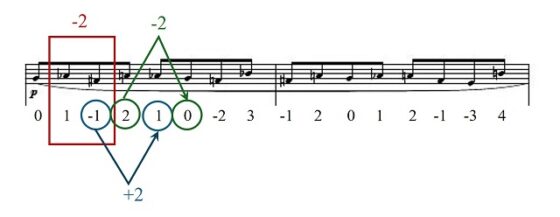

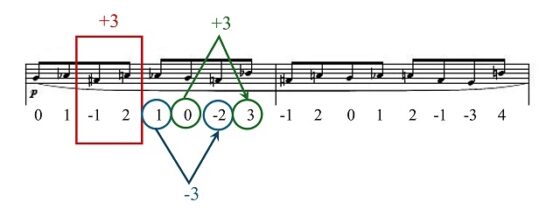

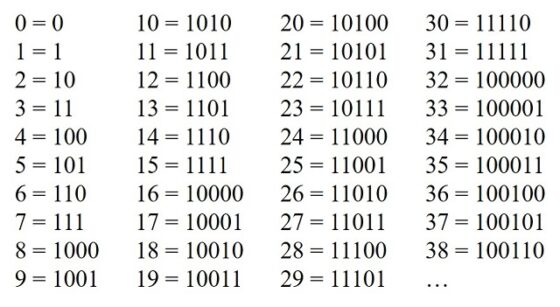

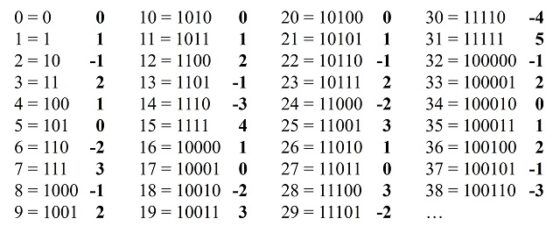

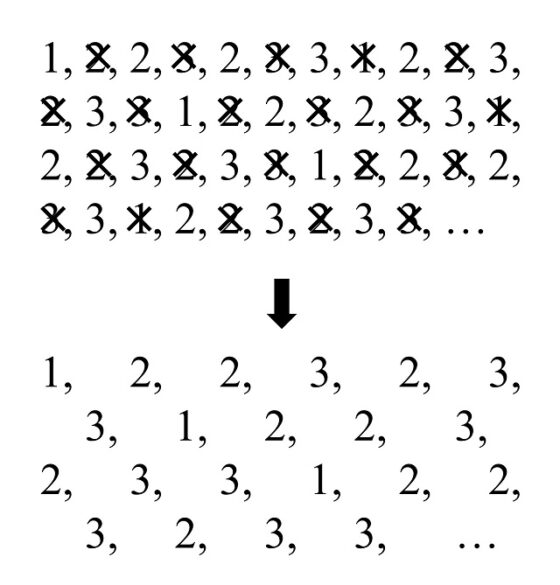

Las primeras 64 notas de la sucesión musical del infinito extraída de la composición Viaje a la pantalla dorada (1968), de Per NørgårdA partir de la anterior imagen, extraída de la partitura de la obra Viaje a la pantalla dorada, vamos a escribir la sucesión de números enteros, que Nørgård descubrió, realizando el proceso inverso al que realizó el compositor al pasar de la sucesión de números a la sucesión de notas musicales. Para ello empezamos indicando que el punto inicial es la primera nota de la sucesión musical, que en este caso es “Sol” y que se corresponde con el número 0. A partir de ahí los números enteros de la sucesión van a indicar, para cada nota, la cantidad de semi-tonos que esa nota está por encima (positivo) de “Sol”, luego es más aguda, o por debajo (negativo), luego es más grave. Así, el segundo número es un 1 puesto que la siguiente nota es “La bemol” que es un semi-tono más alta (aguda) que “Sol” (de “Sol” a “La” subimos un tono, pero el bemol indica que baja un semi-tono, luego de “Sol” a “La bemol” sube un semi-tono). Como la tercera nota es “Fa sostenido”, que es un semi-tono más baja (grave) que “Sol” (de “Sol” a “Fa” se baja un tono, pero el sostenido indica que la nota sube un semi-tono, entonces el “Fa sostenido” es un semi-tono más bajo que “Sol”), el siguiente número de la sucesión es -1. El cuarto número es 2, ya que la cuarta nota es un “La”, un tono, luego dos semi-tonos, por encima de “Sol”. De esta manera descubrimos que los 64 primeros números de la sucesión del infinito, en correspondencia con las notas musicales de la partitura, son los siguientes.