Mosaicos hexagonales para el verano

El pasado 25 de julio, de 2017, tuve el placer de participar en la jornada RSME-ANEM que tuvo lugar en Sevilla, dentro del XVIII Encuentro Nacional de Estudiantes de Matemáticas. Aprovechando mi estancia en la capital hispalense me acerqué a CaixaForum Sevilla, donde disfruté de dos magníficas exposiciones. La primera de ellas, Sorolla, un jardín para pintar, fue una exposición muy interesante sobre la relación del pintor valenciano Joaquín Sorolla con los patios y jardines andaluces y los de su propia casa madrileña, que él mismo diseñó. La segunda fue todo un descubrimiento para mí, la magnífica exposición Anglada-Camarasa (1871-1959), del pintor modernista catalán Hermenegildo Anglada Camarasa.

“La sibila” (1913), de Hermenegildo Anglada Camarasa

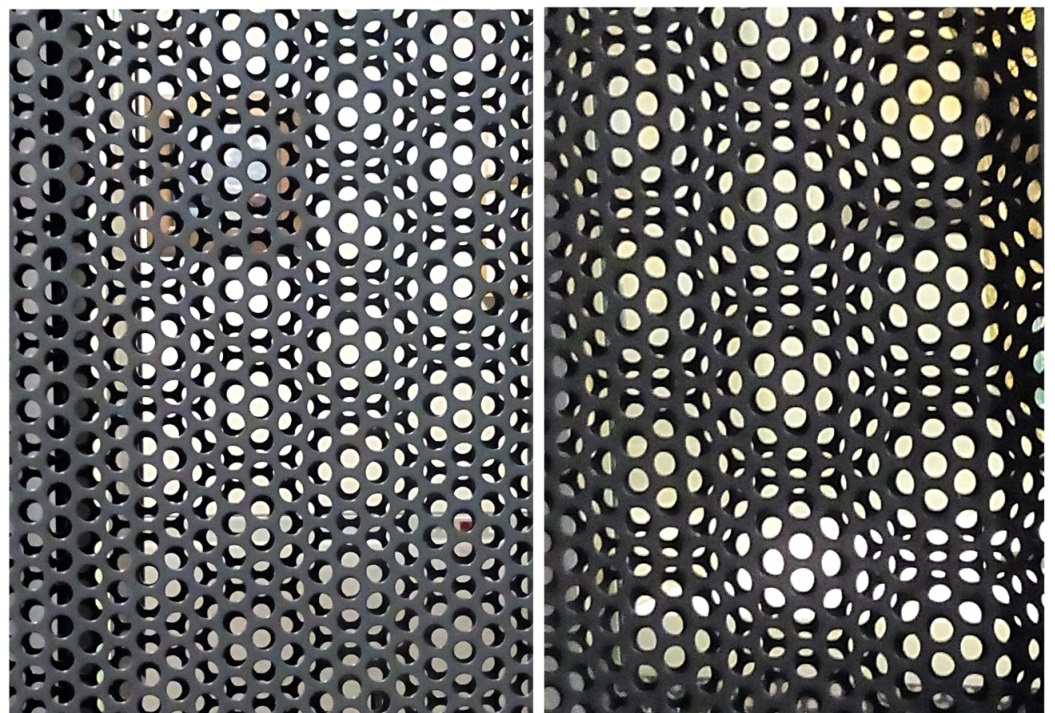

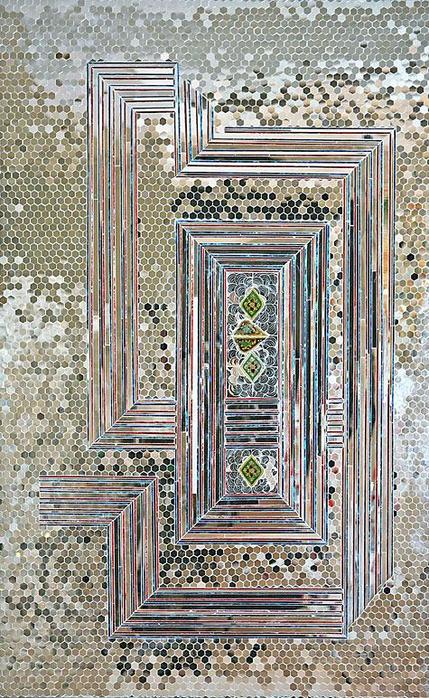

Sin embargo, en esta entrada del Cuaderno de Cultura Científica no voy a hablar de estas dos magníficas exposiciones, sino de un pequeño elemento funcional y decorativo que CaixaForum Sevilla utilizó para separar espacios en la exposición de Anglada Camarasa. Se trataba de una construcción con dos placas de metal con pequeños agujeros redondos y colocadas en paralelo, una detrás de la otra. Lo interesante de este pequeño elemento decorativo era el efecto óptico que se producía al mirarlo. Como se puede apreciar en las siguientes imágenes (que por desgracia no tienen la intensidad de lo que se realmente se veía), el efecto óptico consistía en la impresión de que se estaba mirando un mosaico de hexágonos regulares. Un bello efecto óptico, que no pude evitar fotografiar de inmediato.

Efecto óptico, de mosaico hexagonal, producido por dos placas metálicas paralelas con agujeros redondos en CaixaForum Sevilla

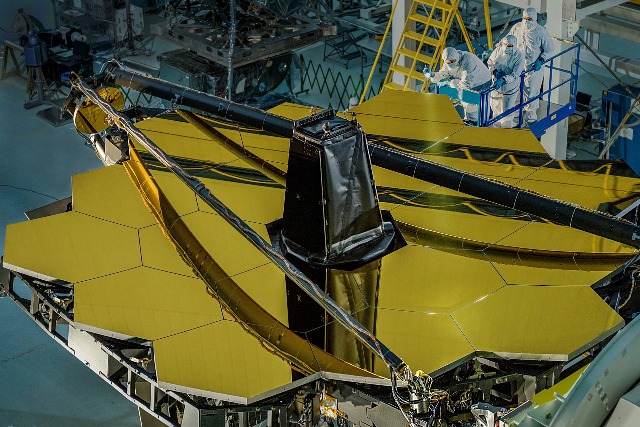

Como ya comentamos en la entrada Diseños geométricos de chocolate, solamente existen tres diseños de mosaicos regulares, es decir, realizados con polígonos regulares, aquellos que utilizan cuadrados, triángulos y hexágonos. El mosaico hexagonal, que vino a mis ojos a través del efecto óptico en CaixaForum Sevilla, está presente en muchos elementos de nuestra vida, desde sencillos elementos decorativos de nuestras casas y ciudades (de hecho, en la mencionada entrada del Cuaderno mostramos el mosaico hexagonal de baldosas que el arquitecto barcelonés Antoni Gaudí (1852-1926) creó para los suelos de la Casa Milá, La Pedrera, de Barcelona, y que ahora es todo un símbolo de la ciudad condal) a importantes aplicaciones industriales (como el Telescopio Espacial James Webb, de la NASA, la ESA y la CSA, cuyo espejo está formado por 18 segmentos hexagonales), pasando por su presencia en el arte.

Mosaico hexagonal del Paseo de Gracia, en Barcelona, con el diseño que realizó Antoni Gaudí para los suelos de la Casa Milá

Espejo, formado por un mosaico hexagonal con 18 hexágonos, del Telescopio Espacial James Webb, que será el sucesor del Telescopio Espacial Hubble y del Spiltzer, y que se lanzará al espacio en octubre de 2018

El objetivo de esta entrada es mostrar algunos ejemplos de la presencia del mosaico de hexágonos en el arte. Debido a que su uso en el arte, el diseño y la arquitectura es enorme, solo vamos a dar una pequeña muestra.

Iniciaremos este corto paseo con algunas obras del maestro del Op Art, arte óptico, el artista húngaro, que vivió la mayor parte de su vida en Francia, Víctor Vasarely (1906-1997). Entre las muchas obras de Vasarely, nos encontramos con una serie de nueve obras con el título conjunto Homenaje al hexágono (1969), que se encuentran en el MOMA (Museo de Arte Moderno) de Nueva York.

Una de las obras de la serie “Homenaje al hexágono” (1969), de Víctor Vasarely, que se encuentra en el MOMA de Nueva York

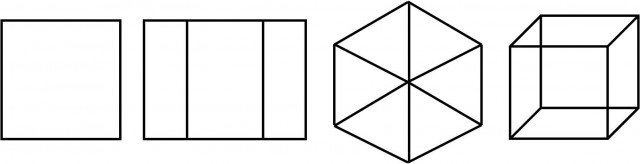

Aunque, como vemos en la imagen anterior, Vasarely no realiza un mosaico limpio de hexágonos, sino que juega con otro efecto óptico, muy habitual en su obra, lo que él llama “cubo de Kepler”. La proyección ortogonal de un cubo (desde una dirección que es paralela a una de las diagonales del cubo) es una imagen plana representada por un hexágono formado por tres rombos, que es la que se observa en cada uno de los hexágonos de la anterior obra de Vasarely. Si el cubo está vacío, es decir, solo está formado por las aristas laterales, entonces la proyección ortogonal del mismo es un hexágono formado por seis triángulos, como comentamos en la entrada Hipercubo, visualizando la cuarta dimensión.

Proyecciones ortogonales de un cubo siguiendo una dirección a) perpendicular a dos de las caras del cubo, y paralela a las otras cuatro; b) paralela solamente a dos de las caras del cubo; c) paralela a la diagonal; d) no paralela ni a las caras ni a la diagonal

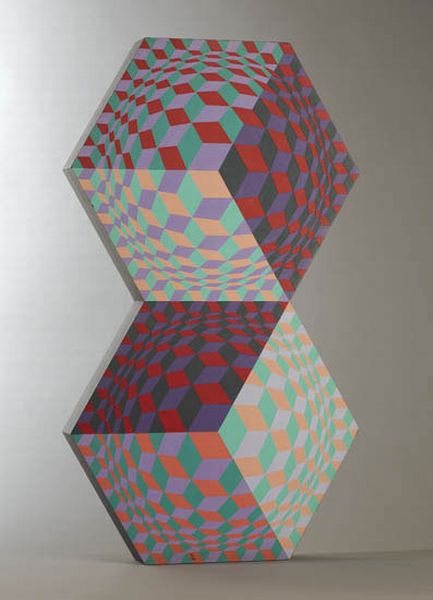

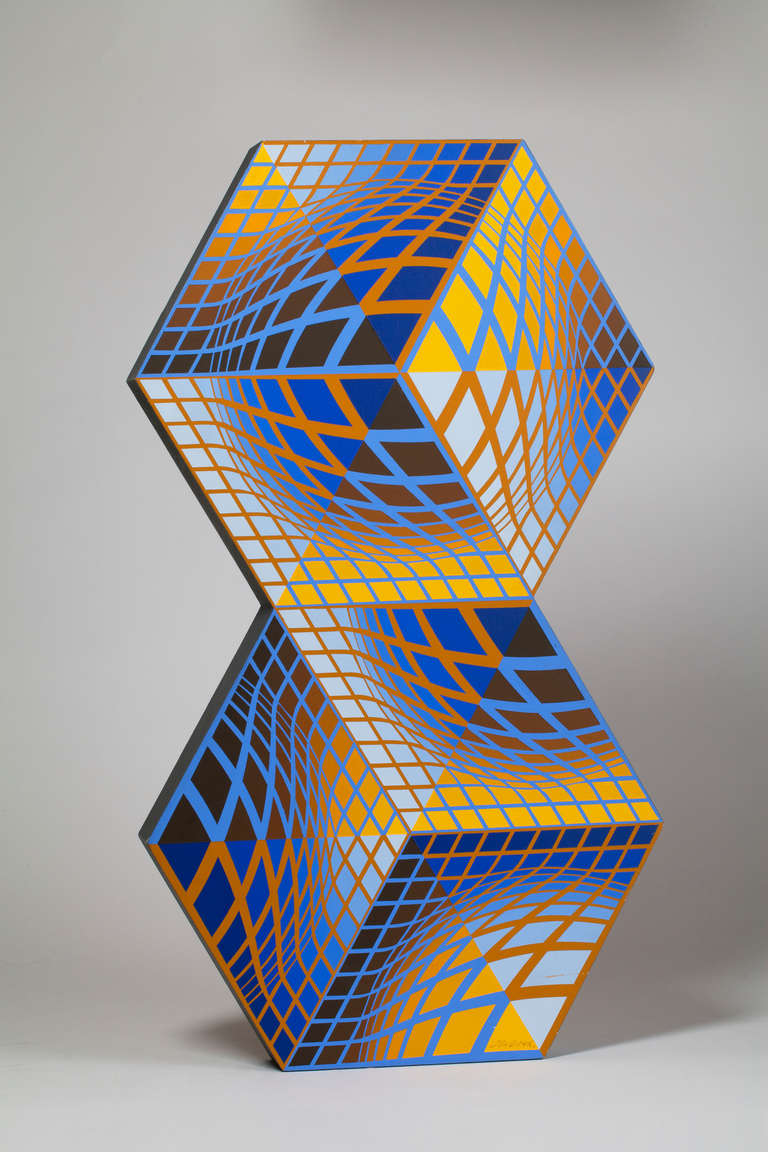

A continuación, mostramos dos esculturas de Victor Vasarely formadas ambas por dos hexágonos y en cada una de ellas se muestra la imagen hexagonal del cubo que acabamos de comentar, en la primera obra formada por rombos y en la segunda por triángulos.

“Kettes” (que en húngaro significa “dos”), obra de Victor Vasarely, de 1984, pintada sobre madera

“Sin título” (1984), obra de Victor Vasarely, pintada sobre madera

El hexágono formado por tres rombos crea un efecto óptico muy conocido, y popular, del cubo, ya que da la impresión tanto de que es un cubo “hacia fuera”, como “hacia dentro”, a la vez. Es decir, se crea una doble impresión visual, en la que vemos tanto la imagen en la que el vértice del cubo que está en el centro de la imagen está más cerca de la persona que observa el “cubo”, como la imagen en la que está más lejos. Además, se puede jugar con los colores del cubo para marcar más una opción u otra. Obsérvense este efecto en las dos primeras obras de Vasarely.

Este efecto óptico del cubo, formado por hexágonos de tres rombos, es muy habitual en la decoración de casas, comercios, bares y otros locales de nuestras ciudades.

El artista óptico Victor Vasarely juega con estos elementos, junto con otros elementos, como formas, colores y proyecciones, para sacarle el máximo rendimiento.

“Cinético” (1971), de Victor Vasarely

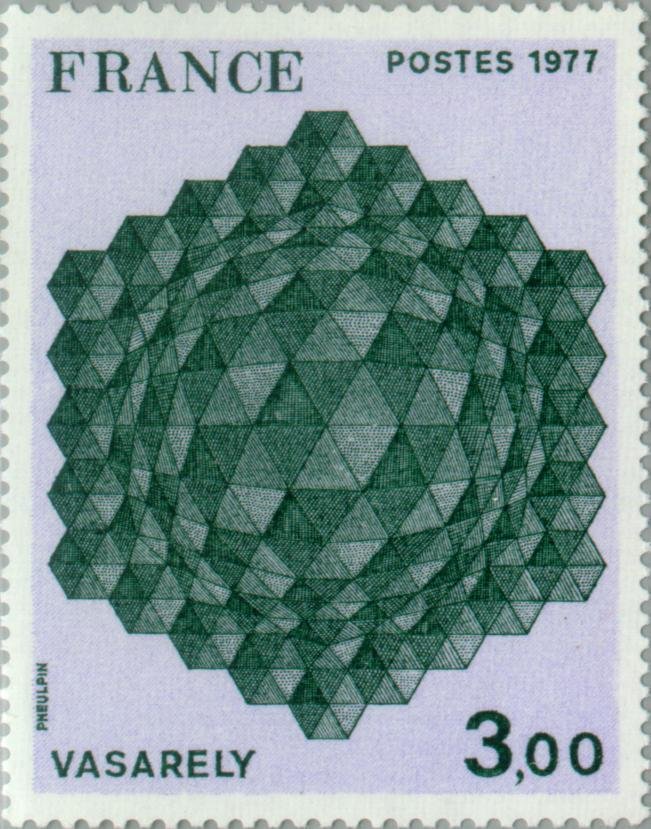

En Francia se realizó un sello en 1977 con la obra de Victor Vasarely Tributo al hexágono, que se puede ver en la siguiente imagen.

Sello de 1977, con el valor de 3,00 francos, de la obra de Victor Vasarely, “Tributo al hexágono”

Estas son solo algunas de las muchas obras de Victor Vasarely relacionadas con el hexágono. Terminamos con otra en la que una vez más se juega con el efecto óptico del cubo, aunque con un doble efecto, como se puede apreciar.

“Bi-sanction”, de Victor Vasarely

Hay una artista muy interesante, por la utilización de patrones geométricos en su trabajo, que tiene algunas obras que me recuerdan mucho a estos estudios ópticos de Victor Vasarely sobre el hexágono y el cubo, es la artista iraní Monir Shahroudy Farmanfarmaian (Qazvin, Irán, 1924).

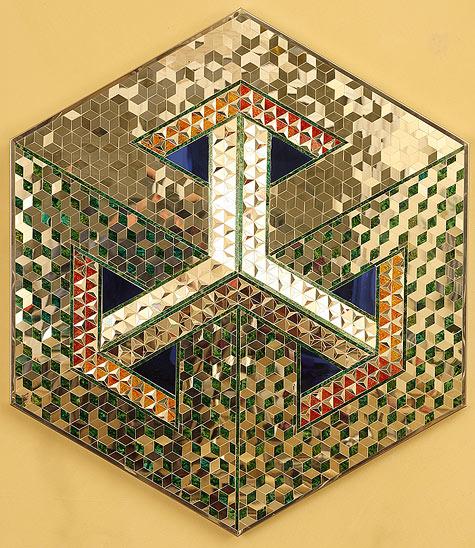

Esta artista iraní tiene una serie de mosaicos de espejos con piezas triangulares, cuadradas y hexagonales con las que juega creando imágenes globales más potentes, en particular, en varias de sus obras utiliza piezas hexagonales, que son cubos proyectados sobre el plano. En la primera de las que traemos aquí la imagen global es de nuevo un hexágono representando una imagen plana del cubo, que a su vez realiza un juego óptico.

“Hexágono” (2004), de la artista iraní Monir Shahroudy Farmanfarmaian

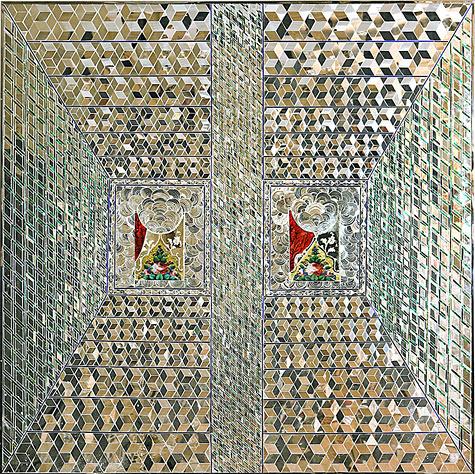

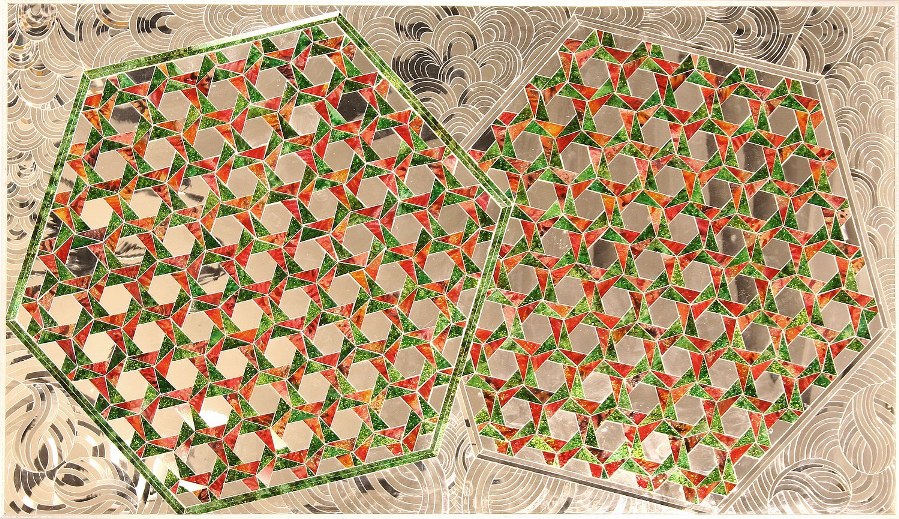

En la siguiente obra de Farmanfarmaian, Recuerdo 1 (2008), que como en sus demás obras nos transmite su admiración por el arte árabe antiguo, sus mosaicos y sus estructuras geométricas, crea una obra cuadrada, de nuevo utilizando piezas espejadas con forma hexagonal, que es un cubo proyectado.

“Recuerdo 1” (2008), de Monir Shahroudy Farmanfarmaian

Con la misma idea, pero con pequeños espejos hexagonales limpios, sin la referencia al cubo, se construye su obra, Recuerdo 2 (2008).

“Recuerdo 2” (2008), de Monir Shahroudy Farmanfarmaian

El hexágono es un elemento principal en muchas de sus obras. Terminaremos este pequeño paseo por el trabajo de la artista iraní Monir Shahroudy Farmanfarmaian con dos obras más relacionadas con este poliedro regular. La primera de ellas es parte de una serie de obras, todas de similar estructura, pero cuyas piezas forman un poliedro regular con diferente número de lados en cada una de ellas, desde tres (triángulo), hasta 10 (decágono) lados.

“Primera familia, hexágono” (2010), de Monir Shahroudy Farmanfarmaian

“Los dos hexágonos” (2005), de Monir Shahroudy Farmanfarmaian

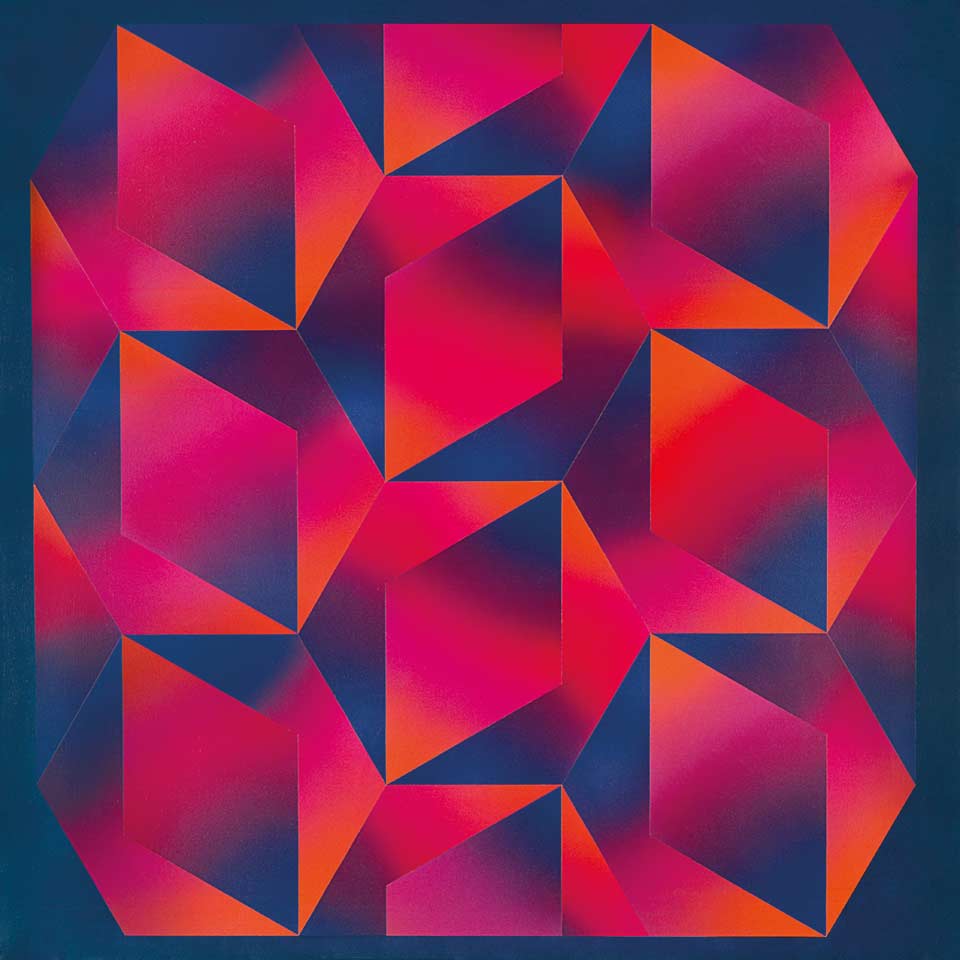

Pero volvamos a los mosaicos hexagonales y de nuevo a los movimientos artísticos del siglo XX. Si antes hablábamos del arte óptico de la mano de Victor Vasarely, ahora nos adentraremos en la abstracción geométrica. El pintor argentino Rogelio Polosello (1939-2014), que fue un pintor que trabajó dentro de la abstracción geométrica, tiene una serie de cuadros que son mosaicos de hexágonos con rombos en su interior, como el que mostramos a continuación.

“Héxagono No. 4” (1974), de Rogelio Polosello

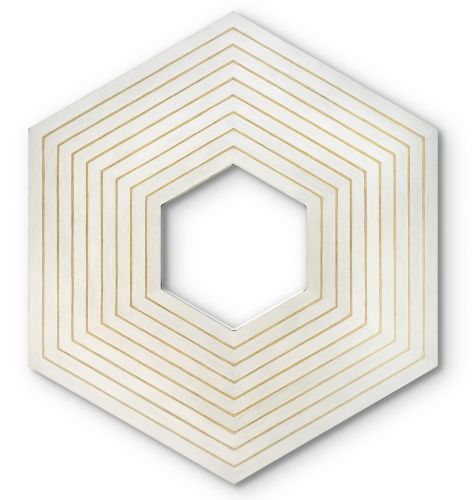

Otros artistas de la abstracción geométrica también han utilizado el hexágono, aunque no sea el mosaico hexagonal. Veamos un par de ejemplos. El primero es del pintor y grabador norteamericano Frank Stella (Massachusetts, 1936).

“Sydney Guberman” (1964), de Frank Stella

Y la segunda es de la artista estadounidense Edna Andrade (1917-2008) cuyo arte podemos enmarcar entre la abstracción geométrica y el arte óptico.

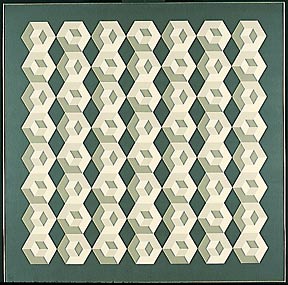

“Hot Blocks” (1966-67), de Edna Andrade

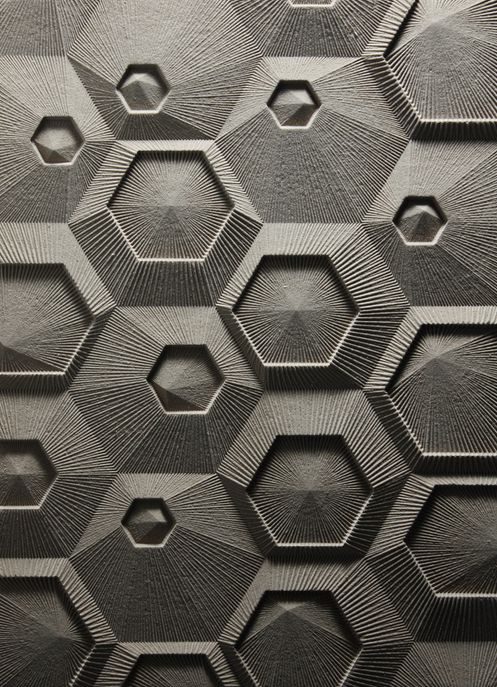

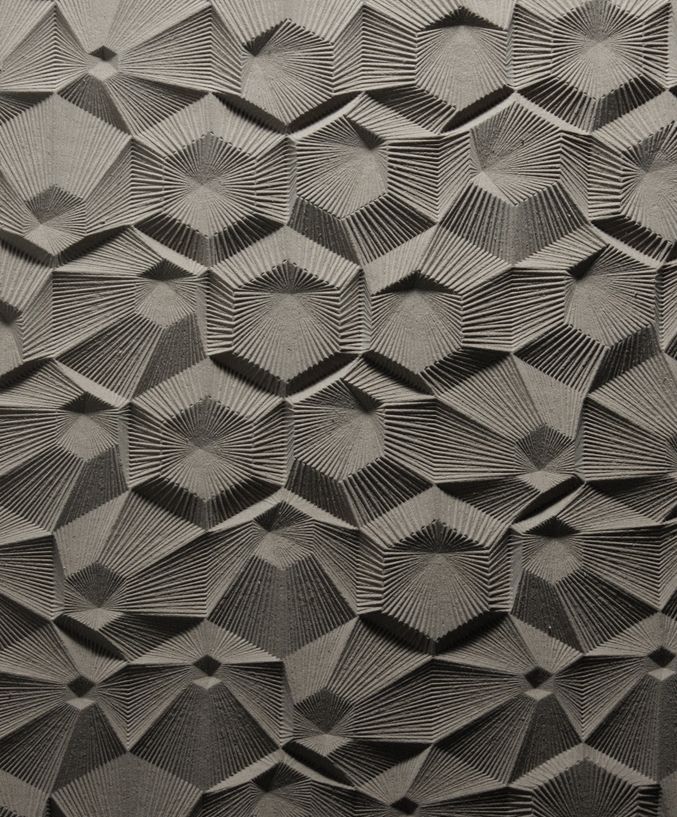

Vamos a terminar con alguien más actual que realiza obras basadas en el mosaico hexagonal, es el joven diseñador y arquitecto estadounidense Elijah Porter. Las siguientes imágenes son proyectos de superficies arquitectónicas realizadas por Porter.

Bibliografía

1.- Sorolla, un jardín para pintar, del 5 de julio al 31 de octubre de 2017, CaixaForum Sevilla

2.- Anglada-Camarasa (1871-1959), del 4 de marzo al 20 de agosto de 2017, CaixaForum Sevilla

3.- Página web de la NASA sobre el Telescopio Espacial James Webb

4.- Victor Vasarely, Hommage to the Hexagon (Hommage À La Hexagone) 1969, serie de obras perteneciente al MOMA

5.- Recollections: Monir Farmanfarmaian (2008), Nafas art magazine, Universes in univers

6.- Cosmic Geometry: The Life and Work of Monir Shahroudy Farmanfarmaian , Vogue, 2011

7.- Frank Stella – Connections – Haunch of Venison – London, Art Splash Contemporary Art

8.- Página de Elijah Porter en Flickr

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Mosaicos hexagonales para el verano se ha escrito en Cuaderno de Cultura Científica.

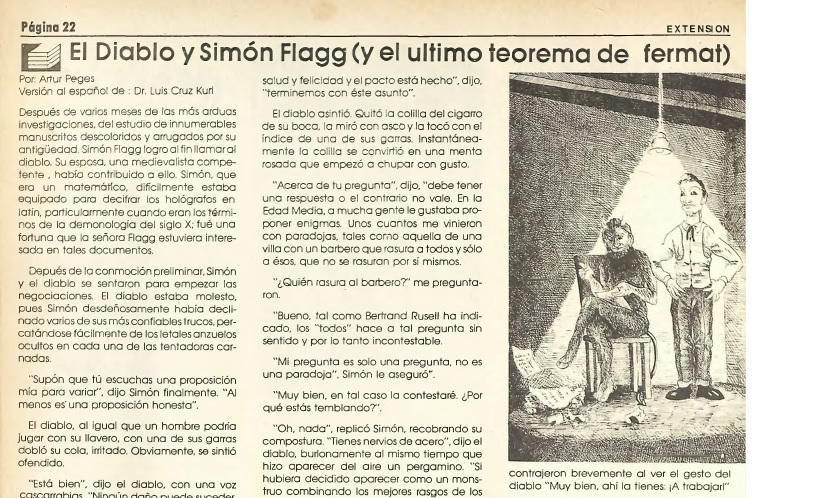

Entradas relacionadas:- El diablo y Simon Flagg, una lectura ligera para el verano

- Cómo se formaron las columnas hexagonales de la Calzada del Gigante

- El número nueve en una noche de verano

Sistemas nerviosos: el sistema límbico

Ubicación de la amígdala en humanos

El sistema límbico no constituye una región encefálica separada, con entidad propia, sino que lo integran un conjunto de estructuras ubicadas en diferentes áreas que se hallan dispuestas, principalmente, a ambos lados del tálamo, justo por debajo del cerebro, y que establecen múltiples e intrincadas conexiones neuronales entre ellas. A este sistema pertenecen ciertas porciones de áreas tales como la corteza cerebral, los núcleos basales, el tálamo y el hipotálamo, por lo que incluye estructuras con origen en diferentes vesículas embrionarias (telencéfalo, mesencéfalo y diencéfalo).

El sistema límbico está implicado en numerosas funciones, como la génesis de las emociones, la motivación, la memoria a largo plazo, la olfacción, el comportamiento sociosexual y la supervivencia.

En el pasado también ha sido denominado cerebro paleomamífero o corteza paleomamífera, un nombre que tiene que ver con una concepción de la arquitectura encefálica basada en su antigüedad evolutiva. Según esa concepción, los componentes del encéfalo serían: (1) el encéfalo primitivo (o reptiliano), al que corresponden el tallo encefálico, el puente, el cerebelo, el mesencéfalo, los ganglios basales más antiguos y los bulbos olfatorios; (2) el encéfalo intermedio (o “mamífero antiguo”), al que corresponden las estructuras del sistema límbico; y (3) el encéfalo superior o racional (o “mamífero nuevo”), integrado por los hemisferios cerebrales y algunas áreas subcorticales. Aunque esa clasificación de las estructuras y sus funciones no está desencaminada, las denominaciones no se compadecen con la historia evolutiva real de las correspondientes áreas, porque la distinción entre “reptiliano”, “mamífero antiguo” y “mamífero nuevo” carece de la debida fundamentación. Los ancestros comunes de reptiles y mamíferos ya tenían un sistema límbico bien desarrollado y configurado de forma similar al actual. Y las aves, que evolucionaron de los dinosaurios en la misma época en que aparecieron los mamíferos también tienen un sistema límbico bien desarrollado.

Uno de los componentes más importantes de este sistema es la amígdala, una estructura subcortical doble (una en cada hemisferio) que se encuentra por debajo del lóbulo temporal. Desempeña funciones importantes en el procesamiento de la memoria, la toma de decisiones y las reacciones emocionales. Es de especial importancia su rol en el procesamiento de señales que generan miedo. La amígdala activa el sistema de estrés de lucha o huida controlado por el hipotálamo y que permite preparar al organismo para que adopte uno de esos dos comportamientos. Aunque la decisión relativa a la adopción de uno de ellos es posterior y corre a cargo de la corteza, el sistema activado por la amígdala permite que, sea cual sea, la respuesta se produzca con la máxima intensidad ya que hace que el organismo disponga de abundante energía y oxígeno para ello.

El hipotálamo mantiene una intrincada red de relaciones con las áreas corticales superiores y con el resto del sistema límbico, principalmente con la amígdala. Juega, como ya vimos en una anotación anterior, un papel clave en la coordinación de diferentes respuestas a cargo del sistema nervioso autónomo y el sistema hormonal. Y es, como acabamos de ver, el centro que desencadena las acciones propias de la respuesta de lucha o huida que activa la amígdala.

La corteza superior también juega un papel importante en el desarrollo de comportamientos en los que está implicado el sistema límbico. Si bien este último desencadena acciones fisiológicas rápidas en respuesta a señales que le llegan directamente, la corteza cerebral interviene para hacer una valoración precisa de la información que ha desencadenado la primera respuesta, y también para dar lugar a la secuencia de respuestas motoras adecuadas. Las respuestas consistentes en atacar o huir de un adversario, desplegar la actividad de emparejamiento o la expresión de emociones pueden ser inducidos por el sistema límbico, pero la valoración precisa de su conveniencia e intensidad y la ejecución de las órdenes motoras que dan lugar a los movimientos que las desarrollan son tareas propias del cerebro. Un ejemplo ilustrativo del papel de la corteza en determinadas respuestas en las que participa el sistema límbico es su intervención en la génesis de la sonrisa. La secuencia estereotipada de movimientos que la producen está preprogramada en la corteza cerebral y, en determinadas circunstancias, el sistema límbico puede invocarla para dar lugar a su expresión de forma involuntaria. Pero como sabemos, también podemos ejecutar la misma secuencia de forma voluntaria como consecuencia de una decisión consciente como, por ejemplo, al posar para una fotografía.

Otra vertiente importante de la actividad del sistema límbico es su implicación en el refuerzo o supresión de comportamientos que han sido, respectivamente, placenteros o desagradables. Las regiones del sistema límbico implicadas en esas funciones se denominan centros de recompensa o de castigo, porque su estimulación provoca sensaciones placenteras o desagradables. Los centros de recompensa son especialmente abundantes en áreas que intervienen en actividades tales como la alimentación, la bebida y la actividad sexual, razón por la cual beber, comer y practicar sexo son actividades que reportan placer.

Fuentes:

Eric R. Kandel, James H. Schwartz, Thomas M. Jessell, Steven A. Siegelbaum & A. J. Hudspeth (2012): Principles of Neural Science, Mc Graw Hill, New York

Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas nerviosos: el sistema límbico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el sistema central de vertebrados

- Sistemas nerviosos: el sistema periférico de vertebrados

- Sistemas nerviosos: el tálamo y el hipotálamo

Una cuestión de movimiento

Hemos visto que durante la década de 1840 muchos científicos reconocieron que el calor no es una sustancia sino una forma de energía que puede convertirse en otras formas. James Prescott Joule y Rudolf Clausius fueron un paso más allá. El calor puede producir energía mecánica, y la energía mecánica puede producir calor; por lo tanto, razonaron, la “energía calorífica” de una sustancia es simplemente la energía cinética de sus átomos y moléculas. Esta idea, que constituye la base de la teoría cinético-molecular del calor, es mayormente correcta.

Sin embargo, y a pesar de lo que pueda parecer leyendo los libros de texto habituales, donde parece que desde que Dalton propone la hipótesis atómica en 1805, ésta es inmediatamente aceptada, la idea de átomos y moléculas tuvo tantos partidarios como detractores a lo largo en el siglo XIX e incluso en el siglo XX [1]. Las moléculas, como sabes, son las partes más pequeñas de una sustancia, y están compuestas de átomos, que son las partes más pequeñas de un elemento. Si admites su existencia ideas como la homeopatía se convierten inmediatamente en absurdos [2] y otras, como las leyes de proporción de la química, se vuelven lógicas.

Volviendo a las ideas de Joule y Clausius, si esos pedacitos de materia realmente existieran, serían demasiado pequeños como para poder observarlos incluso con los más poderosos microscopios. Como los científicos no podían observar las moléculas, no podían confirmar directamente la hipótesis de que el calor es energía cinética molecular. Por lo tanto, recurrieron a la forma indirecta de comprobar la plausibilidad de la hipótesis, que siempre es útil: derivaron de esta hipótesis las predicciones sobre el comportamiento de grandes muestras de materia mensurables, y luego comprobaron estas predicciones con experimentos [3].

Por razones que se harán evidentes según avancemos en esta serie, es más fácil comprobar las predicciones de la hipótesis atómica observando las propiedades de los gases. La consecuencia última de estos desarrollos en la segunda mitad del siglo XIX, la teoría cinética de los gases, es uno de los últimos grandes éxitos de la mecánica newtoniana.

Una de las características más fáciles de medir de un gas confinado es su presión. La experiencia que tenemos con globos y neumáticos hace que la idea de la presión del aire parezca obvia. Pero hay sutilezas importantes. Una implica la presión que ejerce el aire que nos rodea.

En su libro sobre mecánica, Discorsi e Dimostrazioni Matematiche Intorno a Due Nuove Scienze (1638), Galileo llama la atención sobre el hecho de que las bombas de pistón no pueden elevar el agua más de 10 metros. Este era un hecho muy conocido en la época, ya que se usaban este tipo de bombas volumétricas para sacar agua de pozos o para evacuar el agua de las minas. Si recordamos, esta fue la motivación primera para el desarrollo de las máquinas de vapor.

Pero, ¿por qué solo 10 metros? Para empezar, ¿por qué funcionaban siquiera las bombas?

En las próximas entregas observaremos las propiedades de un gas simple para, posteriormente, intentar explicar el origen de las propiedades de los gases además de sus consecuencias prácticas y, además, el de las leyes de la termodinámica basándonos solo en la teoría cinética. Todo ello con las matemáticas de primaria.

Notas:

[1] Incluso hubo premios Nobel de química, como Ostwald, que negaron la existencia de átomos y moléculas hasta que se conocieron los resultados de los experimentos de Perrin en 1908 que probaban que la teoría de Einstein sobre el movimiento browniano, basada precisamente en la existencia de moléculas, era correcta.

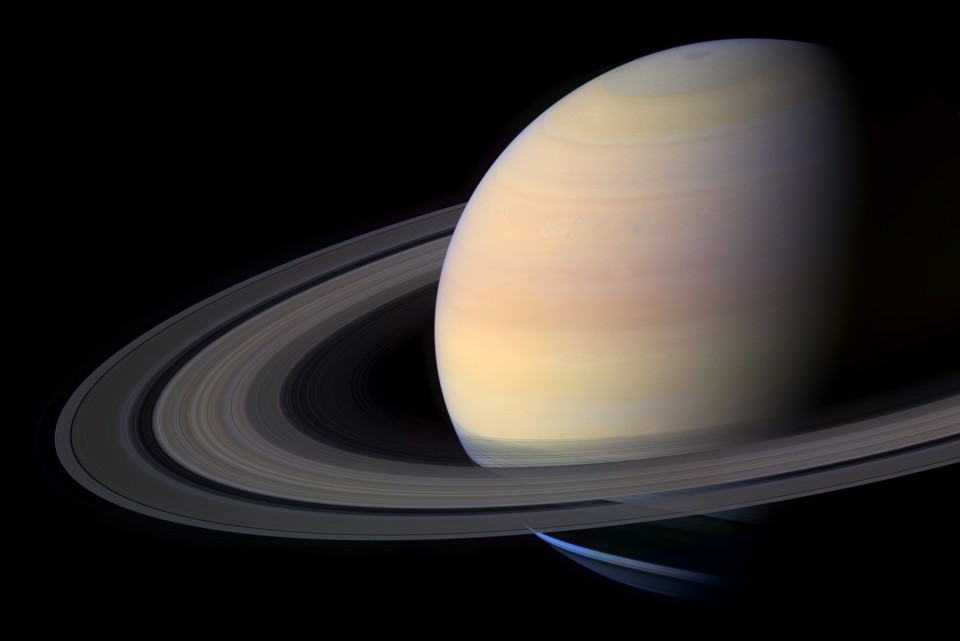

[2] Fue la indefinición del XIX sobre la cuestión atómica una de las patas que permitieron la popularización de esta, hoy ya sí con todas letras, estafa. Las otras dos patas fueron el desconocimiento de la existencia del efecto placebo y el hecho estadístico de que la mayor parte de las personas que enferman se curan por sí mismas (hay cientos de miles de resfriados cada año por cada colangiocarcinoma, por ejemplo). La homeopatía es una práctica iniciada en el desconocimiento que hoy se mantiene basada en el negocio y en la ignorancia. Si admites la existencia de átomos y moléculas, automáticamente el gasto en estudios sobre los efectos de la homeopatía es tan lógico como el gasto en enviar sondas a Saturno a buscar botijos que orbiten el planeta. En ambos casos las base teórica es igualmente absurda.

[3] Como hemos apuntado en la nota [1] hasta que no se pudieron hacer predicciones que eran ciertas si, y solo si, la hipótesis atómica era correcta, como las que se derivan de la teoría del movimiento browniano de Einstein, ningún resultado fue concluyente.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Una cuestión de movimiento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Se intuye la conservación de la energía (1)

- La fe en las leyes de conservación

- Potencia y eficiencia de una máquina

Un alelo para las gafas de color de rosa

Hay una variante alélica de la región promotora del gen del transportador de serotonina (5-HTTLPR) que está asociada con una diferencia a la hora de reparar en unas imágenes u otras, dependiendo de su contenido afectivo, positivo o negativo.

Vayamos por partes. La serotonina es un neurotransmisor, o sea, una molécula mensajera que interviene en las conexiones sinápticas entre neuronas en ciertas vías nerviosas. En otras palabras, es una molécula que una neurona (presináptica) vierte al espacio existente entre ella y la neurona contigua (hendidura sináptica), y se une a unos receptores que hay en la membrana de esta segunda neurona (postsináptica); una vez unida a su receptor, da lugar a los efectos correspondientes. Lo que aquí nos interesa es que el neurotransmisor no permanece permanentemente unido al receptor, sino que se libera del mismo y vuelve a quedar en la hendidura sináptica. Por otro lado, en la neurona presináptica (la que ha vertido el neurotransmisor a la hendidura sináptica) hay unas proteínas transportadoras, que lo recuperan y lo introducen de nuevo en la neurona; de esa forma se recicla y se puede volver a utilizar.

Pues bien, la variante alélica a que hacemos referencia aquí da lugar a que unos individuos tengan transportadores de serotonina diferentes de los que tienen otros. Los individuos homocigóticos para el alelo largo (LL) tienen una tendencia a fijarse y procesar material de contenido afectivo positivo, a la vez que evitan el negativo. Podría decirse, si se permite la metáfora cursi, que tienden a ver la vida de color de rosa. Ese rasgo está ausente en quienes poseen el alelo corto (SS o LS). Al parecer, los homocigóticos para L producen una proteína transportadora más activa que los otros individuos y como consecuencia de ello, reciclan más rápidamente la serotonina y la ponen antes a disposición de las neuronas presinápticas en los circuitos neuronales en los que participan. De esa forma esas neuronas presinápticas disponen de más serotonina. Y son quienes tienden a fijarse en las cosas buenas quienes poseen el alelo largo de la región promotora en cuestión. En definitiva, el sesgo que conduce a fijarse en un tipo de contenidos u otros y procesarlos está asociado con un polimorfismo genético común. En otras palabras, una actitud que puede influir en la visión más o menos optimista que tengamos de las cosas parece que tiene sustrato genético.

Por otra parte, que quienes tienen el alelo LS o SS tiendan a fijarse más en los aspectos desfavorables de las cosas es un problema, porque sufren neurosis, desórdenes emocionales y depresiones con más facilidad que los que se fijan en los aspectos favorables. Un aspecto colateral, pero muy importante de este asunto es que las mujeres tienen en general más receptores postsinápticos de serotonina pero menos transportadores. Como consecuencia de ello, reciclan este neurotransmisor a menor velocidad, lo que hace que su disponibilidad en la neurona presináptica sea menor. Y resulta que las mujeres tienen una mayor predisposición que los hombres a sufrir depresión.

Fuente: Elaine Fox, Anna Ridgewell & Chris Ashwin (2009): Looking on the bright side: biased attention and the human serotonin transporter gene. Proceedings of the Royal Society B 276: 1747-1751

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Un alelo para las gafas de color de rosa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Nacidos para creer?

- Las recetas del franciscano y “El nombre de la rosa” (y 3)

- Una nueva diana terapéutica para el neuroblastoma

Todo lo que se puede medir en un río

El grupo de investigación Ecología de ríos/Stream ecology del Departamento de Biología Vegetal y Ecología de la UPV/EHU es un grupo especializado en el estudio del funcionamiento de los ríos, constituido por expertos en múltiples áreas. Dentro del marco del proyecto europeo Globaqua, en el que participan más de 10 instituciones europeas, han realizado un amplio trabajo de revisión que ha tenido como fruto un artículo “en el que sintetizamos y clasificamos todos los procesos que se pueden medir en los ríos; explicamos cómo se pueden realizar las mediciones (métodos que existen en la literatura), cómo responden dichos procesos a diversos estresores ambientales, etc.”, explica Daniel von Schiller, uno de los autores del artículo. Se trata de una “proposición que plantea un nuevo marco de trabajo muy apropiado tanto para investigadores como para gestores”, manifiesta.

Según constatan en el artículo, “tal y como marca la Directiva Marco del Agua, los ecosistemas de los ríos se deberían evaluar tanto desde el punto de vista de su estructura como de su funcionamiento, porque así se obtiene una mejor estimación del estado ecológico de un río”. El investigador hace una analogía con el cuerpo humano: “Si en un enfermo solo se mira si tiene corazón, pulmones y riñones, pero no se miden el pulso del corazón, cuánto volumen de aire respira o qué filtran los riñones, no se evalúa bien el estado de salud del paciente o en nuestro caso el estado ecológico del ecosistema que se está midiendo”.

Actualmente, las medidas que marcan los protocolos para saber cuál es el estado ecológico de los ríos son estructurales (relacionadas con la forma del canal, calidad del agua o composición de las comunidades biológicas): medidas de comunidades, de contaminantes, de temperatura, de concentración de nutrientes, etc. El funcionamiento de un ecosistema, sin embargo, se define como el conjunto de procesos que regulan tanto los flujos de materia como los flujos de energía dentro de un ecosistema. Los investigadores proponen, en ese sentido, toda una serie de medidas de funcionamiento complementarias, relacionadas con procesos de metabolismo, de descomposición de la materia orgánica, de ciclado de nutrientes, de dinámica de contaminantes y de dinámica de las comunidades fluviales.

En el estudio, además de recopilar métodos de medida de los diferentes procesos encontrados en la bibliografía, los han clasificado en función de variables como dificultad, complejidad, costes, escalas espaciales y temporales de medida, etc. “Por último —explica Daniel von Schiller—, hemos realizado un estudio exhaustivo en la literatura de las respuestas de los diferentes procesos a estresores ambientales de origen antropogénico (tales como contaminación, canalizaciones, acidez, etc.)”.

Como conclusión, el investigador manifiesta que “es la primera vez que se sintetiza todo lo que se puede medir en cuanto a procesos en ríos, y no solo presentamos qué se puede medir, sino también presentamos por qué, cómo y qué ventajas tiene un proceso frente a otro, y además cómo responde a estresores”. El objetivo de los investigadores ha sido crear una herramienta con la que puedan trabajar tanto personal investigador como gestor. El equipo, además, está ya en contacto con diferentes agentes y organismos relacionados con el control de aguas, entre las que se encuentra la Agencia Vasca del Agua – URA, para poner en marcha un novedoso proyecto de implementación de medidas e índices funcionales en ríos.

Referencia:

Daniel von Schiller et al. (2017).. “River ecosystem processes: A synthesis of approaches, criteria of use and sensitivity to environmental stressors”.. Science of the Total Environment. Vol. 596–597. Pages 465–480.. DOI: 10.1016/j.scitotenv.2017.04.081

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Todo lo que se puede medir en un río se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: ¡La geología por encima de todo!

- Un nuevo mecanismo de resistencia antifúngico

- El análisis del supercúmulo “El Gordo” limita qué puede ser la materia oscura

La parábola del coche eléctrico

El XX parecía destinado a ser el siglo de los vehículos eléctricos. Otras muchas facetas de la actividad industrial, urbana y doméstica se vieron afectadas por la electrificación en ese siglo. No así los automóviles. El primer vehículo eléctrico del que se tiene noticia fue obra del químico británico Robert Davidson. Lo fabricó en Aberdeen en 1837. En 1842 construyó otro con una batería de zinc, llamado Galvani, que se desplazaba a 4 millas por hora. El zinc que consumía era cuarenta veces más caro que el carbón que había que quemar en una máquina de vapor para conseguir el mismo resultado y, en todo caso, no era de ninguna utilidad. En 1884 Thomas Parker construyó en Londres el primer coche eléctrico de baterías recargables –un prototipo, en realidad- y en 1888 Andreas Flocken creó en Alemania el Flocken Elektrowagen, considerado el primer coche eléctrico verdadero de la historia. A partir de entonces se empezaron a fabricar industrialmente y llegaron a ser bastante populares por su fácil manejo y comodidad.

A finales del XIX había en Londres una amplia flota de taxis eléctricos conocidos con el nombre de “colibríes”. El Comisionado de la Policía Metropolitana aprobó su uso para hacer frente al creciente problema de tráfico, ya que ocupaban la mitad de espacio que los coches de caballos. Taxis similares circularon por París, Berlín y Nueva York. A comienzo del siglo XX había en los Estados Unidos más de treinta mil coches eléctricos registrados. Eran mucho más populares que los de gasolina, menos ruidosos y no contaminaban el aire de las ciudades. Sin embargo, en poco más de una década la fabricación de esos coches se redujo hasta cesar. Los conductores de los coches de caballos londinenses lanzaron una intensa campaña haciendo publicidad de las averías y accidentes de sus rivales eléctricos hasta conseguir sacar del mercado a la London Electric Cab Company. Los coches eléctricos tuvieron algunos problemas técnicos, es cierto, pero fueron exagerados por sus rivales, que se esforzaron por mostrar a sus nuevos competidores bajo la peor apariencia posible.

Al mismo tiempo, el descubrimiento de grandes reservas de petróleo hizo que el precio de éste se desplomase, y Henry Ford empezó a vender coches de gasolina a la mitad de precio que los eléctricos. La construcción de mejores carreteras en Norteamérica incentivó los desplazamientos de larga distancia en automóvil, algo que no estaba al alcance de los coches eléctricos por su escasa autonomía y excesivo tiempo necesario para recargar las baterías. La introducción en 1912 del motor de arranque eléctrico acabó por inclinar la balanza a favor del coche con motor de combustión interna. Así fue como este acabó siendo el que ganó el siglo que, al comienzo, iba a ser del motor eléctrico.

El prematuro fracaso de los coches eléctricos es una parábola que ilustra una de las dificultades más sorprendentes que afectan al desarrollo de ciertas novedades. Hay innovaciones supuestamente beneficiosas que no consiguen abrirse camino en el momento en que se intentan por primera vez. Para que la novedad tenga éxito deben darse, de forma simultánea, determinadas condiciones. En caso contrario, la experiencia está abocada al fracaso. En otras palabras: no basta con buenas ideas, hace falta, además, que las circunstancias acompañen. Es posible que en el pasado se quedasen en el cajón o la estantería ideas excelentes que tuvieron la mala fortuna de nacer antes de tiempo. Esa es la razón por la que se desarrollan hoy programas para recuperar buenas ideas que, cuando surgieron, no tenían el terreno abonado pero que quizás lo tengan en la actualidad.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 21 de mayo de 2017.

El artículo La parábola del coche eléctrico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Gilbert, el campo y lo eléctrico

- La diferencia de potencial eléctrico

- El misterio del pez eléctrico monofásico*

Arte & Ciencia: La ciencia como herramienta del arte

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Jornada 4. 2ª conferencia.

Déborah García Bello es investigadora de la relación entre arte y ciencia y divulgadora científica: La ciencia como herramienta del arte.

Las colaboraciones que existen entre artistas y científicosEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: La ciencia como herramienta del arte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: Analogías entre el arte y la ciencia como formas de conocimiento

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

Por qué no nos basta con el viento

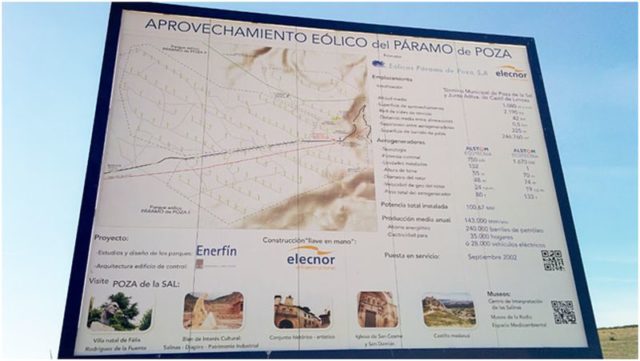

Parque eólico de Páramo de Poza II, Poza de la Sal. Foto del autor

Sobrevivir a largo plazo como especie es, como las infames resoluciones de año nuevo, uno de esos objetivos que nadie persigue pero que todos aceptamos como evidente en sí mismo. Lo cierto es que hay muchas formas de plantearlo: ¿qué consideramos «largo plazo»? ¿Tiene que importarnos, necesariamente, lo que pueda ocurrirles a unos Homo sapiens que todavía no han nacido? Y, sobre todo, ¿qué entendemos por sobrevivir? La existencia de nuestros antepasados en las sabanas africanas, en números reducidos y rodeados de miseria, privaciones y aplicados depredadores es un modo de vida sin duda natural y sostenible. Así se mantuvo década tras década, siglo tras siglo, durante muchas decenas de miles de años. ¿Es esto lo que queremos para nuestra descendencia?

No cuesta mucho dudar de semejante concepto de supervivencia. Dejemos de lado a los ecologistas radicales que, secretamente o no tanto, desearían diezmar nuestras muchedumbres hasta dejarlas en poquedumbres, arrancarnos de las manos nuestros teléfonos inteligentes y nuestros frigoríficos y arrojarnos de vuelta al paleolítico, donde podremos poner en práctica la «dieta paleo»… de algún animal con dientes afilados. Lo que de verdad entendemos por «supervivencia a largo plazo» es una existencia estable e iluminada, con tecnología —desde luego— pero en equilibrio con el resto de los seres vivos que nos rodean, a lo largo de al menos tantas decenas de miles de años como llevamos en este caballito de tiovivo esférico que llamamos Tierra.

Dejaré para mejor ocasión el frente abierto de si tal deseo puede cumplirse, pero suponiéndolo posible, tengo una noticia: no hay forma de poder realizar un objetivo así si no encontramos el modo de satisfacer nuestras necesidades energéticas de un modo completamente renovable. El segundo principio de la Termodinámica prohíbe, a la postre, la existencia de fuentes de energía sin fin: sin embargo, en tanto nuestro número no se dispare exponencialmente ni hablemos de escalas de tiempo cósmicas no deberíamos preocuparnos. Podemos representarnos a nosotros mismos «agotando» el petróleo, o —al nivel de extracción energética de los procesos de fisión nuclear industrial actuales— el uranio: es mucho más difícil pergeñar formas de acabar con el viento o la luz del sol.

La tecnología de nuestro siglo tiene, en el campo de las energías renovables, tres protagonistas fundamentales: la eólica, la solar y la hidroeléctrica. En el caso de esta última, parece evidente el motivo por el que no satisfacemos todas nuestras necesidades de energía con ella: es fuertemente dependiente de la existencia de grandes masas de agua que represar y terrenos con cuencas en los que hacerlo —recursos que no están disponibles con la frecuencia que desearíamos. Las otras dos fuentes energéticas no tienen, a primera vista, más límites para su despliegue que la disponibilidad de terrenos y la voluntad inversora de Estado y empresas; competirán entre sí y la más rentable tomará la delantera. El mercado decide: ¿qué está escogiendo?

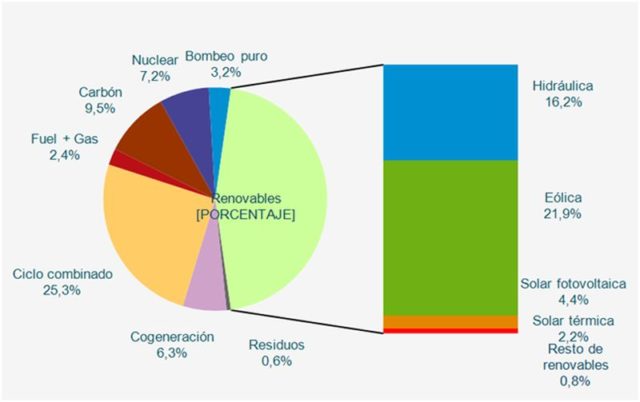

Estructura de potencia instalada a 31/12/2016. Sistema eléctrico nacional. Fuente: Red Eléctrica de España.

Observemos el gráfico de distribución de la potencia instalada en España por tipo de fuente. Si recalculamos los porcentajes de las renovables sobre su propio total obtenemos que la energía hidráulica supone un 35,6%, la eólica un 48,1% y la solar, en todos sus tipos, un magro 9,7%, quedando un testimonial 4,8% para otras fuentes de energía como la biomasa, la geotérmica o la maremotriz. La inmensa mayoría de los embalses posibles en España ya están construidos, así que no es de esperar que el porcentaje de la energía hidráulica aumente significativamente en el futuro. Está claro que el modo de generación que más rentable está resultando y sobre el que puede predecirse un mayor crecimiento en los próximos cinco años es el viento. La pregunta clave para el futuro de nuestras necesidades energéticas es: ¿por qué no alimentar todo con aerogeneradores?

Los nuevos gigantes

Desde finales de los años 90, los aerogeneradores han pasado de ser una visión extraña a salpicar nuestra geografía con casi mil parques contabilizados a finales de 2016, distribuidos por todas las regiones españolas con las llamativas excepciones de Extremadura y Madrid (Ceuta y Melilla tampoco tienen parques eólicos, pero su pequeño tamaño hace más difícil sorprenderse por ello). Estos nuevos molinos serían, a la vista de un aspirante a moderno Alonso Quijano, una vista mucho más espantable que los antiguos: bestias blancas dispuestas en grupos de varias decenas, de tres aspas con un diámetro de giro de más de sesenta metros, apoyadas sobre una airosa columna de otros tantos de altura —el diseño convencional, de origen danés, dicta que la longitud de la pala tenga aproximadamente la mitad de la altura de la columna para un efecto más agradable a la vista.

La rotación del aerogenerador, comprendida habitualmente entre las 8 y las 30 revoluciones por minuto para velocidades del viento entre los 5 m/s (la llamada «velocidad de conexión», por debajo de la cual el sistema no puede girar) y los 25 m/s (la «velocidad de corte», a partir de la que las aspas frenan para evitar problemas de sobrecalentamiento y cargas mecánicas excesivas), permite mover un generador que transforma el movimiento en energía eléctrica. El sistema es más complejo de lo que parece —¿qué no lo es?— pero funciona con una eficiencia de conversión máxima del 46%: de la energía total contenida en el movimiento del aire frente a las palas, hasta un 46% puede extraerse y convertirse en electricidad apta para ser vertida a las redes de distribución.

Para un sistema cuyo «combustible» es completamente gratuito, la cifra es completamente excepcional. De hecho, esta conversión máxima se encuentra tan cerca del límite teórico de extracción de energía del viento (conocido como límite de Betz, y que surge del hecho de que la velocidad del aire tras atravesar el plano de las aspas del aerogenerador no puede descender a cero) que el sistema no se optimiza para un aprovechamiento máximo, sino para un coste mínimo de fabricación y despliegue dada una conversión razonable. La energía eólica ya puede compararse en pie de igualdad con otras fuentes energéticas.

No es de extrañar, por tanto, que en los últimos tiempos un número creciente de colectivos ecologistas estén clamando por la sustitución de las centrales nucleares con energías renovables. El último ejemplo, el pasado mes de junio en Madrid, vio reunirse a varios cientos de personas en una manifestación convocada por más de 120 asociaciones (!). El lema principal de esta manifestación, «Cerrar Almaraz y todas las demás, 100% renovables», expresa la preocupación común entre los colectivos que hacen política con la ecología de que las centrales nucleares son peligrosas y deben ser sustituidas, a la mayor brevedad posible, por fuentes de energía renovable. Como hemos visto, la fuente de energía más preparada para intentar realizar esa transición en un plazo relativamente corto de tiempo es el viento. Planteémosnos la pregunta: ¿es posible sustituir una central nuclear como Almaraz con parques eólicos? Y de ser la respuesta afirmativa, ¿qué implicaría exactamente?

Efecto estela y factor de carga

Cuando se trata de adaptar una tecnología como la eólica para su uso a gran escala es necesario no perder de vista dos fenómenos fundamentales. El primero de ellos impone una consideración práctica de alcance a la hora de diseñar parques eólicos. El segundo establece una limitación más seria, dependiente de la naturaleza misma del recurso aprovechado.

Fijémonos en un molino concreto, con un determinado diámetro de rotor (utilizaremos este parámetro más adelante). El efecto estela es la alteración en el flujo de aire que lo atraviesa debido a las turbulencias inducidas por las aspas y a la propia extracción de la energía del movimiento. El viento saliente de la hélice se mueve más lentamente que el entrante —esa es exactamente la diferencia entre un aerogenerador y un ventilador— y lo hace, además, de un modo más irregular. Esto afectará a otros generadores situados a sotavento del molino en el que nos hemos fijado.

Para compensar el efecto estela, los diseñadores de parques eólicos utilizan el criterio de separar los generadores en filas perpendiculares a la dirección de los vientos dominantes en cada zona, separadas entre sí entre 5 y 9 diámetros de rotor. La separación entre molino y molino en la dirección perpendicular a la de los vientos dominantes (es decir, según las filas en las que se ubiquen) puede ser inferior, de 3 a 5 diámetros. Además, los generadores se colocan al tresbolillo, de manera que se aumente la distancia al máximo posible entre los ubicados en filas contiguas. A pesar de estas precauciones, es común encontrarse con pérdidas «de parque» del orden del 5% respecto a lo que podría generar un solo molino en las mismas condiciones de viento.

Construcción del parque eólico de Loja (Ecuador). Foto de franzpc con licencia CC BY-ND 2.0.

Diseñar un parque de aerogeneradores no es una tarea trivial. Desde el punto de vista del mantenimiento y la interconexión eléctrica, interesa colocar los molinos lo más próximos posible entre sí para reducir pérdidas eléctricas y disminuir las distancias de los viales (los caminos que permiten recorrer el parque para realizar tareas de mantenimiento y que tienen que soportar el paso de los transportes especiales y las grúas necesarios para el montaje de los aerogeneradores). Sin embargo, el efecto estela obliga a mantener unas distancias mínimas que, para diámetros de rotor de 60 metros, puede superar el medio kilómetro —será mayor para rotores más grandes. La topografía de la zona conspira en la mayor parte de las ocasiones para hacer todo más complejo aún, restringiendo las posiciones posibles para las bases de los aerogeneradores, complicando la distribución de los viales y alterando localmente el flujo del viento.

El segundo fenómeno a considerar es el llamado factor de carga. El viento, por su naturaleza, es un recurso variable en el tiempo: y varía, además, de una forma muy compleja a diferentes escalas. En nuestras latitudes el viento suele ser más fuerte en invierno que en verano: se trata de la variación estacional. Por su parte, los cambios en la temperatura del suelo y el aire a lo largo del día suelen provocar un patrón de variación diaria por el que los vientos son más rápidos en las horas cercanas al mediodía solar que por la noche. Finalmente, y a escalas temporales más pequeñas, el viento se comporta de forma aleatoria que puede modelarse matemáticamente. El factor de carga es la razón entre la energía efectivamente generada por un molino a lo largo de un periodo de tiempo determinado y la máxima que podría generar, para una velocidad óptima y constante del viento. Los factores de carga habituales en aerogeneradores suelen estar entre el 20 y el 30%.

El viento frente al uranio

Ya disponemos de las herramientas necesarias para contestar a la pregunta que nos planteamos hace unos párrafos: ¿es posible sustituir una central nuclear como la de Almaraz con parques eólicos? En caso afirmativo, ¿cómo sería un parque de aerogeneradores con la misma potencia? Observemos primero los siguientes datos reales de los últimos diez años para la generación eólica y la nuclear, obtenidos del anuario estadístico de Red Eléctrica de España.

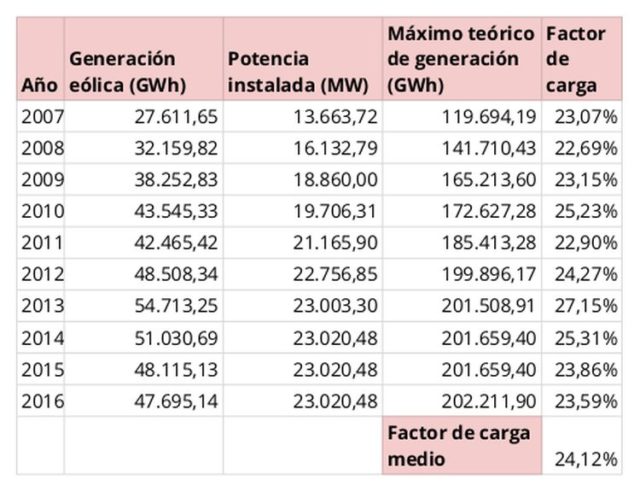

Generación eólica en España (2007-2016). Fuente: Red Eléctrica Española

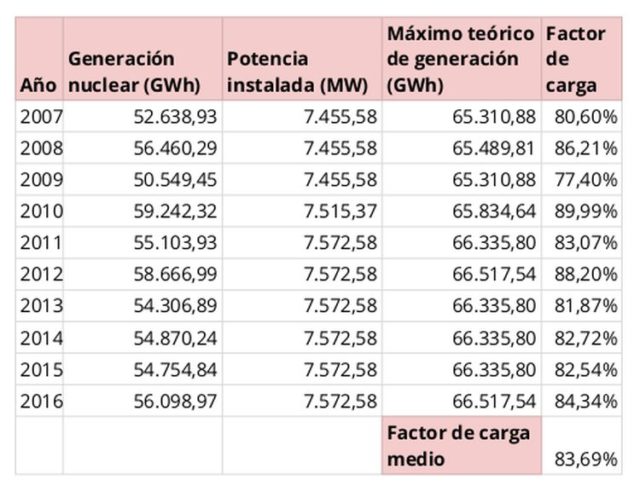

Generación nuclear en España (2007-2016). Fuente: Red Eléctrica Española

Los datos han sido tabulados de forma que la comparación sea sencilla. Para empezar, llama la atención la gran diferencia entre potencia instalada eólica y nuclear. El número de aerogeneradores ha aumentado de forma constante en nuestro país hasta el año 2012, en el que un cambio legislativo en la asignación de primas de generación renovable detuvo por completo la expansión del sector —este mismo año se han reanudado las subastas de potencia renovable con un sistema nuevo de subasta que tiende, a la vista de los resultados, a eliminar las primas: veremos cómo evoluciona el mercado a partir del año que viene.

Por su parte, la energía nuclear apenas ha variado: no se han construido centrales nuevas —y no se hace desde el inicio de la llamada «moratoria nuclear» en 1982. Las únicas modificaciones en la potencia instalada son debidas a pequeñas mejoras técnicas y puntuales en las centrales existentes. Sin embargo, pese a que hay instalados tres vatios eólicos por cada vatio nuclear (en 2016), las centrales nucleares todavía producen casi un 18% más. Esto es debido al efecto del factor de carga característico de cada tecnología, que para los últimos 10 años ha sido de un 24% para la eólica frente a casi un 84% para la nuclear. Es decir: si la central nuclear de Almaraz tiene una potencia instalada de 2093 MW, no basta con instalar los mismos vatios eólicos para igualar su capacidad de generación. Ajustando los diferentes factores de carga, resulta que necesitaremos 7262 MW eólicos para igualar la capacidad de generación de la nuclear.

Cartelón descriptivo de los parques eólicos de Páramo de Poza I y II. Foto del autor

Ya tenemos una cifra de potencia a instalar, pero ¿cómo será de grande el parque eólico necesario para sustituir Almaraz? Esta deberá ser una cuenta aproximada debido a la complejidad del diseño de un parque eólico, que depende fuertemente de su ubicación. Vamos a suponer, sin embargo, un parque ideal de aerogeneradores no excesivamente caros, de 600 kW y un diámetro de rotor de 50 metros, para unas distancias entre postes medias de 7 diámetros de rotor en la dirección del viento dominante y de 4 diámetros en la perpendicular. En primer lugar, dividiendo la potencia que necesitamos entre la de un aerogenerador (sin olvidar igualar las unidades), obtenemos la cifra de molinos a instalar: aproximadamente 12000. Que un parque normal de aerogeneradores en España tenga alrededor de 60 unidades instaladas nos está indicando que nos enfrentamos a una empresa complicada. Sigamos adelante, sin embargo.

La separación que hemos estimado entre generadores nos puede dar una idea de cuál será la «huella» de cada uno de ellos. Usando una disposición aproximadamente rectangular podríamos ubicar 110 generadores en 110 filas. Cada fila tendrá 22 kilómetros de longitud, y el conjunto de filas se extenderá a lo largo de 38 kilómetros: multiplicando, obtenemos un parque de 847 kilómetros cuadrados. Por poner la cifra en algún contexto significativo, estaríamos hablando de un parque que ocuparía el 40% del área de Bizkaia y que tendría alrededor de 3000 kilómetros de viales de acceso para comunicar entre sí los generadores. Con molinos más grandes (y más caros) de 2000 kW y diámetros de rotor de 80 metros, el parque teórico tendría 645 km².

Vistas estas cifras, lo razonable sería fragmentar la potencia en varios centenares de parques, que podrían convertirse en algunos miles si el objetivo fuera sustituir por energía eólica toda la generación nuclear actual de España. ¿Es posible? Solo marginalmente, y a un coste muy elevado tanto económico como ecológico. No debemos olvidar que este análisis no tiene en cuenta que el factor de carga de la energía eólica es un promedio: la energía realmente generada mostrará la misma variabilidad compleja que hemos descrito antes para el viento. Hacerla constante requeriría del concurso de tecnologías adicionales, como inmensos bancos de baterías, que aún no se encuentran desarrolladas a la escala necesaria. Podemos hacer también una predicción para el futuro que tiene muchas probabilidades de cumplirse: la oposición ecologista a la energía nuclear se iría desplazando, paulatinamente, a la energía eólica conforme esta adoptara una posición preponderante en el combinado energético.

Cartel informativo en Valle de Mena. Foto: Plataforma para la defensa de los valles del sur de Cantabria.

Una política energética racional debería potenciar y diversificar las energías renovables, pero no a expensas de la potencia nuclear ya instalada y con una vida útil aún larga por delante, sino frente a las tecnologías que más comprometen los objetivos de emisión de CO₂: carbón y petróleo. Combinar este enfoque con una decidida inversión en ahorro energético e investigación y desarrollo en todos los campos de producción de energía aparece como la apuesta de futuro con más probabilidades de llevar a nuestra especie más allá de los confines de este aterrador siglo. Después… veremos.

Este post ha sido realizado por Iván Rivera (@Brucknerite) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU

Referencias y más información:

Red Eléctrica de España. (28/06/2017). Las energías renovables en el sistema eléctrico español 2016. Visitado el 20/07/2017 en http://www.ree.es/es/estadisticas-del-sistema-electrico-espanol/informe-de-energias-renovables

Barbero, A. J. (2012). Curso de Física Ambiental, Universidad de Castilla-La Mancha. Visitado el 24/07/2017 en https://previa.uclm.es/profesorado/ajbarbero/FAA/EEOLICA_Febrero2012_G9.pdf

Grodira, F. (10/06/2017). Más de medio millar de personas se manifiestan en Madrid contra las nucleares. Público. Visitado el 25/07/2017 en http://www.publico.es/sociedad/medio-millar-personas-manifiestan-madrid.html

El artículo Por qué no nos basta con el viento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El Peine del Viento de Chillida: materia, forma y lugar

- La fe en las leyes de conservación

- Máquinas inteligentes (I): Del molino de viento al test de Turing

La contradicción de la publicación

La ciencia, como actividad, se basa en la publicación de sus resultados: en que los científicos hagan públicos los descubrimientos, reflexiones y datos, permitiendo así que otros científicos los conozcan y utilicen en sus propias reflexiones y experimentos. En el ámbito científico se lleva al extremo aquel viejo refrán de literatos que dice que escribir para el cajón es masturbación; en ciencia lo que no se ha publicado sencillamente no existe. Las reputaciones de quienes practican ciencia, su importancia y su influencia dependen de sus publicaciones; artículos, principalmente, aunque después también revisiones y libros de texto. Hacer ciencia incluye, por definición, hacer pública la ciencia.

Pero en los últimos tiempos dos factores han contribuido a deformar el sistema de publicación, retorciéndolo y haciendo que cada vez se aparte más de su función original dentro del método de la ciencia. Por una parte la práctica científica se ha burocratizado: al convertirse los estados en una parte clave de la financiación y el respaldo de la ciencia necesariamente su práctica se ha transformado. Las carreras científicas se han estandarizado; los sistemas para solicitar financiación se han convertido en estructuras burocráticas con sus plazos, sus instancias y sus currículos normalizados. Para que cualquier sistema burocrático funcione es necesario evaluar los resultados de las diferentes medidas tomadas; el rendimiento de los fondos invertidos, o la calidad y productividad de los científicos individuales.

Porque a la hora de dar plazas, o recursos, la burocracia exige baremos y la cantidad y calidad de los trabajos publicados se han convertido en las medidas clave del sistema científico. El número de ‘papers’ publicados y su impacto según diversos índices (número de citas, calidad de las revistas, etc) son ahora la llave para obtener plazas, laboratorios, becarios, proyectos; en suma, para progresar en ciencia. De ahí el famoso ‘publish or perish’ (publica o perece) que impulsa a los científicos en activo. Ya no la reputación o el gran descubrimiento: lo que hace falta es tener muchas publicaciones en revistas de impacto y un índice h cuanto mayor, mejor.

Simultáneamente a esto y en paralelo la publicación científica se ha convertido en un negocio multimillonario que proporciona pingües beneficios a un puñado de poderosas empresas. Gracias a la inteligencia empresarial de algunos y a la necesidad de vehículos de publicación que tiene la creciente masa de científicos en activo (sobre todo del sector público) han ido surgiendo decenas de miles de revistas especializadas en campos cada vez más recónditos con un modelo de negocio espectacular para cualquier editor: los autores no cobran por publicar (a veces pagan), los editores no cobran por editar (o reciben pagas ridículas) y universidades y centros de investigación están obligados a comprar las revistas resultantes al precio que les pongan (o a pagar la suscripción electrónica). Un verdadero chollo de negocio, respaldado además por una legislación de ‘propiedad’ intelectual excesiva que sesga el mercado hacia los intereses de las editoriales en cuestión.

Como consecuencia de estos dos factores se está produciendo una serie de deformaciones y monstruosidades que están afectando a la ciencia misma. Estamos viendo a científicos que cometen ‘piratería’ para dar a conocer su propio trabajo a otros científicos del ramo. Las universidades y centros de investigación dedican enormes sumas a pagar suscripciones, un dinero que no se puede dedicar a la propia investigación. La situación llega a tal punto que se han creado grandes depósitos ‘piratas’ de artículos que millones de científicos de todo el mundo usan como último recurso, además de proyectos de ciencia en abierto, con éxito creciente. Al mismo tiempo ha nacido y crecido una industria de revistas predatorias que se aprovechan de la enorme necesidad de publicar para cobrar a los científicos por hacerlo, aunque sea con ínfima calidad. Todo esto supone el desvío de ingentes cantidades de dinero público a bolsillos privados, con el agravante de que esos beneficios se basan no en dar a conocer los resultados de la ciencia, sino en limitar el acceso a sus publicación.

Hay indicaciones de que el sistema está sometido a tanta tensión que se está rompiendo. Sci-Hub es ahora tan grande que podría acabar por destruir el sistema de publicación ‘for profit’ y el cártel de las grandes editoriales; el problema de las revistas predatorias (también hay seminarios y simposios) está recibiendo más atención y se está dejando de considerar el simple número de publicaciones y firmas como criterio válido para científicos o proyectos. Los centros de investigación públicos, que ya han pagado por crear los resultados, están apostando por sistemas de distribución de estos resultados que no les cuesten aún más dinero. Todo lo cual son pasos en la buena dirección, que no serán suficientes mientras los sistemas de evaluación de calidad y productividad se sigan basando en criterios tan poco inteligentes como los actuales. Porque por definición ciencia es publicar, y es una contradicción intrínseca y un absurdo basar su medida en cualquier limitación de la publicación.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La contradicción de la publicación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El teorema de Marion (Walter)

El teorema de Marion es un bonito ejemplo de resultado de geometría afín. No se sabe quién fue la primera persona que lo enunció, pero la matemática Marion Walter (1928) lo explicó en alguna de sus clases y también aparece en varios sus trabajos; por ello se recuerda con su nombre.

El teorema afirma lo siguiente:

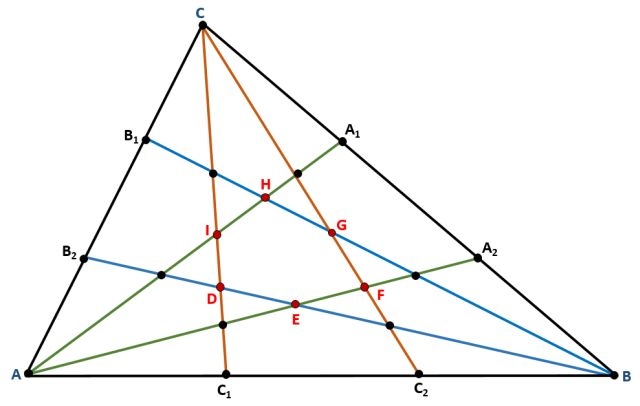

Tomemos un triángulo cualquiera ABC, trisequemos sus lados y unamos cada uno de los dos puntos que definen esta división con el vértice del lado opuesto del triángulo (ver la figura 1). Queda determinada una región hexagonal central (de vértices DEFGHI en la figura 1) cuya área es 1/10 del área del triángulo original.

Figura 1: Imagen que ilustra el teorema de Marion.

La demostración de este teorema no es complicada; puede encontrarse, por ejemplo, una prueba en [1] en la que se utilizan coordenadas trilineales respecto del triángulo ABC.

En 1994, Ryan Morgan (ver [2]) generalizó este teorema en los siguientes términos:

Dado un triángulo cualquiera ABC, si se dividen sus lados en n partes iguales (donde n es un número entero impar) y se une cada uno de los n-1 puntos que definen esta división con el vértice del lado opuesto del triángulo, entonces queda determinada una pequeña región hexagonal central. La razón entre el área de este hexágono y la del triángulo original es constante. Más concretamente, el área de esta región es

del área del triángulo original.

Para n=3 tenemos, efectivamente, el teorema de Marion.

Si n es par, el proceso anteriormente descrito no produce un hexágono central necesariamente, o no tiene porqué ser único. Aunque existen resultados parciales como el dado en [3] para n=4.

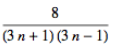

Recordemos que se llaman números poligonales centrados a aquellos números figurados que pueden representarse mediante un conjunto de puntos equidistantes formando un polígono regular. Entre ellos, los números nonagonales centrados son aquellos que pueden representarse sobre un nonánogo, con un punto en el centro rodeado de sucesivas capas nonagonales:

Figura 2: Los primeros números nonagonales centrados: 10, 28, 55 y 91. Imagen de Wikipedia.

Los números (3n+1)(3n-1)/8, para n entero impar, que aparecen en el teorema de Morgan son precisamente números nonagonales centrados. Puede encontrarse un listado con los primeros y algunas de sus propiedades en The On-Line Encyclopedia of Integer Sequences (ver [4]); son: 1, 10, 28, 55, 91, 136, 190, 253, 325, 406, 496, 595, 703, 820, 946, 1081, 1225, 1378, 1540, 1711, 1891, 2080, 2278, 2485, 2701, 2926, 3160, 3403, 3655, 3916, 4186, 4465, 4753, 5050, 5356, 5671, 5995, 6328, 6670, 7021, 7381, 7750, 8128, 8515, 8911, 9316, …

¿No es emocionante ver como se relacionan estos números –los del teorema de Morgan y los nonagonales centrados–procedentes de acercamientos diferentes?

Por cierto, aparte de este bellísimo teorema, otra de las aportaciones que debemos a Marion Walter es una colección de setenta fotografías de su colección particular realizadas, en su mayoría, por la propia Marion y que han pasado a formar parte de los Archives of American Mathematics. En ellas aparecen notables matemáticas y matemáticos, comoTobias Danzig, Paul Erdös, Paul Halmos, Irving Kaplansky, Alexander Ostrowski, George Pólya, Mina Rees, Isaac Schoenberg u Olga Taussky-Todd, entre otros.

Referencias

[1] Marion’s theorem, Wolfram MathWorld

[2] Ryan Morgan, No Restriction Needed. The Mathematics Teacher 87, 726 y 743, 1994.

[3] Luca Goldoni, A generalization of Marions Walter’s theorem, 2016

[4] A060544: Centered 9-gonal, OEIS

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo El teorema de Marion (Walter) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

- El teorema de los cuatro colores (1): una historia que comienza en 1852

- El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura?

Evolución de los sistemas nerviosos: el tálamo y el hipotálamo

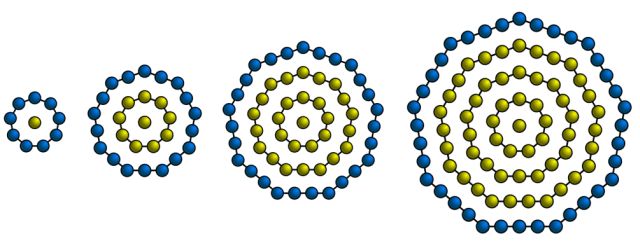

Como vimos en la anotación anterior de esta serie, el prosencéfalo o encéfalo anterior de los vertebrados está integrado por el diencéfalo y el cerebro. En esta ocasión nos ocuparemos del diencéfalo que, como también vimos, comprende el tálamo y el hipotálamo, dos estructuras con funciones netamente diferenciadas.

El tálamo

Del tálamo se podría decir que se encuentra en lo más profundo del encéfalo, justo por encima del tallo encefálico y cerca de los ganglios basales. Cumple la función de “estación de relevo” y centro de integración sináptica para un primer procesamiento de las señales sensoriales en su trayecto hacia la corteza cerebral. Realiza una labor de cribado de señales insignificantes y dirige los impulsos sensoriales importantes a las áreas de la corteza somatosensorial (a la que nos referiremos en próximas anotaciones) y a otras regiones del encéfalo. Y de la misma forma que conduce información sensorial a la corteza, también recibe señales de aquélla, señales susceptibles de modificar su propia actividad, haciendo variar la intensidad y naturaleza de la información que remite a otros centros.

Junto con el tallo encefálico y áreas asociativas de la corteza, el tálamo es clave para dirigir la atención hacia estímulos relevantes. Un ejemplo ilustrativo de esa función (en mamíferos) es la facilidad con la que la madre –y el padre en aquellas en que el cuidado parental es compartido- despierta al menor suspiro del bebé pero permanece dormido en medio de una tormenta violenta. También es capaz de hacer conscientes otras sensaciones, aunque no lo es de identificar la localización de los correspondientes estímulos o de determinar su intensidad.

Además de las anteriores, el tálamo juega un papel importante en el control motor, reforzando el comportamiento motor voluntario iniciado por la corteza.

El hipotálamo

Su posición es, como su nombre indica, inferior a la del tálamo, y algo más adelantada. Es una colección de núcleos específicos con sus fibras nerviosas asociadas. Es un centro de integración de varias y muy importantes funciones de regulación homeostática del organismo. Vincula funcionalmente el sistema nervioso autónomo con el sistema endocrino; de ahí el carácter integrador al que acabamos de aludir. De hecho, el hipotálamo conforma el sistema de integración neuroendocrino por excelencia: el denominado sistema hipotálamo-hipofisario que, como su nombre indica, está integrado por la hipófisis o glándula pituitaria (glándula máster del sistema hormonal) y el hipotálamo. En futuras anotaciones nos referiremos con detalle a este sistema.

En concreto, el hipotálamo controla los siguientes procesos o funciones: (1) la temperatura corporal en homeotermos; (2) la sed y la producción de orina, o sea, controla el balance de agua y de sales del organismo; (3) la ingestión de alimento; (4) las contracciones uterinas y la eyección de leche en mamíferos; (5) coordina el sistema nervioso autónomo, lo que afecta a la actividad de músculo liso y del cardiaco, así como a las glándulas exocrinas; y (6) juega un papel fundamental en el comportamiento y la expresión de las emociones. Parte de estas tareas las realiza mediante la intermediación o a través de la glándula pituitaria.

El hipotálamo ocupa un nivel intermedio en la jerarquía del control neurológico y está considerado como un centro integrador de reflejos. Quiere esto decir que recibe señales de receptores sensoriales internos y, en respuesta, envía órdenes a través de vías en las que intervienen muy pocas sinapsis para generar rápidamente las respuestas reguladoras. Como ocurre con otros reflejos, esas respuestas se producirían con más retraso si interviniesen los centros superiores del cerebro. Un ejemplo ilustrativo es lo que ocurre con la señal de frío: la respuesta hipotalámica da lugar a una serie de acciones que promueven la producción de calor (como la tiritación), a la vez que se reduce la pérdida de calor corporal disminuyendo notablemente la circulación periférica al provocar el estrechamiento de los vasos sanguíneos más superficiales, o sea, aumentando el aislamiento.

Fuentes:

David Randall, Warren Burggren & Kathleen French (2002): Eckert Animal Physiology: Mechanisms and Adaptations 5th ed.; Freeman & Co, New York

Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evolución de los sistemas nerviosos: el tálamo y el hipotálamo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Evolución de los sistemas nerviosos: el sistema central de vertebrados

- Evolución de los sistemas nerviosos: el tronco encefálico y el cerebelo

- Evolución de los sistemas nerviosos: el sistema periférico de vertebrados

El estatus de la segunda ley de la termodinámica

La segunda ley de la termodinámica tiene un estatus bastante diferente al de las leyes de conservación.

Efectivamente, si bien al igual que éstas la segunda ley es extremadamente efectiva y de gran alcance, además de ser una de las leyes fundamentales de la ciencia, tiene una diferencia fundamental con las leyes de conservación o con las leyes del movimiento de Newton. La segunda ley de la termodinámica más que proporcionar resultados mensurables con precisión establece qué procesos o fenómenos son imposibles.

Así, por ejemplo, es imposible hacer que la entropía del universo (o de un sistema aislado) disminuya; es imposible hacer que el flujo de calor vaya de un cuerpo frío a uno caliente a no ser que se efectúe trabajo sobre algo, como ocurre en una máquina frigorífica; es imposible inventar un motor térmico con una eficiencia superior al 100%.

En otras palabras, la segunda ley implica de forma fundamental que los procesos en los que interviene el calor suceden sólo en una dirección: la entropía aumenta; el calor fluye de objetos calientes a los fríos. Por lo tanto, la segunda ley enlaza de forma fundamental con la idea de que el tiempo transcurre en una sola dirección. Esto es, eso que vemos cuando hacemos que una película de acontecimientos cotidianos vaya marcha atrás no puede ocurrir en el mundo real. Por ejemplo, dos líquidos se pueden mezclar rápida y espontáneamente por sí mismos; pero no pueden desmezclarse espontáneamente

Hemos visto, aunque no lo hemos dicho expresamente así, que durante los procesos reversibles, como en los que intervienen máquinas térmicas ideales sin fricción, la entropía del universo se mantiene constante, o sea, que ΔSuniverso= 0 . Sin embargo, en todos los demás procesos, todos los que no son reversibles, la entropía del universo aumentará, ΔSuniverso> 0. Esto implica que no existe ningún caso en el que la energía del universo disminuya. Lo que quiere decir, por ejemplo, que el calor no fluirá espontáneamente de los cuerpos fríos a los calientes, porque ello implicaría una disminución de entropía. De forma análoga, no cabe esperar que una pelota que está en el suelo del patio adquiera espontáneamente energía del entorno y se lance hasta el tercer piso del colegio; ni que un huevo batido se desbata, ni que el barco en el que haces un crucero tome energía del mar y lance cubitos de hielo por la chimenea. Démonos cuenta de que todos estos procesos podrían ocurrir sin que se violase ninguna de las leyes de la mecánica newtoniana o ninguna ley de conservación. Pero son cosas que no pasan. Y no pasan porque las “prohíbe” la segunda ley de la termodinámica [1].

Todos los procesos reales [2] que podamos enumerar serán con casi total seguridad, irreversibles y, por lo tanto, contribuirán al incremento de la entropía del universo. Pero esto tiene una consecuencia ingenieril importante: el calor útil para conseguir que las máquinas hagan trabajo se está agotando. William Thomson, más conocido por la fórmula de tratamiento nobiliario británica, Lord Kelvin, predijo que al final todos los cuerpos del universo alcanzarían la misma temperatura a base de intercambiar calor unos con otros. Cuando esto ocurriese, sería imposible producir trabajo útil a partir del calor, ya que el trabajo solo se puede producir a partir de máquinas térmicas cuando el calor fluye de los cuerpos calientes a los fríos. Los ingenieros dejarían de ser necesarios, todo lo parecido a vida (una forma de máquina térmica) dejaría de existir, las estrellas se disgregarían tras apagarse, y el universo habría muerto [3].

Veremos estas ideas con más detalle y algo matizadas en próximas entregas cuando introduzcamos las moléculas en nuestro estudio de la dinámica del calor. Porque, efectivamente, para todo esto no nos ha hecho falta ni siquiera suponer que existen los átomos.

Nota:

[1] Entrecomillamos “prohíbe” porque la segunda ley, tal y como la hemos deducido, es solo una ley fenomenológica que describe qué ocurre, no prescribe qué ocurre. Es como los diccionarios bien entendidos, describen cómo se usa el lenguaje pero no tienen potestad alguna para decir cómo se debe hablar (por mucha autoridad dictatorial que alguno se atribuya y muchos seguidores que tenga el dictador).

[2] Preventivamente: un cambio infinitesimal es una idealización matemática.

[3] El tema de la muerte térmica puede encontrarse en muchos relatos de ciencia ficción. Especialmente reseñables son “La máquina del tiempo” de H.G. Wells y el relato breve “La última pregunta” de Isaac Asimov.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El estatus de la segunda ley de la termodinámica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La segunda ley de la termodinámica

- La primera ley de la termodinámica

- Carnot y los comienzos de la termodinámica (2)

El tono absoluto y las lenguas tonales

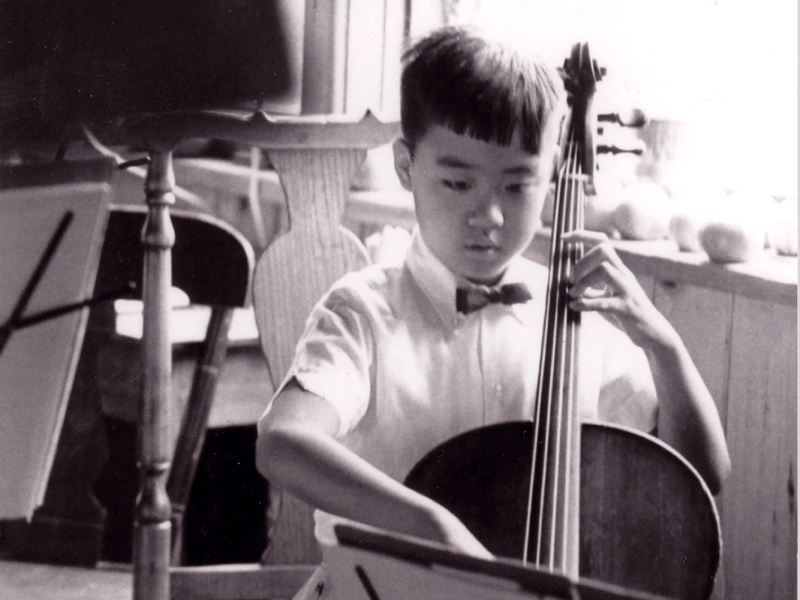

Yo-Yo Ma en 1962. Nacido en Francia de padres chinos, Ma dio su primer concierto público con 5 años. En la imagen tiene 7 y estaba recién llegado a Estados Unidos; en esta época actuaría ante los presidentes D. D. Eisenhower y J.F. Kennedy. Su primera actuación en televisión sería al año siguiente dirigido por Leonard Bernstein. Es considerado un niño prodigio. Posee tono absoluto.

El tono absoluto (absolute pitch) o tono perfecto (perfect pitch) es la capacidad para identificar una nota musical cualquiera en ausencia de una nota de referencia. En Europa y Estados Unidos tan solo una persona de cada diez mil posee esa capacidad, aunque esa proporción es algo mayor entre quienes han recibido formación musical en edades inferiores a los cinco años.

La mayoría de la gente es capaz de identificar centenares de pasajes musicales y sin embargo, el tono absoluto es, como hemos visto, rarísimo. Aunque no tanto, también es raro en músicos profesionales, que pasan miles de horas leyendo partituras e interpretándolas. Y aunque se ha intentado entrenar a músicos adultos para que lo adquiriesen, los intentos no han dado el resultado buscado.

Desde 2006 se sabe que la capacidad para identificar un tono es mayor aún en los estudiantes de música que hablan mandarín, cantonés o vietnamita. Eso es debido al hecho de que hablan, desde pequeños, lenguas tonales, lenguas en las que el significado depende de modo crítico de la entonación con la que se pronuncian las sílabas.

En una prueba en la que se pedía que se identificasen 36 notas de tres octavas y emitidas en orden aleatorio, las personas que hablaban con fluidez alguna de esas tres lenguas identificaban más del 90% de las notas si habían empezado a estudiar música antes de los cinco años y algo menos del 90% si lo habían hecho entre los cinco y los nueve años. Por contraste, los hablantes de inglés, que no es una lengua tonal, tan solo identificaban el 25% y el 12% en cada caso. Y esos porcentajes no variaban dependiendo de si esos hablantes eran de origen caucásico o si se trataba de descendientes de familias que procedían de países en los que se hablan lenguas tonales. En otras palabras, no se trata de una capacidad ligada al origen de los individuos, sino a si la lengua que hablan es tonal o no. Por cierto, las citadas no son las únicas lenguas tonales; hay algunas en América y bastantes lenguas africanas lo son también.

Fuente: esta información procede de diferentes trabajos dirigidos por la profesora Diana Deutsch, del Departamento de Psicología de la Universidad de California en La Jolla. Pueden encontrarse aquí.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El tono absoluto y las lenguas tonales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 30 milésimas por encima del cero absoluto, electrónicamente

- ¿Nacidos para creer?

- El corpus de confusión consistente del inglés oral

Nuevo arte parietal en Arbil V

Vista general del monte Arbil de Deba. Foto: Jabi León

En el marco del Proyecto de prospecciones arqueológicas para la localización de nuevos vestigios de arte parietal, dirigido por María José Iriarte (UPV/EHU-IKERBASQUE) y financiado por la Diputación Foral de Gipuzkoa, los miembros de Antxieta Jakintza Taldea de Azpeitia han logrado un nuevo hallazgo en el monte Arbil.

En esta ocasión se ha realizado en el término municipal de Deba; concretamente en la cueva Arbil V, que mira hacia el valle de Lastur.

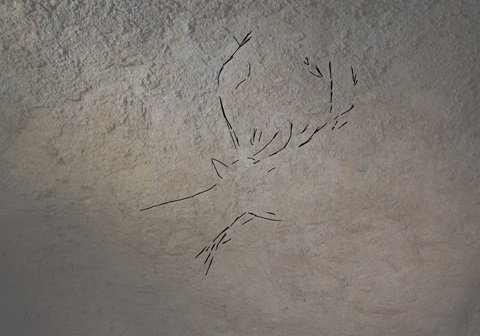

La cueva se conocía desde hace varias décadas, cuando fue catalogada por el grupo Munibe de Azkoitia. Pero ha sido gracias al impulso de este renovado interés por el arte parietal y a las nuevas referencias con las que se están enfocando las investigaciones en la actualidad, cuando el equipo de la sociedad Antxieta de Azpeitia ha conseguido reconocer las líneas grabadas en la roca que corresponden al menos a tres animales.

La cueva catalogada bajo los nombres de Arbil V y Sustraixako kobea, en el valle de Lastur (Deba) ha proporcionado grabados figurativos, de probable cronología magdaleniense. Aunque la cueva tiene importantes proporciones y los trabajos de prospección en su interior son aún preliminares, ya han sido determinadas dos figuras animales completas y porciones de otras dos. Las figuras completas se refieren a una cierva y a otro cérvido macho, probablemente un reno. Se trata del cuarto hallazgo de arte parietal consecutivo del grupo Antxieta, desde el arranque de este proyecto en 2015 (Danbolinzulo, Erlaitz, Astui gaiña y ahora, Arbil V/ Sustraixako kobea).”

El hallazgo se produjo el 26 de marzo. Ese domingo miembros del grupo de arqueología Antxieta (Jose Inaxio Arrieta, Jabier Lazkano, Iñigo Olarte, Javier Maiz, Iñigo Arizaga, Aitor Suinaga, Andres Maiz, Xabier Azkoitia, Igone Elejalde y Ion Uranga) visitaron la cueva y encontraron varias pinturas que podían ser del del Paleolítico. Unos días más tarde, el 9 de abril, especialistas en arte paleolítico (Blanca Ochoa eta Irene Vigiola) y arqueologos especialistas en Paleolítico (María José Iriarte y Alvaro Arrizabalaga) visitaron la cueva y confirmaron el hallazgo.